3DGS

⚠️ 以下所有内容总结都来自于 Google的大语言模型Gemini-Pro的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-02-23 更新

Identifying Unnecessary 3D Gaussians using Clustering for Fast Rendering of 3D Gaussian Splatting

Authors:Joongho Jo, Hyeongwon Kim, Jongsun Park

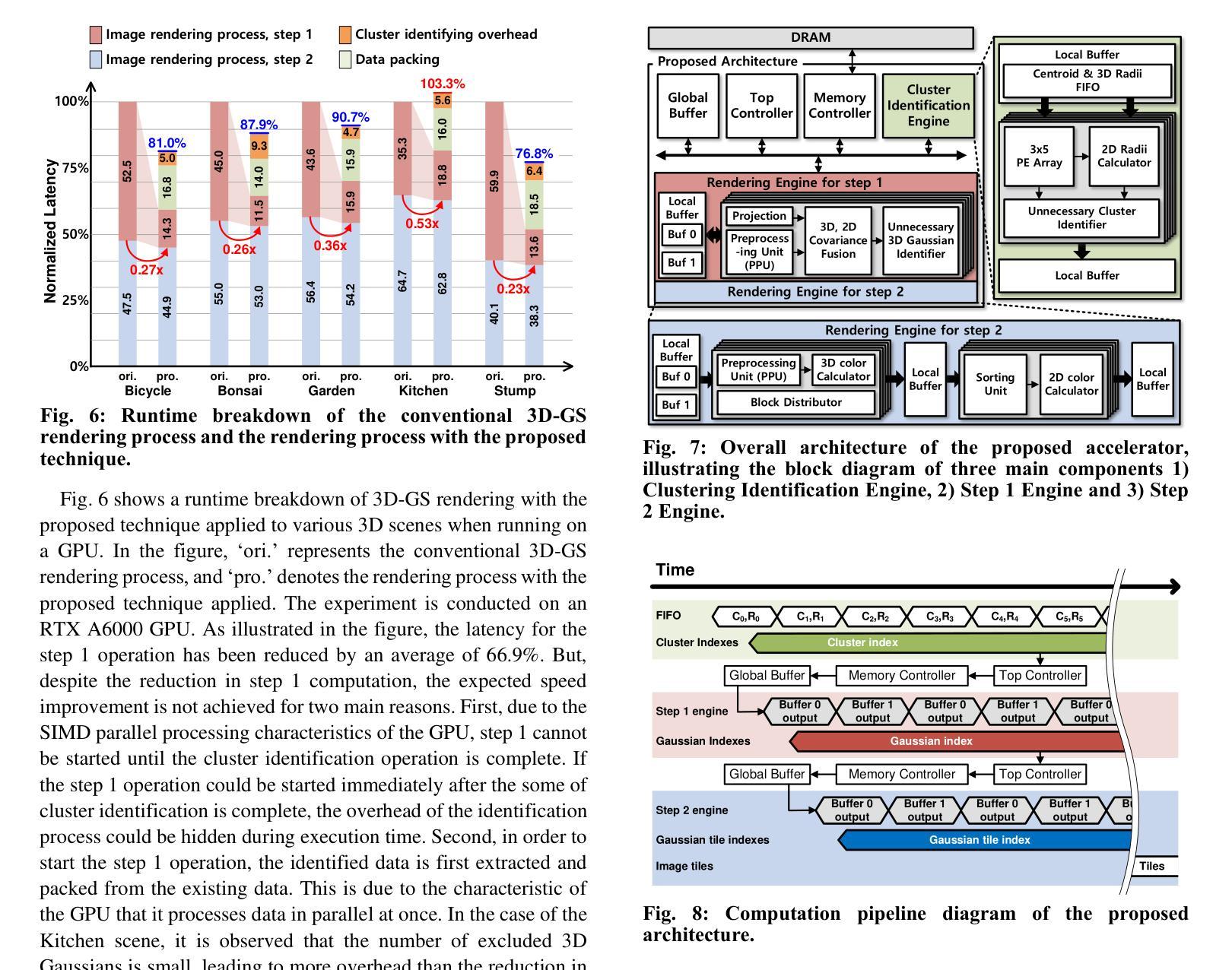

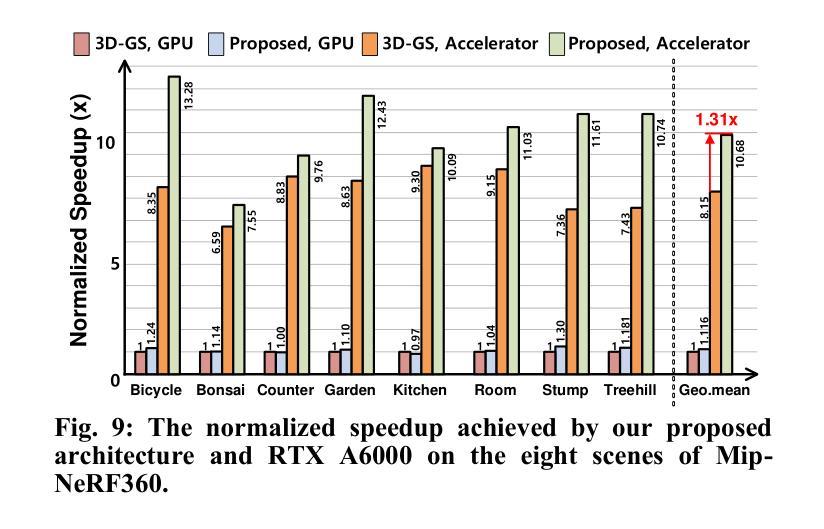

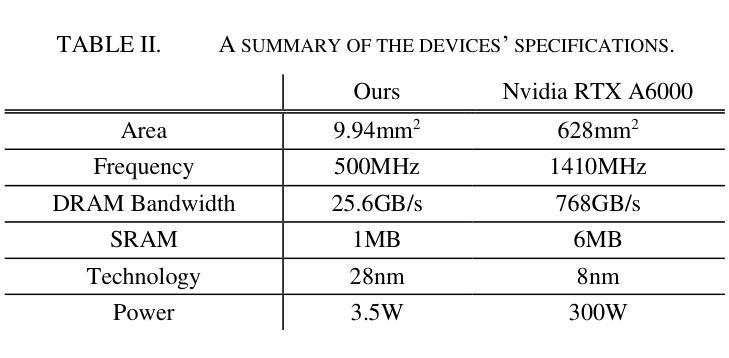

3D Gaussian splatting (3D-GS) is a new rendering approach that outperforms the neural radiance field (NeRF) in terms of both speed and image quality. 3D-GS represents 3D scenes by utilizing millions of 3D Gaussians and projects these Gaussians onto the 2D image plane for rendering. However, during the rendering process, a substantial number of unnecessary 3D Gaussians exist for the current view direction, resulting in significant computation costs associated with their identification. In this paper, we propose a computational reduction technique that quickly identifies unnecessary 3D Gaussians in real-time for rendering the current view without compromising image quality. This is accomplished through the offline clustering of 3D Gaussians that are close in distance, followed by the projection of these clusters onto a 2D image plane during runtime. Additionally, we analyze the bottleneck associated with the proposed technique when executed on GPUs and propose an efficient hardware architecture that seamlessly supports the proposed scheme. For the Mip-NeRF360 dataset, the proposed technique excludes 63% of 3D Gaussians on average before the 2D image projection, which reduces the overall rendering computation by almost 38.3% without sacrificing peak-signal-to-noise-ratio (PSNR). The proposed accelerator also achieves a speedup of 10.7x compared to a GPU.

Summary

3D 高斯散splatting 通过聚类 和 投影优化,减少了 38.3% 的渲染计算,且不损失图像质量。

Key Takeaways

- 3D 高斯散splatting(3D-GS)是一种新的渲染方法,在速度和图像质量上优于神经辐射场(NeRF)。

- 3D-GS 使用数百万个 3D 高斯表示 3D 场景,并将这些高斯投影到 2D 图像平面上进行渲染。

- 在渲染过程中,大量不必要的高斯存在于当前视图方向,导致与识别它们相关的计算成本巨大。

- 提出了一种计算简化技术,可在运行时快速识别出不必要的高斯,用于渲染当前视图,且不损害图像质量。

- 这种简化技术方法是离线对距离相近的高斯进行聚类,然后在运行时将这些集群投影到 2D 图像平面上。

- 对该技术在 GPU 上执行时的瓶颈进行了分析,并提出了一种与该方案无缝兼容的高效硬件架构。

- 对于 Mip-NeRF360 数据集,该技术在 2D 图像投影之前平均排除了 63% 的高斯,将整体渲染计算减少了 38.3%,且不损失峰值信噪比 (PSNR)。

- 该加速器与 GPU 相比,还实现了 10.7 倍的加速。

- 题目:使用聚类识别不必要的 3D 高斯体,以快速渲染 3D 高斯体飞溅

- 作者:Joongho Jo、Hyeongwon Kim 和 Jongsun Park

- 隶属机构:韩国大学电气工程学院

- 关键词:3D 高斯体飞溅、渲染、NeRF、神经辐射场、硬件加速器

- 论文链接:Paper_info:Identifying Unnecessary 3D Gaussians using Clustering for Fast Rendering of 3D Gaussian Splatting,Github 链接:无

- 摘要:

(1)研究背景:在计算机视觉应用中,例如增强现实 (AR)、虚拟现实 (VR) 和元宇宙,快速且高质量的图像渲染非常重要。虽然已经广泛研究了使用深度神经网络的渲染技术,例如神经辐射场 (NeRF),但 3D 高斯体飞溅 (3D-GS) 作为一种新的渲染方法,最近因其与传统 NeRF 相比能够快速渲染高质量图像而备受关注。3D-GS 利用数百万个 3D 高斯体来表示复杂的 3D 场景,并通过将 3D 高斯体投影到 2D 图像平面上来渲染 3D 场景。

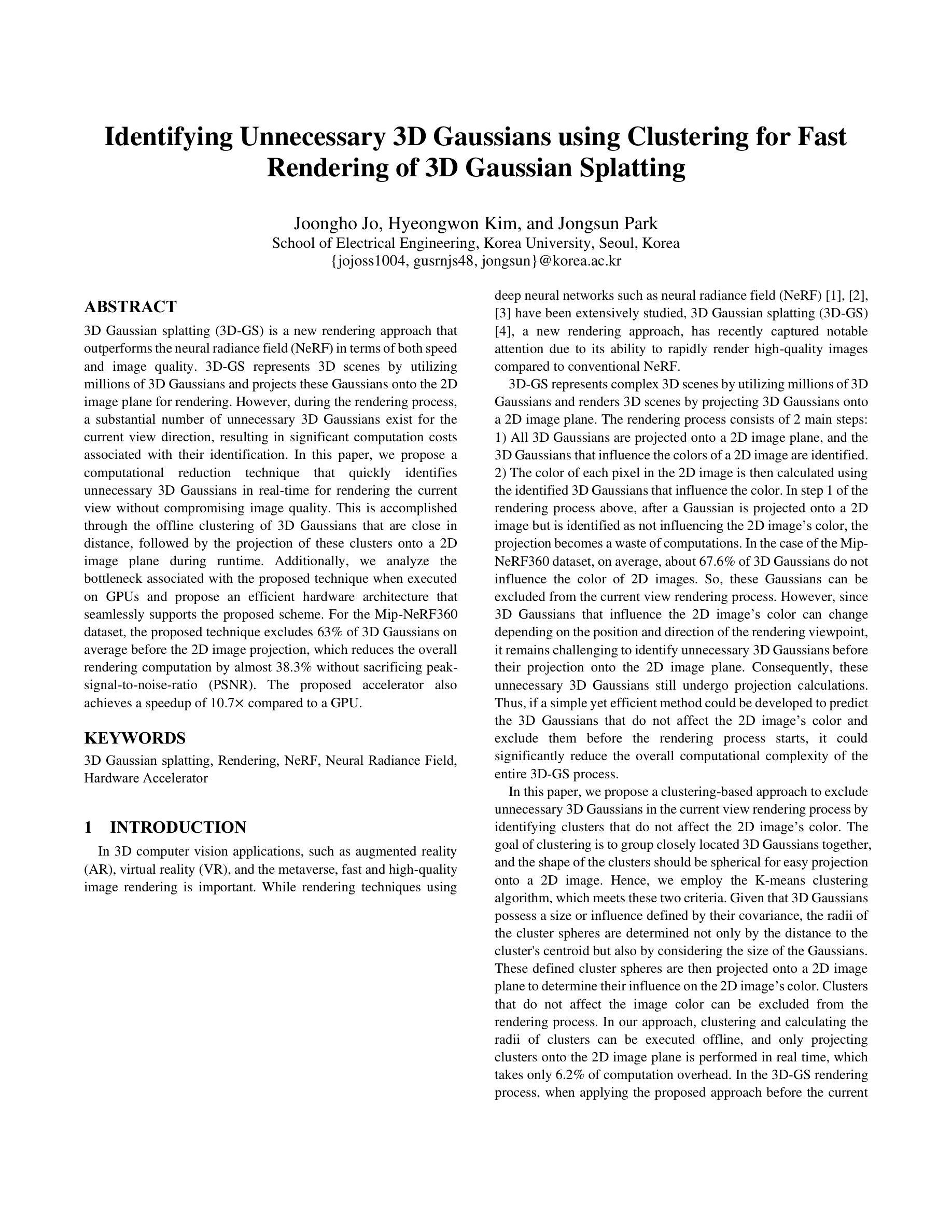

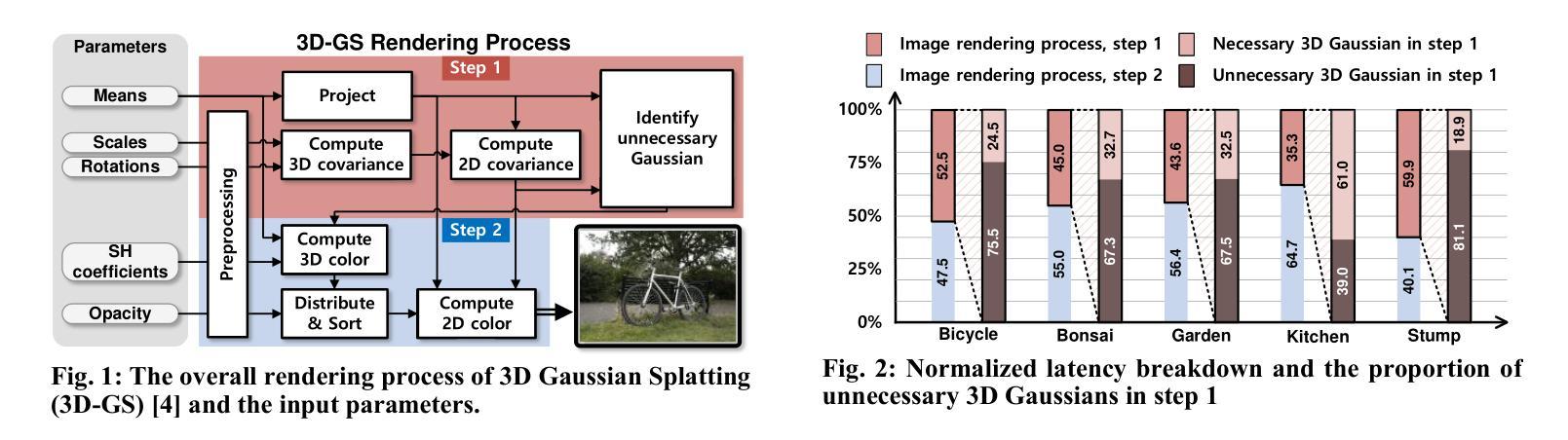

(2)过去的方法及其问题:3D-GS 渲染过程主要分为两步:首先,将所有 3D 高斯体投影到 2D 图像平面上,并识别影响 2D 图像颜色的 3D 高斯体。然后,使用影响颜色的已识别 3D 高斯体计算 2D 图像中每个像素的颜色。在渲染过程的第一步中,高斯体投影到 2D 图像上后,如果被识别为不影响 2D 图像的颜色,那么投影就变成了计算浪费。在 Mip-NeRF360 数据集中,平均约有 67.6% 的 3D 高斯体不影响 2D 图像的颜色。因此,这些高斯体可以从当前视图渲染过程中排除。但是,由于影响 2D 图像颜色的 3D 高斯体可能会随着渲染视点的方向和位置而改变,因此在将 3D 高斯体投影到 2D 图像平面上之前识别不必要的高斯体仍然具有挑战性。因此,这些不必要的高斯体仍然会进行投影计算。因此,如果可以开发出一种简单而有效的方法来预测不会影响 2D 图像颜色的 3D 高斯体,并在渲染过程开始之前将它们排除,那么可以显着降低整个 3D-GS 过程的总体计算复杂度。

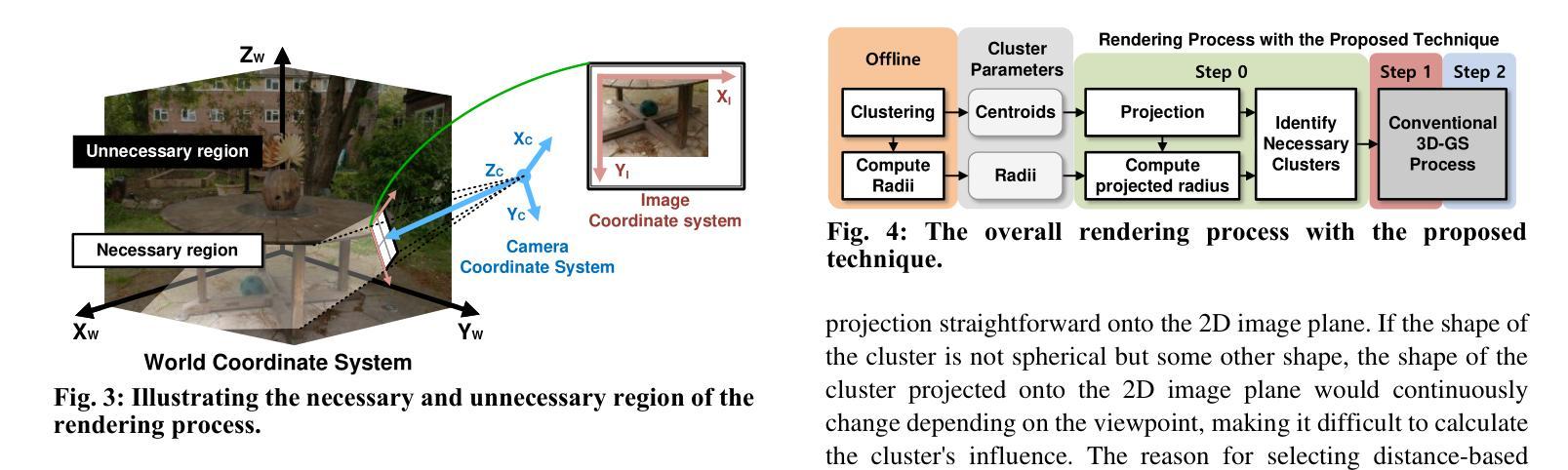

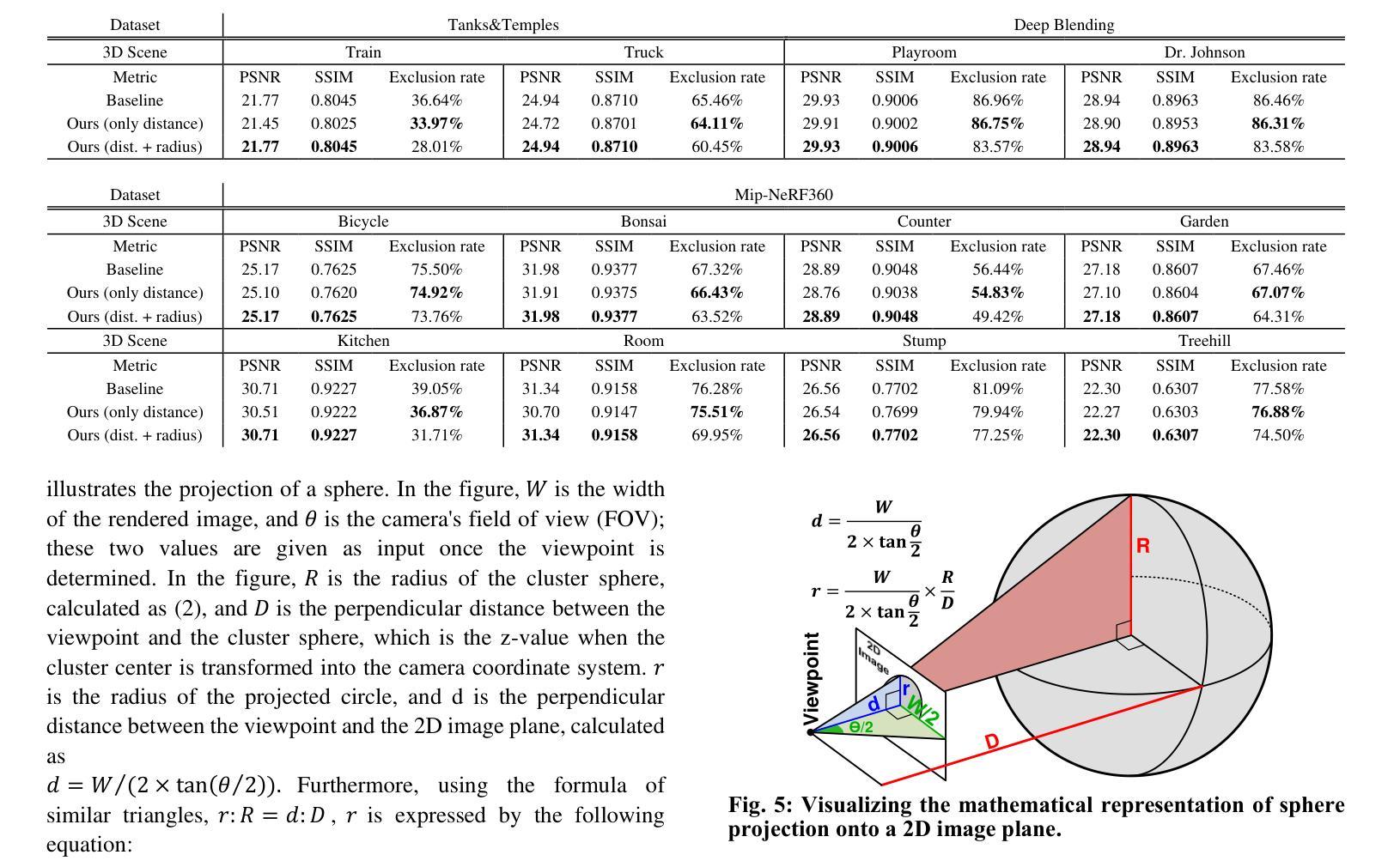

(3)本文提出的研究方法:本文提出了一种基于聚类的方案,通过识别不影响 2D 图像颜色的簇来排除当前视图渲染过程中的不必要 3D 高斯体。聚类的目标是将位置相近的 3D 高斯体分组在一起,并且簇的形状应该是球形的,以便于投影到 2D 图像上。因此,本文采用 K-means 聚类算法,该算法满足这两个标准。考虑到 3D 高斯体具有由其协方差定义的大小或影响,簇球体的半径不仅由到簇质心的距离确定,还要考虑高斯体的大小。然后将这些定义的簇球体投影到 2D 图像平面上,以确定它们对 2D 图像颜色的影响。不影响图像颜色的簇可以从渲染过程中排除。在本文的方法中,可以在离线执行聚类和计算簇的半径,并且仅在实时执行将簇投影到 2D 图像平面上,这仅需 6.2% 的计算开销。在 3D-GS 渲染过程中,在当前视图渲染之前应用所提出的方法时,平均可以排除 63% 的 3D 高斯体,从而在不牺牲峰值信噪比 (PSNR) 的情况下将整体渲染计算减少了近 38.3%。所提出的加速器还实现了与 GPU 相比 10.7 倍的加速。

(4)方法在任务和性能上的表现:在 Mip-NeRF360 数据集上,所提出的方法平均排除了 63% 的 3D 高斯体,在不牺牲峰值信噪比 (PSNR) 的情况下将整体渲染计算减少了近 38.3%。所提出的加速器还实现了与 GPU 相比 10.7 倍的加速。这些性能支持了本文的目标,即快速且高质量地渲染 3D 场景。

Some Error for method(比如是不是没有Methods这个章节)

- 结论: (1):本文提出了一种基于聚类的方案,通过识别不影响 2D 图像颜色的簇来排除当前视图渲染过程中的不必要 3D 高斯体。该方法平均可以排除 63% 的 3D 高斯体,在不牺牲峰值信噪比 (PSNR) 的情况下将整体渲染计算减少了近 38.3%。所提出的加速器还实现了与 GPU 相比 10.7 倍的加速。 (2):创新点:

- 提出了一种基于聚类的方案来识别不必要的 3D 高斯体。

- 该方法可以离线执行聚类和计算簇的半径,并且仅在实时执行将簇投影到 2D 图像平面上,这仅需 6.2% 的计算开销。

- 所提出的加速器实现了与 GPU 相比 10.7 倍的加速。 性能:

- 在 Mip-NeRF360 数据集上,该方法平均排除了 63% 的 3D 高斯体,在不牺牲峰值信噪比 (PSNR) 的情况下将整体渲染计算减少了近 38.3%。 工作量:

- 该方法可以在离线执行聚类和计算簇的半径,并且仅在实时执行将簇投影到 2D 图像平面上,这仅需 6.2% 的计算开销。

点此查看论文截图

GaussianObject: Just Taking Four Images to Get A High-Quality 3D Object with Gaussian Splatting

Authors:Chen Yang, Sikuang Li, Jiemin Fang, Ruofan Liang, Lingxi Xie, Xiaopeng Zhang, Wei Shen, Qi Tian

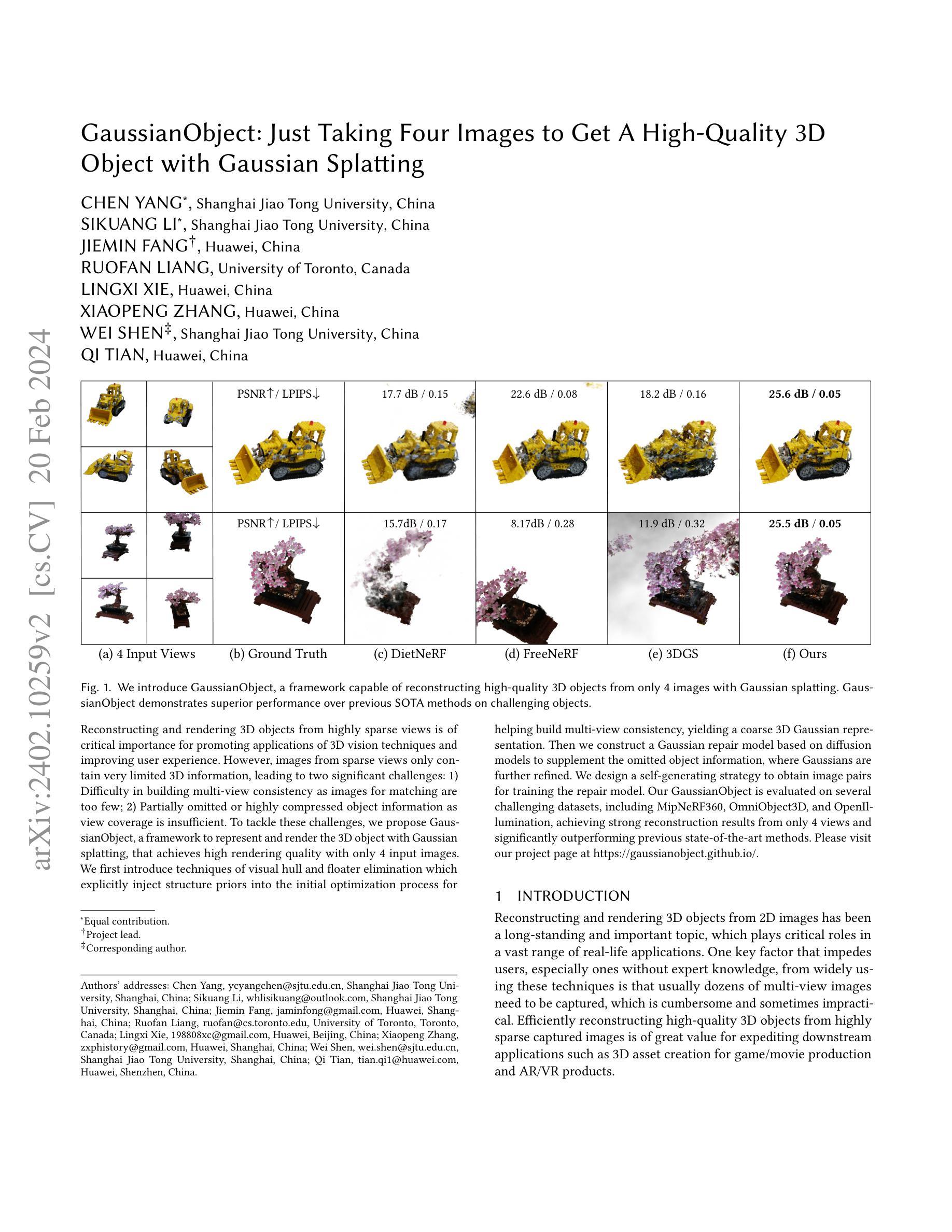

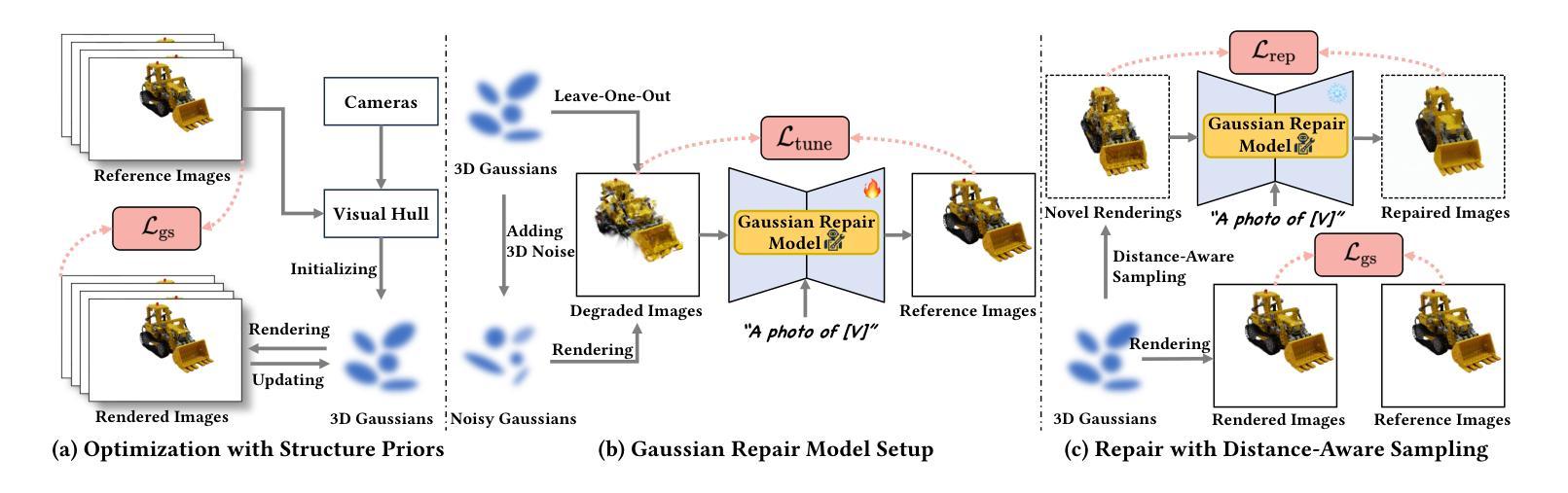

Reconstructing and rendering 3D objects from highly sparse views is of critical importance for promoting applications of 3D vision techniques and improving user experience. However, images from sparse views only contain very limited 3D information, leading to two significant challenges: 1) Difficulty in building multi-view consistency as images for matching are too few; 2) Partially omitted or highly compressed object information as view coverage is insufficient. To tackle these challenges, we propose GaussianObject, a framework to represent and render the 3D object with Gaussian splatting, that achieves high rendering quality with only 4 input images. We first introduce techniques of visual hull and floater elimination which explicitly inject structure priors into the initial optimization process for helping build multi-view consistency, yielding a coarse 3D Gaussian representation. Then we construct a Gaussian repair model based on diffusion models to supplement the omitted object information, where Gaussians are further refined. We design a self-generating strategy to obtain image pairs for training the repair model. Our GaussianObject is evaluated on several challenging datasets, including MipNeRF360, OmniObject3D, and OpenIllumination, achieving strong reconstruction results from only 4 views and significantly outperforming previous state-of-the-art methods.

PDF Project page: https://gaussianobject.github.io/

摘要

利用仅有 4 张输入图像,以高斯散点图表示和渲染三维对象,展现出极佳的渲染质量。

要点

- 重建和渲染高度稀疏视图的 3D 对象对于促进 3D 视觉技术应用和改善用户体验至关重要。

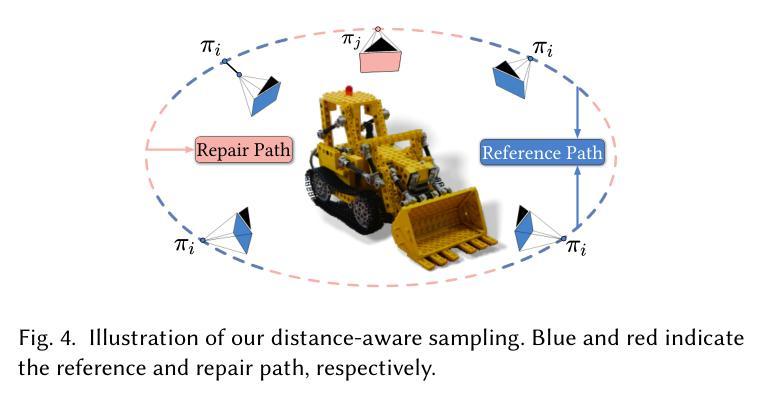

- 提出 GaussianObject,一种以高斯散点图表示和渲染 3D 对象的框架,仅需 4 张输入图像即可实现高渲染质量。

- 引入视觉外壳和浮子消除技术,将结构先验明确注入初始优化过程,帮助建立多视图一致性,产生粗糙的 3D 高斯表示。

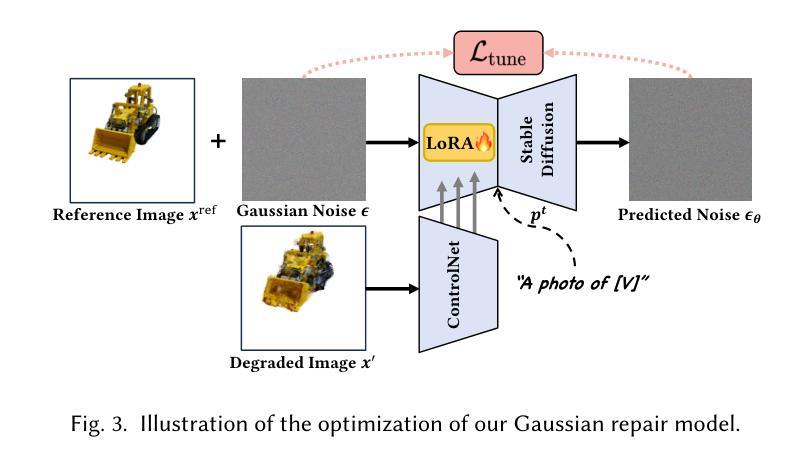

- 基于扩散模型构建高斯修复模型,以补充省略的对象信息,其中高斯值进一步细化。

- 设计了一种自生成策略来获取图像对,以训练修复模型。

- 在多个具有挑战性的数据集上评估了 GaussianObject,包括 MipNeRF360、OmniObject3D 和 OpenIllumination,仅使用 4 个视图即可实现强大的重建结果,并且明显优于先前的最先进方法。

- 题目:高斯对象:只需四张图像即可获取高质量的 3D 对象

- 作者:陈阳,李思宽,方杰民,梁若凡,谢凌希,张晓鹏,沈巍,田齐

- 单位:上海交通大学

- 关键词:神经辐射场、3D 重建、稀疏视图、高斯球面体

- 论文链接:https://arxiv.org/abs/2402.10259,Github 链接:None

摘要: (1)研究背景:重建和渲染 3D 对象是计算机视觉领域的重要课题,但传统方法通常需要大量视图才能获得高质量的结果。这对于用户来说非常繁琐,限制了 3D 技术的广泛应用。 (2)过去的方法:一些研究尝试减少对密集捕获的依赖,但当视图变得极度稀疏时,仍然难以生成高质量的 3D 对象。主要挑战在于难以建立多视图一致性,以及部分缺失或高度压缩的对象信息。 (3)研究方法:本文提出了一种名为高斯对象的新框架,旨在从稀疏视图中重建高质量的 3D 对象。该框架使用 3D 高斯球面体作为基本表示,并设计了几种技术来引入对象结构先验,帮助建立多视图一致性。此外,还提出了一种基于扩散模型的高斯修复模型,以消除由缺失或高度压缩的对象信息引起的伪影。 (4)性能表现:高斯对象方法在几个具有挑战性的真实世界数据集上表现出强大的性能,在定性和定量评估中均优于以前的最先进方法。这表明该方法能够有效地从稀疏视图中重建高质量的 3D 对象。

方法: (1) 高斯球面体表示:将3D对象表示为一个3D高斯球面体,该球面体由一系列3D高斯分布组成。每个高斯分布对应于对象的一个局部区域,其参数(中心位置、尺度和权重)由神经网络学习得到。 (2) 结构先验引入:设计了几种技术来引入对象结构先验,帮助建立多视图一致性。这些技术包括:

- 形状正则化:使用一个预训练的形状生成模型来正则化高斯球面体的形状,使其更加真实和自然。

- 拓扑正则化:使用一个拓扑生成模型来正则化高斯球面体的拓扑结构,使其更加连通和完整。

- 语义正则化:使用一个语义分割模型来正则化高斯球面体的语义信息,使其更加准确和一致。 (3) 高斯修复模型:提出了一种基于扩散模型的高斯修复模型,以消除由缺失或高度压缩的对象信息引起的伪影。该模型通过迭代地扩散和恢复高斯球面体的参数,逐步消除伪影并生成高质量的3D对象。

结论: (1):高斯对象是一种新颖的框架,旨在从极度稀疏的 360° 视图中重建高质量的 3D 对象,该框架基于 3D 高斯球面体,并具有实时的渲染能力。我们设计了两种主要方法来实现这一目标:辅助结构先验的优化,以促进多视图一致性的构建,以及高斯修复模型,以去除由遗漏或高度压缩的对象信息引起的伪影。我们希望高斯对象能够推进重建 3D 对象的日常应用。 (2):创新点:

- 提出了一种新的 3D 对象表示形式——高斯球面体,该表示形式能够有效地捕获对象的形状、拓扑结构和语义信息。

- 设计了几种技术来引入对象结构先验,帮助建立多视图一致性,包括形状正则化、拓扑正则化和语义正则化。

- 提出了一种基于扩散模型的高斯修复模型,以消除由缺失或高度压缩的对象信息引起的伪影。 性能:

- 在几个具有挑战性的真实世界数据集上,高斯对象方法在定性和定量评估中均优于以前的最先进方法。

- 高斯对象方法能够从极度稀疏的 360° 视图中重建高质量的 3D 对象,这对于用户来说非常方便,并且可以广泛应用于各种领域。 工作量:

- 高斯对象方法需要大量的训练数据,这可能会增加训练时间和成本。

- 高斯对象方法需要使用神经网络来学习高斯球面体的参数,这可能会增加计算复杂度。

点此查看论文截图

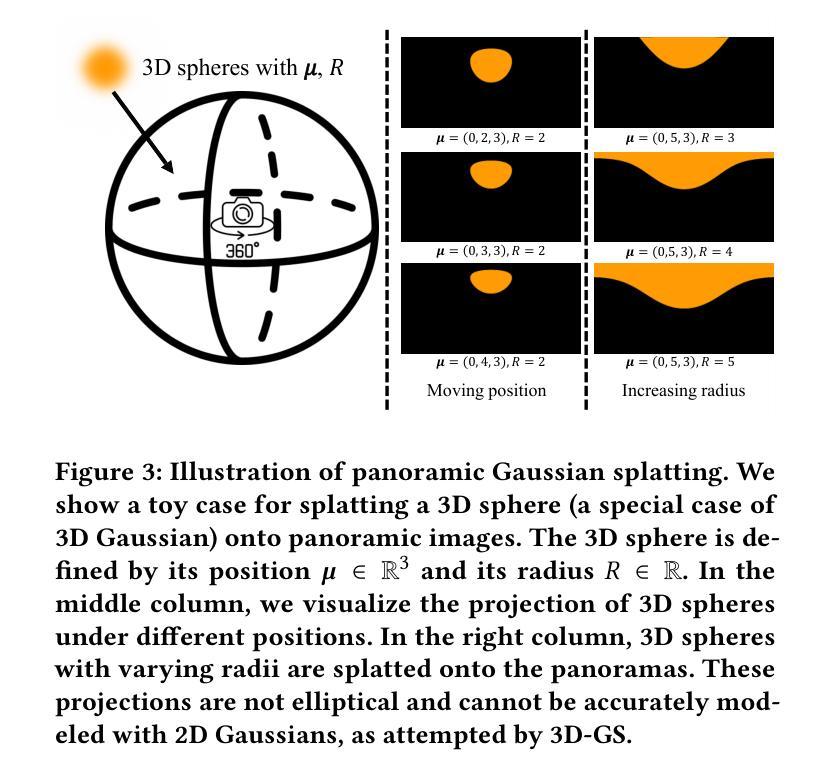

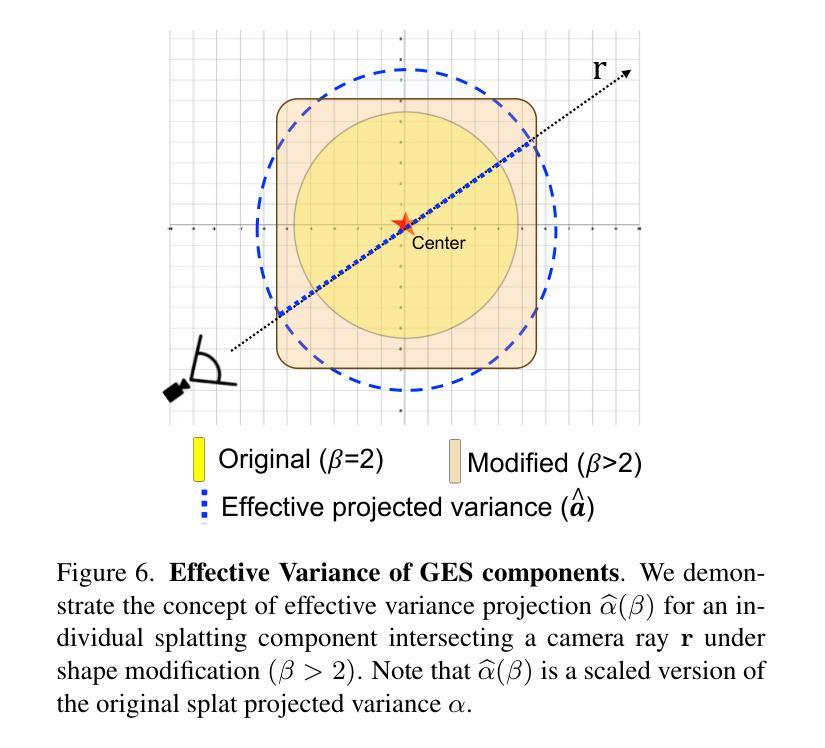

GES: Generalized Exponential Splatting for Efficient Radiance Field Rendering

Authors:Abdullah Hamdi, Luke Melas-Kyriazi, Guocheng Qian, Jinjie Mai, Ruoshi Liu, Carl Vondrick, Bernard Ghanem, Andrea Vedaldi

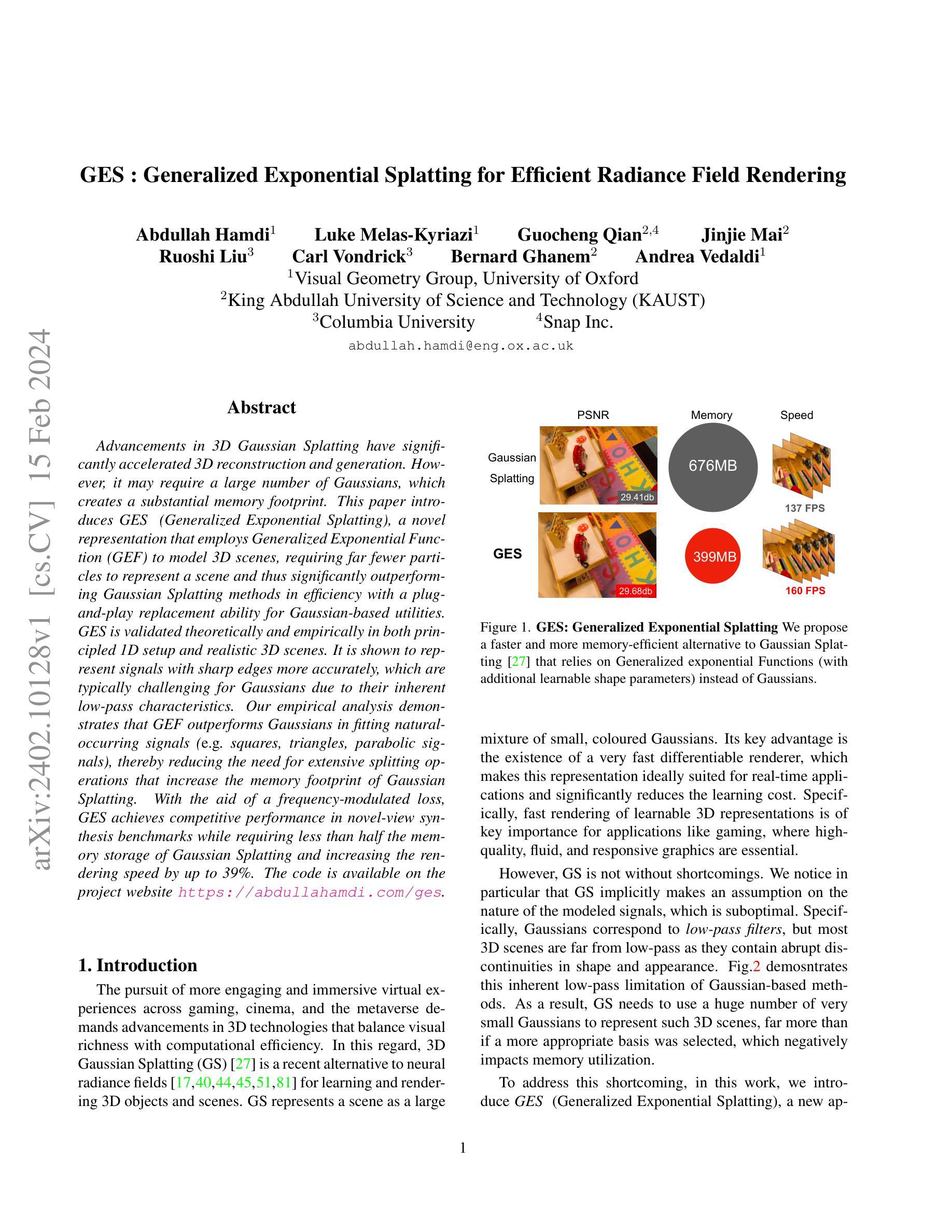

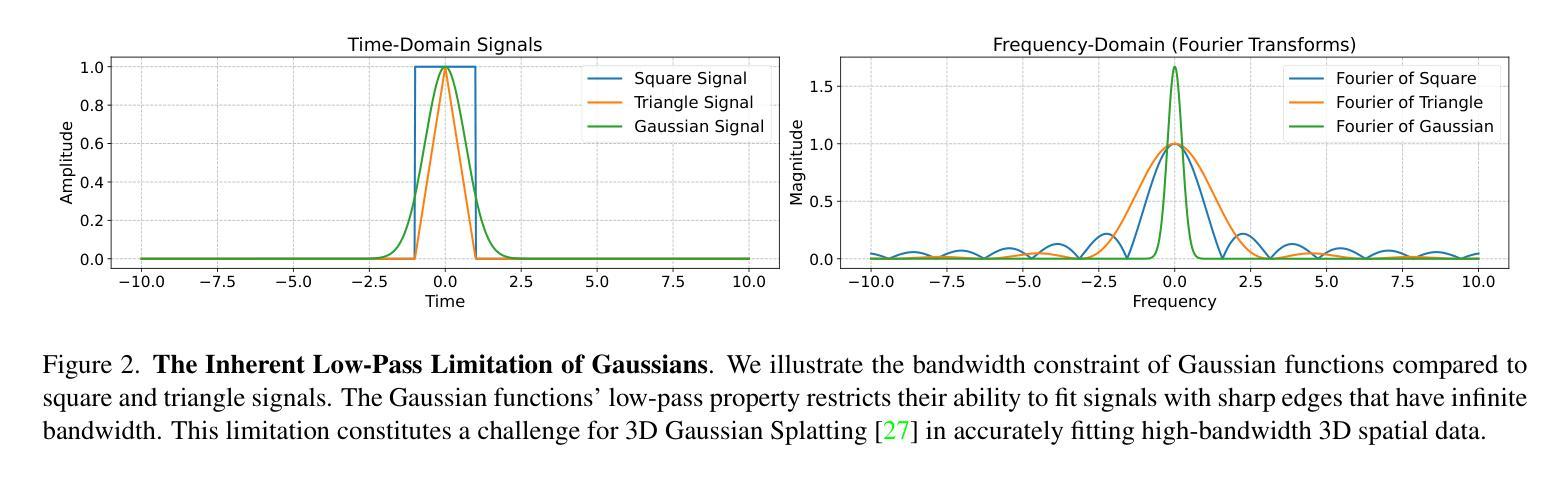

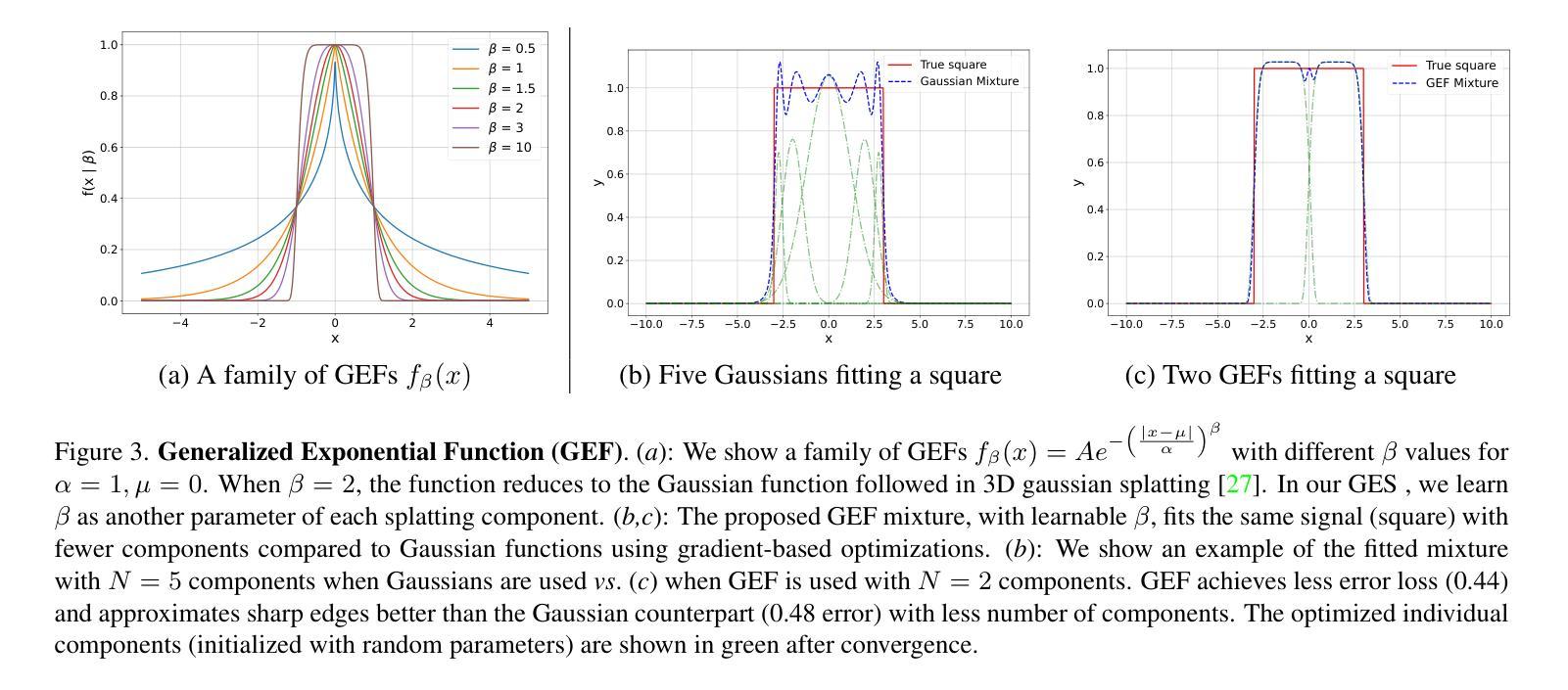

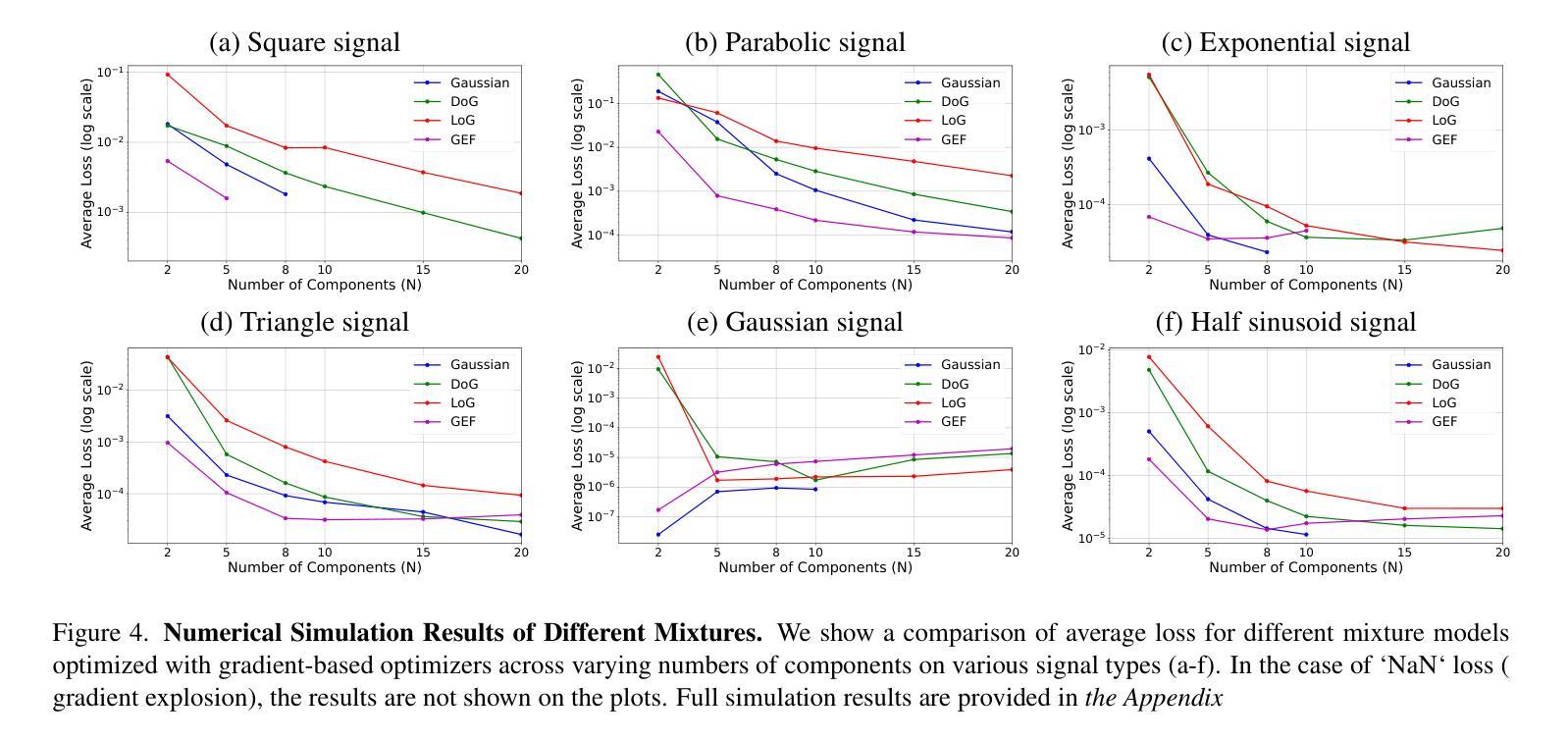

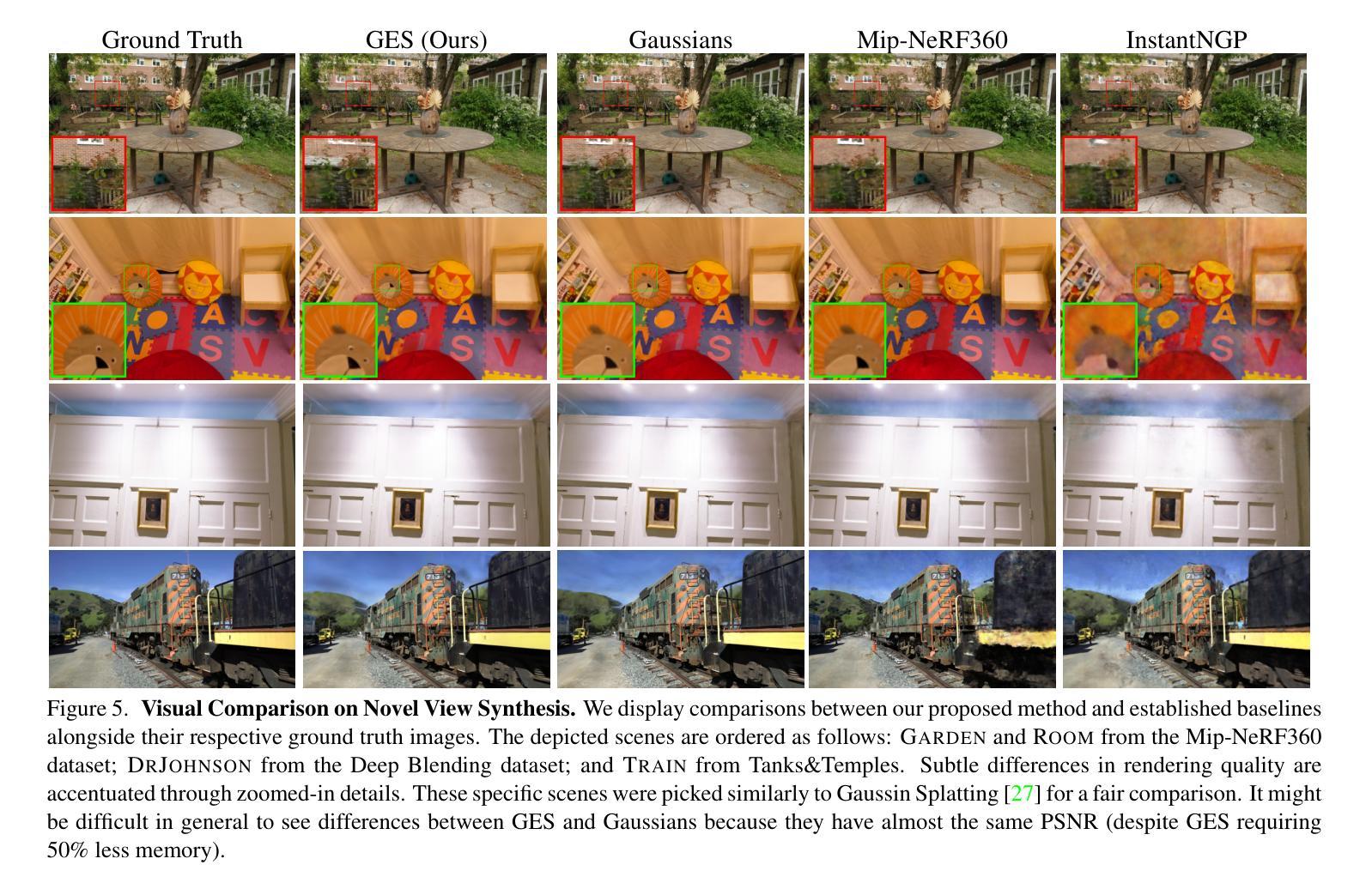

Advancements in 3D Gaussian Splatting have significantly accelerated 3D reconstruction and generation. However, it may require a large number of Gaussians, which creates a substantial memory footprint. This paper introduces GES (Generalized Exponential Splatting), a novel representation that employs Generalized Exponential Function (GEF) to model 3D scenes, requiring far fewer particles to represent a scene and thus significantly outperforming Gaussian Splatting methods in efficiency with a plug-and-play replacement ability for Gaussian-based utilities. GES is validated theoretically and empirically in both principled 1D setup and realistic 3D scenes. It is shown to represent signals with sharp edges more accurately, which are typically challenging for Gaussians due to their inherent low-pass characteristics. Our empirical analysis demonstrates that GEF outperforms Gaussians in fitting natural-occurring signals (e.g. squares, triangles, and parabolic signals), thereby reducing the need for extensive splitting operations that increase the memory footprint of Gaussian Splatting. With the aid of a frequency-modulated loss, GES achieves competitive performance in novel-view synthesis benchmarks while requiring less than half the memory storage of Gaussian Splatting and increasing the rendering speed by up to 39%. The code is available on the project website https://abdullahamdi.com/ges .

PDF preprint

摘要

广义指数散列法(GES)是一种新颖的 3D 场景表示方法,它使用广义指数函数 (GEF) 对 3D 场景进行建模,从而显著减少了表示场景所需的粒子数量,比高斯散列方法更加高效,并且即插即用,可以替代基于高斯的工具。

要点

- GES 使用广义指数函数 (GEF) 对 3D 场景进行建模,显著减少了所需粒子数量,提高了效率。

- GES 优于高斯散列法,能够将 3D 场景建模为更少的粒子,在效率方面显著优于高斯散列法。

- GES 在原理性的一维设置和现实的 3D 场景中经过理论和经验验证。

- GES 在表达具有清晰边缘的信号方面更准确,而这些信号通常对高斯函数构成挑战,因其本身具有低通特性。

- GES 在拟合自然发生的信号(例如正方形、三角形和抛物线信号)方面优于高斯函数,因而减少了增加高斯散列法的内存占用的大量分裂操作的需要。

- 使用调制频率损失,GES 可实现在新视图合成基准中具有竞争力的性能,同时所需的存储空间不到高斯散列法的二分之一,并使渲染速度提高多达 39%。

- GES 的代码可在项目网站 https://abdullahamdi.com/ges 上获取。

- 题目:GES:用于高效光场渲染的广义指数散射(中文翻译)

- 作者:Abdullah Hamdi、Luke Melas-Kyriazi、Guocheng Qian、Jinjie Mai、Ruoshi Liu、Carl Vondrick、Bernard Ghanem、Andrea Vedaldi

- 第一作者单位:牛津大学视觉几何组(中文翻译)

- 关键词:3D 重建、3D 生成、3D 表示、光场渲染、广义指数函数

- 论文链接:https://arxiv.org/abs/2402.10128,Github 代码链接:无

- 摘要: (1)研究背景:3D 高斯散射在 3D 重建和生成方面取得了重大进展。然而,它可能需要大量高斯函数,这会造成巨大的内存占用。 (2)过去的方法及其问题:高斯散射方法假设场景信号是低通的,但大多数 3D 场景都包含形状和外观上的突变,因此高斯散射需要使用大量非常小的高斯函数来表示这些 3D 场景,这会对内存利用率产生负面影响。 (3)本文提出的研究方法:本文提出 GES(广义指数散射),它使用广义指数函数(具有额外的可学习形状参数)来建模 3D 场景,从而可以减少表示场景所需的粒子数量,从而在效率上明显优于高斯散射方法,并且可以即插即用地替换基于高斯的实用工具。 (4)方法在什么任务上取得了什么性能,这些性能是否支持其目标:GES 在原理性 1D 设置和逼真的 3D 场景中都得到了理论和经验验证。结果表明,它可以更准确地表示具有锐利边缘的信号,而这对于高斯函数来说通常具有挑战性,因为它们具有固有的低通特性。实证分析表明,GES 在拟合自然出现的信号(例如,正方形、三角形、抛物线信号)方面优于高斯函数,从而减少了增加高斯散射内存占用率的广泛分裂操作的需要。在频率调制损失的帮助下,GES 在新视图合成基准测试中取得了具有竞争力的性能,同时所需的内存存储量不到高斯散射的一半,并且渲染速度提高了 39%。

- 结论: (1): 本文提出了一种新的光场渲染方法 GES,它使用广义指数函数来建模 3D 场景,从而可以减少表示场景所需的粒子数量,从而在效率上明显优于高斯散射方法,并且可以即插即用地替换基于高斯的实用工具。 (2): 创新点:

- GES 使用广义指数函数来建模 3D 场景,从而可以减少表示场景所需的粒子数量,从而在效率上明显优于高斯散射方法。

- GES 在原理性 1D 设置和逼真的 3D 场景中都得到了理论和经验验证。结果表明,它可以更准确地表示具有锐利边缘的信号,而这对于高斯函数来说通常具有挑战性,因为它们具有固有的低通特性。

- 实证分析表明,GES 在拟合自然出现的信号(例如,正方形、三角形、抛物线信号)方面优于高斯函数,从而减少了增加高斯散射内存占用率的广泛分裂操作的需要。

- 在频率调制损失的帮助下,GES 在新视图合成基准测试中取得了具有竞争力的性能,同时所需的内存存储量不到高斯散射的一半,并且渲染速度提高了 39%。 性能:

- GES 在原理性 1D 设置和逼真的 3D 场景中都得到了理论和经验验证。结果表明,它可以更准确地表示具有锐利边缘的信号,而这对于高斯函数来说通常具有挑战性,因为它们具有固有的低通特性。

- 实证分析表明,GES 在拟合自然出现的信号(例如,正方形、三角形、抛物线信号)方面优于高斯函数,从而减少了增加高斯散射内存占用率的广泛分裂操作的需要。

- 在频率调制损失的帮助下,GES 在新视图合成基准测试中取得了具有竞争力的性能,同时所需的内存存储量不到高斯散射的一半,并且渲染速度提高了 39%。 工作量:

- GES 的实现相对简单,并且可以很容易地集成到现有的光场渲染工具中。

- GES 的训练过程相对较快,并且可以在几分钟内完成。

- GES 的渲染速度很快,并且可以在几秒钟内生成高质量的图像。

点此查看论文截图

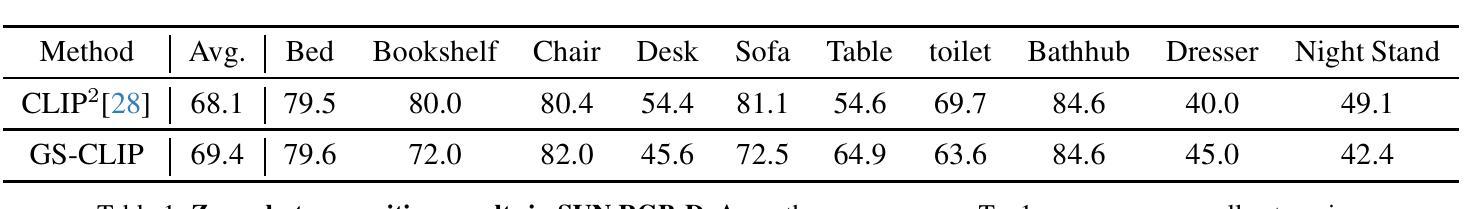

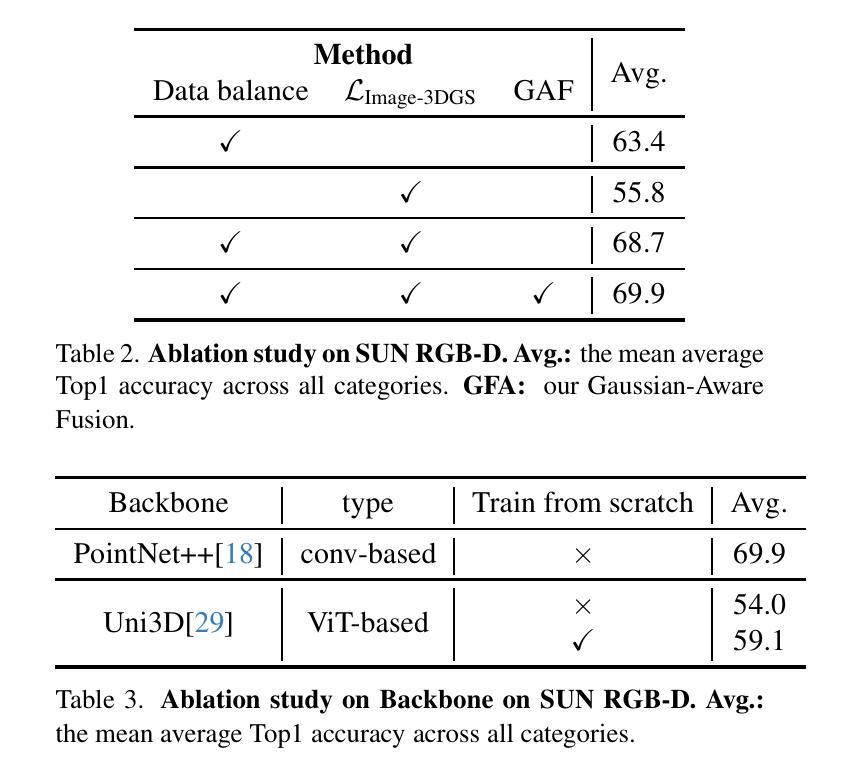

GS-CLIP: Gaussian Splatting for Contrastive Language-Image-3D Pretraining from Real-World Data

Authors:Haoyuan Li, Yanpeng Zhou, Yihan Zeng, Hang Xu, Xiaodan Liang

3D Shape represented as point cloud has achieve advancements in multimodal pre-training to align image and language descriptions, which is curial to object identification, classification, and retrieval. However, the discrete representations of point cloud lost the object’s surface shape information and creates a gap between rendering results and 2D correspondences. To address this problem, we propose GS-CLIP for the first attempt to introduce 3DGS (3D Gaussian Splatting) into multimodal pre-training to enhance 3D representation. GS-CLIP leverages a pre-trained vision-language model for a learned common visual and textual space on massive real world image-text pairs and then learns a 3D Encoder for aligning 3DGS optimized per object. Additionally, a novel Gaussian-Aware Fusion is proposed to extract and fuse global explicit feature. As a general framework for language-image-3D pre-training, GS-CLIP is agnostic to 3D backbone networks. Experiments on challenging shows that GS-CLIP significantly improves the state-of-the-art, outperforming the previously best results.

PDF The content of the technical report needs to be updated and retracted to avoid other impacts

摘要

利用3DGS(三维高斯渲染)增强3D表现,以进行多模态预训练,提升图像、语言和三维数据的对齐,改善物体识别、分类和检索任务。

要点

- 利用点云表示的3D形状在图像和语言描述的对齐上取得了多模态预训练的进步,这对于物体识别、分类和检索至关重要。

- 点云的离散表示丢失了物体的曲面形状信息,并在渲染结果和2D对应关系之间制造差距。

- 提出GS-CLIP,首次尝试将3DGS(三维高斯渲染)引入多模态预训练,以增强3D表示。

- GS-CLIP利用预训练的视觉-语言模型,在大量真实世界图像-文本对上学习一个通用的视觉和文本空间,然后学习一个针对每个物体优化3DGS的3D编码器。

- 提出了一种新的高斯感知融合来提取和融合全局显式特征。

- 作为语言-图像-3D预训练的通用框架,GS-CLIP独立于3D骨干网络。

- 具有挑战性的实验表明,GS-CLIP显著优于最先进的技术,超越了以前最好的成果。

- 题目:GS-CLIP:用于对比语言-图像-3D 预训练的高斯喷绘

- 作者:李昊源、周雁鹏、曾义涵、徐航、梁晓丹

- 第一作者单位:深圳大学

- 关键词:3D 表示、对比学习、多模态预训练、高斯喷绘

- 论文链接:https://arxiv.org/abs/2402.06198,Github 代码链接:无

摘要: (1)研究背景:3D 形状表示为点云在多模态预训练中取得了进展,可以对齐图像和语言描述,这对物体识别、分类和检索至关重要。然而,点云的离散表示丢失了物体的表面形状信息,并在渲染结果和 2D 对应关系之间产生了差距。 (2)过去的方法及其问题:现有方法主要集中在对点云进行建模,但这些方法通常会丢失物体的几何信息和形状纹理。此外,现有方法通常需要大量的数据,这使得它们难以应用于现实世界中的场景。 (3)提出的研究方法:为了解决上述问题,本文提出了一种新的框架 GS-CLIP,该框架将 3D 高斯喷绘 (3DGS) 引入多模态预训练中,以增强 3D 表示。GS-CLIP 利用预训练的视觉语言模型在大量真实世界图像-文本对上学习一个共同的视觉和文本空间,然后学习一个 3D 编码器来对齐针对每个对象优化的 3DGS。此外,本文还提出了一种新的高斯感知融合方法,用于提取和融合全局显式特征。 (4)方法在任务和性能上的表现:在 SUN-RGBD 数据集上的实验表明,GS-CLIP 在真实世界环境中的零样本/开放世界学习中取得了最先进的性能。这些结果表明,3DGS 在跨模态学习中具有强大的表示能力。

方法: (1)跨模态预训练:利用预训练的语言-图像模型CLIP,为文本、图像和3DGS建立共同的语言-图像潜在空间,作为3DGS的目标潜在空间。 (2)语言-3DGS对齐和图像-3DGS对齐:分别使用对比损失函数来对齐文本与3DGS、图像与3DGS的特征表示。 (3)高斯感知融合:采用基于Transformer的分支直接对高斯特征进行建模,并将其与残差形式注入到3D主干网络中。

结论: (1):本工作首次将 3DGS 纳入跨模态学习,作为补充形状和纹理信息的通用 3D 表示。为此,提出了一种高斯感知融合,以便更好地从补充信息中学习信息。我们证明了我们提出的 GS-CLIP 在最先进的方法中取得了优异的性能,并在真实世界环境中实现了零样本/开放世界学习的最新性能。 (2):创新点:

- 将 3DGS 引入跨模态学习,作为补充形状和纹理信息的通用 3D 表示。

- 提出了一种高斯感知融合,以便更好地从补充信息中学习信息。

- 在真实世界环境中实现了零样本/开放世界学习的最新性能。 性能:

- 在 SUN-RGBD 数据集上,GS-CLIP 在真实世界环境中的零样本/开放世界学习中取得了最先进的性能。

- 这些结果表明,3DGS 在跨模态学习中具有强大的表示能力。 工作量:

- 该工作涉及到大量的数据预处理和模型训练。

- 需要对 3DGS 进行优化,以使其能够更好地对齐文本和图像的特征表示。

- 需要对高斯感知融合进行进一步的研究,以使其能够更好地提取和融合全局显式特征。

点此查看论文截图

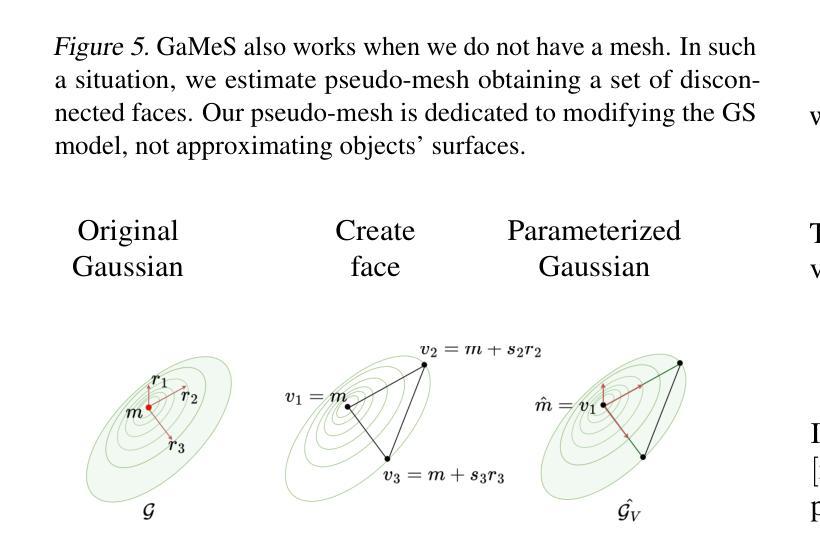

GaMeS: Mesh-Based Adapting and Modification of Gaussian Splatting

Authors:Joanna Waczyńska, Piotr Borycki, Sławomir Tadeja, Jacek Tabor, Przemysław Spurek

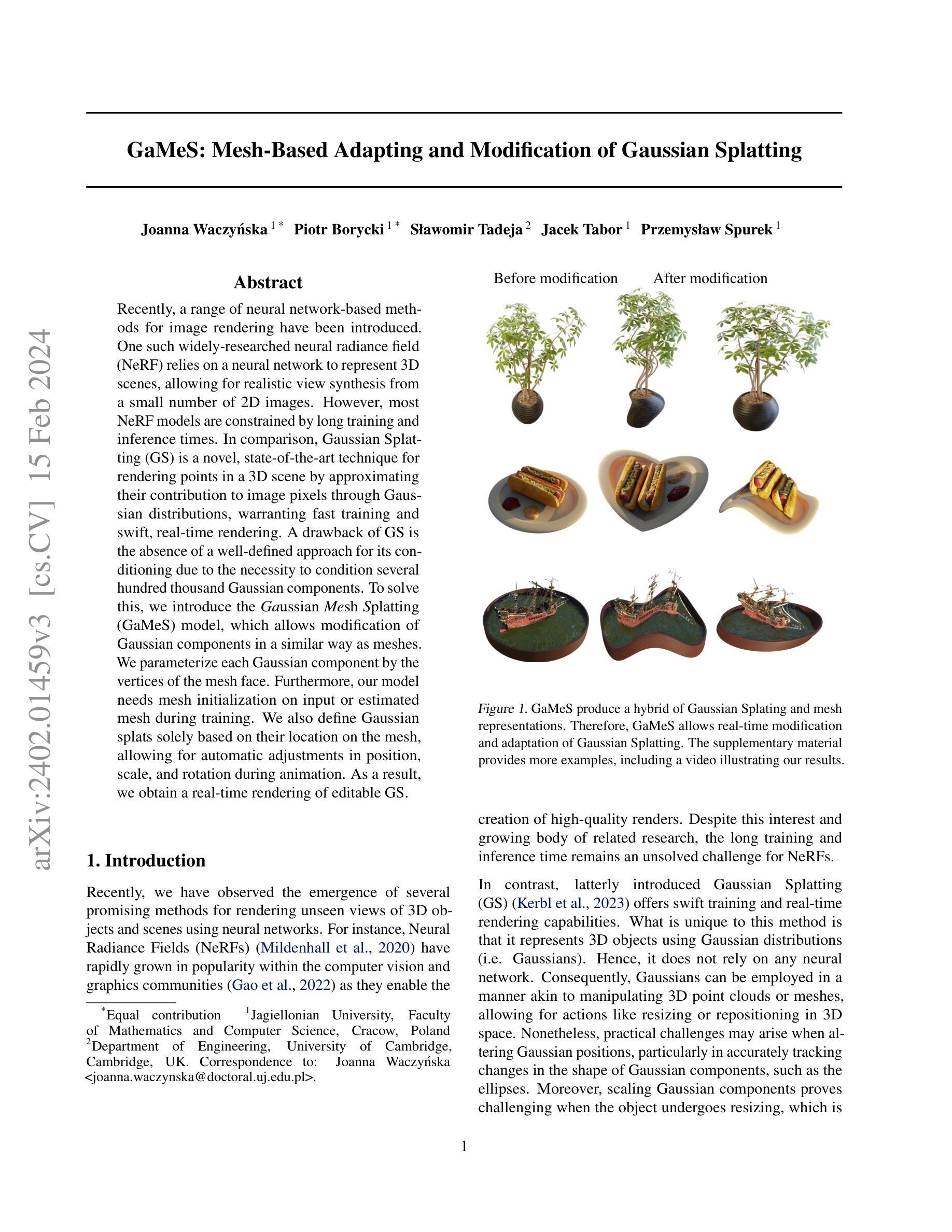

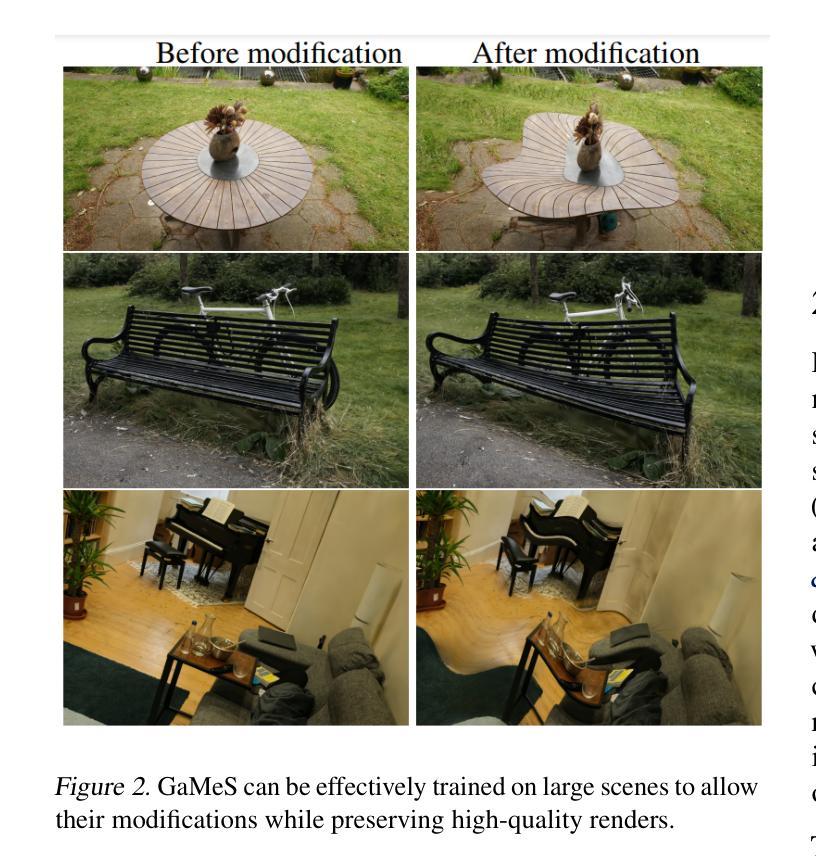

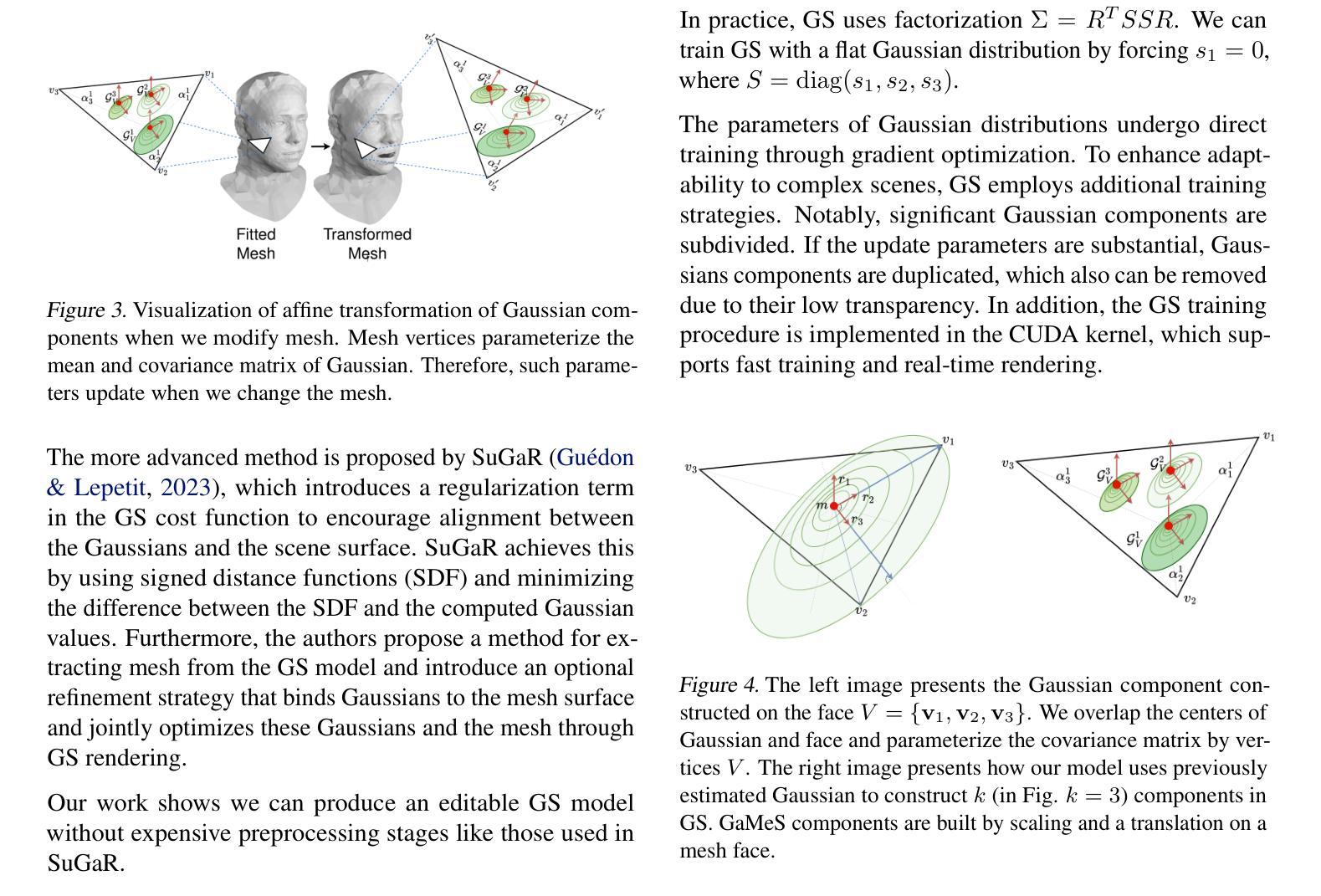

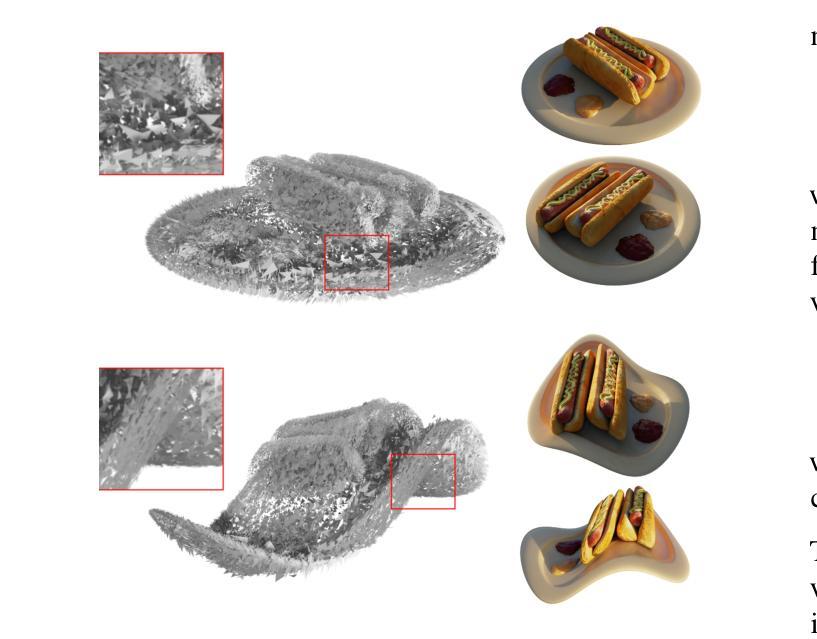

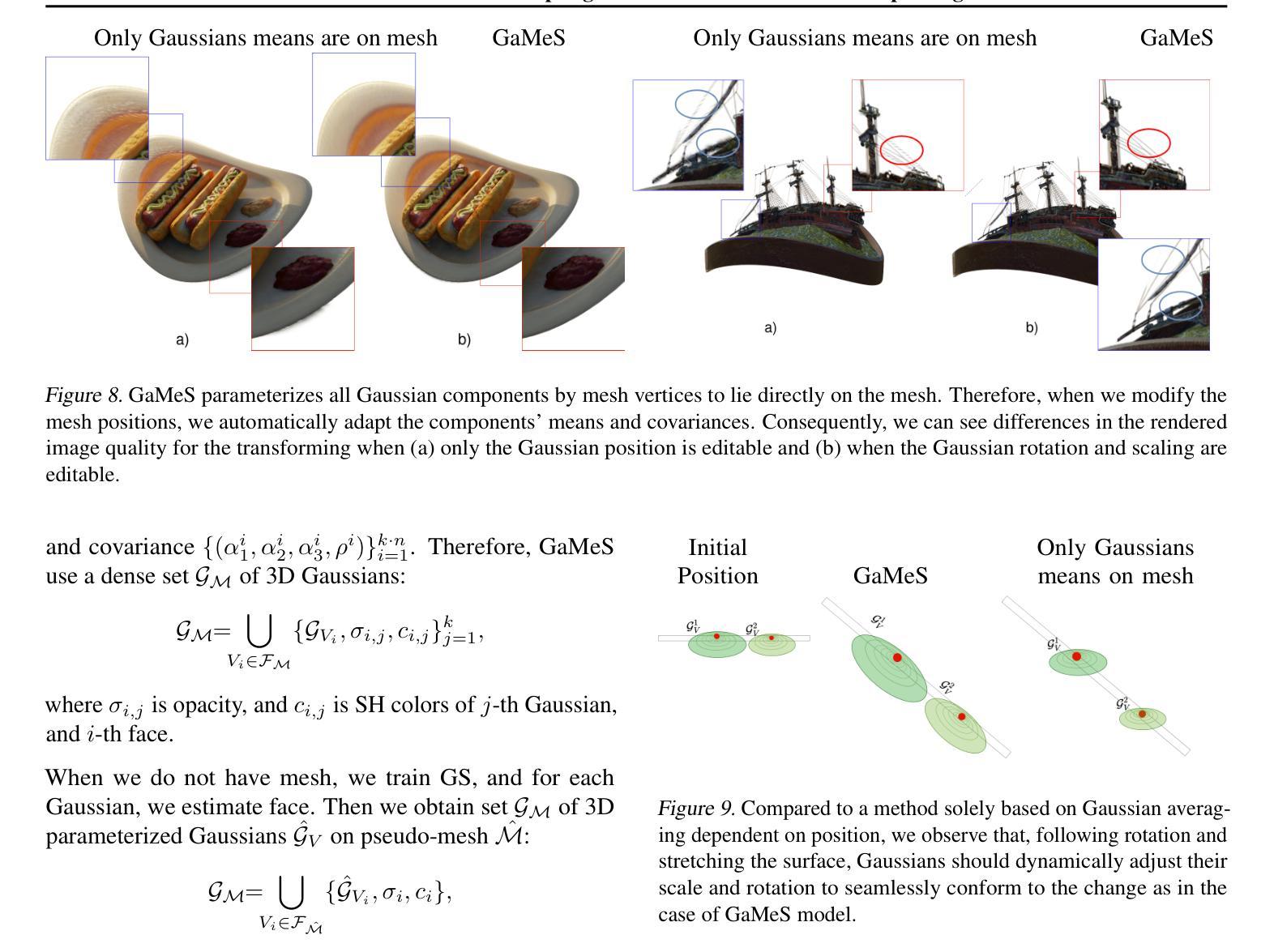

Recently, a range of neural network-based methods for image rendering have been introduced. One such widely-researched neural radiance field (NeRF) relies on a neural network to represent 3D scenes, allowing for realistic view synthesis from a small number of 2D images. However, most NeRF models are constrained by long training and inference times. In comparison, Gaussian Splatting (GS) is a novel, state-of-the-art technique for rendering points in a 3D scene by approximating their contribution to image pixels through Gaussian distributions, warranting fast training and swift, real-time rendering. A drawback of GS is the absence of a well-defined approach for its conditioning due to the necessity to condition several hundred thousand Gaussian components. To solve this, we introduce the Gaussian Mesh Splatting (GaMeS) model, which allows modification of Gaussian components in a similar way as meshes. We parameterize each Gaussian component by the vertices of the mesh face. Furthermore, our model needs mesh initialization on input or estimated mesh during training. We also define Gaussian splats solely based on their location on the mesh, allowing for automatic adjustments in position, scale, and rotation during animation. As a result, we obtain a real-time rendering of editable GS.

Summary:

神经辐射场 (NeRF) 是一种用于图像渲染的神经网络方法,而高斯网格泼溅 (GaMeS) 模型则通过高斯分布来估算 3D 场景中点的贡献,从而实现快速训练和实时渲染。

Key Takeaways:

- 利用神经网络表征 3D 场景的 NeRF,允许从少量 2D 图像中进行逼真的视点合成。

- 高斯泼溅 (GS) 通过高斯分布来估算 3D 场景中点的贡献,从而实现快速训练和实时渲染。

- GaMeS 模型允许以与网格类似的方式修改高斯分量,从而为 GS 的调节提供了一个明确的方法。

- 将每个高斯分量参数化为网格面的顶点,这使得 GaMeS 模型可以对 GS 进行实时渲染。

- GaMeS 模型需要在输入时初始化网格或在训练期间估计网格。

- 根据其在网格上的位置定义高斯泼溅,从而允许在动画期间自动调整位置、缩放和旋转。

- GaMeS 模型可以实现可编辑 GS 的实时渲染。

- 题目:GaMeS:基于网格的自适应和修改高斯喷绘

- 作者:Joanna Waczyńska、Piotr Borycki、Sławomir Tadeja、Jacek Tabor、Przemysław Spurek

- 第一作者单位:雅盖隆大学数学与计算机科学学院,波兰克拉科夫

- 关键词:高斯喷绘、神经辐射场、神经渲染、网格、实时渲染

- 论文链接:https://arxiv.org/abs/2402.01459,Github 代码链接:无

- 摘要: (1):研究背景:近年来,基于神经网络的图像渲染方法取得了很大进展,其中神经辐射场(NeRF)是一种流行的方法,它使用神经网络来表示 3D 场景,并能够从少量 2D 图像中合成逼真的视图。然而,大多数 NeRF 模型都受到训练和推理时间长的限制。与之相比,高斯喷绘(GS)是一种新颖的、最先进的技术,它通过高斯分布来近似点对图像像素的贡献,从而渲染 3D 场景中的点,具有快速训练和快速实时渲染的能力。 (2):过去的方法和问题:GS 的一个缺点是缺乏明确的调节方法,因为需要调节数十万个高斯分量。为了解决这个问题,本文介绍了高斯网格喷绘(GaMeS)模型,它允许像修改网格一样修改高斯分量。我们将每个高斯分量参数化为网格面的顶点。此外,我们的模型需要在输入或训练期间估计的网格上进行网格初始化。我们还定义了仅基于其在网格上的位置的高斯喷绘,允许在动画期间自动调整位置、比例和旋转。因此,我们获得了可编辑 GS 的实时渲染。 (3):研究方法:我们提出了 GaMeS 模型,它允许像修改网格一样修改高斯分量。我们将每个高斯分量参数化为网格面的顶点。此外,我们的模型需要在输入或训练期间估计的网格上进行网格初始化。我们还定义了仅基于其在网格上的位置的高斯喷绘,允许在动画期间自动调整位置、比例和旋转。 (4):方法的性能:实验结果表明,GaMeS 模型能够在保持高质量渲染的同时,实现实时修改和适应高斯喷绘。这使得 GaMeS 成为交互式应用程序和游戏中的一个有前景的技术。

Some Error for method(比如是不是没有Methods这个章节)

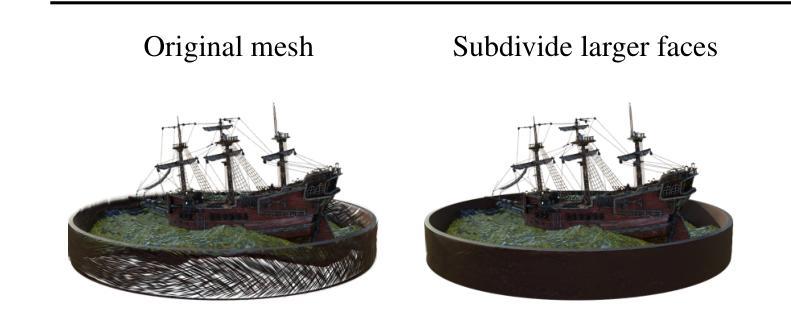

- 结论: (1)GaMeS 允许实时修改,但对于具有大面的网格,在发生重大变化的情况下会出现伪影。在实践中,大面应该被分成更小的面。当网格面分裂时如何在 GaMeS 中更改高斯分量尚不清楚。 (2)创新点:GaMeS 提出了一种新的基于网格的自适应和修改高斯喷绘模型,该模型允许像修改网格一样修改高斯分量,从而实现了实时修改和适应高斯喷绘。 性能:实验结果表明,GaMeS 模型能够在保持高质量渲染的同时,实现实时修改和适应高斯喷绘。这使得 GaMeS 成为交互式应用程序和游戏中的一个有前景的技术。 工作量:GaMeS 模型需要在输入或训练期间估计网格,这可能会增加模型的训练和推理时间。此外,GaMeS 模型需要对网格进行修改,这可能会增加模型的修改时间。

点此查看论文截图