Talking Head Generation

⚠️ 以下所有内容总结都来自于 Google的大语言模型Gemini-Pro的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-07-05 更新

Talking to Machines: do you read me?

Authors:Lina M. Rojas-Barahona

In this dissertation I would like to guide the reader to the research on dialogue but more precisely the research I have conducted during my career since my PhD thesis. Starting from modular architectures with machine learning/deep learning and reinforcement learning to end-to-end deep neural networks. Besides my work as research associate, I also present the work I have supervised in the last years. I review briefly the state of the art and highlight the open research problems on conversational agents. Afterwards, I present my contribution to Task-Oriented Dialogues (TOD), both as research associate and as the industrial supervisor of CIFRE theses. I discuss conversational QA. Particularly, I present the work of two PhD candidates Thibault Cordier and Sebastien Montella; as well as the work of the young researcher Quentin Brabant. Finally, I present the scientific project, where I discuss about Large Language Models (LLMs) for Task-Oriented Dialogue and Multimodal Task-Oriented Dialogue.

PDF French Doctoral Habilitation HDR manuscript: https://hal.science/tel-04620199

Summary

本文总结了作者在对话生成领域的研究经历,重点介绍了从模块化架构到端到端深度神经网络的演进,以及在任务导向对话和多模态任务对话中的贡献。

Key Takeaways

- 研究涵盖了从模块化架构到深度神经网络的技术进展。

- 作者关注了对话系统中的开放性研究问题。

- 讨论了作者在任务导向对话中的工作及其对PhD候选人的指导。

- 提出了对话问答系统的挑战和解决方案。

- 强调了大型语言模型在任务导向对话中的应用。

- 讨论了多模态任务对话的科学项目。

- 引用了若干博士生和年轻研究者的具体工作成果。

Please refer to relevant websites for more information, and feel free to ask me any other questions.

- 方法论概述:

这篇论文主要探讨了一种全新的对话系统方法,该方法融合了多种技术和算法来构建更自然、更高效的任务导向型对话系统。主要的方法论思想如下:

(1) 对话系统的建模:采用强化学习(Reinforcement Learning)结合深度神经网络的方法对对话系统进行建模,能够模拟真实的对话环境并实现决策和响应的自动化。

(2) 任务导向型对话系统的构建:构建了一套包含多个模块的任务导向型对话系统,如语义解析、信念状态追踪、动作决策等模块,并采用了深度学习技术进行参数优化和模型训练。

(3) 强化学习的应用:采用强化学习算法来训练对话策略,利用奖励函数来引导对话系统的行为,使其能够完成任务并满足用户的需求。同时,结合部分可观测马尔可夫决策过程(POMDP)理论来处理对话中的不确定性问题。

(4) 端到端的实现:提出了一种端到端的对话系统实现方式,通过联合训练多个模块来优化整个系统的性能。这种实现方式可以更好地捕捉对话的上下文信息,提高系统的对话质量和效率。

以上仅是简略概括了该论文的主要方法论思想,具体的实现细节和技术手段需要进一步阅读论文以获取更全面的信息。

好的,我会根据您给出的方法论概述和结论部分进行中文总结。以下是对应的回答:

结论:

(1) 这项工作的意义是什么?

这项工作提出了一种全新的对话系统方法,通过融合多种技术和算法,构建了更自然、更高效的任务导向型对话系统。这为人工智能领域的对话系统研究开辟了新的方向,有助于提高对话系统的性能和用户体验。(2) 请从创新点、性能和工作量三个方面概括本文的优缺点。

创新点:该论文提出了融合强化学习、深度神经网络和POMDP理论的方法论,构建了一种新型的任务导向型对话系统,具有较高的创新性。

性能:通过采用强化学习算法训练对话策略,并结合深度学习技术进行参数优化和模型训练,该论文提出的方法在对话质量和效率方面表现出较好的性能。

工作量:该论文对方法论进行了详细的阐述,但关于具体实现细节和技术手段的描述相对较少,可能需要进一步阅读论文以获取更全面的信息。此外,对于该方法的实际表现和性能评估,可能需要更多的实验数据和案例分析来支持。

希望这个回答符合您的要求。如果有任何其他问题或需要进一步的信息,请随时告诉我。

点此查看论文截图

Enhancing Speech-Driven 3D Facial Animation with Audio-Visual Guidance from Lip Reading Expert

Authors:Han EunGi, Oh Hyun-Bin, Kim Sung-Bin, Corentin Nivelet Etcheberry, Suekyeong Nam, Janghoon Joo, Tae-Hyun Oh

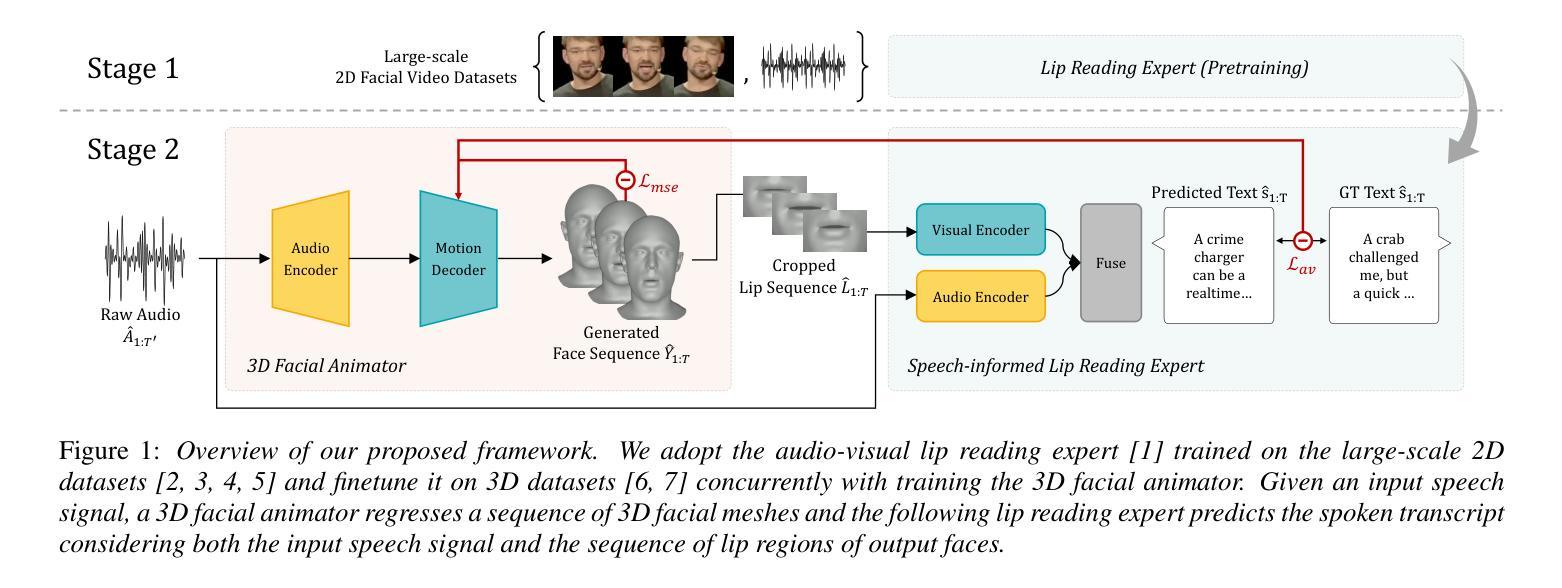

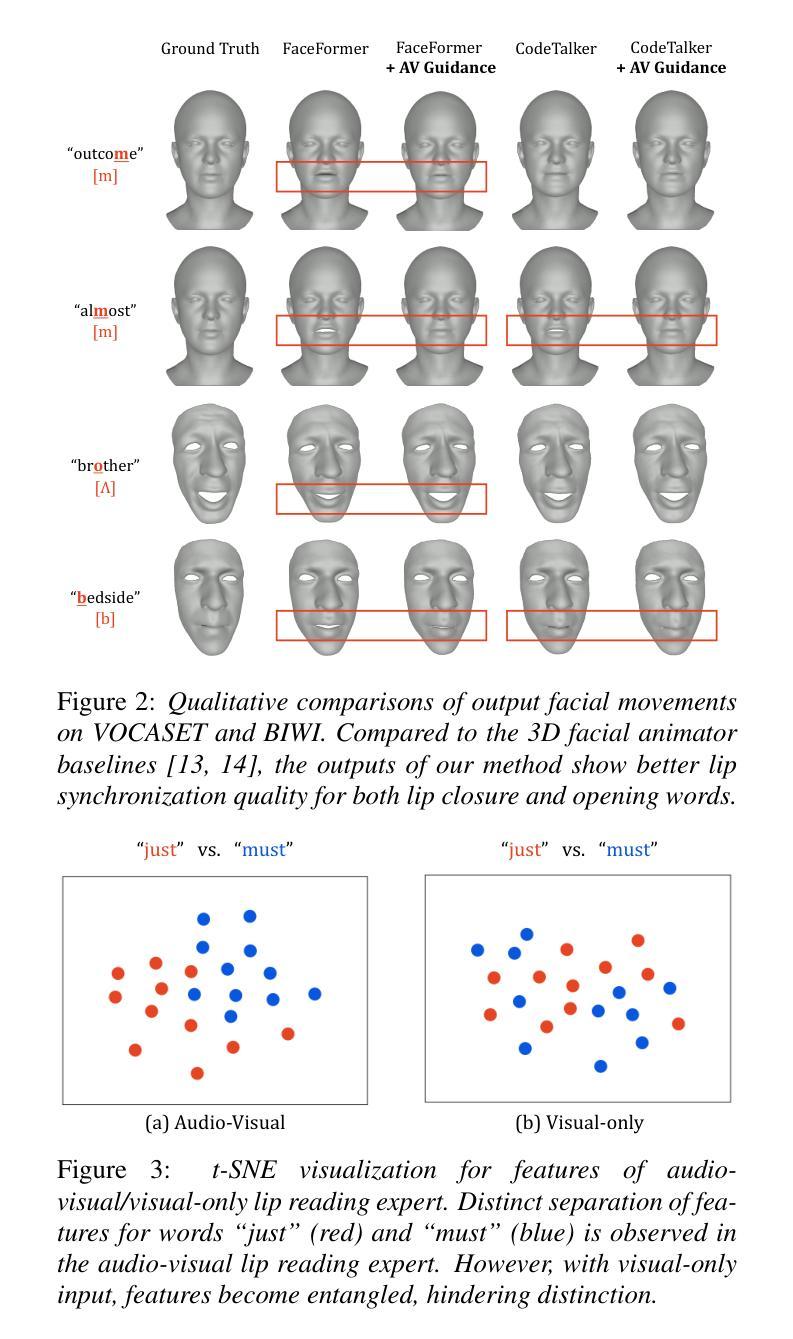

Speech-driven 3D facial animation has recently garnered attention due to its cost-effective usability in multimedia production. However, most current advances overlook the intelligibility of lip movements, limiting the realism of facial expressions. In this paper, we introduce a method for speech-driven 3D facial animation to generate accurate lip movements, proposing an audio-visual multimodal perceptual loss. This loss provides guidance to train the speech-driven 3D facial animators to generate plausible lip motions aligned with the spoken transcripts. Furthermore, to incorporate the proposed audio-visual perceptual loss, we devise an audio-visual lip reading expert leveraging its prior knowledge about correlations between speech and lip motions. We validate the effectiveness of our approach through broad experiments, showing noticeable improvements in lip synchronization and lip readability performance. Codes are available at https://3d-talking-head-avguide.github.io/.

PDF INTERSPEECH 2024

Summary

语音驱动的3D面部动画近年来因其在多媒体制作中的成本效益备受关注,但目前大多数进展忽视了唇部运动的清晰度,限制了面部表情的逼真度。本文介绍了一种语音驱动的3D面部动画方法,通过提出的视听多模感知损失来生成准确的唇部运动,从而提高了唇部同步和可读性性能。

Key Takeaways

- 语音驱动的3D面部动画在多媒体制作中具有成本效益。

- 当前技术忽视了唇部运动的清晰度,影响面部表情的真实性。

- 提出了视听多模感知损失方法来改进唇部运动的生成。

- 损失方法通过训练面部动画师,使其生成与口头文本对齐的合理唇部运动。

- 设计了视听唇读专家来整合提出的视听损失方法。

- 实验证实了方法的有效性,并显示出在唇部同步和可读性性能方面的显著改进。

- 提供了代码资源,详见 https://3d-talking-head-avguide.github.io/。

Please refer to relevant websites for more information, and feel free to ask me any other questions.

- 方法论概述:

这篇文章介绍了一种结合音频和视觉信息的三维面部动画方法。其主要步骤包括:

- (1)提出一个包含两个组件的框架:一个三维面部动画生成器和一个语音驱动的唇部阅读专家。

- (2)三维面部动画生成器学习从输入语音信号回归一系列三维面部顶点。这个过程通过最小化真实面部动画和生成面部动画之间的均方误差来进行训练。

- (3)唇部阅读专家则利用大量的二维谈话面部数据集进行训练,学习唇部运动和对应文本内容之间的关联。该专家接收渲染的二维视频帧作为输入,并预测对应的文本内容。

- (4)为了结合音频和视觉信息,将音频特征引入到唇部阅读专家的输入中,并利用音频视觉感知损失来指导三维面部动画模型生成更逼真的唇部形状。

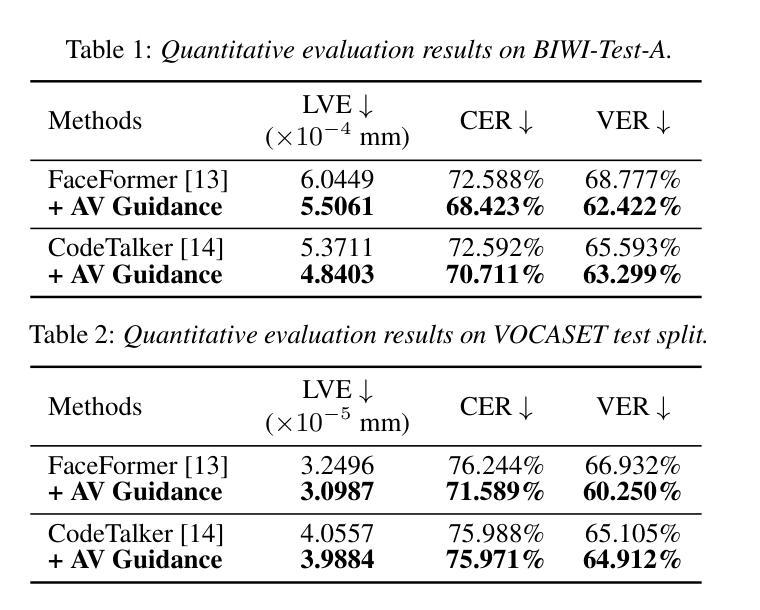

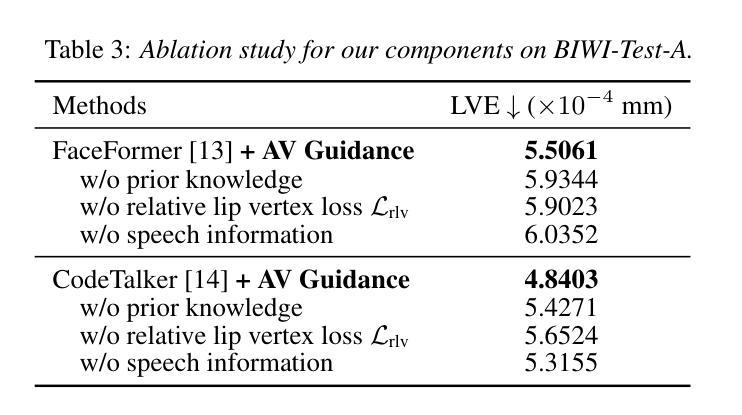

- (5)为了评估模型性能,使用了公开数据集进行试验,并使用了唇顶点误差、字符错误率和语素错误率等指标来评估模型在唇同步和可读性方面的性能。实验结果表明,引入音频视觉感知损失后,模型的性能得到了显著提高。

总的来说,该方法通过结合音频和视觉信息,提高了三维面部动画的逼真度和可理解性,为语音驱动的面部动画提供了新的思路和方法。

- Conclusion:

(1)工作意义:该研究提出了一种结合音频和视觉信息的三维面部动画方法,旨在提高语音驱动的三维面部动画的逼真度和可理解性,为相关领域的研究提供了新的思路和方法。

(2)评价:

创新点:该研究提出了一种音频视觉感知损失的方法,能够指导三维面部动画模型生成更逼真的唇部形状,并结合音频和视觉信息,增强了语音驱动的三维面部动画的效果。这是该研究领域的一个创新点。

性能:该研究通过实验评估了模型性能,使用了公开数据集进行试验,并采用了唇顶点误差、字符错误率和语素错误率等指标来评估模型在唇同步和可读性方面的性能。实验结果表明,引入音频视觉感知损失后,模型的性能得到了显著提高。

工作量:从文章所述内容来看,该研究进行了大量的实验和数据分析,涉及了多个步骤和组件的训练和集成,工作量较大。

点此查看论文截图