Diffusion Models

⚠️ 以下所有内容总结都来自于 Google的大语言模型Gemini-Pro的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-07-26 更新

Self-supervised pre-training with diffusion model for few-shot landmark detection in x-ray images

Authors:Roberto Di Via, Francesca Odone, Vito Paolo Pastore

In the last few years, deep neural networks have been extensively applied in the medical domain for different tasks, ranging from image classification and segmentation to landmark detection. However, the application of these technologies in the medical domain is often hindered by data scarcity, both in terms of available annotations and images. This study introduces a new self-supervised pre-training protocol based on diffusion models for landmark detection in x-ray images. Our results show that the proposed self-supervised framework can provide accurate landmark detection with a minimal number of available annotated training images (up to 50), outperforming ImageNet supervised pre-training and state-of-the-art self-supervised pre-trainings for three popular x-ray benchmark datasets. To our knowledge, this is the first exploration of diffusion models for self-supervised learning in landmark detection, which may offer a valuable pre-training approach in few-shot regimes, for mitigating data scarcity.

Summary

本研究介绍了基于扩散模型的自监督预训练协议,用于X射线图像中的地标检测,证明其在少样本情况下优于传统的监督和自监督方法。

Key Takeaways

- 深度神经网络在医学领域的广泛应用受限于数据稀缺,尤其是标注和图像方面。

- 研究提出的自监督框架利用扩散模型,能够在仅有少量标注训练图像的情况下实现精准的地标检测。

- 该方法在三个流行的X射线基准数据集上表现优异,超过了ImageNet监督预训练和现有的自监督方法。

- 这是扩散模型在地标检测自监督学习中的首次探索,可能为少样本情景下的预训练提供宝贵的方法。

- 自监督学习的框架有助于减轻医学图像数据稀缺性的问题。

- 研究为医学图像处理领域提供了新的技术路径,特别是在面对少量数据时的挑战。

- 结果表明,基于扩散模型的自监督预训练有望成为未来医学影像分析中的重要工具。

好的,基于您提供的信息,我会按照要求的格式输出内容。

标题:基于扩散模型的自监督预训练在少量X光图像中的地标检测

作者:Roberto Di Via、Francesca Odone、Vito Paolo Pastore

隶属机构:意大利热那亚大学

关键词:自监督预训练、扩散模型、X光图像、地标检测、少量数据

链接:尚未提供论文链接和GitHub代码链接。

总结:

(1)研究背景:本文的研究背景是关于在医疗领域,特别是在X光图像中进行地标检测的深度学习应用。由于数据稀缺性和标注成本高昂的问题,研究人员一直在寻找更有效的预训练策略。

(2)过去的方法和存在的问题:过去,研究者通常使用深度神经网络进行地标检测,并依赖于大量的标注数据进行监督学习。然而,这种方法在医疗领域面临数据稀缺和标注困难的问题。虽然有一些自监督学习方法被提出,但它们在某些任务上的性能可能并不理想。因此,需要一种更有效的自监督预训练方法来解决数据稀缺问题。

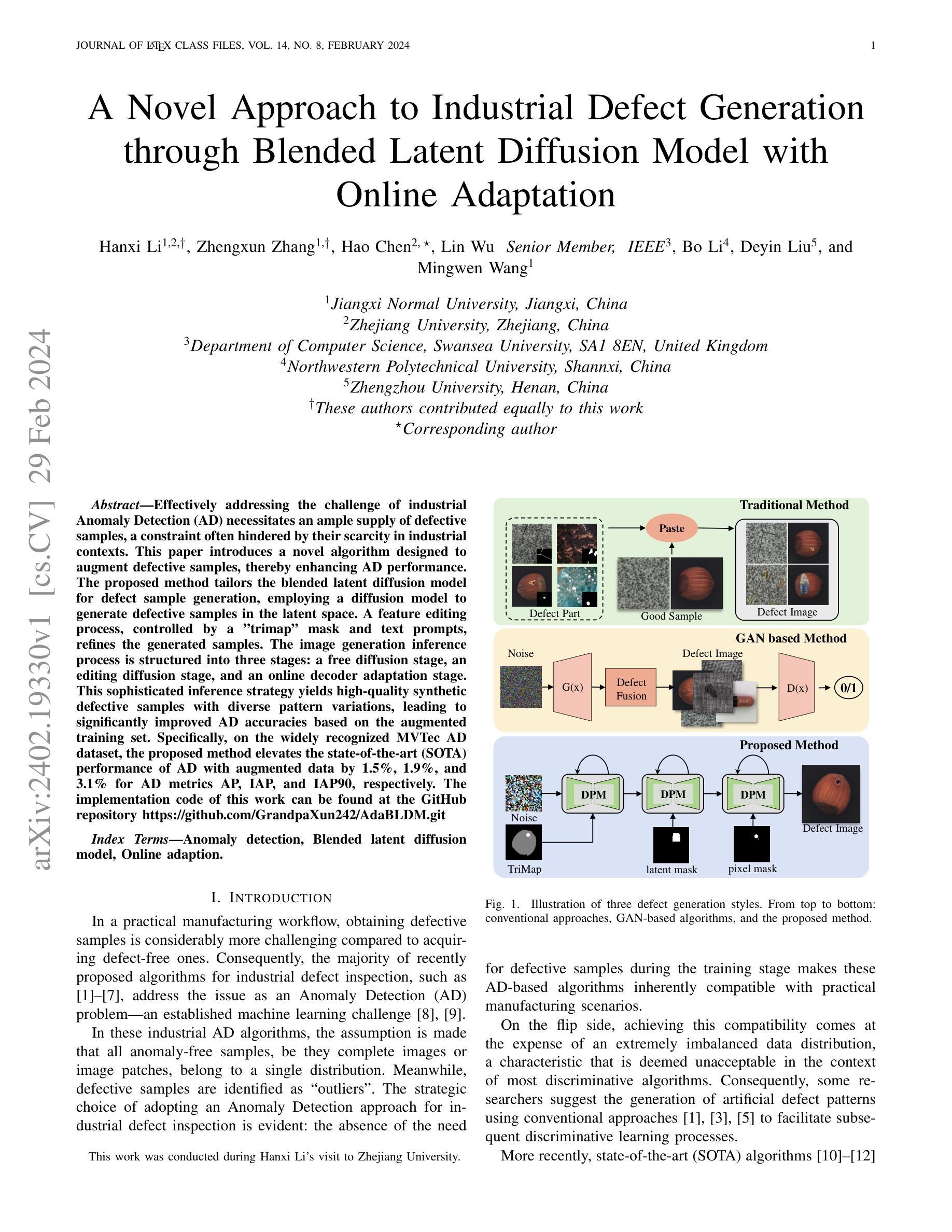

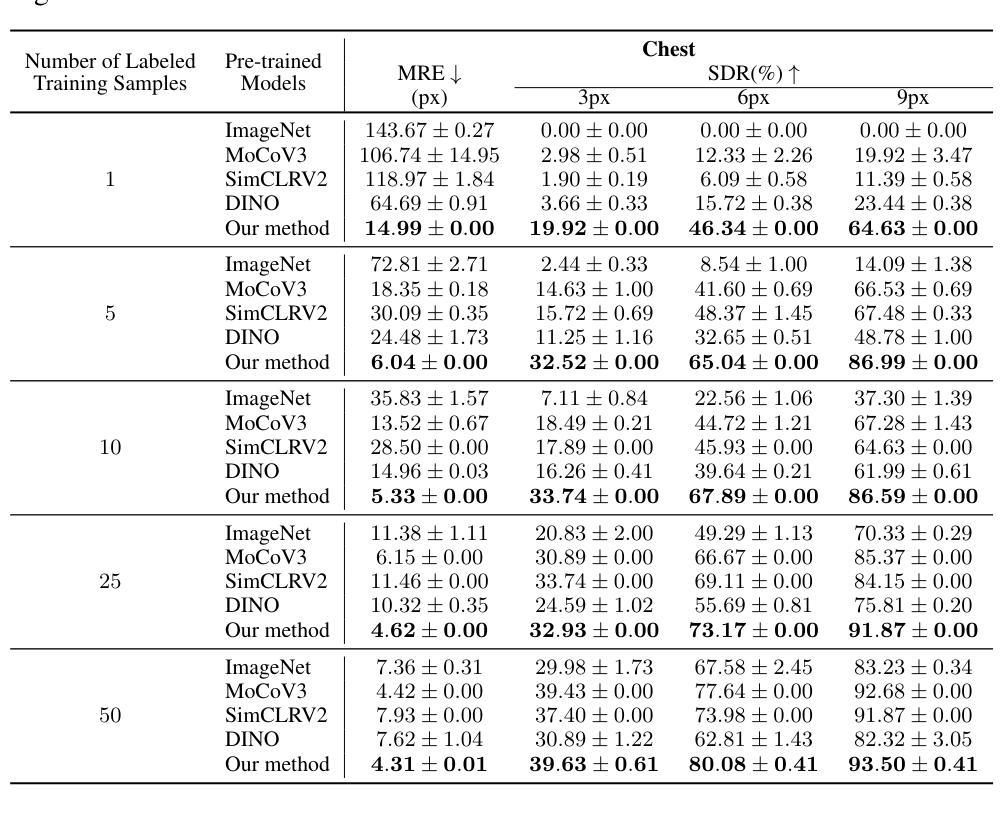

(3)研究方法:本文提出了一种基于扩散模型的自监督预训练方法,用于X光图像中的地标检测。该方法利用扩散模型学习图像特征表示,并通过少量的标注数据进行微调。实验结果表明,该方法在三个流行的X光基准数据集上均表现出优异的性能。

(4)任务与性能:本文的方法在X光图像地标检测任务上取得了显著的性能提升。与现有的监督预训练和自监督预训练方法相比,该方法在少量标注数据的情况下实现了更高的准确率。实验结果支持了方法的有效性,表明了其在数据稀缺环境下的优越性。

希望这个总结符合您的要求!

方法论概述:

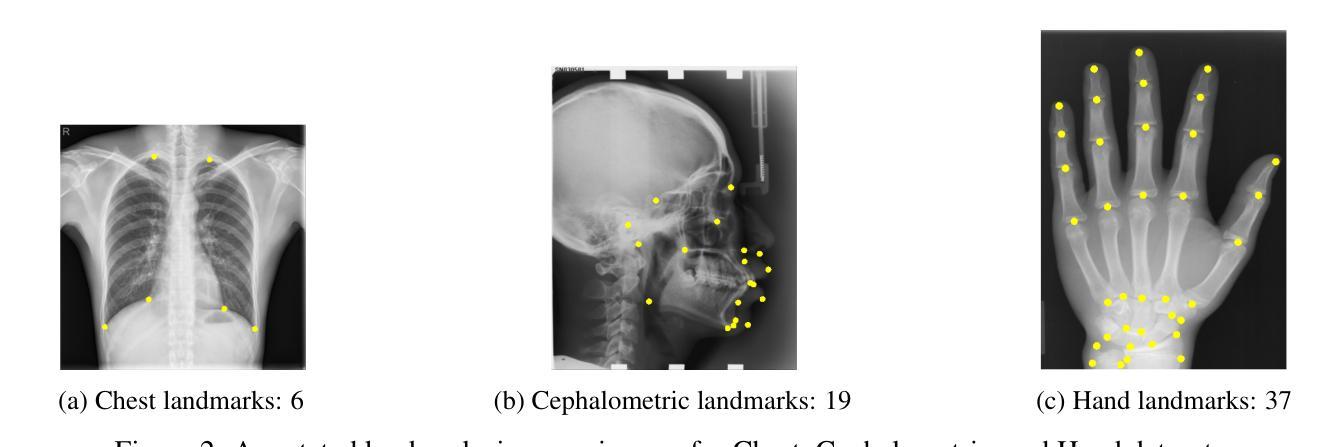

(1) 研究背景与问题定义:针对医疗领域,特别是在X光图像中进行地标检测的深度学习应用,由于数据稀缺性和标注成本高昂的问题,研究人员一直在寻找更有效的预训练策略。过去的方法和存在的问题主要是使用深度神经网络进行地标检测,并依赖于大量的标注数据进行监督学习,这在医疗领域面临数据稀缺和标注困难的问题。

(2) 方法概述:本文提出了一种基于扩散模型的自监督预训练方法,用于X光图像中的地标检测。首先,使用扩散概率模型(DDPM)进行自监督预训练,学习图像特征表示。然后,利用少量的标注数据进行微调。

(3) 预训练阶段:采用DDPM模型进行自监督预训练。DDPM是一种生成模型,通过正向扩散过程将数据逐渐转化为噪声,再通过反向过程从噪声中生成新数据样本。在这个阶段,模型接收图像及其对应的扩散时间步长作为输入,并预测数据中的扰动。由于真实世界的地标检测数据集通常规模较小,因此预期DDPM模型能够在小规模未标注数据集上进行预训练,同时提供丰富且通用的特征用于下游任务。

(4) 微调阶段:预训练的模型在少量标注数据上进行微调,用于地标检测。此阶段只需修改最后的分类层以适应要预测的地标数量。虽然第一阶段采用自监督策略(无需注释),但第二阶段采用监督方法,使用地面真实热图作为标签进行训练。

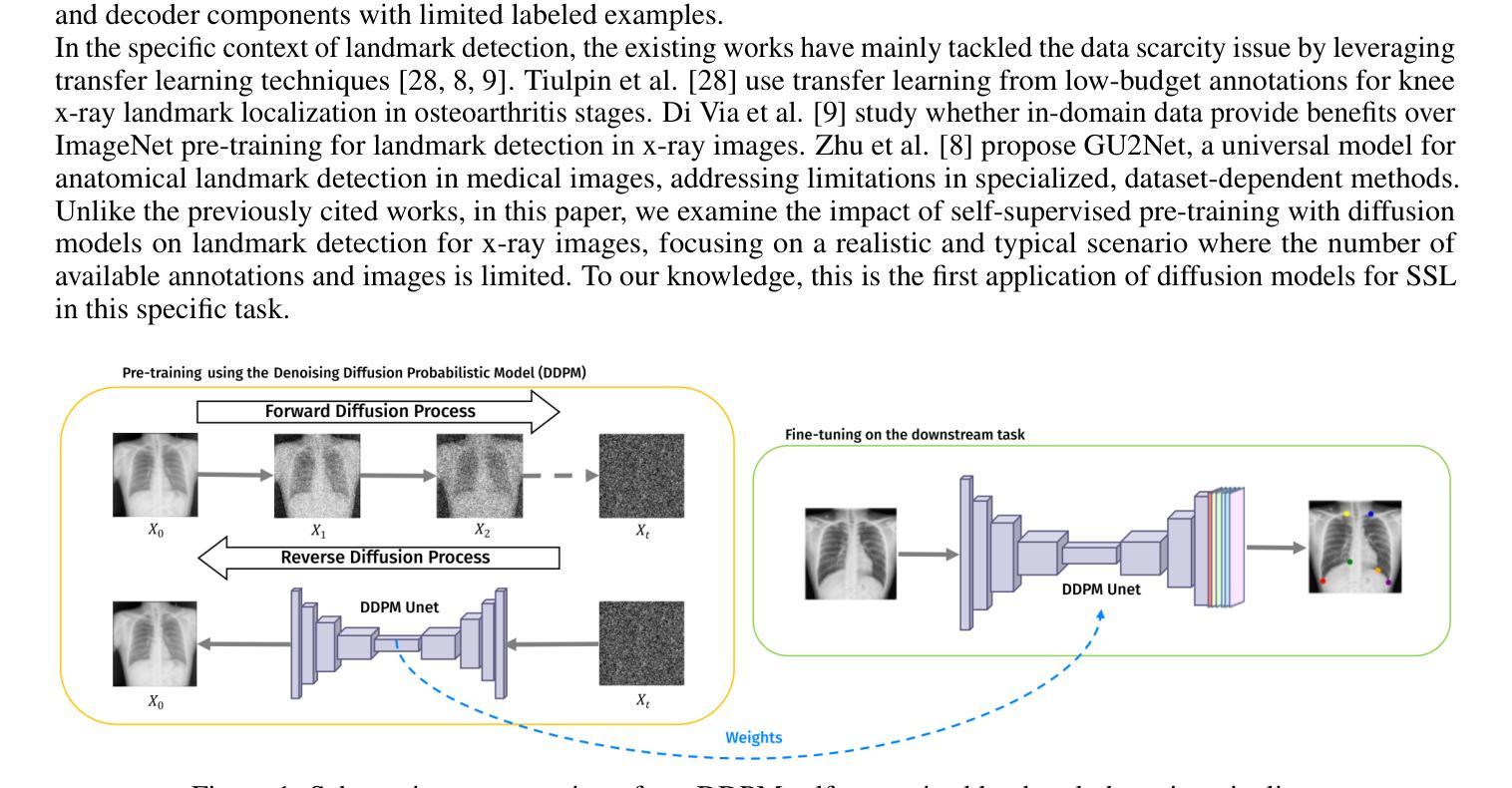

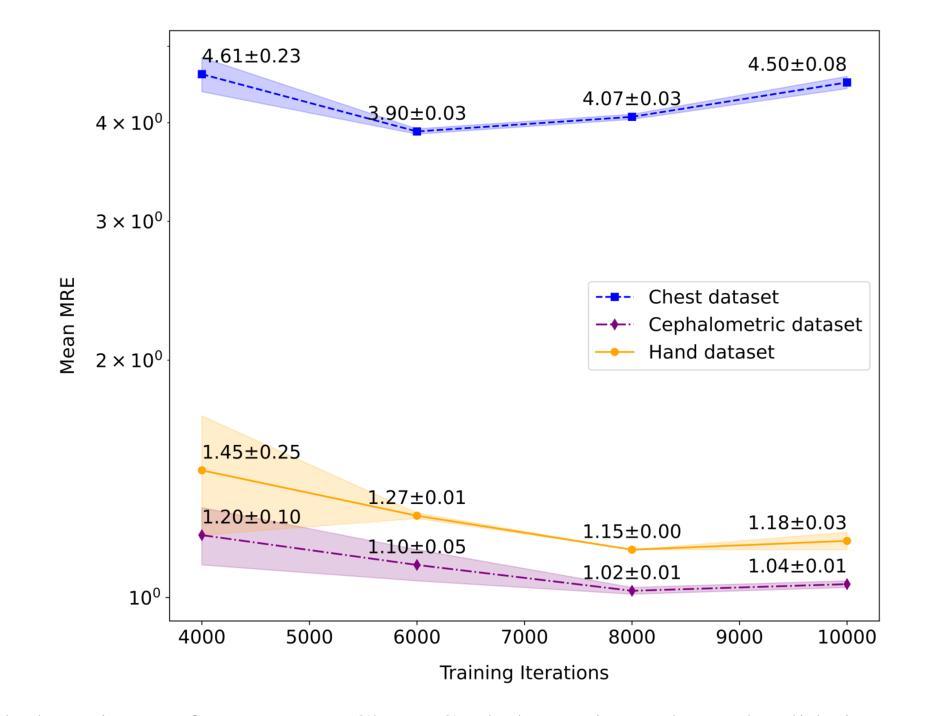

(5) 实验设置:实验阶段描述了使用的数据集、采用的评估指标以及DDPM架构的训练程序细节。数据集包括Chest x射线、Cephalometric x射线和Hand x射线。此外,还介绍了数据预处理、实施细节和评估指标等。

(6) 结果评估:采用均方根误差(MRE)和成功检测率(SDR)等评估指标来评估地标检测算法的性能。MRE衡量预测地标的准确性,而SDR则评估算法的稳健性。

- Conclusion:

(1)这项工作的重要意义在于解决了医疗领域X光图像地标检测中的数据稀缺和标注困难的问题。通过提出一种基于扩散模型的自监督预训练方法,提高了在少量数据下的地标检测性能,为医疗影像分析领域提供了一种有效的解决方案。

(2)创新点:本文提出了基于扩散模型的自监督预训练方法,该方法在X光图像地标检测任务上表现出较强的性能。其创新之处在于利用扩散模型学习图像特征表示,并通过少量标注数据进行微调。

性能:实验结果表明,该方法在三个流行的X光基准数据集上均表现出优异的性能,与现有的监督预训练和自监督预训练方法相比,在少量标注数据的情况下实现了更高的准确率。

工作量:文章对方法进行了详细的介绍和实验验证,包括方法论概述、实验设置和结果评估等。然而,文章未提供代码链接,无法直接评估其实现的复杂性和工作量。

点此查看论文截图

Diffusion Models for Multi-Task Generative Modeling

Authors:Changyou Chen, Han Ding, Bunyamin Sisman, Yi Xu, Ouye Xie, Benjamin Z. Yao, Son Dinh Tran, Belinda Zeng

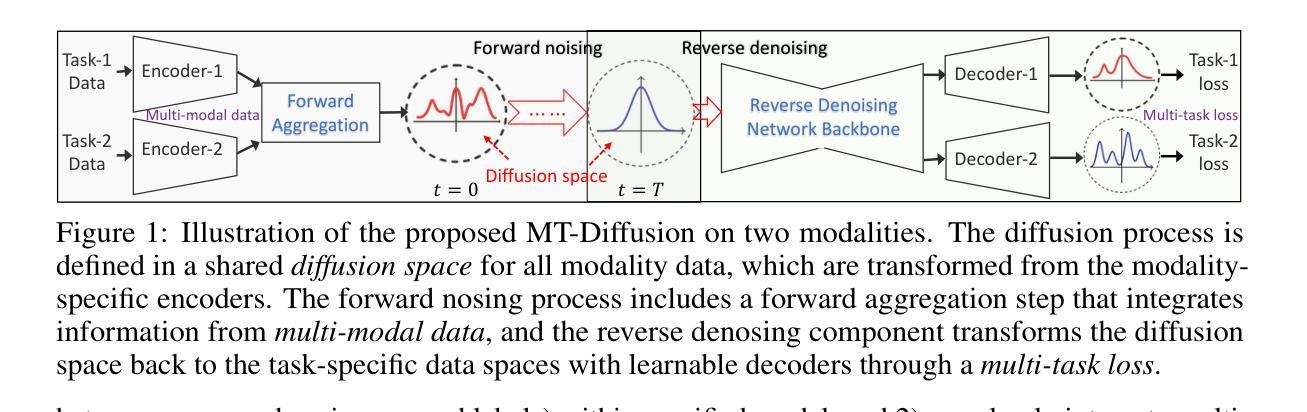

Diffusion-based generative modeling has been achieving state-of-the-art results on various generation tasks. Most diffusion models, however, are limited to a single-generation modeling. Can we generalize diffusion models with the ability of multi-modal generative training for more generalizable modeling? In this paper, we propose a principled way to define a diffusion model by constructing a unified multi-modal diffusion model in a common diffusion space. We define the forward diffusion process to be driven by an information aggregation from multiple types of task-data, e.g., images for a generation task and labels for a classification task. In the reverse process, we enforce information sharing by parameterizing a shared backbone denoising network with additional modality-specific decoder heads. Such a structure can simultaneously learn to generate different types of multi-modal data with a multi-task loss, which is derived from a new multi-modal variational lower bound that generalizes the standard diffusion model. We propose several multimodal generation settings to verify our framework, including image transition, masked-image training, joint image-label and joint image-representation generative modeling. Extensive experimental results on ImageNet indicate the effectiveness of our framework for various multi-modal generative modeling, which we believe is an important research direction worthy of more future explorations.

PDF Published as a conference paper at ICLR 2024

Summary

多模态扩散模型在生成建模中展现了突出的效果和潜力。

Key Takeaways

- 多模态扩散模型在生成任务中达到了最先进的结果。

- 传统扩散模型局限于单一生成任务,本文探讨了多模态生成的泛化能力。

- 提出了统一的多模态扩散模型框架,通过共享信息和多任务损失实现不同类型数据的生成。

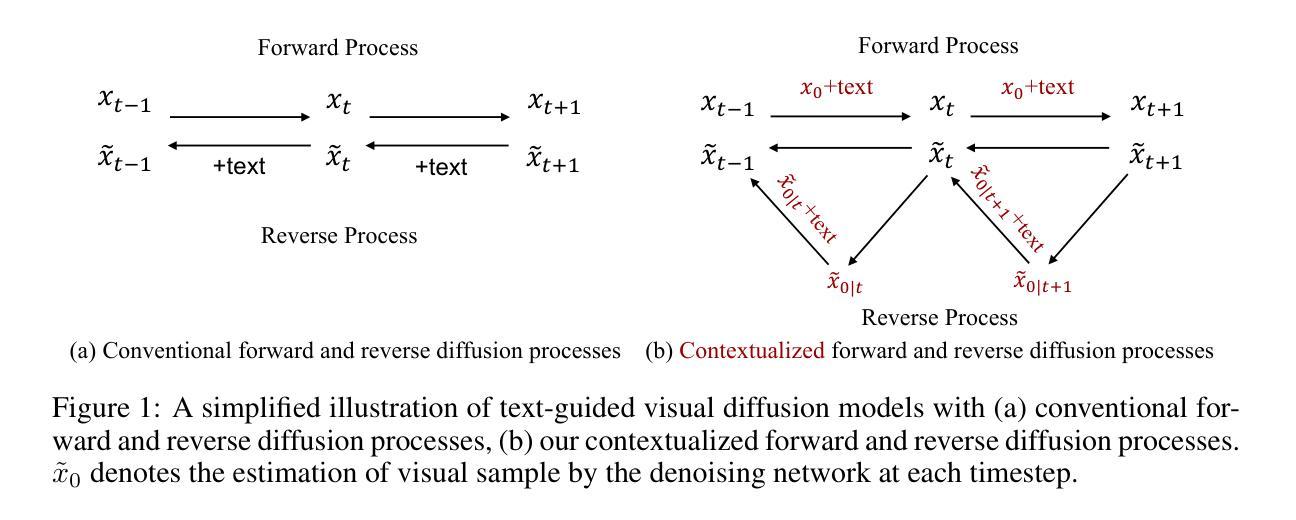

- 正向扩散过程聚合多类型任务数据信息,逆向过程则通过参数化的共享去噪网络和特定解码器头实现信息共享。

- 提出了多种多模态生成设置以验证框架,如图像过渡、掩码图像训练和联合图像-标签生成建模。

- 在ImageNet上的广泛实验结果表明了该框架在多模态生成建模中的有效性。

- 这一研究方向对未来的探索具有重要意义,值得进一步深入探讨和研究。

好的,我已经理解您的要求。下面是关于这篇论文的总结:

标题:多模态扩散模型的生成建模研究

作者:Changyou Chen(陈长友)及其他合作者。合作者包括Han Ding(丁涵)、Bunyamin Sisman(布纳亚敏·西斯曼)、Yi Xu(徐毅)、Ouye Xie(谢欧耶)、Benjamin Yao(姚本晟)、Son Tran(宋灿)、Belinda Zeng(曾碧琳)。

所属机构:第一作者陈长友为University at Buffalo大学,其他作者均属于亚马逊公司。

关键词:多模态扩散模型、生成建模、多任务学习、多模态数据生成、图像过渡、遮罩图像训练。

Urls:论文链接待补充;GitHub代码链接(如有):GitHub:None。

总结:

(1) 研究背景:随着人工智能领域的发展,生成模型尤其是扩散模型在多种生成任务上取得了显著成果。然而,大多数扩散模型仅限于单一模态数据的生成。文章旨在探索多模态扩散模型的构建,以支持多种类型数据的生成。

(2) 相关工作:现有生成模型大多专注于单一数据类型或模态的生成,如图像、文本等。扩散模型作为一种先进的生成模型,已经独立用于生成图像、文本、音频和标签数据。然而,缺乏一种方法将多模态数据集成到扩散模型中。本研究旨在通过多任务学习的方法来解决这一问题。存在的问题是现有模型无法同时处理多种类型的数据生成任务。提出的解决方案是构建一个统一的多模态扩散模型。

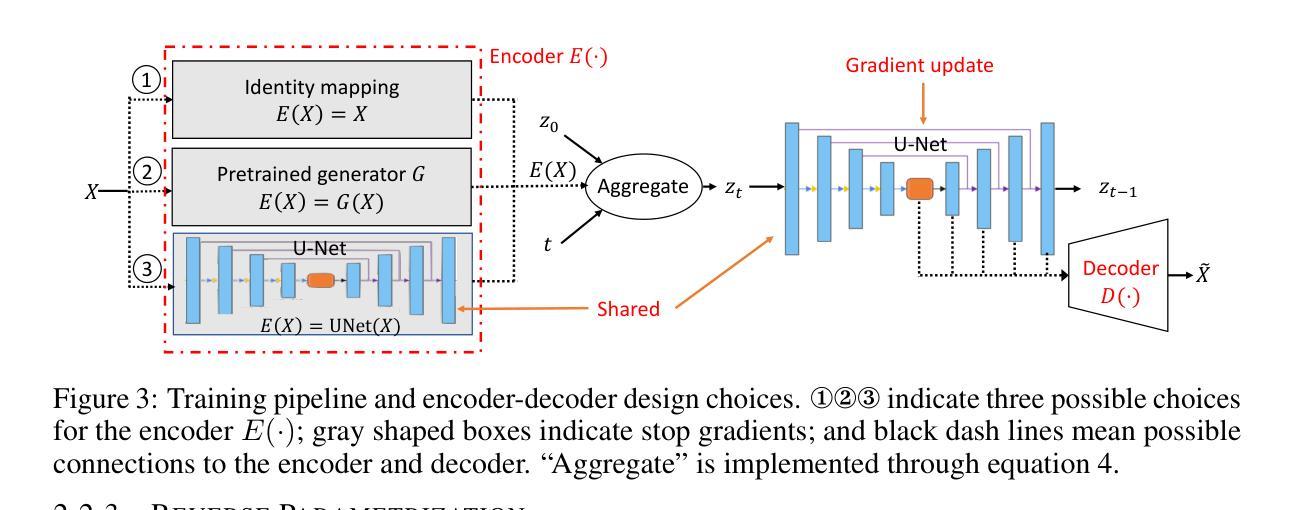

(3) 研究方法:本研究提出了一种基于多任务学习的多模态扩散模型(MT-Diffusion)。该模型通过构建一个统一的扩散模型来同时处理多模态数据的生成任务。在正向扩散过程中,通过从多种任务数据中聚合信息来驱动扩散过程,例如使用图像进行生成任务和使用标签进行分类任务。在反向过程中,通过共享去噪网络参数并添加针对特定模态的解码器头来强制信息共享。该模型可以学习生成不同类型的多模态数据,并使用多任务损失进行优化。该损失是基于新的多模态变分下界推导得出的,该下界推广了标准扩散模型。提出了多种多模态生成设置来验证框架的有效性,包括图像过渡、遮罩图像训练、联合图像标签和联合图像表示生成建模等。本研究通过采用多任务学习框架实现了多模态数据的联合建模和生成。

(4) 实验结果:在ImageNet数据集上的实验结果表明,所提出的框架在各种多模态生成建模任务上均表现出有效性。本研究验证了通过多任务学习框架结合多模态数据和损失到扩散模型中的可能性,从而更好地整合任务间的共享信息以实现更好的生成建模。实验结果支持了该研究的目标和方法的有效性。这项工作为未来在该方向上的更多探索提供了重要的研究基础。

好的,根据您的要求,我将对这篇文章的意义以及从创新点、性能和工作量三个方面对这篇文章进行简要的总结评价。以下是我的回答:

- 结论:

(1) 工作意义:该文章提出了基于多任务学习的多模态扩散模型,是生成建模领域的重要突破。该模型对于支持多种类型数据的生成具有重大意义,推动了人工智能领域中生成模型的发展。这一模型能够广泛应用于图像、文本、音频等多种数据类型,为多模态数据的生成和应用提供了全新的解决方案。同时,该研究为未来的多模态扩散模型和多任务学习研究提供了重要的基础。

(2) 创新点总结:该文章的创新点在于将多任务学习与多模态扩散模型相结合,实现了多模态数据的联合建模和生成。这一模型通过共享去噪网络参数并添加针对特定模态的解码器头来强制信息共享,能够学习生成不同类型的多模态数据,并使用多任务损失进行优化。该研究突破了传统扩散模型的局限性,能够同时处理多种类型的数据生成任务。

(3) 性能评价:该文章提出的模型在ImageNet数据集上的实验结果表明,在各种多模态生成建模任务上均表现出有效性。通过与单一任务设置的对比实验,证明了多任务学习框架在结合多模态数据和损失到扩散模型中的有效性。该研究实现了更好的生成建模,为未来在该方向上的更多探索提供了重要的研究基础。

(4) 工作量评价:该文章的工作量大,涉及多个领域的知识和技术,包括扩散模型、多任务学习、多模态数据生成等。同时,实验部分需要大量的数据预处理、模型训练和结果分析等工作。作者通过提出多种多模态生成设置来验证框架的有效性,包括图像过渡、遮罩图像训练、联合图像标签和联合图像表示生成建模等,充分证明了该模型的泛化能力和适用性。

总体而言,该文章具有重要的理论和实践价值,为生成建模领域的发展做出了重要贡献。

点此查看论文截图

LPGen: Enhancing High-Fidelity Landscape Painting Generation through Diffusion Model

Authors:Wanggong Yang, Xiaona Wang, Yingrui Qiu, Yifei Zhao

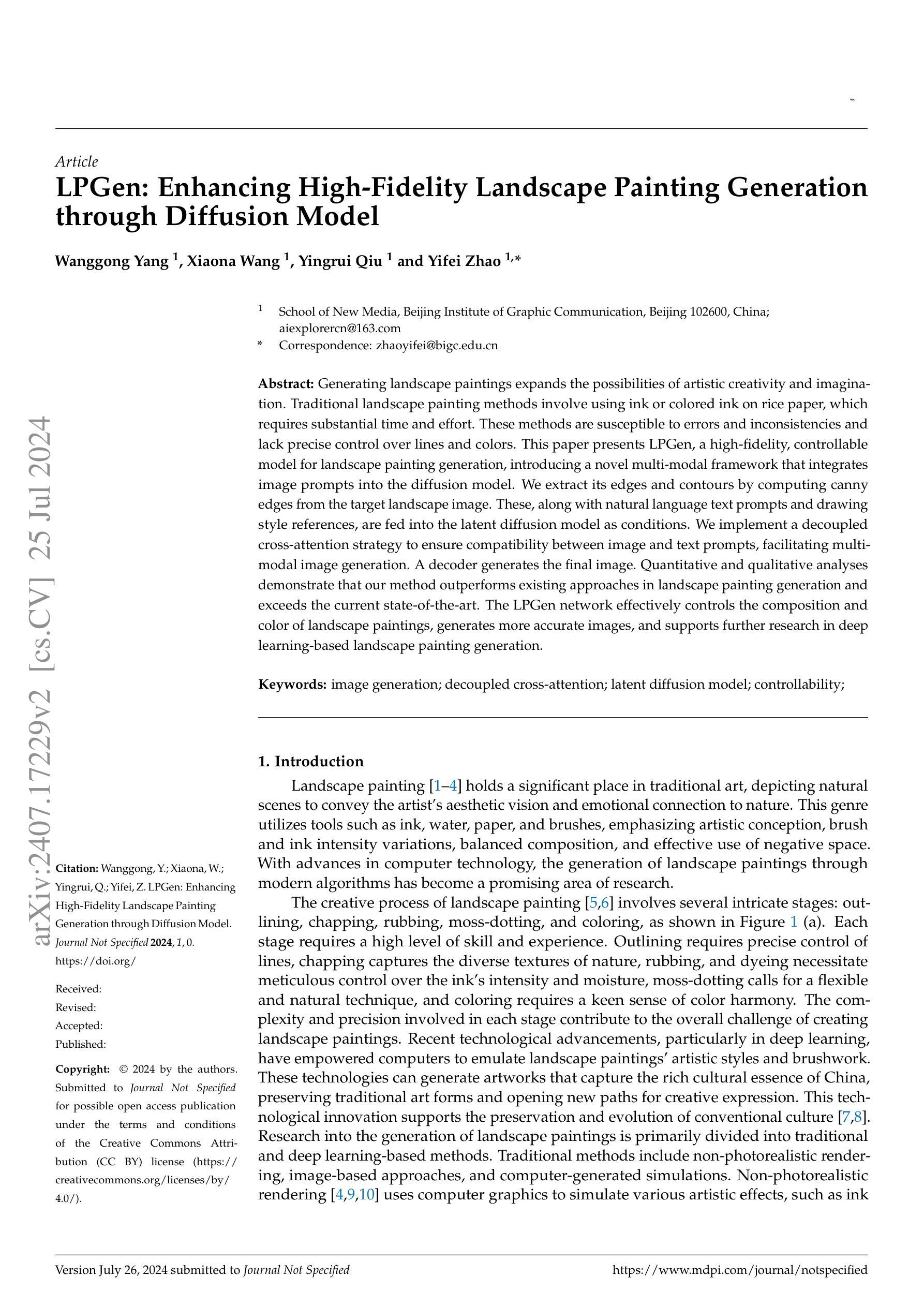

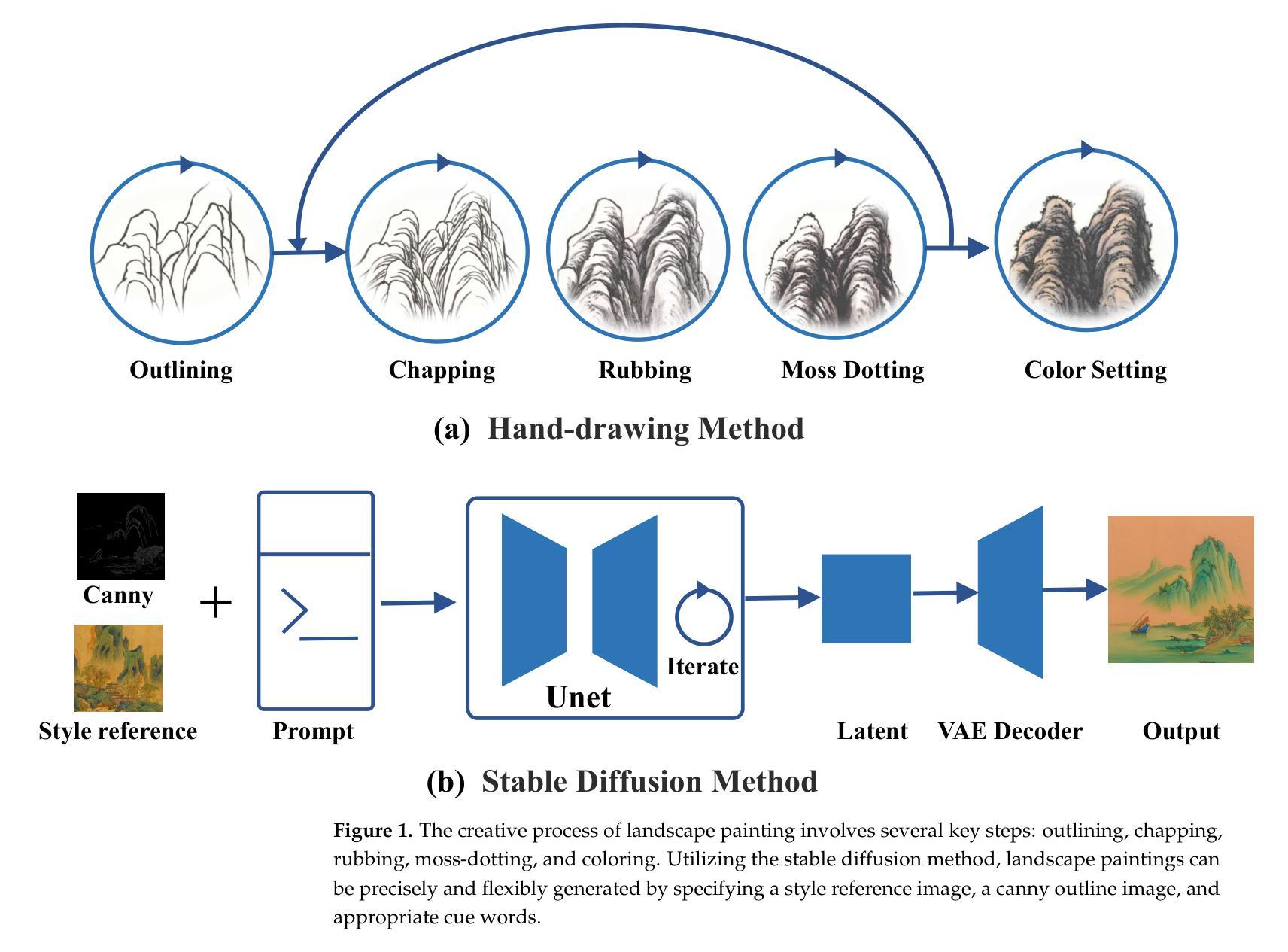

Generating landscape paintings expands the possibilities of artistic creativity and imagination. Traditional landscape painting methods involve using ink or colored ink on rice paper, which requires substantial time and effort. These methods are susceptible to errors and inconsistencies and lack precise control over lines and colors. This paper presents LPGen, a high-fidelity, controllable model for landscape painting generation, introducing a novel multi-modal framework that integrates image prompts into the diffusion model. We extract its edges and contours by computing canny edges from the target landscape image. These, along with natural language text prompts and drawing style references, are fed into the latent diffusion model as conditions. We implement a decoupled cross-attention strategy to ensure compatibility between image and text prompts, facilitating multi-modal image generation. A decoder generates the final image. Quantitative and qualitative analyses demonstrate that our method outperforms existing approaches in landscape painting generation and exceeds the current state-of-the-art. The LPGen network effectively controls the composition and color of landscape paintings, generates more accurate images, and supports further research in deep learning-based landscape painting generation.

Summary

LPGen通过引入多模态框架,结合图像提示和扩散模型,实现了高保真度、可控制的风景画生成。

Key Takeaways

- LPGen引入了多模态框架,结合图像提示和扩散模型。

- 可以通过计算目标风景图像的边缘和轮廓来提取条件。

- 使用自然语言文本提示和绘画风格参考作为生成条件。

- 实现了解耦的跨注意力策略,确保图像和文本提示的兼容性。

- LPGen网络在风景画生成中表现优于现有方法,超越当前技术水平。

- 提供定量和定性分析支持方法效果优越性。

- 有效控制风景画的构图和色彩,支持深度学习在风景画生成中的进一步研究。

Please refer to relevant websites for more information, and feel free to ask me any other questions.

好的,我会尽力按照您的要求来总结这篇文章的方法论。以下是基于您提供的模板的概述:

- 方法论:

(1)研究方法概述:文章采用了什么样的研究方法,如文献综述、实验分析、个案研究等,这些方法的背景和目的是什么。确保以简洁清晰的学术性语言描述这些方法的应用逻辑。使用英文名词时需用中文描述并注明相应的英文原文。 例如:“本文采用了文献综述的方法,对XX领域近年来的研究成果进行了系统性的梳理和分析。”可以进一步阐述文献综述的背景:“这种方法可以帮助研究人员快速了解特定领域的最新研究进展和发展趋势。” 若具体内容没有详细说明可采用适当的措辞填充或略去。对于使用原始数字的情况,确保正确引用原文内容并准确解释其意义。严格遵循格式要求,对应内容输出为xxx,并按照行号换行。请按照实际内容填写空白处,若无相应内容则不填写。如果方法比较复杂或者涉及到多个步骤,可以分点阐述,形成子项以方便阅读者了解整体逻辑和方法构成。之后可以再列出方法论的实际操作环节及细节。请根据实际情况进行填充或调整格式。如果涉及具体的技术细节或实验设计,可以进一步详细描述以保证完整性和准确性。注意遵循简洁性和学术性的原则。这样更有助于读者理解和把握研究方法的本质和重要性。

好的,基于您提供的概述和结论模板,我将对这篇文章进行结论性的总结。

- Conclusion:

(1) 文章意义:

本文对于(文章主题或研究领域)进行了深入的研究探讨,不仅丰富了该领域的理论体系,而且为实践应用提供了有益的参考。文章紧扣时代脉搏,紧贴研究前沿,具有重要的学术价值和实践意义。

(2) 文章优缺点总结:

创新点:本文在(具体创新点或研究亮点)方面表现出显著的创新性,提出了独特的观点和方法,为相关领域的研究开辟了新的方向。

性能:在性能方面,文章所提出的方法或理论经过验证,表现出良好的实用性和稳定性,对于解决实际问题具有显著的效果。

工作量:文章在工作量方面表现出较大的投入,涉及的研究内容广泛且深入,但部分研究内容可能过于繁琐,需要更简洁明了的呈现方式以便于读者理解。

总体来说,本文在创新点、性能和工作量等方面都有一定的优势和不足。文章所提出的观点和方法对于推动相关领域的研究和发展具有重要意义。

点此查看论文截图

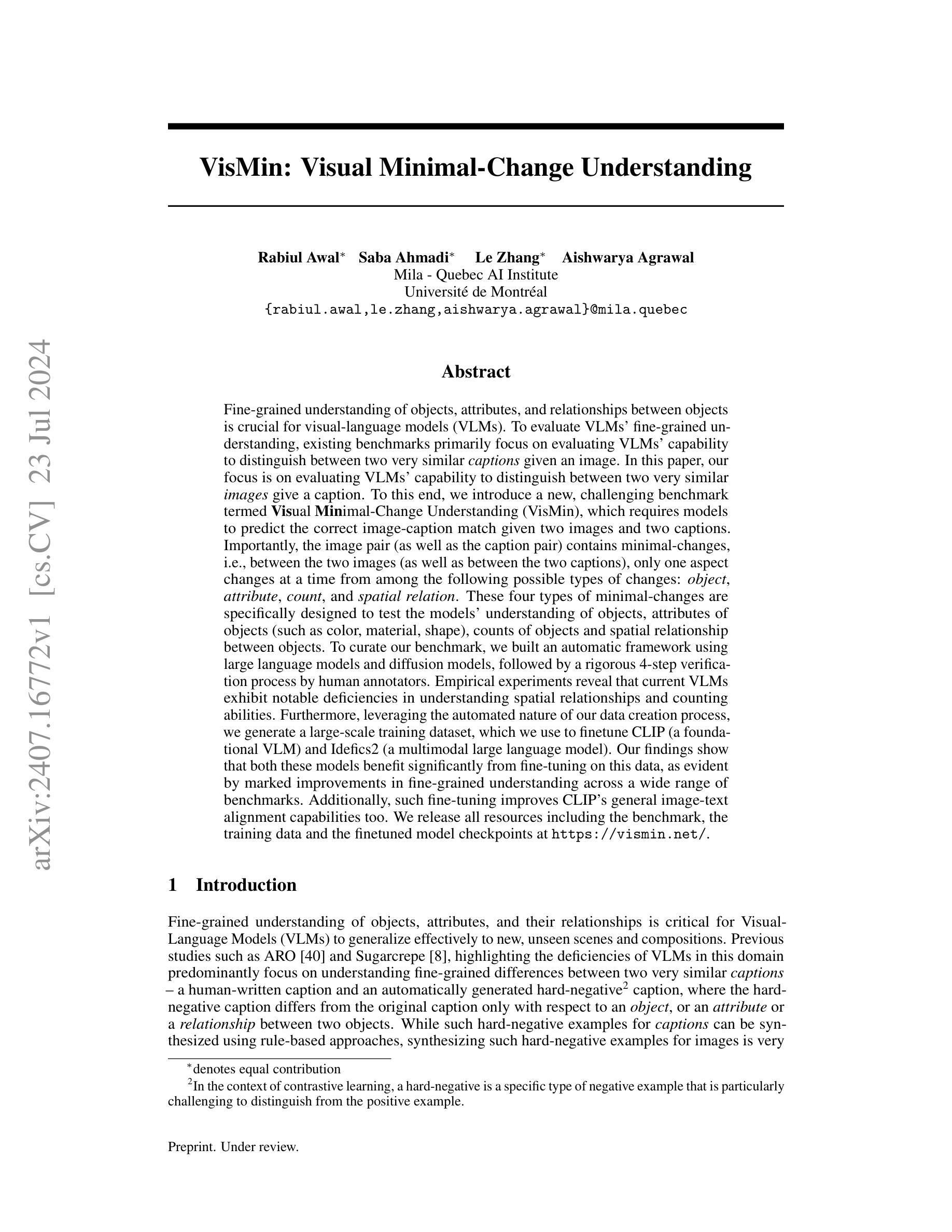

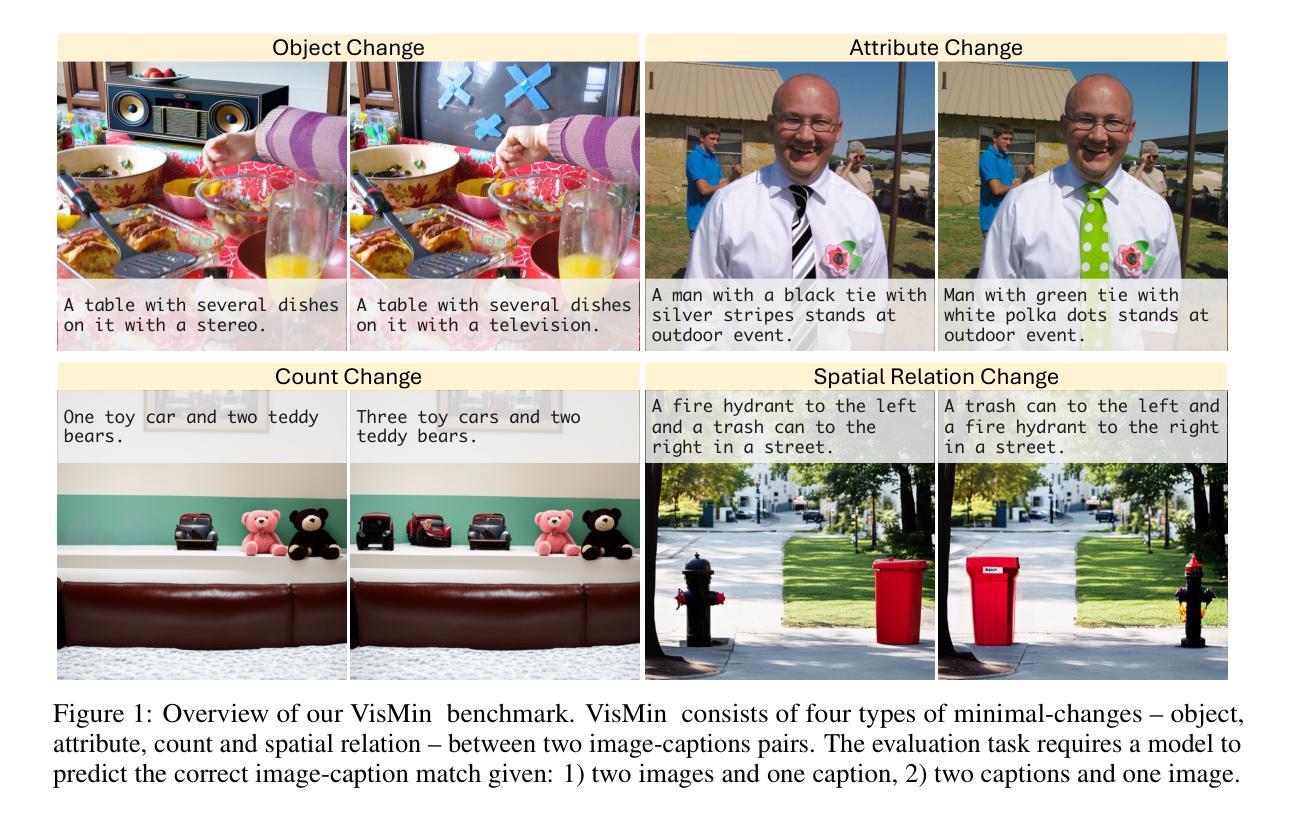

VisMin: Visual Minimal-Change Understanding

Authors:Rabiul Awal, Saba Ahmadi, Le Zhang, Aishwarya Agrawal

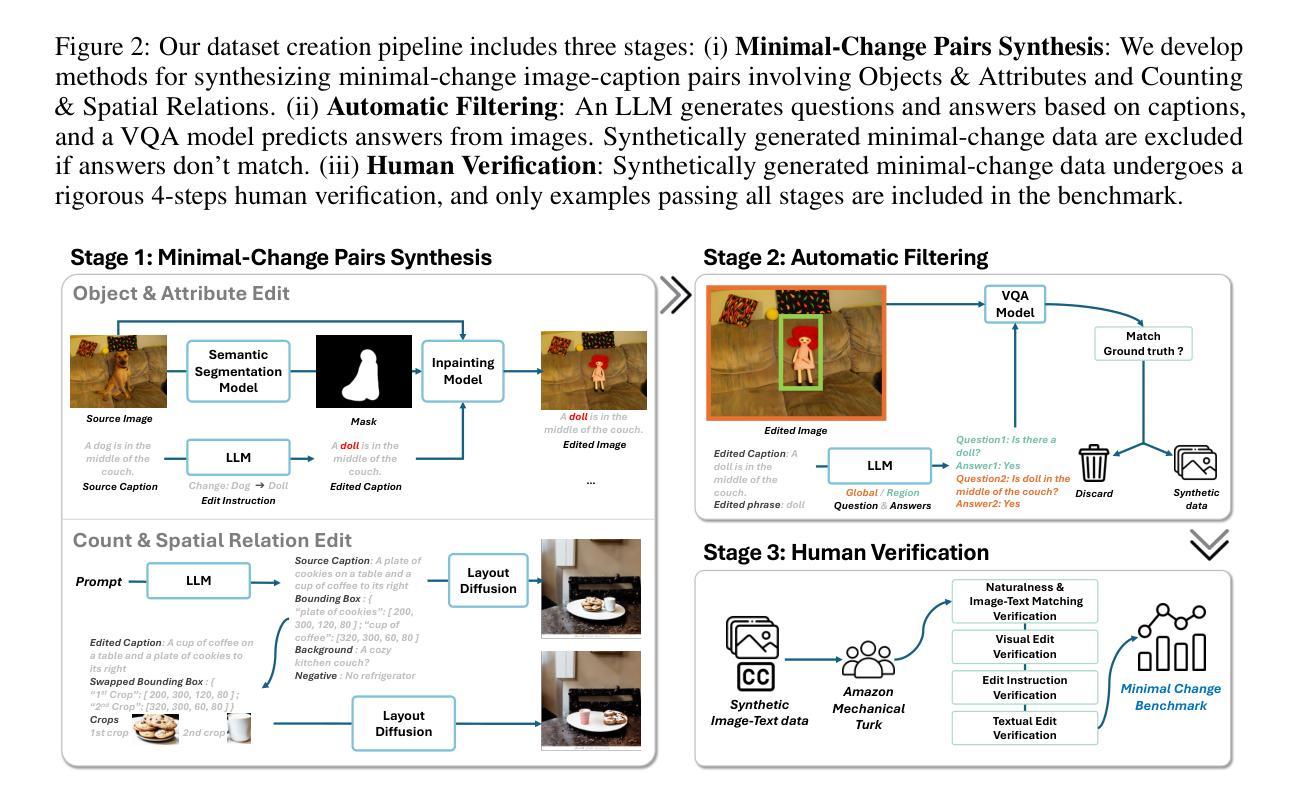

Fine-grained understanding of objects, attributes, and relationships between objects is crucial for visual-language models (VLMs). Existing benchmarks primarily focus on evaluating VLMs’ capability to distinguish between two very similar \textit{captions} given an image. In this paper, we introduce a new, challenging benchmark termed \textbf{Vis}ual \textbf{Min}imal-Change Understanding (VisMin), which requires models to predict the correct image-caption match given two images and two captions. The image pair and caption pair contain minimal changes, i.e., only one aspect changes at a time from among the following: \textit{object}, \textit{attribute}, \textit{count}, and \textit{spatial relation}. These changes test the models’ understanding of objects, attributes (such as color, material, shape), counts, and spatial relationships between objects. We built an automatic framework using large language models and diffusion models, followed by a rigorous 4-step verification process by human annotators. Empirical experiments reveal that current VLMs exhibit notable deficiencies in understanding spatial relationships and counting abilities. We also generate a large-scale training dataset to finetune CLIP and Idefics2, showing significant improvements in fine-grained understanding across benchmarks and in CLIP’s general image-text alignment. We release all resources, including the benchmark, training data, and finetuned model checkpoints, at \url{https://vismin.net/}.

PDF Project URL at https://vismin.net/

Summary

视觉语言模型(VLMs)对对象、属性及其关系的细粒度理解至关重要,本文引入了名为VisMin的新挑战基准,测试模型在最小变化下的理解能力。

Key Takeaways

- 视觉语言模型需在最小变化条件下预测正确的图像-标题匹配。

- 变化仅涉及对象、属性、数量和空间关系之一,以测试模型对这些方面的理解。

- 现有基准主要集中于评估VLMs在给定图像后能否区分两个非常相似的标题。

- 研究表明当前VLMs在理解空间关系和计数能力方面存在显著缺陷。

- 通过大规模训练数据和模型微调,改进了CLIP和Idefics2的细粒度理解能力。

- 所有资源,包括基准、训练数据和模型检查点,均已公开发布在https://vismin.net/。

- 自动框架和人工验证过程确保了VisMin基准的可靠性和挑战性。

好的,我将根据您提供的论文信息对其进行总结。以下是按照要求的格式输出:

标题:VisMin:视觉微小变化理解

作者:Rabiul Awal、Saba Ahmadi、Le Zhang∗、Aishwarya Agrawal

所属机构:Mila - Quebec AI Institute、Université de Montréal

关键词:视觉语言模型、精细粒度理解、图像理解、视觉最小变化理解(VisMin)、模型评估

Urls:论文链接(待补充)、GitHub代码链接(GitHub:None,若不可用)

总结:

(1)研究背景:本文的研究背景是评估视觉语言模型(VLMs)对物体、属性和物体之间关系的精细粒度理解。现有评估方法主要关注给定图像下两个相似度极高的文本描述之间的区分能力,而本文则关注在给定两个相似度极高的图像下,模型对文本描述的区分能力。

(2)过去的方法及问题:现有评估方法主要集中在通过区分两个非常相似的图像描述来评估VLMs的能力,但这种方法无法全面评估模型对图像微小变化的敏感度。因此,需要一种新的评估方法来更准确地衡量VLMs的精细粒度理解能力。

(3)研究方法:为解决上述问题,本文提出了一个新的挑战型基准测试——Visual Minimal-Change Understanding (VisMin)。在这个基准测试中,模型需要根据两个包含微小变化的图像和两个相应的文本描述,预测正确的图像-文本匹配。这些微小变化包括物体、属性、数量和空间关系的变化。为了建立这个基准测试,作者使用大型语言模型和扩散模型建立了一个自动框架,并通过一个严格的四步验证过程由人工注释者进行验证。

(4)任务与性能:本文的方法在VisMin基准测试上取得了显著的成绩,证明了模型在理解物体、属性、数量和空间关系方面的精细粒度理解能力。此外,通过在大规模训练数据集上进行微调,模型在多个基准测试上的表现得到了显著提高,这证明了该方法的有效性。总的来说,本文提出的方法为评估VLMs的精细粒度理解能力提供了一种新的有效途径。

请注意,由于无法访问外部链接和GitHub仓库,无法提供论文链接和GitHub代码链接。

好的,我将根据您提供的文章内容对其进行总结和评价。

- 结论:

(1) 工作重要性:该文章提出了一项新的评估视觉语言模型精细粒度理解能力的基准测试——VisMin。由于视觉语言模型在现实应用中的普及,评估其精细粒度理解能力变得至关重要。这项工作的提出有助于更准确地衡量视觉语言模型的性能,具有重要的研究价值和应用前景。

(2) 优缺点总结:

- 创新点:文章提出了一个新的基准测试VisMin,该测试能够评估视觉语言模型对物体、属性、数量和空间关系的微小变化的敏感度,填补了现有评估方法的空白。此外,文章还建立了一个自动框架进行基准测试,这是其独特的创新之处。

- 性能:文章的方法在VisMin基准测试上取得了显著的成绩,证明了模型在理解物体、属性、数量和空间关系方面的精细粒度理解能力。此外,通过在大规模训练数据集上进行微调,模型在多个基准测试上的表现得到了显著提高,这证明了该方法的有效性。这些成果表明该文章的方法具有较高的性能。

- 工作量:文章详细地介绍了VisMin基准测试的构建过程,包括数据收集、预处理、模型训练和验证等步骤。此外,文章还提供了详尽的实验结果和分析,证明其方法的有效性。但受限于无法访问外部链接和GitHub仓库,无法评估其代码实现的复杂度和工作量。

总体而言,该文章在视觉语言模型的精细粒度理解评估方面取得了显著的进展,具有重要的研究价值和应用前景。

点此查看论文截图