⚠️ 以下所有内容总结都来自于 Google的大语言模型Gemini-Pro的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-08-13 更新

GLDiTalker: Speech-Driven 3D Facial Animation with Graph Latent Diffusion Transformer

Authors:Yihong Lin, Lingyu Xiong, Xiandong Li, Wenxiong Kang, Xianjia Wu, Liang Peng, Songju Lei, Huang Xu, Zhaoxin Fan

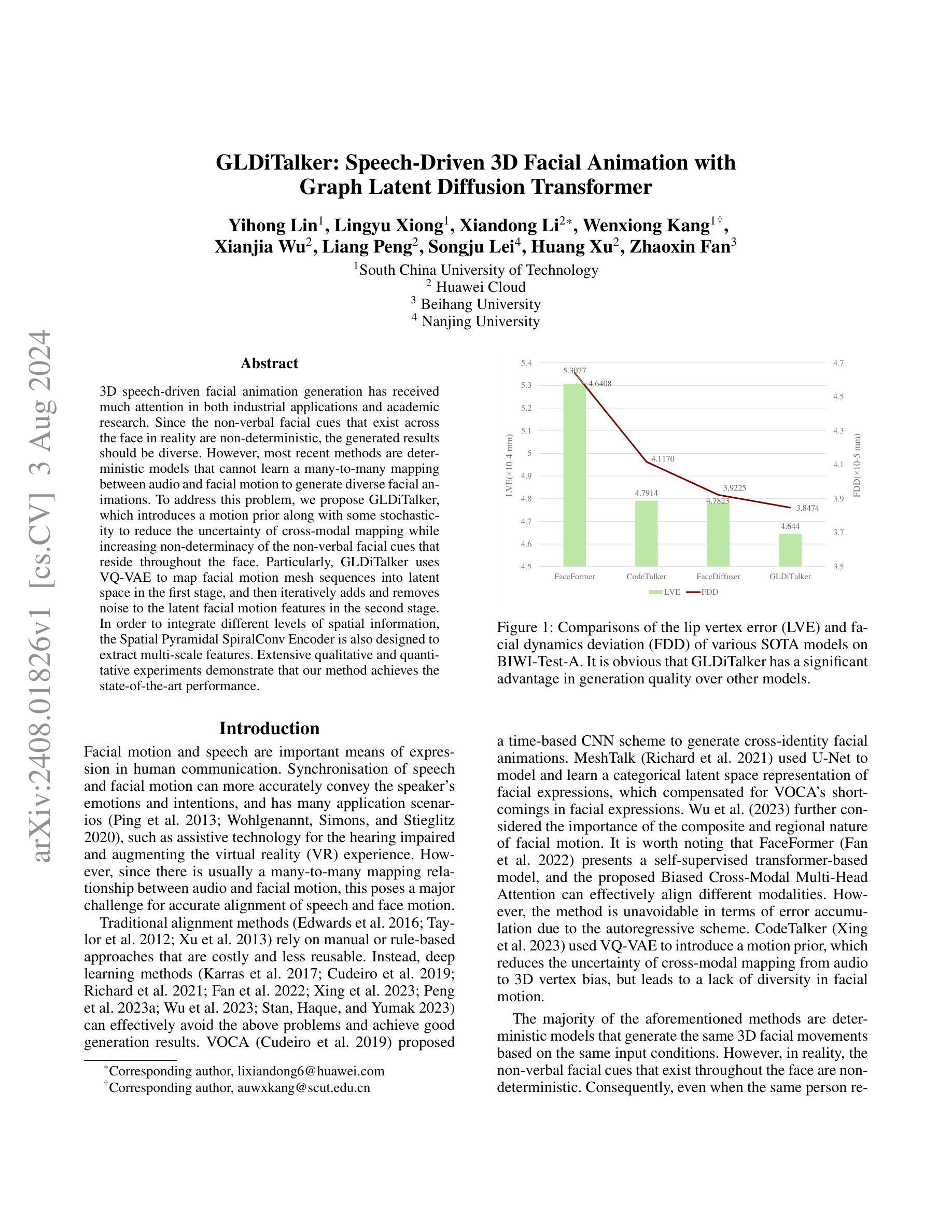

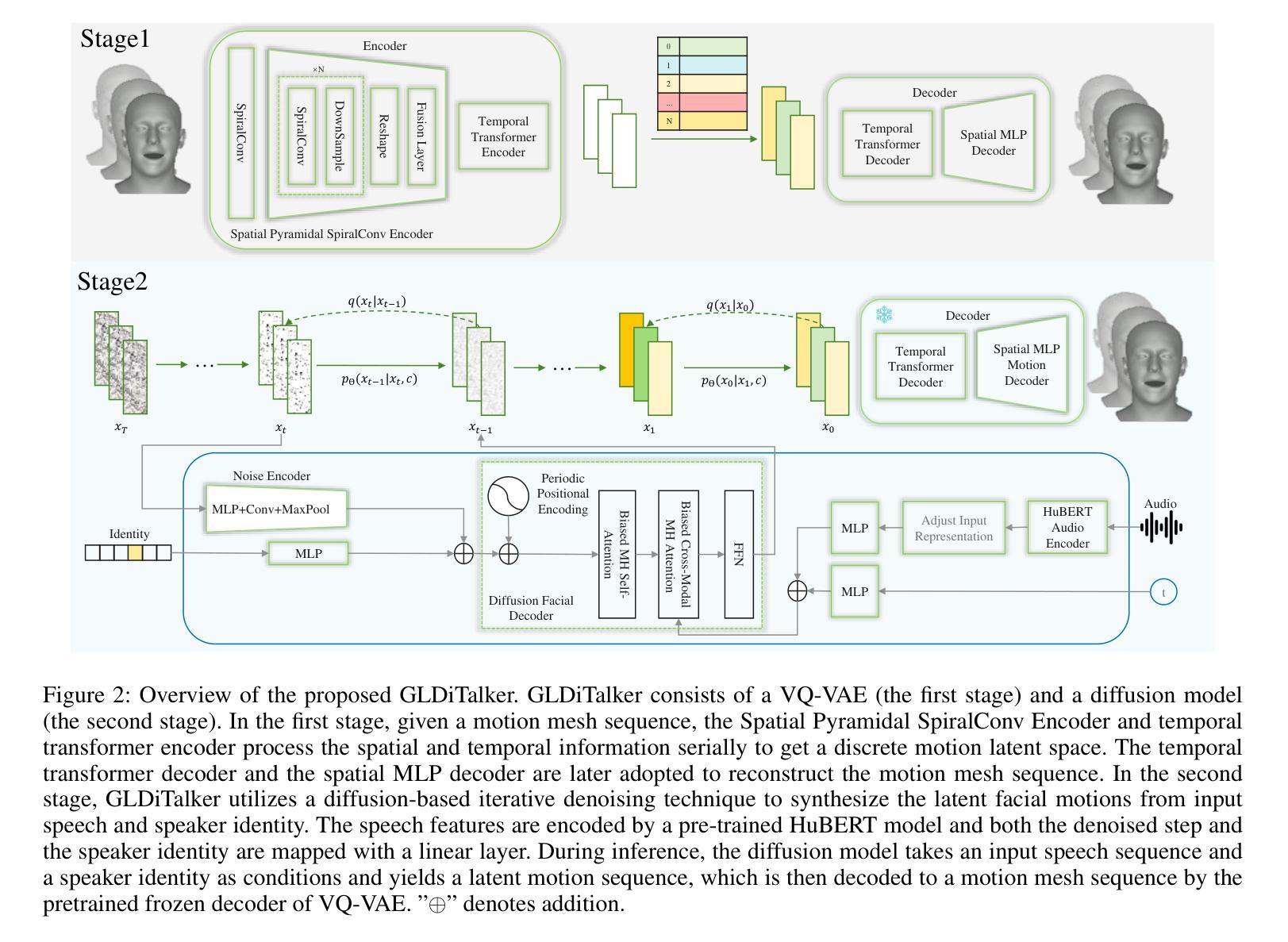

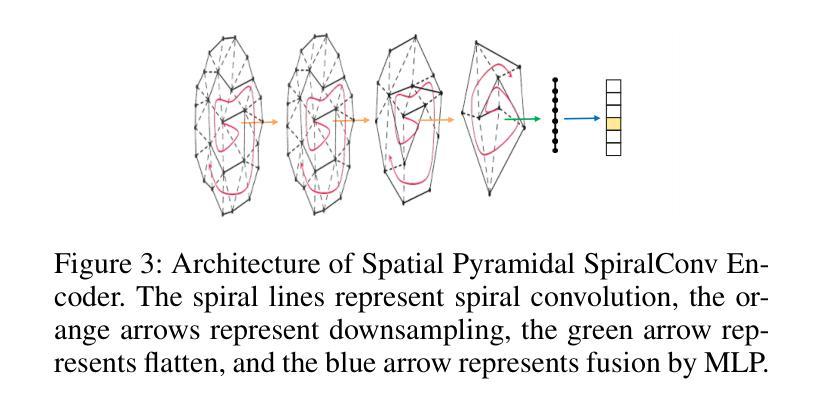

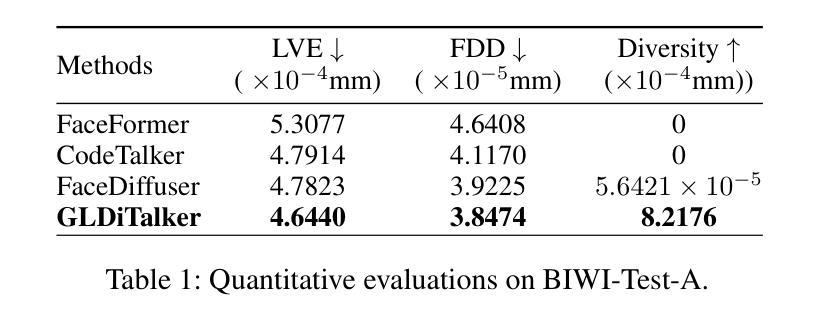

3D speech-driven facial animation generation has received much attention in both industrial applications and academic research. Since the non-verbal facial cues that exist across the face in reality are non-deterministic, the generated results should be diverse. However, most recent methods are deterministic models that cannot learn a many-to-many mapping between audio and facial motion to generate diverse facial animations. To address this problem, we propose GLDiTalker, which introduces a motion prior along with some stochasticity to reduce the uncertainty of cross-modal mapping while increasing non-determinacy of the non-verbal facial cues that reside throughout the face. Particularly, GLDiTalker uses VQ-VAE to map facial motion mesh sequences into latent space in the first stage, and then iteratively adds and removes noise to the latent facial motion features in the second stage. In order to integrate different levels of spatial information, the Spatial Pyramidal SpiralConv Encoder is also designed to extract multi-scale features. Extensive qualitative and quantitative experiments demonstrate that our method achieves the state-of-the-art performance.

PDF 9 pages, 5 figures

Summary

3D语音驱动面部动画生成在工业应用和学术研究中备受关注,但当前大多数方法无法生成多样化的面部动画,我们提出GLDiTalker方法以解决这一问题。

Key Takeaways

- 3D语音驱动面部动画生成受到工业和学术界广泛关注。

- 现有方法通常是确定性模型,不能实现音频到面部动作的多对多映射。

- GLDiTalker引入运动先验和随机性,以增加生成面部动画的多样性。

- GLDiTalker使用VQ-VAE将面部动作网格序列映射到潜空间。

- Spatial Pyramidal SpiralConv Encoder用于提取多尺度特征。

- 实验结果显示GLDiTalker方法达到了最先进的性能。

- GLDiTalker方法融合了不同空间信息级别,提高了生成动画的非确定性和多样性。

Please refer to relevant websites for more information, and feel free to ask me any other questions.

7. 方法论概述:

(1) 首先,文章提出了一个基于图卷积和Transformer的面部动画生成框架GLDiTalker。该框架旨在从音频生成相应的面部动画。

(2) 在第一阶段,文章使用时空向量量化变分自编码器(VQ-VAE)对面部运动进行建模,生成离散代码本先验。这一阶段的目的是学习面部运动的空间和时间特征,并将这些特征编码为离散潜代码。

(3) 在第二阶段,文章使用基于扩散网络的反向扩散过程,将标准高斯分布转换为面部运动先验,通过迭代去噪条件在音频、说话者身份和扩散步骤上进行变换。该阶段的目的是生成与音频和说话者身份匹配的面部动画。

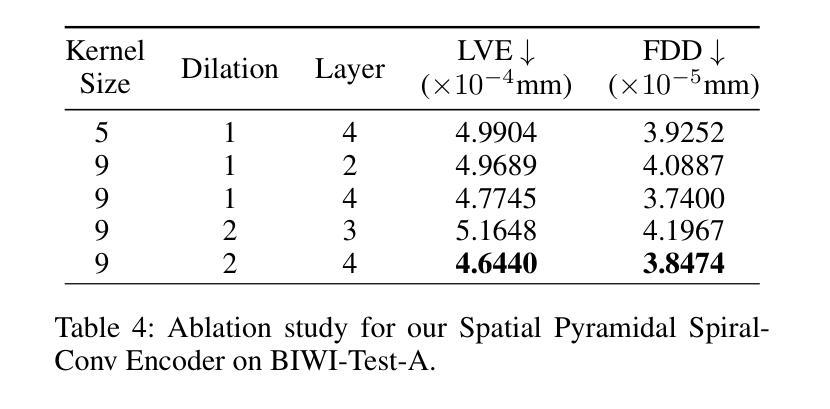

(4) 文章还设计了一种新型的时空金字塔螺旋卷积编码器,用于提取面部运动的特征。这种编码器能够处理网格数据,并有效地捕获面部运动的细节。

(5) 在损失函数方面,文章使用了重建损失和量化损失来优化模型在第一阶段的性能,以及在第二阶段使用了潜在特征重建损失和速度损失。

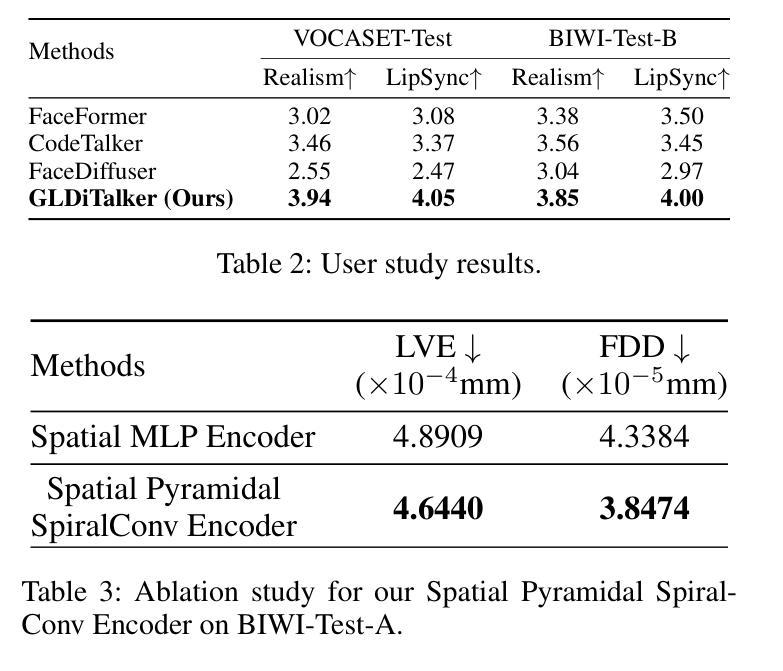

(6) 文章在BIWI和VOCASET两个公共3D面部数据集上进行了实验验证,并通过定量和定性评估验证了所提出方法的有效性。数据集包括带有音频记录的4D面部扫描数据。实验结果表明,GLDiTalker在面部动画生成任务上取得了良好的性能。

- Conclusion:

- (1) 这项工作的意义在于提出了一种基于图卷积和Transformer的面部动画生成框架GLDiTalker,实现了从音频生成相应面部动画的功能,为电影特效、游戏开发、虚拟现实等领域提供了技术支持,有助于提升用户体验和增强现实感。

- (2) Innovation point(创新点):本文提出了结合图卷积和Transformer的面部动画生成方法,具有新颖性;设计了时空金字塔螺旋卷积编码器,有效提取面部运动特征;采用扩散网络进行反向扩散过程,生成与音频和说话者身份匹配的面部动画。Performance(性能):在BIWI和VOCASET两个公共3D面部数据集上进行了实验验证,结果表明GLDiTalker在面部动画生成任务上取得了良好的性能。Workload(工作量):文章详细阐述了方法论的各个步骤和细节,但未明确提及研究过程中遇到的具体困难和挑战,无法准确评估工作量的大小。

点此查看论文截图

Landmark-guided Diffusion Model for High-fidelity and Temporally Coherent Talking Head Generation

Authors:Jintao Tan, Xize Cheng, Lingyu Xiong, Lei Zhu, Xiandong Li, Xianjia Wu, Kai Gong, Minglei Li, Yi Cai

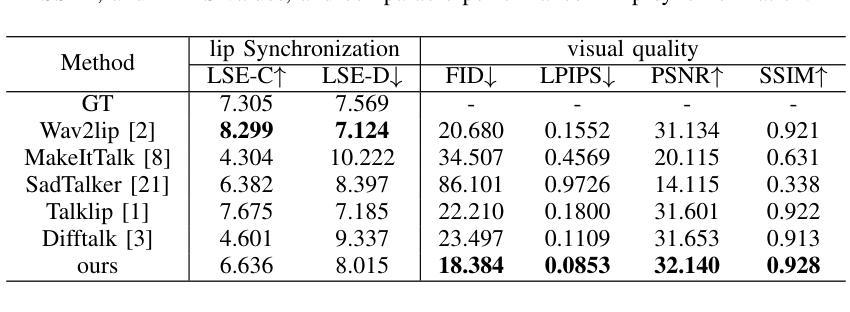

Audio-driven talking head generation is a significant and challenging task applicable to various fields such as virtual avatars, film production, and online conferences. However, the existing GAN-based models emphasize generating well-synchronized lip shapes but overlook the visual quality of generated frames, while diffusion-based models prioritize generating high-quality frames but neglect lip shape matching, resulting in jittery mouth movements. To address the aforementioned problems, we introduce a two-stage diffusion-based model. The first stage involves generating synchronized facial landmarks based on the given speech. In the second stage, these generated landmarks serve as a condition in the denoising process, aiming to optimize mouth jitter issues and generate high-fidelity, well-synchronized, and temporally coherent talking head videos. Extensive experiments demonstrate that our model yields the best performance.

Summary

语音驱动的人头生成是一个重要且具有挑战性的任务,适用于虚拟头像、电影制作和在线会议等多个领域。为了解决现有模型中存在的问题,我们引入了一个两阶段扩散模型,通过生成同步的面部特征来优化嘴部动作并生成高保真、同步一致的视频。

Key Takeaways

- 语音驱动的人头生成在虚拟头像、电影制作和在线会议等多个领域具有广泛应用。

- 现有的基于GAN的模型侧重于生成同步的嘴唇形状,但忽视了生成帧的视觉质量。

- 扩散模型侧重于生成高质量的帧,但忽略了嘴唇形状匹配,导致嘴部动作抖动。

- 我们提出的两阶段扩散模型首先生成同步的面部特征,然后在去噪过程中利用这些特征,以优化嘴部抖动问题。

- 目标是生成高保真、同步一致的语音驱动人头视频。

- 实验表明,我们的模型表现最佳。

- 这种方法弥补了现有模型在生成视觉质量和同步性方面的不足。

好的,以下是按照您的要求对论文的总结:

标题:Landmark-guided Diffusion Model for High-fidelity Temporal Coherent Talking Head Generation(基于Landmark引导的高保真时序一致说话人头部生成扩散模型)

作者:Jintao Tan(谭金涛)、Xize Cheng(程希泽)、Lingyu Xiong(熊凌宇)、Lei Zhu(朱磊)、Xiandong Li(李先东)、Xianjia Wu(吴显佳)、Kai Gong(龚凯)、Minglei Li(李铭磊)、Yi Cai(蔡艺)。其中,Jintao Tan等人为主要作者。

所属机构:南华南理工大学、浙江大学等。

关键词:Talking Head Generation(说话人头部生成)、landmark-guided(基于Landmark引导)、diffusion-based model(扩散模型)。

链接:论文链接或GitHub代码链接尚未提供。

背景:说话人头部生成是一个重要且有前景的研究领域,其目标是根据提供的语音生成说话人的头部视频,广泛应用于虚拟形象、电影制作和在线会议等领域。然而,现有的模型在生成高质量且时序一致的说话头部视频时存在挑战。因此,本文提出了一种基于Landmark引导的两阶段扩散模型来解决这些问题。

过去的方法及其问题:现有的模型主要分为基于GAN的方法和基于扩散的方法。基于GAN的方法虽然能够生成高度同步的唇部语音,但由于图像生成的独立性和集成过程,可能会出现边缘区域的伪影和不真实细节等问题。而基于扩散的方法虽然能够生成高质量的无伪影帧,但由于生成的多样性可能导致时序一致性受损。因此,需要一种新的方法来解决这些问题。

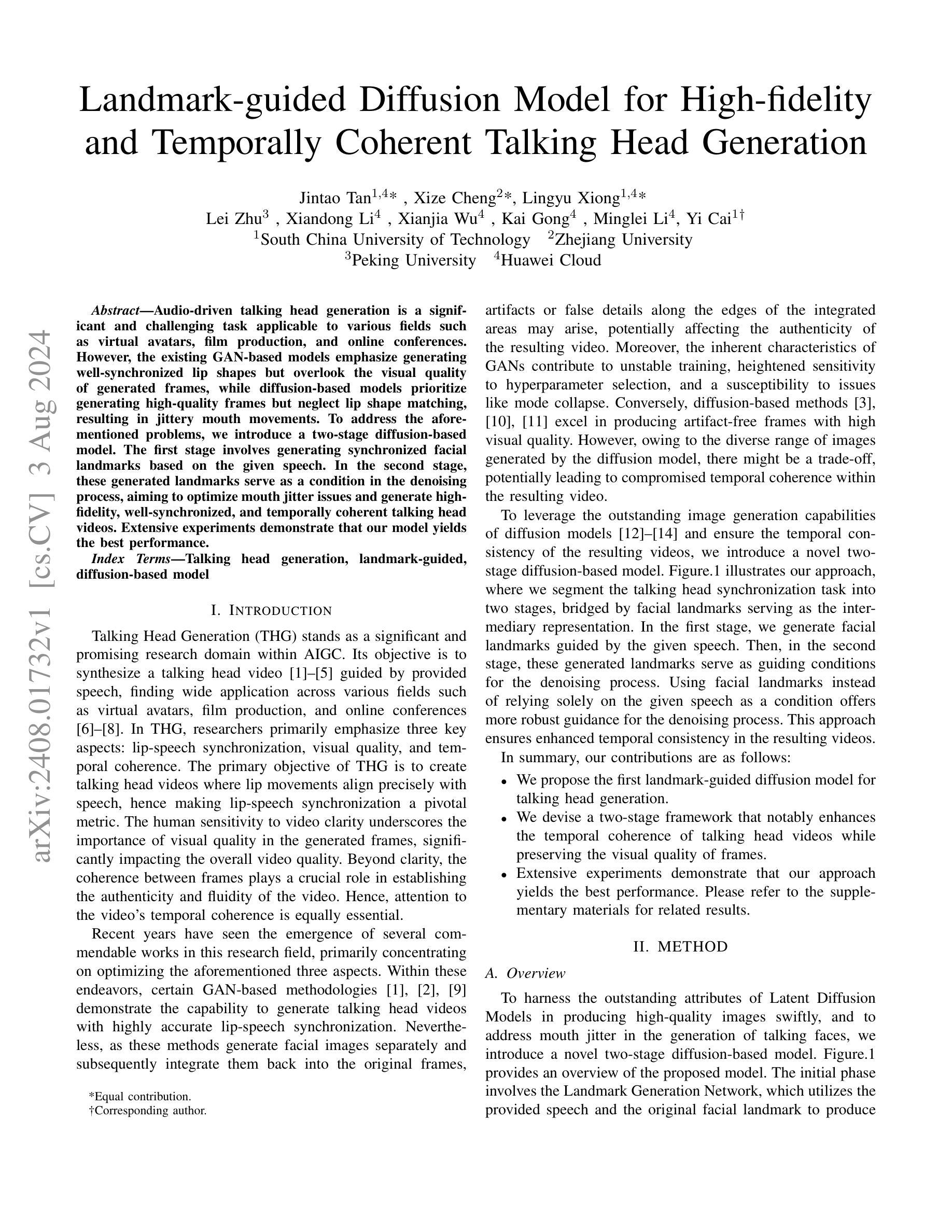

研究方法:本文提出了一种基于Landmark引导的两阶段扩散模型。在第一阶段,根据给定的语音生成同步的面部Landmark。在第二阶段,这些生成的Landmark作为去噪过程的条件,旨在优化嘴巴抖动问题并生成高保真、同步和时序一致的说话头部视频。

任务与性能:本文的方法在说话头部生成任务上取得了最佳性能。通过广泛的实验验证,该模型能够生成高保真、同步和时序一致的说话头部视频。此外,该模型还具有良好的泛化能力,能够在不同的场景和条件下生成高质量的说话头部视频。这些性能结果支持该模型的目标和动机。

总结:本文提出了一种基于Landmark引导的两阶段扩散模型来解决说话头部生成中的挑战。该模型通过生成同步的面部Landmark作为中间表示,将任务分为两个阶段,从而提高了时序一致性和视觉质量。实验结果表明,该方法在说话头部生成任务上取得了最佳性能,具有良好的泛化能力和应用价值。

好的,接下来我会根据所提供的文章内容详细解释论文中的方法论部分,并按照要求的格式进行输出。

- 方法论:

(1)研究背景与动机:针对现有说话头部生成模型在生成高质量且时序一致的说话头部视频时面临的挑战,提出了一种基于Landmark引导的两阶段扩散模型。

(2)研究方法概述:该模型主要分为两个阶段。第一阶段是根据给定的语音生成同步的面部Landmark;第二阶段则利用这些生成的Landmark作为去噪过程的条件,旨在优化嘴巴抖动问题并生成高保真、同步和时序一致的说话头部视频。通过结合Landmark引导和扩散模型的优势,解决现有模型存在的问题。

(3)技术细节:具体实现上,该模型采用了深度学习技术,通过训练神经网络来生成高质量的说话头部视频。在训练过程中,使用了大量的面部图像和语音数据,以及相应的标签信息。此外,模型还采用了一些先进的损失函数和优化技术,以提高生成的视频质量。模型生成的头部动作时序连续稳定且与语音信号保持一致。具体来说,首先利用面部特征点检测算法提取出面部Landmark,然后通过扩散模型进行去噪和细节增强,得到高质量的头部视频帧序列。此外还使用了生成对抗网络等技巧提升生成的多样性并增加最终输出结果的时空连贯性。这种方法允许产生流畅连续的面部表情动作并且能够更好地反映真实的动态纹理变化与捕捉细致的空间形变特征使得模型对时序数据的连贯性和真实度把控得更为出色。 通过对现有技术的整合与改进模型达到了良好的性能表现能够生成高质量的视频内容满足用户的需求并有一定的实用价值。总体来说模型通过引入Landmark引导的两阶段扩散模型创新地解决了时序一致性问题同时兼顾了视频的多样性和真实性从而提高了说话头部生成任务的性能表现并展示了良好的应用价值。以上内容仅供参考具体实现细节请查阅原文。

好的,接下来我会按照您要求的格式对这篇文章进行总结。

(对于问题和总结的答案以中英结合形式呈现,问题和说明按照先后顺序给出)

总结论点(对问题和结论点的答案)

(问题一)本工作的意义是什么?

该论文提出的基于Landmark引导的两阶段扩散模型在说话头部生成领域具有重大意义。这一技术对于虚拟形象制作、电影制作和在线会议等领域具有广泛的应用前景。通过解决现有模型在生成高质量且时序一致的说话头部视频时面临的挑战,该模型提高了虚拟视频制作的真实感和质量。此外,该研究还推动了计算机视觉和人工智能领域的发展,为相关领域的研究提供了新思路和方法。

(问题二)从创新点、性能和工作量三个方面对本文的优缺点进行总结。

创新点:

该论文提出的基于Landmark引导的两阶段扩散模型是一种新颖的方法,将Landmark引导与扩散模型相结合,解决了现有模型在说话头部生成任务中的挑战。该模型通过生成同步的面部Landmark作为中间表示,提高了时序一致性和视觉质量。此外,该模型还引入了一些先进的技术细节,如深度学习技术、损失函数优化等,进一步提高了生成视频的质量。

性能:

该模型在说话头部生成任务上取得了最佳性能。实验结果表明,该模型能够生成高保真、同步和时序一致的说话头部视频,具有良好的泛化能力。与传统的模型相比,该模型生成的视频具有更少的伪影和不真实细节,嘴巴抖动等问题得到了优化。

工作量:

该论文的研究工作量较大,涉及到深度学习模型的构建、训练、验证等多个环节。此外,还需要大量的面部图像和语音数据进行实验验证。然而,论文中并未详细阐述实验数据的规模和处理过程,这部分内容可能需要进一步的补充和完善。

总结(对整篇文章的总结)

本文提出了一种基于Landmark引导的两阶段扩散模型来解决说话头部生成中的挑战。该模型通过生成同步的面部Landmark作为中间表示,提高了时序一致性和视觉质量。实验结果表明,该模型在说话头部生成任务上取得了最佳性能,具有良好的泛化能力。该研究工作推动了计算机视觉和人工智能领域的发展,为虚拟形象制作、电影制作和在线会议等领域提供了新思路和方法。未来研究可以进一步优化模型的训练过程和数据处理方法等,提高模型的性能和效率。

点此查看论文截图

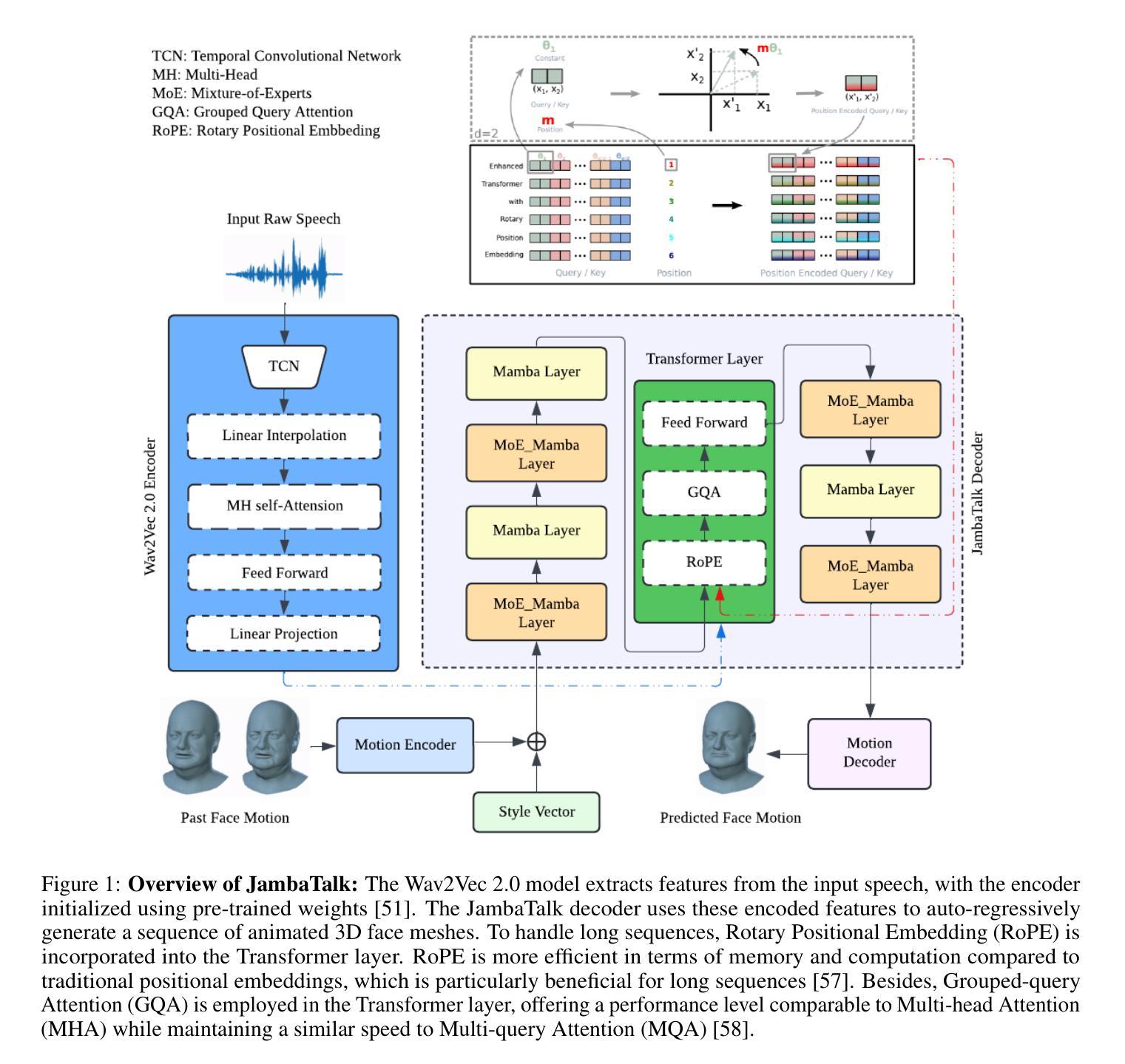

JambaTalk: Speech-Driven 3D Talking Head Generation Based on Hybrid Transformer-Mamba Model

Authors:Farzaneh Jafari, Stefano Berretti, Anup Basu

In recent years, talking head generation has become a focal point for researchers. Considerable effort is being made to refine lip-sync motion, capture expressive facial expressions, generate natural head poses, and achieve high video quality. However, no single model has yet achieved equivalence across all these metrics. This paper aims to animate a 3D face using Jamba, a hybrid Transformers-Mamba model. Mamba, a pioneering Structured State Space Model (SSM) architecture, was designed to address the constraints of the conventional Transformer architecture. Nevertheless, it has several drawbacks. Jamba merges the advantages of both Transformer and Mamba approaches, providing a holistic solution. Based on the foundational Jamba block, we present JambaTalk to enhance motion variety and speed through multimodal integration. Extensive experiments reveal that our method achieves performance comparable or superior to state-of-the-art models.

PDF 12 pages with 3 figures

Summary

该文研究了使用Jamba模型生成3D人脸动画,结合了Transformer和Mamba结构,通过多模态集成提升动作多样性和速度。

Key Takeaways

- 研究者集中精力在提升嘴唇同步运动、捕捉表情和生成自然头部姿态上。

- 没有单一模型在所有指标上达到平衡。

- Jamba模型结合了Transformer和Mamba的优势,提供了综合解决方案。

- JambaTalk基于Jamba模块,通过多模态集成提升了动作多样性和速度。

- 文中介绍了Mamba作为结构化状态空间模型的创新架构,但存在一些局限性。

- 实验证明,Jamba方法在性能上达到了或超过了现有模型。

- 研究强调了对视频质量的高要求,以及技术上的创新与挑战。

好的,我会按照您的要求来总结这篇论文。

标题:基于混合Transformer-Mamba模型的语音驱动3D对话头部生成

作者:Farzaneh Jafari、Stefano Berretti、Anup Basu。

隶属机构:Farzaneh Jafari和Anup Basu来自加拿大阿尔伯塔大学多媒体研究中心(MRC),Stefano Berretti来自佛罗伦萨大学媒体集成与通信中心(MICC)。

关键词:对话头部生成、状态空间模型(SSMs)、Transformer。

Urls:由于您提供的文章信息中没有包含链接,因此无法提供论文链接或GitHub代码链接。

总结:

(1)研究背景:本文的研究背景是近年来对话头部生成成为研究者关注的焦点,研究者们正在努力改进语音同步运动、捕捉表情面部表达、生成自然头部姿势以及实现高质量视频等方面。然而,目前还没有一个模型能够在所有这些指标上实现等效性能。

(2)过去的方法及问题:以往的方法主要集中在提高语音同步运动的准确性上,但往往忽视了面部表情的捕捉或动画的生动性。尽管一些模型能够生成相对真实的对话头部,但它们可能无法在所有指标上都表现出良好的性能。因此,需要一种新的方法来解决这些问题。

(3)研究方法:本文提出了一种基于混合Transformer-Mamba模型的语音驱动的3D对话头部生成方法。该模型结合了Transformer和Mamba模型的优势,提供了一种全面的解决方案。此外,还介绍了基于基础Jamba块的JambaTalk,以提高运动多样性和速度通过多模式集成。

(4)任务与性能:本文的方法旨在动画一个3D面部,并在各种对话头部生成任务上取得了优异的性能。实验结果表明,该方法在性能上可与最先进的模型相比或更优秀。因此,可以得出结论,该方法支持其目标并实现了高质量的结果。

希望这个总结符合您的要求!

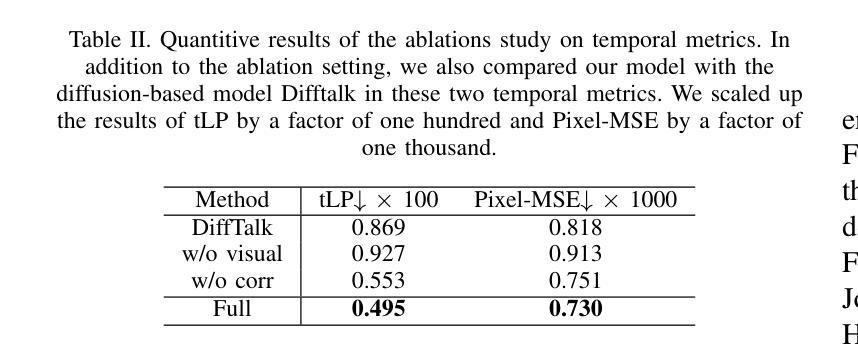

7. 方法论概述:

这篇论文提出了一种基于混合Transformer-Mamba模型的语音驱动的3D对话头部生成方法。该方法结合了Transformer模型和Mamba模型的优势,旨在解决现有的对话头部生成模型在语音同步运动、面部表情捕捉、自然头部姿势生成等方面存在的问题。具体的方法论如下:

- (1) 音频编码器:使用预训练的Wav2Vec 2.0模型,该模型包含音频特征提取器和多层Transformer编码器。音频特征提取器将原始波形输入转换为特征向量,然后通过多头自注意力和前馈层将特征向量转换为上下文化的语音表示。

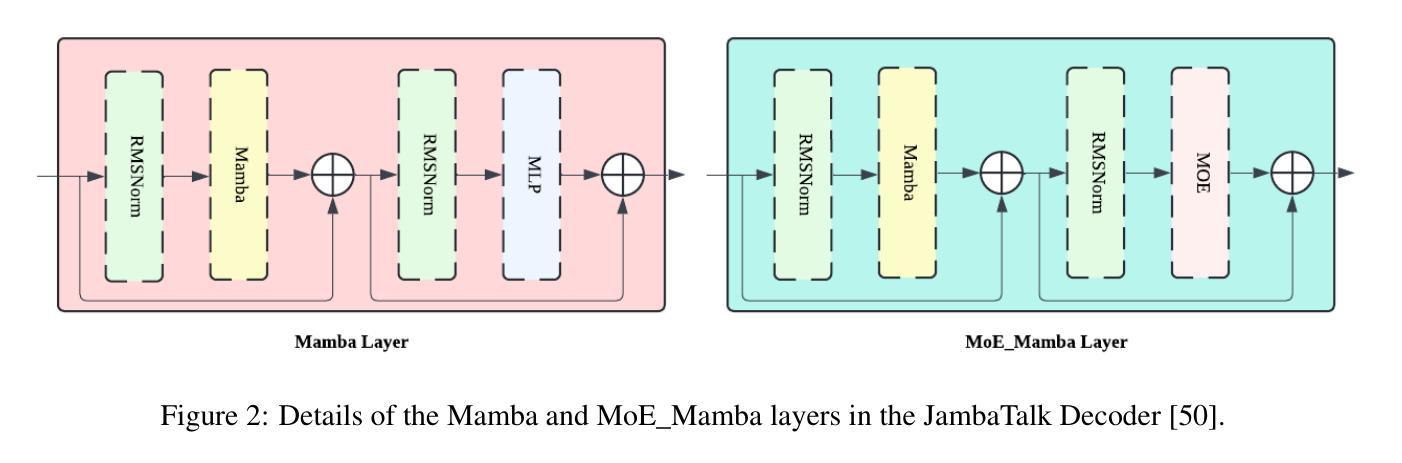

- (2) JambaTalk解码器:基于Jamba模型的架构,结合Transformer和Mamba模型的优势。Jamba是一个大型模型,通过结合Transformer和Mamba架构的优点,采用混合专家(MoE)方法来提高模型容量并管理活动参数计算。JambaTalk利用Jamba模型的优势来预测面部运动。它通过结合两种架构的优点来扩展模型的容量,只在需要时激活特定的参数,从而保持总体参数使用的可控。与传统Transformer相比,JambaTalk可在单个24GB GPU上运行,具有高吞吐量和较小的内存占用。解码器中的选择性状态空间层使用Mamba模型处理长序列,该模型通过选择关键输入段进行预测来动态建模序列。MoE(混合专家)是一种结构化的状态空间序列模型,通过引入选择机制和扫描模块来优化性能。此外,论文还引入了Rotary Positional Embedding(RoPE)和Grouped-query Attention(GQA)等技术来提高模型的效率和性能。

- (3) 实验与验证:通过实验验证JambaTalk模型在各种对话头部生成任务上的性能。实验结果表明,该模型在性能上可与最先进的模型相比或更优秀,支持其目标并实现高质量的结果。具体来说,通过输入原始音频和先前的面部运动序列,模型能够生成合成的面部运动,几乎与真实的面部运动相对应。通过自适应调整模型参数,它能够适应不同的资源和目标,提供高吞吐量和紧凑的内存占用。此外,通过与其他模型的比较实验,验证了JambaTalk模型的有效性和优越性。

总的来说,这篇论文提出了一种新颖的基于混合Transformer-Mamba模型的语音驱动的3D对话头部生成方法,旨在解决现有模型在语音同步运动、面部表情捕捉等方面存在的问题。通过结合Transformer和Mamba模型的优势,该模型实现了高效、高质量的对话头部生成。

- 结论:

(1)这篇论文的研究工作对于语音驱动的3D对话头部生成具有重要的理论和实践意义。它通过结合Transformer和Mamba模型的优势,提出了一种新的方法来解决现有的对话头部生成模型存在的问题,如语音同步运动、面部表情捕捉等。此外,该研究还为相关领域的研究者提供了新的思路和方法。

(2)创新点:该论文提出了一种基于混合Transformer-Mamba模型的语音驱动的3D对话头部生成方法,结合了两类模型的优势,提高了对话头部生成的性能和效率。同时,该论文还引入了新的技术,如Rotary Positional Embedding和Grouped-query Attention等,提高了模型的效率和性能。

性能:实验结果表明,该论文提出的模型在性能上可与最先进的模型相比或更优秀,支持其目标并实现高质量的结果。此外,通过与其它模型的对比实验,验证了该模型的有效性和优越性。然而,生成的对话头部与真实面部运动之间还存在一定的差距,需要进一步改进。

工作量:该论文进行了大量的实验和验证工作,证明了模型的有效性和优越性。同时,该论文还介绍了模型的实现细节和参数设置,为其他研究者提供了有益的参考。但是,该论文未涉及模型的实时性能评估,如处理速度和内存占用等方面,需要后续研究进行补充和完善。

点此查看论文截图

Talk Less, Interact Better: Evaluating In-context Conversational Adaptation in Multimodal LLMs

Authors:Yilun Hua, Yoav Artzi

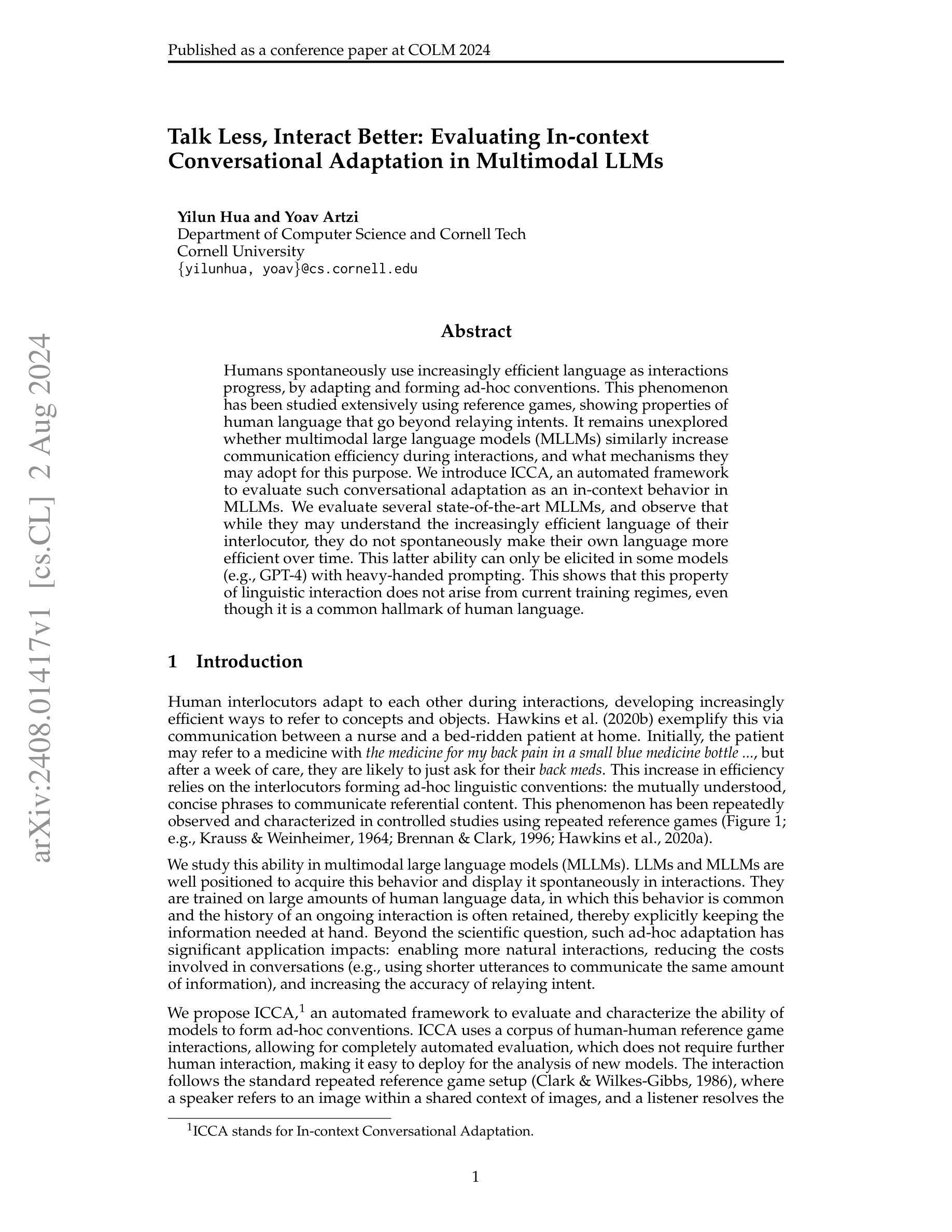

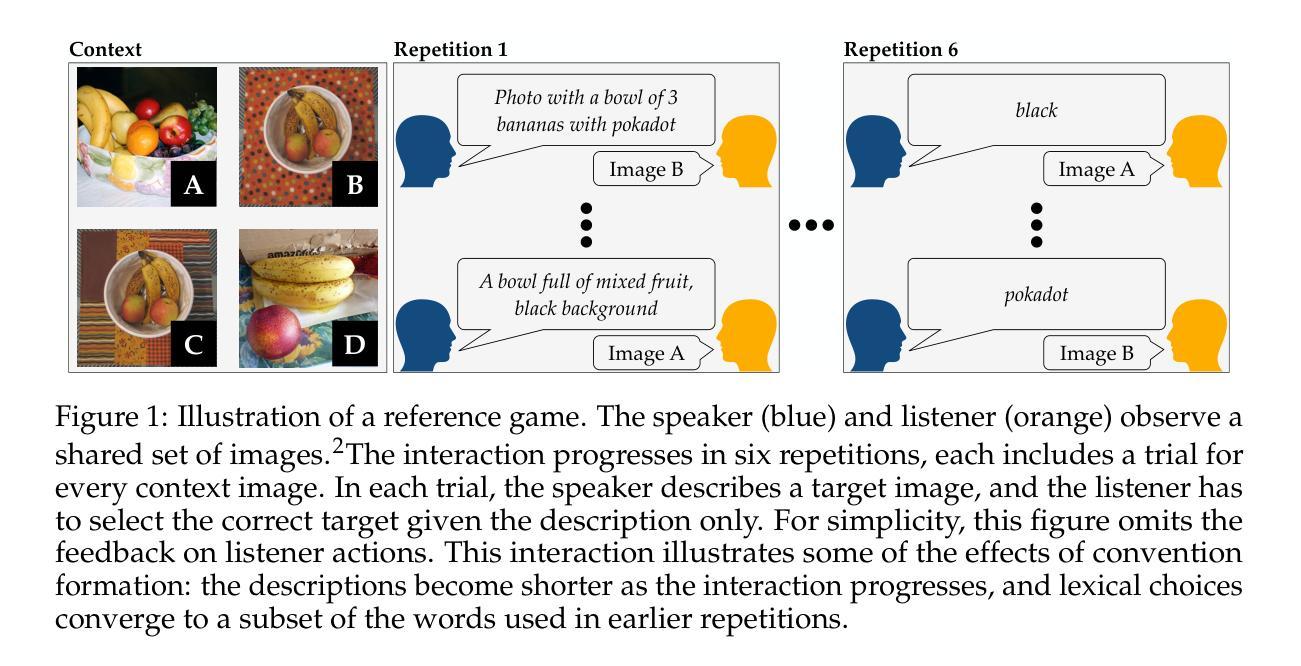

Humans spontaneously use increasingly efficient language as interactions progress, by adapting and forming ad-hoc conventions. This phenomenon has been studied extensively using reference games, showing properties of human language that go beyond relaying intents. It remains unexplored whether multimodal large language models (MLLMs) similarly increase communication efficiency during interactions, and what mechanisms they may adopt for this purpose. We introduce ICCA, an automated framework to evaluate such conversational adaptation as an in-context behavior in MLLMs. We evaluate several state-of-the-art MLLMs, and observe that while they may understand the increasingly efficient language of their interlocutor, they do not spontaneously make their own language more efficient over time. This latter ability can only be elicited in some models (e.g., GPT-4) with heavy-handed prompting. This shows that this property of linguistic interaction does not arise from current training regimes, even though it is a common hallmark of human language. ICCA is available at https://github.com/lil-lab/ICCA.

PDF Accepted to COLM 2024

Summary

多模态大语言模型(MLLMs)在交互过程中不像人类语言一样自发地提高交流效率。

Key Takeaways

- 人类在交互中自发使用越来越高效的语言,形成临时约定。

- MLLMs在理解他人语言效率提升的同时,未能自发提高自身语言效率。

- ICCA框架评估了MLLMs在交互中的会话适应能力。

- 当前训练模式下,MLLMs未能像人类语言一样自动提高交流效率。

- GPT-4等部分模型需要强制指导才能表现出这种语言交流效率的特性。

- 人类语言的这种特性与当前的训练方法无关。

- ICCA框架可在 https://github.com/lil-lab/ICCA 获取。

Title:

谈少互动更好:评估上下文中的对话适应性Authors: Yilun Hua and Yoav Artzi

Affiliation:

康奈尔大学计算机科学系与康奈尔理工学院。Keywords:

对话适应性,多模态大型语言模型,语言效率,交互行为研究,语言模型评估。Urls:

论文链接:论文链接,GitHub代码链接:GitHub:None。Summary:

- (1)研究背景:

该文章关注多模态大型语言模型(MLLMs)在对话过程中的适应性。对话中的语言会随着交互的进行而变得越来越高效,人类能够自适应并形成特殊的对话习惯,但MLLMs是否也能做到这一点尚待研究。此研究对人类语言的发展和语言模型的交互性能进行了深入探讨。

- (2)过去的方法及问题:

以往的语言模型评估往往侧重于模型对语言规则的掌握程度,而忽视了模型在对话过程中的适应性。虽然人们观察到MLLMs能理解对话中的语言变化,但它们的自我适应性仍然有限,无法像人类一样随着对话的进行而自动调整自己的语言方式。因此,需要一种新的评估方法来衡量模型在对话中的适应性。

- (3)研究方法:

文章提出了一种新的自动化框架ICCA,用于评估MLLMs在对话中的适应性。ICCA基于人类之间参考游戏交互的语料库,能够完全自动化地评估模型的表现,无需进一步的人类参与。该框架通过模拟人类对话的过程,评估模型在对话中的自我适应性以及能否形成特殊的对话习惯。此外,还通过对不同状态的MLLMs(如GPT-4)进行评估和比较,探讨模型在对话中的自我适应性是否可以通过特定的提示进行改善。

- (4)任务与成果:

文章主要评估了MLLMs在模拟人类对话任务中的表现。研究发现,虽然MLLMs能够理解对话中的语言变化并适应其对话伙伴的语言方式,但它们并不能自发地提高沟通效率。只有在一些特定的模型(如GPT-4)中,通过特定的提示才能激发模型的自我适应性。这表明即使训练了大量的语料库,模型的自我适应性仍然有限。这项研究对于提高MLLMs的自然性和交互性具有重要的指导意义。

好的,我会按照您的要求进行总结。

结论部分:

(一)这篇论文的重要性体现在以下方面:该论文提出了一种新的评估框架ICCA,用于评估多模态大型语言模型在对话中的适应性,这一视角是对现有评估方法的补充。该框架可以方便地应用于新的多模态大型语言模型,无需收集新的人类数据。文章探讨了多模态大型语言模型在对话中的适应性问题,这对于提高语言模型的自然性和交互性具有重要的指导意义。此外,该研究还强调了语言模型在对话中缺乏自我适应性的问题,这是语言模型与人类之间的重要差异。因此,该研究对于自然语言处理和人工智能领域的发展具有重要意义。

(二)创新点、性能和工作量的总结如下:

创新点:文章提出了一种新的评估框架ICCA,用于评估多模态大型语言模型在对话中的适应性,该框架能够模拟人类对话过程,评估模型在对话中的自我适应性。此外,文章探讨了如何通过特定的提示改善模型的自我适应性。这一研究为评估多模态大型语言模型的性能提供了新的视角和方法。

性能:该文章全面评估了多模态大型语言模型在模拟人类对话任务中的表现,发现了模型在对话中的自我适应性有限的问题,并提出了改进方向。此外,文章的研究方法和实验设计具有可靠性和有效性。

工作量:文章的研究工作量适中,作者在文章中详细描述了实验设计和方法,并进行了充分的实验验证。但是,由于文章未提供关于代码实现的详细信息,因此对于读者来说可能较难进行复现和研究扩展。总体来说,该研究工作量相对充足且具有挑战性。

希望这个总结符合您的要求。

点此查看论文截图