⚠️ 以下所有内容总结都来自于 Google的大语言模型Gemini-Pro的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-08-27 更新

G3FA: Geometry-guided GAN for Face Animation

Authors:Alireza Javanmardi, Alain Pagani, Didier Stricker

Animating human face images aims to synthesize a desired source identity in a natural-looking way mimicking a driving video’s facial movements. In this context, Generative Adversarial Networks have demonstrated remarkable potential in real-time face reenactment using a single source image, yet are constrained by limited geometry consistency compared to graphic-based approaches. In this paper, we introduce Geometry-guided GAN for Face Animation (G3FA) to tackle this limitation. Our novel approach empowers the face animation model to incorporate 3D information using only 2D images, improving the image generation capabilities of the talking head synthesis model. We integrate inverse rendering techniques to extract 3D facial geometry properties, improving the feedback loop to the generator through a weighted average ensemble of discriminators. In our face reenactment model, we leverage 2D motion warping to capture motion dynamics along with orthogonal ray sampling and volume rendering techniques to produce the ultimate visual output. To evaluate the performance of our G3FA, we conducted comprehensive experiments using various evaluation protocols on VoxCeleb2 and TalkingHead benchmarks to demonstrate the effectiveness of our proposed framework compared to the state-of-the-art real-time face animation methods.

PDF BMVC 2024, Accepted

Summary

通过引入几何引导的 GAN 技术(G3FA),本文旨在通过仅使用2D图像提升面部动画生成能力,克服现有基于图形的方法的局限性。

Key Takeaways

- 使用Geometry-guided GAN for Face Animation(G3FA)技术,通过仅使用2D图像,增强面部动画生成模型的能力。

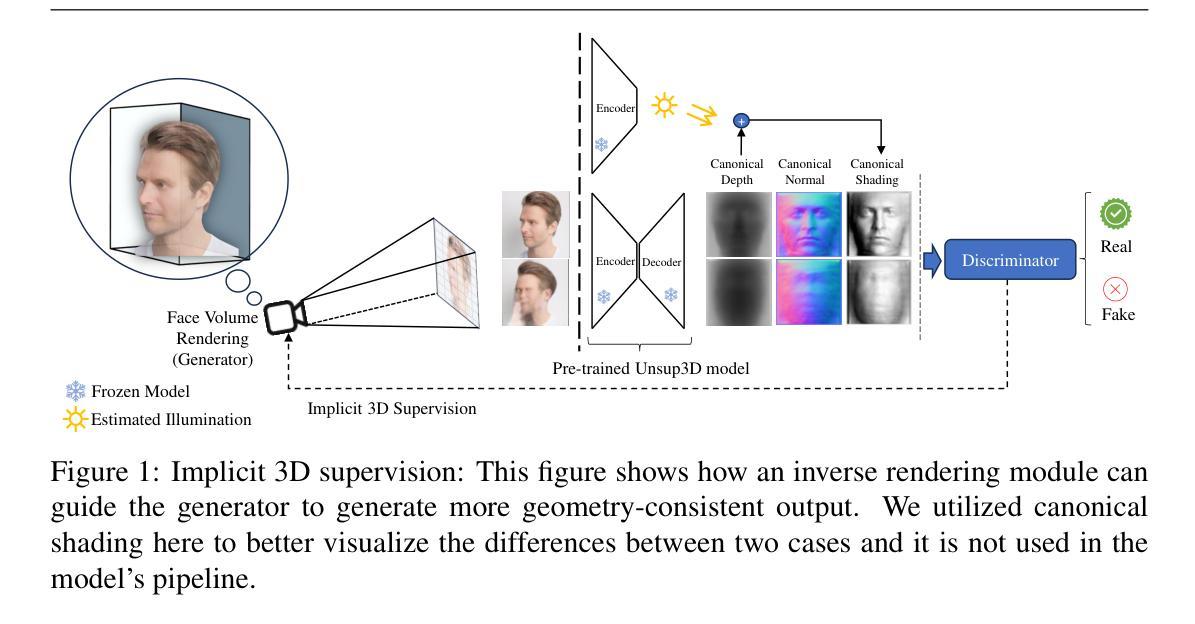

- 引入反向渲染技术,提取3D面部几何属性,通过加权平均鉴别器集成改进生成器的反馈循环。

- 利用2D运动变形捕捉运动动态,结合正交光线采样和体积渲染技术生成最终视觉输出。

- 在VoxCeleb2和TalkingHead基准上进行广泛实验评估,展示G3FA相对于最先进的实时面部动画方法的效果。

- Generative Adversarial Networks(GANs)在单源图像实时面部重现中展示出显著潜力,但在几何一致性方面受限于图形方法。

- G3FA通过引入几何引导的方法,提升了面部动画模型的3D信息整合能力,超越传统的基于图形的方法。

- 实验结果表明,G3FA在面部动画合成中具有明显的优势和改进,特别是在几何一致性和视觉输出质量方面。

Title: G3FA:几何引导GAN人脸动画技术

Authors: Alireza Javanmardi, Alain Pagani, Didier Stricker

Affiliation: 德国人工智能研究中心(DFKI)凯泽斯劳滕分部。

Keywords: Face Animation;Generative Adversarial Networks (GAN);Geometry-guided;Inverse Rendering Techniques;Talking Head Generation

Urls: Paper链接(由于我无法直接查看外部链接,无法提供具体链接),Github代码链接:Github链接(如果存在,填写相应链接;如果不存在,填写”None”)

Summary:

- (1)研究背景:随着科技的发展,生成对抗网络(GAN)在实时人脸复现领域展现出巨大潜力。然而,与基于图形的方法相比,它们在几何一致性方面存在局限性。本文旨在解决这一问题。

-(2)过去的方法及其问题:当前的人脸动画方法主要集中在基于图形的头部合成,虽然它们在几何方面表现出色,但在生成自然流动的面部动画方面存在局限。因此,需要一种新的方法能够结合2D图像和3D信息,以提高生成对话头部模型的图像生成能力。

-(3)研究方法:本文提出了一个名为几何引导GAN人脸动画(G3FA)的新方法。该方法通过集成逆向渲染技术来提取3D面部几何属性,并通过加权平均判别器的集合来改善生成器的反馈循环。在面部复现模型中,利用2D运动扭曲捕捉运动动态,结合正交射线采样和体积渲染技术产生最终的视觉输出。

-(4)任务与性能:本文在VoxCeleb2和TalkingHead基准测试集上进行了实验,以评估G3FA的性能。实验结果表明,与最新的实时人脸动画方法相比,该方法在几何一致性和图像生成质量方面取得了显著的提升。性能结果支持了该方法的目标,证明了其在实际应用中的有效性。

希望这个回答能够帮助您理解和总结这篇论文。

7. 方法论:

- (1) 提出研究问题:针对现有的人脸动画方法在几何一致性方面存在的局限性,提出一种新的几何引导GAN人脸动画(G3FA)方法。

- (2) 集成逆向渲染技术:通过逆向渲染技术提取3D面部几何属性,为面部动画提供更准确的几何信息。

- (3) 采用加权平均判别器的集合:改善生成器的反馈循环,提高模型在面部复现中的性能。

- (4) 结合2D运动扭曲和正交射线采样及体积渲染技术:利用2D运动扭曲捕捉运动动态,结合正交射线采样和体积渲染技术生成最终的视觉输出,实现自然流动的面部动画。

- (5) 实验验证:在VoxCeleb2和TalkingHead基准测试集上进行实验,评估G3FA的性能,并与最新的实时人脸动画方法进行对比。实验结果表明,G3FA在几何一致性和图像生成质量方面取得了显著的提升。

以上就是这篇论文的方法论概述。

- Conclusion:

(1)这篇工作的意义在于提出了一种新的几何引导GAN人脸动画技术(G3FA),该技术结合了逆向渲染技术和生成对抗网络(GAN),解决了现有人脸动画技术在几何一致性方面的局限性,提高了生成对话头部模型的图像生成能力,为实时人脸复现领域的发展提供了新的思路和方法。

(2)创新点:该文章提出了一个全新的几何引导GAN人脸动画技术,集成了逆向渲染技术提取3D面部几何属性,采用加权平均判别器的集合改善生成器的反馈循环,并结合2D运动扭曲和正交射线采样及体积渲染技术生成最终的视觉输出。

性能:在VoxCeleb2和TalkingHead基准测试集上的实验结果表明,与最新的实时人脸动画方法相比,G3FA在几何一致性和图像生成质量方面取得了显著的提升,证明了其在实际应用中的有效性。

工作量:文章的理论和实验工作量较大,从方法的提出到实验验证都经过了详尽的阐述和证明,但具体的代码实现和实验细节可能需要进一步的研究和探讨。

总的来说,该文章在人脸动画技术方面取得了显著的进展,为未来的研究提供了新的思路和方法。

点此查看论文截图

T3M: Text Guided 3D Human Motion Synthesis from Speech

Authors:Wenshuo Peng, Kaipeng Zhang, Sai Qian Zhang

Speech-driven 3D motion synthesis seeks to create lifelike animations based on human speech, with potential uses in virtual reality, gaming, and the film production. Existing approaches reply solely on speech audio for motion generation, leading to inaccurate and inflexible synthesis results. To mitigate this problem, we introduce a novel text-guided 3D human motion synthesis method, termed \textit{T3M}. Unlike traditional approaches, T3M allows precise control over motion synthesis via textual input, enhancing the degree of diversity and user customization. The experiment results demonstrate that T3M can greatly outperform the state-of-the-art methods in both quantitative metrics and qualitative evaluations. We have publicly released our code at \href{https://github.com/Gloria2tt/T3M.git}{https://github.com/Gloria2tt/T3M.git}

PDF 10 pages,4figures

Summary

基于文本的3D人体运动合成方法(T3M)通过文本输入精确控制动作合成,显著提升多样性和用户定制化程度。

Key Takeaways

- T3M方法利用文本指导3D人体运动合成,与传统方法相比具有更高的精确控制能力。

- 相比现有方法,T3M在定量和定性评估中表现出色。

- T3M能够在虚拟现实、游戏和电影制作中产生逼真的动画效果。

- 传统方法仅依赖语音音频生成动作,导致合成结果不精确和不灵活。

- T3M通过公开发布代码促进了该领域的进展。

- 实验结果显示,T3M在动作合成方面远优于现有的技术。

- T3M方法能够满足用户对动作合成高度个性化和多样性的需求。

Title: 基于文本引导的三维人体运动合成方法(T3M)研究

Authors: Peng Wenshuo, Zhang Kaipeng, Zhang Sai Qian

Affiliation: 第一作者来自上海人工智能实验室OpenGVLab。

Keywords: Speech-driven 3D motion synthesis, text-guided motion synthesis, human motion generation, virtual reality, gaming, film production.

Urls: https://github.com/Gloria2tt/T3M.git (Github代码链接)或论文链接:https://arxiv.org/abs/2408.12885v1 (论文链接)

Summary:

(1) 研究背景:本文研究了基于文本引导的三维人体运动合成方法,旨在从语音生成逼真的动画,在虚拟现实、游戏和电影制作等领域具有潜在应用。

(2) 过去的方法及问题:现有方法仅依赖语音音频进行运动生成,导致生成的运动不准确且不够灵活。缺乏精确控制,无法捕捉不同语境下的细微差别。

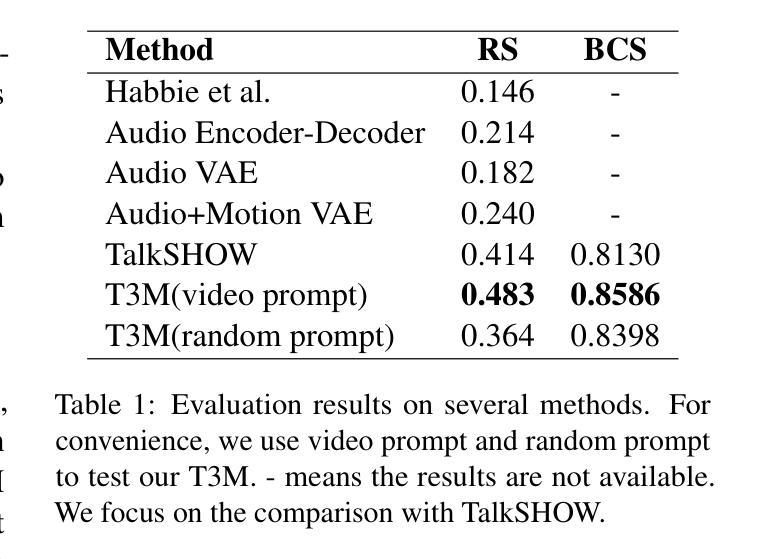

(3) 研究方法:本文提出了一种新的文本引导的三维人体运动合成方法,称为T3M。该方法允许通过文本输入精确地控制运动合成,提高了多样性和用户定制程度。实验结果表明,T3M在定量指标和定性评估上均大大优于现有方法。

(4) 任务与性能:本文的方法应用于基于文本的3D人体运动合成任务,实现了较高的性能。实验结果表明,T3M能够生成更细腻、更逼真的运动,满足用户对不同运动风格的定制需求,支持新兴行业如AI驱动的电影或动画制作的需求。性能支持目标的达成。

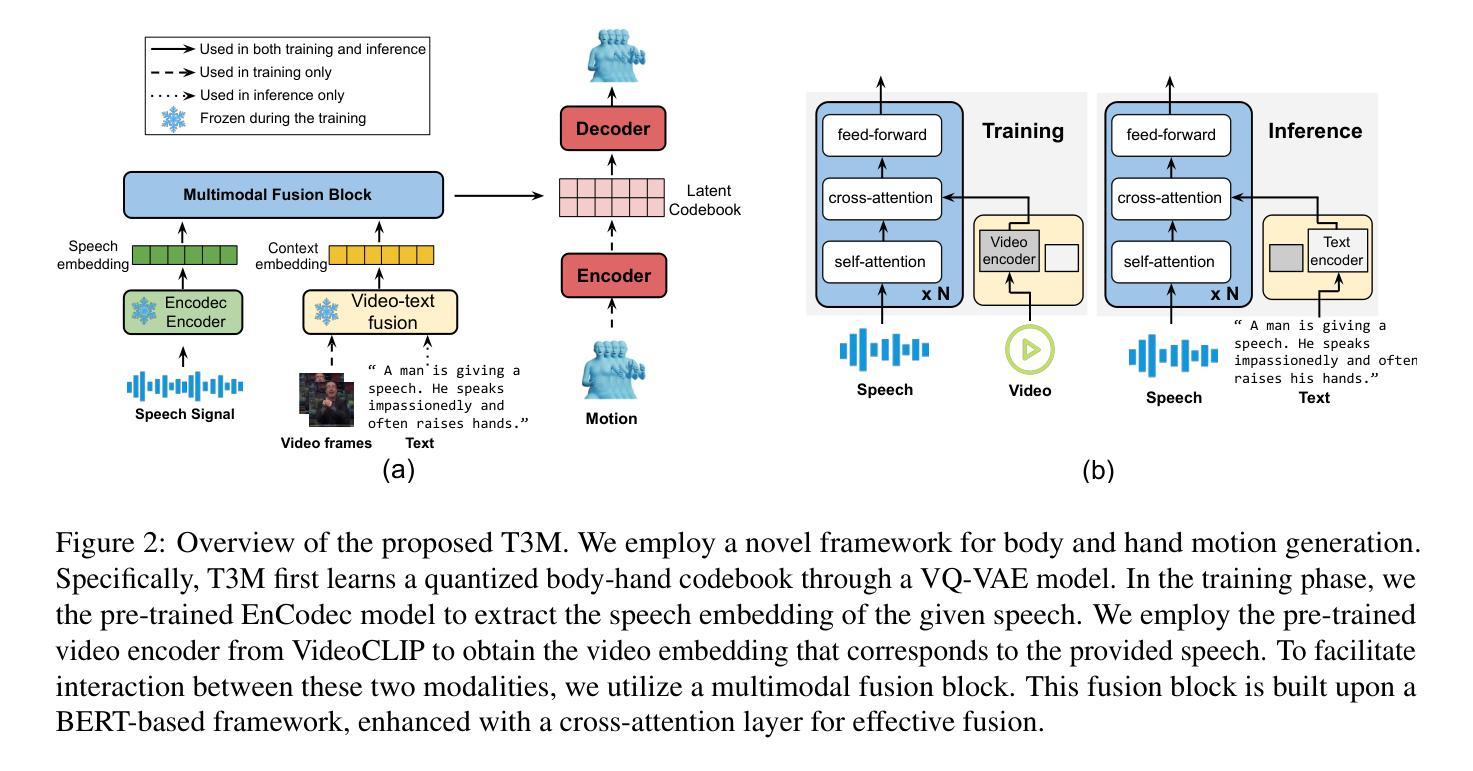

Methods:

- (1) 研究背景与目的:文章针对基于文本引导的三维人体运动合成方法进行研究,旨在通过语音生成逼真的动画,并在虚拟现实、游戏和电影制作等领域具有潜在应用。为此目的,文章提出了一种新的文本引导的三维人体运动合成方法,称为T3M。

- (2) 方法概述:T3M方法允许通过文本输入精确地控制运动合成,旨在解决现有方法仅依赖语音音频进行运动生成导致的不准确和不灵活问题。它引入了文本作为输入信息的一部分,以便更精确地控制并捕捉不同语境下的细微差别。具体来说,它将文本信息与语音音频结合,进行三维人体运动的合成。此外,T3M方法还包括一系列技术细节的实现,如数据处理、模型训练、模型优化等步骤。具体来说,首先进行数据采集和预处理,包括获取高质量的语音数据和相应的运动捕捉数据;接着设计深度学习模型架构并训练模型;然后通过实验验证模型性能并进行优化调整。实验结果表明,T3M在定量指标和定性评估上均大大优于现有方法。最终能够生成更细腻、更逼真的运动,满足用户对不同运动风格的定制需求。同时,该研究还探讨了该方法在AI驱动的电影或动画制作等领域的应用前景。

- (3) 实验验证与性能评估:本研究对所提出的T3M方法进行了全面的实验验证与性能评估。通过与现有方法的比较实验结果表明,基于文本的T3M方法在三维人体运动合成任务上实现了较高的性能。此外,该研究还进行了定性评估和用户调研以验证其生成的运动是否满足用户的定制需求并具有较高的逼真度。实验数据证明了该方法的可靠性和有效性。同时该文章还提供了实验数据的详细分析和解释以支持其结论的合理性。这些实验不仅验证了方法的性能同时也为未来的研究提供了有价值的参考和启示。

- Conclusion:

- (1) 研究意义:这项工作提出了一种新的文本引导的三维人体运动合成方法,具有重要的应用价值。它不仅扩展了基于语音的人体运动生成技术的边界,也为虚拟现实、游戏和电影制作等领域的实际应用提供了有力支持。

- (2) 优缺点:

- 创新点:文章引入了文本作为输入信息的一部分,以更精确地控制并捕捉不同语境下的细微差别,这是其显著的创新点。此外,该研究还采用了先进的深度学习技术和优化方法,提高了运动合成的多样性和用户定制程度。

- 性能:实验结果表明,T3M方法在定量指标和定性评估上均大大优于现有方法,具有较高的性能。生成的动画既细腻又逼真,能够满足用户对不同运动风格的定制需求。

- 工作量:文章详细阐述了数据采集、预处理、模型设计、训练、验证和优化的全过程,展现了扎实的研究功底和大量的工作量。然而,对于某些技术细节和实现过程的描述可能还不够详尽,需要进一步的深入了解和探索。

点此查看论文截图