⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

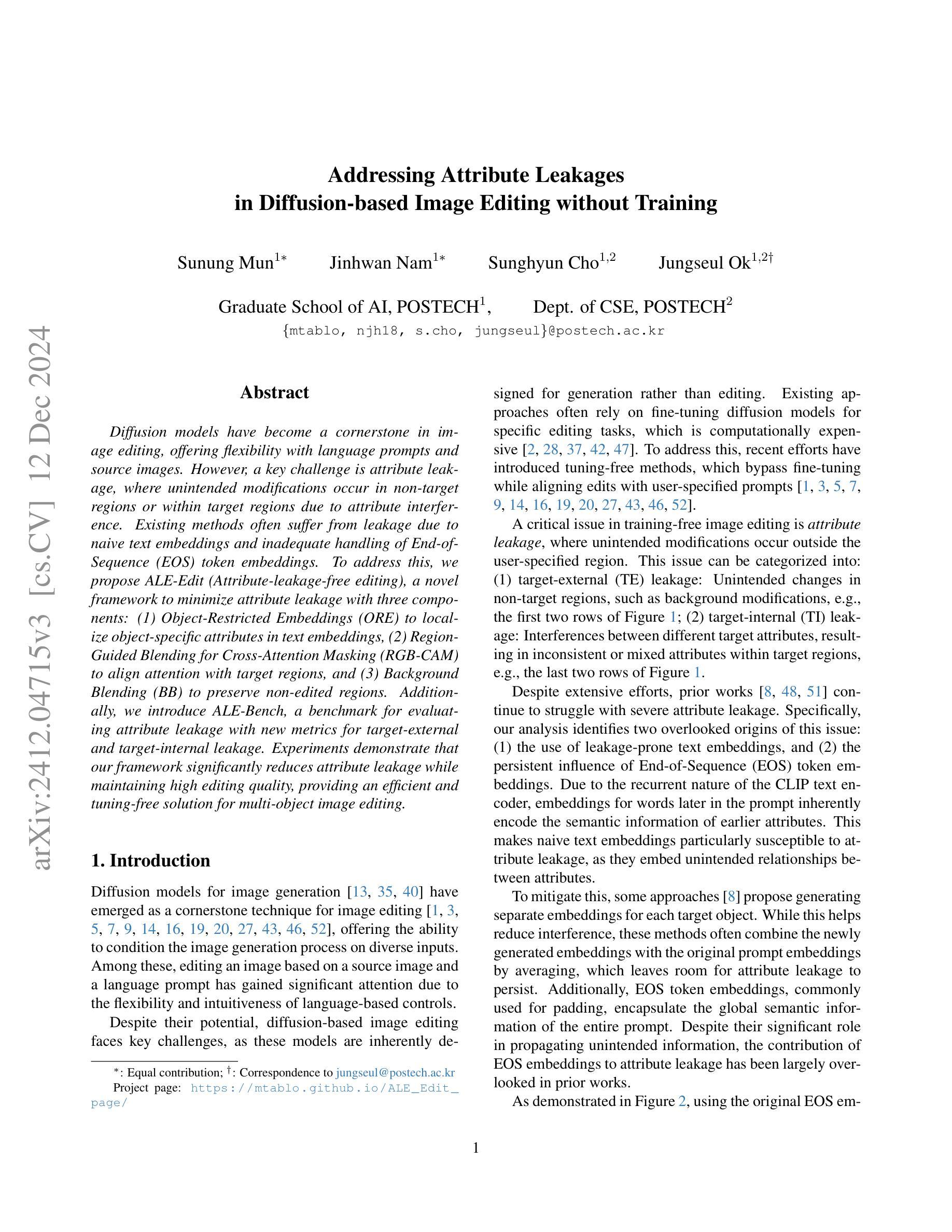

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-13 更新

FreeScale: Unleashing the Resolution of Diffusion Models via Tuning-Free Scale Fusion

Authors:Haonan Qiu, Shiwei Zhang, Yujie Wei, Ruihang Chu, Hangjie Yuan, Xiang Wang, Yingya Zhang, Ziwei Liu

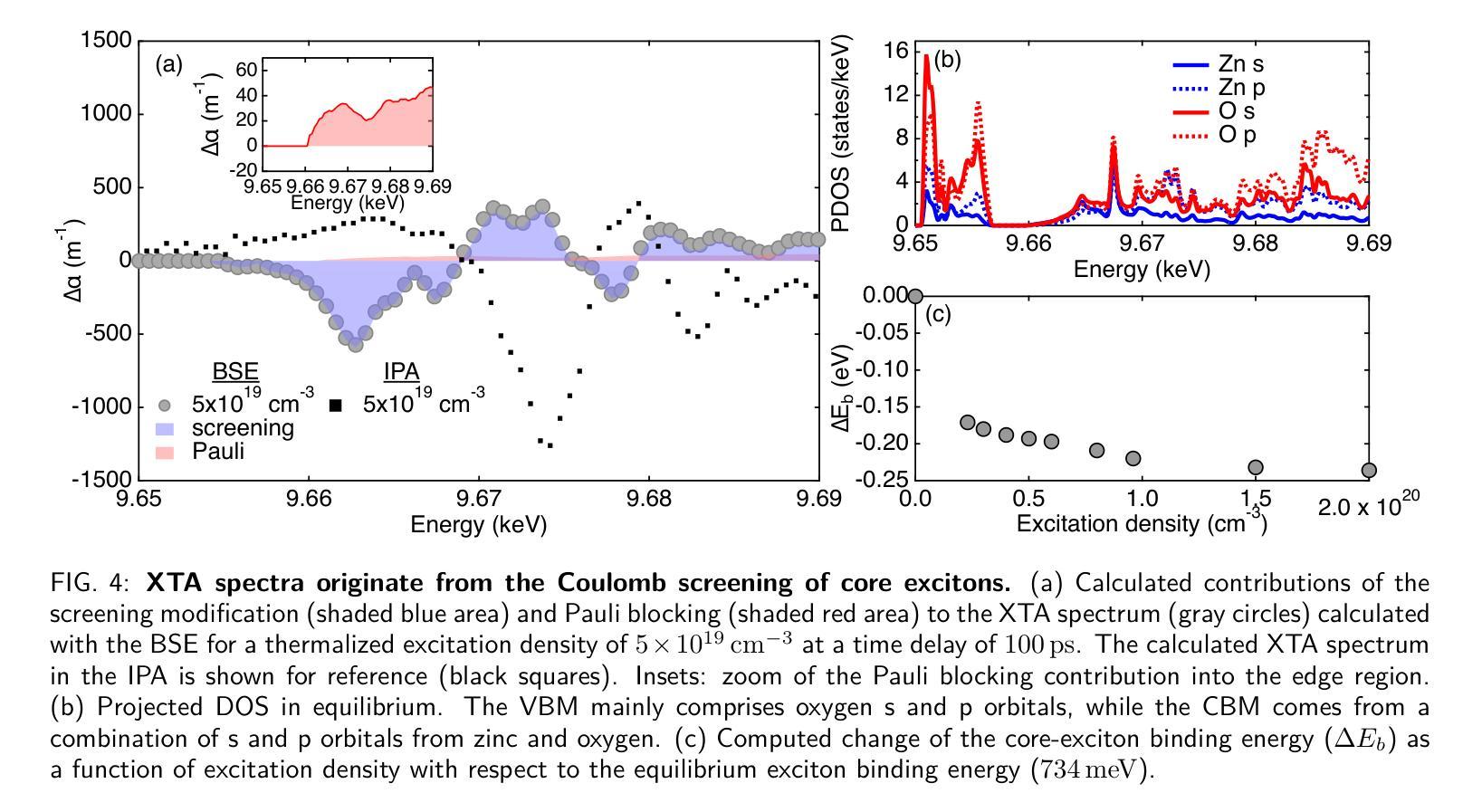

Visual diffusion models achieve remarkable progress, yet they are typically trained at limited resolutions due to the lack of high-resolution data and constrained computation resources, hampering their ability to generate high-fidelity images or videos at higher resolutions. Recent efforts have explored tuning-free strategies to exhibit the untapped potential higher-resolution visual generation of pre-trained models. However, these methods are still prone to producing low-quality visual content with repetitive patterns. The key obstacle lies in the inevitable increase in high-frequency information when the model generates visual content exceeding its training resolution, leading to undesirable repetitive patterns deriving from the accumulated errors. To tackle this challenge, we propose FreeScale, a tuning-free inference paradigm to enable higher-resolution visual generation via scale fusion. Specifically, FreeScale processes information from different receptive scales and then fuses it by extracting desired frequency components. Extensive experiments validate the superiority of our paradigm in extending the capabilities of higher-resolution visual generation for both image and video models. Notably, compared with the previous best-performing method, FreeScale unlocks the generation of 8k-resolution images for the first time.

视觉扩散模型取得了显著的进步,但由于缺乏高分辨率数据和有限的计算资源,它们通常只在有限的分辨率上进行训练,这限制了它们在更高分辨率下生成高保真图像或视频的能力。最近的研究已经探索了无微调策略来展示预训练模型尚未开发的潜在高分辨率视觉生成能力。然而,这些方法仍然容易产生具有重复模式的高质量视觉内容。主要障碍在于模型生成超过其训练分辨率的视觉内容时,高频信息不可避免的增多,导致来自累积误差的不理想的重复模式。为了应对这一挑战,我们提出了FreeScale,这是一种无需调整的无微调推断范式,通过尺度融合实现高分辨率视觉生成。具体来说,FreeScale处理来自不同感受尺度的信息,然后通过提取所需的频率成分将其融合。大量实验验证了我们的范式在图像和视频模型的高分辨率视觉生成能力方面的优越性。值得注意的是,与以前表现最好的方法相比,FreeScale首次实现了8k分辨率图像的生成。

论文及项目相关链接

PDF Project Page: http://haonanqiu.com/projects/FreeScale.html

Summary

视觉扩散模型取得显著进展,但受限于高分辨率数据的缺乏和计算资源的限制,通常只在低分辨率下进行训练,制约了其在更高分辨率下生成高保真图像或视频的能力。最近的研究尝试采用无需调整的策略来展示预训练模型在更高分辨率视觉生成方面的潜力,但这些方法仍容易产生带有重复模式的低质量视觉内容。关键障碍在于模型生成超过其训练分辨率的视觉内容时,高频信息的不可避免增加,导致源于累积误差的不理想重复模式。为解决这一挑战,我们提出FreeScale,一种无需调整的推理范式,通过尺度融合实现更高分辨率的视觉生成。它通过从不同接收尺度处理信息并融合,提取所需频率成分。大量实验验证了我们的方法在图像和视频模型的高分辨率视觉生成方面的优越性。特别是,与以前性能最佳的方法相比,FreeScale首次实现了8k分辨率图像的生成。

Key Takeaways

- 视觉扩散模型受限于高分辨率数据的缺乏和计算资源的限制,通常只在低分辨率环境下进行训练。

- 最近的策略尝试通过预训练模型进行更高分辨率的视觉生成,但易产生低质量和重复模式的视觉内容。

- 面临的关键挑战是模型在生成超过训练分辨率的视觉内容时,高频信息的增加导致出现重复模式。

- 提出了一种名为FreeScale的无需调整的推理范式,通过尺度融合来提高视觉生成的质量。

- FreeScale能够处理并融合不同尺度的信息,从而提取所需的频率成分。

- 实验证明FreeScale方法在图像和视频模型的高分辨率视觉生成方面具有优越性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是视觉扩散模型在生成更高分辨率图像和视频时面临的挑战。具体来说,这些挑战包括:

有限的训练数据和计算资源限制:由于缺乏高分辨率数据和受限的计算资源,当前的视觉扩散模型通常仅在有限的分辨率上进行训练,这限制了它们在更高分辨率下生成高保真图像或视频的能力。

重复模式和低质量视觉内容:尽管已有研究探索了无需微调(tuning-free)的策略来发挥预训练模型在更高分辨率视觉生成上的潜力,但这些方法仍然容易产生带有重复模式的低质量视觉内容。

高频信息增加导致的问题:当模型生成超出其训练分辨率的视觉内容时,不可避免地会增加高频信息,导致累积误差并产生不期望的重复模式。

为了应对这些挑战,论文提出了FreeScale,这是一个无需微调的推理范式,通过尺度融合(scale fusion)来实现更高分辨率的视觉生成。FreeScale通过处理不同感受野尺度的信息,然后通过提取所需的频率成分来融合它们,从而在保持结构整体合理性和对象局部质量的同时,扩展了图像和视频模型在更高分辨率视觉生成上的能力。

Q: 有哪些相关研究?

A: 根据论文内容,以下是一些与FreeScale相关的研究工作:

扩散模型在视觉生成中的应用:

- DDPM [20] 和 Guided Diffusion [12]:展示了扩散过程能够产生出色的图像质量。

- LDM [39]:引入了潜在空间扩散,显著降低了计算负担和训练需求。

- SDXL [36]:基于LDM进一步推进了高分辨率图像合成。

- Pixart-alpha [11]:采用了基于变换器的架构,实现了高保真度和成本效益的图像生成。

- VDM [21] 和 LVDM [17]:在视频生成领域应用扩散模型,并提出了分层潜在视频扩散框架。

- Align-Your-Latents [6] 和 AnimateDiff [15]:引入时间变换器到现有的文本到图像(T2I)模型中,以实现文本到视频(T2V)的能力。

高分辨率视觉生成:

- 一类方法是使用高分辨率数据和大型模型进行训练/微调,如 [14, 22, 33, 38, 43, 51]。

- 另一类是无需额外数据需求的无需微调方法,如 [7, 13, 16, 18, 25, 27, 30, 31]。

- ScaleCrafter [18]:提出使用扩张卷积层来扩大卷积感受野,解决对象重复问题。

- MultiDiffusion [2] 和 DemoFusion [13]:通过融合局部和全局补丁来减少局部重复。

- FouriScale [23]:通过移除潜在的高频信号来消除重复,但可能导致颜色和纹理不自然。

其他相关技术:

- VideoComposer [46]:提供了可控的文本到视频(T2V)生成方法。

- VideoCrafter [9, 10] 和 SVD [5]:扩展了潜在视频扩散模型以处理大规模数据集。

- Lumiere [3]:提出了在空间时间U-Net中进行时间下采样以提高效率。

- CogVideoX [48] 和 Pyramid Flow [26]:展示了视频生成中的DiT结构的优越性能。

这些研究构成了FreeScale方法的理论和技术支持,FreeScale在此基础上进一步提出了无需微调的尺度融合策略,以实现更高分辨率的视觉生成。

Q: 论文如何解决这个问题?

A: 论文提出了FreeScale,一个无需微调的推理范式,通过以下方法解决高分辨率视觉生成中的问题:

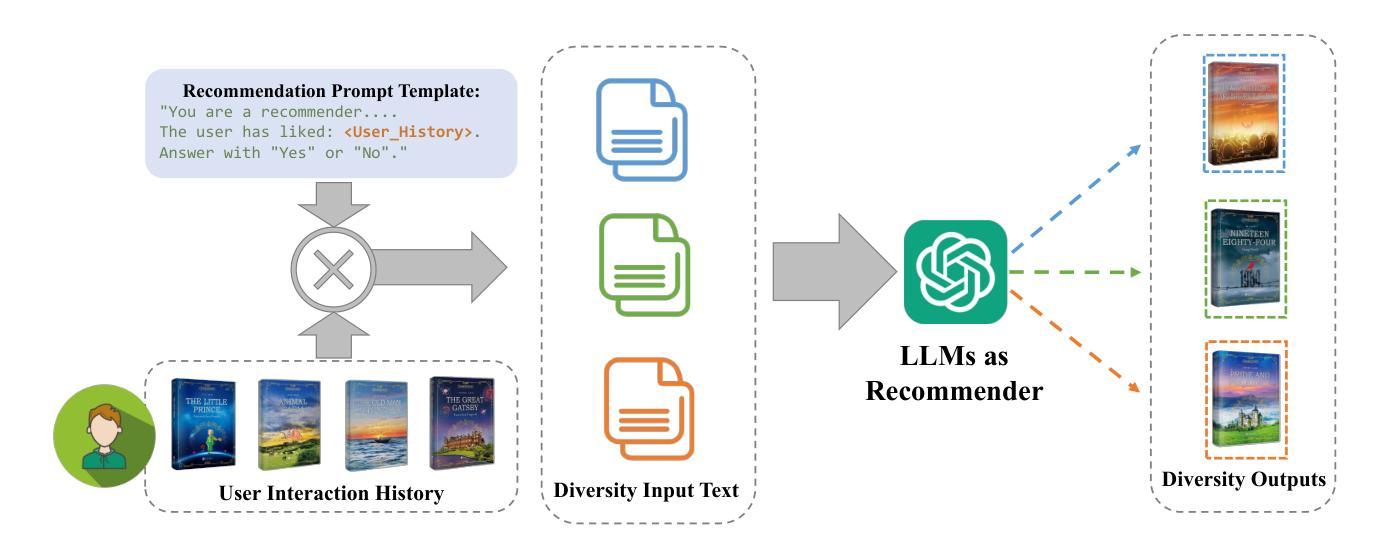

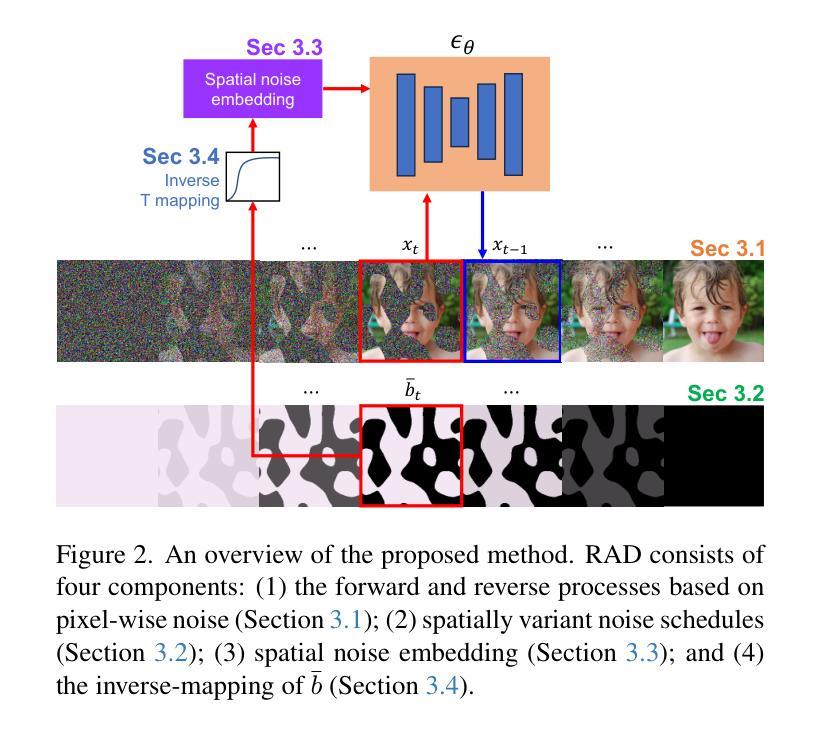

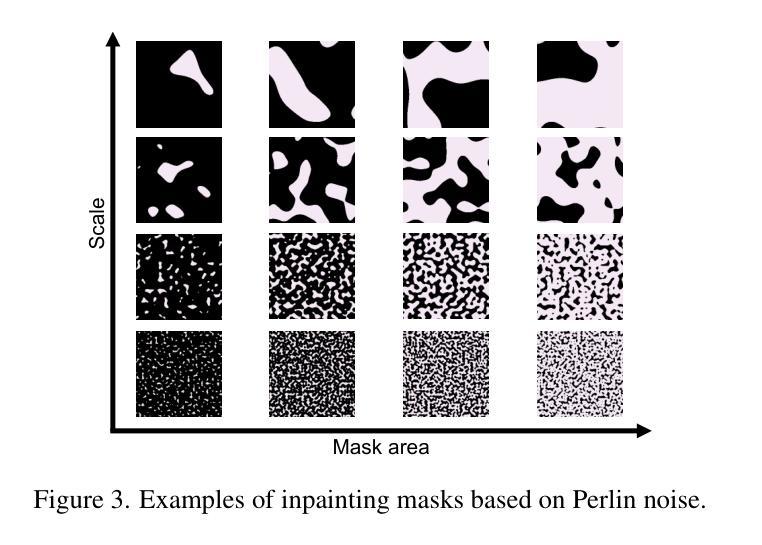

1. 定制的自级联上采样(Tailored Self-Cascade Upscaling)

FreeScale使用自级联上采样框架逐步增加生成结果的分辨率,从低分辨率的合理视觉结构开始,然后保持这个结构生成更高分辨率的结果。具体来说,这个过程通过以下公式实现:

$$

\tilde{z}_r \sim \mathcal{N}\left(\sqrt{\bar{\alpha}_K \phi(z_r^0)}, \sqrt{1 - \bar{\alpha}_K} I\right)

$$

其中,$\tilde{z}$ 表示噪声中间潜在表示,$r$ 是分辨率级别,$\phi$ 是上采样操作。

2. 限制的扩张卷积(Restrained Dilated Convolution)

为了解决对象重复问题,FreeScale使用扩张卷积来增加卷积的感受野,但与之前工作不同的是,只在UNet的下块和中块中应用扩张卷积,并在最后几个时间步使用原始卷积。

3. 尺度融合(Scale Fusion)

尺度融合通过从不同感受野尺度处理信息并提取所需的频率成分来融合信息,平衡了局部和全局细节的增强。具体来说,尺度融合利用全局自注意力特征提取全局信息,并通过局部自注意力增强局部焦点。然后,通过以下公式融合高频细节和低频语义:

$$

h_{\text{fusion out}} = h_{\text{global out}} - G(h_{\text{global out}}) + G(h_{\text{local out}})

$$

其中,$G$ 是作为高斯模糊实现的低通滤波器,$h_{\text{global out}} - G(h_{\text{global out}})$ 作为 $h_{\text{fusion out}}$ 的高频部分,$G(h_{\text{local out}})$ 作为低频部分。

4. 灵活控制细节级别

FreeScale通过以下公式修改生成细节级别的控制:

$$

\hat{r}_t = c \times \tilde{z}_r^t + (1 - c) \times z_r^t

$$

其中,$c$ 是一个按比例缩放的余弦衰减因子,允许用户根据不同语义区域分配不同的值来控制细节级别。

通过这些方法,FreeScale能够有效地生成高分辨率图像和视频,同时避免了重复模式和质量退化的问题。实验结果表明,FreeScale在视觉质量上超越了现有方法,并且在推理时间上具有显著优势。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证FreeScale方法的有效性,包括以下几类实验:

1. 实验设置

- 模型和数据集:使用开源的文本到图像扩散模型SDXL和文本到视频扩散模型VideoCrafter2进行实验。

- 分辨率:图像生成在2048×2048和4096×4096分辨率下进行评估,视频生成在640分辨率下进行评估。

- GPU资源:所有实验都在单个A800 GPU上完成。

- 数据集:图像生成使用LAION5B数据集,视频生成使用WebVid-10M数据集。

- 评估指标:使用Frechet Image Distance (FID)、Kernel Image Distance (KID)、Frechet Video Distance (FVD)等指标评估生成质量。

2. 更高分辨率图像生成

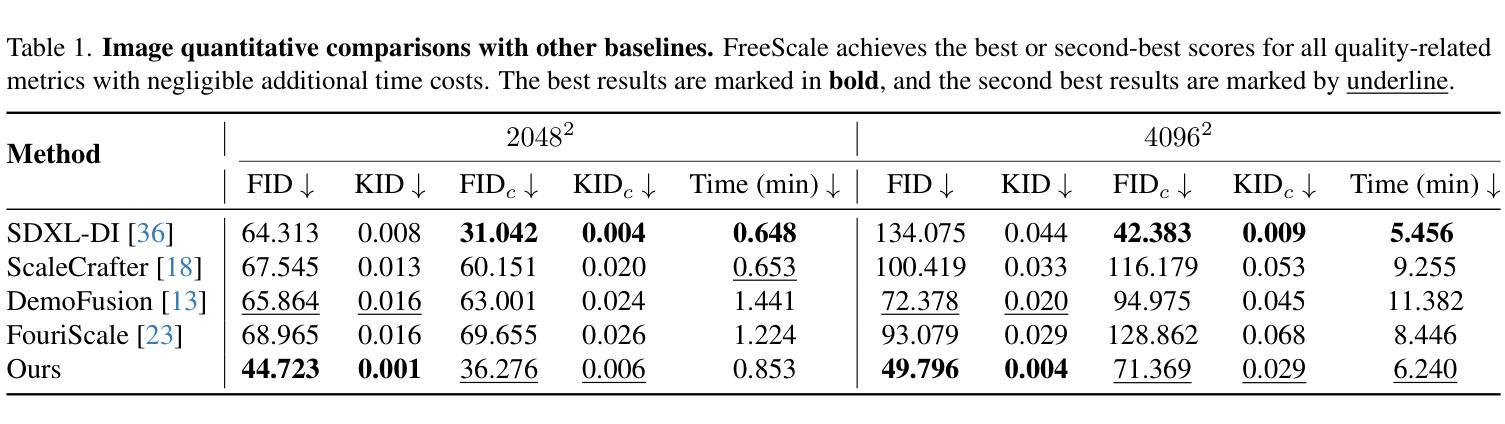

- 对比方法:与SDXL直接推理(SDXL-DI)、ScaleCrafter、DemoFusion和FouriScale等方法进行比较。

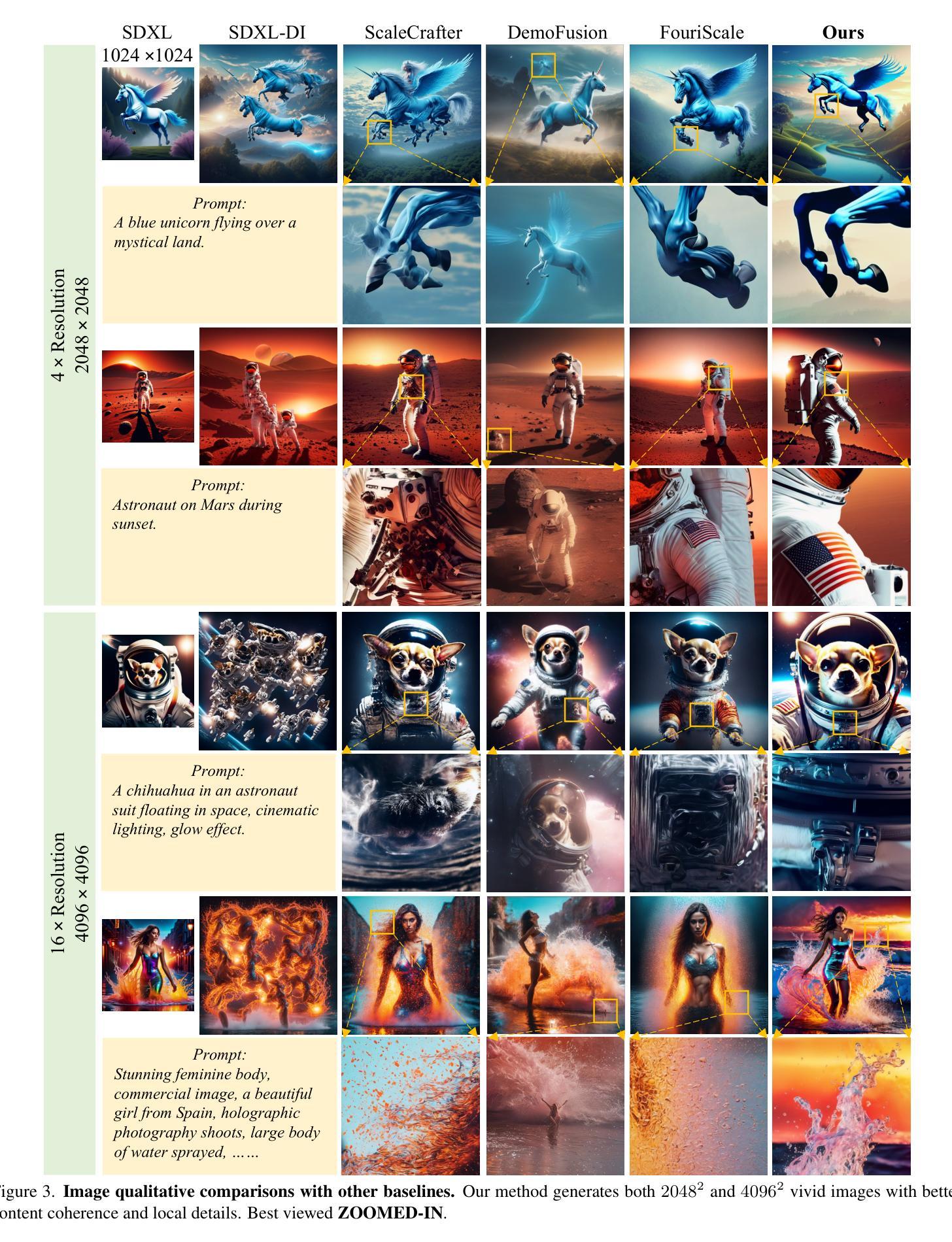

- 定性比较:通过视觉比较展示FreeScale生成的图像在内容连贯性和局部细节上的优势。

- 定量比较:使用FID、KID、FIDc和KIDc等指标验证FreeScale在不同分辨率下的性能。

3. 更高分辨率视频生成

- 对比方法:与VideoCrafter2直接推理(VC2-DI)、ScaleCrafter和DemoFusion等方法进行比较。

- 定性比较:展示FreeScale在视频生成中保持高保真度的能力。

- 定量比较:使用FVD等指标评估视频生成质量。

4. 可控制细节级别的灵活性

- 演示:展示了如何通过调整不同区域的α值来控制生成结果中的细节级别。

5. 消融研究

- 组件效果:对FreeScale的三个主要组件(定制的自级联上采样、限制的扩张卷积和尺度融合)进行了消融研究,以展示每个组件对最终性能的贡献。

6. 用户研究

- 主观评估:通过用户研究评估生成图像的文本对齐、图像质量和视觉结构,并与基线方法进行比较。

这些实验全面地评估了FreeScale在不同方面的表现,包括图像和视频的高分辨率生成能力、细节控制的灵活性以及与其他方法的性能比较。通过这些实验,论文证明了FreeScale在无需微调的情况下有效提高了预训练扩散模型生成高分辨率结果的能力。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和补充材料,以下是一些可以进一步探索的点:

1. 多GPU推理策略

- 内存限制问题:对于超过8k分辨率的图像生成,内存限制可能是一个问题。探索多GPU推理策略可能有助于缓解这一问题。

2. 推理加速技术

- 计算效率:尽管FreeScale的推理成本接近基础模型的直接推理,但对于超高分辨率生成,推理成本仍然很高。研究和应用推理加速技术可能有助于提高计算效率。

3. 模型的先验知识限制

- 上采样能力限制:FreeScale的上采样能力受限于模型学习的先验知识。探索如何突破这一限制,合理地添加更多细节,是一个重要的研究方向。

4. 模型泛化能力

- DiT-based LDMs:FreeScale目前仅支持UNet-based LDMs。探索如何将FreeScale适配到DiT-based LDMs,以利用这些模型在视觉生成上的优势。

5. 定制化解决方案

- 特定模型的适配:为DiT-based LDMs定制FreeScale的解决方案,以实现更好的性能和质量。

6. 质量损失问题

- 不同模型间的质量损失:使用DiT-based LDMs生成中间结果,再利用FreeScale生成更高分辨率结果时,可能会有轻微的质量损失。研究如何减少这种质量损失。

7. 知识蒸馏和压缩

- 模型压缩:探索知识蒸馏和模型压缩技术,以减少高分辨率生成时的内存和计算需求。

8. 跨模态融合

- 图像和文本的融合:FreeScale主要关注图像和视频生成,探索其在跨模态任务(如图像到图像翻译)中的应用潜力。

9. 实时应用

- 实时高分辨率生成:研究如何优化FreeScale以实现实时或近实时的高分辨率视觉内容生成。

10. 交互式应用

- 用户交互和编辑能力:探索FreeScale在交互式环境中的潜力,如允许用户在生成过程中进行编辑和调整。

这些探索点可以帮助进一步提升FreeScale的性能,扩展其应用范围,并解决当前的一些限制。

Q: 总结一下论文的主要内容

A: 论文提出了FreeScale,一个无需微调的推理范式,用于扩展预训练扩散模型在更高分辨率视觉生成上的能力。以下是论文的主要内容总结:

1. 问题背景

- 视觉扩散模型在生成高分辨率图像和视频方面受到训练数据和计算资源的限制。

- 现有方法在生成高分辨率内容时容易产生低质量的重复模式。

2. FreeScale方法

- 定制的自级联上采样:逐步增加生成结果的分辨率,从低分辨率的合理视觉结构开始,然后保持这个结构生成更高分辨率的结果。

- 限制的扩张卷积:使用扩张卷积增加卷积感受野,但只在UNet的下块和中块中应用,以避免局部重复问题。

- 尺度融合:通过处理不同感受野尺度的信息并提取所需的频率成分来融合信息,平衡局部和全局细节的增强。

- 灵活控制细节级别:允许用户根据不同语义区域分配不同的值来控制生成结果中的细节级别。

3. 实验验证

- 在图像和视频生成任务上,与现有方法相比,FreeScale在视觉质量上取得了显著优势,同时保持了较低的推理时间。

- 实现了8k分辨率图像的生成,突破了以往方法的限制。

4. 贡献总结

- 提出了FreeScale,一个无需微调的推理范式,使预训练的扩散模型能够生成更高分辨率的结果。

- 在文本到图像和文本到视频模型上验证了方法的有效性。

- 首次实现了8k分辨率图像的生成,与现有方法相比,在视觉质量上获得了显著提升。

5. 未来工作

- 探索多GPU推理策略以缓解内存限制。

- 应用推理加速技术以提高计算效率。

- 突破模型的先验知识限制,合理地添加更多细节。

- 适配DiT-based LDMs以利用这些模型的优势。

- 减少不同模型间生成结果的质量损失。

FreeScale通过其创新的方法,有效地解决了高分辨率视觉生成中的重复模式和质量退化问题,为未来在这一领域的研究提供了新的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Illusion3D: 3D Multiview Illusion with 2D Diffusion Priors

Authors:Yue Feng, Vaibhav Sanjay, Spencer Lutz, Badour AlBahar, Songwei Ge, Jia-Bin Huang

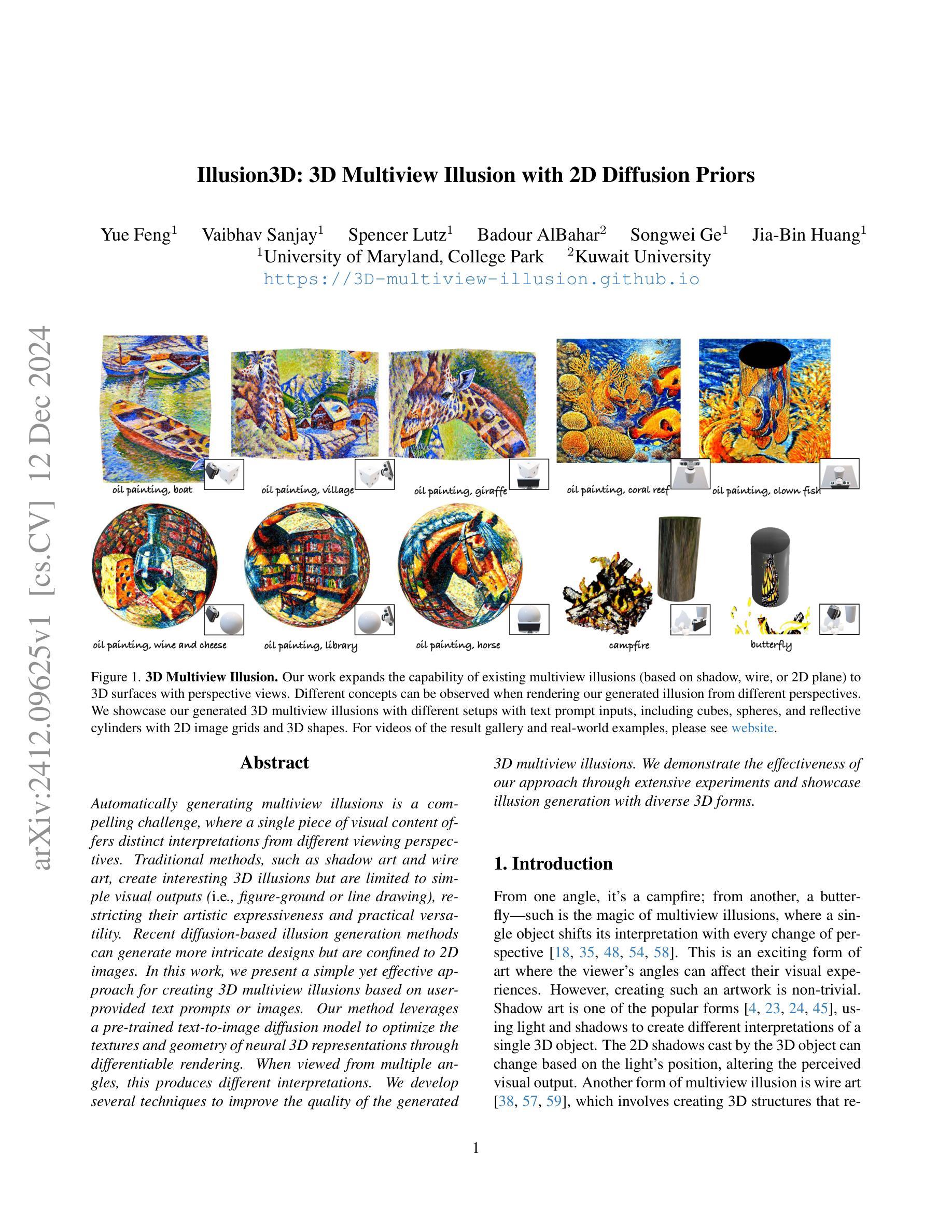

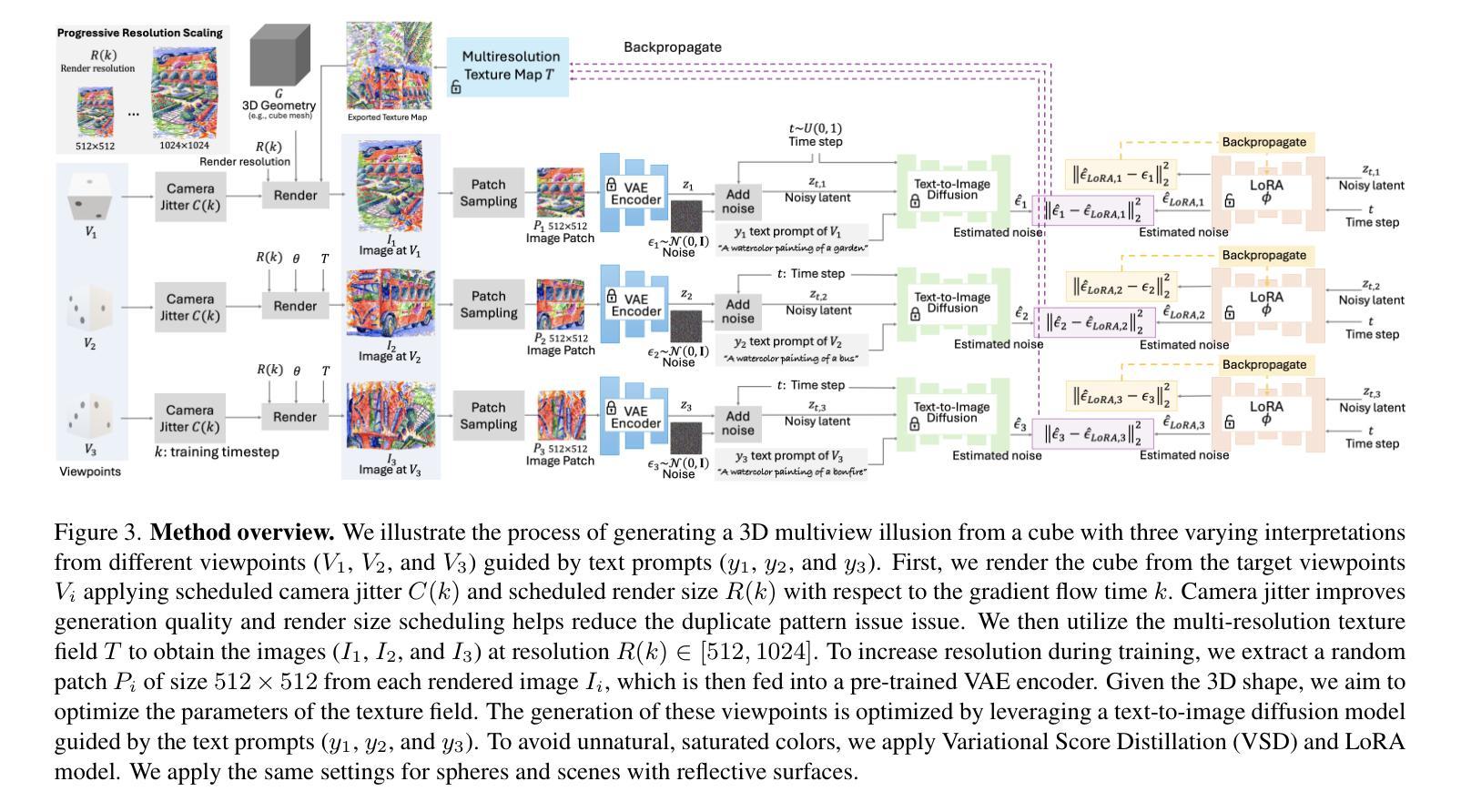

Automatically generating multiview illusions is a compelling challenge, where a single piece of visual content offers distinct interpretations from different viewing perspectives. Traditional methods, such as shadow art and wire art, create interesting 3D illusions but are limited to simple visual outputs (i.e., figure-ground or line drawing), restricting their artistic expressiveness and practical versatility. Recent diffusion-based illusion generation methods can generate more intricate designs but are confined to 2D images. In this work, we present a simple yet effective approach for creating 3D multiview illusions based on user-provided text prompts or images. Our method leverages a pre-trained text-to-image diffusion model to optimize the textures and geometry of neural 3D representations through differentiable rendering. When viewed from multiple angles, this produces different interpretations. We develop several techniques to improve the quality of the generated 3D multiview illusions. We demonstrate the effectiveness of our approach through extensive experiments and showcase illusion generation with diverse 3D forms.

自动生成多视角错觉是一项引人入胜的挑战,其中,单一的视觉内容从不同的观看角度呈现出不同的解读。传统的方法,如影子艺术和线条艺术,可以创造出有趣的3D错觉,但它们仅限于简单的视觉输出(例如,图形背景或线条绘制),从而限制了其艺术表现力和实际应用的灵活性。最近的基于扩散的错觉生成方法可以生成更复杂的设计,但仅限于2D图像。在这项工作中,我们提出了一种简单而有效的方法,用于根据用户提供的文本提示或图像创建基于3D的多视角错觉。我们的方法利用预训练的文本到图像扩散模型,通过可微渲染优化神经3D表示的纹理和几何结构。从多个角度观看时,会产生不同的解读。我们开发了几种技术来提高所生成3D多视角错觉的质量。我们通过大量实验证明了我们的方法的有效性,并展示了具有多种3D形式的错觉生成。

论文及项目相关链接

PDF Project page: https://3d-multiview-illusion.github.io/

Summary

本文介绍了一种基于用户提供的文本提示或图像,创建3D多角度错觉的简单有效方法。该方法利用预训练的文本到图像扩散模型,通过可微分渲染优化神经3D表示的纹理和几何结构。从不同角度观看时,会产生不同的解读。

Key Takeaways

- 本文提出了一种创建3D多角度错觉的新方法,该方法结合了文本提示或图像。

- 该方法利用预训练的文本到图像扩散模型,优化神经3D表示的纹理和几何结构。

- 通过可微分渲染,能够实现多角度观看产生不同的视觉效果。

- 文章介绍了提高生成3D错觉质量的多项技术。

- 该方法突破了传统错觉生成方法的限制,能够生成更复杂的设计。

- 实验结果证明了该方法的有效性,并展示了在多种3D形式下的错觉生成。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

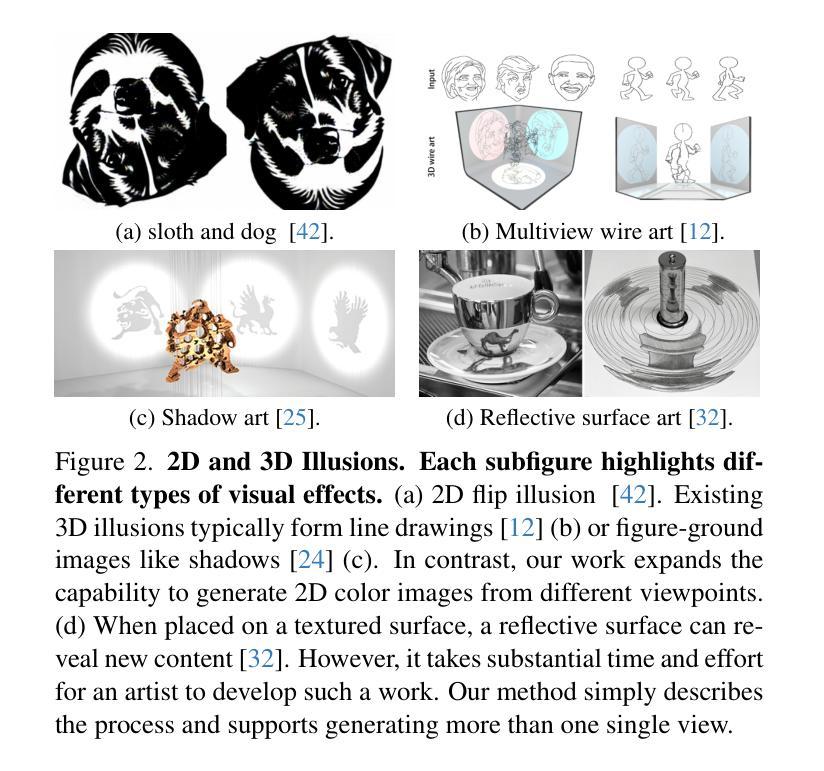

A: 这篇论文试图解决的问题是如何自动生成3D多视错觉(3D multiview illusions),即从不同的视角观察单一视觉内容时能够呈现出不同的解释或图像。具体来说,这项工作旨在扩展现有的多视错觉艺术形式(如基于阴影、线条或2D平面的错觉)到具有透视视角的3D表面。传统的方法,例如阴影艺术和线条艺术,虽然能够创造出有趣的3D错觉效果,但限于简单的视觉输出,这限制了它们的艺术表现力和实用性。而近期基于扩散模型的错觉生成方法虽然能够生成更复杂的设计,但这些方法仅限于2D图像。因此,该研究提出了一种基于用户提供的文本提示或图像来创建3D多视错觉的简单而有效的方法。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个领域:

2D错觉:

- 心理学家自1930年以来研究的关于人类对模糊和错觉图像的感知。

- 基于人类感知的算法开发,用于选择图像和创建定制的混合图像和马赛克图像。

- 将视觉错觉扩展到卷积神经网络(CNNs)。

- 使用各种模型(包括深度学习、GANs和扩散模型)实现场景中隐藏对象的伪装图像生成。

- 通过量化错觉图像中的歧义和使用生成分类器理解感知错觉。

3D错觉:

- 3D对象的感知可能涉及多种错觉形式,不同视角可能导致对同一对象的不同解释。

- 2D阴影和3D线条图的解释也是错觉的一部分。

- 反射艺术和反射圆柱艺术呈现有趣的视觉效果,但通常限于单一视角。

使用扩散模型的3D生成:

- 扩散模型在生成逼真的2D图像方面展现出了显著的能力,并且最近被广泛用于3D生成。

- 例如,DreamFusion、Magic3D和ProlificDreamer等方法利用文本到图像的扩散模型进行3D合成。

这些相关研究为本文提出的3D多视错觉生成方法提供了理论基础和技术背景。论文中提到的具体文献编号如下:

- [1] Michael Bach. Object perception: When our brain is impressed but we do not notice it. 2009.

- [2] Edwin G. Boring. A new ambiguous figure. American Journal of Psychology, 42:444, 1930.

- [3] Ryan Burgert, Xiang Li, Abe Leite, Kanchana Ranasinghe, and Michael Ryoo. Diffusion illusions: Hiding images in plain sight. In ACM SIGGRAPH 2024 Conference Papers, pages 1–11, 2024.

- [9] Daniel Geng, Inbum Park, and Andrew Owens. Visual anagrams: Generating multi-view optical illusions with diffusion models. ArXiv, abs/2311.17919, 2023.

- [19] Chen-Hsuan Lin, Jun Gao, Luming Tang, Towaki Takikawa, Xiaohui Zeng, Xun Huang, Karsten Kreis, Sanja Fidler, Ming-Yu Liu, and Tsung-Yi Lin. Magic3d: High-resolution text-to-3d content creation. In CVPR, 2023.

- [37] Ben Poole, Ajay Jain, Jonathan T. Barron, and Ben Mildenhall. Dreamfusion: Text-to-3d using 2d diffusion. In ICLR, 2022.

- [50] Zhengyi Wang, Cheng Lu, Yikai Wang, Fan Bao, Chongxuan Li, Hang Su, and Jun Zhu. Prolificdreamer: High-fidelity and diverse text-to-3d generation with variational score distillation. In NeurIPS, 2023.

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤解决了自动生成3D多视错觉的问题:

预训练的扩散模型:

- 利用预训练的文本到图像扩散模型来优化神经3D表示的纹理和几何结构,通过可微分渲染技术生成从不同视角观察时呈现不同解释的3D错觉。

优化技术:

- 开发了几种技术来提高生成3D多视错觉的质量,包括:

- 分块去噪(Patch-wise denoising):允许基于VSD的方法在更高分辨率下有效优化。

- 计划性相机抖动(Scheduled camera jittering):在训练期间通过高斯噪声扰动渲染相机,以确保视角之间的平滑过渡。

- 渐进式渲染分辨率缩放(Progressive render resolution scaling):通过在优化过程中逐步增加渲染分辨率来提高生成错觉的质量,并减少重复图案问题。

- 开发了几种技术来提高生成3D多视错觉的质量,包括:

方法框架:

- 提出了一个简单的但有效的框架,通过文本提示和图像指导创建3D多视错觉。该方法优化3D神经表示,通过可微分渲染产生所需的视觉解释。

技术细节:

- 使用多分辨率哈希编码MLP从InstantNGP中嵌入纹理特征,并用神经网络参数化纹理场。

- 采用变分得分蒸馏(VSD)方法来更新纹理映射参数,并优化可训练的LoRA模块。

解决3D歧义问题:

- 针对3D歧义导致的局部最小值问题,提出了上述技术来改善优化过程,减少优化过程中的歧义和重复图案问题。

实验验证:

- 通过大量实验验证了所提方法的有效性,并展示了使用不同3D形式(包括立方体、球体、反射面和模糊3D形状)生成的错觉。

综上所述,论文通过结合预训练的扩散模型、优化技术、3D表示学习和渲染技术,提出了一种创新的方法来自动生成可以从多个视角提供不同视觉解释的3D多视错觉。

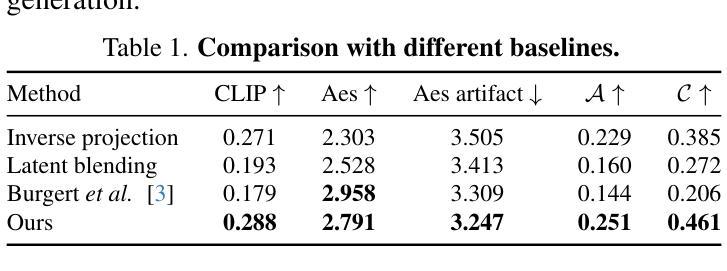

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证所提出方法的性能和有效性,具体包括:

与基线方法的比较:

- 论文定义了一个基线方法,并与其他几种基线方法(包括逆投影基线和潜在混合基线)进行了比较。这些基线方法使用Stable Diffusion独立生成图像并通过不同的方式优化立方体的纹理图。

定量结果:

- 使用CLIP分数、审美分数、审美人工制品分数、对齐分数和隐藏分数等指标对不同方法进行了定量评估。这些指标用于衡量生成的错觉图像的质量。

定性结果:

- 展示了与基本基线方法的定性比较结果,证明了所提方法可以融合不同提示的内容并生成吸引人的结果。

反射表面和3D形状错觉的实验:

- 展示了在反射圆柱和曲面镜上生成的3D多视错觉,以及使用两个反射圆柱/镜子创建的错觉。

个性化图像错觉生成:

- 通过使用L2损失监督圆柱视图的生成,展示了如何使用实际的RGB图像生成个性化的错觉。

3D形状错觉:

- 训练了一个3D形状错觉模型,展示了通过观察旁边的反射圆柱来揭示不同内容的3D对象。

消融研究:

- 对不同的设计选择进行了消融研究,包括随机补丁去噪、有无分辨率缩放和有无相机抖动等,以评估这些组件和超参数对生成质量的影响。

失败案例分析:

- 展示了一些典型的失败案例,分析了随机补丁方法和所提方法的失败情况。

这些实验不仅验证了所提方法的有效性,还展示了该方法在实际应用中的潜力和限制。通过这些实验,论文证明了其方法在生成高质量3D多视错觉方面的优势。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

更复杂的形状和结构:

- 研究可以探索将该方法应用于更复杂的3D形状和结构,例如非规则形状或更详细的3D模型,以提高艺术表现力和实用性。

优化效率和实时生成:

- 探索优化算法和计算框架,以减少生成3D多视错觉所需的时间和资源,实现更高效的实时生成。

增强现实感和真实感:

- 通过改进渲染技术和材质模拟,增强生成的3D错觉的真实感和视觉效果,使其更接近现实世界的物理特性。

交互式应用和用户体验:

- 开发交互式应用,允许用户实时调整视角和文本提示,以探索不同的3D错觉效果,增强用户体验。

更广泛的文本提示和风格:

- 扩展模型以处理更广泛的文本提示和艺术风格,提高模型的泛化能力和创造性。

解决高重叠和低扭曲形状的挑战:

- 针对高重叠和低扭曲形状难以生成高质量错觉的问题,研究新的技术解决方案。

负提示和内容隐藏:

- 探索使用负提示来改善特定视角内容的隐藏效果,增强错觉的艺术效果。

多模态输入和输出:

- 结合视觉、语音和触觉等多种感官输入和输出,创造更丰富的多模态3D多视错觉体验。

大规模数据集和训练:

- 构建和使用大规模的多视错觉数据集进行训练,以提高模型的鲁棒性和多样性。

跨领域应用:

- 探索3D多视错觉在游戏、电影、虚拟现实和教育等领域的应用,以实现更广泛的社会和经济价值。

这些探索点可以帮助推动3D多视错觉技术的发展,并将其应用于更广泛的领域和场景中。

Q: 总结一下论文的主要内容

A: 本文提出了一种创新的方法,名为Illusion3D,用于生成3D多视错觉,即从不同视角观察时能够呈现出不同视觉解释的3D表面。主要内容包括:

问题定义:

- 自动生成多视错觉是一个挑战,它允许单一视觉内容从不同视角提供不同的解释。传统方法如阴影艺术和线条艺术限于简单的视觉输出,而近期的扩散模型方法仅限于2D图像。

方法介绍:

- 该方法基于用户提供的文本提示或图像,利用预训练的文本到图像扩散模型,通过可微分渲染优化神经3D表示的纹理和几何结构,以产生不同视角下的多种解释。

技术贡献:

- 提出了分块去噪、计划性相机抖动和渐进式渲染分辨率缩放等技术,以提高生成3D多视错觉的质量。

- 这些技术解决了3D歧义导致的优化难题,如局部最小值问题和重复图案问题。

实验验证:

- 通过大量实验,包括与基线方法的比较、定量和定性结果分析、消融研究以及失败案例分析,验证了所提方法的有效性。

- 实验结果表明,该方法在生成具有不同3D形式(如立方体、球体和反射面)的高质量3D多视错觉方面具有优势。

潜在应用和未来研究方向:

- 论文讨论了该方法在艺术创作和实际应用中的潜力,并提出了未来可能的研究方向,包括探索更复杂的形状、优化效率、增强现实感、交互式应用等。

总体而言,Illusion3D通过结合预训练的扩散模型、3D表示学习和渲染技术,为自动生成3D多视错觉提供了一个有效的框架,并展示了在多个视角下创造动态视觉体验的能力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

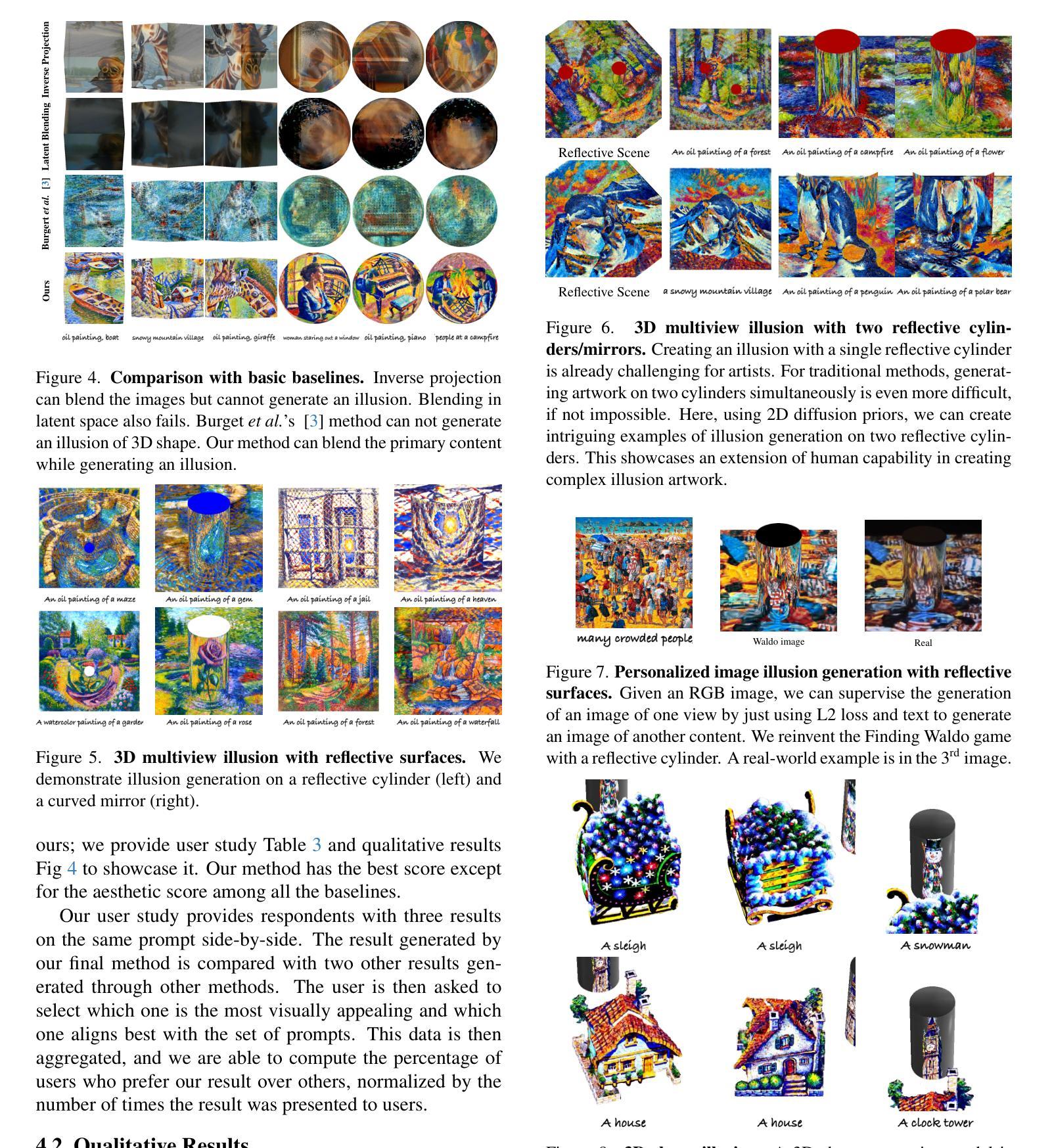

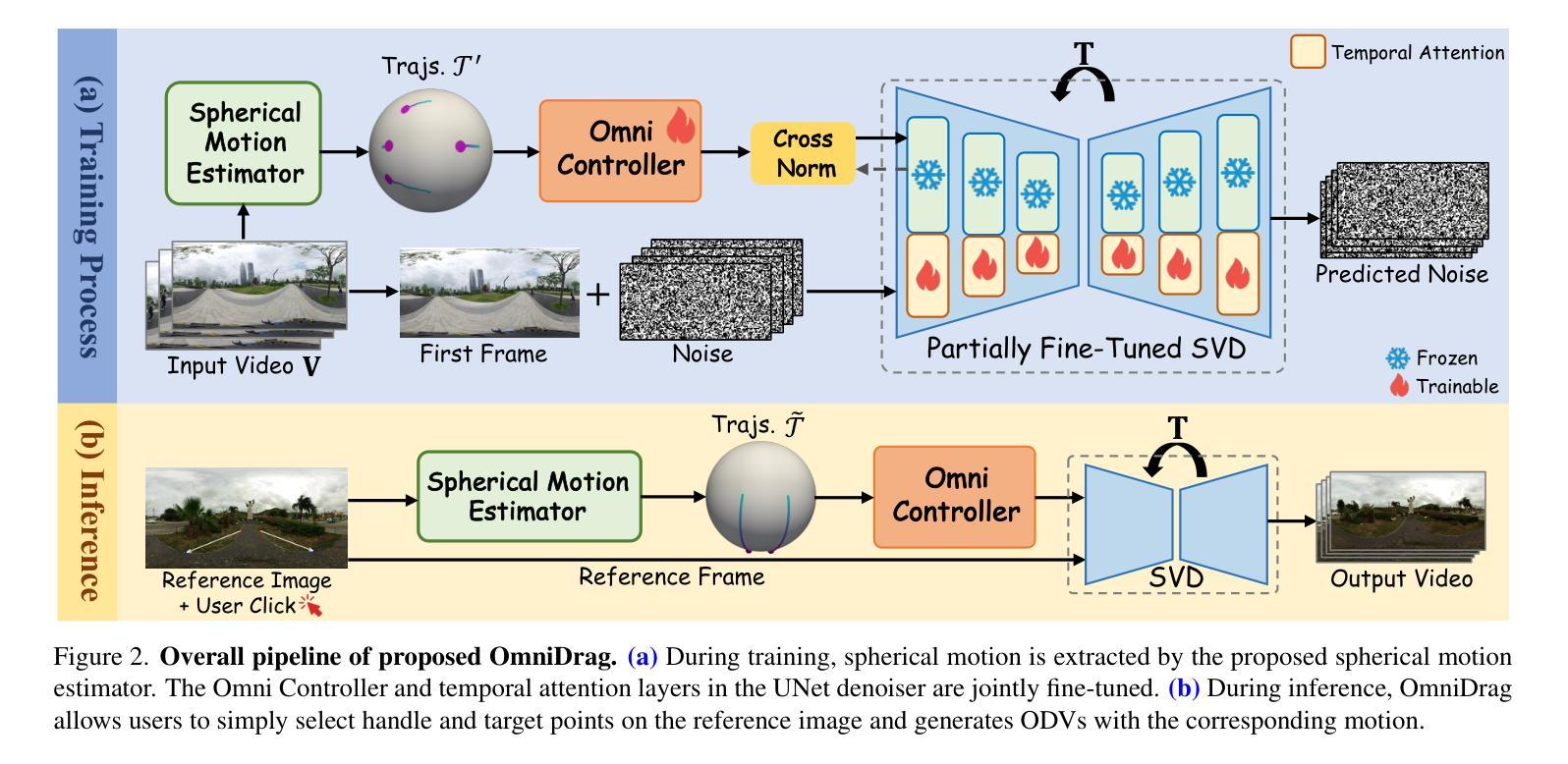

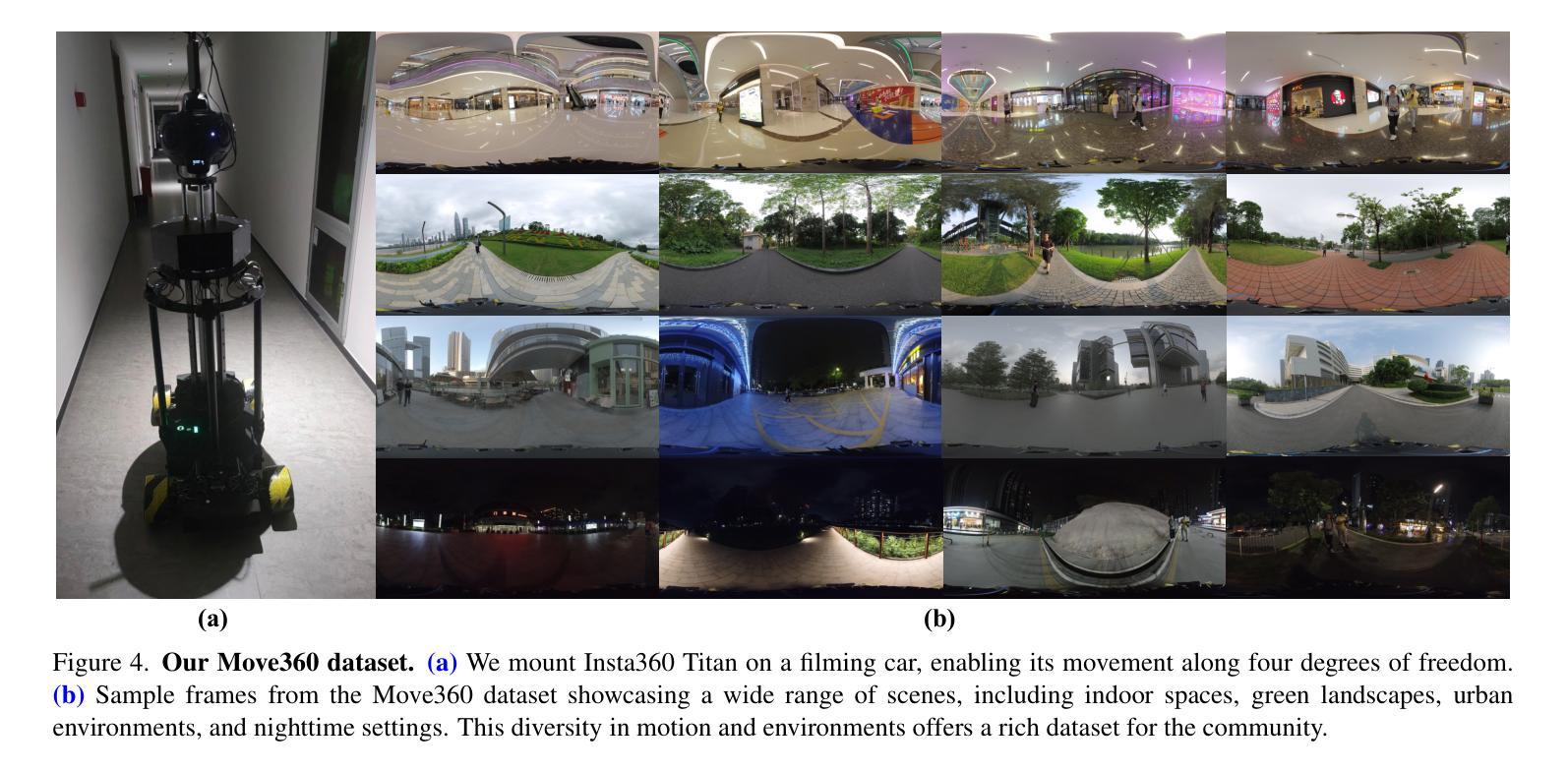

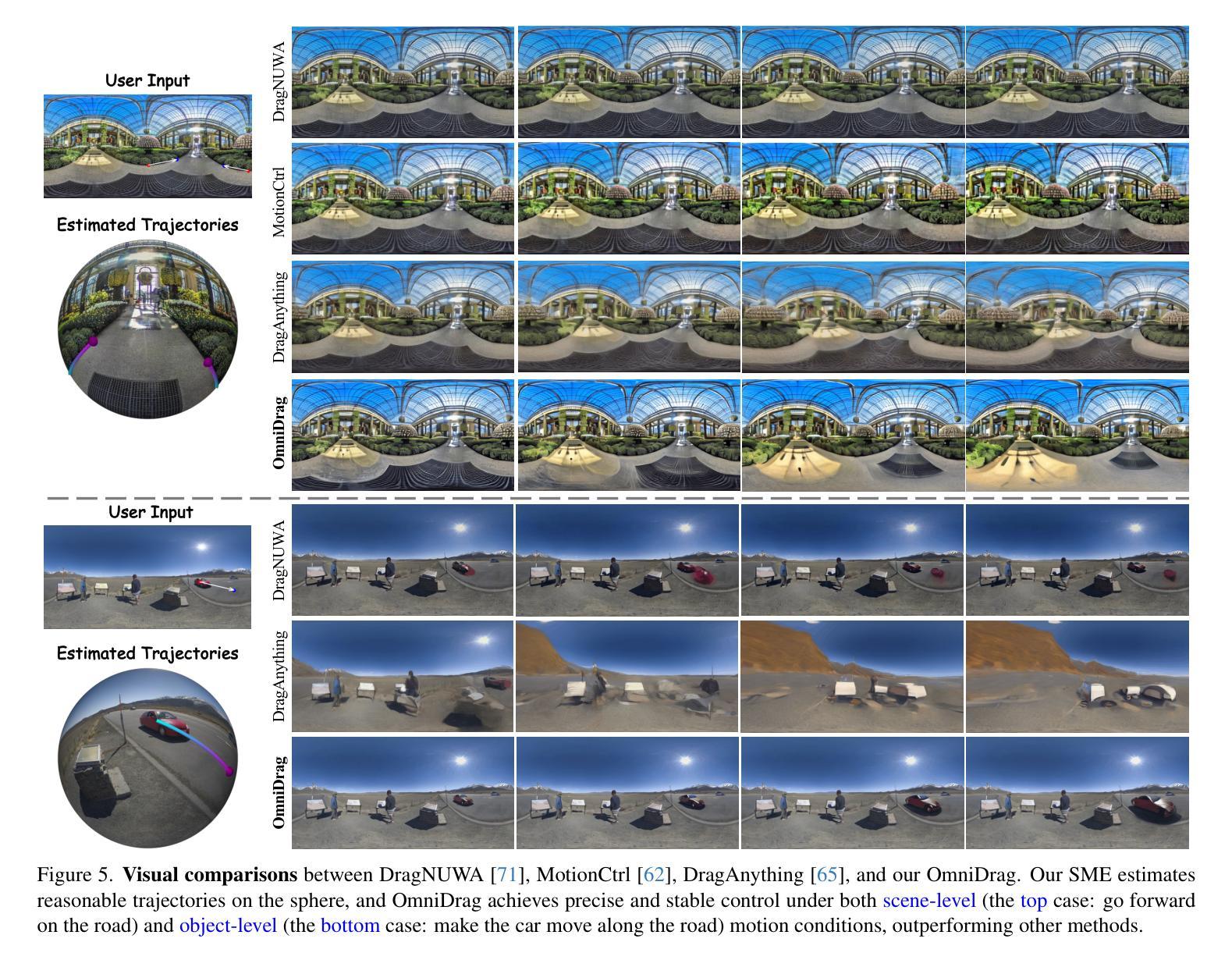

OmniDrag: Enabling Motion Control for Omnidirectional Image-to-Video Generation

Authors:Weiqi Li, Shijie Zhao, Chong Mou, Xuhan Sheng, Zhenyu Zhang, Qian Wang, Junlin Li, Li Zhang, Jian Zhang

As virtual reality gains popularity, the demand for controllable creation of immersive and dynamic omnidirectional videos (ODVs) is increasing. While previous text-to-ODV generation methods achieve impressive results, they struggle with content inaccuracies and inconsistencies due to reliance solely on textual inputs. Although recent motion control techniques provide fine-grained control for video generation, directly applying these methods to ODVs often results in spatial distortion and unsatisfactory performance, especially with complex spherical motions. To tackle these challenges, we propose OmniDrag, the first approach enabling both scene- and object-level motion control for accurate, high-quality omnidirectional image-to-video generation. Building on pretrained video diffusion models, we introduce an omnidirectional control module, which is jointly fine-tuned with temporal attention layers to effectively handle complex spherical motion. In addition, we develop a novel spherical motion estimator that accurately extracts motion-control signals and allows users to perform drag-style ODV generation by simply drawing handle and target points. We also present a new dataset, named Move360, addressing the scarcity of ODV data with large scene and object motions. Experiments demonstrate the significant superiority of OmniDrag in achieving holistic scene-level and fine-grained object-level control for ODV generation. The project page is available at https://lwq20020127.github.io/OmniDrag.

随着虚拟现实技术的普及,对可控创建沉浸式和动态全向视频(ODVs)的需求不断增加。虽然之前的文本到ODV生成方法取得了令人印象深刻的结果,但由于它们仅依赖于文本输入,因此在内容准确性和一致性方面存在挑战。虽然最近的运动控制技术为视频生成提供了精细的控制,但直接将这些方法应用于ODVs通常会导致空间失真和性能不佳,尤其是在复杂的球形运动中。为了应对这些挑战,我们提出了OmniDrag,这是一种新方法,能够实现对场景和对象级别的运动控制,以实现准确、高质量的全向图像到视频的生成。我们基于预训练的视频扩散模型,引入了一个全向控制模块,该模块与临时注意力层联合微调,以有效处理复杂的球形运动。此外,我们开发了一种新型球形运动估计器,能够准确提取运动控制信号,并允许用户通过简单地绘制把手和目标点来执行拖放式ODV生成。我们还展示了一个新的数据集Move360,以解决带有大场景和对象运动的大规模ODV数据稀缺问题。实验表明,OmniDrag在整体场景级别和精细的对象级别控制ODV生成方面表现出显著的优势。项目页面可在https://lwq20020127.github.io/OmniDrag访问。

论文及项目相关链接

Summary

随着虚拟现实技术的普及,全向视频(ODV)的需求不断增长。针对文本生成ODV方法的不足,如内容不准确和不一致,以及直接应用现有运动控制技术在ODV上会导致空间失真和性能不佳的问题,本文提出了一种全新的方法OmniDrag。该方法结合了预训练的视频扩散模型和全新设计的全向控制模块,能够处理复杂的球形运动,实现了场景和物体级别的运动控制,为准确、高质量的全向图像到视频的生成提供了解决方案。此外,还开发了一种新型球形运动估计器,并创建了一个新的数据集Move360。实验证明,OmniDrag在全景视频生成中实现了场景级别和精细物体级别的控制显著优于其他方法。

Key Takeaways

- 虚拟现实技术的普及促进了全向视频(ODV)需求的增长。

- 现有文本生成ODV方法存在内容不准确和不一致的问题。

- OmniDrag方法结合了预训练的视频扩散模型和全向控制模块,实现了场景和物体级别的运动控制。

- OmniDrag能够处理复杂的球形运动,为准确、高质量的全向图像到视频的生成提供了解决方案。

- 提出了一种新型球形运动估计器,提高了运动控制的准确性。

- 创建了新的数据集Move360,解决了ODV数据缺乏大规模场景和物体运动的问题。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为OmniDrag的方法,旨在解决以下问题:

虚拟现实中对沉浸式和动态全景视频(Omnidirectional Videos, ODVs)的可控创造需求增加:随着虚拟现实技术的发展,用户对能够生成高质量、沉浸式全景视频的需求日益增长。

现有方法的局限性:先前的方法,尤其是基于文本到全景视频(text-to-ODV)的生成方法,虽然取得了令人印象深刻的结果,但由于完全依赖于文本输入,常常导致内容不准确和不一致。

直接应用2D视频生成中的运动控制技术到ODVs中的挑战:这些方法在应用于全景视频生成时,常常导致空间失真和不满意的性能,特别是在处理复杂的球面运动时。

全景视频数据集样本运动幅度有限:现有的全景视频数据集包含的样本运动幅度有限,限制了深度可控全景视频生成模型在面对用户对更大运动范围要求时的有效性。

为了解决这些问题,OmniDrag作为第一个方法,能够基于强大的预训练视频扩散模型,实现对全景图像到视频生成的精确、高质量的运动控制。具体来说,OmniDrag引入了一个能够处理复杂球面运动的全方位控制器,并提出了一个新的球面运动估计器,允许用户通过简单地绘制手柄和目标点来进行拖拽风格的全景视频生成。此外,论文还介绍了一个新的数据集Move360,旨在解决全景视频数据缺乏大规模场景和对象运动的问题。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个领域:

1. 可控制的图像和视频生成

- 扩散模型:近期的发展中,扩散模型如Stable Diffusion、Imagen和DALL-E2等利用文本输入来指导生成过程。

- 额外控制模块:方法如ControlNet和T2I-Adapter将额外的控制模块整合到预训练的扩散模型中,以实现更精细的控制能力。

- 视频生成:早期方法依赖文本条件,如Video LDM、Imagen Video和AnimateDiff等。但最近的研究采用基于图像的条件进行更精确和有效的控制,例如Video ControlNet和ControlNeXt。

2. 全景图像和视频生成

- 基于生成对抗网络(GAN)的方法:广泛探索了基于GAN的方法来生成全景图像(ODIs)。

- 扩散模型:最近,扩散模型显著推进了ODI生成技术,例如PanoDiffusion、PanFusion和LayerPano3D等。

- 全景视频(ODV)生成:360DVD利用运动建模模块和360Adapter实现文本到ODV的生成,但完全依赖文本输入会导致生成帧的不准确和不一致。

3. 运动控制技术

- 基于轨迹的方法:如DragNUWA、MotionCtrl、DragAnything和Tora等,这些方法通过编码稀疏轨迹或相机运动到潜在空间来有效引导对象运动。

- 基于盒子的技术:如Peekaboo和Freetraj等,这些方法通过盒子来控制视频生成中的对象运动。

这些相关研究为OmniDrag提供了理论基础和技术背景,使其能够在全景视频生成领域实现精确的运动控制和高质量的视频生成。OmniDrag通过结合这些技术,提出了一种新的方法来处理全景视频中复杂的球面运动,并提供了用户友好的控制方式。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为OmniDrag的方法来解决上述问题,具体的解决方案包括以下几个关键点:

1. Omni Controller(全方位控制器)

- 动机:由于全景视频中的运动模式通常是球面的,这与2D视频中的简单运动模式不同,因此需要一个专门的控制器来处理这种复杂的球面运动。

- 方法:提出了一个轻量级的Omni Controller,它由多个ResNet块组成,用于提取控制信号,并将这些信号集成到主去噪分支中。

2. 联合微调技术(Joint Fine-tuning)

- 动机:为了有效地学习全景视频中的复杂球面运动模式,需要对控制器和时间注意力层进行联合微调。

- 方法:提出了联合微调Omni Controller和UNet去噪器中的时间注意力层的方法,以提高模型对球面运动模式的学习效果。

3. 球面运动估计器(Spherical Motion Estimator, SME)

- 动机:为了在训练和推理阶段提供精确的运动控制信号,需要一个能够准确捕捉球面运动的估计器。

- 方法:提出了一个新颖的SME,它使用等面积等纬度球面点初始化和基于球面距离的过滤器来跟踪和选择具有较大运动幅度的轨迹。在推理阶段,用户只需指定手柄和目标点,SME就可以通过球面插值自动估计整个轨迹。

4. Move360数据集

- 动机:为了训练OmniDrag模型,需要一个包含高质量运动内容的全景视频数据集。

- 方法:收集并构建了一个新的高质量全景视频数据集Move360,该数据集包含丰富的场景和对象运动,有助于提高OmniDrag的场景级控制能力。

5. 实验验证

- 动机:通过实验验证OmniDrag在生成平滑且视觉上吸引人的全景视频方面的效果和性能。

- 方法:与现有的一些最先进的视频生成方法进行了比较,包括DragNUWA、MotionCtrl和DragAnything,并在不同的控制条件下进行了评估。

通过这些解决方案,OmniDrag能够实现对全景图像到视频生成的精确、高质量的运动控制,同时提供了用户友好的交互方式,使得用户可以通过简单的点击和拖拽操作来控制视频内容。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了一系列实验来验证OmniDrag方法的有效性和性能。以下是实验的具体内容:

1. 实验设置

- 基础模型:选择Stable Video Diffusion (SVD)模型作为基础模型。

- 跟踪函数:使用CoTracker作为跟踪函数。

- 训练数据集:在Move360和WEB360数据集上训练OmniDrag。

- 优化器和迭代次数:使用Adam优化器进行40K次迭代训练。

- 分辨率和学习率:分辨率降低到640×320,学习率设置为(1 \times 10^{-5})。

- 评估指标:使用Fréchet Inception Distance (FID)、Fréchet Video Distance (FVD)和ObjMC等自动评估指标,以及进行人类评估来衡量结果的质量。

2. 与最新方法的比较

- 比较对象:与DragNUWA、MotionCtrl和DragAnything等最新视频生成方法进行比较。

- 控制条件:在场景级和对象级控制条件下进行实验。

- 参考图像:选择ODISR和SUN360数据集中的全景图像作为参考图像。

- 测试集:创建十二对输入作为测试集。

- 视觉比较和定量比较:展示视觉比较结果,并使用FID、FVD和ObjMC等指标进行定量比较。

3. 消融研究

- 联合微调时间注意力层:评估冻结整个主UNet去噪分支的变体。

- Move360数据集的影响:评估仅在WEB360数据集上训练的OmniDrag变体。

- 球面运动估计器(SME)的影响:评估替换HEALPix初始化、球面距离计算和球面插值的变体。

4. 定量和定性结果

- 定量结果:在表1中展示了OmniDrag与其他方法的定量比较结果。

- 视觉结果:在图5中展示了不同方法的视觉比较结果。

- 消融研究结果:在图6和图7中展示了消融研究的视觉结果,并在表2中提供了定量结果。

这些实验旨在全面评估OmniDrag在全景视频生成中的表现,特别是在场景级和对象级运动控制方面的能力。通过与现有技术的比较和消融研究,作者展示了OmniDrag在生成高质量、可控全景视频方面的优越性能。

Q: 有什么可以进一步探索的点?

A: 尽管OmniDrag在全景视频生成方面取得了显著成果,但仍有一些领域可以进一步探索和改进:

1. 提高生成质量

- 基础模型的改进:尽管OmniDrag基于SVD模型,但在某些情况下生成质量仍有限制。研究更先进的视频生成模型可能进一步提升生成质量。

2. 相机和对象运动的解耦

- 运动解耦:将相机运动和对象运动分离是一个开放性问题。研究如何有效地区分和控制这两种运动,可能提高模型的灵活性和控制精度。

3. 交互方式的优化

- 用户交互:虽然OmniDrag提供了通过点击和拖拽来控制视频的简单交互方式,但可以进一步探索更自然和直观的交互方式,如语音控制或手势识别。

4. 数据集的扩展和多样化

- 数据集多样性:尽管Move360数据集提供了丰富的运动内容,但扩展数据集以包含更多样化的场景和运动对于提高模型的泛化能力至关重要。

5. 实时性能的提升

- 推理效率:OmniDrag在实际应用中可能需要实时生成视频,因此提高模型的推理效率是一个重要的研究方向。

6. 多模态输入的融合

- 多模态控制:除了基于图像和运动的控制,融合文本、音频等其他模态的输入可能提供更丰富的控制方式。

7. 模型的可解释性和稳定性

- 模型解释性:提高模型的可解释性,让研究者和用户更好地理解模型的决策过程。

- 模型稳定性:在各种输入条件下保持模型生成的稳定性和一致性。

8. 跨模态迁移学习

- 迁移学习:探索如何将OmniDrag模型迁移到其他相关任务,如视频预测、视频编辑等。

9. 长期运动趋势的学习

- 长期运动预测:研究模型如何捕捉和预测长时间跨度内的运动趋势。

这些方向不仅可以推动全景视频生成技术的发展,还可能对虚拟现实、增强现实以及其他多媒体应用产生深远影响。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为OmniDrag的新方法,用于实现对全景图像到视频生成(ODV)的运动控制。以下是论文的主要内容总结:

1. 问题背景

- 随着虚拟现实技术的发展,对沉浸式和动态全景视频(ODVs)的需求不断增加。

- 现有方法依赖文本输入,导致内容不准确和不一致。

- 直接应用2D视频生成技术到ODVs中会导致空间失真和性能不佳。

- 现有的ODV数据集样本运动幅度有限,限制了深度可控ODV生成模型的效果。

2. OmniDrag方法

- Omni Controller:提出了一个全方位控制器,接收轨迹作为输入,允许简单的拖拽式控制。

- 联合微调:提出了联合微调控制器和时间层在扩散去噪UNet中的方法,以有效学习复杂的球面运动模式。

- 球面运动估计器(SME):开发了一个球面运动估计器,用于在训练期间准确捕获控制信号,并在推理期间提供用户友好的交互。

- Move360数据集:收集了一个新的高质量ODV数据集,包含丰富的场景和对象运动,增强了OmniDrag的场景级控制能力。

3. 实验

- 与现有最先进的视频生成方法(如DragNUWA、MotionCtrl和DragAnything)进行了比较。

- 在场景级和对象级控制条件下进行了评估。

- 进行了消融研究,验证了OmniDrag各个组成部分的有效性。

4. 结果

- OmniDrag在生成平滑且视觉上吸引人的全景视频方面表现出色,并且在交互式运动控制方面优于其他方法。

- 实验结果表明,OmniDrag在视频质量和运动控制性能方面均优于现有技术。

5. 结论与局限性

- OmniDrag是一个新颖的基于扩散的方法,用于实现全景图像到视频的动态运动控制。

- 尽管取得了有希望的结果,但其生成质量仍受到基础SVD模型的限制。

- 解耦相机和对象级运动是一个未来的研究方向。

这篇论文通过引入新的技术和数据集,为全景视频的生成和控制提供了一个先进的解决方案,并展示了其在实际应用中的潜力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

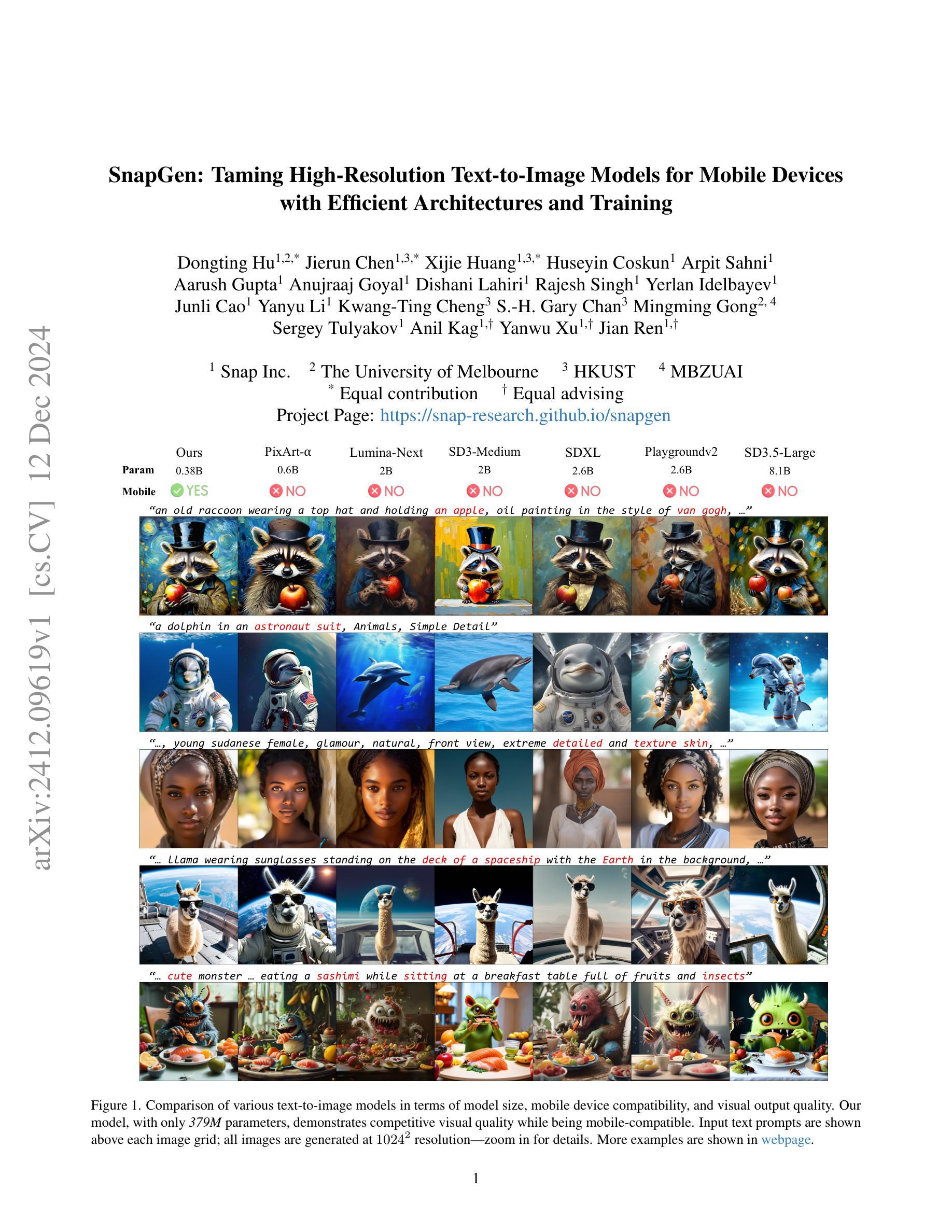

SnapGen: Taming High-Resolution Text-to-Image Models for Mobile Devices with Efficient Architectures and Training

Authors:Dongting Hu, Jierun Chen, Xijie Huang, Huseyin Coskun, Arpit Sahni, Aarush Gupta, Anujraaj Goyal, Dishani Lahiri, Rajesh Singh, Yerlan Idelbayev, Junli Cao, Yanyu Li, Kwang-Ting Cheng, S. -H. Gary Chan, Mingming Gong, Sergey Tulyakov, Anil Kag, Yanwu Xu, Jian Ren

Existing text-to-image (T2I) diffusion models face several limitations, including large model sizes, slow runtime, and low-quality generation on mobile devices. This paper aims to address all of these challenges by developing an extremely small and fast T2I model that generates high-resolution and high-quality images on mobile platforms. We propose several techniques to achieve this goal. First, we systematically examine the design choices of the network architecture to reduce model parameters and latency, while ensuring high-quality generation. Second, to further improve generation quality, we employ cross-architecture knowledge distillation from a much larger model, using a multi-level approach to guide the training of our model from scratch. Third, we enable a few-step generation by integrating adversarial guidance with knowledge distillation. For the first time, our model SnapGen, demonstrates the generation of 1024x1024 px images on a mobile device around 1.4 seconds. On ImageNet-1K, our model, with only 372M parameters, achieves an FID of 2.06 for 256x256 px generation. On T2I benchmarks (i.e., GenEval and DPG-Bench), our model with merely 379M parameters, surpasses large-scale models with billions of parameters at a significantly smaller size (e.g., 7x smaller than SDXL, 14x smaller than IF-XL).

现有的文本到图像(T2I)扩散模型面临几个局限性,包括模型体积大、运行速度慢以及在移动设备上的生成质量低。本文旨在通过开发一个极小且快速的T2I模型来解决所有这些挑战,该模型能够在移动平台上生成高分辨率和高质量的图像。我们提出了几种技术来实现这一目标。首先,我们系统地检查网络架构的设计选择,以减少模型参数和延迟,同时确保高质量的生成。其次,为了进一步提高生成质量,我们采用跨架构知识蒸馏的方法,从一个更大的模型中蒸馏知识,并使用多层次的方法从零开始引导我们的模型训练。第三,我们通过将对抗性指导与知识蒸馏相结合,实现了几步生成。我们的模型SnapGen首次在移动设备上实现了约1.4秒内生成1024x1024像素的图像。在ImageNet-1K上,我们的模型仅有3.72亿个参数,实现了256x256像素生成的FID为2.06。在T2I基准测试(即GenEval和DPG-Bench)中,我们的模型仅有3.79亿个参数,在显著更小的规模上超越了大规模模型(例如,比SDXL小7倍,比IF-XL小14倍)。

论文及项目相关链接

摘要

本文提出了一种针对文本到图像(T2I)扩散模型的优化方案,旨在解决现有模型面临的模型体积大、运行速度慢和在移动设备上生成质量低的问题。通过设计极小的快速T2I模型,实现了在移动平台上生成高分辨率高质量图像的目标。本文采用多种技术实现这一目标,包括系统研究网络架构的设计选择以减小模型参数和延迟,同时确保高质量生成;采用跨架构知识蒸馏技术,从大型模型中引导模型训练;以及结合对抗性指导和知识蒸馏实现几步生成。本文的模型SnapGen首次实现了在移动设备上以约1.4秒的时间生成1024x1024像素的图像。在ImageNet-1K上,仅有372M参数的模型实现了2.06的FID值(针对256x256像素生成)。在文本到图像基准测试(如GenEval和DPG-Bench)中,仅有379M参数的模型在尺寸显著减小的情况下(例如,比SDXL小7倍,比IF-XL小14倍)超越了大规模模型。

关键见解

- 文本到图像(T2I)扩散模型面临模型体积大、运行速度慢和在移动设备上生成质量低的问题。

- 提出了一种极小的快速T2I模型,能在移动平台上生成高分辨率高质量图像。

- 通过系统研究网络架构的设计选择,实现了模型参数和延迟的减少,同时保证了高质量生成。

- 采用跨架构知识蒸馏技术,利用多层次方法从大型模型中引导模型训练。

- 结合对抗性指导和知识蒸馏实现了模型的几步生成。

- 模型SnapGen在移动设备上实现了快速生成大分辨率图像。

- 模型在ImageNet-1K上表现出优异的性能,并在文本到图像基准测试中超越了大型模型。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决现有文本到图像(Text-to-Image, T2I)扩散模型在移动设备上部署时面临的几个主要问题,包括:

模型尺寸大:现有的T2I扩散模型通常具有庞大的模型尺寸,这使得它们难以被部署到资源受限的移动设备上。

运行速度慢:这些模型在移动设备上的运行速度较慢,无法满足用户对即时生成图像的需求。

图像生成质量低:在移动设备上部署的T2I模型往往无法生成高分辨率和高质量的图像。

为了解决这些问题,论文提出了一种极小且快速的T2I模型,能够在移动平台上生成高分辨率和高质量的图像。具体来说,论文提出了以下几种技术:

高效的网络架构:通过系统地检查网络架构设计选择,减少模型参数和延迟,同时确保生成质量。

改进的训练技术:引入了几项改进措施来从头开始训练一个紧凑的T2I模型,包括流匹配目标和多级知识蒸馏。

先进的步骤蒸馏:通过结合对抗训练和知识蒸馏,实现了几步生成,以减少去噪步骤,同时保持图像质量。

通过这些技术,论文中提出的模型SnapGen能够在移动设备上大约1.4秒内生成10242像素的高分辨率图像,并且在参数数量远少于现有大规模模型的情况下,在多个基准测试中取得了竞争性能。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的工作:

高分辨率文本到图像模型:

- SDXL [56]:采用级联方法和UNet主干生成高细节图像,产生保持锐度和清晰度的照片真实输出。

- 其他研究 [6, 7, 16, 21, 32, 39–41, 44, 48, 51, 71]:探索更先进的文本编码器、更好的图像细化或改进的数据集准备,以获得更好的文本-图像对齐或更高质量的生成。

高效的扩散模型:

- 一些工作探索了架构优化以去除大型模型中的冗余,展示了在设备上几秒钟内生成图像的能力 [11, 43, 69, 88]。

- SANA [76] 和 LinFusion [49]:通过整合线性注意力机制实现在笔记本GPU上1K分辨率的生成。

扩散模型中的知识蒸馏:

- 先前工作专注于将大型、高容量教师模型蒸馏到更紧凑、高效的学生模型中,保持架构结构 [35, 49]。

- 通过移除某些组件(如注意力或残差块)来降低模型复杂性,同时保持性能。

对抗性步骤蒸馏:

- UFOGen [79] 和 DMD2 [81]:使用对抗训练技术减少扩散步骤数,同时保持高图像质量。

其他相关技术:

- 流匹配 [47, 50]:作为目标函数,与大型模型如SD3 [19] 和 SD3.5 [3] 对齐,实现有效的知识和步骤蒸馏。

- 多级知识蒸馏与时间步长感知缩放:结合多个训练目标,考虑不同时间步长中的目标预测难度。

这些相关工作为本研究提供了理论基础和技术背景,使得研究者能够开发出更小、更快且能在移动设备上运行的高分辨率文本到图像模型。通过借鉴和改进这些技术,本研究的模型SnapGen在参数数量显著减少的同时,实现了与大型模型相媲美的图像生成质量。

Q: 论文如何解决这个问题?

A: 论文通过以下方法解决文本到图像扩散模型在移动设备上部署的问题:

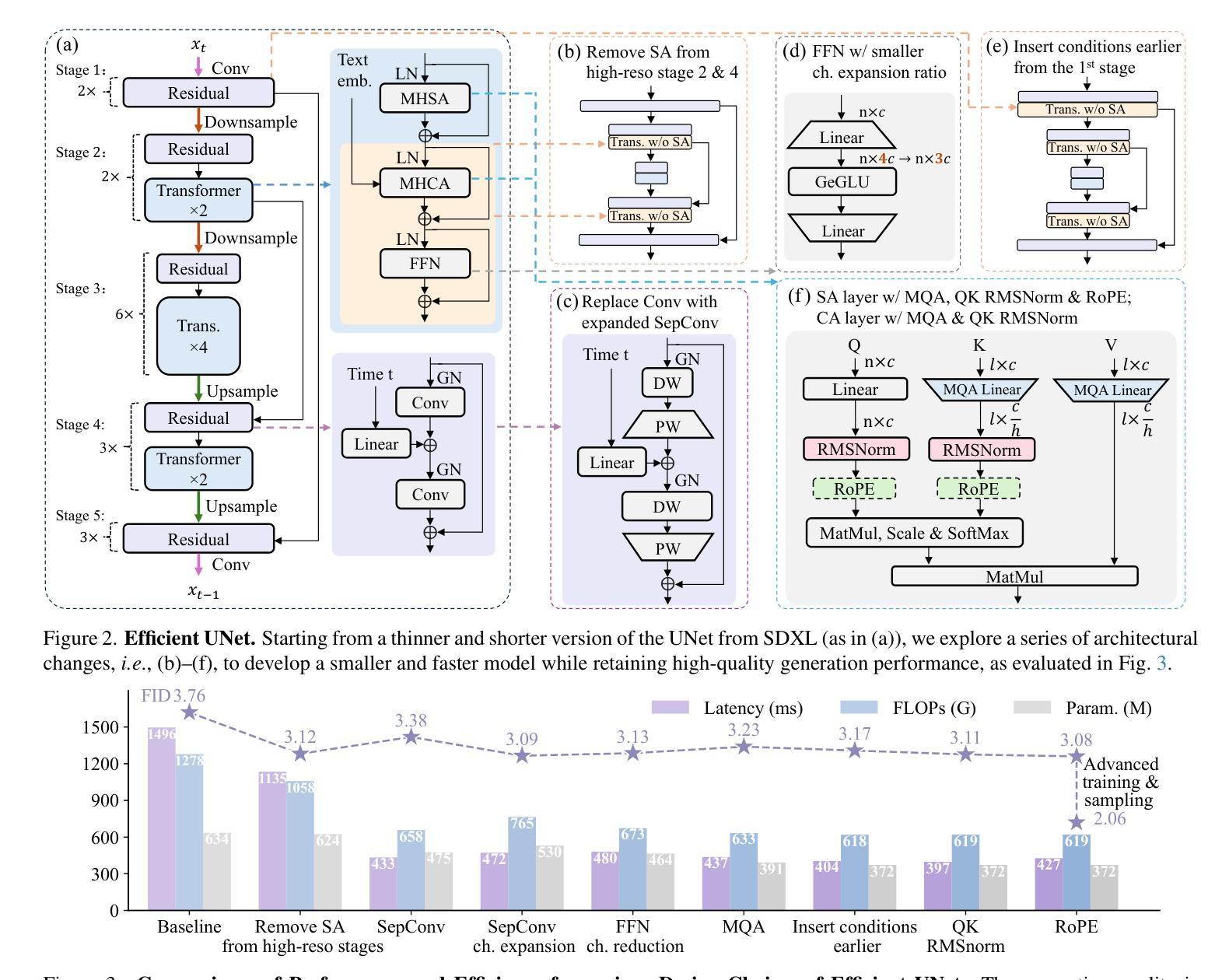

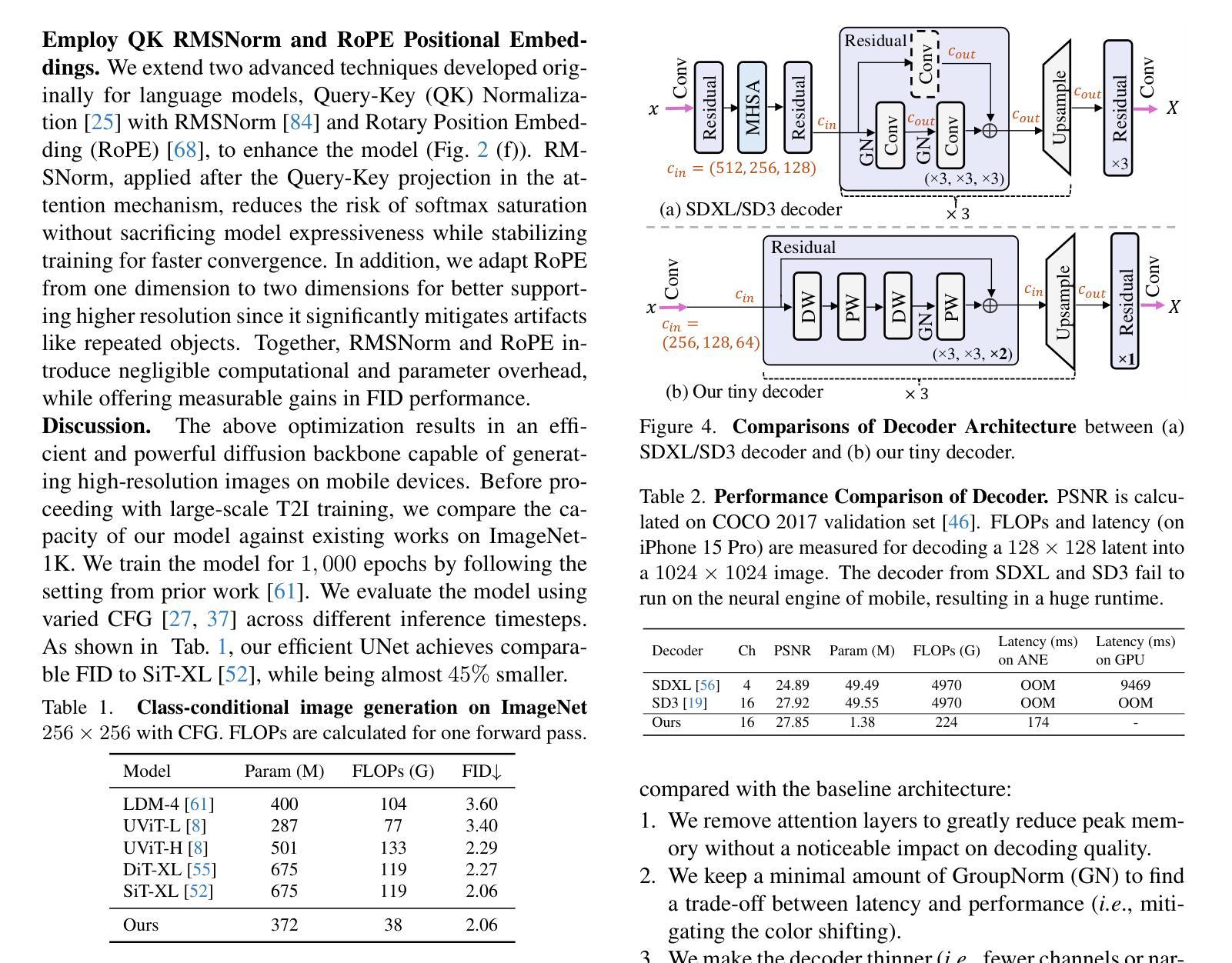

1. 高效网络架构

- 优化UNet和Autoencoder(AE):对网络架构进行深入分析,以获得资源使用和性能之间的最佳权衡。通过减少模型大小和计算复杂度,同时保持生成质量。

- 移除高分辨率阶段的自注意力(SA):由于自注意力层的二次计算复杂度,导致高分辨率输入时计算成本和内存消耗高,因此只在最低分辨率阶段保留SA层。

- 用可分离卷积(SepConv)替换普通卷积(Conv):减少参数和计算量,并通过扩展中间通道来平衡性能、延迟和模型参数。

- 精简前馈网络(FFN)层:降低FFN层的隐藏通道扩展比例,以减少模型参数和计算量。

- 用多查询注意力(MQA)替换多头自注意力(MHSA):减少参数和延迟,同时对性能影响最小。

- 将条件信息注入到第一阶段:确保从第一阶段开始就有条件引导,使模型更小、更快、更高效。

- 使用QK RMSNorm和RoPE位置嵌入:引入这些技术来增强模型,提高性能,同时引入的计算和参数开销可以忽略不计。

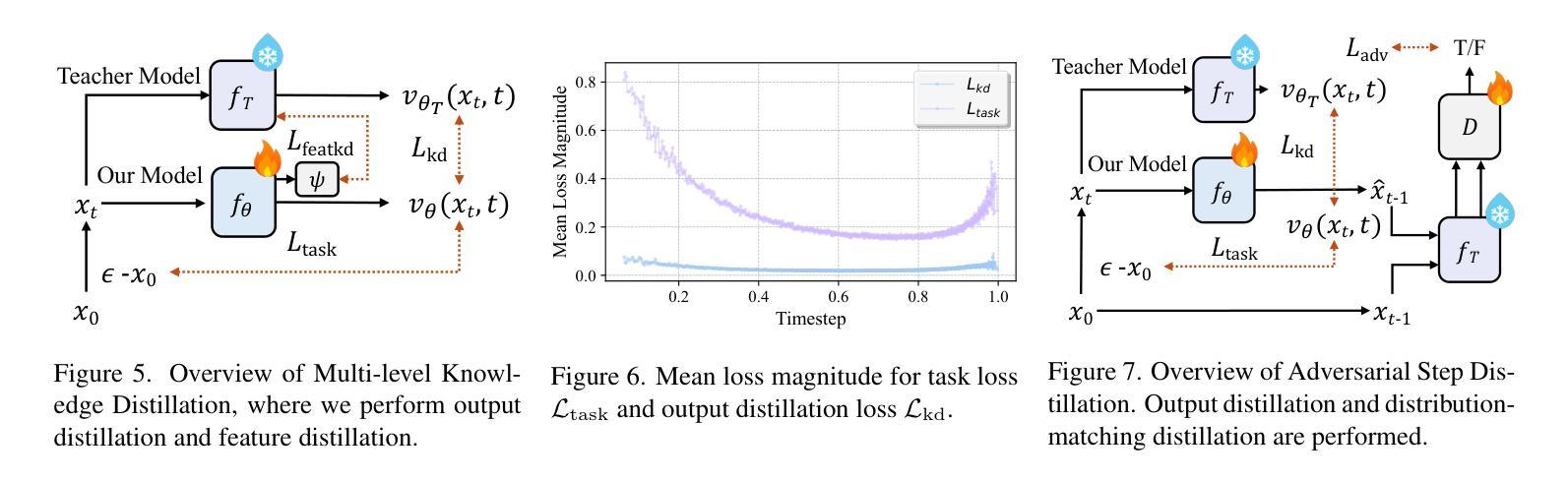

2. 改进的训练技术

- 流匹配目标:使用流匹配目标和Logit-Normal采样来增强训练稳定性。

- 多级知识蒸馏:结合输出蒸馏和特征蒸馏,使用来自大型模型的多级指导来从头开始训练我们的模型。

3. 先进的步骤蒸馏

- 对抗性步骤蒸馏:结合对抗训练和知识蒸馏,通过几步生成实现超快速的高质量生成。

4. 实验验证

- 量化基准测试:使用GenEval和DPG-Bench等基准测试评估模型性能。

- 人类评估:通过用户研究比较不同模型生成的图像在美学质量、文本-图像对齐和真实感方面的属性。

5. 移动设备部署

- 压缩解码器:开发新的压缩解码器架构,使其在移动设备上快速高效地进行高分辨率图像生成。

通过这些方法,论文成功地开发了一个参数数量仅为379M的模型SnapGen,该模型能够在移动设备上大约1.4秒内生成10242像素的高分辨率图像,并且在多个基准测试中超过了拥有数十亿参数的大型模型。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,以下是论文中进行的实验:

1. 效率和性能比较实验

- 对比不同网络架构设计选择(例如,去除自注意力层、替换卷积层、调整FFN层等)对模型效率(包括参数数量、延迟和FLOPs)和性能(FID得分)的影响。

2. 知识蒸馏实验

- 通过多级知识蒸馏来提升模型的图像生成质量,并比较有无知识蒸馏(KD)对模型在GenEval和DPG-Bench基准测试中的表现。

3. 量化基准测试

- 使用GenEval和DPG-Bench基准测试评估模型的文本到图像对齐能力。

- 报告模型在MS-COCO验证数据集上的CLIP得分以及在PixArt提示上的Image Reward得分,以衡量模型的审美质量。

4. 人类评估

- 通过用户研究比较不同模型生成的图像在图像-文本对齐、审美质量和真实感方面的属性。

5. 少步骤生成实验

- 比较模型在进行步骤蒸馏前后,在少步骤(4步和8步)生成情况下的性能,使用GenEval得分进行评估。

6. 模型细节和训练食谱

- 提供了模型的详细配置和训练策略,包括使用不同的文本编码器和多阶段训练方法。

7. 附加的定性比较和示例

- 展示了额外的定性可视化,比较了不同模型在1024×1024分辨率下的生成结果,并展示了由模型生成的额外图像示例。

8. 知识蒸馏组件的消融研究

- 对知识蒸馏的不同组件(包括不同蒸馏损失项和时间步长感知缩放操作)进行了消融研究,以展示它们对模型性能的提升。

这些实验旨在全面评估所提出的模型在效率、性能、图像质量和部署实用性等方面的表现,并与现有的一些最先进的模型进行比较。通过这些实验,论文证明了其模型在保持较小模型尺寸的同时,能够在移动设备上实现高质量的高分辨率图像生成。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了一种高效的文本到图像模型,并且取得了不错的效果,但仍有一些方向可以进一步探索和改进:

1. 模型泛化能力

- 跨领域测试:在不同的数据集和领域上测试模型的泛化能力,例如艺术风格、抽象概念等领域。

- 长尾分布处理:探索模型在处理类别不平衡数据时的表现和可能的改进方法。

2. 模型解释性

- 注意力可视化:分析模型内部的注意力机制,提供生成过程中的可视化解释。

- 特征重要性分析:研究不同特征对最终图像生成结果的影响,增强模型的可解释性。

3. 模型压缩和加速

- 知识蒸馏的改进:探索更高级的知识蒸馏技术,以进一步压缩模型大小并保持性能。

- 硬件加速:针对特定硬件平台(如特定型号的GPU或FPGA)优化模型,以实现更快的推理速度。

4. 多模态输入

- 多模态融合:研究如何将图像、文本和其他模态数据(如音频)融合,以生成更丰富的内容。

- 条件控制生成:允许用户通过多种条件(如风格、情感)控制生成过程,增强交互性和创造性。

5. 伦理和安全性

- 避免偏见和滥用:确保模型生成的内容不包含偏见,并且不能被用于制造虚假信息或滥用。

- 内容过滤机制:开发有效的内容过滤机制,防止生成不当或有害的图像。

6. 用户研究和体验

- 大规模用户测试:进行大规模的用户测试,收集反馈以改进模型的用户体验。

- 个性化定制:允许用户根据自己的偏好定制生成参数,提供更个性化的图像生成服务。

7. 模型鲁棒性

- 对抗性攻击防御:研究模型对对抗性攻击的鲁棒性,并开发防御机制。

- 数据增强和正则化:探索不同的数据增强和正则化技术,提高模型在面对异常输入时的稳定性和鲁棒性。

这些方向不仅可以推动文本到图像模型的技术发展,还可以扩展其应用范围,并确保技术的负责任使用。

Q: 总结一下论文的主要内容

A: 论文的主要内容可以总结如下:

问题阐述:

- 论文指出了现有的文本到图像(T2I)扩散模型在移动设备上部署时面临的挑战,包括模型尺寸大、运行速度慢和图像生成质量低。

研究目标:

- 旨在开发一个极小且快速的T2I模型,该模型能够在移动平台上生成高分辨率和高质量的图像。

方法论:

- 提出了几种技术来实现目标,包括:

- 高效的网络架构:通过系统地检查网络架构设计选择,减少模型参数和延迟,同时确保高生成质量。

- 改进的训练技术:使用流匹配作为目标,结合多级知识蒸馏,从头开始训练一个紧凑的T2I模型。

- 先进的步骤蒸馏:结合对抗训练和知识蒸馏,通过几步生成实现超快速的高质量生成。

- 提出了几种技术来实现目标,包括:

实验验证:

- 通过一系列实验,包括效率和性能比较、知识蒸馏效果、量化基准测试、人类评估和少步骤生成实验,验证了所提出模型的有效性。

- 模型在参数数量显著减少的同时,在多个基准测试中超过了拥有数十亿参数的大型模型。

主要贡献:

- 提出了一个参数数量仅为379M的模型SnapGen,该模型能够在移动设备上大约1.4秒内生成10242像素的高分辨率图像,并且在多个基准测试中取得了竞争性能。

未来工作:

- 论文也提出了一些可以进一步探索的方向,如模型泛化能力、模型解释性、模型压缩和加速、多模态输入、伦理和安全性以及用户研究和体验等。

总体而言,论文针对在移动设备上部署高分辨率文本到图像模型的挑战,提出了一种高效的解决方案,并通过对模型的系统优化和创新训练方法,实现了在保持较小模型尺寸的同时生成高质量图像的目标。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

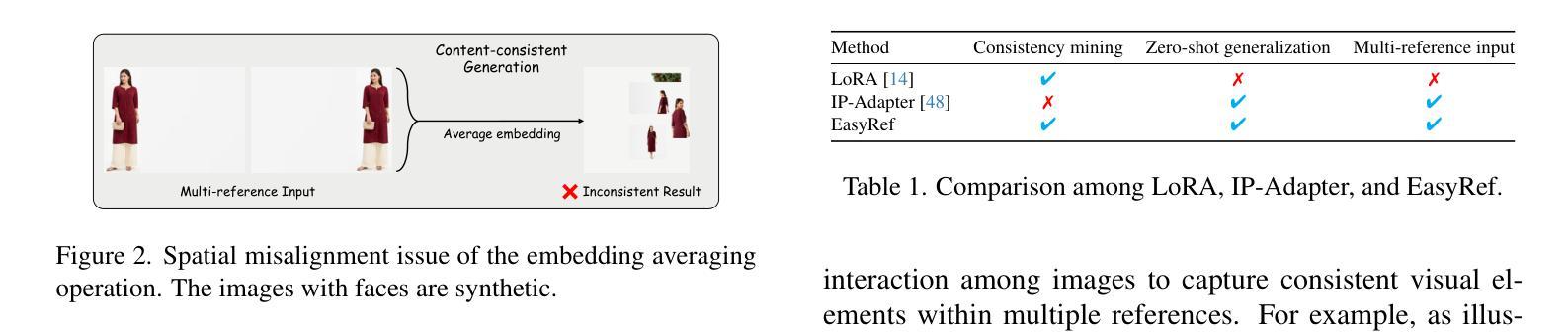

EasyRef: Omni-Generalized Group Image Reference for Diffusion Models via Multimodal LLM

Authors:Zhuofan Zong, Dongzhi Jiang, Bingqi Ma, Guanglu Song, Hao Shao, Dazhong Shen, Yu Liu, Hongsheng Li

Significant achievements in personalization of diffusion models have been witnessed. Conventional tuning-free methods mostly encode multiple reference images by averaging their image embeddings as the injection condition, but such an image-independent operation cannot perform interaction among images to capture consistent visual elements within multiple references. Although the tuning-based Low-Rank Adaptation (LoRA) can effectively extract consistent elements within multiple images through the training process, it necessitates specific finetuning for each distinct image group. This paper introduces EasyRef, a novel plug-and-play adaptation method that enables diffusion models to be conditioned on multiple reference images and the text prompt. To effectively exploit consistent visual elements within multiple images, we leverage the multi-image comprehension and instruction-following capabilities of the multimodal large language model (MLLM), prompting it to capture consistent visual elements based on the instruction. Besides, injecting the MLLM’s representations into the diffusion process through adapters can easily generalize to unseen domains, mining the consistent visual elements within unseen data. To mitigate computational costs and enhance fine-grained detail preservation, we introduce an efficient reference aggregation strategy and a progressive training scheme. Finally, we introduce MRBench, a new multi-reference image generation benchmark. Experimental results demonstrate EasyRef surpasses both tuning-free methods like IP-Adapter and tuning-based methods like LoRA, achieving superior aesthetic quality and robust zero-shot generalization across diverse domains.

在扩散模型的个性化方面取得了显著的成就。传统的无需调整的方法大多通过将多个参考图像的平均图像嵌入作为注入条件来编码,但这样的图像无关操作无法在不同图像之间进行交互,从而无法捕获多个参考内的连续视觉元素。尽管基于调整的低秩适应(LoRA)可以有效地通过训练过程提取多个图像中的连续元素,但它需要针对每个不同的图像组进行特定的微调。本文介绍了一种新型的即插即用适应方法EasyRef,它使扩散模型能够基于多个参考图像和文本提示进行条件化。为了有效利用多个图像中的连续视觉元素,我们利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力,提示它基于指令捕获连续的视觉元素。此外,通过适配器将MLLM的表示注入扩散过程,可以轻松地推广到未见领域,挖掘未见数据中的连续视觉元素。为了降低计算成本并增强细节保留的精细度,我们引入了一种有效的参考聚合策略和一种渐进的训练方案。最后,我们引入了新的多参考图像生成基准MRBench。实验结果表明,EasyRef超越了无需调整的IP-Adapter方法和基于调整的LoRA方法,在美学质量和跨不同领域的零样本泛化方面都更具优势。

论文及项目相关链接

PDF Tech report

Summary

本文提出一种名为EasyRef的新型适应方法,使扩散模型能够根据多个参考图像和文本提示进行条件化。该方法利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力,有效捕捉多个图像中的一致视觉元素。通过注入MLLM的表示形式到扩散过程中,EasyRef能够轻松推广到未见领域,挖掘未见数据中的一致视觉元素。实验结果证明,EasyRef在美学质量和跨域零样本概括能力上超越了无调整方法和基于调整的方法。

Key Takeaways

- EasyRef是一种新型适应方法,用于使扩散模型能够根据多个参考图像和文本提示进行条件化。

- 该方法利用MLLM的多图像理解和指令遵循能力,有效捕捉多个图像中的一致视觉元素。

- 通过将MLLM的表示形式注入到扩散过程中,EasyRef能够轻松推广到未见领域。

- EasyRef采用高效的参考聚合策略和渐进式训练方案,以降低计算成本并增强精细细节保留。

- MRBench是一个新的多参考图像生成基准,用于评估类似EasyRef的方法。

- 实验结果表明,EasyRef在美学质量和跨域零样本概括能力上超越了现有方法。

- EasyRef具有广泛的应用前景,特别是在需要根据多个参考图像和文本提示生成图像的任务中。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为EasyRef的新方法,旨在解决以下问题:

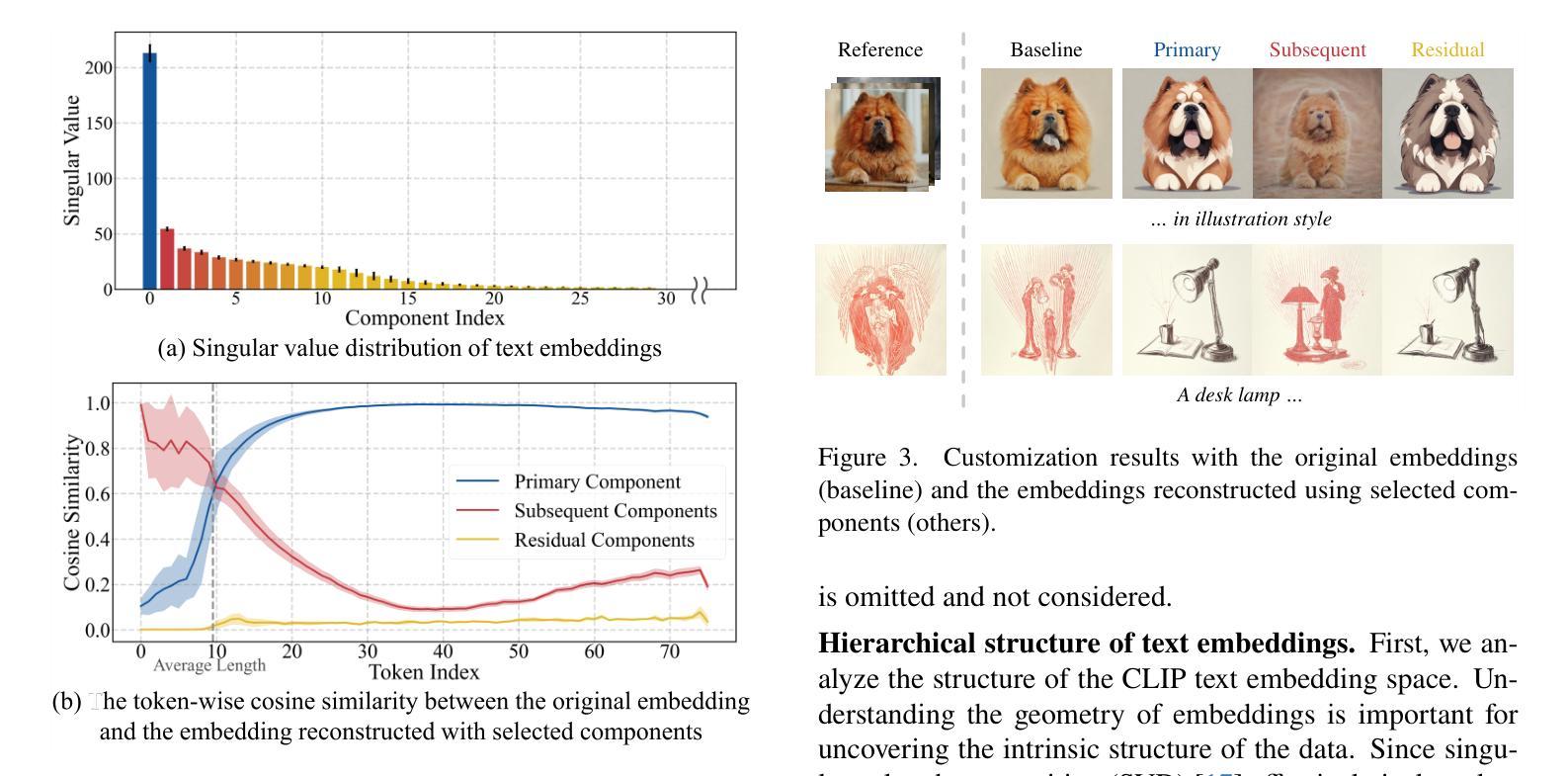

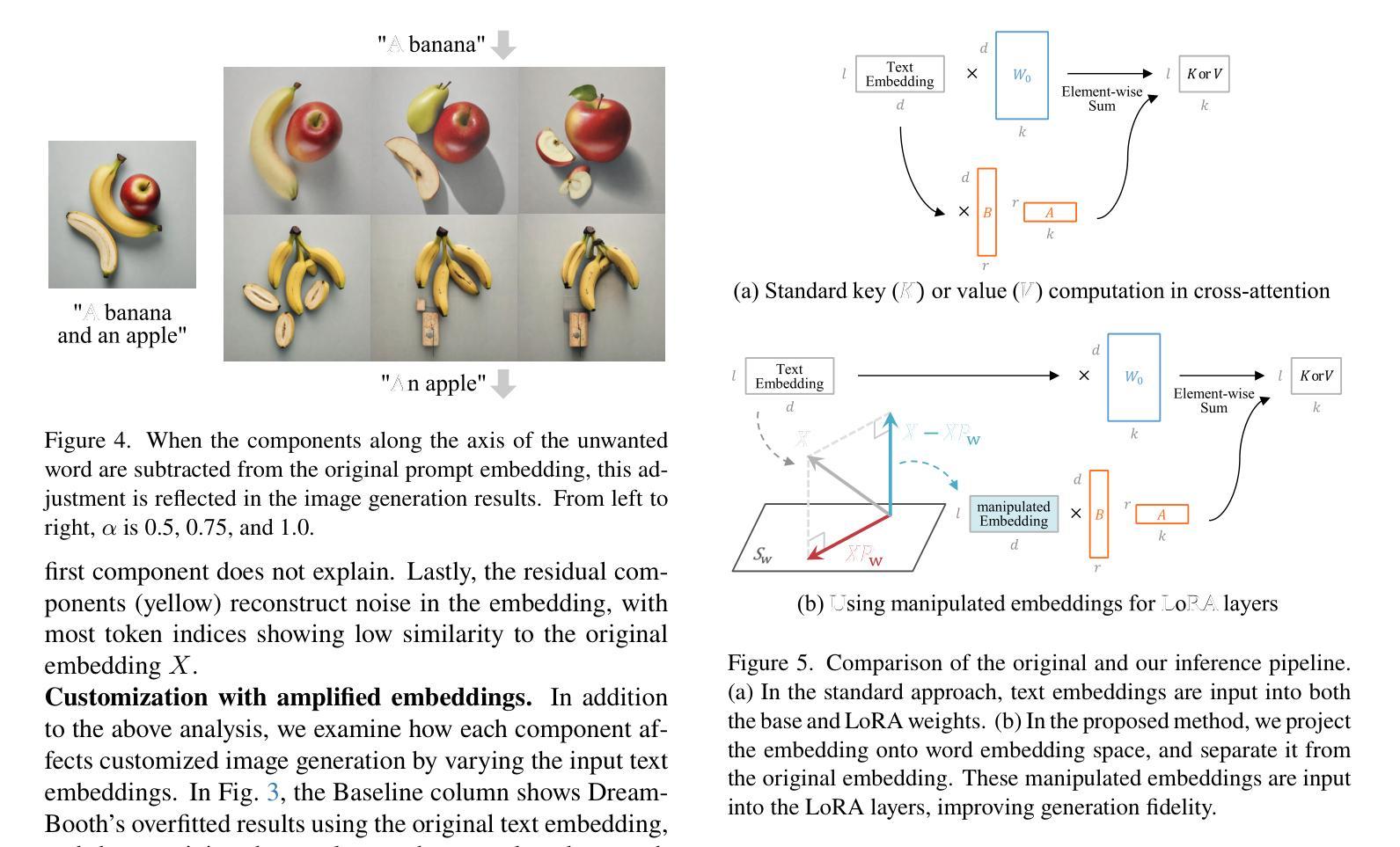

多参考图像的一致性视觉元素捕捉问题:传统的无需调整的方法(tuning-free methods)主要通过平均多个参考图像的图像嵌入来编码,这种图像独立的操作无法在图像之间进行交互以捕获多个参考中的一致视觉元素。尽管基于调整的方法(tuning-based methods)如Low-Rank Adaptation (LoRA)可以通过训练过程提取多个图像中的一致元素,但它需要针对每个不同的图像组进行特定的微调。

个性化图像生成的控制性和精确性问题:为了提高扩散模型的控制性和精确性,研究者们探索了基于少量参考图像进行条件生成的个性化图像生成方法。这些方法主要分为无需调整的方法和基于调整的方法,但它们在处理多参考图像和文本提示时存在局限性。

计算成本和细粒度细节保持问题:为了减轻多图像输入的上下文长度对计算需求的影响,并解决MLLM(多模态大型语言模型)在捕获细粒度视觉细节方面的限制,论文提出了一种高效的参考聚合策略和渐进式训练方案。

多参考图像生成的评估问题:为了评估在多参考图像生成场景下的扩散模型,论文引入了一个名为MRBench的新评估基准。

总的来说,EasyRef旨在通过利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力,来有效地利用多个图像中的一致视觉元素,并将其注入到扩散过程中,以实现对多个参考图像和文本提示的条件化,同时保持对未见领域的强泛化能力。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要分为以下几个领域:

图像个性化(Image Personalization):

- 无需调整的方法(Tuning-free methods),例如IP-Adapter [48]、InstantStyle [41, 42]、IP-Adapter-Face [48] 和 InstantID [44],这些方法通过提取参考图像的视觉表示(如风格和特征)并将其注入扩散模型来增强图像提示能力。

- 基于调整的方法(Tuning-based methods),例如LoRA [14],通过使用有限的图像集对扩散模型进行微调。

多模态大型语言模型(Multimodal Large Language Models, MLLMs):

- 先驱工作如LLaVA [24] 和 BLIP-2 [17] 将视觉表示从预训练的CLIP视觉编码器投影到LLM以进行多模态理解。

- 混合视觉专家设计,例如SPHINX [21]、MoF [40] 和 MoVA [51],旨在增强MLLMs的视觉能力。

- 模型如LLaVANeXT [23] 和 Qwen2-VL [43] 寻求处理任意分辨率的图像。

扩散模型(Diffusion Models):

- 扩散模型因其在创建令人惊叹的图像方面的能力而受到关注,例如Denoising Diffusion Probabilistic Models (DDPMs) [13]。

图像生成和控制(Image Generation and Control):

- 研究者们探索了多种方法来改善扩散模型的精确性和可控性,包括风格和内容的控制,例如ControlNet++ [18] 和 Photomaker [19]。

评估指标(Evaluation Metrics):

- 用于评估图像生成模型性能的指标,例如CLIPScore [11] 用于图像描述的无参考评估。

这些相关研究构成了EasyRef方法的理论和实践基础,并为进一步的研究提供了对比和参考。论文通过与这些现有方法的比较,展示了EasyRef在多参考图像生成任务中的优越性和创新点。

Q: 论文如何解决这个问题?

A: 论文通过提出EasyRef方法解决了上述问题,具体解决方案如下:

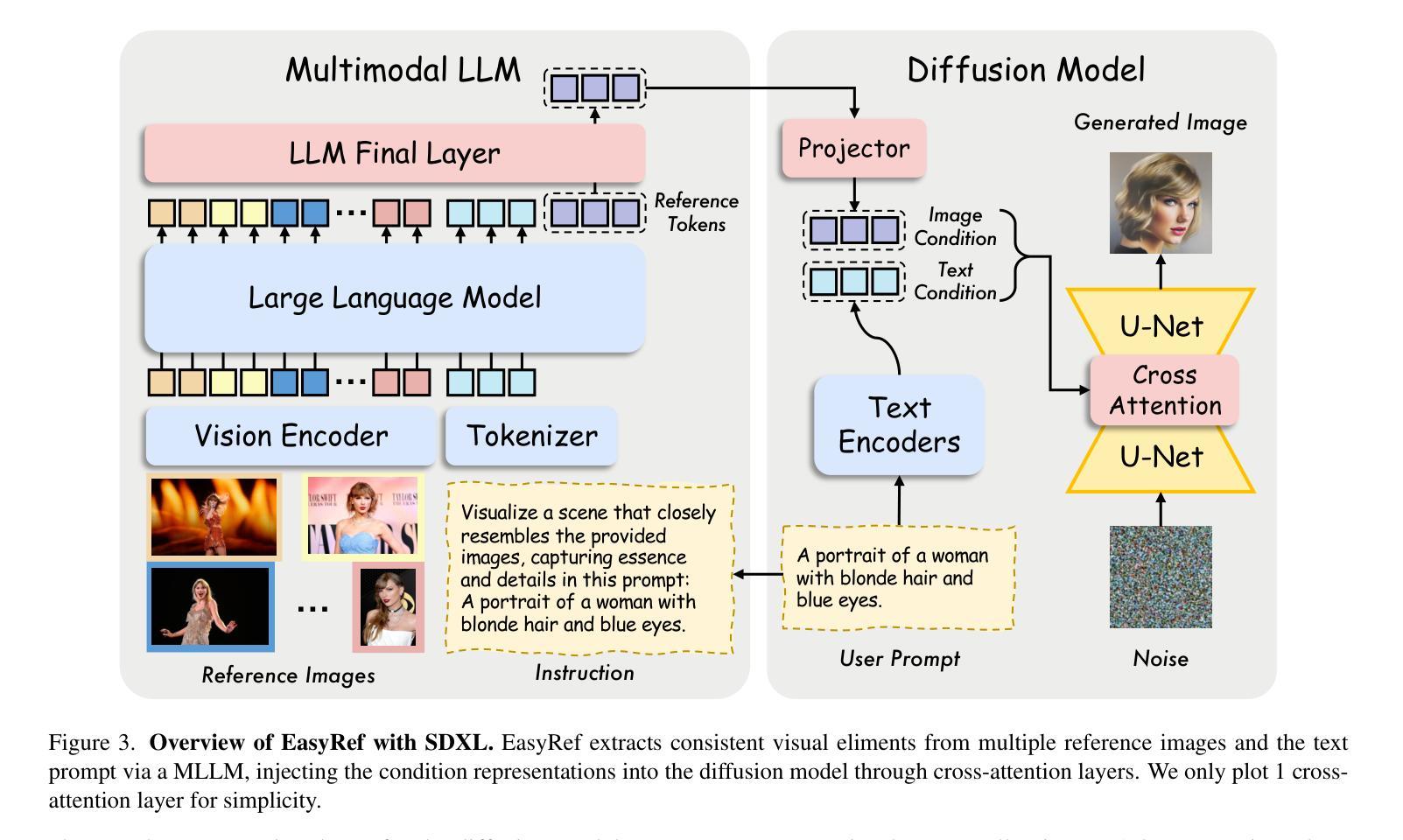

1. EasyRef方法概述

EasyRef是一种新型的即插即用适应方法,它使得扩散模型能够基于多个参考图像和文本提示进行条件生成。该方法利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力,来有效地从多个参考图像中提取一致的视觉元素,并将其注入到扩散过程中。

2. 关键组件

EasyRef主要包括以下四个关键组件:

- 预训练的扩散模型:用于条件图像生成。

- 预训练的MLLM:用于编码一组参考图像和文本提示。

- 条件投影器:将MLLM的表示映射到扩散模型的潜在空间。

- 可训练的适配器:将图像条件嵌入整合到扩散过程中。

3. 方法细节

- 参考表示编码:与传统方法不同,EasyRef不简单地平均所有参考图像的CLIP图像嵌入作为参考条件,而是利用MLLM的多图像理解和指令遵循能力,根据指令编码多参考输入和文本提示。

- 高效参考聚合:为了减轻多图像输入上下文长度对计算成本的影响,EasyRef将参考表示封装到N个可学习的参考标记(tokens)中,并在MLLM的最后层进行聚合和处理。

- 参考表示注入:将文本条件通过交叉注意力层注入到预训练的扩散模型中。

4. 渐进式训练方案

- 对齐预训练:在大规模数据集上优化MLLM的最后一层和参考标记,同时保持MLLM和扩散模型的初始能力。

- 单参考微调:在对齐预训练后,对MLLM进行单参考微调,增强其对细粒度视觉感知的能力。

- 多参考微调:使MLLM能够准确理解多个图像参考中的共同元素,并生成高质量、一致的图像。

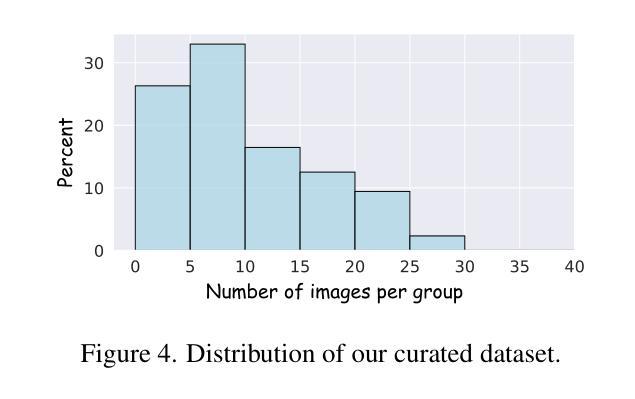

5. 多参考生成基准(MRBench)

- 构建了一个包含多个参考图像的多参考图像生成基准,用于评估EasyRef的性能,并为未来的研究提供指导。

6. 实验结果

实验结果表明,EasyRef在多种领域中都取得了优越的审美质量和鲁棒的零样本泛化能力,超越了无需调整的方法(如IP-Adapter)和基于调整的方法(如LoRA)。

总结来说,EasyRef通过结合MLLM的多图像理解和指令遵循能力,以及适配器注入机制,有效地解决了多参考图像中的一致性视觉元素捕捉问题,同时保持了对未见领域的强泛化能力。此外,通过提出的高效参考聚合策略和渐进式训练方案,EasyRef在计算效率和细粒度细节保持方面也表现出色。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估EasyRef方法的性能,这些实验包括:

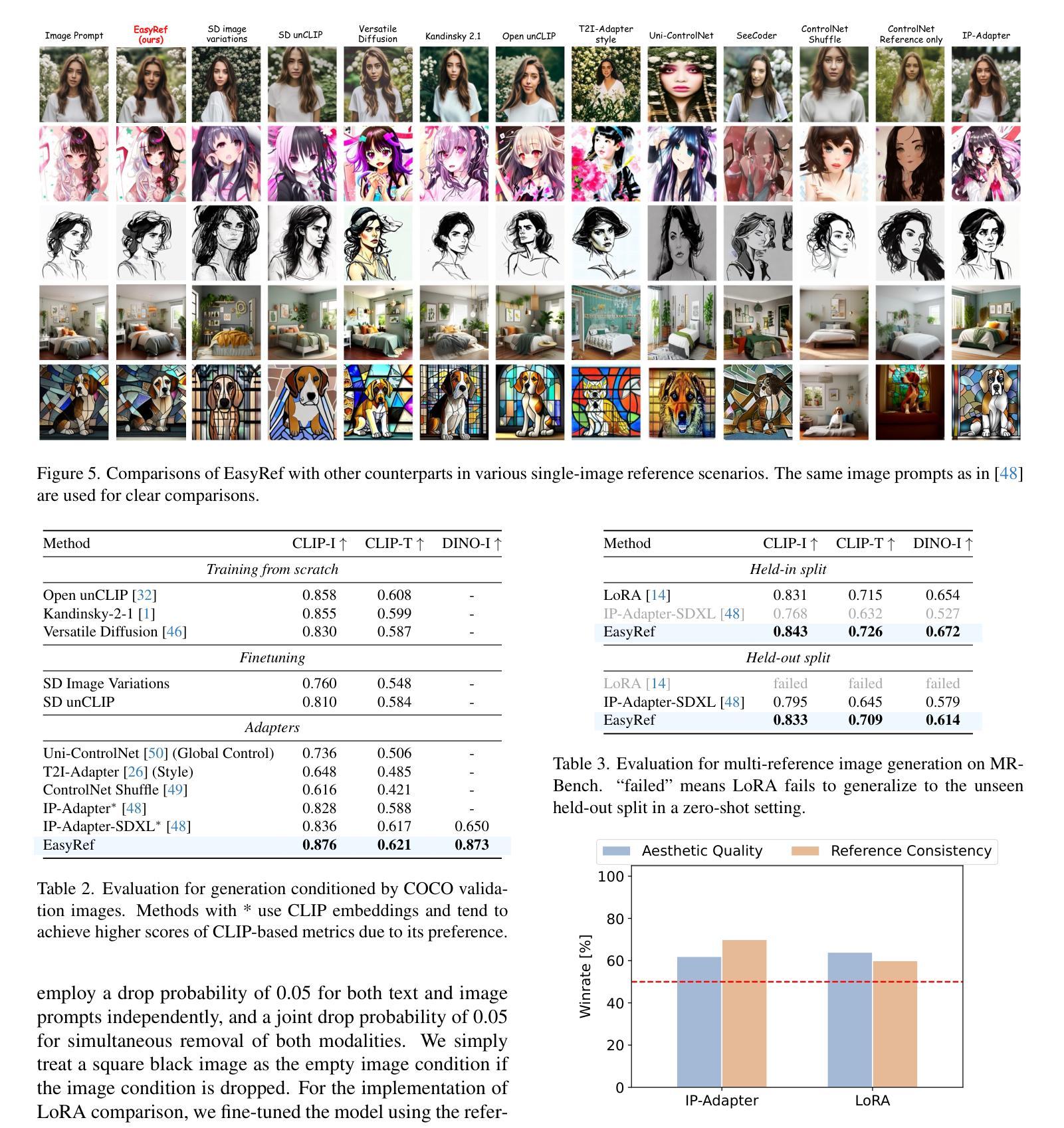

单参考图像场景下的定量比较(Single-image reference):

- 使用COCO 2017验证数据集(包含5000个图像-文本对)进行实验,比较EasyRef与其他方法(如IP-Adapter、LoRA等)在CLIP-T和DINO-I指标上的性能。

- 结果显示EasyRef在这些指标上一致性地超越了其他方法,展示了更好的对齐性能。

多参考图像生成(Multi-image references):

- 在MRBench数据集上比较EasyRef与IP-Adapter和LoRA的性能。

- 在零样本设置中,EasyRef在与参考图像和用户提示的对齐方面超越了IP-Adapter和LoRA。

人类评估(Human evaluation):

- 在MRBench上系统地评估EasyRef与IP-Adapter和LoRA在参考一致性和审美质量方面的表现。

- 结果显示EasyRef在图像-参考对齐和视觉美学方面优于其他模型。

与ControlNet的兼容性(Compatibility with ControlNet):

- 展示了EasyRef与流行的可控工具ControlNet的兼容性,与IP-Adapter相比,EasyRef在处理多个参考图像和额外结构控制时能生成更高质量、更一致的结果。

扩展参考图像数量的实验(Scaling the number of reference images):

- 评估EasyRef在不同数量的参考图像下的性能,分析了模型在训练约束内和超出训练约束时的表现。

多模态指令输入的消融研究(Multimodal instruction input):

- 研究了将指令包含在LLM输入中对生成性能的影响,发现包含指令可以提高生成性能。

参考标记设计的消融研究(Reference token design):

- 研究了不同数量的参考标记和插入位置对性能的影响,选择了64个标记并将其插入到最后一层以获得最佳性能。

参考表示聚合的消融研究(Reference representation aggregation):

- 比较了EasyRef的参考标记聚合方法与嵌入平均和嵌入连接的效果,发现使用MLLM的多图像理解能力可以提高模型性能。

渐进式训练方案的消融研究(Progressive training scheme):

- 通过系统地移除每个训练阶段,可视化了每个阶段对模型捕获细粒度视觉细节和保持身份一致性能力的影响。

这些实验全面评估了EasyRef在多参考图像生成任务中的性能,并与现有技术进行了比较,证明了EasyRef在审美质量和零样本泛化能力方面的优越性。

Q: 有什么可以进一步探索的点?

A: 尽管EasyRef在多参考图像生成领域取得了显著的成果,但仍有一些方向可以进一步探索和改进:

提高模型泛化能力:

- 探索新的训练策略或正则化技术,以增强模型对新领域和未见过的参考图像的泛化能力。

优化计算效率:

- 研究更高效的参考聚合策略,以降低模型在处理大量参考图像时的计算成本。

- 探索模型压缩和加速技术,以使EasyRef适用于资源受限的环境。

增强细粒度控制:

- 提高模型对图像中细粒度特征和复杂结构的控制能力,例如面部表情、纹理细节等。

- 结合用户研究反馈,优化模型以更好地满足特定用户需求。

改进评估基准:

- 扩展MRBench数据集,包含更多样化的参考图像和文本提示,以全面评估模型性能。

- 开发新的评估指标,更准确地衡量生成图像的质量和一致性。

多模态输入的深入研究:

- 研究如何更有效地结合文本、图像和其他模态信息,以提高生成图像的相关性和准确性。

- 探索不同类型指令对图像生成过程的影响。

跨领域应用:

- 将EasyRef应用于其他领域,如视频生成、3D建模或虚拟现实,以探索其在这些领域的潜力和局限性。

模型解释性:

- 提高模型的可解释性,帮助研究人员和用户理解模型的决策过程和潜在偏差。

- 研究如何通过可视化技术揭示MLLM在处理多参考图像时的内部机制。

鲁棒性和安全性:

- 增强模型对对抗性攻击和异常输入的鲁棒性。

- 确保生成图像的安全性和合规性,避免生成不当内容。

交互式应用:

- 开发基于EasyRef的交互式系统,允许用户实时提供反馈并调整生成过程。

- 结合自然语言处理技术,实现更自然和直观的用户交互。

这些方向不仅可以推动EasyRef技术的发展,还可能为多模态学习和扩散模型的研究提供新的视角和挑战。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了EasyRef,一个创新的即插即用适应方法,它使得扩散模型能够基于多个参考图像和文本提示进行条件生成。以下是论文的主要内容总结:

问题陈述:

- 现有方法在处理多参考图像时存在局限性,无法有效捕捉多个参考中的一致视觉元素。

- 需要一种新方法来提高扩散模型的个性化生成能力和控制精确性。

EasyRef方法:

- 提出了EasyRef,一个利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力的新型适应方法。

- EasyRef通过适配器将MLLM的表示注入到扩散过程中,以提取和利用多个参考图像中的一致视觉元素。

关键贡献:

- 提出了一种有效的参考聚合策略和渐进式训练方案,以减轻计算成本并增强MLLM的细粒度感知能力。

- 引入了MRBench,一个新的多参考图像生成基准,用于评估和指导未来的研究。

实验结果:

- EasyRef在多个领域中展现出优越的审美质量和鲁棒的零样本泛化能力,超越了无需调整的方法和基于调整的方法。

- 通过广泛的实验验证了EasyRef在多参考图像生成任务中的性能。

方法细节:

- EasyRef包括预训练的扩散模型、MLLM、条件投影器和可训练的适配器。

- 通过交叉注意力层将文本条件注入到扩散模型中。

- 采用渐进式训练策略,包括对齐预训练、单参考微调和多参考微调。

未来工作:

- 提出了一些潜在的研究方向,包括提高模型泛化能力、优化计算效率、增强细粒度控制等。

总体而言,EasyRef通过结合MLLM的多图像理解和指令遵循能力,以及适配器注入机制,有效地解决了多参考图像中的一致性视觉元素捕捉问题,同时保持了对未见领域的强泛化能力。这项工作为多参考图像生成领域提供了一种新的视角和解决方案。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

LiftImage3D: Lifting Any Single Image to 3D Gaussians with Video Generation Priors

Authors:Yabo Chen, Chen Yang, Jiemin Fang, Xiaopeng Zhang, Lingxi Xie, Wei Shen, Wenrui Dai, Hongkai Xiong, Qi Tian

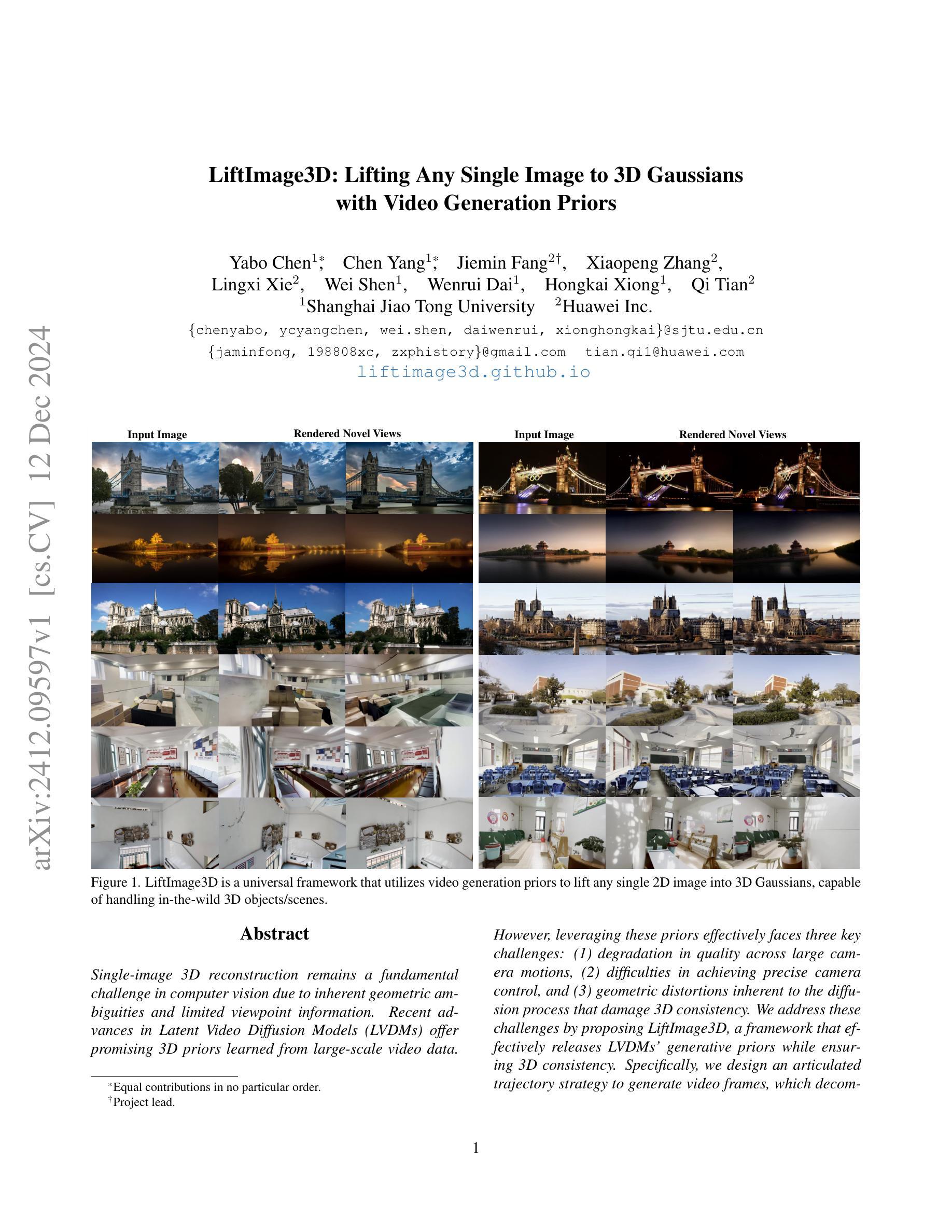

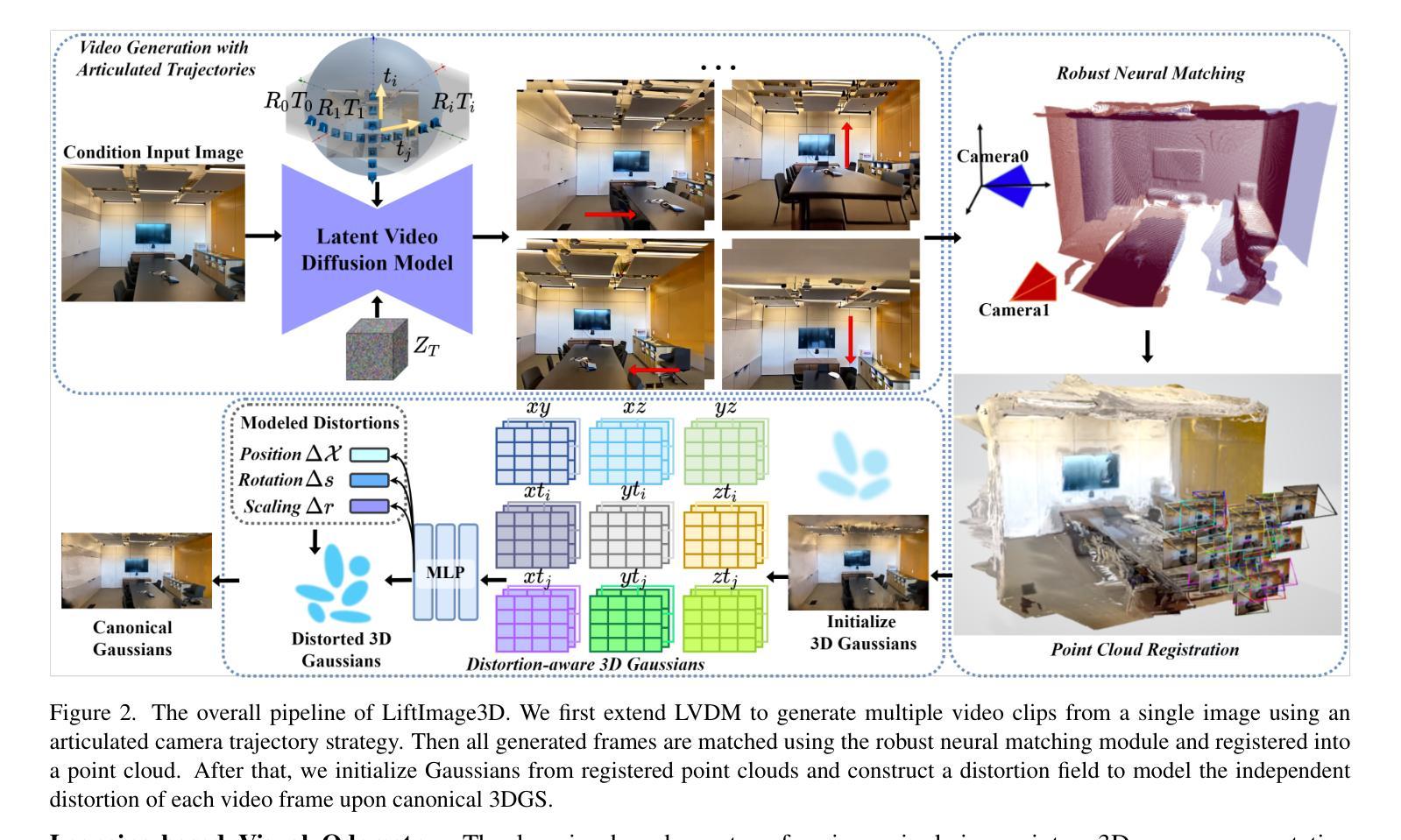

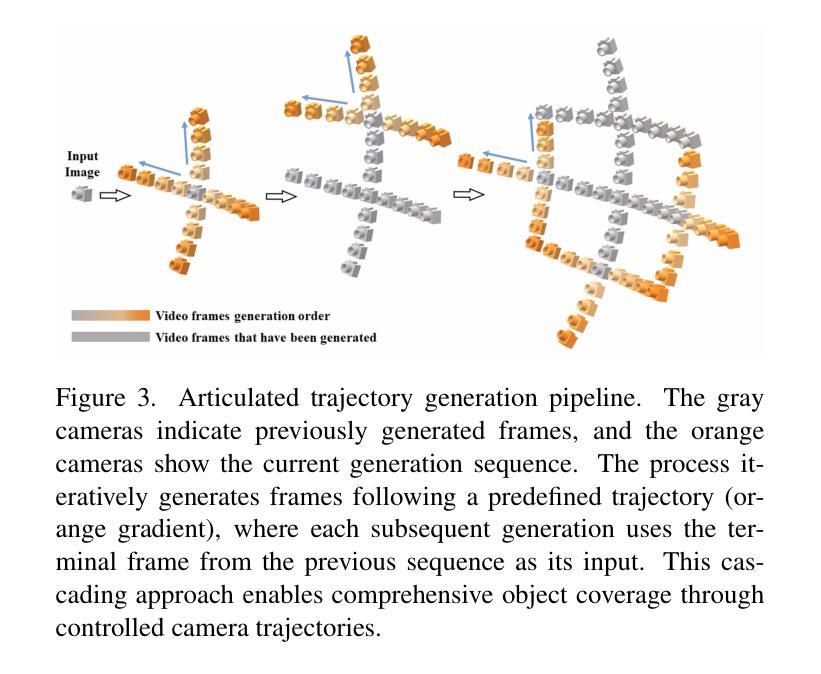

Single-image 3D reconstruction remains a fundamental challenge in computer vision due to inherent geometric ambiguities and limited viewpoint information. Recent advances in Latent Video Diffusion Models (LVDMs) offer promising 3D priors learned from large-scale video data. However, leveraging these priors effectively faces three key challenges: (1) degradation in quality across large camera motions, (2) difficulties in achieving precise camera control, and (3) geometric distortions inherent to the diffusion process that damage 3D consistency. We address these challenges by proposing LiftImage3D, a framework that effectively releases LVDMs’ generative priors while ensuring 3D consistency. Specifically, we design an articulated trajectory strategy to generate video frames, which decomposes video sequences with large camera motions into ones with controllable small motions. Then we use robust neural matching models, i.e. MASt3R, to calibrate the camera poses of generated frames and produce corresponding point clouds. Finally, we propose a distortion-aware 3D Gaussian splatting representation, which can learn independent distortions between frames and output undistorted canonical Gaussians. Extensive experiments demonstrate that LiftImage3D achieves state-of-the-art performance on two challenging datasets, i.e. LLFF, DL3DV, and Tanks and Temples, and generalizes well to diverse in-the-wild images, from cartoon illustrations to complex real-world scenes.

单图像3D重建仍是计算机视觉领域的一个基本挑战,其挑战原因在于固有的几何模糊性和有限的视点信息。基于潜在视频扩散模型(LVDMs)的最新进展提供了从大规模视频数据中学习的有前途的3D先验知识。然而,有效利用这些先验知识面临三个关键挑战:(1)大相机运动导致的质量下降;(2)实现精确相机控制的困难;(3)扩散过程固有的几何失真损害3D一致性。我们通过提出LiftImage3D框架来解决这些挑战,该框架能够有效地释放LVDMs的生成先验知识,同时确保3D一致性。具体来说,我们设计了一种灵活的运动轨迹策略来生成视频帧,该策略将具有大相机运动的视频序列分解为具有可控小运动的序列。然后,我们使用鲁棒的神经匹配模型(即MASt3R)来校准生成帧的相机姿势并产生相应的点云。最后,我们提出了一种扭曲感知的3D高斯喷绘表示,它可以学习帧之间的独立扭曲并输出无扭曲的标准高斯。大量实验表明,LiftImage3D在两个具有挑战性的数据集LLFF、DL3DV以及Tanks and Temples上达到了最佳性能,并且在从卡通插图到复杂现实场景的多种野外图像上具有良好的泛化能力。

论文及项目相关链接

PDF Project page: https://liftimage3d.github.io/

Summary

基于大型视频数据的潜在视频扩散模型(LVDM)为三维重建提供了新的视角。然而,在应用这些模型时面临三大挑战:大相机运动导致的质量下降、难以精确控制相机以及扩散过程导致的几何失真。为解决这些问题,我们提出了LiftImage3D框架,该框架有效释放了LVDM的生成先验知识,同时保证了三维一致性。通过设计灵活的运动轨迹策略生成视频帧,并采用鲁棒性神经匹配模型校准相机姿态和生成点云,最终提出一种感知失真的三维高斯拼贴表示方法。实验表明,LiftImage3D在两个具有挑战性的数据集上取得了最佳性能,并很好地泛化到各种野外图像。

Key Takeaways

- 潜在视频扩散模型(LVDM)为三维重建提供新的视角。

- LVDM在应用时面临三大挑战:大相机运动导致质量下降、相机控制难度高和几何失真问题。

- LiftImage3D框架旨在解决这些挑战,通过释放LVDM的生成先验知识并保障三维一致性。

- 设计灵活的运动轨迹策略生成视频帧,分解大相机运动为可控的小运动。

- 采用鲁棒性神经匹配模型校准相机姿态和生成点云。

- 提出一种感知失真的三维高斯拼贴表示方法,学习帧间独立失真并输出无失真规范高斯。

- 实验表明,LiftImage3D在两个具有挑战性的数据集上表现最佳,并能很好地泛化到各种野外图像。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决单图像3D重建中的几个关键挑战,这些挑战包括:

大相机运动下的质量问题:现有方法在小相机运动下可以生成高质量的新视角图像,但当相机发生大幅度运动时,渲染质量会显著下降。这是因为在大视角变化中累积了生成误差,导致在远视图之间维持几何一致性变得困难。

精确相机控制的困难:尽管潜在视频扩散模型(LVDMs)擅长生成时间连贯的视频,但控制其生成以遵循期望的相机轨迹仍然是一个挑战。由于缺乏场景的底层3D信息,导致生成结果与输入相机条件不匹配。

扩散过程中的几何失真:扩散模型的固有噪声和去噪过程在帧生成过程中引入了微妙但持续的几何失真。这些失真虽然在视觉上不易察觉,但会在不同视图间累积,严重破坏3D重建质量,破坏帧之间的几何一致性。

为了应对这些挑战,论文提出了一个名为LiftImage3D的框架,该框架能够有效地利用LVDMs的生成先验,同时确保3D一致性。具体来说,论文设计了一个关节轨迹策略来生成视频帧,将具有大相机运动的视频序列分解为可控制的小运动。然后使用鲁棒的神经匹配模型(例如MASt3R)来校正生成帧的相机姿态,并产生相应的点云。最后,提出了一种失真感知的3D高斯溅射表示方法,该方法可以学习帧间的独立失真,并输出未失真的规范高斯。通过这些技术,LiftImage3D在多个具有挑战性的数据集上实现了最先进的性能,并且能够很好地泛化到多样化的野外图像,从卡通插图到复杂的真实世界场景。

Q: 有哪些相关研究?

A: 根据提供的论文内容,相关研究可以分为以下几个领域:

3D摄影:

- 利用多平面图像(MPI)技术从单张图像中合成新视角的场景。

- 基于深度的变形方法,用于引导变形视图中的修复。

2D生成模型基础上的单图像到3D:

- 研究者探索了仅使用单张图像生成3D模型和实现新视角合成的方法。

- 一些研究直接在3D数据上训练3D模型,但这些方法往往只在与训练集相似的场景上表现良好。

- 基于条件潜在扩散模型(LDM)的方法,通过大规模多视图图像学习构建几何先验。

基于LVDM(潜在视频扩散模型)的单图像到3D:

- 研究者认为视频扩散模型可以提供强大的多视图3D先验。

- 一些工作尝试在多视图数据集上微调LVDM,以增强生成新视图的能力。

以下是一些具体的相关工作和文献:

MPI(多平面图像)相关方法:

- [16, 29, 40] 基于MPI构建3D摄影的方法。

- [60, 61, 72, 93] MPI技术的发展和应用。

基于深度的变形和修复方法:

- [4, 77] 基于深度的变形方法。

- [6, 28, 46, 58, 70] 尝试使用文本到图像扩散方法生成视图外内容,并将其投影到扩展的多平面图像中。

单图像到3D模型生成:

- [5, 24, 30, 33, 57, 59, 73, 75, 88, 90] 使用单张图像生成3D模型和新视角合成的研究。

LVDM(潜在视频扩散模型)相关研究:

- [1, 37, 71] 探讨视频扩散模型在提供多视图3D先验方面的潜力。

- [15, 25, 42, 47, 64, 89] 在多视图数据集上微调LVDM以增强新视图合成能力的工作。

这些相关工作为LiftImage3D框架的发展提供了理论和技术基础,同时也突显了现有方法在处理大相机运动、精确相机控制和3D一致性失真方面的局限性。LiftImage3D通过结合关节轨迹策略、鲁棒的神经匹配和失真感知的3D高斯溅射表示等技术,旨在克服这些挑战,实现更高质量的单图像3D重建。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为LiftImage3D的框架来解决单图像3D重建中的挑战,具体解决方案包括以下几个关键组件:

1. 关节轨迹策略(Articulated Trajectory Strategy)

为了克服大相机运动导致的质量问题,论文设计了一种关节轨迹策略,将大的相机运动分解为小的、可控的步骤。这种方法通过将生成的帧用作后续视频生成的新起点,实现了在保持帧质量的同时扩大视图覆盖范围。

2. 鲁棒的神经匹配模型(Robust Neural Matching Models)

针对精确相机控制的挑战,论文采用了一种名为MASt3R的鲁棒神经匹配方法,直接从生成的帧中估计相机轨迹和粗略几何结构。这种方法绕过了输入条件和生成帧之间的不一致性,提高了相机控制的准确性。

3. 失真感知的3D高斯溅射表示(Distortion-aware 3D Gaussian Splatting)

为了处理扩散模型引入的3D不一致失真,论文提出了一种失真感知的3D高斯溅射(3DGS)表示方法。这种方法通过一个失真场来表示规范3DGS和失真的映射关系,能够学习帧间的独立失真,并输出未失真的规范高斯。

4. 深度先验注入(Depth Prior Injection)

为了产生更平滑和深度一致的结果,论文利用从神经匹配得到的粗糙但绝对的深度图来校准单目深度估计的精细深度图,确保深度图具有适当的比例和偏移。

5. 损失函数设计(Loss Function Design)

论文设计了一个损失函数,确保建模的失真不会偏离规范3DGS太远。这个损失函数结合了L1 RGB损失、LPIPS损失、基于网格的总变分损失以及L1深度损失,以优化失真场并确保3DGS的质量。

通过这些技术和策略的综合应用,LiftImage3D能够有效地利用潜在视频扩散模型(LVDMs)的生成先验,同时确保从单张图像到3D场景的重建过程中保持3D一致性。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估LiftImage3D框架的性能,并与现有的最先进方法进行比较。以下是实验的具体内容:

1. 评估协议和数据集

- 数据集:实验使用了三个数据集:LLFF、DL3DV和Tanks and Temples。这些数据集包含了从室内到室外环境、单一对象到多个对象的多视角数据,适用于评估图像质量和3D一致性。

- 评估协议:遵循AdaMPI和SinMPI的评估协议,使用单个图像作为输入视图,并使用多个周围的视图作为真实图像进行定量评估。

2. 实施细节

- 相机运动方向:设置潜在相机姿态移动方向D为4,包括上、下、左和右。

- LVDM帧生成:LVDM每次产生16帧。

- MASt3R全局对齐:MASt3R需要400次迭代进行全局对齐。

- 3DGS训练:3DGS首先在常规设置下训练3k次迭代,然后使用失真场网络再训练14k次迭代。

3. 定量和定性比较

- 定量比较:在LLFF、DL3DV和Tanks and Temples数据集上,与先前的方法(如AdaMPI、SinMPI、LucidDreamer和ViewCrafter)进行了PSNR、SSIM和LPIPS等指标的定量比较,LiftImage3D在这些指标上显示出显著的改进。

- 定性比较:展示了LiftImage3D在非周围视图中的更强泛化能力,所有显示的图像都是从与输入图像差异较大的视点拍摄的。

4. 使用不同LVDMs的LiftImage3D

- 不同LVDMs:LiftImage3D可以利用不同的LVDMs(如MotionCtrl和ViewCrafter)来展示其在不同LVDM先验下的有效性。

- 结果:无论是使用MotionCtrl还是ViewCrafter作为LVDM的骨干网络,LiftImage3D都能显著提高性能。

5. 消融研究

- 失真感知3DGS:验证了失真感知3DGS设计的有效性。

- 二维时间戳:验证了二维时间戳设计的有效性。

- 深度先验注入:验证了深度先验注入模块的有效性,并通过可视化展示了如何利用神经匹配的粗糙深度图来校准单目深度估计的精细深度图。

这些实验全面评估了LiftImage3D在不同情况下的性能,并证明了其在单图像3D重建任务中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 尽管LiftImage3D在单图像3D重建方面取得了显著进展,但仍有一些领域可以进一步探索和改进:

1. 提升相机控制精度

尽管LiftImage3D采用了MASt3R等鲁棒神经匹配模型来估计相机姿态,但在精确控制相机轨迹方面仍存在挑战。未来的工作可以探索更精细的相机控制策略,以进一步提高生成视频帧的质量和一致性。

2. 优化失真感知3DGS

失真感知3DGS是LiftImage3D中的关键技术之一,用于处理扩散模型引入的几何失真。未来的研究可以探索更高效的失真建模和补偿方法,以减少失真对3D重建质量的影响。

3. 深度先验的改进

虽然LiftImage3D利用了从神经匹配得到的粗糙深度图来校准单目深度估计,但深度估计的准确性仍有提升空间。研究更先进的深度估计方法,或者结合多模态数据(如立体视觉、激光雷达等)来提高深度信息的精度,可能是一个有价值的方向。

4. 泛化能力的增强

LiftImage3D在多种数据集上展示了良好的性能,但在处理更多样化和复杂场景时,其泛化能力仍需进一步提升。未来的工作可以探索如何使模型更好地适应不同的场景和条件,包括极端光照、遮挡和动态环境。

5. 实时性能的优化

LiftImage3D的处理流程可能在计算资源和时间上要求较高,限制了其在实时应用中的可行性。研究如何优化算法和计算流程,以实现更快的推理速度和更低的计算成本,对于实际应用至关重要。

6. 交互式应用的探索

将LiftImage3D应用于交互式环境,如虚拟现实(VR)和增强现实(AR),需要进一步研究。这包括提高场景的动态交互能力,以及在用户与环境互动时实时更新3D场景表示。

7. 多模态数据融合

考虑将LiftImage3D与其他类型的数据(如音频、触觉反馈)结合起来,以创建更丰富的多模态3D体验。这种融合可以提供更自然和沉浸式的用户体验。

8. 模型压缩和移动端部署

研究如何压缩LiftImage3D模型,以便在资源受限的设备(如智能手机和平板电脑)上部署。这对于将3D重建技术带到更广泛的用户群体具有重要意义。

通过在这些领域进行进一步的研究和开发,LiftImage3D及其衍生技术有望在未来实现更广泛的应用,并在单图像3D重建领域取得更大的突破。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为LiftImage3D的框架,旨在利用视频生成先验将任何单张2D图像提升到3D高斯表示,以处理野外3D对象/场景。下面是论文的主要内容总结:

1. 问题背景与挑战:

- 单图像3D重建是计算机视觉中的一个基本挑战,由于几何歧义和有限的视点信息,任务十分困难。

- 近期的潜在视频扩散模型(LVDMs)提供了从大规模视频数据中学习到的有希望的3D先验。

2. 面临的三个关键挑战:

- 大相机运动下的退化:随着相机运动幅度的增加,渲染质量显著下降。

- 精确相机控制的困难:控制LVDMs生成遵循特定相机轨迹存在困难。

- 扩散过程中的几何失真:扩散模型的噪声和去噪过程引入的几何失真会破坏3D一致性。

3. LiftImage3D框架:

- 关节轨迹策略:将大的相机运动分解为小的、可控的步骤,以保证生成质量。

- 鲁棒神经匹配模型:使用MASt3R等模型校正生成帧的相机姿态,生成相应的点云。

- 失真感知3D高斯溅射(3DGS)表示:学习独立失真,输出未失真的规范高斯。

4. 贡献:

- 提出了一个系统化的框架,释放了LVDMs的3D能力,并以可控的方式提升单张图像至3D高斯。

- 通过关节轨迹策略、帧匹配策略、深度先验注入和有效的3DGS表示来解决从生成视频帧到3D重建的挑战。

- 在LLFF、DL3DV和Tanks and Temples数据集上进行了广泛的实验,证明了LiftImage3D在视觉质量和3D一致性方面相较于先前技术的状态-of-the-art性能。

5. 实验:

- 在多个数据集上进行了定量和定性比较,展示了LiftImage3D在不同情况下的有效性。

- 探讨了不同LVDMs在LiftImage3D框架下的性能,并进行了消融研究以验证各个组件的有效性。

6. 结论:

LiftImage3D作为一个创新的框架,通过一系列技术解决了使用LVDMs进行多视图帧生成时的挑战,并为未来利用视频生成先验促进3D重建的研究提供了新的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

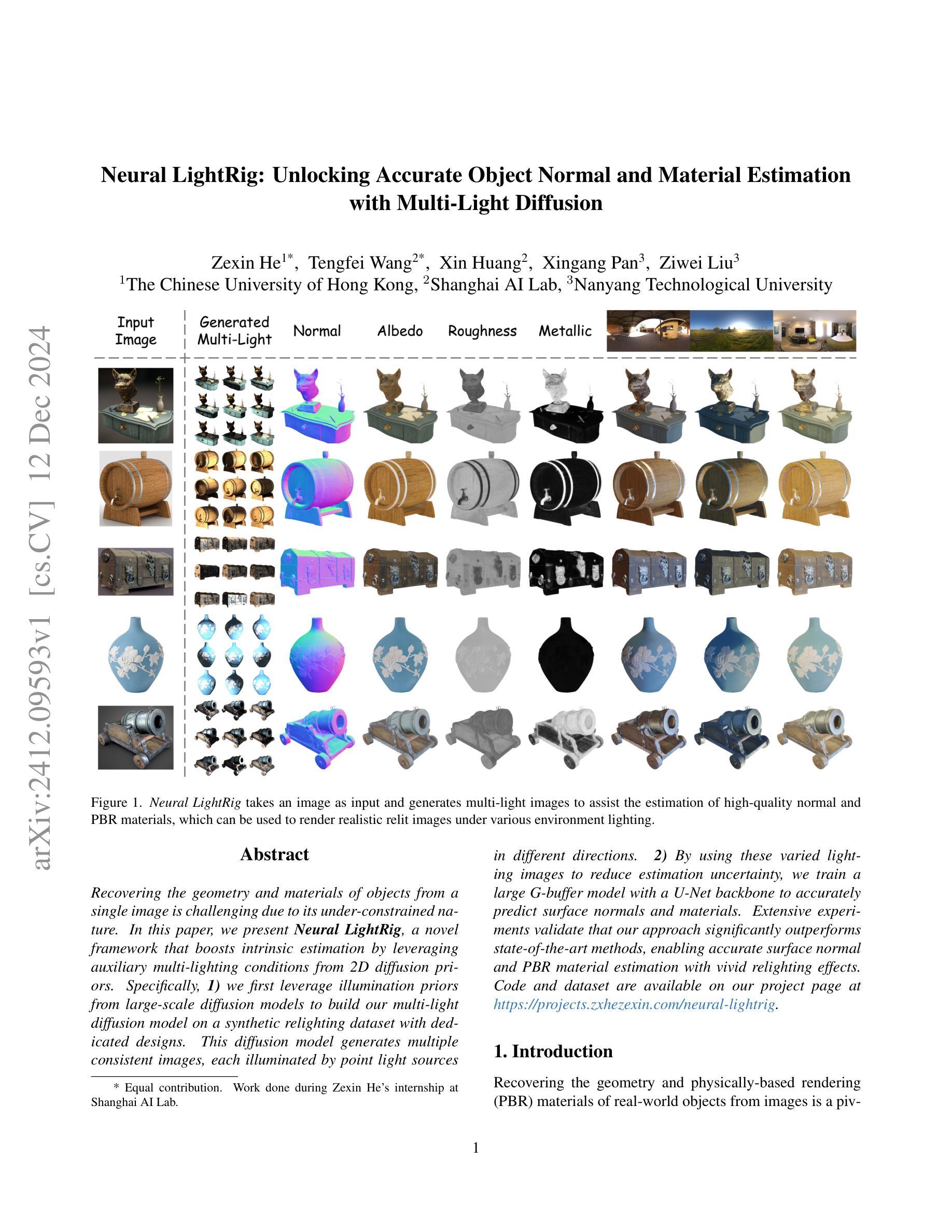

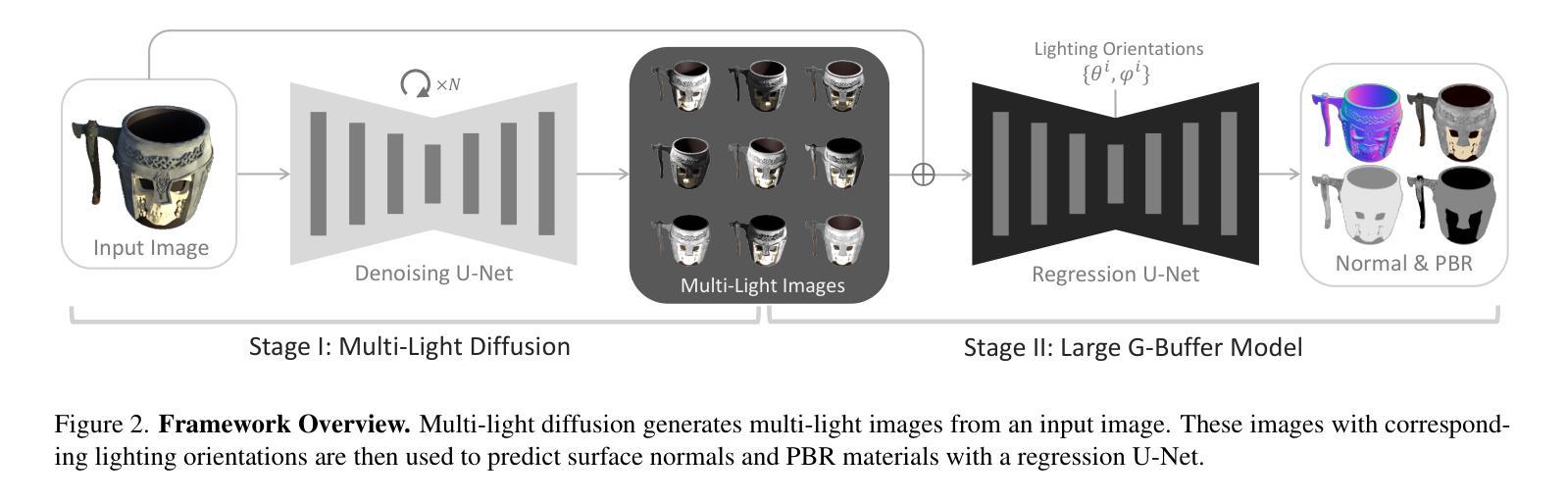

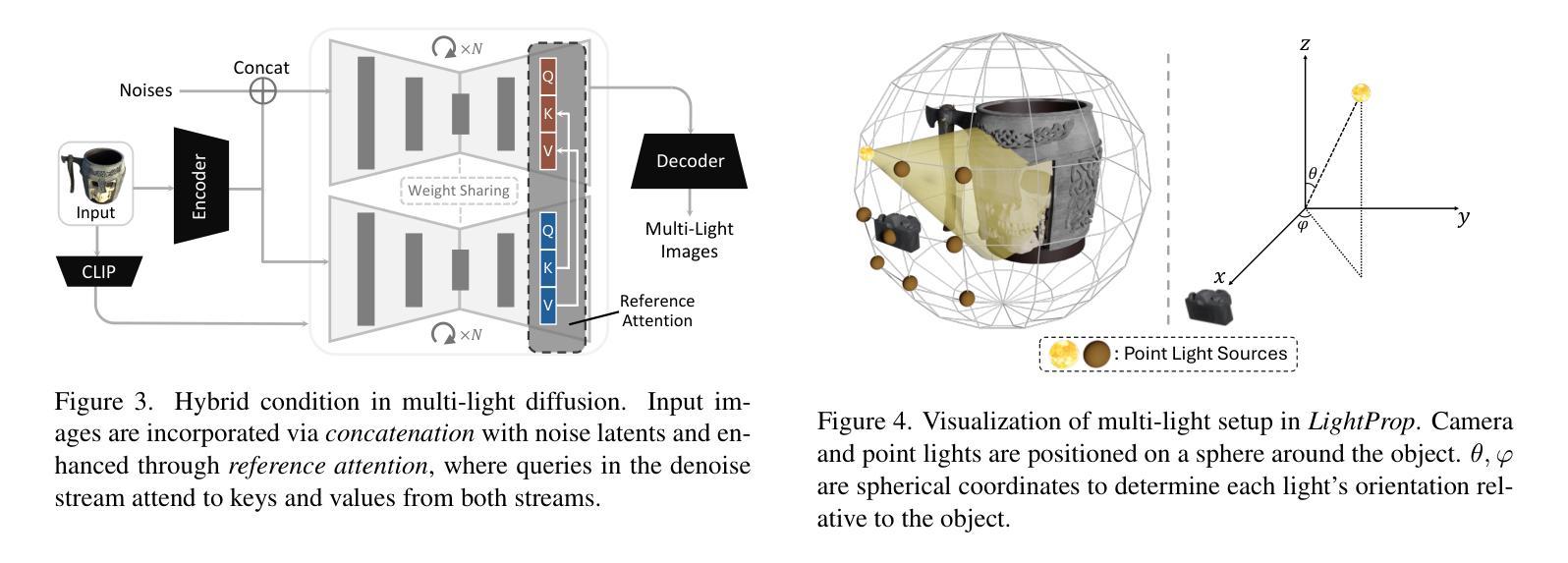

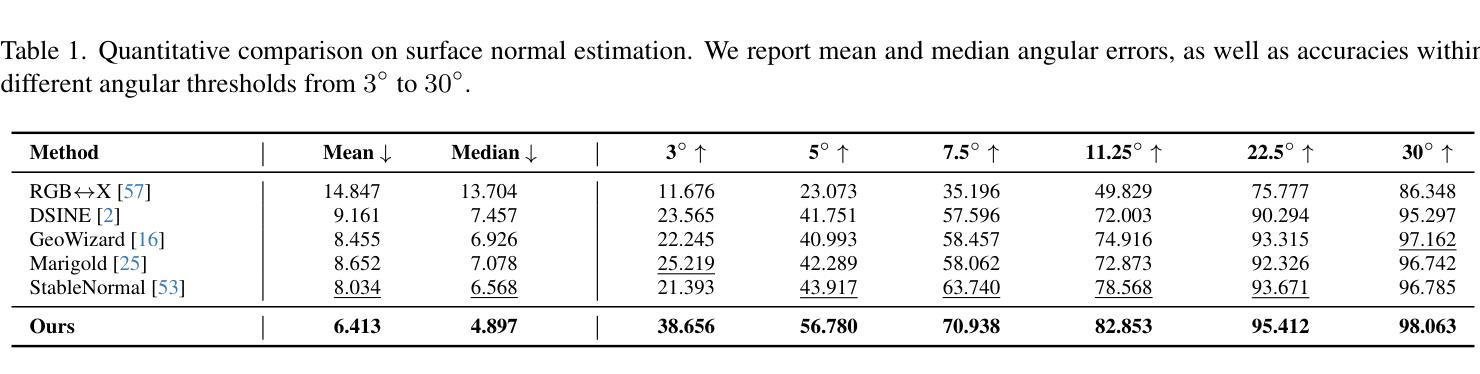

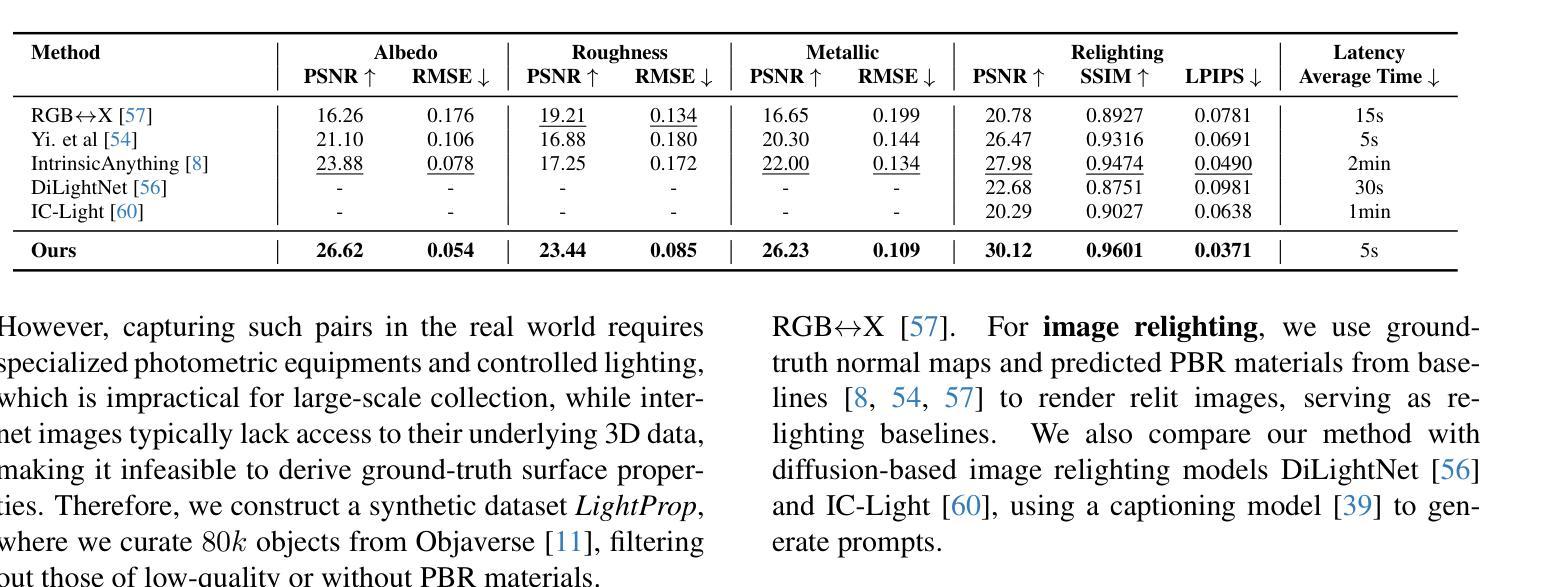

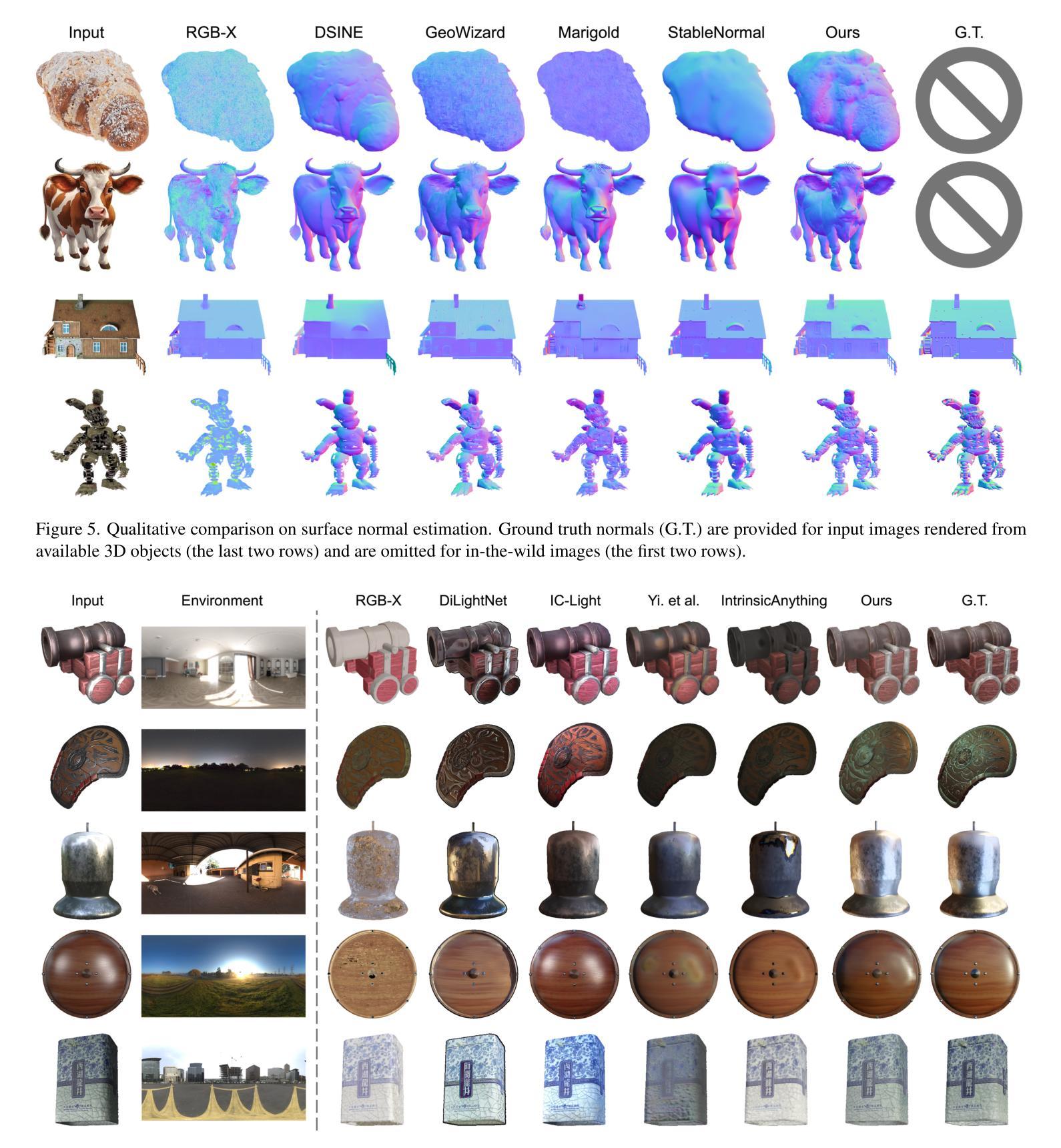

Neural LightRig: Unlocking Accurate Object Normal and Material Estimation with Multi-Light Diffusion

Authors:Zexin He, Tengfei Wang, Xin Huang, Xingang Pan, Ziwei Liu

Recovering the geometry and materials of objects from a single image is challenging due to its under-constrained nature. In this paper, we present Neural LightRig, a novel framework that boosts intrinsic estimation by leveraging auxiliary multi-lighting conditions from 2D diffusion priors. Specifically, 1) we first leverage illumination priors from large-scale diffusion models to build our multi-light diffusion model on a synthetic relighting dataset with dedicated designs. This diffusion model generates multiple consistent images, each illuminated by point light sources in different directions. 2) By using these varied lighting images to reduce estimation uncertainty, we train a large G-buffer model with a U-Net backbone to accurately predict surface normals and materials. Extensive experiments validate that our approach significantly outperforms state-of-the-art methods, enabling accurate surface normal and PBR material estimation with vivid relighting effects. Code and dataset are available on our project page at https://projects.zxhezexin.com/neural-lightrig.

从单一图像中恢复物体的几何形状和材料是一项具有挑战性的任务,因为其本质上的约束不足。在本文中,我们提出了Neural LightRig,这是一个新型框架,它通过利用来自2D扩散先验的辅助多光照条件来提高内在估计。具体来说,1)我们首先利用大规模扩散模型的照明先验知识,在合成重光照数据集上建立我们的多光扩散模型,该数据集具有专门的设计。该扩散模型生成多个一致性的图像,每个图像都由不同方向的点光源照亮。2)通过使用这些不同的照明图像来减少估计的不确定性,我们训练了一个大型的G缓冲区模型,该模型以U-Net为主干,可以准确地预测表面法线和材料。大量实验验证,我们的方法显著优于最先进的方法,能够实现准确的表面法线和物理基础渲染材料估计,具有生动的重新照明效果。代码和数据集可在我们的项目页面https://projects.zxhezexin.com/neural-lightrig上找到。

论文及项目相关链接

PDF Project page: https://projects.zxhezexin.com/neural-lightrig

Summary

本文提出了Neural LightRig框架,通过利用辅助的二维扩散先验的多光照条件来提升内在估计。该框架利用大规模扩散模型产生的照明先验信息,在合成重光照数据集上建立多光扩散模型,生成由点光源从不同方向照射的多个一致图像。通过利用这些不同的光照图像来减少估计的不确定性,训练了一个大型G缓冲区模型,使用U-Net骨架来准确预测表面法线和材料。该方法显著优于现有技术,能够实现准确的表面法线和物理基础渲染材料估计,具有生动的重光照效果。

Key Takeaways

- Neural LightRig框架利用辅助的二维扩散先验的多光照条件来提升内在估计。

- 通过合成重光照数据集建立多光扩散模型,生成多个一致图像。

- 利用不同光照图像减少估计不确定性。

- 使用大型G缓冲区模型和U-Net骨架进行表面法线和材料的准确预测。

- 该方法显著优于现有技术。

- 实现准确的表面法线估计和物理基础渲染材料估计。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为Neural LightRig的新框架,旨在解决从单张图像中准确恢复物体的几何形状和基于物理的渲染(PBR)材料的问题。这是一个具有挑战性的任务,因为受到多种因素影响,如物体的几何形状、材料属性和环境光照之间的复杂相互作用,使得这个问题本质上是欠定的。具体来说,论文试图解决以下几个关键问题:

单图像的局限性:由于单张图像提供的信息有限,很难从中准确推断出物体的表面法线和材料属性。

光照条件的不确定性:不同的光照条件可能导致相同的图像外观,使得从单张图像中恢复物体的内在属性变得困难。

计算效率和准确性的平衡:优化基于渲染的方法虽然可以提供准确的结果,但通常计算成本高,并且严重依赖于可微渲染器的能力。

数据驱动方法的泛化能力:尽管数据驱动的方法在某些情况下表现出色,但由于从单张图像推断几何和材料的固有不确定性,它们的质量和泛化能力仍然是一个挑战。

为了解决这些问题,论文提出了利用多光源扩散模型来模拟不同方向光照下的图像,从而改善表面法线和材料估计的方法。通过这种方式,Neural LightRig框架能够生成在各种点光源下一致且高质量的重光照图像,显著减少了估计表面属性时的不确定性,并提高了预测的准确性。

Q: 有哪些相关研究?

A: 论文中提到了多个与Neural LightRig框架相关的研究领域和具体工作,可以概括如下:

扩散模型(Diffusion Models)

- 扩散模型在提供欠定任务的基本先验方面展现出了潜力。相关工作展示了图像扩散模型在新视角合成和高质量3D生成中的实用性。

- [38] High-resolution image synthesis with latent diffusion models.

- [43] Zero123++: a single image to consistent multi-view diffusion base model.

单目法线估计(Monocular Normal Estimation)

- 从单张图像估计表面法线是一个经典但欠定的问题。早期的工作依赖于光度线索或手工特征,而后来的工作采用深度学习来提高准确性。

- [15] Datadriven 3d primitives for single image understanding.

- [19] Automatic photo pop-up.

- [26] Discriminatively trained dense surface normal estimation.

材料估计(Material Estimation)

- 材料估计旨在从图像中恢复内在属性,这是一个欠定问题,因为多种材料和光照条件的组合可能导致相同的外观。

- [7] Nerd: Neural reflectance decomposition from image collections.

- [31] Shape and material capture at home.

逆渲染(Inverse Rendering)

- 逆渲染是一个关键问题,它促进了如电子游戏、增强现实和虚拟现实以及机器人技术等领域的广泛应用。

- [6] Shape, albedo, and illumination from a single image of an unknown object.

多视角图像生成和3D重建(Multi-View Image Generation and 3D Reconstruction)

- 这些工作利用扩散模型生成多视角图像,并训练重建模型进行3D重建。

- [21] LRM: Large reconstruction model for single image to 3d.

- [30] Instant3d: Fast text-to-3d with sparse-view generation and large reconstruction model.

光照和反射率分解(Lighting and Reflectance Decomposition)

- 这些方法优化神经表示,使用多视角图像来分解光照和材料属性。

- [45] Nerv: Neural reflectance and visibility fields for relighting and view synthesis.

这些相关工作为Neural LightRig框架提供了理论基础和技术背景,同时也展示了在单图像几何和材料估计方面的最新进展。通过结合这些相关技术,Neural LightRig旨在通过模拟多光源条件下的图像来提高表面法线和PBR材料的估计质量。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为Neural LightRig的框架来解决从单张图像中准确恢复物体的几何形状和基于物理的渲染(PBR)材料的问题。该框架主要包含两个阶段:多光源扩散模型(Multi-Light Diffusion)和大型G缓冲区模型(Large G-Buffer Model)。以下是具体的解决方案:

1. 多光源扩散模型(Multi-Light Diffusion)

- 目的:利用大规模扩散模型中的光照先验来构建多光源扩散模型,生成由不同方向的点光源照明的多个一致图像。

- 生成多光源图像:通过这个模型,可以从输入图像I生成L个多光源图像,每个图像由不同方向的点光源照明。

- 混合条件策略:结合通道级联和参考注意力机制,将输入图像融合到扩散模型中,以生成高质量和逼真的多光源图像。

- 微调方案:采用两阶段训练策略,先冻结大部分参数,仅训练部分层以稳定早期训练,然后微调整个模型以适应多光源生成。

2. 大型G缓冲区模型(Large G-Buffer Model)

- 预测模型:使用U-Net架构来预测表面法线和PBR材料,因为U-Net在高分辨率预测中效率较高,并且适合学习空间关系。

- 训练目标:对G缓冲区属性应用损失函数,包括余弦相似性损失和均方误差(MSE)损失,以训练模型准确预测法线、反照率、粗糙度和金属度。

- 数据增强策略:为了弥合由扩散模型生成的多光源图像和真实渲染图像之间的域差距,设计了一系列数据增强策略,包括随机降级、随机强度调整、随机方向扰动和数据混合。

3. LightProp数据集

- 数据收集:构建一个合成数据集LightProp,包含80k个从Objaverse筛选的高质量对象,每个对象都有多光源图像和对应的G缓冲区图。

- 渲染设置:使用Blender的Cycles渲染引擎,为每个视点应用五种不同的照明条件,并生成多光源图像及其对应的G缓冲区图。

通过结合这些组件,Neural LightRig框架能够有效地从单张图像中估计出准确的表面法线和PBR材料,并在各种环境光照下渲染逼真的重光照图像。这种方法显著提高了表面法线估计、PBR材料估计和单图像重光照的质量和泛化能力。

Q: 论文做了哪些实验?

A: 论文中进行了一系列的实验来评估Neural LightRig框架的性能,这些实验包括定量评估和定性评估,具体如下:

1. 定量评估

表面法线估计:在LightProp数据集的1,000个未见过的对象的子集上计算度量指标,包括平均角度误差、中位数角度误差以及在不同角度阈值下的准确率(从3°到30°)。与DSINE、GeoWizard、Marigold和StableNormal等基线方法进行比较。

PBR材料估计和单图像重光照:计算反照率、粗糙度和金属度图的峰值信噪比(PSNR)和均方根误差(RMSE),并使用PSNR、SSIM和LPIPS评估重光照图像的质量。同时报告了每帧的平均时间,计算了从单个输入图像渲染120帧重光照图像的总时间,并除以帧数。

2. 定性评估

表面法线估计:在Objaverse子集和野外图像上展示与基线方法的定性比较结果,展示Neural LightRig在捕获复杂表面几何形状方面的优势。

PBR材料估计:比较Neural LightRig与基线方法在估计PBR材料方面的定性结果,展示Neural LightRig在区分金属和非金属材料方面的鲁棒性。

单图像重光照:展示Neural LightRig在不同环境光照下生成的逼真光照效果,并与DiLightNet和IC-Light等扩散模型进行比较。

3. 消融研究

多光源扩散的条件策略:探讨了不同的条件策略(如拼接、参考注意力和混合方法)对多光源扩散模型性能的影响。

多光源图像数量对性能的影响:评估了不同数量的多光源图像(0、3、6和9)对大型G缓冲区模型性能的影响。

增强策略的效果:检查了数据增强策略对提高G缓冲区预测模型的鲁棒性和泛化能力的影响。

这些实验全面评估了Neural LightRig在表面法线估计、PBR材料估计和单图像重光照方面的性能,并与现有方法进行了比较。通过定量和定性的结果,论文证明了Neural LightRig在这些任务中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 尽管Neural LightRig框架在表面法线和PBR材料估计方面取得了显著的成果,但仍有一些可以进一步探索和改进的方向:

1. 复杂场景和多物体环境

当前的Neural LightRig框架主要针对单个物体的设计。将其扩展到更复杂的场景和多物体环境中是一个重要的研究方向。这可能需要处理物体间的遮挡、相互影响的光照以及更复杂的背景。

2. 提高模型分辨率

论文中提到的多光源扩散模型的分辨率限制了生成图像的细节水平。提高模型的分辨率可能有助于生成更高质量的多光源图像,从而提高最终表面属性预测的精度。

3. 优化计算效率

虽然Neural LightRig在性能上取得了突破,但扩散模型和大型G缓冲区模型的训练和推理可能仍然计算密集。进一步优化模型结构和训练过程,以减少计算资源的需求,是一个值得探索的方向。

4. 增强泛化能力

尽管Neural LightRig在合成数据集上表现出色,但在野外图像和多样化数据上可能面临泛化能力的挑战。增强模型对不同光照条件、材质和场景的泛化能力是一个重要的研究方向。

5. 集成到3D重建系统

将Neural LightRig与3D重建系统集成,以实现从单张或多张图像中恢复更完整的3D场景表示,这将是一个有价值的扩展。

6. 实时应用

探索Neural LightRig在实时应用中的潜力,例如增强现实(AR)和虚拟现实(VR),可能需要进一步的模型压缩和加速。

7. 更多的光照条件

当前的框架主要关注点光源照明。将其他类型的光源(如环境光、聚光灯等)纳入模型,以处理更丰富的光照环境。

8. 无监督或自监督学习

探索无监督或自监督学习策略,以减少对大量标注数据的依赖,这可能有助于模型在数据受限的情况下进行训练。

9. 错误分析和模型鲁棒性

进行更深入的错误分析,以识别模型在哪些类型的输入和条件下表现不佳,并针对性地改进模型的鲁棒性。

10. 用户交互和编辑能力

开发用户交互工具,允许用户对Neural LightRig生成的表面法线和材料进行编辑和调整,以满足特定的视觉效果需求。

这些方向不仅可以推动Neural LightRig框架的发展,还可能对计算机视觉和计算机图形学中的相关领域产生深远影响。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为Neural LightRig的框架,旨在从单张图像中准确估计物体的表面法线和基于物理的渲染(PBR)材料。以下是论文的主要内容总结:

1. 问题背景

- 从单张图像中恢复物体的几何形状和材料是一个具有挑战性的任务,因为这个问题本质上是欠定的。

- 该任务对于图形和计算机视觉领域至关重要,并且有许多应用,如视频游戏、增强现实和虚拟现实、机器人技术等。

2. Neural LightRig框架

- 多光源扩散模型:利用大规模扩散模型的光照先验,生成由不同方向的点光源照明的多个一致图像。

- 大型G缓冲区模型:使用U-Net架构,结合多光源图像来预测表面法线和PBR材料。

- LightProp数据集:构建了一个合成数据集,包含多光源图像和对应的G缓冲区图,用于训练和评估模型。

3. 方法细节

- 扩散模型:采用两阶段训练策略,先微调部分层以稳定早期训练,然后微调整个模型以适应多光源生成。

- 预测模型:使用U-Net架构进行高分辨率预测,并通过像素级端到端监督进行训练。

- 数据增强:设计了一系列数据增强策略,以弥合由扩散模型生成的多光源图像和真实渲染图像之间的域差距。

4. 实验

- 进行了定量和定性评估,验证了Neural LightRig在表面法线估计、PBR材料估计和单图像重光照方面的性能。

- 与现有方法相比,Neural LightRig在质量上和泛化能力上都有显著提升。

5. 贡献

- 提出了一种从单目图像中估计物体法线和PBR材料的新方法,通过模拟多光源条件来重新构造这个欠定问题。

- 构建了一个用于多光源图像生成和表面属性估计的合成数据集。

- 通过广泛的实验验证了该方法的有效性,并建立了新的最先进结果。

6. 未来工作

- 将Neural LightRig扩展到更复杂的场景和与3D重建系统的集成。

- 提高模型的分辨率和计算效率,增强模型的泛化能力。

这篇论文通过创新地结合扩散模型和大型G缓冲区模型,显著推进了从单张图像中恢复物体表面属性的研究。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

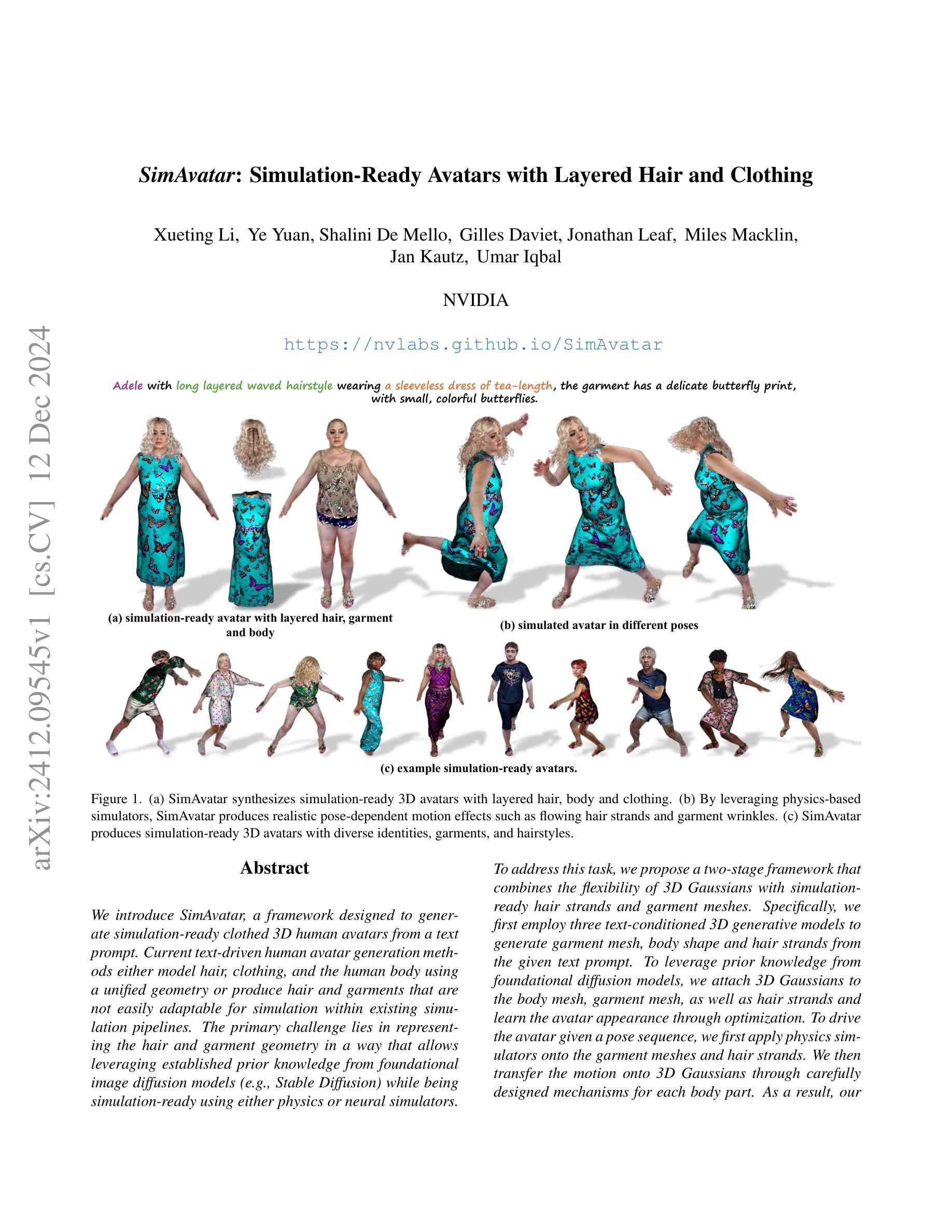

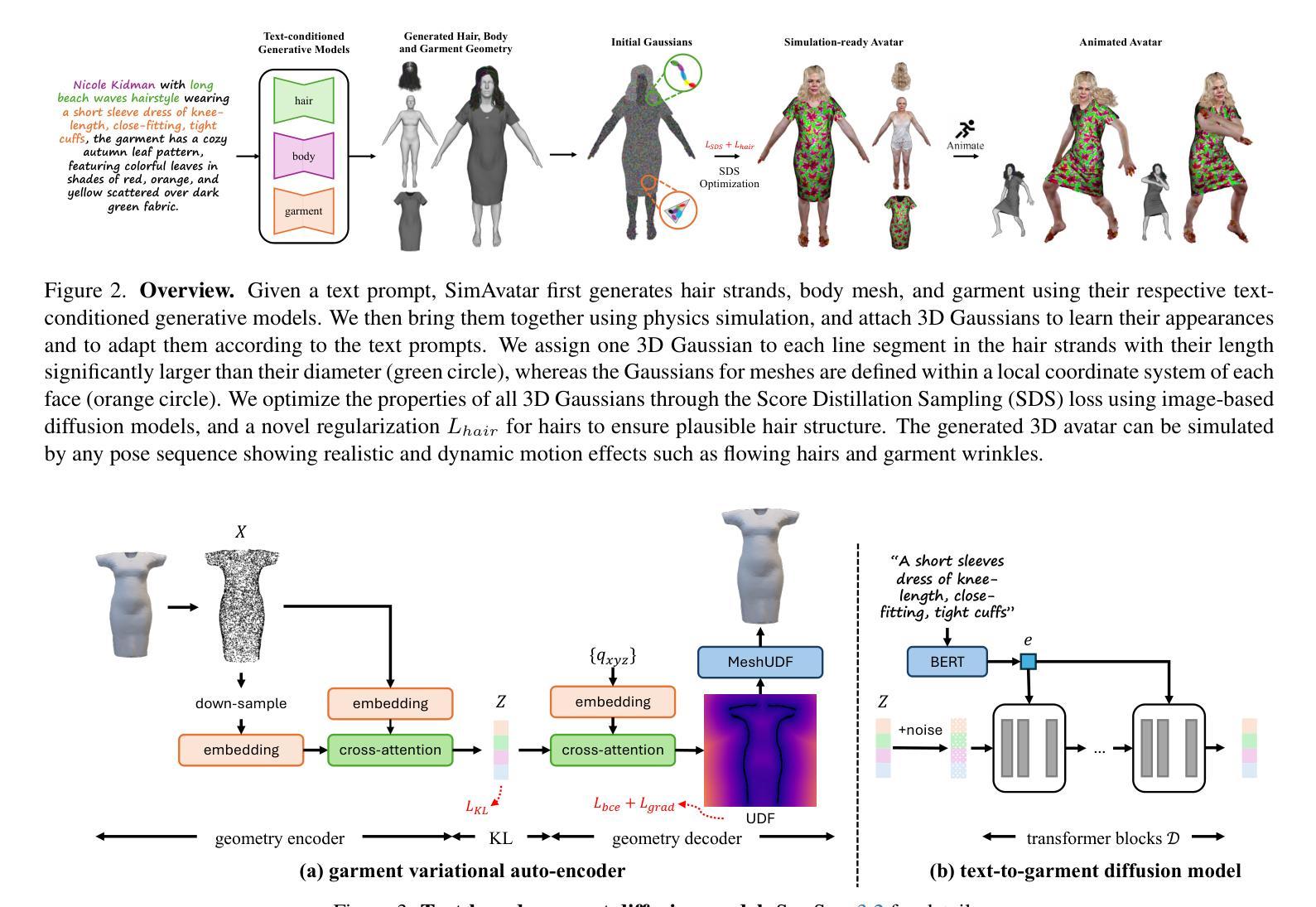

SimAvatar: Simulation-Ready Avatars with Layered Hair and Clothing

Authors:Xueting Li, Ye Yuan, Shalini De Mello, Gilles Daviet, Jonathan Leaf, Miles Macklin, Jan Kautz, Umar Iqbal

We introduce SimAvatar, a framework designed to generate simulation-ready clothed 3D human avatars from a text prompt. Current text-driven human avatar generation methods either model hair, clothing, and the human body using a unified geometry or produce hair and garments that are not easily adaptable for simulation within existing simulation pipelines. The primary challenge lies in representing the hair and garment geometry in a way that allows leveraging established prior knowledge from foundational image diffusion models (e.g., Stable Diffusion) while being simulation-ready using either physics or neural simulators. To address this task, we propose a two-stage framework that combines the flexibility of 3D Gaussians with simulation-ready hair strands and garment meshes. Specifically, we first employ three text-conditioned 3D generative models to generate garment mesh, body shape and hair strands from the given text prompt. To leverage prior knowledge from foundational diffusion models, we attach 3D Gaussians to the body mesh, garment mesh, as well as hair strands and learn the avatar appearance through optimization. To drive the avatar given a pose sequence, we first apply physics simulators onto the garment meshes and hair strands. We then transfer the motion onto 3D Gaussians through carefully designed mechanisms for each body part. As a result, our synthesized avatars have vivid texture and realistic dynamic motion. To the best of our knowledge, our method is the first to produce highly realistic, fully simulation-ready 3D avatars, surpassing the capabilities of current approaches.

我们介绍了SimAvatar框架,该框架旨在从文本提示生成可用于模拟的穿衣3D人类头像。目前的文本驱动的人类头像生成方法要么使用统一几何对头发、服装和人体进行建模,要么生成在现有模拟管道中不易适应模拟的头发和服装。主要挑战在于以一种方式表示头发和服装几何,该方式允许利用来自基础图像扩散模型(例如Stable Diffusion)的现有先验知识,同时使用物理或神经模拟器进行模拟。为了解决此任务,我们提出了一种两阶段框架,该框架结合了3D高斯分布的灵活性与可用于模拟的头发束和服装网格。具体来说,我们首先采用三个文本条件化的3D生成模型,根据给定的文本提示生成服装网格、身体形状和头发束。为了利用基础扩散模型的先验知识,我们将3D高斯分布附加到身体网格、服装网格和头发束上,并通过优化学习头像外观。为了在给定的姿势序列驱动下驱动头像,我们首先对服装网格和头发束应用物理模拟器。然后,通过针对每个身体部位精心设计的机制,将运动转移到3D高斯分布上。因此,我们合成的头像具有生动的纹理和逼真的动态运动。据我们所知,我们的方法是第一个产生高度逼真、完全模拟就绪的3D头像的方法,超越了当前方法的能力。

论文及项目相关链接

PDF Project website: https://nvlabs.github.io/SimAvatar/

Summary

新一代文本驱动仿真化三维人物角色生成框架SimAvatar问世。通过结合文本提示与图像扩散模型,SimAvatar能生成逼真的仿真化三维人物角色,包括服装、发型等细节。采用两阶段方法,结合高斯分布模拟与物理仿真技术,实现角色纹理与动态运动的真实表现。目前该技术尚属领先。

Key Takeaways

- SimAvatar框架首次实现基于文本生成仿真化三维人物角色的技术。

- 利用文本提示与图像扩散模型生成服装、发型等细节。

- 采用两阶段方法结合高斯分布模拟与物理仿真技术,提高角色纹理和动态运动真实性。

- 角色动态表现利用物理仿真器驱动。运动效果可精准传输到不同身体部位的高斯分布模拟中。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了一个名为SimAvatar的框架,旨在解决如何从文本提示生成模拟就绪(simulation-ready)的、穿着服装的3D人体化身的问题。具体来说,论文试图解决以下几个挑战:

现有方法的局限性:当前基于文本驱动的人体化身生成方法要么使用统一的几何模型来建模头发、服装和人体,要么生成的头发和服装不容易适应现有的模拟流程。这些方法难以在保持模拟就绪性的同时利用基础图像扩散模型(例如Stable Diffusion)的先验知识。

头发和服装的几何表示:挑战在于如何表示头发和服装的几何形状,以便既能利用现有的扩散模型的先验知识,又能适应物理或神经网络模拟器进行模拟。

模拟准备性与细节表现:需要生成具有详细几何结构、真实纹理和动态服装及头发运动的3D化身,这些运动效果随姿势变化而变化,如头发流动和服装皱纹。

不同表示方式的整合:将当前模拟器使用的表示方式与文本驱动的化身生成流程所使用的表示方式相连接,前者通常需要干净、紧凑、平滑的网格或特定设计的发丝,后者则常采用隐式表示(如NeRF或SDF),这些虽然可以通过扩散模型的噪声信号进行优化,但难以转换为适合模拟的开放网格或发丝。

为了解决这些问题,SimAvatar框架采用了一个两阶段的方法,结合了3D高斯分布的灵活性和模拟就绪的头发丝和服装网格,使得生成的3D化身能够被现有的头发和服装模拟器轻松动画化,同时保持真实感和动态运动效果。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以归纳为以下几个领域:

文本到3D化身生成(Text to 3D Avatar Generation):

- ClipMatrix、AvatarClip、DreamAvatar、AvatarCraft、DreamHumans、DreamWaltz、AvatarVerse、HumanNorm、AvatarBooth等方法,这些方法通过文本或图像输入来生成和控制3D人体化身。

- TADA、GAvatar等方法,探索了不同的表示方式来建模化身,例如基于网格的方法和基于3D高斯的方法。

服装建模和模拟(Garment Modeling and Simulation):

- SMPL+D等方法,通过在SMPL人体网格上添加顶点位移来捕捉穿着服装的人体几何形状。

- BCNet、DeepCloth等方法,通过学习回归器直接预测服装类型和形状参数,或通过规范的UV表示来编码服装。

- 使用隐式无符号距离场(Unsigned Distance Fields, UDF)的方法,因其在建模任意拓扑和处理开放表面方面的灵活性而受到青睐。

头发建模和模拟(Hair Modeling and Simulation):

- 基于发丝表示的方法,因其与物理模拟器的兼容性和几何操作的便利性而受到青睐。

- 使用数据驱动先验的方法,基于扩散模型来估计合理的内部发丝,尽管在观测数据中这些发丝可能被遮挡。

- 使用3D高斯表示来有效模拟复杂头发纹理和不同发丝厚度的方法。

这些相关研究为SimAvatar框架的发展提供了理论基础和技术手段,特别是在3D人体建模、服装和头发的几何表示、物理模拟以及基于文本的生成模型等方面。SimAvatar框架通过结合这些领域的技术进展,提出了一种新的方法来生成具有独立层次的身体、服装和头发的模拟就绪3D化身。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为SimAvatar的框架来解决从文本提示生成模拟就绪的3D人体化身的问题。该框架通过以下几个关键步骤来解决这个问题:

1. 两阶段框架

SimAvatar采用了一个两阶段框架,结合了3D高斯的灵活性和模拟就绪的头发丝以及服装网格。

2. 文本条件3D生成模型

- 服装网格生成:使用变分自编码器(VAE)学习服装几何分布,并训练一个条件潜在扩散模型从文本提示生成服装网格。

- 头发丝生成:利用基于扩散的文本到头发生成模型从文本提示创建头发丝。

- 身体形状生成:使用基于GPT的LLM模型预测头发丝和SMPL形状参数。

3. 3D高斯Splatting(3DGS)外观模型

- 在不同的人体部位(如头发、身体和服装)上附加3D高斯,并使用得分蒸馏采样(SDS)优化这些高斯属性,以学习真实的外观细节。

4. 动态模拟

- 服装模拟:使用神经网络模拟器(例如HOOD)根据目标身体姿势序列模拟服装网格。

- 头发模拟:使用头发模拟器根据目标身体网格序列和模拟的服装序列模拟头发丝。

5. 外观细节优化

- 使用SDS目标和预训练的文本到图像扩散模型来优化高斯的属性,从而精细化外观细节。

6. 特定部位的3D高斯定制

- 身体和服装网格:将3D高斯与身体和服装网格结合,并根据网格的运动来驱动这些高斯。

- 头发丝:为每根头发丝的每个线段分配一个3D高斯,并根据头发丝的运动来驱动这些高斯。

7. 着色模型

- 为了捕捉运动中的外观细节,如服装皱纹,将Phong着色模型纳入流程中。

8. 实验和评估

- 使用用户研究和定量评估(如VQAScore和CLIP分数)来验证SimAvatar在生成外观和动态运动方面相较于现有技术的优越性。

通过这些步骤,SimAvatar能够生成具有详细几何结构、真实纹理和动态服装及头发运动的3D化身,这些运动效果随姿势变化而变化,如头发流动和服装皱纹。这种方法不仅提高了生成化身的真实感,而且使得化身能够被现有的头发和服装模拟器轻松动画化。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来评估SimAvatar框架的性能:

1. 数据集

- 为了学习基于文本的服装扩散模型,作者使用了Garment Pattern Generator (GPG) 数据集和CLOTH3D 数据集,并利用GPT4v生成与服装网格配对的文本提示。

2. 定性评估

- 作者将SimAvatar生成的化身与几种最先进的文本驱动的3D化身生成方法(包括Fantasia3D、TADA和GAvatar)进行了视觉比较。

- 展示了在标准姿势下的合成化身以及动画化身,以展示SimAvatar在模拟动态效果(如服装皱纹和头发流动)方面的优势。

3. 用户研究

- 通过A/B用户研究定量评估SimAvatar。研究包括对22个提示的比较,生成静态360度视频和显示化身驱动的运动序列的视频。

- 用户被要求选择具有更好外观的方法和更注重运动的方法。研究收集了18名用户的540票,并在表格中展示了结果。

4. 定量评估

- 使用VQAScore和CLIP分数来定量比较SimAvatar与基线方法。

- VQAScore:评估生成资产与输入提示之间的对齐程度,特别适合涉及多个实体和关系的复杂提示。

- CLIP分数:虽然用于评估,但作者指出其在评估视觉质量和文本提示对齐方面的不可靠性。

5. 实施细节

- 描述了文本到服装扩散模型的训练细节和高斯化身学习的优化过程。

6. 层级训练策略

- 为了促进头发、身体和服装的解耦,作者采用了分别渲染每个层并使用不同提示进行优化的策略。

7. 消融研究

- 评估了不同模块的有效性,包括头发约束、提示工程和解耦训练策略,并展示了相应的定性结果。

8. 更多定性结果

- 提供了与基线方法的更多比较结果,并展示了SimAvatar方法的各个层(包括头发、面部、服装、身体和完整化身)的几何和纹理的额外结果。

这些实验全面评估了SimAvatar在生成现实感、可动画化3D服装化身方面的能力,并与现有技术进行了比较。通过这些实验,论文证明了SimAvatar在生成具有动态效果的高质量3D化身方面的有效性。

Q: 有什么可以进一步探索的点?

A: 论文在最后提出了几个可以进一步探索的点:

数据集多样性:当前的头发和服装生成模型是在特定的数据集上训练的,这可能因为训练数据的局限性而限制了生成的多样性。未来的工作可以探索方法,以生成超越现有数据集多样性的模拟就绪化身。

联合模拟:SimAvatar目前是顺序地模拟服装和头发,这在某些情况下(如穿着帽子的化身)可能会失败。实现头发和服装的联合模拟将使我们能够处理更复杂的服装。

配饰和鞋类:目前的SimAvatar框架中,配饰和鞋类仍然与身体或服装层纠缠在一起;未来的工作可以集中在生成完全分离的配饰和鞋类,以创建完全解耦的化身。

优化和计算效率:虽然SimAvatar能够生成高质量的3D化身,但是优化过程可能既耗时又计算密集。研究更高效的优化算法和计算策略可能是一个有价值的方向。

更复杂的纹理和外观细节:尽管SimAvatar在模拟动态服装和头发方面取得了进展,但在生成更复杂的纹理和外观细节方面仍有改进空间,例如模拟更逼真的织物纹理和更细致的光影效果。

交互性和实时应用:将SimAvatar应用于实时系统,如虚拟试衣或游戏,可能需要进一步的研究以确保实时性能和用户交互。

跨模态融合:探索将SimAvatar与其他模态的输入(如语音或视频)结合起来,以创建更丰富的交互体验。

更广泛的用户定制:提供更多的用户定制选项,允许用户调整化身的各种特征,包括面部特征、体型和风格。

评估和度量:开发和验证新的评估度量,以更准确地衡量3D化身生成系统的性能,特别是在动态模拟和真实感方面。

应用扩展:探索SimAvatar在其他领域的应用,如电影和游戏制作、虚拟助理、增强现实/虚拟现实和远程存在等。

这些方向都有助于推动3D人体化身生成技术的发展,并扩大其在不同领域的应用。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了一个名为SimAvatar的框架,旨在从文本提示生成模拟就绪的3D人体化身,包括头发、服装和身体。以下是论文的主要内容总结:

问题定义:论文指出了现有文本驱动的3D人体化身生成方法的局限性,包括无法适应模拟流程的头发和服装表示,以及难以利用图像扩散模型的先验知识。

SimAvatar框架:提出了一个两阶段框架,首先使用文本条件的3D生成模型生成服装网格、身体形状和头发丝,然后通过优化附着在这些几何结构上的3D高斯来学习化身的外观。

服装和头发的模拟:利用物理模拟器和神经网络模拟器(如HOOD)来模拟服装和头发的运动,以实现动态效果,如流动的头发和服装皱纹。

3D高斯Splatting(3DGS):为了捕捉细节外观,框架在身体网格、服装网格和头发丝上附加3D高斯,并使用得分蒸馏采样(SDS)优化这些高斯的属性。

动态模拟:通过将运动从模拟的服装网格和头发丝转移到3D高斯,确保化身在不同姿势下的外观保持一致。

实验:通过定性和定量实验,包括用户研究和VQAScore评估,展示了SimAvatar在生成现实感和动态服装化身方面的优越性能。

未来工作:论文提出了几个未来研究方向,包括扩展数据集多样性、实现头发和服装的联合模拟、生成完全解耦的配饰和鞋类等。

总体而言,SimAvatar通过结合3D高斯的灵活性和模拟就绪的头发丝及服装网格,提出了一种新的方法来生成具有独立层次的身体、服装和头发的模拟就绪3D化身,这些化身在动画化时能够展现出逼真的动态效果。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

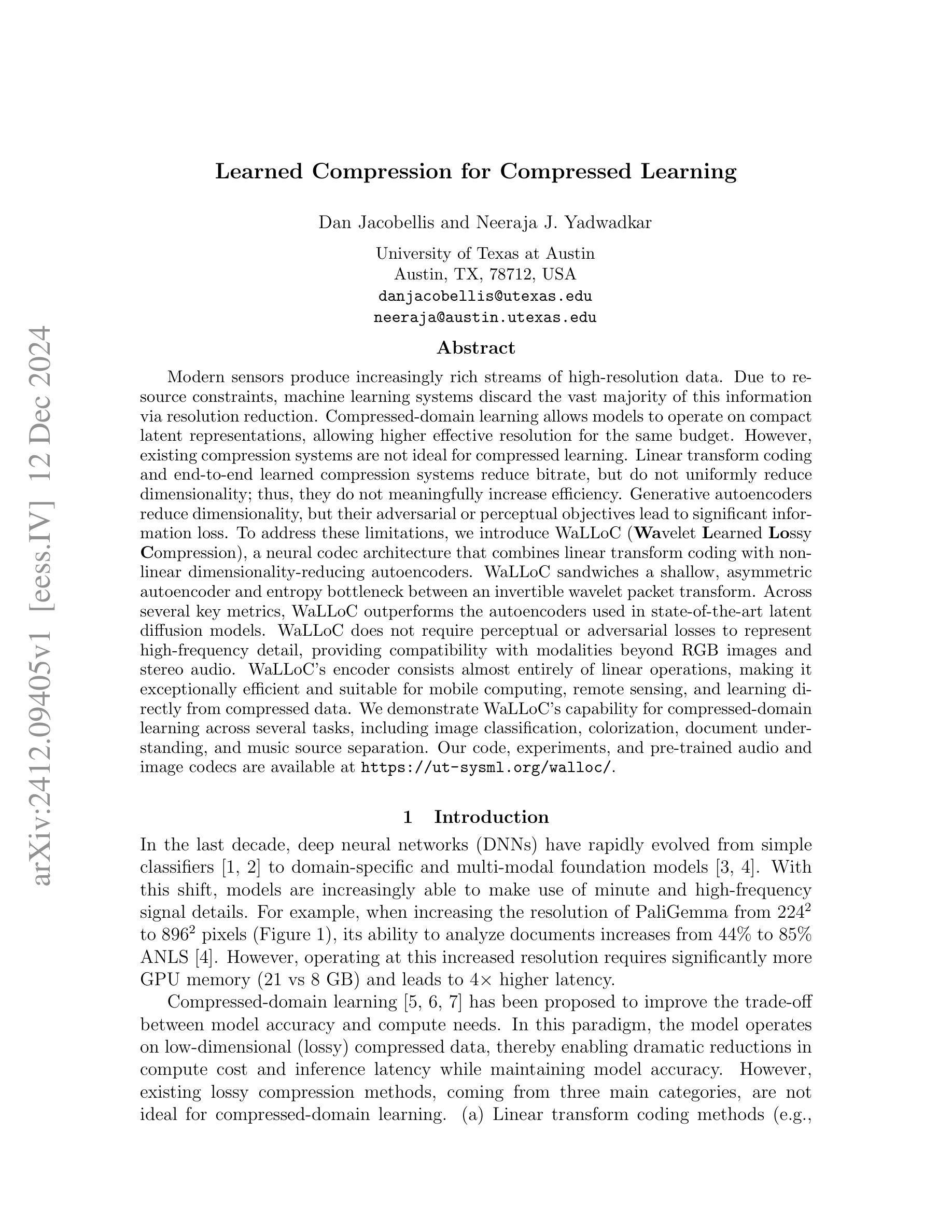

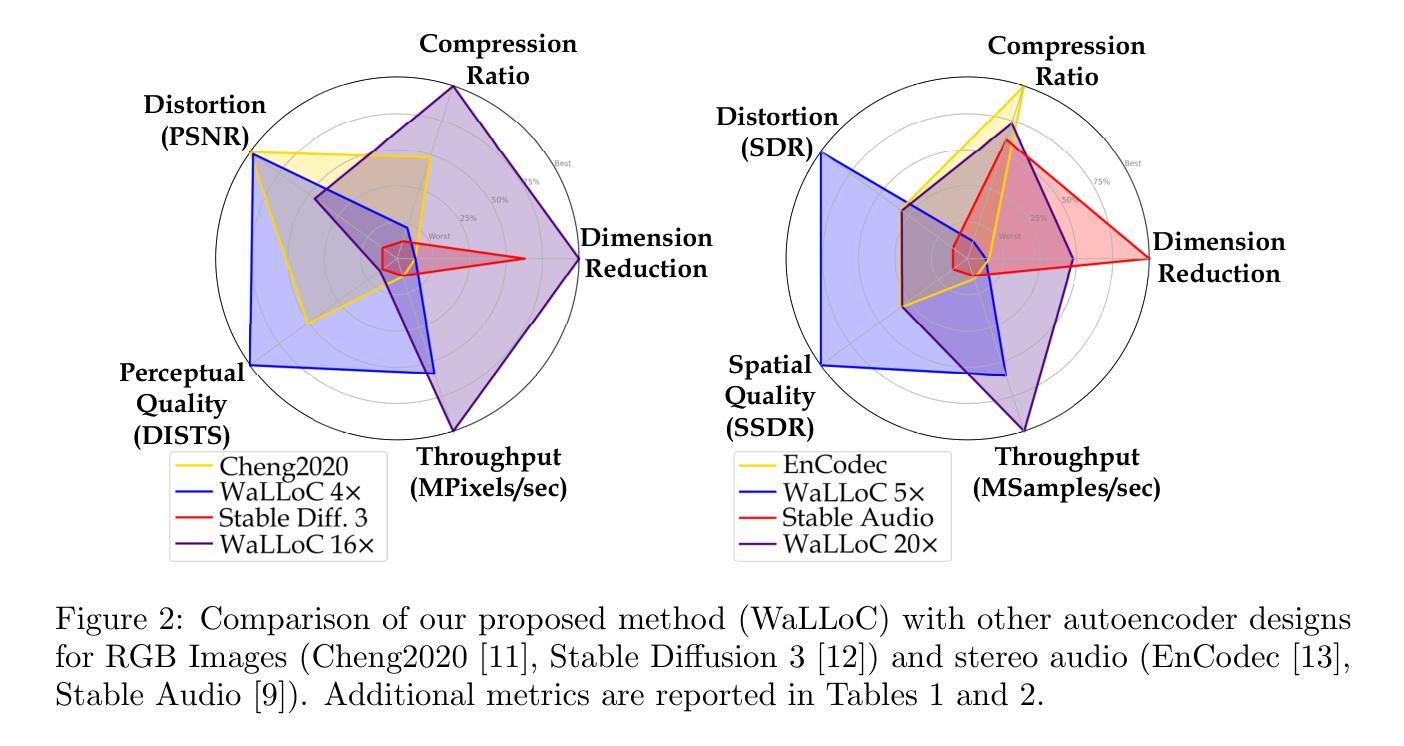

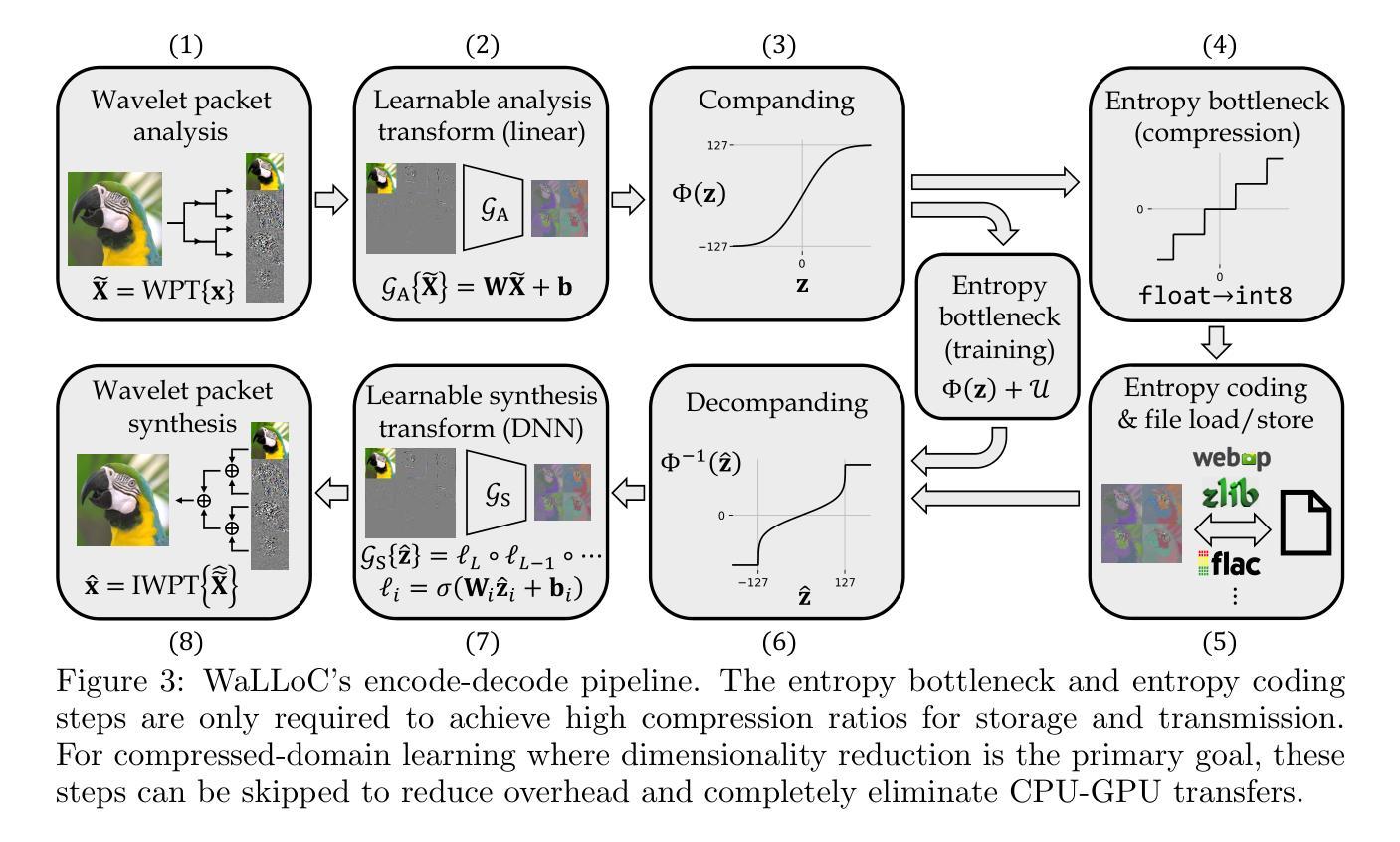

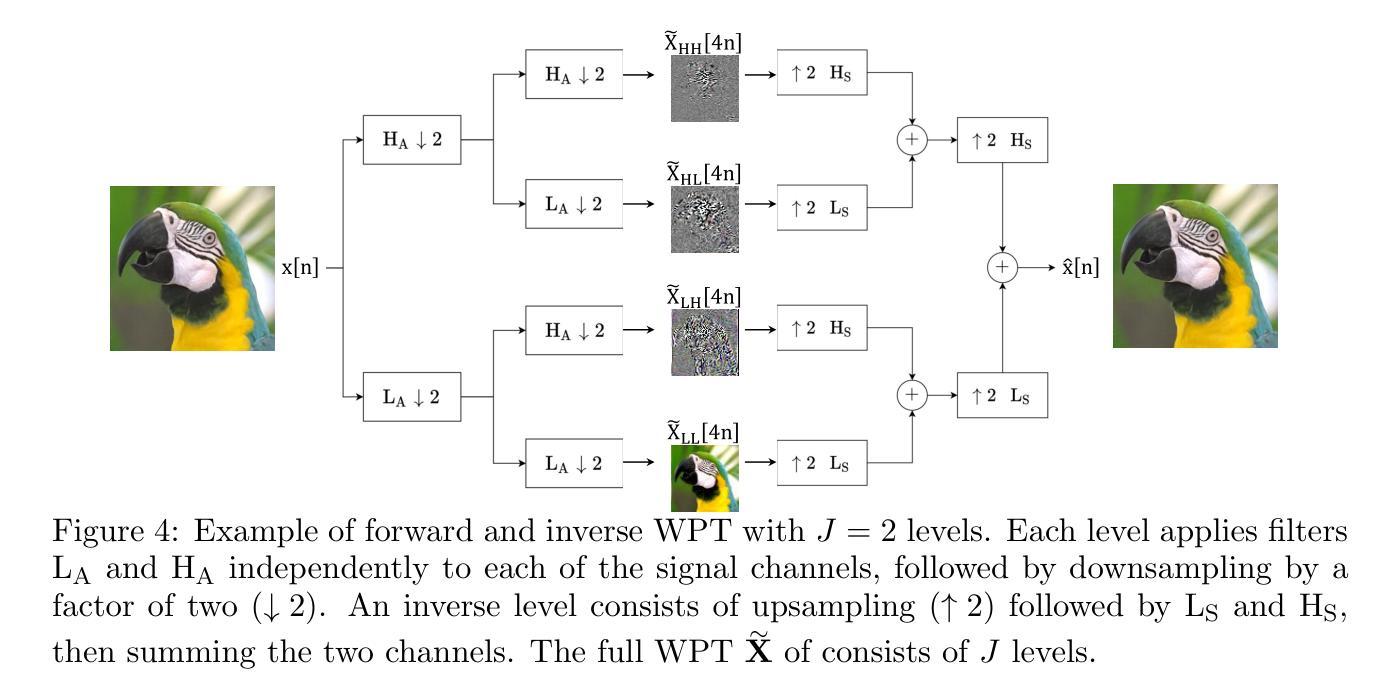

Learned Compression for Compressed Learning

Authors:Dan Jacobellis, Neeraja J. Yadwadkar

Modern sensors produce increasingly rich streams of high-resolution data. Due to resource constraints, machine learning systems discard the vast majority of this information via resolution reduction. Compressed-domain learning allows models to operate on compact latent representations, allowing higher effective resolution for the same budget. However, existing compression systems are not ideal for compressed learning. Linear transform coding and end-to-end learned compression systems reduce bitrate, but do not uniformly reduce dimensionality; thus, they do not meaningfully increase efficiency. Generative autoencoders reduce dimensionality, but their adversarial or perceptual objectives lead to significant information loss. To address these limitations, we introduce WaLLoC (Wavelet Learned Lossy Compression), a neural codec architecture that combines linear transform coding with nonlinear dimensionality-reducing autoencoders. WaLLoC sandwiches a shallow, asymmetric autoencoder and entropy bottleneck between an invertible wavelet packet transform. Across several key metrics, WaLLoC outperforms the autoencoders used in state-of-the-art latent diffusion models. WaLLoC does not require perceptual or adversarial losses to represent high-frequency detail, providing compatibility with modalities beyond RGB images and stereo audio. WaLLoC’s encoder consists almost entirely of linear operations, making it exceptionally efficient and suitable for mobile computing, remote sensing, and learning directly from compressed data. We demonstrate WaLLoC’s capability for compressed-domain learning across several tasks, including image classification, colorization, document understanding, and music source separation. Our code, experiments, and pre-trained audio and image codecs are available at https://ut-sysml.org/walloc

现代传感器产生越来越丰富的高分辨率数据流。由于资源限制,机器学习系统通过降低分辨率来丢弃绝大多数信息。压缩域学习允许模型在紧凑的潜在表示上运行,从而在相同的预算下实现更高的有效分辨率。然而,现有的压缩系统并不理想用于压缩学习。线性变换编码和端到端学习压缩系统降低了比特率,但并不统一地降低维度;因此,它们并没有有效地提高效率。生成自编码器降低了维度,但它们的对抗性或感知目标导致了信息的大量损失。为了解决这些局限性,我们引入了WaLLoC(Wavelet Learned Lossy Compression,小波学习有损压缩),这是一种神经网络编码架构,结合了线性变换编码和非线性降维自编码器。WaLLoC在可逆的小波包变换之间夹着一个浅的不对称自编码器和熵瓶颈。在多个关键指标上,WaLLoC的表现优于最先进潜伏扩散模型的自编码器。WaLLoC不需要感知或对抗性损失就能表示高频细节,为RGB图像和立体声音频以外的模式提供了兼容性。WaLLoC的编码器几乎完全由线性操作组成,使其非常高效,适用于移动计算、遥感以及直接从压缩数据中学习。我们在多个任务上展示了WaLLoC在压缩域学习的能力,包括图像分类、上色、文档理解和音乐源分离。我们的代码、实验以及预训练的音频和图像编码器可在https://ut-sysml.org/walloc上找到。

论文及项目相关链接

PDF Accepted as paper to 2025 IEEE Data Compression Conference

Summary:现代传感器产生大量丰富的高分辨率数据,但由于资源限制,机器学习系统通过降维来舍弃大部分信息。压缩域学习能让模型在压缩的潜在表示上运行,提高有效分辨率。然而,现有的压缩系统并不理想。线性变换编码和端到端学习压缩系统降低了比特率,但并不统一地降低维度,因此并未有效提高效率。为了解决这些问题,我们提出了WaLLoC(小波学习有损压缩),一种结合线性变换编码和非线性降维自动编码器的神经网络编码架构。WaLLoC在多个关键指标上优于现有扩散模型中使用的自动编码器。它不需要感知或对抗性损失就能表示高频细节,适用于非RGB图像和立体声频之外的模态。WaLLoC的编码器几乎完全由线性操作组成,使其非常高效,适用于移动计算、遥感以及直接从压缩数据中学习。我们在多个任务上展示了WaLLoC进行压缩域学习的能力。

Key Takeaways:

- 现代传感器产生大量高分辨率数据,但机器学习系统因资源限制常通过降维处理信息。

- 压缩域学习允许在紧凑的潜在表示上操作,提高有效分辨率。

- 现有压缩系统存在缺陷,无法统一降低维度以提高效率。

- WaLLoC结合线性变换编码和非线性降维自动编码器,以改进现有系统。

- WaLLoC在多个关键指标上超越现有自动编码器。

- WaLLoC无需感知或对抗性损失即可表示高频细节,适用于多种模态。

- WaLLoC的编码器高效且适用于多种场景,包括移动计算、遥感及从压缩数据中直接学习。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是如何在资源受限的情况下,有效地利用高分辨率数据进行机器学习。具体来说,论文关注以下几个核心问题:

高分辨率数据的处理效率:现代传感器产生的高分辨率数据流非常丰富,但由于资源限制,大多数机器学习系统通过降低分辨率来丢弃这些信息,这导致了信息的大量损失。

压缩域学习(Compressed-domain learning):压缩域学习允许模型在紧凑的潜在表示上操作,从而在相同的预算下实现更高的有效分辨率。然而,现有的压缩系统并不理想,因为它们要么不均匀地降低维度,要么在保留细节方面存在问题。

现有压缩方法的局限性:包括线性变换编码方法、端到端学习压缩系统和生成自编码器在内的现有压缩方法,都不能很好地满足压缩域学习的需求。它们要么不能有效地降低维度,要么在编码效率上存在问题,要么在保留高频细节信息方面表现不佳。

为了解决这些问题,论文提出了一种名为WaLLoC(Wavelet Learned Lossy Compression)的神经编解码器架构,它结合了线性变换编码和非线性降维自编码器,旨在同时实现计算效率高的编码、高压缩比和均匀的维度降低,以支持压缩域学习。

Q: 有哪些相关研究?

A: 论文中提到了多个与压缩域学习(Compressed-domain learning)和神经网络压缩相关的研究工作。以下是一些主要的相关研究:

线性变换编码方法(Linear Transform Coding):

- 论文提到了传统的有损压缩标准,如JPEG和MP3,它们基于线性变换编码(LTC)。这些方法通过时间-频率变换集中信号能量,以达到高压缩比和最小的感知失真。

端到端学习压缩(End-to-end Learned Compression):

- 论文引用了Johannes Ballé的工作,他们提出了一种端到端优化的图像压缩方法,该方法通过非线性自编码器实现比传统LTC更高的压缩比。

- David Minnen和Nick Johnston的工作,他们推进了神经图像压缩的率失真计算前沿。

生成自编码器(Generative Autoencoders):

- 论文提到了Rombach等人的工作,他们使用潜在扩散模型进行高分辨率图像合成。

- 还有关于使用低分辨率生成模型与生成对抗自编码器(GADR-AE)配对的研究,这些模型在压缩域学习中取得了突破。

特定压缩算法和模型:

- 论文中还提到了Cheng等人的工作,他们提出了一种使用离散高斯混合似然和注意力模块的学习图像压缩方法。

- 论文还比较了WaLLoC与Stable Diffusion 3和EnCodec等其他自编码器设计。

压缩域学习的其他应用:

- 论文提到了EfficientNet模型,这是一个广泛使用的高效卷积神经网络模型,用于比较编码器的参数数量和计算复杂度。

- 还有关于使用WaLLoC进行图像分类、着色、文档理解和音乐源分离等任务的研究。

这些相关研究为WaLLoC的设计和评估提供了理论基础和技术对比,使得WaLLoC能够在压缩域学习中实现更高效的编码、更高的压缩比和更好的维度降低。

Q: 论文如何解决这个问题?

A: 论文通过提出WaLLoC(Wavelet Learned Lossy Compression)框架来解决压缩域学习中的问题。WaLLoC的设计旨在满足压缩域学习的三个关键要求:计算效率高的编码、高压缩比以及均匀的维度降低。以下是WaLLoC解决这些问题的具体方法:

计算效率高的编码:

- WaLLoC使用计算成本低廉且可逆的小波包变换(wavelet packet transform, WPT)来预先处理信号,以暴露信号冗余,从而减少自动编码(autoencoding)前的计算需求。

- WaLLoC的编码器主要由线性操作组成,几乎不需要参数,这使得编码过程非常高效,适合移动计算、远程传感和直接从压缩数据学习。

高压缩比:

- WaLLoC通过量化和熵编码实现高压缩比。为了使自动编码器的潜在表示对量化具有弹性,WaLLoC在训练期间引入了熵瓶颈(即添加噪声),以保证在推理时能够抵抗量化带来的失真。

- WaLLoC优化了噪声比例,以适应8位量化,并使用标准的无损编解码器(如PNG或WebP)进行熵编码,从而实现了比仅通过降低维度获得的压缩比高出12倍。

均匀的维度降低:

- WaLLoC的编码器将高维信号块投影到低维潜在表示中,实现了高达20倍的维度降低。

- WaLLoC的设计允许其作为分辨率降低的替代方案,同时在加速下游模型的同时提供更好的细节保留和下游准确性。

WaLLoC的实现:

- WaLLoC的编码器包括五个阶段:小波包变换(WPT)、学习分析变换、压缩处理、熵瓶颈和熵编码。

- 解码器则包括相反的操作:熵解码、解压缩处理、学习合成变换和逆WPT。

- WaLLoC在训练时采用均方重建误差最小化作为目标,并在不同的数据集上训练了多个编解码器。

压缩域学习的评估:

- 论文通过在多个机器学习任务(包括图像分类、着色、文档理解和音乐源分离)上评估WaLLoC,并与基于像素和基于样本的版本进行比较,展示了WaLLoC在压缩域学习中的有效性。

- WaLLoC在这些任务中表现出比简单分辨率降低更高的准确性,同时提供了相同的延迟和内存消耗改进。

通过这些方法,WaLLoC能够在保持高准确性的同时显著加速下游模型,实现了高达20倍的维度降低和最小的编码成本。

Q: 论文做了哪些实验?

A: 论文中进行了一系列的实验来评估WaLLoC(Wavelet Learned Lossy Compression)框架的性能和在压缩域学习中的有效性。以下是实验的具体内容:

压缩权衡分析:

- 比较WaLLoC与其他流行的传统和神经网络编解码器(包括WEBP、Cheng2020、Stable Diffusion 3和EnCodec)在五个关键指标上的表现:维度降低、压缩比、失真、感知质量和计算成本。

- 使用不同的平台(低功耗CPU、高功耗CPU和GPU)来测量这些编解码器的平均编码和解码吞吐量。

压缩学习和分辨率缩放:

- 在四个机器感知任务上评估WaLLoC:图像分类、图像着色、文档理解和音乐源分离。

- 对于图像分类和着色,训练了带有条件位置编码的ViT-Ti模型,并在ImageNet-1k数据集上进行测试。

- 对于音乐源分离,训练了一个CNN来分离MUSDB18-HQ中的音乐片段中的声乐轨道。

- 对于文档理解,使用了PaliGemma模型,并在DocVQA数据集上报告了平均归一化的Levenshtein相似度(ANLS)。

分辨率缩放策略:

- 对于图像分类,通过减少输入序列长度(4倍或16倍)来比较WaLLoC编码的输入与相同WaLLoC潜在表示上训练的模型的准确性。

- 对于文档理解,由于训练PaliGemma模型超出了工作范围,因此使用最高分辨率的PaliGemma变体在解码的WaLLoC表示上进行评估。

- 对于图像着色和音乐源分离,通过增加输入补丁大小来保持序列长度和所需计算大致恒定。

压缩域学习和分辨率缩放的结果:

- 展示了使用WaLLoC派生表示代替分辨率降低时性能的提高。在所有四个任务中,WaLLoC都提供了比简单分辨率降低更高的准确性,同时提供了相同的延迟和内存消耗改进。

这些实验全面评估了WaLLoC在压缩域学习中的性能,并与现有的压缩方法和直接在原始数据上操作的方法进行了比较。结果表明,WaLLoC在保持准确性的同时显著提高了计算效率和压缩比。

Q: 有什么可以进一步探索的点?

A: 论文在最后提出了一些未来工作的方向,指出了可以进一步探索的点:

扩展到高分辨率信号类型:

- WaLLoC可以扩展到其他高分辨率信号类型,例如高光谱图像或全切片显微镜图像。这些领域对现有压缩方法提出了额外的挑战,但由于信号冗余度更高,因此采用WaLLoC可能获得更大的潜在好处。

优化和改进编解码器架构:

- 进一步研究和优化WaLLoC的编解码器架构,以提高压缩效率和降低计算成本,特别是在资源受限的环境中。

探索不同的小波变换和滤波器:

- 研究不同的小波变换和滤波器,以找到在特定应用中提供最佳能量压缩和计算效率的组合。

增强模型的泛化能力:

- 探索如何提高WaLLoC模型在不同数据集和任务中的泛化能力,使其能够适应更广泛的应用场景。

提高压缩比和感知质量:

- 继续寻找提高压缩比和感知质量之间的平衡,特别是在不同的应用领域中。

实时压缩和去压缩的应用:

- 研究WaLLoC在需要实时压缩和去压缩的应用中的性能,例如视频会议、流媒体服务等。

跨模态学习:

- 探索WaLLoC在跨模态学习中的应用,例如结合图像和音频数据进行联合学习。

模型压缩和加速:

- 研究WaLLoC在模型压缩和加速方面的潜力,特别是在移动和边缘计算设备上。

对抗性攻击和模型鲁棒性:

- 研究WaLLoC模型对于对抗性攻击的鲁棒性,并探索提高模型鲁棒性的方法。

开源社区和工业界的合作:

- 与开源社区和工业界合作,进一步开发和优化WaLLoC框架,以及探索其在实际应用中的有效性。

这些方向为未来的研究提供了明确的道路,并有助于推动压缩域学习技术的发展和应用。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

问题背景:

- 现代传感器产生大量高分辨率数据,但机器学习系统因资源限制而丢弃大部分信息。

- 压缩域学习允许模型在压缩的潜在表示上操作,以提高效率和降低计算成本,但现有压缩方法并不理想。

WaLLoC框架:

- 提出了WaLLoC(Wavelet Learned Lossy Compression),一个结合线性变换编码和非线性自编码器的神经编解码器架构。

- WaLLoC旨在满足压缩域学习的三个关键要求:计算效率高的编码、高压缩比和均匀的维度降低。

主要贡献:

- 评估了现有压缩方法(线性变换编码、端到端学习压缩和生成自编码器)的局限性。

- 构建了适用于RGB图像和立体声音频的WaLLoC编解码器,并在多个关键指标上超越了现有的自编码器设计。

- 通过压缩域操作加速了多种机器学习模型,并在图像分类、着色、文档理解和音乐源分离等任务中展示了WaLLoC的有效性。

WaLLoC设计和实现:

- WaLLoC利用小波包变换(WPT)和熵瓶颈技术,实现了计算效率高的编码和高压缩比。

- WaLLoC的编码器主要由线性操作组成,适合移动计算和直接从压缩数据学习。

实验评估:

- 在多个任务上评估了WaLLoC,并与基于像素和基于样本的方法进行了比较。

- 结果表明,WaLLoC在保持准确性的同时显著提高了计算效率和压缩比。

未来工作:

- 探索将WaLLoC扩展到其他高分辨率信号类型,如高光谱图像或全切片显微镜图像。

- 进一步优化WaLLoC架构,提高压缩效率和降低计算成本。

总体而言,这篇论文提出了一个创新的压缩框架WaLLoC,旨在提高压缩域学习的效率和效果,并通过一系列实验验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

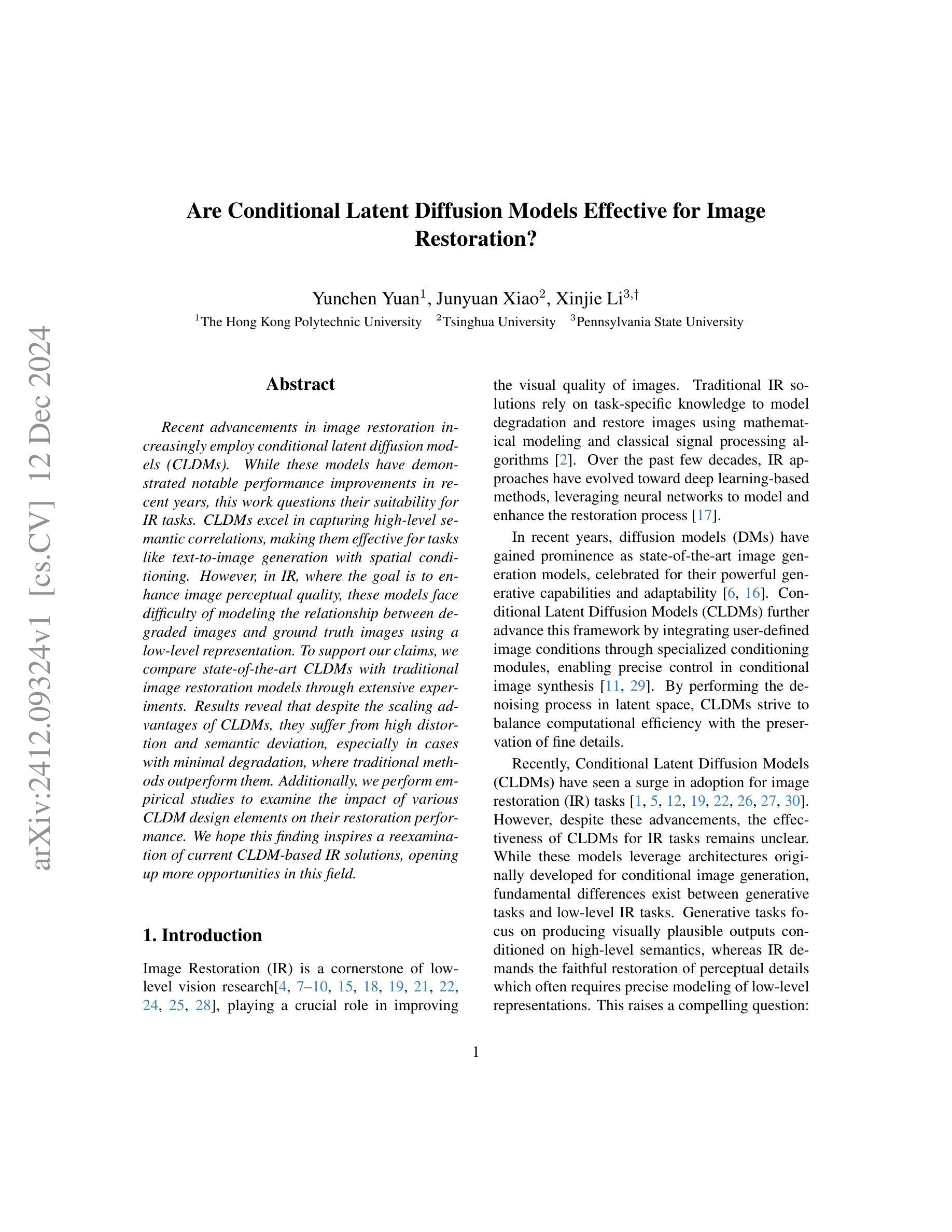

Are Conditional Latent Diffusion Models Effective for Image Restoration?

Authors:Yunchen Yuan, Junyuan Xiao, Xinjie Li

Recent advancements in image restoration increasingly employ conditional latent diffusion models (CLDMs). While these models have demonstrated notable performance improvements in recent years, this work questions their suitability for IR tasks. CLDMs excel in capturing high-level semantic correlations, making them effective for tasks like text-to-image generation with spatial conditioning. However, in IR, where the goal is to enhance image perceptual quality, these models face difficulty of modeling the relationship between degraded images and ground truth images using a low-level representation. To support our claims, we compare state-of-the-art CLDMs with traditional image restoration models through extensive experiments. Results reveal that despite the scaling advantages of CLDMs, they suffer from high distortion and semantic deviation, especially in cases with minimal degradation, where traditional methods outperform them. Additionally, we perform empirical studies to examine the impact of various CLDM design elements on their restoration performance. We hope this finding inspires a reexamination of current CLDM-based IR solutions, opening up more opportunities in this field.

近期图像修复领域越来越广泛地应用了条件潜在扩散模型(CLDM)。虽然这些模型在近年来表现出了显著的性能提升,但本文对其在图像修复任务中的适用性提出了质疑。CLDM在捕捉高级语义关联方面表现出色,因此在空间条件下进行文本到图像生成等任务时非常有效。然而,在图像感知质量提升的图像修复任务中,这些模型在使用低级表示法建模退化图像和原始图像之间的关系时面临困难。为了支持我们的观点,我们通过大量实验将最先进的CLDM与传统图像修复模型进行了比较。结果表明,尽管CLDM具有规模优势,但在失真和语义偏差方面存在缺陷,尤其是在退化轻微的情况下,传统方法优于它们。此外,我们还通过实证研究检验了不同CLDM设计元素对修复性能的影响。我们希望这一发现能激发对当前基于CLDM的图像修复解决方案的重新审视,为该领域带来更多的机会。

论文及项目相关链接

PDF 16 pages, 12 figures, submitted to IEEE / CVF Computer Vision and Pattern Recognition Conference (CVPR 2025)

Summary

条件潜在扩散模型(CLDM)在图像修复任务上的适用性受到质疑。虽然CLDM在捕捉高级语义关联方面表现出色,适用于文本到图像生成等任务,但在图像修复中旨在提高图像感知质量的任务中,它们难以使用低级表示法来模拟退化图像和原始图像之间的关系。对比实验结果显示,尽管CLDM具有规模优势,但在轻微退化的场景中,传统方法表现更佳,存在较少的失真和语义偏差。此外,我们对CLDM的不同设计元素进行了实证研究,以评估其对修复性能的影响。

Key Takeaways

- 条件潜在扩散模型(CLDM)在图像修复任务上的适用性受到挑战。

- CLDM擅长捕捉高级语义关联,但在图像修复任务中面临建模退化图像和原始图像关系的困难。

- 对比实验显示,在轻微退化的场景中,传统方法表现优于CLDM。

- CLDM在高失真和语义偏差方面存在挑战。

- 通过对CLDM的不同设计元素进行实证研究,以评估其对图像修复性能的影响。

点击展开 Cool Papers 详细信息

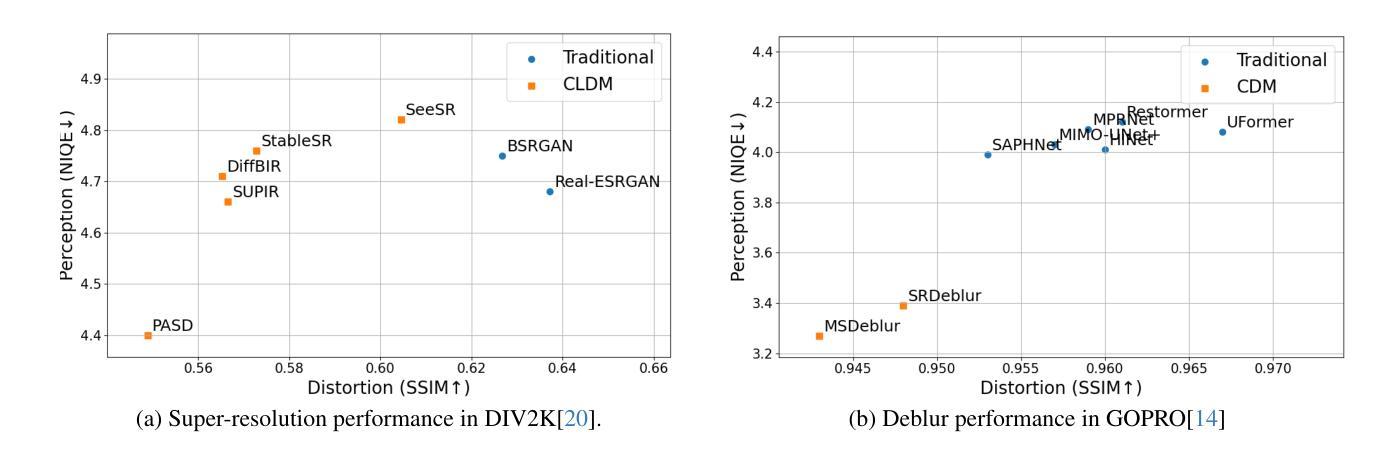

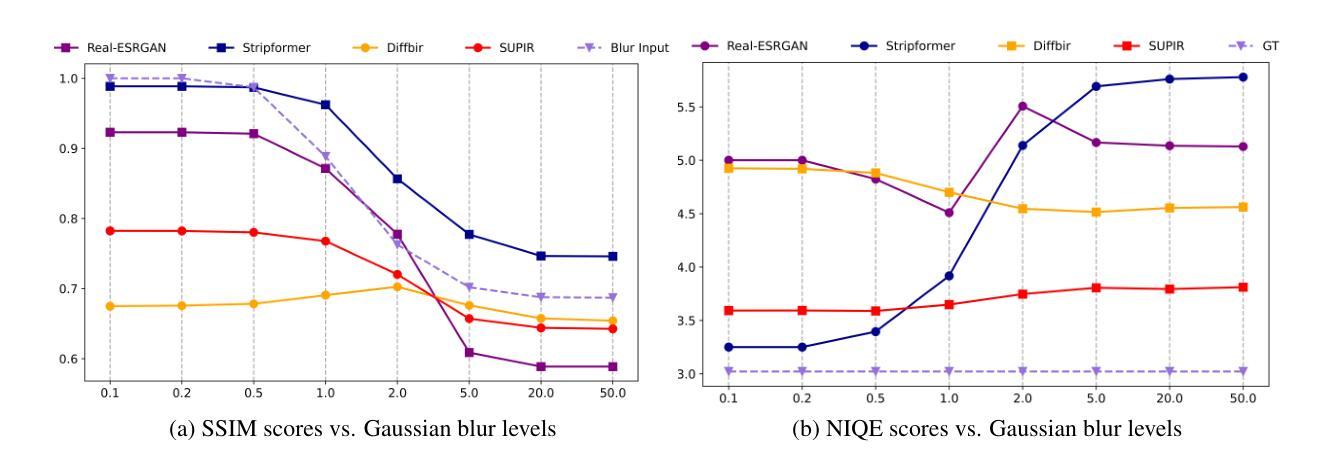

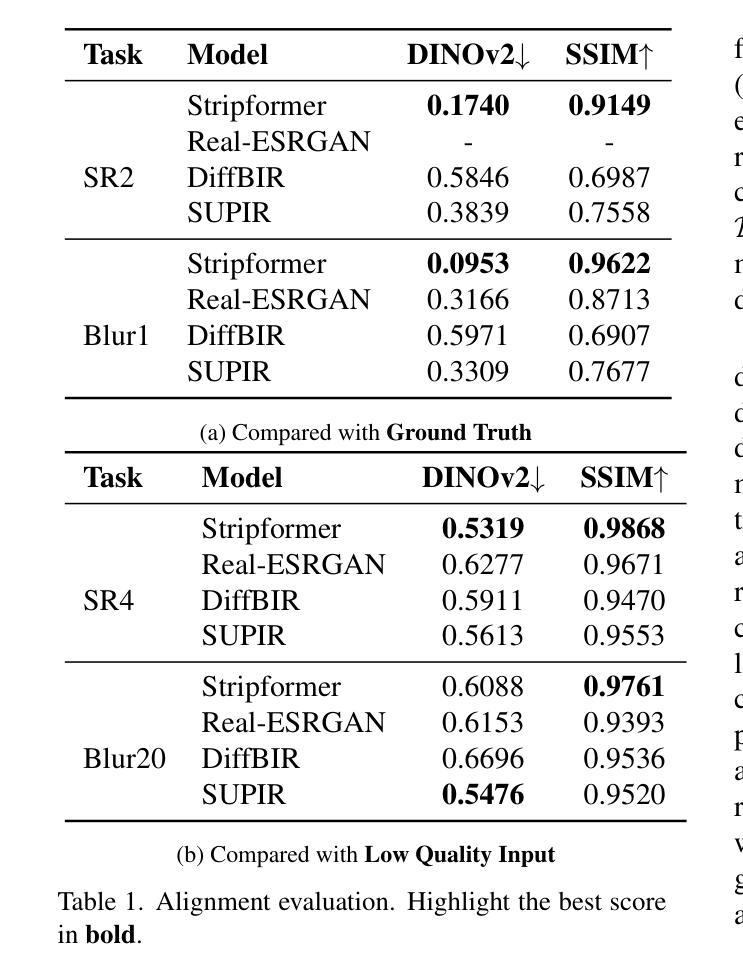

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是评估条件潜在扩散模型(Conditional Latent Diffusion Models, CLDMs)在图像恢复(Image Restoration, IR)任务中的有效性。具体来说,论文提出了以下几个关键点:

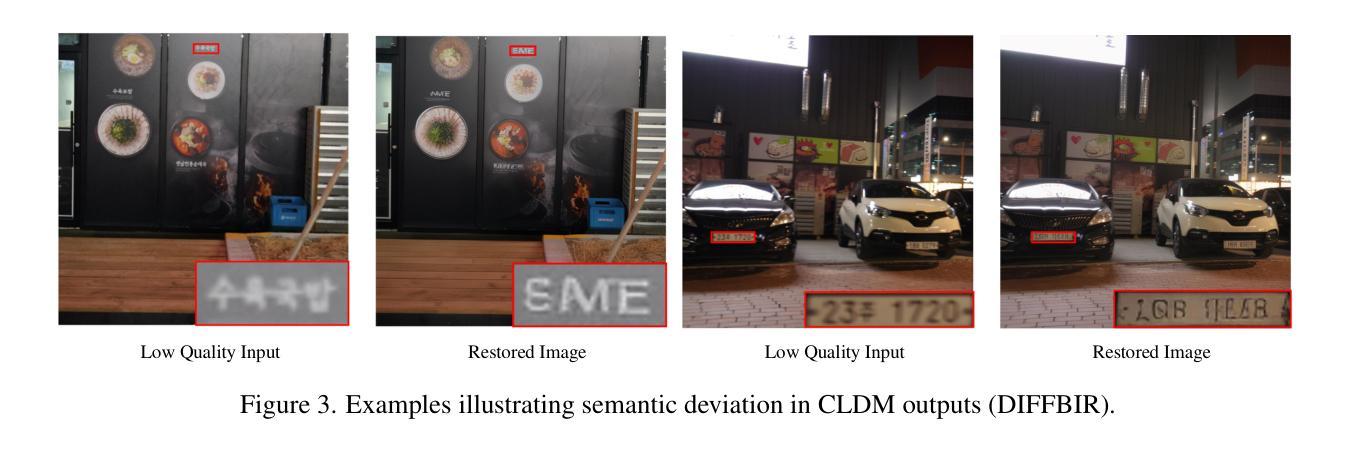

CLDMs在图像恢复任务中的适用性质疑:尽管CLDMs在捕获高级语义相关性方面表现出色,适用于文本到图像的生成等任务,但在图像恢复任务中,这些模型面临着在低级表示中建模退化图像与真实图像之间关系的困难。

CLDMs与传统图像恢复模型的性能比较:通过广泛的实验比较,论文发现尽管CLDMs具有扩展优势,但在保持细节和实现良好失真度量方面表现不佳,尤其是在退化程度较低的情况下,传统方法的表现优于CLDMs。

CLDMs在图像恢复中的语义偏差问题:CLDMs在恢复过程中经常改变语义细节,导致与原始输入语义的偏差,这对于需要精确保真度的恢复任务来说尤其成问题。

CLDMs设计与图像恢复任务目标的不一致性:论文通过对CLDM架构的关键设计元素(如潜在空间表示、扩散过程中的噪声处理和多时间步采样)进行实证分析,发现这些元素对恢复质量的影响,并指出当前CLDM解决方案在架构上与图像恢复任务的目标不一致。

CLDMs在资源利用与模型性能之间的差距:尽管CLDMs在模型规模和训练数据量方面具有显著优势,但与传统模型相比,性能提升有限,并且引入了新的挑战,如失真和语义偏差。

综上所述,论文的核心问题是质疑CLDMs在图像恢复任务中的有效性,并通过对CLDMs与传统方法的比较分析,揭示了CLDMs在这一领域的局限性和潜在问题。

Q: 有哪些相关研究?

A: 论文中提到了多个与条件潜在扩散模型(CLDMs)和图像恢复(IR)相关的研究工作。以下是一些主要的相关研究:

图像恢复的传统方法:

- [2] J Amudha et al. 提供了数字图像恢复的综述。

- [4] Chaofeng Chen et al. 讨论了真实世界盲超分辨率通过特征匹配。

- [7] Rusul Sabah Jebur et al. 提供了深度学习中图像去噪的综述。

- [8] ChuMiao Li 提供了图像去模糊的综述。

- [9] Chongyi Li et al. 提供了深度学习在低光照图像和视频增强中的综述。

- [10] Haoying Li et al. 讨论了真实世界的深度局部运动去模糊。

扩散模型(DMs)和条件潜在扩散模型(CLDMs):

- [6] Jonathan Ho et al. 提出了去噪扩散概率模型。

- [11] Ming Li et al. 提出了Controlnet++,用于改善条件控制。

- [12] Xinqi Lin et al. 提出了DiffBIR,一种用于盲图像恢复的生成扩散先验方法。

- [16] Robin Rombach et al. 提出了高分辨率图像合成的潜在扩散模型。

- [26] Bin Xia et al. 提出了DiffIR,一种用于图像恢复的高效扩散模型。

- [27] Fanghua Yu et al. 讨论了模型扩展以实现野外照片真实感图像恢复。