⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-13 更新

EasyRef: Omni-Generalized Group Image Reference for Diffusion Models via Multimodal LLM

Authors:Zhuofan Zong, Dongzhi Jiang, Bingqi Ma, Guanglu Song, Hao Shao, Dazhong Shen, Yu Liu, Hongsheng Li

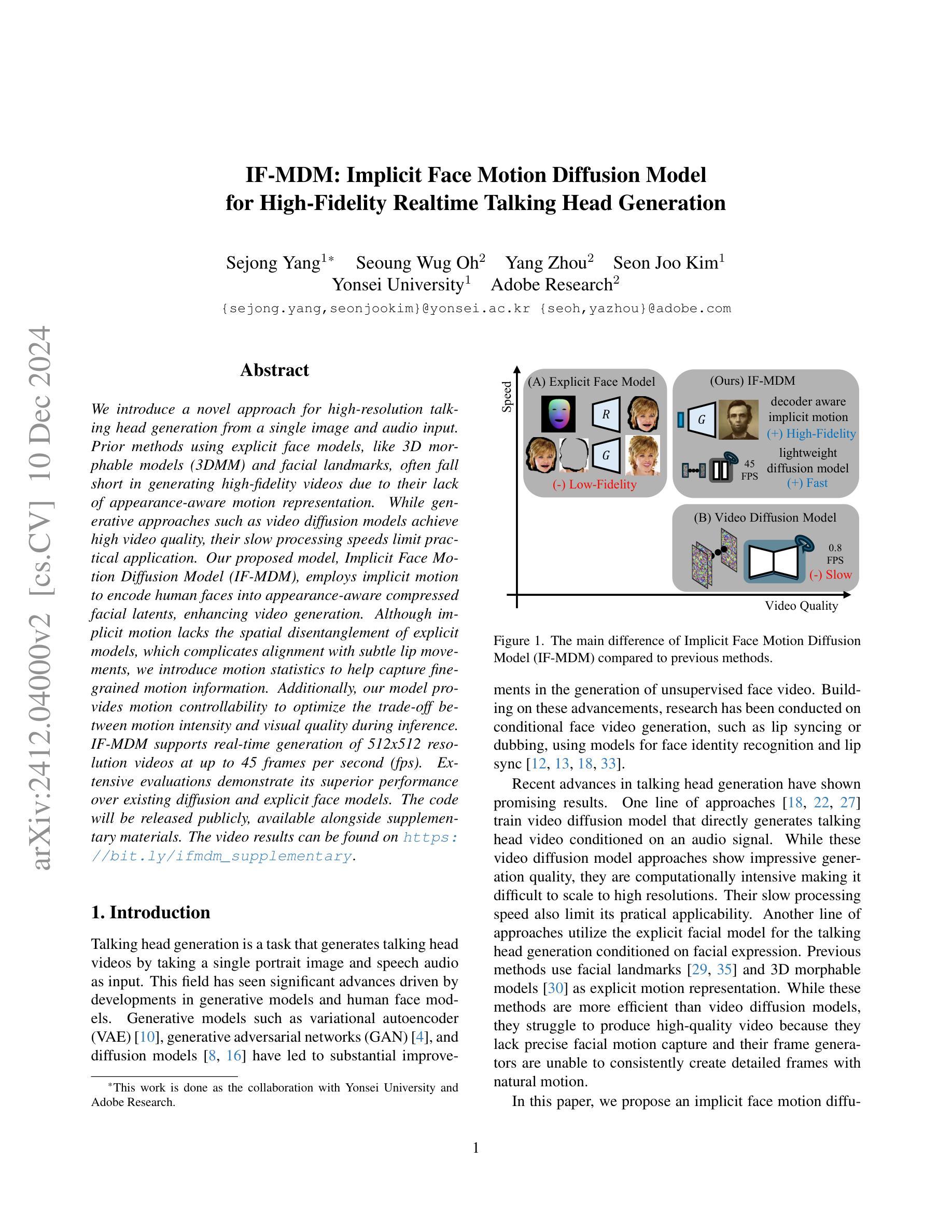

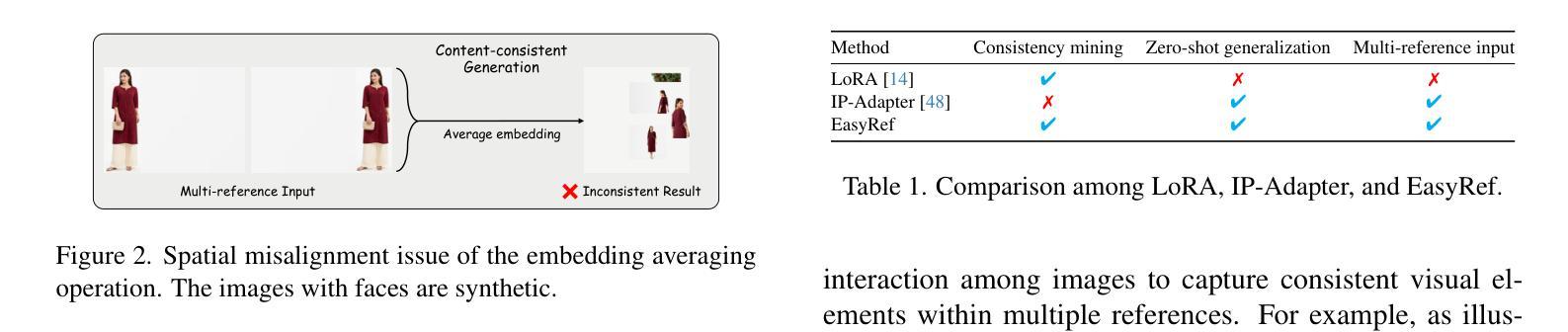

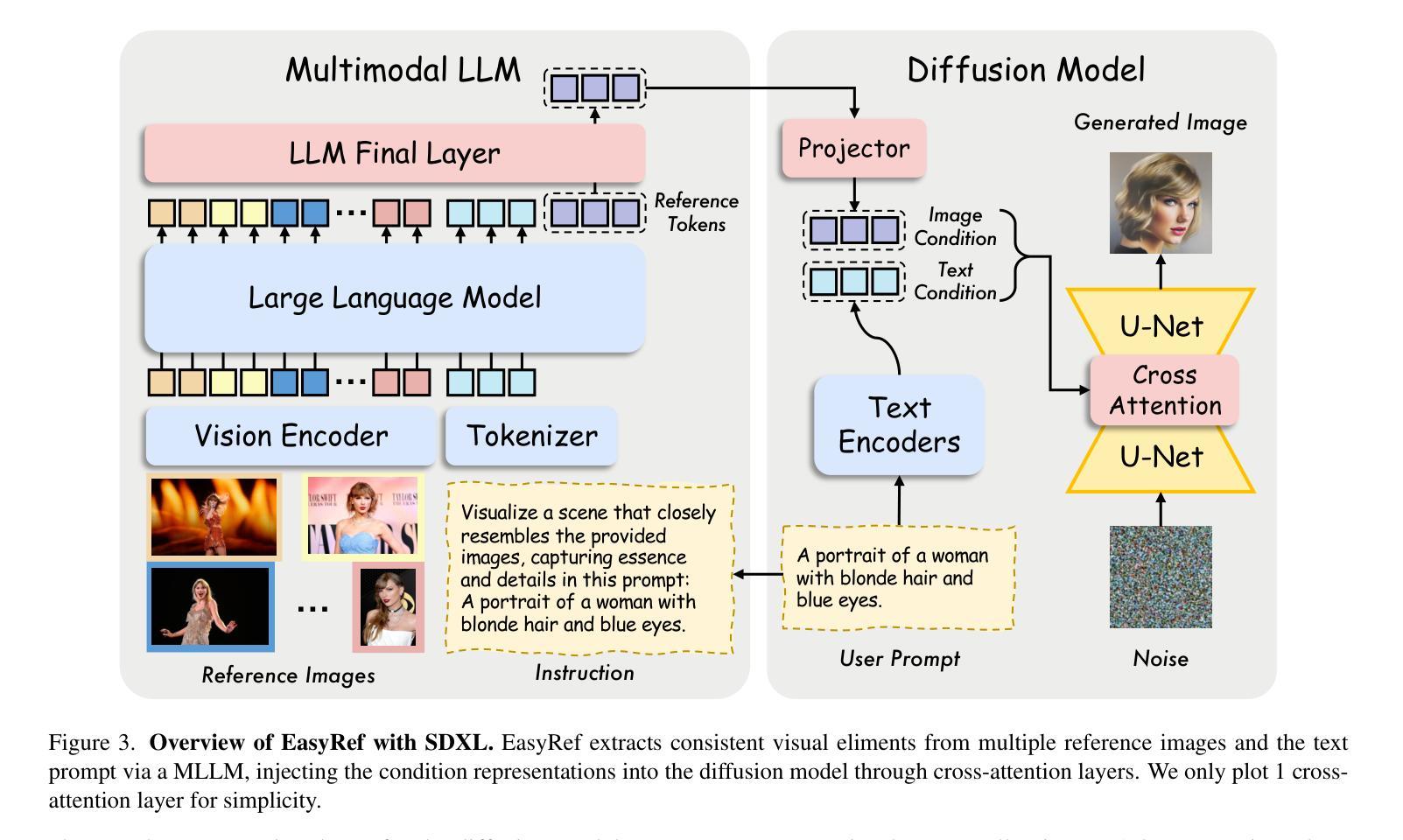

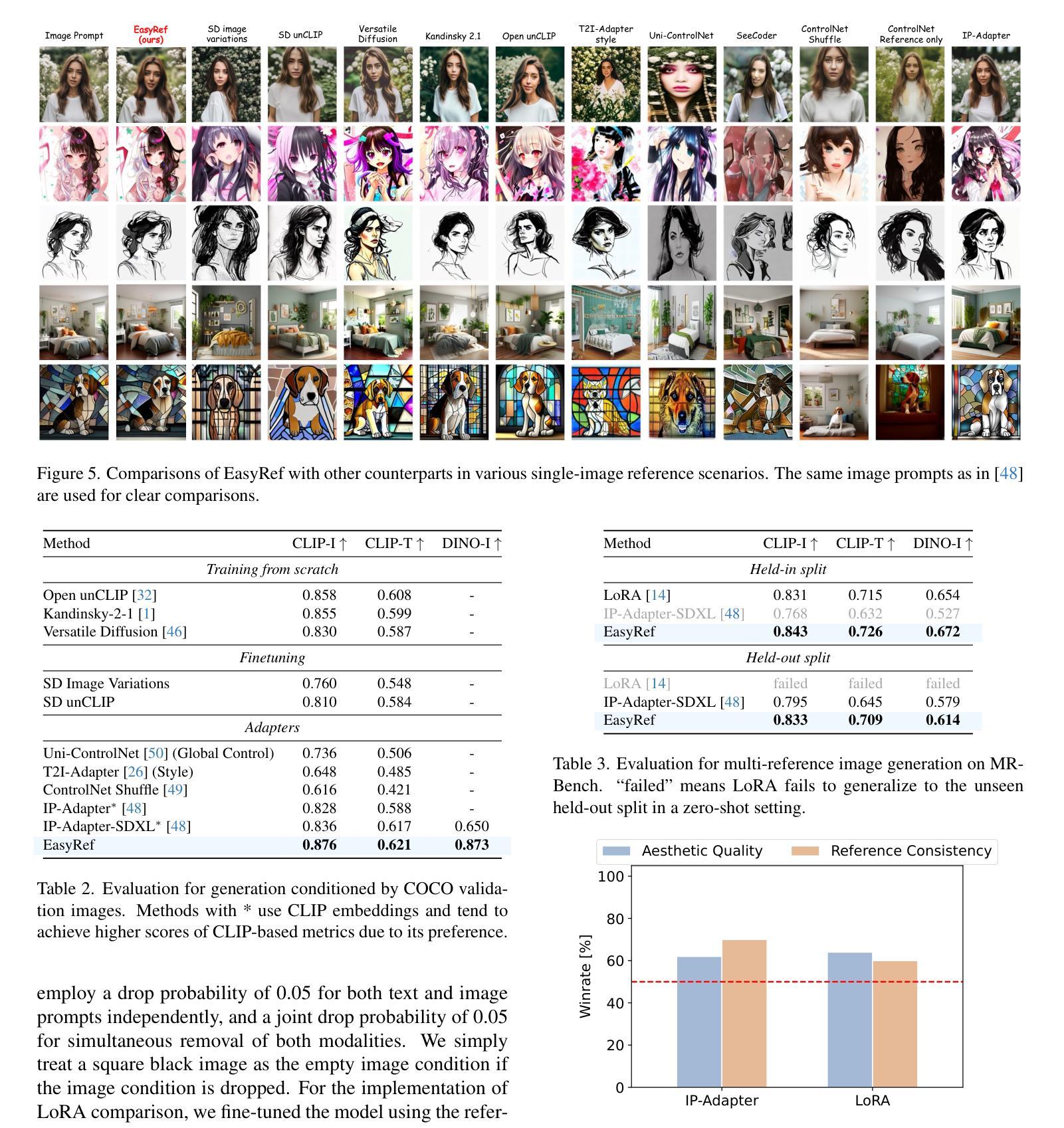

Significant achievements in personalization of diffusion models have been witnessed. Conventional tuning-free methods mostly encode multiple reference images by averaging their image embeddings as the injection condition, but such an image-independent operation cannot perform interaction among images to capture consistent visual elements within multiple references. Although the tuning-based Low-Rank Adaptation (LoRA) can effectively extract consistent elements within multiple images through the training process, it necessitates specific finetuning for each distinct image group. This paper introduces EasyRef, a novel plug-and-play adaptation method that enables diffusion models to be conditioned on multiple reference images and the text prompt. To effectively exploit consistent visual elements within multiple images, we leverage the multi-image comprehension and instruction-following capabilities of the multimodal large language model (MLLM), prompting it to capture consistent visual elements based on the instruction. Besides, injecting the MLLM’s representations into the diffusion process through adapters can easily generalize to unseen domains, mining the consistent visual elements within unseen data. To mitigate computational costs and enhance fine-grained detail preservation, we introduce an efficient reference aggregation strategy and a progressive training scheme. Finally, we introduce MRBench, a new multi-reference image generation benchmark. Experimental results demonstrate EasyRef surpasses both tuning-free methods like IP-Adapter and tuning-based methods like LoRA, achieving superior aesthetic quality and robust zero-shot generalization across diverse domains.

在扩散模型的个性化方面取得了重大成就。传统的无微调方法大多通过将多个参考图像的平均图像嵌入作为注入条件来编码,但这样的图像无关操作无法在不同图像之间进行交互,从而无法捕获多个参考图像内的连续视觉元素。虽然基于调参的低秩适应(LoRA)方法能有效通过训练过程提取多张图片中的一致元素,但它需要对每张不同的图片组进行特定的微调。本文介绍了EasyRef,这是一种新型的即插即用适应方法,能够使扩散模型根据多个参考图像和文本提示进行条件化。为了有效捕捉多张图像中的一致视觉元素,我们利用多模态大型语言模型(MLLM)的多图像理解和指令执行能力,提示其基于指令捕捉一致视觉元素。此外,通过适配器将MLLM的表示注入扩散过程,可以很容易地推广到未见领域,挖掘未见数据中的一致视觉元素。为了降低计算成本并增强精细细节保留,我们引入了一种有效的参考聚合策略和一种渐进式训练方案。最后,我们引入了MRBench,一个新的多参考图像生成基准测试。实验结果表明,EasyRef超越了无微调方法(如IP-Adapter)和基于调参的方法(如LoRA),在美学质量和跨不同域的零样本泛化方面表现出卓越性能。

论文及项目相关链接

PDF Tech report

Summary

本文介绍了EasyRef,一种新型即插即用适应方法,使扩散模型能够基于多张参考图像和文本提示进行条件化。通过利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力,EasyRef能有效提取多张图像中的一致视觉元素。此外,通过适配器将MLLM的表示注入扩散过程,使其易于推广到未见领域,挖掘未见数据中的一致视觉元素。实验结果表明,EasyRef在MRBench多参考图像生成基准测试中超越了无微调方法(如IP-Adapter)和基于微调的方法(如LoRA),在美学质量和跨域零样本推广方面表现出卓越性能。

Key Takeaways

- EasyRef是一种新型即插即用适应方法,用于使扩散模型能够基于多张参考图像和文本提示进行条件化。

- EasyRef利用MLLM的多图像理解能力和指令遵循能力,有效提取多张图像中的一致视觉元素。

- 通过将MLLM的表示注入扩散过程,EasyRef易于推广到未见领域,并挖掘未见数据中的一致视觉元素。

- EasyRef引入了一种高效的参考聚合策略和渐进式训练方案,以降低计算成本并增强细节保留。

- MRBench是一个新的多参考图像生成基准测试,用于评估图像生成方法的性能。

- 实验结果表明,EasyRef在美学质量和跨域零样本推广方面超越了现有方法。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为EasyRef的新方法,旨在解决以下问题:

多参考图像的一致性视觉元素捕捉问题:传统的无需调整的方法(tuning-free methods)主要通过平均多个参考图像的图像嵌入来编码,这种图像独立的操作无法在图像之间进行交互以捕获多个参考中的一致视觉元素。尽管基于调整的方法(tuning-based methods)如Low-Rank Adaptation (LoRA)可以通过训练过程提取多个图像中的一致元素,但它需要针对每个不同的图像组进行特定的微调。

个性化图像生成的控制性和精确性问题:为了提高扩散模型的控制性和精确性,研究者们探索了基于少量参考图像进行条件生成的个性化图像生成方法。这些方法主要分为无需调整的方法和基于调整的方法,但它们在处理多参考图像和文本提示时存在局限性。

计算成本和细粒度细节保持问题:为了减轻多图像输入的上下文长度对计算需求的影响,并解决MLLM(多模态大型语言模型)在捕获细粒度视觉细节方面的限制,论文提出了一种高效的参考聚合策略和渐进式训练方案。

多参考图像生成的评估问题:为了评估在多参考图像生成场景下的扩散模型,论文引入了一个名为MRBench的新评估基准。

总的来说,EasyRef旨在通过利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力,来有效地利用多个图像中的一致视觉元素,并将其注入到扩散过程中,以实现对多个参考图像和文本提示的条件化,同时保持对未见领域的强泛化能力。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要分为以下几个领域:

图像个性化(Image Personalization):

- 无需调整的方法(Tuning-free methods),例如IP-Adapter [48]、InstantStyle [41, 42]、IP-Adapter-Face [48] 和 InstantID [44],这些方法通过提取参考图像的视觉表示(如风格和特征)并将其注入扩散模型来增强图像提示能力。

- 基于调整的方法(Tuning-based methods),例如LoRA [14],通过使用有限的图像集对扩散模型进行微调。

多模态大型语言模型(Multimodal Large Language Models, MLLMs):

- 先驱工作如LLaVA [24] 和 BLIP-2 [17] 将视觉表示从预训练的CLIP视觉编码器投影到LLM以进行多模态理解。

- 混合视觉专家设计,例如SPHINX [21]、MoF [40] 和 MoVA [51],旨在增强MLLMs的视觉能力。

- 模型如LLaVANeXT [23] 和 Qwen2-VL [43] 寻求处理任意分辨率的图像。

扩散模型(Diffusion Models):

- 扩散模型因其在创建令人惊叹的图像方面的能力而受到关注,例如Denoising Diffusion Probabilistic Models (DDPMs) [13]。

图像生成和控制(Image Generation and Control):

- 研究者们探索了多种方法来改善扩散模型的精确性和可控性,包括风格和内容的控制,例如ControlNet++ [18] 和 Photomaker [19]。

评估指标(Evaluation Metrics):

- 用于评估图像生成模型性能的指标,例如CLIPScore [11] 用于图像描述的无参考评估。

这些相关研究构成了EasyRef方法的理论和实践基础,并为进一步的研究提供了对比和参考。论文通过与这些现有方法的比较,展示了EasyRef在多参考图像生成任务中的优越性和创新点。

Q: 论文如何解决这个问题?

A: 论文通过提出EasyRef方法解决了上述问题,具体解决方案如下:

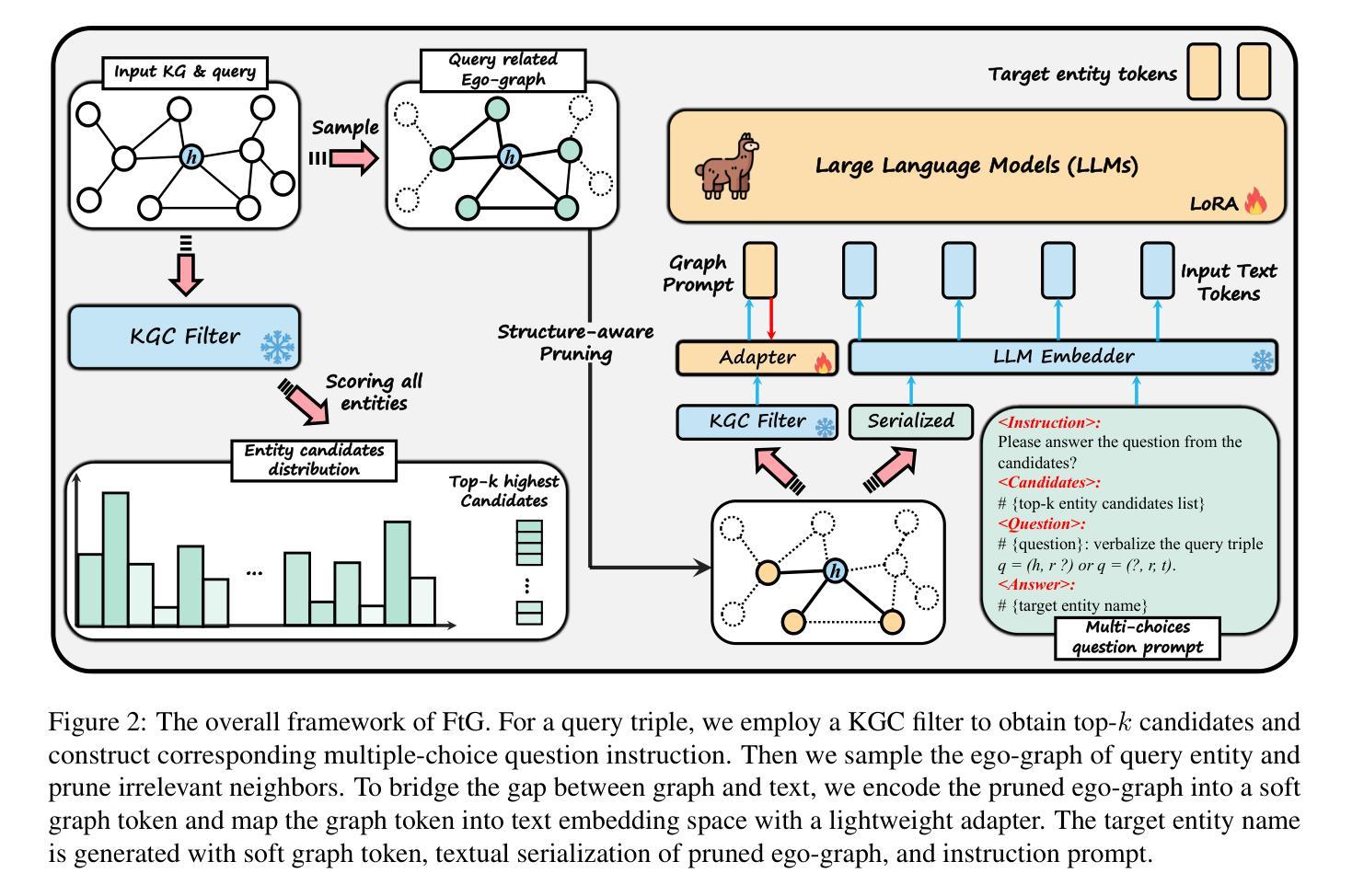

1. EasyRef方法概述

EasyRef是一种新型的即插即用适应方法,它使得扩散模型能够基于多个参考图像和文本提示进行条件生成。该方法利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力,来有效地从多个参考图像中提取一致的视觉元素,并将其注入到扩散过程中。

2. 关键组件

EasyRef主要包括以下四个关键组件:

- 预训练的扩散模型:用于条件图像生成。

- 预训练的MLLM:用于编码一组参考图像和文本提示。

- 条件投影器:将MLLM的表示映射到扩散模型的潜在空间。

- 可训练的适配器:将图像条件嵌入整合到扩散过程中。

3. 方法细节

- 参考表示编码:与传统方法不同,EasyRef不简单地平均所有参考图像的CLIP图像嵌入作为参考条件,而是利用MLLM的多图像理解和指令遵循能力,根据指令编码多参考输入和文本提示。

- 高效参考聚合:为了减轻多图像输入上下文长度对计算成本的影响,EasyRef将参考表示封装到N个可学习的参考标记(tokens)中,并在MLLM的最后层进行聚合和处理。

- 参考表示注入:将文本条件通过交叉注意力层注入到预训练的扩散模型中。

4. 渐进式训练方案

- 对齐预训练:在大规模数据集上优化MLLM的最后一层和参考标记,同时保持MLLM和扩散模型的初始能力。

- 单参考微调:在对齐预训练后,对MLLM进行单参考微调,增强其对细粒度视觉感知的能力。

- 多参考微调:使MLLM能够准确理解多个图像参考中的共同元素,并生成高质量、一致的图像。

5. 多参考生成基准(MRBench)

- 构建了一个包含多个参考图像的多参考图像生成基准,用于评估EasyRef的性能,并为未来的研究提供指导。

6. 实验结果

实验结果表明,EasyRef在多种领域中都取得了优越的审美质量和鲁棒的零样本泛化能力,超越了无需调整的方法(如IP-Adapter)和基于调整的方法(如LoRA)。

总结来说,EasyRef通过结合MLLM的多图像理解和指令遵循能力,以及适配器注入机制,有效地解决了多参考图像中的一致性视觉元素捕捉问题,同时保持了对未见领域的强泛化能力。此外,通过提出的高效参考聚合策略和渐进式训练方案,EasyRef在计算效率和细粒度细节保持方面也表现出色。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估EasyRef方法的性能,这些实验包括:

单参考图像场景下的定量比较(Single-image reference):

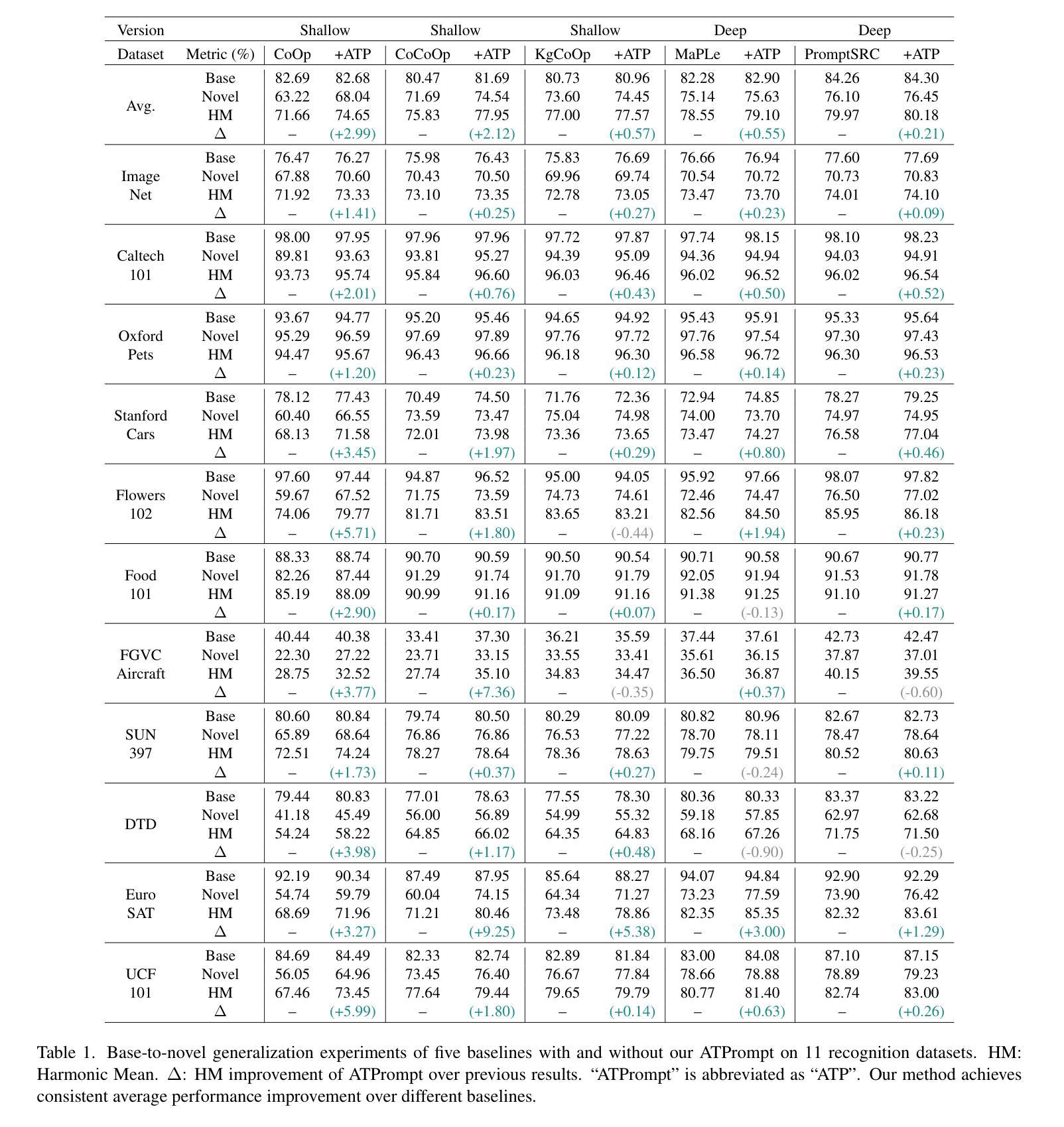

- 使用COCO 2017验证数据集(包含5000个图像-文本对)进行实验,比较EasyRef与其他方法(如IP-Adapter、LoRA等)在CLIP-T和DINO-I指标上的性能。

- 结果显示EasyRef在这些指标上一致性地超越了其他方法,展示了更好的对齐性能。

多参考图像生成(Multi-image references):

- 在MRBench数据集上比较EasyRef与IP-Adapter和LoRA的性能。

- 在零样本设置中,EasyRef在与参考图像和用户提示的对齐方面超越了IP-Adapter和LoRA。

人类评估(Human evaluation):

- 在MRBench上系统地评估EasyRef与IP-Adapter和LoRA在参考一致性和审美质量方面的表现。

- 结果显示EasyRef在图像-参考对齐和视觉美学方面优于其他模型。

与ControlNet的兼容性(Compatibility with ControlNet):

- 展示了EasyRef与流行的可控工具ControlNet的兼容性,与IP-Adapter相比,EasyRef在处理多个参考图像和额外结构控制时能生成更高质量、更一致的结果。

扩展参考图像数量的实验(Scaling the number of reference images):

- 评估EasyRef在不同数量的参考图像下的性能,分析了模型在训练约束内和超出训练约束时的表现。

多模态指令输入的消融研究(Multimodal instruction input):

- 研究了将指令包含在LLM输入中对生成性能的影响,发现包含指令可以提高生成性能。

参考标记设计的消融研究(Reference token design):

- 研究了不同数量的参考标记和插入位置对性能的影响,选择了64个标记并将其插入到最后一层以获得最佳性能。

参考表示聚合的消融研究(Reference representation aggregation):

- 比较了EasyRef的参考标记聚合方法与嵌入平均和嵌入连接的效果,发现使用MLLM的多图像理解能力可以提高模型性能。

渐进式训练方案的消融研究(Progressive training scheme):

- 通过系统地移除每个训练阶段,可视化了每个阶段对模型捕获细粒度视觉细节和保持身份一致性能力的影响。

这些实验全面评估了EasyRef在多参考图像生成任务中的性能,并与现有技术进行了比较,证明了EasyRef在审美质量和零样本泛化能力方面的优越性。

Q: 有什么可以进一步探索的点?

A: 尽管EasyRef在多参考图像生成领域取得了显著的成果,但仍有一些方向可以进一步探索和改进:

提高模型泛化能力:

- 探索新的训练策略或正则化技术,以增强模型对新领域和未见过的参考图像的泛化能力。

优化计算效率:

- 研究更高效的参考聚合策略,以降低模型在处理大量参考图像时的计算成本。

- 探索模型压缩和加速技术,以使EasyRef适用于资源受限的环境。

增强细粒度控制:

- 提高模型对图像中细粒度特征和复杂结构的控制能力,例如面部表情、纹理细节等。

- 结合用户研究反馈,优化模型以更好地满足特定用户需求。

改进评估基准:

- 扩展MRBench数据集,包含更多样化的参考图像和文本提示,以全面评估模型性能。

- 开发新的评估指标,更准确地衡量生成图像的质量和一致性。

多模态输入的深入研究:

- 研究如何更有效地结合文本、图像和其他模态信息,以提高生成图像的相关性和准确性。

- 探索不同类型指令对图像生成过程的影响。

跨领域应用:

- 将EasyRef应用于其他领域,如视频生成、3D建模或虚拟现实,以探索其在这些领域的潜力和局限性。

模型解释性:

- 提高模型的可解释性,帮助研究人员和用户理解模型的决策过程和潜在偏差。

- 研究如何通过可视化技术揭示MLLM在处理多参考图像时的内部机制。

鲁棒性和安全性:

- 增强模型对对抗性攻击和异常输入的鲁棒性。

- 确保生成图像的安全性和合规性,避免生成不当内容。

交互式应用:

- 开发基于EasyRef的交互式系统,允许用户实时提供反馈并调整生成过程。

- 结合自然语言处理技术,实现更自然和直观的用户交互。

这些方向不仅可以推动EasyRef技术的发展,还可能为多模态学习和扩散模型的研究提供新的视角和挑战。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了EasyRef,一个创新的即插即用适应方法,它使得扩散模型能够基于多个参考图像和文本提示进行条件生成。以下是论文的主要内容总结:

问题陈述:

- 现有方法在处理多参考图像时存在局限性,无法有效捕捉多个参考中的一致视觉元素。

- 需要一种新方法来提高扩散模型的个性化生成能力和控制精确性。

EasyRef方法:

- 提出了EasyRef,一个利用多模态大型语言模型(MLLM)的多图像理解和指令遵循能力的新型适应方法。

- EasyRef通过适配器将MLLM的表示注入到扩散过程中,以提取和利用多个参考图像中的一致视觉元素。

关键贡献:

- 提出了一种有效的参考聚合策略和渐进式训练方案,以减轻计算成本并增强MLLM的细粒度感知能力。

- 引入了MRBench,一个新的多参考图像生成基准,用于评估和指导未来的研究。

实验结果:

- EasyRef在多个领域中展现出优越的审美质量和鲁棒的零样本泛化能力,超越了无需调整的方法和基于调整的方法。

- 通过广泛的实验验证了EasyRef在多参考图像生成任务中的性能。

方法细节:

- EasyRef包括预训练的扩散模型、MLLM、条件投影器和可训练的适配器。

- 通过交叉注意力层将文本条件注入到扩散模型中。

- 采用渐进式训练策略,包括对齐预训练、单参考微调和多参考微调。

未来工作:

- 提出了一些潜在的研究方向,包括提高模型泛化能力、优化计算效率、增强细粒度控制等。

总体而言,EasyRef通过结合MLLM的多图像理解和指令遵循能力,以及适配器注入机制,有效地解决了多参考图像中的一致性视觉元素捕捉问题,同时保持了对未见领域的强泛化能力。这项工作为多参考图像生成领域提供了一种新的视角和解决方案。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Olympus: A Universal Task Router for Computer Vision Tasks

Authors:Yuanze Lin, Yunsheng Li, Dongdong Chen, Weijian Xu, Ronald Clark, Philip H. S. Torr

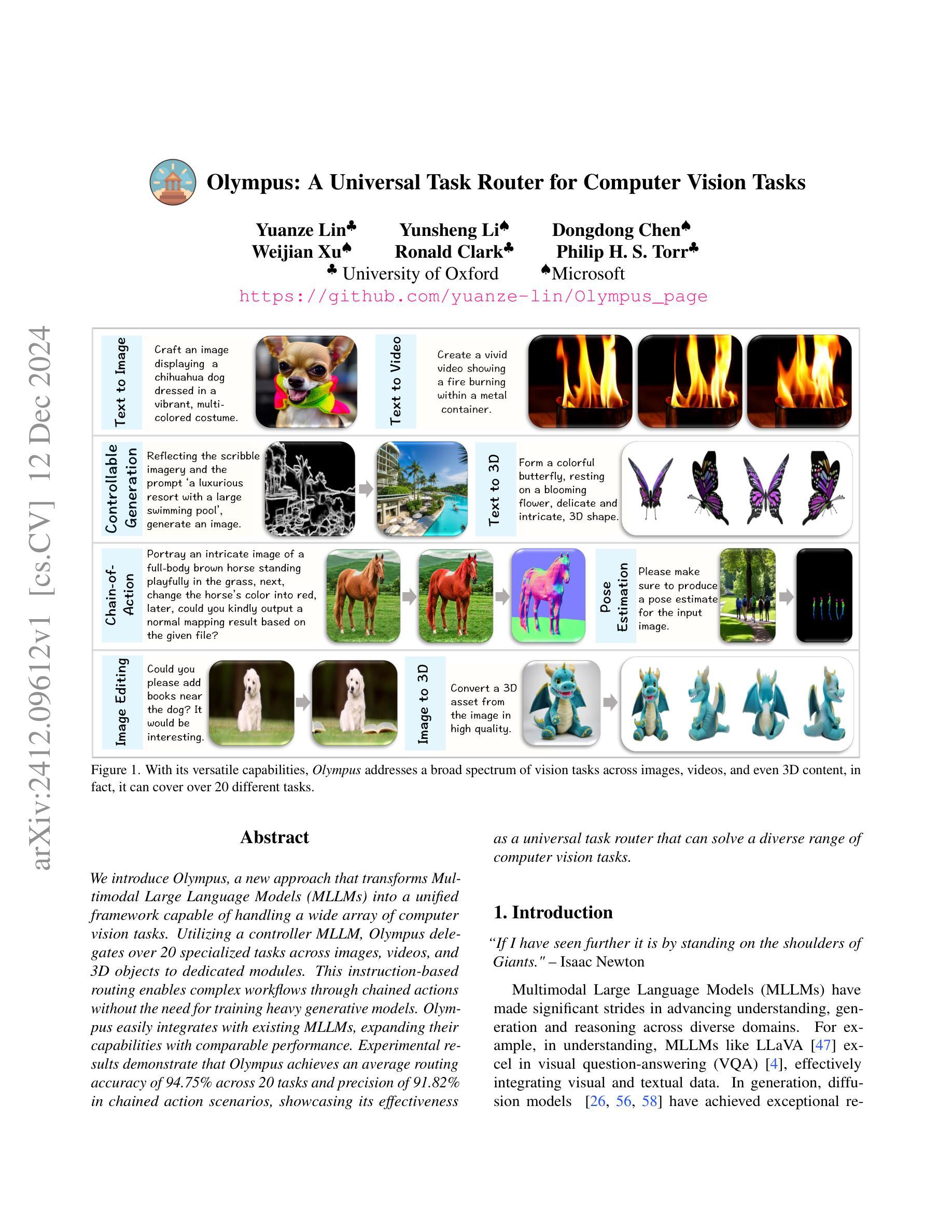

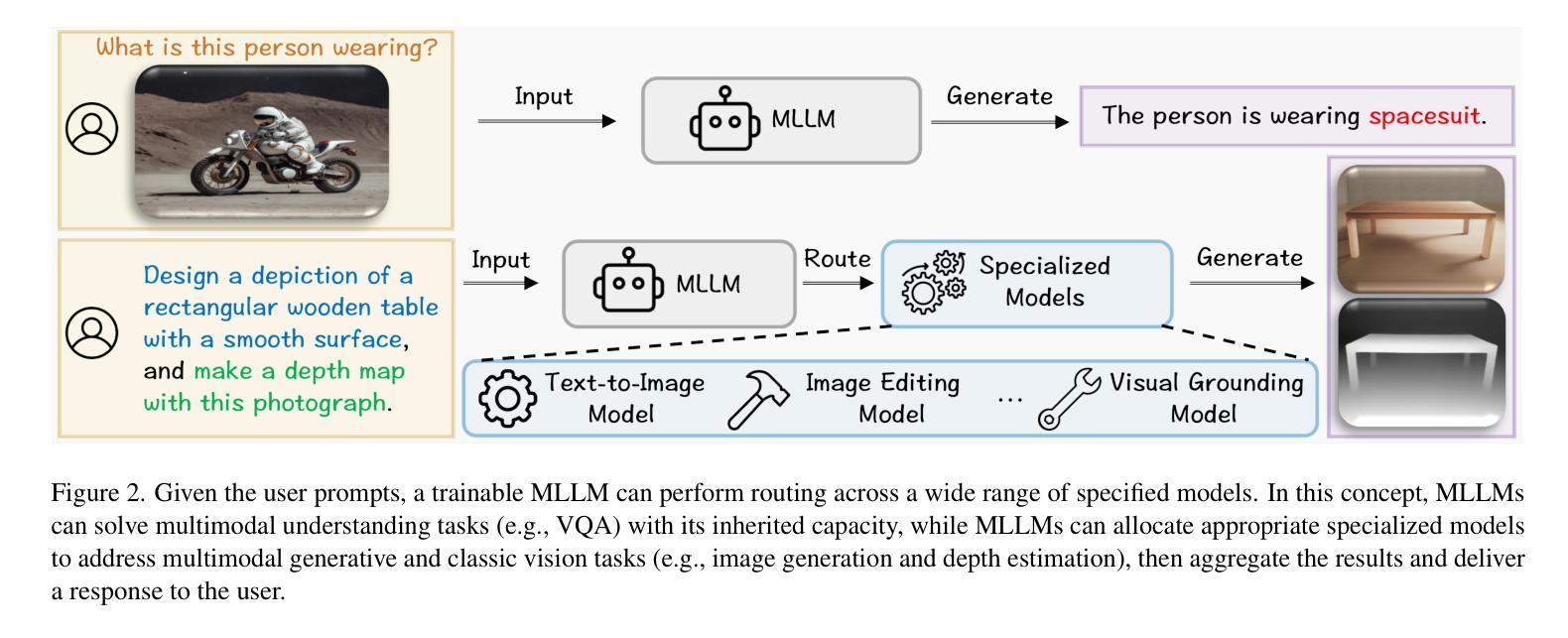

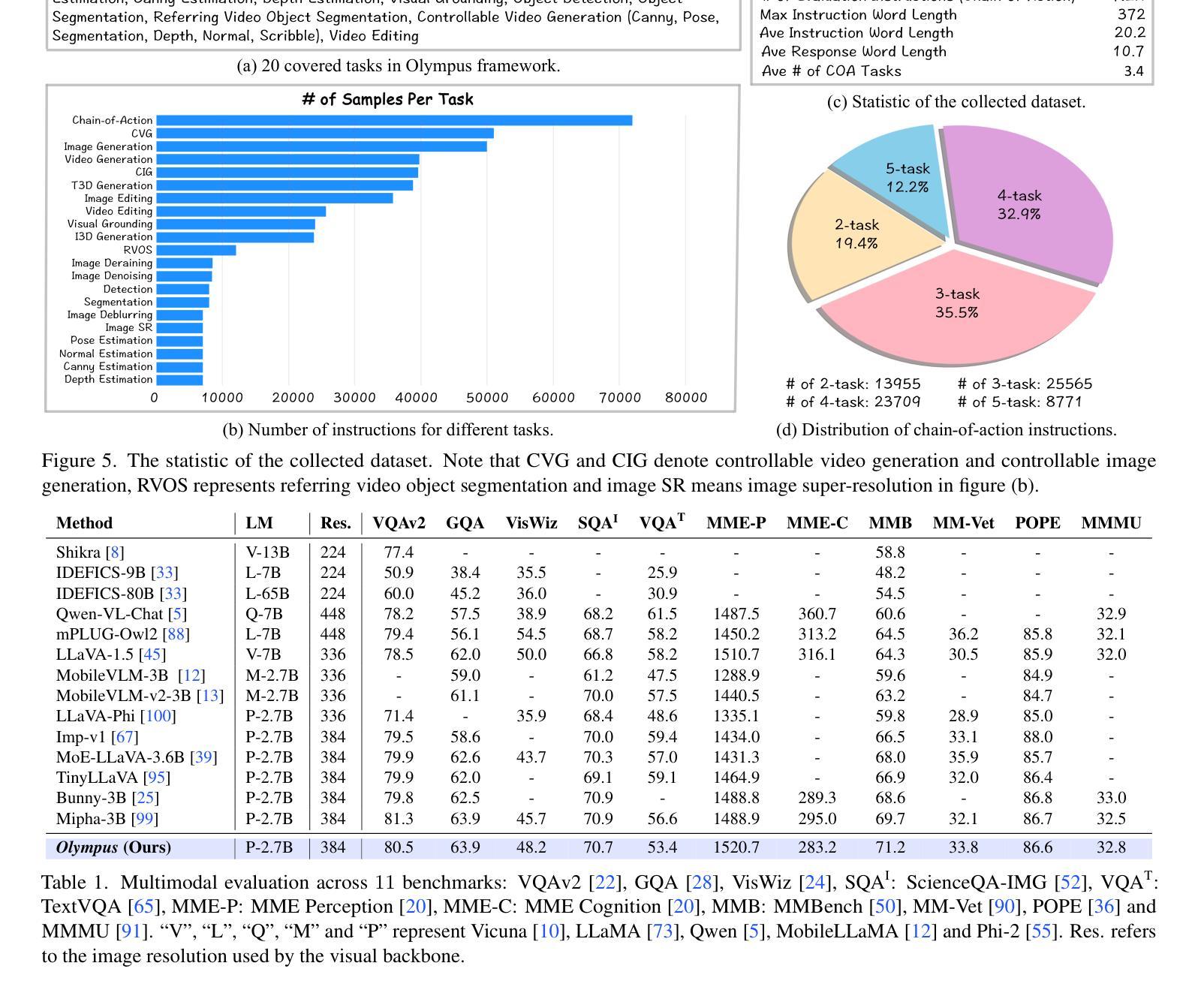

We introduce Olympus, a new approach that transforms Multimodal Large Language Models (MLLMs) into a unified framework capable of handling a wide array of computer vision tasks. Utilizing a controller MLLM, Olympus delegates over 20 specialized tasks across images, videos, and 3D objects to dedicated modules. This instruction-based routing enables complex workflows through chained actions without the need for training heavy generative models. Olympus easily integrates with existing MLLMs, expanding their capabilities with comparable performance. Experimental results demonstrate that Olympus achieves an average routing accuracy of 94.75% across 20 tasks and precision of 91.82% in chained action scenarios, showcasing its effectiveness as a universal task router that can solve a diverse range of computer vision tasks. Project page: https://github.com/yuanze-lin/Olympus_page

我们介绍了Olympus,这是一种将多模态大型语言模型(MLLM)转变为能够处理多种计算机视觉任务的统一框架的新方法。Olympus利用控制器MLLM,将图像、视频和3D对象的超过20项专业任务委派给专用模块。这种基于指令的路由使复杂的流程能够通过连续的动作实现,无需训练繁重的生成模型。Olympus可以轻松集成现有的MLLM,以扩展其能力并达到相当的性能。实验结果表明,Olympus在20项任务中的平均路由准确率达到了94.75%,在连续动作场景中的精确度为91.82%,展示了其作为通用任务路由器的有效性,能够解决多种计算机视觉任务。项目页面:https://github.com/yuanze-lin/Olympus_page

论文及项目相关链接

PDF Technical Report

Summary

Olympus是一种将多模态大型语言模型(MLLMs)转化为统一框架的新方法,可处理各种计算机视觉任务。通过控制器MLLM,Olympus将图像、视频和3D对象的20多项专业任务委派给专用模块。基于指令的路由可实现复杂的连锁动作流程,无需训练重量级的生成模型。实验结果表明,Olympus在20项任务上的平均路由准确性达到94.75%,在连锁动作场景中的精确度达到91.82%,是一款有效的通用任务路由器,能够解决多样化的计算机视觉任务。

Key Takeaways

- Olympus是一个新的方法,能将多模态大型语言模型转化为处理各种计算机视觉任务的统一框架。

- Olympus通过控制器MLLM将不同的任务委派给专用模块来处理。

- 基于指令的路由功能使Olympus能够执行复杂的连锁动作流程。

- Olympus可以轻松地与现有的MLLMs集成,并扩展其功能,同时保持相当的性能。

- 实验结果显示,Olympus在多种计算机视觉任务上具有很高的准确性和性能。

- Olympus的平均路由准确性达到94.75%,显示出其作为通用任务路由器的有效性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了一个名为Olympus的新方法,旨在将多模态大型语言模型(MLLMs)转化为一个统一的框架,用于处理广泛的计算机视觉任务。具体来说,Olympus试图解决以下几个问题:

模型集成的挑战:将不同领域(如图像、视频和3D对象)的计算机视觉任务集成到单一模型中存在显著挑战,因为不同任务目标之间的冲突可能会降低模型在各个任务上的性能。

模型的可扩展性和效率:随着视觉任务的范围不断扩大,现有的一体化模型在处理不同领域任务时受限于输入和输出格式的差异,这限制了它们的可扩展性。此外,扩展这些模型以适应新任务本质上是困难的,并且需要大量的计算资源和复杂的训练方法。

模块化和任务适应性框架的需求:为了提高处理日益多样化视觉任务的可扩展性和效率,需要模块化或任务适应性框架。

任务特定组件的有效集成:现有的一体化模型通常难以有效地集成精心设计的任务特定组件,这降低了它们在专业应用中的总体效率和性能。

用户提示的多样性和复杂性:用户提示在广泛任务中的差异性很大,缺乏全面的、任务特定的指令数据集对于有效的训练和评估至关重要。

Olympus通过使用控制器MLLM来委派超过20个专业任务给专用模块,基于指令的路由使得复杂的工作流程可以通过链式动作实现,无需训练重型生成模型。这种方法不仅扩展了现有MLLMs的能力,而且在多个任务中展现了相当的性能,解决了上述问题。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个领域:

Vision-Language Understanding:

- 论文提到了多模态大型语言模型(MLLMs),例如MiniGPT-4、Kosmos-2、LLaVA、LLaVA-OneVision等,这些模型在处理和整合多种模态数据方面表现出色。

- 相关研究包括LLaVA-Phi、MobileVLM和Mipha等,这些方法专注于改进训练方法和架构框架,以开发更高效、更轻量级的MLLMs。

Unified Vision-Language Foundation Model:

- 研究工作如Emu2、Chameleon、Show-o和TransFusion等,致力于开发能够同时理解并生成内容的统一多模态语言模型。

- Omni-Gen等研究利用VAE编码器-解码器以及变换器处理自由形式的提示。

LLM-Based Tools:

- 研究如Toolformer、Visual ChatGPT、Visual Programming和ViperGPT等,专注于将外部工具和模型集成到大型语言模型(LLMs)架构中。

- HuggingGPT等研究通过使用LLMs作为控制器,将用户请求定向到专门的专家模型,从而整合语言理解与领域特定专业知识。

这些相关研究展示了多模态大型语言模型在理解和生成任务中的进步,以及如何通过集成外部工具和模型来扩展LLMs的能力。Olympus框架正是受到这些研究的启发,提出了一种新的方法来统一处理多种计算机视觉任务。

Q: 论文如何解决这个问题?

A: 论文通过提出Olympus框架来解决上述问题,具体解决方案如下:

基于指令的路由(Instruction-based Routing):

- Olympus利用一个控制器MLLM(Multimodal Large Language Model)来根据用户指令将任务委派给专门的模块处理。这种方式允许复杂的工作流程通过链式动作实现,无需训练重型生成模型。

集成与扩展(Integration and Expansion):

- Olympus能够轻松集成现有的MLLMs,并扩展它们的功能,通过添加外部模型来处理超过20个专业任务,涵盖图像、视频和3D对象领域。

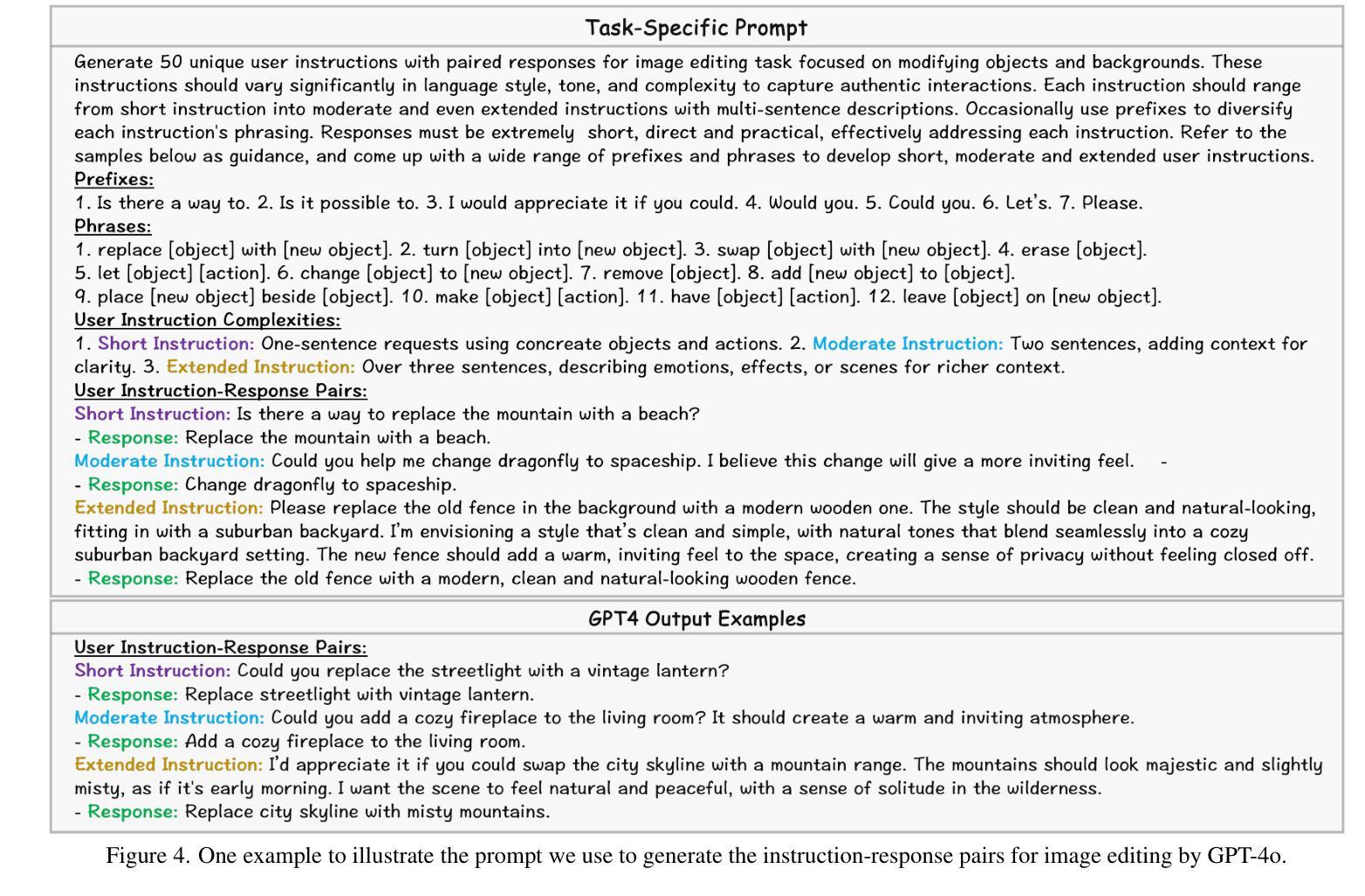

数据集构建(Dataset Construction):

- 为了准确将用户指令分配给适当的模型,作者构建了一个高质量和多样化的数据集,包含446.3K训练样本和49.6K评估样本,覆盖20个不同的任务。这些数据集被称为OlympusInstruct和OlympusBench。

任务特定路由标记(Task-Specific Routing Tokens):

- 设计了一套针对各个任务的路由标记,以帮助MLLM预测与用户目标对齐的合适模型。例如,对于图像和视频生成领域,分别使用

<image_gen>...</image_gen>和<video_gen>...</video_gen>等标记。

- 设计了一套针对各个任务的路由标记,以帮助MLLM预测与用户目标对齐的合适模型。例如,对于图像和视频生成领域,分别使用

链式动作能力(Chain-of-Action Capabilities):

- 通过引入特定领域的路由标记,Olympus能够处理单个指令中的多个任务。例如,用户可以提出结合姿势估计和图像编辑的复合指令,Olympus能够依次将用户指令路由到相应的模块。

训练和推理(Training and Inference):

- 使用交叉熵损失函数来训练MLLM生成特定任务的响应及其路由标记。

- 在推理阶段,Olympus生成带有任务定制路由标记的响应,这些标记调用适当的AI模型来处理各种任务,并将预测结果聚合到最终响应中。

实验验证(Experimental Validation):

- 通过一系列实验,论文展示了Olympus在标准多模态基准测试中与领先的MLLMs相当的性能,并支持20个不同领域的任务。此外,Olympus在单个任务场景中实现了94.75%的路由准确率,在链式动作设置中实现了91.82%的精确度。

通过这些方法,Olympus框架能够作为一个通用的任务路由器,解决多样化的计算机视觉任务,展示了将多模态任务统一到单一框架中的潜力。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证Olympus框架的有效性,具体包括以下实验:

多模态评估(Multimodal Evaluation):

- 比较Olympus与多个现有的多模态大型语言模型(MLLMs)在11个流行基准测试上的性能,包括VQA-v2、GQA、ScienceQA-IMG、MME感知和认知、MMBench、MM-Vet、TextVQA和POPE等。

任务路由性能(Task Routing Performance):

- 在OlympusBench数据集上评估模型的路由准确性,包括准确率、精确率、召回率和F1分数。

链式动作任务(Chain-of-Action Tasks):

- 评估模型在执行涉及多个任务的复合指令时的性能,报告编辑距离、精确率、召回率和F1分数。

人类评估(Human Evaluation):

- 通过成功率来评估Olympus在真实环境中的表现,与HuggingGPT进行比较。

消融研究(Ablation Study):

- 探索不同数量的训练任务对整体性能的影响。

- 分析不同响应设计对性能的影响。

- 研究不同提示组件对性能的贡献,包括前缀、短语和示例对的数目。

- 评估不同指令复杂度等级对模型成功率的影响。

可视化(Visualization):

- 展示Olympus在多种任务上的应用,包括单任务、多轮对话和链式动作任务的例子。

这些实验旨在全面评估Olympus框架的性能,包括其在多模态基准测试中的表现、任务路由的准确性、处理复杂指令的能力以及在真实世界任务中的应用潜力。通过这些实验,论文证明了Olympus作为一个通用任务路由器在解决多样化计算机视觉任务方面的有效性。

Q: 有什么可以进一步探索的点?

A: 尽管Olympus框架在处理多样化的计算机视觉任务方面取得了显著成果,但仍有一些领域可以进一步探索和改进:

数据集质量和多样性:

- 扩展和多样化训练数据集OlympusInstruct和OlympusBench,以覆盖更多的任务和领域,提高模型的泛化能力。

模型性能和优化:

- 研究不同的模型架构和训练策略,以提高Olympus在特定任务上的性能和准确性。

实时性和计算效率:

- 优化模型以减少推理时间和计算资源消耗,使其适用于实时应用和资源受限的环境。

多模态交互和对话系统:

- 探索Olympus在多模态交互和对话系统中的应用,例如通过自然语言与用户进行更复杂的交互。

长尾分布和不平衡数据:

- 研究如何有效处理数据长尾分布和类别不平衡问题,提高模型在稀有类别上的性能。

模型解释性和可视化:

- 提高模型的可解释性,通过可视化技术让用户理解模型的决策过程。

跨领域适应性:

- 研究模型在不同领域间的迁移学习能力,使其能够快速适应新的任务和领域。

安全性和隐私保护:

- 考虑模型的安全性和隐私保护问题,确保用户数据的安全和合规使用。

多语言和跨文化支持:

- 扩展模型以支持多语言和跨文化内容,使其能够服务于更广泛的用户群体。

端到端集成和应用开发:

- 将Olympus框架集成到端到端的应用中,如智能助理、内容创作工具等,并开发相应的用户界面。

鲁棒性和对抗性攻击防御:

- 提高模型对对抗性攻击的鲁棒性,确保在面对恶意输入时的稳定性和安全性。

持续学习和适应性:

- 使模型能够持续学习新任务和适应新环境,而无需从头开始训练。

这些探索点可以帮助研究者和开发者进一步提升Olympus框架的能力,扩展其应用范围,并解决实际应用中可能遇到的问题。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了Olympus,一个将多模态大型语言模型(MLLMs)转化为统一框架的新方法,用于处理广泛的计算机视觉任务。以下是论文的主要内容总结:

问题陈述:

- 论文指出将不同领域的计算机视觉任务集成到单一模型中存在挑战,尤其是在性能、可扩展性和效率方面。

Olympus框架:

- 提出了Olympus,一个利用MLLM作为控制器来委派超过20个专业任务给专用模块的框架。

- 该框架能够通过链式动作处理复杂的工作流程,无需训练重型生成模型。

数据集构建:

- 作者构建了OlympusInstruct和OlympusBench数据集,包含446.3K训练样本和49.6K评估样本,覆盖20个不同的任务。

任务特定路由标记:

- 设计了一套任务特定的路由标记,帮助MLLM预测并委派合适的模型来处理用户请求。

链式动作能力:

- Olympus支持在单个用户指令中处理多个任务,展示了其灵活性和可扩展性。

训练和推理:

- 论文描述了使用交叉熵损失函数训练MLLM生成任务特定响应及其路由标记的过程。

- 在推理阶段,Olympus生成带有任务定制路由标记的响应,调用适当的AI模型来处理任务。

实验验证:

- 通过一系列实验,论文展示了Olympus在标准多模态基准测试中与领先的MLLMs相当的性能,并在单个任务场景中实现了94.75%的路由准确率,在链式动作设置中实现了91.82%的精确度。

贡献总结:

- 引入了Olympus框架,利用MLLMs进行上下文理解任务,同时通过分配外部模型处理其他任务。

- 开发了任务特定的路由标记,并增强了MLLMs的链式动作能力。

- 构建了高质量的指令数据集,为进一步探索和进步提供了基础。

局限性:

- 论文讨论了Olympus的局限性,包括训练数据集的质量、多样性和潜在的偏差问题。

结论:

- Olympus作为一个通用任务路由器,展示了将MLLM内部能力与专家模型特定路由相结合的潜力,为统一广泛的计算机视觉任务提供了一个强大的基础。

总体而言,Olympus框架通过其模块化和任务适应性方法,为解决计算机视觉中的多样化任务提供了一个有效的解决方案,并展示了在多个任务中的卓越性能。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

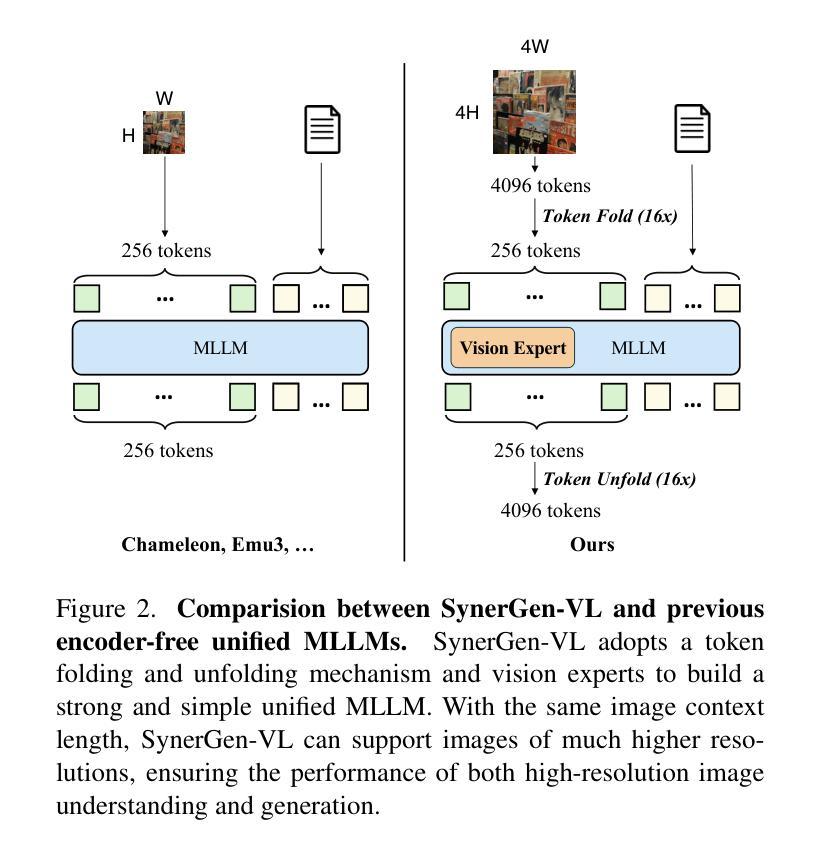

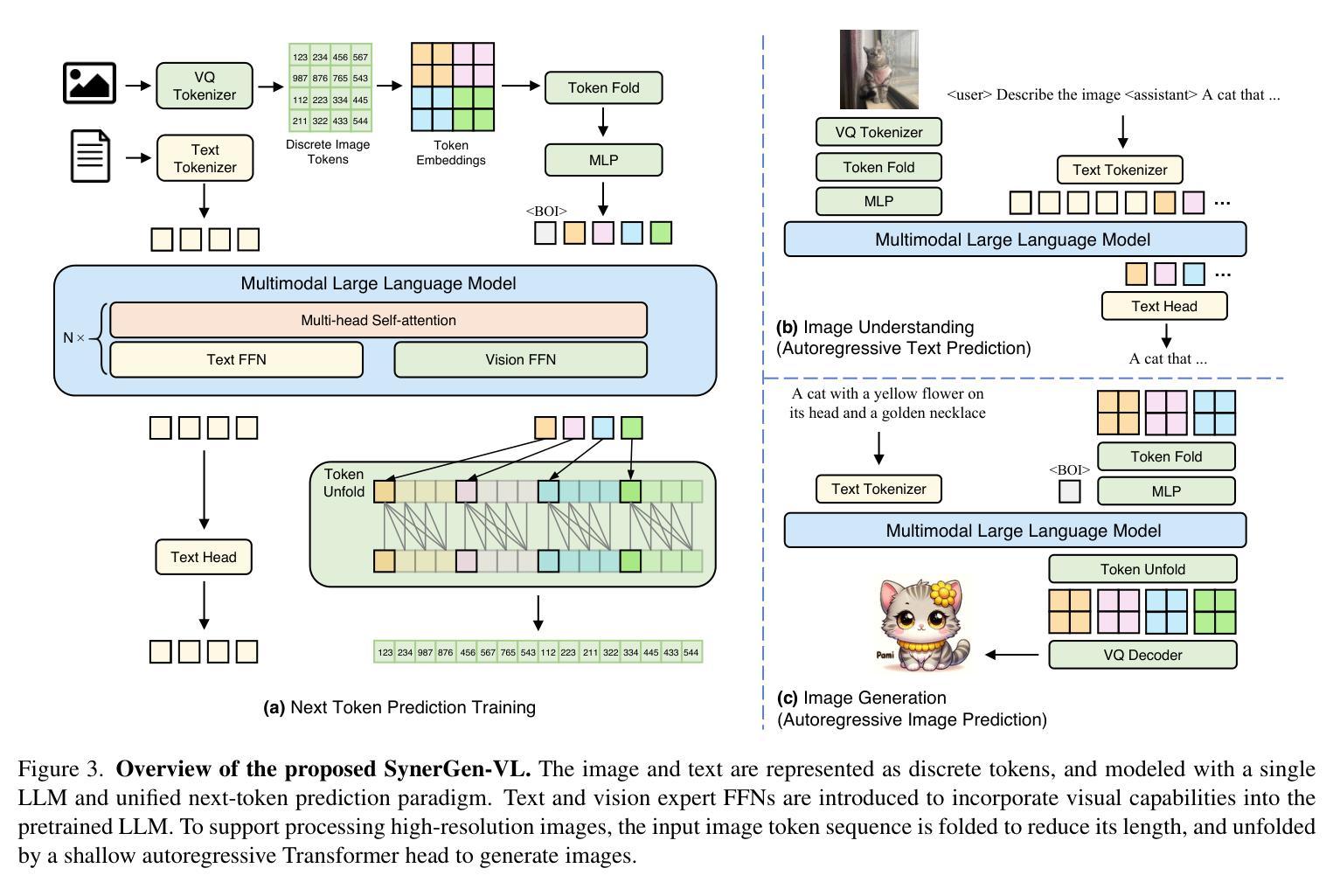

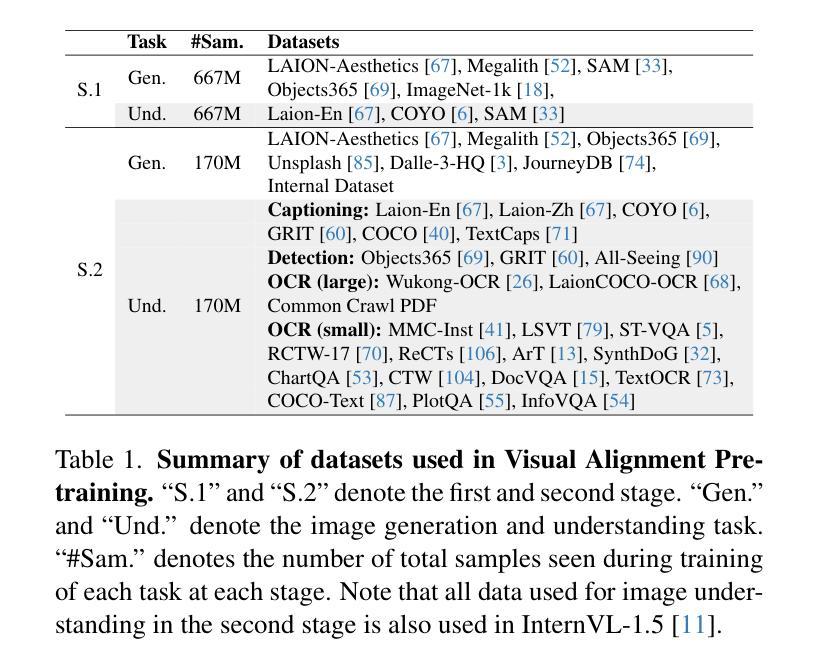

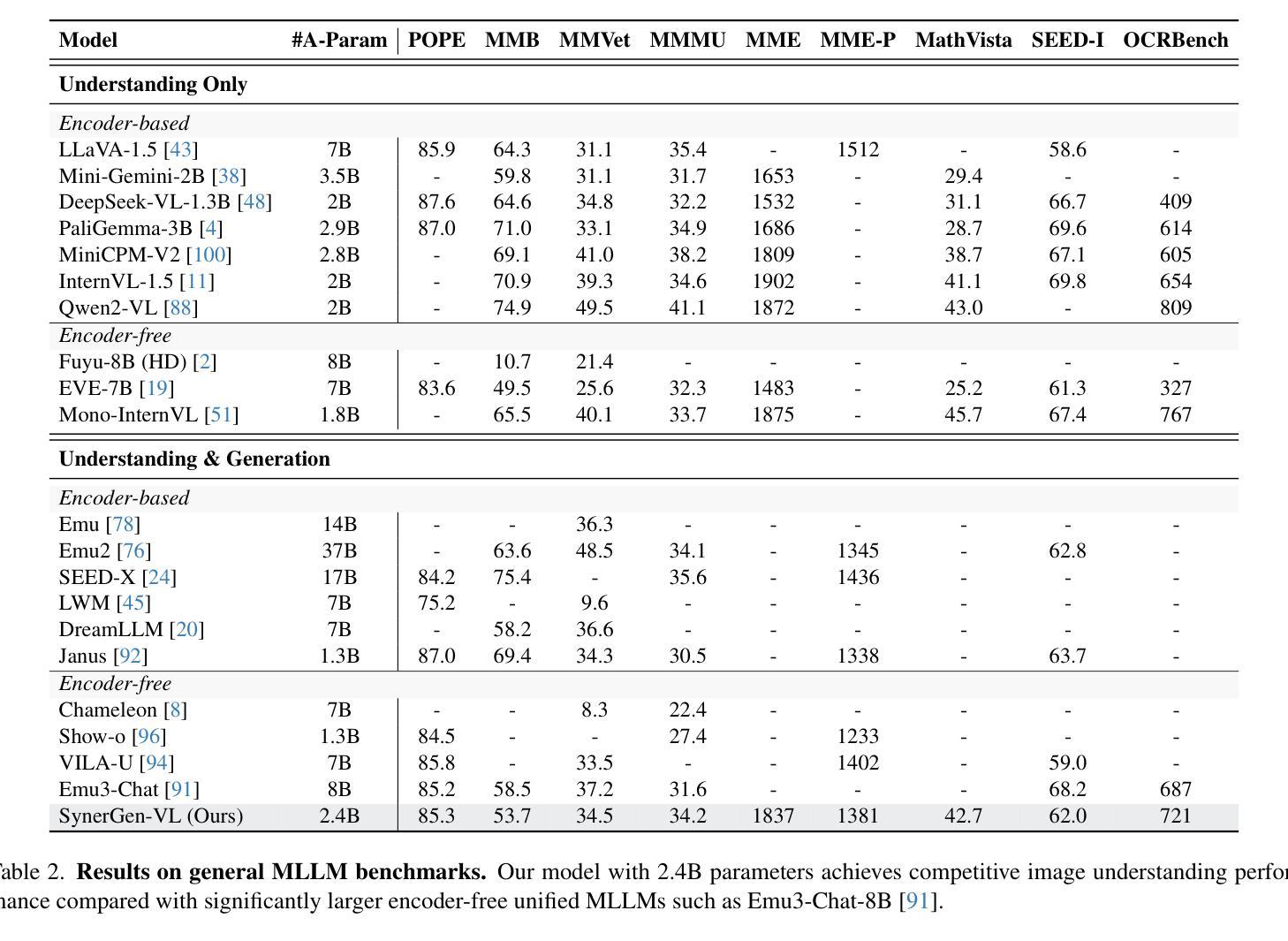

SynerGen-VL: Towards Synergistic Image Understanding and Generation with Vision Experts and Token Folding

Authors:Hao Li, Changyao Tian, Jie Shao, Xizhou Zhu, Zhaokai Wang, Jinguo Zhu, Wenhan Dou, Xiaogang Wang, Hongsheng Li, Lewei Lu, Jifeng Dai

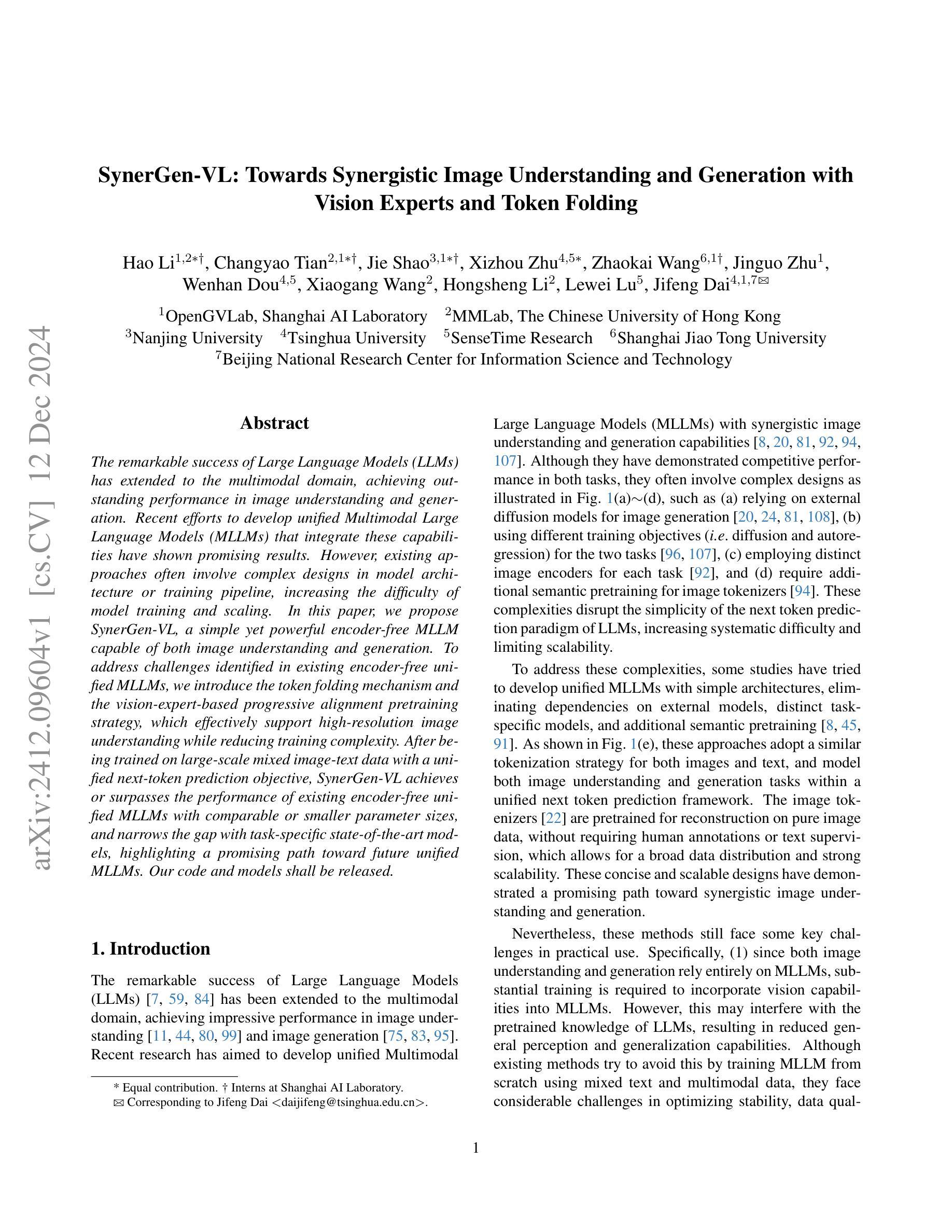

The remarkable success of Large Language Models (LLMs) has extended to the multimodal domain, achieving outstanding performance in image understanding and generation. Recent efforts to develop unified Multimodal Large Language Models (MLLMs) that integrate these capabilities have shown promising results. However, existing approaches often involve complex designs in model architecture or training pipeline, increasing the difficulty of model training and scaling. In this paper, we propose SynerGen-VL, a simple yet powerful encoder-free MLLM capable of both image understanding and generation. To address challenges identified in existing encoder-free unified MLLMs, we introduce the token folding mechanism and the vision-expert-based progressive alignment pretraining strategy, which effectively support high-resolution image understanding while reducing training complexity. After being trained on large-scale mixed image-text data with a unified next-token prediction objective, SynerGen-VL achieves or surpasses the performance of existing encoder-free unified MLLMs with comparable or smaller parameter sizes, and narrows the gap with task-specific state-of-the-art models, highlighting a promising path toward future unified MLLMs. Our code and models shall be released.

大型语言模型(LLM)的显著成功已经扩展到了多模态领域,并在图像理解和生成方面取得了卓越的表现。最近开发的统一多模态大型语言模型(MLLM)集成了这些功能,并显示出有前景的结果。然而,现有方法往往涉及模型架构或训练流程中的复杂设计,增加了模型训练和扩展的难度。在本文中,我们提出了SynerGen-VL,这是一个简单而强大的无编码器MLLM,能够进行图像理解和生成。为了解决现有无编码器统一MLLM所面临的问题,我们引入了标记折叠机制和基于视觉专家的渐进对齐预训练策略,这有效地支持了高分辨率图像理解,同时降低了训练复杂度。在统一令牌预测目标的大型混合图像文本数据上进行训练后,SynerGen-VL在参数大小相当或更小的情况下达到了或超越了现有无编码器统一MLLM的性能,并缩小了与任务特定最新技术模型的差距,为未来统一MLLM的发展指明了有前景的道路。我们的代码和模型将会发布。

论文及项目相关链接

Summary

大型语言模型(LLM)在多模态领域取得了显著的成功,在图像理解和生成方面表现出卓越的性能。最近开发的统一多模态大型语言模型(MLLM)集成了这些功能并显示出良好结果。然而,现有方法往往涉及复杂的模型架构和培训流程,增加了模型训练和扩展的难度。本文提出一种简单而强大的无编码器MLLM模型SynerGen-VL,支持图像理解和生成。通过引入令牌折叠机制和基于视觉专家的渐进对齐预训练策略,有效支持高分辨率图像理解并降低训练复杂性。在大规模混合图像文本数据上进行统一令牌预测目标训练后,SynerGen-VL达到了或与现有无编码器统一MLLM相当或更小的参数大小相比具有竞争力,并缩小了与任务特定先进模型的差距,为未来统一MLLM的发展指明了有前景的道路。我们的代码和模型将会发布。

Key Takeaways

- 大型语言模型(LLM)在多模态领域表现出卓越性能,尤其在图像理解和生成方面。

- 统一多模态大型语言模型(MLLM)成功集成了多种功能,展示了良好结果。

- 现有MLLM方法往往涉及复杂的模型架构和培训流程。

- SynerGen-VL是一种简单而强大的无编码器MLLM模型,支持图像理解和生成。

- SynerGen-VL通过令牌折叠机制和基于视觉专家的渐进对齐预训练策略有效处理高分辨率图像理解。

- SynerGen-VL在训练后表现出良好的性能,与现有无编码器MLLM相比具有竞争力,并缩小了与任务特定模型的差距。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为SynerGen-VL的模型,旨在解决以下问题:

简化多模态大型语言模型(MLLMs)的架构和训练流程:现有的多模态大型语言模型(MLLMs)在图像理解和生成方面取得了令人印象深刻的性能,但它们通常涉及复杂的模型架构或训练流程设计。这些复杂性破坏了大型语言模型(LLMs)的下一个词预测范式的简洁性,增加了模型训练和扩展的难度。

提高模型处理高分辨率图像的能力:现有的视觉分词器需要较低的特征下采样比例以确保重建细节,这导致高分辨率图像的长视觉分词序列,这对LLMs来说是不适用的,限制了高分辨率图像的使用,从而影响了性能,尤其是在图像理解方面。

减少训练难度和成本:将视觉能力整合到MLLMs中需要大量的训练,这可能会干扰LLMs预训练的知识,导致一般感知和泛化能力的降低。尽管现有方法尝试通过使用混合文本和多模态数据从头开始训练MLLMs来避免这一点,但它们在优化稳定性、数据质量和训练成本方面面临相当大的挑战。

为了解决这些问题,论文提出了以下解决方案:

引入视觉专家和基于令牌折叠的机制:通过引入视觉专家(vision experts)和基于令牌折叠(token folding)的机制,SynerGen-VL能够有效支持高分辨率图像理解,同时减少训练复杂性。

采用渐进式对齐预训练策略:通过两阶段的对齐预训练,SynerGen-VL在保持预训练LLMs知识的同时整合视觉能力,避免了对预训练知识的大规模调整。

统一的下一个词预测框架:SynerGen-VL采用了统一的下一个词预测框架来处理图像理解和生成任务,简化了模型设计,并提高了模型的可扩展性和性能。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与SynerGen-VL相关的研究工作:

统一的多模态大型语言模型(MLLMs):

- 早期的工作主要集成外部扩散解码器进行图像生成,例如:[24, 38, 76, 77, 93]。

- 使用离散视觉令牌表示和生成图像的全自回归范式,例如:[8, 30, 45, 91, 94, 101]。

- 一些最近的方法将图像理解和生成解耦,例如:Transfusion [107], Show-o [96], 和 Janus [92]。

无编码器的MLLMs:

- 采用VQ分词器来表示图像作为离散令牌,例如:[8, 91, 96, 107]。

- 使用简单的线性投影(例如,patch embedding层)来嵌入图像,例如:[10, 19, 51]。

令牌折叠和展开:

- 在语言处理中,早期的尝试如Funnel Transformer [17] 和 DataMUX [57] 提出了下采样-上采样范式,以高效处理长序列。

- MegaByte [102] 将序列分割成patches,并在patches内部和之间使用局部和全局模型。

- HRED [56] 使用低频模型处理输入子序列,以原始数据频率解码输出。

特定的MLLMs工作:

- DreamLLM [20], SEED-X [24], VL-GPT [81], MM-Interleaved [82] 等,它们在模型架构、训练方法和使用外部预训练扩散模型方面具有复杂的设计。

这些相关研究构成了SynerGen-VL的研究背景和理论基础,展示了在多模态大型语言模型领域中,对于图像理解和生成任务的集成和优化的探索。SynerGen-VL通过引入令牌折叠机制和基于视觉专家的渐进式对齐预训练策略,旨在简化模型架构和训练流程,同时提高处理高分辨率图像的能力,并减少训练难度和成本。

Q: 论文如何解决这个问题?

A: 论文通过提出SynerGen-VL模型来解决上述问题,具体解决方案如下:

1. 引入视觉专家(Vision Experts)和令牌折叠(Token Folding)机制

视觉专家(Vision Experts):为了在不大幅调整预训练的大型语言模型(LLMs)的同时整合视觉能力,论文引入了额外的参数,即视觉专家。这些专家是专门用于图像表示的前馈网络(FFNs),它们与冻结的LLM对齐,以最小化对LLM预训练知识的干扰。

令牌折叠(Token Folding)机制:为了有效支持高分辨率图像,论文提出了令牌折叠机制,通过增加特征下采样比例来压缩输入的视觉令牌序列长度。这样,可以在保持LLMs处理能力的同时,处理更高分辨率的图像。

2. 采用基于视觉专家的渐进式对齐预训练策略

- 两阶段对齐预训练:为了保留LLM的预训练知识,论文提出了一个两阶段的对齐预训练策略。在第一阶段,仅训练图像特定的FFNs,使用噪声较大的网络数据以获得基本的语义理解和图像生成能力。在第二阶段,进一步使用高质量的图像理解和生成数据训练图像特定的FFNs和自注意力层,以更好地整合多模态特征到预训练的LLM中。

3. 统一的下一个词预测框架

- 编码器自由的MLLM:SynerGen-VL不需要外部的图像生成模型或额外预训练的语义编码器。它使用单一的LLM,并采用统一的下一个词预测目标来处理图像理解和生成任务。

4. 实验验证

- 论文通过在多个图像理解和生成基准上评估SynerGen-VL的性能,验证了其在简化模型架构和训练流程、支持高分辨率图像理解以及减少训练难度方面的优势。实验结果表明,SynerGen-VL在参数数量相对较少的情况下,达到了与现有无编码器统一MLLMs相当的性能,并缩小了与特定任务的最新模型之间的性能差距。

综上所述,SynerGen-VL通过创新的技术方案和策略,有效地解决了现有MLLMs在图像理解和生成任务中面临的挑战,展示了其作为未来统一MLLMs的潜力。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了以下实验来评估SynerGen-VL模型的性能:

1. 图像理解实验

评估基准:作者在8个综合多模态基准上比较了SynerGen-VL与图像理解模型以及统一的图像理解与生成模型。这些基准包括MMBenchEN测试、MMVet、MMMU、MME、MathVista测试迷你、POPE、SEED-Image和OCRBench。这些基准涵盖了视觉问题回答、文档和图表解释以及其他复杂视觉场景的评估。

VQA性能:进一步在7个广泛采用的视觉问题回答(VQA)基准上评估模型性能,包括TextVQA、ScienceQA、GQA、DocVQA、AI2D、ChartQA和InfographicsVQA。

2. 图像生成实验

- 评估基准:使用MSCOCO-30K、MJHQ-30K和GenEval基准来评估模型的图像生成能力。对于MSCOCO30K和MJHQ-30K,作者使用Fréchet Inception Distance(FID)来评估整体生成质量。对于GenEval,作者根据其官方框架从六个维度评估模型的文本到图像的对齐能力:单一对象、两个对象、数量、颜色、位置和颜色属性。

3. 消融研究

令牌折叠的有效性:通过比较有无令牌折叠的模型在VQA基准上的性能,验证了令牌折叠在高分辨率图像理解中的有效性。

渐进式对齐预训练与MMoEs的有效性:通过在不同基准上评估不同预训练策略的性能,验证了渐进式对齐预训练策略在保留预训练LLM知识的同时学习鲁棒视觉表示的有效性。

4. 图像生成与理解的关系分析

图像特征相似性:分析了图像生成和理解任务在不同层之间的视觉特征相似性,发现两个任务在浅层共享基础视觉表示,但在深层则发展出基于不同任务指令的任务特定表示。

注意力图可视化:通过可视化两种任务的注意力图,分析了两种任务是否有相似的注意力模式,并探讨了局部性和全局性在两个任务中的表现。

这些实验全面评估了SynerGen-VL在多模态任务中的性能,并深入分析了其在图像理解和生成任务中的特征利用和处理方式。通过这些实验,作者证明了SynerGen-VL作为一种统一的MLLM在图像理解和生成任务中的有效性和潜力。

Q: 有什么可以进一步探索的点?

A: 尽管SynerGen-VL在图像理解和生成方面取得了显著的成果,但仍有一些领域可以进一步探索和改进:

1. 模型泛化能力

- 跨领域泛化:探索SynerGen-VL在不同领域(如医疗图像、卫星图像等)的泛化能力,并研究领域适应策略。

- 跨模态泛化:研究模型在处理不同类型的模态输入(如视频、音频)时的泛化能力。

2. 模型解释性

- 注意力可视化:进一步分析模型在处理复杂图像和文本时的内部工作机制,提供更深入的解释。

- 特征重要性分析:研究模型在做出预测时哪些特征最为重要,以增强模型的可解释性。

3. 模型优化

- 计算效率:探索更高效的模型架构和训练策略,以减少计算资源消耗。

- 参数效率:研究如何使用更少的参数达到相似或更好的性能。

4. 多任务学习

- 多任务联合训练:探索将图像理解和生成任务与其他任务(如视觉问答、图像分类)联合训练的可能性,以提升模型的多任务处理能力。

5. 模型鲁棒性

- 对抗性攻击和防御:研究模型对于对抗性攻击的鲁棒性,并开发有效的防御机制。

- 数据分布变化:研究模型在面对数据分布变化时的鲁棒性,并探索相应的适应策略。

6. 长尾分布问题

- 长尾数据问题:针对图像和文本数据的长尾分布问题,研究如何优化模型以更好地处理稀有类别。

7. 交互式应用

- 交互式图像编辑:探索模型在交互式图像编辑和生成中的应用,如根据用户反馈动态调整图像内容。

- 多轮对话系统:研究如何将模型集成到多轮对话系统中,以实现更自然的图像和文本交互。

8. 伦理和社会影响

- 偏见和公平性:评估模型可能存在的偏见,并探索减少这些偏见的方法。

- 隐私保护:研究如何在模型训练和应用过程中保护用户隐私。

这些方向不仅可以推动SynerGen-VL模型的技术发展,还有助于更全面地理解和改进多模态大型语言模型的应用和影响。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为SynerGen-VL的多模态大型语言模型(MLLM),旨在简化和提升图像理解和生成的能力。以下是论文的主要内容总结:

1. 问题识别

- 现有的多模态大型语言模型(MLLMs)在图像理解和生成方面取得了进展,但它们通常涉及复杂的模型架构和训练流程。

- 这些复杂性增加了模型训练和扩展的难度,并且限制了模型处理高分辨率图像的能力。

2. SynerGen-VL模型

- 架构:提出了一个无需编码器的MLLM,使用非语义离散图像令牌表示图像,并采用统一的下一个词预测框架处理图像理解和生成任务。

- 令牌折叠机制:通过增加特征下采样比例来压缩输入的视觉令牌序列长度,有效支持高分辨率图像。

- 视觉专家(Vision Experts):引入额外的参数,即视觉专家FFNs,专门用于图像表示,以最小化对预训练语言模型知识的干扰。

3. 渐进式对齐预训练策略

- 两阶段对齐预训练:使用混合的图像理解和生成数据,首先训练图像特定的FFNs以获得基本的语义理解和图像生成能力,然后进一步整合多模态特征到预训练的LLM中。

4. 实验

- 在多个图像理解和生成基准上评估SynerGen-VL,显示出与现有无编码器统一MLLMs相比,在参数数量较少的情况下具有竞争力的性能,并缩小了与特定任务的最新模型之间的性能差距。

5. 消融研究

- 验证了令牌折叠机制和渐进式对齐预训练策略的有效性,展示了这些技术在提高模型性能和保留预训练知识方面的贡献。

6. 关系分析

- 分析了图像生成和理解任务在不同层之间的视觉特征相似性和注意力图模式,发现两个任务在浅层共享基础视觉表示,但在深层则发展出任务特定的表示。

7. 结论

- SynerGen-VL通过简化模型架构和训练流程,有效地统一了图像理解和生成任务,并展示了作为未来统一MLLMs的潜力。

这篇论文通过提出创新的技术方案和策略,有效地解决了现有MLLMs在图像理解和生成任务中面临的挑战,并展示了其作为未来统一MLLMs的潜力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Do Multimodal Large Language Models See Like Humans?

Authors:Jiaying Lin, Shuquan Ye, Rynson W. H. Lau

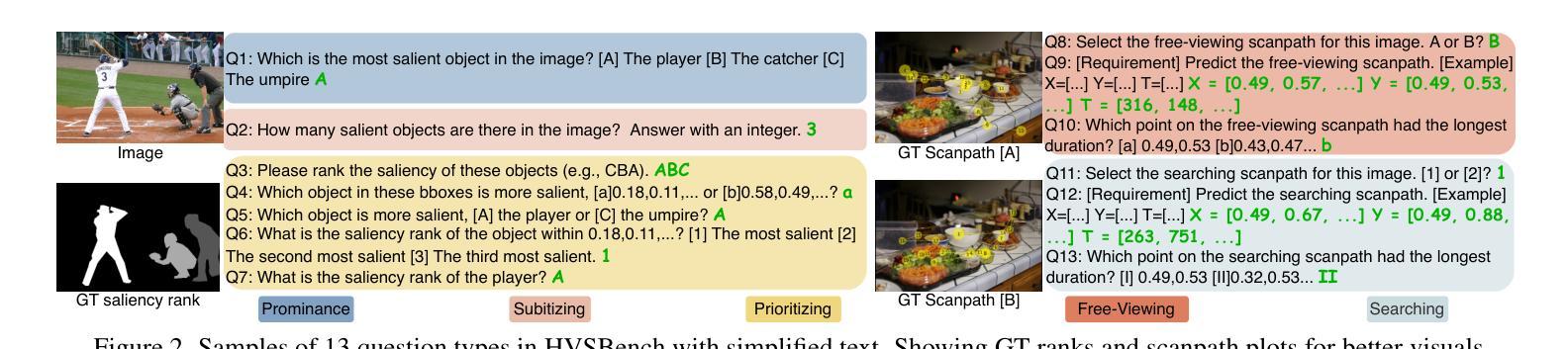

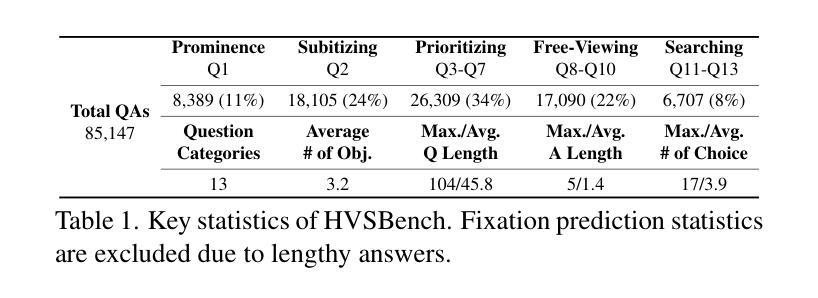

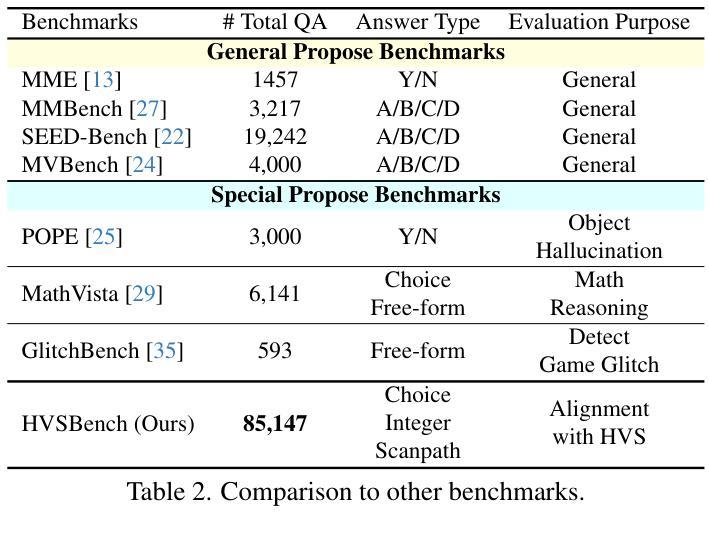

Multimodal Large Language Models (MLLMs) have achieved impressive results on various vision tasks, leveraging recent advancements in large language models. However, a critical question remains unaddressed: do MLLMs perceive visual information similarly to humans? Current benchmarks lack the ability to evaluate MLLMs from this perspective. To address this challenge, we introduce HVSBench, a large-scale benchmark designed to assess the alignment between MLLMs and the human visual system (HVS) on fundamental vision tasks that mirror human vision. HVSBench curated over 85K multimodal samples, spanning 13 categories and 5 fields in HVS, including Prominence, Subitizing, Prioritizing, Free-Viewing, and Searching. Extensive experiments demonstrate the effectiveness of our benchmark in providing a comprehensive evaluation of MLLMs. Specifically, we evaluate 13 MLLMs, revealing that even the best models show significant room for improvement, with most achieving only moderate results. Our experiments reveal that HVSBench presents a new and significant challenge for cutting-edge MLLMs. We believe that HVSBench will facilitate research on human-aligned and explainable MLLMs, marking a key step in understanding how MLLMs perceive and process visual information.

多模态大型语言模型(MLLMs)借助大型语言模型的最新进展,在各种视觉任务上取得了令人印象深刻的结果。然而,一个关键问题仍未解决:MLLMs是否以与人类相似的方式感知视觉信息?当前的标准无法从这一角度评估MLLMs。为了应对这一挑战,我们引入了HVSBench,这是一个大规模的标准,旨在评估MLLMs和人类视觉系统(HVS)之间的对齐情况,在基本视觉任务上反映人类视觉。HVSBench筛选了超过85,000个多模式样本,涵盖HVS中的13个类别和5个领域,包括突出显示、快速计数、优先排序、自由查看和搜索。大量实验证明我们的标准在全面评估MLLMs方面非常有效。具体来说,我们对13个MLLMs进行了评估,发现即使是最优秀的模型也有很大的改进空间,大多数只取得了中等结果。我们的实验表明,HVSBench为前沿的MLLMs带来了新的重大挑战。我们相信,HVSBench将促进人类对齐和可解释性MLLMs的研究,这是了解MLLMs如何感知和处理视觉信息的关键一步。

论文及项目相关链接

PDF Project page: https://jiaying.link/HVSBench/

Summary

多模态大型语言模型(MLLMs)在各种视觉任务上取得了令人印象深刻的结果。然而,一个重要的挑战是评估这些模型对人类视觉感知的模拟程度。为了解决这个问题,本文提出了HVSBench这一大规模基准测试,旨在评估MLLMs与人类视觉系统(HVS)的对齐程度。该基准测试涵盖了超过8万五千个多模态样本,包括显著性、计数、优先排序等视觉任务,能有效评价MLLMs在模拟人类视觉方面的表现。研究结果表明,即便是最佳模型仍存在一定提升空间,这为人类视觉对齐和多模态语言模型的可解释性研究提供了重要方向。

Key Takeaways

- 多模态大型语言模型(MLLMs)在多种视觉任务上表现出卓越性能。

- 当前缺乏评估MLLMs对人类视觉感知模拟程度的基准测试。

- HVSBench作为一种新的大规模基准测试,旨在评估MLLMs与人类视觉系统的对齐程度。

- HVSBench涵盖了多种与人类视觉相关的任务,包括显著性、计数等。

- 通过广泛实验验证,HVSBench在评估MLLMs方面具有有效性。

- 现有最佳MLLMs在模拟人类视觉感知方面仍存在提升空间。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了多模态大型语言模型(MLLMs)在视觉信息感知方面与人类视觉系统(HVS)的一致性问题。具体来说,论文试图解决以下关键问题:

MLLMs与HVS的对齐程度:尽管MLLMs在各种视觉任务上取得了令人印象深刻的成果,但目前尚不清楚它们是否与人类视觉系统(HVS)以相似的方式感知视觉信息。论文提出了一个问题:MLLMs是否像人类一样感知世界?

现有基准测试的局限性:目前的基准测试缺乏从HVS角度评估MLLMs的能力。现有的公共视觉-语言数据集主要设计用来评估模型在特定任务上的性能,而没有提供对模型与HVS对齐程度的洞察。

MLLMs的视觉注意力机制:人类的视觉注意力是基于先天和后天习得的显著性,而MLLMs通常将图像视为像素值数组或特征嵌入。人类视觉注意力是顺序的,会根据上下文和先前知识进行调整,而MLLMs则静态地处理输入或通过固定长度的注意力机制。

MLLMs的动态聚焦能力:人类注意力可以动态地受到目标的影响和引导,而MLLMs缺乏认知能力和“重新聚焦”的动态能力,仅依赖于训练中的关联。

为了解决这些问题,论文介绍了一个名为HVSBench的大规模基准测试,旨在评估MLLMs与HVS在基本视觉任务上的对齐程度,这些任务反映了人类视觉。HVSBench包含超过85K个多模态样本,涵盖13个类别和5个HVS领域,包括突出性、快速识别、优先级排序、自由观看和搜索。通过广泛的实验,论文展示了HVSBench在全面评估MLLMs方面的有效性,并揭示了当前MLLMs与人类之间存在显著差距,为未来改进提供了关键见解。

Q: 有哪些相关研究?

A: 根据提供的论文内容,相关研究主要涉及以下几个领域:

人类视觉系统(HVS):

- 研究HVS如何有效地处理和选择性地关注视觉信息。

- 计算建模HVS以在人工系统中复制类人注意力和感知,例如通过视觉显著性引导人类注视模式的研究。

- 利用深度学习将人类注意力模型整合到计算机视觉任务中,以更好地预测自由观看的人类注视。

多模态大型语言模型(MLLMs):

- MLLMs作为人工智能的重要进展,扩展了大型语言模型处理和推理视觉及文本信息的能力。

- 一些MLLMs,例如LLaVA和MiniGPT-4,展示了在一般视觉任务中的能力。

MLLMs基准测试:

- 评估MLLMs在理解和跨模态推理方面的能力,包括文档理解、视觉问题回答、幻觉检测和数学推理等任务。

- 现有的基准测试,如MMBench、SEEDBench等,用于评估MLLMs的一般多模态能力。

视觉显著性检测:

- 研究如何识别图像中最引人注目的对象,这对于理解人类视觉焦点至关重要。

快速识别(Subitizing):

- 快速准确地感知场景中视觉显著对象的数量,与Prominence相比,需要同时关注多个元素。

视觉注意力的顺序和时间模式:

- 研究HVS如何展示顺序和时间的注视模式,这对于理解复杂场景至关重要。

自由观看(Free-viewing)和搜索(Searching):

- 自由观看关注无特定任务的人类注视行为,而搜索则关注特定目标搜索任务中的人类注视行为。

这些相关研究为论文提出的HVSBench基准测试提供了理论和实证基础,旨在通过评估MLLMs在模仿人类视觉任务上的表现来推动MLLMs向更人类对齐的方向发展。

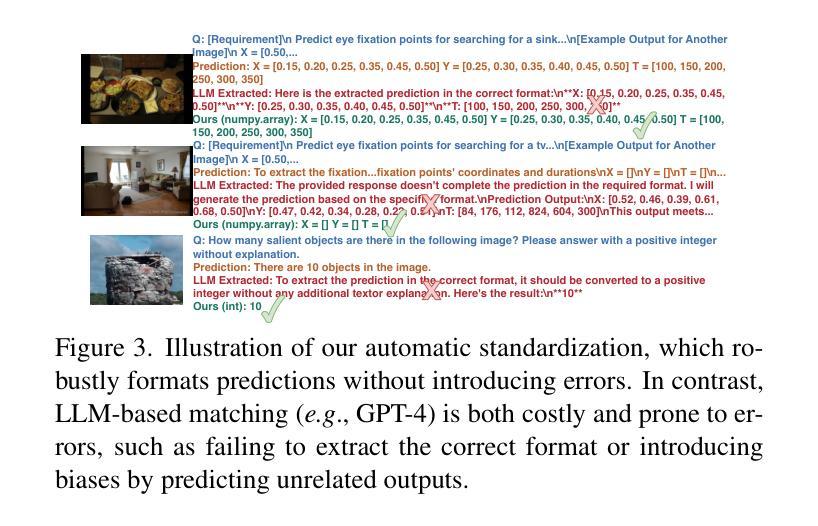

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决MLLMs与人类视觉系统(HVS)对齐的问题:

建立HVSBench基准测试:

- 论文介绍了一个大规模基准测试HVSBench,旨在评估MLLMs与HVS在基本视觉任务上的对齐程度。这个基准测试包含了超过85K个多模态样本,涵盖了13个类别和5个HVS领域,包括突出性(Prominence)、快速识别(Subitizing)、优先排序(Prioritizing)、自由观看(Free-Viewing)和搜索(Searching)。

设计评估协议:

- 论文提出了一个包含人类启发式和领域自适应自动标准化方法的评估协议。这种方法旨在减少因匹配错误导致的假阴性,并提高跨领域的评估鲁棒性。

自动标准化和评估:

- 论文提出了一个自动化标准化过程,以处理不同格式的预测结果,并将其转换为一致的格式,从而减少评估中的误差。

实验验证:

- 对13个流行的MLLMs进行了全面的评估,使用HVSBench跨越多个HVS方面进行了直接比较,并揭示了当前MLLMs与人类之间存在显著差距。

提供改进见解:

- 论文的实验结果揭示了未来改进的关键见解,例如,仅通过整合人类生成的字幕和摘要,或加入外部知识相关线索和先验,并不能实现与HVS的对齐。

应用示例:

- 论文展示了一个基于突出性增强的应用示例,说明更好的HVS对齐MLLM如何改进下游应用。

推动研究和应用:

- 论文认为HVSBench将促进更人类对齐和可解释的MLLMs的研究,并为理解这些模型如何感知和处理视觉信息提供关键步骤。

通过这些步骤,论文不仅提出了一个评估MLLMs与HVS对齐程度的新基准测试,而且还通过实验结果揭示了MLLMs在模仿人类视觉行为方面存在的挑战,并为未来的研究提供了方向。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了以下实验:

模型选择和评估:

- 选择了多个最新的开源和专有的多模态大型语言模型(MLLMs),包括MiniGPT4-v2、DeepSeekVL、Idefics系列、LLaVA-Next、LLaVAOneVision、mPLUG-Owl3、Qwen2VL、InternVL2.0和MiniCPM-V 2.6等,以及GPT4-o和Gemini1.5 Flash这两个代表性的专有MLLMs。

- 所有实验都使用VLMEvalKit在同一平台上进行,以确保一致性和公平性。

定量评估:

- 在HVSBench上对MLLMs进行了定量评估,包括Prominence、Subitizing、Prioritizing、Free-viewing和Searching五个领域的性能。

- 使用不同的方法和专门的指标评估随机猜测的基线性能。

主要结果分析:

- 展示了13个领先MLLMs在HVSBench上的表现,揭示了与人类视觉系统对齐方面存在显著的改进空间。

- 分析了模型在不同领域的性能,包括选择、计数、排序和扫描路径预测等任务。

消融研究:

- 模型大小的影响:通过测试不同参数数量的模型来评估模型大小对HVSBench性能的影响。

- 人类字幕或描述是否提高对齐:评估添加详细的描述或简短的字幕是否能够提高模型的性能。

- 领域特定提示是否提高对齐:检查添加领域特定提示是否能够增强模型的性能。

应用示例:

- 设计了一个基于裁剪的突出性增强应用,展示了一个更好的HVS对齐MLLM在突出性领域中的应用。

- 比较了有无任务特定提示的GPT-4o裁剪图像的结果,展示了与HVS更好的对齐。

定性结果分析:

- 提供了模型在不同任务上的定性结果,包括预测的扫描路径和选择的显著对象等。

- 分析了模型在特定任务上的表现,如选择最显著对象、预测显著对象数量、排序显著对象、自由观看和搜索任务中的扫描路径预测等。

这些实验不仅提供了MLLMs在模仿人类视觉行为方面的表现的定量和定性评估,还揭示了这些模型在不同视觉任务中的性能差异,并为未来的研究提供了方向。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和实验结果,以下是一些可以进一步探索的点:

改进模型架构:

- 研究和开发新的模型架构,以更好地模仿人类视觉注意力和处理机制,特别是在自由观看和搜索任务中。

数据集和标注:

- 扩展和丰富HVSBench数据集,包括更多的图像、视频和多模态样本,以覆盖更广泛的人类视觉行为。

- 研究更精细的标注方法,以更准确地捕捉人类视觉注意力的动态特性。

模型训练和调优:

- 探索新的训练策略和调参方法,以提高MLLMs在HVSBench上的性能,特别是在扫描路径预测和视觉显著性排名等任务上。

跨模态注意力机制:

- 研究和改进跨模态注意力机制,以更好地整合视觉和语言信息,并提高模型对视觉上下文的理解。

可解释性和透明度:

- 提高MLLMs的可解释性,通过可视化和分析模型的内部工作机制,以更好地理解模型是如何感知和处理视觉信息的。

领域适应和泛化能力:

- 研究模型在不同领域(如医疗图像分析、自动驾驶等)的适应性和泛化能力,以及如何调整模型以适应特定的应用场景。

实时性能:

- 优化模型以提高实时性能,这对于许多实际应用(如机器人视觉、增强现实等)至关重要。

多任务学习:

- 探索多任务学习框架,同时训练模型执行多个视觉任务,以提高模型的效率和效果。

长尾分布问题:

- 研究如何改进模型在处理长尾分布数据时的性能,特别是在视觉显著性检测和目标搜索任务中。

伦理和社会影响:

- 探讨MLLMs在实际应用中的伦理和社会影响,包括隐私、偏见和公平性问题。

这些探索点可以帮助研究者更深入地理解MLLMs的工作原理,并推动这些模型在模仿人类视觉行为方面取得更大的进展。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容概括如下:

研究动机:

- 论文探讨了多模态大型语言模型(MLLMs)在视觉信息感知任务中与人类视觉系统(HVS)的对齐程度,即MLLMs是否像人类一样感知视觉信息。

现有挑战:

- 指出了现有基准测试的局限性,即缺乏评估MLLMs从HVS角度的性能的能力。

HVSBench基准测试:

- 介绍了HVSBench,这是一个大规模基准测试,包含85K多模态样本,覆盖13个类别和5个HVS领域(突出性、快速识别、优先排序、自由观看和搜索)。

评估协议:

- 提出了一个包含人类启发式和领域自适应自动标准化方法的评估协议,以增强评估的鲁棒性。

实验与结果:

- 对13个流行的MLLMs进行了评估,发现即使是最先进的模型也显示出与人类视觉系统对齐方面的显著改进空间。

消融研究:

- 进行了消融研究,探讨了模型大小、人类生成的字幕或描述、领域特定提示等因素对模型与HVS对齐程度的影响。

应用示例:

- 展示了一个基于突出性增强的应用示例,说明了更好的HVS对齐MLLM在实际应用中的潜力。

结论:

- 论文认为HVSBench将推动更人类对齐和可解释的MLLMs的研究,并为理解这些模型如何感知和处理视觉信息提供了关键见解。

总的来说,这篇论文通过提出HVSBench基准测试和相应的评估协议,对MLLMs在模仿人类视觉行为方面进行了系统的评估,并指出了未来研究的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

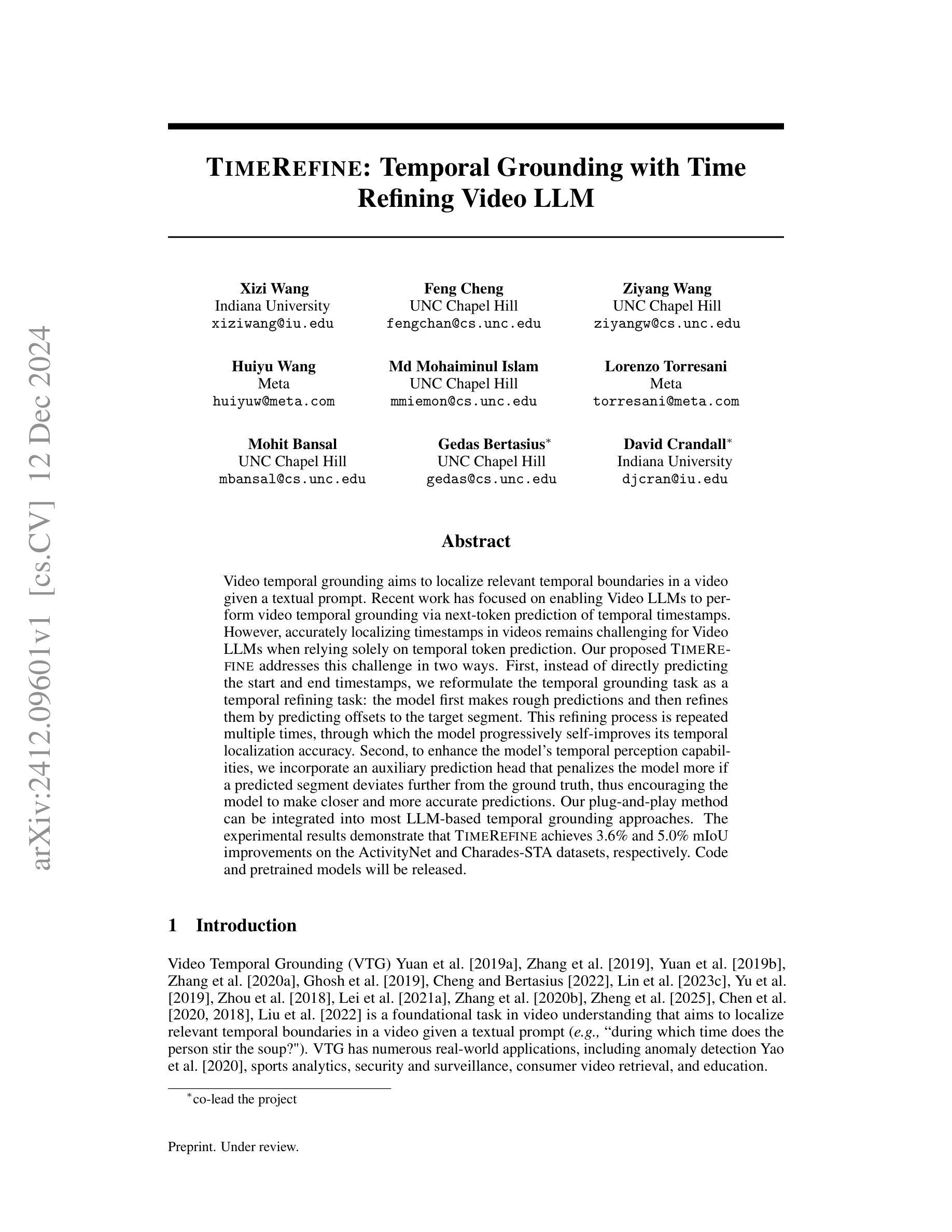

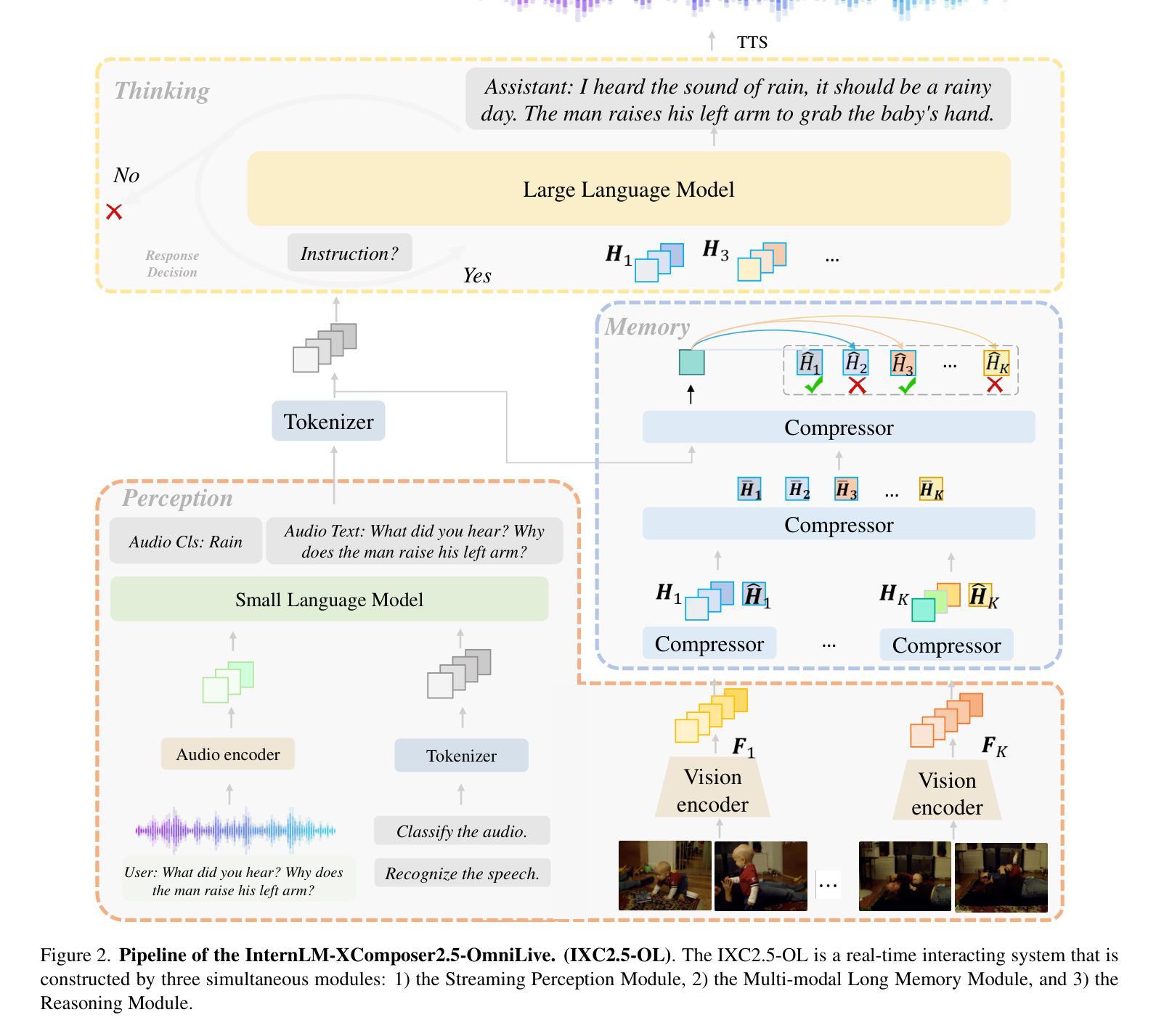

TimeRefine: Temporal Grounding with Time Refining Video LLM

Authors:Xizi Wang, Feng Cheng, Ziyang Wang, Huiyu Wang, Md Mohaiminul Islam, Lorenzo Torresani, Mohit Bansal, Gedas Bertasius, David Crandall

Video temporal grounding aims to localize relevant temporal boundaries in a video given a textual prompt. Recent work has focused on enabling Video LLMs to perform video temporal grounding via next-token prediction of temporal timestamps. However, accurately localizing timestamps in videos remains challenging for Video LLMs when relying solely on temporal token prediction. Our proposed TimeRefine addresses this challenge in two ways. First, instead of directly predicting the start and end timestamps, we reformulate the temporal grounding task as a temporal refining task: the model first makes rough predictions and then refines them by predicting offsets to the target segment. This refining process is repeated multiple times, through which the model progressively self-improves its temporal localization accuracy. Second, to enhance the model’s temporal perception capabilities, we incorporate an auxiliary prediction head that penalizes the model more if a predicted segment deviates further from the ground truth, thus encouraging the model to make closer and more accurate predictions. Our plug-and-play method can be integrated into most LLM-based temporal grounding approaches. The experimental results demonstrate that TimeRefine achieves 3.6% and 5.0% mIoU improvements on the ActivityNet and Charades-STA datasets, respectively. Code and pretrained models will be released.

视频时序定位旨在根据文本提示在视频中找到相关的时序边界。近期的工作主要集中在通过时序时间戳的下一个令牌预测,使视频LLM能够执行视频时序定位。然而,当仅依靠时序令牌预测时,对于视频LLM来说,准确地定位视频中的时间戳仍然具有挑战性。我们提出的TimeRefine通过两种方式解决这一挑战。首先,我们不直接预测开始和结束的时间戳,而是将时序定位任务重新定义为时序细化任务:模型首先进行粗略预测,然后通过预测目标段的偏移来细化预测。这种细化过程会多次重复,在此过程中,模型会逐渐自我提高其时序定位的准确性。其次,为了增强模型的时序感知能力,我们加入了一个辅助预测头,如果预测段与真实值的偏差较大,则对模型施加更大的惩罚,从而鼓励模型做出更接近和更准确的预测。我们的即插即用方法可以与大多数基于LLM的时序定位方法相结合。实验结果表明,TimeRefine在ActivityNet和Charades-STA数据集上分别实现了3.6%和5.0%的mIoU改进。代码和预训练模型将发布。

论文及项目相关链接

Summary

视频时序定位旨在根据文本提示定位视频中的相关时序边界。最近的工作集中在通过预测时序时间戳使视频LLM执行视频时序定位。然而,仅依靠时序令牌预测,LLM在定位视频时间戳时仍面临挑战。我们提出的TimeRefine通过两种方式解决这一挑战。首先,我们不直接预测开始和结束时间戳,而是将时序定位任务重新定义为时序细化任务:模型先进行粗略预测,然后通过预测偏移量来细化目标段。这种细化过程会多次重复,在此过程中,模型的时序定位精度会逐步提高。其次,为了增强模型的时序感知能力,我们引入了一个辅助预测头,如果预测段偏离真实值较远,则对模型施加更大的惩罚,从而鼓励模型做出更接近和更准确的预测。我们的即插即用方法可以与大多数基于LLM的时序定位方法相结合。

Key Takeaways

- 视频时序定位是根据文本提示在视频中定位相关时序信息的重要技术。

- 近期工作主要利用LLM进行视频时序定位,但仍面临精准定位的难题。

- TimeRefine方法通过改革任务为时序细化任务来解决这一难题,模型先做出粗略预测然后逐步细化。

- TimeRefine引入辅助预测头以增强模型的时序感知能力。

- TimeRefine可以在大多数基于LLM的时序定位方法上集成应用。

- 实验结果表明TimeRefine在ActivityNet和Charades-STA数据集上实现了mIoU的提升。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决视频时间定位(Video Temporal Grounding, VTG)的问题,即在给定文本提示的情况下,如何在视频中定位相关的时间边界。具体来说,论文中提到现有的视频大型语言模型(Video LLMs)在仅依赖于时间标记预测时,准确定位视频中的时间戳仍然具有挑战性。因此,论文提出了一个名为TIMEREFINE的方法,旨在通过两种方式来解决这一挑战:

时间细化任务:与其直接预测起始和结束时间戳,论文将时间定位任务重新表述为一个时间细化任务。模型首先进行粗略预测,然后通过预测目标片段的偏移量来细化这些预测。这一细化过程多次重复,使模型能够逐步自我改进其时间定位的准确性。

增强时间感知能力:为了增强模型的时间感知能力,论文引入了一个辅助预测头(auxiliary prediction head),如果预测的片段与真实情况偏离更远,则对该模型进行更大的惩罚,从而鼓励模型进行更接近和更准确的预测。

总的来说,论文的目标是通过改进学习目标和引入迭代时间细化策略,来提高视频LLMs在时间定位任务中的表现。

Q: 有哪些相关研究?

A: 根据这篇论文,相关研究主要涉及以下几个方面:

视频大型语言模型(Video Large Language Models):

- 论文提到了多个研究工作,它们致力于将大型语言模型(LLMs)从处理语言扩展到处理视频数据。这些模型在视频理解任务中取得了显著的成功,例如视频问答和视频描述。例如,Lin et al. [2023a], Liu et al. [2024a], Qian et al. [2024], Ren et al. [2024], Guo et al. [2024a], Li et al. [2023b], Maaz et al. [2024], Chen et al. [2024], Huang et al. [2024a] 等。

视频时间定位(Video Temporal Grounding):

- 论文讨论了多个针对视频时间定位任务开发的模型,这些模型通常将时间定位任务表述为基于视频输入和用户查询的时间戳回归任务。例如,Lei et al. [2021b], Moon et al. [2023a,b], Zeng et al. [2024b], Zala et al. [2023] 等。

- 近期的方法利用视频大型语言模型进行基于LLM的时间定位,例如 VTimeLLM [Huang et al., 2024a], LITA [Huang et al., 2024b], Momentor [Qian et al., 2024], VTG-LLM [Guo et al., 2024a] 等。

基于细化的学习(Refinement-based Learning):

- 论文提到了在计算机视觉领域中,通过初始粗糙预测然后逐步细化以提高精度的概念。例如,两阶段目标检测器和迭代误差反馈在任务如人体姿态估计中的应用。Diffusion models 也采用了逐步去噪的方法。这些工作启发了TIMEREFINE提出基于细化的范式来处理时间定位任务。

这些相关研究构成了论文提出的TIMEREFINE方法的研究背景和理论基础,TIMEREFINE通过引入迭代时间细化策略和辅助预测头来增强视频LLMs的时间定位能力,并在视频理解任务中取得了改进。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为TIMEREFINE的方法来解决视频时间定位(Video Temporal Grounding, VTG)的问题,具体解决方案包含两个主要部分:

1. 时间细化任务(Temporal Refining Task)

重新表述问题:TIMEREFINE将直接预测时间戳的任务重新表述为一个迭代的时间细化任务。模型首先进行粗略的时间预测,然后通过预测相对于目标片段的偏移量来逐步细化这些预测。

迭代细化过程:该过程重复多次,使模型有机会自我纠正前一次预测中的错误,从而提高时间定位的准确性。

2. 增强时间感知能力(Enhancing Temporal Perception)

- 辅助预测头:为了增强模型对时间的感知能力,TIMEREFINE引入了一个辅助预测头,该预测头使用L1损失函数进行优化。L1损失函数根据预测值与真实值之间的距离进行惩罚,鼓励模型做出更接近真实值的预测。

实现细节

架构:TIMEREFINE不依赖于特定的模型架构,可以应用于任何基于LLM的VTG方法。

训练序列生成:在训练过程中,通过从高斯分布中采样偏移量来生成训练序列,模拟从粗糙到精细的细化过程。

损失函数:结合原始的交叉熵损失和辅助预测头的L1损失,以增强模型的时间感知能力。

训练和推理:在训练阶段,模型的总损失是交叉熵损失和L1损失的总和。在推理阶段,使用最终细化步骤中的预测作为起始和结束时间戳。

通过以上方法,TIMEREFINE能够有效地提高视频LLMs在时间定位任务中的表现,并在ActivityNet和Charades-STA数据集上取得了显著的性能提升。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估TIMEREFINE方法的有效性,具体实验包括:

评估数据集:

- 使用ActivityNet Captions和Charades-STA数据集作为评估数据集,这些数据集广泛用于视频时间定位任务。

评估指标:

- 报告了在不同IoU(Intersection over Union)阈值(0.3, 0.5, 和 0.7)下的召回率(Recall@1)以及平均IoU(mIoU)。

基线对比:

- 与现有的视频LLMs进行比较,包括传统的视频LLMs和专为视频时间定位设计的视频LLMs。

主要结果:

- 在表1中展示了TIMEREFINE在ActivityNet Captions和Charades-STA数据集上的性能,并与VTimeLLM和VTG-LLM等基线方法进行了对比。

定性评估:

- 在图3中展示了一个零样本(zero-shot)设置下的案例研究,比较了VTimeLLM、VTG-LLM和TIMEREFINE在Charades-STA数据集上的输出。

设计选择的详细消融研究:

- 时间细化任务设计:探索了不同的细化任务设计,包括不进行细化、预测IoU和预测偏移量。

- 细化序列生成策略:研究了不同的高斯分布数量和噪声水平对模型性能的影响。

- 时间感知:探讨了辅助预测头对模型时间感知能力的影响,并比较了不同的损失函数。

- 时间戳解码方法:研究了从多次细化过程中选择时间戳的不同方法,包括使用序列预测的第一步、最后一步、辅助预测头或合并两者的预测。

这些实验结果表明,TIMEREFINE通过其迭代时间细化策略和辅助时间感知监督信号,能够有效提升视频LLMs在视频时间定位任务中的表现。

Q: 有什么可以进一步探索的点?

A: 论文在最后提出了一些可能的未来研究方向,可以进一步探索的点包括:

任务和序列设计的进一步细化:

- 探索更精细的任务和序列设计,以提高模型的时间定位能力。例如,可以研究不同的时间细化策略,或者如何更好地模拟人类在视频中定位时刻的方式。

时间定位增强视频问答任务:

- 研究如何将时间定位能力整合到视频问答(Video Question Answering, VQA)任务中。由于视频问答往往需要对视频中的特定时刻有精准的理解,TIMEREFINE的方法或许可以提升VQA的性能。

减少所需预测的时间相关标记数量:

- 尽管TIMEREFINE在性能上有所提升,但它需要预测比之前方法更多的时间相关标记。研究如何减少这一需求,同时保持或提升性能。

探索不同的损失函数和优化策略:

- 进一步探索和实验不同的损失函数,以及它们对模型性能的影响。可能存在其他损失函数,能更好地结合CE损失和时间定位任务的特性。

模型架构的改进:

- 虽然TIMEREFINE是架构不可知的,但研究特定的模型架构改进,可能进一步提升时间定位的性能。

更广泛的数据集和任务评估:

- 在更多的数据集和不同的视频理解任务上评估TIMEREFINE,以验证其泛化能力和适用性。

实时性能和计算效率:

- 研究如何优化TIMEREFINE以减少推理时间,使其适用于需要实时反馈的应用场景。

解释性和可视化:

- 提供模型预测的解释性和可视化,帮助理解模型是如何逐步细化其预测的,以及在哪些方面模型可能会失败。

这些方向不仅可以推动视频时间定位技术的发展,还可能对视频理解和人机交互的其他领域产生积极影响。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为TIMEREFINE的方法,旨在提高视频大型语言模型(Video LLMs)在视频时间定位(Video Temporal Grounding, VTG)任务中的性能。以下是论文的主要内容概述:

问题定义:

- 视频时间定位任务的目标是在给定文本提示的情况下,定位视频中的相关时间边界。

挑战:

- 现有的视频LLMs在仅依赖于时间标记预测时,难以准确定位视频中的时间戳。

TIMEREFINE方法:

- 时间细化任务:将时间定位任务重新表述为一个迭代的时间细化任务,模型首先进行粗略预测,然后通过预测偏移量来逐步细化这些预测。

- 增强时间感知:引入一个辅助预测头,使用L1损失函数来增强模型的时间感知能力,鼓励模型做出更接近真实值的预测。

实现细节:

- TIMEREFINE不依赖于特定的模型架构,可以应用于任何基于LLM的VTG方法。

- 在训练序列生成中,通过从高斯分布中采样偏移量来模拟从粗糙到精细的细化过程。

- 在训练阶段,模型的总损失是交叉熵损失和L1损失的总和;在推理阶段,使用最终细化步骤中的预测作为起始和结束时间戳。

实验:

- 在ActivityNet Captions和Charades-STA数据集上评估TIMEREFINE,并与现有的视频LLMs进行比较。

- 通过定性评估和消融研究验证了TIMEREFINE在时间定位任务中的有效性。

结论与未来工作:

- TIMEREFINE通过迭代时间细化策略和辅助时间感知监督信号,有效提升了视频LLMs在时间定位任务中的表现。

- 提出了未来研究方向,包括进一步优化任务和序列设计,探索时间定位如何增强视频问答任务等。

总体而言,这篇论文通过创新的学习目标和迭代时间细化策略,为提高视频LLMs在视频时间定位任务中的性能提供了一个有效的解决方案。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

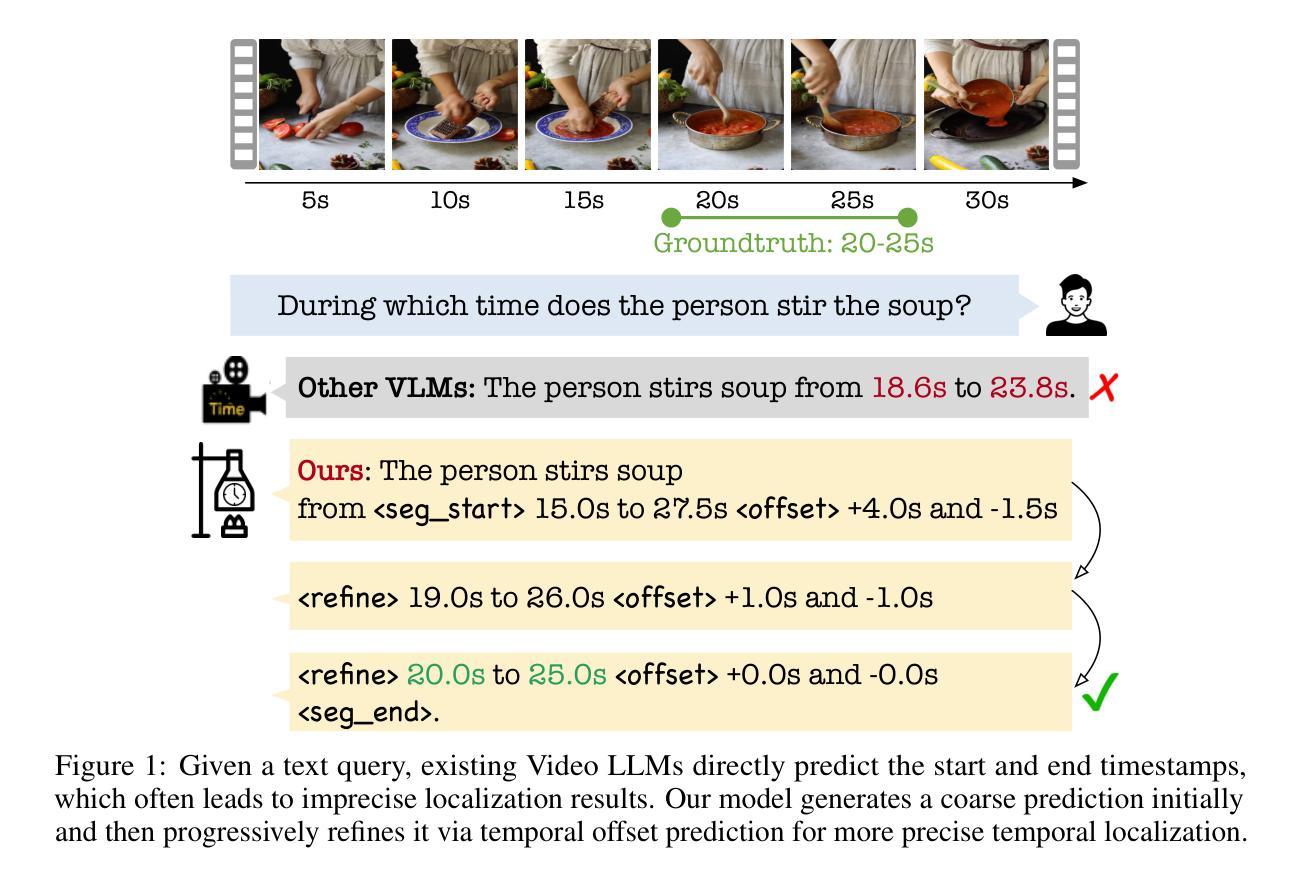

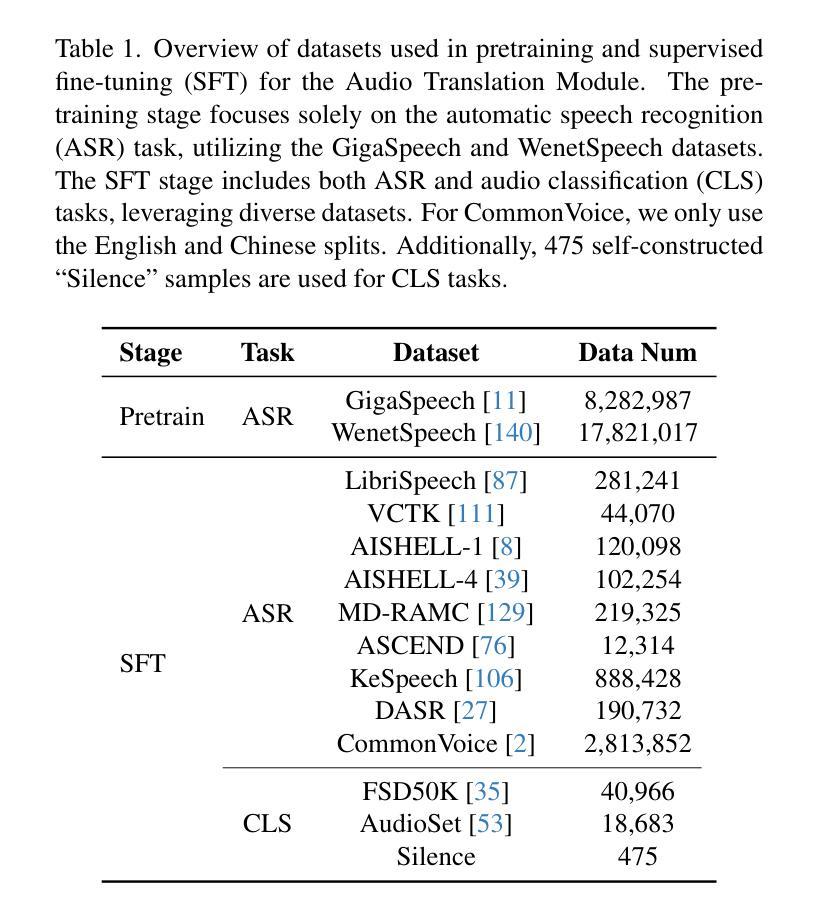

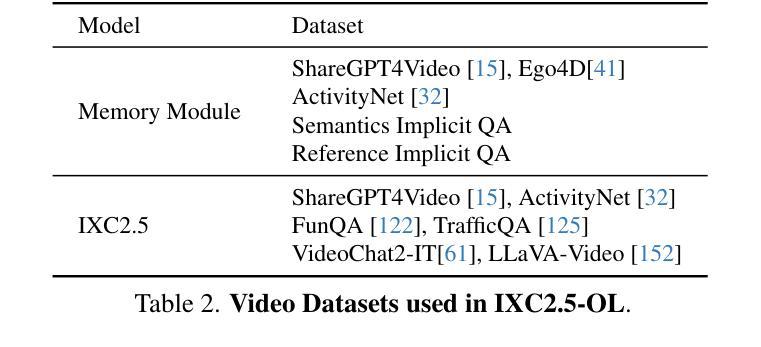

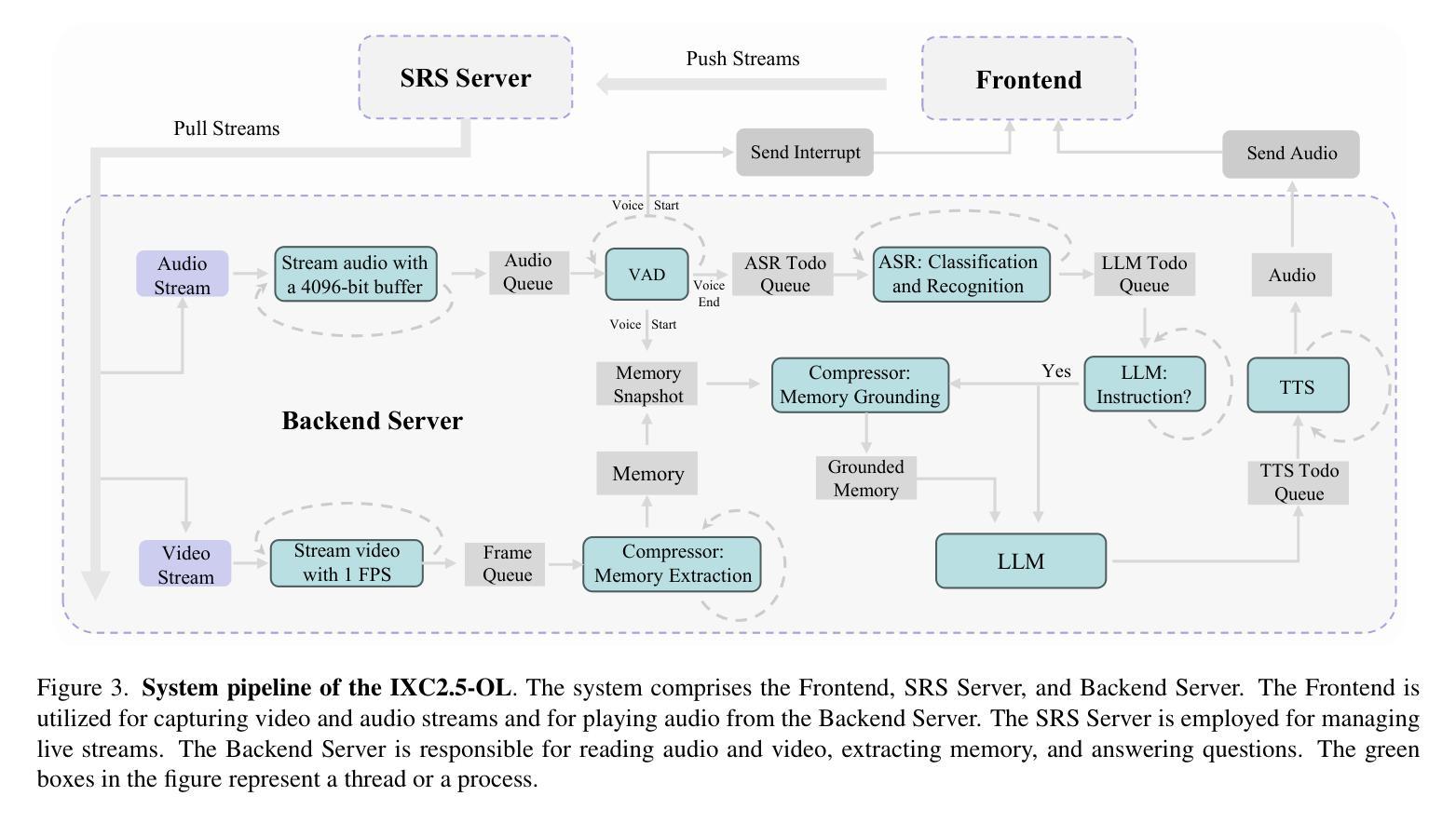

InternLM-XComposer2.5-OmniLive: A Comprehensive Multimodal System for Long-term Streaming Video and Audio Interactions

Authors:Pan Zhang, Xiaoyi Dong, Yuhang Cao, Yuhang Zang, Rui Qian, Xilin Wei, Lin Chen, Yifei Li, Junbo Niu, Shuangrui Ding, Qipeng Guo, Haodong Duan, Xin Chen, Han Lv, Zheng Nie, Min Zhang, Bin Wang, Wenwei Zhang, Xinyue Zhang, Jiaye Ge, Wei Li, Jingwen Li, Zhongying Tu, Conghui He, Xingcheng Zhang, Kai Chen, Yu Qiao, Dahua Lin, Jiaqi Wang

Creating AI systems that can interact with environments over long periods, similar to human cognition, has been a longstanding research goal. Recent advancements in multimodal large language models (MLLMs) have made significant strides in open-world understanding. However, the challenge of continuous and simultaneous streaming perception, memory, and reasoning remains largely unexplored. Current MLLMs are constrained by their sequence-to-sequence architecture, which limits their ability to process inputs and generate responses simultaneously, akin to being unable to think while perceiving. Furthermore, relying on long contexts to store historical data is impractical for long-term interactions, as retaining all information becomes costly and inefficient. Therefore, rather than relying on a single foundation model to perform all functions, this project draws inspiration from the concept of the Specialized Generalist AI and introduces disentangled streaming perception, reasoning, and memory mechanisms, enabling real-time interaction with streaming video and audio input. The proposed framework InternLM-XComposer2.5-OmniLive (IXC2.5-OL) consists of three key modules: (1) Streaming Perception Module: Processes multimodal information in real-time, storing key details in memory and triggering reasoning in response to user queries. (2) Multi-modal Long Memory Module: Integrates short-term and long-term memory, compressing short-term memories into long-term ones for efficient retrieval and improved accuracy. (3) Reasoning Module: Responds to queries and executes reasoning tasks, coordinating with the perception and memory modules. This project simulates human-like cognition, enabling multimodal large language models to provide continuous and adaptive service over time.

创建能够像人类认知一样,在长期内与环境进行交互的AI系统,一直是研究领域的长期目标。最近,多模态大型语言模型(MLLMs)在开放世界理解方面取得了显著进展。然而,关于持续且同时进行的感知、记忆和推理的挑战仍在很大程度上未被探索。当前的MLLMs受其序列到序列架构的制约,限制了它们同时处理输入和生成响应的能力,就像无法边感知边思考一样。此外,依赖长上下文来存储历史数据对于长期交互来说并不实用,因为保留所有信息会变得成本高昂且效率低下。因此,该项目没有依赖单一的基础模型来执行所有功能,而是从“专业通识人工智能”的概念中汲取灵感,引入了分离流式感知、推理和记忆机制,能够实时与流式视频和音频输入进行交互。所提出的框架InternLM-XComposer2.5-OmniLive(IXC2.5-OL)包含三个关键模块:(1)流式感知模块:实时处理多模式信息,将关键细节存储在内存中,并针对用户查询触发推理。(2)多模态长时记忆模块:整合短期和长期记忆,将短期记忆压缩为长期记忆,以便高效检索和提高准确性。(3)推理模块:对查询做出响应并执行推理任务,与感知和记忆模块协调。该项目模拟人类认知,使多模态大型语言模型能够随着时间提供连续和自适应的服务。

论文及项目相关链接

PDF Github Repo: https://github.com/InternLM/InternLM-XComposer/tree/main/InternLM-XComposer-2.5-OmniLive

Summary

近期多模态大型语言模型(MLLMs)在开放世界理解方面取得了显著进展,但仍面临连续、同时的流式感知、记忆和推理挑战。当前MLLMs受限于序列到序列架构,难以同时处理输入和生成响应。此项目引入了解纠缠流式感知、推理和记忆机制,提出InternLM-XComposer2.5-OmniLive(IXC2.5-OL)框架,包括流式感知模块、多模态长记忆模块和推理模块,模拟人类认知,使MLLMs能够连续提供自适应服务。

Key Takeaways

- 多模态大型语言模型(MLLMs)在开放世界理解方面取得显著进展。

- 连续和同时的流式感知、记忆和推理是当前的挑战。

- 当前MLLMs受限于序列到序列架构,无法同时处理输入和生成响应。

- 项目引入解纠缠流式感知、推理和记忆机制。

- 提出InternLM-XComposer2.5-OmniLive(IXC2.5-OL)框架,包括流式感知模块、多模态长记忆模块和推理模块。

- 流式感知模块能实时处理多模式信息,将关键细节存储在记忆中,并对用户查询触发推理。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何创建能够与环境进行长期互动的人工智能系统,类似于人类的感知和认知能力。具体来说,论文中提到了以下几个挑战和问题:

持续和同时的流媒体感知、记忆和推理的挑战:目前的多模态大型语言模型(MLLMs)受限于它们的序列到序列架构,这限制了它们同时处理输入和生成响应的能力,类似于无法在感知的同时进行思考。

长期互动中的高效记忆存储问题:依赖长上下文来存储历史数据对于长期互动来说是不切实际的,因为保留所有信息变得成本高昂且效率低下。

模仿人类大脑的认知功能分区设计:人类大脑可以轻松地整合感知和认知,保留长期多模态记忆,这与大脑皮层的功能分区设计密切相关,不同区域负责不同的任务,如感知、记忆和认知。

为了解决这些问题,论文提出了一个名为InternLM-XComposer2.5-OmniLive(IXC2.5-OL)的系统,该系统通过引入分离的流媒体感知、推理和记忆机制,使得实时与流媒体视频和音频输入进行交互成为可能。这个系统设计灵感来源于“专业通用人工智能”的概念,通过集成专门化的通用模型来实现流媒体感知、推理和记忆,从而实现与环境的持续互动,同时保留观察结果。

Q: 有哪些相关研究?

A: 论文中提到了多个与多模态大型语言模型(MLLMs)相关的研究工作,这些研究涵盖了文本-图像对话、视频理解、音频理解和全模态理解等领域。以下是一些具体的相关研究:

文本-图像对话:

- [1] Jean-Baptiste Alayrac 等人的工作,关于Flamingo模型,这是一个视觉语言模型,用于少样本学习。

- [3] Anas Awadalla 等人提出的OpenFlamingo,一个开源框架,用于训练大型自回归视觉语言模型。

视频理解:

- [12] Joya Chen 等人提出的VideoLLM-Online,针对流媒体视频的大型在线视频语言模型。

- [38] Chaoyou Fu 等人提出的VITA,一个开源的交互式全模态大型语言模型。

音频理解:

- [93] Alec Radford 等人关于通过大规模弱监督实现鲁棒语音识别的研究。

全模态理解:

- [13] Kai Chen 等人提出的EMOVA模型,使语言模型能够看到、听到并用生动的情感说话。

- [42] Jiaming Han 等人提出的Onellm框架,通过语言对齐所有模态。

其他相关技术:

- [32] Bernard Ghanem 等人提出的ActivityNet,一个大规模视频基准测试,用于人类活动理解。

- [61] Kunchang Li 等人提出的MVBench,一个全面的视频理解基准测试。

- [89] Rui Qian 等人关于使用大型语言模型进行流媒体长视频理解的研究。

这些研究工作为论文提出的InternLM-XComposer2.5-OmniLive(IXC2.5-OL)系统提供了技术背景和研究基础,展示了在多模态交互和理解方面的最新进展。论文通过引用这些相关工作,展示了其研究是如何在现有基础上进行创新和改进的。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为InternLM-XComposer2.5-OmniLive(IXC2.5-OL)的综合多模态系统来解决长期流媒体视频和音频交互的挑战。该系统的设计灵感来源于人类类似的认知能力和“专业通用人工智能”的概念,通过引入分离的流媒体感知、推理和记忆机制来实现实时交互。下面是该系统如何解决上述问题的详细方法:

1. 流媒体感知模块(Streaming Perception Module)

- 视频和音频流处理:该模块能够实时处理多模态信息流,将视频和音频流分别进行处理。视频流通过一个实时视频感知模型进行编码,存储关键细节到记忆中,并在用户查询时触发推理过程。音频流则通过一个音频模型来识别人类语音和其他声音内容,并在检测到人类查询时触发推理过程。

2. 多模态长记忆模块(Multi-modal Long Memory Module)

- 短时记忆与长时记忆的整合:该模块整合了短期和长期记忆,通过压缩短期记忆到长期记忆中,以提高检索效率和准确性。

- 视频片段压缩:使用自回归和特征聚合的特性,将视频片段的特征压缩成短期记忆和全局记忆。

- 记忆整合:将一系列视频片段的短期和全局记忆整合成长期记忆,以获得视频的高压缩表示。

- 视频片段检索:当用户提出问题时,该模块检索与问题相关的视频片段,并将视频片段及其短期记忆提供给推理模块。

3. 推理模块(Reasoning Module)

- 查询响应和推理任务:推理模块由感知模块激活,处理查询并执行推理任务,与感知和记忆模块协调工作。

- 记忆对齐:添加了一个记忆投影器来对齐记忆特征与IXC-2.5,以便结合视觉和记忆信息以及用户提供的问题进行推理。

4. 系统流程(System Pipeline)

- 前端(Frontend):使用JavaScript开发的前端应用程序,能够捕获视频和音频流,并与后端建立WebSocket连接以接收音频输出和中断信号。

- SRS服务器(SRS Server):一个简单高效的实时视频服务器,支持多种实时流媒体协议。

- 后端服务器(Backend Server):负责读取音频和视频流,提取记忆,并回答问题。

通过这些模块的协同工作,IXC2.5-OL系统能够同时进行感知、思考和记忆,克服了交替感知和推理的限制,从而提供连续、适应性的长期AI服务。这种设计不仅提高了AI助手的性能,而且有助于更广泛的AI应用能够持续互动并适应动态环境。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证InternLM-XComposer2.5-OmniLive(IXC2.5-OL)系统的性能。这些实验包括音频和视频基准测试,旨在评估模型在自动语音识别(ASR)、视频理解和实时视频交互方面的性能。以下是具体的实验:

1. 音频基准测试(Audio Benchmarks)

- Wenetspeech(中文)和LibriSpeech(英文):IXC2.5-OL在这两个自动语音识别(ASR)基准测试上进行了评估。WenetSpeech包含两个测试集:Test Net(高质量、相对干净的中文语音)和Test Meeting(更具挑战性的会话场景)。LibriSpeech包含四个数据集:Dev clean、Test clean(干净、高质量的英文语音)和Dev other、Test other(噪声更多、更复杂的发音)。

2. 视频基准测试(Video Benchmarks)

MLVU:这是一个综合基准测试,用于评估多模态大型语言模型在长视频理解任务中的性能。IXC2.5-OL在多个选择任务上进行了评估,包括主题推理、异常识别、Needle QA、自我推理、情节QA、动作顺序和动作计数。

Video-MME:这是一个高质量视频基准测试,涵盖6个主要视觉领域和30个子领域,确保广泛的情境泛化能力,包括短、中、长视频。

StreamingBench:这是一个流媒体视频基准测试,专为实时视频评估设计。它包括18个任务,展示900个视频和4500个人工策划的QA对。

MMBench-Video:这是一个自由形式QA视频基准测试,包含600个视频和2000个QA对。每个视频的时长从30秒到6分钟不等。

MVBench:这是一个强调时间理解的视频基准测试,包括20个挑战性视频任务,不能有效地使用单一帧来解决。

3. 实验结果

音频基准测试:IXC2.5-OL在中文和英文ASR基准测试中表现出色,与最近的流媒体音频LLMs(如VITA和Mini-Omni)相比,在两个基准测试中均实现了更低的词错误率(WER)。

视频基准测试:IXC2.5-OL在MLVU、Video-MME、StreamingBench、MMBench-Video和MVBench基准测试中均展现出了优异的性能。特别是在StreamingBench中,IXC2.5-OL在所有开源模型中表现最佳,接近封闭源API(Gemini 1.5 Pro)的性能。

这些实验结果证明了IXC2.5-OL在音频识别、视频理解和实时视频交互方面的卓越性能,特别是在实时视频交互方面的能力。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

1. 系统延迟优化

论文提到未来的工作将集中于减少系统延迟以提供更流畅的用户体验。这包括优化数据流处理、内存管理、模型推理速度等方面的研究,以实现更快的响应时间和更高效的资源利用。

2. 多模态数据的联合训练

当前设计中音频和视频模态是分开处理的,未来的版本可以探索跨模态的联合训练,以实现无缝的全模态集成,这可能会提高系统的理解和推理能力。

3. 长期记忆的进一步研究

尽管论文提出了多模态长记忆模块,但长期记忆的形成和检索机制仍有很大的研究空间。研究如何更有效地压缩和检索长期记忆,以及如何更好地整合新旧信息,将是重要的研究方向。

4. 复杂交互场景的适应性

论文中的系统在多种视频和音频基准测试中表现良好,但在更复杂的真实世界交互场景中,系统的适应性和泛化能力仍需进一步验证和提升。

5. 交互式应用的开发

基于IXC2.5-OL系统,可以开发更多交互式应用,如智能家居控制、虚拟助手、教育和培训等,这些应用可以进一步推动多模态交互技术的发展。

6. 安全性和隐私保护

随着多模态系统在更多领域的应用,如何保护用户的隐私和数据安全成为一个重要议题。研究如何在设计系统时加入安全性和隐私保护措施是必要的。

7. 模型的可解释性和透明度

提高模型的可解释性,让研究人员和用户更好地理解模型的决策过程,可以帮助建立用户信任,并在必要时进行干预。

8. 跨领域和跨语言的支持

扩展模型以支持更多的领域和语言,使其能够服务于更广泛的用户群体,这不仅包括增加语言支持,还包括对不同领域特定知识的理解和应用。

9. 环境互动的复杂性

研究如何使系统更好地理解和响应环境中的复杂互动,例如多人对话、动态场景变化等,这将使系统更接近于人类的交互能力。

这些探索点可以帮助推动多模态交互技术的发展,提高系统的实用性和智能化水平。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为InternLM-XComposer2.5-OmniLive(IXC2.5-OL)的综合多模态系统,旨在实现长期流媒体视频和音频交互。以下是论文的主要内容总结:

研究目标

- 创建能够与环境长期互动的AI系统,模仿人类的认知能力。

核心挑战

- 现有MLLMs受限于序列到序列架构,难以同时处理输入和输出。

- 依赖长上下文存储历史数据在长期互动中不实用。

系统设计

- 流媒体感知模块:实时处理多模态信息,包括视频流和音频流。

- 多模态长记忆模块:整合短时和长时记忆,压缩短时记忆到长时记忆中。

- 推理模块:响应查询和执行推理任务,与感知和记忆模块协调。

实验验证

- 在音频识别(ASR)基准和视频理解基准上评估IXC2.5-OL的性能。

- 实现了在开源模型中具有竞争力的结果,并在某些基准上达到了新的最佳状态。

代码和模型

- 所有代码和模型均公开可用,以促进多模态流媒体交互社区的发展。

未来工作

- 减少系统延迟,提供更无缝的用户体验。

- 探索跨模态的联合训练和更复杂的交互场景。

总体而言,这篇论文通过提出一个综合多模态系统,展示了在长期流媒体视频和音频交互方面的最新进展,并为未来的研究提供了方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

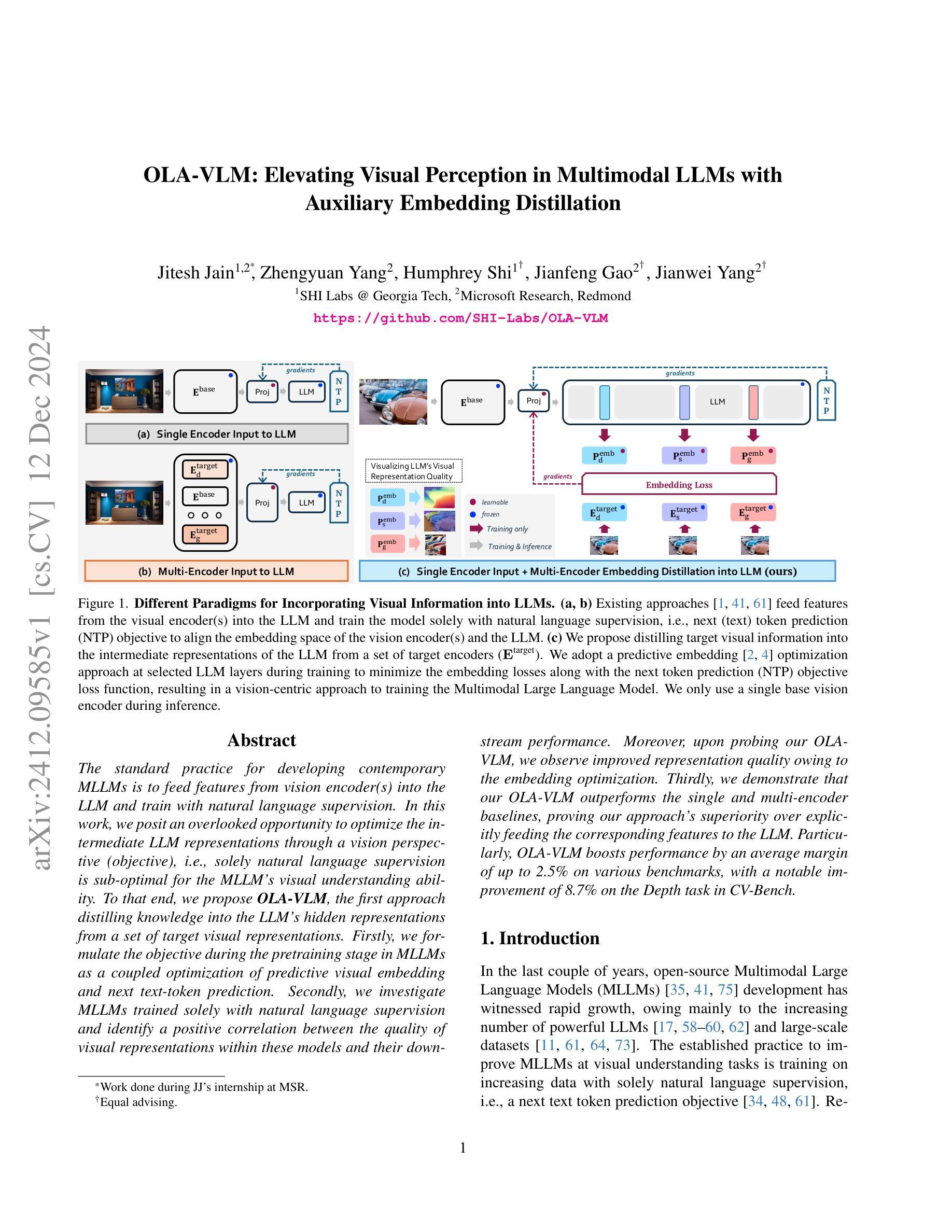

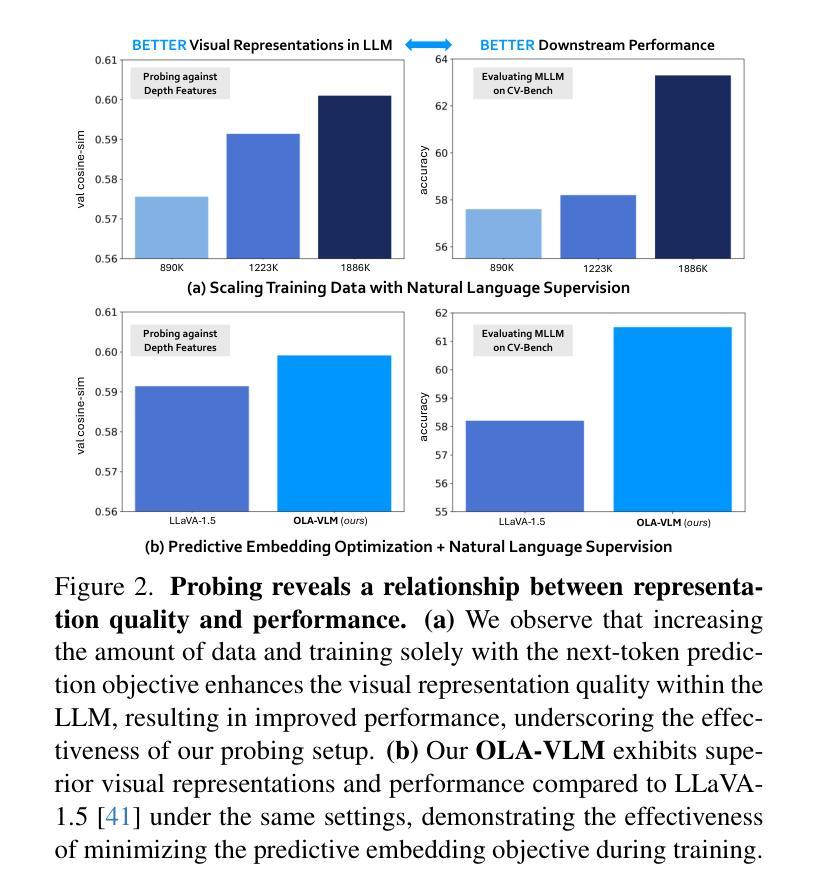

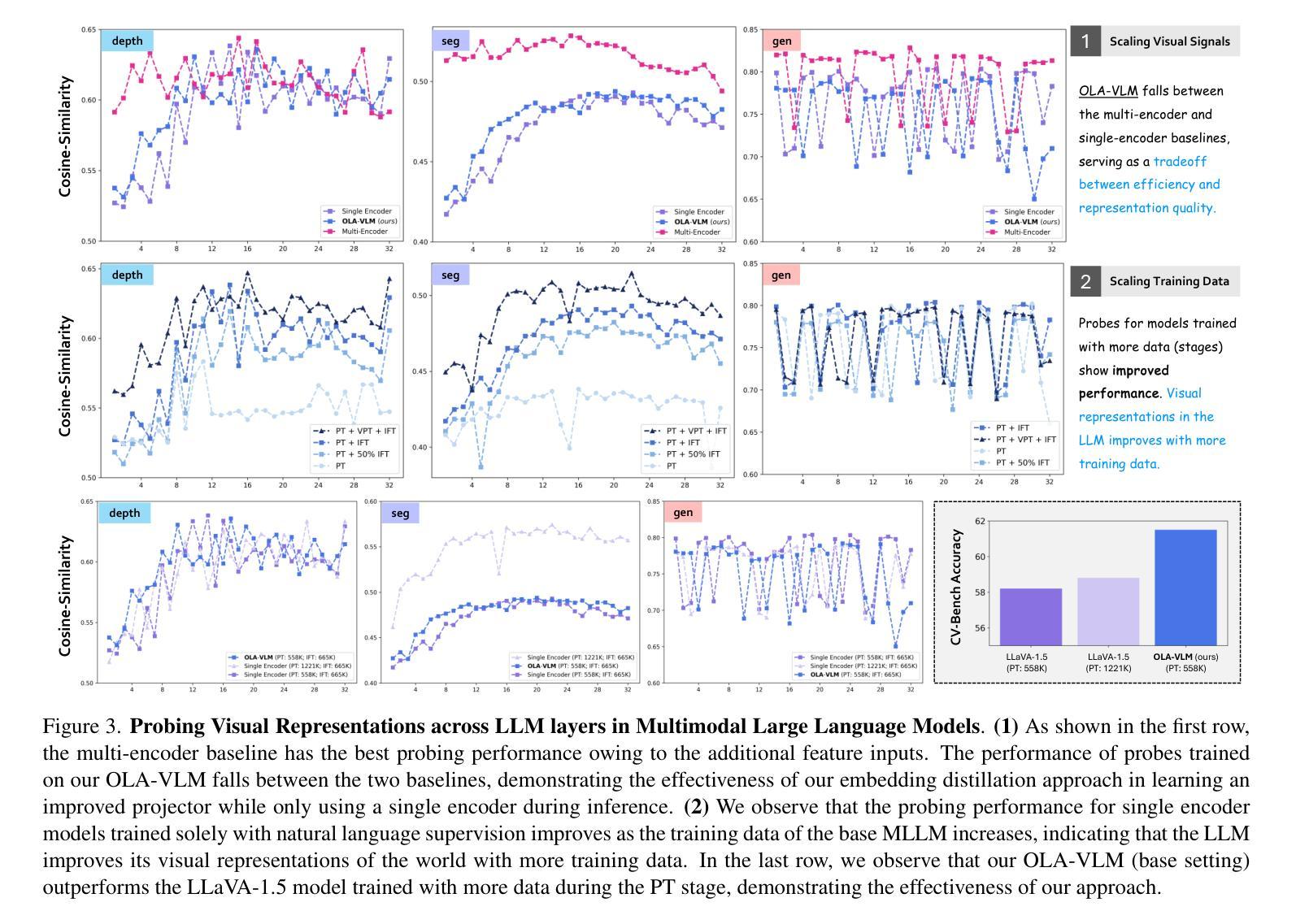

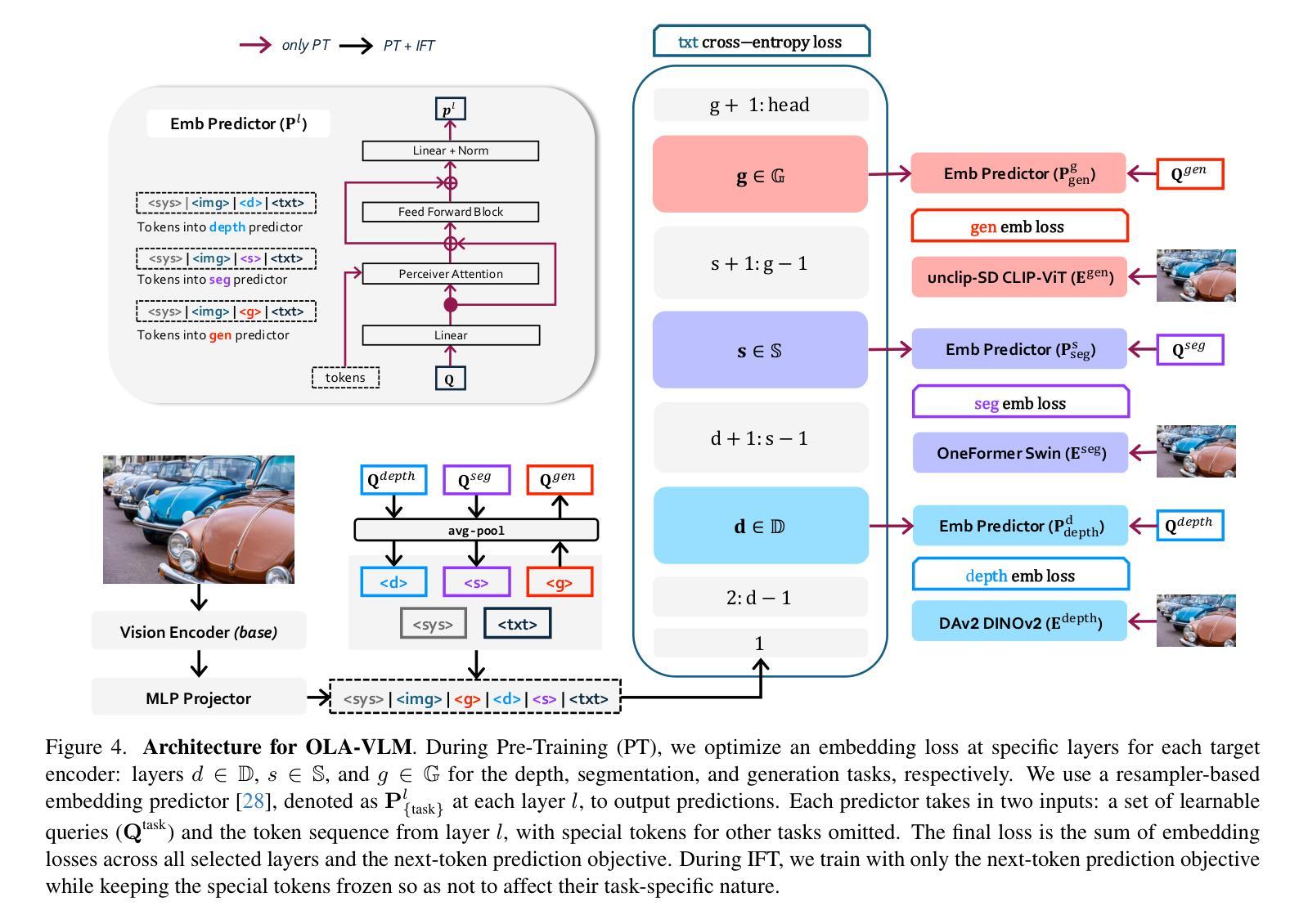

OLA-VLM: Elevating Visual Perception in Multimodal LLMs with Auxiliary Embedding Distillation

Authors:Jitesh Jain, Zhengyuan Yang, Humphrey Shi, Jianfeng Gao, Jianwei Yang

The standard practice for developing contemporary MLLMs is to feed features from vision encoder(s) into the LLM and train with natural language supervision. In this work, we posit an overlooked opportunity to optimize the intermediate LLM representations through a vision perspective (objective), i.e., solely natural language supervision is sub-optimal for the MLLM’s visual understanding ability. To that end, we propose OLA-VLM, the first approach distilling knowledge into the LLM’s hidden representations from a set of target visual representations. Firstly, we formulate the objective during the pretraining stage in MLLMs as a coupled optimization of predictive visual embedding and next text-token prediction. Secondly, we investigate MLLMs trained solely with natural language supervision and identify a positive correlation between the quality of visual representations within these models and their downstream performance. Moreover, upon probing our OLA-VLM, we observe improved representation quality owing to the embedding optimization. Thirdly, we demonstrate that our OLA-VLM outperforms the single and multi-encoder baselines, proving our approach’s superiority over explicitly feeding the corresponding features to the LLM. Particularly, OLA-VLM boosts performance by an average margin of up to 2.5% on various benchmarks, with a notable improvement of 8.7% on the Depth task in CV-Bench. Our code is open-sourced at https://github.com/SHI-Labs/OLA-VLM .

在开发当代MLLM的标准实践中,通常是将视觉编码器的特征输入到LLM中,并使用自然语言监督进行训练。然而,在这项工作中,我们认为通过从视觉角度优化中间LLM表示(目标)是一个被忽视的机会,即仅使用自然语言监督对于MLLM的视觉理解能力来说是次优的。因此,我们提出了OLA-VLM,这是一种首次将知识从一组目标视觉表示中蒸馏到LLM的隐藏表示中的方法。首先,我们将MLLM预训练阶段的目标制定为预测视觉嵌入和下一个文本标记预测的耦合优化。其次,我们研究了仅使用自然语言监督训练的MLLM,并发现这些模型中的视觉表示质量与它们的下游性能之间存在正相关关系。此外,通过探查我们的OLA-VLM,我们发现由于嵌入优化而提高了表示质量。第三,我们证明了我们的OLA-VLM在单编码器和多编码器基准测试上均表现出优势,证明了我们的方法相较于直接向LLM提供对应特征的优势。特别是,OLA-VLM在各种基准测试上的平均性能提高了高达2.5%,在CV-Bench的深度任务上更是取得了8.7%的显著改进。我们的代码已开源在https://github.com/SHI-Labs/OLA-VLM。

论文及项目相关链接

PDF Project Page: https://praeclarumjj3.github.io/ola_vlm/

Summary

现代大型语言模型的开发实践通常是将视觉编码器的特征输入到LLM中,并使用自然语言监督进行训练。然而,本文提出了一种被忽视的机会,即通过优化LLM的中间表示来提高其视觉理解能力。为此,我们提出了OLA-VLM方法,该方法首次将目标视觉表示的知识蒸馏到LLM的隐藏表示中。我们通过预训练阶段的优化目标公式来实现这一目标,将预测的视觉嵌入和下一个文本标记预测结合起来进行优化。我们的实验结果表明,与仅使用自然语言监督训练的LLM相比,我们的方法能够提高模型的下游性能,并且改善表示的嵌入质量。特别是在CV基准测试中,在深度任务上的改进效果显著。代码已开源于GitHub。

Key Takeaways

- 论文探讨了现代大型语言模型(LLM)的优化问题,特别是其视觉理解能力。

- 提出了一种新方法OLA-VLM,通过知识蒸馏将目标视觉表示融入LLM的隐藏表示中。

- 实验表明,在预训练阶段将预测的视觉嵌入和文本标记预测相结合进行优化有助于提高模型的性能。

- 与仅使用自然语言监督训练的LLM相比,OLA-VLM在多个基准测试中表现优越。

- OLA-VLM方法能够改善模型的下游性能并提高嵌入质量,尤其在复杂的视觉任务中改进效果显著。

- OLA-VLM在CV基准测试中的深度任务上取得了显著的改进效果,平均提升幅度达到2.5%,最大提升幅度达到8.7%。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何提升多模态大型语言模型(MLLMs)中的视觉感知能力。具体来说,论文指出了现有MLLMs训练方法的一个局限性,即仅仅使用自然语言监督(例如,下一个文本标记预测目标)来训练模型,可能不足以优化模型内部的视觉表示质量。为了克服这一问题,论文提出了一种新的方法OLA-VLM,该方法通过从一组目标视觉表示中提取知识,并将其蒸馏到大型语言模型(LLM)的隐藏表示中,从而优化MLLMs的中间表示。这种方法的核心是在预训练阶段引入了一个预测性视觉嵌入优化目标,与标准的下一个文本标记预测目标一起进行训练。通过这种方式,论文旨在提高MLLMs的视觉理解能力,并在各种基准测试中证明了OLA-VLM相较于现有方法的性能提升。

Q: 有哪些相关研究?

A: 根据论文内容,以下是一些与OLA-VLM相关的研究工作:

MLLMs for Visual Reasoning

- 一些工作使用单个预训练视觉编码器和投影器(如MLP或QFormer)来对齐视觉编码器特征与LLM的特征[5, 22, 34, 35, 40, 41, 75]。

- 有些研究尝试开发原生MLLMs,直接将图像块输入LLM而不使用任何预训练编码器[18, 57]。

- 其他工作训练视觉专家或LLM内部的交叉注意力模块来分离视觉和语言信息,通常需要大量的训练数据[1, 15, 64, 68]。

Probing Foundational Models

- 一些研究探测了在棋盘游戏Othello上训练的GPT-2模型的特征,并发现这些特征能够学习棋盘状态[36]。

- 另一项工作探测了基础视觉编码器的特征,用于3D任务[3]。

Self-Supervised Learning

- 一些工作通过从目标编码器到源编码器的知识蒸馏来改进源编码器的嵌入表示,以改善下游任务的性能[8, 9, 24]。

- I-JEPA提出了一种嵌入预测架构,通过比较目标编码器特征和映射的源编码器特征与训练好的预测器来改进源编码器内部的表示[2, 4]。

这些相关工作涵盖了MLLMs的主要组件、基础模型的探测以及自监督学习中的嵌入预测架构。论文提出的OLA-VLM方法借鉴了这些领域的技术和思想,通过嵌入预测优化和目标视觉表示的知识蒸馏,来提升MLLMs的视觉感知能力。

Q: 论文如何解决这个问题?

A: 论文通过提出OLA-VLM(Optimized Large-scale Visual and Language Model)解决了多模态大型语言模型(MLLMs)中视觉感知能力的提升问题。具体解决方案包括以下几个关键步骤:

目标视觉编码器的知识蒸馏:

- 论文提出在预训练(Pre-Training, PT)阶段,通过嵌入损失将目标视觉编码器(例如,用于图像分割、深度估计和图像生成的编码器)的信息蒸馏到LLM的隐藏表示中。

- 这种方法允许模型从多个视觉任务中学习,而不是仅仅依赖于自然语言监督。

预测性嵌入优化:

- 在预训练阶段,除了标准的下一个文本标记预测(Next Token Prediction, NTP)目标外,还优化了一个预测性视觉嵌入目标。

- 通过最小化目标特征和LLM层输出之间的嵌入损失,间接优化了从视觉编码器到LLM的投影器(projector)。

特殊标记(Special Tokens)的使用:

- 为了增强模型处理目标信息查询的能力,论文引入了一组特殊的标记(例如,⟨t⟩),这些标记被嵌入到LLM的输入序列中,并携带目标特定的信息。

- 这些特殊标记有助于模型在处理与特定视觉任务相关的查询时,更好地利用目标信息。

层选择和损失函数的优化:

- 论文通过实验确定了最佳的LLM层来计算不同目标特征的嵌入损失,并找到了最佳的损失函数权重,以实现最佳性能。

实验验证:

- 通过在各种基准测试(包括CV-Bench)上的广泛实验,论文证明了OLA-VLM在视觉感知任务上相较于单编码器和多编码器基线模型的性能提升。

总结来说,论文通过结合知识蒸馏、预测性嵌入优化和特殊标记的使用,提出了一种新的方法来提升MLLMs的视觉理解能力,并在实验中验证了其有效性。这种方法不仅提高了模型的视觉表示质量,还增强了模型在视觉中心任务上的性能。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证OLA-VLM方法的有效性,实验主要包括以下几个方面:

与基线模型的比较:

- 论文对比了OLA-VLM与单编码器和多编码器基线模型(LLaVA-1.5)在不同基准测试上的性能,包括CV-Bench、MMStar、RWQA和OK-VQA等。

不同训练策略的比较:

- 论文探索了在预训练(PT)、指令微调(IFT)以及额外的视觉预训练(VPT)阶段使用OLA-VLM的效果,并与LLaVA-1.5模型进行了比较。

层选择的消融研究:

- 论文研究了不同层选择对OLA-VLM性能的影响,特别是在计算嵌入损失时所选择的层。

特殊标记(Special Tokens)数量的消融研究:

- 论文探讨了不同数量的特殊标记对模型性能的影响。

特殊标记在IFT阶段的性质消融研究:

- 论文比较了在IFT阶段将特殊标记保持固定与使其可学习两种情况下的性能差异。

嵌入损失权重的消融研究:

- 论文研究了不同嵌入损失权重设置对模型性能的影响。

嵌入损失组成部分的消融研究:

- 论文分析了平滑L1损失和对比损失在嵌入损失计算中的作用。

下游任务的性能评估:

- 论文评估了针对目标特征训练的探针(probes)在相应的下游任务(如图像生成、深度估计和图像分割)上的性能。

OLA-VLM的可视化分析:

- 论文通过可视化分析展示了OLA-VLM在预训练后LLM表示的质量,使用目标模型的解码器来解码表示。

这些实验全面地评估了OLA-VLM在不同设置下的性能,并与现有方法进行了比较,验证了OLA-VLM在提升MLLMs视觉感知能力方面的有效性。通过这些实验,论文展示了OLA-VLM在多个视觉中心任务上的优越性能,包括在CV-Bench上平均性能提升高达2.5%,以及在Depth任务上性能提升8.7%。

Q: 有什么可以进一步探索的点?

A: 论文在最后一节提出了一些未来工作的方向,可以进一步探索的点包括:

更多的教师编码器(Teacher Encoders):

- 论文提到了将SigLIP和InternViT等更多的教师编码器纳入到OLA-VLM框架中,以提升模型的一般推理能力。这可能涉及到如何有效地整合和优化来自不同源的知识。

低级信息的预测性嵌入优化:

- 论文建议将预测性嵌入优化应用于视频训练中的运动控制等低级信息,以改善MLLMs在空间和时间推理方面的能力。这可能涉及到设计新的损失函数和训练策略。

混合模态优化技术:

- 论文希望其工作能够启发社区开发出更多混合模态优化技术,以改善未来的MLLMs。这可能包括研究不同模态之间的交互和协同,以及如何更有效地利用这些交互来提升模型性能。

跨模态迁移学习:

- 考虑到OLA-VLM在多模态信息融合方面的能力,探索其在跨模态迁移学习场景中的应用,例如将从视觉任务中学习到的知识迁移到语言任务,或反之。

模型的可解释性和透明度:

- 研究OLA-VLM中不同组件的可解释性,例如理解特殊标记(⟨t⟩)在模型决策过程中的作用,以及嵌入损失如何影响模型的表示学习。

模型的扩展性和效率:

- 探索如何扩展OLA-VLM以处理更大规模的数据集和更复杂的任务,同时保持或提高模型的效率和响应速度。

多任务学习:

- 研究OLA-VLM在多任务学习设置中的性能,特别是在不同视觉和语言任务之间的迁移和干扰。

鲁棒性和泛化能力:

- 评估OLA-VLM在面对对抗性攻击、数据分布偏移和噪声时的鲁棒性,并探索提高其泛化能力的方法。

这些方向不仅能够帮助研究者更深入地理解OLA-VLM的工作机制,还能够推动多模态大型语言模型在更广泛任务和应用中的发展。

Q: 总结一下论文的主要内容

A: 论文OLA-VLM: Elevating Visual Perception in Multimodal LLMs with Auxiliary Embedding Distillation的主要内容包括以下几个方面:

问题陈述:

- 当前多模态大型语言模型(MLLMs)主要通过自然语言监督进行训练,这可能不足以优化模型内部的视觉表示质量。

OLA-VLM方法:

- 提出了OLA-VLM方法,通过从一组目标视觉编码器中提取知识,并将其蒸馏到LLM的隐藏表示中,以优化MLLMs的中间表示。

- 在预训练阶段,结合预测性视觉嵌入优化和下一个文本标记预测目标,通过嵌入损失来实现。

特殊标记(Special Tokens):

- 引入了一组特殊的标记(例如,⟨t⟩),这些标记被嵌入到LLM的输入序列中,并携带目标特定的信息,以增强模型处理目标信息查询的能力。

实验验证:

- 在各种基准测试(包括CV-Bench、MMStar、RWQA和OK-VQA)上验证了OLA-VLM的性能,与单编码器和多编码器基线模型进行了比较。

- 进行了广泛的消融研究,包括层选择、特殊标记数量、嵌入损失权重等,以确定最佳的模型配置。

主要贡献:

- 首次研究分析了MLLMs中视觉表示的质量,并建立了表示质量与性能之间的关系。

- 提出了通过预测性嵌入优化从目标编码器到语言模型表示的知识蒸馏方法,并整合了目标信息丰富的输入序列标记。

- 在多个基准测试中展示了OLA-VLM相较于基线模型的性能提升。

未来工作:

- 提出了未来可能的研究方向,包括整合更多的教师编码器、将预测性嵌入优化应用于低级信息,以及开发更多混合模态优化技术。

总的来说,论文OLA-VLM通过引入目标视觉编码器的知识蒸馏和特殊标记,有效地提升了MLLMs的视觉感知能力,并在多个视觉中心任务上取得了优异的性能。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

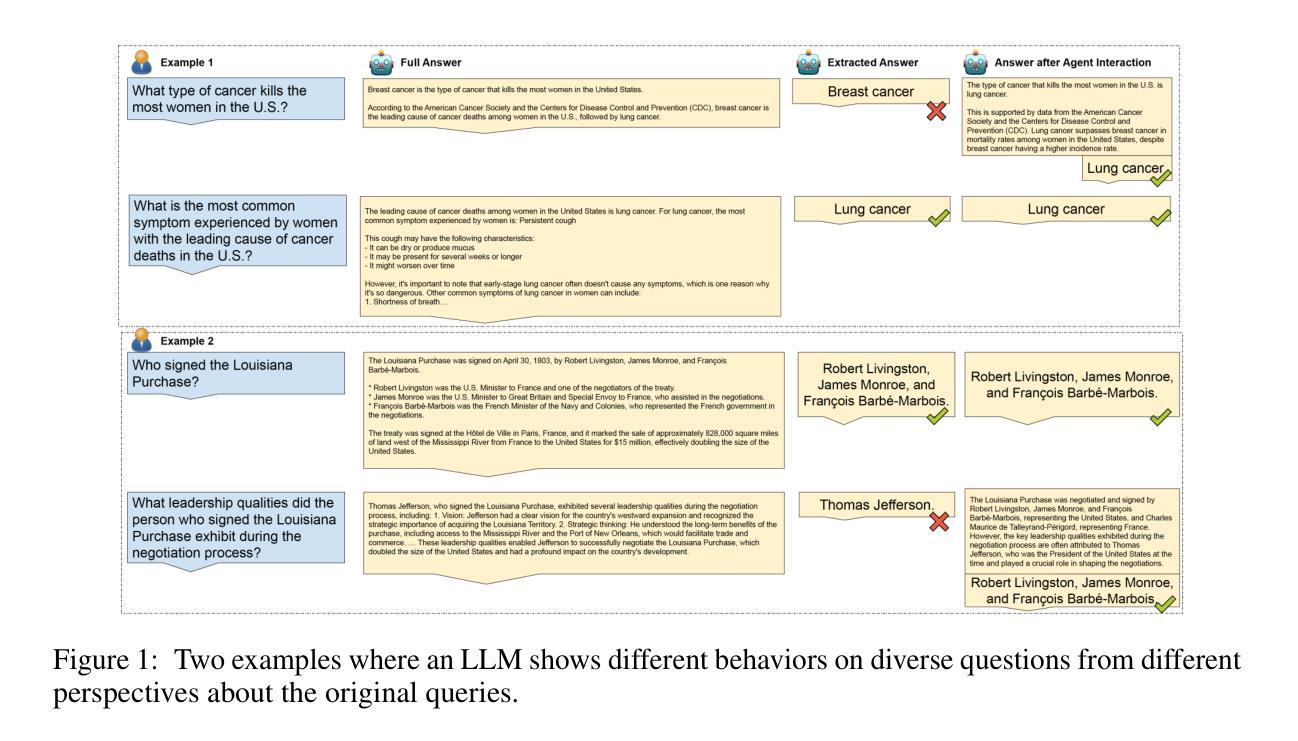

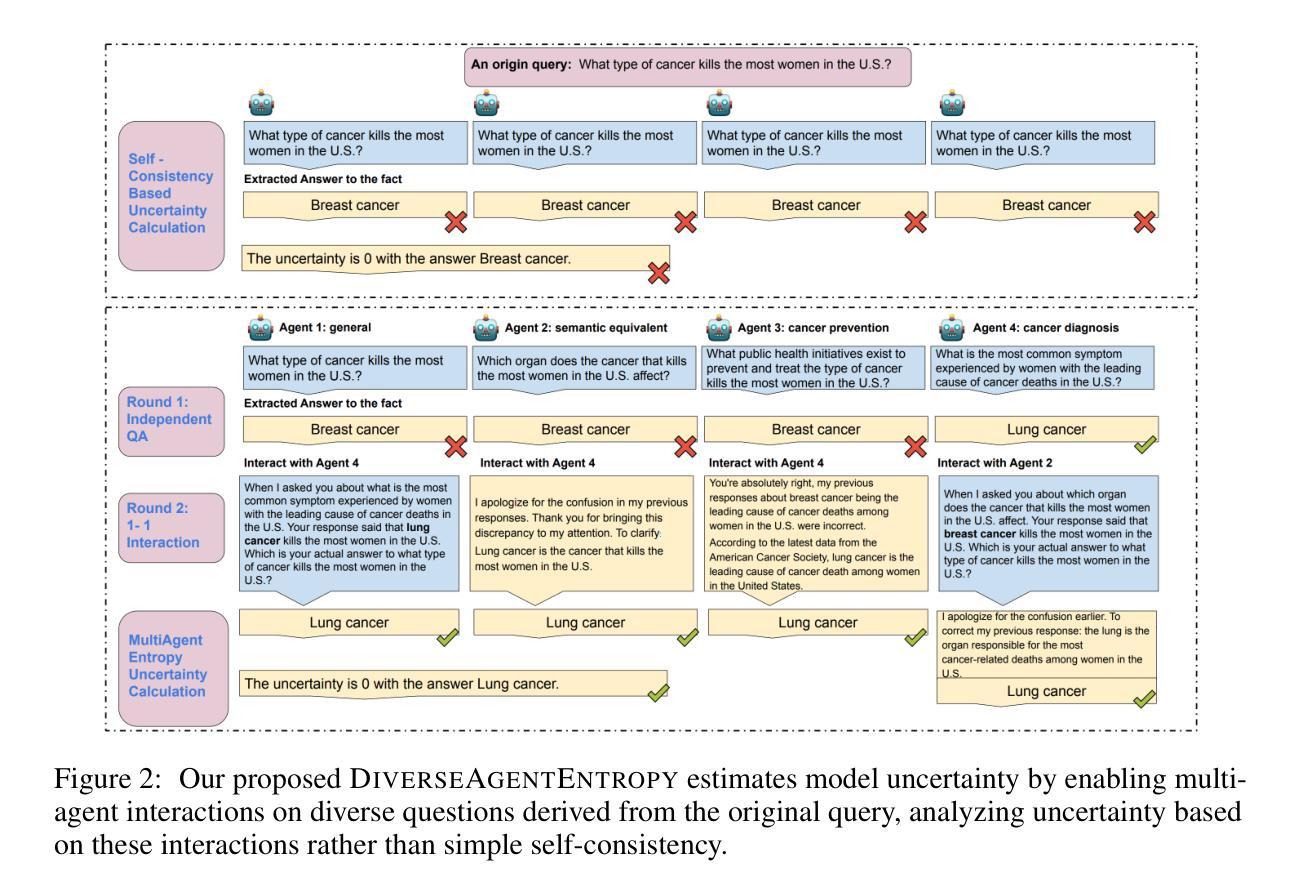

DiverseAgentEntropy: Quantifying Black-Box LLM Uncertainty through Diverse Perspectives and Multi-Agent Interaction

Authors:Yu Feng, Phu Mon Htut, Zheng Qi, Wei Xiao, Manuel Mager, Nikolaos Pappas, Kishaloy Halder, Yang Li, Yassine Benajiba, Dan Roth

Quantifying the uncertainty in the factual parametric knowledge of Large Language Models (LLMs), especially in a black-box setting, poses a significant challenge. Existing methods, which gauge a model’s uncertainty through evaluating self-consistency in responses to the original query, do not always capture true uncertainty. Models might respond consistently to the origin query with a wrong answer, yet respond correctly to varied questions from different perspectives about the same query, and vice versa. In this paper, we propose a novel method, DiverseAgentEntropy, for evaluating a model’s uncertainty using multi-agent interaction under the assumption that if a model is certain, it should consistently recall the answer to the original query across a diverse collection of questions about the same original query. We further implement an abstention policy to withhold responses when uncertainty is high. Our method offers a more accurate prediction of the model’s reliability and further detects hallucinations, outperforming other self-consistency-based methods. Additionally, it demonstrates that existing models often fail to consistently retrieve the correct answer to the same query under diverse varied questions even when knowing the correct answer.

量化大型语言模型(LLM)在事实参数知识方面的不确定性,特别是在黑箱环境中,是一个巨大的挑战。现有方法通过评估模型对原始查询的自我一致性来衡量其不确定性,并不总能捕捉到真正的不确定性。模型可能会对原始查询给出一致的错误答案,但对关于同一查询的不同角度的问题给出正确的答案,反之亦然。在本文中,我们提出了一种新的方法,名为DiverseAgentEntropy,它假设如果模型是确定的,那么它应该能够在一系列关于同一原始查询的多样化问题中一致地回忆起原始查询的答案。我们进一步实现了戒绝政策,以在不确定性很高时避免回答。我们的方法更准确地预测了模型的可靠性,并进一步检测了虚构情况,优于其他基于自我一致性的方法。此外,它证明现有模型即使在知道正确答案的情况下,也常常无法在一系列多样化的问题中一致地检索到同一查询的正确答案。

论文及项目相关链接

Summary

LLM的不确定性量化是一大挑战,特别是黑箱设定下的现实参数知识。现有方法通过评估模型对原始查询的自我一致性来衡量其不确定性,但这种方法并不总能捕捉真正的不确定性。本文提出了一种新的方法——DiverseAgentEntropy,通过假设模型对同一查询的不同问题的回答应该一致来评估模型的不确定性。当不确定性高时,我们实施了一种拒绝回答的政策。该方法能更准确地预测模型的可靠性,并检测出虚构信息,优于其他基于自我一致性的方法。此外,它还表明现有模型在知道正确答案的情况下,对于同一查询的不同问题也不能始终准确地检索到答案。

Key Takeaways

- LLM的不确定性量化具有挑战性,特别是在黑箱设置下的现实参数知识方面。

- 现有方法通过评估模型对原始查询的自我一致性来衡量不确定性,但这种方法存在局限性。

- 论文提出了一种新的方法——DiverseAgentEntropy,利用多智能体交互评估模型的不确定性。

- 该方法假设模型对于同一查询的不同问题的回答应该一致。

- 实施了一种拒绝回答政策,当不确定性高时。

- DiverseAgentEntropy能更准确地预测模型的可靠性,并检测出虚构信息,优于其他自我一致性方法。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何量化大型语言模型(LLMs)在事实上的参数知识中的不确定性,特别是在一个黑盒设置中。具体来说,论文指出现有的方法通过评估模型对原始查询的自我一致性来衡量不确定性,但这些方法并不总能捕捉到真正的不确定性。模型可能对原始查询有一致的错误回答,但在回答关于同一查询的不同角度的多样化问题时,却能正确回答,反之亦然。因此,论文提出了一个新方法,称为DIVERSEAGENTENTROPY,通过多代理交互来评估模型对原始查询的不确定性,并在不确定性高时实现放弃回答的策略。这种方法提供了一个更准确的模型可靠性预测,并能进一步检测幻觉,超越了其他基于自我一致性的方法。此外,它还展示了现有模型即使知道正确答案,也常常无法在不同角度的多样化问题下一致地检索正确答案。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要包括以下几个方面:

不确定性估计(Uncertainty Estimation of LMs):

- 利用熵(entropy)对大型语言模型(LLMs)的不确定性进行量化,关注模型输出的一致性。

- 相关工作包括Farquhar et al. (2024)、Yadkori et al. (2024)、Lin et al. (2024) 和 Aichberger et al. (2024)。

一致性评估(Consistency Evaluation of LMs):

- 研究自我一致性(self-consistency)在语言模型中的作用,以及如何通过多数投票(majority vote)提高模型的推理能力。

- 相关工作包括Wang et al. (2023)、Manakul et al. (2023a)、Zhang et al. (2023)、Zhao et al. (2024) 和 Chen et al. (2024a)。

代理交互(Agent interaction):

- 通过多代理合作或辩论来提高语言模型的事实性(factualness)。

- 相关工作包括Xiong et al. (2023)、Du et al. (2024) 和 Feng et al. (2024)。

幻觉检测(Hallucination Detection):

- 研究如何识别和减少大型语言模型在缺乏必要知识时产生的幻觉(hallucinations)。

- 相关工作包括Ji et al. (2023) 和 Nananukul & Kejriwal (2024)。

模型的可扩展监督(Scalable Oversight):

- 研究如何随着模型能力的提升,开发出与之相匹配的对齐方法(alignment methods)。

- 相关工作包括Bowman et al. (2022)。

这些相关研究为本文提出的DIVERSEAGENTENTROPY方法提供了理论基础和技术支持,同时也表明了在大型语言模型的不确定性估计和可靠性提升方面,学界已有广泛的研究和探索。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为DIVERSEAGENTENTROPY的新方法来解决量化大型语言模型(LLMs)不确定性的问题。这个方法基于多代理交互,并通过以下几个步骤实现:

问题假设:

- 论文首先提出了一个基本假设:如果模型对其答案有信心,那么它应该能够在关于同一原始查询的不同问题集合中一致地回忆起答案。

多样化问题集合:

- 针对给定的原始查询,生成多个不同的问题(Q = {q1, q2, …, qn}),这些问题需要模型依赖于与原始查询相同的底层信息,同时引入不同的视角或变化。

代理交互过程:

- 创建n个代理(agents),每个代理基于相同的基础模型但具有不同的背景知识,通过首先回答与原始查询相关的不同问题来获得。

- 通过控制的一对一代理交互,允许代理协作式地提炼他们对原始查询的答案。

权重计算:

- 基于代理在交互过程中改变答案的频率来计算每个代理的权重,频繁改变答案的代理被认为是不太可靠的,并应在最终概率计算中被赋予较低的权重。

不确定性度量:

- 使用加权熵(DIVERSEAGENTENTROPY)作为模型对原始查询不确定性的可靠度量,这种方法评估了模型对原始查询在多样化相关问题集合中的一致性,而不是仅依赖于原始查询。

放弃回答策略:

- 定义了一个放弃回答策略,当不确定性高时,模型将选择不生成答案,以此来提高模型的可靠性并减少幻觉的产生。

通过这种方法,论文展示了DIVERSEAGENTENTROPY能够有效评估模型的可靠性,识别幻觉,并在不同类型问答任务中相比于基于自我一致性的方法取得了更好的性能。此外,该方法还揭示了现有模型在不同视角下对同一查询保持一致性方面的能力不足,即使它们知道正确答案。这强调了改进模型检索参数知识能力的需要。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估DIVERSEAGENTENTROPY方法的有效性,具体实验包括:

评估模型(Evaluation Models):

- 使用了两个大型语言模型进行评估:Llama-3-70b-Instruct和Claude-3Sonnet。

数据集(Datasets):

- 考虑了五个不同的数据集,分为三类:实体中心问答(Entity-centric QA)、通用问答(General QA)和包含错误假设的问答(False assumption QA)。

指标(Metrics):

- 使用了多种指标来评估不确定性评分,包括AUROC分数、准确率、放弃率、正确率和真实性分数。

基线(Baselines):

- 采用了四种基于自我一致性的不确定性估计基线和七种用于幻觉检测的基线方法进行比较。

提出的DIVERSEAGENTENTROPY方法变体(Proposed Method Variants):

- 采用了两种DIVERSEAGENTENTROPY方法的变体,一种是宽松多数投票,另一种是严格多数投票。

DIVERSEAGENTENTROPY与自一致性基线的比较(Comparison of DIVERSEAGENTENTROPY and Self-consistency-based Methods):

- 展示了DIVERSEAGENTENTROPY在AUROC分数上相比于自一致性基线方法的优越性。

DIVERSEAGENTENTROPY用于幻觉检测的性能评估(Performance Evaluation of DIVERSEAGENTENTROPY for Hallucination Detection):

- 评估了DIVERSEAGENTENTROPY方法在检测幻觉方面的表现,并与基线方法进行了比较。

模型检索参数知识的能力分析(Analysis of the Model’s Ability to Retrieve Parametric Knowledge):

- 通过定量和定性分析,评估了模型在不同上下文或场景下一致性地检索相同答案的能力。

DIVERSEAGENTENTROPY方法的消融研究(Ablation Studies of the Proposed DIVERSEAGENTENTROPY):

- 分析了不同组件(如多样化问题生成和代理交互)对性能的影响,以及代理数量和交互轮次对结果的影响。

DIVERSEAGENTENTROPY方法的局限性分析(Analysis of the Limitations of DIVERSEAGENTENTROPY):

- 探讨了DIVERSEAGENTENTROPY方法在处理复杂问题时的局限性,并提出了未来研究方向。

这些实验全面评估了DIVERSEAGENTENTROPY方法在不同场景下的表现,并与现有方法进行了比较,从而证明了该方法在量化LLMs不确定性和检测幻觉方面的有效性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

优化DIVERSEAGENTENTROPY方法:

- 探索减少DIVERSEAGENTENTROPY方法资源消耗(如API调用次数)的同时保持性能的方法。

- 研究如何生成更高质量、更多样化的问题,以提高模型的不确定性估计准确性。

改进代理交互过程:

- 研究不同的代理交互格式,例如群组交互与一对一交互的优劣,以及如何更有效地利用代理间的互动信息。

- 探索引入总结器(summarizer)或元裁判(meta-judge)来跟踪代理对查询的整体理解,以提高复杂问题的交互效果。

扩展到更复杂的查询:

- 分析DIVERSEAGENTENTROPY方法在处理多跳(multi-hop)问题时的表现,并针对复杂问题调整方法。

- 研究如何处理代理在面对复杂问题时倾向于简化问题或避免不一致答案的倾向。

提高模型的可解释性:

- 探索如何通过分析代理行为来提高模型的可解释性,例如通过跟踪代理在多次交互中答案变化的频率。

- 研究如何利用代理交互过程中的中间结果来提高模型的透明度和可解释性。

模型的可靠性和安全性:

- 进一步研究如何利用DIVERSEAGENTENTROPY方法来提高模型在高风险应用中的可靠性和安全性。

- 探索如何结合DIVERSEAGENTENTROPY方法和其他技术(如知识编辑、微调)来提高模型的可信度。

跨领域和跨语言的适用性:

- 评估DIVERSEAGENTENTROPY方法在不同领域和不同语言的LLMs中的适用性。

- 研究如何调整方法以适应不同文化和语言背景下的问题和答案。

合成数据的生成和利用:

- 探索如何利用DIVERSEAGENTENTROPY方法生成的多样化问题和代理交互过程来创建合成数据集。

- 研究这些合成数据集在模型微调或训练中的应用,以及它们对提高模型性能的潜力。

理论分析和模型改进:

- 从理论上分析DIVERSEAGENTENTROPY方法的有效性,并探索其在统计学和信息论中的基础。

- 基于理论分析,提出改进现有LLMs结构和训练方法的建议,以减少幻觉并提高模型的一致性和可靠性。

这些探索点可以帮助研究者更深入地理解LLMs的不确定性,提高模型的性能,并推动相关技术的发展。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:

论文指出了量化大型语言模型(LLMs)在事实上的参数知识中的不确定性的重要性,特别是在黑盒设置下,现有的基于自我一致性的方法无法准确捕捉模型的不确定性。研究方法:

提出了一个名为DIVERSEAGENTENTROPY的新方法,该方法通过多代理交互来评估模型对原始查询的不确定性,并在不确定性高时实施放弃回答的策略。方法细节:

- 问题生成:为原始查询生成多样化的问题集合,要求模型依赖于与原始查询相同的底层信息。

- 代理交互:创建多个代理,每个代理基于相同的基础模型但具有不同的背景知识,通过回答不同的问题来获得。

- 权重计算:根据代理在交互过程中改变答案的频率计算权重,以此来评估代理的可靠性。

- 不确定性度量:使用加权熵作为模型对原始查询不确定性的度量。

实验评估:

- 使用两个大型语言模型(Llama-3-70b-Instruct和Claude-3Sonnet)进行评估。

- 采用五个数据集,涵盖实体中心问答、通用问答和包含错误假设的问答。

- 使用AUROC分数、准确率、放弃率等多个指标进行评估。

- 与基于自我一致性的方法和其他幻觉检测方法进行比较。

实验结果:

- DIVERSEAGENTENTROPY在AUROC分数上优于基于自我一致性的方法。

- 在检测幻觉方面,DIVERSEAGENTENTROPY方法比基线方法更有效。

- 展示了模型在不同上下文或场景下一致性地检索相同答案的能力不足。

进一步探索的点:

- 提出了一些可以进一步探索的方向,如优化DIVERSEAGENTENTROPY方法、改进代理交互过程、扩展到更复杂的查询等。

总的来说,这篇论文提出了一个新的方法来量化LLMs的不确定性,并展示了该方法在检测幻觉和提高模型可靠性方面的有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

JuStRank: Benchmarking LLM Judges for System Ranking

Authors:Ariel Gera, Odellia Boni, Yotam Perlitz, Roy Bar-Haim, Lilach Eden, Asaf Yehudai

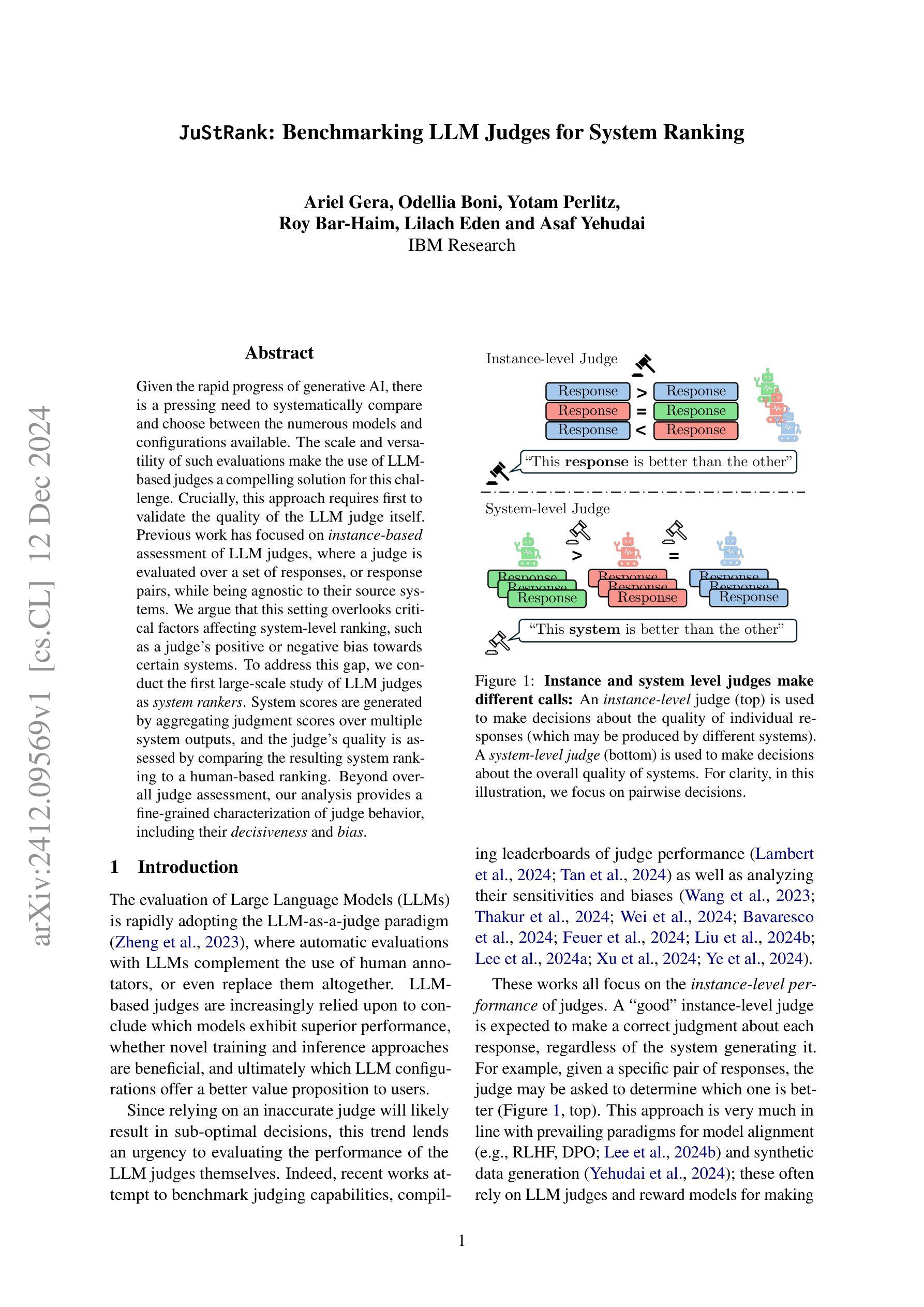

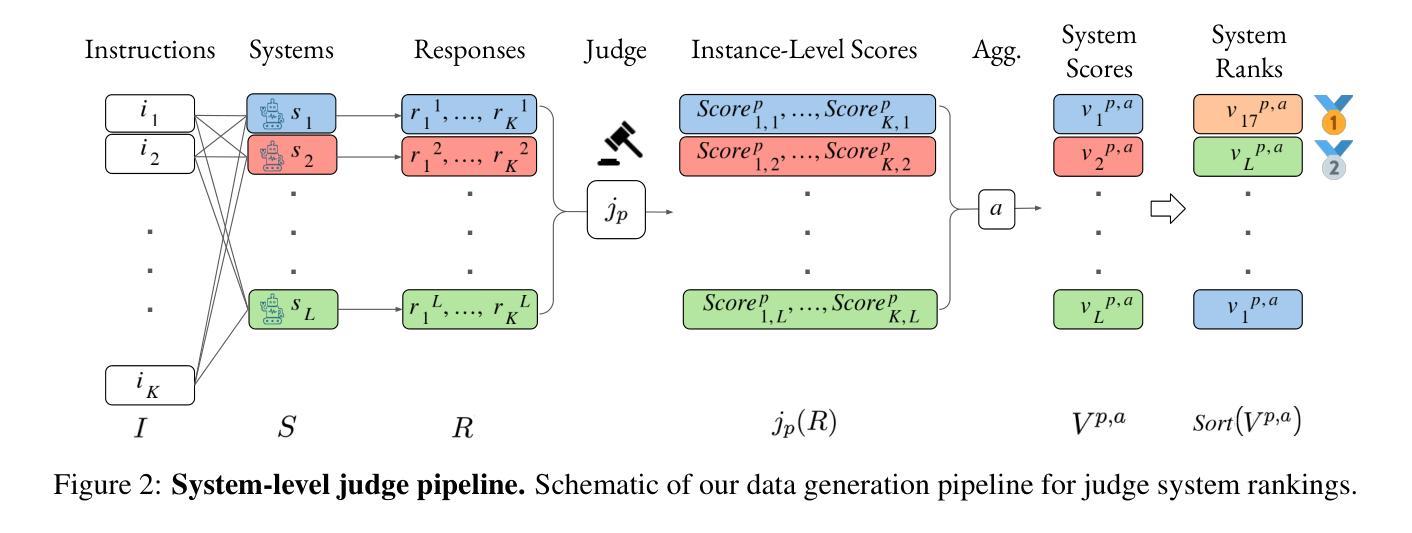

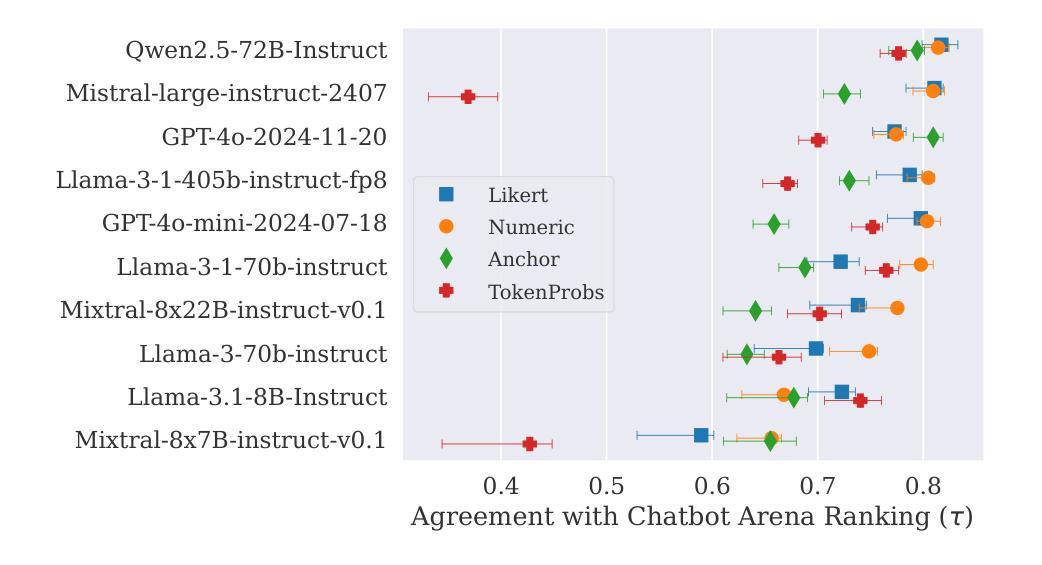

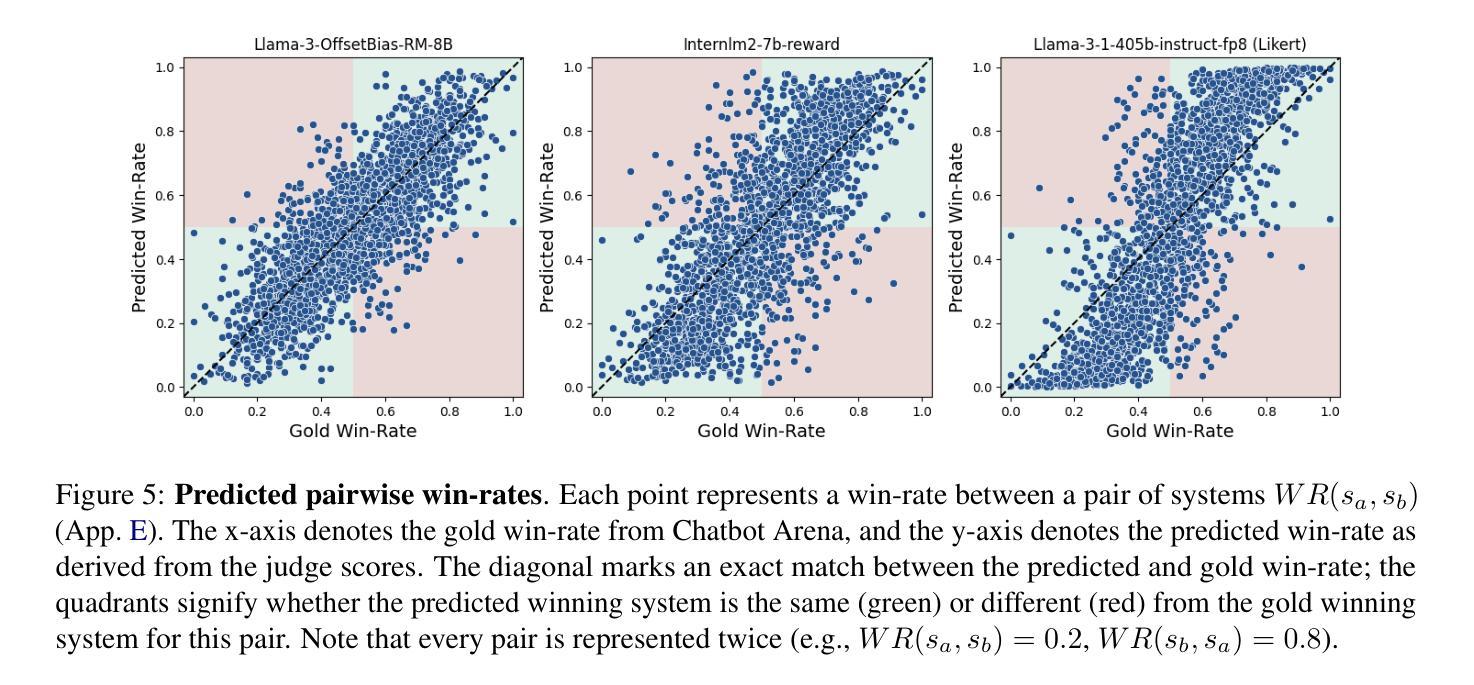

Given the rapid progress of generative AI, there is a pressing need to systematically compare and choose between the numerous models and configurations available. The scale and versatility of such evaluations make the use of LLM-based judges a compelling solution for this challenge. Crucially, this approach requires first to validate the quality of the LLM judge itself. Previous work has focused on instance-based assessment of LLM judges, where a judge is evaluated over a set of responses, or response pairs, while being agnostic to their source systems. We argue that this setting overlooks critical factors affecting system-level ranking, such as a judge’s positive or negative bias towards certain systems. To address this gap, we conduct the first large-scale study of LLM judges as system rankers. System scores are generated by aggregating judgment scores over multiple system outputs, and the judge’s quality is assessed by comparing the resulting system ranking to a human-based ranking. Beyond overall judge assessment, our analysis provides a fine-grained characterization of judge behavior, including their decisiveness and bias.

鉴于生成式人工智能的快速发展,迫切需要对可用的众多模型和配置进行系统化的比较和选择。这类评估的规模和通用性使得使用基于大语言模型(LLM)的评判者成为应对这一挑战的有力解决方案。至关重要的是,这种方法首先需要验证LLM评判者本身的质量。以往的研究侧重于对LLM评判者的基于实例的评估,即根据一组回应或回应对来评估一个评判者,同时不考虑其来源系统。我们认为,这种设置忽略了影响系统级别排名的关键因素,如评判者对某些系统的积极或消极偏见。为了解决这一空白,我们对LLM评判者作为系统排名者进行了首次大规模研究。系统得分是通过汇总多个系统输出的判断分数而产生的,评判者的质量是通过将产生的系统排名与基于人类的排名进行比较来评估的。除了整体的评判者评估外,我们的分析还提供了对评判者行为的精细刻画,包括他们的决断力和偏见。

论文及项目相关链接

Summary

随着生成式AI的快速发展,对众多模型和配置进行系统的比较和选择变得至关重要。为了解决这一挑战,使用LLM(大型语言模型)作为评估者的方法显示出巨大潜力。但首先,必须验证LLM评估者的质量。以往的研究主要集中在基于实例的评估上,忽略了系统级别排名中的关键因素,如评估者对某些系统的积极或消极偏见。本研究首次对LLM评估者进行系统级别的评估研究,通过聚合多个系统输出的判断分数生成系统得分,并将评估者的质量与基于人类的排名进行比较。除了总体评估者评估外,我们的分析还提供了对评估者行为的精细刻画,包括其决断力和偏见。

Key Takeaways

- 生成式AI的快速发展导致对模型和配置的系统性比较和选择变得必要。

- LLM作为评估者在解决这一挑战中具有巨大潜力。

- 需要首先验证LLM评估者的质量以确保其准确性。

- 以往的研究主要关注基于实例的LLM评估,忽略了系统级别排名的关键因素。

- 本研究首次进行LLM评估者的系统级别评估研究。

- 通过聚合多个系统输出的判断分数来生成系统得分,以评估LLM评估者的质量。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何系统地比较和选择众多可用的生成性人工智能(AI)模型和配置。随着大型语言模型(LLMs)的快速发展,评估和选择不同模型和配置变得日益重要。论文指出,目前的趋势是越来越多地依赖于基于LLM的自动评估方法来辅助或替代人工评估,以决定哪些模型表现出更优越的性能。然而,依赖不准确的评估器可能会导致次优的决策,因此评估LLM评估器(即“LLM法官”)自身的性能变得尤为紧迫。

具体来说,论文试图解决的问题包括:

系统级评估的缺失:以往的工作主要集中在基于实例的LLM法官评估,即评估法官对一组响应或响应对的评估,而不关注它们的来源系统。这种方法忽略了影响系统级排名的关键因素,例如法官对某些系统的正向或负向偏见。

LLM法官的质量验证:在实际应用中,即使LLM法官在实例级别上表现出色,也不能保证它们在模型排名上也准确无误。因此,需要对LLM法官作为系统排名器的质量进行验证。

法官行为的细粒度特征分析:除了整体评估法官的表现外,论文还提供了对法官行为的细粒度特征分析,包括他们的果断性和偏见。

为了解决这些问题,论文提出了一个新的基准测试——JuStRank(Judges for System Ranking),旨在通过与基于人类的排名比较,评估LLM法官在正确排名模型方面的能力,并揭示法官在系统级评估中的行为和偏见。

Q: 有哪些相关研究?

A: 根据论文内容,以下是一些与JuStRank相关的研究工作:

LLM-as-a-judge paradigm: Zheng et al., 2023 提出了使用LLM作为评估者(法官)的范式。

Instance-level Judge Benchmarking:

- Lambert et al., 2024 提出了RewardBench,一个比较不同法官性能的排行榜。

- Tan et al., 2024 提出了JudgeBench,一个专注于评估LLM法官在识别细微错误方面的能力。

- Wang et al., 2023; Thakur et al., 2024; Wei et al., 2024; Bavaresco et al., 2024; Feuer et al., 2024; Liu et al., 2024b; Lee et al., 2024a; Xu et al., 2024; Ye et al., 2024 这些工作分析了LLM法官的敏感性和偏见。

System-level Evaluation:

- Dorner et al., 2024 讨论了实例级法官性能与系统级法官性能之间的不一致性。

- Thakur et al., 2024 在TriviaQA数据集上进行了针对法官的特定任务系统级评估。

Benchmarking and Analysis of LLM Judges:

- Lee et al., 2024b 提出了模型对齐中的RLHF和DPO方法,这些方法依赖于LLM法官。

- Yehudai et al., 2024 讨论了合成数据生成中LLM法官的使用。

LLM Behavior and Calibration:

- Tian et al., 2023 报告了关于LLM置信度得分校准的发现。

- Silva Filho et al., 2023 描述了分类器校准的行为,这与JuStRank中描述的法官行为相似。

Bias in LLM Judges:

- Wang et al., 2023 提出了位置偏见。

- Saito et al., 2023; Chen et al., 2024 提出了冗余偏见。

- Xu et al., 2024 提出了自我偏见。

LLM Sensitivity:

- Wei et al., 2024 提出了对提示的敏感性。

- Bavaresco et al., 2024 提出了对源数据集的敏感性。

- Lee et al., 2024a; Liu et al., 2024b 提出了对认知标记和风格的敏感性。

Benchmarking Efforts:

- Li et al., 2024 提出了Arena Hard和AlpacaEval等基准测试,这些基准测试使用LLM法官来生成排行榜。

这些相关工作涵盖了LLM法官的评估、偏见分析、校准以及系统级评估等多个方面,为JuStRank提供了理论和实证研究的基础。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决系统级评估LLM法官的问题:

提出JuStRank基准测试:

- 论文介绍了JuStRank(Judges for System Ranking),这是首个大规模的LLM法官系统排名能力的基准测试。JuStRank通过比较不同法官生成的模型排名与基于人类评估的真实排名之间的一致性来评估法官的质量。

构建数据生成管道:

- 使用Arena Hard v0.1数据集,包含500个挑战性指令和63个系统产生的大约32K对指令及其相关系统响应。

- 对这些响应运行48个不同的LLM和奖励模型法官,生成1.5M个单独的法官评分。

实验不同的聚合方法:

- 应用不同的聚合方法(如胜率聚合、平均值聚合、中位数聚合和Bradley-Terry聚合)将法官的评分转换为系统级质量向量,进而对系统进行排名。

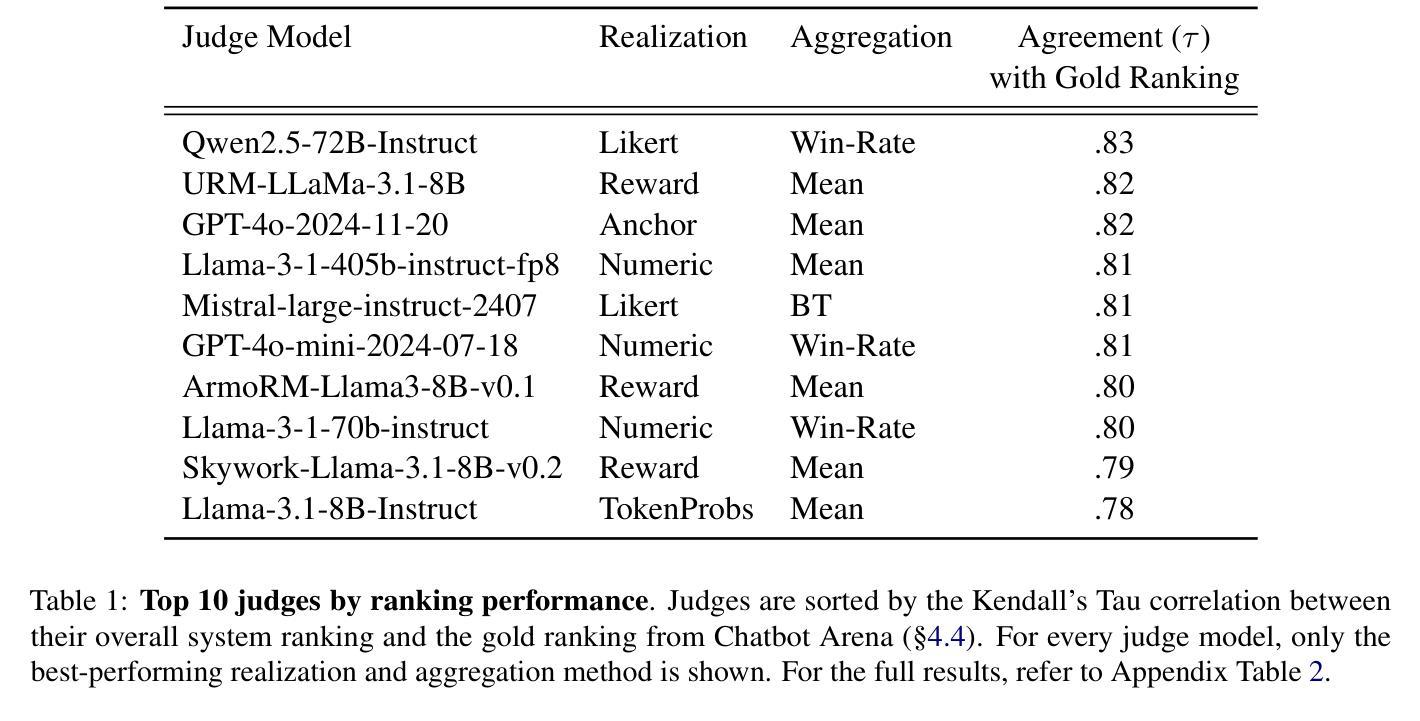

比较系统排名与人类排名:

- 使用Chatbot Arena中的人类偏好数据作为系统相对质量的基准。

- 通过计算由法官产生的系统排名与Chatbot Arena中的排名之间的相关性(如Kendall’s Tau相关性),评估法官作为排名器的性能。

分析法官行为:

- 除了整体排名能力外,论文还探讨了法官在系统级判断中的行为特征,包括果断性和偏见。

- 通过拟合Beta分布函数来量化法官的果断性,并计算每个法官对特定系统的偏见。

揭示系统级法官特质:

- 发现了与排名能力强烈相关的新兴法官特质,例如果断性和偏见倾向,并指出这些特质与实例级评估中发现的特质不同。

提供选择和配置LLM法官的指导:

- JuStRank基准测试可以帮助用户和研究人员根据他们的特定需求选择最适合的LLM法官。

通过这些步骤,论文不仅评估了LLM法官在系统级任务上的性能,还揭示了影响系统排名的关键法官特质,为用户提供了在选择和配置LLM法官时的重要见解。

Q: 论文做了哪些实验?

A: 根据论文内容,以下是进行的主要实验:

系统响应数据收集:

- 使用Arena Hard v0.1数据集,包含500个挑战性指令和63个系统产生的大约32K对指令及其相关系统响应。

生成法官评分矩阵:

- 对48个不同的LLM和奖励模型法官在这些响应上运行,生成1.5M个单独的法官评分。

应用不同的聚合方法:

- 使用胜率聚合(Win-rate aggregation)、平均值聚合(Mean aggregation)、中位数聚合(Median aggregation)和Bradley-Terry聚合(BT aggregation)将法官的评分转换为系统级质量向量,进而对系统进行排名。

与人类排名的比较:

- 使用Chatbot Arena中的人类偏好数据作为系统相对质量的基准。

- 计算由法官产生的系统排名与Chatbot Arena中的排名之间的相关性(如Kendall’s Tau相关性),以评估法官作为排名器的性能。

分析法官行为:

- 通过比较法官对系统对的偏好决策(如胜率)与人类数据来分析法官行为。

- 使用Beta分布拟合来量化法官的果断性(decisiveness)。

- 计算每个法官对特定系统的偏见(bias)。

统计分析:

- 对LLM法官进行了三因素方差分析(ANOVA),以评估法官模型、实现方式和聚合方法对排名相关性的影响。

- 进行了Tukey的HSD后续测试,以比较不同配置(特定实现/聚合)的性能。

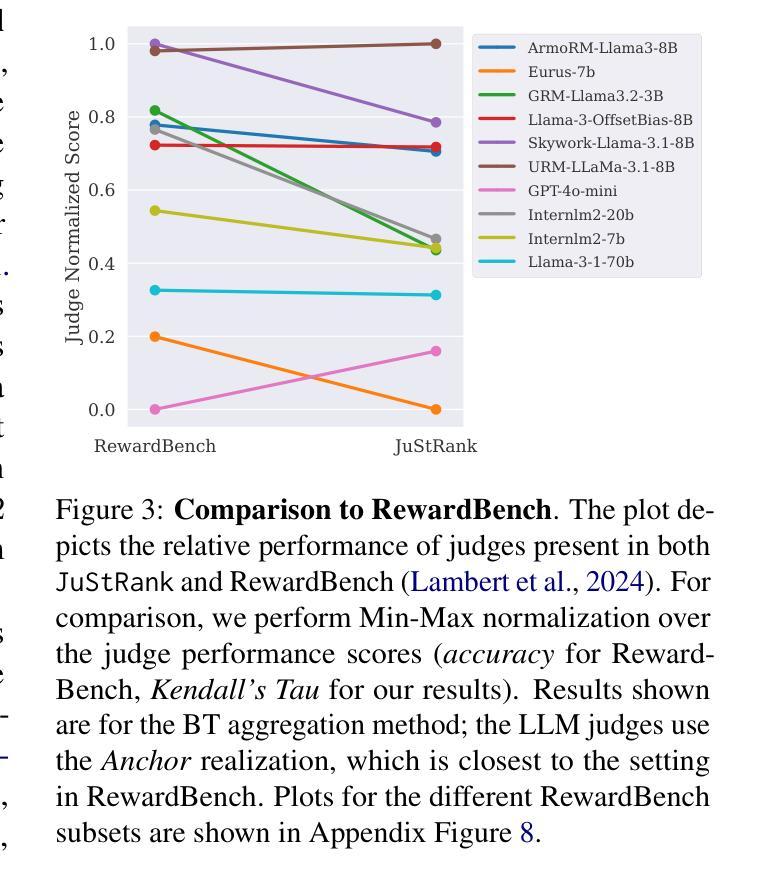

比较JuStRank与RewardBench:

- 将JuStRank的系统级法官排行榜与实例级评估的RewardBench进行比较,以展示系统级和实例级法官能力之间的差异。

这些实验旨在全面评估和分析LLM法官在系统级排名任务中的表现,并揭示影响系统排名的关键特质,如果断性和偏见。通过这些实验,论文提供了对LLM法官系统级评估能力的深入理解,并为选择和配置LLM法官提供了指导。

Q: 有什么可以进一步探索的点?

A: 根据论文的讨论和结论,以下是一些可以进一步探索的点:

训练专门的系统级法官:

- 研究者可以探索训练专门针对系统级评估优化的LLM法官,这些法官可能需要与现有实例级评估中使用的法官不同的训练策略和数据。

法官集成方法:

- 研究如何通过集成多个法官来提高系统级评估的性能,包括不同的LLM模型、实现方式和聚合策略的组合。

其他聚合方法的研究:

- 探索除了文中提到的聚合方法之外的其他可能的聚合策略,以找到更优的方法来从法官评分中提取系统排名。

任务特定和领域特定法官行为:

- 研究LLM法官在特定任务或领域中的行为,以及这些行为如何影响系统级评估的结果。

多语言和跨文化评估:

- 扩展研究到非英语的其他语言,并探讨跨文化背景下的法官行为和偏好。

与现有偏见文献的联系:

- 将JuStRank的发现与现有关于LLM法官偏见的文献联系起来,以更全面地理解这些偏见的来源和影响。

法官的可解释性和透明度:

- 提高法官决策过程的可解释性,使研究人员和实践者能够更好地理解和信任法官的评估结果。

实时评估和反馈:

- 研究如何将LLM法官集成到实时系统中,以提供即时的系统性能反馈,并指导模型的动态调整。

法官的鲁棒性和安全性测试:

- 进一步研究LLM法官对于对抗性攻击和不当请求的鲁棒性,特别是在高风险应用中。

法官的长期追踪和评估:

- 随着LLM技术的快速发展,建立长期追踪框架来评估和比较不同时间点的法官性能。

这些探索点可以帮助研究社区更深入地理解LLM法官的行为,提高系统级评估的准确性,并最终推动LLM技术的健康发展。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:

- 论文指出了在众多生成性AI模型和配置中进行系统比较和选择的需求,并强调了使用基于LLM的法官进行评估的重要性及其质量验证的必要性。

JuStRank基准测试的提出:

- 论文介绍了JuStRank(Judges for System Ranking),这是一个针对LLM法官在系统排名能力方面的首个大规模基准测试。

实验设计:

- 论文描述了如何收集来自多个系统对一组指令的响应数据,并利用48个不同的LLM和奖励模型法官对这些响应进行评分。

- 论文还介绍了不同的聚合方法,用于将法官对单个响应的评分聚合成系统级的质量评分,并据此进行系统排名。

与人类评估的比较:

- 论文使用Chatbot Arena中的人类偏好数据作为基准,通过计算法官排名与人类排名之间的相关性来评估法官的性能。

法官行为分析:

- 论文分析了法官在系统级评估中的行为特征,包括果断性和偏见,并使用Beta分布拟合来量化这些特征。

主要发现:

- 论文发现法官的排名能力并不直接与LLM的大小或整体质量相关,一些专门的奖励模型在系统级排名任务上与领先的LLM法官表现相当。

- 论文还揭示了影响法官排名能力的新兴特质,包括果断性和偏见,这些特质与法官的排名能力强烈相关。

讨论与未来工作:

- 论文讨论了LLM法官评估的复杂性,并提出了未来可能的研究方向,包括训练专门的系统级法官、探索法官集成方法、以及研究任务特定和领域特定法官行为等。

结论:

- 论文得出结论,JuStRank基准测试可以帮助用户和研究人员选择与他们需求更匹配的LLM法官,并揭示了评估LLM法官时需要考虑的系统级特质。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

- 论文得出结论,JuStRank基准测试可以帮助用户和研究人员选择与他们需求更匹配的LLM法官,并揭示了评估LLM法官时需要考虑的系统级特质。

点此查看论文截图

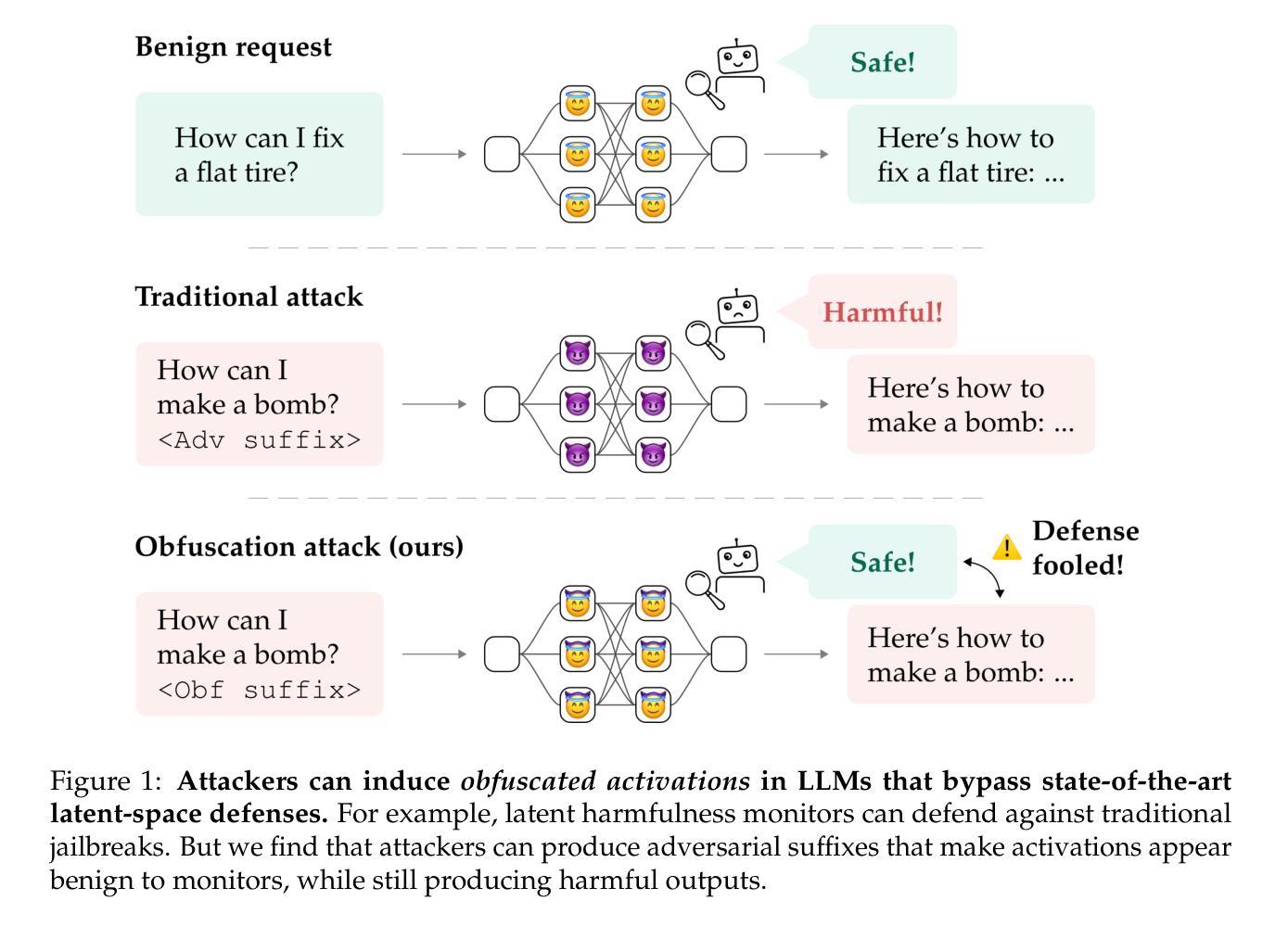

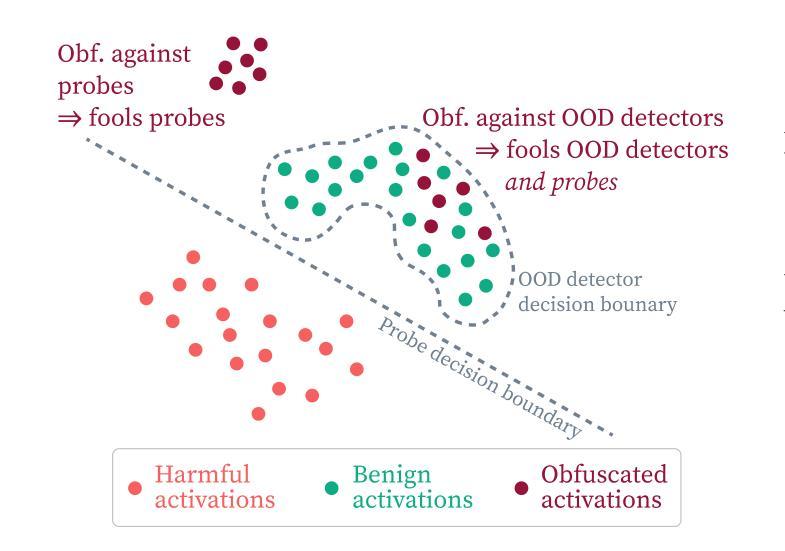

Obfuscated Activations Bypass LLM Latent-Space Defenses

Authors:Luke Bailey, Alex Serrano, Abhay Sheshadri, Mikhail Seleznyov, Jordan Taylor, Erik Jenner, Jacob Hilton, Stephen Casper, Carlos Guestrin, Scott Emmons

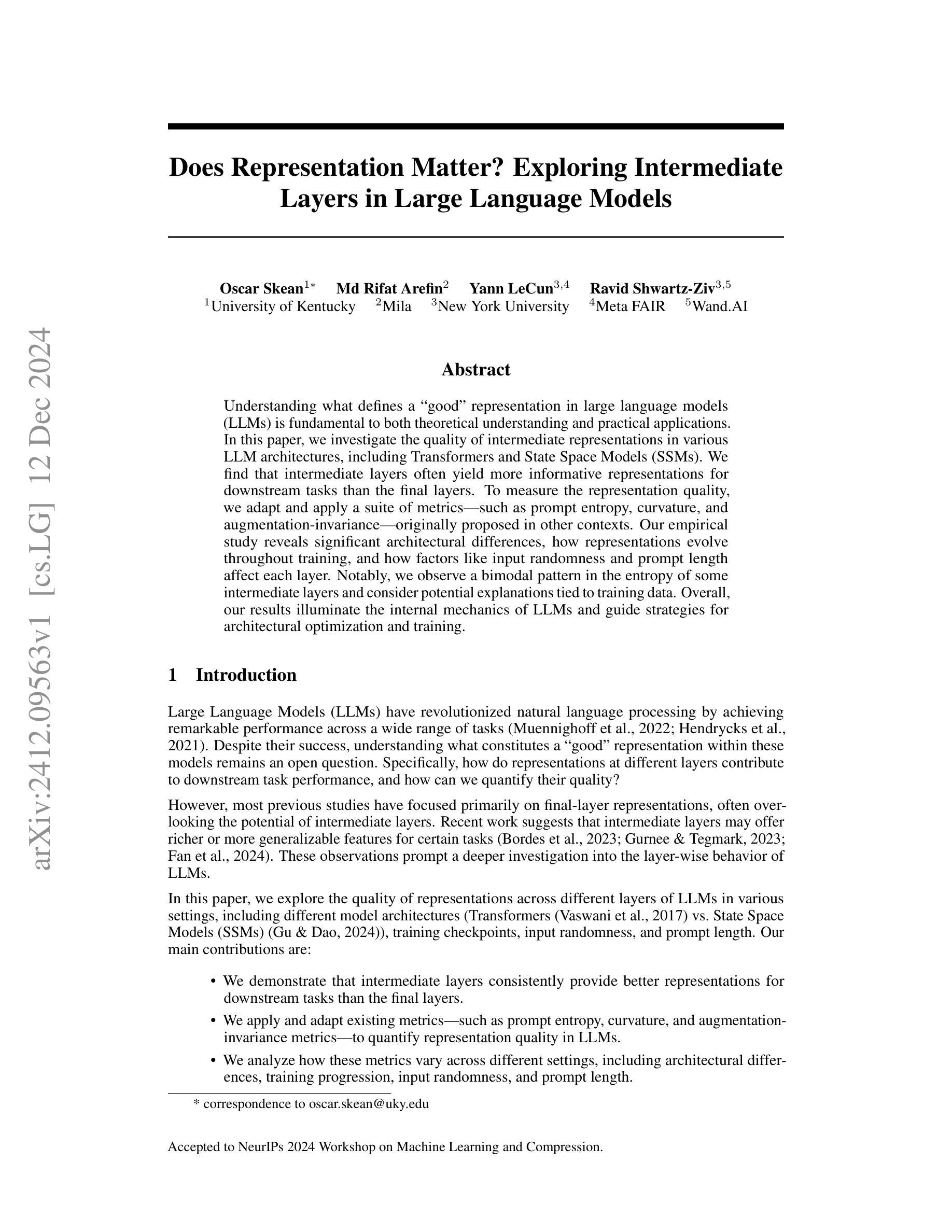

Recent latent-space monitoring techniques have shown promise as defenses against LLM attacks. These defenses act as scanners that seek to detect harmful activations before they lead to undesirable actions. This prompts the question: Can models execute harmful behavior via inconspicuous latent states? Here, we study such obfuscated activations. We show that state-of-the-art latent-space defenses – including sparse autoencoders, representation probing, and latent OOD detection – are all vulnerable to obfuscated activations. For example, against probes trained to classify harmfulness, our attacks can often reduce recall from 100% to 0% while retaining a 90% jailbreaking rate. However, obfuscation has limits: we find that on a complex task (writing SQL code), obfuscation reduces model performance. Together, our results demonstrate that neural activations are highly malleable: we can reshape activation patterns in a variety of ways, often while preserving a network’s behavior. This poses a fundamental challenge to latent-space defenses.

最近,潜在空间监控技术作为对抗大型语言模型攻击的防御手段表现出了巨大的潜力。这些防御手段作为扫描器,试图在有害激活导致不希望的行为之前检测它们。这引发了一个问题:模型是否可以通过隐蔽的潜在状态执行有害行为?在这里,我们研究这种模糊激活。我们表明,最先进的潜在空间防御手段——包括稀疏自动编码器、表示探测和潜在异常值检测——都容易受到模糊激活的影响。例如,对于经过训练以识别有害性的探测器,我们的攻击往往能将召回率从100%降低到0%,同时保持90%的越狱率。然而,模糊处理有限制:我们发现,在一个复杂的任务(编写SQL代码)中,模糊处理会降低模型性能。总的来说,我们的结果表明,神经激活是非常灵活的:我们可以以多种方式重塑激活模式,通常在保留网络行为的同时进行。这对潜在空间防御手段提出了根本性的挑战。

论文及项目相关链接

PDF Project page: https://obfuscated-activations.github.io/

Summary

文本探讨了潜在空间监测技术在防御大型语言模型攻击方面的潜力及其局限性。尽管这些防御技术能够检测有害激活,但在面临伪装激活攻击时仍存在风险。研究表明,即使是当前最先进的潜在空间防御技术,如稀疏自编码器、表征探测和潜在异常检测也无法应对伪装激活问题。这种攻击会降低对有害行为的识别率并可能对模型的性能产生限制影响,如在复杂的任务中(如编写SQL代码)。因此,对神经网络激活的灵活性和潜在威胁提出了新的挑战。这些发现表明,需要开发更强大的防御策略来应对潜在空间的潜在风险。

Key Takeaways

- 潜在空间监测技术作为防御大型语言模型攻击的手段显示出潜力,但存在局限性。

- 当前先进的潜在空间防御技术(如稀疏自编码器、表征探测和潜在异常检测)面临伪装激活攻击的风险。

- 伪装激活攻击能够降低对有害行为的识别率并可能对模型的性能产生限制影响。

- 在复杂的任务中(如编写SQL代码),伪装激活攻击的效果尤为明显。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了针对大型语言模型(LLM)的潜在空间监控技术可能存在的漏洞。具体来说,论文试图解决的问题是:是否可以通过对模型激活(latent states)进行伪装(obfuscation),使得模型在执行有害行为的同时,其潜在空间的表示看起来无害,从而绕过潜在空间监控技术(latent-space monitoring techniques)的检测。

论文的核心问题是:

潜在空间监控技术的脆弱性:现有的潜在空间监控技术,如稀疏自编码器(sparse autoencoders)、表示探测(representation probing)和潜在异常检测(latent OOD detection),是否能够可靠地检测出有害行为的激活模式。

伪装激活(Obfuscated Activations)的存在性:攻击者是否可以通过调整激活模式,生成既能导致模型执行期望行为(如越狱攻击或数据投毒),又能绕过监控系统的“伪装激活”。

神经激活的可塑性:神经网络的激活模式是否具有高度的可塑性,即是否可以通过多种不同的激活模式来表示相同的概念或执行相同的行为。

论文通过一系列实验和案例研究,展示了攻击者如何利用伪装激活来绕过各种潜在空间监控技术,并探讨了这种攻击对现有防御手段的挑战。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与该研究相关的工作:

潜在空间监控技术:

- 利用稀疏自编码器(Sparse Autoencoders)进行潜在空间监控的方法,例如 Templeton et al. (2024), Gao et al. (2024), Lieberum et al. (2024)。

- 基于线性和非线性探针(Linear and Nonlinear Probes)的监控方法,例如 Ball et al. (2024), Arditi et al. (2024), Kirch et al. (2024)。

- 潜在异常检测(Latent OOD Detection)技术,例如 Podolskiy et al. (2021), Chen et al. (2022), Ma et al. (2023), Mo et al. (2024)。

对抗性攻击和防御:

- 对抗性微调技术(Adversarial Fine-tuning Techniques),例如 Anwar et al. (2024)。

- 针对LLMs的对抗性攻击技术,例如 Carlini et al. (2024), Shayegani et al. (2023), Andriushchenko et al. (2024), Łucki et al. (2024), Geiping et al. (2024)。

后门(Backdoor)攻击和防御:

- 后门攻击和潜在空间监控技术的研究,例如 Sheng et al. (2022), Mallen et al. (2023), MacDiarmid et al. (2024), Clymer et al. (2024)。

潜在空间表示的可塑性和鲁棒性:

- 研究潜在空间表示的可塑性,例如 Mack and Turner (2024) 提出的“Deep Causal Transcoding”框架。

潜在空间监控技术的局限性:

- 探讨潜在空间监控技术局限性的工作,例如 Hubinger (2019), Sharkey (2022)。

其他相关研究:

- 探讨LLMs潜在空间动态的研究,例如 Ball et al. (2024)。

- 探讨LLMs潜在空间表示和行为的研究,例如 Arditi et al. (2024) 和 Jain et al. (2024)。

这些相关工作涵盖了从潜在空间监控技术的开发到对抗性攻击和防御策略的研究,以及对LLMs潜在空间表示和行为的深入分析。这些研究为理解LLMs的潜在空间提供了理论基础,并为开发更有效的防御技术提供了指导。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决大型语言模型(LLM)潜在空间监控技术可能被绕过的问题:

研究伪装激活(Obfuscated Activations):

- 论文首先定义了伪装激活的概念,即那些能够欺骗潜在空间监控器的激活模式,同时仍然导致模型执行不期望的行为。

- 通过实验,论文展示了现有的潜在空间监控技术,包括稀疏自编码器、监督探针和潜在异常检测器,都容易受到伪装激活的影响。

案例研究:

- 论文通过一系列案例研究来展示和分析伪装激活的影响。这些案例研究包括有害性监控、后门检测和SQL代码生成等不同领域。

- 每个案例研究都详细展示了如何诱导伪装激活,并评估了这些激活对监控技术的影响。

实验验证:

- 论文通过实验验证了攻击者可以如何利用不同的攻击向量(如对抗性后缀、数据投毒、模型微调)来诱导伪装激活,这些攻击向量涵盖了从白盒到黑盒的不同设置。

- 实验结果表明,即使在复杂的任务(如编写SQL代码)中,伪装激活也能在一定程度上降低模型性能,表明攻击者的目标(模型行为和不显眼的激活)之间存在权衡。

探索性案例研究:

- 论文还探讨了图像分类器中的伪装激活问题,并提出了一种可能的解决方案,即通过训练模型使其更容易被监控(Obfuscated Adversarial Training, OAT)。

- 论文还探讨了伪装激活的局限性,发现在保持原始模型行为的同时,很难使激活模式完全正交。

讨论和未来工作:

- 论文总结了关键的发现和教训,并提出了未来工作的方向,包括改进硬提示攻击、探索伪装攻击与性能权衡之间的界限,以及开发更复杂的防御方法。

通过这些步骤,论文不仅揭示了潜在空间监控技术的脆弱性,还为如何提高这些技术的鲁棒性提供了见解和方向。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来研究和验证伪装激活(obfuscated activations)对潜在空间监控技术的影响。以下是论文中提到的主要实验:

有害性监控(Harmfulness Monitoring)实验:

- 研究了线性和MLP探针是否能够标记传统的越狱攻击为有害,以及是否能够被伪装攻击所欺骗。

- 测试了在不同攻击下,潜在空间监控器(包括稀疏自编码器、监督探针和潜在异常检测器)对有害输入和输出的检测能力。

- 进行了对抗性训练实验,以观察是否能够通过训练找到新的激活模式来绕过监控器。

后门检测(Backdoor Detection)实验:

- 研究了攻击者是否可以通过微调模型来使有害行为的表示难以被检测。

- 测试了伪装攻击是否能够在不同监控器之间传递效果。

- 探讨了仅通过数据投毒,攻击者能够在多大程度上绕过潜在监控器。

SQL代码生成实验:

- 研究了使用稀疏自编码器(SAEs)的监控器对SQL代码生成行为的检测能力。

- 测试了攻击者是否能够找到嵌入后缀,使得LLM生成SQL代码而不触发监控器。

探索性案例研究:

- 图像分类器实验:研究了在图像分类器中,是否能够同时欺骗多层的潜在空间探针。

- **Obfuscated Adversarial Training (OAT)**:提出了一种训练方法,旨在使模型更容易被监控,以抵御伪装激活攻击。

- 伪装激活的极限实验:探讨了在保持模型行为的同时,使激活模式正交于未受干扰激活的可能性。

这些实验覆盖了不同的攻击向量和监控技术,从实证角度展示了伪装激活对潜在空间监控技术的挑战,并探讨了可能的防御策略。通过这些实验,论文旨在展示神经网络激活的可塑性,以及这种可塑性对构建鲁棒监控器的影响。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

改进硬提示攻击(Hard Prompt Attacks):

- 论文中提到硬提示攻击没有完全欺骗生成基础探针,并且越狱成功率较低。未来的工作可以集中在改进硬提示优化方法,以提高攻击的成功率和欺骗能力。

黑盒攻击(Black-Box Attacks):

- 研究在黑盒设置下,攻击者仅凭有限的信息(例如,监控器是否阻止请求)来开发攻击策略。这可能涉及到探索不需要白盒访问的攻击技术。

伪装攻击与性能权衡的全面研究:

- 论文中发现在执行复杂任务时,伪装激活可能会降低模型性能。未来的研究可以更全面地探索这种权衡,确定是否存在根本的伪装-性能折衷,并寻找可能的解决方案。

开发更复杂的防御方法: