⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

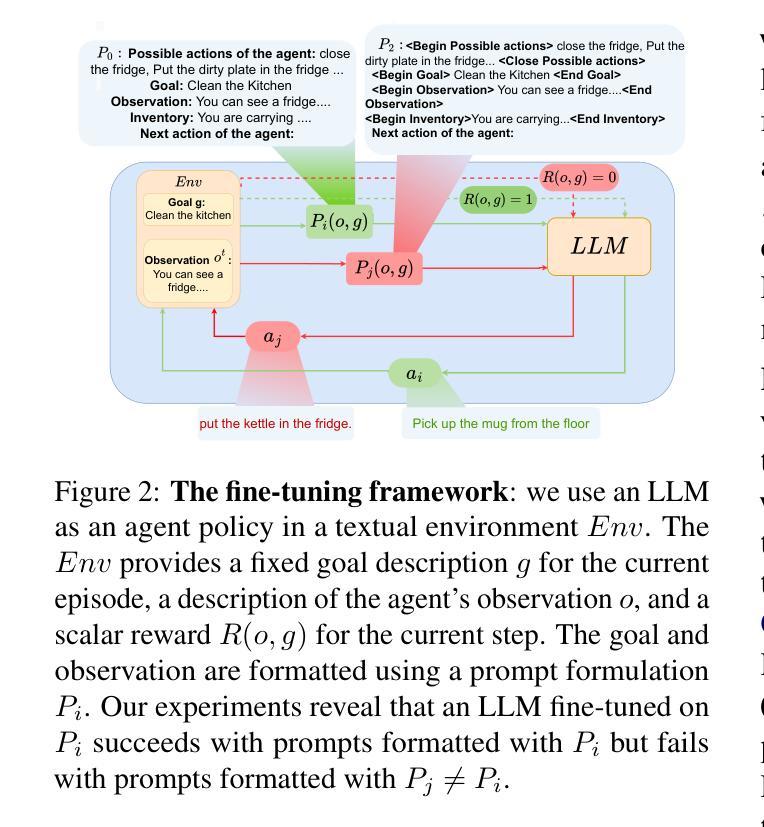

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-14 更新

AgentTrek: Agent Trajectory Synthesis via Guiding Replay with Web Tutorials

Authors:Yiheng Xu, Dunjie Lu, Zhennan Shen, Junli Wang, Zekun Wang, Yuchen Mao, Caiming Xiong, Tao Yu

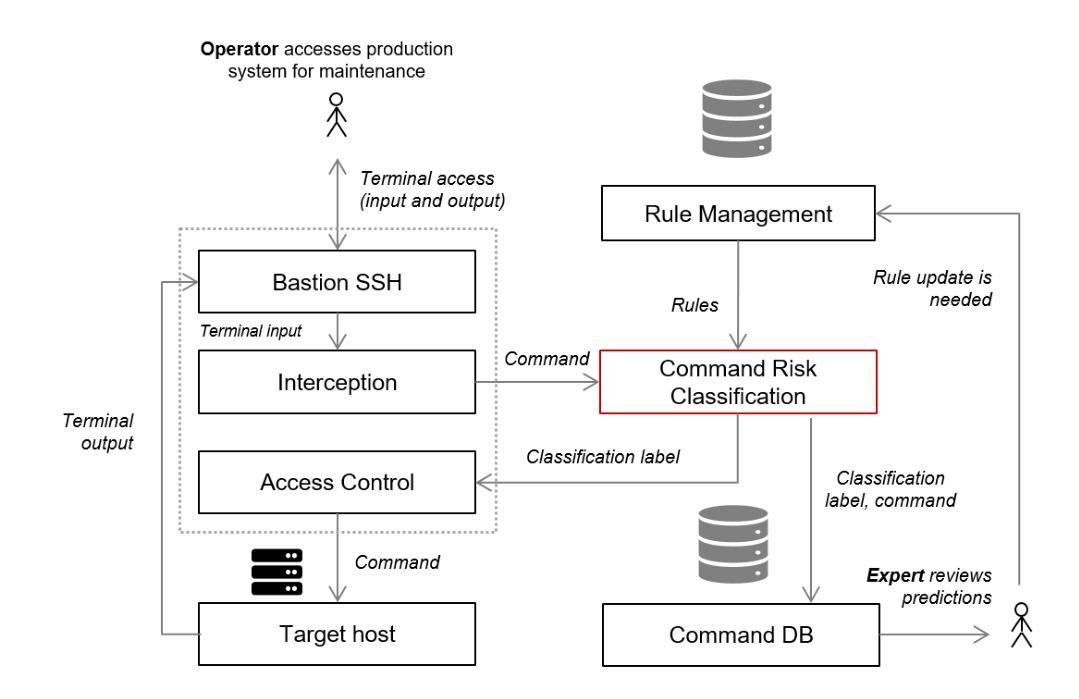

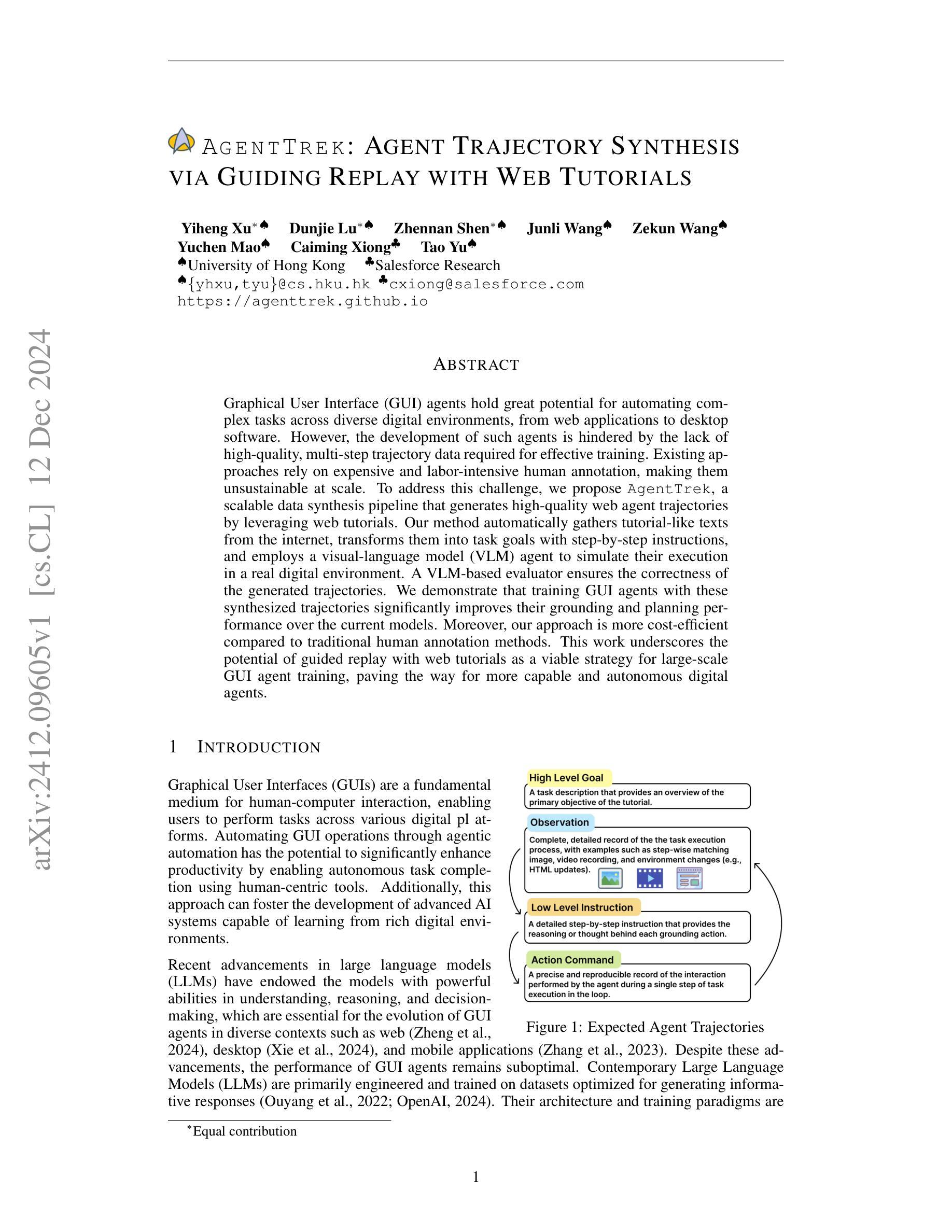

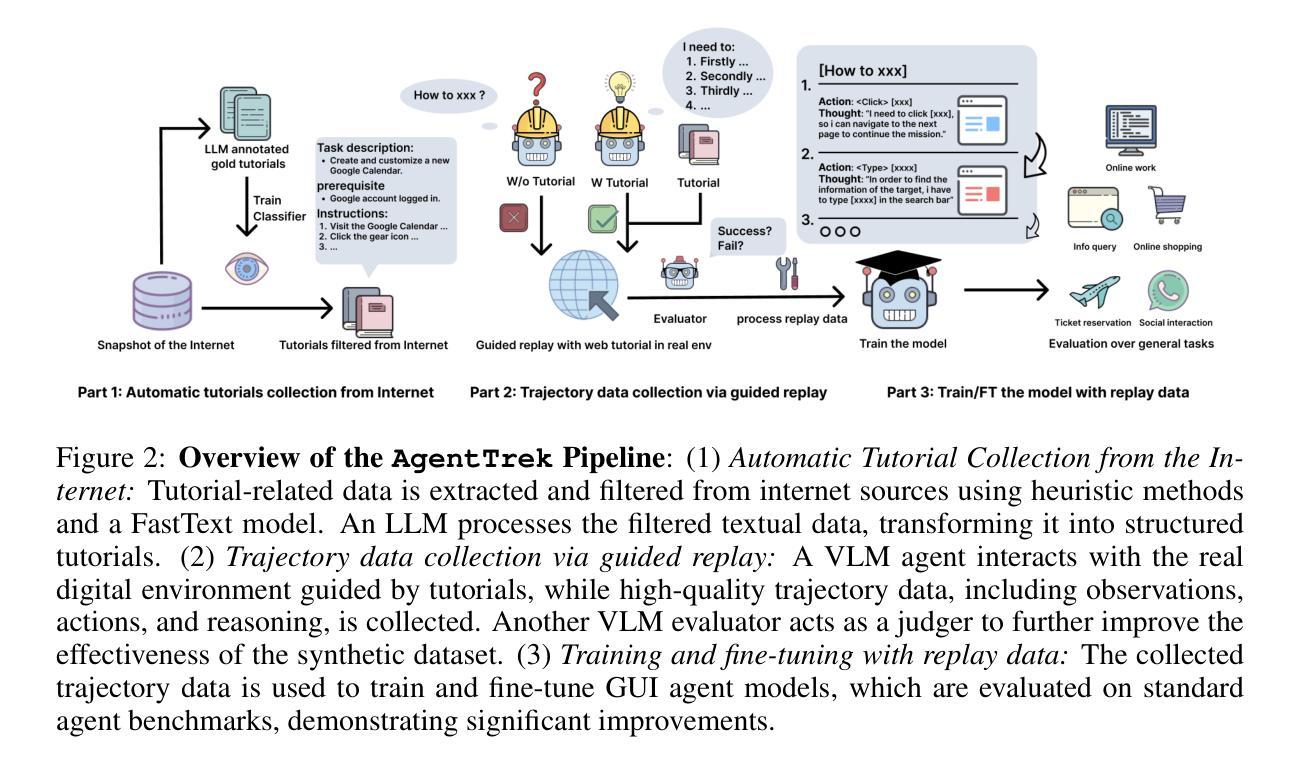

Graphical User Interface (GUI) agents hold great potential for automating complex tasks across diverse digital environments, from web applications to desktop software. However, the development of such agents is hindered by the lack of high-quality, multi-step trajectory data required for effective training. Existing approaches rely on expensive and labor-intensive human annotation, making them unsustainable at scale. To address this challenge, we propose AgentTrek, a scalable data synthesis pipeline that generates high-quality GUI agent trajectories by leveraging web tutorials. Our method automatically gathers tutorial-like texts from the internet, transforms them into task goals with step-by-step instructions, and employs a visual-language model agent to simulate their execution in a real digital environment. A VLM-based evaluator ensures the correctness of the generated trajectories. We demonstrate that training GUI agents with these synthesized trajectories significantly improves their grounding and planning performance over the current models. Moreover, our approach is more cost-efficient compared to traditional human annotation methods. This work underscores the potential of guided replay with web tutorials as a viable strategy for large-scale GUI agent training, paving the way for more capable and autonomous digital agents.

图形用户界面(GUI)代理在自动化跨多个数字环境(从Web应用程序到桌面软件)的复杂任务方面具有巨大潜力。然而,此类代理的开发受到缺乏高质量多步骤轨迹数据的阻碍,这些轨迹数据对于有效的训练至关重要。现有的方法依赖于昂贵且劳动密集的人工注释,使得它们在大规模上不可持续。为了应对这一挑战,我们提出了AgentTrek,这是一个可扩展的数据合成管道,通过利用网络教程生成高质量的GUI代理轨迹。我们的方法自动从互联网上收集类似教程的文本,将它们转化为具有分步说明的任务目标,并采用视觉语言模型代理来模拟在真实数字环境中的执行。基于VLM的评估器确保生成的轨迹的正确性。我们证明,使用这些合成轨迹训练的GUI代理在接地和规划性能方面显著优于当前模型。此外,我们的方法与传统的人工注释方法相比成本更低。这项工作强调了利用网络教程进行引导回放作为大规模GUI代理培训的可行策略,为更具能力和更自主的代理铺平了道路。

论文及项目相关链接

PDF https://agenttrek.github.io

Summary

GUI代理在自动化复杂任务方面具有巨大潜力,但高质量的多步轨迹数据缺乏阻碍了其发展。现有方法依赖昂贵且耗时的手动标注,难以扩展。本研究提出AgentTrek,一种基于网络教程的可扩展数据合成管道,可生成高质量GUI代理轨迹。该方法自动收集类似教程的文本,将其转化为具有逐步指令的任务目标,并利用视觉语言模型代理模拟其在真实数字环境中的执行。本研究验证了使用这些合成轨迹训练的GUI代理在接地和规划性能上的显著提高,且相比传统的手动标注方法更具成本效益。这为使用网络教程的引导回放作为一种可行的大规模GUI代理训练方法铺平了道路。

Key Takeaways

- GUI代理在自动化复杂任务中具有巨大潜力,但缺乏高质量的多步轨迹数据限制了其发展。

- 现有方法依赖手动标注,成本高且难以扩展。

- AgentTrek是一种基于网络教程的数据合成管道,可生成高质量的GUI代理轨迹。

- AgentTrek自动收集类似教程的文本,转化为任务目标,并利用视觉语言模型代理模拟执行。

- 使用合成轨迹训练的GUI代理在接地和规划性能上显著提高。

- 相比传统手动标注方法,AgentTrek更具成本效益。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何高效地为图形用户界面(GUI)代理生成高质量的多步轨迹数据,以便于训练和提升这些代理的自动化任务执行能力。具体来说,论文中提到了以下几个关键问题:

数据稀缺问题:现有的GUI代理训练方法依赖于昂贵且劳动密集型的人工标注,这限制了它们的可扩展性。

复杂任务自动化:图形用户界面(GUI)代理在自动化复杂任务时面临挑战,因为它们需要理解和执行多步操作序列,这超出了当前大型语言模型(LLMs)的训练和架构设计。

数据合成的挑战:合成GUI代理轨迹数据非常具有挑战性,因为它需要将自然语言指令、视觉观察和上下文特定的操作精确地整合到GUI环境中。

为了解决这些问题,论文提出了一个名为AgentTrek的可扩展数据合成管道,该管道通过利用网络教程来生成高质量的Web代理轨迹。这一方法自动从互联网收集教程类文本,将其转换为具有详细步骤说明的任务目标,并使用视觉-语言模型(VLM)代理在真实数字环境中模拟执行这些任务。此外,还采用了基于VLM的评估器来确保生成的轨迹数据的正确性。通过这种方法,研究者们旨在提高GUI代理的基础和规划性能,并降低与传统人工标注方法相比的成本。

Q: 有哪些相关研究?

A: 根据论文内容,以下是与AgentTrek相关的一些研究工作:

LLM-based Agents:

- WebGPT:一个浏览器辅助的问答系统,结合人类反馈来提升性能(Nakano et al., 2021)。

- SeeAct 和 WebVoyager:旨在将代理行为泛化到真实世界网站的模型(Zheng et al., 2024; He et al., 2024)。

Agent Data:

- RUSS、ScreenAgent、WebLINX、MM-Mind2Web、GUIAct:这些数据集主要作为各种基准测试的补充,但很少有专门为代理轨迹分析设计的数据集(L`u et al., 2024; Deng et al., 2024; Yao et al., 2022; Song et al., 2024; Wornow et al., 2024)。

Automatic Evaluation for Digital Agents:

- 使用Vision-Language Models (VLMs) 和 Large Language Models (LLMs) 自动评估数字代理的表现,包括基于轨迹级别的成功评估和基于指令遵循的逐步成功评估(Pan et al., 2024; Wornow et al., 2024)。

具体数据集和模型:

- Redpajama dataset:用于从网络提取和过滤教程数据(Computer, 2023)。

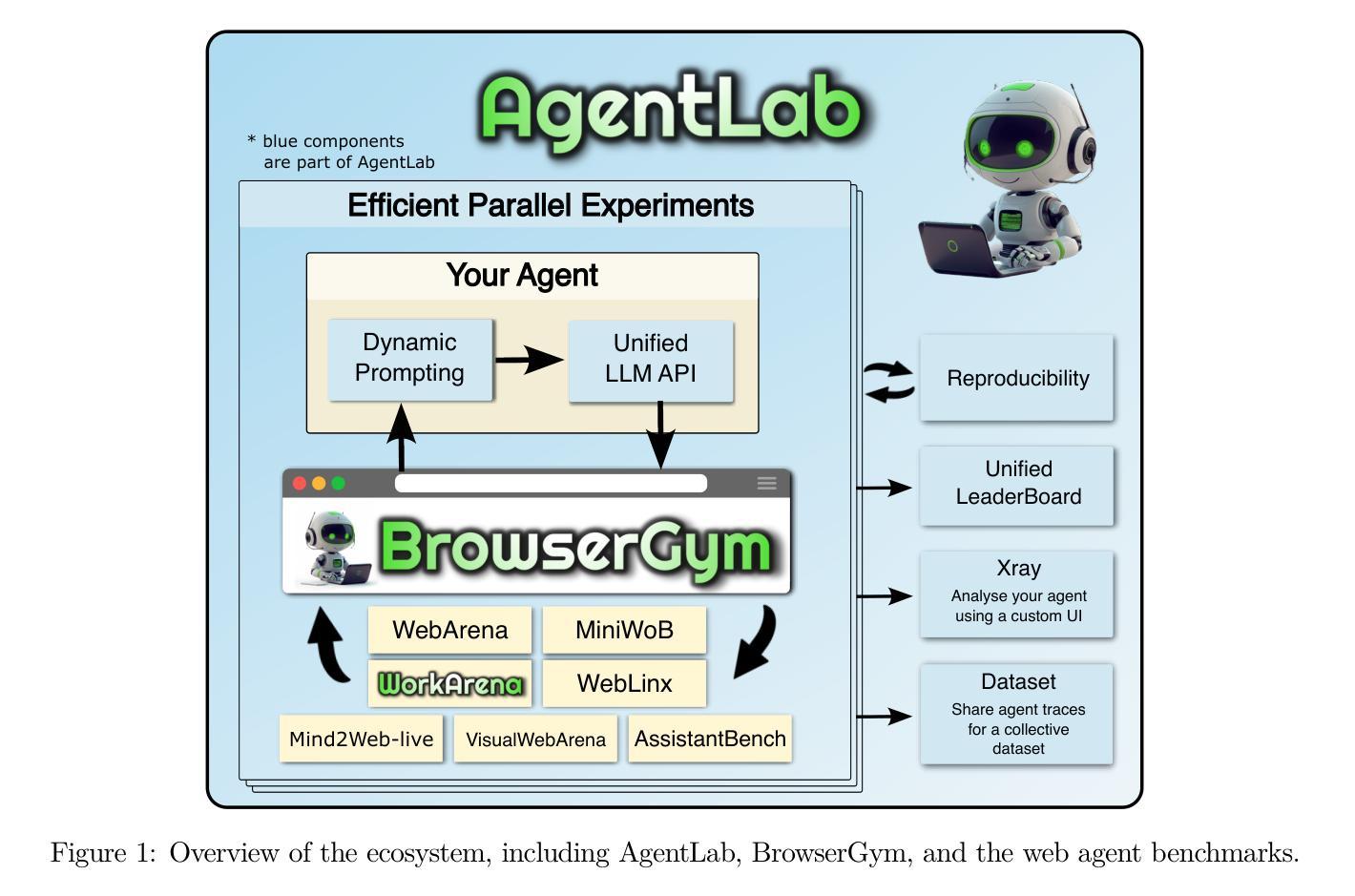

- BrowserGym:一个用于Web任务自动化的环境,允许VLM代理执行基于Web的操作(Drouin et al., 2024)。

- Qwen2-VL:一个视觉语言模型,用于处理任何分辨率的图像,适合GUI代理任务(Wang et al., 2024)。

相关工作比较:

- 论文中还提到了与AgentTrek相比的其他轨迹数据集,并在Table 1中进行了详细比较,包括它们的大小、平均步骤数、是否包含HTML、AxTree、中间推理、视频匹配、截图和网站任务指令级别等。

这些相关工作涵盖了从基于大型语言模型的代理、自动化数据收集和评估,到具体的数据集和模型架构等多个方面,为AgentTrek的研究提供了背景和对比。通过这些比较,论文展示了AgentTrek在自动生成GUI代理轨迹数据方面的创新性和优势。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为AgentTrek的解决方案,该方案通过以下三个主要步骤来解决为GUI代理生成高质量多步轨迹数据的问题:

1. 自动收集网络教程

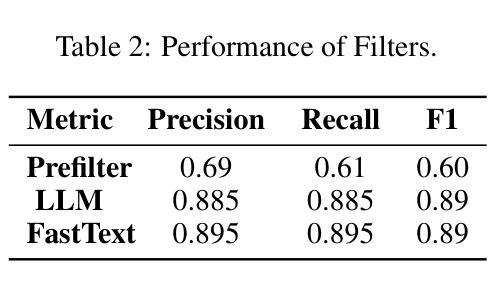

- 预过滤(Prefilter Function):使用基于规则的启发式过滤器和FastText模型从互联网上提取和过滤与教程相关的数据。

- LLM标注器(LLM Labeler):利用高级大型语言模型(如GPT-4O MINI)自动标注教程内容,提高数据质量和相关性。

- FastText过滤器:使用n-gram深度学习模型进一步过滤和分类教程文本。

- 标记和改写(Tag & Paraphrase):使用LLM将原始教程文本标记和改写为标准化格式,为后续的重放阶段做准备。

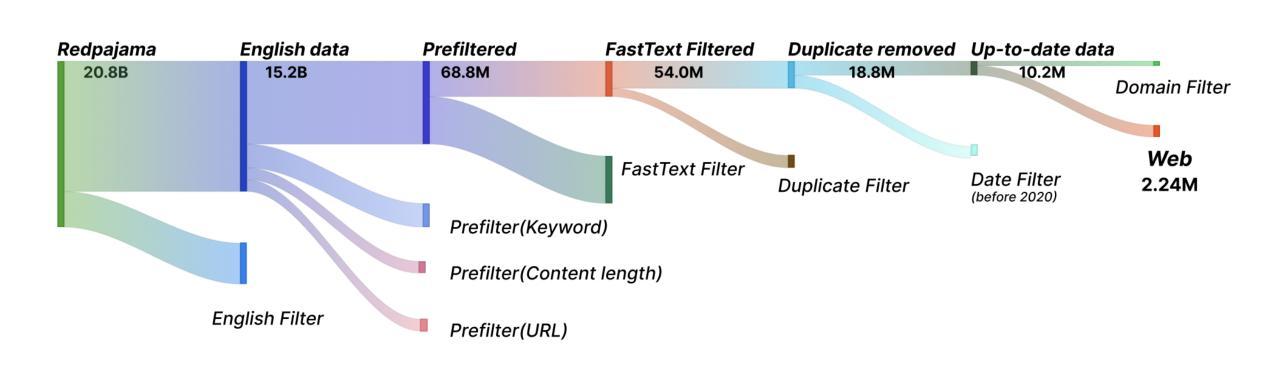

2. 通过引导重放收集轨迹数据

- 轨迹数据定义(Trajectory Data Definition):设计的数据实例包括任务信息、经过处理的文本轨迹、屏幕截图和视频记录以及可重现的原生痕迹。

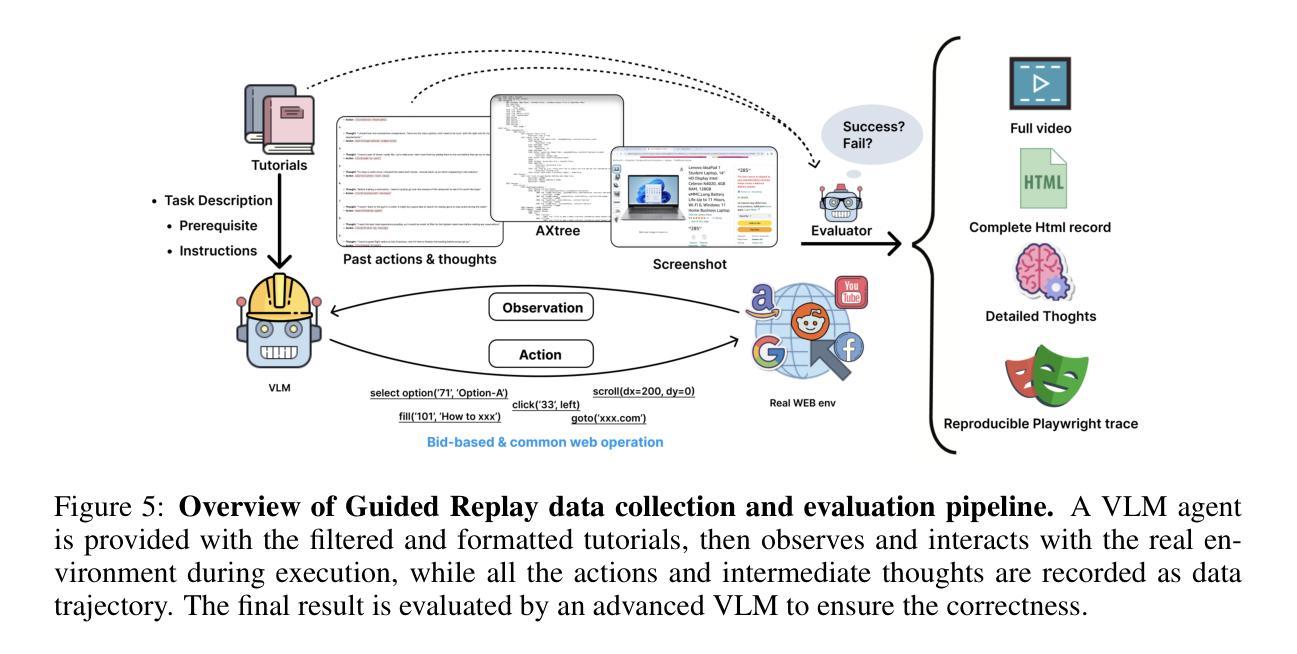

- 引导重放(Guided Replay with Tutorials):使用BrowserGym环境,让VLM代理在生成的教程指导下执行任务,并记录所有动作和中间思考作为数据轨迹。

- 轨迹评估(Evaluation of Trajectory):使用基于VLM的评估器来验证生成的轨迹数据的有效性,确保数据质量。

3. 使用重放数据训练和微调模型

- 纯视觉和GUI动作框架(Pure Vision & GUI Action Framework):选择基于纯视觉的代理模型,使用标准的pyautogui命令作为动作空间,以降低计算开销并提高泛化能力。

- 模型架构和训练(Model Architecture and Training):使用Qwen2VL模型,该模型使用NaViT作为图像编码器,支持动态分辨率,并整合2D-RoPE以高效处理图像。

通过这三个步骤,AgentTrek能够自动生成大量高质量的Web代理轨迹数据,这些数据不仅提高了GUI代理的基础和规划性能,而且与人工标注方法相比,显著降低了成本,强调了AgentTrek在大规模GUI代理训练中的可扩展性和经济可行性。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证AgentTrek数据合成管道的有效性以及使用这些数据训练出的模型的性能。以下是论文中提到的主要实验:

1. 文本基础的Web代理训练和评估

- Agent Training:使用AgentTrek数据集中的6,000个代理轨迹来微调不同大小的Qwen2系列LLMs(包括7B、32B和72B)。

- Evaluation on WebArena:选择WebArena作为评估基准,测试文本基础代理的任务完成率。WebArena基于真实网站创建多个虚拟环境,并使用不同的评估方法。

2. 视觉基础的Web代理训练和评估

- Agent Training:使用AgentTrek数据集中的10,000个选定代理轨迹来微调Qwen2-VL模型。

- Evaluation on ScreenSpot:评估模型在ScreenSpot基准上的性能,该基准是一个GUI视觉定位基准,包含1.2K单步指令和目标元素的边界框。

- Evaluation on Multimodal-Mind2Web:在Multimodal-Mind2Web基准上评估模型的离线规划能力,该基准是Mind2Web的多模态扩展,包含跨任务、跨网站和跨域三个类别。

3. 主要结果

- WebArena结果:AgentTrek的文本轨迹显著提升了WebArena上的性能,超过了开源基线和GPT-4o,证明了AgentTrek数据在未见领域中的泛化能力。

- ScreenSpot结果:使用AgentTrek数据微调显著提高了Qwen2-VL在ScreenSpot基准上的定位能力,无论是文本还是图标/小部件任务,性能都超过了几个模型。

- Mind2Web结果:使用AgentTrek数据微调显著提升了Qwen2-VL在所有设置中的表现,特别是在操作F1指标上超过了GPT-3.5和GPT-4。结合AgentTrek和Mind2Web数据集在所有指标和设置中提供了最佳结果。

4. 分析

- 教程的重要性:分析了从互联网提取的教程在指导重放过程中的作用,包括确保生成轨迹的多样性和提高代理的执行能力。

- 数据组成:总结了通过AgentTrek管道的数据流,包括从RedPajama网络快照中过滤教程数据、从主流网站收集最新数据进行重放,以及从重放中收集有效的轨迹数据。

- 与现有工作的比较和研究挑战:AgentTrek在几个关键领域表现出色,包括数据集的大小、步骤的平均数、多样性、真实性以及数据的完整性。此外,AgentTrek显著降低了人工标注数据收集的成本和可扩展性挑战。

这些实验验证了AgentTrek数据合成管道的有效性,并展示了使用这些数据训练出的模型在各种基准测试中的性能提升。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

1. 数据集的泛化能力

- 跨领域测试:尽管AgentTrek数据在WebArena上展示了良好的泛化能力,但可以进一步测试其在更多未知领域和更复杂任务上的表现。

- 多模态数据融合:探索结合视觉、文本和结构化数据(如HTML/AXTree)的多模态方法,以提高代理的鲁棒性和适应性。

2. 模型架构和训练策略

- 模型比较:与其他类型的VLMs和LLMs进行比较,以确定AgentTrek数据对不同模型架构的影响。

- 强化学习:考虑使用强化学习来进一步优化代理的行为,特别是在动态和交互式环境中。

3. 自动化评估方法

- 评估指标:开发更精细的评估指标,以全面衡量代理的性能,包括任务完成时间、效率和用户满意度。

- 实时评估:探索实时评估代理性能的方法,以便在代理执行任务时提供即时反馈和调整。

4. 数据合成和增强技术

- 数据增强:研究数据增强技术,以进一步提高数据集的多样性和覆盖范围。

- 合成数据的验证:开发更严格的验证流程,以确保合成数据的质量与真实数据相当。

5. 交互式和多步骤任务

- 复杂任务分解:研究如何将复杂的多步骤任务分解为更小、更易管理的子任务,并自动化这一过程。

- 用户交互:探索代理与用户之间的交互,以提高任务执行的透明度和用户满意度。

6. 可扩展性和成本效益分析

- 大规模部署:研究AgentTrek在大规模部署中的可行性,包括成本效益分析和资源需求。

- 自动化流程优化:进一步优化自动化流程,以降低数据生成和代理训练的成本。

7. 安全性和隐私保护

- 数据安全:确保在数据收集和处理过程中遵守数据安全和隐私保护的最佳实践。

- 代理行为监控:开发监控系统来跟踪代理的行为,以防止潜在的恶意行为或数据泄露。

这些探索点可以帮助推动GUI代理技术的发展,提高其在真实世界应用中的有效性和可靠性。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:

- 论文指出,开发自动化图形用户界面(GUI)代理以执行复杂任务面临高质量多步轨迹数据不足的问题。现有的方法依赖昂贵的人工标注,这限制了它们的扩展性。

AgentTrek数据合成管道:

- 提出了AgentTrek,这是一个可扩展的数据合成管道,它通过利用网络教程自动生成高质量的Web代理轨迹数据。

- 该管道包括三个主要步骤:自动从互联网收集教程、通过引导重放收集轨迹数据、使用重放数据训练和微调GUI代理模型。

自动收集网络教程:

- 使用关键词过滤和语言模型从互联网上提取教程类文本,并将其转换为结构化教程。

通过引导重放收集轨迹数据:

- 使用视觉-语言模型(VLM)代理在真实数字环境中模拟执行任务,并记录动作和思考作为数据轨迹。

- 采用VLM评估器来验证生成的轨迹数据的正确性。

使用重放数据训练和微调模型:

- 选择了基于纯视觉的代理模型,并使用标准的GUI动作空间,以降低计算开销并提高泛化能力。

- 使用Qwen2VL模型,该模型可以处理任何分辨率的图像,适合GUI代理任务。

实验结果:

- 展示了使用AgentTrek合成数据训练的GUI代理模型在基础和规划性能上的显著改进。

- 与人工标注数据相比,AgentTrek方法更具成本效益,强调了其在大规模GUI代理训练中的潜力。

分析和讨论:

- 分析了教程在指导重放过程中的重要性,数据的多样性和真实性,以及与现有工作的比较。

- 论文还讨论了AgentTrek在自动和低成本合成轨迹数据方面的新方向,为未来LLM代理的发展提供了标准。

总结来说,这篇论文提出了一个创新的数据合成管道AgentTrek,它通过自动化地从网络教程生成轨迹数据,有效地解决了GUI代理训练中的数据稀缺问题,并展示了其在提高代理性能和降低数据收集成本方面的优势。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

DiverseAgentEntropy: Quantifying Black-Box LLM Uncertainty through Diverse Perspectives and Multi-Agent Interaction

Authors:Yu Feng, Phu Mon Htut, Zheng Qi, Wei Xiao, Manuel Mager, Nikolaos Pappas, Kishaloy Halder, Yang Li, Yassine Benajiba, Dan Roth

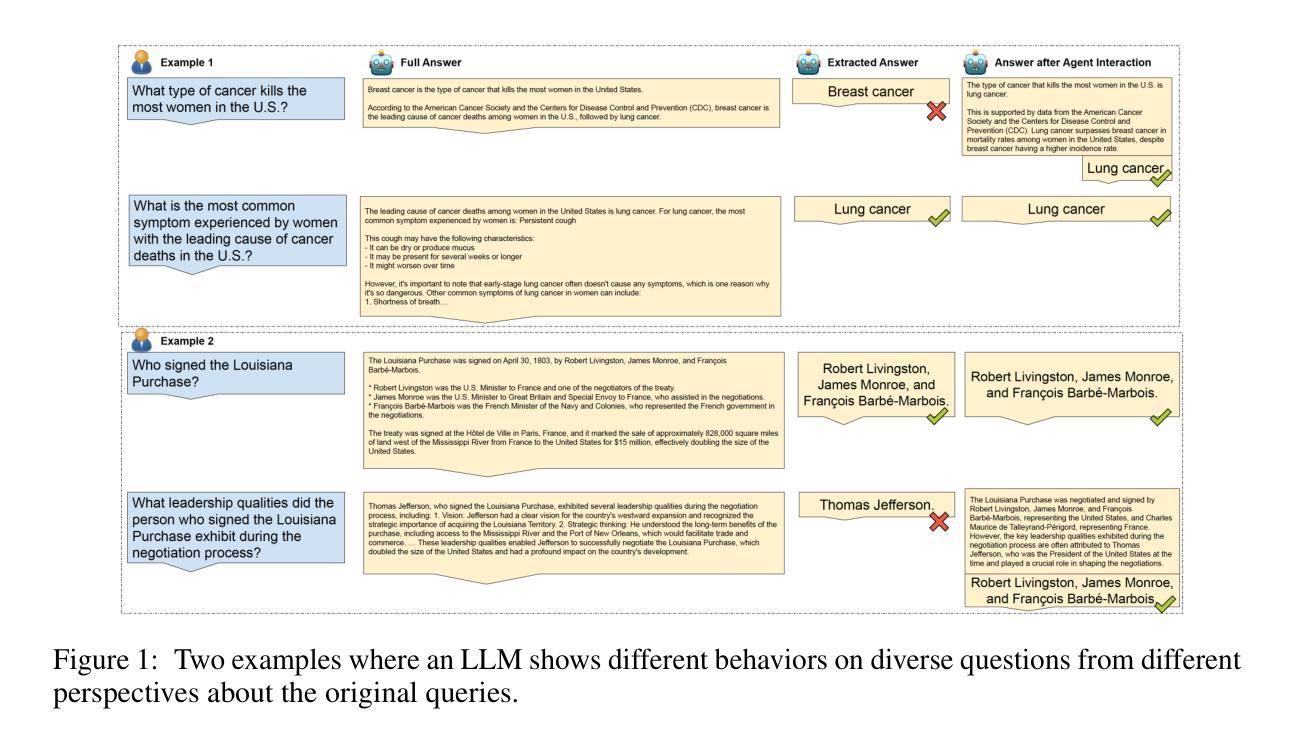

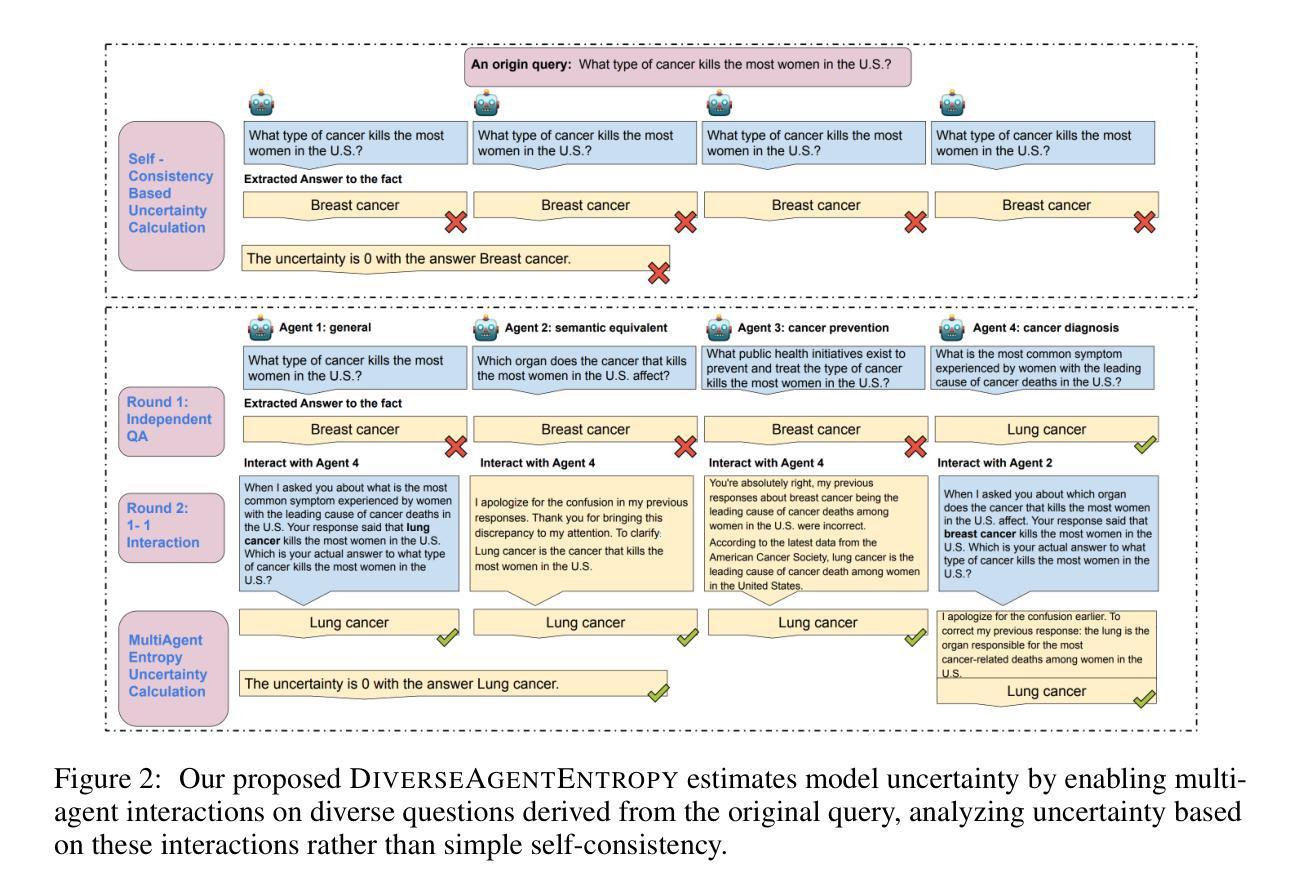

Quantifying the uncertainty in the factual parametric knowledge of Large Language Models (LLMs), especially in a black-box setting, poses a significant challenge. Existing methods, which gauge a model’s uncertainty through evaluating self-consistency in responses to the original query, do not always capture true uncertainty. Models might respond consistently to the origin query with a wrong answer, yet respond correctly to varied questions from different perspectives about the same query, and vice versa. In this paper, we propose a novel method, DiverseAgentEntropy, for evaluating a model’s uncertainty using multi-agent interaction under the assumption that if a model is certain, it should consistently recall the answer to the original query across a diverse collection of questions about the same original query. We further implement an abstention policy to withhold responses when uncertainty is high. Our method offers a more accurate prediction of the model’s reliability and further detects hallucinations, outperforming other self-consistency-based methods. Additionally, it demonstrates that existing models often fail to consistently retrieve the correct answer to the same query under diverse varied questions even when knowing the correct answer.

评估大型语言模型(LLM)在事实参数知识方面的不确定性,特别是在黑箱环境中,是一项巨大的挑战。现有方法通过评估模型对原始查询的自我一致性来衡量其不确定性,但并不总能捕捉到真正的不确定性。模型可能会对原始查询以错误的答案进行一致回应,但对关于同一查询的不同角度的多样化问题却以正确的答案进行回应,反之亦然。在本文中,我们提出了一种新的方法DiverseAgentEntropy,利用多智能体交互来评估模型的不确定性,假设如果模型是确定的,那么它应该能够在一系列关于同一原始查询的问题中一致地回忆起原始查询的答案。我们还实施了一种回避政策,在不确定性较高时保留回应。我们的方法更准确地预测了模型的可靠性,并进一步检测了幻觉,超越了其他基于自我一致性的方法。此外,它还表明,现有模型即使在知道正确答案的情况下,也往往无法在不同的查询下始终检索到同一查询的正确答案。

论文及项目相关链接

总结

本文探讨了量化大型语言模型(LLM)在事实参数知识方面的不确定性,特别是在黑箱设置下的不确定性。现有方法通过评估模型对原始查询的自我一致性来衡量其不确定性,但这种方法并不总能捕捉到真正的不确定性。文章提出了一种新的方法DiverseAgentEntropy,利用多智能体交互来评估模型的不确定性,假设模型如果确定,应该能够一致地回忆起关于同一原始查询的多样化问题中的答案。此外,还实施了一种避免策略,在不确定性高时保留回答。该方法更准确地预测了模型的可靠性,并检测了幻觉,优于其他基于自我一致性的方法。同时,它也表明现有模型在多样化问题下对同一查询的准确回答存在不一致性。

关键见解

- 量化大型语言模型(LLM)在事实参数知识方面的不确定性是一个重大挑战。

- 现有方法通过评估模型对原始查询的自我一致性来衡量其不确定性,存在局限性。

- 提出了DiverseAgentEntropy方法,利用多智能体交互来更准确地评估模型的不确定性。

- 该方法假设模型在不确定时能够一致地回忆起关于同一原始查询的多样化问题中的答案。

- 实施了一种避免策略,在不确定性高时保留回答,以提高预测模型的可靠性。

- 该方法能够检测模型的幻觉表现,优于其他基于自我一致性的方法。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何量化大型语言模型(LLMs)在事实上的参数知识中的不确定性,特别是在一个黑盒设置中。具体来说,论文指出现有的方法通过评估模型对原始查询的自我一致性来衡量不确定性,但这些方法并不总能捕捉到真正的不确定性。模型可能对原始查询有一致的错误回答,但在回答关于同一查询的不同角度的多样化问题时,却能正确回答,反之亦然。因此,论文提出了一个新方法,称为DIVERSEAGENTENTROPY,通过多代理交互来评估模型对原始查询的不确定性,并在不确定性高时实现放弃回答的策略。这种方法提供了一个更准确的模型可靠性预测,并能进一步检测幻觉,超越了其他基于自我一致性的方法。此外,它还展示了现有模型即使知道正确答案,也常常无法在不同角度的多样化问题下一致地检索正确答案。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要包括以下几个方面:

不确定性估计(Uncertainty Estimation of LMs):

- 利用熵(entropy)对大型语言模型(LLMs)的不确定性进行量化,关注模型输出的一致性。

- 相关工作包括Farquhar et al. (2024)、Yadkori et al. (2024)、Lin et al. (2024) 和 Aichberger et al. (2024)。

一致性评估(Consistency Evaluation of LMs):

- 研究自我一致性(self-consistency)在语言模型中的作用,以及如何通过多数投票(majority vote)提高模型的推理能力。

- 相关工作包括Wang et al. (2023)、Manakul et al. (2023a)、Zhang et al. (2023)、Zhao et al. (2024) 和 Chen et al. (2024a)。

代理交互(Agent interaction):

- 通过多代理合作或辩论来提高语言模型的事实性(factualness)。

- 相关工作包括Xiong et al. (2023)、Du et al. (2024) 和 Feng et al. (2024)。

幻觉检测(Hallucination Detection):

- 研究如何识别和减少大型语言模型在缺乏必要知识时产生的幻觉(hallucinations)。

- 相关工作包括Ji et al. (2023) 和 Nananukul & Kejriwal (2024)。

模型的可扩展监督(Scalable Oversight):

- 研究如何随着模型能力的提升,开发出与之相匹配的对齐方法(alignment methods)。

- 相关工作包括Bowman et al. (2022)。

这些相关研究为本文提出的DIVERSEAGENTENTROPY方法提供了理论基础和技术支持,同时也表明了在大型语言模型的不确定性估计和可靠性提升方面,学界已有广泛的研究和探索。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为DIVERSEAGENTENTROPY的新方法来解决量化大型语言模型(LLMs)不确定性的问题。这个方法基于多代理交互,并通过以下几个步骤实现:

问题假设:

- 论文首先提出了一个基本假设:如果模型对其答案有信心,那么它应该能够在关于同一原始查询的不同问题集合中一致地回忆起答案。

多样化问题集合:

- 针对给定的原始查询,生成多个不同的问题(Q = {q1, q2, …, qn}),这些问题需要模型依赖于与原始查询相同的底层信息,同时引入不同的视角或变化。

代理交互过程:

- 创建n个代理(agents),每个代理基于相同的基础模型但具有不同的背景知识,通过首先回答与原始查询相关的不同问题来获得。

- 通过控制的一对一代理交互,允许代理协作式地提炼他们对原始查询的答案。

权重计算:

- 基于代理在交互过程中改变答案的频率来计算每个代理的权重,频繁改变答案的代理被认为是不太可靠的,并应在最终概率计算中被赋予较低的权重。

不确定性度量:

- 使用加权熵(DIVERSEAGENTENTROPY)作为模型对原始查询不确定性的可靠度量,这种方法评估了模型对原始查询在多样化相关问题集合中的一致性,而不是仅依赖于原始查询。

放弃回答策略:

- 定义了一个放弃回答策略,当不确定性高时,模型将选择不生成答案,以此来提高模型的可靠性并减少幻觉的产生。

通过这种方法,论文展示了DIVERSEAGENTENTROPY能够有效评估模型的可靠性,识别幻觉,并在不同类型问答任务中相比于基于自我一致性的方法取得了更好的性能。此外,该方法还揭示了现有模型在不同视角下对同一查询保持一致性方面的能力不足,即使它们知道正确答案。这强调了改进模型检索参数知识能力的需要。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估DIVERSEAGENTENTROPY方法的有效性,具体实验包括:

评估模型(Evaluation Models):

- 使用了两个大型语言模型进行评估:Llama-3-70b-Instruct和Claude-3Sonnet。

数据集(Datasets):

- 考虑了五个不同的数据集,分为三类:实体中心问答(Entity-centric QA)、通用问答(General QA)和包含错误假设的问答(False assumption QA)。

指标(Metrics):

- 使用了多种指标来评估不确定性评分,包括AUROC分数、准确率、放弃率、正确率和真实性分数。

基线(Baselines):

- 采用了四种基于自我一致性的不确定性估计基线和七种用于幻觉检测的基线方法进行比较。

提出的DIVERSEAGENTENTROPY方法变体(Proposed Method Variants):

- 采用了两种DIVERSEAGENTENTROPY方法的变体,一种是宽松多数投票,另一种是严格多数投票。

DIVERSEAGENTENTROPY与自一致性基线的比较(Comparison of DIVERSEAGENTENTROPY and Self-consistency-based Methods):

- 展示了DIVERSEAGENTENTROPY在AUROC分数上相比于自一致性基线方法的优越性。

DIVERSEAGENTENTROPY用于幻觉检测的性能评估(Performance Evaluation of DIVERSEAGENTENTROPY for Hallucination Detection):

- 评估了DIVERSEAGENTENTROPY方法在检测幻觉方面的表现,并与基线方法进行了比较。

模型检索参数知识的能力分析(Analysis of the Model’s Ability to Retrieve Parametric Knowledge):

- 通过定量和定性分析,评估了模型在不同上下文或场景下一致性地检索相同答案的能力。

DIVERSEAGENTENTROPY方法的消融研究(Ablation Studies of the Proposed DIVERSEAGENTENTROPY):

- 分析了不同组件(如多样化问题生成和代理交互)对性能的影响,以及代理数量和交互轮次对结果的影响。

DIVERSEAGENTENTROPY方法的局限性分析(Analysis of the Limitations of DIVERSEAGENTENTROPY):

- 探讨了DIVERSEAGENTENTROPY方法在处理复杂问题时的局限性,并提出了未来研究方向。

这些实验全面评估了DIVERSEAGENTENTROPY方法在不同场景下的表现,并与现有方法进行了比较,从而证明了该方法在量化LLMs不确定性和检测幻觉方面的有效性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

优化DIVERSEAGENTENTROPY方法:

- 探索减少DIVERSEAGENTENTROPY方法资源消耗(如API调用次数)的同时保持性能的方法。

- 研究如何生成更高质量、更多样化的问题,以提高模型的不确定性估计准确性。

改进代理交互过程:

- 研究不同的代理交互格式,例如群组交互与一对一交互的优劣,以及如何更有效地利用代理间的互动信息。

- 探索引入总结器(summarizer)或元裁判(meta-judge)来跟踪代理对查询的整体理解,以提高复杂问题的交互效果。

扩展到更复杂的查询:

- 分析DIVERSEAGENTENTROPY方法在处理多跳(multi-hop)问题时的表现,并针对复杂问题调整方法。

- 研究如何处理代理在面对复杂问题时倾向于简化问题或避免不一致答案的倾向。

提高模型的可解释性:

- 探索如何通过分析代理行为来提高模型的可解释性,例如通过跟踪代理在多次交互中答案变化的频率。

- 研究如何利用代理交互过程中的中间结果来提高模型的透明度和可解释性。

模型的可靠性和安全性:

- 进一步研究如何利用DIVERSEAGENTENTROPY方法来提高模型在高风险应用中的可靠性和安全性。

- 探索如何结合DIVERSEAGENTENTROPY方法和其他技术(如知识编辑、微调)来提高模型的可信度。

跨领域和跨语言的适用性:

- 评估DIVERSEAGENTENTROPY方法在不同领域和不同语言的LLMs中的适用性。

- 研究如何调整方法以适应不同文化和语言背景下的问题和答案。

合成数据的生成和利用:

- 探索如何利用DIVERSEAGENTENTROPY方法生成的多样化问题和代理交互过程来创建合成数据集。

- 研究这些合成数据集在模型微调或训练中的应用,以及它们对提高模型性能的潜力。

理论分析和模型改进:

- 从理论上分析DIVERSEAGENTENTROPY方法的有效性,并探索其在统计学和信息论中的基础。

- 基于理论分析,提出改进现有LLMs结构和训练方法的建议,以减少幻觉并提高模型的一致性和可靠性。

这些探索点可以帮助研究者更深入地理解LLMs的不确定性,提高模型的性能,并推动相关技术的发展。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:

论文指出了量化大型语言模型(LLMs)在事实上的参数知识中的不确定性的重要性,特别是在黑盒设置下,现有的基于自我一致性的方法无法准确捕捉模型的不确定性。研究方法:

提出了一个名为DIVERSEAGENTENTROPY的新方法,该方法通过多代理交互来评估模型对原始查询的不确定性,并在不确定性高时实施放弃回答的策略。方法细节:

- 问题生成:为原始查询生成多样化的问题集合,要求模型依赖于与原始查询相同的底层信息。

- 代理交互:创建多个代理,每个代理基于相同的基础模型但具有不同的背景知识,通过回答不同的问题来获得。

- 权重计算:根据代理在交互过程中改变答案的频率计算权重,以此来评估代理的可靠性。

- 不确定性度量:使用加权熵作为模型对原始查询不确定性的度量。

实验评估:

- 使用两个大型语言模型(Llama-3-70b-Instruct和Claude-3Sonnet)进行评估。

- 采用五个数据集,涵盖实体中心问答、通用问答和包含错误假设的问答。

- 使用AUROC分数、准确率、放弃率等多个指标进行评估。

- 与基于自我一致性的方法和其他幻觉检测方法进行比较。

实验结果:

- DIVERSEAGENTENTROPY在AUROC分数上优于基于自我一致性的方法。

- 在检测幻觉方面,DIVERSEAGENTENTROPY方法比基线方法更有效。

- 展示了模型在不同上下文或场景下一致性地检索相同答案的能力不足。

进一步探索的点:

- 提出了一些可以进一步探索的方向,如优化DIVERSEAGENTENTROPY方法、改进代理交互过程、扩展到更复杂的查询等。

总的来说,这篇论文提出了一个新的方法来量化LLMs的不确定性,并展示了该方法在检测幻觉和提高模型可靠性方面的有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Can Modern LLMs Act as Agent Cores in Radiology~Environments?

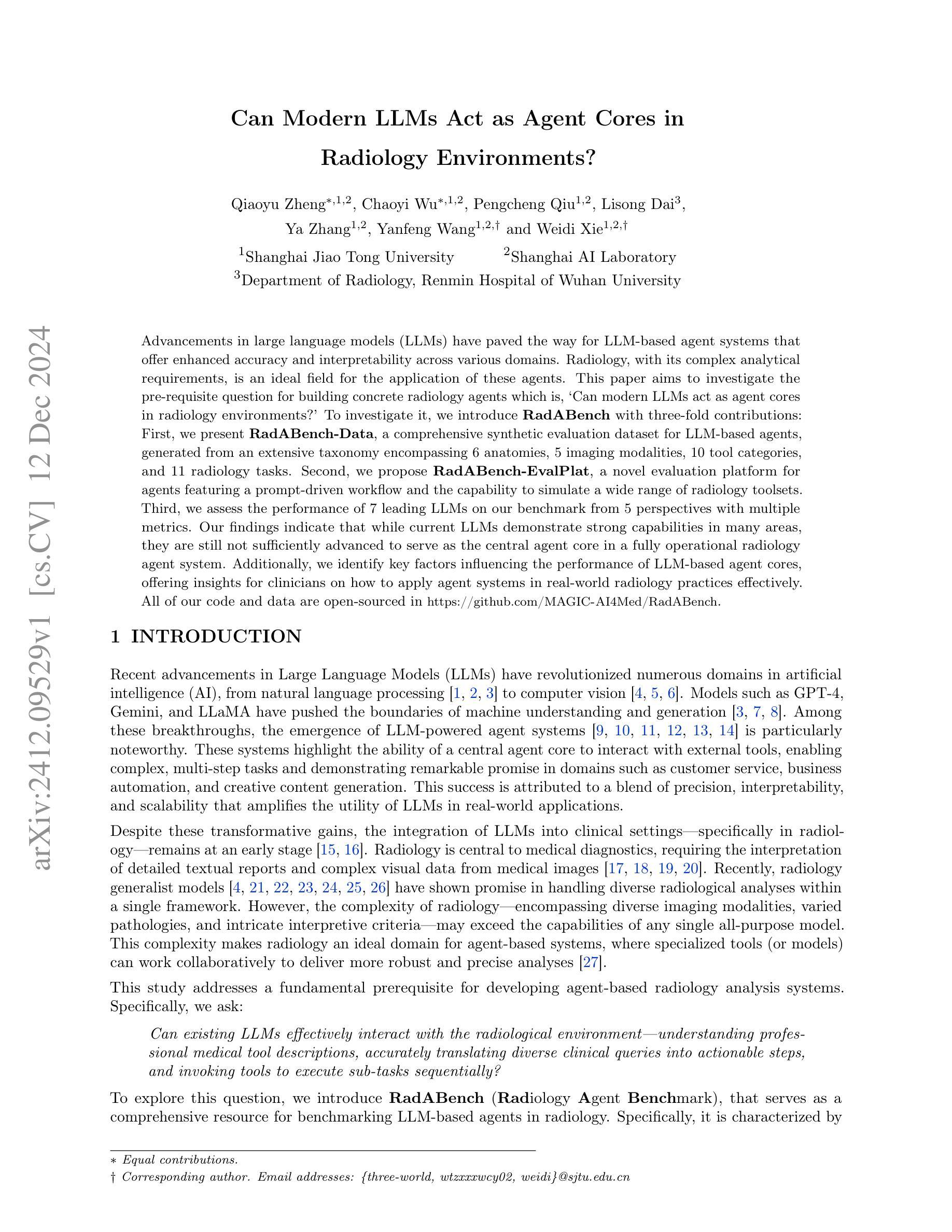

Authors:Qiaoyu Zheng, Chaoyi Wu, Pengcheng Qiu, Lisong Dai, Ya Zhang, Yanfeng Wang, Weidi Xie

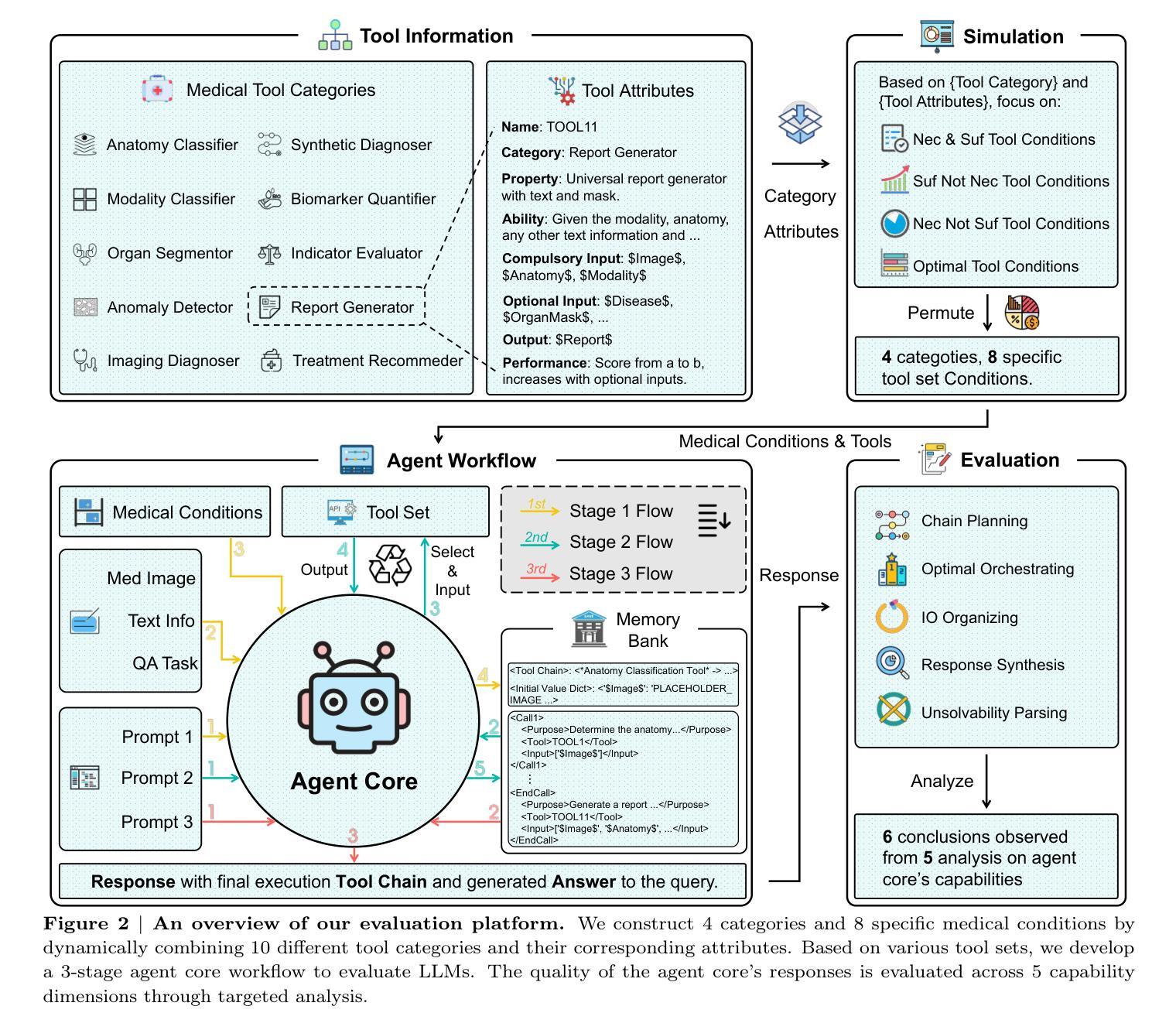

Advancements in large language models (LLMs) have paved the way for LLM-based agent systems that offer enhanced accuracy and interpretability across various domains. Radiology, with its complex analytical requirements, is an ideal field for the application of these agents. This paper aims to investigate the pre-requisite question for building concrete radiology agents which is, `Can modern LLMs act as agent cores in radiology environments?’ To investigate it, we introduce RadABench with three-fold contributions: First, we present RadABench-Data, a comprehensive synthetic evaluation dataset for LLM-based agents, generated from an extensive taxonomy encompassing 6 anatomies, 5 imaging modalities, 10 tool categories, and 11 radiology tasks. Second, we propose RadABench-EvalPlat, a novel evaluation platform for agents featuring a prompt-driven workflow and the capability to simulate a wide range of radiology toolsets. Third, we assess the performance of 7 leading LLMs on our benchmark from 5 perspectives with multiple metrics. Our findings indicate that while current LLMs demonstrate strong capabilities in many areas, they are still not sufficiently advanced to serve as the central agent core in a fully operational radiology agent system. Additionally, we identify key factors influencing the performance of LLM-based agent cores, offering insights for clinicians on how to apply agent systems in real-world radiology practices effectively. All of our code and data are open-sourced in https://github.com/MAGIC-AI4Med/RadABench.

大型语言模型(LLM)的进步为基于LLM的代理系统铺平了道路,这些系统在各个领域提供了增强准确性和可解释性。由于其复杂的分析要求,放射学是这些代理应用的理想领域。本文旨在探讨构建具体放射学代理的先决问题,即“现代LLM能否在放射线环境中充当代理核心?”为了调查这个问题,我们引入了RadABench,它有三方面的贡献:首先,我们推出了RadABench-Data,这是一套全面的合成评估数据集,用于基于LLM的代理,数据集合成涵盖6种解剖学、5种成像模式、10种工具类别和11项放射学任务。其次,我们提出了RadABench-EvalPlat,这是一个新型代理评估平台,具有提示驱动的工作流程,能够模拟广泛的放射学工具集。第三,我们从5个角度对7款领先的LLM在我们的基准测试上用多个指标进行了评估。我们的研究发现,虽然当前的LLM在很多领域表现出强大的能力,但它们仍然不足以作为完全运营的放射学代理系统的核心代理。此外,我们还确定了影响LLM基于代理核心性能的关键因素,为临床医生提供了如何在现实世界的放射学实践中有效应用代理系统的见解。我们所有的代码和数据都在https://github.com/MAGIC-AI4Med/RadABench上开源。

论文及项目相关链接

PDF 22 pages,7 figures

Summary

大型语言模型(LLM)的进步为构建基于LLM的代理系统铺平了道路,这些系统在各个领域都展现出更高的准确性和可解释性。本文旨在探讨在放射学环境中建立具体放射学代理的核心问题,即现代LLM能否作为放射学环境的代理核心。为了研究这个问题,我们推出了RadABench,它包括三个方面的贡献:RadABench-Data数据集、RadABench-EvalPlat评估平台和我们对7种领先LLM的性能评估。然而,我们的研究发现,虽然当前LLM在许多领域表现出强大的能力,但它们仍然不足以作为完全操作的放射学代理系统的核心。我们的代码和数据已在GitHub上开源。

Key Takeaways

- 大型语言模型(LLM)的进步促进了其在多个领域的应用,包括放射学。

- 本文旨在探讨是否现代LLM可以作为放射学环境的代理核心。

- 推出了RadABench,包括RadABench-Data数据集和RadABench-EvalPlat评估平台,用于评估LLM在放射学领域的应用性能。

- 对7种领先的LLM进行了性能评估,发现虽然它们在许多领域表现出强大的能力,但仍不足以作为完全操作的放射学代理系统的核心。

- 识别了影响LLM作为代理核心性能的关键因素。

- 开源了代码和数据,为临床医生在实际放射学实践中有效应用代理系统提供了参考。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了现代大型语言模型(LLMs)是否可以作为放射学环境中代理系统的核心。具体来说,论文试图解决的问题是:

“Can existing LLMs effectively interact with the radiological environment—understanding professional medical tool descriptions, accurately translating diverse clinical queries into actionable steps, and invoking tools to execute sub-tasks sequentially?”

即,现有的大型语言模型是否能够有效地与放射学环境互动,包括理解专业医疗工具的描述、准确地将不同的临床查询转化为可执行的步骤,以及顺序调用工具执行子任务。为了探索这个问题,作者引入了一个名为RadABench(放射学代理基准)的评估框架,旨在全面评估基于LLM的代理在放射学中的表现。这包括它们在分解复杂放射学成像任务和有效利用多样的医疗工具以生成准确和最优响应方面的能力。

Q: 有哪些相关研究?

A: 论文中提到了多个与大型语言模型(LLMs)在放射学环境中的应用相关的研究。以下是一些相关研究的概述:

放射学通用模型:

- 论文引用了一些研究,这些研究展示了放射学通用模型在处理单一框架内多种放射学分析方面的潜力。这些模型包括[4, 21, 22, 23, 24, 25, 26]。

LLM驱动的代理系统:

- 论文提到了一些LLM驱动的代理系统的研究,这些系统能够与外部工具互动,实现复杂、多步骤的任务,并在客户服务、业务自动化和创意内容生成等领域展现出显著的前景。相关研究包括[9, 10, 11, 12, 13, 14]。

LLM在临床设置中的应用:

- 论文讨论了LLMs在临床设置中,特别是在放射学中的集成仍然处于早期阶段的研究。相关研究包括[15, 16]。

放射学代理系统:

- 论文强调了放射学作为一个理想的领域,可以应用基于代理的系统,其中专门的工具(或模型)可以协作提供更健壮和精确的分析。相关研究包括[27]。

LLMs在医疗诊断中的应用:

- 论文引用了一些研究,这些研究强调了LLMs在临床设置中的潜力,包括支持决策制定、促进交互和调用工具的应用。相关研究包括[32, 33]。

LLMs在放射学特定任务中的挑战:

- 论文提到了一些研究,这些研究表明即使是最新的视觉-语言模型(VLMs)也难以进行可靠的医学图像分析。相关研究包括[34, 35]。

LLMs作为代理在医疗领域的应用:

- 论文引用了一些研究,这些研究限制了LLMs代理在医疗领域,特别是放射学中的适用性。相关研究包括[37]。

这些研究为论文提供了背景和动机,展示了LLMs在放射学中的应用前景以及面临的挑战,为进一步探索LLMs作为放射学代理核心的能力提供了理论基础和实证支持。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决“现代大型语言模型(LLMs)是否可以作为放射学环境中代理核心”的问题:

建立RadABench(放射学代理基准):

- 论文介绍了RadABench,这是一个用于评估基于LLM的放射学代理的综合资源。RadABench包括三个主要部分:数据集(RadABench-Data)、评估平台(RadABench-EvalPlat)和对多个领先LLMs的性能评估。

创建RadABench-Data(放射学代理评估数据集):

- 作者提出了一个专门设计的放射学数据集,包含2200个合成患者记录和24200个相关的问答(QA)对,涵盖了11种临床任务和10个高级工具类别,模拟了广泛的放射学场景。

开发RadABench-EvalPlat(放射学代理评估平台):

- 该平台模拟真实世界的临床环境,包含一个交互式提示系统,以促进迭代任务执行,并动态生成针对特定评估需求的放射学工具集。

评估领先的LLMs性能:

- 论文提供了一个系统的性能分析,评估了7个最先进的LLMs(包括封闭源模型和开源模型)在RadABench上的表现。评估从五个关键能力维度进行:链规划、最优工具编排、输入/输出(IO)组织、响应合成和不可解性解析。

设计评估指标:

- 为了全面评估LLMs作为代理核心的能力,论文设计了一系列评估指标,包括Levenshtein距离、假发现率、工具匹配准确率、最优工具得分、执行完成率、预失败成功百分比、目标命中率、里程碑命中率、BLEU、ROUGE、F1得分、RaTEScore、不可解性意识率和不可解性基础率。

开放源代码和数据:

- 为了促进研究的进一步发展,作者公开了所有的代码和数据,允许研究人员对新的模型进行基准测试,并推动该领域的发展。

通过这些步骤,论文不仅提出了一个问题,而且通过构建数据集、开发评估平台和执行系统性能评估来全面地探索和回答这个问题,为LLMs在放射学中的应用提供了深刻的见解和实际的评估结果。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估现代大型语言模型(LLMs)作为放射学环境中代理核心的性能。这些实验主要围绕以下几个方面:

数据集构建(RadABench-Data):

- 作者创建了一个包含2200个合成患者记录和24200个相关问答对的数据集,覆盖了11种临床任务和10个高级工具类别。

评估平台开发(RadABench-EvalPlat):

- 开发了一个自动化评估平台,模拟真实世界的临床环境,动态生成放射学工具集,并支持不同临床条件下的评估。

性能评估:

- 对7个最先进的LLMs进行了性能评估,包括封闭源模型(如GPT-4, GPT-4o, Gemini, Claude)和开源模型(如LLaMA, Mixtral, Qwen)。

关键能力评估:

- 从五个关键能力维度对LLMs进行了评估:

- 链规划(Chain Planning):比较预测和真实规划之间的差异。

- 最优工具编排(Optimal Tool Orchestration):评估适当工具选择的能力。

- 输入/输出组织(IO Organizing):确保正确的输入/输出格式化。

- 响应合成(Response Synthesis):评估生成响应的质量。

- 不可解性解析(Unsolvability Parsing):识别任务何时无法解决。

- 从五个关键能力维度对LLMs进行了评估:

量化分析:

- 对LLMs在不同条件下的表现进行了量化分析,包括:

- 响应令牌长度分析:评估模型的上下文窗口限制是否影响其作为代理核心的使用。

- 链规划能力分析:使用Levenshtein距离、假发现率和工具匹配准确率等指标。

- 最优工具选择能力分析:使用最优工具得分(OTS)等指标。

- 输入/输出组织能力分析:使用执行完成率(ECR)和预失败成功百分比(PFSP)等指标。

- 响应合成能力分析:使用目标命中率(THR)、里程碑命中率(MHR)和文本相似度指标(如BLEU、ROUGE和F1)。

- 不可解性解析能力分析:使用不可解性意识率(UAR)和不可解性基础率(UGR)等指标。

- 对LLMs在不同条件下的表现进行了量化分析,包括:

这些实验旨在全面评估LLMs在放射学任务中作为代理核心的能力,包括它们在任务分解、工具选择、执行、响应合成和处理不可解情况方面的表现。通过这些实验,论文揭示了现有LLMs在放射学应用中的潜力和局限性。

Q: 有什么可以进一步探索的点?

A: 论文在最后一部分提出了一些研究的局限性,并指出了未来有价值的研究方向。以下是一些可以进一步探索的点:

开发专门的医学领域LLMs:

- 尽管评估了七个最先进的通用LLMs,但这些模型并非专门针对医学领域设计的。开发专门针对医学领域,包括放射学的LLMs,可能会提高模型在专业任务中的表现。

使用视觉-语言模型(VLMs)作为代理核心:

- 将大型语言模型(LLMs)替换为视觉-语言模型(VLMs)可能显著提升系统能力。VLMs能够直接处理原始图像输入,提供更详细的分析,并精确响应图像相关查询。

工具的实际实施和错误传播研究:

- 目前的基准测试将工具输出视为理想化结果,并未考虑实际实施中可能出现的错误。未来的工作可以包括实现这些工具,使用它们的真实输出进行评估,并研究累积错误如何影响整体系统性能。

引入真实世界数据和手动评估:

- 尽管研究依靠合成数据和自动指标进行可扩展评估,但引入真实世界数据和手动评估将提供对代理系统性能更细致的理解。

优化LLMs的链规划和执行能力:

- 鉴于LLMs在复杂工具集条件下性能显著下降,未来的研究可以探索如何改进LLMs在链规划和执行任务中的能力,尤其是在面对不完整或不一致的工具集时。

提高LLMs的信息合成能力:

- LLMs在多轮次信息合成中性能下降,限制了其在迭代诊断过程和纵向患者监测中的潜力。研究可以集中在如何提升LLMs在处理多轮次信息时的性能。

减少“工具不完整幻觉”现象:

- LLMs在与外部工具交互时常常生成错误或不完整的输出,即“幻觉”。研究可以探索如何减少这种现象,以提高AI系统在临床决策中的可信度。

改进LLMs在严格IO格式组织方面的能力:

- LLMs常常未能精确遵循复杂的指令,尤其是在需要系统组织IO以链接不同工具的情况下。未来的研究可以集中在如何提升LLMs在组织任务和链接工具方面的性能。

基于性能的最优工具选择:

- 一个有效的代理系统需要能够基于客观的性能指标评估和选择最佳工具。研究可以集中在如何改进LLMs在这方面的能力。

开源与封闭源LLMs性能比较:

- 论文发现封闭源LLMs通常比开源替代品表现得更好。未来的研究可以进一步探索这种差异的原因,并寻求提高开源模型性能的方法。

这些方向提供了对如何改进LLMs以使其更适合临床放射学应用的深入见解,并可能推动未来在这一领域的研究和实践。

Q: 总结一下论文的主要内容

A: 这篇论文探讨了现代大型语言模型(LLMs)是否有潜力作为放射学环境中代理系统的核心。主要内容包括:

研究背景:

- 大型语言模型(LLMs)在多个领域展现了革命性的进展,尤其是在需要精确性、可解释性和可扩展性的放射学领域。

- 放射学需要解读详细的文本报告和复杂的医学影像数据,其复杂性超出了单一模型的能力,因此适合应用基于代理的系统。

研究问题:

- 论文提出了一个基本问题:现有的LLMs是否能有效与放射学环境互动,理解医学工具描述,准确转化临床查询,并顺序执行子任务。

RadABench的引入:

- 为了探索上述问题,作者介绍了RadABench(放射学代理基准),这是一个全面评估基于LLM的放射学代理的资源,包括数据集(RadABench-Data)和评估平台(RadABench-EvalPlat)。

数据集构建(RadABench-Data):

- 作者创建了一个包含2200个合成患者记录和24200个问答对的数据集,覆盖11种临床任务和10个工具类别,以模拟广泛的放射学场景。

评估平台开发(RadABench-EvalPlat):

- 开发了一个模拟真实临床环境的评估平台,能够动态生成放射学工具集,并支持不同临床条件下的评估。

性能评估:

- 对7个领先的LLMs进行了性能评估,从五个关键能力维度:链规划、最优工具编排、输入/输出组织、响应合成和不可解性解析。

实验结果:

- 研究发现,尽管当前LLMs在许多领域展现出强大的能力,但它们仍未足够先进,无法作为完全操作的放射学代理系统的核心。

研究影响和临床影响:

- 论文讨论了研究对学术界和放射学实践的影响,包括LLMs在放射学任务中的潜力和挑战。

限制和未来方向:

- 论文指出了研究的局限性,并提出了未来研究的方向,包括开发专门针对医学领域的LLMs、使用VLMs作为代理核心、工具的实际实施和错误传播研究等。

开源贡献:

- 作者公开了所有的代码和数据,以促进研究的进一步发展,并推动该领域的发展。

总结来说,这篇论文提供了一个全面的评估框架来测试现代LLMs在放射学环境中作为代理核心的能力,并揭示了它们在实际应用中面临的挑战和未来的改进方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

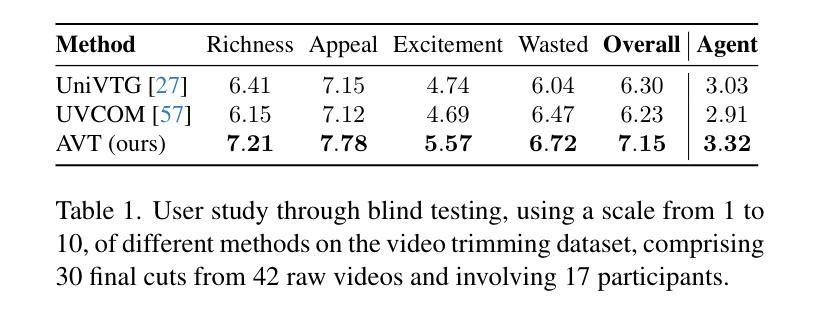

Agent-based Video Trimming

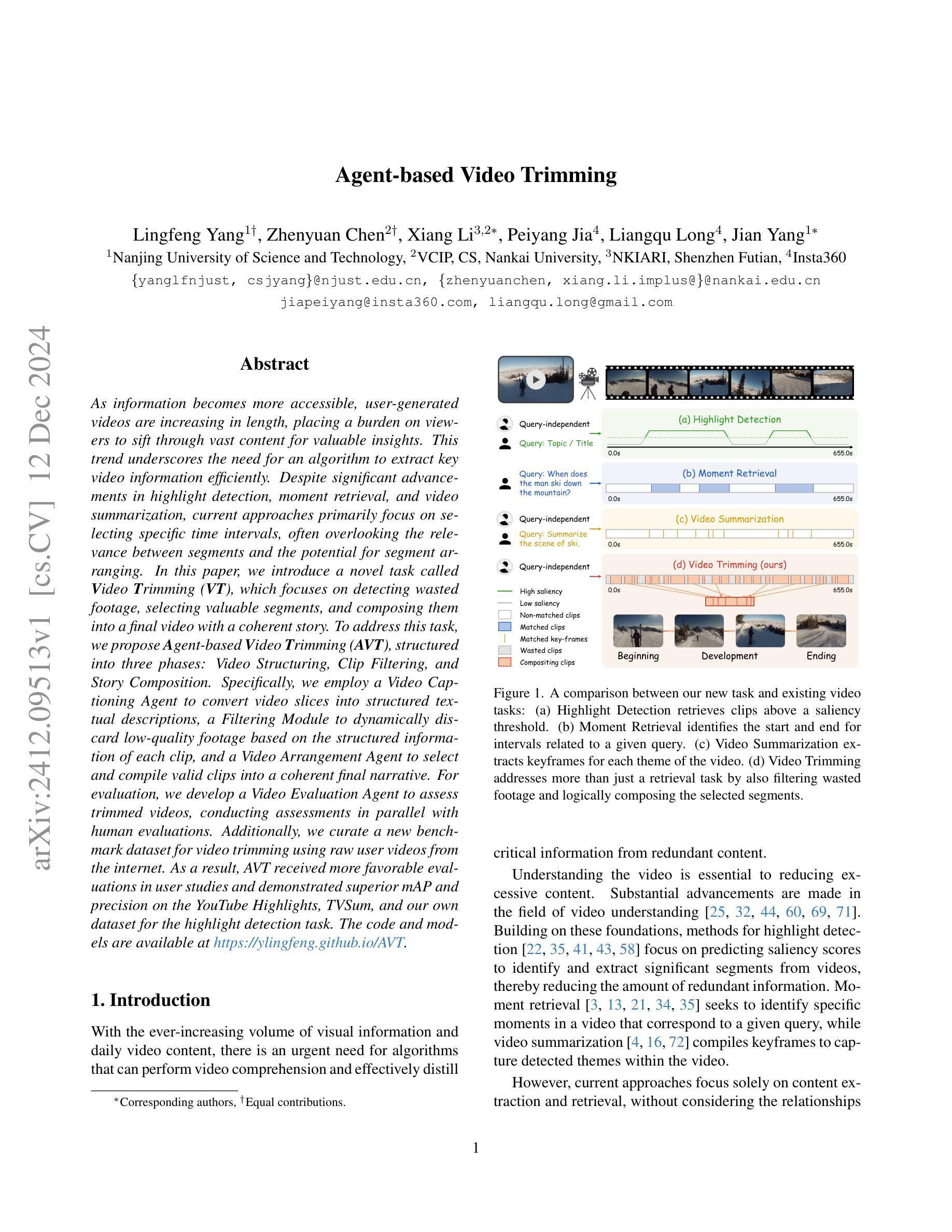

Authors:Lingfeng Yang, Zhenyuan Chen, Xiang Li, Peiyang Jia, Liangqu Long, Jian Yang

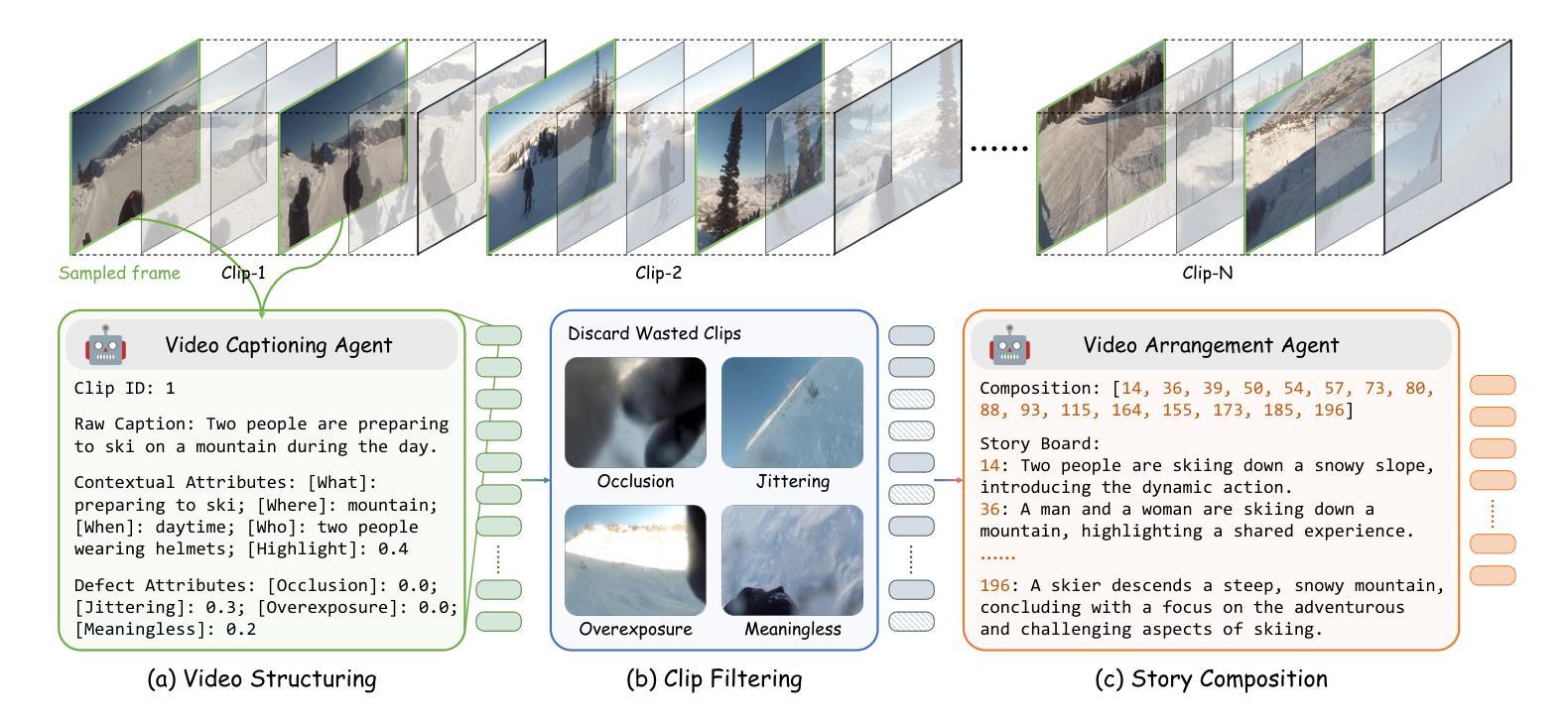

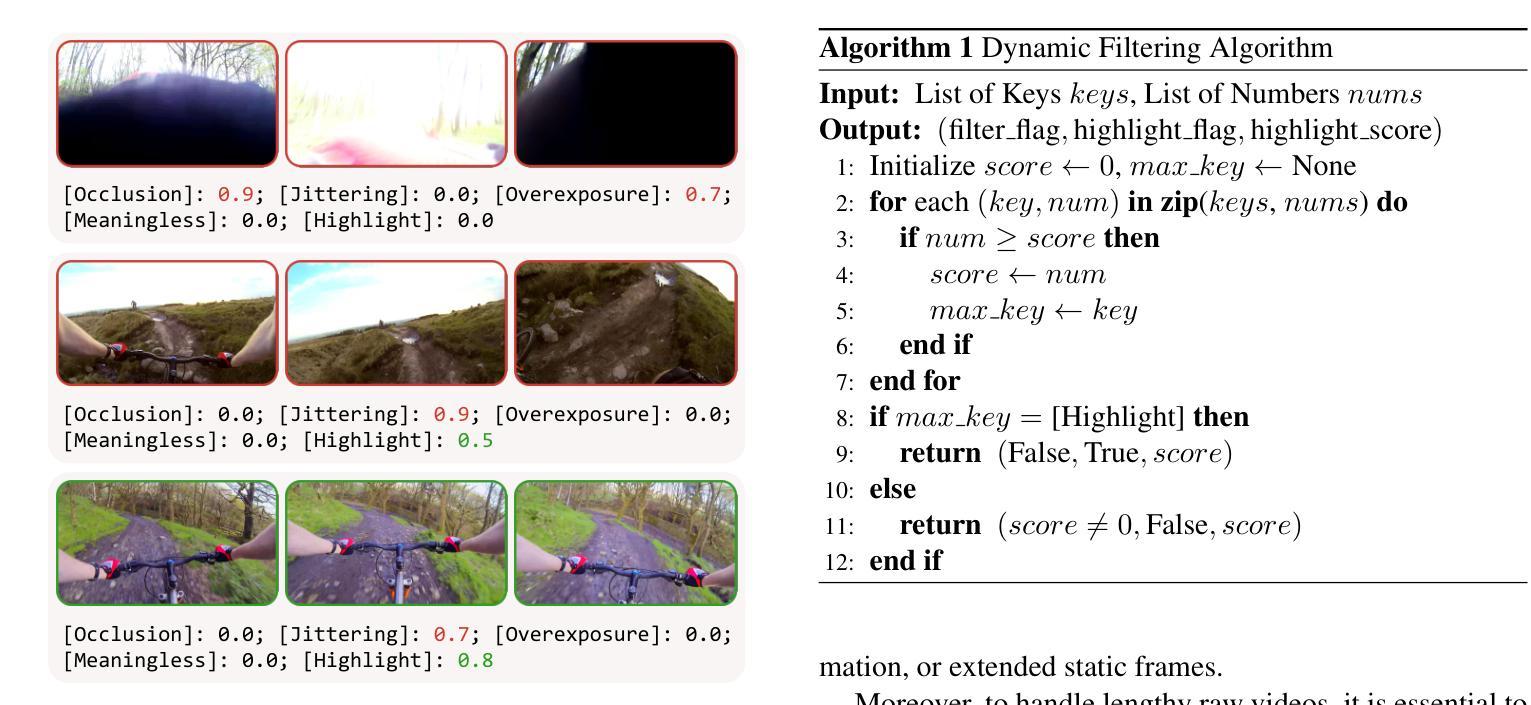

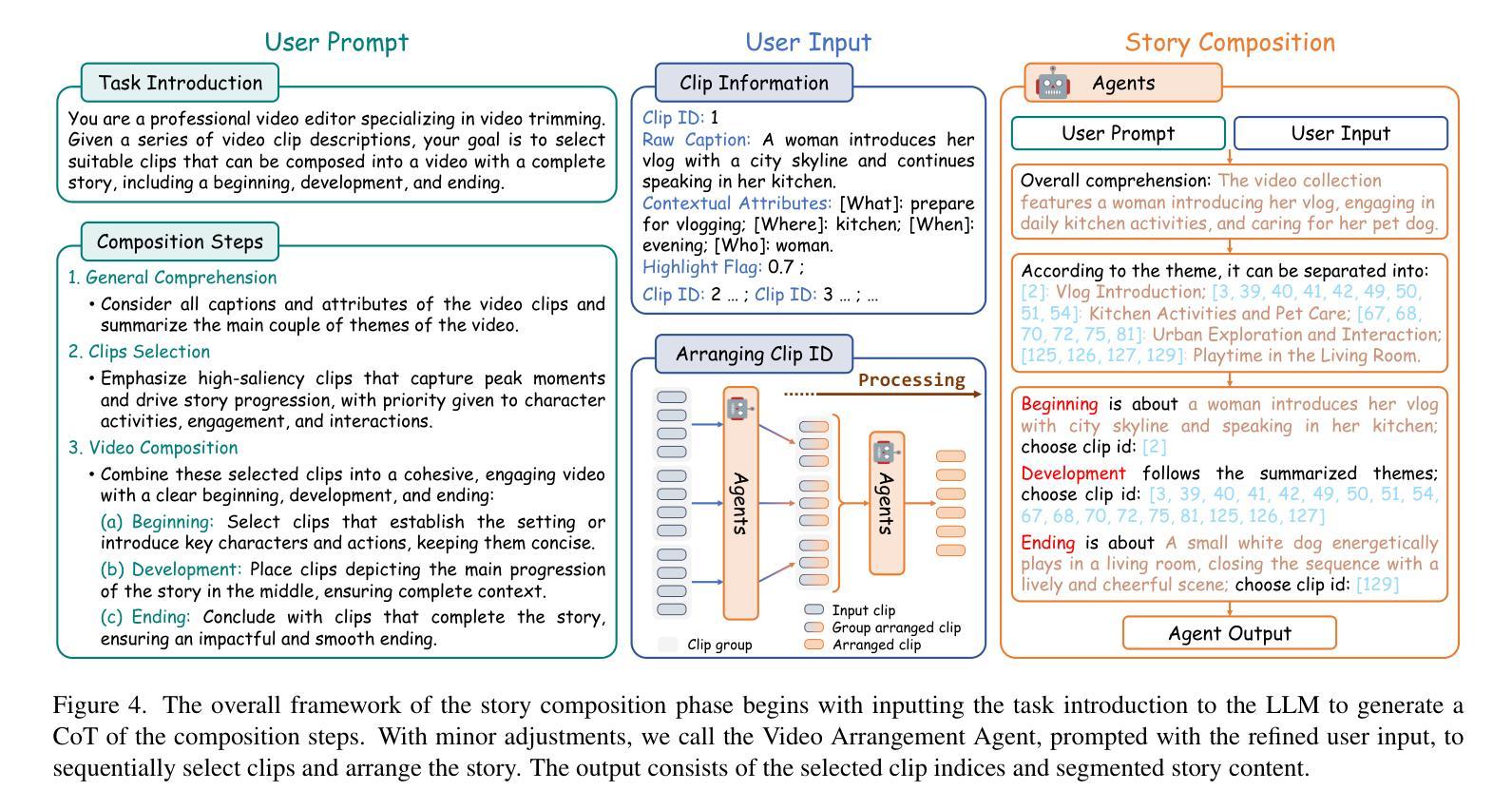

As information becomes more accessible, user-generated videos are increasing in length, placing a burden on viewers to sift through vast content for valuable insights. This trend underscores the need for an algorithm to extract key video information efficiently. Despite significant advancements in highlight detection, moment retrieval, and video summarization, current approaches primarily focus on selecting specific time intervals, often overlooking the relevance between segments and the potential for segment arranging. In this paper, we introduce a novel task called Video Trimming (VT), which focuses on detecting wasted footage, selecting valuable segments, and composing them into a final video with a coherent story. To address this task, we propose Agent-based Video Trimming (AVT), structured into three phases: Video Structuring, Clip Filtering, and Story Composition. Specifically, we employ a Video Captioning Agent to convert video slices into structured textual descriptions, a Filtering Module to dynamically discard low-quality footage based on the structured information of each clip, and a Video Arrangement Agent to select and compile valid clips into a coherent final narrative. For evaluation, we develop a Video Evaluation Agent to assess trimmed videos, conducting assessments in parallel with human evaluations. Additionally, we curate a new benchmark dataset for video trimming using raw user videos from the internet. As a result, AVT received more favorable evaluations in user studies and demonstrated superior mAP and precision on the YouTube Highlights, TVSum, and our own dataset for the highlight detection task. The code and models are available at https://ylingfeng.github.io/AVT.

随着信息越来越容易获取,用户生成的视频长度不断增加,观众需要筛选出大量内容以获取有价值的见解,这给观众带来了负担。这一趋势凸显了需要一个算法来高效提取视频关键信息的必要性。尽管在亮点检测、时刻检索和视频摘要方面取得了显著进展,但当前的方法主要侧重于选择特定的时间间隔,经常忽略片段之间的关联性和片段排列的潜力。在本文中,我们引入了一项名为视频剪辑(VT)的新任务,该任务专注于检测冗余镜头、选择有价值的片段,并将它们组合成具有连贯故事性的最终视频。为了解决此任务,我们提出了基于代理的视频剪辑(AVT),分为三个阶段:视频结构、片段过滤和故事组成。具体来说,我们采用视频描述代理将视频切片转换为结构化的文本描述,过滤模块根据每个剪辑的结构化信息动态丢弃低质量镜头,视频排列代理则选择和编译有效片段以形成连贯的最终叙事。为了进行评估,我们开发了一个视频评估代理来评估剪辑后的视频,并与人类评估同时进行。此外,我们使用来自互联网的原始用户视频制作了一个新的视频剪辑基准数据集。因此,在用户研究中,AVT获得了更有利的评价,并在YouTube亮点、TVSum以及我们自己的数据集上显示出较高的mAP和精度。代码和模型可在https://ylingfeng.github.io/AVT找到。

论文及项目相关链接

Summary

随着信息获取的便捷性提高,用户生成的视频长度不断加长,观众需要耗费大量时间寻找有价值的内容。本文提出了一种新的任务——视频剪辑(VT),旨在检测冗余片段,选择有价值的片段,并将它们组合成一个具有连贯性的最终视频。为此,我们提出了基于代理的视频剪辑(AVT)方法,包括视频结构、剪辑过滤和故事编排三个阶段。我们的方法在互联网用户视频上取得了良好的评价,并提供了代码和模型供公众使用。

Key Takeaways

- 信息获取便捷性提高导致用户生成视频长度增加,观众面临筛选内容的挑战。

- 视频剪辑(VT)任务旨在检测冗余片段并选取有价值的片段。

- 基于代理的视频剪辑(AVT)方法包括视频结构、剪辑过滤和故事编排三个阶段。

- 视频结构阶段使用视频描述代理将视频片段转换为结构化文本描述。

- 过滤模块根据每个剪辑的结构化信息动态丢弃低质量片段。

- 视频安排代理选择和编译有效片段以形成连贯的最终叙事。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是用户生成视频内容的日益增长和冗余,给观众带来了筛选有价值信息的负担。具体来说,论文中提到:

视频内容的增长:随着信息越来越易于获取,用户生成的视频长度不断增加,这使得观众需要从大量的内容中筛选出有价值的信息。

现有方法的局限性:尽管在高光检测、时刻检索和视频摘要方面取得了显著进展,但现有方法主要关注选择特定的时间间隔,往往忽视了片段之间的相关性以及片段排列的潜力。

视频修剪的需求:为了克服这些限制,论文提出了一种名为视频修剪(Video Trimming, VT)的新任务,它不仅涉及选择高关注度的片段,还包括过滤掉浪费的镜头,并安排剩余的片段,从而产生一个逻辑结构化和连贯的视频输出。

论文通过引入基于代理的视频修剪(Agent-based Video Trimming, AVT)算法,旨在高效提取关键视频信息,通过检测冗余镜头、选择有价值的片段,并将其组合成一个具有连贯故事的最终视频,以解决上述问题。

Q: 有哪些相关研究?

A: 论文中提到了多个与视频理解、视频代理和视频时间定位相关的研究工作。以下是一些主要的相关研究:

1. 视频理解 (Video Understanding)

- InternVid: 通过对比学习和多阶段预训练构建大规模视频-文本模型。

- InternVideo: 使用多模态数据扩展视频理解。

- LaViLa 和 Valley: 通过微调提高基于视频的指令理解。

- Merlin 和 MovieChat: 提升视频问题回答和长视频理解。

- PaLM-E: 将真实世界感官数据整合到语言模型中。

- SeViLA: 使用关键帧定位进行事件预测。

- Vid2Seq 和 VideoChat: 通过微调实现以聊天为中心的视频理解。

- LongVLM 和 VTimeLLM: 通过分割和识别时刻来提高长视频的理解。

2. 视频代理 (Video Agent)

- DoraemonGPT: 通过使用符号记忆提高VQA任务的检索和总结能力。

- InternGPT: 通过交互式投票提高推理能力。

- MM-ReAct: 将REACT机制扩展到多模态任务。

- Video ChatCaptioner: 通过多代理迭代投票加强视频理解。

- AssistGPT: 通过规划、执行、检查和学习循环提高VQA和时刻检索。

- ChatVideo: 将视频内容结构化为文本数据库以实现高效查询。

- LLoVi: 专注于使用字幕进行细粒度VQA和区间检索。

- MM-Vid 和 VideoAgent: 将多模态信息视为文本数据,并通过迭代投票和相似性匹配提高时刻检索。

3. 视频时间定位 (Video Temporal Grounding)

- Highlight Detection: 预测显著性分数以提取高光片段,捕捉关键视觉或上下文时刻。

- Moment Retrieval: 根据给定查询选择视频中的时刻。

- Video Summarization: 通过选择最能代表原始视频内容的关键镜头来压缩视频。

这些研究涵盖了视频理解的不同方面,包括视频问题回答、长视频理解、时刻定位和视频摘要等任务。论文提出的视频修剪任务(VT)和基于代理的视频修剪(AVT)算法旨在结合这些领域的进展,通过选择和组合视频片段来创建一个连贯、有吸引力的视频输出。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为Agent-based Video Trimming (AVT) 的算法来解决视频内容的冗余和提取关键信息的问题。AVT算法分为三个主要阶段来实现视频修剪任务:

1. 视频结构化(Video Structuring)

- 将视频分割成较小的单元(clips),每个clip默认持续3秒钟。

- 使用视频字幕代理(Video Captioning Agent)将这些单元转换成结构化的文本描述,包括原始字幕、上下文属性和缺陷属性。

- 这样的结构化信息使得后续处理可以脱离视觉内容,仅通过文本输入进行,提高了处理速度和效率。

2. 片段过滤(Clip Filtering)

- 利用从视频字幕代理获得的缺陷属性和高光分数,动态地选择有用的clips。

- 通过一个名为动态过滤器(Dynamic Filter)的机制,仅当一个clip的“高光”分数超过所有缺陷分数时,该clip才被视为有效,从而平衡内容的丰富性和拍摄缺陷。

3. 故事组合(Story Composition)

- 使用视频排列代理(Video Arrangement Agent)将筛选后的clips组织成连贯的最终视频。

- 通过用户提示和链式思考(Chain of Thought, CoT)生成视频组合步骤,考虑全局概念、片段选择和组合排列。

- 输出包括组合片段的顺序以及组织它们的理由。

4. 最终剪辑评估(Final Cut Evaluation)

- 设计了视频评估代理(Video Evaluation Agent)来评估修剪后视频的质量。

- 通过定义评估标准和创建CoT指令,利用大型语言模型(LLM)作为评估代理,对最终视频进行评分和理由说明。

此外,论文还创建了一个新的视频修剪基准数据集,并使用视频评估代理与人类评估一起对视频质量进行评估。通过这些方法,AVT算法不仅提高了视频修剪的性能,还在零样本高光检测任务中展示了优越性,并在用户研究中获得了更多的偏好。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估和验证所提出的Agent-based Video Trimming (AVT) 方法。以下是实验的详细内容:

1. 数据集介绍

- 现有数据集:使用了YouTube Highlights和TVSum这两个已建立的视频时间定位任务的数据集。

- 视频修剪数据集:作者收集并构建了一个专门的视频修剪基准数据集,包含从YouTube上抓取的42个视频,涵盖日常生活、体育和旅行博客等多种主题。

2. 实现细节

- 所有代理使用GPT-4o模型实现。

- 视频被分割成长度为3秒的片段,每秒采样一个关键帧。

- 输入输出配置导致每个10分钟的原始视频大约需要153,000个输入图像标记、100,000个输入文本标记和20,000个输出文本标记。

3. 视频修剪质量比较

- 人类评估:基于构建的视频修剪数据集,进行了用户研究,让参与者对不同方法输出的视频进行评分。

- 代理评估:使用设计的Video Evaluation Agent在YouTube Highlights和TVSum数据集的验证集上评估视频质量。

4. 高光检测性能比较

- 在YouTube Highlights和TVSum数据集上,比较了AVT方法与先前的高光检测和视频摘要方法的性能。

- 使用构建的视频修剪数据集展示了高光检测的mAP和选定剪辑中的高光片段的精确度。

5. AVT组件的消融研究

- 分析了AVT中每个组件的有效性,包括视频结构化、片段过滤、动态模块以及故事组合阶段。

- 比较了替换故事组合阶段为简单的时间顺序视频片段连接的结果。

6. 评估代理与人类评估的相关性

- 使用皮尔逊(Pearson)、斯皮尔曼(Spearman)和肯德尔-陶(Kendall-Tau)相关性指标来衡量评估代理与人类评分之间的一致性。

7. 结果可视化

- 展示了不同方法修剪视频的显著性得分和选定间隔的可视化。

- 通过案例研究进一步讨论了AVT模块设计的重要性。

这些实验全面评估了AVT方法在视频修剪任务中的性能,包括与现有方法的比较、用户研究、代理评估以及消融研究,验证了AVT在视频修剪和高光检测任务中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出的Agent-based Video Trimming (AVT) 方法在视频修剪任务中取得了显著的成果,但仍有一些领域可以进一步探索和改进:

1. 算法的可扩展性和实时性

- 探索如何提高AVT算法的可扩展性,以便能够处理更长或更高分辨率的视频。

- 研究如何优化算法以实现实时视频修剪,这对于直播内容尤其重要。

2. 多模态融合技术

- 研究更先进的多模态融合技术,结合视频的视觉信息和音频信息,以提高视频理解和修剪的准确性。

3. 更复杂的叙事结构

- 开发能够理解和生成更复杂叙事结构的算法,例如包含多个子情节和闪回的视频故事。

4. 自适应内容评估

- 研究如何使视频评估代理能够根据视频内容和上下文自适应地调整其评估标准。

5. 用户定制化和交互

- 开发用户交互界面,允许用户根据自己的偏好和需求定制视频修剪的结果。

- 探索用户反馈循环,以进一步微调和改进修剪结果。

6. 多语言和跨文化内容理解

- 扩展AVT算法,使其能够理解和处理多语言和跨文化的视频内容。

7. 增强现实和虚拟现实中的应用

- 研究如何将视频修剪技术应用于增强现实(AR)和虚拟现实(VR)内容的创建和编辑。

8. 法律和伦理问题

- 探讨视频内容自动修剪和编辑可能涉及的版权、隐私和伦理问题。

9. 更广泛的数据集和场景

- 在更广泛的数据集和多样化的场景上测试AVT算法,包括不同类型的视频内容和事件。

10. 算法的解释性和透明度

- 提高AVT算法的解释性,让用户能够理解算法背后的决策过程。

这些探索方向不仅可以推动视频修剪技术的发展,还可能对视频内容创作、分发和消费产生深远影响。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个新的任务——视频修剪(Video Trimming, VT),旨在从冗余内容中提取关键信息,并生成具有连贯故事线的精简视频。为了解决这一任务,作者们设计了一个基于代理的算法——Agent-based Video Trimming (AVT),该算法分为三个主要阶段:

视频结构化(Video Structuring):

- 将视频分割成小片段,并使用视频字幕代理将这些片段转换成结构化的文本描述,包括基本描述和缺陷属性。

片段过滤(Clip Filtering):

- 基于视频字幕代理提供的缺陷属性和高光分数,动态选择有用的片段,并过滤掉质量低的镜头。

故事组合(Story Composition):

- 使用视频排列代理将选定的片段组织成一个连贯的最终视频,确保叙事的连贯性和吸引力。

此外,论文还提出了一个视频评估代理来评估修剪后视频的质量,并通过用户研究和定量实验在多个基准数据集上验证了AVT算法的有效性。实验结果表明,AVT在视频修剪和零样本高光检测任务中均优于现有方法,并且在用户研究中获得了更多的偏好。

总结来说,这篇论文的主要贡献包括:

- 提出了视频修剪这一新任务,旨在从长视频中提取关键片段并生成具有连贯故事的视频。

- 提出了AVT算法,该算法通过结构化描述、片段过滤和故事组合三个阶段来实现视频修剪。

- 开发了一个视频评估代理,用于自动评估修剪后视频的质量。

- 构建了一个新的视频修剪基准数据集,并在多个数据集上验证了AVT算法的有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

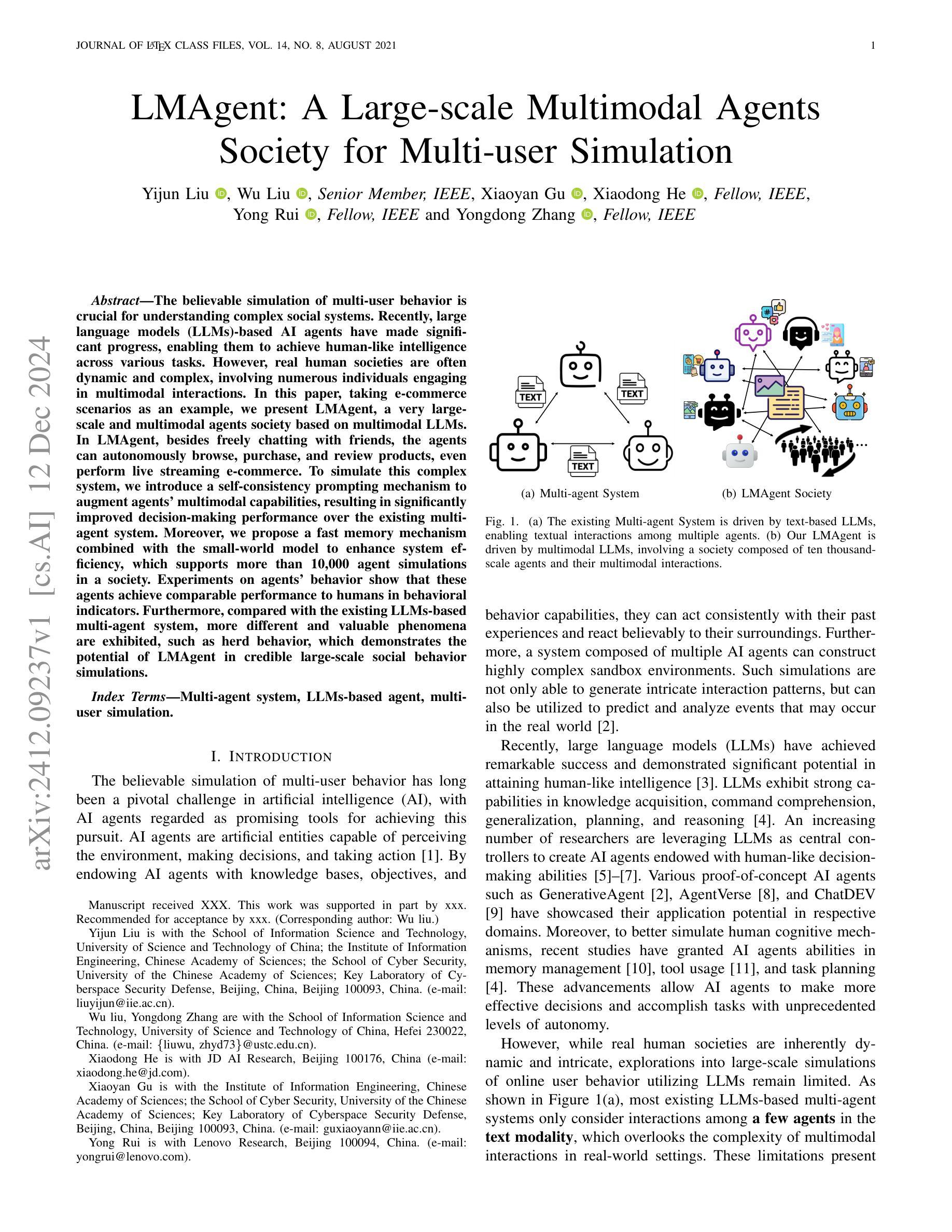

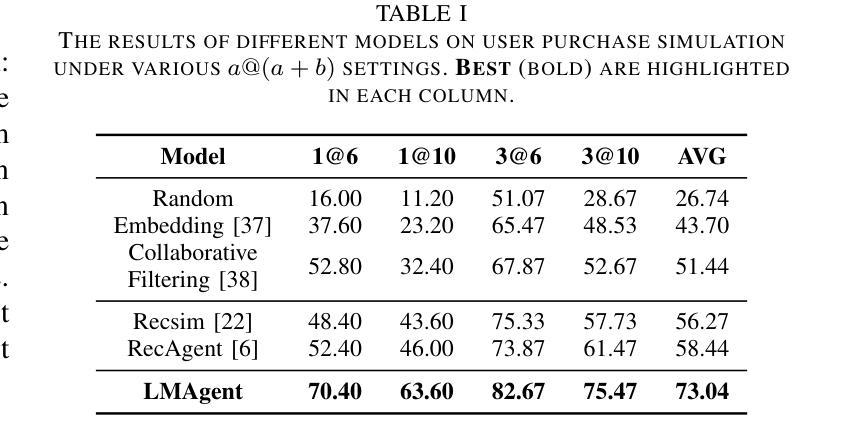

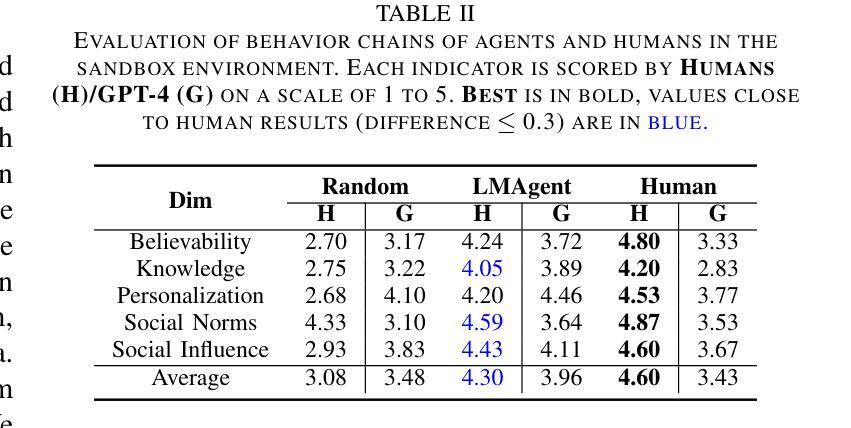

LMAgent: A Large-scale Multimodal Agents Society for Multi-user Simulation

Authors:Yijun Liu, Wu Liu, Xiaoyan Gu, Yong Rui, Xiaodong He, Yongdong Zhang

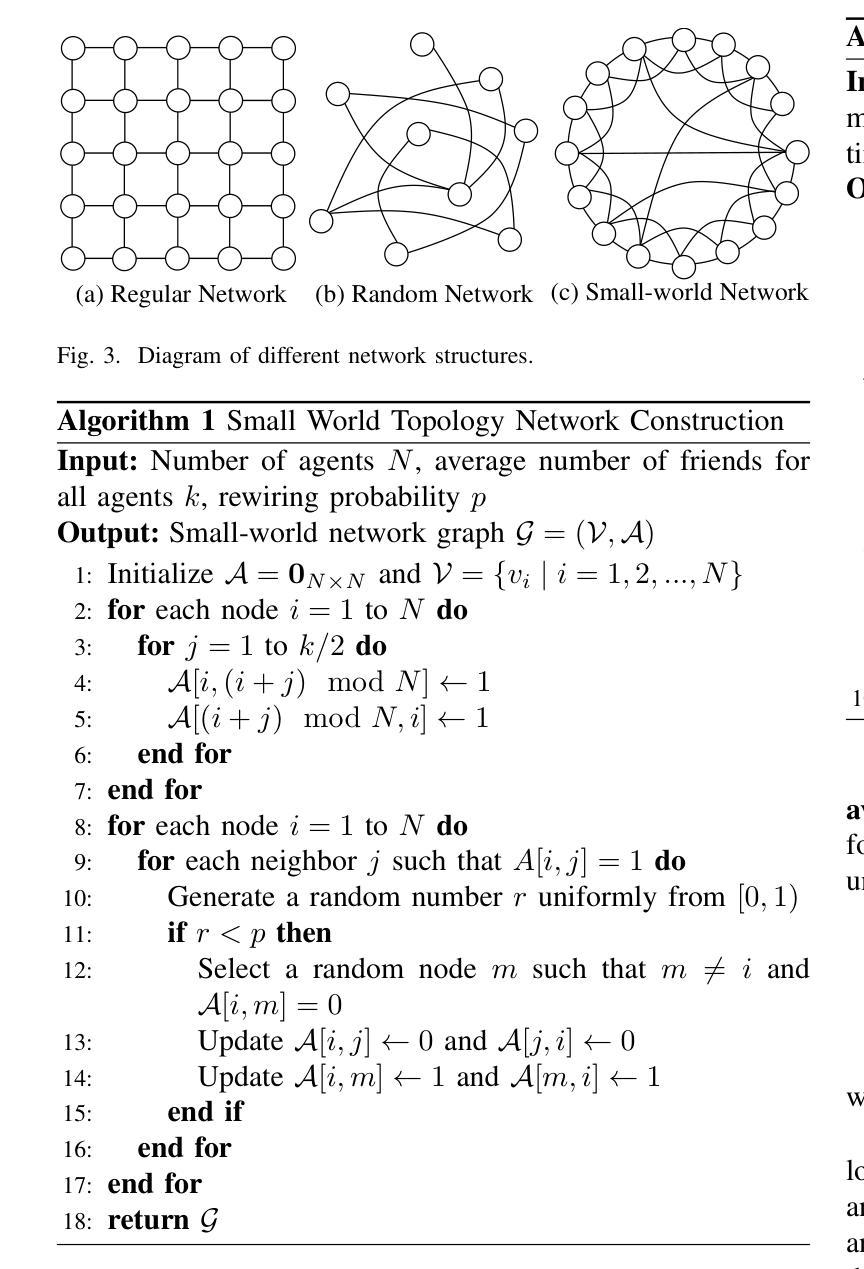

The believable simulation of multi-user behavior is crucial for understanding complex social systems. Recently, large language models (LLMs)-based AI agents have made significant progress, enabling them to achieve human-like intelligence across various tasks. However, real human societies are often dynamic and complex, involving numerous individuals engaging in multimodal interactions. In this paper, taking e-commerce scenarios as an example, we present LMAgent, a very large-scale and multimodal agents society based on multimodal LLMs. In LMAgent, besides freely chatting with friends, the agents can autonomously browse, purchase, and review products, even perform live streaming e-commerce. To simulate this complex system, we introduce a self-consistency prompting mechanism to augment agents’ multimodal capabilities, resulting in significantly improved decision-making performance over the existing multi-agent system. Moreover, we propose a fast memory mechanism combined with the small-world model to enhance system efficiency, which supports more than 10,000 agent simulations in a society. Experiments on agents’ behavior show that these agents achieve comparable performance to humans in behavioral indicators. Furthermore, compared with the existing LLMs-based multi-agent system, more different and valuable phenomena are exhibited, such as herd behavior, which demonstrates the potential of LMAgent in credible large-scale social behavior simulations.

多用户行为的可信模拟对于理解复杂的社交系统至关重要。最近,基于大型语言模型(LLM)的人工智能代理取得了显著进展,使它们能够在各种任务中实现类似人类的智能。然而,真实的人类社会通常是动态和复杂的,涉及许多个人进行多模式互动。在本文中,以电子商务场景为例,我们提出了LMAgent,这是一个基于多模式LLM的大规模多模式代理社会。在LMAgent中,除了与朋友自由聊天外,代理还可以自主浏览、购买和评论产品,甚至进行直播电子商务。为了模拟这个复杂的系统,我们引入了一种自洽提示机制来增强代理的多模式能力,与现有的多代理系统相比,这大大提高了决策性能。此外,我们提出了一种快速记忆机制,结合小世界模型来提高系统效率,支持社会中的超过10000个代理模拟。关于代理行为的实验表明,这些代理在行为指标上达到了与人类相当的性能。与现有的基于LLM的多代理系统相比,还表现出了更多不同且有价值的现象,如群体行为,这显示了LMAgent在可信的大规模社会行为模拟中的潜力。

论文及项目相关链接

Summary

多用户行为模拟对于理解复杂社会系统至关重要。基于大型语言模型(LLMs)的人工智能代理通过实现人类智能的跨任务模拟,取得了显著进展。本文提出基于多模态LLMs的大规模多模态代理社会LMAgent,以电子商务场景为例。LMAgent代理可自主浏览、购买和评论产品,甚至进行直播电商。通过引入自我一致性提示机制增强代理的多模态能力,并在现有多代理系统上显著提高决策性能。结合快速记忆机制和小世界模型提高系统效率,支持超过一万个代理的社会模拟。实验表明,这些代理在行为指标上达到了与人类相当的表现,展现了LMAgent在可信的大规模社会行为模拟中的潜力。

Key Takeaways

- 多用户行为模拟对理解复杂社会系统非常重要。

- 基于大型语言模型(LLMs)的AI代理已取得了显著进展,可以执行多种人类智能任务。

- LMAgent是一个基于多模态LLMs的大规模多模态代理社会模型,可模拟真实人类的动态和复杂行为。

- LMAgent代理可以自主进行电子商务活动,如浏览、购买、评论和直播。

- 通过自我一致性提示机制,LMAgent代理的多模态能力得到增强,提高了决策性能。

- 结合快速记忆机制和小世界模型,提高了系统效率,支持大规模代理模拟。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文旨在解决多用户行为的可信模拟问题,特别是在理解复杂社会系统方面。具体来说,论文中提到了以下几个挑战:

多模态信息的整合与分析能力提升:现实社会中的人类行为是动态且复杂的,涉及众多个体进行多模态互动。现有基于大型语言模型(LLMs)的多智能体系统主要考虑文本模态中的少数智能体之间的互动,忽略了现实世界中多模态互动的复杂性。

提高基于LLM的智能体的运行效率:进行大规模用户行为模拟时,计算成本较高。论文需要提出一种方法来提高系统的运行效率,使得能够模拟大规模的用户行为。

为了应对这些挑战,论文提出了一个名为LMAgent的大规模多模态智能体社会,它基于多模态大型语言模型(LLMs)。LMAgent通过以下方式来增强智能体的多模态分析能力,并提高系统的运行效率:

自洽提示机制(Self-consistency prompting mechanism):通过链式思考推理动态生成多模态提示,显著提高智能体在复杂多模态场景中决策的一致性,从而提高模拟性能。

快速记忆机制(Fast memory mechanism):结合小世界模型(small-world model),通过限制多模态LLM调用复杂行为来减少系统负载,提高效率。

论文通过在电子商务场景中模拟多达10,000个智能体的多模态社交和购物行为,验证了LMAgent在大规模社会行为模拟中的潜力和可信度。

Q: 有哪些相关研究?

A: 论文中提到了以下几类相关研究:

A. 可信的用户行为代理(Believable Proxies of User Behavior)

这类研究关注于如何设计能够创建人类行为幻觉的可信代理,使它们能够根据意愿做出决策和行动。过去几十年中,提出了多种方法来创建可信的代理,包括基于规则的方法(如有限状态机和行为树)和基于强化学习的方法。这些方法旨在自动化决策过程,例如:

- RecSim:使用强化学习模拟用户连续行为以进行交互式推荐。

- AlphaStar 和 DQN:使代理能够在未知环境中自主学习,从而在某些决策游戏中取得令人印象深刻的表现。

B. 基于LLM的代理系统(LLMs-based Agent System)

这类系统利用LLMs作为引擎,驱动多个代理进行各种行为决策。每个代理都有自己的知识库、目标和能力,并且能够互动和协作以增强系统处理复杂任务和动态环境的能力。近期的一些进展包括:

- GenerativeAgent、AgentVerse 和 ChatDEV:展示了在各自领域中应用LLMs的潜力。

- LLMs在经济行为模拟中的应用:利用LLMs代理代替人类参与者,赋予代理才能、背景和偏好,并促使它们模拟经济行为。

- LLMs在多智能体系统中模拟人类意见动态:揭示了LLM代理在产生准确信息方面的固有偏见。

其他相关研究

- Collaborative software development:使用LLMs构建其他代理系统以进行模拟或提高工作效率。

- Social simulation 和 Game playing:LLMs在社交模拟和游戏玩法中的应用。

这些相关研究展示了LLMs在模拟人类行为和决策中的潜力,以及在构建复杂社会系统模拟中的应用前景。论文提出的LMAgent系统在这些研究的基础上,旨在构建一个更大规模、更真实的多用户行为模拟环境。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键方法解决了多用户行为的可信模拟问题:

1. LMAgent系统

提出了LMAgent,一个基于多模态大型语言模型(LLMs)的超大规模多智能体社会。LMAgent模拟了电子商务场景中多达10,000个智能体的多模态社交和购物行为。

2. 自洽提示机制(Self-consistency prompting mechanism)

为了增强智能体在复杂多模态场景中的决策一致性,论文提出了一种自洽提示机制。这种机制通过链式思考推理动态生成多模态提示,显著提高了智能体决策的一致性,从而增强了模拟性能。

3. 快速记忆机制(Fast memory mechanism)

为了提高系统的运行效率,论文设计了一种快速记忆机制,该机制限制了多模态LLM调用仅用于复杂行为,减少了系统负载,提高了效率。

4. 小世界模型(Small-world model)

LMAgent使用小世界模型初始化智能体的社会网络,以提高通信效率,并更贴近现实世界的网络结构。小世界网络具有较高的聚类系数和较短的平均路径长度,类似于现实世界的网络。

5. 多模态智能体架构

LMAgent中的每个智能体都有内部行为(包括个性和记忆模块)和外部行为(社交或购物活动)。内部行为由多模态LLMs驱动,能够根据智能体的记忆和个性进行规划和反思。

6. 沙盒环境(Sandbox Environment)

LMAgent提供了一个沙盒环境,智能体可以自由地进行多模态社交或购物互动。这些行为可以改变智能体的记忆,并影响其他智能体的行为。

7. 实验验证

通过广泛的实验,论文验证了LMAgent在模拟用户行为方面的有效性。实验包括评估智能体在沙盒环境中的购买行为模拟能力、比较智能体和人类行为以及在电子商务场景中进行大规模消费者行为模拟。

综上所述,论文通过结合先进的多模态LLMs、自洽提示机制、快速记忆机制和小世界模型,提出了一个能够进行大规模、多模态、可信社会行为模拟的智能体系统LMAgent。通过实验验证,LMAgent不仅能够模拟与人类行为相似的指标,还能展现出类似现实世界的集体行为模式,展示了其在大规模社会行为模拟中的潜力。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来评估LMAgent系统的性能和有效性:

A. 实验设置

- LLM使用:使用的是ChatGPT (version: gpt-4-1106-preview)。

- 系统实现:基于LangChain实现。

- 数据集:使用亚马逊评论数据集,包含2.331亿个独特购买和评论信息。

B. 用户购买行为评估

- 任务:模拟用户购买行为,基于LMAgent沙盒环境。

- 评估指标:使用a@(a+b)指标评估购买准确率。

- 结果:与多个推荐算法比较,LMAgent显示出优越的性能。

C. 智能体行为分析

- 数据收集:分析1000个智能体的行为链和行为内容,与50名志愿者控制的500个智能体的行为进行比较。

- 评估指标:基于人类评分的多维评估框架。

- 行为链分析:比较Random、LMAgent和人类的行为表现。

- 行为内容分析:评估LMAgent与人类在社交内容创造方面的能力。

- 社会影响分析:分析社会信息对智能体购买行为的影响。

D. 消融研究

- 快速记忆的影响:通过测量LMAgent的令牌消耗量来量化快速记忆机制对系统效率的影响。

- 自洽提示的影响:评估多模态输入和自洽提示对用户购买行为模拟性能的影响。

E. 大规模消费者模拟分析

- 购买统计:比较LMAgent模拟的用户购买数据与京东用户行为数据的一致性。

- 网络拓扑分析:研究不同网络拓扑结构对大规模信息传播的影响。

这些实验全面评估了LMAgent在模拟用户行为方面的能力,包括购买行为的准确性、行为的合理性、社交互动的真实性以及系统运行的效率。实验结果表明,LMAgent能够产生与真实用户行为高度一致的模拟结果,并在大规模社会模拟中展现出与现实世界相似的集体行为模式。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了一个强大的LMAgent系统来模拟大规模多用户行为,但仍有一些领域可以进一步探索和改进:

1. 多样化场景应用

- 不同领域的模拟:将LMAgent应用于其他领域,如政治选举、公共卫生危机响应等,以测试其在不同复杂社会现象中的适用性和有效性。

2. 提升个性化和自适应性

- 更复杂的人格模型:研究更复杂的人格和情感模型,使智能体的行为更加个性化和不可预测,更贴近真实人类行为。

3. 增强交互性

- 多智能体间的复杂交互:探索智能体之间更复杂的交互模式,如形成联盟、竞争和合作等。

4. 提高模拟的实时性

- 实时数据集成:研究如何将实时数据集成到模拟中,使模拟环境能够响应现实世界中的即时变化。

5. 优化算法效率

- 计算效率提升:进一步优化算法和计算架构,以处理更大规模的智能体社会,减少计算资源消耗。

6. 强化学习的应用

- 强化学习集成:探索将强化学习技术集成到LMAgent中,使智能体能够从环境中学习并优化其行为策略。

7. 伦理和隐私问题

- 伦理和隐私考量:在模拟真实人类行为时,考虑伦理和隐私问题,确保模拟的道德合理性和用户数据的安全。

8. 跨模态能力的进一步研究

- 跨模态学习:研究如何进一步提升智能体的跨模态学习能力,使其能更有效地处理和整合来自不同模态(如视觉、语言、声音)的信息。

9. 长期行为模式和趋势分析

- 长期模拟:进行长期模拟以分析智能体行为的演变趋势和社会结构的长期变化。

10. 开放式问题和挑战

- 开放性问题:设计和参与挑战,邀请学术界和工业界共同探索和推动多智能体系统的极限。

这些探索点不仅可以推动LMAgent系统的发展,还可能为社会科学、人工智能和多智能体系统的研究提供新的视角和工具。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为LMAgent的大规模多模态智能体社会,旨在通过模拟多达10,000个智能体的复杂社交和购物行为,来理解和预测现实世界中的复杂社会系统。以下是论文的主要内容总结:

1. 问题陈述

- 可信的多用户行为模拟对于理解复杂社会系统至关重要。

- 现实社会是动态和复杂的,涉及大量个体的多模态互动。

- 现有的基于大型语言模型(LLMs)的多智能体系统主要关注文本模态的少量智能体互动,忽略了现实世界的多模态复杂性。

2. LMAgent系统介绍

- LMAgent是一个基于多模态LLMs的大规模多智能体社会。

- 智能体可以自由地进行聊天、浏览、购买、评论产品,甚至进行直播电商活动。

- 引入自洽提示机制增强智能体的多模态能力,显著提高决策性能。

- 提出快速记忆机制和小世界模型以提高系统效率,支持超过10,000个智能体的模拟。

3. 关键贡献

- 提出了LMAgent,一个大规模多模态智能体社会,用于模拟真实世界的复杂用户行为。

- 通过自洽提示引入多模态智能体,实验表明其性能显著优于现有基于LLMs的多智能体系统。

- 提出快速记忆机制和小世界模型,支持大规模智能体社会的模拟,准确捕捉大规模用户共购模式,并展现出群体行为。

4. 实验验证

- 在电子商务场景中对智能体的购买行为进行了模拟和评估。

- 与人类行为进行了比较,验证了LMAgent在模拟用户行为方面的有效性。

- 进行了大规模消费者行为模拟,分析了由LMAgent产生的群体行为。

5. 结论

- LMAgent能够产生与真实用户行为高度一致的模拟结果,并在大规模社会模拟中展现出与现实世界相似的集体行为模式。

- 这项研究在可信的大规模用户行为模拟领域迈出了重要一步,随着LLMs的发展,未来有望创造更加真实的模拟。

论文的研究成果不仅展示了在大规模社会行为模拟中的潜力,还为社会科学、人工智能和多智能体系统的研究提供了新的视角和工具。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

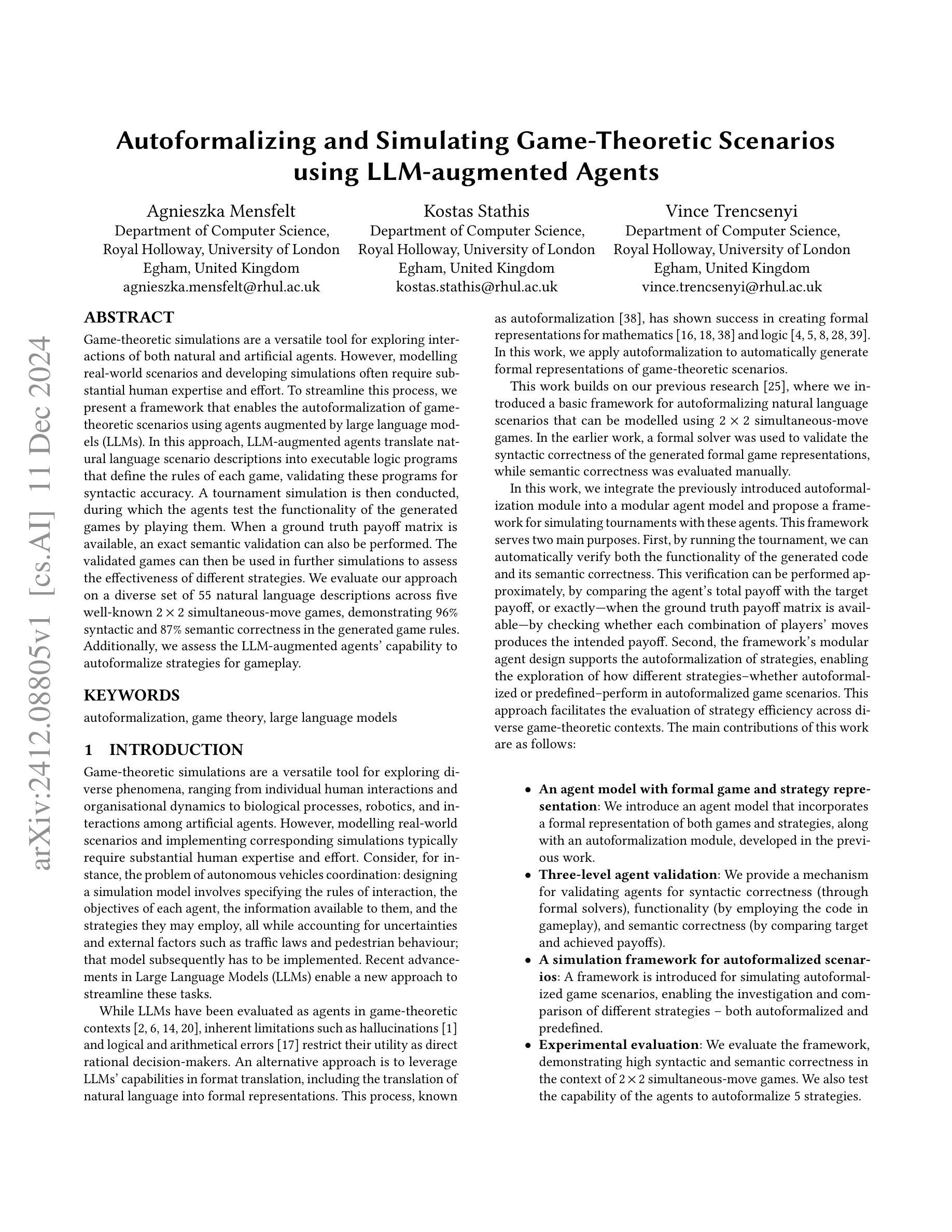

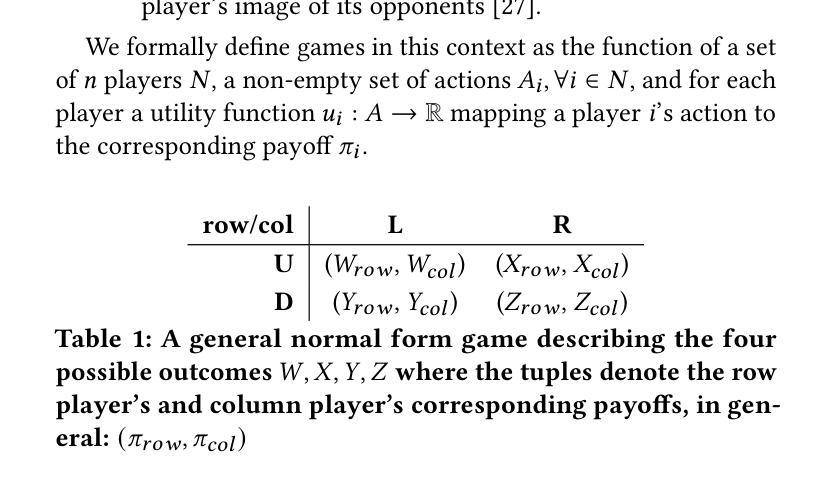

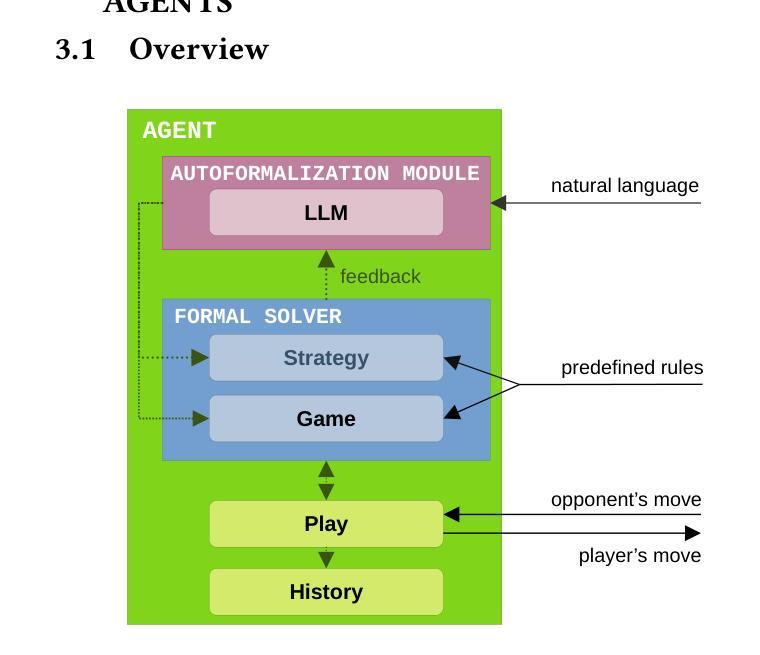

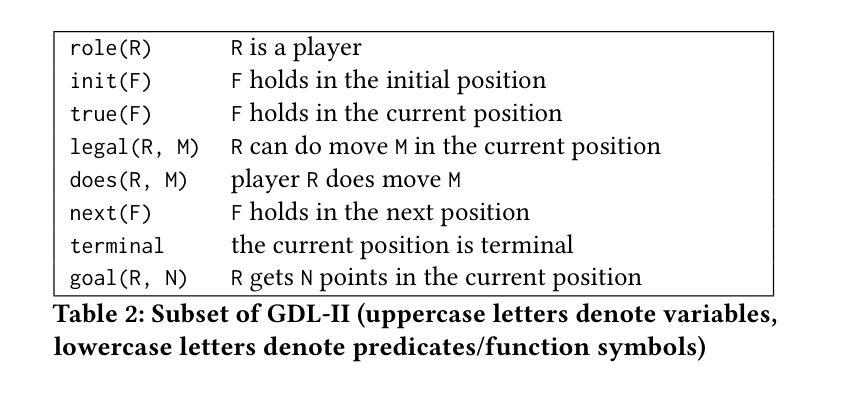

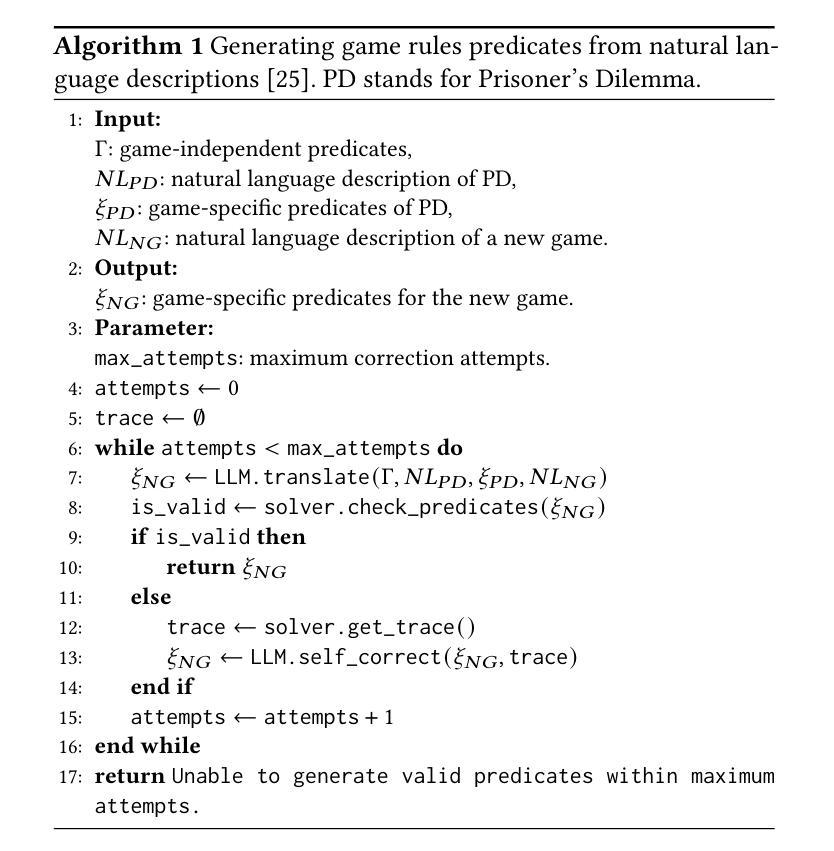

Autoformalizing and Simulating Game-Theoretic Scenarios using LLM-augmented Agents

Authors:Agnieszka Mensfelt, Kostas Stathis, Vince Trencsenyi

Game-theoretic simulations are a versatile tool for exploring interactions of both natural and artificial agents. However, modelling real-world scenarios and developing simulations often require substantial human expertise and effort. To streamline this process, we present a framework that enables the autoformalization of game-theoretic scenarios using agents augmented by large language models (LLMs). In this approach, LLM-augmented agents translate natural language scenario descriptions into executable logic programs that define the rules of each game, validating these programs for syntactic accuracy. A tournament simulation is then conducted, during which the agents test the functionality of the generated games by playing them. When a ground truth payoff matrix is available, an exact semantic validation can also be performed. The validated games can then be used in further simulations to assess the effectiveness of different strategies. We evaluate our approach on a diverse set of 55 natural language descriptions across five well-known 2x2 simultaneous-move games, demonstrating 96% syntactic and 87% semantic correctness in the generated game rules. Additionally, we assess the LLM-augmented agents’ capability to autoformalize strategies for gameplay.

博弈论模拟是探索自然和人工智能交互的一种通用工具。然而,模拟真实场景和构建博弈论模型通常需要大量的人力资源和专业知识。为了简化这一过程,我们提出了一种使用大型语言模型(LLM)增强代理来实现博弈论场景的自动形式化框架。在此方法中,LLM增强型代理将自然语言场景描述转化为可执行逻辑程序,定义每个游戏的规则,并验证这些程序的语法准确性。随后进行一场锦标赛模拟,代理通过在生成的游戏中进行比赛来测试游戏的功能。当存在真实收益矩阵时,还可以执行精确的语义验证。经过验证的游戏可用于进一步的模拟,以评估不同策略的有效性。我们在5种著名的2x2同步移动游戏的大量自然语言描述中评估了我们的方法,结果显示生成的游戏规则中语法正确率为96%,语义正确率为87%。此外,我们还评估了LLM增强型代理在自动形成游戏规则方面的能力。

论文及项目相关链接

PDF code: https://github.com/dicelab-rhul/autoformalizing-agents

Summary

本文主要介绍了利用大型语言模型增强后的智能体进行游戏理论场景自动形式化的框架。该框架能将自然语言场景描述转化为可执行的游戏规则逻辑程序,并通过仿真验证程序语法正确性。利用地面真实支付矩阵进行语义验证后,可用于进一步评估不同策略的效用。评估显示,在自然语言描述的游戏中,规则生成的语法正确性高达96%,语义正确性达87%。此外,还评估了智能体在游戏策略自动形式化方面的能力。

Key Takeaways

- 大型语言模型增强智能体能实现游戏理论场景的自动形式化。

- 自然语言描述能转化为可执行的游戏规则逻辑程序。

- 通过仿真验证程序语法正确性,并利用地面真实支付矩阵进行语义验证。

- 框架能用于评估不同策略的效用。

- 在自然语言描述的游戏中,规则生成的语法正确性高达96%。

- 在自然语言描述的游戏中,规则生成的语义正确性达到87%。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个框架,旨在解决以下问题:

现实世界场景建模和游戏理论模拟的开发需要大量的人类专业知识和努力。 论文中提到,设计一个模拟模型涉及到指定交互规则、每个代理的目标、他们可用的信息以及他们可能采用的策略,同时还要考虑到不确定性和外部因素,如交通法规和行人行为等。

利用大型语言模型(LLMs)的能力来简化这些任务。 尽管LLMs在游戏理论环境中作为代理已经被评估过,但它们在直接作为理性决策者时存在局限性,例如幻觉和逻辑及算术错误。因此,论文提出了一种替代方法,即利用LLMs在格式转换方面的能力,包括将自然语言转换为正式表示,这个过程被称为自动形式化(autoformalization)。

自动形式化游戏理论场景。 论文中提出的工作基于之前的研究成果,通过自动形式化自然语言场景来自动生成游戏理论场景的形式化表示。这包括将自然语言场景描述转换为可执行的逻辑程序,定义每款游戏的规则,并验证这些程序的语法准确性。

通过模拟比赛来验证自动形式化的游戏规则和策略的有效性。 论文中提出的框架不仅能够自动验证生成代码的功能和语义正确性,而且还支持自动形式化策略的探索,评估不同策略(无论是自动形式化的还是预定义的)在自动形式化游戏场景中的表现。

综上所述,论文的主要贡献在于提出了一个能够自动形式化游戏理论场景的框架,并通过模拟比赛来评估不同策略的效果,旨在减少在游戏理论模拟中对人类专业知识和努力的依赖。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以概括为以下几个方面:

游戏理论模拟:

- 游戏理论被广泛应用于探索人类互动、组织动态、生物过程、机器人技术和人工智能代理之间的交互。相关研究涵盖了从个体人类互动到更广泛的社会科学和生物学现象。

大型语言模型(LLMs)在游戏中的应用:

- 近期的研究开始探索LLMs在游戏中的表现,包括它们作为理性玩家参与游戏理论场景的能力、在不完全信息游戏中的决策能力,以及与人类参与者的行为比较。

一般游戏玩法(General Game Playing, GGP):

- GGP致力于开发能够明确表示任意新游戏规则并自主学习的智能系统。Game Description Language (GDL) 和 GDL-II 作为描述任意游戏规则的形式、机器可处理语言,被广泛研究。

自动形式化(Autoformalization):

- 将自然语言转换为数学和逻辑形式化表示的研究领域。先前的研究已经展示了在数学和逻辑领域自动形式化的成功案例,论文中提到的方法扩展了这一领域的应用,特别是在游戏理论场景的形式化表示中。

交互式翻译和错误修正:

- 一些研究致力于开发交互式系统,允许用户在LLMs生成的翻译中进行迭代式细化,以提高翻译的准确性。

LLMs的微调(Fine-tuning):

- 微调是一种提高LLMs在特定应用上下文中性能的方法,通过在特定自定义数据集上训练LLMs来实现。

链式思考提示(Chain-of-thought prompting):

- 通过引导LLMs将复杂请求分解为更简单的步骤,提高模型处理复杂请求或特定上下文的准确性。

多模态和多语言模型:

- 如OpenAI的GPT-4 Omni模型,支持文本、视觉和音频数据,已在推理基准测试中显示出卓越的性能。

这些研究领域为论文提出的框架提供了理论和技术基础,同时也展示了LLMs在游戏中的潜在应用和自动形式化过程中的挑战。论文通过结合这些研究成果,提出了一个新颖的方法来自动化游戏理论场景的形式化过程,并在模拟比赛中验证了这一方法的有效性。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决提出的问题:

构建自动形式化框架:

- 论文提出了一个框架,该框架利用大型语言模型(LLMs)增强的代理,将自然语言描述的博弈场景自动形式化为可执行的逻辑程序。这些逻辑程序定义了每款游戏的规则,并验证这些程序的语法准确性。

代理模型与验证机制:

- 引入了一个包含形式化游戏和策略表示的代理模型,并提供了一个自动形式化模块。这个模型通过正式求解器验证代理的语法正确性,通过游戏玩法验证功能性,并通过比较目标和实现的收益来验证语义正确性。

模拟比赛:

- 通过模拟比赛来自动验证生成的代码的功能性和语义正确性。当提供基准收益矩阵时,可以通过检查玩家移动组合产生的收益是否与目标收益匹配来进行精确的语义验证。

策略的自动形式化与评估:

- 框架支持自动形式化策略,允许探索不同策略(自动形式化或预定义)在自动形式化游戏场景中的表现。这使得可以评估策略效率跨多个博弈理论背景。

实验验证:

- 通过一系列实验(实验1:游戏描述的自动形式化,实验2:Axelrod比赛,实验3:策略的自动形式化)来评估框架的有效性。这些实验涉及多种自然语言描述,并在五个知名的2×2同时移动游戏中测试了自动形式化的游戏规则和策略。

结果分析与反馈:

- 分析实验结果,并根据求解器生成的跟踪信息以及运行时错误来提供反馈,从而优化自动形式化模块,提高成功率。

未来工作:

- 论文提出了未来工作的方向,包括扩展框架以模拟超出2×2同时移动游戏的场景,改进反馈机制以更有效地利用LLMs,以及在复杂场景中引入交互式模式以允许用户迭代细化生成的代码。

通过这些步骤,论文展示了如何利用LLMs来自动化游戏理论场景的形式化,并在模拟环境中验证这些形式化场景和策略的有效性,从而减少对人类专业知识和努力的依赖。

Q: 论文做了哪些实验?

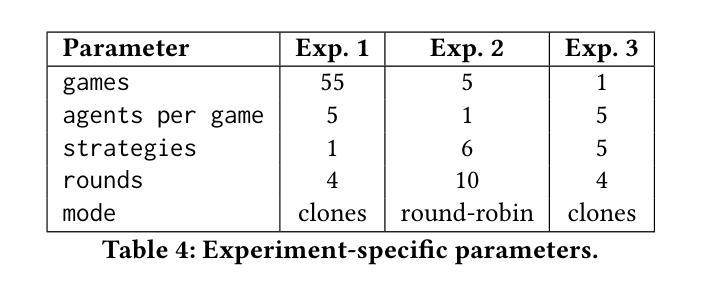

A: 论文中进行了三个实验来评估提出的框架:

实验1:游戏描述的自动形式化(Exp. 1: Autoformalization of Game Descriptions)

- 目的:测试自动形式化游戏场景的语法和语义准确性。

- 数据集:包含55个自然语言游戏理论场景描述,涵盖5种不同的经典2×2游戏,每种游戏有10个避免使用典型隐喻的替代描述。

- 方法:为每个场景生成5个代理,每个代理尝试自动形式化游戏规则,并在克隆模式下进行比赛,比较代理的总收益与目标收益以验证语义正确性。

- 结果:整体语法正确性为96%,语义正确性为87%。

实验2:Axelrod比赛(Exp. 2: Axelrod’s Tournament)

- 目的:使用自动形式化的游戏规则在不同策略间进行比赛,评估策略表现。

- 设置:从实验1中选择5个代理,每个游戏创建6个副本,每个代理分配一种策略,进行循环赛制的比赛。

- 策略:包括“反默认移动”、“反针锋相对”、“最佳响应”、“默认移动”、“随机”和“针锋相对”。

- 结果:展示了每种策略在不同游戏中的归一化总收益,其中“最佳响应”策略平均表现最好。

实验3:策略的自动形式化(Exp. 3: Autoformalization of Strategies)

- 目的:评估自动形式化策略的语义正确性。

- 方法:使用“针锋相对”策略的自然语言描述和Prolog实现作为参考,自动形式化其他5种策略,并分配给代理进行比赛。

- 结果:简单策略如“默认移动”和“反默认移动”总是正确自动形式化,而更复杂的策略如“随机”和“最佳响应”的自动形式化正确率较低。

这些实验综合评估了框架在自动形式化游戏规则和策略、模拟比赛以及验证正确性方面的能力。通过这些实验,论文展示了框架在不同游戏场景和策略中的有效性和准确性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

扩展游戏模型:

- 将框架扩展到2×2同时移动游戏之外,以模拟更复杂的游戏场景,例如具有更多参与者、动作或信息不完全的游戏。

多样化示例学习:

- 增加更多多样化的示例供自动形式化模块学习,以提高其在特定场景中自动形式化的能力。

改进反馈机制:

- 通过结合运行时错误和求解器生成的跟踪信息,扩展LLMs的反馈机制,从而提高自动形式化模块的鲁棒性和准确性。

交互式自动形式化:

- 在复杂场景中引入交互式模式,允许用户与自动形式化模块一起迭代细化生成的代码。

应用到其他领域:

- 将框架的灵活性和泛化能力应用到游戏理论和类似游戏的交互之外的其他领域。

优化策略自动形式化:

- 提供更多样化的策略示例给自动形式化模块,以提高对复杂策略的自动形式化能力。

增强模型的泛化能力:

- 开发方法来检索与特定场景最相关的示例,以实现对更广泛类别游戏的成功泛化。

评估模型的鲁棒性:

- 测试模型在面对不同类型错误输入或异常情况时的表现和鲁棒性。

结合其他AI技术:

- 考虑将LLMs与其他AI技术(如强化学习或多智能体系统)结合,以进一步提升模型在游戏中的表现和决策能力。

伦理和社会影响:

- 研究自动形式化框架在现实世界应用中的伦理和社会影响,特别是在涉及决策和策略制定的领域。

这些探索点可以帮助研究者进一步提升自动形式化框架的性能,扩展其应用范围,并更全面地理解其潜力和局限性。

Q: 总结一下论文的主要内容

A: 论文提出了一个框架,旨在自动形式化游戏理论场景,并使用大型语言模型(LLMs)增强的代理来模拟这些场景。以下是主要内容的总结:

问题陈述:

- 现实世界场景的建模和游戏理论模拟需要大量的人类专业知识和努力。

- LLMs在直接作为理性决策者时存在局限性,但它们在格式转换(如自然语言到形式化表示)方面展现出潜力。

自动形式化框架:

- 利用LLMs将自然语言描述的游戏场景转换为可执行的逻辑程序,定义游戏规则,并验证程序的语法准确性。

- 通过模拟比赛验证生成的游戏规则的功能性和语义正确性。

代理模型与验证:

- 引入包含形式化游戏和策略表示的代理模型,并提供自动形式化模块。

- 通过正式求解器、游戏玩法和收益比较进行三级验证:语法正确性、功能正确性和语义正确性。

模拟比赛:

- 通过模拟比赛自动验证自动形式化的游戏规则和策略,支持不同策略间的比较和评估。

实验评估:

- 进行三个实验:自动形式化游戏描述、Axelrod比赛和策略自动形式化,验证框架的有效性。

- 实验结果表明高语法和语义正确性,并展示了不同策略的表现。

未来工作:

- 扩展框架以模拟更复杂的游戏场景。

- 改进反馈机制,增强LLMs的利用。

- 引入交互式模式,允许用户迭代细化生成的代码。

结论:

- 论文提出的框架有效地自动形式化了2×2同时移动游戏,并在模拟比赛中验证了自动形式化规则和策略的准确性。

- 该框架减少了对人类专业知识和努力的依赖,并为游戏理论模拟提供了一个自动化的方法。

论文的工作展示了LLMs在自动形式化游戏理论场景中的应用潜力,并为未来的研究提供了新的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

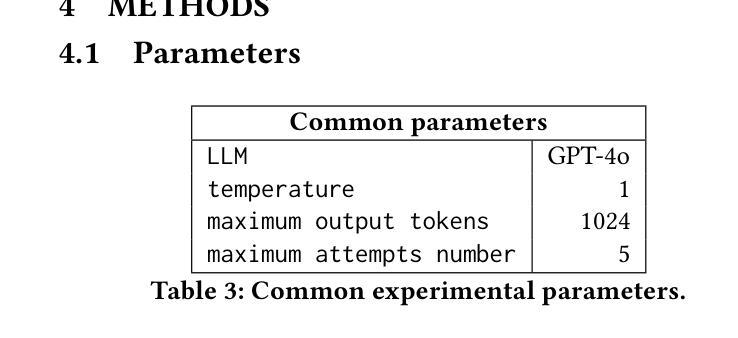

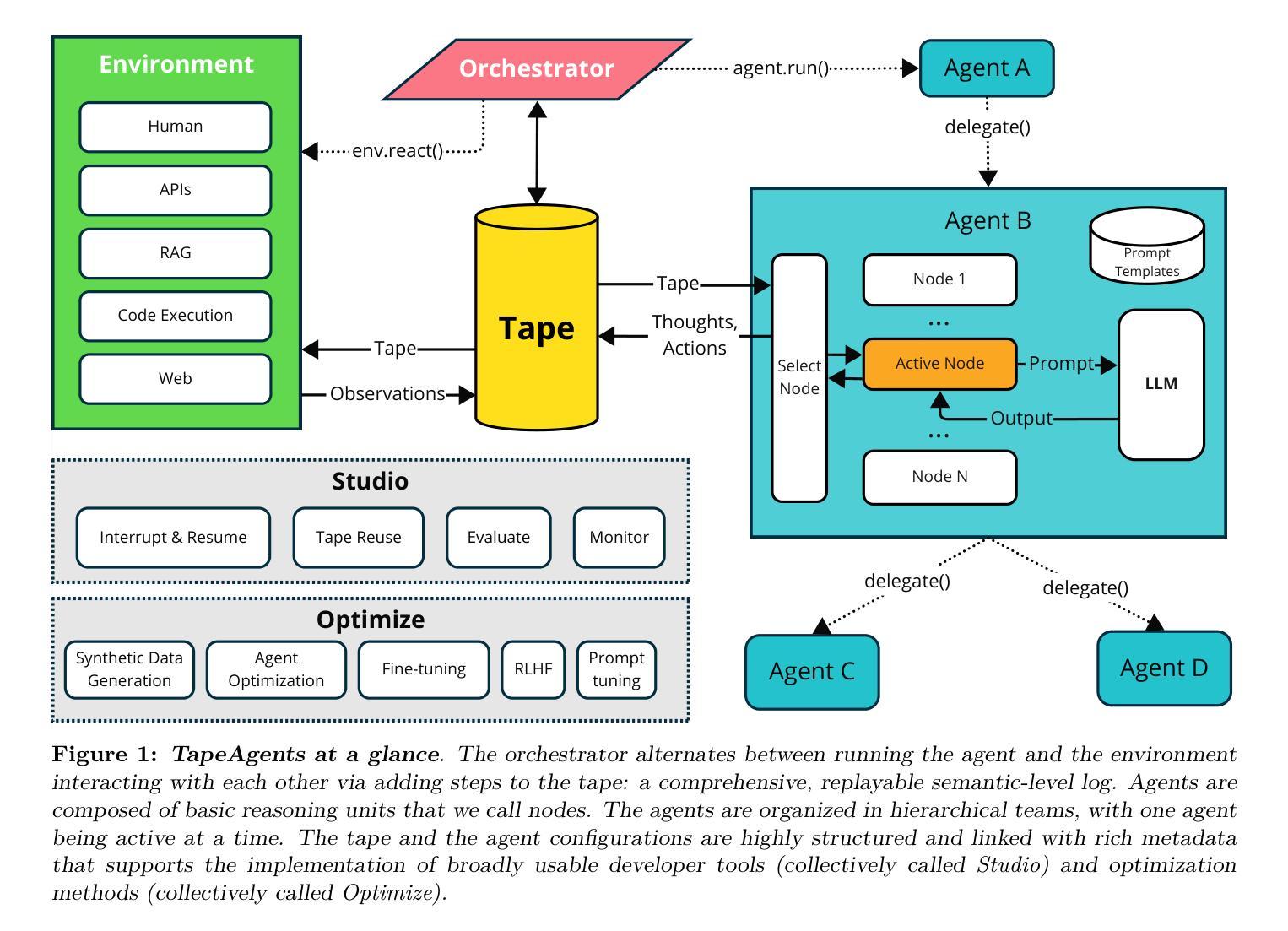

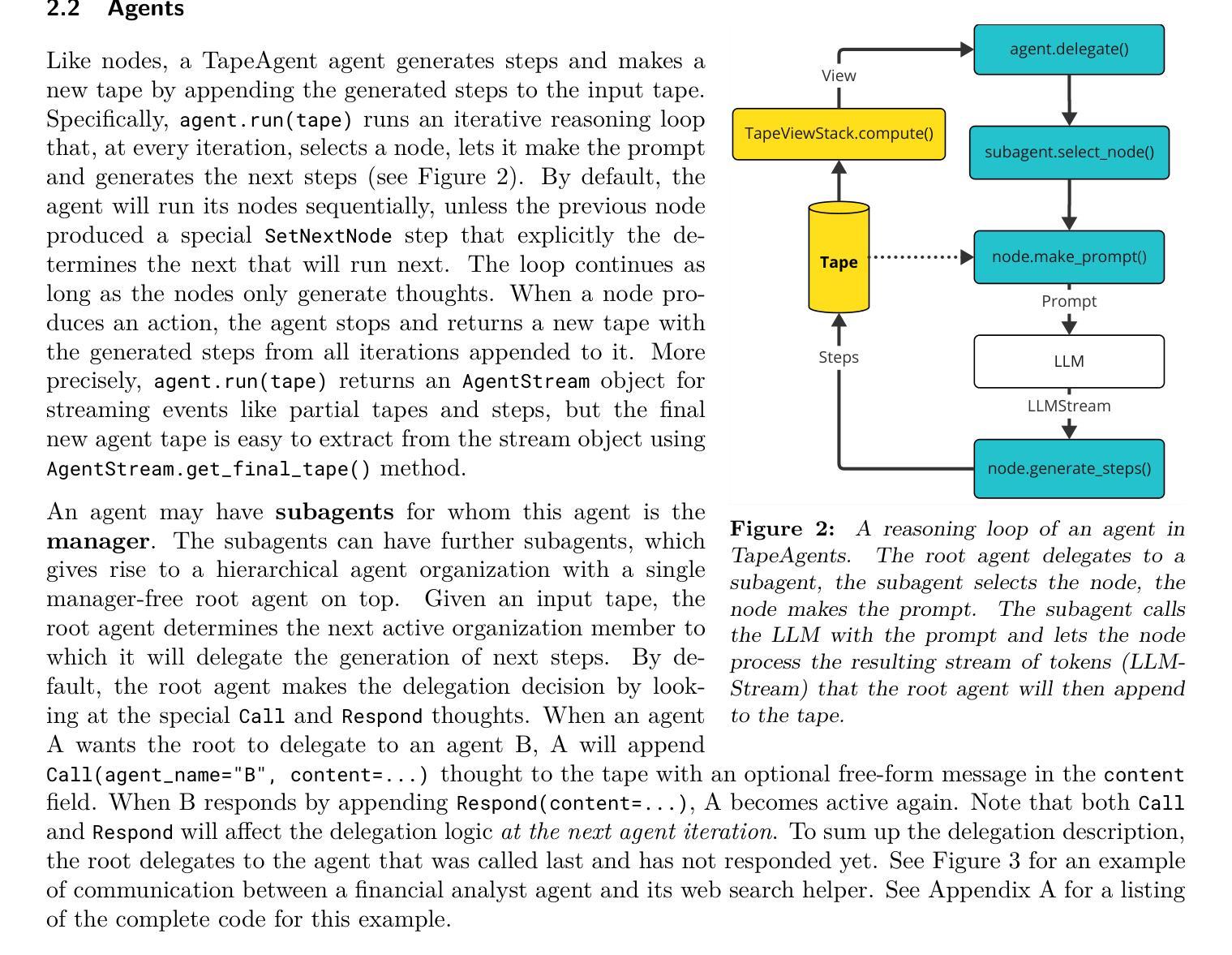

TapeAgents: a Holistic Framework for Agent Development and Optimization

Authors:Dzmitry Bahdanau, Nicolas Gontier, Gabriel Huang, Ehsan Kamalloo, Rafael Pardinas, Alex Piché, Torsten Scholak, Oleh Shliazhko, Jordan Prince Tremblay, Karam Ghanem, Soham Parikh, Mitul Tiwari, Quaizar Vohra

We present TapeAgents, an agent framework built around a granular, structured log tape of the agent session that also plays the role of the session’s resumable state. In TapeAgents we leverage tapes to facilitate all stages of the LLM Agent development lifecycle. The agent reasons by processing the tape and the LLM output to produce new thought and action steps and append them to the tape. The environment then reacts to the agent’s actions by likewise appending observation steps to the tape. By virtue of this tape-centred design, TapeAgents can provide AI practitioners with holistic end-to-end support. At the development stage, tapes facilitate session persistence, agent auditing, and step-by-step debugging. Post-deployment, one can reuse tapes for evaluation, fine-tuning, and prompt-tuning; crucially, one can adapt tapes from other agents or use revised historical tapes. In this report, we explain the TapeAgents design in detail. We demonstrate possible applications of TapeAgents with several concrete examples of building monolithic agents and multi-agent teams, of optimizing agent prompts and finetuning the agent’s LLM. We present tooling prototypes and report a case study where we use TapeAgents to finetune a Llama-3.1-8B form-filling assistant to perform as well as GPT-4o while being orders of magnitude cheaper. Lastly, our comparative analysis shows that TapeAgents’s advantages over prior frameworks stem from our novel design of the LLM agent as a resumable, modular state machine with a structured configuration, that generates granular, structured logs and that can transform these logs into training text – a unique combination of features absent in previous work.

我们推出了TapeAgents,这是一个围绕代理会话的颗粒化、结构化日志磁带构建的代理框架,它也扮演着会话的可恢复状态的角色。在TapeAgents中,我们利用磁带促进LLM代理的整个开发生命周期的所有阶段。代理通过处理磁带和LLM输出来进行推理,产生新的思考和行动步骤,并追加到磁带中。然后,环境会对代理的行动做出反应,同样将观察步骤追加到磁带中。凭借这种以磁带为中心的设计,TapeAgents可以为人工智能从业者提供全面的端到端支持。在开发阶段,磁带便于会话持久性、代理审计和逐步调试。部署后,人们可以重复使用磁带进行评估、微调提示;关键的是,人们可以适应其他代理的磁带或使用修订后的历史磁带。本报告详细介绍了TapeAgents的设计。我们通过构建单体代理和多代理团队、优化代理提示和微调代理的LLM等具体示例来展示TapeAgents的可能应用。我们展示了工具原型,并报告了一个使用TapeAgents微调Llama-3.1-8B表单填写助手以媲美GPT-4o性能的同时降低成本的研究案例。最后,我们的比较分析表明,TapeAgents相对于现有框架的优势来自于我们对LLM代理的独特设计,即将其设计为可恢复、模块化状态机,具有结构化配置,能够生成颗粒化、结构化日志,并将这些日志转化为训练文本——这是以前工作中所缺少的独特功能组合。

论文及项目相关链接

Summary

TapeAgents是一个围绕结构化日志磁带设计的代理框架,该磁带也作为会话的可恢复状态。通过利用磁带,TapeAgents能够支持LLM代理的整个生命周期发展。代理通过处理磁带和LLM输出来进行推理,并产生新的思考和行动步骤,将其追加到磁带中。环境会响应代理的行动,同样将观察步骤追加到磁带中。基于磁带为中心的设计,TapeAgents可以为AI从业者提供端到端的全面支持,包括开发阶段的会话持久性、代理审计和逐步调试,以及部署后的评估、微调提示等功能。本文详细阐述了TapeAgents的设计,展示了在构建单一代理和多代理团队、优化代理提示和微调代理LLM等方面的应用实例。我们还报告了一个使用TapeAgents微调Llama-3.1-8B表单填写助理的案例研究,使其性能接近GPT-4o,但成本却大大降低。最后,我们的比较分析显示,TapeAgents的优势源于我们对LLM代理的新颖设计——作为一个可恢复、模块化的状态机,具有结构化配置,能够生成结构化日志,并将这些日志转化为训练文本。这一独特组合的特征在以前的研究中尚未出现。

Key Takeaways

- TapeAgents是一个基于结构化日志磁带的代理框架,支持LLM代理的全生命周期发展。

- 磁带在TapeAgents中扮演关键角色,用于促进代理的推理、环境反应以及状态恢复。

- TapeAgents为AI从业者提供全面的端到端支持,包括开发阶段的会话持久性、代理审计和调试,以及部署后的评估、微调等。

- 通过具体实例展示了TapeAgents在构建代理团队、优化代理提示和微调LLM等方面的应用。

- 案例研究展示了使用TapeAgents微调表单填写助理的性能接近GPT-4o,但成本大大降低。

- TapeAgents的优势源于其新颖的设计——将LLM代理设计为可恢复、模块化的状态机,具有结构化配置和日志生成能力。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了TapeAgents,一个全面的框架,旨在解决与大型语言模型(LLM)代理开发和优化相关的挑战。具体来说,它试图解决以下几个问题:

非静态环境和非确定性LLM行为的挑战:随着LLM代理在复杂用户面向和后台工作流中的广泛部署,AI实践者需要在非静态环境中操作,并且必须处理LLM的非确定性行为和脆弱的指令遵循能力。

代理开发和优化的支持:为了使LLM代理的采用顺利进行并取得良好结果,需要适当的框架来支持代理开发者和应用科学家,以便他们能够有效地开发和优化系统。

会话持久性、审计和调试:在代理框架中,需要能够持久保存代理会话、进行代理审计和逐步调试,以便开发者能够理解和改进代理的行为。

数据驱动的代理优化:需要一种方法来重用来自其他代理的会话记录(tapes),以便评估和算法性地改进代理,包括手动调试和算法优化。

代理作为可优化工作流的实现:需要一种方法将可优化的工作流程实现为LLM代理,以便利用数据驱动的算法进行改进。

成本效益和性能的平衡:在企业环境中,需要开发成本效益高的LLM代理,同时保持优秀的用户体验和性能。

TapeAgents框架通过提供一个以结构化日志(tape)为中心的设计来解决这些问题,该日志记录了代理会话的详细信息,并作为代理状态的可恢复表示。这种设计允许开发者在开发、部署和优化LLM代理的整个生命周期中获得全面的支持。

Q: 有哪些相关研究?

A: 论文中提到了多个与TapeAgents框架相关的研究工作,涉及代理开发、优化以及大型语言模型(LLM)的应用。以下是一些具体提及的相关研究:

**LangChain (Chase, 2022)**:这是一个帮助开发者使用低代码范式(如提示链或多代理团队)快速构建代理的框架。

**CrewAI and AutoGen (Wu et al., 2024a)**:这些框架同样支持开发者使用低代码方法构建代理。

**LangGraph (Chase, 2023)**:提供了低层次的支持以实现可恢复性、异步执行、并发和仪器化。

DSPy (Khattab et al., 2023a)、TextGrad (Yuksekgonul et al., 2024) 和 **Agents (Zhou et al., 2023a)**:这些由研究人员构建的框架通常专注于通过模型微调和提示调整算法进行数据驱动的代理性能优化,对代理开发者的需求关注较少。

Langfun Agent v2.0、HuggingFace Agents、MSR Magentic-1:这些是在GAIA基准测试中与TapeAgent进行比较的框架和模型。

Agentlab:在Workarena基准测试中与TapeAgent进行比较的框架。

**ReAct (Yao et al., 2023b)**:这是一个结合了规划和行动的框架,用于构建Web浏览代理。

**Magnetic-1 (Fourney et al., 2024)**:这是一个集成了多个执行器代理和进度记录的复杂系统。

**Constitutional AI (Bai et al., 2022)**:研究了通过AI反馈实现无害AI的方法。

LangSmith 和 Langfuse:这些是提供代理执行可见性的软件平台。

这些研究工作展示了LLM代理领域的多样性,从低代码开发框架到数据驱动的优化技术,再到代理的可观察性和性能评估。TapeAgents框架通过结合这些研究的优点,提供了一个全面的工具,旨在支持LLM代理的整个开发和优化生命周期。

Q: 论文如何解决这个问题?

A: 论文通过提出TapeAgents框架来解决上述问题,具体方法如下:

基于Tape的代理会话记录:

- 引入了“tape”的概念,即代理会话的粒状、结构化日志,同时充当会话的可恢复状态。

- 代理通过处理tape和LLM(大型语言模型)的输出来产生新的思考和行动步骤,并将它们追加到tape上。

- 环境对代理的行动做出反应,通过追加观察步骤到tape。

全周期支持:

- 在开发阶段,tape支持会话持久性、代理审计和逐步调试。

- 部署后,可以重用tape进行评估、微调和提示调整;也可以适应其他代理的tape或使用修订过的历史tape。

模块化和可优化的代理结构:

- 通过将代理配置标准化为Pydantic模型,使得代理提示和结构的调整算法可以应用于尽可能多的代理。

- 代理能够从给定的tape重构LLM调用,验证重构的正确性,并返回训练文本。

环境交互和编排:

- 定义了环境如何响应代理的行动,通过添加观察步骤到tape。

- 提供了一个默认的orchestrator来交替运行根代理和环境,但也允许开发者构建自定义的orchestrator以控制代理-环境通信。

工具和算法支持:

- 提供了Studio工具套件用于开发和调试,以及Optimize工具套件用于代理优化。

- 包括自动提示、LLM微调和模块化强化学习编排器等算法。

案例研究:

- 通过一个实际案例(优化成本效益的对话助手)展示了如何使用TapeAgents框架和工具来实现高质量的服务。

比较分析:

- 展示了TapeAgents相对于先前框架的优势,这些优势来自于其新颖的设计:作为可恢复的、模块化的状态机的LLM代理,具有结构化配置,能够生成粒状、结构化日志,并将这些日志转换为训练文本。

通过这些方法,TapeAgents框架提供了一个独特的组合,支持AI实践者在LLM代理的开发和优化阶段进行有效的工具使用和算法实现。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证TapeAgents框架的有效性,具体实验包括:

金融分析师及其网络搜索助手:

- 实现了一个用户面向的金融分析师代理,该代理可以委托其子代理执行网络搜索任务。

- 展示了分析师代理的结构和示例tape,并详细说明了如何构建此代理。

开放域问题回答和网络浏览与单体代理:

- 构建了一个针对GAIA基准的问题回答(QA)代理,该代理可以搜索网络、运行Python代码和阅读多种文件类型。

- 构建了一个针对WorkArena基准的网络浏览代理,并使用BrowserGym环境进行评估。

数据科学与代理团队:

- 实现了一个由请求者、管理者、软件工程师、代码执行者和资产审查者组成的“数据科学”代理团队。

- 展示了该团队如何协作构建股票价格比较图表。

为Agentic RAG进行提示调整:

- 使用LLMFunction提示模板,通过添加示例来调整代理的提示。

- 通过在HotpotQA训练样本上运行代理并选择最佳代理来评估性能提升。

构建成本效益的企业表单填写助手:

- 通过模拟环境(合成公司和用户交互)来训练成本效益的对话代理,帮助用户填写和提交表单。

- 对比了使用大型模型的教师代理和使用小型模型的学生代理在GREADTH指标上的性能,并评估了学生代理经过微调后的效果。

这些实验覆盖了TapeAgents框架的不同方面,包括单体代理和多代理团队的构建、优化以及成本效益分析。通过这些实验,论文展示了TapeAgents如何在实际应用中发挥作用,以及它在开发和优化LLM代理方面的潜力。

Q: 有什么可以进一步探索的点?

A: 论文在第七部分讨论了可能的扩展和未来的工作,提出了一些可以进一步探索的点:

添加协程实现:

- 为代理循环和代理-环境编排添加协程实现,以支持并行运行多个代理环境循环以及在共享tape上并行运行同一代理团队的成员。

在线强化学习训练器:

- 即将发布一个在线强化学习(RL)训练器,用于使用标注代理计算的奖励来改进助手代理。

基于文本的反馈传播算法:

- 在TapeAgents中实现一个基于文本的反馈传播算法,类似于TextGrad中的算法,将tape步骤作为附加反馈的完美媒介。

LLM代理与程序、工作流或软件的界定:

- 进一步探讨什么应该被称为LLM代理,什么应该被称为程序、工作流或软件,并推荐将那些打算通过数据驱动算法优化的部分实现为LLM代理。

合成数据生成:

- 使用TapeAgents作为基础,为具有人类反馈的多代理管道提供持续改进的支持,将所有管道模块实现为TapeAgents,使它们立即可优化。

扩展TapeAgents以支持更多的并发LLM调用:

- 论文提到了当前TapeAgents在支持并发LLM调用方面的局限性,并提出了未来可能的解决方案。

增强TapeAgents的优化算法:

- 考虑将更多的优化算法集成到TapeAgents中,以进一步提高代理的性能。

提高TapeAgents的可扩展性和灵活性:

- 探索如何使TapeAgents更加灵活和可扩展,以便能够适应更广泛的应用场景。

深入研究代理的自适应和自学习能力:

- 研究如何使代理能够根据实时反馈动态调整其行为和策略。

跨领域应用的案例研究:

- 在不同的领域和应用场景中进行更多的案例研究,以验证TapeAgents框架的通用性和有效性。

这些探索点不仅有助于提升TapeAgents框架的能力,也有助于推动LLM代理技术的发展和应用。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了TapeAgents,一个全面的框架,旨在支持大型语言模型(LLM)代理的开发和优化。以下是论文的主要内容总结:

TapeAgents框架介绍:

- 构建基于一个称为“tape”的粒状、结构化日志,该日志记录代理会话并作为会话的可恢复状态。

- 代理通过处理tape和LLM的输出来产生新的思考和行动步骤,并将这些步骤追加到tape上。

全周期支持:

- 在开发阶段,tape支持会话持久性、代理审计和逐步调试。

- 部署后,可以重用tape进行评估、微调和提示调整。

代理架构和环境交互:

- 定义了节点(nodes)、代理(agents)和环境(environment)的基本构建块,以及它们如何组合和编排以构建以tape为中心的系统。

- 环境响应代理的行动,通过追加观察步骤到tape。

工具和算法:

- 提供了Studio工具套件用于开发和调试,以及Optimize工具套件用于代理优化。

- 包括自动提示、LLM微调和模块化强化学习编排器等算法。

实验和案例研究:

- 展示了使用TapeAgents构建单体代理和多代理团队的例子。

- 通过一个实际案例(优化成本效益的对话助手)展示了如何使用TapeAgents框架和工具来实现高质量的服务。

比较分析:

- 展示了TapeAgents相对于先前框架的优势,这些优势来自于其新颖的设计:作为可恢复的、模块化的状态机的LLM代理,具有结构化配置,能够生成粒状、结构化日志,并将这些日志转换为训练文本。

未来工作和扩展:

- 讨论了TapeAgents的未来发展,包括添加协程实现、在线强化学习训练器、基于文本的反馈传播算法等。

- 提出了将TapeAgents应用于合成数据生成和跨领域应用的案例研究。

总体而言,TapeAgents框架提供了一个独特的方法来构建、优化和部署LLM代理,通过其创新的tape设计支持代理的整个生命周期。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

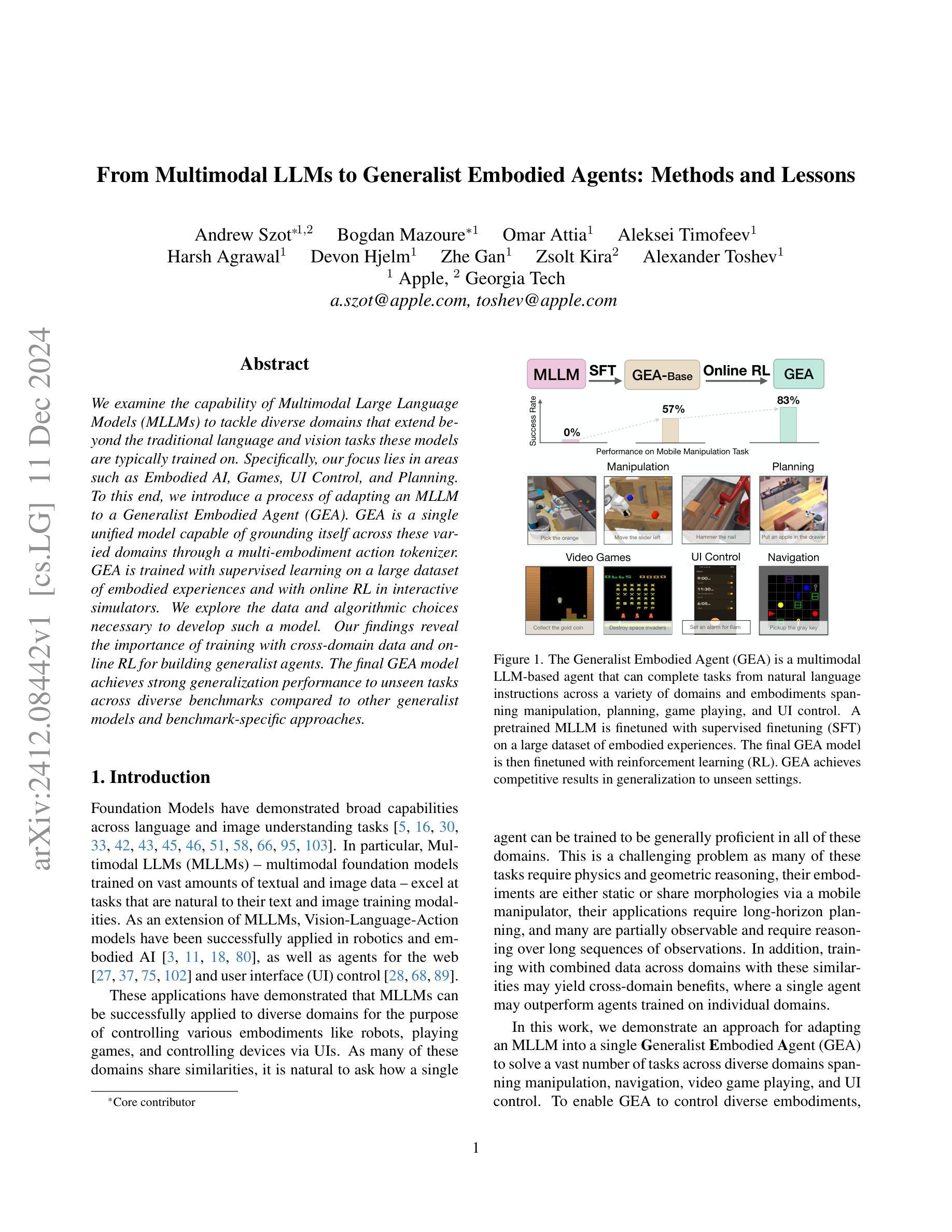

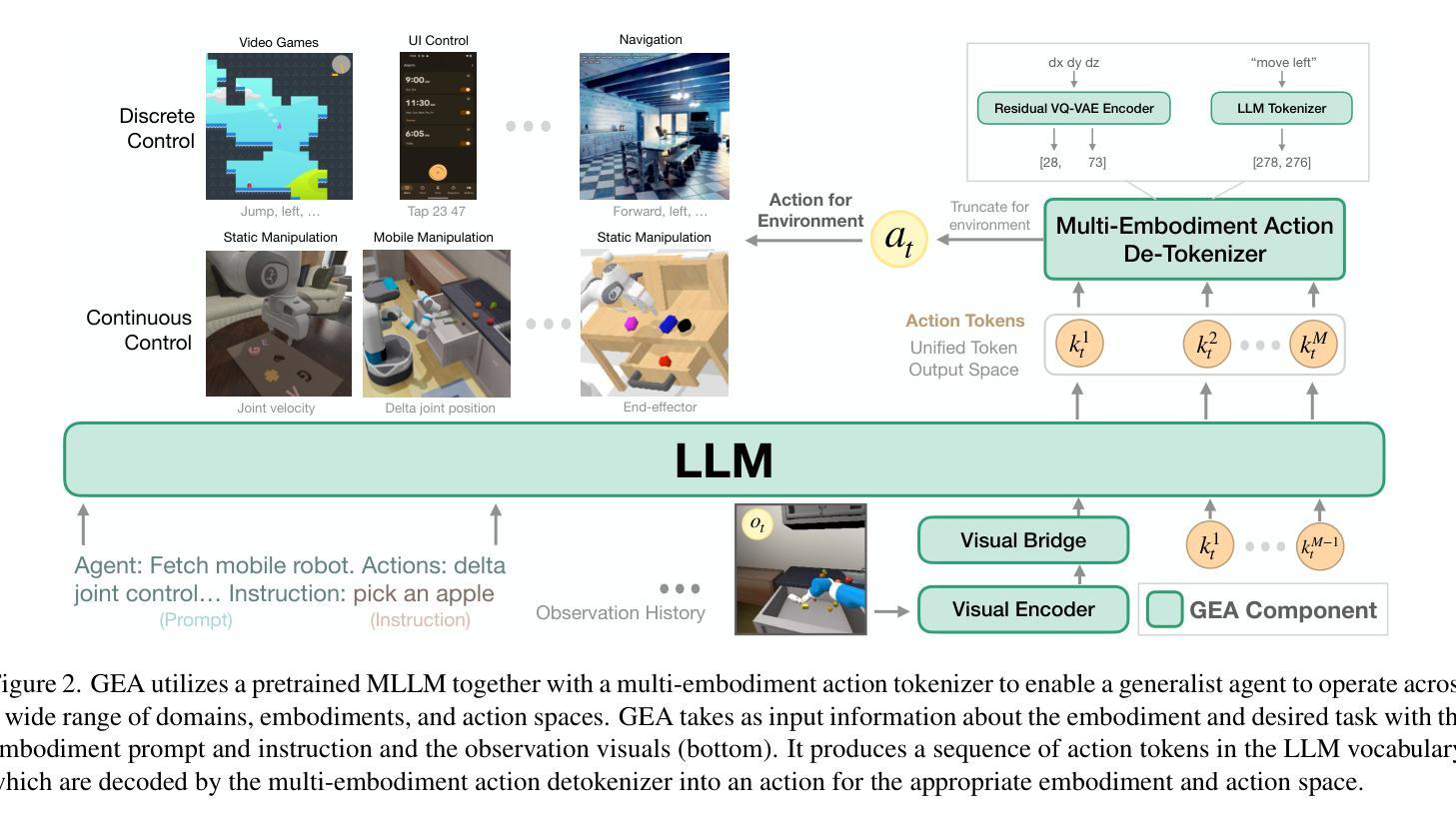

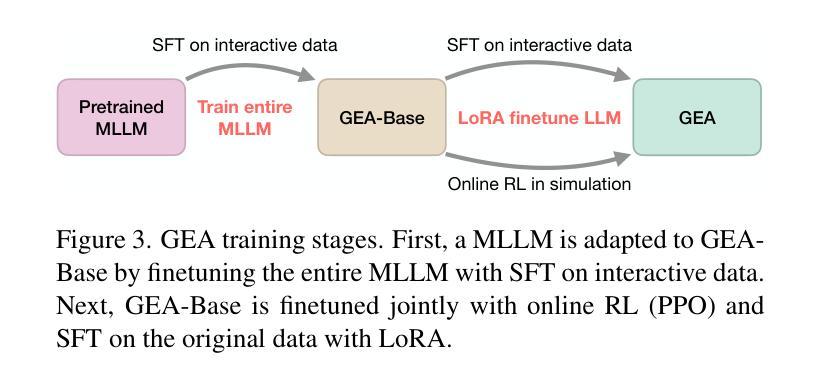

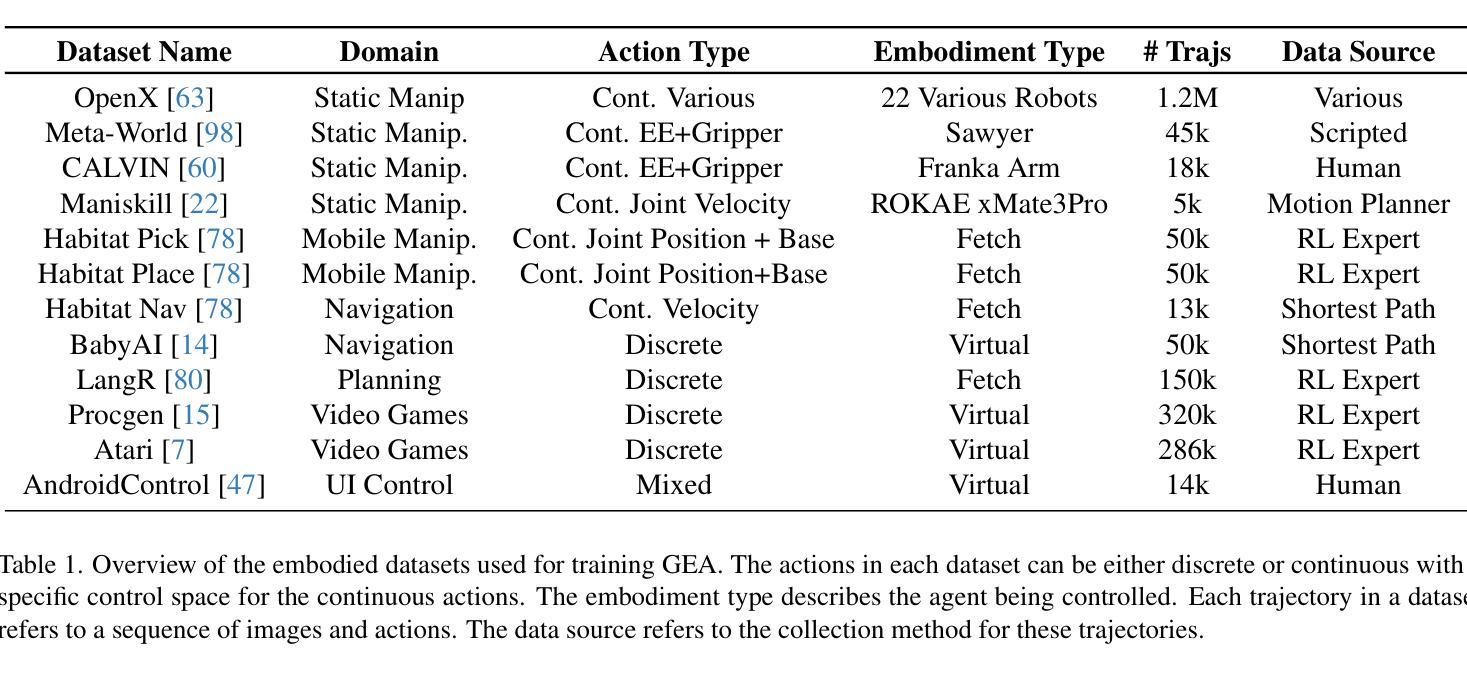

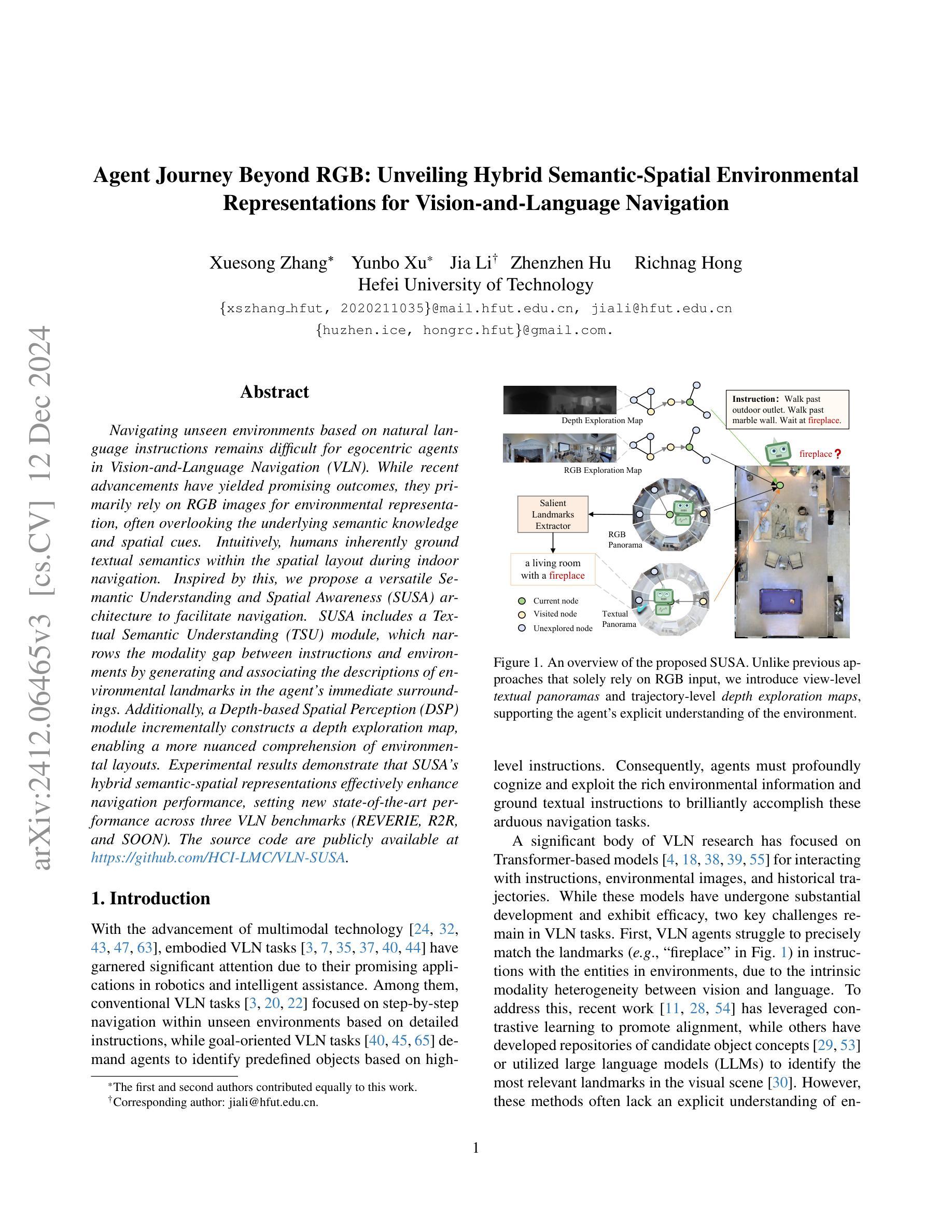

From Multimodal LLMs to Generalist Embodied Agents: Methods and Lessons

Authors:Andrew Szot, Bogdan Mazoure, Omar Attia, Aleksei Timofeev, Harsh Agrawal, Devon Hjelm, Zhe Gan, Zsolt Kira, Alexander Toshev

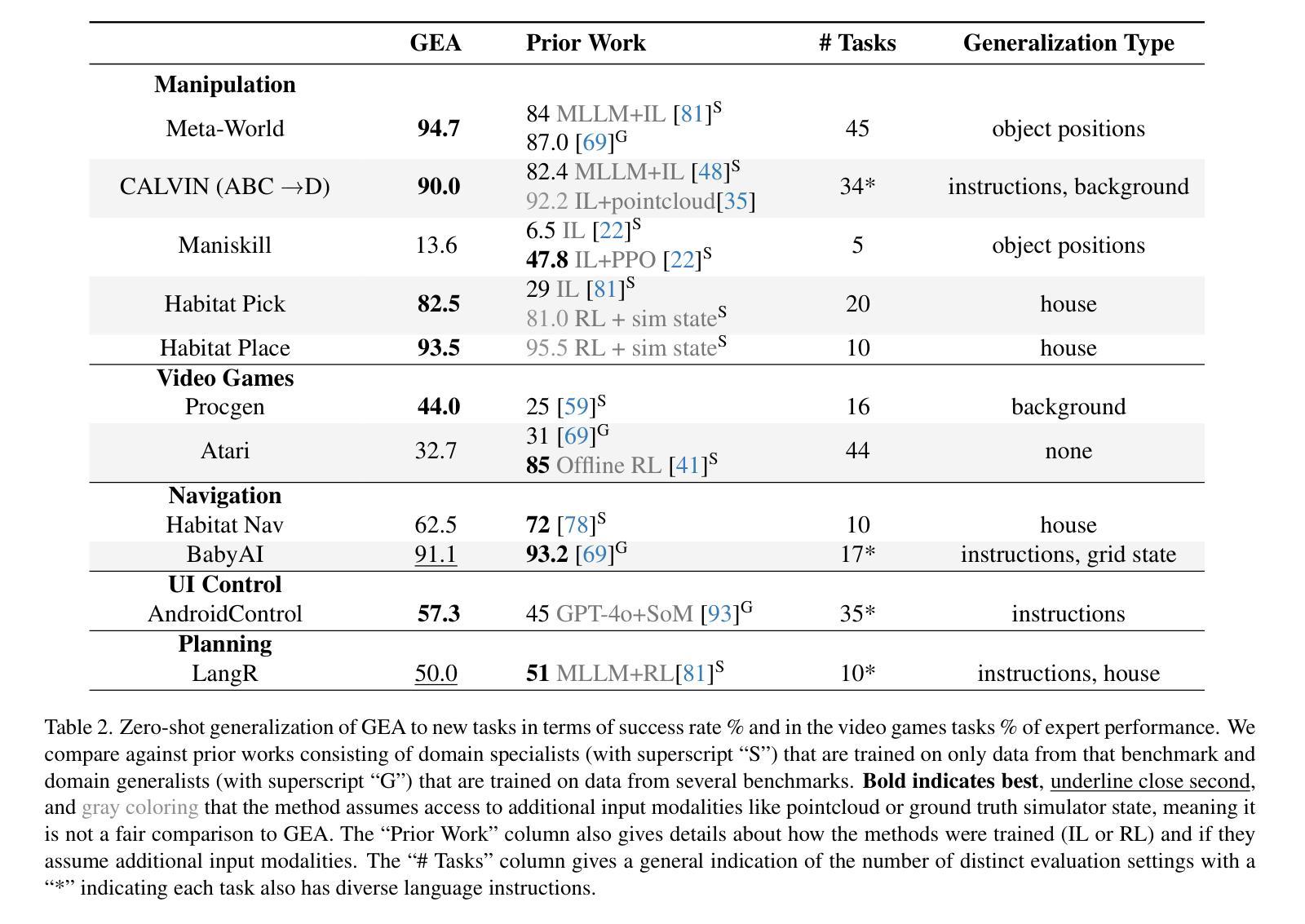

We examine the capability of Multimodal Large Language Models (MLLMs) to tackle diverse domains that extend beyond the traditional language and vision tasks these models are typically trained on. Specifically, our focus lies in areas such as Embodied AI, Games, UI Control, and Planning. To this end, we introduce a process of adapting an MLLM to a Generalist Embodied Agent (GEA). GEA is a single unified model capable of grounding itself across these varied domains through a multi-embodiment action tokenizer. GEA is trained with supervised learning on a large dataset of embodied experiences and with online RL in interactive simulators. We explore the data and algorithmic choices necessary to develop such a model. Our findings reveal the importance of training with cross-domain data and online RL for building generalist agents. The final GEA model achieves strong generalization performance to unseen tasks across diverse benchmarks compared to other generalist models and benchmark-specific approaches.

我们研究了多模态大型语言模型(MLLMs)在处理超越这些模型通常训练的传统的语言和视觉任务的各种领域的能力。具体来说,我们的重点研究领域包括嵌入式人工智能、游戏、用户界面控制和规划等。为此,我们提出了将MLLM适应于通用嵌入式代理(GEA)的过程。GEA是一个单一统一的模型,能够通过多体现动作标记器在这些不同的领域之间进行自我定位。GEA通过大型嵌入式体验数据集进行有监督学习训练,并在交互式模拟器中进行在线强化学习训练。我们探讨了开发此类模型所需的数据和算法选择。我们的研究结果表明,使用跨域数据和在线强化学习进行培训对于构建通用代理的重要性。最终,与其他的通用模型和特定基准测试的方法相比,GEA模型在未见过的任务上实现了强大的泛化性能。

论文及项目相关链接

Summary

基于本文的分析,我们研究了多模态大型语言模型(MLLMs)在非传统语言和视觉任务领域的应用能力,特别是在嵌入式人工智能、游戏、用户界面控制和规划等领域的应用。为此,我们提出了一种将MLLMs适应为通用嵌入式代理(GEA)的过程。GEA是一个单一的统一模型,能够在不同的领域中实现自身定位,并依靠多体态动作标记器实现这一功能。通过大量的嵌入式经验数据集进行有监督学习和在线强化学习模拟训练,我们探索了开发此类模型所需的数据和算法选择。我们发现跨域数据和在线强化学习对于构建通用代理模型至关重要。最终开发的GEA模型在多个基准测试中实现了对未见任务的强大泛化性能。

Key Takeaways

- 研究了多模态大型语言模型(MLLMs)在非传统任务领域的应用潜力,特别是在嵌入式人工智能(Embodied AI)等领域。

- 提出了一种通用嵌入式代理(GEA)的概念,这是一个统一模型,可以在不同的领域中自我定位并完成一系列任务。

- 通过使用多体态动作标记器,GEA能够适应各种领域并执行多样化任务。

- GEA的训练结合了大型数据集的有监督学习和交互式模拟器中的在线强化学习(RL)。

- 研究发现跨域数据和在线强化学习对于构建通用代理至关重要。

- GEA模型在各种基准测试中表现优异,展现出强大的泛化性能。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了如何将多模态大型语言模型(Multimodal Large Language Models, MLLMs)扩展应用于超越传统语言和视觉任务的多样化领域,特别是关注于体现智能(Embodied AI)、游戏、用户界面控制和规划等领域。具体来说,论文提出了一个将MLLM适配到通用体现智能体(Generalist Embodied Agent, GEA)的过程。GEA是一个单一的统一模型,能够通过多体现动作标记化器(multi-embodiment action tokenizer)在这些不同领域之间建立联系。GEA通过监督学习在大规模体现经验数据集上进行训练,并通过在线强化学习(online RL)在交互式模拟器中进行训练。论文探讨了开发这种模型所需的数据和算法选择,并发现使用跨领域数据和在线RL进行训练对于构建通用智能体至关重要。最终的GEA模型在多样化基准测试中对未见任务的泛化性能表现出色,与其他通用模型和特定基准方法相比具有竞争力。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以概括为以下几个方面:

多任务学习与通用智能体:

- 先前的研究通过在大型多任务数据集上训练策略,展示了创建能够处理多任务的通用智能体的重要性[20, 69, 88]。

通用智能体架构:

- 一些研究专注于为通用智能体设计新的架构[24, 86],而其他研究则关注于将通用智能体应用于机器人领域[9, 10, 83]。

特定领域的通用模型:

- 部分研究调查了在特定领域基准测试中的通用模型[34, 82]或跨体现场景中的通用模型[17, 65]。

基于MLLM的智能体:

- 与GEA类似,这些方法利用大量数据,但论文强调了通过监督学习和在线RL适应预训练MLLM的重要性。例如,GEA与Gato[69]的区别在于GEA利用了RL,使用预训练的MLLM,学习多体现动作标记器,并专注于评估对新任务设置的泛化能力。

MLLM的领域特定应用:

- 一些工作提出了使用MLLM零样本能力的领域特定流程,用于决策制定[3, 31, 50, 85, 91, 100],而本文工作侧重于微调MLLM。

MLLM的微调:

- 其他工作调查了微调MLLM用于决策的方案以及这样做的好处,但也在特定领域的背景下[48, 76, 80, 81]。

MLLM作为通用智能体的微调:

- 一些工作微调MLLM作为通用智能体[11, 36, 63]。然而,本文展示了在更多样的领域中的结果,并研究了监督学习与多领域数据和RL微调的重要性。

MLLM的其他应用方式:

- 除了作为策略之外,还有通过奖励模型[55, 56]、世界模型[90]或环境生成[94]等方式利用MLLM。

LLM用于交互和推理:

- 先前的工作展示了如何使用LLM为能够推理和交互的智能体,各种工作专注于通过特定流程训练LLM智能体[101]。

这些相关研究构成了GEA方法的理论和实证基础,并与GEA在多模态大型语言模型应用于更广泛任务和领域的探索相互补充。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决将多模态大型语言模型(MLLMs)扩展应用于多样化领域的问题:

提出通用体现智能体(GEA):

- 论文提出了一个单一的统一模型GEA,该模型能够跨多个领域(如操纵、导航、视频游戏播放和用户界面控制)执行任务。

多体现动作标记化器:

- 为了使GEA能够控制不同的体现(embodiments),研究者们学习了一个统一的标记化机制,用于所有连续和离散动作空间。

监督微调(Supervised Finetuning, SFT):

- 使用监督学习对预训练的MLLM进行微调,使其能够根据代理完成任务的轨迹预测动作。这个过程涉及超过220万条来自不同收集方法(如人类标注或学习策略)的轨迹数据。

在线强化学习(Online Reinforcement Learning, RL):

- 除了SFT外,论文还提出了使用在线RL对GEA进行第二阶段训练,使代理能够在交互式模拟器中收集数据并从中学习。

跨领域数据和算法选择:

- 论文探索了训练这种模型所需的数据和算法选择,强调了使用跨领域数据和在线RL对构建通用智能体的重要性。

评估和比较:

- 最终的GEA模型在多个基准测试中展现出强大的泛化能力,与其他通用模型和特定基准方法相比具有竞争力。

开源贡献:

- 论文承诺将发布用于训练和评估GEA的代码以及GEA模型本身,以促进社区进一步的研究和发展。

通过这些步骤,论文不仅提出了一个能够处理多样化任务的通用模型GEA,而且还展示了如何通过结合监督学习和强化学习来提高模型在新任务和新环境中的泛化能力。这种方法为未来在更广泛的领域中应用MLLM提供了有价值的见解和方法论。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估和分析通用体现智能体(GEA)的性能和泛化能力。以下是实验的主要内容:

GEA泛化能力评估:

- 研究者们在多个基准测试中评估了GEA模型的泛化能力,这些基准测试覆盖了操纵、导航、视频游戏、用户界面控制和规划等多个领域。这些测试包括Meta-World、CALVIN、Habitat Pick、Procgen、Atari、Habitat Nav、BabyAI、LangR和AndroidControl等。

与先前工作的比较:

- GEA的性能与领域专家(specialist)模型和领域通用(generalist)模型进行了比较。这些模型包括MLLM+IL、Gato、IL+pointcloud等,涉及不同的训练方法和是否使用额外的输入模态。

RL训练对GEA性能的影响:

- 通过比较仅使用监督微调(SFT)训练的GEA-Base模型和进一步使用在线RL训练的GEA模型,研究者们分析了RL训练对GEA性能的影响。

多领域数据的影响:

- 研究者们探讨了使用多领域数据进行训练对GEA性能的影响,比较了仅使用单一领域数据与使用跨领域数据训练的模型性能。

策略收集数据的影响:

- 分析了除了专家演示数据外,使用策略收集的数据(包括成功和失败的轨迹)对GEA性能的影响。这包括了成功SFT、IQL离线RL和在线RL等不同的数据收集和训练方法。

预训练MLLM的影响:

- 研究者们评估了预训练MLLM在GEA架构中的重要性,包括使用不同大小和类别的MLLM作为基础模型。

模型和训练的稳健性分析:

- 分析了不同随机种子对GEA训练和评估性能的影响,以及模型对不同领域数据的转移学习能力。

这些实验不仅验证了GEA模型在多样化任务和领域的泛化性能,还深入探讨了不同训练方法和数据对模型性能的影响,为未来模型的改进和优化提供了有价值的见解。

Q: 有什么可以进一步探索的点?

A: 论文提出了一些可以进一步探索的点,包括:

扩展到更多任务和领域:

- 尽管GEA展示了在多个领域的泛化能力,但它仍然不能零样本控制任意体现和操作任意环境。未来的工作可以继续扩展GEA,使其能够处理更多任务和领域。

改进RL训练:

- 论文中提到GEA在某些领域(如Maniskill、Atari和AndroidControl)的性能还有待提高。将在线RL扩展到这些领域可能是提高性能的一个解决方案。

优化数据和算法选择:

- 论文强调了跨领域数据和在线RL在构建通用智能体中的重要性。未来的研究可以探索更优的数据组合和算法选择,以进一步提升模型性能。

提高模型的样本效率:

- 在实验中,GEA-Base模型通过在线RL训练显示出比基础MLLM更高的样本效率。研究如何进一步提高模型的样本效率是一个有价值的研究方向。

探索模型的可解释性和鲁棒性:

- 虽然GEA在多个基准上表现良好,但其决策过程的可解释性仍然是一个挑战。研究如何提高模型的可解释性和鲁棒性,特别是在面对错误和不确定性时,是一个重要的研究方向。

模型和训练的稳健性分析:

- 论文中提到了对不同随机种子的敏感性分析。未来的工作可以进一步探索模型和训练过程中的随机性和不确定性,以及如何提高模型对这些因素的稳健性。

跨领域迁移学习:

- 论文中的实验表明,某些领域(如Procgen和CALVIN)从其他领域的数据中获益良多。未来的研究可以更深入地探索跨领域迁移学习,以及如何有效地利用来自不同领域的知识。

模型的实时性能和资源效率:

- 在实际应用中,模型的实时性能和资源效率至关重要。未来的工作可以探索如何优化GEA,使其在保持高性能的同时,减少计算资源的需求。

这些探索点不仅可以推动GEA模型的发展,还有助于推动通用人工智能领域的研究进展。

Q: 总结一下论文的主要内容

A: 论文《From Multimodal LLMs to Generalist Embodied Agents: Methods and Lessons》主要探讨了如何将多模态大型语言模型(MLLMs)扩展应用于传统语言和视觉任务之外的多样化领域,特别是体现智能(Embodied AI)、游戏、用户界面控制和规划等领域。以下是论文的主要内容总结:

问题定义:

- 论文提出了将MLLMs适配到通用体现智能体(GEA)的挑战,目标是使单一智能体能够在多个领域中通用。

GEA模型介绍:

- 介绍了GEA的概念,这是一个基于MLLM的多模态智能体,能够通过多体现动作标记化器在不同领域中执行任务。

训练方法:

- 描述了将预训练的MLLM通过监督微调(SFT)和在线强化学习(RL)训练,以适应GEA模型的过程。

跨领域数据和在线RL的重要性:

- 论文通过实验发现,使用跨领域数据和在线RL对构建通用智能体至关重要。

性能评估:

- GEA模型在多个基准测试中展现出强大的泛化能力,与其他通用模型和特定领域的专家系统相比具有竞争力。

实验和分析:

- 论文进行了一系列实验来评估GEA的泛化能力,并分析了不同训练数据和方法对GEA性能的影响。

开源贡献:

- 论文承诺将发布用于训练和评估GEA的代码及模型本身,以促进社区进一步的研究和发展。

未来工作:

- 论文提出了未来可能的研究方向,包括扩展GEA到更多任务和领域,改进RL训练,优化数据和算法选择,提高模型的样本效率和稳健性等。

总体而言,论文提出了一个将多模态大型语言模型转化为能够跨多个领域执行任务的通用体现智能体的方法,并验证了该方法的有效性,为未来在更广泛的领域中应用MLLM提供了有价值的见解和方法论。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

SweetieChat: A Strategy-Enhanced Role-playing Framework for Diverse Scenarios Handling Emotional Support Agent

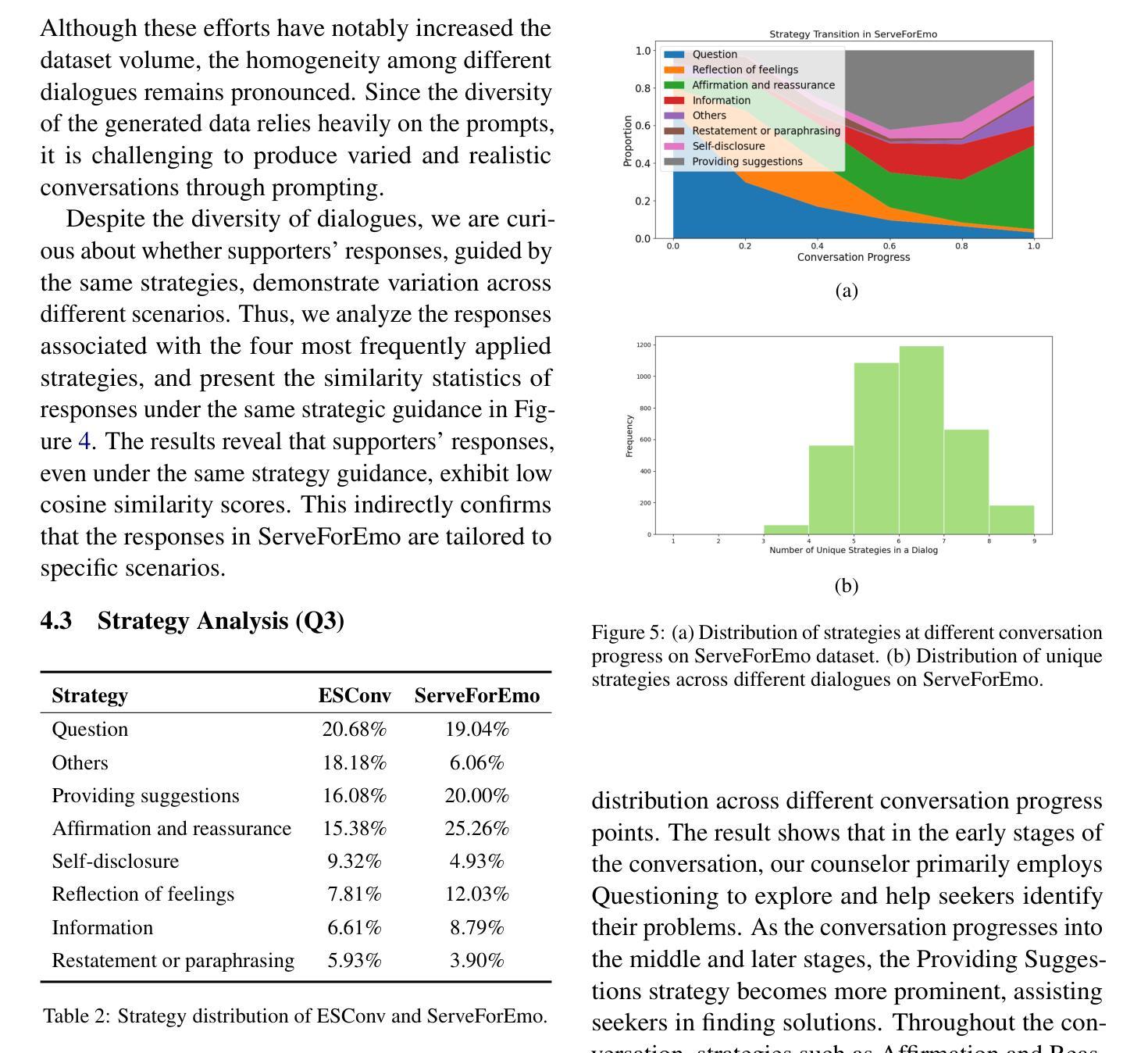

Authors:Jing Ye, Lu Xiang, Yaping Zhang, Chengqing Zong

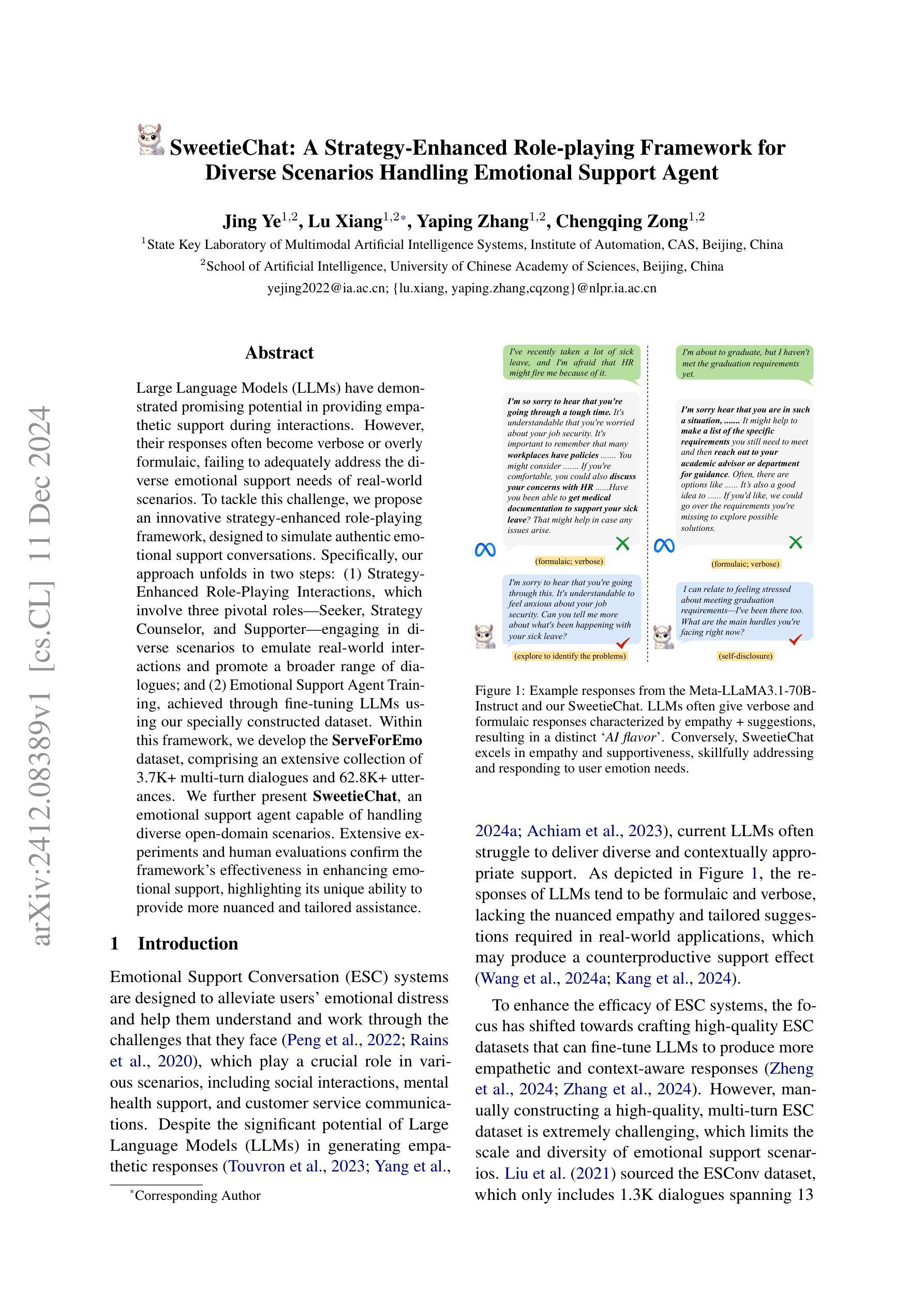

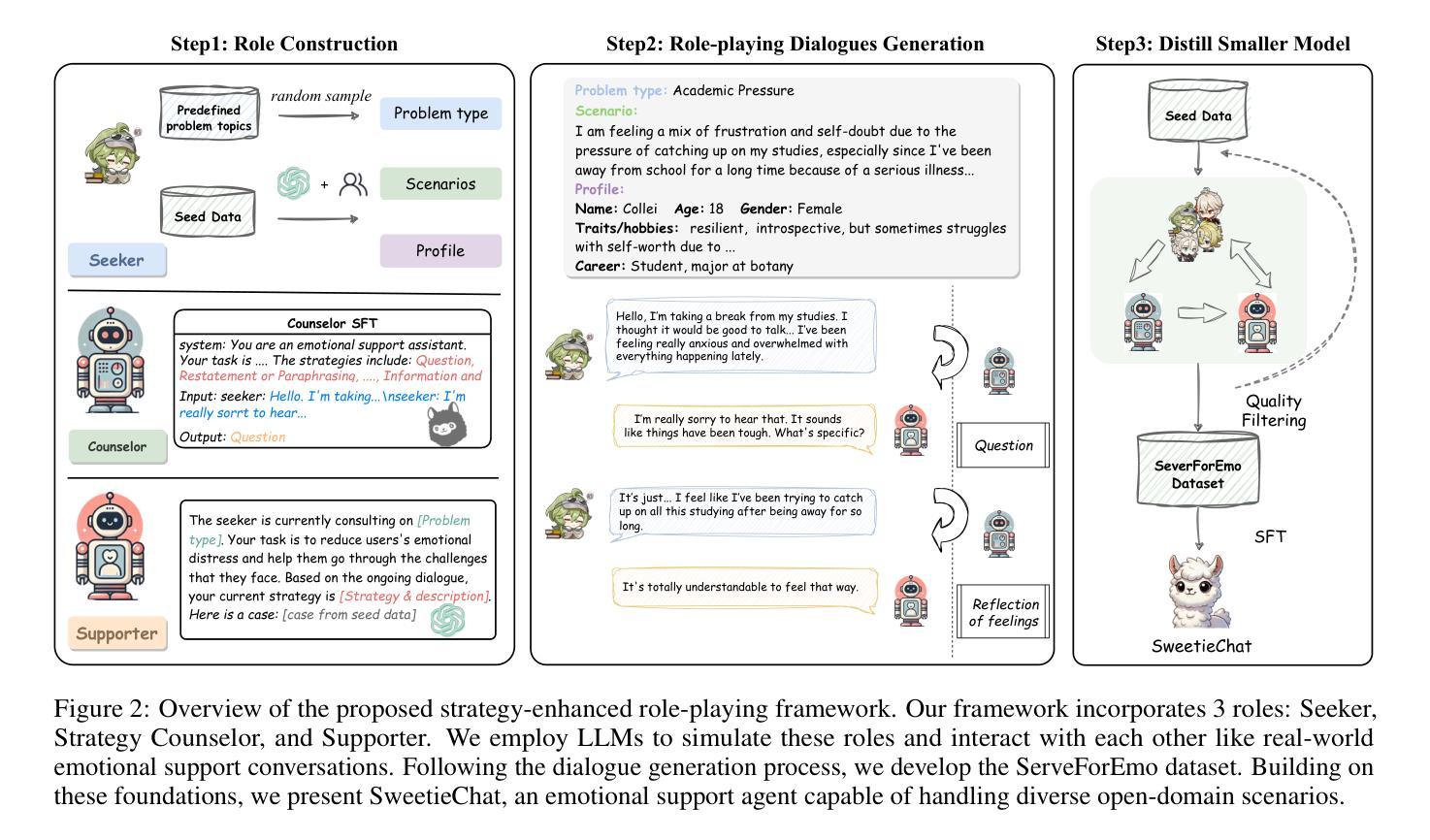

Large Language Models (LLMs) have demonstrated promising potential in providing empathetic support during interactions. However, their responses often become verbose or overly formulaic, failing to adequately address the diverse emotional support needs of real-world scenarios. To tackle this challenge, we propose an innovative strategy-enhanced role-playing framework, designed to simulate authentic emotional support conversations. Specifically, our approach unfolds in two steps: (1) Strategy-Enhanced Role-Playing Interactions, which involve three pivotal roles – Seeker, Strategy Counselor, and Supporter – engaging in diverse scenarios to emulate real-world interactions and promote a broader range of dialogues; and (2) Emotional Support Agent Training, achieved through fine-tuning LLMs using our specially constructed dataset. Within this framework, we develop the \textbf{ServeForEmo} dataset, comprising an extensive collection of 3.7K+ multi-turn dialogues and 62.8K+ utterances. We further present \textbf{SweetieChat}, an emotional support agent capable of handling diverse open-domain scenarios. Extensive experiments and human evaluations confirm the framework’s effectiveness in enhancing emotional support, highlighting its unique ability to provide more nuanced and tailored assistance.

大型语言模型(LLM)在交互过程中展现出提供富有同情心的支持的巨大潜力。然而,它们的回应通常过于冗长或过于公式化,无法充分满足真实场景中的多样化情感支持需求。为了应对这一挑战,我们提出了一种策略增强的角色扮演框架,旨在模拟真实的情感支持对话。具体来说,我们的方法分为两步:(1)策略增强角色扮演互动,涉及三个关键角色——寻求者、策略顾问和支持者——参与各种场景,模拟真实互动,促进更广泛的对话;(2)情感支持代理训练,通过我们专门构建的数据集对大型语言模型进行微调来实现。在此框架下,我们开发了“ServeForEmo”数据集,包含3.7K+多轮对话和62.8K+话语的广泛集合。我们还推出了“SweetieChat”,这是一款能够处理各种开放场景的情感支持代理。广泛的实验和人类评估证实,该框架在增强情感支持方面的有效性,突显了其提供更为细致和个性化的援助的独特能力。

论文及项目相关链接

PDF 24 pages. Accepted by COLING 2025

Summary

大型语言模型在提供同情支持方面的潜力令人瞩目,但其回应往往冗长或过于公式化,难以满足真实世界场景中多样化的情感支持需求。为此,研究提出了一种策略增强角色扮演框架,旨在模拟真实的情感支持对话。该框架包括两个步骤:策略增强角色扮演互动和情绪支持代理训练。其中,策略增强角色扮演互动涉及寻求者、策略顾问和支持者三个关键角色,模拟真实互动场景以促进更广泛的对话;情绪支持代理训练则通过微调大型语言模型实现。研究开发了ServeForEmo数据集和SweetieChat情绪支持代理,实验和人类评估证明了该框架在增强情感支持方面的有效性,能提供更细微和个性化的帮助。

Key Takeaways

- 大型语言模型在情感支持方面具有潜力,但需克服回应冗长、公式化问题。

- 提出策略增强角色扮演框架,模拟真实情感支持对话。

- 框架包括策略增强角色扮演互动和情绪支持代理训练两个步骤。

- 开发ServeForEmo数据集,包含3.7K+多轮对话和62.8K+语句。

- 推出SweetieChat情绪支持代理,能处理多种开放场景。

- 实验和人类评估证明该框架有效性,能提供更细致、个性化的支持。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是大型语言模型(LLMs)在提供情感支持对话(Emotional Support Conversation, ESC)时存在的不足。具体来说,论文指出LLMs在以下方面存在挑战:

响应的多样性和情境适宜性不足:当前的LLMs在生成情感支持响应时,往往显得过于冗长或公式化,缺乏现实世界应用中所需的细致同情心和针对性建议。

对话数据集的构建困难:手动构建高质量、多轮次的情感支持对话数据集极其困难,这限制了情感支持场景的规模和多样性。

对话多样性不足:尽管一些努力显著增加了数据集的体量,但不同对话之间的同质性仍然明显,导致交互显得重复和可预测,难以满足不同寻求者的独特需求。

策略实施无效:有效的情感支持对话通常需要策略性的方法,包括通过询问来深入了解用户的情况,从而提供更有针对性的支持。然而,LLMs倾向于提供希望、肯定和建议等策略,忽视了真正理解和协助用户所需的细致策略。

为了解决这些限制,论文提出了一个创新的策略增强型角色扮演框架,旨在模拟真实的情感支持对话,增强对话的多样性和提供的支持的有效性。该框架通过特别构建的数据集对LLMs进行微调,以训练出能够处理多样化开放领域场景的情感支持代理SweetieChat。

Q: 有哪些相关研究?

A: 相关研究主要涉及以下几个方面:

情感支持对话系统(Emotional Support Conversation, ESC):

- 研究者们探索了如何利用大型语言模型(LLMs)来生成具有同理心的响应,并强调了构建高质量ESC数据集的重要性,以便微调LLMs以产生更具同理心和情境感知的响应。

数据集构建和增强:

- 刘等(Liu et al., 2021)引入了第一个人工策划的情感支持对话数据集ESConv。

- 近期研究集中于使用LLMs来扩展和丰富现有数据集,通过修改和扩展数据集的方法来增加数据多样性。

角色扮演(Role-playing):

- 近期的进步显著推动了角色扮演代理(Role-Playing Agents)的发展,这些框架在个性化创建和生成任务中表现出色。

- 角色扮演也被用于评估中,例如通过角色扮演代理与ESC模型进行交互。

具体到文献引用,以下是一些相关研究的详细说明:

情感支持对话:

- Huang et al. (2020) 讨论了在人机交互中情感支持的重要性。

- Sharma et al. (2020) 强调了构建现实世界和全面的语料库对于提高聊天机器人情感支持能力的重要性。

- Liu et al. (2021) 引入了第一个人工策划的情感支持对话数据集ESConv。

数据集增强:

- Qiu et al. (2023) 通过使用ChatGPT将单轮次PsyQA交互转换为多轮次对话来创建SMILECHAT数据集。

- Zheng et al. (2023) 和 Zheng et al. (2024) 通过对话完成和模仿现有数据集来扩展数据集。

- Zhang et al. (2024) 提出了ESCoT数据集,通过添加情感和策略推理来提高可解释性。

角色扮演:

- Li et al. (2024) 和 Wang et al. (2024b) 提出了角色扮演框架来构建定制化的角色驱动的对话数据集。

- Wu et al. (2024) 探索了在创建互动戏剧叙事中的角色扮演。

- Zhao et al. (2024) 引入了一个ESC评估框架,该框架使用角色扮演代理与ESC模型进行交互。

这些研究为本文提出的策略增强型角色扮演框架提供了理论和技术背景,并展示了情感支持对话系统和数据集构建领域的最新进展。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决大型语言模型(LLMs)在提供情感支持对话(ESC)时存在的挑战:

1. 提出策略增强型角色扮演框架

论文提出了一个创新的策略增强型角色扮演框架,用于生成更真实、更多样化的情感支持对话。该框架涉及三个关键角色:寻求者(Seeker)、策略顾问(Strategy Counselor)和支持者(Supporter)。这些角色模拟现实世界中的情感支持互动,增强对话的多样性和提供的支持的有效性。

2. 构建ServeForEmo数据集

在该框架内,作者开发了ServeForEmo数据集,包含3.7K+多轮对话和62.8K+话语,是ESConv数据集规模的大约3倍。这个数据集涵盖了广泛的ESC场景,并得到有效和情感支持策略的支持。

3. 微调LLaMA模型

基于ServeForEmo数据集,作者构建了情感支持对话系统SweetieChat,通过微调LLaMA模型来优化其性能。这一步骤旨在缩小LLMs和人类在情感响应上的差距,并提高模型在多样化ESC场景中的性能。

4. 实施细节

- 角色构建:详细构建了Seeker、Strategy Counselor和Supporter三个角色,每个角色都有特定的任务和指导,以生成真实、全面的情感支持对话。

- 对话生成:通过角色间的互动生成情感支持对话,Counselor作为助手提供策略指导,Supporter根据这些策略提供清晰、可解释的情感支持。

- SweetieChat代理:基于ServeForEmo数据集开发的情感支持代理,专门用于提供情感支持。

5. 数据分析和实验

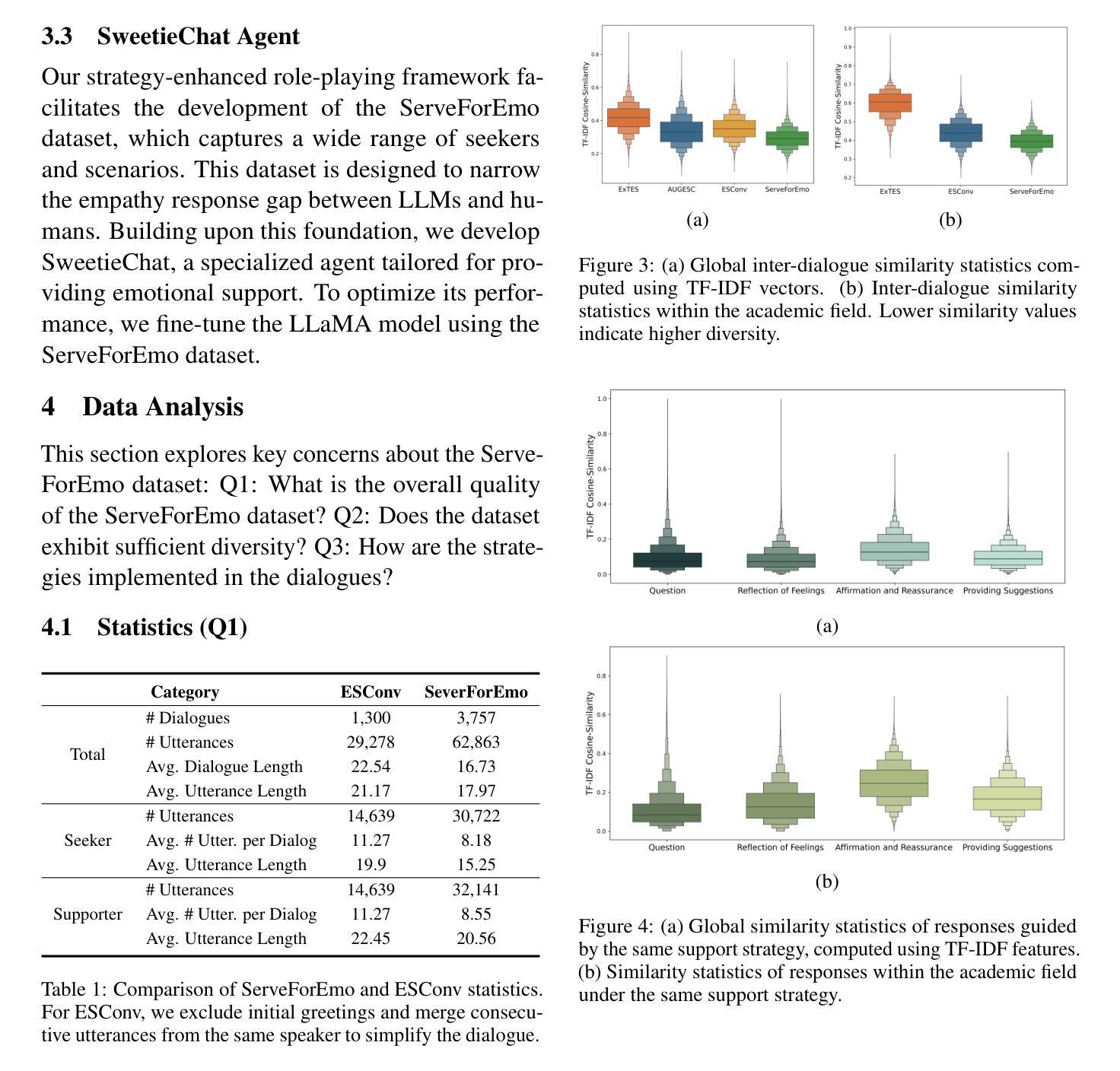

- 数据分析:对ServeForEmo数据集进行了统计、多样性和策略分析,以确保数据集的质量和策略的有效实施。

- 实验:通过与多个基线模型的比较,验证了ServeForEmo数据集的有效性,并进行了自动和人类评估,证明了SweetieChat在提供情感支持方面的优势。

通过这些步骤,论文不仅提出了一个创新的框架来增强LLMs在情感支持对话中的表现,而且还通过实验验证了该框架的有效性,展示了其在多样化和开放领域场景中提供情感支持的潜力。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证所提出的ServeForEmo数据集和基于该数据集训练的情感支持代理SweetieChat的有效性。以下是实验的详细内容:

1. 基线模型比较

为了验证ServeForEmo数据集的有效性,作者与以下基线模型进行了比较:

- LLaMA:基础的开源大型语言模型。

- AUGESC:使用AUGESC数据集微调的模型,该数据集是通过对话完成任务生成的。

- ExTES:使用ExTES数据集微调的模型,该数据集是通过模仿种子对话生成的。

- ESConv:使用ESConv数据集微调的模型,这是一个人工策划的情感支持对话数据集。

- ServeForEmo:使用ServeForEmo数据集微调的模型,即SweetieChat。

2. 实施细节

- 使用LoRA适应技术对模型参数进行调整。

- 使用AdamW优化器进行训练,设置学习率为3×10^-5,并在训练的前1%的步骤中进行线性预热。

- 每个设备批量大小设置为2,训练进行5个周期。

- 实施早停策略,以防止过拟合。

3. 评估设置

- 使用ESConv数据集的手动标注测试集作为基准,以评估模型在现实世界人类标注条件下的性能。

- 评估指标分为自动评估指标和人类评估指标。

4. 自动评估结果

- 使用BLEU-n、ROUGE-L、Distinct-n和BERT-Score等自动评估指标。

- 在两种实验配置下进行评估:交互式评估(生成上下文)和交互式评估(参考上下文)。

5. 人类评估结果

- 进行人类评估,以比较不同模型生成的响应。

- 评估维度包括:同理心、信息量、连贯性、建议、理解、帮助性和总体质量。

6. 新场景下的评估

- 邀请志愿者与SweetieChat和ExTES进行互动,并根据一系列指标对模型进行评分。

- 评分使用五点李克特量表(Likert scale),范围从1到5,分数越高表示质量越好。

7. 结果分析

- 自动评估结果显示,SweetieChat在内容相关性指标上优于其他基线模型。

- 人类评估结果表明,SweetieChat的响应通常优于其他模型。

- 在新场景下,SweetieChat表现出更强的情感支持能力,尽管在建议、帮助性和信息量方面仍有改进空间。

通过这些实验,论文全面评估了SweetieChat的性能,并证明了其在多样化和开放领域场景中提供情感支持的有效性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

1. 数据集的多样性和质量控制

- 扩大数据集规模:尽管ServeForEmo数据集比ESConv数据集大,但仍有扩大规模的空间,以覆盖更广泛的情境和需求。

- 提高数据质量:进一步优化和细化数据构建过程,以减少错误和不一致性,例如支持者不一致地遵循分配的策略和寻求者不完全遵循其角色背景。

2. 策略选择和实施

- 策略细化:研究更细致和多样化的情感支持策略,以提高模型在不同情境下的适应性和有效性。

- 策略与人类偏好对齐:探索如何使模型更好地理解和模拟人类在情感支持对话中的策略选择和实施。

3. 多模态交互

- 整合语音和视觉信息:扩展研究以包括语音和视觉信息,使人工智能系统能够更自然地与人类进行交互。

4. 模型的泛化能力

- 跨领域测试:在更多种类的情感支持场景中测试模型的泛化能力,以评估其在现实世界应用中的有效性。

5. 个体化和适应性

- 个体化模型:研究如何根据用户的个人背景和偏好定制模型,以提供更个性化的支持。

- 动态适应:探索模型如何在对话过程中动态适应用户情绪和需求的变化。

6. 评估方法的改进

- 评估指标的多样化:开发和测试更多评估指标,以全面评估情感支持对话系统的有效性。

- 评估的客观性:寻找减少评估过程中主观性的方法,例如通过自动化评估工具或利用大规模众包数据。

7. 伦理和隐私问题

- 数据隐私保护:确保在收集和使用情感支持对话数据时保护用户隐私。

- 伦理审查:对情感支持系统的设计和实施进行伦理审查,确保其符合伦理标准和用户的最佳利益。

这些探索点可以帮助研究者进一步提升情感支持系统的性能,使其更加有效、个性化,并适用于更广泛的应用场景。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个创新的策略增强型角色扮演框架,旨在提高大型语言模型(LLMs)在情感支持对话(ESC)中的性能。主要内容可以总结如下:

问题识别:论文指出LLMs在提供情感支持时往往回应过于冗长和公式化,缺乏现实世界情感支持需求的多样性和情境适应性。

框架提出:为了解决上述问题,论文提出了一个策略增强型角色扮演框架,通过模拟真实情感支持对话来增强对话的多样性和支持的有效性。框架涉及三个关键角色:寻求者(Seeker)、策略顾问(Strategy Counselor)和支持者(Supporter)。

数据集构建:在此框架下,作者开发了ServeForEmo数据集,包含3.7K+多轮对话和62.8K+话语,覆盖广泛的ESC场景,并得到有效情感支持策略的支持。

模型训练:基于ServeForEmo数据集,作者构建并微调了情感支持对话系统SweetieChat,以提高其在多样化ESC场景中的表现。

实验验证:通过与多个基线模型的比较,实验结果表明,使用ServeForEmo数据集训练的SweetieChat在自动评估和人类评估中都展现出优越的性能,能更好地处理多样化的开放领域情感支持场景。

分析讨论:论文还对ServeForEmo数据集的质量和策略实施进行了详细分析,证明了数据集的多样性和策略的有效性。

未来工作:论文最后讨论了研究的局限性和未来可能的研究方向,包括数据集的扩展、模型泛化能力的提高、多模态交互的整合等。

综上所述,这篇论文通过提出新的框架和数据集,有效地提升了LLMs在情感支持对话中的表现,为未来情感支持系统的研究提供了新的方向和资源。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

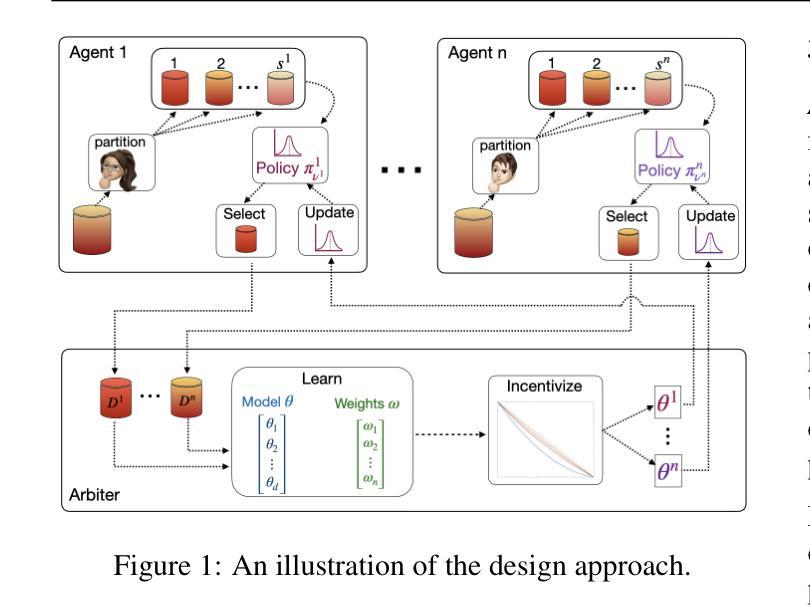

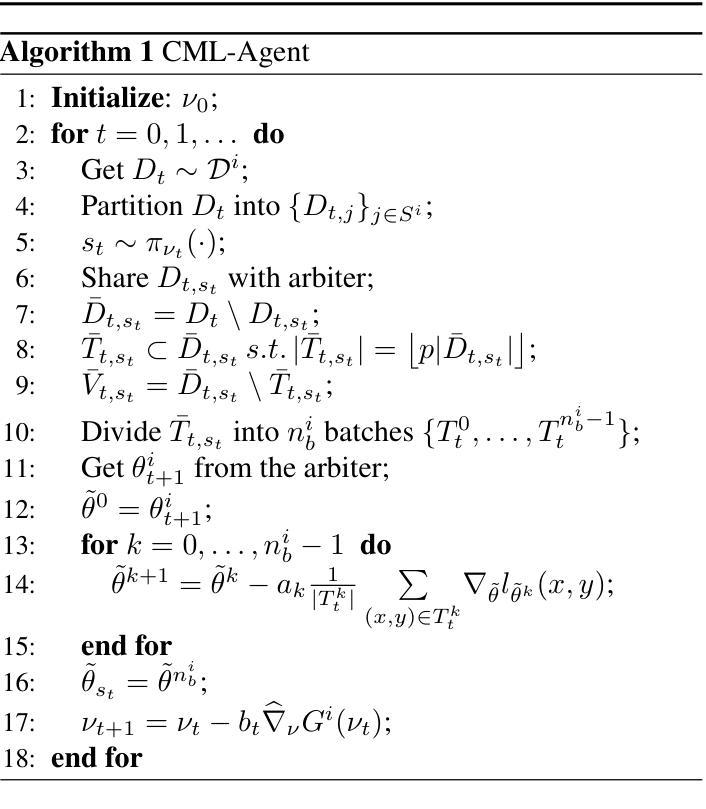

Self-Interested Agents in Collaborative Learning: An Incentivized Adaptive Data-Centric Framework

Authors:Nithia Vijayan, Bryan Kian Hsiang Low

We propose a framework for adaptive data-centric collaborative learning among self-interested agents, coordinated by an arbiter. Designed to handle the incremental nature of real-world data, the framework operates in an online manner: at each step, the arbiter collects a batch of data from agents, trains a machine learning model, and provides each agent with a distinct model reflecting its data contributions. This setup establishes a feedback loop where shared data influence model updates, and the resulting models guide future data-sharing strategies. Agents evaluate and partition their data, selecting a partition to share using a stochastic parameterized policy optimized via policy gradient methods to optimize the utility of the received model as defined by agent-specific evaluation functions. On the arbiter side, the expected loss function over the true data distribution is optimized, incorporating agent-specific weights to account for distributional differences arising from diverse sources and selective sharing. A bilevel optimization algorithm jointly learns the model parameters and agent-specific weights. Mean-zero noise, computed using a distortion function that adjusts these agent-specific weights, is introduced to generate distinct agent-specific models, promoting valuable data sharing without requiring separate training. Our framework is underpinned by non-asymptotic analyses, ensuring convergence of the agent-side policy optimization to an approximate stationary point of the evaluation functions and convergence of the arbiter-side optimization to an approximate stationary point of the expected loss function.

我们提出了一个以数据为中心的自适应协作学习框架,该框架适用于自我利益驱动的主体之间通过仲裁者进行的协作学习。该框架旨在处理真实世界的增量数据,以在线方式运行:在每个步骤中,仲裁者从主体收集一批数据,训练机器学习模型,并为每个主体提供反映其数据贡献的独特模型。这种设置建立了一个反馈循环,其中共享数据影响模型更新,并且所得的模型指导未来的数据共享策略。主体评估和划分其数据,并使用通过策略梯度方法优化的随机参数策略来选择要共享的划分,以优化由主体特定评估函数定义的接收模型的效用。在仲裁者方面,优化了真实数据分布上的预期损失函数,纳入主体特定权重以考虑来自不同源的选择性共享所产生的分布差异。一种两级优化算法联合学习模型参数和主体特定权重。使用失真函数计算均值为零的噪声,该失真函数调整这些主体特定权重,从而产生独特的主体特定模型,促进有价值的数据共享而无需单独训练。我们的框架以非渐近分析为基础,确保主体侧的策略优化收敛到评估函数的近似平稳点,以及仲裁者侧的优化收敛到预期损失函数的近似平稳点。

论文及项目相关链接

Summary

该框架支持自适应数据驱动的合作式学习,由仲裁者协调多个自利代理。框架采用在线模式处理数据的增量特性,仲裁者收集代理数据,训练机器学习模型,并为每个代理提供反映其数据贡献的独特模型。通过反馈循环,共享数据影响模型更新,而模型结果指导未来的数据共享策略。代理评估并划分其数据,选择使用随机参数化策略分享数据片段,通过策略梯度法优化策略以获得最优效用模型。仲裁者期望优化真实数据分布的损失函数,包括处理不同来源和选择性共享产生的分布差异所需的代理特定权重。一个双级优化算法同时学习模型参数和代理特定权重。通过引入基于失真函数计算的平均零噪声来生成独特的代理特定模型,促进有价值的数据共享而无需单独训练。我们的框架由非渐近分析支持,确保代理侧的优化策略收敛于近似评价函数的稳定点,以及仲裁者侧的优化在预期的损失函数上收敛于近似稳定点。

Key Takeaways

- 框架支持自适应数据驱动的合作式学习,适用于处理真实世界的增量数据。

- 框架包含在线模式,允许实时处理数据和训练模型。

- 每个代理的数据贡献反映在模型中,建立共享数据的反馈循环。

- 代理通过随机参数化策略选择分享的数据片段,该策略经过优化以提高模型的效用。

- 仲裁者期望优化损失函数以处理数据分布的差异和选择性共享。

- 使用双级优化算法同时学习模型参数和代理特定权重。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个适应性数据中心式协作学习框架,旨在解决以下问题:

自利性代理的协作学习问题:在现实世界中,参与协作学习的代理(如企业或组织)往往是自利的,它们可能因为担心数据质量、数据相关性或保持竞争优势而选择性地共享数据。这种自利性可能导致代理不愿意完全共享其数据集,从而影响协作学习的效果。

现实世界数据的增量特性:传统数据中心式协作学习方法通常假设所有参与者都是善意的,并自由共享数据以支持协作模型的发展。此外,这些方法常常依赖于离线学习,即整个数据集一开始就可用,而不是适应于在线算法处理逐渐到达的数据。然而,在现实世界中,数据通常是逐渐收集的,而不是一次性全部可用,这就需要一个在线方法来处理。

数据分布差异和选择性共享:来自不同代理的数据往往显示出分布差异,这种差异可能因选择性数据共享而加剧。需要一种机制来纠正这些差异,并有效地利用共享的数据进行模型训练。

激励机制的设计:为了鼓励代理提供高质量的数据贡献,论文提出了一种通过引入均值为零的噪声来生成独特模型的方法,这种机制不需要为每个代理单独训练模型,而是通过调整代理特定权重来生成不同的模型,以此激励代理共享有价值的数据。

综上所述,论文旨在通过考虑代理的自利性质和数据收集的增量特性,提出一个能够适应现实世界场景的协作学习框架,并提供严格的非渐近分析来确保所提出方法的鲁棒性和实用性。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的工作:

Federated Learning (FL):

- Yang et al., 2019 提出了联邦学习(FL),这是一种模型中心的方法,通过迭代更新参数来优化全局模型,同时通过避免原始数据共享来保护隐私。

- Wu et al., 2024; Lin et al., 2023 讨论了FL通常忽视个别代理特定目标和跨代理数据分布的多样性。

数据中心式协作学习:

- Sim et al., 2020; 2024 提出了通过公平奖励激励数据共享的数据中心式协作学习方法,这些方法假设代理行为是善意的。

- 这些数据中心式方法通常使用离线算法,未能适应代理的自利行为或动态适应代理行为的变化。

激励机制:

- Sim et al., 2020; 2024 还探讨了在私人协作机器学习中的激励问题,特别是在FL环境中如何通过模型奖励来激励代理。

优化算法:

- Nesterov, 2014 提供了关于凸优化的基础知识,包括梯度下降算法,这些算法在本研究中用于优化代理的策略参数和仲裁者的数据权重。

概率和计算:

- Gao and Pavel, 2018 讨论了softmax函数的性质,该函数在本研究中用于实现代理的参数化随机策略。

机器学习会议论文:

- 论文还引用了在ICML、NIPS和ICLR等机器学习顶级会议上发表的相关研究工作。

这些相关工作为本研究提供了理论基础和方法论支持,特别是在处理代理的自利行为、数据分布差异以及设计有效的激励机制方面。通过综合这些相关研究,本文提出了一个适应性数据中心式协作学习框架,旨在解决自利代理在协作学习中的数据共享和模型训练问题。

Q: 论文如何解决这个问题?

A: 论文通过以下方式解决了自利代理在协作学习中的问题:

1. 框架设计

提出了一个由仲裁者协调的自利代理之间的适应性数据中心式协作学习框架。这个框架以在线方式运作,处理现实世界中数据的增量特性,允许模型持续更新以适应新数据。

2. 代理策略

- 每个代理使用参数化的随机策略来决定在每个时间步骤中与仲裁者共享哪个数据分区。

- 通过策略梯度方法优化这些策略,以最大化代理从接收到的模型中获得的效用,这由代理特定的评估函数定义。

3. 数据权重方案

- 为了处理来自不同代理的数据所展现的分布差异,并解决选择性数据共享的问题,提出了一个数据权重方案,为每个代理的数据分配相对权重。

- 使用独立的验证集为每个代理评估其数据在协作模型中的贡献,并据此调整权重。

4. 双层优化算法

- 开发了一个双层优化算法,同时学习模型参数和代理特定的权重。

- 该算法确保模型适应于代理不断演变的数据共享策略。

5. 激励机制

- 通过引入均值为零的噪声和扭曲函数来生成独特的代理特定模型,激励代理共享更有价值的数据,无需为每个代理单独训练模型。

6. 非渐近分析

- 提供了严格的非渐近分析,确保代理端策略优化和仲裁端预期损失最小化都收敛到评估函数和预期损失函数的近似稳定点。

7. 应用实例

- 论文还讨论了该框架在医疗保健和金融等领域的潜在应用,例如通过合作提高癌症治疗研究或信用卡欺诈检测的模型性能。

通过这些方法,论文旨在实现一个既能满足个体代理目标,又能最大化整体协作效益的协作学习环境。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,文中并未提及具体的实验部分。论文主要集中于提出一个理论框架,并通过非渐近分析来保证算法的收敛性。因此,论文的重点在于算法设计和理论分析,而不是实验验证。

通常在这类研究中,实验部分可能包括以下几个方面:

- 模拟实验:在合成数据集上测试算法的性能,以验证理论分析的正确性。

- 真实数据集实验:在真实世界的数据集上评估算法的有效性,可能包括不同领域的数据,如医疗、金融等。

- 与现有方法的比较:将提出的框架与现有的协作学习方法进行比较,展示其优势和潜在的改进。

- 收敛性和稳定性测试:通过实验验证算法的收敛速度和对不同条件(如不同的数据分布、代理数量等)的稳定性。

然而,由于论文内容中没有包含具体的实验结果,我们无法提供更详细的信息。如果需要了解实验部分的具体内容,可能需要查看论文的其他部分或相关的补充材料。

Q: 有什么可以进一步探索的点?