⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-15 更新

NestedMorph: Enhancing Deformable Medical Image Registration with Nested Attention Mechanisms

Authors:Gurucharan Marthi Krishna Kumar, Janine Mendola, Amir Shmuel

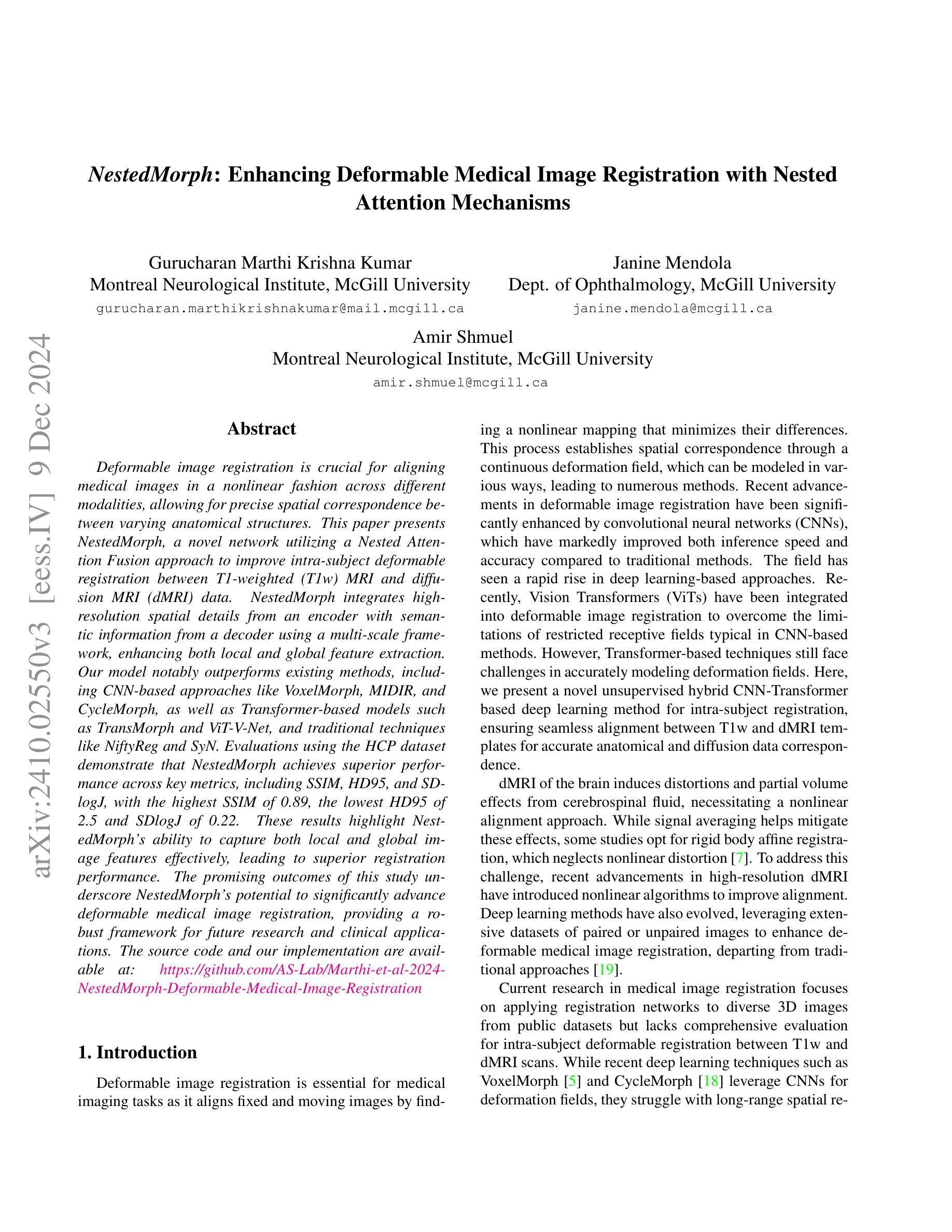

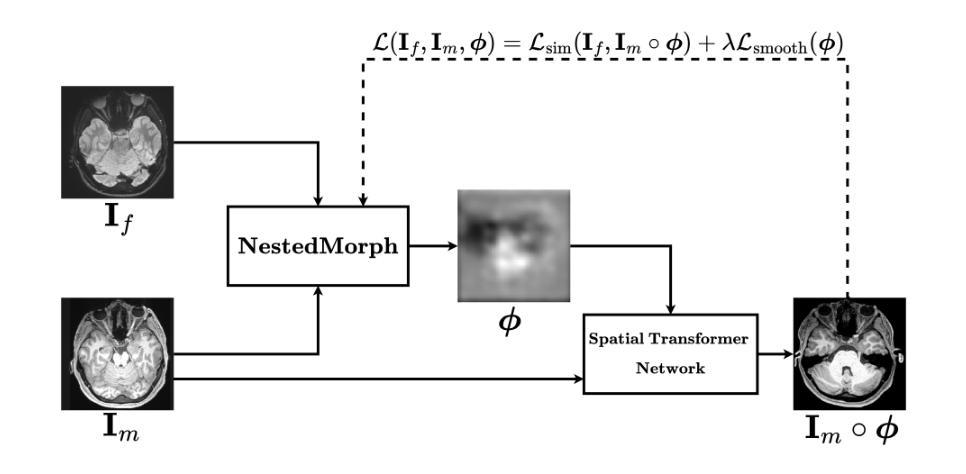

Deformable image registration is crucial for aligning medical images in a nonlinear fashion across different modalities, allowing for precise spatial correspondence between varying anatomical structures. This paper presents NestedMorph, a novel network utilizing a Nested Attention Fusion approach to improve intra-subject deformable registration between T1-weighted (T1w) MRI and diffusion MRI (dMRI) data. NestedMorph integrates high-resolution spatial details from an encoder with semantic information from a decoder using a multi-scale framework, enhancing both local and global feature extraction. Our model notably outperforms existing methods, including CNN-based approaches like VoxelMorph, MIDIR, and CycleMorph, as well as Transformer-based models such as TransMorph and ViT-V-Net, and traditional techniques like NiftyReg and SyN. Evaluations using the HCP dataset demonstrate that NestedMorph achieves superior performance across key metrics, including SSIM, HD95, and SDlogJ, with the highest SSIM of 0.89, the lowest HD95 of 2.5 and SDlogJ of 0.22. These results highlight NestedMorph’s ability to capture both local and global image features effectively, leading to superior registration performance. The promising outcomes of this study underscore NestedMorph’s potential to significantly advance deformable medical image registration, providing a robust framework for future research and clinical applications. The source code and our implementation are available at: https://github.com/AS-Lab/Marthi-et-al-2024-NestedMorph-Deformable-Medical-Image-Registration

可变形的图像配准对于跨不同模态以非线性方式对齐医学图像至关重要,它允许在不同解剖结构之间实现精确的空间对应关系。本文介绍了NestedMorph,这是一种新型网络,采用Nested Attention Fusion方法,旨在改进T1加权(T1w)MRI和扩散MRI(dMRI)数据之间的个体内可变形配准。NestedMorph通过多尺度框架将编码器的高分辨率空间细节与解码器的语义信息进行集成,提高了局部和全局特征提取能力。我们的模型显著优于现有方法,包括基于CNN的方法(如VoxelMorph、MIDIR和CycleMorph),基于Transformer的方法(如TransMorph和ViT-V-Net),以及传统技术(如NiftyReg和SyN)。使用HCP数据集进行的评估表明,NestedMorph在关键指标上表现出卓越的性能,包括SSIM、HD95和SDlogJ,其中SSIM最高达到0.89,HD95最低为2.5,SDlogJ为0.22。这些结果突显了NestedMorph在有效捕获局部和全局图像特征方面的能力,从而实现了出色的配准性能。这项研究的令人鼓舞的结果强调了NestedMorph在可变形医学图像配准方面的潜力,为未来的研究和临床应用提供了稳健的框架。源代码和我们的实现可在https://github.com/AS-Lab/Marthi-et-al-2024-NestedMorph-Deformable-Medical-Image-Registration上找到。

论文及项目相关链接

PDF Accepted to IEEE/CVF Winter Conference on Applications of Computer Vision 2025

摘要

本文介绍了一种名为NestedMorph的新型网络,该网络采用Nested Attention Fusion方法,改进了T1加权MRI和扩散MRI数据之间的个体内可变形图像配准。NestedMorph结合了编码器的高分辨率空间细节和解码器的语义信息,利用多尺度框架,增强了局部和全局特征提取。与现有的VoxelMorph、MIDIR、CycleMorph等CNN模型,以及TransMorph、ViT-V-Net等Transformer模型和NiftyReg、SyN等传统技术相比,我们的模型表现优异。在HCP数据集上的评估结果表明,NestedMorph在关键指标SSIM、HD95和SDlogJ上表现卓越,其中SSIM最高达到0.89,HD95最低为2.5,SDlogJ为0.22。这些结果证明了NestedMorph在捕捉图像局部和全局特征方面的有效性,实现了出色的配准性能。该研究的成果为NestedMorph在可变形医学图像配准方面的应用提供了潜力,为未来的研究和临床应用提供了稳健的框架。

要点

- NestedMorph网络采用Nested Attention Fusion方法,改进了跨不同模态的非线性医学图像配准。

- 该模型结合了高分辨率的空间细节和语义信息,使用多尺度框架进行特征提取。

- NestedMorph在关键指标SSIM、HD95和SDlogJ上表现优于其他现有方法。

- 研究结果证明了NestedMorph在捕捉图像局部和全局特征方面的有效性。

- NestedMorph具有潜在的临床应用价值,为未来的医学图像配准研究提供了稳健的框架。

- 公开了源代码和实现,便于进一步研究和应用。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是医学图像配准中的非刚性(可变形)图像配准问题,特别是在不同模态之间对齐医学图像,例如T1加权(T1w)MRI和扩散MRI(dMRI)数据。具体来说,论文旨在通过提出一个名为NestedMorph的新型网络,利用嵌套注意力融合方法来改善主体内(intra-subject)T1w MRI和dMRI数据之间的可变形配准。

论文强调了以下几点挑战和目标:

非刚性图像配准的重要性:在医学成像任务中,非刚性图像配准对于通过非线性映射对齐固定和移动图像至关重要,这有助于建立不同解剖结构之间的精确空间对应关系。

现有方法的局限性:尽管卷积神经网络(CNN)和视觉Transformer(ViT)已在非刚性图像配准中取得了进展,但它们在准确建模变形场方面仍面临挑战。

提出的方法:论文提出了一个基于CNN和Transformer混合模型的无监督深度学习方法,专门针对主体内T1w和dMRI模板之间的对齐,以实现准确的解剖和扩散数据对应。

性能提升:通过与现有最先进方法(包括基于CNN的方法如VoxelMorph、MIDiR、CycleMorph,基于Transformer的模型如TransMorph和ViT-V-Net,以及传统技术如NiftyReg和SyN)的比较,论文展示了NestedMorph在关键指标(如SSIM、HD95和SDlogJ)上取得了更好的性能。

方法的潜力:论文的结果强调了NestedMorph在捕获局部和全局图像特征方面的有效性,从而实现了更优越的配准性能,并指出了其在推进可变形医学图像配准方面的潜力,为未来的研究和临床应用提供了一个强大的框架。

Q: 有哪些相关研究?

A: 论文中提到了多个与可变形医学图像配准相关的研究工作,以下是一些关键的相关研究:

VoxelMorph [5]:这是一个基于CNN的编码器-解码器架构,类似于UNet,用于计算移动和固定图像对之间的变形场,并通过空间变换网络迭代地扭曲移动图像。

MIDiR [25]:该方法采用B样条参数化来生成微分同胚变形场,使用互信息损失和平稳速度场(SVF)以实现平滑变形。

CycleMorph [18]:该方法结合了两个配准网络来计算位移向量场,并引入了一个循环一致性学习模型,以在保持图像拓扑结构的同时进行无监督配准。

TransMorph [9]:这是一个新颖的混合模型,结合了Transformer和CNN,专门用于3D医学图像配准。该模型利用Transformer的自注意力机制和广泛的有效感受野来增强配准精度。

ViT-V-Net [10]:这是一个混合CNN-Transformer架构,用于自监督体积图像配准。它将视觉Transformer(ViT)应用于高级图像特征以捕获长距离依赖,而长跳跃连接保持编码器和解码器阶段之间的定位信息。

NiftyReg [24] 和 SyN [2]:这些是传统的配准方法,通过优化算法来实现图像之间的对齐。

其他监督学习方法:这些方法利用外部数据,如标签图,来指导训练过程。它们需要真实的变形场,这在计算上可能很昂贵。

其他无监督学习方法:这些方法不依赖于真实的变形场,而是通过探索数据的内在特征来执行配准。

这些相关研究展示了可变形医学图像配准领域的多样性,从传统的基于优化的方法到最新的基于深度学习的方法,每种方法都有其优势和局限性。论文提出的NestedMorph模型旨在结合这些方法的优点,通过嵌套注意力机制和多尺度框架来提高配准的准确性和鲁棒性。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为NestedMorph的新型网络来解决医学图像的非刚性配准问题,具体方法如下:

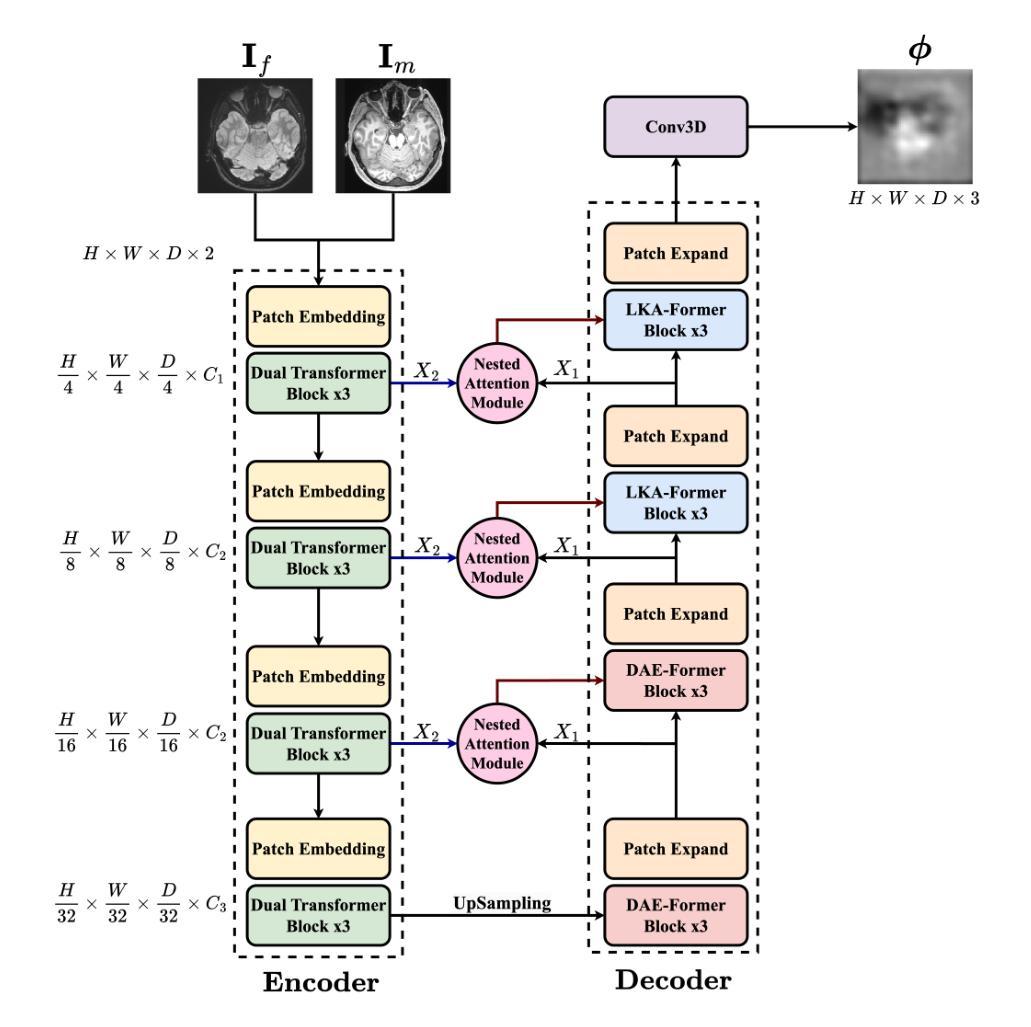

1. Nested Attention Fusion网络架构

- 编码器(Encoder):使用多级设计,结合重叠的patch嵌入和双注意力机制(Efficient Attention和Channel Attention),从3D医学图像中提取和处理特征。编码器通过不同阶段处理输入图像,逐步降低空间维度并增加特征丰富度,最终输出多尺度特征图。

2. 双注意力机制

- Efficient Attention:通过优化上下文矩阵的计算来增强传统自注意力,使用单通道特征图作为所有位置的权重,减少计算复杂度同时保持高表示能力。

- Channel Attention:通过转置注意力机制处理更大的输入尺寸,集中于整个通道维度,提高效率。

3. 双注意力Transformer块

- 结合Efficient Attention和Channel Attention,通过Add & Norm步骤和MLP(多层感知机)增强特征提取和表示。

4. 解码器(Decoder)

- DAE-Former块:在较低分辨率的图像中保持长距离依赖性,整合空间和通道注意力,保持图像结构完整性。

- LKA(Large Kernel Attention)模块:处理局部和全局特征,对高分辨率图像处理尤为重要。

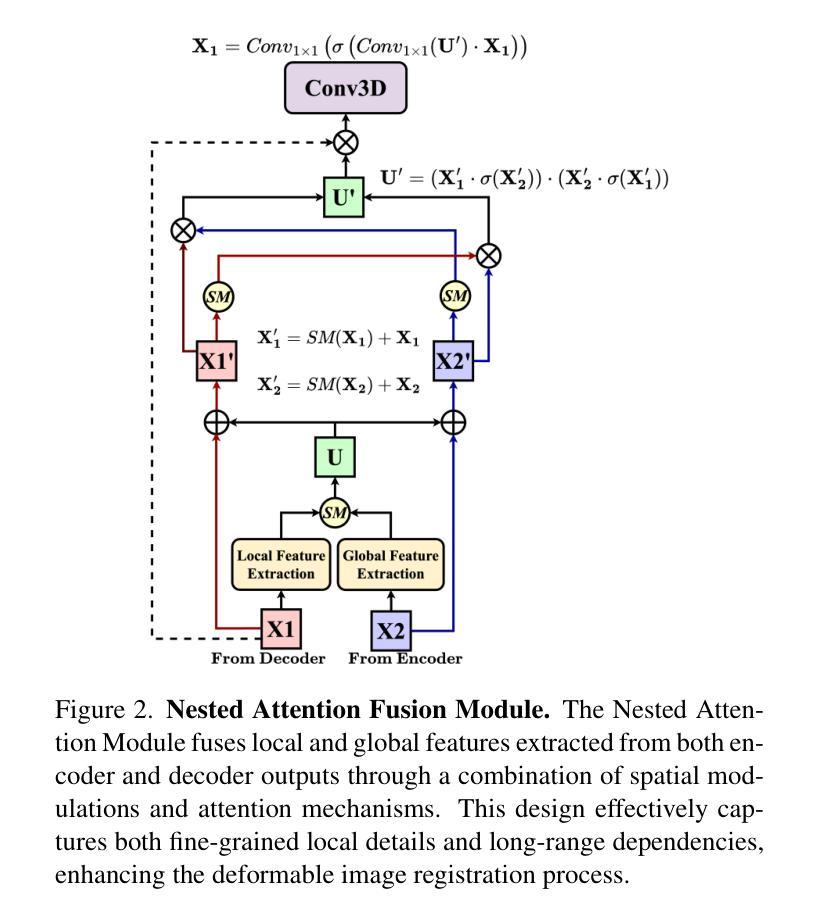

5. 嵌套注意力融合模块(Nested Attention Fusion Module)

- 利用多尺度融合技术聚合编码器和解码器输出,通过空间选择和交叉调制增强特征映射,整合局部细节和全局上下文。

6. 空间变换网络(Spatial Transformer Network, STN)

- 应用预测的变形场对移动图像进行扭曲,通过迭代训练最小化移动图像和固定图像之间的差异。

7. 实验和评估

- 使用HCP(Human Connectome Project)数据集对模型进行评估,显示出NestedMorph在SSIM、HD95和SDlogJ等关键指标上优于现有方法。

8. 无监督学习方法

- 该方法为无监督的,不依赖于真实的变形场,而是通过探索数据的内在特征来执行配准。

通过上述方法,NestedMorph能够有效地捕捉局部和全局图像特征,提供精确的变形场估计,从而实现T1w MRI和dMRI数据之间的准确对齐。这种设计提高了配准的精度和可靠性,为医学图像配准领域提供了一个强大的新工具。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估和验证NestedMorph模型的性能,具体实验包括:

1. 数据集和预处理

- 使用了来自HCP Aging Dataset的205名受试者的数据,包括T1w和dMRI扫描。

- 其中180名受试者的数据用于训练网络,剩余的25名受试者的数据用于测试。

- T1w扫描的体素大小为0.7 mm等向性,dMRI扫描的体素大小为1.25 mm等向性。

- 将T1w和平均dMRI扫描调整为128×128×128体素。

- 使用SimpleITK将T1w图像仿射配准到平均dMRI图像,形成移动的T1w和固定的平均dMRI图像对。

2. 训练参数

- NestedMorph模型使用PyTorch框架在NVIDIA A100 GPU上实现。

- 训练使用了一批大小为4的随机梯度下降,基础学习率为(1 \times 10^{-4}),权重衰减为(3 \times 10^{-5})。

- 模型训练了100个周期,使用复合损失函数计算变形移动图像和固定图像之间的相似性,并施加变形场的平滑性以正则化。

3. 基线和比较

- 将NestedMorph网络与现有的无监督可变形配准技术进行比较,包括CNN方法(VoxelMorph、MIDiR、CycleMorph)和基于Transformer的方法(TransMorph、ViT-V-Net)。

- 还包括了传统方法(NiftyReg和SyN)。

- 使用结构相似性指数(SSIM)、95百分位数Hausdorff距离(HD95)和Jacobian行列式对数的标准差(SDlogJ)等相似性指标来评估不同配准网络的性能。

4. 定量结果

- 使用25名受试者的数据进行测试,比较不同配准网络的性能。

- NestedMorph在SSIM、HD95和SDlogJ三个评估指标上均优于其他模型,显示出最高的SSIM值和最低的HD95和SDlogJ值。

5. 消融研究

- 对NestedMorph模型进行了消融研究,以评估不同网络模块对配准性能的影响。

- 研究了注意力头数、网络深度、patch大小和批量大小等参数对性能的影响。

- 还探讨了不同配置的注意力机制和DAE-Former及LKA块的数量对配准性能的影响。

这些实验全面评估了NestedMorph模型的性能,并与现有的先进方法进行了比较,证明了其在医学图像配准中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 论文提出了NestedMorph这一新型网络架构,并在T1w MRI和dMRI数据的非刚性配准任务中取得了优异的性能。尽管如此,仍有一些领域可以进一步探索和研究:

1. 跨模态和跨受试者配准

- 论文主要关注了主体内(intra-subject)配准,未来的研究可以探索NestedMorph在跨受试者(inter-subject)和跨模态(cross-modality)配准任务中的有效性。

2. 计算复杂度优化

- NestedMorph由于其双注意力机制和多尺度融合框架,计算复杂度较高。未来的研究可以探索优化策略,以减少计算资源的需求,使其更适合资源受限的环境。

3. 网络架构调整

- 论文中通过消融实验确定了最佳的网络配置,但可能还有其他的网络架构调整可以进一步提升性能,例如不同的注意力头数、层数或不同类型的注意力机制。

4. 损失函数和优化策略

- 研究不同的损失函数和优化策略对模型性能的影响,可能可以发现更适合特定配准任务的损失函数或优化算法。

5. 临床应用和验证

- 在临床环境中对NestedMorph进行验证,评估其在实际临床工作流程中的适用性和效果。

6. 大规模数据集的测试

- 在更大的、多样化的数据集上测试NestedMorph,以评估其泛化能力和鲁棒性。

7. 多任务学习

- 探索将配准任务与其他相关任务(如分割、分类)结合的多任务学习框架,以提高模型的效用和准确性。

8. 实时性能

- 研究NestedMorph在实时或近实时应用中的性能,这对于手术导航等应用场景非常重要。

9. 模型解释性

- 提高模型的可解释性,帮助医生和研究人员理解模型的决策过程,增加其在临床应用中的可信度。

10. 集成传统方法

- 探索将NestedMorph与传统的医学图像配准方法结合,以利用各自的优势,可能提高配准的准确性和鲁棒性。

这些方向不仅可以推动NestedMorph模型的发展,还可能为医学图像配准领域带来新的突破。

Q: 总结一下论文的主要内容

A: 本文提出了一个名为NestedMorph的新型网络,旨在提高医学图像非刚性配准的性能,特别是在T1加权(T1w)MRI和扩散MRI(dMRI)数据之间的配准。以下是论文的主要内容总结:

1. 问题背景

- 非刚性图像配准对于跨不同模态对齐医学图像至关重要,它通过连续变形场建立精确的空间对应关系。

2. 现有方法的局限性

- 尽管基于CNN和Transformer的方法在配准领域取得了进展,但仍存在挑战,特别是在准确建模变形场方面。

3. NestedMorph网络

- 提出了一个无监督的混合CNN-Transformer深度学习模型,专门用于主体内T1w和dMRI模板之间的对齐。

- NestedMorph利用嵌套注意力融合方法,整合编码器的高分辨率空间细节和解码器的语义信息,增强局部和全局特征提取。

4. 网络架构

- 编码器:采用多级设计,结合重叠patch嵌入和双注意力机制(Efficient Attention和Channel Attention)来提取特征。

- 解码器:使用Dual Attention Enhanced Transformer(DAE-Former)块和Large Kernel Attention(LKA)模块来维持长距离依赖和结构完整性。

- 嵌套注意力融合模块:整合编码器和解码器的特征,通过多尺度融合技术聚合局部和全局特征。

- 空间变换网络(STN):应用预测的变形场对移动图像进行扭曲,以实现精确的图像配准。

5. 实验和评估

- 使用HCP数据集对NestedMorph进行评估,与现有的CNN和Transformer方法以及传统技术进行比较。

- NestedMorph在SSIM、HD95和SDlogJ等关键指标上显示出优越的性能。

6. 消融研究

- 对NestedMorph模型的不同组件和参数进行了消融研究,以评估它们对配准性能的影响。

7. 讨论和结论

- NestedMorph通过其嵌套注意力机制有效地捕获局部和全局图像特征,提供了一种强大的框架,用于改进医学图像的非刚性配准。

- 尽管NestedMorph在精度上表现出色,但也存在计算复杂度高的挑战,未来研究可以探索优化和扩展其应用。

总体而言,NestedMorph为医学图像配准领域提供了一种新的深度学习方法,具有显著的性能提升潜力,并为未来的研究和临床应用铺平了道路。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

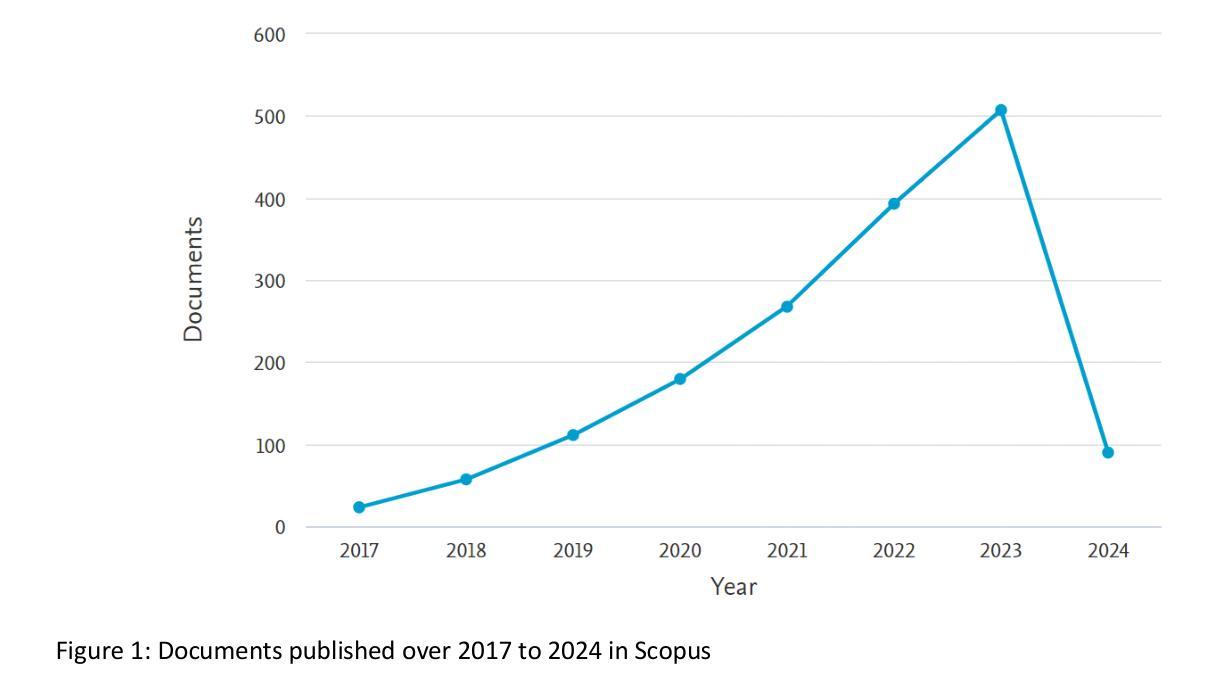

Grading and Anomaly Detection for Automated Retinal Image Analysis using Deep Learning

Authors:Syed Mohd Faisal Malik, Md Tabrez Nafis, Mohd Abdul Ahad, Safdar Tanweer

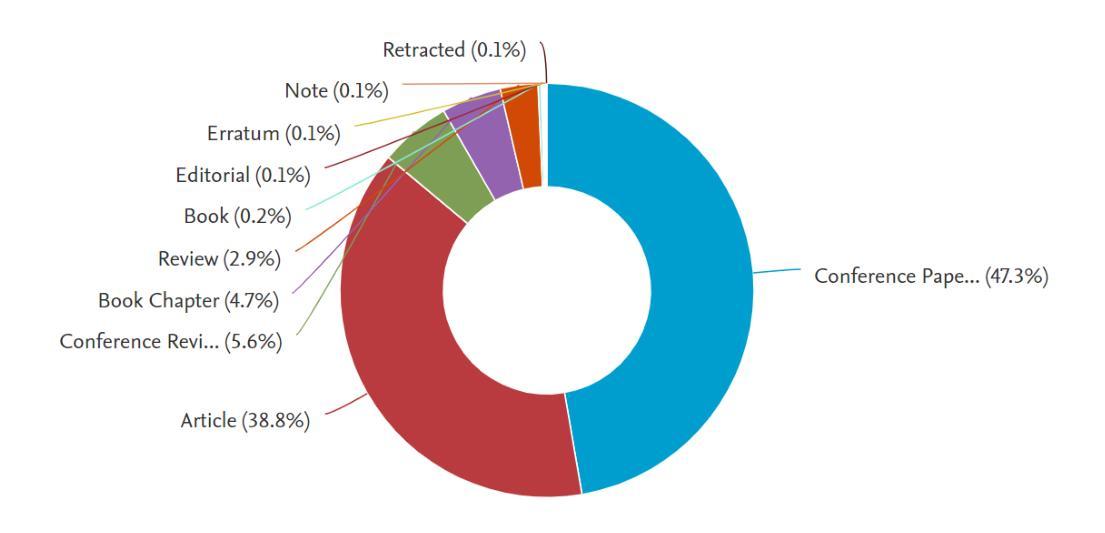

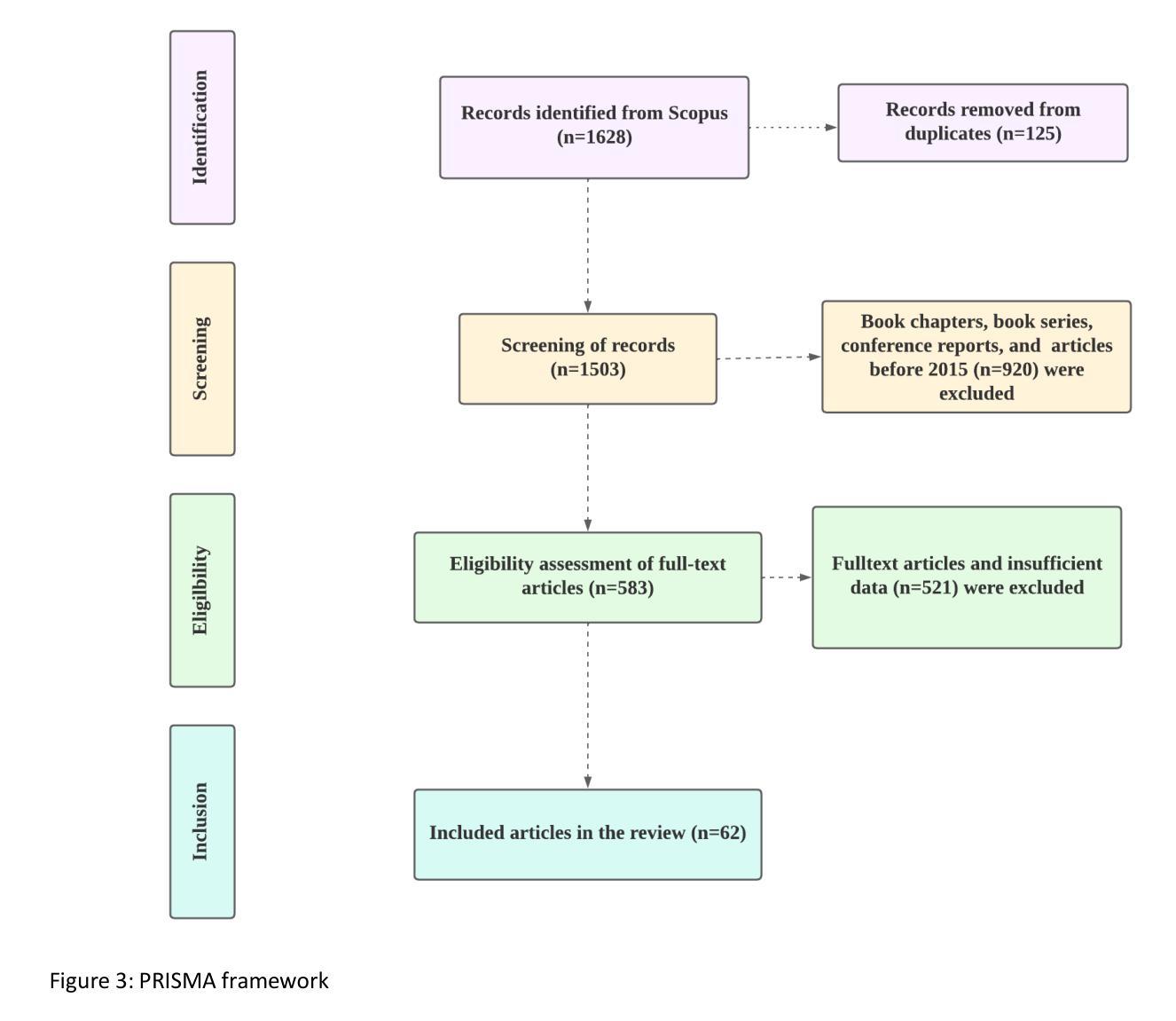

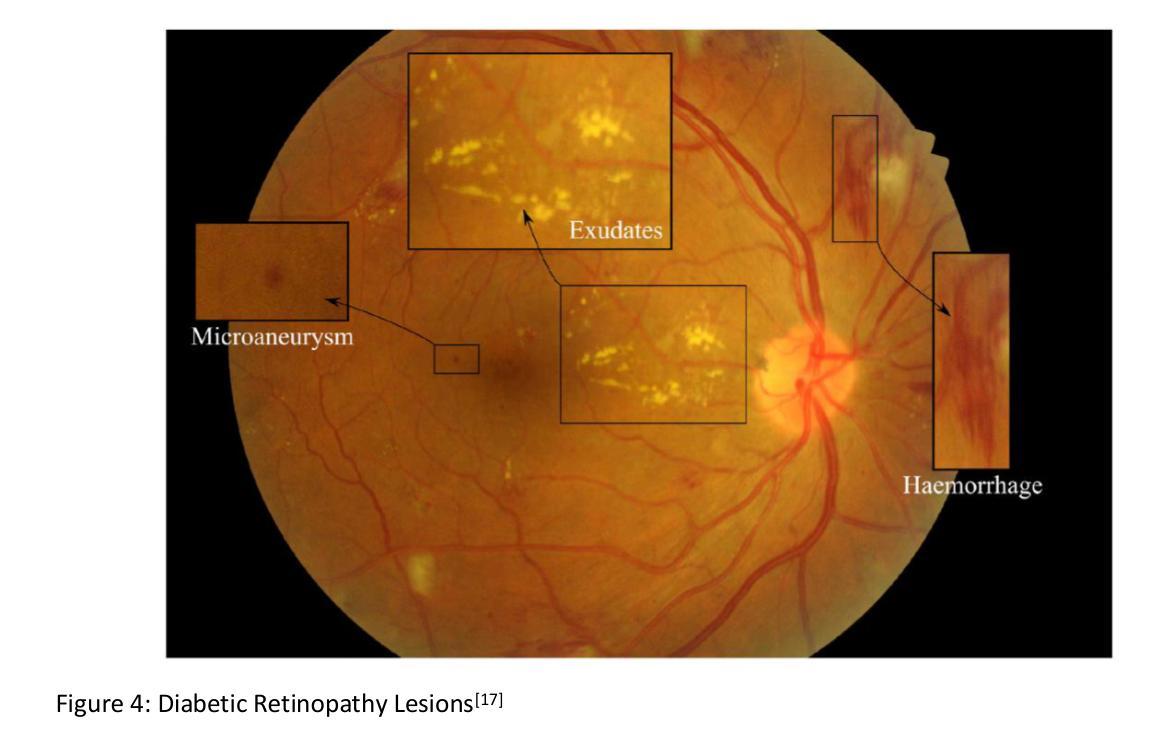

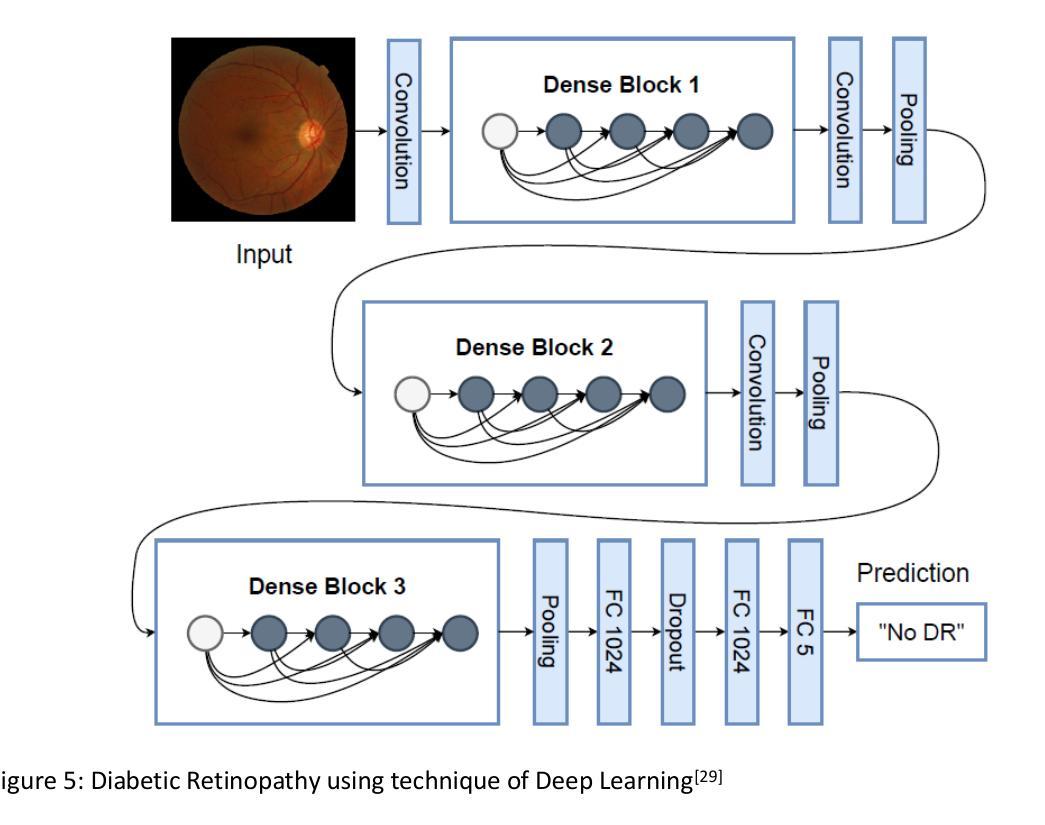

The significant portion of diabetic patients was affected due to major blindness caused by Diabetic retinopathy (DR). For diabetic retinopathy, lesion segmentation, and detection the comprehensive examination is delved into the deep learning techniques application. The study conducted a systematic literature review using the PRISMA analysis and 62 articles has been investigated in the research. By including CNN-based models for DR grading, and feature fusion several deep-learning methodologies are explored during the study. For enhancing effectiveness in classification accuracy and robustness the data augmentation and ensemble learning strategies are scrutinized. By demonstrating the superior performance compared to individual models the efficacy of ensemble learning methods is investigated. The potential ensemble approaches in DR diagnosis are shown by the integration of multiple pre-trained networks with custom classifiers that yield high specificity. The diverse deep-learning techniques that are employed for detecting DR lesions are discussed within the diabetic retinopathy lesions segmentation and detection section. By emphasizing the requirement for continued research and integration into clinical practice deep learning shows promise for personalized healthcare and early detection of diabetics.

大量糖尿病患者受到糖尿病视网膜病变(DR)导致的主要失明影响。针对糖尿病视网膜病变、病变分割和检测,深入研究深度学习技术的应用。该研究采用PRISMA分析进行了系统文献综述,并调查了62篇文章。研究中探索了多种深度学习方法论,包括用于DR分级的CNN模型和特征融合。为了提高分类精度和稳健性,对数据增强和集成学习策略进行了严格审查。通过展示相较于单一模型的优越性能,对集成学习方法的功效进行了调查。通过集成多个预训练网络与自定义分类器,显示出集成方法在DR诊断中的潜在应用,取得了较高的特异性。在糖尿病视网膜病变病变分割和检测部分,讨论了用于检测DR病变的各种深度学习技术。深度学习强调继续研究和融入临床实践的需求,为个性化医疗和糖尿病的早期检测带来了希望。

论文及项目相关链接

PDF Diabetic retinopathy, segmentation, images on retinal fundus, convolutional neural network

Summary

糖尿病视网膜病变(DR)严重影响糖尿病患者,其病变检测与分割需深入研究深度学习技术。本研究通过PRISMA分析进行文献综述,探讨卷积神经网络(CNN)在DR分级中的应用及特征融合等深度学习手段。为提高分类精度和稳健性,研究数据增强和集成学习策略。集成学习方法通过对比单一模型展现优势,在DR诊断中展现出潜在价值。深度学习技术对于DR病变检测具有临床意义,并有望应用于个性化医疗和糖尿病早期检测。

Key Takeaways

- 糖尿病视网膜病变(DR)是糖尿病患者中的主要致盲原因。

- 深度学习技术在DR病变分割和检测方面进行了深入研究,包括CNN模型的应用。

- 研究通过PRISMA分析进行文献综述,共调查了62篇文章。

- 数据增强和集成学习策略被研究以提高分类精度和稳健性。

- 集成学习方法在DR诊断中展现出优势,通过集成多个预训练网络和自定义分类器获得高特异性。

- 深度学习技术对于DR病变检测具有临床意义,并有望应用于个性化医疗。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文主要探讨了利用深度学习技术进行糖尿病视网膜病变(Diabetic Retinopathy, DR)的自动分级和异常检测。论文试图解决的关键问题包括:

DR的早期检测和诊断:糖尿病视网膜病变是导致失明的主要原因之一,尤其在糖尿病患者中。论文强调了早期检测和治疗对于预防由DR引起的失明的重要性。

深度学习技术的应用:研究了深度学习技术,特别是卷积神经网络(CNN)在DR的病变分割和检测中的应用,以及如何通过这些技术提高DR的诊断准确性和鲁棒性。

数据增强和集成学习方法:探讨了数据增强和集成学习策略在提高分类准确性和模型鲁棒性方面的有效性,以及如何通过集成多个预训练网络与自定义分类器来提高DR诊断的特异性。

临床实践的整合:论文强调了将深度学习技术整合到临床实践中的必要性,以实现糖尿病的个性化医疗和早期检测。

系统性文献综述:通过系统性文献综述,研究者们调查了62篇文章,以提供一个关于深度学习模型开发、数据集分析、预处理流程和临床实际应用的综合视角。

技术挑战和未来发展:论文讨论了在模型可解释性、数据集异质性和跨不同人群的适用性等挑战,并展望了深度学习技术在DR诊断中的未来发展方向。

总的来说,这篇论文试图提供一个关于如何利用深度学习技术来提高DR检测和分级的准确性和效率的全面分析,并探讨了这些技术在实际临床环境中的应用潜力。

Q: 有哪些相关研究?

A: 根据论文内容,以下是一些与糖尿病视网膜病变(DR)的深度学习技术相关的研究:

Nielsen KB, Lautrup ML, Andersen JKH, Savarimuthu TR, Grauslund J. 这项研究系统性地回顾了基于深度学习的糖尿病视网膜病变筛查算法的诊断性能。[Ophthalmology Retina, 2019]

Islam MM, Yang HC, Poly TN, Jian WS, (Jack) Li YC. 这项系统回顾和元分析研究了基于深度学习的算法在视网膜底片照片中检测糖尿病视网膜病变的能力。[Computer Methods and Programs in Biomedicine, 2020]

Asiri N, Hussain M, Al Adel F, Alzaidi N. 这项调查研究了基于深度学习的计算机辅助诊断系统在糖尿病视网膜病变中的应用。[Artificial Intelligence in Medicine, 2019]

Badar M, Haris M, Fatima A. 这篇综述文章探讨了深度学习在视网膜图像分析中的应用。[Computer Science Review, 2020]

Grzybowski A, Brona P, Lim G, Ruamviboonsuk P, Tan GSW, Abramoff M, et al. 这篇综述文章讨论了人工智能在糖尿病视网膜病变筛查中的应用。[Eye, 2020]

Li T, Gao Y, Wang K, Guo S, Liu H, Kang H. 这项研究对深度学习算法在糖尿病视网膜病变筛查中的诊断评估进行了探讨。[Information Sciences, 2019]

Esfahani MT, Ghaderi M, Kafiyeh R. 该研究使用新的深度学习方法对糖尿病和正常眼底图像进行分类。[Leonardo Electron J Pract Technol, 2018]

Lam C, Yi D, Guo M, Lindsey T. 这项研究探讨了使用深度学习自动检测糖尿病视网膜病变。[AMIA summits on translational science proceedings, 2018]

Das S, Kharbanda K, M S, Raman R, D ED. 这项研究基于分割的眼底图像特征构建深度学习架构,用于糖尿病视网膜病变的分类。[Biomedical Signal Processing and Control, 2021]

Melo T, Mendonça AM, Campilho A. 这项研究针对糖尿病视网膜病变筛查中的微动脉瘤检测。[Computers in Biology and Medicine, 2020]

这些研究涵盖了从深度学习算法的开发、性能评估到特定病变检测等多个方面,体现了深度学习技术在糖尿病视网膜病变检测和分级中的广泛应用和研究进展。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决糖尿病视网膜病变(DR)的自动分级和异常检测问题:

系统性文献综述:

- 使用PRISMA分析方法对相关文献进行系统性回顾,筛选和分析了62篇相关研究文章。

深度学习技术的应用:

- 探索了基于卷积神经网络(CNN)的模型以及其他深度学习方法在DR的检测和分割中的应用。

- 研究了数据增强和集成学习策略以提高分类准确性和模型的鲁棒性。

模型性能评估:

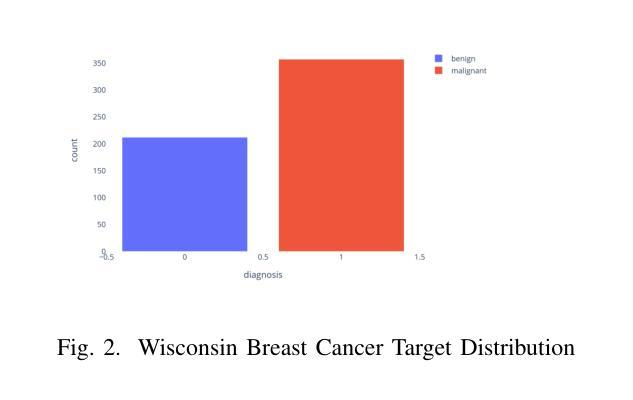

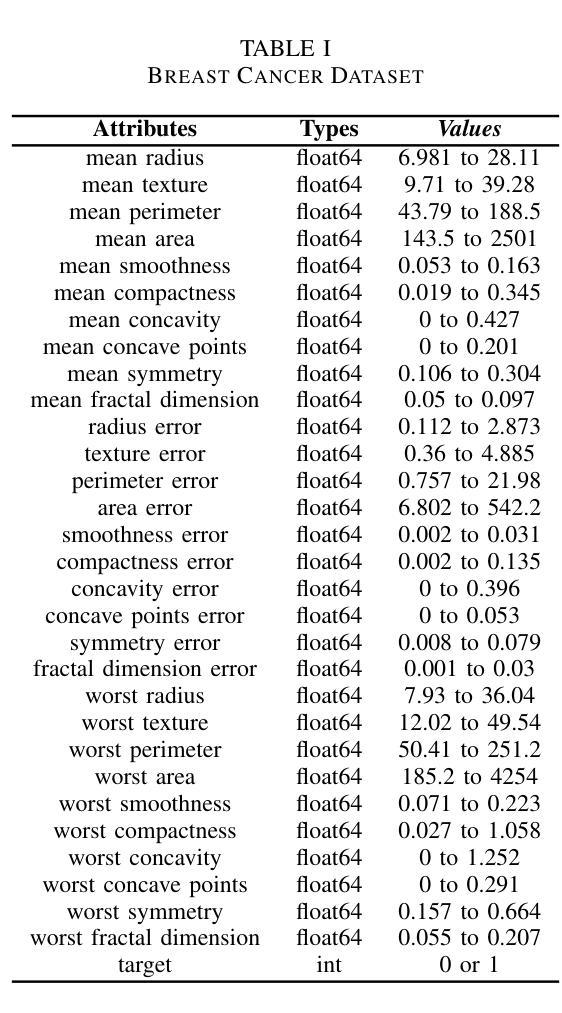

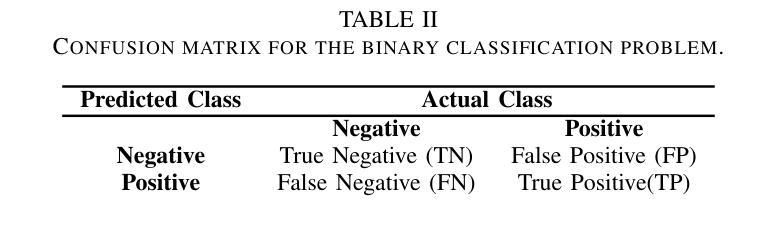

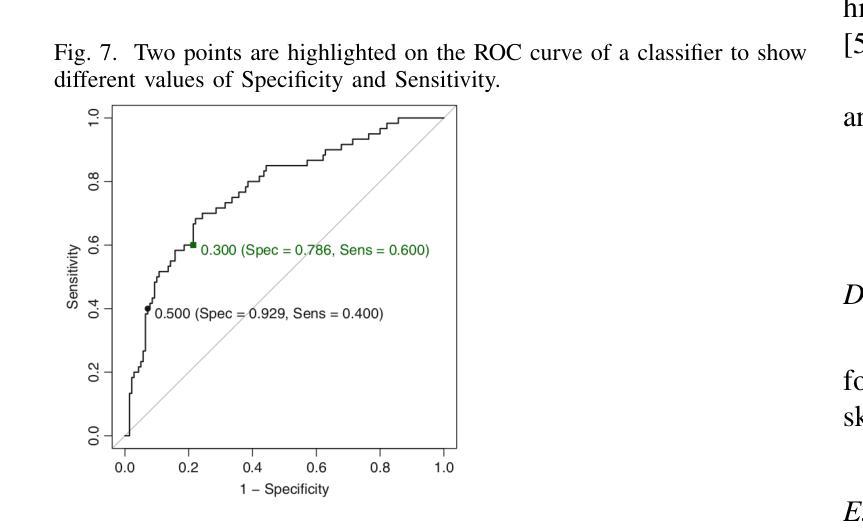

- 利用混淆矩阵和不同的性能评估指标(如Cohen’s Kappa、Sensitivity、Accuracy、F1 Score和Specificity)来评估二元分类模型的性能。

- 使用ROC曲线和AUC值来量化分类器的整体性能。

深度学习模型的开发与比较:

- 开发和评估了不同的深度学习模型,包括CNN架构,以及它们的变体和集成模型,用于DR的自动诊断。

- 比较了单个模型与集成学习方法的性能,展示了集成方法如何通过结合多个预训练网络和自定义分类器来提高特异性。

数据集的分析与应用:

- 分析了多个公开的视网膜图像数据集,这些数据集用于训练、验证和测试深度学习系统,并比较不同系统的性能。

图像预处理技术:

- 讨论了图像预处理方法,包括尺寸调整、裁剪、归一化和去噪,以提高图像特征的一致性。

DR分类和分割方法:

- 详细讨论了用于DR分级的不同分类系统和用于DR病变分割和检测的深度学习技术。

集成学习方法的应用:

- 展示了如何通过集成多个预训练网络来构建集成模型,以提高疾病分级和识别的性能。

未来研究方向的讨论:

- 强调了将深度学习技术整合到临床实践中的必要性,并讨论了模型可解释性、数据集异质性和跨不同人群的适用性等挑战。

通过这些步骤,论文提供了一个全面的分析框架,以评估和改进深度学习技术在DR自动检测和分级中的应用,旨在推动这些技术向临床实践的转化,并提高DR的早期检测和管理。

Q: 论文做了哪些实验?

A: 根据论文内容,以下是一些关键的实验和研究活动:

系统性文献回顾:

- 遵循PRISMA指南进行系统性文献回顾,通过Scopus数据库检索相关文章,并按照特定的纳入和排除标准筛选出62篇相关研究文章进行深入分析。

深度学习模型的应用与评估:

- 实施了基于卷积神经网络(CNN)的模型来处理DR的分级和检测问题。

- 探索了数据增强和集成学习策略以提高模型的分类准确性和鲁棒性。

性能评估指标的计算:

- 使用混淆矩阵、Cohen’s Kappa、Sensitivity、Accuracy、F1 Score和Specificity等指标来评估模型性能。

- 利用ROC曲线和AUC值来量化分类器的整体性能。

二元筛查实验:

- 使用CNN对Kaggle数据集中的正常图像进行自动分类,并对数据进行增强和尺寸调整。

- 应用不同的CNN架构和SoftMax函数进行图像的分类。

多级DR分类实验:

- 利用CNN方法对Eyepacs-1数据集和Messidor-2数据集进行测试,以检测糖尿病视网膜病变和糖尿病黄斑水肿。

- 训练了多个CNN模型,并使用线性平均函数计算最终结果。

集成学习方法实验:

- 设计了集成模型,结合多个预训练网络进行特征提取,并与自定义的密集神经网络耦合作为分类器。

- 使用Adaboost分类器结合三个模型(基于Inception V3, Inception-Resnet-V2架构, ResNet152)进行训练。

DR病变分割和检测实验:

- 利用深度学习方法和领域知识来检测DR图像中的红病变。

- 应用随机森林方法对DIARETDB1、MESSIDOR和E-ophtha数据集中的图像进行分类。

这些实验覆盖了从数据预处理、模型训练、性能评估到结果验证等多个方面,旨在全面评估深度学习技术在糖尿病视网膜病变自动检测和分级中的有效性和准确性。

Q: 有什么可以进一步探索的点?

A: 论文提出了一些挑战和未来的研究方向,以下是一些可以进一步探索的点:

模型可解释性:

- 增强深度学习模型在DR诊断中的可解释性,以便医生和临床工作者能够理解和信任AI系统的决策过程。

数据集的多样性和异质性:

- 扩展和多样化训练数据集,以包含不同种族、性别和地理位置的患者,以提高模型的泛化能力。

跨人群的适用性:

- 评估和改进深度学习模型在不同人群和不同医疗环境中的适用性,特别是资源受限的环境。

集成学习策略的优化:

- 进一步研究和优化集成学习策略,以提高模型的性能和鲁棒性。

实时诊断系统的开发:

- 开发实时或近实时的DR诊断系统,可以直接在临床设置中使用。

临床协议的整合:

- 将深度学习技术更紧密地整合到临床协议和工作流程中,以促进其在实际医疗实践中的应用。

标准化和验证:

- 在更大的、多样化的数据集上验证模型,并制定标准化流程,以便在不同研究和应用之间进行公平比较。

技术进步的利用:

- 利用最新的技术进步,如新的深度学习架构、注意力机制和多模态学习,以进一步提高DR检测和分级的准确性。

患者结果的改善:

- 研究如何通过深度学习技术改善糖尿病患者的结果,包括早期检测、个性化治疗和长期管理。

成本效益分析:

- 进行成本效益分析,以评估深度学习技术在DR筛查和诊断中的经济可行性。

跨学科合作:

- 促进眼科医生、计算机科学家、数据科学家和政策制定者之间的合作,以推动深度学习技术在DR管理中的应用。

这些探索点可以帮助研究人员、开发者和医疗专业人员更好地理解和应用深度学习技术,以提高糖尿病视网膜病变的检测和管理。

Q: 总结一下论文的主要内容

A: 这篇论文主要探讨了利用深度学习技术进行糖尿病视网膜病变(DR)的自动分级和异常检测。以下是其主要内容的总结:

背景与重要性:

- 论文强调了糖尿病视网膜病变(DR)作为导致失明的主要原因之一,尤其在全球糖尿病患病率上升的背景下,早期检测和治疗的重要性。

深度学习技术:

- 论文探讨了多种基于深度学习的方法,特别是卷积神经网络(CNN)在DR的病变分割和检测中的应用。

数据增强与集成学习:

- 研究了数据增强和集成学习策略在提高分类准确性和模型鲁棒性方面的有效性。

系统性文献综述:

- 遵循PRISMA指南,对62篇相关研究文章进行了系统性回顾,提供了一个关于深度学习模型开发、数据集分析、预处理流程和临床实际应用的综合视角。

性能评估:

- 使用混淆矩阵和多种性能评估指标(如Cohen’s Kappa、Sensitivity、Accuracy、F1 Score和Specificity)来评估模型性能。

DR分类与分割实验:

- 实施了多个实验,包括二元筛查、多级分类和DR病变的分割与检测,展示了深度学习模型在这些任务上的应用和性能。

集成学习方法的应用:

- 展示了如何通过集成多个预训练网络来构建集成模型,以提高疾病分级和识别的性能。

挑战与未来方向:

- 讨论了将深度学习技术整合到临床实践中的必要性,并强调了模型可解释性、数据集异质性和跨不同人群的适用性等挑战。

结论:

- 论文得出结论,深度学习技术在DR的自动检测和分级中显示出巨大潜力,但仍需进一步研究和标准化,以充分发挥其在临床诊断中的作用。

总体而言,这篇论文提供了一个全面的分析框架,以评估和改进深度学习技术在DR自动检测和分级中的应用,并探讨了这些技术在实际临床环境中的应用潜力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

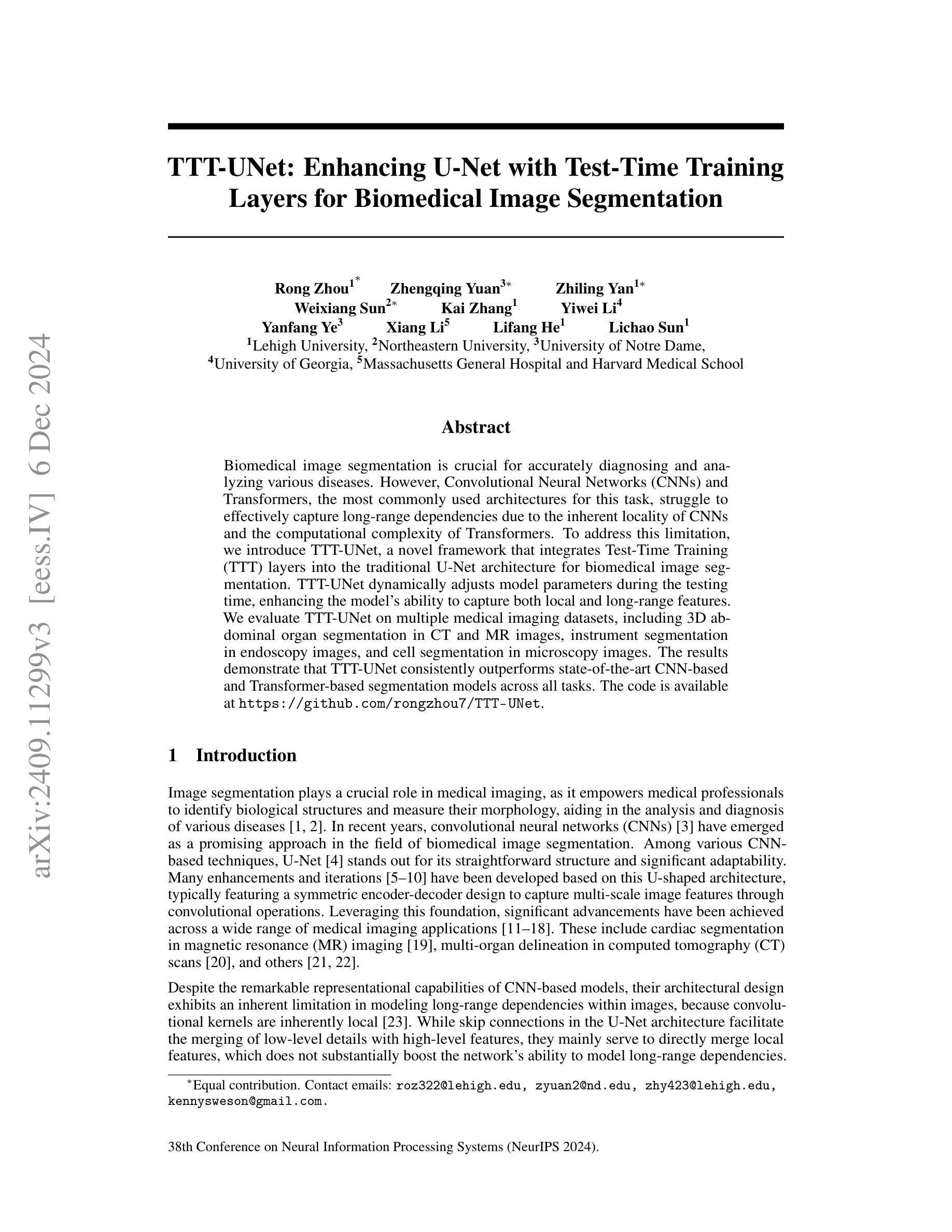

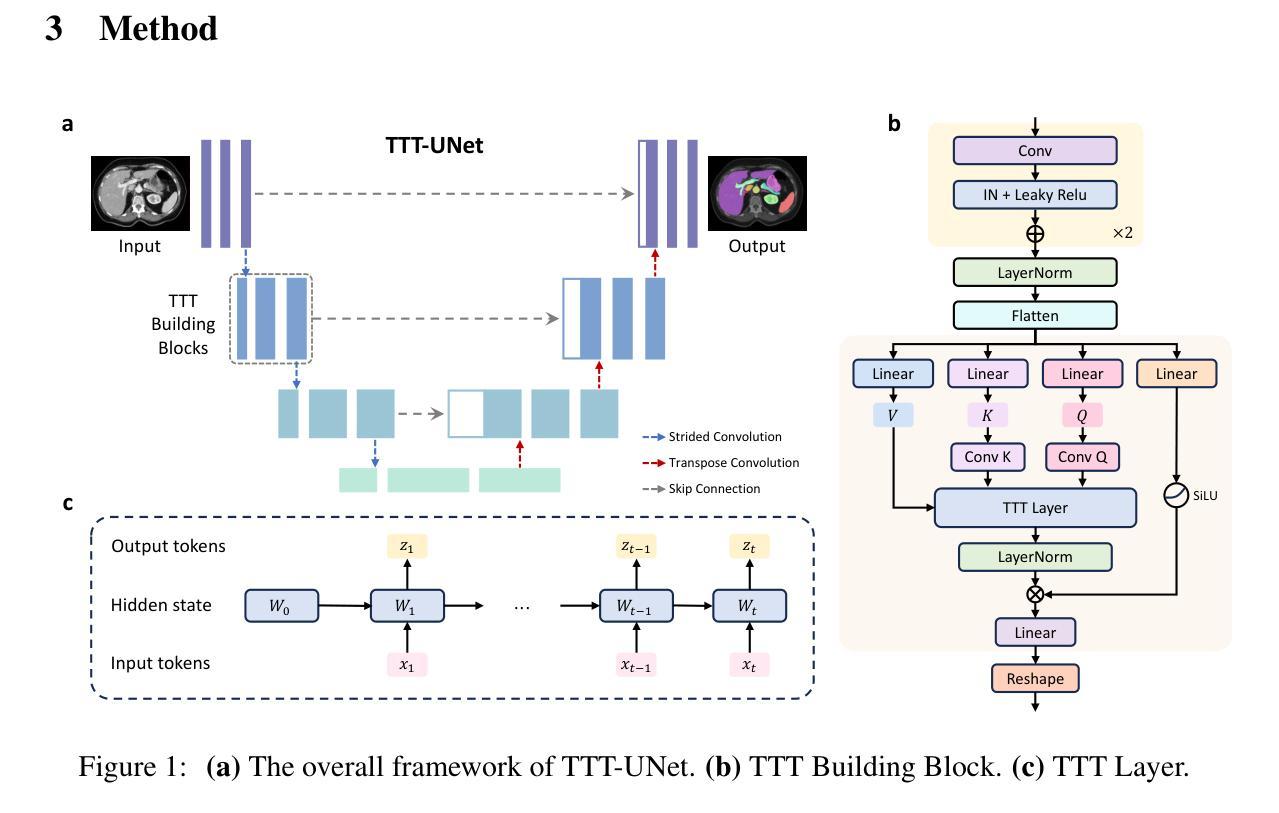

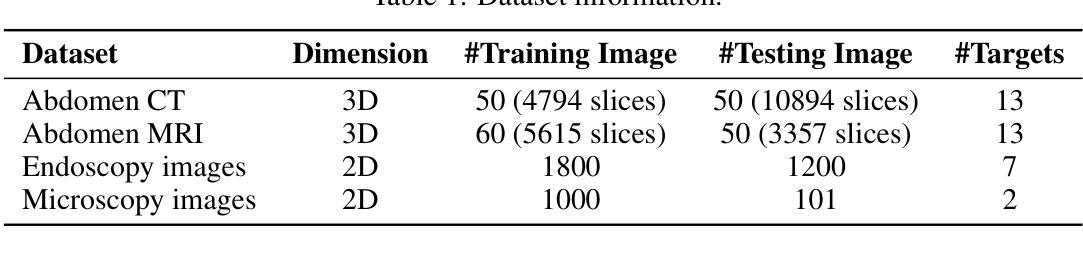

TTT-Unet: Enhancing U-Net with Test-Time Training Layers for Biomedical Image Segmentation

Authors:Rong Zhou, Zhengqing Yuan, Zhiling Yan, Weixiang Sun, Kai Zhang, Yiwei Li, Yanfang Ye, Xiang Li, Lifang He, Lichao Sun

Biomedical image segmentation is crucial for accurately diagnosing and analyzing various diseases. However, Convolutional Neural Networks (CNNs) and Transformers, the most commonly used architectures for this task, struggle to effectively capture long-range dependencies due to the inherent locality of CNNs and the computational complexity of Transformers. To address this limitation, we introduce TTT-Unet, a novel framework that integrates Test-Time Training (TTT) layers into the traditional U-Net architecture for biomedical image segmentation. TTT-Unet dynamically adjusts model parameters during the testing time, enhancing the model’s ability to capture both local and long-range features. We evaluate TTT-Unet on multiple medical imaging datasets, including 3D abdominal organ segmentation in CT and MR images, instrument segmentation in endoscopy images, and cell segmentation in microscopy images. The results demonstrate that TTT-Unet consistently outperforms state-of-the-art CNN-based and Transformer-based segmentation models across all tasks. The code is available at https://github.com/rongzhou7/TTT-Unet.

生物医学图像分割对于准确诊断和治疗各种疾病至关重要。然而,卷积神经网络(CNN)和Transformer是最常用于此任务的架构,由于CNN的固有局部性和Transformer的计算复杂性,它们难以有效地捕获长距离依赖关系。为了解决这一局限性,我们引入了TTT-Unet,这是一个将测试时间训练(TTT)层集成到传统U-Net架构中的新型框架,用于生物医学图像分割。TTT-Unet在测试时动态调整模型参数,提高了模型捕获局部和长距离特征的能力。我们在多个医学成像数据集上评估了TTT-Unet的性能,包括CT和MR图像的3D腹部器官分割、内窥镜图像的仪器分割以及显微镜图像的细胞分割。结果表明,TTT-Unet在所有任务上均优于最新的基于CNN和基于Transformer的分割模型。代码可通过以下链接获取:[链接](https://github.com/rongzhou7/TTT-Unet)。

论文及项目相关链接

Summary

生物医学图像分割对于疾病的准确诊断和治疗分析至关重要。针对卷积神经网络(CNNs)和Transformer在捕捉长距离依赖方面的局限性,我们提出了TTT-Unet框架。它将测试时训练(TTT)层融入传统U-Net架构中,可在测试时动态调整模型参数,提升模型捕捉局部和长距离特征的能力。在多个医学图像数据集上的评估显示,TTT-Unet在所有任务上均优于最新的CNN和Transformer分割模型。

Key Takeaways

- 生物医学图像分割对疾病诊断和治疗分析至关重要。

- 卷积神经网络(CNNs)和Transformer在捕捉长距离依赖方面存在局限性。

- TTT-Unet框架结合了测试时训练(TTT)层和传统U-Net架构。

- TTT-Unet能在测试时动态调整模型参数。

- TTT-Unet增强了模型捕捉局部和长距离特征的能力。

- 在多个医学图像数据集上,TTT-Unet的表现优于其他先进的CNN和Transformer分割模型。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决生物医学图像分割中准确捕捉长距离依赖性的问题。具体来说,它指出了现有的卷积神经网络(CNNs)和变换器(Transformers)在处理这项任务时面临的挑战:

CNNs的局限性:由于卷积核固有的局部性,CNNs在建模图像中的长距离依赖性方面存在固有的局限性。尽管U-Net架构中的跳跃连接有助于合并低级细节和高级特征,但它们主要用于直接合并局部特征,这并不能显著提升网络建模长距离依赖性的能力。

Transformers的计算复杂性:虽然Transformers能够自然理解全局上下文,从而捕捉全局依赖性,但它们在密集的生物医学图像分割任务中的计算成本较高。

为了克服这些限制,论文引入了一种名为TTT-Unet的新型框架,该框架通过在传统的U-Net架构中整合测试时训练(Test-Time Training, TTT)层,动态调整模型参数,以增强模型捕获局部和长距离特征的能力。

Q: 有哪些相关研究?

A: 相关研究涵盖了多个方面,主要聚焦在生物医学图像分割领域,特别是U-Net及其变体、基于Transformer的模型,以及混合模型(结合CNN和SSMs)。以下是论文中提及的一些具体相关研究:

U-Net及其变体:

- U-Net:一种对称的编码器-解码器架构,通过跳跃连接更好地保留细节,广泛应用于生物医学图像分割。

- nnU-Net:一种自配置的U-Net框架,能够在多种生物医学图像分割任务中表现出色。

- TransUNet:将Vision Transformer(ViT)用于编码阶段的特征提取,并与CNN结合用于解码,展示了处理全局信息的能力。

- Swin-UNETR 和 UNETR:将Transformer架构与传统U-Net结合,增强3D成像分析。

基于Transformer的模型:

- Transformer在生物医学图像分割中的应用:如TransUNet、UNETR和SwinUNETR,展示了Transformer在处理长距离依赖性方面的优势。

混合模型(结合CNN和SSMs):

- U-Mamba:首次将SSM(状态空间模型)应用于医学图像领域,结合了高分辨率空间细节和长距离依赖性建模。

- SegMamba 和 nnMamba:在编码器中结合SSM,在解码器中使用CNN,展示了SSM在增强医学成像分析中的有效性和多样性。

其他相关技术:

- 自配置的网络结构:如nnU-Net,能够根据数据集自动调整网络结构。

- 跳跃连接:在U-Net架构中用于合并不同层级的特征,以改善分割性能。

这些研究为TTT-Unet的发展提供了基础,特别是在处理长距离依赖性和提高分割精度方面。TTT-Unet通过整合测试时训练(TTT)层,进一步增强了模型在这些方面的性能。

Q: 论文如何解决这个问题?

A: 论文通过引入TTT-Unet框架解决了生物医学图像分割中长距离依赖性的问题。TTT-Unet是一种新颖的混合架构,它将测试时训练(Test-Time Training, TTT)层集成到传统的U-Net框架中。以下是解决这个问题的关键步骤:

集成TTT层:TTT-Unet在U-Net网络的Mamba块中整合了TTT层,这使得模型能够根据测试数据持续更新其参数,从而增强其特征提取能力,并使其能够自适应地学习长距离依赖性。

动态参数调整:TTT层将传统的固定大小的隐藏状态视为可以通过自监督学习动态更新的机器学习模型。这种动态调整允许模型根据测试数据来细化其参数,从而提供更大的灵活性和表现力,以捕捉复杂的长距离依赖性。

自监督任务:TTT层采用自监督任务来训练模型,这包括从输入数据生成多个视图,并通过学习这些视图之间的关系来提升模型对输入数据的深入理解。

TTT-Unet架构:该架构由编码器-解码器结构组成,其中编码器通过TTT构建块增强了适应性,而解码器遵循标准U-Net设计,专注于重建分割图。

实验验证:作者在多个医学成像数据集上广泛实验,包括3D腹部器官分割、内窥镜图像中的仪器分割和显微镜图像中的细胞分割等任务。实验结果表明,TTT-Unet在所有任务中一致性地超越了现有的最先进模型。

通过这些方法,TTT-Unet能够有效地处理复杂的解剖结构,并在多样化的临床场景中表现出鲁棒性。特别是,TTT-Unet在生物医学图像分割任务中展示了显著的改进,使其成为医学图像分析的多功能解决方案。

Q: 论文做了哪些实验?

A: 论文中进行了多个实验来评估TTT-Unet在生物医学图像分割任务中的性能和可扩展性。以下是实验的具体内容:

数据集:实验使用了四个不同的生物医学图像数据集,涵盖了多种分割任务和成像方式,包括:

- Abdomen CT dataset:用于腹部器官从CT扫描中的分割。

- Abdomen MRI dataset:用于腹部器官从MRI扫描中的分割。

- Endoscopy dataset:用于内窥镜图像中仪器的分割。

- Microscopy dataset:用于显微镜图像中细胞的分割。

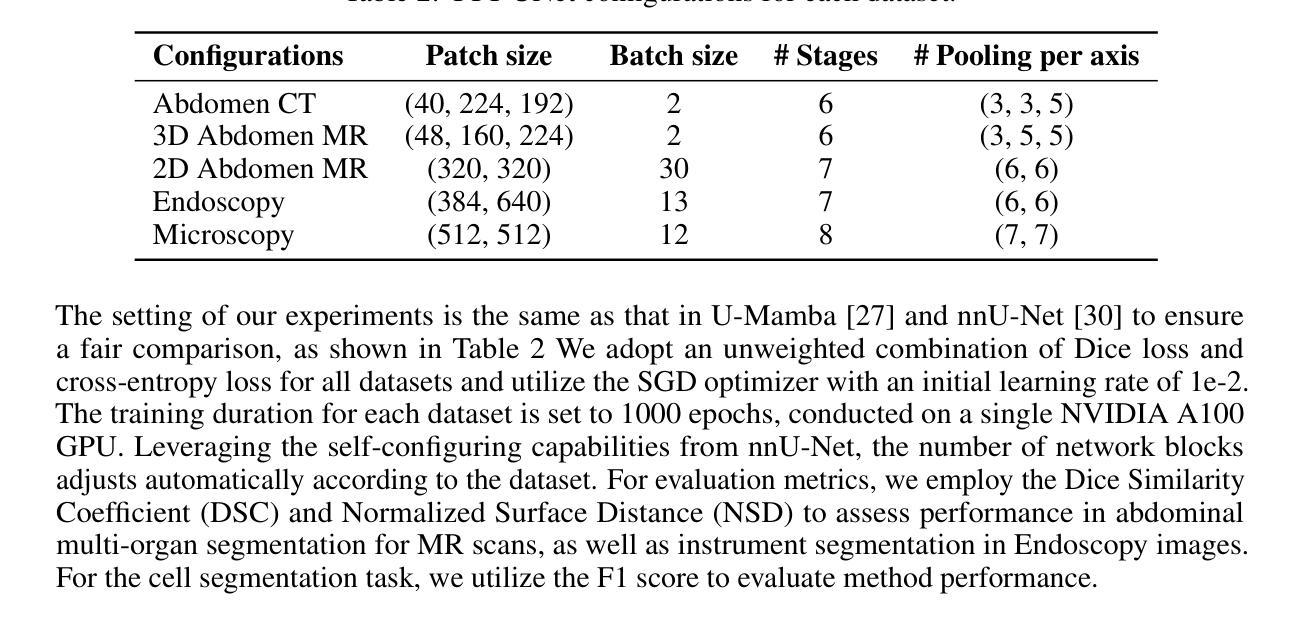

实验设置:实验的设置与U-Mamba和nnU-Net保持一致,以确保公平比较。实验采用了Dice损失和交叉熵损失的无权重组合,使用SGD优化器进行训练。

基线比较:TTT-Unet与多个先进的CNN和Transformer模型进行比较,包括nnU-NET、SegResNet、UNETR和SwinUNETR等。

评估指标:使用了Dice相似系数(DSC)、归一化表面距离(NSD)和F1分数等指标来评估分割性能。

定量分割结果:在2D和3D分割任务中,TTT-Unet在所有数据集上均展现出优越的性能,超越了其他比较的模型。

定性分割结果:通过可视化分割结果,展示了TTT-Unet在处理复杂解剖结构和仪器分割任务中的有效性。

变体评估:论文还实现了TTT-Unet的两种变体:TTT-Unet_Bot和TTT-Unet_Enc,分别在瓶颈部分和整个编码器中应用TTT层,以评估不同集成方式的效果。

这些实验结果一致表明,TTT-Unet在多种生物医学图像分割任务中提供了显著的性能改进,证明了其在处理复杂和多样化的医学图像数据中的有效性和鲁棒性。

Q: 有什么可以进一步探索的点?

A: 尽管TTT-Unet在生物医学图像分割任务中表现出色,但仍有一些潜在的研究方向可以进一步探索:

优化测试时训练(TTT)层:虽然TTT层在动态调整模型参数方面表现出色,但是计算成本相对较高。未来的研究可以集中在优化TTT层,以减少计算开销,同时保持或提高性能。

扩展到更多数据集和任务:目前的实验主要在几个特定的数据集上进行。将TTT-Unet扩展到更广泛的数据集和不同类型的生物医学图像分割任务上,可以进一步验证其泛化能力和实用性。

实时应用:考虑TTT-Unet在实时或近实时临床应用中的可行性,探索如何平衡测试时训练带来的性能提升和实时处理的需求。

更复杂的网络架构:研究是否可以将TTT层与其他先进的网络架构(如更深的网络或注意力机制)结合,以进一步提升分割性能。

解释性和可视化:提高模型的可解释性,通过可视化技术揭示TTT层是如何在测试时动态调整参数以及这些调整如何影响最终的分割结果。

多模态数据融合:探索TTT-Unet在处理和融合来自不同成像模态(如CT、MRI、超声等)的数据时的表现,以及如何优化模型以处理多模态数据。

鲁棒性和泛化能力的进一步研究:尽管TTT-Unet在多个数据集上表现良好,但进一步研究其在面对更具挑战性的数据(如存在噪声、不完整或异常值的数据)时的鲁棒性和泛化能力仍然很重要。

临床验证和评估:与临床医生合作,进行更深入的临床验证和评估,以确定TTT-Unet在实际临床环境中的潜在价值和局限性。

软件和硬件的协同优化:研究如何结合软件和硬件的优化来提升TTT-Unet的运行效率,使其更适合在资源受限的环境中使用。

通过这些进一步的探索,可以不断提升TTT-Unet的性能,扩展其应用范围,并推动生物医学图像分析技术的发展。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了TTT-Unet,这是一个创新的生物医学图像分割框架,它通过整合测试时训练(Test-Time Training, TTT)层到传统的U-Net架构中,有效提升了模型在捕获局部和长距离特征方面的能力。以下是论文的主要内容总结:

问题阐述:论文首先指出了现有的卷积神经网络(CNNs)和变换器(Transformers)在生物医学图像分割任务中面临的挑战,尤其是在捕捉图像中的长距离依赖性方面的局限性。

TTT-Unet框架:为了解决上述问题,论文提出了TTT-Unet,这是一个将TTT层集成到U-Net架构中的混合模型。TTT层允许模型在测试期间动态调整参数,从而更好地适应不同测试样本的特点。

TTT层的介绍:详细描述了TTT层的工作原理,包括其如何通过自监督学习动态更新模型权重,以及如何利用输入数据的多个视图来提升模型对长距离依赖性的捕捉能力。

TTT-Unet架构:论文阐述了TTT-Unet的整体架构,包括编码器和解码器的设计,以及如何通过TTT构建块增强编码器的适应性。

实验验证:通过在多个医学成像数据集上的广泛实验,论文展示了TTT-Unet在3D腹部器官分割、内窥镜图像中的仪器分割和显微镜图像中的细胞分割等任务中的优越性能。实验结果表明,TTT-Unet在各项任务中均超越了现有的最先进模型。

定性分析:论文还提供了定性分析,通过可视化分割结果,展示了TTT-Unet在处理复杂解剖结构和不同成像模态中的有效性。

讨论和结论:最后,论文讨论了TTT-Unet的主要优势,包括其在测试时动态调整参数的能力以及在多样化数据集上的鲁棒性能。同时,论文也指出了未来工作的方向,如进一步优化TTT层以减少计算开销。

总体而言,TTT-Unet通过其创新的测试时训练机制,为生物医学图像分割领域提供了一种新的、有效的解决方案,具有在多种临床场景中应用的潜力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

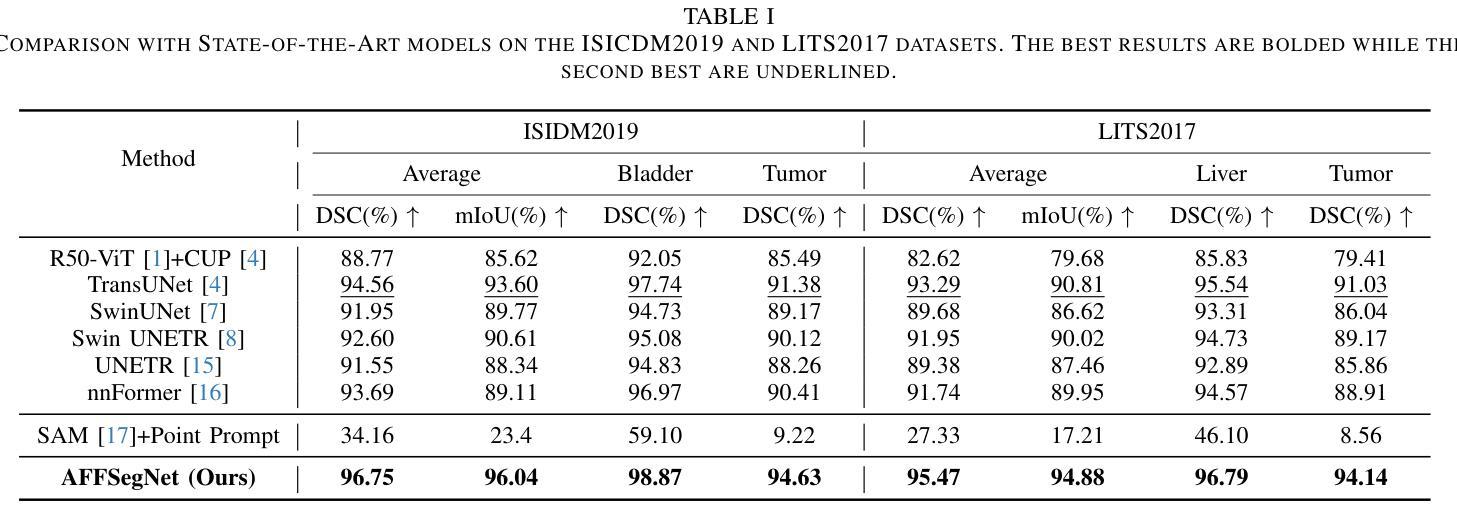

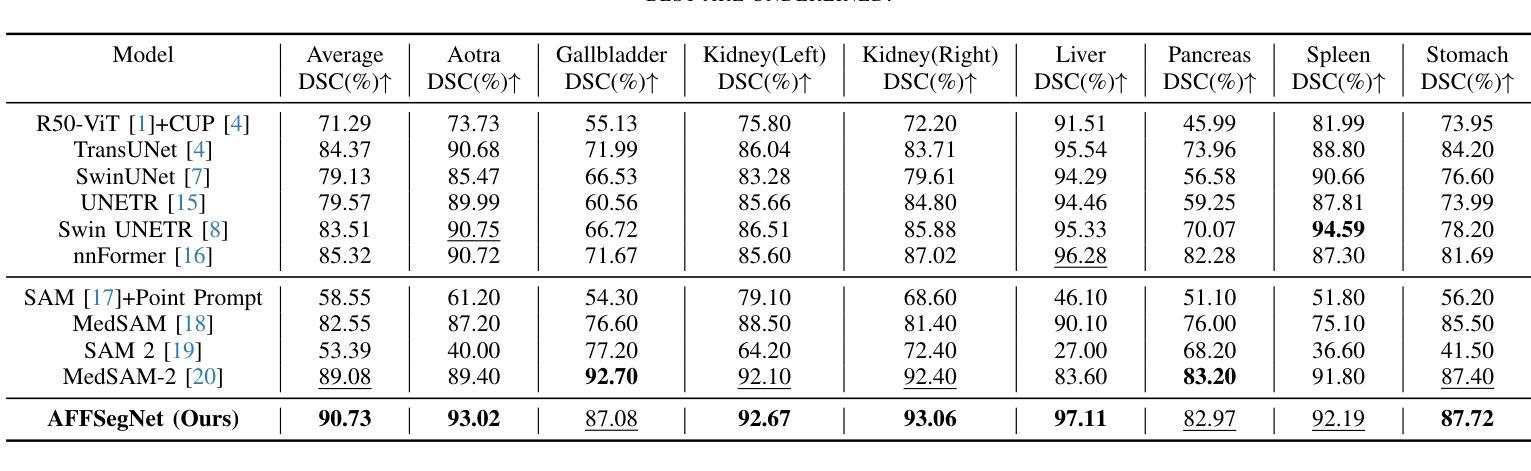

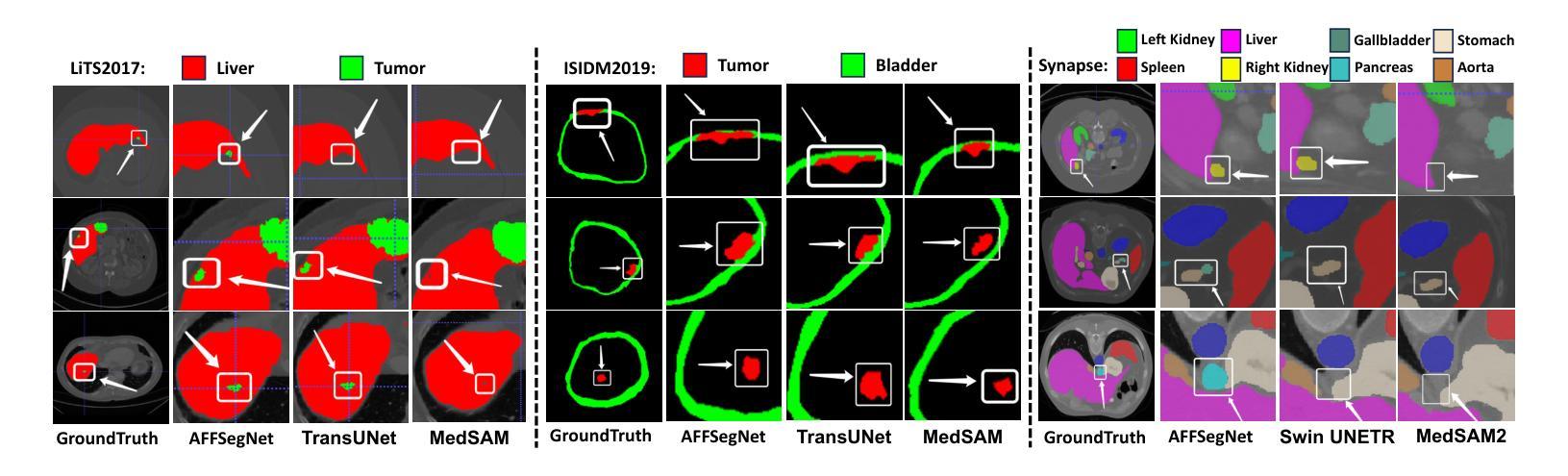

AFFSegNet: Adaptive Feature Fusion Segmentation Network for Microtumors and Multi-Organ Segmentation

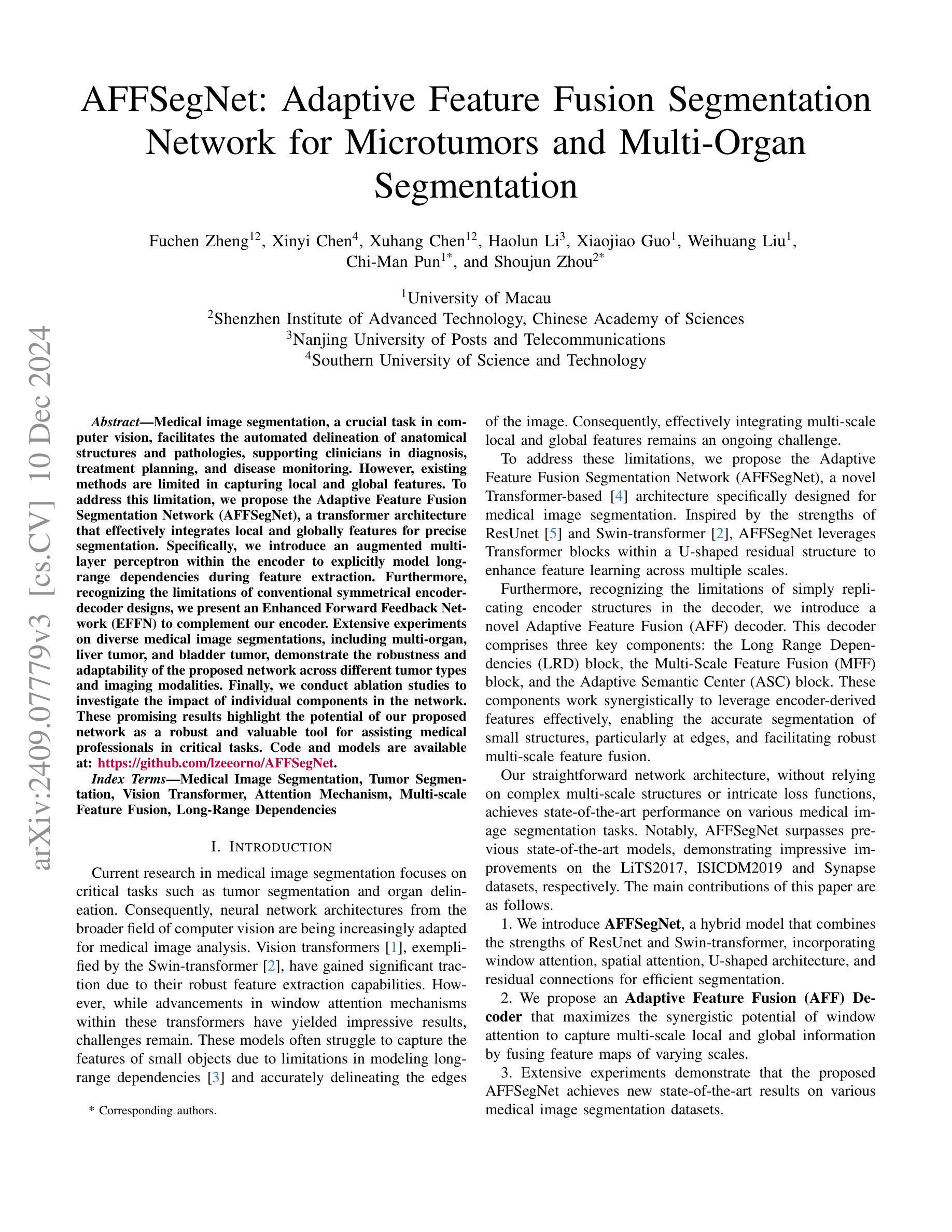

Authors:Fuchen Zheng, Xinyi Chen, Xuhang Chen, Haolun Li, Xiaojiao Guo, Weihuang Liu, Chi-Man Pun, Shoujun Zhou

Medical image segmentation, a crucial task in computer vision, facilitates the automated delineation of anatomical structures and pathologies, supporting clinicians in diagnosis, treatment planning, and disease monitoring. Notably, transformers employing shifted window-based self-attention have demonstrated exceptional performance. However, their reliance on local window attention limits the fusion of local and global contextual information, crucial for segmenting microtumors and miniature organs. To address this limitation, we propose the Adaptive Semantic Segmentation Network (ASSNet), a transformer architecture that effectively integrates local and global features for precise medical image segmentation. ASSNet comprises a transformer-based U-shaped encoder-decoder network. The encoder utilizes shifted window self-attention across five resolutions to extract multi-scale features, which are then propagated to the decoder through skip connections. We introduce an augmented multi-layer perceptron within the encoder to explicitly model long-range dependencies during feature extraction. Recognizing the constraints of conventional symmetrical encoder-decoder designs, we propose an Adaptive Feature Fusion (AFF) decoder to complement our encoder. This decoder incorporates three key components: the Long Range Dependencies (LRD) block, the Multi-Scale Feature Fusion (MFF) block, and the Adaptive Semantic Center (ASC) block. These components synergistically facilitate the effective fusion of multi-scale features extracted by the decoder while capturing long-range dependencies and refining object boundaries. Comprehensive experiments on diverse medical image segmentation tasks, including multi-organ, liver tumor, and bladder tumor segmentation, demonstrate that ASSNet achieves state-of-the-art results. Code and models are available at: \url{https://github.com/lzeeorno/ASSNet}.

医学图像分割是计算机视觉中的一项重要任务,它有助于自动描绘解剖结构和病理,支持临床医生进行诊断、治疗规划和疾病监测。值得注意的是,采用基于移位窗口的自注意力的变压器表现出了卓越的性能。然而,它们对局部窗口注意力的依赖,限制了局部和全局上下文信息的融合,这对于分割微肿瘤和微小器官至关重要。为了解决这一局限性,我们提出了自适应语义分割网络(ASSNet),这是一种有效的结合局部和全局特征的变压器架构,用于精确医学图像分割。ASSNet由基于变压器的U形编码器-解码器网络组成。编码器在五个分辨率上利用移位窗口自注意力提取多尺度特征,然后通过跳跃连接传播到解码器。我们在编码器内引入增强型多层感知器,以在特征提取过程中显式建模长距离依赖关系。认识到传统对称编码器-解码器设计的局限性,我们提出了一种自适应特征融合(AFF)解码器来补充我们的编码器。该解码器包含三个关键组件:长距离依赖(LRD)块、多尺度特征融合(MFF)块和自适应语义中心(ASC)块。这些组件协同工作,促进解码器提取的多尺度特征的有效融合,同时捕捉长距离依赖关系并细化对象边界。在多种医学图像分割任务上的综合实验,包括多器官、肝脏肿瘤和膀胱肿瘤分割,证明了ASSNet达到了最新结果。代码和模型可在https://github.com/lzeeorno/ASSNet上找到。

论文及项目相关链接

PDF 8 pages, 4 figures, 3 tables

摘要

医学图像分割是计算机视觉中的关键任务,有助于自动描绘解剖结构和病理,支持临床医生进行诊断、治疗计划和疾病监测。采用基于移位窗口的自注意力的变压器展示了卓越的性能,但它们依赖于局部窗口注意力,限制了局部和全局上下文信息的融合,对于分割微肿瘤和微小器官尤为重要。为解决此局限性,我们提出了自适应语义分割网络(ASSNet),这是一种有效的结合局部和全局特征的变压器架构,用于精确医学图像分割。ASSNet由基于变压器的U形编码器-解码器网络组成。编码器利用五个分辨率的移位窗口自注意力提取多尺度特征,然后通过跳过连接传播到解码器。我们在编码器内引入增强型多层感知器,以在特征提取过程中显式建模长程依赖关系。考虑到传统对称编码器-解码器设计的局限性,我们提出了一种自适应特征融合(AFF)解码器来补充我们的编码器。该解码器包含三个关键组件:长程依赖(LRD)块、多尺度特征融合(MFF)块和自适应语义中心(ASC)块。这些组件协同工作,有助于解码器提取的多尺度特征的有效融合,同时捕捉长程依赖关系并细化对象边界。在多种医学图像分割任务上的综合实验,包括多器官、肝脏肿瘤和膀胱肿瘤分割,表明ASSNet达到了最新结果。代码和模型可用链接:\url{https://github.com/lzeeorno/ASSNet}。

关键见解

- 医学图像分割是计算机视觉中的核心任务,有助于临床诊断、治疗规划和疾病监测。

- 基于移位窗口自注意力的变压器在医学图像分割中展现出卓越性能。

- 局部窗口注意力限制了上下文信息的融合,特别是在分割微肿瘤和微小器官时。

- 提出了一种新的医学图像分割方法——自适应语义分割网络(ASSNet)。

- ASSNet结合局部和全局特征,采用基于变压器的U形编码器-解码器网络。

- 编码器利用多尺度特征和移位窗口自注意力,而解码器通过自适应特征融合进行补充。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为AFFSegNet(Adaptive Feature Fusion Segmentation Network)的新型网络架构,旨在解决医学图像分割领域中的关键问题,尤其是在微肿瘤和多器官分割方面。具体来说,论文试图解决以下几个问题:

局部和全局特征的捕捉:现有的方法在捕获局部和全局特征方面存在局限性,尤其是在对小物体的特征提取和图像边缘的准确描绘上。

长距离依赖关系的建模:许多模型在对长距离依赖关系的建模上存在挑战,这影响了它们对图像中远距离特征相关性的捕捉能力。

多尺度特征融合:有效整合多尺度局部和全局特征是一个持续的挑战,尤其是在医学图像分割中,这对于精确分割小结构和复杂边缘结构至关重要。

编码器-解码器设计的局限性:传统的对称编码器-解码器设计在特征融合和利用方面存在不足,特别是在解码器中整合多尺度局部和全局特征的能力。

为了解决这些问题,论文提出了AFFSegNet,这是一个基于Transformer的架构,通过在编码器中引入增强的多层感知机(MLP)和提出一个新颖的自适应特征融合(AFF)解码器,有效地整合了局部和全局特征,以实现精确的分割。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要涉及以下几个方面:

Vision Transformer和混合架构:

- Vision Transformer (ViT) 模型利用自注意力机制捕获图像中的长距离依赖关系,已在图像分类任务中取得了突破性的性能。

- Swin Transformer 展示了在各种医学图像应用中的卓越性能,采用分层方法计算局部窗口内的自注意力,然后通过移动窗口捕获不同图像区域间的关系,降低了计算复杂性同时保留了建模长距离依赖的能力。

医学图像分割网络:

- ResUnet 和 Swin-transformer 结合了窗口注意力机制和空间注意力机制,以及U形结构和残差连接,用于提高分割效率。

- TransUNet 和 SwinUNet 是基于Transformer的网络,它们通过使用U-Net类似的结构来改进医学图像分割。

编码器-解码器结构的局限性:

- 论文提到了现有编码器-解码器结构在特征融合和利用方面的局限性,特别是在解码器中整合多尺度局部和全局特征的能力。

自注意力和多头自注意力机制:

- 论文中提到了在标准Transformer中使用的多头自注意力(MSA)模块,并对其进行了改进以适应医学图像分割任务。

损失函数和优化:

- 论文中提到了BCE Dice损失,这是一种结合了二元交叉熵损失和Dice损失的组合,广泛应用于医学图像分割任务。

数据集和评估指标:

- 论文中使用了LiTS2017、ISICDM2019和Synapse等公共医学图像数据集,并采用Dice相似系数(DSC)和平均交并比(mIoU)作为性能评估指标。

这些相关研究为AFFSegNet的设计提供了理论基础和技术支持,同时也表明了医学图像分割领域的研究进展和挑战。AFFSegNet通过结合这些相关研究的优势,提出了一种新的网络架构来提高医学图像分割的性能。

Q: 论文如何解决这个问题?

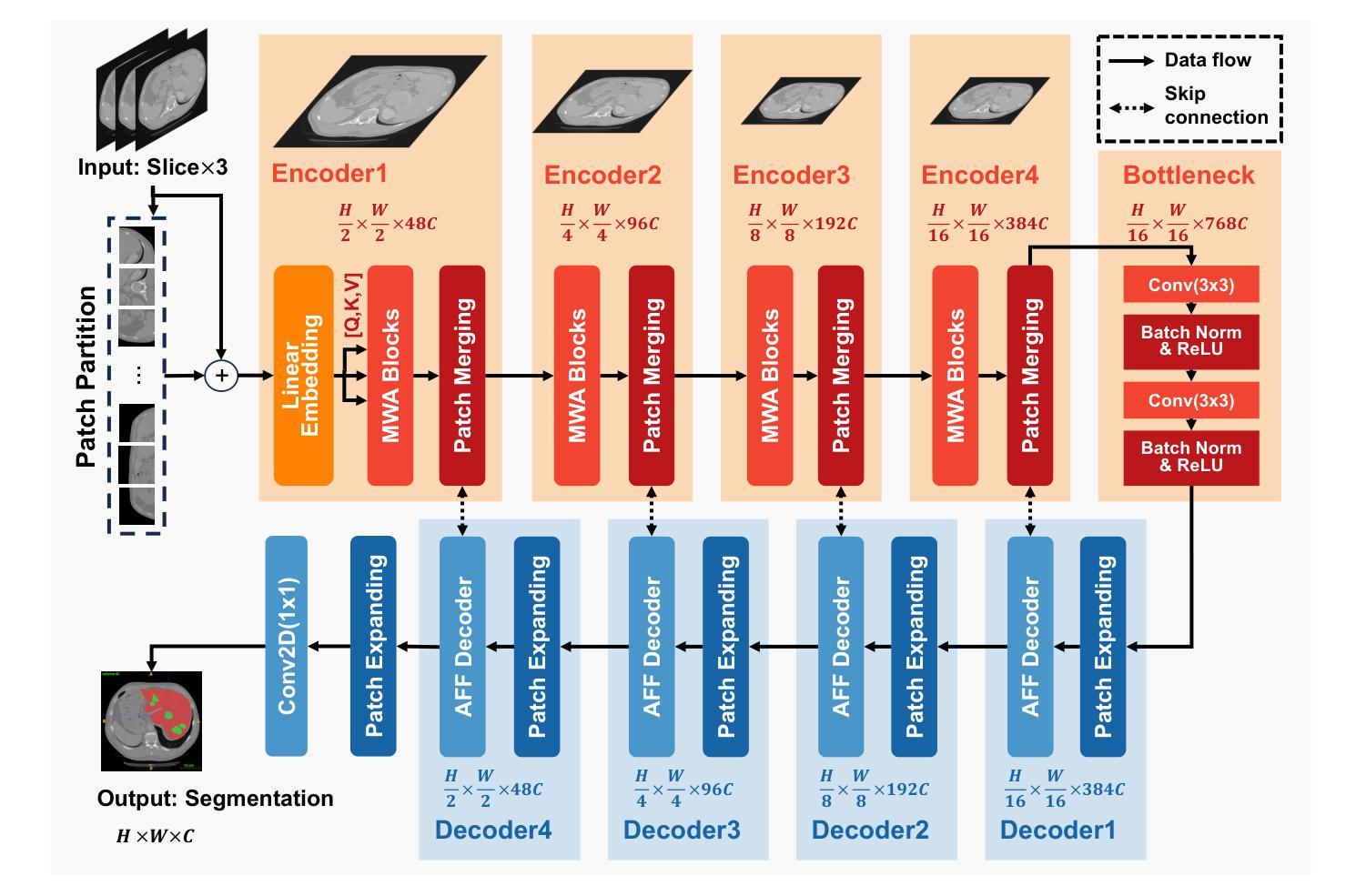

A: 论文通过提出一个名为AFFSegNet(Adaptive Feature Fusion Segmentation Network)的新型网络架构来解决上述问题。AFFSegNet的设计包含了以下几个关键组件和策略:

1. 增强的编码器和多层感知机(MLP)

- 编码器:引入了一个增强的多层感知机(MLP)来显式地建模特征提取过程中的长距离依赖关系。这是通过在编码器中加入额外的MLP层来实现的,以增强对全局特征的捕捉能力。

2. 改进的编码器-解码器结构

- EFFN(Enhanced Forward Feedback Network):为了补充编码器并克服传统对称编码器-解码器设计的局限性,提出了EFFN。EFFN通过前馈反馈机制来增强特征的传递和融合。

3. 自适应特征融合(AFF)解码器

- AFF解码器:包括三个关键组件:长距离依赖(LRD)块、多尺度特征融合(MFF)块和自适应语义中心(ASC)块。这些组件共同工作,有效地利用编码器派生的特征,实现小结构的精确分割,尤其是在边缘区域,并促进多尺度特征的融合。

4. 多尺度窗口注意力(MWA)Transformer块

- MWA Transformer块:作为AFFSegNet的核心编码器组件,通过替换标准Transformer中的多头自注意力(MSA)模块为基于窗口的MSA模块,并保留其他组件不变。每个MWA块包括一个基于窗口的MSA模块,后跟一个EFFN。

5. 损失函数

- BCE Dice损失:在训练过程中,AFFSegNet使用结合了二元交叉熵(BCE)损失和Dice损失的BCE Dice损失函数,这种损失函数在医学图像分割任务中广泛使用。

6. 实验验证

- 广泛的实验:在包括多器官、肝肿瘤和膀胱肿瘤在内的多种医学图像分割任务上进行了广泛的实验,验证了所提出网络的鲁棒性和适应性。

通过这些设计和策略,AFFSegNet能够有效地整合局部和全局特征,实现精确的医学图像分割,特别是在微肿瘤和多器官分割方面。这些创新的设计使得AFFSegNet在多个医学图像分割数据集上取得了优于现有最先进模型的性能。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证AFFSegNet的性能,并与现有的最先进方法进行比较。以下是实验的具体内容:

数据集和实现细节

数据集:实验使用了三个公共医学图像数据集,包括:

- LiTS2017:专注于肝脏肿瘤分割,包含131个对比增强的3D腹部CT扫描。

- ISICDM2019:专注于膀胱肿瘤分割,包括2200张膀胱癌图像。

- Synapse:针对多器官分割,由40个3D腹部CT扫描组成,涵盖多个器官。

实验设置:使用nnformer数据集划分(80%训练,15%验证,5%测试)以保证一致性和公平比较。输入图像被调整至512×512像素。AFFSegNet在PyTorch中实现,并在NVIDIA GeForce RTX 4090 GPU上训练。

性能比较

- 与最先进方法的比较:在上述三个数据集上,AFFSegNet与多种现有的最先进医学图像分割方法进行了性能比较。结果总结在论文的表I和表II中,包括对肝脏肿瘤、膀胱肿瘤和多器官分割的性能评估。

消融研究

- 消融研究:为了研究AFFSegNet中各个组件的贡献,进行了消融研究,逐个移除网络中的组件,并评估性能变化。结果表明所有组件都对AFFSegNet的整体性能有所贡献,特别是EFFN、LRD、MFF和ASC块。

可视化分割结果

- 可视化评估:为了直观评估AFFSegNet的分割能力,论文中还展示了与其他最先进方法在LiTS2017、ISICDM2019和Synapse数据集中代表性切片的定性比较。AFFSegNet能够准确地分割肝脏周边的小肿瘤结节,并保留经常被其他方法遗漏或分割不准确的小型器官的完整性。

这些实验全面验证了AFFSegNet在医学图像分割任务中的有效性和优越性,并展示了其在不同肿瘤类型和成像方式中的鲁棒性和适应性。

Q: 有什么可以进一步探索的点?

A: 尽管AFFSegNet在医学图像分割领域取得了显著的性能提升,但仍有一些方向可以进一步探索和改进:

1. 数据集的多样性和泛化能力

- 多模态数据集:探索AFFSegNet在多模态医学图像数据集上的性能,例如MRI和CT图像的组合,以测试模型的泛化能力。

- 跨疾病类型的泛化:评估AFFSegNet在不同疾病类型和病理条件下的表现,例如在心脏病或神经系统疾病中的应用。

2. 模型的计算效率和实用性

- 计算资源优化:研究如何减少AFFSegNet的计算资源需求,使其更适合在资源受限的环境中使用,例如在移动设备或边缘计算设备上。

- 实时性能:探索模型在实时医学图像分割任务中的性能,这对于手术导航和介入治疗等应用至关重要。

3. 模型解释性和可视化

- 特征可视化:通过可视化技术来解释模型的决策过程,帮助理解模型是如何学习和识别不同特征的。

- 错误分析:对模型的失败案例进行深入分析,以识别模型的局限性和潜在的改进方向。

4. 模型的鲁棒性和安全性

- 对抗性攻击和防御:研究模型对对抗性攻击的鲁棒性,并开发有效的防御策略,以确保在实际应用中的安全性。

- 数据增强和正则化技术:探索不同的数据增强和正则化技术,以提高模型对异常值和噪声的鲁棒性。

5. 模型的集成和融合

- 多模型融合:研究如何将AFFSegNet与其他类型的网络(如基于CNN的模型)集成,以进一步提高分割的准确性和鲁棒性。

- 跨尺度特征融合:进一步探索不同尺度特征的融合策略,以更有效地捕捉图像中的局部和全局信息。

6. 临床验证和应用

- 临床数据的验证:与医疗机构合作,使用真实的临床数据来验证模型的性能,并根据临床需求调整模型。

- 实际应用开发:开发基于AFFSegNet的实际应用,如辅助诊断工具或个性化治疗规划系统。

这些方向不仅可以推动AFFSegNet技术的发展,还可能为医学图像分割领域带来新的突破和应用。

Q: 总结一下论文的主要内容

A: 本文提出了一个名为AFFSegNet(Adaptive Feature Fusion Segmentation Network)的新型Transformer架构,专门用于医学图像分割任务,特别是在微肿瘤和多器官分割方面。以下是论文的主要内容总结:

1. 问题背景

- 医学图像分割是计算机视觉中的一个重要任务,对于辅助临床医生进行诊断、治疗规划和疾病监测至关重要。

- 现有方法在捕获局部和全局特征方面存在局限性,尤其是在对小物体和图像边缘的精确分割上。

2. 方法论

- AFFSegNet架构:提出了一个基于Transformer的网络,通过在编码器中引入增强的多层感知机(MLP)和提出自适应特征融合(AFF)解码器,有效地整合了局部和全局特征。

- MWA Transformer块:作为核心编码器组件,通过替换标准Transformer中的多头自注意力(MSA)模块为基于窗口的MSA模块,并保留其他组件不变。

- AFF解码器:包括长距离依赖(LRD)块、多尺度特征融合(MFF)块和自适应语义中心(ASC)块,以增强对小结构和复杂边缘结构的分割能力。

3. 实验

- 在LiTS2017、ISICDM2019和Synapse等多个医学图像分割数据集上进行了广泛的实验,与现有的最先进方法进行了比较。

- 实验结果表明,AFFSegNet在各种数据集上均取得了优于现有最先进模型的性能,特别是在Dice相似系数(DSC)和平均交并比(mIoU)两个评估指标上。

- 进行了消融研究,验证了网络中各个组件的重要性和贡献。

4. 结论

- AFFSegNet作为一种新的Transformer架构,在微肿瘤和多器官分割方面表现出色,能够有效地捕捉局部和全局特征,提高医学图像分割的精度和效率。

- 该网络有望成为辅助临床医生进行关键诊断和治疗规划的有力工具。

总体而言,AFFSegNet通过其创新的网络架构和自适应特征融合策略,在医学图像分割领域提供了一种新的解决方案,具有显著的性能提升和广泛的应用前景。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

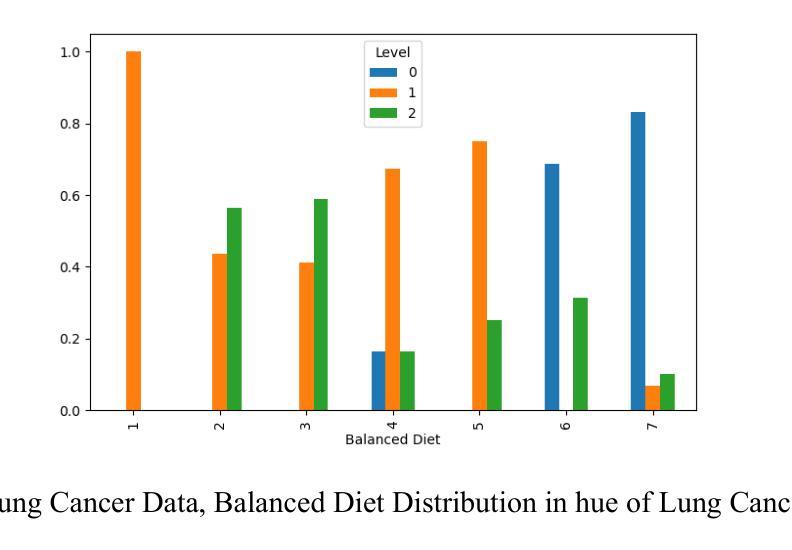

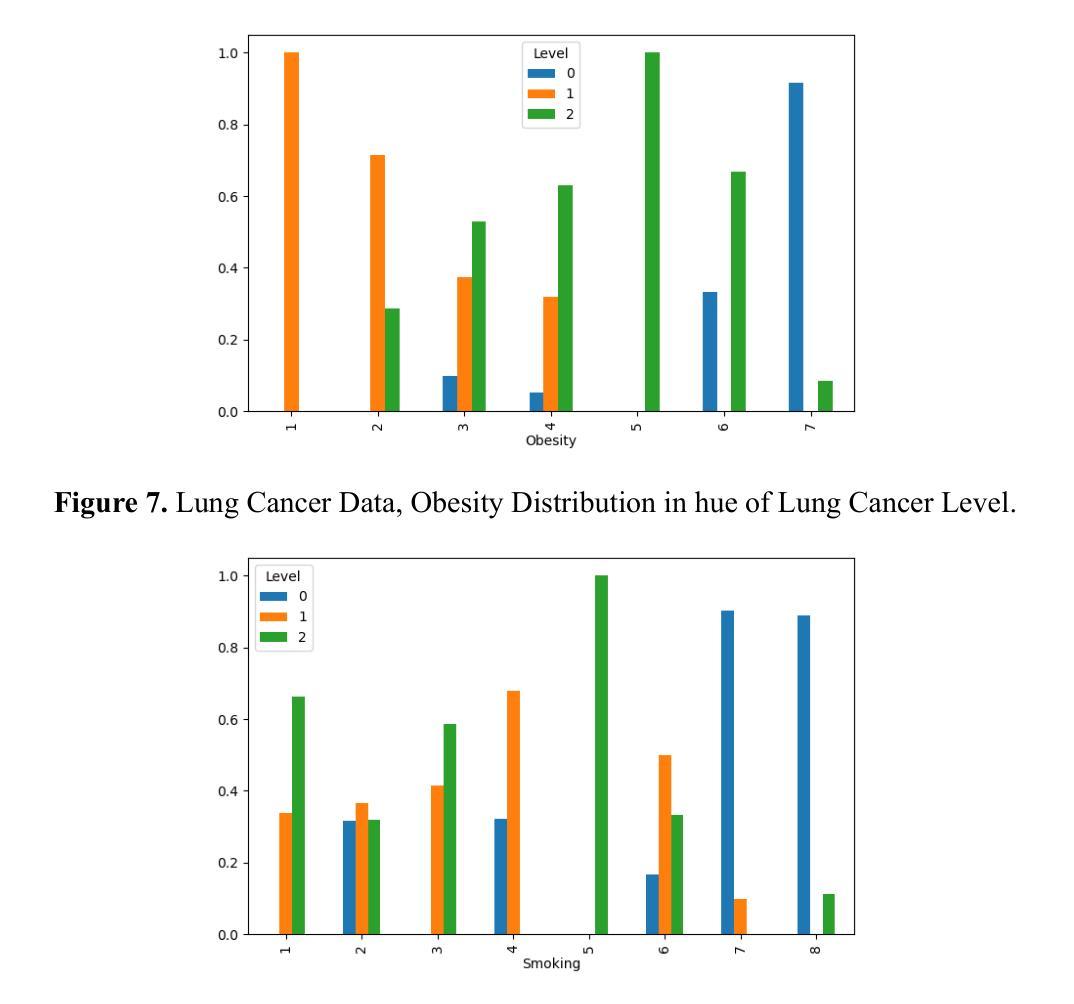

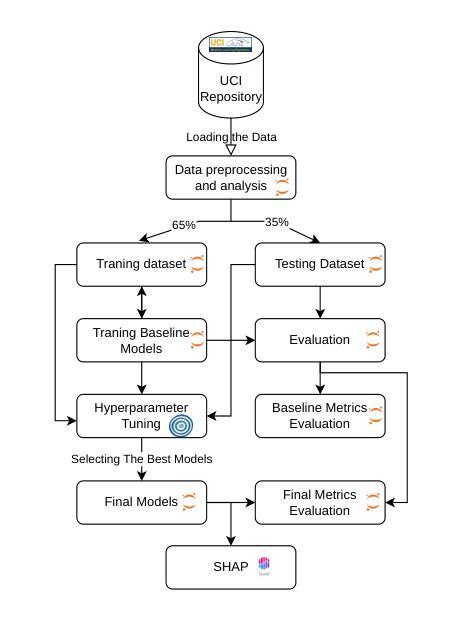

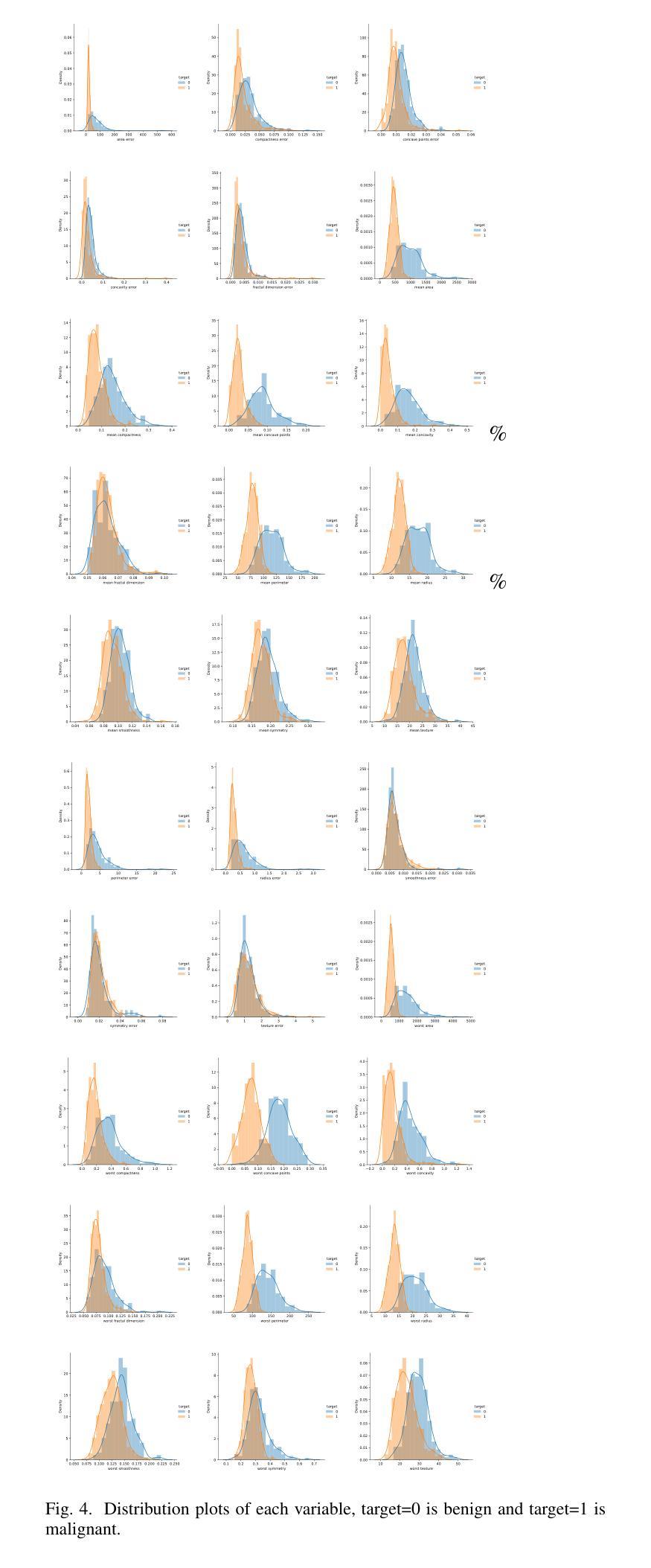

Exploring Machine Learning Models for Lung Cancer Level Classification: A comparative ML Approach

Authors:Mohsen Asghari Ilani, Saba Moftakhar Tehran, Ashkan Kavei, Hamed Alizadegan

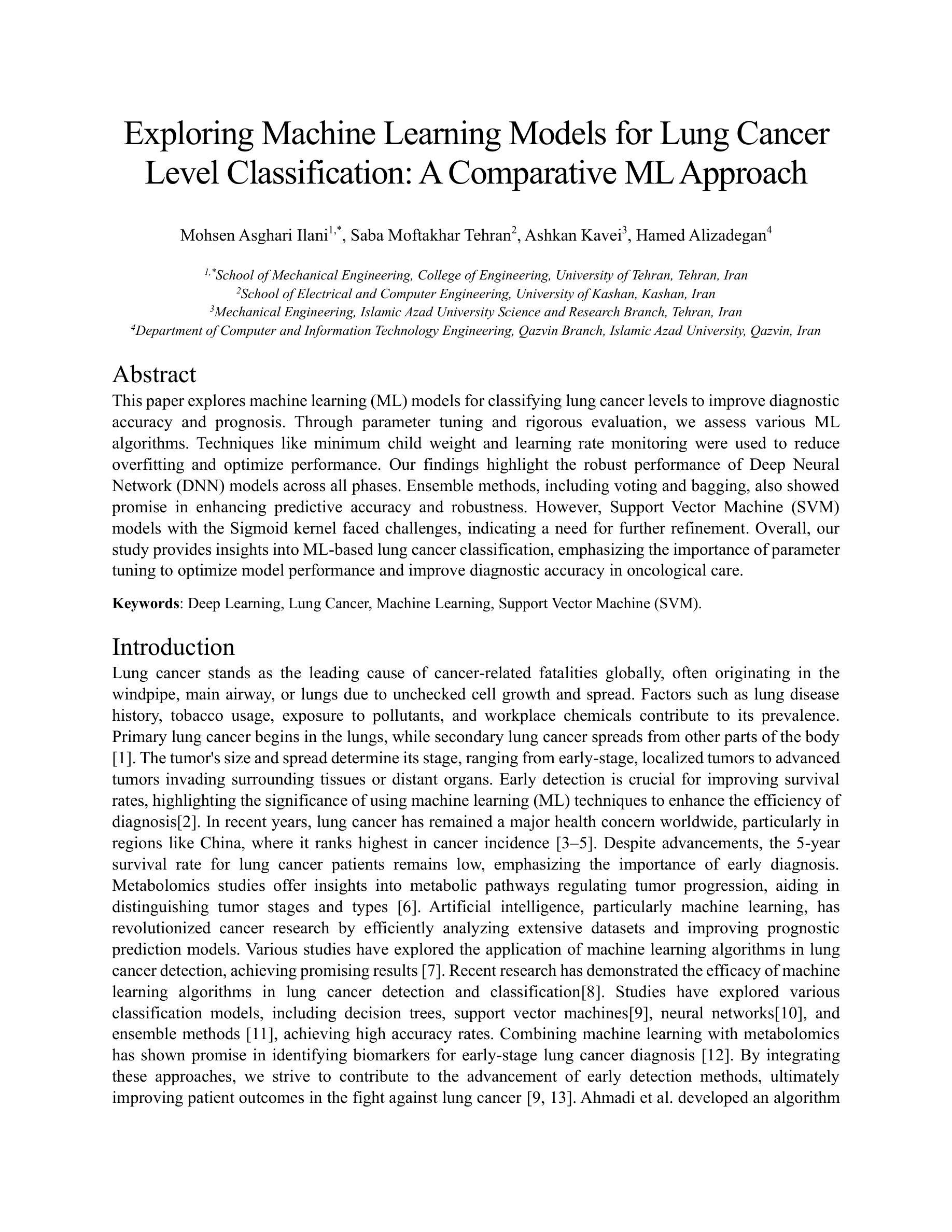

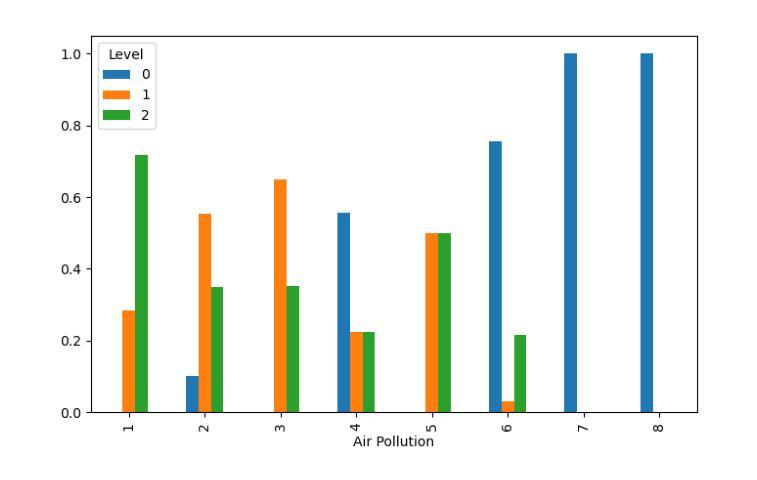

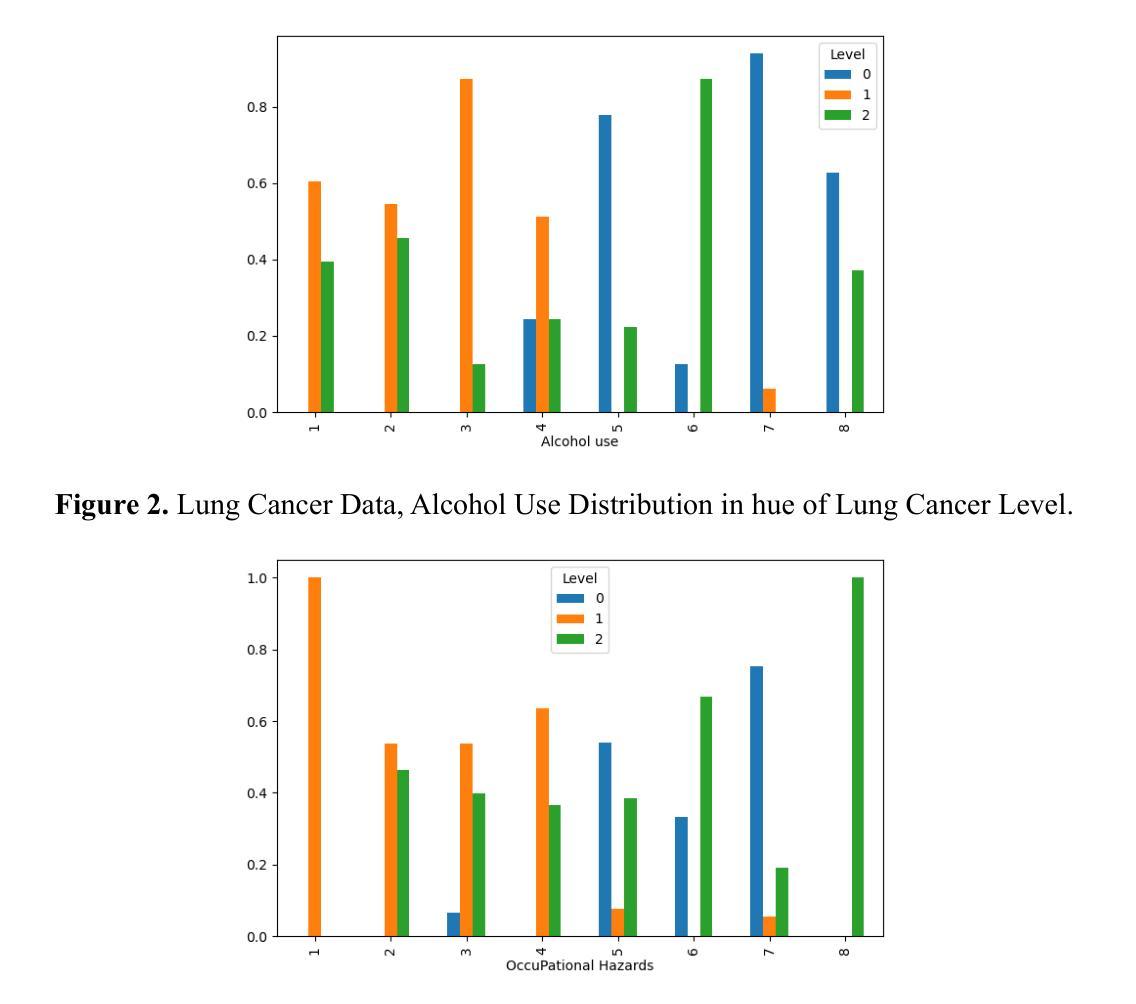

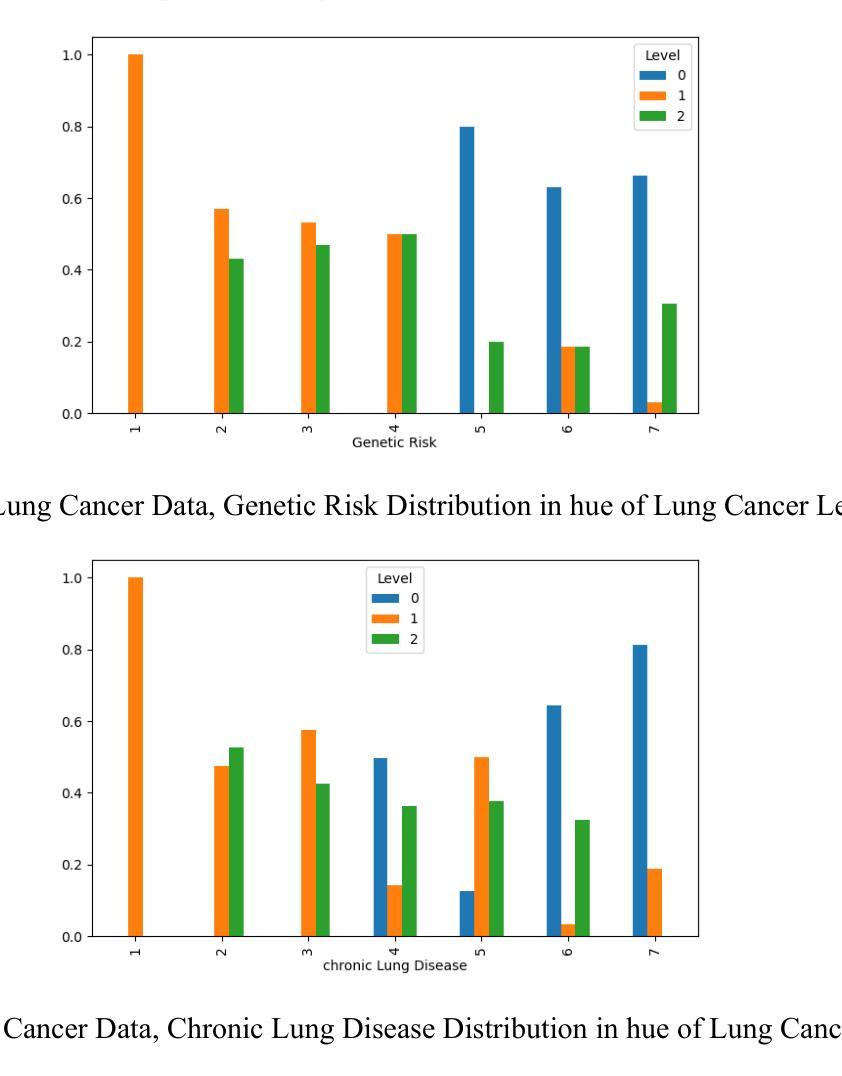

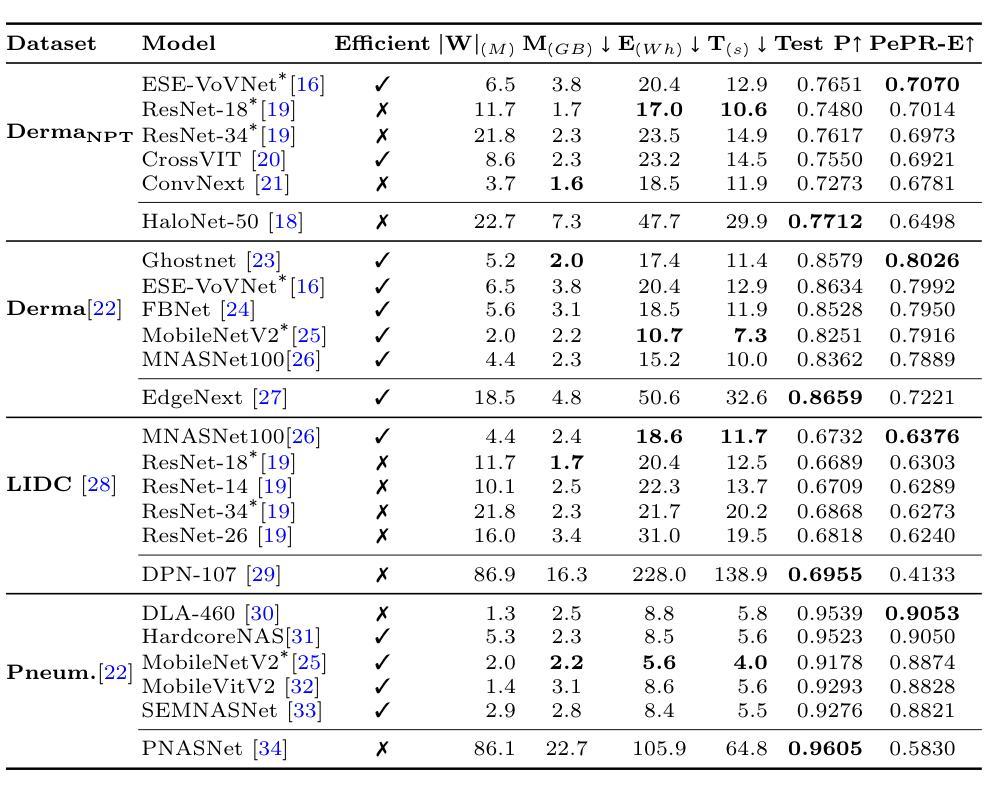

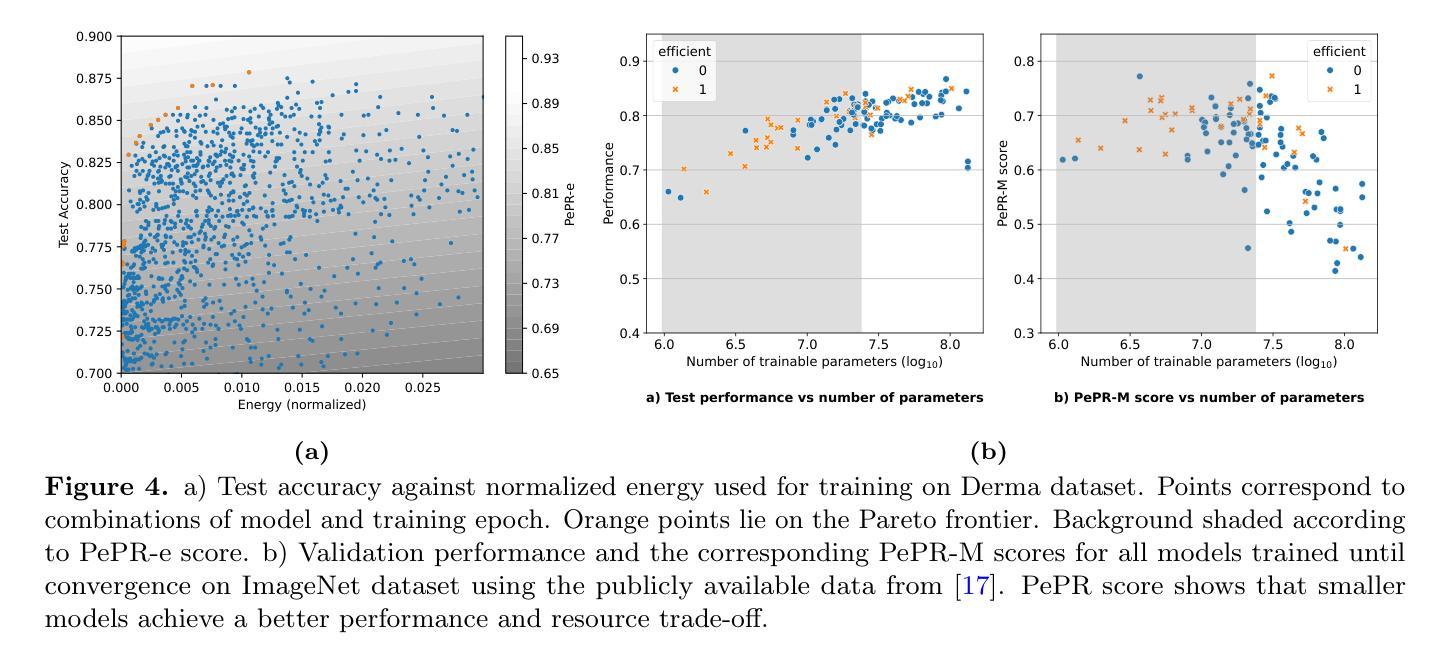

This paper explores machine learning (ML) models for classifying lung cancer levels to improve diagnostic accuracy and prognosis. Through parameter tuning and rigorous evaluation, we assess various ML algorithms. Techniques like minimum child weight and learning rate monitoring were used to reduce overfitting and optimize performance. Our findings highlight the robust performance of Deep Neural Network (DNN) models across all phases. Ensemble methods, including voting and bagging, also showed promise in enhancing predictive accuracy and robustness. However, Support Vector Machine (SVM) models with the Sigmoid kernel faced challenges, indicating a need for further refinement. Overall, our study provides insights into ML-based lung cancer classification, emphasizing the importance of parameter tuning to optimize model performance and improve diagnostic accuracy in oncological care.

本文探讨了利用机器学习(ML)模型对肺癌等级进行分类,以提高诊断准确性和预后预测的方法。通过参数调整和严格评估,我们评估了多种ML算法。采用最小子节点增长和学习速率监测等技术以减少过度拟合并优化性能。我们的研究结果突出了深度神经网络(DNN)模型在所有阶段的稳健性能。集成方法,包括投票和集成袋,也显示出在提高预测准确性和稳健性方面的潜力。然而,使用Sigmoid内核的支持向量机(SVM)模型面临挑战,表明需要进一步改进。总体而言,本研究为基于ML的肺癌分类提供了见解,强调参数调整在优化模型性能和提高肿瘤护理中的诊断准确性方面的重要性。

论文及项目相关链接

Summary

医学图像领域机器学习模型在肺癌分类中的应用。通过参数调整与严格评估,发现深度神经网络模型表现稳健,集成方法能提高预测精度和稳健性。支持向量机模型需进一步优化。研究为提高肺癌诊断准确性提供了见解。

Key Takeaways

- 机器学习模型被应用于医学图像领域以分类肺癌水平,旨在提高诊断准确性和预后。

- 通过参数调整和严格评估,发现深度神经网络模型在所有阶段都表现出稳健的性能。

- 集成方法(如投票和bagging)提高了预测精度和稳健性。

- 支持向量机模型使用Sigmoid核时面临挑战,需要进一步改进。

- 研究强调了参数调整在优化模型性能和提高肺癌诊断准确性方面的重要性。

- 研究结果可为医学图像领域的肺癌分类提供有价值的见解。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是利用机器学习(ML)模型对肺癌水平进行分类,以提高诊断的准确性和预后。具体来说,论文通过参数调整和严格评估各种ML算法,探讨了不同模型在肺癌水平分类任务中的性能,旨在通过优化模型性能来改善肿瘤学护理中的诊断准确性。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的研究:

肺癌风险预测与机器学习模型:

- Dritsas E, Trigka M. 在《Big Data and Cognitive Computing》上发表的论文《Lung Cancer Risk Prediction with Machine Learning Models》。[参考文献 1]

基于基因表达水平的肺癌分类机器学习算法评估:

- Podolsky MD 等人在《Asian Pacific Journal of Cancer Prevention》上发表的论文《Evaluation of Machine Learning Algorithm Utilization for Lung Cancer Classification Based on Gene Expression Levels》。[参考文献 2]

机器学习方法预测肺癌对肿瘤反应:

- El Naqa I 在《Wiley Interdiscip Rev Data Min Knowl Discov》上发表的论文《Machine learning methods for predicting tumor response in lung cancer》。[参考文献 6]

基于质谱的肺癌预测机器学习方法:

- Hilario M 等人在《Proteomics》上发表的论文《Machine learning approaches to lung cancer prediction from mass spectra》。[参考文献 7]

机器学习在肺癌检测中的应用:

- Singh GAP, Gupta PK 在《Neural Comput Appl》上发表的论文《Performance analysis of various machine learning-based approaches for detection and classification of lung cancer in humans》。[参考文献 9]

基于集成特征选择和机器学习方法的肺癌分类:

- Cai Z 等人在《Mol Biosyst》上发表的论文《Classification of lung cancer using ensemble-based feature selection and machine learning methods》。[参考文献 10]

使用机器学习算法的肺癌检测比较研究:

- Radhika PR 等人在《Proceedings of 2019 3rd IEEE International Conference on Electrical, Computer and Communication Technologies, ICECCT 2019》上发表的论文《A Comparative Study of Lung Cancer Detection using Machine Learning Algorithms》。[参考文献 11]

使用常规临床和实验室数据的机器学习进行早期肺癌识别:

- Gould MK 等人在《Am J Respir Crit Care Med》上发表的论文《Machine learning for early lung cancer identification using routine clinical and laboratory data》。[参考文献 12]

这些研究涵盖了机器学习在肺癌风险预测、分类、检测以及早期识别等多个方面的应用,为本研究提供了理论和实证基础。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决肺癌水平分类的问题:

数据收集与预处理:

- 从全球多样化的数据源(如世界卫生组织、Kaggle和Google数据集)中收集数据,确保数据集具有代表性,并能够覆盖不同的地理区域和临床情况。

- 对数据进行严格的清洗和预处理,以建立特征与目标变量之间的有意义关系。

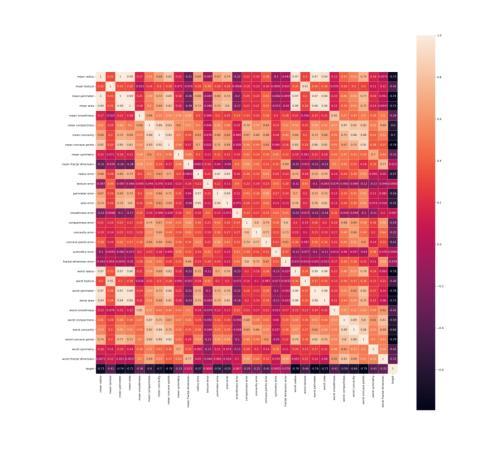

特征选择:

- 通过相关性分析识别与肺癌水平有显著相关性的特征,创建新的数据框列以增强模型的预测效果。

- 移除相关性较低的特征,以避免模型过拟合。

数据分割:

- 使用MinMaxScaler进行数据标准化,确保特征尺度统一。

- 应用SMOTE技术处理类别不平衡问题,以促进训练数据中少数类别的均衡表示。

- 采用train_test_split方法进行数据划分,保持训练集和测试集类别分布的一致性。

模型训练与评估:

- 使用k折交叉验证(k=5)来评估模型性能,减少过拟合的风险,并提供模型性能的准确估计。

- 训练六种不同的机器学习模型,包括深度神经网络(DNN)、投票分类器、Bagging、以及采用不同核函数的支持向量机(SVM)。

模型优化与调整:

- 通过调整最小子权重和学习率等超参数来控制模型复杂性,防止过拟合。

- 监控训练和验证误差,确保模型在不同数据集上具有良好的泛化能力。

结果分析:

- 分析不同模型的性能,比较它们的准确性、精确度、召回率和F1分数。

- 通过混淆矩阵和学习曲线评估模型的稳定性和收敛行为。

结论与未来研究方向:

- 基于模型性能的比较分析,总结每种模型的优势和局限性。

- 提出未来研究的方向,包括进一步优化ML算法和技术,以提高肺癌分类的准确性和可靠性。

通过这些步骤,论文旨在提供一个基于机器学习的肺癌水平分类框架,以提高诊断的准确性和预后,并为未来的研究提供坚实的基础。

Q: 论文做了哪些实验?

A: 根据论文内容,以下是进行的实验和分析:

数据收集与预处理:

- 从多个公共数据源收集数据,并对数据进行清洗和预处理,以建立特征与目标变量之间的有意义关系。

特征选择与工程:

- 通过相关性分析识别与肺癌水平有显著相关性的特征,并据此创建新的数据框列,以增强模型的预测效果。

- 对特征进行组合以形成新的数据列,增强数据集的预测能力。

数据分割:

- 使用MinMaxScaler进行数据标准化处理。

- 应用SMOTE技术处理类别不平衡问题。

- 采用train_test_split方法进行数据划分,保持训练集和测试集类别分布的一致性。

模型训练与评估:

- 训练六种不同的机器学习模型,包括深度神经网络(DNN)、投票分类器、Bagging以及采用不同核函数的支持向量机(SVM)。

- 使用k折交叉验证(k=5)来评估模型性能,减少过拟合的风险,并提供模型性能的准确估计。

性能监测与优化:

- 监控训练和验证误差,调整最小子权重和学习率等超参数,以控制模型复杂性,防止过拟合。

结果分析:

- 分析不同模型的性能,比较它们的准确性、精确度、召回率和F1分数。

- 使用混淆矩阵和学习曲线评估模型的稳定性和收敛行为。

模型性能比较:

- 提供了详细的比较分析图表,展示了不同模型在各种评估指标上的性能。

这些实验和分析构成了论文的主要研究内容,旨在评估和比较不同机器学习模型在肺癌水平分类任务中的性能,并探索提高诊断准确性和预后的方法。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

改进和优化模型架构:

- 对于表现不佳的模型,如SVM与Sigmoid核,进一步调整和优化其超参数,以提高其性能。

- 探索不同的神经网络架构,例如卷积神经网络(CNN)或循环神经网络(RNN),以处理可能的图像或时间序列肺癌数据。

集成学习和模型融合:

- 研究不同的集成学习技术,如Stacking或Blending,以结合多个模型的预测,提高整体分类性能。

- 探索模型融合策略,比如通过加权平均或学习最优权重来组合不同模型的输出。

特征重要性分析:

- 进行更深入的特征选择和特征重要性分析,以识别对肺癌分类最有影响的特征。

- 使用先进的特征选择方法,如基于模型的特征选择或基于聚类的特征选择。

数据增强和合成数据生成:

- 应用数据增强技术,如图像旋转、缩放等,以增加数据多样性并提高模型的泛化能力。

- 使用生成模型,如生成对抗网络(GANs),生成合成的肺癌数据以解决数据不平衡问题。

多模态数据融合:

- 结合不同类型的数据(如基因组数据、影像数据和临床数据)进行多模态学习,以提高肺癌分类的准确性。

跨数据集验证:

- 在更多的数据集上验证模型性能,包括不同地区、不同人群的数据集,以测试模型的泛化能力。

实时数据和动态学习:

- 探索实时数据流的机器学习模型,以适应随时间变化的肺癌诊断模式。

- 开发动态学习系统,能够根据新数据不断更新和调整模型。

解释性和可视化:

- 提高模型的可解释性,使医生和研究人员能够理解模型的决策过程。

- 开发可视化工具,以直观展示模型发现的模式和关系。

临床试验和实际应用:

- 与医疗机构合作,进行临床试验,以评估模型在实际医疗环境中的表现和影响。

- 探索将机器学习模型集成到电子健康记录和临床决策支持系统中。

伦理和社会影响考量:

- 研究机器学习模型在医疗诊断中的伦理问题,如隐私保护、数据安全和算法偏见。

- 探讨机器学习技术在肺癌诊断中应用的社会和经济影响。

这些探索点可以帮助研究人员和开发者进一步提高肺癌分类的准确性,优化模型性能,并推动机器学习技术在医疗健康领域的应用。

Q: 总结一下论文的主要内容

A: 本文的主要内容概括如下:

研究目的:

- 探索机器学习(ML)模型在肺癌水平分类中的应用,旨在提高诊断的准确性和预后。

数据收集与预处理:

- 从全球多样化的数据源收集数据,并进行严格的清洗和预处理,以建立特征与目标变量之间的有意义关系。

特征工程:

- 通过相关性分析识别与肺癌水平显著相关的特征,并通过特征组合增强数据集的预测能力。

数据分割:

- 使用MinMaxScaler进行数据标准化,SMOTE技术处理类别不平衡问题,并采用train_test_split方法进行数据划分。

模型训练与评估:

- 训练六种不同的机器学习模型,包括深度神经网络(DNN)、投票分类器、Bagging以及采用不同核函数的支持向量机(SVM)。

- 使用k折交叉验证评估模型性能,减少过拟合的风险,并提供模型性能的准确估计。

性能监测与优化:

- 监控训练和验证误差,调整最小子权重和学习率等超参数,以控制模型复杂性,防止过拟合。

结果分析:

- 分析不同模型的性能,比较它们的准确性、精确度、召回率和F1分数。

- 使用混淆矩阵和学习曲线评估模型的稳定性和收敛行为。

结论与未来研究方向:

- 基于模型性能的比较分析,总结每种模型的优势和局限性,并提出未来研究的方向。

总的来说,论文通过综合评估多种机器学习模型在肺癌水平分类任务中的性能,并探索提高诊断准确性和预后的方法,为未来的研究提供了坚实的基础。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

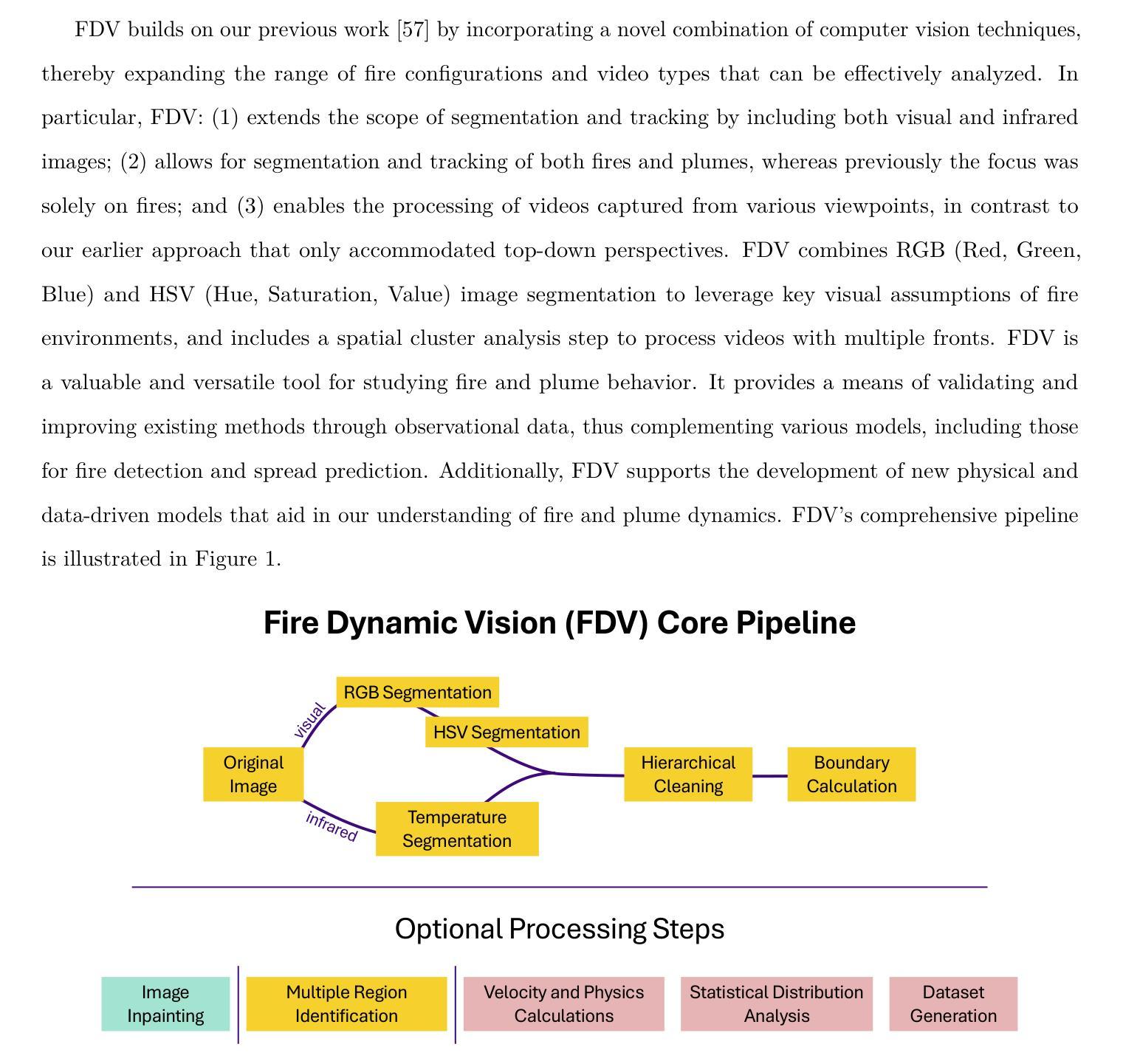

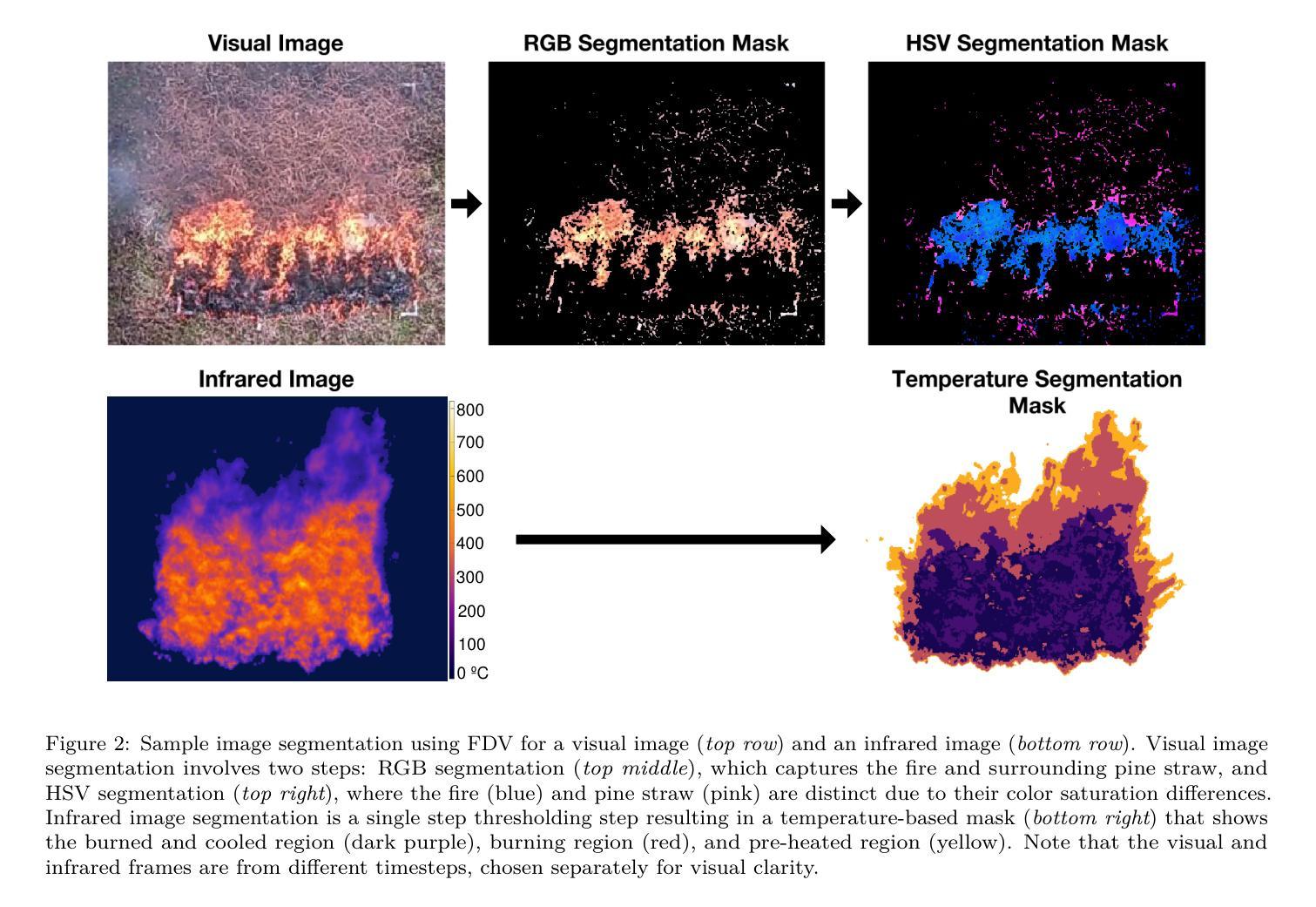

Fire Dynamic Vision: Image Segmentation and Tracking for Multi-Scale Fire and Plume Behavior

Authors:Daryn Sagel, Bryan Quaife

The increasing frequency and severity of wildfires highlight the need for accurate fire and plume spread models. We introduce an approach that effectively isolates and tracks fire and plume behavior across various spatial and temporal scales and image types, identifying physical phenomena in the system and providing insights useful for developing and validating models. Our method combines image segmentation and graph theory to delineate fire fronts and plume boundaries. We demonstrate that the method effectively distinguishes fires and plumes from visually similar objects. Results demonstrate the successful isolation and tracking of fire and plume dynamics across various image sources, ranging from synoptic-scale ($10^4$-$10^5$ m) satellite images to sub-microscale ($10^0$-$10^1$ m) images captured close to the fire environment. Furthermore, the methodology leverages image inpainting and spatio-temporal dataset generation for use in statistical and machine learning models.

野火的频率和严重程度不断增加,凸显了对准确火势和烟羽扩散模型的需求。我们介绍了一种方法,该方法可以有效地在不同空间和时间尺度以及不同类型的图像中隔离和追踪火势和烟羽行为,识别系统中的物理现象,并为开发和验证模型提供有用的见解。我们的方法结合了图像分割和图论来划分火线和烟羽边界。我们证明该方法可以有效地将火势和烟羽与视觉上相似的物体区分开来。结果展示了在各种图像源中火势和烟羽动态的成功隔离和追踪,从宏观尺度的卫星图像($10^4$-$10^5$米)到接近火环境的微观尺度图像($10^0$-$10^1$米)。此外,该方法还利用图像修复和时空数据集生成,用于统计和机器学习模型。

论文及项目相关链接

Summary

本文介绍了一种结合图像分割和图论的方法,用于在不同空间和时间尺度以及不同类型的图像中有效识别和追踪火灾和烟羽行为。该方法能够区分火灾和烟羽与视觉上相似的物体,并为开发和验证模型提供有用的见解。此外,该方法还利用图像修复和时空数据集生成技术,为统计和机器学习模型提供数据。

Key Takeaways

- 介绍了结合图像分割和图论的方法,有效识别和追踪火灾和烟羽行为。

- 方法可以在不同空间和时间尺度以及多种类型的图像中应用。

- 通过区分火灾和烟羽与视觉上相似的物体,为模型开发和验证提供有价值的信息。

- 利用图像修复技术提高模型的性能。

- 该方法可用于生成时空数据集,为统计和机器学习模型提供数据。

- 该方法对于应对日益频繁和严重的野火灾害具有重要意义。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了一种名为Fire Dynamic Vision (FDV) 的方法,旨在解决以下问题:

野火和烟羽行为的准确模型需求:随着全球大型野火的频率和严重性的增加,需要更深入地理解和更精确的预测野火及烟羽行为的能力。这对于土地管理者、消防人员和政策制定者来说尤为关键,因为他们面临着日益增长的城市-野生界面、更强烈的火灾、空气质量法规和越来越窄的计划燃烧窗口等问题。

复杂火行为的多尺度、多物理和多视角建模挑战:火灾的驱动元素(大气、热量、燃料)之间存在复杂的相互作用,表现出跨物理和时间尺度的多变性。这导致了多方面、多物理和多尺度的系统特性,开发和验证统计上准确的模型和数值方法仍然是一个挑战。

现有火灾和烟羽动态测量方法的局限性:传统的测量仪器(如风速计、温度计等)通常昂贵,并且只能在一两个位置记录稀疏的测量数据。此外,设备需要防火保护,这常常使得在燃烧领域内测量小尺度特征变得困难或不可能。

图像和视频资料在火灾研究中的未充分利用:尽管摄像头是捕捉火灾和烟羽特征的优秀工具,但现有的计算机视觉工具和黑盒算法通常不适合研究火环境中的湍流运动。

为了解决这些问题,FDV方法结合了图像分割和图论来划分火前线和烟羽边界,能够有效地区分火灾和烟羽与视觉上相似的物体。该方法成功地在不同图像源(从大尺度的卫星图像到近距离捕捉的亚微观尺度图像)中隔离和跟踪火和烟羽动态,并利用图像修复和时空数据集生成,用于统计和机器学习模型。

Q: 有哪些相关研究?

A: 根据提供的论文内容,相关研究主要集中在以下几个领域:

火灾和烟羽动态模型:研究人员开发了多种模型来描述火灾和烟羽动力学,这些模型涵盖了从景观尺度到热解和燃烧尺度的范围。这些模型需要大量的计算工作,并且必须用实地收集的数据进行验证和校准。

图像分割和聚类分析:在计算机视觉应用中,仅依赖RGB分割通常被认为是不够的。HSV颜色空间因其在分割时的成功而被广泛记录,特别是在区分具有相似RGB颜色的对象时。此外,k-means、模糊c-均值和DBSCAN等聚类分析方法被广泛应用于卫星图像的分析。

基于视频的跟踪:跟踪火或烟羽的边界对于研究人员和从业者都很重要。粒子图像测速(PIV)或热图像测速(TIV)等光学流动方法被用来通过相关兴趣点和温度区域在连续帧之间跟踪演变结构。

基于视频的检测:近年来,机器学习领域在利用视觉视频进行火灾检测方面的兴趣显著增加。这在一定程度上归因于大型卫星图像数据集的可用性以及火焰区域和烟雾羽流的独特视觉外观。

图像修复:图像修复技术用于处理视频中的遮挡问题,如由于画面中的树木导致的分割结果中的间隙。这使得研究人员能够使用更广泛的视频源,而不受视频可用性特征的限制。

多尺度和多视图工具:FDV(Fire Dynamic Vision)是一个多尺度和多视图工具,它在视觉和红外视频以及统计解释火和烟羽动态中分割火和烟羽。

统计分析:使用马尔可夫链蒙特卡洛(MCMC)等方法对火和烟羽扩散的动态进行统计描述,以增强对潜在过程的理解。

这些研究为FDV方法的开发提供了理论基础和技术手段,使其能够有效地处理和分析火和烟羽行为的图像和视频数据。

Q: 论文如何解决这个问题?

A: 论文通过开发一个名为Fire Dynamic Vision (FDV) 的方法来解决上述问题。FDV是一个多尺度和多视图工具,它结合了图像分割和图论来隔离和跟踪火和烟羽行为。以下是FDV解决这些问题的关键步骤:

图像分割:FDV使用RGB和HSV颜色空间对视觉图像进行分割,同时对红外图像根据温度进行分割。这有助于区分火焰、燃烧区域和烟羽,即使它们在视觉上与周围环境相似。

边界计算和聚类分析:通过空间聚类分析方法(如DBSCAN)对分割后的图像进行清理和区域识别,然后使用α-shape算法计算每个感兴趣区域的边界。

跟踪和统计分析:FDV计算连续帧之间边界点的局部位移,并将这些位移转换为速度向量。然后,使用马尔可夫链蒙特卡洛(MCMC)方法对速度分布进行统计拟合,提供更准确的结果和误差范围。

数据集生成:FDV能够自动生成和格式化基于用户指定的区域和计算结果的时空数据集。这些数据集可以直接用于训练机器学习模型和进行统计分析。

图像修复:FDV可选地使用图像修复技术来处理视频中的遮挡问题,如树木导致的间隙,使得研究人员能够利用更广泛的视频源生成空间连续的数据集。

多尺度和多视角处理:FDV能够处理从微观尺度(如几米)到宏观尺度(如数十公里)的图像,并且可以处理从不同视角(如顶视图和侧视图)捕获的视频。

通过这些方法,FDV能够有效地从各种图像源中隔离和跟踪火和烟羽动态,为火灾行为建模和验证提供详细的观察数据。此外,FDV的自动化数据处理和分析功能提高了火灾行为分析的效率和准确性,使其成为该领域研究人员和从业者的宝贵工具。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了一系列实验来验证Fire Dynamic Vision (FDV) 方法的有效性。这些实验包括:

分布拟合实验:作者使用MCMC(马尔可夫链蒙特卡洛)和矩匹配方法对火线传播速度和燃烧时间的统计分布进行了拟合。实验结果表明,MCMC在拟合分布时比矩匹配方法更为准确,并且能够提供误差范围。

亚微观尺度火势扩散实验:作者使用FDV处理了在2米 x 2米松针燃料床上进行的火势扩散的红外和视觉图像数据。通过比较红外和视觉数据,作者分析了火势在水平(x-y)平面上的结构和运动。

视觉数据不同采样率的比较实验:作者探讨了视觉视频以不同采样率(1 Hz和2 Hz)记录时,FDV计算出的火势扩散速度分布的差异。实验结果表明,尽管最大和最小值有所不同,但两种采样率下的速度分布形状相似。

微观尺度烟羽演变实验:作者分析了在10米 x 10米松针燃料床上进行的烟羽扩散实验的视觉图像数据。这些数据以30 Hz的频率记录,并使用FDV计算了烟羽边界的演变和速度。

不同火势几何形态的分割和边界计算:作者展示了FDV在处理环状火势和两个接近的侧翼火势前线等更复杂的火势几何形态时的分割和边界计算能力。

卫星图像的分析:作者还简要展示了FDV在分析卫星图像上的潜力,尽管更深入的分析被留给了未来的工作。

这些实验覆盖了从微观到宏观的不同尺度,包括了不同的图像源和视角,验证了FDV方法在多种情况下的有效性和适用性。通过这些实验,作者展示了FDV在火势和烟羽行为分析中的实用性,并证明了其在自动生成用于机器学习和统计分析的数据集方面的潜力。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

多方向火势扩散分析:论文中提到了FDV处理环状火和两个接近的侧翼火前线的能力,但对多方向火势扩散和多个火焰前线之间相互作用的详细分析被保留为未来的工作。可以进一步研究这些复杂火势场景中的火焰动态。

结合视觉和红外数据的烟羽分析:论文提出了将FDV应用于结合视觉和红外数据的烟羽分析的可能性,但尚未进行深入研究。可以探索这种结合方法如何提高对烟羽行为的理解。

扩展烟羽物理计算:论文提到了烟羽物理计算(如涡度、扫掠和喷射等)的初步分析,表明不同实验间的趋势具有相似性。未来的工作可以扩展这些计算,以包括更多样化的烟羽情景。

图像稳定化方法:使用无人机或其他非固定数据捕获框架时,需要讨论图像稳定化方法。论文提到,火环境由于画面中大部分元素的不断运动和火焰可见度的变化,为图像稳定化带来了独特的挑战。可以进一步研究针对火环境的最优算法选择和每种方法引入误差的量化。

卫星图像的详细分析:论文简要展示了FDV在分析卫星图像方面的潜力。未来的工作可以更详细地分析宏观尺度的烟羽动态,以及与火灾研究相关的其他卫星测量,如大气化学化合物浓度。

算法优化和计算效率:虽然FDV已经在多种资源条件下表现出良好的效率,但进一步优化算法和提高计算效率始终是一个值得探索的方向,特别是在处理大规模数据集或实现实时分析时。

数据集和模型的进一步验证:论文中提到了FDV生成的数据集可以用于训练机器学习模型。可以进一步探索这些数据集在不同模型和算法中的应用,以及它们在实际火灾预测和分析中的有效性。

用户界面和可用性改进:为了使FDV更容易被非专业用户使用,可以探索开发更友好的用户界面和提高软件的可用性,包括自动化参数选择、增强的可视化工具和更直观的操作流程。

这些探索点不仅可以增强FDV作为一个研究工具的能力,还可能为火灾科学和应急管理领域带来新的见解和应用。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了一种名为Fire Dynamic Vision (FDV) 的方法,旨在提高对野火和烟羽行为的理解和预测能力。以下是论文的主要内容总结:

问题背景:论文指出了全球大型野火频率和严重性的增加,以及对更准确的火灾和烟羽行为预测模型的需求。强调了火灾的复杂性,以及现有模型和测量方法的局限性。

FDV方法介绍:FDV结合了图像分割、图论和统计分析技术,用于从各种图像源(包括卫星图像、无人机拍摄的图像和近距离拍摄的图像)中分割和跟踪火和烟羽行为。

图像分割:FDV使用RGB和HSV颜色空间对视觉图像进行分割,同时对红外图像进行基于温度的分割。这种方法有助于区分火焰、燃烧区域和烟羽,即使它们在视觉上与周围环境相似。

边界计算和聚类分析:通过空间聚类分析方法(如DBSCAN)对分割后的图像进行清理和区域识别,然后使用α-shape算法计算每个感兴趣区域的边界。

跟踪和统计分析:FDV计算连续帧之间边界点的位移,并将其转换为速度向量。使用马尔可夫链蒙特卡洛(MCMC)方法对速度分布进行统计拟合,提供更准确的结果和误差范围。

数据集生成:FDV能够自动生成和格式化基于用户指定的区域和计算结果的时空数据集,这些数据集可以直接用于训练机器学习模型和进行统计分析。

图像修复:FDV可选地使用图像修复技术来处理视频中的遮挡问题,如树木导致的间隙,使得研究人员能够利用更广泛的视频源生成空间连续的数据集。

实验验证:论文通过一系列实验验证了FDV方法的有效性,包括分布拟合、亚微观尺度火势扩散、视觉数据不同采样率的比较、微观尺度烟羽演变等。

应用和未来工作:论文讨论了FDV在处理不同火势几何形态、卫星图像分析等方面的应用潜力,并提出了未来研究的方向,包括多方向火势扩散分析、结合视觉和红外数据的烟羽分析等。

总体而言,FDV提供了一个强大的工具,用于分析和理解火灾和烟羽行为,有助于改进火灾模型的验证和预测能力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

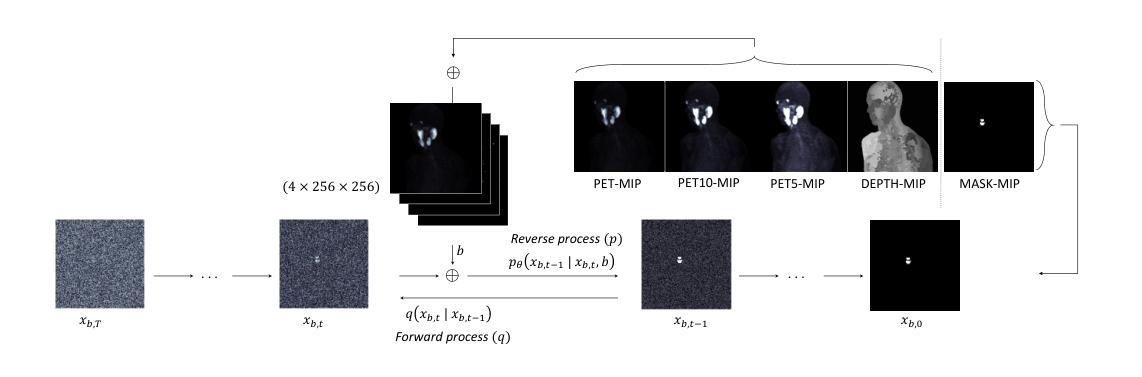

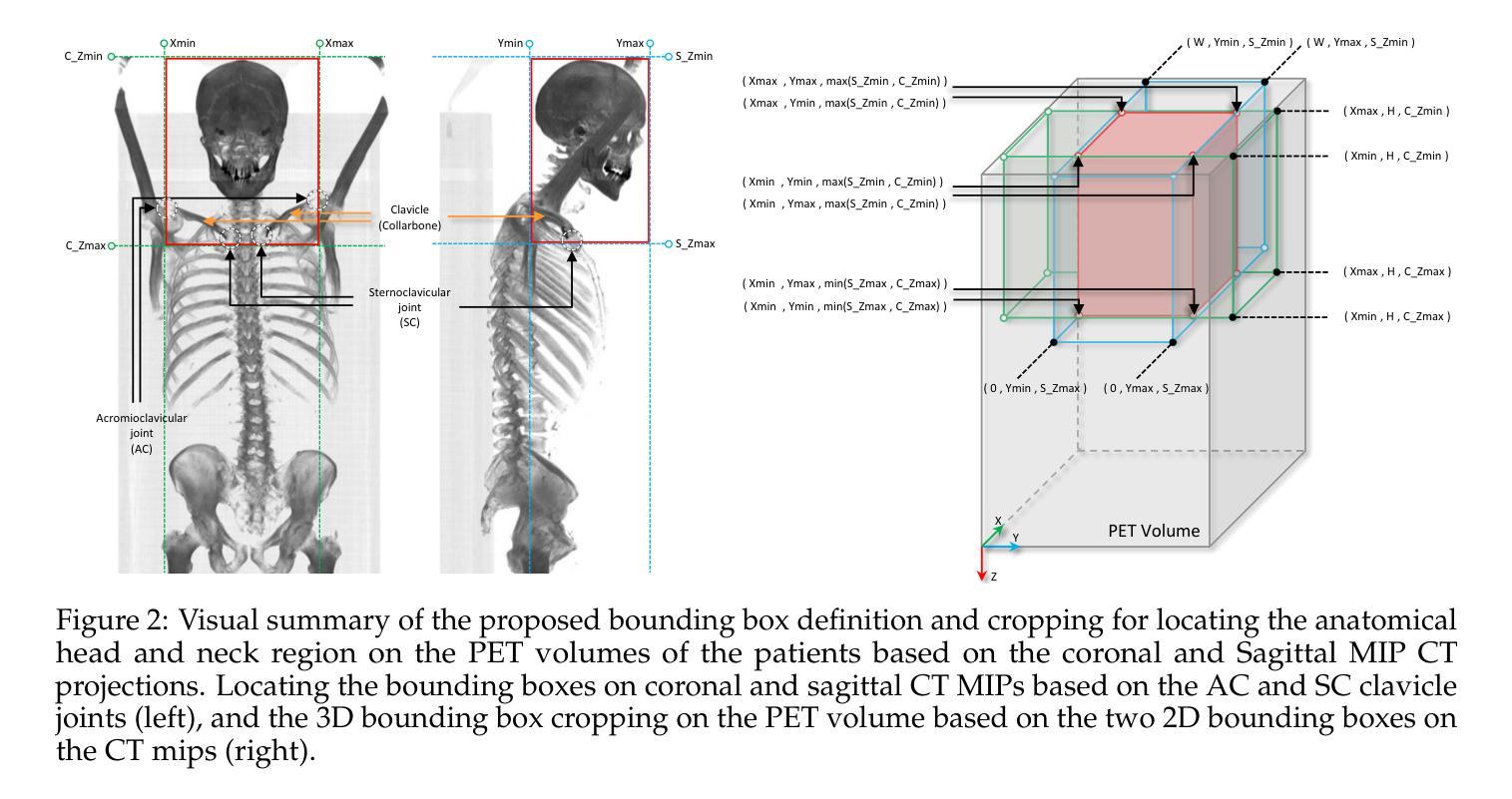

How to Segment in 3D Using 2D Models: Automated 3D Segmentation of Prostate Cancer Metastatic Lesions on PET Volumes Using Multi-angle Maximum Intensity Projections and Diffusion Models

Authors:Amirhosein Toosi, Sara Harsini, François Bénard, Carlos Uribe, Arman Rahmim

Prostate specific membrane antigen (PSMA) positron emission tomography/computed tomography (PET/CT) imaging provides a tremendously exciting frontier in visualization of prostate cancer (PCa) metastatic lesions. However, accurate segmentation of metastatic lesions is challenging due to low signal-to-noise ratios and variable sizes, shapes, and locations of the lesions. This study proposes a novel approach for automated segmentation of metastatic lesions in PSMA PET/CT 3D volumetric images using 2D denoising diffusion probabilistic models (DDPMs). Instead of 2D trans-axial slices or 3D volumes, the proposed approach segments the lesions on generated multi-angle maximum intensity projections (MA-MIPs) of the PSMA PET images, then obtains the final 3D segmentation masks from 3D ordered subset expectation maximization (OSEM) reconstruction of 2D MA-MIPs segmentations. Our proposed method achieved superior performance compared to state-of-the-art 3D segmentation approaches in terms of accuracy and robustness in detecting and segmenting small metastatic PCa lesions. The proposed method has significant potential as a tool for quantitative analysis of metastatic burden in PCa patients.

前列腺特异性膜抗原(PSMA)正电子发射断层扫描/计算机断层扫描(PET/CT)成像为可视化前列腺癌(PCa)转移病灶提供了一个非常激动人心的前沿领域。然而,由于信号与噪声比较低以及病灶大小、形状和位置的差异,准确分割转移病灶是一个挑战。本研究提出了一种新的方法,利用二维去噪扩散概率模型(DDPMs)自动分割PSMA PET/CT三维容积图像中的转移病灶。该方法不是在二维横断面切片或三维体积上进行分割,而是在生成的PSMA PET图像的多角度最大强度投影(MA-MIPs)上进行病灶分割,然后从二维MA-MIPs分割的3D有序子集期望最大化(OSEM)重建中获得最终的3D分割掩膜。与最先进的3D分割方法相比,我们所提出的方法在检测和分割小型转移性PCa病灶的准确性和稳健性方面表现出卓越的性能。该方法作为定量分析工具评估PCa患者的转移负担具有显著潜力。

论文及项目相关链接

PDF 11 pages, 2 figures, accepted in the DGM4MICCAI workshop, MICCAI, 2024

Summary

PSMA PET/CT成像在前列腺癌转移灶的可视化方面有着巨大的潜力,但准确分割转移灶是一个挑战。本研究提出了一种基于二维去噪扩散概率模型(DDPMs)的自动化分割方法,该方法在PSMA PET图像的多个角度最大强度投影(MA-MIPs)上进行分割,然后从二维MA-MIPs分割的3D有序子集期望最大化(OSEM)重建中获得最终的3D分割掩膜。该方法在检测和小型转移前列腺癌病灶的分割方面表现出卓越的性能和稳健性,有望作为定量评估前列腺癌患者转移负担的工具。

Key Takeaways

- PSMA PET/CT成像在可视化前列腺癌转移灶方面具有巨大潜力。

- 准确分割转移灶具有挑战性,原因在于信号噪声比低以及病灶大小、形状和位置的多样性。

- 本研究提出了一种新的自动化分割方法,该方法基于二维去噪扩散概率模型(DDPMs)。

- 该方法在MA-MIPs上进行分割,然后结合3D OSEM重建获得最终的3D分割掩膜。

- 该方法在检测和小型转移前列腺癌病灶的分割方面表现出卓越的性能。

- 该方法相较于现有的其他三维分割方法具有更高的准确性和稳健性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一种新的方法,用于在前列腺特异性膜抗原(PSMA)正电子发射断层扫描/计算机断层扫描(PET/CT)的3D容积图像中自动分割前列腺癌(PCa)转移性病变。这项研究的主要挑战在于,由于转移性病变的信号-噪声比较低、大小、形状和位置的变异性,使得准确分割这些病变变得困难。论文中提出的解决方案是利用2D去噪扩散概率模型(DDPMs)在生成的多角度最大强度投影(MA-MIPs)上进行病变分割,然后从2D MA-MIPs分割的3D有序子集期望最大化(OSEM)重建中获得最终的3D分割掩模。这种方法在检测和分割小的转移性前列腺癌病变方面,与现有的最先进的3D分割方法相比,展现出了更高的准确性和鲁棒性。

Q: 有哪些相关研究?

A: 论文中提到了若干相关研究,主要集中在以下几个方面:

前列腺癌的诊断和治疗决策:前列腺癌的复发可能表现为区域淋巴结和骨骼结构的转移。随着疾病进展,可能还会涉及到肝脏和肺部等其他部位。因此,精确识别复发位置对于治疗决策至关重要。

PSMA-PET/CT成像:正电子发射断层扫描(PET)成像技术的最新进展提高了对许多类型原发和转移性病变的检测和定量能力。特别是针对PSMA的PET放射性药物,如[18F]DCFPyL,与传统成像方式相比具有更高的灵敏度和特异性。

深度学习算法在计算机辅助诊断中的应用:深度学习算法在医学图像分割和检测方面展现出巨大潜力,但它们必须应对成像方式带来的挑战,包括低对比度、患者间和患者内的高度异质性,以及图像中的模糊和噪声。

前列腺癌转移性病变的分割:论文中提到了使用深度学习算法进行前列腺癌肿瘤/转移性病变检测和分割的先前研究,但这些研究主要集中在局部原发性(前列腺内)肿瘤分割,这是一个相对容易的任务。

2D和3D分割方法:论文中提到了在前列腺癌复发患者的数据集上评估基于卷积神经网络(CNN)的分割模型的性能的研究。

扩散模型(Diffusion Models):论文中使用了一种去噪扩散概率模型(DDPM),这是一种用于图像分割的深度学习模型,它通过在2D图像上训练并在3D容积上应用来实现分割。

有序子集期望最大化(OSEM)算法:这是一种在医学成像中广泛使用的迭代重建技术,用于从不同角度获取的2D投影数据重建3D容积图像。

多角度最大强度投影(MA-MIPs):论文中提出了一种新颖的方法,使用MA-MIPs来增强2D分割模型的性能,并通过OSEM算法将2D分割结果重建为3D分割掩模。

这些研究为论文提出的新方法提供了理论和技术基础,并帮助作者构建了一个在前列腺癌转移性病变分割方面具有优越性能的自动化系统。

Q: 论文如何解决这个问题?

A: 论文提出了一种创新的方法来解决前列腺癌转移性病变在PSMA PET/CT 3D容积图像中的自动分割问题。具体解决方案包括以下几个关键步骤:

多角度最大强度投影(MA-MIPs)生成:首先,从PSMA PET图像数据中生成MA-MIPs。这些投影通过在多个角度(每5度一个)旋转原始3D体积数据来创建,以增强病变的可视化并减少背景噪声。

数据预处理:将PSMA-PET的活性浓度值转换为标准摄取值(SUV),并对SUV值进行裁剪,以降低高摄取正常器官与小病变之间的对比度。此外,对CT和PET图像进行重采样和裁剪,以统一图像尺寸。

2D去噪扩散概率模型(DDPM):使用DDPM进行2D图像分割。DDPM通过在正向过程中逐步添加高斯噪声,然后在反向过程中逐步去除噪声来训练模型。这种方法利用了U-Net架构的网络,通过L2损失进行训练。

3D分割的OSEM重建:使用有序子集期望最大化(OSEM)算法,将2D分割掩模重建为3D分割体积。OSEM算法通常用于从2D投影数据中重建3D图像,这里创新性地应用于从2D MA-MIPs分割结果中重建3D分割掩模。

模型训练与评估:使用U-Net作为DDPM模型的骨干网络进行训练。模型在NVIDIA V100 GPU上训练,并使用Adam优化器进行优化。训练完成后,使用测试集评估模型性能。

性能比较:将所提出的基于MIP-DDPM的方法与现有的最先进的3D分割方法进行比较,以验证新方法的有效性。

通过这种方法,论文成功地提高了小转移性前列腺癌病变的检测和分割的准确性和鲁棒性,为前列腺癌患者的量化分析提供了一个有潜力的工具。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来评估所提出的基于多角度最大强度投影(MA-MIPs)和2D去噪扩散概率模型(DDPM)的3D分割方法:

数据集准备:使用了510个全身体[18F]DCFPyL PSMA-PET/CT图像,这些图像来自经过初次治疗后生化复发的前列腺癌患者。

数据预处理:包括SUV值的转换和裁剪,以及CT和PET图像的重采样和裁剪。

MA-MIPs生成:对每个患者的PSMA-PET图像数据,生成72个不同角度的旋转体积,并计算这些体积的最大强度投影(MIPs)。

DDPM模型训练:使用U-Net作为DDPM模型的骨干网络,对MA-MIPs进行训练。训练使用了特定的噪声计划和优化器设置。

模型评估:在独立的测试集上评估DDPM模型的性能,包括生成多个分割掩模并进行集成,以提高分割精度。

3D重建:使用有序子集期望最大化(OSEM)算法,将2D分割掩模重建为3D分割体积。

性能比较:将所提出的MIP-DDPM方法与其他8种现有的最先进的3D分割方法进行比较,使用Dice分数、95百分位Hausdorff距离、Jaccard指数和体积误差百分比等指标。

视觉比较:在样本病例上,通过视觉比较展示了所提出方法与其他方法的分割结果。

临床意义讨论:讨论了所提出方法在早期检测转移性病变、改善管理决策方面的潜在临床应用。

这些实验结果表明,所提出的MIP-DDPM方法在分割精度、鲁棒性等方面优于现有的3D分割技术,为前列腺癌转移性病变的自动分割提供了一种有效的新工具。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了一种有效的3D分割方法,但仍有一些潜在的研究方向可以进一步探索,以提高性能或扩展应用:

算法优化:进一步优化DDPM模型,可能通过改进网络结构、调整训练策略或引入新的损失函数来提高分割精度。

数据增强:研究不同的数据增强技术,以增加训练数据的多样性并提高模型的泛化能力。

多模态融合:探索将PET/CT图像与其他成像模态(如MRI)结合,以提供更丰富的解剖和功能信息,可能有助于提高分割的准确性。

自动化阈值选择:研究自动化阈值选择方法,以替代固定的阈值(如0.5),可能有助于提高分割掩模的质量。

模型泛化能力:在不同的患者群体、不同的疾病阶段或不同的成像设备上测试模型的泛化能力。

计算效率:研究如何提高模型的计算效率,减少训练和推理时间,使其更适合实时或大规模临床应用。

模型解释性:提高模型的解释性,帮助医生理解模型的决策过程,增加模型在临床环境中的可接受性。

多任务学习:探索多任务学习方法,同时进行病变分割和其他相关任务(如病变检测、疾病分期)。

跨病变类型泛化:研究模型在不同类型病变(如肺癌、乳腺癌等)上的泛化能力,探索其在其他癌症类型中的应用潜力。

临床验证:在更大的患者群体中进行前瞻性临床试验,以验证模型在实际临床环境中的有效性和安全性。

集成学习:研究如何将所提出的方法与其他先进的分割技术结合,通过集成学习提高整体性能。

模型鲁棒性:研究模型在面对不同噪声水平、不同病变大小和形状时的鲁棒性,并探索提高鲁棒性的方法。

这些研究方向可以帮助进一步推动医学图像分割技术的发展,提高其在临床诊断和治疗决策中的应用价值。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以概括为以下几个要点:

研究背景:前列腺癌(PCa)是男性中第二常见的癌症,PSMA-PET/CT成像技术在可视化前列腺癌转移性病变方面具有重要意义,但准确分割这些病变存在挑战。

研究目标:提出一种自动化方法,用于在PSMA PET/CT 3D容积图像中分割前列腺癌的转移性病变。

方法论:

- 使用多角度最大强度投影(MA-MIPs)增强病变的可视化。

- 应用2D去噪扩散概率模型(DDPM)在MA-MIPs上进行病变分割。

- 利用有序子集期望最大化(OSEM)算法将2D分割结果重建为3D分割掩模。

实验设计:

- 从510个全身体[18F]DCFPyL PSMA-PET/CT图像中选择数据集,包括经过初次治疗后生化复发的前列腺癌患者。

- 对图像数据进行预处理,包括SUV值的转换和裁剪,以及图像的重采样和裁剪。

- 生成MA-MIPs并使用DDPM模型进行训练和评估。

实验结果:所提出的MIP-DDPM方法在Dice分数、Hausdorff距离、Jaccard指数和体积误差百分比等指标上优于现有的最先进的3D分割方法。

临床意义:该方法有助于早期检测转移性病变,改善治疗决策,特别是在生化复发疾病的情况下。

结论:论文提出的基于2D模型的3D分割方法在分割小的转移性前列腺癌病变方面表现出色,具有重要的临床应用潜力。

致谢:研究得到了加拿大健康研究院(CIHR)项目资助和微软AI for Health提供的计算资源与服务支持。

利益披露:作者声明没有与本文内容相关的竞争利益。

参考文献:论文列出了相关领域的参考文献,涵盖了前列腺癌的转移模式、PSMA-PET/CT成像技术、深度学习在医学成像中的应用等主题。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

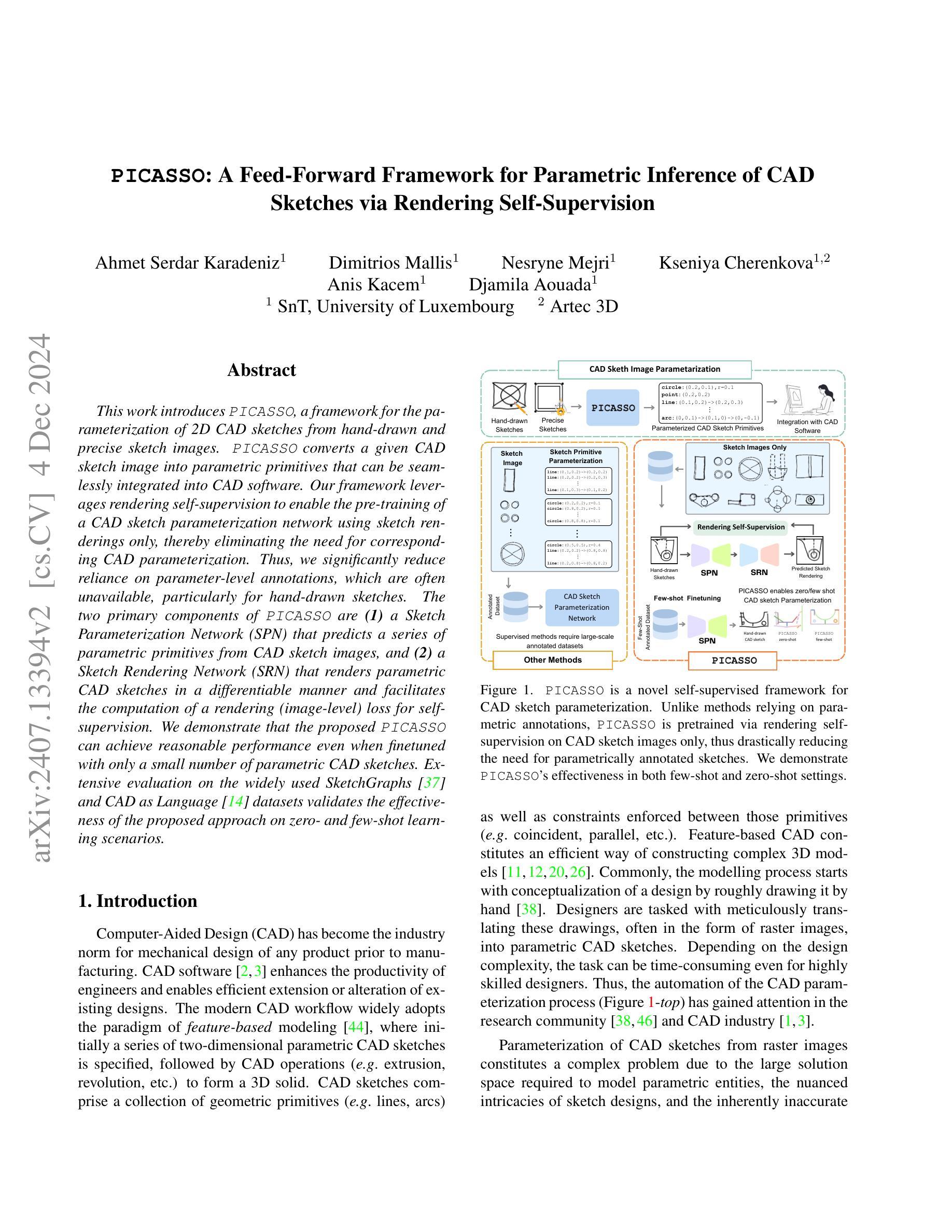

PICASSO: A Feed-Forward Framework for Parametric Inference of CAD Sketches via Rendering Self-Supervision

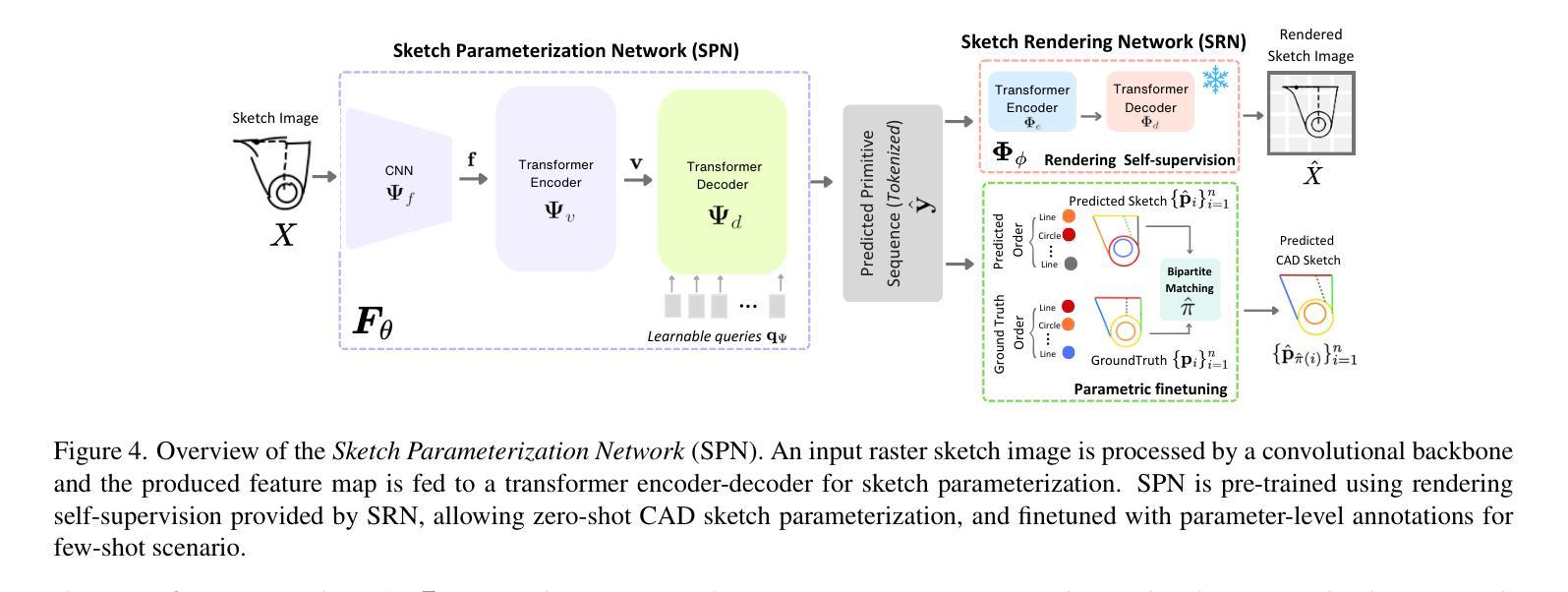

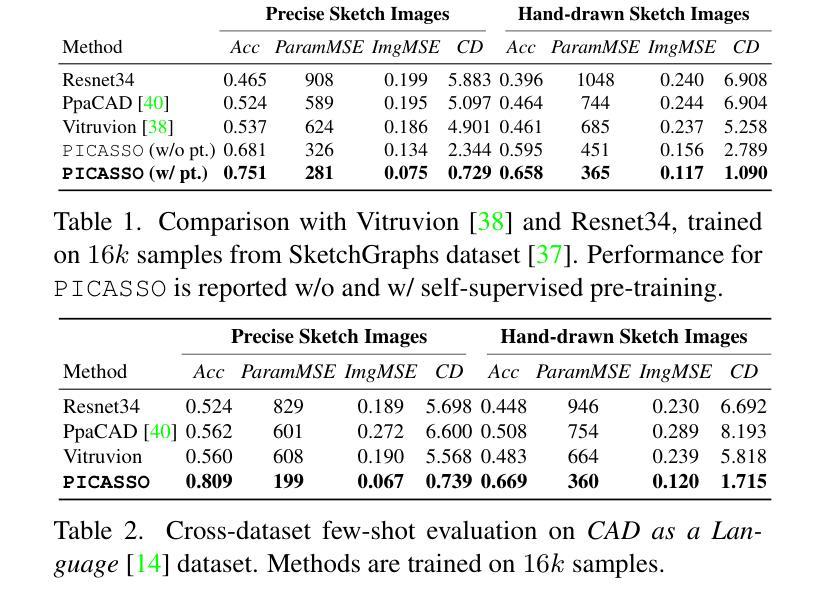

Authors:Ahmet Serdar Karadeniz, Dimitrios Mallis, Nesryne Mejri, Kseniya Cherenkova, Anis Kacem, Djamila Aouada

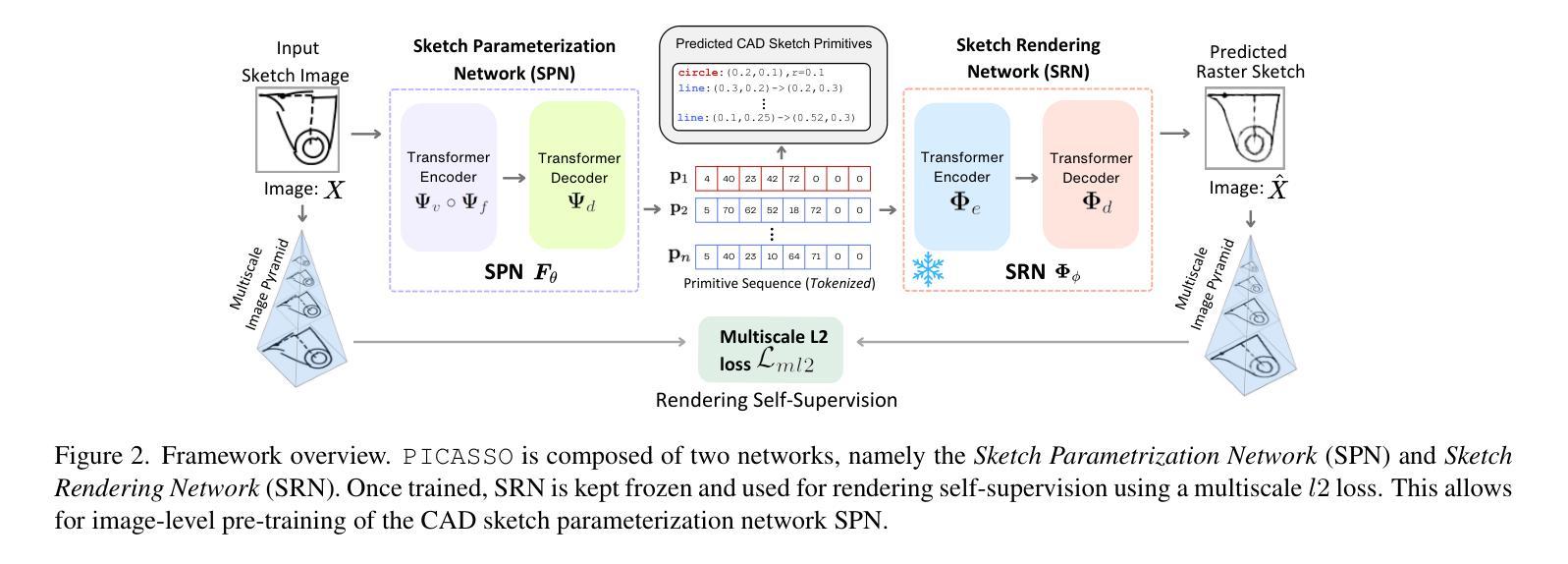

This work introduces PICASSO, a framework for the parameterization of 2D CAD sketches from hand-drawn and precise sketch images. PICASSO converts a given CAD sketch image into parametric primitives that can be seamlessly integrated into CAD software. Our framework leverages rendering self-supervision to enable the pre-training of a CAD sketch parameterization network using sketch renderings only, thereby eliminating the need for corresponding CAD parameterization. Thus, we significantly reduce reliance on parameter-level annotations, which are often unavailable, particularly for hand-drawn sketches. The two primary components of PICASSO are (1) a Sketch Parameterization Network (SPN) that predicts a series of parametric primitives from CAD sketch images, and (2) a Sketch Rendering Network (SRN) that renders parametric CAD sketches in a differentiable manner and facilitates the computation of a rendering (image-level) loss for self-supervision. We demonstrate that the proposed PICASSO can achieve reasonable performance even when finetuned with only a small number of parametric CAD sketches. Extensive evaluation on the widely used SketchGraphs and CAD as Language datasets validates the effectiveness of the proposed approach on zero- and few-shot learning scenarios.

本文介绍了PICASSO,这是一个将手绘和精确草图图像参数化为二维CAD草图框架。PICASSO将给定的CAD草图图像转换为可以无缝集成到CAD软件中的参数化基本元素。我们的框架利用渲染自监督功能,使用草图渲染进行CAD草图参数化网络的预训练,从而无需相应的CAD参数化。因此,我们极大地减少了对于参数级别注释的依赖,这些注释通常不可用,尤其是对手绘草图而言。PICASSO的两个主要组件包括:(1)草图参数化网络(SPN),可从CAD草图图像预测一系列参数化基本元素;(2)草图渲染网络(SRN),以可区分的方式呈现参数化CAD草图,并促进计算用于自监督的渲染(图像级别)损失。我们证明,即使仅使用少量的参数化CAD草图进行微调,所提出的PICASSO也可以实现合理的性能。在广泛使用的SketchGraphs和CAD作为语言数据集上进行评估,验证了该方法在零样本和少样本学习场景中的有效性。

论文及项目相关链接

PDF Accepted at WACV 2025

Summary

本文介绍了PICASSO框架,该框架可将手绘和精确草图图像转化为参数化原始形式,并无缝集成到CAD软件中。PICASSO利用渲染自监督技术,仅使用草图渲染进行CAD草图参数化网络的预训练,从而无需对应的参数化标注。这大大降低了对参数级别标注的依赖,尤其是手绘草图。PICASSO主要包括两个组件:Sketch Parameterization Network (SPN) 和 Sketch Rendering Network (SRN)。SPN可从CAD草图图像预测一系列参数化原始形式,而SRN则以可区分的方式渲染参数化CAD草图,并为自监督计算图像级损失。实验证明,PICASSO在仅使用少量参数化CAD草图进行微调时也能取得合理的效果。在广泛使用的SketchGraphs和CAD as Language数据集上的评估验证了该方法在零样本和少样本学习场景中的有效性。

Key Takeaways

- PICASSO是一个用于将手绘和精确草图图像转化为参数化原始形式的框架,可无缝集成到CAD软件中。

- 利用渲染自监督技术,仅使用草图渲染进行预训练,降低对参数级别标注的依赖。

- 主要包含两个组件:Sketch Parameterization Network (SPN) 和 Sketch Rendering Network (SRN)。

- SPN能从CAD草图图像预测参数化原始形式。

- SRN以可区分的方式渲染参数化CAD草图,计算图像级损失以实现自监督。

- PICASSO在仅使用少量参数化CAD草图进行微调时表现出合理的效果。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了一个名为PICASSO的框架,旨在解决从手绘和精确草图图像中参数化2D CAD草图的问题。具体来说,PICASSO的目标是将给定的CAD草图图像转换成可以无缝集成到CAD软件中的参数化基元。这个框架通过利用渲染自监督(rendering self-supervision)来实现这一点,从而在不需要对应的CAD参数化的情况下,使用仅草图渲染进行CAD草图参数化网络的预训练,显著减少了对参数级注释的依赖,这些注释通常难以获得,尤其是对于手绘草图。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要集中在以下几个领域:

CAD Sketch Parameterization:

- 研究工作集中在CAD草图的生成或合成上。最近的方法采用自回归变换器(autoregressive transformers)来处理CAD草图的参数化。

- 例如,[14]利用协议缓冲区规范(protocol buffer specification)为2D草图生成受约束的CAD草图。

- [41]探索了基于超图(hypergraphs)或海龟图形(turtle graphics)的两种不同的草图表示,并引入了相应的生成模型CurveGen和TurtleGen。

- [29]和[38]提出了两阶段架构,分别用于基元和约束的生成,并研究了这些模型用于手绘草图参数化的有效性。

Parametric Rendering:

- 渲染是指将矢量参数转换为光栅图像的过程。由于直接矢量监督并不总是可用的,渲染模块可以连接矢量和光栅域,并启用基于梯度的优化。

- 相关工作探索了可微分渲染器(differentiable renderers),这些渲染器可以自动计算相对于输入矢量参数的梯度。

- 更多相关工作调查了可学习的渲染方法,将参数转换为光栅图像,允许使用基于图像的损失进行优化。

Differentiable Rendering:

- [18]、[23]等研究了可微分渲染技术,这些技术可以将参数转换为光栅图像,允许通过图像损失进行优化。

- 这些工作通常处理矢量图形,与矢量图形相比,用于CAD草图自监督的渲染应该能够捕获多种类型的参数基元(例如线条、圆形)。

这些相关研究为PICASSO框架的开发提供了理论基础和技术背景。PICASSO框架通过结合这些领域的技术,提出了一种新的自监督学习方法,用于在参数注释有限或不可用的情况下进行CAD草图的参数化。

Q: 论文如何解决这个问题?

A: 论文通过提出PICASSO框架来解决从手绘和精确草图图像中参数化2D CAD草图的问题。PICASSO框架主要包含两个组成部分:

**Sketch Parameterization Network (SPN)**:这是一个预测网络,用于从CAD草图图像中预测一系列参数基元。SPN采用前馈(feed-forward)变换器编码器-解码器架构,将输入的草图图像编码成一组参数基元的标记(tokens)。

**Sketch Rendering Network (SRN)**:这是一个神经可微分渲染器,用于将参数CAD草图渲染成可微分的方式,从而计算自监督的渲染(图像级)损失。SRN使得仅使用草图渲染进行SPN的预训练成为可能,从而减少了对参数级注释的依赖。

解决方案的关键步骤如下:

渲染自监督:通过SRN,PICASSO能够仅使用草图渲染进行SPN的预训练,无需对应的CAD参数化。这通过计算预测基元和输入草图图像之间的图像到图像损失来实现。

零样本和少样本学习:利用预训练的SPN,PICASSO能够在参数注释有限或不可用的情况下,直接从精确或手绘图像中学习参数化CAD草图。在零样本设置中,预训练的SPN直接用于推断草图参数。在少样本场景中,预训练的SPN使用少量注释样本进行微调。

前馈网络设计:与最近的自回归网络设计不同,SPN是一个前馈网络,将草图视为无序的基元集合,并以非自回归方式预测CAD序列。

多尺度L2损失:为了在不同分辨率下提供信息梯度,PICASSO使用了多尺度L2损失来计算预测渲染和输入光栅图像之间的差异。

通过这些方法,PICASSO框架能够在参数注释稀缺或不存在的情况下,有效地从手绘或精确的CAD草图光栅图像中学习参数化CAD草图。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证PICASSO框架的有效性,具体包括:

Few-shot和Zero-shot CAD Sketch Parameterization:

- 在Few-shot设置中,首先使用渲染自监督对PICASSO进行预训练,然后在较小的、策划好的参数化草图数据集上进行微调。

- 在Zero-shot设置中,直接使用通过渲染自监督预训练的SPN模型来推断草图参数,完全不需要参数级注释。

Cross-dataset Evaluation:

- 为了评估模型的泛化能力,作者将在SketchGraphs数据集上训练的Few-shot模型测试在CAD as a Language数据集上。

Ablation Study:

- 比较了提出的SRN与不同的可微分渲染器DiffVG,在测试时优化设置下的性能。

- 评估了不同损失函数对SRN训练的影响。

- 评估了SPN在有参数监督的情况下对精确和手绘草图图像进行CAD草图参数化的性能。

- 对SPN的不同架构组件进行了消融研究,包括双分图匹配(Bipartite Matching)和基于U-Net的背景。

Impact of CAD Sketch Parameterization on CAD Constraint Inference:

- 评估了由PICASSO推断的参数化基元对现有约束预测模型性能的影响。

Semi-supervised CAD Sketch Parameterization via Rendering Supervision:

- 探索了通过渲染监督进行半监督学习的场景,其中SRN在未标记的草图图像上进行渲染监督训练,并在较小的参数化草图数据集上进行参数监督训练。

Sensitivity to Rendering Quality:

- 进行了消融研究,探讨了SRN渲染性能的变化如何影响自监督预训练的有效性。

Extension to Other Primitives:

- 作为未来工作的预实验,作者在包含随机生成的B-splines的合成数据集上训练和测试了SPN和SRN,并与DiffVG进行了比较。

Qualitative Results:

- 提供了Few-shot CAD草图参数化的额外视觉结果。

- 展示了Zero-shot CAD草图参数化的额外视觉结果。

- 展示了在精确草图上进行测试时优化的视觉结果。

这些实验全面评估了PICASSO框架在不同设置下的性能,并与现有方法进行了比较,证明了PICASSO在参数化2D CAD草图方面的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

扩展到更多类型的CAD基元:

- 论文中提到,由于现有数据集中自由曲线(如B样条、双曲线和NURBS)的表示不足,这些类型的基元没有被包括在内。未来的工作可以探索如何将PICASSO框架扩展到这些自由曲线。

提高零样本学习的性能:

- 论文指出,在零样本设置中,由于手绘草图和SRN渲染的精确草图之间的差异,渲染自监督可能会受到影响。开发对手绘图不变的损失函数,以提高零样本性能,是一个有趣的研究方向。

改进渲染网络(SRN):

- 进一步优化SRN的渲染质量,使其能够更准确地捕捉手绘草图的特性,这可能会提高自监督预训练的效果。

探索半监督学习:

- 论文中提到了通过渲染监督进行半监督学习的可能性。未来的工作可以更深入地研究这种设置,特别是如何更有效地结合渲染监督和参数监督。

优化网络架构:

- 对SPN和SRN的网络架构进行进一步的优化和调整,以提高参数化精度和渲染质量。

处理复杂和噪声数据:

- 研究如何提高PICASSO处理复杂或噪声数据的能力,特别是在实际应用中,手绘草图的质量可能变化很大。

减少对合成数据的依赖:

- 探索如何减少对合成数据的依赖,通过利用少量的真实世界数据来提高模型的泛化能力。

实际应用和集成:

- 将PICASSO集成到实际的CAD软件中,并在真实世界的机械设计任务中测试其性能和实用性。

提高计算效率:

- 尽管SPN比自回归模型快,但仍有进一步优化空间,特别是在处理大规模数据集时。

多模态学习:

- 探索如何结合视觉信息和其他模态信息(如触觉反馈或语音指令)来改进CAD草图的参数化。

这些探索点可以帮助推动CAD草图参数化技术的发展,提高其在实际应用中的有效性和可靠性。

Q: 总结一下论文的主要内容

A: 论文介绍了PICASSO框架,这是一个用于从手绘和精确草图图像中参数化2D CAD草图的前馈式(feed-forward)框架。主要内容包括:

问题背景:

- CAD软件在产品设计中广泛使用,而将手绘草图转换为参数化CAD草图是一个耗时的过程。

- 现有的基于学习的方法依赖大规模标注数据集,但在现实场景中,这些标注数据尤其是手绘草图的参数化信息难以获得。

PICASSO框架:

- 包含两个主要组件:Sketch Parameterization Network(SPN)和Sketch Rendering Network(SRN)。

- SPN用于从草图图像中预测参数基元,而SRN用于可微分地渲染这些参数基元,从而实现自监督学习。

渲染自监督:

- 利用SRN仅通过草图图像进行SPN的预训练,无需CAD参数化标注,减少了对参数级注释的依赖。

零样本和少样本学习:

- PICASSO能够在零样本和少样本的设置下进行CAD草图参数化,这对于参数化手绘草图尤其重要。

实验验证:

- 在SketchGraphs和CAD as Language数据集上进行了广泛的实验,验证了PICASSO在零样本和少样本学习场景下的有效性。

- 与现有方法相比,PICASSO在参数化精确和手绘CAD草图方面取得了更好的性能。

主要贡献:

- 提出了一种新的框架,允许在没有大规模标注数据的情况下进行CAD草图参数化。

- 首次探索了使用神经可微分渲染器进行CAD草图参数化的自监督学习。

- 提出的前馈式SPN在CAD草图参数化任务中达到了最先进的性能。

未来工作:

- 探索将PICASSO扩展到更多类型的CAD基元,包括自由曲线。

- 改进SRN的渲染质量,提高零样本学习的性能。

- 进一步优化网络架构,提高计算效率,并探索实际应用中的集成。

总体而言,PICASSO通过其创新的自监督学习方法,为在参数化标注稀缺的情况下从图像中直接参数化CAD草图提供了一个有效的解决方案。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

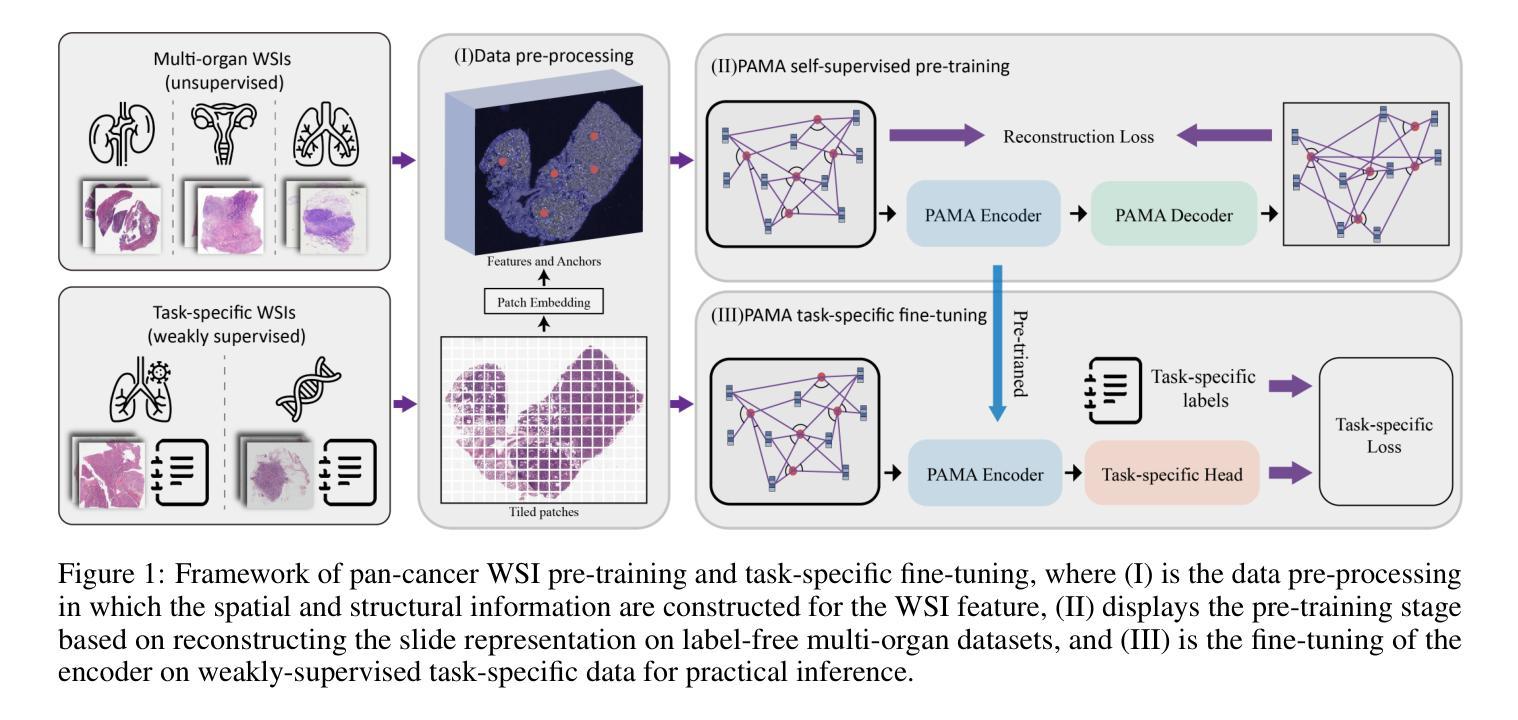

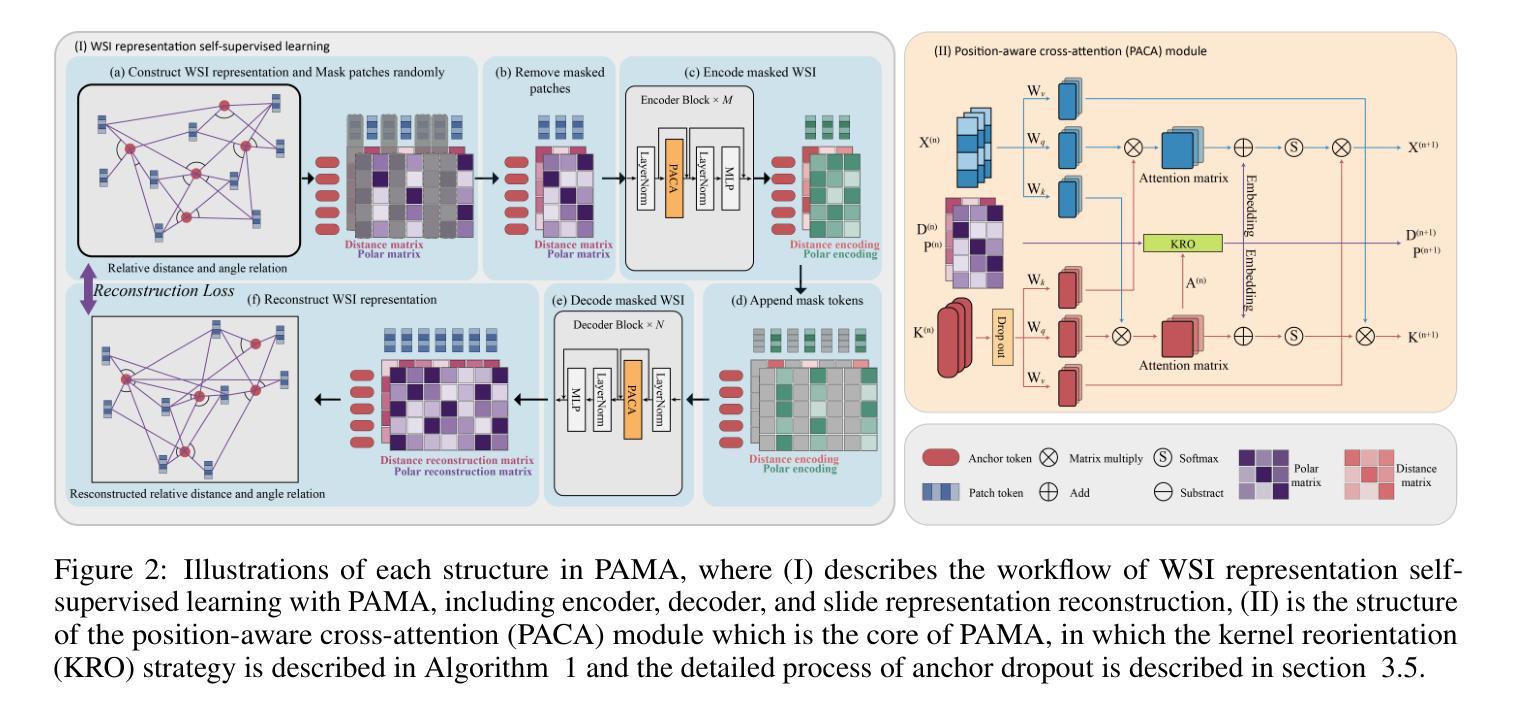

Pan-cancer Histopathology WSI Pre-training with Position-aware Masked Autoencoder

Authors:Kun Wu, Zhiguo Jiang, Kunming Tang, Jun Shi, Fengying Xie, Wei Wang, Haibo Wu, Yushan Zheng

Large-scale pre-training models have promoted the development of histopathology image analysis. However, existing self-supervised methods for histopathology images primarily focus on learning patch features, while there is a notable gap in the availability of pre-training models specifically designed for WSI-level feature learning. In this paper, we propose a novel self-supervised learning framework for pan-cancer WSI-level representation pre-training with the designed position-aware masked autoencoder (PAMA). Meanwhile, we propose the position-aware cross-attention (PACA) module with a kernel reorientation (KRO) strategy and an anchor dropout (AD) mechanism. The KRO strategy can capture the complete semantic structure and eliminate ambiguity in WSIs, and the AD contributes to enhancing the robustness and generalization of the model. We evaluated our method on 7 large-scale datasets from multiple organs for pan-cancer classification tasks. The results have demonstrated the effectiveness and generalization of PAMA in discriminative WSI representation learning and pan-cancer WSI pre-training. The proposed method was also compared with 8 WSI analysis methods. The experimental results have indicated that our proposed PAMA is superior to the state-of-the-art methods. The code and checkpoints are available at https://github.com/WkEEn/PAMA.

大规模预训练模型促进了病理图像分析的发展。然而,现有的针对病理图像的自我监督方法主要集中在学习补丁特征上,而在专为WSI级特征学习设计的预训练模型方面存在明显的差距。在本文中,我们提出了一种新型的自监督学习框架,用于具有位置感知掩码自动编码器(PAMA)的泛癌WSI级表示预训练。同时,我们提出了带有内核重新定位(KRO)策略和锚点丢弃(AD)机制的位置感知交叉注意力(PACA)模块。KRO策略可以捕获完整的语义结构并消除WSIs中的歧义,而AD有助于提高模型的鲁棒性和通用性。我们在来自多个器官的7个大型数据集上对我们的方法进行了泛癌分类任务的评估。结果证明了PAMA在判别WSI表示学习和泛癌WSI预训练中的有效性和通用性。将所提出的方法与8种WSI分析方法进行了比较。实验结果表明,我们提出的PAMA优于最先进的方法。代码和检查点位于https://github.com/WkEEn/PAMA。

论文及项目相关链接

Summary

一种针对大规模预训练模型的新颖自监督学习框架被提出,用于泛癌全视野显微镜图像(WSI)级别的特征学习。该框架引入了位置感知掩码自编码器(PAMA),并结合了位置感知交叉注意力(PACA)模块、内核重新定位(KRO)策略和锚点丢弃(AD)机制。在多个器官的七个大型数据集上进行泛癌分类任务评估,证明其在区分全视野显微镜图像表示学习和泛癌WSI预训练中的有效性和泛化能力。与现有方法相比,PAMA展现出优越性。

Key Takeaways

- 自监督学习方法在病理图像分析中得到发展,但针对全视野显微镜图像(WSI)级别的预训练模型存在缺口。

- 提出了一种新型自监督学习框架,用于泛癌WSI级别的特征学习。

- 引入了位置感知掩码自编码器(PAMA)以及位置感知交叉注意力(PACA)模块。

- 采用内核重新定位(KRO)策略捕捉完整的语义结构并消除WSIs中的歧义。

- 锚点丢弃(AD)机制增强了模型的稳健性和泛化能力。

- 在七个大型数据集上进行了泛癌分类任务评估,证明所提方法的有效性和泛化能力。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为PAMA(Position-Aware Masked Autoencoder)的自监督学习框架,旨在解决以下问题:

全切片图像(WSI)级别的特征学习:现有的自监督学习方法主要关注于学习组织切片图像的局部特征(即图像块特征),而缺乏专门针对WSI级别特征学习的预训练模型。PAMA框架通过设计位置感知的掩码自编码器来填补这一空白,专注于从大规模未标记数据中挖掘WSI的语义特征。

多癌种(pan-cancer)WSI的预训练:尽管有多癌种分析模型和数据库的研究,但缺乏能够利用大量未标记WSI进行WSI级别特征学习的模型。PAMA框架通过在多器官数据集上进行预训练,展示了其在多癌种分析中的有效性和泛化能力。

位置感知和结构信息的整合:传统的Transformer模型可能无法有效处理病理图像的各向异性特征,导致位置编码产生歧义。PAMA框架通过提出位置感知交叉注意力(PACA)模块和核心重定向(KRO)策略,整合了局部和全局信息的双向通信,并动态更新锚点的主方向,以更好地获取完整的语义结构并消除歧义。

提高模型的鲁棒性和泛化能力:通过引入锚点dropout机制,增强模型对不同数据集的泛化能力,并减少WSI预训练过程中的过拟合问题。

总结来说,这篇论文主要关注于开发一个能够处理大规模病理图像数据、具有位置感知能力、并且能够进行多癌种预训练的自监督学习框架,以提高WSI级别的表示学习,并在多种病理学图像分析任务中实现更好的性能。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个领域:

基于MIL的方法(Multiple Instance Learning based methods):

- 这些方法通常用于WSI分析,涉及提取图像块特征和聚合WSI级别的表示。

- 例如,Li等人[25]提出了一个双流框架整合实例,并应用金字塔融合机制进行多尺度WSI特征提取。

- 其他研究如Graph Attention MIL[26]和LAGE-Net[27]构建了图像块的图结构以编码局部关系。

自监督学习(Self-supervised learning):

- 这类方法在计算机视觉中越来越受到关注,主要集中于不同的代理任务以进行无监督预训练。

- 一些工作关注基于上下文的方法,例如预测病理图像的交叉染色、预测WSI中的分辨率序列排序等[35-37]。

- 其他方法利用生成模型构建代理任务,通过最小化像素空间中的重构损失隐式学习特征,例如SD-MAE[31]和MAE-MIL[32]。

全切片图像(WSI)分析:

- 涉及使用深度学习框架促进癌症亚型、组织病理图像检索、基因突变预测和生存预测等方面的研究。

- 例如,Huang等人[20]将CLIP[14]应用于多模态病理语言-图像预训练(PLIP)。

基于Transformer的结构:

- Transformer结构在自然语言处理领域取得了令人印象深刻的进展,也被用于WSI分析以捕获和聚合长距离信息。

- 例如,TransMIL[28]和SETMIL[29]利用CNN块和空间编码模块聚合局部信息,并使用自注意力模型进行全局信息传递。

多癌种分析(Pan-cancer analysis):

- 涉及构建多癌种分析模型和相关数据库的计算病理学研究。

- 例如,Komura等人[47]构建了一个通用编码器,通过深度神经网络从多种癌症类型的组织学图像中预测基因组特征。

这些相关研究展示了在病理图像分析领域,特别是在WSI级别的特征学习和多癌种分析中,如何利用深度学习和自监督学习技术来处理和分析大规模数据集。PAMA框架正是基于这些相关研究,进一步提出了一个新颖的自监督学习框架来改进WSI级别的表示学习。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键方法解决了全切片图像(WSI)级别的特征学习问题:

提出PAMA(Position-Aware Masked Autoencoder)框架:

- PAMA是一个自监督学习框架,用于在WSI级别上进行表示预训练。通过设计slide-level的掩码图像建模(MIM)代理任务,PAMA能够从大量未标记数据中挖掘出病理幻灯片的语义特征。

引入PACA(Position-Aware Cross-Attention)模块:

- PACA模块嵌入了相对距离和方向信息到幻灯片表示中,使得模型能够保持空间语义的完整性。

- PACA模块通过动态更新策略和锚点dropout机制增强模型的鲁棒性和泛化能力。

设计KRO(Kernel Reorientation)策略:

- KRO策略动态更新锚点的主要方向,以更好地获取完整的语义结构并消除WSI表示中的歧义。

采用AD(Anchor Dropout)机制:

- 通过随机丢弃一些锚点来增强模型的泛化能力,类似于神经网络中的神经元dropout机制。

多器官数据集的预训练和评估:

- 作者收集了7个大规模数据集,包含13,685个WSI,涵盖了多个器官,用于评估PAMA框架的有效性和泛化能力。

- 通过与8种WSI分析方法的比较实验,展示了PAMA在组织学WSI预训练和下游任务(包括癌症亚型和生物标志物预测)中的优越性能。

实验验证:

- 论文中的实验部分验证了PAMA在多个数据集上的性能,并与现有的SOTA方法进行了比较,证明了PAMA在多癌种分类任务中的有效性和泛化能力。

通过这些方法,论文成功地提出了一个能够处理大规模病理图像数据、具有位置感知能力、并且能够进行多癌种预训练的自监督学习框架,以提高WSI级别的表示学习,并在多种病理学图像分析任务中实现更好的性能。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估PAMA框架的有效性和泛化能力,具体实验包括:

数据集收集与划分:

- 作者收集了四个公共大规模数据集和三个内部数据集,包含多个器官的8,892个WSI,用于多器官预训练和特定任务的微调。数据集被随机划分为训练、验证和测试子集。

预训练条件实验:

- 在WSI级别的表示预训练阶段,作者没有使用任何监督信息。预训练的编码器将被用作各种下游任务的幻灯片表示提取器。作者比较了不同预训练策略(无预训练、单器官预训练和多器官预训练)的性能。

多器官预训练的有效性:

- 作者展示了PAMA在多器官数据集上预训练后,在各个内部数据集测试集上的性能,以证明PAMA在利用大量未标记的组织病理学图像数据和增强表示能力方面的有效性。

跨域预训练的泛化能力:

- 作者使用来自TCGA的大规模多癌种数据集作为跨域数据,评估了PAMA预训练的泛化能力。将PAMA与SOTA方法Prov-GigaPath进行比较,展示了PAMA在未见数据上的特征表征和分析能力。

半监督WSI分类的有效性:

- 作者评估了在有限WSI标签条件下WSI级别自监督学习的有效性。比较了PAMA与MAE、HIPT和Prov-GigaPath等方法的性能。

与其他弱监督方法的比较:

- 作者将PAMA与BYOL、MAE、HIPT、Prov-GigaPath等自监督框架以及其他SOTA弱监督方法(包括DSMIL、TransMIL、SETMIL和KAT)在Endometrium-3k和TCGA-NSCLC数据集上进行了比较。

消融研究:

- 作者进行了消融研究,验证了相对空间嵌入和策略(包括极角嵌入、KRO模块、相对距离嵌入和AD机制)对性能的影响。

超参数分析:

- 作者对PAMA框架的不同超参数进行了调整和分析,包括掩码比率、dropout概率、每个锚点的补丁数和极角箱数,以找到最佳的参数设置。

可视化分析:

- 作者通过可视化评估了PAMA框架的可解释性,展示了预训练和微调过程中锚点注意力的分布情况。

这些实验全面地评估了PAMA框架在不同条件下的性能,并与其他方法进行了比较,证明了PAMA在组织病理学图像分析中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

多癌种分析的扩展:

- 论文中提到的多器官数据集尚未包含所有癌症类型,未来的工作可以扩展数据集以包含更多种类的癌症,以进行更全面的多癌种分析。

多模态数据融合:

- 目前PAMA框架仅依赖于病理图像数据。未来的研究可以探索将基因组学等多模态数据融入预训练过程中,以增强癌症诊断的准确性。

空间属性的显式设计:

- 尽管PAMA框架通过PACA模块和KRO策略处理了WSI的空间结构信息,但未来的工作可以进一步探索显式设计来挖掘多癌种数据中的语义信息,例如构建特定的损失函数。

泛癌种特征的深入研究:

- 论文中提到了跨癌种分析模型的构建,未来的研究可以更深入地探讨跨癌种特征,以及如何利用这些特征进行更有效的疾病建模。

模型泛化能力的进一步提升:

- 尽管PAMA显示出良好的跨域泛化能力,但进一步研究如何提升模型在面对更多样化、更复杂的病理图像数据时的泛化能力仍然是一个重要的研究方向。

计算效率的优化:

- 考虑到病理图像数据的大规模特性,优化PAMA框架的计算效率,减少资源消耗,使其更适合在实际临床环境中部署也是一个值得探索的方向。

模型解释性的增强:

- 提高模型的可解释性,使得病理学家能够更好地理解和信任模型的决策过程,这对于临床应用至关重要。

更广泛的下游任务探索:

- 除了论文中提到的肿瘤亚型分类和生物标志物预测任务外,探索PAMA预训练模型在更多病理学图像分析任务中的应用,如肿瘤边界检测、组织分割等。

跨平台数据的一致性和校准:

- 不同医疗中心可能使用不同的染色和扫描技术,研究如何校准跨平台数据以保持一致性,对于构建更稳健的预训练模型非常重要。

这些探索点可以帮助研究人员进一步提升PAMA框架的性能,并扩展其在病理学图像分析领域的应用范围。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为PAMA(Position-Aware Masked Autoencoder)的自监督学习框架,专门针对病理学全切片图像(WSI)的预训练和表示学习。以下是论文的主要内容总结:

问题陈述:

- 针对现有的自监督学习方法主要关注于局部图像块特征学习,缺乏专门针对WSI级别特征学习的预训练模型的问题。

PAMA框架:

- 提出了PAMA框架,通过slide-level的掩码图像建模(MIM)代理任务,从大量未标记数据中挖掘病理幻灯片的语义特征。

PACA模块:

- 引入了位置感知交叉注意力(PACA)模块,嵌入相对距离和方向信息,以保持WSI的空间语义完整性。

KRO策略:

- 提出了核心重定向(KRO)策略,动态更新锚点的主方向,以消除WSI表示中的歧义。

AD机制:

- 引入锚点dropout(AD)机制,增强模型的鲁棒性和泛化能力。

数据集和实验:

- 作者收集了7个大规模数据集,包含13,685个WSI,覆盖多个器官,用于评估PAMA框架的有效性和泛化能力。

- 与8种WSI分析方法比较,证明了PAMA在多癌种分类任务中的优越性能。

实验结果:

- 实验结果表明,PAMA在组织学WSI预训练和下游任务(包括癌症亚型和生物标志物预测)中表现出色,具有很好的泛化能力。

未来工作:

- 论文指出了两个主要的改进方向:扩展多器官数据集以包含更多癌症类型,以及引入多模态数据(如基因组数据)参与预训练过程。

总的来说,这篇论文通过提出PAMA框架,为病理学WSI的自监督学习提供了一个有效的解决方案,通过在多器官数据集上进行预训练,展示了其在多癌种分析中的有效性和泛化能力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Transfer or Self-Supervised? Bridging the Performance Gap in Medical Imaging

Authors:Zehui Zhao, Laith Alzubaidi, Jinglan Zhang, Ye Duan, Usman Naseem, Yuantong Gu

Recently, transfer learning and self-supervised learning have gained significant attention within the medical field due to their ability to mitigate the challenges posed by limited data availability, improve model generalisation, and reduce computational expenses. Transfer learning and self-supervised learning hold immense potential for advancing medical research. However, it is crucial to recognise that transfer learning and self-supervised learning architectures exhibit distinct advantages and limitations, manifesting variations in accuracy, training speed, and robustness. This paper compares the performance and robustness of transfer learning and self-supervised learning in the medical field. Specifically, we pre-trained two models using the same source domain datasets with different pre-training methods and evaluated them on small-sized medical datasets to identify the factors influencing their final performance. We tested data with several common issues in medical domains, such as data imbalance, data scarcity, and domain mismatch, through comparison experiments to understand their impact on specific pre-trained models. Finally, we provide recommendations to help users apply transfer learning and self-supervised learning methods in medical areas, and build more convenient and efficient deployment strategies.

最近,迁移学习和自监督学习在医学领域受到了广泛关注,因为它们能够缓解因数据有限而带来的挑战,提高模型的通用性,并降低计算成本。迁移学习和自监督学习在推动医学研究方面拥有巨大潜力。然而,重要的是要认识到迁移学习和自监督学习架构具有各自独特的优势和局限性,在准确性、训练速度和稳健性方面存在差异。本文比较了迁移学习和自监督学习在医学领域的性能和稳健性。具体来说,我们使用相同的源域数据集和不同预训练方法对两个模型进行预训练,并在小型医学数据集上评估它们,以确定影响它们最终性能的因素。我们测试了医学领域中存在的几个常见问题数据,如数据不平衡、数据稀缺和领域不匹配等,通过对比实验来了解它们对特定预训练模型的影响。最后,我们提供建议,帮助用户了解在医学领域应用迁移学习和自监督学习方法,并建立更便捷高效的部署策略。

论文及项目相关链接

PDF 37 pages, 8 figures

Summary

这篇论文比较了迁移学习和自监督学习在医学领域的性能和稳健性。研究通过对使用相同源域数据集但采用不同预训练方法的两个模型进行预训练,并在小型医学数据集上进行评估,以识别影响最终性能的因素。此外,该研究还通过对比实验测试了数据不平衡、数据稀缺和域不匹配等医学领域常见问题的模型影响,并提供了针对迁移学习和自监督学习方法在医学领域应用的建议,以构建更便捷高效的部署策略。

Key Takeaways

- 迁移学习和自监督学习在医学领域具有显著潜力,能有效解决数据有限和计算成本高昂的问题,提高模型的通用性。

- 迁移学习和自监督学习在准确性、训练速度和稳健性方面展现出不同的优势和局限性。

- 论文通过预训练两个模型并对其进行评估,探讨了不同预训练方法对模型性能的影响。

- 研究通过对比实验,深入了解了数据不平衡、数据稀缺和域不匹配等医学领域常见问题对模型的影响。

- 论文提供了针对迁移学习和自监督学习方法在医学领域的实际应用建议。

- 通过研究,可以更好地理解如何构建更便捷高效的模型部署策略。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是在医学领域中,如何选择和利用迁移学习(Transfer Learning, TL)和自监督学习(Self-supervised Learning, SSL)这两种预训练方法来提高模型性能、解决数据稀缺问题,并减少计算成本。具体来说,论文的主要目标包括:

比较迁移学习和自监督学习:通过实验对比这两种方法在不同类型(彩色和灰度)医学图像数据集上的表现,包括准确率、训练速度和鲁棒性。

解决数据不平衡问题:研究数据增强和下采样技术与预训练模型结合使用时,在处理不平衡数据方面的效率。

处理领域不匹配问题:探索双重微调技术(double fine-tuning)在减少源域和目标域之间的领域不匹配问题方面的有效性。

提高模型的可解释性:使用可解释人工智能(XAI)技术评估预训练模型的可靠性和鲁棒性。

提供选择指导:为研究人员提供在不同场景下选择最合适预训练设置的指导,以提高模型在医学研究中的性能和应用潜力。

论文通过广泛的实验和分析,提供了对这两种预训练方法在医学图像分析中性能的深入理解,并探讨了它们在实际应用中的潜在价值和局限性。

Q: 有哪些相关研究?

A: 论文中提及了多个与迁移学习(Transfer Learning, TL)和自监督学习(Self-supervised Learning, SSL)在医学图像处理领域应用相关的研究。以下是一些关键的相关研究:

Niu et al. (2020): 该研究探讨了迁移学习在医学图像分析中的广泛应用,包括不同疾病的研究。

Raghu et al. (2019): 这项研究提出了对医学领域使用ImageNet预训练模型的普遍性提出质疑,因为ImageNet数据集与医学图像在领域上存在差异。

Yang et al. (2020): 进行了迁移学习和自监督学习两种预训练方法的比较实验,分析了领域相似性对这两种预训练方法的影响。

Azizi et al. (2023): 阐明了SSL方法的好处,指出其在目标域数据少于10%的情况下,能够实现与TL模型相当的性能。

Hosseinzadeh Taher et al. (2021): 对迁移学习和自监督学习的性能进行了基准测试,为未来架构的改进提供了信息。

Ericsson et al. (2022b): 研究了预训练数据集的大小和模型容量对下游任务性能的影响。

Morid et al. (2021): 报道了使用预训练的ImageNet模型在彩色目标数据集上取得的积极结果。

Alzubaidi et al. (2020): 指出预训练的ImageNet特征与医学图像不匹配,尤其是在灰度医学数据集上。

Shurrab & Duwairi (2022): 讨论了自监督学习在医学领域的吸引力,提供了一种有效的解决方案来使用大量未标记的数据。

Truong et al. (2021): 研究了使用ImageNet和自监督预训练方法进行医学成像任务的积极结果。

Wu et al. (2023): 研究了自监督学习框架,并探讨了视觉注意力驱动的良性-恶性肺结节分类。

Zhang et al. (2023): 深入研究了自监督学习在医学图像分析中的细节。

Zhao et al. (2023): 提供了TL和SSL方法的比较综述,定义、应用、优势和局限性。

这些研究涵盖了迁移学习和自监督学习在医学图像分析中的多个方面,包括它们的适用性、性能、以及面临的挑战。论文通过这些相关研究,进一步探讨了在医学领域中如何选择和优化预训练方法。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决选择和利用迁移学习(Transfer Learning, TL)和自监督学习(Self-supervised Learning, SSL)在医学图像处理领域的问题:

实验设计:作者设计了一个比较实验,使用两种广泛采用的深度学习模型,Xception和ResNet,分别在迁移学习和自监督学习设置下提取特征。然后,这些预训练模型在彩色(Kvasirv2, EyePacs)和灰度(BusI, 胸部CT)医学数据集上进行了微调(fine-tuning)和测试。

数据集选择:研究涉及多个彩色和灰度医学图像数据集,这些数据集代表了不同的医学成像技术(如X射线、CT、MRI等)和不同的疾病类型。

数据增强和下采样:为了解决医学领域常见的数据不平衡问题,作者采用了数据增强和下采样技术,并与预训练模型结合使用,以比较它们在处理这些问题方面的效率。

双重微调技术:针对领域不匹配问题,作者采用了双重微调技术,结合提出的预训练TL和SSL模型,以减少源域和目标医学数据之间的差异。

可解释人工智能技术:使用可解释人工智能(XAI)技术评估预训练模型的可靠性,包括生成类激活映射(Class Activation Mapping, CAM),以可视化和解释模型的决策过程。

性能评估:通过比较两种预训练方法在不同数据集上的性能(包括准确率、训练速度和鲁棒性),作者探讨了它们在医学图像分析中的优势和局限性。

结果分析和建议:基于实验结果,作者提出了关于在医学研究中选择适当预训练设置的建议,并讨论了如何根据不同场景选择TL或SSL方法。

深入分析:作者探讨了颜色信息、数据集大小和领域差异对预训练方法性能的影响,并提供了详细的分析和讨论。

通过这些步骤,论文不仅提供了TL和SSL在医学图像分析中的比较分析,还提出了实用的指导建议,帮助研究人员在面对特定医学图像处理任务时,选择最合适的预训练策略。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来比较迁移学习(Transfer Learning, TL)和自监督学习(Self-supervised Learning, SSL)在医学图像处理中的性能。以下是实验的主要步骤和内容:

预训练模型的选择:选择了Xception和ResNet两种深度学习模型,分别用于迁移学习和自监督学习的预训练。

数据集:使用了多个彩色和灰度医学图像数据集进行实验,包括Kvasirv2、EyePacs、BusI和胸部CT扫描数据集。

预训练:

- 迁移学习:使用Xception模型和预训练的ImageNet权重进行迁移学习。

- 自监督学习:使用ResNet模型和SimCLR方法进行自监督学习。

微调和测试:在预训练完成后,对模型进行了微调,并在目标数据集上进行了测试。

数据增强和下采样:

- 数据增强:对训练数据应用了旋转、翻转、缩放和模糊等数据增强技术,以解决数据不平衡问题。

- 下采样:通过随机删除多数类样本,使各类样本数量一致,以处理数据不平衡。

双重微调:

- 对预训练的模型首先在一个相关领域数据集上进行微调,然后再在目标数据集上进行微调,以减少领域不匹配问题。

模型性能评估:使用准确率、损失、敏感性、精确度和F1分数等指标评估模型性能。

可解释性分析:使用Grad-CAM技术生成热图,以可视化模型在进行预测时关注图像的哪些区域,评估模型的可靠性和鲁棒性。

比较分析:

- 比较了TL和SSL方法在不同数据集上的性能。

- 分析了数据增强和下采样技术对模型性能的影响。

- 对比了双重微调前后的模型性能。

- 将提出的模型与当前最先进的模型进行了比较。

结果总结:基于实验结果,提供了在不同医学应用场景下选择合适预训练方法的指导。

这些实验提供了深入的见解,帮助理解迁移学习和自监督学习在医学图像分析中的适用性和效果,以及如何通过不同的技术和方法提高模型的性能和鲁棒性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提供了关于迁移学习(TL)和自监督学习(SSL)在医学图像处理中的深入比较和分析,但仍有一些领域和方向可以进一步探索:

更广泛的数据集和任务:研究可以在更广泛的医学图像数据集和不同类型的任务(如分割、检测)上进行,以验证和比较TL和SSL方法的普适性和有效性。

更先进的预训练模型:随着深度学习模型的快速发展,可以尝试使用更先进的模型(如Vision Transformers)进行TL和SSL,探索它们在医学图像分析中的潜力。

多模态学习:在医学领域中,多模态数据(如图像、文本、电子健康记录)的融合越来越受到关注。研究TL和SSL在多模态学习中的应用可能揭示新的见解。

半监督和无监督学习:除了完全监督的迁移学习和完全无监督的自监督学习,探索半监督学习或弱监督学习在医学图像处理中的应用,可能会在标注成本和模型性能之间取得更好的平衡。

领域适应和对抗训练:研究领域适应技术,如对抗训练,以进一步提高模型对新领域或分布外数据的泛化能力。

计算效率和资源优化:在资源有限的环境中,如移动设备或边缘设备,探索如何优化TL和SSL方法以实现高效的模型推理。

模型压缩和加速:研究如何对预训练的医学图像模型进行压缩和加速,使其在临床实践中更加实用。

长期跟踪和预测:在医学图像分析中,长期跟踪疾病进展的能力非常重要。研究如何利用TL和SSL方法进行时间序列分析和预测可能具有重要意义。

模型解释性和伦理:提高模型的可解释性,并考虑伦理问题,如隐私保护和公平性,特别是在处理敏感的医疗数据时。

跨领域应用:探索TL和SSL方法在其他领域的应用,如金融、安全和自动驾驶,以了解这些方法在不同行业中的适用性和挑战。

合作和多任务学习:研究TL和SSL在多任务学习设置中的性能,这可能有助于提高模型的效率和效果。

动态数据和实时分析:研究模型如何处理动态变化的数据集,以及如何实时更新和优化模型以适应新的数据。

这些方向不仅可以推动医学图像分析技术的发展,还可以为深度学习在更广泛领域的应用提供有价值的见解。

Q: 总结一下论文的主要内容

A: 这篇论文主要探讨了在医学图像处理领域,迁移学习(Transfer Learning, TL)和自监督学习(Self-supervised Learning, SSL)两种方法的性能比较。以下是论文的主要内容总结:

研究背景:论文首先介绍了迁移学习(TL)和自监督学习(SSL)在医学图像分析中的研究背景和重要性,强调了这两种方法在处理医学数据时面临的挑战,如数据隐私、数据收集成本和数据不平衡问题。

研究目的:论文旨在通过实验比较TL和SSL在不同类型(彩色和灰度)医学图像数据集上的性能,包括准确率、训练速度和鲁棒性,并探讨它们在医学领域的应用潜力。

实验设计:研究者选择了Xception和ResNet两种深度学习模型,分别在TL和SSL设置下进行预训练,然后在多个彩色和灰度医学图像数据集上进行微调和测试。

数据集:实验使用了多个公开的医学图像数据集,包括Kvasirv2、EyePacs、BusI和胸部CT扫描数据集。

实验方法:

- 迁移学习:使用预训练的ImageNet权重初始化Xception模型,然后在医学图像数据集上进行微调。

- 自监督学习:使用SimCLR方法和ResNet模型在医学图像数据集上进行预训练,然后进行微调。

数据增强和下采样:研究了数据增强和下采样技术在处理数据不平衡问题方面的有效性。

双重微调:探讨了双重微调技术在减少领域不匹配问题和提高模型性能方面的有效性。

性能评估:使用准确率、损失、敏感性、精确度和F1分数等指标评估模型性能。

可解释性分析:使用Grad-CAM技术生成热图,评估模型的可靠性和鲁棒性。

结果分析:

- TL在彩色数据集上表现更好,而SSL在灰度数据集上表现更优。

- 数据增强技术提高了预训练模型的鲁棒性,而下采样技术可能导致信息丢失。

- 双重微调技术有效提高了模型在目标数据集上的性能。

结论和建议:论文最后提出了在选择TL和SSL方法时应考虑的因素,并提供了在不同医学应用场景下选择合适预训练方法的指导。

研究贡献:论文的贡献在于提供了TL和SSL在医学图像分析中的比较评估,深入分析了它们的优势和局限性,并为未来的研究提供了有价值的见解和指导。

整体而言,这篇论文通过实验研究和分析,为医学图像分析领域中迁移学习和自监督学习的应用提供了深入的见解,并探讨了如何优化这些方法以提高模型性能和鲁棒性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

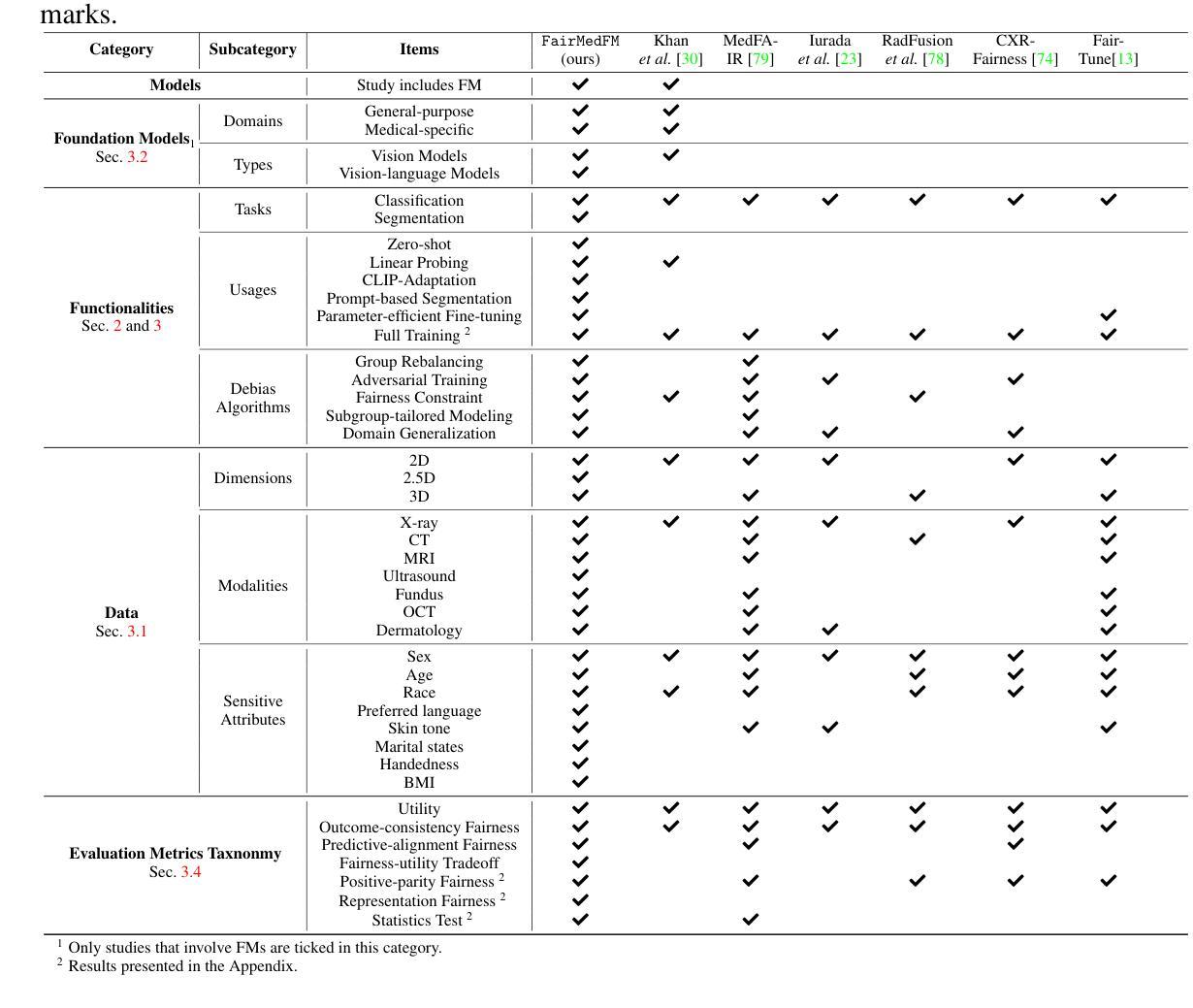

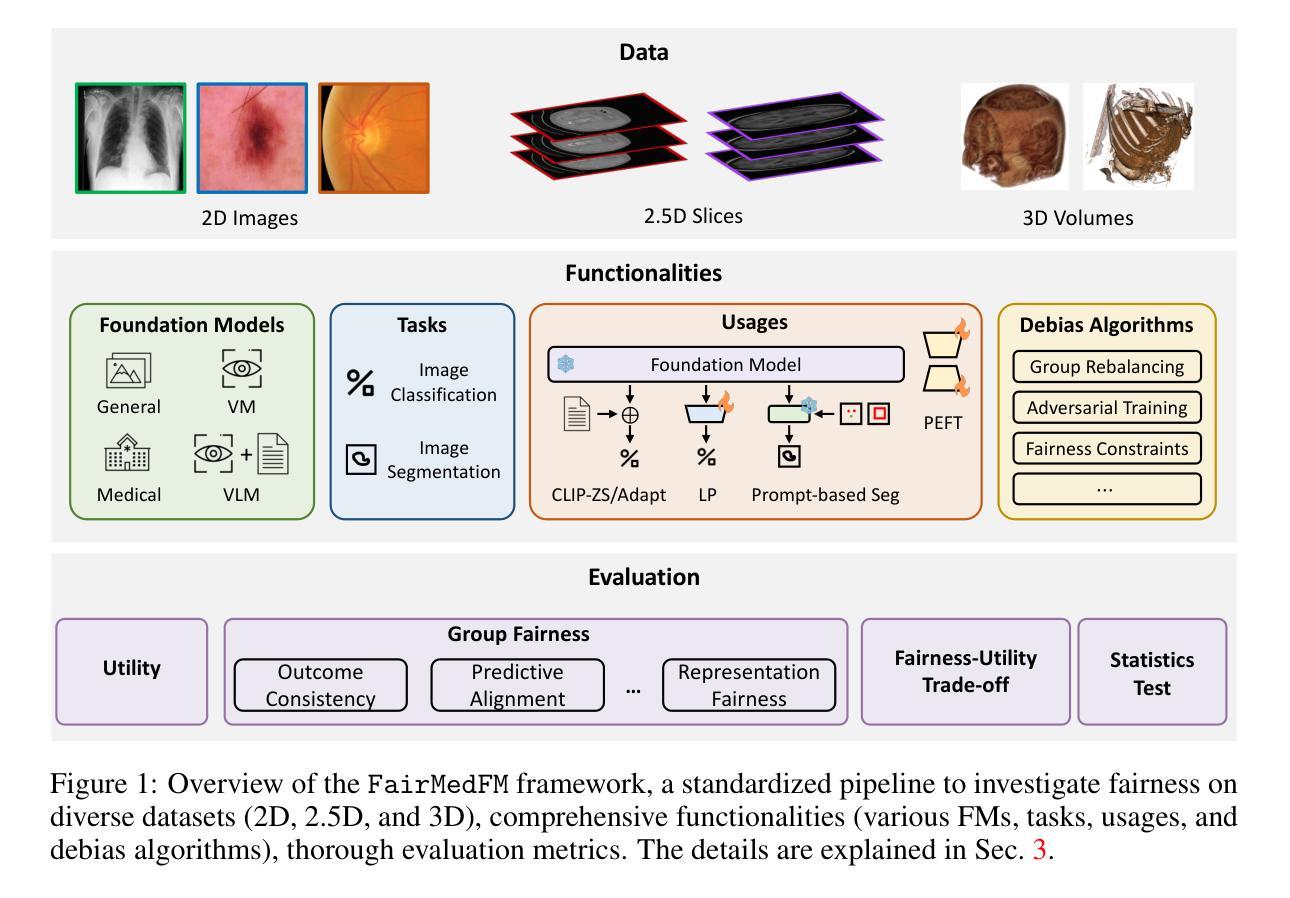

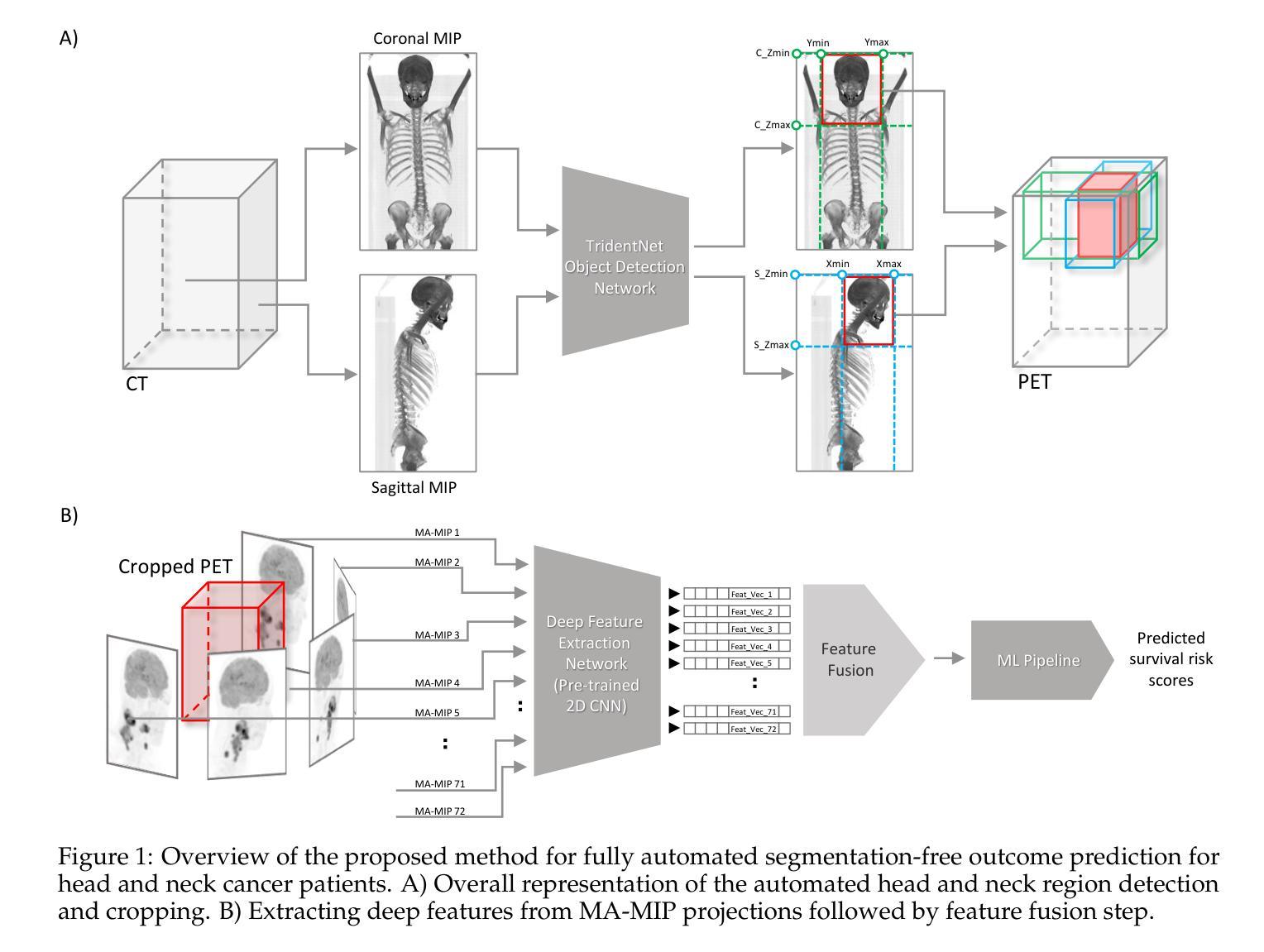

FairMedFM: Fairness Benchmarking for Medical Imaging Foundation Models

Authors:Ruinan Jin, Zikang Xu, Yuan Zhong, Qiongsong Yao, Qi Dou, S. Kevin Zhou, Xiaoxiao Li