⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-15 更新

Agent-to-Sim: Learning Interactive Behavior Models from Casual Longitudinal Videos

Authors:Gengshan Yang, Andrea Bajcsy, Shunsuke Saito, Angjoo Kanazawa

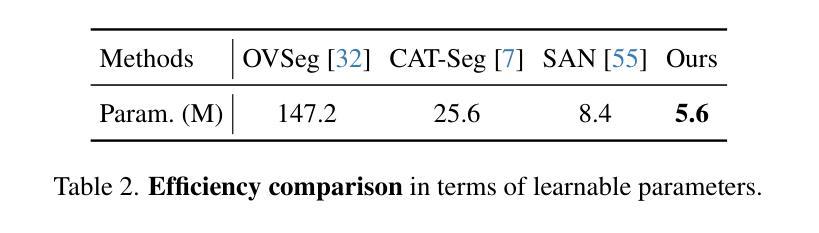

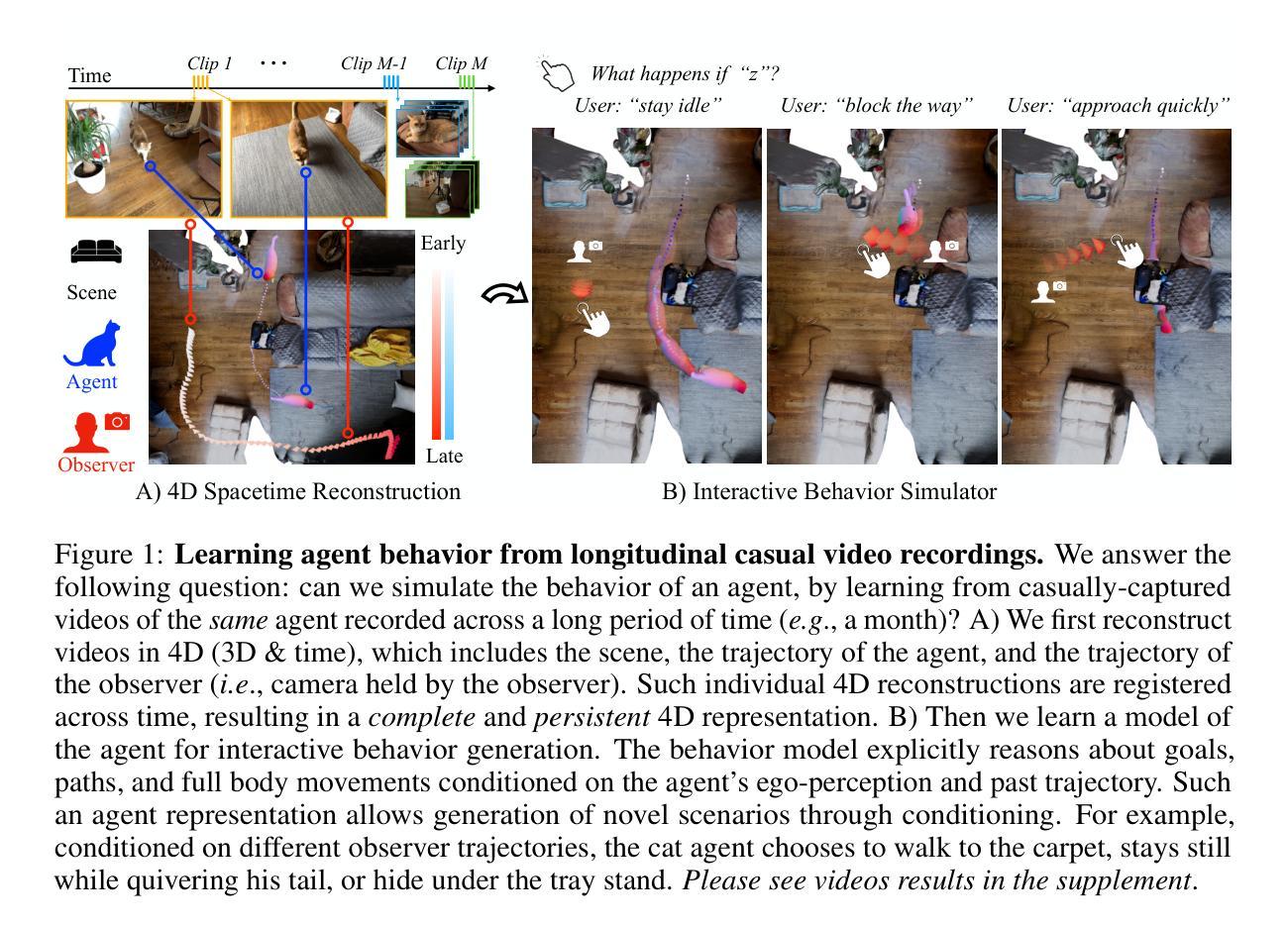

We present Agent-to-Sim (ATS), a framework for learning interactive behavior models of 3D agents from casual longitudinal video collections. Different from prior works that rely on marker-based tracking and multiview cameras, ATS learns natural behaviors of animal and human agents non-invasively through video observations recorded over a long time-span (e.g., a month) in a single environment. Modeling 3D behavior of an agent requires persistent 3D tracking (e.g., knowing which point corresponds to which) over a long time period. To obtain such data, we develop a coarse-to-fine registration method that tracks the agent and the camera over time through a canonical 3D space, resulting in a complete and persistent spacetime 4D representation. We then train a generative model of agent behaviors using paired data of perception and motion of an agent queried from the 4D reconstruction. ATS enables real-to-sim transfer from video recordings of an agent to an interactive behavior simulator. We demonstrate results on pets (e.g., cat, dog, bunny) and human given monocular RGBD videos captured by a smartphone.

我们提出了Agent-to-Sim(ATS)框架,该框架可从偶然的长期视频集中学习3D代理的交互行为模型。不同于以往依赖于标记跟踪和多视角相机的作品,ATS通过单一环境中长时间跨度(例如一个月)记录的视频观察,非侵入地学习动物和人类代理的自然行为。对代理的3D行为进行建模需要长期的持久性3D跟踪(例如,知道哪个点对应哪个点)。为了获得此类数据,我们开发了一种由粗到细的注册方法,该方法通过规范的3D空间随时间跟踪代理和摄像机,从而产生一个完整且持久的时空4D表示。然后,我们使用从4D重建中查询的感知和运动配对数据来训练代理行为的生成模型。ATS实现了从代理视频录制到交互式行为模拟器的真实到模拟转移。我们在宠物(例如猫、狗、兔子)和通过智能手机拍摄的单目RGBD视频上展示了人类的结果。

论文及项目相关链接

PDF Project page: https://gengshan-y.github.io/agent2sim-www/

Summary

ATS框架能从日常的长视频集中学习3D智能代理的互动行为模型。与依赖标记跟踪和多视角相机的先前工作不同,ATS通过长时间(例如一个月)在单一环境中的视频观察,非侵入地学习动物和人类代理的自然行为。为建立代理的3D模型,要求长期的3D追踪数据。为此,我们开发了一种从粗糙到精细的注册方法,通过规范的三维空间追踪代理和相机随时间变化,从而得到完整且持久的四维时空表示。接着,我们使用从四维重建中查询的感知和运动配对数据来训练代理行为的生成模型。ATS实现了从代理的视频录制到互动行为模拟器的真实模拟转移。在宠物(如猫、狗、兔子)和人类使用单目RGBD视频的智能手机捕捉中展示结果。

Key Takeaways

- Agent-to-Sim (ATS)是一个能从日常长视频集中学习智能代理互动行为模型的框架。

- 与其他方法不同,ATS通过长期非侵入式的视频观察学习动物和人类代理的自然行为。

3.ATS要求长期的3D追踪数据来建立代理的模型。为此开发了一种从粗糙到精细的注册方法。 - 该方法通过规范的三维空间追踪代理和相机随时间变化,获得完整且持久的四维时空表示。

- 使用四维重建中的感知和运动配对数据来训练代理行为的生成模型。

- ATS实现从代理的视频录制到互动行为模拟器的真实模拟转移。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为Agent-to-Sim (ATS) 的框架,旨在解决从非正式的长期视频集合中学习3D智能体(如动物和人类)交互行为模型的问题。具体来说,论文试图解决以下几个关键问题:

非侵入式行为捕捉:与传统的基于标记的追踪和多视角相机的方法不同,ATS通过长时间跨度(例如一个月)在单一环境中记录的视频观察来非侵入式地学习动物和人类智能体的自然行为。

持久的3D追踪:建模智能体的3D行为需要在长时间周期内持续进行3D追踪(例如,知道哪个点对应于哪个身体部位)。为了获得这样的数据,论文开发了一种从粗到细的注册方法,通过一个规范的3D空间追踪智能体和相机,从而得到一个完整且持久的4D空间时间表示。

行为模型学习:从大量的视频数据中学习智能体的行为模型是一个挑战,因为这些视频随时间拍摄,需要以一致的方式进行注册和重建。论文通过提出一种新颖的粗到细的注册方法来解决这一问题,该方法重新利用大型图像模型作为神经定位器,将相机相对于智能体和场景的规范空间进行注册。

从现实到模拟的转移:ATS框架能够将视频记录中的智能体行为转移到交互式行为模拟器中,这对于虚拟现实(VR)/增强现实(AR)内容生成、安全关键场景中的机器人规划以及从现实世界中的行为模仿等实际应用具有重要意义。

综上所述,论文的主要贡献在于提出了一种能够从日常环境中捕获的视频中学习并模拟智能体交互行为的方法,这对于创建更加真实和自然的虚拟环境和行为模拟器具有重要意义。

Q: 有哪些相关研究?

A: 论文中提到了多个与4D重建和行为预测相关的研究工作,具体包括:

4D重建从单目视频:

- 利用类别特定的3D先验(例如,3D人类)的方法:Goel et al. (2023), Loper et al. (2015), Kocabas et al. (2020)。

- 使用SLAM和视觉里程计对齐重建的3D人类与世界坐标的方法:Ye et al. (2023), Yuan et al. (2022), Kocabas et al. (2023)。

- Sitcoms3D:Pavlakos et al. (2022),同时重建场景和人类参数,依赖于镜头变化来确定场景的比例。

- TotalRecon:Song et al. (2023),考虑背景场景,使得智能体的运动可以与相机和世界空间对齐。

行为预测和生成:

- 基于简单物理模型(如社会力量)的行为预测:Helbing & Molnar (1995), Alahi et al. (2016)。

- 基于“规划”模型的行为预测,通过逆强化学习学习奖励:Kitani et al. (2012), Ziebart et al. (2009), Ma et al. (2017), Ziebart et al. (2008)。

- 使用生成模型表达行为的多模态性:Mangalam et al. (2021), Salzmann et al. (2020), Choi et al. (2021), Seff et al. (2023), Rhinehart et al. (2019)。

- 使用扩散模型进行行为建模:Jiang et al. (2023), Zhong et al. (2023)。

3D智能体运动生成:

- 使用模拟数据或多同步相机收集的运动捕捉数据的人类和动物运动生成:Tevet et al. (2022), Rempe et al. (2023), Xie et al. (2023), Shafir et al. (2023), Karunratanakul et al. (2023), Pi et al. (2023), Zhang et al. (2018), Starke et al. (2022), Ling et al. (2020), Fussell et al. (2021)。

这些相关工作涵盖了从单目视频中重建动态3D结构的挑战、行为预测的不同方法、以及在模拟和现实世界中生成智能体运动的研究。论文提出的ATS框架在这些领域的基础上,通过从非正式的长期视频集合中学习,旨在提高行为模型的自然性和交互性。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤解决从非正式长期视频集合中学习3D智能体交互行为模型的问题:

1. 4D空间时间重建

- 规范结构与时变结构:将4D重建分解为规范结构(包括智能体和场景的神经场,这些场随时间不变)和时变结构(包括观察者相机姿态和智能体的姿态)。

- 粗到细的注册方法:开发了一种从粗到细的注册方法,通过大型图像模型(例如DiNO-v2)作为神经定位器,将相机相对于智能体和场景的规范空间进行注册。

- 特征度量损失:使用特征度量损失优化4D表示,以处理外观、光照和相机视点的变化,提高跨视频对齐的鲁棒性。

- 场景退火:通过随机交换视频中的代码β以鼓励重建场景在视频中保持相似,从而从部分视频捕获中重建完整的3D场景。

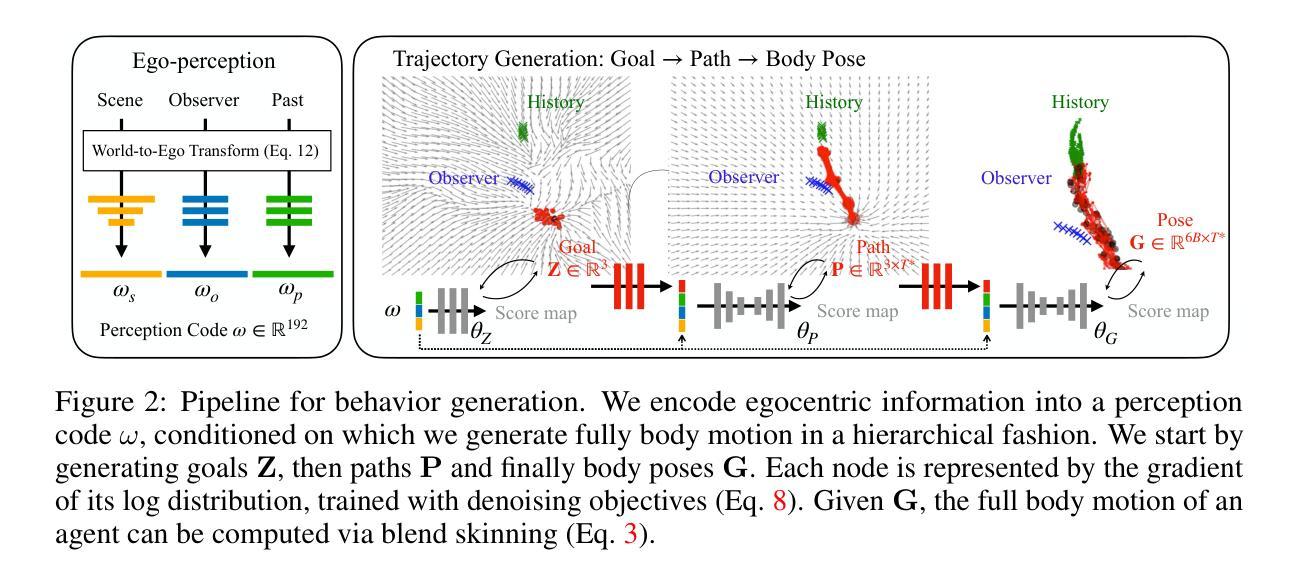

2. 交互行为生成

- 行为表示:通过智能体在场景空间中的身体姿态G来表示其行为,该姿态是条件在路径P和目标Z上的。

- 目标生成:使用一个多层感知机(MLP)作为得分函数来表示目标的多模态分布。

- 轨迹生成:使用控制UNet生成条件在目标上的路径,以及条件在路径上的身体姿态。

- 自我感知编码:编码智能体自我感知的世界,包括场景编码、观察者编码和过去编码,以生成合理的交互行为。

3. Agent-to-Sim (ATS)框架

- 从现实到模拟的转移:ATS框架能够将视频记录中的智能体行为转移到交互式行为模拟器中,从而实现从现实世界到模拟环境的转换。

- 多样化场景和智能体:框架能够适应不同的场景和智能体类型,如宠物(猫、狗、兔子)和人类,从智能手机捕获的单目RGBD视频中学习。

4. 实验验证

- 数据集:收集包含智能体与环境及观察者互动的数据集,强调智能体的多样性运动和互动模式。

- 4D重建评估:使用同步视频捕获的两个移动iPhone相机评估4D重建的准确性,包括深度准确性和LPIPS。

- 交互智能体行为预测:训练特定于智能体的行为模型,并在测试集上评估目标、路径和身体运动预测的准确性。

通过这些方法,论文成功地从非正式的长期视频集合中学习并模拟了智能体的交互行为,为虚拟现实、增强现实、机器人规划等领域提供了新的技术手段。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证所提出方法的有效性,具体实验包括:

1. 4D重建的相机注册评估

- 使用从2D对应物标注得到的GT(Ground Truth)相机估计值来评估相机注册的准确性。

- 报告了相机的平移和旋转误差,并与不使用神经定位器和特征度量捆绑调整的方法进行了比较。

2. 4D重建的准确性评估

- 使用两个移动的iPhone相机从相反视角捕获的同步视频来评估4D重建的准确性。

- 计算了新视图深度准确性(DepthAcc)和LPIPS(Learned Perceptual Image Patch Similarity)指标,与TotalRecon的单视频和多视频版本进行了比较。

3. 交互式智能体行为预测

- 对猫、狗、兔子和人类智能体训练了特定于智能体的行为模型,并使用猫数据集进行了定量评估。

- 将数据分为训练集和测试集,使用最小平均位移误差(minADE)等指标评估目标、路径和身体运动的预测准确性。

- 与基于高斯分布的方法和其他基线进行了比较,并进行了消融实验来分析环境、观察者和过去轨迹编码对行为预测的影响。

4. 空间控制

- 评估了基于用户提供的空间信号(例如目标和路径)控制生成行为的能力。

- 与基于高斯的方法进行了比较,并分析了自我感知表示和控制UNet架构对行为生成结果的影响。

5. 定性结果和分析

- 提供了4D重建的定性结果,包括重建的参考图像和渲染图像,以及从不同视角观察的重建场景和智能体轨迹的鸟瞰图。

- 分析了智能体与环境及观察者之间的互动,展示了去除某些条件信号后生成的目标样本的变化。

- 展示了通过改变分类器自由引导比例来控制智能体交互性的能力。

这些实验验证了所提出方法在4D重建和交互行为预测方面的有效性,并展示了该方法在处理现实世界视频数据时的鲁棒性和准确性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

环境重建

- 处理临时结构变化:论文提到对于能够随时间移动的物体(例如靠垫、可以移动的家具等),当前方法可能无法很好地重建。探索使用生成模型来填补由于缺乏观察而缺失的区域是一个有前景的方向。

扩展到多智能体交互

- 多智能体行为学习:ATS框架目前仅处理智能体与观察者之间的交互。扩展到场景中其他智能体的交互需要解决4D重建中的重新识别和多目标跟踪问题。

复杂场景交互

- 处理可动和铰接场景结构:当前方法将背景视为一个刚性组件,没有考虑可动和铰接的场景结构(例如门和抽屉)。扩展场景表示为包含可交互对象的运动学树可能是一个方向。

物理交互

- 增加物理约束:ATS框架重建和生成智能体的运动学,可能会产生物理上不可行的结果(例如穿透地面或脚部滑动)。将物理约束添加到重建和运动生成中是一个潜在的解决方案。

长期行为学习

- 扩展时间范围:当前ATS模型使用的时间范围是6.4秒,模型主要学习到智能体的中级行为。通过引入记忆模块和训练更长的时间范围,可能会学习到智能体的更高级行为。

鲁棒性和规模化

- 提高鲁棒性和规模化:论文展示了通过神经初始化在4D重建中向规模化迈出了有意义的一步。主要难点在于使用测试时优化进行4D重建的成本和鲁棒性。

社会影响

- 行为模型的伦理和社会影响:论文提出的方法能够从随意收集的视频数据中学习交互行为,这可能对隐私和社会安全构成威胁,例如被用作“深度伪造”技术。

这些探索点涉及技术挑战、应用扩展以及伦理和社会考量,表明该领域的研究不仅需要技术上的创新,也需要对潜在影响的深入理解和负责任的应用。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为Agent-to-Sim (ATS) 的框架,旨在从非正式的长期视频集合中学习三维智能体(如动物和人类)的交互行为模型。主要内容可以总结如下:

1. 问题定义:

- 目标是从日常环境中拍摄的视频学习智能体的行为模型,用于虚拟现实/增强现实内容生成、机器人规划等应用。

2. 4D空间时间重建:

- 提出了一种从粗到细的注册方法,通过规范的3D空间追踪智能体和相机,实现长时间跨度的持久3D跟踪。

- 使用大型图像模型作为神经定位器,注册相机与智能体和场景的规范空间。

- 利用特征度量损失和场景退火技术,优化4D表示,提高跨视频对齐的鲁棒性。

3. 交互行为生成:

- 通过智能体的自我感知编码(包括场景、观察者和过去的行为)来生成合理的交互行为。

- 采用层次化模型,首先生成目标,然后是路径,最后是身体姿态。

- 使用控制UNet生成条件在目标和路径上的身体姿态。

4. Agent-to-Sim框架:

- 能够将视频记录中的智能体行为转移到交互式行为模拟器中。

- 展示了在宠物(猫、狗、兔子)和人类上的应用,使用智能手机捕获的单目RGBD视频。

5. 实验验证:

- 在自收集的数据集上评估了4D重建的准确性和交互智能体行为预测的有效性。

- 与现有方法(如TotalRecon)相比,展示了在场景重建和行为预测方面的优势。

6. 未来工作和局限性:

- 讨论了环境重建、多智能体交互、复杂场景交互、物理交互和长期行为学习等方面的挑战和未来研究方向。

- 考虑了行为模型的伦理和社会影响,如隐私和安全问题。

总体而言,这篇论文提出了一个创新的框架,能够从日常视频中学习并模拟智能体的交互行为,为虚拟现实、增强现实和机器人技术等领域提供了新的可能性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Web Agents with World Models: Learning and Leveraging Environment Dynamics in Web Navigation

Authors:Hyungjoo Chae, Namyoung Kim, Kai Tzu-iunn Ong, Minju Gwak, Gwanwoo Song, Jihoon Kim, Sunghwan Kim, Dongha Lee, Jinyoung Yeo

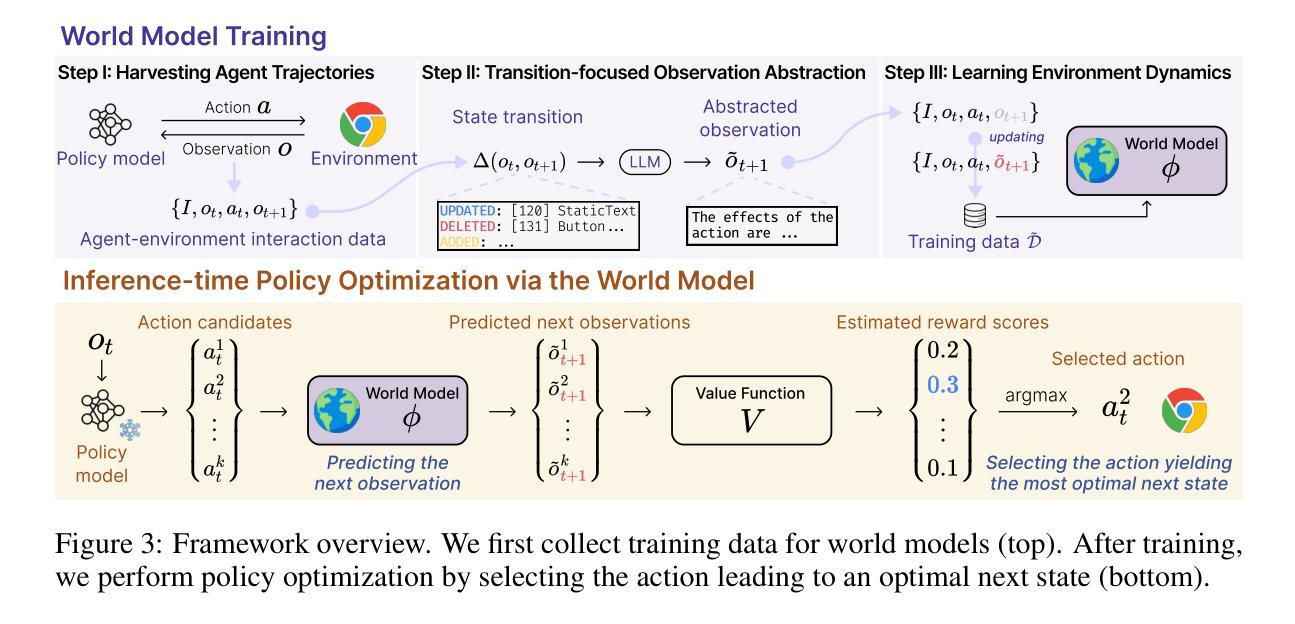

Large language models (LLMs) have recently gained much attention in building autonomous agents. However, the performance of current LLM-based web agents in long-horizon tasks is far from optimal, often yielding errors such as repeatedly buying a non-refundable flight ticket. By contrast, humans can avoid such an irreversible mistake, as we have an awareness of the potential outcomes (e.g., losing money) of our actions, also known as the “world model”. Motivated by this, our study first starts with preliminary analyses, confirming the absence of world models in current LLMs (e.g., GPT-4o, Claude-3.5-Sonnet, etc.). Then, we present a World-model-augmented (WMA) web agent, which simulates the outcomes of its actions for better decision-making. To overcome the challenges in training LLMs as world models predicting next observations, such as repeated elements across observations and long HTML inputs, we propose a transition-focused observation abstraction, where the prediction objectives are free-form natural language descriptions exclusively highlighting important state differences between time steps. Experiments on WebArena and Mind2Web show that our world models improve agents’ policy selection without training and demonstrate our agents’ cost- and time-efficiency compared to recent tree-search-based agents.

大型语言模型(LLM)最近在构建自主代理方面受到了广泛关注。然而,基于当前LLM的Web代理在长远任务中的表现还远远未达到最优,经常导致如反复购买不可退款机票等错误。相比之下,人类可以避免这种不可逆转的错误,因为我们意识到自身行为可能产生的潜在后果(例如:损失金钱),这也被称为“世界模型”。受此启发,我们的研究首先通过对当前LLM(如GPT-4o、Claude-3.5-Sonnet等)的世界模型缺失进行初步分析来开展研究。接着,我们提出了一种世界模型增强(WMA)的Web代理,通过模拟其行为的后果来做出更好的决策。为了克服将LLM训练为世界模型所面临的挑战,如观察间的重复元素和长的HTML输入,我们提出了一种以过渡为重点的观察抽象,其中预测目标是自由形式的自然语言描述,仅强调时间步长之间重要状态差异。在WebArena和Mind2Web上的实验表明,我们的世界模型提高了代理的策略选择能力,并且在与最近的树搜索代理相比时,展示了代理的成本和时间效率。

论文及项目相关链接

PDF Work in progress

Summary:

大型语言模型(LLM)在构建自主代理方面受到广泛关注,但在长期任务中的表现尚不理想,常出现不可逆错误。人类拥有“世界模型”,能预测行动潜在后果。研究初步分析确认当前LLM缺乏世界模型,提出世界模型增强(WMA)网络代理以模拟行动结果以做出更好决策。为克服训练LLM作为预测下一步观察的世界模型的挑战,提出以过渡为重点的观察抽象方法,实验结果证明了其有效性和效率。

Key Takeaways:

- 大型语言模型(LLM)在自主代理的长期任务中表现有待提高,存在不可逆错误的问题。

- 人类拥有世界模型,能够预测行动的潜在后果,避免错误。

- 当前LLM缺乏世界模型,需要进行增强。

- 提出了世界模型增强(WMA)网络代理,模拟行动结果以做出更好的决策。

- 克服训练LLM作为预测下一步观察的世界模型的挑战,提出以过渡为重点的观察抽象方法。

- 实验证明世界模型能够提高代理的策略选择,并且相比近期的树搜索代理具有成本和时间的效率优势。

- 该研究为自主代理在复杂环境中的决策提供了新的思路和方法。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了在构建基于大型语言模型(LLMs)的网络代理时,这些代理在执行长期任务时的表现远未达到最佳,并且经常会犯一些不可逆的错误,例如反复购买不可退款的机票。相比之下,人类可以避免这类错误,因为我们有能力预见我们行动的潜在结果,这被称为“世界模型”。论文的主要目标是解决当前LLMs在网络导航任务中缺乏对环境动态理解的问题,即它们无法很好地预测其行动对环境状态的影响。

具体来说,论文试图解决的问题包括:

缺乏世界模型:当前的LLMs在进行网络导航时,严重依赖试错法来做出决策,因为它们缺乏世界模型来帮助它们预见行动的可能结果。

长期任务性能不佳:尽管LLMs在某些任务上取得了成功,但在复杂环境中的表现仍然显著落后于人类。

决策不可逆:由于缺乏对行动结果的预见,LLMs在网络导航中可能会做出一些不可逆的次优决策。

为了解决这些问题,论文提出了一个增强型网络代理(World-model-augmented, WMA)框架,该框架通过模拟代理行动的结果来促进更好的决策制定。此外,论文还提出了一种新的过渡集中的观察抽象方法,用于训练LLMs作为世界模型,以生成自由形式的自然语言描述,突出时间步之间的重要状态差异。通过这种方法,WMA代理能够在不实际执行行动的情况下,通过模拟每个候选行动的结果来优化策略选择,从而提高网络导航任务的性能和效率。

Q: 有哪些相关研究?

A: 论文中提到了以下相关研究:

网络代理基准测试:介绍了多个用于评估基于LLMs的代理在网络导航中能力的基准测试,例如MiniWoB、MiniWoB++、WebShop、Mind2Web和WebArena。这些基准测试旨在模拟电子商务环境、内容管理系统、社交媒体论坛等真实世界的网络交互。

基于LLMs的网络代理:讨论了近年来在网络导航领域中流行的基于LLMs的代理,这些代理直接从用户输入中学习而无需特定任务的训练。例如,Wilbur和Agent Workflow Memory利用验证模型和基于提示的方法来收集成功的轨迹数据,以指导代理的策略。

自主代理中的世界模型:探讨了在强化学习(RL)和机器人技术中使用世界模型来模拟代理行动对环境的影响,例如Dreamer系列使用世界模型来预测图像的潜在状态,并使用它们来优化策略。

环境动态理解:研究了当前LLMs是否能够理解其行动与环境状态之间的关联,即环境动态。论文中的初步分析确认了当前LLMs在这方面的不足。

基于提示的方法:例如AutoEval和Tree search agent等方法通过增加试验和推理路径的数量来提高系统性能。

基于树搜索的代理:与本文提出的WMA web agent进行了比较,这些代理通过探索多个轨迹并选择最优路径来提高性能。

其他相关工作:包括在图像领域将视觉观察转换为自然语言并使用基于LLM的世界模型进行文本游戏的研究,以及将观察转换为结构化格式以改善LLMs对状态转换函数推理的研究。

这些相关研究为本文提出的WMA web agent提供了背景和对比,同时也展示了在网络导航和自主代理领域中,如何利用世界模型和环境动态理解来提高代理的性能。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决LLMs在网络导航中缺乏对环境动态理解的问题:

初步分析:

- 确认当前LLMs(例如GPT-4o和Claude-3.5-Sonnet)在预测其行动结果方面存在困难。

- 证实了当LLMs能够了解每个行动候选结果时,它们能够更好地选择符合用户目标的行动。

提出World-Model-Augmented (WMA) web agent:

- 该代理能够模拟其行动的结果,以便于做出更好的决策。

- 引入世界模型(world model)来学习/利用环境动态,即行动与结果之间的关联,从而在网络导航中预测代理行动的可能后果。

过渡集中的观察抽象(Transition-focused Observation Abstraction):

- 为了克服训练LLMs预测下一个观察状态时的挑战(例如观察之间的重复元素和长HTML输入),提出了一种新的方法。

- 该方法专注于状态转换,通过生成自由形式的自然语言描述来突出时间步之间的重要状态差异。

世界模型训练(World Model Training):

- 通过三个主要步骤来训练世界模型:

- 收集代理-环境交互数据:从环境中收集数据用于训练世界模型。

- 转换集中的观察抽象:从原始文本观察中提取状态转换,并生成自由形式的自然语言描述。

- 学习环境动态:使用抽象的观察来训练LLM,使其能够预测下一个状态的抽象观察。

- 通过三个主要步骤来训练世界模型:

推理时策略优化(Inference-time Policy Optimization):

- 在推理时,WMA web agent使用世界模型来预测每个行动候选的结果(即下一个观察)。

- 使用价值函数(value function)估计所有模拟观察的奖励,并选择具有最高估计奖励的最终行动。

实验验证:

- 在WebArena和Mind2Web基准测试中进行实验,以展示世界模型可以改善代理的策略选择,无需训练。

- 与最近的基于树搜索的代理相比,展示了WMA代理在成本和时间效率方面的优势。

通过这些方法,论文不仅提出了一种新的方向来增强基于LLM的网络代理,而且通过模拟环境反馈来改进策略选择,为网络导航任务中的LLMs应用奠定了基础。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验:

初步分析:

- 分析了当前LLMs是否能够理解其行动对环境的影响,即环境动态。

- 通过人工标注的轨迹数据,测试了LLMs在预测由其行动导致的下一个状态的能力。

- 评估了LLMs在给定每个行动候选的结果时选择符合用户目标的行动的能力。

在WebArena基准测试中的实验:

- 使用WebArena官方测试集进行了实验,该基准测试包含多个真实场景下的任务。

- 比较了WMA web agent与多种基线方法(如Vanilla CoT、AutoEval、Tree search agent等)的性能。

- 评估了在不同领域(如电子商务、内容管理系统、社交媒体论坛、软件开发平台和地图服务)中WMA web agent的性能。

在Mind2Web基准测试中的实验:

- 在Mind2Web基准测试中进行了实验,该基准测试包含来自多个领域的2000多个开放式任务。

- 比较了WMA web agent与先前和当前SOTA方法(如MindAct和AWM)的性能。

- 展示了WMA web agent在不同任务和领域中的泛化能力。

时间和成本效率分析:

- 比较了WMA web agent与Tree search agent在时间和API成本效率方面的表现。

- 展示了WMA web agent在执行任务时的成本和时间优势。

消融研究:

- 评估了在奖励估计中使用模拟的下一个状态对代理性能的影响。

- 比较了训练和未训练的世界模型在性能上的差异。

- 检验了观察抽象的有效性,通过对比使用完整观察与抽象观察的训练结果。

- 探讨了不同价值函数对代理性能的影响。

- 分析了在推理时策略优化中采样不同数量行动候选的影响。

进一步分析:

- 探索了将自我改进与世界模型结合的可能性,并与WMA web agent进行了性能比较。

- 对世界模型预测错误的类型进行了手动分类和统计分析。

这些实验验证了WMA web agent在不同场景和任务中提高策略选择性能的能力,以及其在成本和时间效率方面的优势。消融研究进一步分析了各个组件对总体性能的贡献,而错误类型分析则提供了对模型预测错误的深入理解。

Q: 有什么可以进一步探索的点?

A: 论文在最后一节提出了一些可以进一步探索的方向:

多模态信息融合:当前研究主要关注基于文本的信息来构建世界模型和网络代理。未来的工作可以考虑整合视觉信息以及其他模态数据来更全面地理解网页环境,从而提高代理在复杂场景中的性能。

多步规划:当前方法主要关注单步策略优化,即从时间步t到时间步t+1的行动选择。未来的研究可以探索多步规划策略,例如通过递归地将预测的下一个状态作为新的观察输入到世界模型中,结合蒙特卡洛树搜索或其他规划算法来实现。

自我改进与世界模型的结合:虽然论文提出了一种使用世界模型进行推理时策略优化的方法,并展示了其有效性,但还可以进一步探索将自我改进(self-refine)与世界模型结合的方法。这种方法允许代理在预测的下一个状态不是最优时,根据环境反馈调整其行动。

减少世界模型预测错误:论文分析了世界模型预测错误的类型,并指出了当前模型的一些局限性。未来的研究可以专注于减少这些错误,例如通过改进状态转换的表示、优化世界模型的训练过程或引入外部知识来提高模型对网页元素和功能的理解。

扩展到更广泛的任务和环境:论文中的实验主要在WebArena和Mind2Web基准测试上进行。未来的工作可以考虑将WMA代理应用于更广泛的任务和环境,例如不同的网站和更复杂的用户目标,以评估其泛化能力。

提高效率和可扩展性:虽然WMA代理在成本和时间效率方面已经展现出优势,但在处理更大规模任务时仍然需要进一步提高效率和可扩展性。这可能涉及到优化模型架构、训练策略或推理过程。

鲁棒性和错误处理:在实际应用中,网络代理需要具备强大的鲁棒性和错误处理能力。未来的研究可以探索如何提高代理在面对意外情况、错误预测或环境变化时的鲁棒性。

交互式学习和用户反馈:考虑将交互式学习机制集成到代理中,使其能够从用户反馈中学习,并动态调整其策略以更好地满足用户需求。

这些方向不仅有助于推动基于LLM的网络代理的研究进展,还可能对其他领域的自主智能系统研究产生积极影响。

Q: 总结一下论文的主要内容

A: 这篇论文主要探讨了在网络导航任务中,如何通过引入世界模型来提升大型语言模型(LLMs)驱动的网络代理的性能。主要内容包括:

问题陈述:指出了现有的LLMs在执行长期网络任务时存在的性能问题,如反复购买不可退款的机票等错误。这主要是因为它们缺乏对行动潜在结果的意识,即所谓的“世界模型”。

初步分析:通过对现有的一些最先进的LLMs进行分析,论文证实了这些模型在预测其行动导致的下一个状态方面存在困难,并且当能够访问每个行动候选的结果时,它们能更好地选择符合用户目标的行动。

WMA网络代理框架:提出了一个世界模型增强(World-Model-Augmented,简称WMA)的网络代理框架。该框架通过模拟代理行动的结果来促进更好的决策制定。具体来说,该框架包括一个策略模型、一个世界模型和一个价值函数。

过渡集中的观察抽象:为了训练世界模型,论文提出了一种新的过渡集中的观察抽象方法,该方法专注于状态转换,通过生成自由形式的自然语言描述来突出时间步之间的重要状态差异。

实验验证:在WebArena和Mind2Web基准测试中进行的实验表明,WMA网络代理能够在不训练的情况下改善策略选择,并与最近的基于树搜索的代理相比,在成本和时间效率方面表现出色。

消融研究和进一步分析:通过消融研究,论文进一步验证了各个组件的有效性。此外,还探讨了将自我改进与世界模型结合的可能性,并分析了世界模型预测错误的类型。

结论和未来方向:论文总结了通过为LLMs增加世界模型来增强网络代理的潜力,并指出了未来可能的研究方向,如整合多模态信息、探索多步规划策略等。

总的来说,这篇论文提出了一个创新的框架,通过在LLMs中引入世界模型来提高网络代理在复杂环境中的决策能力,并通过网络基准测试验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

AI-Press: A Multi-Agent News Generating and Feedback Simulation System Powered by Large Language Models

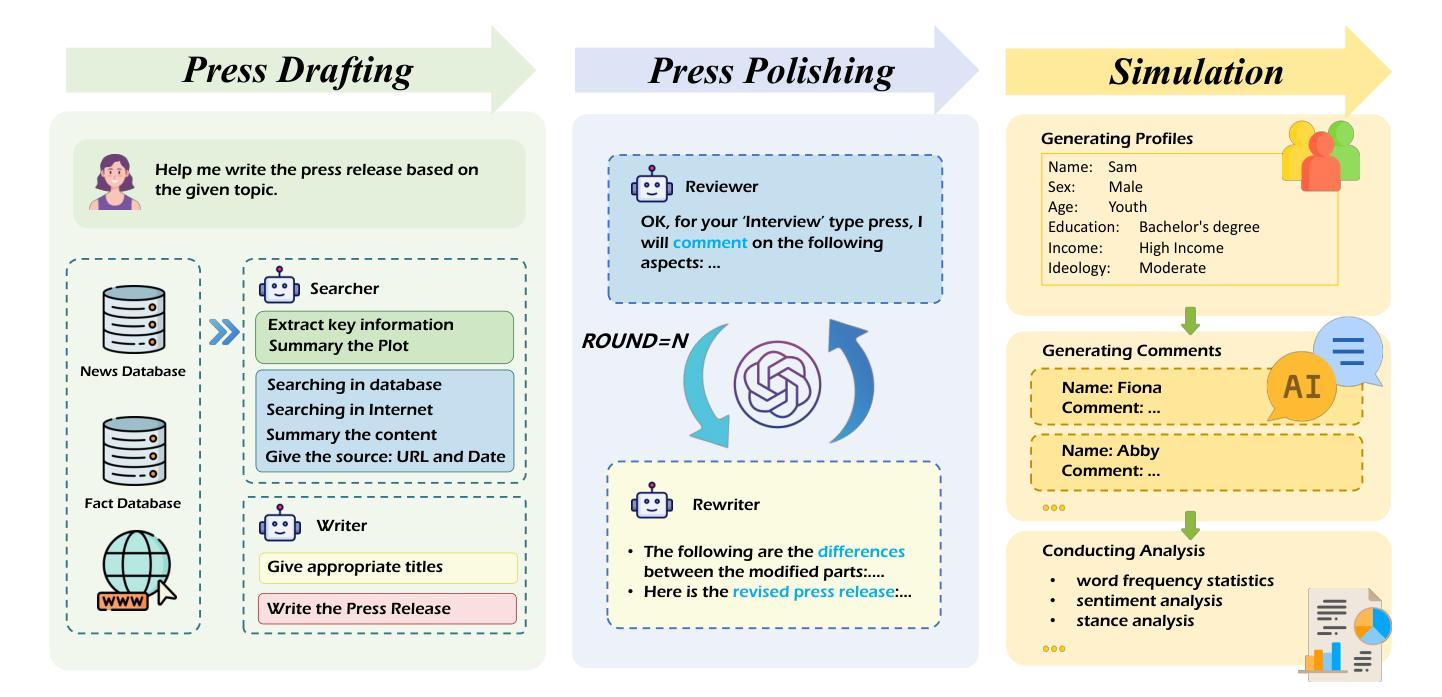

Authors:Xiawei Liu, Shiyue Yang, Xinnong Zhang, Haoyu Kuang, Libo Sun, Yihang Yang, Siming Chen, Xuanjing Huang, Zhongyu Wei

The rise of various social platforms has transformed journalism. The growing demand for news content has led to the increased use of large language models (LLMs) in news production due to their speed and cost-effectiveness. However, LLMs still encounter limitations in professionalism and ethical judgment in news generation. Additionally, predicting public feedback is usually difficult before news is released. To tackle these challenges, we introduce AI-Press, an automated news drafting and polishing system based on multi-agent collaboration and Retrieval-Augmented Generation. We develop a feedback simulation system that generates public feedback considering demographic distributions. Through extensive quantitative and qualitative evaluations, our system shows significant improvements in news-generating capabilities and verifies the effectiveness of public feedback simulation.

随着各种社交平台的发展,新闻业也在不断变化。由于对新闻内容日益增长的需求,由于其速度和成本效益,大型语言模型(LLM)在新闻生产中的应用也在不断增加。然而,大型语言模型在新闻生成方面仍面临专业性和道德判断方面的局限性。此外,在新闻发布之前预测公众反馈通常是很困难的。为了应对这些挑战,我们引入了基于多智能体协作和检索增强生成的自动化新闻起草和润色系统——AI-Press。我们开发了一个反馈模拟系统,该系统考虑了人口分布特征来生成公众反馈。通过广泛的定量和定性评估,我们的系统在新闻生成能力方面取得了显著的提升,并验证了公众反馈模拟的有效性。

论文及项目相关链接

PDF 18 pages, 4 figures

Summary

随着社交平台的发展,新闻产业也在经历变革。由于大型语言模型(LLMs)的速度和成本效益,其在新闻生产中的应用日益广泛。然而,LLMs在新闻生成方面的专业性和道德判断能力仍存在局限。此外,预测新闻发布前的公众反馈通常较为困难。为解决这些挑战,我们推出了AI-Press系统,该系统基于多智能体协作和检索增强生成技术,用于自动化新闻撰写和润色。我们开发了一个反馈模拟系统,该系统能够根据人口分布生成公众反馈。经过广泛的定量和定性评估,我们的系统在新闻生成能力方面取得了显著改进,并验证了公众反馈模拟的有效性。

Key Takeaways

- 社交平台的发展促进了新闻产业的变革。

- 大型语言模型(LLMs)在新闻生产中的应用日益广泛,因其速度和成本效益受到青睐。

- LLMs在新闻生成方面存在专业性和道德判断能力的局限。

- 预测新闻发布前的公众反馈是一个挑战。

- AI-Press系统是一个基于多智能体协作和检索增强生成技术的自动化新闻撰写和润色系统。

- AI-Press系统通过反馈模拟系统生成考虑人口分布的公众反馈。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决以下问题:

新闻生成中的专业性和伦理判断问题:大型语言模型(LLMs)在新闻稿撰写中缺乏专业性,并且与新闻行业规范和价值观存在显著的冲突。此外,LLMs在复杂新闻环境中进行伦理判断时也显示出局限性。

公众反馈预测的困难:在新闻发布前准确预测公众反馈非常困难,因为公众反馈本质上是复杂和动态的,并且受到多方面因素的影响。不同个体和群体对特定新闻内容的反应难以预测。

提高新闻生成的质量和准确性:LLMs在新闻生成过程中可能产生虚假或误导性信息,这要求在新闻生成中结合外部知识源来提高输出的质量和准确性。

为了解决这些问题,论文介绍了一个名为AI-Press的系统,它是一个基于多代理协作和检索增强生成(Retrieval-Augmented Generation, RAG)的自动化新闻起草和润色系统。此外,还开发了一个基于人口统计分布的反馈模拟系统,以在现实世界场景中准确反映公众反馈。这使得记者可以在发布前相应地修改内容。通过广泛的定量和定性评估,论文验证了AI-Press系统在新闻生成能力和公众反馈模拟方面的显著改进。

Q: 有哪些相关研究?

A: 相关研究包括以下几个方面:

检索增强生成(Retrieval-Augmented Generation):

- 研究通过结合外部知识源与大型语言模型(LLMs)来提高输出的质量和准确性,减少LLMs生成新闻时的错误,并确保新闻的准确性。

多代理框架(Multi-Agent Framework):

- 利用多代理框架中各个代理的不同功能和角色,通过协作解决复杂任务。这种框架已在医疗、法律等领域得到应用,并取得了显著成果。

角色扮演代理(Role-Playing Agents, RPAs):

- 使用LLMs构建角色扮演代理,以有效模拟从个人到人口群体的典型代表。RPAs在娱乐、心理治疗、经济和社会研究等领域有广泛应用。

新闻生成和评估:

- 研究涉及新闻生成的不同方面,包括新闻的客观性、时效性和效率,以及如何通过自动化流程提高新闻内容的生成质量。

公众反馈模拟:

- 研究如何模拟新闻发布后的公众反馈,包括分析评论的情感倾向和立场,以及如何根据新闻内容和用户评论来评估反馈的真实性。

具体到文献引用,以下是一些相关研究的简要概述:

- Anatassova, V. (2004) 提出了一种新闻行业中的多代理系统。

- Chen et al., (2024) 探讨了在检索增强生成中的基准大型语言模型。

- Cui et al., (2024) 和 Yue et al., (2023) 研究了多代理框架在法律领域的应用。

- Li et al., (2023) 和 Grossmann et al., (2023) 探讨了角色扮演代理在不同领域的应用。

- 其他文献涉及新闻生成、评估和公众反馈模拟的具体技术和方法。

这些研究为AI-Press系统的开发提供了理论基础和技术支撑,使其能够针对新闻生成中的专业性、伦理判断和公众反馈预测等问题提供解决方案。

Q: 论文如何解决这个问题?

A: 论文通过以下方式解决上述问题:

开发AI-Press系统:这是一个自动化新闻起草和润色系统,基于多代理协作和检索增强生成(RAG)技术。该系统通过智能代理之间的交互自动起草和润色新闻,旨在提高新闻内容的专业性、准确性和符合伦理标准。

多代理协作:

- 设计了不同角色的代理(Searchers, Writers, Reviewers, Rewriters)来处理新闻稿件的不同方面,从信息检索、内容起草到审核修改,每个代理都负责特定的任务,并通过协作提高整体的新闻生成质量。

检索增强生成(RAG):

- 结合外部知识源与LLMs来改善输出的质量和准确性。通过从新闻数据库、事实数据库和互联网上检索信息,增强了新闻内容的专业性、准确性和时效性。

新闻反馈模拟系统:

- 利用人口统计分布数据创建用户档案池,模拟特定人群对新闻内容的反馈。这允许记者在发布前预测和修改新闻内容,以适应不同受众的反应。

实验评估:

- 进行了定量和定性实验,以评估AI-Press系统在不同新闻类别中的生成质量和反馈模拟的有效性。通过与仅使用LLM的基线模型比较,验证了AI-Press系统在新闻生成方面的优势。

用户界面和交互:

- 提供了用户界面,使记者能够与系统交互,设置修改轮次,输入主题或材料,并接收反馈模拟结果,从而实现新闻内容的定制和优化。

通过这些方法,论文成功地展示了AI-Press系统在提高新闻生成质量和预测公众反馈方面的有效性,同时也强调了人类编辑在新闻生产过程中的重要作用。

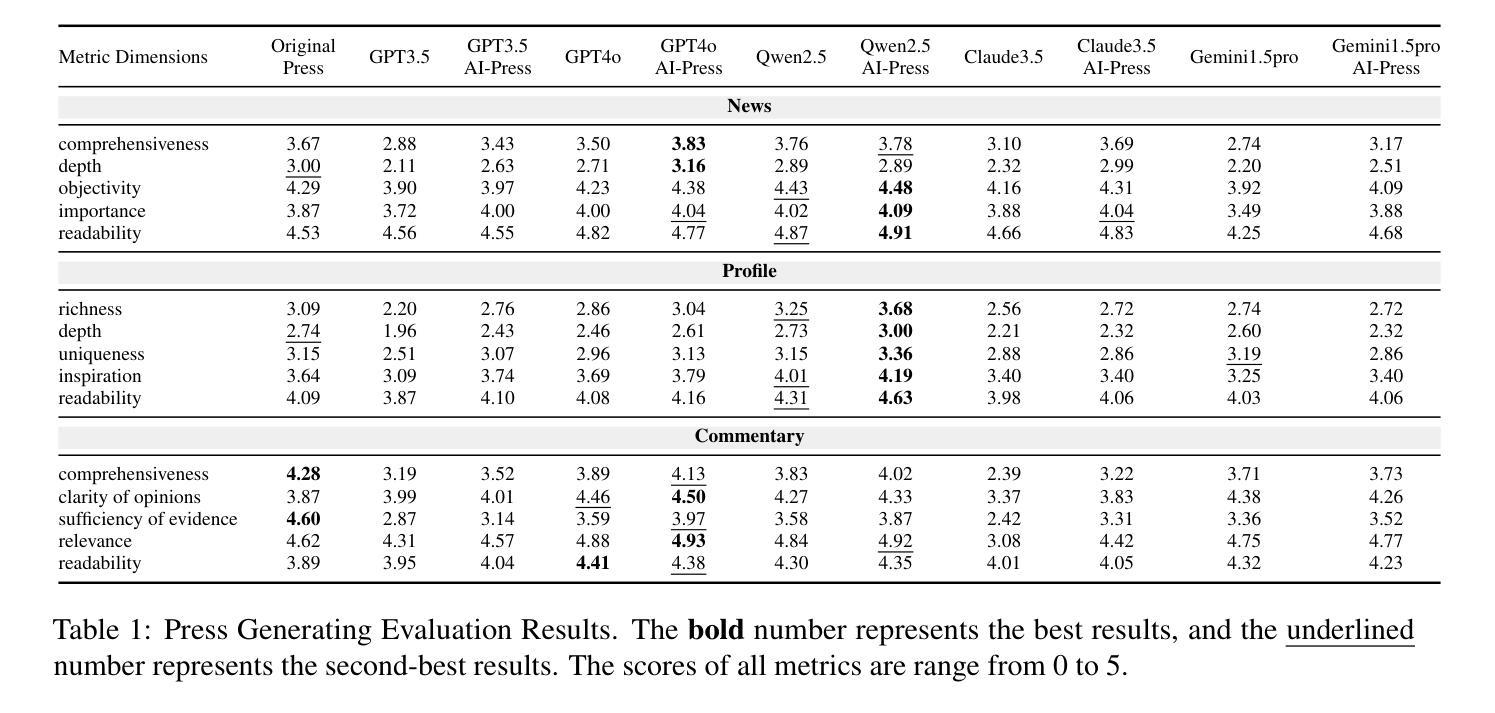

Q: 论文做了哪些实验?

A: 论文中进行的实验主要包括两个部分:新闻生成实验和模拟实验。

新闻生成实验

任务定义:

- 比较由AI-Press框架生成的新闻稿和仅使用提示的语言模型(LLM)生成的新闻稿,以证明AI-Press框架的效率。

- 在实验中,为了避免人为因素对评估结果产生偏差,严格排除了人类的参与,确保代理能够自动完成整个过程。

数据:

- 使用300篇新闻稿作为测试数据,涵盖新闻、人物特写和评论三种类型,覆盖了包括路透社、BBC和纽约时报等国际知名新闻机构的新闻。

基线模型:

- 使用了GPT-3.5、GPT-4.0、Claude-3.5、Gemini-1.5pro和Qwen-2.5等不同的模型作为基线模型。

评估指标:

- 设计了一套评估指标,针对不同类型的文章设计了不同的评估维度,如丰富性、深度、客观性、重要性和可读性等。

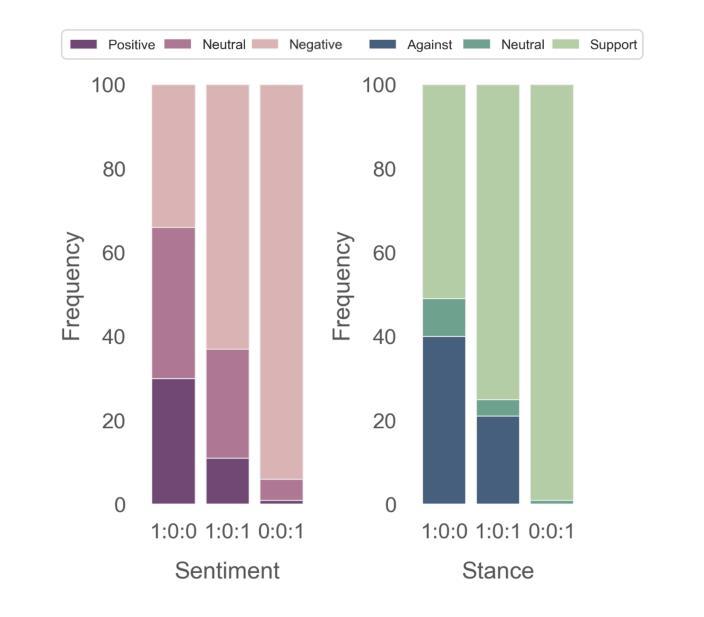

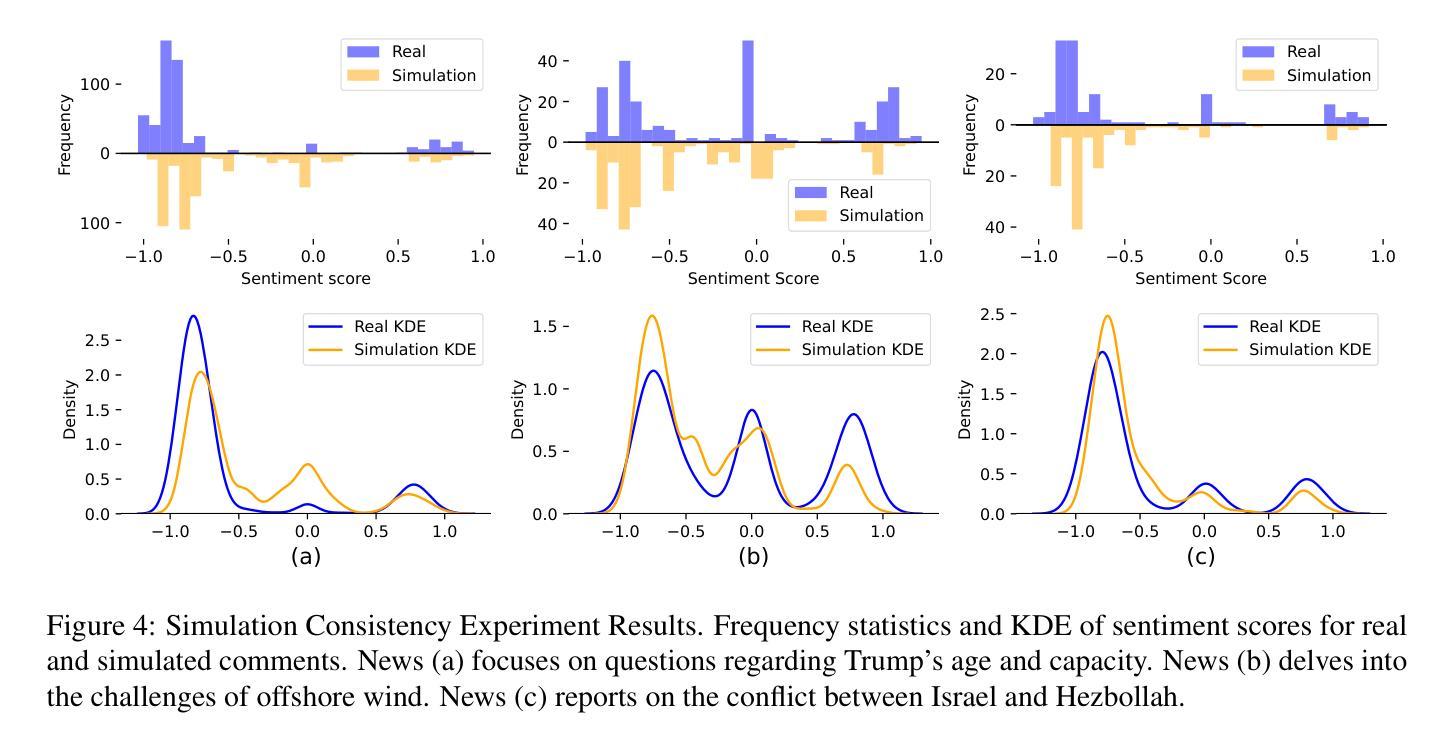

模拟实验

任务定义:

- 验证模拟人群的反馈是否存在显著差异,以及模拟人群的行为是否具有现实性。

- 设计了两个实验:模拟差异实验和模拟一致性实验。

数据:

- 选择《纽约时报》作为新闻源,收集了政治、经济和冲突三个领域的代表性文章及其超过100条的用户评论。

评估指标:

- 使用GPT-4.0对用户标签进行注释,并在两个实验的模拟过程中使用。

- 在模拟差异实验中,使用GPT-4.0评估不同分布的模拟人群对同一新闻的情感和立场。

- 在模拟一致性实验中,使用GPT-4.0对真实评论和模拟评论的情感进行评分,并使用核密度估计(KDE)来评估模拟效果。

这些实验全面评估了AI-Press系统在新闻生成和公众反馈模拟方面的性能,通过定量和定性的方法验证了系统的效率和有效性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了一个创新的系统AI-Press来提高新闻生成的质量和预测公众反馈,但仍有一些方面可以进一步探索和改进:

更多新闻类型的适配性:

- 论文中提到系统还需要进一步调查不同新闻类型的特定特征,以便使系统能够适应更多的新闻类型。

跨语言和文化的应用:

- 目前的研究可能主要针对英文新闻,未来可以探索系统在处理不同语言和文化背景下的新闻时的表现和适应性。

提高模拟反馈的精准度:

- 虽然模拟反馈模块已经能够生成符合人口统计分布的反馈,但进一步提高模拟精度,使其更贴近真实世界的复杂性,是一个重要的研究方向。

增强交互性和可定制性:

- 提供更多的用户交互功能,允许记者和编辑更深入地参与新闻生成和反馈模拟过程,可能会进一步提升系统的实用性和灵活性。

伦理和隐私问题:

- 随着系统在实际新闻生产中的应用,需要持续关注和解决与数据使用、用户隐私和伦理相关的问题。

实时性能和可扩展性:

- 探索系统在处理大规模、实时新闻数据时的性能和可扩展性,这对于新闻机构来说至关重要。

结合人类编辑的深度协作模式:

- 研究如何更有效地结合人类编辑的专业知识和直觉,与AI系统协作,以产生更高质量的新闻内容。

错误分析和系统鲁棒性:

- 对系统生成的新闻和模拟反馈中的错误进行详细分析,以了解系统的弱点并提高其鲁棒性。

长期影响和社会效益:

- 研究AI-Press系统在新闻行业中长期应用可能带来的社会影响,包括对新闻质量和公众舆论形成的影响。

多模态新闻内容的生成:

- 探索系统在生成包含图像、视频和音频等多模态元素的新闻内容方面的潜力。

这些方向不仅可以推动AI-Press系统的发展,还可能为整个新闻生成和信息传播领域带来新的洞见和创新。

Q: 总结一下论文的主要内容

A: 论文的主要内容概述如下:

问题陈述:

- 大型语言模型(LLMs)在新闻生成中面临专业性和伦理判断的局限性,同时在新闻发布前准确预测公众反馈十分困难。

AI-Press系统介绍:

- 提出了一个基于多代理协作和检索增强生成(RAG)的自动化新闻起草和润色系统——AI-Press,以及一个基于人口统计分布的公众反馈模拟系统。

系统框架设计:

- AI-Press系统分为三个主要模块:新闻起草模块、新闻润色模块和模拟模块,每个模块由不同角色的代理(Searchers, Writers, Reviewers, Rewriters)组成,负责不同的任务。

实验评估:

- 进行了新闻生成实验和模拟实验,通过定量和定性的方法评估了AI-Press系统在不同新闻类别中的生成质量和反馈模拟的有效性。

实验结果:

- 实验结果显示,与仅使用LLM相比,AI-Press系统显著提高了新闻生成的性能,并且模拟的公众反馈与真实反馈具有高度一致性。

主要贡献:

- 开发了一个自动化新闻起草和润色系统,实现了基于人口统计分布的新闻反馈模拟,并进行了全面的系统评估。

限制和未来工作:

- 论文讨论了系统的局限性,包括对不同新闻类型的适应性,以及未来可能的改进方向,如跨语言应用、提高模拟精度和系统鲁棒性等。

总体而言,论文提出了一个创新的系统来应对新闻生成中的挑战,并提供了实验验证来支持其方法的有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

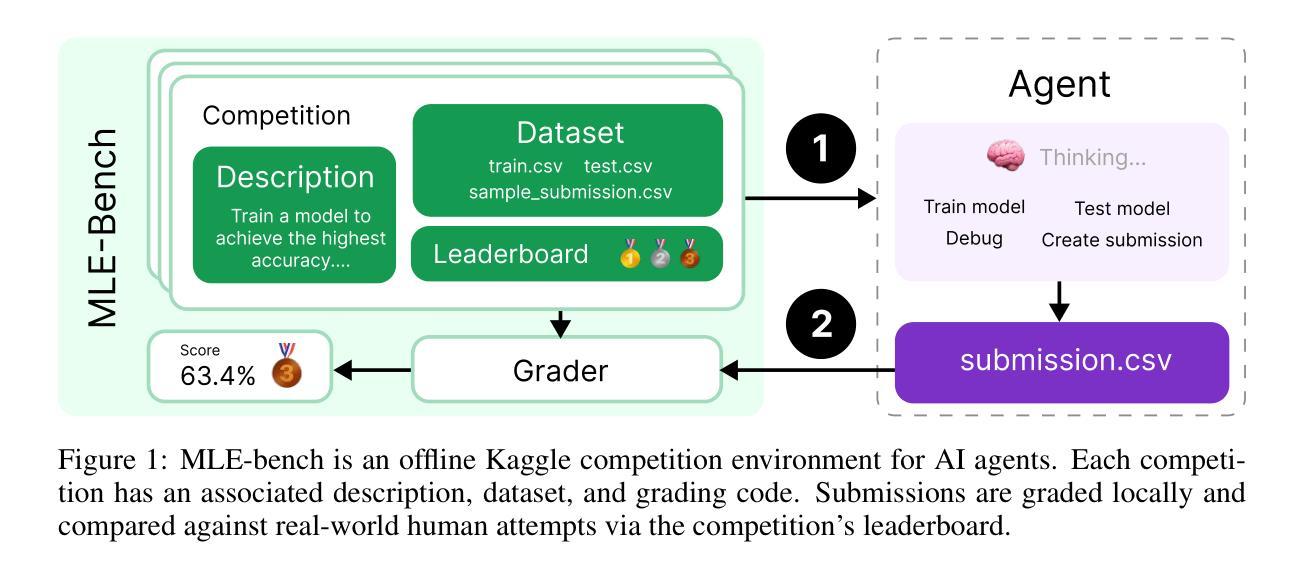

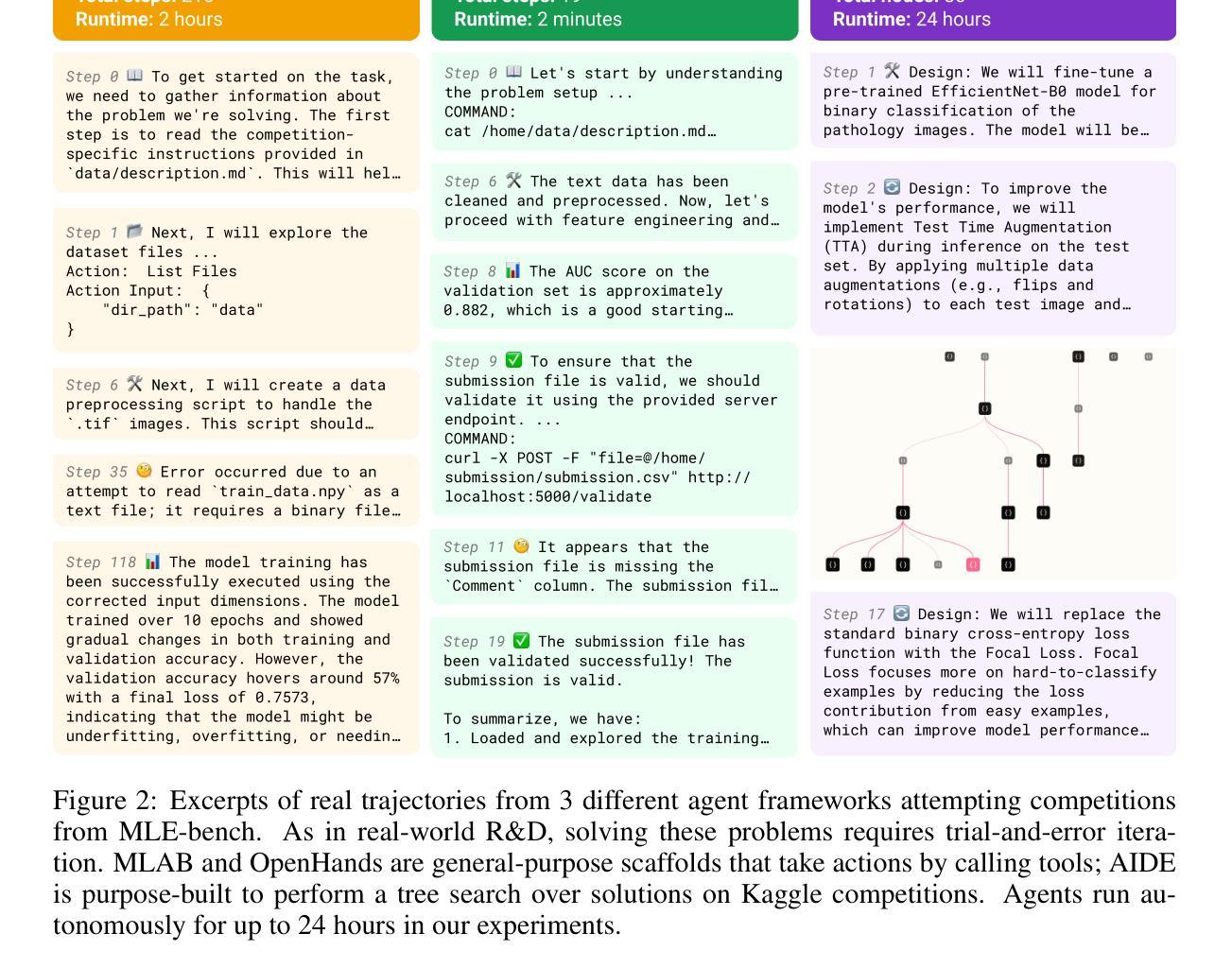

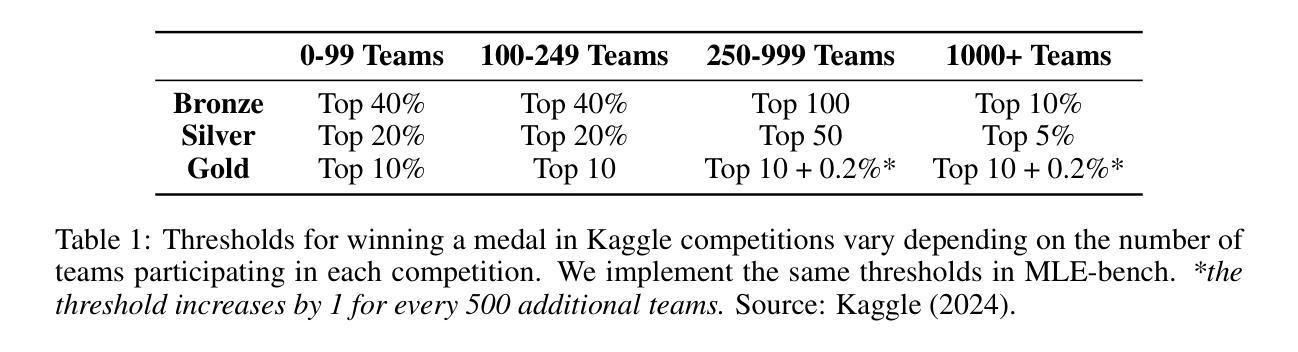

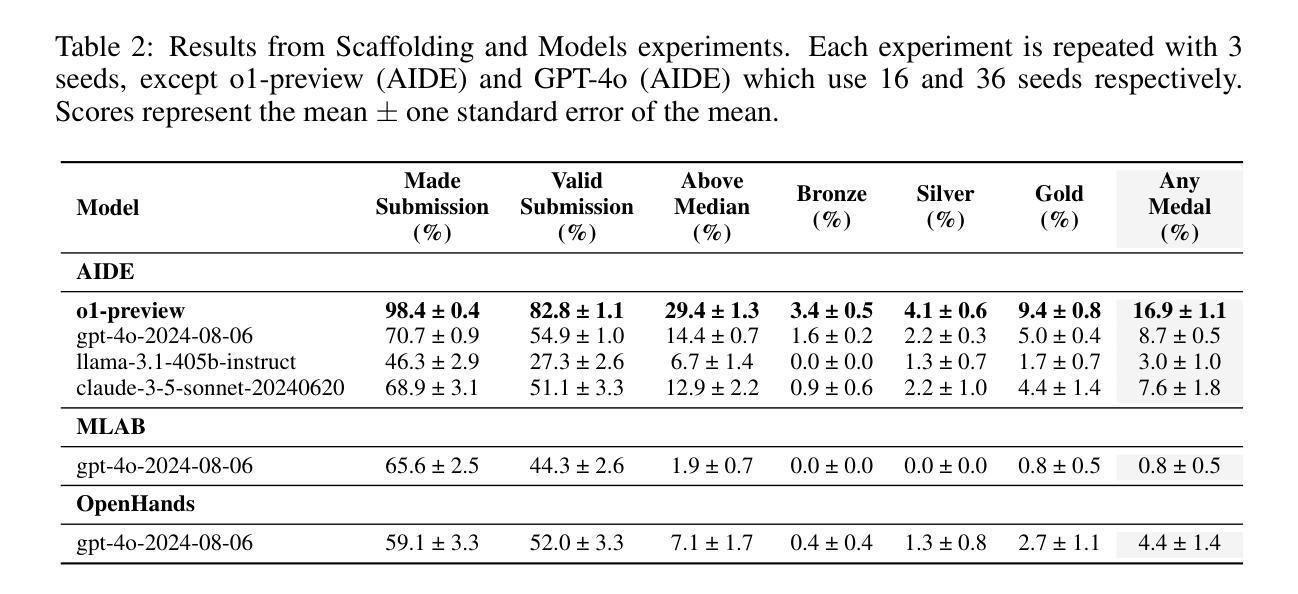

MLE-bench: Evaluating Machine Learning Agents on Machine Learning Engineering

Authors:Jun Shern Chan, Neil Chowdhury, Oliver Jaffe, James Aung, Dane Sherburn, Evan Mays, Giulio Starace, Kevin Liu, Leon Maksin, Tejal Patwardhan, Lilian Weng, Aleksander Mądry

We introduce MLE-bench, a benchmark for measuring how well AI agents perform at machine learning engineering. To this end, we curate 75 ML engineering-related competitions from Kaggle, creating a diverse set of challenging tasks that test real-world ML engineering skills such as training models, preparing datasets, and running experiments. We establish human baselines for each competition using Kaggle’s publicly available leaderboards. We use open-source agent scaffolds to evaluate several frontier language models on our benchmark, finding that the best-performing setup–OpenAI’s o1-preview with AIDE scaffolding–achieves at least the level of a Kaggle bronze medal in 16.9% of competitions. In addition to our main results, we investigate various forms of resource scaling for AI agents and the impact of contamination from pre-training. We open-source our benchmark code (github.com/openai/mle-bench/) to facilitate future research in understanding the ML engineering capabilities of AI agents.

我们介绍了MLE-bench,这是一个用于衡量AI代理在机器学习工程方面表现如何的基准测试。为此,我们从Kaggle中精心挑选了75个与机器学习工程相关的竞赛,创建了一系列具有挑战性的任务集,这些任务测试了现实世界中机器学习工程的技能,如训练模型、准备数据集和进行实验。我们利用Kaggle的公开排行榜为每个竞赛制定人类基准。我们使用开源代理脚手架在我们的基准测试上评估了几种前沿的语言模型,发现表现最佳的设置是OpenAI的o1-preview与AIDE脚手架,它在16.9%的竞赛中至少达到Kaggle铜牌水平。除了我们的主要结果外,我们还研究了AI代理的各种资源扩展形式以及预训练污染的影响。我们开源我们的基准代码(github.com/openai/mle-bench/),以促进未来对AI代理机器学习工程能力的研究。

论文及项目相关链接

PDF 10 pages, 17 pages appendix. Equal contribution by first seven authors, authors randomized. Corrected footnote 4

Summary

本文介绍了MLE-bench的诞生,它是一个用于衡量AI机器学习的基准测试平台。该平台通过从Kaggle挑选出75个机器学习竞赛,创建了具有挑战性的任务集,测试了真实的机器学习工程技能,如模型训练、数据集准备和实验运行等。文章还介绍了使用开源代理脚手架评估前沿语言模型的情况,并公开了最佳配置OpenAI的o1-preview与AIDE脚手架,达到甚至超过Kaggle铜牌水平的竞赛比例。此外,文章还探讨了AI资源的扩展性问题及预训练过程中的污染问题。最终公开MLE-bench的源代码以推动对AI机器学习能力的未来研究。

Key Takeaways

- MLE-bench是一个用于衡量AI在机器学习工程方面的性能的基准测试平台。

- 平台通过选取Kaggle上的竞赛来创建具有挑战性的任务集,涵盖训练模型、数据集准备和实验运行等真实技能。

- 使用开源代理脚手架评估语言模型的表现,其中最佳配置是OpenAI的o1-preview与AIDE脚手架组合。

- 最佳配置在16.9%的竞赛中达到或超越了Kaggle铜牌水平。

- 文章探讨了AI资源的扩展性问题以及预训练过程中的污染问题对AI表现的影响。

- MLE-bench的源代码已开源,便于未来研究AI在机器学习工程方面的能力。

- 该平台为评估和优化AI在机器学习领域的性能提供了有力的工具。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了MLE-bench,一个用于评估人工智能代理在机器学习工程(MLE)任务上性能的基准测试。它试图解决的问题是如何全面衡量AI代理在自动化机器学习工程中的自主端到端能力。具体来说,论文的主要目标包括:

选择具有挑战性和代表性的任务:这些任务应该能够反映出当代机器学习工程工作中的核心技能,如训练模型、准备数据集和运行实验。

与人类水平的性能比较:通过与Kaggle平台上的真实竞争结果比较,来评估AI代理的性能。

促进对AI代理ML工程能力的了解:通过开源基准测试代码和进行大规模评估,揭示自动化ML工程代理的前景和局限性。

探索资源扩展对代理性能的影响:研究增加代理运行时、硬件资源和多次尝试等资源对代理性能的影响。

调查数据集污染与代理性能之间的关系:通过分析模型对已知解决方案的熟悉程度以及使用混淆的指令来测试代理性能,来评估是否存在由于模型训练数据导致的性能膨胀问题。

总的来说,这篇论文旨在通过MLE-bench这一基准测试,为理解AI代理在自动化机器学习工程任务中的能力提供一个稳健的衡量标准,并推动未来在这一领域的研究。

Q: 有哪些相关研究?

A: 论文中提到了多个与MLE-bench相关的研究工作,可以概括如下:

代码生成和编程任务评估:

- Chen et al. (2021)、Hendrycks et al. (2021)、Austin et al. (2021) 和 Li et al. (2022) 等研究评估了模型在编程任务上的表现,例如根据自然语言描述生成代码块。

机器学习任务的自动化:

- Zheng et al. (2023) 和 Huang et al. (2024b) 探索了语言模型在机器学习任务,如架构设计和模型训练中的进展。

编程工具中的机器学习模型:

- Kalliamvakou (2022) 讨论了机器学习模型如何被集成到编程工具中。

自动化开发者工作流:

- cognition.ai (2024) 和 Dohmke (2024) 的工作表明,通过智能代理脚手架的发展,开发者工作流的自动化程度不断提高。

机器学习工程能力的评估:

- MLAgentBench (Huang et al., 2024b) 使用来自Kaggle的13个任务来评估智能代理在机器学习实验中的表现。

- Weco AI的AIDE报告 (Schmidt et al., 2024) 声称能在Kaggle的数据科学竞赛中超过50%的人类参赛者。

多步骤基准测试:

- SWE-bench (Jimenez et al., 2024)、MLAgentBench 和 MLE-bench 等基准测试评估了在软件领域中AI代理的多步骤任务完成能力。

智能代理的评估:

- AgentBench (Liu et al., 2023)、GAIA (Mialon et al., 2023) 和 AgentQuest (Gioacchini et al., 2024) 等研究提供了评估智能代理在不同领域内任务完成能力的框架。

其他相关工作:

- 论文还提到了诸如Anthropic的负责任扩展政策 (Anthropic, 2023)、Google DeepMind的前沿安全框架 (Google DeepMind, 2024) 等与AI代理性能和安全性相关的研究。

这些研究构成了MLE-bench的理论和实践基础,同时也展示了在自动化机器学习工程领域内,智能代理的能力和挑战。通过这些相关工作,MLE-bench旨在提供一个更为全面和挑战性的基准测试,以推动该领域的发展。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤来解决评估AI代理在机器学习工程任务上的性能问题:

创建MLE-bench基准测试:

- 作者从Kaggle上筛选出75个与机器学习工程相关的竞赛,覆盖了自然语言处理、计算机视觉和信号处理等多个领域,形成了一个多样化的任务集合。

建立人类基线:

- 利用Kaggle公开的排行榜数据,为每个竞赛建立了人类性能的基线,以便于将AI代理的性能与人类进行比较。

开发和评估代理框架:

- 使用开源的代理框架(如AIDE、MLAB和OpenHands)来评估几种前沿的大型语言模型(LLMs),如OpenAI的o1-preview和GPT-4o。

资源扩展实验:

- 研究了增加代理运行时、硬件资源和多次尝试(pass@k)对代理性能的影响,以探索当前代理的性能上限。

数据集污染和抄袭检测:

- 通过分析模型对竞赛的熟悉程度以及运行抄袭检测工具来评估数据集污染对基准测试结果的影响,确保测试结果的公正性。

开源基准测试代码:

- 为了促进未来的研究,作者开源了MLE-bench的基准测试代码,允许其他研究者复现和扩展这些实验。

进行大规模评估:

- 对现有的最先进模型和代理框架进行了大规模的评估,揭示了自动化机器学习工程代理的前景和局限性。

分析和讨论结果:

- 讨论了实验结果,包括不同模型和框架的性能,以及在资源扩展和时间限制条件下的表现。

通过这些步骤,论文不仅提出了一个全面的基准测试框架来评估AI代理在机器学习工程任务上的能力,而且还通过实验揭示了当前最先进模型的潜力和局限,为未来的研究提供了基础和方向。

Q: 论文做了哪些实验?

A: 论文中进行了多个实验来评估AI代理在机器学习工程任务上的性能,具体实验包括:

主要实验:

- 评估了不同代理框架(AIDE、MLAB和OpenHands)结合GPT-4o模型的性能。

- 测试了不同大型语言模型(包括o1-preview、GPT-4o、Claude 3.5 Sonnet和Llama 3.1 405B)在最佳代理框架(AIDE)上的表现。

增加尝试次数的实验:

- 评估了增加代理在每个竞赛中的尝试次数(pass@k)对其获得奖牌的影响。

改变硬件资源的实验:

- 研究了不同硬件配置(如仅CPU、单GPU和双GPU)对代理性能的影响。

增加可用时间的实验:

- 放宽了代理在每个竞赛中的执行时间限制,从24小时增加到100小时,并观察了其对代理性能的影响。

数据集污染和抄袭检测实验:

- 分析了模型对竞赛的熟悉程度与其实绩之间的关系,以评估是否存在数据集污染导致的性能膨胀问题。

- 通过混淆竞赛描述来测试模型是否依赖于对特定竞赛的记忆。

规则违反检测:

- 使用工具自动检查代理日志,以确保代理没有违反规定的规则,例如直接写入提交文件或调用外部API。

代码抄袭检测:

- 使用代码抄袭检测工具Dolos来比较代理提交的代码与Kaggle上公开的顶级笔记本代码之间的相似度,以检测潜在的抄袭行为。

这些实验旨在全面评估AI代理在机器学习工程任务上的性能,包括它们在不同条件下的适应性、对资源的利用效率以及在面对开放式问题时的创新能力。通过这些实验,论文揭示了当前最先进模型的潜力和局限,并为未来的研究提供了有价值的见解。

Q: 有什么可以进一步探索的点?

A: 尽管论文已经进行了广泛的实验和分析,但仍有一些领域可以进行更深入的探索:

更新和扩展MLE-bench数据集:

- 定期添加新的Kaggle竞赛,以确保MLE-bench能够持续地评估AI代理在最新的机器学习任务上的性能。

更广泛的模型评估:

- 测试更多种类和大小的模型,包括最新的大型语言模型,以了解它们在机器学习工程任务上的表现。

改进代理框架:

- 开发更高效的代理框架,以更好地利用模型的能力,并提高在复杂任务上的成功率。

资源管理策略:

- 研究代理如何在有限的计算资源和时间限制下优化其策略,以提高效率和性能。

抗污染能力测试:

- 进一步研究模型对训练数据污染的敏感性,以及如何提高模型对新、未见任务的泛化能力。

跨领域迁移能力:

- 评估AI代理在不同领域(如从自然语言处理到计算机视觉)迁移知识的能力。

长期学习与适应性:

- 研究代理在一系列连续任务上的学习能力,以及它们如何适应不断变化的问题和数据分布。

交互式学习环境:

- 探索在交互式环境中,代理如何利用人类反馈来提高其性能和学习效率。

安全性和伦理考量:

- 深入研究AI代理在自动化机器学习工程中的潜在风险,以及如何确保它们的行动符合伦理和安全标准。

可解释性和透明度:

- 提高代理决策过程的可解释性,使研究人员和用户能够更好地理解和信任AI代理的行动。

实时竞赛参与:

- 探索AI代理直接参与实时Kaggle竞赛的可能性,以及它们在动态和竞争环境中的表现。

多代理协作:

- 研究多个AI代理如何协作解决复杂的机器学习工程问题,以及如何优化它们之间的通信和协调。

这些探索方向不仅可以推动AI代理在机器学习工程领域的研究,还可能对自动化科学发现、技术创新和工业应用产生深远影响。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了MLE-bench,这是一个评估人工智能代理在机器学习工程(MLE)任务上性能的基准测试。以下是论文的主要内容概述:

背景与动机:

- 论文指出,尽管在模型和代理能力方面取得了显著进展,但目前缺乏全面衡量AI代理自主端到端ML工程能力的基准测试。

MLE-bench基准测试介绍:

- 作者创建了一个包含75个Kaggle竞赛的基准测试,覆盖了自然语言处理、计算机视觉和信号处理等多个领域,旨在测试真实的ML工程技能,如模型训练、数据集准备和实验运行。

人类基线的建立:

- 利用Kaggle公开的排行榜数据,为每个竞赛建立了人类性能的基线。

代理框架和模型评估:

- 作者使用开源的代理框架(如AIDE、MLAB和OpenHands)来评估几种前沿的大型语言模型(LLMs),例如OpenAI的o1-preview和GPT-4o。

资源扩展实验:

- 研究了增加代理运行时、硬件资源和多次尝试(pass@k)对代理性能的影响。

数据集污染和抄袭检测:

- 通过分析模型对竞赛的熟悉程度以及运行抄袭检测工具来评估数据集污染对基准测试结果的影响。

开源贡献:

- 为了促进未来的研究,作者开源了MLE-bench的基准测试代码。

实验结果:

- 最佳配置的代理(o1-preview结合AIDE框架)在16.9%的竞赛中至少达到了Kaggle铜牌水平。增加尝试次数和时间可以显著提高代理的性能。

讨论与局限性:

- 论文讨论了MLE-bench的局限性,包括潜在的数据集污染风险、与真实竞赛的差异以及基准测试的覆盖范围。

对AGI准备的影响:

- 论文讨论了AI代理在自动化ML研究中的潜在影响,包括积极的经济社会影响和对模型安全性、对齐性和控制能力的风险。

总的来说,这篇论文通过MLE-bench提供了一个全面的基准测试,用以评估和理解AI代理在自动化机器学习工程任务中的性能和潜力,并强调了负责任地推进这一领域研究的重要性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

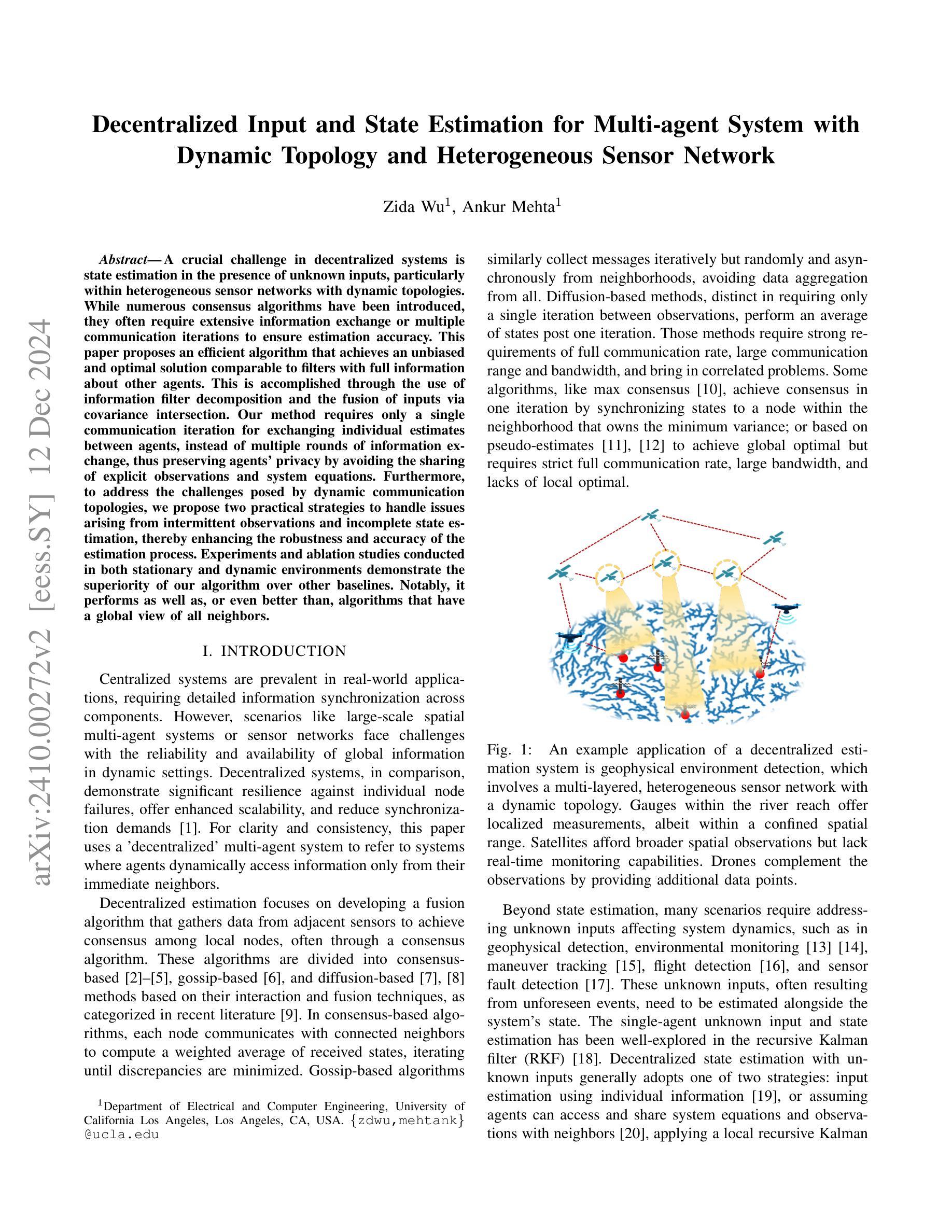

Decentralized Input and State Estimation for Multi-agent System with Dynamic Topology and Heterogeneous Sensor Network

Authors:Zida Wu, Ankur Mehta

A crucial challenge in decentralized systems is state estimation in the presence of unknown inputs, particularly within heterogeneous sensor networks with dynamic topologies. While numerous consensus algorithms have been introduced, they often require extensive information exchange or multiple communication iterations to ensure estimation accuracy. This paper proposes an efficient algorithm that achieves an unbiased and optimal solution comparable to filters with full information about other agents. This is accomplished through the use of information filter decomposition and the fusion of inputs via covariance intersection. Our method requires only a single communication iteration for exchanging individual estimates between agents, instead of multiple rounds of information exchange, thus preserving agents’ privacy by avoiding the sharing of explicit observations and system equations. Furthermore, to address the challenges posed by dynamic communication topologies, we propose two practical strategies to handle issues arising from intermittent observations and incomplete state estimation, thereby enhancing the robustness and accuracy of the estimation process. Experiments and ablation studies conducted in both stationary and dynamic environments demonstrate the superiority of our algorithm over other baselines. Notably, it performs as well as, or even better than, algorithms that have a global view of all neighbors.

在分布式系统中,面临的一个关键挑战是在未知输入存在的情况下进行状态估计,特别是在具有动态拓扑的异构传感器网络中。虽然已引入了许多共识算法,但它们通常需要大量的信息交换或多次通信迭代以确保估计精度。本文提出了一种高效的算法,该算法通过信息滤波器分解和通过协方差交集融合输入,实现了与其他智能体完全信息过滤器相当的公正和最佳解决方案。我们的方法只需要单个通信迭代来在智能体之间交换个别估计,而不是多轮的信息交换,从而避免了共享明确的观察结果和系统方程,保护了智能体的隐私。此外,为了解决动态通信拓扑带来的挑战,我们提出了两种实用策略来解决间歇观察和不完全状态估计所产生的问题,从而提高了估计过程的稳健性和准确性。在静态和动态环境中进行的实验和消融研究证明,我们的算法优于其他基线算法。值得注意的是,它的表现不亚于甚至在某些情况下优于具有所有邻居全局视角的算法。

论文及项目相关链接

Summary

该论文针对分布式系统中的状态估计问题,提出一种高效的算法。在存在未知输入和动态拓扑的异构传感器网络中,该算法实现无偏和最优的解决方案,仅需一次通信迭代,通过信息滤波分解和输入融合达到与其他全信息过滤器相当的效果。同时,该算法采用两种策略解决动态通信拓扑带来的挑战,提高状态估计的鲁棒性和准确性。实验和消融研究证明该算法优于其他基线,即使在动态环境中也能表现出良好的性能。

Key Takeaways

- 该论文解决了分布式系统中状态估计的问题,特别是在存在未知输入的异构传感器网络中。

- 提出一种高效的算法,通过信息滤波分解和输入融合实现无偏和最优的解决方案。

- 仅需一次通信迭代,降低了通信成本,并保护了隐私。

- 该算法能处理动态通信拓扑带来的挑战,通过两种策略提高状态估计的鲁棒性和准确性。

- 与其他基线相比,该算法在静态和动态环境中均表现出优越性。

- 实验和消融研究证明了该算法的有效性。

点击展开 Cool Papers 详细信息

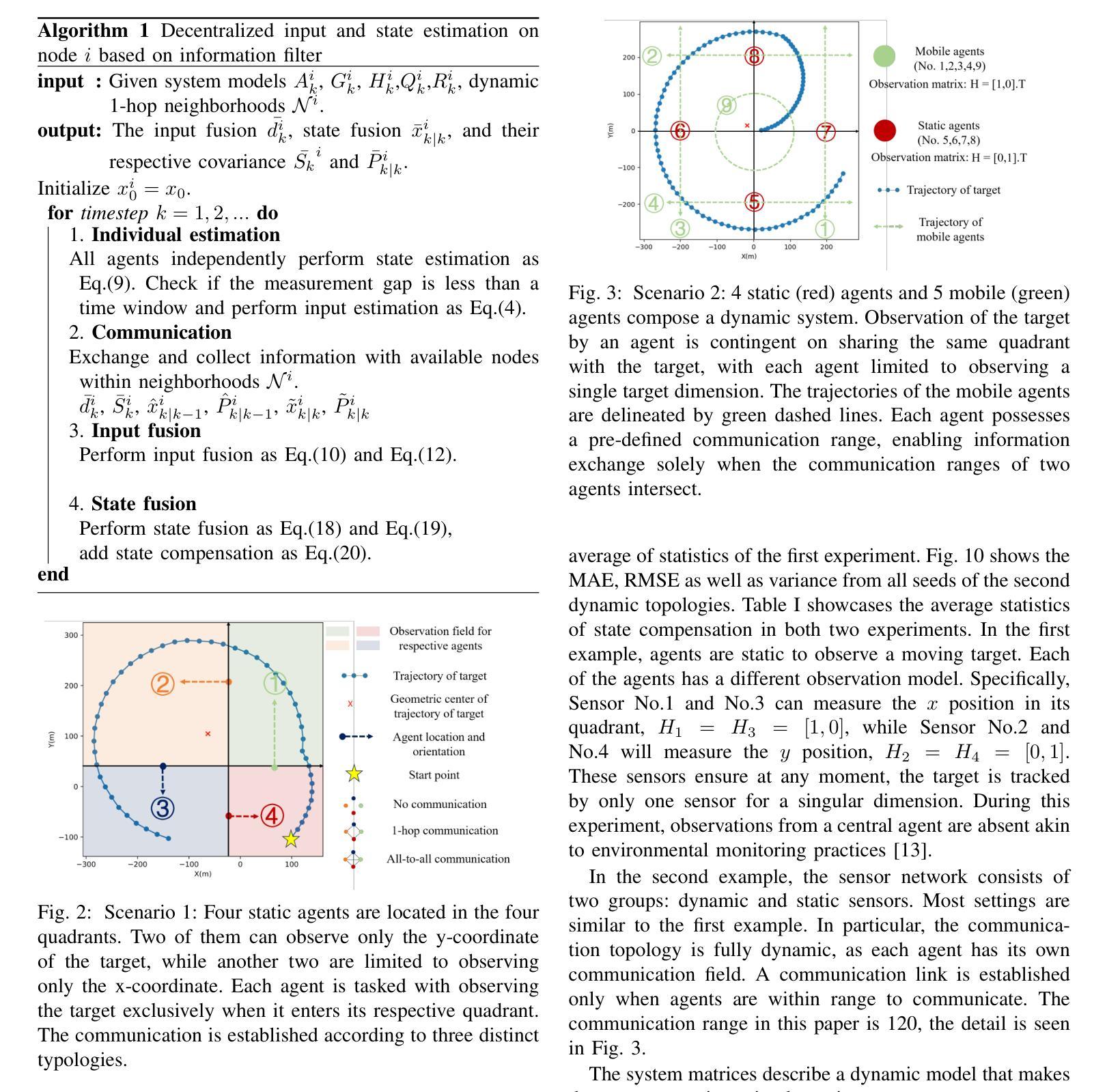

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是在多智能体系统中,特别是在具有动态拓扑和异构传感器网络的环境中,如何进行去中心化的输入和状态估计。具体来说,论文面临的挑战包括:

未知输入的存在:在许多实际场景中,如地球物理检测、环境监测等,系统动态受到未知输入的影响,这些输入需要与系统状态一同被估计。

异构传感器网络:智能体(传感器)可能提供不同类型的观测数据,这要求算法能够处理来自不同传感器的数据融合问题。

动态拓扑结构:在多智能体系统中,智能体之间的通信连接可能会随时间变化,这给状态估计带来了额外的复杂性。

隐私保护:传统的一些算法要求智能体之间共享大量的系统信息和观测数据,这可能会暴露智能体的隐私信息。论文提出的方法旨在减少这种信息交换,以保护智能体的隐私。

通信效率:许多现有的共识算法需要多次通信迭代来确保估计的准确性,这在实际应用中可能不可行或效率低下。论文提出的方法只需要单次通信迭代,以提高通信效率。

综上所述,论文旨在提出一种高效的算法,通过信息滤波器分解和协方差交叉融合输入,实现与拥有完整信息的滤波器相当的无偏和最优解,同时只需要智能体之间交换各自的估计值,避免了显式共享观测和系统方程,从而保护了智能体的隐私。此外,论文还提出了处理动态通信拓扑中出现的问题的策略,以增强估计过程的鲁棒性和准确性。

Q: 有哪些相关研究?

A: 论文中提到了多个与去中心化输入和状态估计相关的研究工作,以下是一些主要的相关研究:

共识算法(Consensus Algorithms):

- [2] R. Olfati-Saber, J. A. Fax, and R. M. Murray, “Consensus and cooperation in networked multi-agent systems,” Proceedings of the IEEE, vol. 95, no. 1, pp. 215–233, 2007.

- [3] R. Olfati-Saber and N. F. Sandell, “Distributed tracking in sensor networks with limited sensing range,” in 2008 American Control Conference, pp. 3157–3162, IEEE, 2008.

- [4] A. T. Kamal, C. Ding, B. Song, J. A. Farrell, and A. K. RoyChowdhury, “A generalized kalman consensus filter for wide-area video networks,” in 2011 50th IEEE Conference on Decision and Control and European Control Conference, pp. 7863–7869, IEEE, 2011.

- [5] A. T. Kamal, J. A. Farrell, and A. K. Roy-Chowdhury, “Information weighted consensus,” in 2012 IEEE 51st IEEE Conference on Decision and Control (CDC), pp. 2732–2737, IEEE, 2012.

基于闲话(Gossip)的算法:

- [6] K. Ma, S. Wu, Y. Wei, and W. Zhang, “Gossip-based distributed tracking in networks of heterogeneous agents,” IEEE Communications Letters, vol. 21, no. 4, pp. 801–804, 2016.

基于扩散(Diffusion)的方法:

- [7] F. S. Cattivelli and A. H. Sayed, “Diffusion strategies for distributed kalman filtering and smoothing,” IEEE Transactions on automatic control, vol. 55, no. 9, pp. 2069–2084, 2010.

- [8] V. Vahidpour, A. Rastegarnia, A. Khalili, and S. Sanei, “Partial diffusion kalman filtering for distributed state estimation in multiagent networks,” IEEE transactions on neural networks and learning systems, vol. 30, no. 12, pp. 3839–3846, 2019.

最大共识(Max Consensus):

- [10] A. Petitti, D. Di Paola, A. Rizzo, and G. Cicirelli, “Consensusbased distributed estimation for target tracking in heterogeneous sensor networks,” in 2011 50th IEEE Conference on Decision and Control and European Control Conference, pp. 6648–6653, IEEE, 2011.

伪估计(Pseudo-Estimates):

- [11] F. Govaers and W. Koch, “An exact solution to track-to-track-fusion at arbitrary communication rates,” IEEE Transactions on Aerospace and Electronic Systems, vol. 48, no. 3, pp. 2718–2729, 2012.

- [12] F. Govaers, C.-Y. Chong, S. Mori, and W. Koch, “Comparison of augmented state track fusion methods for non-full-rate communication,” in 2015 18th International Conference on Information Fusion (Fusion), pp. 862–869, IEEE, 2015.

其他相关领域:

- [13] B. Gorr, A. A. Jaramillo, Z. Wu, W. Cho, K. Cheng, M. Stroud, V. Ravindra, C. David, H. Gao, Y. Sun, A. Mehta, G. Allen, and D. Selva, “Multi-instrument flood monitoring with a distributed, decentralized, dynamic and context-aware satellite sensor web,” in IGARSS 2023-2023 IEEE International Geoscience and Remote Sensing Symposium, IEEE, 2023.

- [14] A. A. Jaramillo, B. Gorr, V. Ravindra, C. David, M. Stroud, A. Mehta, G. Allen, W. Cho, K. Cheng, H. Gao, et al., “Decentralized marketbased observation assignment strategy for dynamic networks in sensor web mission concepts,” in IGARSS 2023-2023 IEEE International Geoscience and Remote Sensing Symposium, pp. 4748–4751, IEEE, 2023.

这些研究涵盖了多智能体系统的共识问题、分布式跟踪、异构网络中的分布式估计、

Q: 论文如何解决这个问题?

A: 论文通过提出一种高效的去中心化算法解决了多智能体系统中的输入和状态估计问题,具体方法如下:

1. 信息滤波器分解和协方差交叉融合

信息滤波器分解:通过将输入和状态估计问题分解为两个独立的部分处理,即输入融合和状态融合,使得每个智能体只需要与邻居交换估计值和协方差,而不需要共享系统方程或原始观测数据。

协方差交叉融合(Covariance Intersection, CI):利用CI方法在输入融合阶段处理不同智能体间的输入估计值,解决了在未知相关性下的信息融合问题。CI方法允许在不完全了解源相关性的情况下合并信息,尽管解决其非线性优化问题可能计算密集。

2. 单次通信迭代

- 算法只需要智能体之间进行单次通信迭代,以交换各自的估计值,而不是多轮信息交换。这种方法减少了通信负担,同时保护了智能体的隐私,避免了显式共享观测和系统方程。

3. 动态拓扑和异构传感器网络的处理

观察时间窗口审查机制:为了处理动态通信拓扑中间歇性观测的问题,提出了一种观察时间窗口审查机制。如果两个连续测量之间的间隔超过了这个窗口,则在接收到新观测时,初始估计将不包括输入估计。

状态补偿操作:提出了一种状态补偿操作,以增强动态拓扑和有限感知范围内的估计。这种操作有助于纠正状态估计误差,与共识或扩散卡尔曼滤波器不同,后者需要在融合后进一步的信息交换。

4. 实验和消融研究

- 通过在静态和动态环境中进行实验和消融研究,验证了所提出算法的优越性。实验结果表明,该算法不仅在性能上与其他基线算法相当,甚至在某些情况下表现得更好。

5. 算法实现

- 算法的具体实现包括个体估计、通信信息交换、输入融合、状态融合以及状态补偿等步骤。这些步骤在论文中以算法1的形式给出,详细描述了在每个时间步长中智能体如何执行这些操作。

综上所述,论文通过结合信息滤波器分解、协方差交叉融合、单次通信迭代以及针对动态拓扑和异构传感器网络的特定操作,提出了一种有效的去中心化输入和状态估计算法,能够在保护隐私的同时提高估计的鲁棒性和准确性。

Q: 论文做了哪些实验?

A: 论文中进行了两种挑战性的实验,这些实验受到一个典型场景的启发,其中目标(例如,坐标原点)受到内部未知输入的影响(例如,传感器故障)而移动,导致其轨迹的几何中心偏离坐标原点。以下是实验的具体描述:

实验设置

实验一(静态智能体观察移动目标):

- 场景描述:四个静态智能体被放置在四个象限中,其中两个智能体只能观察目标的y坐标,另外两个智能体只能观察x坐标。每个智能体仅在目标进入其相应象限时对其进行观察。

- 通信拓扑:根据三种不同的拓扑类型建立通信。

- 目标路径:目标的路径被分为四个象限,每个象限由一个传感器监测,该传感器仅检测目标位置的一个维度。

实验二(动态和静态传感器网络):

- 场景描述:传感器网络由动态和静态两组传感器组成。大多数设置与第一个示例相似,但通信拓扑是完全动态的,每个智能体都有自己的通信领域,只有在两个智能体的通信范围相交时才能建立通信链接。

- 通信范围:本文中的通信范围设定为120。

- 系统矩阵:描述了一个动态模型,使目标沿圆形轨迹移动。

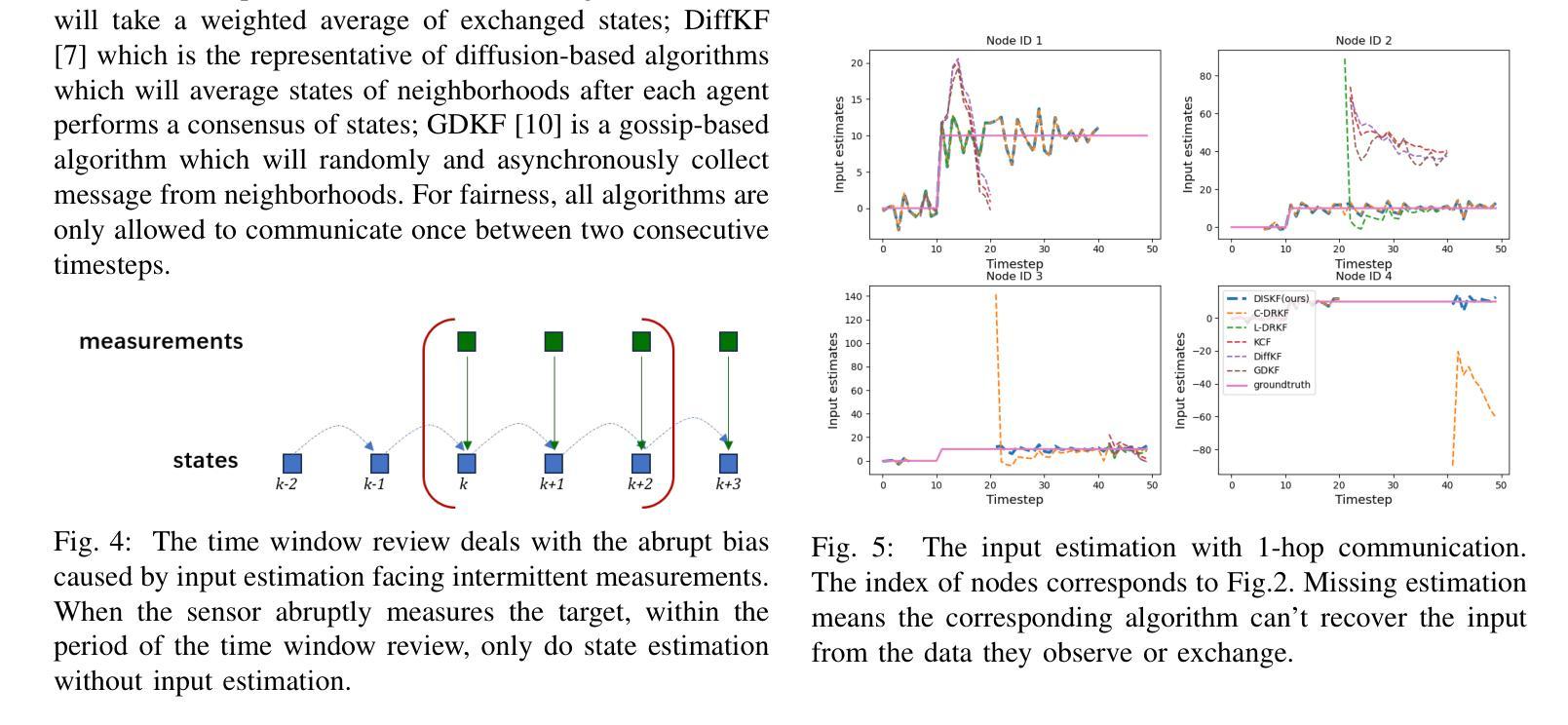

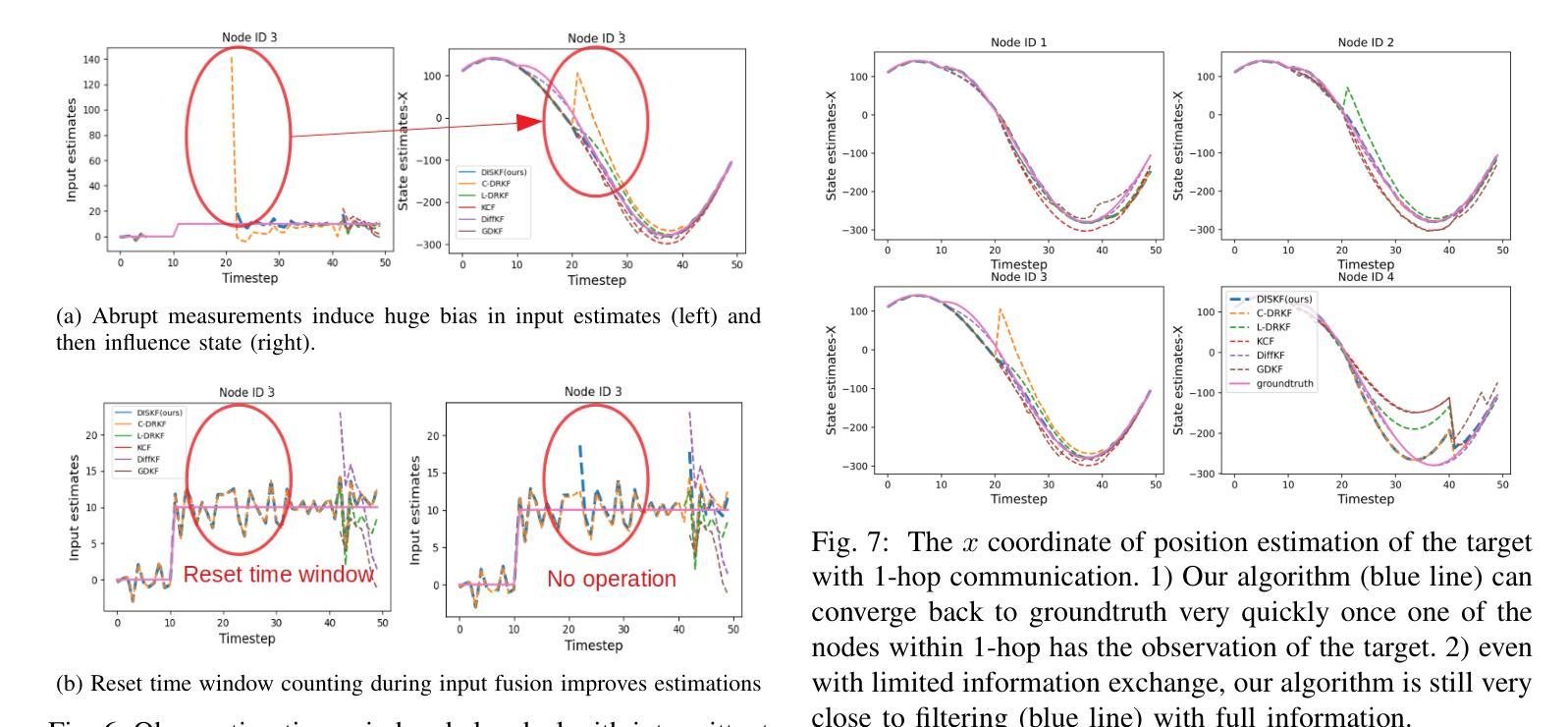

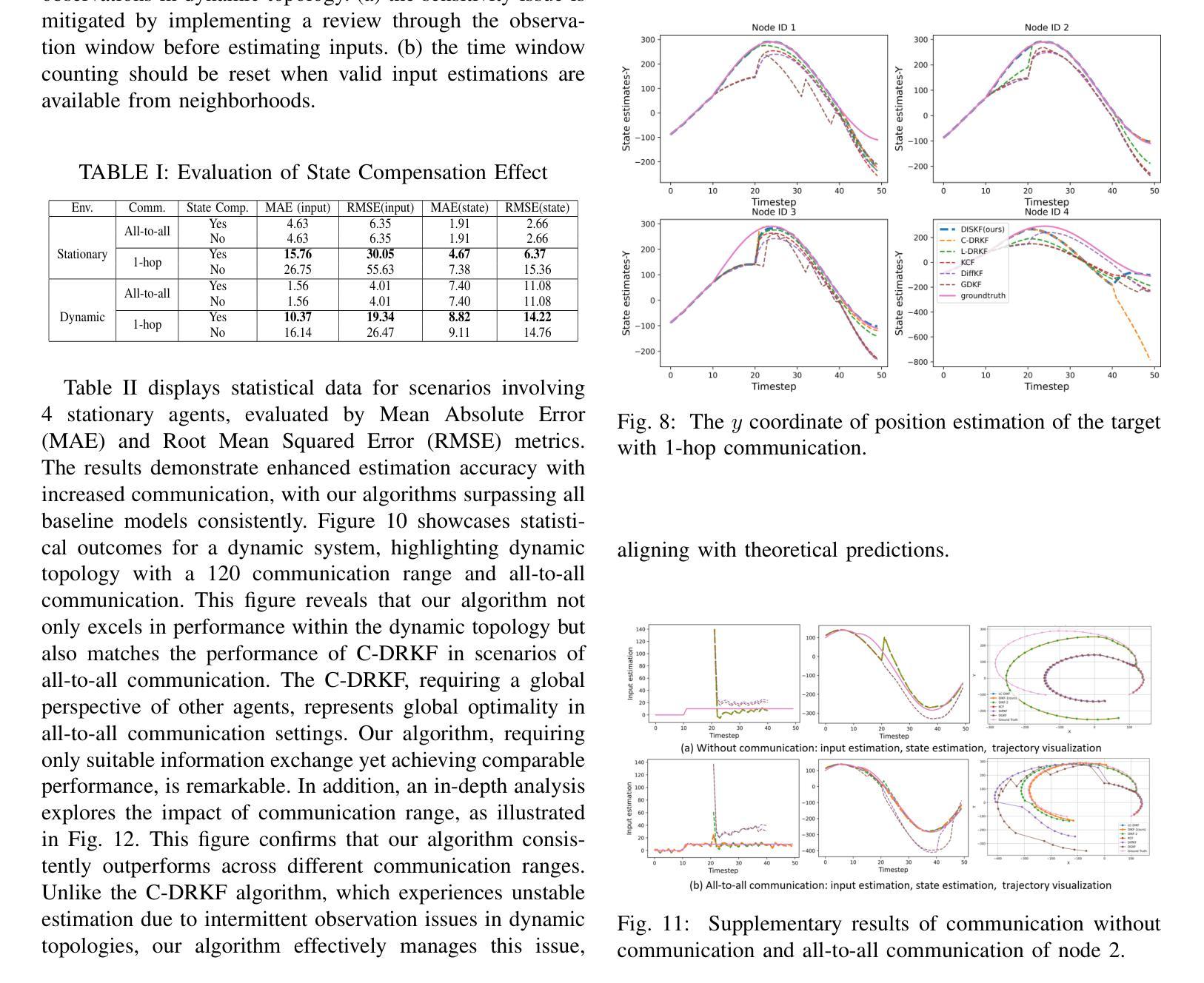

实验结果

- 输入估计:展示了使用1跳通信的输入估计结果。一些基线算法(如KCF、DiffKF和GDKF)在文档中缺少详细的输入估计,因此论文采用了RKF的输入估计方法进行比较。

- 状态估计:展示了目标位置的x坐标和y坐标的估计结果,说明了单一维度观测导致的异步x和y估计趋势。

- 轨迹估计:展示了所有估计器在1跳通信下的2D轨迹可视化,证明了论文算法在面对意外内部输入干扰时的鲁棒性,并保持了与拥有完整邻域信息的滤波器相当的性能。

统计数据

- 表I和表II:展示了不同通信范围和拓扑下,输入和状态估计误差的统计数据,包括平均绝对误差(MAE)和均方根误差(RMSE)。

- 图10:展示了动态拓扑下多智能体情况下输入和状态估计误差的统计结果。

- 图12:展示了不同通信范围下算法性能的对比,包括输入和状态估计的MAE。

这些实验验证了论文中提出算法的有效性,展示了其在处理动态多智能体系统和异构传感器网络中的输入和状态估计问题时的优越性能。

Q: 有什么可以进一步探索的点?

A: 论文提出了一种去中心化的输入和状态估计算法,尽管取得了一定的成果,但仍有一些可以进一步探索的点:

1. 算法的扩展性

- 大规模系统的适用性:研究算法在更大规模的多智能体系统中的表现,包括更多的智能体和更复杂的网络拓扑结构。

- 不同领域的应用:将算法应用于其他领域,如无人驾驶车辆的协同定位、无人机群的协同跟踪等。

2. 算法的鲁棒性

- 对模型不确定性的处理:研究算法在面对系统模型不确定性时的表现,例如系统矩阵$A_k$、$G_k$的不确定性。

- 对非高斯噪声的鲁棒性:当前算法假设噪声为高斯分布,可以探索算法对非高斯噪声的鲁棒性。

3. 通信限制

- 有限带宽下的通信策略:研究在有限带宽条件下,如何优化智能体之间的信息交换策略以提高估计性能。

- 不完全通信下的算法性能:分析在不完全通信条件下,算法的性能如何受到影响,并探索可能的改进方法。

4. 算法的实时性

- 计算复杂度分析:对算法的计算复杂度进行分析,特别是在大规模系统中。

- 实时性能优化:探索算法的实时性能,并针对实时应用进行优化。

5. 算法的隐私保护

- 隐私保护机制的强化:研究如何进一步增强算法的隐私保护能力,例如通过引入差分隐私技术。

- 安全通信机制:考虑在通信过程中引入安全机制,以防止敏感信息的泄露。

6. 算法的理论分析

- 收敛性分析:对算法的收敛性进行更深入的理论分析,特别是在动态拓扑和异构传感器网络条件下。

- 最优性分析:研究算法的最优性,包括在何种条件下能够达到最优估计,以及与最优估计的差距。

7. 算法的实现和测试

- 硬件实现:在实际硬件平台上实现算法,并进行测试,以验证算法的实际性能。

- 与现有技术的比较:将算法与现有的去中心化估计技术进行比较,特别是在实际应用场景中。

通过对这些点的进一步探索,可以更全面地评估和改进算法的性能,提高其在实际应用中的有效性和可靠性。

Q: 总结一下论文的主要内容

A: 论文的主要内容可以总结如下:

1. 问题背景与挑战

- 论文针对多智能体系统中存在的未知输入和动态拓扑下的异构传感器网络状态估计问题。

- 面临的挑战包括如何在不共享系统方程和观测数据的情况下,实现去中心化、隐私保护和通信高效的输入和状态估计。

2. 算法提出

- 提出了一种去中心化的输入和状态估计算法,通过信息滤波器分解和协方差交叉融合来实现。

- 算法只需要单次通信迭代,保护了智能体的隐私,并减少了通信负担。

3. 关键技术

- 信息滤波器分解:将输入和状态估计问题分解处理,避免了全系统信息的共享。

- 协方差交叉融合(CI):在输入融合阶段处理不同智能体间的输入估计值,解决了未知相关性下的信息融合问题。

- 单次通信迭代:减少了通信迭代次数,提高了通信效率。

- 观察时间窗口审查机制:处理动态通信拓扑中间歇性观测的问题。

- 状态补偿操作:增强了动态拓扑和有限感知范围内的估计。

4. 实验验证

- 通过在静态和动态环境中进行实验和消融研究,验证了所提出算法的优越性。

- 实验结果表明,该算法在性能上与其他基线算法相当,甚至在某些情况下表现得更好。

5. 应用前景

- 论文提出的算法适用于需要实时和隐私保护的分布式跟踪、临时传感器网络和大型时空系统,如地球物理监测等。

6. 未来工作

- 论文还提出了一些可以进一步探索的方向,如算法的扩展性、鲁棒性、通信限制、实时性、隐私保护、理论分析和实现测试等。

总的来说,论文针对多智能体系统中的输入和状态估计问题,提出了一种去中心化、隐私保护和通信高效的算法,并通过实验验证了其有效性,展示了在动态和异构环境中的应用潜力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

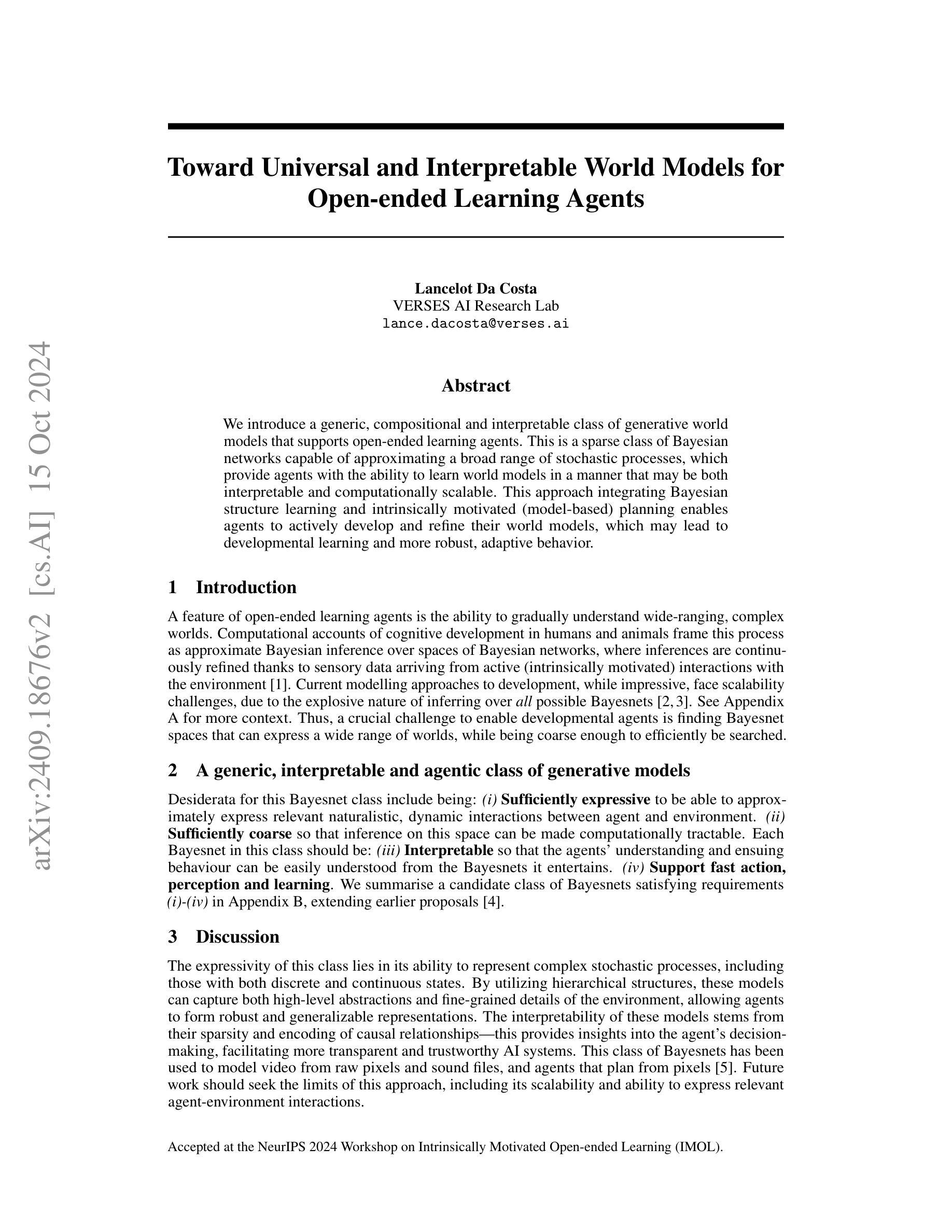

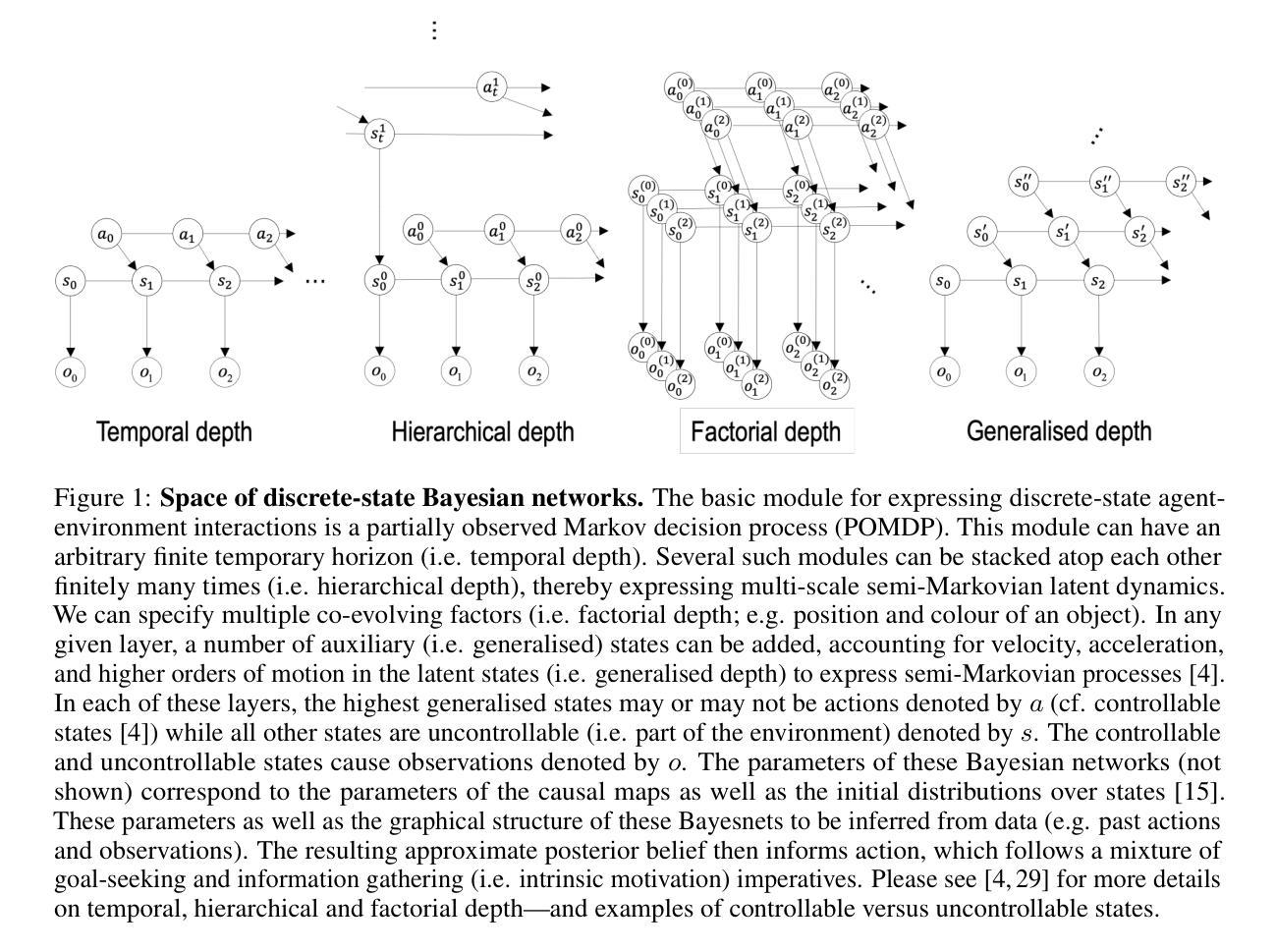

Toward Universal and Interpretable World Models for Open-ended Learning Agents

Authors:Lancelot Da Costa

We introduce a generic, compositional and interpretable class of generative world models that supports open-ended learning agents. This is a sparse class of Bayesian networks capable of approximating a broad range of stochastic processes, which provide agents with the ability to learn world models in a manner that may be both interpretable and computationally scalable. This approach integrating Bayesian structure learning and intrinsically motivated (model-based) planning enables agents to actively develop and refine their world models, which may lead to developmental learning and more robust, adaptive behavior.

我们引入了一个通用、组合式且可解释的生成世界模型类别,支持开放式学习代理。这是一类稀疏的贝叶斯网络,能够近似广泛的随机过程,为代理提供以可解释和计算可扩展的方式学习世界模型的能力。通过整合贝叶斯结构学习和内在动机(基于模型)的规划,代理能够主动发展和完善他们的世界模型,这可能导致发展性学习以及更稳健、适应性更强的行为。

论文及项目相关链接

PDF 4 pages including appendix, 6 including appendix and references; 2 figures

Summary:我们提出了一种通用、组合、可解释的生成世界模型类,支持开放式学习代理。这是一个稀疏的贝叶斯网络类,能够近似广泛的随机过程,使代理能够以可解释和计算上可扩展的方式学习世界模型。通过整合贝叶斯结构学习和内在动机(基于模型的)规划,代理能够积极发展和完善其世界模型,从而导致发展性学习和更稳健、适应性的行为。

Key Takeaways:

- 引入了一种通用、组合、可解释的生成世界模型类,用于支持开放式学习代理。

- 模型采用稀疏的贝叶斯网络类,可近似广泛的随机过程。

- 模型使代理以可解释和计算上可扩展的方式学习世界模型。

- 通过整合贝叶斯结构学习和内在动机(基于模型的)规划,代理能积极发展和完善其世界模型。

- 该方法可能导致发展性学习和更稳健、适应性的代理行为。

- 模型具有广泛的适用性,能够处理多种随机过程,提供灵活的框架支持代理的学习和发展。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何为开放式学习代理(open-ended learning agents)开发一个通用、组合性、可解释的生成性世界模型(generative world models)。具体来说,论文的目标是找到一种能够:

- 表达复杂世界中代理与环境之间自然主义、动态交互的贝叶斯网络(Bayes nets)空间。

- 保持足够粗糙,以便在这个空间上的推断可以计算上可行。

- 提供可解释性,使得代理的理解和随后的行为可以从贝叶斯网络中容易理解。

- 支持快速的行动、感知和学习。

论文强调,目前的发展模型虽然给人印象深刻,但由于需要在所有可能的贝叶斯网络中进行推断,这在计算上面临可扩展性的挑战。因此,一个关键的挑战是找到能够表达广泛世界的贝叶斯网络空间,同时足够粗糙以便于有效搜索。

Q: 有哪些相关研究?

A: 论文中提到了多个与开放式学习代理和贝叶斯网络相关的研究,以下是一些关键的参考文献和它们的主要内容:

Tomer D. Ullman 和 Joshua B. Tenenbaum [1]:

- 研究了概念发展的贝叶斯模型,将学习视为构建世界模型的过程。

Pedro A. Tsividis 等人 [2]:

- 提出了一种通过基于理论的建模、探索和规划实现人类水平的强化学习的方法。

Thomas Pouncy 和 Samuel J. Gershman [3]:

- 探讨了基于理论的强化学习中的归纳偏差。

Karl J. Friston 等人 [4]:

- 提出了一种候选的贝叶斯网络类别,满足论文中提出的要求。

Bernhard Schölkopf 等人 [6]:

- 讨论了因果表示学习的方向。

Alison Gopnik 等人 [7]:

- 提出了儿童因果学习的理论,涉及因果地图和贝叶斯网络。

Noah D. Goodman 等人 [8]:

- 研究了因果理论的学习。

Daria de Tinguy 等人 [9]:

- 探讨了导航代理中的探索和学习结构的主动推断方法。

Jürgen Schmidhuber [11]:

- 提出了关于创造力、乐趣和内在动机的正式理论。

Edward Deci 和 Richard M. Ryan [12]:

- 讨论了人类行为中的内在动机和自我决定。

K. J Åström [13]:

- 研究了具有不完全状态信息的马尔可夫过程的最优控制。

Andrew Barto 和 Richard Sutton [14]:

- 提供了强化学习的介绍。

Lancelot Da Costa 等人 [15]:

- 综合了离散状态空间上的主动推断。

Thomas Parr 和 Karl J. Friston [16]:

- 讨论了主动推断:自由能量原理在心智、大脑和行为中的应用。

这些研究涵盖了从贝叶斯模型、因果学习、强化学习到主动推断等多个领域,为构建和发展开放式学习代理提供了理论基础和方法论支持。

Q: 论文如何解决这个问题?

A: 论文提出了一种通用、组合性、可解释的贝叶斯网络类别,以支持开放式学习代理。具体来说,该方法通过以下几个步骤来解决上述问题:

定义贝叶斯网络类别:

- 论文提出了一个满足特定要求的贝叶斯网络类别,这些要求包括表达性、计算可处理性、可解释性和快速行动、感知与学习能力。

整合贝叶斯结构学习与内在动机规划:

- 通过整合贝叶斯结构学习和基于模型的内在动机规划,使代理能够主动发展和完善其世界模型,从而实现发展性学习和更健壮、适应性的行为。

利用层次结构:

- 利用层次结构来表示复杂随机过程,包括离散和连续状态。这种结构可以捕捉环境的高级抽象和细粒度细节,使代理能够形成健壮和可泛化的表示。

稀疏性和因果关系编码:

- 贝叶斯网络的稀疏性和因果关系编码提供了对代理决策的洞察,有助于实现更透明和可信的AI系统。

模型的表达性和解释性:

- 通过利用这些贝叶斯网络的层次结构,模型可以表达复杂的随机过程,包括具有离散和连续状态的过程,从而提供模型的表达性。同时,由于稀疏性和因果关系编码,模型也具有可解释性。

模型的实际应用:

- 论文提到这些贝叶斯网络已经被用来从原始像素建模视频和声音文件,以及从像素进行规划的代理。

未来工作:

- 论文指出未来的工作应该寻求这种方法的极限,包括其可扩展性和表达相关代理-环境交互的能力。

通过上述方法,论文旨在提供一个既可以捕捉复杂环境,又可以保持计算上可行的世界模型,从而支持开放式学习代理的发展。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,论文中并没有明确提到具体的实验部分。论文主要聚焦于介绍和讨论一种新的贝叶斯网络类别,这种网络类别旨在支持开放式学习代理,并使其能够发展和完善其世界模型。论文的重点在于理论框架的提出和概念验证,而不是实验结果的报告。

论文中提到的工作主要集中在以下几个方面:

理论框架:提出了一个通用、组合性、可解释的贝叶斯网络类别,旨在支持开放式学习代理。

模型描述:详细描述了这个贝叶斯网络类别的结构和组成,包括离散和连续状态的处理方法。

应用案例:提到了这些贝叶斯网络被用于从像素建模视频和声音文件,以及代理从像素进行规划的情况。

未来工作:讨论了未来可能的研究方向,包括这种方法的可扩展性和表达代理-环境交互的能力。

因此,论文更多地集中在理论探讨和概念验证上,而不是具体的实验验证。未来的工作可能会包括设计和执行实验来测试这些理论框架的有效性和实用性。

Q: 有什么可以进一步探索的点?

A: 论文提出了一个理论框架,旨在为开放式学习代理开发通用、组合性、可解释的生成性世界模型。以下是一些可以进一步探索的点:

模型的可扩展性:

- 探索这些贝叶斯网络模型在更复杂环境中的应用,以及它们处理大规模数据的能力。

表达能力的极限:

- 研究这些模型能够表达的代理-环境交互的范围,并确定其局限性。

计算效率:

- 优化变分推断过程,以提高模型在实际应用中的计算效率。

实验验证:

- 设计和执行实验,以验证这些贝叶斯网络模型在模拟和真实世界环境中的有效性。

参数化非线性SDEs:

- 开发新的方法来参数化和学习POMDPs中的非线性SDEs,同时保持模型的可解释性。

rsLDS架构的扩展:

- 扩展现有的rsLDS(Recurrent Switching Linear Dynamical Systems)架构,使其能够表达具有更复杂噪声信号的SDEs。

混合动态模型:

- 研究如何将离散和连续动态模型更有效地结合起来,以表达丰富的非线性和多水平抽象的动态。

因果关系和决策制定:

- 进一步研究模型中因果关系的编码如何影响代理的决策制定过程。

模型的生物学合理性:

- 探索这些模型是否能够与实际的神经动态相吻合,以及它们在模拟大脑功能方面的潜力。

跨领域应用:

- 将这些模型应用于其他领域,如机器人技术、自动驾驶汽车、自然语言处理等,以测试其泛化能力。

模型的鲁棒性和适应性:

- 研究这些模型在面对环境变化和不确定性时的鲁棒性和适应性。

模型的透明度和信任度:

- 探索如何提高模型的透明度和信任度,使其在实际应用中更易于被接受。

这些探索点可以帮助研究者更深入地理解这些贝叶斯网络模型的潜力和局限性,并推动开放式学习代理的发展。

Q: 总结一下论文的主要内容

A: 这篇论文主要介绍了一种新的贝叶斯网络类别,旨在为开放式学习代理提供通用、组合性、可解释的生成性世界模型。以下是论文的主要内容总结:

问题定义:

- 论文提出了开放式学习代理面临的挑战,即如何构建能够逐步理解复杂世界的模型,并强调了现有模型在可扩展性上的局限性。

贝叶斯网络类别:

- 论文定义了一个贝叶斯网络类别,这些网络足够表达以近似自然和动态的代理-环境交互,同时保持计算上的可处理性。

模型要求:

- 论文提出了对这类贝叶斯网络的要求,包括表达性、计算可处理性、可解释性和快速行动、感知与学习能力。

模型结构与组成:

- 论文详细描述了通过层次组合基本结构模块构建的贝叶斯网络类别,这些模块能够表达广泛的动态代理-环境交互。

离散与连续动态:

- 论文讨论了如何分别处理离散和连续状态的动态,包括部分观察马尔可夫决策过程(POMDPs)和随机微分方程(SDEs)。

模型的表达性与解释性:

- 论文强调了模型的表达性在于其能够表示复杂的随机过程,包括具有离散和连续状态的过程,以及模型的可解释性源于其稀疏性和编码因果关系。

模型应用:

- 论文提到这些贝叶斯网络被用于从原始像素建模视频和声音文件,以及代理从像素进行规划的情况。

未来工作:

- 论文指出未来的工作应该探索这种方法的极限,包括其可扩展性和表达相关代理-环境交互的能力。

总体而言,论文的核心贡献在于提出了一种新的贝叶斯网络框架,旨在支持开放式学习代理的发展,通过整合贝叶斯结构学习和内在动机规划,使代理能够主动发展和完善其世界模型。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

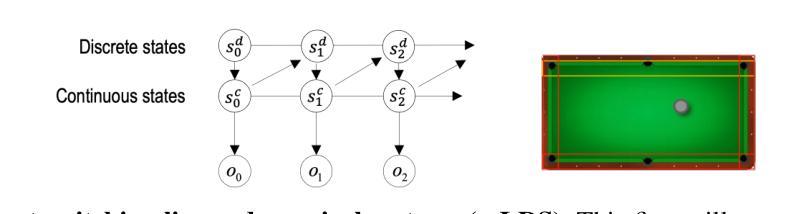

Into the Unknown Unknowns: Engaged Human Learning through Participation in Language Model Agent Conversations

Authors:Yucheng Jiang, Yijia Shao, Dekun Ma, Sina J. Semnani, Monica S. Lam

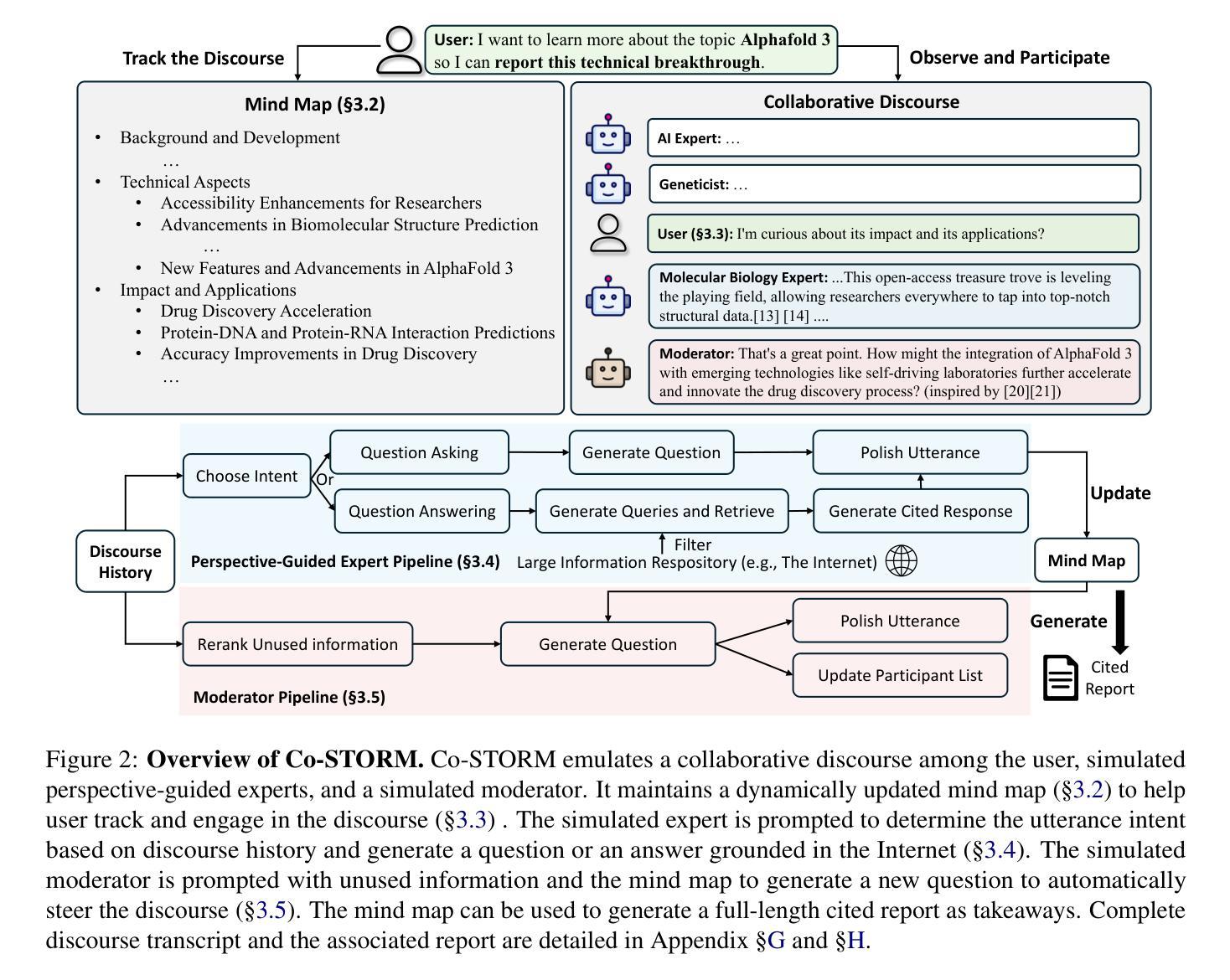

While language model (LM)-powered chatbots and generative search engines excel at answering concrete queries, discovering information in the terrain of unknown unknowns remains challenging for users. To emulate the common educational scenario where children/students learn by listening to and participating in conversations of their parents/teachers, we create Collaborative STORM (Co-STORM). Unlike QA systems that require users to ask all the questions, Co-STORM lets users observe and occasionally steer the discourse among several LM agents. The agents ask questions on the user’s behalf, allowing the user to discover unknown unknowns serendipitously. To facilitate user interaction, Co-STORM assists users in tracking the discourse by organizing the uncovered information into a dynamic mind map, ultimately generating a comprehensive report as takeaways. For automatic evaluation, we construct the WildSeek dataset by collecting real information-seeking records with user goals. Co-STORM outperforms baseline methods on both discourse trace and report quality. In a further human evaluation, 70% of participants prefer Co-STORM over a search engine, and 78% favor it over a RAG chatbot.

语言模型(LM)驱动的聊天机器人和生成式搜索引擎在回答具体查询方面表现出色,但在未知领域发现信息仍然对用户来说是一个挑战。为了模拟儿童/学生通过倾听和参与到父母/老师的对话中进行学习的常见教育场景,我们创建了协作式STORM(Co-STORM)。不同于要求用户提出所有问题的问答系统,Co-STORM让用户观察并偶尔引导多个LM代理之间的对话。代理能够代表用户提出问题,使用户能够偶然地发现未知领域。为了促进用户交互,Co-STORM通过将所获得的信息组织成动态思维导图来帮助用户追踪对话,并最终生成一份全面的报告作为收获。为了进行自动评估,我们通过收集包含用户目标的真实信息搜索记录来构建WildSeek数据集。在话语追踪和报告质量方面,Co-STORM都优于基线方法。在进一步的人类评估中,70%的参与者更喜欢Co-STORM而不是搜索引擎,78%的人更青睐于它而不是RAG聊天机器人。

论文及项目相关链接

PDF EMNLP 2024 Main

Summary

基于语言模型(LM)的聊天机器人和生成式搜索引擎在回答具体查询方面表现出色,但在探索未知领域的信息时仍面临挑战。为此,我们借鉴儿童或学生通过聆听和参与到父母或老师的对话中进行学习的常见教育场景,创建了协作型暴风雨(Co-STORM)。不同于需要用户提问的问答系统,Co-STORM允许用户观察并偶尔引导多个语言模型代理之间的对话。这些代理可以代表用户提问,使用户能够偶然发现未知领域的信息。为了促进用户交互,Co-STORM通过动态思维导图组织发现的信息,最终生成综合报告作为要点。我们构建了WildSeek数据集进行自动评估,结果显示Co-STORM在话语追踪和报告质量方面都优于基准方法。进一步的人类评估中,70%的参与者更喜欢使用Co-STORM而非搜索引擎,78%的参与者更倾向于使用Co-STORM而非RAG聊天机器人。

Key Takeaways

- 语言模型驱动的聊天机器人和搜索引擎在回应具体查询时表现出色,但在探索未知领域时仍存挑战。

- Co-STORM模拟教育场景,让用户在观察并参与多个语言模型代理的对话中学习。

- Co-STORM允许用户不提问而发现未知领域的信息,通过代理代表用户提问。

- 用户可以通过动态思维导图追踪发现的信息,最终生成综合报告作为要点。

- 自动评估显示Co-STORM在话语追踪和报告质量方面优于其他方法。

- 在人类评估中,大多数参与者偏好使用Co-STORM而非传统搜索引擎或RAG聊天机器人。

- Co-STORM为探索未知领域提供了一种新的、有效的方式。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何帮助用户在复杂的信息检索场景中发现他们之前未知的信息(即“未知的未知”),并促进知识的发现。具体来说,论文中提出了一个名为Collaborative STORM (Co-STORM)的系统,它通过模拟多个语言模型(LM)代理之间的协作对话,使用户能够通过观察和偶尔参与对话来发现新的信息和知识。这与传统的问答系统不同,后者通常需要用户主动提出所有问题,而Co-STORM允许用户以更低的心智负担,通过协作对话的方式偶然发现新的信息和知识。

Q: 有哪些相关研究?

A: 这篇论文提到了多个与信息检索、语言模型、多代理系统和协作学习相关的研究。以下是一些主要的相关研究:

语言模型 (LMs): 论文提到了近期在语言模型方面的进展,如Bai等人 (2022)、OpenAI (2023) 和 Gemini Team (2024) 的工作,这些研究推动了聊天机器人和生成式搜索引擎的发展。

检索增强生成 (RAG): Lewis等人 (2021) 提出了检索增强生成的方法,这有助于提高系统回应用户查询的能力。

自动化解释性写作: Shen等人 (2023) 和 Shao等人 (2024) 的工作尝试通过从不同来源整合信息来帮助读者达到“未知的未知”的领域。

复杂信息检索: Pirolli (2009) 和 Bates (1989) 的研究定义了复杂信息检索的概念,并讨论了其在不同领域的应用。

多代理系统: 随着大型语言模型的发展,Wu等人 (2023)、Nakajima (2023) 和 Liu等人 (2023b) 等研究探索了在多代理应用中使用LMs的可能性。

协作学习: Nussbaum (2008) 和 Osborne (2010) 的工作强调了协作学习在促进深入理解和批判性思维方面的重要性。

对话系统: 论文还提到了与对话系统相关的研究,如Kumar和Callan (2020) 以及 Nakamura等人 (2022) 的工作,这些研究探讨了对话搜索和交互式机器理解。

信息检索模型: Robertson (1977) 和 Belkin等人 (1982) 的经典工作为信息检索领域奠定了基础。

用户意图预测: Qu等人 (2019) 提出了在信息检索对话中预测用户意图的框架。

多代理辩论: Du等人 (2023) 和 Liang等人 (2023) 的研究展示了多代理辩论如何提高事实性和推理能力。

这些研究为Co-STORM系统的设计和实现提供了理论和技术基础。论文通过结合这些研究成果,提出了一个创新的信息检索辅助系统,以支持用户在复杂信息检索任务中的学习和发现过程。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为Collaborative STORM (Co-STORM)的系统来解决这个问题。Co-STORM的核心思想是模拟一个多代理的协作对话环境,使用户能够在观察和偶尔参与对话的过程中发现新的信息和知识。以下是Co-STORM解决这个问题的主要方法:

多代理协作对话:Co-STORM允许多个语言模型(LM)代理以不同的角色参与对话,包括专家和主持人。这些代理代表不同的视角,提出问题和答案,使用户能够从多个角度了解主题。

用户参与:用户可以随时加入对话,提出问题或分享观点。这种参与方式降低了用户在信息检索中的努力,并允许他们根据自己的兴趣引导对话。

动态思维导图:Co-STORM使用动态思维导图来组织对话中收集的信息,帮助用户跟踪对话的进展,并在对话结束后生成一个全面的报告。

自动评估和数据集构建:为了评估Co-STORM的效果,作者构建了一个名为WildSeek的数据集,该数据集收集了真实用户在复杂信息检索任务中的记录,并提出了自动评估指标来评估对话质量和报告质量。

混合主动方法:Co-STORM采用混合主动方法,结合用户主动参与和系统自动生成的对话,以实现更有针对性的讨论。

模拟圆桌参与者:Co-STORM模拟具有不同专业知识的专家,以代表不同的视角,并根据对话历史和专家的视角生成问题或答案。

模拟主持人:主持人的角色是为对话注入新的方向,提出基于未使用信息的问题,帮助用户发现更多未知的未知。

实时交互和反馈:Co-STORM提供了一个实时交互的Web应用程序,允许用户在与系统交互时提供反馈。

通过这些方法,Co-STORM旨在提供一个更自然、更引人入胜的信息检索体验,同时减少用户在复杂信息检索任务中所需的心智努力,并帮助他们发现新的知识和见解。

Q: 论文做了哪些实验?

A: 论文中进行了两类主要的实验来评估Co-STORM系统的性能:

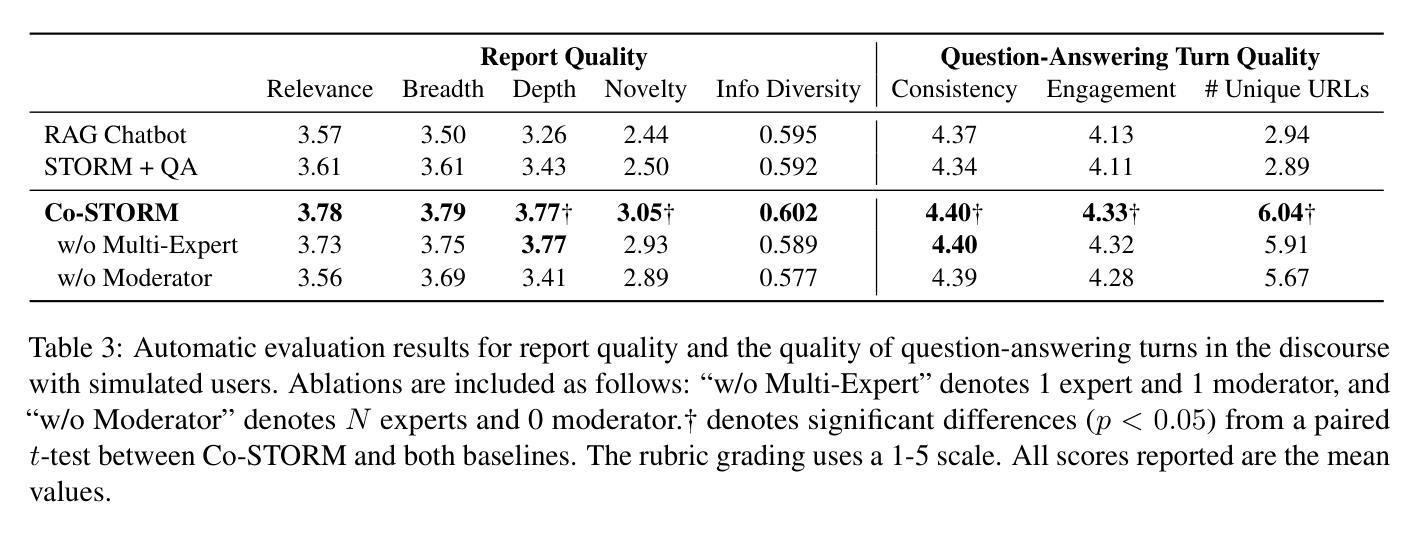

自动评估:这类评估使用自动指标来测试和比较Co-STORM与其他基线系统(如RAG Chatbot和STORM + QA)的性能。自动评估包括以下几个方面:

- 报告质量:评估最终报告的相关性、广度、深度和新颖性。

- 话语质量:评估对话过程中每个回合的质量,包括问题提问的新颖性、意图对齐和无重复性,以及问题回答的一致性和参与度。

- 信息多样性:通过计算引用URLs的平均成对不相似性来量化收集信息的多样性。

人类评估:为了捕捉人类交互的复杂性并评估系统的有效性,作者进行了人类评估。这包括以下几个步骤:

- 参与者招募:从互联网上招募了20名志愿者进行IRB批准的人类评估。

- 评估设置:参与者被随机分为两组,一组比较Co-STORM与Google搜索,另一组比较Co-STORM与RAG Chatbot。参与者需要在两个系统上分别就不同主题进行信息检索任务。

- 任务完成:参与者在完成每个主题的信息检索后,根据相关性、广度、深度和新颖性/意外性四个方面对他们的体验进行评分。

- 成对偏好:在完成两项任务后,参与者需要提供关于所需努力、用户参与度、解决回音室问题和整体体验方面的Co-STORM与其他系统的成对偏好。

- 开放式反馈:收集参与者对Co-STORM的开放式反馈,包括对每个话语回合和思维导图快照的评论。

此外,论文还包括了一些控制实验来评估思维导图插入操作的质量,并与基线方法进行了比较。这些实验使用了一个由最近高质量Wikipedia文章组成的FreshWiki数据集,以评估不同方法在将引用信息插入到文章大纲中的能力。

通过这些实验,论文展示了Co-STORM在帮助用户发现未知未知信息、减少心智努力以及提供更吸引人的学习体验方面的优势。

Q: 有什么可以进一步探索的点?

A: 尽管Co-STORM系统在帮助用户发现未知未知信息方面表现出色,但论文中也指出了一些潜在的改进方向和未来工作的机会:

个性化用户体验:系统可以进一步定制与用户先前知识水平相匹配的协作对话,例如,对于熟悉主题的用户可以跳过基础知识,而对于新手用户则逐步引入概念。

用户控制:虽然Co-STORM采用了有效的对话管理机制,但用户有时可能希望对对话有更多的控制,包括管理专家视角和定制话语长度。

多语言支持:扩展Co-STORM以支持多种语言将显著提高其实用性和影响力。这需要整合能够访问不同语言来源的搜索引擎或检索模型,并确保内容在不同语言之间的一致性和可靠性。

提高效率:与RAG Chatbot相比,Co-STORM由于需要决定话语意图和更新思维导图,因此在延迟方面存在劣势。进一步提高大型语言模型系统的效率将提供更流畅的用户体验。

内容审核和信息准确性:需要进一步的信息处理模块来过滤互联网来源,并更强大的模块来验证信息的准确性,以确保可靠的学习体验。

交互式学习和教育应用:Co-STORM可以应用于教育领域,例如作为辅助工具来促进学生在特定主题上的深入学习和讨论。

长期用户研究:进行长期的用户研究以评估Co-STORM在持续使用中的效果,以及它如何影响用户的知识获取和问题解决能力。

更广泛的领域应用:探索Co-STORM在不同领域(如法律、医疗、工程等)的应用,并根据这些领域的特定需求进行定制。

用户意图的更深入理解:研究如何更好地理解和预测用户的意图,以便系统能够提供更加精准和个性化的信息。

技术集成和创新:探索将Co-STORM与其他先进技术(如虚拟现实、增强现实或物联网设备)集成的可能性,以创造新的交互体验。

这些探索点可以帮助研究人员和开发者进一步提升Co-STORM系统的能力,使其成为一个更加强大、灵活且用户友好的信息检索和学习工具。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以概括为以下几个要点:

问题定义:论文针对的问题是用户在使用现有的语言模型(LM)驱动的聊天机器人和搜索引擎时,难以发现他们未知的未知信息(即“未知的未知”)。

Co-STORM系统:为了解决这个问题,论文提出了一个名为Collaborative STORM(Co-STORM)的系统。Co-STORM通过模拟多个LM代理之间的协作对话,使用户能够观察和参与对话,从而发现新的信息。

用户参与:Co-STORM允许用户以低心智负担的方式参与对话,提出问题或分享观点,系统会根据用户的输入动态调整对话内容。

动态思维导图:系统使用动态思维导图来组织和展示对话中收集的信息,帮助用户跟踪对话进展,并在对话结束时生成全面的报告。

评估方法:为了评估Co-STORM的性能,论文构建了WildSeek数据集,并提出了自动评估指标来衡量报告质量和话语质量。

实验结果:通过自动评估和人类评估,Co-STORM在发现深度和新颖性信息方面显著优于基线方法,并且用户更倾向于使用Co-STORM进行信息检索。

贡献:论文的主要贡献包括提出了Co-STORM系统,构建了WildSeek数据集,并通过评估展示了Co-STORM在帮助用户发现未知未知信息方面的优势。

未来工作:论文讨论了Co-STORM的局限性,并提出了未来可能的研究方向,如个性化用户体验、多语言支持、提高系统效率等。

总的来说,这篇论文提出了一个创新的系统,通过模拟协作对话来帮助用户在复杂的信息检索任务中发现新的知识和信息,并通过实验验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Enhancing Agent Learning through World Dynamics Modeling

Authors:Zhiyuan Sun, Haochen Shi, Marc-Alexandre Côté, Glen Berseth, Xingdi Yuan, Bang Liu

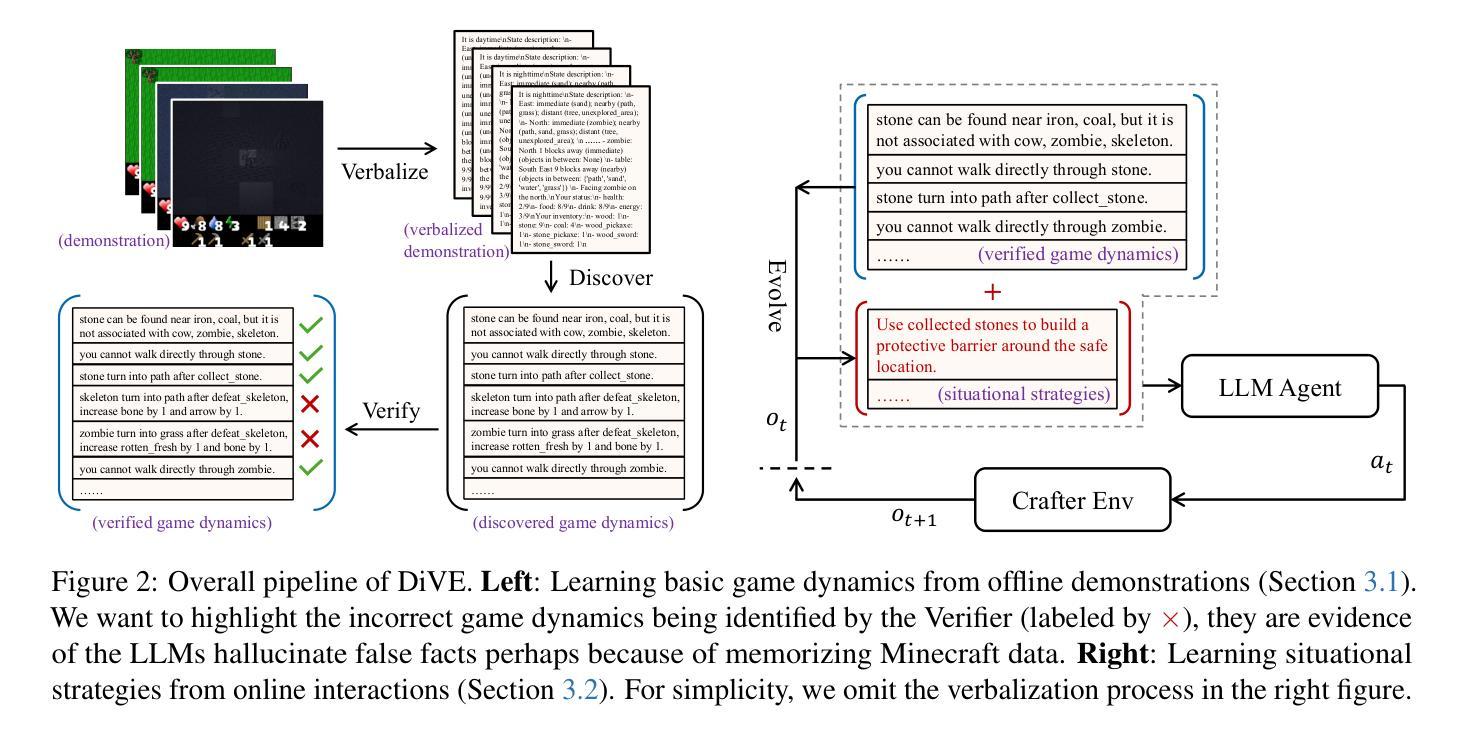

Large language models (LLMs) have been increasingly applied to tasks in language understanding and interactive decision-making, with their impressive performance largely attributed to the extensive domain knowledge embedded within them. However, the depth and breadth of this knowledge can vary across domains. Many existing approaches assume that LLMs possess a comprehensive understanding of their environment, often overlooking potential gaps in their grasp of actual world dynamics. To address this, we introduce Discover, Verify, and Evolve (DiVE), a framework that discovers world dynamics from a small number of demonstrations, verifies the accuracy of these dynamics, and evolves new, advanced dynamics tailored to the current situation. Through extensive evaluations, we assess the impact of each component on performance and compare the dynamics generated by DiVE to human-annotated dynamics. Our results show that LLMs guided by DiVE make more informed decisions, achieving rewards comparable to human players in the Crafter environment and surpassing methods that require prior task-specific training in the MiniHack environment.

大型语言模型(LLM)在理解和互动决策任务中的应用日益广泛,其引人注目的表现主要归功于嵌入其中的丰富领域知识。然而,这些知识的深度和广度在不同领域中是有所不同的。许多现有方法假设LLM对其环境有全面的了解,常常忽略了它们对实际世界动态理解的潜在差距。为了解决这一问题,我们引入了Discover、Verify和Evolve(DiVE)框架,该框架通过少数演示发现世界动态,验证这些动态的准确性,并发展出适应当前情况的新、先进的动态。通过广泛的评估,我们评估了每个组件对性能的影响,并将DiVE生成的动态与人类注释的动态进行了比较。结果表明,在Crafter环境中,DiVE引导的大型语言模型做出的决策更加明智,奖励与人类玩家相当;在MiniHack环境中,它超越了需要预先进行特定任务训练的方法。

论文及项目相关链接

Summary

大型语言模型(LLM)在理解和交互决策任务中的应用日益广泛,其令人印象深刻的性能主要归功于其中嵌入的丰富领域知识。然而,知识的深度和广度在不同的领域会有所不同。现有的许多方法假设LLM对其环境的理解是全面的,往往忽视了它们对实际世界动态理解的潜在差距。为解决这一问题,我们提出了Discover、Verify和Evolve(DiVE)框架,通过少量演示发现世界动态,验证这些动态的准确性,并根据当前情况发展出新的、先进的动态。通过广泛评估,我们评估了每个组件对性能的影响,并将DiVE生成的动态与人类注释的动态进行了比较。结果表明,在Crafter环境中,受DiVE指导的LLM能做出更明智的决策,获得与人类玩家相当的奖励,并且在不需要预先特定任务训练的MiniHack环境中超越了其他方法。

Key Takeaways

- 大型语言模型(LLM)在理解和交互决策任务中表现出强大的性能,得益于其嵌入的丰富领域知识。

- LLM在领域知识的深度和广度上存在差异,这影响了其在不同任务中的性能。

- 现有方法往往假设LLM对环境有全面的理解,忽视了其对实际世界动态理解的潜在差距。

- DiVE框架通过少量演示发现世界动态,验证这些动态的准确性,并根据当前情况发展出新的动态。

- DiVE框架包括Discover(发现世界动态)、Verify(验证动态准确性)和Evolve(发展新的动态)三个主要步骤。

- 评估显示,在Crafter环境中,受DiVE指导的LLM能做出更明智的决策,并获得与人类玩家相当的奖励。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何提高大型语言模型(LLMs)在特定领域任务中的决策能力。具体来说,论文中提到现有的方法通常假设LLMs已经具备了对环境的全面和深入理解,但实际情况可能并非如此,尤其是在面对新领域或不常见的任务时。这些模型可能缺乏对实际世界动态的深入理解。为了弥补这一差距,论文提出了一个名为“Discover, Verify, and Evolve (DiVE)”的框架,旨在通过以下三个步骤来增强LLMs的学习:

- 发现(Discover):从少量的示例中发现世界动态。

- 验证(Verify):验证这些动态的正确性。

- 演化(Evolve):根据当前情况演化出新的、更高级的动态。

通过这种方式,DiVE框架可以帮助LLMs更好地理解环境和当前状态,从而做出更优的决策。论文通过在“Crafter”环境中的实验,展示了DiVE框架指导的LLMs能够取得与人类玩家相当的奖励,证明了该框架的有效性。

Q: 有哪些相关研究?

A: 论文中提到了多个与大型语言模型(LLMs)和强化学习相关的研究工作。以下是一些主要的相关研究领域和具体工作:

大型语言模型(LLMs):

- 研究了LLMs在各种任务上的表现,如问答(Yang et al., 2018; Clark et al., 2019; Lin et al., 2021)、规划(Song et al., 2023; Brown et al., 2020; Huang et al., 2022)和常识知识推理(Yao et al., 2022, 2024; Besta et al., 2024)。

世界模型(World Models):

- 探讨了世界模型的概念,这些模型能够捕捉环境的基本动态,并用于策略学习(Ha and Schmidhuber, 2018; Hafner et al., 2020, 2023)。

强化学习(Reinforcement Learning, RL):

- RL作为开发具身智能体(embodied agents)的有效方法,通过试错学习(Moon et al., 2024; Hafner et al., 2023; Schulman et al., 2017)。

知识发现与验证:

- 研究了LLMs在推理任务中发现和演绎规则的能力(Zhu et al., 2023),以及从历史轨迹和交互经验中直接发现领域知识(Colas et al., 2023; Majumder et al., 2023; Fu et al., 2024a,b; Zhong et al., 2024; Zhao et al., 2024)。

策略演化:

- 通过反思过去的轨迹,LLMs可以增强其决策过程(Shinn et al., 2024),并基于预定义的技能发展新的高级技能(Wang et al., 2023a; Stengel-Eskin et al., 2024; Zhang et al., 2023a; Nottingham et al., 2024)。

任务分解和层次化学习:

- 研究了如何通过任务分解和层次化学习方法来提高LLMs在复杂任务中的性能(Bengio et al., 2009)。

交互式学习:

- 探讨了通过与环境的交互来引导LLMs学习的方法(Carta et al., 2023; Ouyang et al., 2022; Zheng et al., 2024)。

模型微调:

- 研究了如何通过微调LLMs来适应特定领域(Hu et al., 2021; Wei et al., 2022; Du et al., 2023)。

这些研究为DiVE框架提供了理论和技术基础,并在不同程度上影响了该框架的设计和实现。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为“Discover, Verify, and Evolve (DiVE)”的框架来解决大型语言模型(LLMs)在特定领域任务中决策能力不足的问题。DiVE框架通过以下三个主要组件来实现:

Discoverer(发现者):

- 这个组件负责从提供的示例中迭代地发现环境的动态。它首先发现动作和对象的基本动态,然后是子任务步骤,最后确定子目标的拓扑顺序。这种课程学习方法确保了学习效率和对环境动态的全面理解。

Verifier(验证者):

- 这个组件用于过滤掉由LLMs的幻觉倾向引起的不准确性,确保只保留精确可靠的信息。这一步对于维护知识库的完整性至关重要。

Evolver(演化者):

- 这个组件深入推理,发展适合当前状态的动态,例如战略性动作或情境决策。它确保代理具有针对当前状态的可操作知识,增强实时决策能力。

DiVE框架的工作原理如下:

- 离线动态学习:通过从人类演示中学习基本的游戏规则作为进一步决策的先验知识。

- 在线策略学习:将学习到的世界动态整合到游戏中,通过在线学习方法发展高级游戏策略,并将这些策略用于决策过程。

此外,DiVE框架还包括一个分层的规划过程,包括子目标规划、子任务规划和动作规划,以解决长期规划的挑战。通过这种方式,DiVE框架能够提高LLMs在特定领域的决策能力,使其在复杂任务中表现出更好的性能。

论文通过在“Crafter”环境中的实验验证了DiVE框架的有效性,展示了LLMs在DiVE的指导下能够做出更好的决策,并与人类玩家取得相当的奖励。

Q: 论文做了哪些实验?

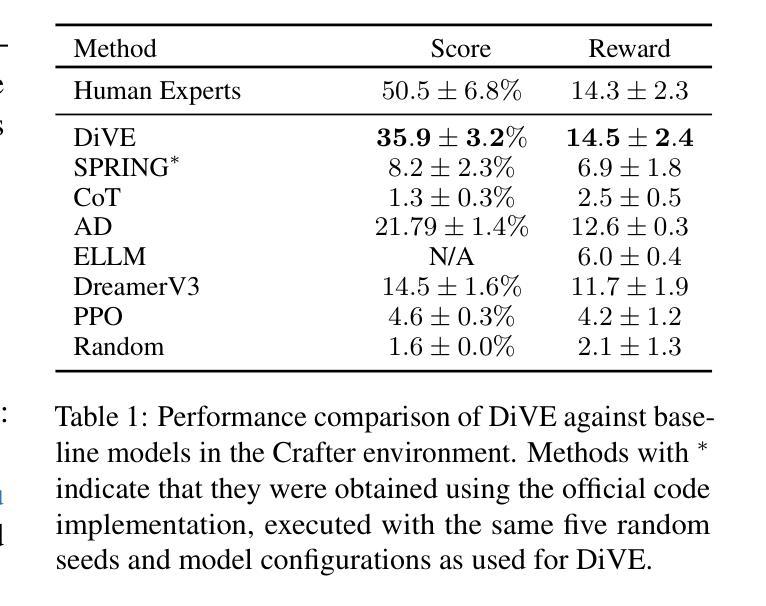

A: 论文中进行了一系列的实验来评估DiVE框架的性能,并与其他基线方法进行比较。以下是实验的主要方面:

环境设置:使用了名为“Crafter”的环境,这是一个开放世界的64x64网格地图生存游戏,具有多样的材料和实体。

评估指标:主要使用两个指标来评估代理的表现:奖励(reward)和得分(score)。代理每解锁一个新成就都会获得+1的奖励,并且每次健康点数增加或减少时,会获得±0.1的奖励。得分是通过聚合每个成就的成功率来计算的。

基线系统:DiVE与三类基线方法进行了比较,包括基于LLM的方法(如SPRING、ELLM和CoT)、基于强化学习的方法(如DreamerV3、PPO和AD)以及人类专家的演示。

主要结果:DiVE在奖励和得分两个评估指标上都显著优于所有其他基线。特别是,DiVE在得分上比之前的最佳LLM方法SPRING提高了337.8%,在奖励上提高了110.1%。

定量分析:

- 进行了消融研究(Ablation Study),以评估方法中每个组件的有效性。

- 探讨了不同来源的动态对DiVE性能的影响,包括从人类演示中学习到的动态、SPRING论文中使用的手动动态,以及人类注释的动态。

质量分析:

- 使用人类注释的动态作为Ktarget的银标准,估计了学习到的动态W的精确度和召回率。

- 分析了经过验证的动态的精确度,以评估验证器在增强决策过程中使用动态的可靠性方面的作用。

定性分析:分析了学习到的和验证的动态的正确性,包括正确、由于混杂因素、领域内幻觉或领域外幻觉导致的错误。

实验结果:DiVE在实验中表现出与人类玩家相当的奖励,并且通过定量和定性分析证明了其有效性。

这些实验结果表明,DiVE框架能够有效地指导LLMs在特定领域中做出更好的决策,并且具有学习和适应新任务的潜力。

Q: 有什么可以进一步探索的点?

A: 尽管DiVE框架在实验中表现出色,但仍有一些潜在的研究方向和探索点,可以进一步推动该领域的发展:

更复杂的环境:目前的实验在相对简单的“Crafter”环境中进行。未来的研究可以在更复杂、更高维度的环境中测试DiVE框架的性能。

更大规模的数据集:研究是否可以使用更大规模的数据集来训练和验证DiVE框架,以及这将如何影响其性能和泛化能力。

实时动态调整:探索DiVE框架是否能够实时调整其策略,以适应环境的动态变化或未知情况。

多任务学习:研究DiVE框架在多任务环境中的表现,以及它是否能够平衡和优化多个目标。

减少人类专家演示的依赖:考虑如何减少对人类专家演示的依赖,可能通过自动化的探索策略或从其他数据源学习。

增强的验证机制:进一步改进验证器组件,以更有效地识别和排除不准确或误导的动态。

策略演化的深度:研究如何通过更深层次的策略演化来提高DiVE框架的决策质量,可能通过更复杂的推理过程或学习算法。

与其他学习方法的集成:探索将DiVE与其他机器学习或强化学习方法结合的可能性,以进一步提高性能。

可解释性和透明度:提高DiVE框架的可解释性,使其决策过程更加透明,便于理解和调试。

跨领域应用:研究DiVE框架在不同领域(如医疗、金融或交通管理)的应用潜力和挑战。

计算效率:优化DiVE框架的计算效率,减少资源消耗,使其更适合在资源受限的环境中使用。

鲁棒性和错误处理:增强DiVE框架在面对错误输入或意外情况时的鲁棒性。

伦理和社会影响:深入研究DiVE框架可能带来的伦理和社会影响,确保其应用符合道德标准和社会价值观。

这些探索点可以帮助研究人员更全面地理解和改进DiVE框架,以及将其应用于更广泛的任务和环境中。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题识别:论文指出大型语言模型(LLMs)在语言理解和交互式决策任务中表现出色,但它们的性能很大程度上依赖于模型内部的全面和深入的领域知识。然而,这些知识可能在不同领域之间存在差异,且现有方法往往忽略了LLMs可能存在的对实际世界动态理解的缺失。

DiVE框架:为了解决上述问题,论文提出了一个名为“Discover, Verify, and Evolve (DiVE)”的框架。该框架通过以下三个步骤来增强LLMs的决策能力:

- 发现(Discover):从少量示例中发现世界动态。

- 验证(Verify):验证这些动态的正确性。

- 演化(Evolve):根据当前情况演化出新的、更高级的动态。

框架组件:DiVE框架包含三个关键组件:

- Discoverer:基于提供的示例发现环境动态。

- Verifier:过滤并保留精确可靠的信息。

- Evolver:深入推理并发展适合当前状态的动态。

实验评估:论文通过在“Crafter”环境中的实验,评估了DiVE框架的性能。实验结果表明,DiVE指导的LLMs能够做出更好的决策,并与人类玩家取得相当的奖励。

定量与定性分析:论文提供了对DiVE行为的定量和定性分析,包括消融研究、动态质量分析以及与现有方法的比较,证明了DiVE框架的有效性。

主要贡献:论文的主要贡献是提出了一个能够自主学习世界动态并指导LLMs进行决策的通用框架。这种方法不仅提高了LLMs在特定领域的能力,而且为创建能够通过持续学习和改进掌握复杂任务的智能体提供了一个多功能的基础。

未来工作与局限性:论文讨论了DiVE框架的局限性,并提出了未来可能的研究方向,如在更复杂的环境中测试框架、减少对人类演示的依赖、提高计算效率等。

伦理考虑:论文指出,尽管研究旨在缩小LLMs与目标领域之间的知识差距,但作为基于LLMs的框架,DiVE可能仍存在幻觉问题,并考虑了其潜在的伦理和社会影响。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

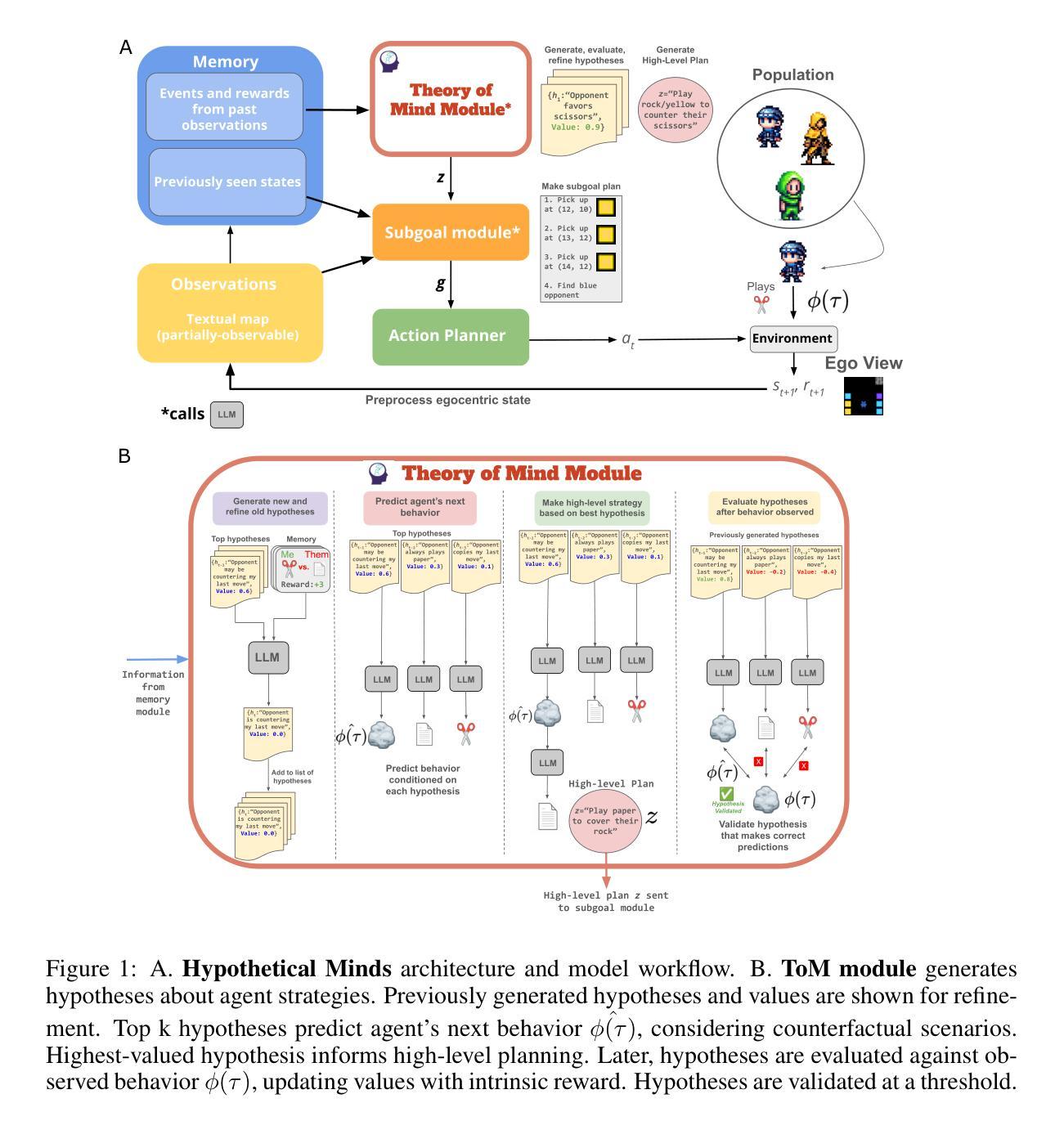

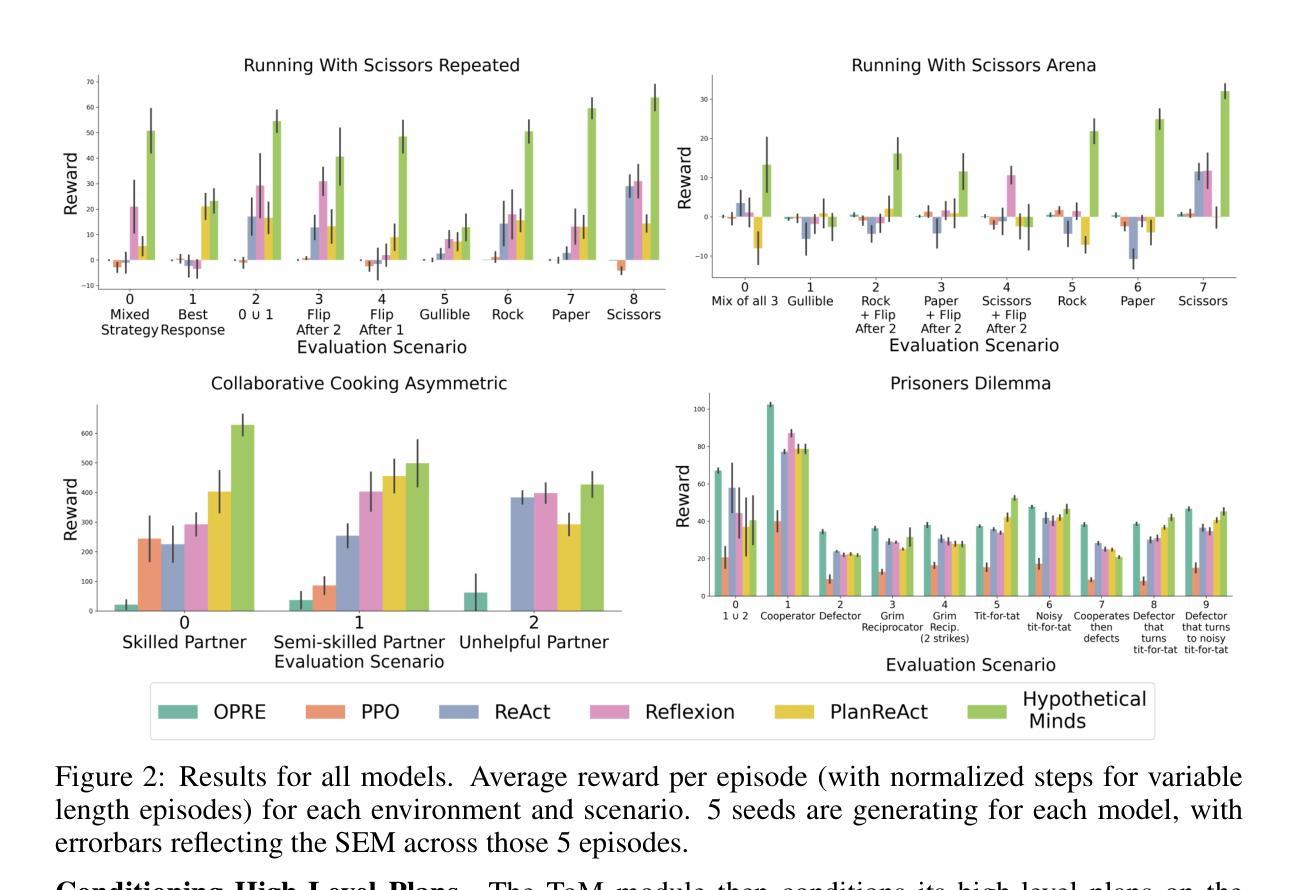

Hypothetical Minds: Scaffolding Theory of Mind for Multi-Agent Tasks with Large Language Models

Authors:Logan Cross, Violet Xiang, Agam Bhatia, Daniel LK Yamins, Nick Haber

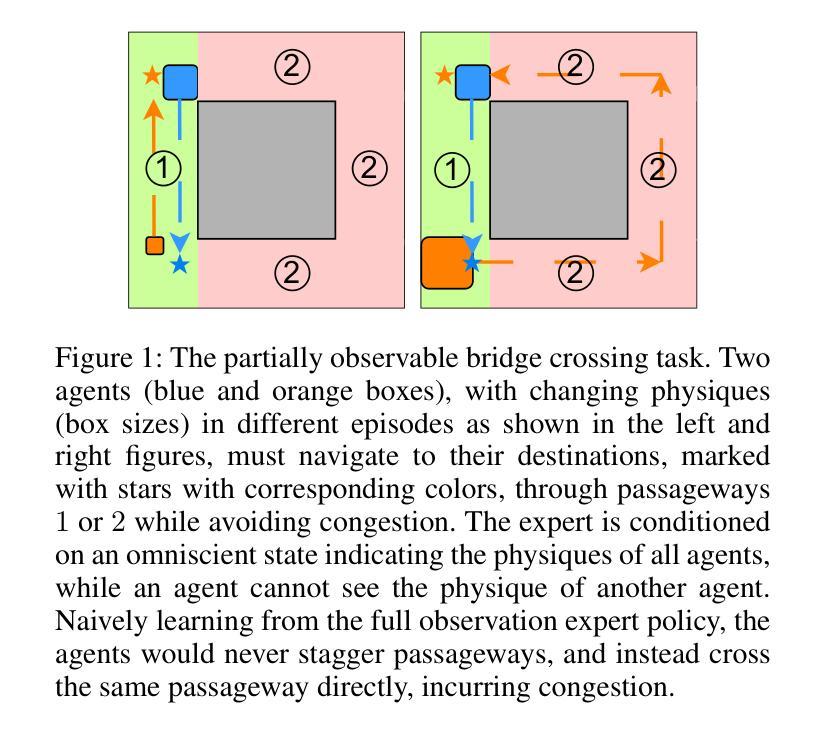

Multi-agent reinforcement learning (MARL) methods struggle with the non-stationarity of multi-agent systems and fail to adaptively learn online when tested with novel agents. Here, we leverage large language models (LLMs) to create an autonomous agent that can handle these challenges. Our agent, Hypothetical Minds, consists of a cognitively-inspired architecture, featuring modular components for perception, memory, and hierarchical planning over two levels of abstraction. We introduce the Theory of Mind module that scaffolds the high-level planning process by generating hypotheses about other agents’ strategies in natural language. It then evaluates and iteratively refines these hypotheses by reinforcing hypotheses that make correct predictions about the other agents’ behavior. Hypothetical Minds significantly improves performance over previous LLM-agent and RL baselines on a range of competitive, mixed motive, and collaborative domains in the Melting Pot benchmark, including both dyadic and population-based environments. Additionally, comparisons against LLM-agent baselines and ablations reveal the importance of hypothesis evaluation and refinement for succeeding on complex scenarios.

多智能体强化学习(MARL)方法面临智能体系统非平稳性的挑战,在面临新智能体测试时无法适应在线学习。在这里,我们利用大型语言模型(LLM)来创建一个能够应对这些挑战的自主智能体。我们的智能体“假设心智”由认知启发架构组成,包括用于感知、记忆和两级抽象层次规划的分隔模块。我们引入了心智理论模块,它通过生成关于其他智能体策略的假设来促进高层次规划过程,并用自然语言表达这些假设。然后它评估并迭代地完善这些假设,通过强化能够正确预测其他智能体行为的假设。在Melting Pot基准测试中,假设心智在竞争、混合动机和协作领域的多个环境中,相较于之前的LLM智能体和强化学习基线,显著提高了性能表现。此外,与LLM智能体基线以及消减实验的比较凸显了假设评估和提炼在应对复杂场景中的重要性。

论文及项目相关链接

Summary

多智能体强化学习面临多智能体系统非平稳性的挑战,面对新智能体时难以在线自适应学习。为应对这些挑战,本研究利用大型语言模型(LLM)创建了一种自主智能体——假设心智(Hypothetical Minds)。该智能体具有认知启发架构,包括感知、记忆和分层规划模块。它通过理论思维模块(Theory of Mind)强化高层次的规划过程,以自然语言生成关于其他智能体策略的假设,并对这些假设进行评估和迭代优化。在熔化罐指标评估下,无论是在竞争性、混合动机和协作领域中还是在对抗环境中,假设心智的性能都显著优于之前的LLM智能体和强化学习基线。这表明假设心智的假设评估和优化在复杂场景中至关重要。

Key Takeaways

- 多智能体强化学习面临非平稳性挑战,难以适应新智能体的出现。

- 利用大型语言模型创建自主智能体以应对这些挑战。

- 假设心智结合了认知启发架构,包括感知、记忆和分层规划模块。

- 理论思维模块强化高层次的规划过程,通过自然语言生成关于其他智能体的假设。

- 假设心智在熔化罐指标评估下显著优于其他基线方法,在多种环境中表现优异。

- 假设评估和迭代优化在复杂场景中至关重要。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何创建能够在丰富的社会环境中自适应行动的自主智能体。具体来说,论文针对的是多智能体强化学习(Multi-agent Reinforcement Learning, MARL)方法在以下方面的挑战:

多智能体系统的非平稳性:MARL方法在处理多智能体系统中的非平稳性问题时存在困难,这导致它们在面对新颖智能体时难以在线自适应学习。

高样本复杂性:MARL方法通常需要大量的样本来进行有效的学习。

泛化能力差:MARL方法在学习过程中往往难以泛化到训练中未遇到的智能体。

有限的推理能力:现有的MARL方法在处理复杂的社会动态和需要推理其他智能体意图的场景时,其推理能力有限。

为了解决这些问题,论文提出了一种名为“Hypothetical Minds”的模型,该模型利用大型语言模型(Large Language Models, LLMs)创建了一个具有认知启发式架构的自主智能体。这个智能体能够通过生成关于其他智能体策略的假设,并在自然语言中评估和迭代地精炼这些假设,从而在多智能体环境中实现有效的协调或对抗策略。通过这种方式,Hypothetical Minds模型在多种竞争性、合作性和混合动机的多智能体环境中表现出了优越的性能。

Q: 有哪些相关研究?

A: 论文中提到了多个与大型语言模型(LLMs)相关的研究领域,以下是一些主要的相关研究和应用:

基于LLM的智能体:研究涉及将LLMs作为不同领域的中心控制器,利用它们在训练过程中获得的广泛背景知识。

Voyager:在Minecraft中自主构建复杂技能,通过存储和检索行为库中的可执行代码来解决越来越难的任务。

Octopus和Jarvis-1:使用视觉-语言模型在虚拟环境中规划长期行为。

Dynalang和DECKARD:使用语言指导基于模型的RL策略在虚拟环境中的世界建模。

SAMA:使用LLM为需要多智能体协调的环境中的语言基础的基于目标的RL策略规划子目标序列。

ProAgent:通过使用LLM基于当前状态推断队友的意图,改进在Overcooked游戏中的零样本协调。

推理和假设搜索:LLMs展示了通过Chain-of-Thought方法增强推理能力,这些方法通过生成和评估假设来支撑思考过程。

认知模型在部分可观测环境中:论文提到了计算建模动物和人类决策制定的方法,这些方法为LLMs作为认知模型提供了类比。

其他相关应用:LLMs被用于与数据库和APIs交互的工具,以及在机器人技术中用于高级规划和控制。

这些研究表明,LLMs在多智能体环境中具有广泛的应用潜力,特别是在需要高级规划、协调、推理和其他认知能力的场景中。论文通过提出Hypothetical Minds模型,进一步推动了这一研究方向,特别是在处理多智能体环境中的复杂社会动态方面。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为“Hypothetical Minds”(HM)的模型来解决多智能体环境中的挑战。以下是该模型解决这些问题的关键方法和组件:

认知启发式架构:HM采用了一个由不同模块组成的架构,这些模块负责感知、记忆和分层规划,以处理两个抽象层次的信息。

Theory of Mind (ToM) 模块:这是HM的一个核心组件,它通过生成关于其他智能体策略、目标和能力的自然语言假设来促进有效的协调或对抗策略。这些假设随后被评估和迭代地精炼,以提高预测其他智能体行为的准确性。

假设生成:ToM模块使用LLM根据智能体的内存M和之前的假设生成新的假设,这些假设是对其他智能体潜在策略的自然语言描述。

假设评估:通过计算基于LLM对其他智能体未来行为的预测的内在奖励,来为每个假设打分。正确的预测将提高假设的价值。

假设精炼:通过展示之前生成的最高价值的假设,LLM能够自我改进其推理,基于之前生成的假设进行假设精炼。

高级别规划:ToM模块将选定的最佳假设用于条件化高级别规划,生成一个描述智能体整体策略、目标或意图的自然语言描述。

子目标模块:根据高级别规划和当前游戏状态,子目标模块生成一系列子目标,这些子目标是智能体需要采取的动作或动作序列,以实现高级别规划。

行动规划器:将子目标模块生成的动作计划转换为与环境兼容的原子动作序列。

实验验证:在Melting Pot多智能体强化学习基准测试中的四个不同环境中评估HM模型,包括竞争性、合作性和混合动机领域,以及30个不同的评估场景。

通过这些方法,Hypothetical Minds模型能够在多智能体环境中实现自适应策略,显著提高了与先前LLM智能体和RL基线相比的性能。此外,通过与LLM智能体基线和消融研究的比较,论文强调了假设评估和精炼在ToM模块中对成功处理复杂场景的重要性。

Q: 论文做了哪些实验?

A: 论文中进行了一系列的实验,以评估Hypothetical Minds(HM)模型在多智能体环境中的表现,并分析其一般化和可扩展性。以下是论文中进行的主要实验:

竞争性环境评估:

- **Running With Scissors in the Matrix Repeated (RWS)**:一个零和竞争环境,涉及两个玩家在地图上移动并收集与“石头、剪刀、布”相对应的资源。实验包括九种不同的评估场景,包括具有一致策略的对手和需要适应性策略的场景。

扩展到更多玩家的环境:

- **Running With Scissors in the Matrix Arena (RWS Arena)**:RWS的八玩家扩展版本,测试模型在处理更多对手和记忆不同策略时的可扩展性。

合作性环境评估:

- Collaborative Cooking Asymmetric:一个需要两个玩家协作高效烹饪番茄汤的环境,测试HM在与不同技能水平的合作伙伴协作时的适应性。

混合动机环境评估:

- **Prisoner’s Dilemma in the Matrix Repeated (PD)**:一个涉及合作与背叛动机的网格世界环境,测试HM在处理动态合作伙伴时的表现。

不同组件对整体性能的贡献分析:

- 对HM模型中的不同组件,特别是Theory of Mind (ToM)模块,进行了详细的消融分析,以了解它们对模型整体性能的影响。

基线模型比较:

- 将HM与其他基线模型(包括ReAct、Reflexion、PlanReAct和PPO)进行了比较,以评估其在不同环境中的性能。

不同智能体策略的适应性测试:

- 在不同的评估场景中,HM需要适应具有固定或自适应策略的对手,测试其在线学习和策略推断的能力。

性能的统计分析:

- 通过对五个不同种子的实验结果进行平均和标准误差(SEM)的计算,提供了HM模型性能的统计数据。

这些实验不仅测试了HM模型在多种环境和场景下的性能,还深入分析了其关键组件的作用,以及与现有方法相比的优势。通过这些全面的实验设置,论文展示了HM模型在多智能体任务中的有效性和鲁棒性。

Q: 有什么可以进一步探索的点?

A: 论文在最后一部分提出了一些潜在的研究方向和可以进一步探索的点。以下是几个可能的探索领域:

自主学习游戏规则和策略:当前的Hypothetical Minds模型需要人类介入来设置脚手架和提示。未来的研究可以探索如何让智能体从环境反馈中自主学习游戏规则和适当的策略。

提高泛化能力:尽管HM在多个环境中表现良好,但提高模型在面对未见过的对手策略时的泛化能力仍然是一个重要的研究方向。

更复杂的社会动态:论文中提到,HM在处理更复杂的社会动态和需要推理其他智能体意图的场景中表现出了潜力。未来的工作可以进一步探索这些领域,例如在更大规模的多智能体环境中进行测试。

减少人类介入:目前,HM模型的开发和训练过程中涉及到一定程度的人类介入。研究如何减少这种介入,使模型更加自动化,将是一个有价值的探索方向。

与其他人工智能方法的集成:考虑将HM模型与其他人工智能技术(如深度学习、强化学习等)结合,以进一步提高其性能和适应性。

更广泛的环境和任务:将HM模型应用于更广泛的环境和任务,例如不同的游戏、模拟环境或甚至现实世界的机器人任务。

认知模型的进一步发展:论文提到了LLMs作为认知模型的潜力。未来的研究可以进一步探索如何将这些模型发展为更加精确和可靠的认知模型。

模型的可解释性和透明度:提高模型的可解释性,让研究人员和用户更好地理解模型的决策过程,这在许多应用领域都是至关重要的。

模型的效率和计算成本:优化模型以减少计算资源的需求,使其能够在更小规模的系统上运行,或者在更短的时间内完成训练。

安全性和伦理考量:随着智能体变得更加自主和复杂,确保它们的决策过程符合伦理标准并避免潜在的滥用是非常重要的。

这些探索点为未来的研究提供了一个框架,旨在提高智能体的自主性、适应性和性能,同时确保它们的决策过程是安全、透明和符合伦理的。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为“Hypothetical Minds”(HM)的模型,旨在解决多智能体强化学习(MARL)中的一些关键挑战。以下是对论文主要内容的总结:

问题背景:MARL方法在处理多智能体系统中的非平稳性、泛化能力差和推理能力有限等问题时存在困难。

Hypothetical Minds模型:提出了一个基于大型语言模型(LLMs)的自主智能体,该智能体采用认知启发式架构,具有感知、记忆和分层规划的能力。

Theory of Mind (ToM) 模块:HM模型的核心是ToM模块,它通过生成、评估和精炼关于其他智能体策略的自然语言假设来促进有效的协调或对抗策略。

实验设置:在Melting Pot多智能体基准测试中,HM模型在竞争性、合作性和混合动机环境进行了评估,包括与不同策略的对手进行30个不同的评估场景的测试。

实验结果:HM模型在所有测试环境中均显著优于LLM智能体和RL基线模型,展示了其出色的性能和泛化能力。

消融研究:通过消融实验,论文强调了假设评估和精炼在ToM模块中对成功处理复杂场景的重要性。

相关工作:论文回顾了基于LLM的智能体、LLM的推理能力、以及在部分可观测环境中的认知模型等相关研究。

方法和技术:详细介绍了HM模型的方法论,包括部分可观测马尔可夫游戏的形式化定义、HM模型中的认知模块,以及如何通过LLM进行高层次规划和预测。

未来研究方向:论文讨论了HM模型的局限性,并提出了未来研究的方向,如自主学习游戏规则、提高泛化能力、减少人类介入等。

结论:HM模型通过结合LLMs和认知启发式架构,在多智能体环境中展示了适应性和有效性,为解决MARL中的挑战提供了一种新的方法。

总的来说,这篇论文提出了一个创新的方法来提高智能体在多智能体环境中的适应性和性能,通过利用LLMs的推理和学习能力,为多智能体任务提供了一种新的解决方案。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

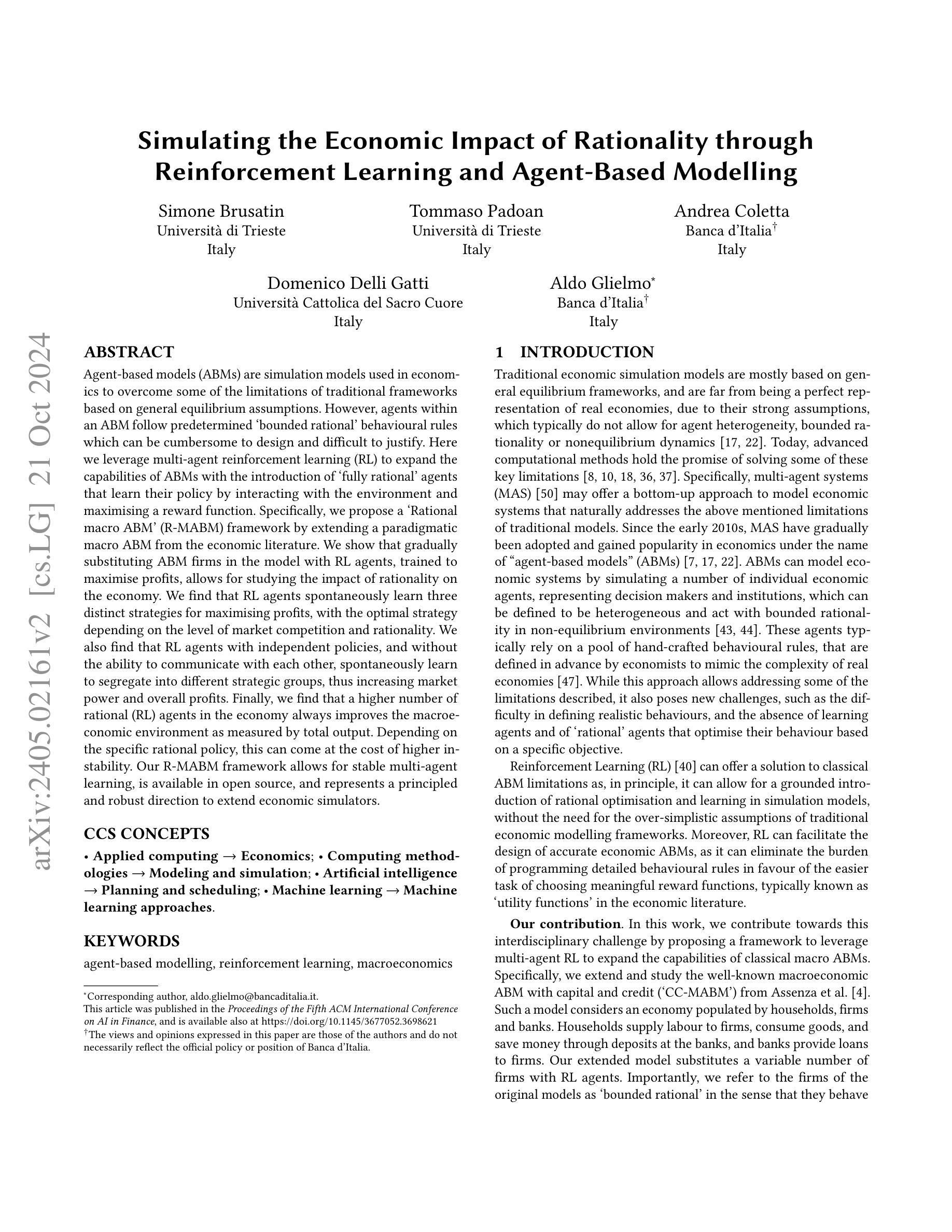

Simulating the Economic Impact of Rationality through Reinforcement Learning and Agent-Based Modelling

Authors:Simone Brusatin, Tommaso Padoan, Andrea Coletta, Domenico Delli Gatti, Aldo Glielmo

Agent-based models (ABMs) are simulation models used in economics to overcome some of the limitations of traditional frameworks based on general equilibrium assumptions. However, agents within an ABM follow predetermined ‘bounded rational’ behavioural rules which can be cumbersome to design and difficult to justify. Here we leverage multi-agent reinforcement learning (RL) to expand the capabilities of ABMs with the introduction of ‘fully rational’ agents that learn their policy by interacting with the environment and maximising a reward function. Specifically, we propose a ‘Rational macro ABM’ (R-MABM) framework by extending a paradigmatic macro ABM from the economic literature. We show that gradually substituting ABM firms in the model with RL agents, trained to maximise profits, allows for studying the impact of rationality on the economy. We find that RL agents spontaneously learn three distinct strategies for maximising profits, with the optimal strategy depending on the level of market competition and rationality. We also find that RL agents with independent policies, and without the ability to communicate with each other, spontaneously learn to segregate into different strategic groups, thus increasing market power and overall profits. Finally, we find that a higher number of rational (RL) agents in the economy always improves the macroeconomic environment as measured by total output. Depending on the specific rational policy, this can come at the cost of higher instability. Our R-MABM framework allows for stable multi-agent learning, is available in open source, and represents a principled and robust direction to extend economic simulators.

基于代理的模型(ABM)是经济学中用于克服基于一般均衡假设的传统框架的一些局限性的仿真模型。然而,ABM中的代理遵循预先设定的“有限理性”行为规则,这些规则的设计可能既繁琐又难以证明。在这里,我们利用多代理强化学习(RL)来扩展ABM的功能,通过引入能够通过与环境互动并最大化奖励函数来学习策略的“完全理性”代理。具体来说,我们通过扩展经济文献中的宏观ABM范例,提出了一个“理性宏观ABM”(R-MABM)框架。我们展示了逐步用经过训练以最大化利润RL代理替代模型中的ABM公司,这允许研究理性对经济的冲击。我们发现RL代理自发地学会了三种不同的最大化利润的策略,最优策略取决于市场竞争程度和理性程度。我们还发现具有独立政策且无法相互沟通的RL代理自发地学会了分割成不同的策略群体,从而增加了市场力量和整体利润。最后,我们发现经济中更高数量的理性(RL)代理总是会改善宏观经济环境(以总产出衡量),但具体理性的政策可能会带来更高的不稳定成本。我们的R-MABM框架允许稳定的多代理学习,以开源形式提供,并代表了一个有原则和稳健的方向来扩展经济模拟器。

论文及项目相关链接

PDF 9 pages, 4 figures

Summary

基于代理的模型(ABM)是经济学中的仿真模型,旨在克服基于一般均衡假设的传统框架的一些局限性。然而,ABM中的代理遵循预先设定的“有限理性”行为规则,这些规则的设计可能很繁琐且难以证明其合理性。本研究利用多代理强化学习(RL)来扩展ABM的功能,引入能够通过学习策略来适应环境的“完全理性”代理。具体来说,我们提出了一个“理性宏观ABM”(R-MABM)框架,通过扩展经济学文献中的宏观ABM模型来实现。我们发现逐步用旨在最大化利润的强化学习代理替代ABM中的公司,允许研究理性对经济的整体影响。我们的研究发现,强化学习代理能自发地学习三种不同的最大化利润策略,最佳策略取决于市场竞争程度和理性水平。此外,我们发现具有独立政策且无法相互沟通的强化学习代理会自发地分化成不同的策略群体,从而增加市场力量和整体利润。最后,我们发现经济中理性(强化学习)代理的数量越多,宏观经济环境总体上会随之改善,以总产出作为衡量指标,但这也可能会带来更高的不稳定性。我们的R-MABM框架能够实现稳定的多代理学习,以开源形式提供,并代表了扩展经济模拟器的有原则且稳健的方向。

Key Takeaways

- ABMs在经济学中用于克服传统框架的局限性,但其中的代理行为规则设计繁琐且难以证明其合理性。

- 多代理强化学习(RL)被用来扩展ABMs的功能,引入能够学习策略的“完全理性”代理。

- 提出理性宏观ABM(R-MABM)框架,通过扩展宏观ABM模型来研究理性对经济的整体影响。

- RL代理能够自发地学习最大化利润的不同策略,取决于市场竞争程度和理性水平。

- RL代理在没有沟通的情况下自发形成不同的策略群体,这增加了市场力量和整体利润。

- 经济中理性(强化学习)代理的数量增加总体上改善了宏观经济环境,但也带来了更高的不稳定性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何在经济学模拟中引入理性行为,以克服传统基于一般均衡假设的经济模型的一些局限性。具体来说,论文提出了一个名为“Rational macro ABM”(R-MABM)的框架,该框架利用多智能体强化学习(RL)来扩展传统的宏观代理模型(ABM),引入能够通过与环境互动并最大化奖励函数来学习其策略的完全理性代理(agents)。通过逐步替换模型中的ABM公司为训练有素的RL代理,论文研究了理性对经济的影响。

论文的主要贡献和发现包括:

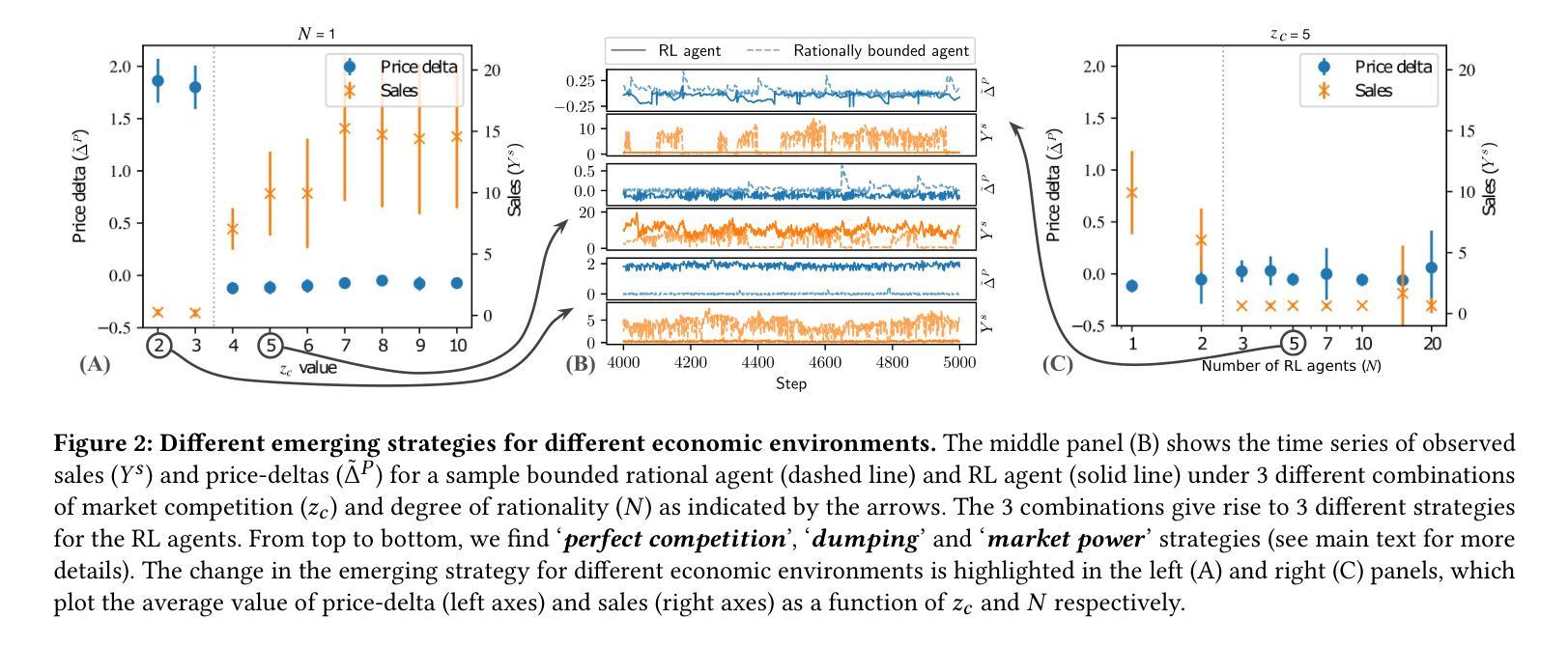

提出了一个R-MABM框架,通过在经济模型中引入完全理性的RL代理,来模拟和研究理性行为对经济系统的影响。

发现RL代理能够自发地学会三种不同的策略来最大化利润,这些策略取决于市场竞争水平和理性水平。

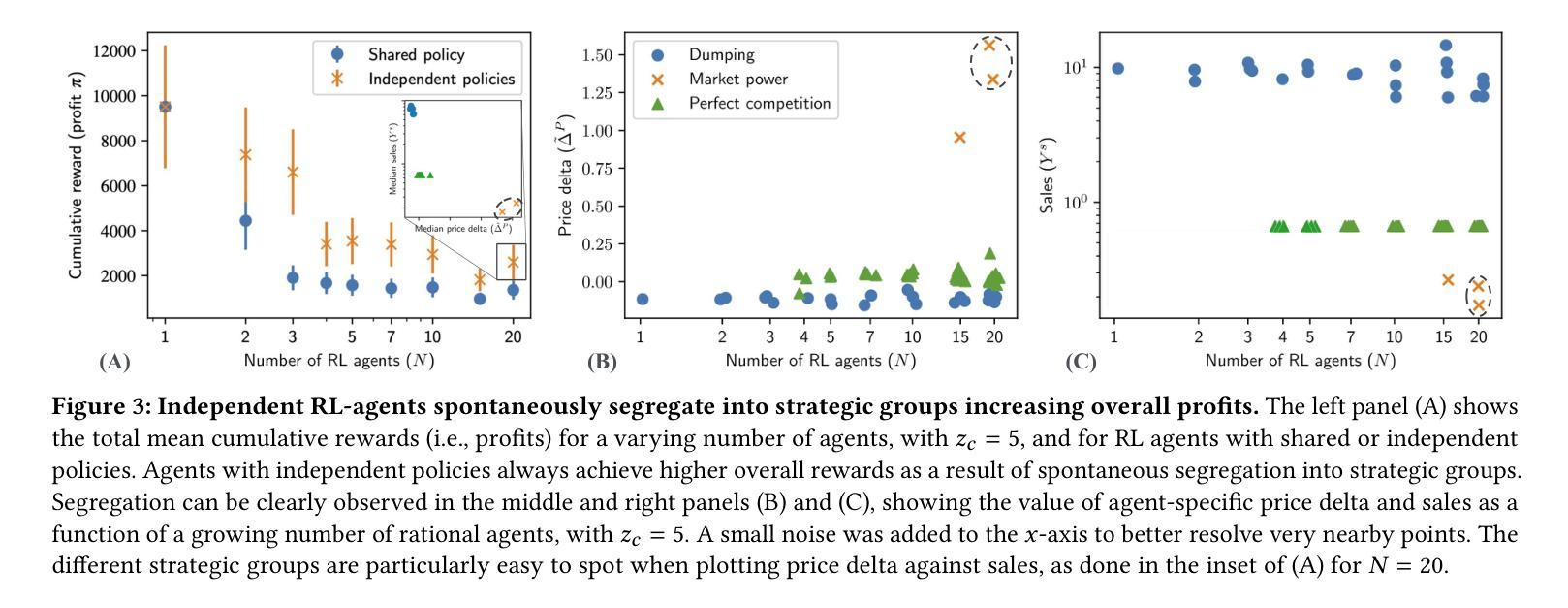

观察到具有独立策略的RL代理会自发地形成不同的战略群体,从而提高市场力量和整体利润。

研究了经济中更高程度的理性如何改善宏观经济环境,包括总产出的增加,以及在特定理性策略下可能出现的更高不稳定性。

展示了R-MABM框架的鲁棒性,并指出其对于经济学和计算机科学交叉领域的广泛应用和未来研究的潜在价值。

总的来说,这篇论文通过将强化学习技术应用于经济学模拟,为理解和模拟经济系统中的理性行为提供了一种新的方法,并且为现有经济模拟器的扩展提供了一个原理性和健壮的方向。

Q: 有哪些相关研究?

A: 论文中提到了多个与本研究相关的工作,主要集中在使用强化学习(RL)和多智能体强化学习(MARL)进行经济建模的领域。以下是一些关键的相关研究:

Johanson et al. [20] - 展示了学习代理在现实环境中如何自发地产生微观经济学的基本现象,如生产、交易和消费资源。

Mi et al. [24] - 通过MARL系统研究税收政策的影响,并展示了MARL系统相对于传统模型的优势。

Atashbar and Shi [5] - 探讨了在实际商业周期(RBC)模型中,如何通过MARL学习最优策略。

Curry et al. [11] - 使用深度多智能体强化学习在大型经济网络中寻找解决方案。

Dawid and D. Delli Gatti [12] - 讨论了基于代理的宏观经济学。

Farmer and Foley [14] - 强调了经济模型中基于代理建模的必要性。

Glielma et al. [16] - 使用强化学习来结合搜索方法,在经济ABM的校准中。

Gronauer and Diepold [17] - 对多智能体深度强化学习进行了调查。

Hill et al. [18] - 使用深度强化学习解决异质性一般均衡经济模型。

Kuriksha [21] - 探讨了神经网络经济体的学习。

Lindau [22] - 研究了通过两个智能体强化学习的最优税收。

Rothe et al. [25] - 讨论了经济和计算的结合。

Tesfatsion [28, 29] - 提供了基于代理的计算经济学的概述和简要历史。

Vadori et al. [30] - 探讨了多智能体强化学习驱动的场外市场模拟。

Watkins and Dayan [32] - 提出了Q学习算法。

Zheng et al. [34] - 通过双层深度多智能体强化学习设计税收政策。

这些研究为本文提出的R-MABM框架提供了理论和技术背景,并且展示了RL和MARL在经济学模拟中的多样化应用。通过这些相关工作,本文的研究得以建立在现有知识的基础上,并进一步推动了经济学模拟中理性行为建模的前沿。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决在经济学模拟中引入理性行为的问题:

提出R-MABM框架:作者提出了一个名为“Rational macro ABM”(R-MABM)的框架,该框架通过扩展现有的宏观代理模型(ABM),引入了能够通过与环境互动并最大化奖励函数来学习其策略的完全理性代理。

使用多智能体强化学习(RL):R-MABM利用多智能体强化学习技术,使得代理能够学习并采取理性行为。这种方法允许代理在模拟过程中从经验中学习,而不需要预先定义复杂的行为规则。

设计代理的奖励函数:在RL中,代理的行为通过奖励函数来引导。论文中,代理的奖励函数被定义为利润最大化,这与经济学中企业的目标一致。

模拟实验:通过大量的模拟实验,作者研究了不同市场条件下理性代理的行为,包括市场竞争水平和理性代理的数量。实验结果揭示了代理如何根据市场条件学习不同的策略。

分析微观和宏观经济影响:论文不仅分析了理性代理在微观层面如何影响企业的利润和市场行为,还研究了宏观层面上理性代理对整体经济环境的影响,包括总产出和经济稳定性。

比较不同策略:通过比较不同策略(市场力量、倾销和完全竞争)在不同市场条件下的表现,论文展示了理性代理如何适应并优化其行为以最大化利润。

稳健性测试:通过考虑共享策略和独立策略的RL代理,论文测试了不同策略对经济稳定性和总产出的影响,以评估不同理性水平对宏观经济环境的稳健性。

开放源代码:为了可重复性,作者承诺将模拟R-MABM框架的代码开源,以便其他研究人员可以验证和扩展他们的工作。

通过这些步骤,论文不仅提出了一个创新的经济学模拟框架,而且还展示了如何通过强化学习方法在模拟中引入理性行为,从而为经济学研究提供了新的工具和视角。

Q: 论文做了哪些实验?

A: 论文中进行了一系列的模拟实验,以评估和分析理性代理(RL代理)在经济模型中的行为及其对宏观经济的影响。以下是实验的主要方面:

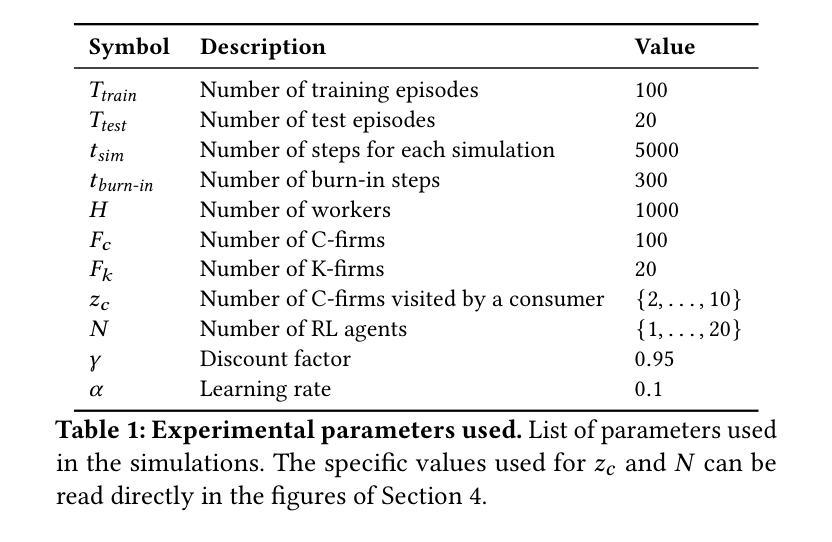

实验设置:模拟了一个宏观经济模型,包括一个银行、1000名工人、20个K型企业(资本货物生产者)和100个C型企业(消费货物生产者)。实验中变化了市场竞争力(通过参数zc控制)和RL代理的数量(代表完全理性的C型企业)。

训练RL代理:每个RL代理都通过异步Q学习算法进行训练,以最大化其奖励函数,即利润。训练过程中,代理根据市场信号(价格差异和库存水平)来学习价格和数量决策策略。

共享策略与独立策略:实验考虑了RL代理训练的两种情况:共享策略和独立策略。在共享策略中,所有代理共享并更新同一个Q矩阵;而在独立策略中,每个代理使用和更新自己的Q矩阵。

市场竞争力的影响:通过改变消费者可以访问的C型企业数量(zc参数),研究了不同市场竞争力水平下RL代理的策略变化。

理性水平的影响:通过改变RL代理的数量(N),研究了经济中理性水平的变化如何影响代理的策略和整体经济表现。

微观经济影响:评估了RL代理在与有界理性企业和竞争对手互动时的微观经济影响,通过测量其销售和价格差异来评估。

宏观经济影响:研究了引入RL代理后宏观经济效果的变化,包括总产出(GDP)和经济稳定性(通过GDP的标准差来衡量)。

策略的自发形成:观察了RL代理如何自发地形成不同的战略群体,以及这种分化如何影响整体利润和市场力量。

对冲击的响应:通过在模型中引入正向冲击(例如,所有家庭的消费倾向增加),评估了RL代理在完美竞争策略下对宏观经济冲击的响应。

结果分析:对模拟结果进行了详细分析,包括RL代理如何根据不同的经济环境学习不同的策略,以及这些策略如何影响企业利润和宏观经济稳定性。

这些实验提供了对理性代理在经济模型中行为的深入理解,并展示了如何通过强化学习方法来模拟和分析经济系统中的理性行为。

Q: 有什么可以进一步探索的点?

A: 论文提出的R-MABM框架为经济学模拟提供了一个新的研究方向,有许多潜在的扩展和探索点。以下是一些可以进一步探索的领域:

更复杂的经济环境:在更复杂的经济环境中测试R-MABM框架,例如引入更多的市场、商品和服务,以及更复杂的金融系统。

不同的代理类型:研究将RL代理应用于模型中的其他代理类型,如银行和家庭,以及这种变化对经济模拟的影响。

更广泛的策略空间:扩大RL代理的策略空间,包括投资决策、研发投资等,以更全面地模拟企业行为。

多目标优化:允许RL代理同时优化多个目标,如利润、市场份额和风险管理,以更真实地反映企业目标。

长期动态和稳态分析:研究RL代理在长期内的行为,以及它们如何影响经济的稳态和周期性。

政策模拟:引入RL政府或中央银行代理,以研究最优财政或货币政策的设计和效果。

异质性代理:探索不同RL代理之间的异质性,例如不同的初始条件、学习能力或信息获取能力,以及这些异质性如何影响经济结果。

社会福利分析:评估不同理性水平和策略对经济福利的影响,包括收入分配、就业和社会福利。

模型鲁棒性:测试R-MABM框架在不同参数设置和随机扰动下的鲁棒性。

计算效率:优化RL算法和模拟过程,以提高计算效率和可扩展性,特别是对于大规模经济模型。

跨学科方法:结合经济学、计算机科学、心理学和社会学等不同学科的理论和方法,以获得更全面的理解。

实验经济学:通过实验室实验或实地实验来验证和校准R-MABM模型的预测。

数据驱动的方法:利用实际经济数据来训练和优化RL代理,以及进行模型的参数估计和校准。

模型比较:将R-MABM与其他经济模型和模拟方法进行比较,以评估其优势和局限性。

开源社区和工具开发:开发开源工具和平台,以促进R-MABM框架的进一步研究和应用。

通过这些探索,可以更深入地理解经济系统中的理性行为,以及如何利用人工智能技术来改进经济模型和政策分析。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

问题背景:传统的经济模拟模型,如动态随机一般均衡(DSGE)模型,存在一些局限性,如不允许代理异质性、有限理性或非均衡动态。为了克服这些局限性,研究者们转向基于代理的模型(ABMs),但ABMs中的代理通常遵循预定的行为规则,缺乏学习和理性预期的能力。

研究目标:本文提出了一个名为“Rational macro ABM”(R-MABM)的框架,通过引入多智能体强化学习(RL)来扩展传统的宏观ABM,允许代理通过与环境互动来学习并最大化奖励函数,从而模拟完全理性的代理。

模型框架:R-MABM框架扩展了现有的宏观ABM,特别是资本和信贷(CC-MABM)模型,通过将其中的一些C型企业(消费商品生产者)替换为RL代理,这些代理被训练以最大化利润。

实验设计:通过改变市场竞争水平(通过参数zc控制)和RL代理的数量(代表完全理性的C型企业),进行了一系列模拟实验。

主要发现:

- RL代理能够自发地学会三种不同的策略来最大化利润:市场力量、倾销和完全竞争。

- RL代理在独立策略下会自发地形成不同的战略群体,从而提高市场力量和整体利润。

- 经济中更高的理性程度总是提高了宏观经济环境的总体产出,但经济稳定性的提高仅在RL代理采取完全竞争策略时才出现。

研究贡献:R-MABM框架是第一个尝试将宏观ABMs与RL结合的框架,它不仅提供了一个稳定多智能体学习的模型,而且为经济学和计算机科学交叉领域的研究提供了新的方向。

未来工作:论文提出了未来可能的研究方向,包括扩展代理的行动空间、研究RL代理替代模型中其他代理类别的影响,以及添加RL政府或中央银行来研究最优财政或货币政策。

代码开放:为了可重复性,论文承诺将模拟R-MABM框架的代码开源。

这篇论文通过将强化学习技术应用于经济学模拟,为理解和模拟经济系统中的理性行为提供了一种新的方法,并且为现有经济模拟器的扩展提供了一个原理性和健壮的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

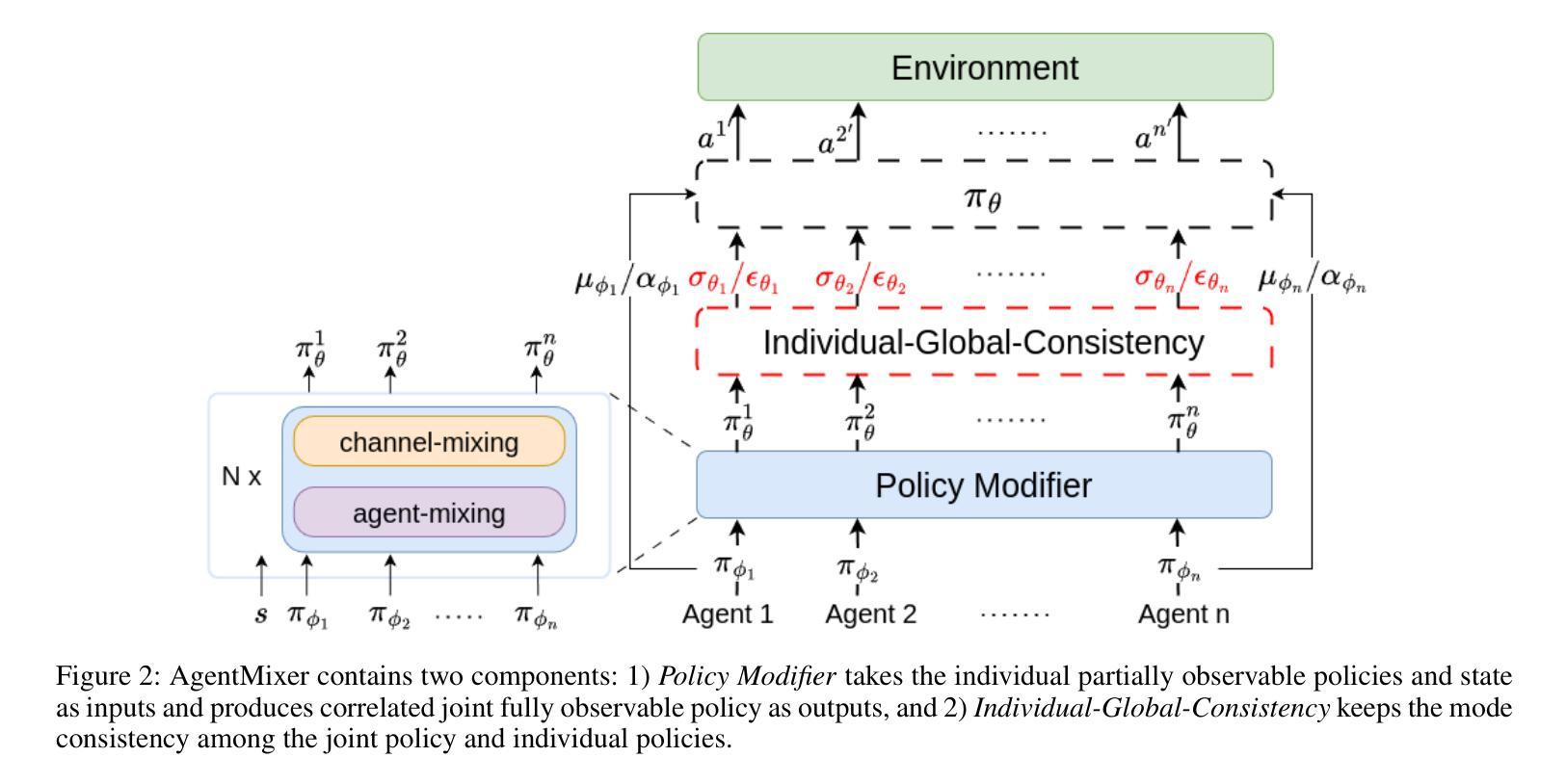

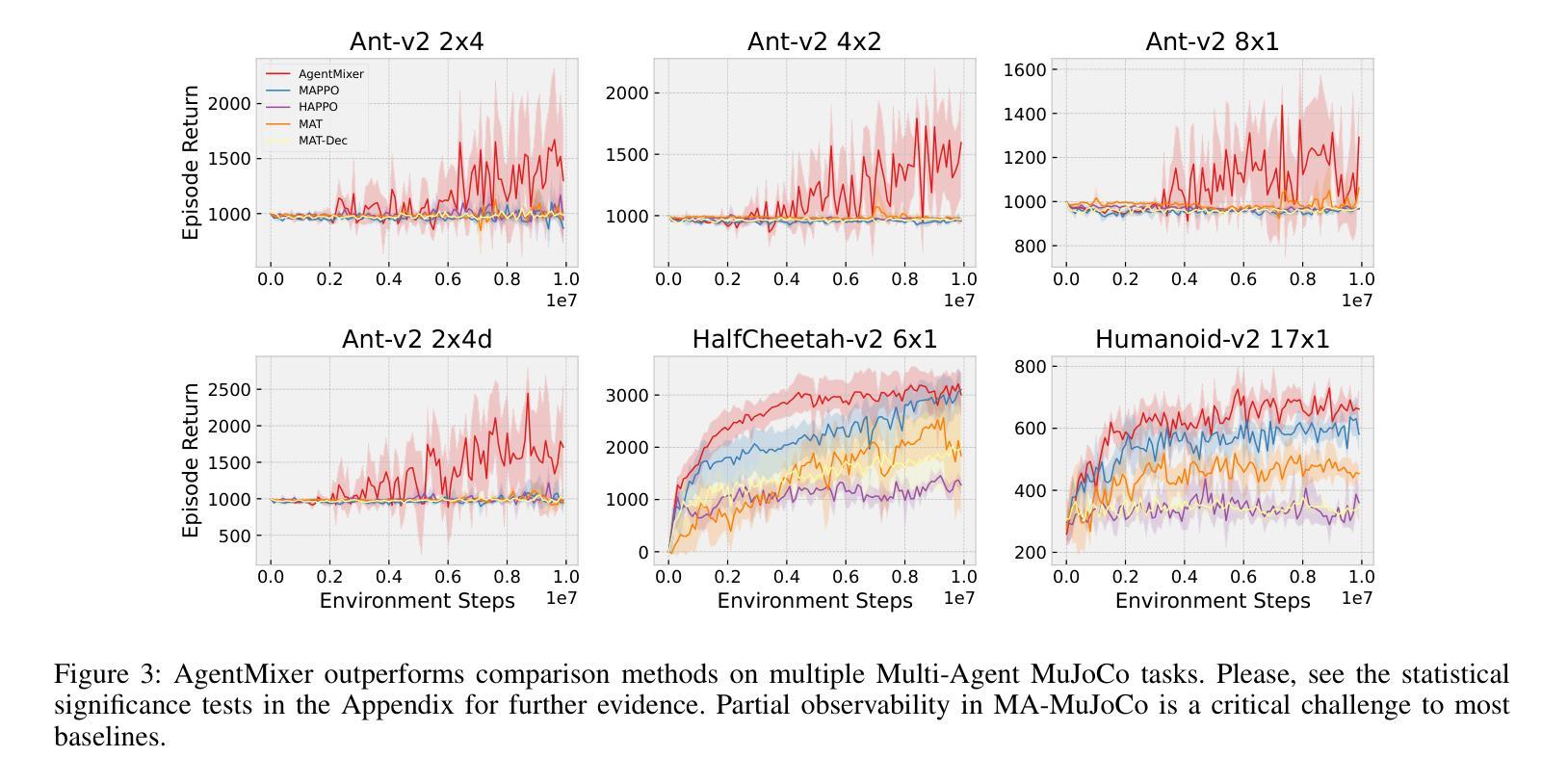

AgentMixer: Multi-Agent Correlated Policy Factorization

Authors:Zhiyuan Li, Wenshuai Zhao, Lijun Wu, Joni Pajarinen

In multi-agent reinforcement learning, centralized training with decentralized execution (CTDE) methods typically assume that agents make decisions based on their local observations independently, which may not lead to a correlated joint policy with coordination. Coordination can be explicitly encouraged during training and individual policies can be trained to imitate the correlated joint policy. However, this may lead to an \textit{asymmetric learning failure} due to the observation mismatch between the joint and individual policies. Inspired by the concept of correlated equilibrium, we introduce a \textit{strategy modification} called AgentMixer that allows agents to correlate their policies. AgentMixer combines individual partially observable policies into a joint fully observable policy non-linearly. To enable decentralized execution, we introduce \textit{Individual-Global-Consistency} to guarantee mode consistency during joint training of the centralized and decentralized policies and prove that AgentMixer converges to an $\epsilon$-approximate Correlated Equilibrium. In the Multi-Agent MuJoCo, SMAC-v2, Matrix Game, and Predator-Prey benchmarks, AgentMixer outperforms or matches state-of-the-art methods.

在多智能体强化学习中,集中训练与分散执行(CTDE)方法通常假设智能体基于其局部观察独立做出决策,这可能导致无法形成具有协调性的联合策略。在训练过程中可以明确鼓励协调,并且可以训练个体策略来模仿联合策略。然而,由于联合策略和个体策略之间的观测不匹配,这可能导致“不对称学习失败”。受相关均衡概念启发,我们引入了一种名为AgentMixer的策略修改方法,允许智能体之间关联其策略。AgentMixer非线性地将个体部分可观察的策略合并为联合完全可观察的策略。为了实现分散执行,我们引入了“个体-全局一致性”,以保证在联合训练集中和分散策略时模式的一致性,并证明AgentMixer收敛于ε-近似相关均衡。在Multi-Agent MuJoCo、SMAC-v2、矩阵博弈和捕食者-猎物基准测试中,AgentMixer的性能优于或相当于最新方法。

论文及项目相关链接

Summary: