⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-15 更新

If Eleanor Rigby Had Met ChatGPT: A Study on Loneliness in a Post-LLM World

Authors:Adrian de Wynter

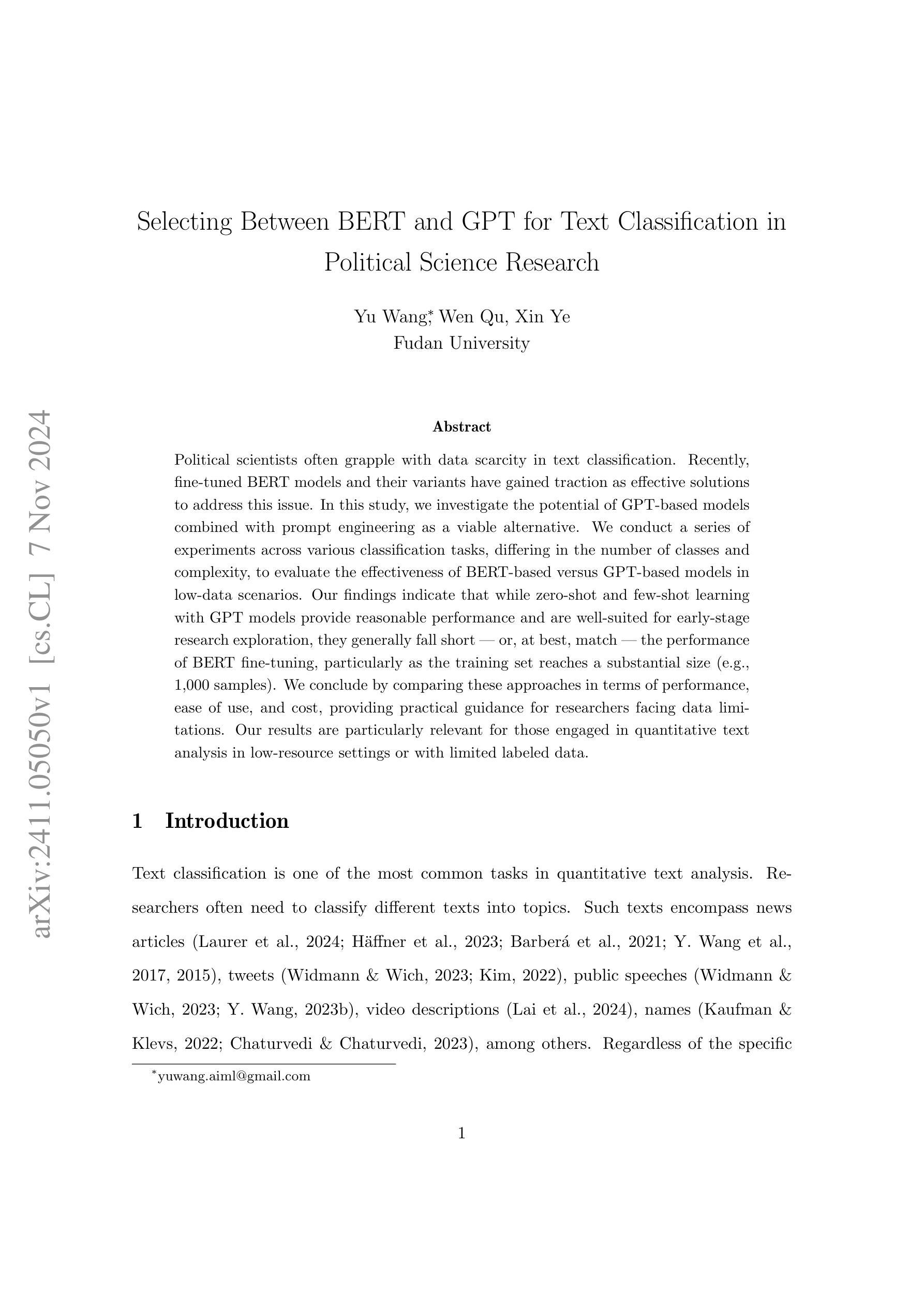

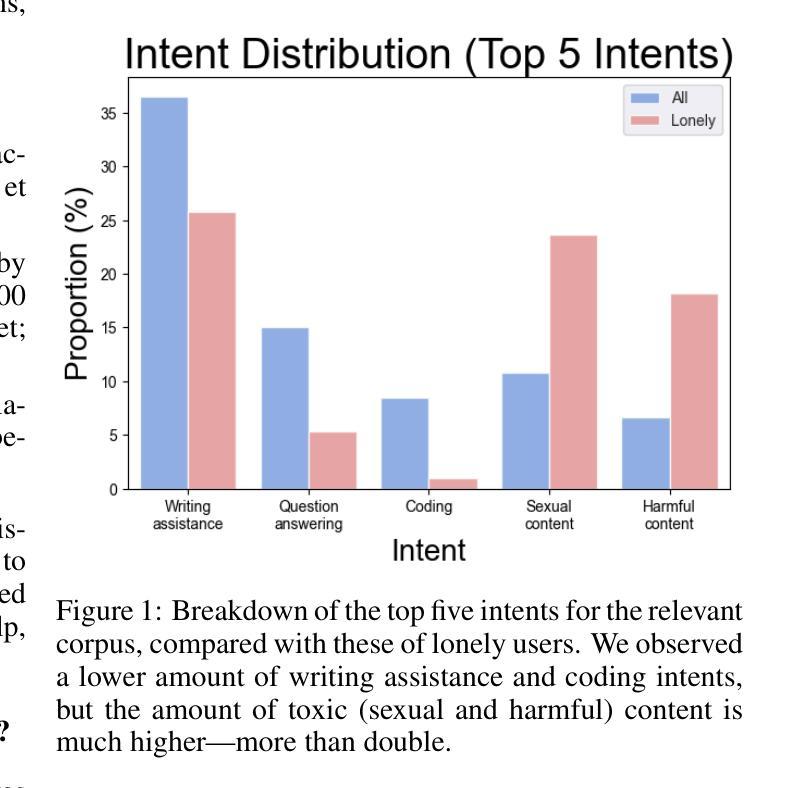

Loneliness, or the lack of fulfilling relationships, significantly impacts a person’s mental and physical well-being and is prevalent worldwide. Previous research suggests that large language models (LLMs) may help mitigate loneliness. However, we argue that the use of widespread LLMs like ChatGPT is more prevalent–and riskier, as they are not designed for this purpose. To explore this, we analysed user interactions with ChatGPT, particularly those outside of its marketed use as task-oriented assistant. In dialogues classified as lonely, users frequently (37%) sought advice or validation, and received good engagement. However, ChatGPT failed in sensitive scenarios, like responding appropriately to suicidal ideation or trauma. We also observed a 35% higher incidence of toxic content, with women being 22 times more likely to be targeted than men. Our findings underscore ethical and legal questions about this technology, and note risks like radicalisation or further isolation. We conclude with recommendations for research and industry to address loneliness.

孤独感或缺乏充实的人际关系会显著影响一个人的身心健康,这一现象在全球范围内普遍存在。之前的研究表明,大型语言模型(LLM)可能有助于缓解孤独感。然而,我们认为广泛使用如ChatGPT等大型语言模型的现象更加普遍,而且风险更高,因为它们并非为此目的而设计。为了探究这一点,我们分析了用户与ChatGPT的互动,尤其是那些超出其作为任务导向型助理的市场用途之外的对话。在被归类为孤独的对话中,用户经常(37%)寻求建议或认可,并获得了良好的互动。然而,ChatGPT在敏感场景(如适当回应自杀念头或创伤)下表现不佳。我们还观察到有毒内容的发病率高出35%,女性被攻击的可能性是男性的22倍。我们的研究结果强调了关于这项技术的伦理和法律问题,并指出了激进化或进一步孤立等风险。最后,我们为研究和产业解决孤独问题提出建议。

论文及项目相关链接

Summary

本研究探讨了孤独感对个人心理健康和身体健康的影响,并指出大型语言模型(LLM)如ChatGPT在缓解孤独感方面的作用。研究发现,ChatGPT在与孤独感相关的对话中被频繁用于寻求建议和验证,但也存在回应不敏感甚至有毒的回应,包括不恰当应对自杀想法和创伤场景等风险问题。因此存在伦理和法律责任的问题,以及加剧孤立化风险等问题。

Key Takeaways

- LLM技术可用来帮助缓解孤独感,特别是针对寻找建议和验证的情境。ChatGPT在其中常被用于这类交流对话。

- 频繁出现用户利用ChatGPT寻求建议和验证的孤独对话场景,但也存在不良回应的情况。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了在后大型语言模型(LLM)时代,孤独感对个人的心理和生理健康的影响,以及大型语言模型(如ChatGPT)在缓解孤独感方面的潜在作用和风险。具体来说,论文试图解决以下几个问题:

孤独感的普遍性和影响:论文首先介绍了孤独感作为一种全球性问题,它影响着许多人的心理和生理健康,并可能导致抑郁、痴呆和死亡率增加等一系列健康问题。

LLMs在缓解孤独感中的潜力和风险:研究指出,尽管LLMs(如ChatGPT)被设计为生产力工具,但它们也可能被用来提供陪伴,从而帮助缓解孤独感。然而,这些模型并非专为心理健康辅助设计,可能存在风险。

用户与ChatGPT的互动分析:论文通过分析用户与ChatGPT的互动,特别是那些超出其作为任务导向助手市场用途的互动,来探索LLMs作为服务在缓解孤独感方面的有效性和局限性。

伦理和法律问题:论文强调了LLMs在公开可访问的全球环境中安全使用和部署的挑战,尤其是在处理孤独感问题时,涉及伦理和法律问题,如知情同意和责任归属。

解决孤独感的建议:最后,论文总结了针对技术和研究社区的建议,以解决孤独感问题,包括透明度、安全标准和设计促进健康社交联系的技术。

总的来说,这篇论文试图解决的核心问题是理解LLMs在缓解孤独感方面的潜力和风险,并提出相应的研究和行业建议,以确保这些技术的负责任使用。

Q: 有哪些相关研究?

A: 论文中提到了多个与孤独感、大型语言模型(LLMs)以及聊天机器人相关的研究。以下是一些关键的相关研究:

**Valtolina和Hu (2021)**:研究了通过提示和部署定制化解决方案来使用LLMs处理孤独感的问题。

**Alessa和AlKhalifa (2023)**:探讨了为老年人设计ChatGPT对话伴侣的可能性。

**Ryu等人 (2020)**:研究了设计聊天机器人服务以改善老年人的心理健康。

**Jo等人 (2023)**:研究了利用大型语言模型进行公共卫生干预的益处和挑战。

**Perlman和Peplau (1981)**:讨论了孤独感的定义和影响,强调孤独感与个人关系的质量及数量有关。

**Hawkley和Cacioppo (2010)**:研究了孤独感与皮质醇水平升高和整体死亡率增加之间的关联。

**Holt-Lunstad等人 (2015)**:进行了孤独感和社交隔离作为死亡风险因素的元分析。

**Jung和Hahn (2023)**:研究了孤独个体对人类化机器人和人工伴侣的偏好。

**Eyssel和Reich (2013)**:研究了孤独感如何增加个体对机器人的心理拟人化。

**Jain等人 (2018)**:研究了人们偏好具有类似人类对话的聊天机器人。

Kim等人 (2024) 和 **Choudhury和Chaudhry (2024)**:探讨了对LLMs的过度依赖问题。

Deshpande等人 (2023) 和 **Chan等人 (2024)**:研究了LLMs如何改变用户的观点和选择。

Sharma等人 (2023) 和 **Pataranutaporn等人 (2023)**:探讨了用户如何通过影响模型输出与自己观点一致的内容来加强自己的信仰。

这些研究为理解孤独感的影响、LLMs在缓解孤独感中的潜在作用以及这些技术部署时可能遇到的挑战提供了理论基础和实证数据。论文通过综合这些研究的发现,提出了对LLMs在处理孤独感方面应用的更深入分析。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决孤独感问题以及相关联的语言模型使用问题:

数据收集与分析:

- 研究者分析了79,951个用户与ChatGPT之间的对话,这些对话被标记为非任务导向的互动。

- 使用GPT-4模型对这些对话进行分类,识别出孤独用户的对话。

孤独感评估:

- 采用Jiang等人 (2022)设计的分类体系来评估和标记孤独感。

- 通过定性分析(Reflexive Thematic Analysis)来深入理解孤独用户的对话。

对话内容分类:

- 将对话分为寻求建议、提供帮助、寻求验证和肯定、社交接触等类别,并分析这些对话的特征。

- 识别和分类对话中的有害内容,包括暴力、有害或性内容,并特别关注这些内容针对的群体(如女性、未成年人)。

伦理和法律问题的探讨:

- 讨论了LLMs在公开可访问的全球环境中安全使用和部署的挑战,尤其是在处理孤独感问题时涉及的伦理和法律问题。

风险识别:

- 识别了LLMs可能加剧社会隔离、无意中造成伤害或放大有害行为的风险。

建议与对策:

- 论文最后提出了针对研究和行业如何应对孤独感的建议,包括技术公司应如何透明地处理其技术对社会联系的影响、支持安全标准以及设计能够培养健康社交联系的技术。

推动社会变革:

- 强调需要社会转变,通过减少对孤独感的污名化和强调个人关系的价值来解决孤独感问题。

通过这些方法,论文不仅分析了LLMs在缓解孤独感方面的潜力和风险,还提出了具体的建议和措施,以促进这些技术的负责任使用,并推动更广泛的社会变革来解决孤独感问题。

Q: 论文做了哪些实验?

A: 论文中进行的实验主要包括以下几个方面:

数据集构建和标注:

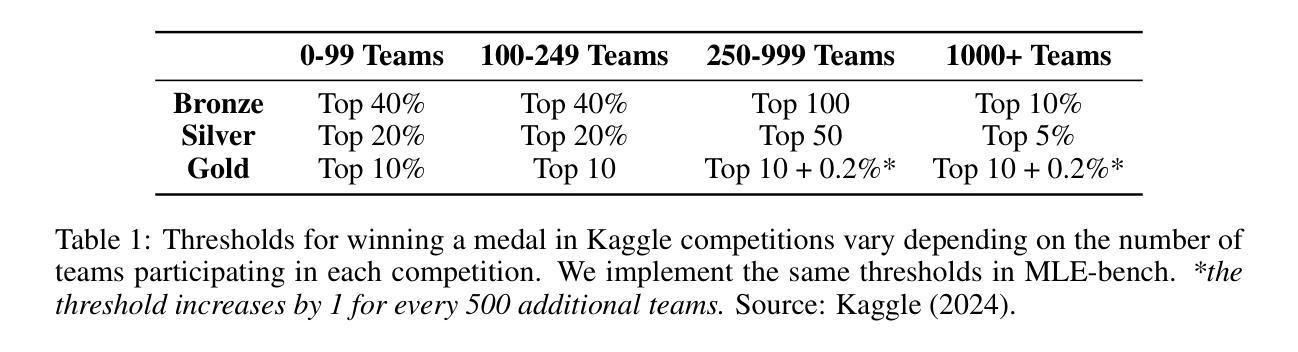

- 研究者使用了名为WildChat的数据集,该数据集包含了100万次用户与ChatGPT之间的互动记录。

- 从这个数据集中随机抽取了79,951个互动实例进行分析。

- 使用GPT-4模型对这些互动进行类型标注,包括意图、原因和目标等分类信息。

孤独感评估:

- 采用Jiang等人 (2022)提出的分类体系对用户对话进行孤独感评估。

- 对标注结果进行手动检查和统计分析,以确保标注的准确性。

对话内容分析:

- 对标注为孤独感相关的对话进行了定性分析,特别是前500条对话,以识别和理解孤独用户与ChatGPT互动的模式和特点。

- 对显示出有害行为的孤独用户对话进行了全面的定性分析。

可靠性分析:

- 对GPT-4模型的标注结果进行了学生t检验,以评估标注的可靠性,并计算了95%置信区间的准确率。

有毒内容分析:

- 对比了包含有害、暴力或性内容的对话在孤独和非孤独对话中的分布情况。

- 分析了这些有毒内容针对的不同目标群体(如性别和年龄)的分布差异。

这些实验的目的是为了评估ChatGPT在处理孤独感问题时的有效性,以及其在与用户互动中可能出现的风险和问题。通过这些实验,研究者能够深入理解ChatGPT作为陪伴工具的潜力和局限性,并提出了相应的建议和对策。

Q: 有什么可以进一步探索的点?

A: 论文提出了一些重要的发现和问题,以下是一些可以进一步探索的点:

LLMs在心理健康支持中的作用:

- 进一步研究LLMs在提供心理健康支持方面的能力,特别是在处理孤独感和自杀意念等敏感问题时的有效性。

伦理和法律框架:

- 开发和评估针对LLMs在心理健康领域的应用的伦理和法律框架,包括知情同意和责任问题。

用户对LLMs的依赖性:

- 研究用户对LLMs的依赖性,以及这种依赖可能对个人心理健康和社会关系产生的影响。

LLMs的个性化和定制化:

- 探索如何更好地个性化和定制化LLMs,以满足不同用户群体的需求,特别是在缓解孤独感方面。

有害内容的检测和过滤:

- 开发更有效的机制来检测和过滤LLMs生成的有害内容,尤其是针对边缘化群体的内容。

用户交互的长期影响:

- 研究LLMs与用户交互的长期影响,包括是否能够真正缓解孤独感,以及可能产生的任何负面后果。

多语言和文化差异:

- 考虑多语言和文化差异对LLMs在不同地区和文化中缓解孤独感效果的影响。

社会和技术的协同作用:

- 研究如何通过社会政策和技术发展共同减少孤独感,包括促进健康的社交联系和社区参与。

LLMs的教育和培训:

- 探索如何使用LLMs作为教育工具,帮助人们更好地理解和处理孤独感。

跨学科研究:

- 促进计算机科学、心理学、社会学和法律等领域的跨学科合作,以全面理解和应对孤独感问题。

这些探索点可以帮助我们更深入地理解LLMs在缓解孤独感方面的潜力和挑战,并为未来的研究和技术发展提供指导。

Q: 总结一下论文的主要内容

A: 这篇论文《如果Eleanor Rigby遇到了ChatGPT:后LLM世界中孤独感的研究》主要探讨了以下几个核心内容:

问题背景:

- 论文首先介绍了孤独感作为一个全球性问题,它对人们的心理健康和生理健康产生重大影响。

- 论文指出,大型语言模型(LLMs)可能有助于缓解孤独感,但存在被滥用的风险,尤其是像ChatGPT这样的模型,它们并非为心理健康支持而设计。

研究目的:

- 论文旨在分析用户与ChatGPT的互动,特别是那些超出其作为任务导向助手市场用途的互动,以探索LLMs作为服务在缓解孤独感方面的有效性和风险。

研究发现:

- 通过对79,951次用户与ChatGPT之间的对话进行定性和定量分析,发现8%的对话可以被归类为孤独。

- 在这些孤独对话中,用户更倾向于寻求建议或验证,并且与ChatGPT的互动轮数多于平均水平。

- ChatGPT在处理需要专业干预的复杂问题(如自杀意念或创伤处理)时表现不佳。

- 孤独对话中有毒内容(暴力、有害或性内容)的比例更高,尤其是针对女性和未成年人。

风险和伦理问题:

- 论文强调了LLMs在公开可访问的环境中安全使用和部署的挑战,尤其是在处理孤独感问题时涉及的伦理和法律问题。

建议和对策:

- 论文最后提出了针对研究和行业如何应对孤独感的建议,包括技术公司应如何透明地处理其技术对社会联系的影响、支持安全标准以及设计能够培养健康社交联系的技术。

社会变革的呼吁:

- 论文强调需要社会转变,通过减少对孤独感的污名化和强调个人关系的价值来解决孤独感问题。

综上所述,论文通过对用户与ChatGPT互动的分析,揭示了LLMs在缓解孤独感方面的潜力和风险,并提出了相应的研究和行业建议,以确保这些技术的负责任使用,并推动更广泛的社会变革来解决孤独感问题。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

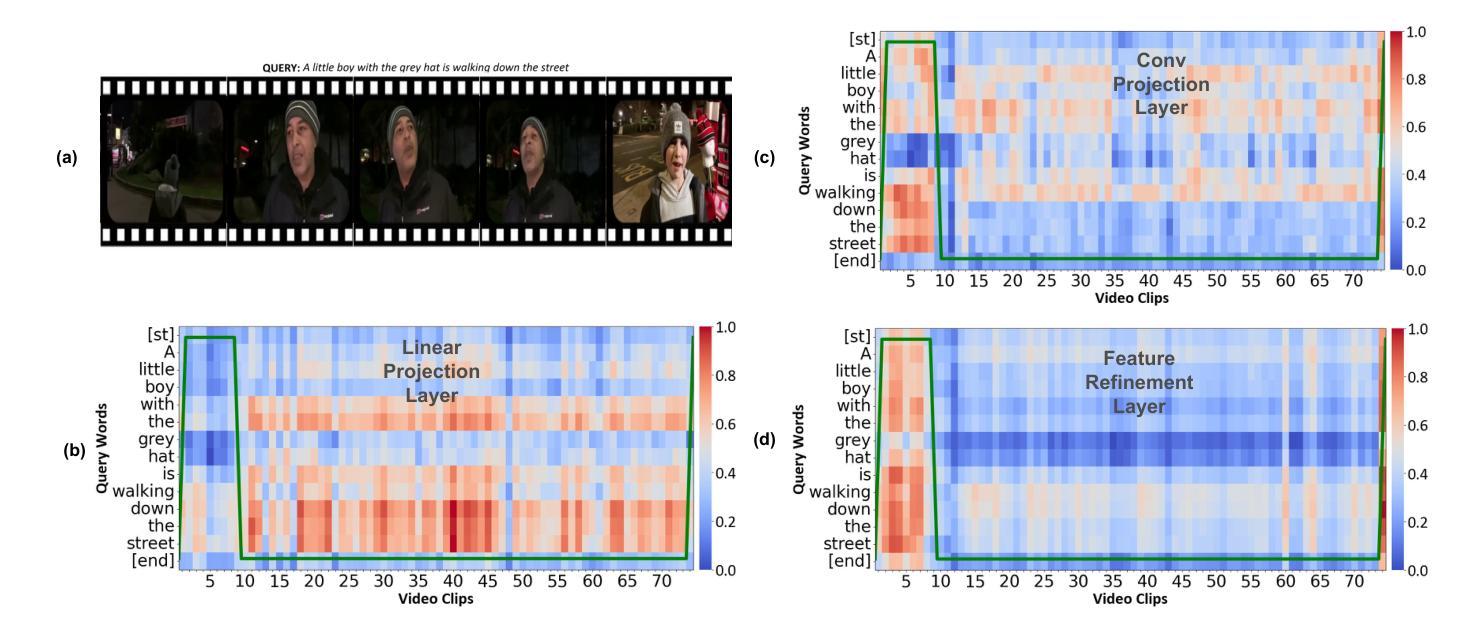

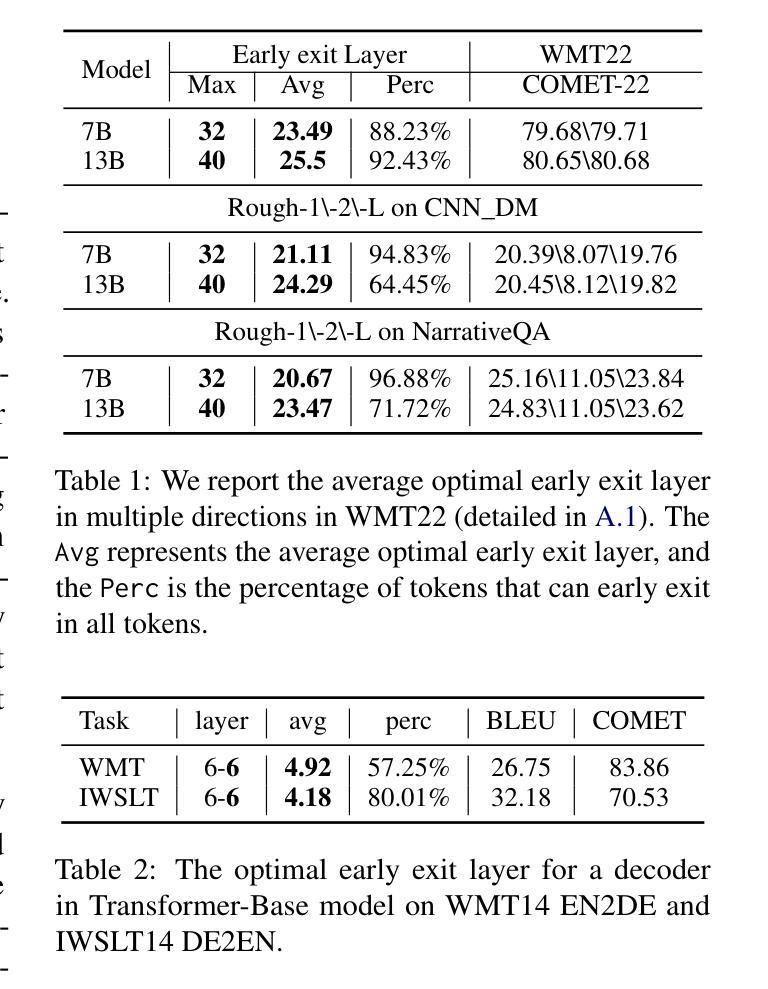

VideoLights: Feature Refinement and Cross-Task Alignment Transformer for Joint Video Highlight Detection and Moment Retrieval

Authors:Dhiman Paul, Md Rizwan Parvez, Nabeel Mohammed, Shafin Rahman

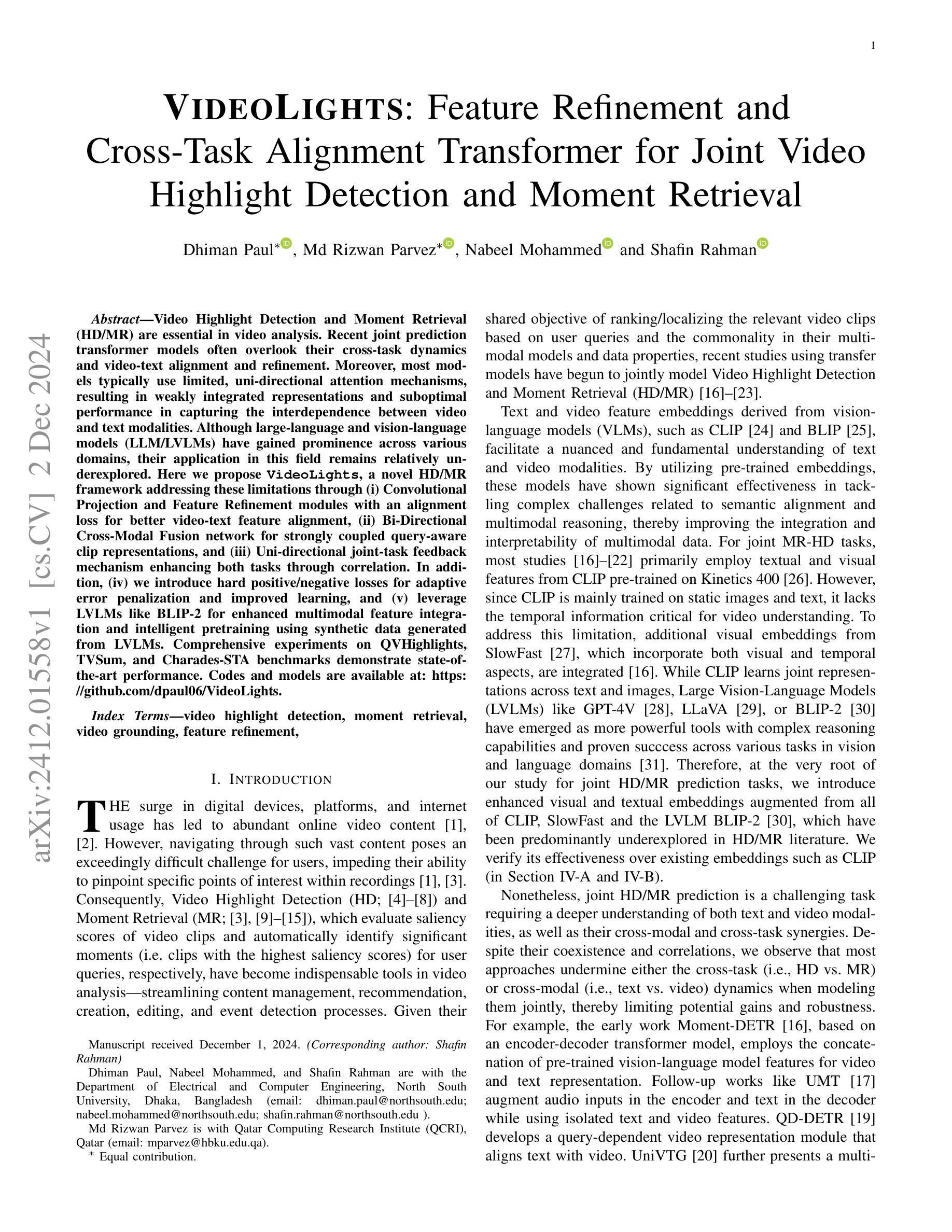

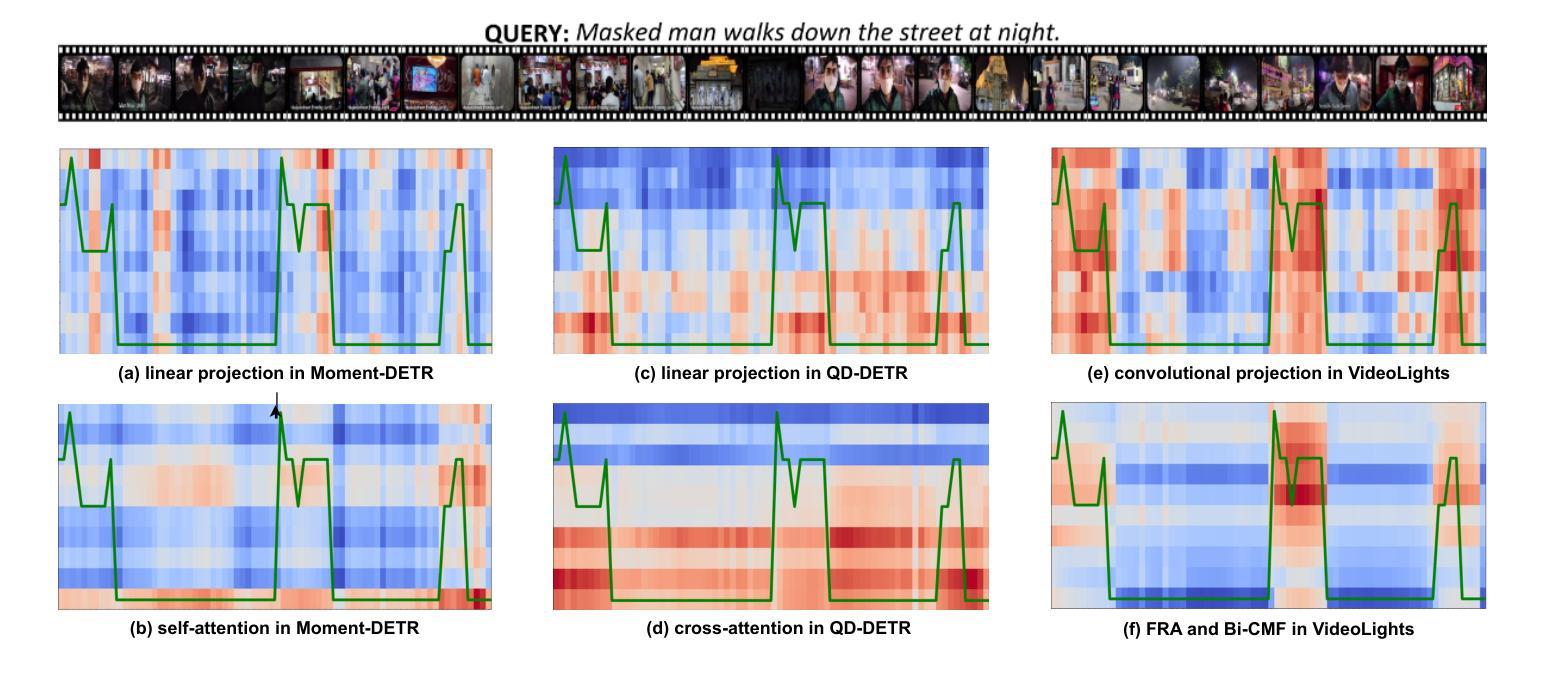

Video Highlight Detection and Moment Retrieval (HD/MR) are essential in video analysis. Recent joint prediction transformer models often overlook their cross-task dynamics and video-text alignment and refinement. Moreover, most models typically use limited, uni-directional attention mechanisms, resulting in weakly integrated representations and suboptimal performance in capturing the interdependence between video and text modalities. Although large-language and vision-language models (LLM/LVLMs) have gained prominence across various domains, their application in this field remains relatively underexplored. Here we propose VideoLights, a novel HD/MR framework addressing these limitations through (i) Convolutional Projection and Feature Refinement modules with an alignment loss for better video-text feature alignment, (ii) Bi-Directional Cross-Modal Fusion network for strongly coupled query-aware clip representations, and (iii) Uni-directional joint-task feedback mechanism enhancing both tasks through correlation. In addition, (iv) we introduce hard positive/negative losses for adaptive error penalization and improved learning, and (v) leverage LVLMs like BLIP-2 for enhanced multimodal feature integration and intelligent pretraining using synthetic data generated from LVLMs. Comprehensive experiments on QVHighlights, TVSum, and Charades-STA benchmarks demonstrate state-of-the-art performance. Codes and models are available at https://github.com/dpaul06/VideoLights .

视频高光检测和时刻检索(HD/MR)是视频分析中的关键。最近的联合预测transformer模型往往忽略了它们的跨任务动态和视频文本对齐和细化。此外,大多数模型通常使用有限的单向注意力机制,导致表示融合较弱,在捕捉视频和文本模态之间的互依赖性方面表现不佳。尽管大型语言模型和视觉语言模型(LLM/LVLMs)在各个领域都获得了突出地位,但它们在视频分析领域的应用仍然相对未被充分探索。在这里,我们提出了VideoLights,这是一个新的HD/MR框架,通过以下方面解决这些限制:(i)卷积投影和特征细化模块以及用于更好的视频文本特征对齐的对齐损失;(ii)双向跨模态融合网络用于强烈耦合的查询感知剪辑表示;(iii)通过相关性增强两个任务的单向联合任务反馈机制。此外,(iv)我们引入了硬正负损失用于自适应误差惩罚和改进学习,(v)利用LVLMs(如BLIP-2)进行增强的多模态特征融合和智能预训练,使用从LVLMs生成的合成数据进行训练。在QVHighlights、TVSum和Charades-STA基准测试上的综合实验证明了其卓越的性能。代码和模型可在https://github.com/dpaul06/VideoLights找到。

论文及项目相关链接

摘要

本文提出了VideoLights框架,解决了视频分析中视频高光检测与时刻检索(HD/MR)的关键问题。通过引入卷积投影和特征细化模块、双向跨模态融合网络、单向联合任务反馈机制等创新技术,实现了视频与文本特征的良好对齐和查询感知剪辑表示。此外,还引入了硬正负损失用于自适应误差惩罚和改进学习,并借助LVLMs如BLIP-2增强多模态特征融合和智能预训练。实验表明,VideoLights在QVHighlights、TVSum和Charades-STA等多个基准数据集上取得了最新技术性能。

关键见解

- VideoLights框架解决了视频高光检测与时刻检索中跨任务动力学和视频文本对齐的问题。

- 通过卷积投影和特征细化模块,实现了视频与文本特征的良好对齐。

- 双向跨模态融合网络提供了查询感知的剪辑表示,增强了视频与文本的相互依赖性。

- 单向联合任务反馈机制通过相关性增强了两个任务的表现。

- 引入硬正负损失用于自适应误差惩罚和改进学习。

- 利用LVLMs如BLIP-2进行智能预训练和多模态特征融合,增强了性能。

- 在多个基准数据集上的实验结果表明VideoLights取得了最新技术性能。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为VideoLights的框架,旨在解决视频分析中的两个关键任务:视频高光检测(Highlight Detection, HD)和时刻检索(Moment Retrieval, MR)。具体来说,论文试图解决的问题包括:

跨任务动态和视频-文本对齐与细化的忽略:现有的联合预测模型往往忽视了HD和MR任务之间的相互关系以及视频和文本模态之间的对齐和细化,这限制了模型捕捉视频和文本之间相互依赖性的潜力。

有限的、单向注意力机制:大多数模型通常使用有限的、单向(从文本到视频)的注意力机制,导致在视频和文本模态之间集成的表示较弱,无法最优地捕捉两者之间的相互依赖性。

大型语言和视觉-语言模型(LLM/LVLMs)在该领域的应用不足:尽管LLM/LVLMs在各个领域已显示出其重要性,但在视频高光检测和时刻检索领域的应用仍相对未被充分探索。

为了解决这些问题,VideoLights框架通过以下几个关键组件来增强跨模态和跨任务的交互:

特征细化和对齐模块(Feature Refinement and Alignment, FRA):通过CNN基础的内模态和跨模态特征交互细化,以及文本-视频对应关系的对齐损失,实现更好的视频-文本特征对齐。

双向跨模态融合网络(Bi-Directional Cross-Modal Fusion, Bi-CMF):采用多阶段层次化处理进行双向文本-视频注意力,生成与查询强相关的视频表示。

单向联合任务反馈机制(Uni-directional joint-task feedback mechanism, Uni-JFM):通过特定任务和跨任务损失增强任务之间的相关性。

自适应误差校正:引入硬正例/负例损失以适应性地惩罚模型在片段显著性预测中的错误,改善学习效果。

智能模型预训练:利用大型视觉-语言模型(如BLIP-2)生成的合成数据进行模型预训练,增强多模态特征集成和智能预训练。

通过这些方法,VideoLights旨在提高视频高光检测和时刻检索任务的性能,并在QVHighlights、TVSum和Charades-STA等基准数据集上展示了其优越性。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要集中在视频理解领域,尤其是视频高光检测(Highlight Detection, HD)和时刻检索(Moment Retrieval, MR)。以下是一些与VideoLights框架相关的研究工作:

Moment-DETR [16]:这是一个基于编码器-解码器变换器模型的早期工作,它使用预训练的视觉-语言模型(如CLIP)的特征来表示视频和文本,并进行查询相关的视频时刻检索和高光检测。

UMT [17]:提出了一个统一的多模态架构,用于处理视频和音频数据进行MR和HD任务。该方法在编码器中增加了音频输入,在解码器中增加了文本输入。

QD-DETR [19]:开发了一个查询依赖的视频表示模块,以对齐文本和视频,改进了MR和HD任务的性能。

UniVTG [20]:提出了一个多任务学习方法,使用统一的微调和预训练方法,但在任务头之间没有直接的跨任务交互。

TaskWeave [18] 和 TR-DETR [22]:这两个模型通过首先独立计算HD和MR,然后让它们相互合作(HD到MR和反之亦然)来重新计算结果,从而解决了(双向)跨任务关系问题。

CLIP [24] 和 BLIP [25]:这些是预训练的视觉-语言模型,它们通过利用文本和视频特征嵌入来理解文本和视频模态,并已在多模态数据的语义对齐和多模态推理中显示出显著的有效性。

SlowFast [27]:这是一个结合了视觉和时间信息的模型,它提供了额外的视觉嵌入,以补充CLIP主要在静态图像和文本上训练的局限性。

GPT-4V [28]、LLaVA [29] 和 BLIP-2 [30]:这些是大型视觉-语言模型(LVLMs),它们在视觉和语言领域的各项任务中表现出了强大的推理能力和成功。

这些研究构成了VideoLights框架的理论基础和技术背景,VideoLights通过结合这些研究的成果,提出了一种新的联合预测HD/MR模型,专注于跨模态和跨任务的相互作用,并在多个基准数据集上取得了优异的性能。

Q: 论文如何解决这个问题?

A: 论文通过提出VideoLights框架来解决视频高光检测(HD)和时刻检索(MR)的问题,具体方法如下:

1. 特征细化和对齐模块(Feature Refinement and Alignment, FRA)

- 实现基于CNN的内模态和跨模态特征交互细化,并通过跨模态对齐损失实现文本-视频对应关系。

- 通过两阶段过程,包括局部(剪辑或单词级别)和全局(视频或句子级别)对齐,增强视频和查询令牌之间的对应关系。

2. 双向跨模态融合网络(Bi-Directional Cross-Modal Fusion, Bi-CMF)

- 利用多阶段层次化处理进行双向文本-视频注意力,生成与查询强相关的视频表示。

- 通过三个多头注意力层实现,包括文本到视频、视频到文本、再次文本到视频的注意力,以提取与查询相关的视频上下文。

3. 单向联合任务反馈机制(Unidirection Joint-Task Feedback Module, Uni-JFM)

- 通过特定任务和跨任务损失增强任务之间的相关性。

- 利用余弦相似度在HD和MR任务的特征向量上计算相似性分数,以改善跨任务学习效率。

4. 自适应误差校正

- 设计了针对难分正例和难分负例的自适应损失函数,以识别和纠正模型中的持续错误。

- 通过动态调整损失权重,强化模型对难分样本的学习。

5. 智能模型预训练

- 利用大型视觉-语言模型(如BLIP-2)的图像到文本生成能力,从视频语料库生成高质量的配对文本查询进行模型预训练。

- 通过将视频分割成10秒间隔,为代表性帧生成描述性字幕,并创建合成数据对,用于模型训练。

6. 综合实验和消融研究

- 在QVHighlights、TVSum和Charades-STA等广泛认可的基准数据集上进行评估,验证VideoLights框架的有效性。

- 通过消融研究分析各个组件和损失函数对模型性能的影响。

通过这些方法,VideoLights框架能够有效地从跨模态和跨任务的交互中学习,提高了视频高光检测和时刻检索任务的性能,并在多个基准数据集上取得了新的最先进结果。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来评估VideoLights框架的性能,并与现有方法进行比较:

数据集

- QVHighlights:一个独特的数据集,结合了时刻检索和高光检测任务,提供了广泛的视频注释,并通过网络服务器维持评估的公正性。

- Charades-STA:用于时刻检索的数据集,包含了大量视频和查询文本。

- TVSum:用于高光检测的数据集,包含了多个类别的视频。

评估指标

- 对于时刻检索,计算了在预定阈值下的召回率(Recall@1)、平均精度均值(mean Average Precision, mAP)以及在多个交并比(Intersection over Union, IoU)阈值下的平均mAP。

- 对于高光检测,评估了平均精度(mAP)和最高得分片段的命中率(HIT@1)。

实施细节

- 训练了四个模型变体:VideoLights、VideoLights-pt(使用CLIP和SlowFast特征)、VideoLights-B(整合了CLIP、BLIP和SlowFast特征)和VideoLights-B-pt(预训练版本)。

- 对于TVSum数据集,使用了I3D模型提取视觉特征,以便与其他方法进行比较。

- 设置了特定的超参数,如隐藏单元大小、Bi-CMF层数、编码器和解码器层数等,并使用AdamW优化器进行训练。

主要结果

- QVHighlights:VideoLights在大多数评估指标上取得了最佳性能,显著超越了先前的方法。

- Charades-STA:VideoLights在没有预训练的情况下在三个评估指标上达到了最佳性能,并与预训练设置下的UniVTG(pt)竞争。

- TVSum:VideoLights在多个领域展现了竞争力的表现,并在整体平均值上接近先前的最佳方法。

消融研究

- FRA模块的影响:通过对比有无FRA模块的模型性能,展示了FRA在提升模型性能方面的效果。

- Bi-CMF模块的影响:通过对比双向和单向跨模态融合的效果,证明了Bi-CMF在提高模型性能方面的优势。

- 新损失函数的影响:通过引入自适应硬正例和负例损失、任务耦合损失、显著性余弦相似度损失和对齐损失,展示了这些损失函数在提升模型性能方面的贡献。

- BLIP-2特征和预训练的影响:通过对比使用不同特征和预训练方法的模型性能,展示了BLIP-2特征和预训练策略在提升模型性能方面的效果。

结论

这些实验和消融研究证明了VideoLights框架在视频高光检测和时刻检索任务中的有效性,并显示了其在多个评估指标上超越现有最先进方法的性能。

Q: 有什么可以进一步探索的点?

A: 论文在结论部分提出了一些可以进一步探索的点,主要包括:

多模态融合技术的改进:

- 研究更先进的多模态融合技术,以更好地整合视频和文本信息,提高跨模态交互的效果。

特征对齐和细化方法的优化:

- 开发更有效的特征对齐和细化方法,以提高视频和文本特征之间的对应关系和交互。

实际视频平台的更广泛应用:

- 将VideoLights框架应用于实际视频平台,探索其在现实世界视频内容管理、推荐和编辑等方面的潜力。

大型视觉-语言模型(LVLMs)在时刻检索任务中的有效性:

- 进一步探索和评估大型视觉-语言模型在视频时刻检索任务中的性能和应用潜力。

预训练模型的依赖和计算开销问题:

- 解决依赖预训练模型可能导致的计算开销和外部资源依赖问题,提高方法的可扩展性和实用性。

预训练数据的偏差和不准确性问题:

- 改进弱监督预训练方法,减少由视觉-语言预训练模型生成的字幕偏差或不准确性对训练过程的影响。

Bi-CMF模块对输入特征和注意力机制的依赖性问题:

- 提高Bi-CMF模块对输入特征和注意力机制的鲁棒性,以适应更复杂和多样化的视频内容。

模型的可解释性和透明度:

- 提高模型的可解释性,帮助理解模型的决策过程,增强用户对模型预测的信任。

模型在不同语言和文化背景下的适应性:

- 探索模型在处理不同语言和文化背景下的视频内容时的适应性和泛化能力。

模型的实时性能和资源效率:

- 优化模型以实现实时视频处理,并提高其在资源受限设备上的运行效率。

这些进一步探索的点有助于推动视频高光检测和时刻检索技术的发展,提高视频内容分析的准确性和效率,并扩展其在实际应用中的潜力。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为VideoLights的框架,旨在联合处理视频高光检测(Highlight Detection, HD)和时刻检索(Moment Retrieval, MR)任务。以下是论文的主要内容总结:

1. 问题定义

- 论文指出现有模型在处理视频高光检测和时刻检索时,常忽略跨任务动态和视频-文本对齐,导致性能受限。

- 引入大型视觉-语言模型(LVLMs)如BLIP-2,以增强模型在视频理解任务中的表现。

2. VideoLights框架

- 特征细化和对齐模块(FRA):通过CNN和对齐损失实现更好的视频-文本特征对齐。

- 双向跨模态融合网络(Bi-CMF):通过多阶段注意力机制加强文本-视频特征的融合。

- 单向联合任务反馈机制(Uni-JFM):通过任务特定和任务耦合损失提升跨任务学习效率。

- 自适应误差校正:引入硬正例/负例损失以适应性地惩罚模型错误。

- 智能模型预训练:利用LVLMs生成合成数据进行预训练,增强模型的多模态特征集成能力。

3. 实验

- 在QVHighlights、TVSum和Charades-STA数据集上进行了广泛的实验,验证了VideoLights在视频高光检测和时刻检索任务上的有效性。

- 与现有方法相比,VideoLights在多个评估指标上取得了新的最佳性能。

4. 消融研究

- 通过消融研究分析了各个组件和损失函数对模型性能的影响,证明了所提方法的有效性。

5. 限制和未来工作

- 论文讨论了当前方法的局限性,包括对预训练模型的依赖和计算开销问题,并提出了未来研究的方向,如改进多模态融合技术和特征对齐方法。

总体而言,VideoLights框架通过创新的跨模态和跨任务交互机制,有效地提高了视频高光检测和时刻检索的性能,并为未来视频理解系统的发展提供了新的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

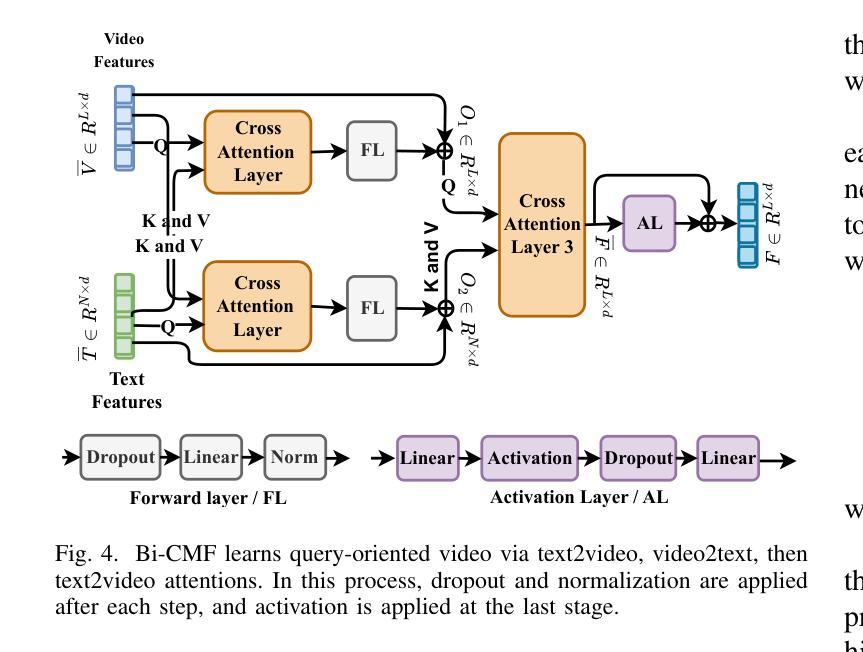

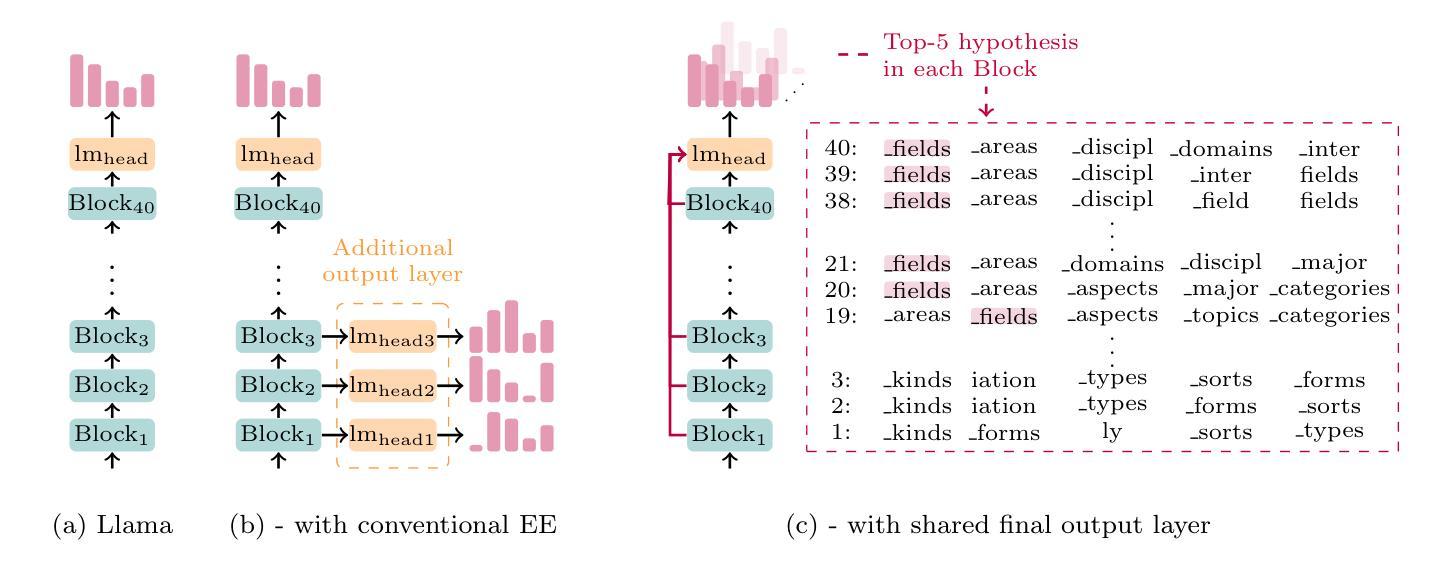

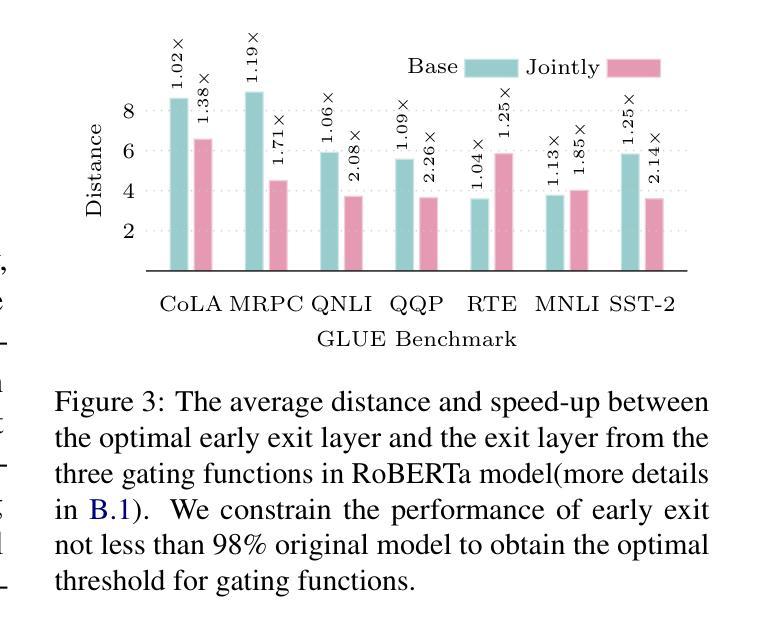

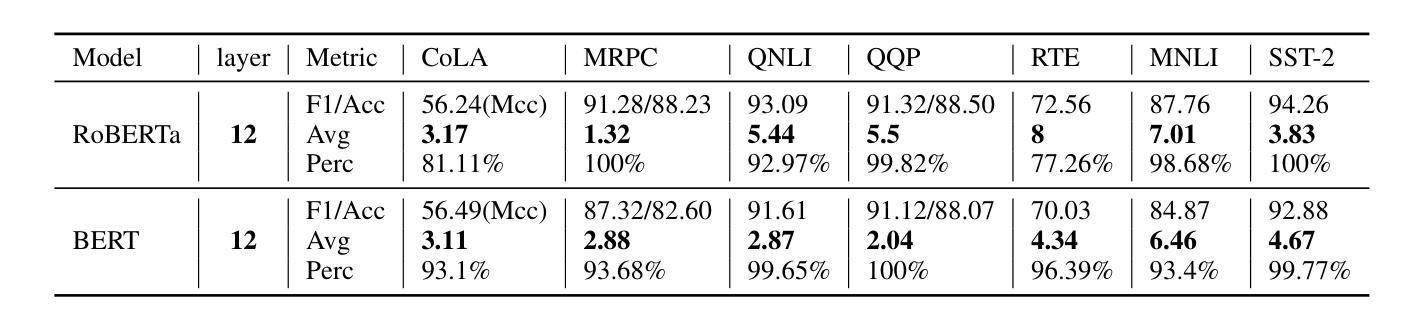

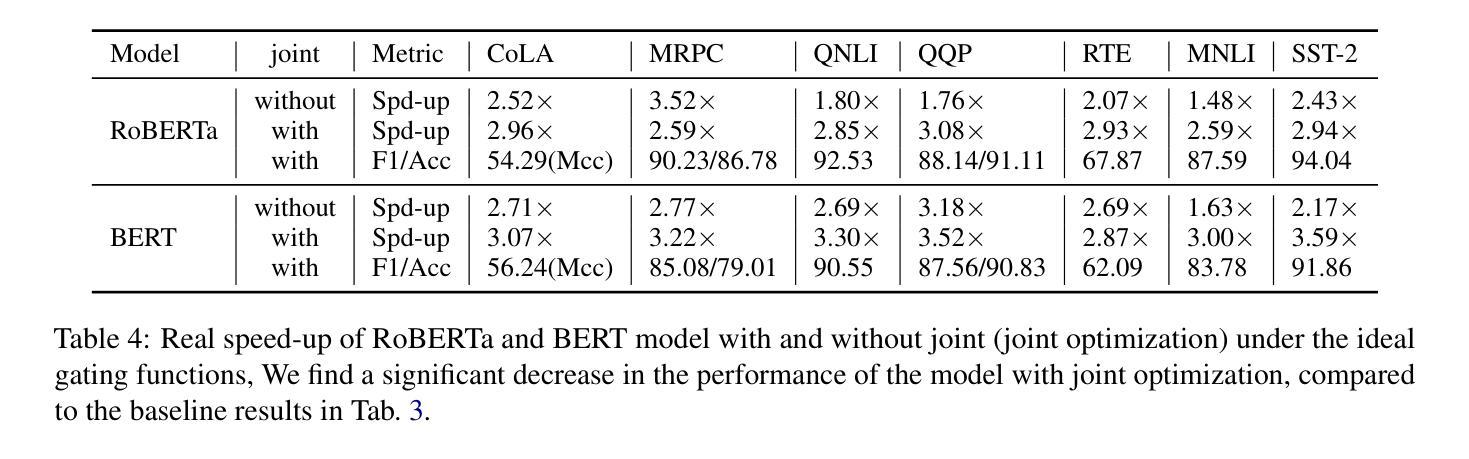

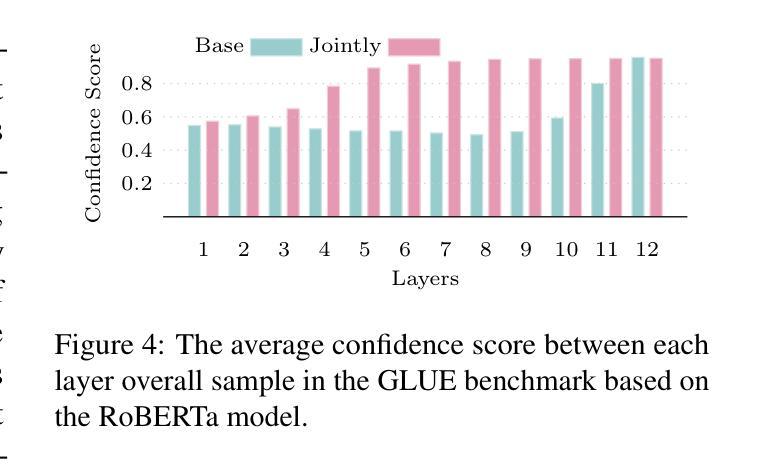

Early Exit Is a Natural Capability in Transformer-based Models: An Empirical Study on Early Exit without Joint Optimization

Authors:Weiqiao Shan, Long Meng, Tong Zheng, Yingfeng Luo, Bei Li, junxin Wang, Tong Xiao, Jingbo Zhu

Large language models (LLMs) exhibit exceptional performance across various downstream tasks. However, they encounter limitations due to slow inference speeds stemming from their extensive parameters. The early exit (EE) is an approach that aims to accelerate auto-regressive decoding. EE generates outputs from intermediate layers instead of using the whole model, which offers a promising solution to this challenge. However, additional output layers and joint optimization used in conventional EE hinder the application of EE in LLMs. In this paper, we explore the possibility of LLMs EE without additional output layers and joint optimization. Our findings indicate that EE is a natural capability within transformer-based models. While joint optimization does not give model EE capability, it must be employed to address challenges by improving the accuracy of locating the optimal EE layer through gating functions. Additionally, our study reveals patterns in EE behavior from a sub-word perspective based on the LLaMA model and the potential possibility for EE based on sub-layers.

大型语言模型(LLM)在各种下游任务中表现出卓越的性能。然而,由于庞大的参数导致的推理速度慢,它们遇到了限制。早期退出(EE)是一种旨在加速自回归解码的方法。EE从中间层生成输出,而不是使用整个模型,这为解决这一挑战提供了有前景的解决方案。然而,传统EE中使用额外的输出层和联合优化阻碍了EE在LLM中的应用。在本文中,我们探索了没有额外输出层和联合优化的LLM EE的可能性。我们的研究结果表明,EE是基于transformer模型的固有功能。虽然联合优化不会赋予模型EE功能,但必须通过改进通过门控函数定位最佳EE层的准确性来解决挑战。此外,我们的研究还基于LLaMA模型从子词视角揭示了EE行为的模式,以及基于子层的EE的潜在可能性。

论文及项目相关链接

Summary

基于大型语言模型(LLM)在多种下游任务中的出色表现,本文探讨了加速其自回归解码的问题。早期退出(EE)作为一种旨在加速LLM的方法被提出。它通过生成中间层的输出来减少模型计算的负担。研究发现在不使用附加输出层和联合优化的前提下,LLM具有潜在的早期退出能力。然而,为实现EE的高效性,仍需要采用联合优化来改进最佳退出层的定位精度。此外,本文还根据LLaMA模型揭示了EE行为的子词视角和基于子层的EE可能性。

Key Takeaways

- 大型语言模型(LLM)在各种下游任务中表现出卓越的性能,但存在推理速度慢的问题。

- 早期退出(EE)方法旨在加速LLM的自回归解码过程。

- EE通过生成中间层的输出来减少计算负担,是一种有前途的解决方案。

- 不需要额外的输出层和联合优化,LLM本身就具有潜在的早期退出能力。

- 联合优化虽不赋予模型EE能力,但能提高定位最佳退出层的准确性。

- 基于LLaMA模型的子词视角揭示了EE行为的模式。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了在大型语言模型(LLMs)中应用早期退出(Early Exit, EE)策略时遇到的问题。具体来说,论文试图解决以下几个关键问题:

大型语言模型的推理速度慢:大型语言模型因其庞大的参数量,在处理自然语言理解和生成任务时表现出色,但这也导致了它们在生成过程中的计算成本和延迟较高。

早期退出策略的局限性:传统的早期退出方法通过在模型的中间层生成输出来加速自回归解码,但这需要额外的输出层和联合优化过程。这些额外的输出层不仅增加了模型参数,而且联合优化过程计算成本高,可能会降低模型性能。

早期退出在大型语言模型中的应用:论文探索了在不增加额外输出层和联合优化的情况下,大型语言模型是否具有自然早期退出的能力,即模型能否在不经过全部层的情况下生成与最终层一致的输出。

早期退出的准确性和效率:论文研究了如何准确定位最优的早期退出层,以及如何提高早期退出策略的效率,特别是在不依赖联合优化的情况下。

早期退出在不同层级的应用:论文还探讨了基于子层(sub-layers)的早期退出的可能性,以及从子词(sub-word)和词性(part-of-speech)角度分析早期退出行为的模式。

总的来说,论文的核心目标是提高大型语言模型的推理效率,同时保持或提高模型性能,通过深入分析和实验验证早期退出策略在这些模型中的自然能力和应用潜力。

Q: 有哪些相关研究?

A: 论文中提到了以下相关研究:

早期退出(Early Exit):

- Panda et al. (2016) 提出了基于条件深度学习的能源效率和增强模式识别。

- Elbayad et al. (2019) 提出了深度自适应变换器(Depth-adaptive Transformer)。

- Liao et al. (2021) 提出了全局过去-未来早期退出方法,用于加速预训练语言模型的推理。

- Schwartz et al. (2020) 讨论了匹配模型和实例复杂度的工具。

- Zhou et al. (2020) 提出了基于耐心的早期退出方法,用于快速且鲁棒的BERT推理。

饱和事件(Saturation Events):

- Geva et al. (2020) 提出了变换器前馈层作为关键-值记忆的观点。

- Geva et al. (2022) 发现变换器前馈层通过在词汇空间中提升概念来构建预测。

大型语言模型(LLMs):

- Brown et al. (2020) 展示了语言模型是少数样本学习者。

- OpenAI (2023) 发布了GPT-4技术报告。

优化和推理加速:

- Xin et al. (2020, 2021) 提出了DeeBERT和Berxit,用于加速BERT推理。

- Kavehzadeh et al. (2023, 2024) 提出了Sorted LLaMa模型,用于动态推理。

其他相关工作:

- Cai et al. (2019) 提出了Once-for-All模型,用于训练一个网络并专门化它以实现高效部署。

- Huang et al. (2017) 提出了多尺度密集网络,用于资源高效的图像分类。

- Sun et al. (2021) 提出了早期退出与集成内部分类器的方法。

这些研究涵盖了早期退出策略的不同方面,包括理论基础、实现方法、以及在特定模型和任务中的应用。论文通过这些相关工作,构建了对早期退出策略的全面理解,并在此基础上探索了不依赖于额外输出层和联合优化的早期退出能力。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决大型语言模型(LLMs)中早期退出(Early Exit, EE)的问题:

探索早期退出的自然能力:

- 论文首先探索了LLMs在没有额外输出层和联合优化的情况下,是否具有自然早期退出的能力。通过实验发现,在不同的任务和模型中,中间层的输出开始与最终输出匹配,表明早期退出是变换器模型的内在特性。

分析早期退出行为:

- 论文通过分析LLaMA模型的子词和词性角度的早期退出行为模式,揭示了早期退出的潜在可能性,并分析了不同子层的早期退出能力。

评估联合优化的必要性:

- 论文评估了联合优化对于早期退出能力的影响,发现虽然联合优化不会赋予模型早期退出能力,但通过改善门控函数的准确性,它对于确定最佳的早期退出层是必需的。

实验验证:

- 论文在多种变换器模型上进行了广泛的实验,包括BERT、RoBERTa和LLaMA模型,验证了早期退出能力的普遍性和有效性。

开发独立的门控函数:

- 鉴于现有的门控网络受限于联合优化,论文探索了开发一个不依赖于联合优化的门控网络的可能性,以减少LLMs中的计算成本。

分析隐藏状态和输出分布的相似性:

- 论文分析了隐藏状态和输出分布的相似性,发现联合优化增强了每层输出分布的相似性,从而提高了门控函数的效果。

处理长序列中的早期退出问题:

- 论文探讨了在长序列生成场景中应用早期退出时,复制键值(KV)缓存会导致错误传播的问题,并提出了解决方案。

总结和展望:

- 论文总结了早期退出在变换器模型中的自然能力,并指出了未来研究的方向,包括在更广泛的模型和资源场景中进行实验,以确保发现可以被推广。

通过这些步骤,论文不仅揭示了早期退出在变换器模型中的自然能力,还探索了在不依赖于传统联合优化的情况下,如何有效地利用这种能力来提高LLMs的推理效率。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来探索早期退出(Early Exit, EE)在大型语言模型(LLMs)中的应用和效果。以下是实验的详细描述:

1. 自然早期退出能力的探索实验

- 目的:验证LLMs是否具有不依赖于额外输出层和联合优化的自然早期退出能力。

- 方法:使用Llama-2-7b-chat和Llama-2-13b-chat模型在WMT22机器翻译基准、NarrativeQA数据集和CNN/DailyMail数据集上进行实验。

- 结果:发现在各种任务中,中间层的输出开始与最终输出匹配,表明早期退出是变换器模型的内在特性。

2. 早期退出能力的普遍性实验

- 目的:探索早期退出能力是否普遍存在于不同的变换器模型和任务中。

- 方法:在包括Transformer-base模型、BERT和RoBERTa模型在内的多种模型和任务上进行实验,使用WMT14-DE2EN数据集和GLUE基准。

- 结果:发现早期退出能力普遍存在于不同的模型和任务中。

3. 早期退出在序列级别和标记级别场景中的实验

- 目的:评估早期退出能力是否可以直接用于提高解码效率,并测试现有的门控函数是否能准确识别最早的退出层。

- 方法:在GLUE基准上使用BERT和RoBERTa模型进行序列级别早期退出实验;在LLaMA模型上进行标记级别早期退出实验。

- 结果:发现在没有联合优化的情况下,准确识别最优早期退出层是一个挑战,而联合优化有助于提高门控网络的准确性。

4. 联合优化对门控函数性能的影响实验

- 目的:分析联合优化如何通过提高输出分布的相似性来增强门控函数的性能。

- 方法:比较了有和没有联合优化的模型在每层输出分布的最大置信度分数。

- 结果:发现联合优化提高了浅层的置信度分数变化,使得门控函数倾向于更早的退出点。

5. 长序列中的早期退出实验

- 目的:探索早期退出是否能够在长序列生成场景中加速LLMs的解码。

- 方法:在LLaMA模型上进行标记级别早期退出实验,测试复制键值(KV)缓存的影响。

- 结果:发现在长序列中,基于最优早期退出层的早期退出会导致重复生成和无法终止序列的问题。

6. 基于子层的早期退出潜力探索实验

- 目的:探索基于子层的早期退出的可能性。

- 方法:分析了最优早期退出层与输出序列长度的关系,并从隐藏状态、子词和词性角度进行了详细分析。

- 结果:发现最优早期退出层随输出序列长度的增加而降低,表明长文本场景中早期退出的潜力更大。

这些实验全面地评估了早期退出在不同模型、任务和场景中的适用性和效果,为早期退出策略的进一步研究和应用提供了实证基础。

Q: 有什么可以进一步探索的点?

A: 论文提出了一些可以进一步探索的点,包括:

更广泛的模型和数据集:

- 论文提到当前研究受限于可用设备,因此只能对有限的模型进行实验。未来的工作可以扩展到更广泛的模型和数据集,以确保发现可以被推广到更多环境。

独立的门控函数开发:

- 论文指出现有的门控网络受限于联合优化,因此探索开发一个不依赖于联合优化的门控网络可以减少LLMs中的计算成本。

长序列生成中的早期退出:

- 论文中提到在长序列生成中应用早期退出时,复制键值(KV)缓存会导致错误传播的问题。进一步探索如何在长序列中有效应用早期退出是一个重要的研究方向。

基于子层的早期退出:

- 论文发现最优早期退出层与输出序列长度有关,这表明长文本场景中早期退出的潜力更大。进一步研究基于子层的早期退出策略,以及如何利用这些信息来优化模型的推理过程。

隐藏状态和输出分布的相似性:

- 论文分析了隐藏状态和输出分布的相似性,并发现联合优化增强了每层输出分布的相似性。进一步探索这些相似性如何影响早期退出决策是一个有价值的研究方向。

词性和子词角度的早期退出行为:

- 论文从词性和子词角度分析了早期退出行为的模式。进一步研究这些模式如何影响早期退出策略的设计和优化。

早期退出与模型性能的权衡:

- 论文提到联合优化虽然提高了门控网络的准确性,但也降低了整体模型性能。研究如何在早期退出带来的加速和模型性能之间取得最佳权衡。

早期退出在实际应用中的部署:

- 考虑将早期退出策略部署到实际应用中,评估其在现实世界场景中的有效性和实用性。

早期退出的动态调整:

- 研究如何根据输入的难度动态调整早期退出策略,以实现更优的计算效率和模型性能。

这些探索点可以帮助研究者更深入地理解早期退出机制,并为设计更高效、更实用的LLMs推理策略提供指导。

Q: 总结一下论文的主要内容

A: 论文《Early Exit Is a Natural Capability in Transformer-based Models: An Empirical Study on Early Exit without Joint Optimization》主要探讨了在不依赖额外输出层和联合优化的情况下,大型语言模型(LLMs)是否具有自然早期退出(Early Exit, EE)的能力。以下是论文的主要内容总结:

问题背景:

- 大型语言模型(LLMs)在各种下游任务中表现出色,但由于参数众多导致推理速度慢。

- 早期退出(EE)是一种加速自回归解码的方法,它从模型的中间层生成输出,而不是使用整个模型。

研究目标:

- 探索LLMs在没有额外输出层和联合优化的情况下是否具有早期退出的能力。

- 分析早期退出行为的模式,并探索基于子层的早期退出可能性。

实验设计:

- 在多种变换器模型上进行实验,包括BERT、RoBERTa和LLaMA模型。

- 使用GLUE基准、WMT14 EN2DE翻译任务、WMT22、CNN Daily Mail和NarrativeQA数据集。

主要发现:

- 变换器模型具有自然早期退出能力,这种能力不依赖于联合优化。

- 联合优化通过提高相邻层输出分布的相似性来提高门控函数的准确性,但也可能会降低模型性能。

- 在序列级别场景中实施早期退出相对简单,而在标记级别场景中由于缺少先前标记的关键和值信息,实施早期退出面临挑战。

实验结果:

- 在多个任务和模型中观察到早期退出能力,表明这是一种普遍现象。

- 没有联合优化的情况下,准确识别最优早期退出层是一个挑战。

- 联合优化提高了模型在早期退出时的速度,但也降低了整体模型性能。

进一步探索的方向:

- 探索更广泛的模型和数据集。

- 开发独立的门控函数。

- 研究长序列生成中的早期退出策略。

- 分析基于子层的早期退出潜力。

结论:

- 早期退出是变换器模型的内在特性,不依赖于额外输出层和联合优化。

- 联合优化对于提高门控函数的准确性和扩大早期退出空间是必需的,但以降低模型性能为代价。

论文通过广泛的实验验证了早期退出的自然能力,并探讨了在实际应用中利用这种能力的可能性和挑战。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

FullStack Bench: Evaluating LLMs as Full Stack Coders

Authors:Siyao Liu, He Zhu, Jerry Liu, Shulin Xin, Aoyan Li, Rui Long, Li Chen, Jack Yang, Jinxiang Xia, Z. Y. Peng, Shukai Liu, Zhaoxiang Zhang, Jing Mai, Ge Zhang, Wenhao Huang, Kai Shen, Liang Xiang

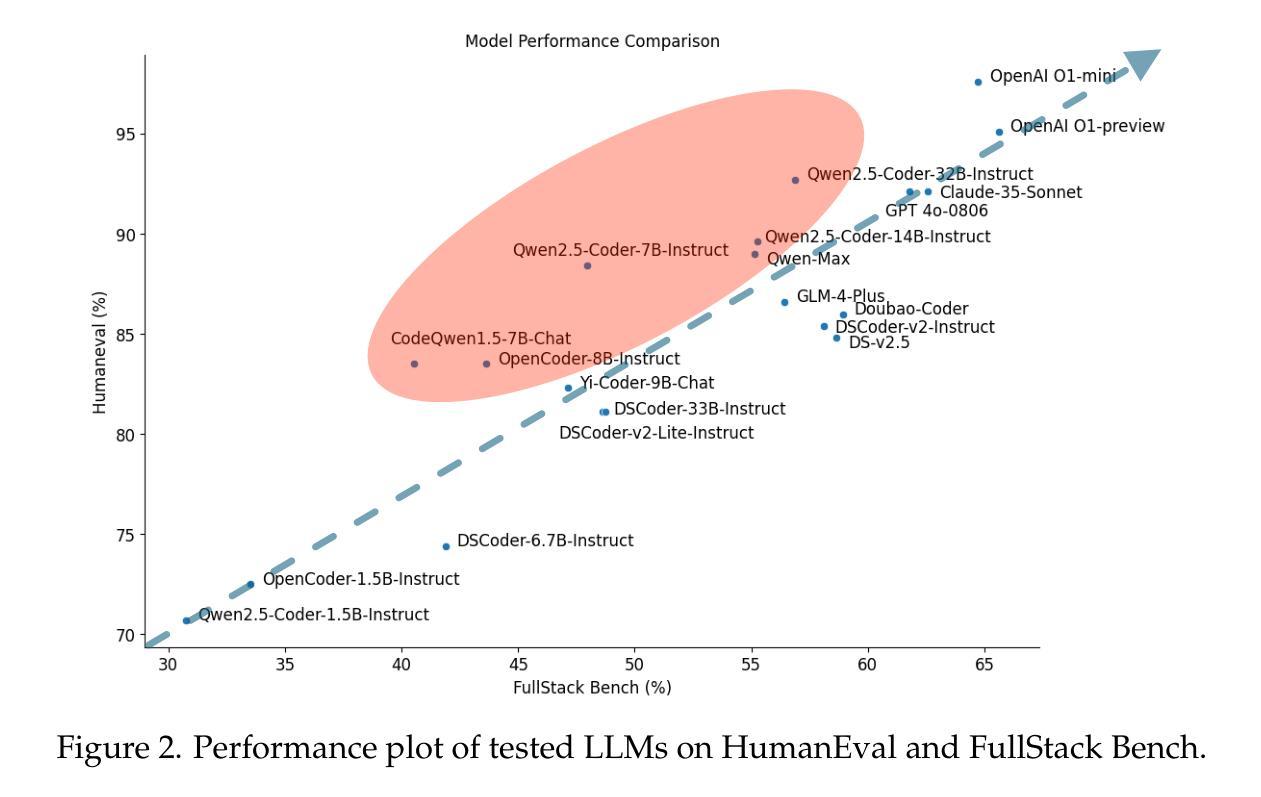

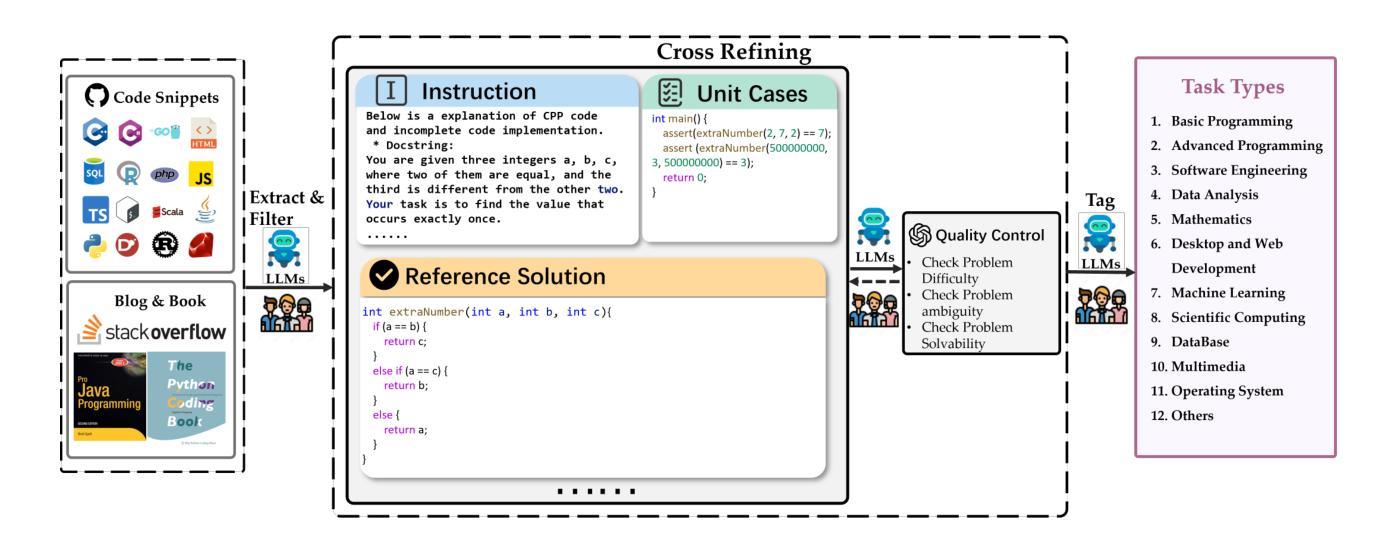

As the capabilities of code large language models (LLMs) continue to expand, their applications across diverse code intelligence domains are rapidly increasing. However, most existing datasets only evaluate limited application domains. To address this gap, we have developed a comprehensive code evaluation dataset FullStack Bench focusing on full-stack programming, which encompasses a wide range of application domains (e.g., basic programming, data analysis, software engineering, mathematics, and machine learning). Besides, to assess multilingual programming capabilities, in FullStack Bench, we design real-world instructions and corresponding unit test cases from 16 widely-used programming languages to reflect real-world usage scenarios rather than simple translations. Moreover, we also release an effective code sandbox execution tool (i.e., SandboxFusion) supporting various programming languages and packages to evaluate the performance of our FullStack Bench efficiently. Comprehensive experimental results on our FullStack Bench demonstrate the necessity and effectiveness of our FullStack Bench and SandboxFusion.

随着大型代码语言模型(LLM)的功能不断扩展,它们在各种代码智能领域的应用也在迅速增加。然而,大多数现有数据集只评估有限的应用领域。为了弥补这一空白,我们开发了一个全面的代码评估数据集FullStack Bench,专注于全栈编程,涵盖广泛的应用领域(如基本编程、数据分析、软件工程、数学和机器学习等)。此外,为了评估多语言编程能力,在FullStack Bench中,我们从1 6种广泛使用的编程语言中设计真实世界的指令和相应的单元测试案例,以反映真实世界的使用场景,而非简单的翻译。而且,我们还发布了一款有效的代码沙盒执行工具(即SandboxFusion),支持各种编程语言和软件包,以高效评估我们的FullStack Bench的性能。在我们FullStack Bench上的综合实验结果证明了FullStack Bench和SandboxFusion的必要性和有效性。

论文及项目相关链接

PDF 26 pages

Summary

全面评价大型代码语言模型(LLM)的应用能力,推出FullStack Bench数据集。该数据集涵盖全栈编程的多个应用领域,包括基本编程、数据分析、软件工程、数学和机器学习等。设计来自16种流行编程语言的真实指令和相应的单元测试案例,以反映真实使用场景而非简单翻译。同时发布支持多种编程语言和包的有效代码沙箱执行工具SandboxFusion,以高效评估FullStack Bench的性能。

Key Takeaways

- LLM的应用在代码智能领域迅速增加,但现有数据集评价领域有限。

- FullStack Bench数据集旨在全面评价编程能力,覆盖多个应用领域。

- 设计了来自16种编程语言的真实指令和单元测试案例,反映真实使用场景。

- 推出SandboxFusion工具,支持多种编程语言和包,高效评估FullStack Bench性能。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是现有代码大型语言模型(LLMs)评估数据集覆盖的应用领域有限,无法全面评估模型在真实世界代码开发场景中的代码相关能力。具体来说,论文中提到:

现有数据集局限性:大部分现有的代码评估数据集只涵盖了有限的应用领域,如基本编程、数据分析等,而没有覆盖更广泛的计算机科学领域和编程语言,这限制了对代码LLMs能力的全面评估。

真实世界应用场景需求:真实世界的软件开发涉及多个领域,包括但不限于基础编程、软件工程、数据分析、机器学习等。现有的评估数据集无法充分模拟这些多样化的应用场景。

多语言编程能力评估:随着代码LLMs在多语言编程领域的应用增加,需要有能够评估模型在多种编程语言下性能的数据集。

为了解决这些问题,论文提出了FullStack Bench数据集和SandboxFusion执行环境:

FullStack Bench:这是一个全面的代码评估数据集,包含了3374个问题,覆盖16种编程语言和多个计算机科学领域,旨在全面评估大型模型在各种真实世界代码开发场景中的能力。

SandboxFusion:这是一个有效的代码沙箱执行工具,支持多种编程语言和包,能够高效评估FullStack Bench中的问题,提供编译和执行反馈,帮助研究人员更好地理解和改进LLMs的性能。

Q: 有哪些相关研究?

A: 根据论文内容,以下是一些与FullStack Bench和SandboxFusion相关的研究工作:

代码大型语言模型(LLMs):

- Chen et al. (2021a) 和 Chen et al. (2021b) 提出了评估在代码上训练的大型语言模型。

- Roziere et al. (2023), Zheng et al. (2023), 和 Guo et al. (2024a) 在代码生成、代码调试、代码翻译等任务中展示了代码LLMs的能力。

代码评估基准(Code Benchmark):

- Austin et al. (2021a) 和 Austin et al. (2021b) 提出了程序合成任务,要求LLMs阅读自然语言描述并生成相应的代码片段。

- Jiao et al. (2023), Yan et al. (2023), 和 Zhu et al. (2022) 专注于代码翻译的评估。

- Huang et al. (2021), Husain et al. (2019), 和 Li et al. (2024) 研究了代码检索任务。

- Huq et al. (2022), Prenner and Robbes (2023), 和 Richter and Wehrheim (2022) 专注于漏洞修复任务。

多语言编程代码生成和调试:

- Roziere et al. (2023), Guo et al. (2024a), 和 Hui et al. (2024) 提出了多语言编程代码生成和调试任务的最新代码LLMs。

代码沙箱执行环境:

- DifySandbox (LangGenius, 2024), MultiPLE (Cassano et al., 2023), 和 MPLSandbox (Dou et al., 2024) 是一些已经提出的沙箱执行环境,它们在支持的语言和功能方面存在局限性。

其他相关数据集和基准:

- HumanEval (Chen et al., 2021a), MBPP (Austin et al., 2021b), DS-1000 (Lai et al., 2022), 和 xCodeEval (Khan et al., 2023) 是一些流行的代码评估数据集,它们主要关注特定的编程任务和领域。

这些相关工作为FullStack Bench和SandboxFusion提供了背景和动机,展示了在代码LLMs评估领域的研究进展和挑战。FullStack Bench旨在通过覆盖更广泛的应用领域和编程语言,提供一个更全面的评估框架,而SandboxFusion则提供了一个有效的执行环境来支持这些评估。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决现有代码评估数据集覆盖范围有限和无法全面评估代码LLMs能力的问题:

开发FullStack Bench数据集:

- 论文提出了一个全面的代码评估数据集FullStack Bench,包含3374个问题,这些问题覆盖了16种广泛使用的编程语言和多个计算机科学领域,如基础编程、软件工程、数据分析、机器学习等。

- 每个问题都包括了实际场景中的指令和相应的单元测试用例,以模拟真实世界的编程任务。

设计多语言编程能力评估:

- FullStack Bench中的问题不仅包含英文指令,还有中文指令,以评估模型在不同语言下的性能。

发布SandboxFusion执行工具:

- 为了有效评估FullStack Bench中的问题,论文发布了一个名为SandboxFusion的代码沙箱执行工具,支持多种编程语言和包。

- SandboxFusion具备以下特点:

- 支持多种语言:能够处理23种常用的编程语言,满足不同的实际使用场景。

- 易于部署:仅需单个服务器即可部署,适用于大型模型评估场景。

- 统一的多数据集执行环境:除了FullStack Bench,还支持10多个广泛使用的代码评估基准。

实验验证:

- 论文通过在FullStack Bench上对多个流行的代码语言模型进行实验,验证了FullStack Bench和SandboxFusion的必要性和有效性。

- 实验结果表明,大多数模型在HumanEval上表现良好,但在FullStack Bench上的表现相对较低,这突出了FullStack Bench评估真实世界编程能力的重要性。

详细分析:

- 论文还对模型在不同编程语言、不同难度级别上的表现进行了详细分析,并探讨了SandboxFusion反馈对模型性能的影响。

通过这些步骤,论文不仅提供了一个更全面的评估框架来测试和改进代码LLMs的能力,还通过SandboxFusion提供了一个有效的执行环境来支持这些评估,从而推动了代码智能领域的发展。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了以下实验:

模型性能测试:

- 选择了27个流行的代码语言模型(包括开源和闭源模型),在FullStack Bench数据集上测试这些模型的性能。

- 根据模型大小将这些AI编码器分为五组:1B+、6B+、13B、20B+和70B+,并比较了它们的性能。

不同领域性能分析:

- 系统地评估了AI编码器在FullStack Bench覆盖的11个实际领域(如基础编程、软件工程、数据分析等)的性能,并在表格中呈现了结果。

不同编程语言性能分析:

- 展示了不同AI编码器在多种编程语言(如Bash、C++、C#、D、Go等)上的性能,并分析了模型在这些语言上的表现。

编译与测试通过率分析:

- 使用SandboxFusion提供的编译器反馈,评估了模型响应的编译通过率,并分析了编译通过率与测试通过率之间的关系。

中英文问题性能分析:

- 分析了模型对中文和英文问题的性能,探讨了问题语言对模型性能的影响。

模型规模定律分析:

- 根据模型大小,分析了不同模型系列的性能,探讨了模型规模与性能之间的关系。

不同难度级别性能分析:

- 根据问题的难易程度(易、中、难),分析了模型在不同难度级别上的性能。

SandboxFusion反馈效果分析:

- 比较了使用SandboxFusion反馈进行自我改进的策略(Reflection)和简单多次推断(BoN)策略的性能差异。

这些实验全面评估了不同代码语言模型在多样化的实际编程任务上的性能,并验证了FullStack Bench数据集和SandboxFusion执行工具的有效性。通过这些实验,论文展示了不同模型在各种编程语言和任务中的性能差异,并分析了影响模型性能的因素。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和实验结果,以下是一些可以进一步探索的点:

模型泛化能力的提升:

- 研究和开发更有效的技术以提高模型在未见过的编程语言和应用领域上的泛化能力。

多语言和多领域融合学习:

- 探索如何通过融合学习不同语言和领域的数据来提升模型的多语言和多领域编程能力。

模型解释性:

- 提高模型的解释性,以便更好地理解模型在解决特定编程问题时的决策过程。

模型训练数据的影响:

- 分析不同训练数据集对模型性能的影响,并探索如何构建更有效的训练数据集。

模型大小与性能的进一步研究:

- 深入研究模型大小与性能之间的关系,特别是对于不同复杂度的任务。

强化学习在代码生成中的应用:

- 利用强化学习进一步优化代码生成任务,特别是在复杂编程问题上。

模型在实际开发环境中的应用:

- 探索模型在实际软件开发流程中的应用,例如在代码审查、自动化测试和维护中的作用。

安全性和隐私保护:

- 研究如何在保护用户数据隐私和代码安全的前提下,使用模型辅助编程。

模型的可扩展性和维护性:

- 研究如何构建易于扩展和维护的模型,以适应不断变化的编程语言和框架。

模型在教育领域的应用:

- 探索模型在编程教育中的应用,例如自动生成教学材料、辅助学生学习和编码。

跨领域知识融合:

- 研究如何将领域外知识融合到模型中,以提高模型解决复杂编程问题的能力。

模型的公平性和偏见问题:

- 研究模型可能存在的偏见问题,并探索减少这些偏见的方法。

这些探索点可以帮助研究人员和开发者更好地理解代码LLMs的能力,并推动其在实际软件开发中的应用。

Q: 总结一下论文的主要内容

A: 论文《FullStack Bench: Evaluating LLMs as Full Stack Coders》主要论文《FullStack Bench: Evaluating LLMs as Full Stack Coders》主要内容包括以下几个方面:

问题陈述:

- 论文指出现有的代码大型语言模型(LLMs)评估数据集覆盖的应用领域有限,无法全面评估模型在真实世界代码开发场景中的代码相关能力。

FullStack Bench数据集:

- 为了解决上述问题,论文提出了一个全面的代码评估数据集FullStack Bench,包含3374个问题,覆盖16种编程语言和多个计算机科学领域,如基础编程、软件工程、数据分析等。

- 每个问题都包括实际场景中的指令和相应的单元测试用例,以模拟真实世界的编程任务。

多语言编程能力评估:

- FullStack Bench中的问题设计为中英文两种语言,以评估模型在不同语言下的性能。

SandboxFusion执行工具:

- 为了有效评估FullStack Bench中的问题,论文发布了一个名为SandboxFusion的代码沙箱执行工具,支持多种编程语言和包。

- SandboxFusion具备支持多种语言、易于部署和统一的多数据集执行环境等特点。

实验验证:

- 论文通过在FullStack Bench上对多个流行的代码语言模型进行实验,验证了FullStack Bench和SandboxFusion的必要性和有效性。

- 实验结果表明,大多数模型在HumanEval上表现良好,但在FullStack Bench上的表现相对较低,突出了FullStack Bench评估真实世界编程能力的重要性。

详细分析:

- 论文还对模型在不同编程语言、不同难度级别上的表现进行了详细分析,并探讨了SandboxFusion反馈对模型性能的影响。

贡献总结:

- 提出了FullStack Bench数据集,覆盖更多主流应用领域,相比现有代码评估基准更全面。

- 发布了SandboxFusion执行工具,有效评估不同编程任务。

- 通过实验结果和分析,展示了FullStack Bench和SandboxFusion的必要性和有效性。

论文通过提出新的评估数据集和执行工具,旨在更全面地评估代码LLMs的能力,并推动代码智能领域的发展。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Forma mentis networks predict creativity ratings of short texts via interpretable artificial intelligence in human and GPT-simulated raters

Authors:Edith Haim, Natalie Fischer, Salvatore Citraro, Giulio Rossetti, Massimo Stella

Creativity is a fundamental skill of human cognition. We use textual forma mentis networks (TFMN) to extract network (semantic/syntactic associations) and emotional features from approximately one thousand human- and GPT3.5-generated stories. Using Explainable Artificial Intelligence (XAI), we test whether features relative to Mednick’s associative theory of creativity can explain creativity ratings assigned by humans and GPT-3.5. Using XGBoost, we examine three scenarios: (i) human ratings of human stories, (ii) GPT-3.5 ratings of human stories, and (iii) GPT-3.5 ratings of GPT-generated stories. Our findings reveal that GPT-3.5 ratings differ significantly from human ratings not only in terms of correlations but also because of feature patterns identified with XAI methods. GPT-3.5 favours ‘its own’ stories and rates human stories differently from humans. Feature importance analysis with SHAP scores shows that: (i) network features are more predictive for human creativity ratings but also for GPT-3.5’s ratings of human stories; (ii) emotional features played a greater role than semantic/syntactic network structure in GPT-3.5 rating its own stories. These quantitative results underscore key limitations in GPT-3.5’s ability to align with human assessments of creativity. We emphasise the need for caution when using GPT-3.5 to assess and generate creative content, as it does not yet capture the nuanced complexity that characterises human creativity.

创造力是人类认知的基本技能。我们使用文本形式心智网络(TFMN)来提取大约一千个人类和GPT3.5生成的故事中的网络(语义/句法关联)和情感特征。我们利用可解释人工智能(XAI)测试,基于Mednick的创造性联想理论的相关特征,来阐释人类和GPT-3.5给出的创造力评价。使用XGBoost,我们研究了三种情景:(i)人类对人类故事的评分,(ii)GPT-3.5对人类故事的评分,以及(iii)GPT-3.5对GPT生成的故事的评分。我们的研究发现,GPT-3.5的评分与人类评分存在显著差异,不仅体现在相关性上,还因为使用XAI方法识别出的特征模式。GPT-3.5偏爱“自己的”故事,对人类故事的评分与人类不同。通过SHAP分数进行的特征重要性分析表明:(i)网络特征对人类创造力和GPT-3.5对人类故事的评分预测更为准确;(ii)在GPT-3.5对自己故事的评分中,情感特征的作用大于语义/句法网络结构。这些定量结果强调了GPT-3.5与人类评估创造力对齐的关键局限性。我们强调在使用GPT-3.5评估和生成创造性内容时要谨慎,因为它还没有捕捉到人类创造力的微妙复杂性。

论文及项目相关链接

Summary

本研究利用文本形式心智网络(TFMN)提取语义、句法关联和情感特征,对比人类和GPT3.5对故事的创造力评价。通过可解释人工智能(XAI)和XGBoost分析,发现GPT3.5的评价与人类存在显著差异,不仅体现在相关性上,还体现在特征模式上。GPT3.5更偏向于评价其生成的故事,对人类故事的评价与人类不同。网络特征对预测人类和GPT3.5的创造力评价都很重要,而情感特征在GPT3.5自评故事时作用更大。这些结果突显了GPT3.5在评估创造力方面的关键局限性。

Key Takeaways

- 本研究使用TFMN提取故事中的语义、句法关联和情感特征。

- 对比了人类和GPT3.5对故事的创造力评价。

- 通过XAI和XGBoost分析,发现GPT3.5的评价与人类存在显著差异。

- GPT3.5更偏向于评价其生成的故事。

- 网络特征对预测人类和GPT3.5的创造力评价都很重要。

- 情感特征在GPT3.5自评故事时作用更大。

- GPT3.5在评估创造力方面存在局限性,需要谨慎使用。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何通过可解释的人工智能(XAI)来预测和理解人类和GPT模拟评分者对短文本创意评分。具体来说,论文通过以下几个方面来探讨这个问题:

创意的量化评估:研究如何利用文本形式心智网络(Textual forma mentis networks, TFMN)从大约一千个由人类和GPT3.5生成的故事中提取网络(语义/句法关联)和情感特征,并测试这些特征是否能够解释人类和GPT-3.5赋予的创意评分。

人类与AI评分的比较:通过对比人类和GPT-3.5对人类故事的评分,以及GPT-3.5对自己生成故事的评分,来揭示两者在创意评估上的差异。

创意评分的特征模式:使用XGBoost算法和SHAP值分析来检验不同场景下(人类评分人类故事、GPT-3.5评分人类故事、GPT-3.5评分GPT生成故事)哪些网络和情感特征对于预测创意评分更为重要。

情感在创意评分中的角色:研究情感特征如何影响创意评分,特别是在GPT-3.5评分自己生成的故事时情感特征与语义/句法网络结构的相对重要性。

AI在创意评估中的应用限制:强调在使用GPT-3.5评估和生成创意内容时需要谨慎,因为它尚未捕捉到人类创意的复杂性。

综上所述,论文的核心目标是利用可解释的人工智能方法来深入理解影响创意评分的关键因素,并评估GPT-3.5在模拟人类创意评估中的准确性和局限性。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的研究:

Mednick的联想理论:Mednick (1962) 提出的关联理论认为,创造力产生于在语义网络中形成遥远且看似无关概念之间的连接能力。这个理论为本研究中使用网络距离作为测试创意水平的代理提供了理论基础。

**Boden (1998)**:Boden 将创造力定义为人类认知的一个基本技能,并探讨了概念关联如何传达创造力。

**Runco & Chand (1995)**:他们对创造力的定义强调了生成新颖且有价值的想法或产品的能力。

Weinstein et al. (2022) 和 **Johnson et al. (2023)**:这些研究提出了评估文本创造力的度量标准,如单词的不频繁使用、独特的单词组合、句法独特性等,并探讨了如何利用网络科学和机器学习方法来评估创造力。

**Guo et al. (2019)、Heinen & Johnson (2018)、Semeraro et al. (2024)**:这些研究强调了个体中语义网络结构与创造力水平之间的显著相关性,并提出网络特征可以作为叙事创造力的可靠指标。

**Acar (2023)、Beaty & Johnson (2021)**:这些研究利用语义网络特征和机器学习算法减少创造力评分中的主观性,并自动赋予更客观的创造力分数。

**Vaswani et al. (2017)**:介绍了BERT模型,这是一个深度学习语言模型,通过分析单词的共现来理解文本中单词的上下文。

Siew et al. (2019) 和 **Stella et al. (2024)**:这些研究在认知网络科学领域提倡可解释模型,其中联想知识被表示为由一种或多种类型的关联链接的概念关系集。

**Plutchik (1980)**:Plutchik 的基本情绪理论认为有八种主要情绪,每种情绪都有一个对立情绪,这些情绪可以组合形成更复杂的情感,对人类如何体验和表达情感起着关键作用。

**Semeraro et al. (2024)**:对比了BERT和TFMNs在复现相同文本数据的创造力评分时显示的不同特征。

**D’Souza (2021)**:识别了短叙事中的创造性,如新词形、情节中的意外转折和原始生动的设定。

Amabile et al. (2005) 和 **Wang et al. (2017)**:研究了积极情绪状态对认知灵活性和创造性问题解决任务表现的影响。

这些相关研究为本论文提供了理论基础和方法论支持,帮助研究者探索和理解人类和人工智能评估创意的不同方式。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决预测和理解人类及GPT模拟评分者对短文本创意评分的问题:

数据收集:

- 收集了约一千个由人类和GPT-3.5生成的故事。

- 使用相同的三个单词提示,让人类参与者和GPT-3.5都创作故事,以保证实验条件的一致性。

特征提取:

- 利用文本形式心智网络(TFMN)从故事中提取语义、句法和情感特征。

- 这些特征包括网络结构特征(如网络距离、聚类系数、度中心性)和情感特征(基于Plutchik基本情绪理论的情绪得分)。

模型开发:

- 使用可解释人工智能(XAI)方法,特别是XGBoost算法,来预测不同评分者对故事的创意评分。

- 开发了三种不同的模型来分析数据集:人类对人类故事的评分、GPT-3.5对人类故事的评分,以及GPT-3.5对自己生成故事的评分。

模型评估:

- 采用4折交叉验证来评估模型性能,确保模型的稳健性和泛化能力。

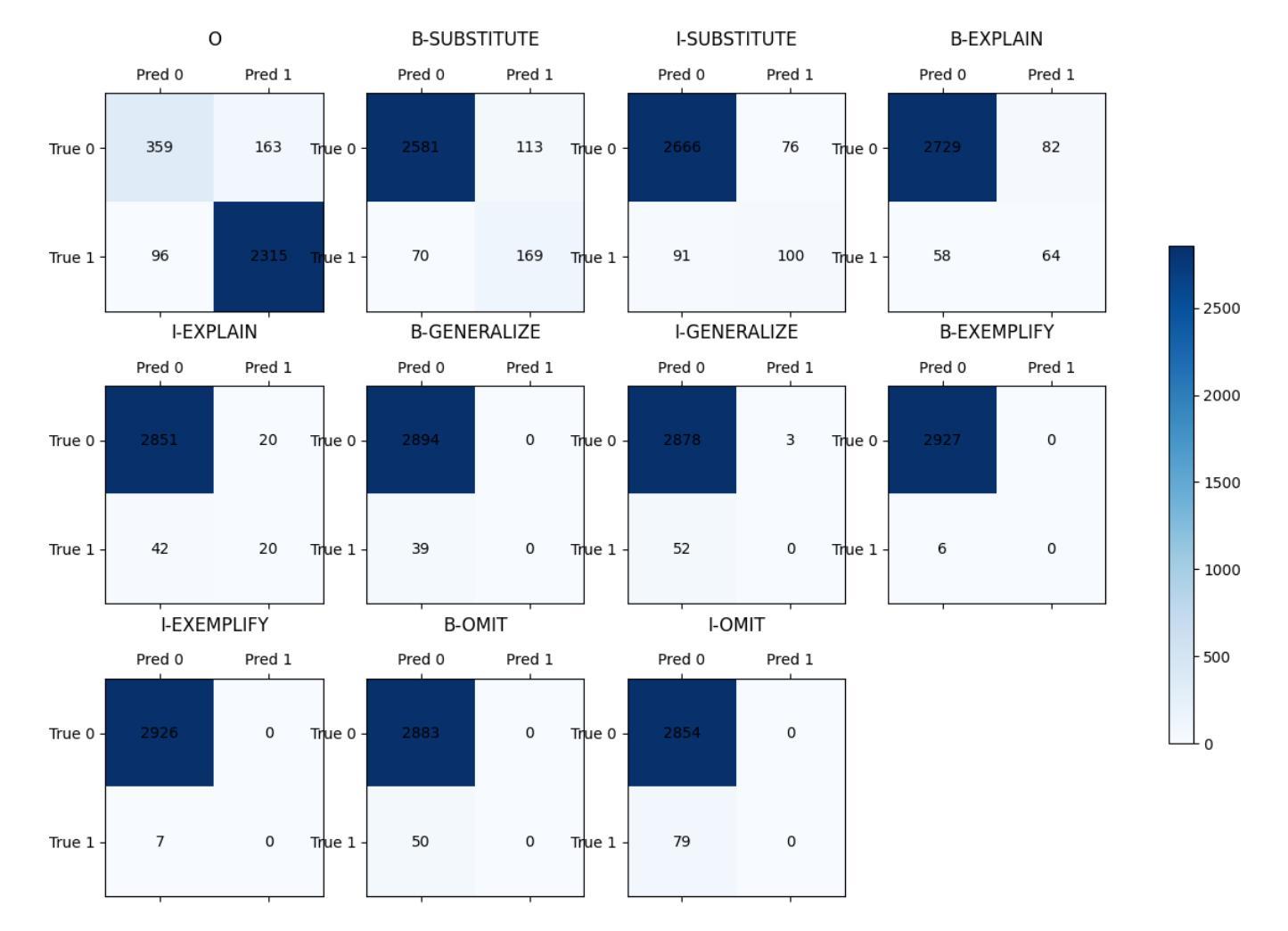

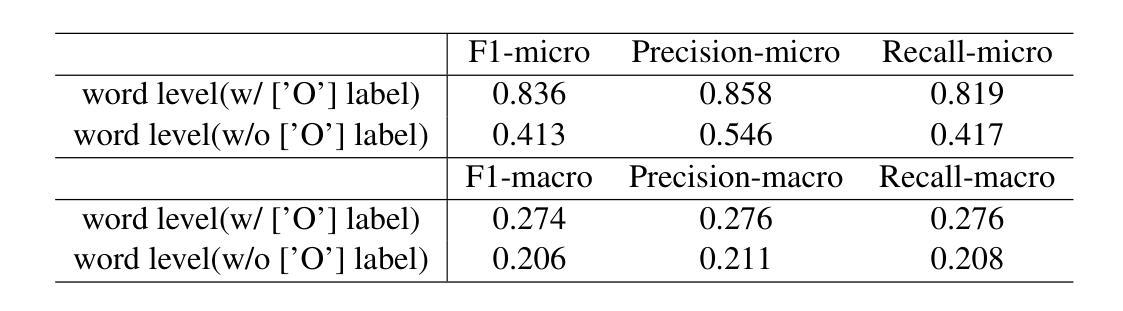

- 使用混淆矩阵和ROC AUC分数来衡量模型在区分不同创意评分水平上的表现。

特征重要性分析:

- 应用SHAP值方法来解释XGBoost模型的预测,识别对创意评分影响最大的网络和情感特征。

- 通过SHAP值分析,比较人类评分者和GPT-3.5评分者在评估创意时依赖的特征差异。

结果解释和讨论:

- 对比人类和GPT-3.5评分者在创意评估上的不同特征模式,揭示GPT-3.5在评估和生成创意内容时的局限性。

- 讨论GPT-3.5在评估人类故事与自己生成故事时的内部评估标准的差异,以及这对使用GPT-3.5进行创意评估和内容生成的影响。

结论和建议:

- 基于研究发现,强调在使用GPT-3.5评估和生成创意内容时需要谨慎,并指出未来研究的方向。

通过这些步骤,论文不仅提供了对人类和GPT-3.5评分者评估创意的深入理解,还揭示了当前大型语言模型在理解和生成创意内容方面的局限性。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,实验设计和步骤如下:

数据收集:

- 实验收集了由人类参与者和GPT-3.5生成的故事数据集。人类数据集来源于Johnson等人的研究,包含153名参与者创作的1071个故事。GPT-3.5数据集则包含同样数量的故事,由GPT-3.5根据相同的提示创作。

故事创作:

- 人类参与者和GPT-3.5都根据给定的三个单词提示创作4-6句的短故事。这些故事后续用于分析和评分。

评分过程:

- 人类故事由四名人类评分者和四个GPT-3.5评分者进行评分,评分范围为1至5,代表从最不创意到最创意。

- GPT-3.5生成的故事仅由GPT-3.5评分者进行评分。

构建文本形式心智网络(TFMN):

- 对每个故事应用TFMN来提取语义、句法和情感特征。这包括使用spaCy库进行自然语言处理,以识别故事中的概念关系和情绪值。

特征提取:

- 从故事的TFMN中提取网络特征,如直径、平均最短路径长度、聚类系数、度中心性和PageRank中心性。

模型训练与评估:

- 使用XGBoost分类器,通过4折交叉验证对三个不同场景的数据集进行模型训练和评估:

- 人类对人类故事的评分(人类评分者)

- GPT-3.5对人类故事的评分(GPT评分者)

- GPT-3.5对自己生成故事的评分(GPT评分者)

- 使用XGBoost分类器,通过4折交叉验证对三个不同场景的数据集进行模型训练和评估:

特征重要性分析:

- 利用SHAP值方法分析不同特征对模型预测的贡献,以识别影响创意评分的关键因素。

统计测试:

- 对人类和GPT-3.5生成的故事进行Mann-Whitney U检验,以确定两者在网络和情感特征上的统计学差异。

描述性统计:

- 对故事的长度、网络特征和情感特征进行描述性统计分析。

这些实验步骤共同构成了论文的研究设计,旨在通过定量的方法比较人类和GPT-3.5在创意评估上的表现,并探索影响创意评分的关键因素。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

更先进的AI模型:

- 研究更先进的模型,如GPT-4或未来的版本,以了解它们在创意评估和生成方面是否比GPT-3.5表现得更好,以及它们是否能够更准确地捕捉人类对创意的评估标准。

跨语言研究:

- 测试不同语言背景下的故事,以确定影响创意评分的结构和情感特征是否具有普遍性,从而为开发跨语言有效的AI模型提供依据。

故意创作不具创意的故事:

- 指导GPT-3.5故意创作不具创意的故事,并由人类和GPT-3.5评分者进行评分,以探索GPT-3.5是否能够准确识别和产生低创意水平的故事。

个体评分者的行为差异:

- 使用线性混合模型等统计方法,考虑不同人类评分者的行为差异,以减少评分者特定倾向可能引入的偏差。

AI评估的偏差问题:

- 深入研究GPT-3.5在评估创意内容时的偏差问题,尤其是对GPT-3.5生成的故事的偏好,以及如何校正这些偏差。

情感和创造力的关系:

- 进一步研究情感在创造力评估中的作用,特别是在GPT-3.5生成的故事中情感特征与创意评分之间的关系。

叙事结构和复杂性:

- 探索AI生成的故事是否缺乏人类创造力中通常关联的结构复杂性,并尝试改进AI模型以更好地模拟人类创意过程。

教育和专业设置中的应用:

- 研究在教育和专业环境中使用GPT-3.5评估创意的潜在应用和局限性,以及如何结合人类评估和AI评估以获得更准确的结果。

AI创意生成的伦理和社会影响:

- 探讨AI在创意内容生成中的应用可能带来的伦理和社会问题,例如版权、原创性和创意作品的社会影响。

多模态创意评估:

- 结合文本、视觉和其他模态数据来评估创意,以提供更全面的创意评估方法。

这些探索点可以帮助研究者更深入地理解AI在创意评估和生成中的能力,以及如何改进AI模型以更好地与人类创意评估标准对齐。

Q: 总结一下论文的主要内容

A: 这篇论文主要探讨了如何利用可解释的人工智能(XAI)技术来预测和理解人类以及GPT-3.5模型对短文本创意评分。以下是论文的主要内容总结:

研究背景与目的:

- 论文强调了创造力是人类认知的一个基本技能,研究如何通过概念关联传达创造力成为了科学关注的焦点。

- 论文旨在使用文本形式心智网络(TFMN)和可解释的人工智能技术来测试与Mednick的关联理论相关的特征是否能解释人类和GPT-3.5赋予的创意评分。

数据集:

- 论文使用了两个数据集:人类创作的故事和GPT-3.5生成的故事,每个数据集包含约一千个短故事。

- 故事由人类参与者和GPT-3.5根据给定的三个单词提示创作。

方法论:

- 利用TFMN从故事中提取语义、句法和情感特征。

- 使用XGBoost算法来评估不同场景下(人类评分人类故事、GPT-3.5评分人类故事、GPT-3.5评分GPT生成故事)的创意评分。

- 应用SHAP值分析来解释模型预测,并识别影响创意评分的关键特征。

主要发现:

- GPT-3.5对人类故事的评分与人类评分者存在显著差异,表明GPT-3.5在评估创意时可能使用不同的标准。

- GPT-3.5倾向于给自己生成的故事较高的创意评分,显示了对“自己”故事的偏好。

- 网络特征对于人类评分者的创意评分预测更为重要,而对于GPT-3.5评分自己生成的故事,情感特征的重要性超过了语义/句法网络结构。

讨论与结论:

- 论文讨论了GPT-3.5在评估和生成创意内容时的局限性,并强调在使用GPT-3.5进行创意评估时应谨慎。

- 论文指出了未来研究方向,包括跨语言研究、探索AI评估的偏差问题,以及进一步研究情感和创造力的关系。

贡献与意义:

- 论文通过定量方法比较了人类和GPT-3.5在创意评估上的表现,并探索了影响创意评分的关键因素,为理解AI在创意评估和生成中的潜力和局限提供了见解。

总体而言,这篇论文通过结合认知科学、机器学习和网络科学的方法,提供了对人类和AI评估创意的新视角,并揭示了当前AI模型在理解和生成创意内容方面的限制。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Non-native speakers of English or ChatGPT: Who thinks better?

Authors:Mohammed Q. Shormani

This study sets out to answer one major question: Who thinks better, non-native speakers of English or ChatGPT?, providing evidence from processing and interpreting center-embedding English constructions that human brain surpasses ChatGPT, and that ChatGPT cannot be regarded as a theory of language. Fifteen non-native speakers of English were recruited as participants of the study. A center-embedding English sentence was presented to both the study participants and ChatGPT. The study findings unveil that human brain is still far ahead of Large Language Models, specifically ChatGPT, even in the case of non-native speakers of an L2, here English. The study concludes that human brain’s ability to process and interpret natural language data is unique and that ChatGPT still lags behind this human unique ability.

本研究旨在回答一个主要问题:在处理和理解中心嵌入的英语结构时,是非英语母语者的大脑思考得更好,还是ChatGPT?本研究提供证据显示,在处理和理解中心嵌入的英语结构方面,人类大脑超越了ChatGPT,且ChatGPT不能被看作是语言理论。本研究招募了15名非英语母语者作为参与者。向这些参与者以及ChatGPT呈现了一个中心嵌入的英语句子。研究发现,即使对于非英语母语者,人类大脑仍然远远领先于大型语言模型,尤其是ChatGPT。研究得出结论,人类大脑处理和解释自然语言数据的能力是独一无二的,而ChatGPT在这方面仍然落后于人类。

论文及项目相关链接

PDF 16 pages, 2 figures

Summary:本研究旨在回答一个重要问题:在处理中心嵌入英语结构时,非英语母语者还是ChatGPT思考得更好?研究结果显示,人类大脑仍然远远超过ChatGPT,即使在非英语母语者的情况下也是如此。这表明人类大脑处理和解释自然语言数据的能力是独一无二的,而ChatGPT在这方面仍落后于人类。

Key Takeaways:

- 本研究关注非英语母语者和ChatGPT在处理中心嵌入英语结构时的思考能力对比。

- 研究结果表明,在处理此类任务时,人类大脑的能力仍然远超ChatGPT。

- 即使是非英语母语者,他们的大脑在处理自然语言数据时也表现出独特的优势。

- 本研究共招募了15名非英语母语者作为参与者。

- 实验结果揭示出人类大脑具有独特的语言处理能力,这一能力在目前的大型语言模型(如ChatGPT)中尚未达到。

- ChatGPT在处理自然语言数据方面仍然滞后于人类。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是:在处理和解释中心嵌入(center-embedding)英语结构方面,非母语英语使用者(non-native speakers of English)和ChatGPT(一种大型语言模型)哪个表现得更好。具体来说,研究旨在提供证据,证明人类大脑(即使是非母语英语使用者的大脑)在处理这类复杂语言结构时,仍然远远超过ChatGPT,并且ChatGPT不能被视为一种语言理论。

Q: 有哪些相关研究?

A: 相关研究包括以下几个方面:

中心嵌入结构的研究:

- Chomsky 和 Miller (1963) 提出了中心嵌入结构对人类工作记忆造成的压力,这是后续研究的基础。

- Frazier (1985) 发现处理这些结构时存在处理中断。

- Dickey (1995) 通过阅读时间实验揭示了不恰当的先行词插入导致的更快阅读时间。

- Thomas (1995) 研究了理解中心嵌入和自嵌入结构的句子所涉及的认知过程。

人工智能(AI)和语言模型的争议:

- Piantadosi (2023) 和 Ambridge & Blything (2024) 认为大型语言模型(LLMs)如ChatGPT是优秀的语言理论,甚至可以“反驳”乔姆斯基的生成语法方法。

- 相反,Katz (2012) 和 Shormani (2024a) 等学者认为尽管这些模型完成了伟大的任务,AI模型仍未达到人类大脑的水平。

AI的起源和定义:

- McCarthy et al. (1955) 提出AI的定义,即让机器表现出如果人类这么做则被称为智能的行为。

- Haenlein & Kaplan (2019) 讨论了AI的现代用途,特别是在处理、计算和解释自然语言数据方面。

LLMs和中心嵌入现象:

- Jiang et al. (2024) 开发了基于提示的方法(PromptEOL),用于嵌入句子并探索其效果。

- Harris et al. (2024) 探索了使用LLMs预处理输入文本以提高文本嵌入性能的方法。

- Kodner et al. (2024) 和 Dentella et al. (2024) 都强调了LLMs作为科学理论的局限性,并认为它们不能替代语言学理论。

- Katzir (2023) 批评了LLMs作为人类语言认知的有力理论的说法,并提出了对Piantadosi (2023) 论点的反驳。

LLMs的自然语言理解(NLU)能力:

- Zhong et al. (2023) 评估了ChatGPT与微调BERT模型的NLU能力,并发现ChatGPT在特定NLU任务中落后于高度专业化的微调模型。

这些研究提供了对LLMs在处理和解释自然语言,特别是复杂结构如中心嵌入句子时的能力和局限的深入理解。论文通过这些研究来构建其研究框架,并探讨非母语英语使用者与ChatGPT在处理这类结构时的表现差异。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决提出的问题:

1. 研究设计

- 参与者招募:招募了15名非母语英语使用者(NNSs)作为研究参与者,他们都是高级的英语学习者。

- 研究材料:使用一个涉及中心嵌入现象的句子作为研究工具,即 “The man that the soldier that the thief slapped deceived died.” 这句话被用作判断和解释的工具。

2. 过程

- 任务分配:通过WhatsApp向参与者发送上述英语句子,并询问他们每个人(男人、士兵和小偷)在句子中做了什么。

- 时间限制:给参与者24小时回答,答案提交时间不同,从立即回答到第二天都有。

- 数据收集:记录参与者的回答以及ChatGPT的回答。

3. 数据分析

- 结果统计:统计参与者和ChatGPT对于句子中各个角色行为的回答。

- 错误分析:分析参与者和ChatGPT在理解中心嵌入结构时的错误。

4. 结果讨论

- 性能对比:比较非母语英语使用者和ChatGPT在处理和解释中心嵌入句子时的表现。

- 错误对比:讨论ChatGPT在处理任务和语法判断任务中的错误,并与人类参与者的表现进行对比。

5. 结论

- 人类大脑的优势:得出结论,即使是非母语英语使用者,人类大脑在处理和解释自然语言数据方面仍然优于ChatGPT。

- LLMs的局限性:指出ChatGPT和其他大型语言模型(LLMs)在处理复杂语言结构时的局限性,并认为它们不能被视为语言的理论。

6. 研究局限和未来方向

- 研究局限:讨论了研究的局限性,如句子类型的限制和ChatGPT版本的限制。

- 未来研究方向:建议未来的研究可以涉及更广泛的复杂英语句子类型,并使用更先进的ChatGPT版本。

通过这些步骤,论文旨在揭示人类大脑(即使是非母语使用者)在处理自然语言时的独特能力,并指出ChatGPT等LLMs在模拟人类语言处理方面的不足。

Q: 论文做了哪些实验?

A: 论文中进行的实验主要包含以下两个部分:

1. 句子理解任务

- 实验目的:评估非母语英语使用者(NNSs)和ChatGPT处理和解释中心嵌入英语句子的能力。

- 实验材料:使用了一个特定的中心嵌入句子:“The man that the soldier that the thief slapped deceived died.”

- 参与者:15名非母语英语使用者,包括不同学习阶段的高级英语学习者(BA、MA和PhD学生)。

- 实验过程:通过WhatsApp向参与者发送上述句子,并询问每个人(男人、士兵和小偷)在句子中做了什么。要求参与者在24小时内回答。

- 数据收集:记录参与者的回答,并对比ChatGPT的回答。

2. 语法判断任务

- 实验目的:评估ChatGPT对同一中心嵌入句子的语法正确性判断能力。

- 实验过程:询问ChatGPT该句子是否语法正确,并记录其回答和判断理由。

这两个实验的设计旨在直接比较非母语英语使用者和ChatGPT在理解和处理复杂语言结构方面的能力,特别是在中心嵌入结构的理解和解释上。通过这些实验,研究者能够收集到有关人类和人工智能在语言处理上表现差异的实证数据。

Q: 有什么可以进一步探索的点?

A: 论文在结论部分提出了一些研究的局限性,并建议了未来研究可以进一步探索的方向。以下是一些可以进一步探索的点:

更广泛的句型研究:

- 进行包含更多类型复杂英语句子的研究,例如涉及DP-islands、多重wh-问题、照应和弱/强交叉现象的句子,以评估NNSs和ChatGPT在更广泛语境下的语言处理能力。

使用更新版本的ChatGPT:

- 使用ChatGPT-4或更新版本进行研究,因为这些版本在功能和特性上据说更加先进,可能提供更深入的见解。

跨语言比较:

- 将研究扩展到其他语言,以评估NNSs和LLMs在不同语言背景下处理复杂句型的能力。

个体差异的影响:

- 研究个体差异(如语言学习背景、年龄、认知能力等)如何影响NNSs处理复杂语言结构的能力。

学习过程的动态性:

- 探索NNSs在学习过程中对复杂语言结构理解能力的变化,以及这种变化如何与他们的语言能力发展相关联。

教育干预的效果:

- 研究特定的教育干预措施如何帮助NNSs提高处理和解释复杂语言结构的能力。

LLMs的解释能力和限制:

- 深入研究LLMs在解释语言结构时的能力和限制,以及它们与人类语言处理机制的差异。

LLMs在不同领域的应用:

- 探索LLMs在不同领域(如法律、医学、教育等)中的应用,并评估其在特定领域内的表现。

LLMs的伦理和社会影响:

- 研究LLMs的广泛应用可能带来的伦理和社会问题,例如偏见、隐私和就业影响。

LLMs与人类协作:

- 探索LLMs如何与人类协作,以提高语言处理任务的效率和准确性。

这些探索点可以帮助未来的研究者更全面地理解NNSs和LLMs在语言处理方面的表现,并为语言学、教育学和人工智能等领域提供新的见解。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

研究目的:

- 探讨非母语英语使用者(NNSs)和ChatGPT在处理和解释中心嵌入英语句子方面的能力,并比较两者谁表现得更好。

理论背景:

- 论文回顾了中心嵌入结构的语言学研究,以及人工智能(AI)和大型语言模型(LLMs)如ChatGPT在语言处理任务中的争议和辩论。

研究方法:

- 招募了15名非母语英语使用者作为研究对象,并通过WhatsApp向他们提出了一个中心嵌入句子的理解任务。

- 同时,也向ChatGPT提出了相同的任务,并询问了其对句子语法正确性的判断。

研究结果:

- 非母语英语使用者在理解和解释中心嵌入句子的任务中表现优于ChatGPT。

- ChatGPT在处理任务和语法判断任务中均出现错误,显示了其在处理复杂语言结构时的局限性。

讨论与结论:

- 论文得出结论,即使是非母语英语使用者,人类大脑在处理自然语言数据方面的能力也是独特的,并且优于ChatGPT。

- 论文认为ChatGPT和其他LLMs不能被视为语言的理论,因为它们在模拟人类语言处理方面存在不足。

研究局限和未来方向:

- 论文讨论了研究的局限性,包括句子类型的限制和ChatGPT版本的限制,并提出了未来研究可以进一步探索的方向。

总体而言,这篇论文提供了对人类(即使是非母语使用者)与LLMs在处理复杂语言结构方面能力的比较分析,并强调了人类大脑在语言处理方面的优越性和LLMs的局限性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

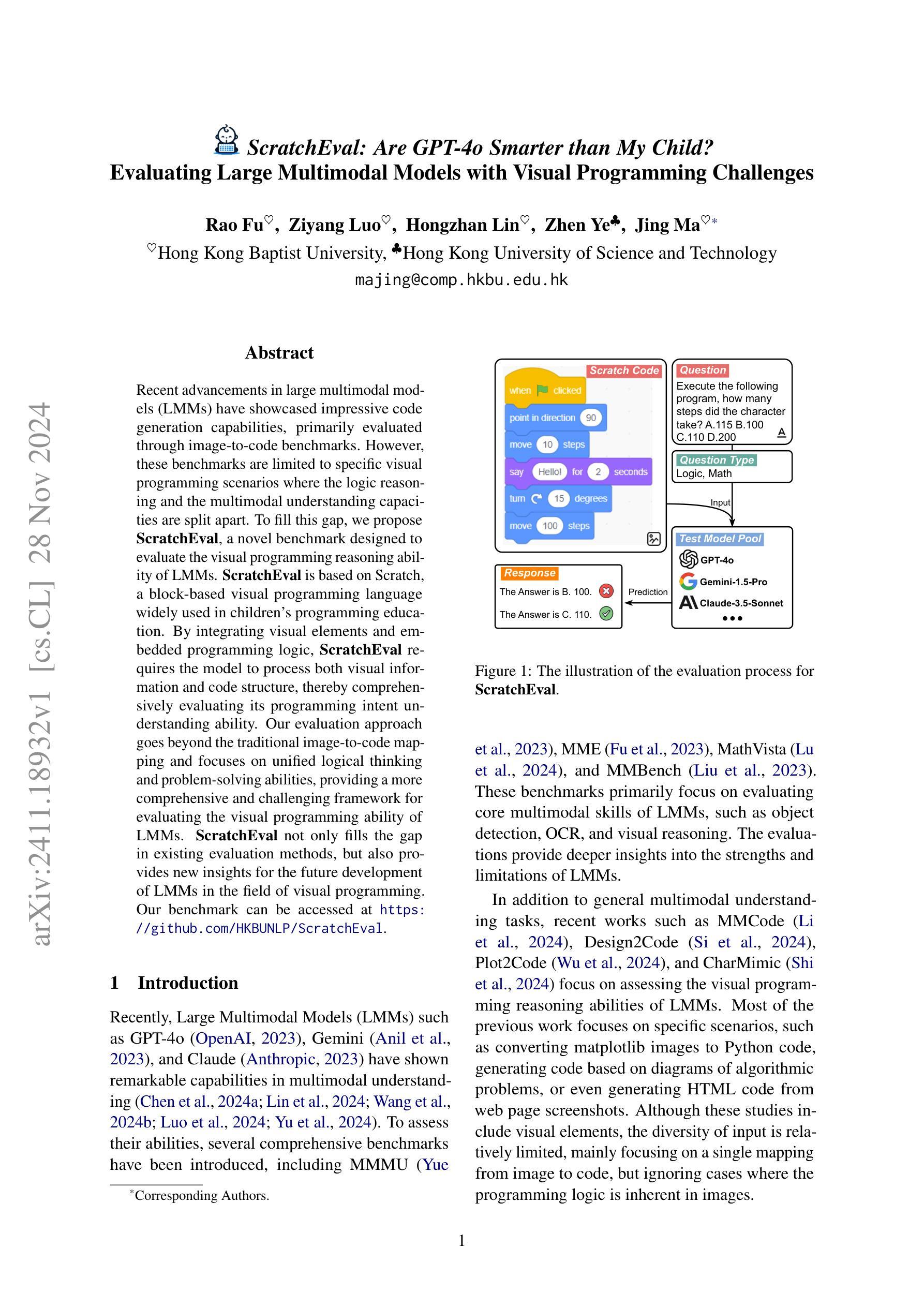

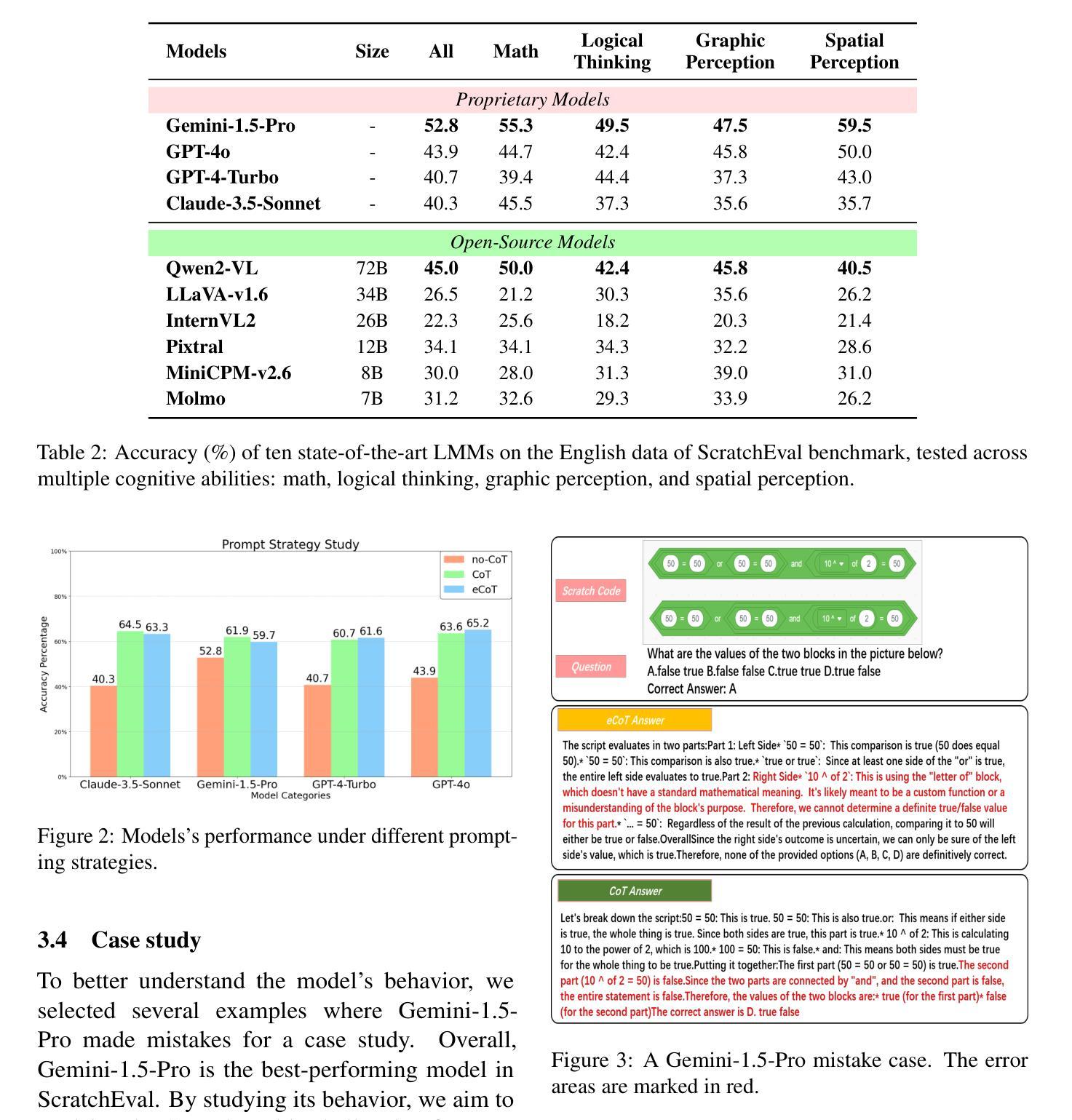

ScratchEval: Are GPT-4o Smarter than My Child? Evaluating Large Multimodal Models with Visual Programming Challenges

Authors:Rao Fu, Ziyang Luo, Hongzhan Lin, Zhen Ye, Jing Ma

Recent advancements in large multimodal models (LMMs) have showcased impressive code generation capabilities, primarily evaluated through image-to-code benchmarks. However, these benchmarks are limited to specific visual programming scenarios where the logic reasoning and the multimodal understanding capacities are split apart. To fill this gap, we propose ScratchEval, a novel benchmark designed to evaluate the visual programming reasoning ability of LMMs. ScratchEval is based on Scratch, a block-based visual programming language widely used in children’s programming education. By integrating visual elements and embedded programming logic, ScratchEval requires the model to process both visual information and code structure, thereby comprehensively evaluating its programming intent understanding ability. Our evaluation approach goes beyond the traditional image-to-code mapping and focuses on unified logical thinking and problem-solving abilities, providing a more comprehensive and challenging framework for evaluating the visual programming ability of LMMs. ScratchEval not only fills the gap in existing evaluation methods, but also provides new insights for the future development of LMMs in the field of visual programming. Our benchmark can be accessed at https://github.com/HKBUNLP/ScratchEval .

最近大型多模态模型(LMM)的进展展示了令人印象深刻的代码生成能力,主要通过图像到代码的基准测试进行评估。然而,这些基准测试仅限于特定的视觉编程场景,其中逻辑推理和多模态理解能力是分开评估的。为了填补这一空白,我们提出了ScratchEval,这是一个新型基准测试,旨在评估LMM的视觉编程推理能力。ScratchEval基于Scratch,一种广泛应用于儿童编程教育的基于图块的视觉编程语言。通过整合视觉元素和嵌入式编程逻辑,ScratchEval要求模型处理视觉信息和代码结构,从而全面评估其编程意图理解能力。我们的评估方法超越了传统的图像到代码的映射,侧重于统一的逻辑思维和问题解决能力,为评估LMM的视觉编程能力提供了更全面、更具挑战性的框架。ScratchEval不仅弥补了现有评估方法的空白,而且为视觉编程领域LMM的未来发展提供了新的见解。我们的基准测试可在https://github.com/HKBUNLP/ScratchEval访问。

论文及项目相关链接

Summary

大型多模态模型(LMMs)在代码生成能力上展现出显著进步,主要通过图像到代码的基准测试进行评估。然而,这些基准测试局限于特定的视觉编程场景,忽视了逻辑理解和多模态感知的综合能力。为此,我们提出ScratchEval基准测试,旨在评估LMMs在视觉编程推理方面的能力。ScratchEval基于Scratch编程语言构建,融合了视觉元素和嵌入式编程逻辑,要求模型处理视觉信息和代码结构,全面评估其编程意图理解能力。我们的评估方法超越了传统的图像到代码的映射,注重统一的逻辑思维和问题解决能力,为LMMs在视觉编程领域的评估提供了更全面、更具挑战性的框架。

Key Takeaways

- LMMs展现出强大的代码生成能力,主要通过图像到代码的基准测试进行评估。

- 现有基准测试局限于特定视觉编程场景,缺乏逻辑理解和多模态感知的综合评估。

- 提出ScratchEval基准测试,旨在全面评估LMMs在视觉编程推理方面的能力。

- ScratchEval基于Scratch编程语言构建,融合视觉元素和编程逻辑。

- ScratchEval要求模型处理视觉信息和代码结构,评估其编程意图理解能力。

- 评估方法超越图像到代码的映射,注重统一的逻辑思维和问题解决能力。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为ScratchEval的新基准测试,旨在评估大型多模态模型(LMMs)在视觉编程任务中的表现。具体来说,论文试图解决以下几个问题:

现有评估方法的局限性:当前对LMMs的评估主要通过图像到代码的基准测试进行,这些基准测试仅限于特定的视觉编程场景,并且将逻辑推理和多模态理解能力分开评估。ScratchEval旨在通过一个更综合的框架来填补这一空白。

视觉编程能力的综合评估:ScratchEval基于Scratch(一种广泛用于儿童编程教育的基于块的视觉编程语言),要求模型同时处理视觉信息和代码结构,从而全面评估其编程意图理解能力。

逻辑思考和问题解决能力:论文强调需要评估LMMs的视觉编程能力,将视觉理解和逻辑推理统一起来,而不是仅仅关注传统的编程语言和语法错误。

现有模型的视觉代码推理能力不足:通过ScratchEval的测试,论文发现现有的最先进LMMs在视觉代码推理方面表现不佳,这表明需要进一步研究,以提升AI系统在视觉理解和逻辑推理之间的桥梁。

评估方法的发展:ScratchEval不仅填补了现有评估方法的空白,还为未来LMMs在视觉编程领域的发展提供了新的见解。

总的来说,这篇论文试图通过一个基于Scratch的新型评估方法,更全面和挑战性地评估LMMs的视觉编程能力,并指出了现有模型的不足和未来研究的方向。

Q: 有哪些相关研究?

A: 根据这篇论文的内容,以下是一些与ScratchEval基准测试相关的研究工作:

多模态理解评估:

- MMMU (Yue et al., 2023):一个大规模多学科多模态理解和推理的基准测试,用于专家级通用人工智能。

- MME (Fu et al., 2023):一个全面评估多模态大型语言模型的基准测试。

- MathVista (Lu et al., 2024):评估基础模型在视觉环境中的数学推理能力。

视觉编程推理能力评估:

- MMCode (Li et al., 2024):评估多模态代码大型语言模型在视觉丰富的编程问题上的表现。

- Design2Code (Si et al., 2024):评估多模态大型语言模型在从设计图生成代码方面的能力。

- Plot2Code (Wu et al., 2024):一个全面评估多模态大型语言模型在从科学图表生成代码方面的能力。

- CharMimic (Shi et al., 2024):通过图表到代码生成评估LMM的跨模态推理能力。

多模态模型和基准测试:

- MMBench (Liu et al., 2023):评估多模态模型是否是全能型选手。

- InternVL2 (Chen et al., 2024b):扩展视觉基础模型并为通用视觉语言任务对齐。

视觉编码和推理:

- Pixtral (Agrawal et al., 2024):一个12B参数的多模态模型。

- LLaVA-v1.6 (Liu et al., 2024):一个34B参数的多模态模型。

链式思考(Chain of Thought)提示策略:

- COT (Wei et al., 2023):研究表明适当的提示可以增强大型语言模型的性能。

这些相关研究涵盖了多模态模型的评估、视觉编程推理、数学推理以及多模态任务的基准测试。ScratchEval在这些领域的研究基础上,提出了一个新的基准测试,专注于评估LMMs在视觉编程任务中的视觉代码推理能力。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决评估大型多模态模型(LMMs)在视觉编程任务中的表现的问题:

构建ScratchEval基准测试:

- 基于Scratch(一种广泛用于儿童编程教育的基于块的视觉编程语言),创建了一个包含305个多项选择题的新基准测试,每个问题都包含问题描述、选项和包含Scratch脚本及其他必要信息的图片。

数据组织和分类:

- 将问题分为四个领域:数学、逻辑思考、图形感知和空间感知,以全面评估模型的视觉代码推理能力。

评估方法论:

- 设计了一个三阶段的评估过程:生成答案、提取答案和计算分数。使用准确率作为评估指标,以确定性评估模型性能。

实验设置:

- 对10个现有的开源和闭源LMMs进行评估,并研究不同的提示策略对模型性能的影响。

分析和案例研究:

- 对测试结果进行详细分析,识别模型在不同任务中的性能差异,并进行案例研究以分析模型的性能瓶颈。

提示策略研究:

- 探索了适当的提示(如Chain of Thought prompting)如何增强模型的视觉代码推理能力。

结果讨论和未来研究方向:

- 论文讨论了现有模型在视觉代码推理能力上的不足,并指出了未来研究的方向,以提升AI系统在视觉理解和逻辑推理之间的桥梁。

通过这些步骤,论文不仅提出了一个全面的评估框架来测试LMMs的视觉编程能力,而且揭示了现有模型的局限性,并为未来的研究提供了新的方向。此外,论文还讨论了ScratchEval的局限性,并强调了需要进一步研究和开发更全面的评估方法。

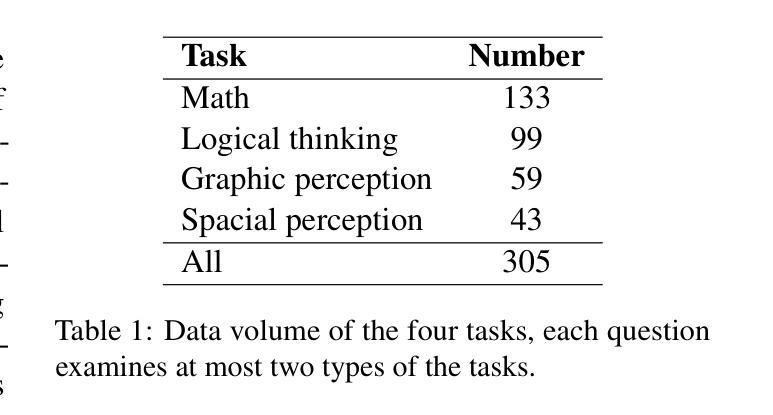

Q: 论文做了哪些实验?

A: 论文中进行的实验包括以下几个方面:

实验设置:

- 评估了总共10个大型多模态模型(LMMs),包括闭源和开源模型,如Gemini-1.5-Pro、GPT-4o、Claude3.5-Sonnet等。使用准确率作为评估指标。

性能评估:

- 在ScratchEval基准测试上评估了这些模型,包括中文和英文数据。分析了模型在数学、逻辑思考、图形感知和空间感知四个不同领域的表现。

提示策略研究:

- 研究了不同的提示策略(如原始提示、零样本链式思考(CoT)和扩展链式思考(eCoT))对模型视觉代码推理能力的影响。

案例研究:

- 对表现最佳的模型Gemini-1.5-Pro的错误案例进行了分析,以解释为什么ScratchEval对大多数模型来说是一个挑战,并揭示模型在某些领域存在的不足。

跨语言评估:

- 通过比较中文和英文数据集的结果,评估了模型在不同语言背景下的跨语言鲁棒性和适应性。

数据分布和分析:

- 根据问题内容将问题分类,并分析了每个类别中问题的具体分布。

评估方法论验证:

- 验证了所提出的评估方法的有效性,包括答案生成、提取和分数计算的三个阶段。

这些实验旨在全面评估LMMs的视觉编程推理能力,并探索提升这些模型性能的可能途径。通过这些实验,论文揭示了现有模型在视觉代码推理方面的局限性,并为未来的研究提供了方向。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

模型的跨语言能力:

- 进一步研究和改进模型在处理不同语言视觉编程问题时的跨语言能力。

模型的多步推理能力:

- 针对数学和逻辑推理任务中模型表现不佳的问题,探索如何提升模型的多步推理能力。

视觉编码器的改进:

- 研究如何改进视觉编码器,以提高模型对图像的理解和视觉代码推理能力。

提示策略的优化:

- 探索更有效的提示策略,以进一步提升模型的性能,尤其是在视觉代码推理任务中。

数据集的扩展和多样化:

- 扩展和多样化ScratchEval数据集,包括更多的视觉编程场景和更复杂的任务,以全面评估模型的能力。

模型的可解释性:

- 提高模型的可解释性,以便更好地理解模型的决策过程和推理链。

模型的泛化能力:

- 研究如何提升模型的泛化能力,使其能够处理更广泛的实际视觉编程任务。

模型的鲁棒性测试:

- 对模型进行鲁棒性测试,包括对抗性攻击和异常情况的处理能力。

结合传统编程语言评估:

- 将视觉编程评估与基于传统编程语言的评估结合起来,以获得关于模型编程能力的更全面视图。

模型训练数据的影响研究:

- 研究不同训练数据(如视觉-语言配对数据)对模型性能的影响,并探索如何利用这些数据提升模型能力。

模型的实时性能:

- 评估模型在实时视觉编程环境中的性能,特别是在需要快速响应的场景中。

多模态融合技术:

- 探索新的多模态融合技术,以改善模型对视觉信息和编程逻辑的整合能力。

这些探索点可以帮助研究者们更好地理解现有模型的局限性,并指导未来模型的开发和优化,以提高其在视觉编程任务中的表现。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为ScratchEval的新型基准测试,旨在全面评估大型多模态模型(LMMs)在视觉编程任务中的表现。以下是论文的主要内容总结:

背景与动机:

- 论文指出现有的图像到代码基准测试无法全面评估LMMs的视觉编程能力,尤其是在逻辑推理和多模态理解方面。

- 为了填补这一空白,提出了ScratchEval,一个基于Scratch(一种儿童视觉编程语言)的基准测试,要求模型同时处理视觉信息和代码结构。

ScratchEval基准测试:

- 包含305个多项选择题,分为数学、逻辑思考、图形感知和空间感知四个领域,以全面评估模型的视觉代码推理能力。

- 数据集包含中文和英文两部分,以评估模型在不同语言背景下的表现。

评估方法论:

- 评估过程包括生成答案、提取答案和计算分数三个阶段,使用准确率作为评估指标。

实验设置与分析:

- 对10个现有的开源和闭源LMMs进行评估,包括Gemini-1.5-Pro、GPT-4o、Claude3.5-Sonnet等。

- 分析了模型在不同任务中的表现,发现大多数模型在视觉代码推理方面表现不佳,尤其是数学和逻辑推理任务。

提示策略研究:

- 研究了不同的提示策略(如原始提示、零样本链式思考(CoT)和扩展链式思考(eCoT))对模型性能的影响。

- 发现CoT和eCoT技术显著提升了模型的视觉代码推理能力,但没有任何模型的整体准确率超过70%。

案例研究:

- 对表现最佳的模型Gemini-1.5-Pro的错误案例进行分析,揭示了模型在某些领域(如细微图像区分)的不足。

结论与局限性:

- 论文得出结论,尽管现有的LMMs在视觉理解方面取得了一些进展,但在视觉代码推理方面仍面临挑战。

- 论文也承认ScratchEval的局限性,如模型无法直接操作图形编程语言,以及基准测试的领域狭窄。

未来研究方向:

- 论文指出了未来研究的方向,包括改进模型的视觉编码器、提升多步推理能力、优化提示策略等。

总的来说,这篇论文通过ScratchEval基准测试,揭示了现有LMMs在视觉编程任务中的不足,并为未来的研究提供了新的方向和见解。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

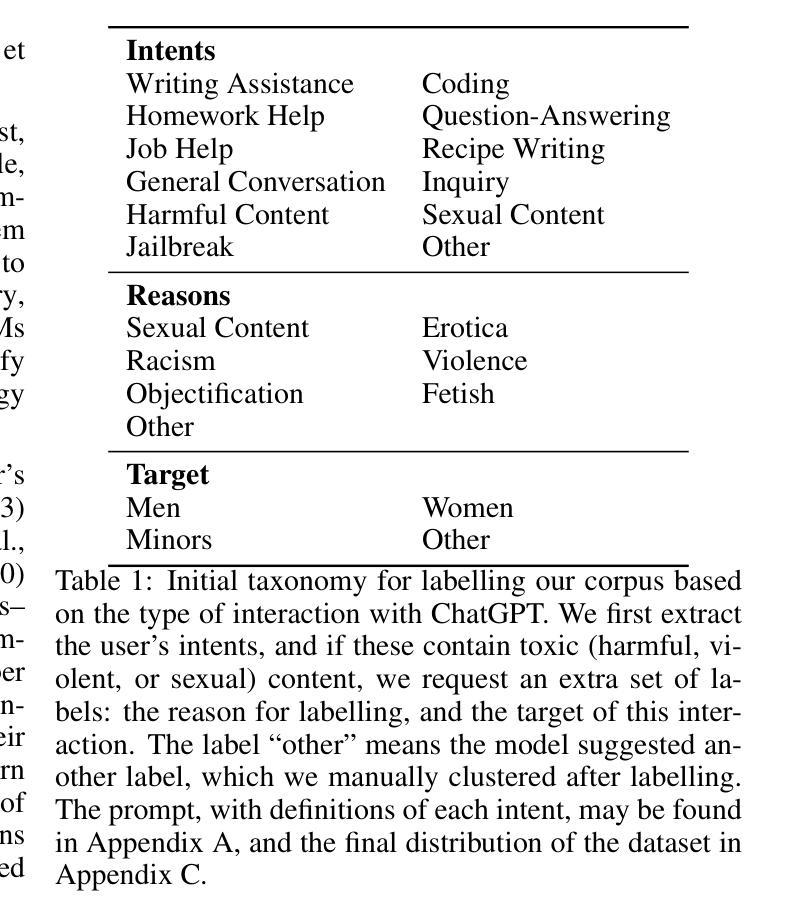

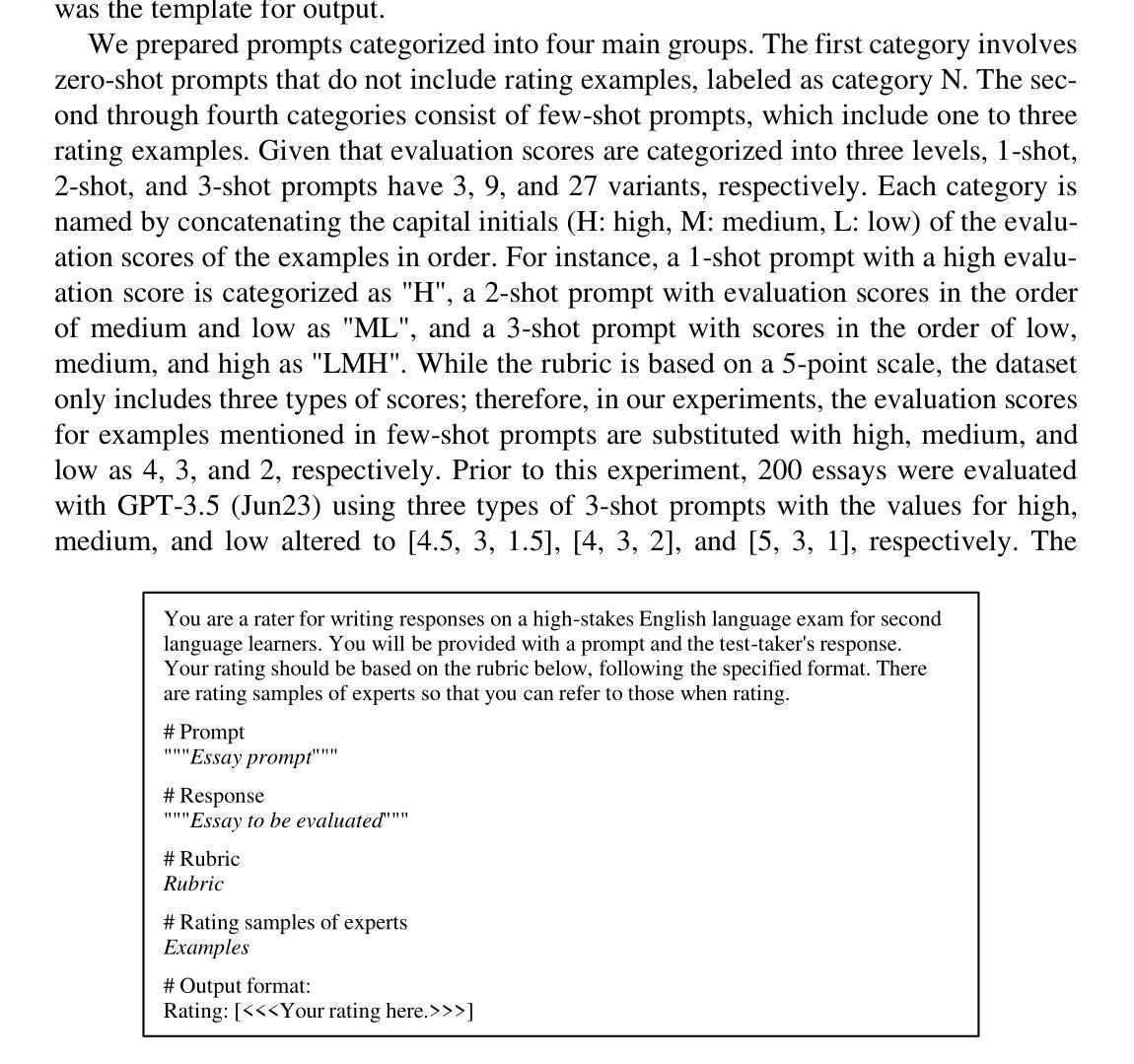

The Impact of Example Selection in Few-Shot Prompting on Automated Essay Scoring Using GPT Models

Authors:Lui Yoshida

This study investigates the impact of example selection on the performance of au-tomated essay scoring (AES) using few-shot prompting with GPT models. We evaluate the effects of the choice and order of examples in few-shot prompting on several versions of GPT-3.5 and GPT-4 models. Our experiments involve 119 prompts with different examples, and we calculate the quadratic weighted kappa (QWK) to measure the agreement between GPT and human rater scores. Regres-sion analysis is used to quantitatively assess biases introduced by example selec-tion. The results show that the impact of example selection on QWK varies across models, with GPT-3.5 being more influenced by examples than GPT-4. We also find evidence of majority label bias, which is a tendency to favor the majority la-bel among the examples, and recency bias, which is a tendency to favor the label of the most recent example, in GPT-generated essay scores and QWK, with these biases being more pronounced in GPT-3.5. Notably, careful example selection enables GPT-3.5 models to outperform some GPT-4 models. However, among the GPT models, the June 2023 version of GPT-4, which is not the latest model, exhibits the highest stability and performance. Our findings provide insights into the importance of example selection in few-shot prompting for AES, especially in GPT-3.5 models, and highlight the need for individual performance evaluations of each model, even for minor versions.

本研究旨在探讨示例选择对使用GPT模型的少样本提示技术在自动化作文评分(AES)性能上的影响。我们评估了少样本提示中示例的选择和顺序对几个版本的GPT-3.5和GPT-4模型的影响。我们的实验涉及119个带有不同示例的提示,并使用二次加权kappa(QWK)来计算GPT和人类评分者分数之间的协议。回归分析被用来定量评估示例选择所带来的偏见。结果表明,示例选择对QWK的影响在不同模型中是变化的,GPT-3.5受示例的影响比GPT-4更大。我们还发现了多数标签偏见和最近偏见的证据,即倾向于支持示例中的多数标签和最新标签的偏见,这些偏见在GPT生成的作文分数和QWK中更为突出,尤其是在GPT-3.5中。值得注意的是,通过仔细选择示例,GPT-3.5模型能够超越一些GPT-4模型的表现。然而,在GPT模型中,并非最新版本的2023年6月的GPT-4版本表现出了最高的稳定性和性能。我们的研究为AES的少样本提示中示例选择的重要性提供了见解,特别是在GPT-3.5模型中,并强调了需要对每个模型,甚至是较小版本进行个别性能评估的必要性。

论文及项目相关链接

PDF Accepted in AIED2024. This preprint has not undergone any post-submission improvements or corrections. The Version of Record of this contribution is published in Communications in Com-puter and Information Science, vol 2150, and is available online at https://doi.org/

Summary

本研究探讨了使用GPT模型进行少量提示时的示例选择对自动作文评分(AES)性能的影响。实验评估了不同GPT-3.5和GPT-4模型在少量提示中的示例选择和顺序的影响,通过二次加权卡帕(QWK)来衡量GPT和人类评分者之间的评分一致性。回归分析用于定量评估示例选择引入的偏见。研究结果表明,示例选择对QWK的影响在不同模型中有所不同,GPT-3.5受到示例的影响较大。此外,还发现存在多数标签偏见和最近偏见,这些偏见在GPT生成的作文评分和QWK中更为突出,且在GPT-3.5中更为显著。研究指出,通过谨慎的示例选择,GPT-3.5模型能够超越某些GPT-4模型的表现。然而,在GPT模型中,并非最新版本的2023年6月的GPT-4模型展现出最高的稳定性和性能。本研究强调了示例选择在GPT模型少量提示中的AES中的重要性,特别是在GPT-3.5模型中,并指出需要对每个模型进行个别性能评估。

Key Takeaways

- 研究探究了示例选择在自动化作文评分中的影响,特别是在使用GPT模型进行少量提示时的效果。

- 通过实验评估了GPT-3.5和GPT-4模型在不同示例选择和顺序下的性能差异。

- 研究发现示例选择对QWK的影响在不同模型中有所不同,GPT-3.5更易受示例影响。

- 存在多数标签偏见和最近偏见,这些偏见在GPT-3.5中的表现尤为突出。

- 谨慎的示例选择能够提升GPT-3.5模型的表现,有时甚至能超越GPT-4模型。

- GPT模型中并非最新版本表现最佳,本研究中发现2023年6月的GPT-4模型表现最为稳定与高效。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是:在使用GPT模型进行自动作文评分(Automated Essay Scoring, AES)时,通过少量样本提示(few-shot prompting)中的示例选择对评分性能的影响。具体来说,论文探讨了以下问题:

示例选择和顺序的影响:研究在少量样本提示中选择和排列示例对不同版本的GPT-3.5和GPT-4模型性能的影响。

性能提升的可能性:探讨通过仔细选择示例是否能够进一步提高AES的性能,尤其是在成本效益较高的GPT-3.5模型上。

模型间影响的一致性:评估示例选择对不同GPT模型(包括小版本)的影响是否一致,以确定是否可以将从一个模型获得的见解应用到其他模型上。

偏见的识别和量化:通过回归分析定量评估示例选择引入的偏见,如多数标签偏见(majority label bias)和最近性偏见(recency bias)。

模型性能的个体评估:强调即使对于小版本,也需要对每个模型进行单独的性能评估,因为最新模型并不总是保证最高性能。

论文通过实验和分析,旨在提供对示例选择在少量样本提示中对AES性能影响的深入理解,并为实际应用提供指导。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的研究:

**Yancey et al. (2023)**:验证了GPT-3.5和GPT-4在AES上的性能,确认了在提示中包含评分示例可以提高性能。GPT-4的表现几乎达到了专家水平。

[ \text{Yancey et al. [7]} ]

**Zhao et al. (2021)**:指出了在情感分析中,少量样本提示的准确性不稳定,并且具体示例的顺序和类型可以引起偏见,显著改变结果。这表明了在AES中可能存在类似的偏见。

[ \text{Zhao et al. [11]} ]

Wei et al. (2022) 和 **Zhang et al. (2022)**:研究了链式思考(Chain of Thought, CoT)提示,即描述解决任务的过程,可以增强性能。

[ \text{Wei et al. [12]} ]

[ \text{Zhang et al. [13]} ]Kojima et al. (2023) 和 **Sanh et al. (2022)**:探讨了零样本提示(zero-shot prompts)也可以改善LLMs的性能,例如通过添加“Let’s think step by step”可以实现CoT并显著提高任务执行性能。

[ \text{Kojima et al. [14]} ]

[ \text{Sanh et al. [15]} ]**Page (1966)**:开始了自动作文评分(AES)的研究,Project Essay Grade是最早的研究之一。

[ \text{Page [18]} ]

Landauer (2003) 和 **Attali and Burstein (2006)**:进一步发展了AES的研究,包括手动设计特征和创建标记数据,以及使用多回归分析、潜在语义分析和机器学习技术。

[ \text{Landauer [19]} ]

[ \text{Attali and Burstein [20]} ]**Uto (2021)**:回顾了基于深度神经网络的AES模型。

[ \text{Uto [26]} ]

Yang et al. (2020) 和 **Wang et al. (2022)**:研究了使用BERT等预训练语言模型进行AES的方法。

[ \text{Yang et al. [27]} ]

[ \text{Wang et al. [28]} ]

这些研究为理解LLMs在AES中的应用和性能提供了背景,并指出了在设计提示和选择示例时需要考虑的关键因素。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决研究问题:

实验设计:

- 使用TOEFL11数据集,包含八个作文提示和相应的考生作文,每个提示大约有1000到1600篇作文,总共12100篇作文,以及专家对作文的评分。

- 从每个提示中选取三篇高分、中分和低分的作文,共72篇作文进行GPT模型评分。

GPT模型选择:

- 选择了OpenAI的GPT-3.5和GPT-4模型的三个不同版本进行实验,以评估跨模型的影响。

示例和提示开发:

- 基于Yancey等人的研究,开发包含指令、作文提示、响应、评分标准、评分示例和输出格式的提示。

- 准备四类提示:零样本提示(N)、一样本提示(1-shot)、两样本提示(2-shot)和三样本提示(3-shot),并为每个类别准备了不同评分等级的变体。

评分和一致性评估:

- 使用API从六个GPT模型获取50976个评分,并将GPT评分转换为与人类评分相同的三个等级(高、中、低),计算二次加权kappa(QWK)以评估GPT评分与人类评分之间的一致性。

回归分析:

- 对GPT生成的作文评分和QWK进行回归分析,以定量评估示例选择引入的偏见,包括多数标签偏见和最近性偏见。

结果分析:

- 分析不同GPT模型在不同提示条件下的QWK平均值和标准差,以确定模型对示例选择的敏感性。

- 通过回归分析结果,识别和比较不同模型中的偏见,并讨论这些偏见对评分和QWK的影响。

讨论和结论:

- 讨论了示例选择对AES性能的影响,不同GPT模型之间的性能差异,以及偏见的存在和影响。

- 强调了对每个模型进行单独性能评估的必要性,包括小版本,并指出最新模型并不总是保证最高性能。

通过这些步骤,论文提供了关于示例选择在少量样本提示中对AES性能影响的深入见解,并为实际应用提供了指导。

Q: 论文做了哪些实验?

A: 论文中进行的实验包括以下几个方面:

数据集选择:

- 使用TOEFL11作为作文数据集,包含八个作文提示和相应的考生作文,总共12,100篇作文,以及专家的评分。

样本选择:

- 从每个提示中选取三篇高分、中分和低分的作文,共72篇作文进行GPT模型评分。

GPT模型应用:

- 应用了三个版本的GPT-3.5和GPT-4模型,以评估跨模型的影响。

提示开发:

- 基于Yancey等人的研究,开发了包含不同评分示例的提示,分为零样本提示(N)、一样本提示(1-shot)、两样本提示(2-shot)和三样本提示(3-shot)。

评分获取:

- 使用API从六个GPT模型获取50,976个评分。

一致性评估:

- 计算二次加权kappa(QWK),以评估GPT评分与人类评分之间的一致性。

回归分析:

- 对GPT生成的作文评分和QWK进行回归分析,以定量评估示例选择引入的偏见,包括多数标签偏见和最近性偏见。

结果分析:

- 分析不同GPT模型在不同提示条件下的QWK平均值和标准差,以确定模型对示例选择的敏感性。

- 识别和比较不同模型中的偏见,并讨论这些偏见对评分和QWK的影响。

这些实验步骤综合起来,旨在评估和理解在使用GPT模型进行自动作文评分时,示例选择和顺序对评分性能的影响,以及不同版本的GPT模型对这些示例选择的敏感性。通过这些实验,论文旨在提供对示例选择在少量样本提示中对AES性能影响的深入见解,并为实际应用提供指导。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和研究结果,以下是一些可以进一步探索的点:

跨模型比较:

- 探索更多不同的大型语言模型(LLMs),如Gemini、Claude、LLaMA和Vicuna,以获得跨模型的见解,并比较它们在AES任务上的表现和对示例选择的敏感性。

更大规模的数据集:

- 增加评估作文的数据集规模,以获得更详细的发现,并验证结果的一致性和普遍性。

不同特征的分析:

- 分析示例中除了评分之外的其他特征,如语言特征和文体特征,以更深入地了解这些特征如何影响评分结果。

偏见的深入研究:

- 对多数标签偏见和最近性偏见进行更深入的研究,探索这些偏见的来源和潜在的缓解策略。

模型训练和微调:

- 研究是否可以通过训练或微调模型来减少示例选择对评分性能的影响,以及提高模型对偏见的鲁棒性。

多语言和跨文化研究:

- 将研究扩展到其他语言和文化背景,以了解模型在不同语言环境中的表现和适用性。

实际应用和教育实践:

- 在实际的教育环境中部署和测试AES系统,以评估其在现实世界中的有效性和可行性。

模型解释性和透明度:

- 提高模型的解释性,使教育工作者和学生能够更好地理解评分背后的逻辑和依据。

评分标准的优化:

- 研究不同的评分标准和方法,以找到最适合自动评分任务的标准,并提高评分的准确性和一致性。

交互式评分系统:

- 开发交互式评分系统,允许用户与模型进行交互,提供反馈,并根据反馈调整评分结果。

这些进一步探索的点可以帮助研究者更全面地理解自动作文评分系统的潜力和局限性,并推动该领域的研究和应用发展。

Q: 总结一下论文的主要内容

A: 这篇论文主要研究了在使用GPT模型进行自动作文评分(AES)时,少量样本提示(few-shot prompting)中示例选择对评分性能的影响。以下是论文的主要内容总结:

研究背景:

- 大型语言模型(LLMs)在教育领域,尤其是自动作文评分(AES)中显示出巨大潜力。

- 少量样本学习是一种提高LLMs性能的强大方法,但示例的选择和顺序可能会引入偏见。

研究目的:

- 评估在少量样本提示中选择和顺序的示例对不同版本的GPT-3.5和GPT-4模型性能的影响。

- 使用二次加权kappa(QWK)衡量GPT评分与人类评分员之间的一致性,并进行回归分析以定量评估示例选择引入的偏见。

实验设计:

- 使用TOEFL11数据集,包含12100篇作文和专家评分。

- 从每个提示中选取三篇不同评分等级的作文,共72篇作文进行评分。

- 应用六个GPT模型(三个版本的GPT-3.5和GPT-4)进行评分。

提示开发:

- 设计了包括零样本提示和一至三样本提示的不同类别的提示。

- 为每个类别准备了不同评分等级的变体。

结果分析:

- GPT-4 (Jun23)模型在所有类别中显示出最高的平均QWK,而GPT-3.5 (Jun23)的QWK最低。

- GPT-3.5模型比GPT-4模型更受示例选择的影响。

- 通过回归分析,发现GPT-3.5模型中存在显著的多数标签偏见和最近性偏见,而GPT-4模型主要表现出多数标签偏见。

结论与建议:

- 仔细选择示例可以提高GPT-3.5模型的性能,使其在某些情况下超过一些GPT-4模型。

- 强调了对每个模型,包括小版本,进行单独性能评估的必要性,因为最新模型并不总是表现最佳。

- 发现的偏见表明,示例选择对AES性能有显著影响,尤其是在GPT-3.5模型中。

未来研究方向:

- 探索更多LLMs,增加样本量,分析示例的其他特征,以及研究减少偏见的策略等。

论文的发现为理解和改进自动作文评分系统提供了重要见解,并强调了在实际应用中考虑示例选择的重要性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

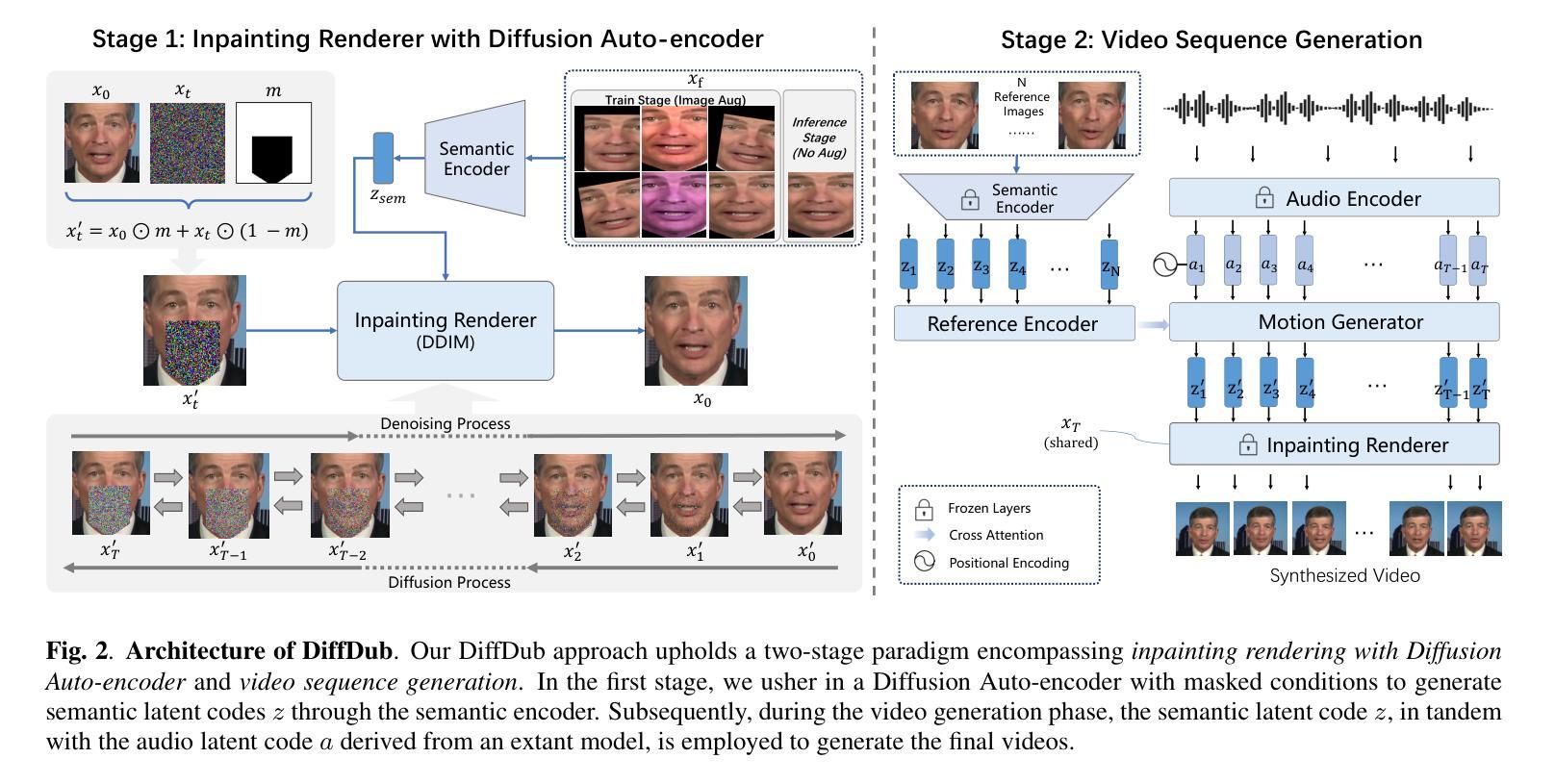

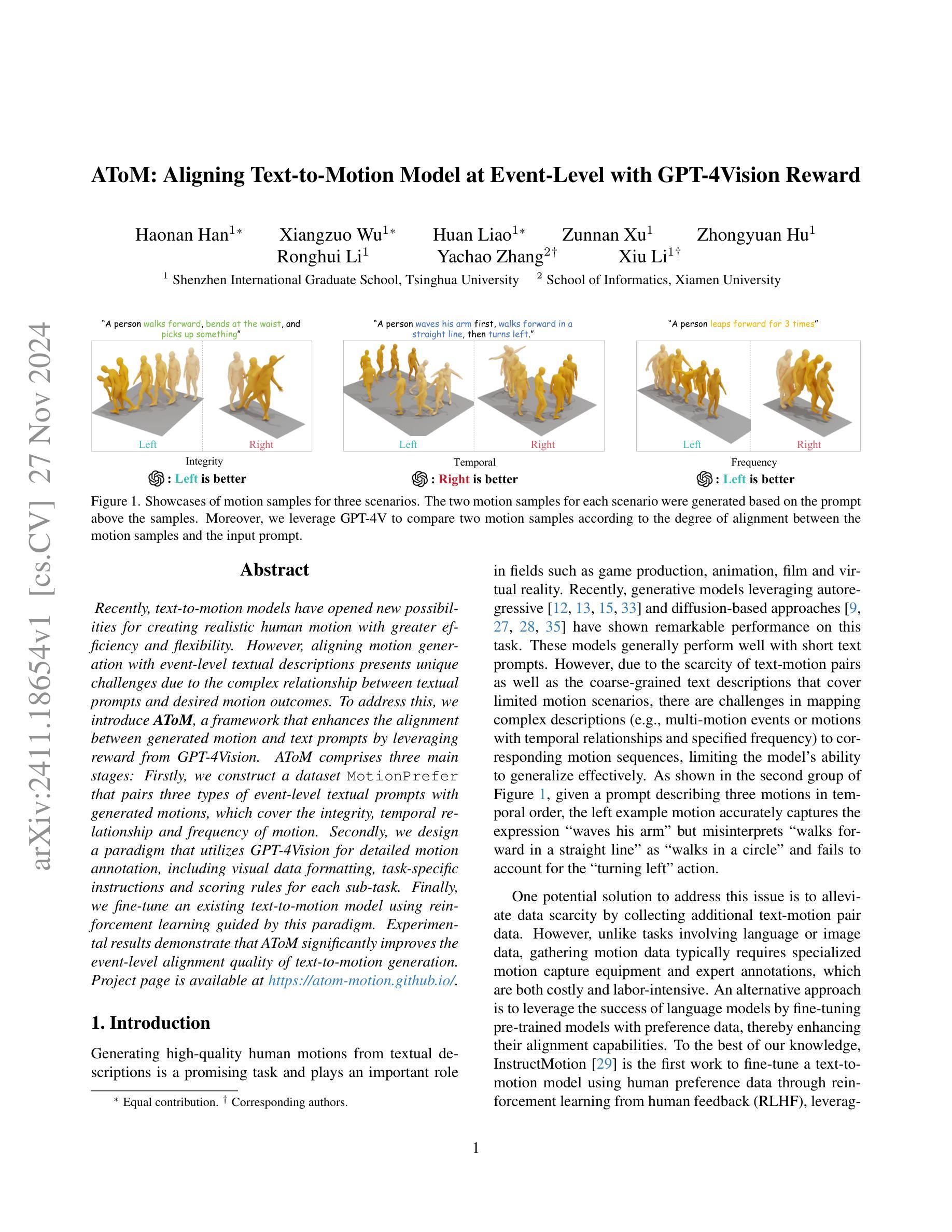

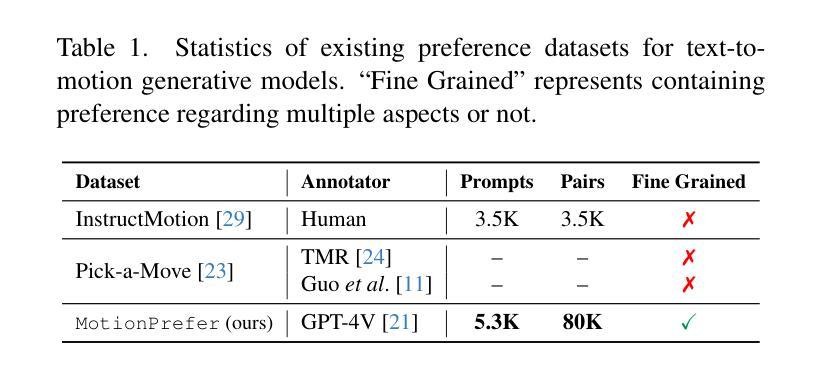

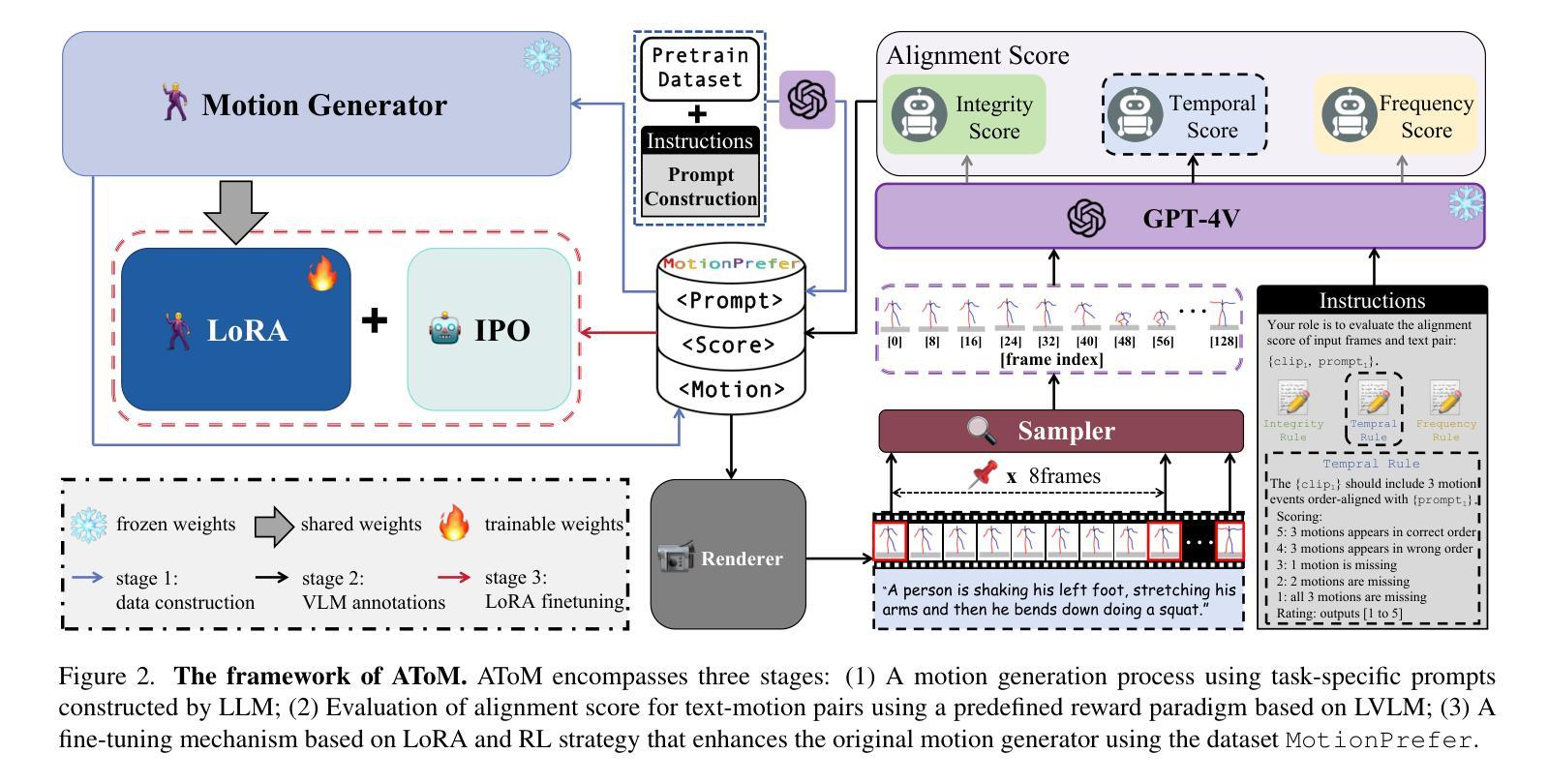

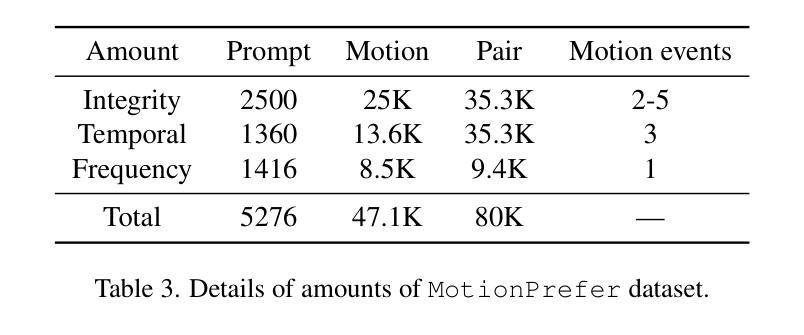

AToM: Aligning Text-to-Motion Model at Event-Level with GPT-4Vision Reward

Authors:Haonan Han, Xiangzuo Wu, Huan Liao, Zunnan Xu, Zhongyuan Hu, Ronghui Li, Yachao Zhang, Xiu Li

Recently, text-to-motion models have opened new possibilities for creating realistic human motion with greater efficiency and flexibility. However, aligning motion generation with event-level textual descriptions presents unique challenges due to the complex relationship between textual prompts and desired motion outcomes. To address this, we introduce AToM, a framework that enhances the alignment between generated motion and text prompts by leveraging reward from GPT-4Vision. AToM comprises three main stages: Firstly, we construct a dataset MotionPrefer that pairs three types of event-level textual prompts with generated motions, which cover the integrity, temporal relationship and frequency of motion. Secondly, we design a paradigm that utilizes GPT-4Vision for detailed motion annotation, including visual data formatting, task-specific instructions and scoring rules for each sub-task. Finally, we fine-tune an existing text-to-motion model using reinforcement learning guided by this paradigm. Experimental results demonstrate that AToM significantly improves the event-level alignment quality of text-to-motion generation.

最近,文本到动作模型为创建更高效、更灵活的真实人类动作开辟了新的可能性。然而,由于文本提示和期望的动作结果之间的复杂关系,使动作生成与事件级别的文本描述对齐呈现出独特的挑战。为了解决这一问题,我们引入了AToM框架,该框架通过利用GPT-4Vision的奖励来增强生成动作与文本提示之间的对齐。AToM主要包括三个阶段:首先,我们构建了一个MotionPrefer数据集,它将三种类型的事件级文本提示与生成的动作配对,涵盖了动作的完整性、时间关系和频率。其次,我们设计了一种利用GPT-4Vision进行详细动作注释的方法,包括视觉数据格式化、针对特定任务的指令以及每个子任务的评分规则。最后,我们使用由此范式引导的强化学习对现有的文本到动作模型进行微调。实验结果表明,AToM显著提高了文本到动作生成的事件级对齐质量。

论文及项目相关链接

Summary

文本至动作模型为创建更真实、更高效和更灵活的人类动作提供了新的可能性。然而,由于文本提示和期望的动作结果之间的复杂关系,使动作生成与事件级别的文本描述对齐带来了独特的挑战。为解决此问题,我们推出了AToM框架,它通过利用GPT-4Vision的奖励值增强了生成动作与文本提示之间的对齐度。AToM主要包括三个阶段:首先,我们构建了一个MotionPrefer数据集,该数据集将三种事件级别的文本提示与生成的动作配对,涵盖了动作的完整性、时间关系和频率。其次,我们设计了一种利用GPT-4Vision进行详细动作注释的方法论,包括视觉数据格式化、针对特定任务的指令和每项子任务的计分规则。最后,我们利用强化学习微调现有的文本至动作模型,由该方法论引导。实验结果表明,AToM显著提高了文本至动作生成的与事件级别的对齐质量。

Key Takeaways

- 文本至动作模型可创建更真实、高效和灵活的人类动作。

- 对齐文本提示和生成动作是一个挑战,因为存在文本与动作的复杂关系。

- AToM框架通过利用GPT-4Vision的奖励值提高了文本与动作的对齐度。

- AToM包含三个主要阶段:构建MotionPrefer数据集、设计利用GPT-4Vision进行动作详细注释的方法论以及微调现有的文本至动作模型。

- MotionPrefer数据集涵盖了动作的完整性、时间关系和频率的文本提示与动作的配对。

- GPT-4Vision用于详细动作注释,包括视觉数据格式化、任务特定指令和子任务计分规则。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是文本到动作(text-to-motion)模型在根据文本提示生成人体动作时与事件级别的文本描述对齐的挑战。具体来说,挑战存在于以下几个方面:

复杂文本提示与期望动作结果之间的复杂关系:由于文本提示和期望动作结果之间存在复杂的映射关系,模型很难准确地将复杂的文本描述(例如,包含多个动作事件或具有时间关系和指定频率的动作)映射到相应的动作序列。

数据稀缺和粗糙的文本描述:现有的文本-动作对数据稀缺,且文本描述通常是粗糙的,覆盖的动作场景有限,这限制了模型对新颖描述的泛化能力。

模型泛化能力有限:由于上述限制,模型在零样本和多事件场景下的性能表现不佳,难以处理复杂的文本提示。

为了解决这些问题,论文提出了一个名为AToM的框架,该框架通过利用GPT-4Vision提供的奖励来增强生成动作和文本提示之间的对齐度。AToM框架包含三个主要阶段:构建与事件级别的文本提示配对的数据集、设计利用GPT-4Vision进行详细动作标注的范式,以及使用这种范式指导的强化学习来微调现有的文本到动作模型。实验结果表明,AToM显著提高了文本到动作生成的事件级别对齐质量。

Q: 有哪些相关研究?

A: 论文中提到了多个与文本到动作生成(Text-to-Motion, T2M)相关的研究工作,以下是一些主要的相关研究:

Text2Action [2]:利用基于SEQ2SEQ模型的GAN将简短描述映射到人体动作。

Language2Pose [3]:引入了一种课程学习方法,用于开发文本和姿态的关节级嵌入。

Lin et al. [18]:提出了一个端到端的SEQ2SEQ模型,用于生成更真实的动画。

Ghosh et al. [10]:开发了一个分层的双流序列模型,能够处理描述多个动作的长句子。

MotionCLIP [30]:将人类动作流形与CLIP空间对齐,赋予模型零样本能力。

TEACH [5]:基于Transformer的模型,能够生成遵循复杂、顺序动作指令的真实3D人体动作。

TEMOS [36]:使用基于Transformer的VAE和额外的文本编码器进行多对象3D场景生成和编辑。

T2M-GPT [33]:结合VQ-VAE和GPT获得高质量的离散表示,实现有竞争力的动作生成结果。

MotionDiffuse [34]:基于扩散模型,允许对身体部位进行细粒度控制。

MDM [27]:无分类器的扩散模型,预测动作样本而非噪声,便于几何损失的应用。

MLD [9]:使用潜在扩散模型进一步推进动作生成。

MotionGPT [15]:开发了统一的大型动作语言模型,通过离散向量量化表示人类动作。

除了这些,论文还讨论了与人类/AI反馈对齐模型相关的研究,包括:

Reinforcement Learning from Human Feedback (RLHF) [7, 22]:用于模型对齐的技术,特别是在目标复杂或不明确的情况下。

Direct Preference Optimization (DPO) [25] 和 Slic-hf [37]:直接基于人类偏好优化模型策略的方法。

InstructMotion [29]:第一个通过人类反馈的强化学习微调文本到动作模型的工作。

RLAIF [8]:展示了另一种有前景的替代方案,即使用AI反馈进行模型对齐。

这些研究构成了文本到动作生成领域的研究基础,并为本文提出的AToM框架提供了理论和技术背景。

Q: 论文如何解决这个问题?

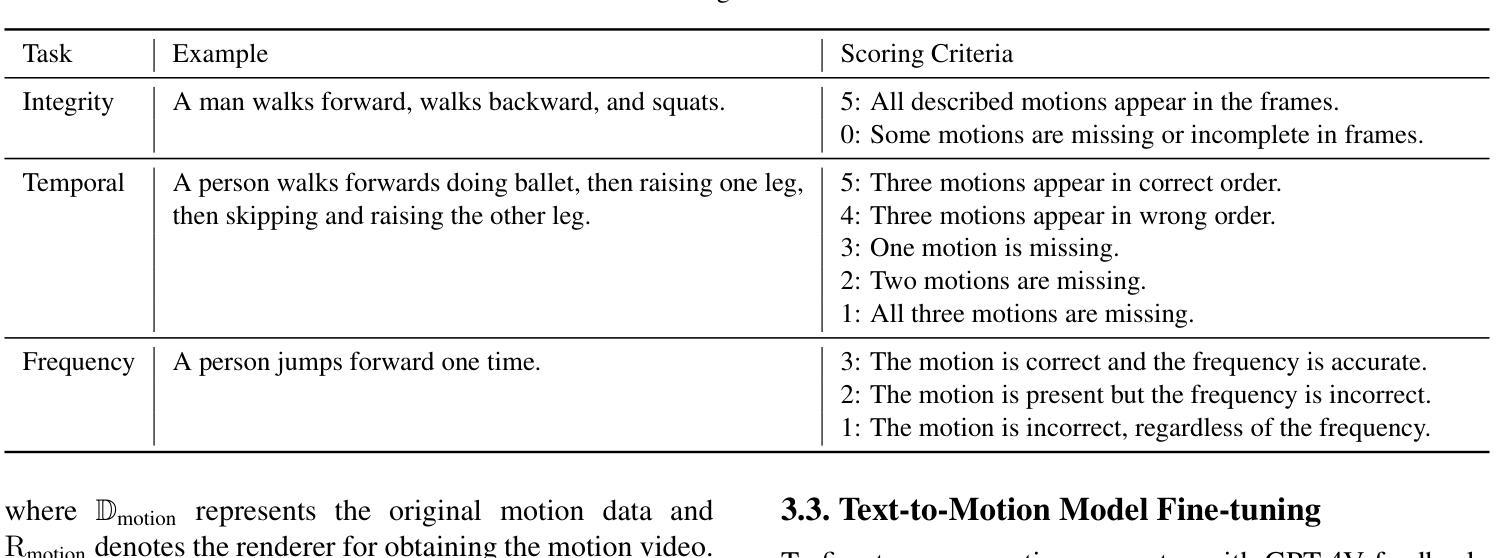

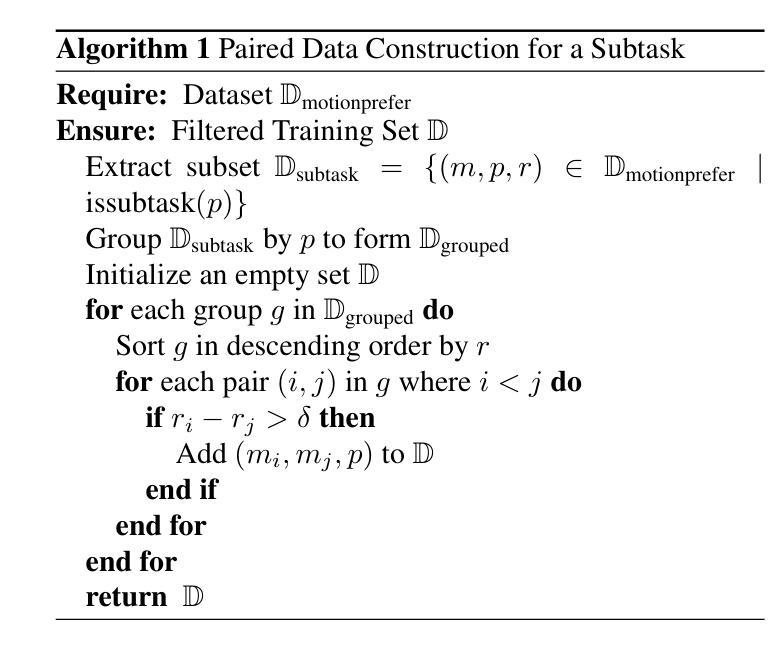

A: 论文通过提出一个名为AToM(Aligning Text-to-Motion Model at Event-Level with GPT-4Vision Reward)的框架来解决文本到动作模型与事件级别文本描述对齐的问题。AToM框架主要包含以下三个阶段:

1. 数据集构建(Dataset Construction)

- 首先,研究者们构建了一个名为MotionPrefer的数据集,该数据集将三种类型的事件级别文本提示与生成的动作配对,涵盖了动作的完整性、时间关系和频率。

- 使用GPT-4生成初始文本提示,然后输入到动作生成模型(例如MotionGPT)中,为每个文本提示生成多个不同的动作。

- 总共包含5,276个提示和47.1k个动作样本。

2. 奖励范式设计(Reward Paradigm Design)

- 将MotionGPT生成的动作序列渲染成视频,并从中采样一系列帧。

- 将采样的动作帧和对应的文本提示输入到GPT-4Vision模型中,利用该模型评估文本和动作之间的对齐得分。

- 根据给定的评分规则为每个子任务(完整性、时间顺序和频率)计算对齐得分,生成带有对齐得分的文本-动作对,构成MotionPrefer数据集。

3. 文本到动作模型微调(Text-to-Motion Model Fine-tuning)

- 使用MotionPrefer数据集和GPT-4Vision的对齐得分作为反馈,微调现有的文本到动作模型(如MotionGPT)。

- 采用LoRA(Low-Rank Adaptation)和IPO(一种强化学习策略)算法进行微调,以提高模型在特定任务上的对齐性能。

- 实验结果表明,AToM显著提高了文本到动作生成的事件级别对齐质量。

通过这三个阶段,AToM框架能够有效地利用视觉语言大模型(如GPT-4Vision)的反馈,显著提高文本到动作模型在事件级别上的对齐质量,从而在文本提示和生成动作之间建立更加精确的对应关系。

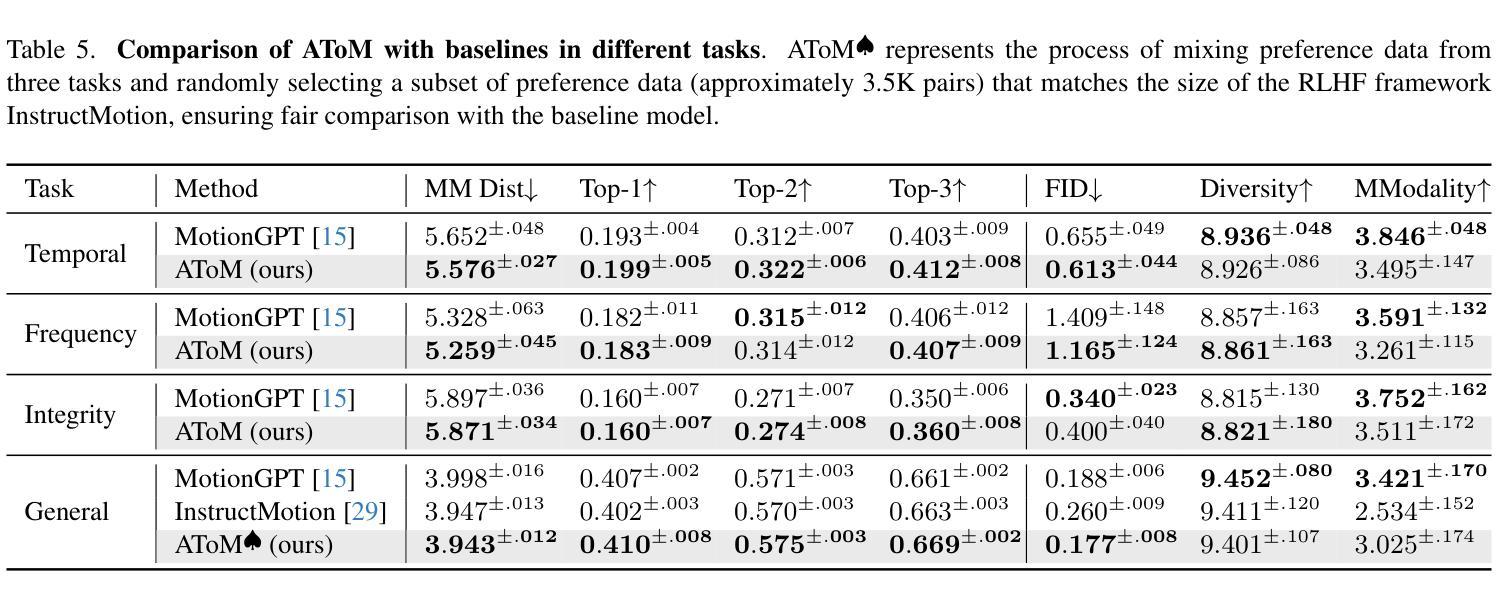

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估AToM框架的有效性,这些实验主要分为以下几个部分:

1. 实施细节(Implementation Details)

- 数据集:使用预训练的MotionGPT模型,并在MotionPrefer数据集的三个子集上进行微调,分别针对时间、完整性和频率任务。

- 实现具体内容:设置了学习率、批量大小和训练周期等超参数,并使用了AdamW优化器和余弦学习率调度器。

- 评估指标:包括多模态距离(MM-Dist)、R-Precision、FID、多样性和MModality等,用于评估动作质量和文本-动作对齐度。

2. 主要结果(Main Results)

- 定量实验:在时间、频率和完整性任务中,AToM在多个评估指标上一致优于基线模型(MotionGPT和InstructMotion),显示出更好的文本-动作对齐度、动作质量和生成真实性。

- 定性实验:通过视觉样本比较,展示了预训练模型(MotionGPT)和微调后的模型(AToM)在生成忠实度上的差异,AToM在多样化动作事件、复杂时间顺序和特定频率方面表现更优。

- 用户研究:50名参与者对AToM和MotionGPT生成的动作在时间、频率和完整性方面进行了评估,AToM在所有子任务中的胜率均高于MotionGPT。

3. 消融研究(Ablation Study)

- 动作注入形式:比较了三种不同的动作注入策略(逐帧、全图像、轨迹图像)对GPT-4V提问的影响。

- 分数过滤:研究了在偏好对构建中使用分数过滤的效果,只有评分高于3的样本被视为正面样本。

- LoRA利用:探讨了LoRA在微调中的效果,与传统微调方法相比,LoRA能够更有效地调整模型参数。

- 强化学习策略:比较了不同的强化学习策略(IPO、DPO、KTO、PPO)在生成模型微调后的表现。

- 动作序列采样步长:研究了不同帧采样间隔对对齐和质量指标的影响。

4. 额外结果(Additional Results)

- 更多定性结果:提供了额外的AToM和基线模型生成的视觉样本比较。

- 微调迭代次数:探讨了微调迭代次数对模型性能的影响。

- IPO超参数β的影响:分析了IPO策略中超参数β对对齐和质量指标的影响。

- 偏好数据集体积对模型性能的影响:研究了偏好对数量对模型性能的影响。

这些实验全面评估了AToM框架在不同方面的表现,并与现有技术进行了比较,证明了其在提高文本到动作模型对齐质量方面的有效性。

Q: 有什么可以进一步探索的点?

A: 基于论文内容和实验结果,以下是一些可以进一步探索的点:

1. 扩展数据集的多样性和复杂性

- 跨领域数据集:探索将AToM框架应用于更广泛的动作类型和场景,例如体育活动、舞蹈和日常复杂交互。

- 多语言支持:研究模型对不同语言文本提示的泛化能力,并构建多语言数据集进行训练和测试。

2. 增强模型的解释性和可视化

- 注意力机制分析:通过引入注意力机制来分析模型在处理特定文本提示时关注的区域,增强模型的解释性。

- 生成过程可视化:研究生成过程中的关键帧和动作变化,以可视化的方式展示模型是如何根据文本提示生成动作的。

3. 探索不同的强化学习策略

- 混合策略:结合人类反馈和AI反馈的优势,开发混合强化学习策略以进一步提高模型性能。

- 自适应策略:研究自适应调整强化学习策略中的参数,以动态适应不同的训练阶段和任务需求。

4. 提升模型的鲁棒性和泛化能力

- 对抗训练:通过引入对抗样本来测试和增强模型的鲁棒性,特别是在面对异常或模糊的文本提示时。

- 零样本学习:探索模型在零样本或少样本情况下的泛化能力,尤其是在未见过的动作类型或描述上。

5. 跨模态应用和集成

- 动作识别和预测:将AToM框架应用于动作识别和预测任务,评估模型在视频理解和未来动作预测方面的表现。

- 虚拟现实和游戏:将模型集成到虚拟现实和游戏引擎中,实现基于自然语言指令的实时动作生成和控制。

6. 优化和加速训练过程

- 分布式训练:研究如何利用分布式计算资源来加速模型的训练过程。

- 模型压缩和加速:探索模型压缩技术,减少模型大小和计算需求,使其更适合在资源受限的设备上运行。

7. 社会和伦理考量

- 偏见和公平性:评估和解决模型可能存在的偏见问题,确保生成的动作多样性和包容性。

- 用户隐私和数据安全:在使用真实世界数据进行训练和测试时,确保遵守数据保护法规和用户隐私。

这些探索点可以帮助研究者们更深入地理解AToM框架的潜力和局限性,并推动文本到动作生成技术的发展。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了一个名为AToM(Aligning Text-to-Motion Model at Event-Level with GPT-4Vision Reward)的框架,旨在提高文本到动作(Text-to-Motion, T2M)模型在事件级别上与文本提示对齐的质量。以下是论文的主要内容总结:

1. 问题背景

- 文本到动作模型能够根据文本提示生成人体动作,但在处理复杂的、多动作事件的文本描述时面临挑战。

- 现有模型在泛化到未见过的文本描述和多事件场景时受限,需要更精细的对齐评估。

2. AToM框架

- 数据集构建:创建了一个名为MotionPrefer的数据集,包含5.3K个文本提示和80K个动作偏好对,涵盖动作的完整性、时间关系和频率。

- 奖励范式设计:利用GPT-4Vision对生成的动作序列和文本描述之间的对齐进行评分,基于给定的评分规则计算对齐得分。

- 模型微调:使用MotionPrefer数据集和GPT-4Vision的对齐得分作为反馈,通过LoRA和IPO强化学习策略微调现有的文本到动作模型。

3. 实验结果

- 定量实验:AToM在多个评估指标上优于基线模型,显示出更好的文本-动作对齐度、动作质量和生成真实性。

- 定性实验:通过视觉样本比较,展示了AToM在生成忠实度上的优势。

- 用户研究:AToM在所有子任务中的用户评估胜率均高于基线模型。

4. 消融研究

- 探讨了不同的动作注入策略、分数过滤、LoRA利用和强化学习策略对模型性能的影响。

5. 结论

- AToM框架有效地利用视觉语言大模型的反馈,显著提高了文本到动作生成的事件级别对齐质量,为文本提示和生成动作之间建立了更精确的对应关系。

这篇论文通过提出一个新的框架,解决了文本到动作模型在复杂文本描述下对齐质量不足的问题,并展示了通过利用先进的视觉语言模型进行微调可以显著提升模型性能。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Dspy-based Neural-Symbolic Pipeline to Enhance Spatial Reasoning in LLMs

Authors:Rong Wang, Kun Sun, Jonas Kuhn

Large Language Models (LLMs) have demonstrated remarkable capabilities across various tasks, yet they often struggle with spatial reasoning. This paper presents a novel neural-symbolic framework that enhances LLMs’ spatial reasoning abilities through iterative feedback between LLMs and Answer Set Programming (ASP). We evaluate our approach on two benchmark datasets: StepGame and SparQA, implementing three distinct strategies: (1) direct prompting baseline, (2) Facts+Rules prompting, and (3) DSPy-based LLM+ASP pipeline with iterative refinement. Our experimental results demonstrate that the LLM+ASP pipeline significantly outperforms baseline methods, achieving an average 82% accuracy on StepGame and 69% on SparQA, marking improvements of 40-50% and 8-15% respectively over direct prompting. The success stems from three key innovations: (1) effective separation of semantic parsing and logical reasoning through a modular pipeline, (2) iterative feedback mechanism between LLMs and ASP solvers that improves program rate, and (3) robust error handling that addresses parsing, grounding, and solving failures. Additionally, we propose Facts+Rules as a lightweight alternative that achieves comparable performance on complex SparQA dataset, while reducing computational overhead.Our analysis across different LLM architectures (Deepseek, Llama3-70B, GPT-4.0 mini) demonstrates the framework’s generalizability and provides insights into the trade-offs between implementation complexity and reasoning capability, contributing to the development of more interpretable and reliable AI systems.

大型语言模型(LLM)在各种任务中表现出了显著的能力,但在空间推理方面常常遇到困难。本文提出了一种新颖的神经符号框架,它通过迭代反馈增强LLM的空间推理能力,这种反馈存在于LLM和答案集编程(ASP)之间。我们在两个基准数据集上评估了我们的方法:StepGame和SparQA,实施了三种不同的策略:(1)直接提示基线,(2)Facts+Rules提示,以及(3)基于DSPy的LLM+ASP管道,具有迭代细化功能。我们的实验结果表明,LLM+ASP管道显著优于基线方法,在StepGame上平均准确率为82%,在SparQA上为69%,相对于直接提示分别提高了40-50%和8-15%。成功源于三个关键创新点:(1)通过模块化管道有效地分离语义解析和逻辑推理,(2)LLM和ASP求解器之间的迭代反馈机制,提高了程序执行率,(3)稳健的错误处理,解决了解析、接地和求解失败的问题。此外,我们提出了Facts+Rules作为轻量级替代方案,在复杂的SparQA数据集上实现了相当的性能,同时降低了计算开销。我们对不同的LLM架构(Deepseek、Llama3-70B、GPT-4.0 mini)的分析表明了该框架的通用性,并深入探讨了实现复杂性和推理能力之间的权衡,为开发更具可解释性和可靠性的AI系统做出了贡献。

论文及项目相关链接

Summary:

本文介绍了一种新型的神经符号框架,它通过迭代反馈机制增强了大型语言模型在空间推理方面的能力。实验表明,该框架在StepGame和SparQA两个基准数据集上的表现显著优于基线方法,平均准确率分别达到82%和69%。其成功源于模块化管道的有效分离语义解析和逻辑推理、LLMs和ASP求解器之间的迭代反馈机制,以及解决解析、接地和求解失败的稳健错误处理。此外,还提出了一种轻量级的Facts+Rules方法,在复杂的SparQA数据集上实现了良好的性能,并降低了计算开销。该框架可应用于不同的LLM架构,为开发更具解释性和可靠性的AI系统提供了见解。

Key Takeaways:

- 神经符号框架通过迭代反馈机制增强了大型语言模型的空间推理能力。

- 在StepGame和SparQA基准数据集上的实验表明,该框架显著提高了空间推理任务的准确率。

- 框架成功源于模块化管道的有效分离语义解析和逻辑推理、LLMs和ASP求解器之间的迭代反馈,以及稳健的错误处理机制。

- 提出了轻量级的Facts+Rules方法,在复杂的SparQA数据集上实现了良好的性能,并降低了计算开销。

- 该框架适用于不同的LLM架构,为AI系统的开发提供了更广泛的选择。

- 框架的贡献包括提高空间推理能力、增强模型可解释性和可靠性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是大型语言模型(Large Language Models,简称LLMs)在空间推理方面的能力不足。具体来说,论文指出LLMs虽然在多种任务上表现出色,但在处理涉及空间、物理和具身推理的任务时,由于缺乏足够的基础,往往难以表现出色。空间推理是人类认知功能的一个重要部分,它使得人们能够在二维或三维空间中概念化和预测对象的运动和相互作用。为了使LLMs接近通用人工智能(Artificial General Intelligence,简称AGI),它们必须具备与人类相当的空间推理能力,这不仅对LLMs自身的发展至关重要,也对基于LLMs的机器人技术、任务规划、路径规划和导航等应用至关重要。

论文中提到,空间推理包括定量和定性推理两个主要类别,LLMs在处理这些空间关系时面临重大挑战,因为它们不仅要理解场景的语义描述,还要进行复杂的多跳推理,以了解对象在空间中如何相互关联。因此,论文提出了一个新颖的神经符号框架(neural-symbolic framework),以增强LLMs的空间推理能力,并在两个基准数据集StepGame和SparQA上评估了这种方法。

Q: 有哪些相关研究?

A: 根据论文内容,以下是一些与LLMs空间推理能力提升相关的研究:

Bang et al. (2023): 这项研究强调了像ChatGPT这样的模型在演绎逻辑推理、空间推理和非文本语义推理方面的局限性。

Cohn (2023): 这项工作突出了LLMs在演绎逻辑推理、空间推理和非文本语义推理方面的限制,并强调了进一步改进空间推理的必要性。

Sharma (2023) 和 Chen et al. (2024): 这些研究强调了空间推理能力在机器人技术、任务规划、路径规划和导航等LLMs应用中的重要性。

Li et al. (2024a) 和 Yang et al. (2024): 这些研究讨论了LLMs在处理空间关系时面临的挑战,尤其是在需要多跳推理的场景中。

Mirzaee and Kordjamshidi (2022): 这项工作介绍了SparQA数据集,这是一个针对空间推理的文本问答基准,强调了模型需要理解自然语言描述的复杂空间关系,并执行多跳推理以准确回答问题。

Fang et al. (2024): 这项研究展示了通过增加外部工具来增强LLMs在需要算术、导航和知识库查找的任务上的表现。

Yang et al. (2023): 提出了一种将语言转换为逻辑的神经符号策略,以增强LLMs的空间推理能力。

Li et al. (2024a): 这项工作关注于简单的数据集(例如StepGame),并应用了一些非神经符号的方法。

Mirzaee and Kordjamshidi (2023): 这项研究尝试通过多个LLMs来探索LLMs的空间推理能力,并通过多个LLMs实施完整的反馈循环。

这些研究提供了对LLMs在空间推理方面局限性的理解,并探索了不同的方法来提升LLMs的空间推理能力。论文中提出的神经符号框架正是在这些研究的基础上,旨在通过结合神经网络和符号系统的优势来解决LLMs在空间推理方面的挑战。

Q: 论文如何解决这个问题?

A: 论文提出了一个新颖的神经符号框架(neural-symbolic framework),通过以下三种策略来增强大型语言模型(LLMs)的空间推理能力:

ASP(Answer Set Programming)基于符号推理:

- 使用ASP作为一种强大的声明式编程范式,适合于复杂推理任务,尤其是涉及知识表示和组合搜索问题的场景。

- 通过逻辑关系定义问题域中的基本事实、规则、约束和查询,利用ASP求解器自动确定满足给定条件的解决方案。

LLM + ASP 管道使用DSPy:

- 提出了一个新颖的神经符号管道,使用DSPy(Declarative Self-improving Language Programs)将LLMs与ASP结合起来。

- 该管道包括四个主要阶段:事实生成阶段、ASP精炼阶段、符号推理阶段和结果解释与评估阶段。

- 利用LLM将自然语言描述转换为符号公式和正式查询,然后迭代地精炼ASP表示,添加规则、检查一致性,并从错误消息中获取反馈。

- 使用Clingo求解器进行推理,确保通过结合LLM的能力和逻辑推理来准确和可解释的推理。

事实 + 逻辑规则:

- 提出了一种替代的神经符号方法,该方法在保持结构化知识表示的优势的同时,减少了形式逻辑编程的复杂性。

- 通过自然语言提示直接嵌入逻辑规则,使LLM能够在结构化知识表示中执行推理,而不是依赖外部逻辑求解器进行推理。

- 通过使用具有精确参数结构的谓词,指导LLM创建一致的知识表示,作为问题回答的中间基础。

这三种策略的实施,使得LLMs在空间推理任务中的表现得到了显著提升。通过实验,论文展示了这些方法在StepGame和SparQA两个基准数据集上的有效性,证明了神经符号方法在增强LLMs空间推理能力方面的潜力。此外,论文还提出了一个集成的、简单而有效的策略集,使用神经符号管道来提升LLMs的空间推理能力,这些策略展示了强大的泛化性和更广泛的适用性。

Q: 论文做了哪些实验?

A: 论文中进行了两个主要的实验来评估提出的神经符号框架在增强LLMs空间推理能力方面的效果:

实验 1: 提出的LLM + ASP方法

实验在StepGame数据集上进行了详细的实施和结果分析。StepGame是一个合成的空间问答数据集,包含需要1到10个推理步骤的问题。实验中,研究者将StepGame数据集分为两个不同的集合:清洁集和噪声集。研究者专注于清洁数据集,并且考虑到StepGame数据集的推理跳跃范围从1到10,分布在10个子集中。实验中,对于每个推理跳跃k ∈ {1, …, 10},收集了前100个数据实例,并使用准确率指标来评估结果。

实验 2: Fact + Logical rules方法

实验扩展到了SparQA数据集,这是一个比StepGame更复杂的基准测试,包含更长的句子、更多样的问题类型和复杂的推理要求。SparQA数据集基于NLVR(自然语言视觉推理)图像构建,展示各种空间排列的合成场景。实验中,研究者构建了SparQA的一个子集,包含220个示例(每种问题类型55个)用于模型推理。实验采用了与StepGame相同的管道方法:(1) 将自然语言上下文和问题转换为ASP事实;(2) 添加规则并完善ASP程序;(3) 符号推理;(4) 结果映射和评估。

实验结果表明,提出的神经符号管道在不同模型和问题类型上显示出了混合的结果。在“寻找关系”(Finding Relation, FR)问题上表现出显著的改进,准确率提高了约20%。在“寻找块”(Finding Block, FB)问题上也取得了显著的提升,尤其是在GPT 4.0模型上。然而,对于“是/否”(Yes/No, YN)问题,直接提示的表现更好,表明更简单的问题类型可能不会从神经符号方法的额外复杂性中受益。

这些实验不仅验证了神经符号方法在增强LLMs空间推理能力方面的有效性,还展示了这些方法在不同复杂度的空间推理挑战中的适应性和泛化能力。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

增强神经符号系统的鲁棒性和适应性:

- 研究如何提高系统处理不一致信息和不确定性的能力,特别是在空间关系推理中。

上下文感知知识图谱嵌入:

- 探索上下文感知知识图谱嵌入的方法,以更有效地捕获隐含的关系,如Zhu和Sun (2024)所建议的。

概率推理能力的整合:

- 将概率推理能力整合到神经符号系统中,以增强系统处理空间关系中的不确定性,如De Raedt等人 (2020)所示范的。

错误检测和自动调试机制:

- 开发错误检测和自动调试机制,以提高系统的可靠性并减少手动干预的需求,如Gu等人 (2023)所建议的。

优化模型间交互:

- 探索优化多个模型和推理组件之间的交互,涉及更复杂的协同技术,改进概率推理与符号求解器的集成,并在神经符号系统的各个阶段利用不同LLMs的优势。

提高模型的解释性和透明度:

- 研究如何增强神经符号系统的解释性和透明度,特别是在复杂的空间推理任务中。

跨领域应用:

- 将神经符号方法应用于其他复杂推理任务,如时间推理和演绎推理,以测试其在不同问题领域的适用性。

改进自然语言到逻辑程序的转换:

- 研究如何减少自然语言到逻辑程序转换过程中的错误,并提高这一转换过程的准确性和可靠性。

计算效率的优化:

- 探索如何优化神经符号系统的计算效率,特别是在需要大量迭代和复杂逻辑推理的场景中。

多模态输入的处理:

- 研究如何将神经符号系统扩展到处理多模态输入(如结合视觉和语言信息)的场景中,以增强模型对复杂情境的理解。

这些探索点可以帮助推动神经符号AI领域的发展,提高LLMs在复杂任务中的性能,并为实现更智能、可解释和高效的AI系统提供新的思路。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个神经符号框架,旨在增强大型语言模型(LLMs)在空间推理方面的能力。主要内容可以总结如下:

问题陈述:

- LLMs在空间推理任务上表现不佳,这限制了它们在需要空间、物理和具身推理的应用中的性能。

研究目标:

- 提出一个神经符号框架,通过结合LLMs和符号推理来提升空间推理能力。

方法论:

- 提出了三种策略:ASP(Answer Set Programming)符号推理、LLM + ASP管道以及事实 + 逻辑规则方法。

实验设计:

- 在两个基准数据集StepGame和SparQA上评估提出的方法。

实验结果:

- 提出的方法在StepGame数据集上实现了40-50%的准确率提升,在更复杂的SparQA数据集上实现了3-13%的准确率提升。

主要发现:

- 神经符号方法能有效提升LLMs的空间推理能力,尤其是在处理复杂空间关系和多跳推理任务时。

- “LLM + ASP”管道在寻找关系(FR)和寻找块(FB)问题上表现尤为出色。

讨论与局限性:

- 尽管神经符号方法提高了性能,但在不同问题类型上的效果并不一致,特别是在简单问题类型上可能不会受益。

- 领域敏感性和自然语言到逻辑程序转换中的错误是需要进一步解决的挑战。

未来方向:

- 增强系统的鲁棒性和适应性,优化模型间交互,提高解释性和透明度,以及探索跨领域应用。

结论:

- 该研究提出的神经符号管道显著提升了LLMs的空间推理能力,并为未来在更广泛的推理领域中的应用奠定了基础。

整体而言,这篇论文展示了通过神经符号集成方法增强LLMs空间推理能力的潜力,并指出了这一领域的未来研究方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图