⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-15 更新

Testing Correctness, Fairness, and Robustness of Speech Emotion Recognition Models

Authors:Anna Derington, Hagen Wierstorf, Ali Özkil, Florian Eyben, Felix Burkhardt, Björn W. Schuller

Machine learning models for speech emotion recognition (SER) can be trained for different tasks and are usually evaluated based on a few available datasets per task. Tasks could include arousal, valence, dominance, emotional categories, or tone of voice. Those models are mainly evaluated in terms of correlation or recall, and always show some errors in their predictions. The errors manifest themselves in model behaviour, which can be very different along different dimensions even if the same recall or correlation is achieved by the model. This paper introduces a testing framework to investigate behaviour of speech emotion recognition models, by requiring different metrics to reach a certain threshold in order to pass a test. The test metrics can be grouped in terms of correctness, fairness, and robustness. It also provides a method for automatically specifying test thresholds for fairness tests, based on the datasets used, and recommendations on how to select the remaining test thresholds. Nine different transformer based models, an xLSTM based model and a convolutional baseline model are tested for arousal, valence, dominance, and emotional categories. The test results highlight, that models with high correlation or recall might rely on shortcuts – such as text sentiment –, and differ in terms of fairness.

语音情绪识别(SER)的机器学习模型可以针对不同的任务进行训练,通常是根据每个任务的可用数据集进行评估。任务包括兴奋度、价值、支配地位、情感类别或语调等。这些模型主要以相关性或召回率进行评估,在预测中总会存在一些错误。这些错误体现在模型的行为上,即使在实现相同的召回率或相关性时,不同维度的行为也可能存在很大差异。本文引入了一个测试框架,通过要求达到某个阈值的多个指标才能通过测试,以研究语音情绪识别模型的行为。测试指标可分为正确性、公平性和稳健性。它还提供了一种基于所用数据集自动指定公平测试阈值的方法,以及如何选择其余测试阈值的建议。对九种不同的基于Transformer的模型、一种基于xLSTM的模型和一种卷积基准模型进行了兴奋度、价值、支配地位和情绪类别的测试。测试结果强调,高相关性或召回率的模型可能会依赖捷径(如文本情感),并且在公平性方面存在差异。

论文及项目相关链接

Summary

本文介绍了一个测试框架,用于评估语音情感识别模型的行为。该框架通过要求不同的指标达到特定阈值以通过测试,以探究模型的行为特点。测试指标可分为正确性、公平性和稳健性。文章还提供了一种基于数据集自动指定公平性测试阈值的方法,并给出了如何选择其他测试阈值的建议。通过对不同模型的测试,发现高相关性或召回率的模型可能存在依赖捷径(如文本情感)的问题,并且在公平性方面存在差异。

Key Takeaways

- 机器学习任务包括情感激发、情感价值、情感支配力和情绪类别等,用于训练语音情感识别模型。

- 模型评估主要基于相关性和召回率,但在预测中总会存在误差。

- 本文提出了一个测试框架来探究语音情感识别模型的行为特性,涵盖正确性、公平性和稳健性三个方面的测试指标。

- 文章提供了一种基于数据集自动指定公平性测试阈值的方法。

- 测试结果显示,高相关性和召回率的模型可能依赖某些捷径(如文本情感),在公平性方面存在差异。

- 文章测试了九种不同的基于转换器的模型、一种基于xLSTM的模型和一种基于卷积的基线模型。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个测试框架,旨在评估和调查语音情感识别(Speech Emotion Recognition, SER)模型在正确性(correctness)、公平性(fairness)和鲁棒性(robustness)方面的行为。具体来说,论文试图解决的问题包括:

模型行为和属性的差异:即使两个模型在某个任务上显示出相同的准确率或召回率,它们的行为和属性可能因开发流程的不完全指定而有很大差异,这可能导致模型包含错误的相关性或学习到的捷径。

模型评估的多维度:传统的评估方法主要关注模型的准确率或召回率,但这些指标无法全面反映模型在不同维度上的表现。论文提出通过多种度量方式来更细致地理解模型的行为。

模型的公平性和偏差:在机器学习模型的应用中,理解模型的公平性、鲁棒性和潜在偏差是非常重要的。当前的SER社区很少关注公平性问题,论文提出了一系列测试来评估模型是否对某些属性存在偏见。

模型的鲁棒性:鲁棒性是指模型在面对输入数据的扰动时保持性能的能力。对于非恶意应用场景,评估模型对噪声等扰动的鲁棒性是必要的。

模型测试的通用性:论文提出的测试框架旨在包含普遍适用的黑盒测试,不依赖于模型架构,以便于在不同模型和应用中进行评估。

综上所述,论文试图提供一个全面的测试框架,以评估和改进SER模型在实际应用中的正确性、公平性和鲁棒性,从而提高模型的可信度和实用性。

Q: 有哪些相关研究?

A: 根据论文内容,以下是一些与提出的测试框架相关的研究:

基准测试和评估:

- [1] J. Thiyagalingam et al., “Scientific machine learning benchmarks,” Nature Reviews Physics, vol. 4, no. 6, pp. 413–420, 2022.

- [11] B. Schuller et al., “Affective and behavioural computing: Lessons learnt from the first computational paralinguistics challenge,” Computer Speech & Language, vol. 53, pp. 156–180, 2019.

多数据集基准测试:

- [12] N. Scheidwasser-Clow et al., “Serab: A multi-lingual benchmark for speech emotion recognition,” in ICASSP 2022 - 2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2022, pp. 7697–7701.

模型鲁棒性和数据增强:

- [13] M. Jaiswal and E. M. Provost, “Best practices for noise-based augmentation to improve the performance of emotion recognition ”in the wild”,” arXiv preprint arXiv:2104.08806, 2021.

模型依赖于文本情感的评估:

- [14] A. Triantafyllopoulos et al., “Probing speech emotion recognition transformers for linguistic knowledge,” in Interspeech 2022, Incheon, Korea, 18-22 September 2022.

公平性和偏见:

- [15] M. Schmitz et al., “Bias and fairness on multimodal emotion detection algorithms,” arXiv preprint arXiv:2205.08383, 2022.

- [16] R. K. Bellamy et al., “Ai fairness 360: An extensible toolkit for detecting, understanding, and mitigating unwanted algorithmic bias,” arXiv preprint arXiv:1810.01943, 2018.

自监督学习模型:

- [17] Q. Kong et al., “Panns: Large-scale pretrained audio neural networks for audio pattern recognition,” IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 28, pp. 2880–2894, 2020.

- [18] W.-N. Hsu et al., “Hubert: Self-supervised speech representation learning by masked prediction of hidden units,” IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 29, pp. 3451–3460, 2021.

- [19] A. Baevski et al., “Wav2vec 2.0: A framework for self-supervised learning of speech representations,” in Advances in Neural Information Processing Systems (NeurIPS), Vancouver, BC, Canada, 2020, pp. 12449–12460.

- [20] S. Chen et al., “Wavlm: Large-scale self-supervised pretraining for full stack speech processing,” IEEE Journal of Selected Topics in Signal Processing, vol. 16, no. 6, pp. 1505–1518, 2022.

语音情感识别模型:

- [22] M. Beck et al., “Xlstm: Extended long short-term memory,” arXiv preprint arXiv:2405.04517, 2024.

这些研究涵盖了语音情感识别的基准测试、模型鲁棒性、偏见和公平性以及自监督学习模型的发展,与本文提出的测试框架直接相关。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决语音情感识别(SER)模型的正确性、公平性和鲁棒性评估问题:

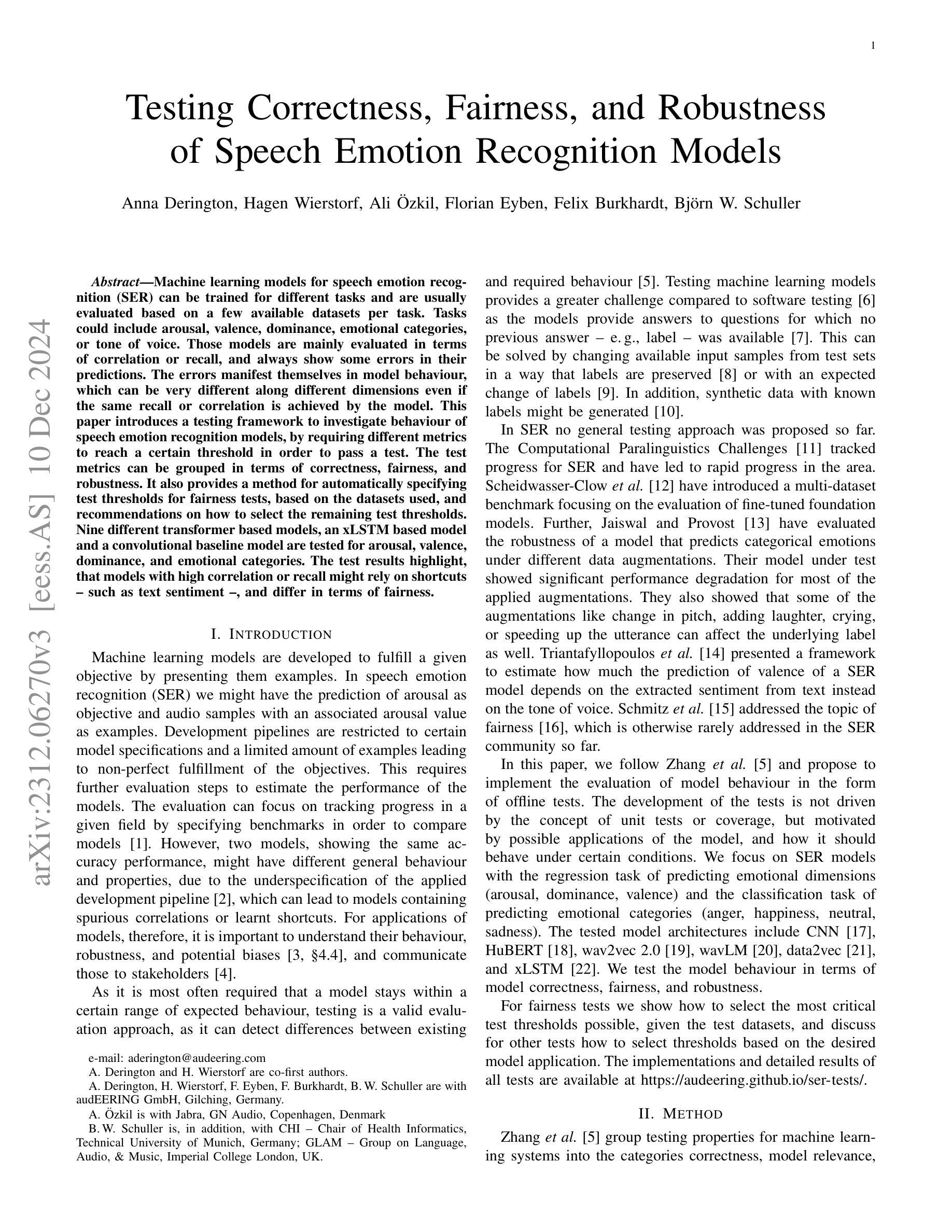

提出测试框架:作者提出了一个测试框架,要求模型在多个不同的度量标准上达到一定的阈值才能通过测试。这些测试度量标准被分为三个主要类别:正确性、公平性和鲁棒性。

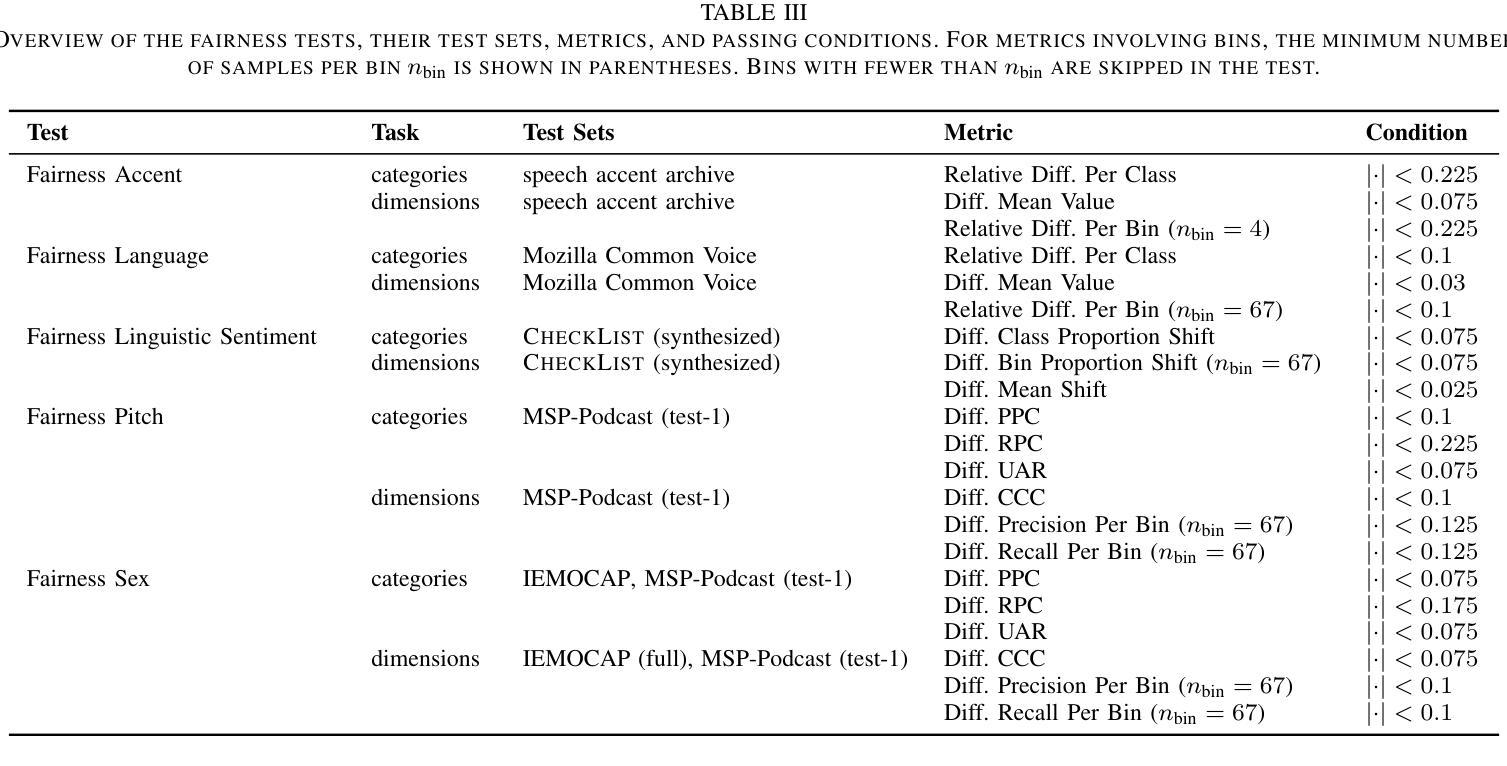

定义测试度量和阈值:对于每个测试类别,论文提出了一系列评估指标,并为这些指标设定了通过测试所需的阈值。例如,正确性测试可能包括准确率、召回率等指标,而公平性测试可能关注模型是否对某些属性(如性别、语言)存在偏见。

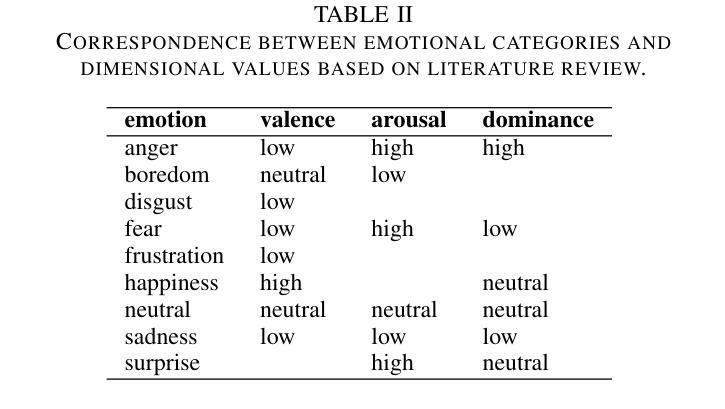

自动设定公平性测试阈值:论文提供了一种基于数据集自动设定公平性测试阈值的方法,这些阈值基于数值模拟,与应用无关。通过模拟随机模型的行为,作者能够为测试设定合理的阈值。

测试多种模型:作者测试了九种基于变换器的模型、一种基于xLSTM的模型和一种卷积基线模型,这些模型用于预测激发度、优势度、愉悦度和情绪类别。

结果分析:通过比较不同模型在测试中的表现,论文揭示了即使高相关性或高召回率的模型也可能依赖于捷径(如文本情感),并且在公平性方面存在差异。

提供测试结果和建议:论文不仅提供了测试结果,还提供了如何选择剩余测试阈值的建议,以及如何根据模型应用的需求调整这些阈值。

公开测试实现和结果:为了促进进一步的研究和模型改进,作者公开了所有测试的实现和详细结果。

通过这种方法,论文不仅评估了模型的性能,还提供了对模型行为的深入理解,并指出了模型可能存在的偏差和鲁棒性问题,从而为改进SER模型提供了指导。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来测试和评估语音情感识别(SER)模型在正确性、公平性和鲁棒性方面的表现。具体的实验包括:

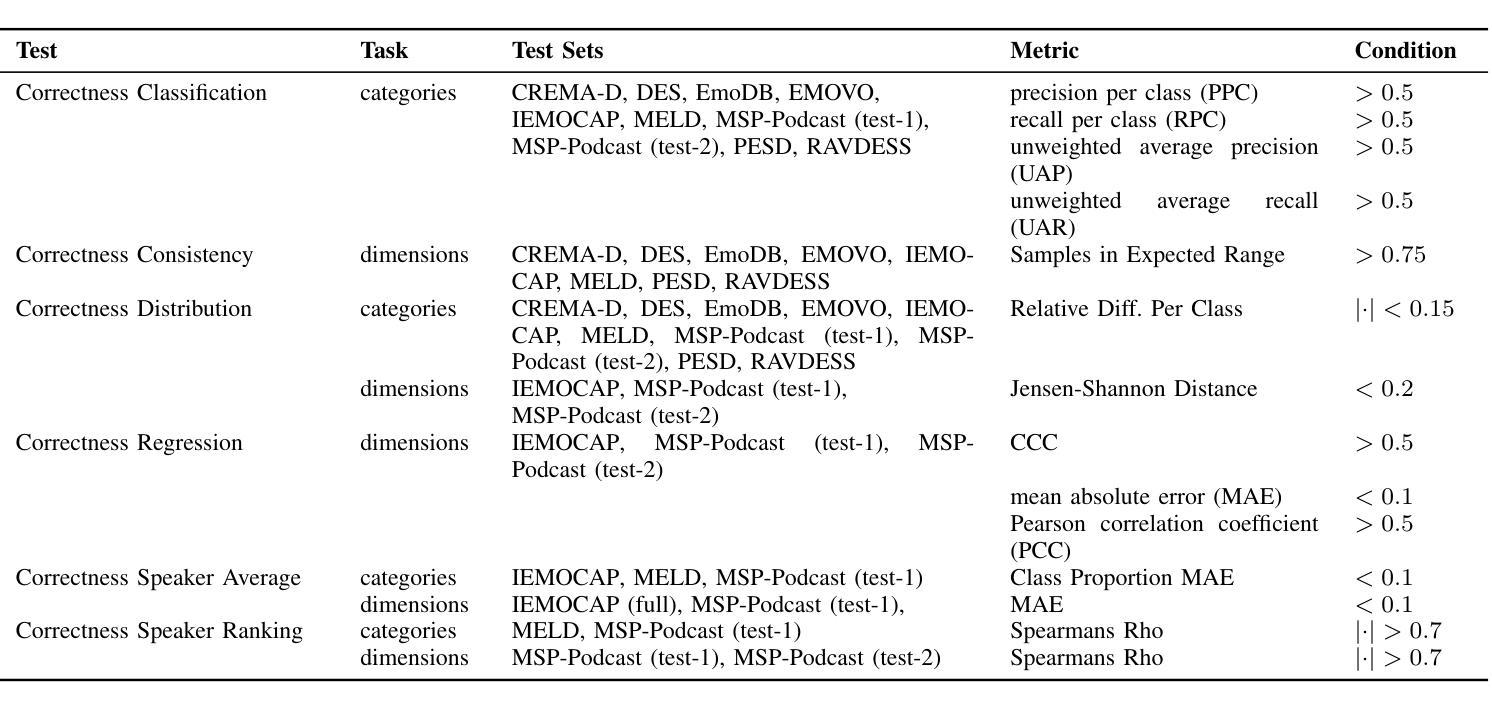

数据集准备:选择了多个情感数据集,并对这些数据集进行了预处理,包括将类别标签映射到标准化的命名集合,对维度标签进行最小-最大缩放,以及在需要时定义测试数据集的拆分。

正确性测试:

- 分类和回归测试:使用标准的准确性指标,如精确度、召回率和皮尔逊相关系数等,来评估模型预测的准确性。

- 一致性测试:检查模型在维度任务上的预测是否与具有特定情感类别标签的样本的预期结果一致。

- 分布测试:确保模型预测的分布与真实分布相似。

- 说话人平均值测试:检查模型对每个说话人平均情感值的估计是否接近真实值。

- 说话人排名测试:基于平均值对说话人进行排名,并检查这种排名的正确性。

公平性测试:

- 群体公平性测试:评估模型是否对特定属性(如口音、语言、情感、音高和性别)存在偏见。

- 统计奇偶校验测试:检查模型输出的分布是否独立于受保护的群体。

- 等化几率测试:确保不同群体在真正例和假正例的比率上相等。

鲁棒性测试:

- 背景噪声测试:评估模型对各种背景噪声(如喧哗声、环境噪声、音乐和人工噪声)的鲁棒性。

- 低质量电话测试:模拟低质量电话连接中的音频,评估模型的鲁棒性。

- 录音条件测试:比较不同录音设备下的模型预测。

- 模拟录音条件测试:使用不同位置和房间的脉冲响应来模拟录音条件,并评估模型的鲁棒性。

- 小变化测试:对音频进行微小的变换(如添加音调、裁剪、增益变化等),并检查模型预测的变化。

- 频谱倾斜测试:模拟频谱中低频或高频的提升,并评估模型的鲁棒性。

模型测试:测试了11种不同的模型,包括基于变换器的模型、基于xLSTM的模型和卷积基线模型。这些模型在MSP-Podcast数据集上进行了微调,并在上述测试中进行了评估。

结果分析:对测试结果进行了详细分析,比较了不同模型在正确性、公平性和鲁棒性方面的表现,并讨论了模型可能依赖的捷径(例如,文本情感)。

这些实验提供了对模型行为的全面评估,并揭示了模型在实际应用中可能遇到的潜在问题。通过这些测试,研究者可以更好地理解模型的性能,并指导未来的模型改进。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

改进测试框架:

- 开发更多的测试用例,以覆盖SER模型在特定应用场景下的行为。

- 探索结合白盒和灰盒测试方法,以深入了解模型内部机制和决策过程。

优化公平性测试阈值设定方法:

- 研究不同的模拟方法和分布,以更准确地设定公平性测试的阈值。

- 探索基于实际应用数据的自适应阈值设定方法。

鲁棒性增强技术:

- 研究新的数据增强技术和训练策略,以提高模型对各种扰动的鲁棒性。

- 探索使用对抗训练和知识蒸馏等技术来提高模型的鲁棒性。

模型解释性和透明度:

- 开发和评估解释性工具,以帮助理解模型的决策过程和潜在偏差。

- 研究如何向利益相关者传达模型的行为、鲁棒性和潜在偏差。

跨领域和跨语言的模型泛化能力:

- 评估和提高模型在不同领域和语言数据上的泛化能力。

- 探索多语言和跨文化情感识别的挑战和解决方案。

实时和低资源环境下的模型应用:

- 研究在实时系统和资源受限设备上部署SER模型的挑战。

- 开发轻量级和高效的模型架构,以适应移动和嵌入式设备。

模型的伦理和社会影响:

- 探讨SER模型在不同应用中的伦理问题和社会影响。

- 研究如何设计和使用模型,以确保公平性、隐私保护和社会责任感。

多模态情感识别:

- 探索结合语音、文本、视觉等多种模态信息的情感识别方法。

- 研究多模态数据融合技术和模型架构,以提高情感识别的准确性和鲁棒性。

模型的可扩展性和灵活性:

- 研究如何设计可扩展和灵活的模型,以适应不断变化的情感识别任务和需求。

- 开发易于调整和定制的模型,以满足特定应用的特定需求。

这些探索点可以帮助研究者和开发者更好地理解和改进SER模型,提高其在实际应用中的有效性和可靠性。

Q: 总结一下论文的主要内容

A: 本文提出了一个全面的测试框架,用以评估和调查语音情感识别(SER)模型在正确性、公平性和鲁棒性方面的表现。以下是论文的主要内容总结:

问题阐述:

- SER模型通常基于有限的数据集进行评估,可能包含错误相关性或学习到的捷径,导致模型行为和属性存在差异。

- 需要一种测试方法来检测模型在预期行为范围内的差异,特别是在实际应用中。

测试框架介绍:

- 引入了一个测试框架,要求模型在多个度量标准上达到特定阈值才能通过测试。

- 测试度量分为三类:正确性、公平性和鲁棒性。

测试度量和阈值设定:

- 为每个测试类别提出了一系列评估指标,并为这些指标设定了通过测试所需的阈值。

- 提供了一种基于数据集自动设定公平性测试阈值的方法。

实验设计:

- 测试了包括变换器模型、xLSTM模型和卷积基线模型在内的九种不同的SER模型。

- 使用多个情感数据集对模型进行了评估,覆盖了激发度、优势度、愉悦度和情绪类别等任务。

结果分析:

- 测试结果揭示了即使高相关性或高召回率的模型也可能依赖于捷径,如文本情感,并在公平性方面存在差异。

- 模型在正确性、公平性和鲁棒性方面的表现存在显著差异,表明需要进一步改进。

结论和建议:

- 提出的测试框架有助于更全面地评估SER模型,揭示了模型可能存在的偏差和鲁棒性问题。

- 建议根据模型应用的需求调整测试阈值,并使用这些测试作为理解模型行为的工具。

未来工作:

- 提出了进一步探索的方向,包括改进测试框架、优化公平性测试阈值设定方法、研究鲁棒性增强技术等。

总体而言,论文通过提出的测试框架,为SER模型的正确性、公平性和鲁棒性的评估提供了一种系统的方法,并通过实验验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Focal Inferential Infusion Coupled with Tractable Density Discrimination for Implicit Hate Detection

Authors:Sarah Masud, Ashutosh Bajpai, Tanmoy Chakraborty

Although pretrained large language models (PLMs) have achieved state-of-the-art on many natural language processing (NLP) tasks, they lack an understanding of subtle expressions of implicit hate speech. Various attempts have been made to enhance the detection of implicit hate by augmenting external context or enforcing label separation via distance-based metrics. Combining these two approaches, we introduce FiADD, a novel Focused Inferential Adaptive Density Discrimination framework. FiADD enhances the PLM finetuning pipeline by bringing the surface form/meaning of an implicit hate speech closer to its implied form while increasing the inter-cluster distance among various labels. We test FiADD on three implicit hate datasets and observe significant improvement in the two-way and three-way hate classification tasks. We further experiment on the generalizability of FiADD on three other tasks, detecting sarcasm, irony, and stance, in which surface and implied forms differ, and observe similar performance improvements. Consequently, we analyze the generated latent space to understand its evolution under FiADD, which corroborates the advantage of employing FiADD for implicit hate speech detection.

虽然预训练的大型语言模型(PLM)在许多自然语言处理(NLP)任务上达到了最新技术水平,但它们对微妙的隐含仇恨言论缺乏理解。为了增强对隐含仇恨的检测,已经进行了各种尝试,例如通过扩充外部上下文或执行基于距离的指标强制标签分离。结合这两种方法,我们引入了FiADD,这是一个新型的有针对性的推断自适应密度判别框架。FiADD通过拉近隐含仇恨言论的表面形式/意义与其隐含形式之间的距离,同时增加不同标签之间的簇间距离,从而增强了PLM微调管道。我们在三个隐含仇恨数据集上测试了FiADD,观察到双向和三方仇恨分类任务有了显著的提升。此外,我们在表面和隐含形式不同的检测讽刺、反语和立场这三个任务上进一步实验了FiADD的通用性,并观察到类似的性能改进。因此,我们分析了在FiADD作用下生成的潜在空间,了解其演变过程,这证实了使用FiADD进行隐含仇恨言论检测的优势。

论文及项目相关链接

PDF 23 pages, 6 Figures, 9 Tables. Accepted at NLE

Summary

预训练大型语言模型(PLM)在自然语言处理任务上表现卓越,但在微妙表达隐性仇恨言论方面存在理解缺陷。通过结合增强外部上下文和强化标签分离的方法,提出了FiADD,一种新型的聚焦推理自适应密度判别框架。FiADD通过拉近隐性仇恨言论的表面形式与隐含意义,同时增加不同标签间的距离,优化了PLM微调管道。在三项隐性仇恨数据集上的测试显示,FiADD在两路和三路仇恨分类任务上取得了显著改进。在检测表面和隐含形式有所不同的讽刺、反讽和立场等任务上,也表现出良好的泛化能力。对FiADD生成的潜在空间的分析证实了其在隐性仇恨言论检测中的优势。

Key Takeaways

- 预训练大型语言模型(PLM)在隐性仇恨言论理解上存在缺陷。

- FiADD框架结合了增强外部上下文和强化标签分离的方法。

- FiADD通过拉近隐性仇恨言论的表面和隐含意义优化了PLM微调过程。

- FiADD在不同类型的仇恨分类任务上取得了显著改进。

- FiADD在检测表面和隐含形式差异较大的任务(如讽刺、反讽和立场)上表现出良好的泛化能力。

- FiADD的潜在空间分析证实了其在隐性仇恨言论检测中的优势。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是预训练大型语言模型(PLMs)在理解和检测隐性仇恨言论(implicit hate speech)方面的不足。隐性仇恨言论相比于显性仇恨言论(explicit hate speech),在表面上看起来词汇和语义上更接近非仇恨/中立的陈述,因此更难以被自动检测系统识别和分类。论文中提到,尽管PLMs在许多自然语言处理(NLP)任务上取得了最先进的成果,但它们在理解隐性仇恨言论的微妙表达上存在缺陷。为了改善隐性仇恨言论的检测,论文提出了一种名为FiADD(Focused Inferential Adaptive Density Discrimination)的新框架,该框架通过结合距离度量学习和注入外部上下文的方式来提高检测性能。具体来说,FiADD的目标是将隐性仇恨言论的表面形式/含义更接近其隐含形式,并增加不同标签之间的类间距离。通过在三个隐性仇恨数据集上的测试,论文观察到了在二元和三元仇恨分类任务中的显著改进,并且进一步在其他三个任务(检测讽刺、反讽和立场)上测试了FiADD的泛化能力,也观察到了类似的性能提升。

Q: 有哪些相关研究?

A: 根据这篇论文,相关研究主要集中在以下几个方面:

隐性仇恨数据集(Implicit Hate Datasets):

- 论文通过关键词“implicit”和“implicit hate”在最新的仇恨言论语料库和ACL Anthology中搜索相关文献,发现了一些包含隐性仇恨标签的数据集,例如LatentHatred、SBIC、ISHate等。

隐性仇恨检测(Implicit Hate Detection):

- 论文提到了多种数据增强技术,例如替代、回译等,以及对抗性数据收集和LLM提示(LLM-prompting)用于增强隐性仇恨语料库和提高检测性能。

- 论文还提到了使用语言模型来增强隐性仇恨语料库和检测仇恨言论的研究,包括零样本(zero-shot)和少样本(few-shot)设置。

通过距离度量改进分类任务(Improvement in Classification Tasks via Distance-based Metrics):

- 论文回顾了使用交叉熵损失(cross-entropy loss)作为基线的方法,并指出其在类间/类内聚类方面的效果不理想。

- 论文提到了对比损失家族(contrastive loss family)和基于聚类的方法,如ADD(Adaptive Density Discrimination)或称为Magnet Loss,这些方法通过优化局部邻域内的类间距离来改善分类性能。

隐性仇恨言论的NLP建模(Modeling Implicit Hate Speech in NLP):

- 论文讨论了传统的统计模型和基于深度学习的模型在隐性仇恨言论检测中的低召回率问题,并提到了研究人员如何利用外部上下文来增加从隐性样本中获得的信息。

知识注入(Knowledge Infusions):

- 论文提到了将外部上下文以知识实体的形式注入到输入中,无论是以知识图谱(KG)元组还是维基百科摘要的形式,以及这种方法对隐性仇恨检测性能的影响。

这些相关研究为论文提出的FiADD框架提供了理论基础和技术支持。论文通过结合这些相关研究的发现,提出了一个新的方法来提高隐性仇恨言论的检测性能。

Q: 论文如何解决这个问题?

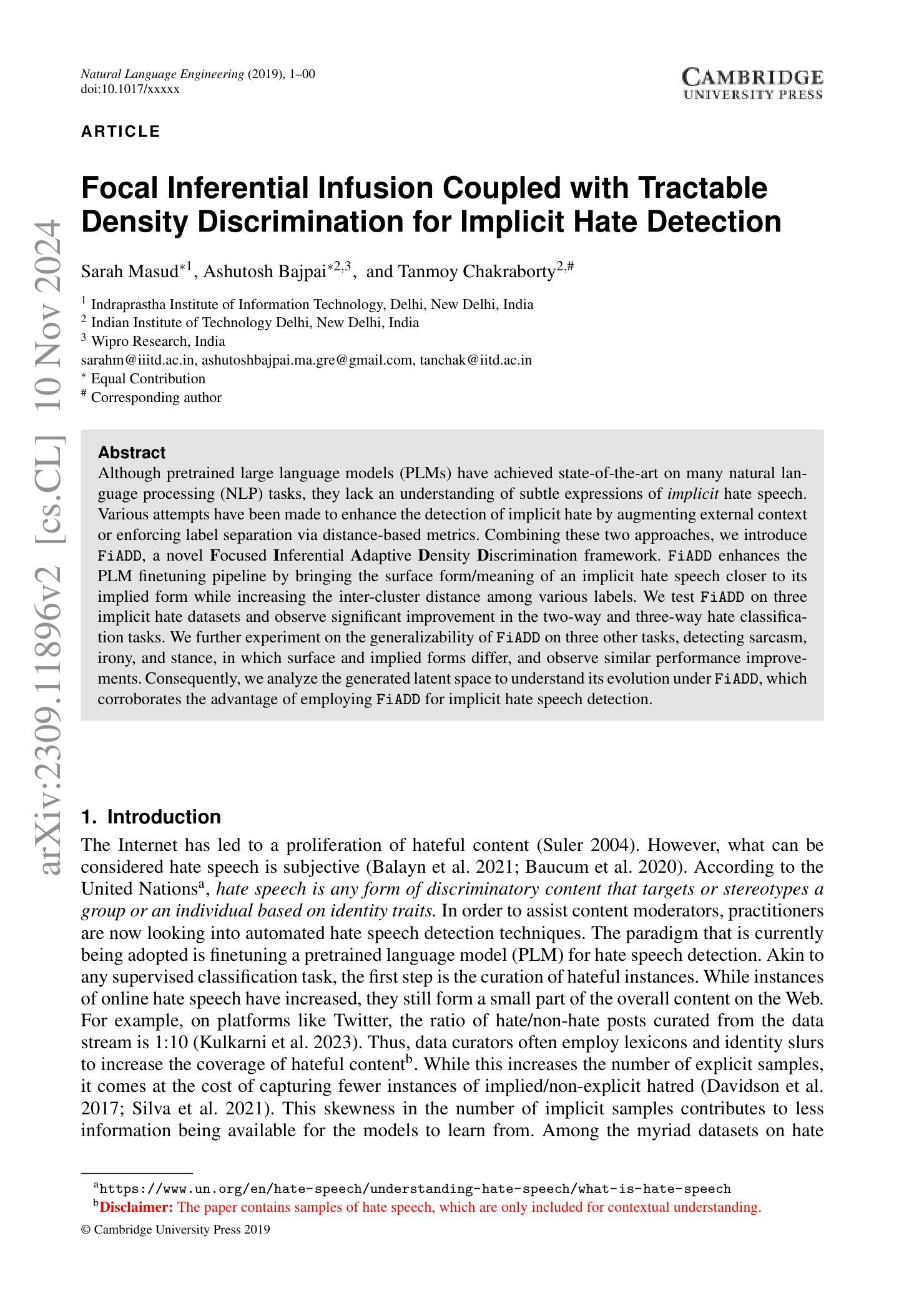

A: 论文通过提出一个名为FiADD(Focused Inferential Adaptive Density Discrimination)的框架来解决隐性仇恨言论检测的问题。FiADD框架主要通过以下方式来增强预训练大型语言模型(PLMs)在隐性仇恨言论检测中的性能:

结合距离度量学习与外部上下文注入:

- FiADD框架结合了自适应密度判别(ADD)和外部上下文注入两种方法。ADD通过在局部邻域内平衡类间相似性和变异性来优化类间距离,而外部上下文注入则通过将隐性仇恨样本与它们的隐含含义联系起来,帮助模型更好地理解和区分隐性仇恨言论。

优化局部邻域的类间距离:

- FiADD利用ADD来改善隐性仇恨和非仇恨样本之间的区域边界,这些样本在语义和词汇上相似,难以区分。

引入隐含/描述性短语:

- 为了将隐性仇恨样本的潜在含义与其表面形式拉近,FiADD引入了隐含/描述性短语,而不是直接使用知识元组或维基百科摘要,以减少输入信号中的噪声。

双重损失函数:

- FiADD框架采用双重损失函数,结合了交叉熵损失和自适应密度判别损失。这种结合使得模型在训练过程中同时关注类别分布的分离和隐性仇恨样本与其隐含含义之间的距离。

焦点权重(Focal Weight):

- FiADD引入了焦点权重的概念,对靠近分类边界的样本施加更高的惩罚,这些样本更难分类,对损失的贡献更大。

广泛的实验验证:

- 论文通过在三个隐性仇恨数据集上进行广泛的实验,验证了FiADD在二元和三元仇恨分类任务中的有效性。此外,论文还将FiADD应用于其他任务(如讽刺、反讽和立场检测)来测试其泛化能力,并观察到类似的性能提升。

潜在空间分析:

- 论文通过分析FiADD在潜在空间中的表现,证实了该方法能够将隐性仇恨样本的表面形式与其隐含形式拉近,并在类间创建更好的分离。

综上所述,FiADD框架通过结合距离度量学习和外部上下文注入,以及引入焦点权重和双重损失函数,有效地提高了PLMs在隐性仇恨言论检测中的性能。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证FiADD(Focused Inferential Adaptive Density Discrimination)框架的有效性。以下是实验的具体内容:

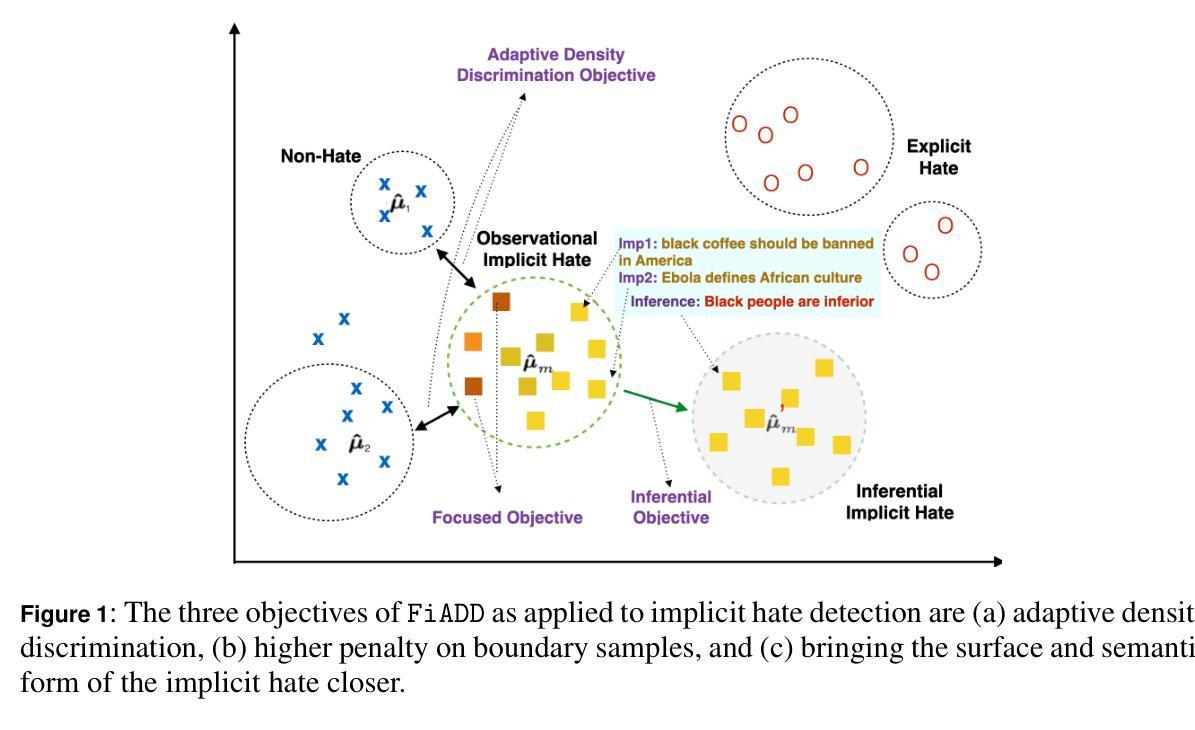

隐性仇恨分类数据集实验:

- 论文选择了三个包含隐性仇恨标签的英语数据集:LatentHatred、ImpGab和AbuseEval。这些数据集用于测试FiADD在隐性仇恨检测任务上的性能。

- 实验包括二元和三元仇恨分类任务,其中二元分类将显性仇恨和隐性仇恨合并为一个类别,三元分类则将它们分开。

泛化能力测试:

- 为了测试FiADD的泛化能力,论文将其应用于三个SemEval任务,分别是讽刺检测、反讽检测和立场检测。这些任务的表面形式和隐含意义存在差异,与隐性仇恨检测任务相似。

与不同预训练语言模型的兼容性测试:

- 论文不仅使用了BERT模型,还实验了HateBERT和XLM模型,以证明FiADD框架不仅限于特定的预训练语言模型。

与交叉熵损失的比较:

- 论文将FiADD与标准的交叉熵损失函数(CE)进行比较,以展示FiADD在隐性仇恨检测任务上的优势。

超参数调整:

- 论文对FiADD中的一些关键超参数进行了调整和测试,包括子簇的数量(k)和焦点参数(γ),以找到最佳的模型性能。

种子分析:

- 论文对不同随机种子下的模型性能进行了分析,以证明FiADD改进的普遍性。

错误分析:

- 论文对隐性仇恨样本的分类正确和错误的情况进行了错误分析,以理解FiADD如何影响隐性仇恨样本的分类。

潜在空间分析:

- 论文通过Silhouette分数来量化FiADD对潜在空间的影响,包括类间分离度和隐性仇恨样本与其隐含含义之间的距离。

这些实验全面地评估了FiADD框架在隐性仇恨检测任务上的有效性,并证明了其在不同数据集、不同任务和不同预训练语言模型上的泛化能力。通过这些实验,论文展示了FiADD在提高隐性仇恨言论检测准确性方面的潜力。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

自动化隐含意义的生成:

- 目前FiADD框架依赖于手动注释的隐含意义,这需要大量的人工努力。未来的工作可以探索使用生成模型来自动生成隐含意义的注释,减少人工成本。

优化K-means算法:

- 论文中提到,K-means算法在每个训练周期后都需要在全部训练集上运行,这在计算上是昂贵的。未来的工作可以探索更快的K-means版本,或者仅对每个批次的数据应用K-means,以提高训练效率。

改进隐性与显性仇恨言论之间的距离约束:

- 论文中提到,错误地将隐性仇恨样本向显性仇恨空间移动可能导致误分类。未来的工作可以引入额外的约束来控制隐性与显性仇恨言论之间的距离,减少这种误分类。

多模态数据的处理:

- 论文主要关注文本特征,没有结合图像等多模态数据。未来的工作可以考虑多模态数据,以提高隐性仇恨言论的检测性能。

跨语言和跨文化的研究:

- 论文主要关注英文数据集。未来的工作可以探索跨语言和跨文化背景下的隐性仇恨言论检测,以增强模型的泛化能力。

更细粒度的超参数调整:

- 论文对一些关键超参数进行了调整,但可能还有更多的超参数调整空间。未来的工作可以进行更细粒度的超参数优化,以进一步提升模型性能。

模型的可解释性和透明度:

- 虽然FiADD框架提高了隐性仇恨言论的检测性能,但其内部工作机制和决策过程的可解释性仍然是一个值得进一步探索的问题。

对抗性攻击和模型鲁棒性:

- 研究模型对于对抗性攻击的鲁棒性,以及如何提高模型在面对这些攻击时的性能和稳定性。

社会影响和伦理考量:

- 进一步研究隐性仇恨言论检测模型对社会的影响,包括误报和漏报的伦理问题,以及如何平衡检测准确性和用户隐私。

这些探索点可以帮助研究者更深入地理解和改进隐性仇恨言论检测技术,同时也考虑到技术实施时的社会和伦理影响。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:

- 论文指出预训练大型语言模型(PLMs)在理解和检测隐性仇恨言论方面存在不足,因为隐性仇恨言论在表面上与非仇恨/中立言论相似,难以自动检测。

研究目标:

- 提出FiADD(Focused Inferential Adaptive Density Discrimination)框架,旨在提高PLMs在隐性仇恨言论检测中的性能,通过结合距离度量学习和注入外部上下文。

方法论:

- FiADD框架包含两个主要部分:自适应密度判别(ADD)和隐含/描述性短语注入。ADD优化类间距离,而隐含短语帮助模型理解隐性仇恨言论的真实含义。

- 引入焦点权重,对边界样本施加更高惩罚,以提高分类准确性。

实验验证:

- 在三个隐性仇恨数据集(LatentHatred、ImpGab和AbuseEval)上进行实验,验证FiADD在二元和三元仇恨分类任务中的有效性。

- 测试FiADD在其他语义分类任务(讽刺、反讽和立场检测)上的泛化能力。

- 与不同的预训练语言模型(BERT、HateBERT和XLM)一起评估FiADD框架。

结果分析:

- 通过广泛的实验,论文展示了FiADD在提高隐性仇恨言论检测准确性方面的优势。

- 进行潜在空间分析,证实FiADD能够将隐性仇恨样本的表面形式与其隐含形式拉近,并在类间创建更好的分离。

贡献:

- 提供了对隐性仇恨数据集的全面文献调查,并为AbuseEval和ImpGab数据集提供了隐含意义的手动注释。

- 提出了FiADD框架,可以作为PLMs微调管道的插件单元,用于仇恨言论检测和其他隐性文本任务。

研究范围和社会影响:

- 论文强调了早期检测隐性仇恨言论的重要性,并指出PLMs在理解隐性仇恨言论方面的局限性。同时,论文也讨论了模型的社会影响和伦理问题。

未来工作:

- 论文提出了未来可能的研究方向,包括自动化隐含意义的生成、优化K-means算法、改进隐性与显性仇恨言论之间的距离约束等。

总的来说,这篇论文提出了一个创新的框架FiADD,以提高隐性仇恨言论的自动检测能力,并在多个数据集和任务上验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Separate Anything You Describe

Authors:Xubo Liu, Qiuqiang Kong, Yan Zhao, Haohe Liu, Yi Yuan, Yuzhuo Liu, Rui Xia, Yuxuan Wang, Mark D. Plumbley, Wenwu Wang

Language-queried audio source separation (LASS) is a new paradigm for computational auditory scene analysis (CASA). LASS aims to separate a target sound from an audio mixture given a natural language query, which provides a natural and scalable interface for digital audio applications. Recent works on LASS, despite attaining promising separation performance on specific sources (e.g., musical instruments, limited classes of audio events), are unable to separate audio concepts in the open domain. In this work, we introduce AudioSep, a foundation model for open-domain audio source separation with natural language queries. We train AudioSep on large-scale multimodal datasets and extensively evaluate its capabilities on numerous tasks including audio event separation, musical instrument separation, and speech enhancement. AudioSep demonstrates strong separation performance and impressive zero-shot generalization ability using audio captions or text labels as queries, substantially outperforming previous audio-queried and language-queried sound separation models. For reproducibility of this work, we will release the source code, evaluation benchmark and pre-trained model at: https://github.com/Audio-AGI/AudioSep.

基于自然语言查询的音频源分离(LASS)是计算听觉场景分析(CASA)的新范式。LASS旨在根据自然语言查询从音频混合物中分离出目标声音,为数字音频应用提供了一个自然且可扩展的接口。尽管最近在LASS方面的工作在特定源(如乐器,有限的音频事件类别)上取得了有希望的分离性能,但它们无法分离开放域中的音频概念。在这项工作中,我们介绍了AudioSep,这是一个用于具有自然语言查询的开放域音频源分离的基准模型。我们在大规模多模式数据集上训练AudioSep,并在包括音频事件分离,乐器分离和语音增强等多项任务上广泛评估其能力。AudioSep利用音频字幕或文本标签作为查询,表现出强大的分离性能和令人印象深刻的零样本泛化能力,显著优于以前的基于音频查询和语言查询的声音分离模型。为了这项工作的可重复性,我们将在以下链接发布源代码,评估基准和预训练模型:https://github.com/Audio-AGI/AudioSep。

论文及项目相关链接

PDF Code, benchmark and pre-trained models: https://github.com/Audio-AGI/AudioSep

总结

语言查询音频源分离(LASS)是计算听觉场景分析(CASA)的新范式。LASS旨在根据自然语言查询从音频混合物中分离出目标声音,为数字音频应用提供了自然且可扩展的接口。尽管最近关于LASS的工作在特定源(如乐器、有限的音频事件类别)上取得了有希望的分离性能,但它们无法在开放领域分离音频概念。在此工作中,我们介绍了AudioSep,这是一个用于开放领域音频源分离的自然语言查询基础模型。我们在大规模多模式数据集上训练AudioSep,并对其在音频事件分离、乐器分离和语音增强等多项任务上的能力进行了广泛评估。AudioSep表现出强大的分离性能和令人印象深刻的零样本泛化能力,使用音频字幕或文本标签作为查询,显著优于以前的音频查询和语言查询的声音分离模型。

关键见解

- LASS是计算听觉场景分析的新范式,旨在根据自然语言查询从音频混合物中分离目标声音。

- AudioSep是一个用于开放领域音频源分离的自然语言查询基础模型,具有强大的分离性能和零样本泛化能力。

- AudioSep能够在多种任务上进行广泛评估,包括音频事件分离、乐器分离和语音增强。

- AudioSep使用音频字幕或文本标签作为查询,显著优于先前的音频查询和语言查询的声音分离模型。

- 该研究将在GitHub上公开源代码、评估基准和预训练模型,以促进工作的可重复性。

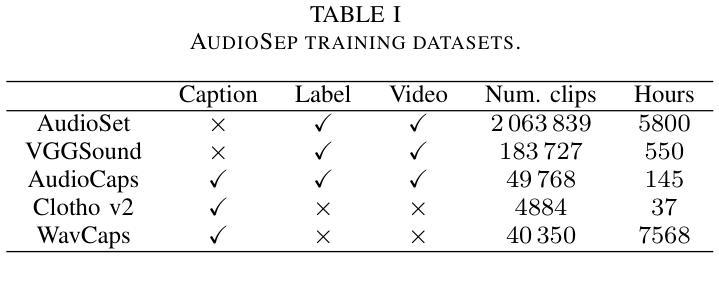

- AudioSep模型是基于大规模多模式数据集进行训练的。

- 该工作对于推进自然语言与音频信号的交互具有重大意义,为数字音频应用提供了更自然、更广泛的接口。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为AudioSep的基础模型,旨在解决开放领域中的音频源分离问题,即给定自然语言查询时,从音频混合中分离出目标声音。这个问题是计算听觉场景分析(CASA)中的一个新范式,被称为语言查询音频源分离(LASS)。LASS的目标是使用自然语言描述来分离任意声源,提供了一种自然且可扩展的接口,用于数字音频应用。尽管先前的研究在特定声源(例如,乐器、有限类别的音频事件)上取得了有希望的分离性能,但它们无法在开放领域中分离音频概念。AudioSep通过在大规模多模态数据集上训练,并在多个任务上进行广泛评估,包括音频事件分离、乐器分离和语音增强等,展示了强大的分离性能和令人印象深刻的零样本泛化能力。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个领域:

A. 音频源分离 (Audio Source Separation)

- 音频源分离是信号处理中的一个基本技术,目的是从它们的混合中提取独立的源信号。

- 近年来,通过整合深度学习模型,音频源分离取得了显著进展。

- 基于深度学习的源分离系统主要采用监督学习方法,通常需要创建模拟的目标和混合源,并开发音频到音频的映射模型。

B. 通用声音分离 (Universal Sound Separation)

- 通用声音分离(USS)旨在分离现实世界声音记录中的任意声源类别。

- USS面临的挑战在于现实世界场景中声音类别的多样性,这增加了使用单一声音分离系统分离所有这些声源的难度。

C. 查询基于的音频分离 (Query-based Sound Separation, QSS)

- QSS旨在根据查询信息从音频混合中分离出特定声源。

- QSS方法可以分为三类:音频视觉、音频查询和标签查询。

D. 语言查询音频源分离 (Language-queried Audio Source Separation, LASS)

- LASS是QSS的一个新范式,使用自然语言描述来分离音频混合中的声源。

- LASS提供了一种潜在的有用工具,用于未来的数字音频应用,允许用户通过自然语言指令提取所需的音频源。

E. 多模态音频-语言学习 (Multimodal Audio-language Learning)

- 音频-语言任务在各种应用场景中具有潜力,例如自动音频描述、基于语言的音频检索和文本到音频的生成。

- 对比语言-音频预训练(CLAP)旨在通过对比学习学习对齐的音频-文本嵌入空间。

这些相关研究领域涵盖了从传统的音频处理技术到最新的深度学习和多模态学习技术,它们共同推动了音频源分离技术的发展,特别是在处理复杂听觉场景和开放领域音频源分离方面。

Q: 论文如何解决这个问题?

A: 论文通过提出AudioSep模型解决了开放领域中的音频源分离问题。以下是解决这个问题的关键步骤和方法:

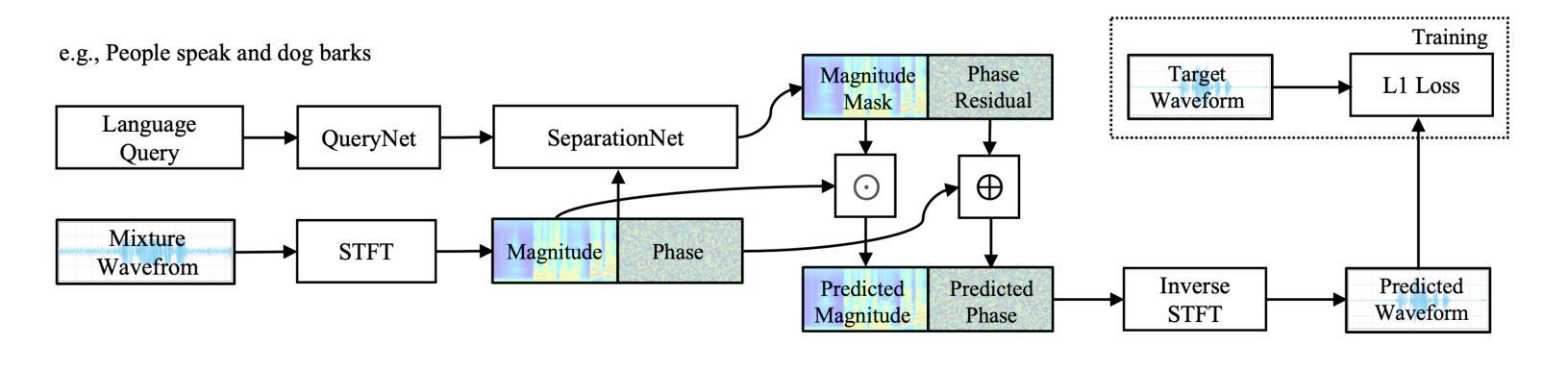

1. 模型架构

- AudioSep 包含两个主要组件:QueryNet 和 SeparationNet。

- QueryNet:使用对比语言音频预训练模型(如CLAP)的文本编码器来提取自然语言查询的文本嵌入。

- SeparationNet:应用频域ResUNet模型作为分离主干,处理输入的音频混合,并输出基于文本嵌入的幅度掩码和相位残差。

2. 查询编码器(QueryNet)

- 使用CLAP模型的文本编码器将输入的文本查询编码成固定长度的向量表示。

3. 分离网络(SeparationNet)

- 输入混合音频剪辑,通过短时傅里叶变换(STFT)提取复数频谱图。

- 构建编码器-解码器网络处理幅度频谱图,使用残差卷积块进行下采样和上采样,并利用跳跃连接传递信息。

- 输出预测的幅度掩码和相位残差,用于从混合频谱图中分离出目标声音。

4. 损失和训练

- 使用L1损失函数进行端到端训练,基于预测和目标波形之间的差异。

- 采用响度增强方法,随机选择信噪比(SNR),确保混合音频具有指定的SNR。

5. 多模态监督

- 利用大规模多模态数据集进行训练,通过对比学习对齐文本嵌入与其他模态(如视觉),实现零样本模式下的推理。

6. 零样本泛化能力

- 通过在多个数据集上进行广泛评估,展示AudioSep在音频事件分离、乐器分离和语音增强等任务上的强分离性能和零样本泛化能力。

7. 代码和模型共享

- 为了促进该领域的研究,作者发布了AudioSep的源代码、评估基准和预训练模型。

通过这些方法,AudioSep模型能够有效地处理开放领域中的音频源分离问题,并在多个任务和数据集上展示了其优越的性能。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估AudioSep模型的性能,这些实验包括:

A. 训练细节

- 描述了模型训练的具体设置,包括数据采样、信号处理、优化器选择和学习率等。

B. 比较系统

- 与现有的语言查询音频源分离(LASS)模型和音频查询分离模型进行比较,包括LASS-Net和CLIPSep等。

C. 在已见数据集上的评估结果

- 在AudioSet、VGGSound、AudioCaps和Clotho数据集上评估AudioSep的性能,并与比较系统的结果进行对比。

D. 零样本评估结果

- 在MUSIC、ESC-50、DCASE 2024 T9和Voicebank-DEMAND等未见数据集上评估AudioSep的零样本分离性能。

E. 分离结果的可视化

- 展示了使用不同文本查询从合成混合音频中分离目标音频源的频谱图,以及实际案例研究的结果。

VI. 消融研究

- 学习与多模态监督:探究了使用大规模多模态监督(CLIP和CLAP模型)对AudioSep进行扩展的有效性。

- 使用不同文本查询的研究:分析了使用不同类型文本查询(包括原始和重新标注的字幕)对模型性能的影响。

- 使用无效文本查询的研究:评估了无效查询(不匹配音频混合中任何源的查询)对音频源分离性能的影响。

这些实验全面评估了AudioSep模型的性能,并与现有技术进行了比较,同时也探索了模型对不同类型文本查询的鲁棒性和泛化能力。通过这些实验,论文展示了AudioSep在开放领域音频源分离任务中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

A. 改进分离性能

- 探索无监督学习技术以提高AudioSep的分离性能,如使用噪声鲁棒的预训练和混合不变训练(MixIT)。

B. 扩展模型能力

- 将AudioSep扩展以支持音频-视觉声音分离、基于音频查询的声音分离和文本引导的说话人分离等任务。

C. 处理无效查询

- 研究如何优化模型以更好地处理无效查询,例如通过监督模型在接收到无效查询时生成静音或利用OCT(Optimal Condition Training)策略。

D. 多模态数据的更好利用

- 研究如何更有效地结合音频和视觉模态的数据来提升模型性能,可能包括改进的嵌入空间对齐技术和模态间关系的学习。

E. 鲁棒性和泛化能力的提高

- 进一步研究如何提高模型对于多样化和个性化文本查询的鲁棒性和泛化能力,尤其是在真实世界的应用场景中。

F. 实际应用测试

- 在更多的实际应用场景中测试AudioSep的性能,如在不同的噪声条件和声源类别下进行评估。

G. 模型解释性

- 提高模型的可解释性,以便更好地理解模型是如何基于文本查询进行声音分离的。

H. 计算效率优化

- 研究如何优化模型的计算效率,使其能够在资源受限的设备上运行。

I. 模型鲁棒性的测试

- 对模型进行更多的鲁棒性测试,包括对抗性攻击和模型在面对异常输入时的行为。

J. 多语言支持

- 探索模型对不同语言的适应性和支持,使其能够处理多种语言的查询。

这些探索点可以帮助研究者进一步提升AudioSep模型的性能和实用性,并扩展其在音频处理领域的应用范围。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了一个名为AudioSep的基础模型,旨在解决开放领域的音频源分离问题,即根据自然语言查询从音频混合物中分离出目标声音。以下是论文的主要内容概述:

核心贡献

- 提出了AudioSep,一个能够处理开放领域音频源分离任务的模型,使用自然语言查询实现声音的分离。

- 通过大规模多模态数据集训练AudioSep,并在多个任务上评估其性能,包括音频事件分离、乐器分离和语音增强等。

- 展示了AudioSep在多个数据集上的卓越性能,包括AudioSet、VGGSound、AudioCaps等,并在零样本情况下也表现出色。

模型架构

- QueryNet:使用对比语言音频预训练模型(如CLAP)的文本编码器来提取文本查询的嵌入。

- SeparationNet:采用频域ResUNet模型作为分离网络,处理音频混合并输出幅度掩码和相位残差。

方法论

- 利用L1损失函数进行端到端训练,通过响度增强方法和随机信噪比(SNR)来构成训练混合音。

- 通过对比学习对齐文本嵌入与其他模态,实现零样本模式下的推理。

实验与评估

- 在多个数据集上评估AudioSep的性能,并与现有的音频查询和语言查询声音分离模型进行比较。

- 进行了消融研究,探讨了多模态监督的有效性、不同文本查询的影响,以及无效查询对模型性能的影响。

结论与未来工作

- AudioSep展示了在开放领域音频源分离任务中的有效性和优越性。

- 提出了未来可能的研究方向,包括改进分离性能、扩展模型能力、处理无效查询等。

代码与模型共享

- 为了促进研究,作者发布了AudioSep的源代码、评估基准和预训练模型。

总体而言,这篇论文提出了一个强大的新模型AudioSep,它能够根据自然语言描述在开放领域中实现音频源分离,并在多个任务和数据集上展示了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图