⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-16 更新

Are Conditional Latent Diffusion Models Effective for Image Restoration?

Authors:Yunchen Yuan, Junyuan Xiao, Xinjie Li

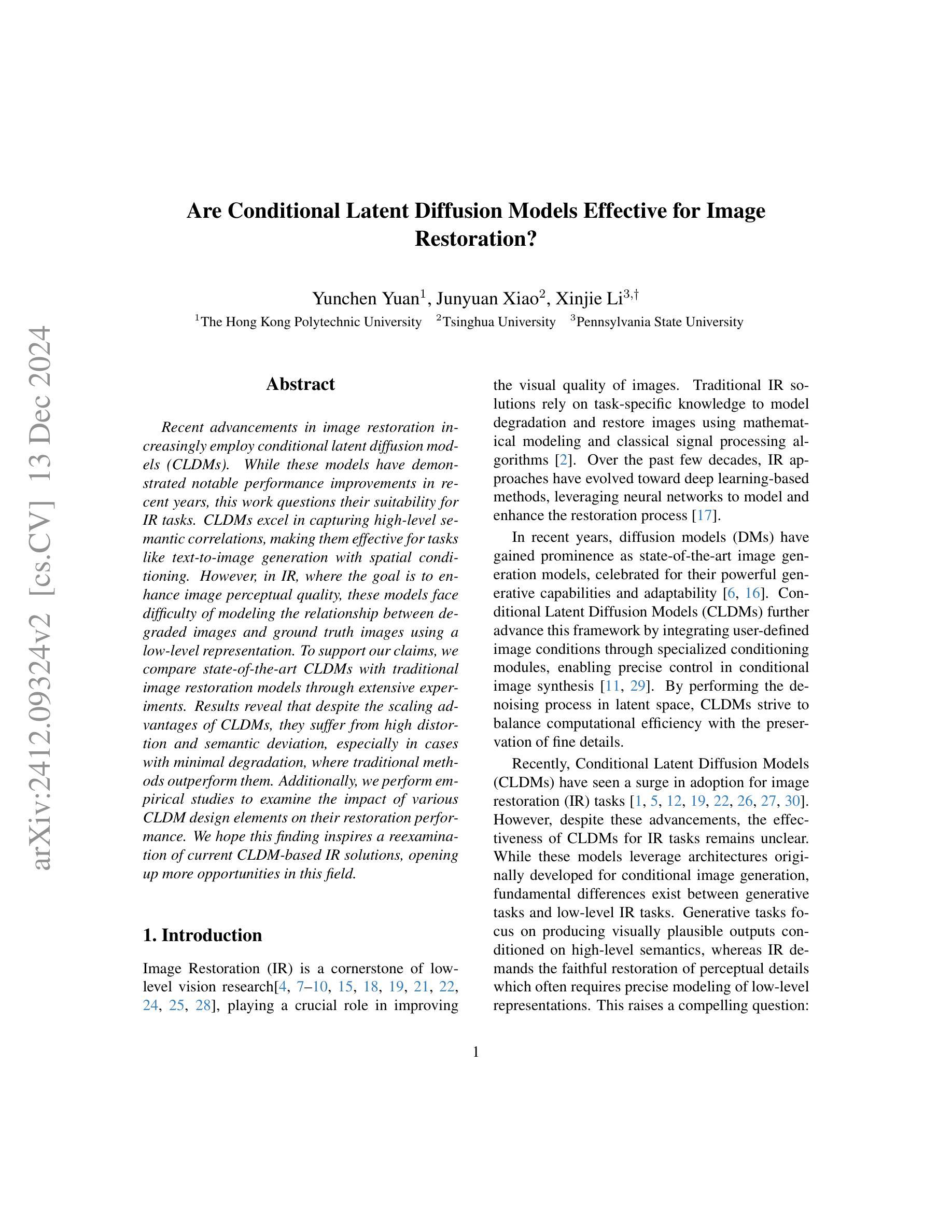

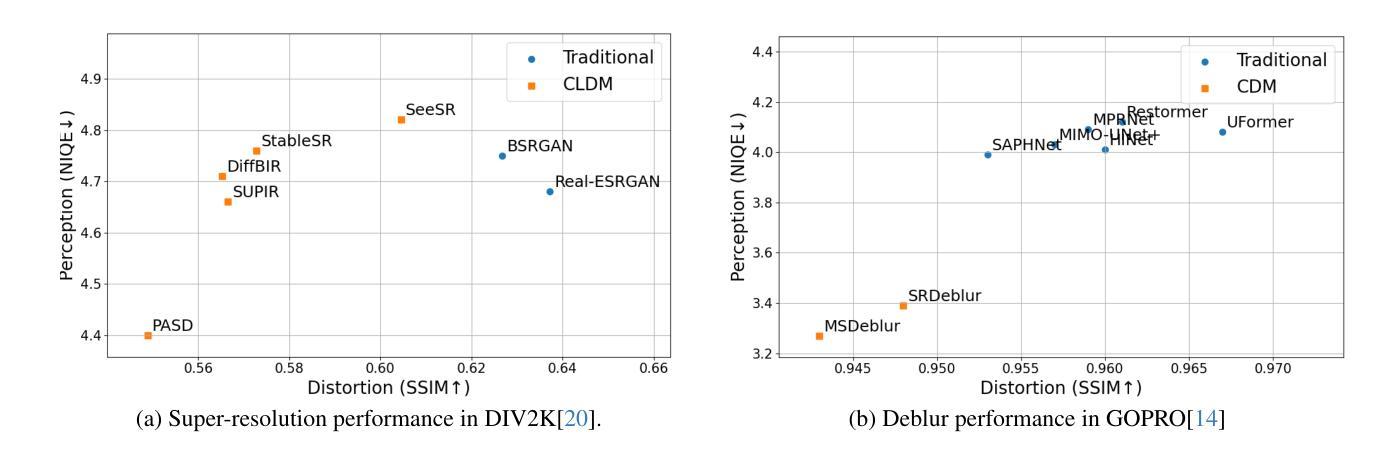

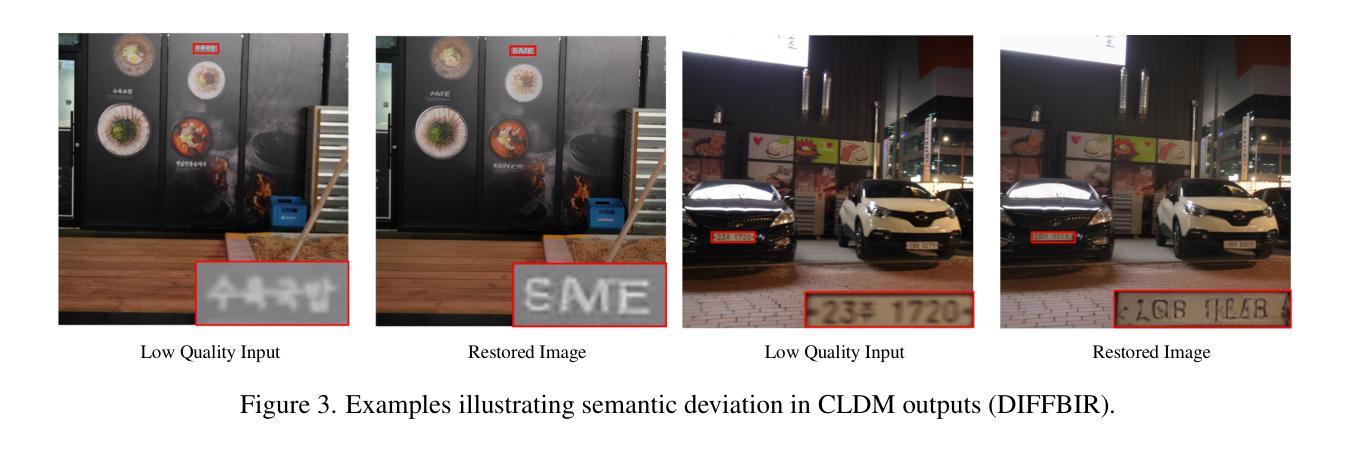

Recent advancements in image restoration increasingly employ conditional latent diffusion models (CLDMs). While these models have demonstrated notable performance improvements in recent years, this work questions their suitability for IR tasks. CLDMs excel in capturing high-level semantic correlations, making them effective for tasks like text-to-image generation with spatial conditioning. However, in IR, where the goal is to enhance image perceptual quality, these models face difficulty of modeling the relationship between degraded images and ground truth images using a low-level representation. To support our claims, we compare state-of-the-art CLDMs with traditional image restoration models through extensive experiments. Results reveal that despite the scaling advantages of CLDMs, they suffer from high distortion and semantic deviation, especially in cases with minimal degradation, where traditional methods outperform them. Additionally, we perform empirical studies to examine the impact of various CLDM design elements on their restoration performance. We hope this finding inspires a reexamination of current CLDM-based IR solutions, opening up more opportunities in this field.

近期图像修复领域越来越倾向于使用条件潜在扩散模型(CLDM)。虽然这些模型在近年来表现出了显著的性能提升,但本文对其在图像修复任务中的适用性提出了质疑。CLDM在捕捉高级语义关联方面表现出色,因此在空间条件下进行文本到图像生成等任务时效果显著。然而,在图像感知质量提升的图像修复中,这些模型在低层次表示上难以把握退化图像和原始图像之间的关系。为了证明我们的观点,我们通过大量实验将最先进的CLDM与传统图像修复模型进行了比较。结果表明,尽管CLDM具有规模优势,但在轻微退化的情况下,它们仍会出现高失真和语义偏差,传统方法表现更佳。此外,我们还通过实证研究检验了不同CLDM设计要素对其修复性能的影响。我们希望这一发现能激励人们重新考虑基于CLDM的当前图像修复解决方案,为这一领域带来更多的机会。

论文及项目相关链接

Summary

条件潜在扩散模型(CLDM)在图像修复任务上的适用性受到质疑。CLDM擅长捕捉高级语义关联,但在图像感知质量提升方面,难以用低层次表示法建模退化图像和原始图像之间的关系。通过广泛的实验和传统图像修复模型的比较,发现CLDM在轻微退化的情况下会出现高失真和语义偏差,且传统方法表现更佳。此外,对CLDM设计元素对其修复性能的影响进行了实证研究。

Key Takeaways

- 条件潜在扩散模型(CLDM)在图像修复(IR)任务上的适用性受到挑战。

- CLDM擅长捕捉高级语义关联,适用于文本到图像的生成等任务。

- 在图像感知质量提升方面,CLDM难以用低层次表示法建模退化图像和原始图像的关系。

- 实验结果显示,在轻微图像退化的情况下,CLDM表现出高失真和语义偏差,传统方法表现更佳。

- 相比于传统模型,CLDM具有规模优势,但在某些情况下并不理想。

- 实证研究探讨了CLDM设计元素对其修复性能的影响。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是评估条件潜在扩散模型(Conditional Latent Diffusion Models, CLDMs)在图像恢复(Image Restoration, IR)任务中的有效性。具体来说,论文提出了以下几个关键点:

CLDMs在图像恢复任务中的适用性质疑:尽管CLDMs在捕获高级语义相关性方面表现出色,适用于文本到图像的生成等任务,但在图像恢复任务中,这些模型面临着在低级表示中建模退化图像与真实图像之间关系的困难。

CLDMs与传统图像恢复模型的性能比较:通过广泛的实验比较,论文发现尽管CLDMs具有扩展优势,但在保持细节和实现良好失真度量方面表现不佳,尤其是在退化程度较低的情况下,传统方法的表现优于CLDMs。

CLDMs在图像恢复中的语义偏差问题:CLDMs在恢复过程中经常改变语义细节,导致与原始输入语义的偏差,这对于需要精确保真度的恢复任务来说尤其成问题。

CLDMs设计与图像恢复任务目标的不一致性:论文通过对CLDM架构的关键设计元素(如潜在空间表示、扩散过程中的噪声处理和多时间步采样)进行实证分析,发现这些元素对恢复质量的影响,并指出当前CLDM解决方案在架构上与图像恢复任务的目标不一致。

CLDMs在资源利用与模型性能之间的差距:尽管CLDMs在模型规模和训练数据量方面具有显著优势,但与传统模型相比,性能提升有限,并且引入了新的挑战,如失真和语义偏差。

综上所述,论文的核心问题是质疑CLDMs在图像恢复任务中的有效性,并通过对CLDMs与传统方法的比较分析,揭示了CLDMs在这一领域的局限性和潜在问题。

Q: 有哪些相关研究?

A: 论文中提到了多个与条件潜在扩散模型(CLDMs)和图像恢复(IR)相关的研究工作。以下是一些主要的相关研究:

图像恢复的传统方法:

- [2] J Amudha et al. 提供了数字图像恢复的综述。

- [4] Chaofeng Chen et al. 讨论了真实世界盲超分辨率通过特征匹配。

- [7] Rusul Sabah Jebur et al. 提供了深度学习中图像去噪的综述。

- [8] ChuMiao Li 提供了图像去模糊的综述。

- [9] Chongyi Li et al. 提供了深度学习在低光照图像和视频增强中的综述。

- [10] Haoying Li et al. 讨论了真实世界的深度局部运动去模糊。

扩散模型(DMs)和条件潜在扩散模型(CLDMs):

- [6] Jonathan Ho et al. 提出了去噪扩散概率模型。

- [11] Ming Li et al. 提出了Controlnet++,用于改善条件控制。

- [12] Xinqi Lin et al. 提出了DiffBIR,一种用于盲图像恢复的生成扩散先验方法。

- [16] Robin Rombach et al. 提出了高分辨率图像合成的潜在扩散模型。

- [26] Bin Xia et al. 提出了DiffIR,一种用于图像恢复的高效扩散模型。

- [27] Fanghua Yu et al. 讨论了模型扩展以实现野外照片真实感图像恢复。

图像恢复的深度学习方法:

- [17] Jingwen Su et al. 提供了图像恢复的深度学习方法的综述。

- [18] Xin Tao et al. 提出了用于深度图像去模糊的尺度递归网络。

- [19] Yang Tao et al. 提出了像素感知稳定扩散,用于真实图像超分辨率和个性化风格化。

- [20] Radu Timofte et al. 提供了NTIRE 2017单图像超分辨率挑战赛的方法和结果。

- [21] Fu-Jen Tsai et al. 提出了Stripformer,一种用于快速图像去模糊的条形变换器。

- [22] Jianyi Wang et al. 利用扩散先验进行真实世界图像超分辨率。

- [23] Xintao Wang et al. 提出了Real-ESRGAN,一种用纯合成数据训练真实世界盲超分辨率的方法。

- [24] Zhihao Wang et al. 提供了深度学习在图像超分辨率中的综述。

- [25] Jay Whang et al. 通过随机细化进行去模糊。

这些研究涵盖了图像恢复的传统方法、深度学习方法,以及扩散模型在图像生成和恢复中的应用。这些工作为理解CLDMs在图像恢复中的有效性提供了背景,并与本文的研究结果形成对比。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤来解决对条件潜在扩散模型(CLDMs)在图像恢复任务中的有效性的质疑问题:

比较实验:

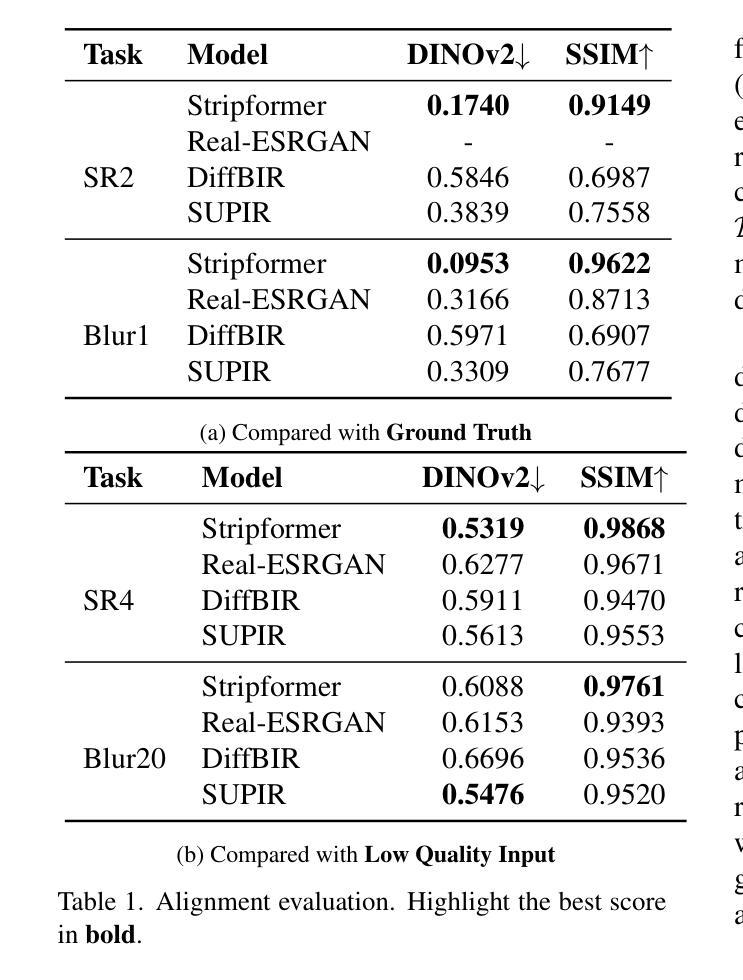

- 论文通过广泛的实验比较了当前最先进的基于CLDM的图像恢复模型与传统的深度学习方法。实验涉及多种任务,包括超分辨率和去模糊等经典图像恢复任务。

引入新的评估指标:

- 论文提出了一个新的评估指标“对齐(Alignment)”,用于衡量恢复图像与其退化输入之间的语义一致性。这对于评估现实世界中的盲图像恢复(BIR)任务尤为重要,因为这些任务缺乏对应的真实图像作为参考。

实证分析CLDM设计元素:

- 论文对CLDM的关键设计元素进行了实证分析,包括潜在空间表示、扩散过程中的噪声处理以及多时间步采样,以评估这些元素对恢复质量的影响。

资源利用与模型性能的对比:

- 论文分析了CLDM模型在资源利用(如模型规模和训练数据量)与实际性能之间的差距,揭示了CLDMs可能存在的性能限制。

提出未来研究方向:

- 论文指出了需要进一步探索的领域,包括更全面的模型和任务评估、深入探索影响因素、开发针对图像恢复的对齐度量方法,以及改进CLDM架构以更好地适应图像恢复任务。

结论和建议:

- 论文总结了CLDMs在图像恢复中的局限性,并建议未来的研究应该重新审视基于CLDM的图像恢复解决方案,开发更好的评估指标,并设计超越当前限制的创新模型。

通过这些步骤,论文不仅质疑了CLDMs在图像恢复任务中的有效性,而且提供了改进现有解决方案和推动该领域发展的见解和建议。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来比较条件潜在扩散模型(CLDMs)与传统图像恢复方法的性能,并分析了CLDMs在图像恢复任务中的有效性。具体的实验包括:

性能比较实验:

- 比较了最先进的CLDM模型与传统深度学习方法在多种图像恢复任务(包括超分辨率和去模糊)上的性能。

- 使用了不同的退化设置(如不同的下采样率和模糊核大小)来评估模型在不同退化水平下的表现。

信息保留率分析:

- 引入了信息保留率(information retention rate, γ)的概念来量化退化过程中的信息损失,并评估不同模型在不同退化水平上的表现。

语义偏差分析:

- 通过视觉和定量的方式分析了CLDM模型在恢复过程中引入的语义偏差问题。

- 提出了“对齐(Alignment)”作为一个新的评估指标,并使用DINOv2模型的嵌入差异来估计语义偏差。

资源利用与性能对比:

- 分析了CLDM模型在模型规模和训练数据量方面的优势与传统模型相比的性能提升,揭示了资源利用和模型性能之间的差距。

CLDM设计元素分析:

- 对CLDM的关键设计元素(如潜在空间表示、扩散过程中的噪声处理和多时间步采样)进行了实证分析,以评估这些元素对恢复质量的影响。

不同噪声水平的影响:

- 通过调整起始时间步来改变采样过程中的噪声水平,分析了不同噪声水平对图像恢复性能的影响。

多时间步采样的有效性:

- 通过改变采样步数来评估多时间步采样对图像恢复性能的影响。

一步预测能力测试:

- 测试了网络从纯高斯噪声开始预测的能力,并分析了多时间步采样过程中的性能变化。

这些实验提供了全面的性能评估,并揭示了CLDMs在图像恢复任务中的潜在问题和局限性。通过这些实验结果,论文挑战了CLDMs在图像恢复任务中的有效性,并为未来的研究方向提供了指导。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

更广泛的模型和任务评估:

- 对更多的模型和多样化的图像恢复任务设置进行广泛的测试,以获得更全面和可推广的结论。

- 开发标准化的基准测试协议,以评估模型在不同退化水平下的性能。

影响因素的深入探索:

- 研究不同的训练配置,例如在潜在空间、像素空间或基于特征的损失函数,动态噪声水平和时间步控制对性能的影响。

- 探讨恢复引导级别、无分类器引导和采样过程中噪声注入等因素的影响。

开发对齐度量指标:

- 鉴于缺乏成熟的度量指标,开发专门用于评估图像恢复中语义一致性的先进度量方法。

- 这些新指标将为图像恢复任务的评估提供新的方法。

优化CLDM架构:

- 调整CLDM架构以更好地适应图像恢复任务,解决高失真、对低退化样本的性能下降和语义偏差等挑战。

- 鉴于CLDM在数据可扩展性、模型大小和推理效率方面的优势,优化其架构可能会释放出超越当前限制的显著潜力。

改进评估框架:

- 结合对齐和感知评估,特别是对于现实世界的盲图像恢复(BIR)任务,开发更有效的评估框架。

探索新的训练策略:

- 研究新的训练策略,可能包括对抗性训练、多任务学习和自监督学习等,以提高CLDMs在图像恢复任务中的性能。

跨领域应用:

- 探索CLDMs在其他低级视觉任务中的应用,例如图像分割、目标检测等,并评估其有效性。

计算效率和实际部署:

- 研究如何提高CLDMs的计算效率,使其更适合实际部署和应用。

解释性和可视化分析:

- 提供更多关于CLDMs在图像恢复过程中的解释性和可视化分析,以更好地理解其行为和决策过程。

这些探索点不仅可以推动CLDMs在图像恢复领域的研究进展,还可能揭示新的研究方向和应用前景。

Q: 总结一下论文的主要内容

A: 这篇论文主要探讨了条件潜在扩散模型(Conditional Latent Diffusion Models, CLDMs)在图像恢复任务中的有效性,并对其适用性提出了质疑。以下是论文的主要内容总结:

问题提出:

- 论文指出尽管CLDMs在捕获高级语义相关性方面表现出色,但其在图像恢复(IR)任务中的有效性尚未得到充分验证。IR任务要求精确建模低级表示,而CLDMs在这一领域面临挑战。

实验比较:

- 通过广泛实验比较了CLDMs与传统图像恢复模型,发现CLDMs在保持细节和失真度量方面表现不佳,尤其在退化程度较低的情况下。

语义偏差问题:

- 论文发现CLDMs在恢复过程中常引入语义偏差,提出了“对齐(Alignment)”作为新的评估指标,以衡量恢复图像与退化输入之间的语义一致性。

资源利用与性能对比:

- 分析了CLDMs在资源利用(模型规模和数据量)与实际性能之间的差距,指出CLDMs可能存在的性能限制。

CLDM设计元素分析:

- 对CLDM的关键设计元素(如潜在空间表示、噪声处理和多时间步采样)进行了实证分析,发现这些元素对恢复质量的影响有限。

结论与建议:

- 论文得出结论,CLDMs在图像恢复任务中存在显著局限性,并建议未来的研究应重新审视基于CLDM的图像恢复解决方案,并开发更好的评估指标和创新模型。

未来研究方向:

- 提出了进一步探索的领域,包括更全面的模型评估、深入探索影响因素、开发新的对齐度量指标,以及改进CLDM架构以更好地适应图像恢复任务。

总体而言,这篇论文挑战了CLDMs在图像恢复领域的应用,并提供了一系列的实验结果和分析来支持其观点,同时为未来的研究方向提供了指导。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

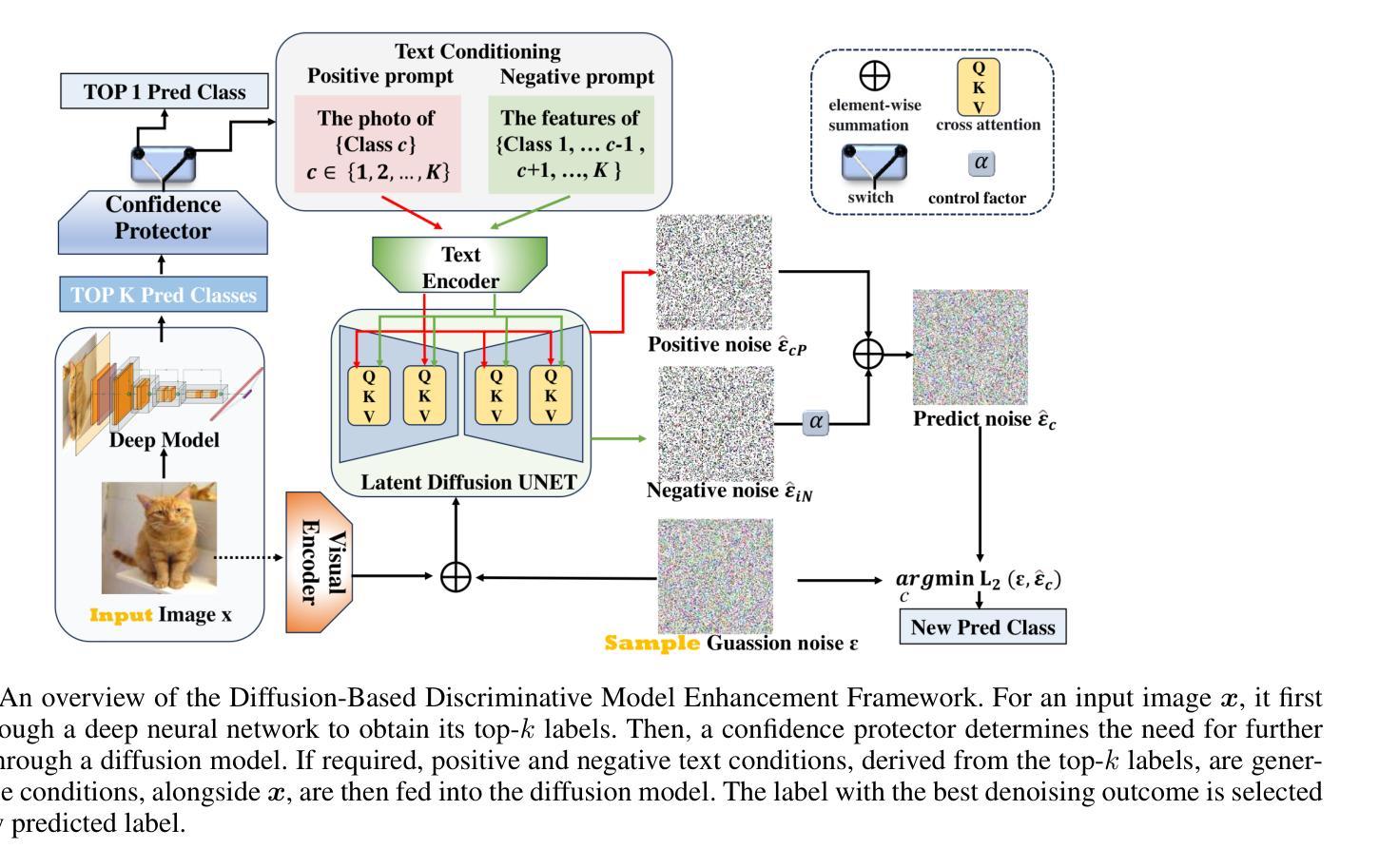

An Efficient Framework for Enhancing Discriminative Models via Diffusion Techniques

Authors:Chunxiao Li, Xiaoxiao Wang, Boming Miao, Chuanlong Xie, Zizhe Wang, Yao Zhu

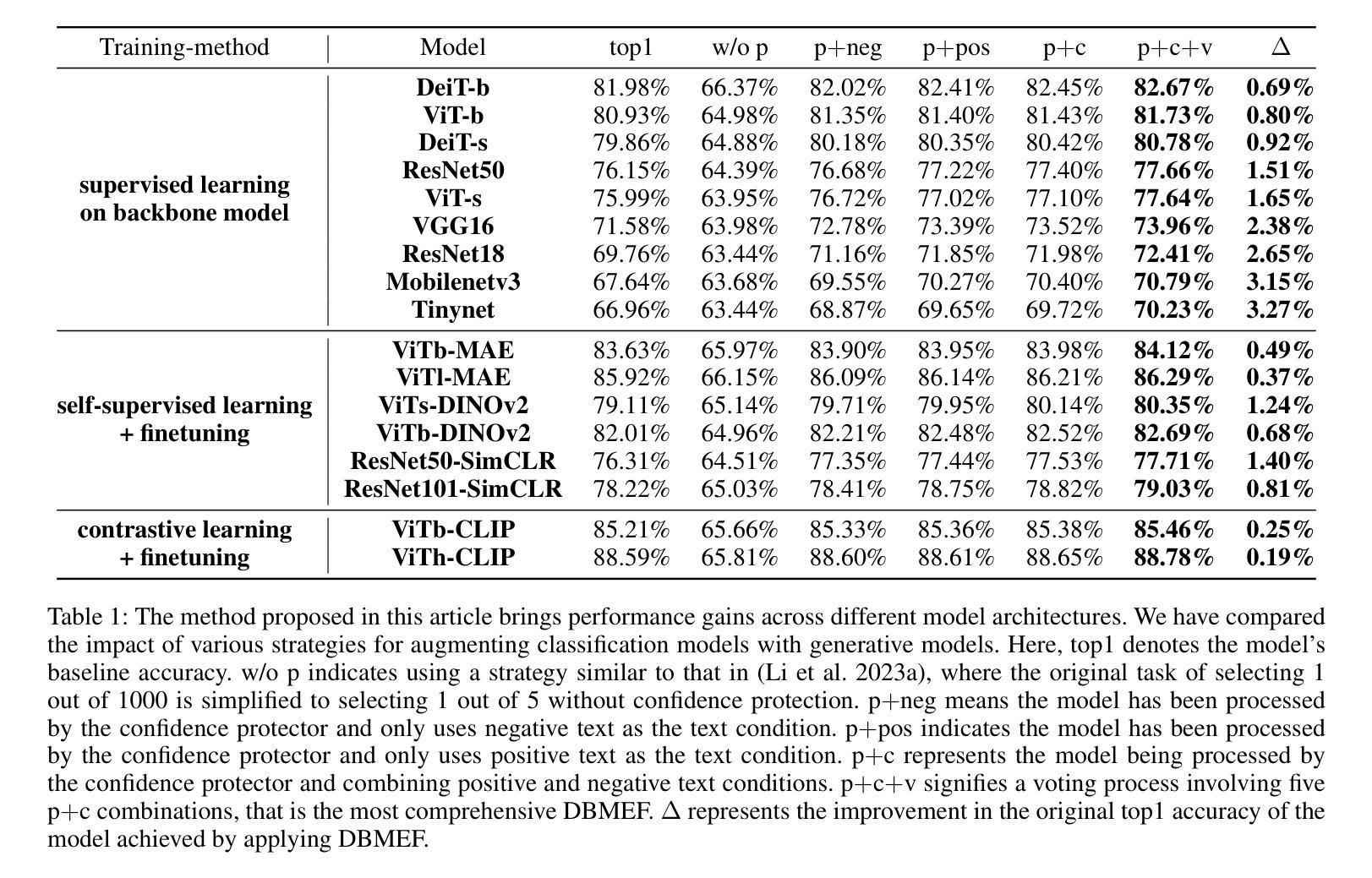

Image classification serves as the cornerstone of computer vision, traditionally achieved through discriminative models based on deep neural networks. Recent advancements have introduced classification methods derived from generative models, which offer the advantage of zero-shot classification. However, these methods suffer from two main drawbacks: high computational overhead and inferior performance compared to discriminative models. Inspired by the coordinated cognitive processes of rapid-slow pathway interactions in the human brain during visual signal recognition, we propose the Diffusion-Based Discriminative Model Enhancement Framework (DBMEF). This framework seamlessly integrates discriminative and generative models in a training-free manner, leveraging discriminative models for initial predictions and endowing deep neural networks with rethinking capabilities via diffusion models. Consequently, DBMEF can effectively enhance the classification accuracy and generalization capability of discriminative models in a plug-and-play manner. We have conducted extensive experiments across 17 prevalent deep model architectures with different training methods, including both CNN-based models such as ResNet and Transformer-based models like ViT, to demonstrate the effectiveness of the proposed DBMEF. Specifically, the framework yields a 1.51% performance improvement for ResNet-50 on the ImageNet dataset and 3.02% on the ImageNet-A dataset. In conclusion, our research introduces a novel paradigm for image classification, demonstrating stable improvements across different datasets and neural networks. The code is available at https://github.com/ChunXiaostudy/DBMEF.

图像分类作为计算机视觉的基石,传统上是通过基于深度神经网络的判别模型来实现的。最近的进展已经引入了基于生成模型的分类方法,这些方法具有零样本分类的优点。然而,这些方法存在两个主要缺点:计算开销大以及相对于判别模型的性能较差。

受人类大脑在识别视觉信号过程中快速-慢速路径交互的协同认知过程的启发,我们提出了基于扩散的判别模型增强框架(DBMEF)。该框架无缝集成了判别模型和生成模型,无需训练即可进行集成。它利用判别模型进行初步预测,并通过扩散模型赋予深度神经网络反思能力。因此,DBMEF可以有效地提高判别模型的分类精度和泛化能力,以一种即插即用(plug-and-play)的方式增强效果。

论文及项目相关链接

PDF Accepted by AAAI2025

Summary

基于扩散模型的判别模型增强框架(DBMEF)结合了判别模型和生成模型的优势,通过无训练的方式实现了图像分类的零样本分类。该框架利用判别模型进行初步预测,并通过扩散模型赋予深度神经网络再思考的能力,从而提高判别模型的分类准确性和泛化能力。在多个流行深度模型架构的实验中,DBMEF表现出稳定的效果提升。

Key Takeaways

- 扩散模型被引入以增强图像分类中的判别模型的性能。

- DBMEF框架结合了判别模型和生成模型的优势,实现了零样本分类。

- DBMEF利用判别模型进行初步预测,并借助扩散模型赋予深度神经网络再思考的能力。

- 框架通过无训练的方式无缝集成判别和生成模型。

- 在多个深度模型架构的实验中,DBMEF提高了分类准确性和泛化能力。

- 对于ResNet-50在ImageNet数据集上的性能提升1.51%,在ImageNet-A数据集上提升3.02%。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是如何在图像分类任务中结合判别模型(discriminative models)和生成模型(generative models)的优势,以提高分类的准确性和泛化能力。具体来说,论文中提到了以下几个关键问题:

判别模型与生成模型的结合:传统的图像分类方法通常独立地使用判别模型或生成模型。判别模型直接对图像进行分类,而生成模型则通过学习数据的联合分布来实现分类。论文提出了一个框架,将这两种模型结合起来,以期达到更好的分类效果。

生成模型在分类中的高计算开销和性能不足:基于生成模型的分类方法,尽管提供了零样本分类(zero-shot classification)的优势,但它们存在两个主要缺点:高计算开销和相比判别模型的性能劣势。论文旨在通过提出的方法来克服这些问题。

模仿人脑处理视觉信号的过程:论文受到人脑在视觉信号识别过程中快速-慢速路径相互作用的协调认知过程的启发,提出了一个框架,通过模仿这一过程来增强判别模型的性能。

提高判别模型的分类准确性和泛化能力:论文提出的框架旨在通过无需训练的方式,以即插即用的形式增强判别模型的分类准确性和泛化能力。

处理分布偏移和低分辨率数据:论文还探讨了所提出框架在面对分布偏移和低分辨率数据时的有效性,以展示其在不同情况下的鲁棒性和适用性。

综上所述,论文的核心目标是提出一个有效的框架,通过结合判别模型和生成模型的优点,来提升图像分类任务的性能,并在不同的数据集和神经网络架构上展示其有效性。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以概括为以下几个方面:

判别模型和生成模型在图像分类中的应用:

- 判别模型直接对图像分类,如VGG、ResNet、ViT等。

- 生成模型通过学习数据的联合分布来进行分类,例如基于能量的模型(EBM)和基于分数的模型(Score-Based Models)。

零样本分类(Zero-Shot Classification):

- 使用生成模型进行零样本分类的研究,如基于扩散模型(Diffusion Models)的方法。

扩散模型(Diffusion Models):

- 扩散模型在图像生成领域的应用,特别是在生成高质量图像方面超越了生成对抗网络(GANs)。

- 分类引导扩散(Classifier Guidance Diffusion)和无分类器引导扩散(Classifier-Free Guidance Diffusion)技术,这些技术通过在生成阶段调整图像的梯度来实现基于指定类别的条件生成。

基于分数的生成模型(Score-Based Generative Models):

- 使用基于分数的生成模型来估计条件概率(P(x|y)),并用于图像分类。

对抗性鲁棒性(Adversarial Robustness):

- 利用扩散模型评估传统判别分类器的对抗性鲁棒性。

结合判别模型和生成模型的方法:

- 先前的研究工作,如SBGC、RDC等,这些方法尝试将扩散模型整合到图像分类任务中。

改进扩散模型的分类性能:

- 将扩散模型应用于DiT-XL/2模型,并在ImageNet数据集上进行监督分类。

加速采样方法:

- 研究工作探索了加速扩散模型采样过程的方法,以减少分类单个图像所需的时间。

这些相关研究构成了论文提出的Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的理论基础和技术背景。论文通过结合这些领域的最新进展,提出了一个新的框架,旨在通过模仿人脑处理视觉信号的过程来增强判别模型的性能。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的框架来解决上述问题。以下是该框架解决这些问题的关键步骤和方法:

1. 结合判别模型和生成模型

DBMEF框架通过以下步骤将判别模型和生成模型结合起来:

- 判别模型初步预测:使用判别模型对测试输入进行初步预测,类似于人脑中的快速通路。

- 生成模型重新评估:对于判别模型不确定的预测,使用扩散模型进行重新评估,模拟人脑中的慢速通路。

2. 模仿人脑处理视觉信号的过程

- 快速-慢速路径交互:框架受到人脑处理视觉信号时快速和慢速路径相互作用的启发,通过重复“猜测-验证-猜测-验证”的过程来识别对象。

3. 增强判别模型的性能

- 置信度保护器(Confidence Protector):通过一个置信度阈值来决定是否需要通过扩散模型进一步评估预测结果。

- 扩散模型分类器:将扩散模型的有条件去噪结果转化为后验概率的估计,以重新分类图像。

4. 处理分布偏移和低分辨率数据

- 适应不同数据集:框架在多个数据集上进行测试,包括ImageNet、ImageNet-A、CIFAR-10和CIFAR-100,以验证其对分布偏移和低分辨率数据的适应性。

5. 提升效率和准确性

- 减少计算开销:通过仅对判别模型不确定的预测进行扩散模型的重新评估,减少了整体计算开销。

- 提高分类准确性:通过结合判别模型的高效率和生成模型的精细化处理,DBMEF显著提高了分类的准确性。

6. 即插即用和无需训练

- 无需额外训练:DBMEF作为一个即插即用的框架,可以直接应用于现有的判别模型,无需额外的训练过程。

总结来说,DBMEF框架通过模仿人脑处理视觉信号的过程,结合了判别模型和生成模型的优势,以提高图像分类任务的准确性和泛化能力,同时减少了计算开销。通过在多个数据集和不同网络架构上的实验,论文证明了该框架的有效性和普适性。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的有效性。以下是实验的主要内容:

1. 不同模型架构的性能测试

- 基线模型:选择了17种基于不同训练方法、数据集和架构的判别模型,包括监督学习模型(如DeiT-Base、ViT-Base、ResNet50等)、自监督学习方法(如MAE、DINOv2等)以及对比学习模型(如CLIP)。

- 实验设置:使用Stable Diffusion V1-5作为扩散模型,设置保护阈值Prot、时间步长、负控制因子λ等参数,并在ImageNet2012-1k验证集上进行评估。

- 结果:DBMEF在这些模型上取得了0.19%到3.27%的准确率提升。

2. 分布偏移的性能测试

- 数据集:使用ImageNet-S、ImageNet-A、ImageNet-V2和ImageNet-E数据集来评估DBMEF在面对不同类型的分布偏移时的性能。

- 基线模型:使用ViT-Base、DeiT-Small、ResNet50和VGG16等预训练的深度判别模型。

- 结果:DBMEF在各种分布偏移数据集上均显示出稳定的性能提升,特别是在ImageNet-A上,ResNet50的准确率从0.00%提升到3.02%。

3. 低分辨率数据集的分类性能测试

- 数据集:选择CIFAR-10和CIFAR-100数据集,这些数据集包含的图像分辨率为32×32像素。

- 基线模型:使用ResNet18、ResNet34和ResNet50等模型,并在这些数据集上进行测试。

- 结果:即使在基线准确率已经很高的低分辨率图像上,应用DBMEF框架仍然能够进一步提升性能。

4. 超参数的影响测试

- 超参数:研究了保护阈值Prot、时间步长T、负控制因子λ以及扩散模型的选择对DBMEF性能的影响。

- 实验结果:分析了不同超参数设置对模型性能的具体影响,提供了关于如何选择这些参数以优化DBMEF性能的见解。

5. 置信度保护器和扩散模型的作用分析

- 置信度保护器:通过详细的可视化和分析,展示了置信度保护器对DBMEF性能的影响。

- 扩散模型:通过实验验证了扩散模型在DBMEF中的关键作用,与使用更多数据训练的判别模型相比,扩散模型提供了更好的性能提升。

这些实验全面地验证了DBMEF框架的有效性、普适性和鲁棒性,并深入分析了框架中各个组件的作用和影响。通过这些实验,论文展示了DBMEF在不同条件下都能显著提升图像分类任务的性能。

Q: 有什么可以进一步探索的点?

A: 论文提出的Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)为图像分类领域提供了一个新范式,以下是一些可以进一步探索的点:

1. 超参数优化

- 研究不同的超参数设置对DBMEF性能的影响,包括保护阈值(Prot)、时间步长(T)、负控制因子(λ)等,以找到最优的配置。

2. 扩散模型的改进

- 探索使用新一代的扩散模型,如更近期版本的Stable Diffusion或其他类型的扩散模型,以进一步提高DBMEF的性能。

- 研究如何定制扩散模型以更好地适应特定的判别模型和数据集。

3. 多模态数据集的应用

- 将DBMEF应用于多模态数据集,如结合图像和文本的数据集,探索其在多模态学习中的潜力。

4. 不同的网络架构

- 测试DBMEF在更多种类的深度学习架构上的效果,包括最新的卷积网络和Transformer变体。

5. 跨域泛化能力

- 研究DBMEF在面对更大分布偏移时的表现,例如跨域识别任务,以及如何改进框架以提高其跨域泛化能力。

6. 实时应用

- 探索DBMEF在实时应用中的可行性,例如在移动设备或嵌入式系统上的部署,并优化其以满足实时处理的需求。

7. 理论分析

- 深入研究DBMEF的理论基础,包括其统计性质和收敛性,以及如何从理论上解释其性能提升的原因。

8. 与其他生成模型的比较

- 将DBMEF与其他类型的生成模型(如GANs)进行比较,分析其在图像分类任务中的优缺点。

9. 鲁棒性和安全性测试

- 对DBMEF进行鲁棒性和安全性测试,特别是在对抗性攻击和数据隐私方面的表现。

10. 应用到其他视觉任务

- 将DBMEF框架扩展到其他计算机视觉任务,如目标检测、语义分割等,探索其在这些任务中的有效性和适用性。

这些探索点可以帮助研究者更深入地理解DBMEF的工作原理,优化其性能,并扩展其在计算机视觉领域的应用范围。

Q: 总结一下论文的主要内容

A: 论文提出了一个名为Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的新框架,旨在通过结合判别模型和生成模型的优势来增强图像分类任务的性能。以下是论文的主要内容总结:

1. 研究动机

- 传统的图像分类方法主要基于判别模型或生成模型,但存在各自的局限性。判别模型虽然分类速度快,但缺乏重新评估的能力;生成模型能进行细致的图像理解,但计算成本高且性能落后于判别模型。

2. DBMEF框架

- 框架概述:DBMEF框架通过模仿人脑处理视觉信号的快速和慢速路径交互过程,整合判别模型和生成模型,以提高分类的准确性和泛化能力。

- 关键组件:包括置信度保护器和扩散模型分类器,以及结合正负文本条件和投票机制的策略。

3. 方法论

- 判别模型初步预测:判别模型首先对测试输入进行预测,类似于人脑的快速通路。

- 生成模型重新评估:对于判别模型不确定的预测,通过扩散模型进行重新评估,模拟人脑的慢速通路。

- 置信度保护器:基于训练集正确分类样本的统计特性,决定是否需要通过扩散模型进一步评估。

- 扩散模型分类器:将扩散模型的有条件去噪结果转化为后验概率的估计,以重新分类图像。

4. 实验验证

- 在多个数据集(包括ImageNet、ImageNet-A、CIFAR-10和CIFAR-100)和多种深度模型架构上验证了DBMEF的有效性。

- 实现了在不同模型上0.19%到3.27%的准确率提升,并在分布偏移和低分辨率数据上显示出稳定的性能提升。

5. 超参数影响和组件作用分析

- 对保护阈值、时间步长、负控制因子等超参数进行了实验分析,探讨了它们对框架性能的影响。

- 分析了置信度保护器和扩散模型在DBMEF中的关键作用。

6. 结论

- DBMEF框架有效地提高了判别模型的分类准确性和泛化能力,同时减少了计算开销。

- 论文提出了一个新的图像分类范式,并鼓励未来研究进一步探索扩散模型在下游应用中的整合。

总体而言,论文通过提出DBMEF框架,展示了如何通过结合判别模型和生成模型的优势来提高图像分类任务的性能,并在多个数据集和模型上验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图