⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-17 更新

Apollo: An Exploration of Video Understanding in Large Multimodal Models

Authors:Orr Zohar, Xiaohan Wang, Yann Dubois, Nikhil Mehta, Tong Xiao, Philippe Hansen-Estruch, Licheng Yu, Xiaofang Wang, Felix Juefei-Xu, Ning Zhang, Serena Yeung-Levy, Xide Xia

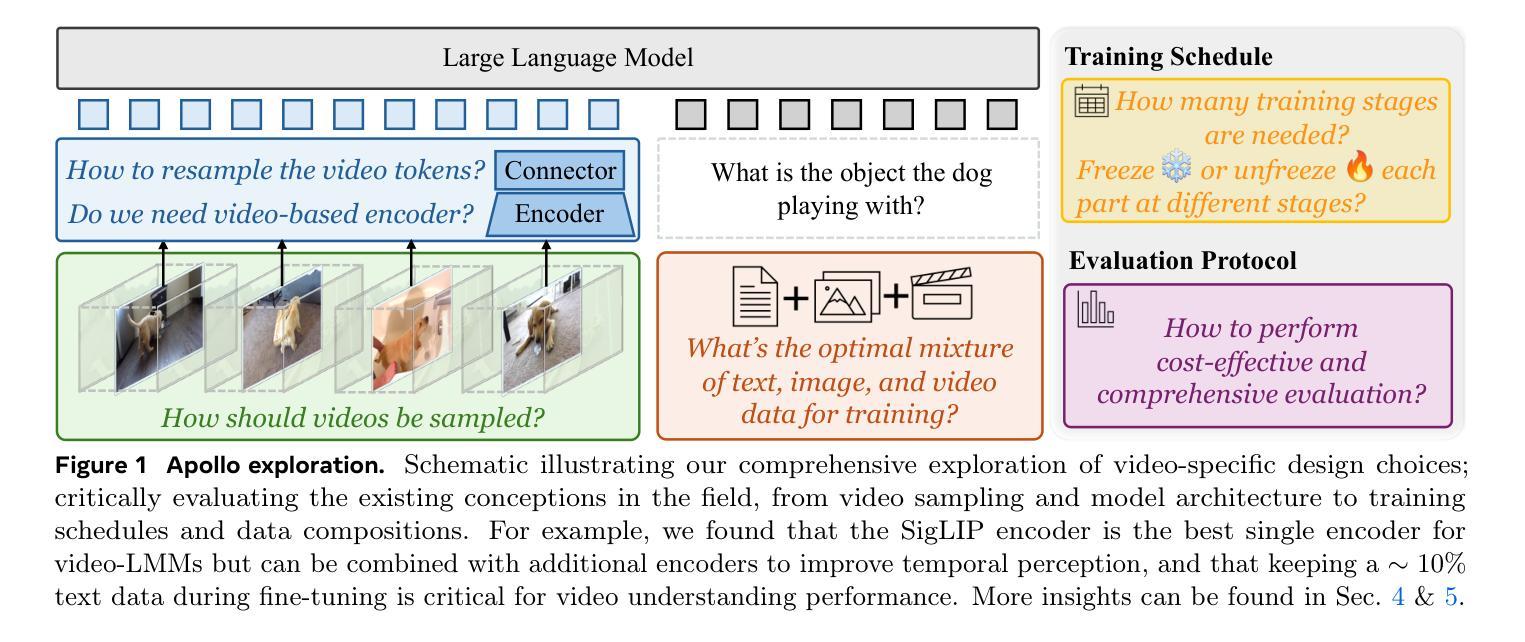

Despite the rapid integration of video perception capabilities into Large Multimodal Models (LMMs), the underlying mechanisms driving their video understanding remain poorly understood. Consequently, many design decisions in this domain are made without proper justification or analysis. The high computational cost of training and evaluating such models, coupled with limited open research, hinders the development of video-LMMs. To address this, we present a comprehensive study that helps uncover what effectively drives video understanding in LMMs. We begin by critically examining the primary contributors to the high computational requirements associated with video-LMM research and discover Scaling Consistency, wherein design and training decisions made on smaller models and datasets (up to a critical size) effectively transfer to larger models. Leveraging these insights, we explored many video-specific aspects of video-LMMs, including video sampling, architectures, data composition, training schedules, and more. For example, we demonstrated that fps sampling during training is vastly preferable to uniform frame sampling and which vision encoders are the best for video representation. Guided by these findings, we introduce Apollo, a state-of-the-art family of LMMs that achieve superior performance across different model sizes. Our models can perceive hour-long videos efficiently, with Apollo-3B outperforming most existing $7$B models with an impressive 55.1 on LongVideoBench. Apollo-7B is state-of-the-art compared to 7B LMMs with a 70.9 on MLVU, and 63.3 on Video-MME.

尽管视频感知能力已迅速融入大型多模态模型(LMMs)中,但驱动其视频理解的底层机制仍知之甚少。因此,该领域的许多设计决策都是在没有适当论证或分析的情况下做出的。此类模型训练和评估的计算成本高昂,再加上开放研究有限,阻碍了视频LMM的发展。为了解决这一问题,我们进行了一项全面的研究,旨在揭示在LMMs中有效驱动视频理解的因素。

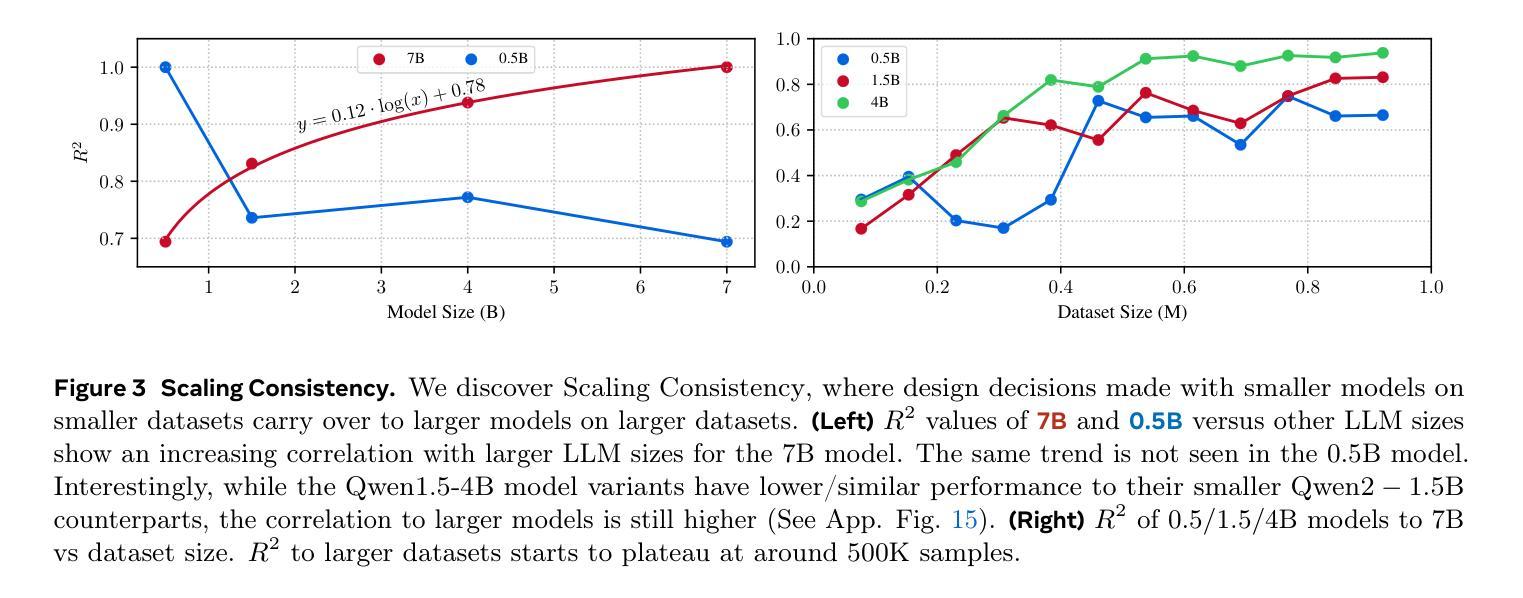

我们首先仔细研究了与视频LMM研究相关的高计算要求的主要贡献者,并发现了“规模一致性”,即在小模型和数据集上做出的设计和训练决策(直至达到临界规模)可以有效地转移到大型模型上。利用这些见解,我们探索了视频LMM的视频特定方面,包括视频采样、架构、数据组成、训练计划等。例如,我们证明了在训练过程中使用fps采样远胜于均匀帧采样,以及哪种视觉编码器最适合视频表示。

论文及项目相关链接

PDF https://apollo-lmms.github.io

摘要

尽管大型多模态模型(LMMs)已迅速融入视频感知能力,但驱动其视频理解的底层机制仍鲜为人知。因此,该领域的许多设计决策都是没有经过适当的验证或分析而做出的。训练和评价此类模型的高计算成本,以及开放研究的有限性,阻碍了视频LMM的发展。为了帮助揭示LMM中有效驱动视频理解的因素,我们进行了一项综合研究。我们首先对与视频LMM研究相关的高计算要求的主要贡献者进行了批判性审查,并发现了规模一致性,即在小模型和数据集上做出的设计和训练决策可以有效地转移到大型模型。利用这些见解,我们探索了视频LMM的许多视频特定方面,包括视频采样、架构、数据组成、训练计划等。例如,我们证明训练过程中的fps采样远优于均匀帧采样,并确定了哪种视觉编码器最适合视频表示。在这些发现的指导下,我们推出了Apollo,一个最先进的LMM家族,在不同规模的模型中表现卓越。我们的模型可以高效地感知长达一小时的视频,其中Apollo-3B在LongVideoBench上得分高达55.1,超越大多数现有的7B模型。Apollo-7B在MLVU上得分70.9,在Video-MME上得分63.3,成为7B LMMs中的最新前沿技术。

要点

- 大型多模态模型(LMMs)的视频理解机制尚待深入理解。

- 当前设计决策往往缺乏适当的验证和分析。

- 视频LMM的研究受到高计算成本和有限开放研究的阻碍。

- 发现“规模一致性”,即小模型和数据集上的设计和训练决策可转移到大型模型。

- 深入研究了视频LMM的视频特定方面,包括视频采样、架构、数据组成等。

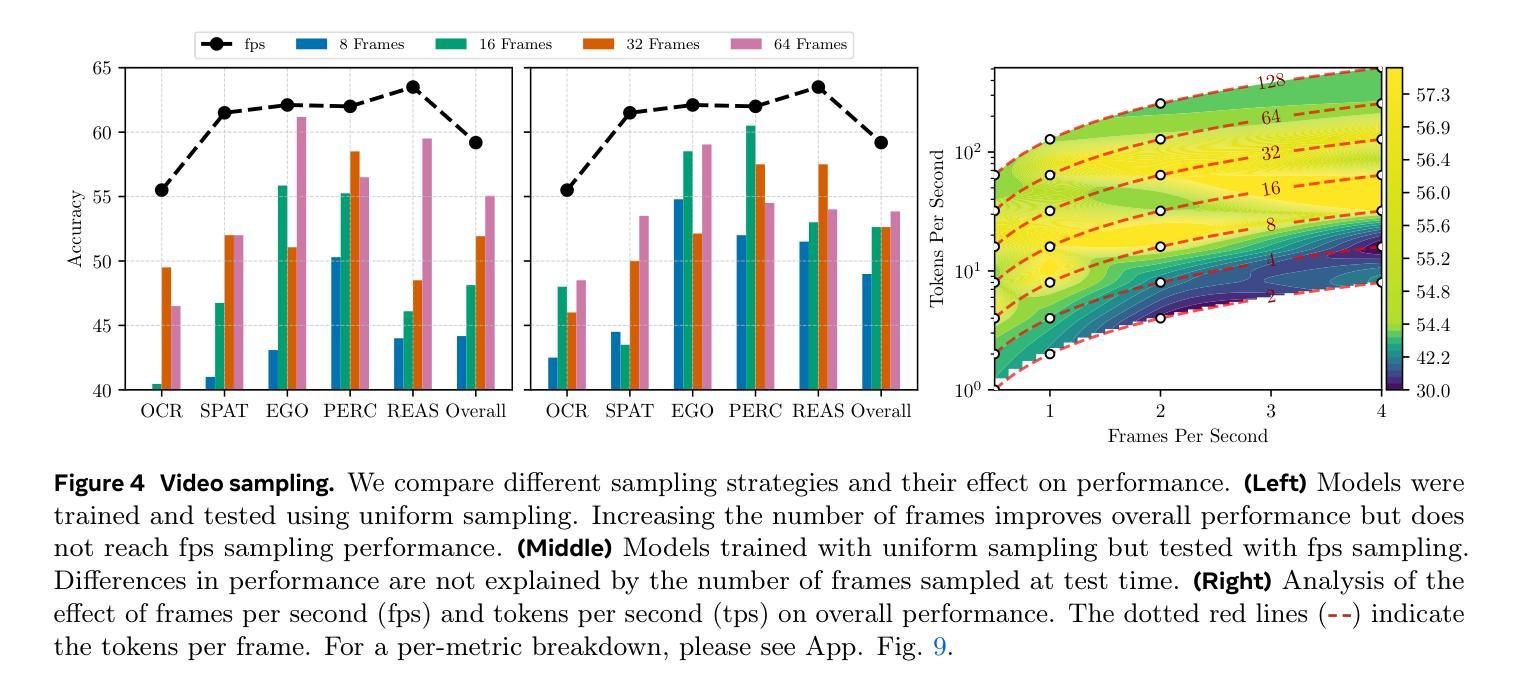

- 表明训练过程中的fps采样优于均匀帧采样。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是视频大型多模态模型(video-LMMs)在理解和处理视频内容方面的效率和性能问题。具体来说,论文关注以下几个核心问题:

视频理解的机制:尽管大型多模态模型(LMMs)已经迅速融入视频感知能力,但其背后的视频理解机制尚不清楚。这导致许多设计决策缺乏适当的理由或分析。

计算成本:训练和评估这类模型需要高昂的计算成本,同时,开放研究有限,这些都阻碍了视频-LMMs的发展。

视频-LMMs的设计和训练:许多关于视频-LMMs设计的基本问题尚未得到解答,例如视频应该如何采样、哪种视觉编码器能产生最优表示、视频令牌的最佳重采样实践等。

视频基准测试的效率和质量:现有的视频问题回答基准测试存在效率低下和冗余的问题,需要更有效的评估方法。

模型规模与性能的关系:传统的扩展法则需要训练多个不同规模的模型来预测性能,这对于LMMs来说不切实际。论文探索了是否可以放宽这些扩展法则,以便在不训练多个模型的情况下预测性能。

论文通过一系列实验和分析,提出了“Apollo”这一家族的LMMs,旨在通过系统地探索视频-LMMs的设计空间,解决上述问题,并推动视频理解领域的发展。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的工作:

视频理解模型的发展:

- Hoffmann et al. (2022) 和 Yang et al. (2024) 讨论了语言和图像-语言模型的快速进步。

- Li et al. (2023a, 2025), Liu et al. (2024d), 和 Li et al. (2024b) 讨论了视频-LMMs面临的计算需求和复杂设计空间。

视频采样和编码器选择:

- Xu et al. (2024b), Kim et al. (2024), 和 Wu (2024) 讨论了直接将图像-LMMs扩展到视频领域的方法。

- Zhang et al. (2024e), Maaz et al. (2023) 提出了视频特定微调方法。

- Zhang et al. (2024e) 提出了更长上下文窗口的设计选择。

- Li et al. (2024a, c) 讨论了多模态混合方法。

- Wang et al. (2024c) 提出了代理工作流。

- Zohar et al. (2024) 讨论了自训练方法。

视频基准测试:

- Fu et al. (2024), Wu et al. (2024), Zhou et al. (2024), 和 Patraucean et al. (2023) 提出了多个视频问题回答基准。

- Goyal et al. (2017) 和 Chen et al. (2024a) 分析了图像问题回答基准的性能驱动因素和数据泄露问题。

模型扩展性和设计决策:

- Aghajanyan et al. (2023) 和 Yu et al. (2023) 观察了LMM预训练中的扩展法则。

- Hoffmann et al. (2022) 讨论了基于模型大小预测性能的传统扩展法则。

视频采样和令牌重采样:

- Jaegle et al. (2021) 提出了Perceiver Resampler,用于减少令牌数量并实现有效的长上下文建模。

- Laurençon et al. (2024b) 讨论了感知器重采样器作为减少令牌数量的有效方法。

视频表示和编码器组合:

- Shi et al. (2024) 测试了多种编码器集成方法,并发现通道级连接在几乎所有配置中都是首选。

视频令牌集成和训练协议:

- Zhao et al. (2024a) 系统地消融了视频和文本令牌集成策略。

这些相关工作为本研究提供了理论基础和实验背景,帮助作者深入探讨视频-LMMs的设计空间,并提出了改进视频理解性能的方法。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决视频大型多模态模型(video-LMMs)在理解和处理视频内容方面的效率和性能问题:

1. 系统探索视频建模设计空间

- 论文首先对影响大型多模态模型(LMMs)在视频语言任务中性能的关键架构设计选择进行了分析,包括视频采样、视频表示、视频令牌重采样和视频令牌集成策略。

- 通过实验比较不同的设计选择,例如不同的采样策略、视觉编码器组合、令牌重采样方法和集成策略,以确定哪些因素对模型性能有显著影响。

2. 引入“Scaling Consistency”概念

- 论文提出了“Scaling Consistency”现象,即在较小的模型和数据集上有效的设计决策可以有效地转移到更大的模型上。

- 利用这一发现,研究者可以在较小的模型上进行设计决策的实验,然后将这些决策应用到更大的模型上,从而减少计算成本并加速研究进程。

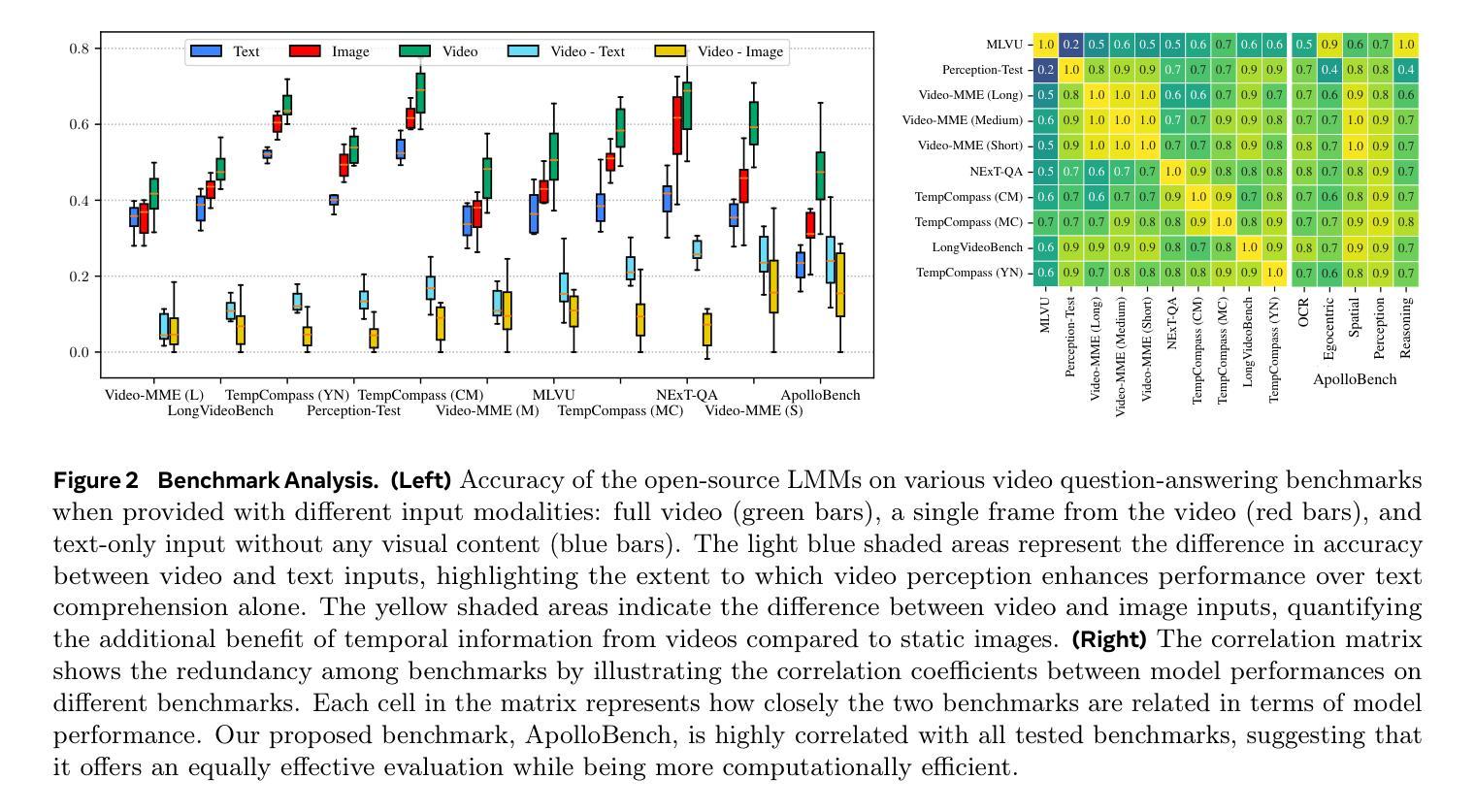

3. 评估和优化现有视频基准测试

- 论文分析了现有视频问题回答基准测试的质量、冗余性,并基于这些分析引入了一个新的基准测试套件ApolloBench。

- ApolloBench旨在提供一个更有效和高效的评估方法,通过精选问题和分类,减少评估时间并提供详细的洞察。

4. 训练策略和数据混合的探索

- 论文探讨了不同的训练计划和协议,包括单阶段、多阶段训练以及视频编码器的训练时机和数据。

- 通过实验确定最佳的训练策略和数据组成,以优化模型性能。

5. 引入Apollo模型家族

- 基于上述发现,论文介绍了Apollo,这是一个在不同模型规模下都能实现优越性能的LMMs家族。

- Apollo模型能够高效感知长达一小时的视频,并在多个基准测试中取得了优于现有模型的性能。

6. 提供资源和指导

- 论文不仅提出了解决方案,还提供了实现这些解决方案的详细资源和指导,包括模型架构、训练细节和数据集信息,以便其他研究者可以复现和扩展这些工作。

通过这些步骤,论文旨在提供一个全面的解决方案,以提高视频-LMMs的效率和性能,并推动该领域的进一步研究。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,作者进行了一系列实验来探索和验证他们的发现和方法。以下是论文中提到的主要实验:

1. 视频采样实验

- 比较了不同的视频采样策略,包括均匀采样(uniform sampling)和每秒帧数(fps)采样,以及它们对模型性能的影响。

- 分析了每秒帧数(fps)和每秒令牌数(tps)对模型性能的影响,并探讨了它们之间的权衡。

2. 视觉编码器实验

- 测试了不同的视觉编码器,包括单一编码器和编码器组合,以确定哪些编码器对视频表示最有效。

- 评估了语言监督和自监督编码器的性能差异。

3. 视频令牌重采样实验

- 测试了不同的视频令牌重采样方法,包括多层感知机(MLP)上投影+平均池化、2D卷积+平均池化和Perceiver重采样器。

4. 视频令牌集成实验

- 探索了不同的视频和文本令牌集成策略,包括直接插入、分隔符、文本时间戳和结合分隔符与时间戳的方法。

5. 训练计划实验

- 系统评估了不同的训练计划对模型性能的影响,包括单阶段、双阶段和三阶段训练协议。

6. 数据组成实验

- 研究了不同文本、图像和视频数据混合比例对模型性能的影响。

7. 扩展一致性(Scaling Consistency)实验

- 通过在不同大小的模型上进行实验,探索了在较小模型上有效的设计决策是否可以可靠地转移到更大的模型上。

8. Apollo模型性能评估

- 在多个基准测试中评估了Apollo模型的性能,包括TempCompass、MLVU、Perception-Test、Video-MME、LongVideoBench和ApolloBench。

这些实验旨在全面探索视频-LMMs的设计空间,并验证作者提出的方法和发现。通过这些实验,作者能够识别出影响视频-LMMs性能的关键因素,并提出了一套有效的设计和训练策略。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的研究方向:

1. 分离架构的探索

论文中提到了使用统一架构处理图像和视频输入的方法。可以进一步探索分离架构,其中图像由图像编码器处理,视频由图像和视频编码器共同处理,以揭示性能优势和更好的模态处理。

2. 视频和图像编码器的训练策略

在分离架构中,训练视频和图像编码器并在监督微调(SFT)中评估它们对性能的个体贡献,可能揭示最优训练策略。

3. 混合数据训练

在统一架构中,同时训练两个编码器处理混合的图像和视频数据可能有助于确定哪个编码器影响观察到的性能下降,从而实现针对性改进。

4. 扩展一致性(Scaling Consistency)的进一步研究

进一步确认扩展一致性是否适用于更广泛的模型大小范围,确保其对更大模型的可靠性。

5. 基于记忆的LMM方法

论文没有探索基于记忆的LMM方法,例如记忆银行或像Q-Former中文本条件池化这样的帧检索方法。评估这些技术可能会测试它们是否适合多轮对话的假设。

6. 对话评估基准

当前基准主要使用学术多项选择格式,这不足以评估对话能力。开发专门的对话评估基准对于更准确地测量和增强模型在现实世界场景中的对话性能至关重要。

7. 优化视频采样策略

根据视频感知任务的具体要求定制视频采样策略,以优化模型性能。

8. 探索不同的数据增强和合成数据技术

使用不同的数据增强技术和合成数据方法来提高模型的泛化能力和鲁棒性。

9. 跨模态迁移学习

研究如何通过跨模态迁移学习提高视频-LMMs的性能,特别是在有限标注数据的情况下。

10. 实际应用中的模型部署和效率

研究如何将这些大型多模态模型有效地部署到实际应用中,并保持高效率和低延迟。

这些方向能够帮助研究社区更深入地理解视频-LMMs,并推动该领域在视频理解任务中取得更好的性能和应用效果。

Q: 总结一下论文的主要内容

A: 这篇论文《Apollo: An Exploration of Video Understanding in Large Multimodal Models》主要探讨了在大型多模态模型(LMMs)中视频理解的效率和性能问题。以下是论文的主要内容总结:

1. 研究背景与挑战

- 视频-LMMs虽然在视频感知能力上有所进展,但其背后的视频理解机制仍不明确。

- 视频-LMMs面临更高的计算需求和更复杂的设计空间。

2. 视频-LMMs设计的关键问题

- 如何采样视频、选择视觉编码器、重采样视频令牌等基本问题尚未得到解答。

3. 系统探索与发现

- 通过实验分析了视频采样、视觉编码器、令牌重采样和集成策略等视频-LMMs设计的关键方面。

- 发现了“扩展一致性”现象,即在较小模型上有效的设计决策可以有效地转移到更大的模型上。

4. 视频基准测试分析

- 分析了现有视频问题回答基准测试的质量、冗余性,并基于这些分析引入了新的基准测试套件ApolloBench。

5. Apollo模型家族

- 基于研究发现,提出了Apollo,一系列在不同模型规模下都能实现优越性能的LMMs。

- Apollo模型能够高效感知长达一小时的视频,并在多个基准测试中取得了优于现有模型的性能。

6. 主要贡献

- 系统地探索了视频建模设计空间,发现关键因素,并提供未来研究的可行见解。

- 通过引入ApolloBench,解决了评估效率问题,并提供了详细的视频感知任务洞察。

- 提出了Apollo模型家族,实现了视频理解多个基准上的最先进结果。

7. 未来工作

- 提出了进一步探索的方向,包括分离架构、训练策略、基于记忆的LMM方法和对话评估基准等。

论文通过一系列实验和分析,提供了对视频-LMMs设计和训练的深入理解,并提出了改进视频理解性能的有效方法。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

IQViC: In-context, Question Adaptive Vision Compressor for Long-term Video Understanding LMMs

Authors:Sosuke Yamao, Natsuki Miyahara, Yuki Harazono, Shun Takeuchi

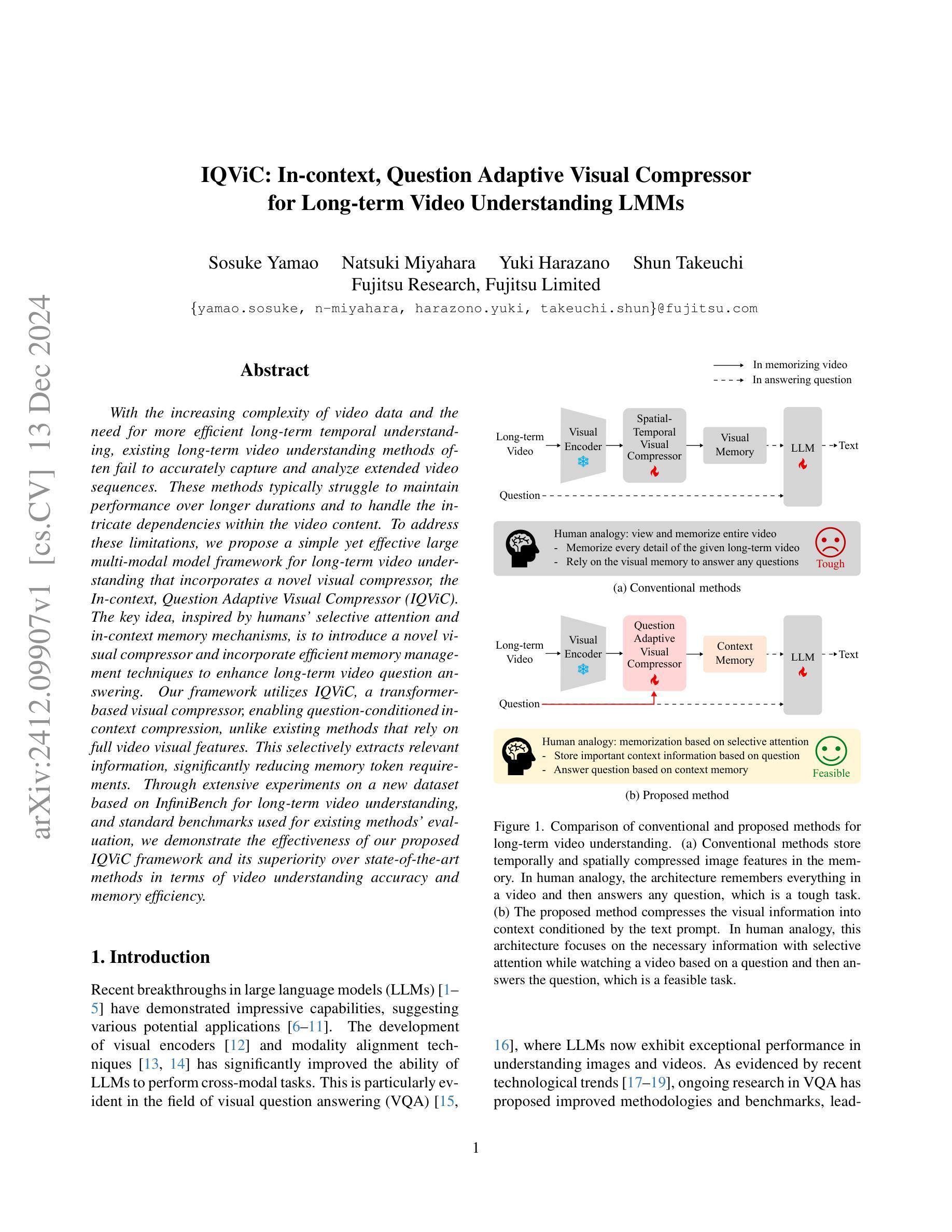

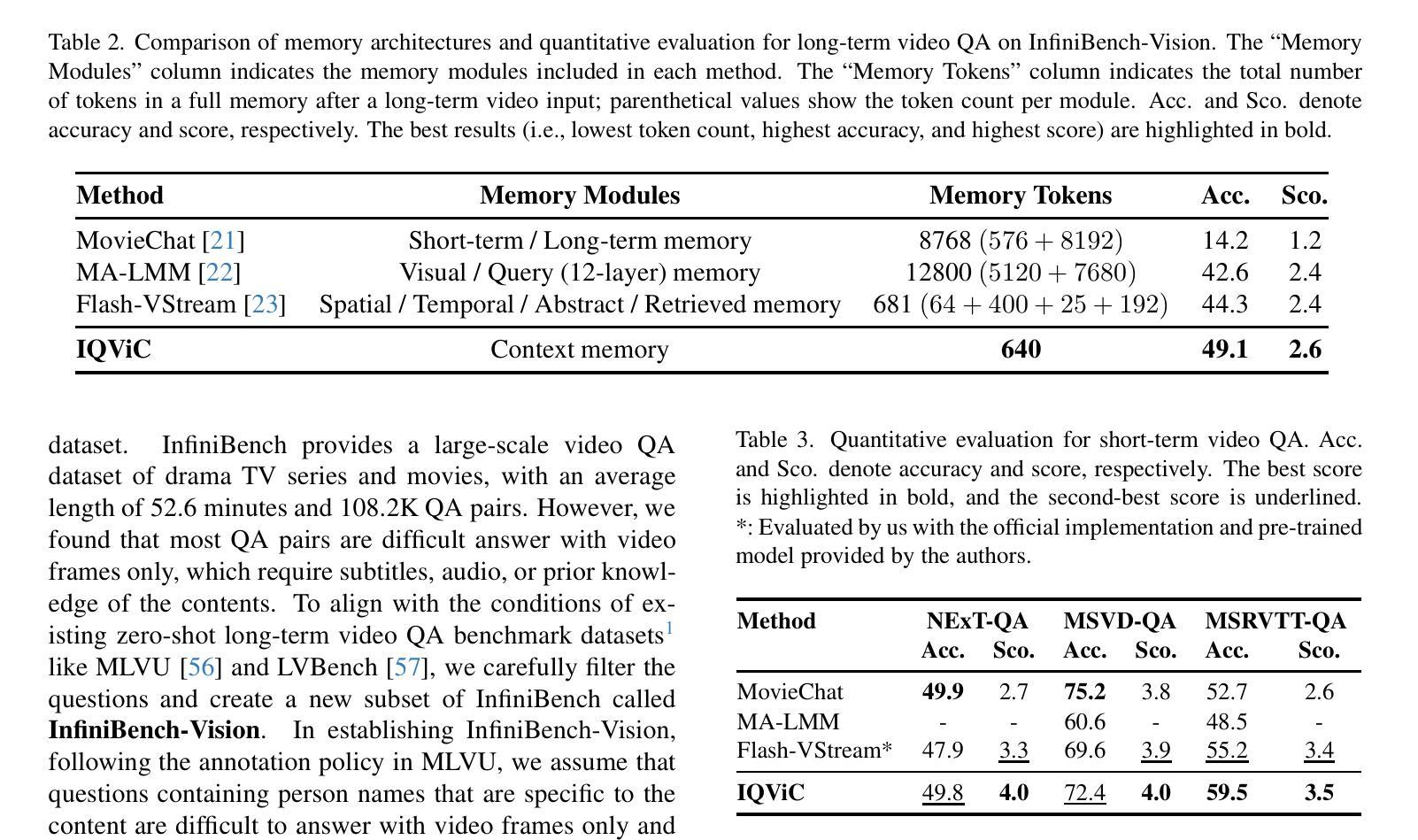

With the increasing complexity of video data and the need for more efficient long-term temporal understanding, existing long-term video understanding methods often fail to accurately capture and analyze extended video sequences. These methods typically struggle to maintain performance over longer durations and to handle the intricate dependencies within the video content. To address these limitations, we propose a simple yet effective large multi-modal model framework for long-term video understanding that incorporates a novel visual compressor, the In-context, Question Adaptive Visual Compressor (IQViC). The key idea, inspired by humans’ selective attention and in-context memory mechanisms, is to introduce a novel visual compressor and incorporate efficient memory management techniques to enhance long-term video question answering. Our framework utilizes IQViC, a transformer-based visual compressor, enabling question-conditioned in-context compression, unlike existing methods that rely on full video visual features. This selectively extracts relevant information, significantly reducing memory token requirements. Through extensive experiments on a new dataset based on InfiniBench for long-term video understanding, and standard benchmarks used for existing methods’ evaluation, we demonstrate the effectiveness of our proposed IQViC framework and its superiority over state-of-the-art methods in terms of video understanding accuracy and memory efficiency.

随着视频数据的复杂性不断增加和对更高效长期时间理解的需求,现有的长期视频理解方法往往无法准确捕获和分析扩展的视频序列。这些方法通常很难在较长的时间内保持性能,并且难以处理视频内容中的复杂依赖关系。为了解决这些局限性,我们提出了一种简单有效的长期视频理解的大型多模态模型框架,该框架结合了新型视觉压缩机——上下文感知问题适应性视觉压缩机(IQViC)。我们的关键想法是借鉴人类的选择性注意力和上下文记忆机制,引入新型视觉压缩机并结合高效的内存管理技术,以提高长期视频问答的效果。我们的框架使用基于变压器的IQViC视觉压缩机,不同于现有方法依赖于全视频视觉特征,实现了上下文感知的问题条件压缩。这有选择地提取相关信息,显著减少内存令牌需求。我们在基于InfiniBench的长期视频理解的新数据集以及现有方法评估的标准基准测试上进行了广泛的实验,证明了IQViC框架的有效性,并在视频理解准确性和内存效率方面展现了其优越性。

论文及项目相关链接

Summary

视频理解的复杂性不断上升,对长期时序理解的需求日益增强。现有的长期视频理解方法难以准确捕捉和分析延伸视频序列。为此,我们提出了一个简单有效的大型多模态模型框架,用于长期视频理解,并引入了新颖的视觉压缩机——上下文自适应问题感知视觉压缩机(IQViC)。该框架利用IQViC进行上下文压缩,不同于依赖全视频视觉特征的传统方法。通过在新建的基于InfiniBench的长期视频理解数据集和现有方法评估标准基准上的广泛实验,证明了IQViC框架的有效性和优越性。

Key Takeaways

- 长期视频理解面临挑战:难以准确捕捉和分析延伸视频序列。

- 现有方法在处理复杂依赖性和维持长期性能上表现不足。

- 引入IQViC框架,结合新颖的视觉压缩机和高效内存管理技术。

- IQViC利用上下文信息实现问题感知的压缩方式。

- IQViC框架通过选择性提取相关信息,显著减少内存令牌需求。

- 在基于InfiniBench的新数据集和现有基准上的实验证明了IQViC的优越性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何有效地理解和分析长期视频数据。具体来说,论文指出现有的长期视频理解方法在处理和分析较长视频序列时常常无法准确捕捉和分析视频内容,这些方法在视频时长增加时难以保持性能,并且难以处理视频内容内部的复杂依赖关系。为了克服这些限制,论文提出了一个新颖的大型多模态模型框架(LMMs),用于长期视频理解,该框架包含了一个名为In-context, Question Adaptive Visual Compressor(IQViC)的新型视觉压缩器。这个框架的核心思想是借鉴人类的选择性注意力和上下文记忆机制,通过引入新型视觉压缩器和高效的内存管理技术来增强长期视频问答能力。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要包括以下几个方面:

大型多模态模型(Large Multi-modal Models):

- 论文提到了BLIP系列模型,该模型通过Querying-transformer连接冻结的图像编码器和冻结的大型语言模型(LLMs),显著减少了可训练参数的数量。

- LLaVA系列模型,通过整合CLIP预训练的视觉编码器和Vicuna语言解码器,针对指令遵循任务设计了新构建的数据集。

- 其他一些模型,如[33–37]中提到的,能够处理多个图像和视频。

长期视频理解(Long-term Video Understanding):

- 论文讨论了LongVA、MM-Vid和Artemis等框架,这些框架分别通过长上下文传递、视频理解的协同组合和利用文本提示及感兴趣区域注释来解决复杂视频数据的指代表达理解挑战。

- 论文还提到了一些记忆增强框架,如MALMM、MovieChat和Flash-VStream,这些框架通过存储视频帧的视觉特征到短期或长期记忆库中,并基于存储的特征和输入问题生成答案。

上下文压缩(In-context Compression):

- 论文提到了GIST、Autocompressor和In-context Autoencoder (ICAE)等方法,这些方法专注于使用预训练的LLMs将长上下文压缩成更短的表示。

- 这些方法在压缩效率和架构简单性方面具有优势,但主要限于文本模态,对于视觉数据的应用是一个挑战。

这些相关研究为论文提出的IQViC框架提供了理论基础和技术背景,特别是在处理长期视频数据和跨模态任务中的LLMs应用方面。论文通过这些相关工作,进一步提出了一个针对长期视频理解的新型视觉压缩器和LMM框架,旨在提高视频理解的准确性和内存效率。

Q: 论文如何解决这个问题?

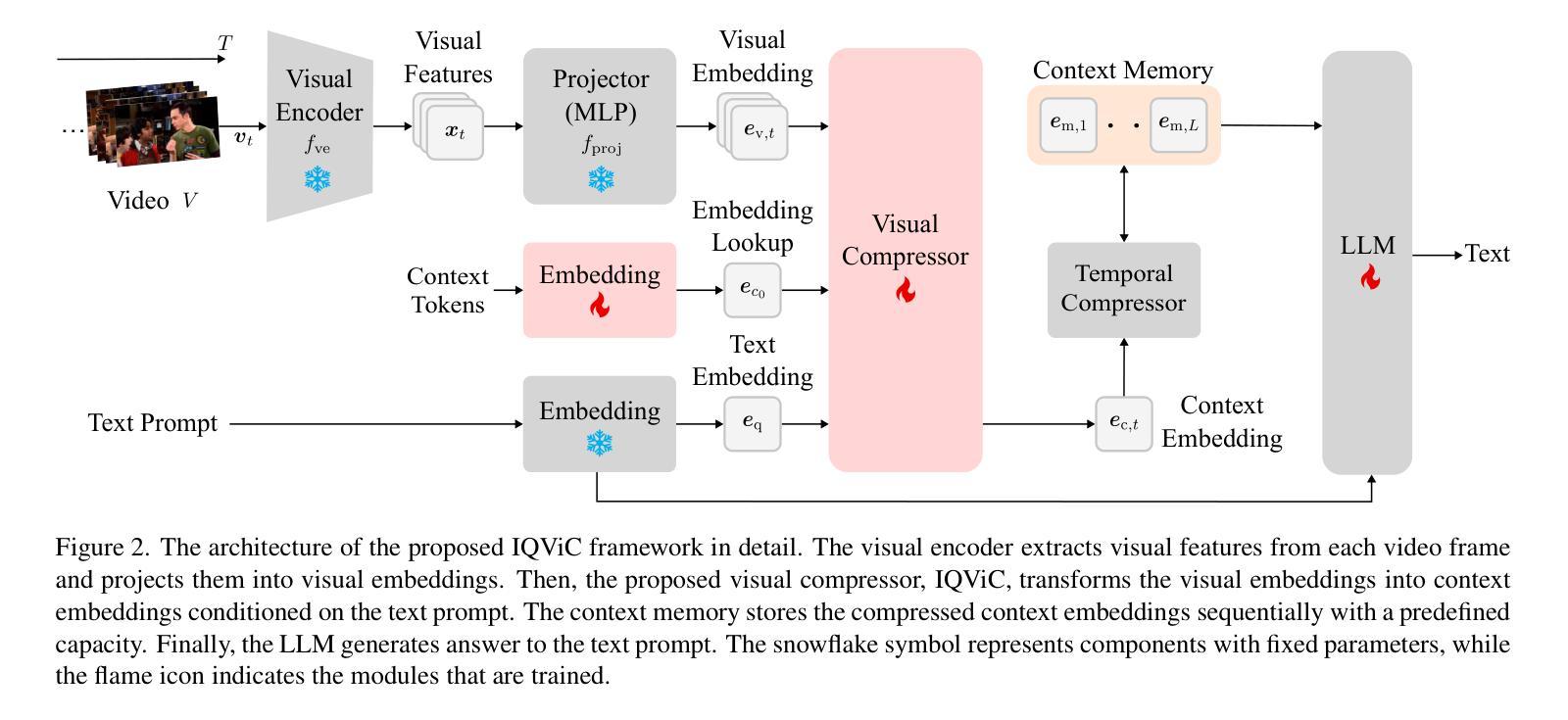

A: 论文通过提出一个名为In-context, Question Adaptive Visual Compressor (IQViC)的新型视觉压缩器来解决长期视频理解的问题。以下是该方法的关键解决方案和步骤:

1. 引入IQViC视觉压缩器

- 选择性信息提取:IQViC基于Transformer的视觉压缩器能够根据问题条件进行上下文压缩,选择性地提取与问题相关的重要信息,显著减少记忆标记的需求。

2. 基于问题的上下文压缩

- 上下文记忆机制:IQViC通过上下文记忆机制,将基于问题提取的视觉信息压缩成上下文,并在时间上压缩这些上下文以保持内存效率。

3. 简单而有效的LMM框架

- 长期视频理解框架:提出了一个新的大型多模态模型(LMM)框架,该框架结合了IQViC视觉压缩器和上下文记忆机制,以提高长期视频问答的能力。

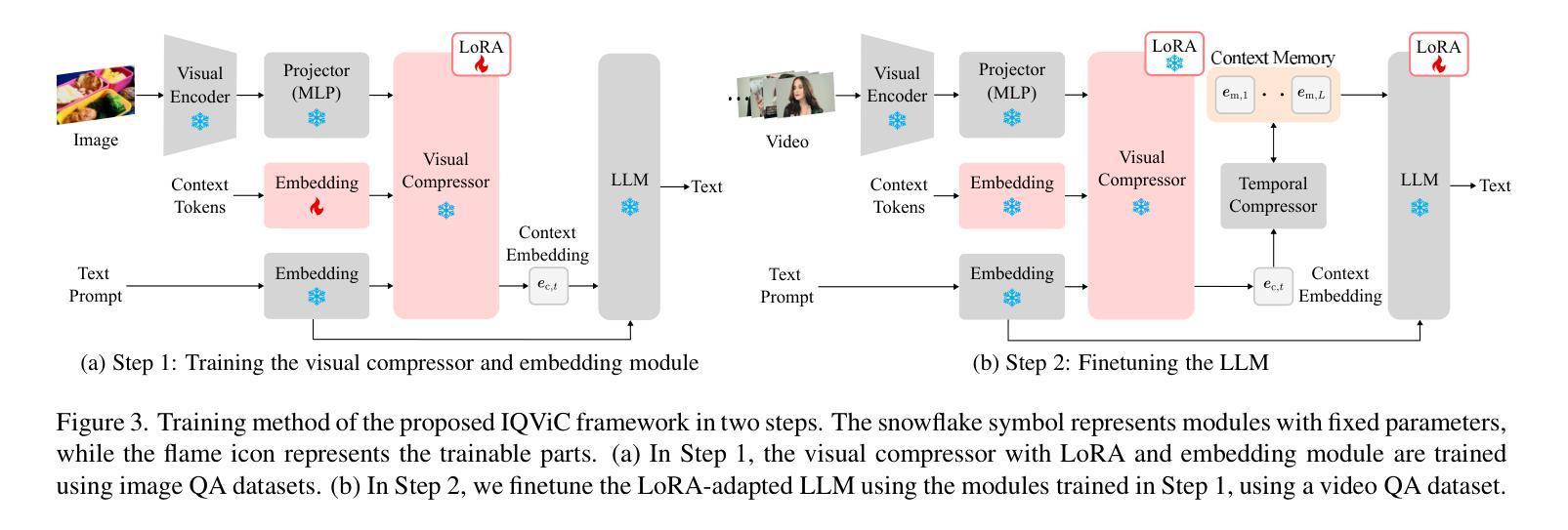

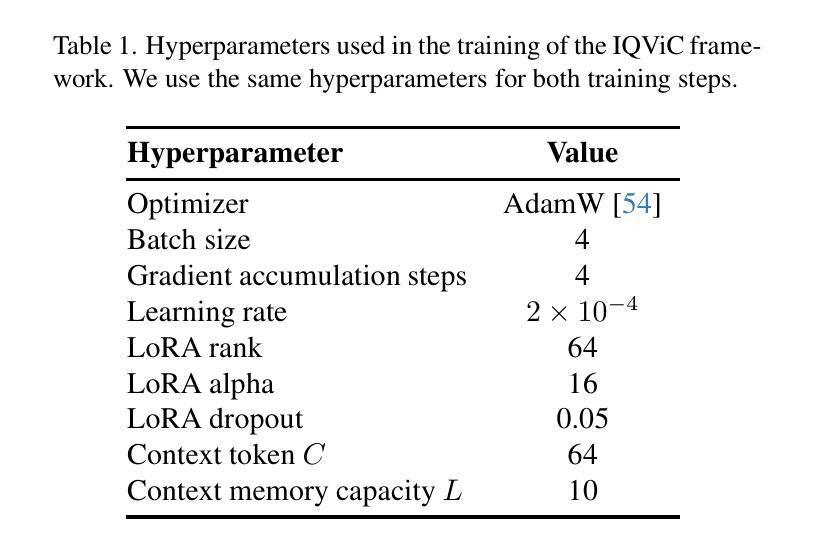

4. 训练和推理方法

两步训练方法:由于直接在视频帧上训练会导致内存消耗过大,论文采用了两步训练方法。首先,使用图像QA数据集训练视觉压缩器和嵌入模块;其次,使用视频QA数据集对LLM进行微调。

推理方法:在推理过程中,视频帧首先被视觉压缩器顺序压缩以构建上下文记忆,然后这个上下文记忆与文本提示一起作为输入提供给解码器以生成文本响应。

5. 实验验证

- 定量评估:通过在新的长期视频理解数据集InfiniBench-Vision和标准基准测试上进行广泛的实验,论文证明了IQViC框架在视频理解准确性和内存效率方面优于现有方法。

总结来说,论文通过引入一个能够根据问题自适应压缩视觉信息的新型视觉压缩器,并结合有效的上下文记忆管理技术,提出了一个简单而有效的框架来提高长期视频理解的性能和效率。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来验证IQViC框架的有效性:

1. 长期视频问答(Long-term Video QA)

- 数据集:使用InfiniBench-Vision数据集,这是从InfiniBench中筛选出来的子集,包含265个视频和599个开放性问答对,平均视频长度为49分钟。

- 比较方法:与现有的最先进方法进行比较,包括MovieChat、MA-LMM和Flash-VStream。

- 评估指标:使用GPT模型来计算准确性和得分,基于预测和真实答案来确定预测是否正确,并给出0到5之间的得分。

- 结果:IQViC在长期视频理解中取得了最高的平均得分,超过了现有的最先进方法,并且在记忆架构和记忆标记使用上更为简单和高效。

2. 短期视频问答(Short-term Video QA)

- 数据集:在NExT-QA、MSVD-QA和MSRVTT-QA这三个短期视频问答基准上进行实验,这些基准包含时长从10秒到40秒不等的短期视频。

- 比较方法:与现有的最先进方法进行比较。

- 评估指标:同样使用GPT模型来计算准确性和得分。

- 结果:IQViC在所有数据集上都取得了最好的得分,并且在MSRVTT-QA上比之前最好的方法Flash-VStream提高了4.3%的准确性。

3. 消融研究(Ablation Study)

- 压缩器比较:使用LLaVA-Bench(in-the-wild)图像理解基准数据集来评估视觉压缩器的压缩性能,比较了IQViC的视觉压缩器与平均池化等标准特征压缩技术的性能。

- 上下文标记大小消融:研究了上下文标记数量对VQA性能的影响,发现即使只使用一个上下文标记,IQViC也保持了惊人的高准确率。

4. 案例研究(Case Study)

- 示例分析:通过InfiniBench-Vision数据集中的一个问答对示例来展示IQViC框架的性能,与其他方法相比,IQViC能够成功回答需要深层上下文理解的问题,而其他方法则未能给出正确答案或产生幻觉答案。

这些实验全面评估了IQViC框架在处理长期和短期视频问答任务时的性能,并与现有最先进方法进行了比较,证明了IQViC在视频理解准确性和内存效率方面的优势。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

1. 动态记忆更新

- 论文中提到,为了准确响应新视频问题,需要根据每个文本提示动态更新记忆。当前需要对每个查询重新处理整个视频,这在计算上是昂贵且不切实际的。未来的工作可以集中在开发新的记忆更新技术,以优化记忆状态,并根据问题的关联性动态调整更新幅度。

2. 端到端训练

- 由于在训练期间高VRAM消耗,论文中的IQViC框架未能实现端到端训练。未来的研究可以探索端到端训练策略,包括滑动窗口或采样技术,并集成长上下文视觉-语言模型,以改善视频理解。

3. 多模态信息融合

- 与现有方法一样,IQViC目前仅关注视觉信息,忽略了字幕、音频和时间信息等可能有价值的外部知识源。未来的工作可以探索将IQViC扩展为多模态信息压缩器,整合这些外部知识源以显著提高长期视频理解能力。

4. 因果和时间推理能力

- 论文提出未来的工作将集中于扩展IQViC框架以在压缩和记忆机制中纳入时间信息,以增强因果和时间推理能力。

5. 扩展到其他模态

- 论文建议将IQViC应用于其他模态,如音频和3D数据,以探索其在不同数据类型上的适用性和有效性。

6. 优化和加速推理过程

- 研究如何优化IQViC框架以加速推理过程,使其适用于实时或近实时的应用场景。

7. 鲁棒性和泛化能力

- 对IQViC框架在不同类型、风格和复杂度的视频内容上的鲁棒性和泛化能力进行进一步的研究和评估。

这些探索点可以帮助提升IQViC框架的性能,并扩展其在视频理解和多模态信息处理领域的应用范围。

Q: 总结一下论文的主要内容

A: 论文的主要内容可以总结如下:

问题陈述:

- 论文指出,现有的长期视频理解方法在处理和分析较长视频序列时常常无法准确捕捉和分析视频内容,特别是在维持性能和处理视频内容内部复杂依赖关系方面存在挑战。

IQViC框架:

- 提出了一个名为In-context, Question Adaptive Visual Compressor (IQViC)的新型视觉压缩器,用于长期视频理解的大型多模态模型(LMMs)框架。

- IQViC框架的核心思想是模仿人类的选择性注意力和上下文记忆机制,通过引入新型视觉压缩器和高效的内存管理技术来增强长期视频问答能力。

方法论:

- IQViC利用基于Transformer的视觉压缩器进行上下文压缩,选择性地提取与问题相关的重要信息,显著减少记忆标记的需求。

- 该框架包括四个主要组件:视觉编码器、视觉压缩器、上下文记忆和解码器。

- 采用了两步训练方法,首先使用图像QA数据集训练视觉压缩器和嵌入模块,然后使用视频QA数据集对LLM进行微调。

实验验证:

- 在长期视频理解数据集InfiniBench-Vision和标准基准测试上进行了广泛的实验,证明了IQViC框架在视频理解准确性和内存效率方面优于现有方法。

- IQViC在长期和短期视频问答任务中均展现出优越的性能,并且在记忆架构和记忆标记使用上更为简单和高效。

未来工作:

- 论文提出了几个未来研究方向,包括动态记忆更新、端到端训练、多模态信息融合、因果和时间推理能力的增强,以及其他模态数据的应用。

综上所述,论文提出了一个创新的框架来解决长期视频理解中的挑战,并通过一系列实验验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

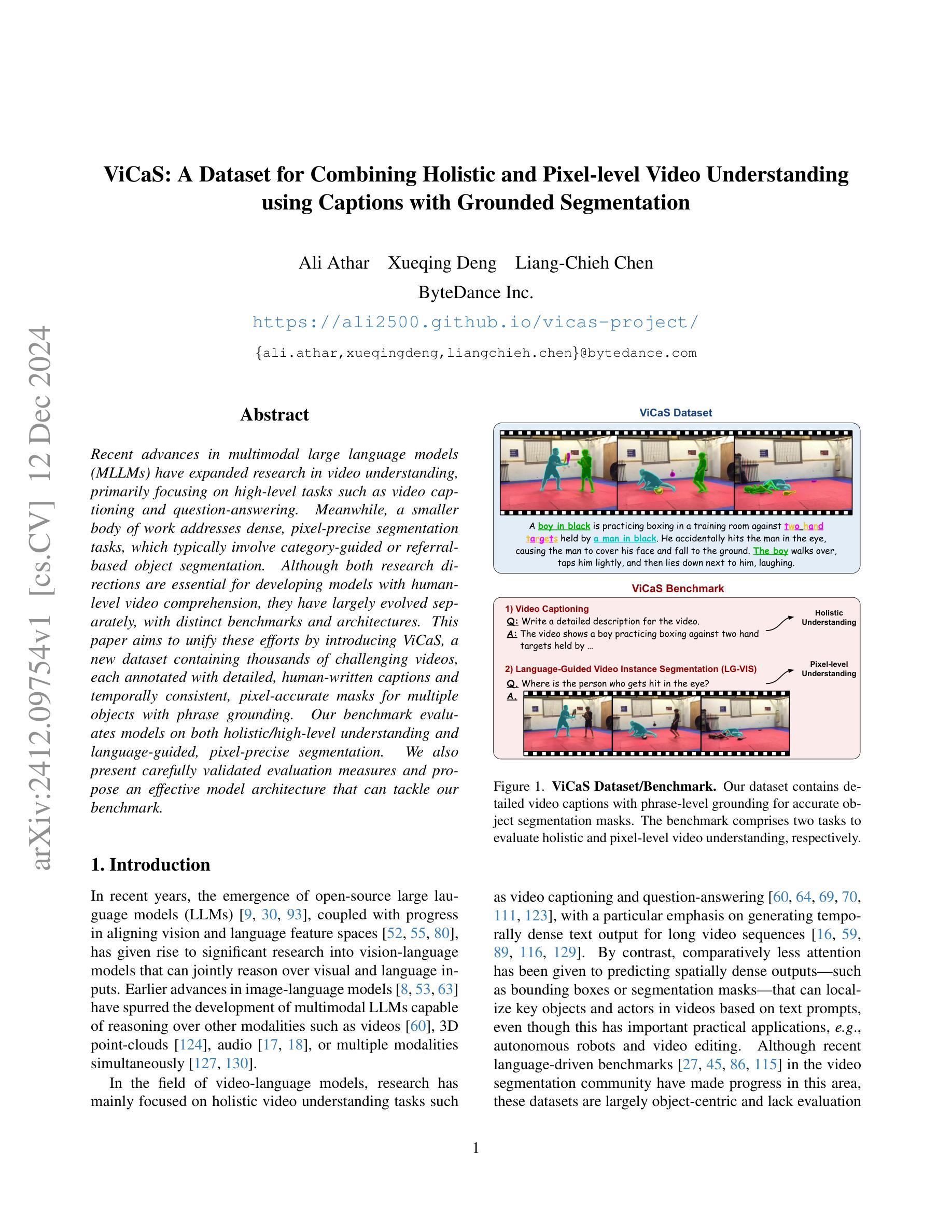

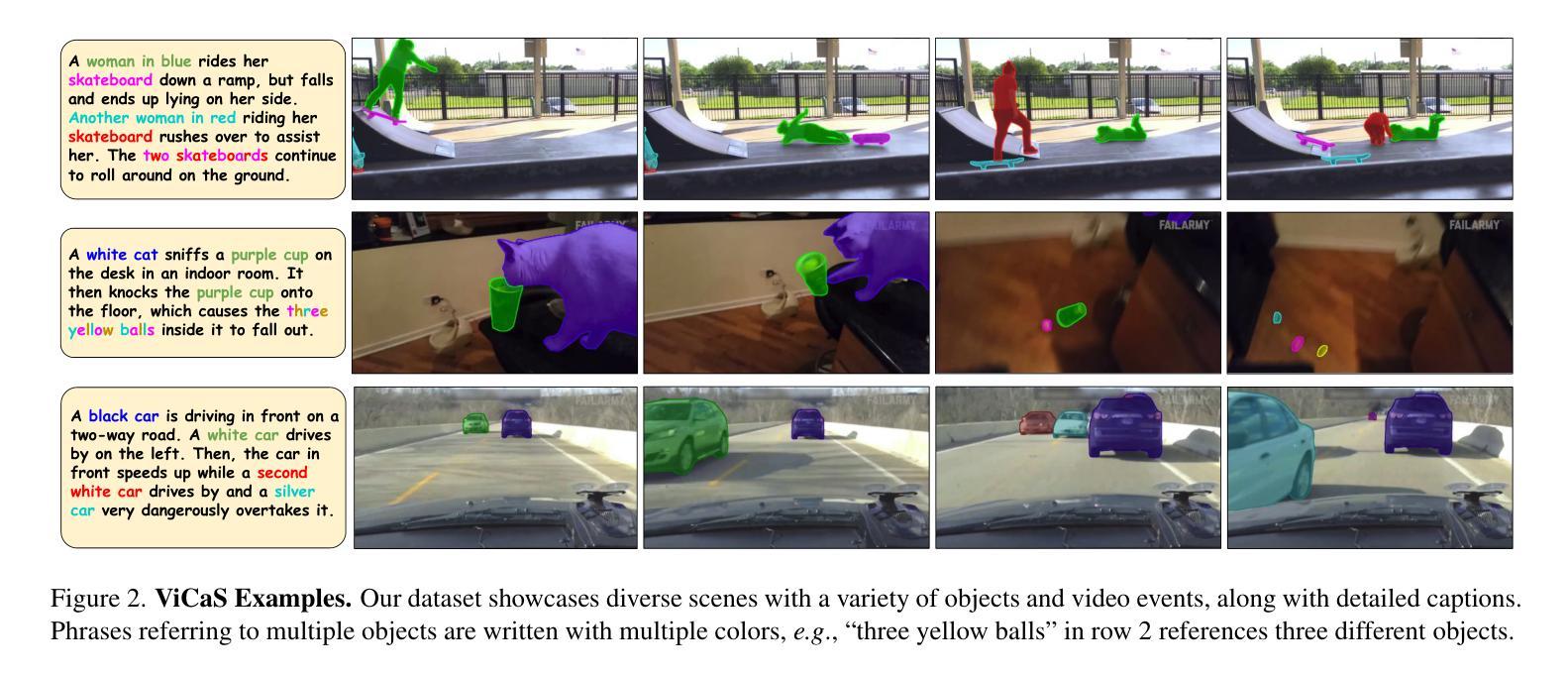

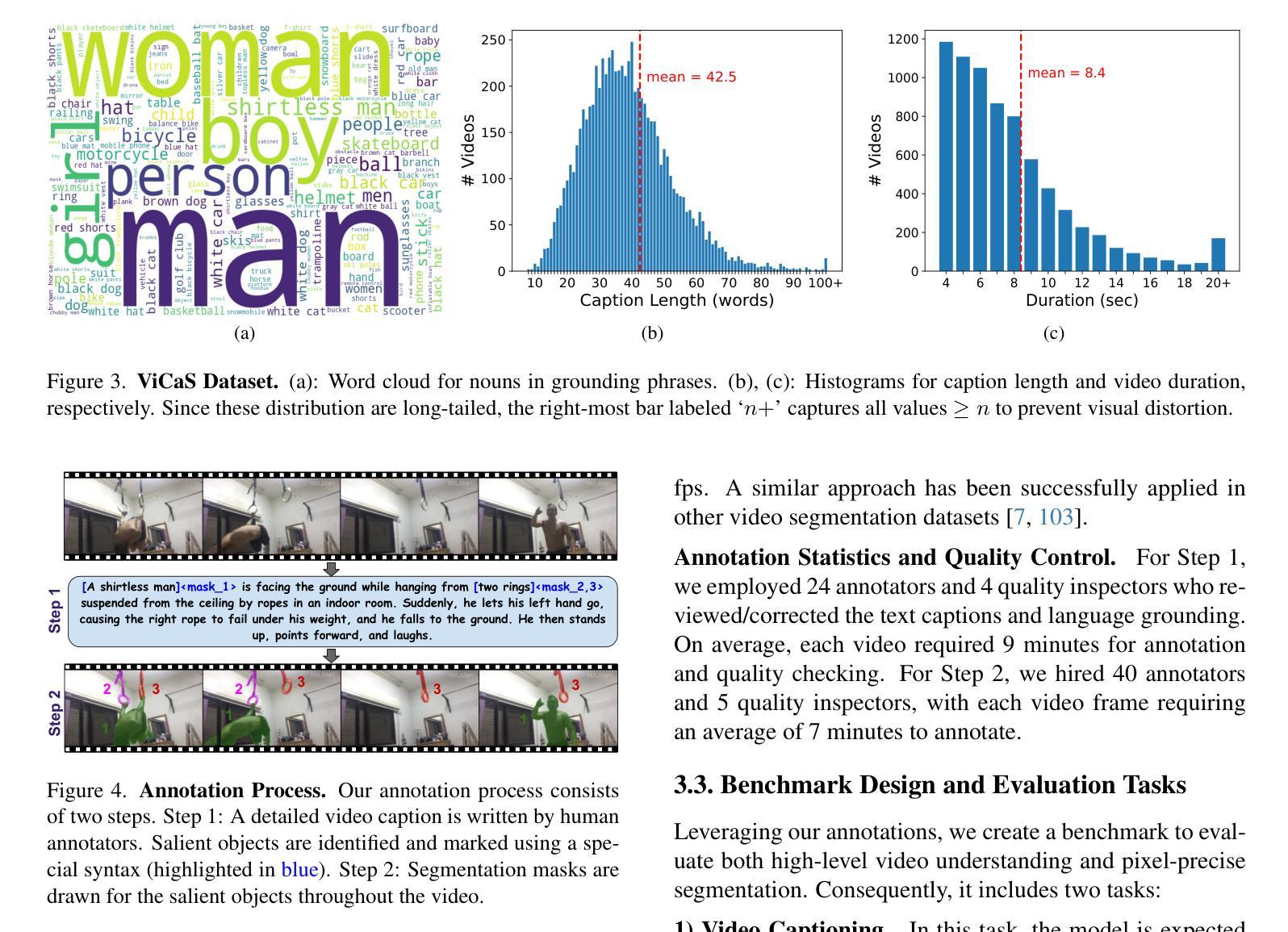

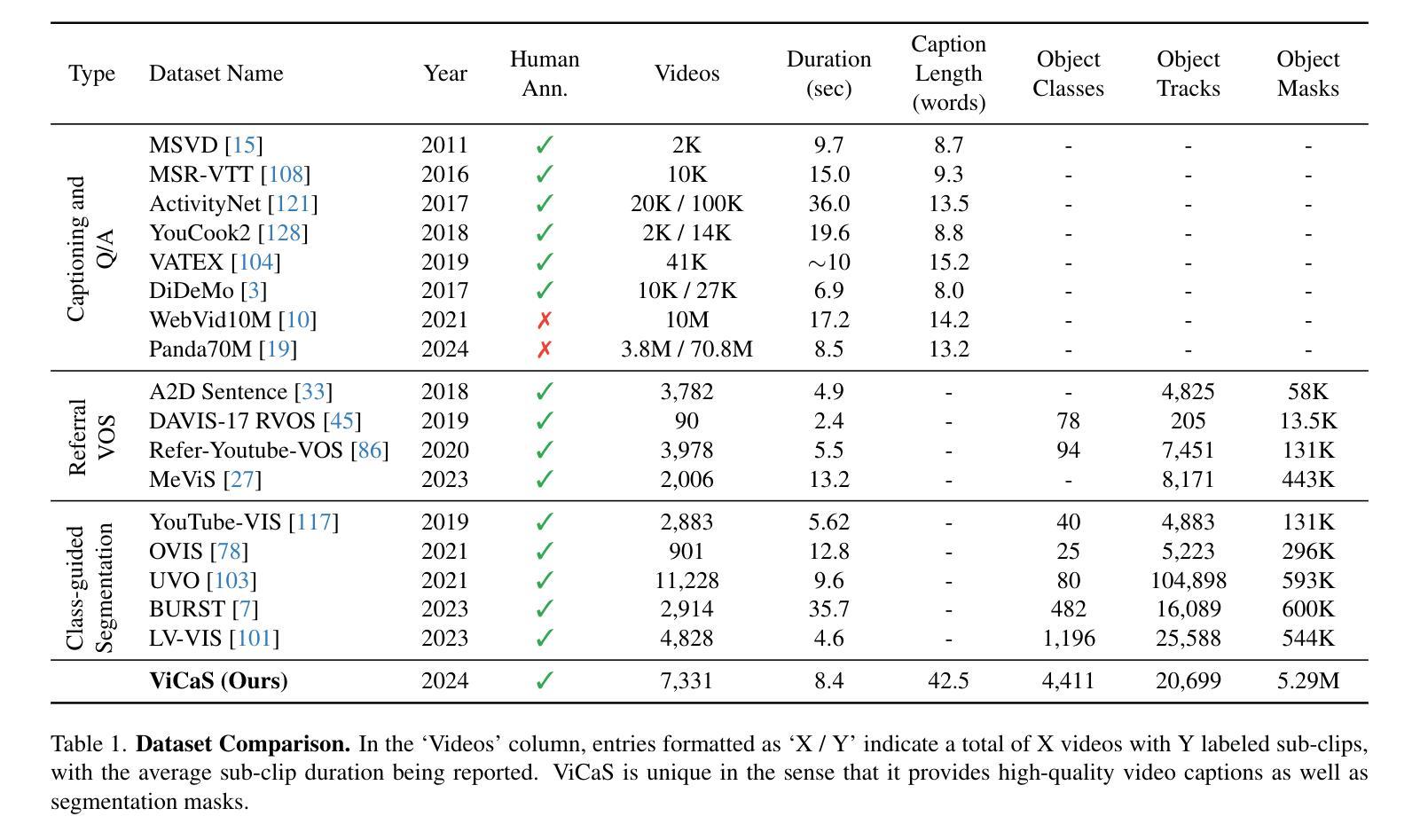

ViCaS: A Dataset for Combining Holistic and Pixel-level Video Understanding using Captions with Grounded Segmentation

Authors:Ali Athar, Xueqing Deng, Liang-Chieh Chen

Recent advances in multimodal large language models (MLLMs) have expanded research in video understanding, primarily focusing on high-level tasks such as video captioning and question-answering. Meanwhile, a smaller body of work addresses dense, pixel-precise segmentation tasks, which typically involve category-guided or referral-based object segmentation. Although both research directions are essential for developing models with human-level video comprehension, they have largely evolved separately, with distinct benchmarks and architectures. This paper aims to unify these efforts by introducing ViCaS, a new dataset containing thousands of challenging videos, each annotated with detailed, human-written captions and temporally consistent, pixel-accurate masks for multiple objects with phrase grounding. Our benchmark evaluates models on both holistic/high-level understanding and language-guided, pixel-precise segmentation. We also present carefully validated evaluation measures and propose an effective model architecture that can tackle our benchmark. Project page: https://ali2500.github.io/vicas-project/

近期多模态大型语言模型(MLLMs)的进步推动了视频理解研究的发展,主要研究重点是高级任务,如视频描述和问答。与此同时,一小部分工作关注密集的、像素精确的分割任务,这通常涉及基于类别指导或基于引用的对象分割。虽然这两个研究方向对于开发具有人类水平视频理解能力的模型都至关重要,但它们大多独立发展,具有不同的基准测试和架构。本文旨在通过引入ViCaS数据集来统一这些努力,该数据集包含数千个具有挑战性的视频,每个视频都经过详细的人类手写描述和与语言描述一致的像素精确的多对象掩膜标注。我们的基准测试对整体/高级理解和语言指导的像素精确分割进行了评估。我们还提供了经过仔细验证的评价指标,并提出了能有效应对基准测试模型架构。项目页面:https://ali2500.github.io/vicas-project/

论文及项目相关链接

Summary

近期多模态大型语言模型(MLLMs)的进步推动了视频理解研究的扩展,主要关注高级任务如视频描述和问答。同时,一小部分工作致力于密集、像素精确的分割任务,通常涉及类别指导或引用基础的对象分割。虽然这两个研究方向对于开发具有人类水平视频理解能力的模型至关重要,但它们大多独立发展,具有不同的基准和架构。本文旨在通过引入ViCaS数据集统一这些工作,该数据集包含数千个具有挑战性的视频,每个视频都经过详细的人类书写描述和与语言一致的像素精确掩膜进行标注。该基准评估模型在整体高级理解和语言指导的像素精确分割方面的表现。同时提供了经过仔细验证的评价指标和有效的模型架构来应对这一基准测试。更多详情访问:链接地址。

Key Takeaways

- 多模态大型语言模型的进步促进了视频理解研究的发展。

- 视频理解研究包括高级任务如视频描述和问答,以及密集、像素精确的分割任务。

- 目前的研究大多集中在两个独立的研究方向上,分别关注高级理解和像素精确分割任务。

- 本文引入了ViCaS数据集,包含了多个挑战视频并进行了详细的标注。

- 该数据集注重整体高级理解和语言指导的像素精确分割评估。

- 项目提供了仔细验证的评价指标和有效的模型架构以应对这一基准测试。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何将视频理解中的两个主要研究方向——整体性(holistic)视频理解和像素级(pixel-level)视频理解——结合起来。具体来说,论文指出:

整体性视频理解:这个方向主要关注于视频的高级任务,如视频描述(video captioning)和视频问答(question-answering),这些任务侧重于生成视频的高级、概述性文本输出。

像素级视频理解:这个方向主要关注于预测空间密集的输出,例如基于文本提示的视频中关键对象和角色的定位,这在实际应用中非常重要,例如自动驾驶机器人和视频编辑。

尽管这两个研究方向对于开发具有人类级别视频理解能力的模型都至关重要,但它们在很大程度上是独立发展的,有着不同的基准测试和架构。因此,论文提出了一个新的数据集ViCaS(Video Captioning with Grounded Segmentation),旨在统一这些努力,通过提供包含详细人类编写的字幕和多个对象的像素精确的掩码来评估模型的整体性/高级理解和语言引导的像素级分割能力。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个领域:

1. 整体性视频理解(Holistic Video Understanding)

视频分类(Video Classification):

- 早期的视频理解任务之一,通过活动识别数据集(如HMDB、UCF101)流行开来,并随着更大数据集(如Kinetics)的扩展而发展。

- 早期深度学习方法使用3D CNNs捕获时空信息,随后基于transformer的注意力架构出现,提供了更好的性能。

视频描述和问答(Video Captioning and Question-Answering):

- 早期数据集(如MSVD、MSR-VTT、TGIF-QA)为视频描述奠定了基础,并后来被改编为问答基准。

- 最初的方法结合了CNNs进行视觉推理和RNNs进行文本生成。随着transformers的流行,出现了如VideoBERT和UniVL等架构,它们通过学习视觉和语言的共享表示来统一这两种模态。

多模态大型语言模型(Multimodal Large Language Models, MLLMs):

- 随着LLMs的流行,研究扩展到处理视觉输入(如图像和视频)的多模态模型。

- 这项研究得到了大规模视频描述数据集和多任务视频理解基准的支持。

2. 像素级视频理解(Pixel-level Video Understanding)

对象跟踪和分割(Object Tracking and Segmentation):

- 对象定位和跟踪是一个深入研究的问题,从早期的边界框级对象跟踪发展到像素精确的视频分割。

- 随着模型架构的进步,出现了基于预定义类别的对象分割任务和给定第一帧真实掩码或点的特定对象分割任务。

语言引导分割(Language-Guided Segmentation):

- 近期在视觉-语言模型方面的进展推动了多个语言引导的视频分割数据集的发展,包括“开放词汇”数据集和基于引用的视频分割基准。

- 当前的方法使用文本和图像主干来编码文本提示和视频帧,然后通过transformer解码器和分割头部生成掩码。

这些相关研究为ViCaS数据集的提出提供了背景和动机,ViCaS旨在通过结合这两种类型的视频理解任务来填补现有研究之间的空白。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤来解决将整体性视频理解和像素级视频理解结合起来的问题:

1. 引入ViCaS数据集

- 数据集构建:创建了一个包含7,331个视频的数据集,每个视频都有详细的人类编写的字幕和多个对象的像素精确的掩码,这些字幕和掩码在时间上是一致的,并且与短语进行了锚定(phrase grounding)。

2. 设计基准测试

- 视频字幕任务(Video Captioning):要求模型生成一个开放式文本摘要,解释视频中的事件,包括描述显著的对象和背景元素。

- 语言引导的视频实例分割(Language-Guided Video Instance Segmentation, LG-VIS):要求模型基于文本提示预测多个对象的时间一致性分割掩码。

3. 提出评估措施

- 视频字幕评估:通过全面的用户研究验证开放式文本相似度的评估措施,选择了基于开源模型的评估方法,并在用户研究中得到验证。

- LG-VIS评估:选择了Track mean Average Precision (mAP)作为主要的评估指标,因为它被广泛用于视频分割基准测试,并且可以适应多对象预测。

4. 提出Video-LLaVA-Seg模型

- 模型架构:提出了一个有效的基线模型Video-LLaVA-Seg,该模型可以处理视频字幕和LG-VIS任务,使用单一的、端到端训练的模型。

- 视觉特征:输入视频帧到视觉主干网络,产生一组视频特征。

- 多模态LLM:将视觉特征通过投影MLP处理后与文本提示嵌入连接,输入到多模态LLM,输出嵌入。

- 分割网络:使用单独的分割主干网络在高分辨率下编码视频帧,产生多尺度特征,与

标记一起输入到掩码解码器以获得最终的分割掩码。

5. 实施和消融研究

- 实现细节:提供了模型的详细实现和训练超参数。

- 消融研究:通过消融研究验证了慢速-快速池化和任务特定训练对模型性能的影响。

通过这些步骤,论文不仅提供了一个新的数据集和基准测试来评估视频理解的两个方面,而且还提出了一个有效的模型架构来处理这些任务,并验证了所提出的评估措施的有效性。这些贡献为视频理解领域提供了新的研究方向和工具。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了以下实验:

1. 用户研究以验证评估措施

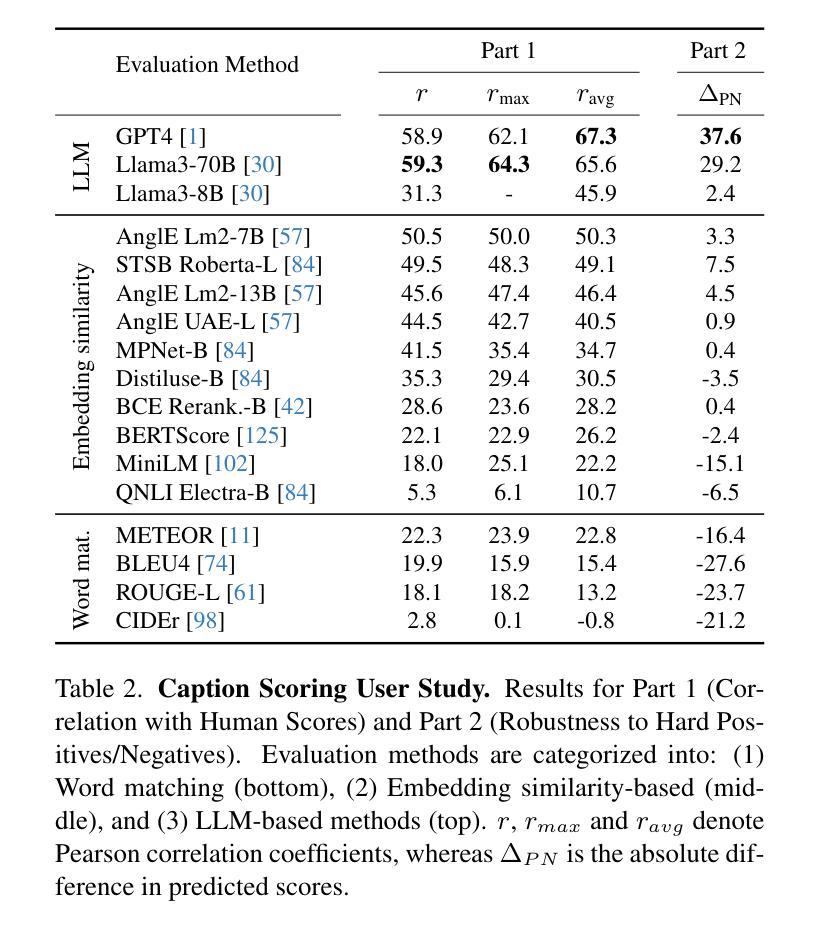

- 视频字幕评分用户研究:为了确定视频字幕任务的评估措施,作者进行了一个两阶段的用户研究,比较了多种评分方法,包括经典的文本相似度度量、基于嵌入的相似度度量和基于最近的大型语言模型(LLM)的评分方法。用户研究的目的是评估这些方法与人类评分之间的相关性以及它们对正面和负面样本的鲁棒性。

2. 模型架构实验

- 消融研究:作者进行了消融研究来评估慢速-快速池化(slow-fast pooling)和针对特定任务训练的影响。这些实验包括:

- 移除慢速-快速池化,使用相同数量的帧来评估其对视频字幕准确性(Caption Accuracy, CA)和语言引导的视频实例分割(Language-Guided Video Instance Segmentation, LG-VIS)性能的影响。

- 仅对视频字幕任务训练模型,以及仅对LG-VIS任务训练模型,以观察多任务训练的效果。

3. 基准测试结果

- 模型性能评估:作者提出了Video-LLaVA-Seg模型,并在ViCaS数据集的验证集和测试集上评估了其性能。性能指标包括视频字幕的Caption Accuracy(CA)和LG-VIS的mAP(mean Average Precision)。作者将Video-LLaVA-Seg与其他现有方法(如LLaVA-Next和一些特定的Referral-VOS方法)进行了比较。

4. 实施细节

- 模型实现和训练:作者提供了Video-LLaVA-Seg模型的详细实现细节和训练超参数,并在不同阶段对模型进行了训练和微调,包括仅用于视频字幕的训练和结合视频字幕及LG-VIS的联合训练。

这些实验旨在验证所提出的评估措施的有效性,展示Video-LLaVA-Seg模型在处理视频字幕和LG-VIS任务时的性能,并与现有方法进行比较。通过这些实验,作者证明了他们的方法在结合整体性和像素级视频理解方面的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了ViCaS数据集和相应的评估方法以及模型架构,但仍有一些领域可以进一步探索:

1. 模型架构的改进

- 多模态融合方法:探索不同的视觉和语言融合方法,以更有效地结合这两种模态的信息。

- 注意力机制:研究更复杂的注意力机制,以更好地定位视频和文本之间的相关部分。

- 跨模态注意力:进一步探索跨模态注意力,以增强模型对视频内容和语言描述之间对应关系的理解。

2. 数据集扩展和多样化

- 多语言字幕:扩展数据集以包含多语言字幕,以增强模型的泛化能力,并支持跨语言的视频理解任务。

- 更复杂的场景:增加更多复杂背景和动态场景的视频,以测试和提高模型在更具挑战性条件下的性能。

- 更广泛的对象和事件:扩大数据集中对象和事件的多样性,以覆盖更广泛的日常生活和专业领域。

3. 评估指标的完善

- 细粒度评估:开发更细粒度的评估指标,以更精确地衡量模型在特定类型的对象或事件上的性能。

- 用户研究:进行更广泛的用户研究,以验证评估指标的可靠性和模型输出的可用性。

4. 应用研究

- 视频编辑和摘要:研究如何利用模型进行视频编辑和自动生成视频摘要。

- 视频问答系统:开发基于模型的视频问答系统,以提供更丰富的用户体验。

- 多模态交互系统:探索如何将模型集成到多模态交互系统中,以实现更自然的人机交互。

5. 计算效率和可扩展性

- 模型压缩和加速:研究模型压缩和加速技术,以使模型能够在资源受限的设备上运行。

- 大规模训练和推理:探索如何有效地在大规模数据集上进行训练和推理,以提高模型的可扩展性和实用性。

6. 鲁棒性和偏差分析

- 对抗攻击和防御:研究模型对对抗攻击的鲁棒性,并开发相应的防御机制。

- 偏差检测和缓解:分析模型是否存在偏差,并探索方法来减少这些偏差,以提高模型的公平性和可解释性。

这些探索方向不仅可以推动视频理解技术的发展,还可能带来新的应用场景和研究问题。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:论文指出了视频理解领域中两个主要研究方向——整体性视频理解和像素级视频理解——之间的鸿沟,并提出了一个新的数据集ViCaS来弥合这一差距。

ViCaS数据集:介绍了一个新的视频数据集ViCaS,包含数千个挑战性视频,每个视频都有详细的人类编写的字幕和多个对象的像素精确的掩码,这些字幕和掩码在时间上是一致的,并且与短语进行了锚定。

基准测试设计:提出了一个基准测试,包括两个任务:视频字幕(要求模型生成描述视频事件和对象的详细文本)和语言引导的视频实例分割(LG-VIS,要求模型基于文本提示预测多个对象的时间一致性分割掩码)。

评估措施:通过全面的用户研究验证了开放式文本相似度的评估措施,并选择了基于开源模型的评估方法。

Video-LLaVA-Seg模型:提出了一个有效的端到端训练架构Video-LLaVA-Seg,它可以处理视频字幕和LG-VIS任务。

实验:进行了广泛的实验,包括用户研究以验证评估措施的有效性,消融研究来评估慢速-快速池化和任务特定训练的影响,以及基准测试结果来展示Video-LLaVA-Seg模型的性能。

结论:论文希望ViCaS数据集和Video-LLaVA-Seg模型能够推动视频理解领域的研究,特别是在结合整体性和像素级视频理解方面。

总体而言,这篇论文通过引入一个新的数据集、设计基准测试、提出评估措施和开发有效的模型架构,为视频理解领域提供了新的研究方向和工具。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图