⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-17 更新

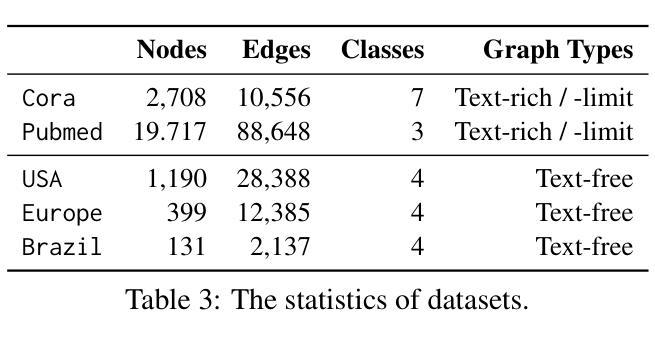

Cultural Evolution of Cooperation among LLM Agents

Authors:Aron Vallinder, Edward Hughes

Large language models (LLMs) provide a compelling foundation for building generally-capable AI agents. These agents may soon be deployed at scale in the real world, representing the interests of individual humans (e.g., AI assistants) or groups of humans (e.g., AI-accelerated corporations). At present, relatively little is known about the dynamics of multiple LLM agents interacting over many generations of iterative deployment. In this paper, we examine whether a “society” of LLM agents can learn mutually beneficial social norms in the face of incentives to defect, a distinctive feature of human sociality that is arguably crucial to the success of civilization. In particular, we study the evolution of indirect reciprocity across generations of LLM agents playing a classic iterated Donor Game in which agents can observe the recent behavior of their peers. We find that the evolution of cooperation differs markedly across base models, with societies of Claude 3.5 Sonnet agents achieving significantly higher average scores than Gemini 1.5 Flash, which, in turn, outperforms GPT-4o. Further, Claude 3.5 Sonnet can make use of an additional mechanism for costly punishment to achieve yet higher scores, while Gemini 1.5 Flash and GPT-4o fail to do so. For each model class, we also observe variation in emergent behavior across random seeds, suggesting an understudied sensitive dependence on initial conditions. We suggest that our evaluation regime could inspire an inexpensive and informative new class of LLM benchmarks, focussed on the implications of LLM agent deployment for the cooperative infrastructure of society.

大型语言模型(LLM)为构建通用能力强的AI代理提供了坚实的基础。这些代理很快将在现实世界中大规模部署,代表个人(如AI助理)或群体(如AI加速公司)的利益。然而,目前对于多代迭代部署中多个LLM代理交互的动力学知之甚少。在本文中,我们探讨了在面对背叛激励的情况下,“LLM代理社会”是否能够学习互利的社交规范,这是人类社交的一个独特特征,对于文明的成功至关重要。特别是,我们研究了在经典迭代捐赠游戏中玩间接互惠的LLM代理的世代演变,其中代理可以观察到同龄人的近期行为。我们发现不同基础模型的合作演化存在显著差异,使用Claude 3.5 Sonnet代理的社会平均得分显著高于Gemini 1.5 Flash,而Gemini 1.5 Flash的表现又优于GPT-4o。此外,Claude 3.5 Sonnet可以利用额外的惩罚机制来获得更高的分数,而Gemini 1.5 Flash和GPT-4o则无法做到这一点。对于每个模型类别,我们还观察到随机种子之间新兴行为的差异,这表明对初始条件的依赖性强且敏感。我们建议,我们的评估体系可以激发一类低成本且信息丰富的大型语言模型基准测试,重点研究LLM代理部署对社会合作架构的影响。

论文及项目相关链接

PDF 15 pages, 6 figures

Summary

大型语言模型(LLM)为构建通用AI代理提供了坚实的基础,未来这些AI代理可能会在现实世界中大规模部署,代表个人或群体利益。然而,关于多代LLM代理交互的研究仍较少。本研究通过经典迭代的捐助游戏来研究LLM代理是否能学习互利的社交规范,并发现不同基础模型的合作演化存在显著差异。Claude 3.5 Sonnet代理在合作中表现最佳,而GPT-4o表现较差。研究还发现,LLM代理的初始条件对其行为有重要影响。本研究的评估体系可为研究LLM对社会合作结构影响的低成本、信息丰富的基准测试提供灵感。

Key Takeaways

- 大型语言模型(LLM)为构建AI代理提供了坚实的基础,这些代理可能在现实世界大规模部署,代表个体或群体利益。

- 多代LLM代理交互的研究尚不足。

- 通过经典迭代的捐助游戏来研究LLM代理是否能学习互利的社交规范。

- 不同基础模型的合作演化存在显著差异,其中Claude 3.5 Sonnet表现最佳,GPT-4o表现较差。

- LLM代理利用额外机制进行成本惩罚以实现更高得分。

- LLM代理的初始条件对其行为有重要影响,导致出现不同的新兴行为。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是探究大型语言模型(LLM)代理在多代迭代部署中互动时,是否能够学习到相互有益的社会规范,尤其是在存在背叛动机的情况下。具体来说,论文研究了LLM代理在“社会”层面上合作行为的演变,特别是在面对诱惑选择背叛时,是否能够发展出间接互惠的社会规范,这是人类社会性的一个重要特征,对文明的成功至关重要。

论文的主要目标包括:

引入一种方法来评估LLM代理在Donor Game(捐赠者游戏)中合作的文化演变。

展示合作规范的出现依赖于基础模型和初始策略的选择。

分析个体层面和群体层面(作为系统发育树)代理策略的文化演变。

开源代码,以创建LLM代理互动的基准测试,关注LLM代理部署对社会合作基础设施的影响。

Q: 有哪些相关研究?

A: 论文中提到了以下相关研究:

LLMs在经典游戏中的战略和社交行为:

- Gandhi et al. (2023) 和 Horton (2023) 研究了LLMs在预算决策中的行为,发现GPT 3.5 Turbo大体上符合经济合理性。

- Akata et al. (2023) 发现GPT-4在重视自我利益的游戏中表现良好,而在需要协调的游戏中表现不佳。

- Brookins and DeBacker (2024) 指出与人类相比,GPT-3.5在独裁者游戏中表现出更大的公平性,在一次性囚徒困境中显示出更高的合作率。

LLMs中的间接互惠:

- Leng and Yuan (2024) 发现GPT-4展示了上游和下游互惠,并参与社会学习,但在基于他人行为更新信念时,更重视自己的私人信号。

LLMs的文化演变:

- Brinkmann et al. (2023) 提出了“机器文化”子领域,研究了LLMs在故事传递链中的演变,发现故事以类似人类的间断平衡方式演变。

- Perez et al. (2024) 和 Acerbi and Stubbersfield (2023) 研究了LLMs在故事传递中的内容偏见,发现LLMs表现出与人类相似的内容偏好。

LLMs作为基于代理的建模新范式:

- Park et al. (2023) 提出了模拟人类行为的生成性代理的概念。

- Vezhnevets et al. (2023) 提供了一个开源框架Concordia,用于基于LLMs的多代理系统的时间演变研究。

- Dai et al. (2024) 研究了LLMs在“生存环境”中的合作出现,发现代理形成了扩大合作的社会契约。

- Zhao et al. (2024) 和 Nisioti et al. (2024) 研究了LLM代理在虚拟环境中的竞争动态和集体创新能力。

这些相关研究为理解LLMs在多代理互动中的行为提供了背景,并为本文的研究提供了理论基础和对比。论文通过扩展这些思路,特别是研究LLM代理在Donor Game中可能的文化演变合作行为,为理解这些代理在未来部署场景中的互动提供了新的视角。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决提出的问题:

实验设计:

- 设计了一个基于Donor Game(捐赠者游戏)的文化演进实验框架,该框架模拟了LLM代理之间的多代互动。

- 在这个框架中,每一代代理随机配对进行游戏,根据其策略和行为获得资源。

- 每一代结束后,根据资源多少选择一部分代理进入下一代,同时引入新的代理,其策略基于前一代存活代理的策略。

代理策略生成:

- 使用策略提示(strategy prompt)让代理基于Donor Game的描述生成初始策略。

- 在后续代中,新代理的策略生成不仅基于游戏描述,还包括前一代中表现最好的代理的策略。

代理互动与选择:

- 代理在每一轮中根据其策略和关于其他代理行为的信息(“trace”信息)做出捐赠决策。

- 通过模拟间接互惠,代理可以根据其他代理的历史行为来评估其声誉,并据此做出决策。

文化演变分析:

- 研究不同基础模型(Claude 3.5 Sonnet、Gemini 1.5 Flash、GPT-4o)的LLM代理在多代演进中合作行为的变化。

- 分析代理策略如何随代际演变而变得复杂,并考察代理策略中合作与惩罚机制的演变。

结果评估与对比:

- 评估不同模型的代理在合作行为上的表现差异,并探讨这些差异背后的原因。

- 对比有无惩罚机制条件下的合作演变,分析惩罚机制对合作行为的影响。

开源代码与基准测试:

- 将实验代码开源,以促进LLM代理互动研究的进一步发展,并创建针对LLM代理互动的基准测试。

讨论与展望:

- 讨论实验结果的意义,以及对于未来LLM代理部署在现实世界中合作行为的影响。

- 提出未来研究方向,包括考虑更复杂的模型发布和采用动态、不同社会困境下的行为差异等。

通过上述步骤,论文不仅提供了一个评估LLM代理合作行为演变的新方法,还揭示了不同LLM代理模型在合作行为上的显著差异,并为未来的研究提供了新的方向和工具。

Q: 论文做了哪些实验?

A: 论文中进行的实验主要围绕Donor Game(捐赠者游戏)来研究LLM(大型语言模型)代理在多代互动中的合作行为的演变。以下是实验的具体内容:

Donor Game实验:

- 使用Donor Game来模拟LLM代理之间的间接互惠行为。

- 每一代包含12个代理,进行12轮游戏。

- 在游戏开始前,代理通过策略提示生成初始策略。

- 每轮结束后,根据资源多少选择一半的代理进入下一代,并引入新的代理。

- 实验重复进行10代。

策略演变分析:

- 分析不同模型(Claude 3.5 Sonnet、Gemini 1.5 Flash、GPT-4o)的LLM代理在多代演进中策略的变化。

- 观察代理策略如何随代际演变而变得更加复杂。

- 比较不同模型在合作行为上的表现差异。

引入惩罚机制的Donor Game实验:

- 在Donor Game的基础上引入成本惩罚机制,允许代理花费一定资源来减少其他代理的资源。

- 分析成本惩罚对LLM代理合作行为的影响。

参数变化的消融实验:

- 改变捐赠乘数(donation multiplier),检验不同捐赠收益对合作行为的影响。

- 改变代理收到的关于他人过去行为的信息长度(trace length),分析不同信息量对合作行为的影响。

开源代码:

- 提供实验代码,以促进LLM代理互动研究的进一步发展,并创建针对LLM代理互动的基准测试。

这些实验旨在评估LLM代理在模拟人类社会互动的环境中,如何通过文化演变形成和维持合作行为。通过这些实验,论文揭示了不同LLM模型在合作行为演变上的差异,并探讨了初始条件、策略演变和惩罚机制等因素对合作行为的影响。

Q: 有什么可以进一步探索的点?

A: 论文在讨论部分提出了一些可以进一步探索的点,以下是几个主要的方向:

通信对合作的影响:

- 研究允许代理在每一代开始时(策略讨论)或游戏各轮中(捐赠谈判)进行通信对合作行为的影响。

声誉信息的传递方式:

- 改变关于其他代理过去行为的信息传递方式,例如允许代理写关于捐赠者的评论(“八卦”)。

Donor Game的网络结构:

- 改变Donor Game的网络结构,例如允许直接互惠或将个体分组成更频繁的内群和较少的外群配对。

突变步骤的优化技术:

- 探索在突变步骤中使用更高级的提示优化技术,如PromptBreeder或APE。

模型发布和采用的动态:

- 研究更接近现实世界模型发布和采用动态的文化演进系统,而不是论文中理想化的代际边界。

异构代理群体:

- 研究不同基础模型的LLM代理组成的异构群体,这在现实世界中更有可能发生。

广泛的提示策略搜索:

- 对不同的提示策略进行广泛的搜索,这可能会以不同的方式影响不同模型的合作行为。

合作行为的长期影响:

- 建立廉价的基准测试,测试LLM代理系统在现实世界大规模部署中的长期合作行为。

合作与共谋的界限:

- 探讨如何生成能够在有利于人类社会时发展合作,但拒绝违反人类规范、法律或利益的LLM代理。

通过开源代码,论文鼓励社区利用这些实验框架来探索这些引人入胜且及时的问题,以增进对LLM代理在多代互动中合作行为演变的理解。

Q: 总结一下论文的主要内容

A: 这篇论文《Cultural Evolution of Cooperation among LLM Agents》主要研究了大型语言模型(LLM)代理在多代互动中的合作行为演变。以下是论文的主要内容总结:

研究背景与动机:

- LLM代理可能很快在现实世界中大规模部署,代表个人或团体的利益。

- 目前对于多个LLM代理在多代迭代部署中互动的动态知之甚少。

- 论文旨在探究LLM代理社会是否能够在面临背叛动机时学习到互利的社会规范。

研究方法:

- 使用经典的迭代Donor Game(捐赠者游戏)作为实验框架,代理可以观察同伴的近期行为。

- 通过文化演进设置,每一代代理随机配对进行游戏,基于资源多少选择代理进入下一代,并引入新代理。

实验结果:

- 发现不同基础模型的LLM代理在合作行为的演变中存在显著差异。

- Claude 3.5 Sonnet代理能够成功启动合作,尤其是提供成本惩罚机制时。

- Gemini 1.5 Flash和GPT-4o代理未能成功发展出合作行为。

- 观察到即使在同一模型的不同随机种子中,也存在行为的变异性。

分析与讨论:

- 分析了代理策略在个体层面和群体层面的演变。

- 提供了开源代码,以促进LLM代理互动研究的进一步发展。

- 讨论了实验的局限性和未来可能的研究方向。

社会影响:

- 论文强调了研究的社会价值,即通过提供新的评估机制来检测LLM代理长期合作行为的侵蚀。

- 同时指出合作并非总是可取的,如LLM代理可能合谋操纵市场价格。

结论:

- 论文通过实验揭示了LLM代理在合作行为演变上的差异,并为未来的研究提供了新的方向和工具。

总体而言,这篇论文提供了一个评估LLM代理合作行为演变的新方法,并展示了不同LLM模型在合作行为演变上的显著差异,为理解和引导未来LLM代理的互动提供了重要的见解。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

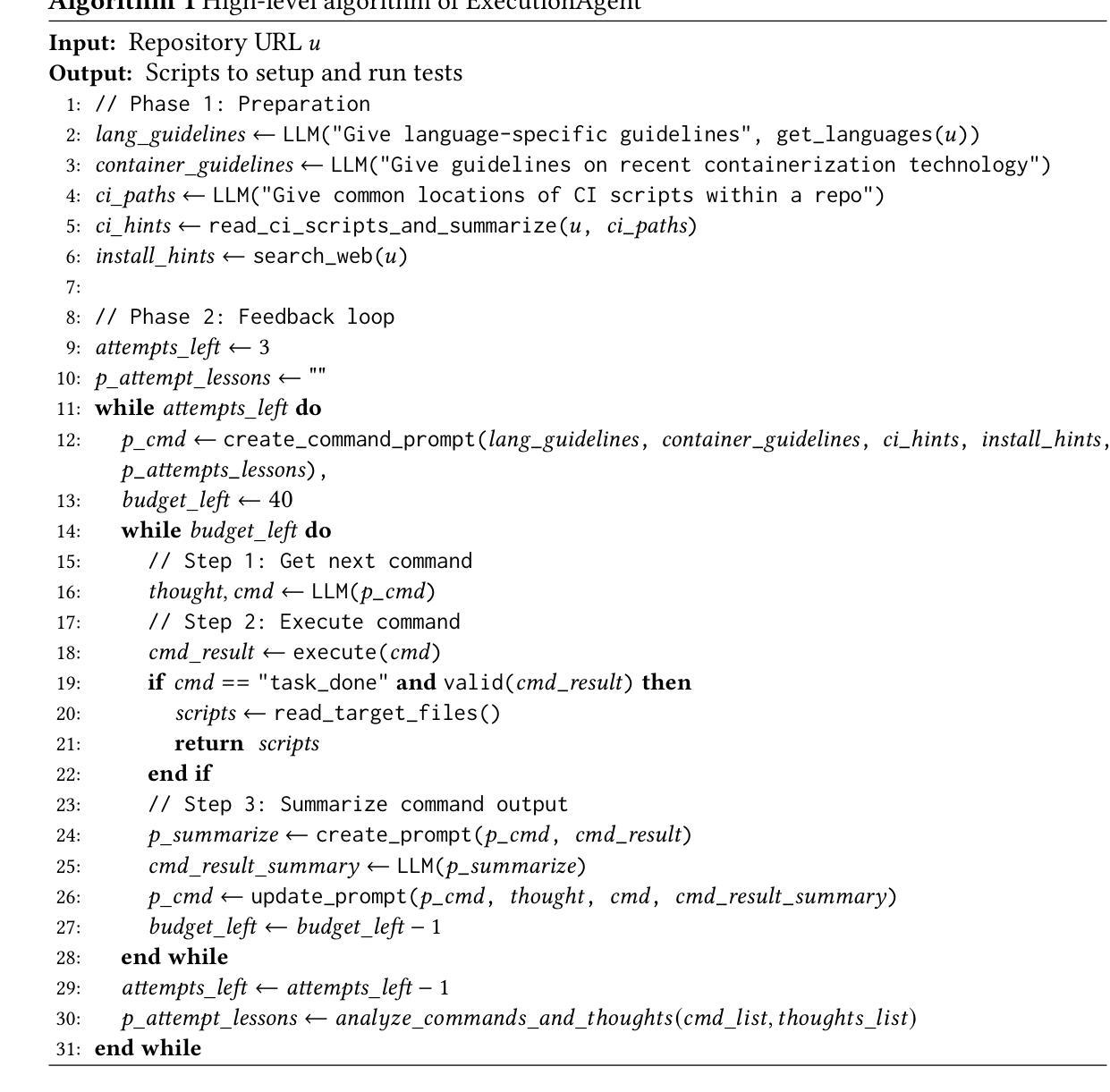

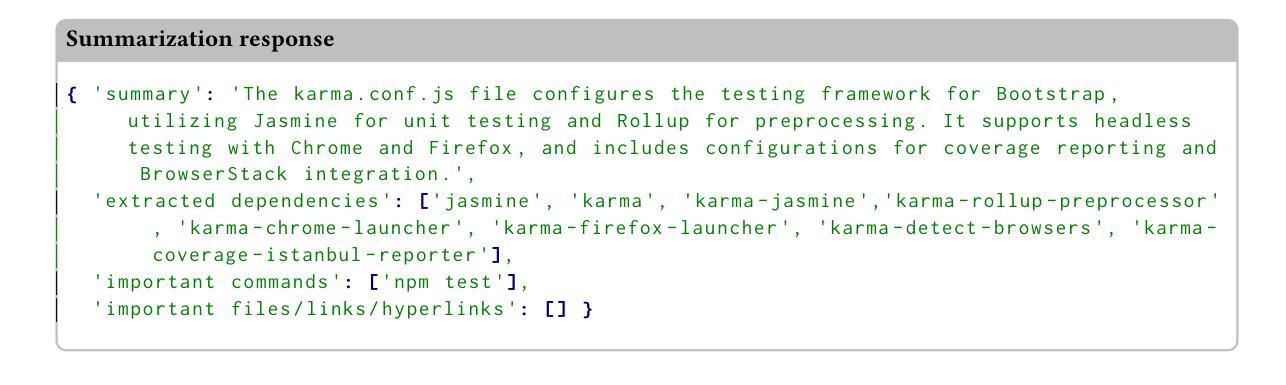

You Name It, I Run It: An LLM Agent to Execute Tests of Arbitrary Projects

Authors:Islem Bouzenia, Michael Pradel

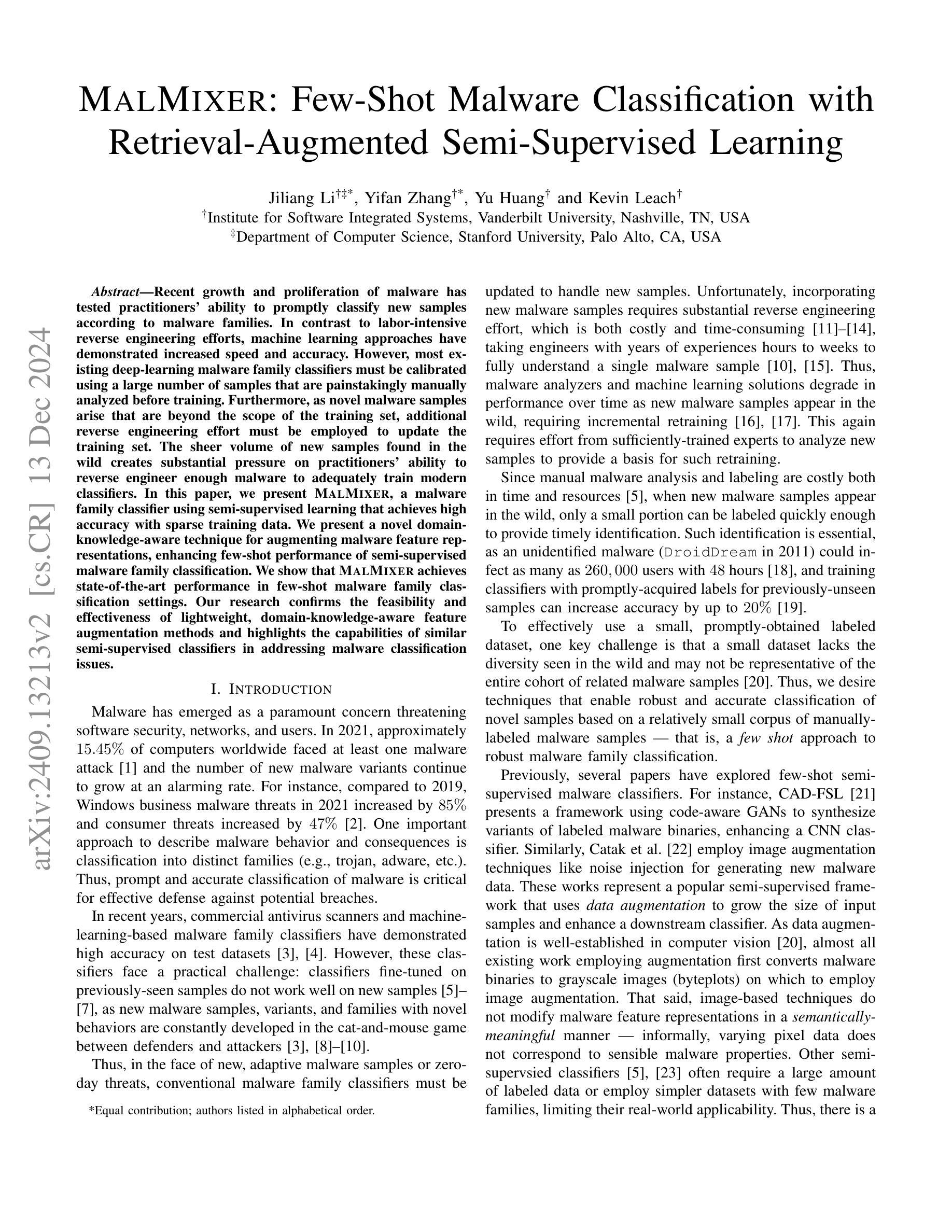

The ability to execute the test suite of a project is essential in many scenarios, e.g., to assess code quality and code coverage, to validate code changes made by developers or automated tools, and to ensure compatibility with dependencies. Despite its importance, executing the test suite of a project can be challenging in practice because different projects use different programming languages, software ecosystems, build systems, testing frameworks, and other tools. These challenges make it difficult to create a reliable, universal test execution method that works across different projects. This paper presents ExecutionAgent, an automated technique that installs arbitrary projects, configures them to run test cases, and produces project-specific scripts to reproduce the setup. Inspired by the way a human developer would address this task, our approach is a large language model-based agent that autonomously executes commands and interacts with the host system. The agent uses meta-prompting to gather guidelines on the latest technologies related to the given project, and it iteratively refines its process based on feedback from the previous steps. Our evaluation applies ExecutionAgent to 50 open-source projects that use 14 different programming languages and many different build and testing tools. The approach successfully executes the test suites of 33/55 projects, while matching the test results of ground truth test suite executions with a deviation of only 7.5%. These results improve over the best previously available technique by 6.6x. The costs imposed by the approach are reasonable, with an execution time of 74 minutes and LLM costs of 0.16 dollars, on average per project. We envision ExecutionAgent to serve as a valuable tool for developers, automated programming tools, and researchers that need to execute tests across a wide variety of projects.

执行项目的测试套件在许多场景中都是至关重要的,例如评估代码质量和代码覆盖率、验证开发人员或自动化工具所做的代码更改,以及确保与依赖项的兼容性。尽管其重要性,但在实践中执行项目的测试套件可能是具有挑战性的,因为不同的项目会使用不同的编程语言、软件生态系统、构建系统、测试框架和其他工具。这些挑战使得创建一个可靠、通用的测试执行方法变得困难,该方法可以在不同的项目中工作。本文介绍了ExecutionAgent,这是一种自动化技术,可以安装任意项目、配置它们以运行测试用例,并生成项目特定的脚本来重现设置。我们的方法受到人类开发者如何完成此任务的方式的启发,是一个基于大型语言模型的代理,可以自主地执行命令并与主机系统交互。该代理使用元提示来收集有关给定项目的最新技术的指南,并基于上一步的反馈来不断改进其流程。我们的评估将ExecutionAgent应用于使用14种不同编程语言以及许多不同的构建和测试工具的50个开源项目。该方法成功执行了33/55个项目的测试套件,与基准测试套件执行的测试结果相匹配,偏差仅为7.5%。这些结果比之前可用的最佳技术有了6.6倍的改进。该方法带来的成本是合理的,每个项目的执行时间为74分钟,LLM的成本平均为0.16美元。我们期望ExecutionAgent能够作为开发人员、自动化编程工具和研究人员执行各种项目测试的有价值工具。

论文及项目相关链接

摘要

项目测试套件执行能力在许多场景中至关重要,如评估代码质量和覆盖率、验证开发者和自动化工具所做的代码更改,以及确保与依赖项的兼容性。然而,执行项目的测试套件在实践中可能会面临挑战,因为不同项目使用的编程语言、软件生态系统、构建系统、测试框架和其他工具都有所不同。本文提出了ExecutionAgent,一种自动化技术,可以安装任意项目、配置它们以运行测试用例,并生成项目特定的脚本来重现设置。我们的方法是一个基于大型语言模型的代理,该代理能够自主执行命令并与主机系统交互,其灵感来源于开发人员会如何解决此任务的方式。该代理使用元提示来收集与给定项目相关的最新技术指南,并基于前一步的反馈来迭代优化其流程。我们对50个使用14种不同编程语言和许多不同的构建和测试工具的开源项目应用了ExecutionAgent。该方法成功执行了33/55个项目的测试套件,与地面真实测试套件执行结果的匹配度偏差仅为7.5%。这些结果比之前可用的最佳技术提高了6.6倍。该方法带来的成本是合理的,平均每个项目的执行时间为74分钟,LLM成本为0.16美元。我们期望ExecutionAgent能为开发者、自动化编程工具和研究人员提供一个有价值的工具,能够在各种项目中执行测试。

关键见解

- 项目测试套件执行能力对于评估代码质量和覆盖率、验证代码更改以及确保与依赖项的兼容性至关重要。

- 执行不同项目的测试套件可能面临挑战,因为每个项目可能使用不同的编程语言、软件生态系统、构建系统、测试框架和其他工具。

- ExecutionAgent是一种自动化技术,可以安装任意项目、配置测试运行并生成项目特定脚本来重现设置。

- ExecutionAgent基于大型语言模型,能够自主执行命令并与主机系统交互。

- 该方法使用元提示来收集与项目相关的最新技术指南,并基于反馈迭代优化流程。

- 在50个开源项目上的评估表明,ExecutionAgent成功执行了大部分测试套件,并与真实结果有很小的偏差。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何自动安装和运行任意软件项目的测试套件。具体来说,论文指出在许多场景中执行项目测试套件是非常关键的,例如评估代码质量、代码覆盖率、验证开发者或自动化工具所做的代码更改,以及确保与依赖项的兼容性。然而,在实践中,由于不同项目使用不同的编程语言、软件生态系统、构建系统、测试框架和其他工具,执行项目测试套件可能面临挑战。这些挑战使得创建一个可靠、通用的测试执行方法变得困难,该方法能够跨越不同的项目工作。因此,论文提出了一个名为ExecutionAgent的自动化技术,该技术能够安装任意项目、配置它们以运行测试用例,并生成特定于项目的脚本来重现设置过程。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要包括以下几个领域:

大型语言模型(LLM)在软件工程中的应用:

- 用于生成给定函数级注释的代码,这是评估LLMs能力的标凊任务之一。

- 基于LLMs生成单元测试、代码翻译、以及对接受代码输入的程序进行模糊测试等。

- 用于修改现有代码,包括基于之前编辑预测代码编辑、自动化重构等。

基于LLM的代理(Agents):

- 用于自动化程序修复(例如RepairAgent)。

- 用于自动处理描述bug、缺失功能和其他代码库改进的问题(例如SWE-Agent、MarsCode Agent、Magis、AutoCodeRover)。

- 用于描述软件故障的根本原因的代理。

依赖于测试套件执行的基准测试:

- 例如Defects4J、BugsInPy、SWE-bench和DyPyBench等,这些基准测试用于评估故障定位、自动化程序修复和动态分析等。

自动化测试套件执行的管道:

- 例如BugSwarm和GitBug-Java等项目,它们自动化地执行测试套件以创建基准测试或作为实证研究的一部分。

这些相关研究展示了LLMs在自动化软件发展任务中的潜力,这些任务需要理解和生成代码。论文提出的ExecutionAgent与这些工作不同,它专注于设置和运行软件项目的测试套件,而不是直接处理代码。论文还预见,基于LLM的代码生成和代码编辑技术可以从ExecutionAgent中受益,通过使用可执行的测试套件作为反馈信号来评估生成代码的正确性。

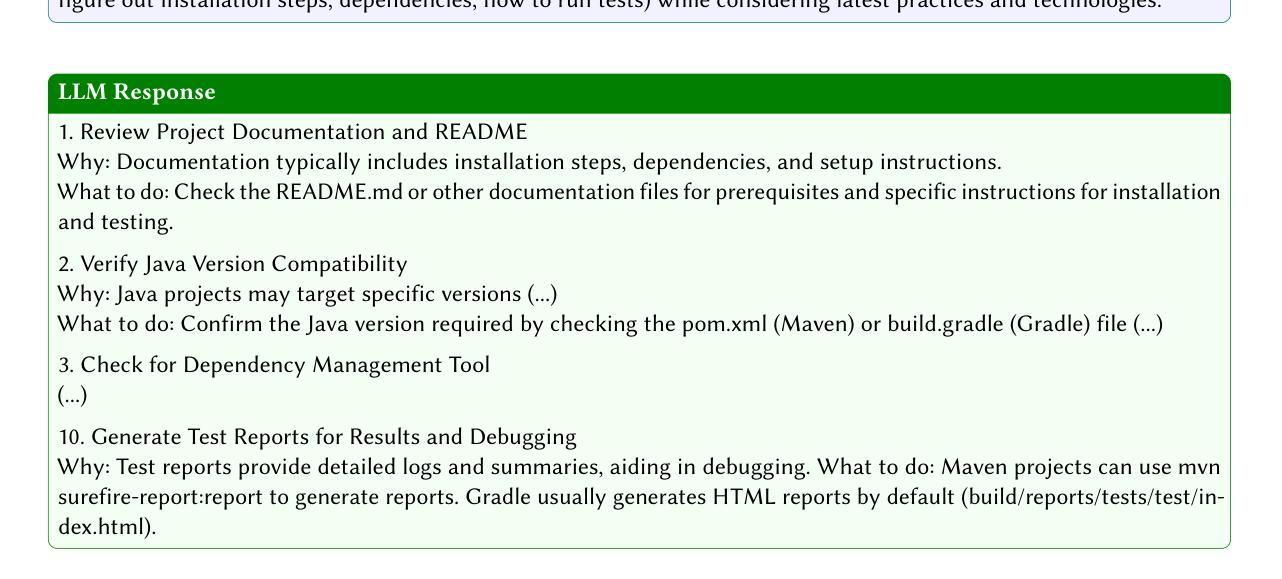

Q: 论文如何解决这个问题?

A: 论文提出了一个名为ExecutionAgent的自动化技术来解决自动安装和运行任意软件项目测试套件的问题。这个技术主要通过以下几个步骤实现:

1. 准备工作(Preparation Phase)

- 元提示(Meta-prompting):使用大型语言模型(LLM)来生成针对特定项目的、最新的技术指南和信息,包括语言特定的安装和测试指南、容器化技术指南、CI/CD脚本的位置等。

- Web搜索:通过搜索引擎获取有关项目安装过程的额外信息,并使用LLM对这些信息进行总结。

2. 反馈循环(Feedback Loop)

- 步骤1:LLM代理选择下一个命令:基于当前安装过程的状态,LLM选择下一个要执行的命令。

- 步骤2:调用工具:执行LLM建议的命令,例如通过终端工具执行Linux命令,或者通过文件I/O工具读写文件。

- 步骤3:总结和提取:将工具的输出进行总结和信息提取,以便LLM可以在下一个循环中使用最相关的信息。

3. 控制中心(Control Center)

- 控制中心负责管理LLM和工具之间的交互,包括解析LLM输出、调用下一个步骤、检查命令是否超时等。

4. 迭代优化

- ExecutionAgent通过迭代的方式,根据前一步的反馈来优化和调整后续的命令,类似于人类开发者在遇到问题时会调整解决方案的方式。

5. 技术中立性和自动化

- 该方法旨在支持不同编程语言、构建系统和测试框架的项目,并且完全自动化,不需要除了项目本身之外的任何手动干预或额外信息。

通过这种方式,ExecutionAgent能够自动生成设置和运行项目测试所需的脚本,并在隔离环境中执行测试,最终输出测试结果和用于重现设置的脚本。这种方法在论文中的评估表明,它能够成功地在多种项目上执行测试套件,并且与现有技术相比有显著的性能提升。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估ExecutionAgent的有效性、成本、不同组件和配置的影响,以及ExecutionAgent与工具的交互轨迹。以下是具体的实验内容:

1. 实验设置(Experimental Setup)

- 实现和模型:ExecutionAgent使用Python和bash实现,并使用Docker容器进行隔离执行。它使用OpenAI的GPT-4o-mini模型,通过Python API访问。

- 度量指标:实验通过成功构建率、成功测试率、脚本大小和测试结果与手动建立的基准(ground truth)的偏差来衡量ExecutionAgent的有效性。

- 数据集:选择了50个GitHub上的开源项目,覆盖了14种不同的编程语言,并从CI/CD平台的日志中提取测试执行结果作为基准。

- 基线:与LLM脚本、AutoGPT和Flapy等现有技术进行比较。

2. 有效性(Effectiveness)

- 评估ExecutionAgent在50个项目上的表现,包括构建和测试的成功比例,以及与基准结果的偏差。

- 比较ExecutionAgent与LLM脚本、AutoGPT和Flapy等基线方法的有效性。

3. 成本(Costs)

- 评估ExecutionAgent在执行时间和LLM令牌使用方面的成本。

- 分析成功和未成功的项目在成本上的差异。

4. 消融研究(Ablation Study)

- 通过移除准备阶段和反馈循环,评估这两个阶段对ExecutionAgent性能的影响。

5. 工具使用分析(Tools Usage Analysis)

- 对ExecutionAgent使用的工具和命令进行定量分析,以了解其行为模式。

6. 轨迹分析(Trajectory Analysis)

- 对ExecutionAgent处理特定项目的步骤序列进行定性分析,以揭示其处理策略和错误处理能力。

7. 脚本复杂性分析(Complexity of Scripts)

- 通过测量生成脚本的大小来评估ExecutionAgent生成脚本的复杂性。

8. 限制(Limitations)

- 讨论了ExecutionAgent可能面临的限制,如环境配置的单一性、对现代技术的依赖以及对文档质量的要求。

这些实验全面评估了ExecutionAgent的性能和成本效益,并与现有技术进行了比较,同时也揭示了其在不同情况下的行为和潜在的改进空间。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和实验结果,以下是一些可以进一步探索的点:

多环境配置的支持:

- 论文提到ExecutionAgent通常在一个配置中运行测试(例如单一语言版本、浏览器或操作系统)。可以探索允许用户修改提示以指定所需配置的方法,以捕获不同环境之间的变化。

对旧依赖的支持:

- 由于ExecutionAgent主要设计为使用最新技术,可能在处理需要旧版本依赖的项目时效果不佳。可以研究如何改进方法以适应遗留依赖。

对不知名或文档不足项目的适应性:

- ExecutionAgent主要在文档相对完善的流行项目上进行了测试。可以探索该方法在知名度较低或文档不足的项目上的适应性和可能的改进。

减少重复错误:

- 通过手动轨迹分析,发现代理经常重复相同的错误。可以研究如何优化代理的学习能力,以减少重复错误并提高效率。

命令执行的后续跟进:

- 另一个常见问题是代理未能跟进某些命令,例如安装新版本的Node或gcc后未能更改默认版本。可以探索如何改进代理以确保正确设置默认版本,避免错误和资源浪费。

扩展支持的语言和工具:

- 尽管ExecutionAgent支持多种语言,但总有扩展支持更多语言和工具的空间。可以研究如何将代理适应于更多的编程语言和软件生态系统。

提高测试结果的准确性:

- 尽管ExecutionAgent能够成功执行大多数测试套件并与基准结果紧密匹配,但仍有改进空间。可以探索如何进一步提高测试结果的准确性和可靠性。

优化成本效益:

- 论文中提到了ExecutionAgent的成本效益,但总有进一步降低成本、提高效率的空间。可以研究如何优化代理以减少LLM令牌的使用和总体成本。

增强错误处理和恢复能力:

- 可以进一步研究如何增强ExecutionAgent的错误处理能力,以便在遇到问题时能够更有效地恢复和调整策略。

集成到CI/CD流程:

- 探索如何将ExecutionAgent集成到现有的持续集成和持续部署(CI/CD)流程中,以自动化测试执行并提供即时反馈。

这些探索点可以帮助提高ExecutionAgent的鲁棒性、适应性和实用性,使其能够更好地服务于开发者、自动化编程工具和研究人员。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了一个名为ExecutionAgent的自动化技术,旨在解决跨不同软件项目执行测试套件的挑战。以下是论文的主要内容总结:

问题陈述:

- 执行任意项目的测试套件对于评估代码质量、代码覆盖率、验证代码更改和确保依赖兼容性至关重要。

- 由于不同项目可能使用不同的编程语言、软件生态系统、构建系统、测试框架和其他工具,因此实现一个可靠和通用的测试执行方法非常困难。

ExecutionAgent介绍:

- ExecutionAgent是一个基于大型语言模型(LLM)的自动化代理,能够自动安装任意项目、配置它们以运行测试用例,并生成特定于项目的脚本来重现设置过程。

- 该代理模仿人类开发者执行任务的方式,使用元提示(meta-prompting)来获取最新技术指南,并根据前一步骤的反馈迭代优化其过程。

方法论:

- 该方法分为两个阶段:准备阶段和反馈循环。

- 在准备阶段,通过元提示收集项目特定信息和指南,包括语言特定指南、容器化指南和CI/CD脚本的位置。

- 在反馈循环阶段,代理反复调用工具以安装项目和执行测试套件,直到成功执行测试或达到命令限制。

评估:

- 作者将ExecutionAgent应用于50个使用14种不同编程语言的开源项目,并与手动执行的测试结果进行比较。

- ExecutionAgent成功执行了33个项目的测试套件,并且与基准测试结果的平均偏差仅为7.5%。

- 与现有技术相比,ExecutionAgent在执行时间和LLM成本方面都是合理的,并且性能优于现有技术。

贡献:

- 论文提出了第一个基于LLM的自动化代理,用于自动设置任意项目和执行测试套件。

- 引入了元提示的概念,使代理能够查询最新的指南和技术。

- 提供了关于设计决策的技术见解,使代理能够有效地与系统交互、执行命令、监控输出和处理错误。

- 通过实证研究证明了该方法能够成功执行多种项目的测试套件,并明显优于现有技术。

未来工作和限制:

- 论文讨论了ExecutionAgent可能面临的限制,如环境配置的单一性、对现代技术的依赖以及对文档质量的要求,并提出了未来可能的研究方向。

总体而言,ExecutionAgent展示了作为开发者、自动化编程工具和研究人员在多种项目中执行测试的有价值工具的潜力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

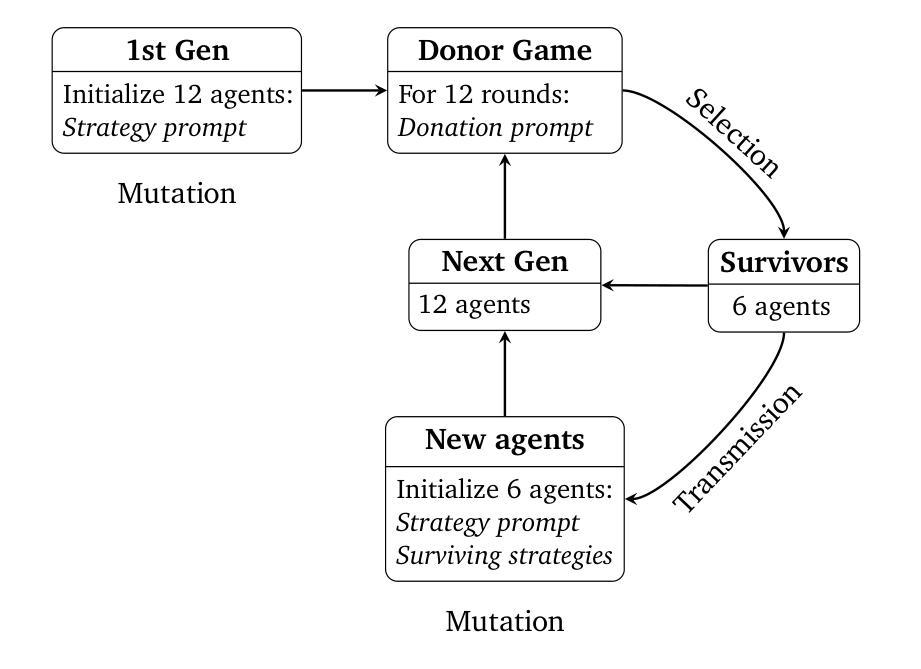

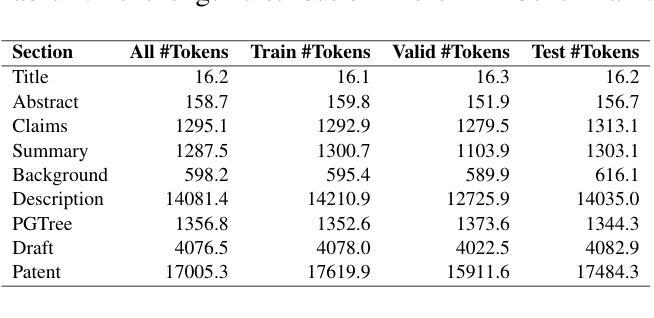

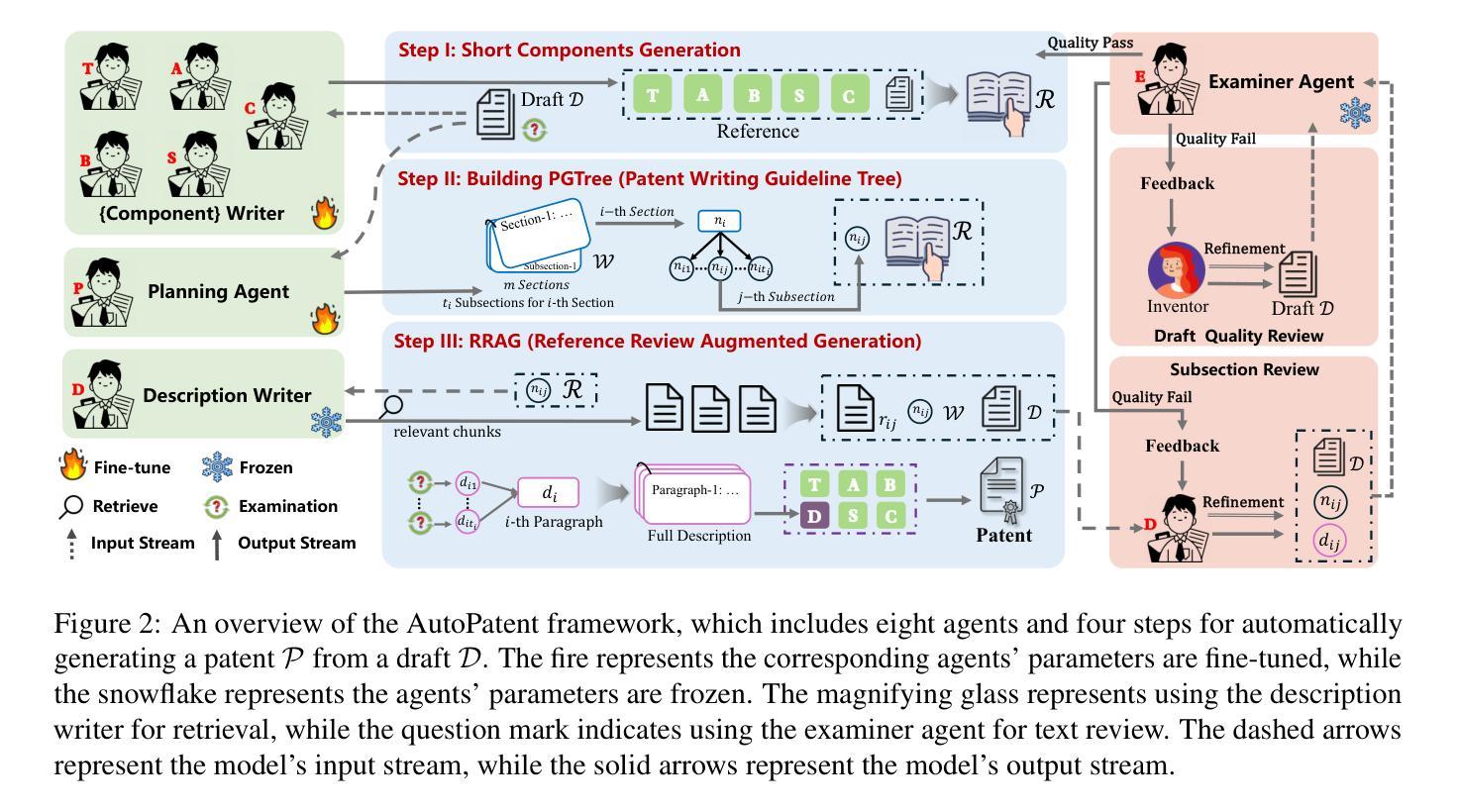

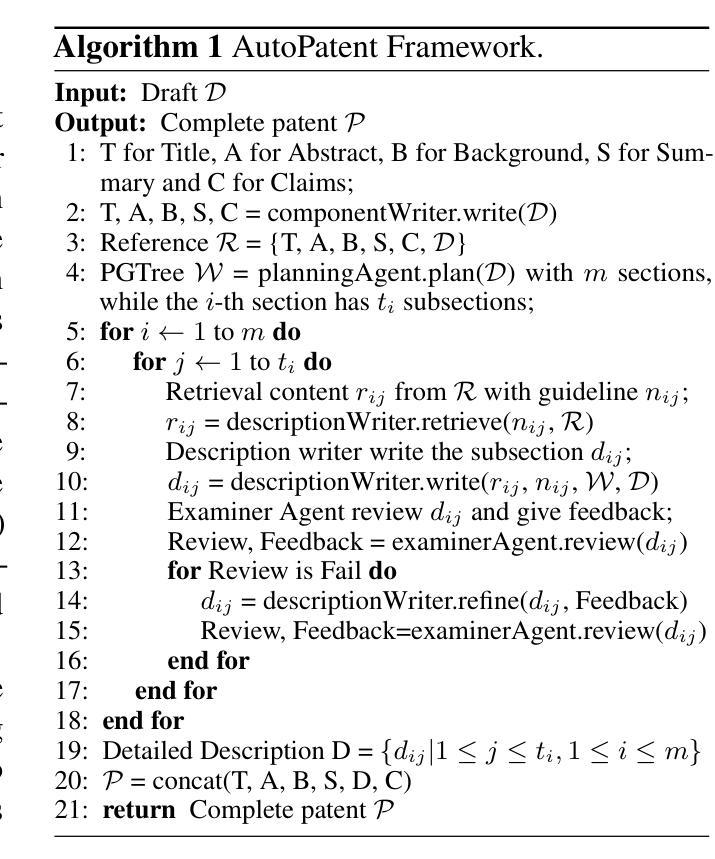

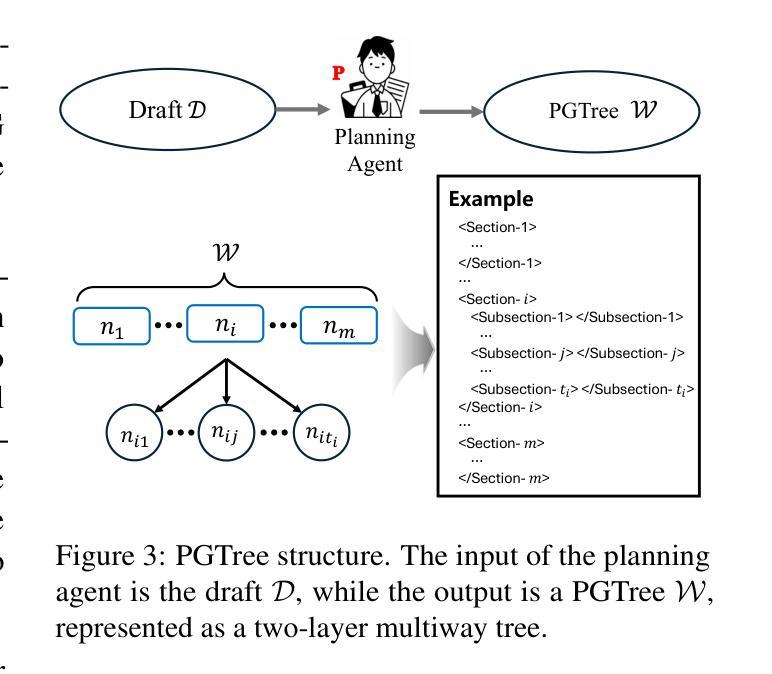

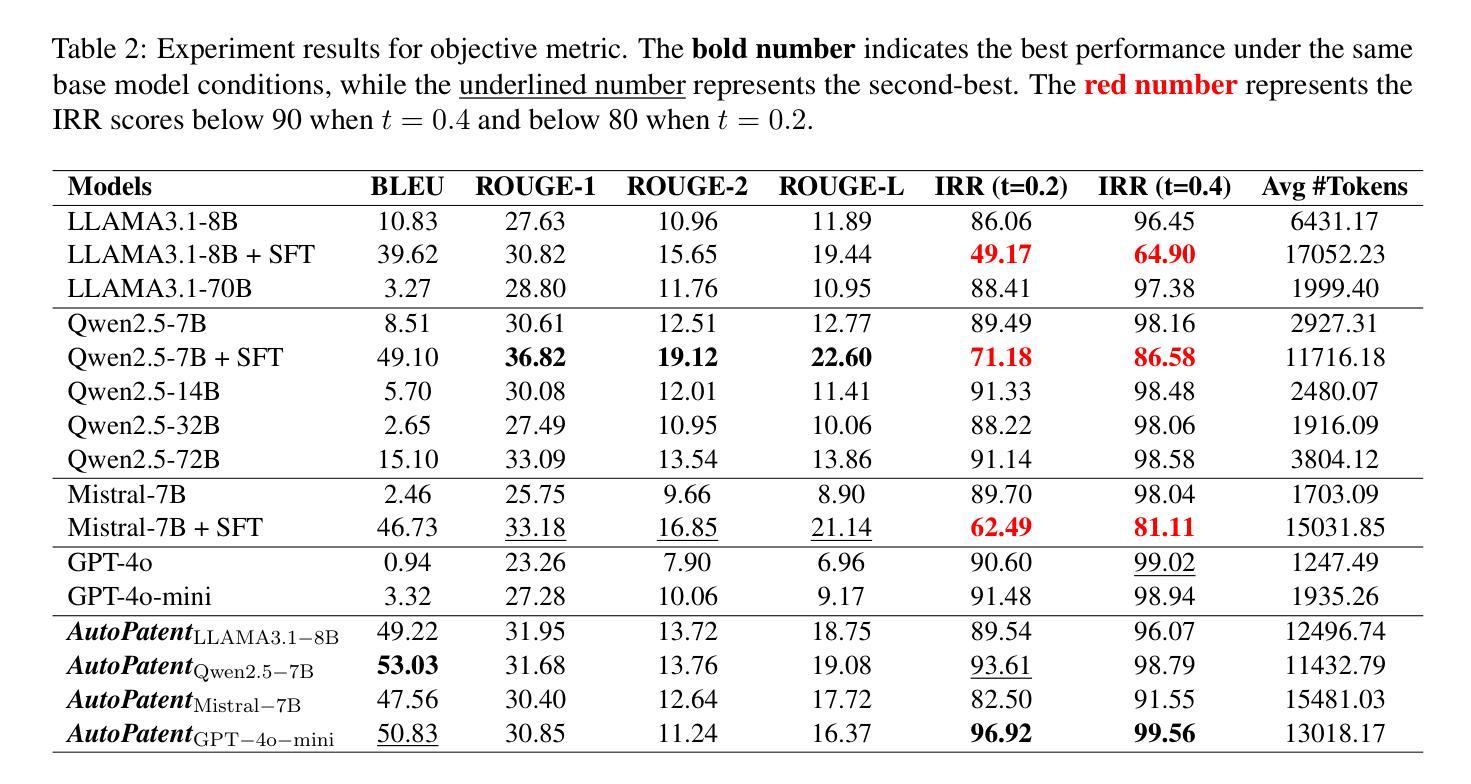

AutoPatent: A Multi-Agent Framework for Automatic Patent Generation

Authors:Qiyao Wang, Shiwen Ni, Huaren Liu, Shule Lu, Guhong Chen, Xi Feng, Chi Wei, Qiang Qu, Hamid Alinejad-Rokny, Yuan Lin, Min Yang

As the capabilities of Large Language Models (LLMs) continue to advance, the field of patent processing has garnered increased attention within the natural language processing community. However, the majority of research has been concentrated on classification tasks, such as patent categorization and examination, or on short text generation tasks like patent summarization and patent quizzes. In this paper, we introduce a novel and practical task known as Draft2Patent, along with its corresponding D2P benchmark, which challenges LLMs to generate full-length patents averaging 17K tokens based on initial drafts. Patents present a significant challenge to LLMs due to their specialized nature, standardized terminology, and extensive length. We propose a multi-agent framework called AutoPatent which leverages the LLM-based planner agent, writer agents, and examiner agent with PGTree and RRAG to generate lengthy, intricate, and high-quality complete patent documents. The experimental results demonstrate that our AutoPatent framework significantly enhances the ability to generate comprehensive patents across various LLMs. Furthermore, we have discovered that patents generated solely with the AutoPatent framework based on the Qwen2.5-7B model outperform those produced by larger and more powerful LLMs, such as GPT-4o, Qwen2.5-72B, and LLAMA3.1-70B, in both objective metrics and human evaluations. We will make the data and code available upon acceptance at \url{https://github.com/QiYao-Wang/AutoPatent}.

随着大型语言模型(LLM)的能力不断提升,自然语言处理社区对专利处理领域给予了更多关注。然而,大多数研究都集中在分类任务上,如专利分类和审查,或短文本生成任务,如专利摘要和专利测验。在本文中,我们介绍了一个新颖且实用的任务,称为Draft2Patent,以及相应的D2P基准测试,该测试挑战LLM根据初步草稿生成平均长度为17K标记的完整专利。专利对LLM构成重大挑战,因为它们具有专业性、标准化术语和广泛长度。我们提出了一种多代理框架,称为AutoPatent,它利用基于LLM的规划代理、写作代理和审查代理,结合PGTree和RRAG生成冗长、复杂且高质量的完整专利文件。实验结果表明,我们的AutoPatent框架显著提高了在各种LLM上生成综合专利的能力。此外,我们发现仅使用基于Qwen2.5-7B模型的AutoPatent框架生成的专利,在客观指标和人类评估中都优于更大、更强大的LLM,如GPT-4o、Qwen2.5-72B和LLAMA3.1-70B。数据代码在审核通过后可通过以下网址获取:https://github.com/QiYao-Wang/AutoPatent。

论文及项目相关链接

PDF 19 pages, 7 figures

Summary

随着大型语言模型(LLM)的功能不断提升,专利处理领域在自然语言处理社区中受到了越来越多的关注。然而,大多数研究都集中在分类任务或短文本生成任务上。本文介绍了一种新的实用任务——Draft2Patent及其对应的D2P基准测试,挑战LLM生成基于初始草图的平均17K令牌的全长专利。我们提出的多代理框架AutoPatent利用基于LLM的规划代理、写作代理和检查代理,生成冗长、复杂且高质量的完整专利文件。实验结果表明,AutoPatent框架显著提高了生成综合专利的能力,并且基于Qwen2.5-7B模型的专利生成结果甚至比更大、更强大的LLM(如GPT-4o、Qwen2.5-72B和LLAMA3.1-70B)更优秀。

Key Takeaways

- 大型语言模型(LLM)在专利处理领域受到关注。

- 现有研究主要集中在专利分类和短文本生成任务上。

- 引入了一个新的实用任务——Draft2Patent,挑战LLM生成全长专利。

- 提出了多代理框架AutoPatent,利用规划代理、写作代理和检查代理生成高质量专利文件。

- AutoPatent框架显著提高了生成综合专利的能力。

- 基于Qwen2.5-7B模型的专利生成结果优于其他更大、更强大的LLM。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为 Draft2Patent 的新任务和相应的 D2P 基准测试,旨在解决以下问题:

自动化专利生成:随着大型语言模型(LLMs)能力的不断进步,专利处理领域在自然语言处理社区中受到了越来越多的关注。然而,大多数研究集中在分类任务(如专利分类和审查)或短文本生成任务(如专利摘要和专利测验)上。这项工作提出了一个挑战性的任务,要求 LLMs 基于初始草稿生成平均长度为 17K 个标记的完整专利文档。

专利的复杂性和专业性:专利具有专业性、标准化术语和内容长度较长的特点,这对 LLMs 来说是一个重大挑战。专利通常包括标题、摘要、背景、概述、详细说明和权利要求等部分,这些部分需要符合技术性和法律性标准。

提高专利生成的效率和质量:传统的专利起草过程完全由人类专利代理人手动进行,这导致劳动和时间成本高,效率低下。论文提出的 AutoPatent 框架旨在通过利用基于 LLM 的规划代理、写作代理和审查代理来自动化生成高质量的完整专利文档,从而提高专利生成的效率和质量。

多代理框架的协同工作:论文提出了一个多代理框架,通过规划代理、写作代理和审查代理的协同工作来生成复杂的、详细的和高质量的完整专利文档。这种框架可以显著提高各种 LLMs 生成全面专利的能力。

综上所述,论文试图通过自动化和多代理合作的方法,解决专利生成过程中的效率、质量和专业性问题,以期达到降低成本和提高专利申请效率的目的。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要集中在以下几个方面:

专利写作:

- 研究者们使用多种自然语言处理方法处理专利领域的文本结构。

- 专利生成任务通常包括摘要、翻译、简化和专利写作等。

- 先前的研究集中在专利内部转换的可行性,例如使用基于 GPT-2 的语言模型构建专利权利要求,或者将专利摘要转换为权利要求。

LLMs 基础的多代理框架用于长文本生成:

- 为了解决长文本生成中的困难和挑战,研究人员构建了许多基于角色扮演或定制合作过程的多代理框架。

- 有研究指出 LLMs 输出长度的限制源于训练数据集长度的长尾分布,并基于代理的规划能力提出了写作管道来解决这一问题。

- 一些研究侧重于基于代理的头脑风暴生成类似维基百科的文章,以及将故事写作任务划分为特定代理的写作任务,并设计了评估长叙述的评估框架。

专利分析和专利生成:

- 专利相关任务被分为专利分析和专利生成两大类。

- 专利写作任务之前更多关注专利内部的转换,而没有聚焦于撰写完整的专利。

专利数据集构建:

- 有研究基于论文-专利对构建了数据集,尝试将论文转换为专利,但在现实场景中,专利授权受之前发表的论文影响。

专利审查和分类:

- 大部分研究集中于专利分类任务,例如专利分类和审查。

这些相关研究为本文提出的 Draft2Patent 任务和 AutoPatent 框架提供了背景和对比,展示了该领域内的研究进展和挑战。本文提出的工作与现有研究相比,更加注重于模拟发明人和专利代理人之间的互动,以生成可以提交给知识产权办公室的完整、高质量专利。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤解决自动化专利生成的问题:

定义 Draft2Patent 任务:

- 论文首先定义了一个新的任务 Draft2Patent,模拟真实场景中发明人和专利代理人之间的互动,将发明人的草稿转换成完整的专利文档。

构建 D2P 数据集:

- 为了支持 Draft2Patent 任务,论文构建了一个包含 1,933 对草稿-专利对的挑战性基准数据集 D2P,以及其他专利元数据。

提出 AutoPatent 多代理框架:

- 论文提出了一个名为 AutoPatent 的多代理框架,该框架利用基于 LLM 的规划代理、写作代理和审查代理共同生成高质量完整的专利文档。

PGTree(Patent Writing Guideline Tree)和 RRAG(Reference-Review-Augmented Generation)方法:

- 论文提出了两种创新方法 PGTree 和 RRAG,用于指导描述部分的生成和审查过程,确保生成的专利内容符合技术和法律标准。

实验验证:

- 论文通过在 D2P 基准数据集上进行实验,验证了 AutoPatent 框架在不同 LLMs 上生成全面专利的能力,并发现基于 Qwen2.5-7B 模型的 AutoPatent 框架在客观指标和人类评估中优于其他更大、更强大的 LLMs。

迁移性和泛化性:

- 论文证明了 AutoPatent 框架具有良好的迁移性和泛化性,能够显著提高各种 LLMs 的专利生成能力。

具体来说,AutoPatent 框架的工作流程分为以下三个步骤:

短组件生成(Short Components Generation):使用不同的代理生成专利的各种短组件,考虑风格差异,并在必要时进行微调以提高组件生成质量。

构建专利写作指南树(Patent Writing Guideline Tree Building):规划代理生成一个两层多路的 PGTree,指导描述部分的 RRAG 过程。

参考审查增强生成(Reference-Review-Augmented Generation, RRAG):描述代理根据 PGTree 指南检索参考内容,并生成描述部分的子节。审查代理主动介入,评估内容质量并提供反馈,直到内容被接受。

通过这些步骤,论文提出的 AutoPatent 框架能够有效地生成符合技术和法律标准的完整专利文档,解决了自动化专利生成中的专业性、标准化术语和长篇幅等挑战。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证 AutoPatent 框架的有效性,以下是实验的详细情况:

评估指标:

- 使用了基于 n-gram 的指标 BLEU、ROUGE-1、ROUGE-2、ROUGE-L 作为客观指标。

- 提出了一个新的指标 IRR(Inverse Repetition Rate),用于衡量专利文档中句子重复的程度。

人类评估:

- 邀请了三位熟悉专利法和专利撰写的专家,对生成的专利质量进行单盲评审,依据准确性、全面性、逻辑性、清晰度、连贯性和一致性等六个维度。

比较方法:

- 将 AutoPatent 框架与两种基线方法进行比较:零样本提示(Zero-shot Prompting)和监督式微调(Supervised Fine-Tuning)。

客观指标结果:

- 在 D2P 测试集上报告了不同模型使用零样本提示和 AutoPatent 框架生成的专利文档的客观指标结果。

- 观察到使用 AutoPatent 框架的模型在相同基础模型条件下,n-gram 指标表现更好。

- 特别是使用 Qwen2.5-7B 作为基础模型时,AutoPatent 框架的性能超过了其他模型。

人类评估结果:

- 报告了人类评估结果,比较了 Qwen2.5-7B+AutoPatent 与其他模型(包括零样本提示和监督式微调)生成的 50 个专利文档。

- 三位专家一致认为使用 AutoPatent 框架生成的完整专利文档在各个维度上的表现优于其他模型。

消融研究:

- 进行了三种消融实验来评估 AutoPatent 框架中不同组件(PGTree 和 RRAG)的贡献。

- 结果显示,移除 PGTree 或 RRAG 模块会导致生成的专利文档长度和客观指标显著下降。

案例研究:

- 对比了使用不同方法生成的专利文档,特别是监督式微调(SFT)生成的专利文档存在的重复错误问题,以及 AutoPatent 框架生成的专利文档在全面性和一致性方面的优势。

这些实验结果表明,AutoPatent 框架能够显著提高各种 LLMs 生成完整专利的能力,并且在客观指标和人类评估中都取得了优异的表现。此外,消融研究进一步证明了 PGTree 和 RRAG 模块对于提高生成质量的重要性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出的 AutoPatent 框架在自动化专利生成方面取得了显著成果,但仍有一些点可以进一步探索和研究:

改进和优化 PGTree 和 RRAG 方法:

- 对 PGTree 结构和 RRAG 过程进行更深入的研究和优化,以进一步提高专利文档生成的质量和一致性。

扩展到其他语言和专利局要求:

- 目前的研究主要集中在英文专利和美国专利商标局(USPTO)的要求上。将 AutoPatent 框架扩展到其他语言和不同国家的专利局要求是一个重要的研究方向。

增强模型的法律和技术知识:

- 通过法律和技术领域的知识增强,提高模型对专利法律和技术细节的理解能力,从而生成更符合法律要求的专利文档。

自动化专利评估方法:

- 开发更高效的自动化专利评估方法,以减少人工评估的成本和提高评估效率。

计算资源限制下的模型训练:

- 论文提到由于计算资源限制,没有对参数规模为 14B 或更大的 LLMs 进行完整的微调。未来的工作可以探索在资源限制下如何更有效地训练和微调大型模型。

多模态专利数据的融合:

- 考虑将图像、图表和文本等多种模态的数据融合到专利生成过程中,以提高描述的准确性和清晰度。

模型解释性和透明度:

- 提高模型的解释性,让研究人员和用户更好地理解模型的决策过程,增加模型的透明度和信任度。

模型的伦理和法律问题:

- 深入探讨模型生成的专利文档可能涉及的伦理和法律问题,确保生成的专利不侵犯他人的知识产权。

跨领域应用:

- 探索 AutoPatent 框架在其他需要复杂文档生成领域的应用,如法律文件、技术规范和政策文件等。

用户交互和反馈循环:

- 研究如何将用户的反馈整合到生成过程中,创建一个迭代的反馈循环,以持续改进生成的专利文档质量。

这些方向不仅可以推动自动化专利生成技术的发展,还可能对其他领域的文档生成任务产生积极影响。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题定义:

- 论文提出了一个新的任务 Draft2Patent,旨在自动化地将发明人的初步草稿转换成符合技术性和法律标准的完整专利文档。

数据集构建:

- 构建了一个名为 D2P 的挑战性基准数据集,包含 1,933 对草稿-专利对以及其他专利元数据,用于支持 Draft2Patent 任务。

AutoPatent 框架:

- 提出了一个多代理框架 AutoPatent,利用基于大型语言模型(LLM)的规划代理、写作代理和审查代理来生成高质量完整的专利文档。

方法创新:

- 引入了 PGTree(Patent Writing Guideline Tree)和 RRAG(Reference-Review-Augmented Generation)两种创新方法,分别用于指导专利文档的生成和审查过程。

实验验证:

- 通过一系列实验验证了 AutoPatent 框架的有效性,包括客观指标评估和人类专家评审,证明了其在生成全面专利方面的优势。

消融研究:

- 进行了消融实验来评估 AutoPatent 框架中不同组件的贡献,特别是 PGTree 和 RRAG 模块。

案例分析:

- 通过案例分析展示了 AutoPatent 框架在生成高质量专利文档方面的能力,尤其是在一致性和全面性方面。

结论与展望:

- 论文总结了 AutoPatent 框架的主要贡献,并提出了未来可能的研究方向,包括改进框架、扩展到其他语言和专利要求、增强模型的法律和技术知识等。

总体而言,这篇论文通过提出一个新的任务、构建相应的数据集和开发一个创新的多代理框架,为自动化专利生成领域做出了重要贡献,并展示了该框架在实际应用中的潜力和效果。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

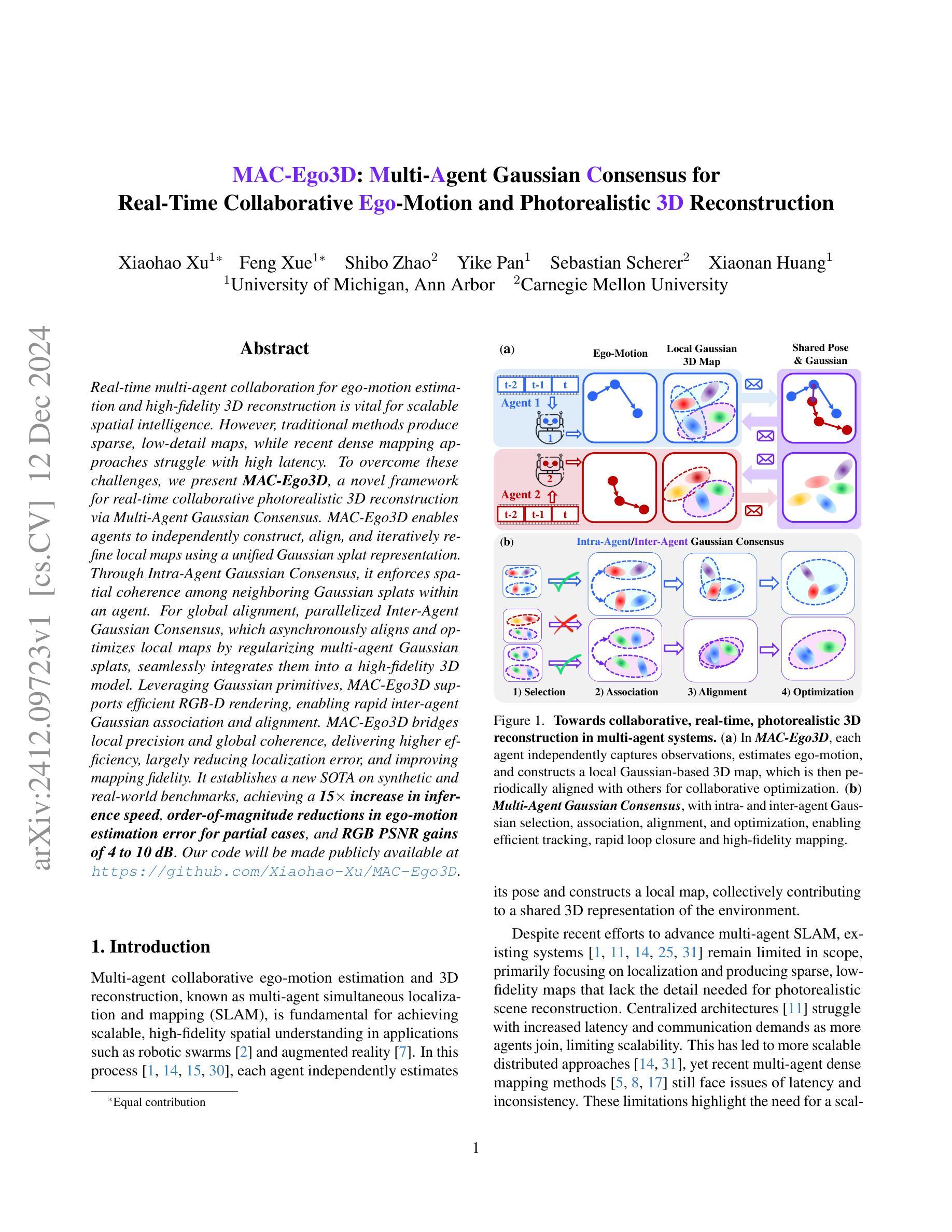

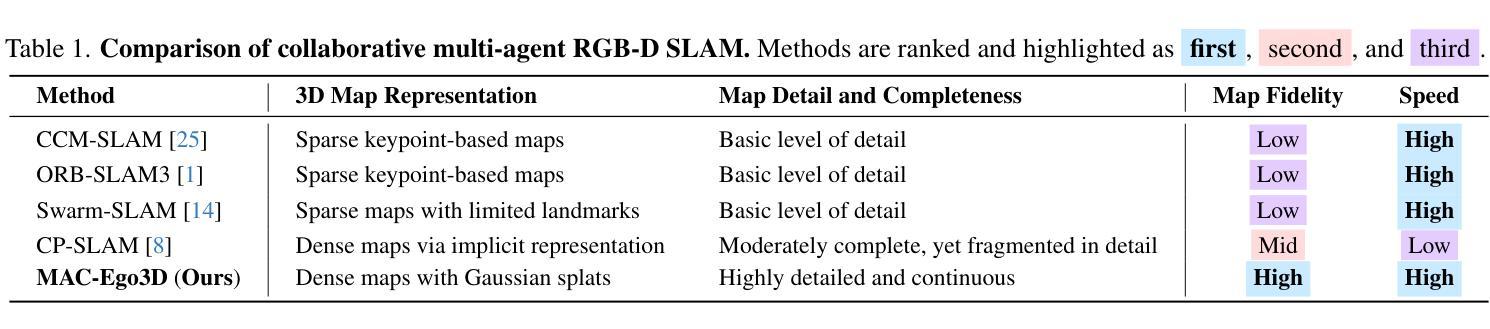

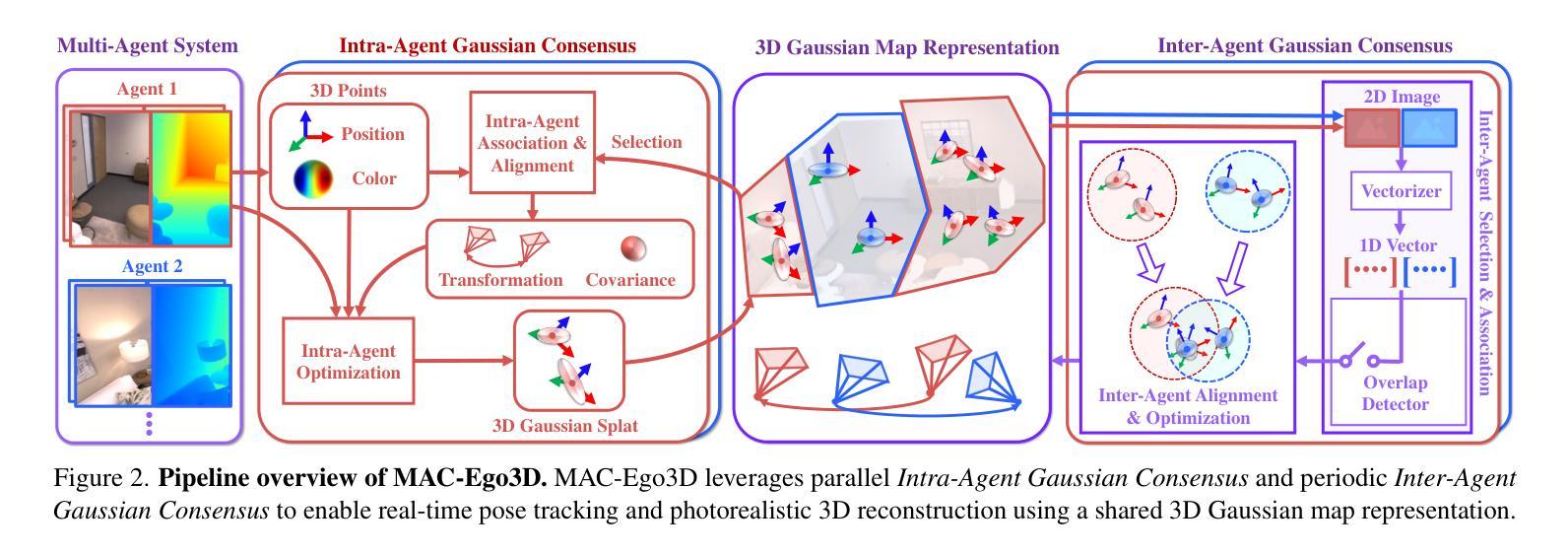

MAC-Ego3D: Multi-Agent Gaussian Consensus for Real-Time Collaborative Ego-Motion and Photorealistic 3D Reconstruction

Authors:Xiaohao Xu, Feng Xue, Shibo Zhao, Yike Pan, Sebastian Scherer, Xiaonan Huang

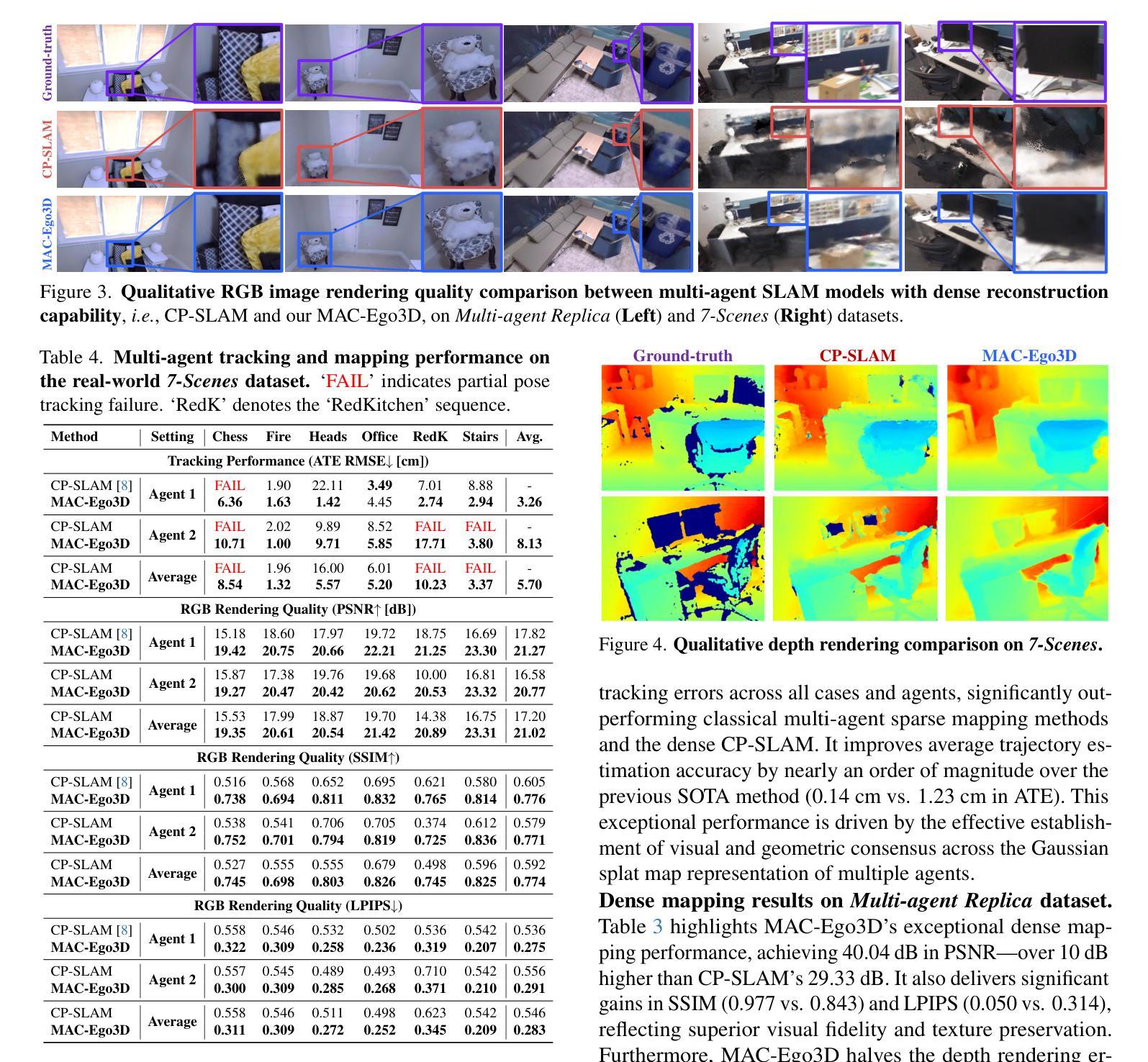

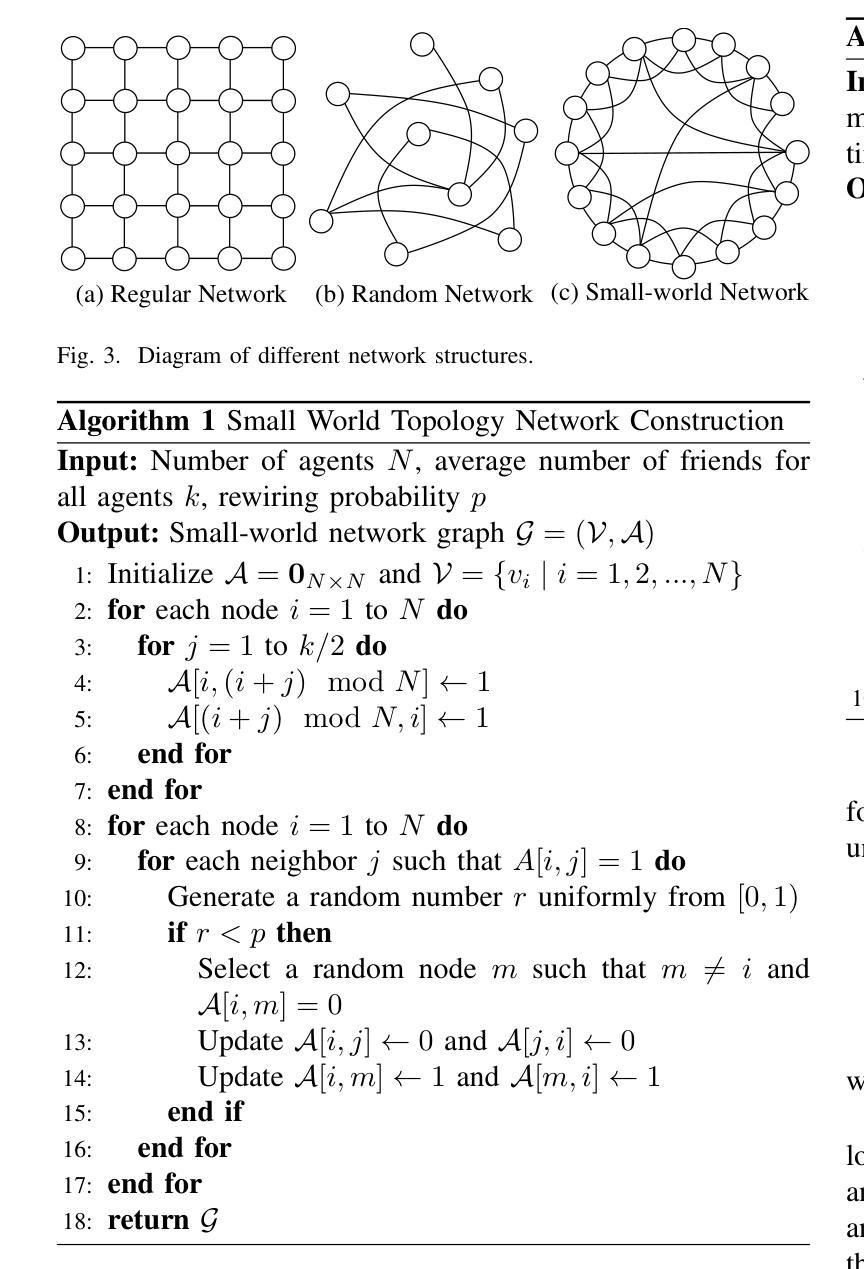

Real-time multi-agent collaboration for ego-motion estimation and high-fidelity 3D reconstruction is vital for scalable spatial intelligence. However, traditional methods produce sparse, low-detail maps, while recent dense mapping approaches struggle with high latency. To overcome these challenges, we present MAC-Ego3D, a novel framework for real-time collaborative photorealistic 3D reconstruction via Multi-Agent Gaussian Consensus. MAC-Ego3D enables agents to independently construct, align, and iteratively refine local maps using a unified Gaussian splat representation. Through Intra-Agent Gaussian Consensus, it enforces spatial coherence among neighboring Gaussian splats within an agent. For global alignment, parallelized Inter-Agent Gaussian Consensus, which asynchronously aligns and optimizes local maps by regularizing multi-agent Gaussian splats, seamlessly integrates them into a high-fidelity 3D model. Leveraging Gaussian primitives, MAC-Ego3D supports efficient RGB-D rendering, enabling rapid inter-agent Gaussian association and alignment. MAC-Ego3D bridges local precision and global coherence, delivering higher efficiency, largely reducing localization error, and improving mapping fidelity. It establishes a new SOTA on synthetic and real-world benchmarks, achieving a 15x increase in inference speed, order-of-magnitude reductions in ego-motion estimation error for partial cases, and RGB PSNR gains of 4 to 10 dB. Our code will be made publicly available at https://github.com/Xiaohao-Xu/MAC-Ego3D .

实时多智能体协同进行自主运动估计和高保真3D重建对于可扩展的空间智能至关重要。然而,传统方法生成的是稀疏、低细节地图,而最近的密集地图方法存在高延迟问题。为了克服这些挑战,我们提出了MAC-Ego3D,这是一个通过多智能体高斯共识进行实时协同光现实3D重建的新框架。MAC-Ego3D使智能体能够使用统一的高斯斑块表示独立构建、对齐和迭代优化本地地图。通过智能体内高斯共识,它强制相邻高斯斑块在智能体内的空间一致性。对于全局对齐,并行化的智能间高斯共识通过异步对齐和优化本地地图,通过正规化多智能体高斯斑块,无缝地将它们集成到高保真3D模型中。利用高斯基本单位,MAC-Ego3D支持高效的RGB-D渲染,能够实现快速的智能体间高斯关联和对齐。MAC-Ego3D融合了局部精度和全局一致性,提高了效率,大大降低了定位误差,提高了映射精度。它在合成和真实世界的基准测试上建立了新的最优表现,实现了推理速度的15倍提升,部分情况下自我运动估计误差降低了数个数量级,RGB峰值信噪比(PSNR)提升了4到10分贝。我们的代码将在https://github.com/Xiaohao-Xu/MAC-Ego3D上公开提供。

论文及项目相关链接

PDF 27 pages, 25 figures

Summary

实时多智能体协同进行自主运动估计和高保真度三维重建对于可扩展的空间智能至关重要。传统方法生成稀疏、低细节地图,而最近的密集地图方法存在高延迟问题。为解决这些挑战,我们提出了MAC-Ego3D框架,通过多智能体高斯共识实现实时协同的光栅化三维重建。MAC-Ego3D使智能体能够独立构建、对齐并迭代优化本地地图,采用统一的高斯斑块表示法。它通过智能体内的高斯共识强化邻近高斯斑块的空间一致性。对于全局对齐,采用并行化智能体间高斯共识,通过正则化多智能体高斯斑块,异步对齐和优化本地地图,无缝集成高保真度三维模型。利用高斯基本单位,MAC-Ego3D支持高效的RGB-D渲染,实现智能体之间的快速高斯关联和对齐。MAC-Ego3D在局部精度和全局一致性之间架起桥梁,提高了效率,大大减少了定位误差,提高了地图精度。它在合成和真实世界的基准测试上建立了新的标准,实现了推理速度的15倍提升,部分情况下自主运动估计误差降低了数个数量级,RGB峰值信噪比增益提高了4到10分贝。我们的代码将在公开渠道发布。

Key Takeaways

- MAC-Ego3D是一个用于实时协同光栅化三维重建的框架。

- MAC-Ego3D解决了传统方法生成稀疏地图和高延迟问题的方法。

- MAC-Ego3D框架支持多智能体的高斯共识协作技术实现局部地图的构建、对齐和迭代优化。

- MAC-Ego3D通过智能体内和智能体间的高斯共识实现空间一致性和全局对齐。

- 利用高斯基本单位,MAC-Ego3D支持高效的RGB-D渲染技术实现快速高斯关联和对齐。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为MAC-Ego3D的框架,旨在解决以下问题:

实时多智能体协作的自我运动估计和高保真度3D重建:这是可扩展空间智能应用(如机器人群和增强现实)中的基本需求。现有的方法要么产生稀疏、细节低的地图,要么在处理密集映射时面临高延迟问题。

多智能体SLAM(Simultaneous Localization and Mapping)的局限性:尽管已有研究推动了多智能体SLAM的发展,现有系统仍然受限,主要集中在定位上,并产生缺乏高保真场景重建所需的细节的稀疏、低精度地图。集中式架构在智能体数量增加时,面临更高的延迟和通信需求,限制了可扩展性。分布式方法虽然更可扩展,但最近的多智能体密集映射方法仍然面临延迟和不一致性的问题。

高保真度和全局一致性的3D表示的实时交付:为了克服这些挑战,论文提出了MAC-Ego3D,这是一个通过多智能体高斯共识机制实现在线高保真度3D重建的协作实时多智能体SLAM框架。

总结来说,MAC-Ego3D框架通过使用高斯splat表示来捕捉空间结构和外观属性,使每个智能体能够独立构建和精细化局部地图,并定期共享姿态和高斯地图以协作优化地图和自我运动估计,从而解决了实时性、精度和一致性的问题。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个领域:

多智能体协作RGB-D SLAM系统:

- 集中式框架,例如CVI-SLAM [11],使用中央服务器管理数据共享和计算任务。

- 分布式SLAM系统,例如Swarm-SLAM [14],依赖于对等通信,实现去中心化方法。

- 基于神经表示的高保真度3D渲染,例如CP-SLAM [8],使用NeRF [18]启发式表示进行协作映射。

密集RGB-D SLAM模型:

- 传统的SLAM模型,如ORB-SLAM [19, 20],在自我运动估计方面表现出色,但因基于特征描述符而产生稀疏地图。

- 非神经SLAM模型提供详细的几何结构,但缺乏精细的外观细节。

- 密集神经SLAM模型结合几何和外观,实现高保真度、逼真的3D重建。

隐式神经技术在SLAM中的应用:

- NeRF [23]被纳入SLAM中,用于高质量的纹理重建。

- 持续的研究改进表现技术,例如[10, 24, 35, 39, 40]。

3D高斯Splatting:

- 3D高斯Splatting [13]显示出对高效RGBD渲染的承诺。

- 进一步的研究提高了SLAM渲染效率和保真度 [5, 6, 12, 17]。

这些相关研究构成了MAC-Ego3D框架的研究背景,其中涉及到多智能体协作、高保真度3D重建、隐式神经表示以及高斯splatting技术。这些技术的发展为实现实时、协作的高保真度3D重建提供了理论和实践基础。

Q: 论文如何解决这个问题?

A: 论文通过提出MAC-Ego3D框架解决了实时多智能体协作自我运动估计和高保真度3D重建的问题。下面是该框架的主要解决方案和步骤:

1. 多智能体高斯共识机制(Multi-Agent Gaussian Consensus)

- MAC-Ego3D 利用高斯splat表示环境,使每个智能体能够独立构建和精细化局部地图,并定期共享姿态和高斯地图以协作优化地图和自我运动估计。

2. 局部和全局高斯共识

- 局部智能体高斯共识(Intra-Agent Gaussian Consensus):每个智能体基于自己的观测构建局部高斯基础的3D地图,通过时间连贯性跨高斯splat进行优化。

- 全局智能体高斯共识(Inter-Agent Gaussian Consensus):多个智能体通过高效关联和协作精细化共视的高斯splat来对齐重叠地图。

3. 高斯共识的四个高级步骤

- 选择(Selection):识别重叠区域中相关的高斯splat以集中对齐工作。

- 关联(Association):基于空间和外观相似性建立对应关系。

- 对齐(Alignment):最小化重叠高斯之间的空间差异。

- 优化(Optimization):智能体微调其对齐的高斯和姿态,以确保局部地图之间的一致转换。

4. 高效的RGB-D渲染

- 利用高斯原语,MAC-Ego3D 支持高效的RGB-D渲染,实现快速智能体间高斯关联和对齐。

5. 平行化高斯共识设计

- MAC-Ego3D 的共识机制允许智能体内部过程和异步智能体间关联的独立执行,确保实时性能。

6. 实验验证

- 在合成和真实世界的基准测试中,MAC-Ego3D 在轨迹估计精度、3D重建保真度和运行时效率方面均优于现有方法。

通过这些解决方案,MAC-Ego3D 在多智能体系统中实现了局部精度和全局连贯性的桥梁,提供了更高的效率,显著降低了定位误差,并提高了映射保真度。

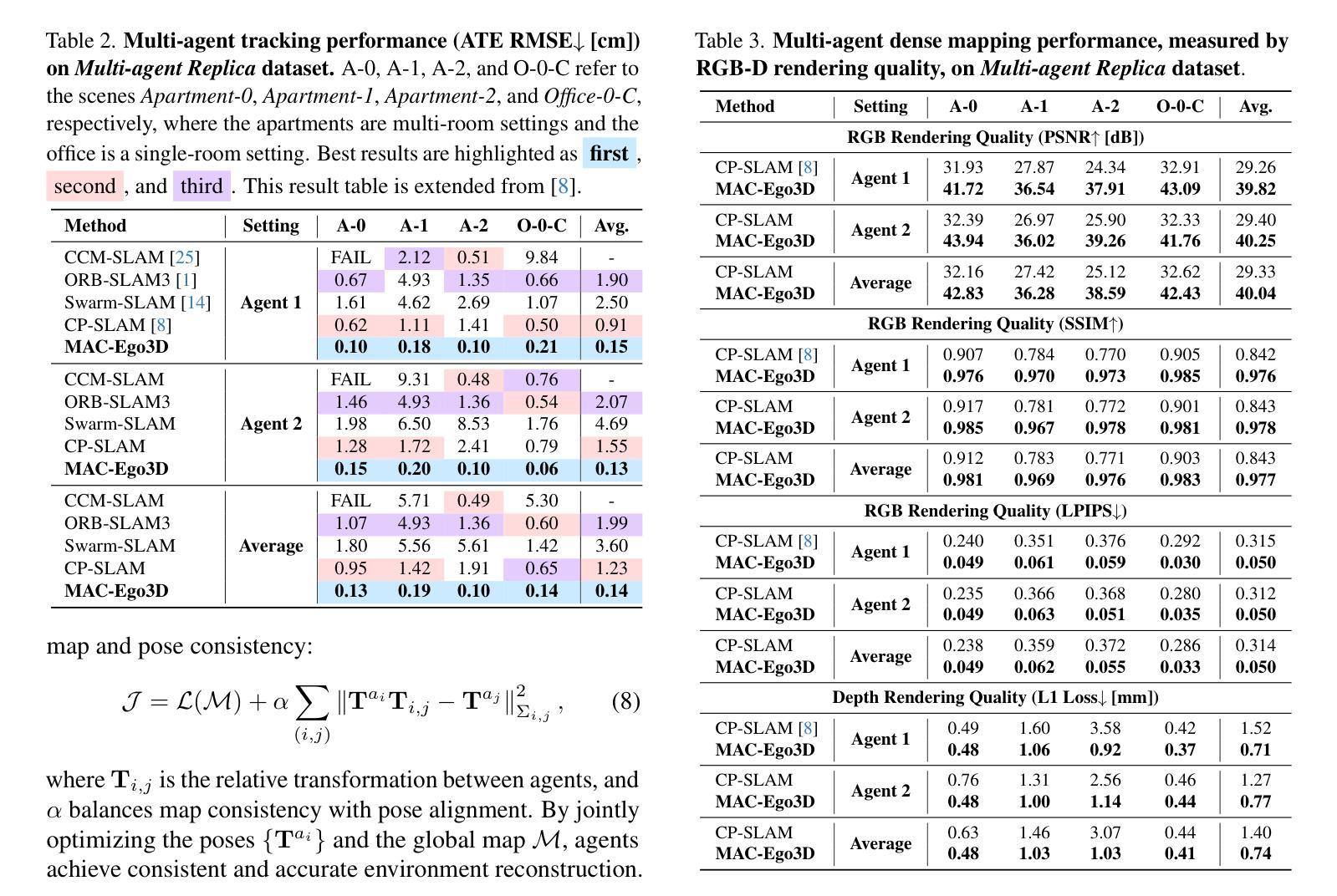

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估MAC-Ego3D框架的性能,具体实验包括:

实验设置:

- 使用了两个多智能体数据集进行评估:合成的Multi-agent Replica数据集和真实世界的7-Scenes数据集。

主要定量结果:

- 在Multi-agent Replica数据集上,MAC-Ego3D在所有情况下都实现了最低的轨迹估计误差,显著优于传统的多智能体稀疏映射方法和密集的CP-SLAM方法。

- 在Multi-agent Replica数据集上,MAC-Ego3D在PSNR、SSIM和LPIPS等指标上显示出卓越的密集映射性能,与CP-SLAM相比,实现了超过10dB的PSNR提升。

- 在真实世界的7-Scenes数据集上,MAC-Ego3D在大多数序列中实现了更低的轨迹估计误差,并且在RGB渲染质量上一致优于CP-SLAM。

定性结果:

- 展示了MAC-Ego3D与CP-SLAM在RGB图像渲染质量、深度渲染和轨迹估计方面的比较,证明了MAC-Ego3D在细节捕捉、颜色准确性和几何完整性方面的优势。

效率和鲁棒性分析:

- 展示了MAC-Ego3D在具有重复环路的Multi-agent Replica序列中的运行时效率,与CP-SLAM相比,实现了更低的误差和更快的处理速度。

- 在存在观察噪声的情况下,MAC-Ego3D显示出比CP-SLAM更好的鲁棒性,无论是在RGB噪声、深度噪声还是复合RGB-D噪声下。

消融研究:

- 展示了通过多智能体协作进行高保真度3D重建的有效性,说明了合作对于提高映射一致性和质量的重要性。

- 分析了通过Inter-Agent Gaussian Consensus进行协作3D地图优化和姿态优化的效果,证明了这些步骤在提高性能方面的重要性。

这些实验全面评估了MAC-Ego3D框架在多智能体场景下的性能,包括轨迹跟踪的准确性、3D重建的保真度、运行时效率以及对噪声和复杂环境的鲁棒性。通过与现有技术的比较,论文证明了MAC-Ego3D在这些方面的优越性能。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

多房间和大规模环境的SLAM:

- 论文提到将多智能体协作SLAM扩展到多房间环境时,会面临关联不同空间中相似模式的挑战。未来的工作可以探索如何在大规模、无界室外环境中实现有效的多智能体SLAM。

高斯压缩技术:

- 由于3D高斯splat表示可能会随着场景规模的增长而增长,因此集成有效的高斯压缩技术对于管理内存效率至关重要。未来的研究可以探索如何优化这一表示以提高存储和计算效率。

增强鲁棒性:

- 尽管MAC-Ego3D在噪声条件下表现出鲁棒性,但在极端情况下或更复杂的动态环境中,其鲁棒性可以进一步增强。研究可以集中在提高系统在面对更极端噪声和快速动态变化时的性能。

提高实时性能:

- 虽然MAC-Ego3D实现了实时性能,但在更强大的硬件或优化算法的帮助下,可以进一步减少跟踪和映射的时间延迟。

跨模态融合:

- 考虑将其他传感器模态(如激光雷达、IMU等)融入框架,以实现更全面的环境感知和更精确的自我运动估计。

更复杂的场景和对象交互:

- 测试和改进MAC-Ego3D在包含更多复杂交互和动态对象的场景中的性能,例如拥挤的公共场所或交通场景。

优化和算法改进:

- 进一步研究和开发更高效的优化算法,以处理更大的数据集和更复杂的环境,同时保持实时性。

开源和社区贡献:

- 论文提到代码将公开提供,这为社区贡献和进一步开发提供了基础。可以通过社区合作进一步改进算法,并在各种应用中测试其有效性。

长期一致性和回环检测:

- 研究如何在长时间运行的SLAM系统中保持一致性,并改进回环检测机制,以处理长时间跨度和大范围环境中的挑战。

这些探索点可以帮助推动多智能体SLAM技术的发展,提高其在更广泛场景和应用中的适用性和有效性。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为MAC-Ego3D的框架,旨在通过多智能体高斯共识机制实现实时自我运动估计和高保真度的3D重建。以下是论文的主要内容总结:

问题定义:

- 论文针对实时多智能体协作在自我运动估计和高保真度3D重建方面的需求,指出现有方法在实时性和细节捕捉上的不足。

MAC-Ego3D框架:

- 提出了MAC-Ego3D框架,一个实时协作的多智能体SLAM系统,使用高斯splat作为连续的、逼真的地图表示,支持局部地图的独立构建、对齐和迭代细化。

多智能体高斯共识:

- 介绍了Intra-Agent和Inter-Agent高斯共识机制,分别用于智能体内部的空间连贯性和全局地图对齐。

- 详细描述了选择、关联、对齐和优化四个步骤,以实现有效的跟踪、快速的闭环检测和高保真度映射。

实验结果:

- 在合成和真实世界的基准测试中,MAC-Ego3D在轨迹估计精度、3D重建质量和运行时效率方面均优于现有方法。

- 实现了15倍的推理速度提升,位置估计误差的数量级降低,以及RGB峰值信噪比(PSNR)提高4到10分贝。

贡献:

- 首次提出了实时全周期多智能体密集SLAM系统,利用高斯splat进行连续、逼真的地图表示,实现高保真度3D重建和精确的姿态跟踪。

- 提出了一个统一框架,用于内部和外部智能体高斯共识优化,有效约束高斯splat,实现鲁棒的闭环检测和一致的地图对齐。

- 通过实验验证了MAC-Ego3D在多个多智能体基准测试中的性能,与先前的方法相比,在轨迹估计精度、3D重建保真度和运行时效率方面都有显著提升。

未来工作:

- 论文提出了未来可能的研究方向,包括扩展到大规模环境、集成高斯压缩技术以提高内存效率,以及提高系统的鲁棒性和实时性能。

总体而言,MAC-Ego3D通过其创新的多智能体高斯共识机制,为实时多智能体协作的自我运动估计和3D重建领域提供了一个高效和高保真的解决方案。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

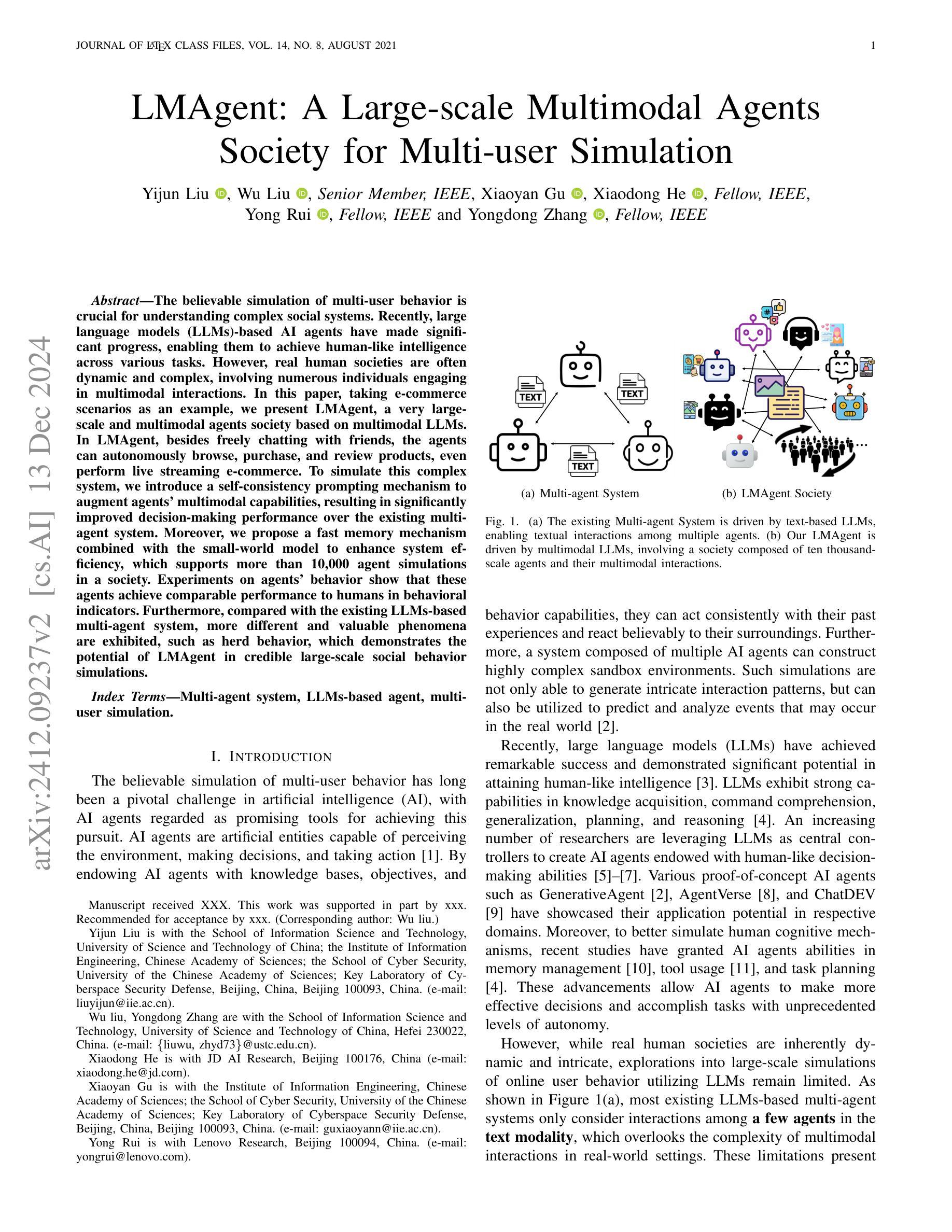

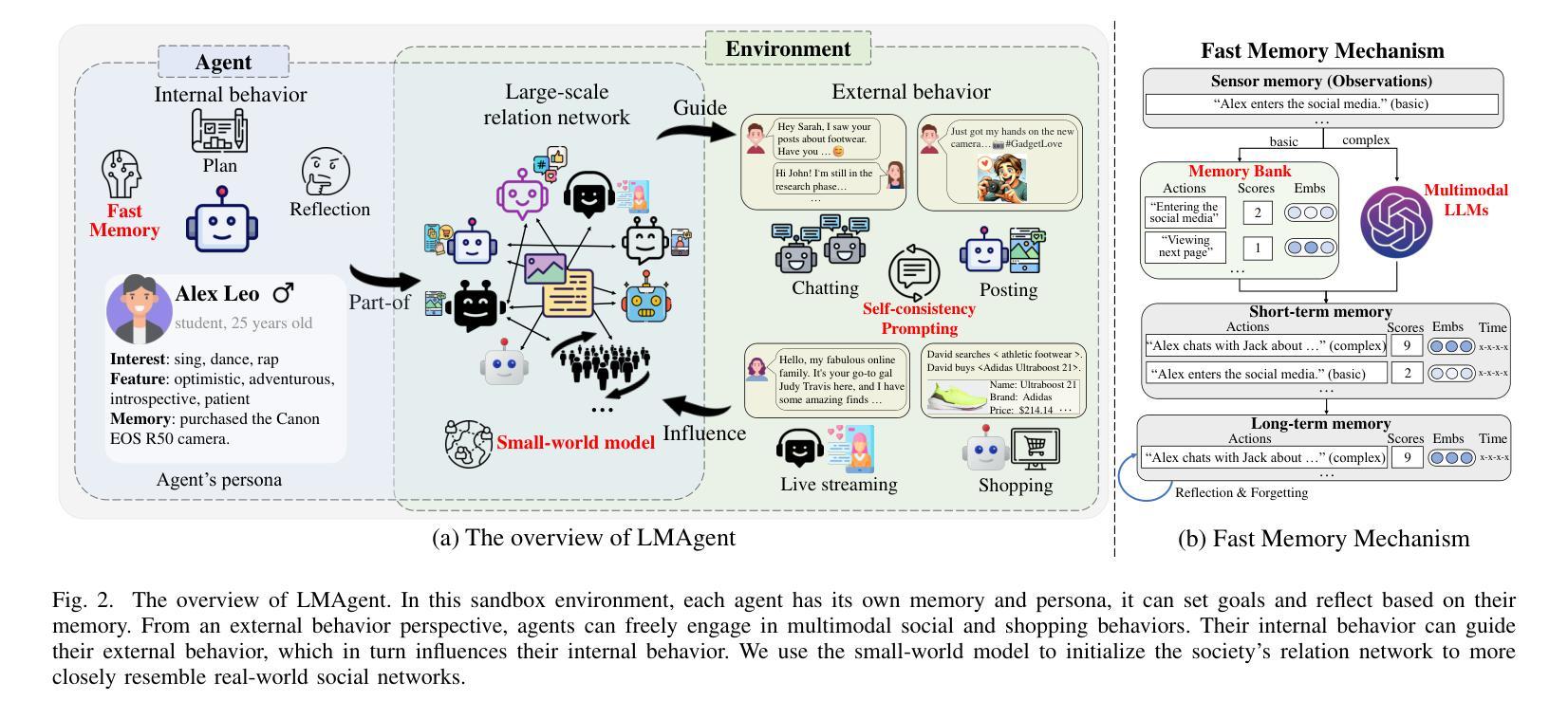

LMAgent: A Large-scale Multimodal Agents Society for Multi-user Simulation

Authors:Yijun Liu, Wu Liu, Xiaoyan Gu, Yong Rui, Xiaodong He, Yongdong Zhang

The believable simulation of multi-user behavior is crucial for understanding complex social systems. Recently, large language models (LLMs)-based AI agents have made significant progress, enabling them to achieve human-like intelligence across various tasks. However, real human societies are often dynamic and complex, involving numerous individuals engaging in multimodal interactions. In this paper, taking e-commerce scenarios as an example, we present LMAgent, a very large-scale and multimodal agents society based on multimodal LLMs. In LMAgent, besides freely chatting with friends, the agents can autonomously browse, purchase, and review products, even perform live streaming e-commerce. To simulate this complex system, we introduce a self-consistency prompting mechanism to augment agents’ multimodal capabilities, resulting in significantly improved decision-making performance over the existing multi-agent system. Moreover, we propose a fast memory mechanism combined with the small-world model to enhance system efficiency, which supports more than 10,000 agent simulations in a society. Experiments on agents’ behavior show that these agents achieve comparable performance to humans in behavioral indicators. Furthermore, compared with the existing LLMs-based multi-agent system, more different and valuable phenomena are exhibited, such as herd behavior, which demonstrates the potential of LMAgent in credible large-scale social behavior simulations.

多用户行为的可信模拟对于理解复杂的社交系统至关重要。最近,基于大型语言模型(LLM)的人工智能代理已经取得了重大进展,使它们能够在各种任务中实现人类智能。然而,真实的人类社会通常是动态和复杂的,涉及许多个体进行多模式交互。在本文中,以电子商务场景为例,我们提出了LMAgent,这是一个基于多模式LLM的大规模多模式代理社会。在LMAgent中,除了与朋友自由聊天外,代理还可以自主浏览、购买和评论产品,甚至进行直播电子商务。为了模拟这个复杂的系统,我们引入了一种自洽提示机制来增强代理的多模式能力,与现有的多代理系统相比,这大大提高了决策性能。此外,我们提出了一种快速记忆机制与小世界模型相结合,提高系统效率,支持社会中的超过10000个代理模拟。对代理行为的实验表明,这些代理在行为指标上达到了与人类相当的性能。与现有的基于LLM的多代理系统相比,还表现出了更多不同且有价值的现象,如群体行为,这展示了LMAgent在可信的大规模社会行为模拟中的潜力。

论文及项目相关链接

Summary

基于多模态大型语言模型(LLM)的AI代理在社会行为模拟中取得显著进展。通过引入自我一致性提示机制和快速记忆机制,LMAgent能够模拟复杂社会系统中的多用户行为,提高决策性能并模拟大规模社会行为。其在电子商务场景中的表现与人类相当,展现出群体行为潜力。

Key Takeaways

- 多用户行为模拟对于理解复杂社会系统至关重要。

- 大型语言模型(LLM)在模拟人类智能方面取得显著进步。

- LMAgent是一个基于多模态LLM的大规模多智能体社会模拟系统。

- LMAgent通过自我一致性提示机制提高智能体的多模态能力,改善决策性能。

- 快速记忆机制结合小世界模型提高了系统效率,支持超过10,000个智能体的社会模拟。

- LMAgent中的智能体在行为指标上与人类表现相当。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文旨在解决多用户行为的可信模拟问题,特别是在理解复杂社会系统方面。具体来说,论文中提到了以下几个挑战:

多模态信息的整合与分析能力提升:现实社会中的人类行为是动态且复杂的,涉及众多个体进行多模态互动。现有基于大型语言模型(LLMs)的多智能体系统主要考虑文本模态中的少数智能体之间的互动,忽略了现实世界中多模态互动的复杂性。

提高基于LLM的智能体的运行效率:进行大规模用户行为模拟时,计算成本较高。论文需要提出一种方法来提高系统的运行效率,使得能够模拟大规模的用户行为。

为了应对这些挑战,论文提出了一个名为LMAgent的大规模多模态智能体社会,它基于多模态大型语言模型(LLMs)。LMAgent通过以下方式来增强智能体的多模态分析能力,并提高系统的运行效率:

自洽提示机制(Self-consistency prompting mechanism):通过链式思考推理动态生成多模态提示,显著提高智能体在复杂多模态场景中决策的一致性,从而提高模拟性能。

快速记忆机制(Fast memory mechanism):结合小世界模型(small-world model),通过限制多模态LLM调用复杂行为来减少系统负载,提高效率。

论文通过在电子商务场景中模拟多达10,000个智能体的多模态社交和购物行为,验证了LMAgent在大规模社会行为模拟中的潜力和可信度。

Q: 有哪些相关研究?

A: 论文中提到了以下几类相关研究:

A. 可信的用户行为代理(Believable Proxies of User Behavior)

这类研究关注于如何设计能够创建人类行为幻觉的可信代理,使它们能够根据意愿做出决策和行动。过去几十年中,提出了多种方法来创建可信的代理,包括基于规则的方法(如有限状态机和行为树)和基于强化学习的方法。这些方法旨在自动化决策过程,例如:

- RecSim:使用强化学习模拟用户连续行为以进行交互式推荐。

- AlphaStar 和 DQN:使代理能够在未知环境中自主学习,从而在某些决策游戏中取得令人印象深刻的表现。

B. 基于LLM的代理系统(LLMs-based Agent System)

这类系统利用LLMs作为引擎,驱动多个代理进行各种行为决策。每个代理都有自己的知识库、目标和能力,并且能够互动和协作以增强系统处理复杂任务和动态环境的能力。近期的一些进展包括:

- GenerativeAgent、AgentVerse 和 ChatDEV:展示了在各自领域中应用LLMs的潜力。

- LLMs在经济行为模拟中的应用:利用LLMs代理代替人类参与者,赋予代理才能、背景和偏好,并促使它们模拟经济行为。

- LLMs在多智能体系统中模拟人类意见动态:揭示了LLM代理在产生准确信息方面的固有偏见。

其他相关研究

- Collaborative software development:使用LLMs构建其他代理系统以进行模拟或提高工作效率。

- Social simulation 和 Game playing:LLMs在社交模拟和游戏玩法中的应用。

这些相关研究展示了LLMs在模拟人类行为和决策中的潜力,以及在构建复杂社会系统模拟中的应用前景。论文提出的LMAgent系统在这些研究的基础上,旨在构建一个更大规模、更真实的多用户行为模拟环境。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键方法解决了多用户行为的可信模拟问题:

1. LMAgent系统

提出了LMAgent,一个基于多模态大型语言模型(LLMs)的超大规模多智能体社会。LMAgent模拟了电子商务场景中多达10,000个智能体的多模态社交和购物行为。

2. 自洽提示机制(Self-consistency prompting mechanism)

为了增强智能体在复杂多模态场景中的决策一致性,论文提出了一种自洽提示机制。这种机制通过链式思考推理动态生成多模态提示,显著提高了智能体决策的一致性,从而增强了模拟性能。

3. 快速记忆机制(Fast memory mechanism)

为了提高系统的运行效率,论文设计了一种快速记忆机制,该机制限制了多模态LLM调用仅用于复杂行为,减少了系统负载,提高了效率。

4. 小世界模型(Small-world model)

LMAgent使用小世界模型初始化智能体的社会网络,以提高通信效率,并更贴近现实世界的网络结构。小世界网络具有较高的聚类系数和较短的平均路径长度,类似于现实世界的网络。

5. 多模态智能体架构

LMAgent中的每个智能体都有内部行为(包括个性和记忆模块)和外部行为(社交或购物活动)。内部行为由多模态LLMs驱动,能够根据智能体的记忆和个性进行规划和反思。

6. 沙盒环境(Sandbox Environment)

LMAgent提供了一个沙盒环境,智能体可以自由地进行多模态社交或购物互动。这些行为可以改变智能体的记忆,并影响其他智能体的行为。

7. 实验验证

通过广泛的实验,论文验证了LMAgent在模拟用户行为方面的有效性。实验包括评估智能体在沙盒环境中的购买行为模拟能力、比较智能体和人类行为以及在电子商务场景中进行大规模消费者行为模拟。

综上所述,论文通过结合先进的多模态LLMs、自洽提示机制、快速记忆机制和小世界模型,提出了一个能够进行大规模、多模态、可信社会行为模拟的智能体系统LMAgent。通过实验验证,LMAgent不仅能够模拟与人类行为相似的指标,还能展现出类似现实世界的集体行为模式,展示了其在大规模社会行为模拟中的潜力。

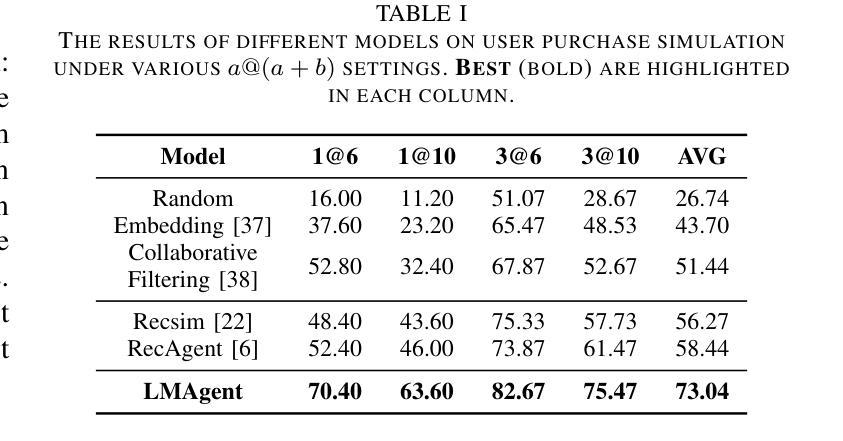

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来评估LMAgent系统的性能和有效性:

A. 实验设置

- LLM使用:使用的是ChatGPT (version: gpt-4-1106-preview)。

- 系统实现:基于LangChain实现。

- 数据集:使用亚马逊评论数据集,包含2.331亿个独特购买和评论信息。

B. 用户购买行为评估

- 任务:模拟用户购买行为,基于LMAgent沙盒环境。

- 评估指标:使用a@(a+b)指标评估购买准确率。

- 结果:与多个推荐算法比较,LMAgent显示出优越的性能。

C. 智能体行为分析

- 数据收集:分析1000个智能体的行为链和行为内容,与50名志愿者控制的500个智能体的行为进行比较。

- 评估指标:基于人类评分的多维评估框架。

- 行为链分析:比较Random、LMAgent和人类的行为表现。

- 行为内容分析:评估LMAgent与人类在社交内容创造方面的能力。

- 社会影响分析:分析社会信息对智能体购买行为的影响。

D. 消融研究

- 快速记忆的影响:通过测量LMAgent的令牌消耗量来量化快速记忆机制对系统效率的影响。

- 自洽提示的影响:评估多模态输入和自洽提示对用户购买行为模拟性能的影响。

E. 大规模消费者模拟分析

- 购买统计:比较LMAgent模拟的用户购买数据与京东用户行为数据的一致性。

- 网络拓扑分析:研究不同网络拓扑结构对大规模信息传播的影响。

这些实验全面评估了LMAgent在模拟用户行为方面的能力,包括购买行为的准确性、行为的合理性、社交互动的真实性以及系统运行的效率。实验结果表明,LMAgent能够产生与真实用户行为高度一致的模拟结果,并在大规模社会模拟中展现出与现实世界相似的集体行为模式。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了一个强大的LMAgent系统来模拟大规模多用户行为,但仍有一些领域可以进一步探索和改进:

1. 多样化场景应用

- 不同领域的模拟:将LMAgent应用于其他领域,如政治选举、公共卫生危机响应等,以测试其在不同复杂社会现象中的适用性和有效性。

2. 提升个性化和自适应性

- 更复杂的人格模型:研究更复杂的人格和情感模型,使智能体的行为更加个性化和不可预测,更贴近真实人类行为。

3. 增强交互性

- 多智能体间的复杂交互:探索智能体之间更复杂的交互模式,如形成联盟、竞争和合作等。

4. 提高模拟的实时性

- 实时数据集成:研究如何将实时数据集成到模拟中,使模拟环境能够响应现实世界中的即时变化。

5. 优化算法效率

- 计算效率提升:进一步优化算法和计算架构,以处理更大规模的智能体社会,减少计算资源消耗。

6. 强化学习的应用

- 强化学习集成:探索将强化学习技术集成到LMAgent中,使智能体能够从环境中学习并优化其行为策略。

7. 伦理和隐私问题

- 伦理和隐私考量:在模拟真实人类行为时,考虑伦理和隐私问题,确保模拟的道德合理性和用户数据的安全。

8. 跨模态能力的进一步研究

- 跨模态学习:研究如何进一步提升智能体的跨模态学习能力,使其能更有效地处理和整合来自不同模态(如视觉、语言、声音)的信息。

9. 长期行为模式和趋势分析

- 长期模拟:进行长期模拟以分析智能体行为的演变趋势和社会结构的长期变化。

10. 开放式问题和挑战

- 开放性问题:设计和参与挑战,邀请学术界和工业界共同探索和推动多智能体系统的极限。

这些探索点不仅可以推动LMAgent系统的发展,还可能为社会科学、人工智能和多智能体系统的研究提供新的视角和工具。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为LMAgent的大规模多模态智能体社会,旨在通过模拟多达10,000个智能体的复杂社交和购物行为,来理解和预测现实世界中的复杂社会系统。以下是论文的主要内容总结:

1. 问题陈述

- 可信的多用户行为模拟对于理解复杂社会系统至关重要。

- 现实社会是动态和复杂的,涉及大量个体的多模态互动。

- 现有的基于大型语言模型(LLMs)的多智能体系统主要关注文本模态的少量智能体互动,忽略了现实世界的多模态复杂性。

2. LMAgent系统介绍

- LMAgent是一个基于多模态LLMs的大规模多智能体社会。

- 智能体可以自由地进行聊天、浏览、购买、评论产品,甚至进行直播电商活动。

- 引入自洽提示机制增强智能体的多模态能力,显著提高决策性能。

- 提出快速记忆机制和小世界模型以提高系统效率,支持超过10,000个智能体的模拟。

3. 关键贡献

- 提出了LMAgent,一个大规模多模态智能体社会,用于模拟真实世界的复杂用户行为。

- 通过自洽提示引入多模态智能体,实验表明其性能显著优于现有基于LLMs的多智能体系统。

- 提出快速记忆机制和小世界模型,支持大规模智能体社会的模拟,准确捕捉大规模用户共购模式,并展现出群体行为。

4. 实验验证

- 在电子商务场景中对智能体的购买行为进行了模拟和评估。

- 与人类行为进行了比较,验证了LMAgent在模拟用户行为方面的有效性。

- 进行了大规模消费者行为模拟,分析了由LMAgent产生的群体行为。

5. 结论

- LMAgent能够产生与真实用户行为高度一致的模拟结果,并在大规模社会模拟中展现出与现实世界相似的集体行为模式。

- 这项研究在可信的大规模用户行为模拟领域迈出了重要一步,随着LLMs的发展,未来有望创造更加真实的模拟。

论文的研究成果不仅展示了在大规模社会行为模拟中的潜力,还为社会科学、人工智能和多智能体系统的研究提供了新的视角和工具。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

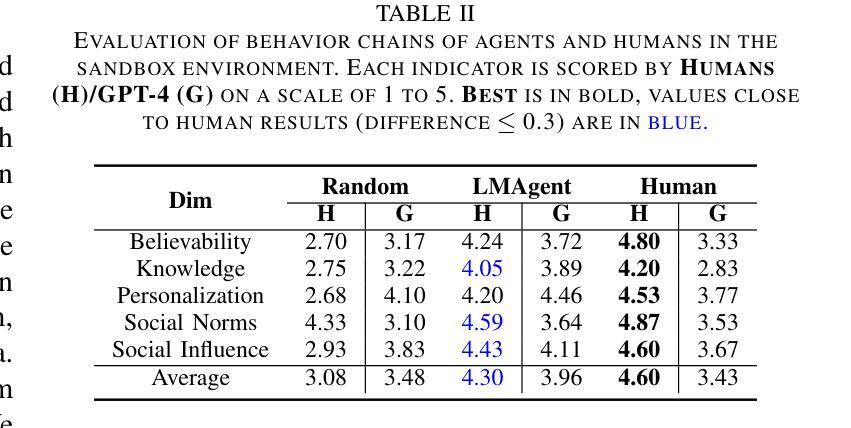

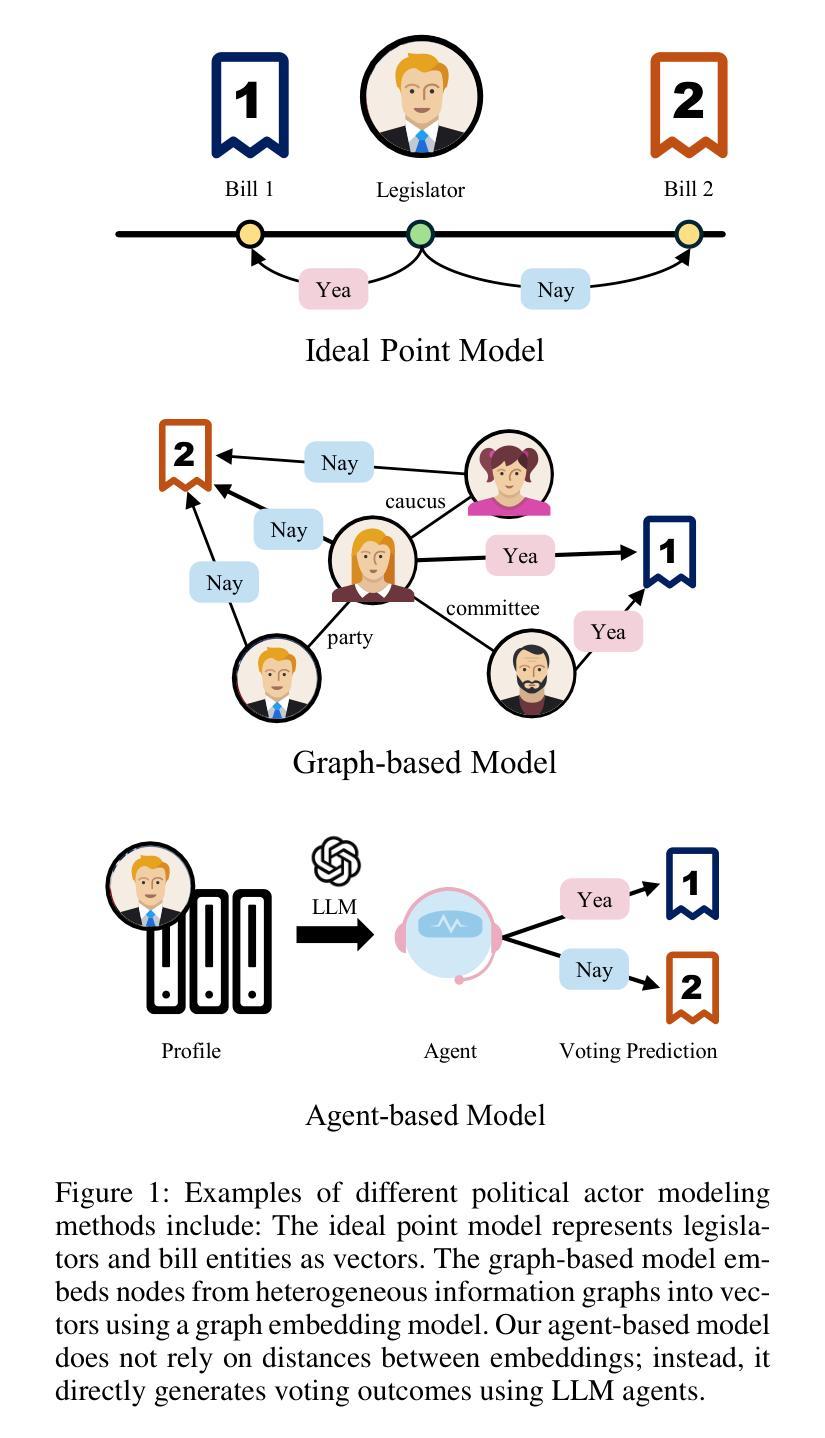

Political Actor Agent: Simulating Legislative System for Roll Call Votes Prediction with Large Language Models

Authors:Hao Li, Ruoyuan Gong, Hao Jiang

Predicting roll call votes through modeling political actors has emerged as a focus in quantitative political science and computer science. Widely used embedding-based methods generate vectors for legislators from diverse data sets to predict legislative behaviors. However, these methods often contend with challenges such as the need for manually predefined features, reliance on extensive training data, and a lack of interpretability. Achieving more interpretable predictions under flexible conditions remains an unresolved issue. This paper introduces the Political Actor Agent (PAA), a novel agent-based framework that utilizes Large Language Models to overcome these limitations. By employing role-playing architectures and simulating legislative system, PAA provides a scalable and interpretable paradigm for predicting roll-call votes. Our approach not only enhances the accuracy of predictions but also offers multi-view, human-understandable decision reasoning, providing new insights into political actor behaviors. We conducted comprehensive experiments using voting records from the 117-118th U.S. House of Representatives, validating the superior performance and interpretability of PAA. This study not only demonstrates PAA’s effectiveness but also its potential in political science research.

通过建模政治行动者来预测投票点名投票已经成为定量政治科学和计算机科学的一个重点。广泛使用的基于嵌入的方法从各种数据集中为立法者生成向量,以预测立法行为。然而,这些方法经常面临挑战,例如需要手动预设特征、依赖大量训练数据以及缺乏可解释性。在灵活条件下实现更具可解释性的预测仍然是一个未解决的问题。本文介绍了政治行动者代理(PAA),这是一个基于大型语言模型的新型代理框架,旨在克服这些局限性。通过采用角色扮演架构并模拟立法系统,PAA提供了一个可扩展且可解释的模式来预测投票点名投票。我们的方法不仅提高了预测的准确性,而且提供了多视角、人类可理解决策依据,为政治行动者行为提供了新见解。我们使用第117-118届美国众议员的投票记录进行了全面的实验,验证了PAA的优越性能和可解释性。这项研究不仅证明了PAA的有效性,还展示了其在政治科学研究中的潜力。

论文及项目相关链接

PDF Accepted at AAAI 2025

总结

本论文针对政治科学家和计算机科学家在预测投票中的关注点,提出了一种基于政治行动者代理(PAA)的新型代理框架。该框架使用大型语言模型克服了传统嵌入方法所面临的挑战,如需要手动预设特征、依赖大量训练数据以及缺乏解释性。PAA通过角色扮演架构模拟立法系统,提供了一个可扩展且可解释的预测投票模式。该方法不仅提高了预测的准确性,还提供了多视角、人类可理解的决策理由,为政治行动者行为提供了新见解。本研究通过实验验证了PAA在预测美国第117-118届众议员投票记录方面的优越性能和解释性。

关键见解

- 政治行动者代理(PAA)是一种新型代理框架,旨在解决预测投票中的挑战。

- PAA利用大型语言模型克服传统嵌入方法的局限。

- PAA通过角色扮演架构模拟立法系统,提供可扩展且可解释的预测投票模式。

- PAA不仅能提高预测准确性,还能提供多视角、人类可理解的决策理由。

- PAA的引入为政治行动者行为提供了新见解。

- 实验结果验证了PAA在预测美国第117-118届众议员投票记录方面的优越性能。

- 本研究展示了PAA在政治科学研究中的潜力和有效性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何通过建模政治参与者来预测投票结果,特别是在量化政治科学和计算机科学领域中,对立法者投票行为的预测。具体来说,论文指出了现有基于嵌入的方法在预测立法者投票行为时面临的几个挑战:

- 预定义特征的局限性:这些模型的训练完全依赖于预定义的特征,这限制了模型自然扩展到新的、未经训练的关系。

- 训练数据的体量:大多数模型依赖于大型数据集来实现最佳性能,这在现实世界场景中并不总是可行的,例如在预测新当选立法者的投票时。

- 预测的可解释性:基于嵌入的预测缺乏可解释性,特别是在以人类可理解的方式提供洞察方面。

为了解决这些挑战,论文提出了一种新颖的基于代理的框架——政治参与者代理(Political Actor Agent, PAA),该框架利用大型语言模型(LLMs)来克服这些限制,旨在提供一个可扩展且可解释的预测投票的范式。

Q: 有哪些相关研究?

A: 相关研究主要涉及以下几个方面:

基于理想点模型的投票预测:

- 理想点模型是一种基于投票记录构建的流行技术,用于表示立法者的一维或多维意识形态位置。

- 一些研究通过主题模型对立法文本进行详细分析,增强了对投票的上下文理解。

- 进一步扩展,开发了主题因子化的理想点模型,为每个主题分配理想点,而不是全局性地,允许对立法行为进行更细致的解释。

基于图的方法:

- 随着知识图谱和图神经网络的进步,基于图的方法变得流行。

- 这些方法将外部知识以异构图的形式引入投票预测中,与理想点模型相比,能够更灵活地捕获复杂的政治关系。

利用大型语言模型(LLMs):

- 近期研究集中在利用大型语言模型。

- 例如,构建多视图政治知识图谱以增强LLMs的领域知识。

- 开发预训练架构,将语言映射到参与者表示。

LLM代理在决策模拟中的应用:

- LLM代理在自然科学、软件工程和体现智能等领域展示了人类水平智能的潜力。

- 在社会科学中,特别是在模拟决策行为方面,LLM代理被用于模拟不同条件下的经济决策。

- 在投票决策模拟领域,研究了使用大型语言模型模拟人类样本的可行性,基于人口统计数据设计代理以模拟不同人群的反应。

这些相关研究表明,LLM代理在相关任务中的能力,但它们仍然作为补充嵌入方法。这篇论文提出了一种新颖的方法,将立法者建模为代理,旨在推进对投票行为的预测和理解。

Q: 论文如何解决这个问题?

A: 论文通过提出政治参与者代理(Political Actor Agent, PAA)框架来解决预测立法者投票行为的问题。PAA框架利用大型语言模型(LLMs)来克服传统方法的局限性,并提供更准确、可解释的预测结果。具体来说,PAA框架通过以下几个关键组件来实现:

角色扮演架构:

- PAA基于角色扮演架构设计,每个代理(即立法者)都被赋予一个可扩展的个人资料,这个资料比手动设计的关联规则更加灵活和易于管理。

多视图规划模块:

- 从多个视角(如代表和受托人视角)出发,PAA可以制定不同的投票计划。这些决策理由对人类来说是可理解的,能够为政治科学研究提供新的见解。

模拟立法行动模块:

- 基于立法者的投票策略,开发了一个影响机制来模拟议会动态。将立法者分为领导代理和追随者代理,追随者代理受到领导代理的投票结果的影响。即使在已知数据有限的情况下,也能准确预测投票结果。

个人资料构建模块:

- 使用角色扮演架构,模拟特定角色的代理以做出投票决策。个人资料构建模块集成到提示中,影响LLMs的设计和行为。个人资料设计高度可扩展,可以合成来自不同数据源的信息,如个人基本信息、职业历史、投票记录等。

多视图规划:

- 受政治科学启发,规划模块将投票决策任务分解为三个主要视图,帮助代理进行决策。包括受托人视角、代表视角和追随者视角。

模拟立法行动:

- 设计了一个“影响机制”来模拟领先代理如何影响其他代理。领导代理首先根据多视图规划模块进行投票,然后其他代理在了解领导代理的决策后做出选择。

通过这些组件,PAA框架不仅提高了预测的准确性,还提供了可解释的决策理由,为政治科学研究提供了新的见解。此外,PAA框架通过设计可扩展的个人资料、多视图规划和模拟立法者行动,显著提高了预测准确性,并为政治科学研究提供了可解释的决策制定洞察。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估政治参与者代理(PAA)在预测投票结果方面的有效性。以下是实验的主要部分:

数据集和基线:

- 实验使用了第117至118届美国众议院的投票数据,涵盖了432名立法者的数据。

- 除了投票数据外,还收集了构建个人资料和异构图的额外数据,包括最新的维基百科页面、选区的维基百科页面、法案的发起人和共同发起人数据以及立法者的推特帖子。

- 选择了五种方法作为基线,包括理想点模型的一个变体、三个基于图的模型和一个结合预训练模型的方法。

数据集划分:

- 数据集按时间顺序划分,并选择了三种不同的数据集划分比例:

- split244:20%训练集、40%验证集、40%测试集。

- split433:40%训练集、30%验证集、30%测试集。

- split622:60%训练集、20%验证集、20%测试集。

- 数据集按时间顺序划分,并选择了三种不同的数据集划分比例:

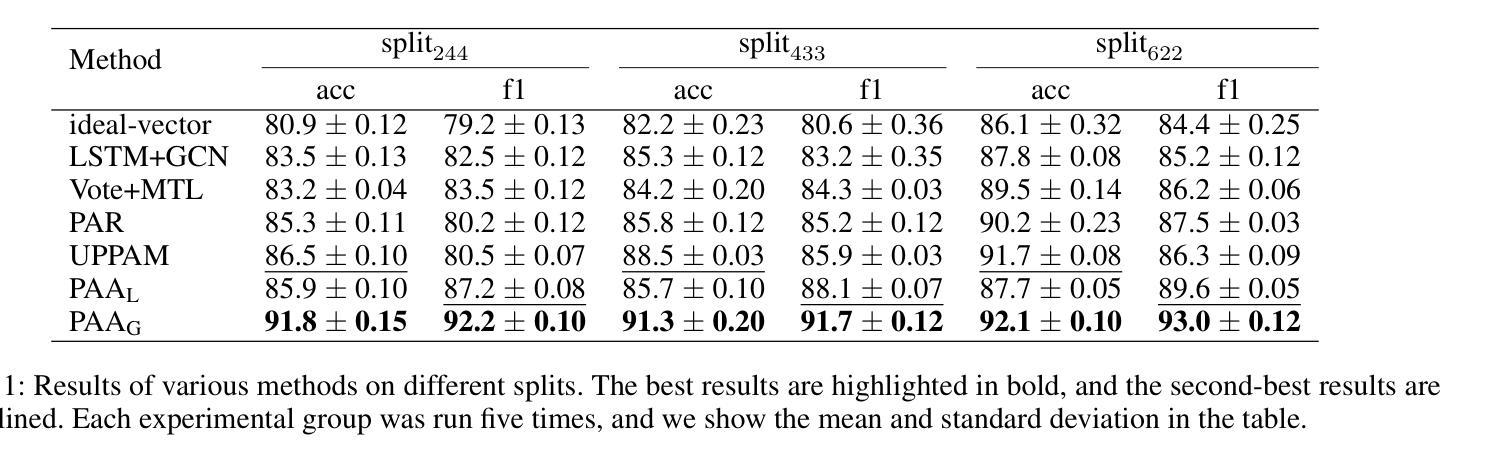

实验结果:

- 展示了不同方法在不同数据集划分上的结果,包括准确率和宏平均F1分数。

- PAA在所有数据集划分上均表现出色,特别是在GPT-4o-mini(PAAG)模型上,其性能优于其他方法。

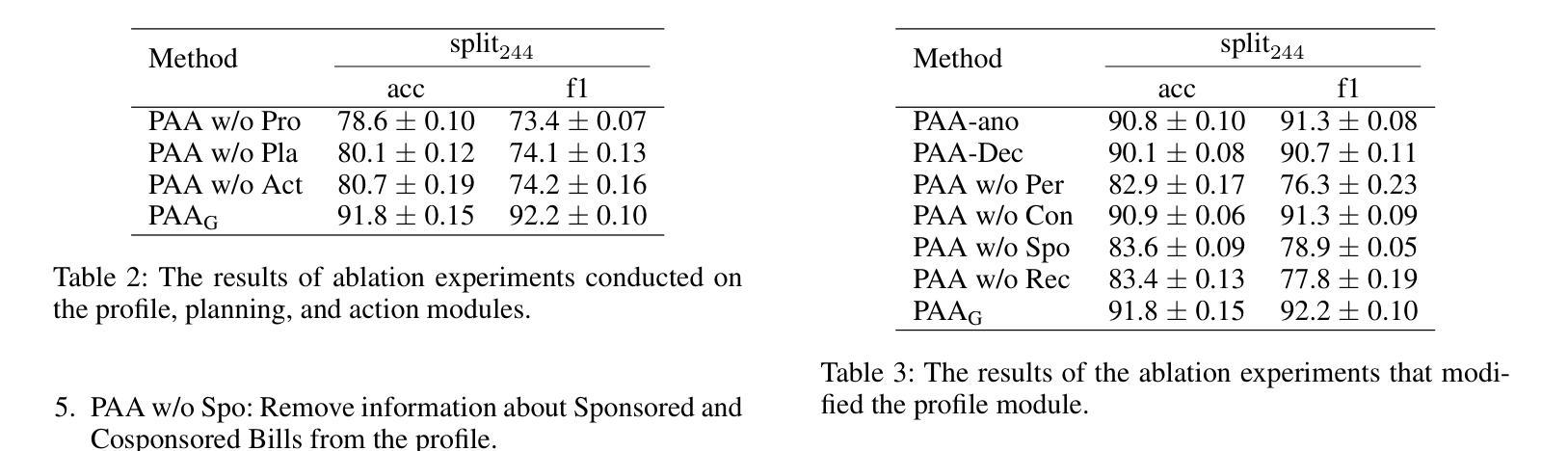

消融研究:

- 设计了消融实验来验证PAA各个模块对性能的影响,包括个人资料模块、规划模块和行动模块。

- 分析了个人资料模块的各个组成部分对PAA性能的影响,包括立法者个人信息、选区详情、立法发起活动和投票记录。

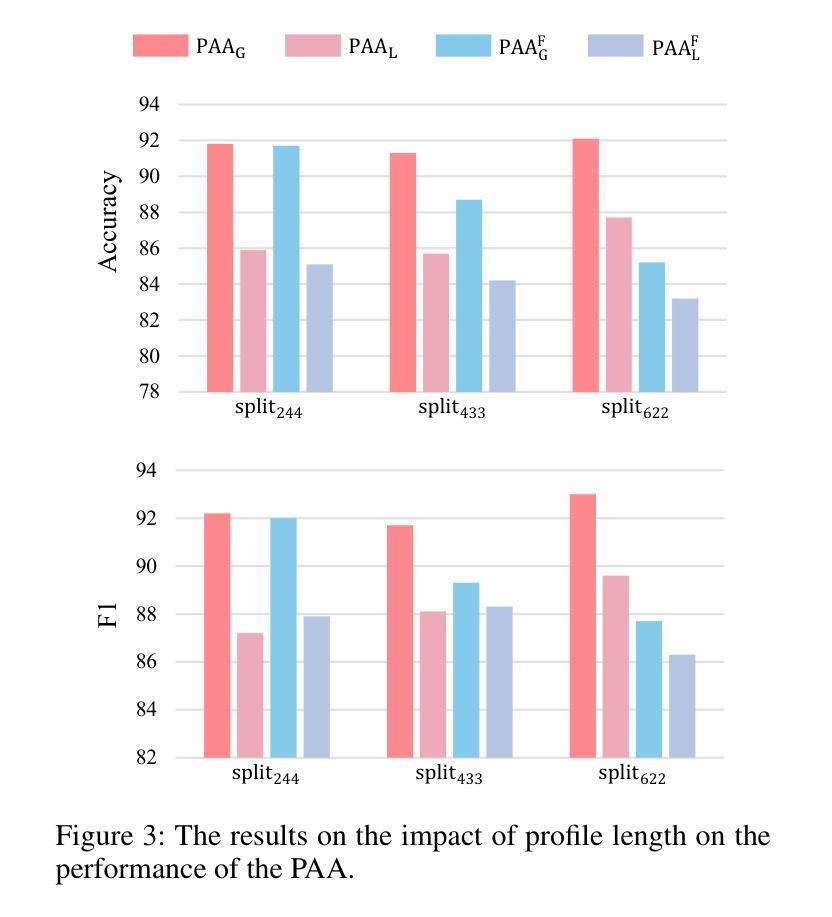

个人资料模块分析:

- 探讨了PAA的个人资料模块中不同信息类型对预测结果的影响,包括立法者的名字和法案编号对结果的影响,以及投票记录的长度对性能的影响。

一致性分析:

- 分析了PAA结果的一致性,通过重复实验来观察大型语言模型可能出现的幻觉现象。

可解释性示例:

- 提供了一个示例来说明PAA如何生成其预测结果,并从三个不同视角解释其选择,每个视角都有事实证据支持。

这些实验全面评估了PAA在预测投票结果方面的准确性、稳定性和可解释性,并与现有的基线方法进行了比较。通过这些实验,论文证明了PAA作为一种新的基于代理的范式,在政治参与者研究中的有效性。

Q: 有什么可以进一步探索的点?

A: 论文在最后提出了几个可以进一步探索的方向:

数据多样性:

- 尽管PAA在数据类型较少的情况下相较于基线方法表现更优,但当前架构还不支持整合社交媒体评论和新闻等多样化的数据源。

- 未来的工作可以探索如何整合更多种类的数据,比如实时社交媒体分析和全球新闻事件,以增强PAA的预测能力。

任务多样性:

- 与现有的政治参与者建模方法相比,PAA主要支持投票预测任务。

- 开发能够支持更多下游任务的机制,扩大PAA在计算政治科学中的适用性和实用性,仍是一个未解决的问题。

幻觉问题:

- 尽管论文从一致性的角度分析了PAA的结果,但LLMs中的幻觉问题复杂,一致性只是衡量幻觉的一个方面。

- 未来的研究可以进一步探索如何减少LLMs中的幻觉现象,提高预测结果的稳定性和可靠性。

模型泛化能力:

- 虽然实验集中在美国立法者上,但PAA可以容易地扩展到其他国家。

- 未来的工作可以探索PAA在不同国家和政治体系中的适用性,以及如何调整模型以适应不同的政治环境。

模型解释性:

- 提高模型的可解释性,以便更好地理解模型的决策过程和结果,对于提升用户对模型的信任和接受度至关重要。

- 可以研究如何提供更深入的解释,包括模型预测的理由和证据。

模型性能优化:

- 尽管PAA在预测准确性方面取得了良好的结果,但进一步优化模型性能,特别是在处理大规模数据集时的效率和效果,也是一个重要的研究方向。

模型鲁棒性测试:

- 对模型进行更多的鲁棒性测试,包括对抗性攻击和压力测试,以确保模型在各种条件下都能表现良好。

这些方向不仅有助于提升PAA模型的性能和适用性,还能推动计算政治科学领域的发展,为理解和预测政治行为提供更强大的工具。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:

- 论文指出了在量化政治科学和计算机科学中,通过建模政治参与者来预测投票结果的重要性,并提出了现有方法(如基于嵌入的方法)的局限性,包括对预定义特征的依赖、对大量训练数据的需求以及预测缺乏可解释性。

PAA框架的提出:

- 论文介绍了政治参与者代理(PAA)这一新的基于代理的框架,该框架利用大型语言模型(LLMs)来克服现有方法的局限性,并提供一个可扩展和可解释的预测投票范式。

PAA框架的组成:

- PAA框架包括个人资料构建模块、多视图规划模块和模拟立法行动模块。个人资料构建模块集成了立法者的个人信息、选区详情、立法发起活动和投票记录。多视图规划模块从代表、受托人和追随者等不同视角辅助代理决策。模拟立法行动模块通过一个影响机制来模拟领导代理对其他代理的影响。

实验验证:

- 论文通过使用第117至118届美国众议院的投票记录进行了广泛的实验,验证了PAA在预测投票结果方面的优越性能和可解释性,并与现有的基线方法进行了比较。

消融研究和一致性分析:

- 论文进行了消融研究来分析PAA各个模块对性能的影响,并评估了PAA结果的一致性,以探究大型语言模型可能出现的幻觉现象。

可解释性示例:

- 论文提供了一个PAA预测投票结果的示例,展示了代理如何从不同视角解释其决策,增强了模型的可解释性。

未来研究方向:

- 论文提出了未来研究的方向,包括整合更多样化的数据源、支持更多下游任务、减少幻觉现象、提升模型泛化能力和鲁棒性。

总体而言,这篇论文提出了一个创新的框架PAA,利用大型语言模型来模拟和预测政治参与者的投票行为,不仅提高了预测的准确性,还增强了预测结果的可解释性,为政治科学研究提供了新的视角和工具。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

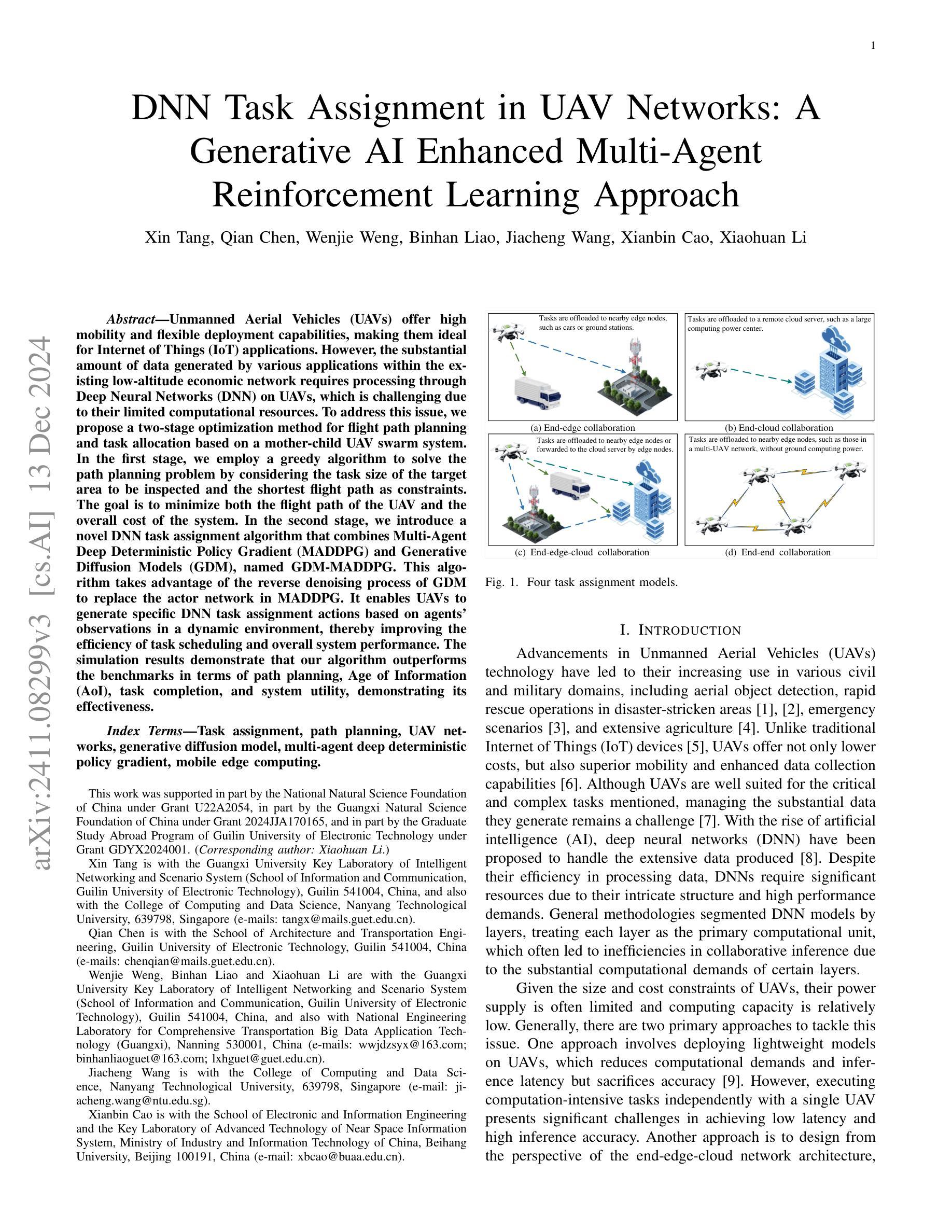

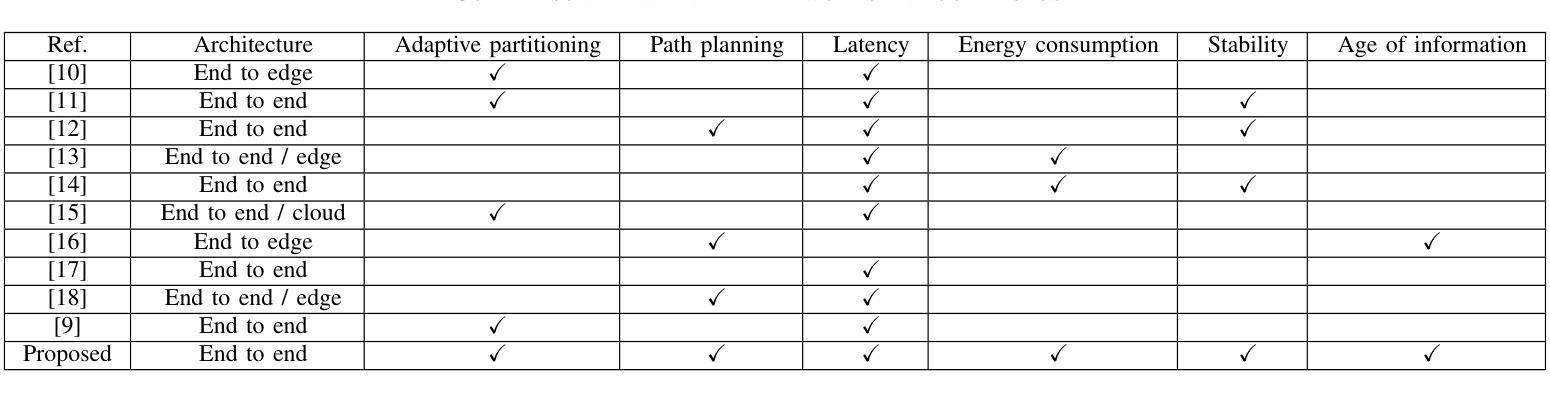

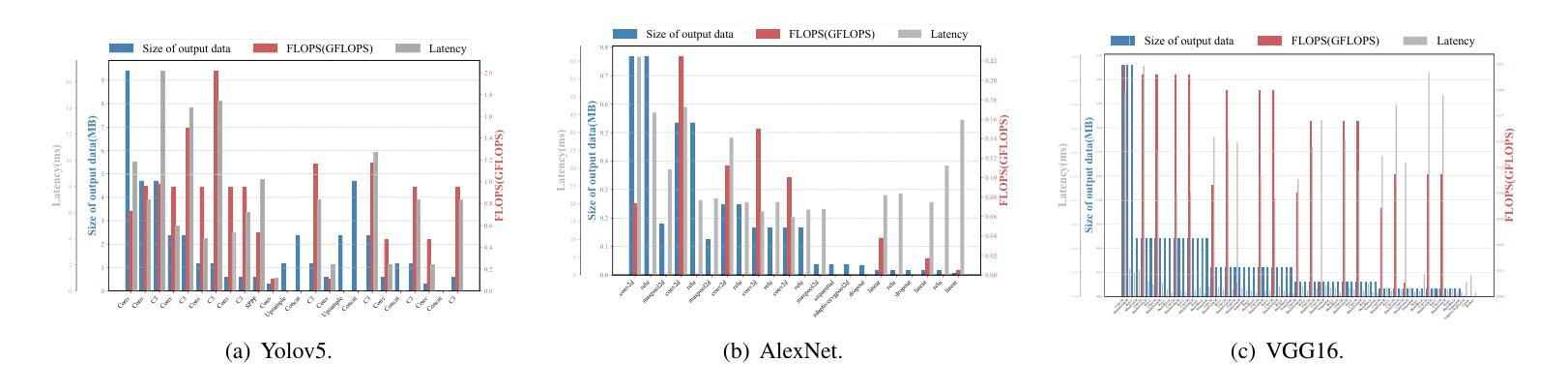

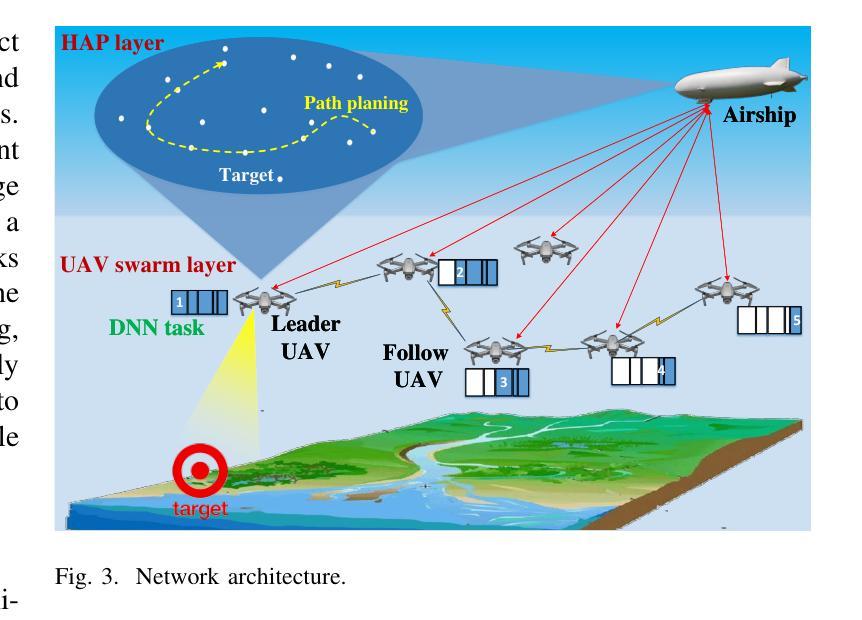

DNN Task Assignment in UAV Networks: A Generative AI Enhanced Multi-Agent Reinforcement Learning Approach

Authors:Xin Tang, Qian Chen, Wenjie Weng, Binhan Liao, Jiacheng Wang, Xianbin Cao, Xiaohuan Li

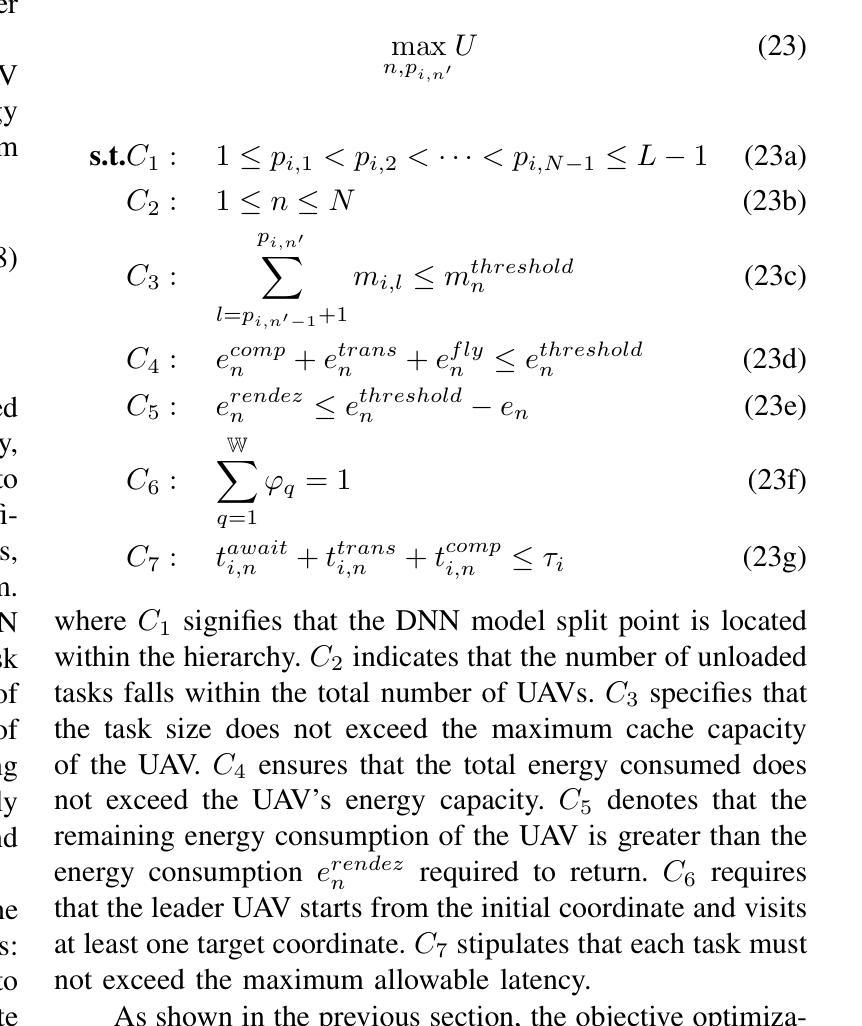

Unmanned Aerial Vehicles (UAVs) possess high mobility and flexible deployment capabilities, prompting the development of UAVs for various application scenarios within the Internet of Things (IoT). The unique capabilities of UAVs give rise to increasingly critical and complex tasks in uncertain and potentially harsh environments. The substantial amount of data generated from these applications necessitates processing and analysis through deep neural networks (DNNs). However, UAVs encounter challenges due to their limited computing resources when managing DNN models. This paper presents a joint approach that combines multiple-agent reinforcement learning (MARL) and generative diffusion models (GDM) for assigning DNN tasks to a UAV swarm, aimed at reducing latency from task capture to result output. To address these challenges, we first consider the task size of the target area to be inspected and the shortest flying path as optimization constraints, employing a greedy algorithm to resolve the subproblem with a focus on minimizing the UAV’s flying path and the overall system cost. In the second stage, we introduce a novel DNN task assignment algorithm, termed GDM-MADDPG, which utilizes the reverse denoising process of GDM to replace the actor network in multi-agent deep deterministic policy gradient (MADDPG). This approach generates specific DNN task assignment actions based on agents’ observations in a dynamic environment. Simulation results indicate that our algorithm performs favorably compared to benchmarks in terms of path planning, Age of Information (AoI), energy consumption, and task load balancing.

无人机(UAVs)具有高机动性和灵活部署能力,推动了其在物联网(IoT)内各种应用场景的无人机开发。无人机的独特能力能够在不确定和潜在恶劣环境中完成越来越关键和复杂的任务。这些应用产生的大量数据必须通过深度神经网络(DNNs)进行处理和分析。然而,无人机在处理DNN模型时面临着有限的计算资源挑战。本文提出了一种结合多智能体强化学习(MARL)和生成扩散模型(GDM)的方法,用于将DNN任务分配给无人机群,旨在减少从任务捕获到结果输出的延迟。为应对这些挑战,我们首先考虑目标区域的任务大小以及最短飞行路径作为优化约束,采用贪心算法解决子问题,重点关注最小化无人机的飞行路径和整体系统成本。在第二阶段,我们引入了一种新型的DNN任务分配算法,称为GDM-MADDPG,它利用GDM的反去噪过程来替代多智能体深度确定性策略梯度(MADDPG)中的actor网络。该方法根据动态环境中智能体的观察生成特定的DNN任务分配动作。仿真结果表明,我们的算法在路径规划、信息年龄(AoI)、能耗和任务负载均衡等方面与基准测试表现相当。

论文及项目相关链接

Summary

本文探讨了无人机(UAVs)在互联网物联网(IoT)中的多种应用场景,尤其是在不确定和恶劣环境中的关键和复杂任务的处理能力。为满足日益增长的数据处理需求,文中介绍了利用深度神经网络(DNNs)处理数据的方法。然而,由于无人机的计算资源有限,处理DNN模型面临挑战。针对这些挑战,本文提出了一种结合多智能体强化学习(MARL)和生成扩散模型(GDM)的联合方法,用于将DNN任务分配给无人机群,旨在减少从任务捕获到结果输出的延迟。该算法采用贪婪算法优化目标区域的检查任务大小和最短飞行路径,并通过一种新型基于生成扩散模型和多智能体深度确定性策略梯度算法的协同算法解决协同计算的任务分配问题。模拟结果显示该算法在路径规划、信息时效、能量消耗和任务负载均衡等方面性能优异。

Key Takeaways

一、无人机(UAVs)具备高度灵活部署的能力以及对于多种物联网应用情境的适用性。其优势在不确定或恶劣环境中尤为突出。

二、无人机在处理复杂任务时面临计算资源有限的挑战,尤其是需要深度神经网络处理的大数据应用需求,该领域具有改善和优化的潜力。

三、提出了利用多智能体强化学习(MARL)与生成扩散模型(GDM)相结合的方法,针对无人机群体进行DNN任务的分配以降低延迟和系统的总成本,提升了协同效能及数据传输的速度与稳定性。此种方法是新技术前沿的一个重要进步,也拓展了强化学习和生成扩散模型的应用领域。

四、通过贪婪算法优化目标区域的检查任务大小和飞行路径,以最小化飞行路径和系统整体成本。这显示了将任务优化与智能决策结合在协同任务中的重要性。

五、首次引入名为GDM-MADDPG的算法,利用生成扩散模型的反向去噪过程替代多智能体深度确定性策略梯度算法中的行动网络,使得无人机群体在动态环境中能根据观察进行特定任务的分配动作。这一创新增强了无人机群体的自适应性和决策效率。

六、模拟实验证明该算法在路径规划、信息时效、能耗以及任务负载均衡等方面表现优异,验证了其在实际应用中的潜力和优势。此算法的先进性为无人机的集群协同作业提供了全新的解决方案和技术支撑。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决在无人机(UAV)网络中进行深度神经网络(DNN)任务分配的问题。具体来说,它旨在减少从任务捕获到结果输出的延迟,同时考虑无人机的计算资源限制。无人机由于其有限的计算能力和能源供应,在处理由各种应用场景产生的大量数据时面临挑战。论文提出了一种结合多智能体强化学习(MARL)和生成扩散模型(GDM)的方法,用于在无人机群中分配DNN任务,以降低延迟并优化整体系统性能。

Q: 有哪些相关研究?

A: 根据提供的论文内容,相关研究可以总结如下:

无人机技术应用:

- 无人机在民用和军事领域的应用不断增加,包括空中目标检测、灾难地区快速救援、紧急情况处理和农业等。

- 无人机相比传统物联网设备具有更低的成本和更高的数据收集能力。

DNN处理大数据:

- 随着人工智能的兴起,DNN被提出用于处理无人机产生的大量数据。

- DNN模型因其复杂的结构和高性能需求而需要显著的资源。

无人机的计算和能源限制:

- 无人机由于尺寸和成本限制,其电源供应有限,计算能力相对较低。

- 存在两种主要方法来解决这一问题:部署轻量级模型以减少计算需求,或从端-边-云网络架构的角度设计解决方案。

多无人机网络中的协作DNN推理:

- 研究从仅依赖云端或单个边缘设备转移到利用云端和边缘服务器的联合能力。

- 出现了四种协作智能类型:端-边、端-云、端-边-云和端-端。

无人机任务分配和路径规划:

- 研究集中在多无人机网络中的DNN任务分割和分配。

- 研究了基于强化学习的无人机任务分配策略,以及通过多无人机协作进行快速DNN推理的方法。

多智能体强化学习(MARL):

- MARL通过观察环境和其他智能体的政策来优化每个智能体的策略。

- 许多基于MARL的方法显著提高了动态网络中的任务卸载效率。

生成人工智能(GAI)在无人机网络中的应用:

- GAI被应用于优化无人机网络,特别是在提高传输率、通信能力和能源效率方面。

这些相关研究为本文提出的无人机网络中的DNN任务分配方法提供了背景和对比,展示了现有方法的局限性,并指出了本文研究的创新点和潜在改进。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决无人机网络中DNN任务分配的问题:

第一阶段:路径规划

- 任务大小与最短飞行路径优化:

- 考虑目标区域的DNN任务大小和最短飞行路径作为优化约束。

- 使用贪心算法来解决子问题,重点最小化无人机的飞行路径和整体系统成本。

第二阶段:DNN任务分配

- GDM-MADDPG算法:

- 提出了一种新的DNN任务分配算法,称为GDM-MADDPG,该算法利用生成扩散模型(GDM)的反向去噪过程替代多智能体深度确定性策略梯度(MADDPG)中的行动网络。

- 该方法基于智能体在动态环境中的观测生成特定的DNN任务分配动作。

具体方法细节:

GDM-MADDPG设计过程:

- 设计了智能体环境,包括任务类型和数据大小的异质性。

- 定义了行动空间,通过GDM的一系列去噪步骤在高斯噪声上生成行动向量。

- 设计了效用函数,旨在通过GDM获得DNN任务分配的行动策略,重点关注AoI、负载均衡和能耗。

- 训练行动网络,使智能体能够根据指定环境中的观测生成特定行动,以最大化效用函数。

GDM的反向去噪过程:

- 将GDM的反向去噪过程作为重建技术,从噪声观测中恢复原始数据。

- 训练GDM以优化训练数据的负对数似然。

MDP建模:

- 将效用最大化问题表述为多智能体马尔可夫决策过程(MDP)。

- 智能体(无人机)基于任务大小、计算资源和任务延迟学习最优任务分配策略,以实现最优的负载均衡和AoI。

模拟结果:

- 论文通过模拟结果表明所提出的算法在路径规划、信息时代(AoI)、能耗和任务负载均衡方面相比于基准算法具有更好的性能。

综上所述,论文通过结合路径规划和DNN任务分配的两阶段优化方法,利用GDM-MADDPG算法有效地解决了无人机网络中DNN任务分配的问题。

Q: 论文做了哪些实验?

A: 论文中进行的实验主要包括以下几个方面:

训练环境和网络配置:

- 使用了Intel i7-3700K CPU和NVIDIA RTX 4090 GPU,24 GB的RAM。

- 软件环境包括PyTorch GPU版本1.11.0和Python版本3.8。

参数设置:

- 为Actor网络和Critic网络设置了特定的神经元数量和学习率。

- 定义了探索的初始值和衰减率等参数。

模拟场景:

- 设定了一个位于10公里高度的空中飞船和九个位于3公里高度的无人机,覆盖12×12平方公里的区域。

- 飞船从地面控制中心接收任务指令,为指定的任务目标制定最佳飞行序列,并将计划的路线信息传递给领头无人机。

- 领头无人机和几个僚机无人机沿预定路线执行协调飞行。

性能评估:

- 路径规划:比较了不同目标点数量下路径规划的总成本,并展示了提出的算法相比传统贪心算法的优势。

- 训练过程:对每种算法进行了十次独立的训练运行,并记录了总奖励的变化,展示了GDM-MADDPG算法随着训练集数的增加而逐渐收敛的性能。

- 参数优化实验:系统地实验了影响MADDPG算法性能的两个关键参数:学习率和批量大小,并找到了最优的学习率和批量大小。

- 不同DNN模型任务的收敛性:展示了GDM-MADDPG算法在不同DNN模型任务上的收敛性。

- 基准算法比较:比较了不同方法在不同任务大小下的AoI、任务完成率和系统效用,展示了提出方法在优化多个目标方面的优越性。

这些实验旨在验证所提出GDM-MADDPG算法的有效性,并与现有基准算法进行比较,以展示其在AoI、任务完成率和系统稳定性方面的性能优势。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了一种有效的方法来解决无人机网络中的DNN任务分配问题,但仍有一些领域可以进一步探索和研究:

算法的可扩展性和鲁棒性:

- 研究算法在更大规模的无人机网络和更复杂的任务场景中的可扩展性和鲁棒性。

- 探索算法对于不同类型和数量的DNN任务的适应性。

实时性能优化:

- 进一步优化算法以满足更严格的实时性要求,特别是在紧急情况下的快速响应能力。

- 研究如何减少算法的计算复杂度和通信开销,以适应资源受限的无人机环境。

安全性和隐私保护:

- 探索在DNN任务分配过程中如何增强数据的安全性和隐私保护。

- 研究如何在保证任务执行效率的同时,防止潜在的数据泄露和攻击。

多目标优化:

- 除了AoI、能耗和任务完成率之外,考虑更多的优化目标,如成本效益、服务质量(QoS)保证等。

- 研究如何在这些目标之间取得更好的平衡和权衡。

环境适应性:

- 研究算法对于环境变化的适应性,如天气条件、电磁干扰等。

- 探索如何利用环境信息来优化任务分配和路径规划。

算法的泛化能力:

- 研究算法在不同类型的无人机和传感器配置中的泛化能力。

- 探索算法在不同应用场景(如搜索救援、环境监测等)中的适用性。

硬件加速和集成:

- 研究如何利用专用硬件(如FPGA、ASIC)来加速算法的执行。

- 探索如何将算法集成到现有的无人机控制系统中。

联合学习与协同进化:

- 研究无人机之间的联合学习和协同进化策略,以提高整个网络的智能和效率。

- 探索如何通过机器学习技术来动态调整和优化无人机的行为和策略。

实验和实际部署:

- 在实际的无人机平台上进行实验,以验证算法的有效性和可行性。

- 探索算法在实际部署中可能遇到的问题和挑战。

这些进一步探索的点可以帮助研究人员更深入地理解和改进无人机网络中的DNN任务分配问题,同时也为未来的研究提供了新的方向和思路。

Q: 总结一下论文的主要内容

A: 这篇论文主要研究了在无人机(UAV)网络中如何高效地分配深度神经网络(DNN)任务,以减少任务完成的延迟并优化无人机群的能源消耗。具体来说,论文的主要内容包括:

问题背景与挑战:

- 无人机因其高移动性和灵活性,在物联网(IoT)中被用于多种应用场景,需要处理大量数据。

- 受限于计算资源,无人机在管理DNN模型时面临挑战。

方法论:

- 提出一种结合多智能体强化学习(MARL)和生成扩散模型(GDM)的方法,用于无人机群的DNN任务分配。

- 使用贪心算法优化无人机的飞行路径,最小化飞行距离和系统成本。

GDM-MADDPG算法:

- 提出了一种新的DNN任务分配算法GDM-MADDPG,该算法利用GDM的反向去噪过程代替MADDPG中的行动网络。

- 该算法基于无人机在动态环境中的观测生成特定的DNN任务分配动作。

系统模型:

- 描述了网络架构、DNN任务模型、通信模型、移动模型、信息时代(AoI)模型和能源消耗模型。

问题表述:

- 将DNN任务分配问题表述为一个混合整数非线性规划问题,并考虑了多个约束条件。

路径规划方法:

- 使用贪心算法优化无人机的飞行路径,并引入随机性以避免局部最优解。

模拟实验:

- 通过模拟实验验证了所提算法的性能,并与几个基准算法进行了比较。

结果分析:

- 论文展示了所提算法在路径规划、AoI、能耗和任务负载均衡方面相比于现有方法的优势。

总结来说,这篇论文提出了一个创新的算法框架,用于在无人机网络中高效地分配DNN任务,并通过模拟实验验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Leveraging Chemistry Foundation Models to Facilitate Structure Focused Retrieval Augmented Generation in Multi-Agent Workflows for Catalyst and Materials Design

Authors:Nathaniel H. Park, Tiffany J. Callahan, James L. Hedrick, Tim Erdmann, Sara Capponi

Molecular property prediction and generative design via deep learning models has been the subject of intense research given its potential to accelerate development of new, high-performance materials. More recently, these workflows have been significantly augmented with the advent of large language models (LLMs) and systems of autonomous agents capable of utilizing pre-trained models to make predictions in the context of more complex research tasks. While effective, there is still room for substantial improvement within agentic systems on the retrieval of salient information for material design tasks. Within this context, alternative uses of predictive deep learning models, such as leveraging their latent representations to facilitate cross-modal retrieval augmented generation within agentic systems for task-specific materials design, has remained unexplored. Herein, we demonstrate that large, pre-trained chemistry foundation models can serve as a basis for enabling structure-focused, semantic chemistry information retrieval for both small-molecules, complex polymeric materials, and reactions. Additionally, we show the use of chemistry foundation models in conjunction with multi-modal models such as OpenCLIP facilitate unprecedented queries and information retrieval across multiple characterization data domains. Finally, we demonstrate the integration of these models within multi-agent systems to facilitate structure and topological-based natural language queries and information retrieval for different research tasks.

通过深度学习模型进行分子属性预测和生成设计,因其加速开发新、高性能材料的潜力而受到深入研究。最近,随着大型语言模型(LLMs)和能够利用预训练模型在更复杂的研究任务背景下进行预测的自体系统的出现,这些工作流程得到了显著增强。尽管这些技术已经相当有效,但在智能系统中检索关键信息以支持材料设计任务方面仍有很大的改进空间。在此背景下,预测性深度学习模型的替代用途(例如利用其潜在表征来促进智能系统中的跨模式检索增强生成,以支持特定任务的材料设计)尚未得到探索。在这里,我们展示了大型预训练化学基础模型可以作为检索小分子、复杂聚合物材料和反应的结构重点语义化学信息的基础。此外,我们还展示了化学基础模型与多模式模型(如OpenCLIP)的联合使用,能够在多个表征数据领域实现前所未有的查询和信息检索。最后,我们展示了将这些模型集成到多智能系统中,以支持不同研究任务的基于结构和拓扑的自然语言查询和信息检索。

论文及项目相关链接

Summary

基于深度学习和大型语言模型的研究,材料设计领域的分子属性预测和生成设计受到广泛关注。本研究展示了使用预训练化学基础模型实现针对小分子、复杂聚合材料和反应的结构性语义化学信息检索的潜力。结合多模态模型如OpenCLIP,提高了跨多个表征数据域的信息检索能力。此外,本研究还展示了将这些模型整合到多智能体系统中,实现结构和拓扑基于自然语言查询和信息检索的不同研究任务。

Key Takeaways

- 深度学习和大型语言模型在材料设计领域的应用受到重视。

- 预训练化学基础模型可用于实现小分子、复杂聚合材料和反应的结构性语义化学信息检索。

- 结合多模态模型如OpenCLIP可提高跨多个表征数据域的信息检索能力。

- 本研究展示了如何将这些模型整合到多智能体系统中。

- 通过整合,实现了结构和拓扑基于自然语言查询和信息检索的不同研究任务。

- 此类技术可望加速新材料的设计和研发过程。

- 未来研究方向包括进一步提高信息检索的准确性和效率。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了如何利用大型预训练的化学基础模型(chemistry foundation models),结合多智能体工作流(multi-agent workflows),来提升催化剂和材料设计中的结构聚焦检索增强生成(Retrieval Augmented Generation, RAG)的能力。具体来说,论文试图解决以下几个问题:

提升检索效率:在材料设计任务中,检索与结构相似的信息是一项关键任务。论文试图通过使用化学语言模型来增强这一过程,以便研究人员可以使用自然语言结合化学语言查询与结构相关的信息资源。

跨模态检索:除了基于文本的检索,论文还探讨了如何结合图像模型(如OpenCLIP)来实现跨多模态(如图像和文本)的查询和信息检索。

结构相似性查询:传统的化学信息检索系统可能没有充分利用深度学习模型的潜力,特别是在结构相似性搜索方面。论文提出了使用化学基础模型作为嵌入模型,以支持基于结构相似性的搜索。

多智能体系统集成:论文探讨了如何将这些系统整合到多智能体系统中,以便于在执行材料设计任务时提供更丰富的上下文信息。

提高生成设计的性能:通过改进检索增强生成(RAG)操作,论文旨在提高大型语言模型(LLMs)在复杂研究任务中的性能。

优化嵌入模型的选择:论文还讨论了如何选择和优化嵌入模型,以便更好地支持语义结构查询。

通过这些方法,论文的目标是加速新型高性能材料的开发,并通过深度学习模型和多智能体系统提高材料设计的效率和效果。

Q: 有哪些相关研究?

A: 论文中提到了多个与化学基础模型、多智能体系统、以及检索增强生成(RAG)相关的研究。以下是一些关键的相关研究和它们的贡献:

ChatGPT Chemistry Assistant: 用于文本挖掘和预测MOF合成的化学助手(Zheng et al., 2023)。

ChatMOF: 一个使用大型语言模型预测和生成金属有机框架(MOFs)的人工智能系统(Kang and Kim, 2024)。

LLaMP: 一个大型语言模型,用于高保真材料知识检索和蒸馏(Chiang et al., 2024)。

Autonomous Chemical Research: 使用大型语言模型进行自主化学研究(Boiko et al., 2023)。

ChemBERTa: 用于分子属性预测的大规模自监督预训练模型(Chithrananda et al., 2020; Ahmad et al., 2022)。

Mol-BERT: 结合BERT的分子表示,用于分子属性预测(Li and Jiang, 2021)。

Mol2Vec: 一种无监督的机器学习方法,具有化学直觉(Jaeger et al., 2018)。

GPT-MolBERTa: 用于分子属性预测的GPT分子特征语言模型(Balaji et al., 2023)。

MoleculeNet: 分子机器学习的基准测试(Wu et al., 2018)。

Neural Network Embeddings: 用于原子系统相似性搜索的神经网络嵌入方法(Yang et al., 2022)。

Chemical Foundation Models: ChemBERTa-2和其他模型,它们是化学基础模型,用于化学属性预测和结构相似性搜索(Ahmad et al., 2022)。

Retrieval-Augmented Generation: 用于知识密集型NLP任务的检索增强生成(Lewis et al., 2021; Zhao et al., 2024)。

这些研究为本文提出的多智能体系统中的化学信息检索和生成设计提供了理论基础和技术支撑。论文通过结合这些研究成果,探索了如何通过化学基础模型和多智能体工作流来增强材料设计任务中的结构聚焦检索和生成能力。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤来解决催化剂和材料设计中的结构聚焦检索增强生成问题:

使用化学基础模型:论文选择了MoLFormer作为基准嵌入模型,该模型在多个基准测试中表现出高效性,能够有效捕捉分子间的相似性,并且可能从SMILES输入中学习到3D空间关系。

构建矢量数据库:使用MoLFormer将约2.5M个有机小分子的SMILES表示正规化并计算矢量嵌入,然后将这些嵌入插入到Milvus矢量数据库中,以便进行结构相似性查询。

多模态检索:结合化学结构嵌入和图像嵌入(使用OpenCLIP模型),实现基于化学结构和图像的查询,以增强信息检索的多样性。

多智能体系统集成:将化学基础模型和图像模型集成到多智能体系统中,以提供更丰富的上下文信息,同时执行材料设计任务。

自适应检索增强生成(RAG):开发了一个分层多智能体自适应自反RAG系统,该系统接受问题作为输入,并输出格式化为研究风格的报告的解决方案。

任务特定工具:为每个智能体提供访问不同矢量存储和它们各自的嵌入策略的工具,这些工具可以在特定任务的上下文中使用。

自我反思的RAG工作流:每个工作智能体自主地执行包括检索文档、评估检索文档的相关性、使用检索到的文档生成响应、检查生成响应的幻觉以及验证每个响应是否完全回答了用户的问题等一系列步骤。

报告生成:一旦所有检查通过,答案将发送到报告生成工具,该工具总结了智能体的发现,并总结了用于生成报告的矢量存储检索内容,以提高工作流的整体透明度。

通过这些方法,论文展示了如何利用大型预训练的化学基础模型和多智能体系统来提高结构聚焦检索增强生成的性能,从而加速新材料和催化剂的开发。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证所提出方法的有效性,这些实验包括:

结构相似性查询:使用MoLFormer嵌入对已知有机催化剂进行环开环聚合(ROP)的结构相似化合物的检索,并通过Milvus矢量搜索能力进行评估。

多模态检索:结合化学结构嵌入(使用MoLFormer)和图像嵌入(使用OpenCLIP)进行多模态语义查询,以检索与化学结构和图像相关的信息。

聚合物和反应的相似性查询:扩展MoLFormer嵌入的使用范围,以支持对聚合物和化学反应的相似性查询,验证模型是否能够捕捉到聚合物和反应的结构关系。

多智能体系统的集成和测试:将上述嵌入模型和检索策略集成到多智能体系统中,并通过一系列问题和任务来测试系统的性能,包括小分子、聚合物、化学反应和核磁共振(NMR)光谱的查询。

自适应检索增强生成(RAG)系统:开发并测试了一个分层多智能体自适应自反RAG系统,该系统可以接收问题作为输入,并通过一系列自动化步骤生成研究风格报告作为输出。

具体任务的报告生成:展示了多智能体系统在处理特定任务时生成的报告样本,如对芳香族聚醚的结构类似物的查询和对二乙醇胺基碳酸酯单体前体的13C NMR光谱的查询。

这些实验验证了论文提出方法的有效性,并展示了在多模态结构和图像检索方面的潜力,以及在材料设计和催化剂开发中的实用性。

Q: 有什么可以进一步探索的点?

A: 尽管论文中提出的方法已经在多个方面展示了其有效性,但仍有一些潜在的探索点,可以进一步扩展和改进当前的研究:

更广泛的数据集测试:在更多样化和大规模的数据集上测试MoLFormer和其他化学基础模型的性能,以验证其泛化能力。

多模态融合策略:研究和开发更先进的多模态融合策略,以更有效地结合化学结构嵌入和图像嵌入。

模型的可解释性:提高模型的可解释性,以便研究人员更好地理解模型的决策过程和检索结果。

模型的泛化能力:探索模型在不同类型的化学结构和反应中的泛化能力,特别是在未见过或罕见的结构上。

实时检索性能优化:优化检索系统的性能,以支持实时或近实时的检索任务,这对于实际应用非常重要。

用户交互和反馈机制:开发更复杂的用户交互和反馈机制,使系统能够根据用户的反馈进行自我改进。

多任务学习:探索多任务学习框架,使模型能够同时学习多种化学属性或任务,提高模型的效率和实用性。

模型鲁棒性:研究模型在面对错误或噪声数据时的鲁棒性,并开发相应的错误处理和数据清洗策略。

跨学科应用:将模型应用于其他相关领域,如药物发现、环境化学或材料科学,探索其在不同领域的适用性。

模型的可扩展性:研究如何将模型扩展到更大的化学空间,包括更大的分子、更复杂的反应和更多样化的化学属性。

硬件优化:针对特定硬件平台(如GPU或TPU)优化模型和检索系统,以提高计算效率。

模型的伦理和社会影响:评估和讨论模型在化学和材料设计中的伦理和社会影响,确保技术的负责任使用。

这些探索点可以帮助研究人员进一步发展和完善论文中提出的方法,同时也为未来的研究提供了新的方向。

Q: 总结一下论文的主要内容

A: 这篇论文主要探讨了如何利用大型预训练的化学基础模型和多智能体系统来增强催化剂和材料设计中的结构聚焦检索增强生成(Retrieval Augmented Generation, RAG)。以下是论文的主要内容总结:

背景介绍:论文首先介绍了大型语言模型(LLMs)和多智能体系统在化学和材料领域的应用背景,以及它们在加速新、高性能材料开发中的潜力。

研究动机:论文指出了现有多智能体系统中在材料设计任务中检索相关信息的局限性,并提出了利用化学基础模型的潜在优势。

方法论:

- 选择了MoLFormer作为基准嵌入模型,用于支持结构相似性查询。

- 构建了包含约2.5M有机小分子的矢量数据库,用于评估MoLFormer嵌入的有效性。

- 展示了如何将化学结构嵌入与图像模型(如OpenCLIP)结合,实现多模态语义查询。

实验验证:

- 对MoLFormer嵌入进行了结构相似性查询的测试,验证了其在检索有机小分子方面的有效性。

- 扩展了MoLFormer嵌入的使用范围,包括聚合物和化学反应的相似性查询。

- 将化学基础模型和图像模型集成到多智能体系统中,展示了在多模态结构和图像检索方面的潜力。

多智能体系统集成:

- 开发了一个分层多智能体自适应自反RAG系统,该系统可以接收问题作为输入,并输出格式化为研究风格的报告的解决方案。

- 展示了多智能体系统在处理特定任务时生成的报告样本。

结论:

- 论文总结了通过结合化学基础模型和多智能体系统,可以显著提高结构聚焦检索增强生成的性能,加速新材料和催化剂的开发。

- 强调了这种方法在化学研究中的潜在应用价值和对未来研究方向的启示。

代码和数据可用性:论文最后提到,相关的数据和代码将在最终出版后提供。

整体而言,这篇论文提出了一种创新的方法,通过结合深度学习模型和多智能体系统,来提升化学和材料设计领域的信息检索和生成设计能力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

AgentMixer: Multi-Agent Correlated Policy Factorization

Authors:Zhiyuan Li, Wenshuai Zhao, Lijun Wu, Joni Pajarinen

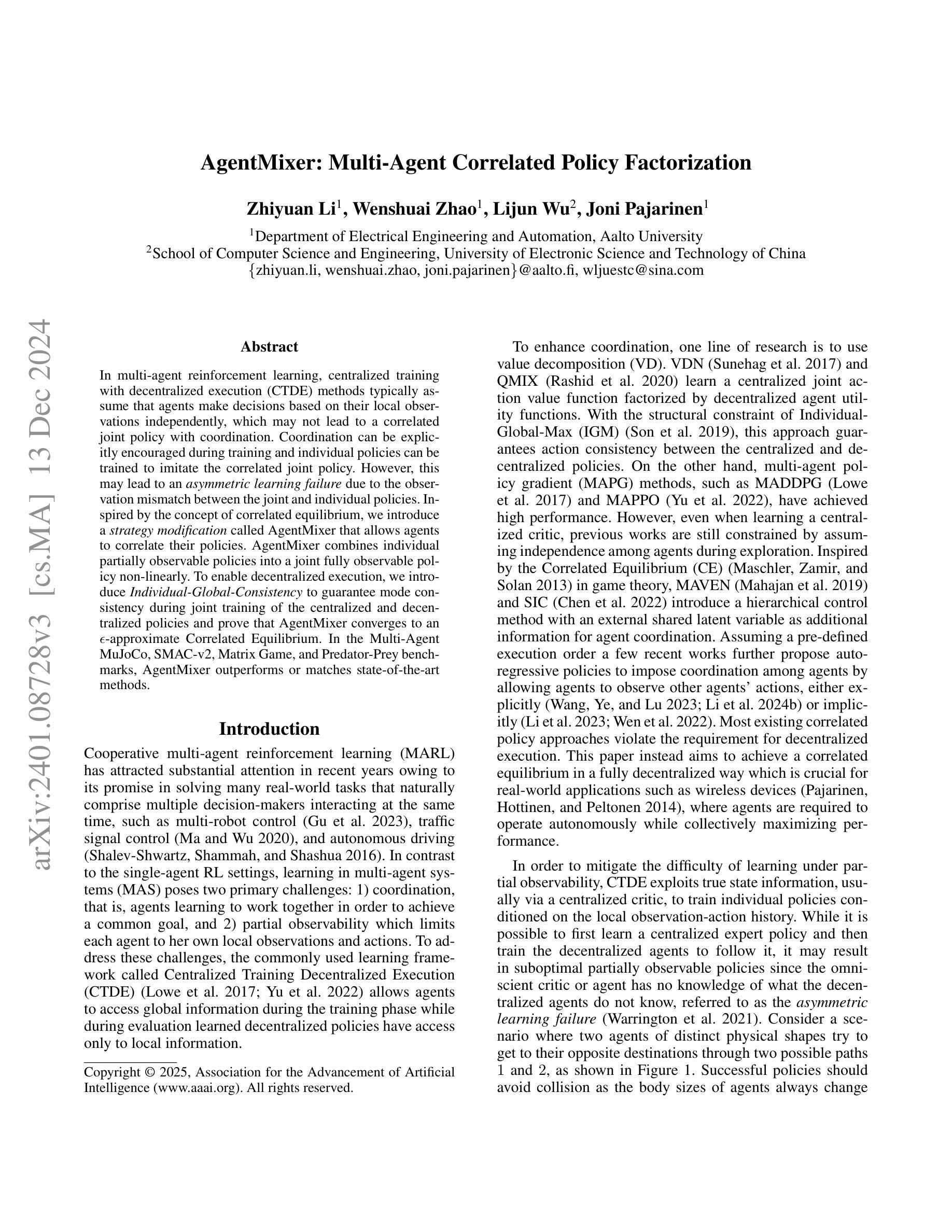

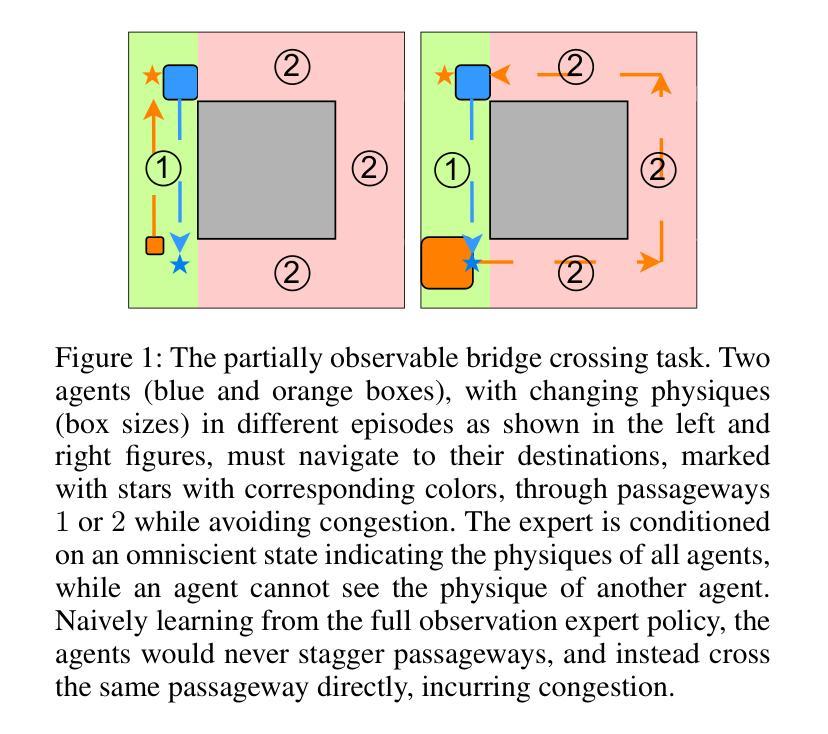

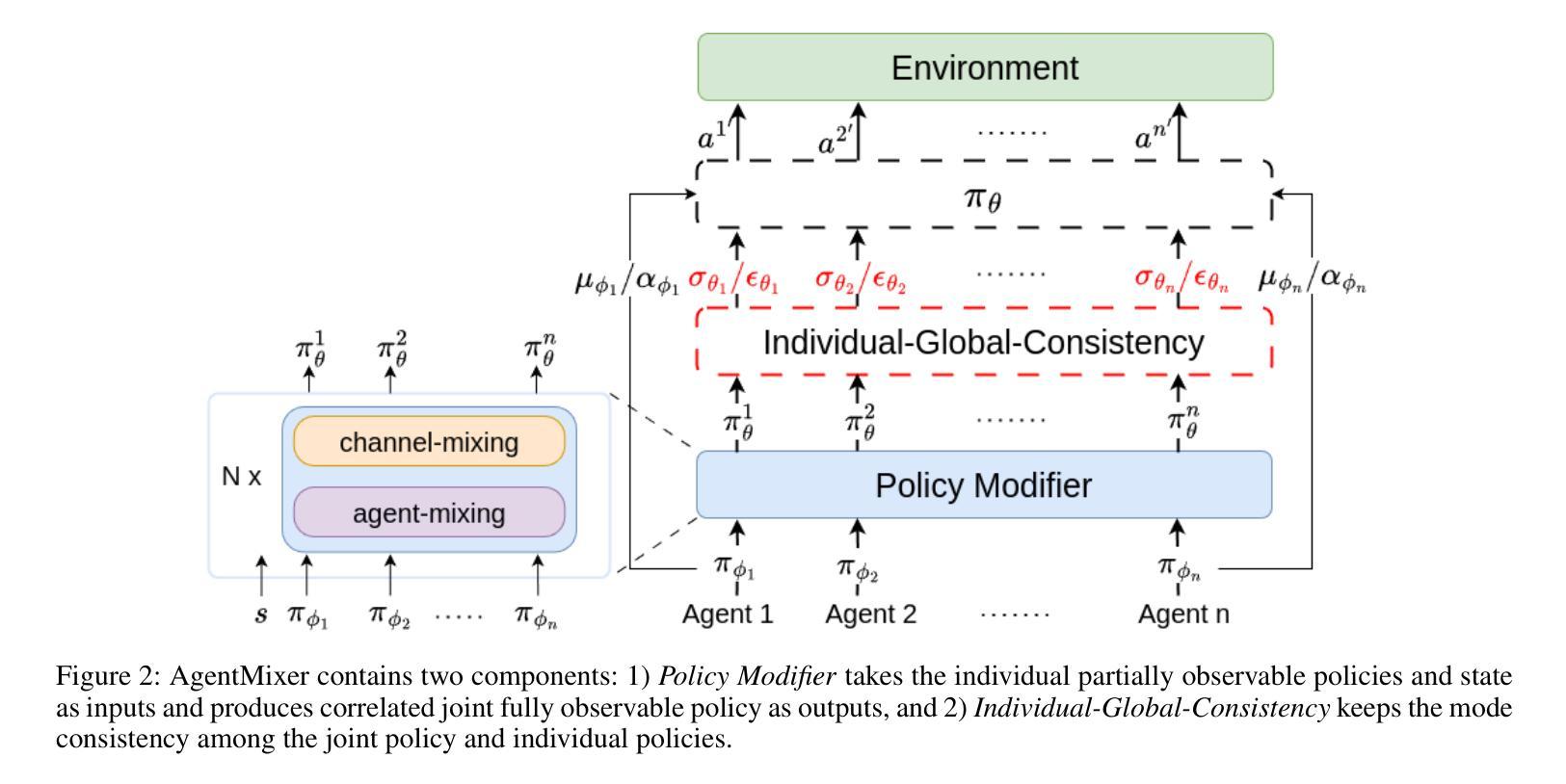

In multi-agent reinforcement learning, centralized training with decentralized execution (CTDE) methods typically assume that agents make decisions based on their local observations independently, which may not lead to a correlated joint policy with coordination. Coordination can be explicitly encouraged during training and individual policies can be trained to imitate the correlated joint policy. However, this may lead to an \textit{asymmetric learning failure} due to the observation mismatch between the joint and individual policies. Inspired by the concept of correlated equilibrium, we introduce a \textit{strategy modification} called AgentMixer that allows agents to correlate their policies. AgentMixer combines individual partially observable policies into a joint fully observable policy non-linearly. To enable decentralized execution, we introduce \textit{Individual-Global-Consistency} to guarantee mode consistency during joint training of the centralized and decentralized policies and prove that AgentMixer converges to an $\epsilon$-approximate Correlated Equilibrium. In the Multi-Agent MuJoCo, SMAC-v2, Matrix Game, and Predator-Prey benchmarks, AgentMixer outperforms or matches state-of-the-art methods.

在多智能体强化学习中,集中训练与分布式执行(CTDE)方法通常假设智能体独立基于其局部观察做出决策,这可能导致无法形成协同工作的联合策略。在训练过程中可以显式鼓励协同工作,并且可以训练个体策略来模仿联合策略。然而,由于联合策略和个体策略之间的观测不匹配,这可能导致“不对称学习失败”。受相关均衡概念启发,我们引入了一种名为AgentMixer的策略修改方法,允许智能体关联其策略。AgentMixer将个体的部分可观察策略非线性地组合成一个联合的完全可观察策略。为了实现分布式执行,我们引入了全局一致性保证在联合训练集中和分散策略时的模式一致性,并证明AgentMixer收敛到ε近似相关均衡状态。在MuJoCo多智能体系统、SMAC-v2游戏矩阵以及捕食者和猎物等多种场景下,AgentMixer的性能优于或匹配当前最新技术方法。

论文及项目相关链接

Summary:

在多智能体强化学习中,中心化训练与去中心化执行(CTDE)方法通常假设智能体基于局部观察独立做出决策,这可能导致无法形成协同的联合策略。训练过程中可以明确鼓励协同,并训练个体策略来模仿联合策略。然而,由于联合策略和个体策略之间的观察不匹配,可能会导致不对称学习失败。受相关均衡概念启发,我们引入了名为AgentMixer的策略修改方法,使智能体能够关联其策略。AgentMixer将个体的部分可观察策略非线性地组合成联合的全局可观察策略。为了实现去中心化的执行,我们引入了个体-全局一致性,以保证在联合训练中心化和去中心化策略时的模式一致性,并证明AgentMixer能够收敛到ε-近似的相关均衡。在Multi-Agent MuJoCo、SMAC-v2、矩阵游戏和捕食者-猎物基准测试中,AgentMixer的性能优于或匹配于最新方法。

Key Takeaways:

- 多智能体强化学习中的CTDE方法假设智能体独立做出决策,可能导致联合策略协调不足。

- 可以通过鼓励训练过程中的协同,并训练个体策略模仿联合策略来解决这一问题。

- 然而,这种方法可能导致不对称学习失败,因为联合策略和个体策略之间的观察不匹配。

- AgentMixer策略修改方法被引入,允许智能体关联其策略,结合个体的部分可观察策略形成联合的全局可观察策略。

- 为实现去中心化执行,引入了个体-全局一致性,保证联合训练时的模式一致性。

- AgentMixer能够收敛到ε-近似的相关均衡。

- 在多个基准测试中,AgentMixer的性能优于或匹配于最新方法。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是在部分可观察的多智能体强化学习(MARL)中实现协调的问题。具体来说,它关注以下两个主要挑战:

协调(Coordination):智能体应该协同工作以实现共同目标并学习最优的联合行为。在多智能体系统中,智能体之间需要有效地协调它们的行动。

部分可观察性(Partial Observability):每个智能体只能访问自己的局部观察和行动,这限制了它们获取环境全局信息的能力。这种部分可观察性在多智能体系统中是一个常见问题,因为它导致智能体在执行任务时可能无法获取到其他智能体的状态信息。

为了应对这些挑战,论文提出了一个新的框架,名为AgentMixer,它通过引入策略修改(strategy modification)来实现智能体之间策略的关联,从而在完全分散执行(fully decentralized execution)的情况下达到相关的均衡(Correlated Equilibrium, CE)。

AgentMixer的核心思想是将联合的完全可观察策略(joint fully observable policy)构建为个体部分可观察策略(individual partially observable policies)的非线性组合。为了使个体策略与联合策略保持一致,论文引入了Individual-Global-Consistency(IGC)机制,以确保在分散执行时策略的模式一致性。

论文的主要贡献包括:

- 提出了一个新颖的框架AgentMixer,用于实现智能体之间策略的关联。

- 引入了Individual-Global-Consistency(IGC)机制,以解决在分散执行时由联合策略和个体策略信息不匹配导致的不对称学习失败问题。

- 理论上证明了AgentMixer能够收敛到ε-近似相关的均衡。

- 在三个MARL基准测试上展示了AgentMixer的强大实验性能。

通过这些贡献,论文旨在提高在部分可观察的多智能体环境中的协调能力和学习效率。

Q: 有哪些相关研究?

A: 相关研究主要集中在以下几个方面:

中央化训练分散执行(Centralized Training Decentralized Execution, CTDE):这个范式在合作多智能体领域已经显示出成功,它允许智能体在训练阶段访问全局信息,同时在分散执行时使用局部信息。例如,QMIX和QPLEX等方法通过价值分解(Value Decomposition, VD)学习一个由分散的智能体效用函数分解的集中式联合动作价值函数。

多智能体策略梯度(Multi-Agent Policy Gradient, MAPG)方法:例如MADDPG和MAPPO等方法,通过学习一个集中式的批评家来实现智能体之间的协调。然而,这些方法在探索时仍然假设智能体之间的独立性。

自回归策略:一些近期的工作提出了自回归策略,通过允许智能体观察其他智能体的动作来实现协调。这些方法可以显式地(如Fu等人的工作)或隐式地(如Li等人的工作)实现。

相关均衡(Correlated Equilibrium, CE):在博弈论中,CE是一个解决方案概念,它允许策略之间存在相关性。一些工作如MAVEN和SIC引入了额外的共享潜在变量作为协调信号,以实现更丰富的联合策略类别。

策略分解(Policy Factorization):现有的方法通常假设智能体的策略是独立的,将联合策略建模为每个智能体完全独立策略的笛卡尔积。然而,这种假设限制了联合策略的表达能力,并限制了智能体的协调能力。

部分可观察性下的挑战:虽然在单智能体强化学习中已经研究了类似的挑战,但在MARL领域中,由于部分可观察性的特性,这个问题尚未得到充分研究。

策略修改(Strategy Modification):一些工作如Correlated Q-learning和Schroeder de Witt等人的方法受到CE的启发,提出了解决均衡选择问题的策略修改方法。

这些研究为本文提出的AgentMixer提供了理论基础和实践经验,AgentMixer通过引入策略修改和IGC机制,旨在在部分可观察的多智能体环境中实现更好的协调和学习。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为AgentMixer的框架来解决部分可观察多智能体强化学习(MARL)中的协调问题。AgentMixer通过以下两个关键组件来实现策略的相关性,并在完全分散执行的情况下达到ε-近似相关均衡(Correlated Equilibrium, CE):

策略修改器(Policy Modifier, PM):这个组件接收每个智能体的部分可观察策略和状态信息,然后输出修改后的策略。PM通过多层感知器(MLP)来构建联合的完全可观察策略,该策略是个体策略的非线性组合。通过这种方式,PM作为从CE视角的观察者,将个体策略组合成一个相关的联合策略。

个体-全局一致性(Individual-Global-Consistency, IGC):为了解决从联合策略学习分散的、部分可观察策略时的不对称学习失败问题,论文引入了IGC机制。IGC确保在联合策略和个体策略之间保持一致的模式,同时允许在联合策略中进行相关的探索。IGC通过将联合策略分解为模式(exploitation)和偏差(exploration)两个部分,并在模式上施加等式约束来实现。

AgentMixer的训练过程是端到端的,目标是最大化期望总奖励,同时满足IGC约束。论文通过以下步骤来训练AgentMixer:

- 使用PM模块生成联合策略。

- 通过IGC机制确保个体策略与联合策略的一致性。

- 结合单智能体强化学习算法(如TD3, PPO, SAC等)来训练个体策略。

理论上,论文证明了AgentMixer可以收敛到ε-近似CE。实验结果在多个MARL基准测试中展示了AgentMixer相对于当前最先进方法的强大性能。

Q: 论文做了哪些实验?

A: 论文在多个实验环境中评估了AgentMixer的性能。这些实验旨在展示AgentMixer在不同场景下的有效性,并与现有的多智能体强化学习(MARL)方法进行比较。以下是实验的主要内容:

攀爬矩阵游戏(Climbing Matrix Game):这是一个简单的矩阵博弈,用于说明AgentMixer在需要智能体之间协调以选择最优联合动作的任务中的性能。

多智能体MuJoCo(MA-MuJoCo):这些是具有连续动作空间的任务,用于评估AgentMixer在部分可观察性设置下的性能。这些任务包括Ant-v2、HalfCheetah-v2、Walker2d-v2和Humanoid-v2等。

星际争霸多智能体挑战v2(SMAC-v2):这是一个具有更高随机性的挑战性基准,用于评估AgentMixer在具有离散动作空间的任务中的性能。这些任务包括10gen_protoss 5v5、10gen_zerg 5v5等。

捕食者-猎物环境(Predator-Prey):这个环境模拟了智能体捕食猎物的场景,用于展示AgentMixer在具有不同捕食者惩罚设置下的性能。

消融研究(Ablation Studies):这些实验旨在分析AgentMixer中不同组件(如策略修改器PM和IGC机制)的贡献,并研究在不同设置下的性能差异。

实验结果表明,AgentMixer在大多数任务中都优于现有的MARL方法,特别是在需要高度协调和部分可观察性的任务中。这些结果支持了论文提出的方法在解决MARL中的协调问题方面的有效性。

Q: 有什么可以进一步探索的点?

A: 论文提出了AgentMixer框架,这是一个在部分可观察多智能体强化学习(MARL)中实现策略相关性的新方法。尽管论文已经取得了显著的进展,但仍有一些潜在的研究方向可以进一步探索:

策略修改器(Policy Modifier, PM)的改进:PM是AgentMixer的核心组件,用于生成相关的联合策略。可以研究不同的网络结构和训练方法来提升PM的性能,例如使用图神经网络(GNN)来捕捉智能体间的复杂交互。

个体-全局一致性(Individual-Global-Consistency, IGC)的泛化:IGC机制在论文中用于保持个体策略和联合策略的一致性。可以探索IGC在不同类型任务和环境中的泛化能力,以及如何将其适应于不同的策略表示和学习算法。

理论分析的深入:虽然论文已经证明了AgentMixer在理论上可以收敛到ε-近似CE,但可以进一步研究其在更广泛条件下的收敛性质,例如在不同的学习动态和通信约束下。

与现实世界应用的结合:论文的实验主要集中在模拟环境中。可以探索AgentMixer在现实世界多智能体系统中的应用,例如机器人团队协作、交通信号控制等。

策略表达能力的扩展:论文中使用的策略表示可能限制了策略空间的表达能力。可以研究如何扩展策略表示,以捕捉更复杂的策略,例如使用可微编程(Differentiable Programming)或强化学习与规划的结合。

异构智能体的协调:论文假设所有智能体具有相同的观察和行动空间。可以研究在异构智能体(即具有不同观察和行动能力的智能体)中的协调问题。

多智能体系统的安全性和鲁棒性:在实际应用中,多智能体系统需要对故障和攻击具有鲁棒性。可以研究如何设计AgentMixer以提高系统的安全性和鲁棒性。

跨领域迁移学习:可以探索AgentMixer在不同领域之间的迁移学习能力,例如从一个游戏环境迁移到另一个游戏环境,或者从模拟环境迁移到现实世界环境。

这些研究方向可以为多智能体强化学习领域提供新的见解,并推动AgentMixer在更广泛场景中的应用。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为AgentMixer的新框架,旨在解决部分可观察多智能体强化学习(MARL)中的协调问题。AgentMixer通过引入策略修改(strategy modification)来实现智能体之间策略的相关性,并在完全分散执行的情况下达到ε-近似相关均衡(Correlated Equilibrium, CE)。以下是论文的主要内容:

问题定义:论文指出MARL中的两个主要挑战是协调(agents need to work together to achieve a common goal)和部分可观察性(agents have limited local observations and actions)。为了解决这些问题,论文提出了AgentMixer。

AgentMixer框架:AgentMixer包含两个主要组件:

- 策略修改器(Policy Modifier, PM):它接收个体部分可观察策略和状态信息,并输出修改后的策略,以构建相关的联合策略。

- 个体-全局一致性(Individual-Global-Consistency, IGC):它确保个体策略与联合策略在模式上保持一致,同时允许在联合策略中进行相关的探索。

理论证明:论文证明了AgentMixer能够收敛到ε-近似CE,这是通过证明在分散执行时,个体策略能够与联合策略保持一致性。

实验验证:论文在三个MARL基准测试上进行了实验,包括攀爬矩阵游戏、多智能体MuJoCo任务和星际争霸多智能体挑战v2(SMAC-v2)。实验结果表明,AgentMixer在大多数任务中都优于现有的MARL方法。

消融研究:论文还进行了消融研究,以展示AgentMixer中不同组件的贡献,并研究在不同设置下的性能差异。

总的来说,AgentMixer通过策略修改和IGC机制,有效地解决了MARL中的协调问题,并在实验中展示了其强大的性能。这项工作为在部分可观察环境中实现智能体之间的策略相关性提供了一个新的视角。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图