⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-17 更新

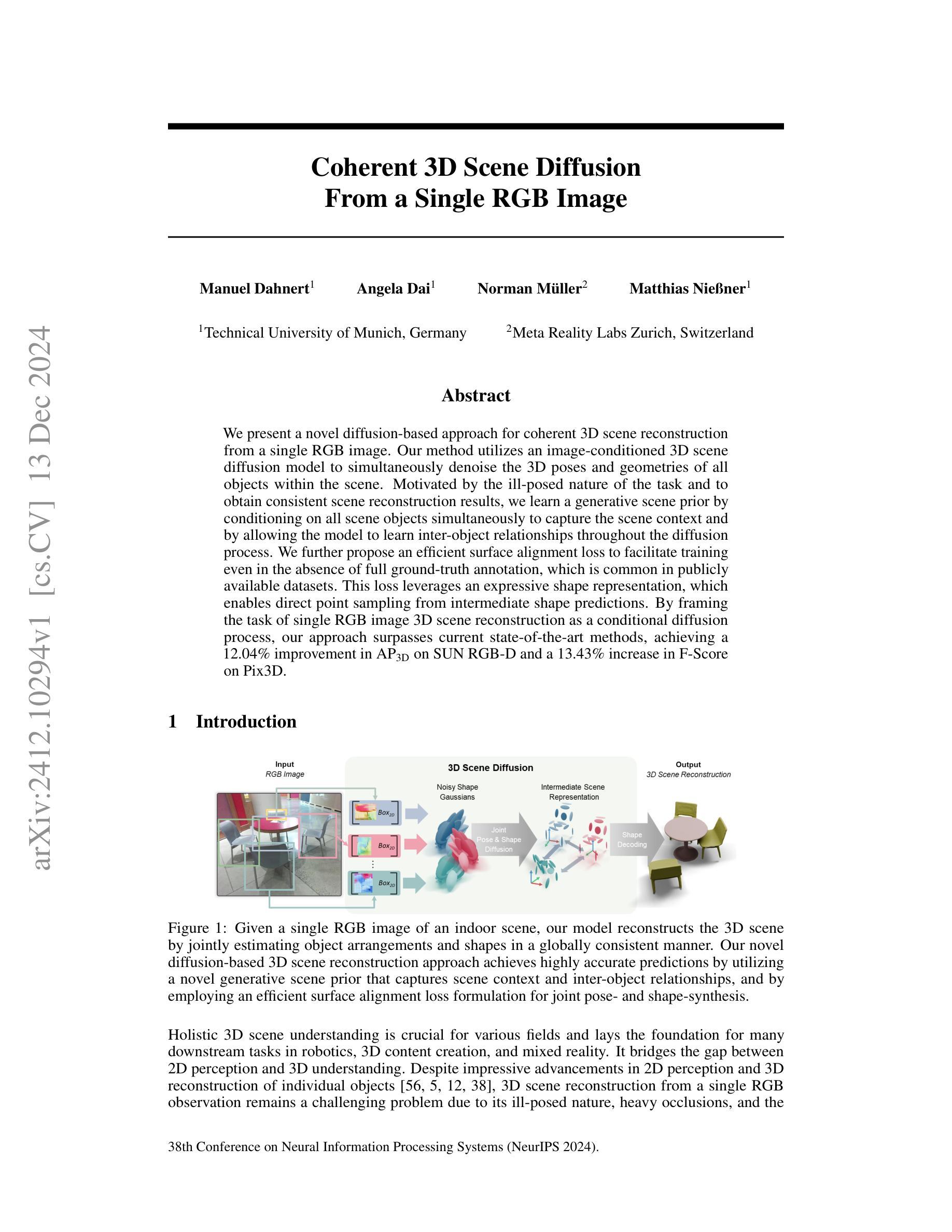

BrushEdit: All-In-One Image Inpainting and Editing

Authors:Yaowei Li, Yuxuan Bian, Xuan Ju, Zhaoyang Zhang, Ying Shan, Qiang Xu

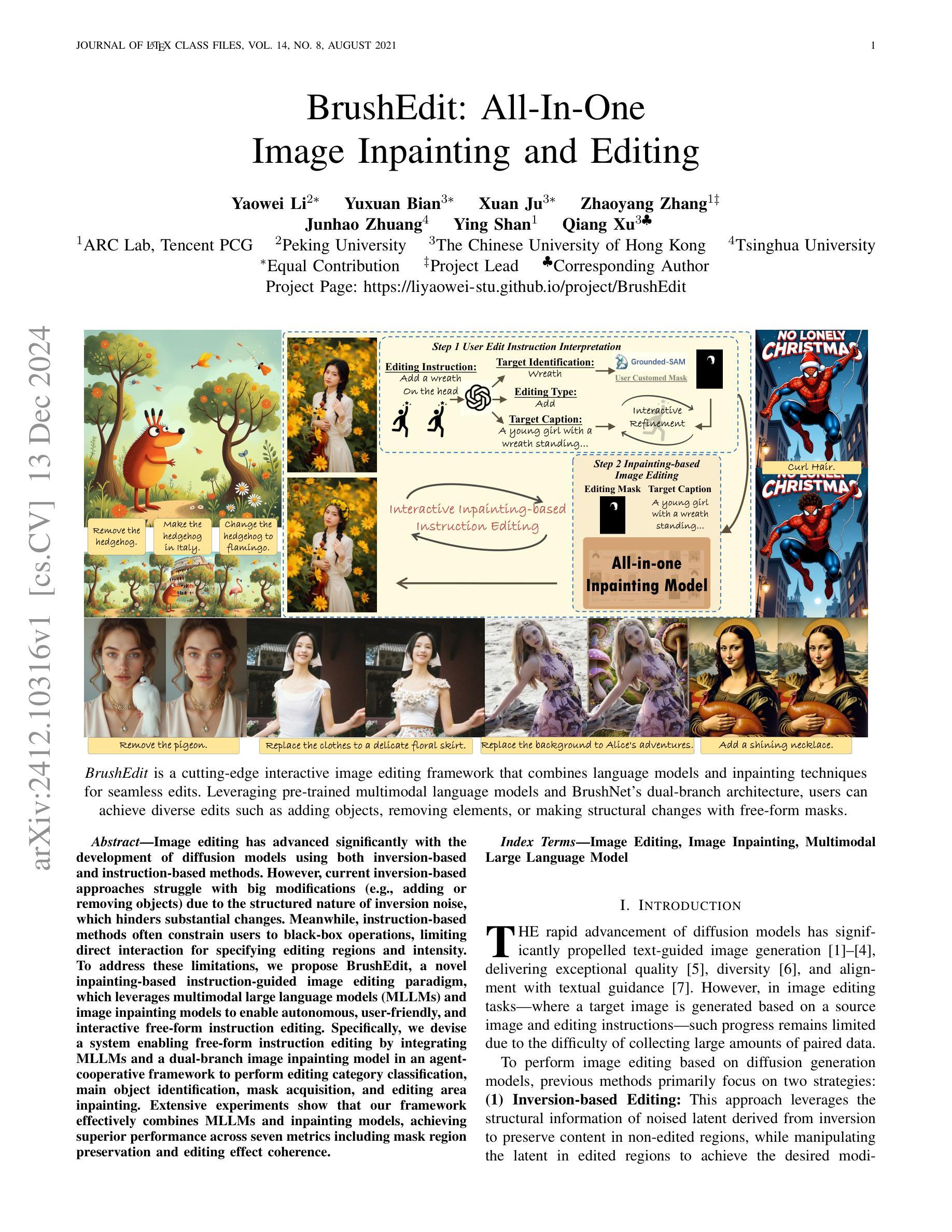

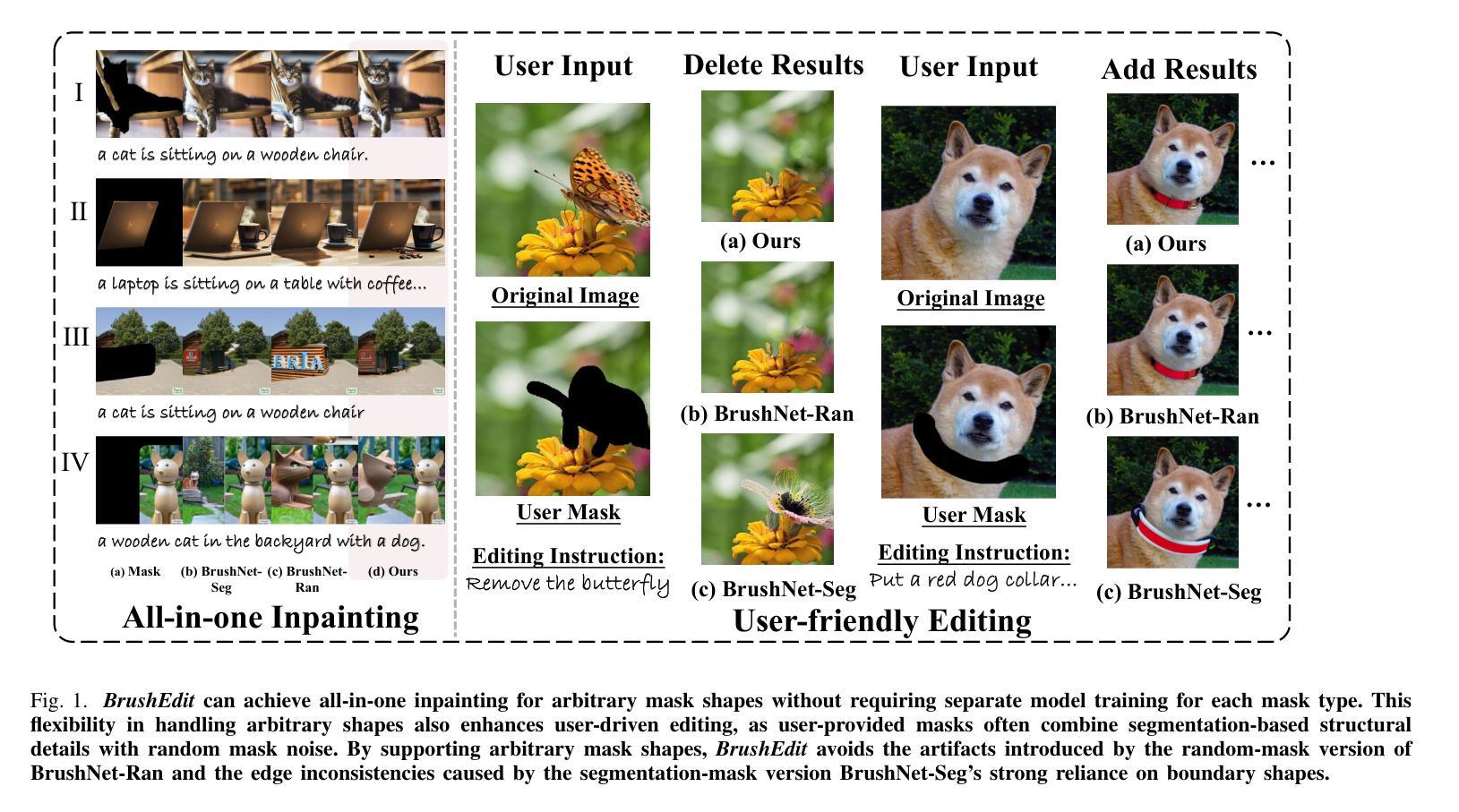

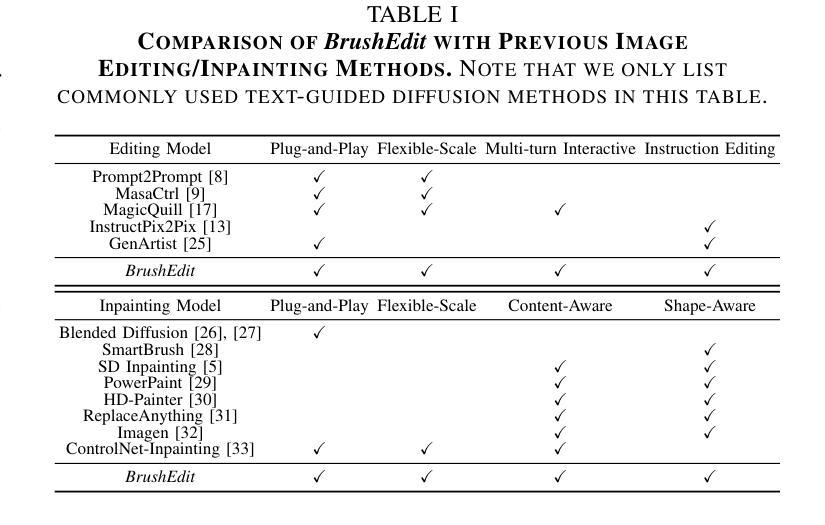

Image editing has advanced significantly with the development of diffusion models using both inversion-based and instruction-based methods. However, current inversion-based approaches struggle with big modifications (e.g., adding or removing objects) due to the structured nature of inversion noise, which hinders substantial changes. Meanwhile, instruction-based methods often constrain users to black-box operations, limiting direct interaction for specifying editing regions and intensity. To address these limitations, we propose BrushEdit, a novel inpainting-based instruction-guided image editing paradigm, which leverages multimodal large language models (MLLMs) and image inpainting models to enable autonomous, user-friendly, and interactive free-form instruction editing. Specifically, we devise a system enabling free-form instruction editing by integrating MLLMs and a dual-branch image inpainting model in an agent-cooperative framework to perform editing category classification, main object identification, mask acquisition, and editing area inpainting. Extensive experiments show that our framework effectively combines MLLMs and inpainting models, achieving superior performance across seven metrics including mask region preservation and editing effect coherence.

随着基于反演法和指令法的方法的发展,图像编辑在扩散模型的推动下取得了显著的进步。然而,当前的基于反演的方法在大型修改(例如添加或删除对象)方面遇到了困难,这主要归因于反演噪声的结构性特征限制了大幅改动。同时,基于指令的方法通常将用户限制在黑箱操作中,限制了直接交互指定编辑区域和强度的能力。为了解决这些限制,我们提出了BrushEdit,这是一种基于图像修复指令引导的新型图像编辑范式,它利用多模态大型语言模型(MLLMs)和图像修复模型,实现自主、友好、交互式的自由形式指令编辑。具体来说,我们设计了一个系统,通过集成MLLMs和双重分支图像修复模型,在一个代理协作框架内进行编辑类别分类、主要对象识别、获取掩模和编辑区域修复,以实现自由形式的指令编辑。大量实验表明,我们的框架有效地结合了MLLMs和图像修复模型,在包括掩模区域保留和编辑效果连贯性在内的七个指标上表现出卓越的性能。

论文及项目相关链接

PDF WebPage available at https://liyaowei-stu.github.io/project/BrushEdit/

摘要

随着扩散模型的发展,图像编辑技术已经取得了重大进展,出现了基于反转和指令的方法。然而,当前的基于反转的方法在进行大型修改(例如添加或删除对象)时面临困难,因为反转噪声的结构性质阻碍了重大变化。而基于指令的方法通常将用户限制在黑箱操作中,限制了直接指定编辑区域和强度的交互性。为解决这些问题,我们提出了BrushEdit,一种基于图像补全指令引导的图像编辑新范式,它利用多模式大型语言模型(MLLMs)和图像补全模型,实现自主、友好、交互式的自由形式指令编辑。具体而言,我们设计了一个系统,通过集成MLLMs和双分支图像补全模型,在一个代理协作框架中进行编辑类别分类、主要对象识别、获取掩膜和编辑区域补全。大量实验表明,我们的框架有效地结合了MLLMs和补全模型,在包括掩膜区域保留和编辑效果连贯性在内的七个指标上取得了卓越的性能。

关键见解

- 当前图像编辑中的基于反转的方法在进行大型修改时存在困难。

- 基于指令的图像编辑方法限制了用户与编辑区域的直接交互。

- BrushEdit结合MLLMs和图像补全模型来解决上述限制。

- BrushEdit能够实现自主、友好、交互式的自由形式指令编辑。

- 该系统设计用于分类编辑类别、识别主要对象、获取掩膜以及执行编辑区域补全。

- 通过集成多个技术模块,BrushEdit框架在多个指标上实现了卓越性能。

- 该系统通过代理协作框架促进了有效的图像编辑流程。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为BrushEdit的新型图像编辑框架,旨在解决现有图像编辑方法面临的几个主要问题:

大修改的挑战:传统的基于反转的方法(inversion-based approaches)在进行大规模修改(如添加或删除对象)时存在困难,因为反转噪声的结构性限制了重大变化的实现。

用户交互性限制:基于指令的编辑方法(instruction-based methods)通常限制用户在黑盒操作中,缺乏直接交互以指定编辑区域和强度的能力。

数据收集难度:基于扩散模型的图像编辑方法需要大量的配对数据(源图像-指令-目标图像),而这些数据难以收集。

编辑质量和效率:现有方法在执行效率、保持背景真实性、遵循编辑指令以及整体内容一致性方面存在不足。

为了解决这些问题,论文提出了BrushEdit框架,它结合了多模态大型语言模型(MLLMs)和图像修复技术,以实现自主、用户友好和交互式的自由形式指令编辑。该框架通过四个主要步骤(编辑类别分类、主要编辑对象识别、编辑掩模和目标标题获取、图像修复)来实现基于指令的图像编辑,同时支持用户在编辑过程中进行多轮交互式调整,以达到满意的编辑结果。此外,BrushEdit通过统一处理随机掩模和分割掩模,避免了为每种掩模类型单独训练模型的需要,增强了对真实世界用户掩模的适应性。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要分为以下几个领域:

A. 图像编辑(Image Editing)

- 扩散模型:近期在图像编辑中,扩散模型(diffusion models)取得了显著进展,如基于文本指令的图像编辑方法,这些方法利用模态如文本指令、遮罩、布局等来实现控制和引导编辑。

- 基于反转的编辑方法:这些方法通过操纵通过反转获得的潜在表示(latents)来实现编辑,主要分为注意力整合、目标嵌入和潜在整合三种范式。

- 端到端方法:这些方法通过训练端到端的扩散模型来进行图像编辑,支持更广泛的编辑类型,并避免了反转方法的速度劣势。

B. 图像修复(Image Inpainting)

- 传统方法和基于VAE/GAN的方法:早期的图像修复方法依赖手工特征,而VAE和GAN方法在图像修复中也有所应用。

- 基于扩散的模型:近期,基于扩散的模型因其优越的生成质量和精确控制而受到关注,这些方法通过修改采样策略或专门训练来增强模型的内容和形状感知能力。

C. 多模态大型语言模型(MLLM)的应用

- 图像编辑中的MLLM应用:MLLM被用于提升图像编辑中的视觉和语言理解能力,例如MGIE、SmartEdit、FlexEdit和GenArtist等方法,它们通过生成更详细和富有表现力的提示或增强复杂指令的理解和推理来改进基于指令的编辑。

这些相关研究展示了图像编辑和修复领域的最新进展,包括基于文本的图像生成、控制引导编辑、以及结合MLLM和图像生成模型的新方法。BrushEdit框架正是在这些研究的基础上,提出了一个新的图像编辑范式,旨在通过结合MLLM和图像修复技术来克服现有方法的局限性。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为BrushEdit的框架来解决上述问题,具体方法如下:

1. 编辑指导的解释和目标识别

- 使用预训练的多模态大型语言模型(MLLM)来解释用户的自由形式编辑指令。

- 对编辑类别进行分类,并识别出主要的编辑对象。

2. 编辑掩模和目标标题的获取

- 利用检测模型根据识别出的对象生成编辑掩模。

- 结合编辑类型、目标对象和源图像生成编辑后的图像标题。

3. 图像修复(Inpainting)模型

- 采用双分支图像修复模型BrushNet,该模型能够处理任意掩模形状,无需针对每种掩模类型单独训练模型。

- 利用混合微调策略,结合随机掩模和分割掩模进行训练,以提高模型处理多样化掩模任务的能力。

4. 代理协作框架

- 将MLLM和图像修复模型集成在一个代理协作框架中,实现自由形式、多轮交互式指令编辑。

- 用户可以在编辑过程中的任何阶段修改或优化中间控制输入,如编辑掩模或编辑后图像的标题,以实现灵活和交互式的编辑。

5. 灵活的控制和定制

- 提供灵活的控制能力,包括基础扩散模型选择和比例调整,以适应不同的编辑或修复需求。

- 允许用户调整未编辑区域保护的程度,提供精确和定制化的编辑结果。

6. 统一的模型处理

- 通过在BrushData-v2数据集上训练,该数据集整合了分割掩模和随机掩模,BrushEdit能够统一处理所有掩模类型的图像编辑和修复任务。

7. 定量和定性评估

- 在多个基准测试和数据集上进行广泛的实验,以定量和定性的方式评估BrushEdit的性能,验证其在保持背景真实性和遵循编辑指令方面的优越性能。

通过这些方法,BrushEdit能够有效地结合MLLM和图像修复模型,实现高质量的交互式指令编辑,同时保持背景区域的真实性和编辑区域的语义一致性。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估BrushEdit框架的性能,具体实验包括:

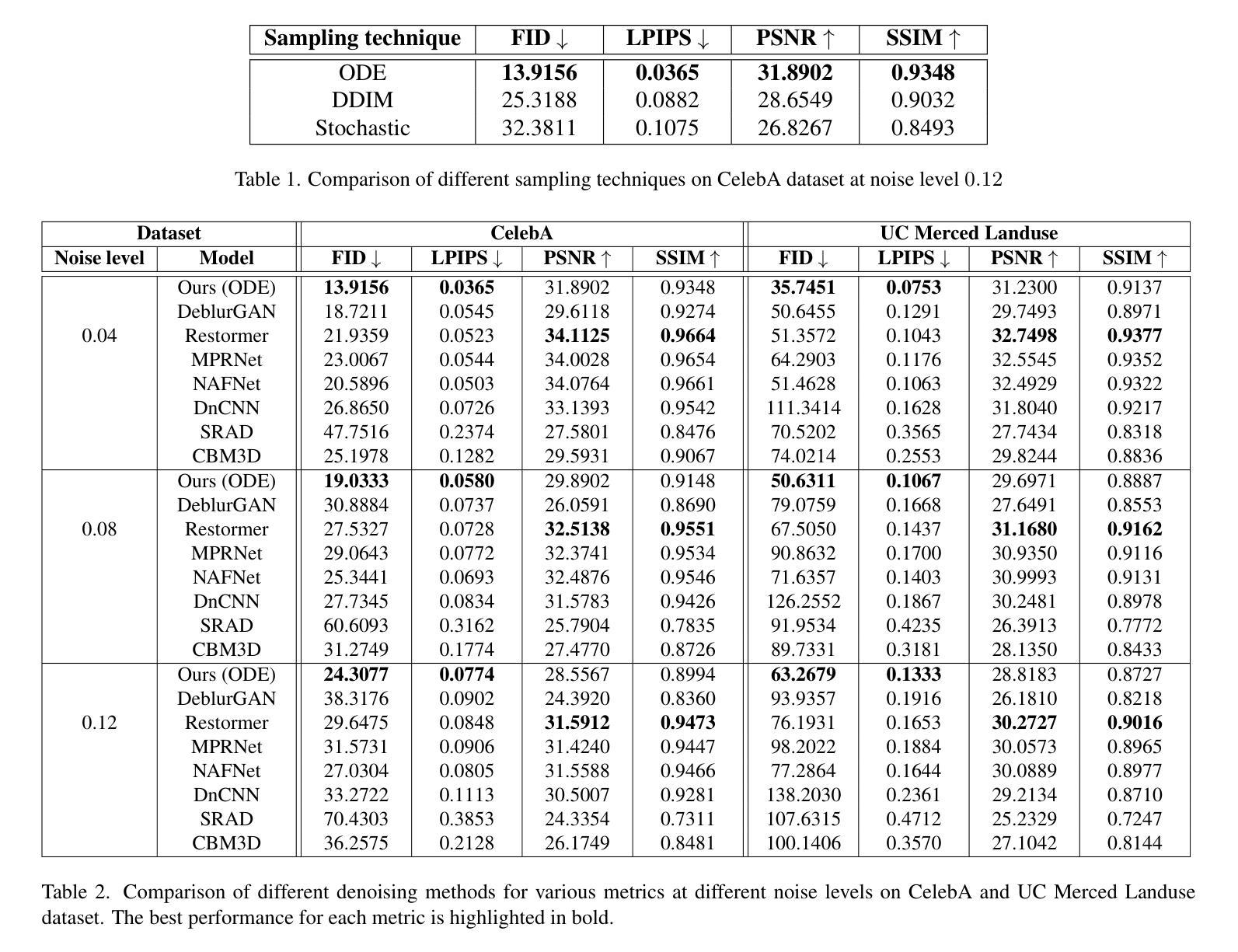

A. 评估基准和指标

- 图像编辑:使用

PIE-Bench(Prompt-based Image Editing Benchmark)评估BrushEdit和其他基线方法在图像编辑任务上的性能。这个基准包含700张图像,涵盖10种编辑类型,分布在自然和人工场景中。 - 图像修复:使用

BrushBench(针对分割掩模)和EditBench(针对随机刷掩模)两个基准来评估图像修复性能。这些基准覆盖了真实和生成的图像,包括人体、动物和室内外场景。

B. 数据集

- BrushData-v2:在之前

BrushData的基础上,整合了分割掩模和随机掩模的子集,并从Laion-Aesthetic数据集中扩展数据,创建了BrushData-v2。这个数据集用于训练和测试BrushEdit模型。

C. 指标

- 背景真实性:使用PSNR、LPIPS、MSE和SSIM等标准指标评估生成图像与原始图像未编辑区域之间的一致性。

- 文本对齐:使用CLIP相似度(CLIP Sim)评估文本-图像一致性,通过将文本和图像投影到CLIP模型的共享嵌入空间并测量它们的表示相似度。

D. 实施细节

- 使用NVIDIA Tesla V100 GPU和Stable Diffusion v1.5作为基础模型进行评估,所有方法都使用推荐的超参数以确保公平性。

E. 定量比较(图像编辑)

- 对比了BrushEdit与其他几种反转方法和编辑方法在

PNPBench上的性能,包括DDIM反转、Null-Text反转、Negative-Prompt反转、StyleDiffusion等。

F. 定性比较(图像编辑)

- 展示了BrushEdit与先前图像编辑方法在自然和合成图像上的编辑操作(如删除对象、添加对象、修改属性和交换对象)的定性比较。

G. 定量比较(图像修复)

- 在

BrushBench和EditBench上对比了BrushEdit与其他扩散模型的结果,包括Blended Latent Diffusion、Stable Diffusion Inpainting、HD-Painter、PowerPaint和ControlNet-Inpainting等。

H. 定性比较(图像修复)

- 展示了BrushEdit与先前图像修复方法在随机掩模修复和分割掩模修复任务上的定性比较。

I. 灵活控制能力

- 展示了BrushEdit在基础扩散模型选择和比例调整方面的灵活控制能力。

J. 消融研究

- 对模型设计的不同方面进行了消融研究,包括双分支与单分支设计、额外分支架构的影响等。

这些实验全面评估了BrushEdit在图像编辑和修复任务中的性能,并与现有方法进行了比较,验证了其在保持背景真实性和遵循编辑指令方面的优越性能。

Q: 有什么可以进一步探索的点?

A: 根据论文的讨论部分,以下是一些可以进一步探索的点:

1. 模型依赖性

- 研究不同基础模型的影响:由于BrushEdit生成的质量和内容依赖于选定的基础模型,探索不同基础模型对编辑结果的影响是一个有价值的方向。

2. 编辑指令和掩模优化

- 优化编辑指令和掩模的处理:研究如何改进模型以更好地处理不规则形状的掩模和与掩模图像不完全对齐的文本指令。

3. 交互式编辑的增强

- 增强用户交互式编辑能力:开发更复杂的用户交互机制,允许用户在编辑过程中进行更细致的控制和调整。

4. 模型泛化能力

- 提高模型的泛化能力:研究如何提高模型处理各种编辑任务的泛化能力,特别是对于未见过的对象和场景。

5. 计算效率

- 提高模型的计算效率:探索模型优化策略,减少计算资源消耗,使得BrushEdit能够更快地执行编辑任务。

6. 多模态输入的融合

- 改进多模态输入的融合:研究如何更有效地融合文本、图像和其他模态输入,以实现更自然和准确的编辑结果。

7. 伦理和社会影响

- 考虑伦理和社会影响:研究如何负责任地使用图像编辑技术,避免放大社会偏见和生成误导性内容。

8. 数据集和训练策略

- 改进数据集和训练策略:研究如何构建更高质量的训练数据集和更有效的训练策略,以提高模型的性能和鲁棒性。

9. 实际应用测试

- 在实际应用中的测试:将BrushEdit应用于实际的图像编辑任务,评估其在现实世界中的有效性和可用性。

10. 模型解释性

- 提高模型的解释性:研究如何提高模型决策过程的透明度和可解释性,帮助用户理解和信任编辑结果。

这些探索点可以帮助研究者进一步提升BrushEdit的性能,扩展其应用范围,并确保技术的安全和负责任使用。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为BrushEdit的创新图像编辑框架,旨在解决现有图像编辑技术在处理大规模修改和用户交互方面的限制。以下是论文的主要内容总结:

1. 问题陈述

- 现有基于反转的方法在进行大规模图像修改时受限于结构噪声,难以实现如添加或删除对象等操作。

- 基于指令的方法通常限制用户在黑盒操作中,缺乏直接交互以指定编辑区域和强度的能力。

2. BrushEdit框架

- 交互式编辑:结合预训练的多模态大型语言模型(MLLMs)和图像修复模型,实现自由形式的指令编辑。

- 代理协作:通过MLLM识别编辑类型、目标对象,并生成编辑掩模和目标标题,然后由图像修复模型完成实际编辑。

- 双分支图像修复模型:BrushNet,能够处理任意掩模形状,无需为每种掩模类型单独训练模型。

3. 方法

- 编辑指导解释:利用MLLM解释用户指令,识别编辑类型和目标对象。

- 编辑掩模和标题获取:基于目标对象生成编辑掩模,并生成编辑后的图像标题。

- 图像修复:使用双分支模型BrushNet,基于目标标题和编辑掩模进行图像修复。

4. 实验

- 在图像编辑和修复基准测试中评估BrushEdit的性能,包括PIE-Bench、BrushBench和EditBench。

- 使用定量和定性指标评估模型性能,包括背景真实性、文本对齐和用户研究。

5. 结果

- BrushEdit在保持背景真实性和遵循编辑指令方面表现出色,与现有方法相比,在多个评估指标上取得了更好的性能。

6. 讨论和未来工作

- 论文讨论了模型的局限性,如对基础模型的依赖和处理不规则掩模的能力。

- 提出了未来的研究方向,包括提高模型泛化能力、优化用户交互和考虑伦理社会影响。

总体而言,BrushEdit通过结合MLLM和图像修复技术,提供了一个用户友好、交互式的图像编辑解决方案,能够在保持背景真实性的同时实现复杂的编辑操作。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Coherent 3D Scene Diffusion From a Single RGB Image

Authors:Manuel Dahnert, Angela Dai, Norman Müller, Matthias Nießner

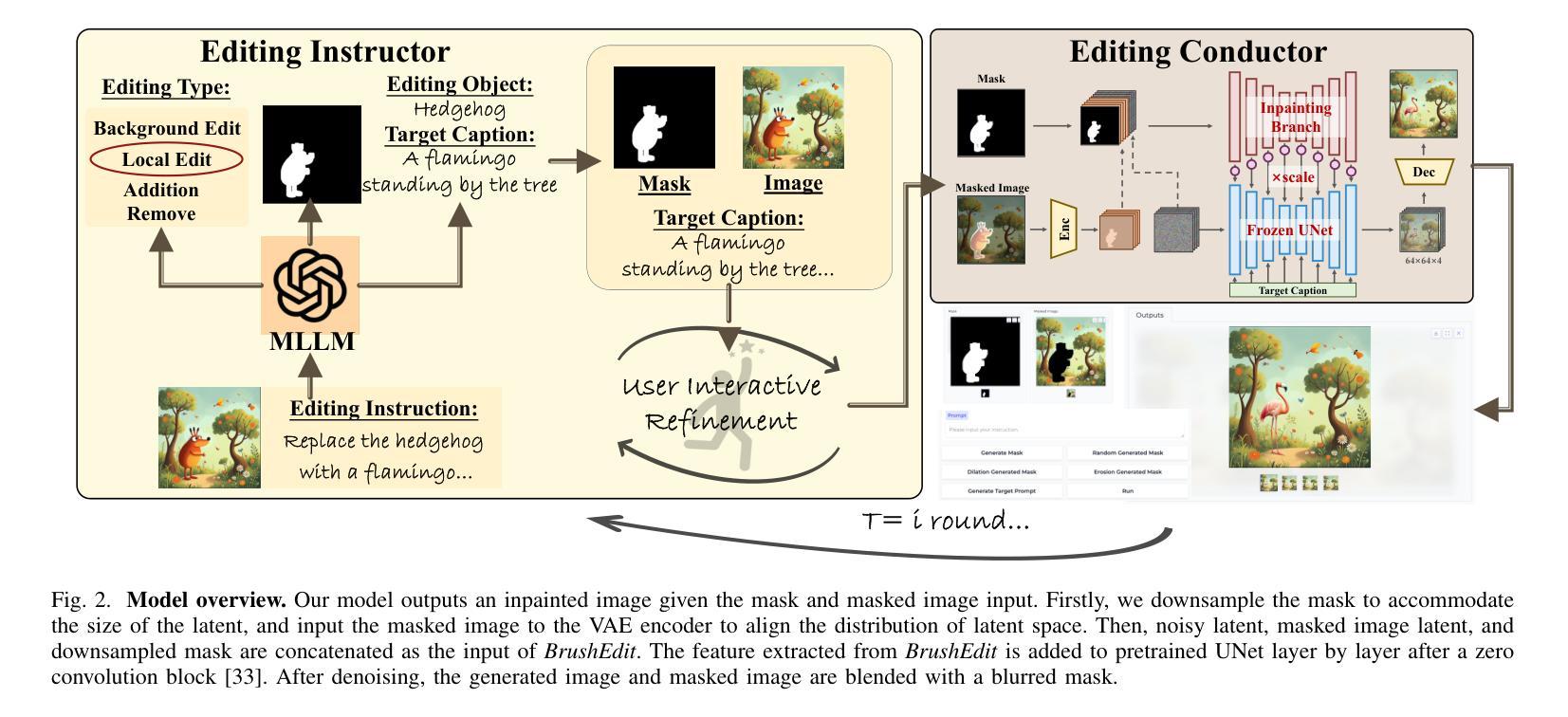

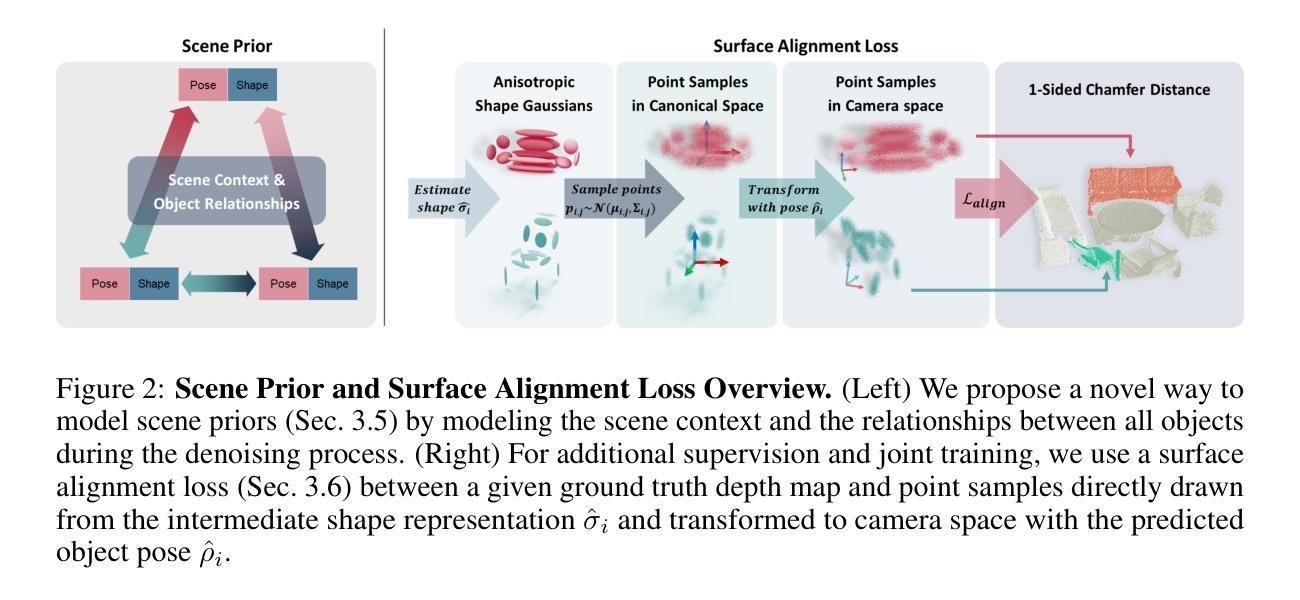

We present a novel diffusion-based approach for coherent 3D scene reconstruction from a single RGB image. Our method utilizes an image-conditioned 3D scene diffusion model to simultaneously denoise the 3D poses and geometries of all objects within the scene. Motivated by the ill-posed nature of the task and to obtain consistent scene reconstruction results, we learn a generative scene prior by conditioning on all scene objects simultaneously to capture the scene context and by allowing the model to learn inter-object relationships throughout the diffusion process. We further propose an efficient surface alignment loss to facilitate training even in the absence of full ground-truth annotation, which is common in publicly available datasets. This loss leverages an expressive shape representation, which enables direct point sampling from intermediate shape predictions. By framing the task of single RGB image 3D scene reconstruction as a conditional diffusion process, our approach surpasses current state-of-the-art methods, achieving a 12.04% improvement in AP3D on SUN RGB-D and a 13.43% increase in F-Score on Pix3D.

我们提出了一种基于扩散的新方法,用于从单一RGB图像进行连贯的3D场景重建。我们的方法利用了一个受图像条件控制的3D场景扩散模型,同时去除场景中所有物体的3D姿态和几何形状的噪声。鉴于该任务的病态性质和为了获得一致的场景重建结果,我们通过同时以所有场景物体为条件来学习生成场景先验,以捕捉场景上下文,并允许模型在整个扩散过程中学习物体间的关系。我们还提出了一种高效的表面对齐损失,即使在缺少常见的公开数据集的全真实标注的情况下,也能促进训练。这种损失利用了一种表现丰富的形状表示,使得能够从中间形状预测中直接采样点。通过将单一RGB图像的3D场景重建任务构造成一个条件扩散过程,我们的方法超越了当前最先进的方法,在SUN RGB-D数据集上AP3D提高了12.04%,在Pix3D数据集上F-Score提高了13.43%。

论文及项目相关链接

PDF Project Page: https://www.manuel-dahnert.com/research/scene-diffusion - Accepted at NeurIPS 2024

Summary

本文提出了一种基于扩散的新方法,用于从单一RGB图像进行连贯的3D场景重建。该方法利用图像条件化的3D场景扩散模型,同时去噪场景内所有物体的3D姿态和几何结构。通过同时考虑所有场景物体并允许模型在扩散过程中学习物体间的关联,学习生成场景先验。此外,还提出了一种高效的表面对齐损失,即使在缺乏常见的公开数据集的全真标注情况下,也能促进训练。通过将有条件的扩散过程作为单一RGB图像的3D场景重建任务框架,该方法超越了当前的最佳实践,在SUN RGB-D上的AP3D提高了12.04%,在Pix3D上的F-Score提高了13.43%。

Key Takeaways

- 提出了一种基于扩散的新方法,用于从单一RGB图像进行3D场景重建。

- 利用图像条件化的3D场景扩散模型,同时去噪场景内物体的3D姿态和几何结构。

- 通过学习生成场景先验,同时考虑所有场景物体并学习它们之间的关系。

- 引入了一种高效的表面对齐损失,可在缺乏全真标注的情况下促进训练。

- 方法利用了条件扩散过程作为任务框架,实现了3D场景重建。

- 在SUN RGB-D和Pix3D数据集上,该方法显著超越了当前的最佳实践。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一种基于扩散模型的新方法,用于从单个RGB图像中重建出连贯的三维场景。这项工作旨在解决以下几个挑战和问题:

单视图3D场景重建的不确定性:从单个RGB图像重建三维场景是一个不确定的问题,因为存在多种可能的3D结构可以对应于同一2D观察结果。这项工作通过引入条件扩散过程来解决这一问题,该过程能够同时预测场景中所有对象的姿态和几何形状。

场景上下文和对象间关系:先前的方法往往独立地恢复3D形状,未能利用场景上下文和对象间关系。这可能导致不切实际和相互交叉的对象排列。论文提出的方法通过学习一个生成性场景先验来捕捉对象间的关系,并在整个扩散过程中进行建模。

在部分标注数据集上的联合训练问题:公共可用的3D数据集通常只提供部分地面真实标注,这使得形状和姿态的联合训练变得复杂。为了克服这一点,论文提出了一种高效的表面对齐损失函数,即使在缺乏完整地面真实监督的情况下也能进行训练。

与现有技术的比较:论文的方法在SUN RGB-D和Pix3D等标准数据集上超越了当前最先进的方法,分别在AP3D和F-Score指标上取得了12.04%和13.43%的改进。

总的来说,这项工作的主要贡献在于提出了一种新的基于扩散的3D场景重建方法,该方法能够联合预测场景中所有可见对象的姿态和形状,并通过学习场景上下文和对象间关系来提高重建的准确性和连贯性。此外,论文还提出了一种有效的表面对齐损失函数,使得在标注不完整的公共数据集上进行训练成为可能。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要涉及以下几个领域:

单视图3D重建(Single-View 3D Reconstruction):

- 对象重建(Object Reconstruction):涉及从单个图像中学习3D对象结构的方法,包括使用图像编码器网络处理输入图像并提取特征,然后将这些特征与形状数据库相关联以检索合适的形状,或使用3D解码器重建特定3D表示(如体素网格、点云、网格或神经场)中的对象。

- 场景重建(Scene Reconstruction):早期工作将单视图场景重建表述为从给定或估计的深度信息中完成3D场景,使用体积网格表示。还有使用原始、体素网格或CAD模型表示对象的方法,同时考虑对象间的关系。

3D扩散模型(3D Diffusion Models):

- 去噪扩散概率模型(Denoising Diffusion Probabilistic Models, DDPMs):作为一类通用的生成模型,已在图像和视频生成中展示出令人印象深刻的结果。这些方法通过迭代地逆转马尔可夫噪声过程来生成详细的输出。

- 条件扩散用于3D重建(Conditional Diffusion for 3D Reconstruction):利用扩散模型进行单视图对象重建的方法,例如通过去噪一组2D图像来学习单一类别的形状分布,或在扩散过程中将图像特征投影到噪声点云上以确保几何合理性。

与本文直接相关的工作:

- Total3D:直接从图像特征中回归3D对象姿态,并使用网格变形和边缘去除方法重建形状。

- Im3D:使用隐式形状表示和图神经网络来细化姿态预测。

- InstPIFu:专注于单对象重建,并提出从输入图像中查询实例对齐特征的方法,以处理遮挡问题。

这些相关研究为本文提出的从单个RGB图像进行3D场景重建的方法提供了理论和技术背景,同时也突显了现有方法的局限性,如对场景上下文和对象间关系的忽视,以及在重构过程中对精确姿态估计和形状细节的挑战。本文通过引入新的生成性场景先验和表面对齐损失函数,旨在克服这些挑战,并在多个标准数据集上取得了优于现有技术的性能。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键技术解决了单视图3D场景重建的问题:

基于扩散的3D场景重建方法:

- 将3D场景重建任务框架为一个条件生成问题,使用一个条件扩散模型,该模型在输入视图的条件下同时预测场景中所有对象的姿态(poses)和3D几何形状(geometries)。

生成性场景先验:

- 通过在条件上同时对所有场景对象进行建模,来学习场景上下文和对象间的关系,这有助于捕获场景的全局结构和对象间的相互关系。

表面对齐损失(Surface Alignment Loss):

- 提出了一种高效的表面对齐损失公式(L_{align}),该公式利用表达性强的中间形状表示来进行额外的监督,即使在缺乏完整地面真实标注的情况下也能进行训练。

架构设计:

- 采用了一个预训练的图像背景模型,一个新颖的图像条件场景先验扩散模型,以及一个条件形状解码器扩散模块。

训练和实现细节:

- 使用AdamW优化器进行模型训练,并在Pix3D和SUN RGB-D数据集上进行训练和评估。

具体来说,论文中的方法通过以下步骤实现:

条件3D场景扩散(Conditional 3D Scene Diffusion):使用扩散模型来逐步从带噪声的数据点中恢复出原始的3D形状和姿态。

对象姿态参数化(Object Pose Parameterization):定义对象的姿态为3D中心、空间尺寸和方向。

形状编码(Shape Encoding):使用高斯混合模型来表示和编码对象的形状。

场景先验建模(Scene Prior Modeling):通过引入场景内注意力(Intra-Scene Attention, ISA)模块,使场景中的所有对象能够相互关注,有效地建模它们之间的关系。

表面对齐损失(Surface Alignment Loss):通过从中间形状表示中直接采样点云,并与部分深度信息对齐,提供了额外的监督信号。

架构(Architecture):结合了预训练的2D实例分割模型和时间条件的UNet架构,以及Transformer模型来去噪对象姿态和形状。

这些技术的结合使得论文提出的方法能够在各种标准数据集上超越当前最先进方法,并在单视图3D场景重建任务中实现更准确的对象姿态和更清晰的几何形状。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来验证所提出方法的有效性:

与现有技术的比较:

- 与现有的最先进的方法进行比较,包括Total3D、Im3D和InstPIFu,使用标准的3D场景重建基准测试。

数据集:

- 在SUN RGB-D数据集上评估3D姿态估计性能,该数据集包含10,335张室内场景图像,每张图像都有2D和3D边界框标注。

- 在Pix3D数据集上评估3D形状重建性能,该数据集包含10,046张图像,涵盖9个类别的常见家具对象,具有像素对齐的3D形状。

评估协议:

- 对于姿态估计,使用IoU3D(3D边界框的交集比)和AP15 3D(平均精度,以15%的IoU3D阈值)进行评估。

- 对于3D形状重建,采样10,000个点在预测的形状表面和地面真实形状上,并计算Chamfer距离(CD)和F-score(在网格对齐后)。

与最新技术的定量比较:

- 在SUN RGB-D和Pix3D数据集上展示与基线方法的定量比较,包括IoU3D、AP15 3D、Lalign、CD和F-Score等指标。

消融研究:

- 对于去噪公式、场景先验建模和联合训练的影响进行了消融研究,以验证所提出的设计决策和贡献的有效性。

泛化能力测试:

- 在ScanNet数据集上评估模型的泛化能力,使用在SUN RGB-D上训练的模型进行推理,不进行额外的微调。

无条件合成结果:

- 展示了通过将空条件(∅)注入模型得到的无条件结果,以展示模型学习到的形状先验在多个语义类别中合成高质量和多样化结果的能力。

形状分解能力:

- 通过将重建网格的每个顶点分配给最近的3D高斯中心,并以不同颜色进行可视化,展示了模型的形状分解能力。

这些实验全面评估了论文提出方法的性能,并与现有技术进行了对比,验证了其在3D场景重建任务中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出的方法在单视图3D场景重建方面取得了显著的进展,但仍有一些领域可以进一步探索和改进:

提高对未见类别的泛化能力:

- 目前的方法依赖于在已知类别上训练的形状先验。未来的工作可以探索如何将该模型与基于文本-图像预训练模型结合,以支持对未见类别的3D形状合成。

动态场景建模:

- 论文中的方法目前假设场景是静态的。未来的研究可以集成对象的可操作性和关节性,以支持更丰富的人-场景交互。

改进2D检测性能:

- 由于该方法依赖于2D对象检测,因此可以通过集成最新的2D检测模型来提高整体性能。

更丰富的数据集和标注:

- 尽管论文提出了一种在标注不完整的情况下进行训练的方法,但使用更丰富的数据集和更完整的标注可以进一步提高模型的性能和鲁棒性。

实时性能优化:

- 探索优化策略,使得模型能够满足实时应用的需求,例如在增强现实(AR)和虚拟现实(VR)中的场景重建。

多模态输入和融合:

- 考虑将其他类型的传感器数据(如深度信息、红外图像)与RGB图像结合,以提供更全面的3D信息。

更复杂的场景和对象关系建模:

- 进一步研究如何更精确地建模场景内对象间的复杂关系和交互,以实现更自然和真实的场景重建。

提高形状和姿态估计的准确性:

- 尽管论文提出的方法在这些领域取得了进展,但仍有空间通过改进模型架构或损失函数进一步提升准确性。

跨模态迁移学习:

- 探索如何将模型从一个领域(例如室内场景)迁移到另一个领域(如室外场景或不同的室内布局)。

可解释性和可视化:

- 提高模型决策过程的可解释性,并通过直观的可视化展示模型是如何逐步构建3D场景的。

鲁棒性测试:

- 在各种异常条件下测试模型的鲁棒性,包括极端光照、遮挡和背景杂乱等情况。

这些方向不仅可以推动单视图3D场景重建技术的发展,还可能对相关领域如计算机视觉、机器人导航和增强现实等产生积极影响。

Q: 总结一下论文的主要内容

A: 论文提出了一种基于扩散模型的新方法,用于从单个RGB图像中重建出连贯的三维场景。主要内容包括:

方法介绍:利用一个图像条件的3D场景扩散模型,同时去噪并预测场景内所有对象的姿态和几何形状。

生成性场景先验:通过在所有场景对象上同时进行条件化,学习场景上下文和对象间的关系,以获得一致的重建结果。

表面对齐损失:提出了一种有效的表面对齐损失公式,即使在只有部分地面真实标注的情况下,也能联合训练形状和姿态。

架构设计:结合了预训练的2D实例分割模型、图像条件场景先验扩散模型和条件形状解码器扩散模块。

实验验证:在SUN RGB-D和Pix3D数据集上进行实验,超越了当前最先进方法,在AP3D和F-Score指标上取得了显著的改进。

消融研究:验证了扩散公式、场景先验建模和联合训练对于性能提升的重要性。

泛化能力:展示了模型在未见过的室内数据集上的泛化能力,无需额外的微调。

无条件合成:展示了模型学习到的形状先验能够在没有条件输入的情况下合成多样化和详细的3D形状。

局限性:讨论了模型依赖于2D对象检测性能和对未见类别泛化能力有限等局限性。

结论:该方法通过结合简单的去噪公式和强大的生成性场景先验,在多个基准上显著提高了3D场景理解的性能,并为未来在混合现实、内容创建和机器人技术等领域的研究奠定了基础。

论文的主要贡献在于提出了一种新的3D场景重建方法,该方法能够有效地利用场景内对象间的关系和上下文信息,以实现更准确和一致的3D场景重建。此外,该方法还解决了公共3D数据集中标注不完整的问题,使其能够在有限的监督下进行训练。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

GAF: Gaussian Avatar Reconstruction from Monocular Videos via Multi-view Diffusion

Authors:Jiapeng Tang, Davide Davoli, Tobias Kirschstein, Liam Schoneveld, Matthias Niessner

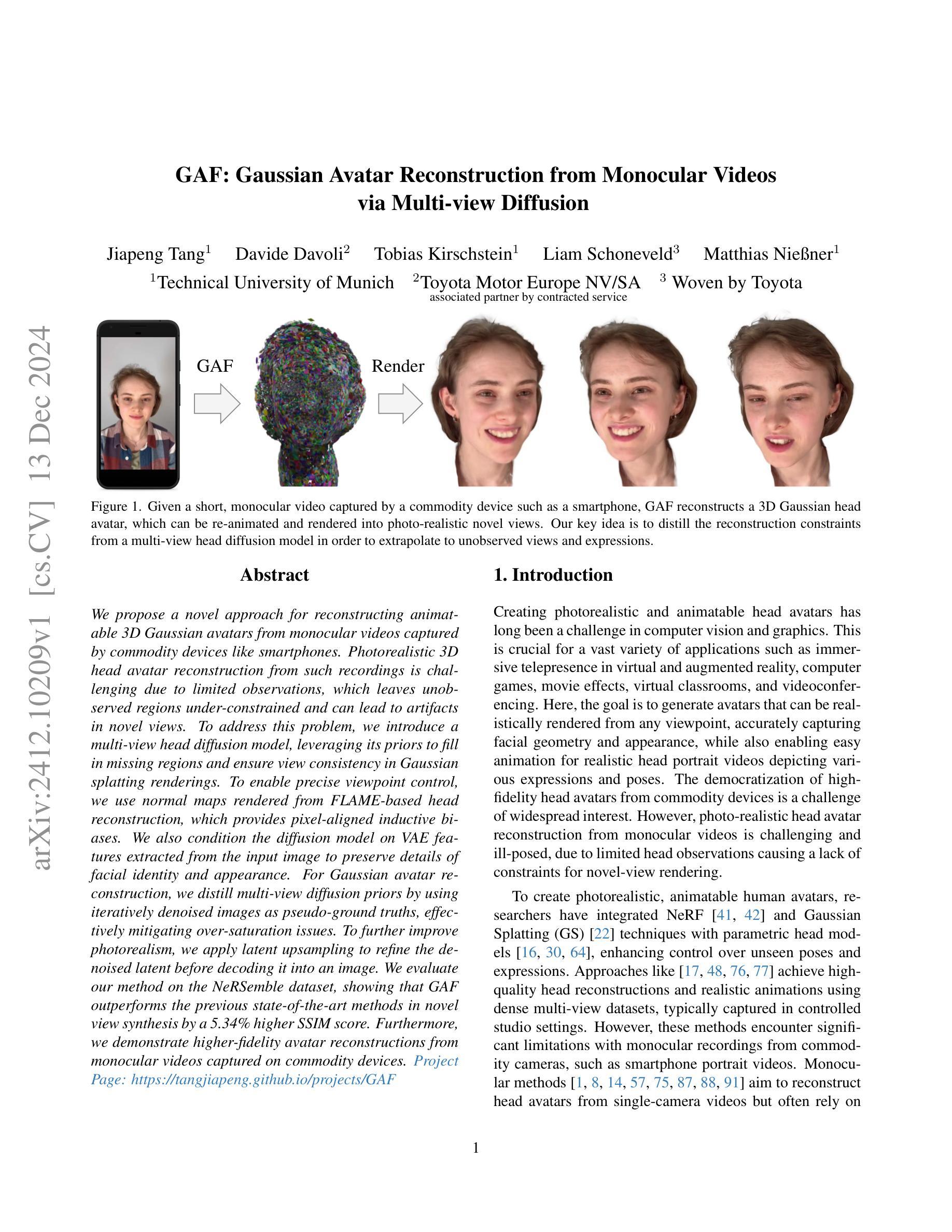

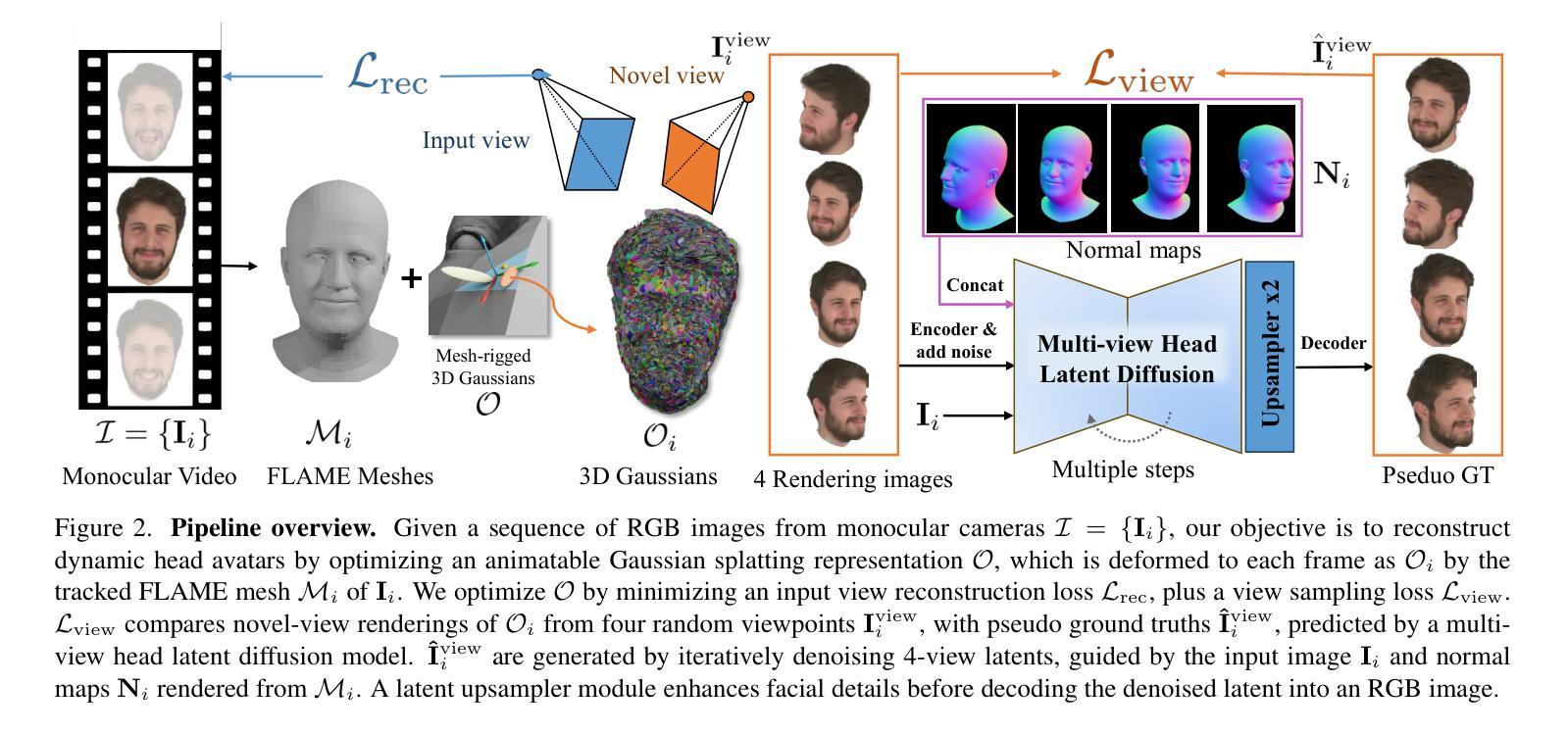

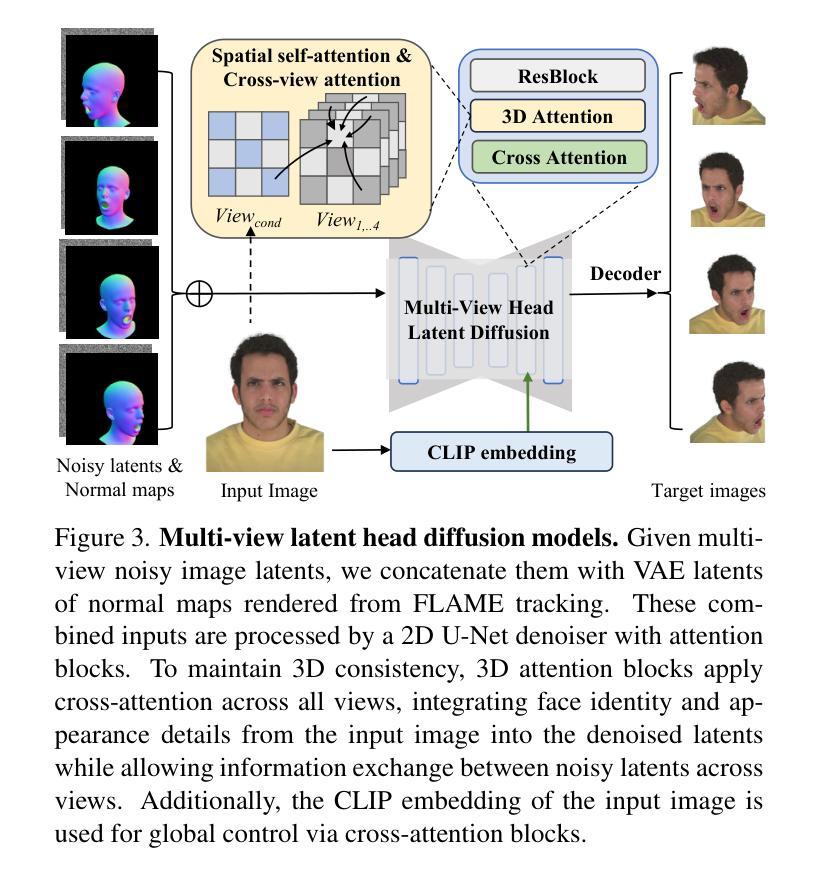

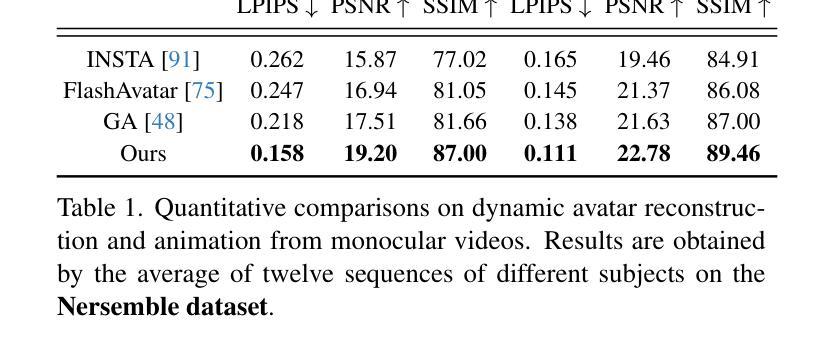

We propose a novel approach for reconstructing animatable 3D Gaussian avatars from monocular videos captured by commodity devices like smartphones. Photorealistic 3D head avatar reconstruction from such recordings is challenging due to limited observations, which leaves unobserved regions under-constrained and can lead to artifacts in novel views. To address this problem, we introduce a multi-view head diffusion model, leveraging its priors to fill in missing regions and ensure view consistency in Gaussian splatting renderings. To enable precise viewpoint control, we use normal maps rendered from FLAME-based head reconstruction, which provides pixel-aligned inductive biases. We also condition the diffusion model on VAE features extracted from the input image to preserve details of facial identity and appearance. For Gaussian avatar reconstruction, we distill multi-view diffusion priors by using iteratively denoised images as pseudo-ground truths, effectively mitigating over-saturation issues. To further improve photorealism, we apply latent upsampling to refine the denoised latent before decoding it into an image. We evaluate our method on the NeRSemble dataset, showing that GAF outperforms the previous state-of-the-art methods in novel view synthesis by a 5.34% higher SSIM score. Furthermore, we demonstrate higher-fidelity avatar reconstructions from monocular videos captured on commodity devices.

我们提出了一种从单目视频重建可动画的三维高斯化身的新方法,这些视频是由智能手机等商品设备捕捉的。从这样的记录中进行逼真的三维头部化身重建是一个挑战,因为观察有限,这使得未观察到的区域约束不足,可能导致新视角出现伪影。为了解决这个问题,我们引入了一个多视角头部扩散模型,利用它的先验知识来填充缺失的区域,并确保在高斯平面渲染中的视角一致性。为了实现精确的观点控制,我们使用基于FLAME的头部重建渲染的法线图,这提供了像素对齐的归纳偏见。我们还根据从输入图像中提取的VAE特征对扩散模型进行条件处理,以保留面部身份和外观的细节。对于高斯化身重建,我们通过使用迭代去噪图像作为伪真实值来提炼多视角扩散先验知识,有效地减轻了过度饱和问题。为了进一步提高逼真度,我们应用潜在上采样来细化去噪的潜在因素,然后再将其解码为图像。我们在NeRSemble数据集上评估了我们的方法,结果表明GAF在新型视角合成方面优于以前的最先进方法,提高了5.34%的SSIM得分。此外,我们还展示了从单目视频捕捉的商品设备上进行的高保真化身重建。

论文及项目相关链接

PDF Paper Video: https://youtu.be/QuIYTljvhyg Project Page: https://tangjiapeng.github.io/projects/GAF

Summary

本文提出了一种利用单目视频构建可动画的三维高斯头像的新方法,该方法使用普通设备如智能手机进行视频捕捉。针对从此类视频进行逼真三维头像重建所面临的挑战,引入了一种多视角头部扩散模型,该模型通过利用其先验知识来填充缺失区域并保证在高斯绘制渲染中的视角一致性。为实现对精确视角的控制,本文采用基于FLAME的头部重建进行法线映射渲染,以提供像素对齐的诱导偏见。此外,还将扩散模型调节到输入图像的VAE特征上,以保留面部身份和外观的细节。通过迭代去噪图像作为伪真实值来提炼多视角扩散先验,有效缓解过度饱和问题。最后通过潜在上采样改善逼真性。在NeRSemble数据集上的评估显示,GAF在新型视角合成方面较之前的最优方法提高了5.34%的SSIM得分。

Key Takeaways

关于这项研究的见解主要有以下七点:

提出了一种新颖的方法利用普通设备拍摄的单目视频来构建可动画的三维高斯头像。

引入了多视角头部扩散模型来解决由于观察受限导致的未观测区域约束不足的问题,并减少新视角的伪影。

利用基于FLAME的头部重建进行法线映射渲染,实现精确视角控制。

将扩散模型调节到输入图像的VAE特征上,确保面部身份和外观的细节得以保留。

通过迭代去噪图像作为伪真实值来提炼多视角扩散先验,解决过度饱和问题。

采用潜在上采样技术改善重建头像的光泽和细节。

在NeRSemble数据集上的实验表明,该方法在新型视角合成方面表现优异,相较于先前技术提高了SSIM得分。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一种新的方法,旨在解决从由普通设备(如智能手机)拍摄的单目视频中重建可动画化的3D高斯头像的问题。具体来说,论文试图解决以下几个挑战:

有限观测导致的约束不足:单目视频由于观测角度有限,导致对头像的不可见区域(如侧面)的重建不足,这会在新视角渲染时产生伪影。

新视角一致性:如何确保从单目视频重建的头像在新视角下渲染时,能够保持外观和身份的一致性。

真实感渲染:从单目视频中重建的头像在新视角下渲染时,如何保持照片级真实感。

为了解决这些问题,论文提出了一种基于多视角头部扩散模型的方法,利用该模型的先验知识来填补缺失区域,并确保在高斯绘制渲染中的视角一致性。此外,论文还引入了从FLAME基础头部重建中渲染的正常图来提供精确的视点控制,并使用从输入图像中提取的VAE特征来保持面部身份和外观的细节。通过迭代去噪图像作为伪真实值,有效缓解了过饱和问题,并应用潜在上采样来提高头像重建的保真度。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的工作:

3D场景表示:

- **Neural Radiance Fields (NeRF)**及其变体:这些方法彻底改变了从多视图图像重建3D场景的方式,但通常在训练和推理阶段计算效率低下。

- **Gaussian Splatting (GS)**:与NeRF相比,GS通过将场景表示为离散的几何原语(3D高斯)并使用显式光栅化器进行渲染,在训练和推理阶段实现了显著的运行速度提升。

参数化面部/头部模型:

- 基于3D形态模型(3DMM)的工作学习从单RGB图像/视频中重建和跟踪3D面部/头部。

- 更近期的方法使用基于坐标的多层感知机(coordinate-MLPs)来实现更细粒度的几何重建,包括头发和胡须。

真实感头像重建:

- 将NeRF/GS与3D形态模型(3DMM)结合起来,以创建真实感和可动画化的头部头像。

- 一些工作探索了基于点的表示以实现高效的训练。

2D先验知识用于3D生成:

- 通过使用Score Distillation Sampling (SDS)损失,可以将大规模预训练的文本到图像先验用于3D资产生成。

多视角扩散模型:

- 一些工作学习图像条件的新视角扩散先验,利用输入图像的身份和外观细节来生成一致的新视角图像。

与Gaussian Splatting相关的工作:

- 将高斯绘制与FLAME网格结合起来,通过三角形变形控制高斯绘制的属性,以实现头像的动画化。

这些相关工作涵盖了3D场景重建、参数化模型、真实感头像生成、2D到3D的转换以及多视角图像生成等领域,为本研究提供了理论和技术基础。论文通过结合这些相关技术,提出了一种新的方法来从单目视频中重建3D高斯头像,并在新视角下进行真实感渲染。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤解决了从单目视频中重建3D高斯头像的问题:

1. 多视角头部扩散模型

论文提出了一个多视角头部扩散模型,该模型能够从单一视图输入生成一致的多视角图像。这个模型利用了扩散先验来填补单目视频中缺失的区域,并确保在高斯绘制渲染中的视角一致性。

2. 正常图引导

为了实现精确的视点控制,论文使用从FLAME头部重建渲染的正常图作为扩散过程的引导。与相机姿态嵌入相比,正常图提供了更强的归纳偏置,从而实现更精确和可靠的新视角生成。

3. VAE特征融合

论文将从输入图像中提取的VAE特征直接整合到多视角扩散模型中。通过在多视角去噪潜在空间和VAE潜在空间之间进行交叉注意力操作,有效地传递了特定身份的细节。

4. 迭代去噪图像作为伪真实值

为了利用多视角扩散先验进行高斯头部重建,论文采用了迭代去噪图像作为伪真实值,而不是单步得分蒸馏采样损失。这种方法可以减少由于随机噪声水平和种子引入的噪声梯度,从而缓解合成3D资产中的过饱和问题。

5. 潜在上采样模型

为了提高高斯渲染的真实感,论文引入了一个潜在上采样模型,在将去噪潜在空间解码回图像空间之前增强面部细节。

6. 损失函数

论文通过组合损失函数来优化高斯绘制,包括像素级L1损失、SSIM损失和LPIPS损失,以及用于惩罚异常分布的高斯的位置和尺度正则化项。

7. 实现细节

论文详细描述了多视角头部扩散模型的训练过程,包括初始化、训练策略和训练数据集的构建。此外,还提供了高斯头像优化的具体实现细节,如FLAME网格的初始获取、可动画高斯的优化过程以及运行时性能。

通过这些方法,论文能够有效地从单目视频中重建出真实感和可动画化的3D高斯头像,并在新视角下进行高质量的渲染。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,作者进行了以下实验:

数据集

- NeRSemble 数据集:用于头部头像重建实验的多视角视频数据集,包含16个视角的RGB视频序列,覆盖了正面和侧面的脸部。

- Monocular Video 数据集:包含从 INSTA 数据集和智能手机捕获的单目视频,用于评估在普通设备上捕获的视频的头像重建效果。

评估指标

- L1损失、LPIPS、PSNR 和 SSIM:用于量化评估重建头像与真实头像之间的相似度。

实验设置

- 新视角合成:评估重建的头像在训练期间看到的头部姿势和表情下,从15个保留的视点渲染的效果。

- 新表情合成:评估重建的头像在训练期间未见的头部姿势和表情下,从5个附近的保留视点渲染的效果。

基线比较

- INSTA、FlashAvatar 和 GaussianAvatars:与三种最先进的方法进行比较。

实验结果

- 定量比较:在 NeRSemble 数据集上,论文的方法在新视角合成任务中超过了所有基线方法,特别是在 PSNR 和 SSIM 指标上取得了显著提升。

- Monocular Video 数据集:由于缺乏单目捕获的真实视角渲染的地面真实数据,只进行了动画效果的定量评估,论文的方法在所有指标上均优于其他方法。

消融研究

- 对多视角头部扩散先验、正常图条件、迭代去噪图像作为伪真实值以及潜在上采样模块等设计选择进行了详细的消融研究,验证了每个组件的有效性。

鲁棒性分析

- 分析了输入单目视频帧数对重建性能的影响,证明了即使在输入帧数较少的情况下,论文的方法也能保持稳定的性能。

额外比较

- 提供了额外的定性比较,包括新视角合成、自我/交叉重演以及不同输入帧数下的鲁棒性分析。

这些实验全面评估了论文提出方法的有效性,并与现有技术进行了比较,同时也探讨了不同设计选择对性能的影响。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和当前的研究进展,以下是一些可以进一步探索的点:

1. 头发建模和动画

当前的参数化头部模型缺乏详细的头发几何形状和动画。未来的工作可以扩展高斯头部头像以包含细粒度的头发建模和动画。

2. 实时4D头像重建

论文提到优化头部高斯使用迭代更新的伪真实值从扩散模型是耗时的。探索实时4D头像重建与前馈大型重建模型可能是一个有价值的研究方向。

3. 材料和外观分离

论文没有明确区分头部的材料和外观,这可能限制了重新照明应用。研究如何分离材料和外观,以支持更多动态的光照和渲染效果。

4. 更广泛的数据集和场景

目前的实验主要基于特定的数据集和受控环境。将方法扩展到更多样化的数据集和更复杂、更自然的场景中,以提高泛化能力。

5. 交互式应用和VR/AR集成

研究如何将头像重建技术集成到交互式应用和虚拟现实(VR)/增强现实(AR)产品中,以提高用户体验。

6. 性能优化和硬件加速

探索新的方法来优化算法性能,减少内存使用和计算时间,使其更适合在资源受限的设备上运行。

7. 更多的先验知识融合

研究如何融合更多的先验知识(如形状先验、表情先验等)到模型中,以提高重建质量和鲁棒性。

8. 多模态输入

考虑将更多的模态(如深度信息、IR图像等)整合到重建流程中,以提供更丰富的输入信息。

9. 伦理和隐私问题

随着技术的发展,进一步探讨与真实感头像生成相关的伦理和隐私问题,确保技术的负责任使用。

10. 用户自定义和编辑能力

研究如何提供用户自定义和编辑头像的能力,以满足个性化需求和创意表达。

这些探索点可以帮助推动3D头像重建技术的发展,并在更广泛的应用中实现其潜力。

Q: 总结一下论文的主要内容

A: 本论文提出了一种从单目视频中重建可动画化的3D高斯头像的新方法,旨在解决由于观测限制导致的重建难题。以下是论文的主要内容总结:

1. 问题定义

- 从普通设备(如智能手机)捕获的单目视频中重建真实感和可动画化的3D头部头像存在挑战,因为有限的观测会导致未观测区域的重建不足,从而在新视角渲染时产生伪影。

2. 关键思想

- 利用多视角头部扩散模型的先验知识来填补单目视频中缺失的区域,并确保在高斯绘制渲染中的视角一致性。

3. 方法论

- 多视角头部扩散模型:通过迭代去噪图像作为伪真实值,生成与输入图像视角一致的多视角图像。

- 正常图引导:使用FLAME头部重建渲染的正常图进行视点控制,提供精确的新视角生成。

- VAE特征融合:将输入图像的VAE特征整合到扩散模型中,以保持面部身份和外观的细节。

- 潜在上采样模型:在将去噪潜在空间解码回图像空间之前增强面部细节,提高渲染的真实感。

4. 实验

- 在NeRSemble数据集和Monocular Video数据集上进行实验,与现有技术进行比较,证明了该方法在新视角合成和新表情合成方面的优越性。

- 进行了消融研究,验证了多视角扩散先验、正常图条件、迭代去噪图像和潜在上采样模块的有效性。

- 进行了鲁棒性分析,展示了该方法对输入视频帧数变化的鲁棒性。

5. 贡献

- 提出了一种新的方法,使用多视角头部扩散先验从单目视频中重建真实感和可动画化的头部头像。

- 提出了一种多视角头部扩散模型,从单一视图输入生成一致的多视角图像,改善了视点控制。

- 通过整合潜在上采样和多视角扩散先验,提高了高斯绘制的跨视角一致性和真实感。

6. 未来工作和局限性

- 论文讨论了当前方法的局限性,如缺乏头发建模和动画、优化过程耗时以及受限于参数化头部模型的表达能力。

- 提出了未来可能的研究方向,包括头发建模、实时4D头像重建和性能优化等。

总体而言,这项工作通过引入多视角扩散先验和潜在上采样,显著提高了从单目视频中重建3D高斯头像的质量,为虚拟现实和增强现实应用中的真实感头像创建提供了新的可能性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

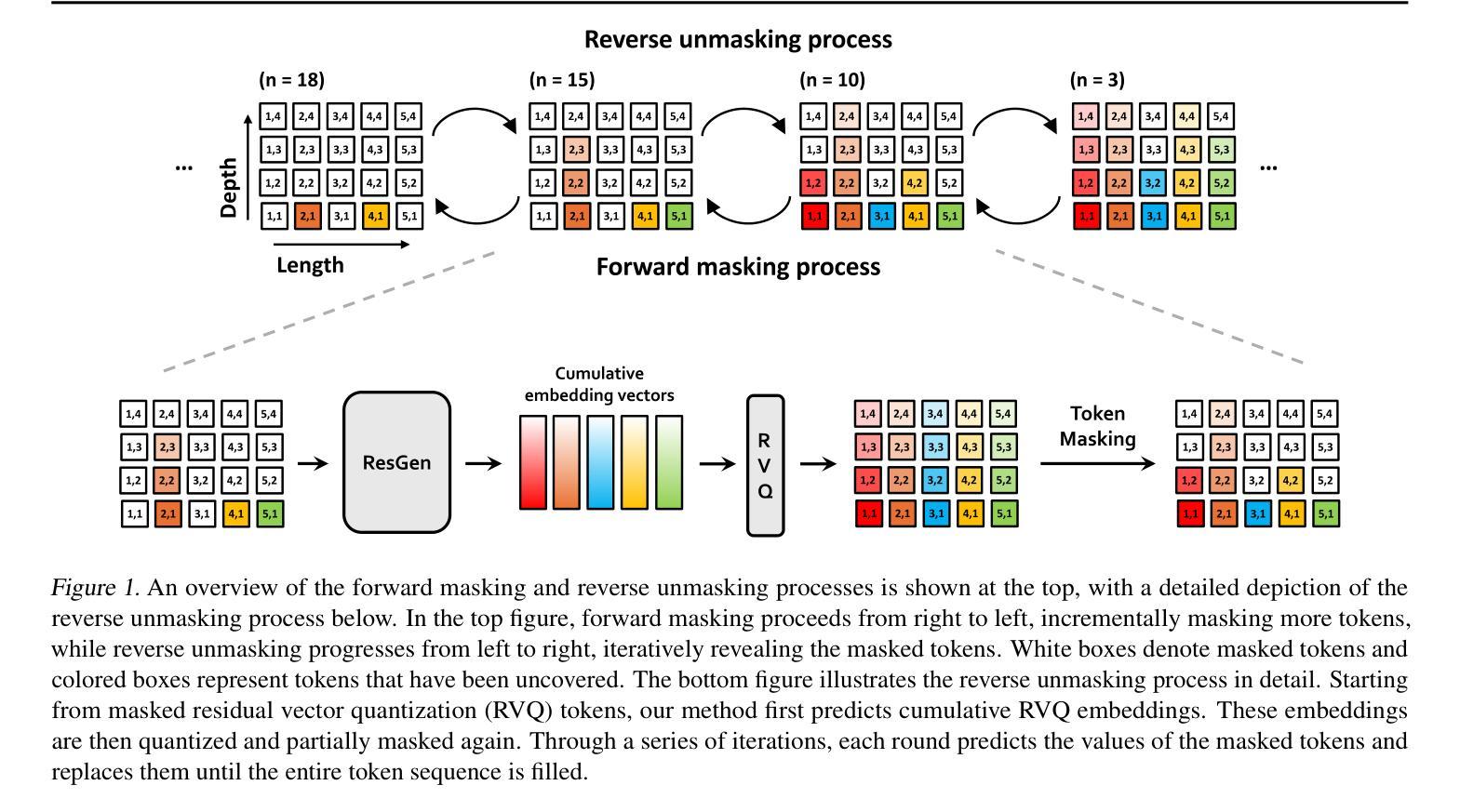

Efficient Generative Modeling with Residual Vector Quantization-Based Tokens

Authors:Jaehyeon Kim, Taehong Moon, Keon Lee, Jaewoong Cho

We explore the use of Residual Vector Quantization (RVQ) for high-fidelity generation in vector-quantized generative models. This quantization technique maintains higher data fidelity by employing more in-depth tokens. However, increasing the token number in generative models leads to slower inference speeds. To this end, we introduce ResGen, an efficient RVQ-based discrete diffusion model that generates high-fidelity samples without compromising sampling speed. Our key idea is a direct prediction of vector embedding of collective tokens rather than individual ones. Moreover, we demonstrate that our proposed token masking and multi-token prediction method can be formulated within a principled probabilistic framework using a discrete diffusion process and variational inference. We validate the efficacy and generalizability of the proposed method on two challenging tasks across different modalities: conditional image generation} on ImageNet 256x256 and zero-shot text-to-speech synthesis. Experimental results demonstrate that ResGen outperforms autoregressive counterparts in both tasks, delivering superior performance without compromising sampling speed. Furthermore, as we scale the depth of RVQ, our generative models exhibit enhanced generation fidelity or faster sampling speeds compared to similarly sized baseline models. The project page can be found at https://resgen-genai.github.io

我们探讨了残差向量量化(RVQ)在向量量化生成模型中的高保真生成应用。这种量化技术通过采用更深入的标记来保持更高的数据保真度。然而,在生成模型中增加标记数量会导致推理速度变慢。为此,我们引入了ResGen,这是一个基于RVQ的高效离散扩散模型,能够在不牺牲采样速度的情况下生成高保真样本。我们的关键想法是预测集体标记的向量嵌入而不是单个标记。此外,我们证明了所提出的标记遮挡和多标记预测方法可以在一个以离散扩散过程和变分推断为原则的概率框架内制定。我们在两个不同的模态中具有挑战性的任务上验证了所提出方法的有效性和通用性:在ImageNet 256x256上进行条件图像生成和零样本文本到语音合成。实验结果表明,ResGen在这两个任务中的表现都优于自回归模型,具有卓越的性能且不牺牲采样速度。此外,随着我们扩展RVQ的深度,我们的生成模型相较于相似规模的基准模型展现出更高的生成保真度或更快的采样速度。项目页面位于https://resgen-genai.github.io。

论文及项目相关链接

Summary

本文探讨了基于Residual Vector Quantization(RVQ)技术的离散扩散模型在生成高质量样本方面的应用。该模型能高效生成高质量样本,同时保持快速的采样速度。它通过预测集体向量的嵌入来实现这一点,而不是单独预测每个标记。此外,本文还展示了如何在离散扩散过程和变分推断的框架下,将提出的标记掩码和多标记预测方法公式化。在ImageNet 256x256的条件图像生成和零样本文本到语音合成等任务上的实验验证了该方法的有效性和泛化能力。与传统的自回归模型相比,ResGen在提高性能的同时不牺牲采样速度。随着RVQ深度的增加,我们的生成模型的生成保真度进一步提高或采样速度更快,相较于类似规模的基准模型表现出优势。

Key Takeaways

- 使用了Residual Vector Quantization(RVQ)技术以提高生成模型的保真度。

- 提出的ResGen模型能在保持快速采样速度的同时生成高质量样本。

- 通过预测集体向量的嵌入,而非单独预测每个标记,提高了效率。

- 将标记掩码和多标记预测方法整合到离散扩散过程和变分推断的框架中。

- 在条件图像生成和零样本文本到语音合成任务上验证了方法的有效性。

- ResGen相较于自回归模型在提高性能的同时不牺牲采样速度。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何在向量量化生成模型中实现高保真度数据生成,同时保持较快的采样速度。具体来说,论文探讨了使用残差向量量化(Residual Vector Quantization, RVQ)技术来提高数据重建质量,同时提出了一个高效的RVQ基的离散扩散模型(ResGen),用于在不牺牲采样速度的情况下生成高保真度样本。论文的主要贡献包括:

直接预测集体标记的向量嵌入:ResGen通过直接预测集体标记的向量嵌入而不是逐个预测每个标记,从而解耦了采样复杂度与序列长度和深度的关系。

基于离散扩散过程和变分推断的概率框架:论文展示了所提出的标记掩蔽和多标记预测方法可以被纳入一个基于离散扩散过程和变分推断的原则化概率框架中。

在不同模态上验证方法的有效性和泛化能力:通过在ImageNet上的有条件图像生成任务和零样本文本到语音合成任务上的实验,论文证明了ResGen在这些任务上相较于自回归模型具有优越的性能,且没有牺牲采样速度。

分析模型特性和超参数的影响:通过消融研究,论文还分析了不同超参数(如采样步骤)对生成质量的影响,并考察了模型在不同RVQ深度下的特性。

总的来说,这篇论文旨在通过引入新的RVQ基生成模型ResGen,解决在生成高分辨率、高保真度数据时面临的质量和计算效率之间的平衡问题。

Q: 有哪些相关研究?

A: 根据论文内容,以下是与本研究相关的一些工作:

向量量化(VQ)标记基础的生成模型:

- VQ-GAN (Esser et al., 2021) 和 DALLE (Ramesh et al., 2021) 利用离散表示进行图像合成,使用变换器(transformers)来实现高质量的数据生成,同时保持计算资源的可管理性。

离散扩散模型:

- MaskGIT (Chang et al., 2022) 和 VQ-Diffusion (Gu et al., 2022) 专注于对平面标记序列进行掩蔽标记预测,与自回归模型相比提高了采样效率。

- GIVT (Tschannen et al., 2023) 引入了一种方法,用基于高斯混合的向量预测代替基于softmax的标记预测,逐步填充掩蔽位置。

基于RVQ的生成模型:

- RQ-Transformer (Lee et al., 2022) 是第一个展示在RVQ标记上使用自回归模型进行生成建模的研究,其计算复杂度随着序列长度和深度的乘积增加。

- Vall-E (Wang et al., 2023) 预测第一深度的标记,然后顺序地预测每个深度的剩余标记。

- SoundStorm (Borsos et al., 2023) 使用掩蔽标记预测给定语义标记生成标记,但其采样时间复杂度仍随残差量化深度线性增加。

- NaturalSpeech 2 (Shen et al., 2024) 在RVQ嵌入空间中使用基于扩散的生成建模而不是标记生成。

- CLaM-TTS (Kim et al., 2024) 使用向量预测进行多标记预测,但以自回归方式沿序列长度操作。

其他生成模型方法:

- VAR (Tian et al., 2024) 和 MAR (Li et al., 2024) 提出了替代基于标记的自回归建模的新范式。VAR引入了粗到细的下一尺度预测机制,有效地捕获了图像中的层次结构。MAR通过使用基于扩散的方法在连续值空间中对概率进行建模,消除了对离散标记的依赖,简化了流程同时保持了强大的性能。

这些相关工作提供了不同的视角和技术,用于处理基于标记的生成模型中的挑战,特别是在处理高分辨率、高保真度数据生成时的质量和计算效率之间的平衡问题。ResGen方法与这些工作相比,提供了一个更有效的解决方案,通过预测掩蔽标记的向量嵌入,从序列长度和标记深度中解耦采样时间复杂度。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为ResGen的高效RVQ(Residual Vector Quantization)基的离散扩散模型来解决高保真度数据生成与快速采样之间的平衡问题。以下是ResGen解决该问题的关键方法:

1. 直接预测集体标记的向量嵌入

ResGen的核心思想是直接预测集体标记的向量嵌入,而不是逐个预测每个标记。这种方法通过对累积嵌入的预测,允许模型在不同深度上估计相关联的标记,与残差量化过程自然对齐。这样,ResGen能够从序列长度和深度中解耦采样复杂度,生成高保真度样本而不影响采样速度。

2. 掩蔽标记策略和多标记预测

掩蔽标记策略:ResGen采用一种特别适合RVQ标记的掩蔽策略,从最高量化层开始逐步掩蔽标记,利用RVQ的层次性质,其中更深层次的标记捕获更精细的细节。

多标记预测:ResGen在训练和解码阶段通过聚焦于预测聚合向量嵌入z而不是直接预测目标标记,有效预测掩蔽标记。这种方法避免了沿深度的标记条件独立性,这对于模型性能可能是有害的。

3. 基于离散扩散过程和变分推断的概率框架

ResGen将掩蔽标记预测过程纳入一个基于离散扩散模型和变分推断的原则化概率框架中。这种观点允许将ResGen视为一个基于似然的生成过程,并为其设计提供了理论基础。

前向离散扩散过程:将标记掩蔽过程解释为离散扩散模型在标记序列上的前向扩散步骤,逐渐将完全未掩蔽的标记序列转化为完全掩蔽的序列。

反向离散扩散过程:旨在从部分掩蔽的序列中重建原始标记,定义了重建原始标记的概率,并计算数据对数似然的变分下界。

4. 实验验证

论文通过在ImageNet上的有条件图像生成任务和零样本文本到语音合成任务上的实验验证了ResGen的有效性和泛化能力。实验结果显示,ResGen在这些任务上的性能超过了自回归模型,并且在RVQ深度扩展时,与同样大小的基线生成模型相比,展现了更高的生成保真度或更快的采样速度。

5. 消融研究

论文还通过消融研究分析了不同超参数(例如采样步骤)对生成质量的影响,并考察了模型在不同RVQ深度下的特性。

通过这些方法,ResGen有效地解决了在向量量化生成模型中生成高保真度数据与保持快速采样速度之间的平衡问题。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来验证ResGen模型的有效性和泛化能力:

1. 实验设置

实验任务:

- 视觉领域:在ImageNet数据集上进行条件图像生成任务,分辨率为256×256。

- 音频领域:使用Voicebox启发的两个任务进行评估:(1) 继续任务(continuation),给定文本和3秒的真实语音段落,目标是生成与提供段落相同风格的无缝语音;(2) 跨句子任务(cross-sentence),给定文本、3秒语音段落及其与文本不同的转录,目标是生成用提供段落风格朗读文本的语音。

评估指标:

- 视觉任务:使用Fréchet Inception Distance (FID) 来比较与其他最先进图像生成模型。

- 音频任务:使用字符错误率(CER)、单词错误率(WER)和说话人相似度(SIM)等客观指标进行评估。

基线和训练配置:与包括自回归模型和非自回归模型在内的最新生成模型进行比较,并详细说明ResGen模型的训练配置。

2. 实验结果

视觉任务:

- 展示了ResGen在保持参数效率的同时,与基线模型相比在准确性和推理时间上的优势。

- 使用FID指标评估生成质量,比较不同模型在生成质量、内存效率和生成速度方面的表现。

音频任务:

- 与生成RVQ标记的自回归模型进行比较,展示了ResGen在WER、CER和SIM指标上的优势,以及需要更少的推理步骤。

- 与最新的TTS模型进行比较,展示了ResGen在计算效率和准确性方面的优势。

3. 消融研究

- 分析了不同采样超参数(如采样步骤数、top-p值和温度缩放)对模型行为和生成质量的影响。

- 展示了增加采样步骤数、调整top-p值和温度对生成质量的改善。

这些实验验证了ResGen在不同模态上的强大性能,包括图像生成和文本到语音合成任务,并与现有的自回归和非自回归方法进行了比较。实验结果显示,ResGen在保持高保真度的同时,提供了更快的采样速度和更好的内存效率。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

1. 利用键值(KV)缓存优化采样速度

论文提到,通过在变换器架构中使用键值(KV)缓存,可以重用已经完全填充的标记的预计算KV值,减少冗余计算。这种策略可以显著提高采样速度和降低整体计算开销,是一个值得未来研究的方向。

2. 探索新的量化方法

论文提到了残差向量量化(RVQ)标记,但也提到了有限标量量化(FSQ)可能带来额外的好处。将ResGen方法扩展到支持FSQ可能需要不同的标记化和嵌入过程,探索这一方向可能带来新的量化策略和改进的生成性能。

3. 提供理论解释

论文中提到,ResGen方法在相对较少的迭代次数下就实现了高质量的生成,相比传统的扩散模型更有效。论文假设这种效率来自于解掩过程而不是去噪过程,因为基于完全解掩的标记进行预测比基于噪声输入的预测更容易。尽管如此,论文缺乏对这一现象的理论证明,提供正式的理论分析解释是一个有前景的未来研究方向。

4. 扩展到其他模态和任务

论文中的实验主要集中在图像和语音合成任务上,但ResGen模型的框架是通用的。将其扩展到其他模态(如视频或更复杂的音频任务)和不同类型的生成任务(如无条件生成或交互式生成)是另一个值得探索的方向。

5. 提高模型的泛化能力

虽然ResGen在特定任务上表现出色,但提高模型对不同领域和分布的泛化能力始终是一个重要的研究方向。这可能包括在更多样化的数据集上训练模型,或者开发更先进的技术来适应不同的生成场景。

6. 优化模型的计算效率

尽管ResGen在内存效率和采样速度方面已经表现出色,但进一步优化模型的计算效率,特别是在资源受限的环境中,仍然是一个重要的研究方向。

7. 探索不同的训练策略

论文中提到了一些训练策略,如使用混合高斯分布来表示潜在嵌入的分布。探索不同的训练策略和正则化技术,以进一步提高模型的性能和稳定性,也是一个有价值的研究方向。

这些方向不仅可以推动ResGen模型的发展,也有助于推动整个生成模型领域的进步。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为ResGen的高效RVQ(Residual Vector Quantization)基的离散扩散模型,旨在解决在向量量化生成模型中生成高保真度数据与保持快速采样速度之间的平衡问题。以下是论文的主要内容总结:

1. 研究动机

- 向量量化生成模型在高保真度数据生成方面面临挑战,尤其是在平衡生成质量和计算效率方面。

2. ResGen模型

- 核心思想:直接预测集体标记的向量嵌入而不是逐个预测每个标记,以解耦采样复杂度与序列长度和深度的关系。

- 掩蔽标记策略:采用特别适合RVQ标记的掩蔽策略,从最高量化层开始逐步掩蔽标记。

- 多标记预测:通过聚焦于预测聚合向量嵌入而不是直接预测目标标记,有效预测掩蔽标记。

3. 概率框架

- 将掩蔽标记预测过程纳入基于离散扩散模型和变分推断的原则化概率框架中,提供了理论基础。

4. 实验验证

- 在ImageNet上的有条件图像生成任务和零样本文本到语音合成任务上的实验验证了ResGen的有效性和泛化能力。

- 实验结果显示,ResGen在这些任务上的性能超过了自回归模型,并且在RVQ深度扩展时,与同样大小的基线生成模型相比,展现了更高的生成保真度或更快的采样速度。

5. 消融研究

- 分析了不同采样超参数对模型行为和生成质量的影响,包括采样步骤数、top-p值和温度缩放。

6. 结论与未来方向

- ResGen通过直接预测集体标记的向量嵌入,有效地解决了生成高保真度数据与快速采样之间的平衡问题。

- 提出了进一步探索的方向,包括利用键值缓存优化采样速度、探索新的量化方法、提供理论解释、扩展到其他模态和任务等。

总的来说,这篇论文提出了一个创新的解决方案来提高向量量化生成模型的效率和保真度,并在多个任务上验证了其有效性,为未来的研究提供了新的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

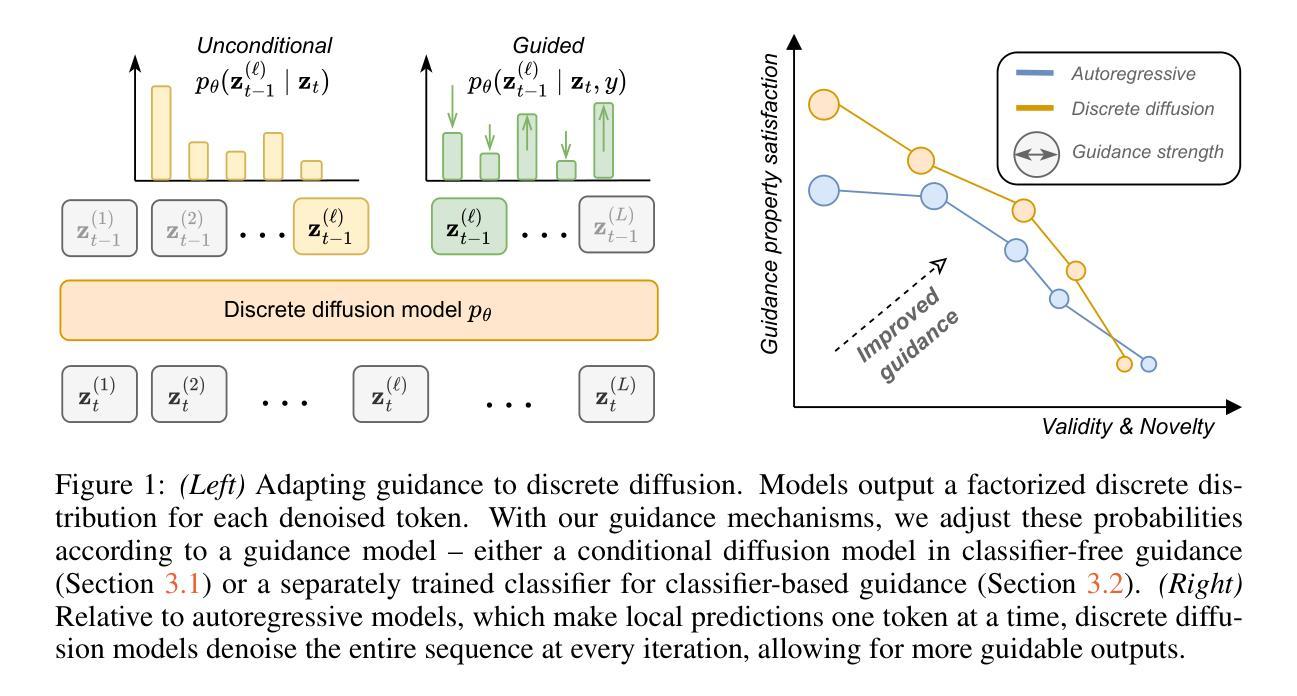

Simple Guidance Mechanisms for Discrete Diffusion Models

Authors:Yair Schiff, Subham Sekhar Sahoo, Hao Phung, Guanghan Wang, Sam Boshar, Hugo Dalla-torre, Bernardo P. de Almeida, Alexander Rush, Thomas Pierrot, Volodymyr Kuleshov

Diffusion models for continuous data gained widespread adoption owing to their high quality generation and control mechanisms. However, controllable diffusion on discrete data faces challenges given that continuous guidance methods do not directly apply to discrete diffusion. Here, we provide a straightforward derivation of classifier-free and classifier-based guidance for discrete diffusion, as well as a new class of diffusion models that leverage uniform noise and that are more guidable because they can continuously edit their outputs. We improve the quality of these models with a novel continuous-time variational lower bound that yields state-of-the-art performance, especially in settings involving guidance or fast generation. Empirically, we demonstrate that our guidance mechanisms combined with uniform noise diffusion improve controllable generation relative to autoregressive and diffusion baselines on several discrete data domains, including genomic sequences, small molecule design, and discretized image generation.

由于连续数据扩散模型的高质量生成和控制机制,它们得到了广泛的应用。然而,对于离散数据的可控扩散面临挑战,因为连续指导方法并不直接适用于离散扩散。在这里,我们提供了无分类器指导和基于分类器的指导的直观推导,以及利用均匀噪声的新型扩散模型,这些模型具有更强的可引导性,因为它们可以连续编辑输出。我们利用一种新的连续时间变分下限提高了这些模型的质量,实现了最先进的性能,特别是在涉及指导或快速生成的环境中。从实证上看,我们证明了我们的指导机制与均匀噪声扩散相结合,相对于几个离散数据域的自回归和扩散基线,可控生成能力有所提高,包括基因组序列、小分子设计和离散图像生成。

论文及项目相关链接

PDF Code to reproduce our experiments is available here: https://github.com/kuleshov-group/discrete-diffusion-guidance

Summary

扩散模型因高质量生成和控制机制而广泛应用于连续数据领域。然而,在离散数据上的可控扩散面临挑战,因为连续指导方法并不直接适用于离散扩散。本文提供了无分类器指导和基于分类器的指导的直观推导,以及利用均匀噪声的新一类扩散模型,这些模型由于可以连续编辑输出而更具指导性。通过引入新型连续时间变分下限,提高了这些模型的质量,尤其在指导或快速生成设置中表现卓越。经验表明,我们的指导机制与均匀噪声扩散相结合,相对于多个离散数据域的自回归和扩散基线,可控生成能力有所提升,包括基因组序列、小分子设计和离散图像生成等领域。

Key Takeaways

- 扩散模型在连续数据领域广泛应用,但离散数据上的可控扩散面临挑战。

- 本文提供了无分类器和基于分类器的指导方法以及利用均匀噪声的扩散模型。

- 新型扩散模型因能连续编辑输出而更具指导性。

- 通过引入连续时间变分下限提高了模型质量。

- 在指导或快速生成设置中表现卓越。

- 实证表明,指导机制与均匀噪声扩散相结合提升了可控生成能力。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了在离散数据上应用可控扩散模型的挑战,并提出了解决这些问题的方法。具体来说,论文试图解决以下几个问题:

离散数据的可控扩散生成挑战:传统的扩散模型和它们的引导机制通常不适用于离散数据,因为它们需要对数据进行梯度操作,而这在离散设置中并未定义。

现有离散扩散模型的局限性:流行的离散扩散模型扩展(例如D3PM)无法对生成的标记进行多次编辑,因此不适合可控生成。

离散扩散模型性能落后:在涉及引导或快速生成的类别中,离散扩散模型的性能(以困惑度衡量)落后于自回归(AR)模型。

为了解决这些问题,论文提出了以下贡献:

- 提供了简单且易于实现的离散分类器基础和无分类器基础引导的适应方法。

- 引入了一类新的离散扩散模型,称为均匀噪声扩散语言模型(UDLM),这些模型特别适用于引导,因为它们可以连续编辑离散数据。

- 通过导出一个连续时间版本的证据下界(ELBO),显著提高了这些模型的性能,特别是在引导或快速生成的设置中。

- 在多个领域(包括基因组序列、小分子设计和离散图像生成)展示了离散引导机制相对于自回归和扩散基线的可控生成优势。

Q: 有哪些相关研究?

A: 论文中提到了多个与离散扩散模型和引导机制相关的研究工作,具体如下:

扩散模型(Diffusion Models):

- Sohl-Dickstein et al. (2015) 提出了扩散模型的概念。

- Ho et al. (2020) 进一步发展了扩散模型,并应用于图像生成和信号处理。

引导机制(Guidance Mechanisms):

- Dhariwal & Nichol (2021a) 提出了基于分类器的引导方法。

- Nichol et al. (2021) 和 Ho & Salimans (2022) 提出了无分类器基础的引导方法。

离散扩散模型(Discrete Diffusion Models):

- Austin et al. (2021) 提出了结构化去噪扩散模型(D3PM)。

- Lou et al. (2023) 和 Sahoo et al. (2024a) 提出了离散扩散模型的扩展。

特定领域的应用:

- Song & Ermon (2019) 将扩散模型应用于MRI去噪。

- Poole et al. (2022) 和 Gao et al. (2024) 将扩散模型应用于3D重建。

- Saharia et al. (2022) 和 Gokaslan et al. (2024) 将扩散模型应用于条件生成。

其他相关工作:

- 论文还提到了一些与离散数据生成和引导相关的其他工作,例如Diffusion-LM (Li et al., 2022),SSD-LM (Han et al., 2022),LD4LG (Lovelace et al., 2024) 等。

这些相关工作为论文提出的离散扩散模型和引导机制提供了理论基础和技术背景。论文通过结合这些已有的研究成果,提出了新的离散扩散模型和引导算法,旨在提高离散数据生成的质量和可控性。

Q: 论文如何解决这个问题?

A: 论文针对离散数据的可控扩散模型面临的挑战,提出了以下解决方案:

1. 离散扩散模型和引导机制

- 离散分类器基础引导(Discrete Classifier-Based Guidance, D-CBG) 和 离散无分类器基础引导(Discrete Classifier-Free Guidance, D-CFG):论文提出了直接适应于离散域的分类器基础和无分类器基础引导方法。这些方法通过调整离散分布的概率,根据一个引导模型来控制生成过程。

2. 均匀噪声扩散语言模型(Uniform Diffusion Language Models, UDLM)

- 均匀噪声扩散:论文重新审视了均匀噪声扩散语言模型(UDLM),这类模型能够连续编辑离散数据,因此更适合引导。通过导出连续时间版本的证据下界(ELBO),论文提高了这些模型的性能。

3. 连续时间变分下界(Continuous-Time Variational Lower Bound)

- 改进的ELBO:论文提出了一个连续时间版本的变分下界,通过分析每个项(Lrecons, Ldiffusion, Lprior)来改进均匀噪声离散扩散模型。这导致了三个改进:简化的ELBO表达式、将Lrecons和Lprior的损失减少到零,以及通过连续时间扩展进一步收紧Ldiffusion。

4. 实验验证

- 跨领域实验:论文在多个领域(基因组学、分子生成和离散图像)进行了实验,证明了所提出的离散引导机制相对于自回归和扩散基线在可控生成方面的优势。

具体技术细节

对于D-CFG和D-CBG:论文详细描述了如何通过训练条件和无条件的去噪扩散网络,并在测试时通过特定的方式调整这些网络的输出概率来实现引导。

UDLM的连续时间ELBO:通过将T → ∞,并分析NELBO中的每个项,论文得到了一个更紧密的变分界限,从而提高了模型性能。

通过这些方法,论文旨在提高离散数据的可控生成质量,并在多个领域展示出相比于现有技术的优势。

Q: 论文做了哪些实验?

A: 论文中进行了多个实验来验证所提出的离散扩散模型和引导机制的有效性。以下是具体的实验内容:

1. 语言模型实验

数据集:使用了多个不同的离散数据领域,包括参考基因组(Species10)、小分子数据集(QM9)、离散化图像数据集(CIFAR10)以及三个自然语言处理数据集(text8、Amazon Review Polarity和LM1B)。

实验内容:

- UDLM性能测试:比较了UDLM(Uniform Diffusion Language Models)与其他离散扩散模型在小词汇表数据集上的性能,发现UDLM在小词汇表数据集上可以达到或超过吸收态扩散模型的性能。

- 连续时间ELBO的影响:通过增加T值(从有限步骤到无限步骤)来观察UDLM在Amazon Polarity数据集上的性能变化,发现增加T可以改善语言模型的性能。

2. 引导离散扩散实验

物种特定基因组生成:在Species10数据集上评估D-CFG(离散无分类器基础引导)与自回归模型(AR)的性能,使用Jensen-Shannon距离、AUROC和F1分数来衡量生成序列的质量和控制能力。

分子属性最大化:在QM9数据集上,研究了不同引导方法在最大化药物相似性(QED)和分子中环的数量这两个属性时的表现。

类条件图像生成:在CIFAR10数据集上,比较了MDLM和UDLM在条件图像生成任务中的性能,使用了Fréchet inception distance(FID)和Inception Score(IS)作为评价指标。

3. 快速采样的鲁棒性测试

- 不同T值的影响:在CIFAR10数据集上,探索了使用更小的T值(即更快的推理设置)对MDLM和UDLM性能的影响,发现UDLM对于更快的采样设置更加鲁棒。

这些实验覆盖了不同的数据类型和应用场景,旨在全面评估所提出方法的有效性和适用性。通过这些实验,论文展示了离散扩散模型和引导机制在多个领域的应用潜力和优越性能。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了一些创新的方法来处理离散数据的扩散模型和引导机制,但仍有一些领域可以进一步探索和研究:

更广泛的数据集和应用领域:

- 论文中主要关注了基因组序列、小分子设计和图像生成等几个领域。将这些方法应用到更广泛的数据类型和应用场景,如文本生成、语音合成等,可能会揭示新的问题和改进方向。

改进引导机制:

- 虽然论文提出了离散分类器基础和无分类器基础引导方法,但仍可以探索更复杂的引导策略,如多任务学习或强化学习,以进一步提高生成的可控性和质量。

优化算法和计算效率:

- 论文中提到的一些方法在计算上可能非常昂贵,尤其是在大型数据集上。研究更高效的优化算法和计算策略,以减少训练和推理的时间和资源消耗。

理论分析和解释性:

- 对于提出的均匀噪声扩散模型和引导机制,可以进行更深入的理论分析,以更好地理解其工作原理和潜在的局限性。

模型鲁棒性和泛化能力:

- 研究模型在面对不同的噪声水平、数据分布偏移或对抗性攻击时的鲁棒性,以及如何提高模型的泛化能力。

结合其他生成模型:

- 考虑将扩散模型与其他类型的生成模型(如GANs、VAEs等)结合,以利用各自的优势,可能会产生新的模型架构和应用。

多模态和跨模态生成:

- 探索扩散模型在多模态数据(例如,结合图像和文本)上的生成能力,以及如何实现有效的跨模态转换和生成。

长序列生成和处理:

- 研究扩散模型在处理非常长的序列数据时的表现,以及如何有效地生成和控制这些长序列。

可解释性和可视化:

- 开发可解释性和可视化工具,以帮助研究人员和用户理解扩散模型的内部工作机制,以及它们是如何响应不同的引导信号的。

这些方向不仅可以推动扩散模型在离散数据上的研究进展,也可能为其他类型的生成模型和应用提供新的见解和方法。

Q: 总结一下论文的主要内容

A: 这篇论文主要研究了离散数据的可控扩散模型,并提出了一些改进方法来提高生成质量和控制能力。以下是论文的主要内容总结:

1. 问题背景

- 扩散模型在连续数据上取得了成功,但在离散数据上面临挑战,因为连续数据的引导方法不适用于离散数据。

2. 主要挑战

- 离散数据的扩散模型不能直接应用标准扩散模型和引导机制,因为它们需要对数据取梯度,而这在离散设置中未定义。

- 现有的离散扩散模型无法对生成的标记进行多次编辑,不适合可控生成。

- 离散扩散模型的性能落后于自回归模型,特别是在需要控制的类别中。

3. 贡献和方法

- 离散引导机制:提出了简单的离散分类器基础和无分类器基础引导方法。

- 均匀噪声扩散模型(UDLM):引入了一类新的离散扩散模型,特别适用于引导,因为它们可以连续编辑离散数据。

- 连续时间变分下界(ELBO):导出了一个连续时间版本的证据下界,显著提高了模型性能。

4. 实验验证

- 在基因组序列、小分子设计和离散图像生成等多个领域验证了所提出的离散引导机制的有效性。

- 证明了离散引导机制相对于自回归和扩散基线在可控生成方面的优势。

5. 实验结果

- 离散扩散模型在小词汇表数据集上可以达到或超过吸收态扩散模型的性能。

- 提出的UDLM在均匀噪声扩散模型中达到了最佳性能。

- 离散引导机制在多个任务中显示出比自回归模型更好的可控性。

6. 结论

- 论文提出了一种改进的离散扩散模型和引导机制,有效提高了离散数据的可控生成质量。

- 通过导出连续时间ELBO,显著提高了均匀噪声离散扩散模型的性能。

- 所提出的离散引导机制在多个领域展示了优越的可控生成能力。

总的来说,这篇论文为离散数据的可控扩散模型提供了新的视角和方法,通过改进引导机制和提出新的均匀噪声扩散模型,提高了离散数据生成的质量和可控性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

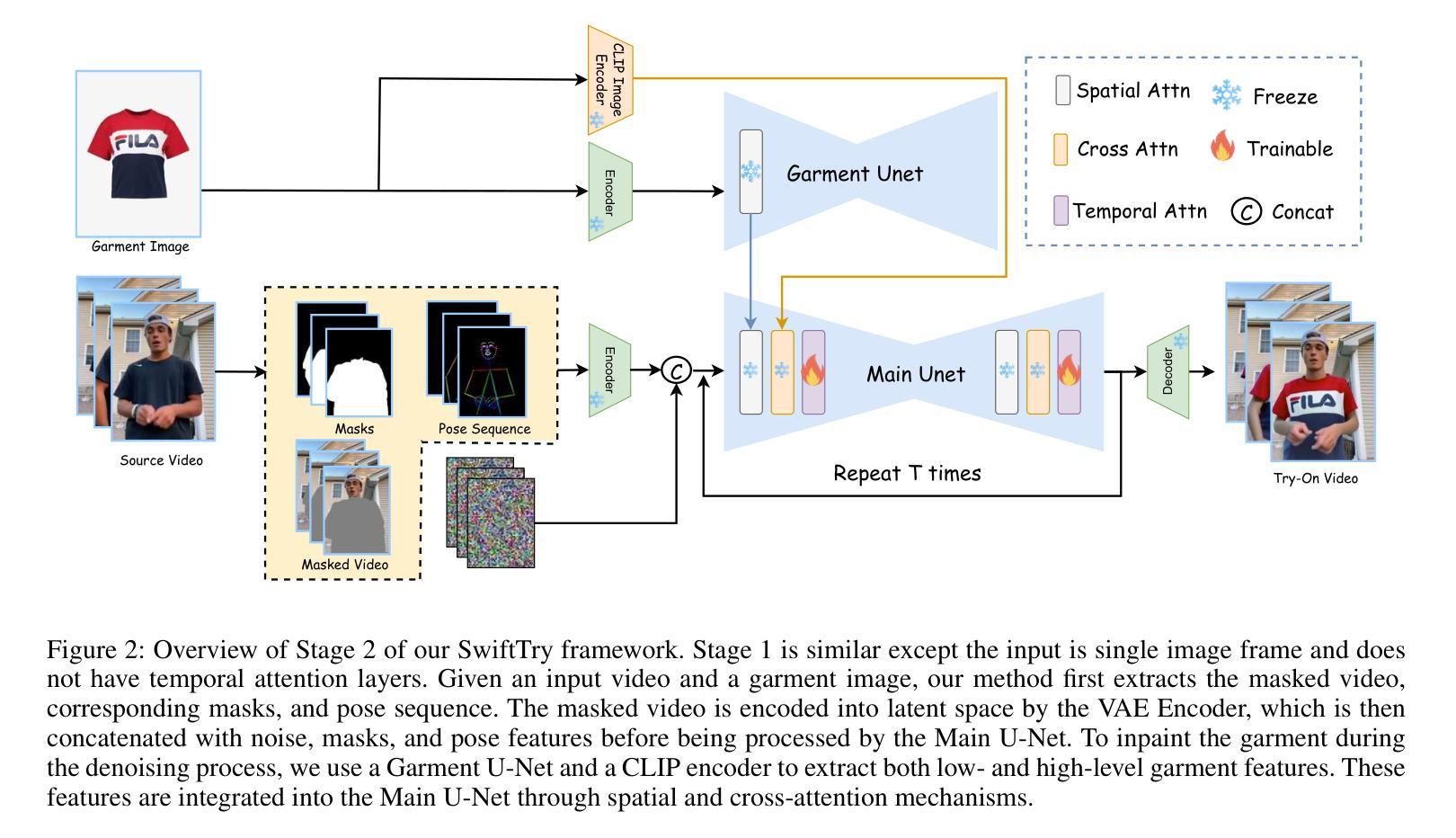

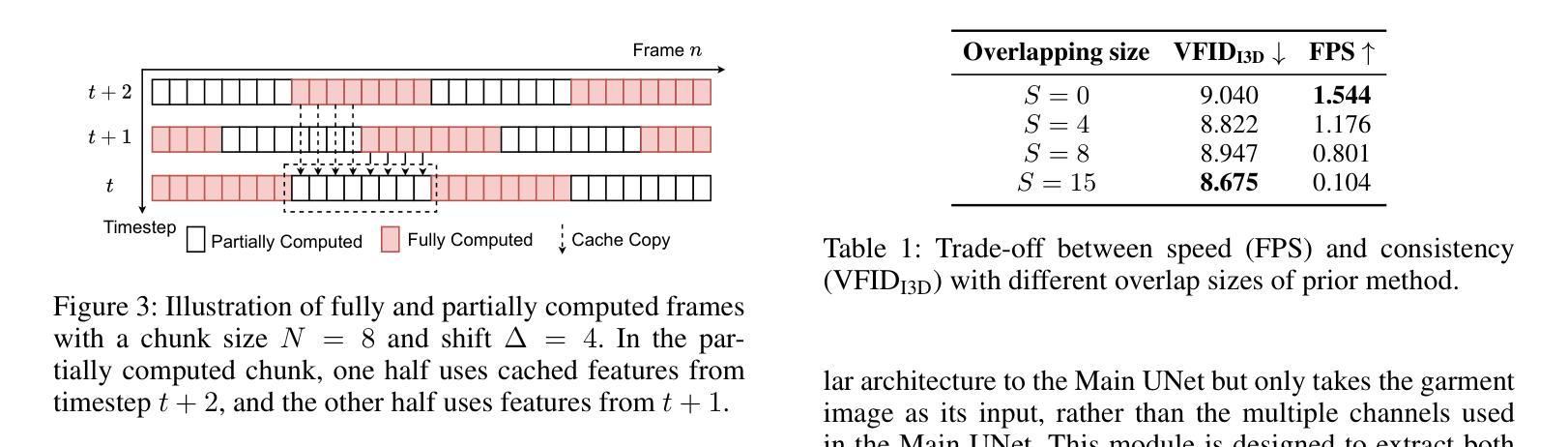

SwiftTry: Fast and Consistent Video Virtual Try-On with Diffusion Models

Authors:Hung Nguyen, Quang Qui-Vinh Nguyen, Khoi Nguyen, Rang Nguyen

Given an input video of a person and a new garment, the objective of this paper is to synthesize a new video where the person is wearing the specified garment while maintaining spatiotemporal consistency. While significant advances have been made in image-based virtual try-ons, extending these successes to video often results in frame-to-frame inconsistencies. Some approaches have attempted to address this by increasing the overlap of frames across multiple video chunks, but this comes at a steep computational cost due to the repeated processing of the same frames, especially for long video sequence. To address these challenges, we reconceptualize video virtual try-on as a conditional video inpainting task, with garments serving as input conditions. Specifically, our approach enhances image diffusion models by incorporating temporal attention layers to improve temporal coherence. To reduce computational overhead, we introduce ShiftCaching, a novel technique that maintains temporal consistency while minimizing redundant computations. Furthermore, we introduce the \dataname~dataset, a new video try-on dataset featuring more complex backgrounds, challenging movements, and higher resolution compared to existing public datasets. Extensive experiments show that our approach outperforms current baselines, particularly in terms of video consistency and inference speed. Data and code are available at https://github.com/VinAIResearch/swift-try

给定一个人穿着新衣物的输入视频,本文的目标是为合成一个新视频,其中人物穿着指定的衣物,同时保持时空一致性。虽然基于图像的虚拟试衣已经取得了重大进展,但这些成功扩展应用到视频上时,往往会导致帧间的不一致性。一些方法试图通过增加多个视频片段之间的帧重叠来解决这一问题,但这带来了高昂的计算成本,因为需要重复处理相同的帧,特别是对于长视频序列。为了应对这些挑战,我们将视频虚拟试衣重新构想为条件视频修复任务,衣物作为输入条件。具体来说,我们的方法通过融入时间注意力层来增强图像扩散模型,以提高时间连贯性。为了减少计算开销,我们引入了ShiftCaching这一新技术,它在保持时间一致性的同时最小化冗余计算。此外,我们推出了新的视频试穿数据集——dataname数据集,该数据集具有更复杂的背景、更具挑战性的动作和更高的分辨率,与现有公共数据集相比有所超越。大量实验表明,我们的方法在视频连贯性和推理速度方面超越了现有基线模型。数据和代码可通过https://github.com/VinAIResearch/swift-try获取。

论文及项目相关链接

Summary

本文旨在合成一个新视频,展示人物穿上指定服装并保持时空一致性。文章提出将视频虚拟试衣重新构想为条件性视频填充任务,以衣物作为输入条件。采用增强图像扩散模型结合时间注意力层来提高时空连贯性,并引入ShiftCaching技术减少计算冗余。此外,还介绍了新的视频试穿数据集,具有更复杂的背景、挑战性的动作和更高的分辨率。实验表明,该方法在视频一致性和推理速度方面优于当前基线。

Key Takeaways

- 本文目标是合成一个新视频,展示人物穿上特定服装,同时保持时空一致性。

- 提出将视频虚拟试衣视为条件性视频填充任务,其中衣物作为输入条件。

- 采用增强图像扩散模型,结合时间注意力层提高时空连贯性。

- 引入ShiftCaching技术,减少计算冗余,提高视频处理的效率。

- 介绍了新的视频试穿数据集,具有更复杂的背景、挑战性的动作和更高的分辨率。

- 实验结果表明,该方法在视频一致性和推理速度方面优于现有方法。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是视频虚拟试穿中的时空一致性和计算效率问题。具体来说,论文的目标是在给定一个人的视频和一件新服装的情况下,合成一个新的视频,显示这个人穿着指定的服装,同时保持时空一致性。以下是论文中提到的一些关键挑战和解决方案:

时空一致性:在视频虚拟试穿中,保持帧与帧之间的一致性是一个重大挑战,因为图像基础的虚拟试穿技术扩展到视频时往往会在帧间产生不一致性,导致视觉伪影和闪烁,影响虚拟试穿体验的真实感。

计算成本:处理长视频序列的高计算成本限制了这些方法在实际应用中的可行性。论文中提到,先前的方法通过增加多个视频块之间帧的重叠来解决这个问题,但这会导致重复处理相同帧的计算成本急剧增加,尤其是对于长视频序列。

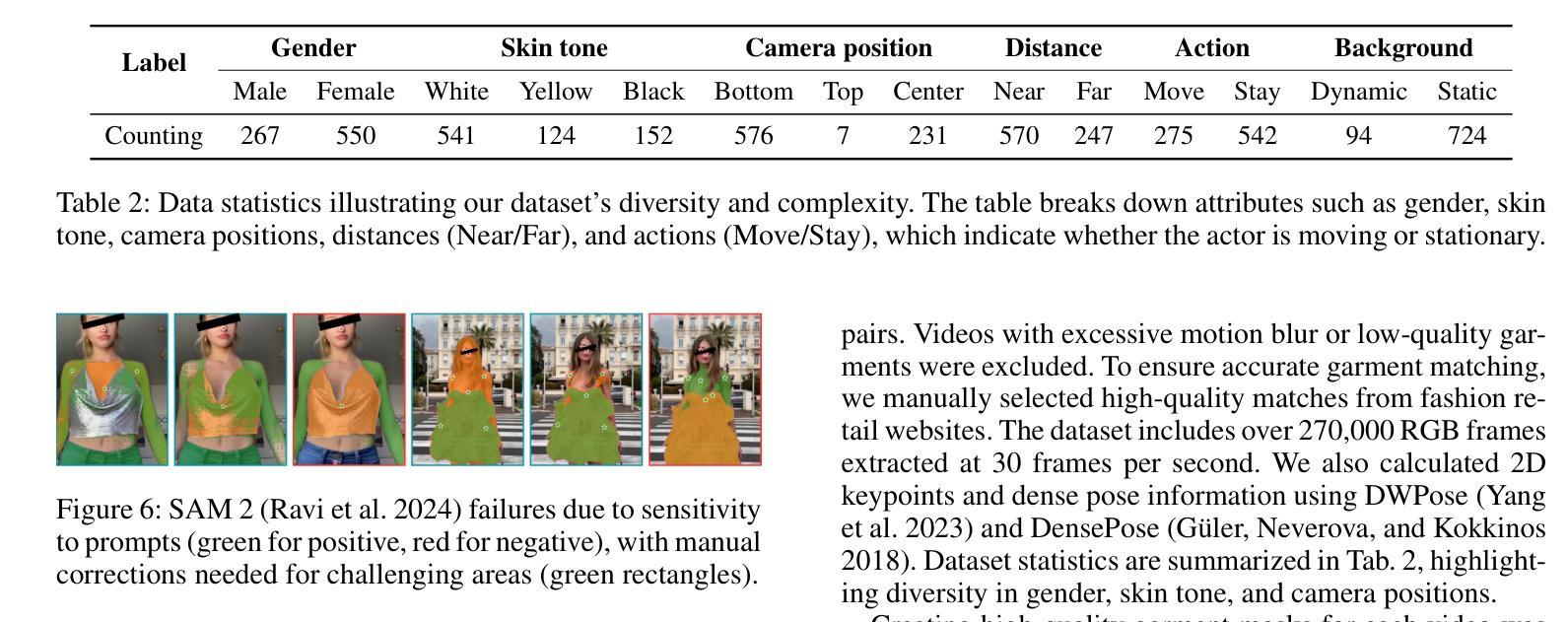

数据集缺乏:现有的公共视频试穿数据集(如VVT)覆盖的基本图案服装、紧身T恤、统一背景、静态相机角度和重复的人体运动,限制了这些数据集在实际应用中的需求,特别是在处理复杂运动和多样化背景时。

为了解决这些问题,论文提出了以下两个主要贡献:

SwiftTry框架:这是一个新颖的视频虚拟试穿框架,它通过在UNet架构中引入时间注意力层来提高时间一致性,并在推理时引入了一种称为ShiftCaching的新技术,以确保视频剪辑之间的时间连贯性和平滑过渡,同时减少与先前方法相比的冗余计算。

TikTokDress数据集:这是一个新的视频试穿数据集,包含了更复杂的背景、挑战性的运动和更高分辨率,与现有的公共数据集相比,提供了一个更坚实的基础,以推进该领域的研究。

Q: 有哪些相关研究?

A: 论文中提到了多个与视频虚拟试穿相关的研究工作,这些工作可以大致分为图像虚拟试穿和视频虚拟试穿两个领域。以下是一些关键的相关研究:

图像虚拟试穿(Image Virtual Try-On)

基于GANs的方法:

- Han et al. (2018) 提出了一种使用薄板样条(TPS)变形的方法。

- Wang et al. (2018a) 提出了一种保持特征的图像基虚拟试穿网络。

- Ge et al. (2021) 提出了一种无需解析器的虚拟试穿方法,通过提取外观流来实现。

基于流估计的方法:

- Xie et al. (2023) 提出了一种基于流估计的方法,用于服装变形。

基于扩散模型的方法:

- Zhu et al. (2023) 提出了TryOnDiffusion,一种使用两个U-Net的虚拟试穿方法。

- Kim et al. (2023) 提出了StableVITON,一种使用ControlNet风格的零交叉注意力块来调节服装的方法。

- Choi et al. (2024) 提出了IDM-VTON,一种结合低级特征和通过IP-Adapter提取的高级语义特征的方法。

视频虚拟试穿(Video Virtual Try-On)

基于光流的方法:

- Dong et al. (2019b) 提出了FW-GAN,集成了Video2Video的光流预测模块,用于变形前一帧到当前帧。

基于记忆细化的方法:

- Zhong et al. (2021) 提出了MV-TON,引入了记忆细化模块,保留并细化前一帧的特征。

基于视觉变换器的方法:

- Jiang et al. (2022) 提出了ClothFormer,使用视觉变换器在其试穿生成器中,以最小化模糊和时间伪影。

基于扩散模型的方法:

- Xu et al. (2024b) 提出了Tunnel Try-On,是第一个将扩散模型应用于视频虚拟试穿的方法,有效处理摄像机运动并保持一致性。

基于大规模数据集的方法:

- Fang et al. (2024) 提出了ViViD,发布了第一个实用的视频虚拟试穿数据集,但受限于简单背景和运动。

这些研究工作为视频虚拟试穿领域提供了多种技术和方法,但大多数方法在处理长视频序列时面临帧间不一致性和计算成本高的问题。论文提出的SwiftTry框架和TikTokDress数据集旨在解决这些问题,提高视频虚拟试穿的质量和实用性。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键技术和方法解决了视频虚拟试穿中的时空一致性和计算效率问题:

1. SwiftTry框架

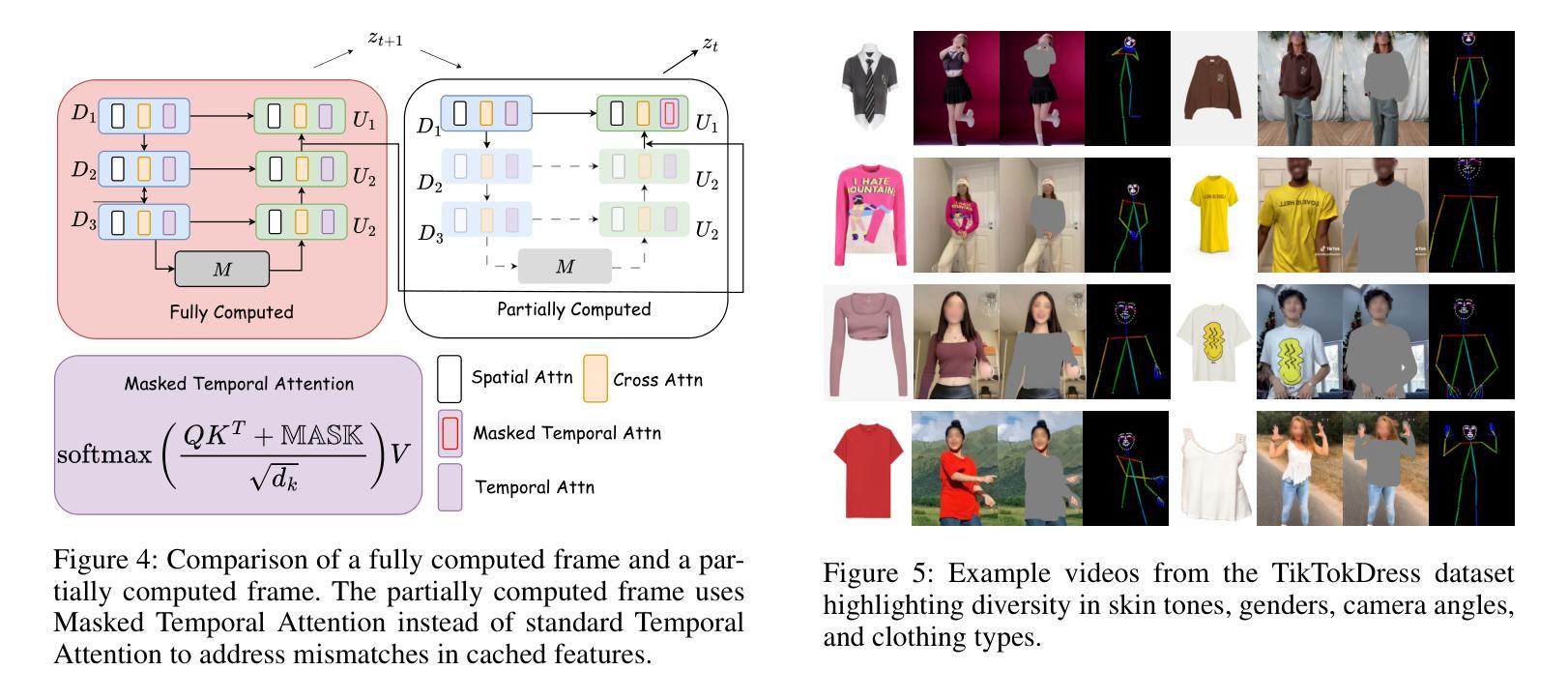

时间注意力层:SwiftTry框架在UNet架构中引入了时间注意力层,以增强模型对视频帧之间时间相关性的理解。这种设计通过将2D层转换为伪3D层,并在空间和交叉注意力层之后添加时间注意力层,使得同一视频块内不同帧的特征能够相互交互。

ShiftCaching技术:为了减少冗余计算并保持视频剪辑之间的时间连贯性,论文提出了ShiftCaching技术。这种技术通过在推理时将长视频分成非重叠的视频块,并在每个DDIM采样时间步长中通过预定义的值∆来移动这些块,避免了重复计算重叠区域。

2. TikTokDress数据集

- 多样化和复杂性:为了提供更接近实际应用的数据支持,论文引入了TikTokDress数据集。该数据集包含了复杂背景、多样化动作和不同分辨率的视频,提供了一个更加全面的测试和训练环境。

3. 训练和推理优化

两阶段训练:SwiftTry的训练分为两个阶段。第一阶段是使用VITON-HD数据集训练扩散模型,第二阶段是将时间注意力层整合到模型中,并使用视频数据集进行训练。

部分计算和缓存:在ShiftCaching中,为了进一步加速推理过程,论文采用了部分计算和缓存机制。这种方法通过缓存先前计算的特征,并在当前时间步中使用这些特征来部分计算当前潜在表示,从而减少了UNet深层块的计算量。

4. 掩码和注意力机制

- 掩码精细控制:为了处理视频帧中的特征不匹配问题,论文提出了掩码时间注意力机制。这种机制在softmax注意力计算期间使用特殊掩码,以防止不太准确的特征影响更准确的特征,同时允许从好的特徵向坏的特征传递信息。

通过这些技术和方法的结合,论文成功地提高了视频虚拟试穿的时空一致性,并显著降低了处理长视频序列的计算成本,使得视频虚拟试穿技术更适用于实际应用场景。

Q: 论文做了哪些实验?

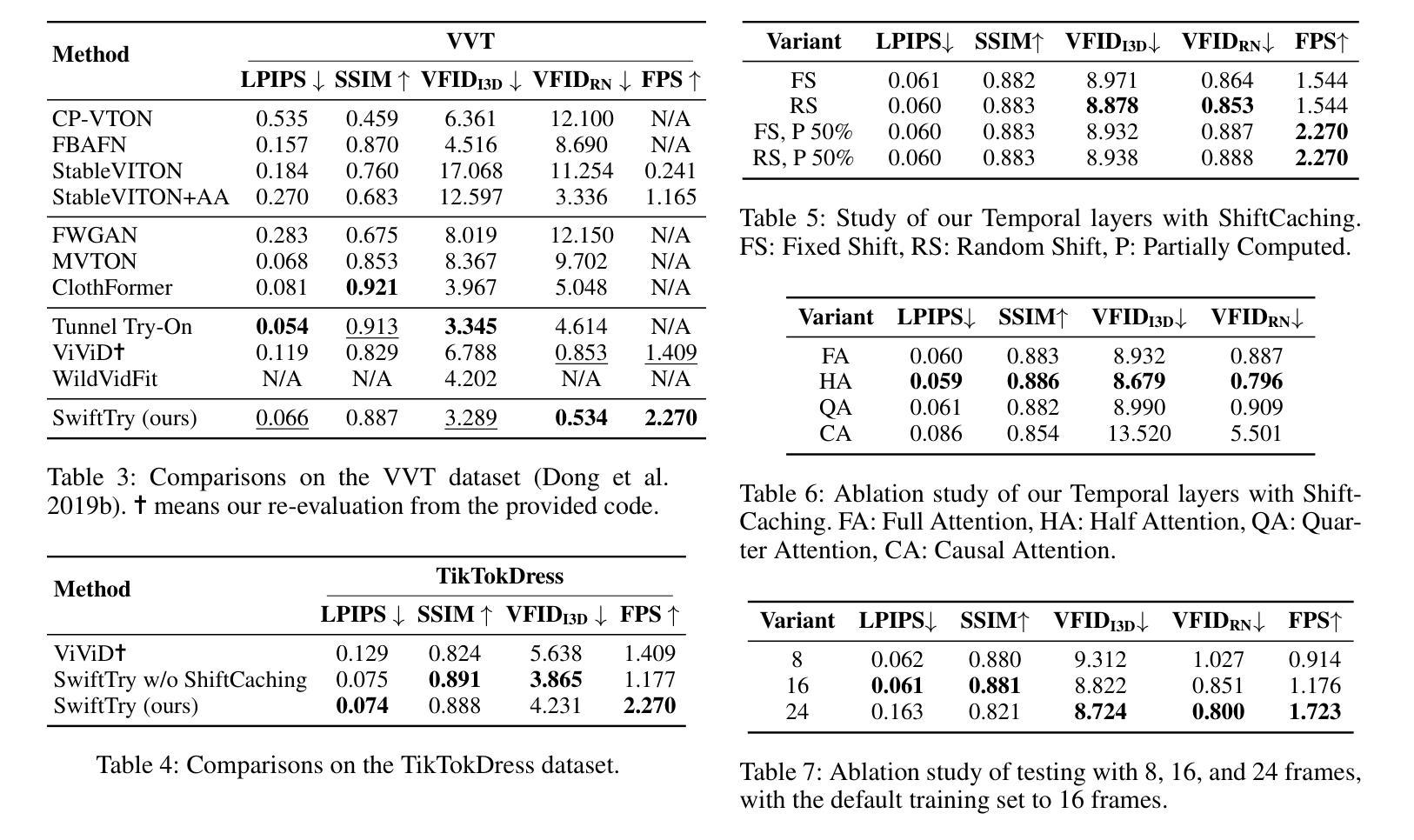

A: 论文中进行了一系列的实验来验证SwiftTry框架的性能和效率,具体实验包括:

数据集评估

VVT数据集:这是一个标准的视频虚拟试穿基准数据集,包含791对个体和服装图像的视频,用于训练和测试。论文在该数据集上评估了SwiftTry的性能。

TikTokDress数据集:这是论文新引入的数据集,包含更复杂的背景、动态动作和不同身体姿势的视频。该数据集提供了232,843帧用于训练和39,705帧用于测试。

性能指标

- 图像基础和视频基础指标:在成对和不成对的设置中,使用SSIM(结构相似性指数)和LPIPS(Learned Perceptual Image Patch Similarity)评估重建质量。使用Video Fréchet Inception Distance (VFID) 评估视觉质量和时间一致性,并测量推理速度(FPS)。

与其他方法的比较

- 与先前方法的比较:论文将SwiftTry与多种视频虚拟试穿方法进行了比较,包括基于GAN的方法(如FW-GAN、MV-TON和ClothFormer)和基于扩散模型的方法(如Tunnel Try-On、ViViD和WildVidFit)。

定量结果

VVT数据集上的比较:在VVT数据集上的比较显示,SwiftTry在VFID指标上表现优异,显示出更好的视觉质量和一致性,并且在FPS上也有显著提升。

TikTokDress数据集上的比较:在TikTokDress数据集上的评估表明,SwiftTry在处理复杂背景和动态动作时,相比其他方法能更好地保持服装纹理的一致性。

定性结果

- 与ViViD的比较:论文提供了与ViViD方法的定性比较,展示了SwiftTry在保持服装纹理和减少帧间闪烁方面的优越性。

消融研究

ShiftCaching技术的消融研究:论文探究了不同的掩码注意力机制对性能的影响,并发现Half Attention机制提供了最佳性能。

视频块长度对推理的影响:论文还研究了训练和推理视频块长度对结果的影响,发现将训练和推理视频块长度都设置为16帧时效果最佳。

这些实验全面评估了SwiftTry框架的性能,验证了其在视频虚拟试穿任务中的有效性和实用性。通过定量和定性的结果,论文展示了SwiftTry在保持时空一致性和提高推理速度方面的优势。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了SwiftTry框架和TikTokDress数据集来解决视频虚拟试穿中的挑战,但仍有一些领域可以进一步探索和改进:

1. 算法优化和模型泛化

- 模型泛化能力:探索如何提高模型对于不同种族、体型和年龄人群的泛化能力。

- 轻量化模型:研究如何优化模型结构和计算流程,以适应资源受限的环境,例如移动设备。

2. 数据集扩展和多样性

- 多语言和文化服装:扩展数据集以包含更多不同语言和文化背景下的服装,提高模型的全球适用性。

- 更复杂的背景和光照条件:增加背景和光照条件的复杂性,以更好地模拟现实世界的挑战。

3. 用户交互和体验

- 实时视频虚拟试穿:研究如何实现实时或近实时的视频虚拟试穿技术,以提升在线购物体验。

- 用户指导的试穿调整:开发允许用户在试穿过程中进行微调的工具,如调整服装大小、颜色等。

4. 计算效率和硬件加速

- 分布式计算和优化:探索使用分布式计算和专用硬件(如GPU、TPU)来加速虚拟试穿过程。

- 模型压缩和加速:研究模型压缩技术,减少模型大小和计算需求,同时保持性能。

5. 交互式应用和集成

- 增强现实(AR)集成:将视频虚拟试穿技术与AR技术结合,提供沉浸式的试穿体验。

- 电子商务平台集成:与电子商务平台合作,将虚拟试穿技术直接集成到购物流程中。

6. 伦理和隐私问题

- 数据隐私和安全性:确保在收集和使用用户数据时遵守隐私法规和伦理标准。

- 模型透明度和可解释性:提高模型的透明度和可解释性,让用户理解模型的工作原理和潜在偏差。

7. 多模态学习和跨领域应用

- 多模态数据融合:探索如何结合视觉、语音和文本等多种模态的数据来提升试穿体验。

- 跨领域技术迁移:研究如何将视频虚拟试穿技术迁移应用到其他领域,如影视制作、游戏开发等。

这些方向不仅可以推动视频虚拟试穿技术的发展,还能扩展其在更广泛领域的应用,为用户带来更加丰富和便捷的体验。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

1. 问题定义

论文的目标是解决视频虚拟试穿中的时空一致性和计算效率问题。具体来说,就是给定一个人的视频和一件服装,合成一个新的视频,显示这个人穿着指定的服装,同时保持时空一致性。

2. SwiftTry框架

- 时间注意力层:提出了一个基于扩散模型的视频虚拟试穿框架,通过在UNet架构中引入时间注意力层来增强模型对视频帧之间时间相关性的理解。

- ShiftCaching技术:为了减少冗余计算并保持视频剪辑之间的时间连贯性,提出了ShiftCaching技术,该技术通过在推理时将长视频分成非重叠的视频块,并在每个DDIM采样时间步长中通过预定义的值∆来移动这些块。

3. TikTokDress数据集

- 提出了一个新的视频虚拟试穿数据集TikTokDress,该数据集包含了更复杂的背景、挑战性的运动和更高分辨率的视频,提供了一个更全面的测试和训练环境。

4. 实验评估

- 在VVT和TikTokDress数据集上评估了SwiftTry的性能,并与其他视频虚拟试穿方法进行了比较。

- 使用了包括SSIM、LPIPS和VFID在内的多种定量和定性指标来评估重建质量和时间一致性。

- 进行了消融研究,探究了不同的掩码注意力机制和视频块长度对性能的影响。

5. 贡献总结

- 提出了ShiftCaching技术,以确保视频剪辑之间的时间连贯性,并减少冗余计算。

- 引入了TikTokDress数据集,提供了一个更接近实际应用场景的数据集,推动了视频虚拟试穿技术的发展。

6. 未来工作

- 论文还提出了一些未来可能的研究方向,包括算法优化、数据集扩展、用户交互体验改进、计算效率提升、跨领域应用等。

总的来说,这篇论文通过提出一个新的框架和数据集,有效地解决了视频虚拟试穿中的一些关键挑战,并展示了良好的性能和应用潜力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

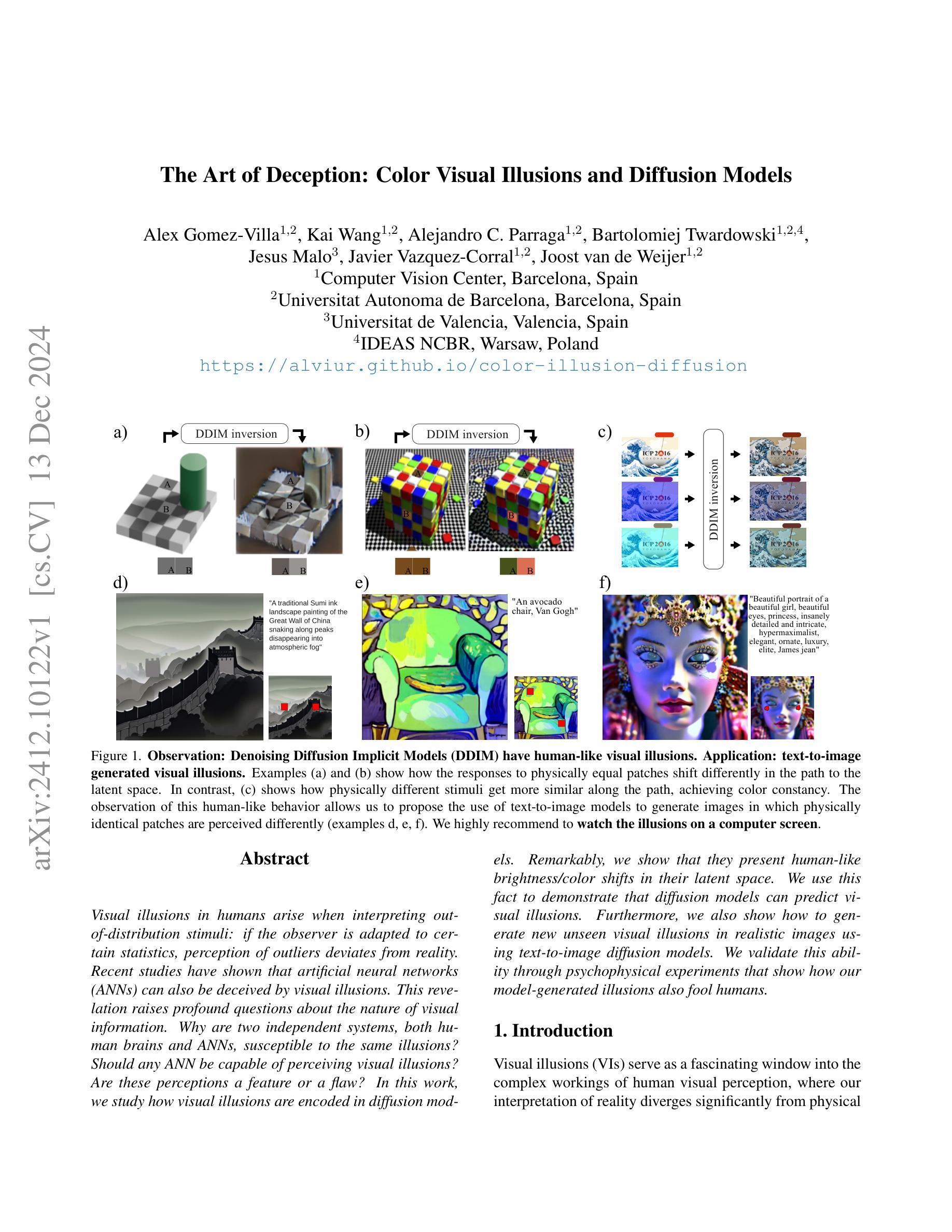

The Art of Deception: Color Visual Illusions and Diffusion Models

Authors:Alex Gomez-Villa, Kai Wang, Alejandro C. Parraga, Bartlomiej Twardowski, Jesus Malo, Javier Vazquez-Corral, Joost van de Weijer

Visual illusions in humans arise when interpreting out-of-distribution stimuli: if the observer is adapted to certain statistics, perception of outliers deviates from reality. Recent studies have shown that artificial neural networks (ANNs) can also be deceived by visual illusions. This revelation raises profound questions about the nature of visual information. Why are two independent systems, both human brains and ANNs, susceptible to the same illusions? Should any ANN be capable of perceiving visual illusions? Are these perceptions a feature or a flaw? In this work, we study how visual illusions are encoded in diffusion models. Remarkably, we show that they present human-like brightness/color shifts in their latent space. We use this fact to demonstrate that diffusion models can predict visual illusions. Furthermore, we also show how to generate new unseen visual illusions in realistic images using text-to-image diffusion models. We validate this ability through psychophysical experiments that show how our model-generated illusions also fool humans.

在人类中,视觉错觉的产生源于对异常分布刺激的解释:当观察者适应于某些统计数据时,对异常值的感知会偏离现实。最近的研究表明,人工神经网络(ANNs)也会受到视觉错觉的欺骗。这一发现引发了关于视觉信息本质的深刻问题。为什么人类大脑和人工神经网络这两个独立系统都会受到同样的错觉影响?任何人工神经网络都能感知视觉错觉吗?这些感知是特征还是缺陷?在这项工作中,我们研究了视觉错觉如何在扩散模型中编码。值得注意的是,我们展示它们在潜在空间中呈现出类似人类的亮度/色彩变化。我们利用这一事实来证明扩散模型可以预测视觉错觉。此外,我们还展示了如何使用文本到图像的扩散模型在真实图像中生成新的未见过的视觉错觉。我们通过心理物理实验验证了模型生成的错觉也能欺骗人类的能力。

论文及项目相关链接

Summary

人类和人工神经网络(ANNs)都会受到视觉错觉的影响,这引发了关于视觉信息本质的深刻问题。本研究探讨了扩散模型中如何编码视觉错觉,发现它们在人脑的亮度和颜色变化上具有类似性。利用这一点,我们证明了扩散模型可以预测视觉错觉,并通过心理物理实验验证了使用文本到图像扩散模型生成新的未见过视觉错觉在现实图像中的能力,这些生成的错觉同样可以欺骗人类。

Key Takeaways

- 人类和人工神经网络(ANNs)都会受到视觉错觉的影响。

- 扩散模型能够编码视觉错觉。

- 扩散模型在亮度和颜色变化上呈现出与人脑类似的特性。

- 扩散模型能够预测视觉错觉。

- 通过心理物理实验验证了使用文本到图像扩散模型生成新的未见过视觉错觉的能力。

- 生成的视觉错觉能够欺骗人类。

- 这种现象揭示了视觉信息处理的共同机制在人工智能和人类之间的相似性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文探讨了视觉错觉(Visual Illusions, VIs)在人类视觉感知和人工神经网络(Artificial Neural Networks, ANNs)中的出现,并研究了这些错觉如何在扩散模型(Diffusion Models, DMs)中被编码。具体来说,论文试图解决以下问题:

人类和ANNs对视觉错觉的相似性:论文试图解答为什么两个独立的系统——人脑和ANNs——会对相同的视觉错觉敏感。

ANNs感知视觉错觉的必要性:探讨是否所有的ANNs都应该能够感知视觉错觉。

视觉错觉的特征与缺陷:分析这些错觉的感知是ANNs的一个特征还是缺陷。

扩散模型中视觉错觉的编码:研究扩散模型如何在其潜在空间中编码视觉错觉,并展示这些模型展现出类人亮度/颜色偏移的现象。

利用扩散模型预测视觉错觉:基于扩散模型中的人类感知现象,提出使用扩散模型预测视觉错觉的方法。

生成新的未见视觉错觉:展示如何使用文本到图像的扩散模型在真实图像中生成新的、未见的视觉错觉,并通过心理物理实验验证这些模型生成的错觉也能欺骗人类观察者。

综上所述,这篇论文试图深入理解视觉错觉在人类和机器视觉系统中的作用,并探索扩散模型在模拟和生成视觉错觉方面的潜力。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以分为以下几个类别:

1. 视觉错觉在人工神经网络中的研究

- 早期工作:展示了多层感知器可以复制亮度错觉[8]。

- 后续研究:Gomez-Villa等人[12]表明卷积神经网络(CNNs)可以镜像人类在亮度和颜色错觉中的感知。

- 其他相关研究:包括在图像补全[19, 47]、亮度/颜色感知[13, 17, 24, 31, 32, 48]、对比度敏感性[1, 30]、形状感知[35, 54]和视觉-语言模型[6, 36, 44, 55]等领域的研究。

2. 视觉错觉的复制方法

- 图像恢复方法:使用预训练的图像恢复模型处理视觉错觉,并测量输出图像以测量感知[12, 13, 24, 30, 32]。

- 效应偏差方法:受神经科学刺激测量的启发,使用预训练的架构处理视觉错觉,然后使用ANN的内部激活来定义是否存在视觉错觉[1]。

- 似然方法:使用可逆流在自然图像上训练,估计图像中每个像素最可能的感知强度[17]。

- 语言引导方法:使用语言作为测量感知的工具,这些工作使用视觉-语言模型作为测试对象,并询问有关图像感知的问题[36, 55]。

3. 视觉错觉的生成方法

- 使用生成模型合成视觉错觉:尽管已有研究使用生成模型合成视觉错觉[14],但扩散模型最近才被提出作为生成引擎。

- 相关工作:包括通过混合图像和变换生成高级幻觉效应[6],以及创建更一般的幻觉,如旋转、颜色反转和混合图像[10, 11]。

- 与本文工作最相似的研究:Roy等人[43]使用稳定扩散(SD)通过关键词提示生成亮度视觉错觉,但他们的方法没有明确优化感知效果,也没有指定用于感知复制的区域。

这些相关研究为本文提供了理论和技术背景,同时也展示了在视觉错觉领域内的不同研究方向和方法。论文通过这些相关工作,进一步探索了扩散模型在模拟和生成视觉错觉方面的潜力,并提出了新的方法和见解。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决上述问题:

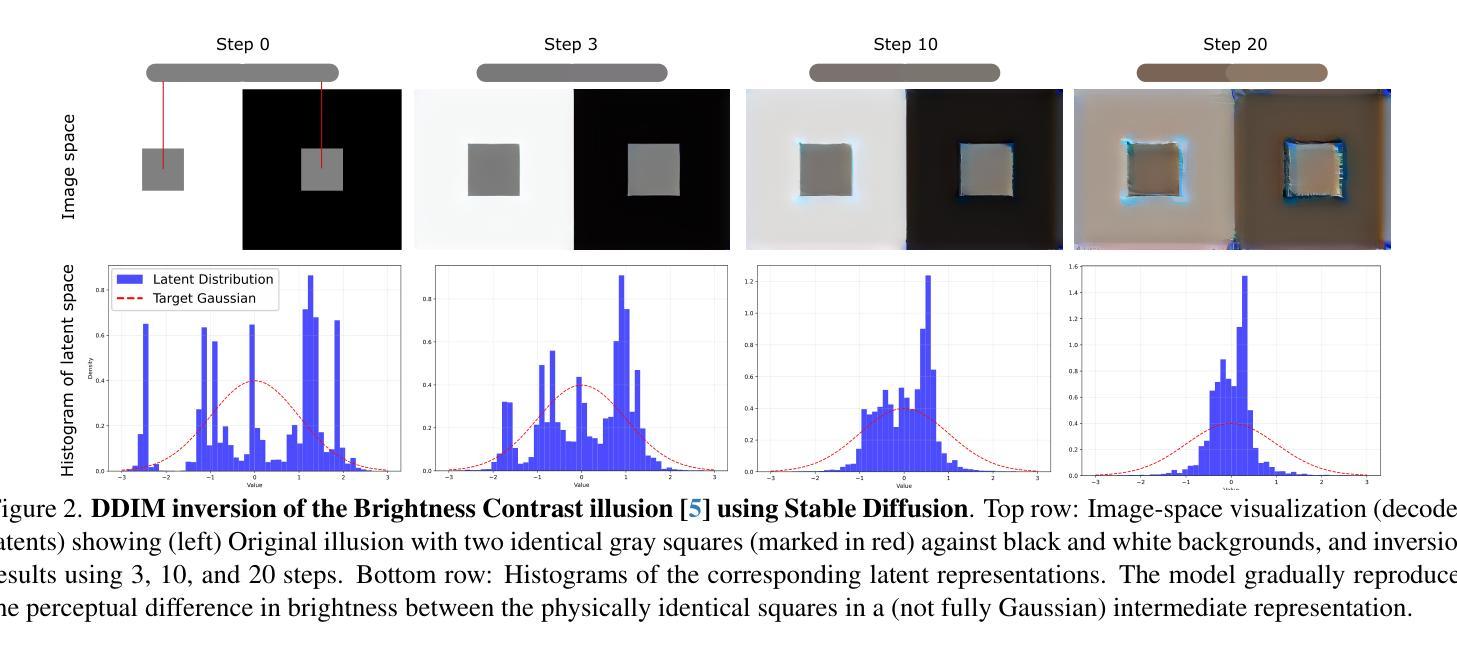

1. 分析扩散模型中的人类感知现象

- 论文首先报告了一个关键发现:在扩散模型的编码过程中,中间步骤显示出与人类感知显著一致的趋势。具体来说,当分析图像通过扩散过程反转时的轨迹,发现亮度和颜色属性的逐步变化与人类感知反应非常相似。

2. 提出基于扩散模型的视觉模型方法

- 论文提出了一种新方法,使用深度自编码器作为视觉模型,通过执行扩散反转过程,并在中间噪声空间测量感知。

3. 验证扩散模型在多种情况下复制人类感知的能力

- 通过在多个视觉错觉数据集、流行的已发布视觉错觉作品和自然图像上进行实验,展示了扩散模型在许多情况下复制人类感知的能力。

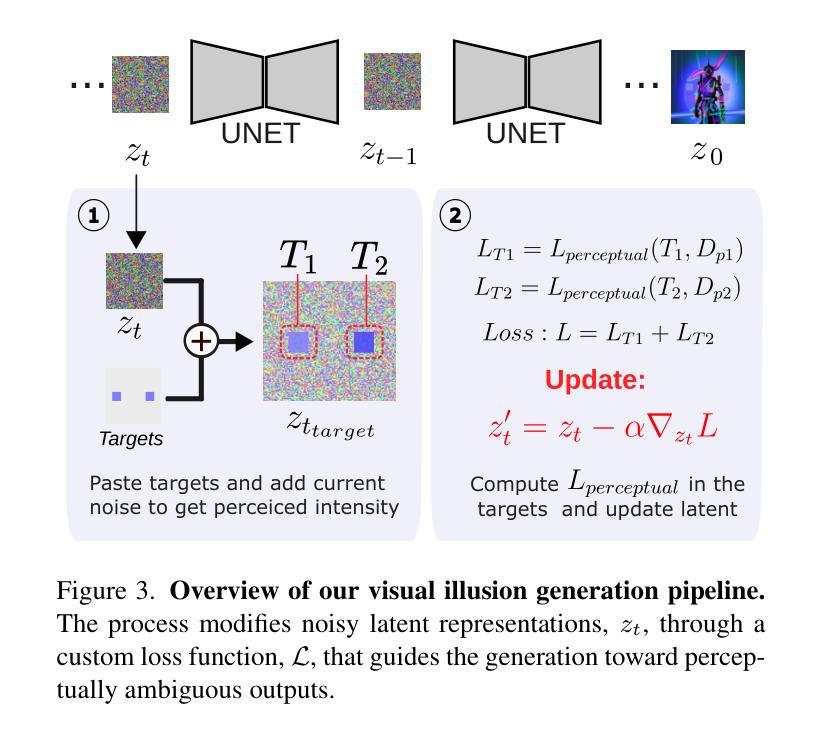

4. 提出使用文本到图像模型生成视觉错觉的新方法

- 利用扩散模型的感知能力,论文提出了一种使用文本到图像模型生成亮度/颜色视觉错觉的新方法。

5. 实施视觉错觉生成流程

- 论文概述了一个视觉错觉生成流程,该流程通过修改噪声潜在表示,使用自定义损失函数引导生成过程朝向感知上模糊的输出。

6. 进行心理物理实验验证

- 通过心理物理实验验证模型生成的错觉也能欺骗人类观察者,从而支持论文提出的方法。

7. 提供定量和定性评估

- 使用定量指标(如感知准确度得分)和定性结果(如图像示例和视觉比较)来评估模型在复制和生成视觉错觉方面的表现。

通过这些步骤,论文不仅展示了扩散模型在复制人类对视觉错觉的感知方面的潜力,而且还提出了一种新的方法来生成能够欺骗人类感知的新的视觉错觉,这为理解和模拟人类视觉感知提供了新的视角。

Q: 论文做了哪些实验?

A: 论文中进行了两组主要的实验来评估所提出方法的能力:

1. 复制视觉错觉的实验

- 目的:测试模型复制亮度和颜色视觉错觉的能力。

- 数据集:使用了BRI3L数据集(包含22366张灰度图像,涵盖五种亮度错觉类型)和视觉错觉VQA数据集(IllusionVQA、GVIL和HallusionBench)。

- 方法:通过比较输入和输出图像在标注的分割掩模内的强度差异来评估模型的性能。

- 评估指标:

- 对于BRI3L数据集,计算模型输出与输入图像在每个分割区域内的平均强度差异($\Delta I$)。

- 对于VQA数据集,创建分割掩模并考虑模型的答案是否与人类感知的预期强度相匹配,计算感知准确度得分(PAS)。

2. 生成视觉错觉的实验

- 目的:检查是否能够在T2I模型分布内的图像中生成视觉错觉。

- 方法:

- 使用DeepFloyd模型的S1阶段生成视觉错觉,然后在S2阶段将其扩展以生成更高分辨率的版本。

- 定义了特定的目标区域,并在这些区域内施加感知效果,同时满足文本提示和感知条件。

- 心理物理确认:

- 创建了40张强制模型产生特定颜色目标的错觉图像和40张对照图像(没有强制产生错觉)。

- 15名观察者参与实验,判断两个目标是否相同或不同。

- 分析结果表明,在模型强制产生错觉的图像中,观察者在64%(平均)和67%(中位数)的情况下认为目标不同,而在对照图像中这一比例为13%(平均)和7%(中位数)。

这些实验不仅展示了模型在复制和生成视觉错觉方面的能力,而且通过心理物理实验验证了生成的错觉能够欺骗人类观察者的感知,从而支持了论文提出的方法的有效性。

Q: 有什么可以进一步探索的点?

A: 论文提出了一些有趣的发现和方法,但仍有一些领域可以进一步探索和研究:

1. 扩散模型的感知机制

- 研究扩散模型如何处理不同类型的视觉错觉:虽然论文主要关注亮度和颜色视觉错觉,但扩散模型可能对其他类型的错觉(如几何、运动错觉)也有反应,值得进一步研究。

2. 模型的泛化能力

- 提高模型对小区域效应的复制能力:由于扩散模型的图像反转过程中空间信息的丢失,模型难以复制基于小区域的视觉效应。改进模型以更好地保留这些细节可能提高复制效果。

3. 生成更自然的错觉

- 基于注意力图的感知区域定义:目前的T2I视觉错觉生成方法在推理时基于预定义区域。利用输入提示产生的注意力图来指导感知区域的定义,可能产生更自然的错觉。

4. 心理物理学实验的扩展

- 增加参与者和错觉类型:扩展心理物理学实验,包括更多的参与者和更多的错觉类型,以进一步验证模型生成的错觉对人类观察者的影响。

5. 模型的解释性和可视化

- 扩散过程的可视化和解释:虽然论文展示了扩散模型能够复制人类感知,但进一步研究和可视化扩散过程中的每一步,可能揭示模型内部的工作原理和感知机制。

6. 模型优化和调整

- 优化感知损失权重(γ):通过实验确定感知损失权重(γ)的最佳值,以更有效地生成视觉错觉。

7. 跨领域应用

- 将视觉错觉研究应用于其他领域:视觉错觉的研究可能对虚拟现实、增强现实、艺术创作等领域产生影响,探索这些跨领域应用是一个有趣的方向。

8. 模型的鲁棒性和可靠性

- 评估模型在不同条件下的鲁棒性:在不同的光照、背景和噪声条件下测试模型的鲁棒性,以确保其在各种环境条件下都能可靠地复制和生成视觉错觉。

这些进一步探索的点可以帮助我们更深入地理解扩散模型如何处理视觉信息,以及如何利用这些模型来模拟和操纵人类视觉感知。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容集中在探讨视觉错觉在人类视觉感知和人工神经网络(ANNs)中的表现,并特别研究了扩散模型(DMs)如何编码这些视觉错觉。以下是论文的核心内容总结:

1. 引言和背景

- 论文首先介绍了视觉错觉(VIs)对理解人类视觉感知的重要性,并讨论了扩散模型(DMs)在图像合成和处理中的最新进展。作者提出了关于人类大脑和ANNs对视觉错觉的相似反应的深刻问题。

2. 相关工作

- 论文回顾了先前在ANNs中复制视觉错觉的研究,并分类讨论了不同的复制方法,包括图像恢复方法、效应偏差方法、似然方法和语言引导方法。

3. 方法

- 扩散模型:介绍了扩散模型(DMs)的基本框架,特别是Denoising Diffusion Implicit Models(DDIM)及其在图像反转过程中的应用。

- DDIM反转可能复制人类视觉:提出了一个假设,即扩散模型在处理自然图像分布之外的刺激时,可能会展现出与人类感知类似的偏差。

- 使用DMs生成视觉错觉:基于上述发现,开发了一种自动生成亮度/颜色视觉错觉的方法,通过评估和推动扩散过程中的感知效果。

4. 实验设置

- 数据集:使用了多个视觉错觉数据集,包括BRI3L、IllusionVQA、GVIL和HallusionBench。

- 基准测试:与经典视觉科学模型和基于神经网络的模型进行比较。

- 评估指标:提出了定量评估模型复制和生成视觉错觉能力的方法。

5. 实验结果

- 复制视觉错觉:展示了模型在复制多种视觉错觉方面的能力,并与基线方法进行了比较。

- 生成视觉错觉:通过心理物理实验验证了模型生成的视觉错觉能够欺骗人类观察者。

6. 限制

- 论文讨论了在复制和生成视觉错觉方面的局限性,包括对小区域效应的处理困难和对预定义区域的依赖。

7. 结论

- 论文总结了两个关键贡献:扩散模型通过图像反转过程自然复制人类对亮度和颜色视觉错觉的响应,以及开发了一种使用文本到图像扩散模型生成视觉错觉的新方法。作者认为这些发现可能有助于开发更符合人类视觉认知的感知意识基础模型。

这篇论文通过实证研究展示了扩散模型在模拟人类视觉感知方面的潜力,并提出了一种新的生成视觉错觉的方法,这可能对未来视觉-语言模型的发展和图像编辑工作流程产生重要影响。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

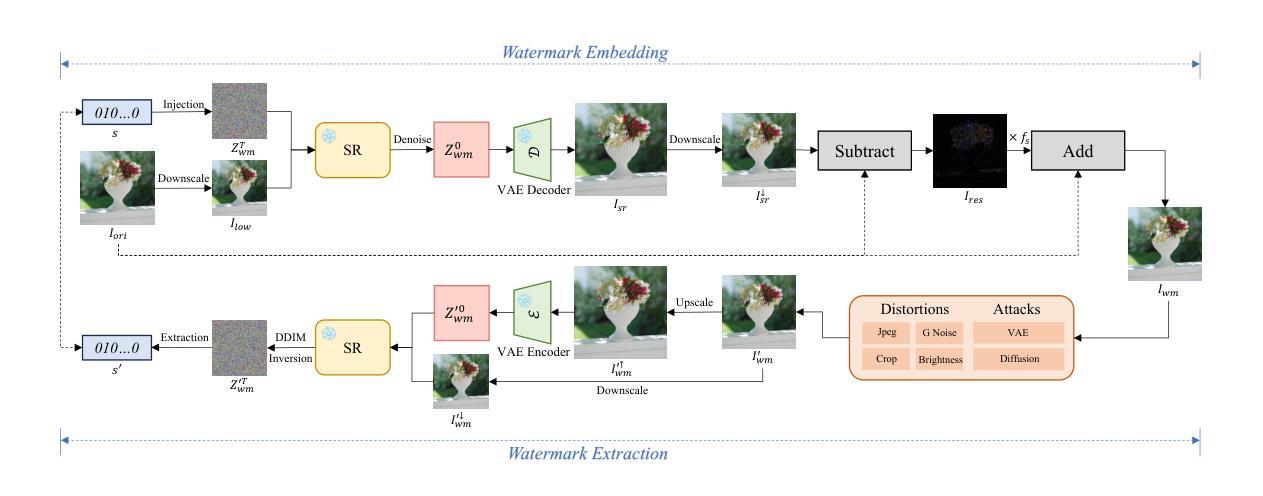

SuperMark: Robust and Training-free Image Watermarking via Diffusion-based Super-Resolution

Authors:Runyi Hu, Jie Zhang, Yiming Li, Jiwei Li, Qing Guo, Han Qiu, Tianwei Zhang

In today’s digital landscape, the blending of AI-generated and authentic content has underscored the need for copyright protection and content authentication. Watermarking has become a vital tool to address these challenges, safeguarding both generated and real content. Effective watermarking methods must withstand various distortions and attacks. Current deep watermarking techniques often use an encoder-noise layer-decoder architecture and include distortions to enhance robustness. However, they struggle to balance robustness and fidelity and remain vulnerable to adaptive attacks, despite extensive training. To overcome these limitations, we propose SuperMark, a robust, training-free watermarking framework. Inspired by the parallels between watermark embedding/extraction in watermarking and the denoising/noising processes in diffusion models, SuperMark embeds the watermark into initial Gaussian noise using existing techniques. It then applies pre-trained Super-Resolution (SR) models to denoise the watermarked noise, producing the final watermarked image. For extraction, the process is reversed: the watermarked image is inverted back to the initial watermarked noise via DDIM Inversion, from which the embedded watermark is extracted. This flexible framework supports various noise injection methods and diffusion-based SR models, enabling enhanced customization. The robustness of the DDIM Inversion process against perturbations allows SuperMark to achieve strong resilience to distortions while maintaining high fidelity. Experiments demonstrate that SuperMark achieves fidelity comparable to existing methods while significantly improving robustness. Under standard distortions, it achieves an average watermark extraction accuracy of 99.46%, and 89.29% under adaptive attacks. Moreover, SuperMark shows strong transferability across datasets, SR models, embedding methods, and resolutions.

在今天的数字时代,人工智能生成的内容和真实内容的融合强调了版权保护和内容认证的需求。水印已成为应对这些挑战的重要工具,保护生成的内容和真实内容。有效的水印方法必须能够承受各种失真和攻击。目前深度水印技术通常采用编码器-噪声层-解码器架构,并通过引入失真来提高稳健性。然而,它们难以在稳健性和保真度之间取得平衡,尽管经过大量训练,但仍容易受到适应性攻击的影响。为了克服这些限制,我们提出了SuperMark,一个稳健、无需训练的水印框架。SuperMark受到水印中水印嵌入/提取与扩散模型中的去噪/噪声处理过程之间的平行的启发,使用现有技术将水印嵌入初始高斯噪声中。然后,它应用预训练的超级分辨率(SR)模型对带水印的噪声进行去噪,生成最终的带水印图像。对于提取过程,则反之:带水印的图像通过DDIM反演返回初始带水印的噪声,从中提取嵌入的水印。这个灵活框架支持各种噪声注入方法和基于扩散的SR模型,实现了增强的自定义性。DDIM反演过程的鲁棒性允许SuperMark在保持高保真度的同时,实现对失真的强韧性。实验表明,SuperMark在保持与现有方法相当的保真度的同时,显著提高了稳健性。在标准失真下,它实现了平均99.46%的水印提取精度,在自适应攻击下为89.29%。此外,SuperMark在数据集、SR模型、嵌入方法和分辨率之间表现出强大的可转移性。

论文及项目相关链接

PDF robust image watermarking

Summary

在水印技术中,超级水印(SuperMark)作为一种无需训练的稳健框架,能够在数字时代的AI生成和真实内容融合中提供版权保护和内容认证。它利用扩散模型中的去噪/噪声处理与水印嵌入/提取的相似性,通过将水印嵌入初始高斯噪声并利用现有技术结合预训练的超级分辨率(SR)模型实现水印的最终输出和提取过程。这一方法具有高鲁棒性和灵活性,支持多种噪声注入方法和基于扩散的SR模型,实验证明其能够在保持高保真度的同时实现强大的抗失真效果,并具有在各种数据集上的优秀转移性能。同时抵御传统与自适应攻击的鲁棒性验证准确率相当优秀。简言之,这一创新框架提升了水印技术的稳健性和效率。

Key Takeaways

- AI生成内容和真实内容的融合加剧了版权保护和内容认证的需求。水印技术已成为应对此挑战的关键工具。

- 当前深度水印技术面临的挑战包括如何在维持稳健性的同时确保高保真度以及对抗自适应攻击的能力不足。

- SuperMark作为一种无需训练的稳健水印框架被提出,它通过结合扩散模型和预训练的超级分辨率模型来嵌入和提取水印。它通过在噪声中加入水印并结合去噪技术产生最终的带有水印的图像,过程灵活多变且支持多种方法。

点击展开 Cool Papers 详细信息

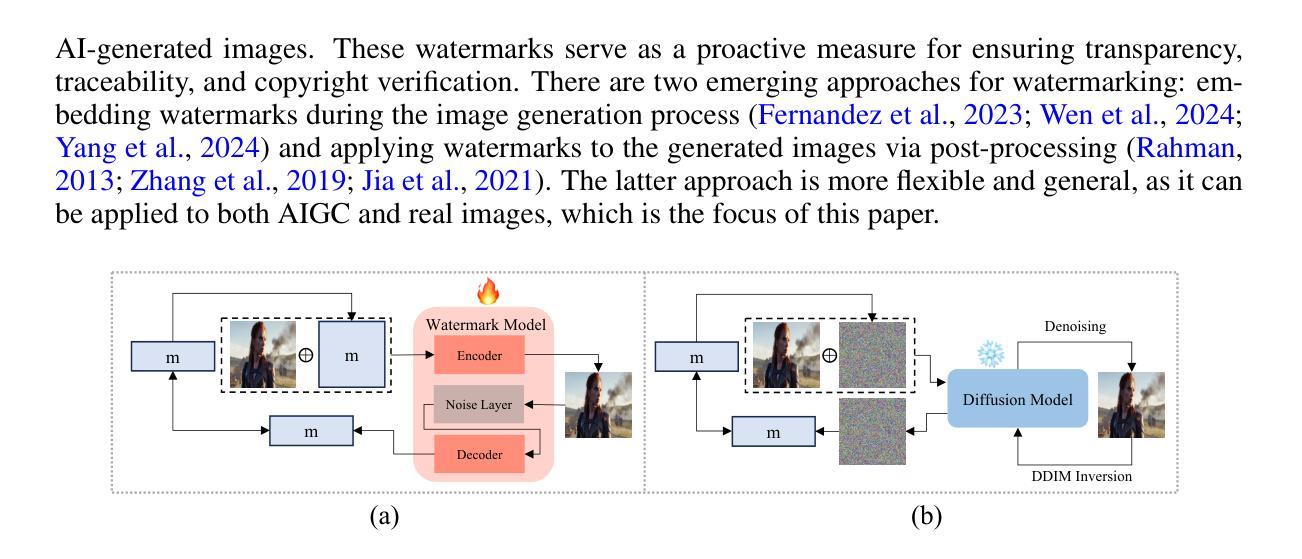

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何在数字时代背景下,对由人工智能生成(AI-generated)和真实内容进行有效的版权保护和内容认证。具体来说,论文关注于图像水印技术,这是一种能够保护生成和真实图像内容的关键技术。论文指出,现有的基于深度学习的水印技术通常采用编码器-噪声层-解码器架构,并在训练过程中引入各种失真以增强鲁棒性,但这些方法往往难以平衡鲁棒性和保真度,并且在适应性攻击面前仍然脆弱,尽管进行了广泛的训练。

为了克服这些限制,论文提出了一个名为SuperMark的新颖鲁棒且无需训练的水印框架。SuperMark从水印模型中的水印嵌入/提取过程与扩散模型中的去噪/加噪过程之间的相似性中获得灵感,利用预训练的超分辨率(SR)模型来去噪加水印的噪声,生成最终的水印图像。对于提取过程,通过DDIM反演将加水印的图像转换回初始加水印的噪声,然后从中提取嵌入的水印。这种方法具有固有的对各种扰动的鲁棒性,同时保持高保真度。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要包括以下几个方面:

AI生成内容(AIGC)的水印技术:

- Tree-Ring(Wen et al., 2024)和Gaussian Shading(Yang et al., 2024)是两种针对基于扩散的文本到图像(T2I)模型的水印技术,它们通过在高斯噪声中嵌入水印并通过DDIM反演提取水印。

后处理水印方法:

- 传统的后处理方法如DwtDct(Rahman, 2013)和DwtDctSvd(Rahman, 2013)在变换域中嵌入水印信息,提供有限的鲁棒性。

- 基于深度学习的后处理水印方法,如MBRS(Jia et al., 2021)、StegaStamp(Tancik et al., 2020)、PIMoG(Fang et al., 2022)、SepMark(Wu et al., 2023)和Robust-Wide(Hu et al., 2024),它们采用编码器-噪声层-解码器框架,并引入定制的噪声层以增强特定类型的鲁棒性。

扩散模型(Diffusion Models, DMs):

- Denoising Diffusion Probabilistic Models(DDPMs, Ho et al., 2020)是扩散模型的一种广泛使用的实现,需要数千次去噪步骤来生成高质量的样本。

- Denoising Diffusion Implicit Models(DDIMs, Song et al., 2021)通过引入确定性采样过程来加速采样过程,同时保持生成数据的质量。

基于潜在扩散的图像超分辨率(SR)模型:

- Latent Diffusion Models(LDMs, Rombach et al., 2022)设计用于在压缩的、低维的潜在空间中操作,通过变分自编码器(VAE)显著降低计算成本。

对抗性攻击:

- 论文还提到了基于VAE和扩散模型的适应性攻击,如Bmshj18(Ballé et al., 2018)、Cheng20(Cheng et al., 2020)、Zhao23(Zhao et al., 2023)和InstructPix2Pix(Brooks et al., 2023)。

这些相关研究构成了SuperMark方法的理论和技术支持,同时也突显了现有技术的局限性,SuperMark旨在通过其新颖的框架来克服这些挑战。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为SuperMark的新颖鲁棒且无需训练的图像水印框架来解决现有深度水印技术中存在的问题。SuperMark框架的核心思想和解决方案如下:

利用扩散模型的鲁棒性:

- 论文发现扩散模型(特别是DDIM反演过程)具有固有的对各种扰动的鲁棒性。SuperMark利用这一特性,通过DDIM反演来实现水印的鲁棒提取。

无需训练的框架:

- 与传统的基于深度学习的水印方法不同,SuperMark不需要训练编码器和解码器。相反,它使用预训练的扩散模型(特别是超分辨率模型)来执行水印的嵌入和提取,从而避免了训练过程中鲁棒性和保真度之间的权衡问题。

水印嵌入和提取的可逆性:

- SuperMark将水印信息嵌入到初始高斯噪声中,然后使用预训练的超分辨率模型对加水印的噪声进行去噪,生成最终的水印图像。对于提取过程,SuperMark通过DDIM反演将加水印的图像转换回初始加水印的噪声,并从中提取水印。

灵活性和可定制性:

- SuperMark支持各种噪声注入方法和基于扩散的超分辨率模型,允许根据需要定制性能。这种灵活性使得SuperMark可以根据不同的应用场景和需求进行调整。

高保真度:

- 通过将加水印的噪声和原始图像输入到预训练的扩散模型中,SuperMark能够生成与原始图像视觉一致的水印图像,从而保持高保真度。

跨数据集、模型和分辨率的强迁移性:

- 论文通过广泛的实验验证了SuperMark在不同数据集、超分辨率模型、水印嵌入方法和图像分辨率下的有效性,展示了其出色的迁移能力。

综上所述,SuperMark通过创新地结合扩散模型的鲁棒性和预训练的超分辨率模型,提出了一种无需训练、鲁棒且保真的图像水印框架,有效地解决了现有深度水印技术中鲁棒性和保真度之间的权衡问题。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了一系列实验来评估SuperMark框架的性能,包括:

数据集测试:

- 使用MS-COCO数据集作为默认数据集,并从InstructPix2Pix官方数据集中提取配对指令-图像数据进行鲁棒性测试。

- 还在DiffusionDB、WikiArt、CLIC和MetFACE等其他数据集上进行了测试,以进一步验证SuperMark的有效性。

实现细节:

- 使用SD-Upscaler作为默认的超分辨率(SR)模型,并为采样和反演应用了特定的配置。

- 对于水印注入,配置了高斯遮蔽(Gaussian Shading)方法,并设置了特定的参数以嵌入32位水印。

正常失真和适应性攻击的鲁棒性测试:

- 考虑了包括JPEG压缩、随机裁剪、高斯模糊、高斯噪声和亮度调整在内的正常失真。

- 检查了包括基于VAE的方法(如Bmshj18和Cheng20)和基于扩散的攻击(如Zhao23和InstructPix2Pix)在内的适应性攻击。

评估指标:

- 使用峰值信噪比(PSNR)和结构相似性指数(SSIM)来评估水印图像的保真度。

- 使用比特准确度(Bit Accuracy)来衡量水印提取的鲁棒性和准确性。

与基线方法的比较:

- 将SuperMark与九种开源基线方法进行了比较,包括DwtDct、DwtDctSvd、RivaGAN、StegaStamp、MBRS、CIN、PIMoG、SepMark和RoSteALS。

迁移性测试:

- 在不同的数据集上测试SuperMark的通用性。

- 使用不同的超分辨率模型(如LDM-SR)来展示SuperMark的多样性。

- 采用Tree-Ring的水印注入方法进一步评估SuperMark的迁移性。

不同分辨率的测试:

- 在不同分辨率的图像上嵌入和提取水印,以评估SuperMark在不同分辨率下的性能。

消融研究:

- 研究了低分辨率图像大小(Slow)和强度因子(fs)对水印图像保真度和提取比特准确度的影响。

- 评估了推理和反演步骤对SuperMark性能的影响。

- 探讨了嵌入不同长度的水印比特对保真度和鲁棒性的影响。

这些实验全面评估了SuperMark在各种条件下的性能,包括其对正常失真和适应性攻击的鲁棒性、不同数据集和超分辨率模型的迁移性、以及不同参数设置下的性能变化。通过这些实验,作者证明了SuperMark在保持高保真度的同时,相比现有方法具有更强的鲁棒性。

Q: 有什么可以进一步探索的点?

A: 论文提出了SuperMark这一新颖的水印框架,并展示了其在多个方面的有效性和灵活性。以下是一些可以进一步探索的点:

改进水印注入技术:

- 研究和开发新的或改进的水印注入技术,以提高SuperMark的鲁棒性,尤其是对抗更复杂的攻击和失真。

优化超分辨率模型:

- 利用更先进的超分辨率模型来提高SuperMark的保真度和鲁棒性,尤其是对于复杂和详细的图像内容。

减少推理开销:

- 探索更高效的采样方法、模型压缩和加速技术,以减少SuperMark在实际应用中的推理开销。

提高反演精度:

- 研究更精确的反演技术,以减少重构误差并提高水印提取的准确性。

跨模态水印应用:

- 探索SuperMark在视频、音频或其他类型的多媒体内容上的应用,以及如何适应这些不同模态的特点。

安全性增强:

- 研究如何增强SuperMark的安全性,例如通过加密技术保护水印信息,防止潜在的攻击者篡改或移除水印。

实时性能优化:

- 针对实时应用场景,优化SuperMark的算法和计算流程,使其能够在保持高鲁棒性的同时实现实时处理。

更广泛的攻击和失真测试:

- 对SuperMark进行更广泛的攻击和失真测试,包括物理攻击和更复杂的数字攻击,以全面评估其鲁棒性。

用户自定义和交互:

- 开发用户友好的接口和工具,允许用户根据具体需求自定义水印参数和行为,如透明度、鲁棒性级别等。

跨平台和设备兼容性:

- 研究如何使SuperMark兼容不同的操作系统和硬件平台,包括移动设备和嵌入式系统。

水印的可逆性和撤销性:

- 探索水印的可逆性,即在需要时能够完全撤销水印,同时不损害原始内容。

水印的法律和伦理问题:

- 研究与水印技术相关的法律和伦理问题,确保SuperMark的应用符合相关法律法规和道德标准。

这些探索点不仅可以推动SuperMark技术的发展,还可能为数字版权保护和内容认证领域带来新的研究方向和解决方案。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为SuperMark的鲁棒且无需训练的图像水印框架,旨在解决数字时代背景下版权保护和内容认证的挑战。以下是论文的主要内容总结:

问题背景:

- 随着AI生成内容的增加,区分真实与生成内容变得困难,需要有效的水印技术来保护和验证这些内容。

现有技术的局限性:

- 当前深度水印技术难以平衡鲁棒性和保真度,并且容易受到适应性攻击的影响。

SuperMark框架:

- 提出了SuperMark,一个新颖的水印框架,利用扩散模型的鲁棒性和预训练的超分辨率(SR)模型来实现水印的嵌入和提取。

方法论:

- SuperMark框架包括水印嵌入和提取两个阶段,无需额外训练,利用DDIM反演实现鲁棒的水印提取。

实验结果:

- 通过广泛的实验,SuperMark在不同数据集和攻击下展示了优越的鲁棒性和高保真度。

贡献:

- 论文指出了现有深度水印技术的局限性,并提出了一个简单有效的基于扩散模型的水印框架。

- SuperMark展示了对正常失真和适应性攻击的强鲁棒性,同时保持高保真度。

迁移性:

- SuperMark展示了在不同数据集、SR模型、水印注入方法和图像分辨率下的强迁移性。

未来工作:

- 提出了未来可能的研究方向,包括改进水印注入技术、优化超分辨率模型、减少推理开销等。

总体而言,SuperMark通过其创新的框架和方法,在图像水印领域提供了一个有效的解决方案,以应对AI生成内容带来的挑战。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Cycle-Consistent Bridge Diffusion Model for Accelerated MRI Reconstruction

Authors:Tao Song, Yicheng Wu, Minhao Hu, Xiangde Luo, Guoting Luo, Guotai Wang, Yi Guo, Feng Xu, Shaoting Zhang

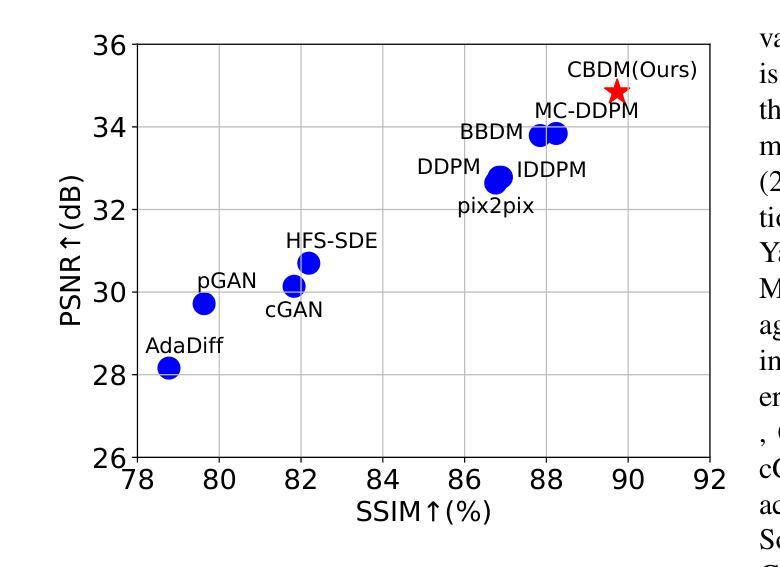

Accelerated MRI reconstruction techniques aim to reduce examination time while maintaining high image fidelity, which is highly desirable in clinical settings for improving patient comfort and hospital efficiency. Existing deep learning methods typically reconstruct images from under-sampled data with traditional reconstruction approaches, but they still struggle to provide high-fidelity results. Diffusion models show great potential to improve fidelity of generated images in recent years. However, their inference process starting with a random Gaussian noise introduces instability into the results and usually requires thousands of sampling steps, resulting in sub-optimal reconstruction quality and low efficiency. To address these challenges, we propose Cycle-Consistent Bridge Diffusion Model (CBDM). CBDM employs two bridge diffusion models to construct a cycle-consistent diffusion process with a consistency loss, enhancing the fine-grained details of reconstructed images and reducing the number of diffusion steps. Moreover, CBDM incorporates a Contourlet Decomposition Embedding Module (CDEM) which captures multi-scale structural texture knowledge in images through frequency domain decomposition pyramids and directional filter banks to improve structural fidelity. Extensive experiments demonstrate the superiority of our model by higher reconstruction quality and fewer training iterations, achieving a new state of the art for accelerated MRI reconstruction in both fastMRI and IXI datasets.

加速MRI重建技术旨在减少检查时间,同时保持高图像保真度,这在临床环境中对于改善患者舒适度和医院效率都非常理想。现有的深度学习方法通常使用传统重建方法对欠采样数据进行图像重建,但它们仍难以提供高保真结果。近年来,扩散模型在提高生成图像的保真度方面显示出巨大潜力。然而,它们的推理过程从随机高斯噪声开始,会导致结果不稳定,通常需要数千个采样步骤,从而导致重建质量不佳和效率低下。为了解决这些挑战,我们提出了循环一致桥梁扩散模型(CBDM)。CBDM采用两个桥梁扩散模型来构建一个循环一致的扩散过程,并使用一致性损失来增强重建图像的细节并减少扩散步骤的数量。此外,CBDM结合了轮廓分解嵌入模块(CDEM),通过频率域分解金字塔和方向滤波器库捕获图像的多尺度结构纹理知识,以提高结构保真度。大量实验表明,我们的模型在更高的重建质量和更少的训练迭代次数方面具有优越性,在fastMRI和IXI数据集上的加速MRI重建方面达到了最新的技术水平。

论文及项目相关链接

Summary

本文介绍了加速MRI重建技术及其面临的挑战。现有的深度学习方法在重建图像时通常使用传统的重建方法,但仍难以提供高保真结果。本文提出了一个名为Cycle-Consistent Bridge Diffusion Model(CBDM)的新模型,它通过两个桥扩散模型构建一个循环一致的扩散过程,并引入一致性损失来提高重建图像的细节和减少扩散步骤数量。此外,CBDM结合了Contourlet Decomposition Embedding Module(CDEM),通过频率域分解金字塔和方向滤波器库捕捉图像的多尺度结构纹理知识,以提高结构保真度。实验证明,该模型在fastMRI和IXI数据集上的重建质量更高,训练迭代次数更少,实现了加速MRI重建的最新技术。

Key Takeaways

以下是本文的主要见解:

- 加速MRI重建技术旨在减少检查时间并保持高图像保真度,对于改善患者舒适度和医院效率具有重要意义。

- 现有的深度学习方法在重建图像时仍面临高保真结果的挑战。

- Cycle-Consistent Bridge Diffusion Model(CBDM)通过引入一致性损失和两个桥扩散模型,提高了重建图像的细节和减少了扩散步骤数量。

- CBDM结合了Contourlet Decomposition Embedding Module(CDEM),以提高结构保真度。

- CBDM模型在MRI重建中表现出优异的性能,实现了更高的重建质量和更少的训练迭代次数。

- 该模型在fastMRI和IXI数据集上达到了最新的加速MRI重建技术。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是加速磁共振成像(MRI)重建。具体来说,论文旨在减少MRI检查时间的同时保持高图像保真度,这在临床设置中非常有用,因为它可以提高病人的舒适度和医院的效率。论文指出,尽管现有的深度学习方法通常可以从欠采样数据中重建图像,并与传统重建方法结合使用,但它们仍然难以提供高保真度的结果。此外,扩散模型近年来显示出在提高生成图像保真度方面的巨大潜力,但其推理过程从随机高斯噪声开始,导致结果不稳定,并且通常需要数千个采样步骤,导致重建质量次优和效率低下。因此,论文提出了一种循环一致的桥扩散模型(Cycle-Consistent Bridge Diffusion Model, CBDM),旨在解决这些挑战。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要包括以下几个方面:

加速MRI重建的传统方法:

- **Sensitivity Encoding (SENSE)**:利用多个接收线圈的空间敏感性,通过减少采集时间来实现快速成像。

- **Generalized Autocalibrating Partially Parallel Acquisitions (GRAPPA)**:通过基于核的插值估计缺失的k空间数据,从而重建欠采样数据,提高图像质量并减少与并行成像技术相关的伪影。

深度学习在加速MRI重建中的应用:

- 结合深度学习和并行成像算法的方法,例如将深度学习与GRAPPA重建算法结合。

- 将迭代收缩阈值算法(ISTA)转化为深度神经网络,优化压缩感知(CS)以加速MRI重建。

- 使用对抗神经网络生成缺失的k空间数据。

生成对抗网络(GANs)在MRI重建中的应用:

- 提出了多种基于GAN的方法,以提高MRI重建的生成性能。

扩散模型在加速MRI重建中的应用:

- 近年来,扩散模型因其在图像生成方面的高性能而被广泛应用于加速MRI重建。

- 从无条件到条件扩散模型,再到基于先验的条件扩散模型的发展。

桥扩散模型:

- 桥扩散模型被提出用于图像翻译任务,扩散过程在成对图像之间构建,从确定性图像(无噪声)开始的逆向扩散使得采样过程更加稳定。

这些相关研究构成了论文提出的循环一致桥扩散模型(CBDM)的理论基础和技术支持。论文通过结合这些相关技术,旨在提高MRI重建的速度和质量。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为循环一致桥扩散模型(Cycle-Consistent Bridge Diffusion Model, CBDM)的方法来解决加速MRI重建的问题。具体解决方案包括以下几个关键点:

循环一致桥扩散模型(CBDM):

- 利用两个桥扩散模型构建循环一致的扩散过程,并引入一致性损失(consistency loss),以增强重建图像的细节,并减少扩散步骤的数量。

桥扩散模型:

- 该模型在两个确定性图像之间进行扩散过程,并且有明确的保证能够产生所需的条件分布,而不是仅依赖于条件图像。

轮廓分解嵌入模块(Contourlet Decomposition Embedding Module, CDEM):

- 通过频域分解金字塔和方向滤波器组捕捉图像中的多尺度结构纹理知识,以提高结构保真度。

- 利用迭代拉普拉斯金字塔和方向滤波器组从每个时间步的图像中提取结构纹理知识,并将其整合到去噪网络中,从而增强网络捕获结构纹理的能力。

实验验证:

- 在fastMRI和IXI数据集上进行了广泛的实验,证明了所提出模型的有效性,特别是在保持高重建质量和减少训练迭代次数方面达到了新的最佳水平。

具体技术实现:

- 论文详细描述了CBDM的框架,包括两个桥扩散模型用于x ← y和y ← x的转换,以及如何通过循环一致性损失来训练模型。

- 提出了一种基于轮廓分解的方法来显式考虑MRI图像的结构纹理知识,以解决欠采样和全采样MR图像之间由于高频成分缺失而引起的结构模糊和伪影问题。

通过这些方法,论文成功地提高了加速MRI重建的效率和图像质量,同时减少了模型训练和推理过程中的时间步骤,提高了临床部署的可行性。

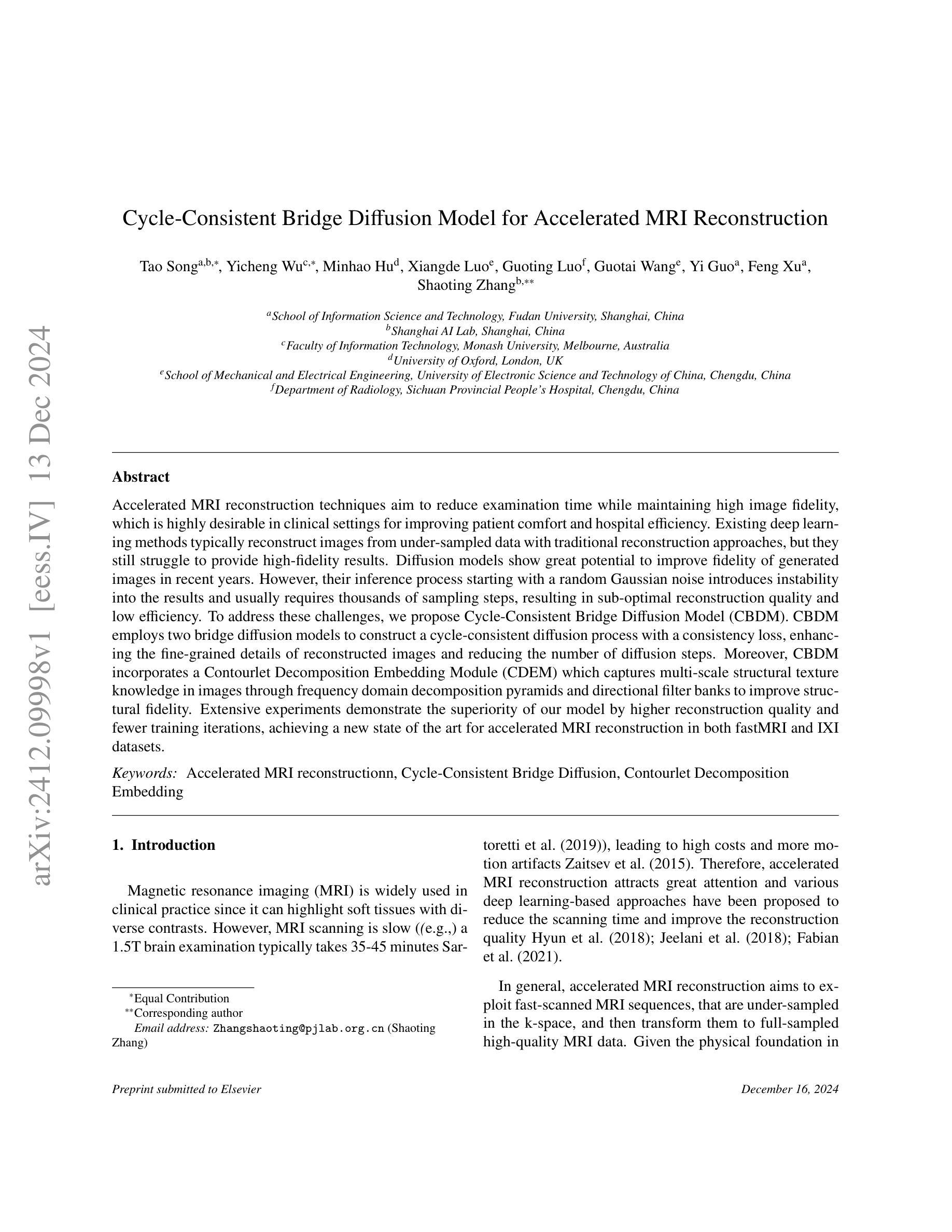

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证所提出的循环一致桥扩散模型(CBDM)的有效性。具体的实验包括:

数据和实现细节:

- 实验在公共基准数据集fastMRI和IXI上进行。

- 从fastMRI数据集中选择了360名个体的多线圈膝盖数据集用于训练,8名用于验证,20名用于测试。

- 从IXI数据集中选择了577名患者的T1图像,随机分为训练(500名患者,44,935个2D图像)、验证(37名患者,3,330个图像)和测试(40名患者,3,600个图像)集。

- 所有图像被裁剪到特定尺寸并归一化到[0, 1]范围内。

- 应用等间距的笛卡尔欠采样,并设置了加速因子为4和8。

训练细节:

- 总迭代次数设置为200k,使用AdamW优化器,学习率为1e-4,批量大小为28。

- 对于CBDM,训练和采样步骤都设置为20,损失权重λ设置为1。

比较方法:

- 将CBDM与多种现有的方法进行比较,包括pGAN、cGAN、pix2pix、DDPM、IDDPM、AdaDiff、MC-DDPM、HFS-SDE和BBDM。

评价指标:

- 使用峰值信噪比(PSNR)、结构相似性指数(SSIM)和归一化均方误差(NMSE)来衡量重建质量。

分布内结果:

- 在fastMRI膝盖数据集和IXI数据集上,CBDM在所有评价指标上均优于其他方法。

分布外结果:

- 进行了分布外实验以验证模型的泛化能力。所有模型在fastMRI膝盖数据上训练,并在fastMRI脑部MRI扫描上进行测试。

- CBDM在脑部数据重建上实现了最佳性能。

推理效率:

- 比较了CBDM和其他扩散方法的推理效率,CBDM由于较少的采样步骤,具有更高的推理效率。

消融研究:

- 对CBDM的不同组件进行了消融研究,包括循环一致性和CDEM的有效性。

- 探讨了在训练过程中t1和t2的不同设置,以及不同噪声方差设置对模型性能的影响。

限制:

- 论文讨论了CBDM的局限性,包括训练过程中需要两个桥扩散模型同时训练可能带来的更高的训练成本,以及分布外实验中性能的下降。

这些实验全面地评估了CBDM在加速MRI重建任务中的表现,并与现有技术进行了比较,证明了其优越性和潜在的临床应用价值。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

降低训练成本:

- 论文提到,虽然循环一致的设计增强了图像表示,但训练过程需要同时训练两个桥扩散模型,这可能带来更高的训练成本。未来的工作可以探索如何减少模型训练的成本,例如通过设计更高效的网络架构或优化训练策略。

提高模型泛化能力:

- 论文中的分布外实验显示,模型的性能在新的分布上有所下降。未来的研究可以集中在提高模型的泛化能力上,使其能够更好地适应不同的数据分布和MRI扫描类型。

改进噪声方差设置:

- 论文中的消融实验表明,不同的噪声方差设置对模型性能有影响。可以进一步研究如何动态调整噪声方差,以提高模型的灵活性和适应性。

优化采样步骤:

- 尽管CBDM通过减少采样步骤提高了推理效率,但进一步优化采样过程,使其在更少的步骤下达到更好的重建效果,仍然是一个有价值的研究方向。

多模态和多对比度MRI重建:

- 扩展CBDM模型以处理多模态和多对比度MRI数据,这可能需要模型能够捕捉不同成像模式之间的复杂关系。

临床验证和评估:

- 在临床环境中对模型进行验证和评估,以确定其实际应用的可行性和效果,这可能包括与临床医生合作,以及在更大的、多样化的患者群体上进行测试。

模型解释性:

- 提高模型的可解释性,帮助临床医生理解模型的决策过程,增加模型在临床应用中的可信度。

跨中心和跨设备的数据融合:

- 探索如何将CBDM模型应用于跨中心和跨设备的数据融合问题,以提高MRI重建的鲁棒性。

结合其他成像技术:

- 研究如何将CBDM与CT、PET等其他成像技术结合,以提供更全面的诊断信息。

这些探索点可以帮助推动加速MRI重建技术的发展,并最终实现更好的临床应用。

Q: 总结一下论文的主要内容

A: 论文的主要内容可以总结如下:

问题陈述:

- 论文针对加速磁共振成像(MRI)重建的问题,旨在减少MRI扫描时间同时保持图像质量,以提高临床舒适度和医院效率。

现有挑战:

- 现有深度学习方法在欠采样数据重建上存在局限性,扩散模型虽有潜力但存在推理不稳定和效率低下的问题。

方法提出:

- 提出循环一致桥扩散模型(CBDM),通过两个桥扩散模型建立循环一致的扩散过程,并引入一致性损失,以增强图像细节并减少扩散步骤。

技术创新:

- 引入轮廓分解嵌入模块(CDEM),通过频域分解捕捉图像的多尺度结构纹理知识,提高结构保真度。

实验验证:

- 在fastMRI和IXI数据集上进行广泛实验,证明了CBDM在重建质量和训练迭代次数上的优势。

结果展示:

- CBDM在多个评价指标上优于现有方法,包括PSNR、SSIM和NMSE,并在分布内外测试中展现了良好的泛化能力。

效率比较:

- CBDM展示了更高的推理效率,相比其他方法大大减少了采样步骤,同时保持了高性能。

消融研究:

- 通过消融研究验证了循环一致性和CDEM设计的有效性,并探讨了不同训练设置对模型性能的影响。

局限性与未来工作:

- 论文讨论了CBDM的局限性,包括训练成本和泛化能力,并提出了未来探索的方向,如降低训练成本和提高模型泛化能力。

结论:

- CBDM通过循环一致性和轮廓分解嵌入模块有效地恢复了MR图像的正常人体结构和纹理细节,并在基准数据集上实现了最先进的性能。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

- CBDM通过循环一致性和轮廓分解嵌入模块有效地恢复了MR图像的正常人体结构和纹理细节,并在基准数据集上实现了最先进的性能。

点此查看论文截图

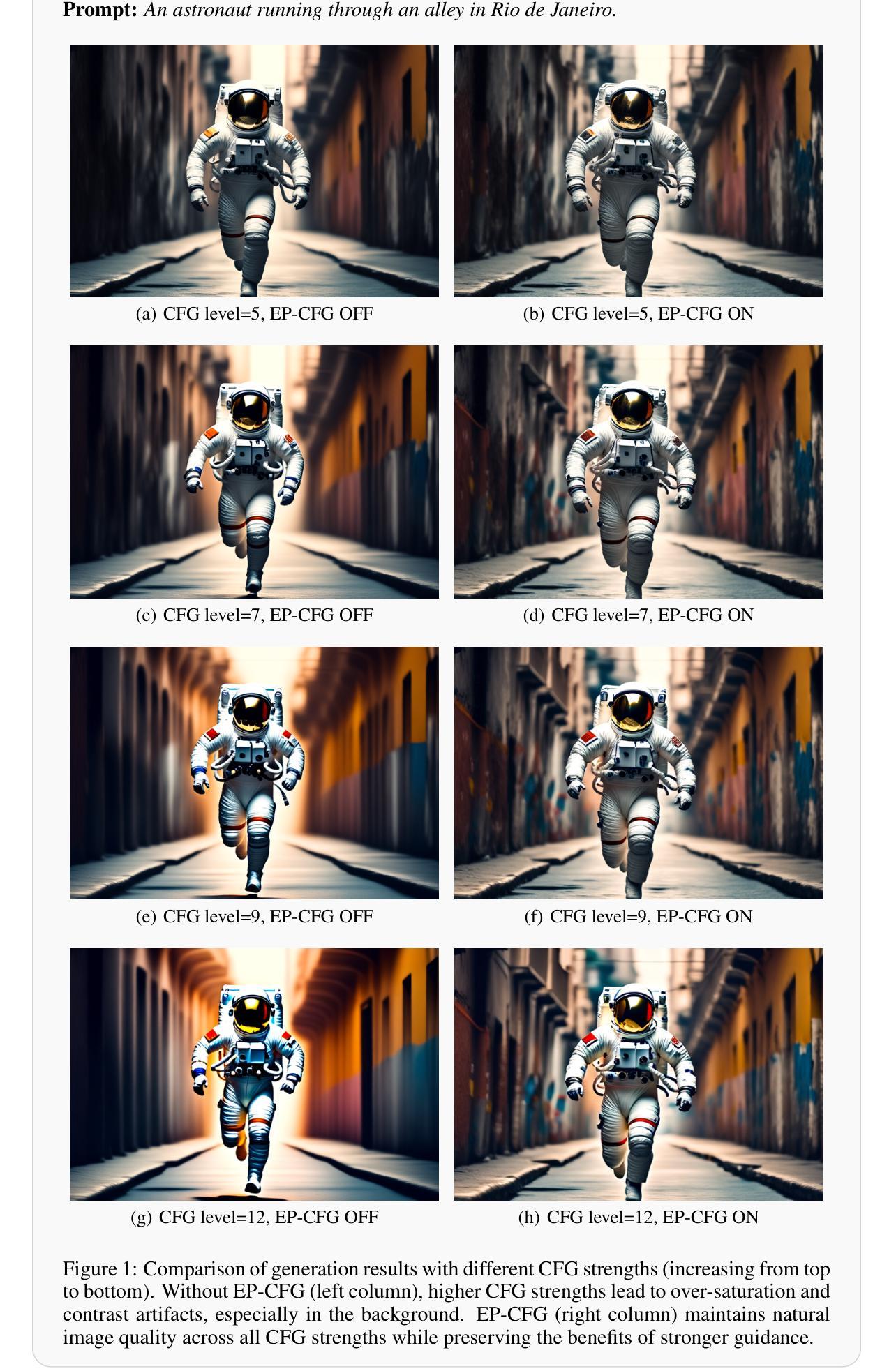

EP-CFG: Energy-Preserving Classifier-Free Guidance

Authors:Kai Zhang, Fujun Luan, Sai Bi, Jianming Zhang

Classifier-free guidance (CFG) is widely used in diffusion models but often introduces over-contrast and over-saturation artifacts at higher guidance strengths. We present EP-CFG (Energy-Preserving Classifier-Free Guidance), which addresses these issues by preserving the energy distribution of the conditional prediction during the guidance process. Our method simply rescales the energy of the guided output to match that of the conditional prediction at each denoising step, with an optional robust variant for improved artifact suppression. Through experiments, we show that EP-CFG maintains natural image quality and preserves details across guidance strengths while retaining CFG’s semantic alignment benefits, all with minimal computational overhead.

无分类器引导(CFG)在扩散模型中广泛应用,但在较高的引导强度下通常会引入过度对比和过度饱和的伪影。我们提出了能量保持无分类器引导(EP-CFG),通过保留指导过程中的条件预测的能量的分布来解决这些问题。我们的方法简单地将引导输出的能量重新缩放,以匹配每个降噪步骤中的条件预测能量,并且还有一个可选的稳健变体,用于改善伪影抑制。通过实验,我们证明了EP-CFG在保持自然图像质量的同时,能够在不同的引导强度下保留细节,同时保留CFG的语义对齐优势,且计算开销最小。

论文及项目相关链接

Summary:

扩散模型中广泛应用Classifier-free guidance(CFG),但在较高指导强度下常出现过度对比度和过度饱和的伪影问题。本研究提出EP-CFG(Energy-Preserving Classifier-Free Guidance),在指导过程中保留条件预测的能量分布以解决这些问题。该方法通过重新调整引导输出的能量,使其在每个去噪步骤中与条件预测的能量相匹配,并有一个可选的稳健变种以提高伪影抑制效果。实验表明,EP-CFG在保持自然图像质量的同时,能够在不同的指导强度下保留细节,并保留CFG的语义对齐优势,且计算开销较小。

Key Takeaways:

- 扩散模型中广泛应用Classifier-free guidance(CFG),但在高指导强度下存在伪影问题。

- EP-CFG旨在解决CFG在较高指导强度下的过度对比度和过度饱和伪影问题。

- EP-CFG通过保留条件预测的能理分布来优化指导过程。

- 方法重新调整引导输出的能量,使其在每个去噪步骤中与条件预测相匹配。

- EP-CFG提供了一个可选的稳健变种以提高伪影抑制效果。

- 实验表明,EP-CFG在保持图像自然质量的同时,能够在不同指导强度下保留细节。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是,在扩散模型中使用分类器无关引导(Classifier-free guidance, CFG)进行文本引导生成时,常出现的过度对比度和过饱和现象。具体来说,CFG方法虽然能够增强语义对齐和结构一致性,但当CFG强度较高时,会导致生成的图像出现过度对比度和过饱和的伪影。论文提出了一种名为EP-CFG(Energy-Preserving Classifier-Free Guidance)的方法,旨在在保持CFG引导的强语义对齐的同时,通过调整能量分布来避免这些问题。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是与EP-CFG相关的研究:

分类器无关引导(CFG):

- Ho & Salimans (2022) 提出了分类器无关引导(CFG)的概念,这是一种在扩散模型中用于文本引导生成的技术。[Ho & Salimans, 2022]

扩散模型:

- Ho et al. (2020) 和 Song et al. (2020) 进行了扩散模型的研究,这些模型是CFG方法的基础。[Ho et al., 2020; Song et al., 2020]

高CFG强度问题:

- 论文中提到,现代文本到图像模型中CFG强度通常设置在7-10之间以生成高质量的视觉内容,但这样的高强度会导致过度对比度和过饱和伪影。[Rombach et al., 2022]

解决过饱和问题的方法:

- Sadat et al. (2024) 提出了APG(可能是另一种方法)来通过更新项分解解决过饱和问题。[Sadat et al., 2024]

扩散噪声计划和样本步数的研究:

- Lin et al. (2024) 对扩散噪声计划和样本步数进行了研究,并指出常见的扩散噪声计划和样本步数存在问题。[Lin et al., 2024]

高分辨率图像合成:

- Rombach et al. (2022) 研究了使用潜在扩散模型进行高分辨率图像合成的方法。[Rombach et al., 2022]

这些研究构成了EP-CFG方法的理论和实践基础,并与EP-CFG试图解决的问题直接相关。论文通过引用这些相关研究,展示了其在现有研究基础上的创新和改进。

Q: 论文如何解决这个问题?

A: 论文提出了一种名为EP-CFG(Energy-Preserving Classifier-Free Guidance)的方法来解决扩散模型中使用CFG时出现的过度对比度和过饱和问题。具体解决方案如下:

能量重缩放机制:

- 论文提出了一个能量重缩放机制,用于调整CFG预测的能量分布,使其与条件预测的能量分布相匹配。具体地,对于给定的无条件预测(x_u)和条件预测(x_c),CFG预测(x_{cfg})由下式给出:

[

x_{cfg} = x_c + (λ - 1)(x_c - x_u)

]

其中,(λ \geq 1)是CFG强度。EP-CFG通过以下方式调整(x_{cfg})的能量:

[

x’{cfg} = x{cfg} \cdot \frac{E_c}{E_{cfg}}

]

其中,(E_c = |x_c|^2)和(E_{cfg} = |x_{cfg}|^2)分别表示条件预测和CFG预测的能量。

- 论文提出了一个能量重缩放机制,用于调整CFG预测的能量分布,使其与条件预测的能量分布相匹配。具体地,对于给定的无条件预测(x_u)和条件预测(x_c),CFG预测(x_{cfg})由下式给出:

鲁棒能量估计:

- 为了增强算法的鲁棒性,论文提出了一种鲁棒能量估计方法,通过忽略能量直方图的两个尾部,只考虑中间区域来估计能量项(E_c)和(E_{cfg})。具体地,设(P_l)和(P_h)为潜在(x)的第(l)和第(h)百分位数,则鲁棒能量为:

[

E_{robust} = \sum_i x_i^2 \cdot 1[P_l \leq x_i^2 \leq P_h]

]

论文推荐使用(l = 45)和(h = 55)作为百分位数,因为这种设置在实验中表现最佳。

- 为了增强算法的鲁棒性,论文提出了一种鲁棒能量估计方法,通过忽略能量直方图的两个尾部,只考虑中间区域来估计能量项(E_c)和(E_{cfg})。具体地,设(P_l)和(P_h)为潜在(x)的第(l)和第(h)百分位数,则鲁棒能量为:

简化的公式和信息保留:

- EP-CFG与先前解决方案的主要区别在于:它基于能量而不是标准差来缩放CFG预测,并且不在使用CFG和条件预测之间进行插值。因此,其公式更简单,更好地保留了CFG预测的信息。

通过这些方法,EP-CFG能够在保持CFG引导的强语义对齐的同时,避免过度对比度和过饱和伪影,从而生成更自然、质量更高的图像。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,作者进行了一系列的实验来展示EP-CFG(Energy-Preserving Classifier-Free Guidance)方法在不同CFG(Classifier-free guidance)强度下的效果。以下是实验的具体内容:

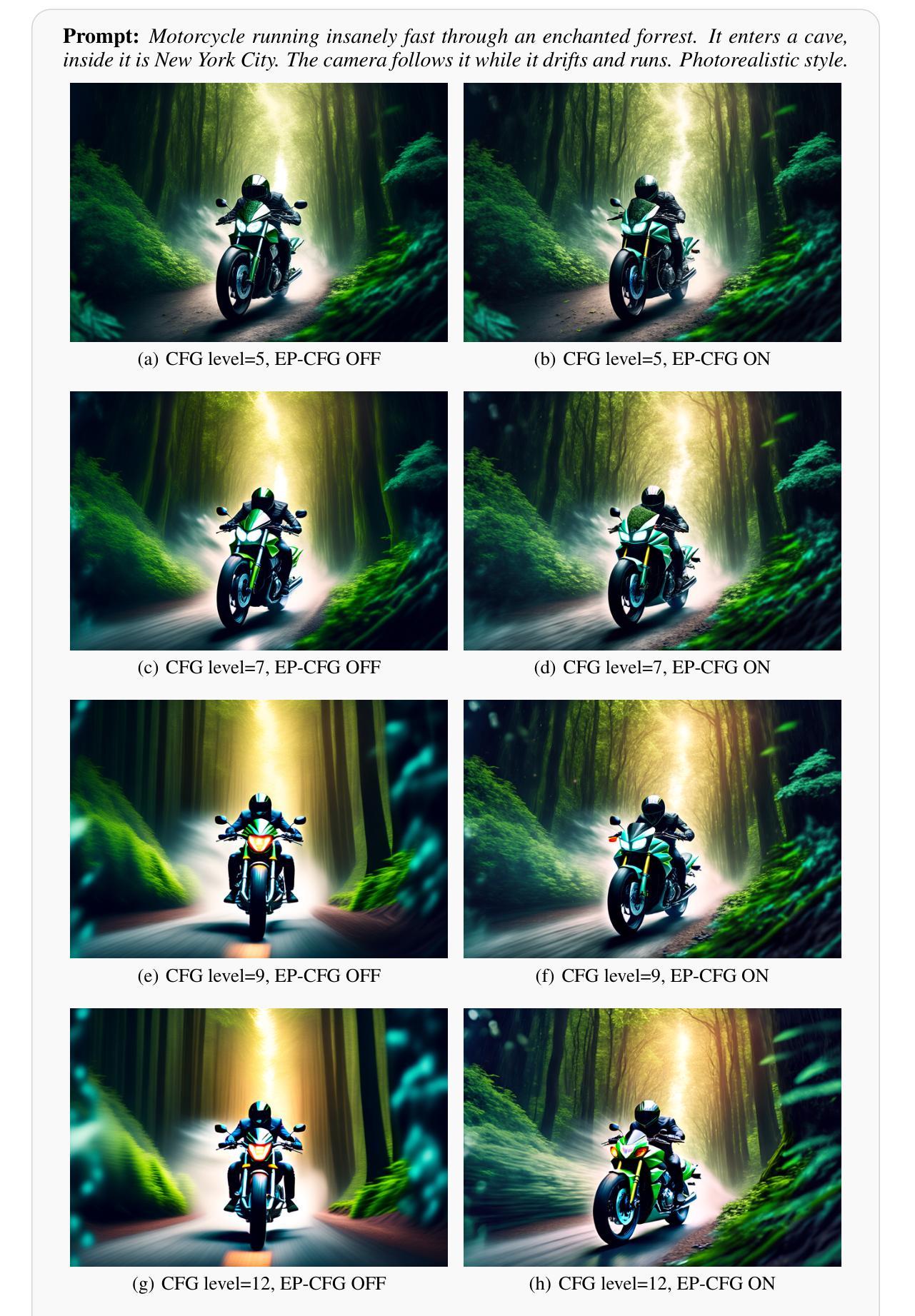

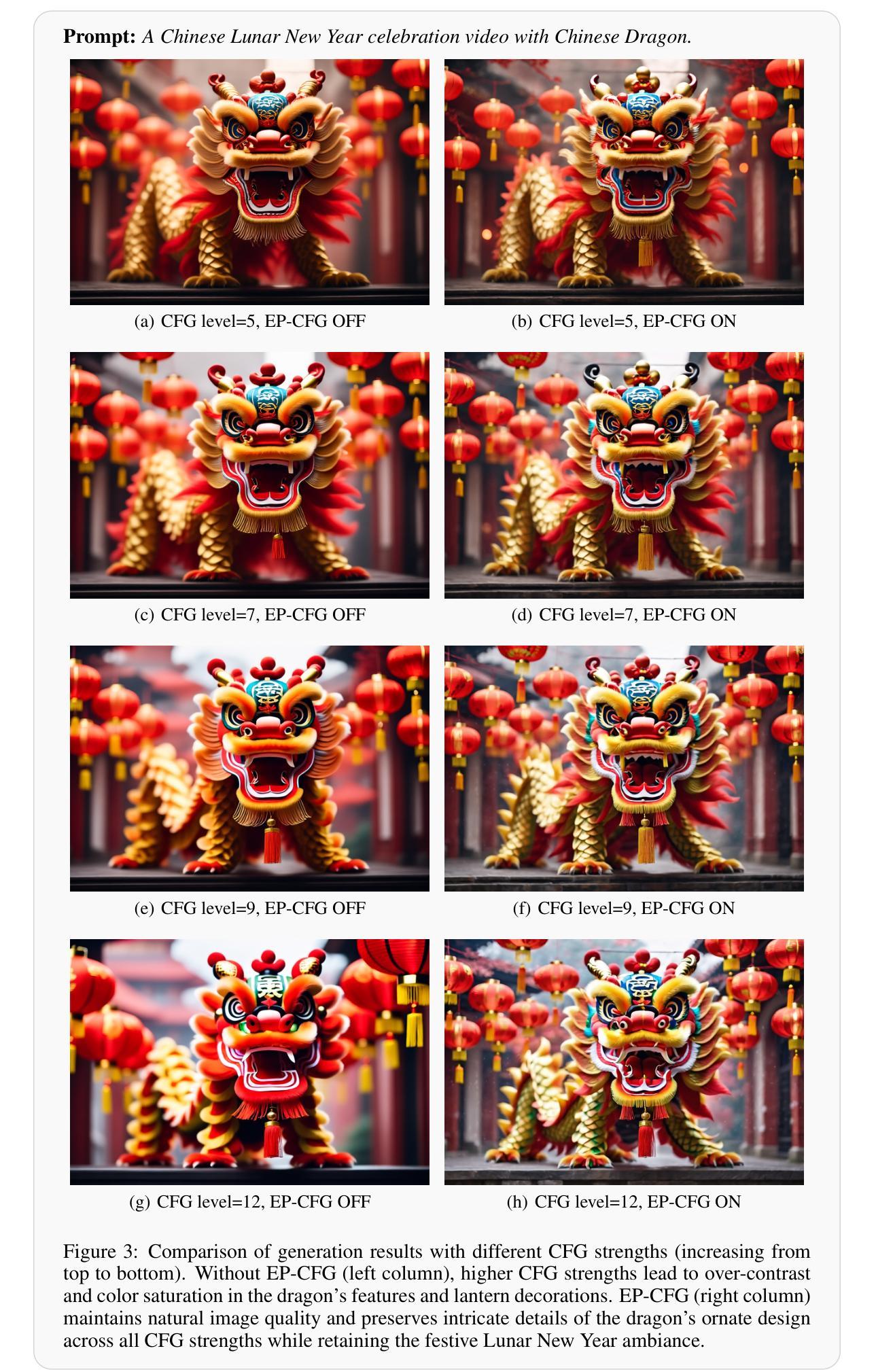

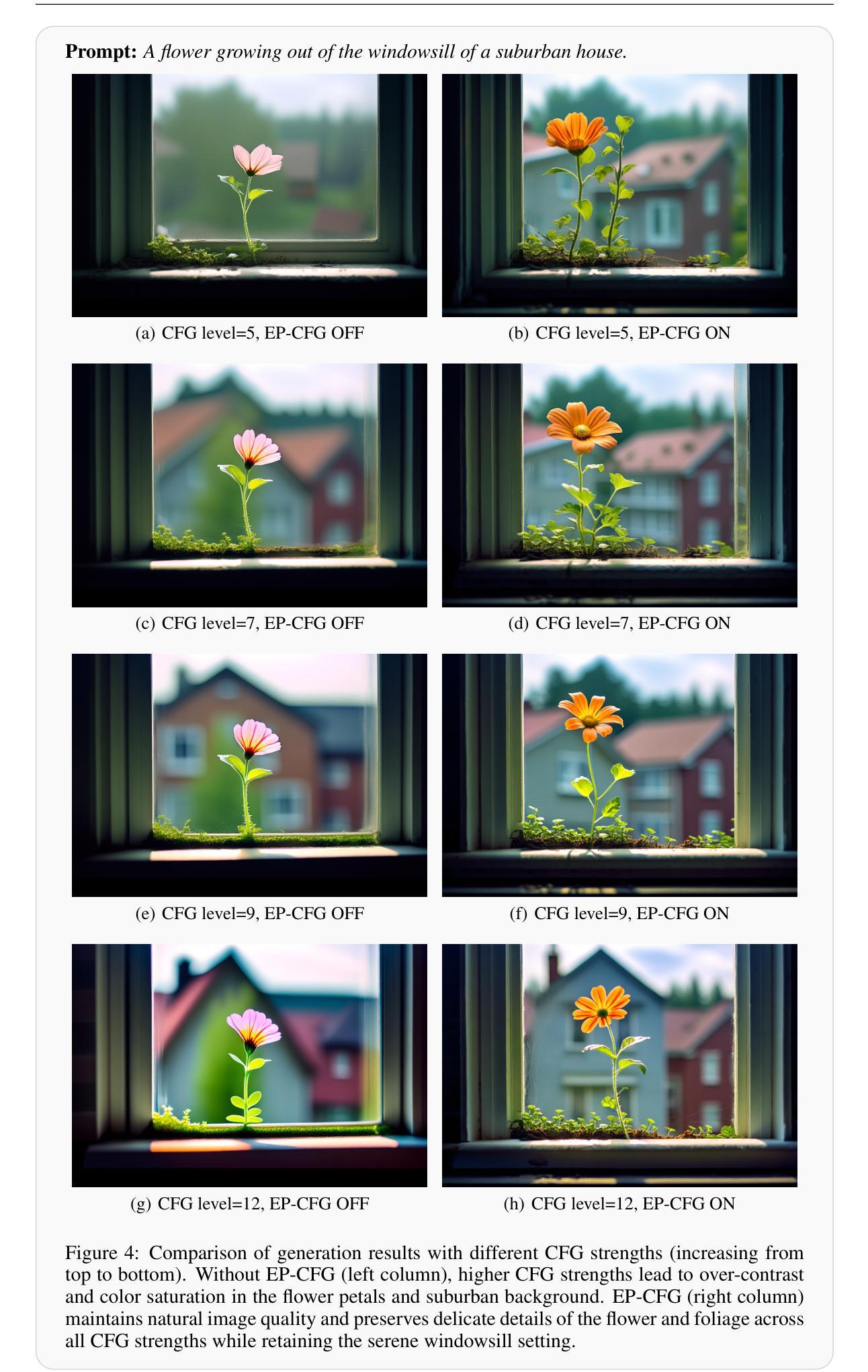

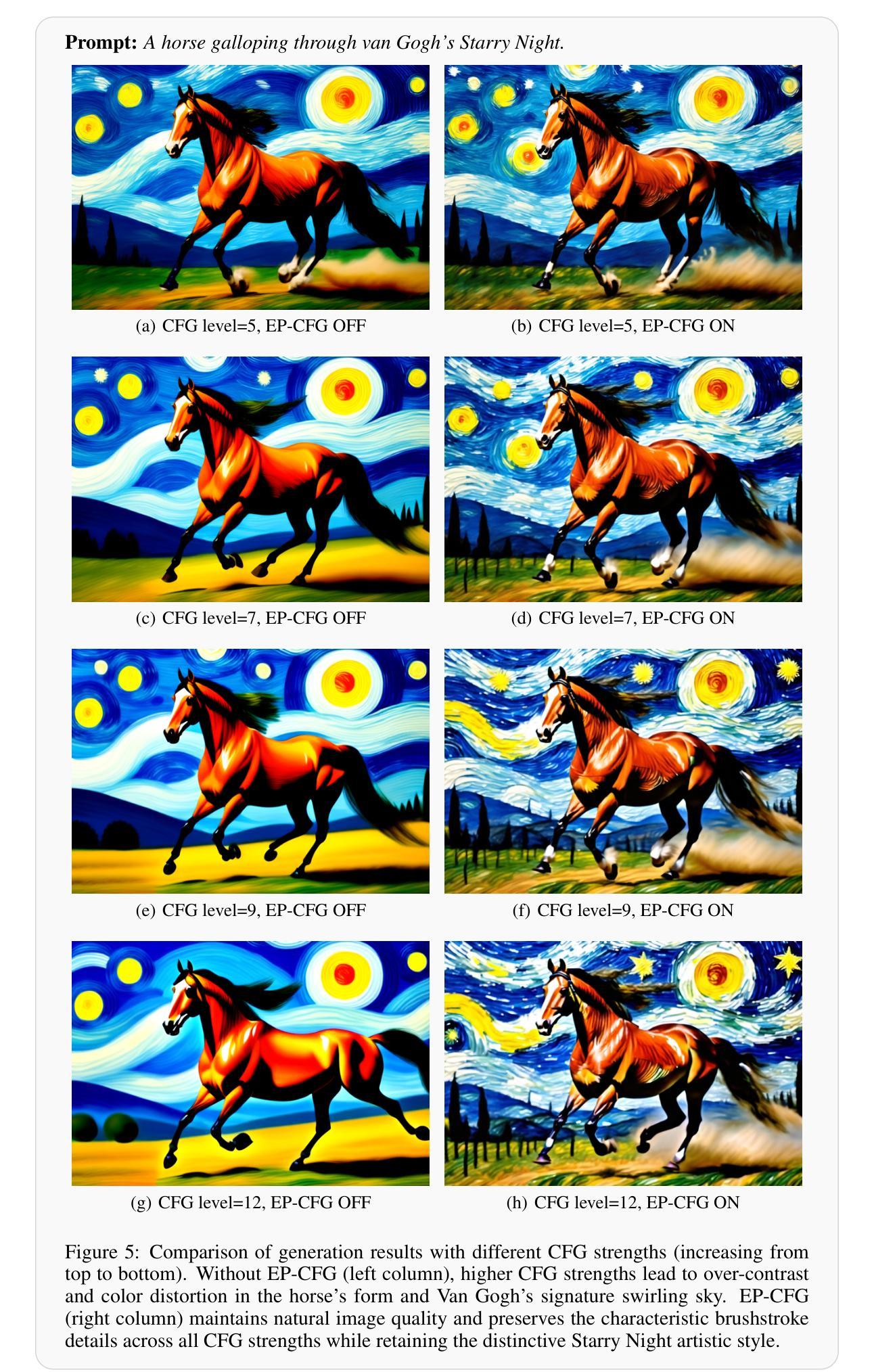

不同CFG强度下的图像生成对比:

- 作者展示了在不同CFG强度(5, 7, 9, 12)下,有无EP-CFG时生成的图像对比。这些图像展示了EP-CFG在保持图像自然质量的同时,如何有效地避免了过饱和和对比度过高的问题。

具体场景的图像生成:

- 作者提供了多个具体的场景描述(prompts),并展示了在这些场景下,有无EP-CFG时生成的图像。这些场景包括:

- 宇航员在里约热内卢的小巷中奔跑

- 摩托车在魔法森林中高速行驶并进入一个洞穴,洞穴内部是纽约市

- 中国农历新年庆祝活动,有中国龙

- 花朵从郊区房屋的窗台上生长出来

- 马在梵高的《星夜》中奔腾

- 东方快车在幻想风景中行驶,画布上的油画

- 装饰华丽的宴会厅,内有金色和银色餐具、水晶吊灯、丝绸窗帘

- 中等侧脸肖像照片,扮演部落豹妆的武田信宏

- 有“Adobe”字样底座的大理石历史女神克利奥雕像

- 一个IT人员被电脑电缆缠绕,类似于拉奥孔雕像

- 从地面视角看,一条通往涂鸦覆盖的城市隧道的道路,背景中有摩天大楼

- 作者提供了多个具体的场景描述(prompts),并展示了在这些场景下,有无EP-CFG时生成的图像。这些场景包括:

图像质量评估:

- 通过视觉比较有无EP-CFG的生成结果,作者展示了EP-CFG如何在不同CFG强度下保持图像质量,特别是在背景、细节和整体自然度方面。

这些实验结果表明,EP-CFG能够有效地在保持CFG引导的强语义对齐的同时,减少过度对比度和过饱和伪影,从而在各种场景下生成更自然和高质量的图像。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出了EP-CFG方法来解决扩散模型中CFG的过度对比度和过饱和问题,但仍有一些方向可以进一步探索和研究:

不同场景和数据集的验证:

- 论文中的实验主要基于特定的场景描述和图像生成任务。进一步的研究可以在更广泛的数据集和不同类型的图像生成任务上验证EP-CFG的效果,以评估其泛化能力和适用性。

定量评估指标:

- 论文主要通过视觉对比来展示EP-CFG的效果。未来工作可以引入更多的定量评估指标,如峰值信噪比(PSNR)、结构相似性指数(SSIM)和多尺度结构相似性(MS-SSIM)等,来更客观地评估图像质量。

不同CFG强度的优化:

- 论文中提到CFG强度通常设置在7-10之间以生成高质量的视觉内容。研究可以进一步探索不同CFG强度对图像质量的具体影响,并尝试自动调整CFG强度以获得最优的图像质量。

与其他技术的结合:

- 考虑将EP-CFG与其他图像生成技术(如GANs、VAEs等)结合,探索其在混合模型中的表现和潜在的改进。

计算效率和实时性:

- 研究EP-CFG方法的计算效率和实时性,特别是在资源受限的设备上,这对于实际应用非常重要。

更深入的理论研究:

- 对EP-CFG中的能量重缩放机制进行更深入的理论分析,探讨其对图像生成过程的影响,以及是否存在更优的能量调整策略。

用户研究和反馈:

- 进行用户研究,收集用户对使用EP-CFG生成的图像的反馈,以了解用户偏好并进一步优化算法。

多模态应用:

- 探索EP-CFG在多模态任务(如图像到图像翻译、文本到视频生成等)中的应用,评估其在这些任务中的有效性和挑战。

模型泛化性和鲁棒性:

- 研究EP-CFG在面对对抗性攻击、数据分布偏移等情况下的鲁棒性,以及如何提高模型的泛化能力。

这些方向不仅可以推动图像生成技术的发展,还可能为其他领域的研究提供新的视角和方法。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容包括以下几个方面:

问题陈述:

论文指出,在扩散模型中使用分类器无关引导(CFG)进行文本引导生成时,高CFG强度会导致过度对比度和过饱和的伪影问题。EP-CFG方法提出:

为了解决上述问题,论文提出了一种名为EP-CFG(Energy-Preserving Classifier-Free Guidance)的方法。该方法通过调整CFG预测的能量分布来匹配条件预测的能量,从而在保持CFG引导的强语义对齐的同时,避免了过度对比度和过饱和伪影。能量重缩放机制:

EP-CFG的核心是能量重缩放机制,通过以下公式调整CFG预测的能量:

[

x’{cfg} = x{cfg} \cdot \frac{E_c}{E_{cfg}}

]

其中,(E_c)和(E_{cfg})分别表示条件预测和CFG预测的能量。鲁棒能量估计:

为了增强算法的鲁棒性,论文提出了一种鲁棒能量估计方法,通过忽略能量直方图的两个尾部,只考虑中间区域来估计能量项。实验验证:

论文通过一系列实验,展示了在不同CFG强度下,有无EP-CFG时生成的图像对比。实验结果表明,EP-CFG能够在保持CFG引导的强语义对齐的同时,减少过度对比度和过饱和伪影,从而生成更自然和高质量的图像。进一步探索的方向:

论文还提出了一些可以进一步探索的方向,如在不同场景和数据集上验证EP-CFG的效果、引入定量评估指标、探索不同CFG强度的优化、与其他技术的结合等。

总的来说,这篇论文针对扩散模型中CFG引导的过度对比度和过饱和问题,提出了一种有效的解决方案EP-CFG,并通过对比其他CFG强度下的图像生成结果,验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

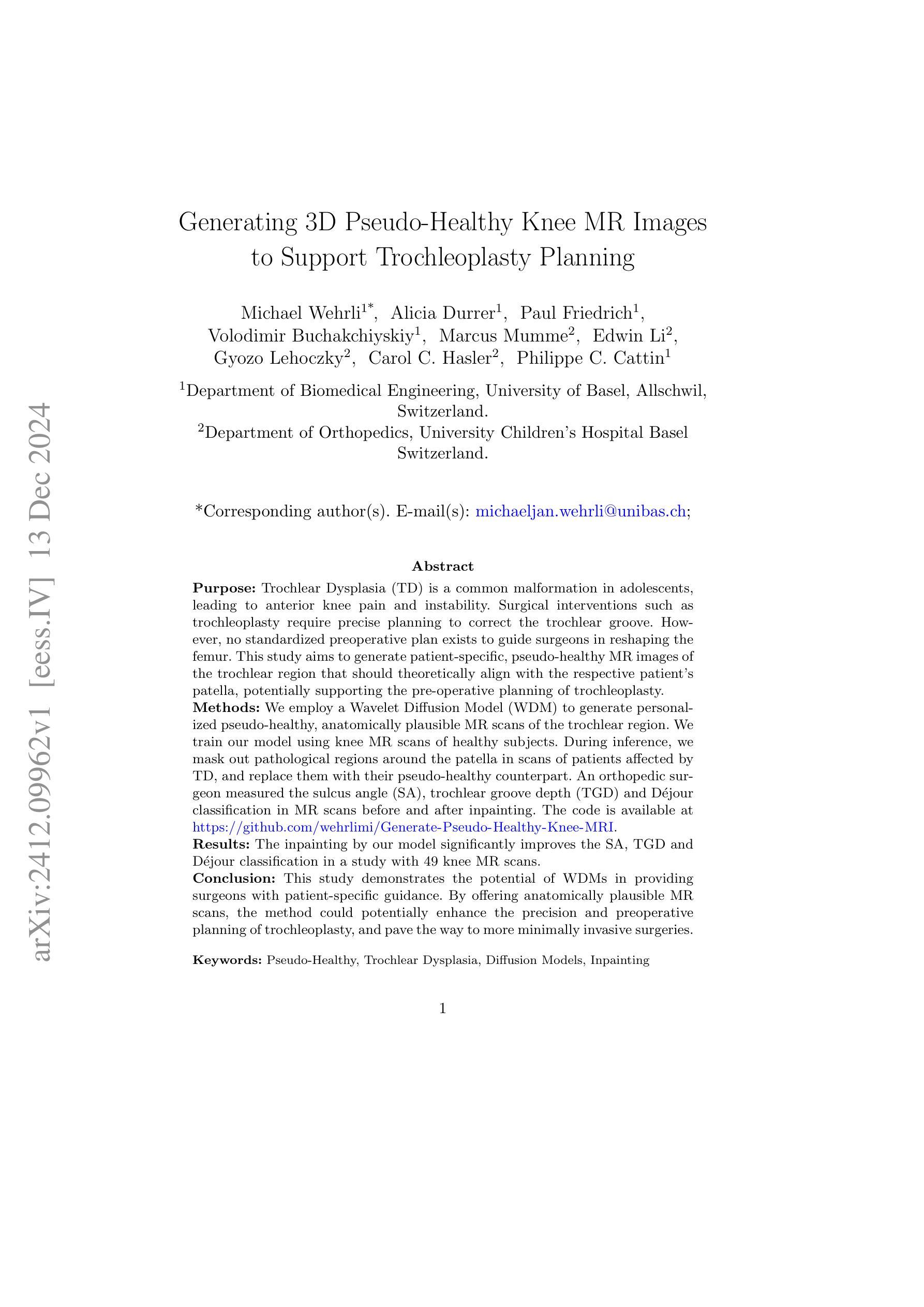

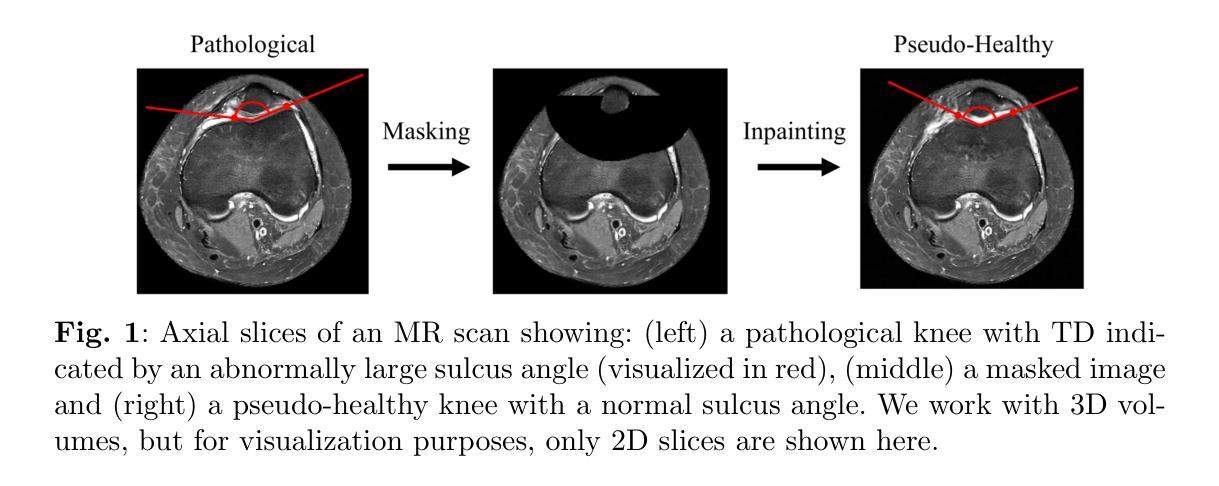

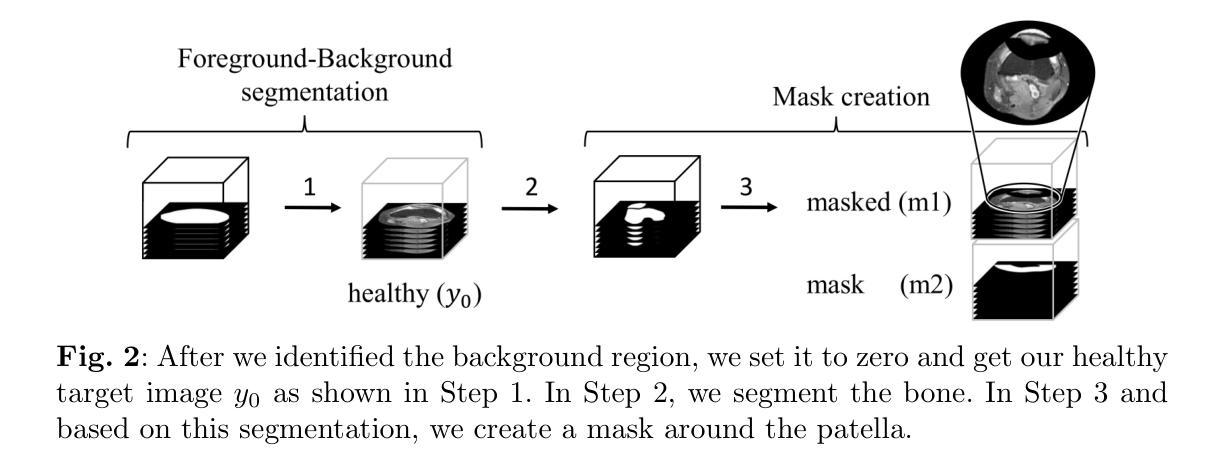

Generating 3D Pseudo-Healthy Knee MR Images to Support Trochleoplasty Planning

Authors:Michael Wehrli, Alicia Durrer, Paul Friedrich, Volodimir Buchakchiyskiy, Marcus Mumme, Edwin Li, Gyozo Lehoczky, Carol C. Hasler, Philippe C. Cattin