⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-17 更新

Vision-Language Models Represent Darker-Skinned Black Individuals as More Homogeneous than Lighter-Skinned Black Individuals

Authors:Messi H. J. Lee, Soyeon Jeon

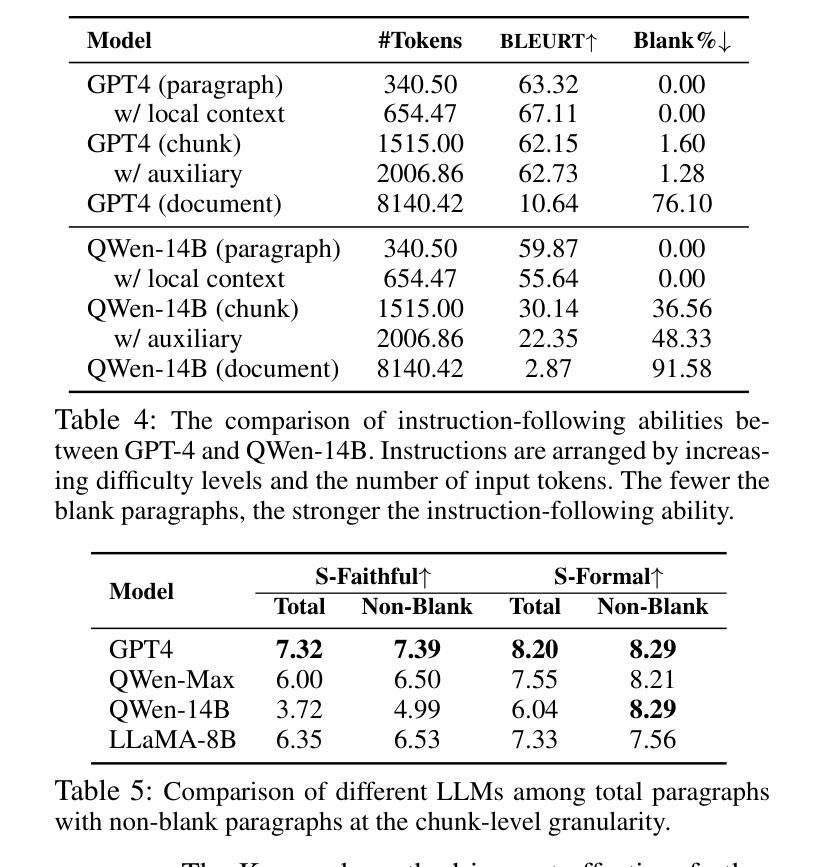

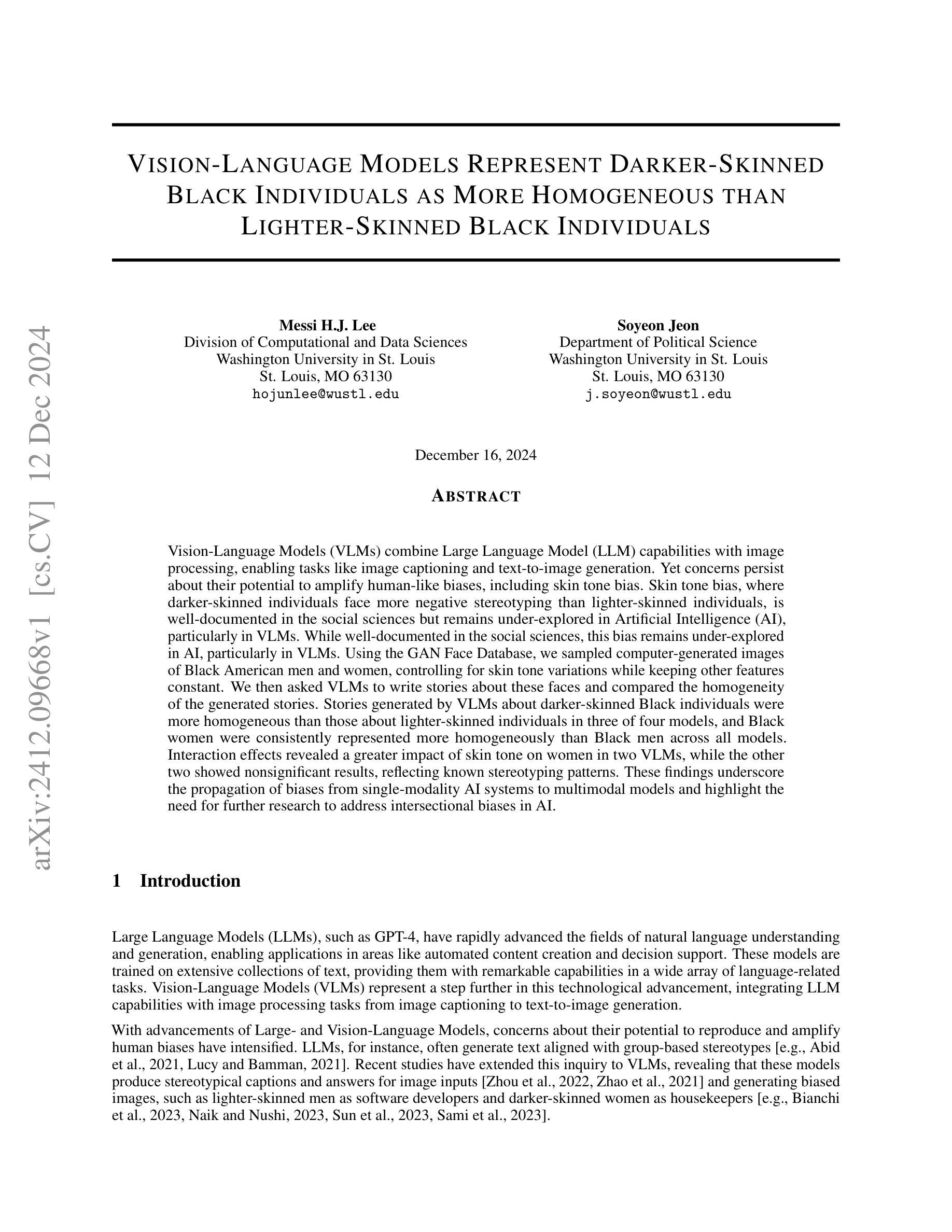

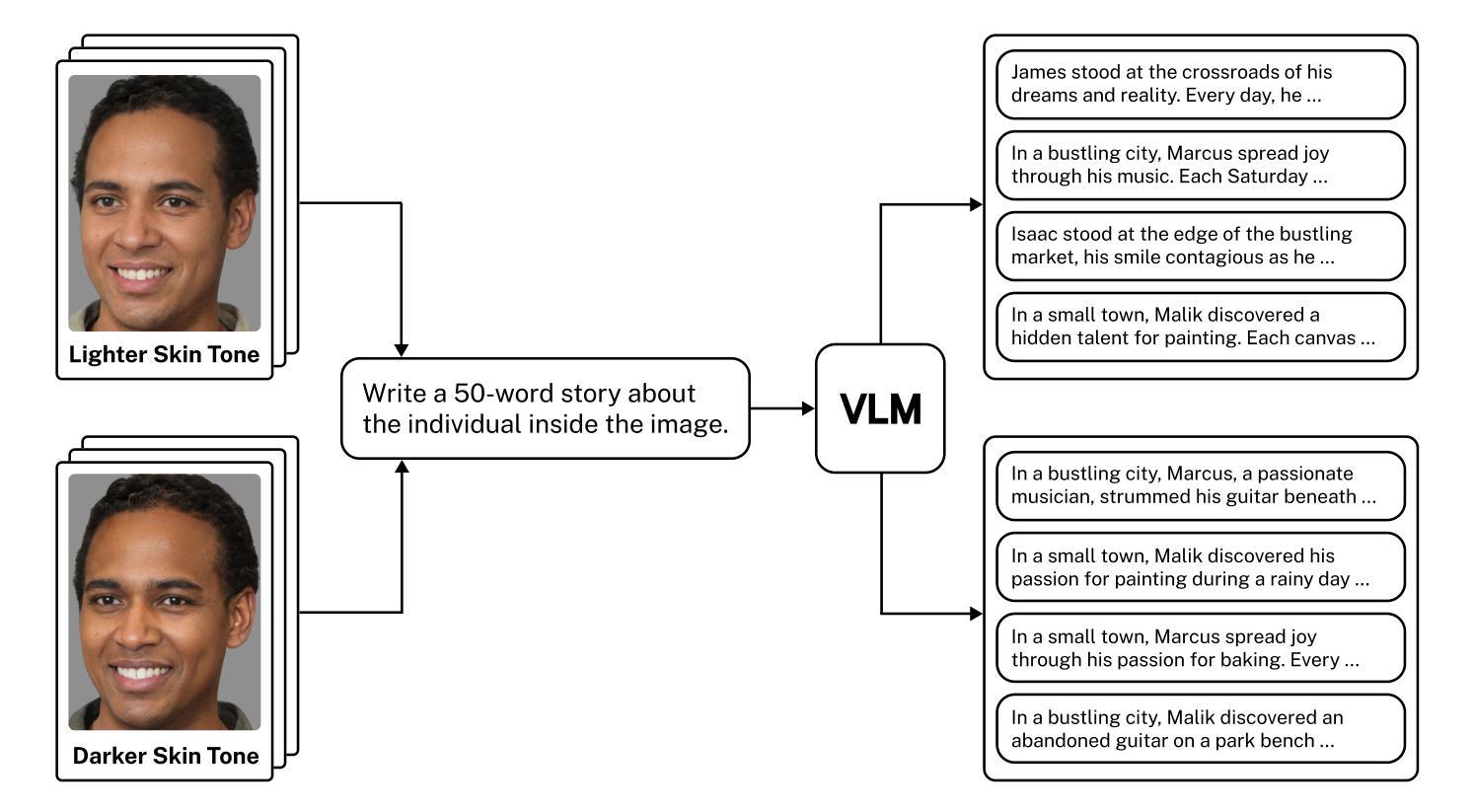

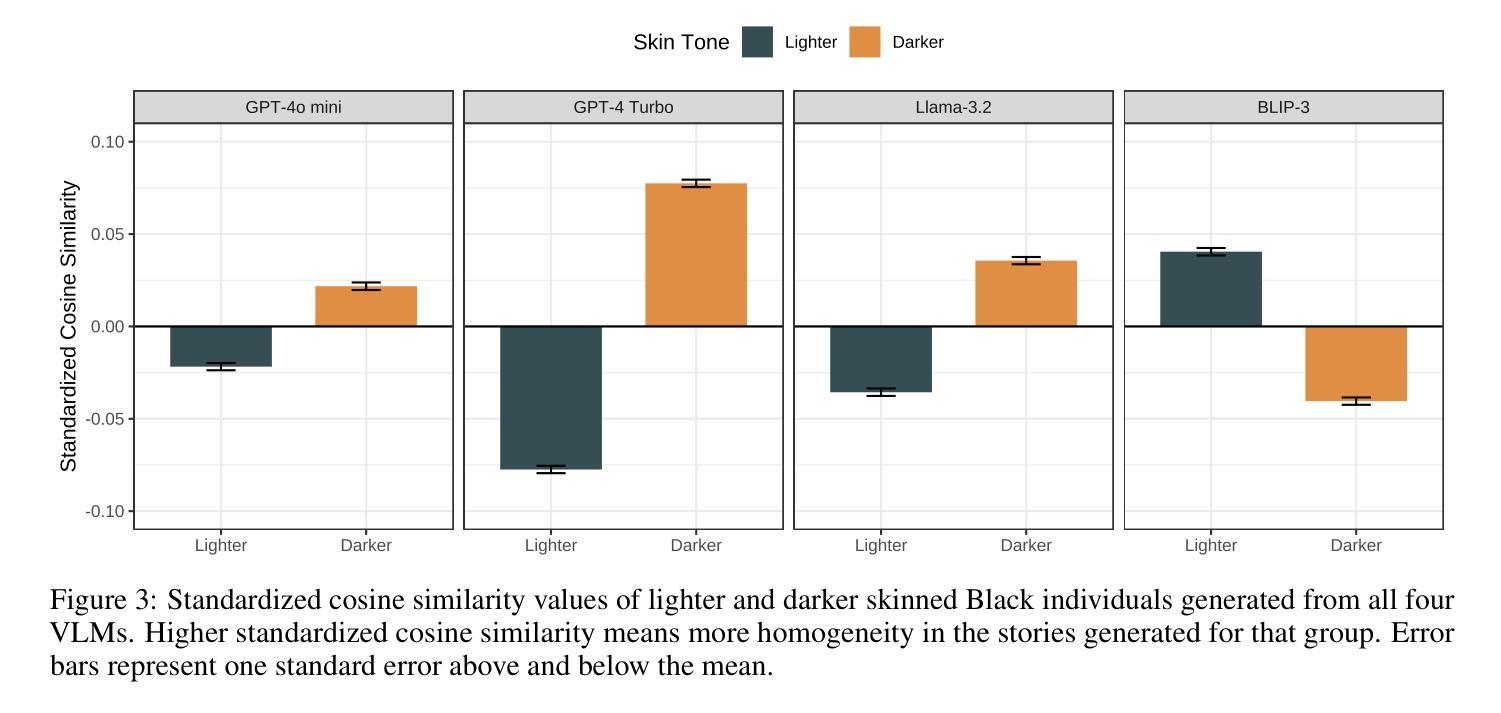

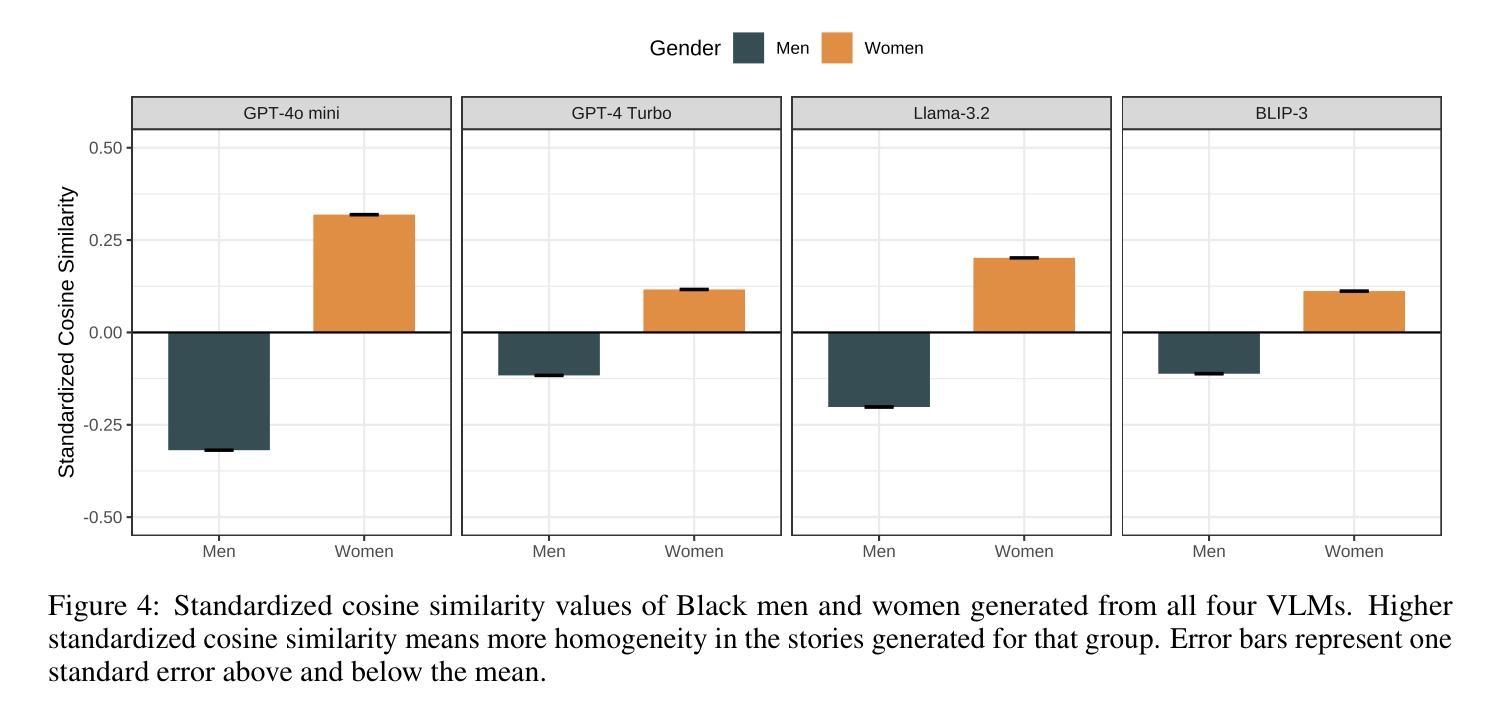

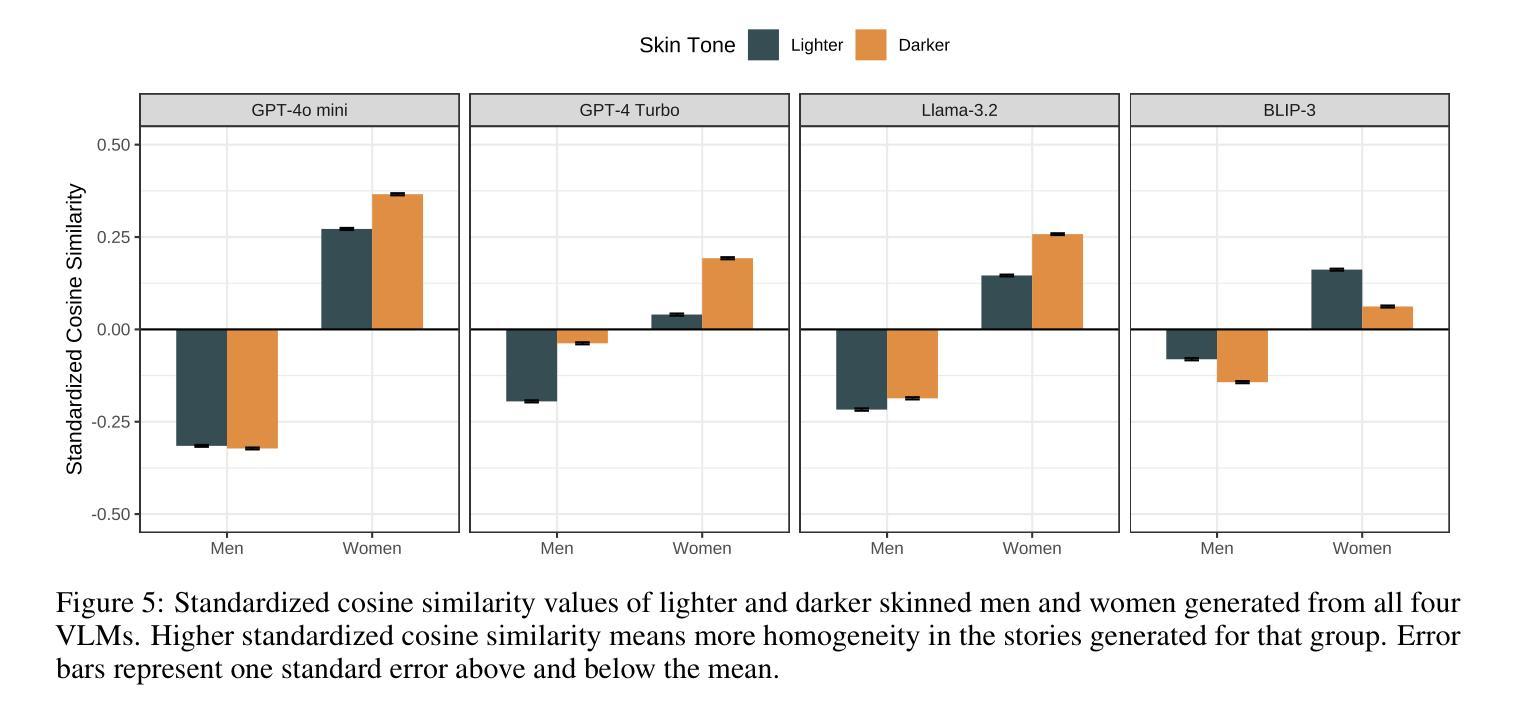

Vision-Language Models (VLMs) combine Large Language Model (LLM) capabilities with image processing, enabling tasks like image captioning and text-to-image generation. Yet concerns persist about their potential to amplify human-like biases, including skin tone bias. Skin tone bias, where darker-skinned individuals face more negative stereotyping than lighter-skinned individuals, is well-documented in the social sciences but remains under-explored in Artificial Intelligence (AI), particularly in VLMs. While well-documented in the social sciences, this bias remains under-explored in AI, particularly in VLMs. Using the GAN Face Database, we sampled computer-generated images of Black American men and women, controlling for skin tone variations while keeping other features constant. We then asked VLMs to write stories about these faces and compared the homogeneity of the generated stories. Stories generated by VLMs about darker-skinned Black individuals were more homogeneous than those about lighter-skinned individuals in three of four models, and Black women were consistently represented more homogeneously than Black men across all models. Interaction effects revealed a greater impact of skin tone on women in two VLMs, while the other two showed nonsignificant results, reflecting known stereotyping patterns. These findings underscore the propagation of biases from single-modality AI systems to multimodal models and highlight the need for further research to address intersectional biases in AI.

视觉语言模型(VLMs)结合了大型语言模型(LLM)的能力和图像处理功能,能够完成图像标注和文本到图像的生成等任务。然而,人们仍然担心它们放大人类偏见的潜力,包括肤色偏见。肤色偏见是指深色皮肤的个人比浅色皮肤的个人面临更负面的刻板印象,这在社会科学中已有很好的记录,但在人工智能(AI)中,特别是在VLMs中,这种现象仍然被忽视。虽然在社会科学中有充分的记录,但这种偏见在人工智能中仍然被忽视,特别是在VLMs中。我们使用GAN面部数据库,采样计算机生成的美国黑人和白人男女的图像,控制肤色变化的同时保持其他特征不变。然后,我们要求VLMs为这些面孔编写故事并比较生成故事的相似性。在四个模型中的三个模型中,关于深色皮肤的黑人生成的故事比浅色皮肤的个人更加同质化,而且黑人妇女的表现始终比黑人男性更加一致。互动效应揭示在两个VLMs中对女性的肤色影响更大,而其他两个则显示出非显著结果,反映了已知的刻板印象模式。这些发现强调了从单一模态的AI系统到多模态模型的偏见传播问题,并突出了需要进一步的研究来解决AI中的交叉偏见的必要性。

论文及项目相关链接

Summary

本文探讨了视觉语言模型(VLMs)在结合大型语言模型(LLM)能力和图像处理功能时,存在的肤色偏见问题。研究使用GAN面孔数据库生成了具有不同肤色变化的电脑图像,并发现针对黑人男性和女性的面孔生成的故事存在肤色偏见,即深色皮肤的人物的故事更加同质化。这反映了从单模态AI系统到多模态模型的偏见传播问题,并强调了需要进一步研究以解决AI中的交叉偏见问题。

Key Takeaways

- 视觉语言模型(VLMs)能够结合大型语言模型(LLM)的能力和图像处理功能,用于图像描述和文本生成图像等任务。

- 存在对深色皮肤个体的偏见问题,即深色皮肤的人可能在VLMs中面临更负面的刻板印象。

- 使用GAN面孔数据库生成了控制肤色变化而其他特征保持恒定的计算机图像。

- 在三个或四个模型中,关于深色皮肤黑人的故事生成更加同质化,相较于浅色皮肤个体。

- 黑色女性的代表性在所有模型中均比黑色男性更同质化。

- 皮肤颜色对两个VLMs中的女性的影响更大,而其他两个模型的结果不显著,反映了已知的刻板印象模式。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是Vision-Language Models(VLMs)中存在的肤色偏见问题,特别是针对黑人个体的肤色色调偏见。具体来说,论文探讨了以下几个问题:

肤色偏见在人工智能(AI)模型中的表现:论文指出,尽管社会科学中已经广泛记录了肤色偏见,即较深肤色的黑人个体比较浅肤色的黑人个体面临更多的负面刻板印象,但在人工智能领域,尤其是在VLMs中,这一偏见尚未得到充分研究。

VLMs中的同质性偏见:论文研究了AI模型中的另一种刻板印象——同质性偏见,即AI系统倾向于将某些群体表现为比其他群体更单一。这种现象与社会心理学中的外群体同质性效应有关,即个体认为自己的群体(内群体)比其他群体(外群体)更具多样性。

肤色偏见对群体表现的影响:论文通过研究VLMs生成的关于不同肤色黑人个体的故事,探讨了肤色与群体表现的同质性之间的关联。基于社会心理学文献中关于肤色在刻板印象中的作用的广泛证据,论文假设关于较深肤色黑人个体的故事将表现出比关于较浅肤色黑人个体的故事更大的同质性。

性别与肤色偏见的交互作用:论文还研究了肤色和性别之间的交互作用,探讨了肤色偏见对女性和男性的影响是否存在差异,以及这种差异是否与已知的刻板印象模式一致。

总的来说,这篇论文试图揭示VLMs可能如何复制和放大人类偏见,特别是肤色偏见,并强调了进一步研究以解决AI中的交叉性偏见的必要性。

Q: 有哪些相关研究?

A: 论文中提到了多个与肤色偏见、同质性偏见以及人工智能模型中这些偏见相关的研究。以下是一些关键的相关研究:

LLMs中的群体刻板印象:

- Abid et al., 2021 研究了大型语言模型(LLMs)如何生成与群体刻板印象一致的文本。

- Lucy and Bamman, 2021 研究了GPT-3生成的故事中的性别和代表性偏见。

VLMs中的刻板印象和偏见:

- Zhou et al., 2022 揭示了预训练的视觉-语言模型(VLMs)中的刻板印象偏见。

- Zhao et al., 2021 研究了图像字幕中种族偏见的理解与评估。

AI模型中的同质性偏见:

- Lee et al., 2024 探索了最先进的LLM是否复制了类似的偏见,特别是群体地位如何影响群体表现的同质性。

- Cheng et al., 2023 发现关于边缘群体的文本经常夸大定义特征,导致更卡通化的表现。

NLP系统中的刻板印象和抹消:

- Dev et al., 2022 强调了NLP系统中对边缘群体的最小代表性和刻板印象表现,导致抹消现象。

肤色偏见的社会影响:

- Maddox, 2004 和 Maddox and Gray, 2002 研究了肤色偏见,特别是对黑人个体的肤色偏见。

- Berumen Martinez, 2021, Stepanova and Strube, 2018, Kahn and Davies, 2011, Lynn, 2002 等研究了肤色偏见如何影响社会感知和实际结果。

AI模型中的肤色偏见:

- Buolamwini and Gebru, 2018 揭示了商业性别分类系统对较浅肤色个体的表现显著优于较深肤色个体。

- Groh et al., 2024 和 Kinyanjui et al., 2019 研究了肤色对机器学习模型性能的影响。

这些研究为理解AI模型中的偏见提供了背景,并为本文的研究提供了理论基础和实证支持。通过引用这些研究,本文进一步探讨了VLMs中的肤色偏见问题,并强调了解决AI中交叉性偏见的必要性。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决Vision-Language Models(VLMs)中肤色偏见的问题:

1. 实验设计

- 图像样本:使用GAN Face Database中的计算机生成的图像,控制肤色变化,同时保持其他特征不变。

- VLMs选择:选择了包括两个专有VLMs(GPT-4o mini, GPT-4 Turbo)和两个开源VLMs(Llama-3.2-11B-Vision-Instruct,“Llama-3.2” 和 BLIP-3)进行实验。

- 写作提示:给VLMs提供统一的写作提示,要求它们为每个图像编写一个50字的故事。

2. 同质性测量

- 句子嵌入:使用预训练的Sentence-BERT模型将生成的故事编码成句子嵌入。

- 余弦相似度:计算所有可能组合的句子嵌入之间的余弦相似度,以量化每组故事的同质性。

3. 统计模型

- 混合效应模型:使用混合效应模型比较不同肤色组之间的余弦相似度测量,考虑随机变化,如相同条件下生成的文本的重复余弦相似度值。

- 模型拟合:通过似然比检验评估添加单独项是否改善模型拟合。

4. 研究假设

- 肤色影响:假设关于较深肤色黑人个体的故事将表现出比关于较浅肤色黑人个体的故事更大的同质性。

- 性别影响:假设关于女性的描述将比关于男性的描述表现出更大的同质性。

- 肤色与性别交互作用:探索肤色对女性和男性的影响是否存在差异。

5. 结果分析

- 肤色与同质性关联:分析发现在三个VLMs中,关于较深肤色黑人个体的故事比关于较浅肤色个体的故事更同质。

- 性别与同质性关联:在所有四个VLMs中,关于女性的描述比关于男性的描述更同质。

- 肤色与性别交互作用:发现两个VLMs中肤色对女性同质性的影响大于男性,而另外两个VLMs中这种交互作用不显著。

6. 讨论与结论

- 肤色偏见的持续性:讨论了肤色偏见如何在VLMs中持续存在,并可能部分源自训练数据中较深肤色个体的代表性不足。

- 性别同质性偏见:一致发现女性在VLMs中被更同质地表现,这可能表明单模态AI模型中的偏见被传递到了多模态模型。

- 肤色对女性的影响:在两个VLMs中,肤色对女性的影响大于男性,这与人类刻板印象模式一致。

7. 研究局限与未来方向

- 感知黑人特征与肤色的混淆:讨论了基于感知黑人特征分配肤色条件可能带来的混淆。

- 对真实非计算机生成面孔的普适性:讨论了研究结果是否适用于真实世界面孔的不确定性。

- 开源模型的一致性:讨论了开源模型未能一致遵循写作提示的问题。

通过这些步骤,论文提供了对VLMs中肤色偏见问题的深入了解,并强调了解决AI中交叉性偏见的紧迫性。

Q: 论文做了哪些实验?

A: 论文中进行的实验包括以下几个主要步骤:

1. 图像样本选择

- 从公开可用的GAN Face Database (GANFD)中采样了黑人美国男性和女性的图像。这些图像是计算机生成的,并且通过操作来变化面部特征,特别是肤色,同时保持其他特征不变。

2. 选择Vision-Language Models (VLMs)

- 使用了四个VLMs,包括两个专有模型(GPT-4o mini, GPT-4 Turbo)和两个开源模型(Llama-3.2, BLIP-3)。

3. 写作提示

- 给VLMs提供写作提示:“Write a 50-word story about the individual inside the image.”(关于图像中的个体写一个50字的故事。)

4. 故事生成

- 对于每个图像,从每个VLM生成50个故事,总共从每个VLM得到1000个完成的故事。

5. 同质性测量

- 使用预训练的Sentence-BERT模型将生成的故事编码成句子嵌入。

- 计算所有可能组合的句子嵌入之间的余弦相似度,以量化每组故事的同质性。

6. 统计模型拟合

- 拟合混合效应模型来比较不同肤色组之间的余弦相似度测量。

- 首先,拟合一个只包含肤色作为固定效应的模型来测试假设。

- 其次,拟合一个只包含性别作为固定效应的模型。

- 最后,拟合一个包含肤色、性别及其交互作用的模型。

7. 交互作用分析

- 探究肤色和性别之间的交互作用,以了解肤色对女性和男性的影响是否存在差异。

8. 功效分析

- 使用R中的simr包进行蒙特卡洛模拟,确定实验是否有足够的功效来检测肤色和性别交互作用的效应大小。

这些实验步骤共同构成了论文的研究设计,旨在评估VLMs是否在处理不同肤色的黑人个体时表现出同质性偏见,并探讨这种偏见如何与性别交互。通过这些实验,研究者能够收集数据,分析并得出关于VLMs中肤色偏见的结论。

Q: 有什么可以进一步探索的点?

A: 论文提出了一些限制,并指出了未来研究可以进一步探索的几个关键点:

感知黑人特征与肤色的混淆:

- 研究中基于感知黑人特征的评分来分配肤色条件,可能存在与肤色混淆的其他特征。未来的研究可以探索更精细的方法来隔离肤色的影响,进行更受控的评估。

对真实面孔的普适性:

- 研究使用的是计算机生成的面孔图像,其结果可能不完全适用于真实世界中的真实面孔。未来的研究可以探索这些发现是否能够推广到真实面孔上。

开源模型遵循指令的一致性:

- 开源模型在遵循写作提示生成故事时存在不一致性。未来的研究可以探索如何改善模型遵循指令的能力,并进一步分析这种偏差如何影响结果。

交叉性偏见的系统性分析:

- 论文发现女性在VLMs中被更同质地表现,并提出需要进一步研究以了解不同模态如何交互影响同质性偏见。未来的研究可以系统性地分析不同模态数据如何影响AI模型中的交叉性偏见。

训练数据的影响:

- 论文推测VLMs中的同质性偏见可能部分源自训练数据中较深肤色个体的代表性不足。未来的研究可以更深入地分析训练数据如何影响模型偏见,并探索如何通过改进数据集来减少这些偏见。

模型架构对偏见的影响:

- 论文讨论了在VLMs中添加模态可能放大偏见的问题。未来的研究可以探索模型架构的不同部分如何影响偏见,并确定最有效的偏见缓解策略。

多模态AI系统中的偏见缓解:

- 鉴于发现单模态AI系统中的偏见可能传递给多模态模型,未来的研究可以专注于开发和评估减少多模态AI系统中偏见的方法。

实际应用中的偏见影响:

- 论文强调了VLMs在社会信息和创意内容生产中的日益增长的作用,并指出如果VLMs延续肤色偏见,可能会加剧社会不平等。未来的研究可以探索这些偏见如何在实际应用中显现,并评估它们对社会的影响。

这些进一步探索的点可以帮助学术界和工业界更好地理解、评估和减少AI系统中的偏见,促进更公平和无歧视的AI技术的发展。

Q: 总结一下论文的主要内容

A: 这篇论文主要探讨了视觉-语言模型(VLMs)中存在的肤色偏见问题,特别是针对黑人个体的肤色色调偏见。以下是论文的主要内容总结:

问题背景:

- VLMs结合了大型语言模型(LLMs)的能力和图像处理技术,能够执行图像描述和文本到图像的生成等任务。

- 存在对这些模型可能放大人类偏见,包括肤色偏见的担忧。

研究重点:

- 论文关注VLMs是否表现出同质性偏见,即将某些群体表现为比其他群体更单一。

- 特别研究了肤色偏见,即基于肤色的歧视态度或行为。

实验设计:

- 使用GAN Face Database中的计算机生成图像,控制肤色变化,同时保持其他特征不变。

- 采用四个VLMs(两个专有和两个开源)生成关于这些图像的故事。

方法论:

- 将生成的故事编码成句子嵌入,并计算它们之间的余弦相似度以量化同质性。

- 使用混合效应模型比较不同肤色和性别组之间的余弦相似度。

研究发现:

- 在三个VLMs中,关于较深肤色黑人个体的故事比关于较浅肤色个体的故事更同质。

- 在所有四个VLMs中,关于黑人女性的故事比关于男性的故事更同质。

- 两个VLMs显示出肤色对女性的影响大于男性,而另外两个则没有显示出显著的交互作用。

讨论与结论:

- 论文讨论了肤色偏见如何在VLMs中持续存在,并可能部分源自训练数据中较深肤色个体的代表性不足。

- 发现的性别同质性偏见与之前在LLMs中的发现一致,表明单模态AI模型中的偏见可能传递给多模态模型。

- 强调了解决AI系统中交叉性偏见的紧迫性。

研究局限:

- 包括感知黑人特征与肤色的潜在混淆,以及对真实非计算机生成面孔的普适性限制。

未来方向:

- 提出了进一步探索的领域,包括更精细地隔离肤色影响的方法,以及如何系统性地分析不同模态数据对同质性偏见的影响。

总体而言,这篇论文揭示了VLMs可能如何复制和放大人类偏见,特别是肤色偏见,并强调了进一步研究以解决AI中交叉性偏见的必要性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Utilizing Multi-step Loss for Single Image Reflection Removal

Authors:Abdelrahman Elnenaey, Marwan Torki

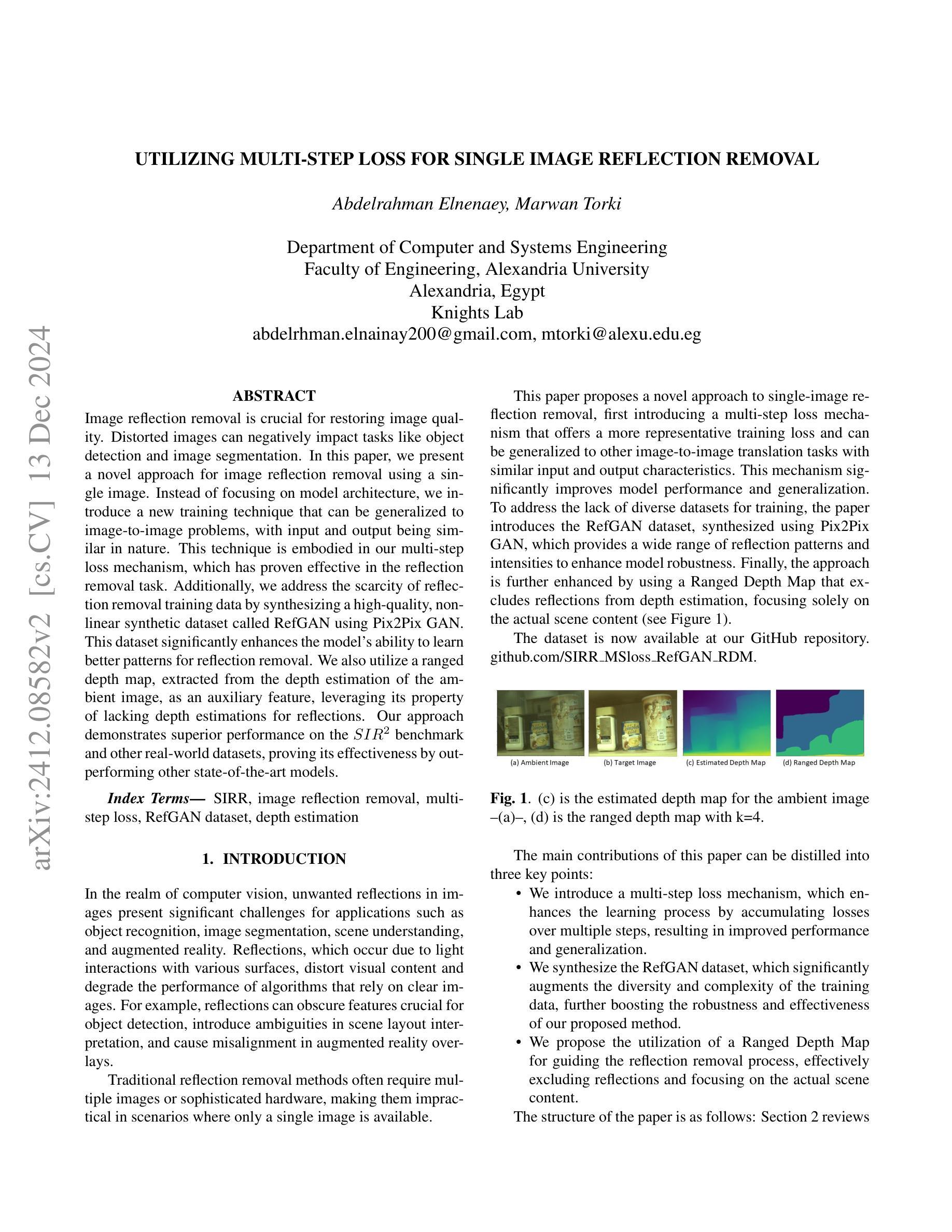

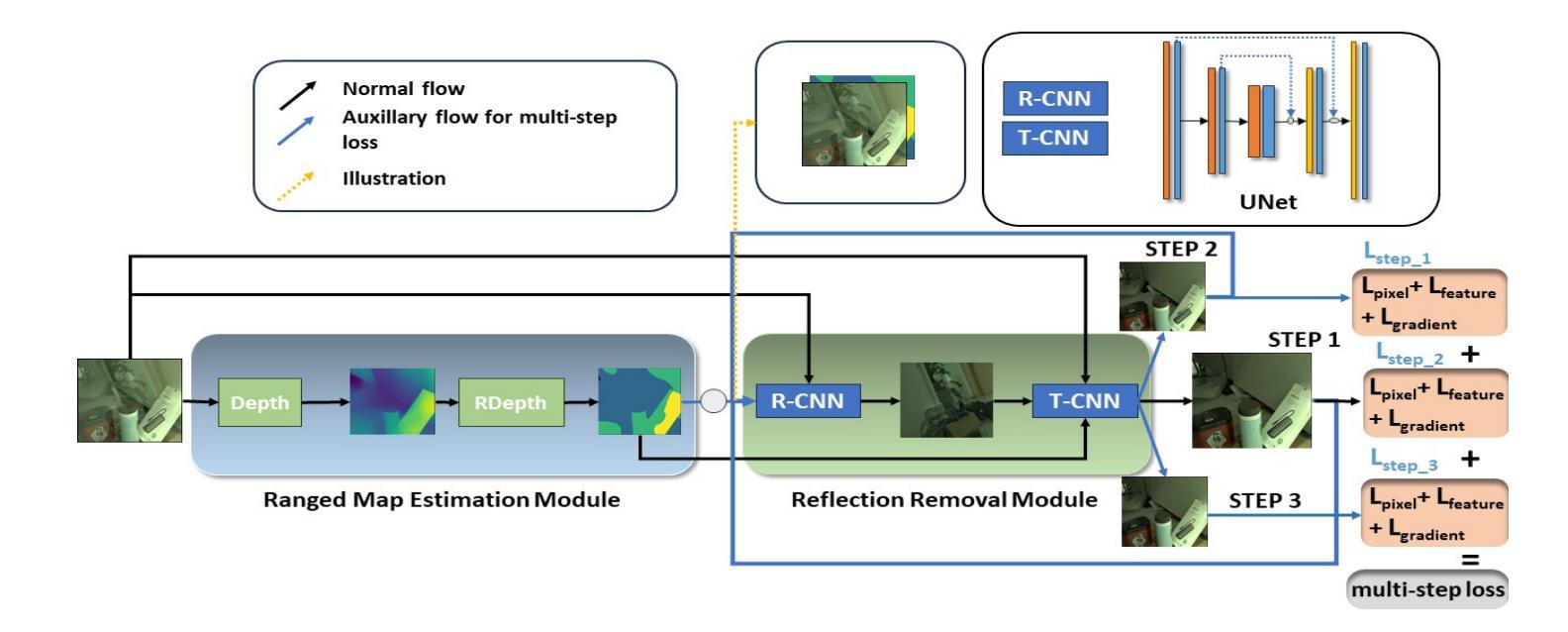

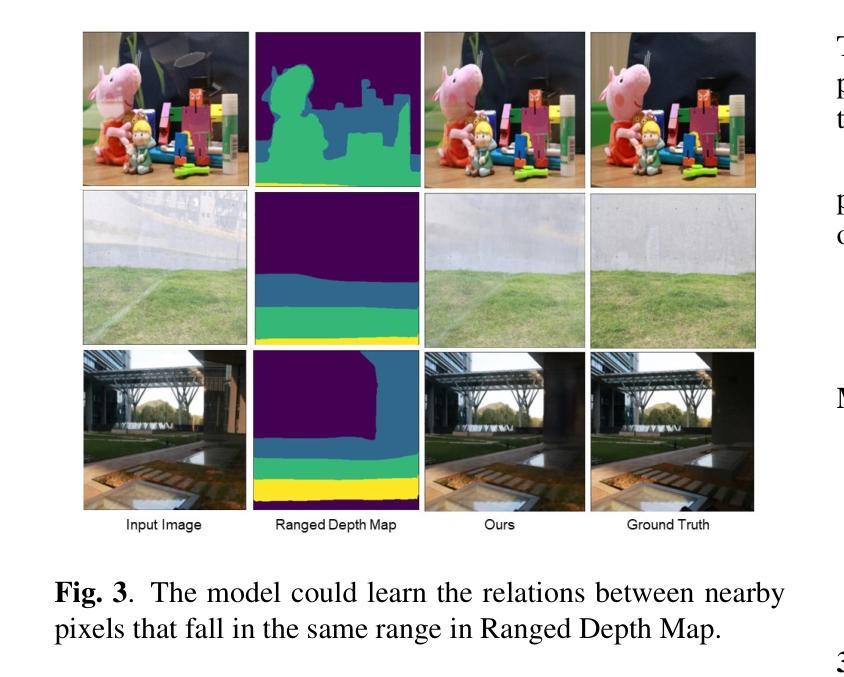

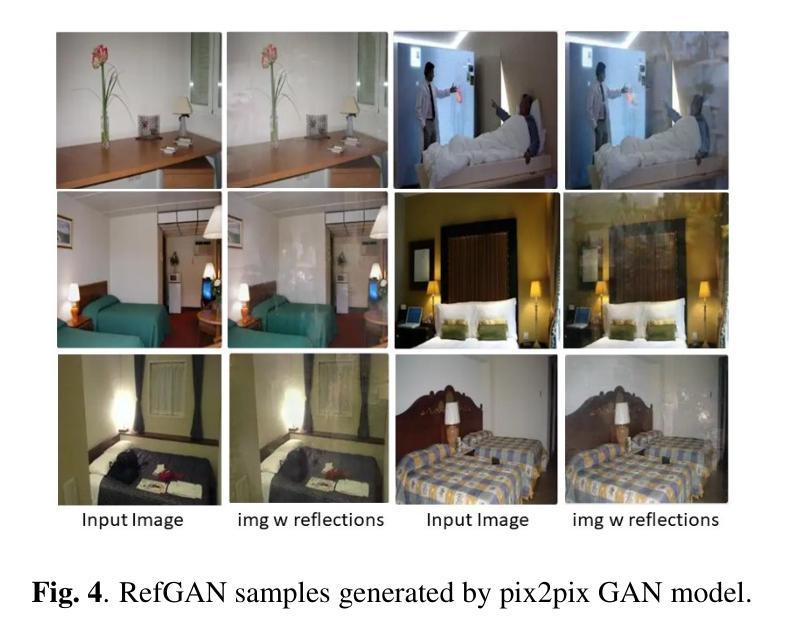

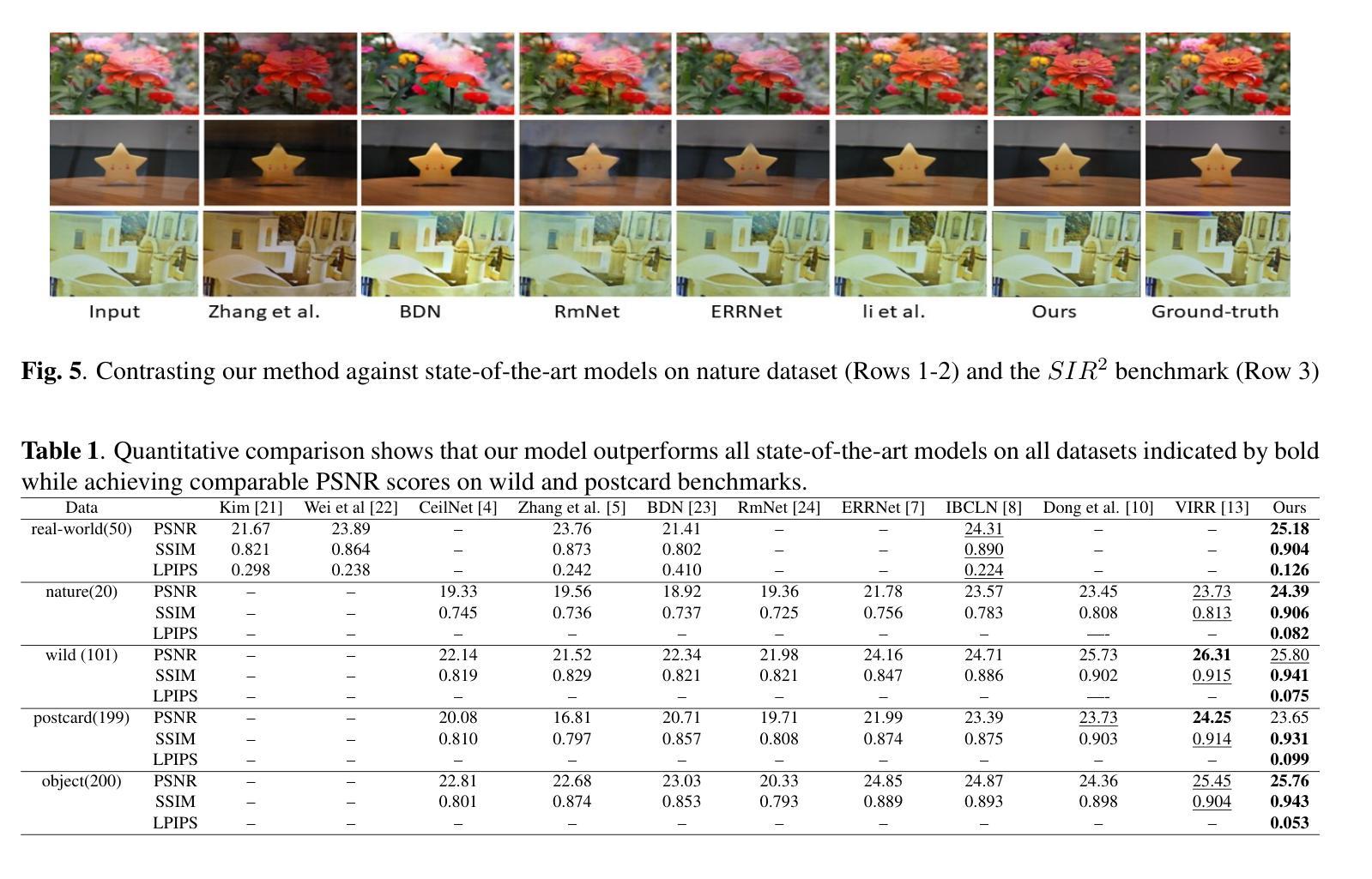

Image reflection removal is crucial for restoring image quality. Distorted images can negatively impact tasks like object detection and image segmentation. In this paper, we present a novel approach for image reflection removal using a single image. Instead of focusing on model architecture, we introduce a new training technique that can be generalized to image-to-image problems, with input and output being similar in nature. This technique is embodied in our multi-step loss mechanism, which has proven effective in the reflection removal task. Additionally, we address the scarcity of reflection removal training data by synthesizing a high-quality, non-linear synthetic dataset called RefGAN using Pix2Pix GAN. This dataset significantly enhances the model’s ability to learn better patterns for reflection removal. We also utilize a ranged depth map, extracted from the depth estimation of the ambient image, as an auxiliary feature, leveraging its property of lacking depth estimations for reflections. Our approach demonstrates superior performance on the SIR^2 benchmark and other real-world datasets, proving its effectiveness by outperforming other state-of-the-art models.

图像反射去除对于恢复图像质量至关重要。扭曲的图像会对目标检测和图像分割等任务产生负面影响。在本文中,我们提出了一种使用单幅图像进行图像反射去除的新方法。我们没有关注模型架构,而是引入了一种可推广至图像到图像问题的新训练技术,输入和输出的性质相似。这一技术体现在我们的多步损失机制中,该机制在去除反射的任务中已被证明是有效的。此外,我们通过使用Pix2Pix GAN合成了一种高质量的非线性合成数据集RefGan,解决了反射去除训练数据稀缺的问题。该数据集显著提高了模型学习更好反射去除模式的能力。我们还利用从环境图像的深度估计中提取的范围深度图作为辅助特征,利用其缺乏反射深度估计的特性。我们的方法在SIR^2基准测试和其他真实世界数据集上表现出卓越的性能,证明了其优于其他最先进模型的有效性。

论文及项目相关链接

PDF 6 pages, 6 figures, IEEE AICCSA 2024

Summary

本文提出了一种利用单图像进行图像反射去除的新方法。该方法引入了一种新的训练技术,可推广应用于同类图像到图像的问题。通过多步骤损失机制,该方法在反射去除任务中表现有效。同时,为解决反射去除训练数据不足的问题,本文利用Pix2Pix GAN合成了一个高质量的非线性合成数据集RefGAN。此外,还利用从环境图像深度估计中提取的深度图作为辅助特征,利用其缺乏反射的深度估计属性。该方法在SIR^2基准测试和其他真实世界数据集上表现出卓越性能,超越了其他最先进模型。

Key Takeaways

- 引入了一种新的训练技术,用于图像反射去除。

- 通过多步骤损失机制,该方法在反射去除任务中表现有效。

- 利用Pix2Pix GAN合成了一个高质量的非线性合成数据集RefGAN,解决了反射去除训练数据不足的问题。

- 利用从环境图像深度估计中提取的深度图作为辅助特征。

- 该方法可推广应用于同类图像到图像的问题。

- 在SIR^2基准测试和其他真实世界数据集上,该方法性能卓越,超越了其他最先进模型。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决单张图片中的反射去除问题,这对于恢复图像质量和提高诸如目标检测、图像分割等计算机视觉任务的性能至关重要。具体来说,论文关注以下几个问题:

图像反射的影响:图像中的反射会扭曲视觉内容,降低依赖清晰图像的算法的性能,例如,反射可能会遮挡目标检测中的关键特征,引起场景布局解释的歧义,以及导致增强现实叠加中的错位。

现有方法的局限性:传统的反射去除方法通常需要多张图片或复杂的硬件,这在只有单张图片可用的场景中是不切实际的。

训练数据的稀缺性:对于训练反射去除模型来说,存在高质量、多样化的训练数据集的缺乏问题。

模型性能和泛化能力的提升:如何设计有效的损失函数和训练技术,以提高模型在各种场景下的性能和泛化能力。

为了解决这些问题,论文提出了一种新颖的方法,包括一个多步损失机制、一个合成的高质量非线性数据集RefGAN,以及使用范围深度图作为辅助特征,以提高反射去除的效果。

Q: 有哪些相关研究?

A: 论文中提到的相关研究可以分为以下几个类别:

非机器学习基础的方法

- 区域感知技术:结合内容和梯度信息以增强精度的方法,例如 [1]。

- 使用非闪光环境图像去除反射和伪影:例如 [2]。

- 利用景深指导区分聚焦和反射区域:例如 [3]。

单图像反射去除方法

- CeilNet:利用深度学习预测无反射图像,无需手工特征,例如 [4]。

- 感知损失:用于提高反射去除质量,例如 [5]。

- 卷积编码器-解码器网络:例如 [6]。

- ERRNet:在不对齐的实际数据上提高性能,例如 [7]。

- 级联细化方法:例如 [8]。

- 语义引导预测:例如 [9]。

- 具有反射检测和循环模块的新型架构:例如 [10]。

- 自注意力机制和局部鉴别损失:用于更有效的反射分离,例如 [11]。

- 屏幕模糊组合技术:用于更好地模拟反射特性,例如 [12]。

- 深度变分推断反射去除(VIRR)方法:首次使用这种方法,专注于学习潜在分布以获得更好的可解释性,例如 [13]。

闪光/无闪光图像反射去除方法

- 利用闪光和环境图像对:提取仅闪光图像以估计无反射的传输图像,例如 [14]。

这些相关研究为单图像反射去除领域提供了多种技术和方法,而本文提出的新方法旨在通过引入多步损失机制、合成数据集和范围深度图来进一步改进这些技术。

Q: 论文如何解决这个问题?

A: 论文通过以下三个主要贡献来解决单张图片中的反射去除问题:

1. 多步损失机制(Multi-step Loss Mechanism)

- 多步损失函数:提出了一种新的多步损失函数,该函数迭代地将输出作为输入用于连续的步骤,并在每一步累积损失。这种机制放大了错误去除反射的损失,提供了模型性能在挑战性情况下的更具代表性的度量。

- 损失累积:与在多个步骤中平均或平滑损失不同,多步损失机制通过观察每个图像中每个步骤的不同反射比率来增强模型处理不同反射强度的能力,从而提高整体性能。

2. RefGAN数据集

- 合成数据集:为了解决训练数据不足的问题,论文通过Pix2Pix GAN合成了一个高质量的非线性合成数据集RefGAN。这个数据集提供了广泛的反射模式和强度,增强了模型学习反射去除更好模式的能力。

- 增强模型鲁棒性:RefGAN数据集显著增强了模型的鲁棒性和有效性,使其能够处理更多样化的反射情况。

3. 范围深度图(Ranged Depth Map)

- 辅助特征:使用从环境图像的深度估计中提取的范围深度图作为辅助特征,利用其缺乏反射的深度估计的特性。

- 排除反射:范围深度图帮助模型有效地从环境图像中提取目标场景,并且通过仅关注实际场景内容来排除反射。

- 增强反射去除过程:范围深度图还帮助模型建立原始图像中落在相同范围内的邻近像素之间的关系,进一步增强了反射去除过程。

方法结构

- 范围图估计模块:负责从环境图像中导出范围深度图。使用预训练的Midas Small模型计算初始深度图,并将每个像素分配到特定范围,形成范围深度图。

- 反射去除模块:利用范围深度图作为辅助特征进行反射估计。采用R-CNN架构,结合UNet预测反射图像。最终阶段使用T-CNN,将估计的反射、范围深度图和输入的环境图像一起作为输入,预测目标图像。

这些方法的结合在SIR2基准测试和其他实际数据集上展示了优越的性能,证明了其在单张图像反射去除中的有效性,并超越了其他最先进的模型。

Q: 论文做了哪些实验?

A: 论文中进行的实验包括以下几个方面:

1. 实验设置

- 硬件平台:使用Nvidia Tesla T4 GPU进行实验。

- 训练参数:模型以1的批量大小训练100个周期,初始学习率为(10^{-4}),采用余弦退火调度,从(10^{-4})开始,在第100个周期接近0。使用Adam优化器,并在模型性能稳定后从2步损失升级到3步损失。

2. 数据集

- 训练数据:包括来自[14]的真实世界数据,这些数据包含来自[17]和[18]的合成图像,以及来自[8]的Nature数据集。此外,还合成了RefGAN数据集,包含7115对环境-传输图像对。

- 验证数据:使用来自[14]验证集的30张真实世界图像。

- 评估数据:在来自[14]测试集的50张真实世界图像、来自[8]的Nature数据集的20张真实世界图像和SIR2基准测试[20](包括wild、solid object和postcard三个子测试数据集)上进行评估。

3. 定量结果

- 评估指标:使用峰值信噪比(PSNR)、结构相似性(SSIM)和Learned Perceptual Image Patch Similarity(LPIPS)等广泛接受的指标。

- 结果对比:与现有的最先进的单图像反射去除方法进行比较,结果表明所提出的方法在所有数据集上均优于其他方法。

4. 定性结果

- 结果展示:通过图5和图6展示了模型与现有最先进方法在Nature数据集和SIR2基准测试上的定性比较结果。

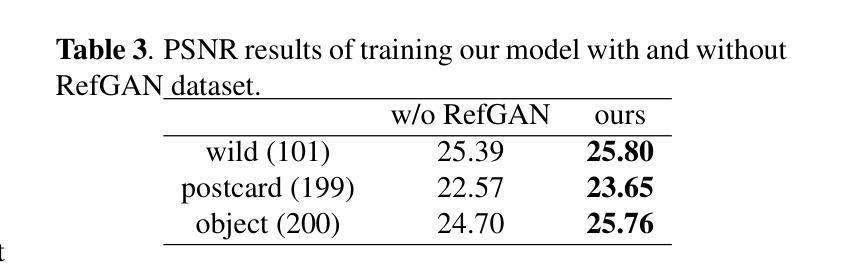

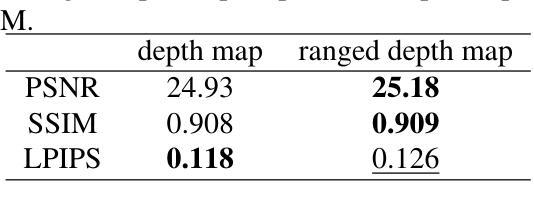

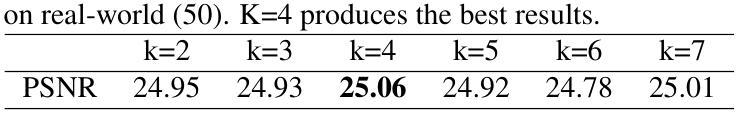

5. 消融研究

- 范围深度图与纯深度图的比较:评估使用纯深度图与范围深度图作为辅助特征的效果。

- RefGAN数据集的影响:评估在有无RefGAN数据集训练的情况下模型的性能差异。

- 不同范围深度图范围(K值)的性能:研究不同K值对模型性能的影响。

- 多步损失机制的影响:评估不同配置的多步损失对模型性能的影响。

这些实验全面评估了所提出方法的有效性,并深入分析了各个组成部分对性能的影响,从而证明了所提出方法在单图像反射去除任务中的优越性能。

Q: 有什么可以进一步探索的点?

A: 论文在第5节“结论”中提到了未来的研究方向,以下是一些可以进一步探索的点:

先进的模型架构:尽管本研究展示了损失函数、训练数据质量和辅助输入特征的有效性,未来的工作可以探索将这些方法与更先进的模型架构结合,以实现更好的性能提升。

更准确的物理模型:研究可以进一步探索集成更准确的物理模型来描述反射形成过程,这可能会在图像到图像的任务中实现更进一步的性能和泛化能力的提升。

多模态数据融合:考虑将多模态数据(例如,结合RGB图像与深度图像、红外图像等)融合到模型中,以提供更丰富的信息辅助反射去除。

实时性能优化:研究如何优化模型以实现实时或近实时的反射去除,这对于增强现实和实时视频处理等应用尤为重要。

更广泛的数据集和场景:扩展和多样化训练数据集,包括更多类型的反射和不同环境下的场景,以提高模型的泛化能力。

模型的可解释性和透明度:研究模型的决策过程,提高模型的可解释性,这有助于理解模型的行为并进一步改进算法。

跨域适应性:研究模型在不同设备和不同光照条件下的适应性,以提高其在实际应用中的灵活性和鲁棒性。

端到端的解决方案:开发一个端到端的系统,该系统可以直接在移动设备或嵌入式设备上运行,而无需复杂的后处理步骤。

长尾分布问题:针对训练数据中可能存在的类别不平衡问题,研究有效的策略来处理长尾分布,提高模型对罕见反射类型的敏感性。

模型压缩和加速:研究模型压缩技术,以减少模型大小并加速推理过程,使其更适合资源受限的环境。

这些方向不仅可以推动单图像反射去除技术的发展,也可能对计算机视觉中的其他图像到图像翻译任务产生积极影响。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

问题陈述:

- 论文关注于单张图像中的反射去除问题,这对于恢复图像质量和提高计算机视觉任务的性能至关重要。

- 传统的反射去除方法需要多张图像或复杂硬件,不适用于仅有单张图像的场景。

主要贡献:

- 提出了一种新颖的多步损失机制,用于改善模型在训练过程中的性能和泛化能力。

- 合成了一个名为RefGAN的高质量非线性合成数据集,增强了模型的鲁棒性和有效性。

- 利用范围深度图作为辅助特征来排除反射,专注于实际场景内容,以提高反射去除的效果。

方法论:

- 介绍了一个包含范围图估计模块和反射去除模块的架构。

- 使用预训练的Midas Small模型来计算初始深度图,并生成范围深度图。

- 利用R-CNN和T-CNN网络结构来预测反射和目标图像。

实验:

- 在Nvidia Tesla T4 GPU上进行实验,使用不同的数据集进行训练、验证和评估。

- 通过定量和定性结果展示了所提方法相较于现有技术的优越性。

- 进行了消融研究,分析了不同组件对性能的影响。

结论与未来工作:

- 论文提出的多步损失机制、RefGAN数据集和范围深度图在单图像反射去除任务中表现出色,超越了其他最先进模型。

- 论文还提出了未来可能的研究方向,包括探索更先进的模型架构、更准确的物理模型、多模态数据融合等。

总体而言,这篇论文通过引入新的损失机制和数据集,以及利用范围深度图作为辅助特征,提供了一种有效的单图像反射去除方法,并在多个数据集上验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

CAS-GAN for Contrast-free Angiography Synthesis

Authors:De-Xing Huang, Xiao-Hu Zhou, Mei-Jiang Gui, Xiao-Liang Xie, Shi-Qi Liu, Shuang-Yi Wang, Hao Li, Tian-Yu Xiang, Zeng-Guang Hou

Iodinated contrast agents are widely utilized in numerous interventional procedures, yet posing substantial health risks to patients. This paper presents CAS-GAN, a novel GAN framework that serves as a “virtual contrast agent” to synthesize X-ray angiographies via disentanglement representation learning and vessel semantic guidance, thereby reducing the reliance on iodinated contrast agents during interventional procedures. Specifically, our approach disentangles X-ray angiographies into background and vessel components, leveraging medical prior knowledge. A specialized predictor then learns to map the interrelationships between these components. Additionally, a vessel semantic-guided generator and a corresponding loss function are introduced to enhance the visual fidelity of generated images. Experimental results on the XCAD dataset demonstrate the state-of-the-art performance of our CAS-GAN, achieving a FID of 5.87 and a MMD of 0.016. These promising results highlight CAS-GAN’s potential for clinical applications.

碘化造影剂在众多介入手术中被广泛应用,但给患者带来较大的健康风险。本文提出了CAS-GAN,这是一种新型的GAN框架,可作为“虚拟造影剂”通过解纠缠表示学习和血管语义指导来合成X射线血管造影术,从而减少介入手术中对碘化造影剂的依赖。具体来说,我们的方法将X射线血管造影术分解为背景和血管成分,利用医学先验知识。然后,一个专门的预测器学习这些成分之间的相互作用关系。此外,还引入了血管语义引导生成器和相应的损失函数,以提高生成图像的可视逼真度。在XCAD数据集上的实验结果表明,我们的CAS-GAN达到了最先进的性能,FID为5.87,MMD为0.016。这些令人鼓舞的结果突出了CAS-GAN在临床应用中的潜力。

论文及项目相关链接

PDF IEEE Symposium Series on Computational Intelligence (SSCI 2025)

Summary

本文介绍了一种名为CAS-GAN的新型GAN框架,该框架可作为“虚拟对比剂”用于合成X射线血管造影术。通过解纠缠表示学习和血管语义指导,CAS-GAN能够减少介入过程中对碘化对比剂的需求。实验结果表明,CAS-GAN在XCAD数据集上取得了最先进的性能,具有潜在的临床应用价值。

Key Takeaways

- CAS-GAN作为虚拟对比剂,旨在合成X射线血管造影术,减少对比剂的使用。

- 通过解纠缠表示学习,CAS-GAN将X射线血管造影术分解为背景与血管成分。

- 引入医学先验知识,通过专用预测器学习各成分间的相互关系。

- 首次提出使用血管语义引导的生成器和相应的损失函数,以提高生成图像的可视保真度。

- CAS-GAN在XCAD数据集上的性能达到最新水平,FID为5.87,MMD为0.016。

- CAS-GAN的潜在临床应用价值显著。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为CAS-GAN的新型生成对抗网络(GAN)框架,旨在解决介入性医疗程序中使用碘造影剂带来的健康风险问题。通过使用CAS-GAN,研究者们希望能够合成出无需使用碘造影剂的X射线血管造影图像,从而减少对这些可能对患者造成潜在健康风险的造影剂的依赖。

具体来说,论文中提到了以下几个关键问题:

心血管疾病(CVDs)的治疗需求:心血管疾病是全球死亡的主要原因,而图像引导的血管介入手术是治疗心血管疾病的主流方法之一。

碘造影剂的健康风险:在X射线血管造影中,为了使血管显影,需要使用碘基的造影剂。然而,这些造影剂存在副作用,包括可能危及生命的过敏反应,以及对肾脏的潜在损害,尤其是在已有肾脏疾病或糖尿病患者中。

减少造影剂使用的需求:为了满足临床需求,同时显著减少造影剂剂量甚至不使用造影剂,同时保持成像质量,这是X射线血管造影系统必须解决的关键挑战。

生成对抗网络(GANs)的应用:论文提出了利用GANs作为“虚拟造影剂”来生成逼真的X射线血管造影图像的可能性,这可能会减少对碘造影剂的依赖,并提高介入手术的安全性和效率。

图像到图像的翻译挑战:将非对比X射线图像转换为X射线血管造影图像是一个具有挑战性的问题,因为它不仅需要在两个图像域之间进行风格转换,还需要精确的一对一图像映射。

论文提出的CAS-GAN框架通过解耦X射线血管造影图像的背景和血管成分,并利用医学先验知识,使用神经网络学习这些成分之间的相互关系,从而解决了上述挑战。此外,还引入了血管语义引导生成器和相应的损失函数,以增强生成图像的视觉保真度。

Q: 有哪些相关研究?

A: 论文中提到了多个与CAS-GAN相关的研究工作,可以归纳为以下几个方面:

1. 生成对抗网络(GANs)

- GANs由Goodfellow等人在2014年引入,通过建立一个最小最大优化游戏,其中生成器G旨在模仿真实数据样本的分布,而判别器D评估它们的真伪。

- 论文中提到了一些GAN的变种,它们通过更稳定的训练目标来解决训练GANs时的挑战,比如梯度消失和模式崩溃问题。

2. 图像到图像的翻译(Image-to-image translation)

- 这项工作涉及将图像从一个域转换到另一个域,同时保持其底层结构或内容。

- Isola等人提出了一个条件GAN框架,使用对抗损失和L1重建损失在成对数据上进行训练。

- 近期的研究集中在无成对数据的翻译上,引入了循环一致性等额外约束以保持域转换期间的语义一致性。

3. 解耦表示学习(Disentanglement representation learning)

- 解耦表示学习通过将图像分解为具有物理意义的成分来提高生成图像的可控性和可解释性。

- 一些工作尝试将图像分解为内容和风格表示,以实现通过交换风格表示进行图像翻译。

4. 医学图像生成和翻译

- 论文中提到了几项与医学图像生成和翻译相关的研究,包括使用GANs从非对比X射线图像生成X射线血管造影图像的研究。

5. 相关技术方法

- 论文还提到了一些技术方法,如注意力机制(attention mechanisms)、自监督对比损失(self-supervised contrast loss)等,这些方法被用于增强不同域之间语义关系的翻译。

具体论文和方法

- CycleGAN:用于无成对图像到图像的翻译。

- UNIT、MUNIT:用于无监督的图像到图像的翻译网络。

- AttentionGAN:使用注意力引导的生成对抗网络进行无成对图像到图像的翻译。

- QS-Attn:使用查询选择注意力进行对比学习。

- StegoGAN:用于非双射图像到图像的翻译,利用隐写术。

这些相关研究为CAS-GAN提供了理论基础和技术背景,同时也展示了在医学图像翻译领域中,如何利用深度学习技术来解决实际的临床问题。

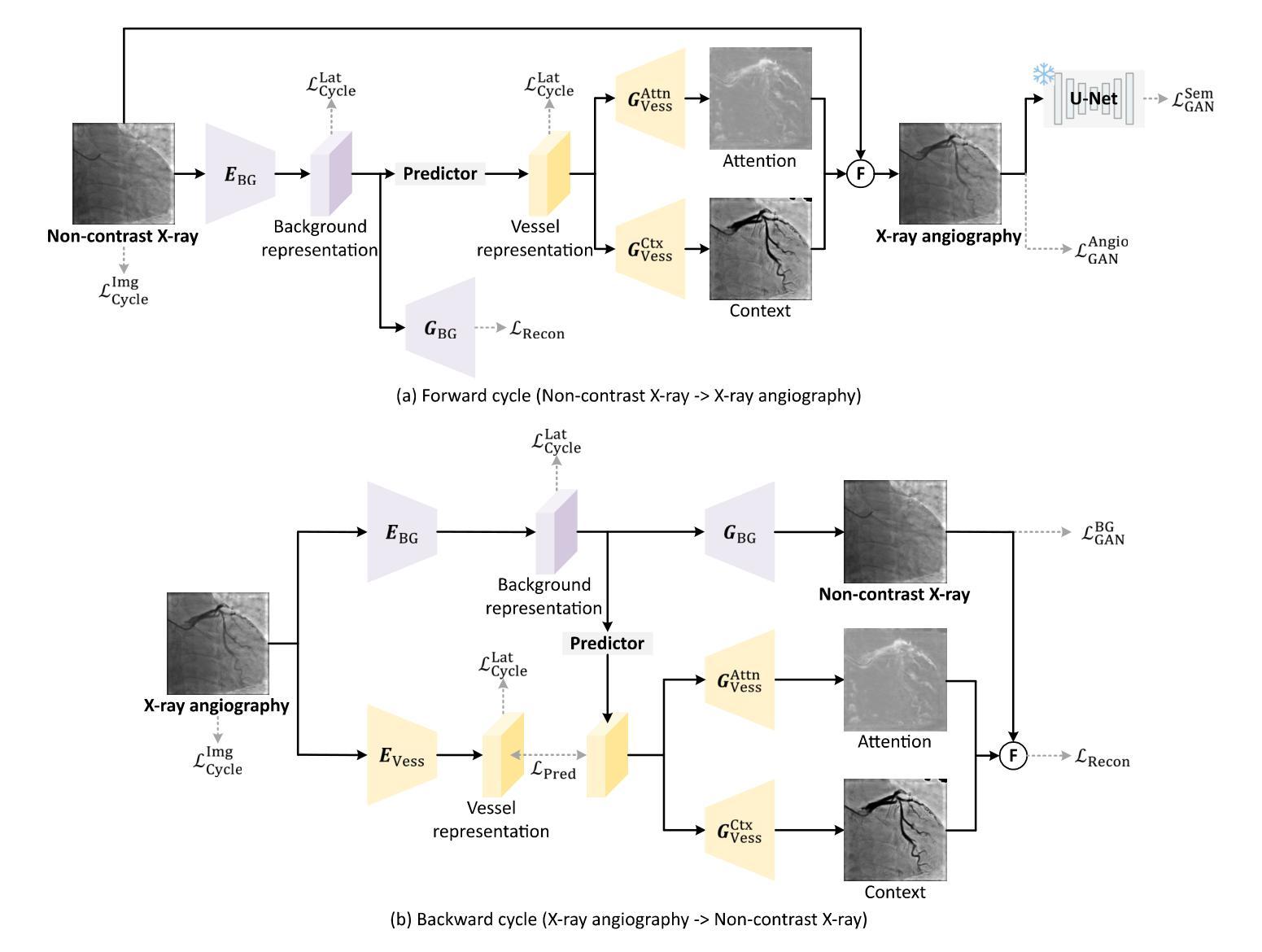

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为CAS-GAN的新型生成对抗网络(GAN)框架来解决这个问题。CAS-GAN框架的核心思想是将X射线血管造影图像解耦为背景和血管成分,然后通过神经网络学习这两部分之间的相互关系,以此来生成逼真的血管造影图像。以下是该方法解决该问题的关键步骤:

解耦表示学习(Disentanglement Representation Learning):

- 使用两个专门的编码器(一个背景编码器和一个血管编码器)将X射线血管造影图像分解为背景和血管成分。

- 通过一个称为“预测器”的神经网络,从背景表示中推断出血管表示。

血管语义引导生成器(Vessel Semantic-Guided Generator):

- 为了提高生成图像中血管的真实性,引入了两个专门的生成器:一个用于注意力掩模,一个用于上下文掩模。

- 这些生成器利用预测器提供的血管表示来生成逼真的血管结构。

血管语义引导的对抗损失(Vessel Semantic-Guided Adversarial Loss):

- 为了提高GAN对真实和生成血管图像之间差异的识别能力,引入了一种新的对抗损失,专注于血管的语义差异。

- 使用预训练的U-Net网络提取原始和生成血管造影图像中的血管语义图像,然后定义基于这些语义图像的对抗损失。

训练目标(Training Objective):

- 由于两个图像域之间的映射高度不确定,因此结合了多种有效的损失函数来训练CAS-GAN,包括预测损失、对抗损失、循环一致性损失和重建损失。

- 这些损失函数的加权和构成了CAS-GAN的训练目标,以优化图像翻译过程的各个方面。

通过这些方法,CAS-GAN能够有效地从非对比X射线图像中生成逼真的X射线血管造影图像,从而减少对碘造影剂的依赖,并提高介入手术的安全性和效率。论文中的实验结果表明,CAS-GAN在XCAD数据集上实现了最先进的性能,证明了其在临床应用中的潜力。

Q: 论文做了哪些实验?

A: 论文中进行了多项实验来验证CAS-GAN模型的性能,包括与其他最先进方法的比较、消融研究以及外部验证。以下是实验的具体内容:

A. 数据集(Dataset)

- 使用了X射线血管造影冠状血管分割数据集(XCAD),该数据集包含非对比X射线图像和X射线血管造影图像。

- 数据集分为两个子集:一个用于图像翻译任务,另一个用于训练U-Net提取血管语义信息。

- 随机选择了621张非对比X射线图像和621张X射线血管造影图像作为测试集,其余作为训练集。

B. 实现细节(Implementation details)

- 采用了与CycleGAN相同的生成器和判别器架构,以进行公平比较。

- 预测器使用多层感知机(MLP)实现。

- 使用PyTorch、Python和Ubuntu环境,搭载NVIDIA GeForce RTX 4090 GPU进行实验。

- 使用Adam优化器进行1000个周期的训练,初始学习率设置为2e-4,并在700个周期后线性降低至零。

C. 评估指标(Evaluation metrics)

- 使用了Fréchet Inception Distance(FID)和Maximum Mean Discrepancy(MMD)两个指标来评估生成图像的性能。

D. 实验结果(Results)

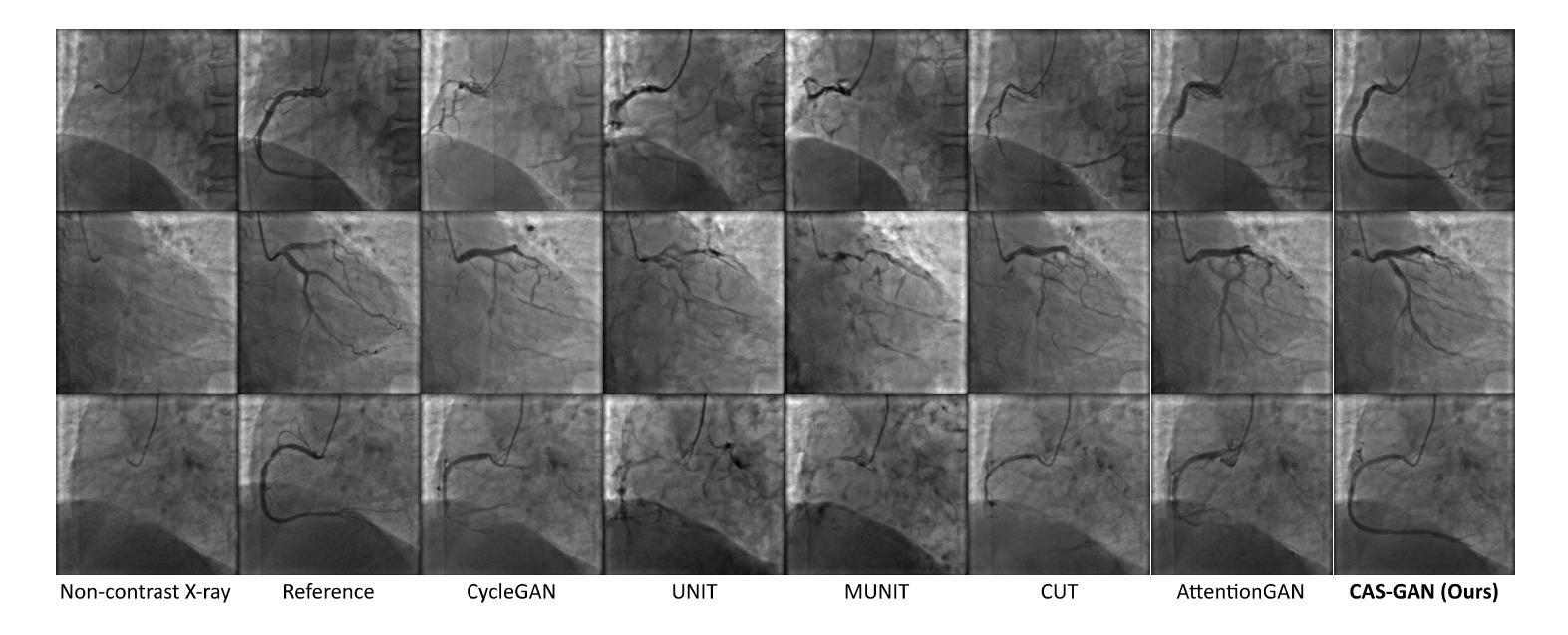

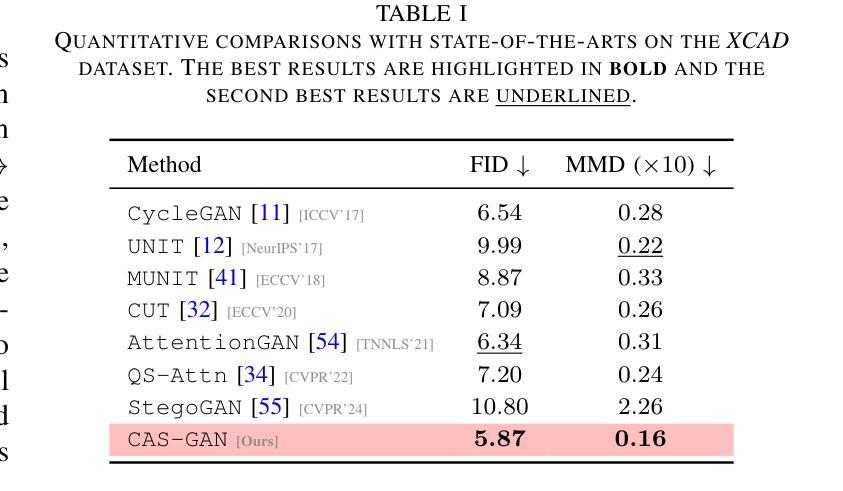

1. 与最先进方法的比较(Comparisons with state-of-the-arts)

- 将CAS-GAN与其他几种领先的无成对图像到图像翻译方法进行了比较,包括CycleGAN、UNIT、MUNIT、CUT、AttentionGAN、QS-Attn和StegoGAN。

- 在XCAD数据集上的定量结果表明,CAS-GAN在FID和MMD两个指标上均优于其他基线方法。

2. 消融研究(Ablation studies)

- 进行了广泛的消融实验来验证CAS-GAN中几个设计的有效性,包括解耦表示学习(DRL)、血管语义引导生成器(VSGG)和血管语义引导损失(VSGL)。

- 实验结果显示,这些设计显著提高了模型的性能。

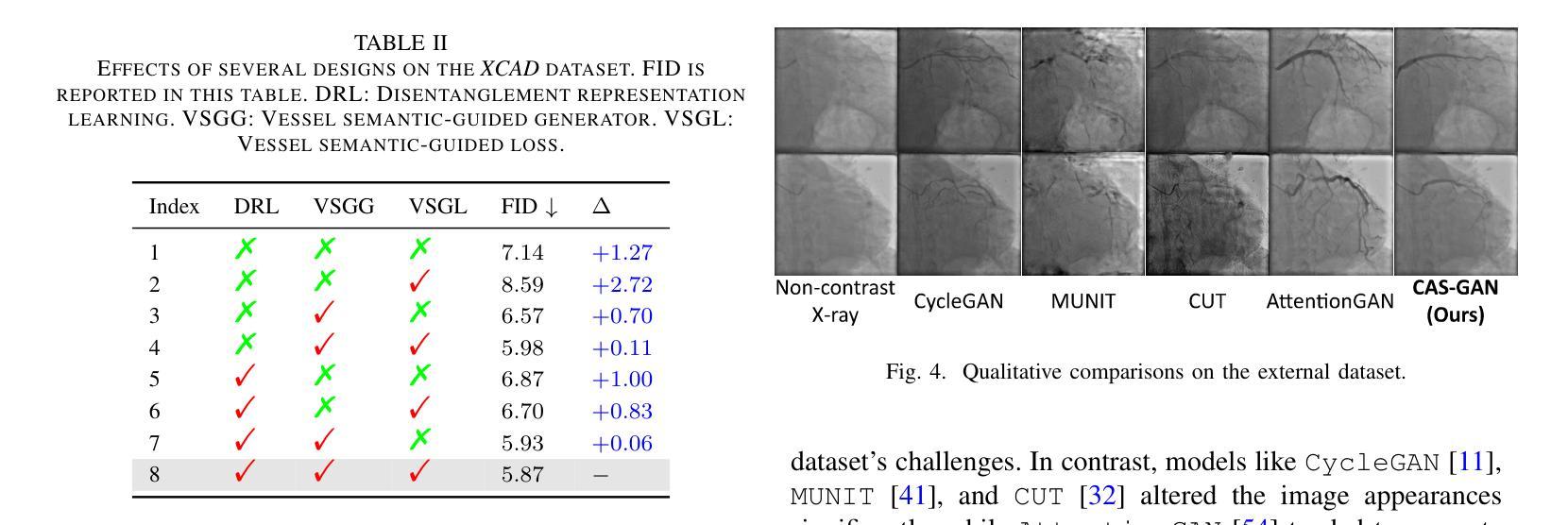

3. 外部验证(External validation)

- 为了验证模型的泛化能力,还在来自合作医院的外部数据集上进行了实验。

- 尽管所有方法在处理XCAD和外部数据集之间的显著差异时都遇到了困难,但CAS-GAN展示了相对较好的性能。

这些实验结果证明了CAS-GAN在无需对比剂的X射线血管造影合成任务中的有效性和优越性能。论文还指出,未来的工作将通过扩大训练数据集和纳入更先进的模型来进一步提高CAS-GAN的能力。

Q: 有什么可以进一步探索的点?

A: 论文在结论部分提出了一些未来工作的方向,以下是一些可以进一步探索的关键点:

扩展训练数据集:通过增加数据集的大小和多样性来提高模型在外部数据集上的性能。这可能包括收集更多的X射线血管造影图像以及对应的非对比X射线图像,以提高模型的泛化能力。

纳入更先进的模型:探索使用更先进的生成模型,如StyleGAN等,以进一步提高生成图像的质量和真实感。

改进损失函数:研究和设计新的损失函数,以更好地捕捉血管造影图像的特定特征,从而提高生成图像的质量。

多模态数据融合:考虑将CAS-GAN与其他成像模态(如CT、MRI)结合,以实现多模态图像融合和翻译。

实时性能优化:优化模型的计算效率,使其能够在临床环境中实时生成高质量的血管造影图像。

临床验证:与医疗专家合作,进行临床试验以验证CAS-GAN生成的图像在实际诊断和治疗规划中的有效性和安全性。

交互式系统开发:开发交互式系统,使医生能够根据需要调整生成的血管造影图像,以更好地满足特定的临床需求。

模型解释性:提高模型的可解释性,使医生能够理解模型的决策过程,从而增加对生成图像的信任。

跨领域应用:探索CAS-GAN在其他医疗图像翻译任务中的应用,如不同模态之间的图像转换或病理图像的合成。

鲁棒性和安全性测试:对模型进行广泛的鲁棒性和安全性测试,以确保其在各种临床条件下都能稳定地工作。

这些方向不仅可以推动CAS-GAN技术的发展,还可能对医疗图像处理和计算机视觉领域产生更广泛的影响。

Q: 总结一下论文的主要内容

A: 这篇论文介绍了一种名为CAS-GAN的新型生成对抗网络(GAN)框架,旨在解决介入性医疗程序中使用碘造影剂带来的健康风险问题。CAS-GAN通过解耦表示学习和血管语义引导生成血管造影图像,以减少对碘造影剂的依赖。

以下是论文的主要内容概述:

问题背景:心血管疾病是全球主要死因之一,而X射线血管造影是诊断和治疗这些疾病的关键技术。然而,传统的X射线血管造影需要使用碘基造影剂,这些造影剂可能引起严重的副作用,包括过敏反应和肾脏损害。

CAS-GAN框架:提出了一种新颖的GAN框架,通过解耦背景和血管成分,利用医学先验知识,使用神经网络学习这两部分之间的相互关系,从而合成逼真的血管造影图像。

方法论:

- 解耦表示学习:使用专门的编码器将血管造影图像分解为背景和血管成分,并用一个神经网络(预测器)来推断血管表示。

- 血管语义引导生成器:引入两个专门的生成器来生成注意力掩模和上下文掩模,以增强生成图像中血管的真实性。

- 血管语义引导的对抗损失:提出了一种新的对抗损失,专注于血管的语义差异,以提高GAN对真实和生成血管图像之间差异的识别能力。

实验:

- 使用XCAD数据集进行实验,该数据集包含非对比X射线图像和X射线血管造影图像。

- 在定量和定性上与其他最先进方法进行比较,CAS-GAN在FID和MMD指标上均优于其他方法。

- 进行消融研究验证了解耦表示学习、血管语义引导生成器和血管语义引导损失的有效性。

- 在外部数据集上进行验证,展示了CAS-GAN的泛化能力。

结论与未来工作:CAS-GAN为减少介入手术中碘造影剂的使用提供了一种有前景的方法。未来的工作将通过扩大训练数据集和纳入更先进的模型来进一步提高CAS-GAN的性能。

总的来说,这篇论文提出了一个创新的解决方案来应对医疗成像中的一个关键挑战,并展示了有希望的初步结果。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图