⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-17 更新

Efficient Generative Modeling with Residual Vector Quantization-Based Tokens

Authors:Jaehyeon Kim, Taehong Moon, Keon Lee, Jaewoong Cho

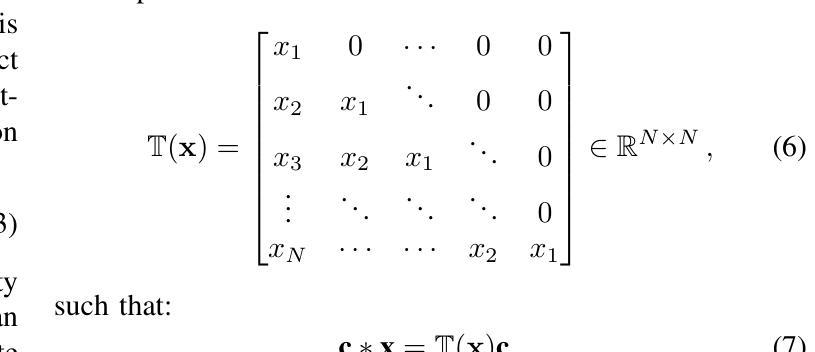

We explore the use of Residual Vector Quantization (RVQ) for high-fidelity generation in vector-quantized generative models. This quantization technique maintains higher data fidelity by employing more in-depth tokens. However, increasing the token number in generative models leads to slower inference speeds. To this end, we introduce ResGen, an efficient RVQ-based discrete diffusion model that generates high-fidelity samples without compromising sampling speed. Our key idea is a direct prediction of vector embedding of collective tokens rather than individual ones. Moreover, we demonstrate that our proposed token masking and multi-token prediction method can be formulated within a principled probabilistic framework using a discrete diffusion process and variational inference. We validate the efficacy and generalizability of the proposed method on two challenging tasks across different modalities: conditional image generation} on ImageNet 256x256 and zero-shot text-to-speech synthesis. Experimental results demonstrate that ResGen outperforms autoregressive counterparts in both tasks, delivering superior performance without compromising sampling speed. Furthermore, as we scale the depth of RVQ, our generative models exhibit enhanced generation fidelity or faster sampling speeds compared to similarly sized baseline models. The project page can be found at https://resgen-genai.github.io

我们探索了残差向量量化(RVQ)在向量量化生成模型中的高保真生成应用。这种量化技术通过采用更深入的标记来保持更高的数据保真度。然而,在生成模型中增加标记数量会导致推理速度变慢。为此,我们引入了ResGen,这是一种基于RVQ的高效离散扩散模型,能够在不牺牲采样速度的情况下生成高保真样本。我们的核心思想是对集体标记的向量嵌入进行直接预测,而不是单独预测。此外,我们证明,通过离散扩散过程和变分推断,我们提出的标记掩码和多标记预测方法可以在有原则的概率框架内制定。我们在不同模态的两个具有挑战性的任务上验证了所提出方法的有效性和通用性:ImageNet 256x256上的条件图像生成和零样本文本到语音合成。实验结果表明,ResGen在这两项任务中的表现均优于自回归模型,在不影响采样速度的情况下取得了优越的性能。此外,随着我们扩大RVQ的深度,我们的生成模型与类似规模的基准模型相比,表现出更高的生成保真度或更快的采样速度。项目页面可在https://resgen-genai.github.io找到。

论文及项目相关链接

Summary

本文探索了用于高保真生成的Residual Vector Quantization(RVQ)技术。为提高数据保真度,研究了一种基于RVQ的离散扩散模型ResGen,可直接预测集体向量的嵌入,而不牺牲采样速度。通过离散扩散过程和变分推断的概率框架,提出了令牌掩码和多令牌预测方法。在ImageNet 256x256的条件图像生成和零样本文本到语音合成的任务中验证了其有效性和通用性。实验结果显示,ResGen在任务上优于自回归模型,提高了生成保真度或采样速度。

Key Takeaways

- 研究采用Residual Vector Quantization(RVQ)技术实现高保真生成。

- 提出一种基于RVQ的离散扩散模型ResGen,可生成高质量样本且不影响采样速度。

- ResGen通过直接预测集体向量的嵌入来提高数据保真度。

- 结合离散扩散过程和变分推断,构建了令牌掩码和多令牌预测方法。

- 在ImageNet 256x256的条件图像生成和零样本文本到语音合成任务中验证了ResGen的有效性。

- 实验结果显示,ResGen在任务性能上优于自回归模型。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何在向量量化生成模型中实现高保真度数据生成,同时保持较快的采样速度。具体来说,论文探讨了使用残差向量量化(Residual Vector Quantization, RVQ)技术来提高数据重建质量,同时提出了一个高效的RVQ基的离散扩散模型(ResGen),用于在不牺牲采样速度的情况下生成高保真度样本。论文的主要贡献包括:

直接预测集体标记的向量嵌入:ResGen通过直接预测集体标记的向量嵌入而不是逐个预测每个标记,从而解耦了采样复杂度与序列长度和深度的关系。

基于离散扩散过程和变分推断的概率框架:论文展示了所提出的标记掩蔽和多标记预测方法可以被纳入一个基于离散扩散过程和变分推断的原则化概率框架中。

在不同模态上验证方法的有效性和泛化能力:通过在ImageNet上的有条件图像生成任务和零样本文本到语音合成任务上的实验,论文证明了ResGen在这些任务上相较于自回归模型具有优越的性能,且没有牺牲采样速度。

分析模型特性和超参数的影响:通过消融研究,论文还分析了不同超参数(如采样步骤)对生成质量的影响,并考察了模型在不同RVQ深度下的特性。

总的来说,这篇论文旨在通过引入新的RVQ基生成模型ResGen,解决在生成高分辨率、高保真度数据时面临的质量和计算效率之间的平衡问题。

Q: 有哪些相关研究?

A: 根据论文内容,以下是与本研究相关的一些工作:

向量量化(VQ)标记基础的生成模型:

- VQ-GAN (Esser et al., 2021) 和 DALLE (Ramesh et al., 2021) 利用离散表示进行图像合成,使用变换器(transformers)来实现高质量的数据生成,同时保持计算资源的可管理性。

离散扩散模型:

- MaskGIT (Chang et al., 2022) 和 VQ-Diffusion (Gu et al., 2022) 专注于对平面标记序列进行掩蔽标记预测,与自回归模型相比提高了采样效率。

- GIVT (Tschannen et al., 2023) 引入了一种方法,用基于高斯混合的向量预测代替基于softmax的标记预测,逐步填充掩蔽位置。

基于RVQ的生成模型:

- RQ-Transformer (Lee et al., 2022) 是第一个展示在RVQ标记上使用自回归模型进行生成建模的研究,其计算复杂度随着序列长度和深度的乘积增加。

- Vall-E (Wang et al., 2023) 预测第一深度的标记,然后顺序地预测每个深度的剩余标记。

- SoundStorm (Borsos et al., 2023) 使用掩蔽标记预测给定语义标记生成标记,但其采样时间复杂度仍随残差量化深度线性增加。

- NaturalSpeech 2 (Shen et al., 2024) 在RVQ嵌入空间中使用基于扩散的生成建模而不是标记生成。

- CLaM-TTS (Kim et al., 2024) 使用向量预测进行多标记预测,但以自回归方式沿序列长度操作。

其他生成模型方法:

- VAR (Tian et al., 2024) 和 MAR (Li et al., 2024) 提出了替代基于标记的自回归建模的新范式。VAR引入了粗到细的下一尺度预测机制,有效地捕获了图像中的层次结构。MAR通过使用基于扩散的方法在连续值空间中对概率进行建模,消除了对离散标记的依赖,简化了流程同时保持了强大的性能。

这些相关工作提供了不同的视角和技术,用于处理基于标记的生成模型中的挑战,特别是在处理高分辨率、高保真度数据生成时的质量和计算效率之间的平衡问题。ResGen方法与这些工作相比,提供了一个更有效的解决方案,通过预测掩蔽标记的向量嵌入,从序列长度和标记深度中解耦采样时间复杂度。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为ResGen的高效RVQ(Residual Vector Quantization)基的离散扩散模型来解决高保真度数据生成与快速采样之间的平衡问题。以下是ResGen解决该问题的关键方法:

1. 直接预测集体标记的向量嵌入

ResGen的核心思想是直接预测集体标记的向量嵌入,而不是逐个预测每个标记。这种方法通过对累积嵌入的预测,允许模型在不同深度上估计相关联的标记,与残差量化过程自然对齐。这样,ResGen能够从序列长度和深度中解耦采样复杂度,生成高保真度样本而不影响采样速度。

2. 掩蔽标记策略和多标记预测

掩蔽标记策略:ResGen采用一种特别适合RVQ标记的掩蔽策略,从最高量化层开始逐步掩蔽标记,利用RVQ的层次性质,其中更深层次的标记捕获更精细的细节。

多标记预测:ResGen在训练和解码阶段通过聚焦于预测聚合向量嵌入z而不是直接预测目标标记,有效预测掩蔽标记。这种方法避免了沿深度的标记条件独立性,这对于模型性能可能是有害的。

3. 基于离散扩散过程和变分推断的概率框架

ResGen将掩蔽标记预测过程纳入一个基于离散扩散模型和变分推断的原则化概率框架中。这种观点允许将ResGen视为一个基于似然的生成过程,并为其设计提供了理论基础。

前向离散扩散过程:将标记掩蔽过程解释为离散扩散模型在标记序列上的前向扩散步骤,逐渐将完全未掩蔽的标记序列转化为完全掩蔽的序列。

反向离散扩散过程:旨在从部分掩蔽的序列中重建原始标记,定义了重建原始标记的概率,并计算数据对数似然的变分下界。

4. 实验验证

论文通过在ImageNet上的有条件图像生成任务和零样本文本到语音合成任务上的实验验证了ResGen的有效性和泛化能力。实验结果显示,ResGen在这些任务上的性能超过了自回归模型,并且在RVQ深度扩展时,与同样大小的基线生成模型相比,展现了更高的生成保真度或更快的采样速度。

5. 消融研究

论文还通过消融研究分析了不同超参数(例如采样步骤)对生成质量的影响,并考察了模型在不同RVQ深度下的特性。

通过这些方法,ResGen有效地解决了在向量量化生成模型中生成高保真度数据与保持快速采样速度之间的平衡问题。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来验证ResGen模型的有效性和泛化能力:

1. 实验设置

实验任务:

- 视觉领域:在ImageNet数据集上进行条件图像生成任务,分辨率为256×256。

- 音频领域:使用Voicebox启发的两个任务进行评估:(1) 继续任务(continuation),给定文本和3秒的真实语音段落,目标是生成与提供段落相同风格的无缝语音;(2) 跨句子任务(cross-sentence),给定文本、3秒语音段落及其与文本不同的转录,目标是生成用提供段落风格朗读文本的语音。

评估指标:

- 视觉任务:使用Fréchet Inception Distance (FID) 来比较与其他最先进图像生成模型。

- 音频任务:使用字符错误率(CER)、单词错误率(WER)和说话人相似度(SIM)等客观指标进行评估。

基线和训练配置:与包括自回归模型和非自回归模型在内的最新生成模型进行比较,并详细说明ResGen模型的训练配置。

2. 实验结果

视觉任务:

- 展示了ResGen在保持参数效率的同时,与基线模型相比在准确性和推理时间上的优势。

- 使用FID指标评估生成质量,比较不同模型在生成质量、内存效率和生成速度方面的表现。

音频任务:

- 与生成RVQ标记的自回归模型进行比较,展示了ResGen在WER、CER和SIM指标上的优势,以及需要更少的推理步骤。

- 与最新的TTS模型进行比较,展示了ResGen在计算效率和准确性方面的优势。

3. 消融研究

- 分析了不同采样超参数(如采样步骤数、top-p值和温度缩放)对模型行为和生成质量的影响。

- 展示了增加采样步骤数、调整top-p值和温度对生成质量的改善。

这些实验验证了ResGen在不同模态上的强大性能,包括图像生成和文本到语音合成任务,并与现有的自回归和非自回归方法进行了比较。实验结果显示,ResGen在保持高保真度的同时,提供了更快的采样速度和更好的内存效率。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

1. 利用键值(KV)缓存优化采样速度

论文提到,通过在变换器架构中使用键值(KV)缓存,可以重用已经完全填充的标记的预计算KV值,减少冗余计算。这种策略可以显著提高采样速度和降低整体计算开销,是一个值得未来研究的方向。

2. 探索新的量化方法

论文提到了残差向量量化(RVQ)标记,但也提到了有限标量量化(FSQ)可能带来额外的好处。将ResGen方法扩展到支持FSQ可能需要不同的标记化和嵌入过程,探索这一方向可能带来新的量化策略和改进的生成性能。

3. 提供理论解释

论文中提到,ResGen方法在相对较少的迭代次数下就实现了高质量的生成,相比传统的扩散模型更有效。论文假设这种效率来自于解掩过程而不是去噪过程,因为基于完全解掩的标记进行预测比基于噪声输入的预测更容易。尽管如此,论文缺乏对这一现象的理论证明,提供正式的理论分析解释是一个有前景的未来研究方向。

4. 扩展到其他模态和任务

论文中的实验主要集中在图像和语音合成任务上,但ResGen模型的框架是通用的。将其扩展到其他模态(如视频或更复杂的音频任务)和不同类型的生成任务(如无条件生成或交互式生成)是另一个值得探索的方向。

5. 提高模型的泛化能力

虽然ResGen在特定任务上表现出色,但提高模型对不同领域和分布的泛化能力始终是一个重要的研究方向。这可能包括在更多样化的数据集上训练模型,或者开发更先进的技术来适应不同的生成场景。

6. 优化模型的计算效率

尽管ResGen在内存效率和采样速度方面已经表现出色,但进一步优化模型的计算效率,特别是在资源受限的环境中,仍然是一个重要的研究方向。

7. 探索不同的训练策略

论文中提到了一些训练策略,如使用混合高斯分布来表示潜在嵌入的分布。探索不同的训练策略和正则化技术,以进一步提高模型的性能和稳定性,也是一个有价值的研究方向。

这些方向不仅可以推动ResGen模型的发展,也有助于推动整个生成模型领域的进步。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为ResGen的高效RVQ(Residual Vector Quantization)基的离散扩散模型,旨在解决在向量量化生成模型中生成高保真度数据与保持快速采样速度之间的平衡问题。以下是论文的主要内容总结:

1. 研究动机

- 向量量化生成模型在高保真度数据生成方面面临挑战,尤其是在平衡生成质量和计算效率方面。

2. ResGen模型

- 核心思想:直接预测集体标记的向量嵌入而不是逐个预测每个标记,以解耦采样复杂度与序列长度和深度的关系。

- 掩蔽标记策略:采用特别适合RVQ标记的掩蔽策略,从最高量化层开始逐步掩蔽标记。

- 多标记预测:通过聚焦于预测聚合向量嵌入而不是直接预测目标标记,有效预测掩蔽标记。

3. 概率框架

- 将掩蔽标记预测过程纳入基于离散扩散模型和变分推断的原则化概率框架中,提供了理论基础。

4. 实验验证

- 在ImageNet上的有条件图像生成任务和零样本文本到语音合成任务上的实验验证了ResGen的有效性和泛化能力。

- 实验结果显示,ResGen在这些任务上的性能超过了自回归模型,并且在RVQ深度扩展时,与同样大小的基线生成模型相比,展现了更高的生成保真度或更快的采样速度。

5. 消融研究

- 分析了不同采样超参数对模型行为和生成质量的影响,包括采样步骤数、top-p值和温度缩放。

6. 结论与未来方向

- ResGen通过直接预测集体标记的向量嵌入,有效地解决了生成高保真度数据与快速采样之间的平衡问题。

- 提出了进一步探索的方向,包括利用键值缓存优化采样速度、探索新的量化方法、提供理论解释、扩展到其他模态和任务等。

总的来说,这篇论文提出了一个创新的解决方案来提高向量量化生成模型的效率和保真度,并在多个任务上验证了其有效性,为未来的研究提供了新的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Enhanced Speech Emotion Recognition with Efficient Channel Attention Guided Deep CNN-BiLSTM Framework

Authors:Niloy Kumar Kundu, Sarah Kobir, Md. Rayhan Ahmed, Tahmina Aktar, Niloya Roy

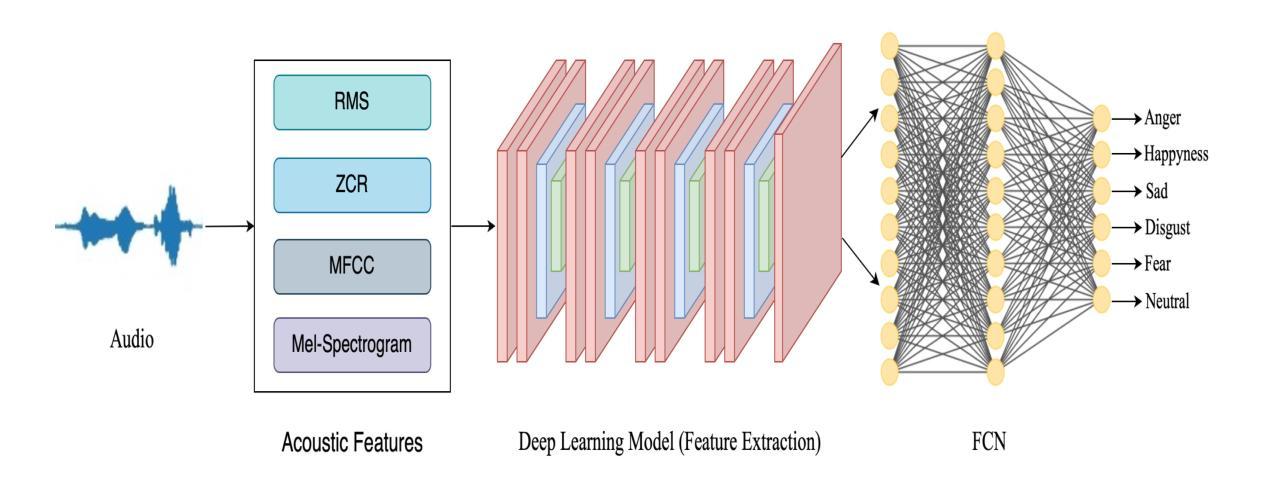

Speech emotion recognition (SER) is crucial for enhancing affective computing and enriching the domain of human-computer interaction. However, the main challenge in SER lies in selecting relevant feature representations from speech signals with lower computational costs. In this paper, we propose a lightweight SER architecture that integrates attention-based local feature blocks (ALFBs) to capture high-level relevant feature vectors from speech signals. We also incorporate a global feature block (GFB) technique to capture sequential, global information and long-term dependencies in speech signals. By aggregating attention-based local and global contextual feature vectors, our model effectively captures the internal correlation between salient features that reflect complex human emotional cues. To evaluate our approach, we extracted four types of spectral features from speech audio samples: mel-frequency cepstral coefficients, mel-spectrogram, root mean square value, and zero-crossing rate. Through a 5-fold cross-validation strategy, we tested the proposed method on five multi-lingual standard benchmark datasets: TESS, RAVDESS, BanglaSER, SUBESCO, and Emo-DB, and obtained a mean accuracy of 99.65%, 94.88%, 98.12%, 97.94%, and 97.19% respectively. The results indicate that our model achieves state-of-the-art (SOTA) performance compared to most existing methods.

语音情感识别(SER)对于增强情感计算和丰富人机交互领域至关重要。然而,SER的主要挑战在于以较低的计算成本从语音信号中选择相关的特征表示。在本文中,我们提出了一种轻量级的SER架构,该架构集成了基于注意力的局部特征块(ALFBs),以捕获语音信号中的高级相关特征向量。我们还采用了全局特征块(GFB)技术,以捕获语音信号中的序列全局信息以及长期依赖性。通过聚合基于注意力的局部和全局上下文特征向量,我们的模型有效地捕获了反映复杂人类情绪线索的突出特征之间的内部相关性。为了评估我们的方法,我们从语音音频样本中提取了四种类型的频谱特征:梅尔频率倒谱系数、梅尔频谱图、均方根值和零交叉率。通过5倍交叉验证策略,我们在五个多语言标准基准数据集上测试了所提出的方法:TESS、RAVDESS、BanglaSER、SUBESCO和Emo-DB,分别获得了99.65%、94.88%、98.12%、97.94%和97.19%的平均准确率。结果表明,与大多数现有方法相比,我们的模型达到了最新(SOTA)的性能水平。

论文及项目相关链接

PDF 42 pages,10 figures

Summary

本文提出了一种轻量级的语音情感识别架构,该架构结合了注意力机制的局部特征块和全局特征块技术,能够从语音信号中捕捉高层次的特征向量和全局信息。在五个多语种标准数据集上的实验结果表明,该模型取得了先进的性能。

Key Takeaways

- 语音情感识别对于提升情感计算和丰富人机交互领域具有重要意义。

- 主要挑战在于从语音信号中选择相关的特征表示,同时降低计算成本。

- 提出了一个轻量级的SER架构,该架构结合了注意力机制的局部特征块(ALFBs)和全局特征块(GFB)技术。

- 通过整合局部和全局的上下文特征向量,模型能有效捕捉反映复杂人类情感线索的显著特征之间的内部关联。

- 在五个多语种标准数据集上进行了5折交叉验证策略的实验评估。

- 该模型取得了平均准确率99.65%、94.88%、98.12%、97.94%、97.19%的优异表现。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是在语音情感识别(Speech Emotion Recognition, SER)领域中,如何从语音信号中选择相关的特征表示,同时降低计算成本。具体来说,论文面临的挑战包括:

复杂人类情感的表示:人类情感的复杂性和语音信号的多样性特征使得准确识别情感状态成为一个显著的挑战。

特征提取:构建一个准确和鲁棒的SER模型的关键在于提取声学特征,这些特征能够充分捕获情感信息,并且对模型训练至关重要。

计算成本:传统的特征提取方法在处理高维语音特征时面临挑战,而且计算成本较高。因此,需要一种更轻量级的方法来有效地从语音信号中提取高层次的相关特征向量。

为了解决这些问题,论文提出了一个轻量级的SER架构,该架构集成了基于注意力的局部特征块(ALFBs)来捕获语音信号中的高级相关特征向量,并结合全局特征块(GFB)技术来捕获语音信号中的序列、全局信息和长期依赖性。这样的模型设计旨在通过聚合基于注意力的局部和全局上下文特征向量,有效地捕获反映复杂人类情感线索的显著特征之间的内部相关性。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的工作:

Kwon et al. [32]: 提出了一个基于一维扩张CNN和残差块的模型,使用跳跃连接来识别语音信号中每个段落的局部特征。该模型在IEMOCAP和Emo-DB数据集上进行了评估,分别达到了73%和90%的预测准确率。

Alluhaidan et al. [33]: 结合了MFCCs和时域特征(MFCCT)来增强SER性能。所提出的混合特征被输入到CNN中以构建SER模型,在Emo-DB、SAVEE和RAVDESS数据集上分别达到了97%、93%和92%的准确率。

Patnaik [34]: 提出了一个基于复杂Mel频率倒谱系数(c-MFCCs)的深度序列模型,用于基于情感的分类。c-MFCCs能够捕获语音信号的幅度和相位信息,提供更全面的信息。

Ahmed et al. [7]: 提出了一个使用MFCC、Chromagram和音高、LMS、ZCR和RMS特征从语音信号中提取信息的模型。他们通过结合1D-CNN、LSTM和GRU神经网络提出了一种新的SER方法,并在多个数据集上取得了优异的性能。

Zhong [35]: 提出了一个基于SVM和CNN的SER系统,并使用MFCC特征提取。通过调整SVM的惩罚系数和Gamma值以及CNN结构中的dropout层来提高准确率。

Sadia et al. [2]: 提出了一个使用深度CNN和BiLSTM以及时间分布式平坦层的模型,专注于孟加拉语的SER,并在SUBESCO和RAVDESS数据集上取得了86.9%和82.7%的加权准确率。

Aggarwal et al. [36]: 提供了两种不同的特征提取方法来处理SER。第一种方法使用主成分分析(PCA)和具有密集层和dropout层的DNN。第二种方法从音频文件中提取mel-spectrogram图像,并将图像输入到预训练的VGG-16模型中。

Zhang et al. [44]: 提出了一个结合随机森林分类器和加权二元杜鹃搜索方法来选择最优特征子集的集成模型。

这些相关工作涵盖了深度学习在SER系统中的应用,包括不同的特征提取方法、模型架构和优化技术。这些研究为本文提出的模型提供了理论基础和技术参考。

Q: 论文如何解决这个问题?

A: 论文通过提出一个轻量级的、基于注意力机制的深度学习架构来解决语音情感识别(SER)中的特征表示和计算成本问题。具体来说,解决方案包括以下几个关键点:

1. 双通道架构

论文设计了一个双通道的网络结构,包括局部特征提取通道和全局特征提取通道。这种设计允许模型同时捕获局部和全局的情感特征。

局部特征块(ALFBs)

- 1D CNN + ECA-Net:使用一维卷积神经网络(1D CNN)来提取局部特征,然后通过高效通道注意力网络(ECA-Net)来增强模型对显著特征的关注,同时减少不相关特征的影响。

全局特征块(GFBs)

- BiLSTM:利用双向长短期记忆网络(BiLSTM)来捕获语音信号中的长期依赖性和上下文信息,这对于理解情感变化尤为重要。

2. 特征提取

论文从语音样本中提取了四种类型的频谱特征:Mel频率倒谱系数(MFCC)、Mel-spectrogram、零交叉率(ZCR)和均方根值(RMS)。这些特征被用来捕获语音信号中的情感信息。

3. 数据增强

为了解决数据不足的问题,论文采用了数据增强技术,包括加性白高斯噪声(AWGN)注入、音高转换、时间拉伸等方法,以增加训练样本的数量和多样性。

4. 模型训练和评估

- 5折交叉验证:通过5折交叉验证来评估模型在多个标准基准数据集上的性能,确保模型具有良好的泛化能力。

- 优化器和损失函数:使用Adam优化器和分类交叉熵损失函数来训练模型,通过反向传播算法调整模型权重。

5. 实验结果

论文在五个多语言的标准基准数据集上测试了所提出的方法,并与现有的最先进方法进行了比较,结果表明所提出的模型在各个数据集上均达到了最先进的性能。

通过上述方法,论文成功地提出了一个能够有效识别语音情感的轻量级模型,同时保持了较低的计算成本,并在多个数据集上实现了优异的性能。

Q: 论文做了哪些实验?

A: 根据提供的论文内容,作者进行了以下实验来评估和验证所提出的语音情感识别(SER)模型:

1. 数据集选择

作者使用了五个不同的多语言标准基准数据集进行实验,这些数据集包括:

- TESS

- RAVDESS

- BanglaSER

- SUBESCO

- Emo-DB

这些数据集涵盖了英语、孟加拉语和德语等多种语言,使得实验结果具有更广泛的适用性和代表性。

2. 特征提取

从语音样本中提取了以下四种类型的频谱特征:

- Mel频率倒谱系数(MFCC)

- Mel-spectrogram

- 零交叉率(ZCR)

- 均方根值(RMS)

这些特征被结合形成一个特征向量,用于训练和测试模型。

3. 数据增强

为了解决数据不足的问题,作者采用了五种类型的音频数据增强技术:

- 添加高斯白噪声(AWGN)

- 音高转换

- 时间拉伸

- 在音高转换后添加噪声

- 在时间拉伸后添加音高转换

4. 模型训练

使用60:25:15的比例将数据分为训练集、验证集和测试集。模型使用NVIDIA Tesla P100 GPU、16 GB的RAM和TensorFlow后端进行训练。模型总共有9.14百万个可训练参数。

5. 超参数调整

使用Keras Tuner库对模型的超参数进行优化,以提高模型的性能。

6. 性能评估指标

选择了以下性能评估指标来衡量模型的效果:

- 精确度(Precision)

- 召回率(Recall)

- F1分数(F1-score)

- 准确率(Accuracy)

7. 5折交叉验证

对每个数据集进行5折交叉验证,以评估模型的整体性能。

8. 结果分析

对模型在每个数据集上的性能进行了详细的分析,包括验证准确率、精确度、召回率、F1分数和平均准确率。

9. 与最新技术的比较

将所提出的模型与最新的技术(SOTA)方法在相同的数据集上进行了比较,以展示所提方法的有效性。

10. 消融研究

进行了消融研究来检验模型中不同组件(如ECA-Net和GFBs)的影响,通过比较完整模型与去除某些组件后的模型性能,来评估这些组件对整体性能的贡献。

这些实验全面地评估了所提出的SER模型的性能,并与现有技术进行了比较,证明了模型的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和结果,以下是一些可以进一步探索的点:

1. 多模态情感识别

未来的研究可以探索结合音频、视频和文本数据的多模态架构,这可能会提供更丰富的情感信息,并提高情感识别的准确性。研究如何有效地融合这些不同模态的特征是一个重要的研究方向。

2. 跨语言和跨文化的SER

考虑到不同语言和文化背景下情感表达的差异,未来的研究可以探索跨语言和跨文化的情感识别模型,以提高模型的泛化能力和适应性。

3. 实时SER系统

研究如何优化模型以实现实时情感识别,这对于许多实际应用场景(如智能助手和客户服务系统)非常重要。

4. 更深层次的特征融合

研究更复杂或创新的特征融合技术,以更有效地结合局部和全局特征,可能进一步提高模型的性能。

5. 计算效率的优化

尽管论文提出了一个轻量级的模型,但进一步探索模型压缩、量化和加速等技术,以在保持高准确率的同时减少计算资源的需求,也是一个有价值的研究方向。

6. 情感识别的可解释性

提高模型的可解释性,帮助研究人员和用户理解模型的决策过程,这对于建立用户信任和模型的透明性至关重要。

7. 情感识别的鲁棒性

研究如何提高模型对于不同录音条件(如噪声环境、不同设备)的鲁棒性,使其在现实世界的应用中更加可靠。

8. 细粒度情感识别

当前的研究大多关注于有限的几种基本情感类别,未来的研究可以探索细粒度情感识别,如区分不同程度的愤怒或快乐等。

9. 长序列情感变化的建模

研究如何更好地建模语音信号中随时间变化的复杂情感动态,特别是在长对话或叙述中的情感变化。

10. 开发新的基准数据集

开发新的、多样化的基准数据集,特别是在资源较少的语言中,这将有助于推动SER领域的进一步发展和创新。

这些方向不仅可以推动语音情感识别技术的发展,还可能带来新的应用场景和商业机会。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个高效的、基于注意力机制的语音情感识别(SER)架构,旨在提高情感识别的准确性,同时降低计算成本。以下是论文的主要内容总结:

1. 研究背景与挑战

- 语音情感识别对于增强情感计算和人机交互至关重要。

- 挑战在于从语音信号中选择相关的特征表示,并降低计算成本。

2. 提出的方法

- 轻量级SER架构,集成了注意力机制,以捕获语音信号中的局部和全局特征。

- 使用了基于注意力的局部特征块(ALFBs)和全局特征块(GFBs)。

- ALFBs结合1D CNN和ECA-Net提取局部特征。

- GFBs使用BiLSTM网络提取全局上下文和序列特征。

3. 特征提取

- 提取了MFCC、Mel-spectrogram、ZCR和RMS等四种频谱特征。

4. 数据集与实验

- 在五个多语言标准基准数据集上进行了实验:TESS、RAVDESS、BanglaSER、SUBESCO和Emo-DB。

- 采用了数据增强技术来处理数据不足的问题。

- 通过5折交叉验证评估模型性能。

5. 实验结果

- 所提出的模型在所有数据集上均达到了最先进的性能。

- 与现有方法相比,展示了显著的性能提升。

6. 贡献

- 提出的模型在多个数据集上实现了高准确率的情感识别。

- 证明了双通道架构和注意力机制在SER中的有效性。

7. 未来工作

- 探索多模态架构,结合音频、视频和文本数据。

- 进一步优化模型以实现实时情感识别。

总体而言,这篇论文通过提出一个新颖的深度学习架构,有效地提高了语音情感识别的性能,并通过在多个数据集上的实验验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

CSL-L2M: Controllable Song-Level Lyric-to-Melody Generation Based on Conditional Transformer with Fine-Grained Lyric and Musical Controls

Authors:Li Chai, Donglin Wang

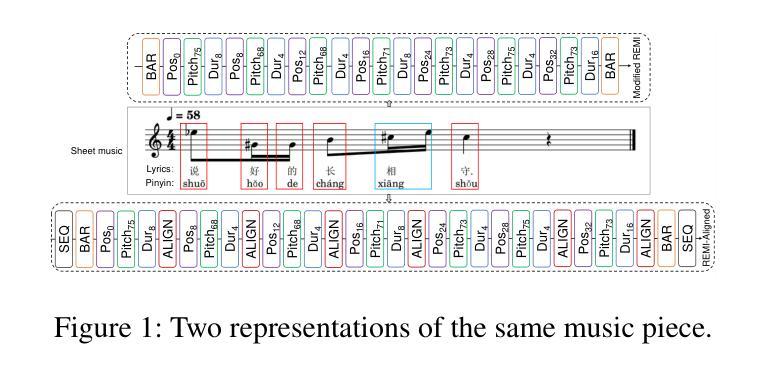

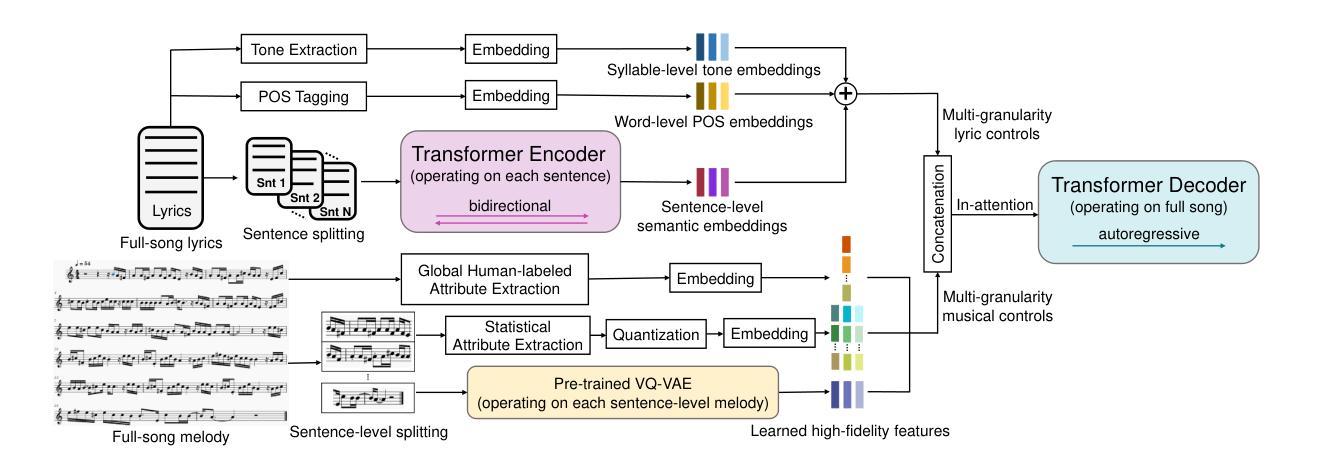

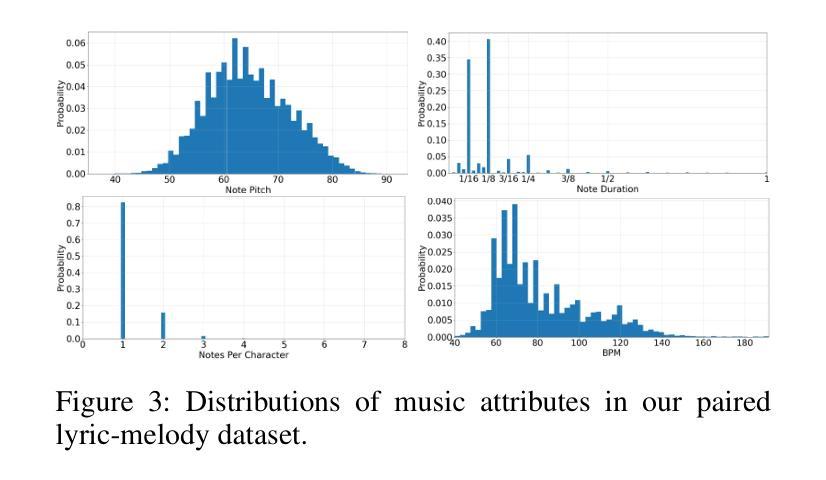

Lyric-to-melody generation is a highly challenging task in the field of AI music generation. Due to the difficulty of learning strict yet weak correlations between lyrics and melodies, previous methods have suffered from weak controllability, low-quality and poorly structured generation. To address these challenges, we propose CSL-L2M, a controllable song-level lyric-to-melody generation method based on an in-attention Transformer decoder with fine-grained lyric and musical controls, which is able to generate full-song melodies matched with the given lyrics and user-specified musical attributes. Specifically, we first introduce REMI-Aligned, a novel music representation that incorporates strict syllable- and sentence-level alignments between lyrics and melodies, facilitating precise alignment modeling. Subsequently, sentence-level semantic lyric embeddings independently extracted from a sentence-wise Transformer encoder are combined with word-level part-of-speech embeddings and syllable-level tone embeddings as fine-grained controls to enhance the controllability of lyrics over melody generation. Then we introduce human-labeled musical tags, sentence-level statistical musical attributes, and learned musical features extracted from a pre-trained VQ-VAE as coarse-grained, fine-grained and high-fidelity controls, respectively, to the generation process, thereby enabling user control over melody generation. Finally, an in-attention Transformer decoder technique is leveraged to exert fine-grained control over the full-song melody generation with the aforementioned lyric and musical conditions. Experimental results demonstrate that our proposed CSL-L2M outperforms the state-of-the-art models, generating melodies with higher quality, better controllability and enhanced structure. Demos and source code are available at https://lichaiustc.github.io/CSL-L2M/.

歌词到旋律的生成是人工智能音乐生成领域中的一个极具挑战性的任务。由于学习歌词和旋律之间严格但微弱的关联存在困难,之前的方法在可控性、质量和结构生成方面存在不足。为了应对这些挑战,我们提出了基于注意力缺失的Transformer解码器的可控歌词级歌词到旋律生成方法CSL-L2M。它能够根据给定的歌词和用户指定的音乐属性生成全曲旋律。具体来说,我们首先引入了REMI-Aligned,这是一种新的音乐表现方式,融合了歌词和旋律之间的音节和句子级别的严格对齐,便于精确对齐建模。接着,从句子级的Transformer编码器中独立提取的语义歌词嵌入与词级的词性嵌入和音节级的音调嵌入相结合,作为精细控制来增强歌词对旋律生成的可控性。然后,我们将人类标注的音乐标签、句子级的统计音乐属性以及从预训练VQ-VAE中提取的学习音乐特征分别引入为粗粒度、细粒度和高保真控制,从而使用户能够控制旋律的生成过程。最后,利用注意力缺失的Transformer解码器技术,在上述歌词和音乐条件下对全曲旋律生成进行精细控制。实验结果表明,我们提出的CSL-L2M优于现有模型,生成的旋律质量更高、可控性更好、结构更加优化。Demo和源代码可通过[https://lichaiustc.github.io/CSL-L2M/]访问。

论文及项目相关链接

PDF Accepted at AAAI-25

Summary

本文介绍了AI音乐生成领域中的歌词到旋律生成任务面临的挑战,并提出了一种基于注意力解码器的可控歌词级歌词到旋律生成方法CSL-L2M。该方法通过引入新型音乐表征REMI-Aligned和多种粒度控制,如语义歌词嵌入、词性嵌入和音调嵌入,提高了旋律生成的控制性和质量。此外,还引入了人类标注的音乐标签、句子级别的统计音乐属性和预训练VQ-VAE提取的音乐特征,为生成过程提供了粗粒度、细粒度和高保真控制。实验结果表明,CSL-L2M在生成高质量、可控性和结构性的旋律方面优于现有模型。

Key Takeaways

- AI音乐生成中的歌词到旋律生成存在挑战,因歌词与旋律之间的关联难以学习,以前的方法存在可控性弱、质量不高和结构不佳的问题。

- CSL-L2M方法基于注意力解码器,通过引入REMI-Aligned音乐表征实现了歌词与旋律的精确对齐。

- CSL-L2M使用了细粒度的控制,包括语义歌词嵌入、词性嵌入和音调嵌入,以提高旋律生成的控制性。

- 通过引入人类标注的音乐标签、句子级别的统计音乐属性和预训练VQ-VAE提取的音乐特征,为用户提供了多种控制粒度。

- CSL-L2M方法提高了旋律生成的质量、可控性和结构性。

- CSL-L2M方法实现了全曲旋律与歌词的匹配,并允许用户根据特定的音乐属性进行定制。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的是歌词到旋律(Lyric-to-Melody)生成领域中的一些挑战性问题,包括:

弱可控性(Weak Controllability):以往的方法在歌词到旋律的生成过程中控制能力较弱,无法很好地满足用户对生成旋律的具体要求。

生成质量低下(Low Quality):由于歌词和旋律之间的关联性较弱,导致生成的旋律质量不高。

结构不良(Poorly Structured):现有方法通常只能生成短旋律,而无法生成具有良好音乐结构的完整歌曲旋律,例如缺乏重复模式和明显的诗歌-副歌结构。

为了解决这些问题,论文提出了一种名为CSL-L2M的可控歌曲级歌词到旋律生成方法,该方法基于条件变换器(Conditional Transformer)解码器,并结合了细粒度的歌词和音乐控制,能够生成与给定歌词和用户指定的音乐属性相匹配的完整歌曲旋律。

Q: 有哪些相关研究?

A: 论文中提到了多个与歌词到旋律生成(Lyric-to-Melody Generation)相关的研究工作,以下是一些主要的相关研究:

**Bao et al. (2019)**:提出了一个基于序列到序列的旋律作曲模型,是第一个使用端到端网络模型从歌词生成旋律的工作。

**Yu, Srivastava, and Canales (2021)**:提出了一个条件LSTM-GAN(生成对抗网络)模型用于从歌词生成旋律。

**Srivastava et al. (2022)**:提出了一个三分支条件LSTM-GAN的新架构,以进一步提高生成质量。

**Sheng et al. (2021)**:提出了一个无监督方法,通过在大量未配对的歌词和旋律数据上进行自监督掩蔽序列到序列预训练来提高生成性能。

**Ju et al. (2021)**:提出了一个基于音乐模板的两阶段生成方法,该方法数据效率高,并在一定程度上解决了配对数据有限的问题。

**Ding et al. (2024)**:尝试利用大型语言模型(LLMs)的能力来模拟歌词和旋律之间的关系。

**Zhang, Yu, and Takasu (2023)**:提出了一种参考风格嵌入技术,以实现对生成旋律风格的控制。

**Duan et al. (2022)**:使用户能够通过选择推荐的音乐属性来与生成过程交互并重新创作音乐。

这些研究涵盖了从传统的基于规则和统计的方法到基于深度学习的端到端生成模型,以及一些探索控制性的研究。论文中提出的CSL-L2M方法在这些现有工作的基础上,进一步探索了细粒度控制和完整的歌曲级旋律生成,以提高生成质量和可控性。

Q: 论文如何解决这个问题?

A: 论文提出了一个名为CSL-L2M(Controllable Song-Level Lyric-to-Melody)的解决方案,旨在解决歌词到旋律生成中的弱可控性、低质量和结构不良问题。以下是该方法的关键步骤和组件:

1. REMI-Aligned音乐表示

- 引入了REMI-Aligned,一种新颖的音乐表示方法,它在旋律和歌词之间建立了严格的音节和句子级别的对齐,从而使得精确对齐建模成为可能。

2. 细粒度控制

- 利用句子级别的语义歌词嵌入、词级别的词性嵌入和音节级别的音调嵌入作为细粒度控制,以增强歌词对旋律生成的控制力。

3. 音乐属性控制

- 引入了人类标注的音乐标签、句子级别的统计音乐属性和从预训练的VQ-VAE中提取的学习音乐特征,作为粗粒度、细粒度和高保真度控制,使用户能够控制旋律生成。

4. 条件变换器解码器

- 使用条件自回归变换器解码器,结合上述歌词和音乐条件,通过in-attention技术实现对完整歌曲旋律生成的细粒度控制。

5. 模型架构

- 模型包括一个句子级别的双向变换器编码器和一个自回归变换器解码器,后者具备在多种细粒度歌词和音乐控制下建模完整歌曲旋律的能力。

6. 实验验证

- 在一个包含10,170首中文流行歌曲的数据集上进行实验,证明了CSL-L2M在生成质量、可控性和结构方面优于现有最先进的模型。

通过这些方法,CSL-L2M能够生成与给定歌词匹配且符合用户指定音乐属性的高质量完整歌曲旋律,从而解决了歌词到旋律生成中的关键挑战。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证CSL-L2M模型的性能和有效性,具体实验包括:

1. 数据集划分

- 将10,170首中文流行歌曲分为训练集、验证集和测试集,比例为9:0.5:0.5。

2. 客观和主观评估

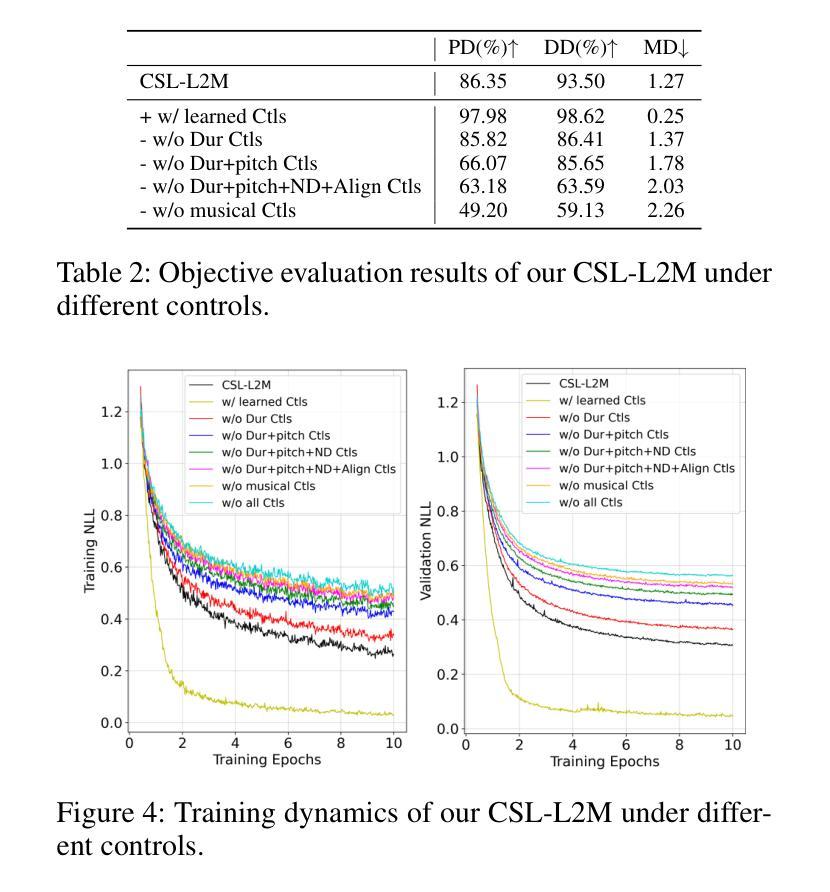

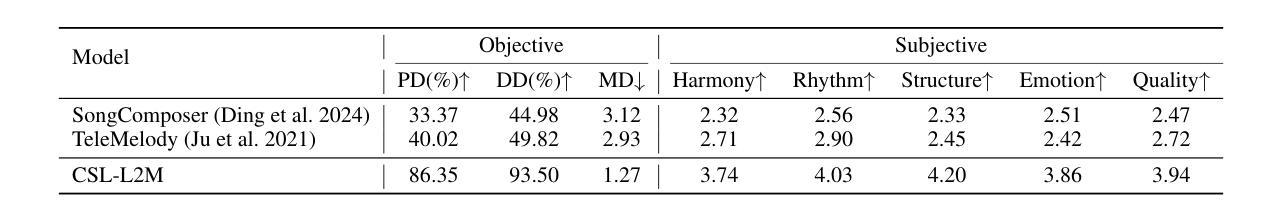

客观评估:在测试集上(约500首歌曲)评估生成旋律与真实旋律之间的相似度,使用了以下客观指标:

- 音高分布相似度(Pitch Distribution Similarity, PD)

- 时值分布相似度(Duration Distribution Similarity, DD)

- 旋律距离(Melody Distance, MD)

主观评估:对测试集中随机选取的10首歌曲进行评估,邀请70名参与者(包括50名业余爱好者和20名专业人士)对旋律属性进行评分,评分范围为1(差)到5(完美)。考虑的主观指标包括:

- 和谐性(Harmony)

- 节奏(Rhythm)

- 结构(Structure)

- 情感(Emotion)

- 质量(Quality)

3. 主要结果

- 将CSL-L2M与两个最先进的模型(SongComposer和TeleMelody)进行比较,结果显示CSL-L2M在客观和主观评估中均显著优于这些模型。

4. 消融研究

- 通过逐步移除时值相关控制、音高相关控制、音符密度和对齐控制以及人工标注的音乐属性控制,观察模型性能的变化,验证了不同控制对模型性能的影响。

5. 控制性研究

- 使用Spearman等级相关系数来量化统计音乐属性控制的强度,并评估在转移特定属性时对其他不相关属性的影响。

6. 案例研究

- 展示了一些由CSL-L2M生成的乐谱,以证明其在生成质量和可控性方面的优势。

这些实验全面评估了CSL-L2M模型在歌词到旋律生成任务中的性能,并验证了其在生成高质量、结构良好且可控制的旋律方面的能力。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出的CSL-L2M模型在歌词到旋律生成任务中取得了显著的成果,但仍有一些可以进一步探索的点:

1. 多语言和跨文化研究

- 目前的研究主要集中在中文流行歌曲上,未来可以探索该模型在其他语言和文化背景下的表现和适应性。

2. 模型泛化能力

- 研究模型对于不同风格、不同长度和复杂度的旋律生成的泛化能力。

3. 细粒度控制的进一步增强

- 探索更多细粒度的音乐控制方式,例如基于节奏模式、和声进程或旋律动机的控制。

4. 交互式音乐创作应用

- 将CSL-L2M模型应用于交互式音乐创作系统,使用户能够实时与模型交互,共同创作音乐。

5. 模型解释性和可视化

- 提高模型的可解释性,通过可视化技术展示模型是如何理解和利用歌词信息生成旋律的。

6. 多模态音乐生成

- 将旋律生成与其他音乐生成任务(如和声生成、鼓点生成)结合起来,实现完整的多模态音乐创作。

7. 模型训练和优化

- 研究更高效的训练策略和优化算法,以提高模型训练的速度和效果。

8. 音乐理论整合

- 将更多的音乐理论知识整合到模型中,以增强生成旋律的音乐性和艺术性。

9. 用户研究和反馈

- 进行用户研究,收集用户反馈,了解用户需求,进一步改进模型以满足实际应用需求。

10. 模型的实时性能

- 研究如何优化模型以实现实时旋律生成,这对于音乐表演和教育等领域具有重要意义。

这些探索点可以帮助研究者和开发者进一步提升歌词到旋律生成技术的性能和应用范围,推动音乐人工智能领域的发展。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为CSL-L2M的可控歌曲级歌词到旋律生成方法,旨在解决现有方法在歌词到旋律生成任务中的弱可控性、低质量和结构不良问题。以下是论文的主要内容总结:

1. 问题陈述

- 歌词到旋律生成是一个挑战性的任务,因为歌词和旋律之间的关联性严格但微弱,导致学习难度大。

- 现有方法存在可控性弱、生成质量低和音乐结构差等问题。

2. CSL-L2M方法

- REMI-Aligned音乐表示:提出了REMI-Aligned音乐表示,整合了严格的音节和句子级别的歌词旋律对齐,便于精确建模。

- 细粒度控制:通过句子级语义嵌入、词级词性嵌入和音节级音调嵌入增强歌词对旋律生成的控制。

- 音乐属性控制:引入人类标注的音乐标签、句子级统计音乐属性和预训练VQ-VAE提取的高保真音乐特征,实现从粗粒度到高保真的控制。

- 条件变换器解码器:利用in-attention技术,结合上述控制,对完整歌曲旋律生成进行细粒度控制。

3. 实验验证

- 在包含10,170首中文流行歌曲的数据集上进行实验,证明CSL-L2M在生成质量、可控性和结构方面优于现有最先进模型。

- 客观和主观评估表明CSL-L2M生成的旋律与给定歌词匹配且符合用户指定的音乐属性。

4. 贡献

- CSL-L2M通过整合细粒度的歌词和音乐控制,提高了歌词到旋律生成的可控性和质量。

- 提供了一个新的音乐表示方法REMI-Aligned,以及一个基于条件变换器的生成框架,为歌词到旋律生成领域提供了新的方向。

5. 未来工作

- 探索多语言和跨文化研究、模型泛化能力、细粒度控制增强、交互式音乐创作应用等。

论文通过提出CSL-L2M模型,为歌词到旋律生成任务提供了一个新的解决方案,推动了音乐人工智能领域的发展。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

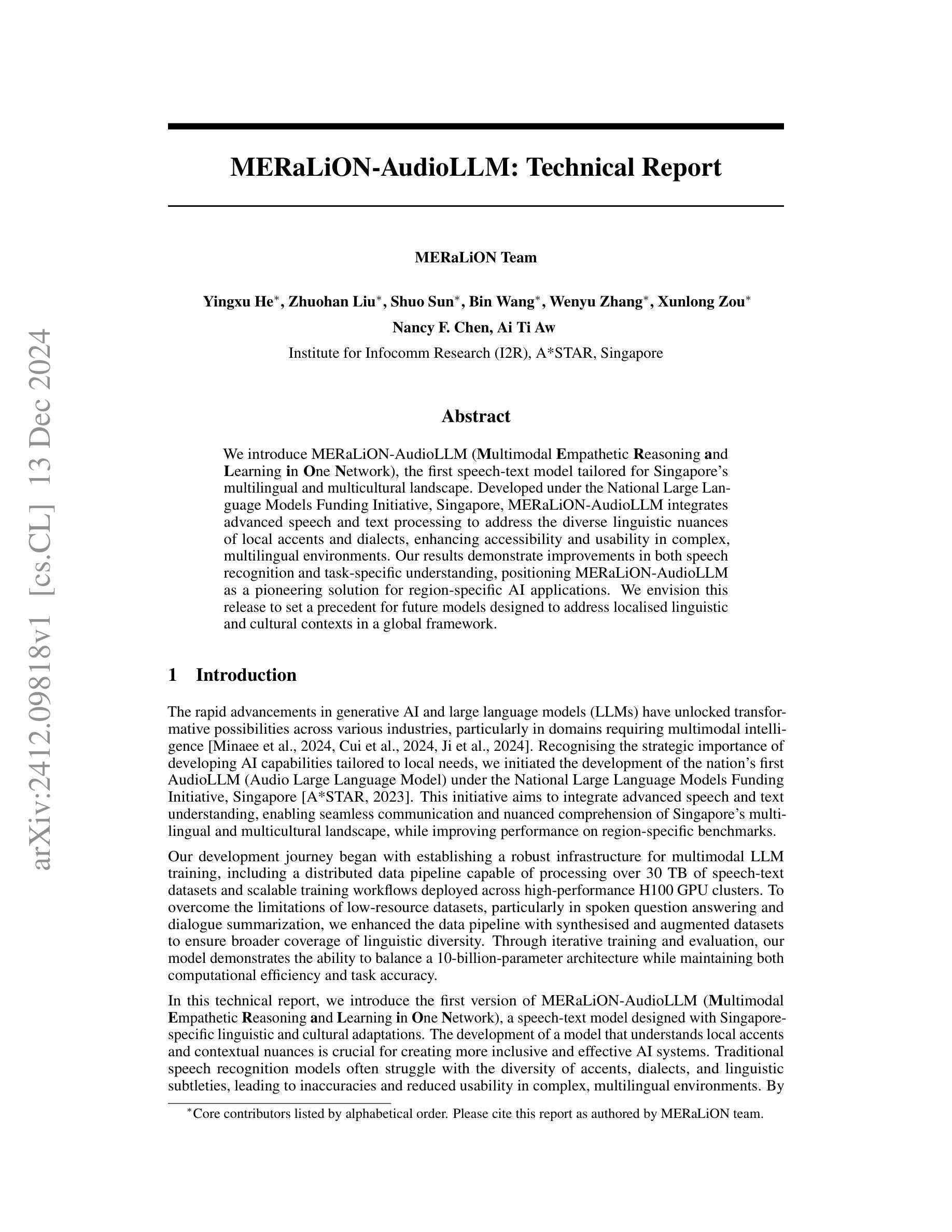

MERaLiON-AudioLLM: Technical Report

Authors:Yingxu He, Zhuohan Liu, Shuo Sun, Bin Wang, Wenyu Zhang, Xunlong Zou, Nancy F. Chen, Ai Ti Aw

We introduce MERaLiON-AudioLLM (Multimodal Empathetic Reasoning and Learning in One Network), the first speech-text model tailored for Singapore’s multilingual and multicultural landscape. Developed under the National Large Language Models Funding Initiative, Singapore, MERaLiON-AudioLLM integrates advanced speech and text processing to address the diverse linguistic nuances of local accents and dialects, enhancing accessibility and usability in complex, multilingual environments. Our results demonstrate improvements in both speech recognition and task-specific understanding, positioning MERaLiON-AudioLLM as a pioneering solution for region specific AI applications. We envision this release to set a precedent for future models designed to address localised linguistic and cultural contexts in a global framework.

我们介绍了MERaLiON-AudioLLM(一站式多模式共情推理与学习网络),这是首个针对新加坡多元语言和文化的背景定制的语音文本模型。该模型在新加坡国家语言模型资助计划下开发,MERaLiON-AudioLLM融合了先进的语音和文本处理技术,以应对当地口音和方言的多样语言细微差别,在复杂的多元语言环境中提高可访问性和可用性。我们的结果证明了其在语音识别和任务特定理解方面的改进,将MERaLiON-AudioLLM定位为针对特定区域AI应用的前沿解决方案。我们期望此次发布能为未来在全球框架下设计解决本地化语言和文化背景的模型树立先例。

论文及项目相关链接

Summary

MERaLiON-AudioLLM是专为新加坡多元语言和多元文化环境设计的语音文本模型。该模型整合先进的语音和文本处理功能,应对当地口音和方言的多元语言细微差别,提高复杂多语言环境中的可用性和易用性。结果证明,MERaLiON-AudioLLM在语音识别和任务特定理解方面有所改进,为地区特定的AI应用提供开创性的解决方案。

Key Takeaways

- MERaLiON-AudioLLM是为新加坡多元语言和多元文化环境量身定制的语音文本模型。

- 该模型整合先进的语音和文本处理功能。

- MERaLiON-AudioLLM能够应对当地口音和方言的多元语言细微差别。

- 模型提高了在复杂多语言环境中的可用性和易用性。

- MERaLiON-AudioLLM在语音识别和任务特定理解方面有所改进。

- 该模型为地区特定的AI应用提供开创性的解决方案。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文介绍了MERaLiON-AudioLLM(Multimodal Empathetic Reasoning and Learning in One Network),这是一个为新加坡多语言和多元文化环境量身定制的首个语音-文本模型。该模型旨在解决以下问题:

多语言和多元文化环境中的语音识别和理解问题:新加坡具有多语言和多元文化的特点,传统语音识别模型常因口音、方言和语言细微差别的多样性而表现不佳,导致在复杂多语言环境中的不准确和可用性降低。

地区特定AI应用的性能提升问题:论文旨在通过整合先进的语音和文本处理技术,提高在地区特定基准测试中的性能,增强在复杂多语言环境中的可访问性和可用性。

低资源数据集的挑战:特别是在口语问答和对话摘要等任务中,低资源数据集限制了模型的训练和性能。通过增强数据管道,包括合成和增强数据集,来确保语言多样性的广泛覆盖。

模型架构和训练方法的优化问题:论文提出了一个10亿参数的模型架构,通过迭代训练和评估,在保持计算效率和任务准确性的同时平衡性能。

多模态和多任务学习问题:MERaLiON-AudioLLM旨在通过端到端的方式整合听觉和文本信息,提高解码速度、多任务学习和避免级联模型中的错误传播。

综上所述,论文的主要贡献在于开发了一个能够理解和适应新加坡本地口音和语境细微差别的模型,以期在多语言和多模态建模方面增强新加坡的能力,并为未来设计以适应本地语言和文化背景的全球框架模型树立先例。

Q: 有哪些相关研究?

A: 论文中提到了多个与MERaLiON-AudioLLM相关的研究工作,具体如下:

AudioLLMs(音频大型语言模型):

- Qwen2-Audio 7B [Chu et al., 2024]:结合了Whisper编码器和Qwen文本解码器的AudioLLM,音频中心指令跟踪能力超越商业模型。

- WavLLM [Hu et al., 2024]:使用双编码器设置,将Whisper与WavLM结合,并采用两阶段课程学习方法。

- SALMONN [Tang et al., 2024]:结合Whisper编码器与BEATS,并使用三阶段课程学习策略训练。

多模态融合:

- Audio Flamingo [Kong et al., 2024]:使用音频表示转换层来适应音频输入。

- Pengi [Deshmukh et al., 2023]:专注于音频任务的音频语言模型。

- GAMA [Ghosh et al., 2024]:具有高级音频理解和复杂推理能力的音频语言模型。

特定任务的AudioLLMs:

- 自动语音识别(ASR)和语音翻译(ST):利用诸如Whisper和Hubert等语音编码器提取特征,增强对口语的理解与处理。

非语音音频任务:

- Audio Captioning、Audio Question Answering 和理解非言语语音线索:这些模型专注于非言语音频任务。

其他多模态架构:

- LLaMA-Omni [Fang et al., 2024] 和 SpeechGPT [Zhang et al., 2023]:通过指令微调额外的模型组件,并与文本解码器对齐。

其他相关工作:

- Spirit LM [Nguyen et al., 2024]:交错语音和文本在一个序列中寻求词级对齐。

- DeSTA [Lu et al., 2024]:通过利用副语言元数据生成具有自然语言描述的语音输入的声学质量的字幕。

这些研究工作展示了在多模态AI系统中结合语音和文本处理技术的不同方法和进展,它们为MERaLiON-AudioLLM的开发提供了理论基础和技术参考。

Q: 论文如何解决这个问题?

A: 论文通过以下几个关键步骤解决上述问题:

1. 建立多模态LLM训练基础设施

- 开发了一个分布式数据管道,能够处理超过30TB的语音-文本数据集,并在高性能H100 GPU集群上部署了可扩展的训练工作流程。

2. 数据集增强

- 为了克服低资源数据集的限制,通过合成和增强数据集来确保语言多样性的广泛覆盖。

3. 模型架构设计

- MERaLiON-AudioLLM 结合了 MERaLiONWhisper 编码器(基于 Whisper-large-v2)和本地化的LLM SEA-LION V3,以端到端的方式整合听觉和文本信息,用于下游任务。

4. 音频编码器(Audio Encoder)

- 使用 Whisper 处理音频,并进一步微调以适应本地口音和语言环境。

5. 适配器模块(Adaptor Module)

- 采用简单的多层感知器(MLP)适配器模块将音频编码器的输出与文本解码器的嵌入空间对齐。

6. 文本解码器(Text Decoder)

- 利用 SEA-LION V3 处理音频上下文标记和文本指令标记,生成基于文本的响应。

7. 训练方法论

- 对 Whisper-large-v2 进行端到端的微调,以更好地捕捉本地语音特征。

- 应用多模态指令微调,以对齐 MERaLiON-Whisper 和 SEA-LION V3 进行跨模态推理和任务特定性能。

8. 持续迭代和社区共享

- 通过迭代训练和评估,平衡10亿参数架构的计算效率和任务准确性。

- 计划持续改进模型,并与社区共享发现,以推动进步和创新。

9. 评估和测试

- 使用AudioBench基准测试套件对模型进行评估,并与其它知名的AudioLLMs进行比较。

通过这些步骤,论文展示了MERaLiON-AudioLLM在语音识别、任务特定理解和多语言环境中的竞争力,尤其是在本地语境中的优化性能。此外,论文还指出了未来工作中需要解决的局限性,包括安全性、上下文长度、指令跟踪能力的丧失以及多语言和共情推理能力的提升。

Q: 论文做了哪些实验?

A: 论文中提到了对MERaLiON-AudioLLM模型进行了一系列实验和评估,具体包括:

1. 基准测试评估

MERaLiON-AudioLLM在AudioBench基准测试套件上进行了评估,与三个知名的AudioLLMs(Qwen2-Audio 7B、WavLLM和SALMONN)以及一个级联模型(Cascaded Model)进行了比较。评估涉及的任务包括自动语音识别(ASR)、语音翻译(ST)、口语问答(SQA)、口语对话摘要(SDS)、语音指令(SI)和副语言(PARA)。

2. 数据集

评估数据来源于以下数据集的测试集:

- ASR: LibriSpeech、Common-Voice-15、Earnings21、Earnings22、NSC

- ST: CoVoST 2

- SQA: SLUE、Spoken-SQuAD、CN-College-Listen-Test、Singapore-Public-Speech-SQA、NSC

- SDS: NSC

- SI: OpenHermes、Alpaca

- PARA: VoxCeleb、MELD

3. 评估指标

- ASR和ST任务分别使用Word Error Rate(WER)和BLEU分数进行评估。

- 其他任务使用LLMas-a-Judge框架,该框架使用预训练的大型语言模型生成和评分响应,基于相关性、连贯性和准确性等标准。

4. 结果

- 在Earnings21-Test和Earnings22-Test数据集上,MERaLiON-AudioLLM取得了最佳性能,显著优于其他AudioLLMs。

- 在本地数据集MNSC ASR Part 2上,MERaLiON-AudioLLM显著优于Qwen2-Audio和Whisper-large-v2,实现了仅为5%的词错误率。

- 在MELD-Sentiment-Test和MELD-Emotion-Test任务上,MERaLiON-AudioLLM的性能明显低于其他模型,论文指出正在积极策划更多的副语言数据集,并探索架构改进以更好地整合副语言信息。

这些实验和评估结果展示了MERaLiON-AudioLLM在多种语音和文本任务上的性能,并与现有技术进行了比较。通过这些实验,论文证明了MERaLiON-AudioLLM在特定本地语境中的优化性能,同时也指出了需要进一步改进的领域。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

安全性和内容过滤

- MERaLiON-AudioLLM 尚未针对安全性进行特别优化,可能生成不适当、冒犯性或有害的内容。未来的工作可以集中在安全微调和实施必要的安全措施上。

上下文长度和长时依赖处理

- 当前模型仅支持最长30秒的音频上下文。未来的工作将致力于提升模型处理长时对话语音和复杂叙事的长距离依赖能力。

指令跟踪能力的丧失

- 为了提升特定任务(如语音识别和语音翻译)的性能,需要端到端微调整个AudioLLM,但这导致了模型在一定程度上忘记了如何遵循某些文本指令。未来的工作将包括:

- 创建一个用于测量指令跟踪能力丧失程度的Speech Instruction Following数据集。

- 在保持文本指令对的重放集合的同时,尝试在更多样化的多模态数据集上训练AudioLLM。

- 探索直接对齐音频编码器和文本解码器的方法,绕过对文本解码器进行微调的需要。

多语言和共情推理能力

- 尽管MERaLiON-AudioLLM能够处理非英语的语音-文本任务以及非语音任务(如情感和性别识别),但通过增加更多数据,这些任务的性能可以进一步提升。未来的工作将探索有效扩展数据收集工作的战略。

架构改进

- 论文提到了对模型架构进行改进以更好地整合副语言信息,包括情感和语调等。

跨领域和跨语言的泛化能力

- 探索模型在不同领域和语言中的泛化能力,特别是在东南亚和其他多语言环境中。

社区共享和协作

- 论文强调了与社区共享发现、推动进步和创新的重要性。未来的工作可以包括更广泛的合作和社区反馈,以进一步优化和调整模型。

这些探索点涵盖了从技术改进到伦理考量的广泛领域,旨在提升MERaLiON-AudioLLM的性能,并确保其在实际应用中的安全性和有效性。

Q: 总结一下论文的主要内容

A: 这篇技术报告介绍了MERaLiON-AudioLLM,这是一个为新加坡多语言和多元文化环境量身定制的语音-文本模型。以下是报告的主要内容总结:

1. 背景与动机

- 随着生成性AI和大型语言模型(LLMs)的快速发展,开发适应本地需求的AI能力变得尤为重要。

- 新加坡启动了国家大型语言模型资助计划,旨在整合先进的语音和文本理解能力,以应对新加坡多语言和多元文化环境的挑战。

2. MERaLiON-AudioLLM模型

- 该模型是新加坡首个音频大型语言模型(AudioLLM),旨在理解和适应新加坡本地的口音和语境细微差别。

- 通过结合真实世界语音数据与合成及增强样本,提高对各种口音和语言环境的覆盖。

3. 方法论

- MERaLiON-AudioLLM 接收音频和文本对作为输入,并生成文本输出。

- 模型架构包括音频编码器、适配器模块和文本解码器,以端到端的方式整合听觉和文本信息。

4. 数据集和训练

- 收集了总共260,000小时的语音-文本指令调整对数据集,包括IMDA国家语音语料库(NSC)。

- 通过多模态指令微调,对齐MERaLiON-Whisper和SEA-LION V3以进行跨模态推理和任务特定性能。

5. 实验和评估

- 在AudioBench基准测试套件上评估MERaLiON-AudioLLM,并与其他AudioLLMs进行比较。

- 模型在多个数据集上展现出竞争力,尤其是在本地数据集上表现优异。

6. 限制和未来工作

- 论文讨论了模型的局限性,包括安全性、上下文长度处理、指令跟踪能力的丧失以及多语言和共情推理能力的提升,并提出了未来的研究方向。

7. 结论

- MERaLiON-AudioLLM通过精心策划的数据和优化,展示了在语音-文本理解和生成方面的重要进展,尤其是在本地语境中。

- 论文强调了结合大规模多模态数据集和先进模型架构以解决现实世界挑战的潜力,并期待进一步的研究和社区贡献。

这篇报告展示了MERaLiON-AudioLLM在多模态AI系统发展中的重要一步,并指出了未来研究的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

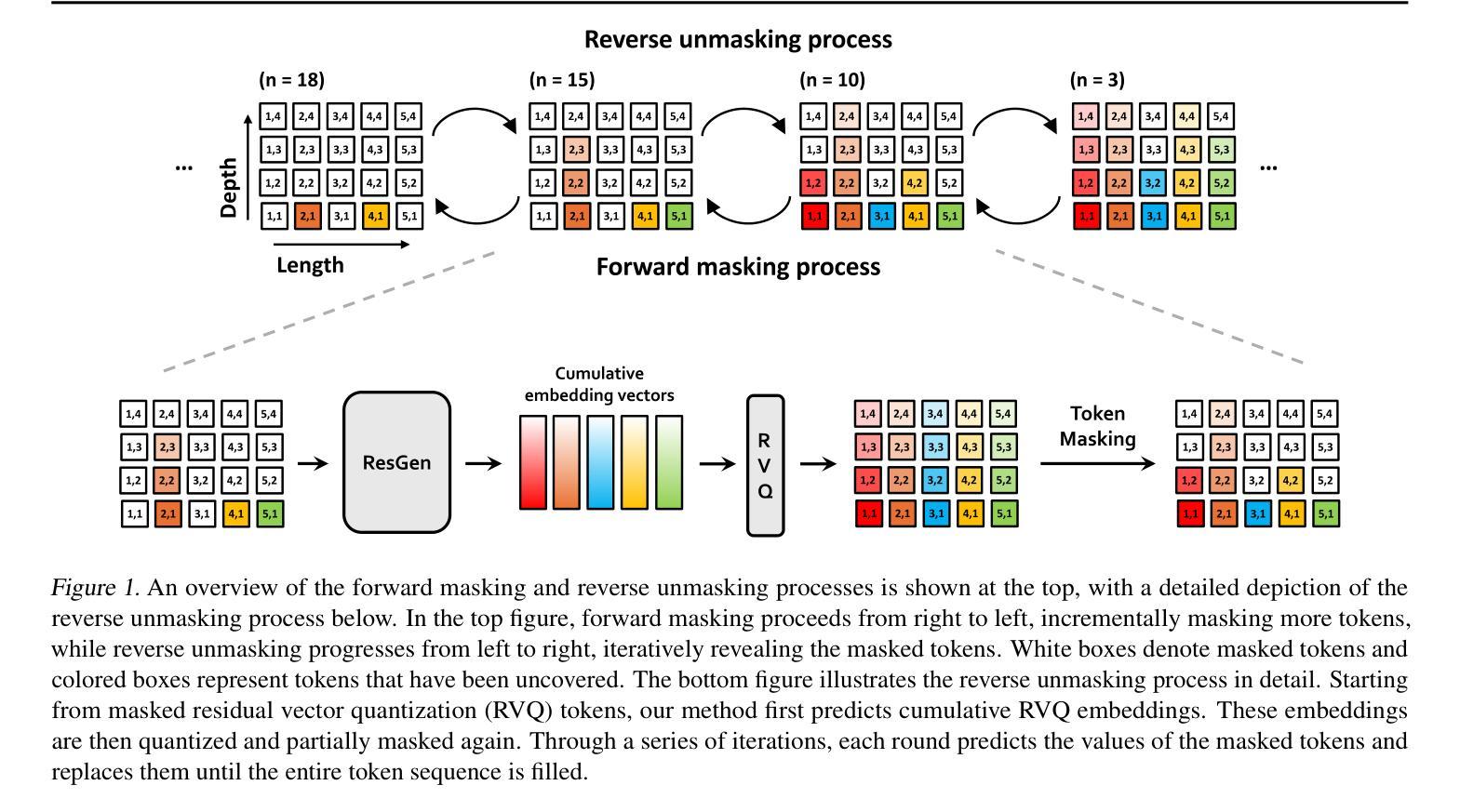

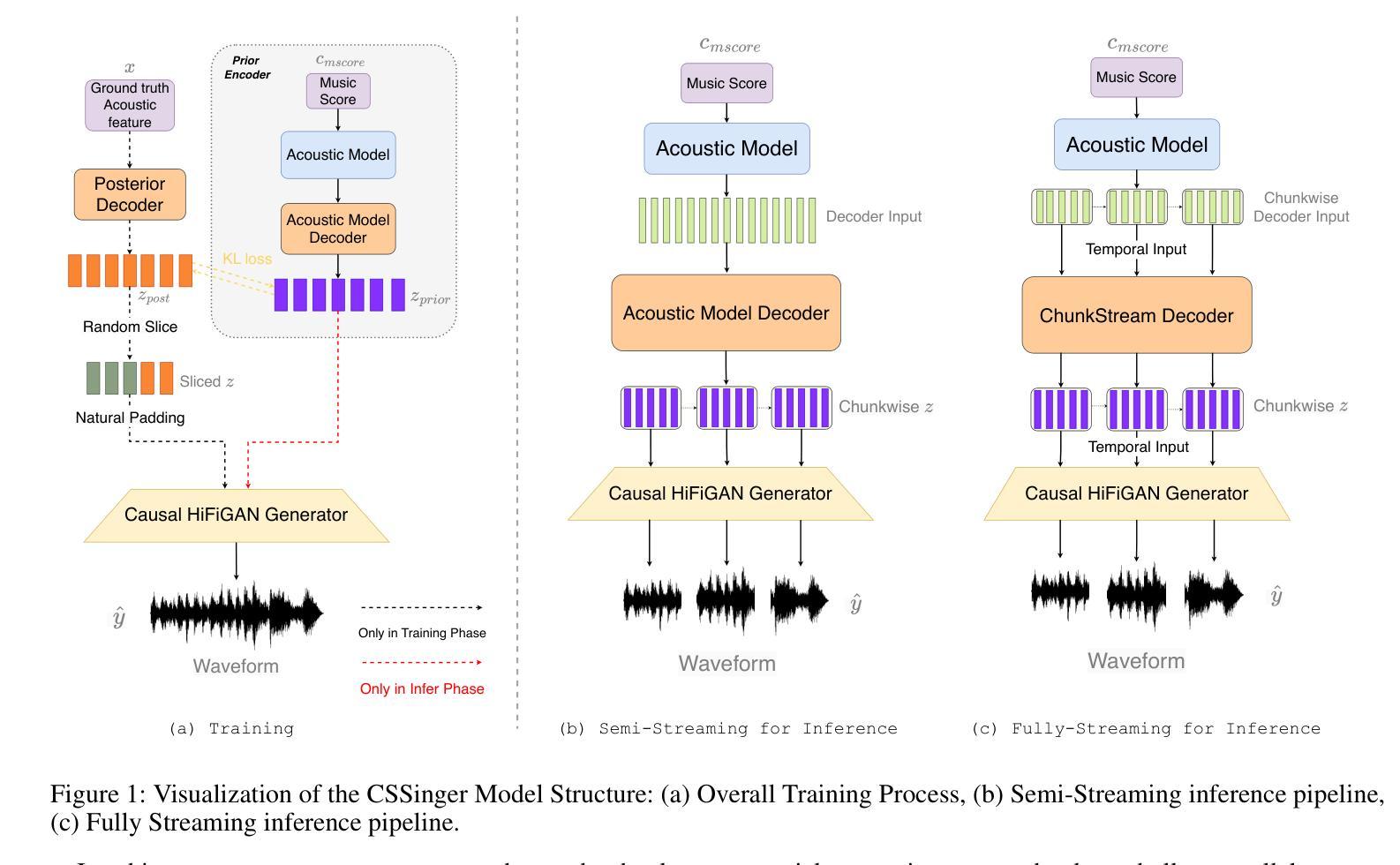

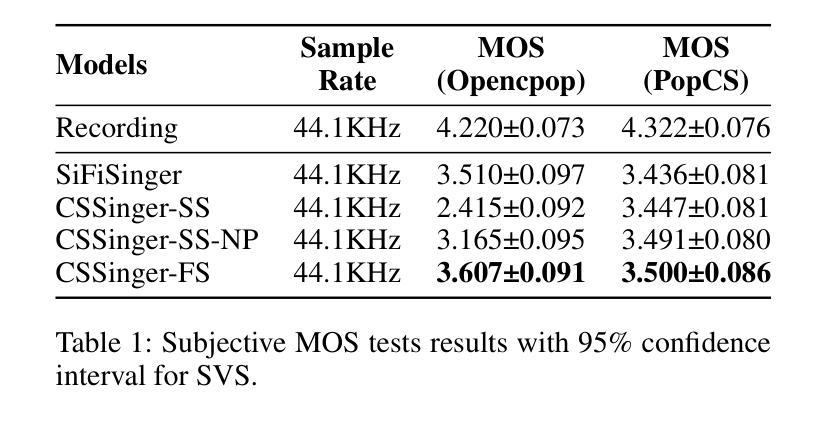

CSSinger: End-to-End Chunkwise Streaming Singing Voice Synthesis System Based on Conditional Variational Autoencoder

Authors:Jianwei Cui, Yu Gu, Shihao Chen, Jie Zhang, Liping Chen, Lirong Dai

Singing Voice Synthesis (SVS) aims to generate singing voices of high fidelity and expressiveness. Conventional SVS systems usually utilize an acoustic model to transform a music score into acoustic features, followed by a vocoder to reconstruct the singing voice. It was recently shown that end-to-end modeling is effective in the fields of SVS and Text to Speech (TTS). In this work, we thus present a fully end-to-end SVS method together with a chunkwise streaming inference to address the latency issue for practical usages. Note that this is the first attempt to fully implement end-to-end streaming audio synthesis using latent representations in VAE. We have made specific improvements to enhance the performance of streaming SVS using latent representations. Experimental results demonstrate that the proposed method achieves synthesized audio with high expressiveness and pitch accuracy in both streaming SVS and TTS tasks.

歌唱声音合成(SVS)旨在生成高保真和富有表现力的歌唱声音。传统的SVS系统通常利用声学模型将乐谱转换为声学特征,然后通过声码器重建歌唱声音。最近的研究表明,端到端建模在SVS和文本到语音(TTS)领域是有效的。因此,我们在工作中提出了一种完全端到端的SVS方法,并引入分段流式推理来解决实际应用中的延迟问题。值得注意的是,这是首次尝试使用变分自动编码器(VAE)中的潜在表示来完全实现端到端流式音频合成。我们对使用潜在表示的流式SVS的性能进行了专项改进。实验结果表明,该方法在流式SVS和TTS任务中实现了高表现力和音高准确度的合成音频。

论文及项目相关链接

PDF Accepted by AAAI2025

Summary

本文介绍了一种全新的端到端歌唱声音合成(SVS)方法,该方法结合潜表征技术,实现了音乐到声音的转换。通过改进技术,提高了流式SVS的性能。实验结果表明,该方法在SVS和文本转语音(TTS)任务中,合成的音频具有高表达力和音高准确性。

Key Takeaways

- 介绍了端到端的歌唱声音合成(SVS)方法。

- 该方法利用潜表征技术实现音乐到声音的转换。

- 首次尝试完全实现基于潜表征的端到流音频合成。

- 对流式SVS的性能进行了改进。

- 该方法合成音频具有高表达力和音高准确性。

- 此方法在SVS和文本转语音(TTS)任务中表现优越。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个基于条件变分自编码器(Conditional Variational Autoencoder, VAE)的端到端分块流式(chunkwise streaming)歌唱语音合成系统(ChunkStreamSinger, CSSinger),旨在解决以下问题:

实时性和计算资源限制:传统的歌唱语音合成(Singing Voice Synthesis, SVS)系统和文本到语音(Text to Speech, TTS)系统通常包含一个声学模型和一个声码器,这些系统在处理长序列时计算量大,实时性能不佳,尤其是在边缘设备和在线网络服务中部署时。

端到端流式音频合成:这是首次尝试完全实现使用VAE中的潜在表示进行端到端流式音频合成。流式合成对于减少延迟和提高实时性至关重要。

潜在表示用于声码器:使用VAE的潜在表示作为声码器的输入并不直观,尤其是对于歌唱语音,直接使用潜在表示进行音频生成会导致合成音频质量下降。

提高流式SVS性能:论文中提出了特定的改进措施,以增强使用潜在表示的流式SVS性能。

综上所述,论文的主要贡献在于提出了一种新的端到端流式歌唱语音合成方法,该方法不仅能够生成高表达性和音高准确性的合成音频,而且相较于传统的平行计算模型,能够显著降低延迟,提高实时性,更好地适应边缘设备和在线服务等实际应用场景。

Q: 有哪些相关研究?

A: 相关研究主要涉及以下几个领域:

Singing Voice Synthesis (SVS): 论文提到了多个基于深度学习的SVS系统,例如XiaoiceSing、ByteSing、VISinger和VISinger2。这些系统利用深度神经网络生成基于乐谱的高质量歌唱语音。

Text-to-Speech (TTS): 论文中提到了TTS系统中使用的端到端建模方法,如VITS (Kim, Kong, and Son 2021) 和SiFiSinger (Cui et al. 2024),它们基于条件VAE框架进行声学建模和音频合成。

Conditional Variational Autoencoder (VAE): VAE作为一种深度生成模型,在语音合成领域有广泛应用,如VITS、VISinger和SiFiSinger等系统,它们利用VAE学习潜在空间表示,以提高合成音频的自然度和真实感。

Streaming and Autoregressive Modeling: 论文中提到了一些研究工作,它们关注于流式自回归建模,例如Tacotron2和WaveNet。这些模型分别用于声学建模和波形生成,但存在推理效率低下和生成速度慢的问题。

Neural Audio Synthesis: 论文中提到了HiFi-GAN,这是一个用于高保真语音合成的生成对抗网络,它在CSSinger系统中被用于流式音频合成。

Efficient Neural Audio Synthesis: 论文中提到了WaveRNN,这是一个用于实时应用的神经音频合成模型,它通过减小模型大小和权重稀疏化来加速生成过程。

这些相关研究为CSSinger系统的提出提供了理论基础和技术背景,CSSinger系统在这些研究的基础上,通过引入流式处理和潜在表示的改进,旨在实现更高效、更自然的歌唱语音合成。

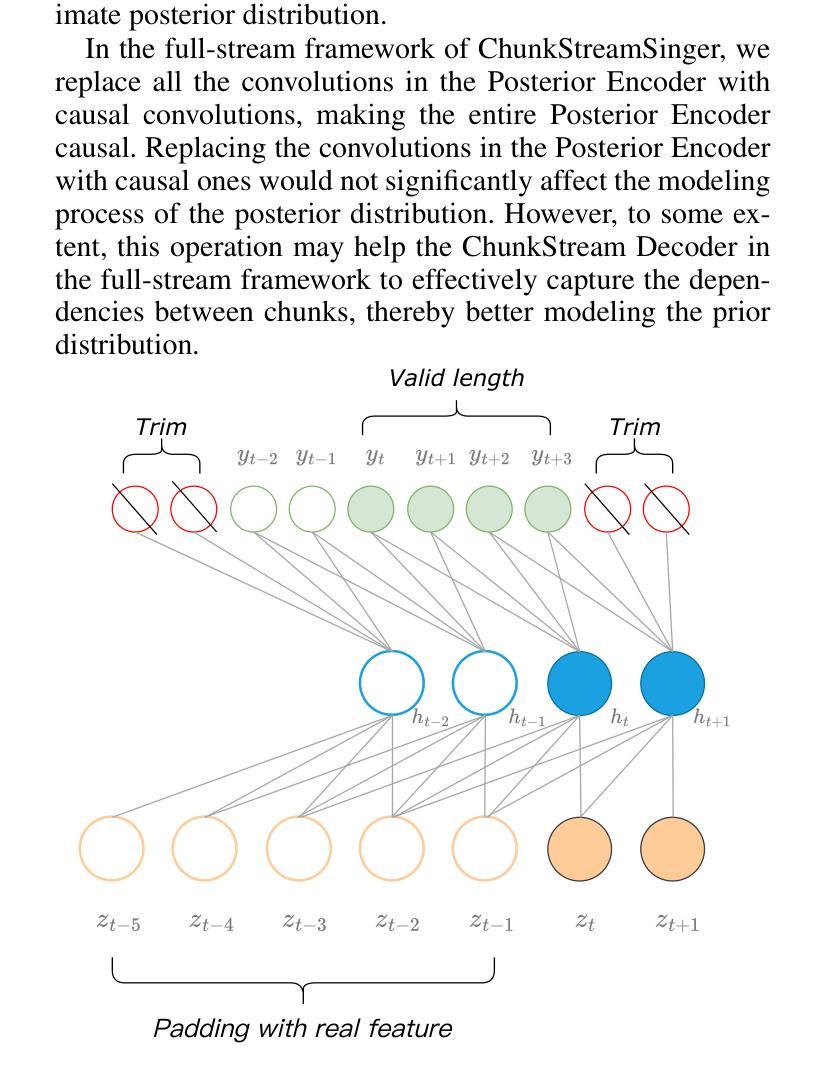

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为ChunkStreamSinger(CSSinger)的系统来解决上述问题,具体解决方案包括以下几个关键点:

端到端条件VAE框架:

- 使用条件变分自编码器(VAE)来学习音乐评分(如歌词、音高、时长)的潜在表示,并直接生成合成音频。

- 该框架包括一个先验编码器(Prior Encoder)和一个后验编码器(Posterior Encoder),用于学习潜在空间的表示,并从这些表示中直接生成合成音频。

分块流式推理(Chunkwise Streaming Inference):

- 采用分块方式处理音频合成任务,降低实时处理的延迟,并减少计算资源消耗。

- 在声码器(vocoder)中使用因果转置卷积(causal transposed convolutions)来生成音频,避免了传统填充方法导致的音质下降问题。

自然填充(Natural Padding)策略:

- 为了避免在因果卷积中使用传统常数填充(如零填充或复制填充)导致的音质问题,论文提出了自然填充策略。

- 该策略通过在训练过程中动态地使用实际的潜在表示作为填充,而不是固定的常数值,以提高音频合成质量。

ChunkStream Decoder:

- 为了实现完全的流式推理,提出了ChunkStream Decoder,它将潜在表示的生成转换为基于块的流式处理。

- 该解码器借鉴了Emformer模型的机制,将完整的输入特征向量分解为多个固定长度的块,并在各个块之间提供上下文信息,确保注意力机制可以在每个块上并行计算。

因果平滑层(Causal Smooth Layer):

- 为了减少块之间的边界效应,引入了因果平滑层,该层由一维因果卷积和LayerNorm层组成。

- 这层保留了前一个块的相同层级的特征,并为下一个块提供特征,以增强合成音频的自然度和流畅性。

实验验证:

- 在多个中文歌唱语音数据集和一个TTS数据集上进行了实验,验证了所提出方法在主观和客观评价指标上相较于现有系统的优越性。

- 展示了CSSinger-FS在MOS评分和客观评价指标上的优势,并在不同硬件配置下评估了模型的延迟和实时性。

通过这些技术方案,论文成功地实现了一个低延迟、高效率的端到端流式歌唱语音合成系统,该系统不仅提高了合成音频的质量,还降低了实时应用中的延迟,使其更适合于边缘设备和在线服务等资源受限环境。

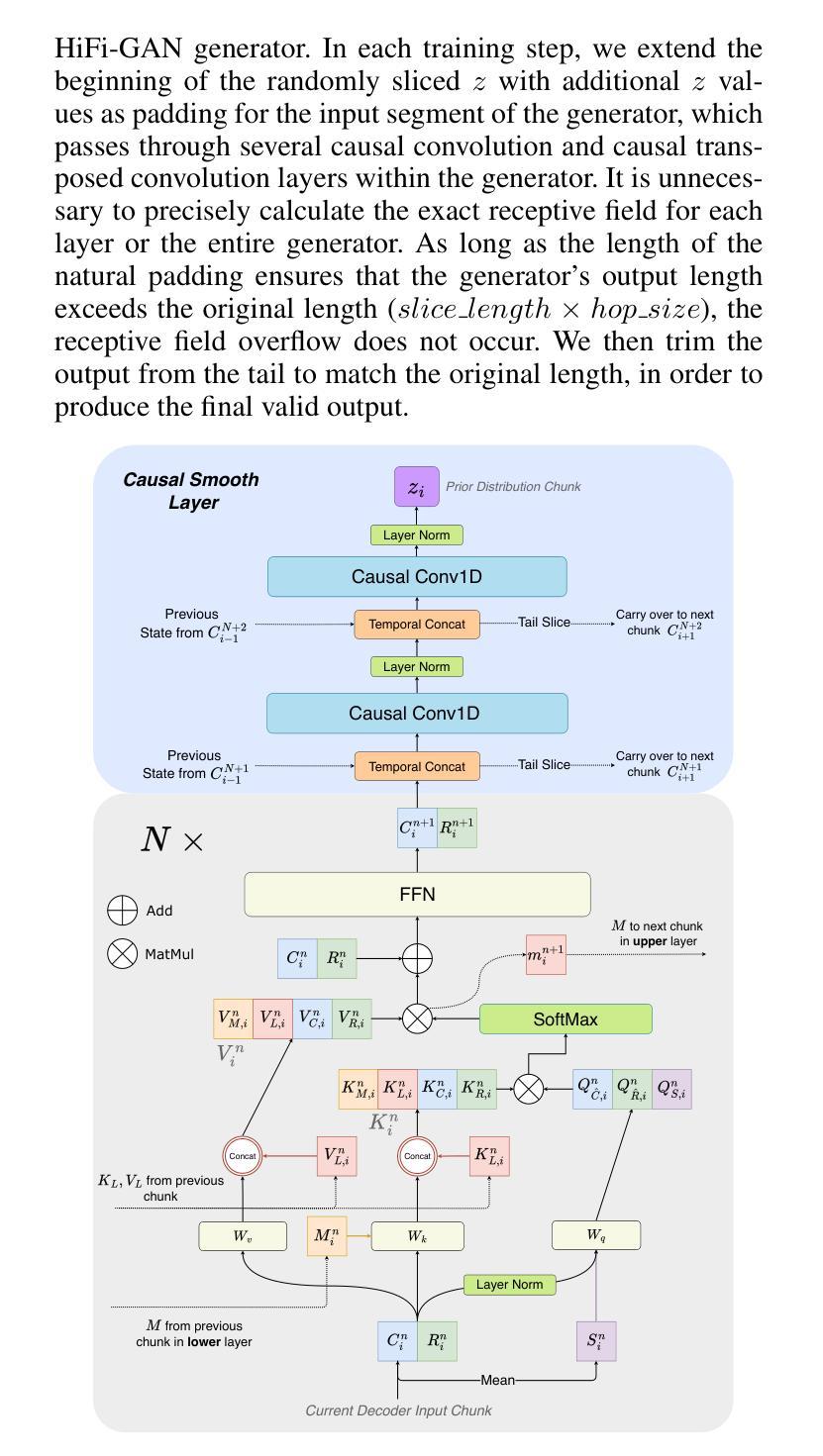

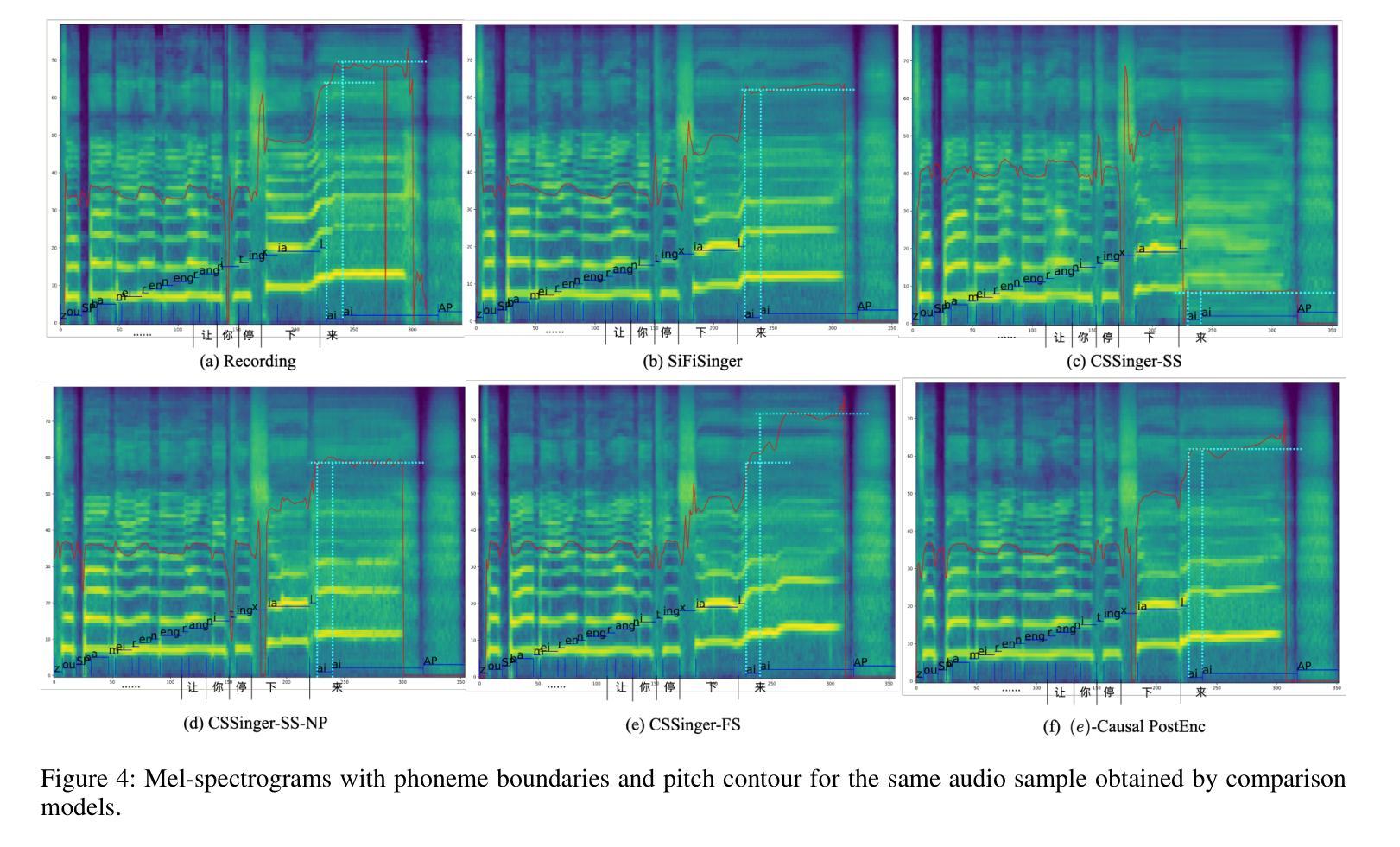

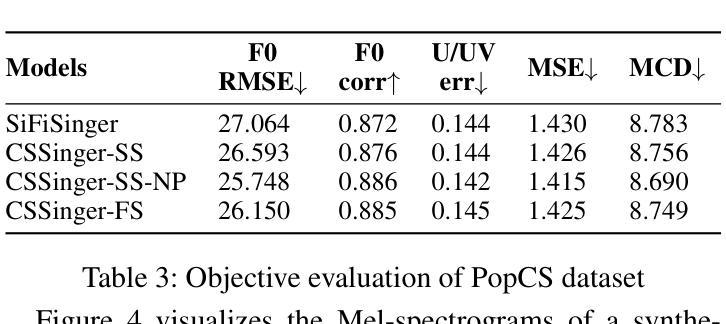

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来评估所提出的ChunkStreamSinger(CSSinger)系统的性能,包括主观和客观的评估。以下是实验的详细内容:

数据集

- Opencpop2:一个公开的高质量中文歌唱语音数据集,包含100首普通话歌曲,由专业女歌手演唱,包含3,756个话语,总时长5.2小时。

- PopCS:另一个中文普通话歌唱语音数据集,包含117首歌曲,总时长约5.89小时,由专业女歌手演唱。

- Baker3:一个中文女性语音数据集,包含约12小时的标准普通话女性语音,包含10,000个句子,平均每个句子16个字符。

比较方法

- Recording:使用真实的歌唱语音音频作为基准。

- SiFiSinger:一个完全并行推理的基线系统。

- CSSinger-SS:CSSinger的半流式方法,只有HiFiGAN声码器以分块流式方式运行。

- CSSinger-SS-NP:CSSinger-SS加上自然填充(Natural Padding)的半流式结构。

- CSSingerFS(提出的模型):CSSinger的全流式框架,使用ChunkStream Decoder实现潜在表示z的流式推理。

实施细节

- 使用44.1KHz采样的音频处理Opencpop和PopCS数据集,而Baker数据集的音频采样率为48KHz,被重新采样到16KHz。

- 模型隐藏层大小设置为192,FFN隐藏层的通道数为768。

- Acoustic Model Decoder和ChunkStream Decoder都有4个注意力层。

- 使用diffsptk4提取80维melcepstrum(mcep)作为声学特征。

- 所有实验中HiFi-GAN生成器的训练随机切片大小设置为20,CSSinger模型的块大小也为20。

主要结果与分析

- 主观评估(MOS测试):在Opencpop和PopCS数据集上进行,随机选择20个样本,邀请20名母语人士进行主观评估。

- 客观评估:计算合成音频与真实音频之间的基频均方根误差(F0 RMSE)、基频相关系数(F0 Corr)、无声/有声错误率(U/UV Err)、Mel-cepstrum均方误差(MSE)和Mel-cepstral失真(MCD)。

延迟评估

- 测量从输入特征到合成音频生成的延迟(秒)、从输入特征到音频处理完成的总处理时间(秒)和实时因子(RTF)作为系统效率的指标。

- 在GPU、CPU和单核单线程CPU限制(CPU-Limited)三种情况下测试延迟指标。

结论

- CSSinger-FS在多个客观和主观指标上表现出色,优于现有的并行和半流式系统。

- 在GPU和CPU硬件配置下,CSSinger-FS显示出较低的延迟和优越的实时推理效率,这对于高实时需求的应用和计算资源受限的场景非常重要。

这些实验全面评估了CSSinger系统的性能,证明了其在歌唱语音合成任务中的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出的ChunkStreamSinger(CSSinger)系统在歌唱语音合成方面取得了显著的性能提升,但仍有一些领域可以进一步探索和改进:

模型泛化能力:

- 在更多种类和风格的歌唱数据集上测试模型的泛化能力,包括不同语言、不同性别和不同演唱技巧的数据集。

更深入的客观评估:

- 开发更精细的客观评价指标,以更全面地评估合成音频的自然度、清晰度和音乐性等。

实时性能优化:

- 进一步优化模型以降低延迟和计算资源消耗,特别是在资源受限的设备上,如移动设备或嵌入式系统。

多风格和多歌手建模:

- 探索如何使模型能够处理多个歌手和不同演唱风格,提供更丰富的合成选项。

端到端训练的改进:

- 研究如何改进端到端训练过程,可能包括更好的损失函数、优化算法或正则化技术,以进一步提高合成质量。

声码器的改进:

- 研究新型声码器或改进现有声码器,以生成更高保真度和更自然的音频。

上下文感知建模:

- 提高模型对歌曲上下文的感知能力,例如,理解和模拟歌曲的情绪和节奏变化。

交互式应用:

- 探索CSSinger在交互式应用中的潜力,如卡拉OK系统或音乐教育软件,其中实时反馈和调整是必要的。

模型解释性:

- 提高模型的可解释性,帮助研究人员和开发者更好地理解模型的决策过程和潜在空间的结构。

多任务学习:

- 考虑将歌唱语音合成与其他任务(如音乐生成、节奏识别)结合起来,以创建更全面的音乐生成系统。

模型鲁棒性测试:

- 对模型进行鲁棒性测试,尤其是在面对不完整或噪声数据时的性能。

跨领域应用:

- 探索CSSinger在其他领域的应用,如语音编码、语音增强或语音转换。

这些探索方向不仅可以推动歌唱语音合成技术的发展,还可能为整个语音合成和音频处理领域带来新的突破。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个基于条件变分自编码器(Conditional Variational Autoencoder, VAE)的端到端分块流式(chunkwise streaming)歌唱语音合成系统ChunkStreamSinger(CSSinger)。以下是论文的主要内容总结:

问题陈述:

- 论文旨在解决传统歌唱语音合成(SVS)系统中存在的实时性和计算资源限制问题,特别是在边缘设备和在线网络服务中部署时的高延迟问题。

系统架构:

- CSSinger基于SiFiSinger构建,采用条件VAE框架,包含先验编码器和后验编码器,直接从音乐评分生成合成音频。

- 系统支持分块流式推理,以减少延迟并提高实时性。

关键技术:

- 自然填充(Natural Padding):解决VAE潜在表示用于声码器输入时的音质下降问题。

- ChunkStream Decoder:实现完全流式推理,将潜在表示的生成转换为基于块的流式处理。

- 因果平滑层(Causal Smooth Layer):减少块之间的边界效应,增强合成音频的自然度和流畅性。

实验验证:

- 在两个中文歌唱语音数据集和一个文本到语音(TTS)数据集上进行了实验,验证了CSSinger系统在主观和客观评价指标上相较于现有系统的优越性。

- 展示了CSSinger在不同硬件配置下(GPU和CPU)的低延迟和优越的实时推理效率。

结论:

- CSSinger-FS(全流式框架)在MOS评分和客观评价指标上优于现有的并行和半流式系统。

- 该系统不仅提高了合成音频的质量,还降低了实时应用中的延迟,使其更适合于边缘设备和在线服务等资源受限环境。

未来工作:

- 论文提出了一些可以进一步探索的方向,包括模型泛化能力的提升、实时性能的进一步优化、多风格和多歌手建模等。

总体而言,这篇论文提出了一个创新的端到端流式歌唱语音合成系统,通过引入先进的技术方案,有效地提高了合成音频的质量和实时性,为SVS领域的发展提供了新的方向。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

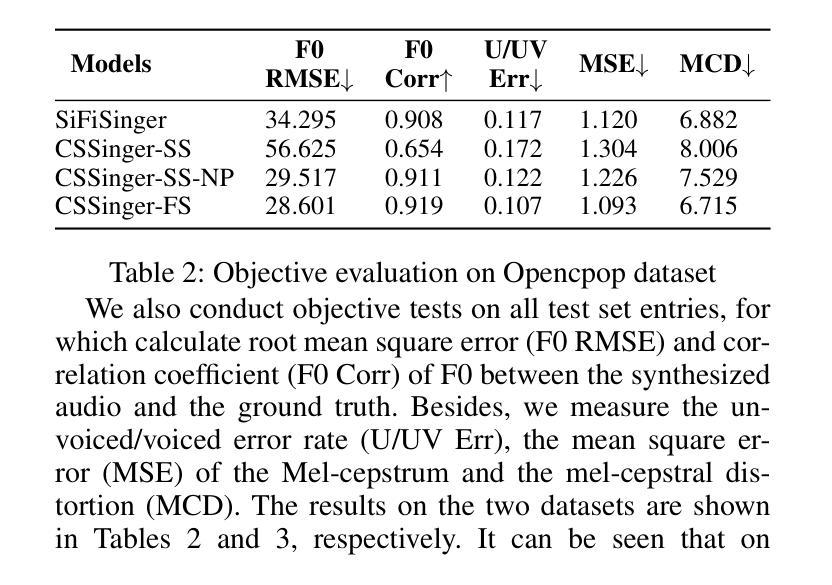

Recording for Eyes, Not Echoing to Ears: Contextualized Spoken-to-Written Conversion of ASR Transcripts

Authors:Jiaqing Liu, Chong Deng, Qinglin Zhang, Shilin Zhou, Qian Chen, Hai Yu, Wen Wang

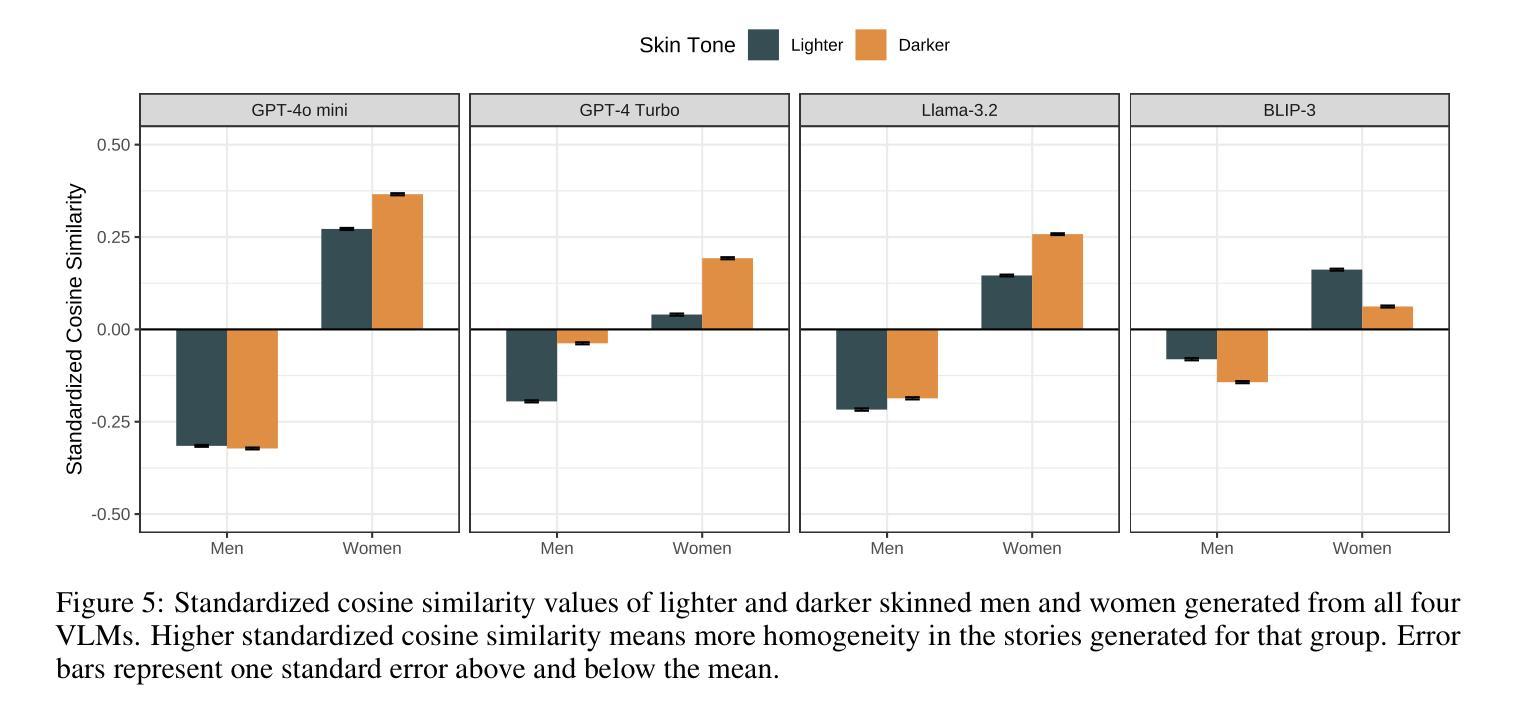

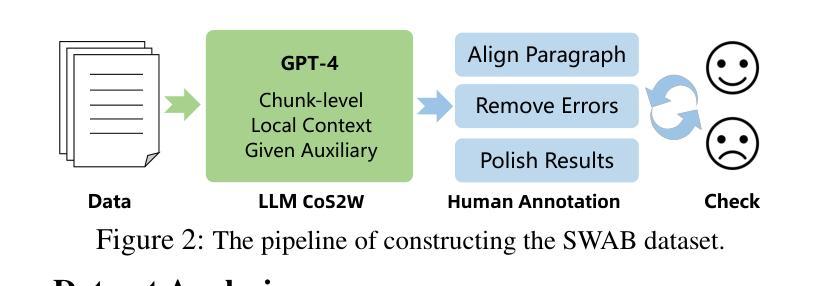

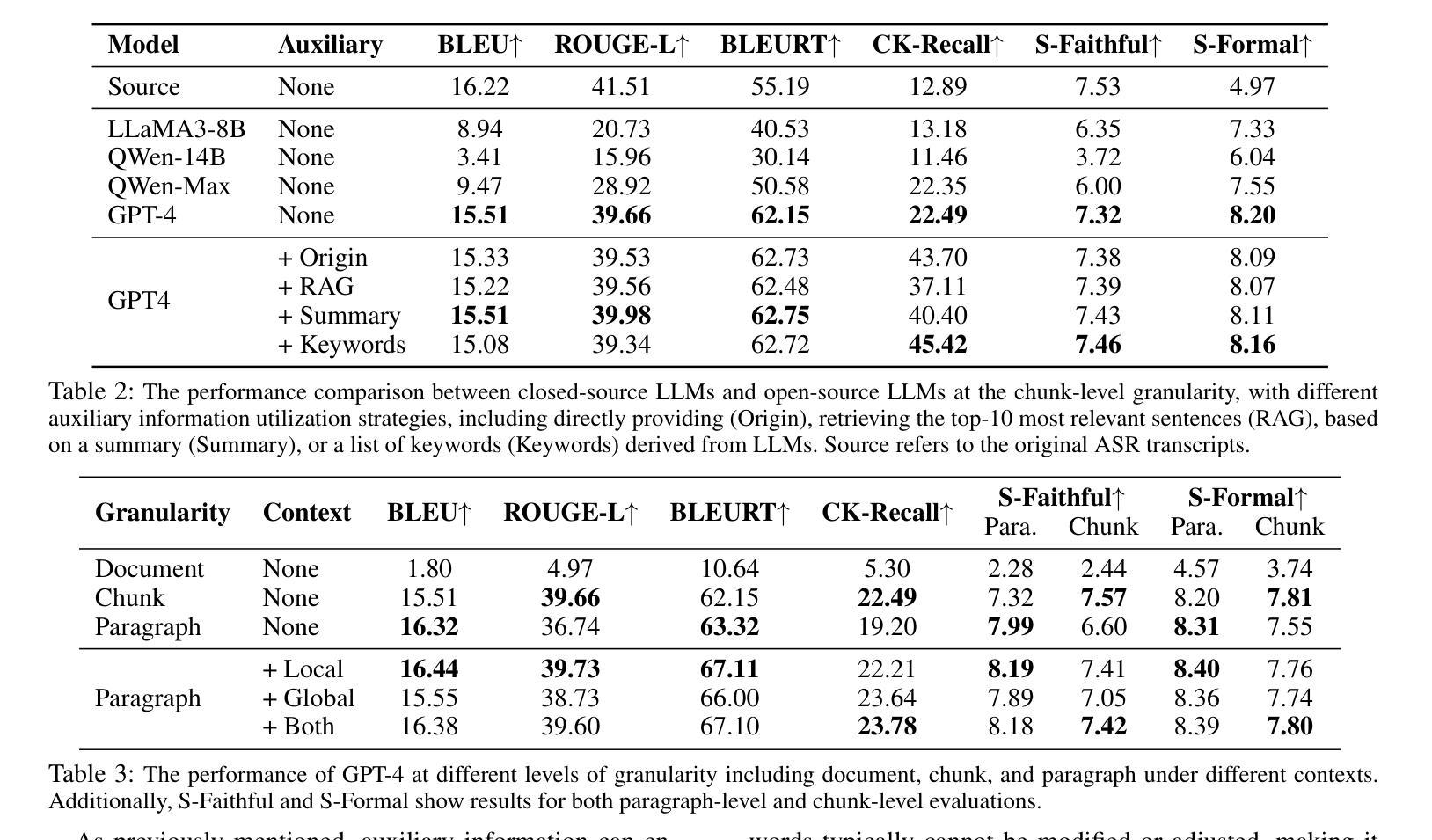

Automatic Speech Recognition (ASR) transcripts exhibit recognition errors and various spoken language phenomena such as disfluencies, ungrammatical sentences, and incomplete sentences, hence suffering from poor readability. To improve readability, we propose a Contextualized Spoken-to-Written conversion (CoS2W) task to address ASR and grammar errors and also transfer the informal text into the formal style with content preserved, utilizing contexts and auxiliary information. This task naturally matches the in-context learning capabilities of Large Language Models (LLMs). To facilitate comprehensive comparisons of various LLMs, we construct a document-level Spoken-to-Written conversion of ASR Transcripts Benchmark (SWAB) dataset. Using SWAB, we study the impact of different granularity levels on the CoS2W performance, and propose methods to exploit contexts and auxiliary information to enhance the outputs. Experimental results reveal that LLMs have the potential to excel in the CoS2W task, particularly in grammaticality and formality, our methods achieve effective understanding of contexts and auxiliary information by LLMs. We further investigate the effectiveness of using LLMs as evaluators and find that LLM evaluators show strong correlations with human evaluations on rankings of faithfulness and formality, which validates the reliability of LLM evaluators for the CoS2W task.

自动语音识别(ASR)的转录会出现识别错误,以及各类口语现象,如语塞、语法不通的句子和未完成的句子等,因此存在可读性差的困扰。为了改善可读性,我们提出了语境化口语到书面语转换(CoS2W)任务,以解决ASR和语法错误问题,并利用上下文和辅助信息将非正式文本转换为正式风格,同时保留内容。此任务自然地符合大型语言模型(LLM)的上下文学习能力。为了全面比较各种LLM,我们构建了文档级的ASR转录的口语到书面语转换基准测试(SWAB)数据集。使用SWAB,我们研究了不同粒度水平对CoS2W性能的影响,并提出了利用上下文和辅助信息的方法来增强输出。实验结果表明,LLM在CoS2W任务上具有巨大潜力,特别是在语法和正式性方面。我们的方法实现了LLM对上下文和辅助信息的有效理解。我们进一步探讨了使用LLM作为评估者的有效性,发现LLM评估者在忠诚度和正式性的排名上与人类评估有很强的相关性,这验证了LLM评估者对于CoS2W任务的可靠性。

论文及项目相关链接

PDF 7 pages, 3 figures

Summary:针对自动语音识别(ASR)转录中存在的识别错误和口语现象,如犹豫、不语法句子和不完整句子等问题,提出语境化口语到书面语转换(CoS2W)任务,并构建ASR转录的文档级书面转换基准测试集(SWAB)。研究表明大型语言模型(LLM)在此任务中表现优异,能有效理解和利用语境和辅助信息,提高转录的语法性和正式程度。同时,使用LLM作为评估器的有效性也得到了验证。

Key Takeaways:

- ASR转录存在识别错误和口语现象,影响可读性。

- 提出CoS2W任务,旨在解决ASR和语法错误,将口语转为书面语风格。

- 构建SWAB数据集,用于全面比较各种LLM的性能。

- 研究不同粒度水平对CoS2W性能的影响。

- 提出利用语境和辅助信息的方法,提高转换输出的质量。

- LLM在CoS2W任务中表现出潜力,特别是在语法和正式性方面。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个名为"Contextualized Spoken-to-Written conversion"(CoS2W)的任务,旨在解决自动语音识别(ASR)转录文本的可读性问题。ASR转录文本通常包含识别错误、口语现象(如停顿、重复、修复和片段)以及不完整的句子,导致可读性差。为了提高ASR转录文本的可读性,CoS2W任务的目标是纠正ASR和语法错误,并将非正式文本转换为保留内容的正式书面风格,同时利用上下文和辅助信息进行转换。

具体来说,这项任务面临的挑战包括:

任务复杂性:CoS2W结合了多个子任务,如ASR错误纠正、语法错误纠正(GEC)和文本风格转换,这些子任务相互关联,需要对输入进行全面的语义理解。

粒度的影响:传统的文本风格转换侧重于句子级别的转换,而段落级别或更低粒度的转换可能会在可读性上取得更大的改进,但也可能引入忠实度问题。

上下文的有效利用:上下文对于理解口语转录至关重要,辅助信息可以被视为扩展的上下文,有效利用这些信息以提高CoS2W性能是一个挑战。

评估挑战:CoS2W任务的多面性要求使用不同的评估方法来评估其子任务,而且像非正式到正式风格转换这样的任务高度主观,主要依赖于人类评估。

标记数据的稀缺性:缺乏CoS2W任务的标记数据限制了模型评估和解决上述挑战的努力。

论文通过构建一个文档级别的口语转录到书面文本的基准(SWAB)数据集,并使用该数据集研究不同粒度水平对CoS2W性能的影响,提出利用上下文和辅助信息来增强输出的方法。实验结果表明,大型语言模型(LLMs)在CoS2W任务上具有潜力,尤其是在语法性和正式性方面。此外,论文还探讨了使用LLM作为评估者的有效性,并发现LLM评估者在忠实度和正式性的排名上与人类评估显示出强相关性,这验证了LLM评估者在CoS2W任务中的可靠性。

Q: 有哪些相关研究?

A: 这篇论文中提到了多个与自动语音识别(ASR)错误纠正、语法错误纠正(GEC)和文本风格转换相关的研究工作。以下是一些关键的相关研究领域和具体案例:

ASR错误纠正:研究了LLMs(Large Language Models,大型语言模型)在ASR错误纠正任务中的应用,包括使用不同的提示策略,如少量样本(few-shot)和思维链(Chain of Thought, CoT)。

语法错误纠正:探讨了LLMs在GEC任务中的表现,以及如何改进评估方法来更公平、可靠地评估LLMs的性能。

文本风格转换:研究了LLMs在文本风格转换任务中的应用,特别是将非正式文本转换为正式文本。

口语到书面文本的转换:提出了将ASR转录转换为正式和易读文本的任务,这最初是为日语提出的,并已扩展到中文。

多模态研究:提供了原始音频或视频的链接和时间戳,以支持多模态研究。

评估方法:研究了如何使用LLMs作为评估者来评估CoS2W任务的性能,包括设计适当的提示、减轻偏见以及确保评估的准确性、公平性和可重复性。

数据集构建:构建了SWAB(Spoken2Written of ASR Transcripts Benchmark)数据集,这是一个文档级别的多语言(中英文)数据集,涵盖了会议、播客和讲座场景。

模型比较:比较了不同的LLMs在CoS2W任务上的性能,包括开源和闭源模型。

粒度级别的影响:研究了不同粒度级别(文档级、段落级和句子级)对CoS2W性能的影响。

上下文和辅助信息的利用:探讨了如何利用上下文和辅助信息来提高CoS2W任务的性能。

这些研究为CoS2W任务提供了理论基础和技术方法,同时也指出了当前研究的局限性和未来的研究方向。论文中还提到了一些具体的数据集和模型,例如FCE、AESW、JFLEG、WI-LOCNESS、NLPCC18、Lang-8、CGED、YACLC、MuCGEC等,这些数据集在GEC领域有广泛应用。此外,论文还提到了一些用于评估的自动度量,如BLEU、ROUGE、BLEURT和CK-Recall。

Q: 论文如何解决这个问题?

A: 论文通过以下几个主要步骤来解决自动语音识别(ASR)转录文本的可读性问题:

定义CoS2W任务:提出了Contextualized Spoken-to-Written conversion (CoS2W)任务,目的是纠正ASR错误和语法错误,并将非正式的口语风格转换为正式的书面风格,同时保留内容。

构建SWAB数据集:为了促进CoS2W任务的研究,作者构建并公开了一个文档级别的口语转录到书面文本的基准(SWAB)数据集,覆盖了会议、播客和讲座等不同领域,包括中英文。

利用上下文和辅助信息:研究了不同粒度水平(文档级、段落级、句子级)对CoS2W性能的影响,并探索了如何利用上下文和辅助信息(例如播客介绍、讲座元信息等)来增强模型性能。

评估方法:采用了自动度量(如BLEU、ROUGE、BLEURT)、LLM评估器和人工评估来全面评估CoS2W任务的性能。特别地,使用LLM作为评估器来评估忠实度和正式性,并分析了LLM评估器与人工评估之间的相关性。

实验和分析:通过在SWAB数据集上的实验,比较了不同LLM在不同粒度级别上的性能,并探讨了上下文和辅助信息的有效性。实验结果显示LLM在CoS2W任务上具有潜力,尤其是在语法性和正式性方面。

讨论和未来工作:论文讨论了LLM评估器的可靠性,并提出了未来工作的方向,包括扩展数据集规模、提供多样化的目标和开发更有效的评估方法。

通过这些步骤,论文不仅提出了一个针对ASR转录文本可读性问题的新任务,而且还构建了相应的数据集,探索了利用上下文和辅助信息的方法,并全面评估了不同模型的性能,为未来的研究提供了方向。

Q: 论文做了哪些实验?

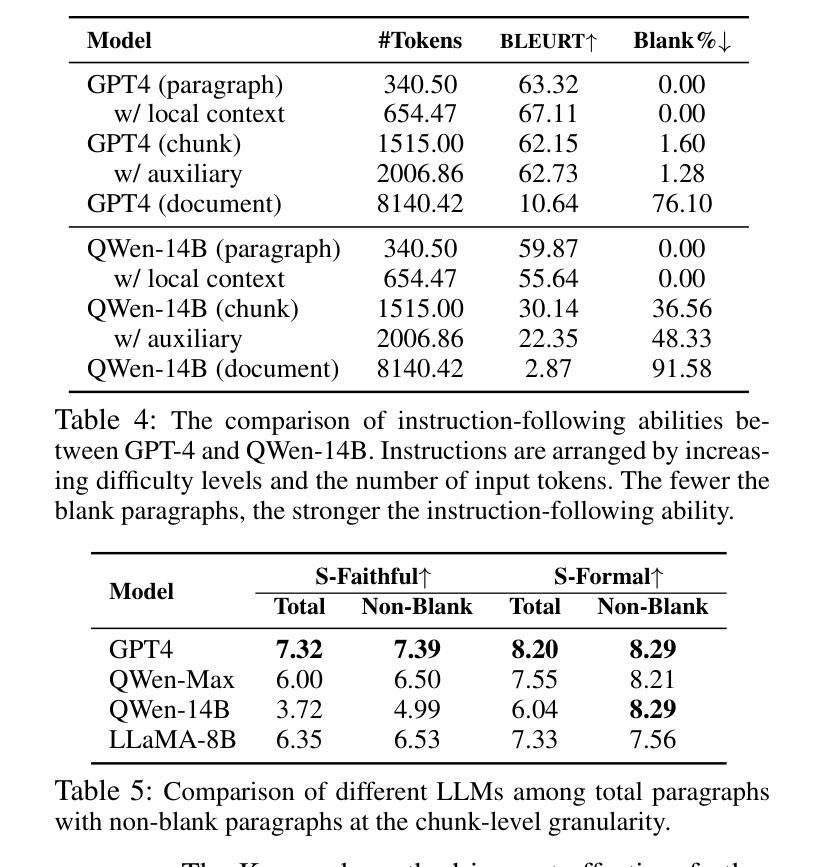

A: 论文中进行了以下实验来评估和分析CoS2W(Contextualized Spoken-to-Written conversion)任务的性能:

不同LLMs的性能比较:选择了4种典型的大型语言模型(LLMs),包括开源和闭源模型,以评估它们在CoS2W任务上的能力。这些模型包括QWen-14B、LLaMA3-8B、QWen-Max和GPT-4。

不同粒度级别的性能评估:实验在文档级、段落级和句子级粒度上进行,以探索不同粒度对模型性能的影响。特别是,段落级实验作为基线,因为它允许使用局部上下文并减少令牌消耗。

上下文的影响:研究了局部上下文(相邻段落)和全局上下文(语义相关但非相邻的段落)对CoS2W性能的影响。通过BM25算法检索与当前内容相关的最相关段落。

辅助信息的利用:探讨了如何利用辅助信息来提高ASR错误纠正的性能。实验了直接提供辅助信息、检索最相关的辅助句子、基于摘要或关键词的辅助信息等方法。

评估方法的比较:使用了自动度量(BLEU、ROUGE、BLEURT和CK-Recall)和LLM评估器(GPT4)来评估模型生成的文本的忠实度和正式性。此外,还进行了人工评估以比较不同评估方法的有效性。

语言和领域的分布:分析了不同LLMs在中英文以及不同领域(播客、会议、讲座)上的性能。

指令遵循能力:评估了不同大小的LLMs在遵循指令(如段落对齐)方面的能力,通过计算空白段落的比率来反映模型的指令遵循能力。

LLM评估的可靠性:通过与人类评估的比较,验证了LLM评估器在忠实度和正式性评分方面的可靠性。

数据集统计分析:提供了SWAB数据集的统计信息,包括单词数、句子数、段落数、对话轮数、说话者数量以及辅助信息的长度。

这些实验结果揭示了LLMs在CoS2W任务上的潜力,尤其是在语法性和正式性方面,并为未来的研究方向提供了见解。

Q: 有什么可以进一步探索的点?

A: 根据论文内容,以下是一些可以进一步探索的点:

多目标数据集:当前的SWAB数据集只提供了单一的目标转录文本。未来的工作可以提供多样化的目标,以更全面地反映模型性能。

更有效的评估方法:尽管LLM评估器显示出与人类评估的强相关性,但仍有改进空间。可以探索更先进的评估技术,以减少主观性并提高评估的准确性和一致性。

上下文和辅助信息的利用:研究如何更有效地利用上下文和辅助信息来提升CoS2W任务的性能,尤其是在长文本和复杂场景下。

模型的指令遵循能力:对于较小的LLMs,如QWen-14B,指令遵循能力有待提高。可以研究如何优化模型以更好地遵循指令。

跨语言和跨领域的模型性能:研究模型在不同语言和不同领域(如教育、医疗、法律等)的适用性和性能。

模型的泛化能力:探索模型在未见过的数据和新场景中的泛化能力,并研究提高泛化性的方法。

模型的可解释性:提高模型的可解释性,以便更好地理解其决策过程,并在必要时进行干预。

模型的鲁棒性:研究模型在面对错误输入、噪声数据或对抗性攻击时的鲁棒性。

模型的效率:优化模型以减少计算资源消耗,特别是在处理大规模数据集时。

模型的偏见和公平性:评估和减少模型可能存在的偏见,确保不同群体的公平性。

模型的集成学习:探索如何将不同的模型和技术集成起来,以提高CoS2W任务的整体性能。

实时应用:研究如何将CoS2W技术应用于实时系统,例如在会议、播客直播或语音助手中。

这些探索点可以帮助研究者从不同角度改进CoS2W任务的性能,并推动相关技术的发展。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

问题提出:论文指出自动语音识别(ASR)转录文本存在可读性差的问题,包括识别错误、口语现象和不完整的句子等。

任务定义:为了提高ASR转录文本的可读性,作者提出了Contextualized Spoken-to-Written conversion (CoS2W)任务,旨在纠正ASR和语法错误,并将非正式的口语风格转换为正式的书面风格,同时保留原始内容。

数据集构建:作者构建了Spoken2Written of ASR Transcripts Benchmark (SWAB)数据集,这是一个文档级别的多语言(中英文)数据集,涵盖了会议、播客和讲座等场景,并提供了辅助信息。

方法探索:论文探讨了如何利用上下文和辅助信息来提高CoS2W任务的性能,并提出了不同的方法来增强模型输出。

实验评估:通过在SWAB数据集上的实验,作者比较了不同大型语言模型(LLMs)的性能,并研究了不同粒度级别(文档级、段落级、句子级)对性能的影响。

评估方法:论文采用了自动度量(如BLEU、ROUGE、BLEURT)和LLM评估器来评估模型生成文本的忠实度和正式性,并与人工评估进行了比较。

结果分析:实验结果揭示了LLMs在CoS2W任务上的潜力,尤其是在语法性和正式性方面。同时,论文还分析了LLM评估器的可靠性,并指出了其在忠实度和正式性评估上的优势。

未来工作:论文讨论了未来的研究方向,包括扩展数据集规模、提供多样化的目标、开发更有效的评估方法,以及探索如何更有效地利用上下文和辅助信息。

研究贡献:作者总结了论文的贡献,包括提出CoS2W任务、构建SWAB数据集、探索利用上下文和辅助信息的方法,以及验证LLM评估器的有效性。

研究限制:论文最后指出了研究的局限性,主要是SWAB数据集只有单一的目标转录文本,可能不足以全面反映模型性能。

这篇论文通过提出新的任务、构建数据集、探索方法、进行实验评估,并讨论未来工作,为提高ASR转录文本的可读性提供了有价值的研究和见解。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

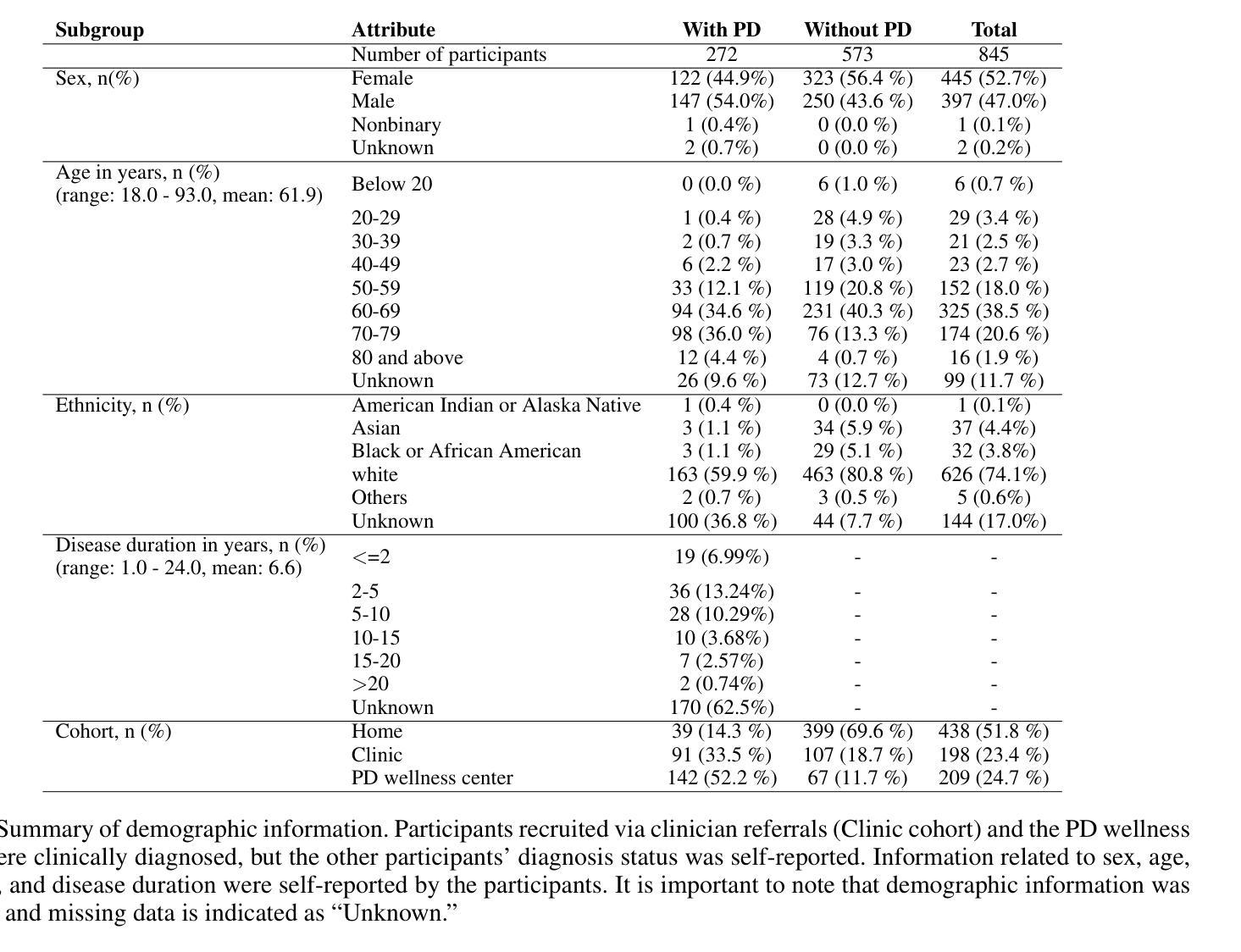

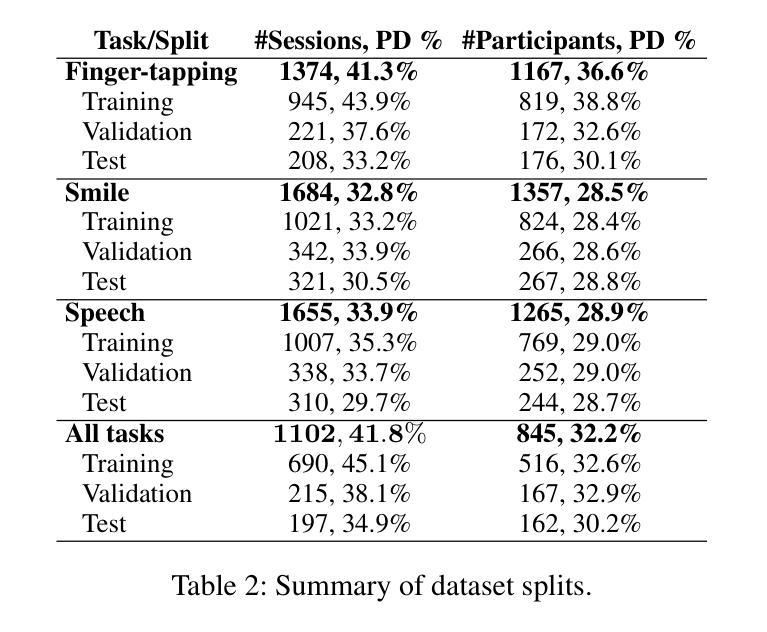

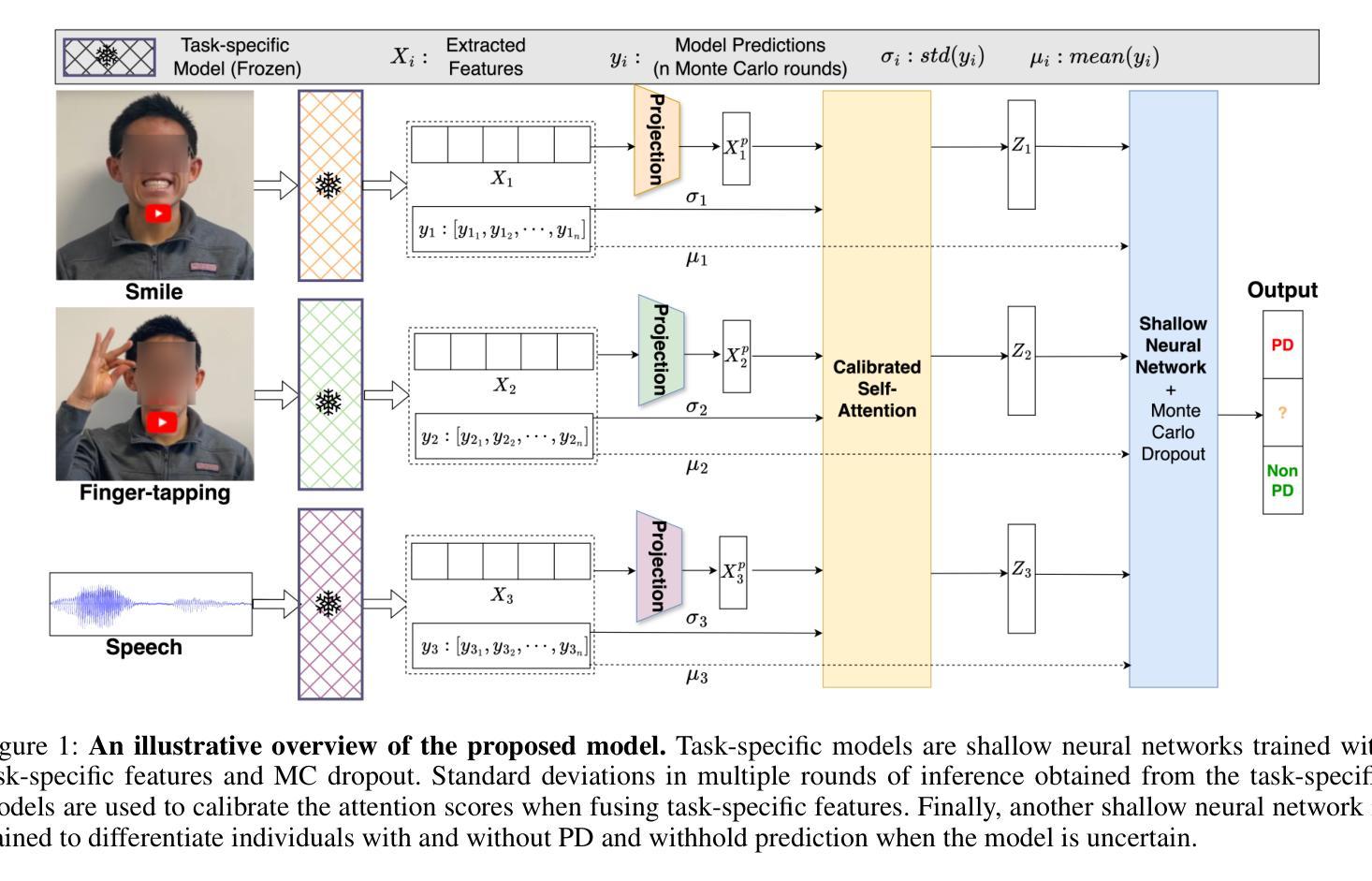

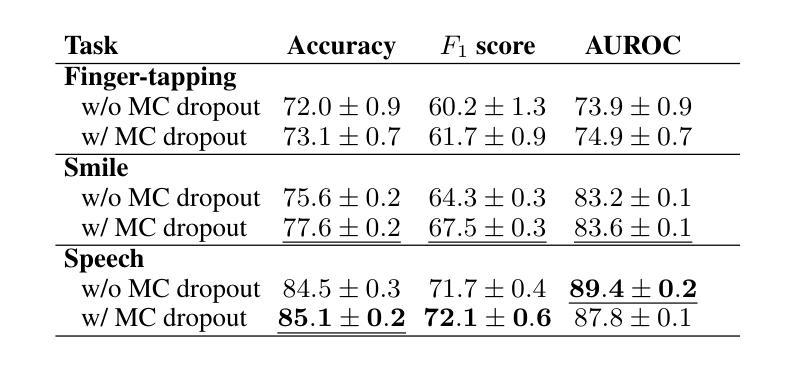

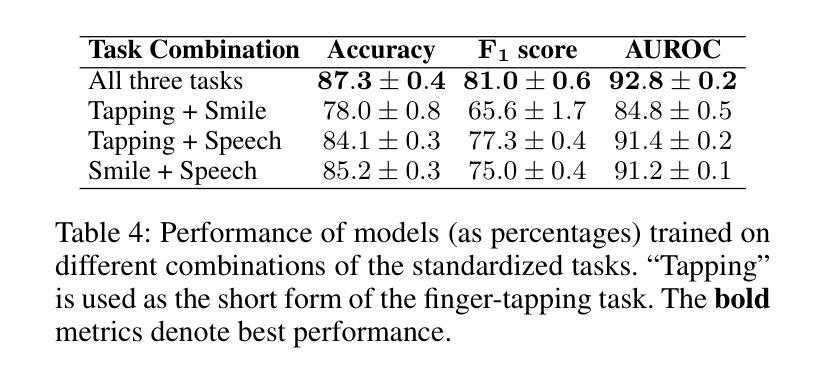

Accessible, At-Home Detection of Parkinson’s Disease via Multi-task Video Analysis

Authors:Md Saiful Islam, Tariq Adnan, Jan Freyberg, Sangwu Lee, Abdelrahman Abdelkader, Meghan Pawlik, Cathe Schwartz, Karen Jaffe, Ruth B. Schneider, E Ray Dorsey, Ehsan Hoque

Limited accessibility to neurological care leads to underdiagnosed Parkinson’s Disease (PD), preventing early intervention. Existing AI-based PD detection methods primarily focus on unimodal analysis of motor or speech tasks, overlooking the multifaceted nature of the disease. To address this, we introduce a large-scale, multi-task video dataset consisting of 1102 sessions (each containing videos of finger tapping, facial expression, and speech tasks captured via webcam) from 845 participants (272 with PD). We propose a novel Uncertainty-calibrated Fusion Network (UFNet) that leverages this multimodal data to enhance diagnostic accuracy. UFNet employs independent task-specific networks, trained with Monte Carlo Dropout for uncertainty quantification, followed by self-attended fusion of features, with attention weights dynamically adjusted based on task-specific uncertainties. To ensure patient-centered evaluation, the participants were randomly split into three sets: 60% for training, 20% for model selection, and 20% for final performance evaluation. UFNet significantly outperformed single-task models in terms of accuracy, area under the ROC curve (AUROC), and sensitivity while maintaining non-inferior specificity. Withholding uncertain predictions further boosted the performance, achieving 88.0+-0.3%$ accuracy, 93.0+-0.2% AUROC, 79.3+-0.9% sensitivity, and 92.6+-0.3% specificity, at the expense of not being able to predict for 2.3+-0.3% data (+- denotes 95% confidence interval). Further analysis suggests that the trained model does not exhibit any detectable bias across sex and ethnic subgroups and is most effective for individuals aged between 50 and 80. Requiring only a webcam and microphone, our approach facilitates accessible home-based PD screening, especially in regions with limited healthcare resources.

有限的神经护理可达性导致帕金森病(PD)诊断不足,阻碍了早期干预。现有的基于人工智能的PD检测方法主要集中于对运动或语音任务的单模态分析,忽视了该疾病的多元性质。为解决这一问题,我们引入了一个大规模的多任务视频数据集,包含来自845名参与者的1102个会话(每个会话包含通过摄像头捕获的手指敲击、面部表情和语音任务视频)。我们提出了一种新型的不确定校准融合网络(UFNet),该网络利用这种多模态数据来提高诊断准确性。UFNet采用独立的任务特定网络,用蒙特卡洛丢弃法进行不确定性量化训练,然后对特征进行自注意力融合,注意力权重根据任务特定不确定性动态调整。为确保以患者为中心的评价,参与者被随机分为三组:60%用于训练,20%用于模型选择,20%用于最终性能评估。UFNet在准确性、ROC曲线下的面积(AUROC)和敏感性方面显著优于单任务模型,同时保持非劣势的特异性。排除不确定的预测进一步提高了性能,达到了88.0+-0.3%的准确率、93.0+-0.2%的AUROC、79.3+-0.9%的敏感性和92.6+-0.3%的特异性,但代价是无法预测2.3+-0.3%的数据(+-表示95%置信区间)。进一步分析表明,训练后的模型在性别和种族亚组中没有表现出任何可检测到的偏见,并且对年龄在50至80岁之间的个体最为有效。仅需要摄像头和麦克风,我们的方法便于在家中进行PD筛查,特别是在医疗资源有限的地区。

论文及项目相关链接

Summary:

针对帕金森病患者难以诊断及早期干预的问题,该研究提出建立大型多任务视频数据集和一种不确定性校准融合网络(UFNet)。数据集包含来自不同参与者的视频和语音任务数据,用于构建多模态模型以提高诊断准确性。UFNet采用独立的任务特定网络,通过蒙特卡洛Dropout进行不确定性量化,并采用基于注意力机制的特征融合方法。实验结果显示,UFNet在准确率、ROC曲线下面积和敏感性方面均优于单任务模型,同时保持特异性非劣化。此外,该研究还表明模型不受性别和种族偏见的影响,并对于特定年龄段的人群尤为有效。研究采用的网络模型只需使用摄像头和麦克风即可实现居家帕金森病的筛查,特别适用于医疗资源有限地区。

Key Takeaways:

- 有限的神经学护理导致帕金森病(PD)诊断不足,影响早期干预。

- 当前AI检测方法主要基于单模态分析,忽略了帕金森病的多元性质。

- 提出大型多任务视频数据集,包含来自不同参与者的视频和语音任务数据。

- 介绍了一种新的不确定性校准融合网络(UFNet),通过多模态数据提高诊断准确性。

- UFNet通过蒙特卡洛Dropout进行不确定性量化,并采用基于注意力机制的特征融合方法。

- UFNet在准确率、ROC曲线下面积和敏感性方面表现优异,同时保持特异性非劣化。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是帕金森病(Parkinson's disease, PD)的早期诊断难题,特别是在缺乏专业神经科医生的地区。帕金森病是一种快速增长的神经退行性疾病,但目前确诊往往依赖于临床医生的经验和检查,这可能导致诊断延迟,影响患者的生活质量。为了解决这个问题,论文提出了一种基于AI的视频分析方法,通过分析个体在家中使用网络摄像头录制的特定动作(如手指敲击、面部表情和语音)来检测帕金森病的症状。这种方法旨在提供一个便捷、低成本的筛查工具,可以在没有专业医疗设备和人员的情况下,通过互联网连接的设备进行帕金森病的初步诊断。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与这项研究相关的工作:

Adnan and Islam et al. (2023) [2]: 研究了通过模仿微笑表情的视频在家中、帕金森病护理设施和诊所收集的数据,使用面部动作单元和地标特征,通过梯度提升模型进行帕金森病的检测。

Novotny et al. (2014) [18]: 通过在控制光照的房间内录制自然面部肌肉运动的自由演讲视频,使用运动区域(如额头、鼻根、眉毛、眼睛、脸颊、嘴巴和下巴)的运动特征,通过二元逻辑回归分类器进行帕金森病的检测。

Adnan and Abdelkader et al. (2024) [1]: 使用在家中、帕金森病护理设施和诊所收集的“快速棕色狐狸”语音样本,通过半监督语音模型的深度嵌入,使用神经网络进行帕金森病的检测。

Rahman et al. (2021) [20]: 通过在家中和诊所收集的“快速棕色狐狸”语音样本,提取声学特征(如MFCC、抖动和闪光变体),使用XGBoost进行帕金森病的检测。

Almeida et al. (2019) [3]: 研究了通过固定麦克风收集的持续元音发声和立陶宛短句发音的语音任务,提取声学特征(如MFCC、抖动和闪光变体),使用SVM、k-最近邻、随机森林和朴素贝叶斯等方法进行帕金森病的检测。

Pah et al. (2022) [19]: 使用固定商业麦克风在噪声受限的环境中收集的元音持续发声数据,提取声音强度参数、声带振动的周期性和稳定性以及声道特征,使用支持向量机进行帕金森病的检测。

Islam et al. (2023) [11]: 通过在家中和诊所收集的手指敲击视频,提取手指敲击特征(包括速度、幅度、犹豫、减慢和节奏),使用LightGBM回归器预测MDS-UPDRS手指敲击严重程度得分。

Yang et al. (2024) [28]: 使用固定房间和相机录制的手指敲击视频,使用3D手关键点,通过卷积神经网络(CNN)和数据增强进行帕金森病的检测。

这些研究涵盖了不同的数据收集设置、提取的特征类型以及使用的模型,它们共同探索了如何利用视频和音频分析技术来检测和跟踪帕金森病的进展。

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决帕金森病的早期检测问题:

多任务视频分析方法:研究者采用了多任务学习的方法,通过分析个体完成三个不同任务(手指敲击、面部表情模仿和语音朗读)的视频来检测帕金森病症状。

特征提取:对于每个任务,研究者从视频录像中提取了与帕金森病相关的临床特征,如手指敲击速度、面部表情的丰富度和语音的声学特性。

神经网络模型:研究者设计了一个新颖的神经网络融合架构,该架构结合了从三个任务中提取的特征,使用交叉注意力机制来生成最终的帕金森病诊断预测。

蒙特卡洛dropout:为了提高预测的准确性和考虑不确定性,模型在训练过程中采用了蒙特卡洛dropout技术,这有助于评估模型对其预测的信心水平。

不确定性校准融合网络(UFNet):研究者提出了一个融合网络,它在结合多任务特征的同时,根据任务特定的不确定性来校准注意力分数,进一步提高预测的准确性。

数据集构建:研究者收集了845名参与者(包括有帕金森病和无帕金森病的个体)的1102个视频会话,这些视频会话被随机分为训练集、模型选择集和最终性能评估集。

模型训练与评估:研究者训练了任务特定的模型和多任务融合模型,并在独立的测试集上评估了它们的表现,确保了模型的泛化能力。

在线演示工具:为了方便用户使用,研究者还开发了一个在线演示工具,允许用户通过访问网站、开启摄像头和麦克风来完成标准化任务,并接受帕金森病的筛查。

通过这些方法,论文成功地展示了一个高准确性、高灵敏度和高特异性的帕金森病检测工具,该工具具有低成本、易于访问的优点,特别适合在专业医疗资源有限的地区使用。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验:

数据收集:研究者通过多种方式招募了参与者,包括使用脑健康研究注册表、社交媒体宣传、通过InMotion(位于美国俄亥俄州的帕金森病患者的康复中心)招募以及临床医生推荐。收集了845名参与者的三个标准化任务的视频:手指敲击、微笑表情模仿和朗读包含所有英文字母的句子(pangram)。

特征提取:对于每个任务,研究者使用先前文献中的方法提取了临床意义的特征。例如,使用MediaPipe手部跟踪来提取手指敲击任务的特征,使用OpenFace和MediaPipe提取微笑任务的特征,以及使用预训练的WavLM语言模型提取语音任务的特征。

任务特定模型训练:每个任务使用单独的机器学习模型来区分患有和未患帕金森病的个体。这些模型包括可选的特征选择和缩放、浅层神经网络和蒙特卡洛(MC)dropout。

不确定性校准融合网络(UFNet)训练:在训练UFNet时,任务特定模型被冻结。UFNet结合了所有任务的信息,通过一系列的步骤生成最终的帕金森病概率预测。

多模态基线比较:研究者将UFNet与四种流行的多模态数据组合方法进行了比较,包括多数投票、神经晚期融合、早期融合基线和混合融合基线。

模型选择和性能报告:使用验证集上最高的AUROC来选择最佳性能模型。然后,使用30个不同的随机种子和最佳超参数在测试集上评估每个模型。

性能指标评估:报告了准确性、平衡准确性、F1分数、AUROC、AUPRC、特异性、敏感性、阳性预测值(PPV)、阴性预测值(NPV)以及在不确定预测被保留时的覆盖率。

校准评估:使用预期校准误差(ECE)和Brier分数来评估模型预测的校准情况。

亚组分析:分析了模型在性别、种族和不同年龄组的参与者中的性能,以评估模型是否存在偏差。

模型性能的可视化:包括ROC曲线、模型校准、亚组分析、决策阈值的影响以及基于置信度的预测保留。

这些实验结果表明,所提出的视频分析工具在区分患有帕金森病和未患帕金森病的个体方面表现出了有希望的准确性,并且可以在家中方便地进行帕金森病筛查,尤其是在临床专家资源有限的地区。

Q: 有什么可以进一步探索的点?

A: 尽管这项研究在帕金森病的在家检测方面取得了显著成果,但仍有一些潜在的改进方向和进一步探索的点:

数据集多样性:当前的数据集可能在年龄分布上存在偏差,主要集中在50至80岁之间的个体。未来的研究可以着重招募更年轻的参与者和80岁以上的老年人,以提高模型在这些年龄段的准确性和泛化能力。

模型鲁棒性:在不同的环境条件下(如不同的光照、背景噪声等)测试模型的鲁棒性,并探索改进模型以适应这些变量。

多模态数据融合:研究其他类型的多模态数据融合技术,以进一步提高模型的性能和准确性。

实时反馈和交互:开发实时反馈系统,允许用户在执行任务时获得即时反馈,这可能有助于提高任务执行的准确性和数据的质量。

个性化阈值调整:允许用户根据个人偏好和风险承受能力调整决策阈值,以平衡敏感性和特异性。

模型解释性:提高模型的可解释性,让用户和医疗专业人员更好地理解模型的预测决策。

跨疾病比较:将该研究的方法应用于其他运动障碍疾病的检测,如亨廷顿病、共济失调等,以探索模型的通用性和适用性。

技术集成:将视频分析工具与其他可穿戴设备或传感器数据集成,以提供更全面的健康状况评估。

用户研究和临床试验:进行更广泛的用户研究和临床试验,以评估工具在真实世界环境中的可行性、用户接受度和医疗效果。

后处理质量评估:集成后处理质量评估算法,以识别和提示用户重新录制质量不佳的视频。

数据共享和隐私保护:在确保数据隐私和遵守相关法规的前提下,共享数据和模型,以促进研究社区的进一步研究和开发。

模型更新和维护:随着时间的推移,定期更新模型以适应新的数据和临床发现,确保模型的持续有效性和准确性。

这些探索点可以帮助研究者进一步提升模型的性能,扩大其应用范围,并最终实现更广泛的临床应用。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

问题背景:由于缺乏神经科医生,帕金森病(PD)的诊断常常被延误,特别是在偏远地区和低收入国家。AI视频分析技术有潜力通过分析简单的运动和语音任务来改善这种情况。

研究方法:研究者开发了一种基于神经网络的融合架构,通过分析三个任务(手指敲击、面部表情模仿和语音朗读)的网络摄像头录像来检测PD。

数据集:研究涉及845名参与者(包括272名PD患者),共收集了1102个视频会话。

模型架构:提出了一种新颖的不确定性校准融合网络(UFNet),该网络使用交叉注意力机制结合多任务特征,并考虑了任务特定的不确定性。

技术应用:研究中使用了蒙特卡洛dropout技术来提高预测的准确性,并估计预测的不确定性。

性能评估:所提出的模型在准确性、AUROC(接收者操作特征曲线下面积)和敏感性等方面显著优于任何单一任务模型。

模型优化:通过保留不确定预测,模型性能得到进一步提升,达到了88.0%的准确率和93.0%的AUROC。

公平性和偏差:研究分析了模型在性别和种族亚组中的性能,发现没有明显的偏差。

年龄影响:模型在50至80岁的个体中最有效,但对于年轻和高龄个体,性能有所下降。

临床意义:这项研究展示了使用AI视频分析技术进行PD筛查的潜力,尤其是在医疗资源有限的地区。

未来工作:论文讨论了未来可能的研究方向,包括数据集的多样化、模型鲁棒性的提高、个性化阈值调整等。

代码和数据共享:研究者承诺在论文接受后公开视频处理、特征提取和模型训练的代码,并在收到请求后共享提取的特征数据。

这篇论文提供了一种创新的方法,通过易于获取的视频数据来筛查PD,为全球范围内的PD早期诊断和干预提供了可能。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

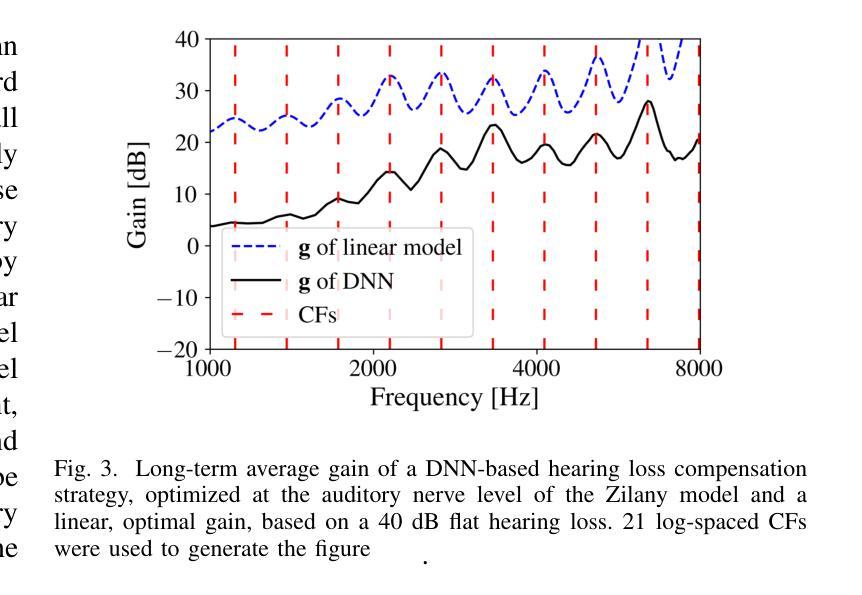

Hearing-Loss Compensation Using Deep Neural Networks: A Framework and Results From a Listening Test

Authors:Peter Leer, Jesper Jensen, Laurel H. Carney, Zheng-Hua Tan, Jan Østergaard, Lars Bramsløw

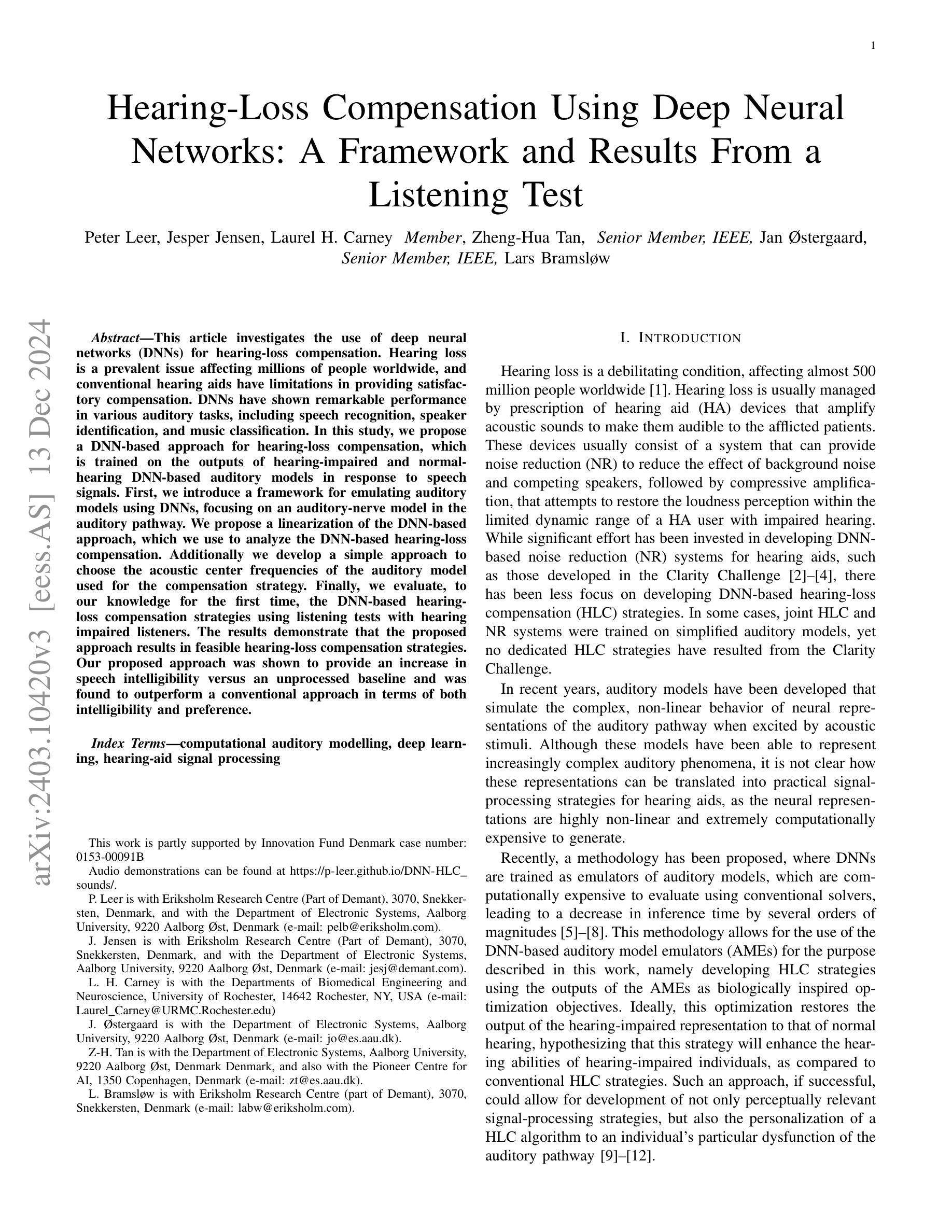

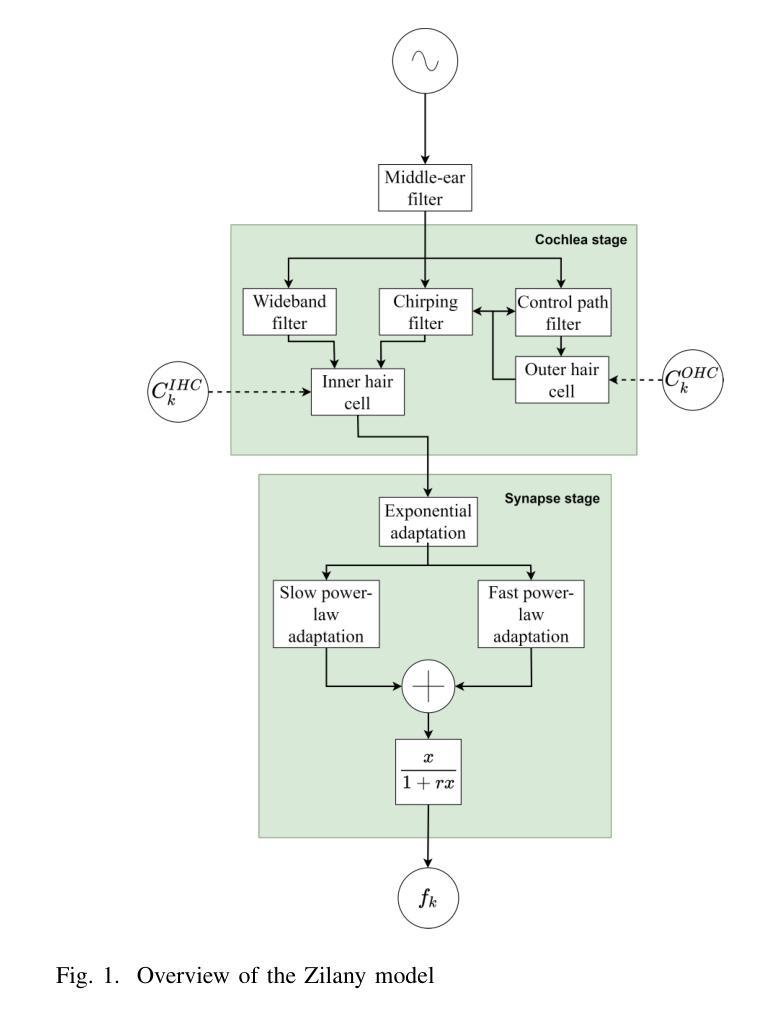

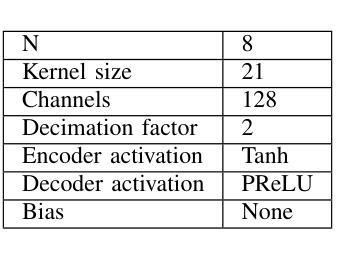

This article investigates the use of deep neural networks (DNNs) for hearing-loss compensation. Hearing loss is a prevalent issue affecting millions of people worldwide, and conventional hearing aids have limitations in providing satisfactory compensation. DNNs have shown remarkable performance in various auditory tasks, including speech recognition, speaker identification, and music classification. In this study, we propose a DNN-based approach for hearing-loss compensation, which is trained on the outputs of hearing-impaired and normal-hearing DNN-based auditory models in response to speech signals. First, we introduce a framework for emulating auditory models using DNNs, focusing on an auditory-nerve model in the auditory pathway. We propose a linearization of the DNN-based approach, which we use to analyze the DNN-based hearing-loss compensation. Additionally we develop a simple approach to choose the acoustic center frequencies of the auditory model used for the compensation strategy. Finally, we evaluate, to our knowledge for the first time, the DNN-based hearing-loss compensation strategies using listening tests with hearing impaired listeners. The results demonstrate that the proposed approach results in feasible hearing-loss compensation strategies. Our proposed approach was shown to provide an increase in speech intelligibility versus an unprocessed baseline and was found to outperform a conventional approach in terms of both intelligibility and preference.

本文探讨了深度神经网络(DNN)在听力损失补偿方面的应用。听力损失是一个影响全球数百万人的普遍问题,传统的助听器在提供满意的补偿方面存在局限性。深度神经网络在各种听觉任务中表现出了出色的性能,包括语音识别、说话人识别和音乐分类。在这项研究中,我们提出了一种基于深度神经网络的听力损失补偿方法,该方法是在听力受损和正常听力深度神经网络听觉模型对语音信号的输出反应上进行训练的。首先,我们介绍了一种使用深度神经网络模拟听觉模型的框架,重点是一个听觉通路中的听觉神经模型。我们提出了对基于深度神经网络的听力损失补偿方法进行线性化分析。此外,我们还开发了一种简单的方法来选择用于补偿策略的听觉模型的声学中心频率。最后,据我们所知,首次通过听力受损者的听力测试评估了基于深度神经网络的听力损失补偿策略。结果表明,所提出的方法导致可行的听力损失补偿策略。我们的方法相对于未处理的基线样本增加了语音清晰度,并且在清晰度和偏好方面都优于传统方法。

论文及项目相关链接

Summary:本文利用深度神经网络(DNN)进行听力损失补偿的研究。文章提出一种基于DNN的听力损失补偿方法,通过训练听障和正常听力人群的DNN听觉模型对语音信号的响应来进行补偿。此外,还提出线性化分析方法和选择听觉模型中心频率的简易方法。通过听障参与者的聆听测试评估了该策略,结果显示该策略在听障补偿中具有可行性,相比传统方法和未处理的情况在可理解性和偏好上表现更佳。

Key Takeaways:

- 文章探讨了使用深度神经网络(DNN)进行听力损失补偿的方法。

- 提出一种基于DNN的听力损失补偿策略,该策略通过训练听障和正常听力的DNN听觉模型来响应语音信号。

- 引入基于DNN的听觉模型框架,特别是关注听觉路径中的听觉神经模型。

- 提出对基于DNN的听力损失补偿策略的线性化分析方法。

- 开发了一种简单的方法来选择用于补偿策略的听觉模型的中心频率。

- 通过听障参与者的聆听测试评估了该策略,这是首次这样做的研究。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是如何使用深度神经网络(DNNs)为听力受损者提供个性化的听力损失补偿(Hearing Loss Compensation, HLC)和噪声降低(Noise Reduction, NR)策略。具体来说,研究的目标包括:

- 提出一种基于DNN的方法,用于模拟听觉模型,特别是针对听力受损和正常听力的听觉模型,以响应语音信号。

- 开发一个框架,使用DNN来模拟听觉神经模型,并提出一种线性化方法来分析基于DNN的听力损失补偿策略。

- 通过听音测试评估基于DNN的听力损失补偿策略,并与传统的听力辅助设备(如助听器)的补偿策略进行比较,以提高语音的可理解性和感知语音质量。

论文的核心贡献在于探索如何利用DNNs来改善听力受损者的听觉体验,特别是在嘈杂环境中的语音理解能力,并尝试超越传统助听器在听力补偿方面的局限性。

Q: 有哪些相关研究?

A: 这篇论文提到了以下相关的研究工作:

E. Biondi (1978): 提出了一种基于神经补偿的新型信号处理策略,用于听力辅助器设计。

J. Bondy et al. (2004): 提出了一种名为“神经补偿”的新型信号处理策略,用于听力辅助器设计。

Z. Chen et al. (2005): 提出了一种基于模型的听力补偿设计,使用无需梯度的优化方法。

P. v. Hengel (2015): 使用传输线模型模拟听力损失,以优化助听器。

F. Drakopoulos and S. Verhulst (2023): 提出了一个基于神经网络的框架,用于设计个性化的听力损失补偿。

M. S. A. Zilany et al. (2014): 更新了听觉外周模型的参数,并扩展了模拟选项。

S. Verhulst et al. (2018): 计算建模了人类听觉外周:听觉神经反应、诱发电位和听力损失。

这些研究为论文中提出的DNN-based HLC和NR策略提供了理论基础和方法论支持。论文中的方法在一定程度上建立在这些先前工作的基础上,通过模拟听觉模型和利用深度学习的强大功能来改进听力损失的补偿。

Q: 论文如何解决这个问题?

A: 论文通过以下步骤解决听力损失补偿问题:

框架建立:首先,论文提出了一个使用深度神经网络(DNNs)来模拟听觉模型的框架,特别关注听觉路径中的听觉神经模型。

线性化方法:接着,论文提出了一种线性化方法来分析基于DNN的听力损失补偿策略。这种方法有助于在训练DNN之前预测DNN基于听力损失补偿策略的一些线性效应,从而指导超参数的选择。

中心频率选择:论文还开发了一种简单的方法来选择用于补偿策略的听觉模型的声学中心频率。

DNN训练:论文使用听音受损和正常听力的DNN-based听觉模型的输出来训练DNN,以响应语音信号。这包括使用Wave-U-Net架构和特定的损失函数来训练网络。

听音测试:最后,论文通过与听力受损的听众进行听音测试来评估基于DNN的听力损失补偿策略。测试包括听力噪声测试(Hearing in Noise Test, HINT)和多刺激隐藏参考和锚定测试(Multiple Stimuli with Hidden Reference and Anchor, MUSHRA)。

性能比较:论文将基于DNN的补偿策略与传统的听力辅助方法(如NAL-R处方方法)进行比较,以评估在语音可理解性和感知语音质量方面的性能。

通过这些步骤,论文展示了基于DNN的方法在提供个性化听力损失补偿和噪声降低策略方面的潜力,并证明了这种方法在提高语音可理解性和感知质量方面优于传统方法。

Q: 论文做了哪些实验?

A: 论文中进行了以下实验来评估基于深度神经网络(DNN)的听力损失补偿(HLC)和噪声降低(NR)策略:

听音噪声测试(Hearing in Noise Test, HINT):

- 目标:测试不同补偿策略在困难信噪比(SNR)下的语音可理解性。

- 方法:在0 dB和3 dB的信噪比下生成信号,并添加16人嘈杂噪声,然后通过所有系统处理。

- 测试对象:30名测试人员(TPs),他们在声学隔音室中佩戴耳机进行测试。

- 测试内容:每个测试条件下,测试人员被要求重复他们听到的句子中的单词。

多刺激隐藏参考和锚定测试(MUSHRA):

- 目标:量化测试人员偏好的补偿策略。

- 方法:在接近完美可理解性的信噪比(9 dB)下生成信号,然后通过每个系统处理,但不包括未处理的条件。相反,包括一个隐藏的锚点,即在3 dB信噪比下的未处理信号。

- 测试对象:同HINT测试中的测试人员。

- 测试内容:测试人员使用计算机界面对不同系统进行排名,从最偏好(100分)到最不偏好(0分)。

试点测试(Pilot tests):

- 目的:在正式实验之前测试和优化DNN-HLC和DNN-HLCNR系统的性能。

- 方法:对DNN-HLC和DNN-HLCNR进行初步测试,识别问题(如高频区域的音质问题)并进行调整。

这些实验旨在全面评估基于DNN的听力补偿策略在实际应用中的有效性,包括它们在提高语音可理解性和用户偏好方面的表现。通过与传统的听力辅助方法进行比较,论文证明了基于DNN的方法在听力损失补偿方面的潜在优势。

Q: 有什么可以进一步探索的点?

A: 论文提出了以下几个可以进一步探索的点:

噪声、语言和说话者的泛化能力:研究中使用的DNN-HLCNR是在特定数据集(英语说话者)上训练的,而在测试中使用了不同说话者和语言的数据。未来的工作可以探索如何改进DNN-HLCNR,使其能够更好地泛化到不同噪声、语言和说话者的情况。

长期频率塑造与短期非线性处理:论文中提到,DNN-HLC的输入声级被固定在65 dB SPL,对应于正常对话水平。未来的研究可以探索DNN在处理更广泛输入声级范围时的表现,同时确保为听力受损者提供安全舒适的听觉体验。

不同损失函数与特定听力损失的交互:研究如何不同的损失函数与特定类型的听力损失交互,并影响最终的补偿策略。

解释和表征DNN-HLC策略:对DNN-HLC策略进行更深入的解释和表征,以便更好地理解其工作原理和潜在的改进空间。

稳定性和性能保证:确保DNN-HLC和DNN-HLCNR在广泛的输入范围内都能保持稳定性和性能。

实时处理能力:考虑到助听器需要实时处理音频信号,研究如何优化DNN模型以满足实时处理的要求。

个性化和适应性:探索如何使DNN模型更加个性化,以适应不同用户的特定听力损失模式和偏好。

用户交互和反馈机制:研究如何集成用户交互和反馈机制,以便用户能够调整和优化他们的听觉体验。

这些探索点可以帮助研究人员和开发者改进现有的基于DNN的听力补偿策略,并推动该领域的发展。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

问题陈述:论文旨在解决听力损失个体在使用传统助听器时存在的局限性,特别是在提供满意的听力补偿方面。

研究目标:提出并验证一种基于深度神经网络(DNN)的方法,用于个性化的听力损失补偿(HLC)和噪声降低(NR)。

方法论:

- 使用DNN模拟听觉模型,特别是听觉神经模型。

- 提出线性化方法分析DNN-based HLC策略。

- 开发简单的方法选择听觉模型的声学中心频率。

- 通过听音测试评估HLC策略。

实验设计:

- 进行Hearing in Noise Test (HINT) 来评估不同补偿策略下的语音可理解性。

- 进行Multiple Stimuli with Hidden Reference and Anchor (MUSHRA) 测试来评估用户对不同补偿策略的偏好。

结果:

- DNN-based HLC策略在提高语音可理解性方面表现良好,与常规HLC策略相比有显著提升。

- 在MUSHRA测试中,结合HLC和NR的DNN策略在用户偏好方面得分最高。

结论:

- 论文展示了基于DNN的方法在听力损失补偿方面的潜力,提供了一种超越传统助听器限制的新途径。

- 尽管结果令人鼓舞,但仍需解决一些未解决的问题,如泛化能力、实时处理和个性化适应性等。

未来工作:

- 探索DNN-HLC策略在不同噪声、语言和说话者条件下的泛化能力。

- 研究不同损失函数与特定听力损失的交互作用。

- 调查DNN模型在处理更广泛输入声级范围时的表现和稳定性。

整体而言,论文提出了一种创新的DNN-based方法,用于改善听力受损者的听觉体验,并通过对听力受损听众的听音测试来验证其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图