⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-17 更新

RemDet: Rethinking Efficient Model Design for UAV Object Detection

Authors:Chen Li, Rui Zhao, Zeyu Wang, Huiying Xu, Xinzhong Zhu

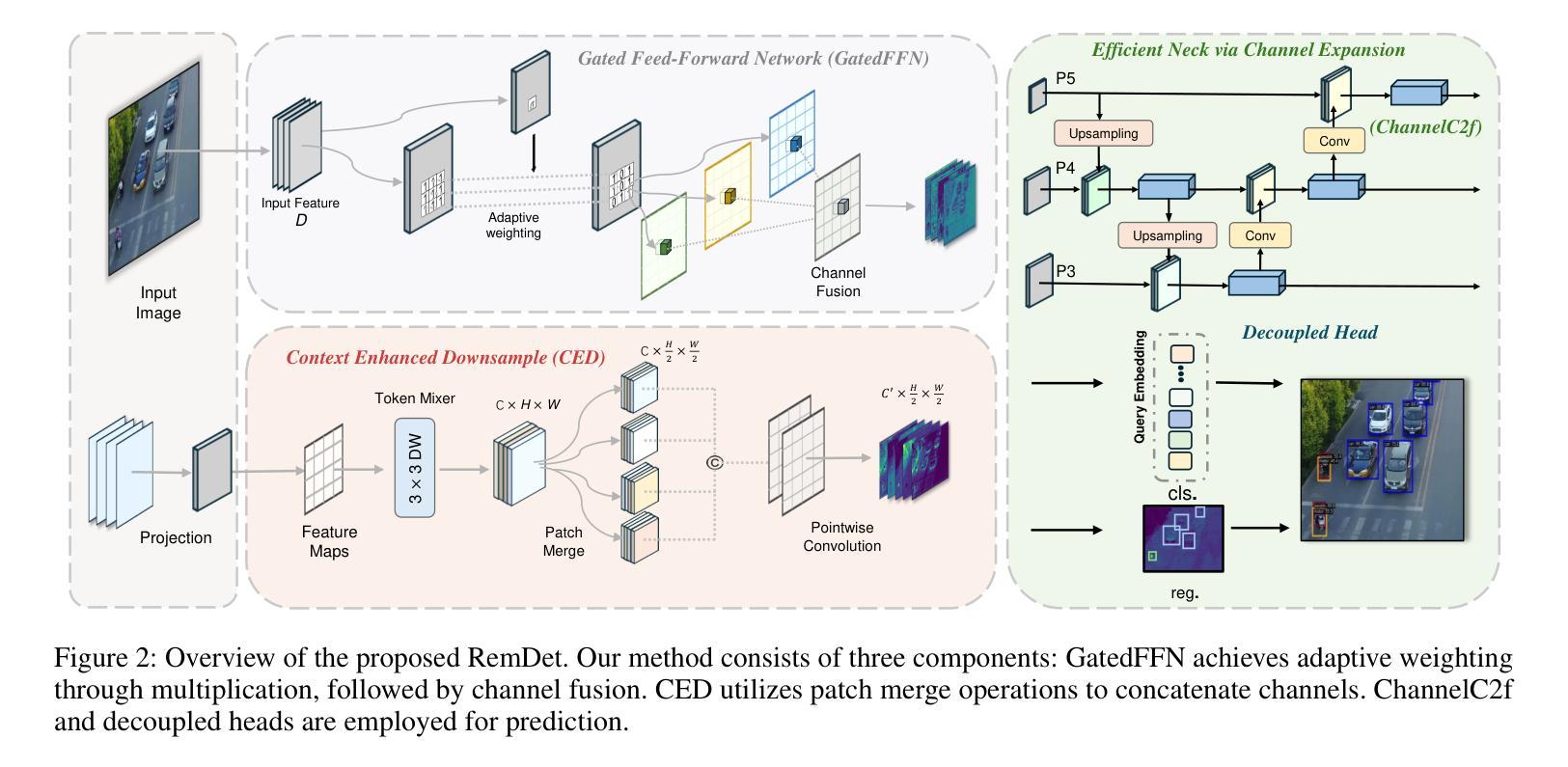

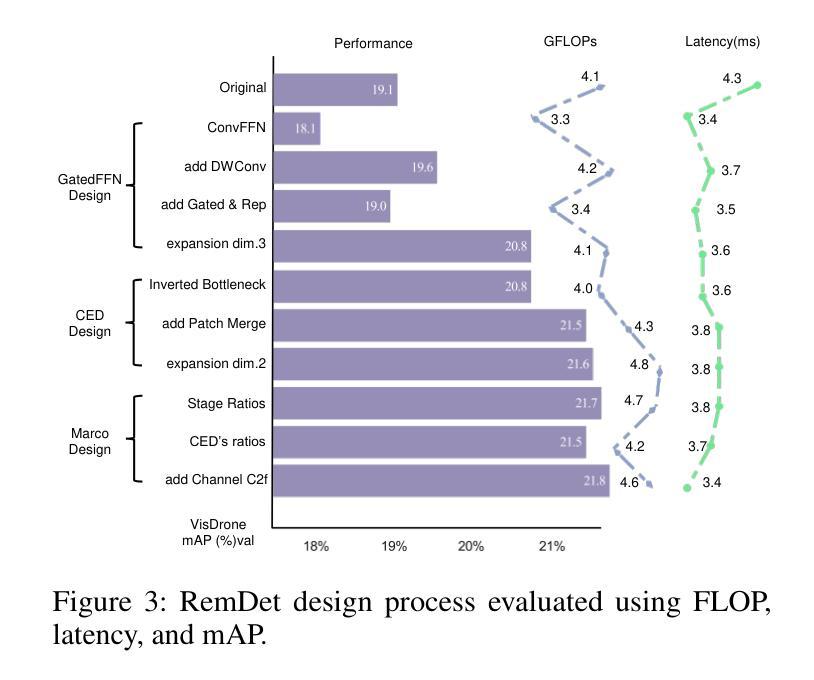

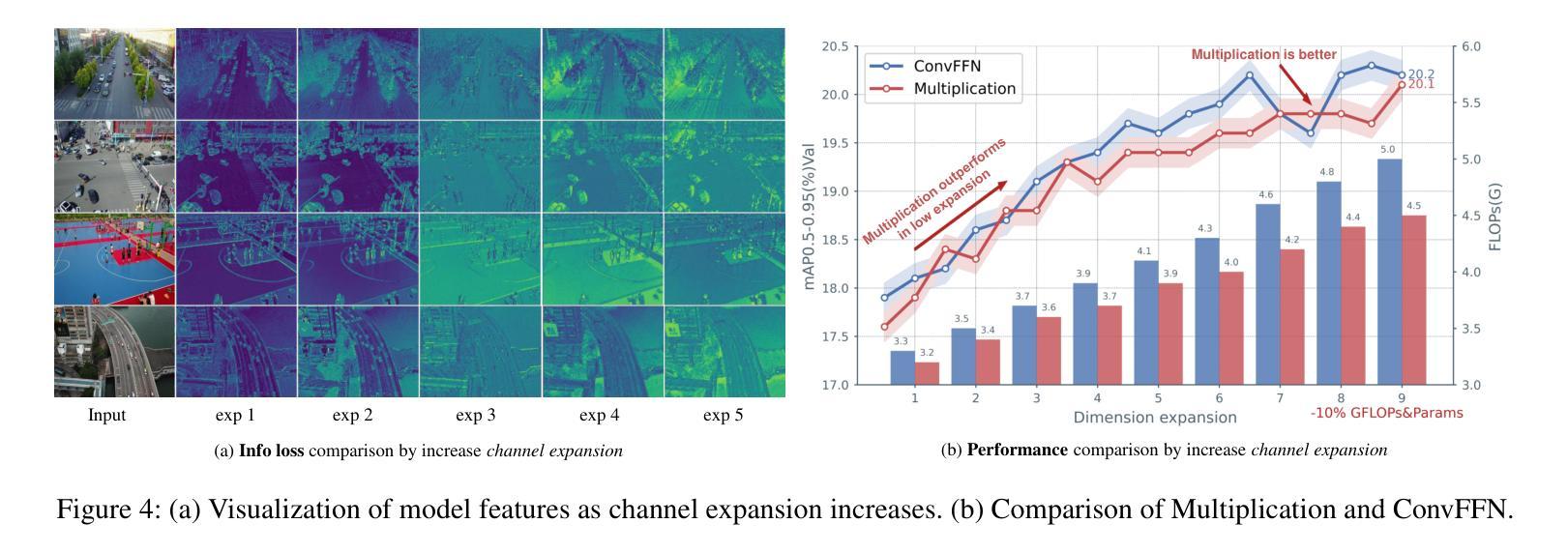

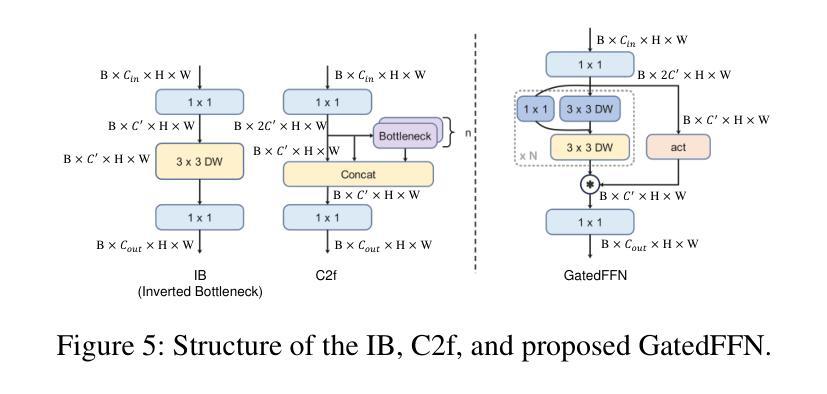

Object detection in Unmanned Aerial Vehicle (UAV) images has emerged as a focal area of research, which presents two significant challenges: i) objects are typically small and dense within vast images; ii) computational resource constraints render most models unsuitable for real-time deployment. Current real-time object detectors are not optimized for UAV images, and complex methods designed for small object detection often lack real-time capabilities. To address these challenges, we propose a novel detector, RemDet (Reparameter efficient multiplication Detector). Our contributions are as follows: 1) Rethinking the challenges of existing detectors for small and dense UAV images, and proposing information loss as a design guideline for efficient models. 2) We introduce the ChannelC2f module to enhance small object detection performance, demonstrating that high-dimensional representations can effectively mitigate information loss. 3) We design the GatedFFN module to provide not only strong performance but also low latency, effectively addressing the challenges of real-time detection. Our research reveals that GatedFFN, through the use of multiplication, is more cost-effective than feed-forward networks for high-dimensional representation. 4) We propose the CED module, which combines the advantages of ViT and CNN downsampling to effectively reduce information loss. It specifically enhances context information for small and dense objects. Extensive experiments on large UAV datasets, Visdrone and UAVDT, validate the real-time efficiency and superior performance of our methods. On the challenging UAV dataset VisDrone, our methods not only provided state-of-the-art results, improving detection by more than 3.4%, but also achieve 110 FPS on a single 4090.Codes are available at (this URL)(https://github.com/HZAI-ZJNU/RemDet).

无人机图像中的目标检测已成为研究的重要领域,这带来了两大挑战:一是对象在广阔的图像中通常较小且密集;二是计算资源限制使得大多数模型不适合实时部署。当前的实时目标检测器并未针对无人机图像进行优化,而针对小目标检测设计的复杂方法往往缺乏实时性能。为了应对这些挑战,我们提出了一种新型检测器RemDet(重参数化高效乘法检测器)。我们的贡献如下:1)重新思考现有检测器在小型和密集无人机图像面临的挑战,并将信息损失作为高效模型的设计指南。2)我们引入了ChannelC2f模块,以提高小目标检测的性能,证明高维表示可以有效地减轻信息损失。3)我们设计了GatedFFN模块,不仅具有强大的性能,而且具有较低延迟,有效地解决了实时检测的挑战。我们的研究表明,通过乘法使用GatedFFN比前馈网络更具成本效益,可实现高维表示。4)我们提出了CED模块,结合了ViT和CNN下采样的优点,有效地减少了信息损失。它特别增强了小且密集对象的上下文信息。在大规模无人机数据集Visdrone和UAVDT上的广泛实验验证了我们方法的实时效率和卓越性能。在具有挑战性的VisDrone无人机数据集上,我们的方法不仅提供了超越最新技术成果的结果,检测准确率提高了3.4%以上,而且在单个4090上实现了110 FPS。代码可在(此URL)获得:RemDet仓库链接。

论文及项目相关链接

PDF Accepted to AAAI25

Summary

在无人机图像的目标检测领域,面临两大挑战:目标小且密集,计算资源受限。针对这些问题,本文提出了一种新型检测器RemDet,其设计理念是重新思考现有检测器在面临无人机图像小目标检测时的挑战,并提出了信息损失作为设计高效模型的关键指南。通过引入ChannelC2f模块提升小目标检测性能,表明高维表示可有效减轻信息损失。同时设计GatedFFN模块,既保证性能又降低延迟,解决实时检测的挑战。此外,本文还提出了CED模块,结合ViT和CNN下采样的优势,有效减少信息损失,特别是对密集小目标的上下文信息增强有显著效果。实验结果表明,本文方法在大型无人机数据集上实现高效实时检测和卓越性能。代码已公开于GitHub。

Key Takeaways

- 无人机图像目标检测面临两大挑战:目标小且密集,计算资源受限。

- 提出新型检测器RemDet,针对无人机图像的特点进行优化。

- 引入ChannelC2f模块以提高小目标检测性能,表明高维表示有助于减轻信息损失。

- 设计GatedFFN模块,兼顾性能和实时性。

- 提出的CED模块结合了ViT和CNN下采样的优势,有效减少信息损失并增强上下文信息。

- 在大型无人机数据集上进行了广泛的实验验证,展示了所提方法的高效性和优越性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决无人机(UAV)图像中的目标检测问题,尤其关注于小目标和密集目标的检测。具体来说,论文面临的挑战包括:

- 小目标和密集目标的检测难度:无人机图像中的对象通常较小且分布密集,这使得检测任务变得更加困难。

- 计算资源限制:大多数现有的目标检测模型由于计算资源的限制,不适合实时部署在无人机上。

论文指出,尽管已有一些实时目标检测器,但它们并未针对无人机图像进行优化。同时,为小目标检测设计的复杂方法往往缺乏实时处理能力。因此,论文提出了一种新的检测器RemDet(Reparameter efficient multiplication Detector),旨在通过减少信息丢失来提高小目标和密集目标检测的效率和准确性。

Q: 有哪些相关研究?

A: 论文中提到了以下几类与无人机(UAV)图像目标检测相关的研究工作:

通用目标检测技术:

- Faster R-CNN (Girshick 2015)

- YOLO (Redmon et al. 2016; Redmon and Farhadi 2017)

- DETR (Carion et al. 2020)

轻量级和高效的架构:

- 针对目标检测设计的轻量级网络,利用深度可分离卷积、重参数化和剪枝技术,在目标检测任务中表现出色。

UAV图像的目标检测:

- ClusDet (Yang et al. 2019):使用基于聚类的尺度估计方法增强小目标检测。

- UFPMP-Det (Huang, Chen, and Huang 2022):通过聚类合并粗略检测器提供的子区域来抑制背景。

- AMRNET (Wei et al. 2020):通过两个特别设计的模块显著扩展了从粗到细的框架。

- CZDet (Meethal, Granger, and Pedersoli 2023):基于密度裁剪方法,首先检测密度裁剪区域和基本类别对象,然后输入到第二阶段推理。

- YOLC (Liu et al. 2024):基于CenterNet,自适应搜索聚类区域并调整到适当尺度,改进损失函数以增强性能。

实时UAV图像检测:

- YOLO系列:YOLOv8 (Jocher, Chaurasia, and Qiu 2023) 通过简单有效的C2f和解耦头提高实时性能。

- QueryDet (Yang, Huang, and Wang 2022) 和 CEASC (Du et al. 2023):在检测头中使用稀疏卷积来减少模型权重,降低计算需求。

这些研究提供了不同的方法和技术来提高无人机图像中目标检测的性能,特别是在小目标和密集目标检测方面。论文提出的RemDet模型在这些现有工作的基础上,进一步探索了如何通过减少信息丢失来优化无人机图像目标检测的效率和准确性。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为RemDet(Reparameter efficient multiplication Detector)的新型检测器来解决无人机(UAV)图像中小目标和密集目标的检测问题。RemDet的设计重点在于减少信息丢失,同时满足实时部署的计算资源约束。具体的解决方案包括以下几个关键组件:

ChannelC2f模块:

- 该模块通过扩展C2f(Channel Concatenation and Fusion)结构,增加了额外的通道,以增强小目标检测性能。这种高维表示可以有效减少信息丢失。

GatedFFN(Gated Feed-Forward Network)模块:

- 设计了GatedFFN模块来实现不仅性能强大而且延迟低的检测,通过使用乘法操作实现高维表示,比前馈网络更具成本效益,有效平衡性能和速度。

CED(Context Enhanced Downsample)模块:

- 结合了ViT和CNN下采样的优势,通过Patch Merge操作连接通道,减少信息丢失,特别增强了小目标和密集目标的上下文信息。

简化和优化结构:

- 论文反思了UAV检测器的设计,摒弃了复杂的手工设计,通过探索信息丢失,使用最简单的结构有效增强了小目标检测。

- 研究还表明,仅高维表示就可以减少信息丢失并增强小目标性能,通过实验结果、理论探索和可视化表示进行了验证。

实验验证:

- 在大型UAV数据集VisDrone和UAVDT上进行了广泛的实验,验证了所提方法的实时效率和优越性能。特别是,在挑战性的数据集VisDrone上,所提方法不仅提供了最先进的结果,提高了超过3.4%的检测性能,而且在一个单独的4090 GPU上实现了110 FPS的高帧率。

总的来说,RemDet通过精心设计的模块和结构优化,在不牺牲准确性的前提下,显著提高了无人机图像中小目标和密集目标的检测效率和实时性。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证所提出的RemDet模型的性能和效率,具体实验包括:

数据集:

- 使用了VisDrone和UAVDT数据集进行UAV检测实验,并包括MSCOCO数据集作为额外的基准。

评估指标:

- 使用COCO风格的平均精度(AP)作为主要的性能评估指标,并报告了小、中、大目标的平均精度,以评估模型在检测小目标方面的性能。

- 使用GFLOPs(每秒浮点运算次数)和延迟(ms)来表示模型的效率。

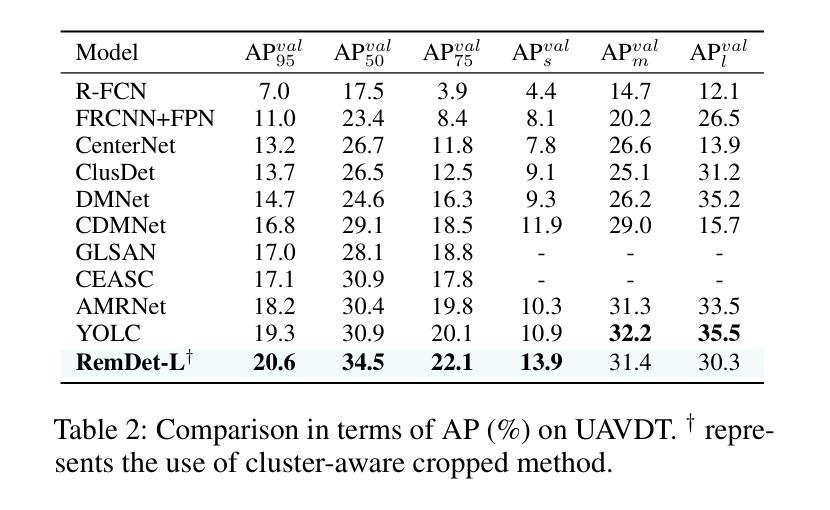

与现有方法的比较:

- 在VisDrone数据集上,将RemDet与现有的模型进行了比较,包括YOLO系列、QueryDet、CEASC等,重点比较了模型的mAP、延迟和计算复杂度。

- 在UAVDT数据集上,与当前最先进的模型YOLC进行了比较,并展示了RemDet在小目标检测精度上的提升。

消融研究:

- 对RemDet的整体设计进行了消融研究,分析了不同模块(如GatedFFN、CED和ChannelC2f)对检测精度和计算复杂度的影响。

- 调整了模型中不同阶段的块比例,以找到最优的设计。

不同规模的模型比较:

- 在MSCOCO数据集上,将RemDet与不同规模的通用目标检测器进行了比较,展示了RemDet在小目标检测方面的性能提升。

实时目标检测器的比较:

- 在VisDrone数据集上,将RemDet与多个实时通用目标检测器进行了比较,评估了不同规模模型的性能和效率。

可视化结果:

- 对RetinaNet、CEASC、GFLv1和RemDet在VisDrone和UAVDT数据集上的结果进行了可视化比较,展示了RemDet在不同场景下的性能。

这些实验全面评估了RemDet在UAV图像目标检测任务中的性能,特别是在小目标和密集目标检测方面,同时也展示了其在实时性方面的优势。通过与现有技术的比较和消融研究,论文验证了所提出方法的有效性和优越性。

Q: 有什么可以进一步探索的点?

A: 尽管论文提出的RemDet模型在无人机(UAV)图像目标检测任务中取得了显著的性能提升,但仍有一些方向可以进一步探索和改进:

大目标检测性能提升:

- 论文中提到RemDet在大目标检测方面稍显不足。未来的工作可以专注于优化模型结构或引入新的技术来提升大目标的检测性能。

模型泛化能力:

- 进一步研究和改进模型的泛化能力,使其能够在更多的数据集和不同的场景下表现良好。

计算效率优化:

- 尽管RemDet已经具有较高的计算效率,但仍可以探索新的网络结构或算法来进一步减少计算资源消耗,使其更适合边缘设备。

实时视频流处理:

- 将RemDet应用于实时视频流检测任务,并优化以满足视频处理的低延迟要求。

模型压缩与加速:

- 研究模型压缩和加速技术,如网络剪枝、量化和知识蒸馏,以减少模型大小并加速推理过程。

多任务学习:

- 探索将目标检测与其他任务(如分割、识别)结合的多任务学习框架,以提高模型的实用性。

鲁棒性增强:

- 提高模型对于不同天气条件、光照变化和遮挡情况的鲁棒性。

融合不同传感器数据:

- 研究如何将来自不同传感器(如红外、多光谱)的数据融合到检测框架中,以提高检测的准确性和鲁棒性。

更深层次的特征融合:

- 探索更高级的特征融合技术,以更有效地结合不同层次的信息。

无监督和自监督学习:

- 研究无监督或自监督学习技术,以减少对大量标注数据的依赖。

模型解释性:

- 提高模型的可解释性,以便更好地理解检测决策过程。

跨域适应性:

- 研究如何使模型更好地适应不同的域,例如从仿真环境到真实世界的迁移。

这些方向不仅可以推动无人机目标检测技术的发展,还可能对计算机视觉领域的其他任务产生积极影响。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个名为RemDet(Reparameter efficient multiplication Detector)的新型无人机(UAV)图像目标检测器,旨在解决现有模型在处理UAV图像中的小目标和密集目标时存在的挑战。以下是论文的主要内容总结:

问题定义:

- 论文指出UAV图像目标检测面临两大挑战:小目标和密集目标的识别困难,以及计算资源限制导致的实时部署难题。

RemDet框架:

- 提出了RemDet,一个一阶段无锚点(anchor-free)检测器,专注于减少信息丢失,并优化小目标和密集目标的检测性能。

主要贡献:

- 重新思考UAV图像检测器的设计,提出了基于信息丢失的高效模型设计原则。

- 引入ChannelC2f模块和Context Enhanced Downsample(CED)模块,增强小目标检测性能。

- 设计了Gated Feed-Forward Network(GatedFFN)模块,通过乘法操作实现高维表示,有效平衡性能和速度。

实验验证:

- 在VisDrone和UAVDT数据集上进行了广泛的实验,验证了RemDet在实时效率和性能上的优越性。

- 与现有方法相比,RemDet在关键指标上取得了显著提升,特别是在小目标检测方面。

方法细节:

- 论文详细介绍了RemDet的各个组件,包括GatedFFN、CED和ChannelC2f的设计和实现。

- 探讨了信息瓶颈理论在模型设计中的应用,以及如何通过减少信息丢失来优化检测性能。

实验结果:

- RemDet在VisDrone数据集上取得了超过3.4%的性能提升,同时在单个4090 GPU上实现了110 FPS的高帧率。

- 在UAVDT数据集上,RemDet也显示出比现有最先进模型更好的性能。

未来工作:

- 尽管RemDet在小目标检测上表现出色,但在大目标检测方面仍有改进空间。

- 提出了未来可能的研究方向,包括模型泛化能力、计算效率优化、实时视频流处理等。

总体而言,这篇论文通过创新的模型设计和实验验证,为UAV图像目标检测领域提供了一个高效且性能强大的解决方案。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

Agtech Framework for Cranberry-Ripening Analysis Using Vision Foundation Models

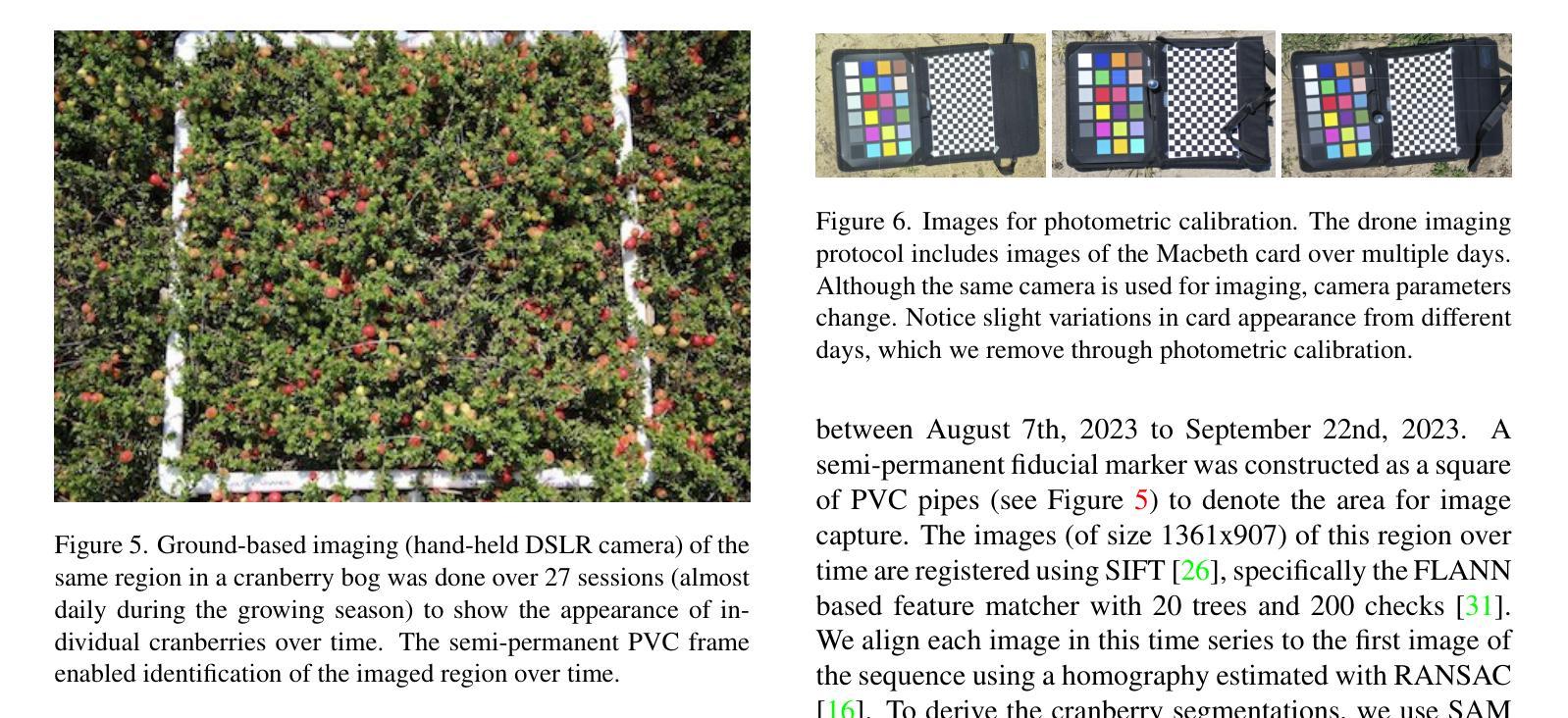

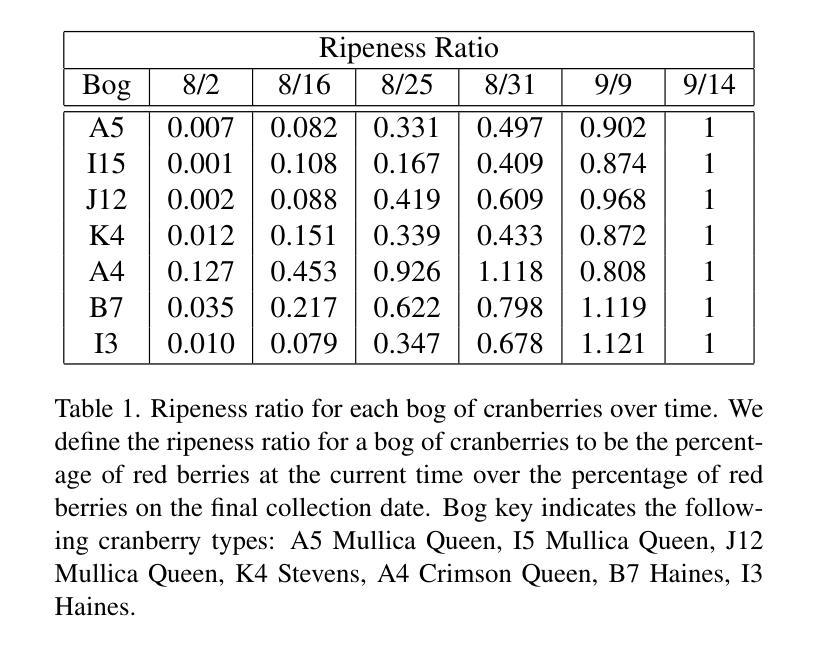

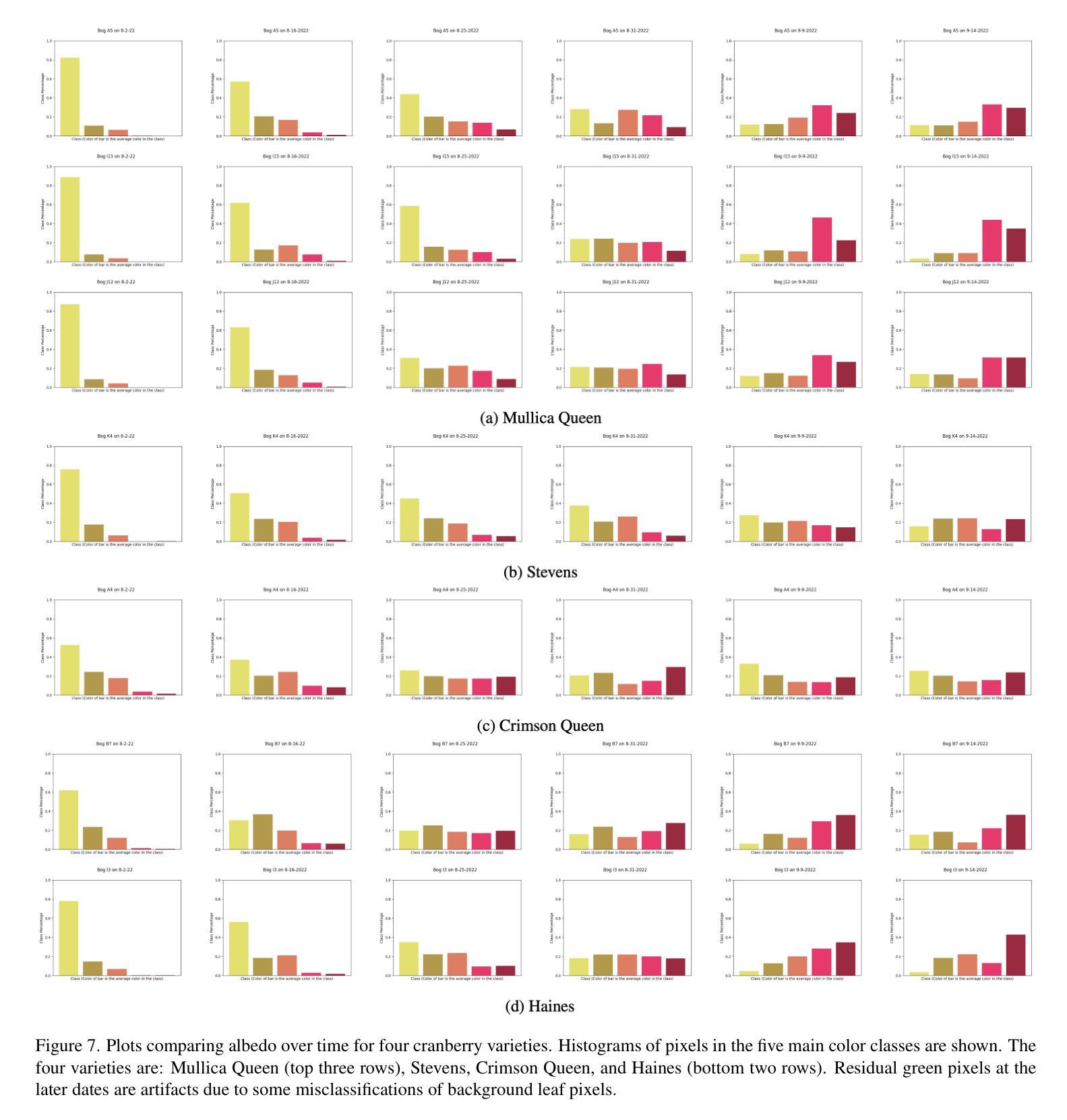

Authors:Faith Johnson, Ryan Meegan, Jack Lowry, Peter Oudemans, Kristin Dana

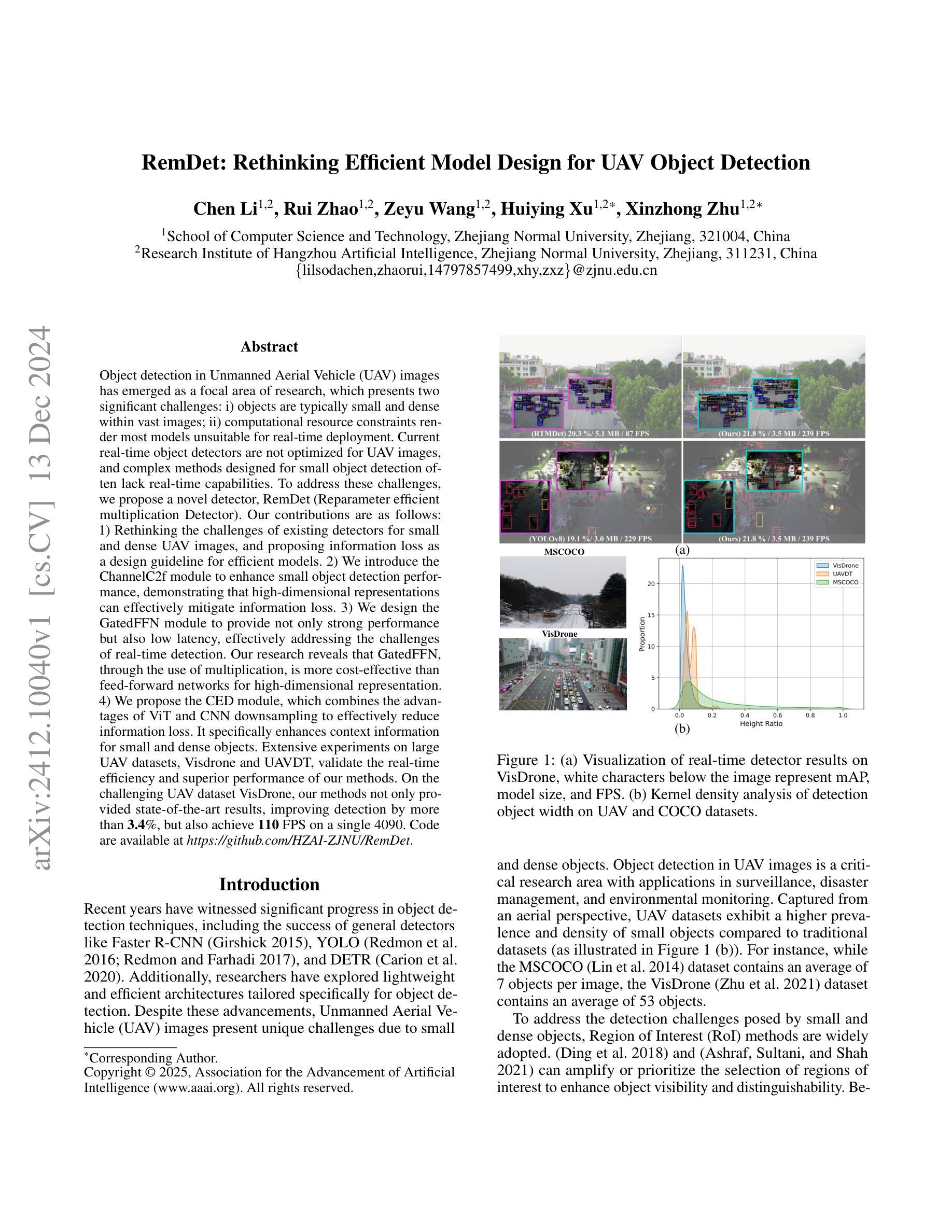

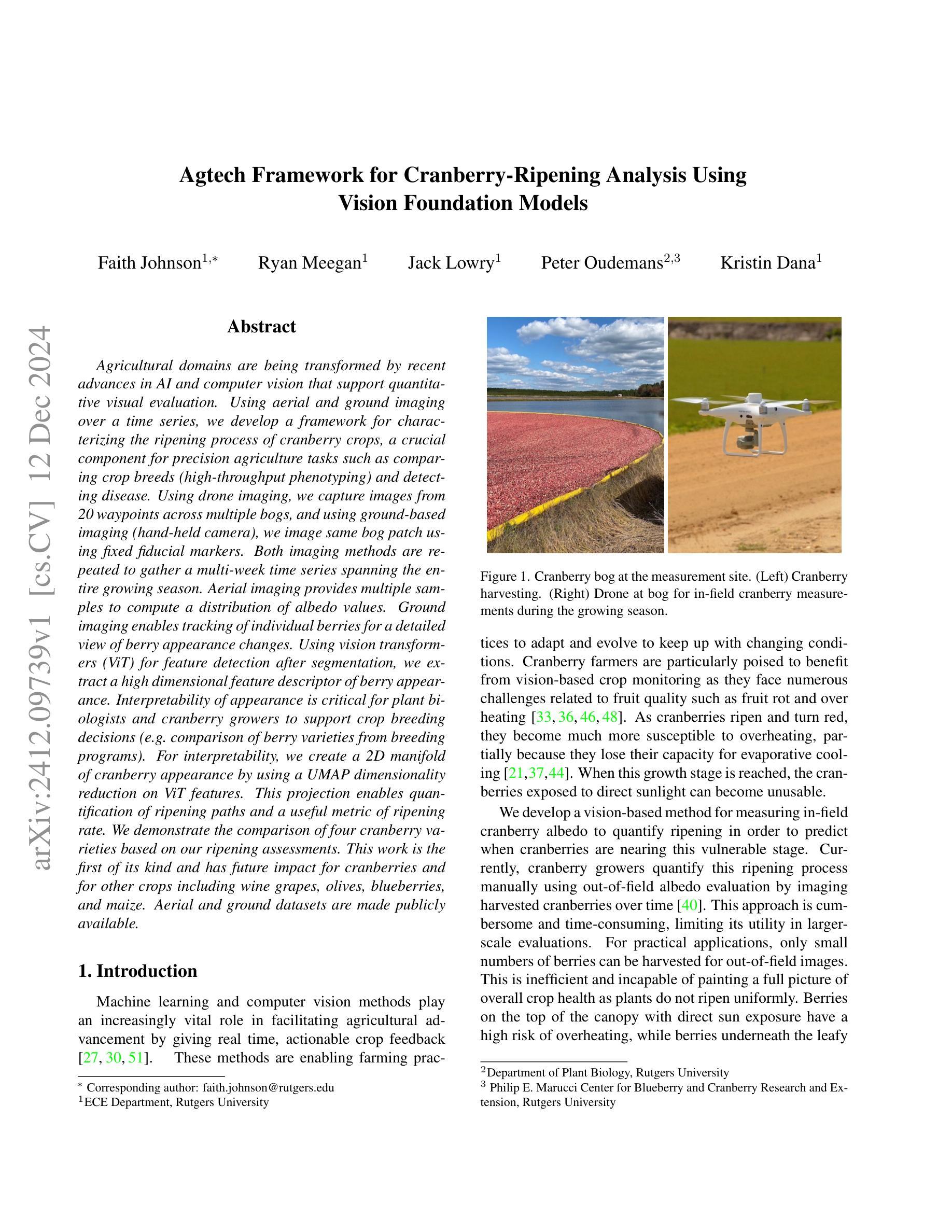

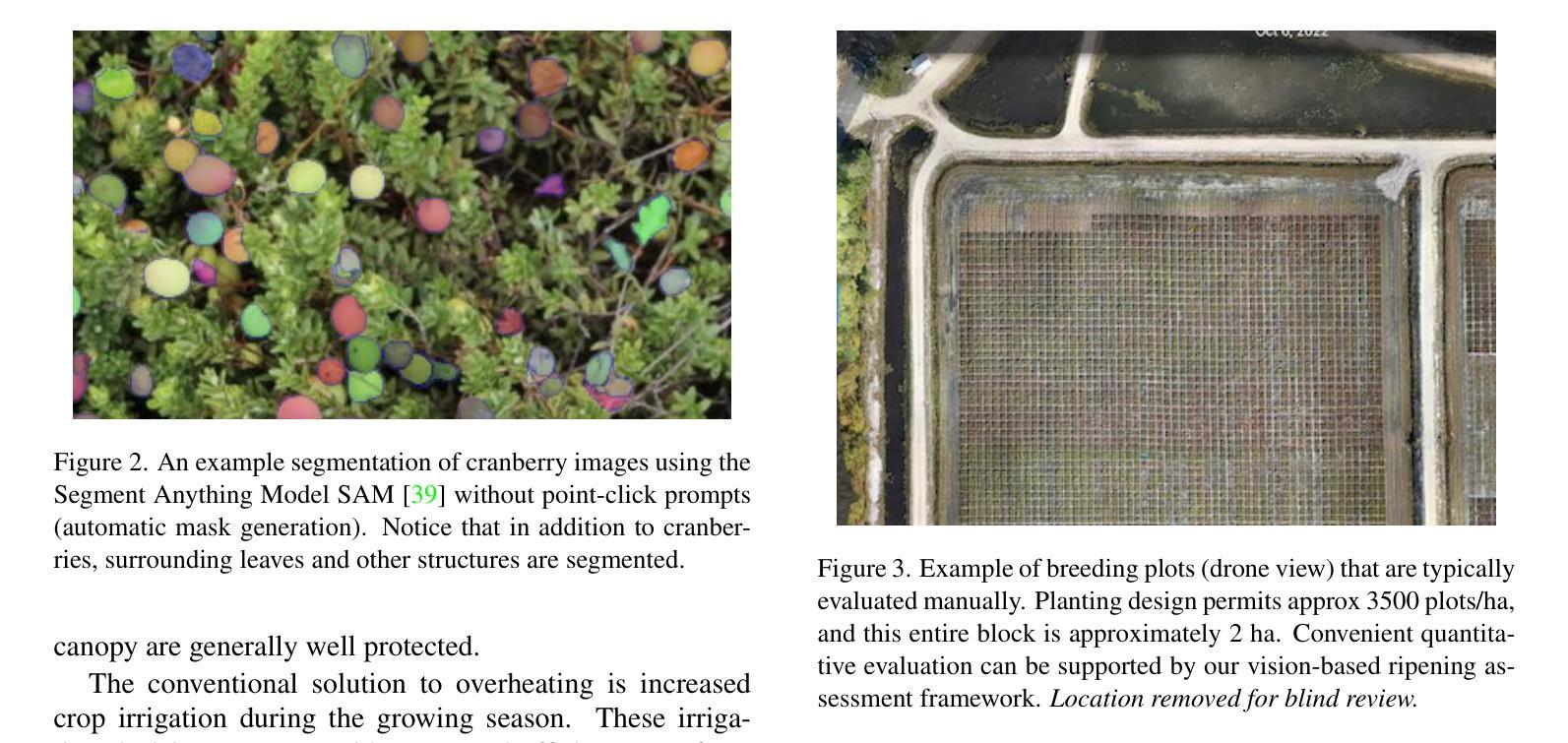

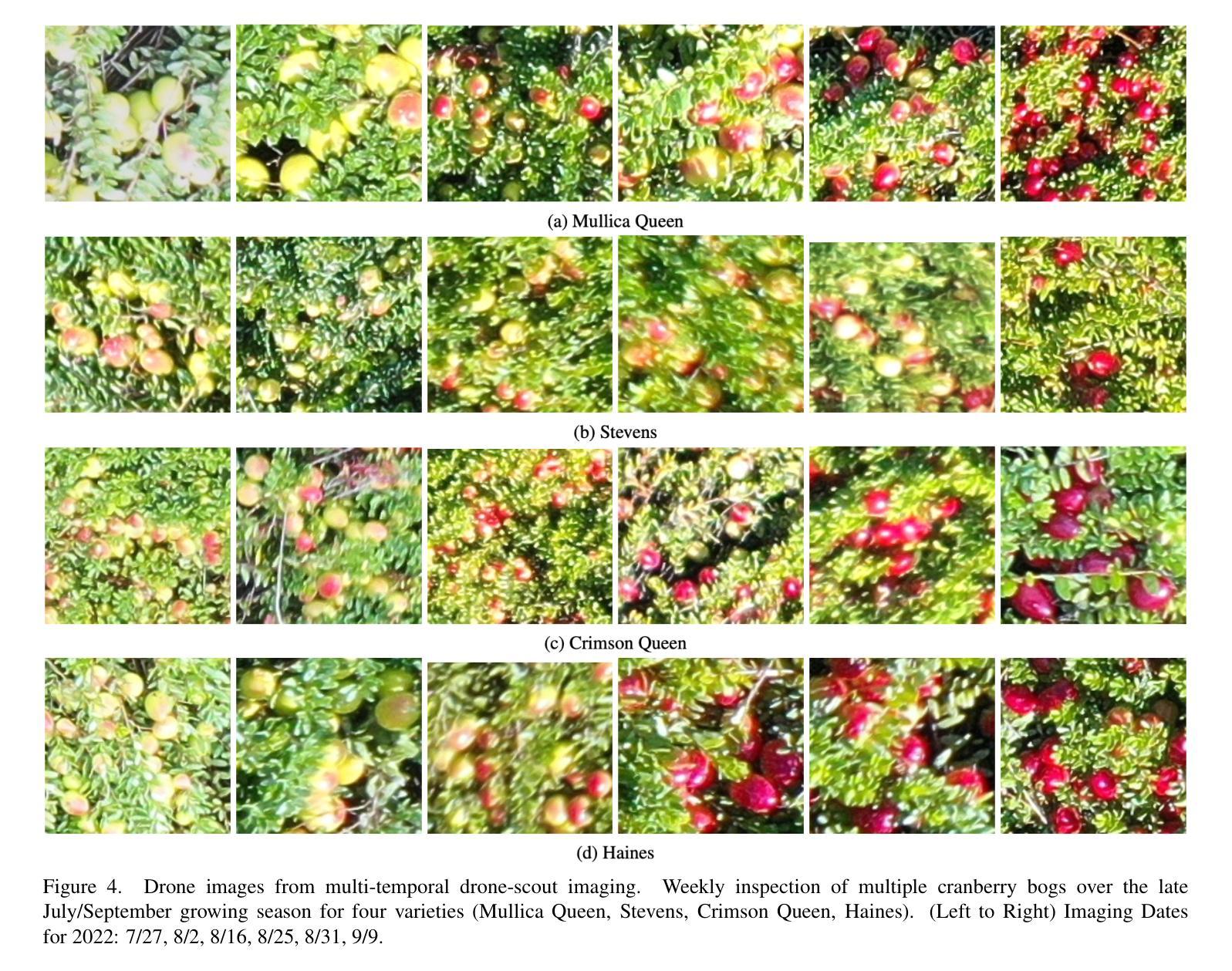

Agricultural domains are being transformed by recent advances in AI and computer vision that support quantitative visual evaluation. Using aerial and ground imaging over a time series, we develop a framework for characterizing the ripening process of cranberry crops, a crucial component for precision agriculture tasks such as comparing crop breeds (high-throughput phenotyping) and detecting disease. Using drone imaging, we capture images from 20 waypoints across multiple bogs, and using ground-based imaging (hand-held camera), we image same bog patch using fixed fiducial markers. Both imaging methods are repeated to gather a multi-week time series spanning the entire growing season. Aerial imaging provides multiple samples to compute a distribution of albedo values. Ground imaging enables tracking of individual berries for a detailed view of berry appearance changes. Using vision transformers (ViT) for feature detection after segmentation, we extract a high dimensional feature descriptor of berry appearance. Interpretability of appearance is critical for plant biologists and cranberry growers to support crop breeding decisions (e.g.\ comparison of berry varieties from breeding programs). For interpretability, we create a 2D manifold of cranberry appearance by using a UMAP dimensionality reduction on ViT features. This projection enables quantification of ripening paths and a useful metric of ripening rate. We demonstrate the comparison of four cranberry varieties based on our ripening assessments. This work is the first of its kind and has future impact for cranberries and for other crops including wine grapes, olives, blueberries, and maize. Aerial and ground datasets are made publicly available.

农业领域正在经历人工智能和计算机视觉方面的最新进展所带来的变革,这些进展支持了定量视觉评估。我们利用时间序列的空中和地面成像技术,开发了一个表征蓝莓作物成熟过程的框架,这对于精确农业任务(如比较作物品种(高通量表型)和检测疾病)至关重要。我们使用无人机成像技术,从多个沼泽地的20个地点采集图像,并使用地面成像技术(手持相机),使用固定的基准标记对相同的沼泽地进行成像。两种成像方法都经过多次重复,以收集跨越整个生长季节的为期数周的序列数据。空中成像提供了多个样本来计算反射率值的分布。地面成像可以追踪单个浆果,以详细了解浆果外观变化。我们使用视觉变压器(ViT)进行特征检测分割后,提取浆果外观的高维特征描述符。对于植物生物学家和蓝莓种植者来说,解释外观对于支持作物育种决策(例如比较育种计划的浆果品种)至关重要。为了提高解释性,我们使用ViT特征的UMAP降维技术创建了一个蓝莓外观的二维流形。这种投影使量化成熟路径和成熟的速率成为可能。我们根据成熟评估比较了四种蓝莓品种。这项工作具有开创性,对未来蓝莓以及其他作物(包括葡萄酒葡萄、橄榄、蓝莓和玉米等)具有重要影响。空中和地面数据集已经公开提供。

论文及项目相关链接

PDF arXiv admin note: substantial text overlap with arXiv:2309.00028

Summary

该文本描述了农业领域如何利用AI和计算机视觉技术的最新进展来进行量化的视觉评估。通过无人机和地面成像的时间序列数据,开发了一个表征蓝莓作物成熟过程的框架,这对精确农业任务如比较作物品种(高通量表型分析)和检测疾病至关重要。利用视觉变压器(ViT)进行特征检测后,提取了蓝莓外观的高维特征描述符。通过UMAP降维技术创建了一个蓝莓外观的二维流形图,用于量化成熟路径和成熟率。此工作对于蓝莓以及其他作物如葡萄酒葡萄、橄榄、蓝莓和玉米具有未来影响力。公开提供了无人机和地面数据集。

Key Takeaways

- 农业领域正受到AI和计算机视觉技术的影响,可进行量化的视觉评估。

- 使用无人机和地面成像技术来捕捉蓝莓作物的成熟过程,对精确农业至关重要。

- 利用视觉变压器(ViT)进行特征检测,提取蓝莓外观的高维特征描述符。

- 通过UMAP降维技术创建蓝莓外观的二维流形图,以量化成熟路径和成熟率。

- 此方法可用于比较不同品种的蓝莓作物。

- 该工作对于其他作物如葡萄酒葡萄、橄榄、蓝莓和玉米具有借鉴意义。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文提出了一个基于农业技术的框架,旨在解决以下问题:

量化评估蔓越橘作物的成熟过程:这对于精准农业任务至关重要,比如比较作物品种(高通量表型分析)和检测疾病。

实时、可操作的作物反馈:通过机器学习和计算机视觉方法,提供实时的作物反馈,帮助农业实践适应变化的条件。

蔓越橘果农面临的特定挑战:包括果实品质问题,如果实腐烂和过热,这些问题在蔓越橘成熟变红时变得更加严重。

传统成熟度评估方法的局限性:目前,蔓越橘种植者通过在收获后对蔓越橘进行成像来手动量化成熟过程,这种方法繁琐耗时,限制了其在大规模评估中的实用性。

作物灌溉决策:不充分或时机不当的灌溉可能导致过热,而过量灌溉则可能促进真菌性果实腐烂的发展。因此,评估可见蔓越橘的当前反照率直接关系到灌溉决策。

高通量表型(HTP)方法的需求:在作物育种中,需要评估成百上千的后代/后代,而HTP方法使这种评估变得实际。

自动化的成熟度评估:大多数现有的成熟度研究依赖于收获后的果实进行成熟度评估,这些方法耗时且无法扩展到大规模评估或实时评估。

综上所述,论文旨在通过开发一个基于视觉的框架,使用无人机成像和地面成像技术,结合先进的计算机视觉和机器学习方法,来自动化和优化蔓越橘作物的成熟度评估,从而支持作物育种决策和精准农业实践。

Q: 有哪些相关研究?

A: 根据提供的论文内容,以下是一些与本研究相关的领域和具体研究工作:

精准农业:

- 涉及土壤传感器、植物可穿戴设备、无人机动力学和遥感等技术的进步,以及机器学习和人工智能在农业应用中的突破。

Albedo(反照率)随时间变化的表征:

- 研究了蔓越橘成熟过程中由于过热风险增加而导致的果实腐烂问题,以及苹果和葡萄中发现的类似现象。

计算机视觉在农业中的应用:

- 包括实时产量估算、表型识别和作物健康评估等应用。

高通量表型(HTP)方法:

- 在作物育种中,需要评估成百上千的后代/后代,HTP方法使这种评估变得实际。

蔓越橘的特定研究:

- 包括蔓越橘产量模式、蔓越橘果实腐烂问题、以及蔓越橘的遗传和基因组研究。

以下是一些具体的文献参考,它们与本研究相关:

- [2] Alireza Abdollahi 等人:关于无线传感器网络在农业中的研究。

- [7] Olufemi J Alabi 等人:关于葡萄叶卷疾病对果实产量和葡萄及葡萄酒化学成分的影响。

- [8] José Luis Araus 和 Jill E Cairns:关于田间高通量表型分析在作物育种中的前沿研究。

- [9] Lefteris Benos 等人:关于机器学习在农业中的综合更新回顾。

- [10] Barbara Blanco-Ulate 等人:关于红斑病对葡萄浆果发育和代谢的影响。

- [15] Alexey Dosovitskiy:关于用于图像识别的 Vision Transformer。

- [18] Leilei He 等人:关于果园中果实产量预测和估算的综述。

- [19] Teja Kattenborn 等人:关于植被遥感中卷积神经网络(CNN)的研究综述。

- [20] Markus Keller:关于葡萄栽培管理以优化果实发展的环境挑战研究。

- [22] Seon Joo Kim 和 Marc Pollefeys:关于鲁棒的辐射度量校准和畸变校正。

- [25] Guoxu Liu 等人:关于计算机视觉技术在植物表型研究中的综述。

- [27] Zifei Luo 等人:关于农业图像的语义分割研究综述。

- [28] Efthimia Mavridou 等人:关于精准农业中机器视觉系统的研究。

- [29] Leland McInnes 等人:关于 UMAP 降维方法的研究。

- [30] Vishal Meshram 等人:关于农业领域机器学习的研究综述。

- [33] Peter V Oudemans 等人:关于东北地区蔓越橘果实腐烂的复杂疾病研究。

- [34] Fernando Palacios 等人:关于不同葡萄品种早期产量预测的研究。

- [35] V Pelletier 等人:关于减少蔓越橘热应激和中午抑郁的蒸发冷却研究。

- [36] JJ Polashock 等人:关于北美蔓越橘果实腐烂真菌群系的研究。

- [37] J Racsko 和 LE Schrader:关于苹果果实日灼的历史背景、最新进展和未来展望。

- [38] Panagiotis Radoglou-Grammatikis 等人:关于无人机在精准农业中的应用综述。

- [39] Nikhila Ravi 等人:关于 SAM 2 模型的研究,用于图像和视频中的任何事物分割。

- [40] Ocean Spray Rodney Serras:私人通信,提供了蔓越橘行业标准的反照率分类。

- [41] Christoph Schuhmann 等人:关于 Laion-5b 数据集的研究,用于训练下一代图像-文本模型。

- [42] Abhinav Sharma 等人:关于精准农业中机器学习应用的综合回顾。

- [43] Rajendra P Sishodia 等人:关于精准农业中遥感应用的综述。

- [44] Richard E Smart 和 Thomas R Sinclair:关于球形果实(如葡萄)的太阳加热研究。

- [45] Thomas Van Klompenburg 等人:关于使用机器学习进行作物产量预测的系统文献综述。

- [46] Nicholi Vorsa 和 Jennifer Johnson-Cicalese:关于美国蔓越橘的研究。

- [47] Nicholi Vorsa 等人:关于 Welcker、Haines 和其他先进品种在区域试验中的表现。

- [48] Nicholi Vorsa 和 Juan Zalapa:关于美国蔓越橘的驯化、遗传和基因组研究。

- [49] Dashuai Wang 等人:关于多尺度农业传感中深度学习的综述。

- [50] Heyu Yin 等人:关于土壤传感器和

Q: 论文如何解决这个问题?

A: 论文通过以下几个步骤解决蔓越橘成熟过程的量化评估问题:

数据收集:

- 使用无人机成像和地面成像技术,在多个时间段内从20个航点跨越多个泥炭地捕获图像。

- 通过手持相机对同一泥炭地区域进行成像,并使用固定的参考标记来跟踪个体浆果。

图像分割:

- 利用基于神经网络的分割技术,如SAM(Segment Anything Model)对蔓越橘图像进行分割,以评估反照率变化。

- 通过分割网络,将图像中的蔓越橘与叶子和其他结构分离。

反照率分析:

- 对无人机图像进行辐射度量校准,以消除相机参数变化和太阳角度变化的影响。

- 使用k-means聚类对RGB像素值进行分类,以确定不同成熟阶段的蔓越橘颜色类别。

- 将每个蔓越橘与其对应的颜色类别匹配,并统计每个图像中每个类别的蔓越橘数量。

特征提取与降维:

- 使用视觉变换器(ViT)等基础模型对分割后的蔓越橘进行特征检测,提取高维特征描述符。

- 利用UMAP(Uniform Manifold Approximation and Projection)降维技术,将ViT特征投影到2D流形上,以量化成熟路径和成熟速率。

成熟度评估:

- 对四种蔓越橘品种进行了为期两个月的成熟度评估,并展示了反照率变化的清晰时间线,指示每个品种何时面临过热风险。

- 通过跟踪单个蔓越橘在生长季节的图像,计算成熟度指标,为农民提供实时的作物状态信息,以便做出更明智的灌溉决策。

结果应用:

- 通过分析蔓越橘的反照率变化,为农民提供关于何时需要更密切监控作物以及何时需要加强灌溉以减轻过热问题的指导。

- 通过自动化大规模作物评估,支持新的高通量表型分析方法。

综上所述,论文通过结合先进的计算机视觉技术、机器学习模型和传统图像处理方法,开发了一个综合框架,用于量化和评估蔓越橘的成熟过程,从而为精准农业和作物育种提供支持。

Q: 论文做了哪些实验?

A: 根据论文内容,作者进行了以下实验:

无人机成像(Cranberry Bog Drone Imaging):

- 作者创建了一个新的数据集CRAID-4,结合了之前的CRAID-1数据集,包含了使用无人机拍摄的四个不同品种的蔓越橘图像。

- 图像在7月至9月间每周拍摄,覆盖了三个不同的泥炭地区域。

- 对无人机图像进行辐射度量校准,并将其裁剪成非重叠的子图像,用于训练蔓越橘分割网络。

个体蔓越橘成像(Individual Cranberry Imaging):

- 作者手动捕获了同一12x12区域的蔓越橘泥炭地图像,持续27天,以追踪单个蔓越橘随时间的变化。

- 使用半永久性参考标记来标记拍摄区域,并使用SIFT和RANSAC算法对时间序列图像进行配准。

辐射度量校准(Photometric Calibration):

- 使用Macbeth Color Checker卡对CRAID-4图像进行辐射度量校准,以消除相机参数变化和太阳角度变化的影响。

泥炭地反照率分析(Bog Albedo Analysis):

- 使用k-means聚类对RGB像素值进行分类,以确定不同成熟阶段的蔓越橘颜色类别。

- 将每个蔓越橘与其对应的颜色类别匹配,并统计每个图像中每个类别的蔓越橘数量,以分析成熟度变化。

个体蔓越橘反照率分析(Individual Berry Albedo Analysis):

- 对14个单独的蔓越橘进行了27个时间点的追踪和成像。

- 使用不同的特征提取器(如DinoV2 Giant、Google ViT Huge、SAM 2 Hiera Huge和Laion CLIP Big G)提取视觉特征,并使用UMAP将特征向量投影到2D流形上。

品种比较:

- 展示了四种蔓越橘品种在两个月内的成熟度评估结果,并分析了每个品种的反照率变化时间线,以确定何时它们面临过热风险。

这些实验的结果提供了关于蔓越橘成熟过程的定量信息,这对于精准农业实践和作物育种决策具有重要意义。通过这些实验,作者能够展示他们提出的框架在评估蔓越橘成熟度和预测过热风险方面的有效性。

Q: 有什么可以进一步探索的点?

A: 根据论文内容和结果,以下是一些可以进一步探索的点:

改进分割模型:

- 进一步优化和调整蔓越橘分割模型,以提高对不同颜色阶段蔓越橘的识别能力,尤其是对绿色浆果的检测。

增强特征提取:

- 探索更多高级的特征提取方法或组合现有方法,以更准确地捕捉蔓越橘成熟过程中的外观变化。

扩展数据集:

- 增加更多的数据收集点和时间段,以扩展CRAID数据集,从而提高模型的泛化能力和鲁棒性。

多品种和环境适应性:

- 在不同的地理环境和气候条件下测试框架,以评估其在不同品种和环境条件下的适应性和准确性。

实时监测系统集成:

- 将该框架集成到实时监测系统中,为农民提供即时反馈和决策支持。

灌溉决策支持系统:

- 开发一个基于该框架的灌溉决策支持系统,帮助农民优化灌溉计划,以减少资源浪费并防止作物腐烂。

作物健康和疾病检测:

- 利用该框架监测作物健康和疾病发展,通过分析蔓越橘的外观变化来预测和识别疾病。

与其他农业应用的整合:

- 探索将该框架与其他农业技术(如土壤传感器、气候监测系统)整合,以提供更全面的作物管理解决方案。

经济影响分析:

- 评估采用该框架对农民经济的影响,包括节省的水资源、提高的产量和品质,以及降低的疾病风险。

模型解释性和可视化:

- 提高模型的解释性,使农民和生物学家更容易理解模型结果,并开发更直观的可视化工具。

跨作物适用性:

- 测试该框架在其他作物(如葡萄酒葡萄、橄榄、蓝莓和玉米)上的应用潜力,并进行必要的调整。

长期研究:

- 进行长期研究,以评估该框架在多个生长周期中的性能和影响。

这些探索点可以帮助研究人员和实践者更好地理解和应用该框架,以提高农业效率和可持续性。

Q: 总结一下论文的主要内容

A: 这篇论文提出了一个基于计算机视觉和机器学习的框架,用于分析蔓越橘作物的成熟过程。以下是论文的主要内容总结:

背景与挑战:

- 蔓越橘种植者面临果实品质问题,如果实腐烂和过热,这些问题随着果实成熟变红而加剧。

- 传统的成熟度评估方法耗时且无法大规模实时评估。

研究目标:

- 开发一个基于视觉的框架,使用无人机和地面成像技术来量化蔓越橘的成熟过程。

- 支持精准农业任务,如品种比较和疾病检测。

方法论:

- 数据收集:使用无人机和手持相机在多个时间点捕获蔓越橘图像。

- 图像分割:应用SAM(Segment Anything Model)进行自动图像分割,提取蔓越橘特征。

- 反照率分析:通过辐射度量校准和k-means聚类分析蔓越橘的反照率变化。

- 特征提取与降维:使用视觉变换器(ViT)提取特征,并通过UMAP降维技术将特征投影到2D流形上。

实验与结果:

- 无人机成像:创建了新的CRAID-4数据集,包含不同品种的蔓越橘图像。

- 个体蔓越橘成像:追踪单个蔓越橘,收集时间序列图像。

- 反照率分析:通过聚类分析不同成熟阶段的蔓越橘颜色类别。

- 特征提取与降维:使用ViT特征和UMAP展示蔓越橘成熟路径。

- 品种比较:比较四种蔓越橘品种的成熟度评估,确定各品种的过热风险时间线。

结论与讨论:

- 提出的框架能够有效地评估蔓越橘的成熟模式,为农民提供关于灌溉决策和作物管理的重要信息。

- 该方法可以自动化大规模作物评估,支持高通量表型分析。

未来工作:

- 改进分割模型,增强特征提取,扩展数据集,以及将框架应用于其他作物。

论文的创新之处在于将先进的计算机视觉技术应用于农业领域,为蔓越橘等作物的成熟度评估提供了一种新的自动化方法,这对于提高农业效率和作物管理具有重要意义。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

An Efficient Framework for Enhancing Discriminative Models via Diffusion Techniques

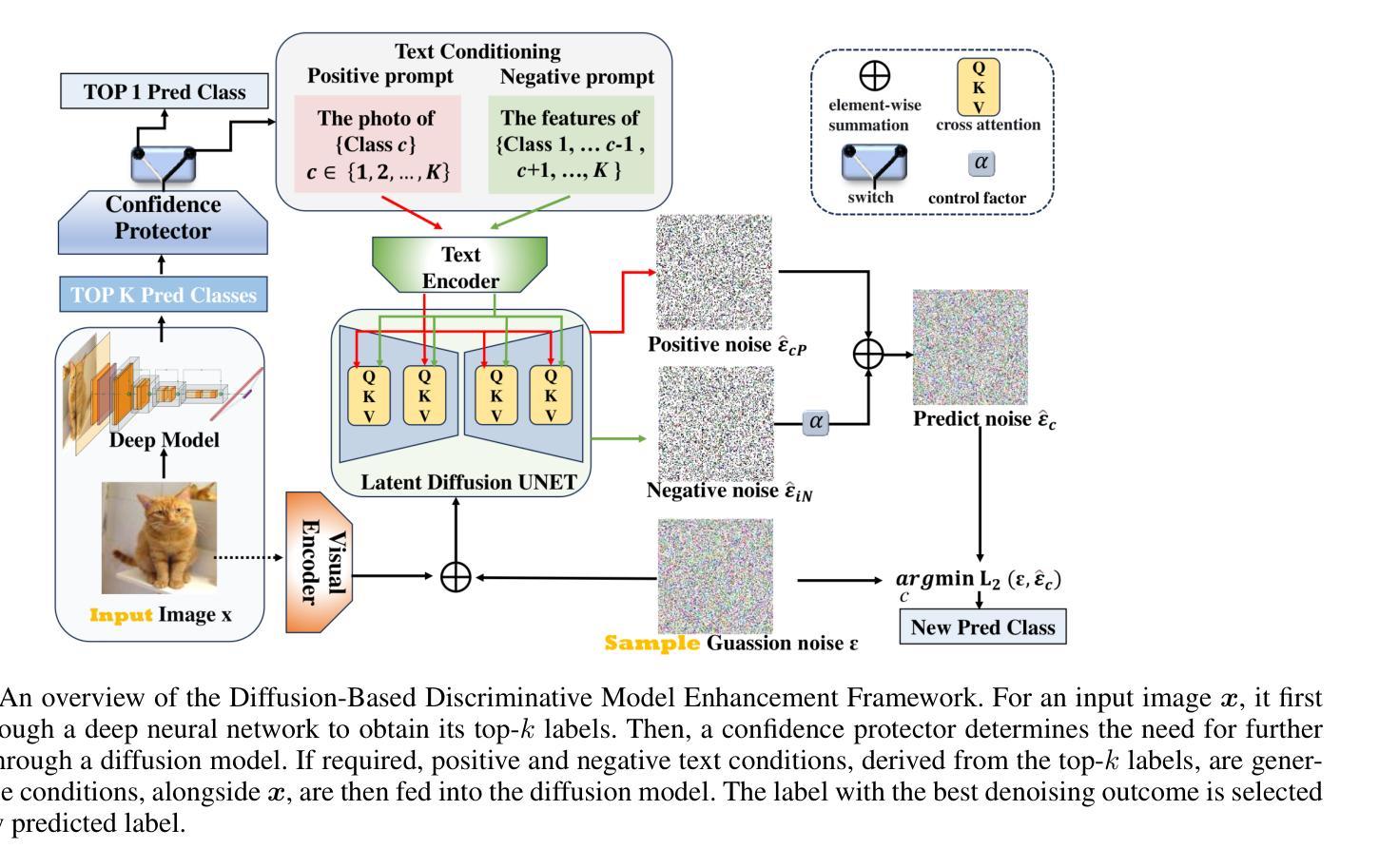

Authors:Chunxiao Li, Xiaoxiao Wang, Boming Miao, Chuanlong Xie, Zizhe Wang, Yao Zhu

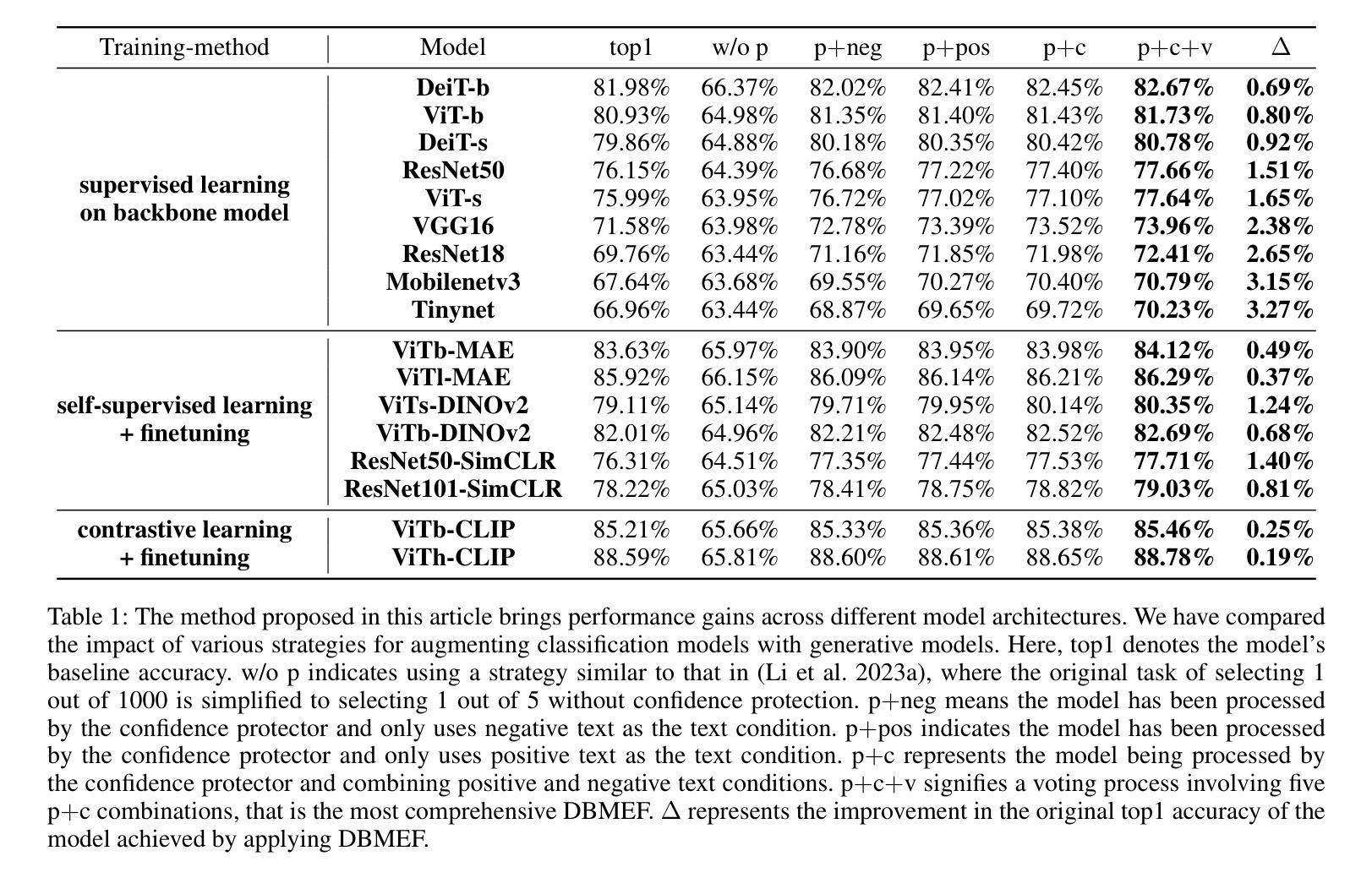

Image classification serves as the cornerstone of computer vision, traditionally achieved through discriminative models based on deep neural networks. Recent advancements have introduced classification methods derived from generative models, which offer the advantage of zero-shot classification. However, these methods suffer from two main drawbacks: high computational overhead and inferior performance compared to discriminative models. Inspired by the coordinated cognitive processes of rapid-slow pathway interactions in the human brain during visual signal recognition, we propose the Diffusion-Based Discriminative Model Enhancement Framework (DBMEF). This framework seamlessly integrates discriminative and generative models in a training-free manner, leveraging discriminative models for initial predictions and endowing deep neural networks with rethinking capabilities via diffusion models. Consequently, DBMEF can effectively enhance the classification accuracy and generalization capability of discriminative models in a plug-and-play manner. We have conducted extensive experiments across 17 prevalent deep model architectures with different training methods, including both CNN-based models such as ResNet and Transformer-based models like ViT, to demonstrate the effectiveness of the proposed DBMEF. Specifically, the framework yields a 1.51% performance improvement for ResNet-50 on the ImageNet dataset and 3.02% on the ImageNet-A dataset. In conclusion, our research introduces a novel paradigm for image classification, demonstrating stable improvements across different datasets and neural networks. The code is available at https://github.com/ChunXiaostudy/DBMEF.

图像分类作为计算机视觉的基石,传统上是通过基于深度神经网络的判别模型来实现的。最近的进展引入了基于生成模型的分类方法,这些方法提供了零样本分类的优势。然而,这些方法存在两个主要缺点:计算开销大以及与判别模型的性能相比表现较差。受人类大脑在识别视觉信号过程中快速-慢速路径交互协同认知过程的启发,我们提出了基于扩散的判别模型增强框架(DBMEF)。该框架无缝集成了判别模型和生成模型,以无训练的方式利用判别模型进行初步预测,并通过扩散模型赋予深度神经网络反思能力。因此,DBMEF可以有效地提高判别模型的分类精度和泛化能力,以一种即插即用方式实现增强。我们在使用不同训练方法的17种流行的深度模型架构上进行了广泛实验,包括基于CNN的模型(如ResNet)和基于Transformer的模型(如ViT),以证明所提出的DBMEF的有效性。具体来说,该框架在ImageNet数据集上为ResNet-50带来了1.51%的性能提升,并在ImageNet-A数据集上带来了3.02%的提升。总之,我们的研究为图像分类引入了一种新的范式,并在不同的数据集和神经网络中表现出了稳定的改进。代码可在https://github.com/ChunXiaostudy/DBMEF获取。

论文及项目相关链接

PDF Accepted by AAAI2025

Summary

本文介绍了基于扩散模型的判别模型增强框架(DBMEF),该框架结合了判别模型和生成模型的优点,以无训练的方式提高了图像分类的准确性和泛化能力。该框架利用判别模型进行初步预测,并通过扩散模型赋予深度神经网络反思能力。在多个流行的深度模型架构上进行的大量实验表明,DBMEF可有效提高图像分类性能。

Key Takeaways

- 介绍了基于扩散模型的判别模型增强框架(DBMEF),结合了判别模型和生成模型的优点。

- DBMEF采用无训练方式,通过利用判别模型进行初步预测,提高了图像分类的准确性和泛化能力。

- 框架通过扩散模型赋予深度神经网络反思能力,增强了其性能。

- 在多个深度模型架构上进行的大量实验证明了DBMEF的有效性。

- DBMEF在ImageNet数据集上实现了ResNet-50模型1.51%的性能提升,在ImageNet-A数据集上实现了3.02%的性能提升。

- 研究为图像分类引入了一种新的范式,该范式在不同的数据集和神经网络上都表现出了稳定的改进。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的主要问题是如何在图像分类任务中结合判别模型(discriminative models)和生成模型(generative models)的优势,以提高分类的准确性和泛化能力。具体来说,论文中提到了以下几个关键问题:

判别模型与生成模型的结合:传统的图像分类方法通常独立地使用判别模型或生成模型。判别模型直接对图像进行分类,而生成模型则通过学习数据的联合分布来实现分类。论文提出了一个框架,将这两种模型结合起来,以期达到更好的分类效果。

生成模型在分类中的高计算开销和性能不足:基于生成模型的分类方法,尽管提供了零样本分类(zero-shot classification)的优势,但它们存在两个主要缺点:高计算开销和相比判别模型的性能劣势。论文旨在通过提出的方法来克服这些问题。

模仿人脑处理视觉信号的过程:论文受到人脑在视觉信号识别过程中快速-慢速路径相互作用的协调认知过程的启发,提出了一个框架,通过模仿这一过程来增强判别模型的性能。

提高判别模型的分类准确性和泛化能力:论文提出的框架旨在通过无需训练的方式,以即插即用的形式增强判别模型的分类准确性和泛化能力。

处理分布偏移和低分辨率数据:论文还探讨了所提出框架在面对分布偏移和低分辨率数据时的有效性,以展示其在不同情况下的鲁棒性和适用性。

综上所述,论文的核心目标是提出一个有效的框架,通过结合判别模型和生成模型的优点,来提升图像分类任务的性能,并在不同的数据集和神经网络架构上展示其有效性。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究可以概括为以下几个方面:

判别模型和生成模型在图像分类中的应用:

- 判别模型直接对图像分类,如VGG、ResNet、ViT等。

- 生成模型通过学习数据的联合分布来进行分类,例如基于能量的模型(EBM)和基于分数的模型(Score-Based Models)。

零样本分类(Zero-Shot Classification):

- 使用生成模型进行零样本分类的研究,如基于扩散模型(Diffusion Models)的方法。

扩散模型(Diffusion Models):

- 扩散模型在图像生成领域的应用,特别是在生成高质量图像方面超越了生成对抗网络(GANs)。

- 分类引导扩散(Classifier Guidance Diffusion)和无分类器引导扩散(Classifier-Free Guidance Diffusion)技术,这些技术通过在生成阶段调整图像的梯度来实现基于指定类别的条件生成。

基于分数的生成模型(Score-Based Generative Models):

- 使用基于分数的生成模型来估计条件概率(P(x|y)),并用于图像分类。

对抗性鲁棒性(Adversarial Robustness):

- 利用扩散模型评估传统判别分类器的对抗性鲁棒性。

结合判别模型和生成模型的方法:

- 先前的研究工作,如SBGC、RDC等,这些方法尝试将扩散模型整合到图像分类任务中。

改进扩散模型的分类性能:

- 将扩散模型应用于DiT-XL/2模型,并在ImageNet数据集上进行监督分类。

加速采样方法:

- 研究工作探索了加速扩散模型采样过程的方法,以减少分类单个图像所需的时间。

这些相关研究构成了论文提出的Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的理论基础和技术背景。论文通过结合这些领域的最新进展,提出了一个新的框架,旨在通过模仿人脑处理视觉信号的过程来增强判别模型的性能。

Q: 论文如何解决这个问题?

A: 论文通过提出一个名为Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的框架来解决上述问题。以下是该框架解决这些问题的关键步骤和方法:

1. 结合判别模型和生成模型

DBMEF框架通过以下步骤将判别模型和生成模型结合起来:

- 判别模型初步预测:使用判别模型对测试输入进行初步预测,类似于人脑中的快速通路。

- 生成模型重新评估:对于判别模型不确定的预测,使用扩散模型进行重新评估,模拟人脑中的慢速通路。

2. 模仿人脑处理视觉信号的过程

- 快速-慢速路径交互:框架受到人脑处理视觉信号时快速和慢速路径相互作用的启发,通过重复“猜测-验证-猜测-验证”的过程来识别对象。

3. 增强判别模型的性能

- 置信度保护器(Confidence Protector):通过一个置信度阈值来决定是否需要通过扩散模型进一步评估预测结果。

- 扩散模型分类器:将扩散模型的有条件去噪结果转化为后验概率的估计,以重新分类图像。

4. 处理分布偏移和低分辨率数据

- 适应不同数据集:框架在多个数据集上进行测试,包括ImageNet、ImageNet-A、CIFAR-10和CIFAR-100,以验证其对分布偏移和低分辨率数据的适应性。

5. 提升效率和准确性

- 减少计算开销:通过仅对判别模型不确定的预测进行扩散模型的重新评估,减少了整体计算开销。

- 提高分类准确性:通过结合判别模型的高效率和生成模型的精细化处理,DBMEF显著提高了分类的准确性。

6. 即插即用和无需训练

- 无需额外训练:DBMEF作为一个即插即用的框架,可以直接应用于现有的判别模型,无需额外的训练过程。

总结来说,DBMEF框架通过模仿人脑处理视觉信号的过程,结合了判别模型和生成模型的优势,以提高图像分类任务的准确性和泛化能力,同时减少了计算开销。通过在多个数据集和不同网络架构上的实验,论文证明了该框架的有效性和普适性。

Q: 论文做了哪些实验?

A: 论文中进行了一系列实验来验证Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的有效性。以下是实验的主要内容:

1. 不同模型架构的性能测试

- 基线模型:选择了17种基于不同训练方法、数据集和架构的判别模型,包括监督学习模型(如DeiT-Base、ViT-Base、ResNet50等)、自监督学习方法(如MAE、DINOv2等)以及对比学习模型(如CLIP)。

- 实验设置:使用Stable Diffusion V1-5作为扩散模型,设置保护阈值Prot、时间步长、负控制因子λ等参数,并在ImageNet2012-1k验证集上进行评估。

- 结果:DBMEF在这些模型上取得了0.19%到3.27%的准确率提升。

2. 分布偏移的性能测试

- 数据集:使用ImageNet-S、ImageNet-A、ImageNet-V2和ImageNet-E数据集来评估DBMEF在面对不同类型的分布偏移时的性能。

- 基线模型:使用ViT-Base、DeiT-Small、ResNet50和VGG16等预训练的深度判别模型。

- 结果:DBMEF在各种分布偏移数据集上均显示出稳定的性能提升,特别是在ImageNet-A上,ResNet50的准确率从0.00%提升到3.02%。

3. 低分辨率数据集的分类性能测试

- 数据集:选择CIFAR-10和CIFAR-100数据集,这些数据集包含的图像分辨率为32×32像素。

- 基线模型:使用ResNet18、ResNet34和ResNet50等模型,并在这些数据集上进行测试。

- 结果:即使在基线准确率已经很高的低分辨率图像上,应用DBMEF框架仍然能够进一步提升性能。

4. 超参数的影响测试

- 超参数:研究了保护阈值Prot、时间步长T、负控制因子λ以及扩散模型的选择对DBMEF性能的影响。

- 实验结果:分析了不同超参数设置对模型性能的具体影响,提供了关于如何选择这些参数以优化DBMEF性能的见解。

5. 置信度保护器和扩散模型的作用分析

- 置信度保护器:通过详细的可视化和分析,展示了置信度保护器对DBMEF性能的影响。

- 扩散模型:通过实验验证了扩散模型在DBMEF中的关键作用,与使用更多数据训练的判别模型相比,扩散模型提供了更好的性能提升。

这些实验全面地验证了DBMEF框架的有效性、普适性和鲁棒性,并深入分析了框架中各个组件的作用和影响。通过这些实验,论文展示了DBMEF在不同条件下都能显著提升图像分类任务的性能。

Q: 有什么可以进一步探索的点?

A: 论文提出的Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)为图像分类领域提供了一个新范式,以下是一些可以进一步探索的点:

1. 超参数优化

- 研究不同的超参数设置对DBMEF性能的影响,包括保护阈值(Prot)、时间步长(T)、负控制因子(λ)等,以找到最优的配置。

2. 扩散模型的改进

- 探索使用新一代的扩散模型,如更近期版本的Stable Diffusion或其他类型的扩散模型,以进一步提高DBMEF的性能。

- 研究如何定制扩散模型以更好地适应特定的判别模型和数据集。

3. 多模态数据集的应用

- 将DBMEF应用于多模态数据集,如结合图像和文本的数据集,探索其在多模态学习中的潜力。

4. 不同的网络架构

- 测试DBMEF在更多种类的深度学习架构上的效果,包括最新的卷积网络和Transformer变体。

5. 跨域泛化能力

- 研究DBMEF在面对更大分布偏移时的表现,例如跨域识别任务,以及如何改进框架以提高其跨域泛化能力。

6. 实时应用

- 探索DBMEF在实时应用中的可行性,例如在移动设备或嵌入式系统上的部署,并优化其以满足实时处理的需求。

7. 理论分析

- 深入研究DBMEF的理论基础,包括其统计性质和收敛性,以及如何从理论上解释其性能提升的原因。

8. 与其他生成模型的比较

- 将DBMEF与其他类型的生成模型(如GANs)进行比较,分析其在图像分类任务中的优缺点。

9. 鲁棒性和安全性测试

- 对DBMEF进行鲁棒性和安全性测试,特别是在对抗性攻击和数据隐私方面的表现。

10. 应用到其他视觉任务

- 将DBMEF框架扩展到其他计算机视觉任务,如目标检测、语义分割等,探索其在这些任务中的有效性和适用性。

这些探索点可以帮助研究者更深入地理解DBMEF的工作原理,优化其性能,并扩展其在计算机视觉领域的应用范围。

Q: 总结一下论文的主要内容

A: 论文提出了一个名为Diffusion-Based Discriminative Model Enhancement Framework (DBMEF)的新框架,旨在通过结合判别模型和生成模型的优势来增强图像分类任务的性能。以下是论文的主要内容总结:

1. 研究动机

- 传统的图像分类方法主要基于判别模型或生成模型,但存在各自的局限性。判别模型虽然分类速度快,但缺乏重新评估的能力;生成模型能进行细致的图像理解,但计算成本高且性能落后于判别模型。

2. DBMEF框架

- 框架概述:DBMEF框架通过模仿人脑处理视觉信号的快速和慢速路径交互过程,整合判别模型和生成模型,以提高分类的准确性和泛化能力。

- 关键组件:包括置信度保护器和扩散模型分类器,以及结合正负文本条件和投票机制的策略。

3. 方法论

- 判别模型初步预测:判别模型首先对测试输入进行预测,类似于人脑的快速通路。

- 生成模型重新评估:对于判别模型不确定的预测,通过扩散模型进行重新评估,模拟人脑的慢速通路。

- 置信度保护器:基于训练集正确分类样本的统计特性,决定是否需要通过扩散模型进一步评估。

- 扩散模型分类器:将扩散模型的有条件去噪结果转化为后验概率的估计,以重新分类图像。

4. 实验验证

- 在多个数据集(包括ImageNet、ImageNet-A、CIFAR-10和CIFAR-100)和多种深度模型架构上验证了DBMEF的有效性。

- 实现了在不同模型上0.19%到3.27%的准确率提升,并在分布偏移和低分辨率数据上显示出稳定的性能提升。

5. 超参数影响和组件作用分析

- 对保护阈值、时间步长、负控制因子等超参数进行了实验分析,探讨了它们对框架性能的影响。

- 分析了置信度保护器和扩散模型在DBMEF中的关键作用。

6. 结论

- DBMEF框架有效地提高了判别模型的分类准确性和泛化能力,同时减少了计算开销。

- 论文提出了一个新的图像分类范式,并鼓励未来研究进一步探索扩散模型在下游应用中的整合。

总体而言,论文通过提出DBMEF框架,展示了如何通过结合判别模型和生成模型的优势来提高图像分类任务的性能,并在多个数据集和模型上验证了其有效性。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

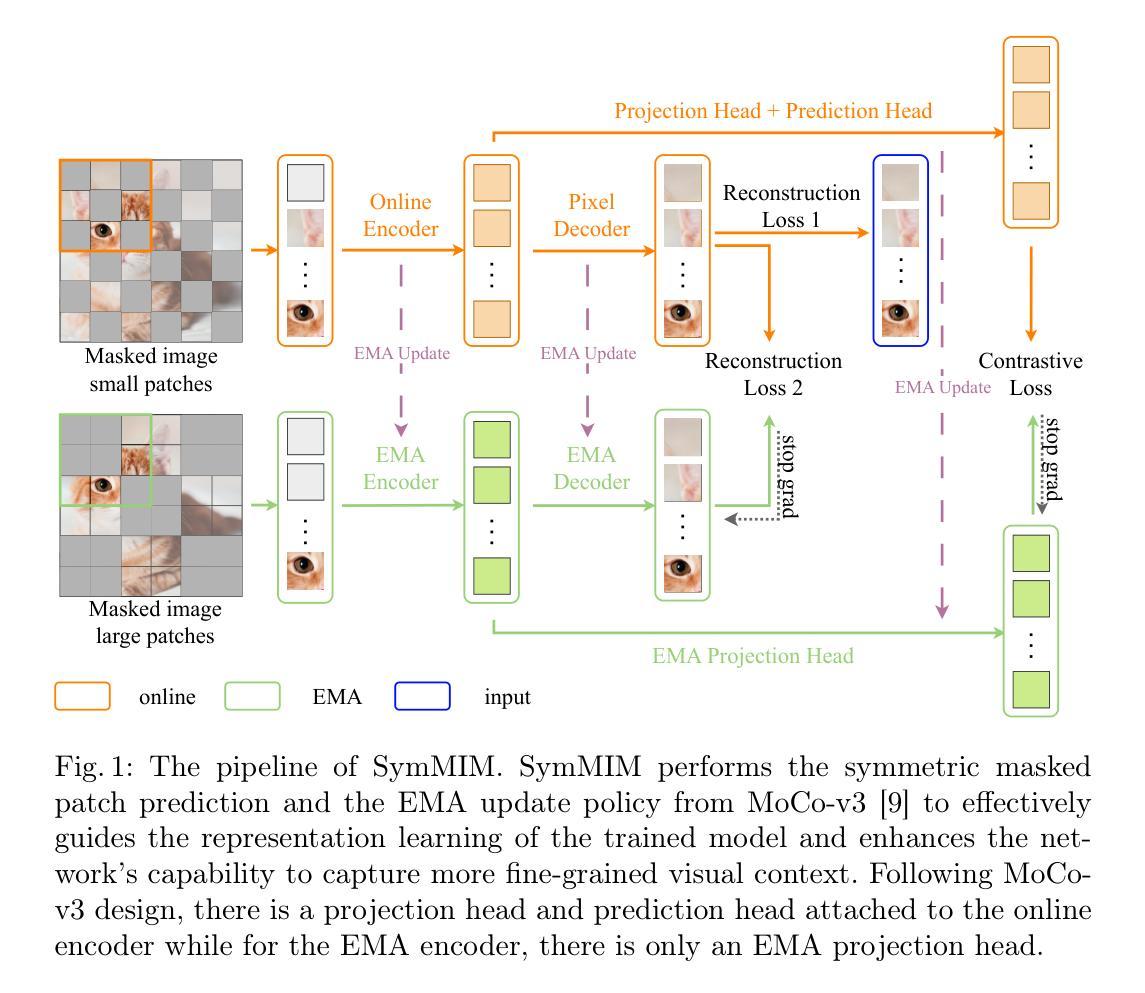

Symmetric masking strategy enhances the performance of Masked Image Modeling

Authors:Khanh-Binh Nguyen, Chae Jung Park

Masked Image Modeling (MIM) is a technique in self-supervised learning that focuses on acquiring detailed visual representations from unlabeled images by estimating the missing pixels in randomly masked sections. It has proven to be a powerful tool for the preliminary training of Vision Transformers (ViTs), yielding impressive results across various tasks. Nevertheless, most MIM methods heavily depend on the random masking strategy to formulate the pretext task. This strategy necessitates numerous trials to ascertain the optimal dropping ratio, which can be resource-intensive, requiring the model to be pre-trained for anywhere between 800 to 1600 epochs. Furthermore, this approach may not be suitable for all datasets. In this work, we propose a new masking strategy that effectively helps the model capture global and local features. Based on this masking strategy, SymMIM, our proposed training pipeline for MIM is introduced. SymMIM achieves a new SOTA accuracy of 85.9% on ImageNet using ViT-Large and surpasses previous SOTA across downstream tasks such as image classification, semantic segmentation, object detection, instance segmentation tasks, and so on.

图像掩模建模(MIM)是一种自监督学习技术,它通过估计随机掩模部分中缺失的像素,从未标记的图像中获取详细的视觉表征。它已被证明是视觉变压器(ViT)初步训练的有力工具,并在各种任务中取得了令人印象深刻的结果。然而,大多数MIM方法严重依赖于随机掩模策略来制定预文本任务。这种策略需要多次试验来确定最佳丢弃率,这可能会消耗大量资源,需要模型在800到1600个周期之间进行预训练。此外,这种方法可能不适合所有数据集。在这项工作中,我们提出了一种新的掩模策略,可以有效地帮助模型捕捉全局和局部特征。基于这种掩模策略,我们介绍了MIM的SymMIM训练管道。SymMIM在ImageNet上使用ViT-Large实现了85.9%的新SOTA精度,并在下游任务(如图像分类、语义分割、目标检测、实例分割任务等)上超越了之前的SOTA。

论文及项目相关链接

Summary

无标注图像中的缺失像素估计是一种自监督学习方法,称为Masked Image Modeling(MIM)。它对Vision Transformers(ViTs)的预训练非常有效,并在各种任务上取得了令人印象深刻的结果。然而,大多数MIM方法严重依赖于随机掩膜策略来构建前序任务。这种策略需要大量试验来确定最佳丢弃率,并要求模型进行长达800至1600轮的预训练。此外,这种方法可能不适用于所有数据集。本研究提出了一种新的掩膜策略,有助于模型捕捉全局和局部特征。基于这种掩膜策略的SymMIM方法实现了对图像分类、语义分割、目标检测和实例分割任务的先进性能提升。SymMIM在ImageNet上实现了最新的最佳准确度,达到85.9%。

Key Takeaways

- Masked Image Modeling (MIM) 是自监督学习中的一种技术,用于从无标签图像中获取详细视觉表示。

- MIM通过估计随机掩蔽部分的缺失像素进行工作,这对Vision Transformers (ViTs)的预训练非常有效。

- 大多数MIM方法依赖随机掩膜策略来创建前序任务,这可能需要大量的资源密集型试验来确定最佳的丢弃率,并需要长时间的预训练。

- 提出了一种新的掩膜策略,该策略有助于模型捕捉全局和局部特征,改进了MIM的效果。

- 基于新掩膜策略的SymMIM方法在多种下游任务上实现了先进性能,包括图像分类、语义分割、目标检测和实例分割。

- SymMIM在ImageNet上的准确度达到了最新的最佳水平,即85.9%。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文试图解决的问题是现有Masked Image Modeling (MIM) 方法在自监督学习中对随机掩码策略的依赖。这种策略需要大量的试验来确定最优的掩码比例,这不仅资源密集,而且可能不适用于所有数据集。具体来说,论文指出以下几个问题:

- 随机掩码策略的局限性:大多数MIM方法依赖于随机掩码策略来构建预训练任务,这可能导致无法充分捕获图像的全局和局部特征。

- 计算成本:确定最优掩码比例需要通过广泛的试验,这在处理不同数据集时尤其具有挑战性。

- 灵活性和效率:现有的图像分词器(如BEiT中使用的离散变分自编码器)依赖于额外的训练阶段和特定领域的知识,导致预训练方法不够灵活。

为了解决这些问题,论文提出了一种新的掩码策略,称为对称掩码策略(Symmetric Masking Strategy),并基于此策略引入了SymMIM,这是一种改进的MIM训练流程。SymMIM通过简化超参数调整,依靠掩码的大小而非比例,减少了整体复杂性,并在多个下游任务中取得了优于先前最先进方法的性能。

Q: 有哪些相关研究?

A: 根据论文内容,相关研究主要包括以下几个方面:

**自监督表示学习 (Self-supervised Representation Learning, SSL)**:

- 对比学习 (Contrastive Learning),如 SimCLR、CPC、MoCo、MoCo-v2、BYOL 和 DINO。

- 群实例对比学习方法,如 DeepCluster 和 SwAV。

**掩码建模 (Masked Modeling)**:

- 在自然语言处理 (NLP) 中,BERT 利用双向变换器进行掩码语言建模。

- GPT 采用自回归、因果掩码,展示多任务、少样本和上下文学习的能力。

- 计算机视觉中的早期工作,如 Stacked Denoising Autoencoders 和 Context Encoder,探索了作为去噪或表示学习手段的掩码图像建模。

- 近期工作,如 BEiT、MAE 和 SimMIM,探索了针对视觉变换器的 BERT 风格预训练。

特定的MIM方法:

- MAE (Masked Autoencoders) 和 SimMIM 强调了与 NLP 方法相比,实现有效的视觉表示学习所需的更高掩码比例。

- CrossMAE 采用交叉注意力块在解码器中重建预训练期间的掩码标记子集。

- Siamese MAE 采用不对称掩码模式并解码视频帧,基于早期帧的条件进行重建。

对比学习与MIM结合的方法:

- ConMIM 利用对比损失来增强 MIM 的表示学习,但与本文提出的基于 InfoNCE 损失的方法不同。

其他相关研究:

- 涉及数据增强、层次化架构以及掩码策略对预训练特征提取器的必要性和影响的研究。

这些研究构成了论文提出的对称掩码策略和 SymMIM 框架的理论基础和背景。论文通过对比分析对称掩码与随机掩码的不同掩码比例,并评估它们对下游任务的影响,进一步验证了对称掩码策略的有效性。

Q: 论文如何解决这个问题?

A: 论文通过提出一种新的对称掩码策略(Symmetric Masking Strategy)和基于此策略的SymMIM训练框架来解决现有Masked Image Modeling(MIM)方法的问题。具体的解决方案包括以下几个关键点:

对称掩码策略:作者提出对称地沿着水平和垂直轴掩码图像块,形成四个可见和掩码的象限。这种设计确保每个掩码块对应一个包含类似语义和结构信息的可见块,从而促进重建任务和特征学习。同时,由于对称掩码策略保持固定的掩码比率(大约50%),消除了寻找最优掩码比率的需求。

Momentum对比学习:论文提出使用不同大小的掩码对在线网络和动量编码器进行动态调整,以平衡输入图像中的局部和全局信息。在线网络使用较小的掩码,隐藏更多的局部信息,而动量编码器使用较大的掩码,隐藏更多的全局信息。动量编码器的参数使用在线网络参数的移动平均值进行更新。

重建损失和对比损失:重建损失通过比较原始图像和在线网络恢复的图像以及在线网络和动量编码器恢复的图像来计算。对比损失则通过将特征映射转换为嵌入表示,并使用InfoNCE损失来规范这一表示,使其更接近正键,同时远离负键。

简化超参数调整:通过对称掩码策略,SymMIM简化了超参数调整过程,仅依赖掩码的大小,从而减少了预训练和微调过程中的复杂性和成本。

实验验证:通过在ImageNet-1K数据集上进行广泛的实验,论文验证了SymMIM在多个下游任务(包括图像分类、目标检测和实例分割)中的有效性和可扩展性。SymMIM在多个视觉基准测试中实现了新的最先进性能。

通过这些方法,论文成功地解决了现有MIM方法在随机掩码策略、计算成本和灵活性方面的局限性,并在多个任务中取得了优异的性能。

Q: 论文做了哪些实验?

A: 论文中进行了一系列的实验来验证所提出的SymMIM(Symmetric Masked Image Modeling)框架的有效性。以下是论文中提到的主要实验:

ImageNet-1K 数据集上的自监督预训练:使用 ImageNet-1K 数据集进行自监督预训练,并与 MAE 和 SimMIM 的方法进行了比较。实验中,作者调整了超参数,以确保与 SimMIM 一致。

图像分类:在 ImageNet-1K 数据集上进行图像分类任务的微调,以评估预训练模型的性能。作者遵循 BEiT 的微调设置,并比较了使用不同架构(如 ViT-Small、ViT-Base 和 ViT-Large)的模型。

目标检测和实例分割:在 COCO 数据集上对 Mask R-CNN 进行端到端的微调,以评估 SymMIM 在目标检测和实例分割任务上的性能。作者调整了注意力块以减少自注意力的二次复杂性,并保留了全局块以进行跨窗口交互。

语义分割:使用 ADE20K 基准进行语义分割任务的评估,该基准包含 25,000 张图像和 150 个语义类别。作者使用 UperNet 并遵循 BEiT 的设置进行微调。

学习目标分析:进行了消融研究,以分析总损失中每个附加学习目标的贡献。实验逐步测试了不同的损失项组合,并报告了在 ImageNet-1K 数据集上的分类准确率。

掩码比例探测:研究了不同掩码比例对微调性能的影响,并比较了传统 MIM 方法与所提出的 SymMIM 方法在掩码比例选择上的差异。

可视化:通过可视化从 ImageNet-1K 验证集中获取的示例图像,展示了使用不同掩码类型恢复的图像,以理解所提出方法的能力和关键设计。

对比学习性能:对比了不同方法在对比学习目标上的性能,以展示对比学习目标对整体性能的重要贡献。

这些实验结果表明,SymMIM 在多个视觉任务中取得了与现有最先进方法相当或更优的性能,并且在某些情况下,使用更少的预训练周期就能实现这些性能提升。此外,SymMIM 通过简化的掩码策略减少了超参数调整的需求,从而降低了训练过程的复杂性和成本。

Q: 有什么可以进一步探索的点?

A: 尽管SymMIM在多个任务上取得了显著的性能提升,但仍有一些潜在的研究方向可以进一步探索:

不同数据集的泛化能力:尽管SymMIM在ImageNet、COCO和ADE20K等数据集上表现出色,但研究其在其他类型数据集(如医学图像、卫星图像等)上的泛化能力仍然是有价值的。

不同模型架构的适用性:SymMIM主要在Vision Transformer(ViT)架构上进行了测试。探索其在其他模型架构(如CNN、ResNet等)上的应用效果和潜在改进是一个很好的研究方向。

损失函数的改进:虽然SymMIM使用了重建损失和对比损失,但研究其他类型的损失函数或这些损失的变体可能进一步提高模型性能。

超参数优化:虽然SymMIM减少了超参数的数量,但进一步研究如何更有效地调整剩余的超参数,例如温度参数τ,可能会带来额外的性能提升。

计算效率:尽管SymMIM简化了训练过程,但研究如何提高算法的计算效率,特别是在大规模数据集和高分辨率图像上的应用,仍然是一个重要问题。

多模态学习:SymMIM目前专注于图像数据,但将其扩展到多模态学习场景,如结合图像和文本或图像和声音,可能是一个有趣的研究方向。

半监督学习:研究SymMIM在半监督学习设置中的性能,即使用少量标记数据和大量未标记数据进行训练。

长期训练稳定性:研究SymMIM在长期训练过程中的稳定性和收敛性,以及如何通过正则化技术进一步改善这些特性。

模型解释性:提高模型的可解释性,以便更好地理解其决策过程和特征学习。

实际应用场景:将SymMIM应用于实际问题,如医疗诊断、自动驾驶车辆的视觉系统等,并针对这些特定领域进行定制和优化。

这些探索点可以帮助研究者更深入地理解SymMIM的优势和局限性,并可能推动自监督学习在更广泛领域的应用。

Q: 总结一下论文的主要内容

A: 这篇论文的主要内容可以总结如下:

问题识别:论文指出了现有Masked Image Modeling (MIM) 方法在自监督学习中的局限性,尤其是对随机掩码策略的依赖,以及确定最优掩码比例的高计算成本和资源消耗。

对称掩码策略:提出了一种新的对称掩码策略,该策略通过沿图像的水平和垂直轴对称地掩码图像块,形成四个象限,每个掩码块都有一个对应的可见块,包含相似的语义和结构信息。

SymMIM框架:基于对称掩码策略,提出了SymMIM,这是一个改进的MIM训练框架,它使用重建损失和对比损失来增强表示学习。

简化超参数调整:SymMIM通过仅依赖掩码的大小而非比例,简化了超参数的调整过程,减少了预训练和微调的复杂性和成本。

实验验证:通过在ImageNet-1K、COCO和ADE20K等数据集上的广泛实验,验证了SymMIM在图像分类、目标检测、实例分割和语义分割等多个下游任务中的有效性和优越性能。

消融研究:进行了消融研究,分析了不同损失项对模型性能的影响,以及掩码比例对微调性能的影响。

可视化分析:通过可视化分析,展示了使用不同掩码类型恢复的图像,以理解所提出方法的能力和关键设计。

性能比较:与现有的最先进方法进行了性能比较,SymMIM在多个任务中取得了显著的性能提升,并且在某些情况下,使用更少的预训练周期就能实现这些性能提升。

结论:论文得出结论,SymMIM通过简单的对称掩码策略和有效的训练框架,显著提高了自监督学习的性能,并且简化了训练过程。

这篇论文通过提出新的掩码策略和训练框架,为自监督学习领域提供了一种有效的改进方法,并在多个视觉任务上展示了其优越的性能。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图

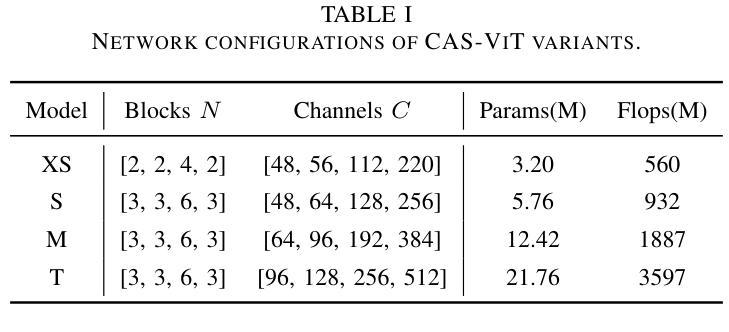

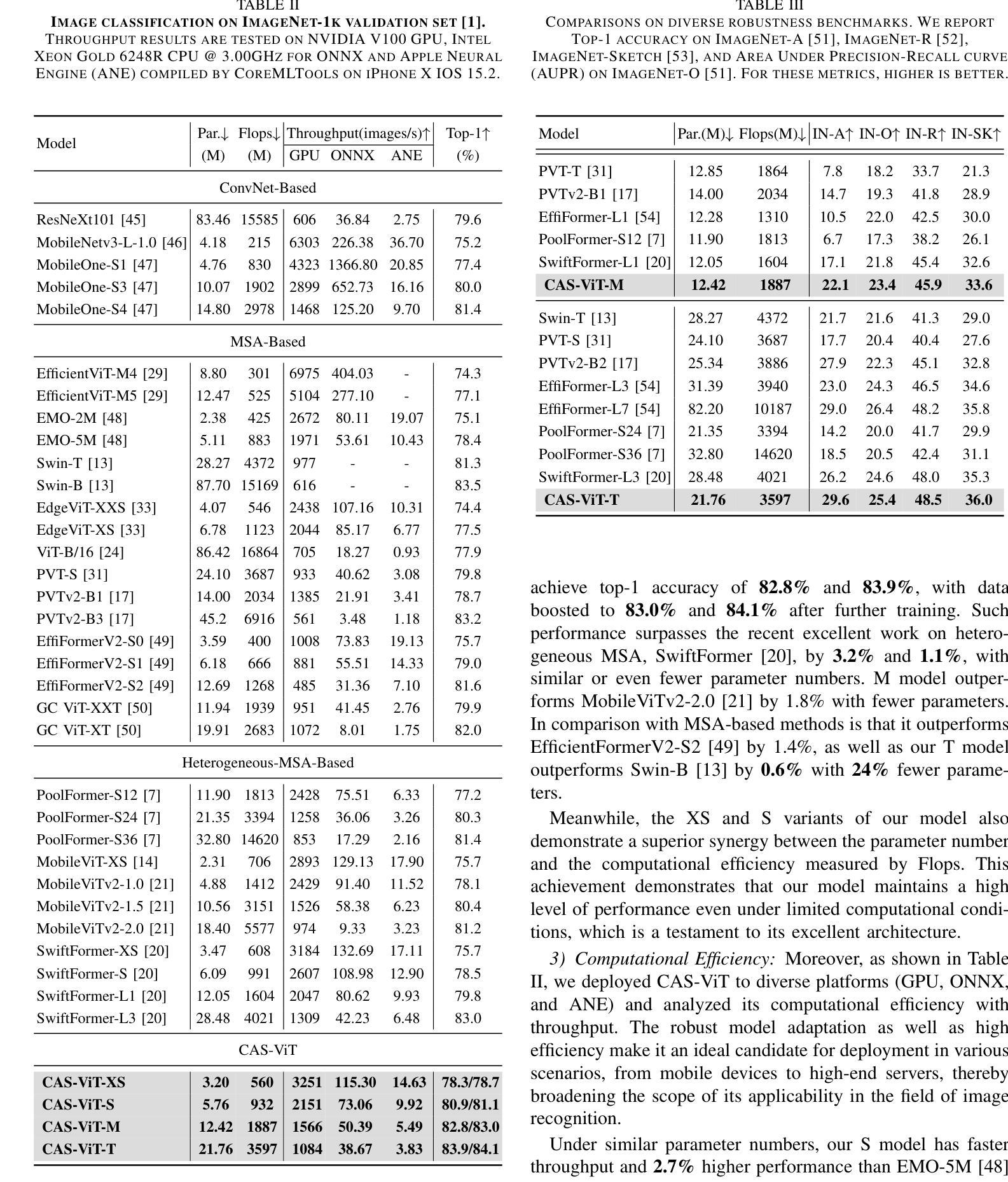

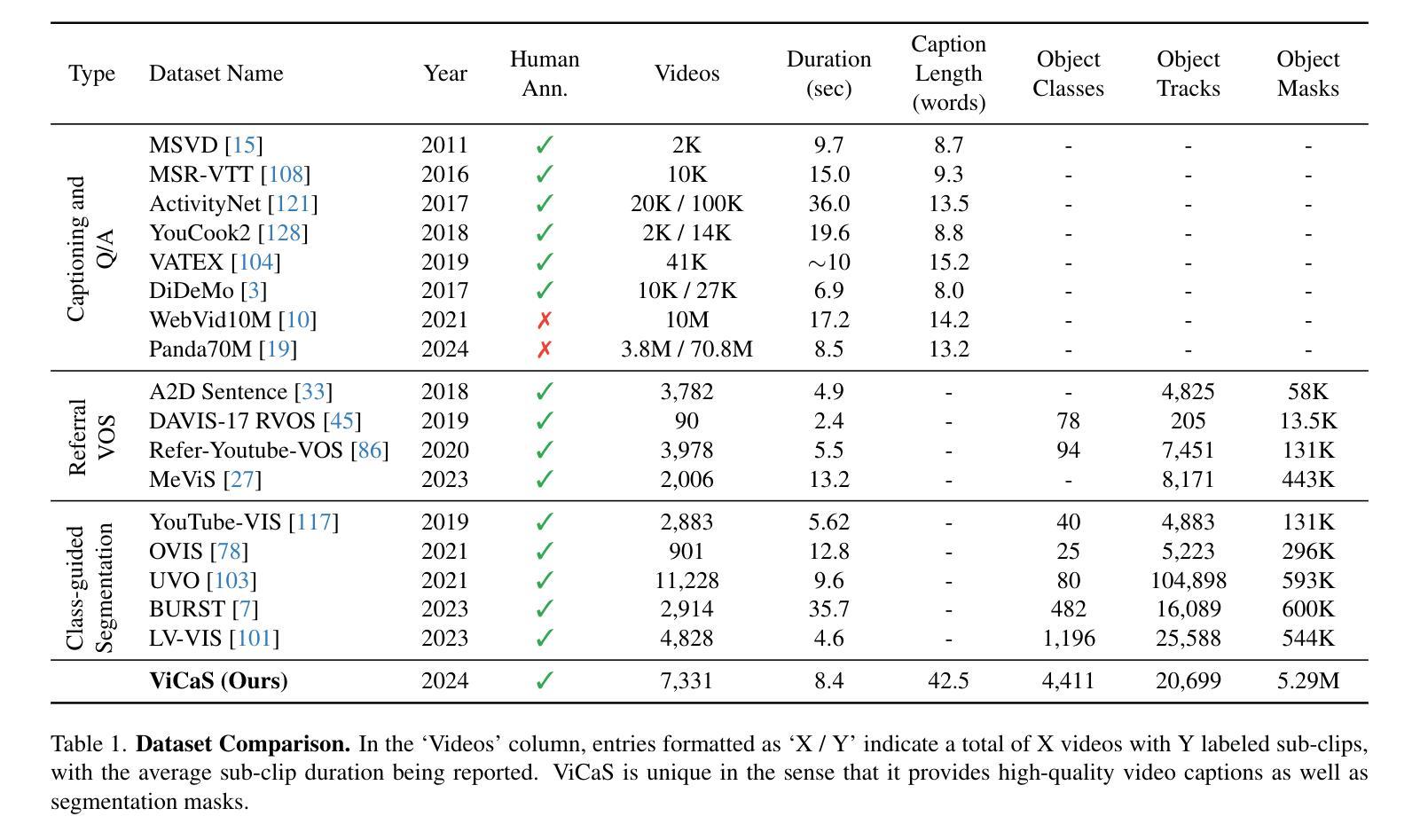

CAS-ViT: Convolutional Additive Self-attention Vision Transformers for Efficient Mobile Applications

Authors:Tianfang Zhang, Lei Li, Yang Zhou, Wentao Liu, Chen Qian, Jenq-Neng Hwang, Xiangyang Ji

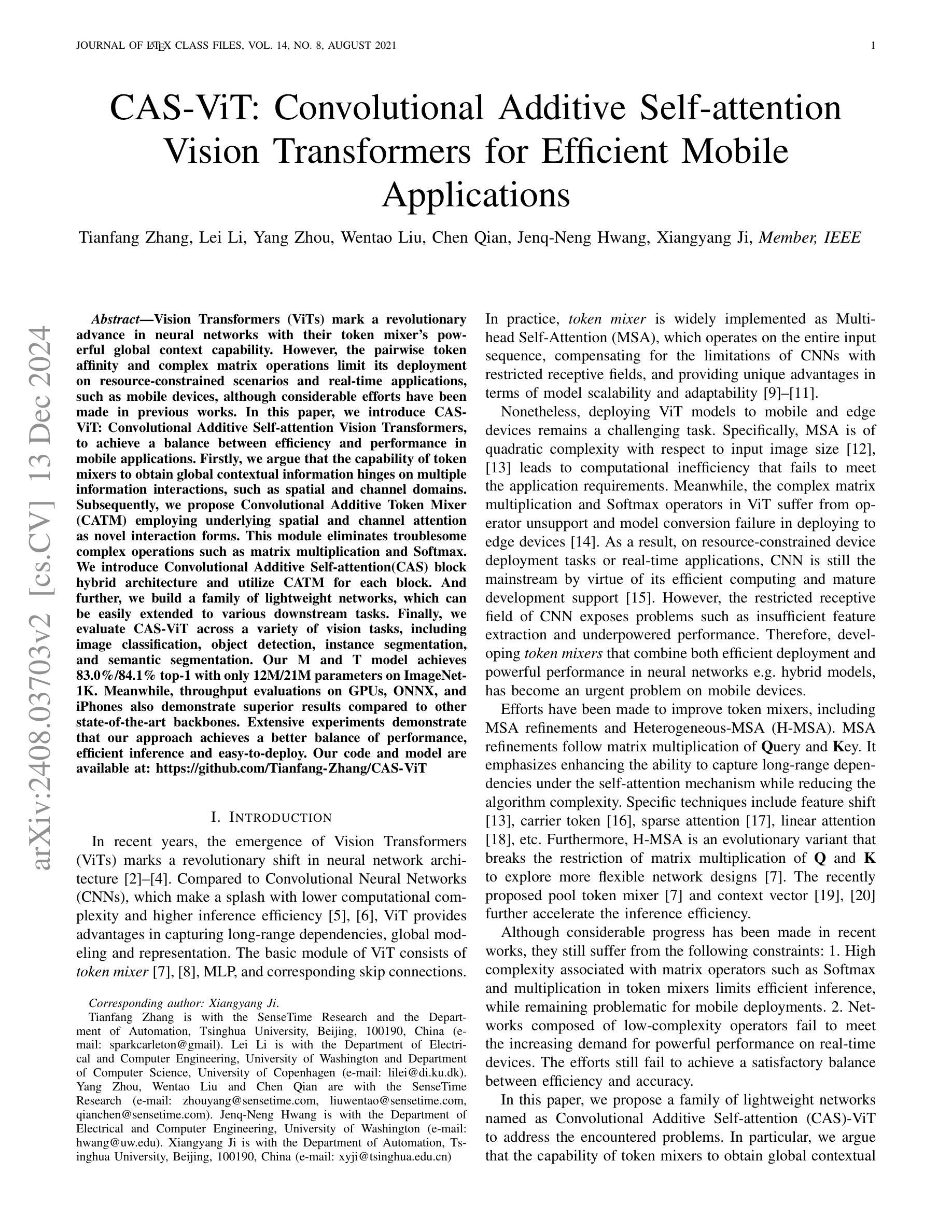

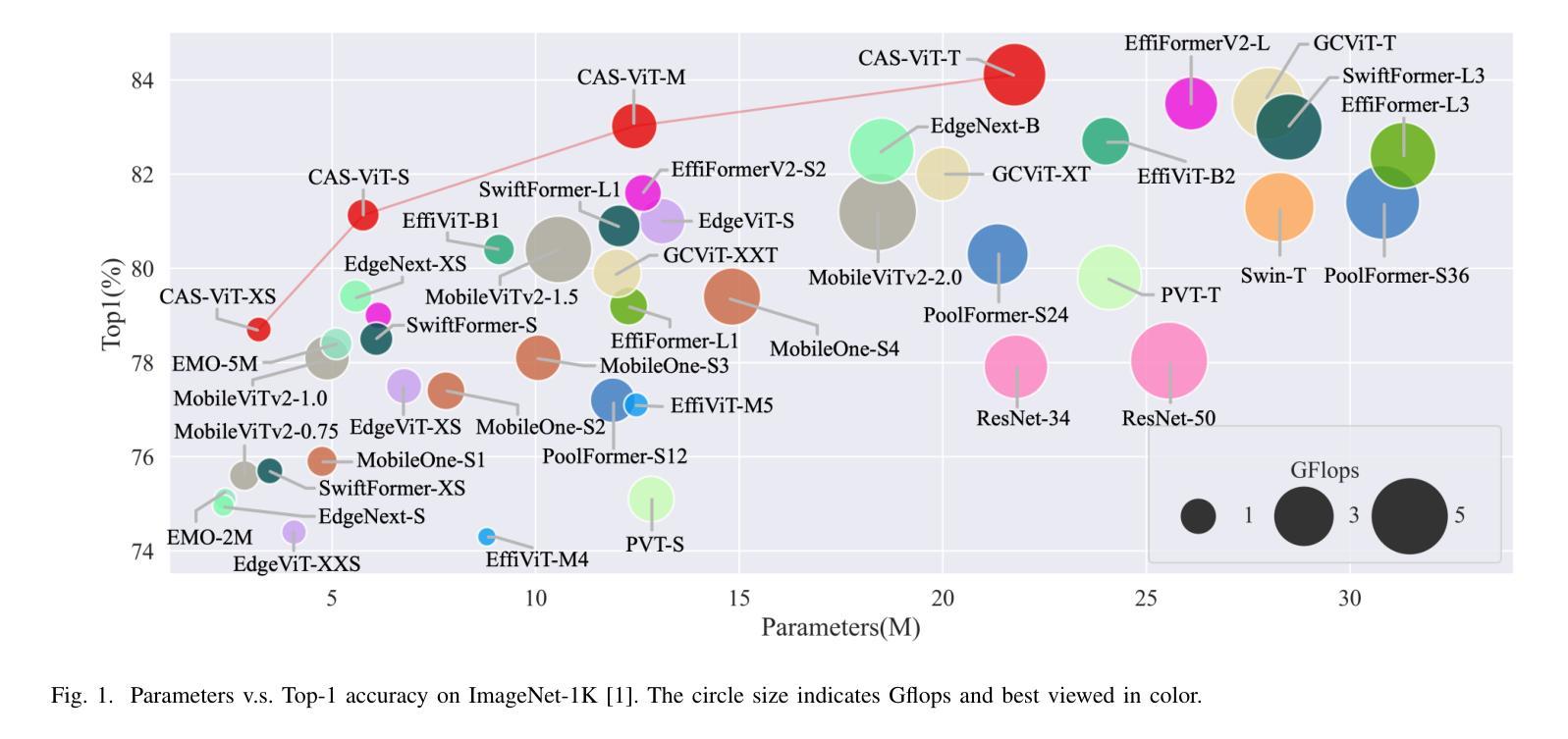

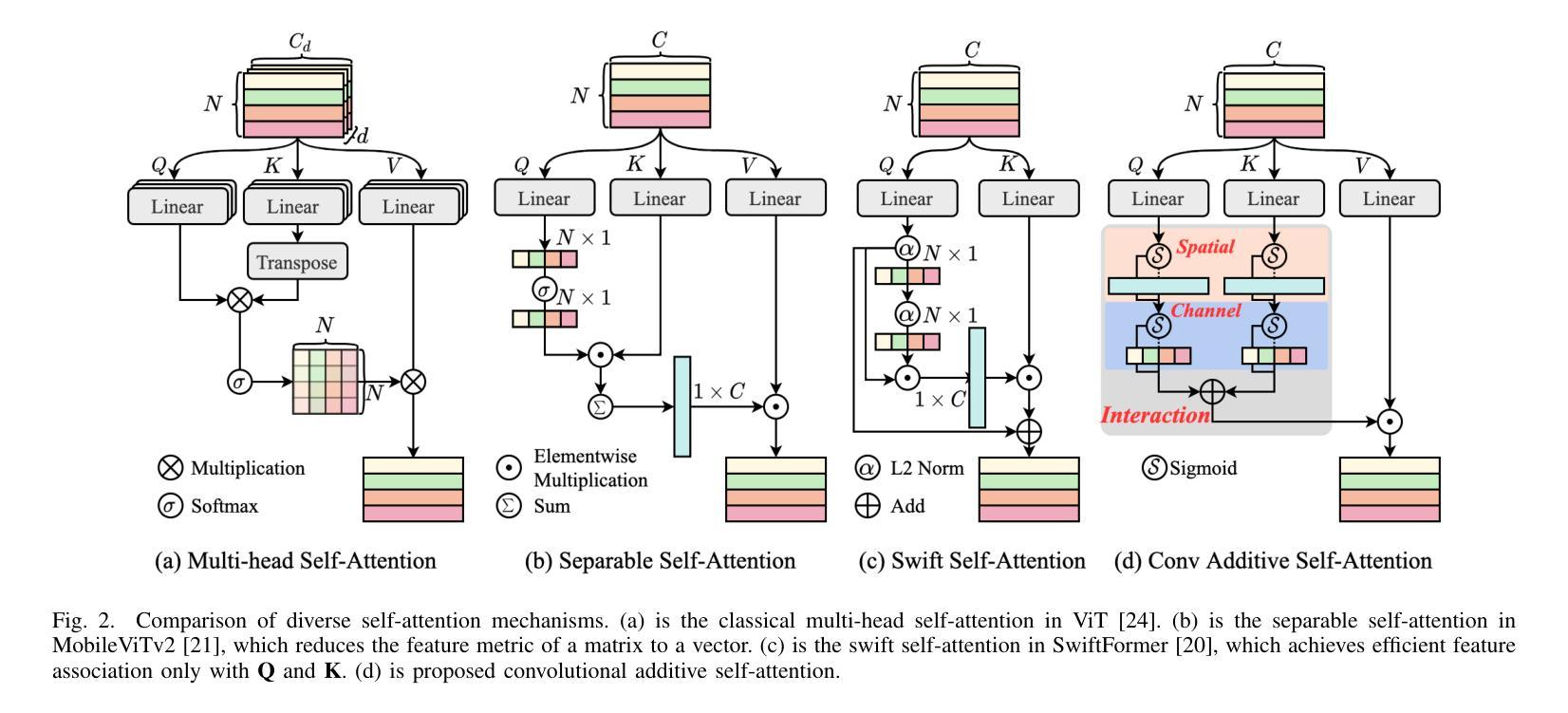

Vision Transformers (ViTs) mark a revolutionary advance in neural networks with their token mixer’s powerful global context capability. However, the pairwise token affinity and complex matrix operations limit its deployment on resource-constrained scenarios and real-time applications, such as mobile devices, although considerable efforts have been made in previous works. In this paper, we introduce CAS-ViT: Convolutional Additive Self-attention Vision Transformers, to achieve a balance between efficiency and performance in mobile applications. Firstly, we argue that the capability of token mixers to obtain global contextual information hinges on multiple information interactions, such as spatial and channel domains. Subsequently, we propose Convolutional Additive Token Mixer (CATM) employing underlying spatial and channel attention as novel interaction forms. This module eliminates troublesome complex operations such as matrix multiplication and Softmax. We introduce Convolutional Additive Self-attention(CAS) block hybrid architecture and utilize CATM for each block. And further, we build a family of lightweight networks, which can be easily extended to various downstream tasks. Finally, we evaluate CAS-ViT across a variety of vision tasks, including image classification, object detection, instance segmentation, and semantic segmentation. Our M and T model achieves 83.0%/84.1% top-1 with only 12M/21M parameters on ImageNet-1K. Meanwhile, throughput evaluations on GPUs, ONNX, and iPhones also demonstrate superior results compared to other state-of-the-art backbones. Extensive experiments demonstrate that our approach achieves a better balance of performance, efficient inference and easy-to-deploy. Our code and model are available at: \url{https://github.com/Tianfang-Zhang/CAS-ViT}

视觉Transformer(ViT)以其强大的全局上下文能力为神经网络带来了革命性的进步。然而,尽管之前的作品已经做出了相当大的努力,但其成对的令牌亲和力和复杂的矩阵操作仍然限制了其在资源受限场景和实时应用(如移动设备)上的部署。在本文中,我们介绍了CAS-ViT:卷积加性自注意力视觉Transformer,以实现移动应用中效率和性能的平衡。首先,我们认为token混合器获取全局上下文信息的能力取决于多种信息交互,如空间和通道域。随后,我们提出了采用基础的空间和通道注意力作为新的交互形式的卷积加性token混合器(CATM)。该模块消除了麻烦的复杂操作,如矩阵乘法和Softmax。我们引入了卷积加性自注意力(CAS)块混合架构,并在每个块中使用CATM。此外,我们构建了一系列轻量级网络,可以轻松地扩展到各种下游任务。最后,我们在各种视觉任务上评估了CAS-ViT,包括图像分类、对象检测、实例分割和语义分割。我们的M和T模型在ImageNet-1K上仅使用12M/21M参数就达到了83.0%/84.1%的top-1准确率。同时,在GPU、ONNX和iPhone上的吞吐量评估也表明,与其他最先进的backbone相比,我们的方法具有更好的性能、高效的推理和易于部署的平衡。我们的代码和模型可在:https://github.com/Tianfang-Zhang/CAS-ViT找到。

论文及项目相关链接

Summary

本文介绍了CAS-ViT模型,它在效率和性能之间实现了平衡,特别适用于移动设备上的实时应用。CAS-ViT引入了一种新型的卷积加法自注意力令牌混合器(CATM),以简化复杂的操作,并提高模型在全球上下文信息获取方面的能力。模型在家庭的一系列轻量级网络中被实现,可以轻松扩展到各种下游任务,并在图像分类、目标检测、实例分割和语义分割等视觉任务上进行了评估。

Key Takeaways

- Vision Transformers (ViTs)具有强大的全局上下文处理能力,但复杂的矩阵操作和成对令牌亲和力限制了其在资源受限场景和实时应用中的部署。

- CAS-ViT模型旨在解决上述问题,通过在卷积加法自注意力(CAS)块中引入新的令牌混合器(CATM)。

- CATM模块通过利用空间域和通道域的基础注意力来消除复杂的操作,如矩阵乘法和Softmax。

- CAS-ViT模型采用CATM作为每个块的核心结构,并能轻松地扩展到各种下游任务。

- 在多种视觉任务上的评估显示CAS-ViT模型的优越性能,包括图像分类、目标检测等。

- CAS-ViT模型在ImageNet-1K上的表现优于其他最新模型,同时其在GPU、ONNX和iPhone上的吞吐量评估也显示出其优越性。

点击展开 Cool Papers 详细信息

Q: 这篇论文试图解决什么问题?

A: 这篇论文《CAS-ViT: Convolutional Additive Self-attention Vision Transformers for Efficient Mobile Applications》主要解决的问题是如何在资源受限的场景和实时应用中,例如移动设备上,实现高效且性能优异的视觉Transformer(ViT)模型部署。具体来说,论文指出了以下几个关键问题:

计算复杂性:传统的Vision Transformers(ViTs)使用多头自注意力(MSA)作为其核心组件,这种结构在输入图像尺寸上具有二次复杂度,导致模型在资源受限设备上部署时需要更多的计算资源。

实时应用的挑战:由于MSA的高计算需求,ViT模型在移动设备等需要实时响应的应用场景中难以实现快速推理。

准确性与效率的平衡:在移动设备上部署的模型需要在保持高准确度的同时,还要兼顾计算效率和易于部署的特性。

为了解决这些问题,论文提出了一种新型的Vision Transformer架构,称为**Convolutional Additive Self-attention Vision Transformers (CAS-ViT)**。CAS-ViT通过引入一种新颖的加性相似性函数和卷积加性令牌混合器(Convolutional Additive Token Mixer, CATM),旨在降低计算开销,同时保持或提升模型性能,以适应移动应用的效率和性能需求。

Q: 有哪些相关研究?

A: 论文中提到了多项与Efficient Vision Transformers和Efficient Token Mixer相关的研究工作。以下是一些主要的相关研究:

ViT (Dosovitskiy et al. 2020): 首次提出视觉Transformer,并在大规模数据集如ImageNet上验证了自注意力机制在计算机视觉任务中的潜力。

PVT (Wang et al. 2021): 采用空间缩减策略实现稀疏注意力,以处理高分辨率图像。

Swin Transformer (Liu et al. 2021): 使用窗口分割方法实现局部自注意力,并通过窗口移动处理补丁间依赖。

EdgeViT (Pan et al. 2022): 结合卷积层和稀疏注意力,分别在块内进行信息整合和传播。

NextViT (Li et al. 2022a): 通过全面实验确认了混合模型和设计策略的有效性。

EfficientViT (Liu et al. 2023): 分析了不同操作的时间消耗比例,以实现高效的推理。

Twins (Chu et al. 2021): 引入了补丁间的自注意力,实现全局和局部依赖的协同。

Linear attention (Shen et al. 2021): 通过假设相似性函数是线性可微的,解决了自注意力机制的二次复杂性问题。

Heteromorphic-MSA (H-MSA): 自注意力机制的发展形式,旨在打破MSA框架的限制,获得更好的特征关系和更强大的推理效率。

MetaFormer (Yu et al. 2022): 提出令牌混合器不是影响Transformer性能的关键组件,但PoolFormer未能被验证为高效。

MobileViTv2 (Mehta and Rastegari 2022): 简化了复杂的矩阵乘法,通过赋予上下文向量全局信息。

SwiftFormer (Shaker et al. 2023): 甚至消除了“Value”,并通过更简单的归一化操作实现特征之间的加权求和,实现了更简洁高效的H-MSA。

这些研究工作为CAS-ViT的设计提供了理论基础和技术支持,同时也表明了在资源受限设备上部署高效视觉模型是一个活跃的研究领域。论文通过回顾这些相关工作,展示了在设计新型视觉Transformer时所面临的挑战和可能的解决方案。

Q: 论文如何解决这个问题?

A: 论文通过提出一种新型的架构——Convolutional Additive Self-attention Vision Transformers (CAS-ViT) 来解决在移动设备上部署高效视觉模型的问题。具体解决方案包括以下几个关键点:

加性相似性函数:论文提出了一种新颖的加性相似性函数,该函数基于Query和Key的上下文分数之和来定义相似度,而不是传统的基于Softmax的相似度计算。

**卷积加性令牌混合器 (Convolutional Additive Token Mixer, CATM)**:CATM通过使用空间和通道注意力的卷积操作来实现信息的交互,从而避免了传统MSA中的复杂矩阵乘法和Softmax操作。

简化的计算复杂性:CATM的设计使得计算复杂度与输入大小呈线性关系,而不是传统的二次方关系,这显著降低了计算开销。

轻量级网络架构:论文构建了一组轻量级ViT模型,通过调整通道数和块的数量来适应不同的计算和性能需求。

多任务评估:CAS-ViT在多种视觉任务上进行了评估,包括图像分类、目标检测、实例分割和语义分割,证明了其在不同应用场景下的竞争力。

跨平台部署:论文还展示了CAS-ViT在不同平台上的部署能力,包括GPU、ONNX和iPhone,证明了其在移动设备上的实际应用潜力。

实验验证:通过在ImageNet-1K数据集上的实验,论文展示了CAS-ViT在保持高准确度的同时,相比于其他SOTA模型具有更低的参数数量和计算复杂性。

通过这些方法,CAS-ViT旨在实现在资源受限的移动设备上高效、准确的视觉模型部署,同时保持模型的可扩展性和适应性。

Q: 论文做了哪些实验?

A: 论文中进行了多项实验来评估和验证CAS-ViT模型的性能和效率。以下是论文中提到的主要实验内容:

ImageNet-1K分类:在ImageNet-1K数据集上进行了图像分类实验,从零开始训练网络,未使用任何预训练模型或额外数据。实验包括了不同模型变体的性能比较,以及与其他SOTA模型的比较。

COCO val2017目标检测和实例分割:使用在ImageNet-1K上预训练的模型作为主干网络,集成了RetinaNet和Mask RCNN,评估了模型在MS COCO 2017数据集上的目标检测和实例分割性能。

ADE20K语义分割:在ADE20K数据集上进行了语义分割实验,结合Semantic FPN评估了模型的性能,并与其他模型进行了比较。

计算效率分析:对所有任务中的模型进行了计算效率的评估,比较了模型的Flops(浮点运算次数)和参数数量。

模型架构的可视化:展示了模型最后一层的热图可视化,比较了CAS-ViT与其他SOTA模型在捕获全局上下文和接收场方面的能力。

消融研究:通过替换CATM模块和其他相似性函数,进行了消融研究,以证明所提出方法的有效性。

跨平台部署和推理效率:展示了CAS-ViT在不同平台上的部署能力,包括GPU、ONNX和iPhone,并报告了推理效率。

这些实验结果表明,CAS-ViT在保持高准确度的同时,相比于其他SOTA模型具有更低的参数数量和计算复杂性,证明了其在移动设备上的实际应用潜力。

Q: 有什么可以进一步探索的点?

A: 论文在最后一部分提出了一些限制和未来的工作方向,以下是一些可以进一步探索的点:

*大规模数据集和大型模型的性能:CAS-ViT在小规模数据集和较小的模型规模上表现良好,但是在大规模数据集和大型模型上可能效果不佳。未来的工作可以探索如何改进CAS-ViT以适应这些场景。

模型的扩展性:研究如何扩展CAS-ViT以处理更大的模型和更复杂的任务,同时保持计算效率。

不同领域的应用:探索CAS-ViT在不同领域的应用,例如医学图像分析、自动驾驶车辆的视觉系统等。

模型压缩和加速:进一步研究模型压缩和加速技术,以提高CAS-ViT在资源受限设备上的性能。

模型鲁棒性:研究如何提高CAS-ViT对于输入噪声、遮挡和变化光照条件的鲁棒性。

多模态学习:考虑将CAS-ViT应用于多模态学习任务,结合图像、文本或其他类型的数据。

模型解释性:提高模型的可解释性,以便更好地理解其决策过程,并在必要时进行调整。

跨平台优化:进一步优化模型以适应不同的硬件平台,包括不同的移动设备、嵌入式系统等。

实时应用的进一步测试:在实际的实时应用场景中测试CAS-ViT的性能,例如视频流处理或实时监控系统。

模型的安全性和隐私保护:研究如何在保持性能的同时,增强模型对潜在安全威胁的抵抗力,以及如何在模型设计中考虑用户隐私。

这些探索点可以帮助研究人员和开发者更好地理解和改进CAS-ViT,以及将其应用于更广泛的领域和场景。

Q: 总结一下论文的主要内容

A: 这篇论文《CAS-ViT: Convolutional Additive Self-attention Vision Transformers for Efficient Mobile Applications》主要介绍了一种新型的适用于移动设备的高效视觉Transformer架构。以下是对论文主要内容的总结:

问题提出:论文指出了传统Vision Transformers(ViTs)在移动设备等资源受限场景下部署的局限性,主要是由于其计算复杂度高和实时应用的挑战。

CAS-ViT架构:为了解决上述问题,论文提出了Convolutional Additive Self-attention Vision Transformers(CAS-ViT),这是一种新型的轻量级网络架构,通过构建新颖的加性相似性函数和卷积加性令牌混合器(Convolutional Additive Token Mixer, CATM)来降低计算开销。

核心思想:CAS-ViT的核心思想是通过空间和通道域的多重信息交互来捕获全局上下文信息,而不是依赖于传统的矩阵乘法和Softmax操作。

实验验证:论文通过在图像分类、目标检测、实例分割和语义分割等多种视觉任务上的实验,验证了CAS-ViT在保持高准确度的同时,相比于其他SOTA模型具有更低的参数数量和计算复杂性。

跨平台部署:论文展示了CAS-ViT在不同平台上的部署能力,包括GPU、ONNX和iPhone,证明了其在移动设备上的实际应用潜力。

消融研究:通过消融研究,论文证明了所提出方法的有效性,包括CATM模块和相似性函数的不同变体对性能的影响。

未来工作:论文提出了一些未来工作的方向,包括在大规模数据集和大型模型上的性能探索,以及开发更轻量级、高效的网络架构。

结论:CAS-ViT通过创新的加性自注意力机制,实现了在移动设备上的高效部署和推理,为资源受限的视觉应用提供了一种新的解决方案。

总的来说,这篇论文提出了一种新的Vision Transformer架构,通过简化传统ViTs中的复杂操作,实现了在移动设备等资源受限场景下的高效部署,同时在多个视觉任务上展现出了竞争力。

Q: 想要进一步了解论文

A: 以上只是了解一篇论文的几个基本FAQ。如果你还想与Kimi进一步讨论该论文,请点击 这里 为你跳转Kimi AI网页版,并启动一个与该论文相关的新会话。

点此查看论文截图