⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-19 更新

Make Imagination Clearer! Stable Diffusion-based Visual Imagination for Multimodal Machine Translation

Authors:Andong Chen, Yuchen Song, Kehai Chen, Muyun Yang, Tiejun Zhao, Min Zhang

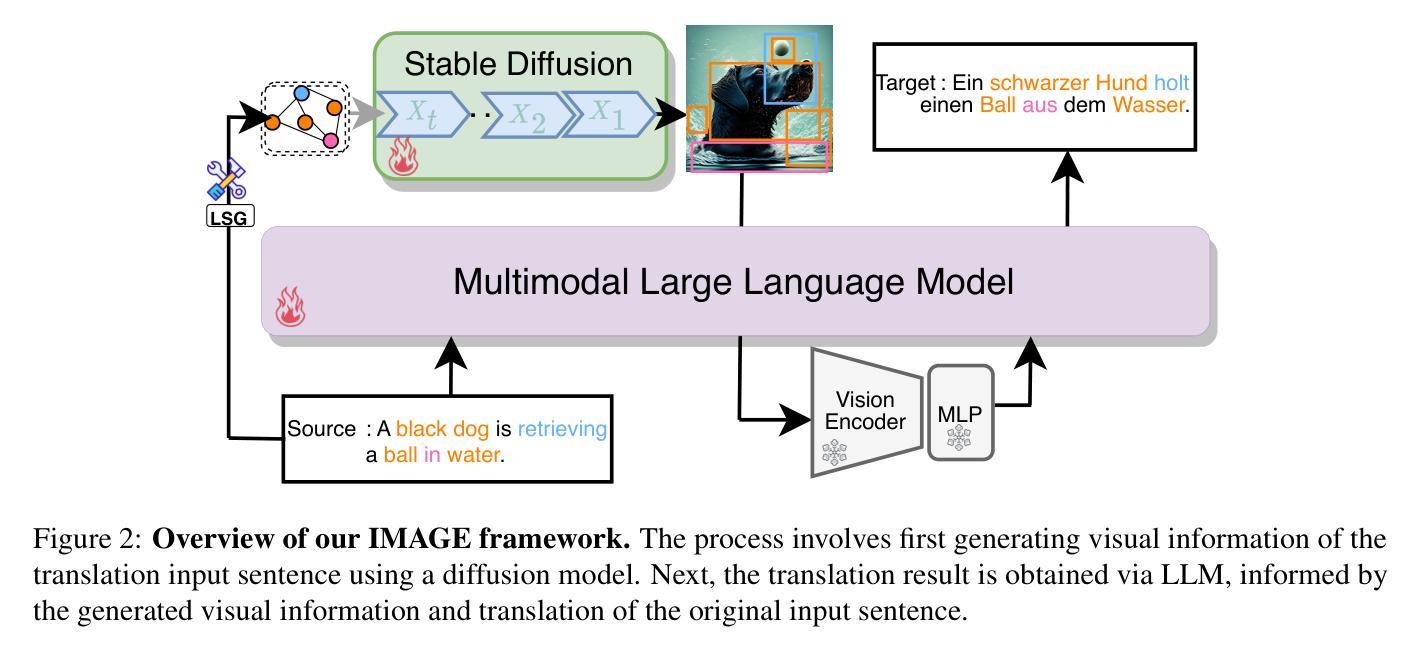

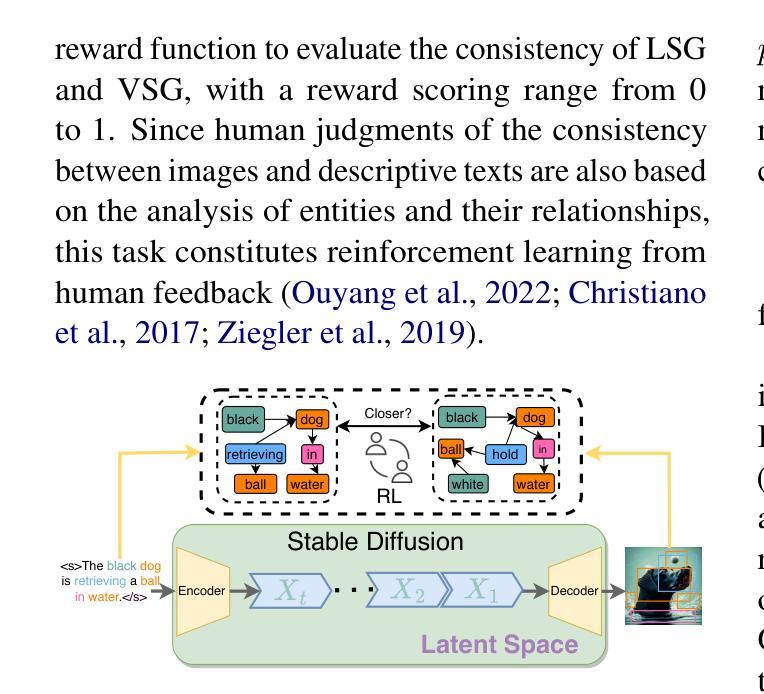

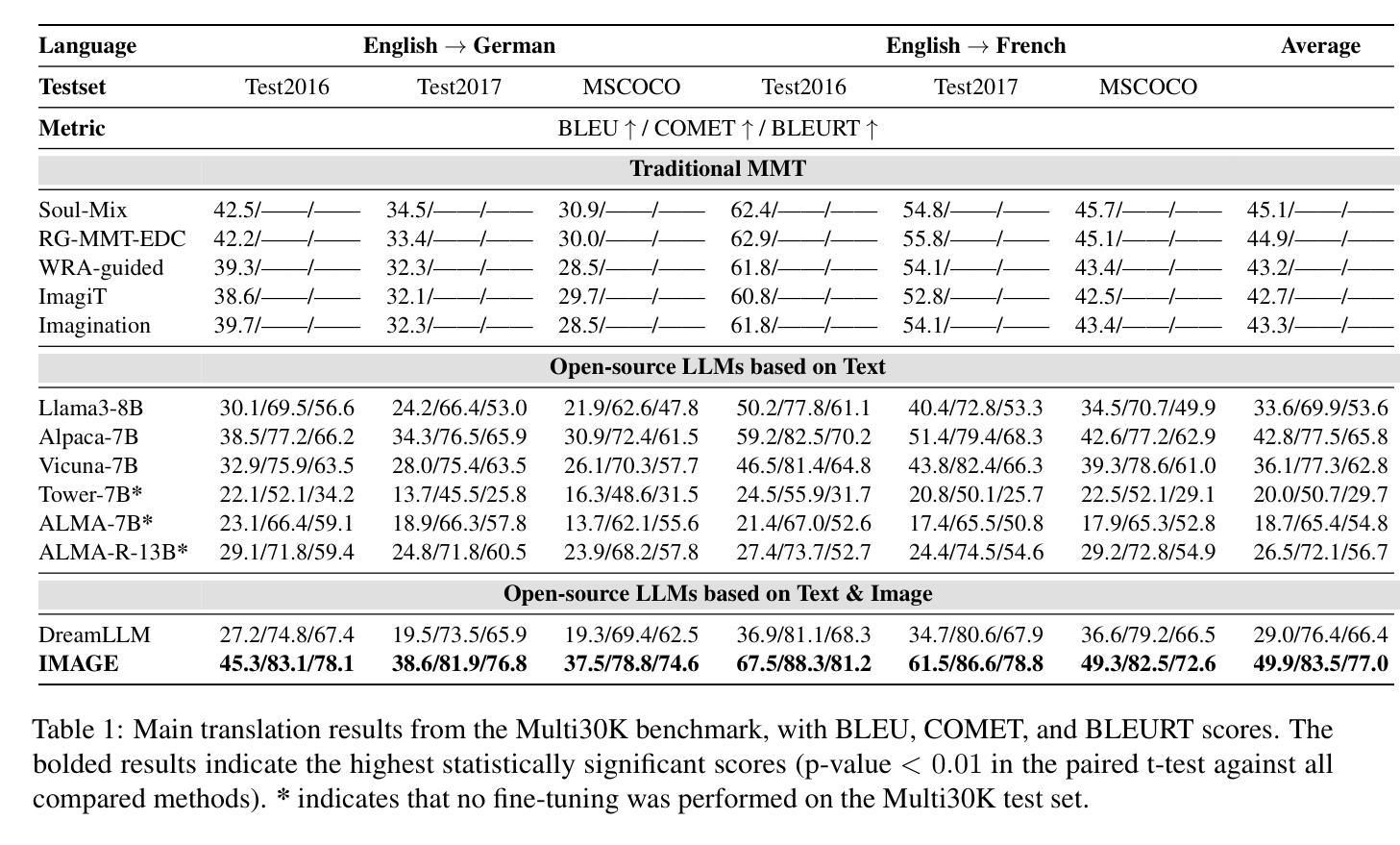

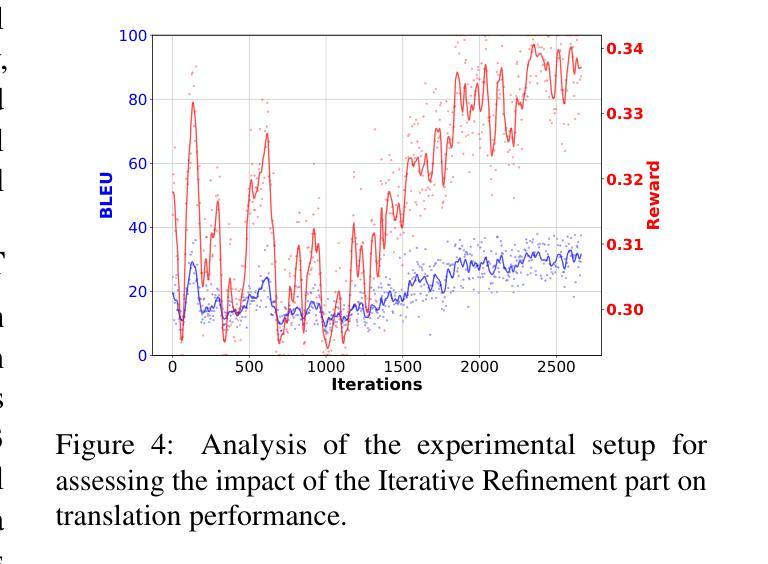

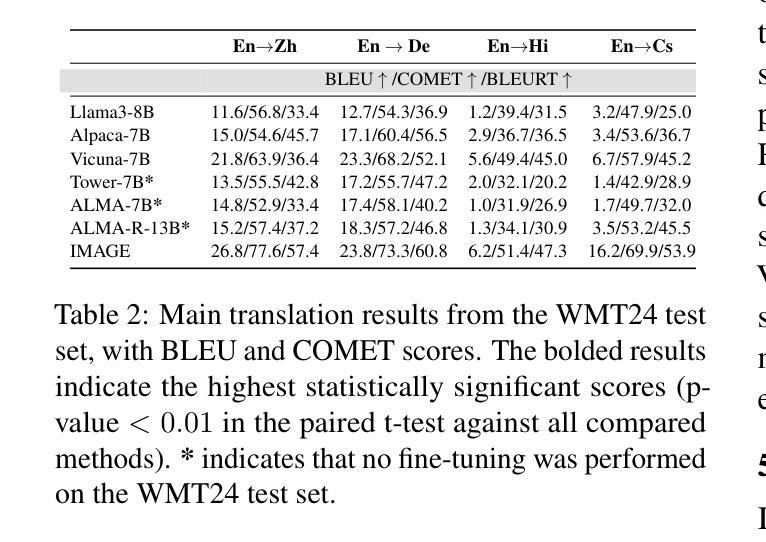

Visual information has been introduced for enhancing machine translation (MT), and its effectiveness heavily relies on the availability of large amounts of bilingual parallel sentence pairs with manual image annotations. In this paper, we introduce a stable diffusion-based imagination network into a multimodal large language model (MLLM) to explicitly generate an image for each source sentence, thereby advancing the multimodel MT. Particularly, we build heuristic human feedback with reinforcement learning to ensure the consistency of the generated image with the source sentence without the supervision of image annotation, which breaks the bottleneck of using visual information in MT. Furthermore, the proposed method enables imaginative visual information to be integrated into large-scale text-only MT in addition to multimodal MT. Experimental results show that our model significantly outperforms existing multimodal MT and text-only MT, especially achieving an average improvement of more than 14 BLEU points on Multi30K multimodal MT benchmarks.

引入视觉信息以增强机器翻译的效果已经得到广泛关注,但其有效性在很大程度上依赖于大量带有手动图像注释的双语并行句子对。在本文中,我们将基于稳定扩散的想象网络引入多模态大型语言模型(MLLM),为源句明确生成图像,从而促进多模态机器翻译的发展。特别地,我们利用强化学习与启发式人工反馈相结合的方法,在无图像注释监督的情况下,确保生成的图像与源句的一致性,打破了机器翻译中使用视觉信息的瓶颈。此外,所提出的方法不仅适用于多模态机器翻译,而且能够将想象性的视觉信息集成到大规模的纯文本机器翻译中。实验结果表明,我们的模型在Multi30K多模态机器翻译基准测试上的表现显著优于现有的多模态机器翻译和纯文本机器翻译,特别是在BLEU得分上平均提高了超过14个点。

论文及项目相关链接

PDF Work in progress

Summary

本文引入了一种基于稳定扩散的想象网络,将其融入多模态大型语言模型(MLLM)中,为每句源文本明确生成对应的图像,从而推动多模态机器翻译的发展。该研究通过强化学习与启发式人类反馈的结合,确保生成图像与源文本的契合度,在无图像标注监督的情况下打破了视觉信息在机器翻译应用中的瓶颈。此外,该方法不仅适用于多模态机器翻译,还能将想象性视觉信息整合到大规模纯文本机器翻译中。实验表明,该模型在多模态机器翻译方面显著优于现有技术,特别是在Multi30K多模态基准测试中,BLEU得分平均提高了14分以上。

Key Takeaways

- 引入稳定扩散基于想象的网络增强机器翻译,通过生成与源句子相对应的图片来推动多模态机器翻译的发展。

- 结合强化学习与启发式人类反馈,确保生成图像与源文本的契合度。

- 该方法在无图像标注监督的情况下提高了视觉信息在机器翻译中的有效性。

- 想象性视觉信息可整合到大规模纯文本机器翻译中。

- 提出的模型在多模态机器翻译方面表现出显著优势。

- 在Multi30K多模态基准测试中,该模型的BLEU得分平均提高了14分以上。

点此查看论文截图