⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-21 更新

Joint Co-Speech Gesture and Expressive Talking Face Generation using Diffusion with Adapters

Authors:Steven Hogue, Chenxu Zhang, Yapeng Tian, Xiaohu Guo

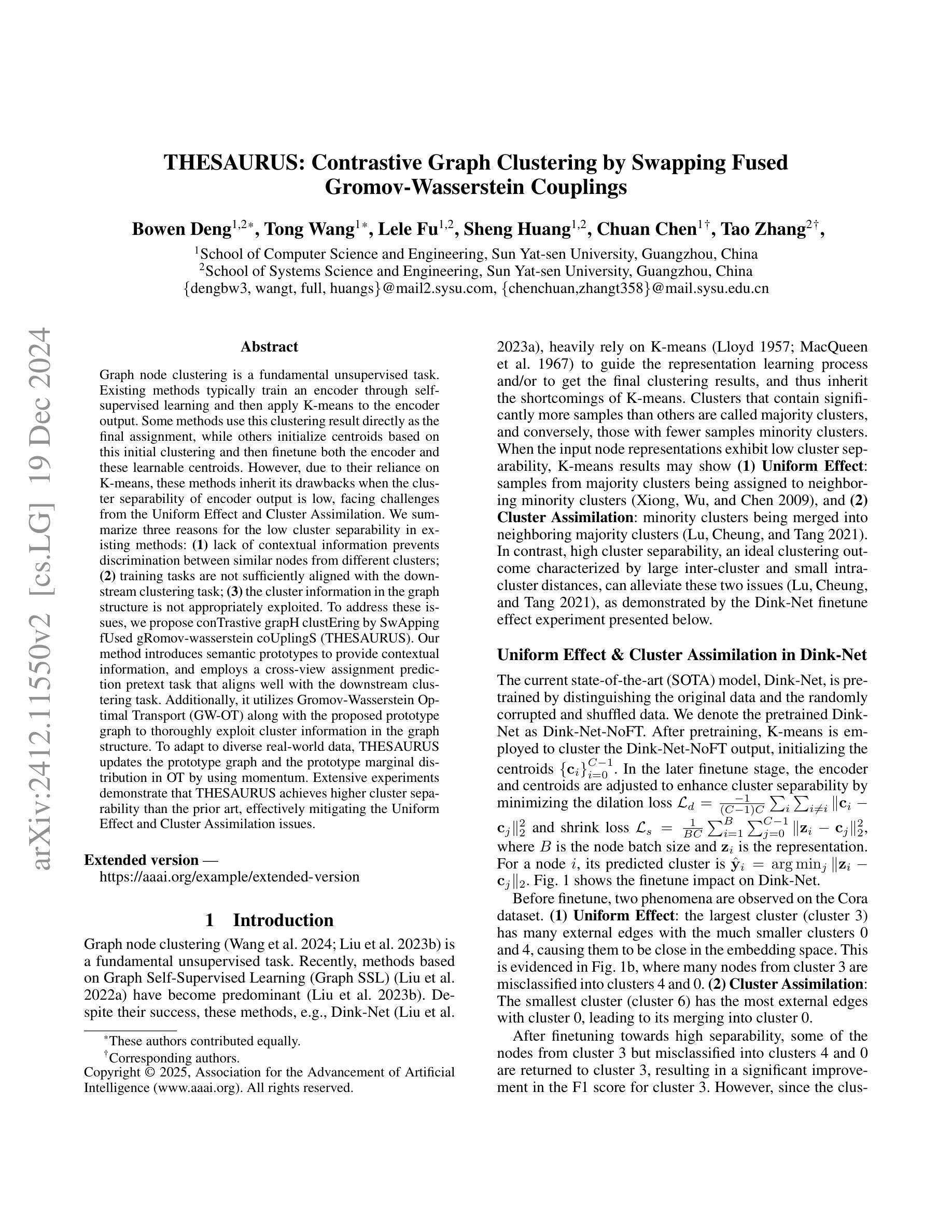

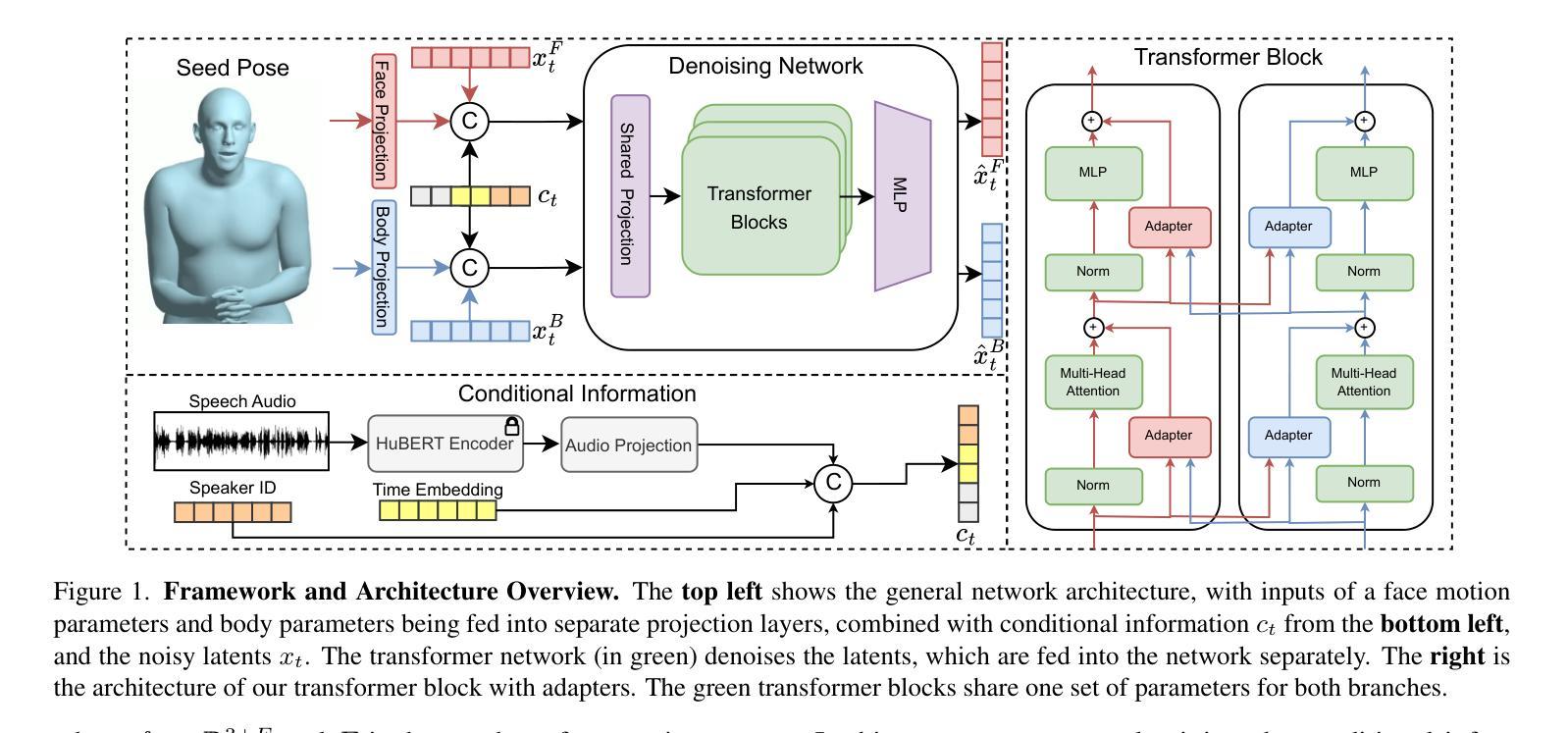

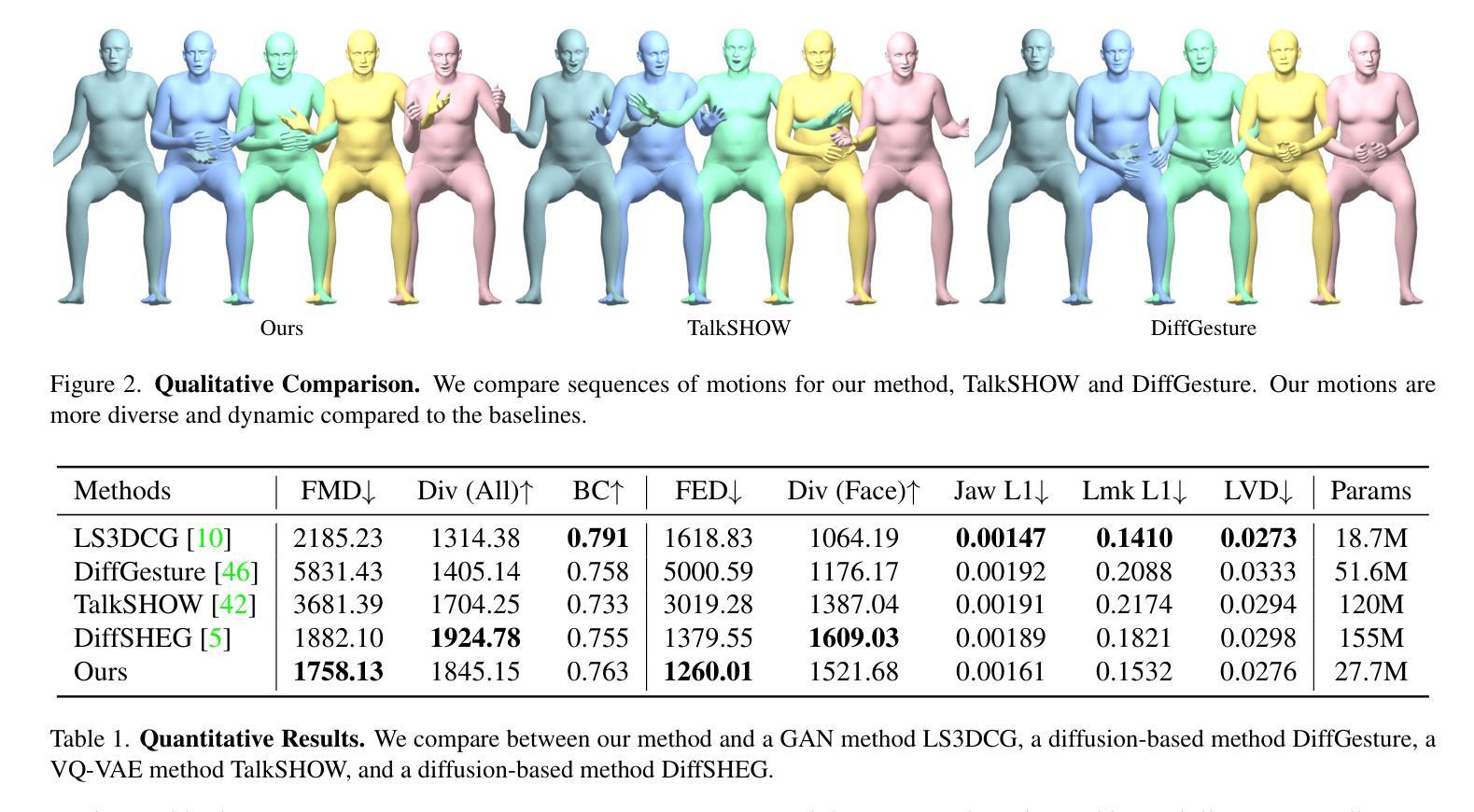

Recent advances in co-speech gesture and talking head generation have been impressive, yet most methods focus on only one of the two tasks. Those that attempt to generate both often rely on separate models or network modules, increasing training complexity and ignoring the inherent relationship between face and body movements. To address the challenges, in this paper, we propose a novel model architecture that jointly generates face and body motions within a single network. This approach leverages shared weights between modalities, facilitated by adapters that enable adaptation to a common latent space. Our experiments demonstrate that the proposed framework not only maintains state-of-the-art co-speech gesture and talking head generation performance but also significantly reduces the number of parameters required.

近期协同语音手势和谈话头部生成的进展令人印象深刻,但大多数方法只专注于其中一个任务。那些试图同时生成两者的方法通常依赖于单独的模型或网络模块,这增加了训练的复杂性,并忽略了面部和肢体动作之间的内在关系。为了解决这些挑战,本文提出了一种新型模型架构,该架构能够在单个网络中联合生成面部和肢体动作。这种方法利用模态之间的共享权重,通过适配器促进适应公共潜在空间。我们的实验表明,所提出的框架不仅保持了最先进的协同语音手势和谈话头部生成性能,而且显著减少了所需的参数数量。

论文及项目相关链接

Summary:

近期在协同语音手势和说话人头部生成方面的进展令人印象深刻,但大多数方法只关注其中一个任务。同时生成两者的方法通常依赖于单独模型或网络模块,增加了训练复杂度并忽略了面部和动作之间的内在关联。本文提出了一种新型模型架构,能够在单一网络中联合生成面部和动作,利用不同模态之间的共享权重,通过适配器实现适应共同潜在空间。实验表明,该框架不仅保持了最先进的协同语音手势和说话人头部生成性能,还大幅减少了所需参数数量。

Key Takeaways:

- 现有方法大多只关注协同语音手势或说话人头部生成中的一个任务,忽略了两者之间的联系。

- 同时生成面部和动作的方法通常使用单独模型或网络模块,增加了训练复杂度。

- 本文提出了一种新型模型架构,能够在单一网络中联合生成面部和动作。

- 该架构利用不同模态之间的共享权重,并通过适配器实现适应共同潜在空间。

- 实验表明,该框架的协同语音手势和说话人头部生成性能达到了先进水平。

- 该框架显著减少了所需参数数量。

点此查看论文截图

Typhoon 2: A Family of Open Text and Multimodal Thai Large Language Models

Authors:Kunat Pipatanakul, Potsawee Manakul, Natapong Nitarach, Warit Sirichotedumrong, Surapon Nonesung, Teetouch Jaknamon, Parinthapat Pengpun, Pittawat Taveekitworachai, Adisai Na-Thalang, Sittipong Sripaisarnmongkol, Krisanapong Jirayoot, Kasima Tharnpipitchai

This paper introduces Typhoon 2, a series of text and multimodal large language models optimized for the Thai language. The series includes models for text, vision, and audio. Typhoon2-Text builds on state-of-the-art open models, such as Llama 3 and Qwen2, and we perform continual pre-training on a mixture of English and Thai data. We employ post-training techniques to enhance Thai language performance while preserving the base models’ original capabilities. We release text models across a range of sizes, from 1 to 70 billion parameters, available in both base and instruction-tuned variants. To guardrail text generation, we release Typhoon2-Safety, a classifier enhanced for Thai cultures and language. Typhoon2-Vision improves Thai document understanding while retaining general visual capabilities, such as image captioning. Typhoon2-Audio introduces an end-to-end speech-to-speech model architecture capable of processing audio, speech, and text inputs and generating both text and speech outputs.

本文介绍了“台风 2”(Typhoon 2)系列,这是一系列针对泰语优化的文本和多模态大型语言模型。该系列包括文本、视觉和音频模型。Typhoon2-Text 建立在最新开源模型(如 Llama 3 和 Qwen2)的基础上,我们对英语和泰语数据的混合进行持续预训练。我们采用后训练技术,在提高泰语性能的同时保持基础模型的原始能力。我们发布了一系列不同大小的文本模型,参数从 1 亿到 70 亿,既有基础版本也有指令调整版本。为保障文本生成,我们发布了 Typhoon2-Safety,这是一款针对泰国文化和语言增强的分类器。Typhoon2-Vision 提高了对泰文文档的理解能力,同时保留了通用的视觉功能,例如图像标题生成。Typhoon2-Audio 引入了一种端到端的语音到语音模型架构,能够处理音频、语音和文本输入,并生成文本和语音输出。

论文及项目相关链接

PDF technical report, 55 pages

Summary

本文介绍了Typhoon 2系列文本和多模态大型语言模型,该系列模型针对泰语进行优化,包括文本、视觉和音频模型。Typhoon2-Text利用前沿开放模型如Llama 3和Qwen2构建,混合英语和泰语数据进行持续预训练。通过采用后训练技术,提高了泰语性能,同时保留了基础模型的原始能力。发布了不同规模的文本模型,包括基础型和指令调整型,并提供了泰语安全分类器。Typhoon2-Vision提高了对泰语文档的理解能力,同时保留了通用的视觉功能。Typhoon2-Audio引入了一种端到端的语音到语音模型架构,能够处理音频、语音和文本输入,并生成文本和语音输出。

Key Takeaways

- Typhoon 2系列模型是针对泰语优化的文本、视觉和音频大型语言模型。

- Typhoon2-Text基于前沿开放模型构建,并进行英语和泰语的混合预训练。

- 采用后训练技术提高泰语性能,同时保留基础模型的原始能力。

- 发布了不同规模的文本模型,包括基础型和指令调整型。

- 提供了一种泰语安全分类器用于文本生成的管理。

- Typhoon2-Vision增强了泰语文档理解能力,并保留通用视觉功能。

点此查看论文截图

ProsodyFM: Unsupervised Phrasing and Intonation Control for Intelligible Speech Synthesis

Authors:Xiangheng He, Junjie Chen, Zixing Zhang, Björn W. Schuller

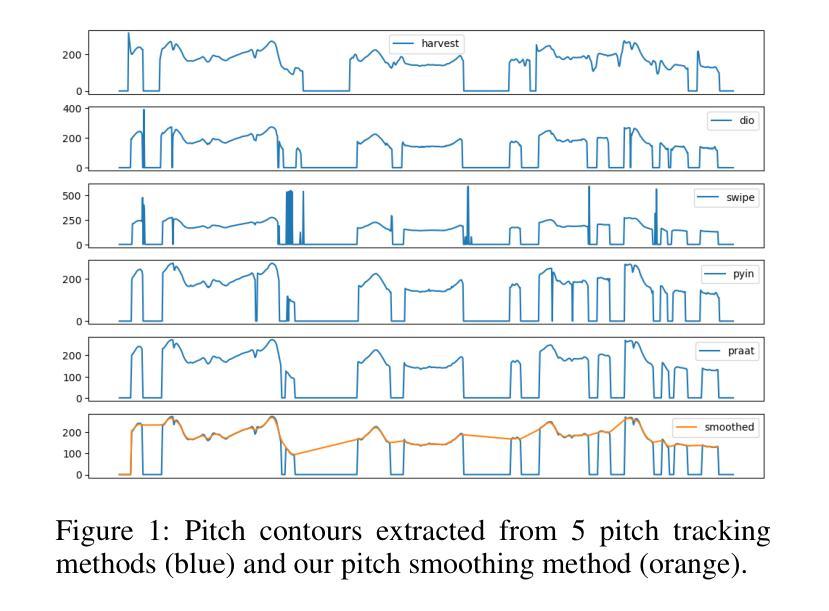

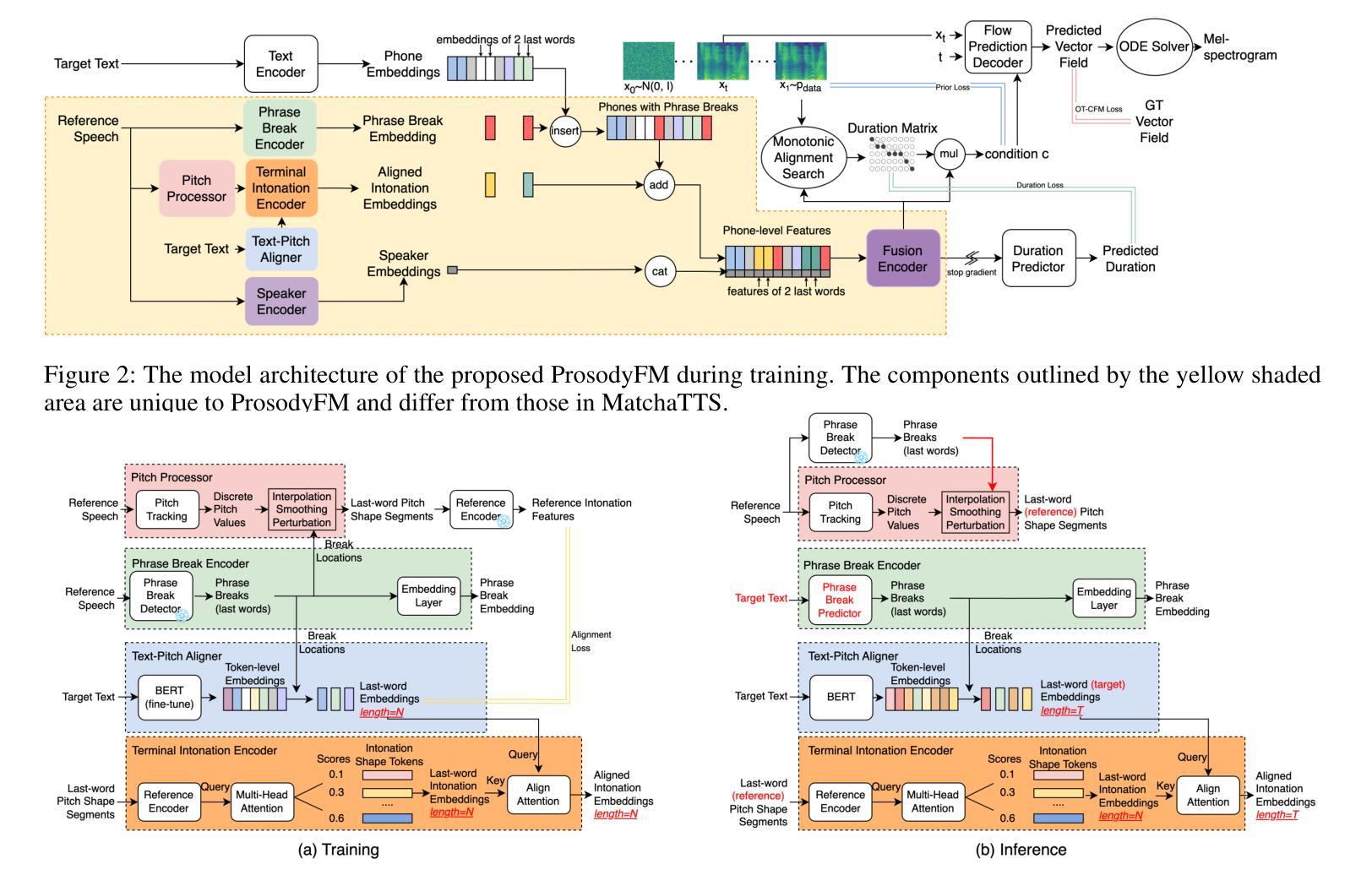

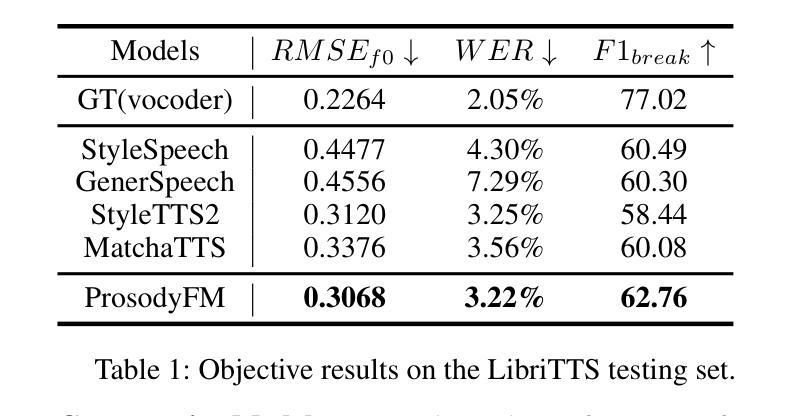

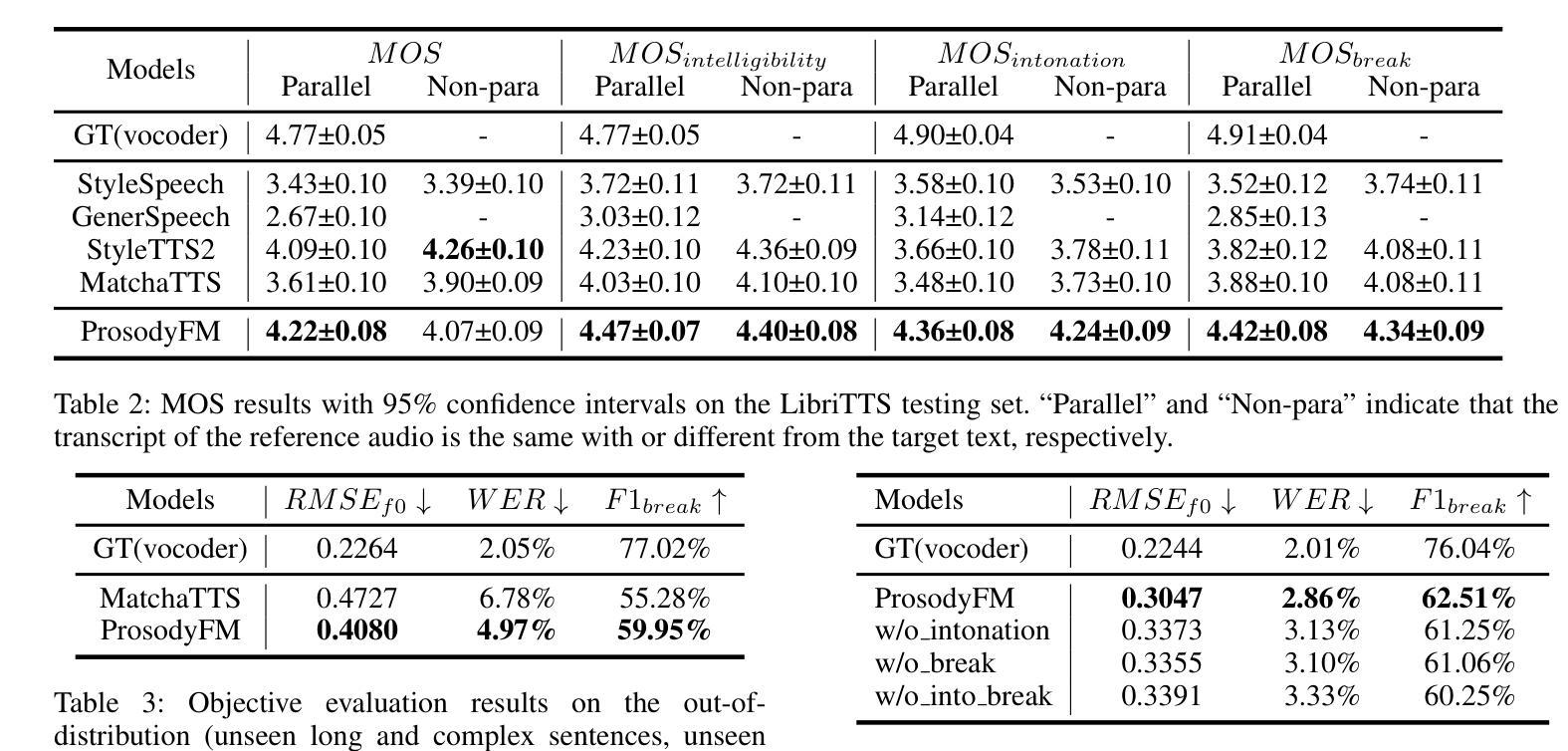

Prosody contains rich information beyond the literal meaning of words, which is crucial for the intelligibility of speech. Current models still fall short in phrasing and intonation; they not only miss or misplace breaks when synthesizing long sentences with complex structures but also produce unnatural intonation. We propose ProsodyFM, a prosody-aware text-to-speech synthesis (TTS) model with a flow-matching (FM) backbone that aims to enhance the phrasing and intonation aspects of prosody. ProsodyFM introduces two key components: a Phrase Break Encoder to capture initial phrase break locations, followed by a Duration Predictor for the flexible adjustment of break durations; and a Terminal Intonation Encoder which learns a bank of intonation shape tokens combined with a novel Pitch Processor for more robust modeling of human-perceived intonation change. ProsodyFM is trained with no explicit prosodic labels and yet can uncover a broad spectrum of break durations and intonation patterns. Experimental results demonstrate that ProsodyFM can effectively improve the phrasing and intonation aspects of prosody, thereby enhancing the overall intelligibility compared to four state-of-the-art (SOTA) models. Out-of-distribution experiments show that this prosody improvement can further bring ProsodyFM superior generalizability for unseen complex sentences and speakers. Our case study intuitively illustrates the powerful and fine-grained controllability of ProsodyFM over phrasing and intonation.

韵律包含词汇字面意义之外的丰富信息,对于语音的清晰度至关重要。当前模型在句法和语调方面仍有所不足;它们在合成具有复杂结构的长句时,不仅会遗漏或错放断句位置,而且会产生不自然的语调。我们提出了ProsodyFM,一个具有流匹配(FM)骨干的韵律感知文本到语音(TTS)合成模型,旨在增强韵律的句法和语调方面。ProsodyFM引入了两个关键组件:一个句法断句编码器,用于捕捉初始句法断句位置,随后是一个时长预测器,用于灵活地调整断句时长;以及一个终端语调编码器,它学习一系列语调形状标记,并结合一个新型音调处理器,更稳健地模拟人类感知到的语调变化。ProsodyFM不需要明确的韵律标签,但可以揭示广泛的断句时长和语调模式。实验结果表明,与四种最先进模型相比,ProsodyFM可以有效地提高韵律的句法和语调方面,从而增强整体清晰度。分布外实验表明,这种韵律改进可以进一步提高ProsodyFM对未见过的复杂句子和说话者的泛化能力。我们的案例研究直观地说明了ProsodyFM对句法和语调的强大而精细的控制能力。

论文及项目相关链接

PDF Accepted by AAAI 2025

摘要

文本中强调了韵律(Prosody)在语音中的重要性,包含超越词汇字面意义的丰富信息,对语音的清晰度至关重要。当前模型在语调和语调方面仍存在不足,不仅会在合成长句复杂结构时遗漏或错位断句,而且产生的语调也不自然。本文提出了ProsodyFM,一个具有流匹配(FM)架构的韵律感知文本到语音(TTS)合成模型,旨在提升韵律的语调和语调方面。ProsodyFM引入了两个关键组件:短语断句编码器用于捕捉初始断句位置,持续预测器用于灵活调整断句持续时间;终端语调编码器学习一系列语调形状标记,并结合新颖的音调处理器,更稳健地模拟人类感知的语调变化。ProsodyFM无需明确的韵律标签即可训练,并能发现广泛的断句持续时间和语调模式。实验结果表明,ProsodyFM能有效改善韵律的语调和语调方面,从而提高与四种最先进模型相比的整体清晰度。在超出分布的实验中,这种韵律改进进一步提高了ProsodyFM对未见过的复杂句子和说话者的泛化能力。我们的案例研究直观地说明了ProsodyFM在语调和语调方面的强大和精细可控性。

关键见解

- 韵律在语音中非常重要,包含超越词汇字面意义的丰富信息,对语音清晰度至关重要。

- 当前语音合成模型在语调和语调方面存在不足,如遗漏或错位断句,以及不自然的语调。

- 提出了一种新的TTS模型ProsodyFM,具有流匹配(FM)架构,旨在改善韵律的语调和语调。

- ProsodyFM引入了两个关键组件:短语断句编码器和终端语调编码器。

- ProsodyFM无需明确的韵律标签即可训练,并能发现广泛的断句持续时间和语调模式。

- 实验结果表明,ProsodyFM有效提高语音清晰度,相较于四种最先进模型有更佳表现。

点此查看论文截图