⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2024-12-26 更新

Hardware-aware Circuit Cutting and Distributed Qubit Mapping for Connected Quantum Systems

Authors:Zefan Du, Yanni Li, Zijian Mo, Wenqi Wei, Juntao Chen, Rajkumar Buyya, Ying Mao

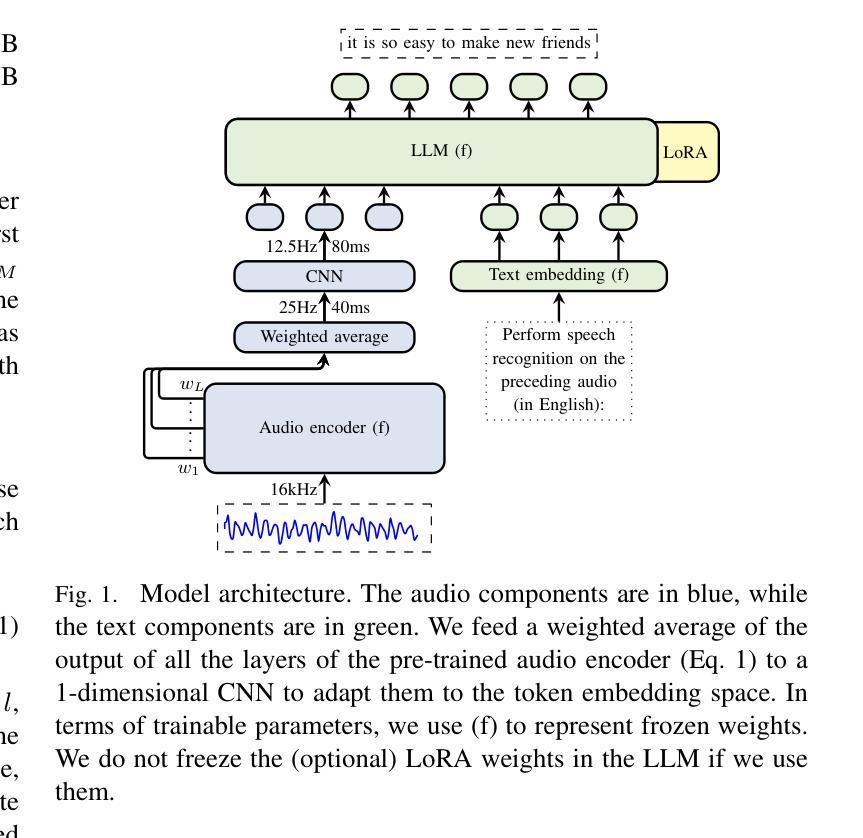

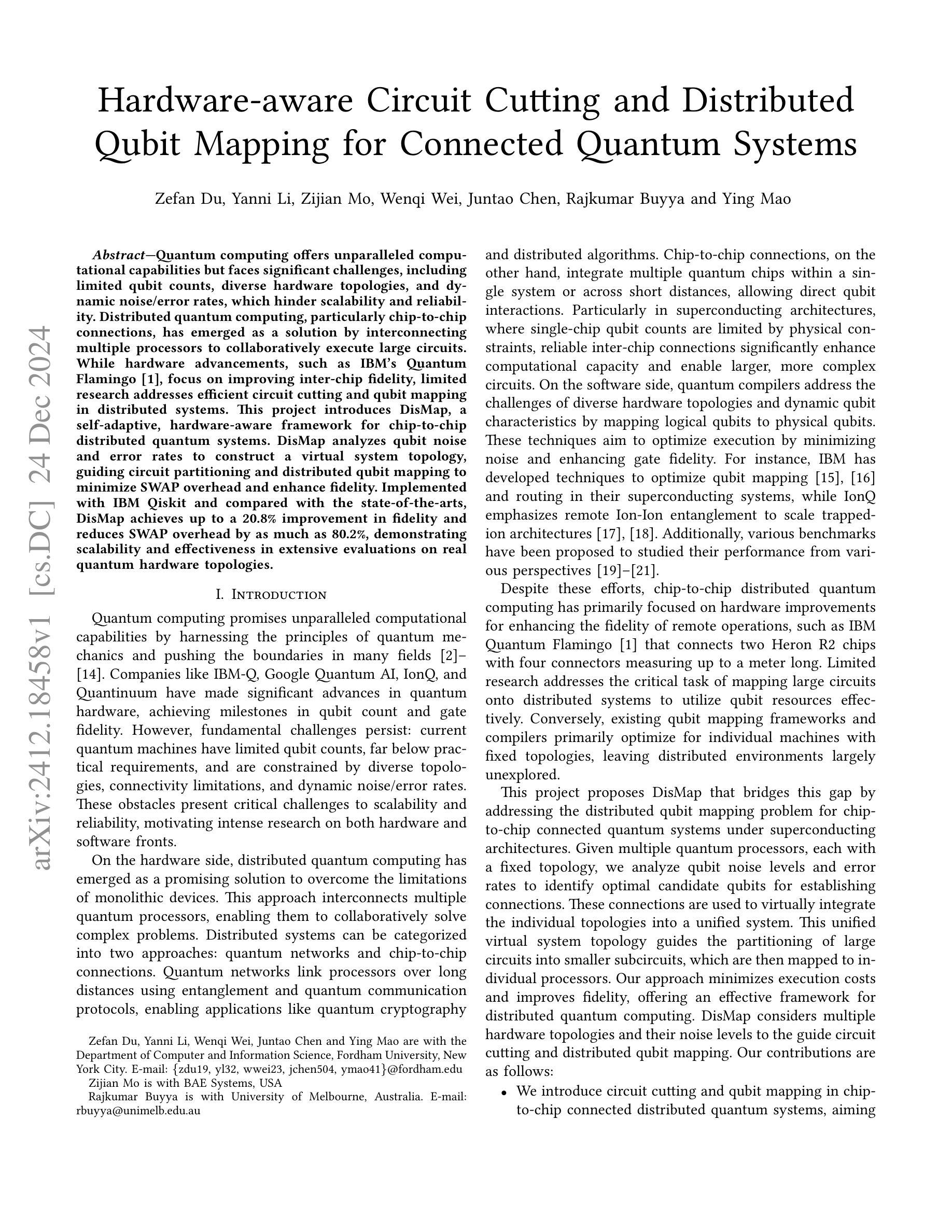

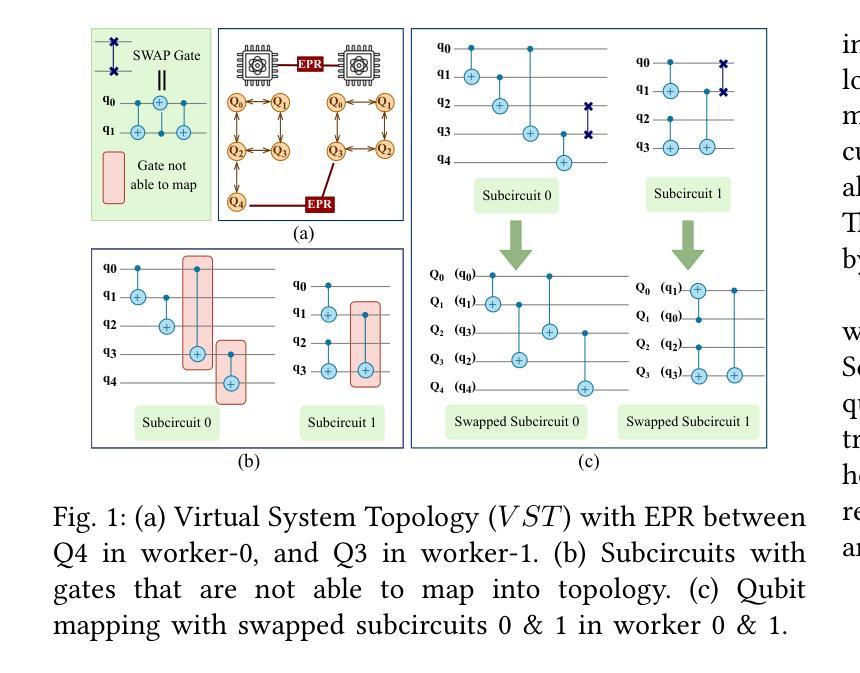

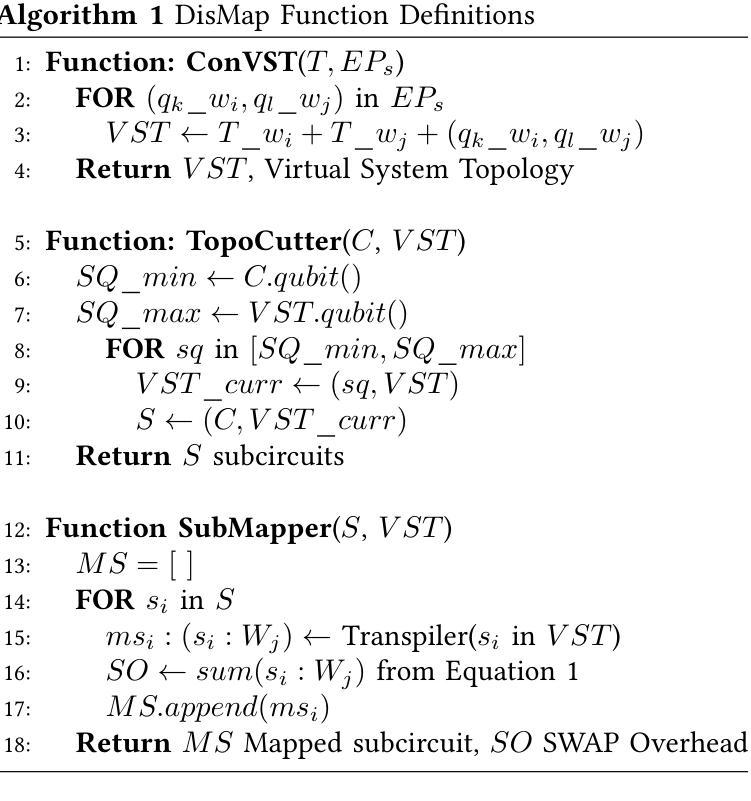

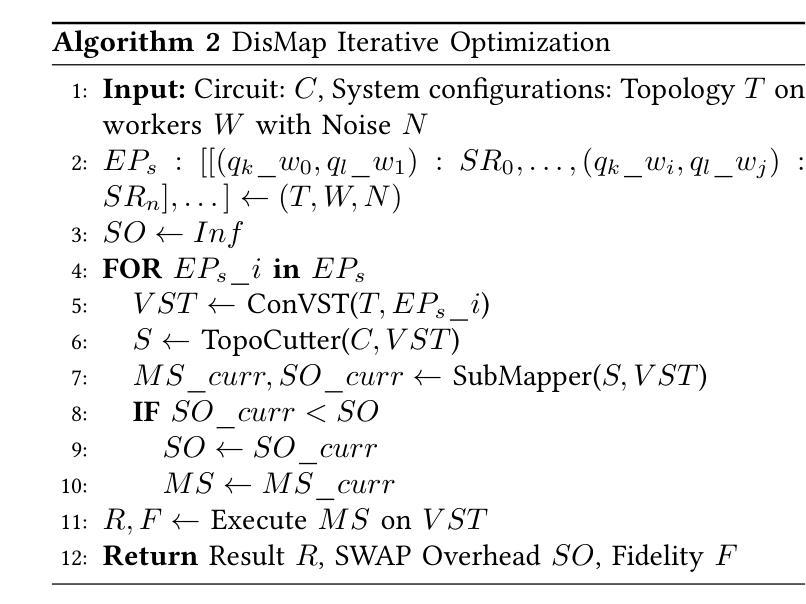

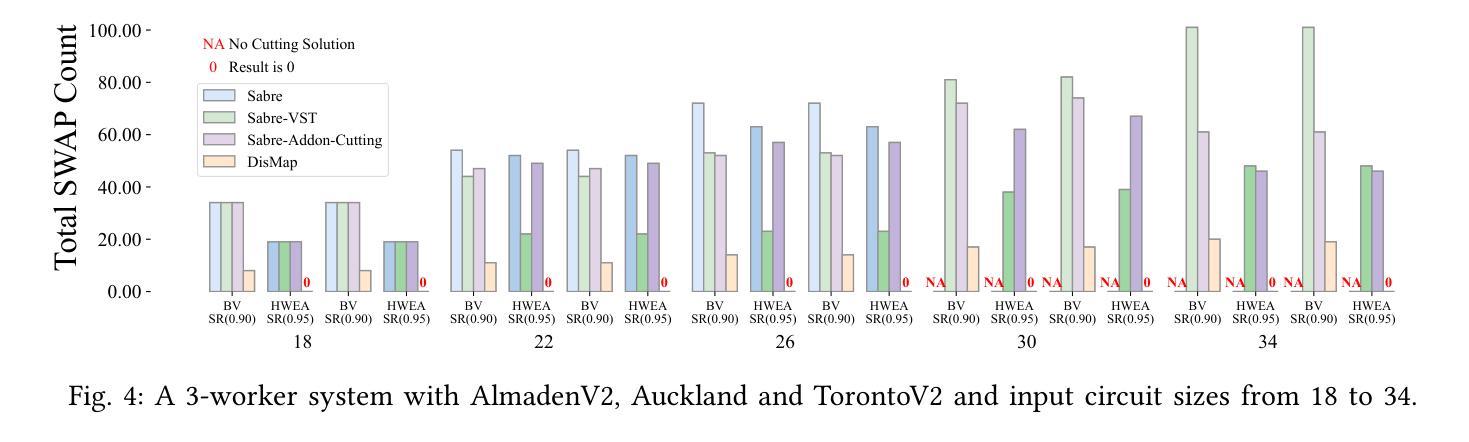

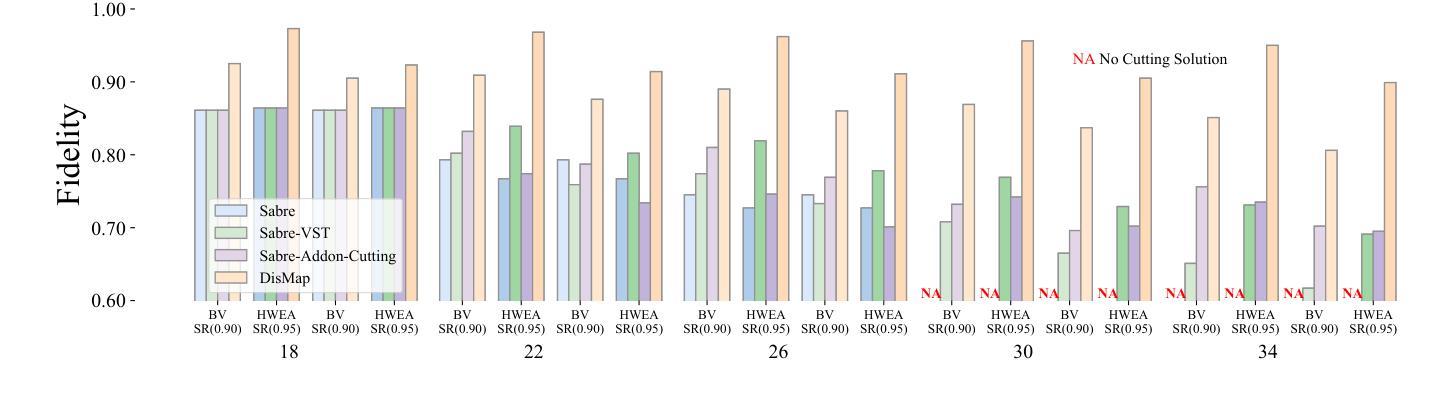

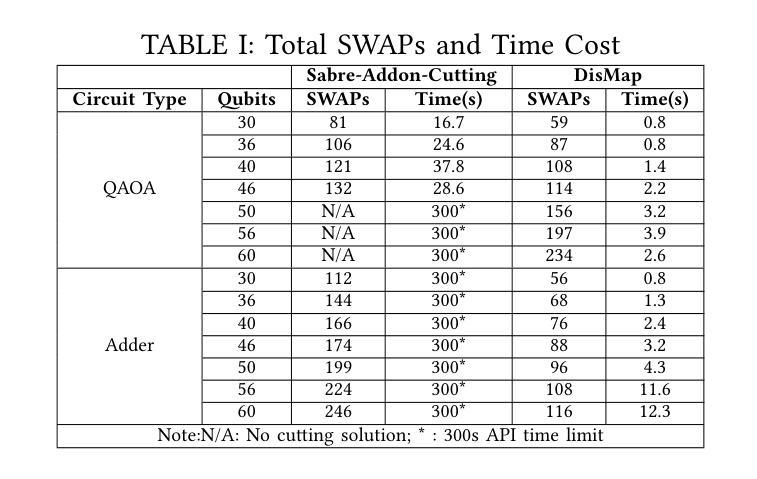

Quantum computing offers unparalleled computational capabilities but faces significant challenges, including limited qubit counts, diverse hardware topologies, and dynamic noise/error rates, which hinder scalability and reliability. Distributed quantum computing, particularly chip-to-chip connections, has emerged as a solution by interconnecting multiple processors to collaboratively execute large circuits. While hardware advancements, such as IBM’s Quantum Flamingo, focus on improving inter-chip fidelity, limited research addresses efficient circuit cutting and qubit mapping in distributed systems. This project introduces DisMap, a self-adaptive, hardware-aware framework for chip-to-chip distributed quantum systems. DisMap analyzes qubit noise and error rates to construct a virtual system topology, guiding circuit partitioning, and distributed qubit mapping to minimize SWAP overhead and enhance fidelity. Implemented with IBM Qiskit and compared with the state-of-the-art, DisMap achieves up to a 20.8% improvement in fidelity and reduces SWAP overhead by as much as 80.2%, demonstrating scalability and effectiveness in extensive evaluations on real quantum hardware topologies.

量子计算提供了无与伦比的计算能力,但面临着巨大的挑战,包括有限的量子比特数、各种硬件拓扑结构和动态噪声/错误率,这些限制了其可扩展性和可靠性。分布式量子计算,特别是芯片间连接,通过相互连接多个处理器来协同执行大型电路,已成为一种解决方案。虽然硬件进步,如IBM的量子火烈鸟(Quantum Flamingo),侧重于提高芯片间保真度,但关于分布式系统中高效电路切割和量子比特映射的研究仍然有限。本项目引入了DisMap,这是一个自适应的、面向硬件的芯片间分布式量子系统框架。DisMap分析量子比特的噪声和错误率来构建虚拟系统拓扑结构,指导电路分区和分布式量子比特映射,以最小化SWAP开销并提高保真度。使用IBM Qiskit实现并与最新技术相比,DisMap在真实量子硬件拓扑的广泛评估中实现了高达20.8%的保真度提升,并将SWAP开销减少了8.提升了高达2%。这表明其在可扩展性和有效性方面表现出色。

论文及项目相关链接

总结

量子计算面临诸如有限量子比特数量、多样化的硬件拓扑结构和动态噪声/错误率等挑战,限制了其可扩展性和可靠性。分布式量子计算通过连接多个处理器来协同执行大型电路,为解决这些问题提供了一种解决方案。本项目介绍了一种名为DisMap的硬件感知框架,用于芯片间分布式量子系统。DisMap分析量子比特的噪声和错误率来构建虚拟系统拓扑结构,引导电路分区和分布式量子比特映射,以最小化SWAP开销并增强保真度。与现有技术相比,DisMap在实际量子硬件拓扑的广泛评估中实现了高达20.8%的保真度提升,并将SWAP开销减少了高达80.2%,证明了其在可扩展性和有效性方面的优势。

关键见解

- 量子计算面临有限量子比特数量、硬件拓扑多样化和动态噪声/错误率的挑战。

- 分布式量子计算通过连接多个处理器来协同执行大型电路,为解决上述问题提供了一种解决方案。

- DisMap框架用于芯片间分布式量子系统,具备硬件感知能力。

- DisMap通过分析量子比特的噪声和错误率来构建虚拟系统拓扑结构。

- DisMap能够引导电路分区和分布式量子比特映射,以最小化SWAP开销并增强运算的保真度。

- 在实际量子硬件拓扑的评估中,DisMap实现了较高的保真度提升和显著的SWAP开销减少。

点此查看论文截图

KunServe: Elastic and Efficient Large Language Model Serving with Parameter-centric Memory Management

Authors:Rongxin Cheng, Yifan Peng, Yuxin Lai, Xingda Wei, Rong Chen, Haibo Chen

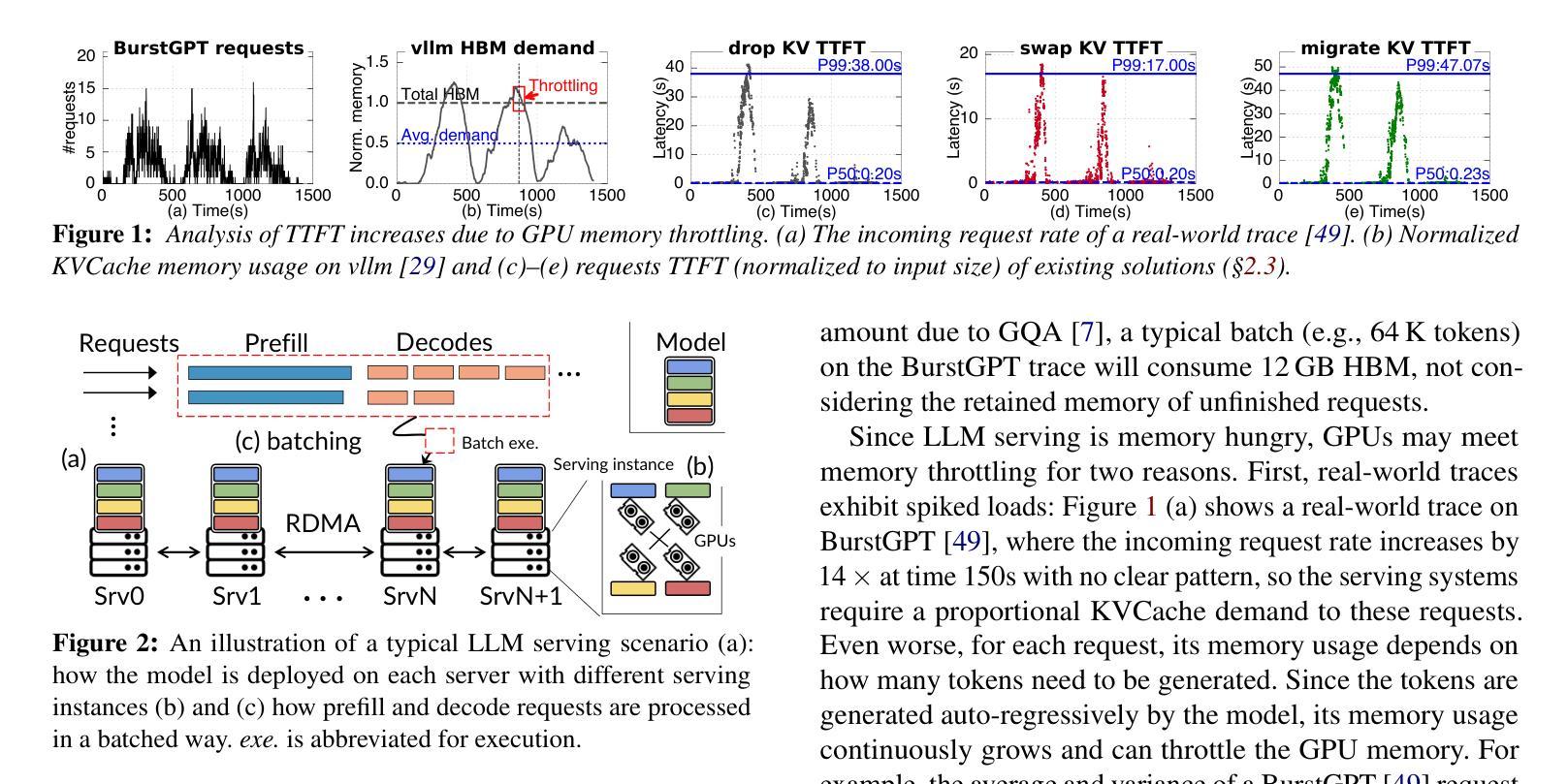

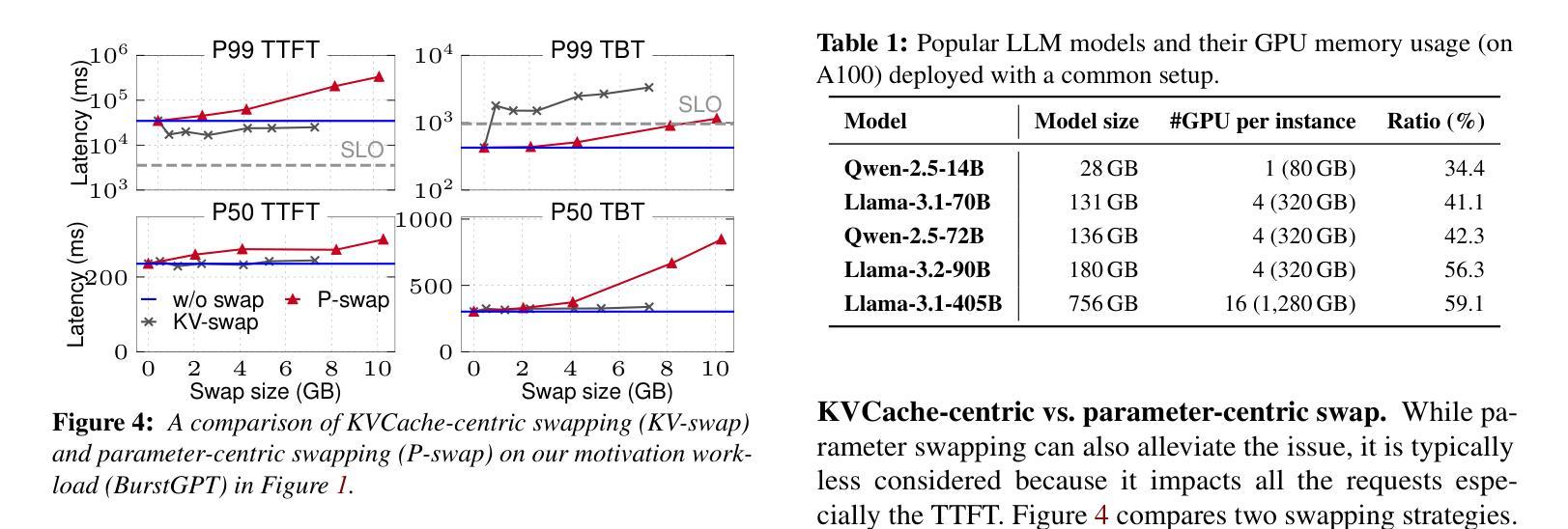

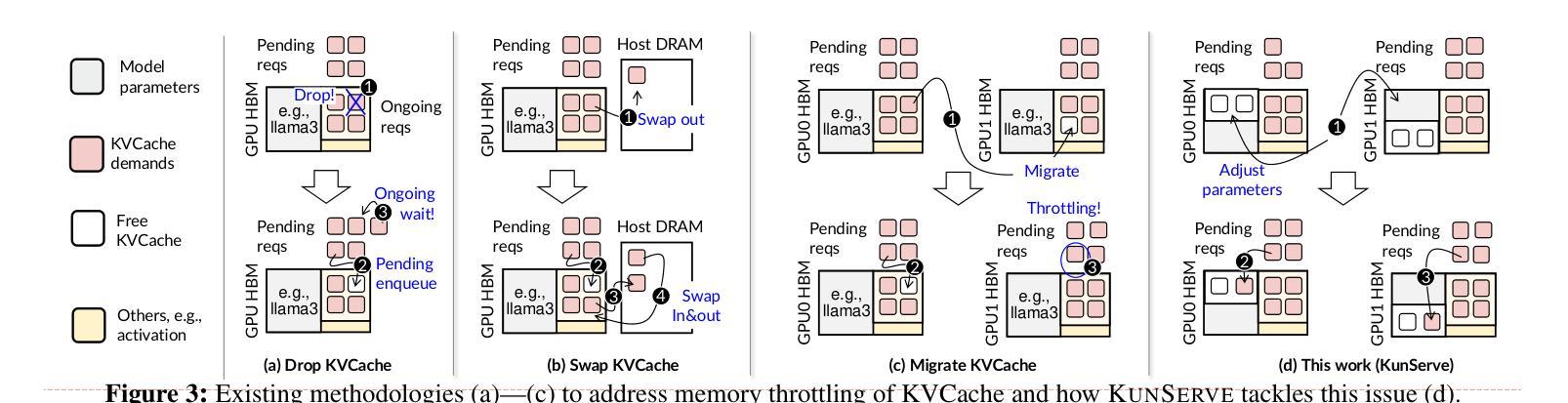

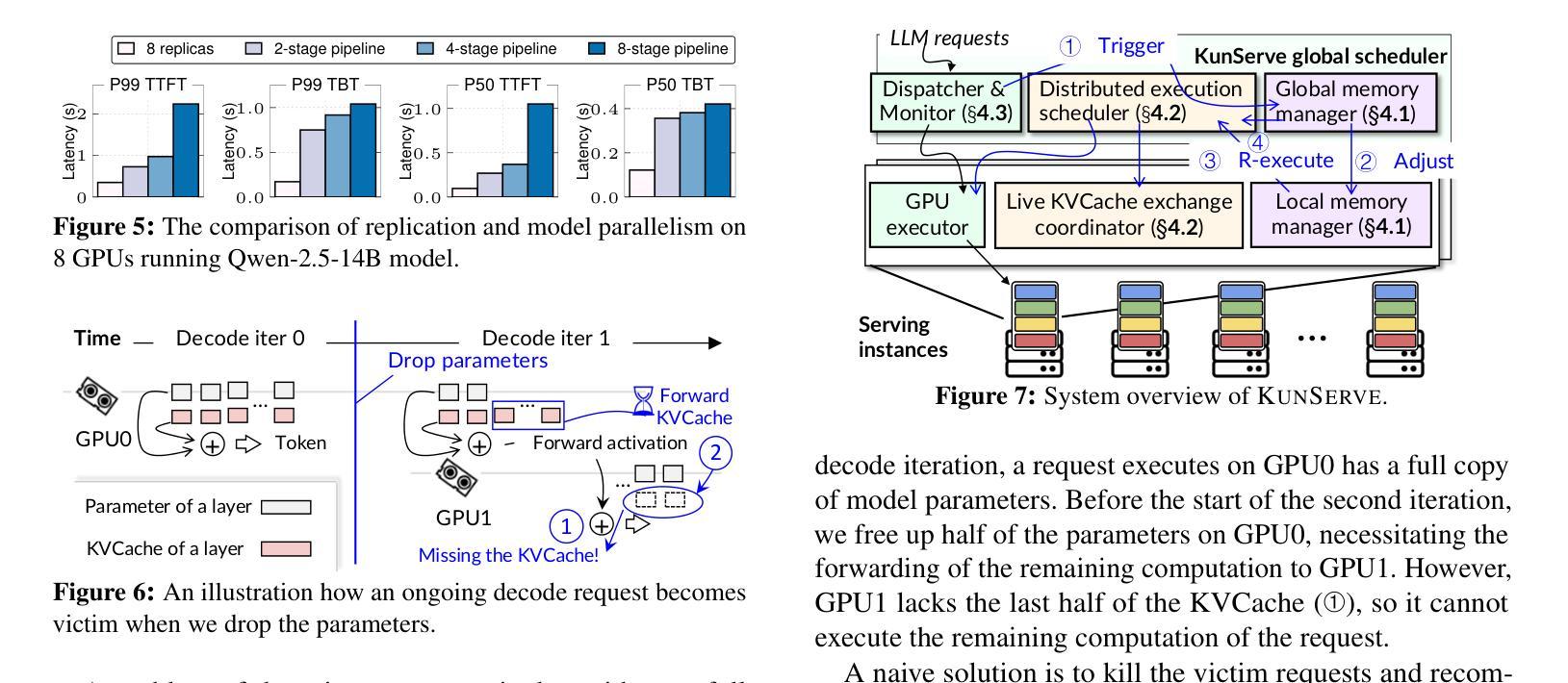

The stateful nature of large language model (LLM) servingcan easily throttle precious GPU memory under load burstor long-generation requests like chain-of-thought reasoning,causing latency spikes due to queuing incoming requests. However, state-of-the-art KVCache centric approaches handleload spikes by dropping, migrating, or swapping KVCache,which faces an essential tradeoff between the performance ofongoing vs. incoming requests and thus still severely violatesSLO.This paper makes a key observation such that model param-eters are independent of the requests and are replicated acrossGPUs, and thus proposes a parameter-centric approach byselectively dropping replicated parameters to leave preciousmemory for requests. However, LLM requires KVCache tobe saved in bound with model parameters and thus droppingparameters can cause either huge computation waste or longnetwork delay, affecting all ongoing requests. Based on the ob-servation that attention operators can be decoupled from otheroperators, this paper further proposes a novel remote attentionmechanism through pipeline parallelism so as to serve up-coming requests with the additional memory borrowed fromparameters on remote GPUs. This paper further addresses sev-eral other challenges including lively exchanging KVCachewith incomplete parameters, generating an appropriate planthat balances memory requirements with cooperative exe-cution overhead, and seamlessly restoring parameters whenthe throttling has gone. Evaluations show thatKUNSERVEreduces the tail TTFT of requests under throttling by up to 27.3x compared to the state-of-the-art.

大型语言模型(LLM)的有状态性质在服务过程中,在应对负载冲击或长时生成请求(如链式思维推理)时,容易占用宝贵的GPU内存资源,从而导致因排队延迟造成请求延迟高峰。然而,最新的以KVCache为中心的方法通过丢弃、迁移或交换KVCache来处理负载高峰,这在处理持续进行和即将到来的请求之间性能权衡方面面临重大挑战,因此仍然严重违反SLO。本文作出一个重要观察,即模型参数独立于请求且可跨GPU进行复制,因此提出了以参数为中心的方法,通过选择性丢弃复制参数为请求留下宝贵内存。然而,LLM要求将KVCache与模型参数绑定保存,因此丢弃参数可能会导致巨大的计算浪费或网络延迟过长,影响所有正在进行的请求。基于注意力运算符可以与其他运算符解耦的观察,本文进一步提出了一种新的远程注意力机制,通过管道并行性服务来处理即将到来的请求,并借用远程GPU上的参数来提供额外的内存。本文还解决了其他几个挑战,包括与不完整参数进行活跃的KVCache交换、生成平衡内存需求和协同执行开销的适当计划、以及在发生节流时无缝恢复参数等。评估表明,KUNSERVE与最新技术相比,在节流情况下将请求的尾端TTFT减少了高达27.3倍。

论文及项目相关链接

Summary

该文探讨了大型语言模型(LLM)在服务过程中的状态特性,在面临负载突发或长时生成请求(如链式思维推理)时,容易占用宝贵的GPU内存,导致延迟峰值。当前先进的KVCache方法试图通过丢弃、迁移或交换KVCache来处理负载峰值,但这种方法在持续请求与传入请求的性能之间面临权衡,仍严重违反SLO。本文观察到模型参数独立于请求并被复制到多个GPU上,因此提出了一种以参数为中心的方法,选择性地丢弃复制的参数以释放内存供请求使用。然而,LLM需要模型参数与KVCache绑定保存,因此丢弃参数可能导致巨大的计算浪费或网络延迟,影响所有正在进行中的请求。文章进一步提出了一种远程注意力机制通过流水线并行性来为即将到来的请求提供服务,并从远程GPU上的参数借用额外的内存。本文还解决了其他挑战,包括与不完整参数进行活跃的KVCache交换、生成适当的计划以平衡内存需求和协作执行开销以及恢复参数等。评估显示,KUNSERVE减少了请求尾部的TTFT在节流情况下最多减少了高达27.3倍与当前先进技术相比。

Key Takeaways

- 大型语言模型(LLM)在面临负载突发或长时生成请求时,会占用大量GPU内存,导致延迟峰值。

- 当前KVCache方法在处理负载峰值时存在性能权衡问题,仍会违反SLO。

- 模型参数可以独立于请求复制到多个GPU上,因此提出了一种以参数为中心的方法来处理内存问题。

- 丢弃参数可能导致计算浪费或网络延迟,影响正在进行中的请求。

- 提出了一种远程注意力机制,通过流水线并行性为即将到来的请求提供服务,并从远程GPU借用内存。

- 文章解决了与参数不完整的KVCache交换、平衡内存需求和协作执行开销等问题。

点此查看论文截图