⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-01-08 更新

LlamaPartialSpoof: An LLM-Driven Fake Speech Dataset Simulating Disinformation Generation

Authors:Hieu-Thi Luong, Haoyang Li, Lin Zhang, Kong Aik Lee, Eng Siong Chng

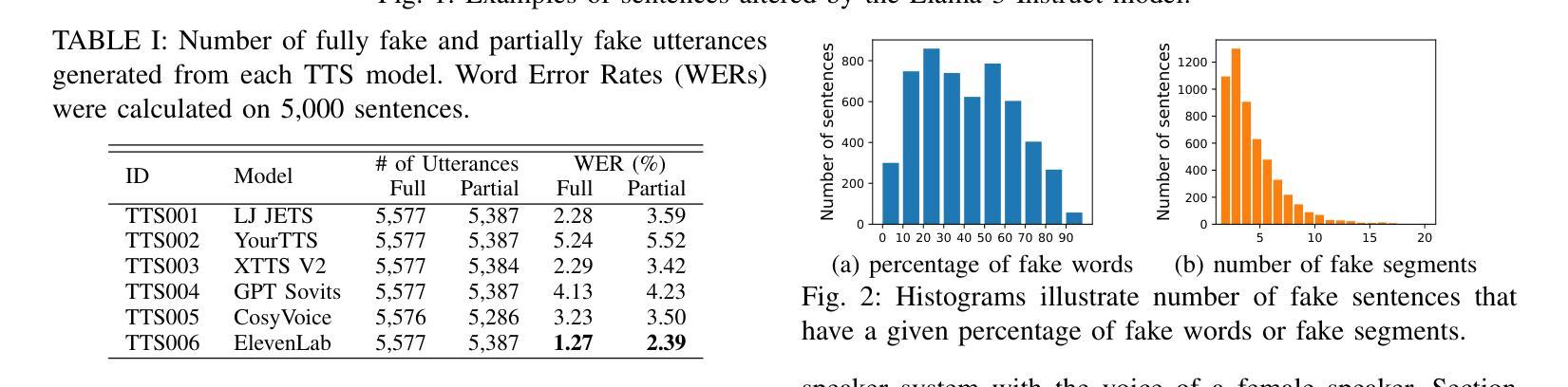

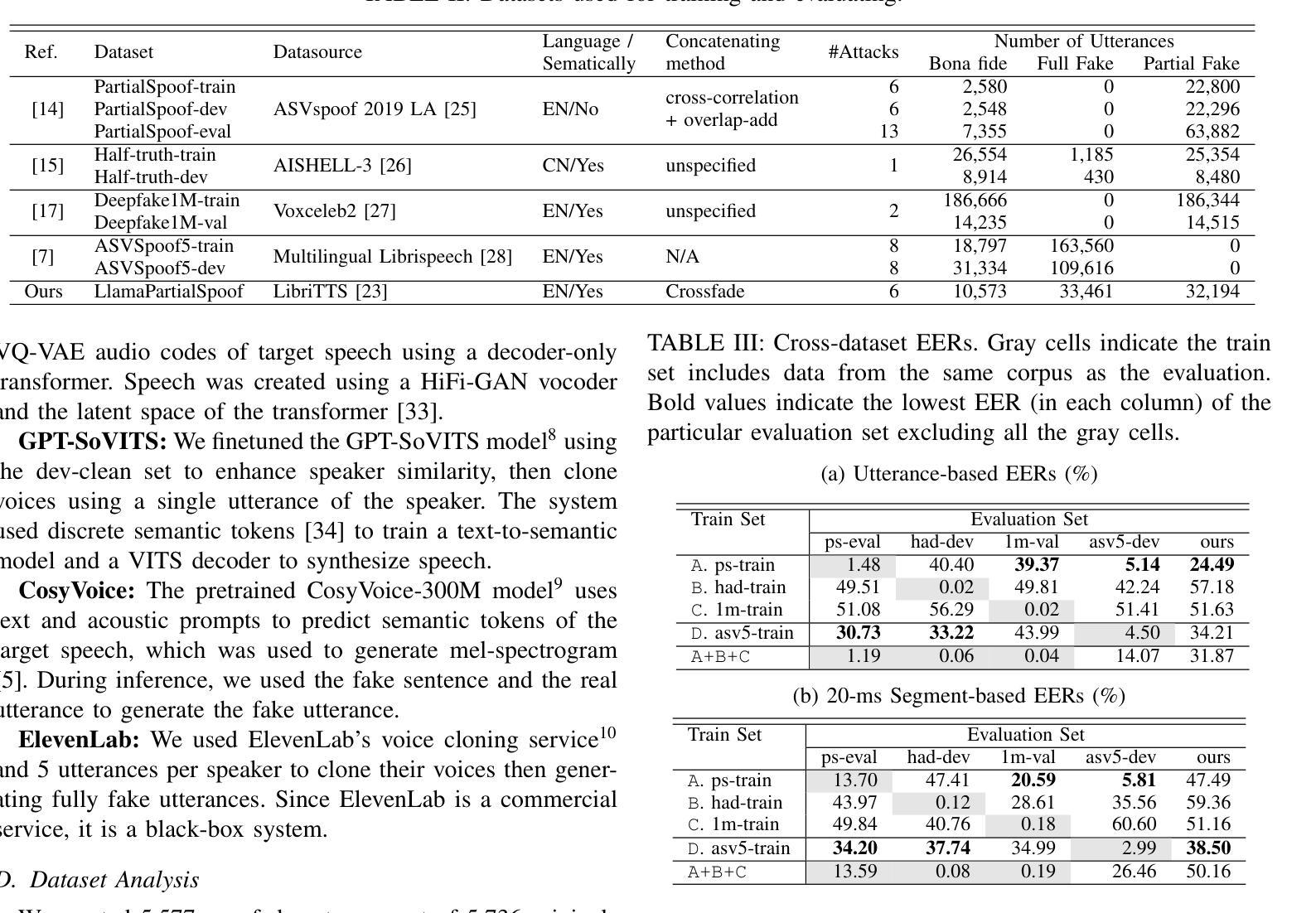

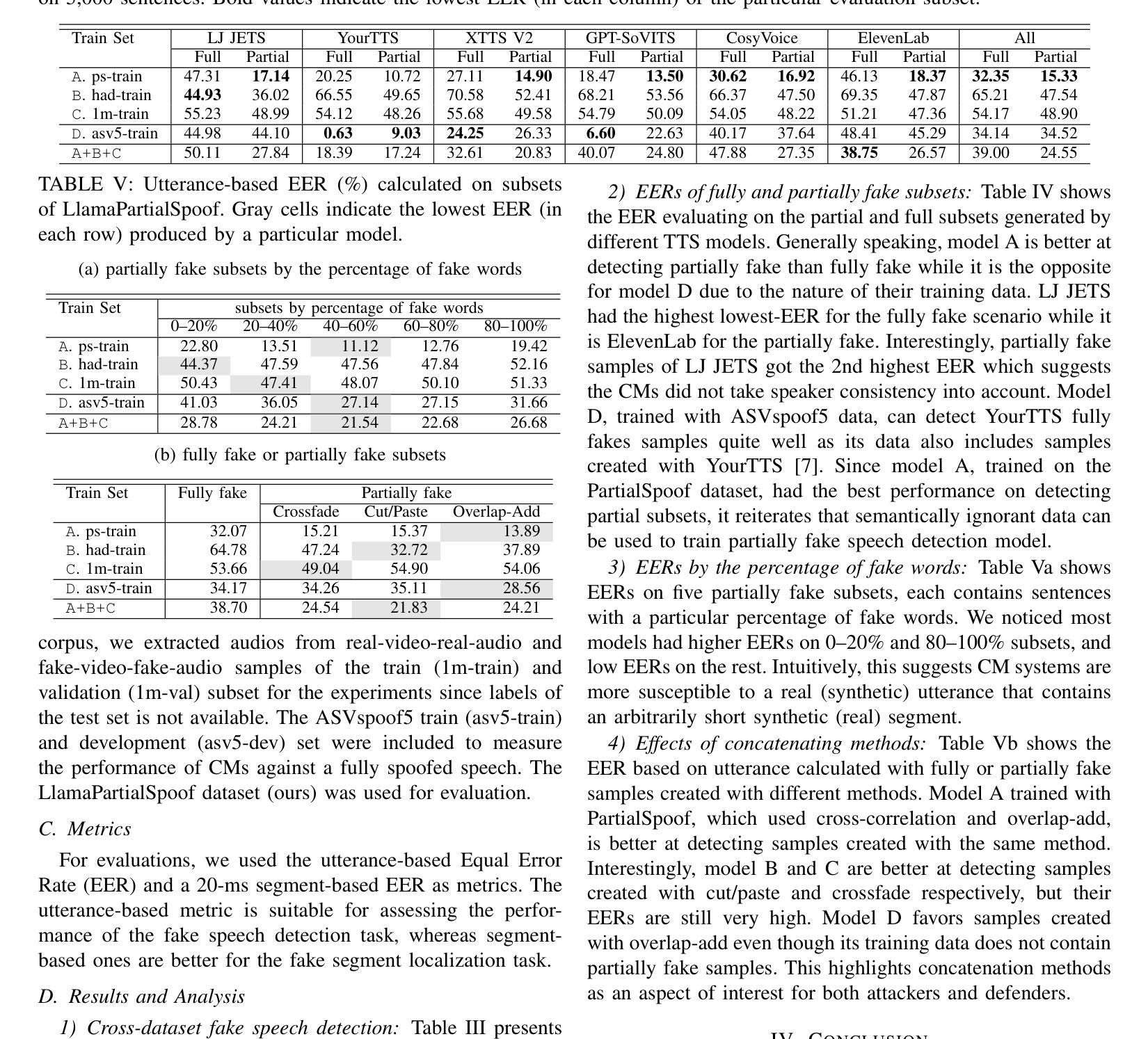

Previous fake speech datasets were constructed from a defender’s perspective to develop countermeasure (CM) systems without considering diverse motivations of attackers. To better align with real-life scenarios, we created LlamaPartialSpoof, a 130-hour dataset that contains both fully and partially fake speech, using a large language model (LLM) and voice cloning technologies to evaluate the robustness of CMs. By examining valuable information for both attackers and defenders, we identify several key vulnerabilities in current CM systems, which can be exploited to enhance attack success rates, including biases toward certain text-to-speech models or concatenation methods. Our experimental results indicate that the current fake speech detection system struggle to generalize to unseen scenarios, achieving a best performance of 24.49% equal error rate.

之前的人工语音数据集是从防御者的角度构建的,旨在开发对抗措施(CM)系统,但未考虑攻击者的不同动机。为了更好地符合现实场景,我们创建了LlamaPartialSpoof数据集,这是一个包含完全和部分人工语音的130小时数据集,利用大型语言模型(LLM)和语音克隆技术来评估对抗措施的稳健性。通过对攻击者和防御者的有价值信息进行考察,我们发现了当前对抗措施系统中的几个关键漏洞,这些漏洞可能会被利用来提高攻击成功率,包括对某些文本到语音模型的偏见或拼接方法。我们的实验结果表明,当前的人工语音检测系统难以推广到未见过的场景,最佳性能为24.49%的等误码率。

论文及项目相关链接

PDF 5 pages, ICASSP 2025

Summary

数据集的创建考虑到了攻击者的动机,推出了包含完全和局部伪造语音的LlamaPartialSpoof数据集,用于评估反措施系统的稳健性。通过分析攻击者和防御者的有价值信息,发现了当前反措施系统的关键漏洞,并指出这些漏洞可提高攻击成功率。当前假语音检测系统的泛化能力有待提高,最佳性能仅为24.49%的错误率。

Key Takeaways

- 现有假语音数据集主要关注防御者视角,缺乏考虑攻击者的多样性动机。

- 创建了名为LlamaPartialSpoof的数据集,包含完全和局部伪造语音,用于评估反措施(CM)系统的稳健性。

- 通过分析发现当前CM系统存在关键漏洞,这些漏洞可能被攻击者利用以提高攻击成功率。

- 漏洞包括对某些文本到语音模型的偏见或使用拼接方法时的缺陷。

- 实验结果表明,当前的假语音检测系统在面对未知场景时泛化能力有限。

- 最佳性能的假语音检测系统达到的错误率是24.49%。

点此查看论文截图