⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-01-18 更新

Knowledge Distillation for Image Restoration : Simultaneous Learning from Degraded and Clean Images

Authors:Yongheng Zhang, Danfeng Yan

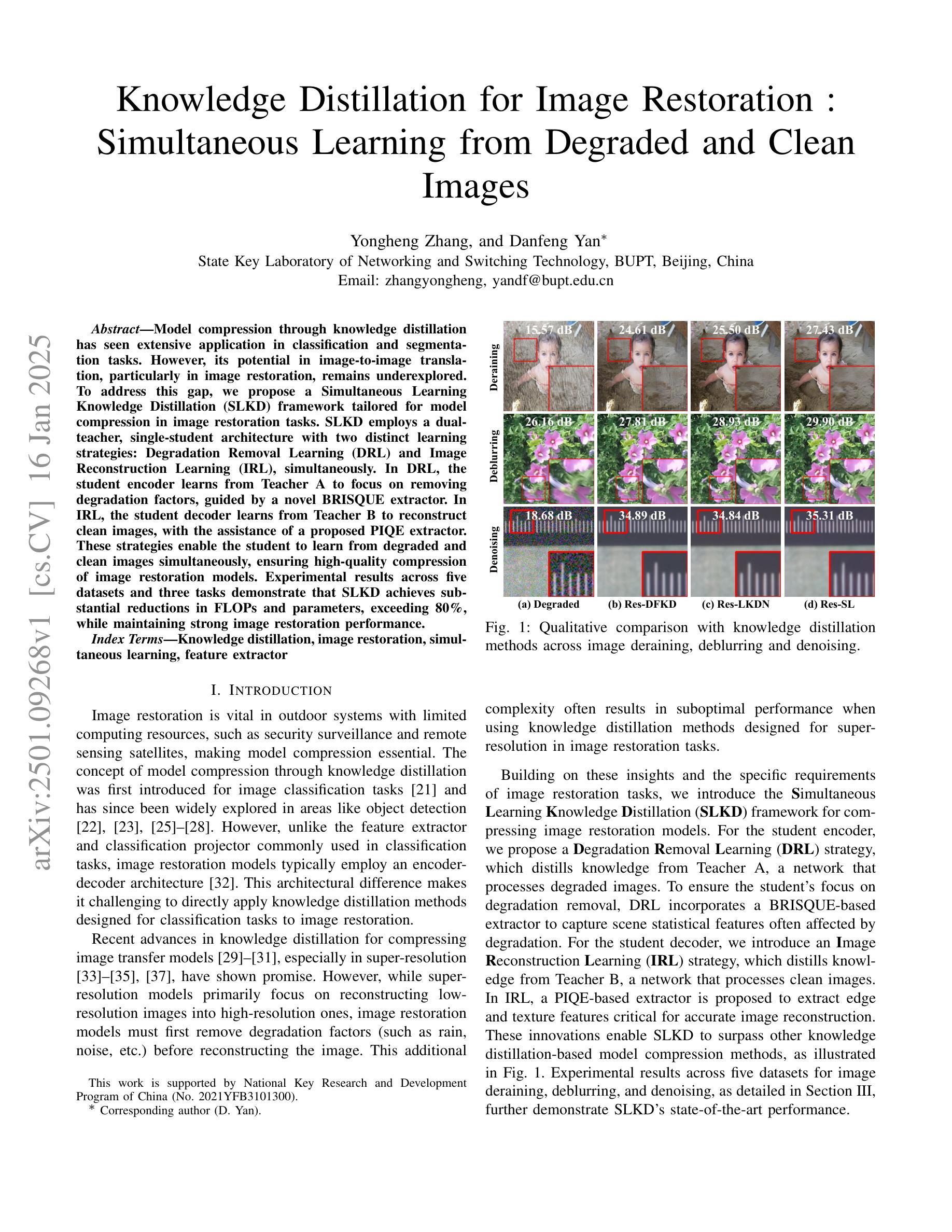

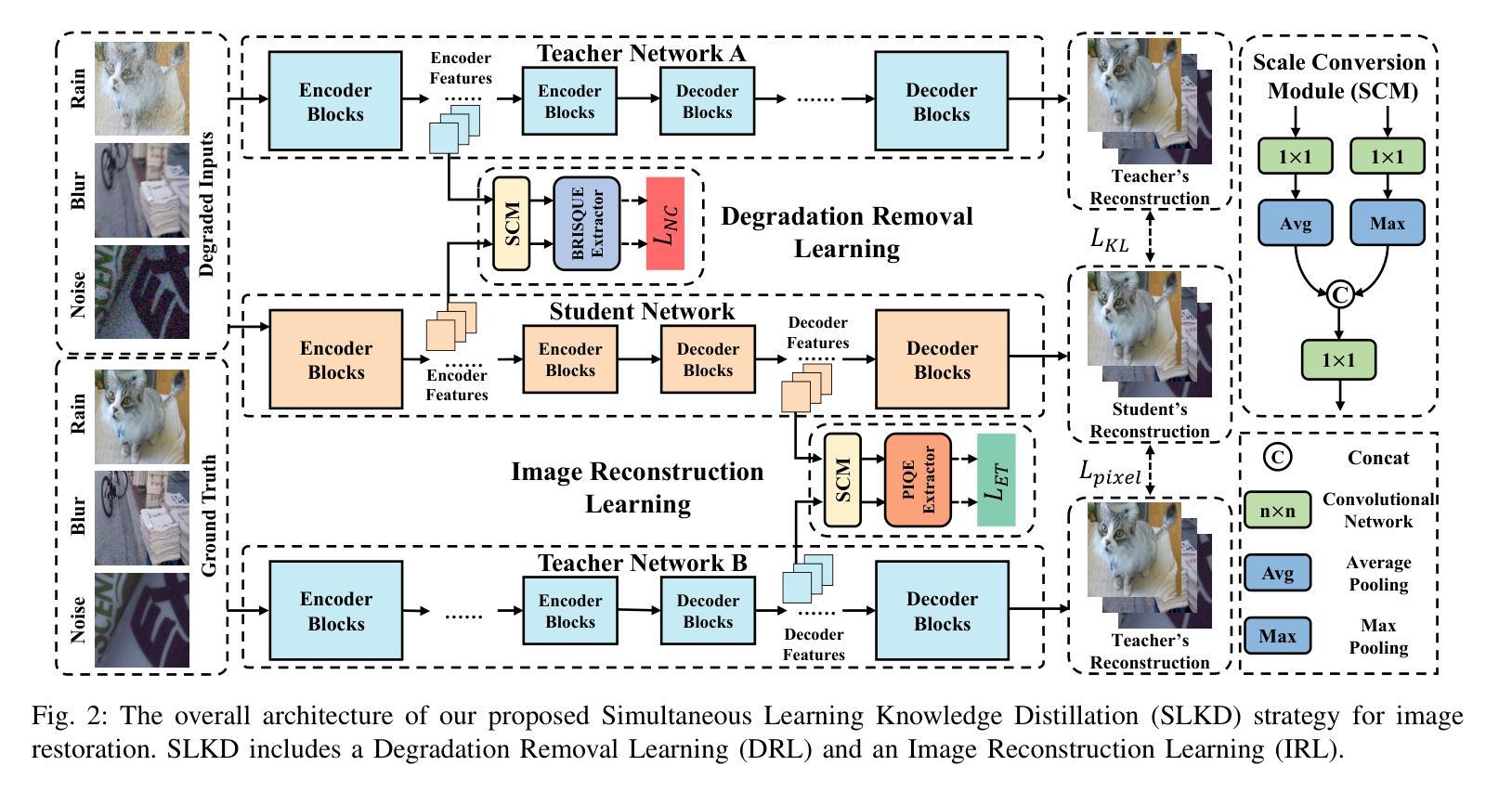

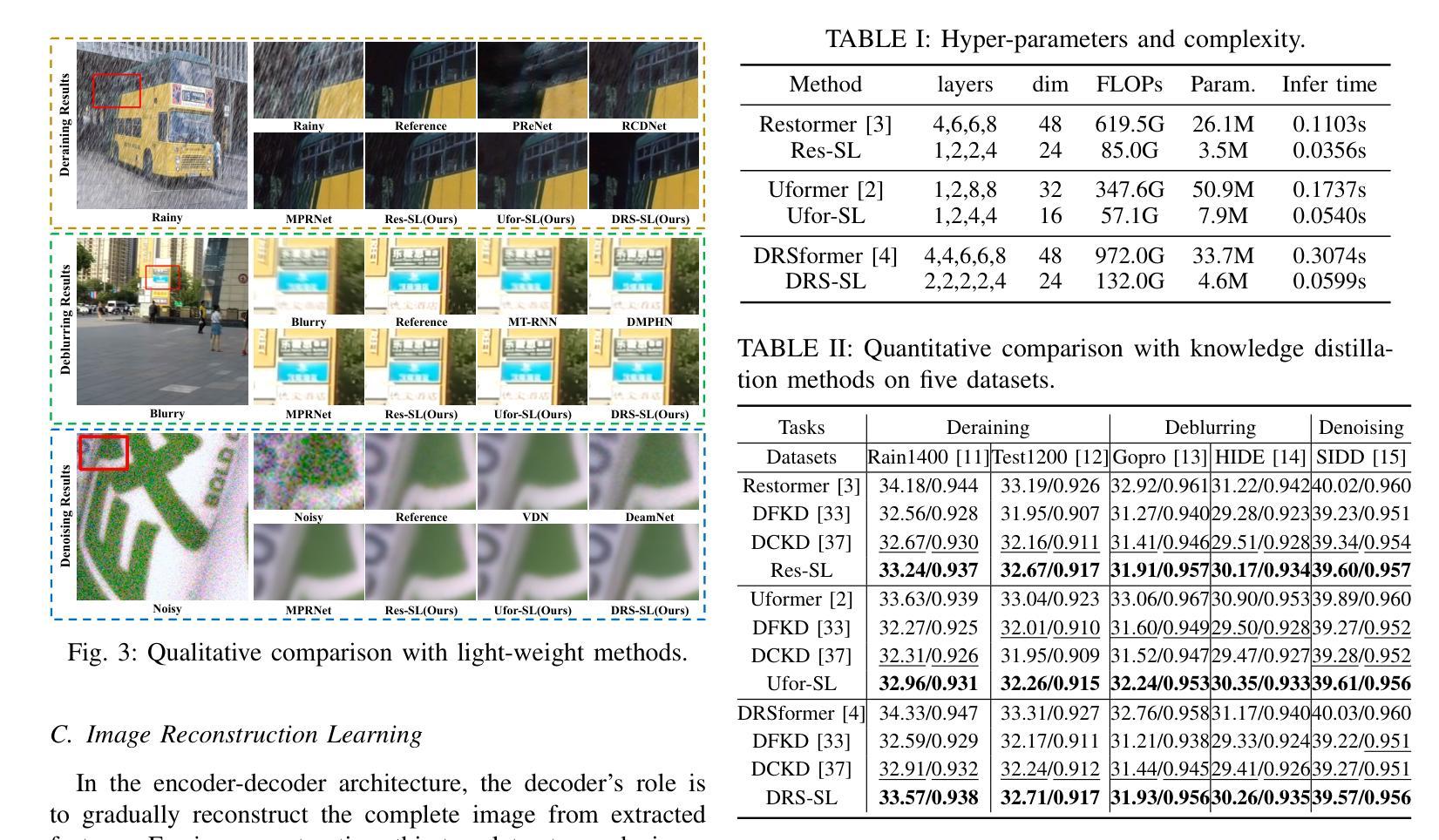

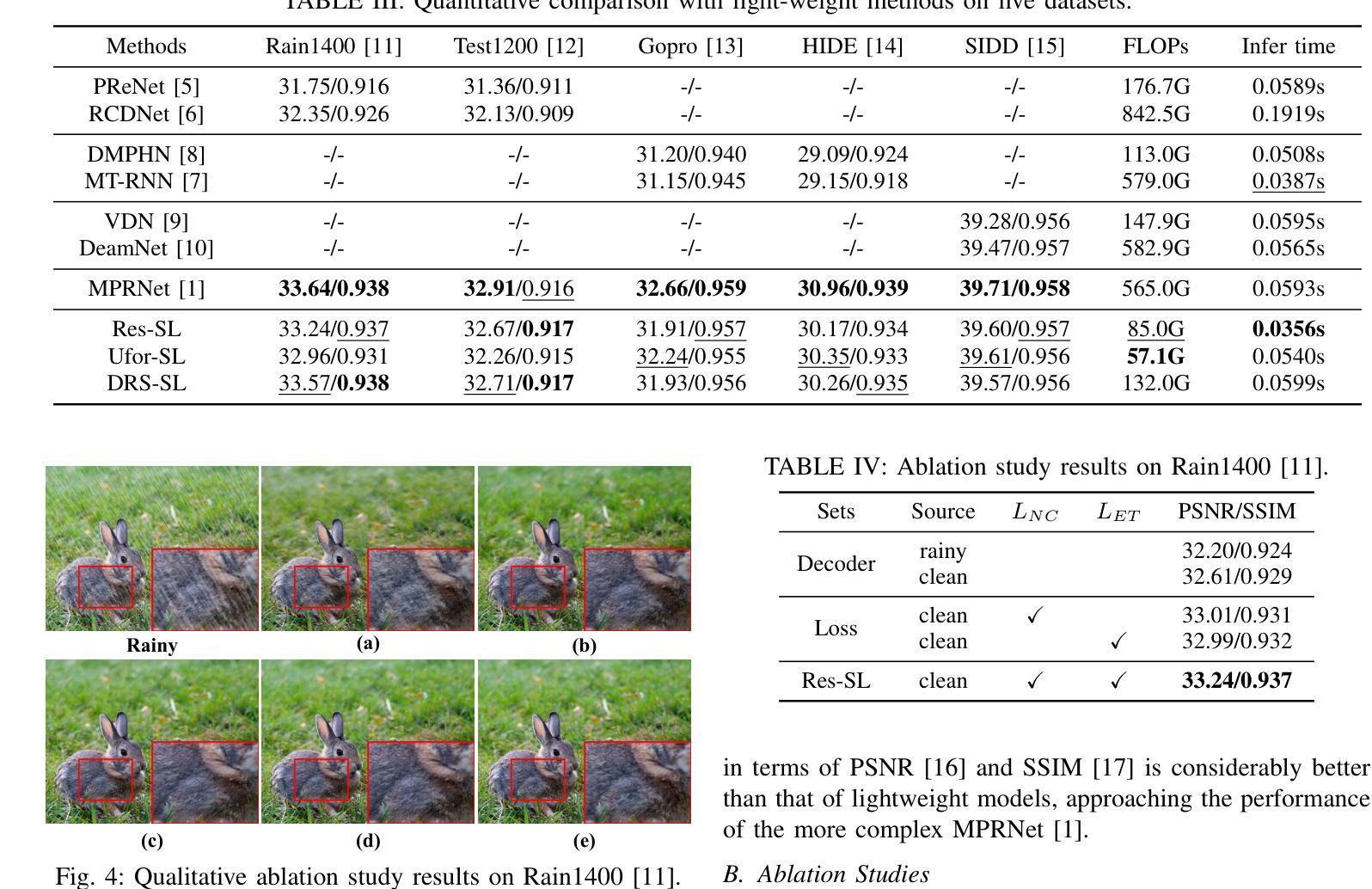

Model compression through knowledge distillation has seen extensive application in classification and segmentation tasks. However, its potential in image-to-image translation, particularly in image restoration, remains underexplored. To address this gap, we propose a Simultaneous Learning Knowledge Distillation (SLKD) framework tailored for model compression in image restoration tasks. SLKD employs a dual-teacher, single-student architecture with two distinct learning strategies: Degradation Removal Learning (DRL) and Image Reconstruction Learning (IRL), simultaneously. In DRL, the student encoder learns from Teacher A to focus on removing degradation factors, guided by a novel BRISQUE extractor. In IRL, the student decoder learns from Teacher B to reconstruct clean images, with the assistance of a proposed PIQE extractor. These strategies enable the student to learn from degraded and clean images simultaneously, ensuring high-quality compression of image restoration models. Experimental results across five datasets and three tasks demonstrate that SLKD achieves substantial reductions in FLOPs and parameters, exceeding 80%, while maintaining strong image restoration performance.

通过知识蒸馏进行模型压缩在分类和分割任务中已得到广泛应用。然而,其在图像到图像的翻译,特别是在图像恢复中的潜力尚未得到充分探索。为了弥补这一空白,我们提出了一种针对图像恢复任务模型压缩的同步学习知识蒸馏(SLKD)框架。SLKD采用双教师、单学生的架构,同时采用两种独特的学习策略:退化去除学习(DRL)和图像重建学习(IRL)。在DRL中,学生编码器从教师A中学习,专注于去除退化因素,由新型BRISQUE提取器引导。在IRL中,学生解码器从教师B中学习重建干净图像,辅以提出的PIQE提取器。这些策略使学生能够从退化和干净图像中同时学习,确保图像恢复模型的高质量压缩。在五个数据集和三个任务上的实验结果表明,SLKD在保持强大的图像恢复性能的同时,实现了高达80%以上的FLOPs和参数的大幅减少。

论文及项目相关链接

PDF Accepted by ICASSP2025

Summary

模型压缩通过知识蒸馏在分类和分割任务中得到广泛应用,但在图像到图像翻译,特别是在图像恢复方面的潜力尚未得到充分探索。为解决这一空白,本文提出了针对图像恢复任务的模型压缩专用框架——同步学习知识蒸馏(SLKD)。SLKD采用双教师、单学生的架构,并辅以两种独特的学习策略:退化移除学习(DRL)和图像重建学习(IRL)。在DRL中,学生编码器从教师A中学习去除退化因素,由新型BRISQUE提取器引导;在IRL中,学生解码器从教师B中学习重建清晰图像,借助提出的PIQE提取器协助。这些策略使学生能够同时从退化图像和清晰图像中学习,确保图像恢复模型的高质量压缩。实验结果显示,SLKD在五个数据集、三个任务上实现了超过80%的FLOPs和参数的大幅减少,同时保持强大的图像恢复性能。

Key Takeaways

- 知识蒸馏在图像恢复领域的模型压缩应用尚待探索。

- 提出SLKD框架,专为图像恢复任务的模型压缩设计。

- 采用双教师、单学生的架构。

- 引入两种学习策略:DRL和IRL。

- 学生编码器从教师A学习去除退化因素,受BRISQUE提取器引导。

- 学生解码器从教师B学习重建清晰图像,借助PIQE提取器。

点此查看论文截图