⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-01-23 更新

On the “Illusion” of Gender Bias in Face Recognition: Explaining the Fairness Issue Through Non-demographic Attributes

Authors:Paul Jonas Kurz, Haiyu Wu, Kevin W. Bowyer, Philipp Terhörst

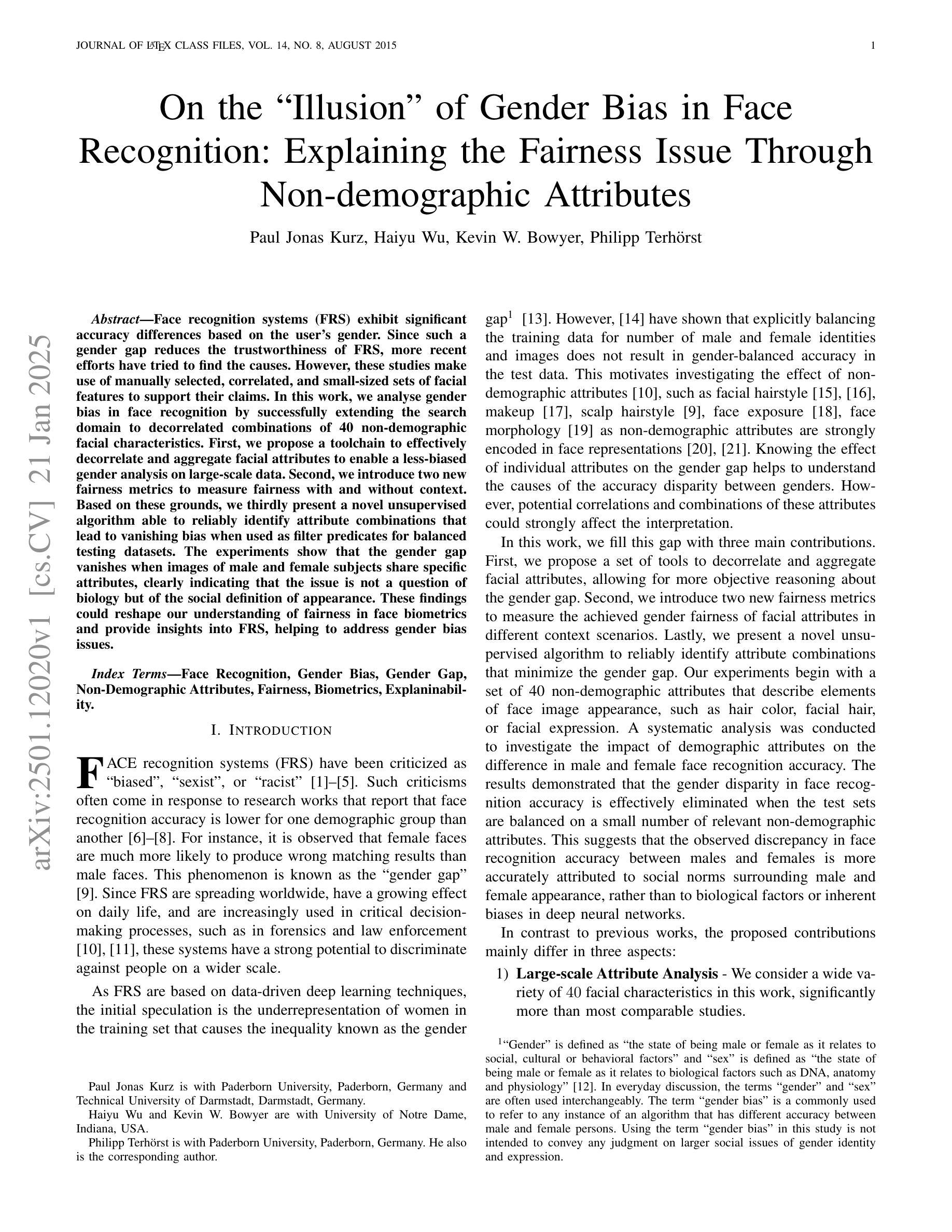

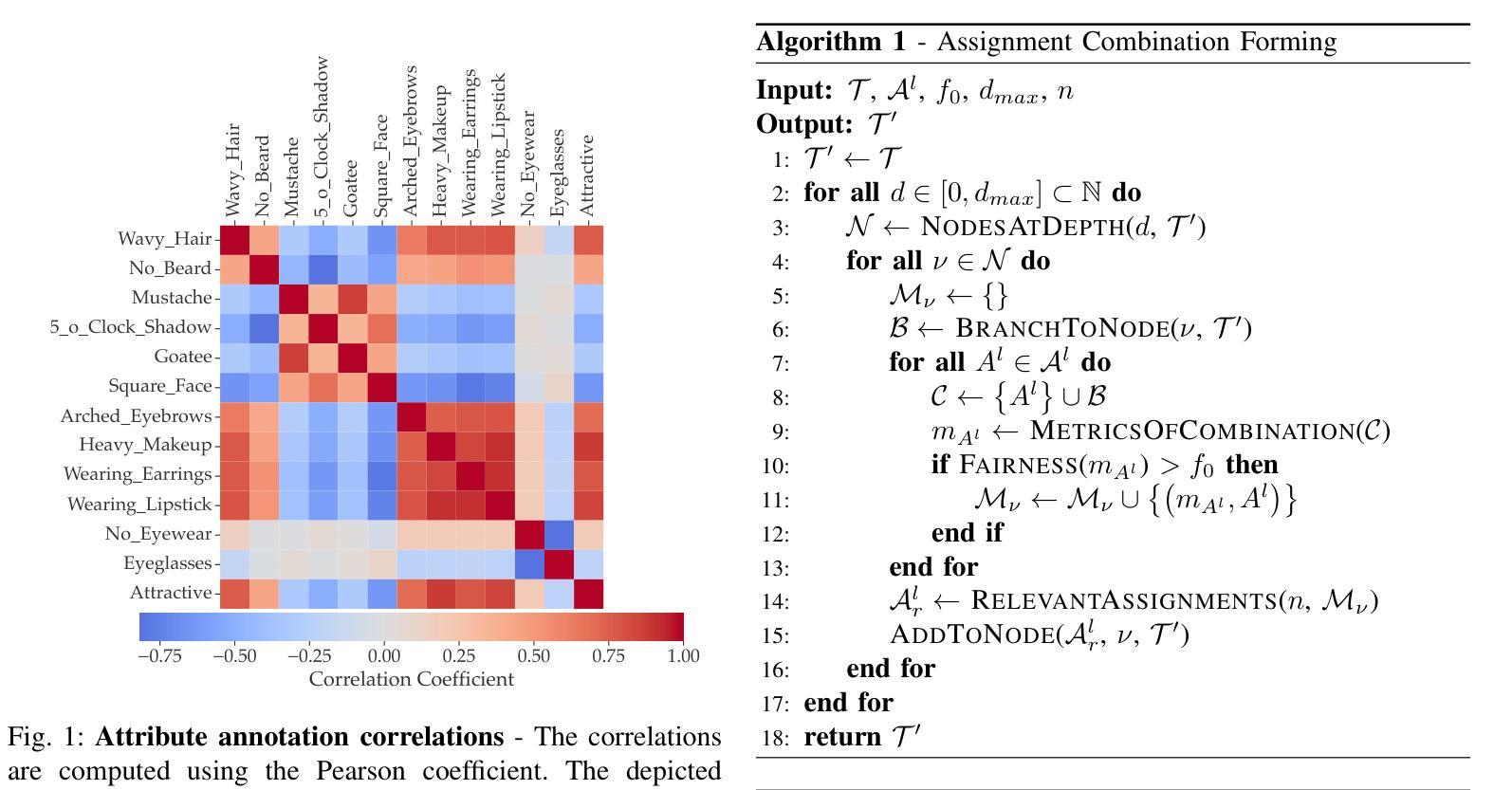

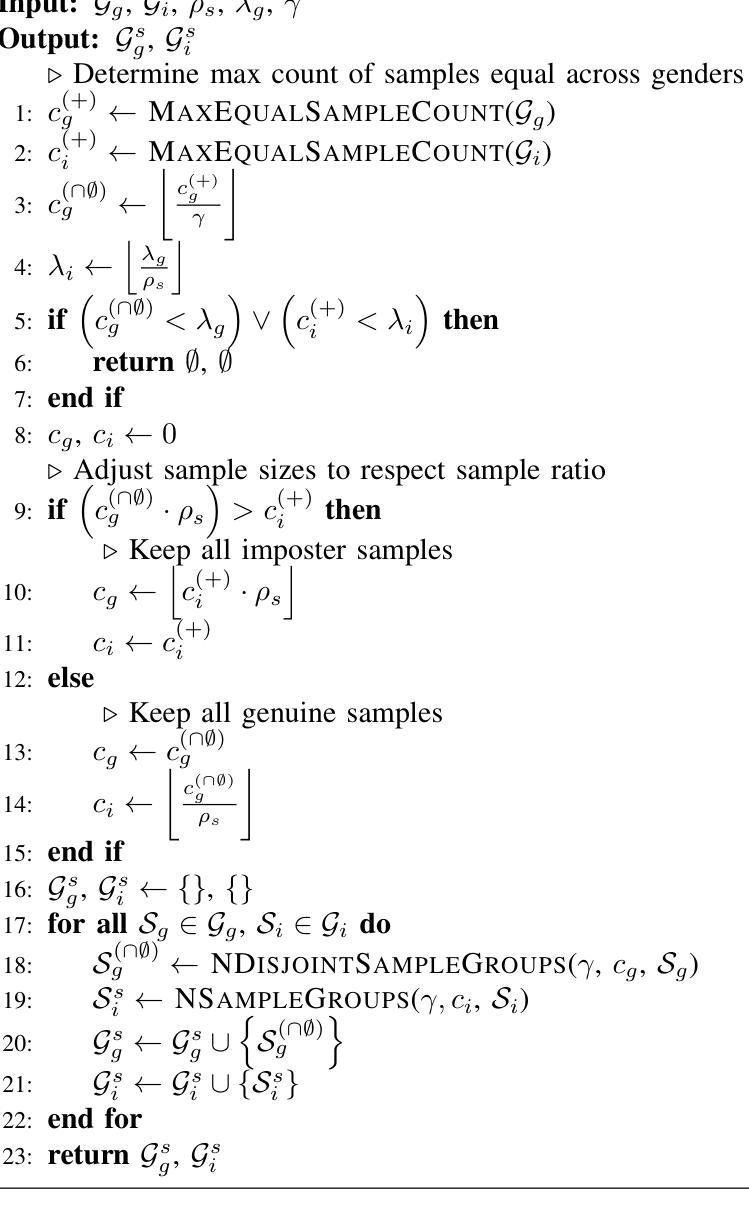

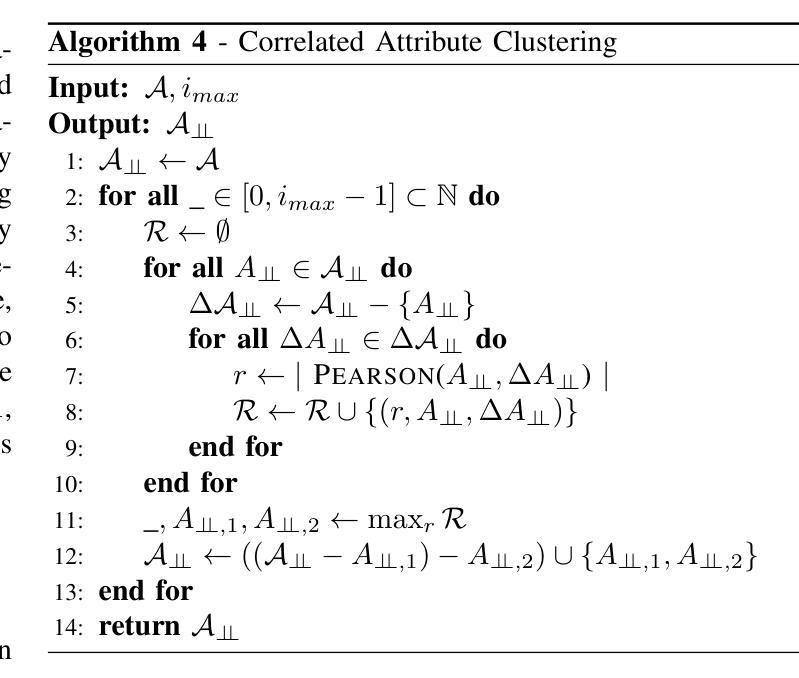

Face recognition systems (FRS) exhibit significant accuracy differences based on the user’s gender. Since such a gender gap reduces the trustworthiness of FRS, more recent efforts have tried to find the causes. However, these studies make use of manually selected, correlated, and small-sized sets of facial features to support their claims. In this work, we analyse gender bias in face recognition by successfully extending the search domain to decorrelated combinations of 40 non-demographic facial characteristics. First, we propose a toolchain to effectively decorrelate and aggregate facial attributes to enable a less-biased gender analysis on large-scale data. Second, we introduce two new fairness metrics to measure fairness with and without context. Based on these grounds, we thirdly present a novel unsupervised algorithm able to reliably identify attribute combinations that lead to vanishing bias when used as filter predicates for balanced testing datasets. The experiments show that the gender gap vanishes when images of male and female subjects share specific attributes, clearly indicating that the issue is not a question of biology but of the social definition of appearance. These findings could reshape our understanding of fairness in face biometrics and provide insights into FRS, helping to address gender bias issues.

人脸识别系统(FRS)在用户性别方面的准确性存在显著差异。由于这种性别差距降低了FRS的可信度,最近的努力都在尝试寻找其原因。然而,这些研究仅使用手动选择、相关度较高且规模较小的面部特征集来支持其观点。在这项工作中,我们通过成功将搜索范围扩展到与性别无关的面部特征的组合来分析了人脸识别中的性别偏见,这些组合包括多达四十种非人口特征的面部特征。首先,我们提出了一套工具链,能够有效地对特征进行去相关和聚合,以实现对大规模数据的非性别偏见分析。其次,我们引入了两种新型公平指标来度量存在与不存在上下文条件下的公平性。基于以上论述,我们第三种推出了一种新型的无需监督的算法,能够可靠地识别出特定属性组合可以在用于平衡测试数据集时导致偏见消失。实验表明,当男性与女性受试者的图像具有某些特定属性时,性别差距就会消失,这显然表明问题并非生物学上的原因而是外观的社会定义造成的。这些发现可以重塑我们对面部生物识别中公平性的理解,为FRS提供洞察力,有助于解决性别偏见问题。

论文及项目相关链接

Summary

本文研究了人脸识别系统中存在的性别偏见问题。通过对40种非人口统计学面部特征的解耦和组合分析,提出了一套减少性别偏见的分析工具链和两个新的公平性度量标准。实验表明,当男性和女性主体的图像具有某些特定属性时,性别差距会消失,这表明问题不在于生物学差异,而在于外观的社会定义。这些发现有助于重塑我们对人脸识别公平性的理解,并为解决人脸识别系统中的性别偏见问题提供了启示。

Key Takeaways

- 人脸识别系统(FRS)存在基于用户性别的准确性差异。

- 现有研究主要通过手动选择、相关性和小规模面部特征集来探讨性别偏见的原因。

- 本文成功将研究范围扩大到40种非人口统计学面部特征的解耦组合,以分析性别偏见。

- 提出了一套有效的工具链,用于解耦和汇总面部特征,以进行更公平的性别分析。

- 介绍了两个新的公平性度量标准,以测量上下文中的公平性或无上下文中的公平性。

- 实验表明,当男性和女性在某些特定属性上相似时,性别差距会消失。这表明问题不在于生物学差异,而在于外观的社会定义。

点此查看论文截图