⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-01-24 更新

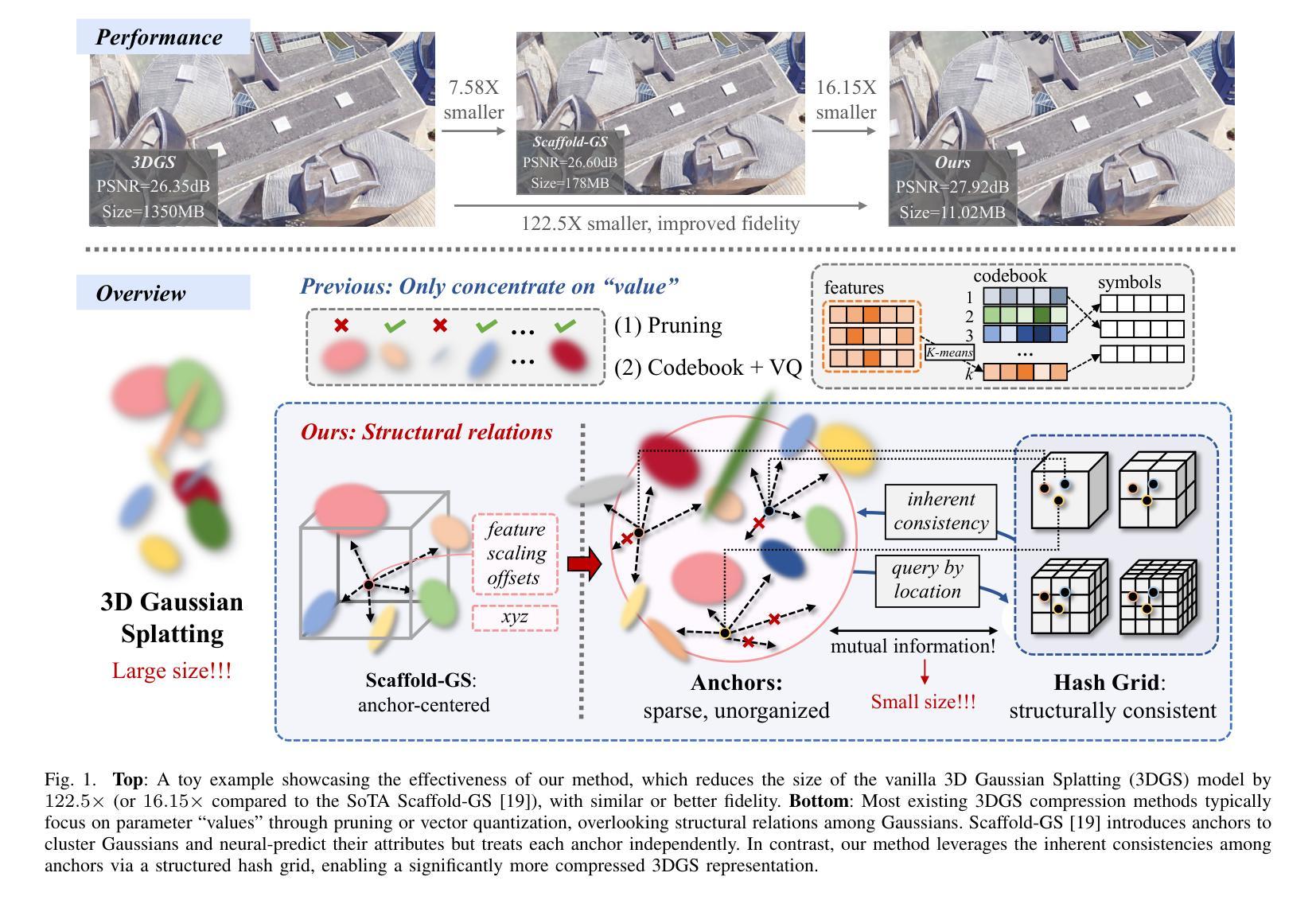

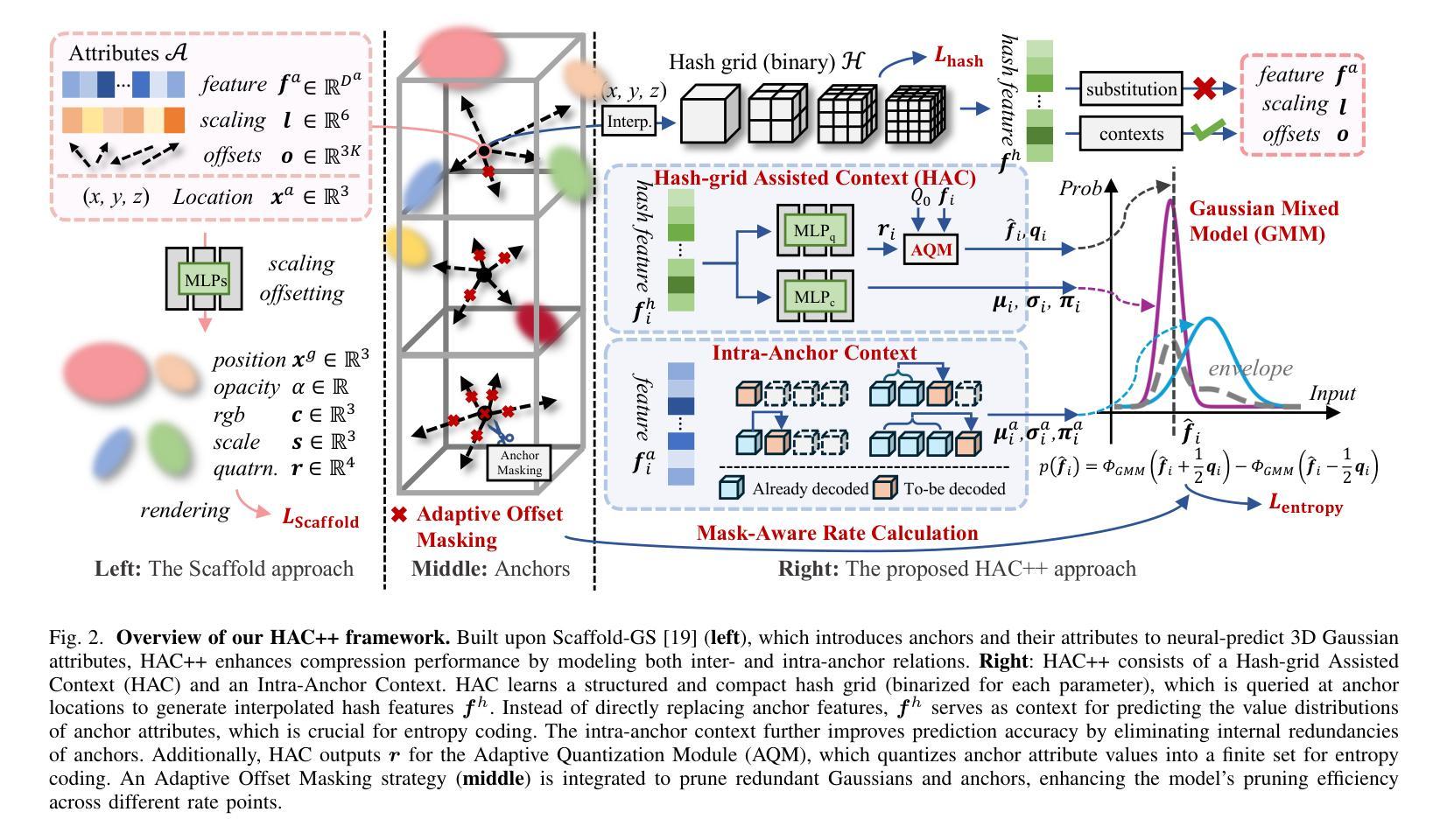

HAC++: Towards 100X Compression of 3D Gaussian Splatting

Authors:Yihang Chen, Qianyi Wu, Weiyao Lin, Mehrtash Harandi, Jianfei Cai

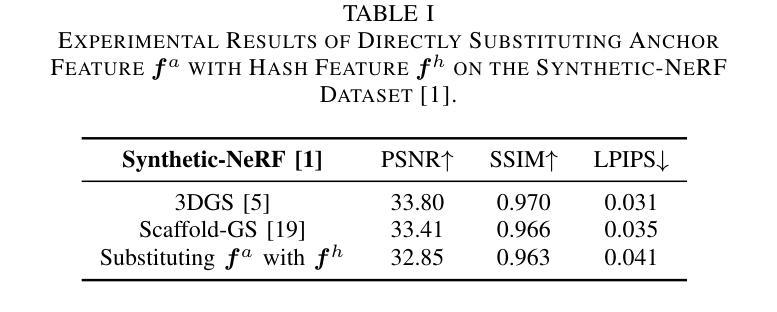

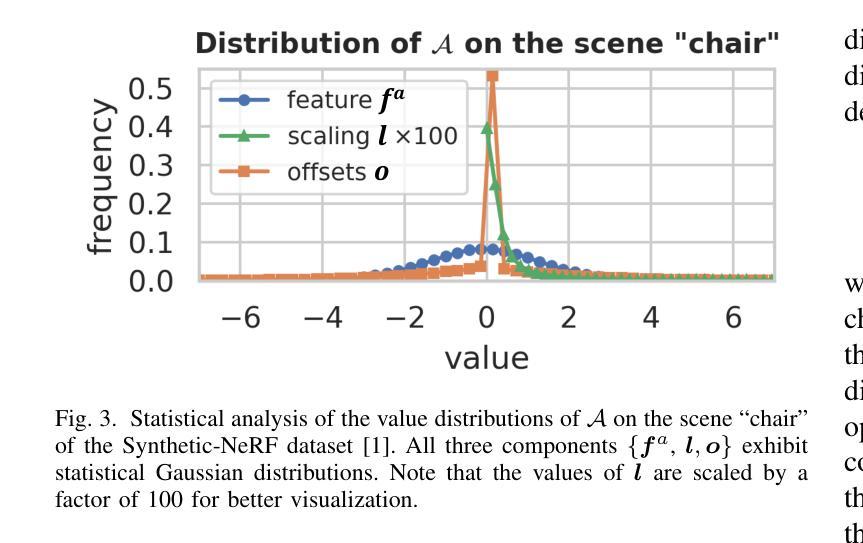

3D Gaussian Splatting (3DGS) has emerged as a promising framework for novel view synthesis, boasting rapid rendering speed with high fidelity. However, the substantial Gaussians and their associated attributes necessitate effective compression techniques. Nevertheless, the sparse and unorganized nature of the point cloud of Gaussians (or anchors in our paper) presents challenges for compression. To achieve a compact size, we propose HAC++, which leverages the relationships between unorganized anchors and a structured hash grid, utilizing their mutual information for context modeling. Additionally, HAC++ captures intra-anchor contextual relationships to further enhance compression performance. To facilitate entropy coding, we utilize Gaussian distributions to precisely estimate the probability of each quantized attribute, where an adaptive quantization module is proposed to enable high-precision quantization of these attributes for improved fidelity restoration. Moreover, we incorporate an adaptive masking strategy to eliminate invalid Gaussians and anchors. Overall, HAC++ achieves a remarkable size reduction of over 100X compared to vanilla 3DGS when averaged on all datasets, while simultaneously improving fidelity. It also delivers more than 20X size reduction compared to Scaffold-GS. Our code is available at https://github.com/YihangChen-ee/HAC-plus.

3D高斯Splatting(3DGS)已成为新型视角合成的一种有前途的框架,具有快速渲染和高保真度的特点。然而,大量的高斯及其相关属性需要进行有效的压缩技术。尽管如此,高斯点云(或我们论文中的锚点)的稀疏和无组织性质给压缩带来了挑战。为了实现紧凑的大小,我们提出了HAC++,它利用无序锚点与结构化哈希网格之间的关系,利用它们的互信息来进行上下文建模。此外,HAC++捕获了锚点内部的上下文关系,以进一步增强压缩性能。为了促进熵编码,我们利用高斯分布精确估计每个量化属性的概率,并提出一个自适应量化模块,实现对这些属性的高精度量化,以提高保真度的恢复。此外,我们采用自适应掩码策略来消除无效的高斯和锚点。总体而言,与基本的3DGS相比,HAC++在所有数据集上的平均压缩比达到了惊人的超过100倍,同时提高了保真度。与Scaffold-GS相比,它实现了超过20倍的压缩。我们的代码可在[https://github.com/YihangChen-ee/HAC-plus找到。]

论文及项目相关链接

PDF Project Page: https://yihangchen-ee.github.io/project_hac++/ Code: https://github.com/YihangChen-ee/HAC-plus. This paper is a journal extension of HAC at arXiv:2403.14530 (ECCV 2024)

Summary

3DGS框架下涌现了一种名为HAC++的新型压缩技术,用于对合成视图所需的大量高斯进行高效压缩。HAC++采用关系网络和无组织锚点的结构化哈希网格实现紧凑大小,通过量化属性和自适应量化模块实现高保真度恢复。同时,HAC++具有自适应掩码策略,可消除无效的高斯和锚点。该技术显著减少了所需存储空间和渲染时间,相较于普通3DGS和Scaffold-GS实现了超过100倍和20倍的压缩效果提升。相关代码已公开于GitHub上。

Key Takeaways

- 3DGS框架在合成新视角时面临高斯的大量存储需求。

- HAC++技术利用锚点间的关系和无组织锚点的结构化哈希网格进行高效压缩。

- HAC++采用量化属性和自适应量化模块,提高恢复数据的保真度。

- HAC++具备自适应掩码策略,消除无效数据以进一步提升性能。

- HAC++显著提高了存储效率并缩短了渲染时间,相较于其他技术有明显优势。

- HAC++实现了超过100倍的数据压缩效果提升,相较于普通3DGS和Scaffold-GS效果更显著。

点此查看论文截图

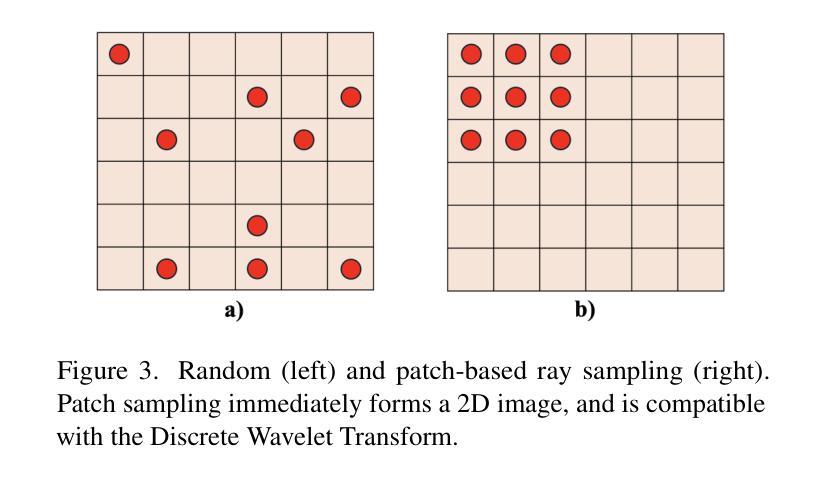

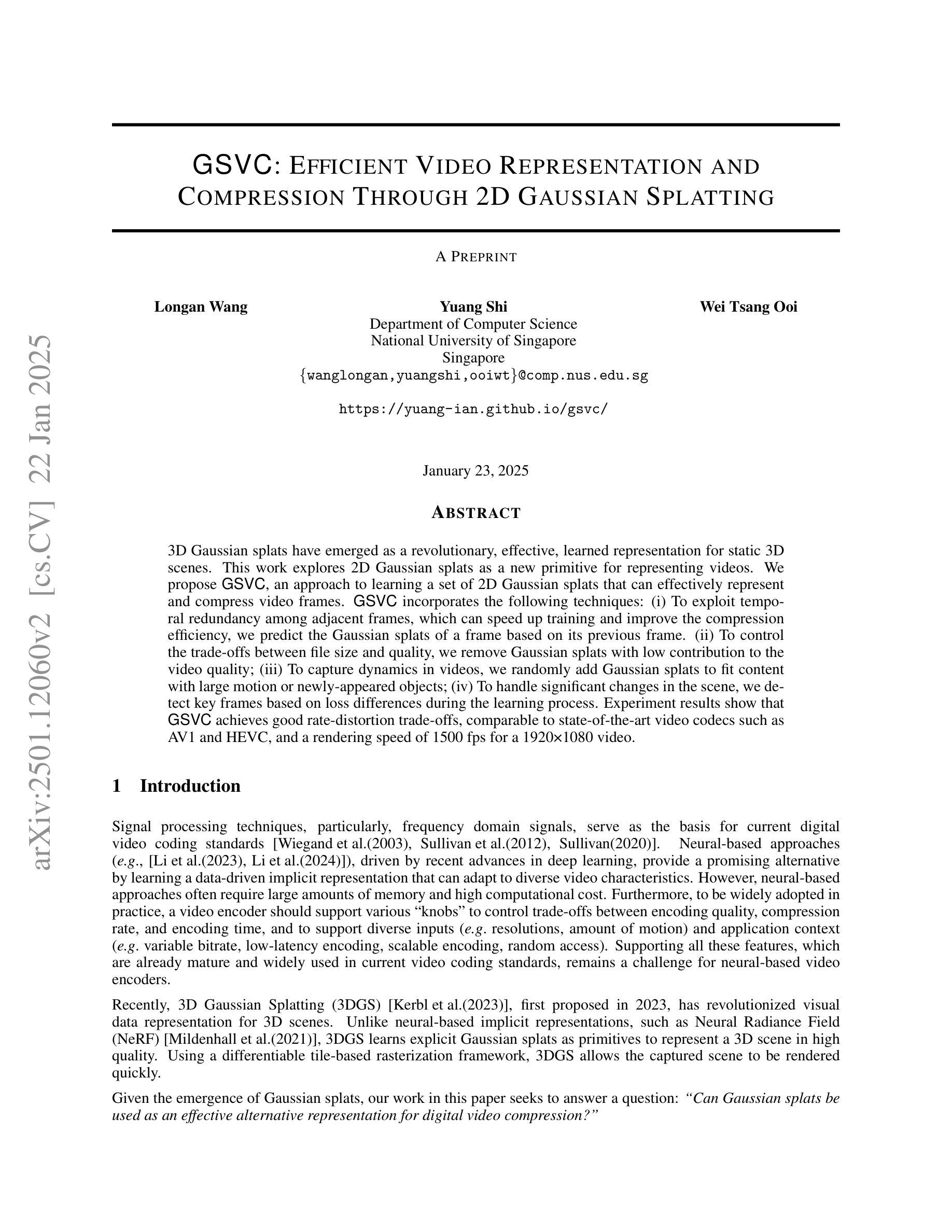

GSVC: Efficient Video Representation and Compression Through 2D Gaussian Splatting

Authors:Longan Wang, Yuang Shi, Wei Tsang Ooi

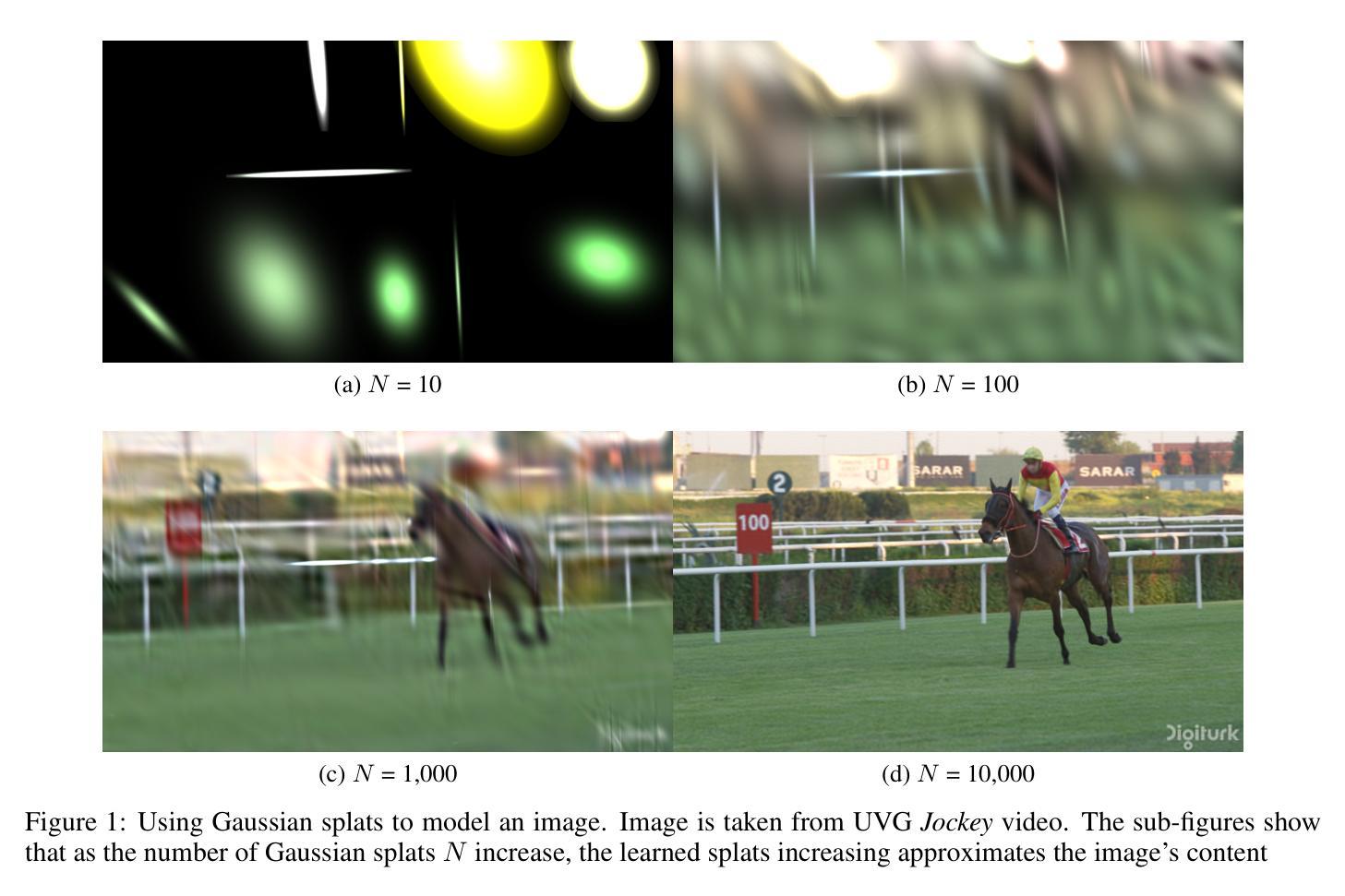

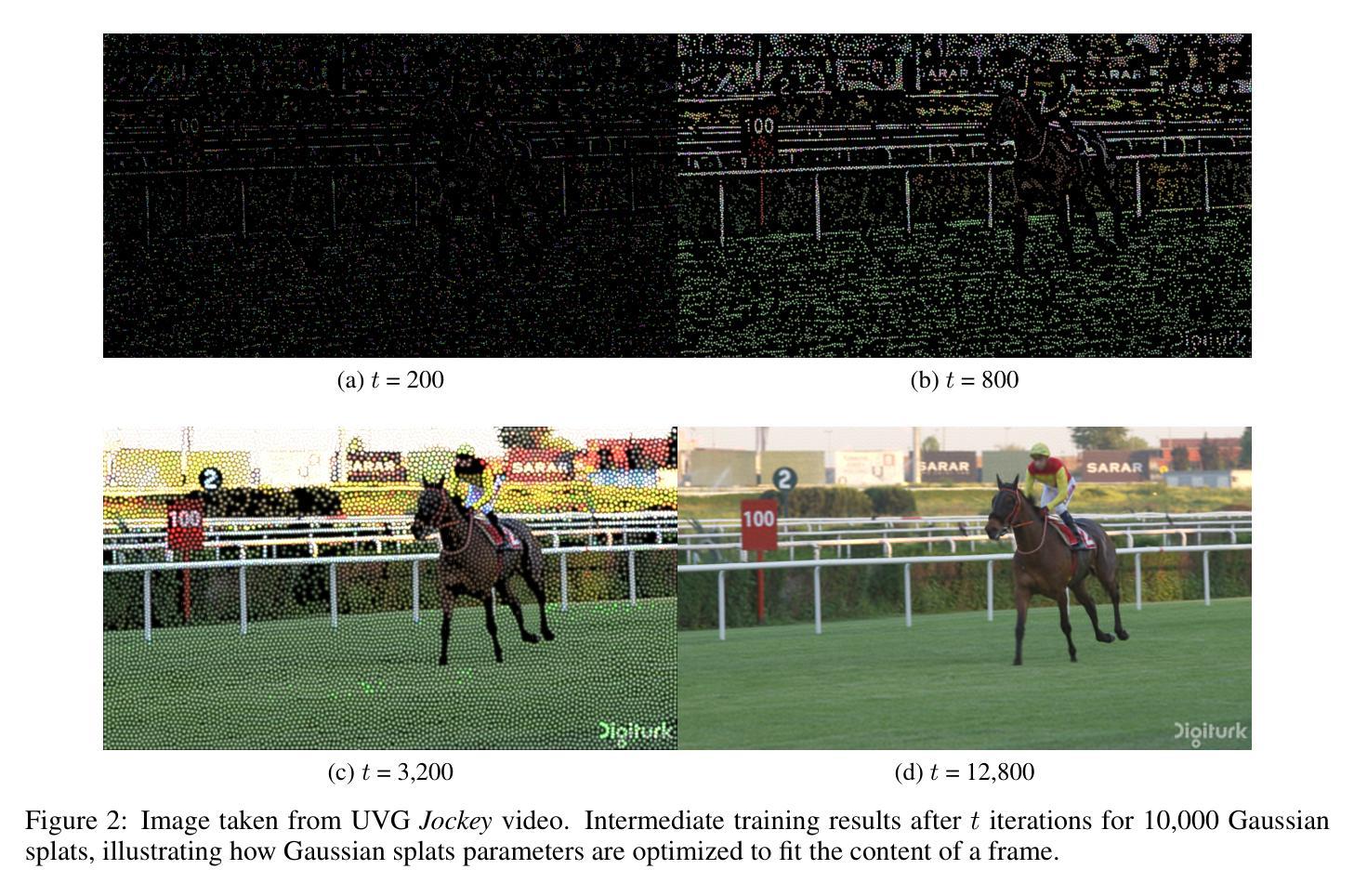

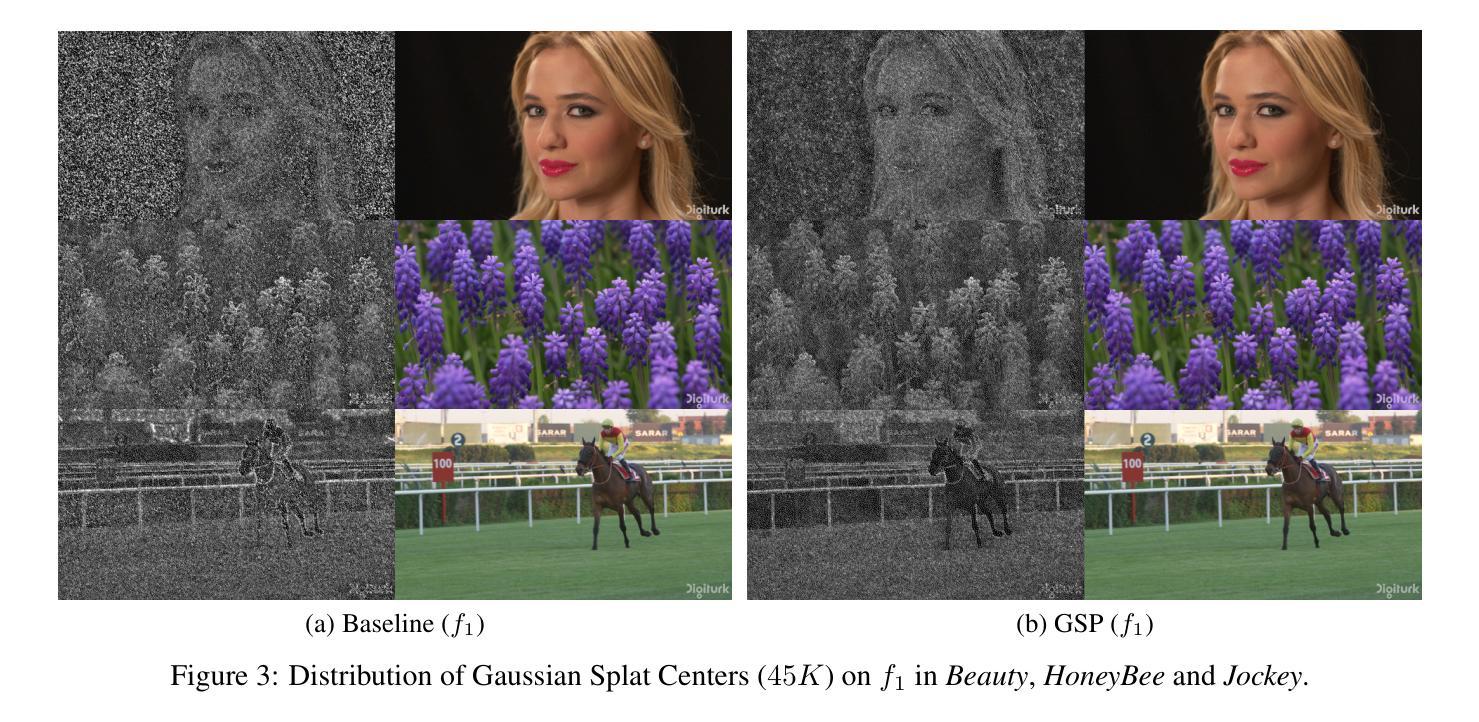

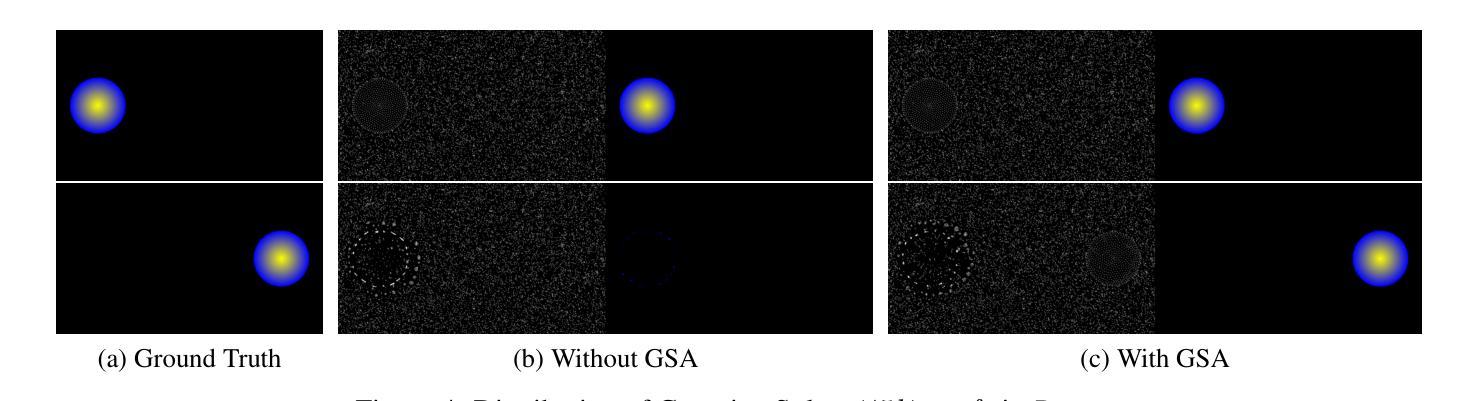

3D Gaussian splats have emerged as a revolutionary, effective, learned representation for static 3D scenes. In this work, we explore using 2D Gaussian splats as a new primitive for representing videos. We propose GSVC, an approach to learning a set of 2D Gaussian splats that can effectively represent and compress video frames. GSVC incorporates the following techniques: (i) To exploit temporal redundancy among adjacent frames, which can speed up training and improve the compression efficiency, we predict the Gaussian splats of a frame based on its previous frame; (ii) To control the trade-offs between file size and quality, we remove Gaussian splats with low contribution to the video quality; (iii) To capture dynamics in videos, we randomly add Gaussian splats to fit content with large motion or newly-appeared objects; (iv) To handle significant changes in the scene, we detect key frames based on loss differences during the learning process. Experiment results show that GSVC achieves good rate-distortion trade-offs, comparable to state-of-the-art video codecs such as AV1 and VVC, and a rendering speed of 1500 fps for a 1920x1080 video.

3D高斯点集已经成为静态3D场景的一种革命性、有效、学习的表示方法。在这项工作中,我们探索使用2D高斯点集作为表示视频的新原始形式。我们提出了GSVC,一种学习一组2D高斯点集的方法,可以有效地表示和压缩视频帧。GSVC结合了以下技术:(i)为了利用相邻帧之间的时间冗余,我们可以加快训练速度并提高压缩效率,我们基于前一帧预测一个帧的高斯点集;(ii)为了控制文件大小和质量之间的权衡,我们去除对视频质量贡献较小的高斯点集;(iii)为了捕捉视频中的动态内容,我们随机添加高斯点集以适应具有大运动或新出现物体的内容;(iv)为了处理场景中的重大变化,我们基于学习过程中的损失差异检测关键帧。实验结果表明,GSVC在速率失真方面取得了良好的权衡,与最先进的视频编码如AV1和VVC相当,并且对1920x1080视频的渲染速度达到1500帧每秒。

论文及项目相关链接

Summary

本文探索使用二维高斯斑块作为新的视频表示基本单位。提出GSVC方法,学习一组二维高斯斑块,以有效表示和压缩视频帧。通过预测相邻帧的高斯斑块来利用时间冗余性,从而提高训练速度和压缩效率;通过去除对视频质量贡献较低的高斯斑块来控制文件大小与质量之间的权衡;随机添加高斯斑块以捕捉视频中的动态内容或新出现物体;基于学习过程中的损失差异检测关键帧。实验结果表明,GSVC在码率失真方面取得了良好的折衷,与主流的AV1和VVC等视频编码技术相比表现良好,同时对1920x1080视频的渲染速度达到每秒1500帧。

Key Takeaways

- 使用二维高斯斑块作为视频表示的新基本单位。

- 提出GSVC方法学习并压缩视频帧的高斯斑块表示。

- 利用时间冗余性预测相邻帧的高斯斑块以提高效率和速度。

- 通过去除对视频质量贡献较低的高斯斑块实现文件大小与质量的平衡。

- 捕捉视频动态内容,随机添加高斯斑块以应对大动作或新出现物体。

- 通过检测关键帧处理场景中的显著变化。

点此查看论文截图

Volumetrically Consistent 3D Gaussian Rasterization

Authors:Chinmay Talegaonkar, Yash Belhe, Ravi Ramamoorthi, Nicholas Antipa

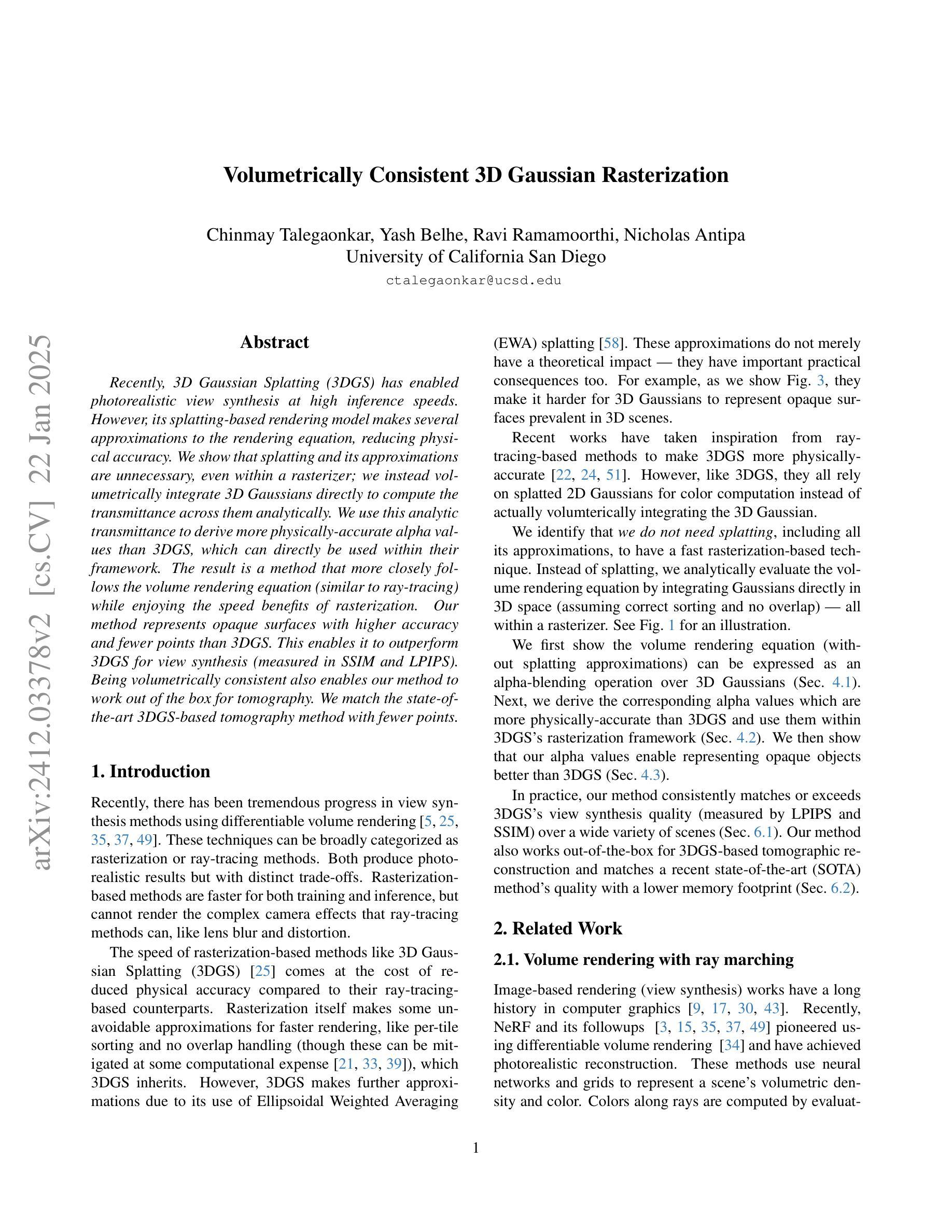

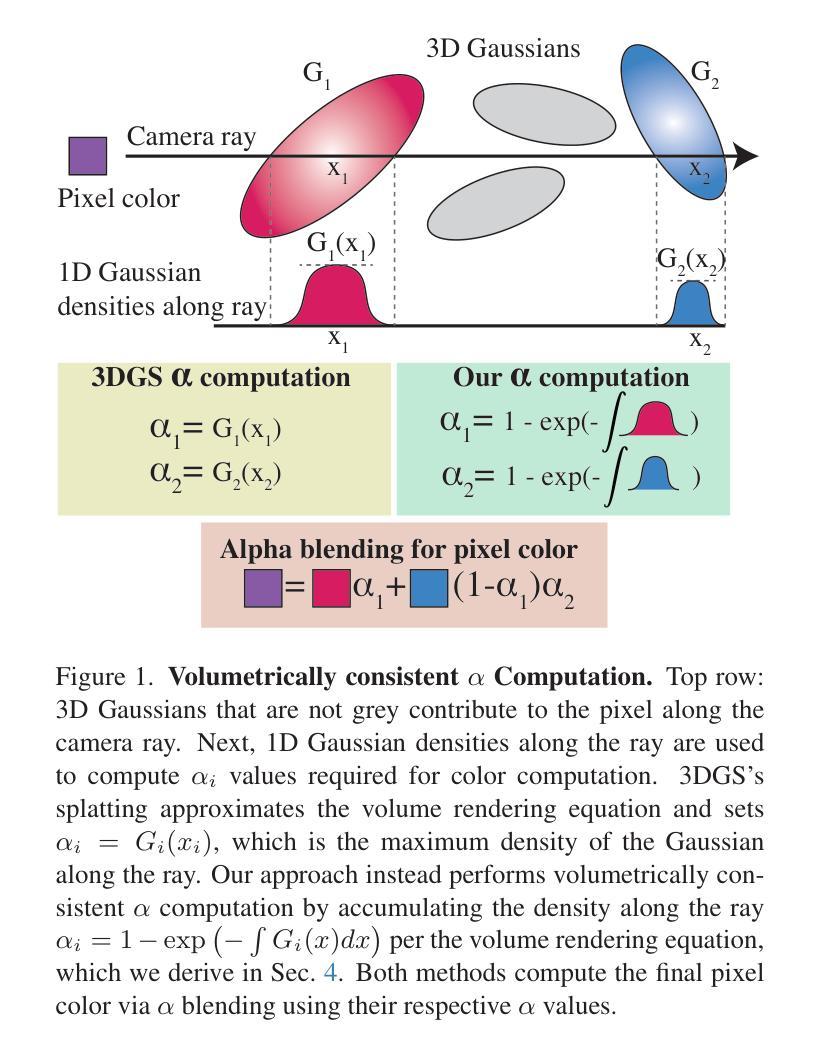

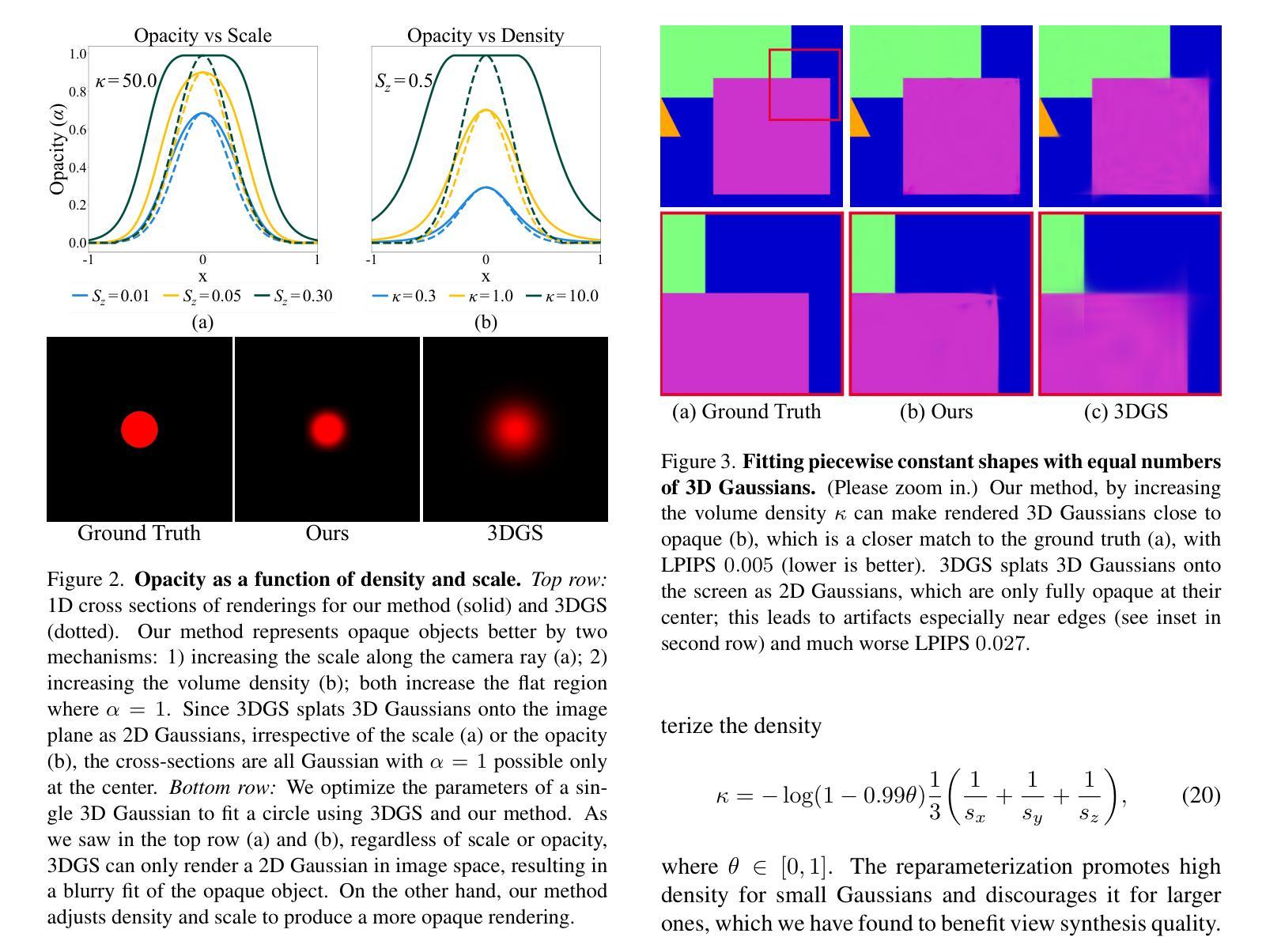

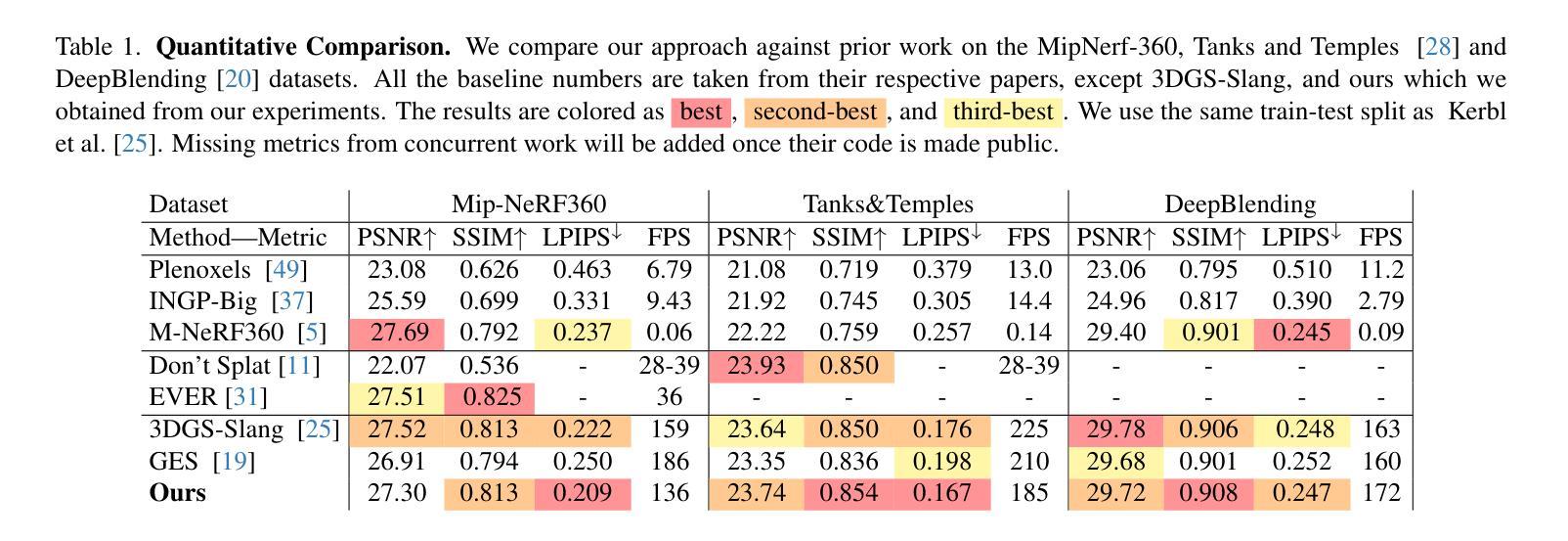

Recently, 3D Gaussian Splatting (3DGS) has enabled photorealistic view synthesis at high inference speeds. However, its splatting-based rendering model makes several approximations to the rendering equation, reducing physical accuracy. We show that splatting and its approximations are unnecessary, even within a rasterizer; we instead volumetrically integrate 3D Gaussians directly to compute the transmittance across them analytically. We use this analytic transmittance to derive more physically-accurate alpha values than 3DGS, which can directly be used within their framework. The result is a method that more closely follows the volume rendering equation (similar to ray-tracing) while enjoying the speed benefits of rasterization. Our method represents opaque surfaces with higher accuracy and fewer points than 3DGS. This enables it to outperform 3DGS for view synthesis (measured in SSIM and LPIPS). Being volumetrically consistent also enables our method to work out of the box for tomography. We match the state-of-the-art 3DGS-based tomography method with fewer points.

最近,三维高斯拼贴(3DGS)技术已经实现了快速推理下的逼真视图合成。然而,其基于拼贴技术的渲染模型对渲染方程进行了多次近似处理,降低了物理准确性。我们证明,即使在光栅化器中,拼贴及其近似处理也是不必要的;相反,我们直接在体积内整合三维高斯,分析其间的透射率。我们使用这种分析透射率来推导比3DGS更贴近物理的alpha值,并可在其框架内直接使用。结果是一种更紧密地遵循体积渲染方程的方法(类似于光线追踪),同时享受光栅化的速度优势。我们的方法能够使用比3DGS更高的精度和更少的点表示不透明表面。这使得它在视图合成方面超越了3DGS(通过SSIM和LPIPS衡量)。其体积一致性也使我们的方法能够轻松应用于断层扫描。我们使用更少的点与最先进的基于3DGS的断层扫描方法相匹配。

论文及项目相关链接

摘要

最近,三维高斯混合技术(3DGS)已实现在高速推理下生成具有逼真视觉效果的效果。然而,其基于涂绘的渲染模型对渲染方程进行了多次近似处理,降低了物理准确性。本文证明涂绘及其近似值在光栅化器内部都不必要,相反我们直接对三维高斯进行体积积分计算分析透射率。我们使用这种分析透射率得出比三维高斯混合技术更准确的alpha值,可直接用于其框架内。该方法更贴近体积渲染方程(类似于光线追踪),同时享有光栅化的速度优势。我们的方法能以更高精度代表不透明表面,使用点数更少,从而在视图合成方面优于三维高斯混合技术(以SSIM和LPIPS衡量)。体积一致性使我们能够轻松应用于层析成像技术。我们的方法以更少的点匹配目前先进的基于三维高斯混合技术的层析成像方法。

要点

- 三维高斯混合技术(3DGS)可实现高速推理下的逼真视觉效果。

- 3DGS的涂绘渲染模型存在物理准确性的降低,因为其对渲染方程进行了近似处理。

- 本研究提出一种直接体积积分三维高斯的方法来计算透射率,以提高物理准确性。

- 与3DGS相比,该方法得出的alpha值更为准确,可直接应用于其框架内。

- 该方法更接近体积渲染方程,同时保持了高速的光栅化优势。

- 在表示不透明表面时,该方法具有更高的精度和更少的计算点数。

点此查看论文截图