⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-01-24 更新

Training Dialogue Systems by AI Feedback for Improving Overall Dialogue Impression

Authors:Kai Yoshida, Masahiro Mizukami, Seiya Kawano, Canasai Kruengkrai, Hiroaki Sugiyama, Koichiro Yoshino

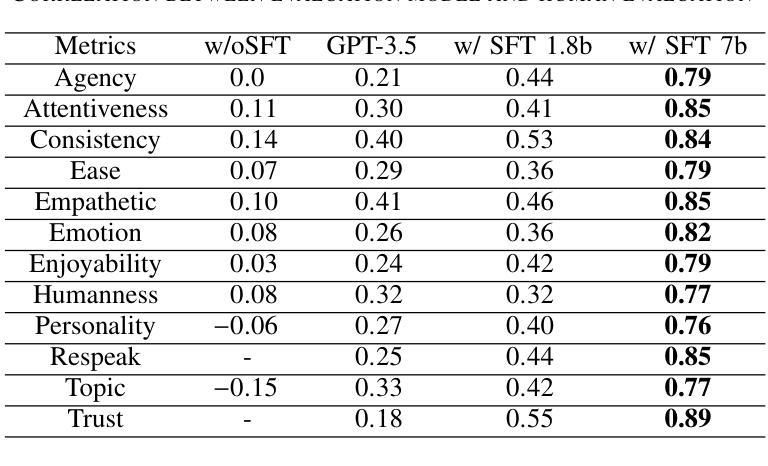

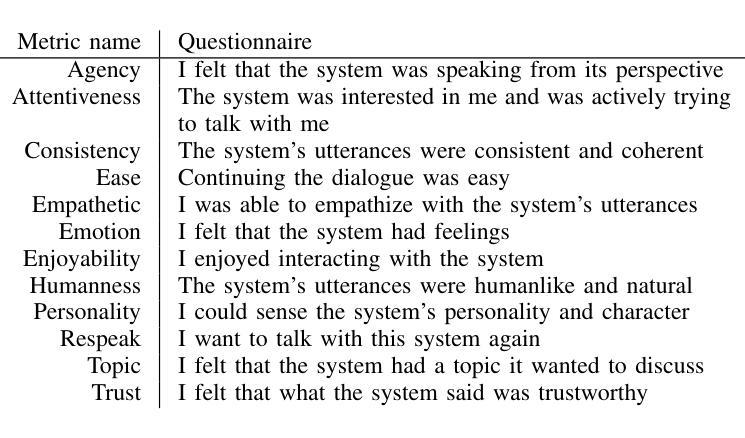

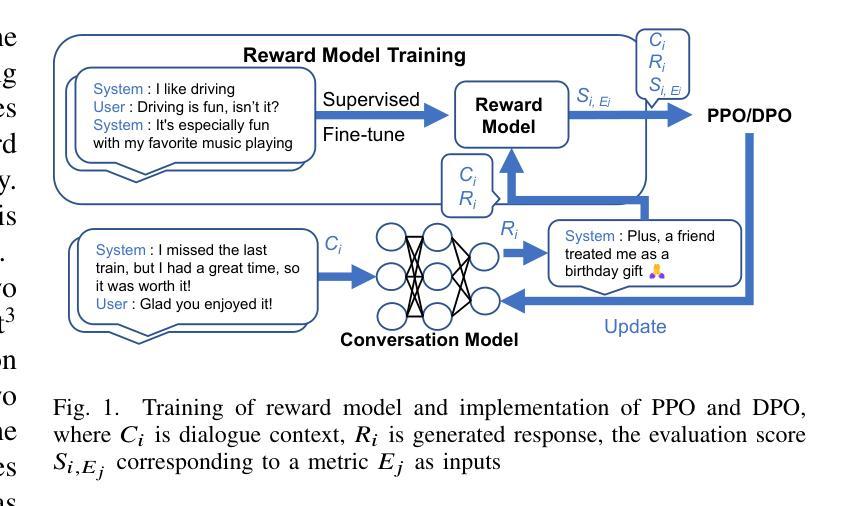

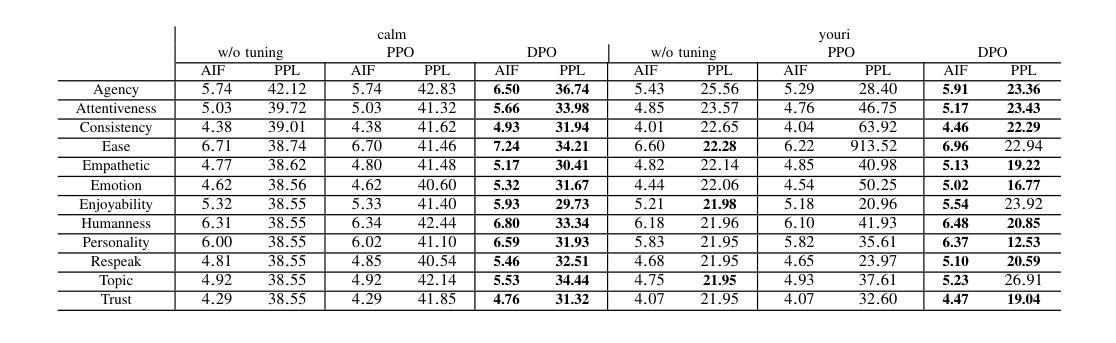

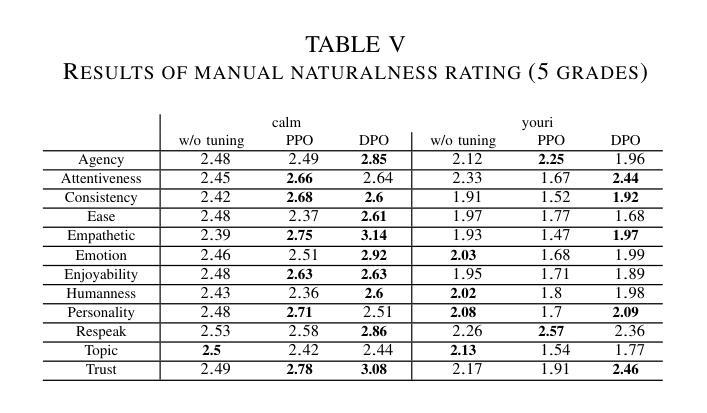

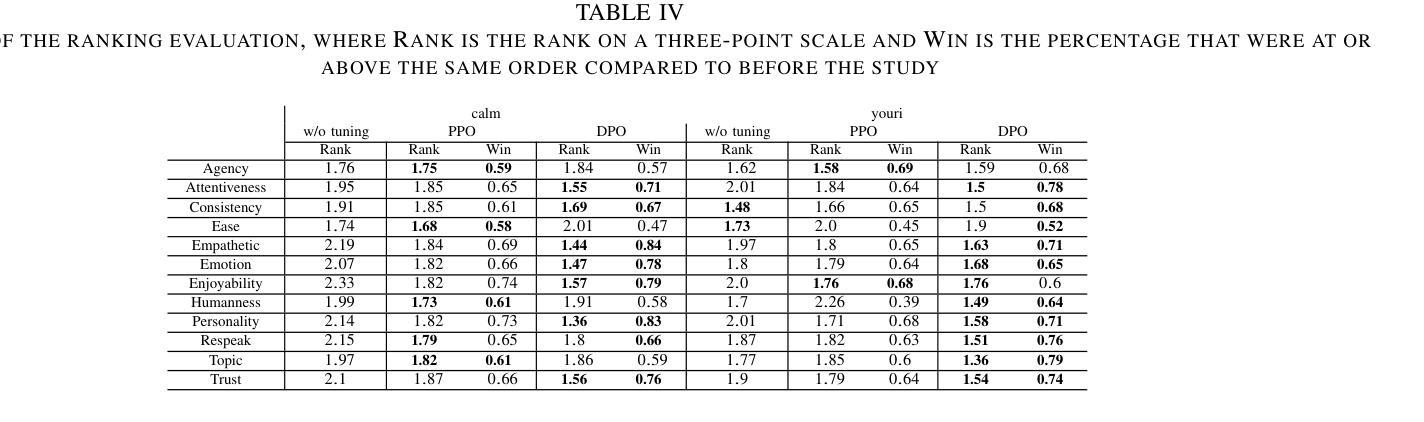

To improve user engagement during conversations with dialogue systems, we must improve individual dialogue responses and dialogue impressions such as consistency, personality, and empathy throughout the entire dialogue. While such dialogue systems have been developing rapidly with the help of large language models (LLMs), reinforcement learning from AI feedback (RLAIF) has attracted attention to align LLM-based dialogue models for such dialogue impressions. In RLAIF, a reward model based on another LLM is used to create a training signal for an LLM-based dialogue model using zero-shot/few-shot prompting techniques. However, evaluating an entire dialogue only by prompting LLMs is challenging. In this study, the supervised fine-tuning (SFT) of LLMs prepared reward models corresponding to 12 metrics related to the impression of the entire dialogue for evaluating dialogue responses. We tuned our dialogue models using the reward model signals as feedback to improve the impression of the system. The results of automatic and human evaluations showed that tuning the dialogue model using our reward model corresponding to dialogue impression improved the evaluation of individual metrics and the naturalness of the dialogue response.

为提高用户与对话系统对话时的参与度,我们必须改善单独的对话回应和整个对话过程中的一致性、个性和同理感等对话印象。虽然这类对话系统凭借大型语言模型(LLM)快速发展,但人工智能反馈的强化学习(RLAIF)已吸引人们的关注,以对齐基于LLM的对话模型以产生此类对话印象。在RLAIF中,基于另一个LLM的奖励模型被用来为基于LLM的对话模型创建训练信号,采用零样本/少样本提示技术。然而,仅通过提示LLM来评估整个对话是有挑战性的。本研究中,我们针对与整个对话印象相关的12项指标,准备了奖励模型来评估对话回应,对LLM进行有监督的微调(SFT)。我们使用奖励模型信号作为反馈来调整我们的对话模型,以提高系统印象。自动和人类评估的结果表明,使用与对话印象相应的奖励模型调整对话模型,提高了单个指标的评估值以及对话回应的自然度。

论文及项目相关链接

PDF Accepted to ICASSP 2025

Summary:

为提高对话系统的用户参与度,需优化单个对话回应和整个对话过程中的一致性、个性及同理等对话印象。借助大型语言模型(LLM)的发展,通过强化学习从人工智能反馈(RLAIF)对齐LLM基础对话模型以达成此目标。本研究中,通过监督微调(SFT)LLM创建与整个对话印象相关的12个指标的奖励模型,以评估对话回应。使用奖励模型信号对对话模型进行微调,以提升系统印象。自动和人工评估结果均显示,使用与对话印象相对应的奖励模型调整对话模型,能提升单个指标的评价和对话回应的自然性。

Key Takeaways:

- 为提高用户与对话系统的参与度,需优化对话回应和对话印象,如一致性、个性和同理心。

- 大型语言模型(LLM)和强化学习从人工智能反馈(RLAIF)在改善对话模型方面发挥重要作用。

- 奖励模型基于另一个LLM创建,用于为LLM基础的对话模型提供训练信号。

- 仅通过提示LLM来评估整个对话具有挑战性。

- 本研究通过监督微调(SFT)LLM创建与整个对话印象相关的奖励模型,以更全面地评估对话回应。

- 使用奖励模型信号微调对话模型,能提升系统印象、单个指标评价和对话回应的自然性。

点此查看论文截图