⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-01-29 更新

TinyLLaVA-Video: A Simple Framework of Small-scale Large Multimodal Models for Video Understanding

Authors:Xingjian Zhang, Xi Weng, Yihao Yue, Zhaoxin Fan, Wenjun Wu, Lei Huang

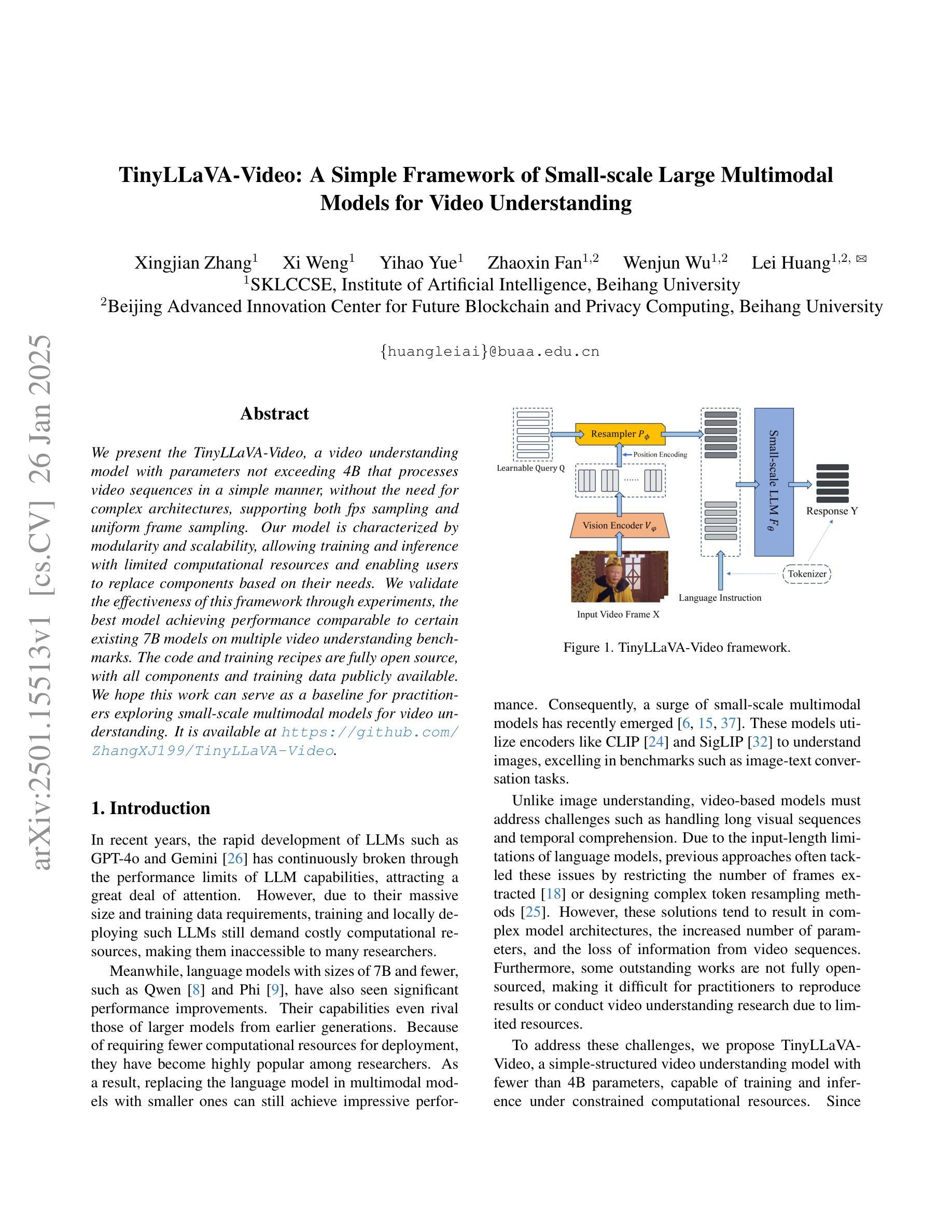

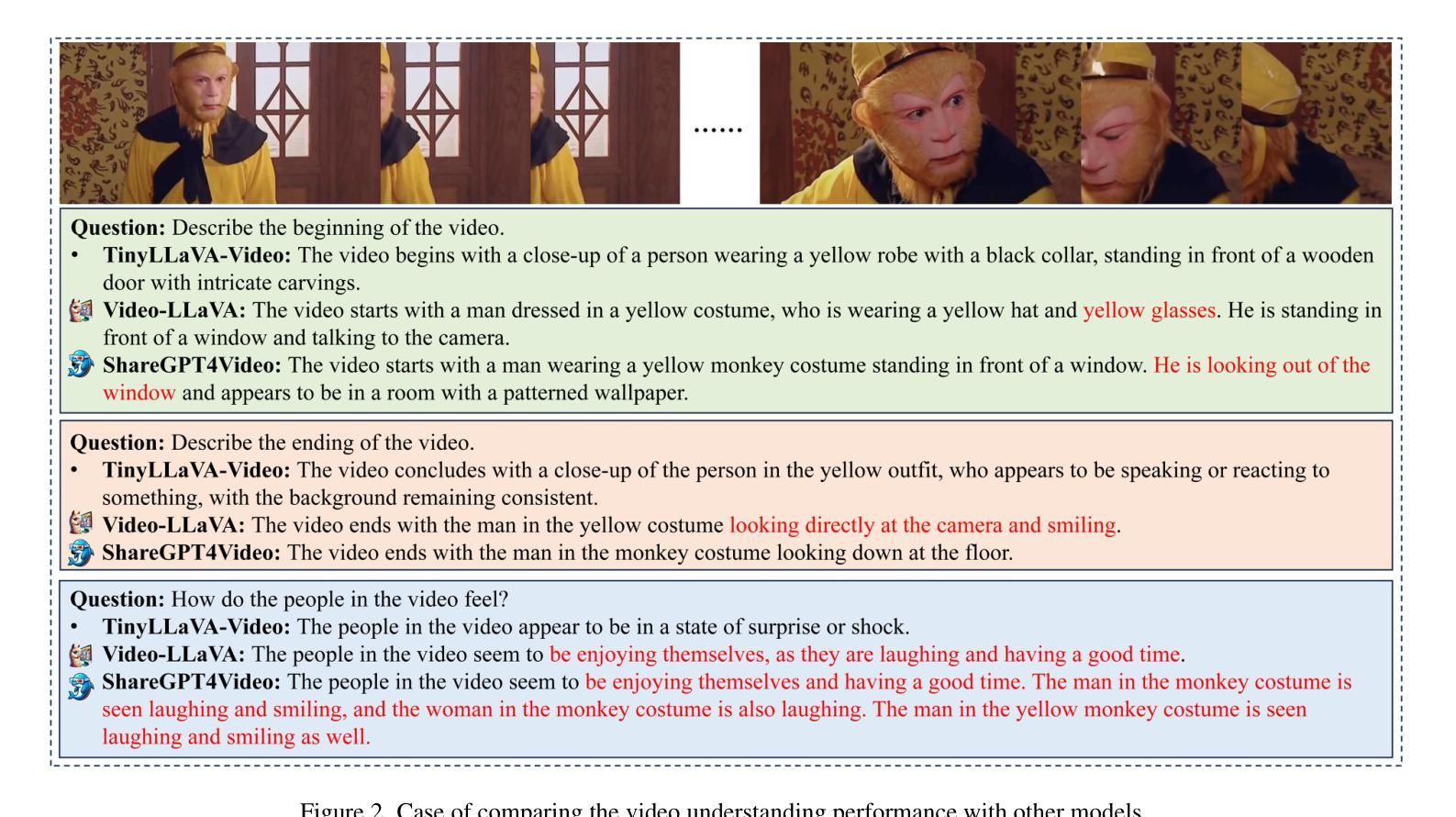

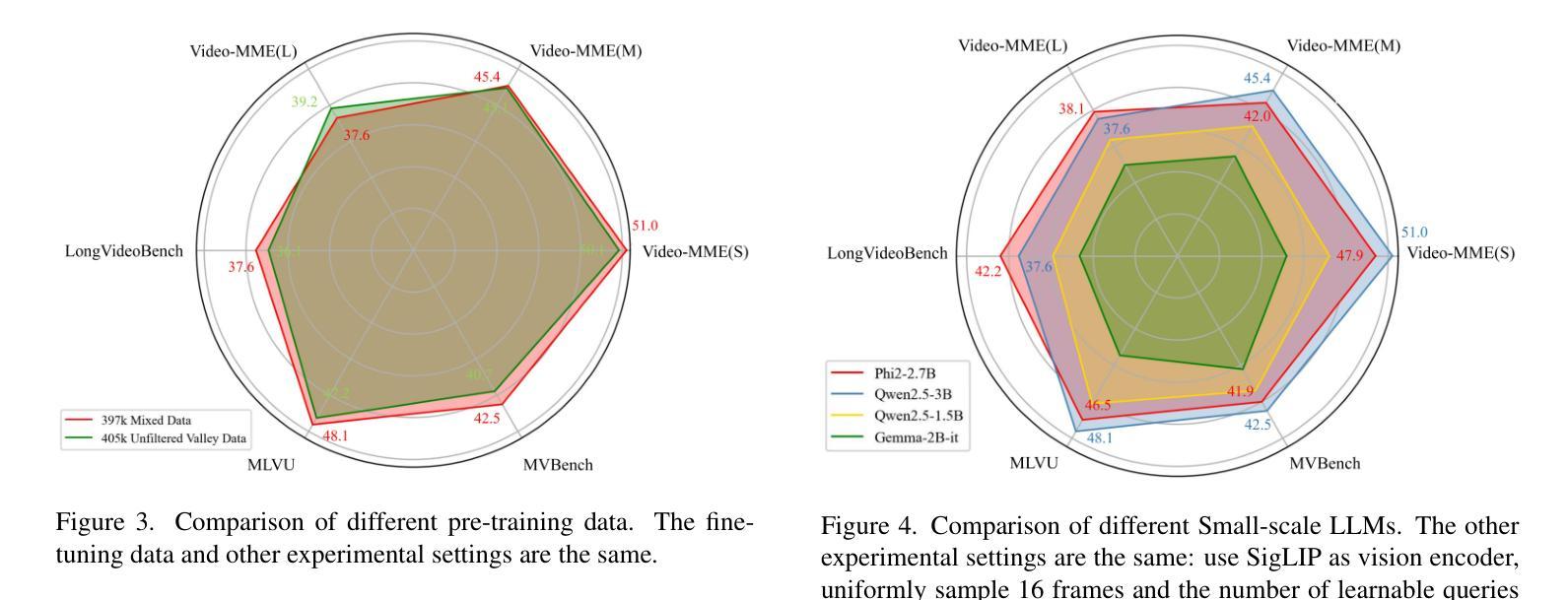

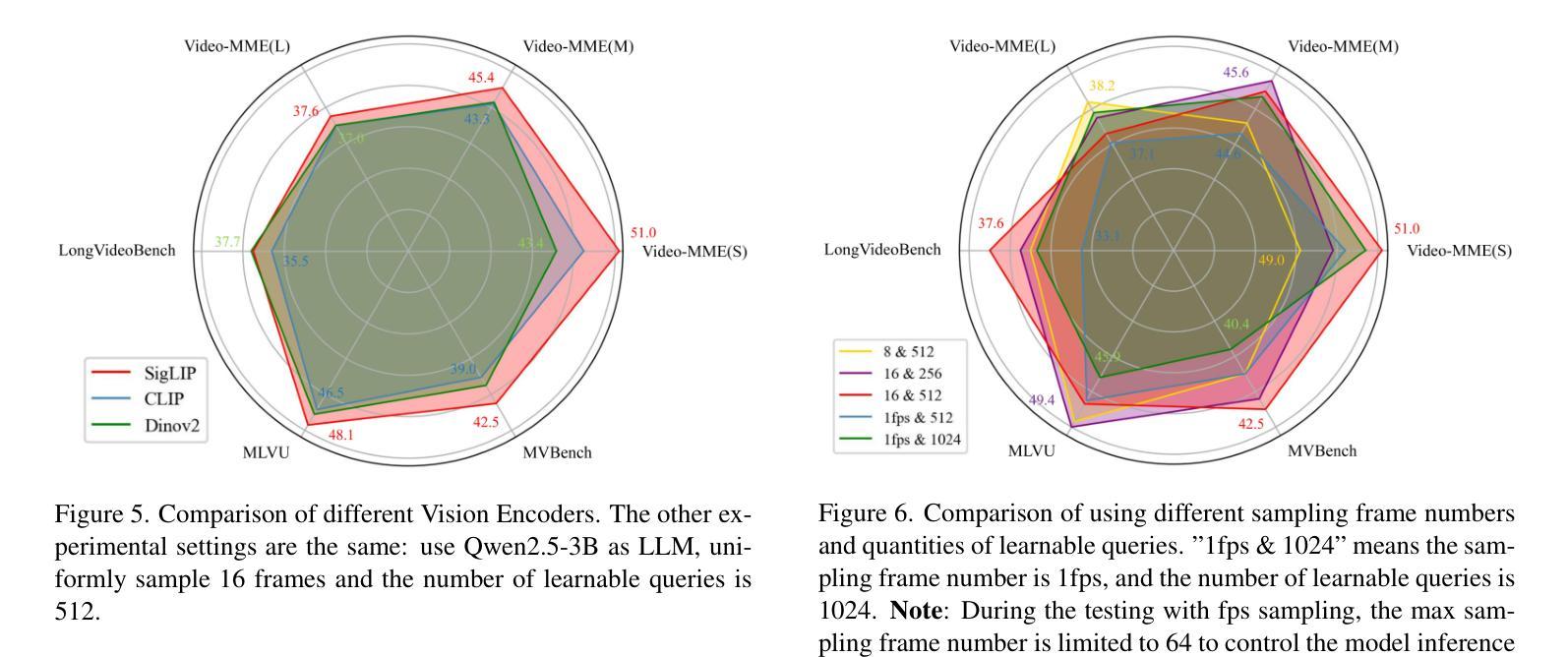

We present the TinyLLaVA-Video, a video understanding model with parameters not exceeding 4B that processes video sequences in a simple manner, without the need for complex architectures, supporting both fps sampling and uniform frame sampling. Our model is characterized by modularity and scalability, allowing training and inference with limited computational resources and enabling users to replace components based on their needs. We validate the effectiveness of this framework through experiments, the best model achieving performance comparable to certain existing 7B models on multiple video understanding benchmarks. The code and training recipes are fully open source, with all components and training data publicly available. We hope this work can serve as a baseline for practitioners exploring small-scale multimodal models for video understanding. It is available at \url{https://github.com/ZhangXJ199/TinyLLaVA-Video}.

我们推出了TinyLLaVA-Video,这是一款参数不超过4B的视频理解模型。它以简单的方式处理视频序列,无需复杂的架构,支持fps采样和均匀帧采样。我们的模型具有模块化和可扩展性特点,可在有限的计算资源上进行训练和推理,并允许用户根据需求替换组件。我们通过实验验证了该框架的有效性,其中最佳模型的性能在多个视频理解基准测试中与某些现有的7B模型相当。代码和培训配方完全开源,所有组件和培训数据均公开可用。我们希望这项工作能为探索用于视频理解的小规模多模态模型的实践者提供基线。可通过\url{https://github.com/ZhangXJ199/TinyLLaVA-Video}获取。

论文及项目相关链接

PDF code and training recipes are available at https://github.com/ZhangXJ199/TinyLLaVA-Video

Summary

TinyLLaVA-Video模型是一个用于视频理解的模型,具有不超过4B的参数,处理视频序列方式简洁,无需复杂架构,支持fps采样和均匀帧采样。模型具有模块化和可扩展性特点,可在有限的计算资源上进行训练和推理,并允许用户根据需求替换组件。实验验证该框架的有效性,最佳模型在多个视频理解基准测试上的性能与某些现有7B模型相当。代码和训练配方完全开源,所有组件和训练数据均可公开获取。

Key Takeaways

- TinyLLaVA-Video是一个用于视频理解的模型,参数不超过4B。

- 模型处理视频序列的方式简洁,不需要复杂架构。

- 支持fps采样和均匀帧采样。

- 模型具有模块化和可扩展性特点。

- 可在有限的计算资源上进行训练和推理。

- 实验证明该框架的有效性,最佳模型性能与某些7B模型相当。

- 代码和训练配方完全开源,所有组件和训练数据均可公开获取。

点此查看论文截图