⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-02-01 更新

EmoDubber: Towards High Quality and Emotion Controllable Movie Dubbing

Authors:Gaoxiang Cong, Jiadong Pan, Liang Li, Yuankai Qi, Yuxin Peng, Anton van den Hengel, Jian Yang, Qingming Huang

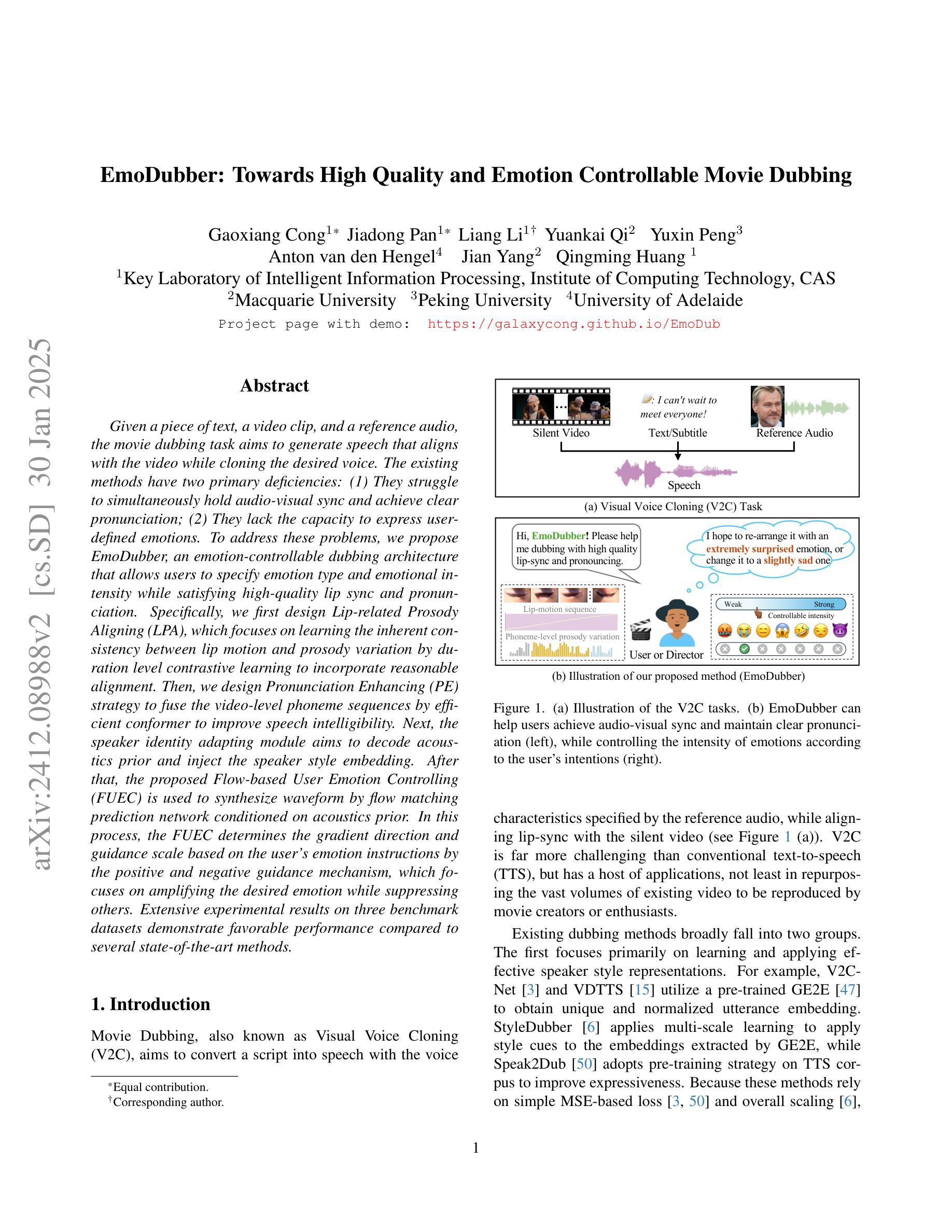

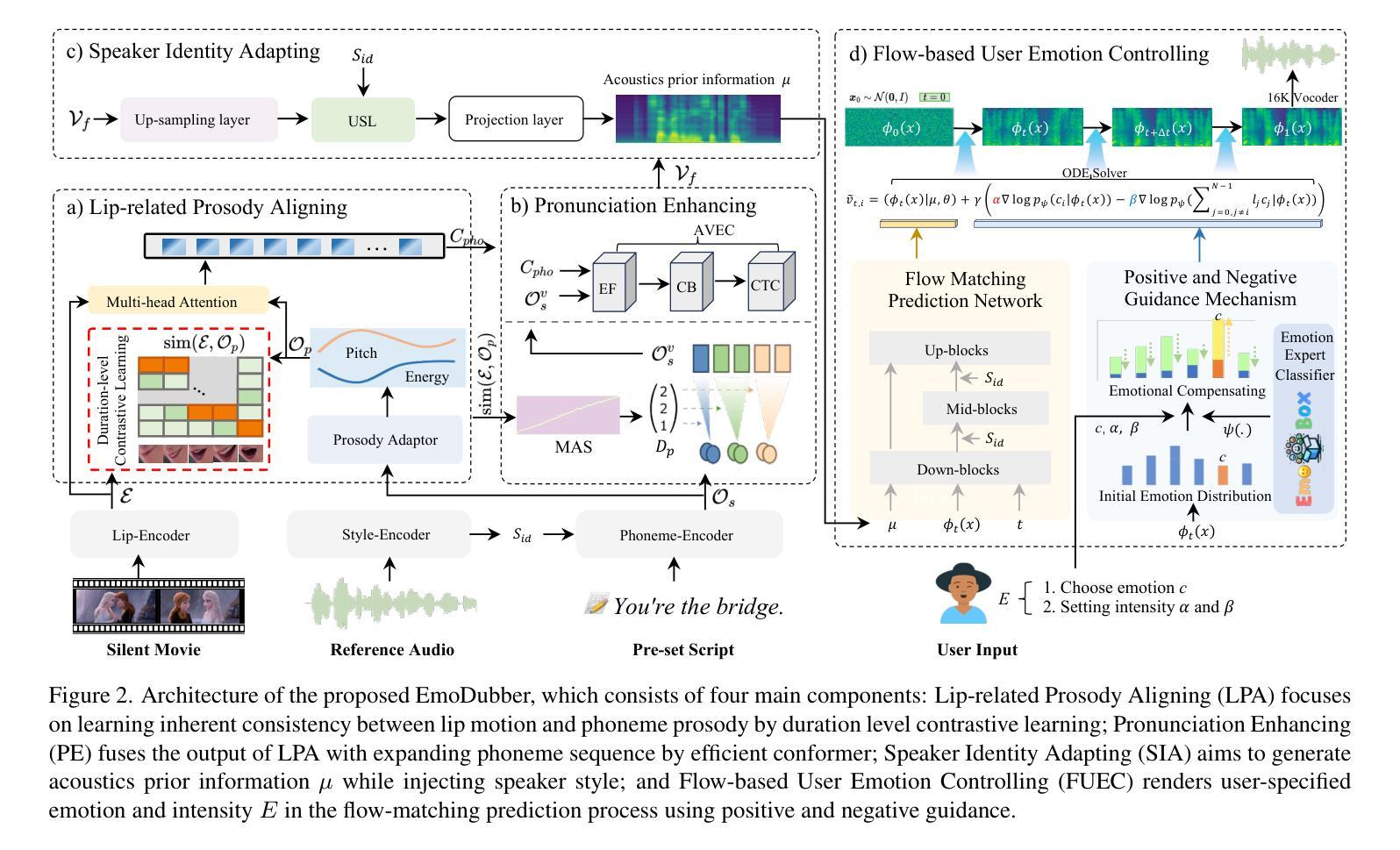

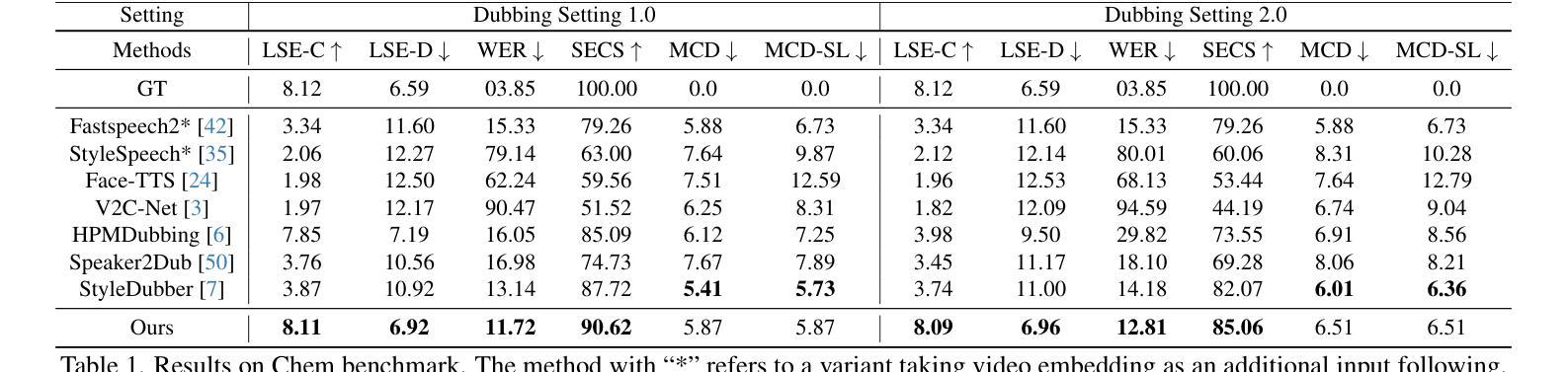

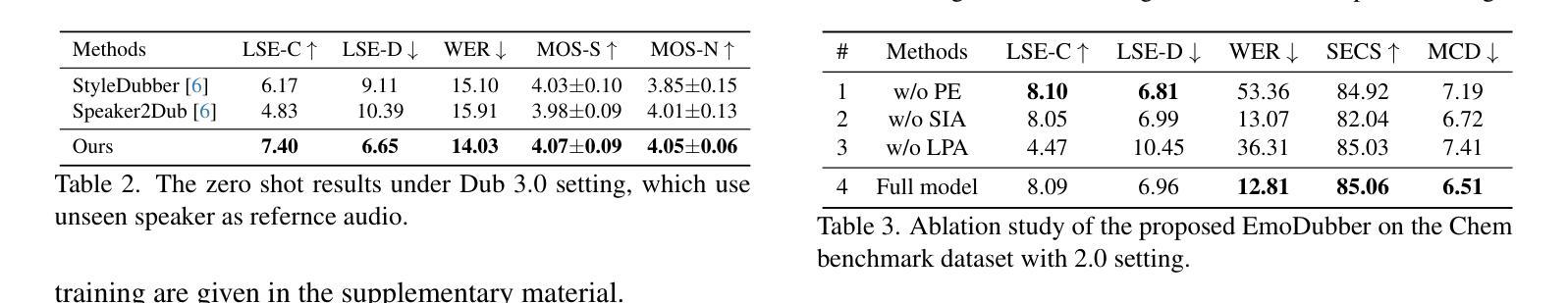

Given a piece of text, a video clip, and a reference audio, the movie dubbing task aims to generate speech that aligns with the video while cloning the desired voice. The existing methods have two primary deficiencies: (1) They struggle to simultaneously hold audio-visual sync and achieve clear pronunciation; (2) They lack the capacity to express user-defined emotions. To address these problems, we propose EmoDubber, an emotion-controllable dubbing architecture that allows users to specify emotion type and emotional intensity while satisfying high-quality lip sync and pronunciation. Specifically, we first design Lip-related Prosody Aligning (LPA), which focuses on learning the inherent consistency between lip motion and prosody variation by duration level contrastive learning to incorporate reasonable alignment. Then, we design Pronunciation Enhancing (PE) strategy to fuse the video-level phoneme sequences by efficient conformer to improve speech intelligibility. Next, the speaker identity adapting module aims to decode acoustics prior and inject the speaker style embedding. After that, the proposed Flow-based User Emotion Controlling (FUEC) is used to synthesize waveform by flow matching prediction network conditioned on acoustics prior. In this process, the FUEC determines the gradient direction and guidance scale based on the user’s emotion instructions by the positive and negative guidance mechanism, which focuses on amplifying the desired emotion while suppressing others. Extensive experimental results on three benchmark datasets demonstrate favorable performance compared to several state-of-the-art methods.

给定一段文本、一个视频片段和参考音频,电影配音任务旨在生成与视频对齐的语音,同时克隆所需的语音。现有方法存在两个主要缺陷:(1)它们难以同时保持视听同步和清晰的发音;(2)它们缺乏表达用户定义情绪的能力。为了解决这些问题,我们提出了EmoDubber,一种情感可控的配音架构,允许用户指定情绪类型和情绪强度,同时满足高质量的唇部同步和发音。具体来说,我们首先设计了一个唇相关韵律对齐(LPA)模块,该模块通过时长级别的对比学习来关注唇动和韵律变化之间的内在一致性,以实现合理对齐。然后,我们设计了发音增强(PE)策略,通过高效转换器融合视频级别的音素序列,以提高语音清晰度。接下来,说话人身份适应模块旨在解码声学先验并注入说话人风格嵌入。之后,我们提出基于流的用户情绪控制(FUEC)方法来合成波形。在这个过程中,FUEC通过正负引导机制根据用户的情绪指令确定梯度方向和指导尺度,侧重于放大所需情绪的同时抑制其他情绪。在三个基准数据集上的大量实验结果证明了该方法与几种最新技术相比的优异性能。

论文及项目相关链接

PDF Under review

摘要

该文本介绍了电影配音任务的目标,即生成与视频对齐的语音,同时克隆所需的语音。现有方法存在两个主要缺陷:一是难以同时保持音视频同步和清晰的发音;二是缺乏表达用户定义情感的能力。为解决这些问题,提出了EmoDubber情感可控配音架构,允许用户指定情感类型和情感强度,同时满足高质量的唇同步和发音。通过设计唇相关韵律对齐(LPA)和发音增强(PE)策略,实现了语音与视频对齐和发音清晰度提升。此外,通过用户情绪控制流(FUEC)合成波形,根据用户的情绪指令确定梯度方向和指导规模。在三个基准数据集上的广泛实验结果证明了该方法的优越性。

关键见解

- 电影配音任务旨在生成与视频对齐的语音,同时克隆所需的语音。

- 现有方法在音视频同步和清晰发音方面存在缺陷。

- 提出了EmoDubber情感可控配音架构,允许用户指定情感类型和强度。

- 通过唇相关韵律对齐(LPA)和发音增强(PE)策略,提高了语音与视频的同步和发音清晰度。

- 提出了基于流的用户情绪控制(FUEC)合成波形,根据用户情绪指令进行调整。

- FUEC通过正负引导机制,放大所需情绪同时抑制其他情绪。

- 在三个基准数据集上的实验结果证明了该方法的优越性。

点此查看论文截图