⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-02-06 更新

EditIQ: Automated Cinematic Editing of Static Wide-Angle Videos via Dialogue Interpretation and Saliency Cues

Authors:Rohit Girmaji, Bhav Beri, Ramanathan Subramanian, Vineet Gandhi

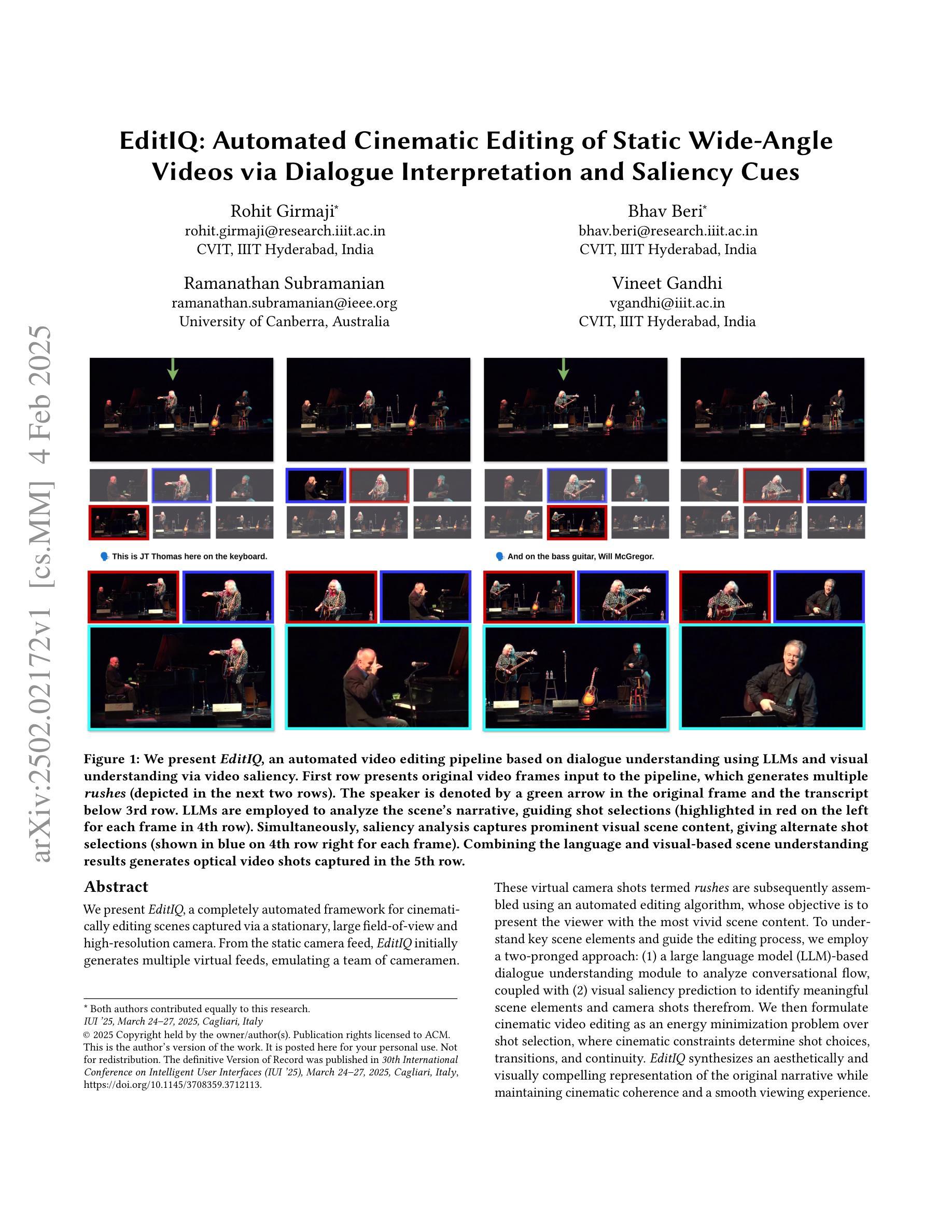

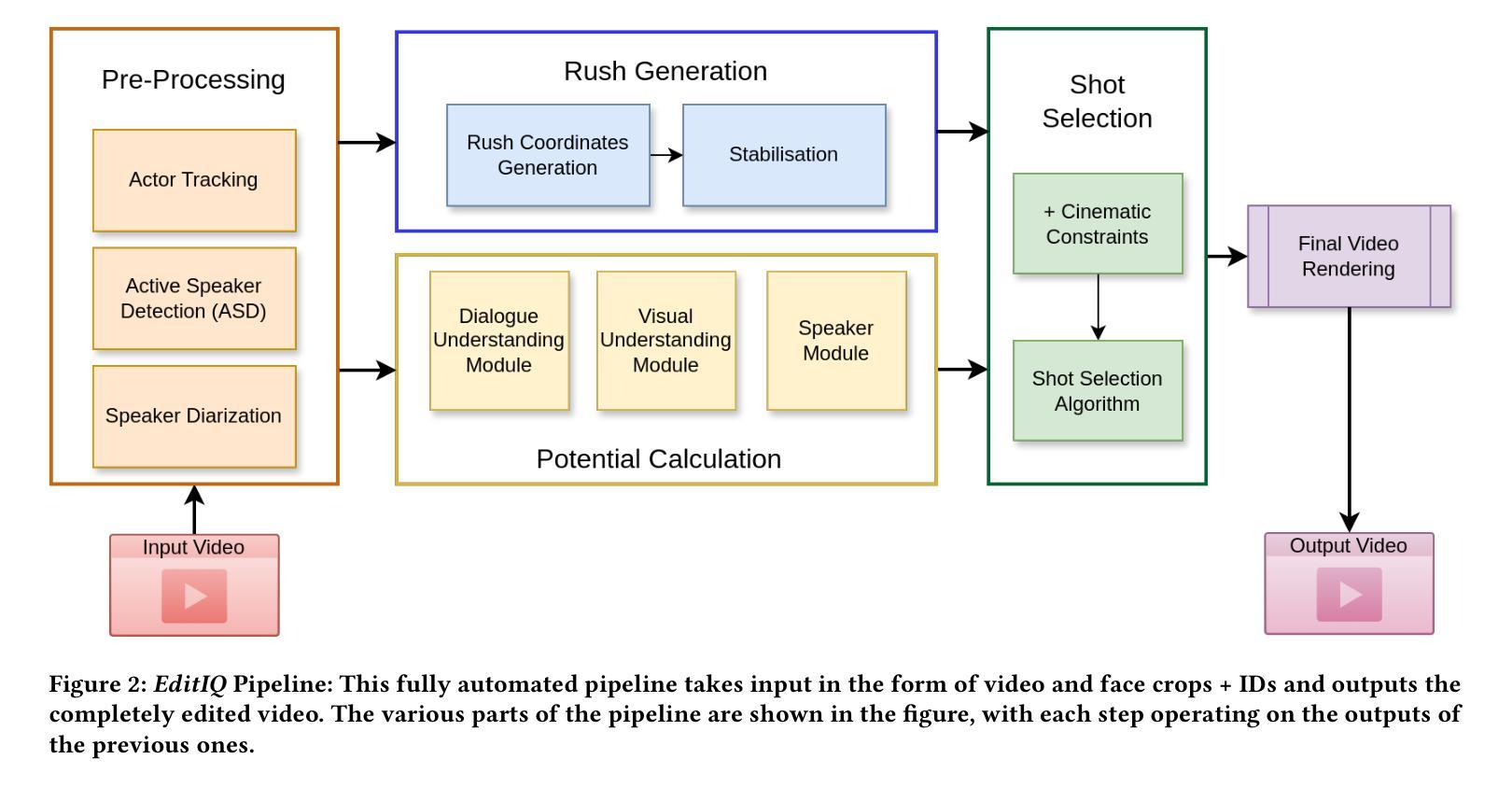

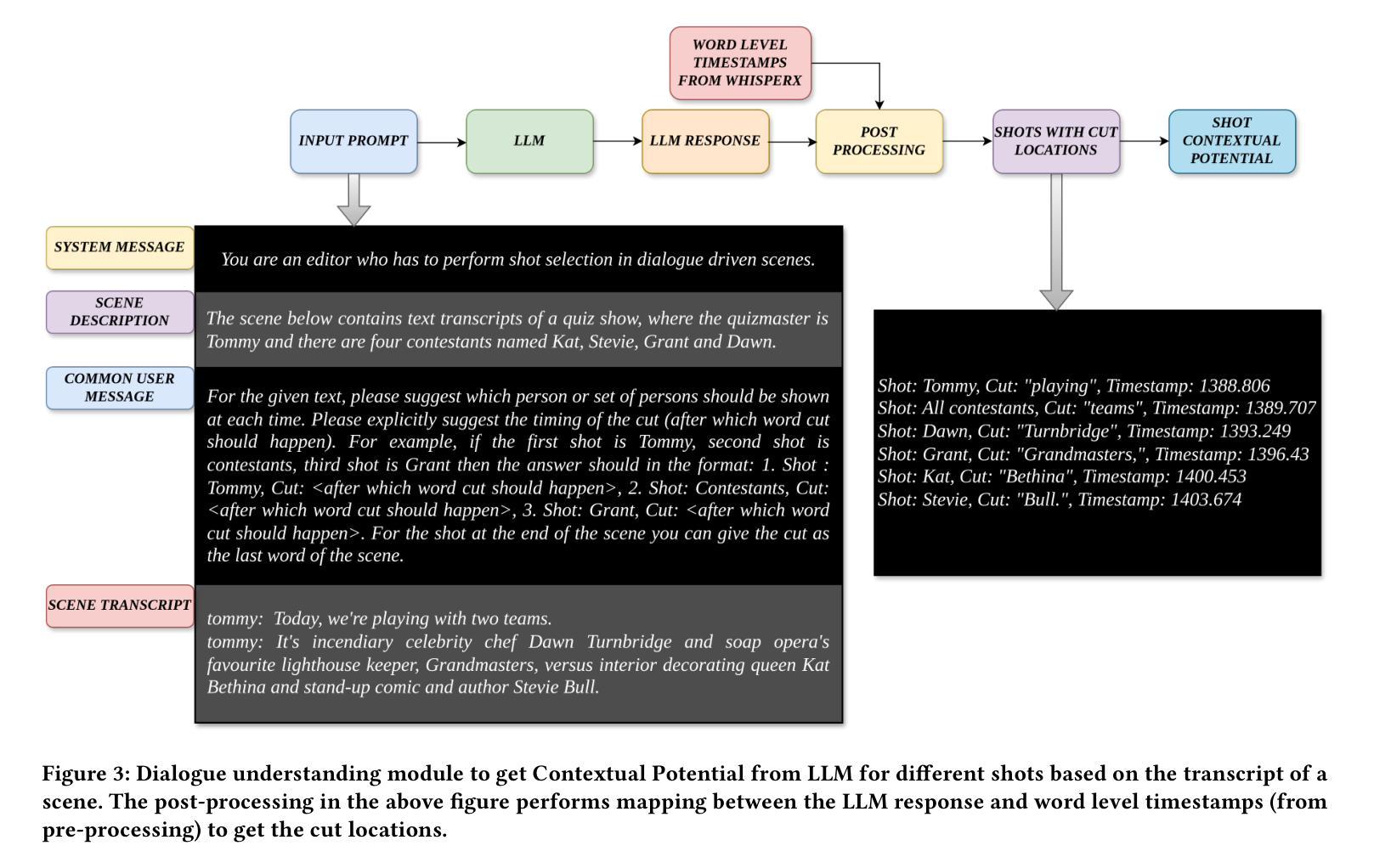

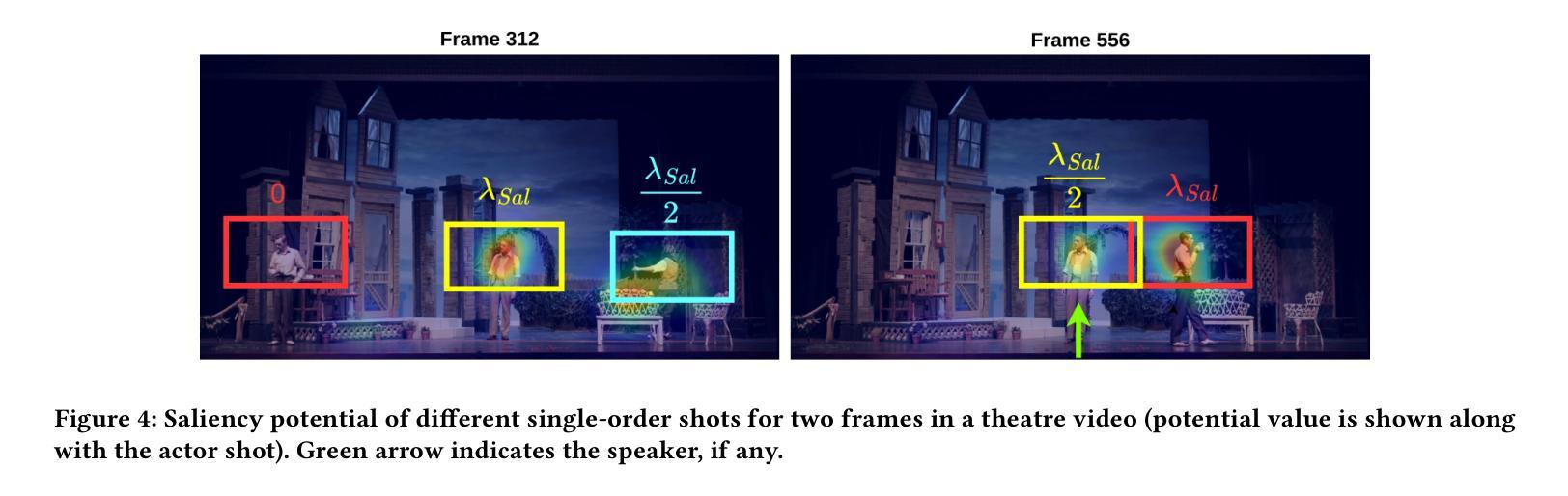

We present EditIQ, a completely automated framework for cinematically editing scenes captured via a stationary, large field-of-view and high-resolution camera. From the static camera feed, EditIQ initially generates multiple virtual feeds, emulating a team of cameramen. These virtual camera shots termed rushes are subsequently assembled using an automated editing algorithm, whose objective is to present the viewer with the most vivid scene content. To understand key scene elements and guide the editing process, we employ a two-pronged approach: (1) a large language model (LLM)-based dialogue understanding module to analyze conversational flow, coupled with (2) visual saliency prediction to identify meaningful scene elements and camera shots therefrom. We then formulate cinematic video editing as an energy minimization problem over shot selection, where cinematic constraints determine shot choices, transitions, and continuity. EditIQ synthesizes an aesthetically and visually compelling representation of the original narrative while maintaining cinematic coherence and a smooth viewing experience. Efficacy of EditIQ against competing baselines is demonstrated via a psychophysical study involving twenty participants on the BBC Old School dataset plus eleven theatre performance videos. Video samples from EditIQ can be found at https://editiq-ave.github.io/.

我们推出了EditIQ,这是一款针对通过静态、大视野和高分辨率相机捕捉的场景进行电影级自动编辑的框架。从静态相机馈送中,EditIQ首先生成多个虚拟馈送,模拟一组摄影师。这些虚拟镜头被称为镜头片段,随后使用自动编辑算法进行组装,该算法的目标是向观众呈现最生动的场景内容。为了理解关键场景元素并引导编辑过程,我们采用了双重方法:(1)基于大型语言模型的对话理解模块来分析对话流程,以及(2)视觉显著性预测来识别有意义的场景元素和镜头片段。然后我们将电影视频编辑制定为镜头选择的能量最小化问题,其中电影约束决定了镜头的选择、过渡和连续性。EditIQ合成了一种具有艺术感和视觉吸引力的原始叙事表示,同时保持了电影的连贯性和流畅的观看体验。EditIQ在BBC Old School数据集以及十一段戏剧表演视频上对二十名参与者的心理物理学研究证明了其相较于其他基准线的有效性。有关EditIQ的视频样本可以在https://editiq-ave.github.io/找到。

论文及项目相关链接

PDF Accepted at 30th International Conference on Intelligent User Interfaces (IUI 25)

Summary

该文本介绍了EditIQ框架,它是一个完全自动化的电影级视频编辑工具。它通过静态摄像头拍摄的场景生成多个虚拟镜头,并运用大型语言模型对话理解模块和视觉显著性预测来指导编辑过程。该框架通过最小化能量问题来选择镜头,从而合成具有艺术感和视觉吸引力的叙事视频。研究表明,在BBC旧学校数据集和剧院表演视频上,其性能优于竞争对手的基线系统。详情参见研究网址。

Key Takeaways

以下是关键要点列表:

- EditIQ是一个完全自动化的电影级视频编辑框架,适用于静态摄像头拍摄的场景。

- 它通过生成多个虚拟镜头来模拟摄像团队的工作。

- 使用大型语言模型对话理解模块和视觉显著性预测来分析和指导编辑过程。

- 将电影级视频编辑公式化为能量最小化问题,涉及选择镜头、过渡和连续性等要素。

- EditIQ能够合成具有艺术感和视觉吸引力的叙事视频,同时保持电影连贯性和流畅的观看体验。

- 在BBC旧学校数据集和剧院表演视频上的研究表明,其性能优于其他基线系统。

点此查看论文截图

Universal Post-Processing Networks for Joint Optimization of Modules in Task-Oriented Dialogue Systems

Authors:Atsumoto Ohashi, Ryuichiro Higashinaka

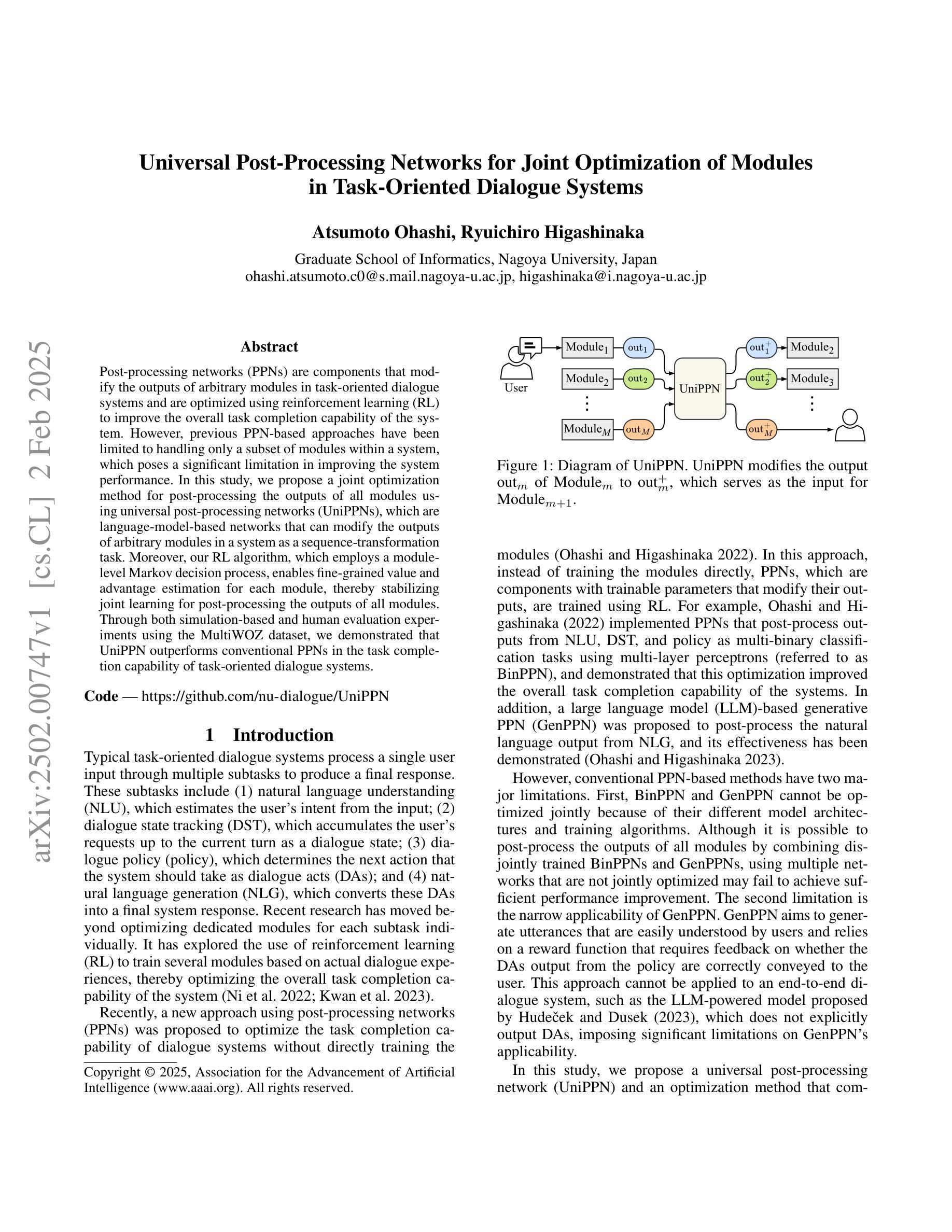

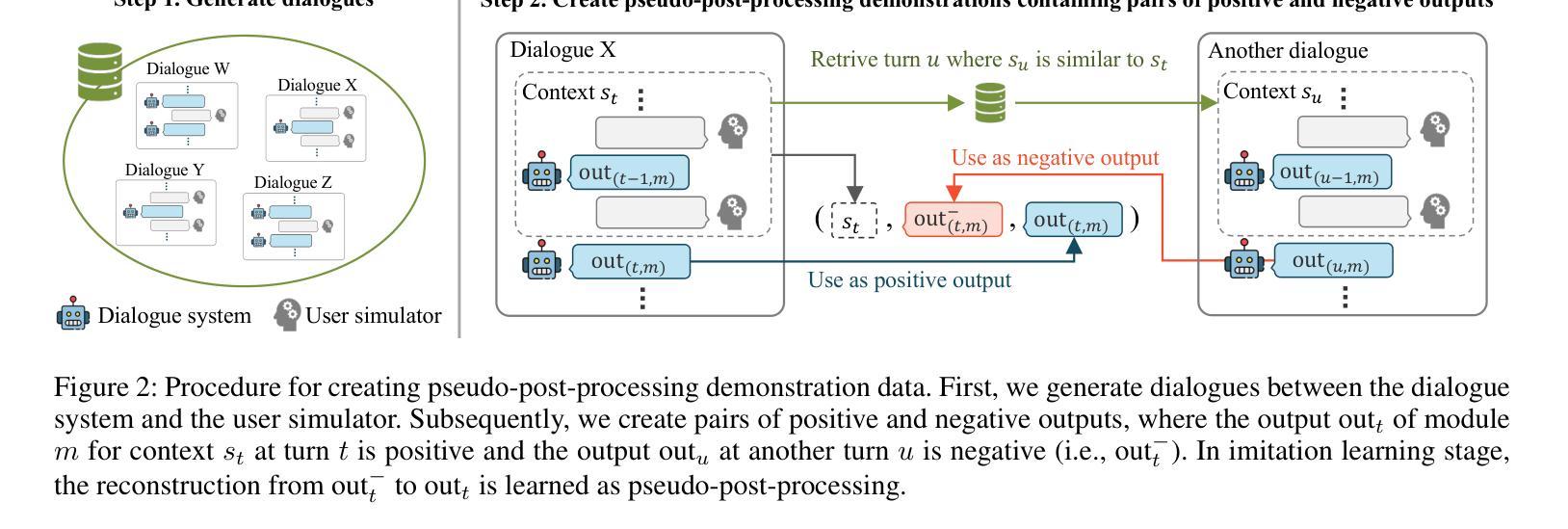

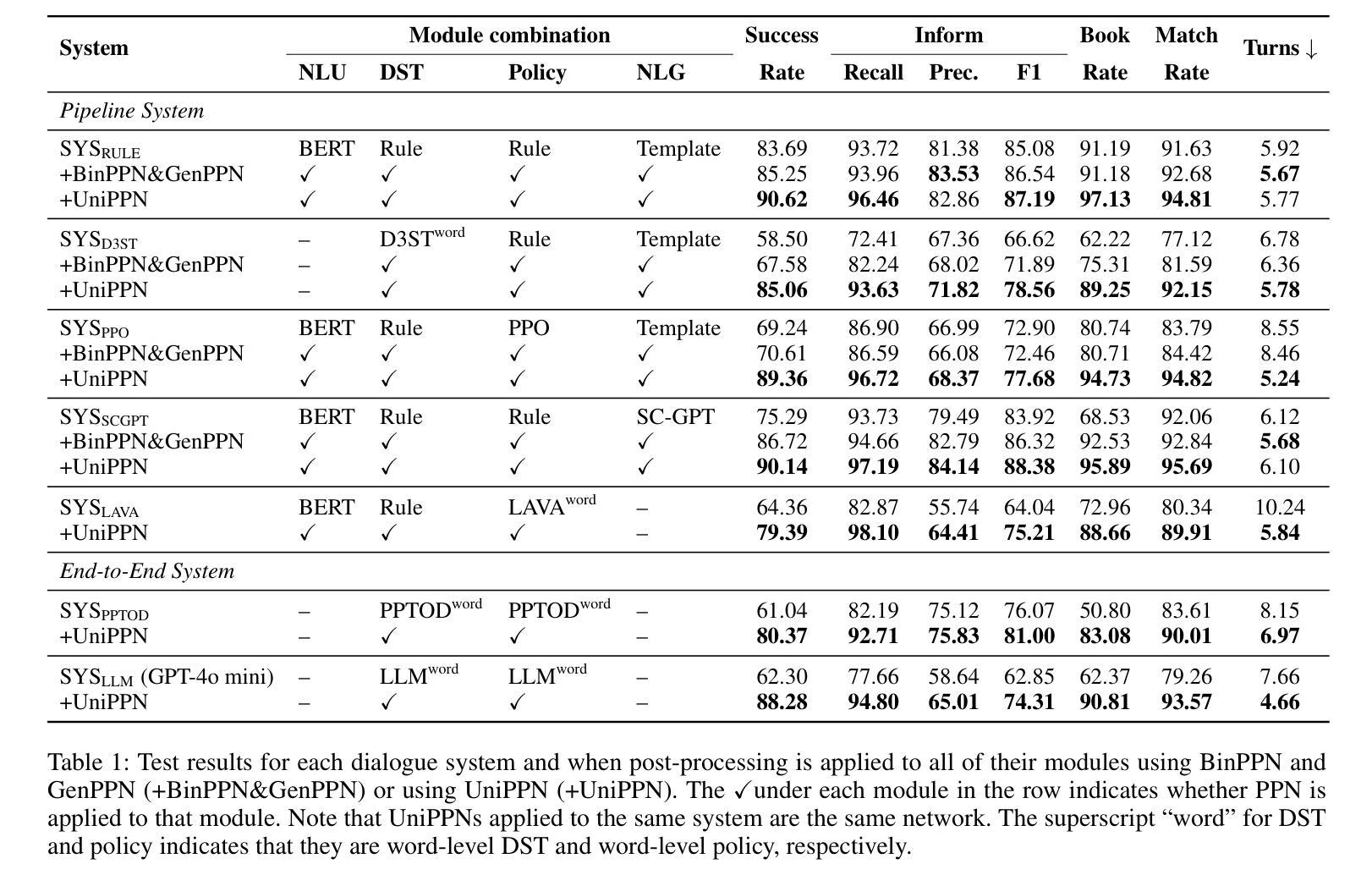

Post-processing networks (PPNs) are components that modify the outputs of arbitrary modules in task-oriented dialogue systems and are optimized using reinforcement learning (RL) to improve the overall task completion capability of the system. However, previous PPN-based approaches have been limited to handling only a subset of modules within a system, which poses a significant limitation in improving the system performance. In this study, we propose a joint optimization method for post-processing the outputs of all modules using universal post-processing networks (UniPPNs), which are language-model-based networks that can modify the outputs of arbitrary modules in a system as a sequence-transformation task. Moreover, our RL algorithm, which employs a module-level Markov decision process, enables fine-grained value and advantage estimation for each module, thereby stabilizing joint learning for post-processing the outputs of all modules. Through both simulation-based and human evaluation experiments using the MultiWOZ dataset, we demonstrated that UniPPN outperforms conventional PPNs in the task completion capability of task-oriented dialogue systems.

后处理网络(PPNs)是任务导向对话系统中任意模块输出的修改组件,通过强化学习(RL)进行优化,以提高系统的总体任务完成能力。然而,基于PPN的方法之前仅限于处理系统内部的部分模块,这为提高系统性能带来了重大挑战。本研究提出了一种基于通用后处理网络(UniPPNs)的联合优化方法,对所有模块的输进行后处理。UniPPNs是一种基于语言模型的网络,可以将系统内部任意模块的输序列转换任务进行修改。此外,我们的RL算法采用模块级马尔可夫决策过程,实现了对每个模块的精细价值优势估计,从而稳定了对所有模块输出进行后处理的联合学习。通过基于模拟和人为评估的实验,使用MultiWOZ数据集,我们证明了UniPPN在任务导向对话系统的任务完成能力方面优于传统PPNs。

论文及项目相关链接

PDF Accepted by AAAI 2025 Main Technical Track

Summary

本研究提出一种基于通用后处理网络(UniPPN)的方法,用于对任务导向型对话系统中所有模块的输出进行后处理。该方法采用基于语言的模型网络,将系统任意模块的输出修改作为序列转换任务。此外,利用模块级马尔可夫决策过程的强化学习算法,实现了对各模块输出进行精细价值评估和优势估算,从而稳定了所有模块输出的联合学习。通过基于模拟和人类的评估实验,证明UniPPN在任务完成能力方面优于传统的PPN。

Key Takeaways

- PPNs用于修改任务导向型对话系统中任意模块的输出,以提高系统整体的任务完成能力。

- 以往PPN方法仅限于处理系统内的部分模块,这限制了系统性能的提升。

- 本研究提出了基于通用后处理网络(UniPPN)的联合优化方法,能够处理系统中所有模块的输出。

- UniPPN是一种基于语言模型的网络,将系统任意模块的输出修改作为序列转换任务。

- 利用强化学习算法和模块级Markov决策过程进行精细价值评估和优势估算,稳定了联合学习。

- 通过模拟和人类的评估实验,证明UniPPN在任务完成能力方面优于传统PPN。

点此查看论文截图