⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-02-15 更新

Self-Calibrating Gaussian Splatting for Large Field of View Reconstruction

Authors:Youming Deng, Wenqi Xian, Guandao Yang, Leonidas Guibas, Gordon Wetzstein, Steve Marschner, Paul Debevec

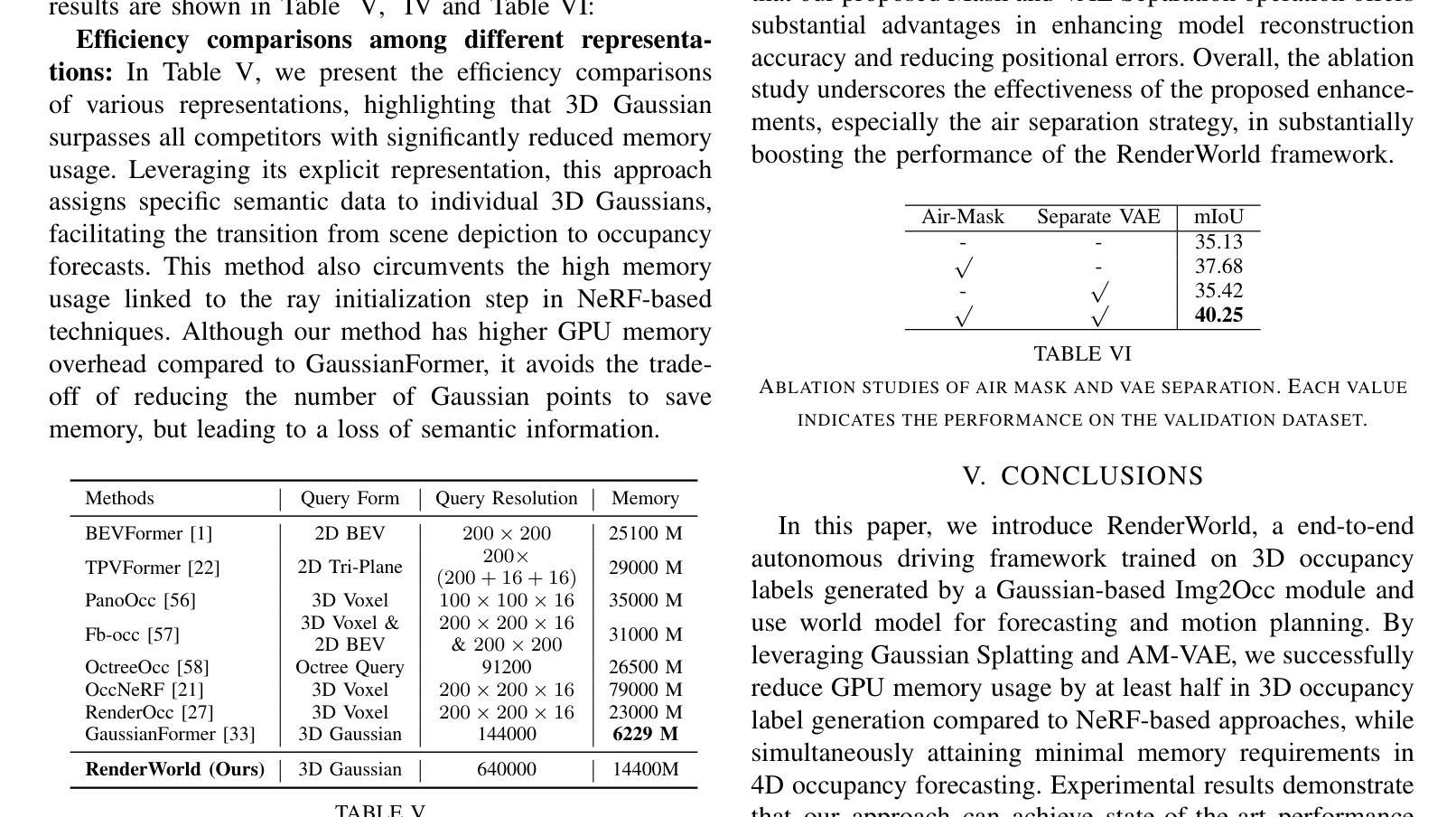

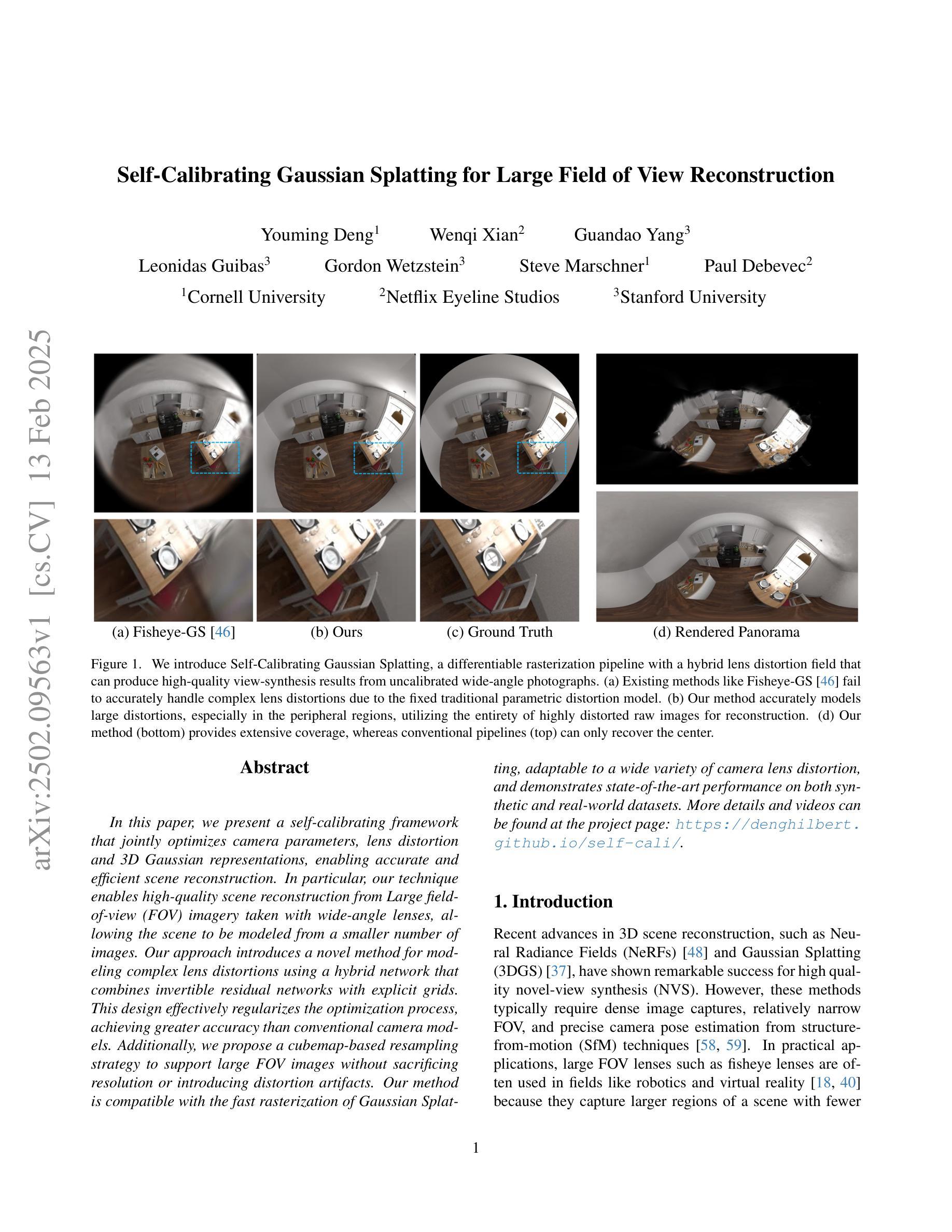

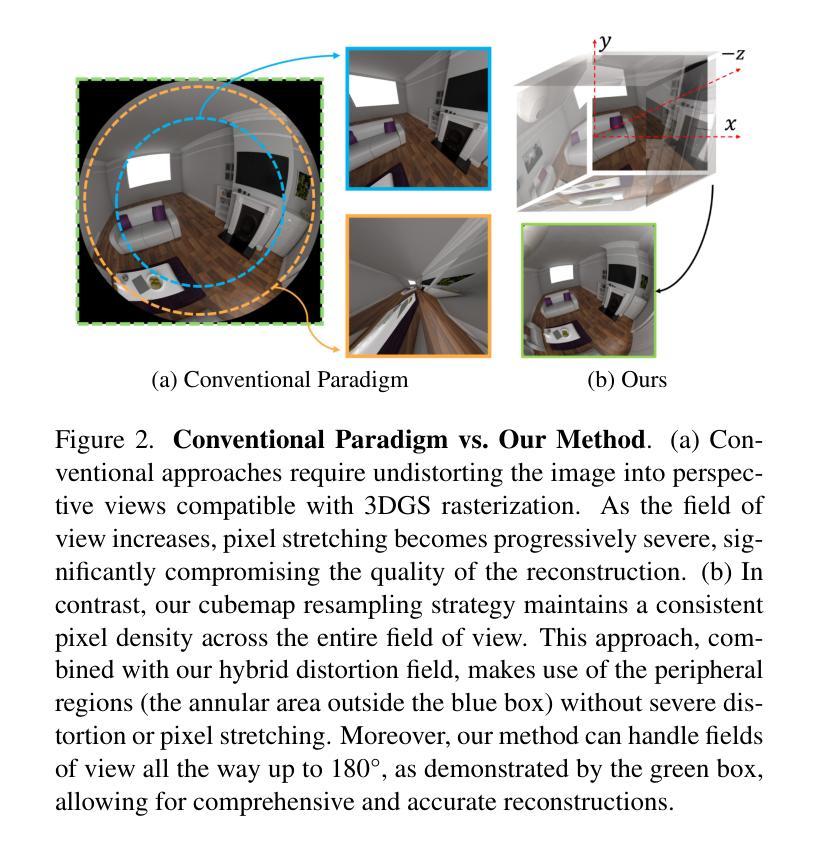

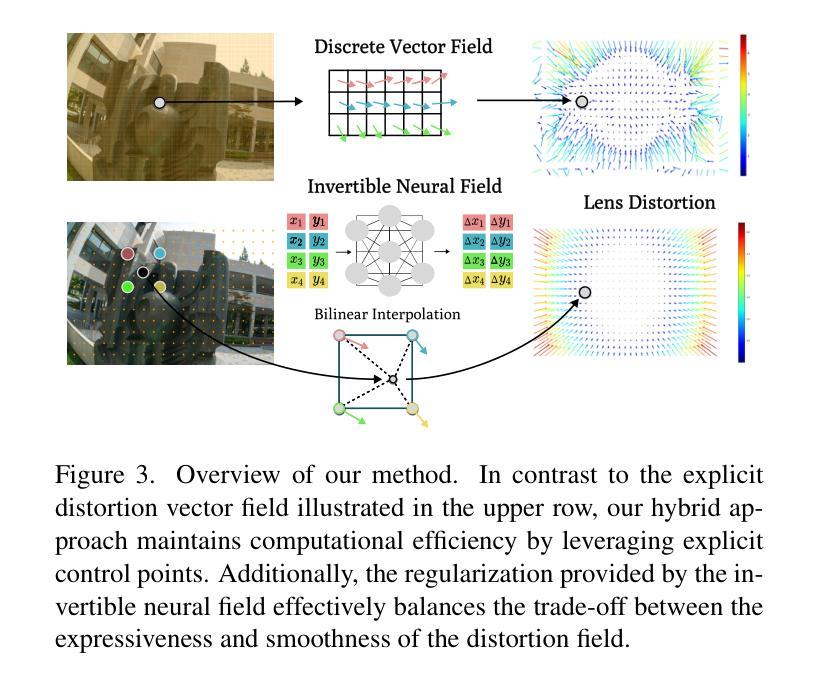

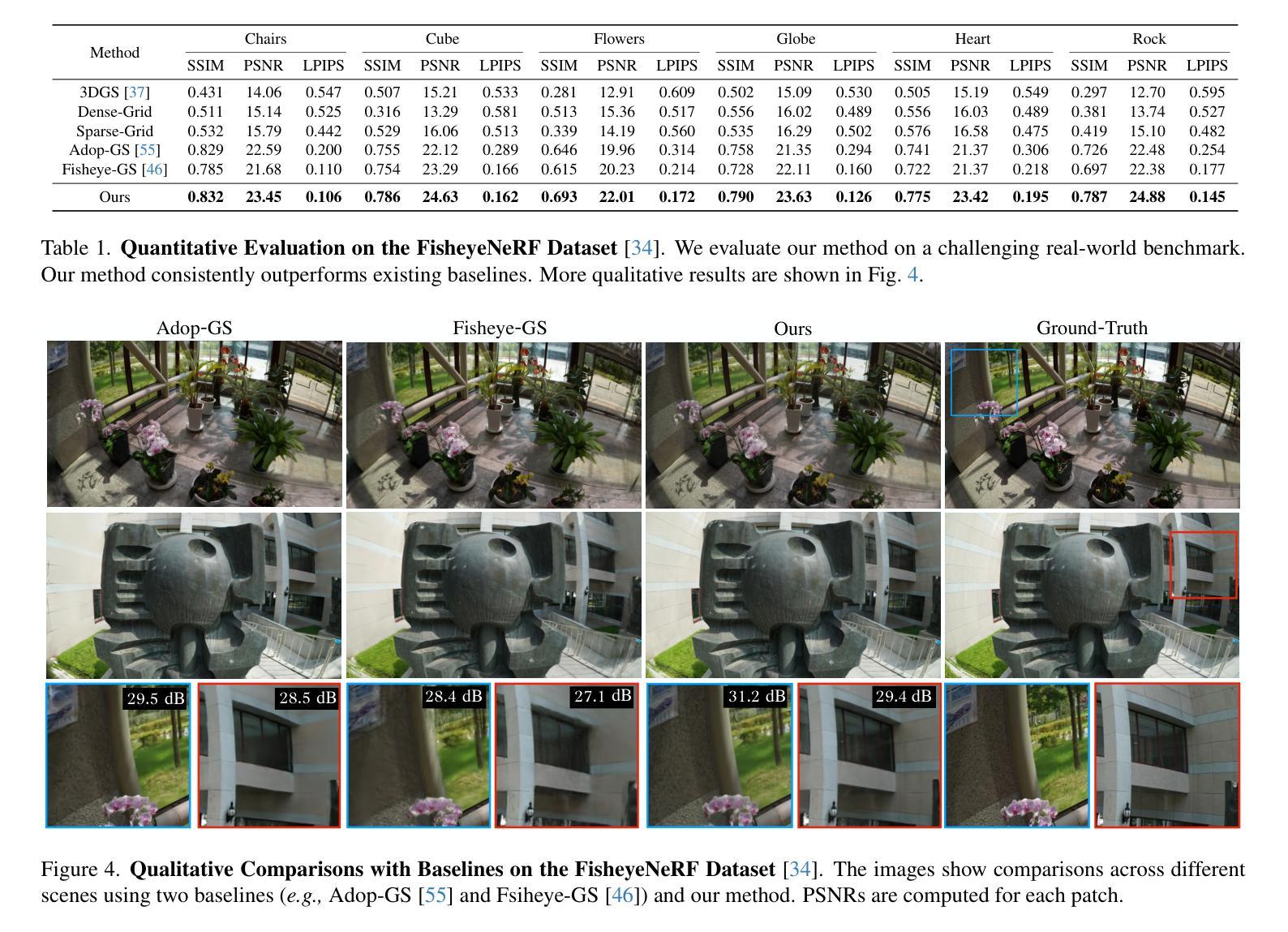

In this paper, we present a self-calibrating framework that jointly optimizes camera parameters, lens distortion and 3D Gaussian representations, enabling accurate and efficient scene reconstruction. In particular, our technique enables high-quality scene reconstruction from Large field-of-view (FOV) imagery taken with wide-angle lenses, allowing the scene to be modeled from a smaller number of images. Our approach introduces a novel method for modeling complex lens distortions using a hybrid network that combines invertible residual networks with explicit grids. This design effectively regularizes the optimization process, achieving greater accuracy than conventional camera models. Additionally, we propose a cubemap-based resampling strategy to support large FOV images without sacrificing resolution or introducing distortion artifacts. Our method is compatible with the fast rasterization of Gaussian Splatting, adaptable to a wide variety of camera lens distortion, and demonstrates state-of-the-art performance on both synthetic and real-world datasets.

本文介绍了一个自校准框架,该框架联合优化了相机参数、镜头失真和3D高斯表示,从而实现了精确高效的场景重建。特别地,我们的技术能够从使用广角镜头拍摄的大视野(FOV)图像中进行高质量的场景重建,允许从较少的图像中对场景进行建模。我们的方法引入了一种新的方法,使用混合网络对复杂的镜头失真进行建模,该网络结合了可逆残差网络和显式网格。这种设计有效地规范了优化过程,实现了比传统相机模型更高的精度。此外,我们提出了一种基于立方体贴图的重采样策略,以支持大视野图像,而不会牺牲分辨率或引入失真伪影。我们的方法与高斯贴图的快速光线投射兼容,能够适应各种相机镜头失真,并在合成和真实世界数据集上均表现出卓越的性能。

论文及项目相关链接

PDF Project Page: https://denghilbert.github.io/self-cali/

Summary

论文提出了一种自校准框架,该框架联合优化相机参数、镜头畸变和三维高斯表示,实现了准确高效的三维场景重建。该技术特别适用于大视野角图像,允许从较少的图像中建立场景模型。论文还提出了一种新的复杂镜头畸变建模方法,使用混合网络结合可逆残差网络和显式网格设计,有效提高了优化过程的准确性。此外,论文还提出了基于立方图的重采样策略,支持大视野图像而不损失分辨率或引入畸变伪影。该方法兼容高斯贴图的快速光线追踪技术,适用于各种相机镜头畸变校正,并在合成和真实数据集上达到了最新性能。

Key Takeaways

- 论文提出了一种自校准框架,联合优化相机参数、镜头畸变和三维高斯表示,提高了三维场景重建的准确性和效率。

- 技术适用于大视野角图像,能从较少的图像中建立高质量的场景模型。

- 引入了一种新的复杂镜头畸变建模方法,使用混合网络有效提高了优化过程的准确性。

- 论文提出了基于立方图的重采样策略,支持大视野图像而不损失分辨率或引入伪影。

- 方法兼容高斯贴图的快速光线追踪技术,提高了实际应用中的效率。

- 方法适用于各种相机镜头畸变校正。

点此查看论文截图

DenseSplat: Densifying Gaussian Splatting SLAM with Neural Radiance Prior

Authors:Mingrui Li, Shuhong Liu, Tianchen Deng, Hongyu Wang

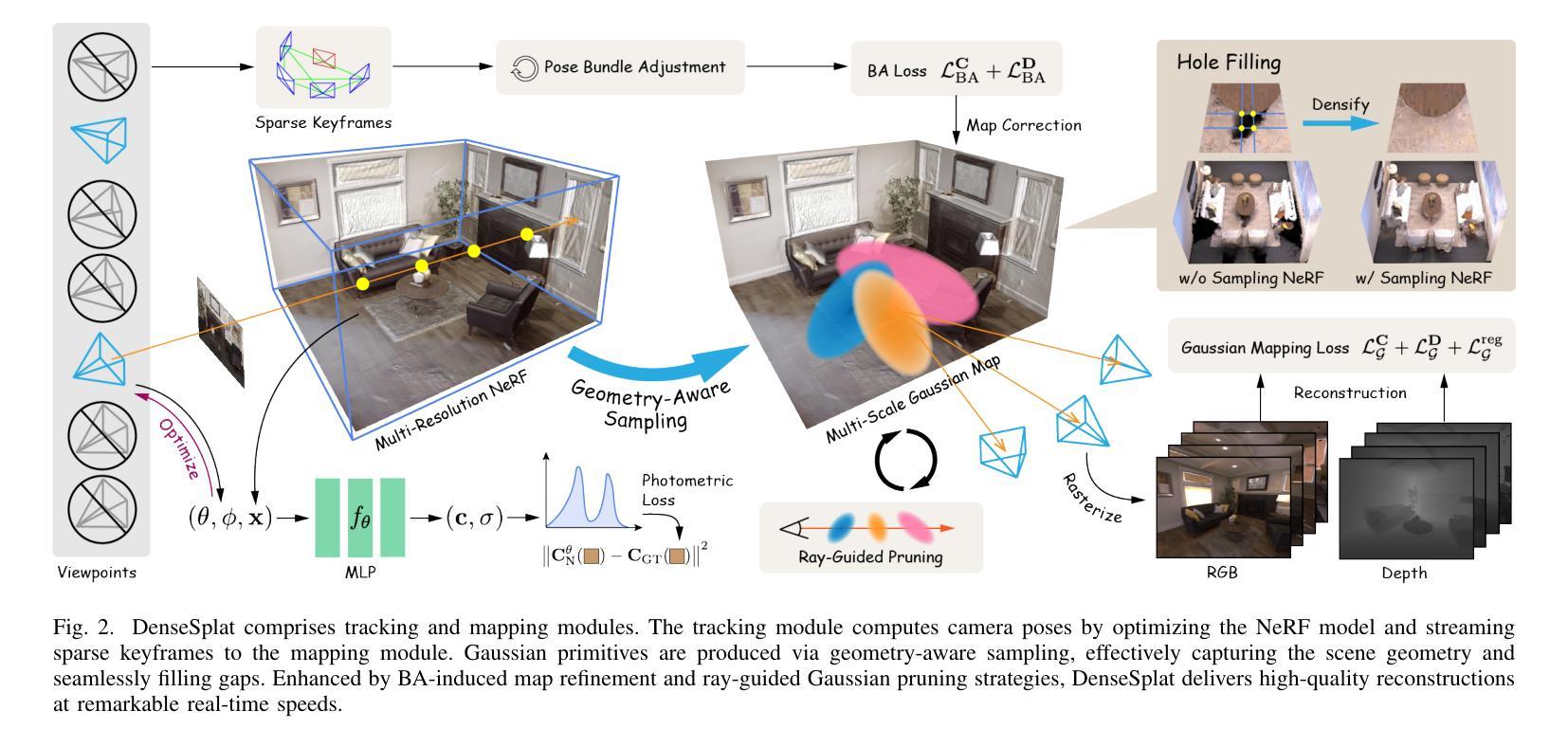

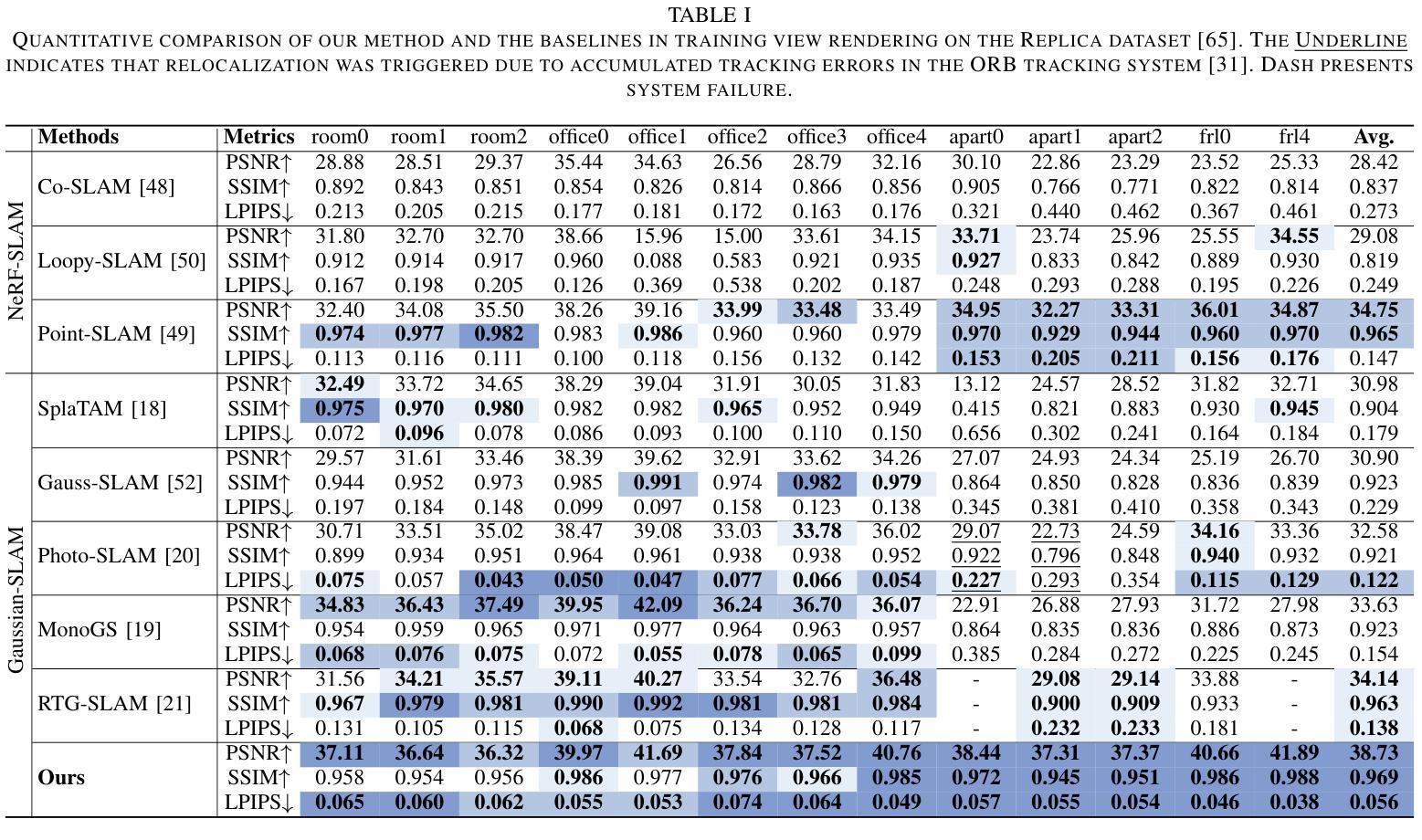

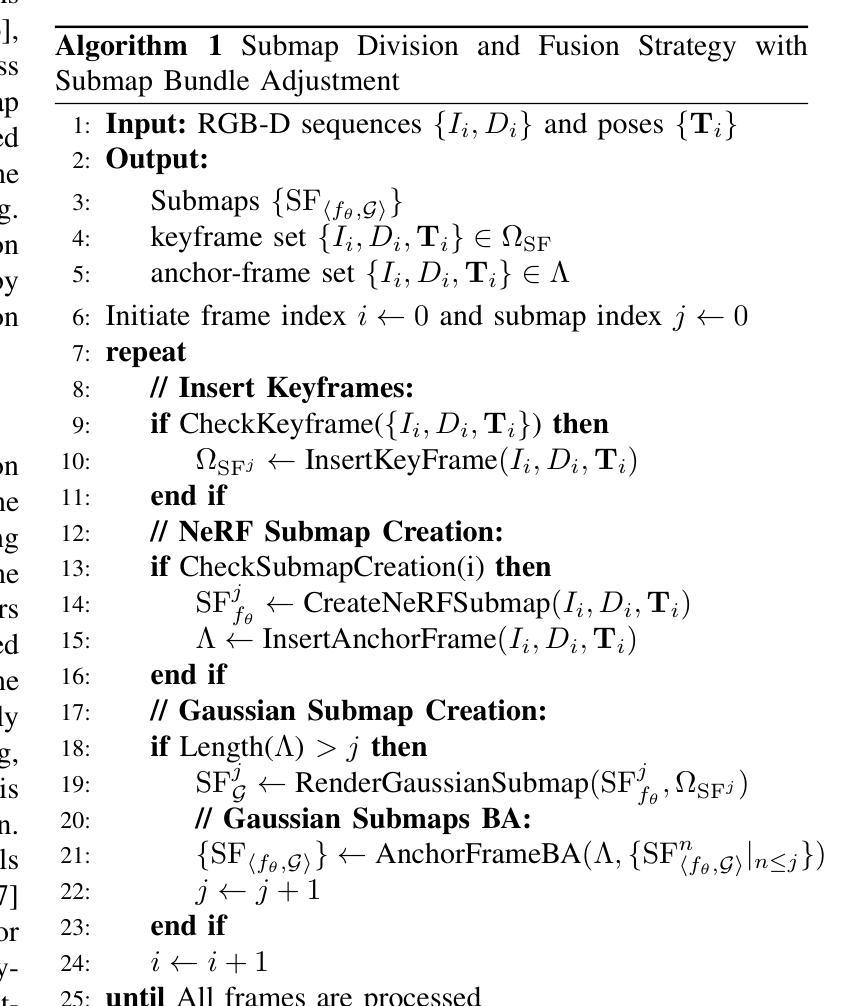

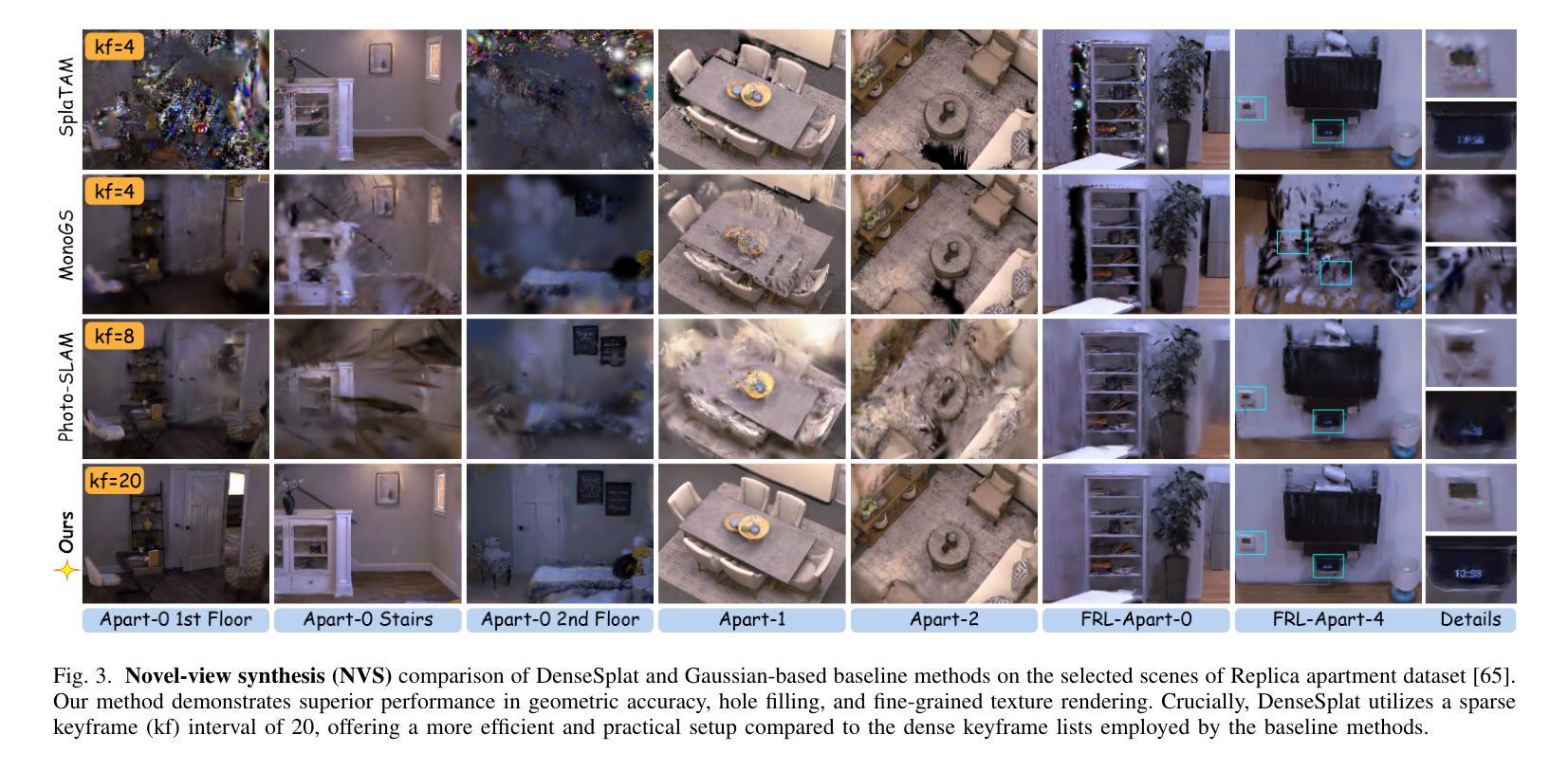

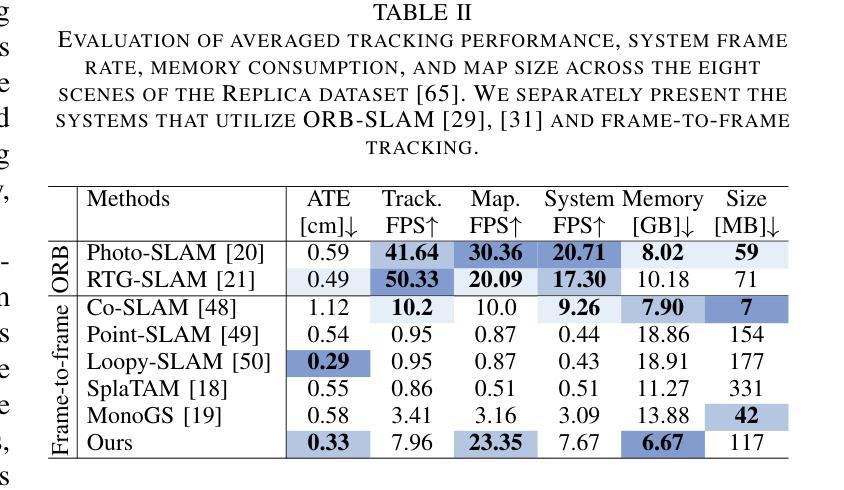

Gaussian SLAM systems excel in real-time rendering and fine-grained reconstruction compared to NeRF-based systems. However, their reliance on extensive keyframes is impractical for deployment in real-world robotic systems, which typically operate under sparse-view conditions that can result in substantial holes in the map. To address these challenges, we introduce DenseSplat, the first SLAM system that effectively combines the advantages of NeRF and 3DGS. DenseSplat utilizes sparse keyframes and NeRF priors for initializing primitives that densely populate maps and seamlessly fill gaps. It also implements geometry-aware primitive sampling and pruning strategies to manage granularity and enhance rendering efficiency. Moreover, DenseSplat integrates loop closure and bundle adjustment, significantly enhancing frame-to-frame tracking accuracy. Extensive experiments on multiple large-scale datasets demonstrate that DenseSplat achieves superior performance in tracking and mapping compared to current state-of-the-art methods.

高斯SLAM系统在实时渲染和精细重建方面优于基于NeRF的系统。然而,它们对大量关键帧的依赖并不适合在真实世界的机器人系统中部署,因为机器人通常在稀疏视角条件下工作,这可能导致地图中产生大量空洞。为了解决这些挑战,我们引入了DenseSplat,这是第一个有效结合NeRF和3DGS优势的首个SLAM系统。DenseSplat利用稀疏关键帧和NeRF先验来初始化密集填充地图并无缝填充空隙的基元。它还实现了几何感知基元采样和修剪策略,以管理粒度并提高渲染效率。此外,DenseSplat集成了闭环和捆绑调整,大大提高了帧到帧的跟踪精度。在多个大规模数据集上的广泛实验表明,与当前最先进的方法相比,DenseSplat在跟踪和映射方面实现了卓越的性能。

论文及项目相关链接

Summary

高斯SLAM系统在实时渲染和精细重建方面表现出色,但依赖于大量关键帧,不适用于实际机器人系统。为解决此问题,我们推出DenseSplat,首个有效结合NeRF和3DGS优势的系统。DenseSplat利用稀疏关键帧和NeRF先验初始化原始数据,密集填充地图并无缝填补空白。它还实现了几何感知的原始采样和修剪策略,提高渲染效率。此外,DenseSplat集成闭环和捆绑调整,显著提高帧间跟踪精度。在多个大型数据集上的广泛实验表明,DenseSplat在跟踪和映射方面的性能优于当前最先进的方法。

Key Takeaways

- 高斯SLAM系统在实时渲染和精细重建方面具有优势,但依赖大量关键帧,不适用于实际机器人系统。

- DenseSplat是首个有效结合NeRF和3DGS优势的系统。

- DenseSplat利用稀疏关键帧和NeRF先验初始化原始数据,以密集填充地图并填补空白。

- DenseSplat实现了几何感知的原始采样和修剪策略,以提高渲染效率。

- DenseSplat集成了闭环和捆绑调整,提高帧间跟踪精度。

- 实验证明,DenseSplat在跟踪和映射方面的性能优于当前最先进的方法。

点此查看论文截图

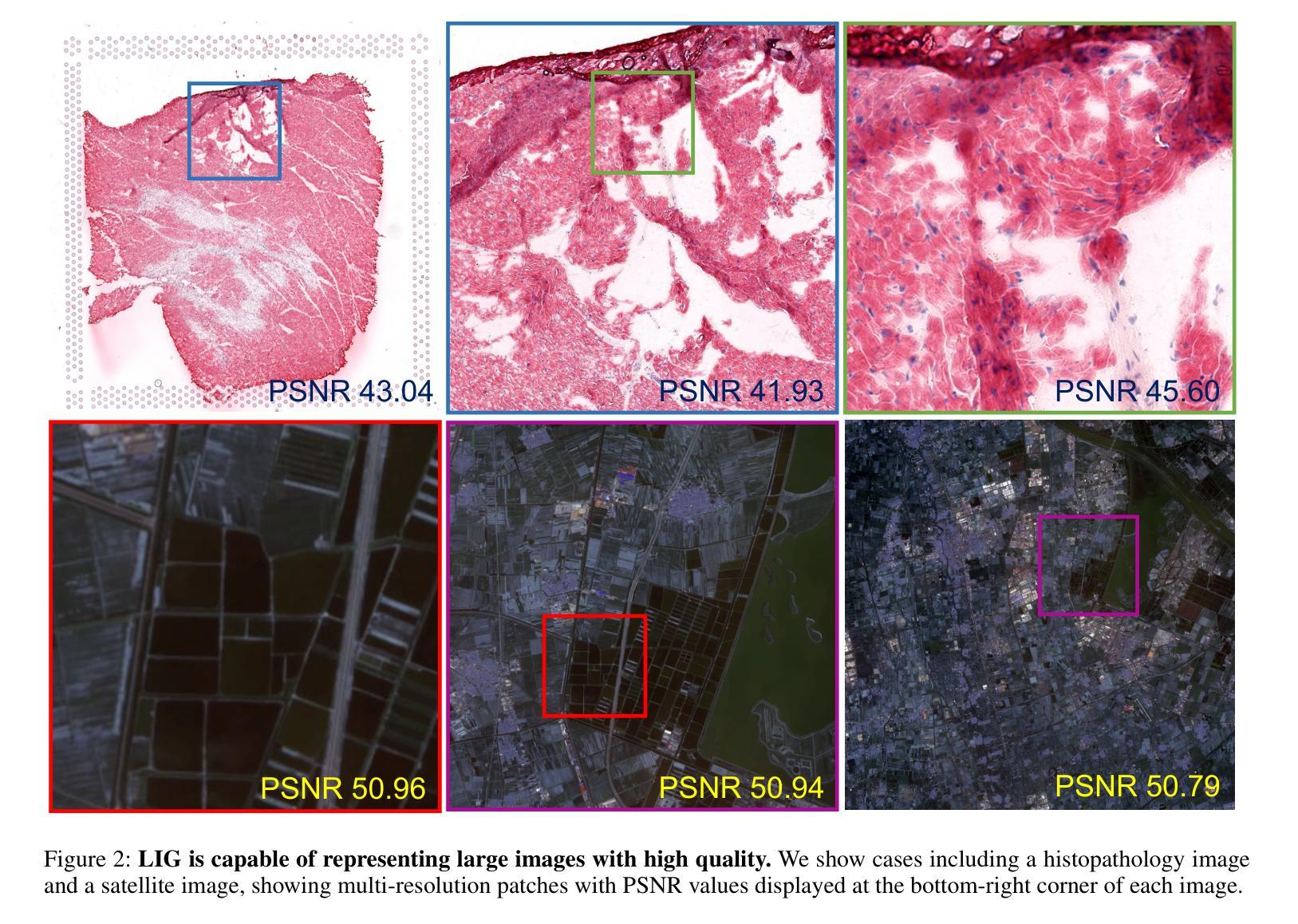

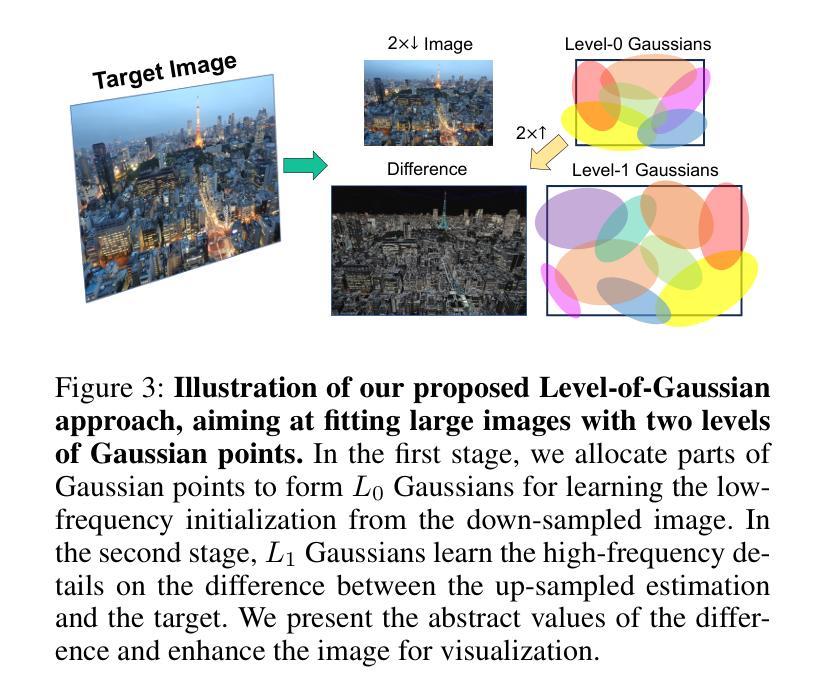

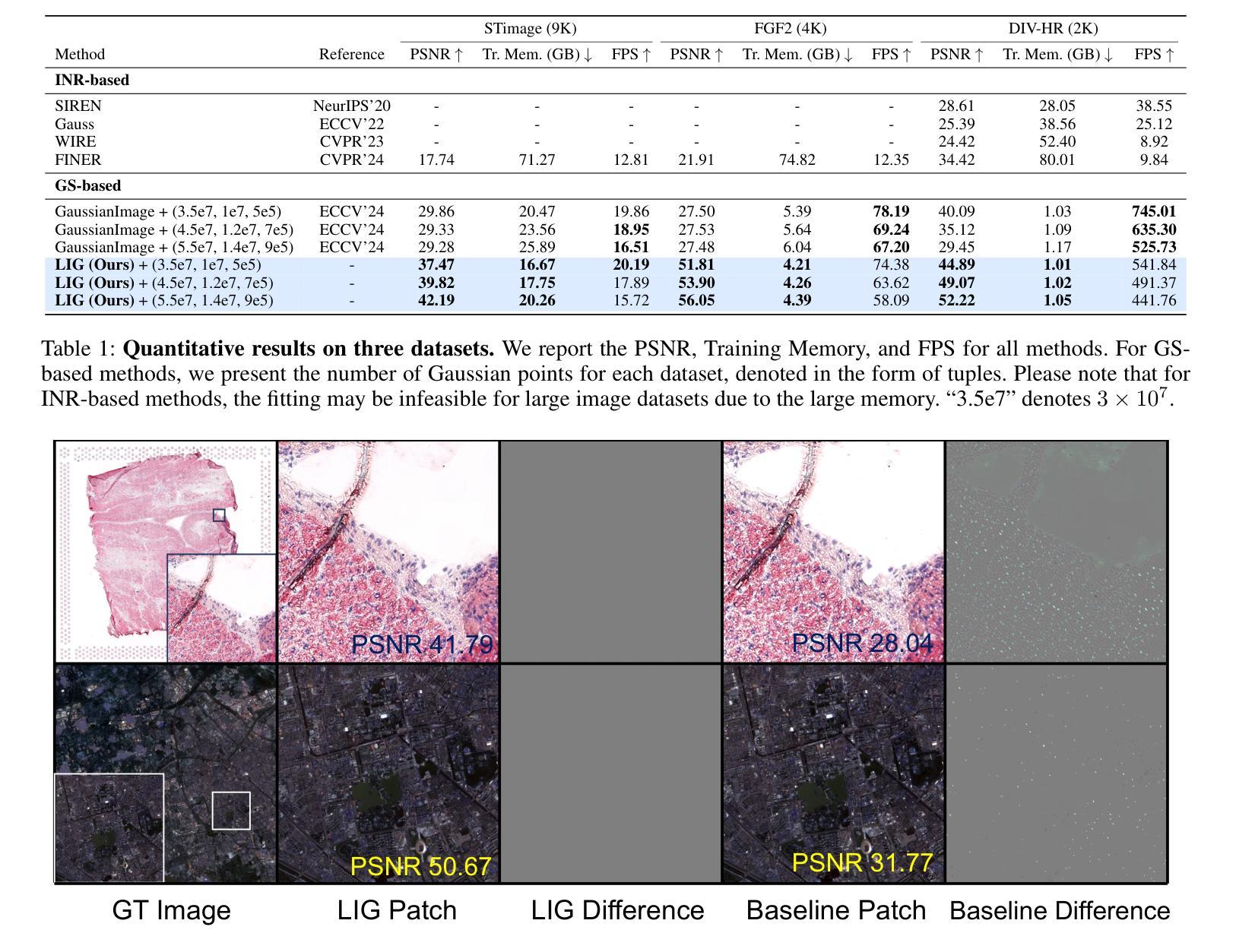

Large Images are Gaussians: High-Quality Large Image Representation with Levels of 2D Gaussian Splatting

Authors:Lingting Zhu, Guying Lin, Jinnan Chen, Xinjie Zhang, Zhenchao Jin, Zhao Wang, Lequan Yu

While Implicit Neural Representations (INRs) have demonstrated significant success in image representation, they are often hindered by large training memory and slow decoding speed. Recently, Gaussian Splatting (GS) has emerged as a promising solution in 3D reconstruction due to its high-quality novel view synthesis and rapid rendering capabilities, positioning it as a valuable tool for a broad spectrum of applications. In particular, a GS-based representation, 2DGS, has shown potential for image fitting. In our work, we present \textbf{L}arge \textbf{I}mages are \textbf{G}aussians (\textbf{LIG}), which delves deeper into the application of 2DGS for image representations, addressing the challenge of fitting large images with 2DGS in the situation of numerous Gaussian points, through two distinct modifications: 1) we adopt a variant of representation and optimization strategy, facilitating the fitting of a large number of Gaussian points; 2) we propose a Level-of-Gaussian approach for reconstructing both coarse low-frequency initialization and fine high-frequency details. Consequently, we successfully represent large images as Gaussian points and achieve high-quality large image representation, demonstrating its efficacy across various types of large images. Code is available at {\href{https://github.com/HKU-MedAI/LIG}{https://github.com/HKU-MedAI/LIG}}.

尽管隐式神经表示(INR)在图像表示方面取得了显著的成功,但它们通常受到大量训练内存和缓慢解码速度的阻碍。最近,由于高质量的新型视图合成和快速渲染能力,高斯喷溅(GS)在3D重建中表现出有前途的解决方案,为其在广泛的应用程序中定位了有价值的工具。特别是,基于GS的表示,2DGS,在图像拟合方面显示出潜力。在我们的工作中,我们提出了“大图像是高斯(\textbf{LIG})”,它进一步探讨了2DGS在图像表示中的应用,通过两种不同的修改解决了在大量高斯点的情况下拟合大图像的挑战:1)我们采用了一种表示和优化策略的变化,便于大量高斯点的拟合;2)我们提出了一种高斯级别的方法,用于重建粗糙的低频初始化和精细的高频细节。因此,我们成功地将大图像表示为高斯点,实现了高质量的大图像表示,并在各种类型的大图像中证明了其有效性。代码可在{\href{https://github.com/HKU-MedAI/LIG}{HKU-MedAI/LIG}网站获取。}

论文及项目相关链接

PDF Accepted by 39th Annual AAAI Conference on Artificial Intelligence (AAAI 2025). 10 pages, 4 figures

Summary

本文介绍了隐式神经网络表示(INR)在图像表示方面的成功应用,但其存在的训练内存大和解码速度慢的问题。近期,高斯点绘制(GS)在3D重建领域展现出良好前景,具有高质量的新视角合成和快速渲染能力。研究提出一种基于GS的表示方法2DGS在图像拟合方面的潜力。本研究进一步深入探讨了2DGS在图像表示中的应用,解决在大量高斯点情况下拟合大图像的难题,通过两种改进方法:采用一种表示和优化策略,提出一种Level-of-Gaussian方法用于重建粗的低频初始化和精细的高频细节。成功将大图像表示为高斯点,实现高质量的大图像表示,并在多种大型图像上证明了其有效性。代码已公开。

Key Takeaways

- 隐式神经网络表示(INR)虽在图像表示上成功,但存在训练内存大和解码速度慢的问题。

- 高斯点绘制(GS)在3D重建领域显示出潜力,尤其是2DGS在图像拟合方面。

- 本研究通过两种改进方法深入探讨了2DGS在图像表示中的应用。

- 采用新的表示和优化策略,能够处理大量高斯点情况下的图像拟合问题。

- 提出Level-of-Gaussian方法,用于重建粗的低频初始化和精细的高频细节。

- 成功将大图像表示为高斯点,实现高质量的大图像表示。

点此查看论文截图

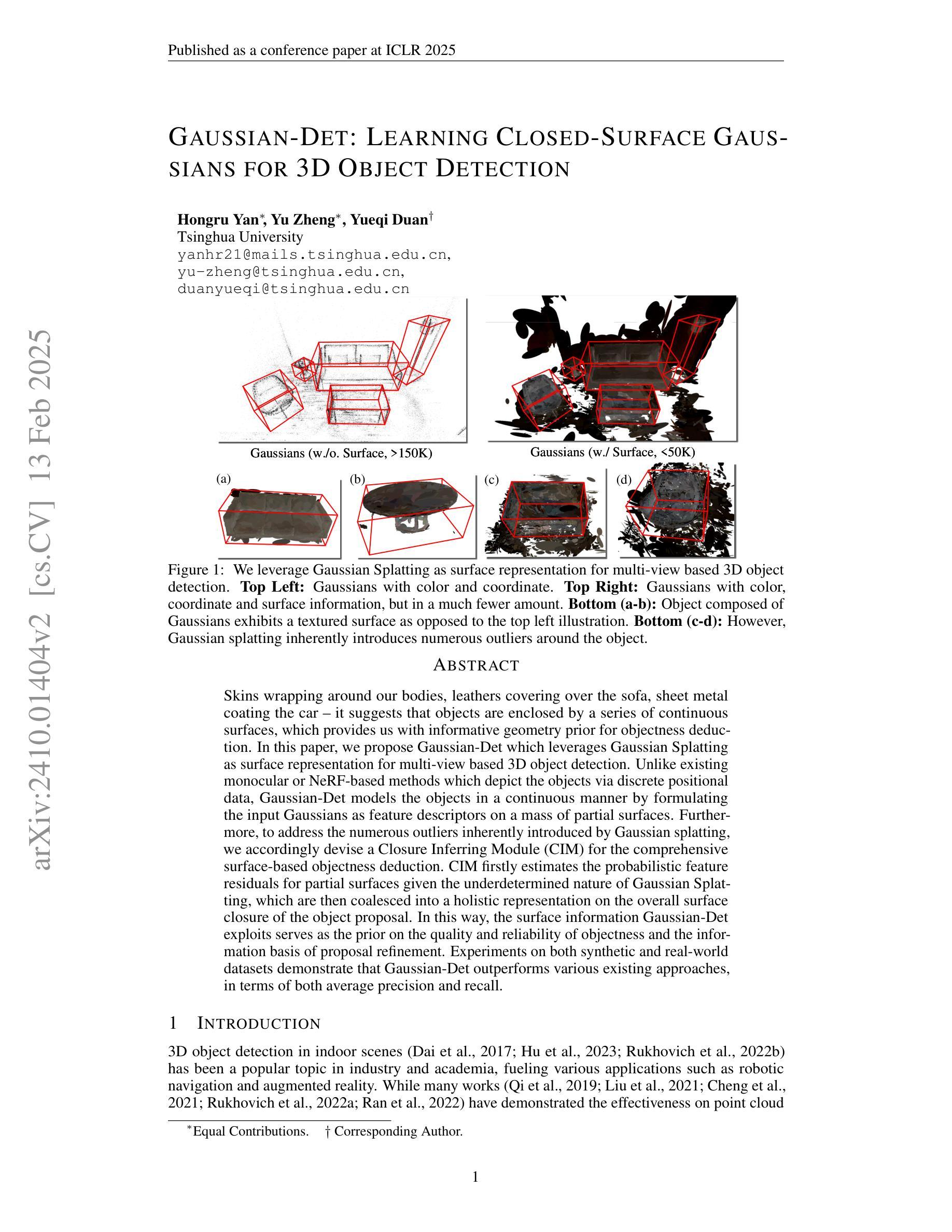

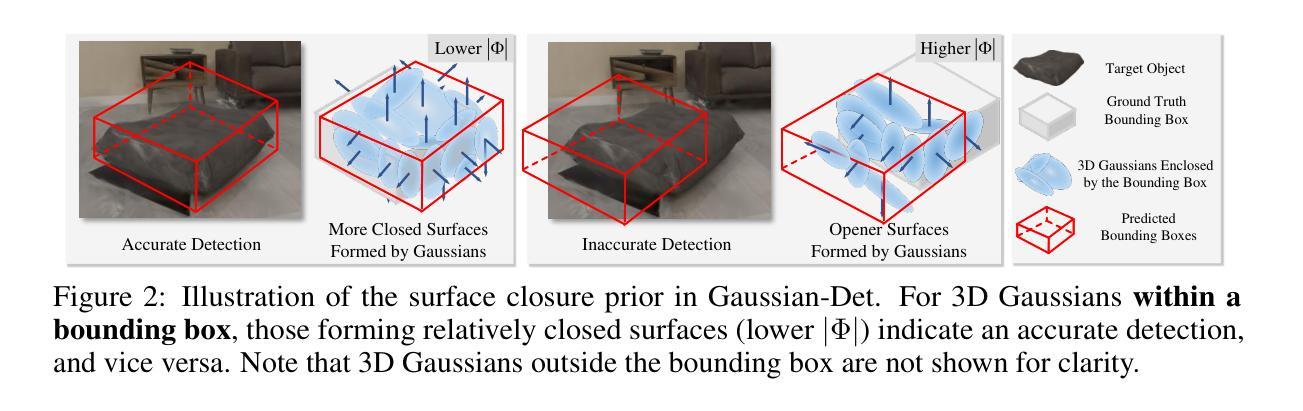

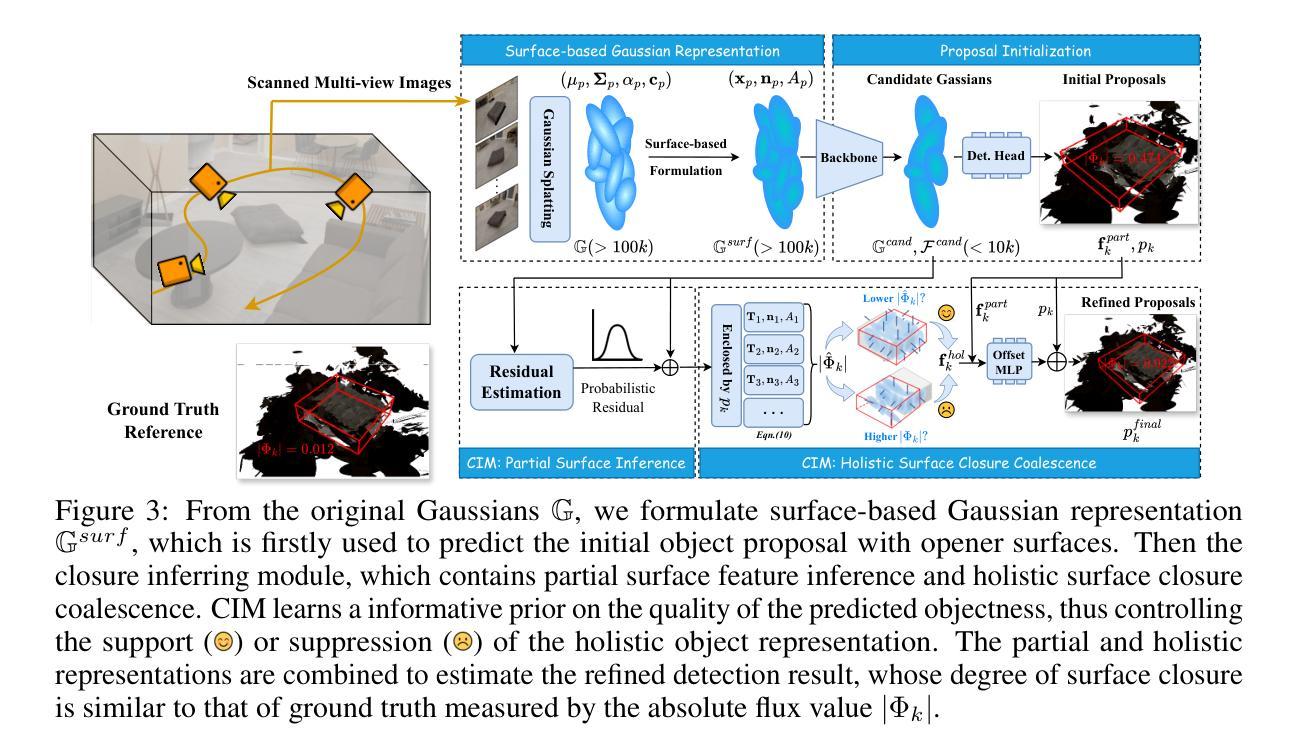

Gaussian-Det: Learning Closed-Surface Gaussians for 3D Object Detection

Authors:Hongru Yan, Yu Zheng, Yueqi Duan

Skins wrapping around our bodies, leathers covering over the sofa, sheet metal coating the car - it suggests that objects are enclosed by a series of continuous surfaces, which provides us with informative geometry prior for objectness deduction. In this paper, we propose Gaussian-Det which leverages Gaussian Splatting as surface representation for multi-view based 3D object detection. Unlike existing monocular or NeRF-based methods which depict the objects via discrete positional data, Gaussian-Det models the objects in a continuous manner by formulating the input Gaussians as feature descriptors on a mass of partial surfaces. Furthermore, to address the numerous outliers inherently introduced by Gaussian splatting, we accordingly devise a Closure Inferring Module (CIM) for the comprehensive surface-based objectness deduction. CIM firstly estimates the probabilistic feature residuals for partial surfaces given the underdetermined nature of Gaussian Splatting, which are then coalesced into a holistic representation on the overall surface closure of the object proposal. In this way, the surface information Gaussian-Det exploits serves as the prior on the quality and reliability of objectness and the information basis of proposal refinement. Experiments on both synthetic and real-world datasets demonstrate that Gaussian-Det outperforms various existing approaches, in terms of both average precision and recall.

物体表面的皮肤、沙发上的皮革、汽车上的金属板,这都表明物体被一系列连续的曲面所包围,为我们提供了关于物体性推断的几何信息。在本文中,我们提出了高斯检测器(Gaussian-Det),它利用高斯贴图作为基于多视角的3D对象检测的表面表示。与现有的基于单目视觉或神经辐射场(NeRF)的方法不同,这些方法通过离散位置数据描述对象,高斯检测器通过制定输入的高斯值作为大量局部曲面上的特征描述符,以连续的方式对对象进行建模。此外,为了解决高斯贴图固有引入的大量异常值,我们相应地设计了一个闭合推断模块(CIM)来进行基于综合曲面的物体性推断。CIM首先估计高斯贴图的未确定性质所对应的局部曲面的特征残差,然后将这些特征残差合并成对象提案整体表面闭合的完整表示。通过这种方式,高斯检测器所利用的表面信息作为物体性质和提案精细化的信息基础和可靠性依据。在合成和真实世界数据集上的实验表明,高斯检测器在平均精度和召回率方面都优于各种现有方法。

论文及项目相关链接

PDF Accepted to ICLR 2025

Summary

本文提出一种基于高斯融合的三维物体检测方法——Gaussian-Det。该方法使用高斯映射作为表面表征,以连续的方式建模物体,相较于现有的单目视觉或NeRF方法更为优越。为解决高斯映射产生的众多异常值,设计了一个闭合推断模块(CIM),用于全面的基于表面的物体性检测。实验证明,Gaussian-Det在合成和真实数据集上的平均精度和召回率均优于现有方法。

Key Takeaways

- Gaussian-Det利用高斯映射作为表面表征,以连续方式建模物体,为物体性检测提供信息几何先验。

- 与现有方法不同,Gaussian-Det通过公式化输入高斯作为部分表面的特征描述符,实现对物体的建模。

- 为解决高斯映射产生的异常值问题,设计了一个闭合推断模块(CIM)。

- CIM估算给定高斯映射不确定性下的部分表面的概率特征残差,然后将它们合并为物体提案整体表面的闭合表示。

- Gaussian-Det利用表面信息作为物体性检测的先验和质量可靠性基础,以及提案优化的信息基础。

- 实验证明,Gaussian-Det在合成和真实数据集上的平均精度和召回率均优于其他方法。

点此查看论文截图

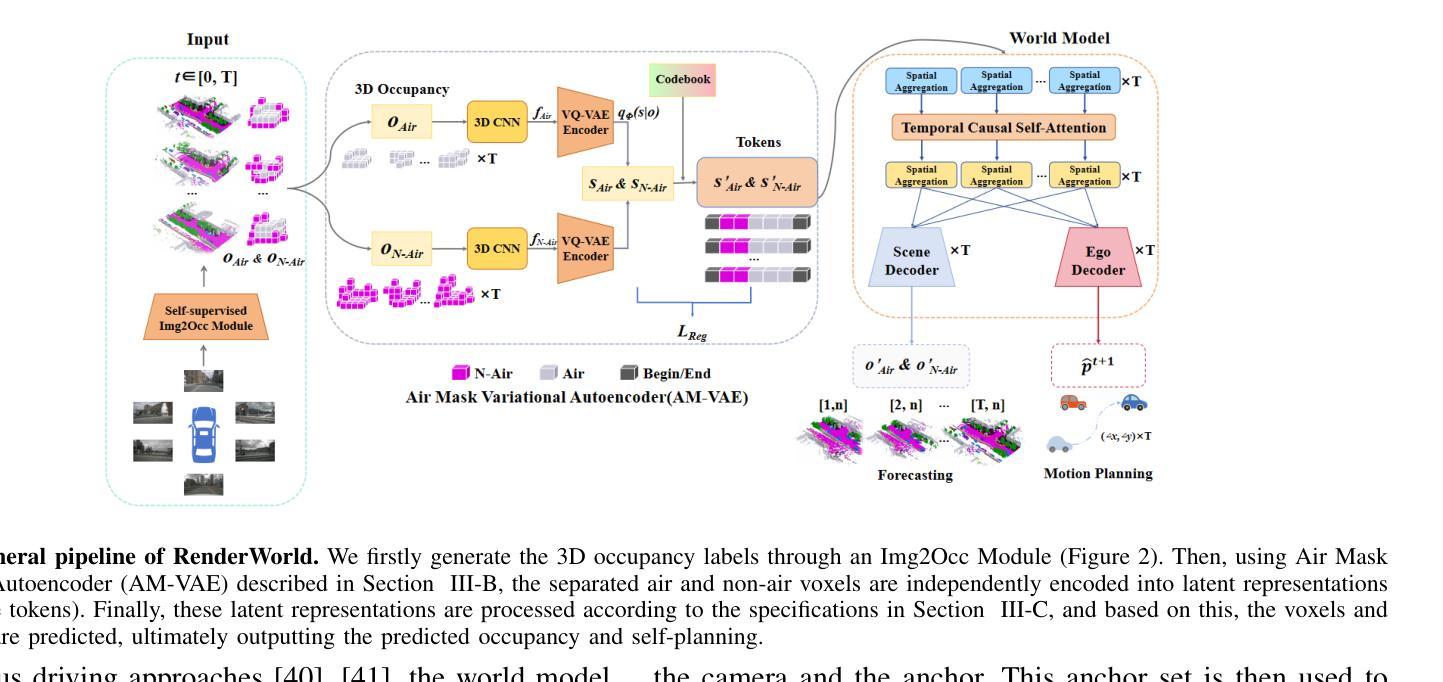

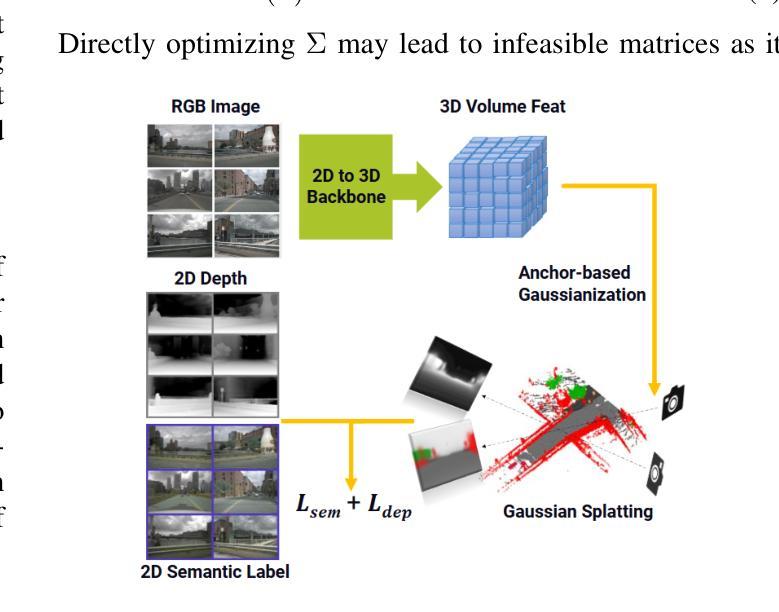

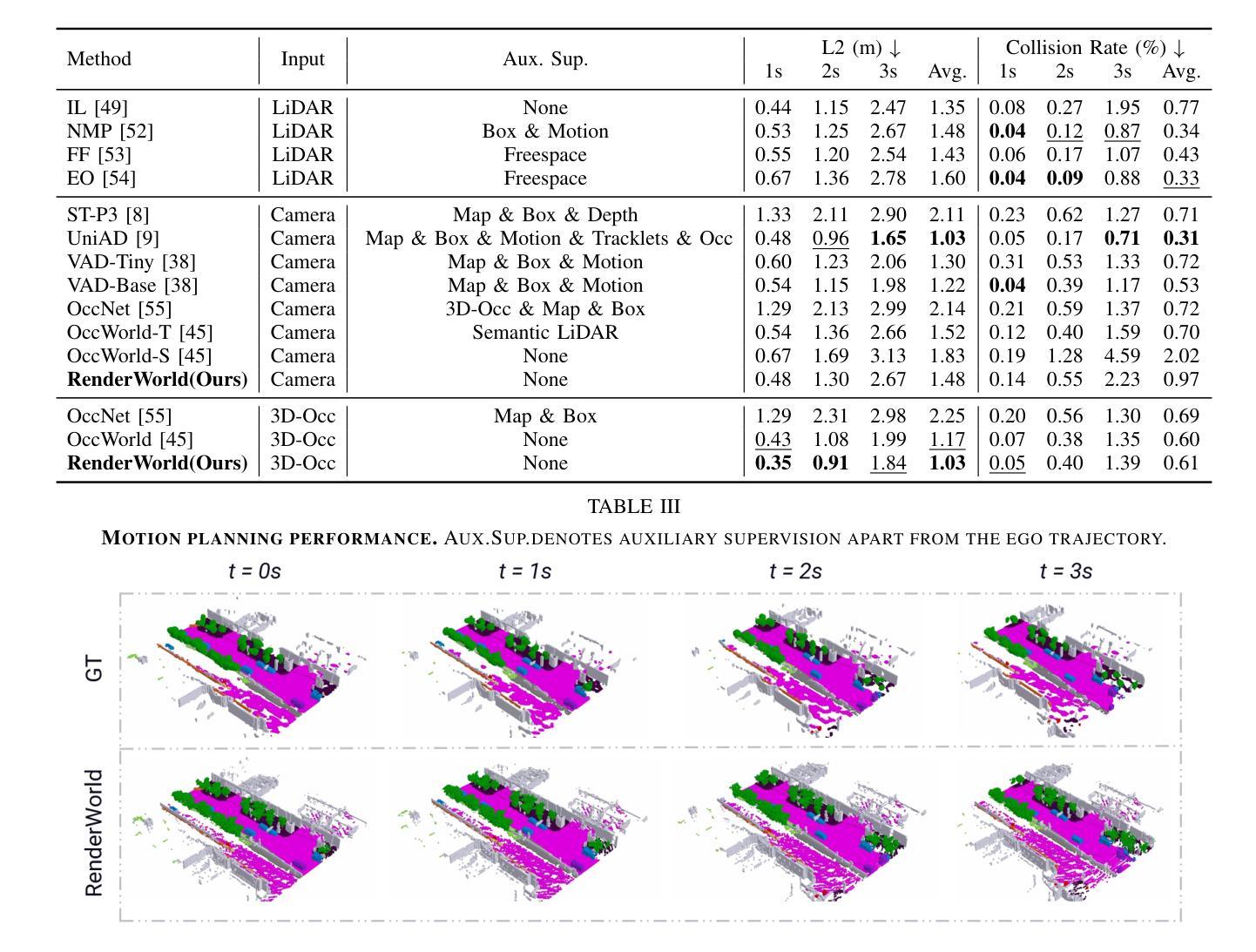

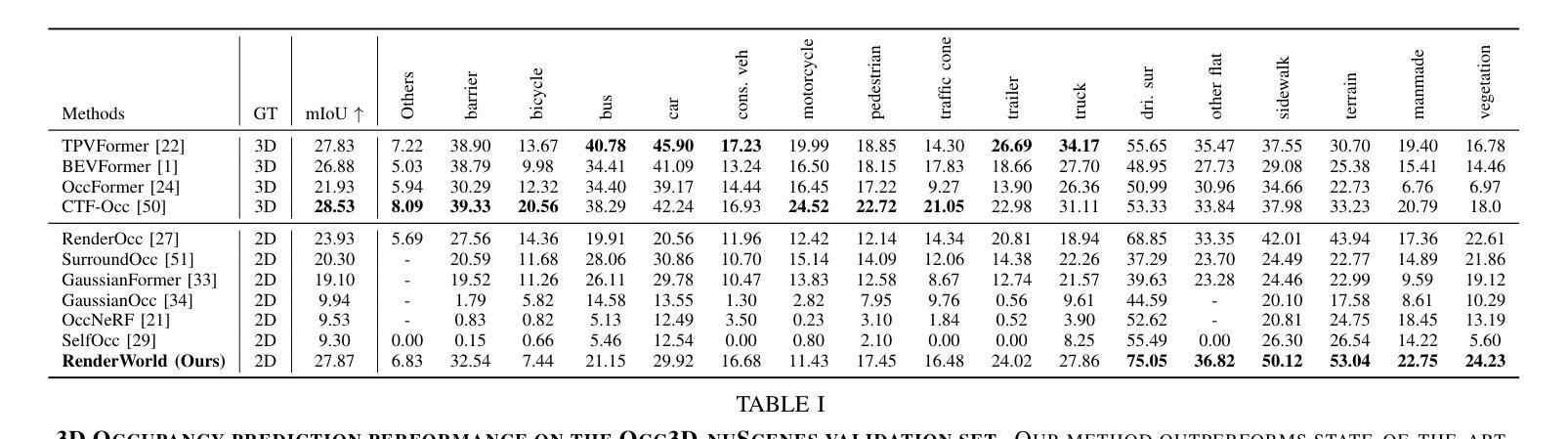

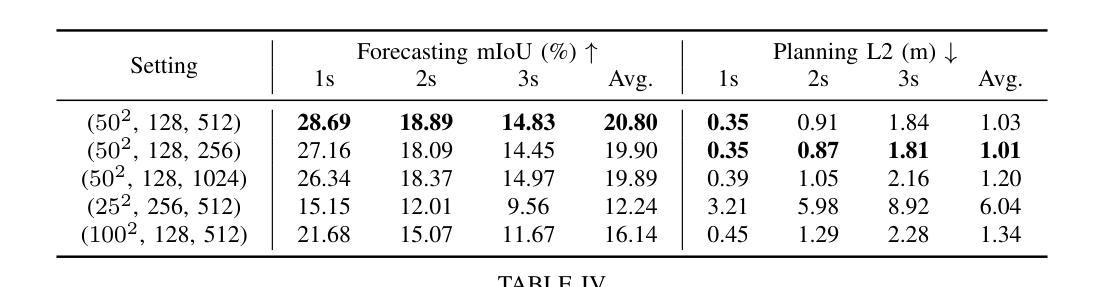

RenderWorld: World Model with Self-Supervised 3D Label

Authors:Ziyang Yan, Wenzhen Dong, Yihua Shao, Yuhang Lu, Liu Haiyang, Jingwen Liu, Haozhe Wang, Zhe Wang, Yan Wang, Fabio Remondino, Yuexin Ma

End-to-end autonomous driving with vision-only is not only more cost-effective compared to LiDAR-vision fusion but also more reliable than traditional methods. To achieve a economical and robust purely visual autonomous driving system, we propose RenderWorld, a vision-only end-to-end autonomous driving framework, which generates 3D occupancy labels using a self-supervised gaussian-based Img2Occ Module, then encodes the labels by AM-VAE, and uses world model for forecasting and planning. RenderWorld employs Gaussian Splatting to represent 3D scenes and render 2D images greatly improves segmentation accuracy and reduces GPU memory consumption compared with NeRF-based methods. By applying AM-VAE to encode air and non-air separately, RenderWorld achieves more fine-grained scene element representation, leading to state-of-the-art performance in both 4D occupancy forecasting and motion planning from autoregressive world model.

仅依赖视觉的端到端自动驾驶不仅与激光雷达视觉融合相比具有更高的成本效益,而且比传统方法更可靠。为了实现经济且稳健的纯视觉自动驾驶系统,我们提出了RenderWorld,这是一个仅依赖视觉的端到端自动驾驶框架。它使用基于自监督的高斯Img2Occ模块生成3D占用标签,然后通过AM-VAE对标签进行编码,并使用世界模型进行预测和规划。RenderWorld采用高斯贴片技术来表示3D场景,并渲染2D图像,这大大提高了分段准确性并降低了GPU的内存消耗,与基于NeRF的方法相比效果更佳。通过分别应用AM-VAE对空气和非空气进行编码,RenderWorld实现了更精细的场景元素表示,从而在自回归世界模型的4D占用预测和运动规划中达到最先进的性能。

论文及项目相关链接

PDF Accepted in 2025 IEEE International Conference on Robotics and Automation (ICRA)

Summary

基于视觉的端到端自动驾驶系统RenderWorld不仅成本更低,而且相较于传统方法更为可靠。该系统采用Img2Occ模块生成三维占用标签,结合AM-VAE编码标签和世界模型进行预测和规划。RenderWorld使用高斯贴片技术表示三维场景并渲染二维图像,相较于NeRF方法提高了分割精度并降低了GPU内存消耗。通过AM-VAE对空气和非空气元素进行单独编码,RenderWorld实现了更精细的场景元素表示,在四维占用预测和自动驾驶运动规划中达到了最先进的性能。

Key Takeaways

- RenderWorld是一个纯视觉的端到端自动驾驶框架,具有更高的成本效益和可靠性。

- Img2Occ模块使用自监督的高斯方法生成三维占用标签。

- RenderWorld采用AM-VAE编码标签,并应用世界模型进行预测和规划。

- 高斯贴片技术用于表示三维场景并渲染二维图像,提高了分割精度并降低了GPU内存消耗。

- RenderWorld通过AM-VAE对空气和非空气元素进行单独编码,实现了更精细的场景元素表示。

- 该系统在四维占用预测方面达到了最先进的性能。

点此查看论文截图