⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-02-19 更新

3D Gaussian Inpainting with Depth-Guided Cross-View Consistency

Authors:Sheng-Yu Huang, Zi-Ting Chou, Yu-Chiang Frank Wang

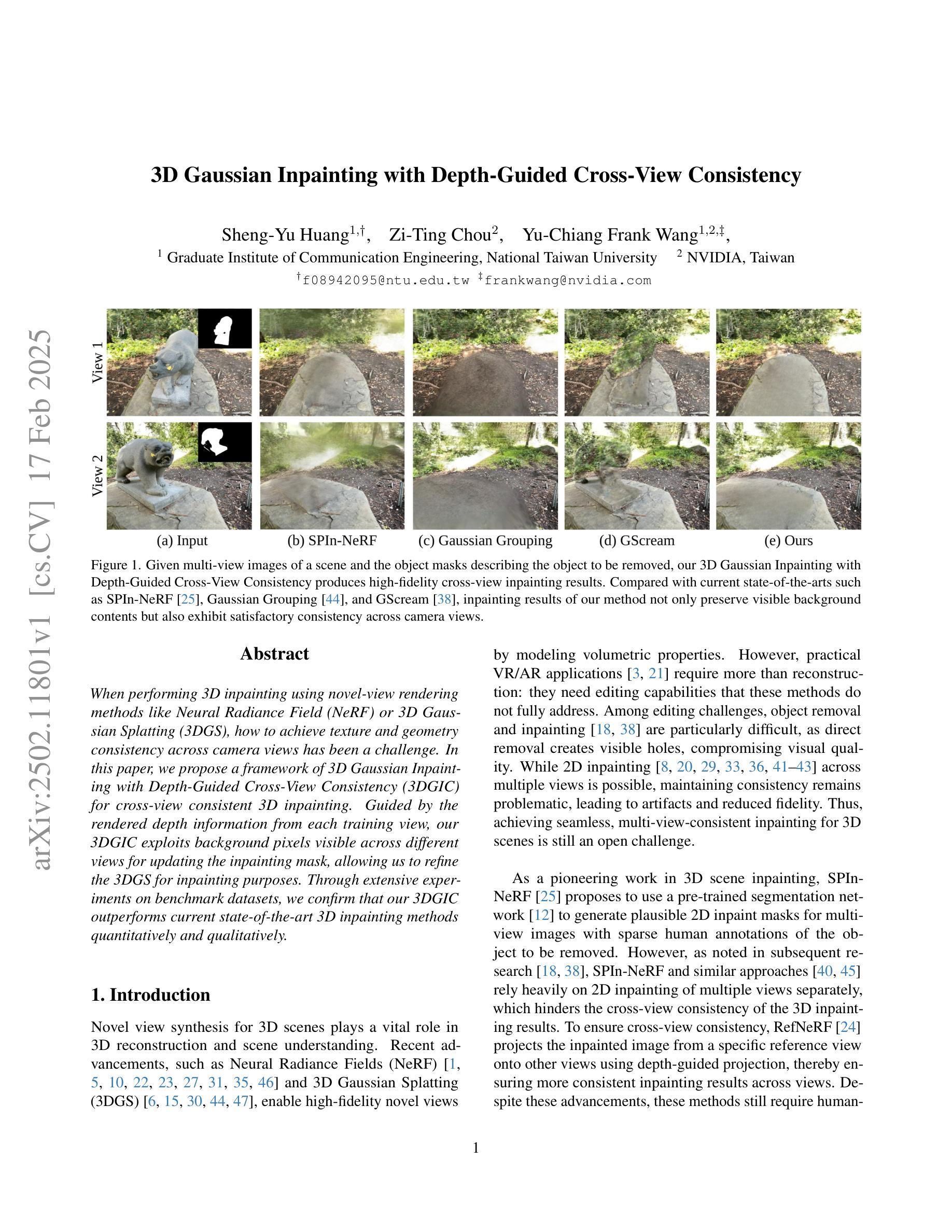

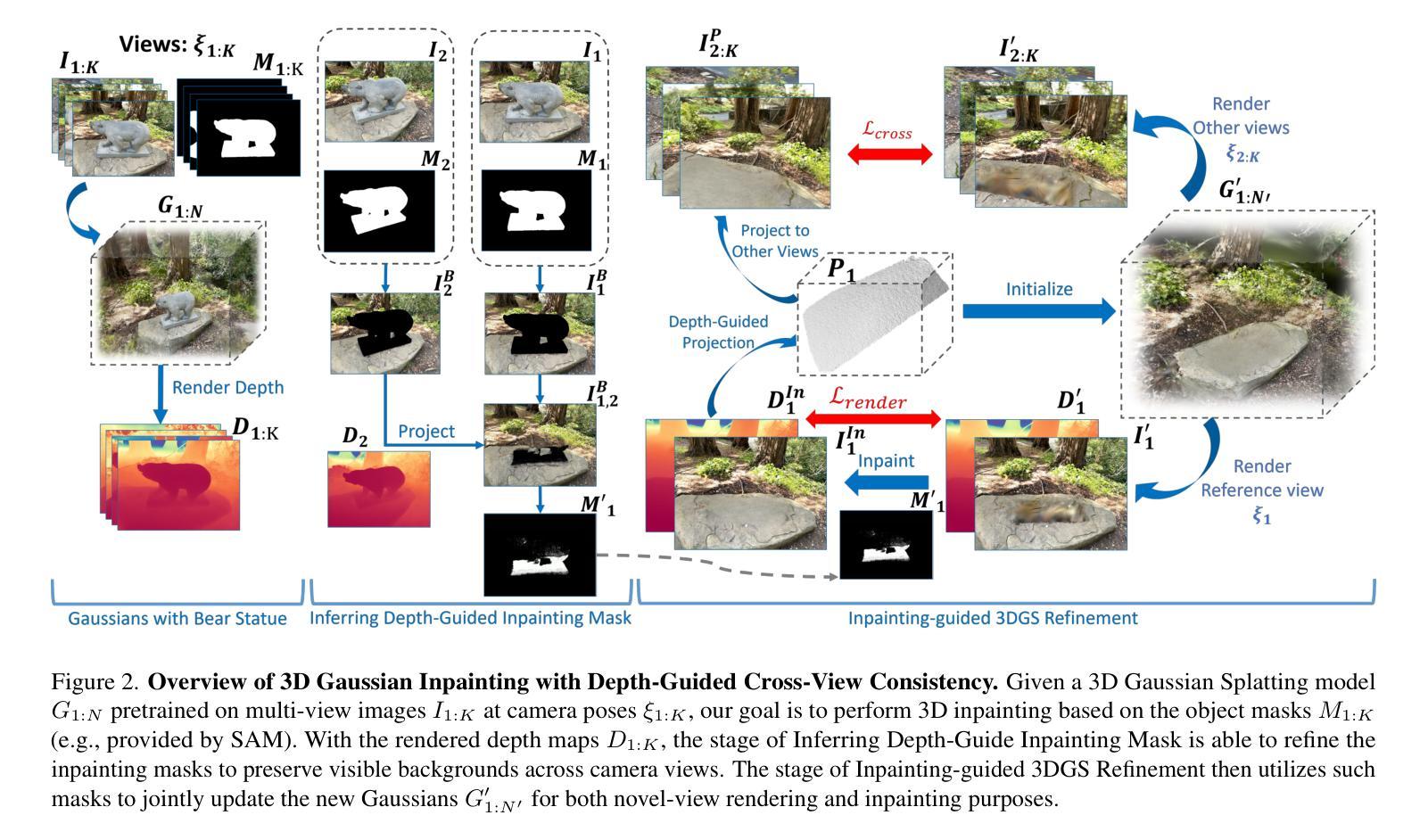

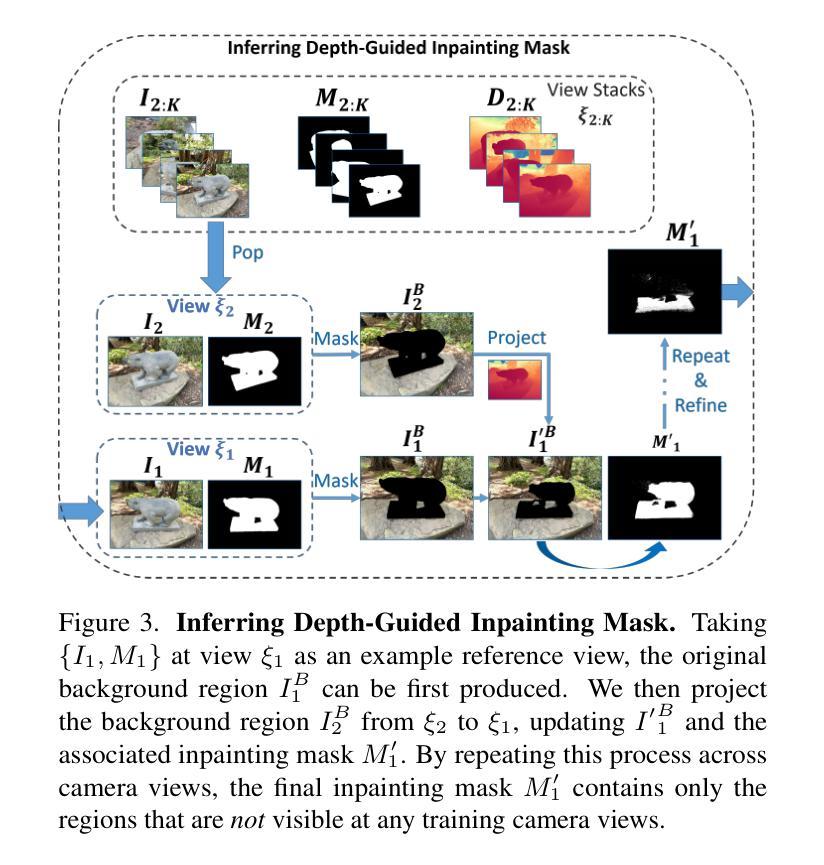

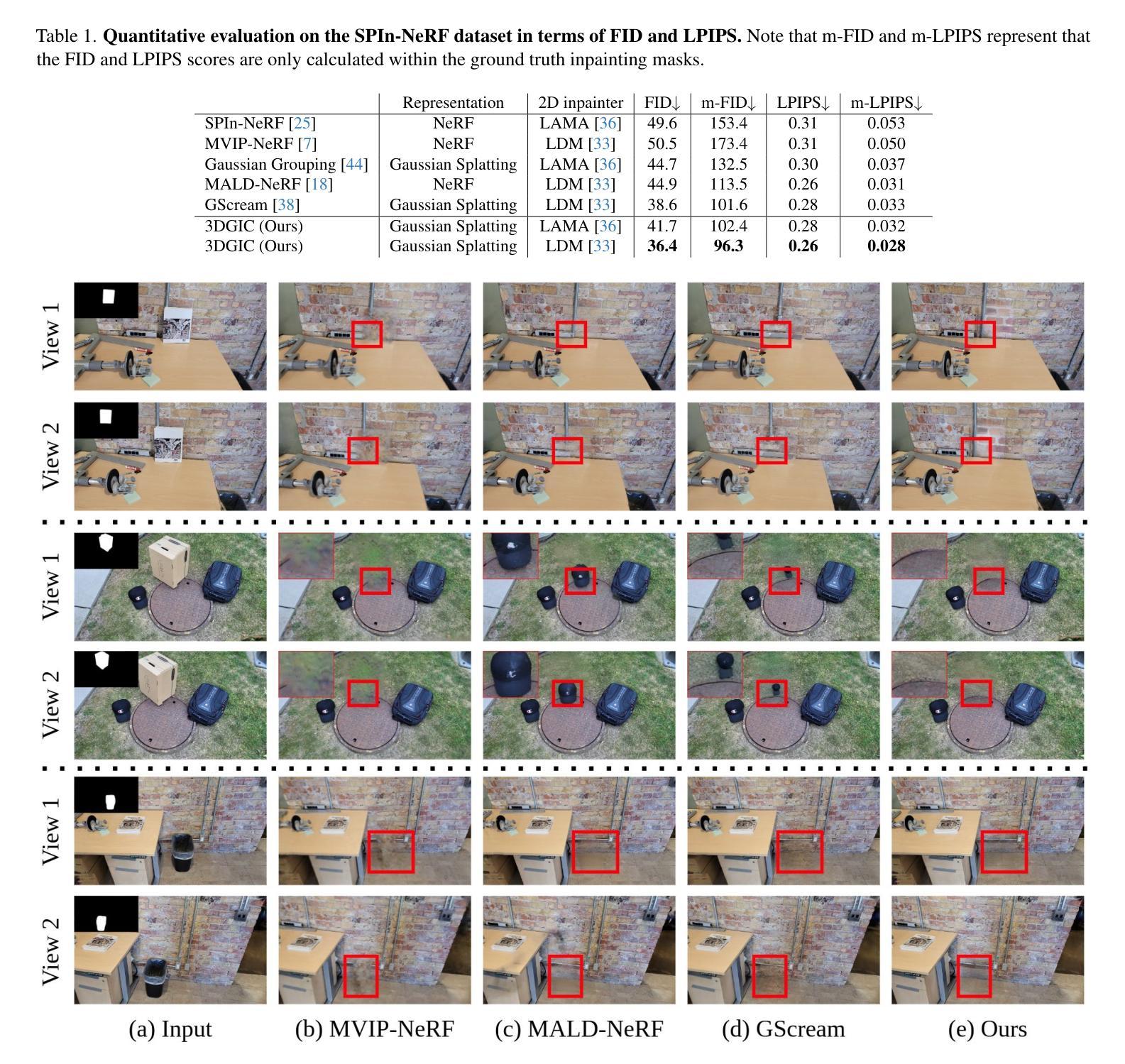

When performing 3D inpainting using novel-view rendering methods like Neural Radiance Field (NeRF) or 3D Gaussian Splatting (3DGS), how to achieve texture and geometry consistency across camera views has been a challenge. In this paper, we propose a framework of 3D Gaussian Inpainting with Depth-Guided Cross-View Consistency (3DGIC) for cross-view consistent 3D inpainting. Guided by the rendered depth information from each training view, our 3DGIC exploits background pixels visible across different views for updating the inpainting mask, allowing us to refine the 3DGS for inpainting purposes.Through extensive experiments on benchmark datasets, we confirm that our 3DGIC outperforms current state-of-the-art 3D inpainting methods quantitatively and qualitatively.

在使用如神经辐射场(NeRF)或3D高斯涂布(3DGS)等新视图渲染方法进行3D补全时,如何在不同的相机视图中实现纹理和几何一致性一直是一个挑战。在本文中,我们提出了一种具有深度引导跨视图一致性(3DGIC)的3D高斯补全框架,用于实现跨视图一致的3D补全。我们的3DGIC通过每个训练视图的渲染深度信息来引导,利用不同视图中可见的背景像素来更新补全掩码,从而允许我们优化用于补全的3DGS。通过对基准数据集的大量实验,我们证实我们的3DGIC在数量和质量上都优于当前最先进的3D补全方法。

论文及项目相关链接

Summary

本论文提出了一种基于深度引导跨视图一致性(Depth-Guided Cross-View Consistency, 简称3DGIC)的3D高斯填充框架,旨在实现跨视图一致的3D填充。该框架利用从各个训练视图中渲染的深度信息,通过跨视图可见的背景像素更新填充掩膜,从而优化用于填充的3DGS技术。在基准数据集上的实验证明,该方法在数量和质量上均优于当前最先进的3D填充技术。

Key Takeaways

- 该论文针对使用NeRF或3DGS等新型视图渲染方法进行3D填充时,如何确保跨视图纹理和几何一致性这一难题进行了研究和解答。

- 提出了一种名为3DGIC的新的跨视图一致的3D填充框架。

- 该框架利用从各个训练视图中渲染的深度信息来引导填充过程,实现跨视图一致性。

- 通过利用跨视图可见的背景像素更新填充掩膜,进一步优化了3DGS技术用于填充的目的。

- 该方法不仅在视觉上表现优异,而且通过基准数据集上的实验验证了其在量化评估方面的优越性。这意味着在各种评估和测试下,所提出的方法在所有现有技术中表现最佳。

- 与现有的先进方法相比,所提出的框架实现了更高质量的纹理和几何一致性,同时保持更准确的细节和视觉效果。这对于改善各种图像修复任务中的结果至关重要。

点此查看论文截图

GaussianMotion: End-to-End Learning of Animatable Gaussian Avatars with Pose Guidance from Text

Authors:Gyumin Shim, Sangmin Lee, Jaegul Choo

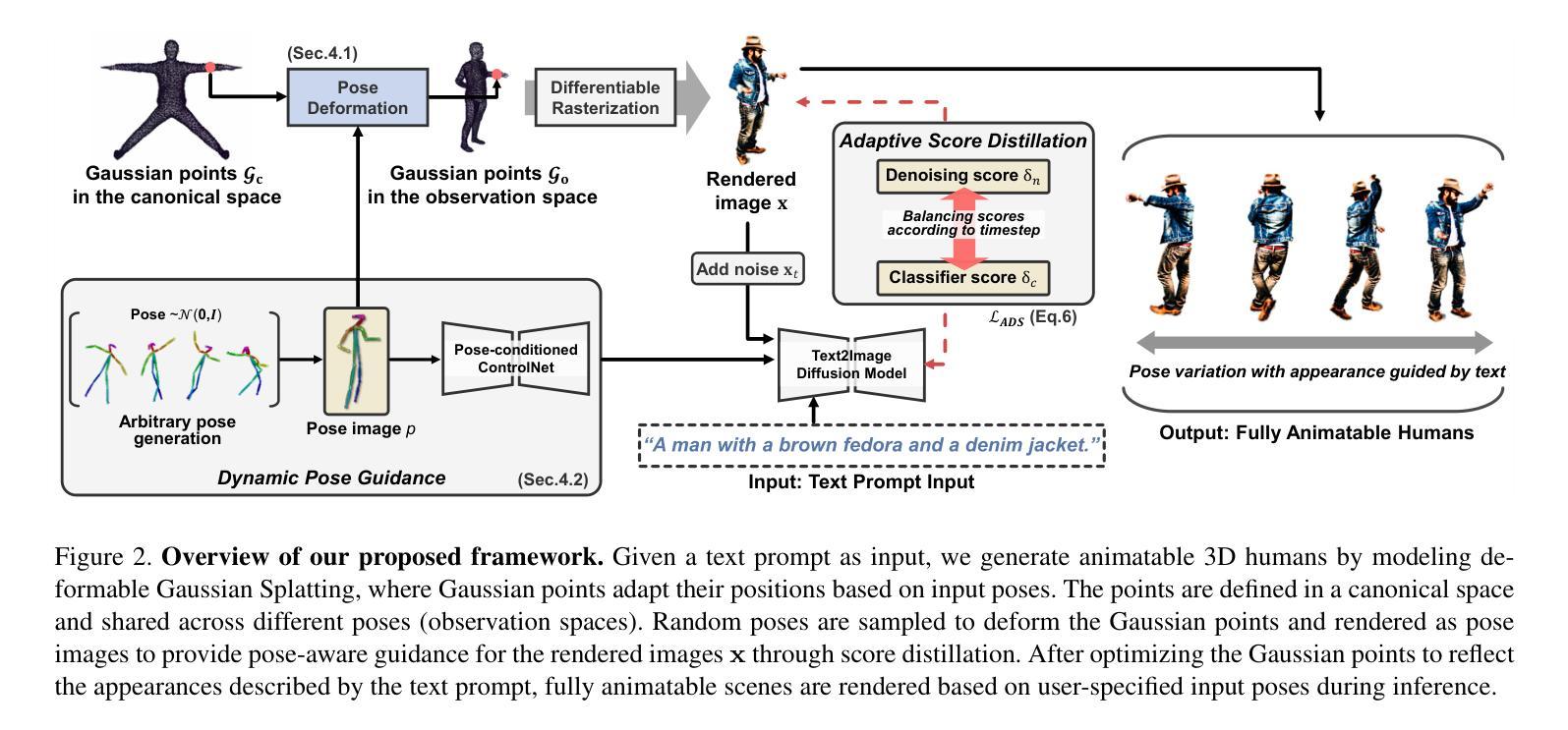

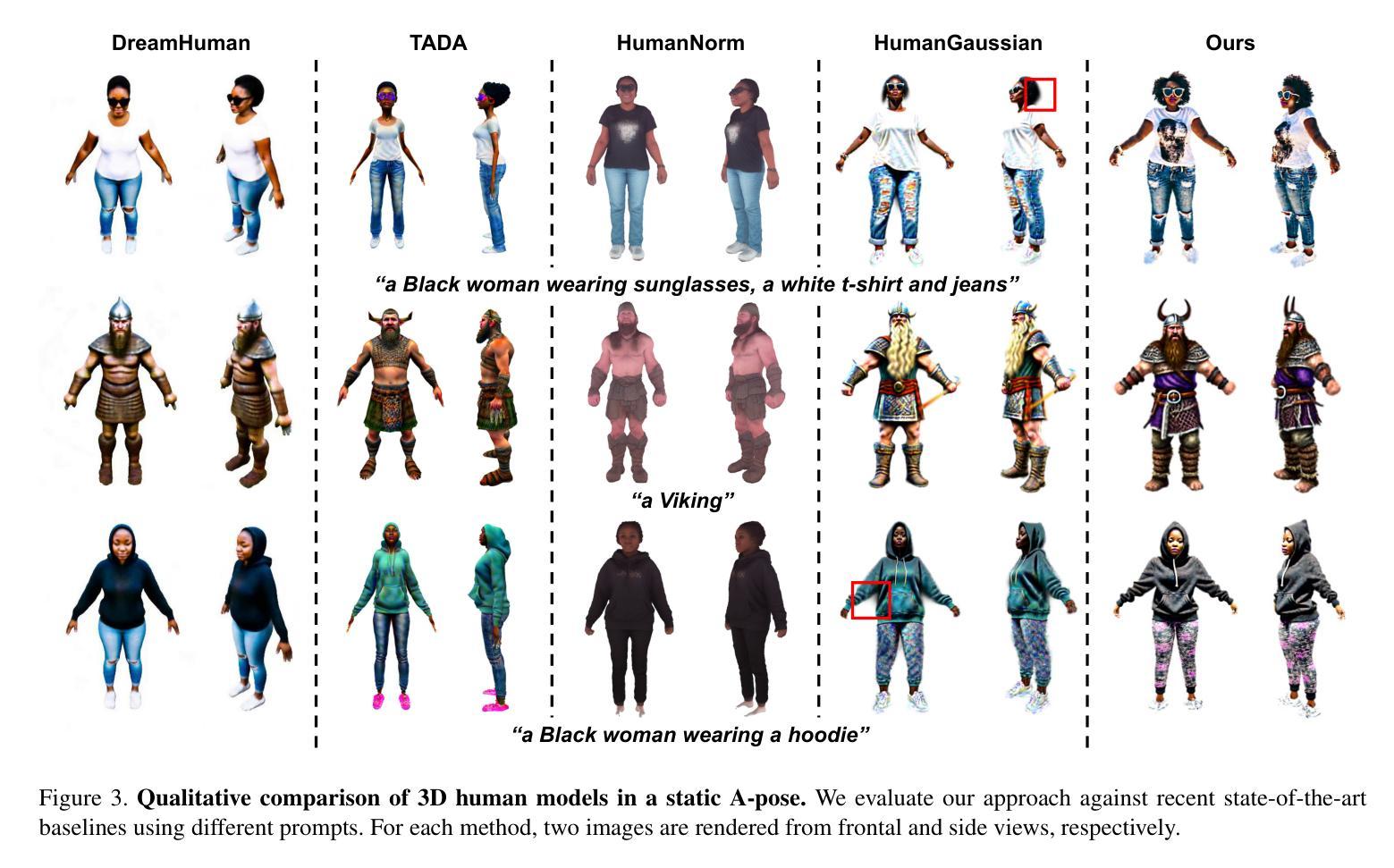

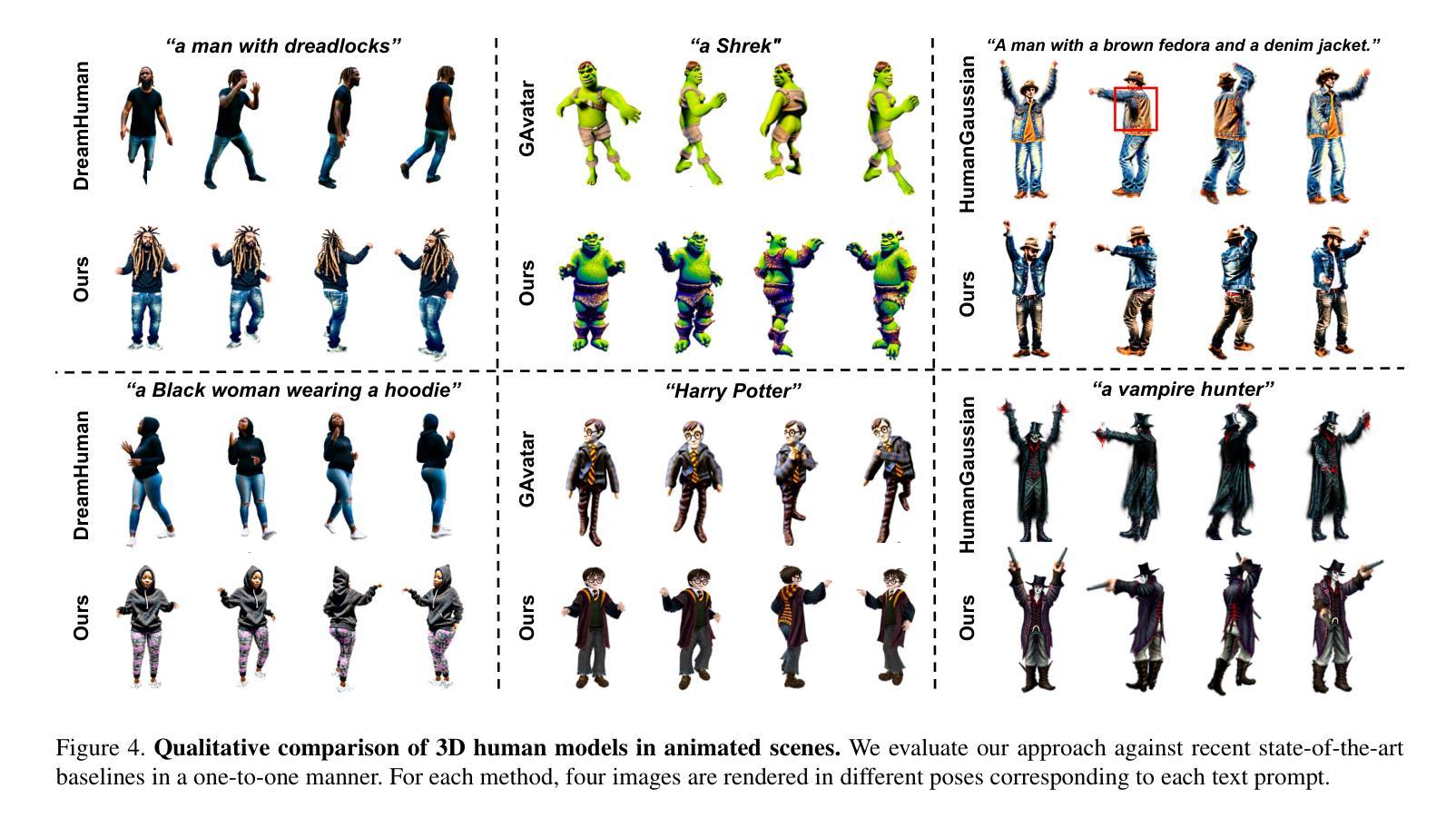

In this paper, we introduce GaussianMotion, a novel human rendering model that generates fully animatable scenes aligned with textual descriptions using Gaussian Splatting. Although existing methods achieve reasonable text-to-3D generation of human bodies using various 3D representations, they often face limitations in fidelity and efficiency, or primarily focus on static models with limited pose control. In contrast, our method generates fully animatable 3D avatars by combining deformable 3D Gaussian Splatting with text-to-3D score distillation, achieving high fidelity and efficient rendering for arbitrary poses. By densely generating diverse random poses during optimization, our deformable 3D human model learns to capture a wide range of natural motions distilled from a pose-conditioned diffusion model in an end-to-end manner. Furthermore, we propose Adaptive Score Distillation that effectively balances realistic detail and smoothness to achieve optimal 3D results. Experimental results demonstrate that our approach outperforms existing baselines by producing high-quality textures in both static and animated results, and by generating diverse 3D human models from various textual inputs.

本文介绍了一种名为GaussianMotion的新型人类渲染模型。该模型使用高斯混合(Gaussian Splatting)技术,根据文本描述生成可动画场景。尽管现有方法使用各种三维表示法实现了合理的文本到三维的人体生成,但它们在保真度和效率方面常常面临局限性,或者主要关注具有有限姿态控制的静态模型。与之相反,我们的方法结合了可变形的三维高斯混合技术和文本到三维得分蒸馏技术,生成了可完全动画化的三维化身,为实现任意姿态的高保真和高效渲染提供了解决方案。通过在优化过程中密集地生成各种随机姿态,我们的可变形三维人体模型以端到端的方式学习捕捉来自姿态条件扩散模型的广泛自然运动。此外,我们提出了自适应得分蒸馏方法,有效地平衡了真实细节和平滑度,以实现最佳的三维结果。实验结果表明,我们的方法在静态和动画结果中都产生了高质量纹理,并且能够从各种文本输入中生成多样化的三维人体模型,从而超越了现有基线。

论文及项目相关链接

PDF 8 pages

Summary

高斯运动模型是一种新型的人类渲染模型,通过高斯溅墨技术根据文本描述生成完整的可动画场景。该模型克服了现有方法在逼真度和效率方面的局限性,并主要关注静态模型的问题,生成了具有姿态控制能力的完全可动画的3D头像。

Key Takeaways

- 高斯运动模型是一种新型的人类渲染模型,基于高斯溅墨技术。

- 该模型能够根据文本描述生成完整的可动画场景。

- 相比现有方法,高斯运动模型在逼真度和效率方面表现更优秀。

- 该模型能够生成具有姿态控制能力的完全可动画的3D头像。

- 通过密集生成不同的随机姿态进行优化,高斯运动模型的变形3D人类模型能够捕捉广泛的自然运动。

- 提出了一种自适应评分蒸馏技术,能够在真实细节和平滑度之间取得有效平衡,以实现最佳的3D结果。

点此查看论文截图

OMG: Opacity Matters in Material Modeling with Gaussian Splatting

Authors:Silong Yong, Venkata Nagarjun Pudureddiyur Manivannan, Bernhard Kerbl, Zifu Wan, Simon Stepputtis, Katia Sycara, Yaqi Xie

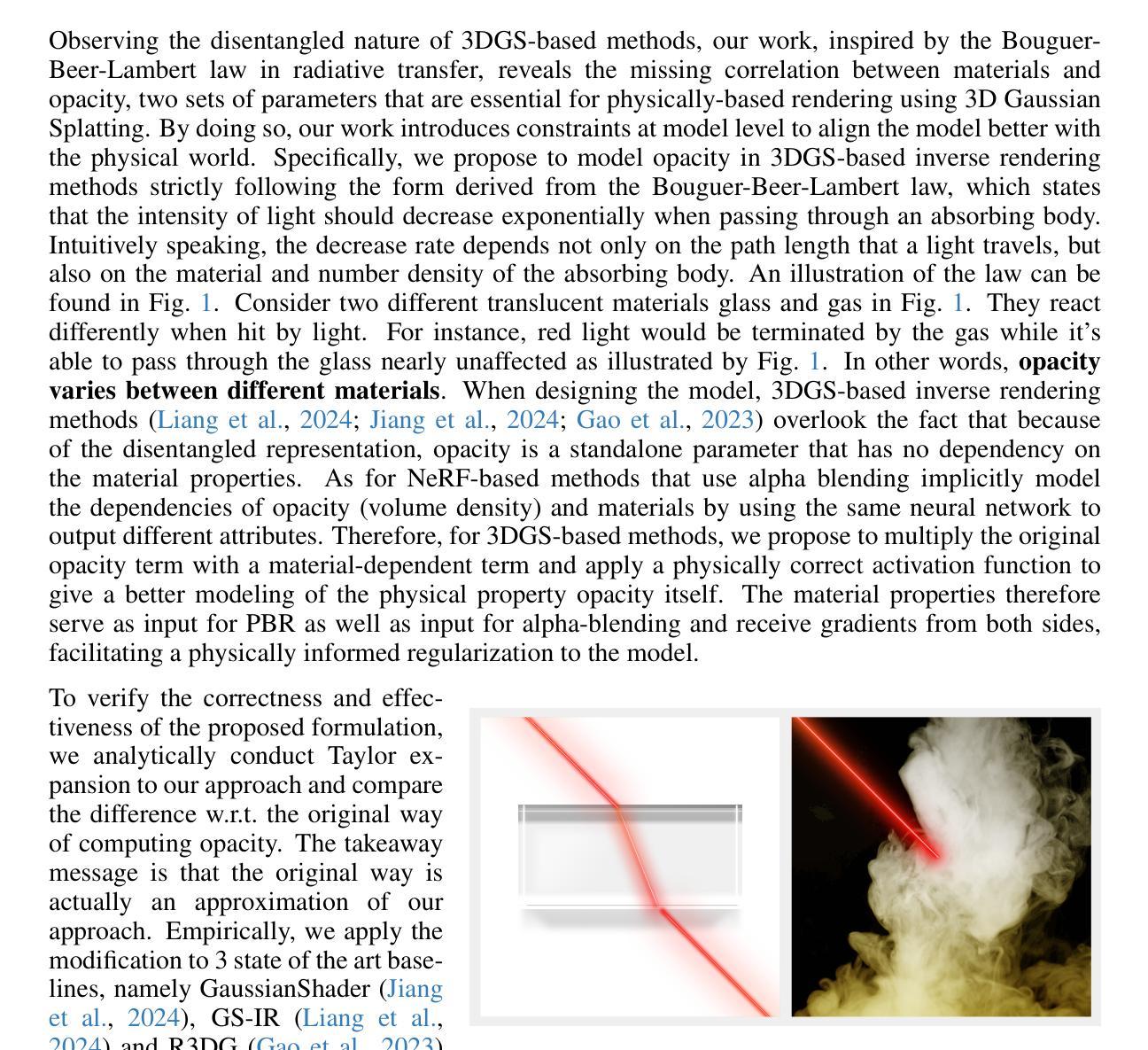

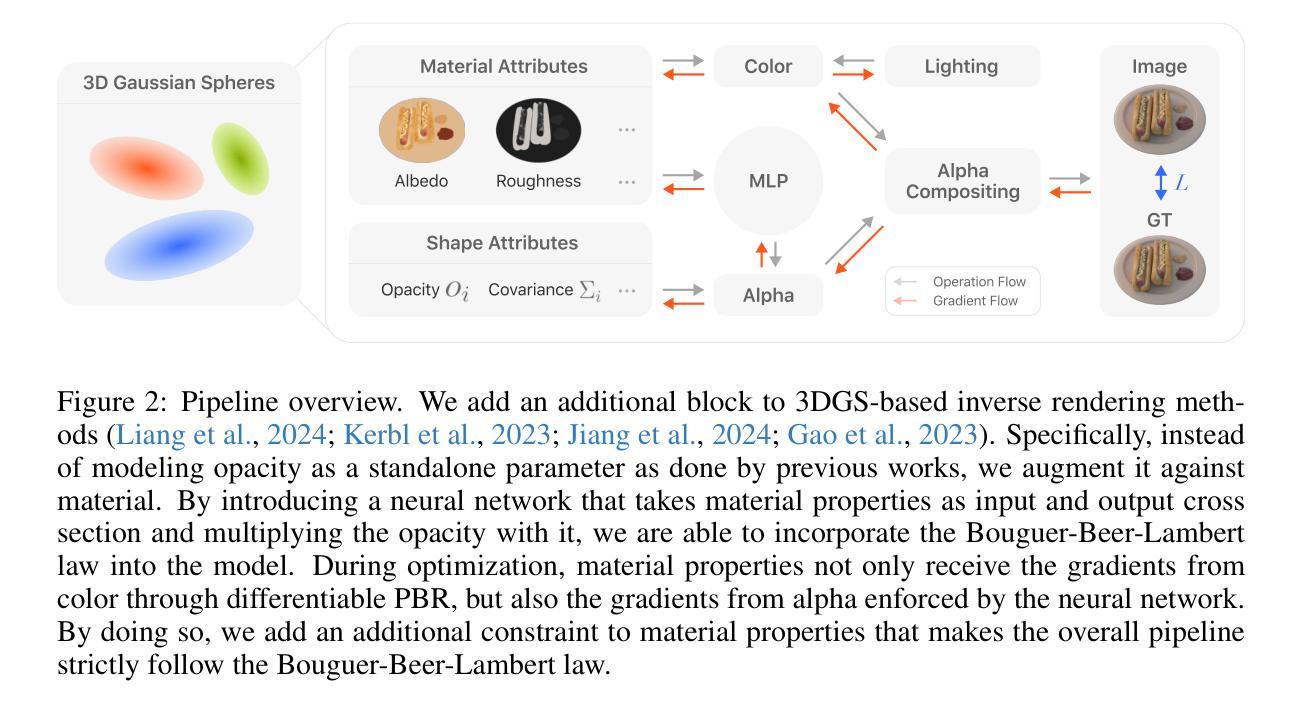

Decomposing geometry, materials and lighting from a set of images, namely inverse rendering, has been a long-standing problem in computer vision and graphics. Recent advances in neural rendering enable photo-realistic and plausible inverse rendering results. The emergence of 3D Gaussian Splatting has boosted it to the next level by showing real-time rendering potentials. An intuitive finding is that the models used for inverse rendering do not take into account the dependency of opacity w.r.t. material properties, namely cross section, as suggested by optics. Therefore, we develop a novel approach that adds this dependency to the modeling itself. Inspired by radiative transfer, we augment the opacity term by introducing a neural network that takes as input material properties to provide modeling of cross section and a physically correct activation function. The gradients for material properties are therefore not only from color but also from opacity, facilitating a constraint for their optimization. Therefore, the proposed method incorporates more accurate physical properties compared to previous works. We implement our method into 3 different baselines that use Gaussian Splatting for inverse rendering and achieve significant improvements universally in terms of novel view synthesis and material modeling.

从一组图像中分解几何、材料和光照,即逆向渲染,是计算机视觉和图形学中长期存在的问题。神经渲染的最新进展实现了逼真的逆向渲染结果。3D高斯喷涂技术的出现将其提升到了下一个层次,展现了实时渲染的潜力。一个直观的发现在于,逆向渲染所使用的模型并没有考虑到材料属性与光学特性的相互依赖关系,例如截面光学性质对物体不透明度的制约。因此,我们开发了一种新型方法,将这一依赖关系添加到建模本身。受到辐射传递的启发,我们通过引入神经网络来增强不透明度术语的应用。神经网络将接收材料属性作为输入来模拟截面建模,并配备物理正确的激活函数。因此,材料属性的梯度不仅来自颜色,还来自不透明度,为其优化提供了约束条件。因此,与以前的工作相比,所提出的方法融入了更准确的物理特性。我们将该方法应用于使用高斯喷涂技术进行逆向渲染的三种不同基线模型上,并在新视角合成和材料建模方面取得了显著的改进。

论文及项目相关链接

PDF Published as a conference paper at ICLR 2025

Summary

神经网络渲染技术的出现推动了逆渲染问题的发展,尤其是近年来兴起的三维高斯贴图技术,展现了实时渲染的巨大潜力。然而,现有的逆渲染模型忽略了材料属性与透明度之间的依赖关系。本文受到光线传递的启发,提出了一种新型神经网络方法来解决这一问题。新方法将透明度与材料属性相结合,并利用神经网络对横截面进行建模,同时引入物理正确的激活函数。此方法考虑了更多的物理属性约束,提高了材料建模和新颖视角合成方面的准确性。

Key Takeaways

- 神经网络渲染技术推动了逆渲染问题的发展。

- 三维高斯贴图技术展示了实时渲染的潜力。

- 当前逆渲染模型未充分考虑材料属性与透明度之间的依赖关系。

- 提出了一种基于光线传递的新方法来解决这一问题。

- 方法结合了透明度与材料属性,使用神经网络对横截面进行建模。

- 引入物理正确的激活函数以增强模型的准确性。

点此查看论文截图

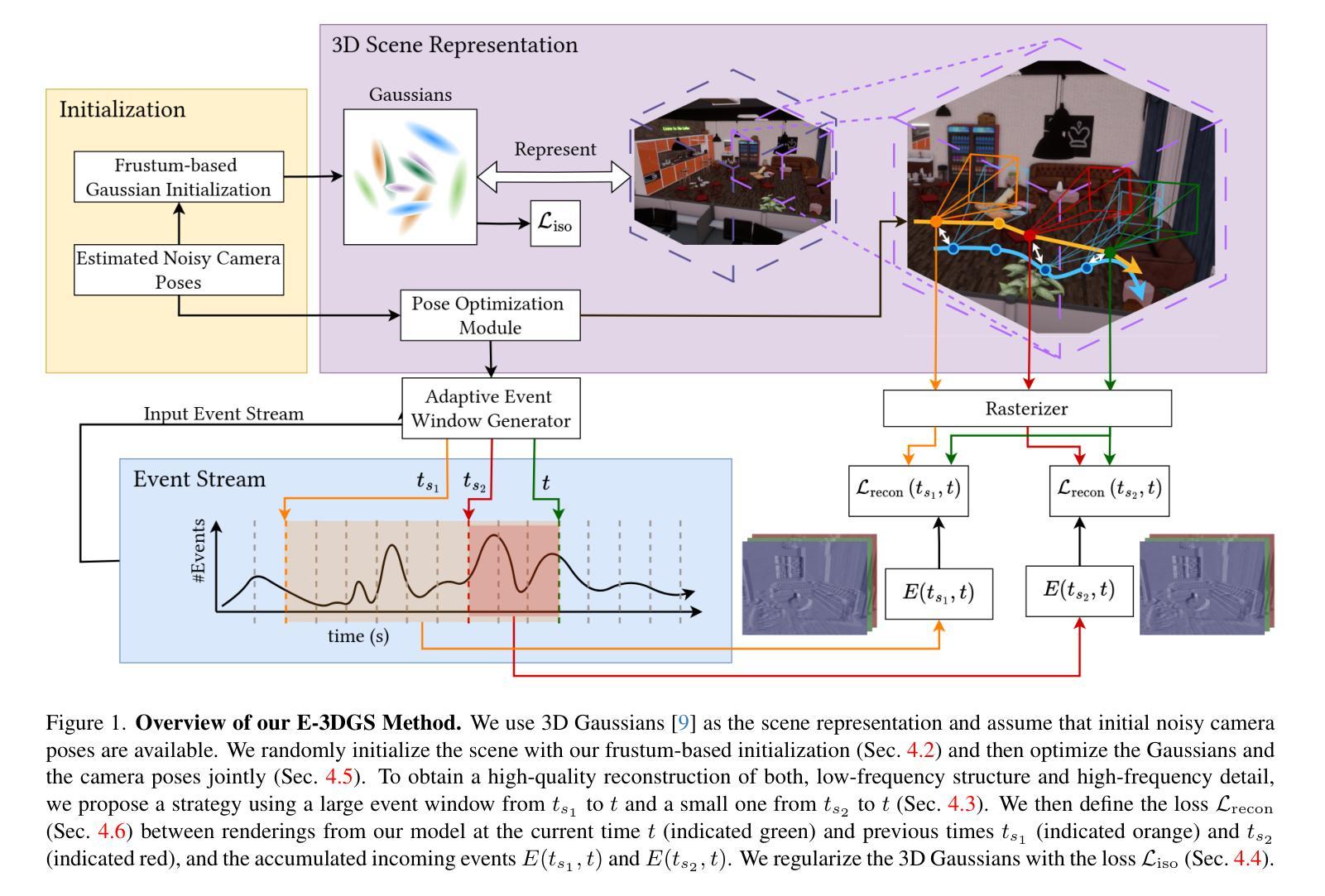

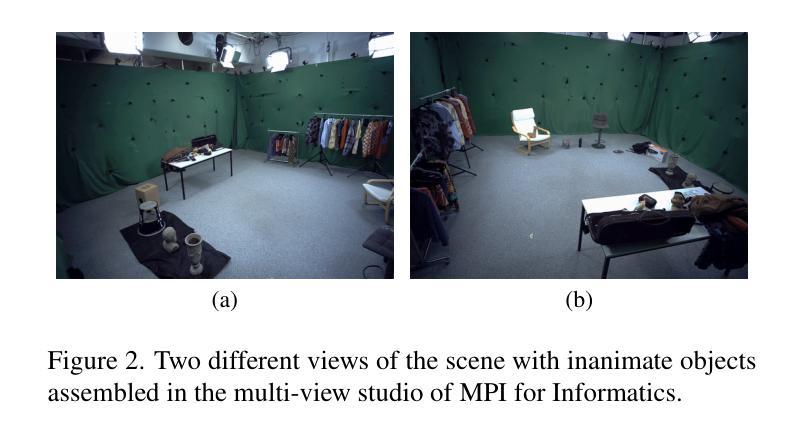

E-3DGS: Event-Based Novel View Rendering of Large-Scale Scenes Using 3D Gaussian Splatting

Authors:Sohaib Zahid, Viktor Rudnev, Eddy Ilg, Vladislav Golyanik

Novel view synthesis techniques predominantly utilize RGB cameras, inheriting their limitations such as the need for sufficient lighting, susceptibility to motion blur, and restricted dynamic range. In contrast, event cameras are significantly more resilient to these limitations but have been less explored in this domain, particularly in large-scale settings. Current methodologies primarily focus on front-facing or object-oriented (360-degree view) scenarios. For the first time, we introduce 3D Gaussians for event-based novel view synthesis. Our method reconstructs large and unbounded scenes with high visual quality. We contribute the first real and synthetic event datasets tailored for this setting. Our method demonstrates superior novel view synthesis and consistently outperforms the baseline EventNeRF by a margin of 11-25% in PSNR (dB) while being orders of magnitude faster in reconstruction and rendering.

新型视图合成技术主要利用RGB相机,继承了其需要充足照明、易受运动模糊影响以及动态范围有限的局限性。相比之下,事件相机对这些局限性具有更强的适应性,但在此领域的研究相对较少,特别是在大规模场景中。当前的方法主要关注面向前方或面向对象的(360度视图)场景。我们首次引入基于事件的3D高斯新型视图合成方法。我们的方法可以重建高质量的大型无界场景。我们为此场景量身定制了第一批真实和合成的事件数据集。我们的方法在新型视图合成方面表现出卓越性能,在PSNR(分贝)方面比基线EventNeRF高出11-25%,同时在重建和渲染方面速度高出数倍。

论文及项目相关链接

PDF 15 pages, 10 figures and 3 tables; project page: https://4dqv.mpi-inf.mpg.de/E3DGS/; International Conference on 3D Vision (3DV) 2025

摘要

本文主要探讨了新型视角合成技术,该技术主要利用RGB相机,但也继承了其需要充足光照、易受运动模糊影响以及动态范围受限等缺点。与之相比,事件相机对这些限制的抵御能力更强,但在大规模场景中的应用探索较少。当前的方法主要集中在面向前方或面向对象的(全视角)场景上。本文首次引入基于事件的视角合成技术的三维高斯方法,可重建大规模、无边界场景并实现高质量视觉重建效果。此外,我们还贡献出了专门针对这一设置的首个真实和合成事件数据集。本方法展现出色的新型视角合成效果,并在PSNR(分贝)上比基线技术EventNeRF高出至少提升了高达25%,同时重建和渲染速度大大提高。总的来说,该研究将为事件相机在视角合成技术中的更广泛应用提供可能性和可行性方案。这一新颖的解决方法采用高效的工具去研究其背景和新颖性和有效地管理解决困难。这为未来在该领域的研究提供了重要基础。

关键见解

一、当前视角合成技术主要依赖于RGB相机,但它面临着需要充足光照等限制性问题。事件相机则具有更强的适应性,但在大规模场景中的应用探索较少。

二、首次引入基于事件的视角合成技术的三维高斯方法,适用于大规模无边界场景的重建,视觉质量高。

三、提出适用于这一特定设置的首个真实和合成事件数据集,为相关研究提供重要资源。

四、本方法相较于现有技术有明显的性能提升,PSNR提升幅度达到了11-25%。同时,在重建和渲染速度上相比传统方法更具优势。

五、该研究提供了一个基于事件相机的视角合成技术的可能性和可行性方案,为未来在该领域的研究提供了重要基础。

六、该研究展示了新颖的解决方法和高效的工具应用,特别是在解决技术难题方面表现出色。

点此查看论文截图

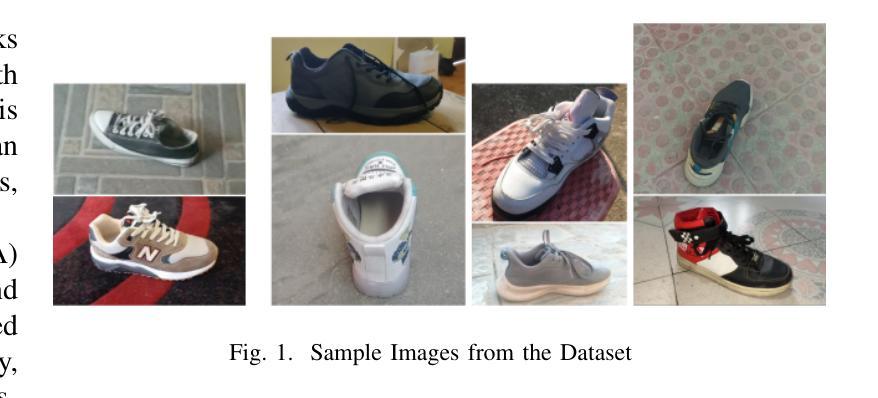

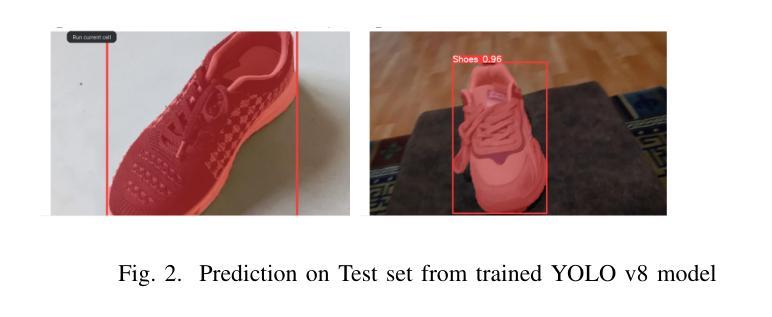

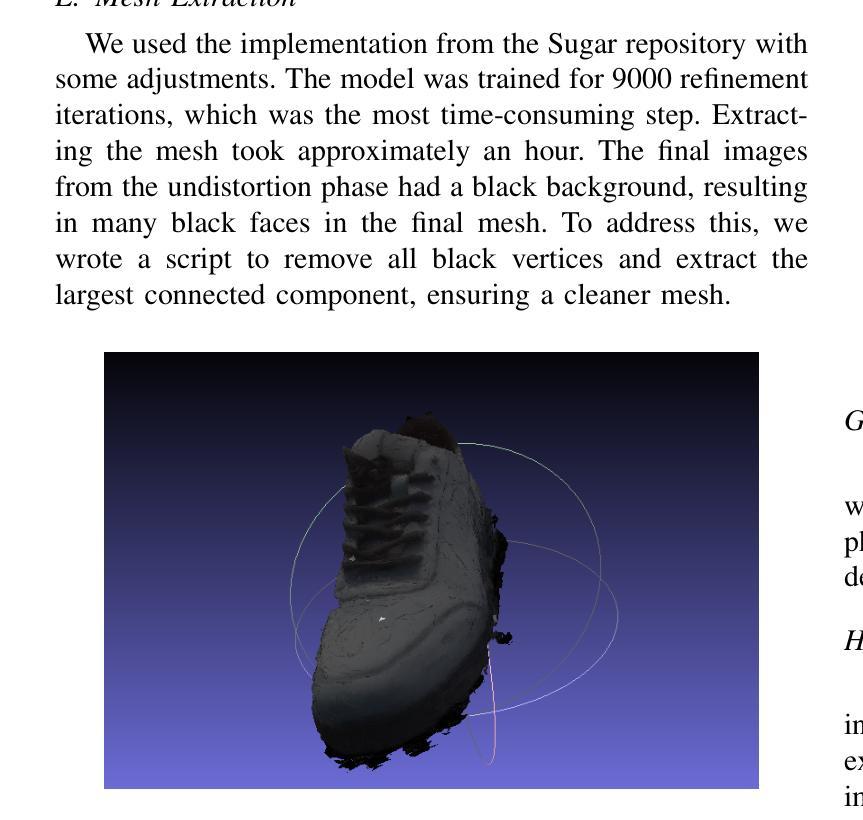

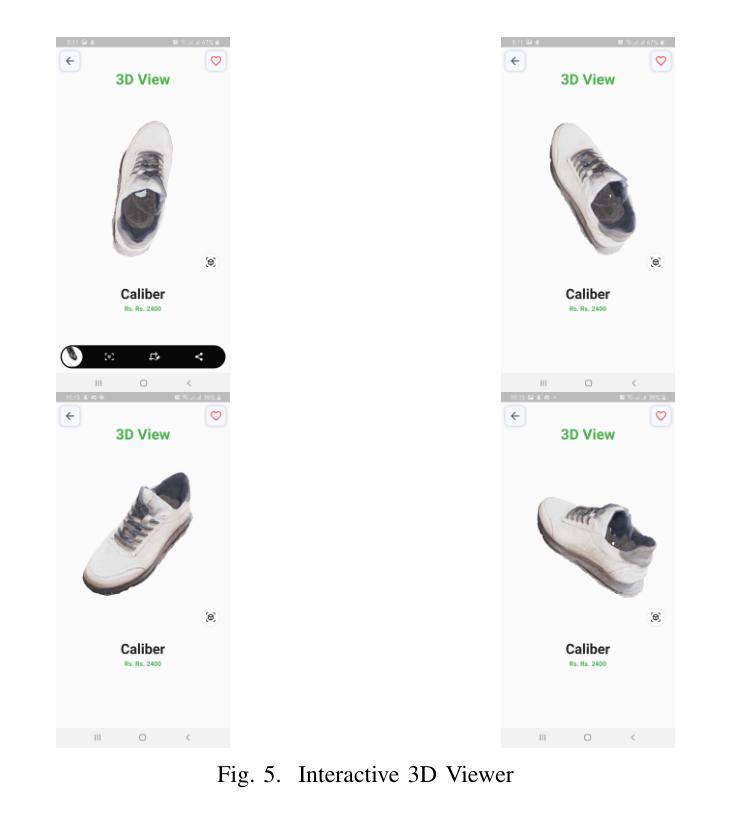

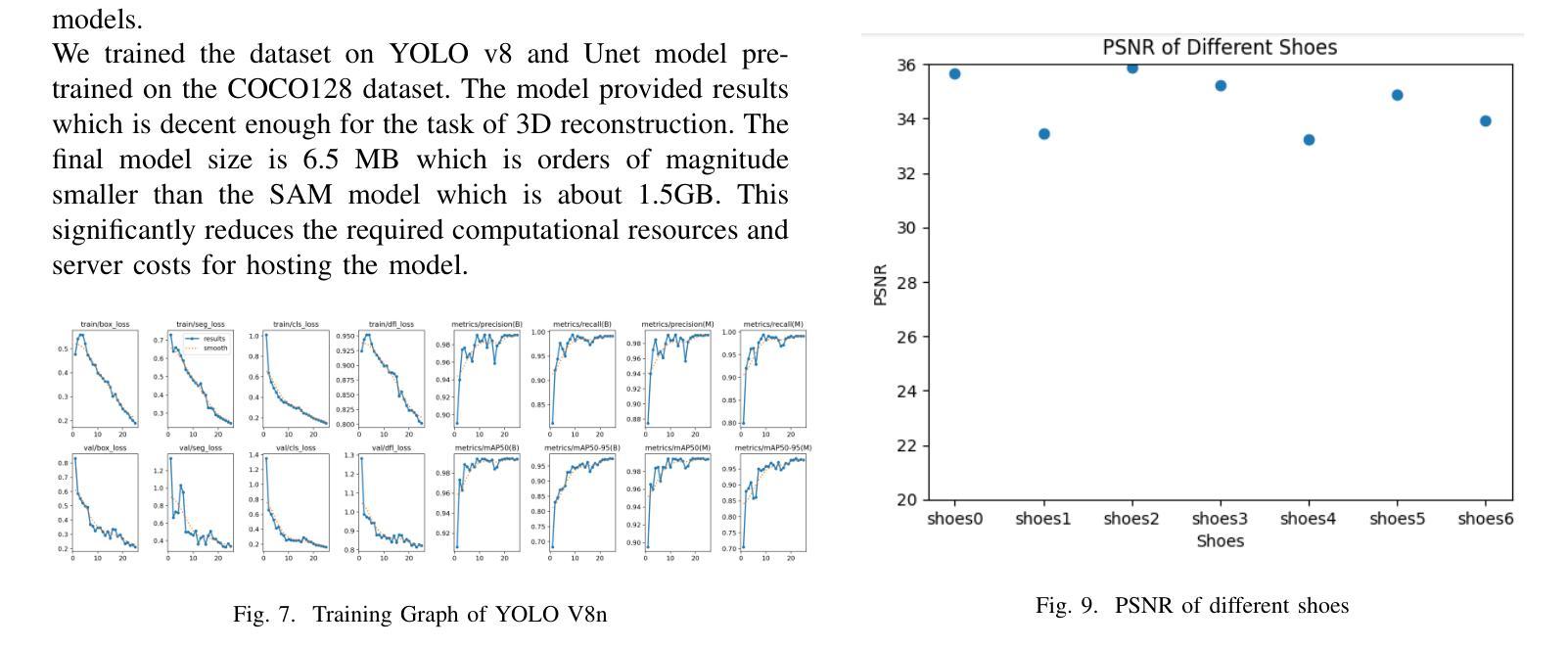

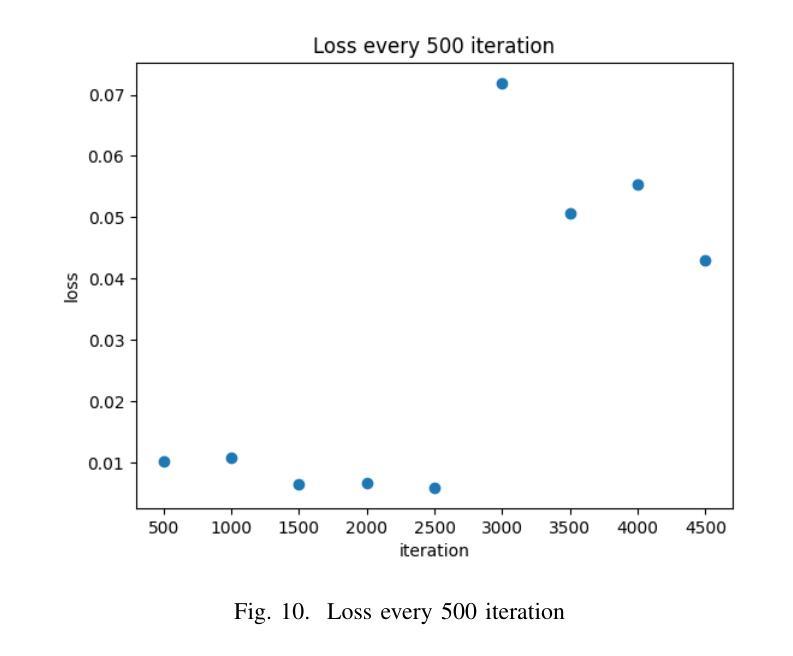

3D Reconstruction of Shoes for Augmented Reality

Authors:Pratik Shrestha, Sujan Kapali, Swikar Gautam, Vishal Pokharel, Santosh Giri

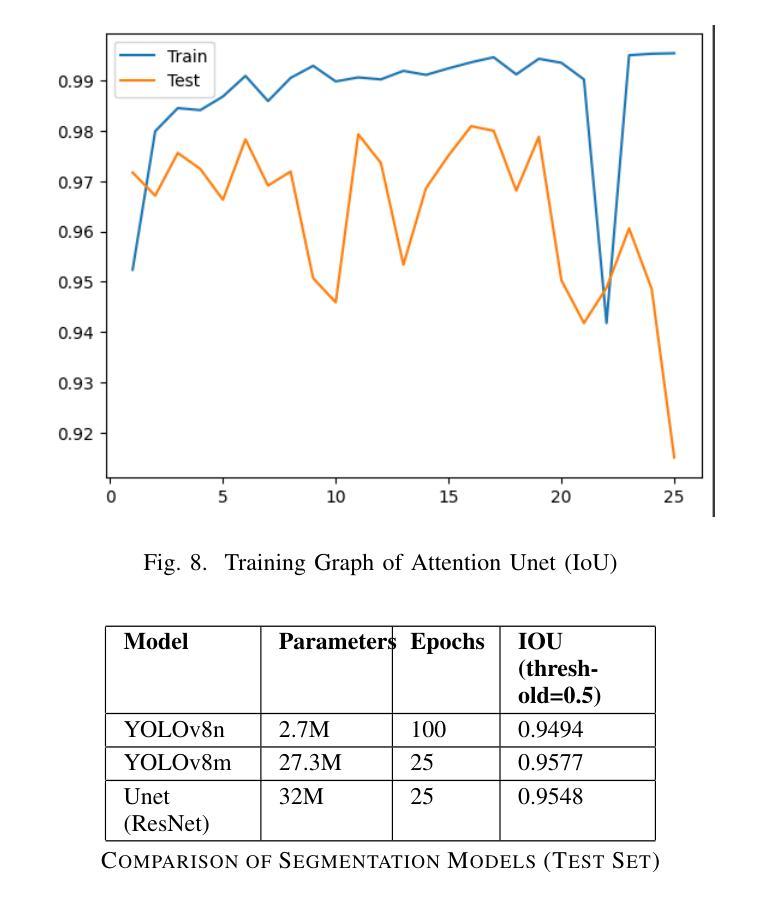

This paper introduces a mobile-based solution that enhances online shoe shopping through 3D modeling and Augmented Reality (AR), leveraging the efficiency of 3D Gaussian Splatting. Addressing the limitations of static 2D images, the framework generates realistic 3D shoe models from 2D images, achieving an average Peak Signal-to-Noise Ratio (PSNR) of 32, and enables immersive AR interactions via smartphones. A custom shoe segmentation dataset of 3120 images was created, with the best-performing segmentation model achieving an Intersection over Union (IoU) score of 0.95. This paper demonstrates the potential of 3D modeling and AR to revolutionize online shopping by offering realistic virtual interactions, with applicability across broader fashion categories.

本文介绍了一种基于移动设备的解决方案,通过3D建模和增强现实(AR)技术提升在线购鞋体验,利用3D高斯喷绘的效率。该框架解决了静态2D图像的限制,能够从2D图像生成逼真的3D鞋模,平均峰值信噪比(PSNR)达到32,并通过智能手机实现沉浸式AR交互。创建了一个包含3120张图片的自定义鞋类分割数据集,最佳分割模型的重叠率(IoU)达到0.95。本文展示了3D建模和AR技术在在线购物中的潜力,通过提供逼真的虚拟交互,为更广泛的时尚类别提供了适用性。

论文及项目相关链接

Summary

本文介绍了一种基于移动设备的在线购鞋解决方案,通过3D建模和增强现实(AR)技术提升用户体验。该研究利用3D高斯拼贴技术的优势,从2D图像生成逼真的3D鞋模,实现平均峰值信噪比(PSNR)为32。此外,该研究还通过智能手机实现了沉浸式AR交互。研究创建了一个包含3120张图像的自定义鞋类分割数据集,最佳分割模型的交并比(IoU)得分达到0.95。该研究展示了3D建模和AR技术在在线购物领域的潜力,通过提供逼真的虚拟交互,为时尚产业带来革命性变革。

Key Takeaways

- 利用移动设备和3D建模技术提升在线购鞋体验。

- 通过增强现实(AR)技术实现沉浸式交互体验。

- 利用3D高斯拼贴技术从2D图像生成逼真的鞋模。

- 平均峰值信噪比(PSNR)达到32,显示出高模型质量。

- 创建了一个大规模的自定义鞋类分割数据集,用于训练和测试模型。

- 最佳分割模型具有高度的准确性,交并比(IoU)得分达到0.95。

点此查看论文截图

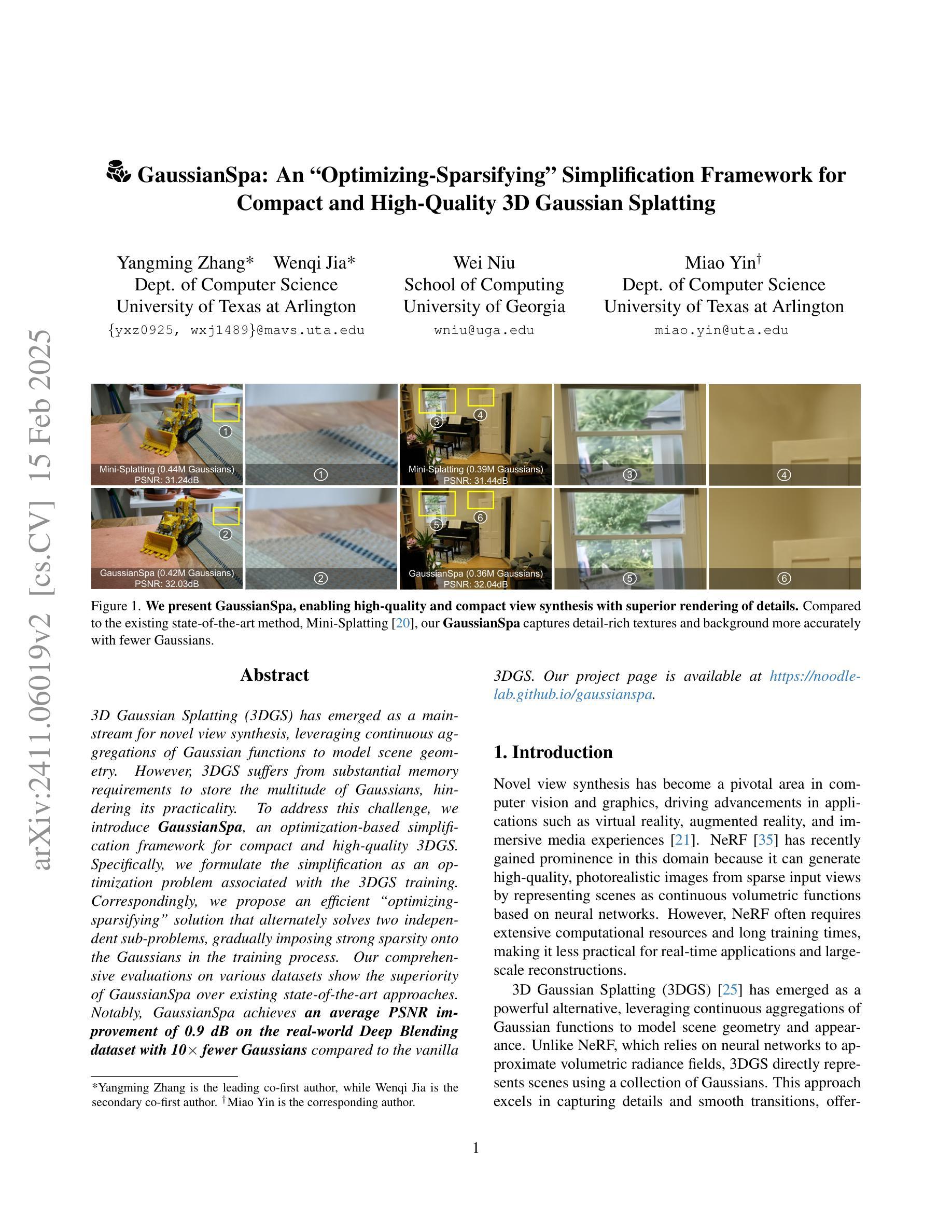

GaussianSpa: An “Optimizing-Sparsifying” Simplification Framework for Compact and High-Quality 3D Gaussian Splatting

Authors:Yangming Zhang, Wenqi Jia, Wei Niu, Miao Yin

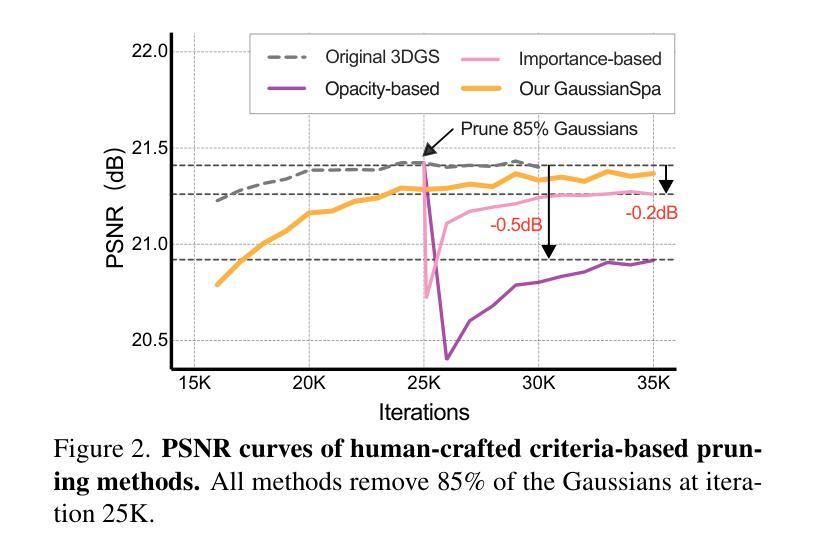

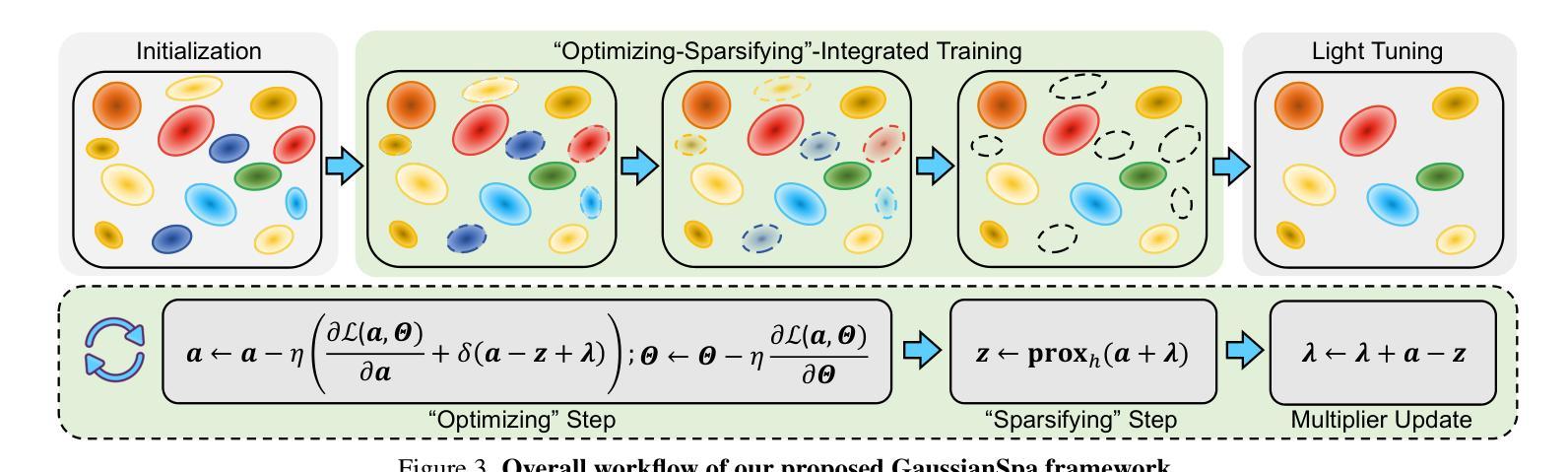

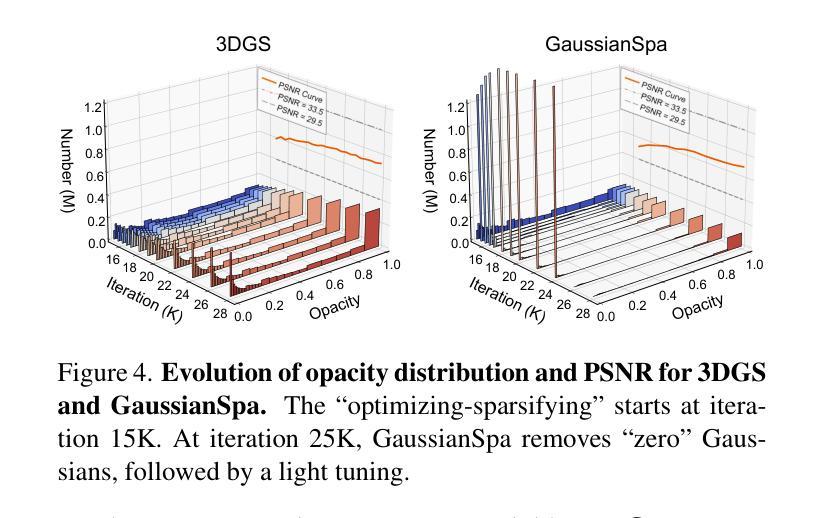

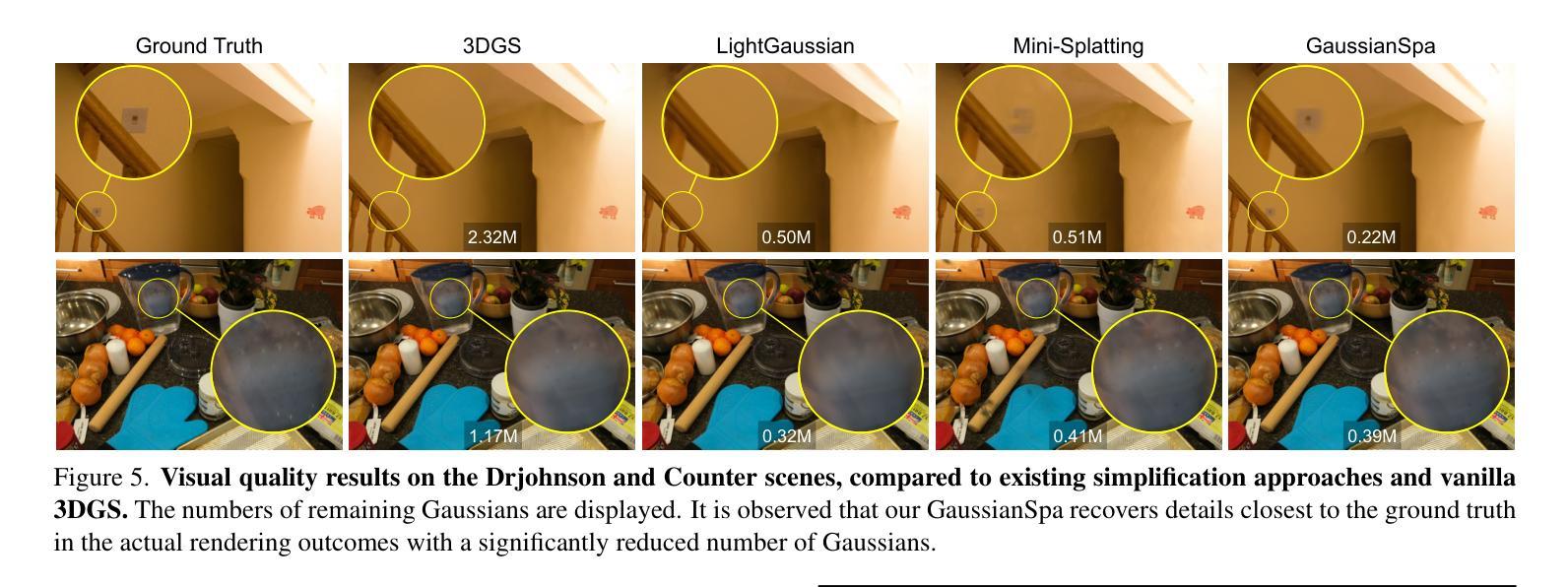

3D Gaussian Splatting (3DGS) has emerged as a mainstream for novel view synthesis, leveraging continuous aggregations of Gaussian functions to model scene geometry. However, 3DGS suffers from substantial memory requirements to store the multitude of Gaussians, hindering its practicality. To address this challenge, we introduce GaussianSpa, an optimization-based simplification framework for compact and high-quality 3DGS. Specifically, we formulate the simplification as an optimization problem associated with the 3DGS training. Correspondingly, we propose an efficient “optimizing-sparsifying” solution that alternately solves two independent sub-problems, gradually imposing strong sparsity onto the Gaussians in the training process. Our comprehensive evaluations on various datasets show the superiority of GaussianSpa over existing state-of-the-art approaches. Notably, GaussianSpa achieves an average PSNR improvement of 0.9 dB on the real-world Deep Blending dataset with 10$\times$ fewer Gaussians compared to the vanilla 3DGS. Our project page is available at https://noodle-lab.github.io/gaussianspa/.

3D高斯延展(3DGS)已经成为新型视角合成的主流技术,它利用高斯函数的连续聚合来模拟场景几何。然而,3DGS需要大量内存来存储多个高斯函数,这限制了其实用性。为了解决这一挑战,我们引入了GaussianSpa,这是一个基于优化的简化框架,用于实现紧凑且高质量的3DGS。具体来说,我们将简化过程表述为与3DGS训练相关的优化问题。相应地,我们提出了一种高效的“优化-稀疏化”解决方案,该方案交替解决两个独立的子问题,在训练过程中逐渐对高斯函数施加强烈的稀疏性。我们在各种数据集上的综合评估表明,GaussianSpa优于现有的最先进的方法。值得注意的是,GaussianSpa在现实世界深度混合数据集上,使用10倍更少的高斯函数实现了平均PSNR提高0.9分贝。我们的项目页面可在https://noodle-lab.github.io/gaussianspa/查看。

论文及项目相关链接

PDF Project page at https://noodle-lab.github.io/gaussianspa/

摘要

针对3D高斯描图法(3DGS)在处理复杂场景几何建模时面临的高内存需求问题,提出一种基于优化的简化框架GaussianSpa。通过优化算法与3DGS训练相结合,实现高斯函数的紧凑表示,降低内存消耗,同时保持高质量渲染。实验结果显示,GaussianSpa在多个数据集上表现优异,相较于传统方法平均PSNR提升0.9dB,并在真实世界的Deep Blending数据集上使用更少的高斯函数实现高效性能。更多详情可访问项目网站。

要点归纳

- 3DGS已成为新视图合成的主流技术,其通过连续聚合高斯函数模拟场景几何结构。

- 然而,大量高斯函数导致存储需求量大,限制了实际应用。

- 为解决此问题,提出GaussianSpa优化简化框架,通过优化算法实现高斯函数的高效表示。

- GaussianSpa通过交替解决两个独立子问题来实现优化和简化过程,逐步在训练过程中对高斯函数施加强稀疏性。

- GaussianSpa在多个数据集上的综合评估表现优于现有先进技术。

- 在真实世界的Deep Blending数据集上,相较于基础3DGS,GaussianSpa使用更少的高斯函数实现了平均PSNR提升0.9dB。

点此查看论文截图