⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-03-04 更新

Persuasion Should be Double-Blind: A Multi-Domain Dialogue Dataset With Faithfulness Based on Causal Theory of Mind

Authors:Dingyi Zhang, Deyu Zhou

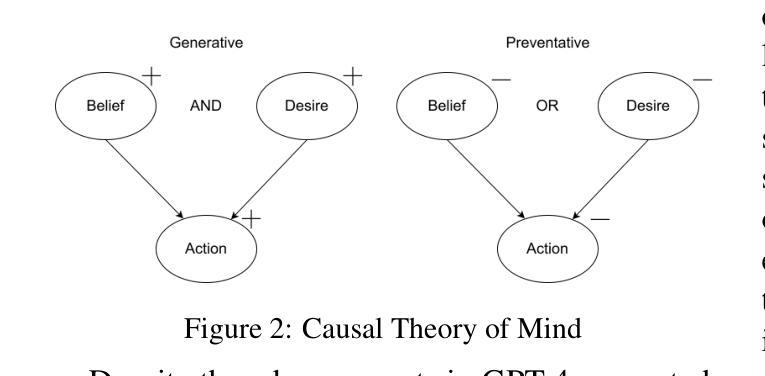

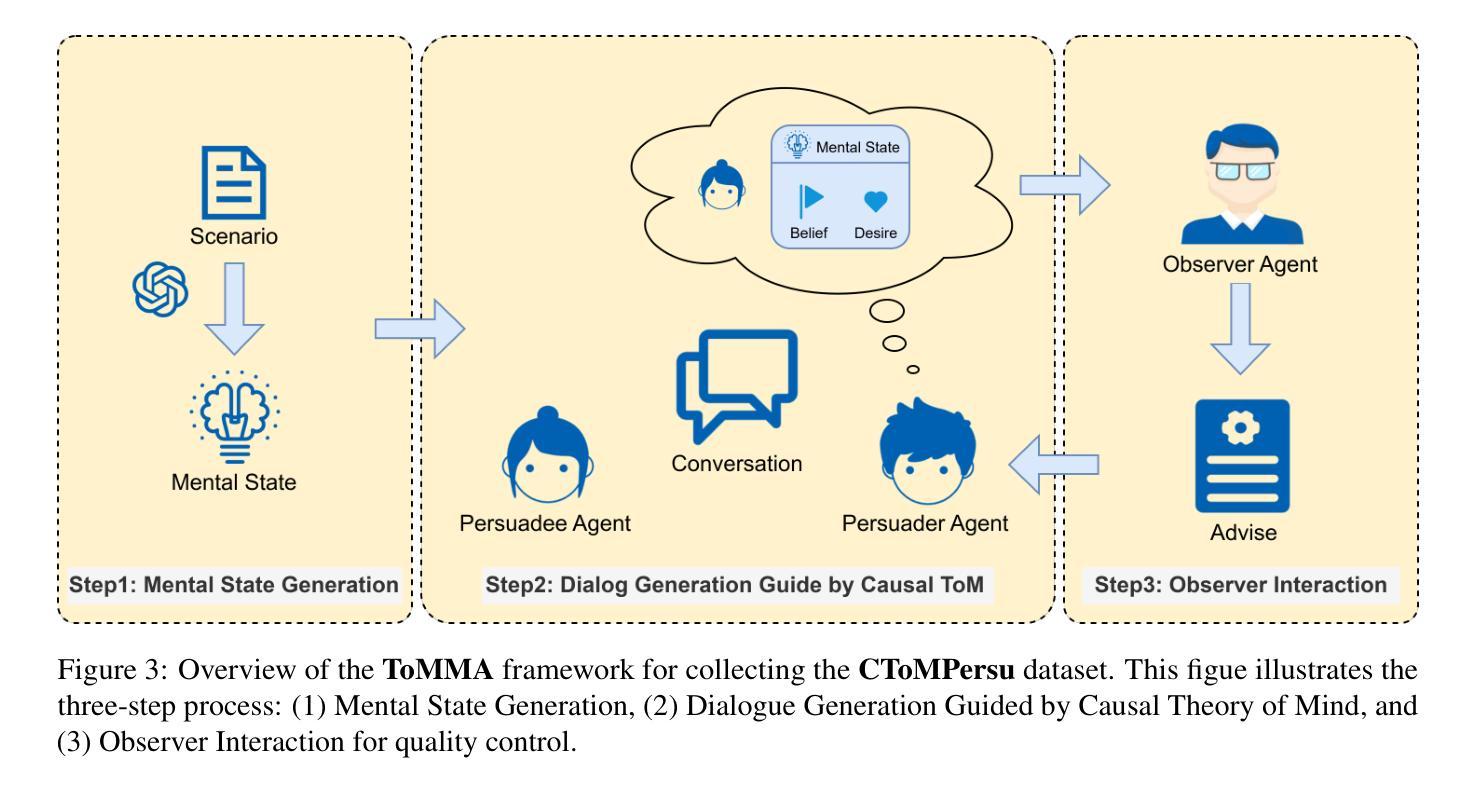

Persuasive dialogue plays a pivotal role in human communication, influencing various domains. Recent persuasive dialogue datasets often fail to align with real-world interpersonal interactions, leading to unfaithful representations. For instance, unrealistic scenarios may arise, such as when the persuadee explicitly instructs the persuader on which persuasion strategies to employ, with each of the persuadee’s questions corresponding to a specific strategy for the persuader to follow. This issue can be attributed to a violation of the “Double Blind” condition, where critical information is fully shared between participants. In actual human interactions, however, key information such as the mental state of the persuadee and the persuasion strategies of the persuader is not directly accessible. The persuader must infer the persuadee’s mental state using Theory of Mind capabilities and construct arguments that align with the persuadee’s motivations. To address this gap, we introduce ToMMA, a novel multi-agent framework for dialogue generation that is guided by causal Theory of Mind. This framework ensures that information remains undisclosed between agents, preserving “double-blind” conditions, while causal ToM directs the persuader’s reasoning, enhancing alignment with human-like persuasion dynamics. Consequently, we present CToMPersu, a multi-domain, multi-turn persuasive dialogue dataset that tackles both double-blind and logical coherence issues, demonstrating superior performance across multiple metrics and achieving better alignment with real human dialogues. Our dataset and prompts are available at https://github.com/DingyiZhang/ToMMA-CToMPersu .

说服性对话在人类交流中扮演着至关重要的角色,影响着各个领域。然而,最近的说服性对话数据集往往不能与真实世界的人际互动相吻合,导致不真实的表示。例如,可能会出现不现实的场景,如被说服者明确指示说服者应采用哪种说服策略,被说服者的每个问题都对应说服者应遵循的特定策略。这个问题可以归结为“双重盲”条件的违反,关键信息在参与者之间完全共享。然而,在实际的人类互动中,如被说服者的心理状态和说服者的说服策略并不是直接可获得的。说服者必须利用心智理论的能力推断被说服者的心理状态,并构建与被说服者动机相符的论点。为了解决这一差距,我们引入了ToMMA,这是一个由因果心智理论引导的新型多智能体对话生成框架。该框架确保信息在智能体之间保持未公开,保持“双重盲”条件,同时因果心智理论指导说服者的推理,提高与人类类似的说服动态的对齐。因此,我们推出了CToMPersu,这是一个多领域、多轮转的说服性对话数据集,解决了双重盲和逻辑连贯性问题,并在多个指标上表现出卓越的性能,更好地与真实人类对话对齐。我们的数据集和提示可在https://github.com/DingyiZhang/ToMMA-CToMPersu上找到。

论文及项目相关链接

PDF 23pages

Summary

本文强调了劝说性对话在人类沟通中的重要性,并指出近期劝说性对话数据集与真实人际互动的不符。文章提出了“双重盲态”条件的违反问题,并介绍了ToMMA框架和CToMPersu数据集,该框架通过因果理论导向对话生成,确保信息在代理人之间保密,同时提高说服者的推理能力,与人类的劝说动态更为一致。CToMPersu数据集解决了双重盲态和逻辑连贯性问题,并在多个指标上表现出卓越性能。

Key Takeaways

- 劝说性对话在人类沟通中起关键作用,影响多个领域。

- 近期劝说性对话数据集与真实人际互动不符,存在不真实场景问题。

- “双重盲态”条件的违反是此问题的关键,信息完全共享导致不真实表示。

- ToMMA框架通过因果理论导向对话生成,确保信息在代理人之间保密。

- ToMMA框架增强了说服者的推理能力,更贴近人类的说服动态。

- CToMPersu数据集解决了双重盲态和逻辑连贯性问题,实现与真实人类对话的更好对齐。

点此查看论文截图

PersuasiveToM: A Benchmark for Evaluating Machine Theory of Mind in Persuasive Dialogues

Authors:Fangxu Yu, Lai Jiang, Shenyi Huang, Zhen Wu, Xinyu Dai

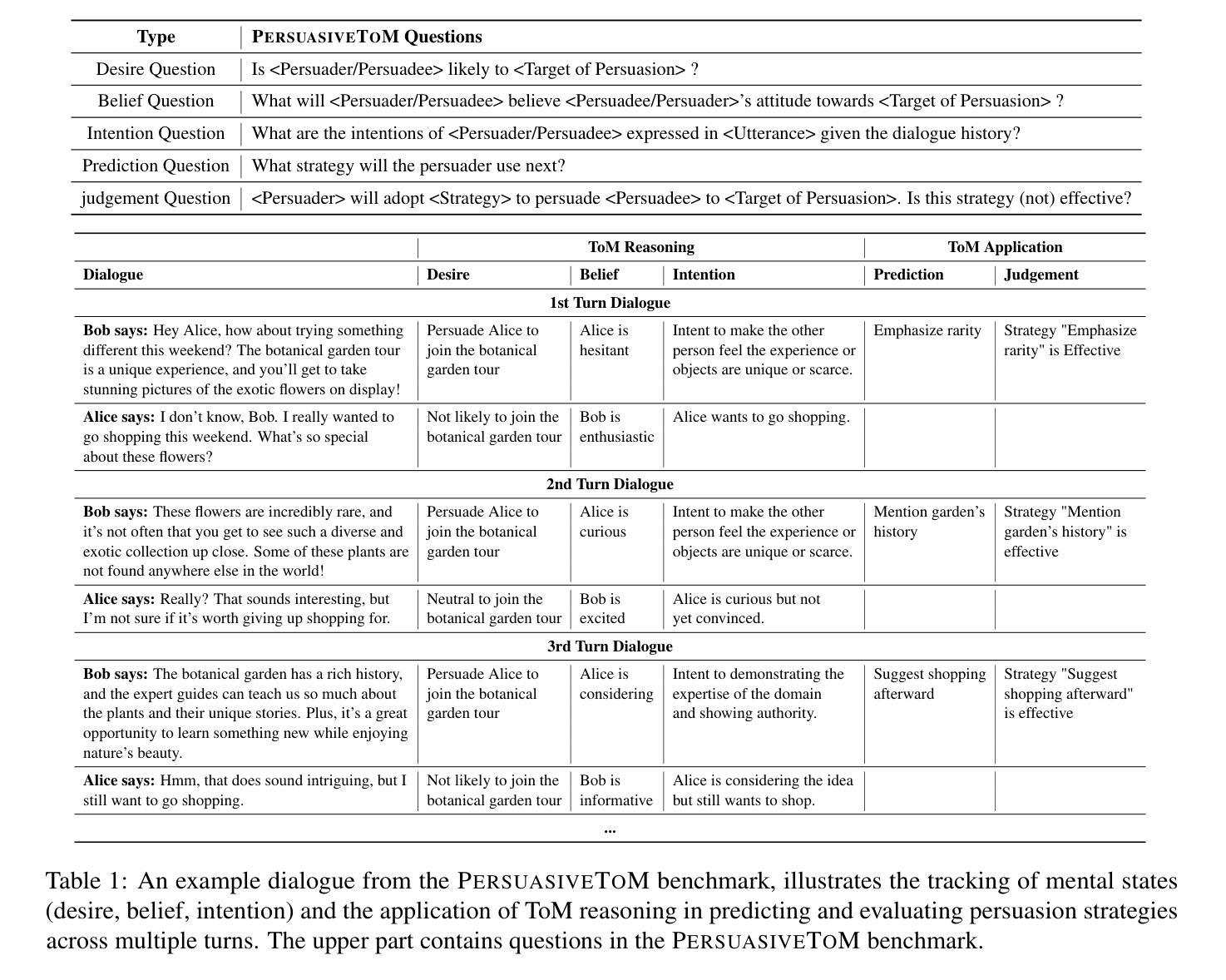

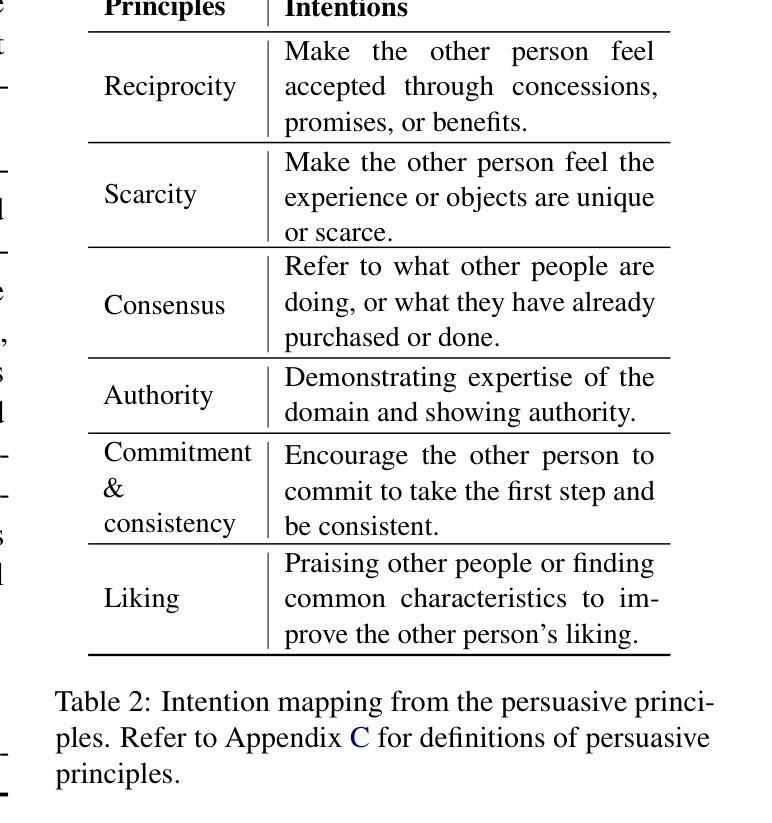

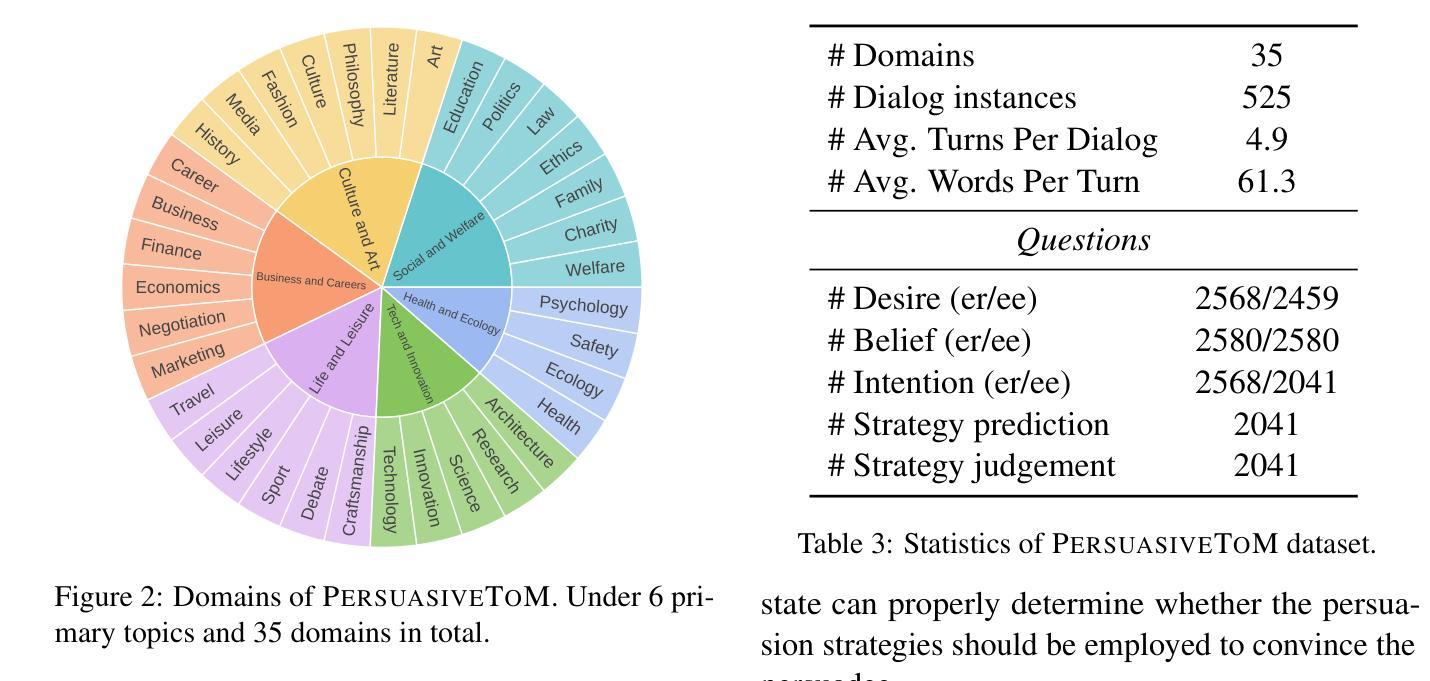

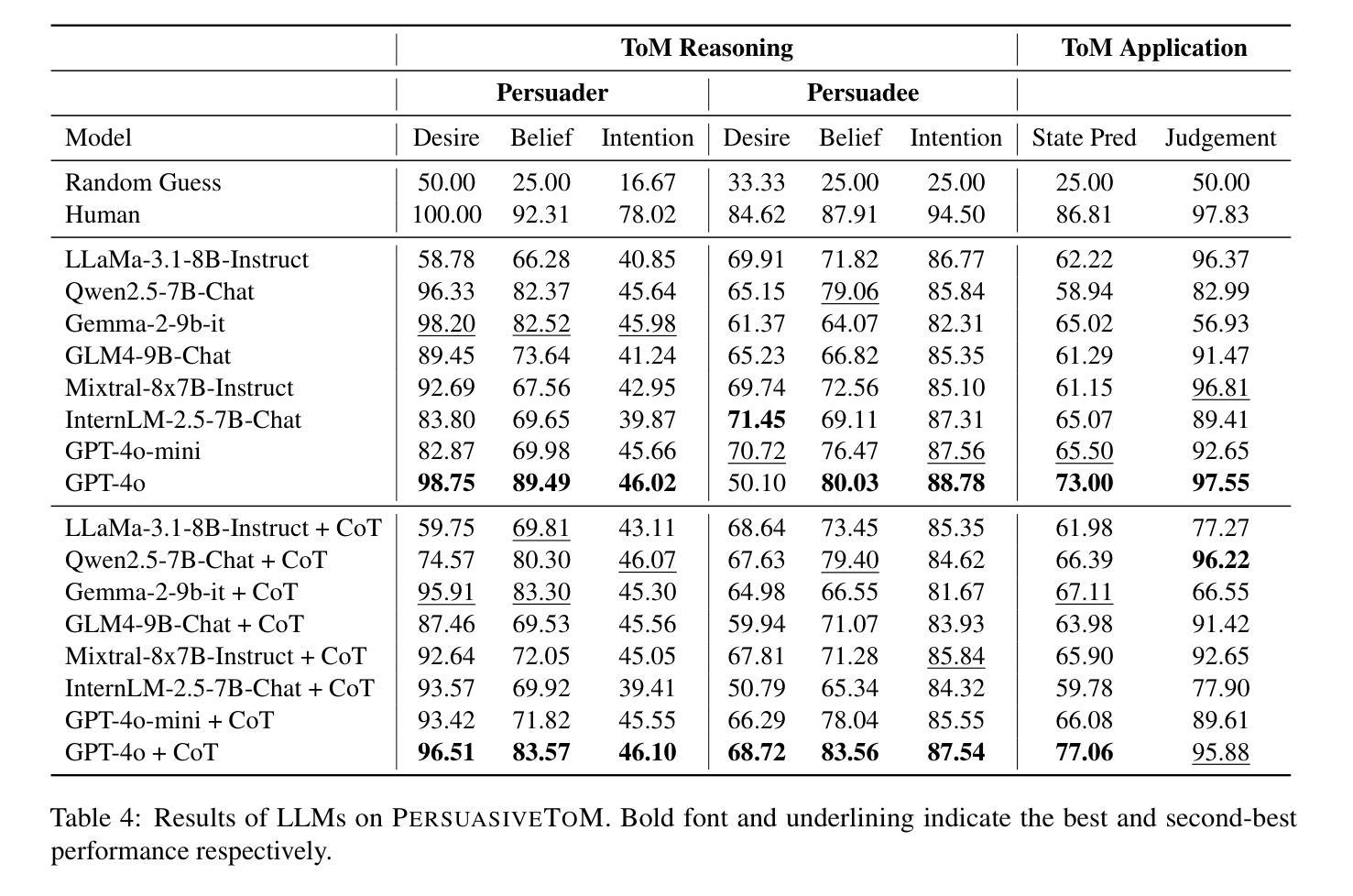

The ability to understand and predict the mental states of oneself and others, known as the Theory of Mind (ToM), is crucial for effective social interactions. Recent research has emerged to evaluate whether Large Language Models (LLMs) exhibit a form of ToM. Although recent studies have evaluated ToM in LLMs, existing benchmarks focus predominantly on physical perception with principles guided by the Sally-Anne test in synthetic stories and conversations, failing to capture the complex psychological activities of mental states in real-life social interactions. To mitigate this gap, we propose PersuasiveToM, a benchmark designed to evaluate the ToM abilities of LLMs in persuasive dialogues. Our framework introduces two categories of questions: (1) ToM Reasoning, assessing the capacity of LLMs to track evolving mental states (e.g., desire shifts in persuadees), and (2) ToM Application, evaluating whether LLMs can take advantage of inferred mental states to select effective persuasion strategies (e.g., emphasize rarity) and evaluate the effectiveness of persuasion strategies. Experiments across eight state-of-the-art LLMs reveal that while models excel on multiple questions, they struggle to answer questions that need tracking the dynamics and shifts of mental states and understanding the mental states in the whole dialogue comprehensively. Our aim with PersuasiveToM is to allow an effective evaluation of the ToM reasoning ability of LLMs with more focus on complex psychological activities. Our code is available at https://github.com/Yu-Fangxu/PersuasiveToM.

理解和预测自己和他人的心理状态的能力,被称为心理理论(ToM),对于有效的社会交往至关重要。最近有研究表明,大型语言模型(LLM)是否表现出某种形式的心理理论。尽管已有研究评估了LLM中的心理理论,但现有的基准测试主要集中在通过合成故事和对话中的莎莉-安妮测试指导的原则来进行物理感知方面,未能捕捉到真实社会互动中心理状态的复杂心理活。为了缓解这一差距,我们提出了PersuasiveToM,这是一个旨在评估LLM在劝说对话中的心理理论能力的基准测试。我们的框架引入了两种类型的问题:(1)心理理论推理,评估LLM跟踪不断发展的心理状态的能力(例如,劝说对象的欲望变化),以及(2)心理理论应用,评估LLM是否能够利用推断的心理状态来选择有效的劝说策略(例如,强调稀有性)并评估劝说策略的有效性。在八个最先进的大型语言模型上的实验表明,虽然模型在多个问题上表现出色,但它们在需要跟踪心理状态的变化和转变以及全面理解整个对话中的心理状态的问题上面临困难。我们创建PersuasiveToM的目标是为了有效地评估LLM的心理理论推理能力,更多地关注复杂的心理活动。我们的代码可在https://github.com/Yu-Fangxu/PersuasiveToM上找到。

论文及项目相关链接

Summary

本文探讨了大语言模型(LLMs)在理解他人和自己心理状态方面的能力,即心智理论(ToM)。现有评估LLMs心智理论的基准测试主要集中在物理感知方面,无法真实反映社交互动中的复杂心理状态。为解决此问题,提出了一种名为PersuasiveToM的新基准测试,旨在评估LLMs在劝说对话中的心智理论能力。该框架包括两类问题:一是心智理论推理,评估LLMs跟踪心理变化状态的能力;二是心智理论应用,评估LLMs是否能利用推断的心理状态选择有效的劝说策略并评估其效果。实验表明,虽然LLMs在多个问题上都表现出色,但在需要全面追踪和理解对话中心理状态动态变化和整体心理状态的问题上仍面临困难。PersuasiveToM旨在更有效地评估LLMs的心智理论推理能力,更侧重于复杂的心理活动和实际应用。

Key Takeaways

- 大语言模型(LLMs)在社会交互中的理解他人和自己心理状态的能力,即心智理论(ToM),非常重要。

- 现有评估LLMs心智理论的基准测试主要集中在物理感知方面,忽略了真实社交互动中的复杂心理状态。

- 提出了一种新的基准测试——PersuasiveToM,旨在评估LLMs在劝说对话中的心智理论能力。

- PersuasiveToM包括两类问题:心智理论推理和心智理论应用。

- 实验表明,LLMs在跟踪和理解对话中心理状态的动态变化和整体心理状态方面仍存在困难。

- PersuasiveToM更有效地评估LLMs的心智理论推理能力,侧重于复杂的心理活动和实际应用。

点此查看论文截图