⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-03-11 更新

StickMotion: Generating 3D Human Motions by Drawing a Stickman

Authors:Tao Wang, Zhihua Wu, Qiaozhi He, Jiaming Chu, Ling Qian, Yu Cheng, Junliang Xing, Jian Zhao, Lei Jin

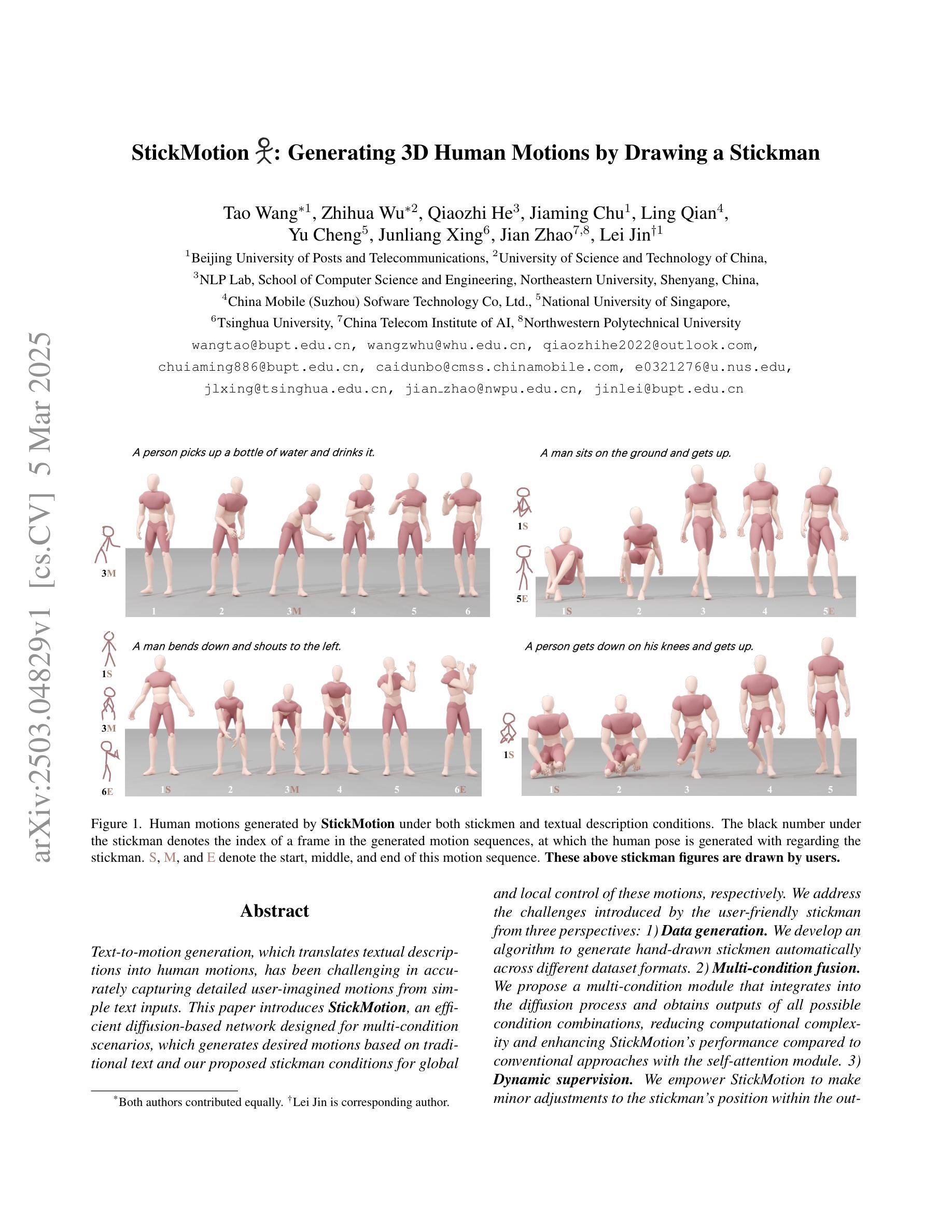

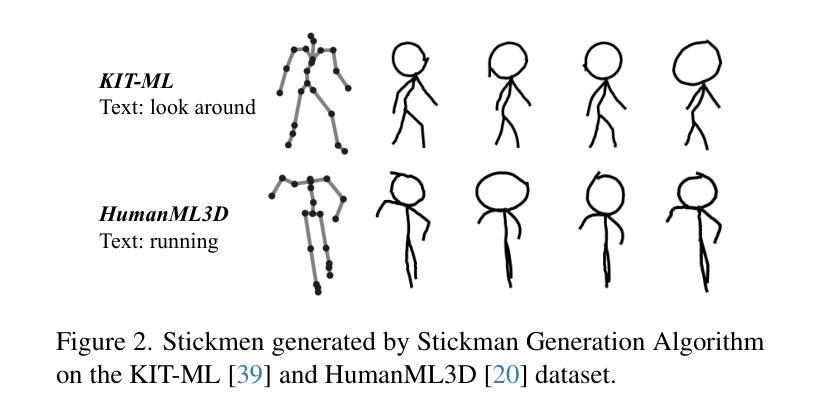

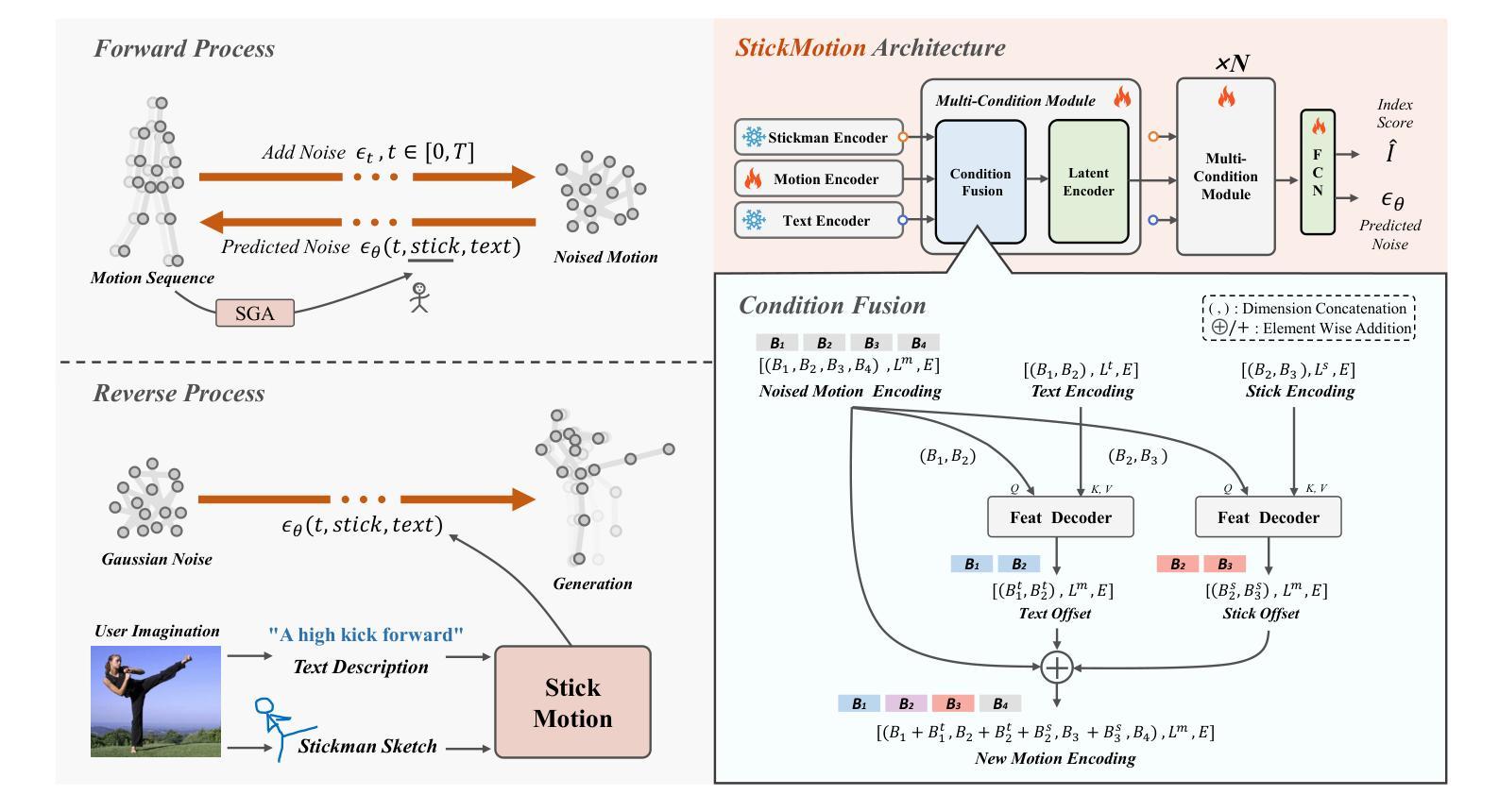

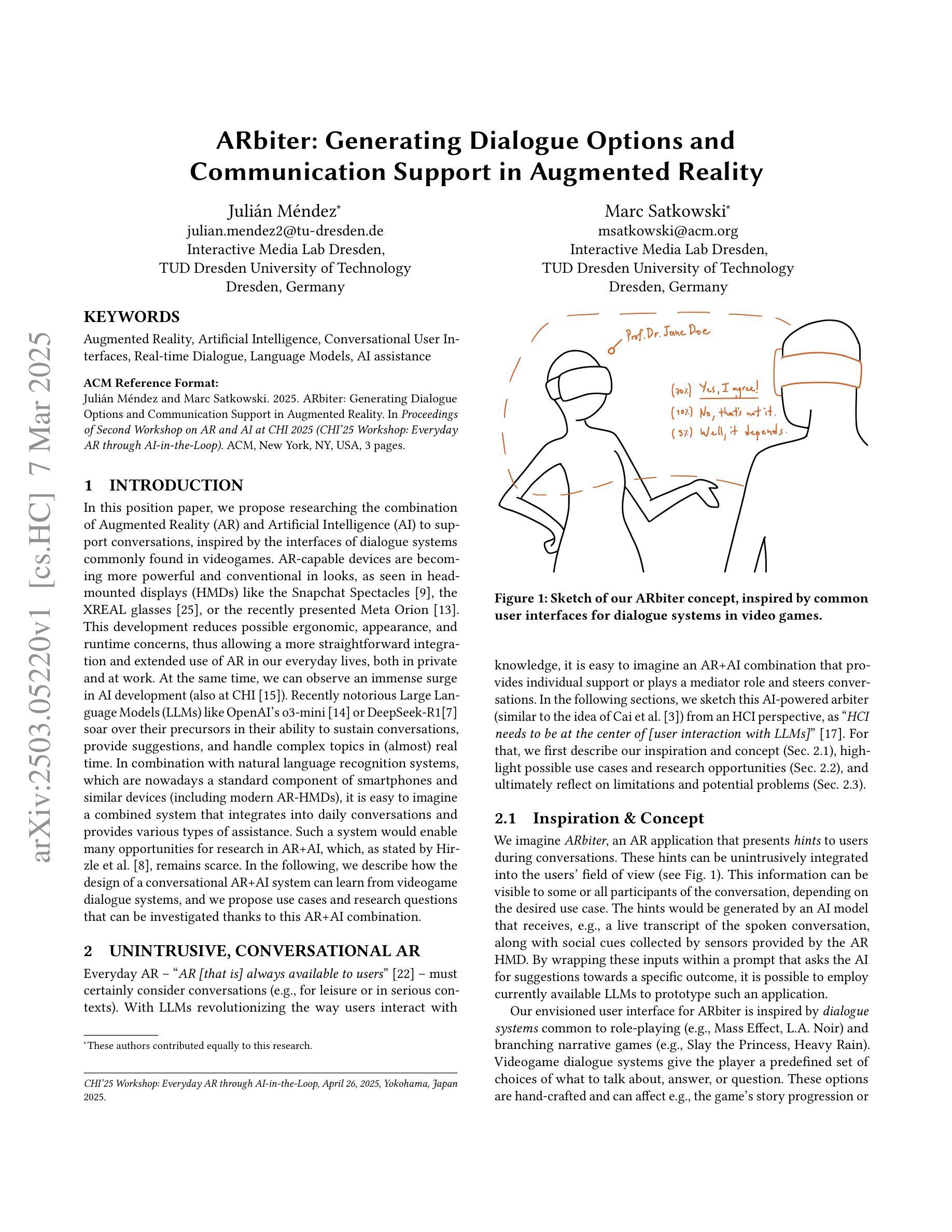

Text-to-motion generation, which translates textual descriptions into human motions, has been challenging in accurately capturing detailed user-imagined motions from simple text inputs. This paper introduces StickMotion, an efficient diffusion-based network designed for multi-condition scenarios, which generates desired motions based on traditional text and our proposed stickman conditions for global and local control of these motions, respectively. We address the challenges introduced by the user-friendly stickman from three perspectives: 1) Data generation. We develop an algorithm to generate hand-drawn stickmen automatically across different dataset formats. 2) Multi-condition fusion. We propose a multi-condition module that integrates into the diffusion process and obtains outputs of all possible condition combinations, reducing computational complexity and enhancing StickMotion’s performance compared to conventional approaches with the self-attention module. 3) Dynamic supervision. We empower StickMotion to make minor adjustments to the stickman’s position within the output sequences, generating more natural movements through our proposed dynamic supervision strategy. Through quantitative experiments and user studies, sketching stickmen saves users about 51.5% of their time generating motions consistent with their imagination. Our codes, demos, and relevant data will be released to facilitate further research and validation within the scientific community.

文本转动作生成(Text-to-Motion)的任务是将文本描述转化为人类动作,其挑战在于从简单的文本输入中准确捕捉用户想象的详细动作。本文介绍了StickMotion,这是一种基于扩散的高效网络,适用于多场景条件,能够根据传统文本和我们所提出的stickman条件生成所需的动作,分别实现对这些动作的全局和局部控制。我们从三个角度解决由用户友好的stickman带来的挑战:1)数据生成。我们开发了一种算法,可以自动在不同数据集格式中生成手绘stickmen。2)多条件融合。我们提出了一种多条件模块,将其集成到扩散过程中,获得所有可能条件组合的输出来降低计算复杂性并增强StickMotion的性能,与传统的自注意力模块方法相比,表现出卓越的效果。3)动态监督。我们通过赋予StickMotion对输出序列中stickman位置的微小调整能力,通过我们提出的动态监督策略生成更自然的动作。通过定量实验和用户研究,绘制stickmen为用户节省了大约51.5%的时间来生成符合他们想象的动作为。我们的代码、演示和相关数据将向科学界发布,以促进进一步的研究和验证。

论文及项目相关链接

PDF 11 pages, 5 figures, accepted by CVPR2025

Summary

文本到动作生成是将文本描述转化为人类动作的过程,这一过程在准确捕捉简单文本输入中的用户想象动作上一直存在挑战。本文介绍了StickMotion,一种为多种场景设计的扩散网络,它可以根据传统文本和提出的棒人条件生成所需动作,分别控制全局和局部动作。通过数据生成、多条件融合和动态监督三个角度解决棒人带来的挑战。实验和用户研究证明,绘制棒人可为用户节省约51.5%的时间,生成与想象一致的动作。

Key Takeaways

- StickMotion是一种基于扩散网络的文本到动作生成方法,适用于多种场景。

- 它结合传统文本和棒人条件来生成动作,实现全局和局部动作的控制。

- 数据生成方面,开发算法自动生成不同数据集格式的棒人。

- 多条件融合模块集成到扩散过程中,获得所有可能条件组合的输出,提高StickMotion性能。

- 动态监督策略使StickMotion能够微调棒人的位置,生成更自然的动作。

- 定量实验和用户研究表明,使用棒人节省用户时间,生成与想象一致的动作。

点此查看论文截图