⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-03-14 更新

Better Together: Unified Motion Capture and 3D Avatar Reconstruction

Authors:Arthur Moreau, Mohammed Brahimi, Richard Shaw, Athanasios Papaioannou, Thomas Tanay, Zhensong Zhang, Eduardo Pérez-Pellitero

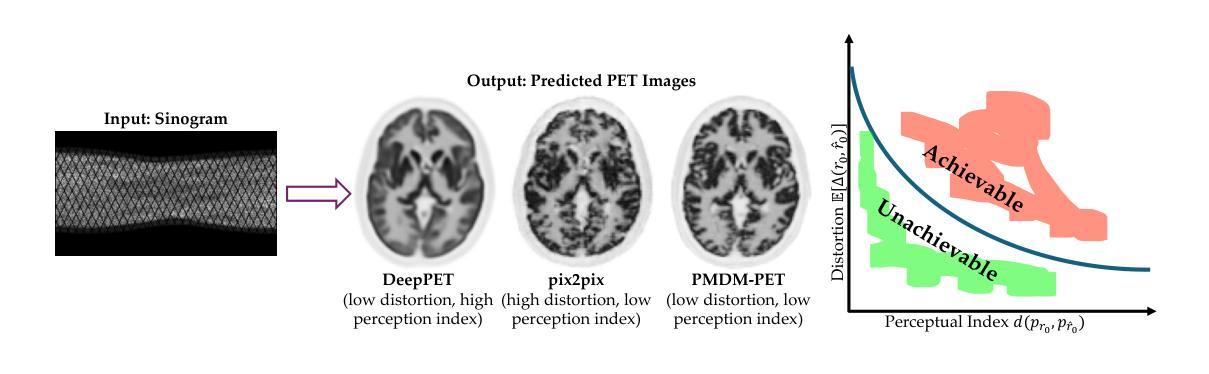

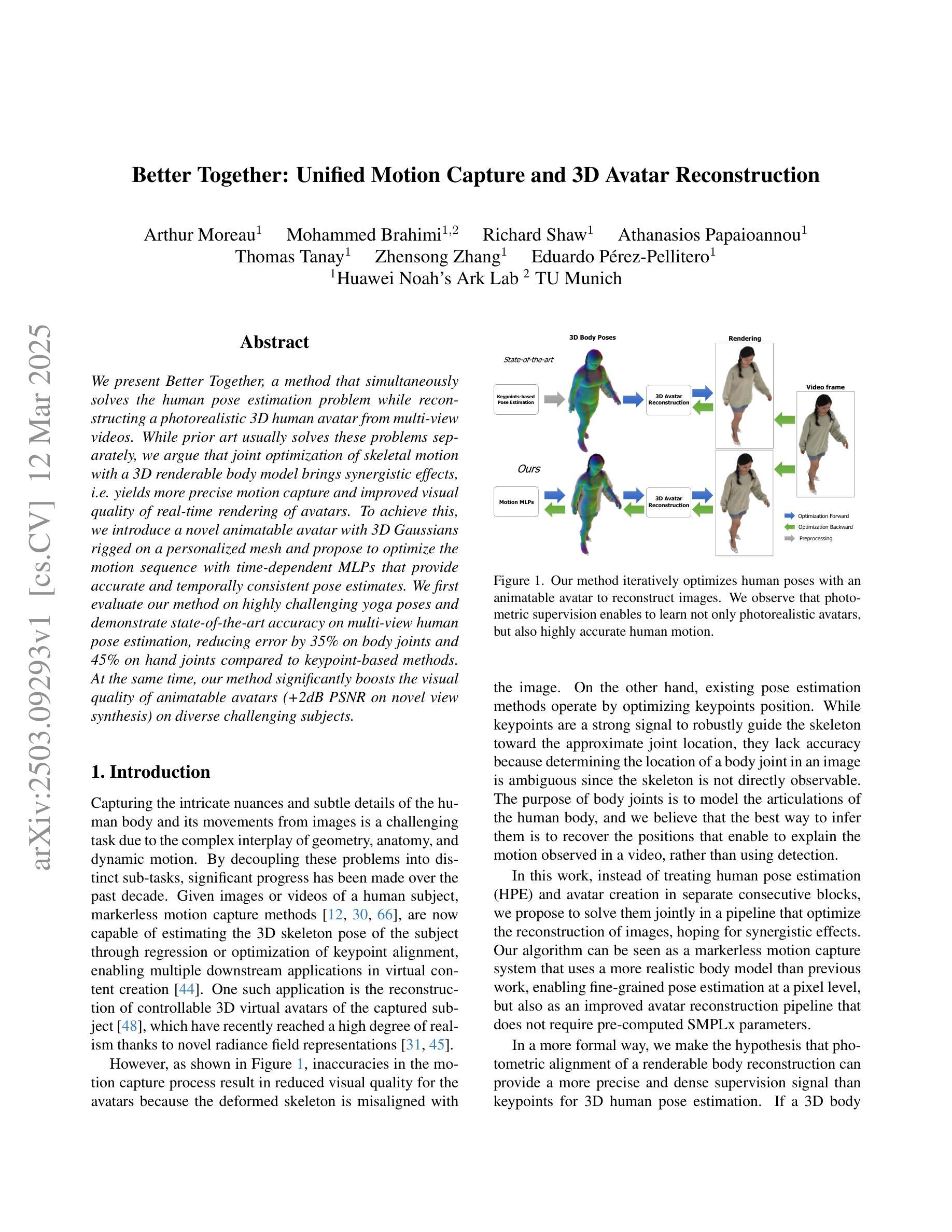

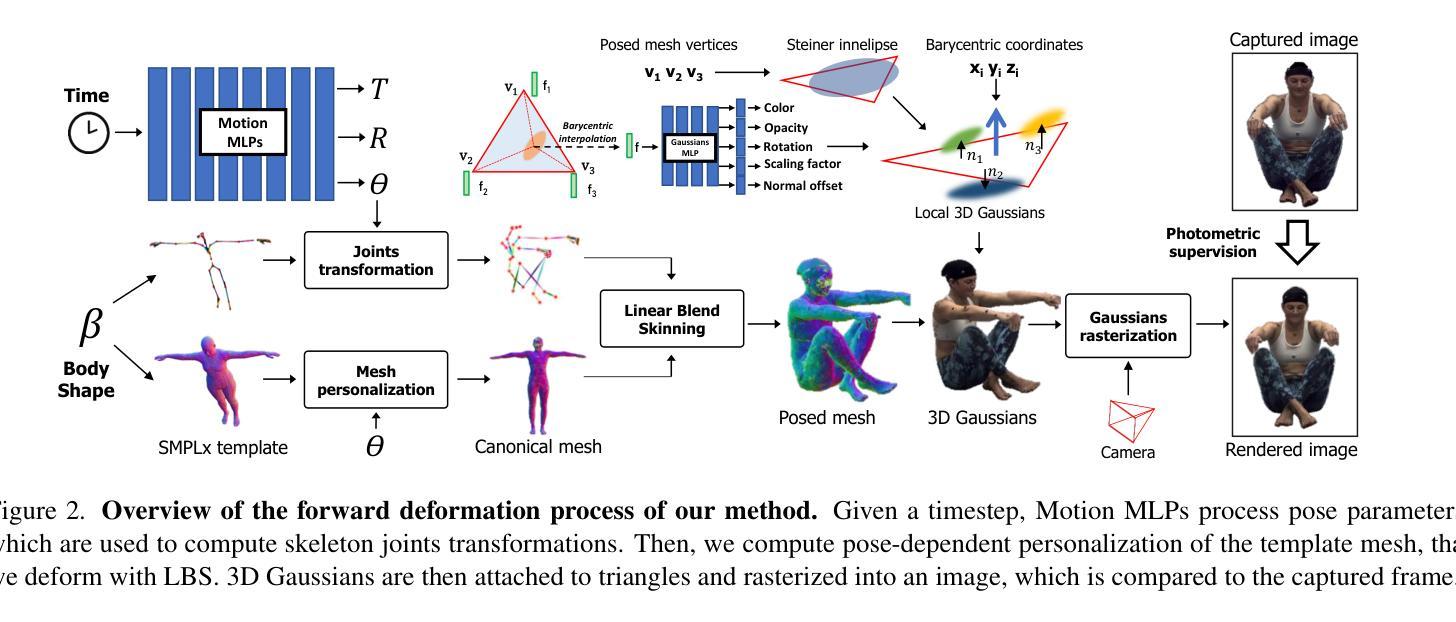

We present Better Together, a method that simultaneously solves the human pose estimation problem while reconstructing a photorealistic 3D human avatar from multi-view videos. While prior art usually solves these problems separately, we argue that joint optimization of skeletal motion with a 3D renderable body model brings synergistic effects, i.e. yields more precise motion capture and improved visual quality of real-time rendering of avatars. To achieve this, we introduce a novel animatable avatar with 3D Gaussians rigged on a personalized mesh and propose to optimize the motion sequence with time-dependent MLPs that provide accurate and temporally consistent pose estimates. We first evaluate our method on highly challenging yoga poses and demonstrate state-of-the-art accuracy on multi-view human pose estimation, reducing error by 35% on body joints and 45% on hand joints compared to keypoint-based methods. At the same time, our method significantly boosts the visual quality of animatable avatars (+2dB PSNR on novel view synthesis) on diverse challenging subjects.

我们提出了“Better Together”方法,该方法可以同时解决人体姿态估计问题,并从多视角视频重建出逼真的3D人类角色。虽然以前的技术通常分别解决这两个问题,但我们认为,对骨骼运动和3D可渲染身体模型的联合优化可以产生协同效应,即可以获得更精确的动作捕捉和实时渲染角色的视觉质量提升。为了实现这一点,我们引入了一种新型的可动画角色,在个性化网格上配备了3D高斯模型,并提出使用时间依赖的MLP优化动作序列,以提供准确且时间一致的姿态估计。我们首先对我们的方法进行了极具挑战性的瑜伽动作评估,并展示了多视角人体姿态估计的最新准确性。与基于关键点的方法相比,我们的方法在身体关节和手部关节的误差分别减少了35%和45%。同时,我们的方法在多种具有挑战性的主题上显著提高了可动画角色的视觉质量(在新型视角合成上的PSNR提高了2dB)。

论文及项目相关链接

PDF 14 pages, 6 figures

Summary

该文章介绍了一种名为“Better Together”的方法,该方法可同时解决人体姿态估计问题并重建多视角视频的光栅化3D人体化身。文章主张骨骼运动与个性化网格的动画化化身模型的联合优化会产生协同效应,可带来更精确的动作捕捉和虚拟角色实时渲染的视觉质量提升。为达到这一目的,文章引入了新型的动画化化身模型并在个性化网格上加入了时间依赖MLPs的优化动作序列来实现精确和一致的姿态估计。通过瑜伽动作的挑战测试,该方法在多视角人体姿态估计方面展现出卓越表现,在关节点误差上相较于关键点方法减少了35%(身体关节)和45%(手部关节)。同时,该方法还能显著提升动画化虚拟角色的视觉质量(新型视角合成上提升了2dB PSNR)。

Key Takeaways

- “Better Together”方法可同时解决人体姿态估计和重建多视角视频的光栅化3D人体化身问题。

- 文章主张通过联合优化骨骼运动与个性化网格的动画化化身模型,产生协同效益。

- 引入新型动画化化身模型并在个性化网格上应用时间依赖MLPs的优化动作序列。

- 在瑜伽动作的测试中,该方法在多视角人体姿态估计方面表现出卓越性能,相较于关键点方法显著减少了关节点误差。

- 该方法显著提升了动画化虚拟角色的视觉质量,尤其是新型视角的合成质量。

- 文章的技术框架对实时虚拟角色生成及虚拟场景互动应用具有重要的实践意义。

点此查看论文截图

WildAvatar: Learning In-the-wild 3D Avatars from the Web

Authors:Zihao Huang, Shoukang Hu, Guangcong Wang, Tianqi Liu, Yuhang Zang, Zhiguo Cao, Wei Li, Ziwei Liu

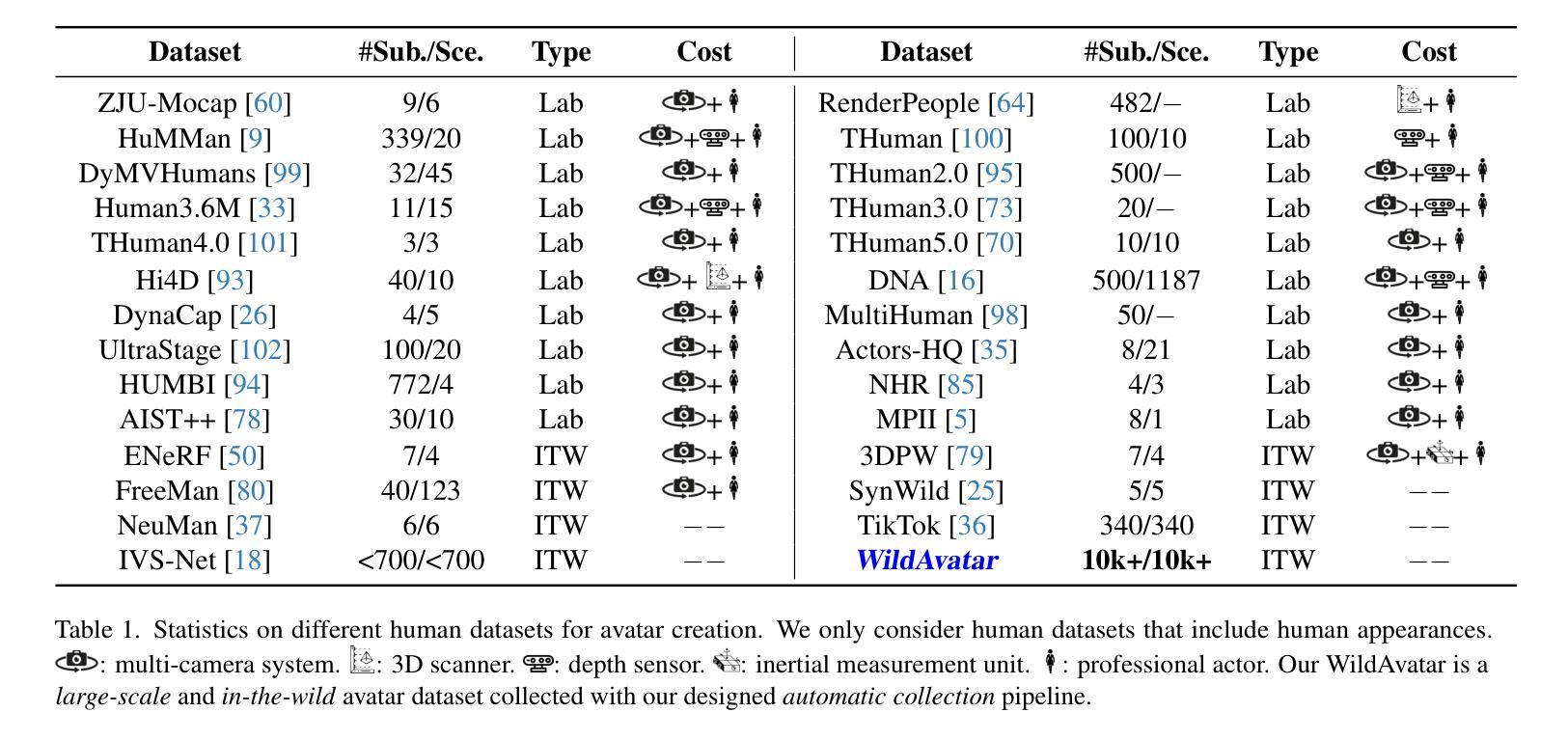

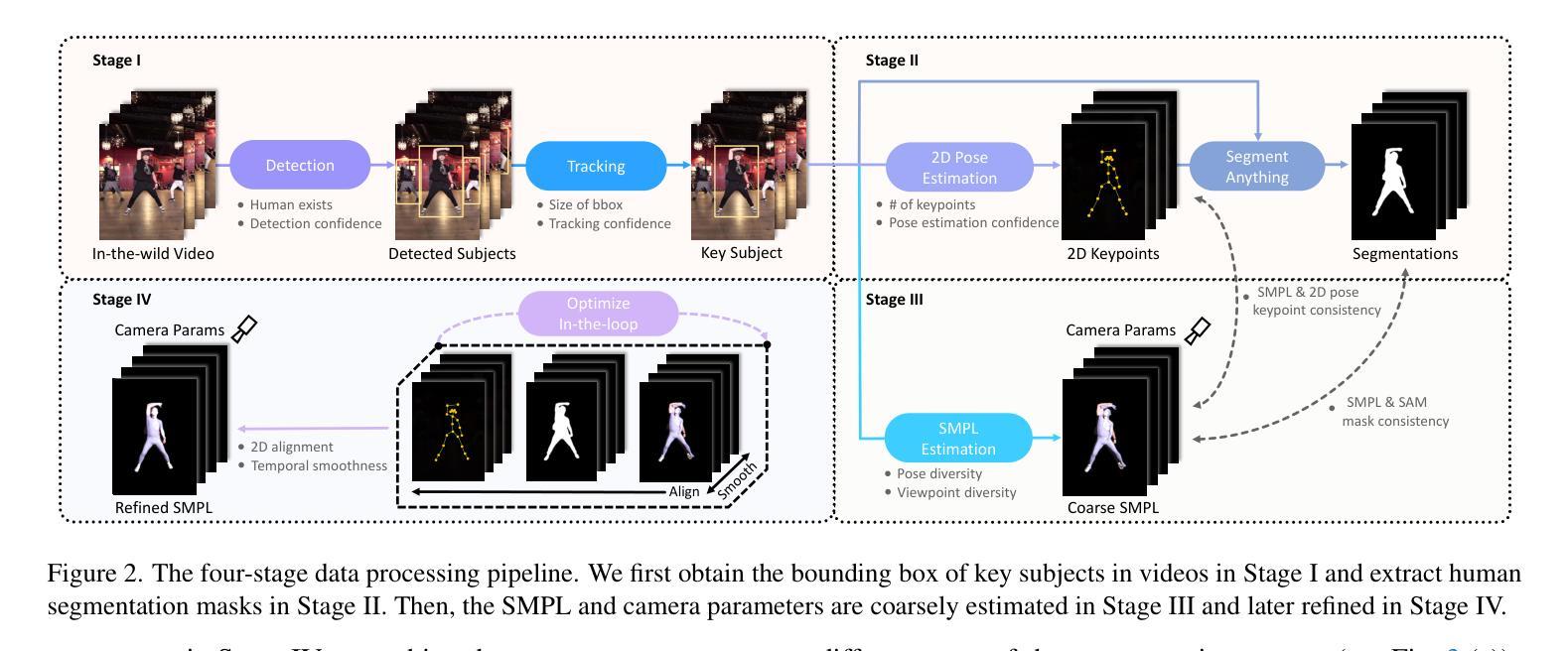

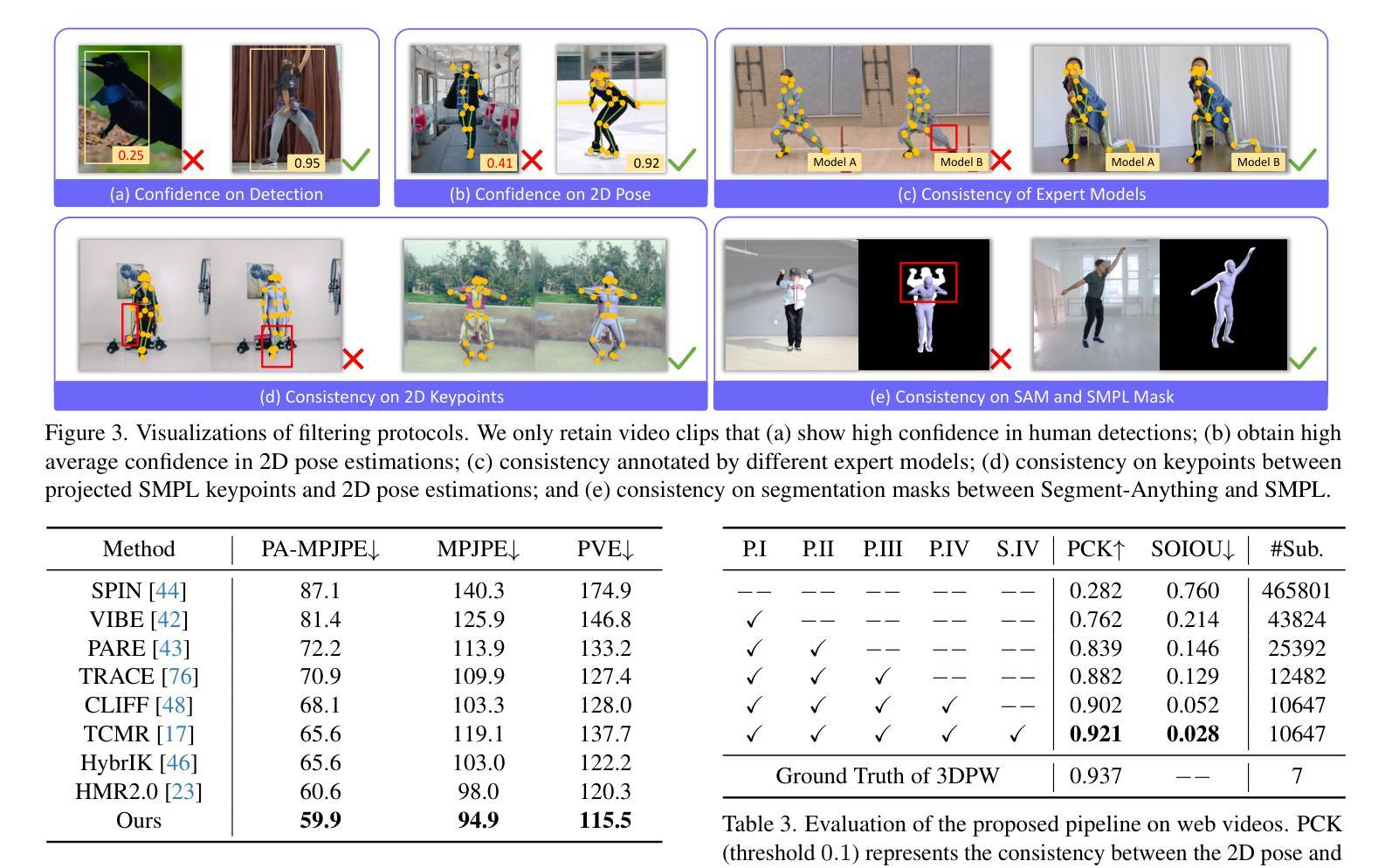

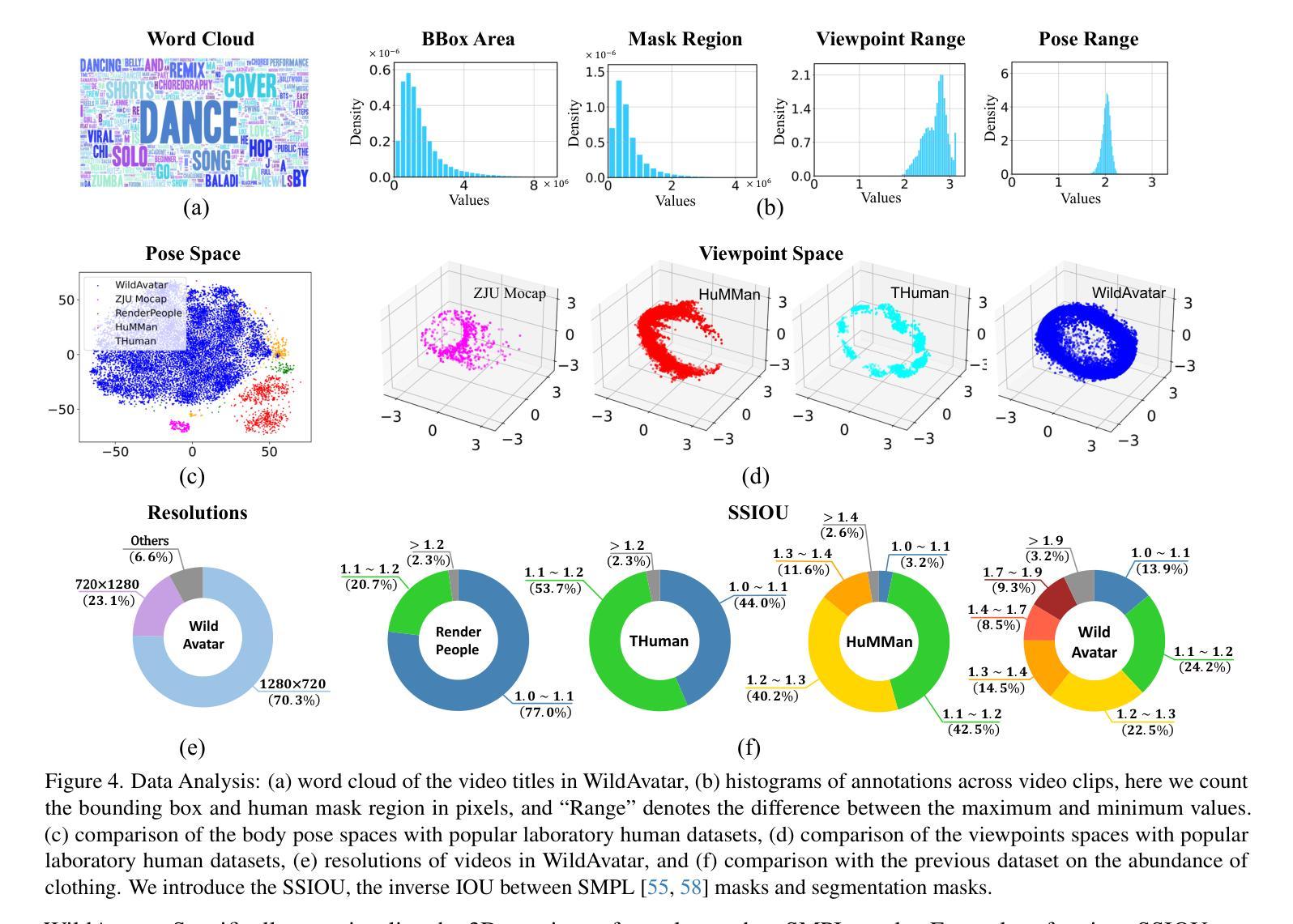

Existing research on avatar creation is typically limited to laboratory datasets, which require high costs against scalability and exhibit insufficient representation of the real world. On the other hand, the web abounds with off-the-shelf real-world human videos, but these videos vary in quality and require accurate annotations for avatar creation. To this end, we propose an automatic annotating pipeline with filtering protocols to curate these humans from the web. Our pipeline surpasses state-of-the-art methods on the EMDB benchmark, and the filtering protocols boost verification metrics on web videos. We then curate WildAvatar, a web-scale in-the-wild human avatar creation dataset extracted from YouTube, with $10000+$ different human subjects and scenes. WildAvatar is at least $10\times$ richer than previous datasets for 3D human avatar creation and closer to the real world. To explore its potential, we demonstrate the quality and generalizability of avatar creation methods on WildAvatar. We will publicly release our code, data source links and annotations to push forward 3D human avatar creation and other related fields for real-world applications.

关于化身创建的研究通常仅限于实验室数据集,这些数据集在可扩展性方面需要高昂的成本,并且不能充分代表现实世界。另一方面,网络上充斥着现成的现实世界中的人类视频,但这些视频质量各异,需要准确的注释才能进行化身创建。为此,我们提出了一种具有过滤协议的自动注释管道来从网络上整理这些人类数据。我们的管道在EMDB基准测试上超越了现有技术方法,过滤协议提高了网络视频的验证指标。然后,我们从YouTube中提取制作了WildAvatar——一个大规模现实人类化身创建数据集,包含超过$ 10,000 $个不同的个体和场景。WildAvatar至少是之前用于3D人类化身创建的数据集的$ 10 \times $,并且更接近现实世界。为了探索其潜力,我们在WildAvatar上展示了化身创建方法的质量和泛化能力。我们将公开发布我们的代码、数据源链接和注释,以推动用于现实应用的3D人类化身创建和其他相关领域的发展。

论文及项目相关链接

PDF CVPR2025, Project page: https://wildavatar.github.io/

Summary

网络上的现成真人视频资源丰富多样,但质量参差不齐,且需要准确的标注才能进行虚拟形象创建。为此,我们提出一种自动标注管道,并加入过滤协议以从网络中筛选人类数据。我们的管道在EMDB基准测试中表现优于现有技术,过滤协议提高了网络视频的验证指标。随后,我们从YouTube中整理出WildAvatar数据集,用于现实世界的三维虚拟形象创建。WildAvatar包含超过一万个不同的人类主体和场景,至少比先前的数据集丰富十倍,更接近现实世界。为探索其潜力,我们在WildAvatar上展示了虚拟形象创建方法的质量和泛化能力。我们将公开发布我们的代码、数据源链接和标注,以推动三维虚拟形象创建和其他相关领域在现实世界的实际应用。

Key Takeaways

- 现有虚拟形象创建研究多局限于实验室数据集,成本高且缺乏现实世界的充分代表性。

- 网络上存在大量真人视频资源,但质量差异大,需要准确的标注才能进行虚拟形象创建。

- 提出一种自动标注管道,结合过滤协议从网络中筛选人类数据,提高数据的质量和准确性。

- 建立的WildAvatar数据集规模庞大,包含超过一万个不同的人类主体和场景,更贴近现实世界的复杂性。

- 自动标注管道和过滤协议在EMDB基准测试中表现优越,提高了数据处理的效率和准确性。

- 在WildAvatar数据集上展示了虚拟形象创建方法的质量和泛化能力。

点此查看论文截图