⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-03-14 更新

Towards Zero-Shot Multimodal Machine Translation

Authors:Matthieu Futeral, Cordelia Schmid, Benoît Sagot, Rachel Bawden

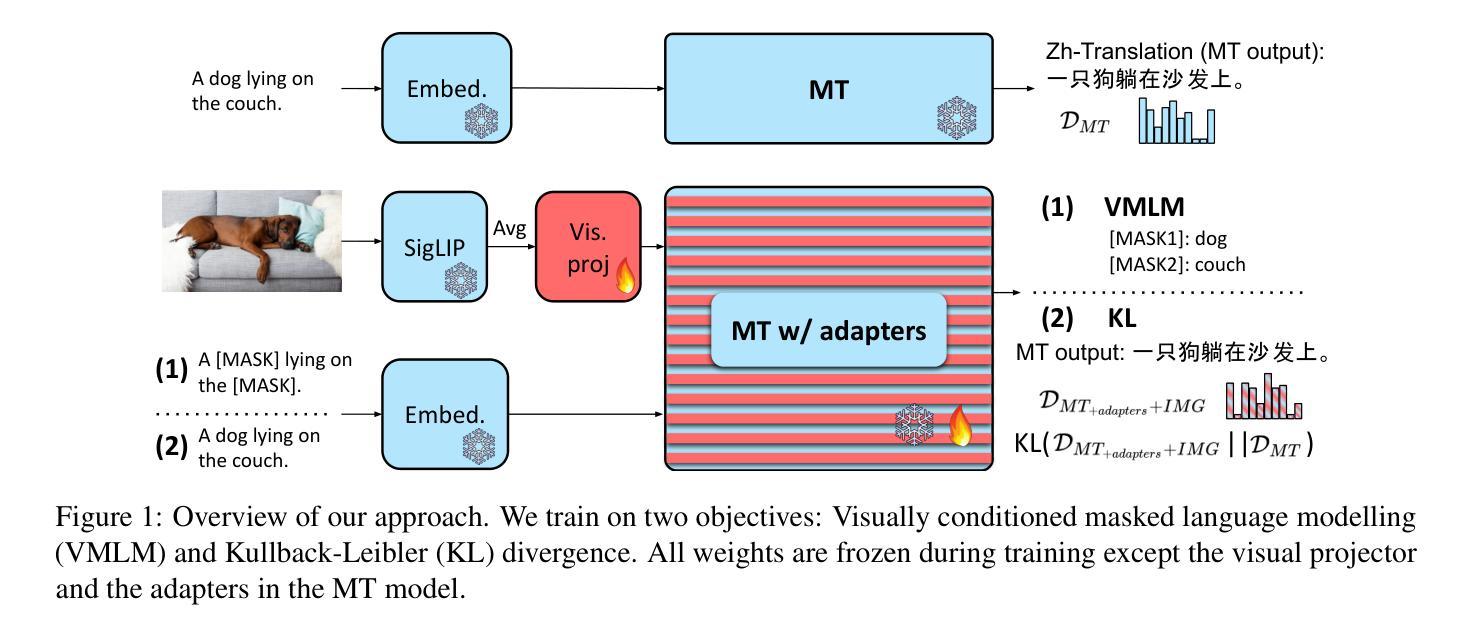

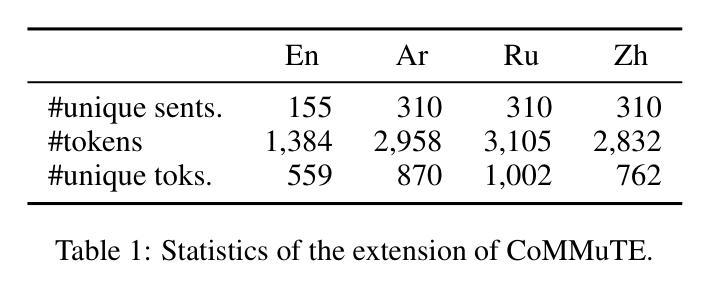

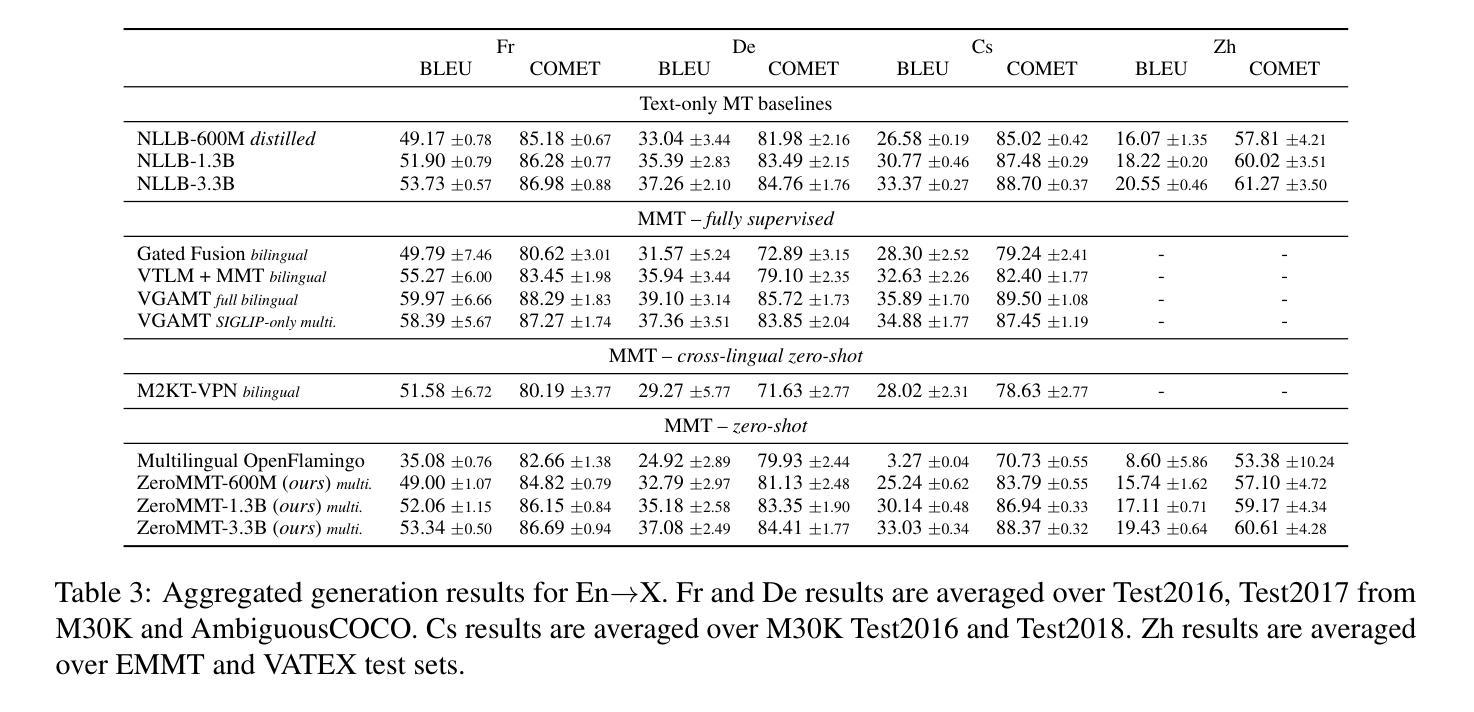

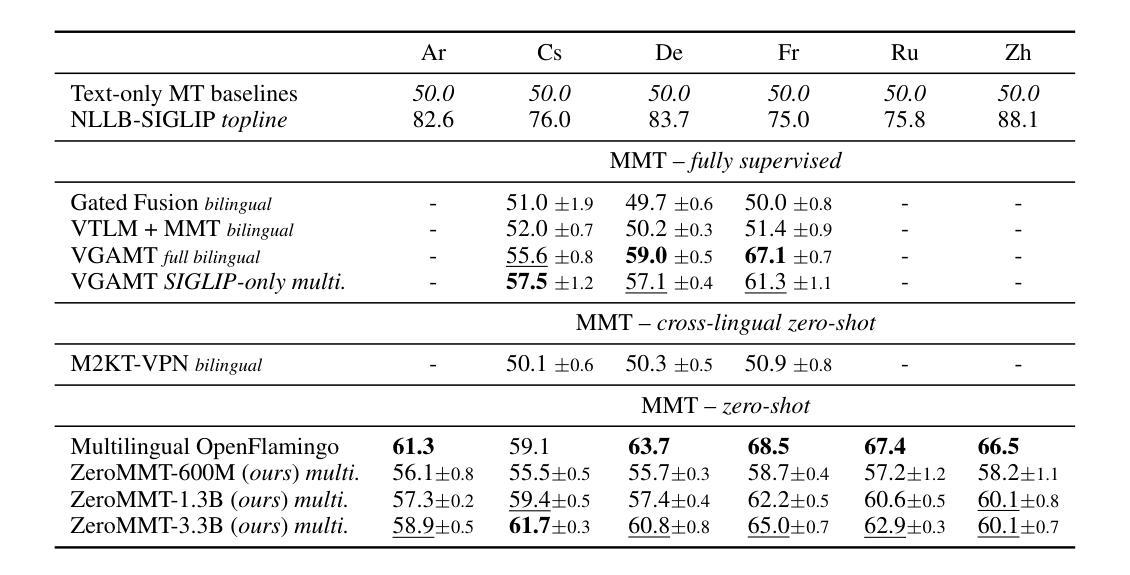

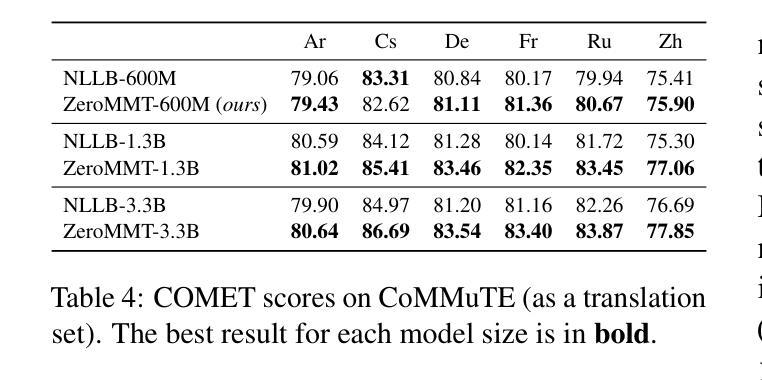

Current multimodal machine translation (MMT) systems rely on fully supervised data (i.e models are trained on sentences with their translations and accompanying images). However, this type of data is costly to collect, limiting the extension of MMT to other language pairs for which such data does not exist. In this work, we propose a method to bypass the need for fully supervised data to train MMT systems, using multimodal English data only. Our method, called ZeroMMT, consists in adapting a strong text-only machine translation (MT) model by training it on a mixture of two objectives: visually conditioned masked language modelling and the Kullback-Leibler divergence between the original and new MMT outputs. We evaluate on standard MMT benchmarks and the recently released CoMMuTE, a contrastive benchmark aiming to evaluate how well models use images to disambiguate English sentences. We obtain disambiguation performance close to state-of-the-art MMT models trained additionally on fully supervised examples. To prove that our method generalizes to languages with no fully supervised training data available, we extend the CoMMuTE evaluation dataset to three new languages: Arabic, Russian and Chinese. We further show that we can control the trade-off between disambiguation capabilities and translation fidelity at inference time using classifier-free guidance and without any additional data. Our code, data and trained models are publicly accessible.

当前的多模态机器翻译(MMT)系统依赖于全监督数据(即模型是在带有翻译和相应图像的句子上进行训练的)。然而,收集这种类型的数据成本很高,限制了MMT在其他没有此类数据存在的语言对中的扩展。在这项工作中,我们提出了一种方法,只需使用多模态英语数据,就可以绕过对全监督数据的需要来训练MMT系统。我们的方法称为ZeroMMT,它通过两个目标来适应强大的纯文本机器翻译(MT)模型:视觉条件下的掩码语言建模和原始与新的MMT输出之间的Kullback-Leibler散度。我们在标准MMT基准测试和最近发布的CoMMuTE(一个旨在评估模型如何利用图像来消除英语句子的歧义性的对比基准测试)上进行了评估。我们获得的消除歧义的性能接近在完全监督的示例上训练的最新MMT模型。为了证明我们的方法可以推广到没有全监督训练数据可用的语言,我们将CoMMuTE评估数据集扩展到了三种新语言:阿拉伯语、俄语和汉语。我们还表明,在推理时间,我们可以利用无分类器引导和没有任何额外数据来控制消除歧义能力和翻译忠实度之间的权衡。我们的代码、数据和训练模型均可公开访问。

论文及项目相关链接

PDF NAACL 2025 (Findings)

Summary

本文提出了一种不需要全监督数据训练多模态机器翻译系统的方法,名为ZeroMMT。该方法通过训练强大的纯文本机器翻译模型,采用两种目标进行混合训练:视觉条件下的掩码语言建模和原始与新的多模态翻译输出之间的Kullback-Leibler散度。在标准多模态翻译基准测试和最近发布的旨在评估模型利用图像解决英语句子歧义的对比基准测试CoMMuTE上,该方法的解歧性能接近使用全监督示例进行训练的多模态翻译模型的最先进水平。此外,我们证明了该方法可以推广到没有全监督训练数据可用的语言,我们将CoMMuTE评估数据集扩展到三种新语言:阿拉伯语、俄语和中文。我们还进一步展示了在推理时间,我们可以利用无分类器引导和无需任何额外数据来控制解歧能力和翻译忠实度之间的权衡。

Key Takeaways

- 当前的多模态机器翻译系统依赖于全监督数据,成本高昂且限制了其在没有此类数据的语言对中的扩展。

- 提出了一种名为ZeroMMT的方法,通过训练强大的纯文本机器翻译模型来解决这一问题。

- ZeroMMT方法混合训练两种目标:视觉条件下的掩码语言建模和原始与新的多模态翻译输出之间的Kullback-Leibler散度。

- 在标准多模态翻译基准测试上,ZeroMMT的解歧性能接近最先进的多模态翻译模型。

- ZeroMMT方法可以推广到没有全监督训练数据的语言,成功将CoMMuTE评估数据集扩展到阿拉伯、俄罗斯和中国三种新语言。

- 通过使用无分类器引导和无需额外数据,可以在推理时间控制解歧能力和翻译忠实度之间的权衡。

点此查看论文截图