⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-03-15 更新

New Trends for Modern Machine Translation with Large Reasoning Models

Authors:Sinuo Liu, Chenyang Lyu, Minghao Wu, Longyue Wang, Weihua Luo, Kaifu Zhang

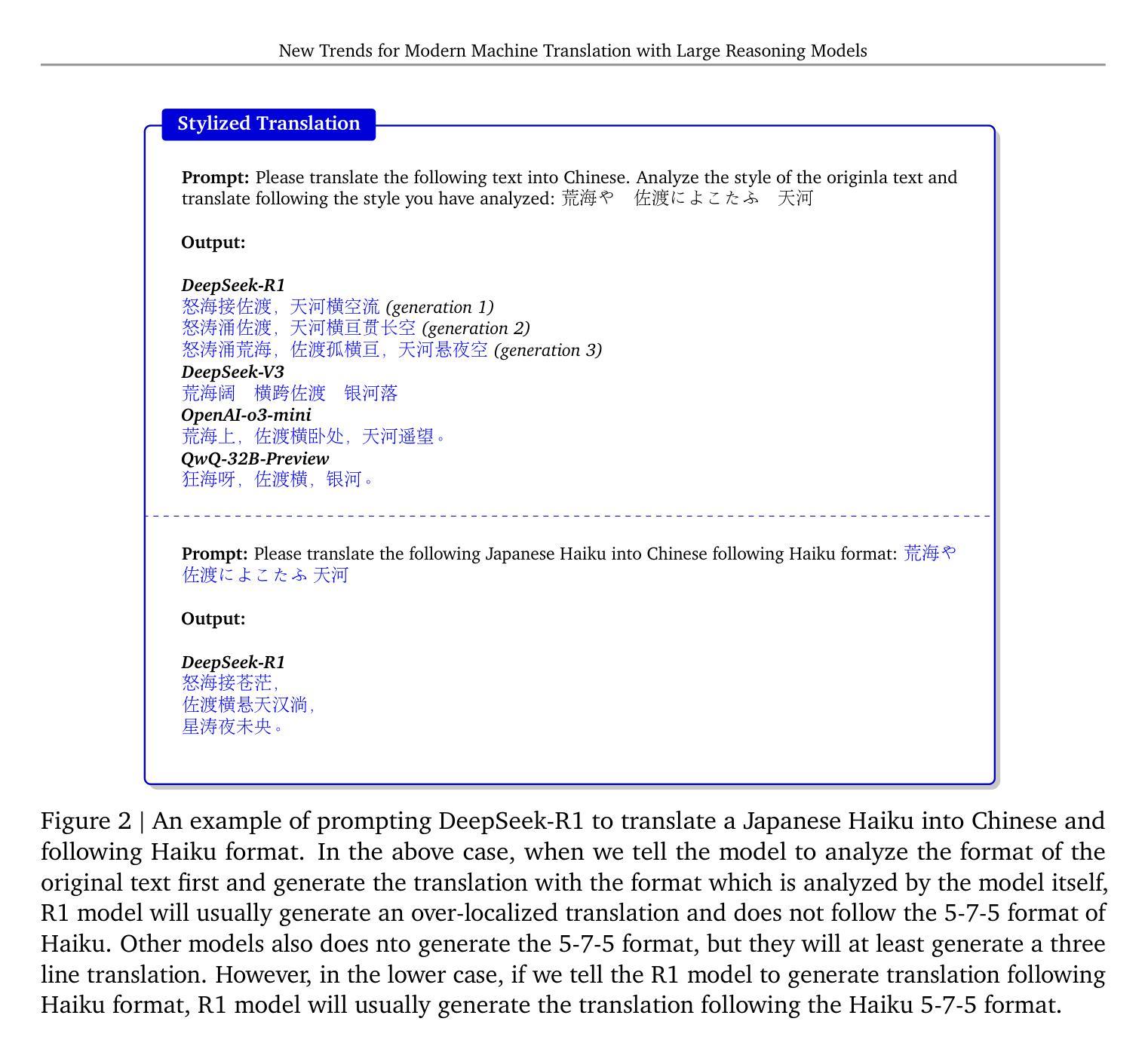

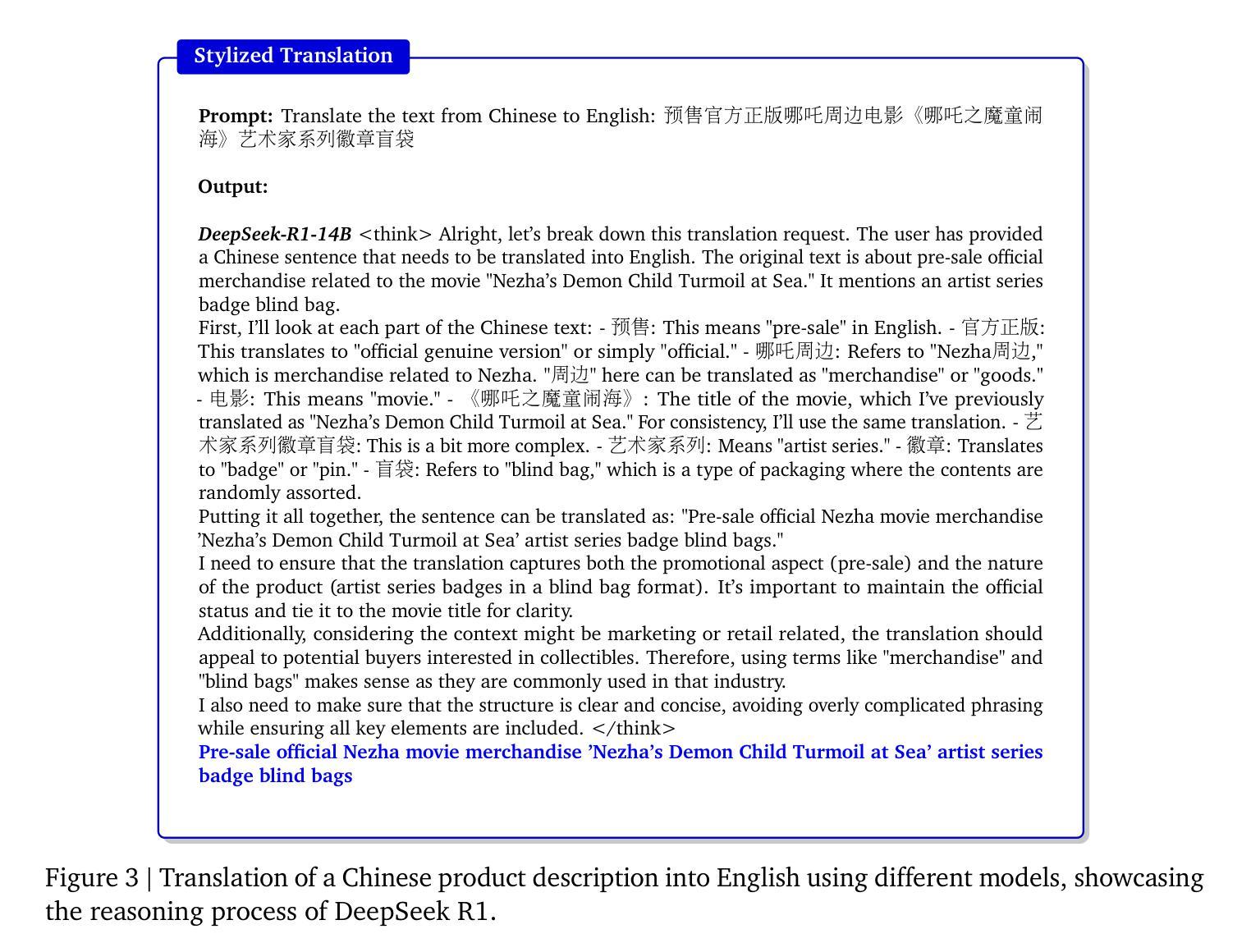

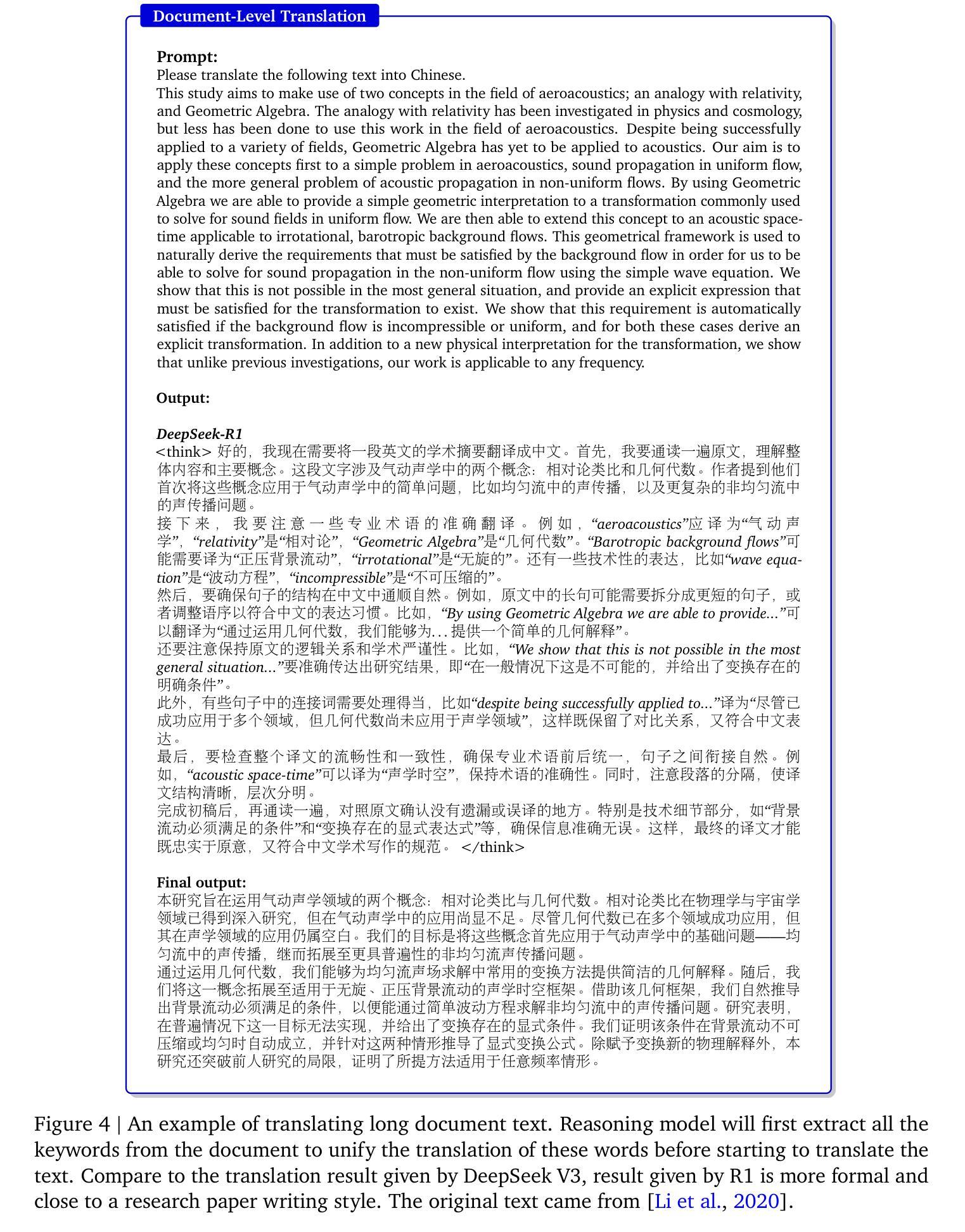

Recent advances in Large Reasoning Models (LRMs), particularly those leveraging Chain-of-Thought reasoning (CoT), have opened brand new possibility for Machine Translation (MT). This position paper argues that LRMs substantially transformed traditional neural MT as well as LLMs-based MT paradigms by reframing translation as a dynamic reasoning task that requires contextual, cultural, and linguistic understanding and reasoning. We identify three foundational shifts: 1) contextual coherence, where LRMs resolve ambiguities and preserve discourse structure through explicit reasoning over cross-sentence and complex context or even lack of context; 2) cultural intentionality, enabling models to adapt outputs by inferring speaker intent, audience expectations, and socio-linguistic norms; 3) self-reflection, LRMs can perform self-reflection during the inference time to correct the potential errors in translation especially extremely noisy cases, showing better robustness compared to simply mapping X->Y translation. We explore various scenarios in translation including stylized translation, document-level translation and multimodal translation by showcasing empirical examples that demonstrate the superiority of LRMs in translation. We also identify several interesting phenomenons for LRMs for MT including auto-pivot translation as well as the critical challenges such as over-localisation in translation and inference efficiency. In conclusion, we think that LRMs redefine translation systems not merely as text converters but as multilingual cognitive agents capable of reasoning about meaning beyond the text. This paradigm shift reminds us to think of problems in translation beyond traditional translation scenarios in a much broader context with LRMs - what we can achieve on top of it.

近期大型推理模型(LRMs)的最新进展,特别是那些利用思维链(CoT)的模型,为机器翻译(MT)开启了全新的可能性。本立场文件认为,LRMs通过重新构建翻译作为一个需要语境、文化和语言理解和推理的动态推理任务,从而极大地转变了传统的神经网络机器翻译以及基于大型语言模型的机器翻译范式。我们确定了三个基本转变:1)语境连贯性,LRMs通过明确的跨句和复杂语境甚至无语境的推理来解决歧义并保留话语结构;2)文化意图,使模型能够通过推断说话者的意图、受众期望和社会语言规范来适应输出;3)自我反思,LRMs可以在推理时间进行自我反思,以纠正翻译中可能出现的错误,特别是在极端噪声情况下,显示出比简单的X->Y翻译更好的稳健性。我们通过展示实证例子来探索翻译中的各种场景,包括风格化翻译、文档级翻译和多模态翻译,这些例子证明了LRMs在翻译中的优越性。我们还确定了LRMs用于机器翻译的若干有趣现象,包括自动枢轴翻译以及关键挑战,如过度本地化翻译和推理效率。总之,我们认为LRMs重新定义了翻译系统,不仅仅作为文本转换器,而是能够超越文本进行意义推理的多语言认知代理。这种范式转变提醒我们,在更广泛的背景下,要超越传统的翻译场景来思考LRMs所带来的翻译问题——我们可以在其基础上实现什么。

论文及项目相关链接

摘要

大型推理模型(LRMs)的最新进展,尤其是利用思维链(CoT)的推理,为机器翻译(MT)领域开启了全新的可能性。本文认为,LRMs极大地转变了传统的神经网络MT以及基于LLMs的MT范式,将翻译重塑为一个需要上下文、文化和语言理解和推理的动态推理任务。本文确定了三个基础转变:1)上下文连贯性,LRMs通过明确的跨句推理和复杂的上下文甚至无上下文来解析歧义并保留话语结构;2)文化意图性,模型能够推断说话者的意图、受众期望和社会语言规范来适应输出;3)自我反思能力,LRMs在推理时间可以进行自我反思,纠正翻译中的潜在错误,特别是在极端噪声情况下表现出更好的稳健性。本文通过实证例子展示了LRMs在风格化翻译、文档级翻译和多模态翻译场景下的优越性,并探讨了LRMs在MT中的自动转换等现象以及过度本地化翻译和推理效率等关键挑战。总之,我们认为LRMs重新定义了翻译系统,不仅是文本转换器,而且是能够进行超越文本意义的多元语言认知代理。这种范式转变提醒我们,在更广泛的背景下考虑翻译问题不仅限于传统翻译场景。

关键见解

- LRM通过引入思维链推理,将翻译重塑为需要上下文、文化和语言理解的动态推理任务。

- LRM实现了三个基础转变:上下文连贯性、文化意图性和自我反思能力。

- LRM在解决翻译中的歧义、保留话语结构和推理方面表现出优越性。

- LRM能够推断说话者的意图、受众期望和社会语言规范,以更灵活地适应输出。

- LRM在推理时间进行自我反思,提高翻译的稳健性,特别是在复杂或噪声情况下。

- LRM在各种翻译场景(如风格化翻译、文档级翻译和多模态翻译)中表现出优越性。

- LRM在机器翻译中面临挑战,如自动转换现象、过度本地化翻译和推理效率问题。

点此查看论文截图