⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

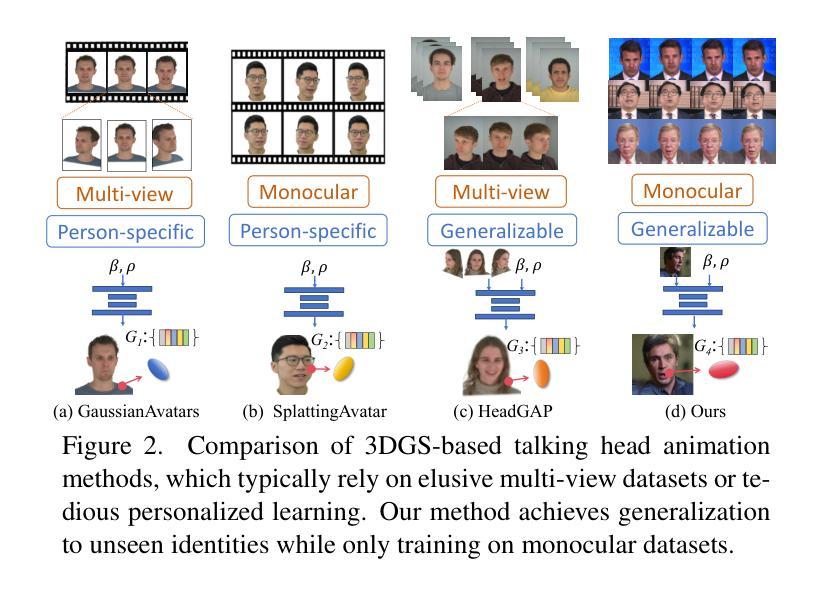

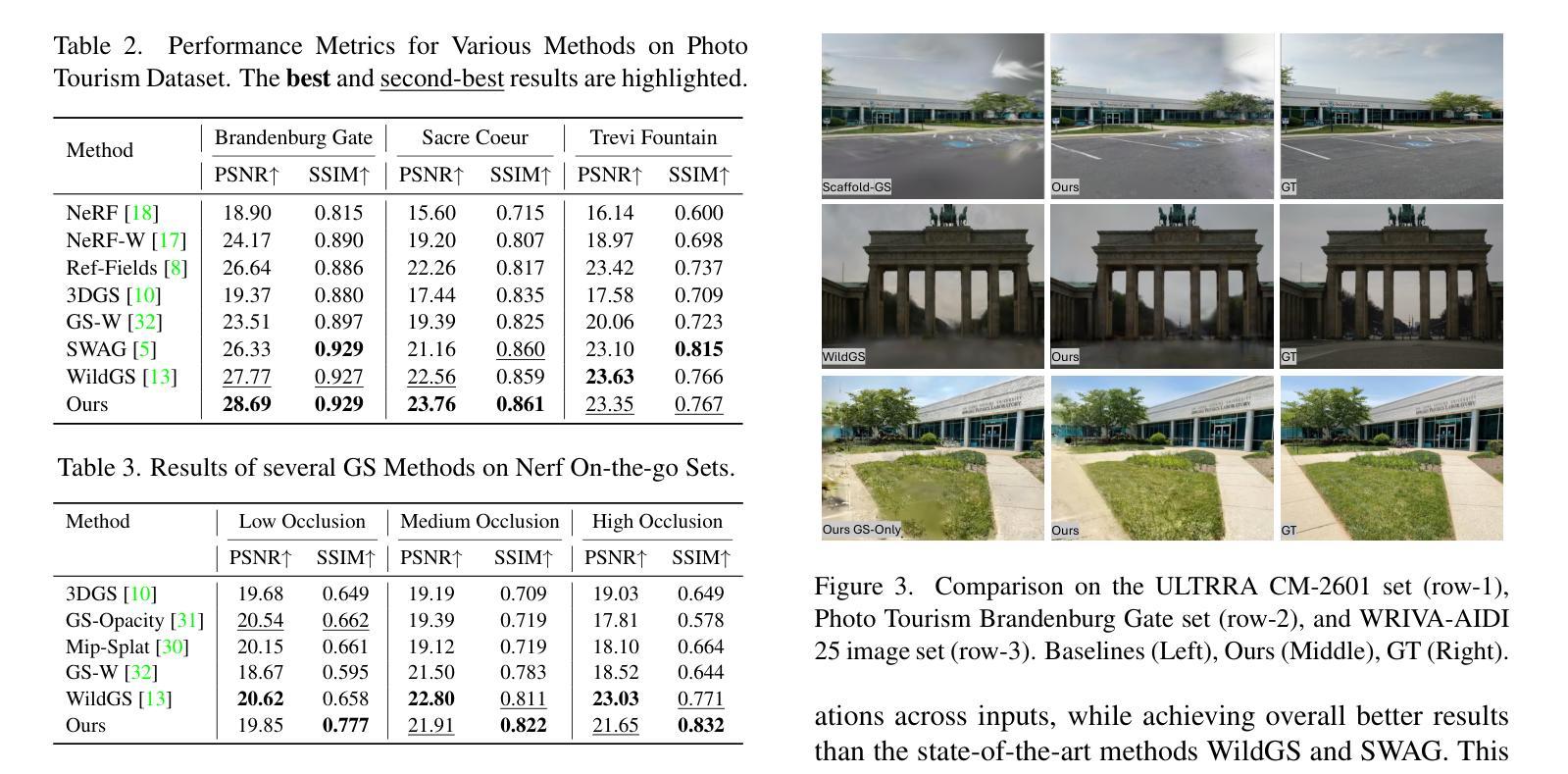

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-04-04 更新

Diffusion-Guided Gaussian Splatting for Large-Scale Unconstrained 3D Reconstruction and Novel View Synthesis

Authors:Niluthpol Chowdhury Mithun, Tuan Pham, Qiao Wang, Ben Southall, Kshitij Minhas, Bogdan Matei, Stephan Mandt, Supun Samarasekera, Rakesh Kumar

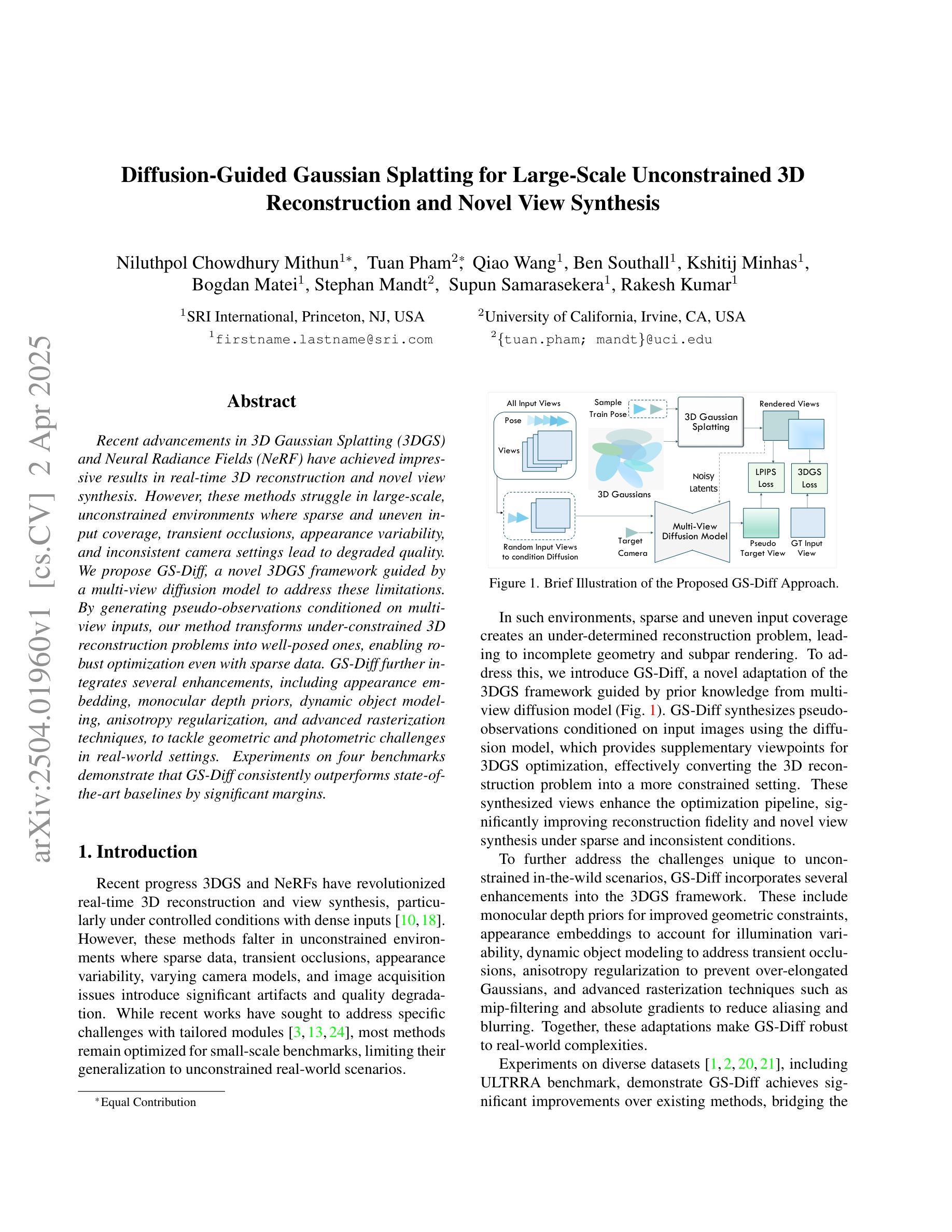

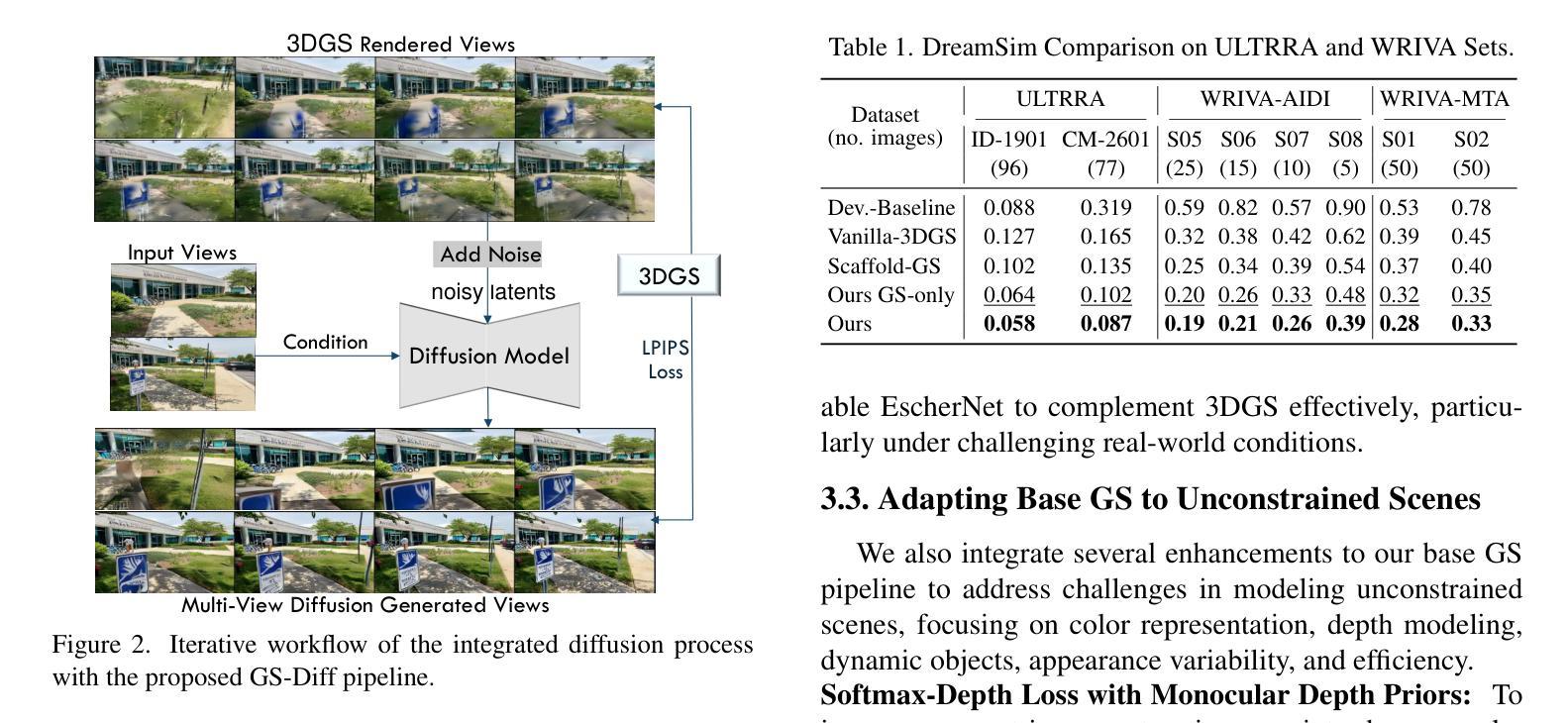

Recent advancements in 3D Gaussian Splatting (3DGS) and Neural Radiance Fields (NeRF) have achieved impressive results in real-time 3D reconstruction and novel view synthesis. However, these methods struggle in large-scale, unconstrained environments where sparse and uneven input coverage, transient occlusions, appearance variability, and inconsistent camera settings lead to degraded quality. We propose GS-Diff, a novel 3DGS framework guided by a multi-view diffusion model to address these limitations. By generating pseudo-observations conditioned on multi-view inputs, our method transforms under-constrained 3D reconstruction problems into well-posed ones, enabling robust optimization even with sparse data. GS-Diff further integrates several enhancements, including appearance embedding, monocular depth priors, dynamic object modeling, anisotropy regularization, and advanced rasterization techniques, to tackle geometric and photometric challenges in real-world settings. Experiments on four benchmarks demonstrate that GS-Diff consistently outperforms state-of-the-art baselines by significant margins.

最近,关于三维高斯蒙版技术(3DGS)和神经辐射场(NeRF)的最新进展在实时三维重建和新型视角合成方面取得了令人印象深刻的结果。然而,这些方法在大型无约束环境中的表现欠佳。在这种环境下,稀疏和不平整输入覆盖、瞬时遮挡、外观变化和不一致的相机设置都会导致质量下降。为了解决这些局限性,我们提出了GS-Diff,这是一种新型的多视角扩散模型引导的3DGS框架。它通过基于多视角输入生成伪观测结果,将不受约束的三维重建问题转化为明确的建模问题,即使在稀疏数据的情况下也能实现稳健优化。GS-Diff还融合了多项改进,包括外观嵌入、单眼深度先验、动态对象建模、各向异性正则化和先进的渲染技术,以应对现实环境中的几何和光度挑战。在四个基准测试集上的实验表明,GS-Diff显著优于最新的基线模型。

论文及项目相关链接

PDF WACV ULTRRA Workshop 2025

Summary

本文介绍了基于3D高斯融合(3DGS)和神经辐射场(NeRF)的最新进展在实时三维重建和新颖视角合成方面取得了显著成果。然而,在大规模、无约束的环境中,这些方法面临稀疏和不均匀输入覆盖、瞬时遮挡、外观变化和不一致相机设置等问题导致质量下降。为此,本文提出了GS-Diff,一种新型的多视角扩散模型引导的3DGS框架。通过生成基于多视角输入的伪观察结果,该方法将约束不足的三维重建问题转化为明确的问题,即使在稀疏数据下也能实现稳健优化。此外,GS-Diff还包括外观嵌入、单眼深度先验、动态对象建模、各向异性正则化和高级光栅化技术等多项改进,以应对现实环境中的几何和光度挑战。在四项基准测试上的实验表明,GS-Diff显著优于现有技术基线。

Key Takeaways

- 3DGS与NeRF融合在实时三维重建和新颖视角合成方面取得了最新进展的重要成果。

- 在大规模、无约束环境中,现有方法面临诸多挑战,如稀疏和不均匀输入覆盖、瞬时遮挡等。

- GS-Diff是一种新型3DGS框架,通过多视角扩散模型解决上述问题,实现稳健优化。

- GS-Diff通过生成伪观察结果,将约束不足的三维重建问题转化为明确的问题。

- GS-Diff集成了多项改进,包括外观嵌入、单眼深度先验等,以应对现实环境中的几何和光度挑战。

- 实验结果显示,GS-Diff在四项基准测试上显著优于现有技术基线。

点此查看论文截图

BOGausS: Better Optimized Gaussian Splatting

Authors:Stéphane Pateux, Matthieu Gendrin, Luce Morin, Théo Ladune, Xiaoran Jiang

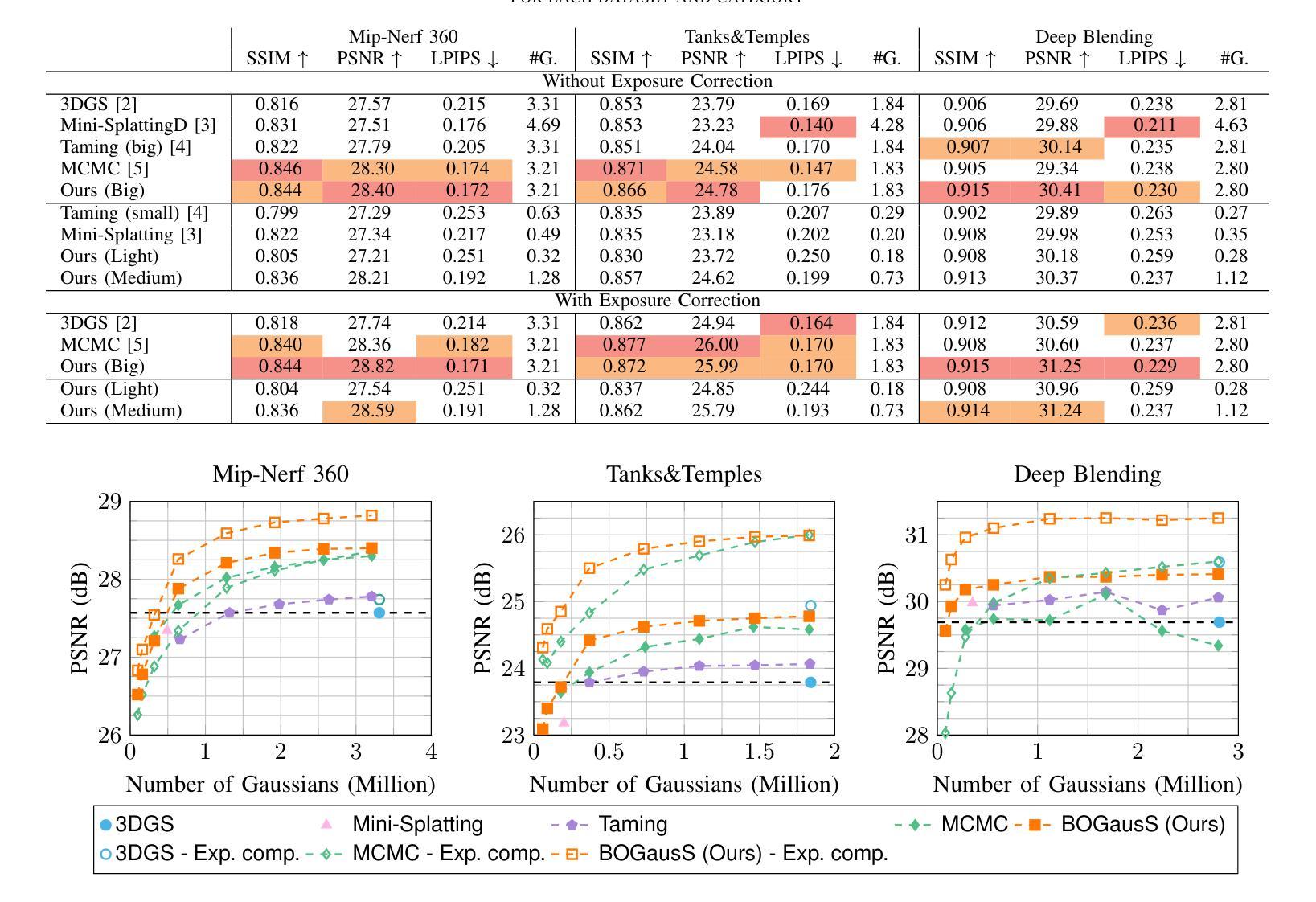

3D Gaussian Splatting (3DGS) proposes an efficient solution for novel view synthesis. Its framework provides fast and high-fidelity rendering. Although less complex than other solutions such as Neural Radiance Fields (NeRF), there are still some challenges building smaller models without sacrificing quality. In this study, we perform a careful analysis of 3DGS training process and propose a new optimization methodology. Our Better Optimized Gaussian Splatting (BOGausS) solution is able to generate models up to ten times lighter than the original 3DGS with no quality degradation, thus significantly boosting the performance of Gaussian Splatting compared to the state of the art.

3D高斯融合(3DGS)为新型视角合成提供了一种高效的解决方案,其框架能够实现快速且高保真的渲染。虽然相较于神经辐射场(NeRF)等其他解决方案,其复杂性较低,但在构建不牺牲质量的小模型方面仍存在挑战。在本研究中,我们对3DGS训练过程进行了详细分析,并提出了一种新的优化方法。我们优化的高斯融合(BOGausS)解决方案能够生成比原始3DGS轻十倍的模型,且没有质量损失,从而显著提高了高斯融合与最新技术的性能。

论文及项目相关链接

Summary

该研究探讨了名为”高斯浮雕”(Gaussian Splatting)的方法在合成三维数据(尤其是用于图像渲染和全景图像生成)时的局限性。提出一种优化后的方案,即更好的优化高斯浮雕(BOGausS),能够生成质量无损但体积更小十倍的模型,极大地提升了高斯浮雕方法的性能。同时其简洁性也意味着该方法能更快地训练出更高质量的数据模型。这是在对原始方法的训练过程进行详细分析的基础上实现的突破。它不仅改善了高斯浮雕的效率问题,也为相关领域提供了一种新型的模型优化方法。这对于实时渲染和游戏等依赖快速处理的应用尤为重要。未来这项技术还有更大的潜力来改进各种模型质量和其他计算效率的挑战性问题。这也将成为机器学习和其他人工智能领域中改进各种模型的下一步关键步骤。此外,它还进一步证明了利用机器学习算法处理大规模数据集的高效性和可靠性。总结起来,该研究展示了人工智能和机器学习在优化复杂算法方面的巨大潜力。通过采用新技术,研究人员已经能够显著提高算法的性能,这有望推动相关领域的发展进步。研究的结果可能会开辟新的应用途径和商业模式。这将促进机器学习和人工智能领域的技术创新,为实际应用带来更多可能性。因此,这项研究不仅具有学术价值,而且具有巨大的实际应用潜力。此外,该技术可能对增强现实(AR)、虚拟现实(VR)等领域产生深远影响。这对于开发具有更好性能的应用程序具有重要影响,同时也有利于推动相关行业的创新和发展。随着技术的不断进步,未来的应用场景将更加广泛和丰富。这项研究将产生重大影响,成为相关领域发展的一个里程碑事件。这也将对现实世界的应用产生重要影响,包括但不限于虚拟空间建模和渲染等任务。总的来说,该研究对于人工智能和机器学习领域的发展具有重大意义。它不仅提高了算法性能,而且为未来的研究和应用提供了重要参考和启示。该研究不仅代表了当前研究的最新进展,也为未来的研究指明了方向。对于这一领域的专业人士来说,这是一个重要的里程碑事件,对于整个行业来说也具有重要意义。它不仅为行业带来了技术进步,也为未来的创新提供了广阔的空间和可能性。同时对于计算机视觉和图形学领域也具有重要意义。Key Takeaways:

* 研究探讨了现有的高斯浮雕技术面临的挑战:生成大规模数据集时的效率问题和模型大小问题。

* 提出了一种名为BOGausS的新优化方法,能在不损失质量的情况下生成体积更小的模型,显著提高了高斯浮雕的性能。

* 研究结果强调了机器学习算法在处理大规模数据集方面的可靠性和潜力。

* 该研究不仅具有学术价值,而且可能对增强现实(AR)、虚拟现实(VR)等实际应用领域产生深远影响。对于开发具有更好性能的应用程序具有重要影响。

* 该研究对人工智能和机器学习领域的发展具有重要意义,代表了当前研究的最新进展和方向指引功能。。

* BOGausS对于缩小机器学习模型和改善数据质量两个方面具有重要的实际意义。这项突破表明了对于利用新方法和优化工具的可能性抱有持续关注和探讨的强烈需求和应用价值判断上很大的商业应用潜力巨大改善的方向多元化发展空间及其开拓的前瞻性和全局性思维紧密关联的成就观点也意味着其价值影响的广度和深度超乎我们的预期和意义体现对它的认知和可能结果的变化已经扩展到科技、教育等多个领域特别是这些创新思路和成功策略对当前人工智能技术行业引领创新和推动行业发展的重要性方面展现出无可替代的价值地位同时其技术本身的可扩展性和灵活性也意味着其应用前景十分广阔为未来的研究和应用提供了重要的参考和启示对于整个行业来说具有里程碑意义的价值判断无疑也是对其价值的认可和肯定以及对未来科技发展的期待和信心表达无疑也体现了对人工智能领域未来发展的乐观态度和对未来技术进步的期待和信心表达体现了科技创新带来的无限可能和改变世界的力量表达了人们对科技的赞美和崇拜。总的来说其重要性在于提高了模型的训练效率和效果解决了原有算法中面临的问题增强了我们对科技行业的理解和进步而人类生活也被新的科研成果推向更高境界包括生活质量和科技发展等多个方面其价值和意义体现在科技进步对人类社会的推动上其潜在的价值和影响力无法估量对于人工智能领域的未来发展来说这是一个重要的里程碑事件为人类科技进步带来重要启示的同时也对未来的科技进步产生了积极的影响其意义重大深远并且持续发挥作用无疑也是对未来发展的信心和乐观态度的体现该研究的成功不仅代表了当前技术的最新进展也为未来的研究和应用提供了重要的参考和启示”。以下是对上述内容的简化并符合要求的总结:

点此查看论文截图

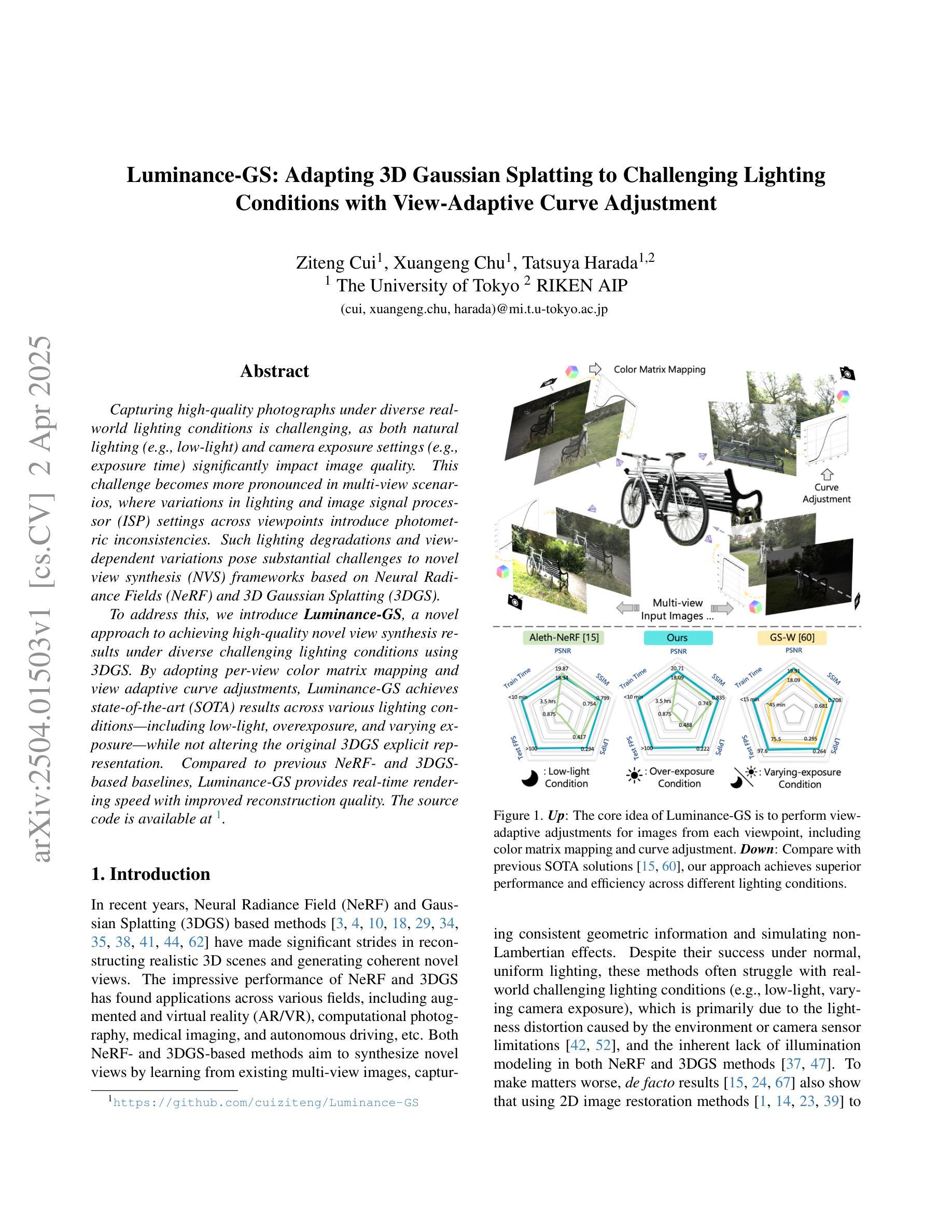

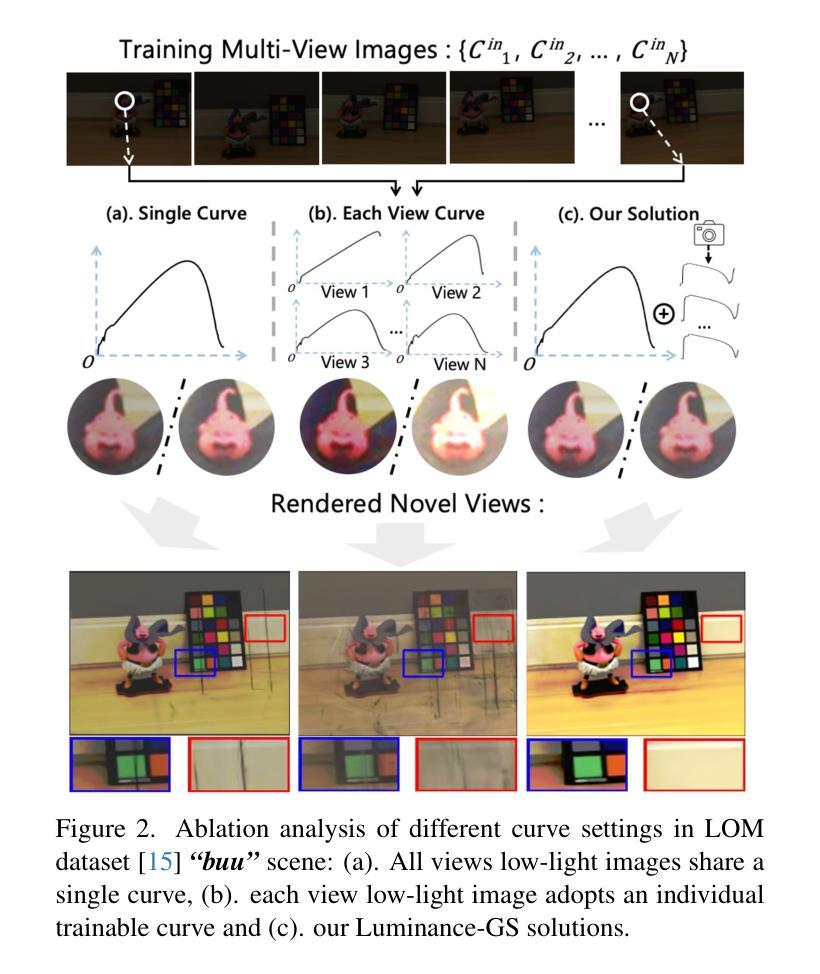

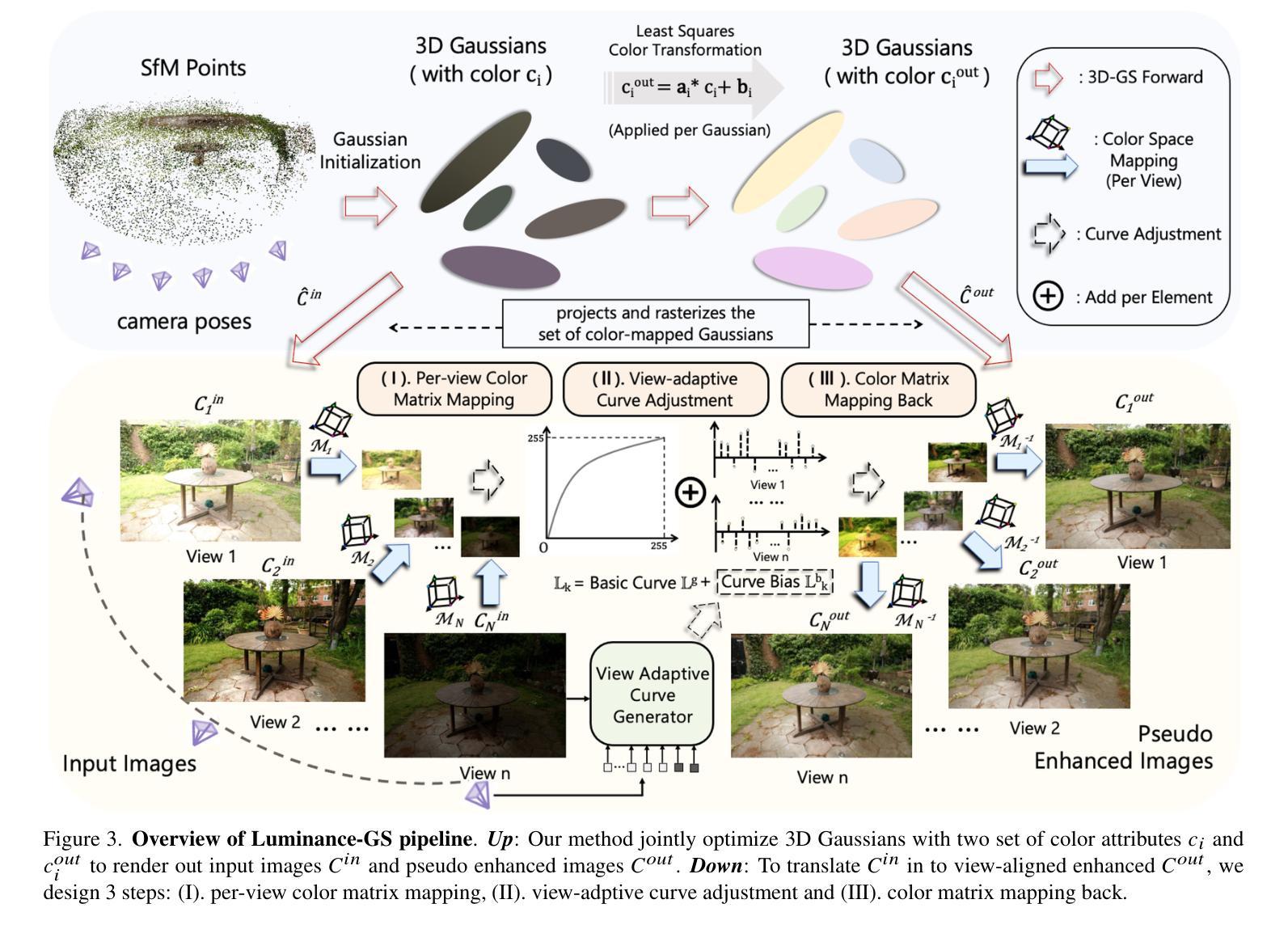

Luminance-GS: Adapting 3D Gaussian Splatting to Challenging Lighting Conditions with View-Adaptive Curve Adjustment

Authors:Ziteng Cui, Xuangeng Chu, Tatsuya Harada

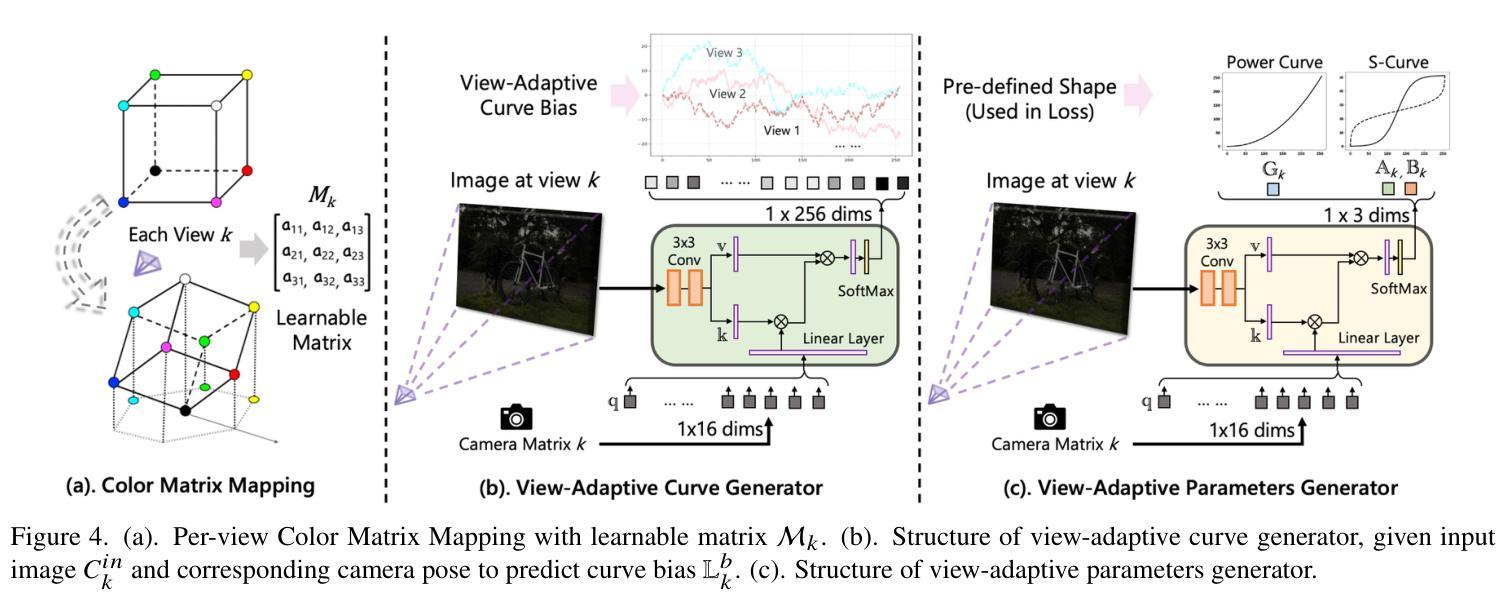

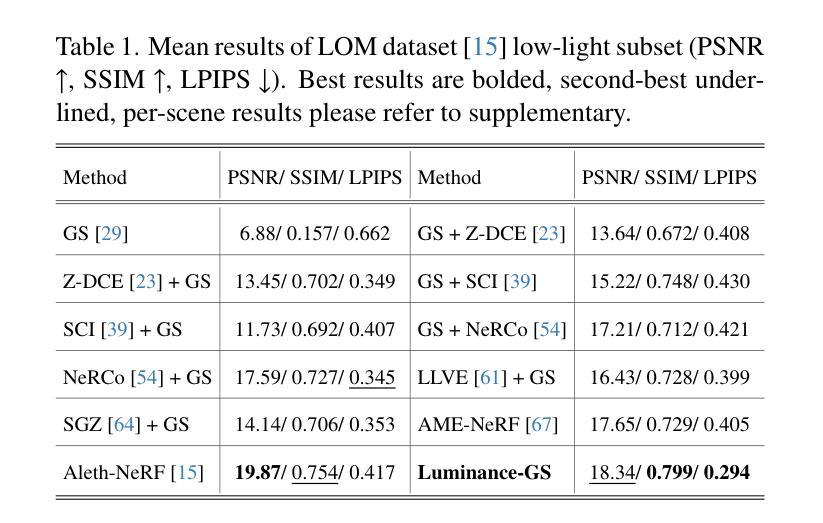

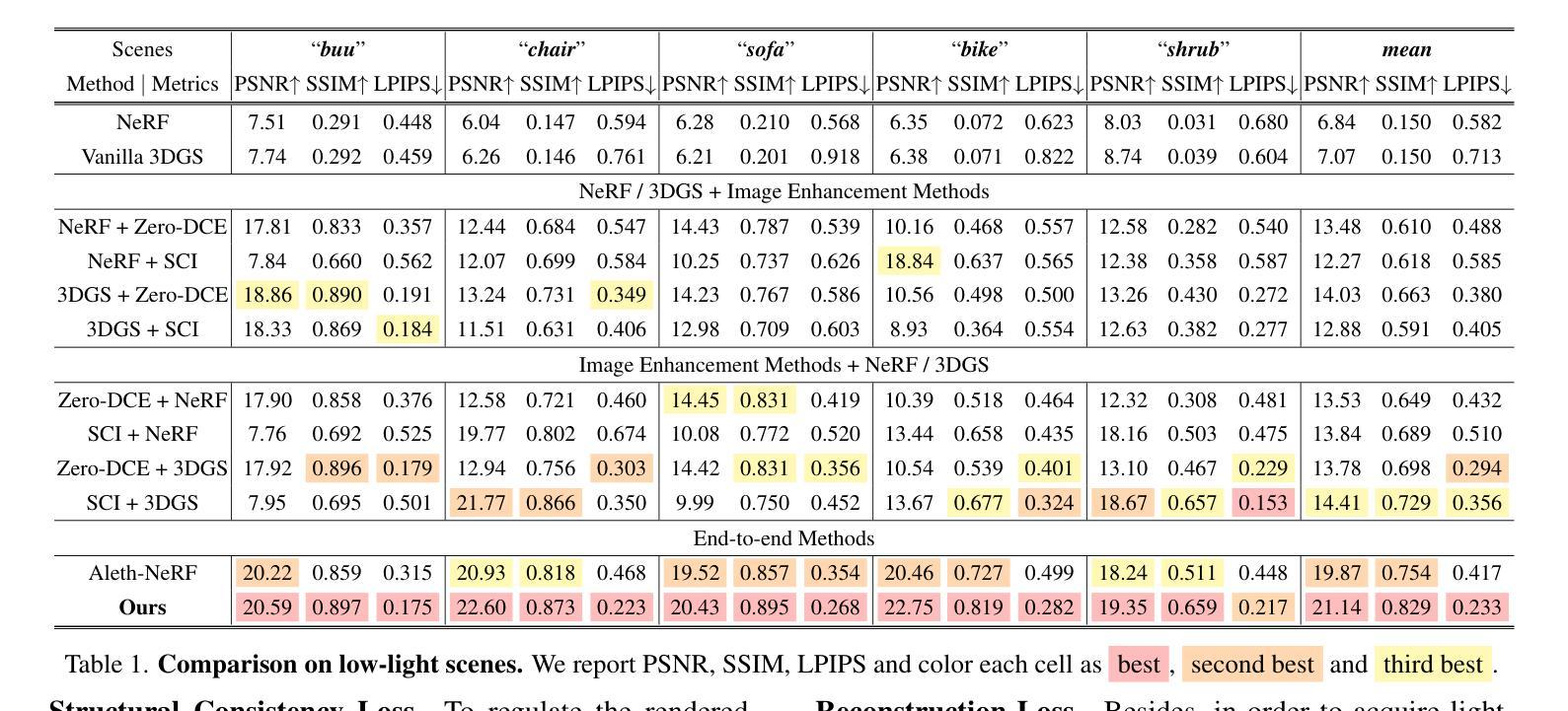

Capturing high-quality photographs under diverse real-world lighting conditions is challenging, as both natural lighting (e.g., low-light) and camera exposure settings (e.g., exposure time) significantly impact image quality. This challenge becomes more pronounced in multi-view scenarios, where variations in lighting and image signal processor (ISP) settings across viewpoints introduce photometric inconsistencies. Such lighting degradations and view-dependent variations pose substantial challenges to novel view synthesis (NVS) frameworks based on Neural Radiance Fields (NeRF) and 3D Gaussian Splatting (3DGS). To address this, we introduce Luminance-GS, a novel approach to achieving high-quality novel view synthesis results under diverse challenging lighting conditions using 3DGS. By adopting per-view color matrix mapping and view-adaptive curve adjustments, Luminance-GS achieves state-of-the-art (SOTA) results across various lighting conditions – including low-light, overexposure, and varying exposure – while not altering the original 3DGS explicit representation. Compared to previous NeRF- and 3DGS-based baselines, Luminance-GS provides real-time rendering speed with improved reconstruction quality.

在多样化的真实世界光照条件下捕捉高质量照片是一个挑战,因为自然光照(例如,低光环境)和相机曝光设置(例如,曝光时间)都会显著影响图像质量。在多视角场景中,这一挑战更为突出,因为不同视角的光照和图像信号处理(ISP)设置变化会引入光度不一致性。这种光照退化和视图相关的变化给基于神经辐射场(NeRF)和三维高斯拼贴(3DGS)的新视图合成(NVS)框架带来了巨大挑战。为了解决这一问题,我们引入了Luminance-GS这一新方法,通过采用视图彩色矩阵映射和视图自适应曲线调整,实现在多样化挑战光照条件下高质量的新视图合成结果。Luminance-GS在各种光照条件下均取得了最新结果,包括低光、过曝光和可变曝光等,同时不改变原始3DGS显式表示。与之前的NeRF和3DGS基线相比,Luminance-GS提供了实时的渲染速度并改善了重建质量。

论文及项目相关链接

PDF CVPR 2025, project page: https://cuiziteng.github.io/Luminance_GS_web/

Summary

这是一篇关于在多种真实世界光照条件下使用神经网络辐射场(NeRF)进行高质量照片捕捉的挑战性研究。该研究提出了一种新的方法Luminance-GS,通过采用每视图颜色矩阵映射和视图自适应曲线调整,在多样化的挑战光照条件下实现了高质量的新型视图合成结果。相较于以往的NeRF和3DGS基线方法,Luminance-GS在不改变原始3DGS显式表示的前提下,实现了实时渲染速度的提升和重建质量的改进。

Key Takeaways

- 在真实世界光照条件下捕捉高质量照片是一个挑战,因为自然光照和相机曝光设置都会影响图像质量。

- 在多视角场景中,光照变化和图像信号处理器(ISP)设置的差异会导致光度学不一致性。

- Luminance-GS是一种新型方法,能够在各种具有挑战性的光照条件下实现高质量的新型视图合成结果。

- 通过采用每视图颜色矩阵映射和视图自适应曲线调整,Luminance-GS达到了在各种光照条件下的最佳结果,包括低光、过曝光和可变曝光。

- Luminance-GS保留了原始的三维高斯平铺(3DGS)显式表示。

- 与基于NeRF和3DGS的先前方法相比,Luminance-GS具有更快的实时渲染速度和更高的重建质量。

点此查看论文截图

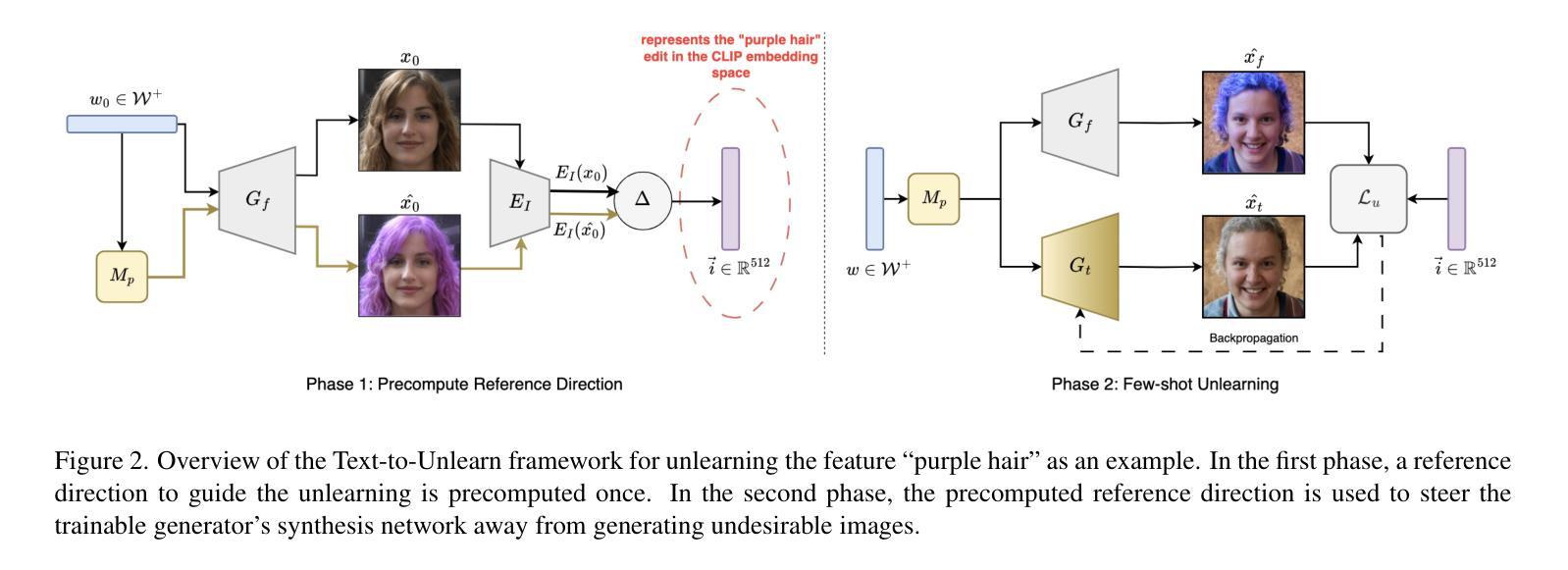

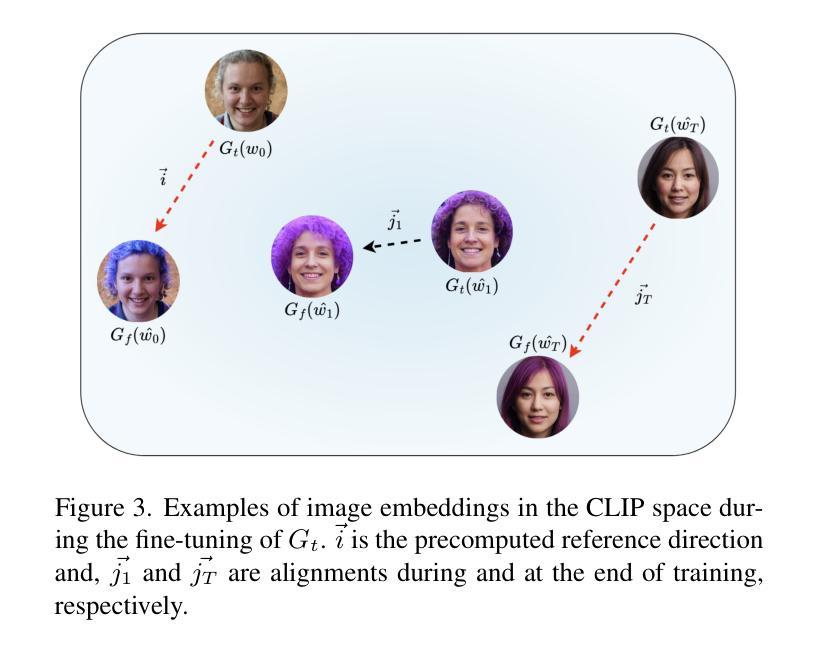

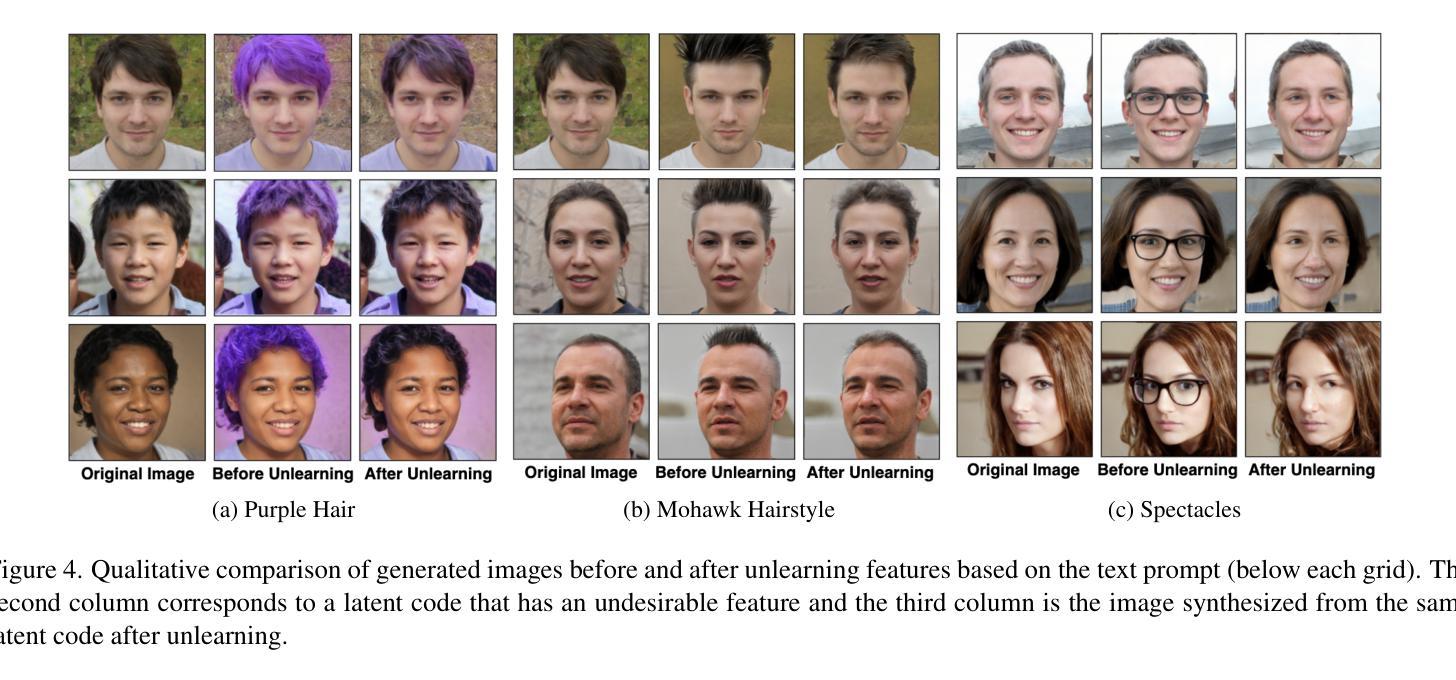

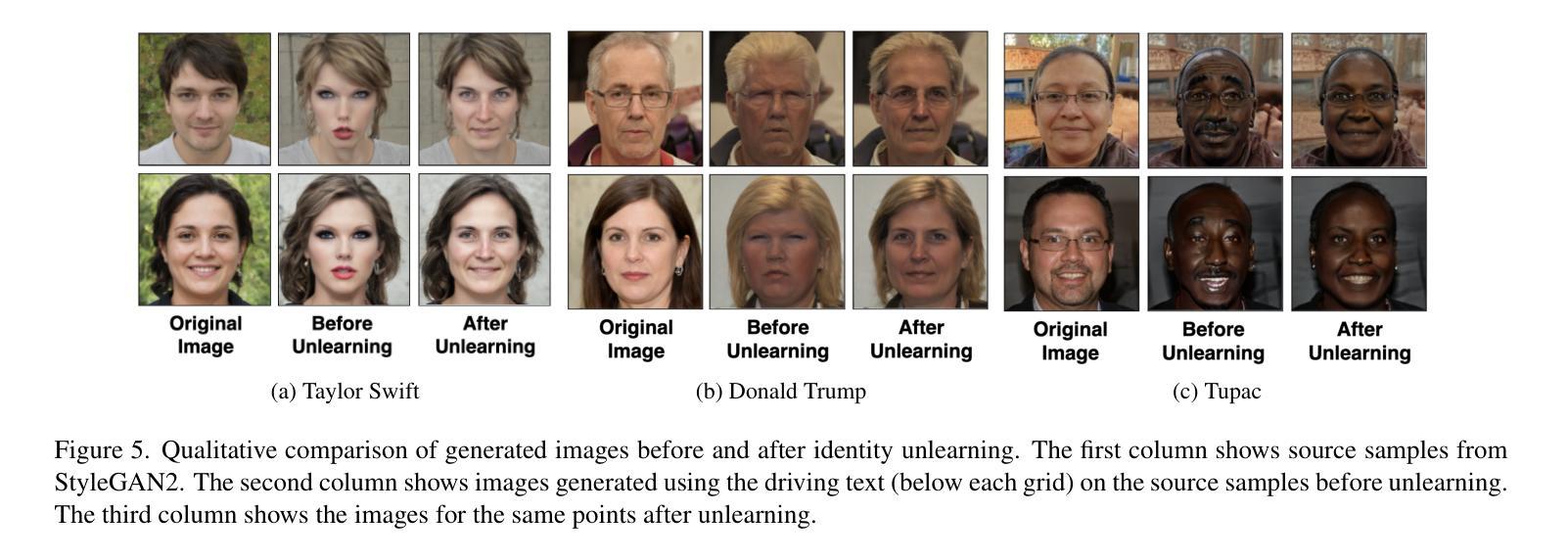

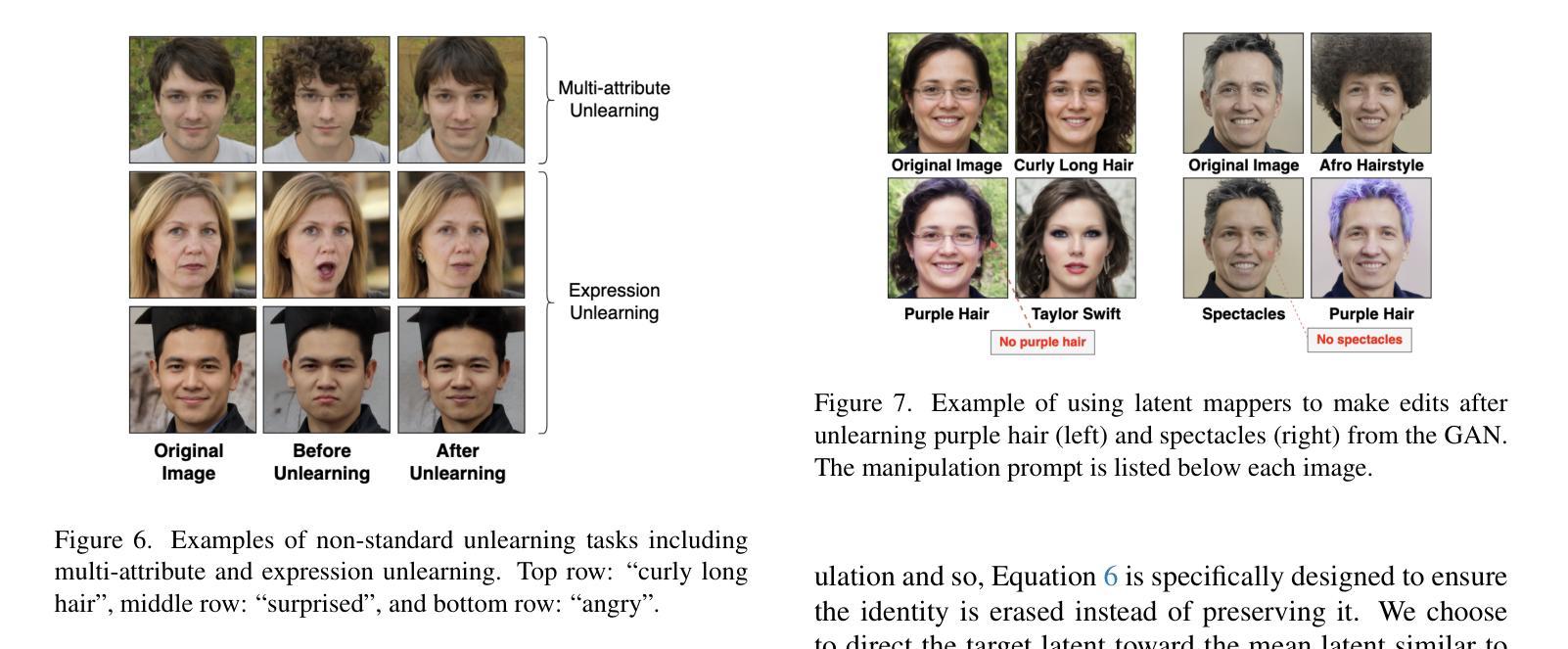

Prompting Forgetting: Unlearning in GANs via Textual Guidance

Authors:Piyush Nagasubramaniam, Neeraj Karamchandani, Chen Wu, Sencun Zhu

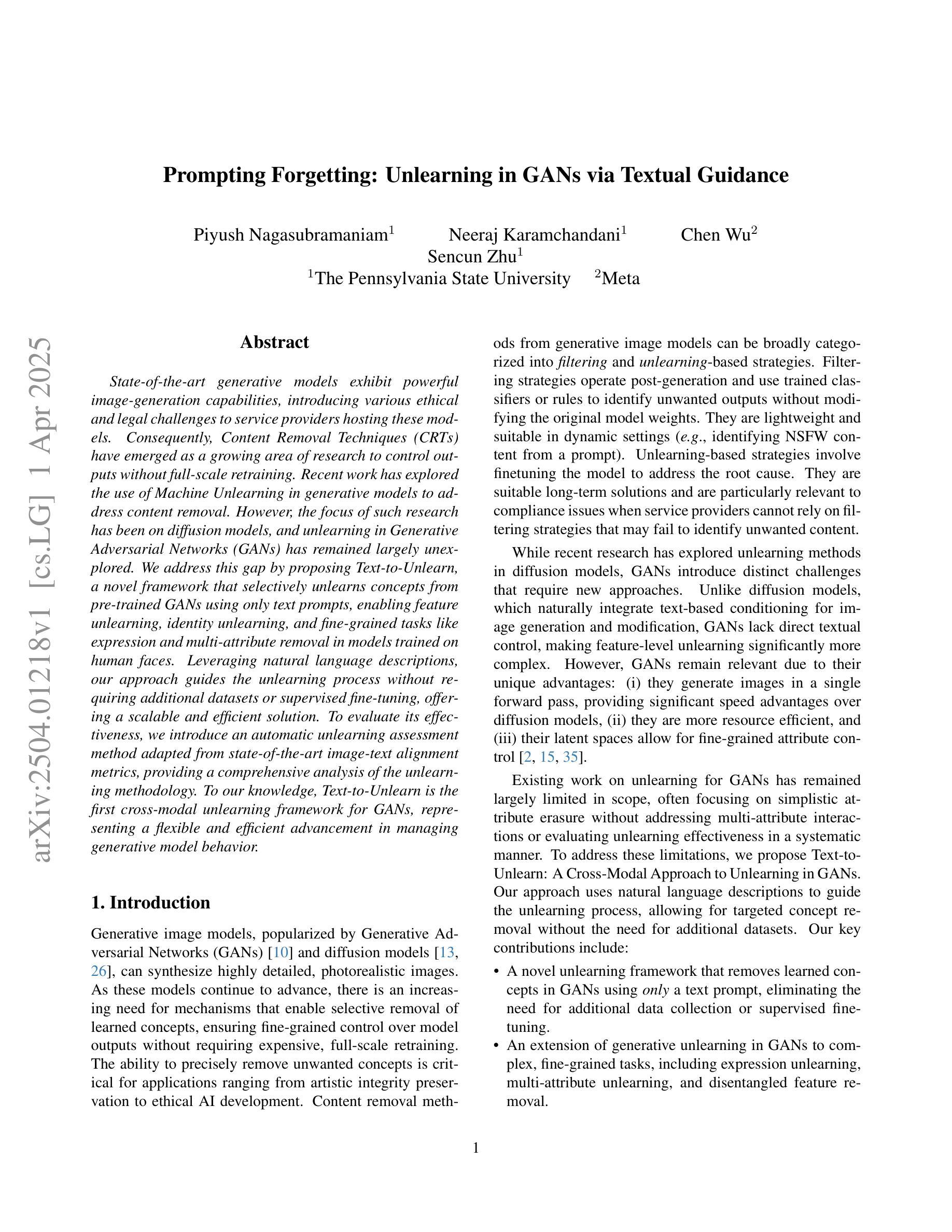

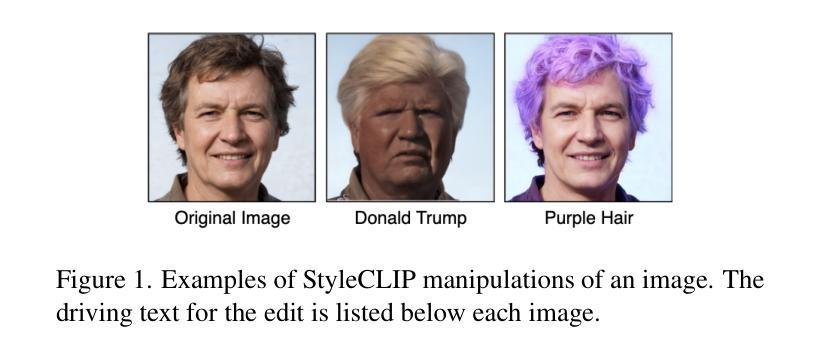

State-of-the-art generative models exhibit powerful image-generation capabilities, introducing various ethical and legal challenges to service providers hosting these models. Consequently, Content Removal Techniques (CRTs) have emerged as a growing area of research to control outputs without full-scale retraining. Recent work has explored the use of Machine Unlearning in generative models to address content removal. However, the focus of such research has been on diffusion models, and unlearning in Generative Adversarial Networks (GANs) has remained largely unexplored. We address this gap by proposing Text-to-Unlearn, a novel framework that selectively unlearns concepts from pre-trained GANs using only text prompts, enabling feature unlearning, identity unlearning, and fine-grained tasks like expression and multi-attribute removal in models trained on human faces. Leveraging natural language descriptions, our approach guides the unlearning process without requiring additional datasets or supervised fine-tuning, offering a scalable and efficient solution. To evaluate its effectiveness, we introduce an automatic unlearning assessment method adapted from state-of-the-art image-text alignment metrics, providing a comprehensive analysis of the unlearning methodology. To our knowledge, Text-to-Unlearn is the first cross-modal unlearning framework for GANs, representing a flexible and efficient advancement in managing generative model behavior.

当前最先进的生成模型展现出强大的图像生成能力,给托管这些模型的服务提供商带来了各种伦理和法律挑战。因此,内容删除技术(CRTs)作为控制输出而无需全面再训练的研究领域正日益兴起。近期的工作探索了在生成模型中使用机器遗忘来应对内容删除。然而,这类研究的重点主要集中在扩散模型上,生成对抗网络(GANs)中的遗忘却被大大忽视了。我们通过提出Text-to-Unlearn来解决这一空白,这是一个新颖的框架,能够仅使用文本提示从预训练的GANs中选择性遗忘概念,实现特征遗忘、身份遗忘以及在人脸训练模型中的表情和多属性删除等精细任务。我们的方法利用自然语言描述来引导遗忘过程,无需额外的数据集或监督微调,提供可伸缩和高效的解决方案。为了评估其有效性,我们引入了一种自动遗忘评估方法,该方法改编自最先进的图像文本对齐指标,对遗忘方法进行全面分析。据我们所知,Text-to-Unlearn是首个用于GANs的跨模态遗忘框架,代表着在管理生成模型行为方面灵活高效的进步。

论文及项目相关链接

Summary

本文提出了一种名为Text-to-Unlearn的新型框架,该框架能够通过文本提示选择性遗忘预训练生成对抗网络(GANs)中的概念,从而实现特征遗忘、身份遗忘以及面部表情和多属性遗忘等精细任务。该框架利用自然语言描述引导遗忘过程,无需额外数据集或监督微调,提供可伸缩和高效的解决方案。

Key Takeaways

- Text-to-Unlearn是一个新型框架,能够选择性遗忘预训练生成对抗网络(GANs)中的特定概念。

- 该框架通过文本提示实现特征遗忘、身份遗忘以及面部表情和多属性遗忘等精细任务。

- Text-to-Unlearn利用自然语言描述来引导遗忘过程,无需额外的数据集或监督微调。

- 该框架提供了一种可伸缩和高效的解决方案,用于管理生成模型的行为。

- Text-to-Unlearn首次实现了跨模态的GANs遗忘框架。

- 该框架的评价方法是基于先进的图像文本对齐度量指标进行自动评估的。

点此查看论文截图

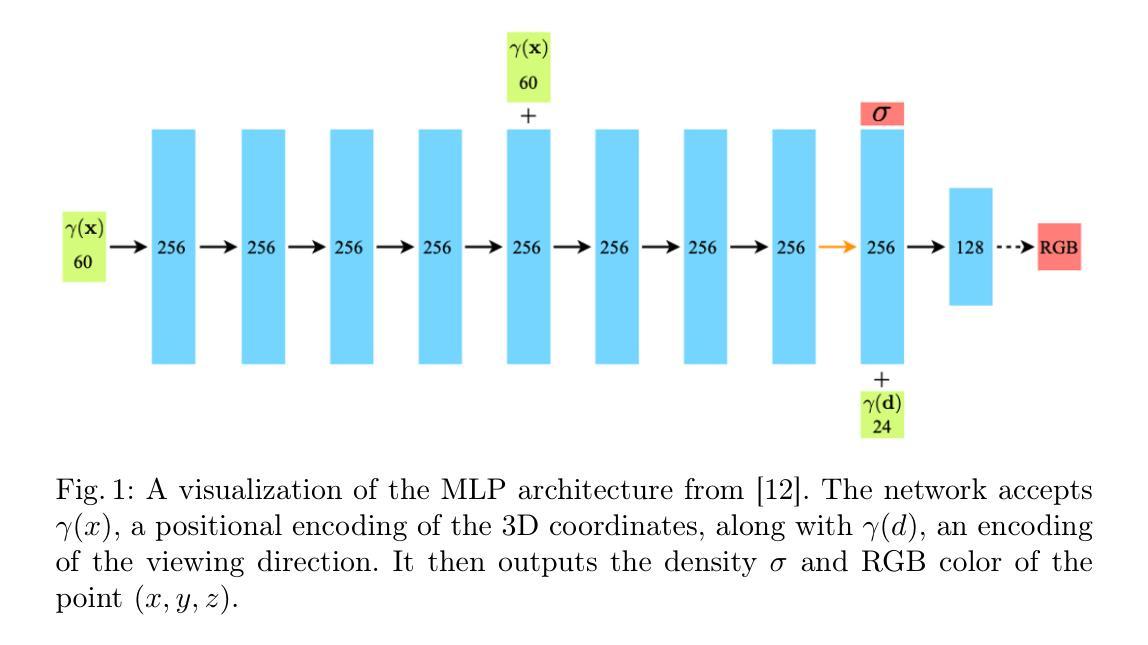

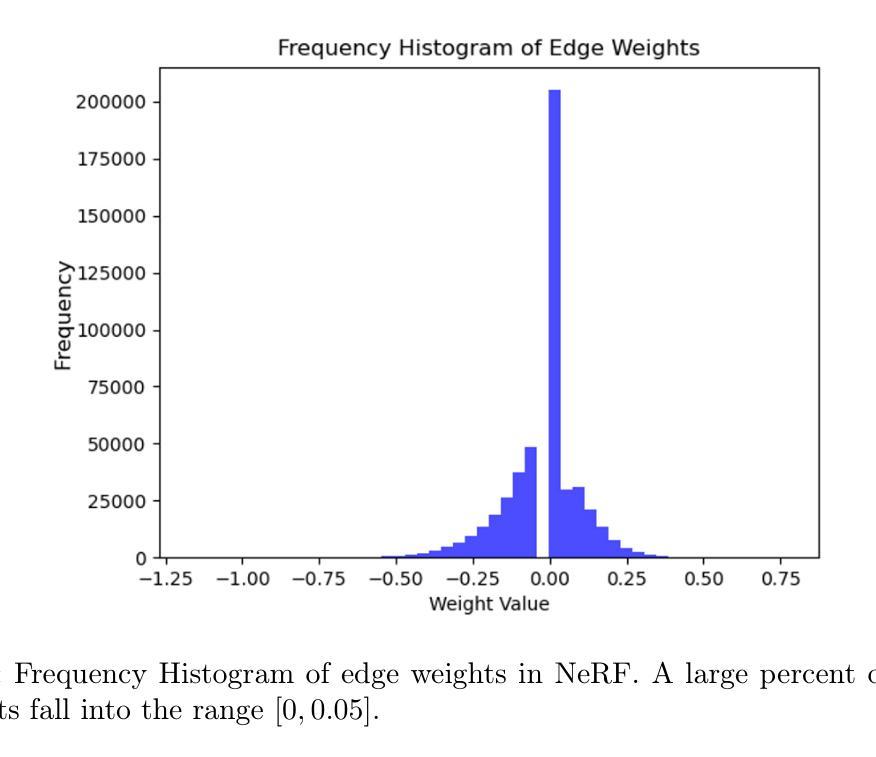

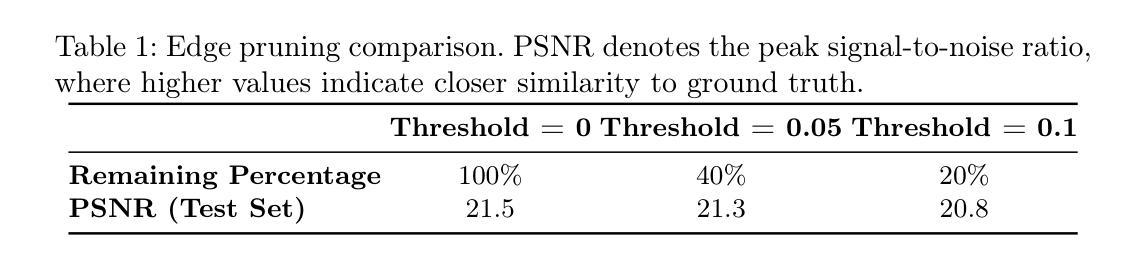

Neural Pruning for 3D Scene Reconstruction: Efficient NeRF Acceleration

Authors:Tianqi Ding, Dawei Xiang, Pablo Rivas, Liang Dong

Neural Radiance Fields (NeRF) have become a popular 3D reconstruction approach in recent years. While they produce high-quality results, they also demand lengthy training times, often spanning days. This paper studies neural pruning as a strategy to address these concerns. We compare pruning approaches, including uniform sampling, importance-based methods, and coreset-based techniques, to reduce the model size and speed up training. Our findings show that coreset-driven pruning can achieve a 50% reduction in model size and a 35% speedup in training, with only a slight decrease in accuracy. These results suggest that pruning can be an effective method for improving the efficiency of NeRF models in resource-limited settings.

神经辐射场(NeRF)近年来已成为流行的3D重建方法。虽然它们能产生高质量的结果,但也需要长时间的训练,通常持续数天。本文研究了神经网络修剪作为一种解决这些问题的策略。我们比较了修剪方法,包括均匀采样、基于重要性方法和基于核心集的技术,以减小模型大小并加快训练速度。我们的研究结果表明,基于核心集的修剪可以实现模型大小减少50%,训练速度提高35%,同时精度略有下降。这些结果表明,在资源受限的环境中,修剪是提高NeRF模型效率的有效方法。

论文及项目相关链接

PDF 12 pages, 4 figures, accepted by International Conference on the AI Revolution: Research, Ethics, and Society (AIR-RES 2025)

Summary

神经网络辐射场(NeRF)是近年来流行的3D重建方法,虽然能生成高质量结果,但训练时间长。本文研究神经网络修剪策略以解决问题。对比了均匀采样、基于重要性和基于核心集的修剪方法,以减小模型尺寸并加速训练。研究发现,基于核心集的修剪方法能在仅轻微降低准确性的情况下,实现模型大小减少50%,训练速度提高35%。表明修剪是改进资源受限环境中NeRF模型效率的有效方法。

Key Takeaways

- NeRF作为一种流行的3D重建方法,虽然能产生高质量结果,但训练时间长。

- 神经网络修剪是解决NeRF训练时间长的一种策略。

- 对比了多种修剪方法,包括均匀采样、基于重要性和基于核心集的修剪。

- 基于核心集的修剪方法能显著减小模型尺寸并加速训练。

- 核心集驱动的修剪能实现模型大小减少50%,训练速度提高35%。

- 修剪方法对准确性的影响较小。

点此查看论文截图

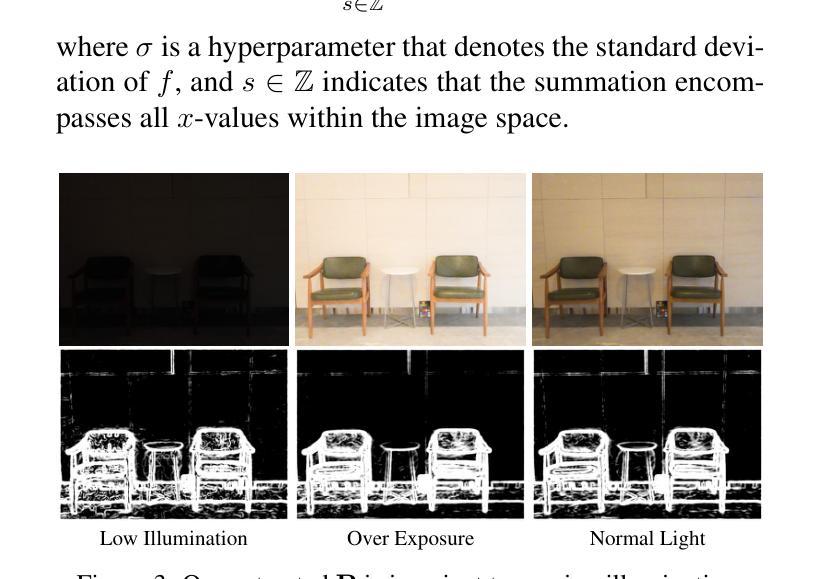

Data Cleansing for GANs

Authors:Naoyuki Terashita, Hiroki Ohashi, Satoshi Hara

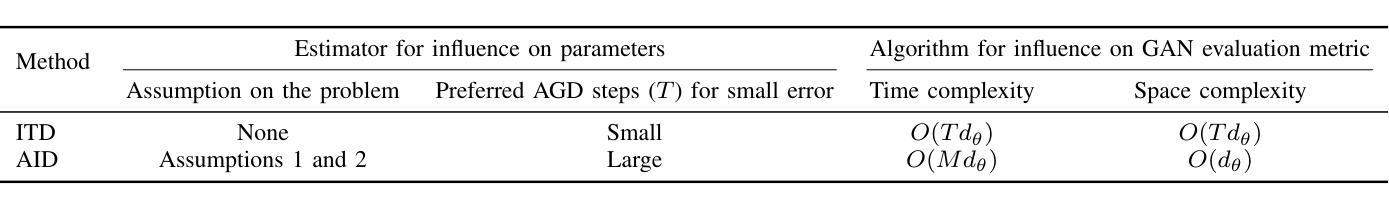

As the application of generative adversarial networks (GANs) expands, it becomes increasingly critical to develop a unified approach that improves performance across various generative tasks. One effective strategy that applies to any machine learning task is identifying harmful instances, whose removal improves the performance. While previous studies have successfully estimated these harmful training instances in supervised settings, their approaches are not easily applicable to GANs. The challenge lies in two requirements of the previous approaches that do not apply to GANs. First, previous approaches require that the absence of a training instance directly affects the parameters. However, in the training for GANs, the instances do not directly affect the generator’s parameters since they are only fed into the discriminator. Second, previous approaches assume that the change in loss directly quantifies the harmfulness of the instance to a model’s performance, while common types of GAN losses do not always reflect the generative performance. To overcome the first challenge, we propose influence estimation methods that use the Jacobian of the generator’s gradient with respect to the discriminator’s parameters (and vice versa). Such a Jacobian represents the indirect effect between two models: how removing an instance from the discriminator’s training changes the generator’s parameters. Second, we propose an instance evaluation scheme that measures the harmfulness of each training instance based on how a GAN evaluation metric (e.g., Inception score) is expected to change by the instance’s removal. Furthermore, we demonstrate that removing the identified harmful instances significantly improves the generative performance on various GAN evaluation metrics.

随着生成对抗网络(GANs)的应用不断扩大,开发一种适用于各种生成任务的统一方法变得越来越关键。对于任何机器学习任务都适用的一个有效策略是识别有害实例,去除这些实例可以提高性能。虽然以前的研究已经在有监督环境中成功地估计了这些有害的训练实例,但它们的方法并不易于应用于GANs。挑战在于之前的方法有两个不适用于GANs的要求。首先,之前的方法要求训练实例的缺失直接影响参数。然而,在GANs的训练中,实例并不会直接影响生成器的参数,因为它们只输入到判别器中。其次,之前的方法假设损失的变化直接量化实例对模型性能的损害程度,而常见的GAN损失并不总是反映生成性能。为了克服第一个挑战,我们提出了使用生成器梯度相对于判别器参数的雅可比(以及反之)进行影响估计的方法。这样的雅可比代表了两个模型之间的间接影响:即移除判别器训练中的一个实例如何改变生成器的参数。其次,我们提出了一种实例评估方案,该方案基于GAN评估指标(例如Inception分数)预期会因实例的移除而如何变化来测量每个训练实例的有害性。此外,我们证明,去除已识别出的有害实例可以显著提高各种GAN评估指标的生成性能。

论文及项目相关链接

PDF Accepted for IEEE Transactions on Neural Networks and Learning Systems (TNNLS, 2025). Journal extention of https://openreview.net/forum?id=opHLcXxYTC_

Summary

本文提出了一种针对生成对抗网络(GANs)的有害实例识别方法。该方法通过评估移除某个训练实例后对生成器参数的影响,来量化实例的“危害性”。采用Jacobian矩阵衡量生成器梯度与判别器参数之间的间接影响,并提出一种基于GAN评价指标(如Inception分数)变化来评估实例危害性的方案。实验证明,移除识别出的有害实例能显著提高GAN在各种评价指标上的生成性能。

Key Takeaways

- 本文提出了一种针对GANs的有害实例识别方法,旨在提高其在各种生成任务中的性能。

- 现有方法难以直接应用于GANs,因为GANs中训练实例并不直接影响生成器参数。

- 通过使用Jacobian矩阵衡量生成器和判别器参数间的间接影响,来克服这一挑战。

- 提出了一种实例评估方案,该方案基于GAN评价指标(如Inception分数)的预期变化来评估每个训练实例的“危害性”。

- 这种方法不仅理论上有依据,而且实验结果显示,移除识别出的有害实例能显著提高GAN的生成性能。

- 该方法具有广泛的应用前景,可应用于其他机器学习任务中有害实例的识别与移除。

点此查看论文截图

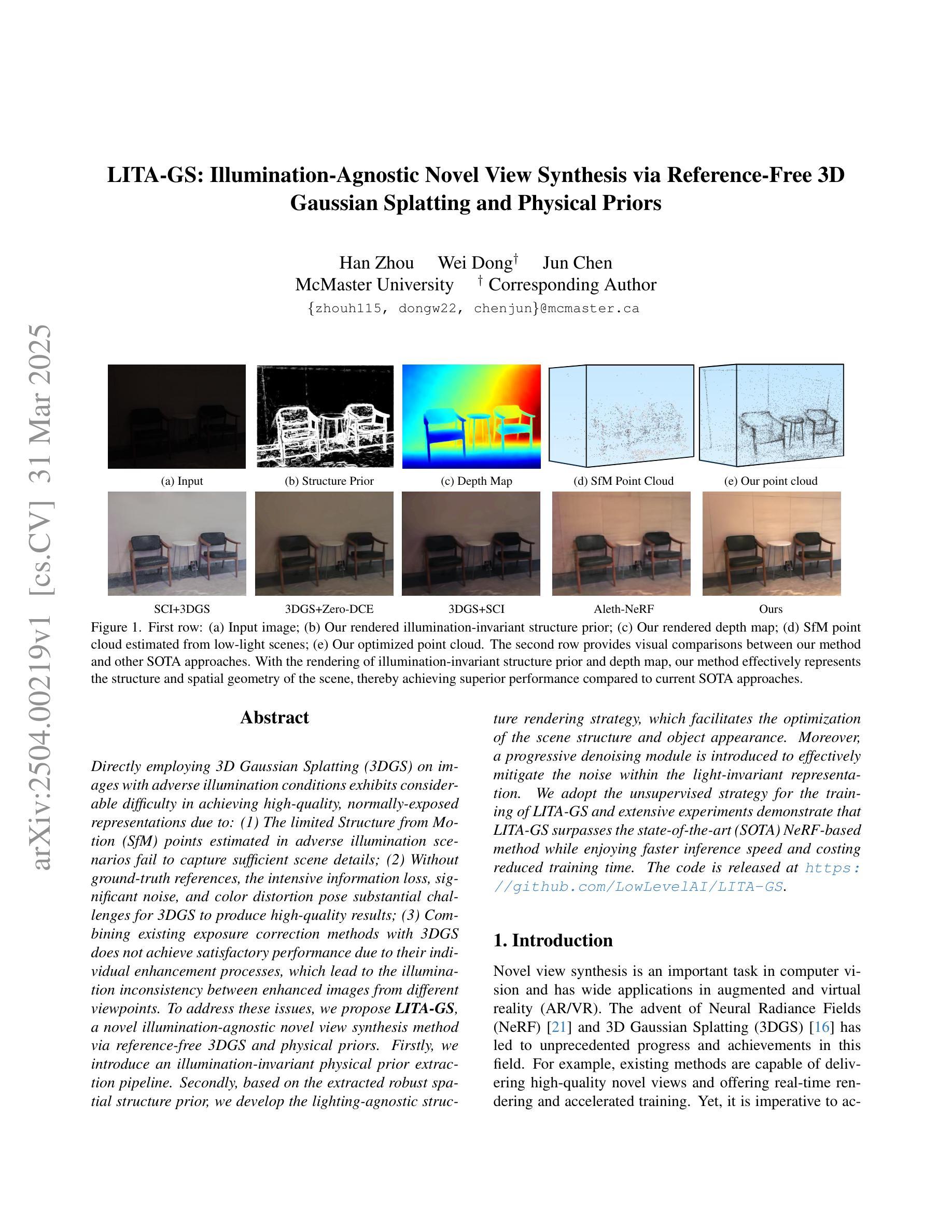

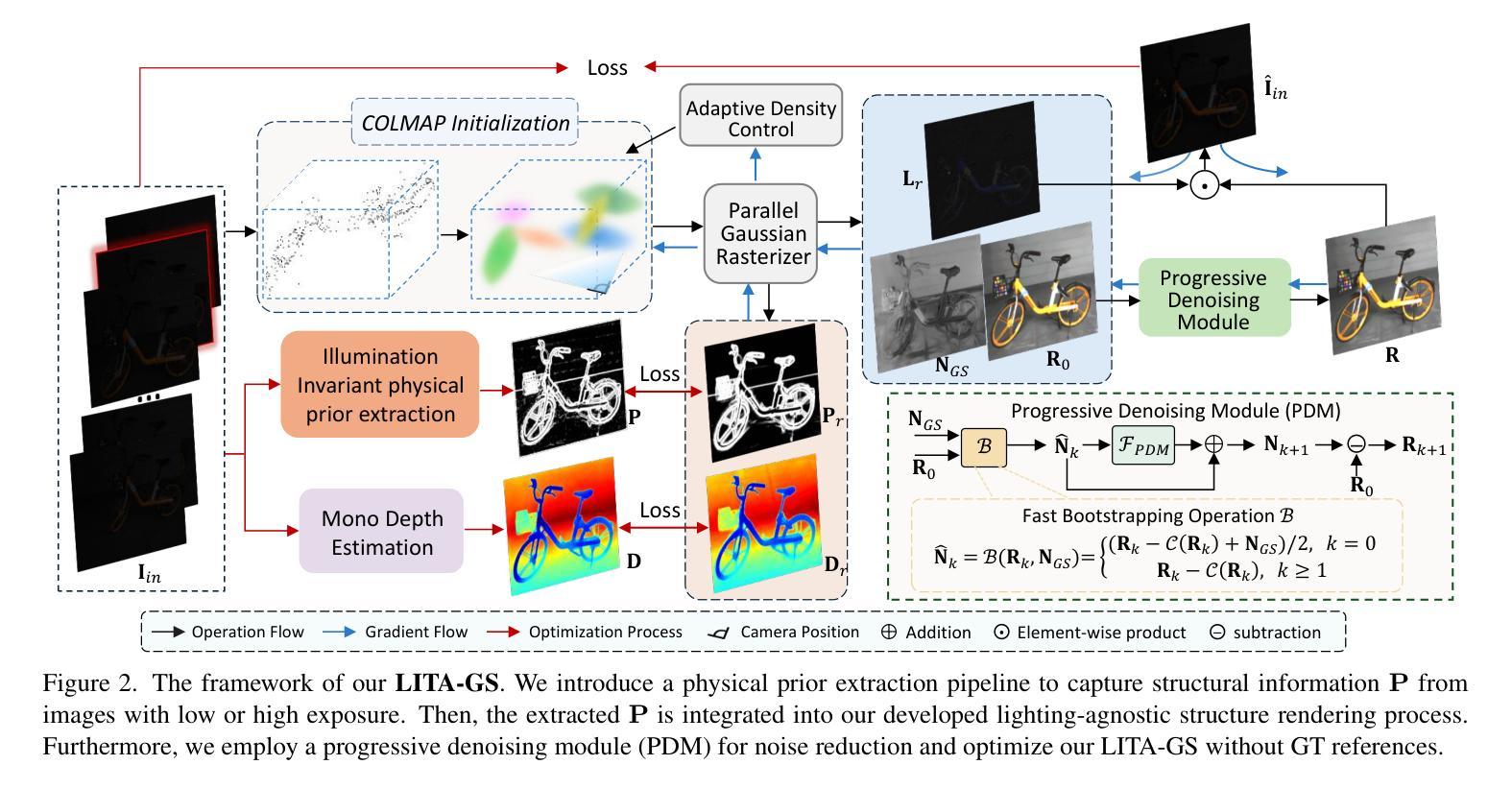

LITA-GS: Illumination-Agnostic Novel View Synthesis via Reference-Free 3D Gaussian Splatting and Physical Priors

Authors:Han Zhou, Wei Dong, Jun Chen

Directly employing 3D Gaussian Splatting (3DGS) on images with adverse illumination conditions exhibits considerable difficulty in achieving high-quality, normally-exposed representations due to: (1) The limited Structure from Motion (SfM) points estimated in adverse illumination scenarios fail to capture sufficient scene details; (2) Without ground-truth references, the intensive information loss, significant noise, and color distortion pose substantial challenges for 3DGS to produce high-quality results; (3) Combining existing exposure correction methods with 3DGS does not achieve satisfactory performance due to their individual enhancement processes, which lead to the illumination inconsistency between enhanced images from different viewpoints. To address these issues, we propose LITA-GS, a novel illumination-agnostic novel view synthesis method via reference-free 3DGS and physical priors. Firstly, we introduce an illumination-invariant physical prior extraction pipeline. Secondly, based on the extracted robust spatial structure prior, we develop the lighting-agnostic structure rendering strategy, which facilitates the optimization of the scene structure and object appearance. Moreover, a progressive denoising module is introduced to effectively mitigate the noise within the light-invariant representation. We adopt the unsupervised strategy for the training of LITA-GS and extensive experiments demonstrate that LITA-GS surpasses the state-of-the-art (SOTA) NeRF-based method while enjoying faster inference speed and costing reduced training time. The code is released at https://github.com/LowLevelAI/LITA-GS.

直接对不良照明条件下的图像应用三维高斯平铺(3DGS)在实现高质量的正常曝光表示方面存在相当大的困难,原因如下:(1)在不良照明场景中估计的运动结构(SfM)点有限,无法捕获足够的场景细节;(2)没有真实参考,密集的信息丢失、显著的噪声和色彩失真给3DGS带来巨大挑战,难以产生高质量的结果;(3)将现有的曝光校正方法与3DGS相结合并未实现令人满意的性能,因为它们各自的增强处理过程导致从不同视点增强的图像之间照明不一致。为了解决这些问题,我们提出了LITA-GS,这是一种新的照明无关的新视图合成方法,通过无参考的3DGS和物理先验来实现。首先,我们引入了一个光照不变物理先验提取管道。其次,基于提取的稳健空间结构先验,我们开发了光照无关的结构渲染策略,这有助于优化场景结构和对象外观。此外,引入了一个渐进的降噪模块,以有效地减轻光不变表示中的噪声。我们采用无监督策略对LITA-GS进行训练,大量实验表明,LITA-GS超越了基于NeRF的最先进方法,同时拥有更快的推理速度和更短的训练时间。代码已发布在https://github.com/LowLevelAI/LITA-GS。

论文及项目相关链接

PDF Accepted by CVPR 2025. 3DGS, Adverse illumination conditions, Reference-free, Physical priors

Summary

该文本主要介绍了在不良光照条件下直接应用3D高斯贴图(3DGS)面临的挑战,并提出了解决方案。通过引入光照不变物理先验提取管道和光照无关的结构渲染策略,以及渐进式降噪模块,成功解决了因光照不佳导致的结构细节缺失、信息丢失、噪声和色彩失真等问题。所提出的方法在训练和推理速度上优于现有的NeRF方法,并已在GitHub上发布相关代码。

Key Takeaways

- 在不良光照条件下直接应用3D高斯贴图(3DGS)面临挑战,包括结构细节缺失、信息丢失、噪声和色彩失真等问题。

- 提出了一种新的光照无关的新视角合成方法LITA-GS,该方法结合了无参考的3DGS和物理先验技术来解决上述问题。

- LITA-GS引入了光照不变物理先验提取管道,以提取稳健的空间结构先验。

- 基于提取的稳健空间结构先验,开发了光照无关的结构渲染策略,优化了场景结构和物体外观。

- LITA-GS还引入了渐进式降噪模块,有效减轻了光照不变表示中的噪声。

- LITA-GS采用无监督策略进行训练,并在实验中表现出优于现有NeRF方法的性能,同时拥有更快的推理速度和减少的训练时间。

点此查看论文截图

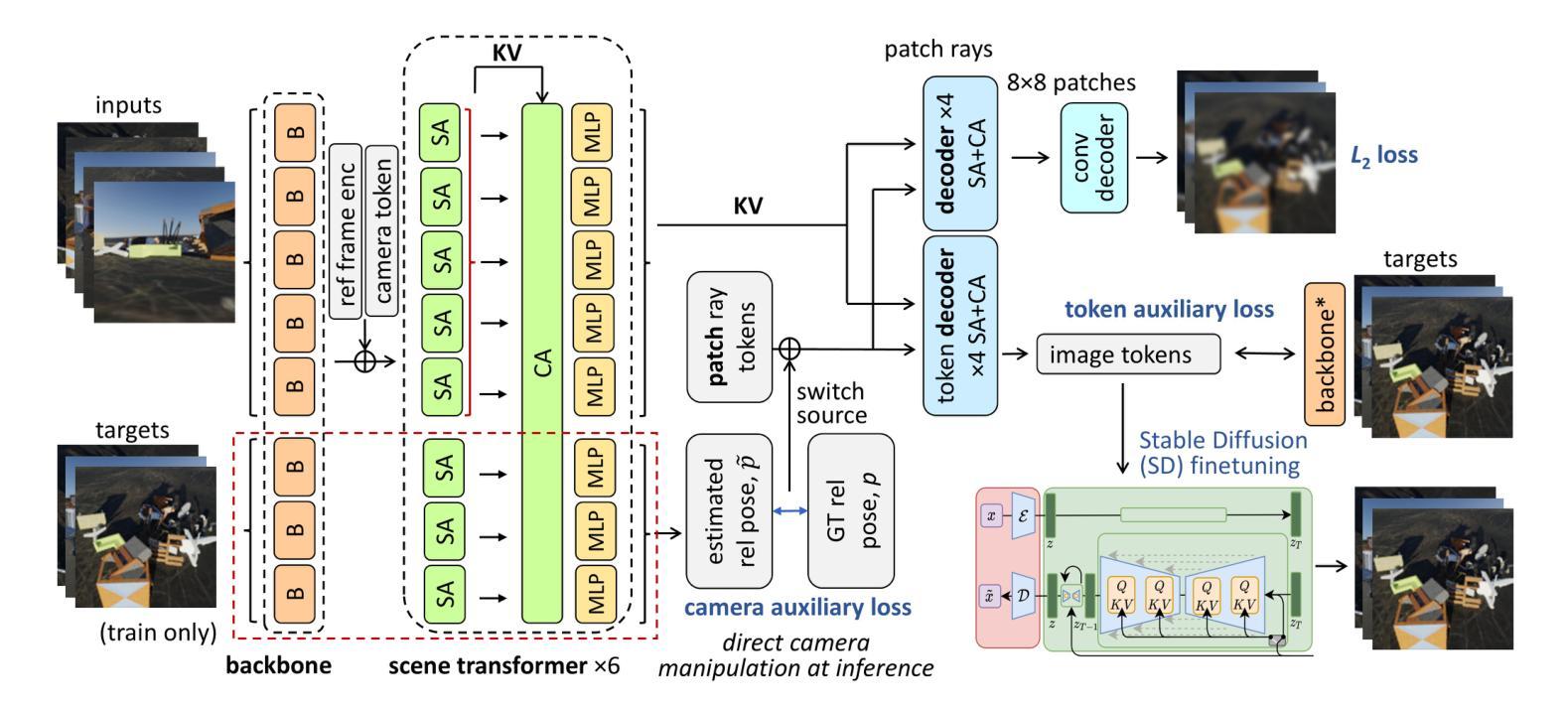

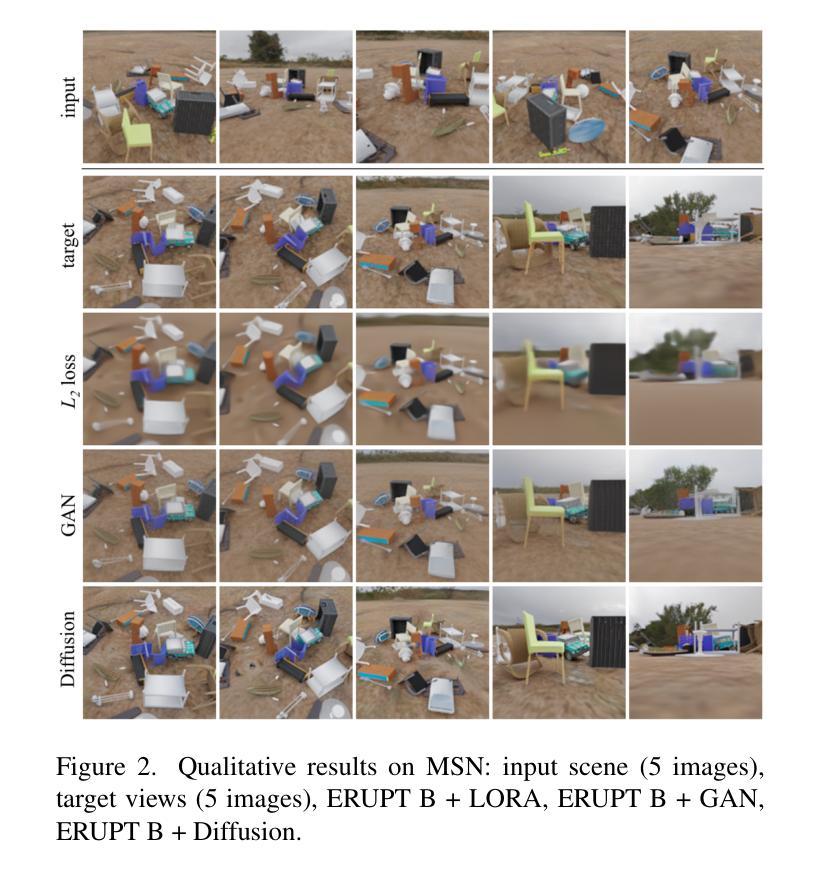

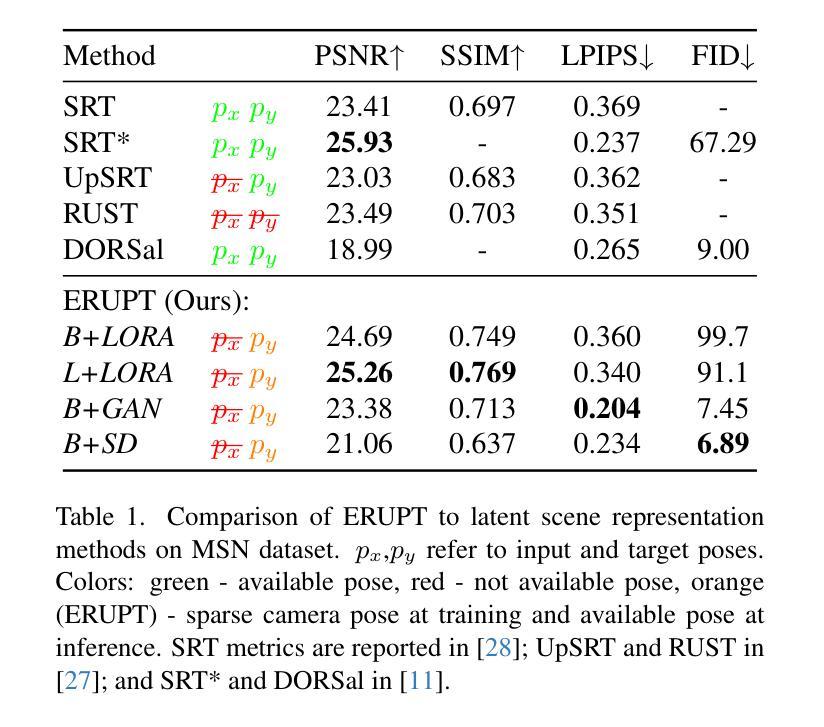

ERUPT: Efficient Rendering with Unposed Patch Transformer

Authors:Maxim V. Shugaev, Vincent Chen, Maxim Karrenbach, Kyle Ashley, Bridget Kennedy, Naresh P. Cuntoor

This work addresses the problem of novel view synthesis in diverse scenes from small collections of RGB images. We propose ERUPT (Efficient Rendering with Unposed Patch Transformer) a state-of-the-art scene reconstruction model capable of efficient scene rendering using unposed imagery. We introduce patch-based querying, in contrast to existing pixel-based queries, to reduce the compute required to render a target view. This makes our model highly efficient both during training and at inference, capable of rendering at 600 fps on commercial hardware. Notably, our model is designed to use a learned latent camera pose which allows for training using unposed targets in datasets with sparse or inaccurate ground truth camera pose. We show that our approach can generalize on large real-world data and introduce a new benchmark dataset (MSVS-1M) for latent view synthesis using street-view imagery collected from Mapillary. In contrast to NeRF and Gaussian Splatting, which require dense imagery and precise metadata, ERUPT can render novel views of arbitrary scenes with as few as five unposed input images. ERUPT achieves better rendered image quality than current state-of-the-art methods for unposed image synthesis tasks, reduces labeled data requirements by ~95% and decreases computational requirements by an order of magnitude, providing efficient novel view synthesis for diverse real-world scenes.

本文解决了从少量RGB图像集合中合成多样场景的新视角的问题。我们提出了ERUPT(无预设补丁转换器的有效渲染)这一先进的场景重建模型,它能够利用无预设的图像进行高效场景渲染。我们引入了基于补丁的查询,与现有的基于像素的查询相比,减少了渲染目标视图所需的计算量。这使得我们的模型在训练和推理过程中都非常高效,能够在商用硬件上以600帧/秒的速度进行渲染。值得注意的是,我们的模型采用学习潜在的相机姿态设计,这允许在数据集上使用无预设目标进行训练,即使数据集具有稀疏或不准确的真实相机姿态。我们证明了我们的方法可以在大型真实世界数据上进行推广,并使用Mapillary收集的街景图像引入了用于潜在视图合成的新基准数据集(MSVS-1M)。与需要密集图像和精确元数据的NeRF和高斯拼贴不同,ERUPT仅使用五张无预设的输入图像就可以渲染任意场景的新视角。ERUPT在无预设图像合成任务上实现了比当前最先进方法更好的渲染图像质量,将标记数据要求降低了约95%,并将计算要求降低了数量级,为多样化的真实世界场景提供了高效的新视角合成。

论文及项目相关链接

PDF Accepted to CVPR 2025

Summary

本文提出一种称为ERUPT(基于未标定图像块的高效渲染)的场景重建模型,用于解决从少量RGB图像中合成新颖视角的问题。通过引入基于图像块的查询方法,降低了渲染目标视角所需的计算量,使模型在训练和推理时都具备高效率,可在商用硬件上以600帧/秒的速度进行渲染。该模型设计用于学习潜在相机姿态,可在数据集上使用未标定的目标进行训练,即使数据集具有稀疏或不准确的真实相机姿态。实验表明,ERUPT方法能够在大型真实世界数据上进行推广,并引入了一个新的基准数据集MSVS-1M,用于使用来自Mapillary的街道视图图像进行潜在视图合成。与需要密集图像和精确元数据的NeRF和高斯拼贴相比,ERUPT仅需少数未标定的输入图像即可合成新颖视角。ERUPT在未经标定的图像合成任务上实现了比当前先进技术更好的渲染图像质量,将标记数据需求减少了约95%,并将计算需求降低了一个数量级,为多样化的真实世界场景提供了高效的新颖视角合成。

Key Takeaways

- ERUPT模型解决了从少量RGB图像中进行新颖视角合成的问题。

- 通过引入基于图像块的查询方法,提高了渲染效率。

- 模型具备高效的学习能力,可在训练和推理时快速渲染。

- ERUPT可以在商业硬件上以高达600帧/秒的速度进行渲染。

- 模型设计用于学习潜在相机姿态,适应于数据集上未标定的目标。

- 引入新的基准数据集MSVS-1M,用于潜在视图合成。

点此查看论文截图

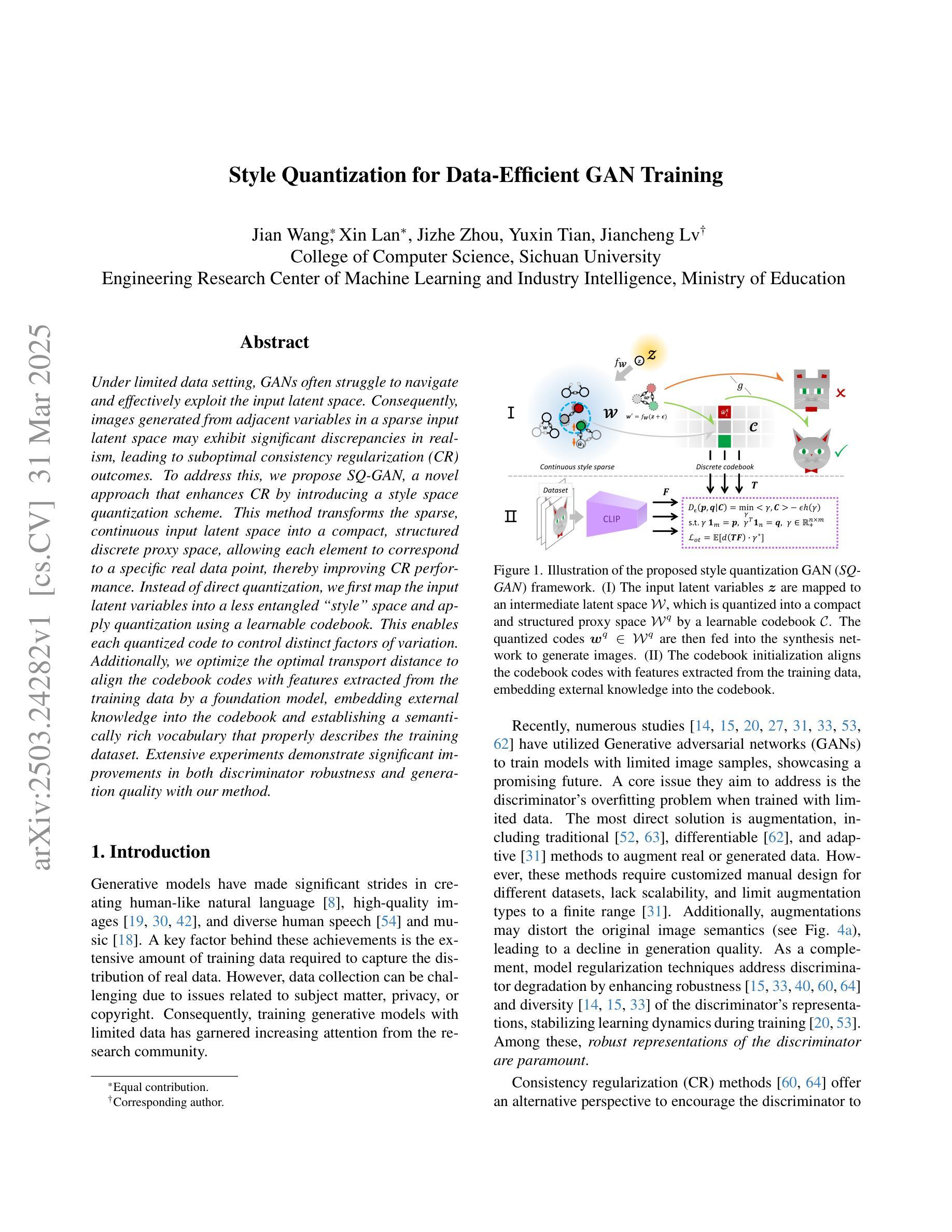

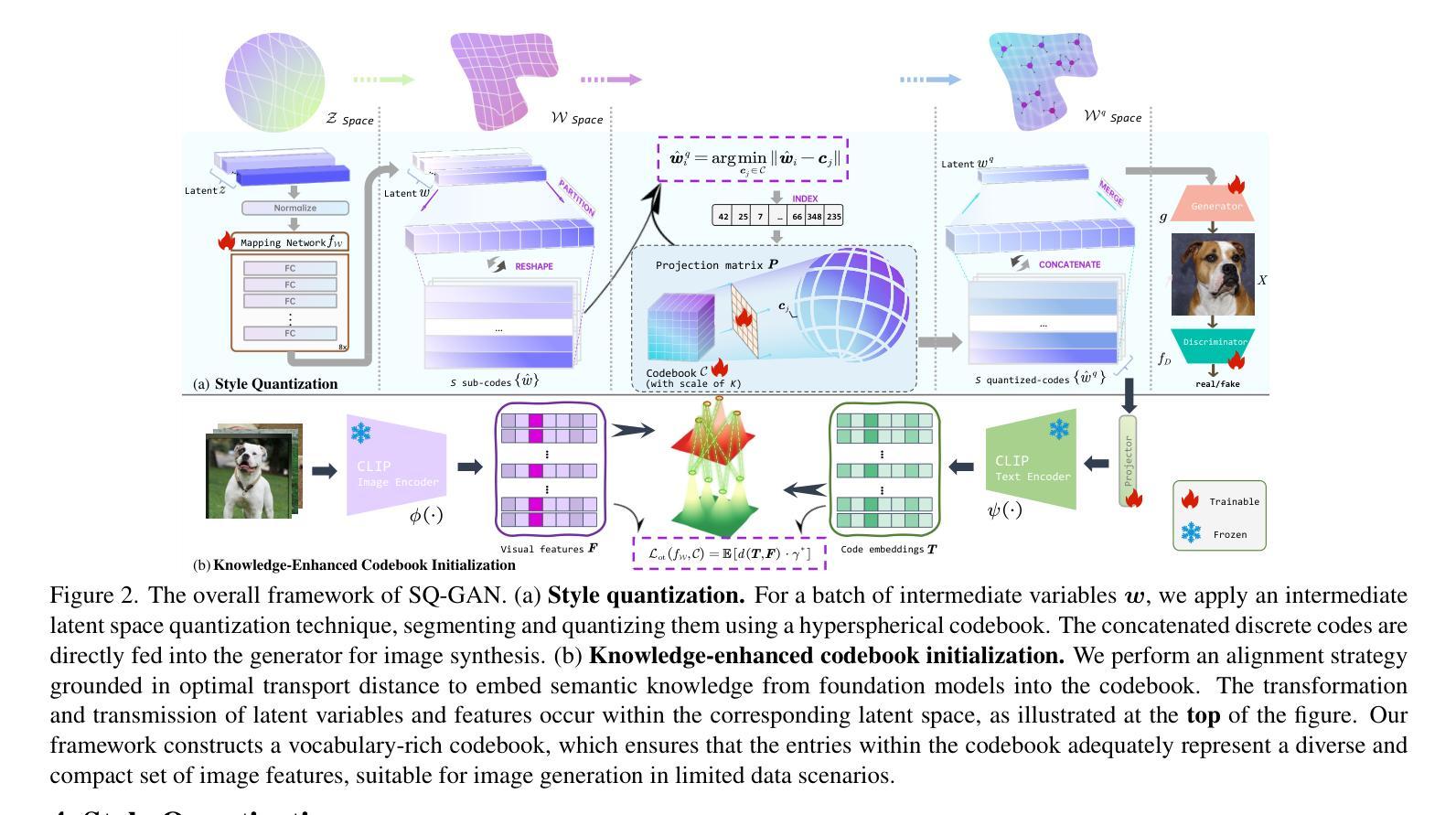

Style Quantization for Data-Efficient GAN Training

Authors:Jian Wang, Xin Lan, Jizhe Zhou, Yuxin Tian, Jiancheng Lv

Under limited data setting, GANs often struggle to navigate and effectively exploit the input latent space. Consequently, images generated from adjacent variables in a sparse input latent space may exhibit significant discrepancies in realism, leading to suboptimal consistency regularization (CR) outcomes. To address this, we propose \textit{SQ-GAN}, a novel approach that enhances CR by introducing a style space quantization scheme. This method transforms the sparse, continuous input latent space into a compact, structured discrete proxy space, allowing each element to correspond to a specific real data point, thereby improving CR performance. Instead of direct quantization, we first map the input latent variables into a less entangled ``style’’ space and apply quantization using a learnable codebook. This enables each quantized code to control distinct factors of variation. Additionally, we optimize the optimal transport distance to align the codebook codes with features extracted from the training data by a foundation model, embedding external knowledge into the codebook and establishing a semantically rich vocabulary that properly describes the training dataset. Extensive experiments demonstrate significant improvements in both discriminator robustness and generation quality with our method.

在有限数据设置下,生成对抗网络(GANs)通常难以导航并有效地利用输入潜在空间。因此,在稀疏输入潜在空间中从相邻变量生成的图像在逼真度方面可能存在显著差异,导致次优的一致性正则化(CR)结果。为了解决这一问题,我们提出了SQ-GAN,这是一种通过引入风格空间量化方案来增强CR的新方法。该方法将稀疏、连续的输入潜在空间转换为一个紧凑、结构化的离散代理空间,使每个元素都能对应一个特定的真实数据点,从而提高CR性能。我们不是直接进行量化,而是首先将输入潜在变量映射到一个不那么纠缠的“风格”空间,并使用可学习的代码本进行量化。这使得每个量化代码能够控制不同的变异因素。此外,我们优化了最优传输距离,将代码本代码与基础模型从训练数据中提取的特征进行对齐,将外部知识嵌入到代码本中,并建立语义丰富的词汇表,恰当地描述训练数据集。大量实验表明,我们的方法在判别器鲁棒性和生成质量方面都有显著提高。

论文及项目相关链接

Summary

本文提出一种名为SQ-GAN的新方法,通过引入风格空间量化方案改进一致性正则化(CR)。该方法将稀疏、连续的输入潜在空间转化为紧凑、结构化的离散代理空间,使每个元素对应一个真实数据点,从而提高CR性能。实验证明,该方法在判别器稳健性和生成质量方面有明显改进。

Key Takeaways

- GANs在有限数据设置下面临导航和有效探索输入潜在空间的挑战。

- 稀疏输入潜在空间中,相邻变量生成的图像在真实性上可能存在显著差异,导致CR结果不理想。

- SQ-GAN通过引入风格空间量化方案改进CR性能。

- 该方法将稀疏、连续的输入潜在空间转化为紧凑、结构化的离散代理空间,每个元素对应一个真实数据点。

- 使用可学习的代码本进行量化,而非直接量化,使每个量化代码控制不同的变量变化因素。

- 通过优化传输距离,将代码本代码与基础模型从训练数据中提取的特征对齐,融入外部知识,建立语义丰富的词汇表,描述训练数据集。

点此查看论文截图

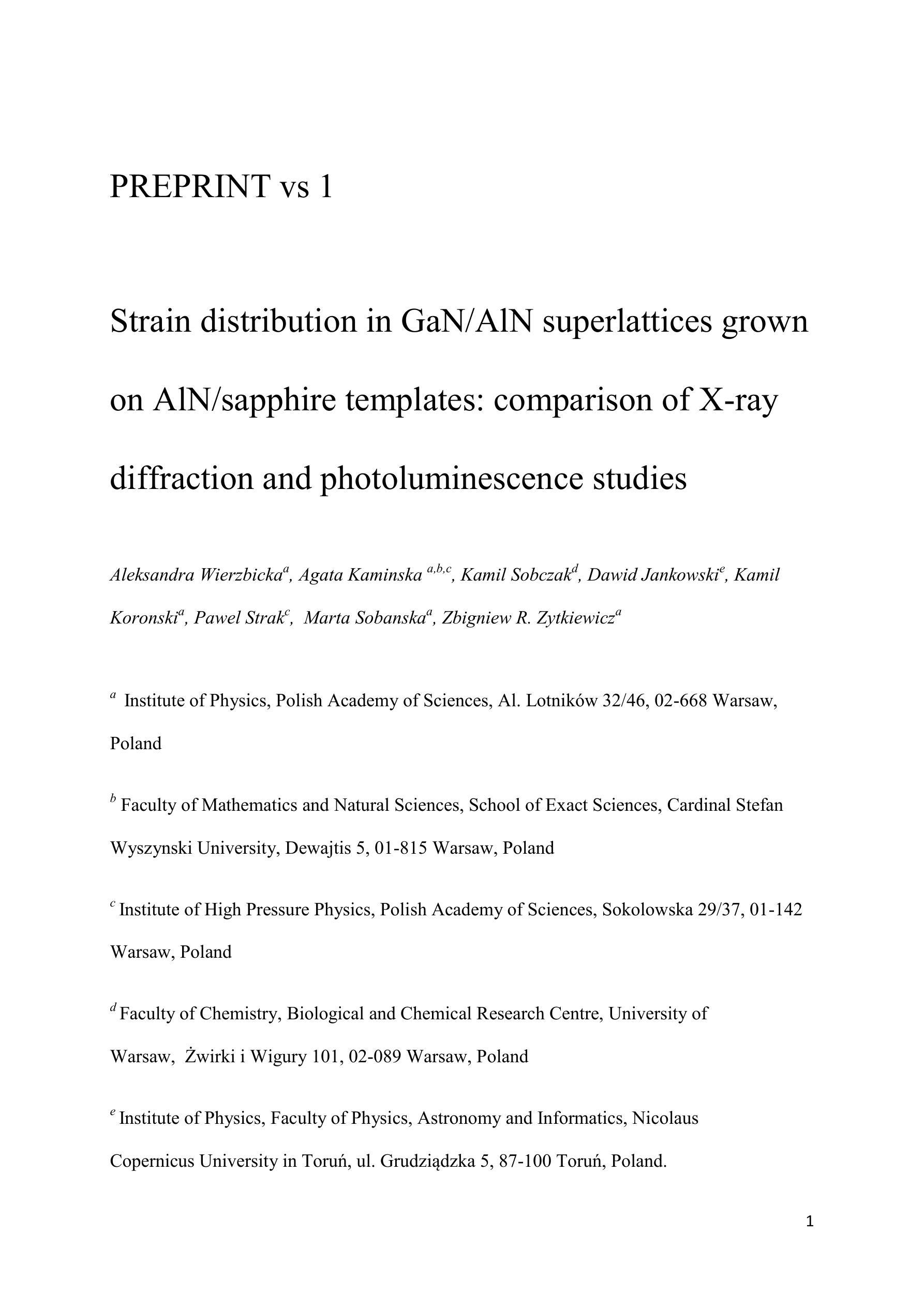

Strain distribution in GaN/AlN superlattices grown on AlN/sapphire templates: comparison of X-ray diffraction and photoluminescence studies

Authors:Aleksandra Wierzbicka, Agata Kaminska, Kamil Sobczak, Dawid Jankowski, Kamil Koronski, Pawel Strak, Marta Sobanska, Zbigniew R. Zytkiewicz

Series of GaN/AlN superlattices (SLs) with various periods and the same thicknesses of GaN quantum wells and AlN barriers have been investigated. X-ray diffraction, photoluminescence (PL) and transmission electron microscopy (TEM) techniques were used to study the influence of thickness of AlN and GaN sublayers on strain distribution in GaN/AlN SL structures. Detailed X-ray diffraction measurements demonstrate that the strain occurring in SLs generally decreases with an increase of well/barrier thickness. Fitting of X-ray diffraction curves allowed determining the real thicknesses of the GaN wells and AlN barriers. Since blurring of the interfaces causes deviation of calculated data from experimental results the quality of the interfaces has been evaluated as well and compared with results of TEM measurements. For the samples with thinner wells/barriers the presence of pin-holes and threading dislocations has been observed in TEM measurements. The best quality of interfaces has been found for the sample with a well/barrier thickness of 3 nm. Finally, PL spectra showed that due to Quantum-Confined Stark Effect the PL peak energies of the SLs decreased with increasing the width of the GaN quantum wells and AlN barriers. The effect is well modelled by ab initio calculations based on the density functional theory applied for tetragonally strained structures of the same geometry using a full tensorial representation of the strain in the SLs.

已经研究了具有不同周期和相同GaN量子阱和AlN势垒厚度的GaN/AlN超晶格(SL)系列。使用X射线衍射、光致发光(PL)和透射电子显微镜(TEM)技术,研究了AlN和GaN亚层厚度对GaN/AlN SL结构中应变分布的影响。详细的X射线衍射测量表明,SLs中的应变通常随着阱/势垒厚度的增加而减小。通过拟合X射线衍射曲线,可以确定GaN阱和AlN势垒的实际厚度。由于界面模糊导致计算数据与实验结果存在偏差,因此还对界面质量进行了评估,并与TEM测量结果进行了比较。在较薄阱/势垒的样品中,通过TEM测量观察到存在针孔和穿线错位。在阱/势垒厚度为3nm的样品中发现了最佳界面质量。最后,PL光谱显示,由于量子限制斯塔克效应,SLs的PL峰能量随着GaN量子阱和AlN势垒宽度的增加而降低。该效应通过基于密度泛函理论的第一性原理计算得到了很好的模拟,该理论应用于具有相同几何形状的四边形应变结构,并使用SLs中应变的全张量表示。

论文及项目相关链接

Summary

该文研究了不同周期的GaN/AlN超晶格(SLs)结构,并采用了X射线衍射、光致发光和透射电子显微镜等技术,探讨了GaN和AlN子层厚度对GaN/AlN超晶格应变分布的影响。研究发现,随着阱/势垒厚度的增加,超晶格中的应变一般会减小。此外,通过X射线衍射曲线的拟合确定了GaN阱和AlN势垒的实际厚度。同时,对界面质量进行了评估并与透射电子显微镜的测量结果进行了比较。对于较薄的阱/势垒样品,透射电子显微镜观察到存在针孔和贯穿位错。在阱/势垒厚度为3nm的样品中获得了最佳界面质量。最后,光致发光光谱表明,由于量子受限斯塔克效应,随着GaN量子阱和AlN势垒宽度的增加,SLs的PL峰能量降低。这一效应通过基于密度泛函理论的从头算法对具有相同几何形状的四边形应变结构进行模拟得到了很好的验证。

Key Takeaways

- GaN/AlN超晶格(SLs)的应变分布受到子层厚度的影响。

- 随着阱/势垒厚度的增加,超晶格中的应变一般会减小。

- X射线衍射被用于确定GaN阱和AlN势垒的实际厚度。

- 界面质量是影响超晶格性能的重要因素,已对其进行了评估和比较。

- 较薄的阱/势垒样品中观察到针孔和贯穿位错。

- 最佳界面质量是在阱/势垒厚度为3nm的样品中发现的。

点此查看论文截图

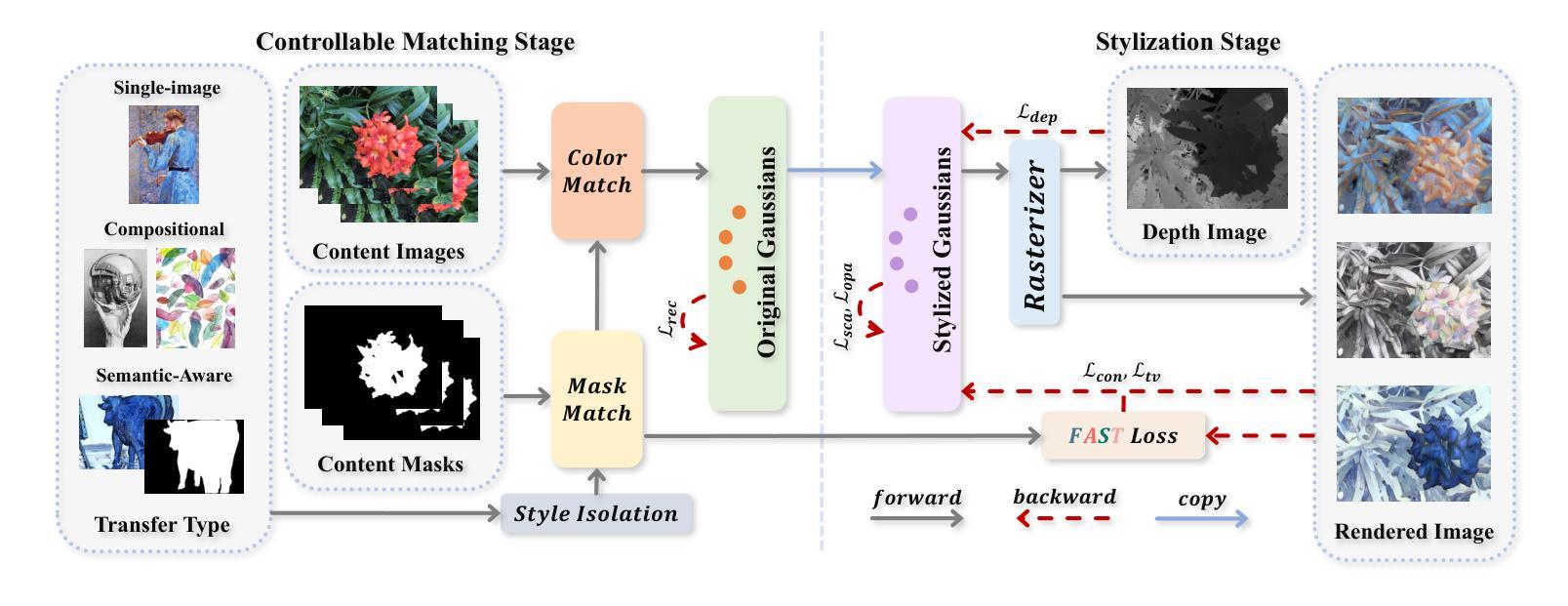

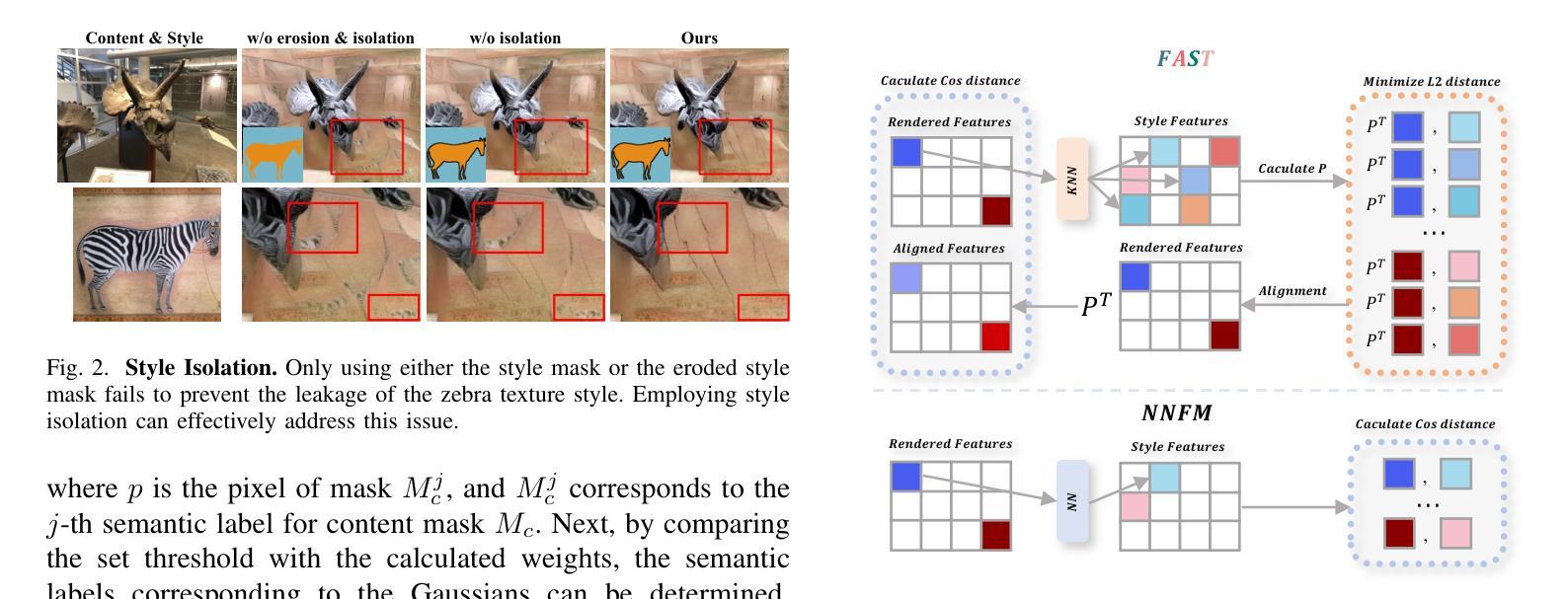

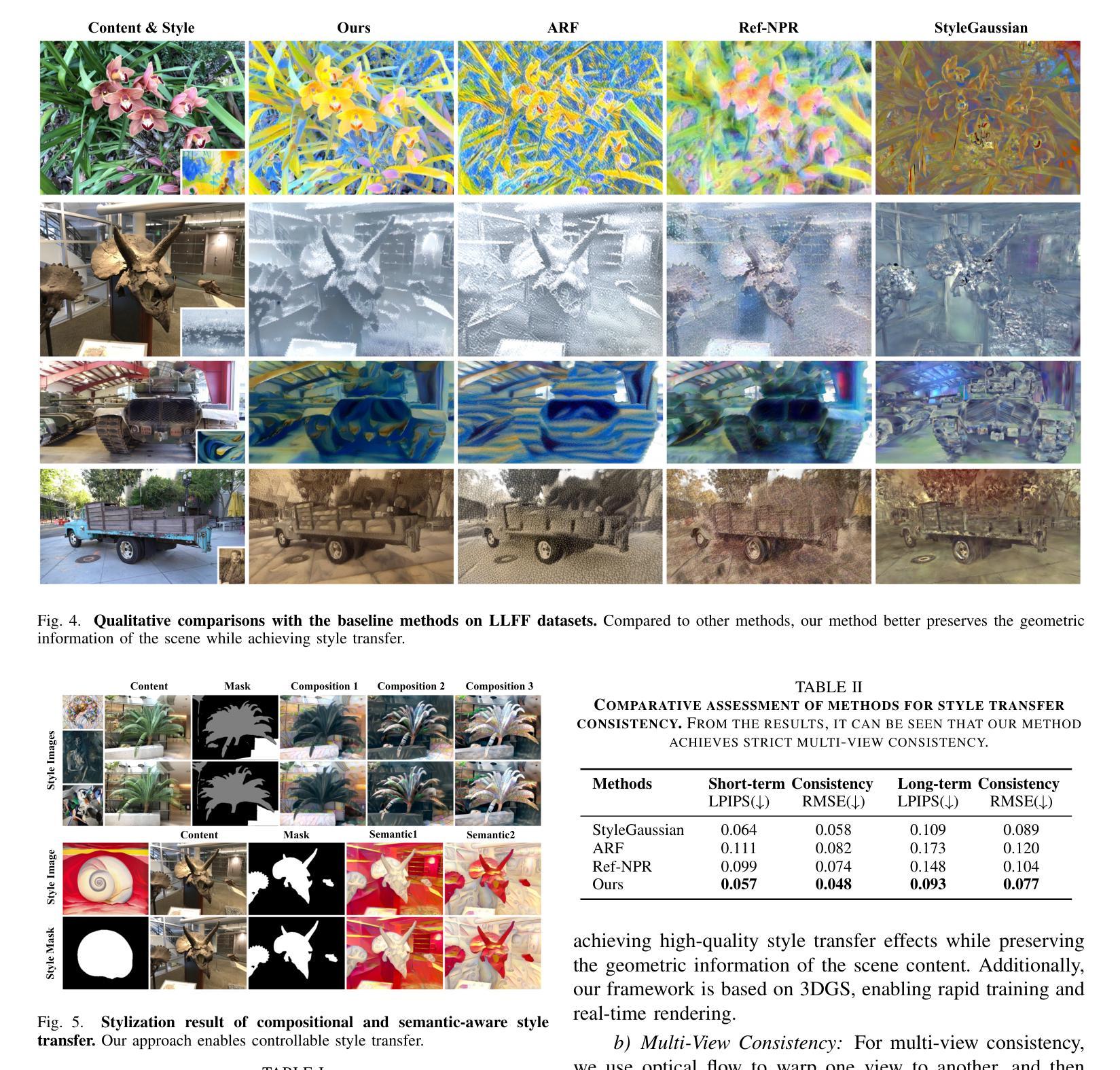

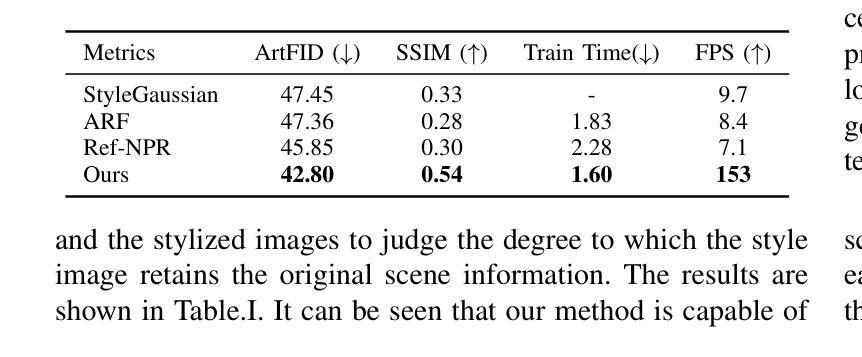

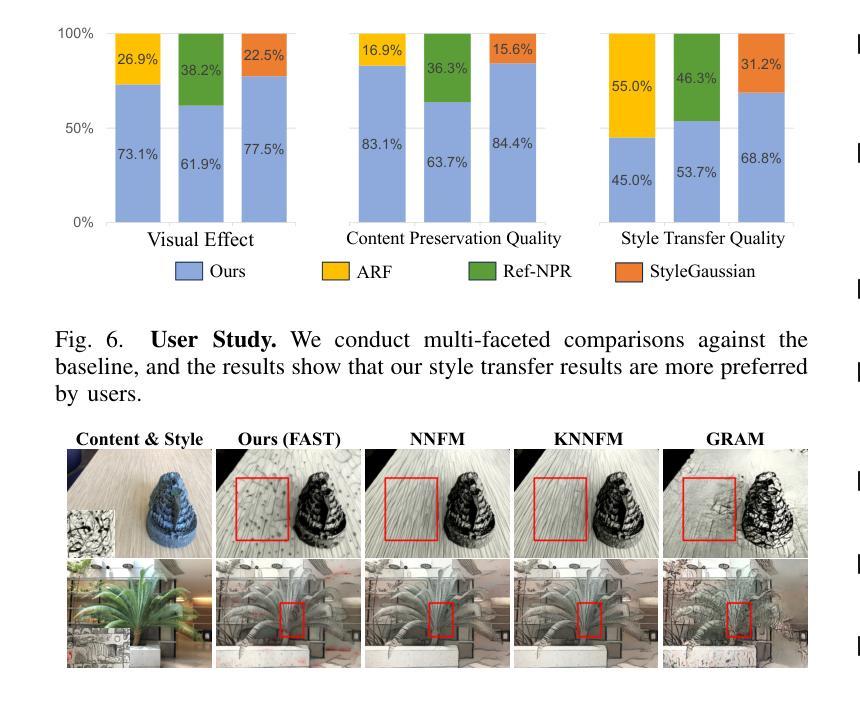

ABC-GS: Alignment-Based Controllable Style Transfer for 3D Gaussian Splatting

Authors:Wenjie Liu, Zhongliang Liu, Xiaoyan Yang, Man Sha, Yang Li

3D scene stylization approaches based on Neural Radiance Fields (NeRF) achieve promising results by optimizing with Nearest Neighbor Feature Matching (NNFM) loss. However, NNFM loss does not consider global style information. In addition, the implicit representation of NeRF limits their fine-grained control over the resulting scenes. In this paper, we introduce ABC-GS, a novel framework based on 3D Gaussian Splatting to achieve high-quality 3D style transfer. To this end, a controllable matching stage is designed to achieve precise alignment between scene content and style features through segmentation masks. Moreover, a style transfer loss function based on feature alignment is proposed to ensure that the outcomes of style transfer accurately reflect the global style of the reference image. Furthermore, the original geometric information of the scene is preserved with the depth loss and Gaussian regularization terms. Extensive experiments show that our ABC-GS provides controllability of style transfer and achieves stylization results that are more faithfully aligned with the global style of the chosen artistic reference. Our homepage is available at https://vpx-ecnu.github.io/ABC-GS-website.

基于神经辐射场(NeRF)的3D场景风格化方法通过最近邻特征匹配(NNFM)损失进行优化,取得了有前景的结果。然而,NNFM损失并没有考虑全局风格信息。此外,NeRF的隐式表示限制了其对结果场景的细粒度控制。在本文中,我们介绍了ABC-GS,一个基于3D高斯喷涂的新型框架,以实现高质量的三维风格转移。为此,设计了一个可控的匹配阶段,通过分割掩膜实现场景内容与风格特征的精确对齐。此外,提出了一种基于特征对齐的风格转移损失函数,以确保风格转移的结果准确反映参考图像的全局风格。此外,通过深度损失和高斯正则化项保留了场景的原几何信息。大量实验表明,我们的ABC-GS提供了风格转移的控制能力,并实现了与所选艺术参考的全局风格更忠实对齐的风格化结果。我们的主页可在https://vpx-ecnu.github.io/ABC-GS-website访问。

论文及项目相关链接

PDF 10 pages, 14 figures

Summary

基于NeRF技术的三维场景风格化方法引入了一种新型框架ABC-GS,结合三维高斯描图实现高质量的三维风格转移。该框架设计了一个可控匹配阶段,通过分割掩膜实现场景内容与风格特征的精确对齐。同时,提出了一种基于特征对齐的风格转移损失函数,确保风格转移结果准确反映参考图像的整体风格。

Key Takeaways

- 利用NeRF技术的三维场景风格化方法取得显著成果。

- NNFM损失不考虑全局风格信息,新型框架ABC-GS解决此问题。

- ABC-GS采用三维高斯描图技术实现高质量三维风格转移。

- 可控匹配阶段设计用于精确对齐场景内容与风格特征。

- 基于特征对齐的风格转移损失函数确保反映参考图像的整体风格。

- 保留原始场景几何信息,通过深度损失和高斯正则化项实现。

点此查看论文截图

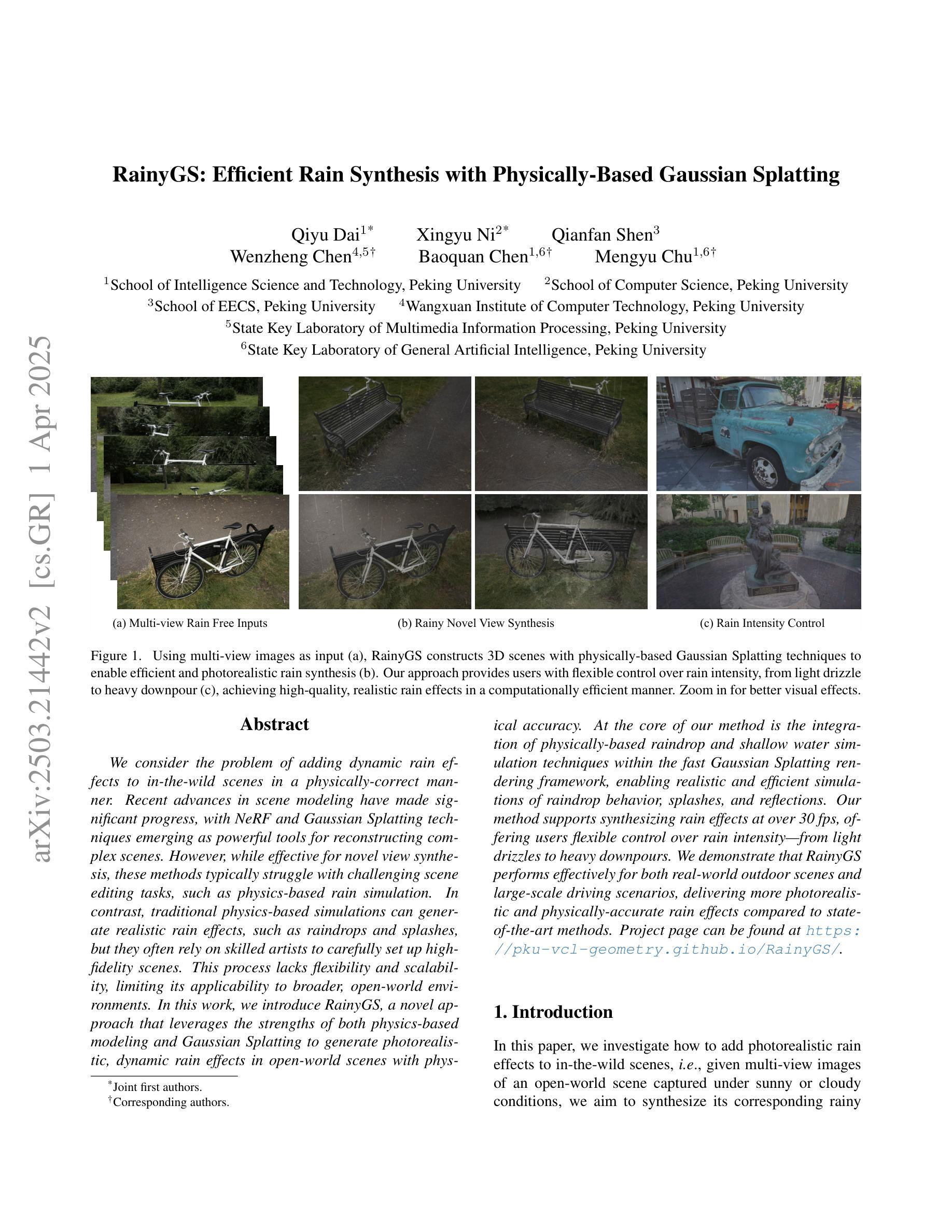

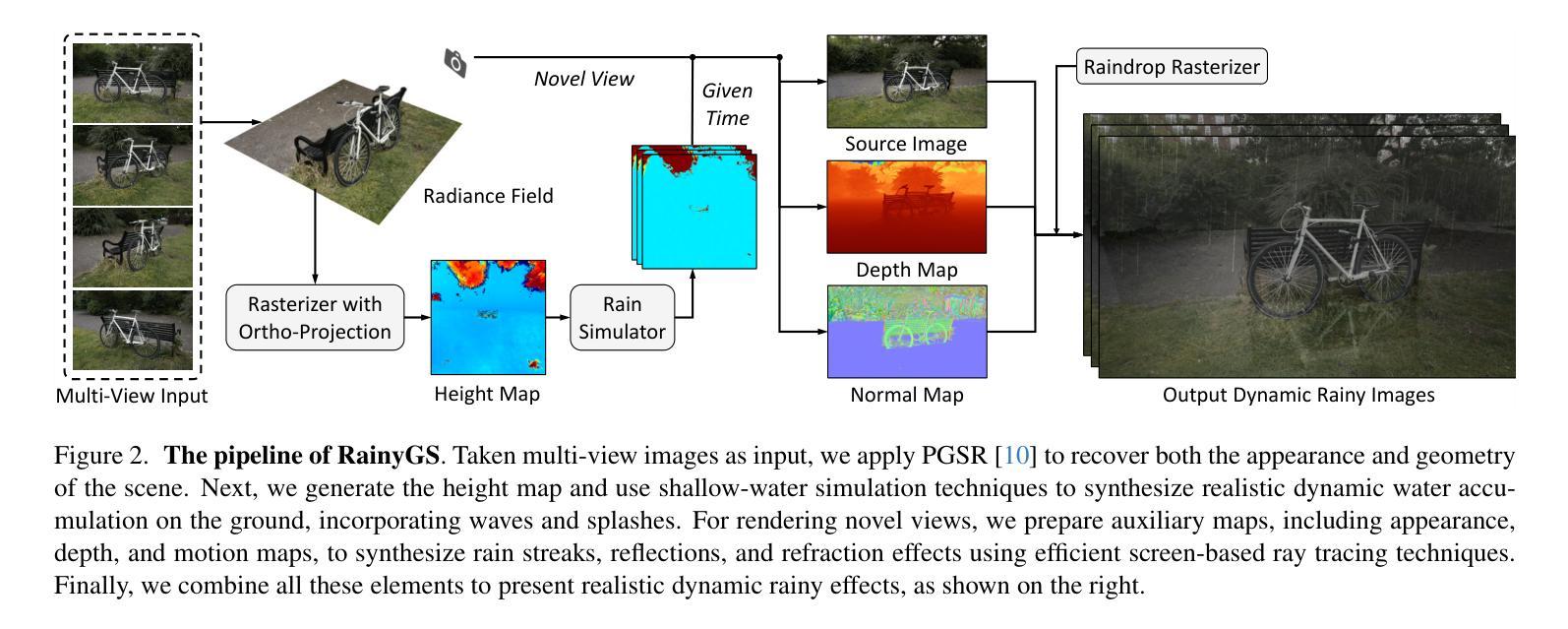

RainyGS: Efficient Rain Synthesis with Physically-Based Gaussian Splatting

Authors:Qiyu Dai, Xingyu Ni, Qianfan Shen, Wenzheng Chen, Baoquan Chen, Mengyu Chu

We consider the problem of adding dynamic rain effects to in-the-wild scenes in a physically-correct manner. Recent advances in scene modeling have made significant progress, with NeRF and 3DGS techniques emerging as powerful tools for reconstructing complex scenes. However, while effective for novel view synthesis, these methods typically struggle with challenging scene editing tasks, such as physics-based rain simulation. In contrast, traditional physics-based simulations can generate realistic rain effects, such as raindrops and splashes, but they often rely on skilled artists to carefully set up high-fidelity scenes. This process lacks flexibility and scalability, limiting its applicability to broader, open-world environments. In this work, we introduce RainyGS, a novel approach that leverages the strengths of both physics-based modeling and 3DGS to generate photorealistic, dynamic rain effects in open-world scenes with physical accuracy. At the core of our method is the integration of physically-based raindrop and shallow water simulation techniques within the fast 3DGS rendering framework, enabling realistic and efficient simulations of raindrop behavior, splashes, and reflections. Our method supports synthesizing rain effects at over 30 fps, offering users flexible control over rain intensity – from light drizzles to heavy downpours. We demonstrate that RainyGS performs effectively for both real-world outdoor scenes and large-scale driving scenarios, delivering more photorealistic and physically-accurate rain effects compared to state-of-the-art methods. Project page can be found at https://pku-vcl-geometry.github.io/RainyGS/

我们考虑以物理正确的方式给自然场景添加动态雨水效果的问题。最近场景建模方面的进展已经取得了重大突破,NeRF和3DGS技术作为重建复杂场景的强大工具而崭露头角。然而,虽然这些方法在合成新视角方面很有效,但它们通常面临具有挑战性的场景编辑任务,如基于物理的雨水模拟。相比之下,传统的基于物理的模拟可以产生逼真的雨水效果,如雨滴和飞溅,但它们通常依赖于熟练的艺术家仔细设置高保真场景。这个过程缺乏灵活性和可扩展性,限制了其在更广泛、开放世界环境中的适用性。在这项工作中,我们介绍了RainyGS,这是一种新的方法,它结合了基于物理的建模和3DGS的优势,在开放世界场景中生成具有物理精度的逼真动态雨水效果。我们方法的核心是在快速的3DGS渲染框架内整合基于物理的雨滴和浅水模拟技术,能够逼真、高效地模拟雨滴行为、飞溅和反射。我们的方法支持以超过30帧/秒的速度合成雨水效果,为用户提供灵活的雨水强度控制——从轻微的小雨到倾盆大雨。我们证明RainyGS在真实户外场景和大规模驾驶场景中都能有效表现,与最新方法相比,它提供了更逼真和更物理准确的雨水效果。项目页面可在https://pku-vcl-geometry.github.io/RainyGS/找到。

论文及项目相关链接

PDF CVPR 2025

Summary

本文提出一种名为RainyGS的新方法,结合了物理建模和3DGS技术,可在开放世界场景中生成具有物理准确性的高逼真的动态雨水效果。该方法融合了基于物理的雨滴和浅水模拟技术,在快速的3DGS渲染框架内进行,能模拟雨滴行为、溅水和反射等。RainyGS支持以超过30帧的速度合成雨水效果,并允许用户灵活控制雨水强度。相较于现有方法,RainyGS在真实户外场景和大规模驾驶场景中有更逼真和物理准确的雨水效果。

Key Takeaways

- 本文介绍了在野外场景中添加动态雨水效果的难题,并指出传统方法依赖于熟练艺术家进行高保真场景的细致设置,缺乏灵活性和可扩展性。

- 提出了名为RainyGS的新方法,结合了物理建模和3DGS技术来生成逼真的动态雨水效果。

- RainyGS集成了基于物理的雨滴和浅水模拟技术,在快速3DGS渲染框架内进行,实现真实且高效的雨水模拟。

- RainyGS支持高帧率(超过30fps)的雨水效果合成,用户可灵活控制雨水强度。

- RainyGS在真实户外场景和大规模驾驶场景中表现出更逼真和物理准确的雨水效果。

- RainyGS方法适用于开放世界环境,具有广泛的应用潜力。

点此查看论文截图

LandMarkSystem Technical Report

Authors:Zhenxiang Ma, Zhenyu Yang, Miao Tao, Yuanzhen Zhou, Zeyu He, Yuchang Zhang, Rong Fu, Hengjie Li

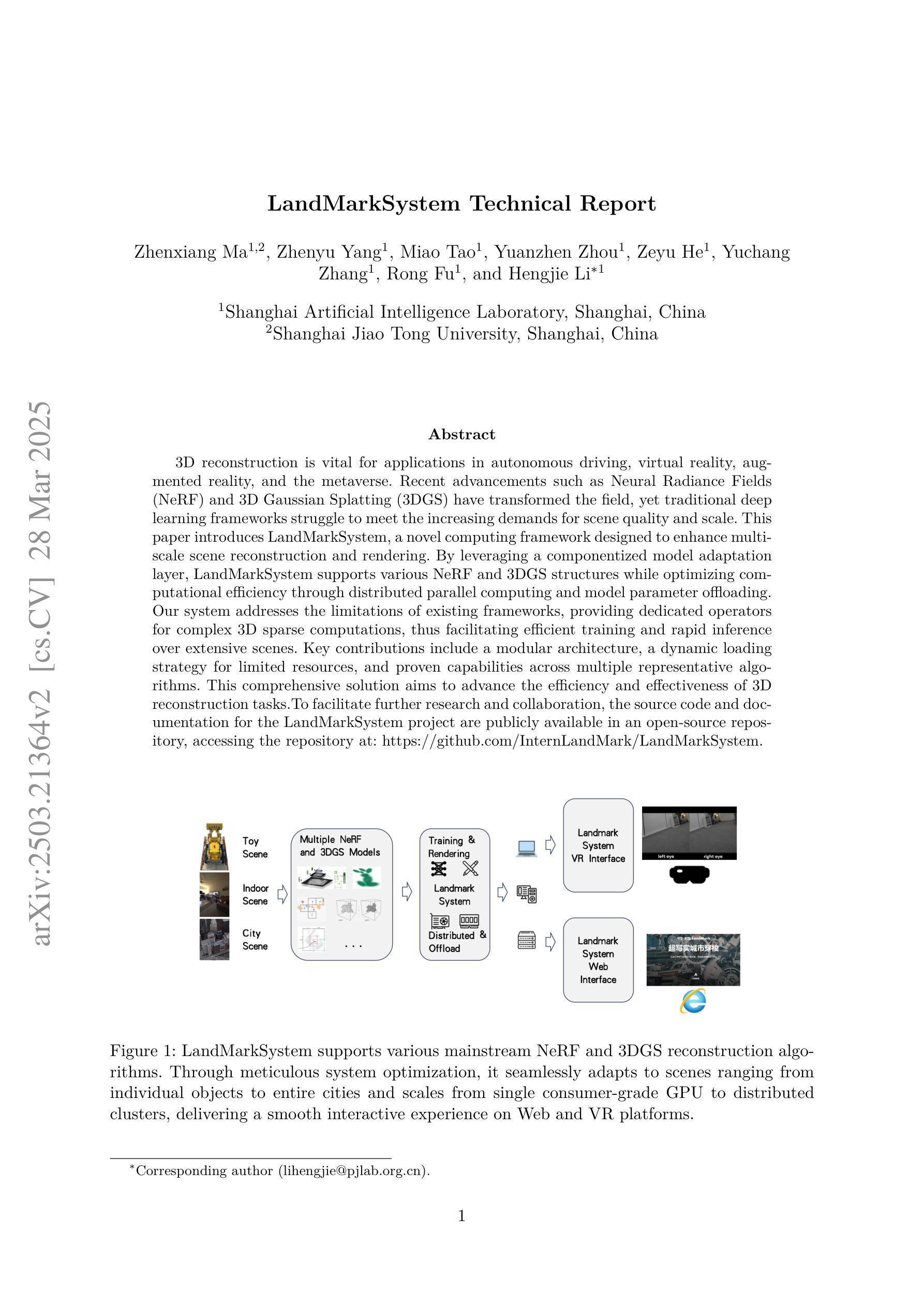

3D reconstruction is vital for applications in autonomous driving, virtual reality, augmented reality, and the metaverse. Recent advancements such as Neural Radiance Fields(NeRF) and 3D Gaussian Splatting (3DGS) have transformed the field, yet traditional deep learning frameworks struggle to meet the increasing demands for scene quality and scale. This paper introduces LandMarkSystem, a novel computing framework designed to enhance multi-scale scene reconstruction and rendering. By leveraging a componentized model adaptation layer, LandMarkSystem supports various NeRF and 3DGS structures while optimizing computational efficiency through distributed parallel computing and model parameter offloading. Our system addresses the limitations of existing frameworks, providing dedicated operators for complex 3D sparse computations, thus facilitating efficient training and rapid inference over extensive scenes. Key contributions include a modular architecture, a dynamic loading strategy for limited resources, and proven capabilities across multiple representative algorithms.This comprehensive solution aims to advance the efficiency and effectiveness of 3D reconstruction tasks.To facilitate further research and collaboration, the source code and documentation for the LandMarkSystem project are publicly available in an open-source repository, accessing the repository at: https://github.com/InternLandMark/LandMarkSystem.

三维重建在自动驾驶、虚拟现实、增强现实和元宇宙等应用中具有重要意义。最近的进展,如神经网络辐射场(NeRF)和三维高斯喷涂(3DGS),已经改变了这一领域,但传统的深度学习框架难以满足对场景质量和规模日益增长的需求。本文介绍了LandMarkSystem,这是一种新型计算框架,旨在提高多尺度场景重建和渲染。通过利用组件化模型适配层,LandMarkSystem支持各种NeRF和3DGS结构,同时通过分布式并行计算和模型参数卸载优化计算效率。我们的系统解决了现有框架的局限性,为复杂的三维稀疏计算提供了专用操作符,从而实现了大规模场景的高效训练和快速推理。主要贡献包括模块化架构、有限资源的动态加载策略以及在多个代表性算法中的证明能力。这个全面的解决方案旨在提高三维重建任务的效率和效果。为促进进一步的研究和合作,LandMarkSystem项目的源代码和文档已在开源仓库中提供,可通过以下链接访问:https://github.com/InternLandMark/LandMarkSystem。

论文及项目相关链接

Summary

基于NeRF技术和组件化模型适配层,LandMarkSystem框架旨在提高多尺度场景重建和渲染的效率和质量。通过分布式并行计算和模型参数卸载优化计算效率,解决了现有框架的限制,为复杂的三维稀疏计算提供专用操作符,旨在推进三维重建任务的效率和效果。

Key Takeaways

- LandMarkSystem利用NeRF技术和组件化模型适配层来增强多尺度场景重建。

- 该框架通过分布式并行计算和模型参数卸载优化计算效率。

- LandMarkSystem解决了现有框架在处理复杂三维稀疏计算方面的限制。

- 它提供了一个模块化架构和动态加载策略以应对有限的资源。

- LandMarkSystem已在多个代表性算法中证明了其能力。

- 该框架旨在提高三维重建任务的效率和效果。

点此查看论文截图

UGNA-VPR: A Novel Training Paradigm for Visual Place Recognition Based on Uncertainty-Guided NeRF Augmentation

Authors:Yehui Shen, Lei Zhang, Qingqiu Li, Xiongwei Zhao, Yue Wang, Huimin Lu, Xieyuanli Chen

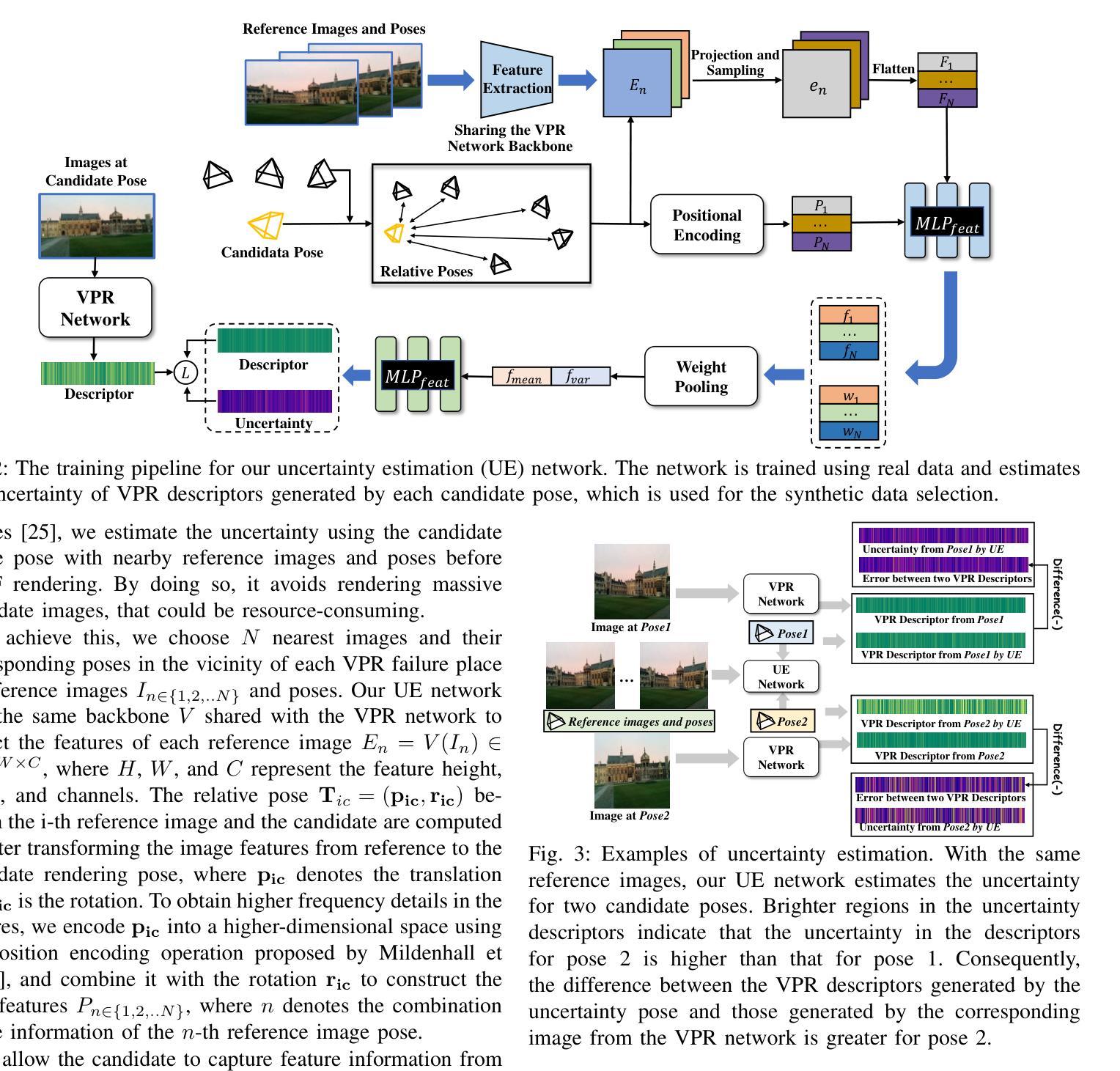

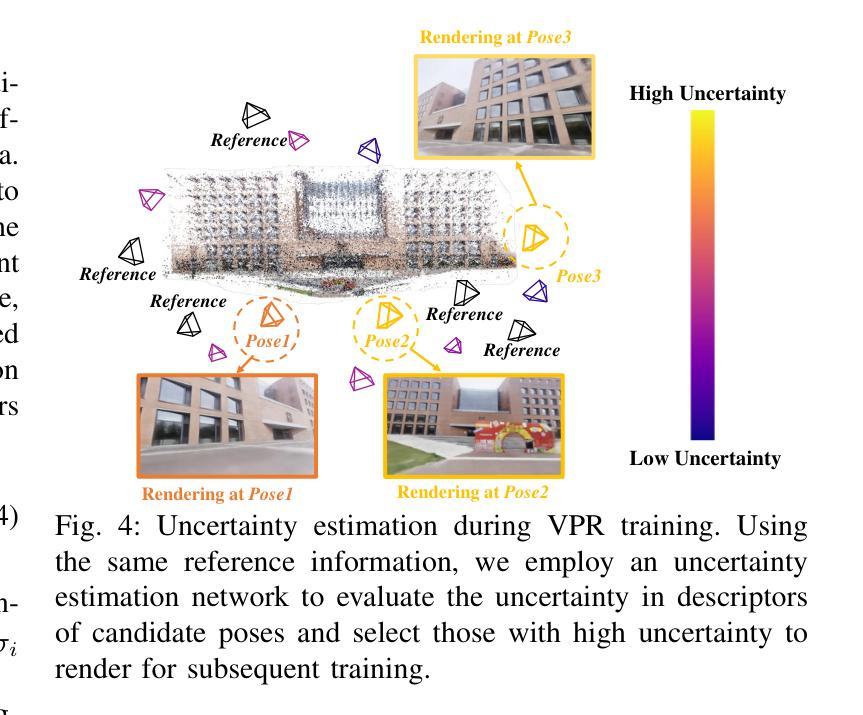

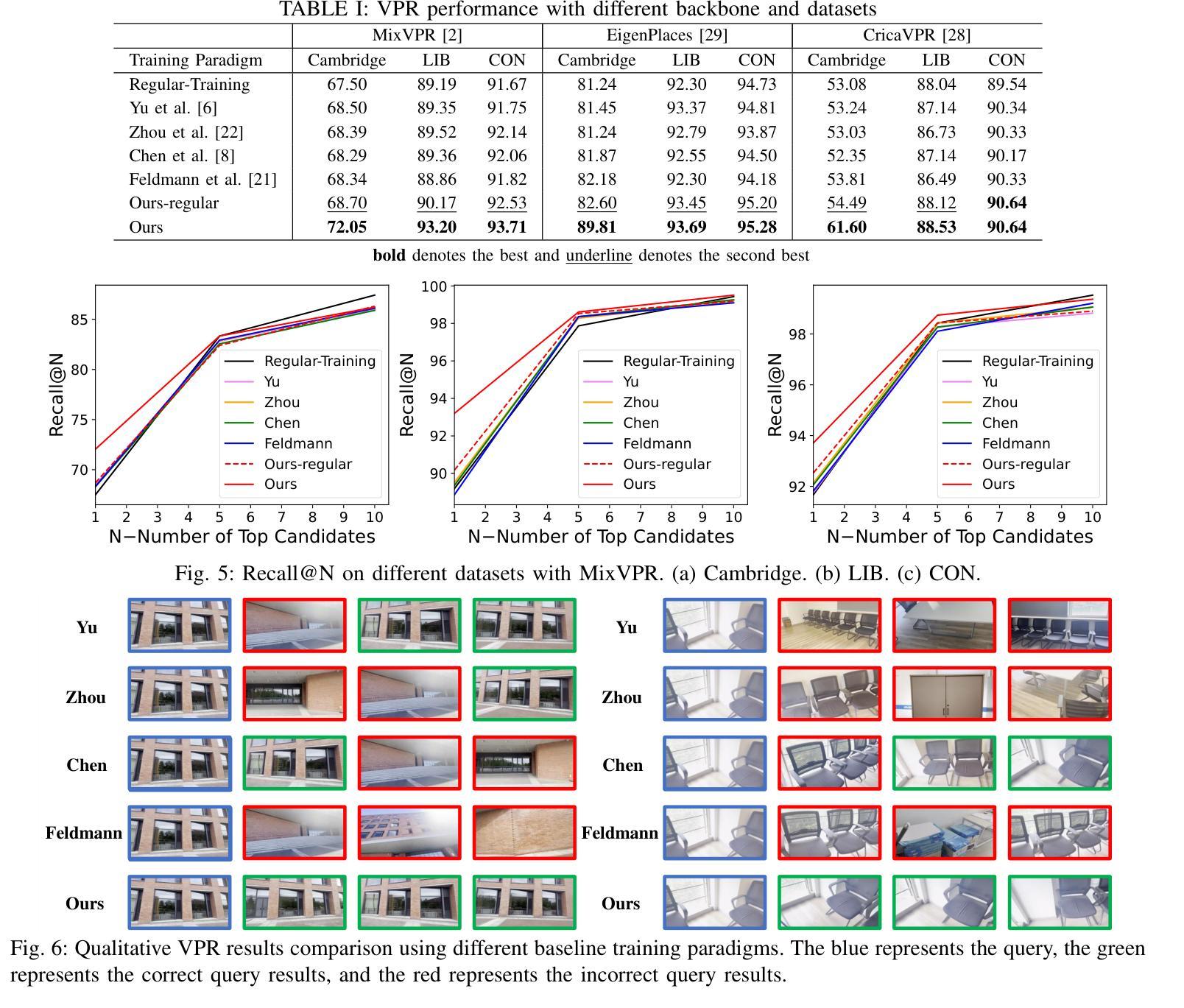

Visual place recognition (VPR) is crucial for robots to identify previously visited locations, playing an important role in autonomous navigation in both indoor and outdoor environments. However, most existing VPR datasets are limited to single-viewpoint scenarios, leading to reduced recognition accuracy, particularly in multi-directional driving or feature-sparse scenes. Moreover, obtaining additional data to mitigate these limitations is often expensive. This paper introduces a novel training paradigm to improve the performance of existing VPR networks by enhancing multi-view diversity within current datasets through uncertainty estimation and NeRF-based data augmentation. Specifically, we initially train NeRF using the existing VPR dataset. Then, our devised self-supervised uncertainty estimation network identifies places with high uncertainty. The poses of these uncertain places are input into NeRF to generate new synthetic observations for further training of VPR networks. Additionally, we propose an improved storage method for efficient organization of augmented and original training data. We conducted extensive experiments on three datasets and tested three different VPR backbone networks. The results demonstrate that our proposed training paradigm significantly improves VPR performance by fully utilizing existing data, outperforming other training approaches. We further validated the effectiveness of our approach on self-recorded indoor and outdoor datasets, consistently demonstrating superior results. Our dataset and code have been released at \href{https://github.com/nubot-nudt/UGNA-VPR}{https://github.com/nubot-nudt/UGNA-VPR}.

视觉位置识别(VPR)对于机器人识别先前访问过的位置至关重要,在室内和室外环境的自主导航中扮演着重要角色。然而,大多数现有的VPR数据集仅限于单视点场景,导致识别精度降低,特别是在多方向驾驶或特征稀疏的场景中。此外,获取额外数据以缓解这些限制通常成本高昂。本文引入了一种新的训练范式,以提高现有VPR网络的性能。我们通过不确定性估计和基于NeRF的数据增强,增强当前数据集内的多视图多样性。具体来说,我们最初使用现有的VPR数据集训练NeRF。然后,我们设计的自监督不确定性估计网络识别出不确定性较高的位置。这些不确定位置的姿态被输入到NeRF中,以生成新的合成观察结果,用于进一步训练VPR网络。此外,我们还提出了一种改进的数据存储方法,以有效地组织增强和原始训练数据。我们在三个数据集上进行了广泛的实验,并测试了三种不同的VPR骨干网络。结果表明,我们提出的训练范式充分利用了现有数据,显著提高了VPR的性能,超越了其他训练方法。我们在自制的室内和室外数据集上进一步验证了我们的方法的有效性,始终表现出卓越的结果。我们的数据集和代码已发布在https://github.com/nubot-nudt/UGNA-VPR。

论文及项目相关链接

PDF Accepted to IEEE Robotics and Automation Letters (RA-L)

Summary

本文提出了一种新的训练范式,通过利用不确定度估计和基于NeRF的数据增强技术,增强现有VPR网络的多视角多样性,提高其在多方向驾驶和特征稀疏场景中的识别准确率。通过NeRF使用现有VPR数据集进行初始训练,然后利用自主设计的自监督不确定度估计网络识别高不确定度地点,将这些地点的姿态输入NeRF生成新的合成观察结果,用于进一步训练VPR网络。同时,提出了一种改进的数据存储方法,以更有效地组织增强和原始训练数据。实验结果表明,该训练范式能充分利用现有数据,显著提高VPR性能。

Key Takeaways

- 引入了一种新的训练范式,旨在提高VPR网络在多种场景中的识别性能。

- 利用不确定度估计技术识别高不确定度地点,通过NeRF生成新的合成观察结果。

- 提出了一个自监督不确定度估计网络,用于辅助生成合成观察数据。

- 采用了一种改进的数据存储方法,以便更有效地组织增强和原始训练数据。

- 通过三个数据集和三种不同的VPR骨干网络进行的实验表明,新训练范式显著提高了VPR性能。

- 在自主录制的室内和室外数据集上验证了方法的有效性,均取得了优异结果。

点此查看论文截图

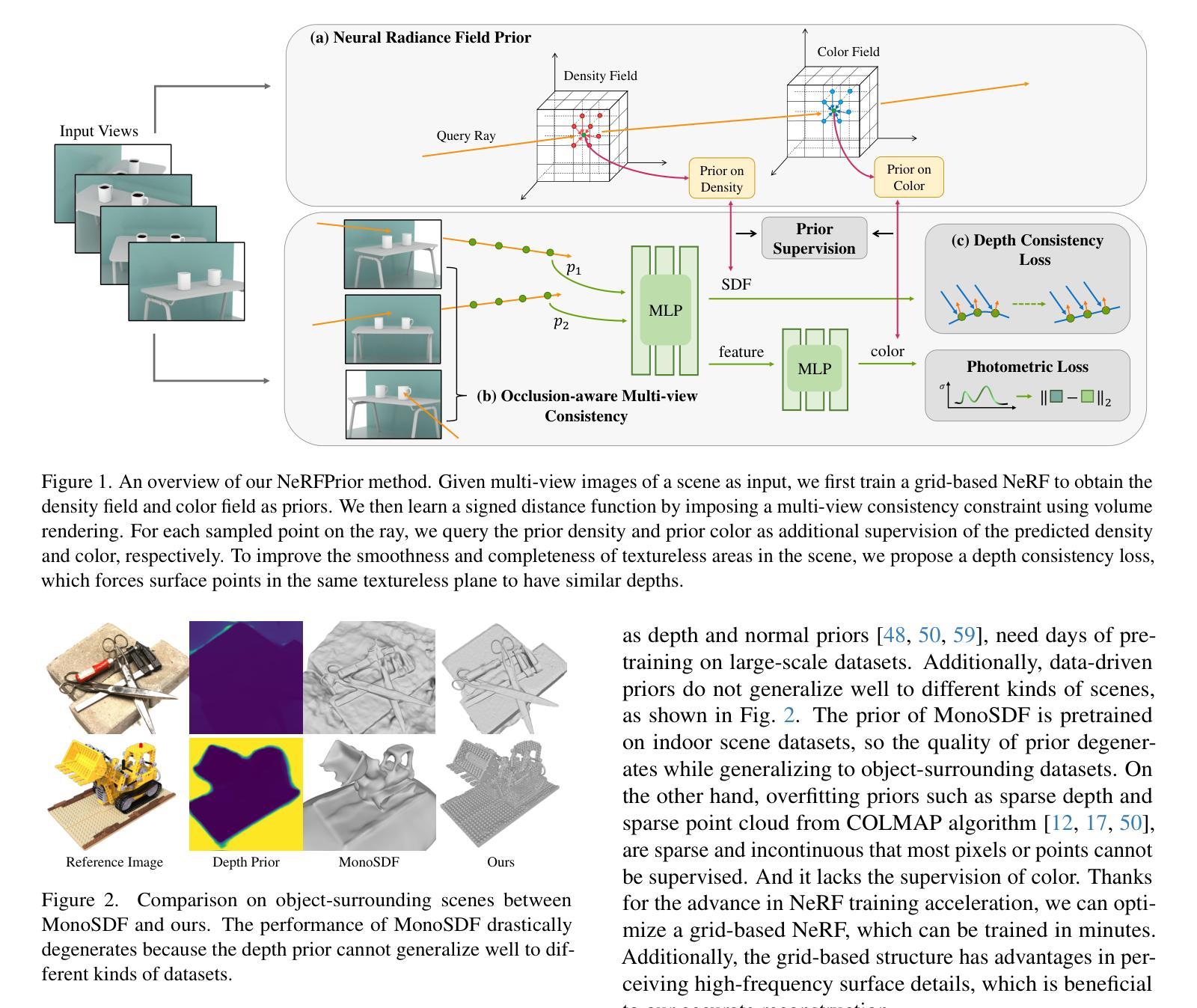

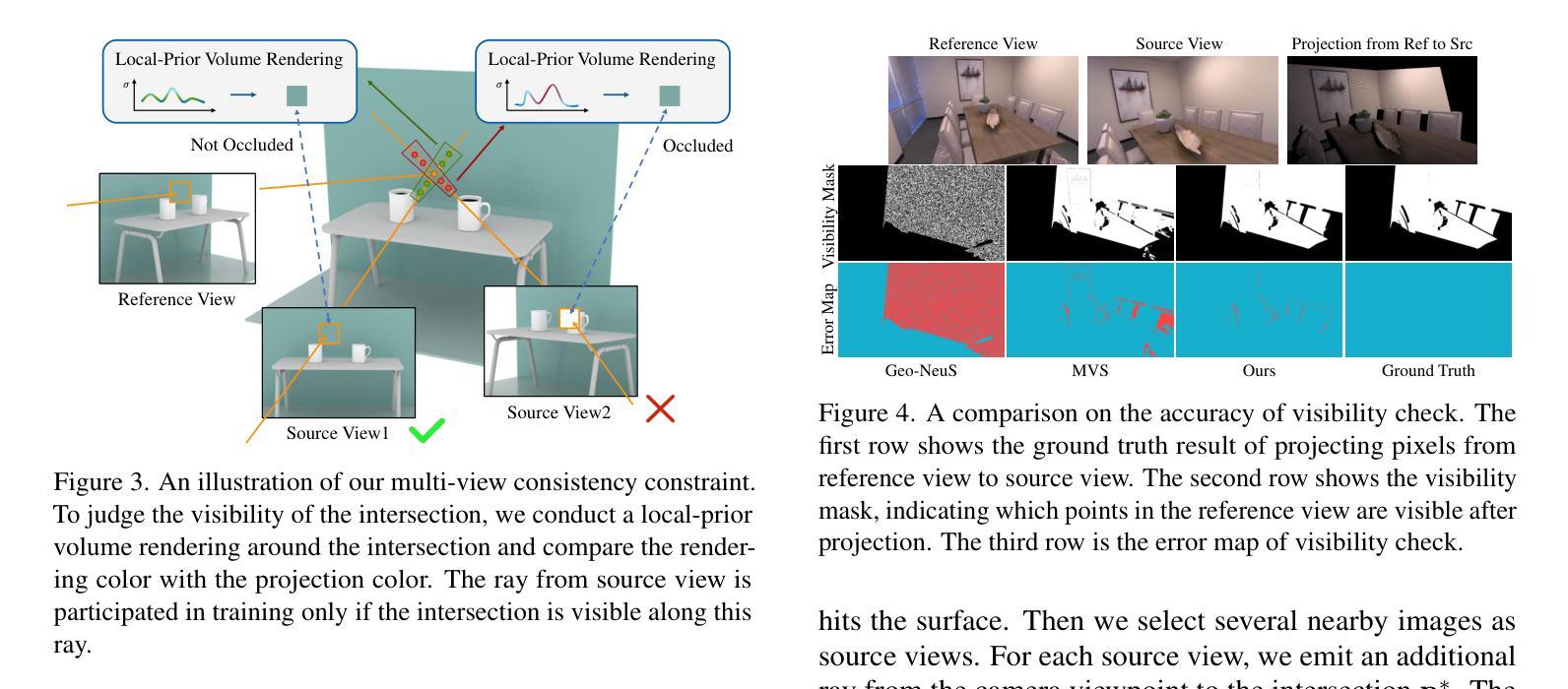

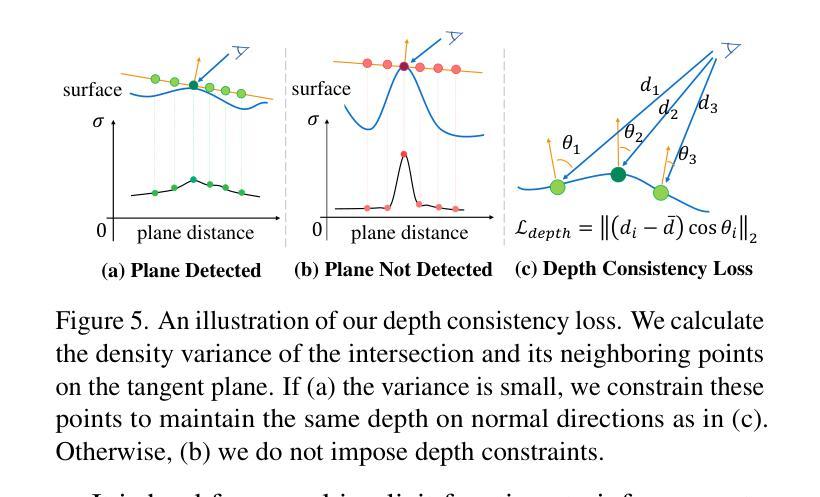

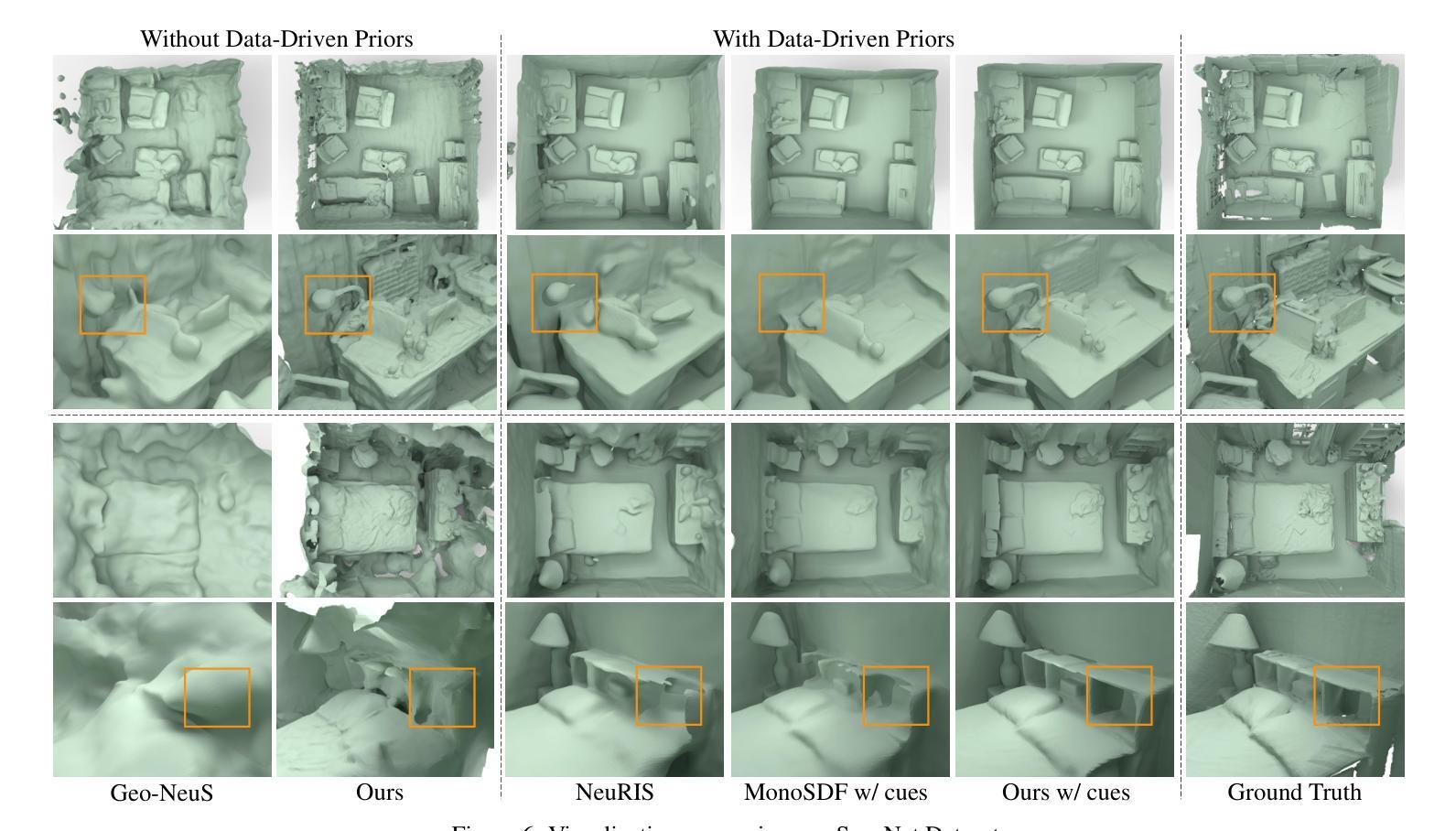

NeRFPrior: Learning Neural Radiance Field as a Prior for Indoor Scene Reconstruction

Authors:Wenyuan Zhang, Emily Yue-ting Jia, Junsheng Zhou, Baorui Ma, Kanle Shi, Yu-Shen Liu, Zhizhong Han

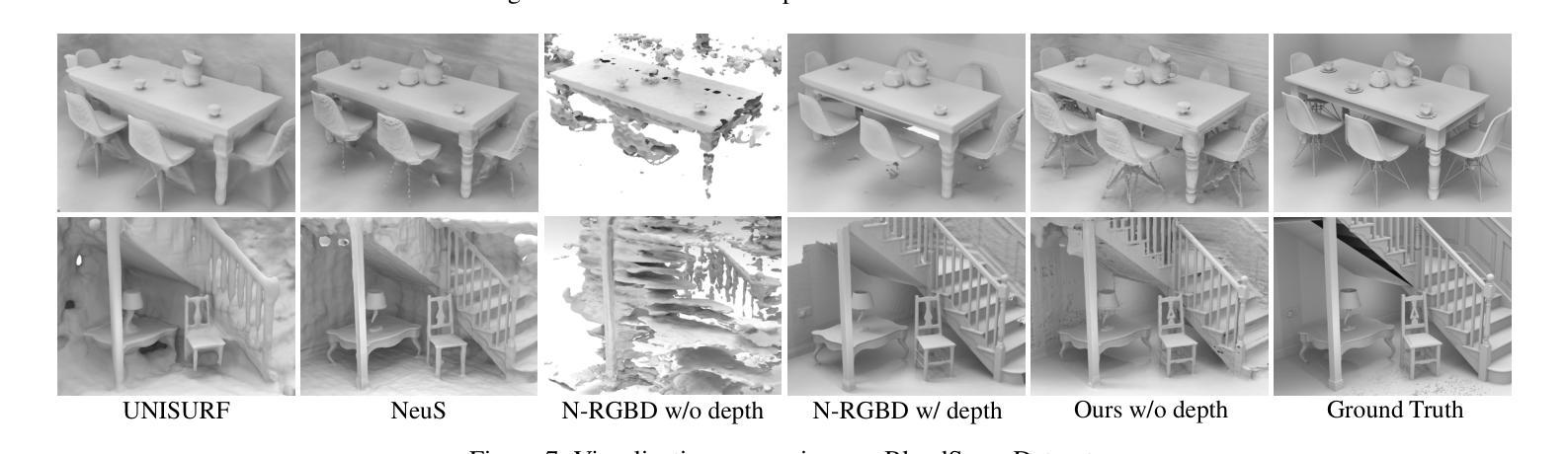

Recently, it has shown that priors are vital for neural implicit functions to reconstruct high-quality surfaces from multi-view RGB images. However, current priors require large-scale pre-training, and merely provide geometric clues without considering the importance of color. In this paper, we present NeRFPrior, which adopts a neural radiance field as a prior to learn signed distance fields using volume rendering for surface reconstruction. Our NeRF prior can provide both geometric and color clues, and also get trained fast under the same scene without additional data. Based on the NeRF prior, we are enabled to learn a signed distance function (SDF) by explicitly imposing a multi-view consistency constraint on each ray intersection for surface inference. Specifically, at each ray intersection, we use the density in the prior as a coarse geometry estimation, while using the color near the surface as a clue to check its visibility from another view angle. For the textureless areas where the multi-view consistency constraint does not work well, we further introduce a depth consistency loss with confidence weights to infer the SDF. Our experimental results outperform the state-of-the-art methods under the widely used benchmarks.

最近,研究显示先验知识对于神经隐式函数从多视角RGB图像重建高质量表面至关重要。然而,当前先验知识需要大量预训练,并且仅提供几何线索,而未考虑颜色的重要性。在本文中,我们提出了NeRFPrior,它采用神经辐射场作为先验知识,使用体积渲染来学习符号距离场进行表面重建。我们的NeRF先验可以提供几何和颜色线索,并在同一场景下无需额外数据进行快速训练。基于NeRF先验,我们能够通过在每条射线交点上明确施加多视角一致性约束来学习符号距离函数(SDF),以实现表面推断。具体来说,在每条射线交点上,我们使用先验中的密度作为粗略的几何估计,同时使用接近表面的颜色作为从另一个视角检查其可见性的线索。对于纹理缺失的区域,多视角一致性约束无法很好地工作,我们进一步引入带有置信权重的深度一致性损失来推断SDF。我们的实验结果优于广泛使用的基准测试中的最新方法。

论文及项目相关链接

PDF Accepted by CVPR 2025. Project page: https://wen-yuan-zhang.github.io/NeRFPrior/

Summary

本文提出了NeRFPrior方法,利用神经辐射场作为先验来学习使用体积渲染的表面重建中的符号距离场。NeRFPrior不仅提供几何线索,还考虑颜色重要性,无需额外数据即可在同一场景下进行快速训练。通过明确对每条射线交点施加多视角一致性约束,实现表面推断的符号距离函数(SDF)学习。在纹理缺失区域,引入带有置信权重的深度一致性损失来推断SDF,实验结果优于广泛使用的基准测试中的最新方法。

Key Takeaways

- NeRFPrior利用神经辐射场作为先验,用于表面重建中的符号距离场学习。

- 该方法不仅能提供几何线索,还考虑颜色的重要性。

- NeRFPrior在同一场景下进行快速训练,无需额外数据。

- 通过明确对每条射线交点施加多视角一致性约束,实现符号距离函数(SDF)学习。

- 在纹理缺失区域,引入深度一致性损失以辅助表面推断。

- NeRFPrior的实验结果优于广泛使用的基准测试中的最新方法。

点此查看论文截图

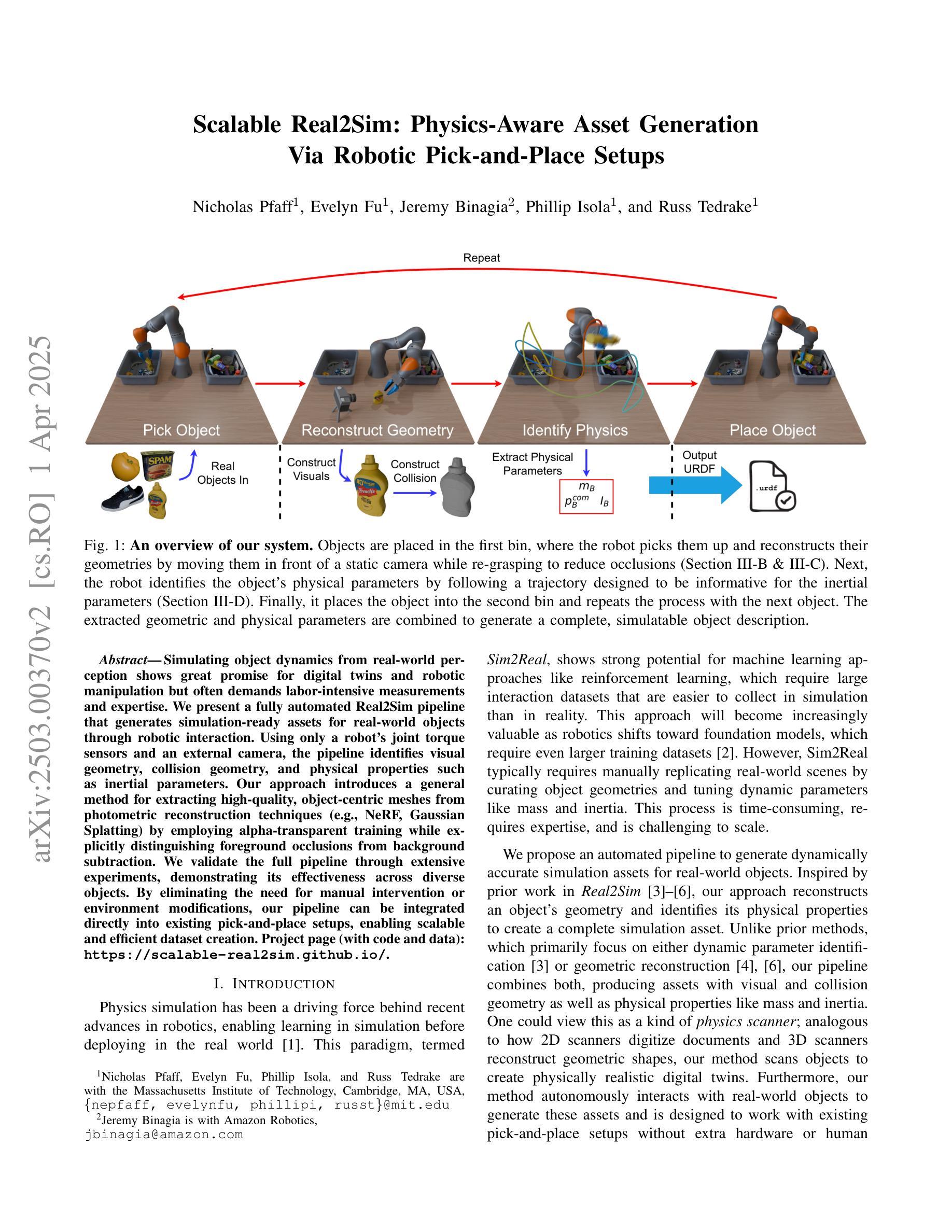

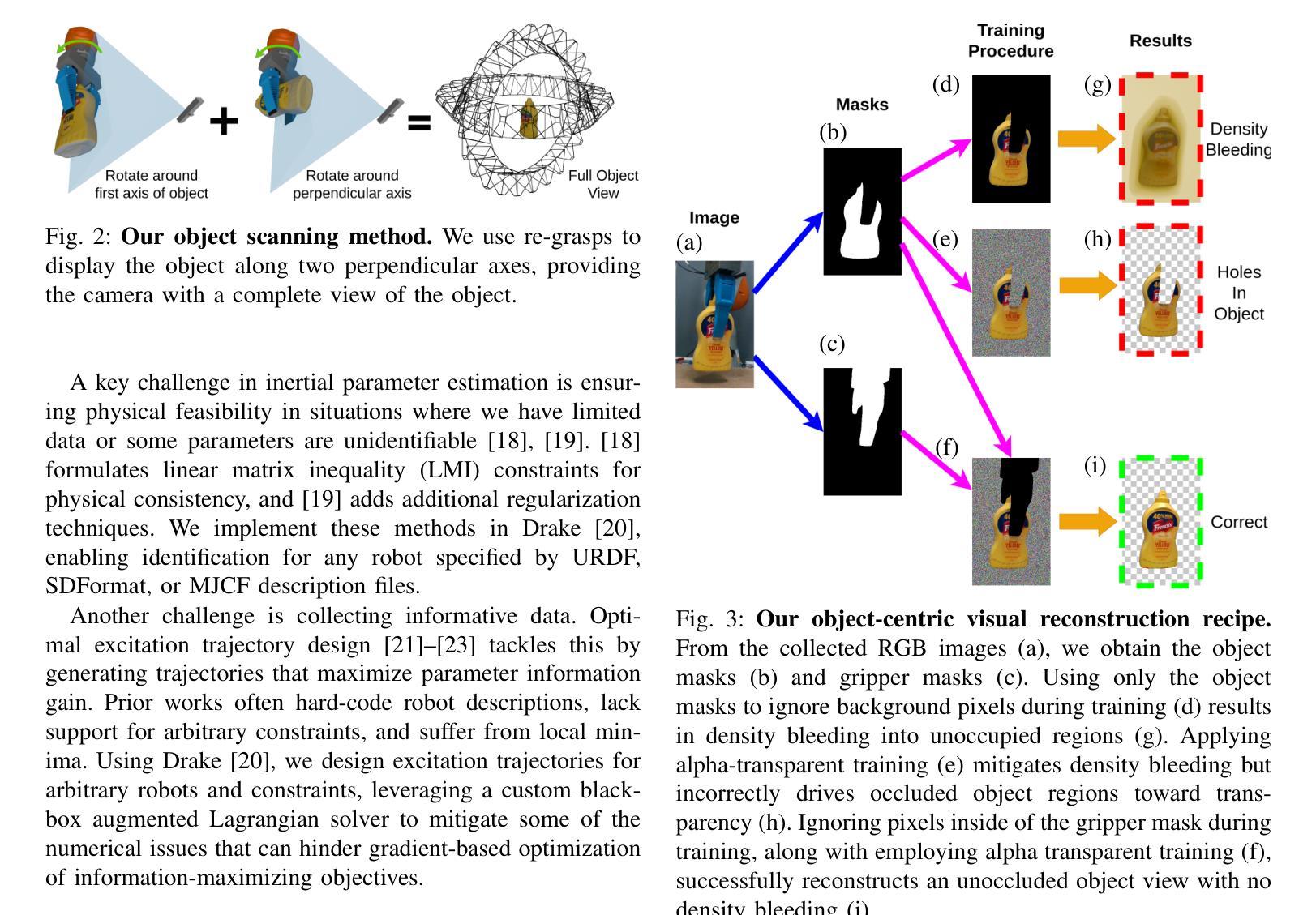

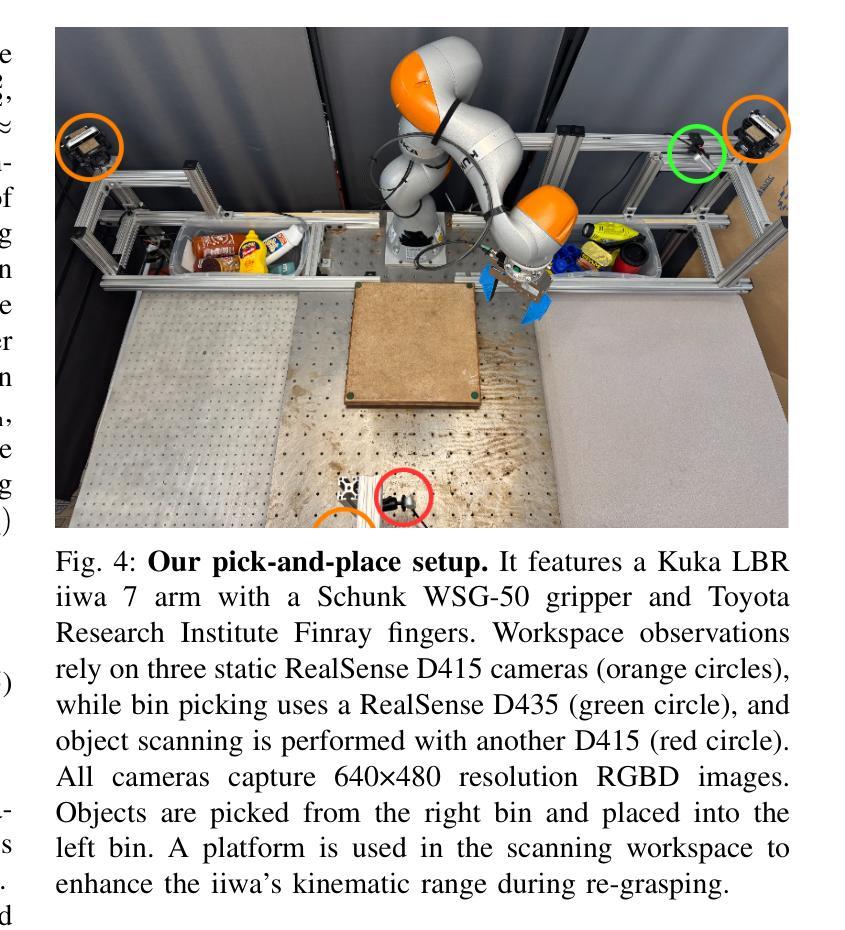

Scalable Real2Sim: Physics-Aware Asset Generation Via Robotic Pick-and-Place Setups

Authors:Nicholas Pfaff, Evelyn Fu, Jeremy Binagia, Phillip Isola, Russ Tedrake

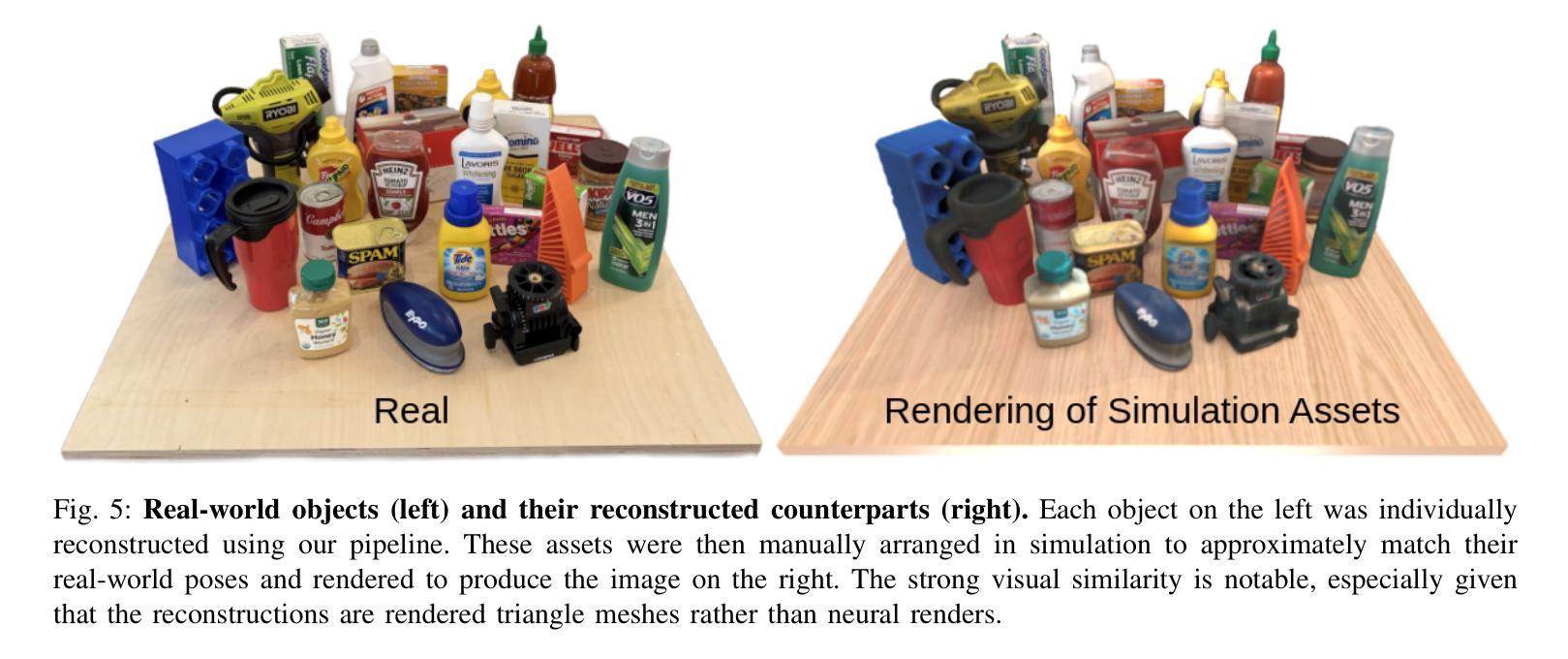

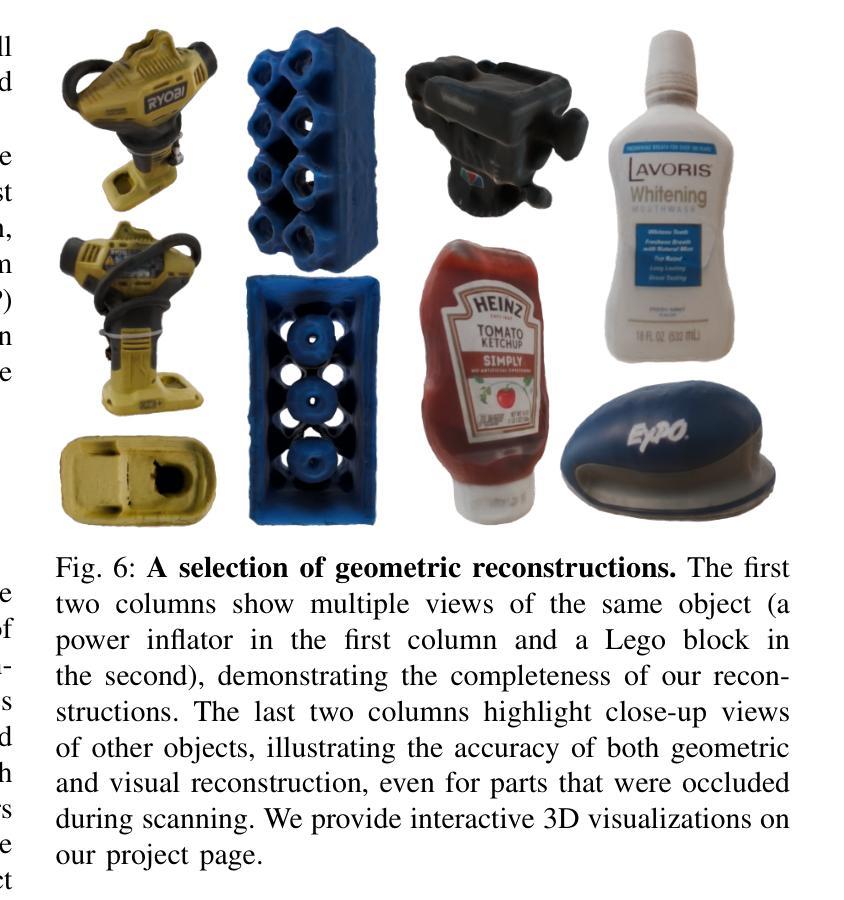

Simulating object dynamics from real-world perception shows great promise for digital twins and robotic manipulation but often demands labor-intensive measurements and expertise. We present a fully automated Real2Sim pipeline that generates simulation-ready assets for real-world objects through robotic interaction. Using only a robot’s joint torque sensors and an external camera, the pipeline identifies visual geometry, collision geometry, and physical properties such as inertial parameters. Our approach introduces a general method for extracting high-quality, object-centric meshes from photometric reconstruction techniques (e.g., NeRF, Gaussian Splatting) by employing alpha-transparent training while explicitly distinguishing foreground occlusions from background subtraction. We validate the full pipeline through extensive experiments, demonstrating its effectiveness across diverse objects. By eliminating the need for manual intervention or environment modifications, our pipeline can be integrated directly into existing pick-and-place setups, enabling scalable and efficient dataset creation. Project page (with code and data): https://scalable-real2sim.github.io/.

通过从真实世界感知模拟物体动态,数字孪生和机器人操作展现出了巨大的潜力,但这通常需要密集劳动的测量和专业知识。我们提出了一种全自动的Real2Sim管道,通过机器人交互为真实世界对象生成模拟就绪资产。仅使用机器人的关节扭矩传感器和外部摄像头,该管道就能识别视觉几何、碰撞几何以及物理属性,如惯性参数。我们的方法通过采用alpha透明训练,引入了一种从光度重建技术(例如NeRF、高斯平板印刷)中提取高质量、以物体为中心的网格的一般方法,同时明确区分前景遮挡和背景减法。我们通过广泛的实验验证了整个管道的有效性,证明了它在各种对象上的有效性。通过消除对人工干预或环境修改的需求,我们的管道可以直接集成到现有的拾取和放置设置中,从而实现可扩展和高效的数据库创建。项目页面(包含代码和数据):https://scalable-real2sim.github.io/。

论文及项目相关链接

PDF Website: https://scalable-real2sim.github.io/

Summary

本摘要介绍了全自动化的Real2Sim管道技术,该技术通过机器人交互为真实世界物体生成模拟仿真资产。仅使用机器人的关节扭矩传感器和外部相机,该技术就能识别物体的视觉几何、碰撞几何和物理属性,如惯性参数。该方法采用alpha透明训练法,结合NeRF等光度重建技术,提取高质量的对象中心网格,并通过前景遮挡与背景减影的明确区分来实现。实验验证表明,该方法在多种对象上均有效。它能直接集成现有的拾取和放置设置,无需人工干预或环境修改,从而实现可扩展和高效的数据库创建。

Key Takeaways

- 介绍了一种全自动化的Real2Sim管道技术,用于生成模拟仿真资产,用于数字双胞胎和机器人操作。

- 仅使用机器人的关节扭矩传感器和外部相机,就能识别物体的视觉几何、碰撞几何和物理属性。

- 采用alpha透明训练法结合NeRF等光度重建技术,实现高质量的对象中心网格提取。

- 明确区分前景遮挡和背景减影,提高了技术的效能。

- 实验验证表明,该方法在多种对象上均有效。

- 该技术能直接集成现有的拾取和放置设置,无需人工干预或环境修改。

点此查看论文截图

ActiveGAMER: Active GAussian Mapping through Efficient Rendering

Authors:Liyan Chen, Huangying Zhan, Kevin Chen, Xiangyu Xu, Qingan Yan, Changjiang Cai, Yi Xu

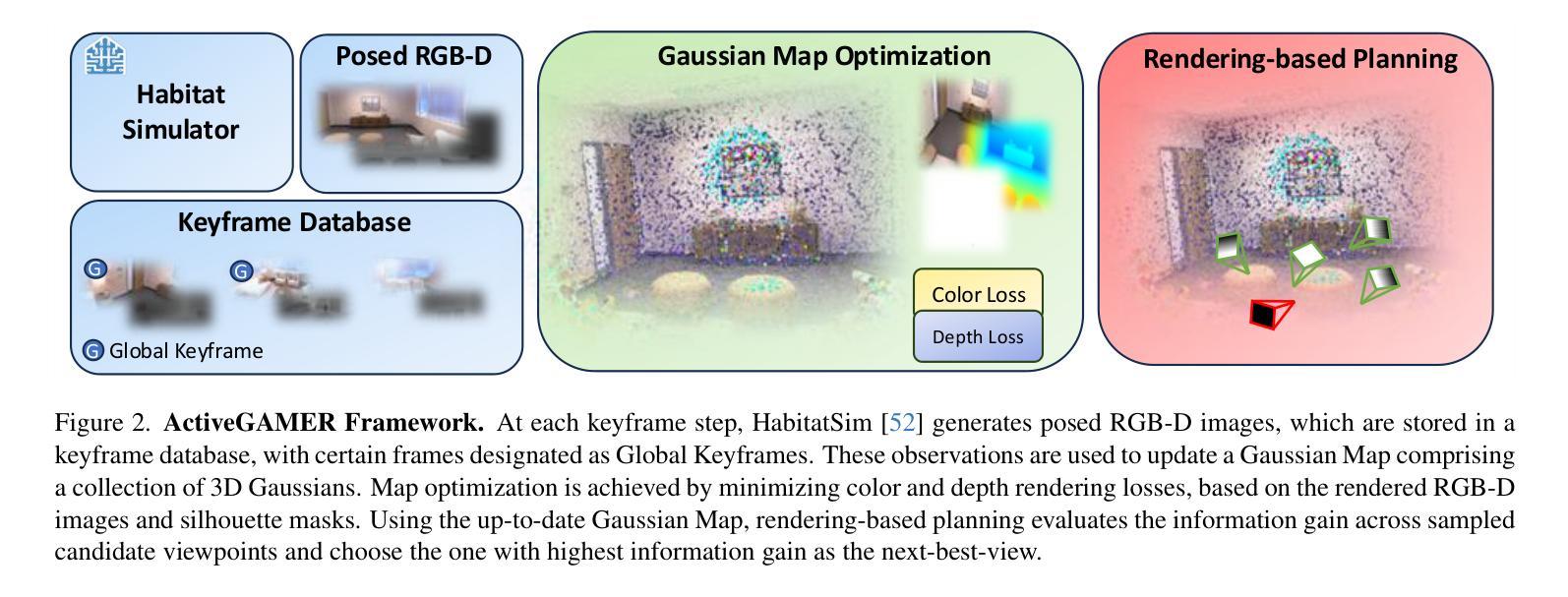

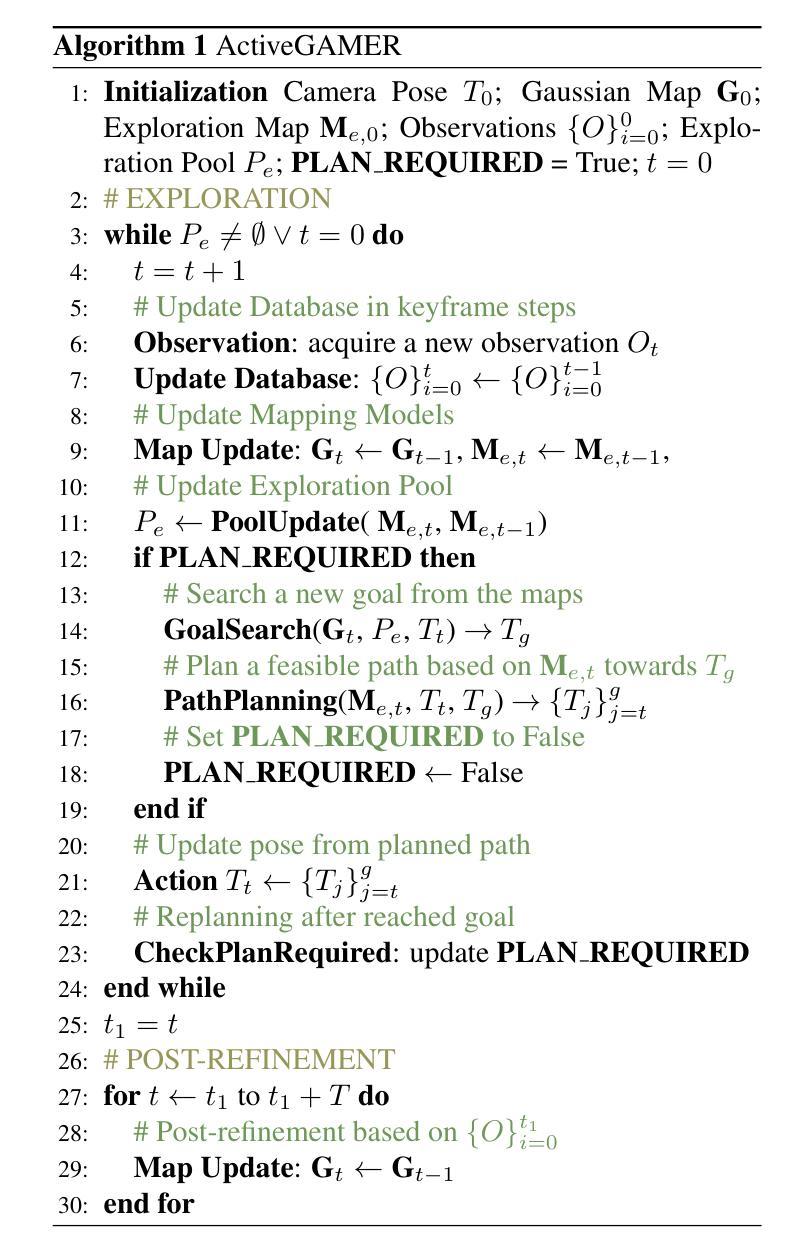

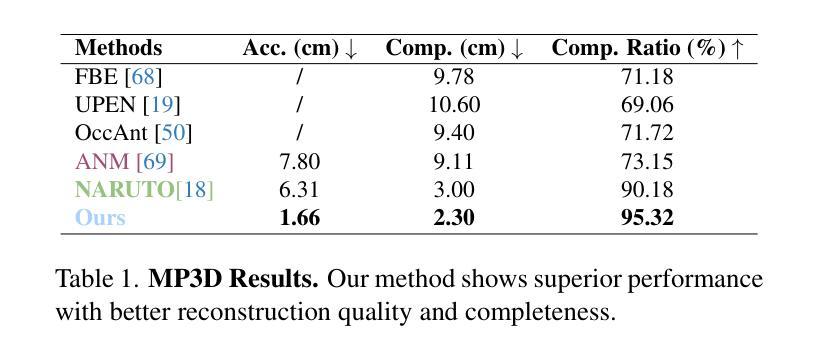

We introduce ActiveGAMER, an active mapping system that utilizes 3D Gaussian Splatting (3DGS) to achieve high-quality, real-time scene mapping and exploration. Unlike traditional NeRF-based methods, which are computationally demanding and restrict active mapping performance, our approach leverages the efficient rendering capabilities of 3DGS, allowing effective and efficient exploration in complex environments. The core of our system is a rendering-based information gain module that dynamically identifies the most informative viewpoints for next-best-view planning, enhancing both geometric and photometric reconstruction accuracy. ActiveGAMER also integrates a carefully balanced framework, combining coarse-to-fine exploration, post-refinement, and a global-local keyframe selection strategy to maximize reconstruction completeness and fidelity. Our system autonomously explores and reconstructs environments with state-of-the-art geometric and photometric accuracy and completeness, significantly surpassing existing approaches in both aspects. Extensive evaluations on benchmark datasets such as Replica and MP3D highlight ActiveGAMER’s effectiveness in active mapping tasks.

我们介绍了ActiveGAMER,这是一个利用3D高斯拼接(3DGS)技术的主动映射系统,可实现高质量、实时的场景映射和探索。与传统的基于NeRF的方法不同,这些方法计算量大,限制了主动映射的性能,我们的方法利用3DGS的高效渲染能力,能够在复杂环境中实现有效且高效的探索。我们的系统的核心是基于渲染的信息增益模块,该模块能够动态识别最具信息量的观点,用于进行下一次最佳视角规划,提高几何和光度重建的精度。ActiveGAMER还整合了一个精心设计的框架,结合了从粗到细的探索、后处理和全局局部关键帧选择策略,以最大化重建的完整性和逼真度。我们的系统以最先进的几何和光度准确性和完整性自主探索和重建环境,在各方面都大大超越了现有方法。在Replica和MP3D等基准数据集上的广泛评估凸显了ActiveGAMER在主动映射任务中的有效性。

论文及项目相关链接

PDF Accepted to CVPR2025

Summary

ActiveGAMER是一种利用3D高斯拼贴技术实现高质量实时场景映射和探索的主动映射系统。它采用高效渲染技术,克服传统NeRF方法计算量大、影响主动映射性能的缺点,在复杂环境中实现高效探索。其核心是一个基于渲染的信息增益模块,能动态识别最具信息量的视角进行下一步最佳视角规划,提高几何和光度重建精度。ActiveGAMER结合粗到细探索、后优化和全局局部关键帧选择策略,最大化重建的完整性和保真度。系统在几何和光度准确性和完整性方面达到领先水平,显著超越现有方法。在如Replica和MP3D等基准数据集上的评估证明了ActiveGAMER在主动映射任务中的有效性。

Key Takeaways

- ActiveGAMER系统利用3D高斯拼贴技术实现高效渲染,提高场景映射和探索的质量。

- 与传统NeRF方法相比,ActiveGAMER具有更高的计算效率,能够克服计算量大对主动映射性能的影响。

- ActiveGAMER通过动态识别最具信息量的视角,提高几何和光度重建的精度。

- 系统结合粗到细探索、后优化和全局局部关键帧选择策略,以最大化重建的完整性和保真度。

- ActiveGAMER在几何和光度准确性和完整性方面达到领先水平。

- 在基准数据集上的评估证明了ActiveGAMER在主动映射任务中的有效性。

点此查看论文截图

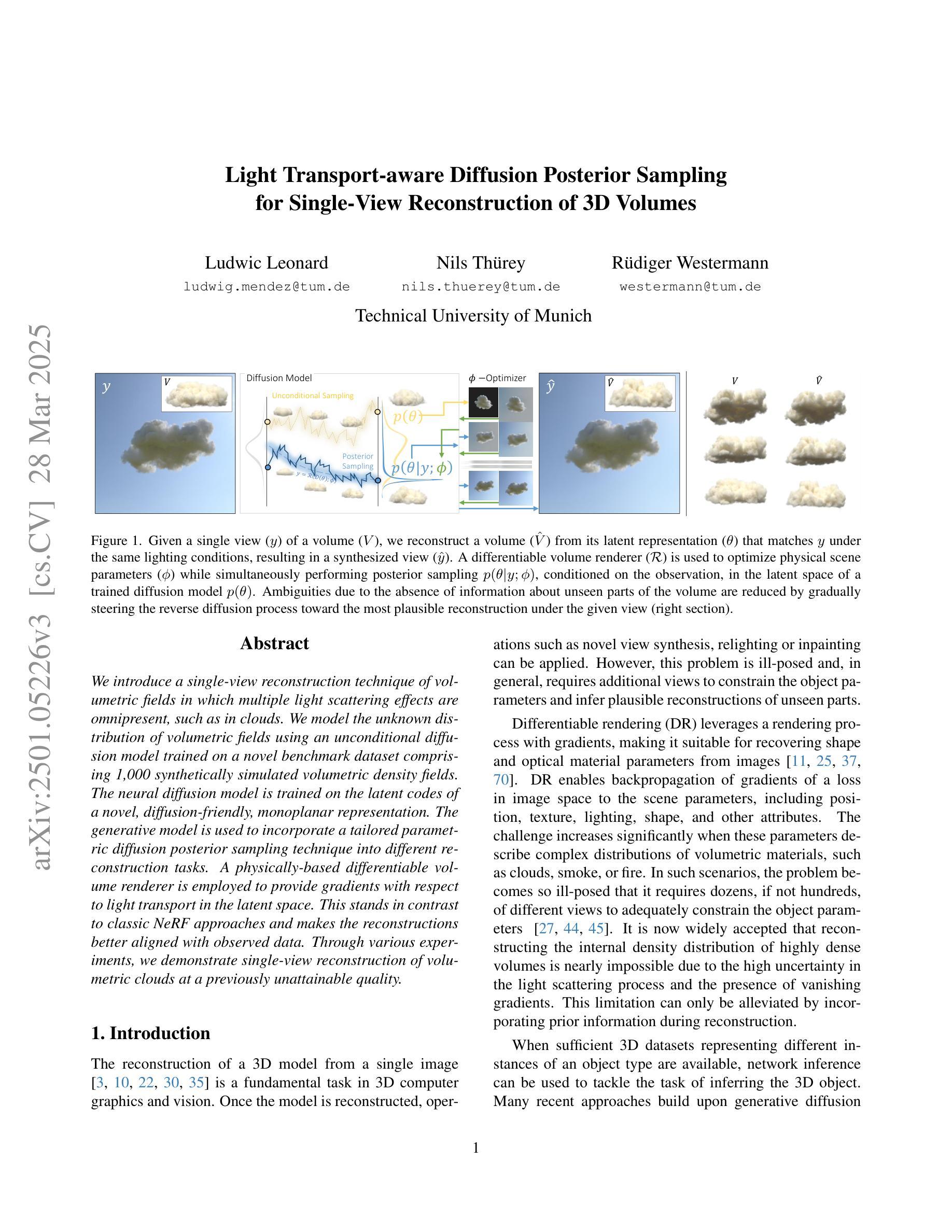

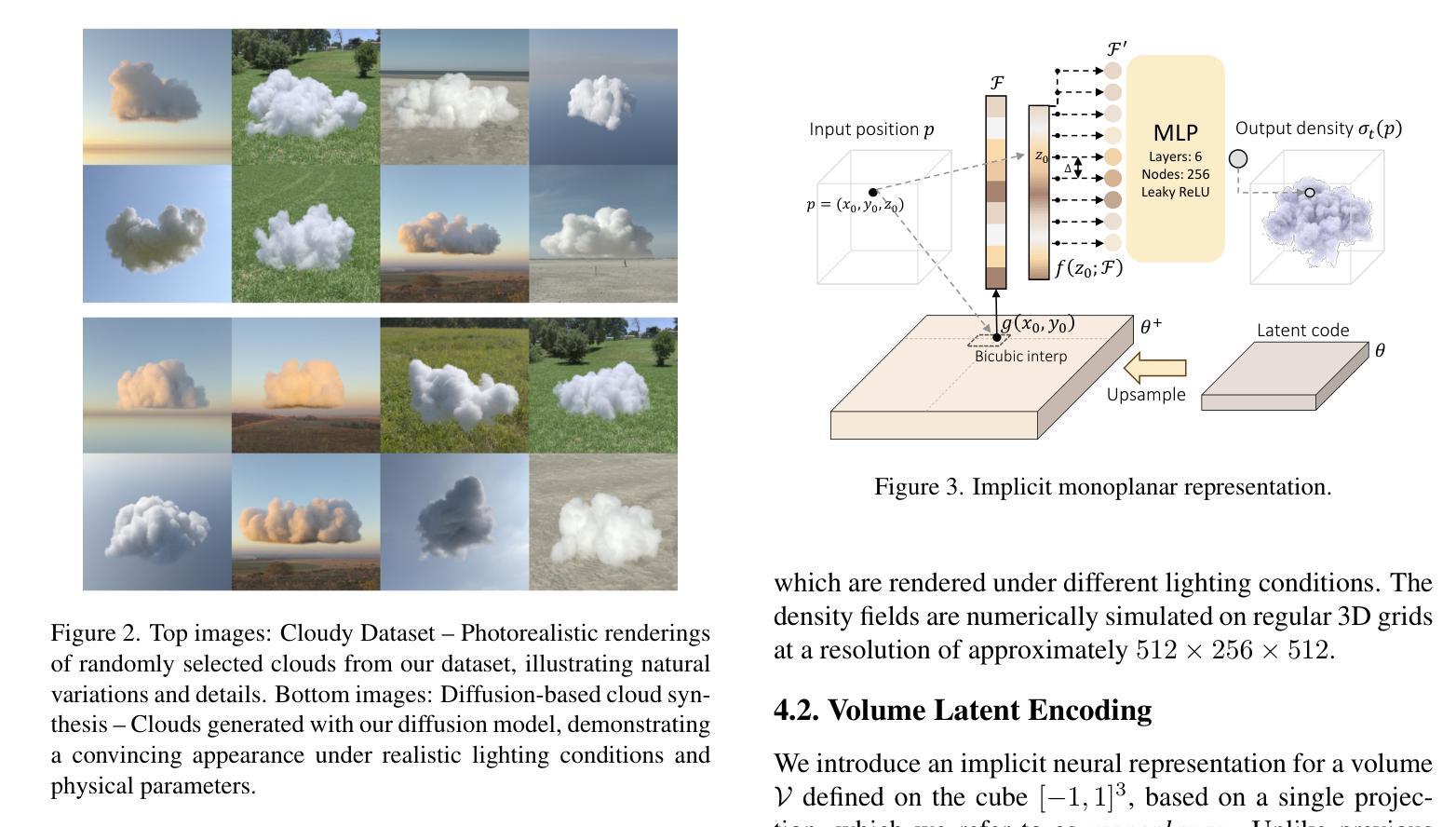

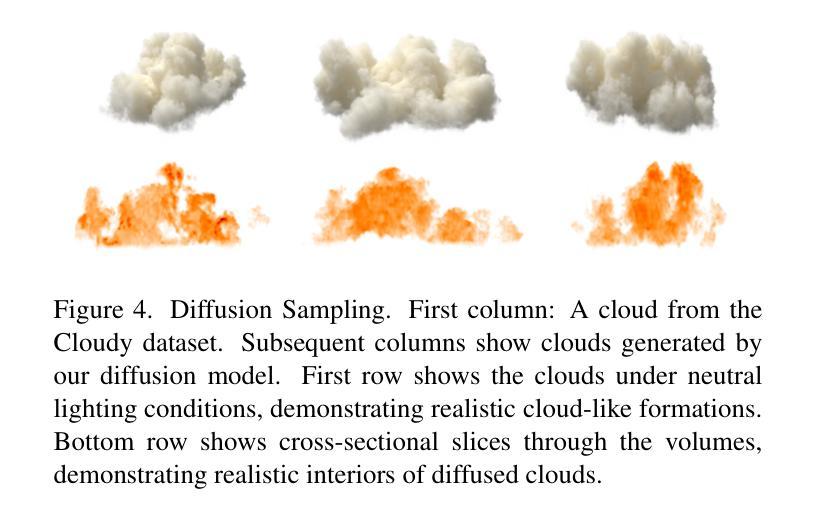

Light Transport-aware Diffusion Posterior Sampling for Single-View Reconstruction of 3D Volumes

Authors:Ludwic Leonard, Nils Thuerey, Ruediger Westermann

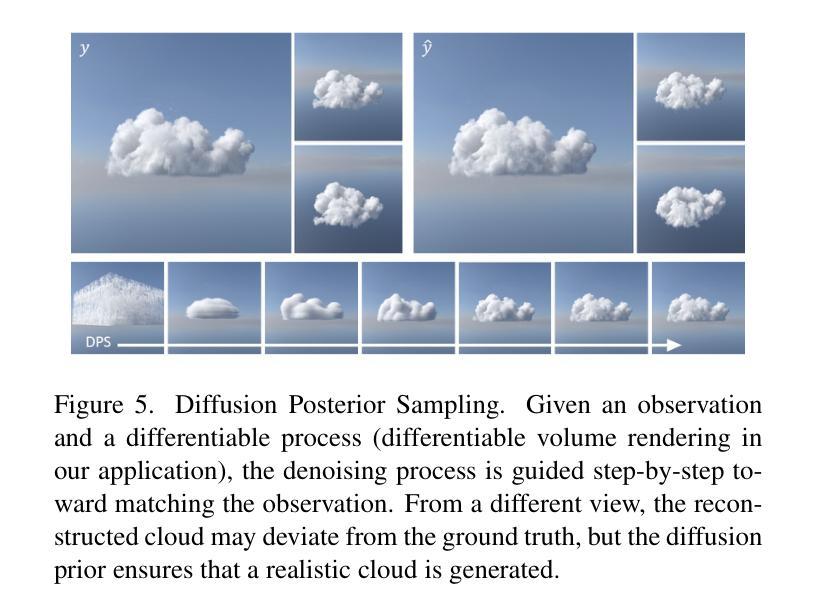

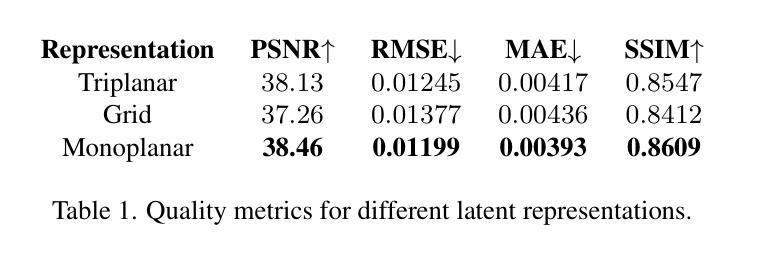

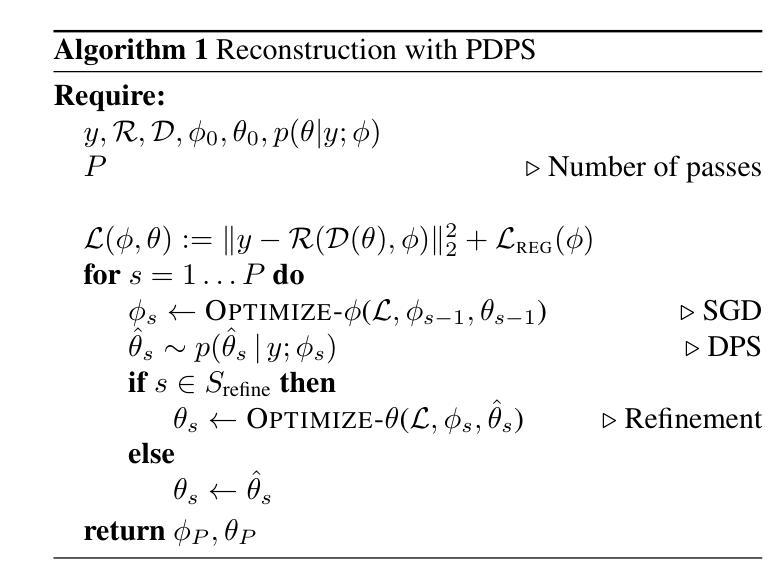

We introduce a single-view reconstruction technique of volumetric fields in which multiple light scattering effects are omnipresent, such as in clouds. We model the unknown distribution of volumetric fields using an unconditional diffusion model trained on a novel benchmark dataset comprising 1,000 synthetically simulated volumetric density fields. The neural diffusion model is trained on the latent codes of a novel, diffusion-friendly, monoplanar representation. The generative model is used to incorporate a tailored parametric diffusion posterior sampling technique into different reconstruction tasks. A physically-based differentiable volume renderer is employed to provide gradients with respect to light transport in the latent space. This stands in contrast to classic NeRF approaches and makes the reconstructions better aligned with observed data. Through various experiments, we demonstrate single-view reconstruction of volumetric clouds at a previously unattainable quality.

我们介绍了一种体积场单视图重建技术,该技术普遍存在多次散射效应,例如在云中。我们使用无条件扩散模型对体积场的未知分布进行建模,该模型是在由1000个合成模拟体积密度场组成的新型基准数据集上进行训练的。神经扩散模型是在一种新型的、适合扩散的单平面表示的潜在代码上进行训练的。生成模型被用于将定制的参数化扩散后采样技术融入不同的重建任务中。采用基于物理的可微体积渲染器,以提供关于潜在空间中光传输的梯度。这与经典的NeRF方法形成对比,使重建与观测数据更好地对齐。通过一系列实验,我们展示了体积云的单视图重建达到了前所未有的质量。

论文及项目相关链接

PDF CVPR 2025

Summary

本文介绍了一种单视图重建技术,该技术能够模拟在云等场景中的多次散射效应。通过采用新型基准数据集,对体积场分布进行建模并使用无条件扩散模型进行训练。该模型基于一种新型的扩散友好型单平面表示方法的潜在代码进行训练。采用定制的参数化扩散后采样技术融入不同的重建任务中,并采用基于物理的可微分体积渲染器来提供关于潜在空间的光传输梯度。与经典NeRF方法相比,这种方法使重建结果更加符合观测数据,并通过实验实现了体积云的单视图重建,达到了前所未有的质量。

Key Takeaways

- 引入了一种单视图重建技术,能够模拟多次散射效应,适用于云等场景。

- 采用新型基准数据集对体积场分布进行建模,并使用无条件扩散模型训练。

- 利用扩散友好型单平面表示方法的潜在代码进行训练。

- 采用定制的参数化扩散后采样技术融入重建任务中。

- 采用基于物理的可微分体积渲染器提供关于潜在空间的光传输梯度。

- 该方法使重建结果更符合观测数据。

点此查看论文截图

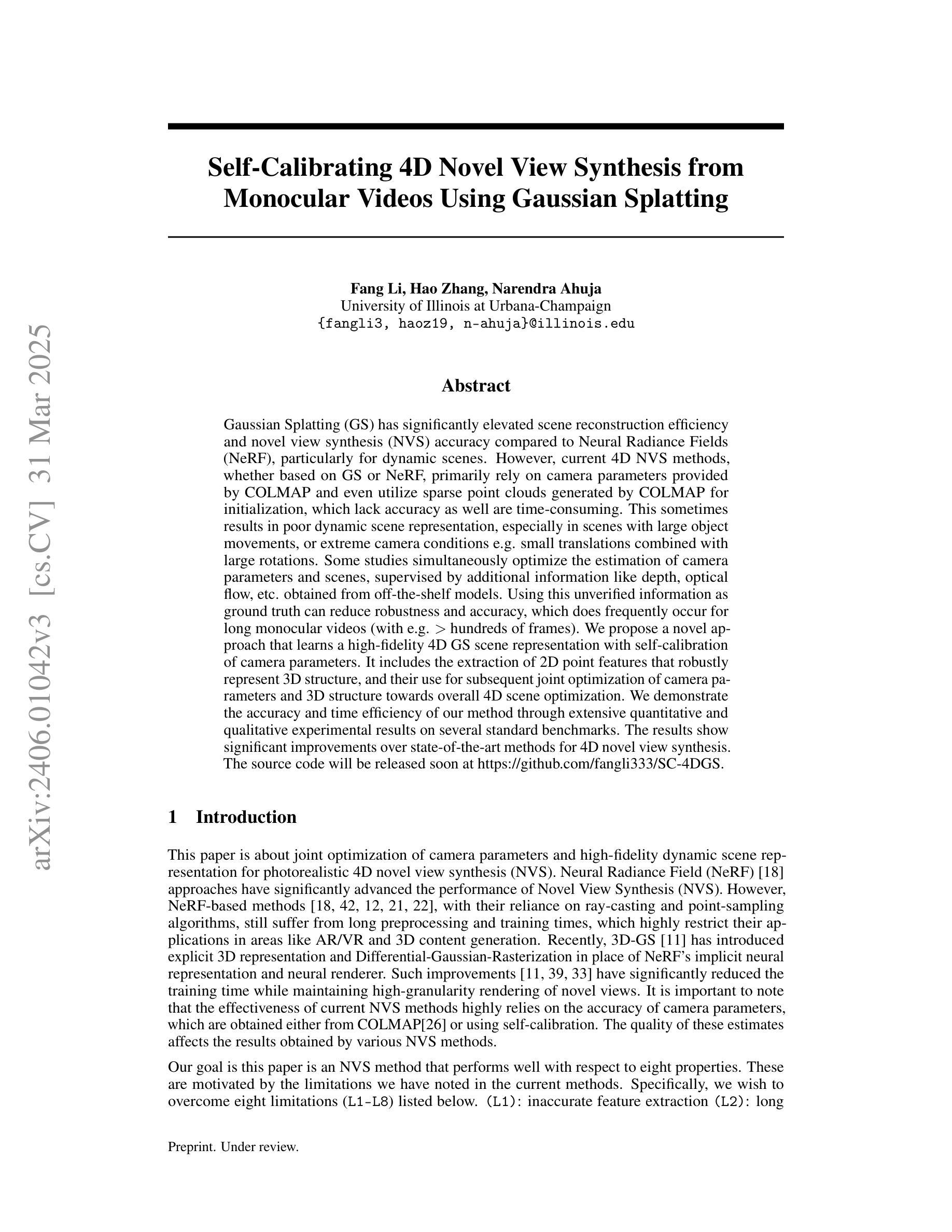

Self-Calibrating 4D Novel View Synthesis from Monocular Videos Using Gaussian Splatting

Authors:Fang Li, Hao Zhang, Narendra Ahuja

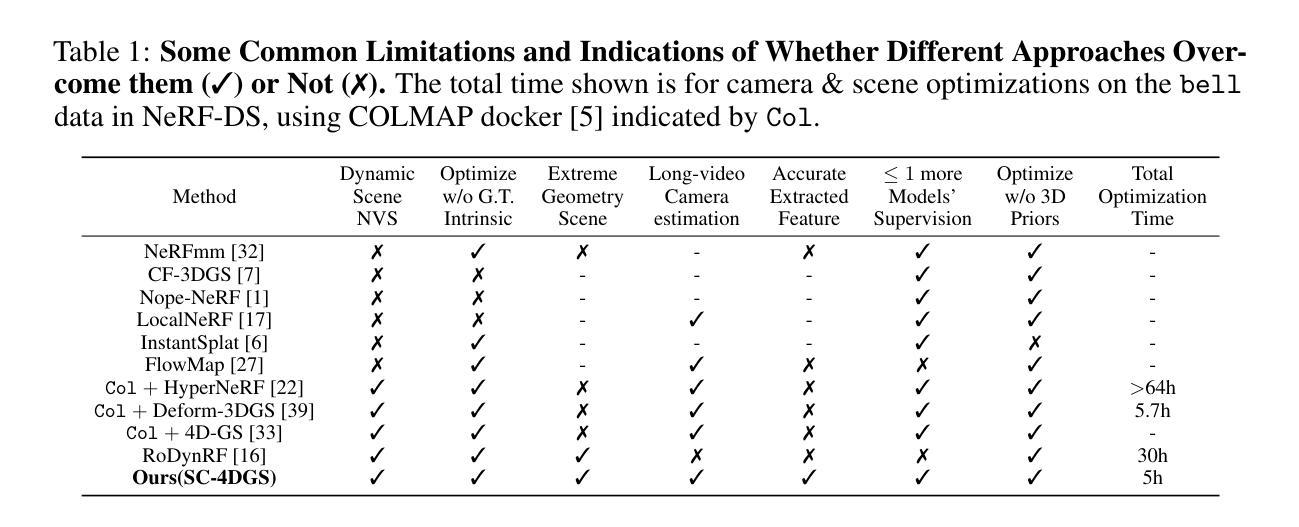

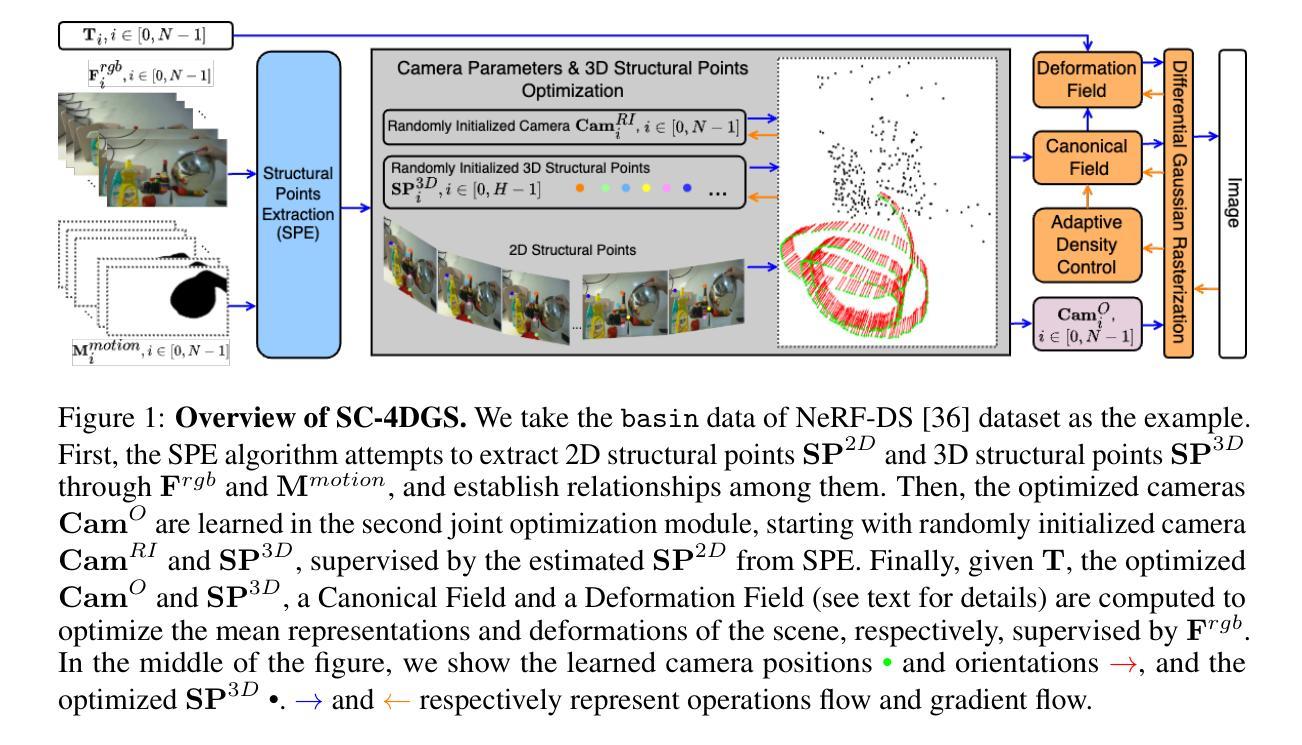

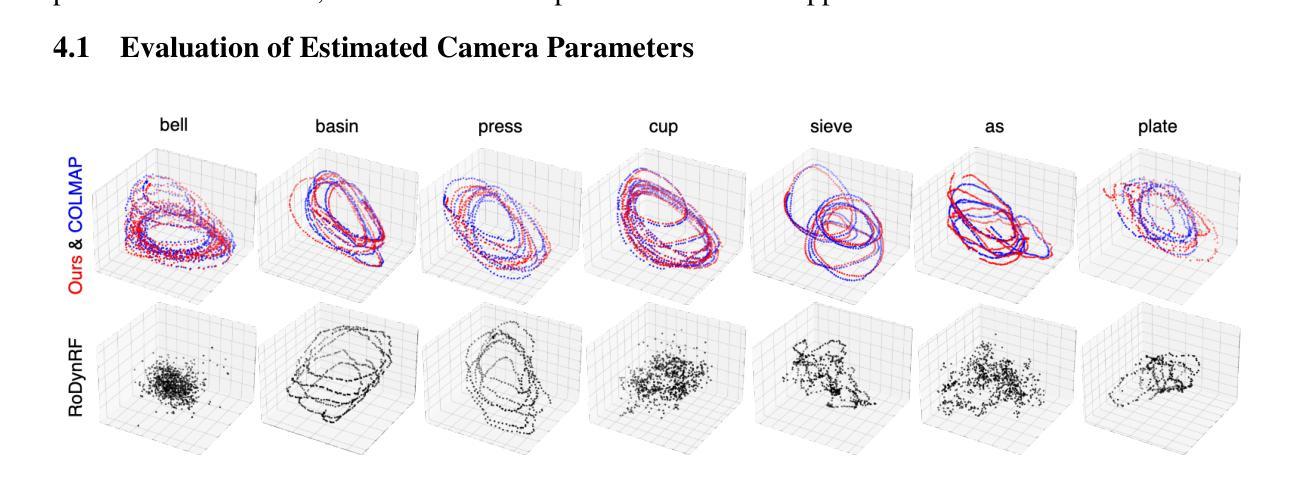

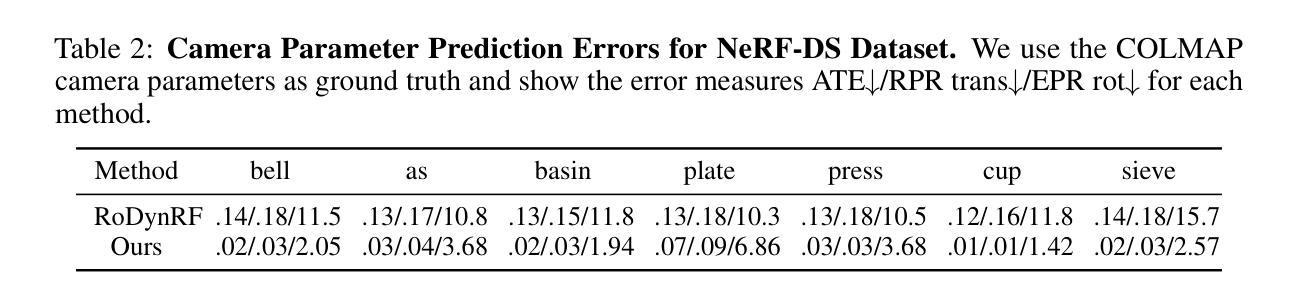

Gaussian Splatting (GS) has significantly elevated scene reconstruction efficiency and novel view synthesis (NVS) accuracy compared to Neural Radiance Fields (NeRF), particularly for dynamic scenes. However, current 4D NVS methods, whether based on GS or NeRF, primarily rely on camera parameters provided by COLMAP and even utilize sparse point clouds generated by COLMAP for initialization, which lack accuracy as well are time-consuming. This sometimes results in poor dynamic scene representation, especially in scenes with large object movements, or extreme camera conditions e.g. small translations combined with large rotations. Some studies simultaneously optimize the estimation of camera parameters and scenes, supervised by additional information like depth, optical flow, etc. obtained from off-the-shelf models. Using this unverified information as ground truth can reduce robustness and accuracy, which does frequently occur for long monocular videos (with e.g. > hundreds of frames). We propose a novel approach that learns a high-fidelity 4D GS scene representation with self-calibration of camera parameters. It includes the extraction of 2D point features that robustly represent 3D structure, and their use for subsequent joint optimization of camera parameters and 3D structure towards overall 4D scene optimization. We demonstrate the accuracy and time efficiency of our method through extensive quantitative and qualitative experimental results on several standard benchmarks. The results show significant improvements over state-of-the-art methods for 4D novel view synthesis. The source code will be released soon at https://github.com/fangli333/SC-4DGS.

基于高斯绘制技术(GS)的场景重建效率和新颖视角合成(NVS)精度相较于神经网络辐射场(NeRF)有显著提升,特别是对于动态场景而言。然而,当前的四维NVS方法,无论是基于GS还是NeRF,主要依赖于COLMAP提供的相机参数,甚至使用COLMAP生成的稀疏点云进行初始化,这既缺乏准确性又耗时。这有时会导致对动态场景的表示不佳,特别是在物体移动较大的场景或极端相机条件下(例如小平移与大旋转结合的情况)。一些研究同时优化相机参数的估计和场景,通过现成的模型获取深度、光流等额外信息进行监督。使用未经验证的信息作为真实数据可能会降低稳健性和准确性,这在针对具有数百帧的长单眼视频时经常发生。我们提出了一种新型方法,该方法采用自校准相机参数的方式学习高保真四维GS场景表示。它包含提取稳健代表三维结构的二维点特征,并将其用于联合优化相机参数和三维结构,以实现整体的四维场景优化。我们通过多个标准基准的定量和定性实验结果,展示了该方法的准确性和时间效率。结果显示,相较于四维新颖视角合成领域的最先进方法有明显的改进。源代码很快将在[https://github.com/fangli333/SC-4DGS发布。]

论文及项目相关链接

PDF GitHub Page: https://github.com/fangli333/SC-4DGS

Summary

本文提出一种基于高斯混成技术(Gaussian Splatting, GS)的自我校准4D场景表示方法。该方法能高效准确地重建场景并合成新视角,尤其适用于动态场景。通过提取稳健的2D特征点,联合优化相机参数和3D结构,达到整体的4D场景优化。在多个标准基准测试中表现优越。

Key Takeaways

- 高斯混成技术(GS)相较于神经网络辐射场(NeRF)提升了场景重建效率和新型视角合成(NVS)的准确性,特别是在动态场景中。

- 当前4D NVS方法主要依赖COLMAP提供的相机参数,并用于初始化稀疏点云,但这种方法准确性和效率较低。

- 文中提到的方法利用提取的2D特征点来稳健地表示3D结构,随后对相机参数和3D结构进行联合优化,实现自我校准的4D场景表示。

- 文中方法显著提高了4D新型视角合成的准确性,并在多个标准测试中表现优越。

- 所提出的方法适用于大型对象移动、极端相机条件(如小平移与大旋转结合)等复杂场景。

- 目前的方法依赖于额外的信息(如深度、光流等)来监督相机参数和场景的估计,这可能降低稳健性和准确性,特别是在长单目视频(如包含数百帧)中。

点此查看论文截图

MixRT: Mixed Neural Representations For Real-Time NeRF Rendering

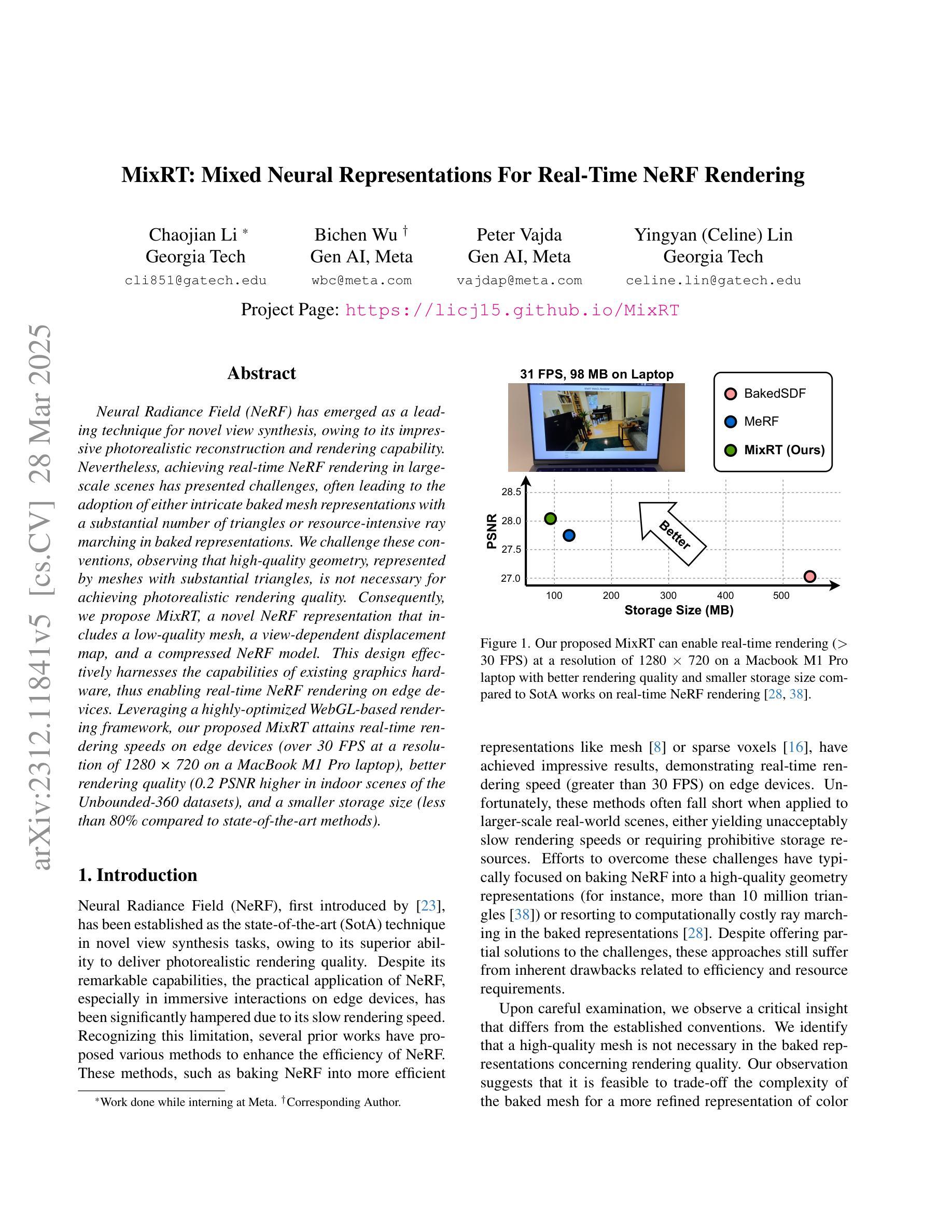

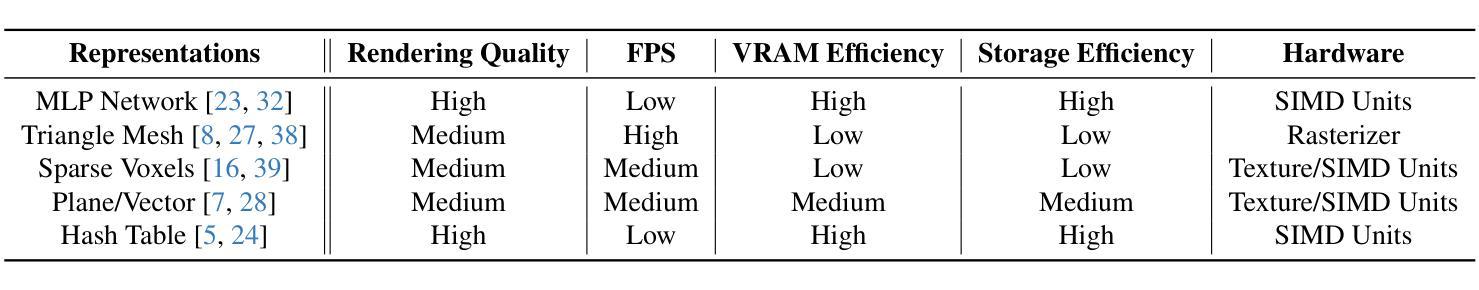

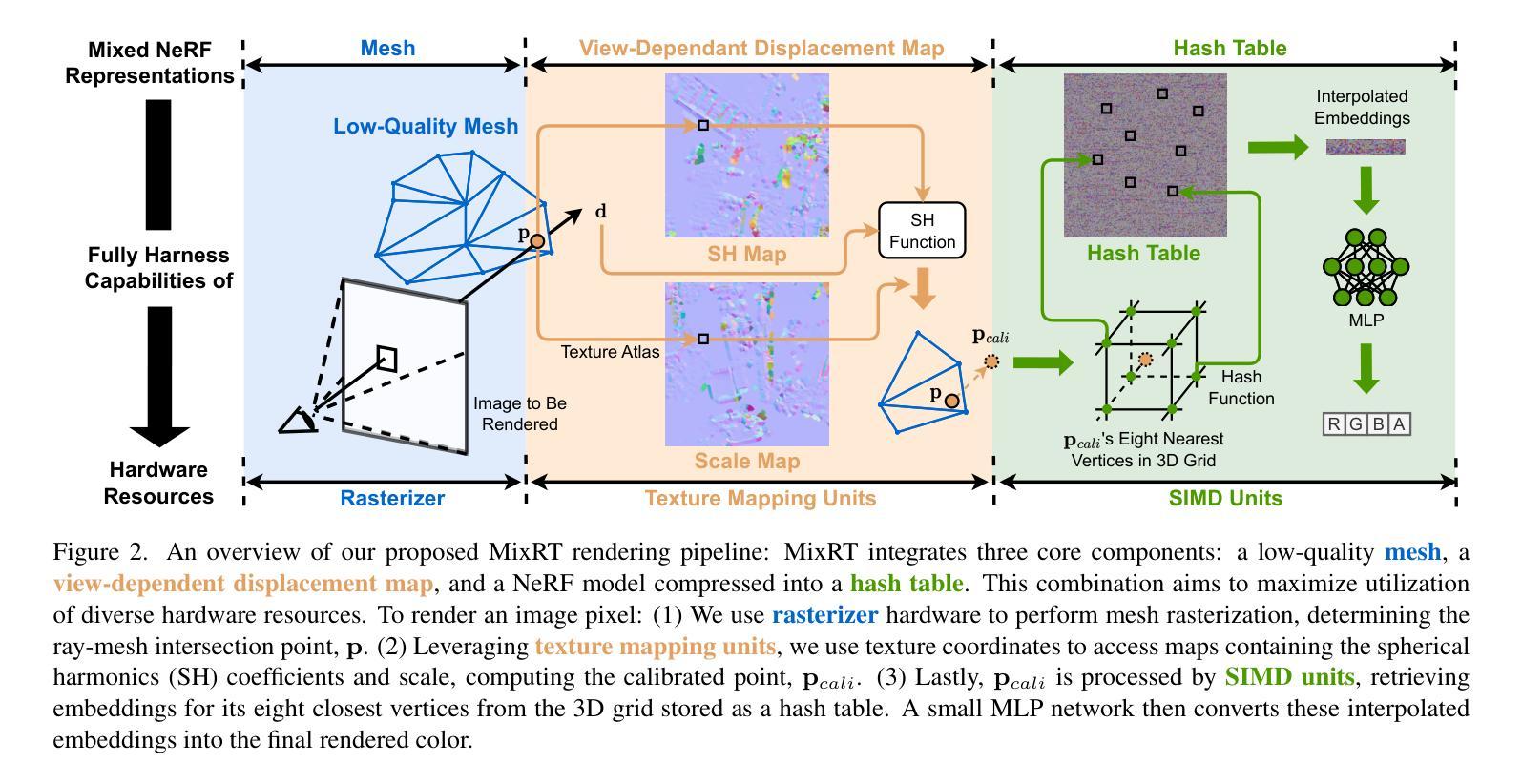

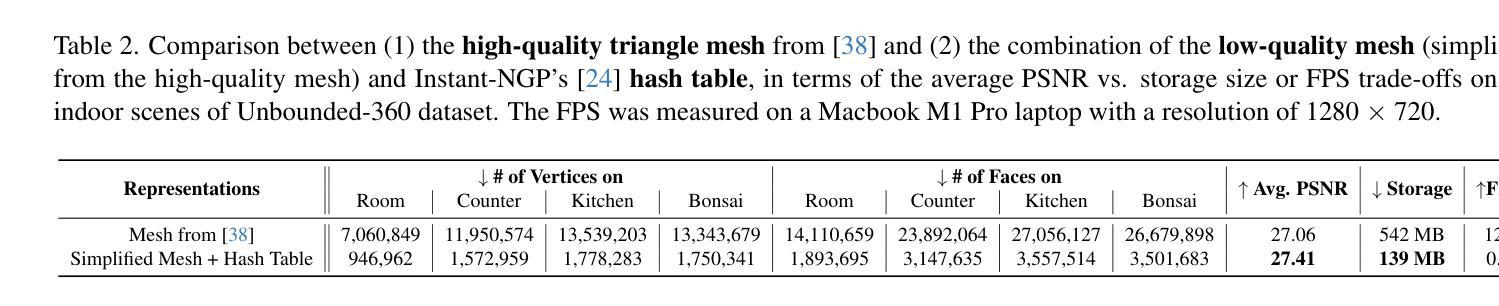

Authors:Chaojian Li, Bichen Wu, Peter Vajda, Yingyan Celine Lin

Neural Radiance Field (NeRF) has emerged as a leading technique for novel view synthesis, owing to its impressive photorealistic reconstruction and rendering capability. Nevertheless, achieving real-time NeRF rendering in large-scale scenes has presented challenges, often leading to the adoption of either intricate baked mesh representations with a substantial number of triangles or resource-intensive ray marching in baked representations. We challenge these conventions, observing that high-quality geometry, represented by meshes with substantial triangles, is not necessary for achieving photorealistic rendering quality. Consequently, we propose MixRT, a novel NeRF representation that includes a low-quality mesh, a view-dependent displacement map, and a compressed NeRF model. This design effectively harnesses the capabilities of existing graphics hardware, thus enabling real-time NeRF rendering on edge devices. Leveraging a highly-optimized WebGL-based rendering framework, our proposed MixRT attains real-time rendering speeds on edge devices (over 30 FPS at a resolution of 1280 x 720 on a MacBook M1 Pro laptop), better rendering quality (0.2 PSNR higher in indoor scenes of the Unbounded-360 datasets), and a smaller storage size (less than 80% compared to state-of-the-art methods).

神经辐射场(NeRF)已经成为新型视角合成的主流技术,因其令人印象深刻的逼真重建和渲染能力。然而,在大规模场景中实现实时NeRF渲染提出了挑战,通常导致采用复杂的预烘焙网格表示法,其中包含大量的三角形,或者采用预烘焙表示法中的资源密集型光线追踪。我们质疑这些传统观念,观察到高质量几何体(由大量三角形表示的网格)对于实现逼真渲染质量并非必要。因此,我们提出了MixRT,这是一种新型的NeRF表示方法,它包含低质量网格、视差相关位移图和压缩NeRF模型。这种设计有效地利用了现有图形硬件的功能,从而在边缘设备上实现了实时NeRF渲染。通过基于高度优化的WebGL渲染框架,我们提出的MixRT在边缘设备上实现了实时渲染速度(在MacBook M1 Pro笔记本电脑上以1280 x 720的分辨率超过30 FPS),更好的渲染质量(在Unbounded-360数据集室内场景中高出0.2 PSNR),并且存储大小更小(与最先进的方法相比减少了不到80%)。

论文及项目相关链接

PDF Accepted by 3DV’24. Project Page: https://licj15.github.io/MixRT/

Summary

本文介绍了NeRF技术在新型视图合成方面的前沿应用,提出一种名为MixRT的NeRF表示方法,通过结合低质量网格、视角相关位移图和压缩NeRF模型,实现了对大规模场景的实时渲染。利用优化的WebGL渲染框架,MixRT在边缘设备上实现了实时渲染速度,同时提高了渲染质量和存储效率。

Key Takeaways

- NeRF技术已成为新型视图合成的领先技术,具有惊人的照片级重建和渲染能力。

- 实现大规模场景实时NeRF渲染具有挑战,通常采用复杂的烘焙网格表示或资源密集型的射线追踪方法。

- 本文挑战了上述常规方法,指出高质量几何网格并非实现照片级渲染质量的必要条件。

- 提出了MixRT,一种结合低质量网格、视角相关位移图和压缩NeRF模型的NeRF表示方法。

- MixRT有效利用现有图形硬件,使实时NeRF渲染在边缘设备上成为可能。

- 利用高度优化的WebGL渲染框架,MixRT实现了边缘设备上的实时渲染速度,并在Unbound-360数据集室内场景中获得更高的渲染质量。

点此查看论文截图