⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-04-04 更新

Are you really listening? Boosting Perceptual Awareness in Music-QA Benchmarks

Authors:Yongyi Zang, Sean O’Brien, Taylor Berg-Kirkpatrick, Julian McAuley, Zachary Novack

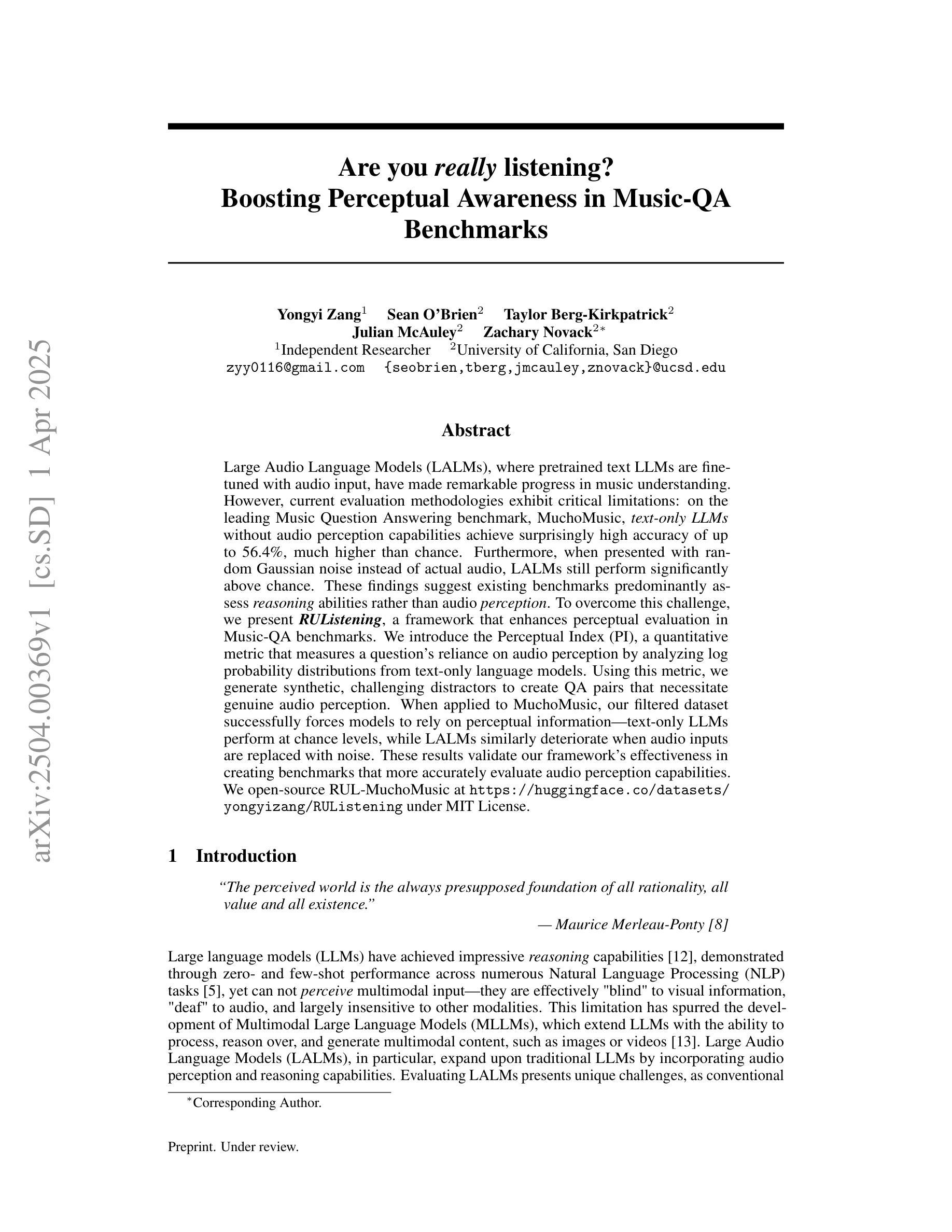

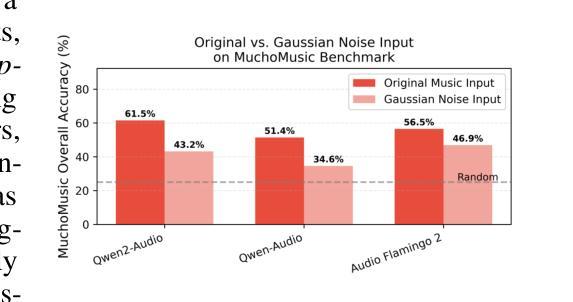

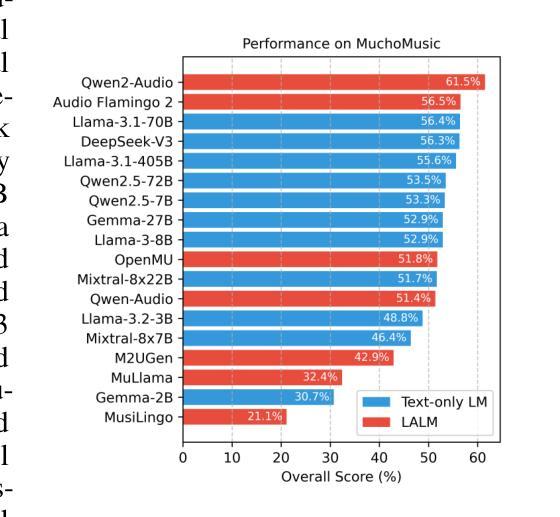

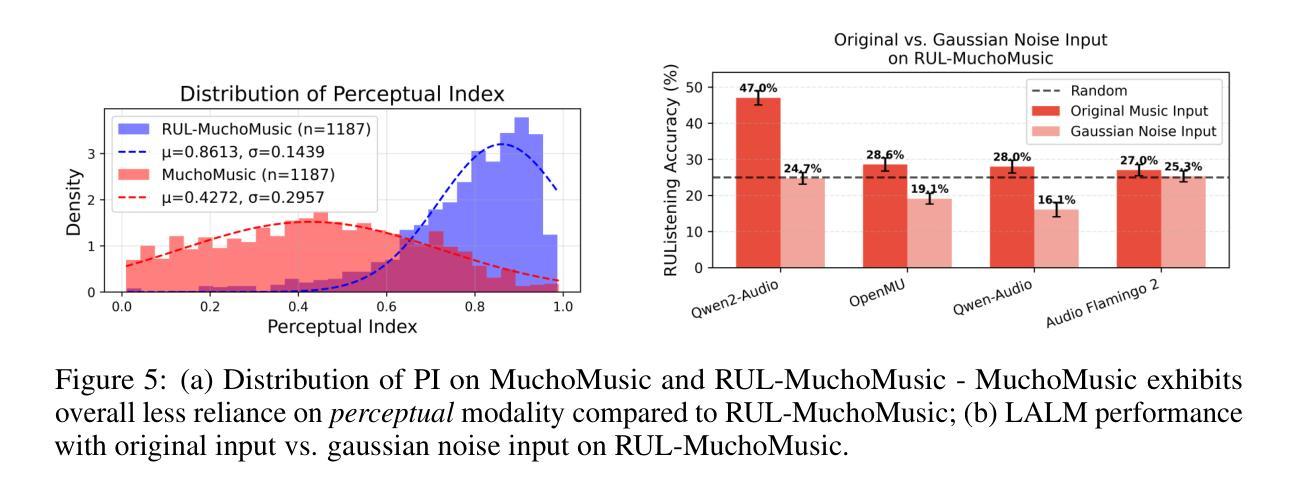

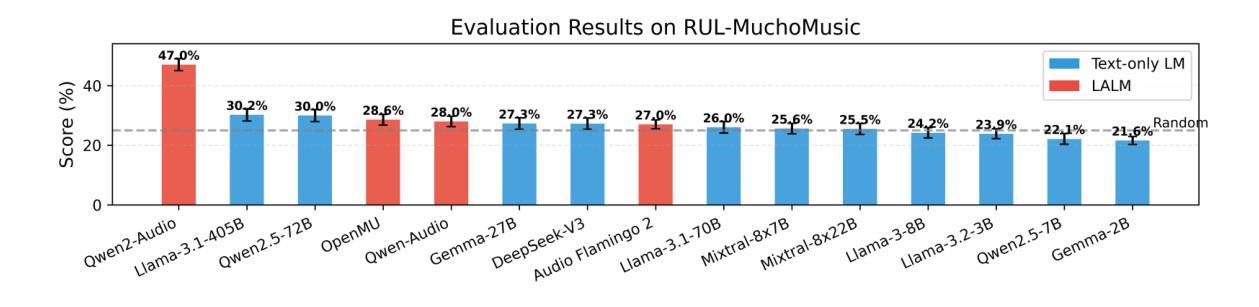

Large Audio Language Models (LALMs), where pretrained text LLMs are finetuned with audio input, have made remarkable progress in music understanding. However, current evaluation methodologies exhibit critical limitations: on the leading Music Question Answering benchmark, MuchoMusic, text-only LLMs without audio perception capabilities achieve surprisingly high accuracy of up to 56.4%, on par or above most LALMs. Furthermore, when presented with random Gaussian noise instead of actual audio, LALMs still perform significantly above chance. These findings suggest existing benchmarks predominantly assess reasoning abilities rather than audio perception. To overcome this challenge, we present RUListening: Robust Understanding through Listening, a framework that enhances perceptual evaluation in Music-QA benchmarks. We introduce the Perceptual Index (PI), a quantitative metric that measures a question’s reliance on audio perception by analyzing log probability distributions from text-only language models. Using this metric, we generate synthetic, challenging distractors to create QA pairs that necessitate genuine audio perception. When applied to MuchoMusic, our filtered dataset successfully forces models to rely on perceptual information-text-only LLMs perform at chance levels, while LALMs similarly deteriorate when audio inputs are replaced with noise. These results validate our framework’s effectiveness in creating benchmarks that more accurately evaluate audio perception capabilities.

音频大语言模型(LALMs)在音乐理解方面取得了显著进展,这些模型是通过在预训练的文本大型语言模型(LLMs)上进行微调,以音频输入进行训练。然而,现有的评估方法存在重要局限性:在领先的Music Question Answering基准测试MuchoMusic上,没有音频感知能力的纯文本LLMs竟然达到了高达56.4%的惊人准确率,与大多数LALM持平或更高。此外,当面对随机高斯噪声而非实际音频时,LALMs的表现仍然显著超过随机水平。这些发现表明,现有的基准测试主要评估的是推理能力,而不是音频感知能力。为了应对这一挑战,我们提出了RUListening:通过倾听实现稳健理解,这是一个增强音乐问答基准测试中感知评估的框架。我们引入了感知指数(PI)这一量化指标,它通过分析纯文本语言模型的日志概率分布来衡量问题对音频感知的依赖程度。使用这一指标,我们生成了合成挑战干扰项,以创建需要真正音频感知的问答对。在MuchoMusic上的应用显示,我们的过滤数据集成功迫使模型依赖感知信息——纯文本LLMs的表现达到了随机水平,而当将LALM的音频输入替换为噪声时,其表现也大幅下降。这些结果验证了我们框架在创建更准确地评估音频感知能力的基准测试中的有效性。

论文及项目相关链接

Summary

大规模音频语言模型(LALMs)在音乐理解方面取得了显著进展,但现有评估方法存在严重局限性。研究表明,在没有音频感知能力的纯文本LLMs上,现有的音乐问答基准测试如MuchoMusic的准确率令人惊讶地高达56.4%,与许多LALMs不相上下或更高。当面对随机高斯噪声时,LALMs的表现仍然显著高于平均水平。这暗示现有的基准测试主要评估的是推理能力而非音频感知能力。为此,我们提出了RUListening框架,通过听力增强音乐问答基准测试的感知评估。我们引入了感知指数(PI)这一量化指标,通过分析纯文本语言模型的日志概率分布来衡量问题对音频感知的依赖程度。利用这一指标,我们生成了需要真实音频感知的QA对作为合成挑战干扰项。在MuchoMusic的应用中,我们的筛选数据集成功迫使模型依赖于感知信息——纯文本LLMs的表现达到了机会水平,而LALMs在音频输入被替换为噪声时也同样表现不佳。这验证了我们框架在创建更准确评估音频感知能力的基准测试中的有效性。

Key Takeaways

- LALMs在音乐理解方面取得显著进展,但现有评估方法存在局限性。

- 纯文本LLMs在Music Question Answering基准测试上的表现令人惊讶。

- 现有基准测试主要评估的是推理能力而非音频感知能力。

- 引入RUListening框架和Perceptual Index(PI)指标以加强音乐问答基准测试中的感知评估。

- 利用PI指标生成合成挑战干扰项以提高评估准确性。

- 在筛选数据集中,纯文本LLMs的表现达到机会水平,说明它们不依赖音频感知。

点此查看论文截图

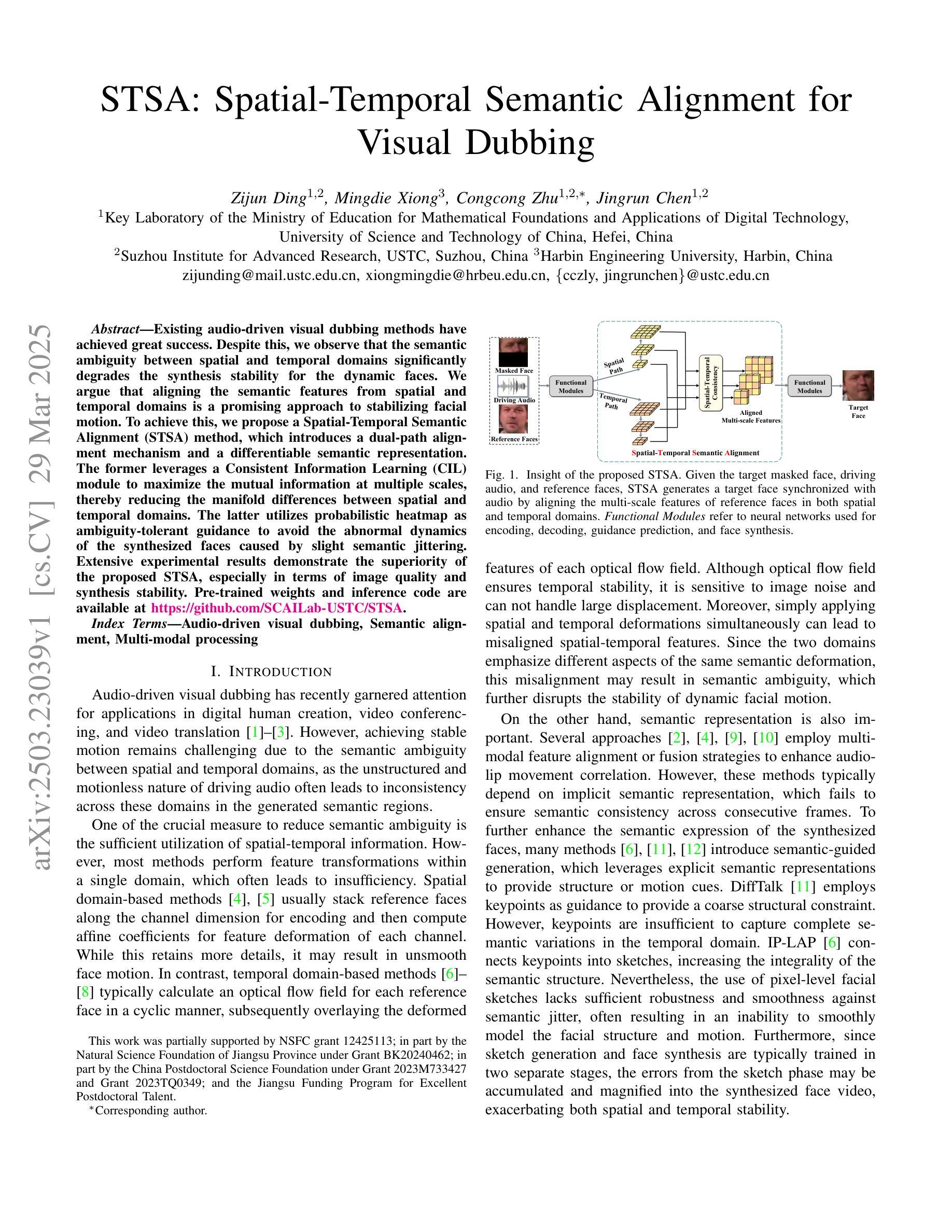

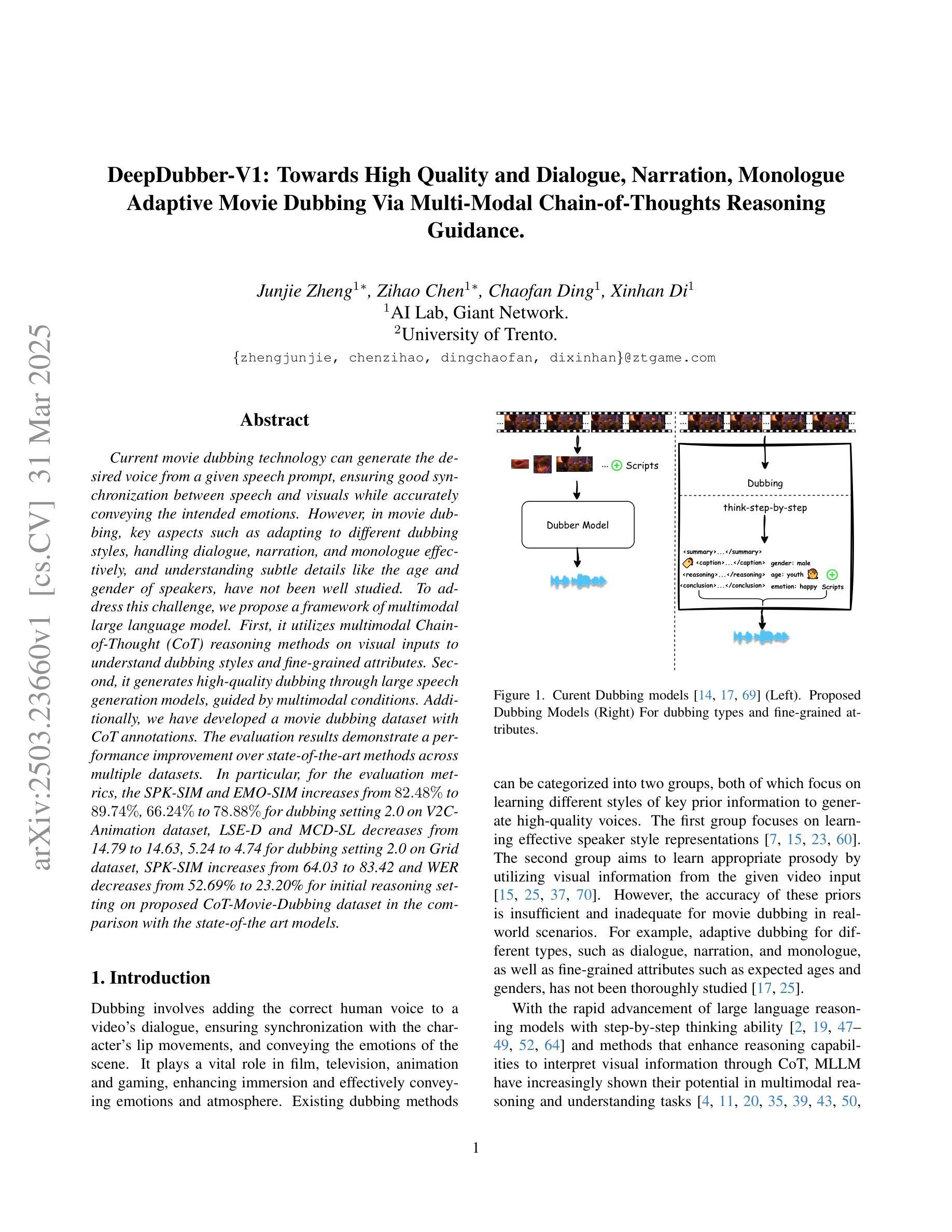

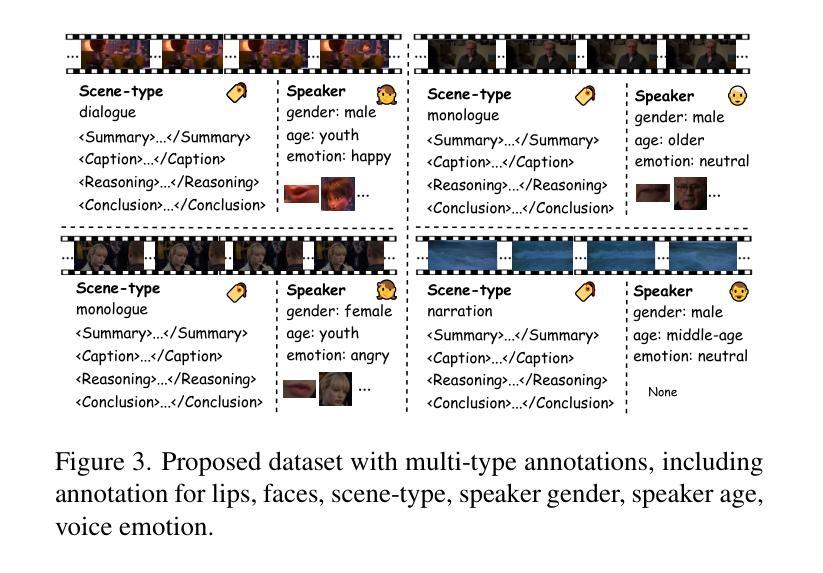

DeepDubber-V1: Towards High Quality and Dialogue, Narration, Monologue Adaptive Movie Dubbing Via Multi-Modal Chain-of-Thoughts Reasoning Guidance

Authors:Junjie Zheng, Zihao Chen, Chaofan Ding, Xinhan Di

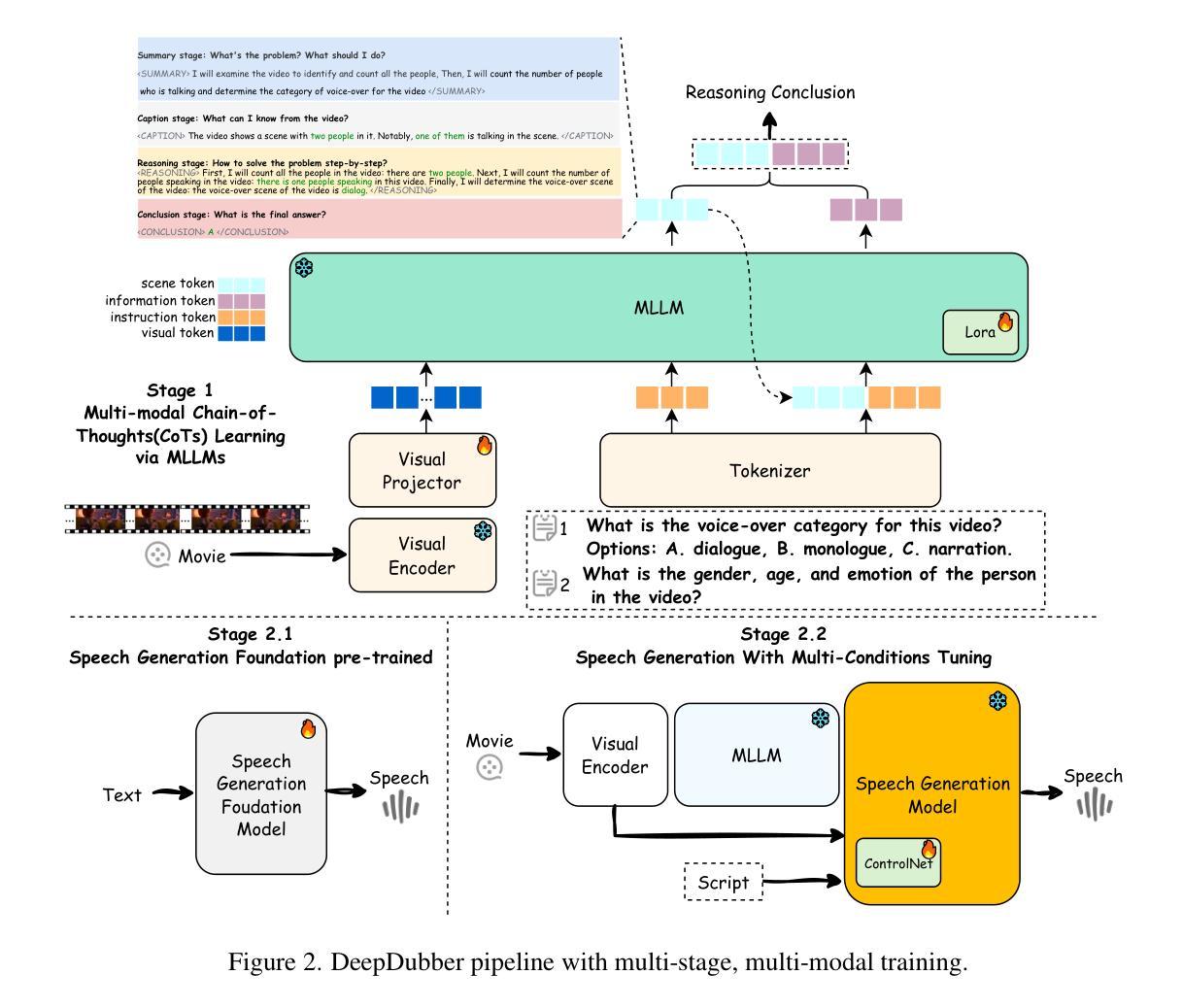

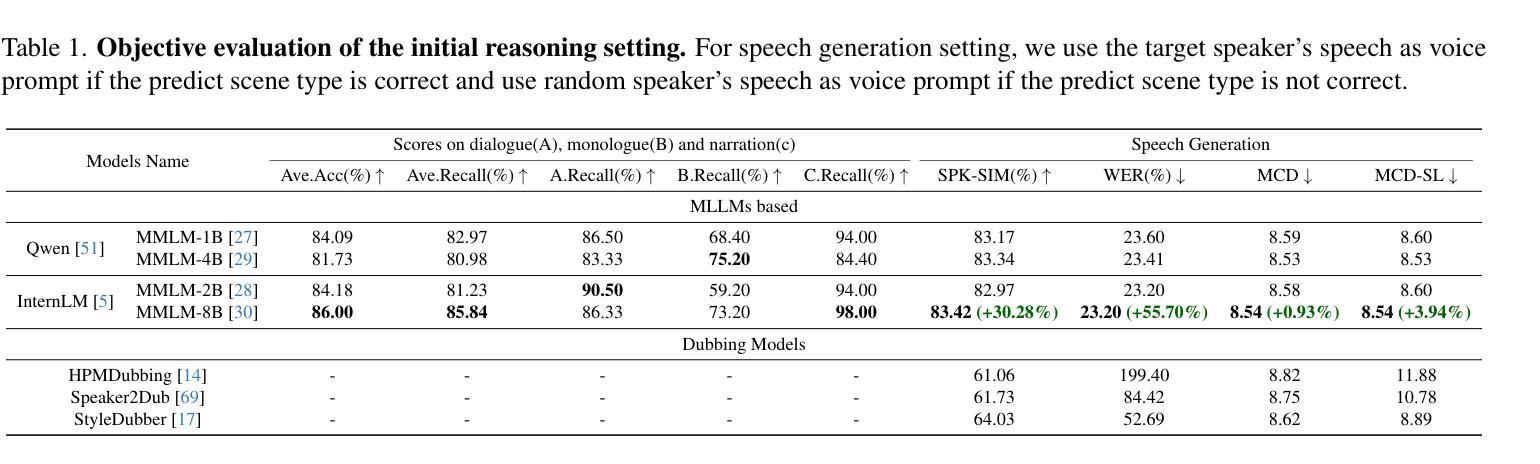

Current movie dubbing technology can generate the desired voice from a given speech prompt, ensuring good synchronization between speech and visuals while accurately conveying the intended emotions. However, in movie dubbing, key aspects such as adapting to different dubbing styles, handling dialogue, narration, and monologue effectively, and understanding subtle details like the age and gender of speakers, have not been well studied. To address this challenge, we propose a framework of multi-modal large language model. First, it utilizes multimodal Chain-of-Thought (CoT) reasoning methods on visual inputs to understand dubbing styles and fine-grained attributes. Second, it generates high-quality dubbing through large speech generation models, guided by multimodal conditions. Additionally, we have developed a movie dubbing dataset with CoT annotations. The evaluation results demonstrate a performance improvement over state-of-the-art methods across multiple datasets. In particular, for the evaluation metrics, the SPK-SIM and EMO-SIM increases from 82.48% to 89.74%, 66.24% to 78.88% for dubbing setting 2.0 on V2C Animation dataset, LSE-D and MCD-SL decreases from 14.79 to 14.63, 5.24 to 4.74 for dubbing setting 2.0 on Grid dataset, SPK-SIM increases from 64.03 to 83.42 and WER decreases from 52.69% to 23.20% for initial reasoning setting on proposed CoT-Movie-Dubbing dataset in the comparison with the state-of-the art models.

当前的电影配音技术可以根据给定的语音提示生成所需的声音,确保语音和视觉之间的良好同步,同时准确传达预期的情绪。然而,在电影配音中,如何适应不同的配音风格、有效处理对话、旁白和独白,以及理解如说话人的年龄和性别等细微细节等方面尚未得到很好的研究。为了应对这一挑战,我们提出了一个多模态大语言模型框架。首先,它利用视觉输入的链式思维(Chain-of-Thought,CoT)推理方法,理解配音风格和精细属性。其次,通过大型语音生成模型生成高质量的配音,由多模态条件引导。此外,我们还开发了一个带有CoT注释的电影配音数据集。评估结果表明,与最先进的方法相比,我们在多个数据集上的性能有所提高。具体而言,对于评估指标,V2C Animation数据集的配音设置2.0中,SPK-SIM和EMO-SIM分别从82.48%提高到89.74%,从66.24%提高到78.88%;Grid数据集的配音设置2.0中,LSE-D和MCD-SL分别从14.79降至到14.63,从5.24降至到4.74;与最先进模型相比,在提出的CoT-Movie-Dubbing数据集上进行初步推理设置时,SPK-SIM从64.03%提高到83.42%,WER从52.69%降至到23.20%。

论文及项目相关链接

PDF 11 pages, 5 figures

摘要

当前电影配音技术可从给定的语音提示生成所需的语音,确保语音与视觉之间的良好同步,同时准确传达预期的情绪。然而,在电影配音中,如何适应不同的配音风格、有效处理对话、旁白和独白,以及理解如说话人的年龄和性别等细微之处尚未得到很好的研究。为应对这一挑战,我们提出了多模态大型语言模型框架。首先,它利用视觉输入的链式思维(CoT)推理方法,理解配音风格和精细属性。其次,通过大型语音生成模型生成高质量配音,受多模态条件的引导。此外,我们还开发了带有CoT注释的电影配音数据集。评估结果表明,与最新方法相比,我们的方法在多个数据集上的表现有所提高。特别是在评估指标方面,V2C动画数据集的说话人相似性(SPK-SIM)和情感相似性(EMO-SIM)分别从82.48%提高到89.74%,66.24%提高到78.88%;Grid数据集的说话人相似性(LSE-D)和语调相似性(MCD-SL)分别从从降低至的对比实验中在提出的数据集上的说话人相似性(SPK-SIM)从原来的提升至,单词错误率(WER)从原来的降至。

关键见解

一、当前电影配音技术已能够同步语音和视觉,准确传达情绪。但仍需研究如何适应不同的配音风格和处理对话、旁白和独白等。

二、提出了多模态大型语言模型框架来解决上述问题,它利用视觉输入的链式思维(CoT)推理方法来理解配音风格和精细属性。

三、通过大型语音生成模型生成高质量配音,此过程受多模态条件引导。

四、开发了带有CoT注释的电影配音数据集以促进研究。

五、与现有方法相比,该框架在多个数据集上的表现有所提升。

六、在V2C动画数据集上的实验结果显示,SPK-SIM和EMO-SIM指标有明显提升。

七、在Grid数据集上的实验结果显示说话人相似性和语调相似性有所改善。

点此查看论文截图

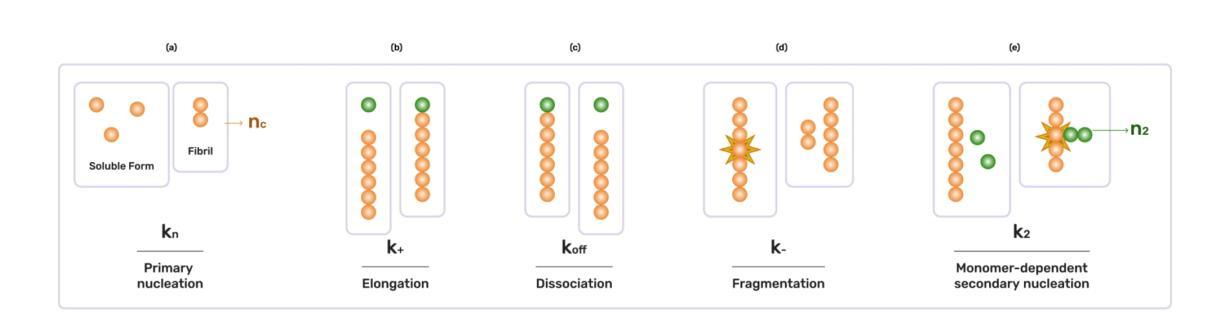

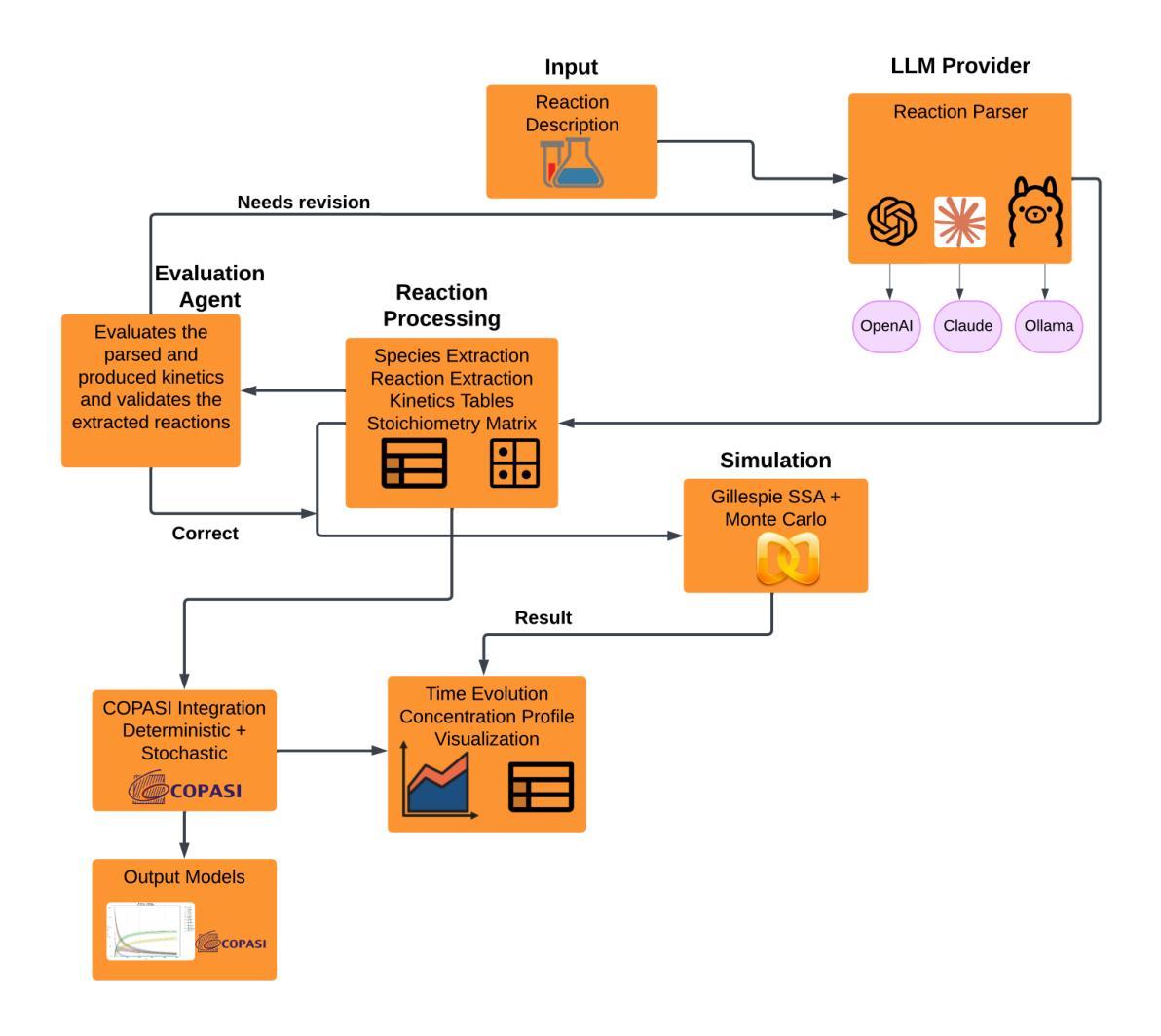

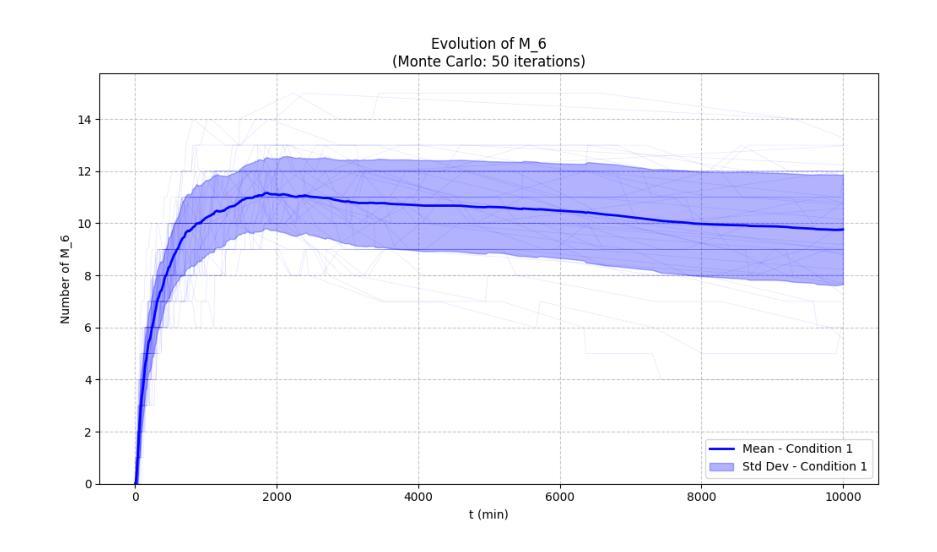

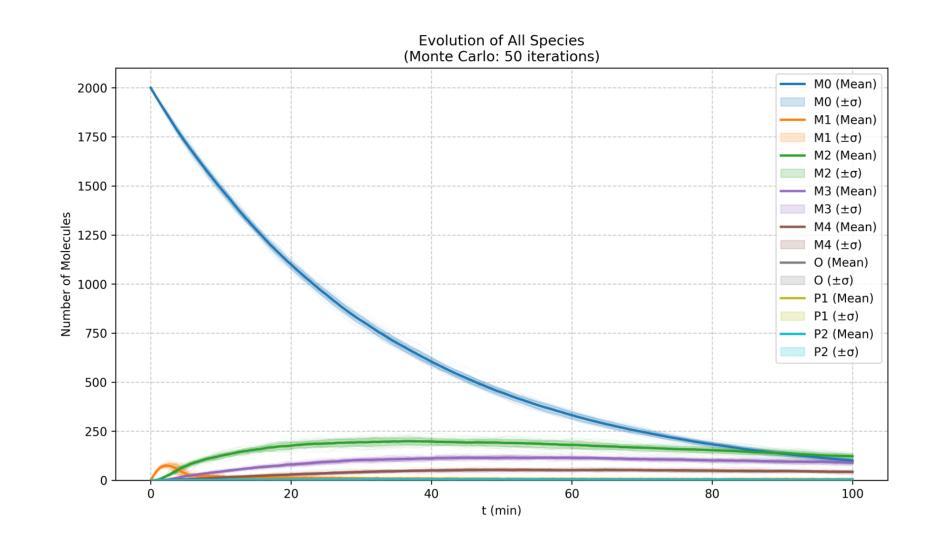

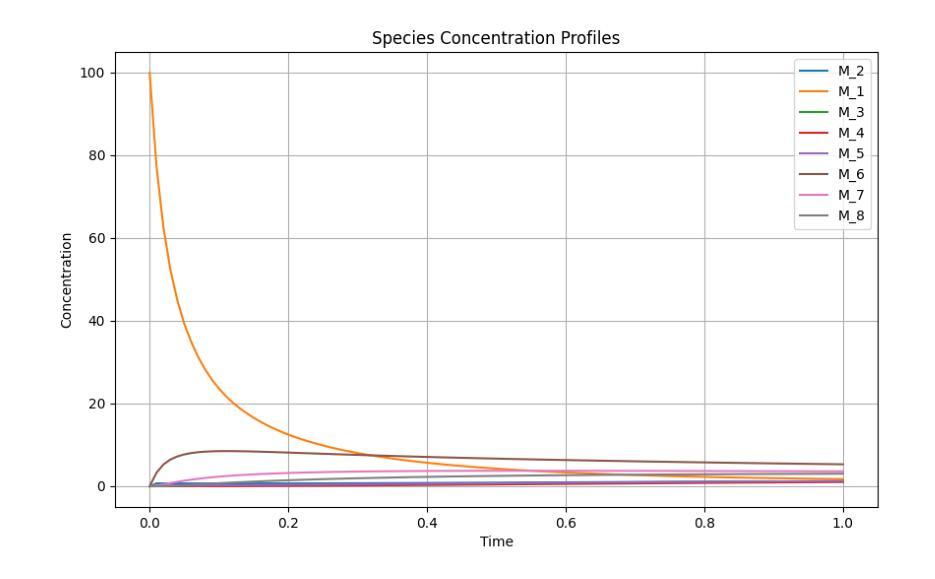

Integrating Large Language Models For Monte Carlo Simulation of Chemical Reaction Networks

Authors:Sadikshya Gyawali, Ashwini Mandal, Manish Dahal, Manish Awale, Sanjay Rijal, Shital Adhikari, Vaghawan Ojha

Chemical reaction network is an important method for modeling and exploring complex biological processes, bio-chemical interactions and the behavior of different dynamics in system biology. But, formulating such reaction kinetics takes considerable time. In this paper, we leverage the efficiency of modern large language models to automate the stochastic monte carlo simulation of chemical reaction networks and enable the simulation through the reaction description provided in the form of natural languages. We also integrate this process into widely used simulation tool Copasi to further give the edge and ease to the modelers and researchers. In this work, we show the efficacy and limitations of the modern large language models to parse and create reaction kinetics for modelling complex chemical reaction processes.

化学反应网络是模拟和探索复杂生物过程、生物化学交互和系统生物学中不同动态行为的重要方法。但是,构建这样的反应动力学需要花费大量时间。在本文中,我们利用现代大型语言模型的效率,自动进行化学反应网络的随机蒙特卡洛模拟,并通过自然语言形式提供的反应描述来实现模拟。我们还将该过程整合到广泛使用的模拟工具Copasi中,以便为建模人员和研究人员提供优势和便利。在这项工作中,我们展示了现代大型语言模型在解析和创建反应动力学以模拟复杂的化学反应过程中的效果和局限性。

论文及项目相关链接

PDF Accepted on MadeAI 2025 Conference

Summary

化学反应网络是系统生物学中模拟和探索复杂生物过程、生物化学相互作用以及不同动力学行为的重要方法,但构建反应动力学需要耗费大量时间。本研究利用现代大型语言模型的效率,实现了化学反应网络的随机蒙特卡洛模拟的自动化,并通过自然语言形式提供的反应描述进行模拟。同时,研究将这一过程整合到广泛使用的模拟工具Copasi中,为建模人员和研究人员提供了优势和便利。本研究展示了现代大型语言模型在解析和创建反应动力学以模拟复杂化学反应过程的效果和局限性。

Key Takeaways

- 化学反应网络是模拟复杂生物过程的关键方法。

- 利用现代大型语言模型可自动化化学反应网络的蒙特卡洛模拟。

- 自然语言的反应描述可用于实现模拟。

- 将该过程整合到Copasi等模拟工具中,为建模和研究提供了便利。

- 大型语言模型在解析和创建反应动力学方面表现出效果和局限性。

- 此方法提高了模拟复杂化学反应过程的效率。

点此查看论文截图

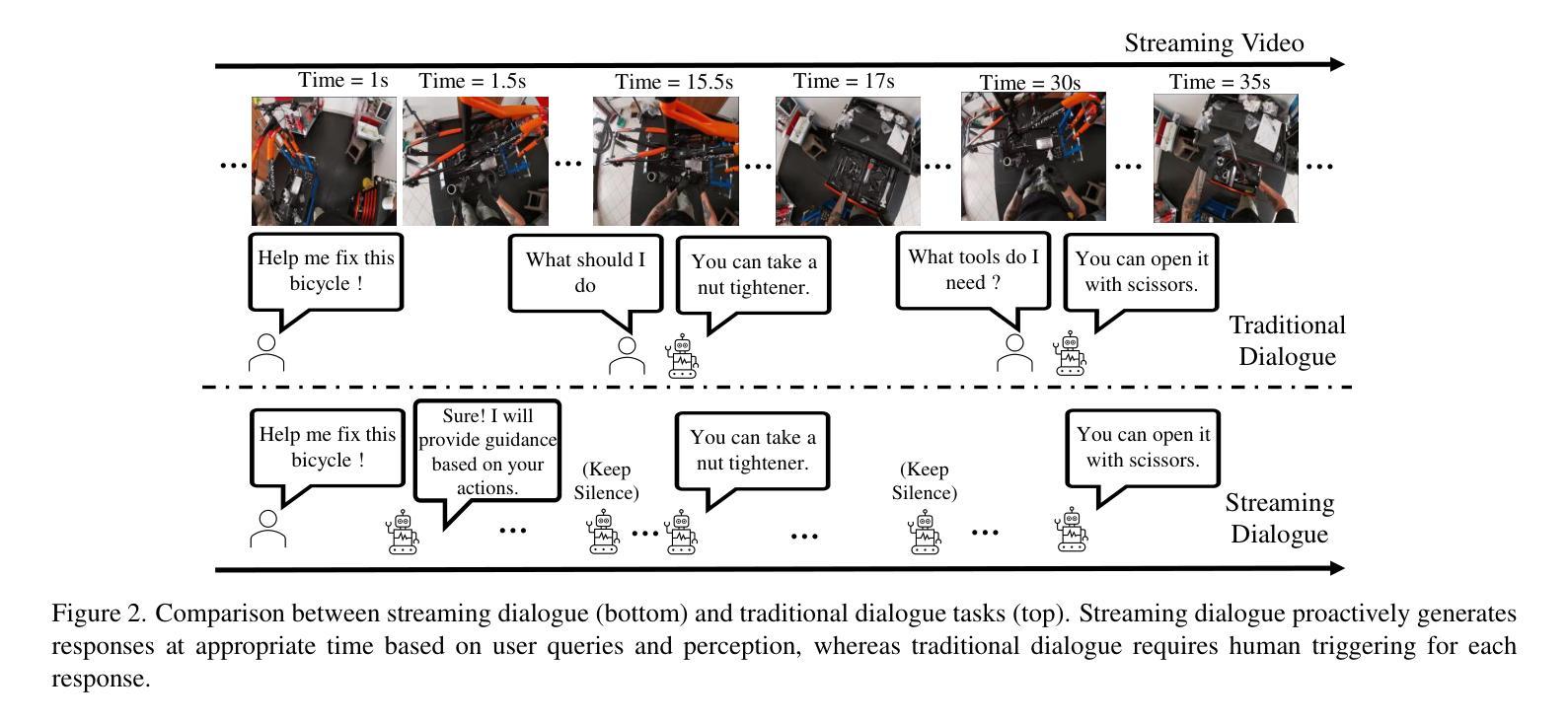

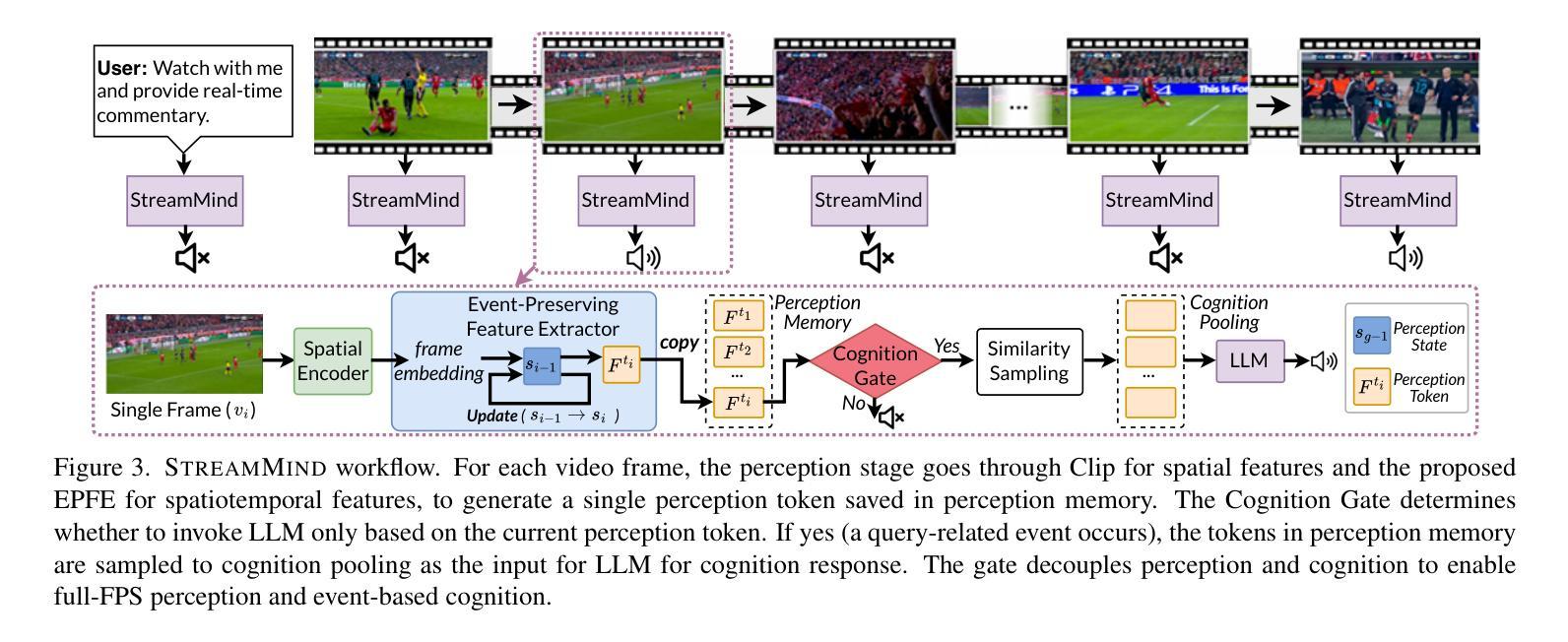

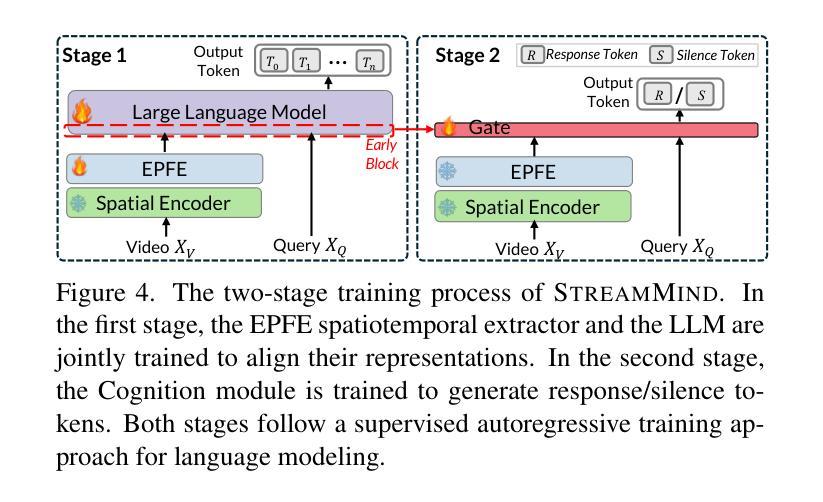

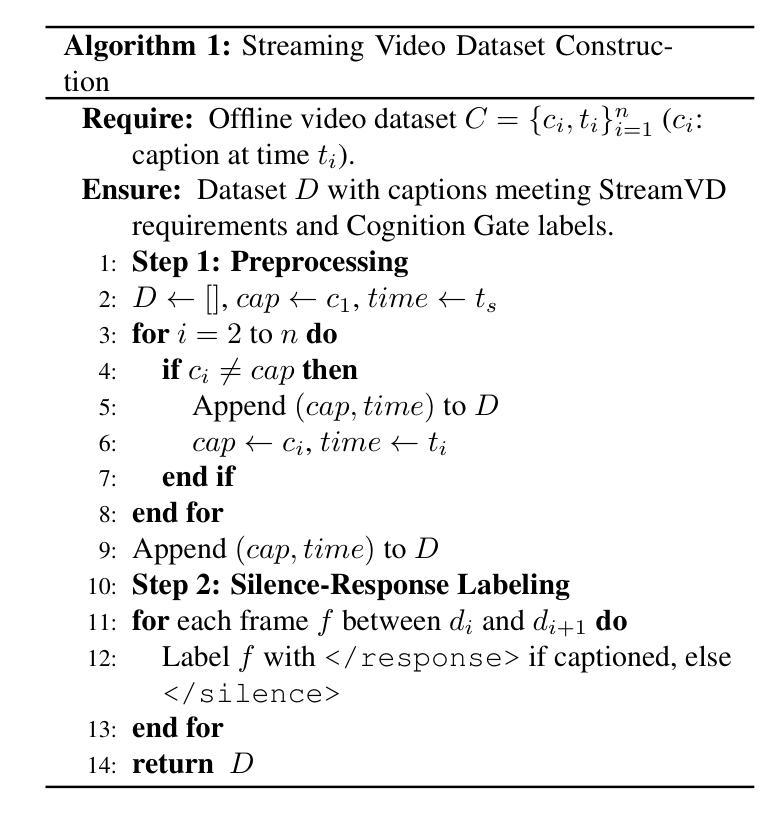

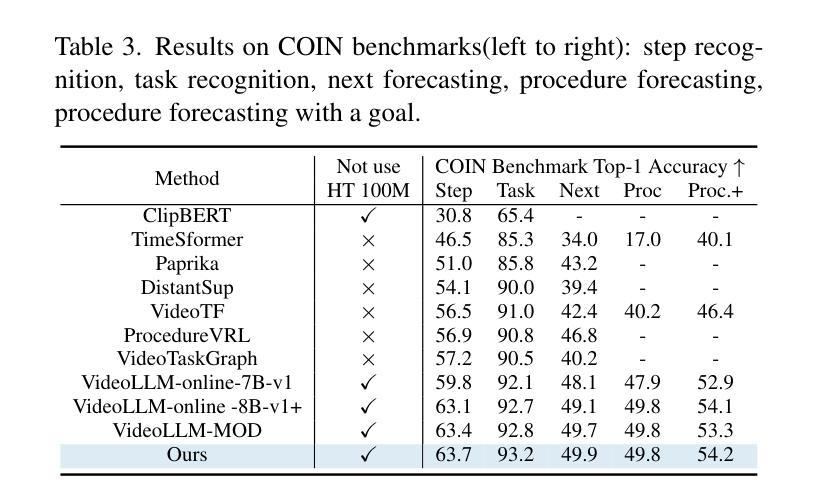

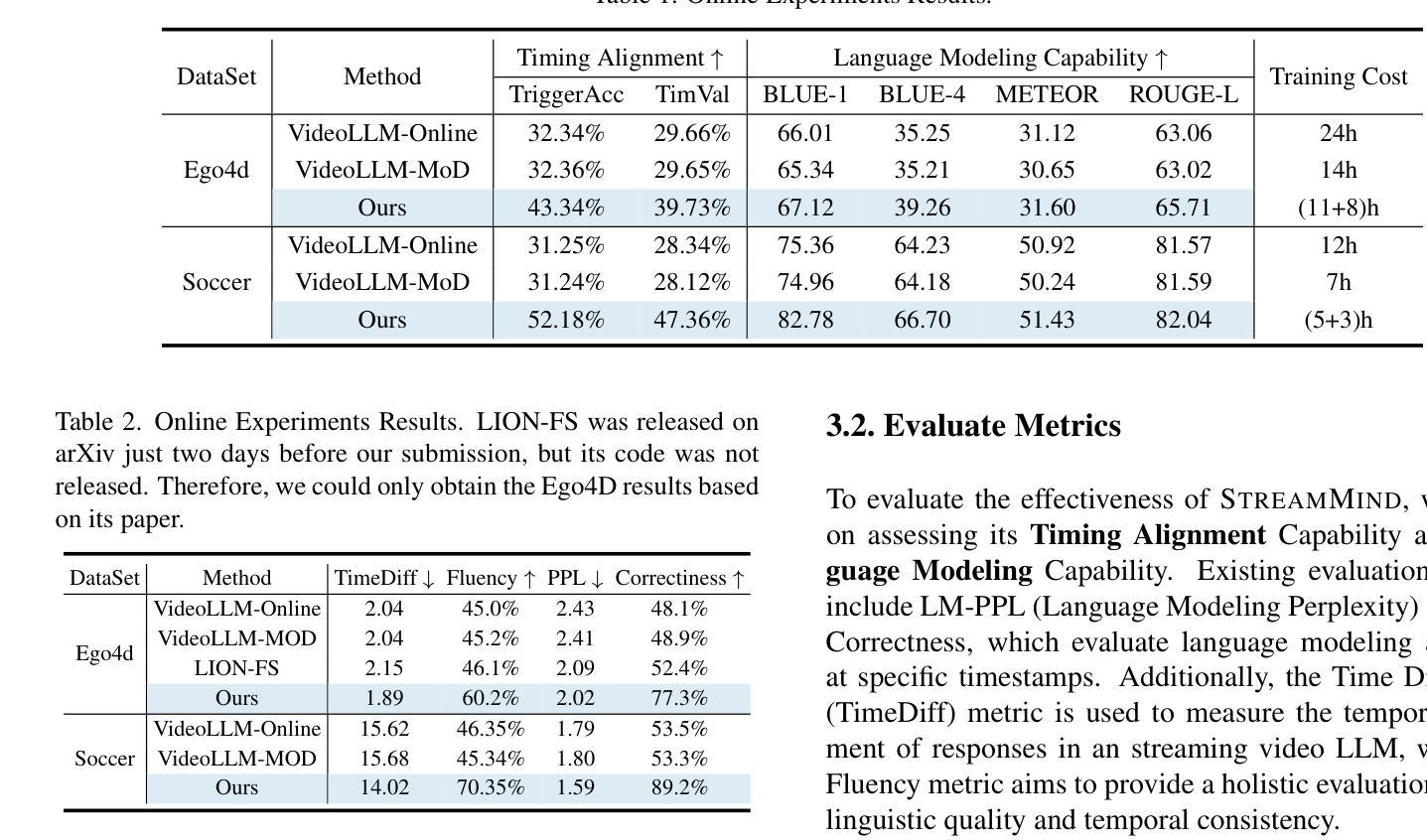

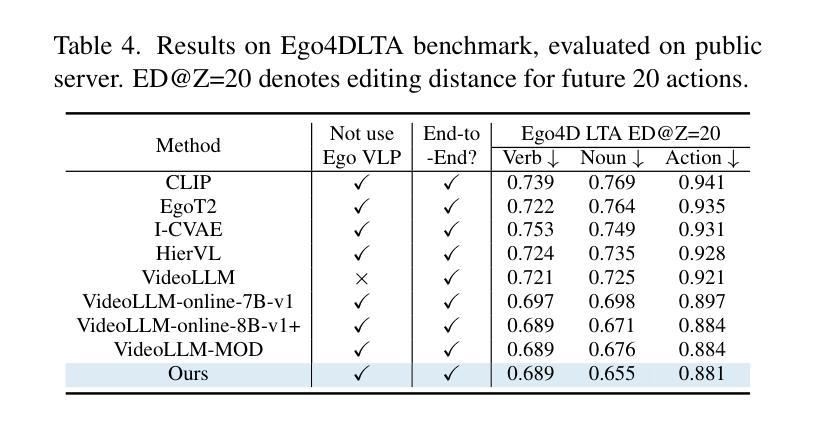

StreamMind: Unlocking Full Frame Rate Streaming Video Dialogue through Event-Gated Cognition

Authors:Xin Ding, Hao Wu, Yifan Yang, Shiqi Jiang, Donglin Bai, Zhibo Chen, Ting Cao

With the rise of real-world human-AI interaction applications, such as AI assistants, the need for Streaming Video Dialogue is critical. To address this need, we introduce StreamMind, a video LLM framework that achieves ultra-FPS streaming video processing (100 fps on a single A100) and enables proactive, always-on responses in real time, without explicit user intervention. To solve the key challenge of the contradiction between linear video streaming speed and quadratic transformer computation cost, we propose a novel perception-cognition interleaving paradigm named ‘’event-gated LLM invocation’’, in contrast to the existing per-time-step LLM invocation. By introducing a Cognition Gate network between the video encoder and the LLM, LLM is only invoked when relevant events occur. To realize the event feature extraction with constant cost, we propose Event-Preserving Feature Extractor (EPFE) based on state-space method, generating a single perception token for spatiotemporal features. These techniques enable the video LLM with full-FPS perception and real-time cognition response. Experiments on Ego4D and SoccerNet streaming tasks, as well as standard offline benchmarks, demonstrate state-of-the-art performance in both model capability and real-time efficiency, paving the way for ultra-high-FPS applications, such as Game AI and interactive media. The code and data is available at https://aka.ms/StreamMind.

随着人工智能助手等现实世界人机交互应用的兴起,对流式视频对话的需求变得至关重要。为了应对这一需求,我们推出了StreamMind,这是一款视频LLM框架,可实现超FPS流式视频处理(单个A100上可达100帧/秒),并可在无需用户明确干预的情况下,实时主动响应。

为了解决线性视频流速度与传播器计算成本之间的主要矛盾,我们提出了一种名为“事件门控LLM调用”的新型感知认知交错范式,这与现有的按时间步长LLM调用形成对比。通过在视频编码器和LLM之间引入认知门网络,只有在相关事件发生时才会调用LLM。为了实现恒定成本的事件特征提取,我们基于状态空间方法提出了事件保留特征提取器(EPFE),为时空特征生成单个感知令牌。这些技术使视频LLM具备全FPS感知和实时认知响应能力。

论文及项目相关链接

摘要

随着人工智能助手等现实世界中人机交互应用的出现,对Streaming Video Dialogue的需求愈发重要。为应对这一需求,我们推出StreamMind,一种视频LLM框架,可实现超高帧率(Ultra-FPS)的视频处理(在单个A100上可达100帧/秒),无需用户干预即可实现主动实时响应。为解决线性视频流速度与二次方转换器计算成本之间的主要矛盾,我们提出了一种名为“事件门控LLM调用”的新型感知认知交替范式,与现有的按时间步长LLM调用形成对比。通过在视频编码器和LLM之间引入认知门网络,仅在发生相关事件时才调用LLM。为实现恒定成本的事件特征提取,我们基于状态空间方法提出了事件保留特征提取器(EPFE),为时空特征生成单个感知令牌。这些技术使视频LLM具备全帧率感知和实时认知响应能力。在Ego4D、SoccerNet流媒体任务以及标准离线基准测试上的实验证明了其在模型能力和实时效率方面的卓越性能,为超高帧率应用如游戏AI和交互式媒体铺平了道路。相关代码和数据可通过https://aka.ms/StreamMind访问。

关键见解

- StreamMind是一个视频LLM框架,支持超高帧率(Ultra-FPS)的视频处理,实现实时主动响应。

- 引入了一种新型感知认知交替范式——“事件门控LLM调用”,以提高效率。

- 通过在视频编码器和LLM之间添加认知门网络,仅在有相关事件发生时才调用LLM。

- 提出了事件保留特征提取器(EPFE),以恒定成本实现事件特征提取。

- StreamMind可实现全帧率感知和实时认知响应的视频LLM。

- 在多个流媒体任务和标准离线基准测试上表现出卓越性能。

- 代码和数据可通过https://aka.ms/StreamMind访问,为超高帧率应用如游戏AI和交互式媒体提供了可能。

点此查看论文截图

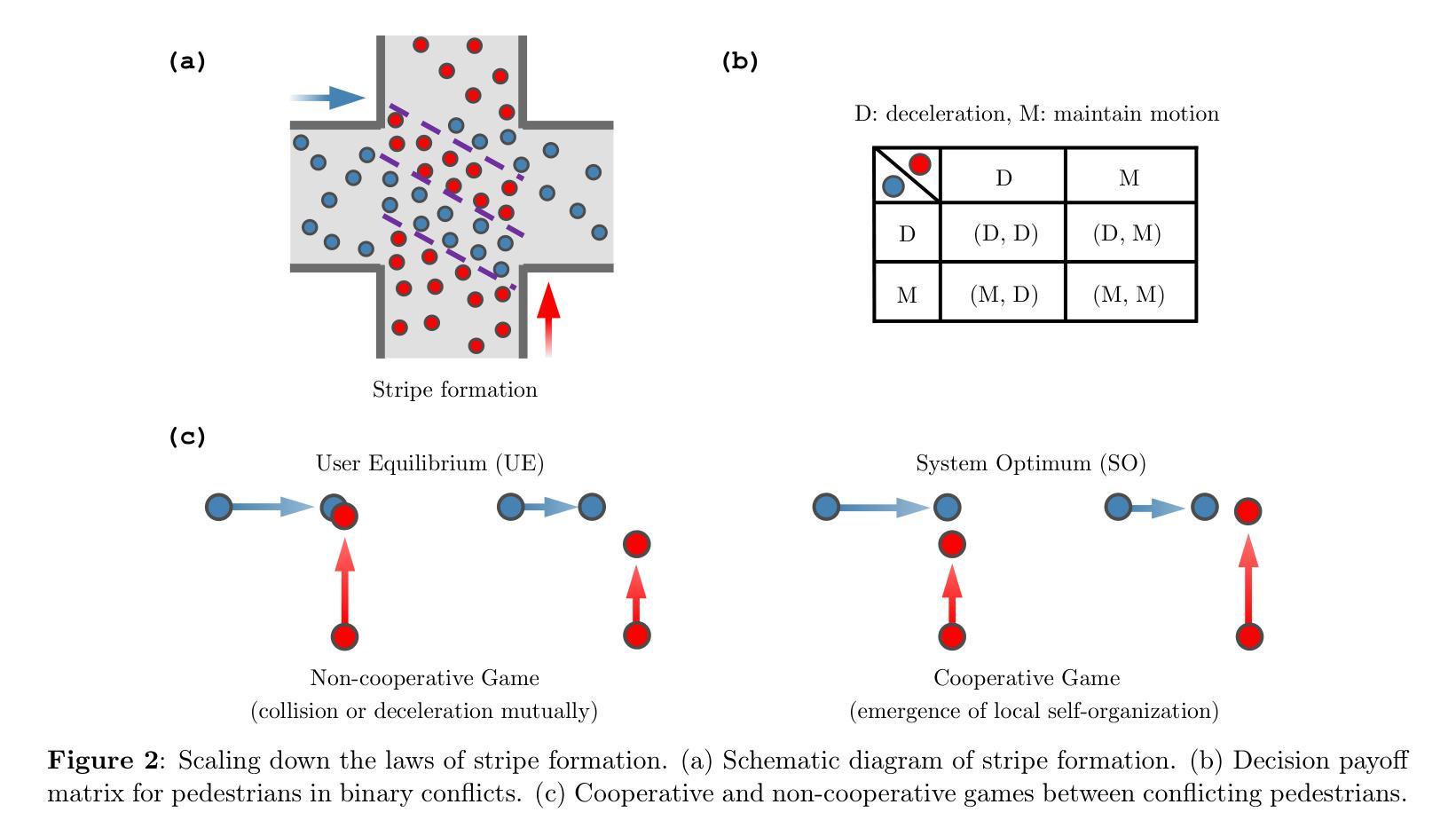

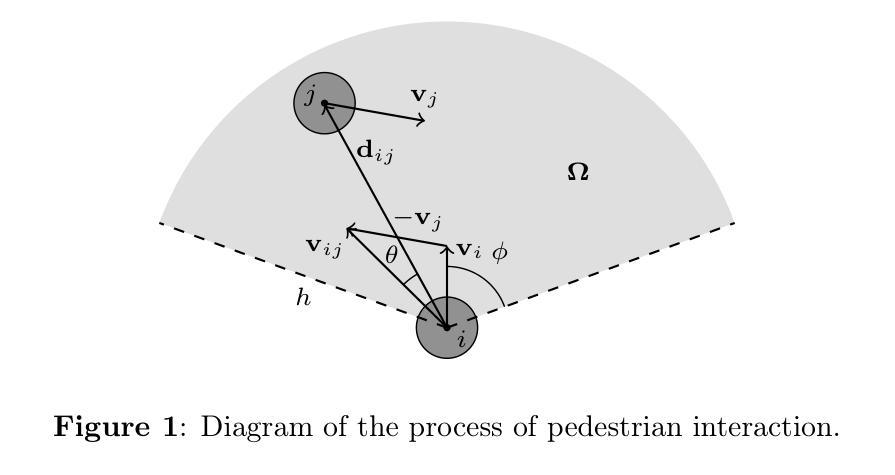

CosForce: A Force-Based General Pedestrian Model with Anticipation and Reaction Mechanisms

Authors:Jinghui Wang, Wei Lv, Shuchao Cao, Chenglin Guo

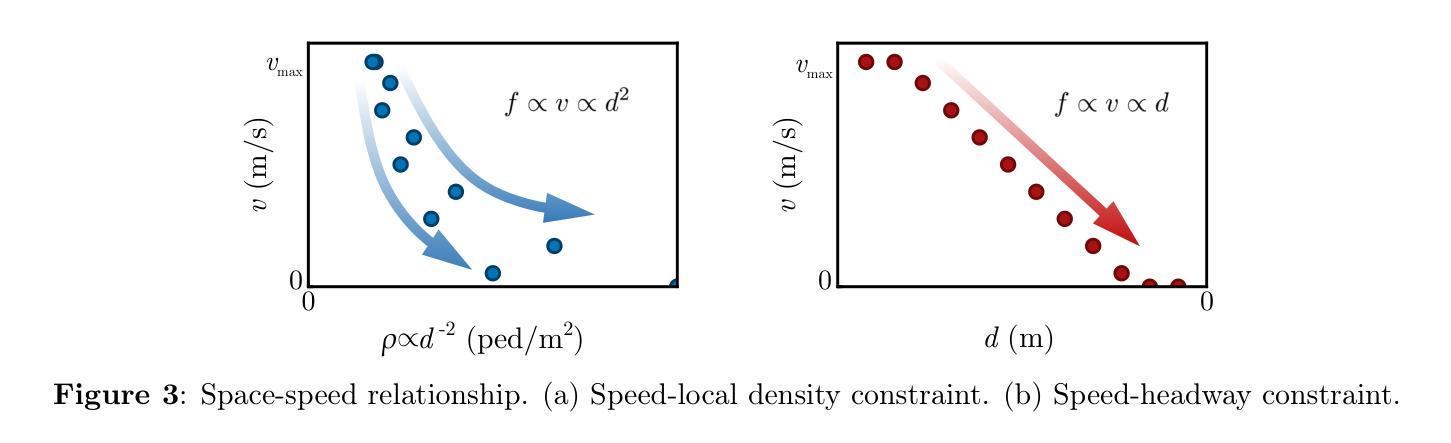

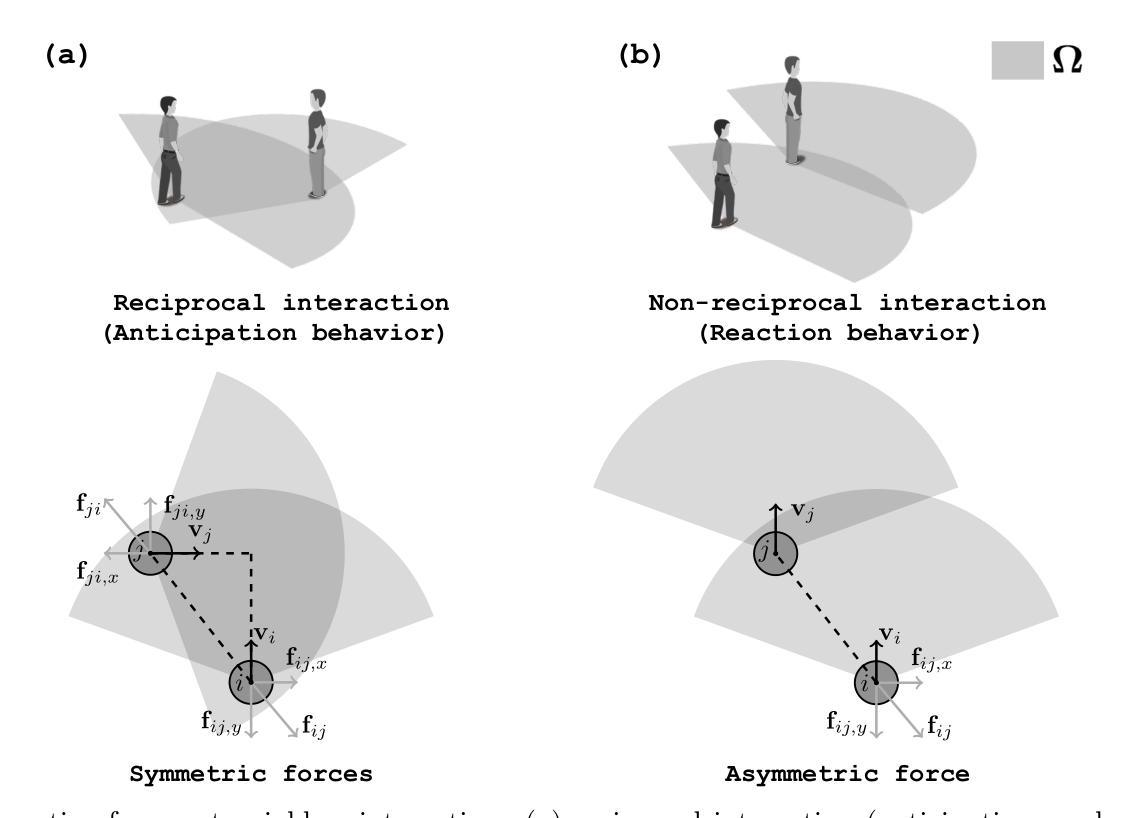

In this study, we developed a force-based general pedestrian model named CosForce. To the best of our knowledge, this may represent the simplest version of the force-based method. The model employs cosine functions to characterize asymmetric interactions, implicitly incorporating anticipation and reaction mechanisms. By focusing on binary interactions, the CosForce model provides new insights into pedestrian modeling while achieving linear computational complexity. Two specific scenarios in crowd dynamics were analyzed: self-organization (entropy decrease) and crowd collapse (entropy increase). The average normalized speed and order parameter were introduced to quantitatively describe the processes of crowd dynamics. Quantitative evaluations demonstrate that phase separation in crowds is effectively reproduced by the model, including lane formation, stripe formation, and cross-channel formation. Next, in the simulation of mass gathering, within a density-accumulating scenario, processes of critical phase transition in high-density crowds are clearly revealed through time series observations of the order parameter. These findings provide valuable insights into crowd dynamics.

在这项研究中,我们开发了一种基于力的通用行人模型,名为CosForce。据我们所知,这可能是基于力方法中最简单的版本。该模型采用余弦函数来表征不对称相互作用,隐含地融入了预期和反应机制。通过关注二元交互,CosForce模型在行人建模方面提供了新的见解,同时实现了线性计算复杂度。分析了人群动力学中的两个特定场景:自组织(熵减少)和人群拥挤(熵增加)。引入平均归一化速度和秩序参数来定量描述人群动力学的过程。定量评估表明,该模型有效地再现了人群中的相分离,包括车道形成、条纹形成和跨通道形成。接下来,在密度累积场景中模拟大规模人群聚集的过程时,通过秩序参数的时间序列观察,清晰地揭示了高密度人群中的临界相变过程。这些发现对人群动力学提供了有价值的见解。

论文及项目相关链接

PDF 28 pages, 25 figures

Summary

本研究开发了一种基于力的一般行人模型——CosForce。据我们所知,这可能是基于力的方法中最简单的版本。该模型采用余弦函数来表征不对称相互作用,隐含地融入了预期和反应机制。通过关注二元交互,CosForce模型为行人建模提供了新的见解,同时实现了线性计算复杂性。分析了人群动力学的两个特定场景:自组织(熵减少)和人群崩溃(熵增加)。引入平均归一化速度和秩序参数来定量描述人群动力学过程。定量评估表明,该模型有效地再现了人群中的相位分离,包括车道形成、条纹形成和跨通道形成。在模拟密度累积场景的大规模聚集时,通过秩序参数的时间序列观察,清晰地揭示了高密度人群中的临界相变过程。这些发现对人群动力学提供了有价值的见解。

Key Takeaways

- 开发了名为CosForce的基于力的通用行人模型,可能是基于力的方法中最简单的版本。

- 该模型采用余弦函数表征不对称相互作用,包含预期和反应机制。

- CosForce模型关注二元交互,为行人建模提供新见解,实现线性计算复杂性。

- 分析了人群动力学的两个特定场景:自组织和人群崩溃(熵的增加和减少)。

- 通过平均归一化速度和秩序参数定量描述人群动力学过程。

- 模型有效再现人群中的相位分离,包括车道、条纹和跨通道的形成。

点此查看论文截图

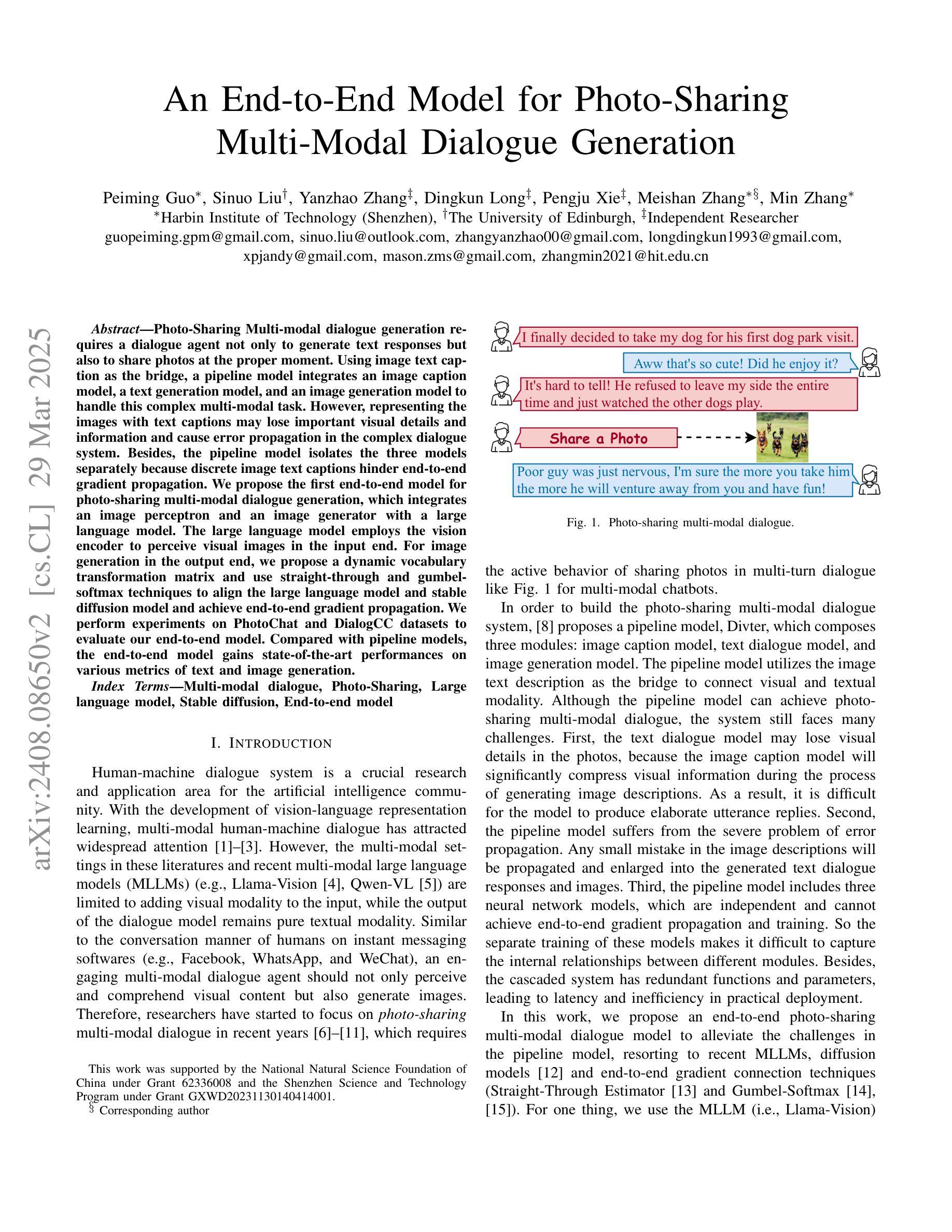

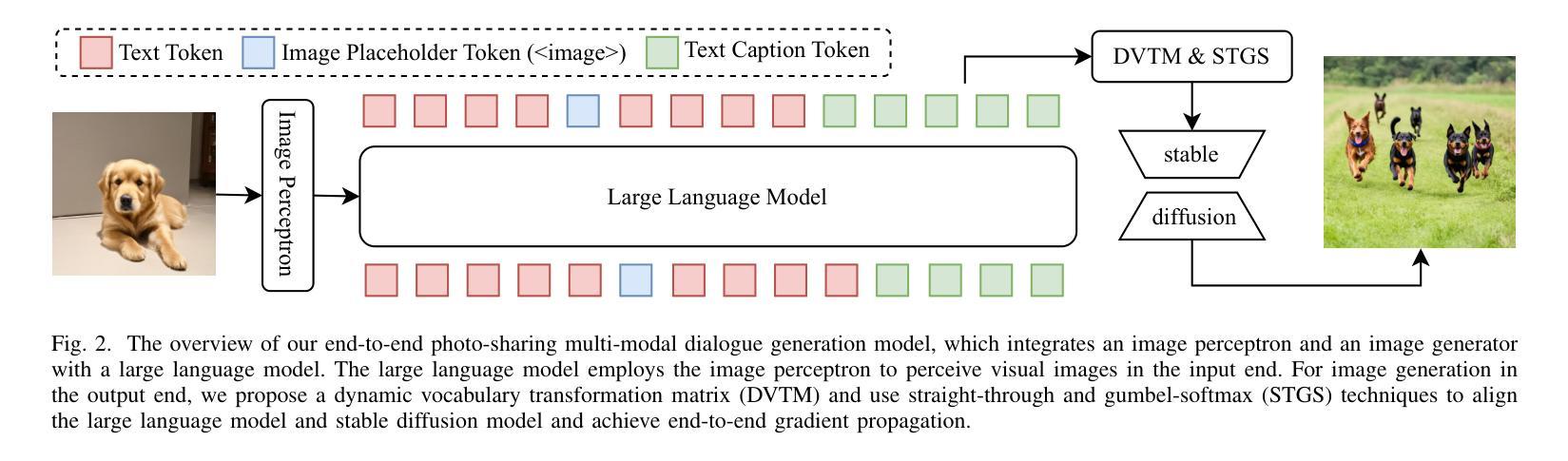

An End-to-End Model for Photo-Sharing Multi-modal Dialogue Generation

Authors:Peiming Guo, Sinuo Liu, Yanzhao Zhang, Dingkun Long, Pengjun Xie, Meishan Zhang, Min Zhang

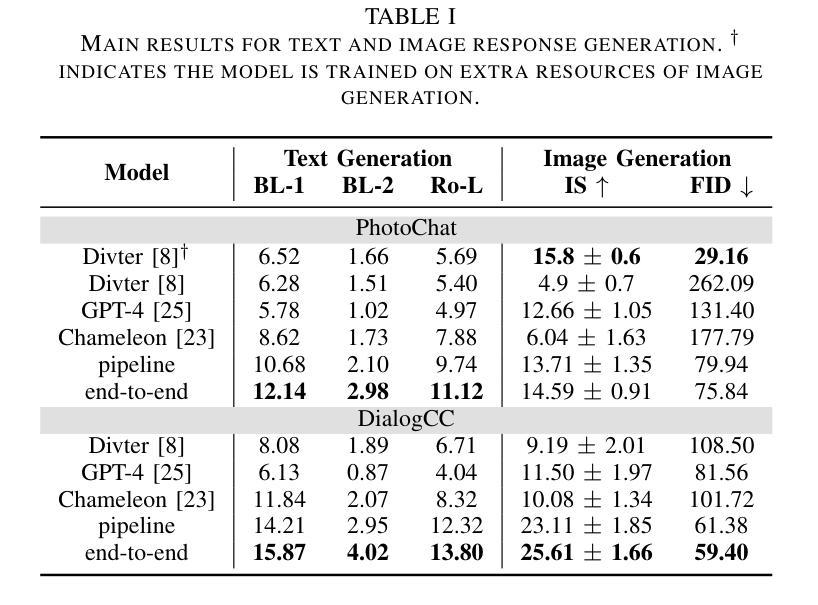

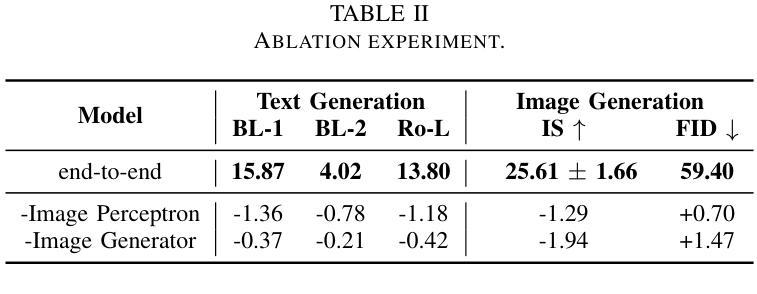

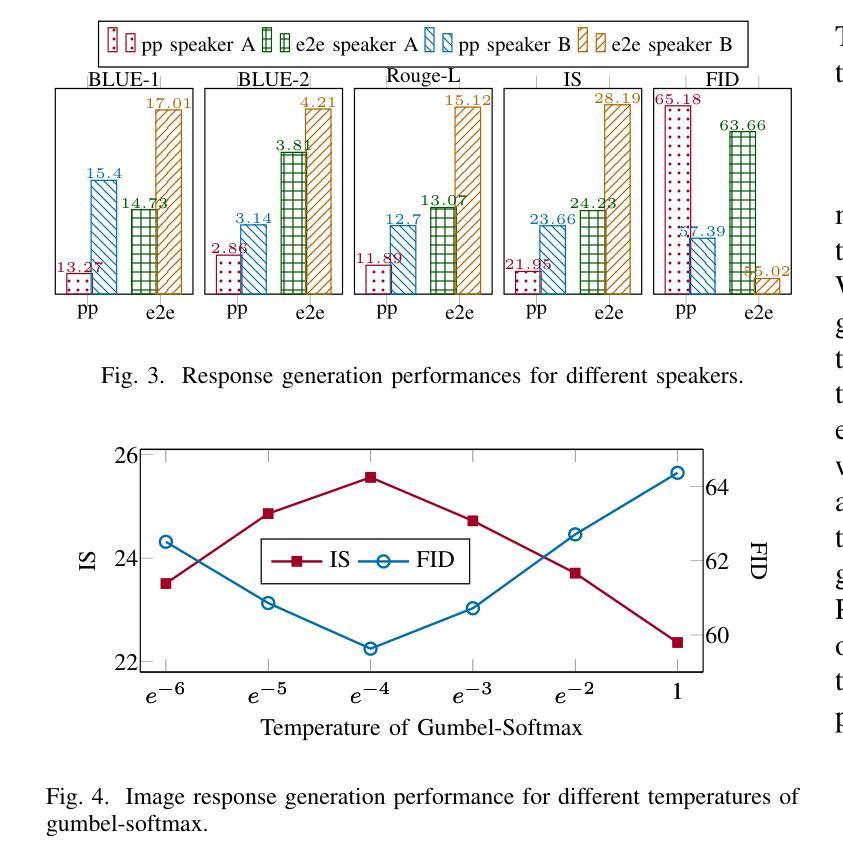

Photo-Sharing Multi-modal dialogue generation requires a dialogue agent not only to generate text responses but also to share photos at the proper moment. Using image text caption as the bridge, a pipeline model integrates an image caption model, a text generation model, and an image generation model to handle this complex multi-modal task. However, representing the images with text captions may loss important visual details and information and cause error propagation in the complex dialogue system. Besides, the pipeline model isolates the three models separately because discrete image text captions hinder end-to-end gradient propagation. We propose the first end-to-end model for photo-sharing multi-modal dialogue generation, which integrates an image perceptron and an image generator with a large language model. The large language model employs the Q-Former to perceive visual images in the input end. For image generation in the output end, we propose a dynamic vocabulary transformation matrix and use straight-through and gumbel-softmax techniques to align the large language model and stable diffusion model and achieve end-to-end gradient propagation. We perform experiments on PhotoChat and DialogCC datasets to evaluate our end-to-end model. Compared with pipeline models, the end-to-end model gains state-of-the-art performances on various metrics of text and image generation. More analysis experiments also verify the effectiveness of the end-to-end model for photo-sharing multi-modal dialogue generation.

图片共享多模态对话生成要求对话代理不仅仅生成文本响应,还要在适当的时刻共享照片。以图像文本标题作为桥梁,管道模型将图像标题模型、文本生成模型和图像生成模型集成在一起,以处理这个复杂的多模态任务。然而,用文本标题表示图像可能会丢失重要的视觉细节和信息,并在复杂对话系统中引起误差传播。此外,管道模型将这三个模型分开处理,因为离散的图像文本标题阻碍了端到端的梯度传播。我们提出了第一个针对图片共享多模态对话生成端到端模型,该模型将图像感知器和图像生成器与大型语言模型集成在一起。大型语言模型采用Q-Former来感知输入端的视觉图像。在输出端进行图像生成时,我们提出了动态词汇转换矩阵,并使用直通和gumbel-softmax技术对齐大型语言模型和稳定扩散模型,实现端到端梯度传播。我们在PhotoChat和DialogCC数据集上对我们的端到端模型进行了实验评估。与管道模型相比,端到端模型在文本和图像生成的各项指标上达到了最先进的性能。更多的分析实验也验证了端到端模型在图片共享多模态对话生成中的有效性。

论文及项目相关链接

PDF Accepted by ICME2025

Summary

本文提出了首个端到端的照片共享多模态对话生成模型,该模型集成了图像感知器、图像生成器与大型语言模型。相较于使用图像文本描述作为桥梁的管道模型,该端到端模型能更好地处理图像与文本的融合,避免了信息损失和误差传播问题。通过Q-Former感知视觉图像,输出端采用动态词汇转换矩阵,结合直通和Gumbel-softmax技术,实现大型语言模型和稳定扩散模型的对接,达到端到端梯度传播。实验证明,该模型在PhotoChat和DialogCC数据集上取得了最先进的性能表现。

Key Takeaways

- 多模态对话生成需要对话代理不仅生成文本响应,还需在适当时候分享照片。

- 管道模型通过图像文本描述来整合模型,但可能丢失视觉细节和信息,并导致误差传播。

- 首次提出端到端的照片共享多模态对话生成模型,集成了图像感知器、图像生成器与大型语言模型。

- 采用Q-Former作为大型语言模型的一部分,以感知视觉图像。

- 在输出端采用动态词汇转换矩阵,结合直通和Gumbel-softmax技术,实现端到端梯度传播。

- 模型在PhotoChat和DialogCC数据集上表现优异,达到 state-of-the-art 的性能。

点此查看论文截图

Safety-Aware Human-Lead Vehicle Platooning by Proactively Reacting to Uncertain Human Behaving

Authors:Jia Hu, Shuhan Wang, Yiming Zhang, Haoran Wang, Zhilong Liu, Guangzhi Cao

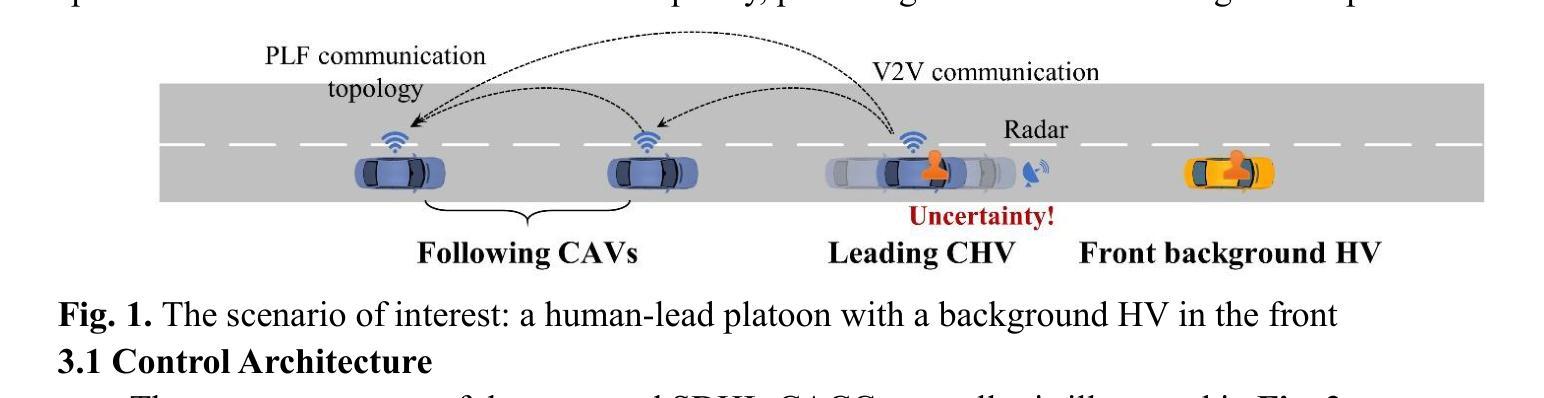

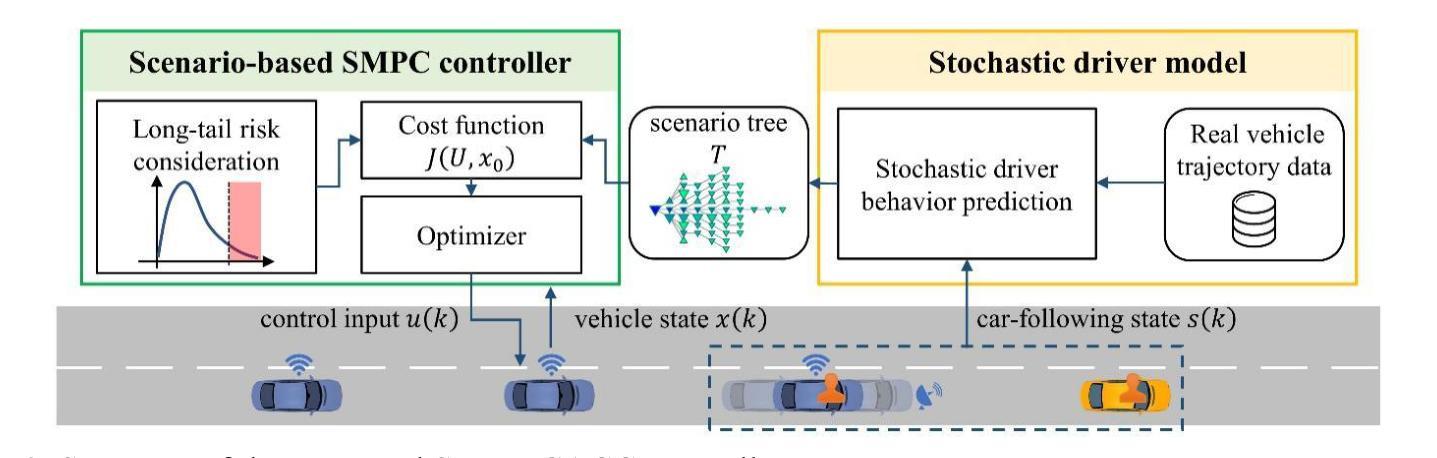

Human-Lead Cooperative Adaptive Cruise Control (HL-CACC) is regarded as a promising vehicle platooning technology in real-world implementation. By utilizing a Human-driven Vehicle (HV) as the platoon leader, HL-CACC reduces the cost and enhances the reliability of perception and decision-making. However, state-of-the-art HL-CACC technology still has a great limitation on driving safety due to the lack of considering the leading human driver’s uncertain behavior. In this study, a HL-CACC controller is designed based on Stochastic Model Predictive Control (SMPC). It is enabled to predict the driving intention of the leading Connected Human-Driven Vehicle (CHV). The proposed controller has the following features: i) enhanced perceived safety in oscillating traffic; ii) guaranteed safety against hard brakes; iii) computational efficiency for real-time implementation. The proposed controller is evaluated on a PreScan&Simulink simulation platform. Real vehicle trajectory data is collected for the calibration of the simulation. Results reveal that the proposed controller: i) improves perceived safety by 19.17% in oscillating traffic; ii) enhances actual safety by 7.76% against hard brakes; iii) is confirmed with string stability. The computation time is approximately 3.2 milliseconds when running on a laptop equipped with an Intel i5-13500H CPU. This indicates the proposed controller is ready for real-time implementation.

人类引导的合作式自适应巡航控制(HL-CACC)被视为一种具有前景的车辆编队技术,在实际应用中具有广阔前景。通过利用人为驾驶车辆(HV)作为车队领导者,HL-CACC降低了感知和决策的成本,并增强了其可靠性。然而,目前最先进的HL-CACC技术由于在考虑领先的人为驾驶员的不确定性行为方面的缺失,在驾驶安全方面仍存在很大的局限性。本研究设计了一种基于随机模型预测控制(SMPC)的HL-CACC控制器。它能够预测领先的人车互联车辆(CHV)的驾驶意图。所设计的控制器具有以下特点:一、在振荡交通中增强了感知安全性;二、确保应对急刹时的安全;三、实时实现计算效率高。该控制器在PreScan&Simulink仿真平台上进行了评估。收集真实车辆轨迹数据对仿真进行校准。结果表明,该控制器:一、在振荡交通中提高了感知安全性达19.17%;二、在应对急刹时提高了实际安全性达7.76%;三、具有串稳定性。在配备Intel i5-13500H CPU的笔记本电脑上运行时,计算时间约为3.2毫秒。这表明该控制器已准备好进行实时应用。

论文及项目相关链接

Summary

基于随机模型预测控制(SMPC)设计的人领航协同自适应巡航控制(HL-CACC)控制器,能预测领先的人驾驶车辆的驾驶意图,提高感知安全、保障行车安全,适合实时应用。

Key Takeaways

- HL-CACC被视为具有前景的车辆编队技术,利用人工驾驶车辆作为车队领导者,降低成本并增强感知和决策可靠性。

- 当前HL-CACC技术在驾驶安全上存在局限性,因为未考虑领先的人驾驶行为的不确定性。

- 基于SMPC设计的HL-CACC控制器能预测领先的人驾驶车辆的驾驶意图。

- 该控制器增强了在振荡交通中的感知安全、保障了对急刹车的安全,并具备实时实施的计算效率。

- 在PreScan&Simulink仿真平台上评估该控制器,利用实际车辆轨迹数据进行校准。

- 结果显示,该控制器提高了感知安全19.17%,实际安全对抗急刹车提高7.76%,并具备队列稳定性。

点此查看论文截图