⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-04-11 更新

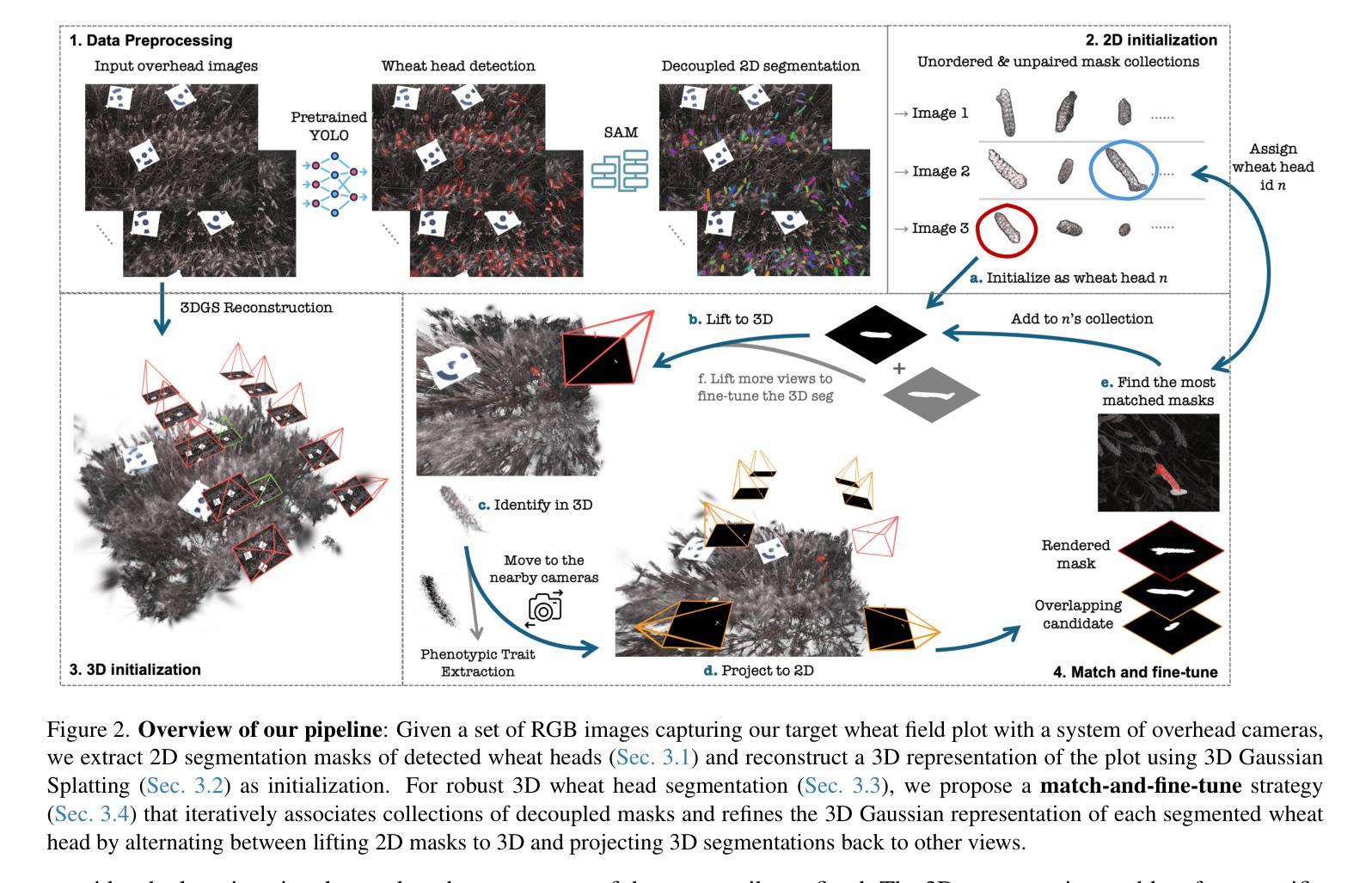

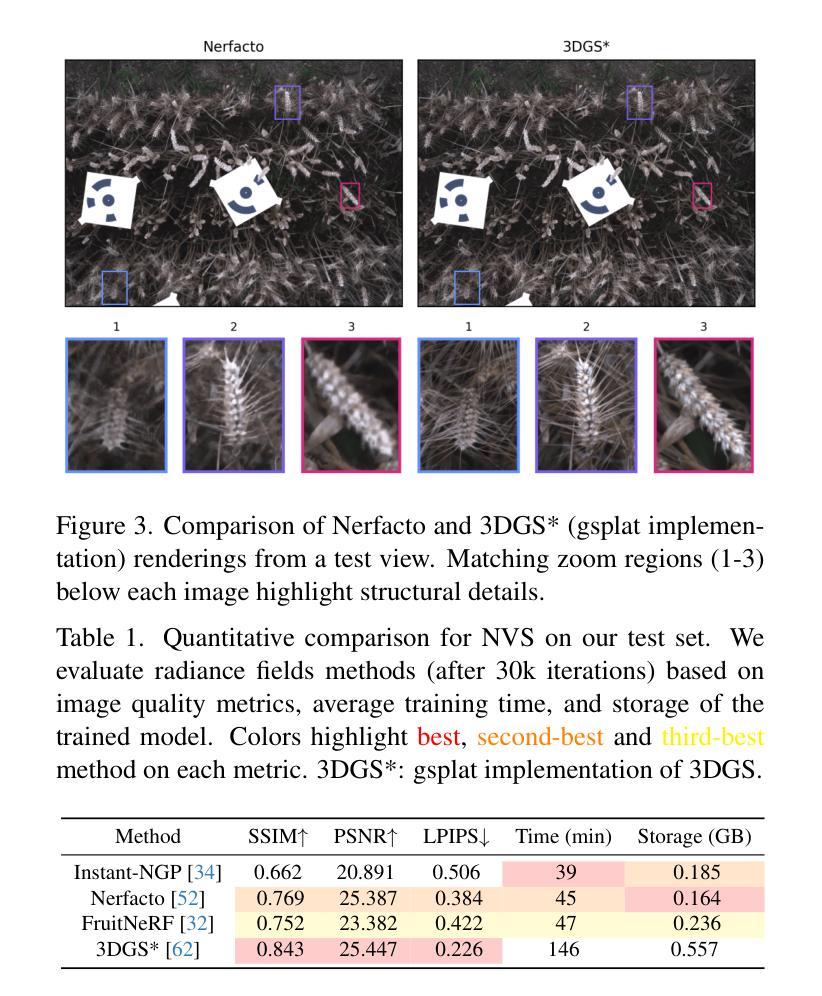

Wheat3DGS: In-field 3D Reconstruction, Instance Segmentation and Phenotyping of Wheat Heads with Gaussian Splatting

Authors:Daiwei Zhang, Joaquin Gajardo, Tomislav Medic, Isinsu Katircioglu, Mike Boss, Norbert Kirchgessner, Achim Walter, Lukas Roth

Automated extraction of plant morphological traits is crucial for supporting crop breeding and agricultural management through high-throughput field phenotyping (HTFP). Solutions based on multi-view RGB images are attractive due to their scalability and affordability, enabling volumetric measurements that 2D approaches cannot directly capture. While advanced methods like Neural Radiance Fields (NeRFs) have shown promise, their application has been limited to counting or extracting traits from only a few plants or organs. Furthermore, accurately measuring complex structures like individual wheat heads-essential for studying crop yields-remains particularly challenging due to occlusions and the dense arrangement of crop canopies in field conditions. The recent development of 3D Gaussian Splatting (3DGS) offers a promising alternative for HTFP due to its high-quality reconstructions and explicit point-based representation. In this paper, we present Wheat3DGS, a novel approach that leverages 3DGS and the Segment Anything Model (SAM) for precise 3D instance segmentation and morphological measurement of hundreds of wheat heads automatically, representing the first application of 3DGS to HTFP. We validate the accuracy of wheat head extraction against high-resolution laser scan data, obtaining per-instance mean absolute percentage errors of 15.1%, 18.3%, and 40.2% for length, width, and volume. We provide additional comparisons to NeRF-based approaches and traditional Muti-View Stereo (MVS), demonstrating superior results. Our approach enables rapid, non-destructive measurements of key yield-related traits at scale, with significant implications for accelerating crop breeding and improving our understanding of wheat development.

自动化提取植物形态特征是支持通过高通量表型技术(HTFP)进行作物育种和农业管理的重要环节。基于多视角RGB图像解决方案具有可扩展性和性价比,能够支持无法直接通过二维方法捕捉的体积测量。虽然像神经辐射场(NeRF)这样的先进方法显示出了一定的潜力,但其应用仅限于计算少数植物或器官的性状。此外,由于在田间条件下作物遮挡严重,密集排列使得观测结构复杂且不可预测等因素导致难以准确测量对研究作物产量至关重要的单个麦穗。最近开发的基于高斯三维拼接技术(Gaussian Splatting)的3DGS提供了一种有前景的替代方案,其高质量重建和基于点的明确表示使其成为HTFP的理想选择。在本文中,我们提出了一种名为小麦三维高斯拼接技术(Wheat3DGS)的新方法,它利用基于3DGS技术和Segmentation Anything模型(SAM)实现精准的三维实例分割和对数百个麦穗的形态特征自动测量,这是首次将高斯拼接技术应用于高通量表型技术。我们通过与高分辨率激光扫描数据验证麦穗提取的准确性,对于长度、宽度和体积的平均绝对误差分别为15.1%、18.3%和40.2%。我们还与NeRF方法和传统的多视角立体技术进行了比较,证明了我们的方法具有更好的效果。我们的方法能够实现大规模的关键产量相关特征的快速无损测量,对于加速作物育种和提高我们对小麦发育的理解具有重大意义。

论文及项目相关链接

PDF Copyright 2025 IEEE. This is the author’s version of the work. It is posted here for your personal use. Not for redistribution. The definitive version is published in the 2025 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW)

Summary

本文提出一种基于3DGS和SAM模型的新方法Wheat3DGS,用于自动对数百个麦穗进行精确的3D实例分割和形态测量。该方法在HTFP中首次应用3DGS,并通过与激光扫描数据对比验证麦穗提取的准确性,获得长度、宽度和体积的实例平均绝对百分比误差分别为15.1%、18.3%和40.2%。与传统方法和NeRF基方法相比,该方法的优越性得以证明。该方法能迅速、非破坏性地对大量关键产量性状进行测量,对加速作物育种和提高对小麦发育的理解具有重大意义。

Key Takeaways

- 自动提取植物形态特征是支持作物育种和农业管理的重要技术,高通量田间表型技术(HTFP)是解决这一问题的有效手段。

- 多视角RGB图像方法因其可扩展性和成本效益而受到关注,但先进的方法如神经辐射场(NeRFs)在复杂结构测量方面存在局限性。

- 3D高斯涂污(3DGS)因其高质量重建和显式点基表示而成为HTFP的有前途的替代方案。

- Wheat3DGS是首个将3DGS应用于HTFP的方法,能自动对数百个麦穗进行精确的3D实例分割和形态测量。

- Wheat3DGS方法的准确性通过与高分辨率激光扫描数据的对比得到了验证,并且在长度、宽度和体积的测量上取得了较低的误差率。

- 与NeRF基方法和传统多视角立体(MVS)相比,Wheat3DGS表现出优越的结果。

点此查看论文截图

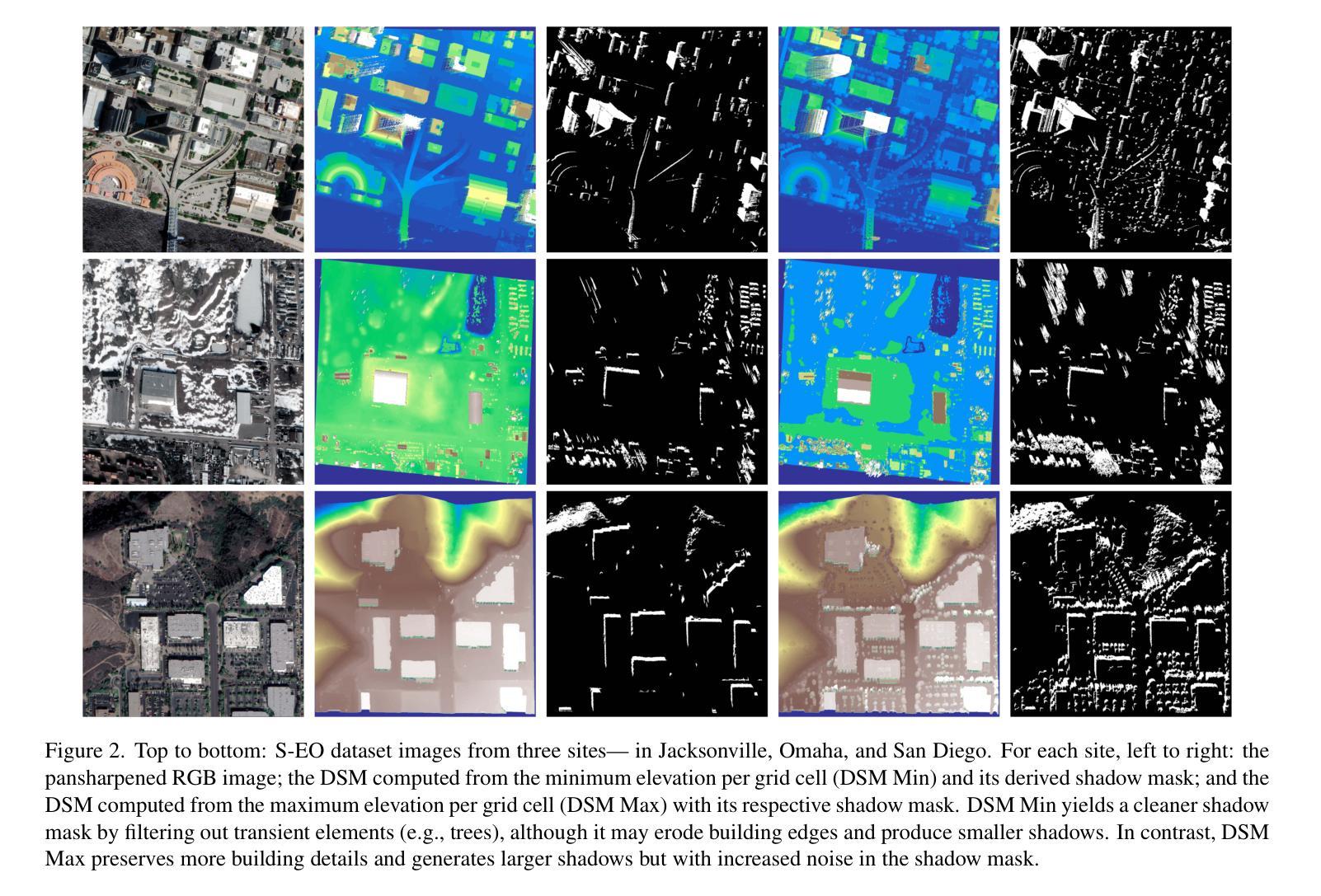

S-EO: A Large-Scale Dataset for Geometry-Aware Shadow Detection in Remote Sensing Applications

Authors:Masquil Elías, Marí Roger, Ehret Thibaud, Meinhardt-Llopis Enric, Musé Pablo, Facciolo Gabriele

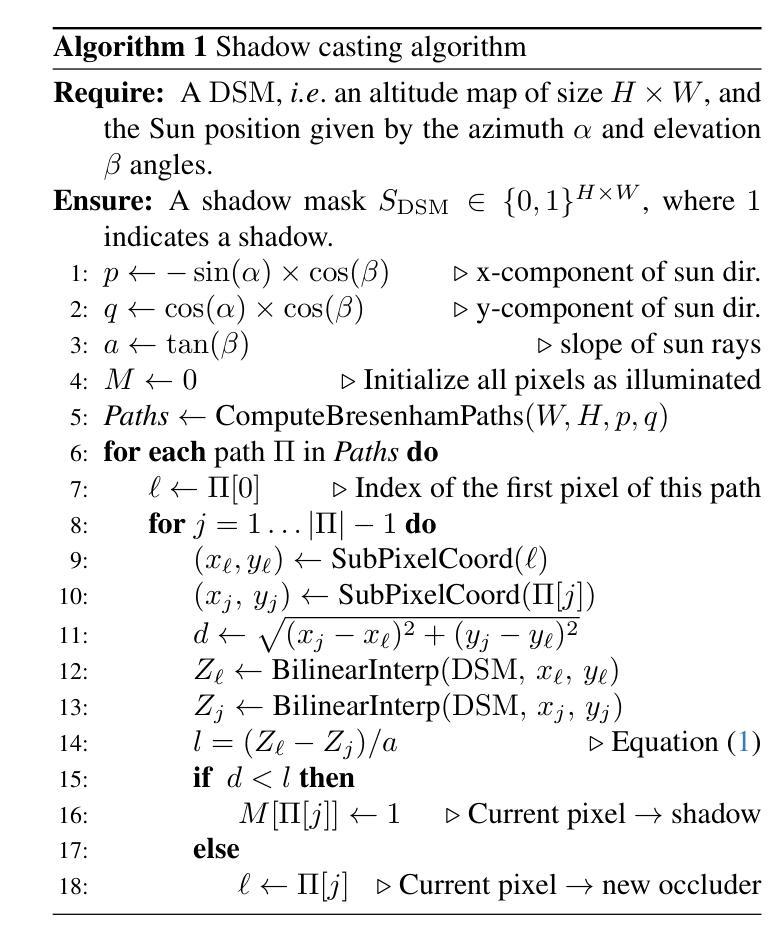

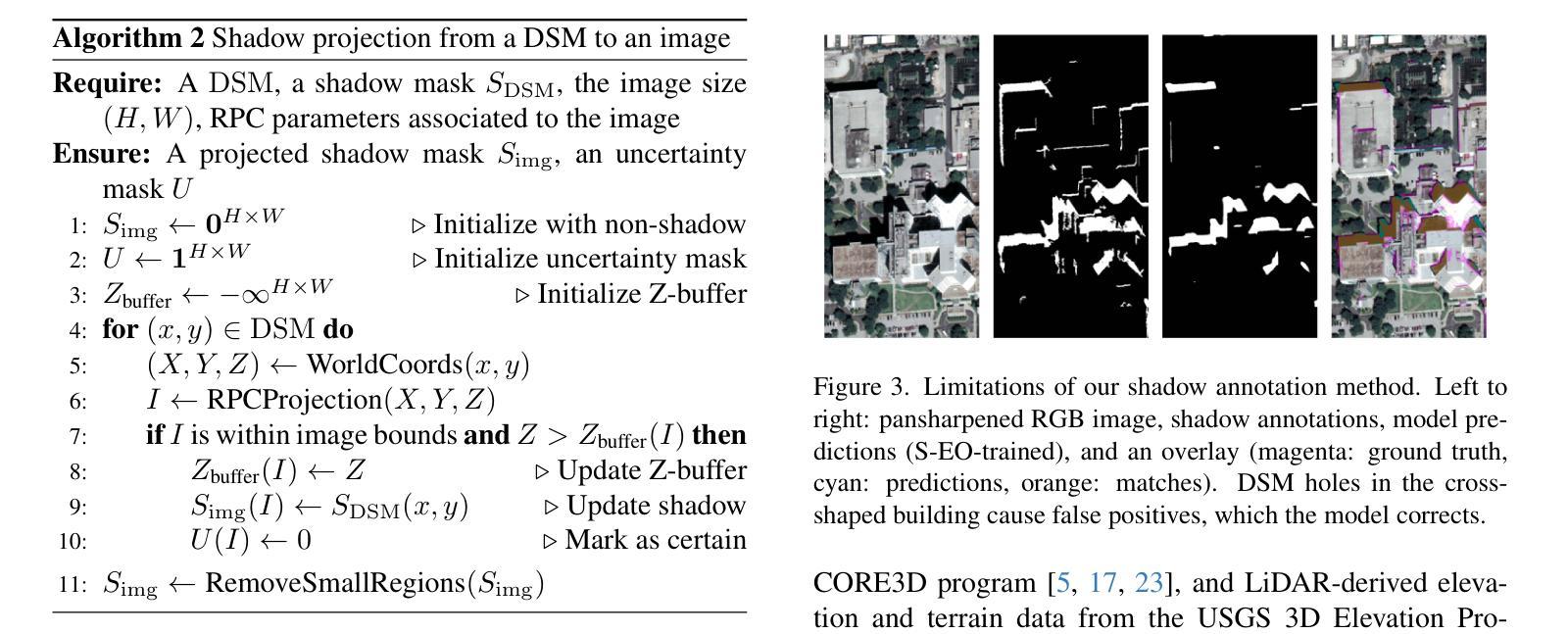

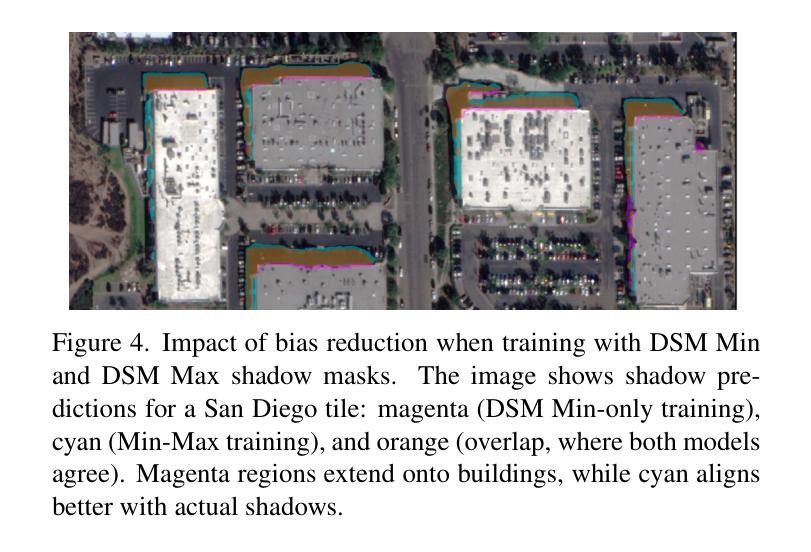

We introduce the S-EO dataset: a large-scale, high-resolution dataset, designed to advance geometry-aware shadow detection. Collected from diverse public-domain sources, including challenge datasets and government providers such as USGS, our dataset comprises 702 georeferenced tiles across the USA, each covering 500x500 m. Each tile includes multi-date, multi-angle WorldView-3 pansharpened RGB images, panchromatic images, and a ground-truth DSM of the area obtained from LiDAR scans. For each image, we provide a shadow mask derived from geometry and sun position, a vegetation mask based on the NDVI index, and a bundle-adjusted RPC model. With approximately 20,000 images, the S-EO dataset establishes a new public resource for shadow detection in remote sensing imagery and its applications to 3D reconstruction. To demonstrate the dataset’s impact, we train and evaluate a shadow detector, showcasing its ability to generalize, even to aerial images. Finally, we extend EO-NeRF - a state-of-the-art NeRF approach for satellite imagery - to leverage our shadow predictions for improved 3D reconstructions.

我们介绍了S-EO数据集:这是一个大规模、高分辨率的数据集,旨在推动几何感知阴影检测的发展。我们的数据集来自各种公共来源,包括挑战数据集和政府供应商,如美国地质调查局,包含美国702个地理坐标的瓷砖,每个瓷砖覆盖500x500米。每个瓷砖包括多日期、多角度的WorldView-3锐化RGB图像、单色图像以及通过激光雷达扫描获得的该地区地面真实数字表面模型。对于每张图像,我们提供基于几何和太阳位置的阴影掩膜、基于归一化植被指数(NDVI)的植被掩膜和束调整的RPC模型。S-EO数据集大约有2万张图像,为遥感影像中的阴影检测及其应用于三维重建提供了全新的公共资源。为了证明数据集的影响力,我们训练并评估了阴影检测器,展示了其即使在航空图像上的泛化能力。最后,我们扩展了EO-NeRF(一种用于卫星图像的先进NeRF方法),利用我们的阴影预测进行改进的三维重建。

论文及项目相关链接

PDF Accepted at Earthvision 2025 (CVPR Workshop)

Summary

S-EO数据集是一款大规模、高分辨率的数据集,用于推进几何感知阴影检测的发展。数据集包含来自多个公共领域来源的挑战数据集和政府机构(如美国地质勘探局)的图像,覆盖美国702个地理定位地块,每个地块包含多日期、多角度的WorldView-3锐化RGB图像、全色图像以及通过激光雷达扫描获得的地面真实数字表面模型。此外,还为每张图像提供了基于几何和太阳位置的阴影掩膜、基于归一化差异植被指数(NDVI)的植被掩膜和经过校正的RPC模型。S-EO数据集为遥感影像中的阴影检测及其应用于三维重建提供了新资源。通过训练和评估阴影检测器,展示了其在空中图像上的泛化能力。此外,扩展了现有的NeRF方法(EO-NeRF),利用阴影预测提高三维重建质量。

Key Takeaways

- S-EO数据集是一款用于推进几何感知阴影检测的大型、高分辨率数据集。

- 数据集涵盖美国702个地理定位地块,包含多日期、多角度的WorldView-3锐化RGB图像等。

- 数据集为每个图像提供了阴影掩膜、植被掩膜和经过校正的RPC模型。

- S-EO数据集为遥感影像中的阴影检测及其应用于三维重建提供了新资源。

- 通过训练和评估阴影检测器,展示了其在不同场景下的泛化能力。

- 扩展了现有的NeRF方法(EO-NeRF),结合阴影预测以提高三维重建质量。

点此查看论文截图

SVG-IR: Spatially-Varying Gaussian Splatting for Inverse Rendering

Authors:Hanxiao Sun, YuPeng Gao, Jin Xie, Jian Yang, Beibei Wang

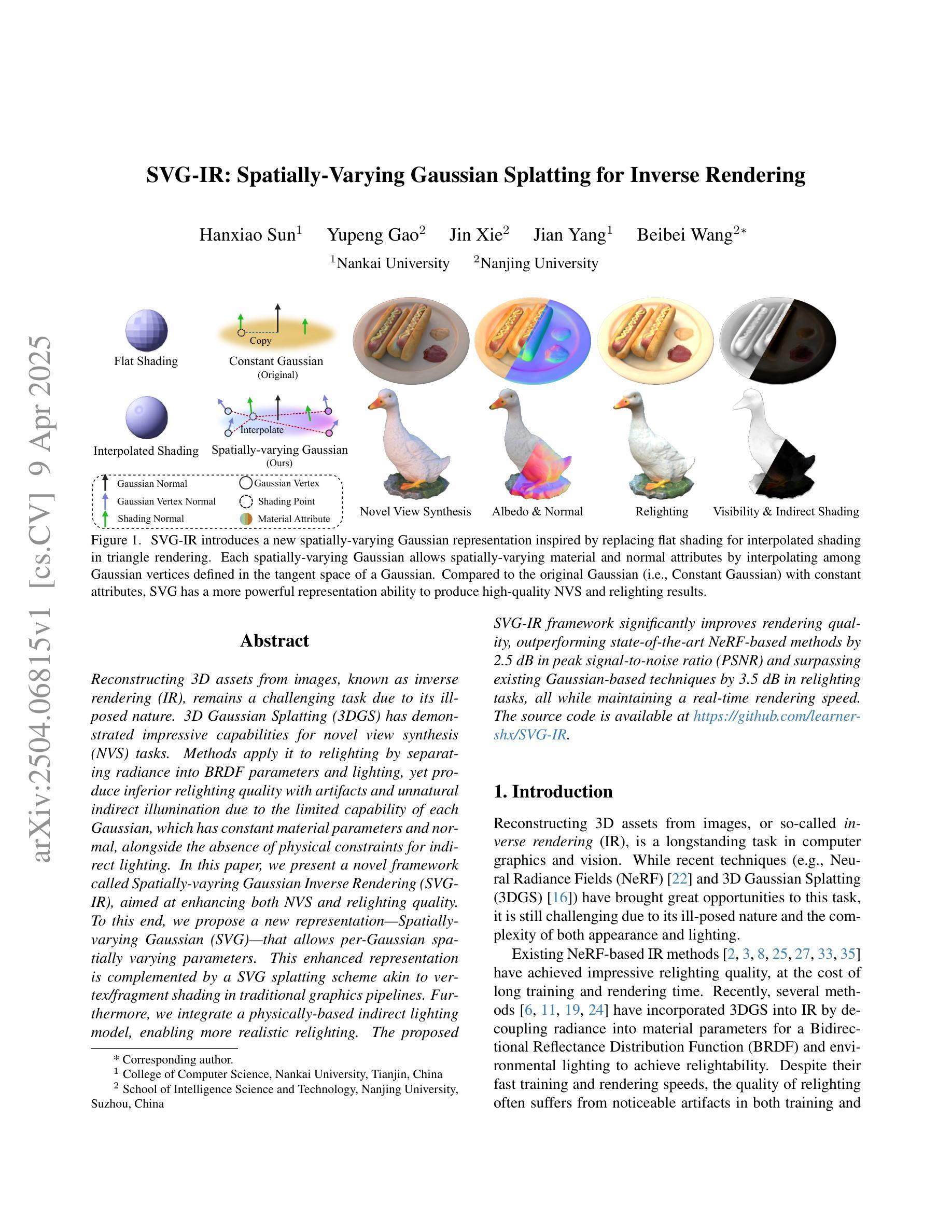

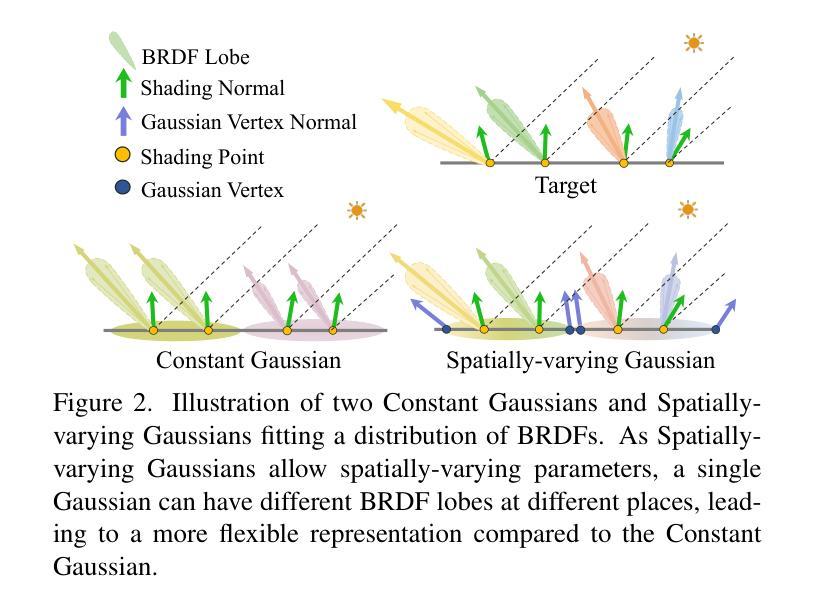

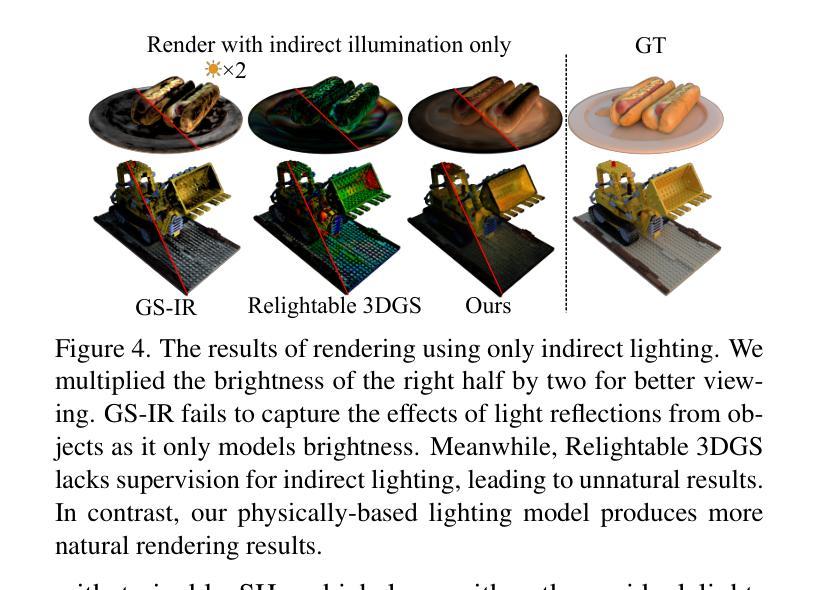

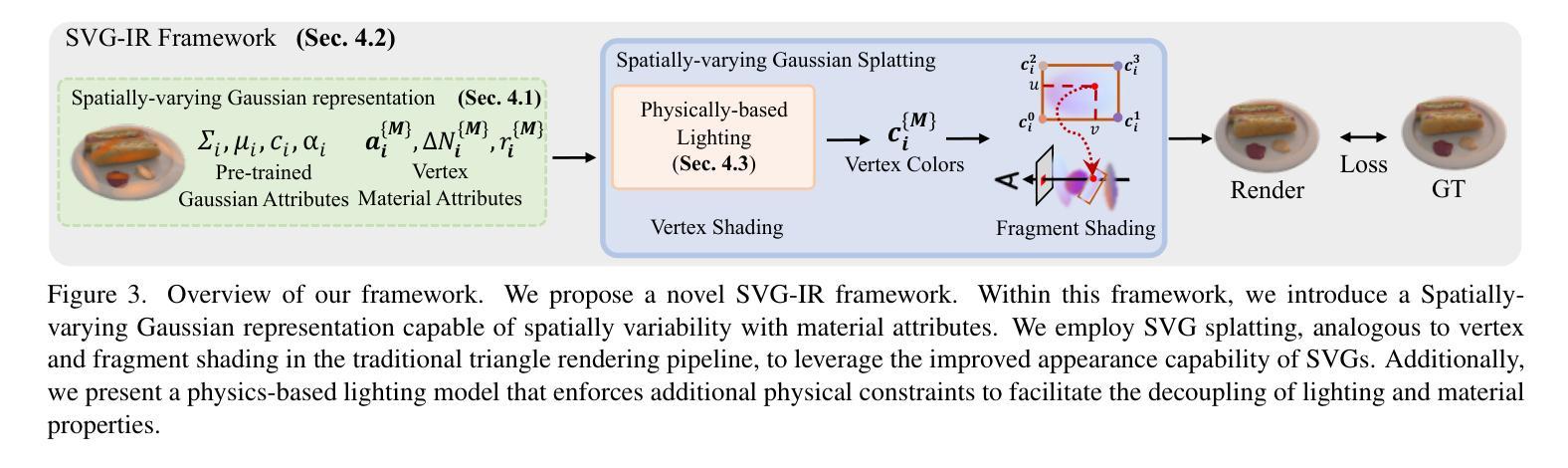

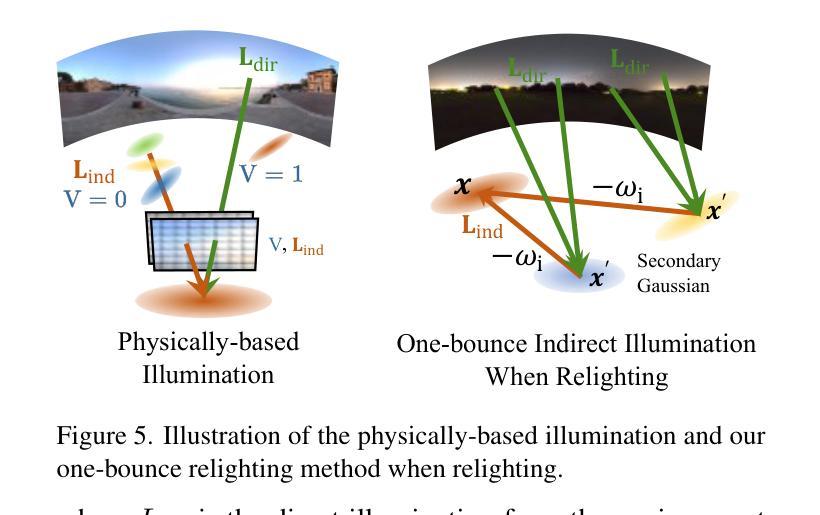

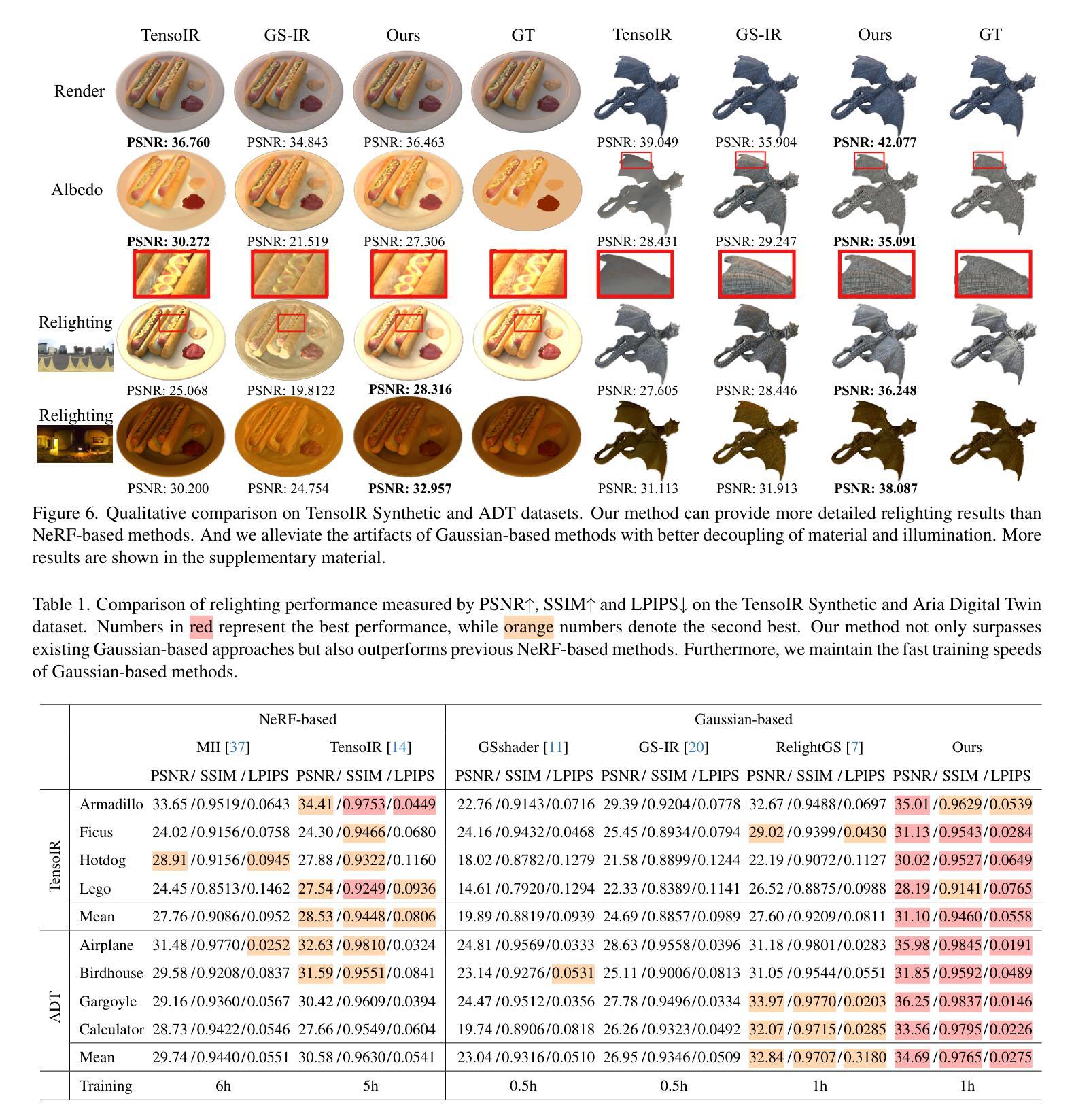

Reconstructing 3D assets from images, known as inverse rendering (IR), remains a challenging task due to its ill-posed nature. 3D Gaussian Splatting (3DGS) has demonstrated impressive capabilities for novel view synthesis (NVS) tasks. Methods apply it to relighting by separating radiance into BRDF parameters and lighting, yet produce inferior relighting quality with artifacts and unnatural indirect illumination due to the limited capability of each Gaussian, which has constant material parameters and normal, alongside the absence of physical constraints for indirect lighting. In this paper, we present a novel framework called Spatially-vayring Gaussian Inverse Rendering (SVG-IR), aimed at enhancing both NVS and relighting quality. To this end, we propose a new representation-Spatially-varying Gaussian (SVG)-that allows per-Gaussian spatially varying parameters. This enhanced representation is complemented by a SVG splatting scheme akin to vertex/fragment shading in traditional graphics pipelines. Furthermore, we integrate a physically-based indirect lighting model, enabling more realistic relighting. The proposed SVG-IR framework significantly improves rendering quality, outperforming state-of-the-art NeRF-based methods by 2.5 dB in peak signal-to-noise ratio (PSNR) and surpassing existing Gaussian-based techniques by 3.5 dB in relighting tasks, all while maintaining a real-time rendering speed.

从图像重建3D资产,也称为逆向渲染(IR),仍然是一项具有挑战性的任务,因为其性质不明确。3D高斯喷绘(3DGS)在新型视图合成(NVS)任务中展现出了令人印象深刻的能力。方法将其应用于重新照明,通过将辐射度分离为BRDF参数和照明,然而由于高斯恒定的材质参数和法线以及间接照明缺乏物理约束的局限性,导致重新照明质量较差,出现伪影和不自然的间接照明。在本文中,我们提出了一种名为空间可变高斯逆向渲染(SVG-IR)的新型框架,旨在提高NVS和重新照明质量。为此,我们提出了一种新的表现形式——空间可变高斯(SVG)——允许每个高斯具有空间变化的参数。这种增强的表现形式由一种类似于传统图形管道中的顶点/片段着色的SVG喷绘方案所补充。此外,我们集成了一个基于物理的间接照明模型,以实现更逼真的重新照明。所提出的SVG-IR框架显著提高了渲染质量,在峰值信噪比(PSNR)上比最先进的NeRF方法高出2.5分贝,在重新照明任务上比现有的高斯技术高出3.5分贝,同时保持实时渲染速度。

论文及项目相关链接

Summary

本文提出了一种名为SVG-IR的新型框架,旨在提高新型视图合成和照明质量。为此,作者提出了一种名为SVG的空间变化高斯表示法,允许每个高斯具有空间变化参数。此外,还结合了基于物理的间接照明模型,以实现更逼真的照明效果。该框架显著提高了渲染质量,在峰值信噪比(PSNR)上比最先进的NeRF方法高出2.5dB,在照明任务上比现有的高斯技术高出3.5dB,同时保持实时渲染速度。

Key Takeaways

- 介绍了名为SVG-IR的新型框架,旨在提高逆渲染任务的性能,包括新型视图合成和照明质量。

- 提出了一种名为SVG的空间变化高斯表示法,允许每个高斯具有空间变化参数,增强了渲染能力。

- 结合了基于物理的间接照明模型,实现了更逼真的照明效果。

- SVG-IR框架显著提高了渲染质量,对比其他技术具有更高的峰值信噪比(PSNR)。

- 该框架对现有的NeRF方法和高斯技术都有显著优势。

- SVG-IR框架保持了实时渲染速度。

点此查看论文截图

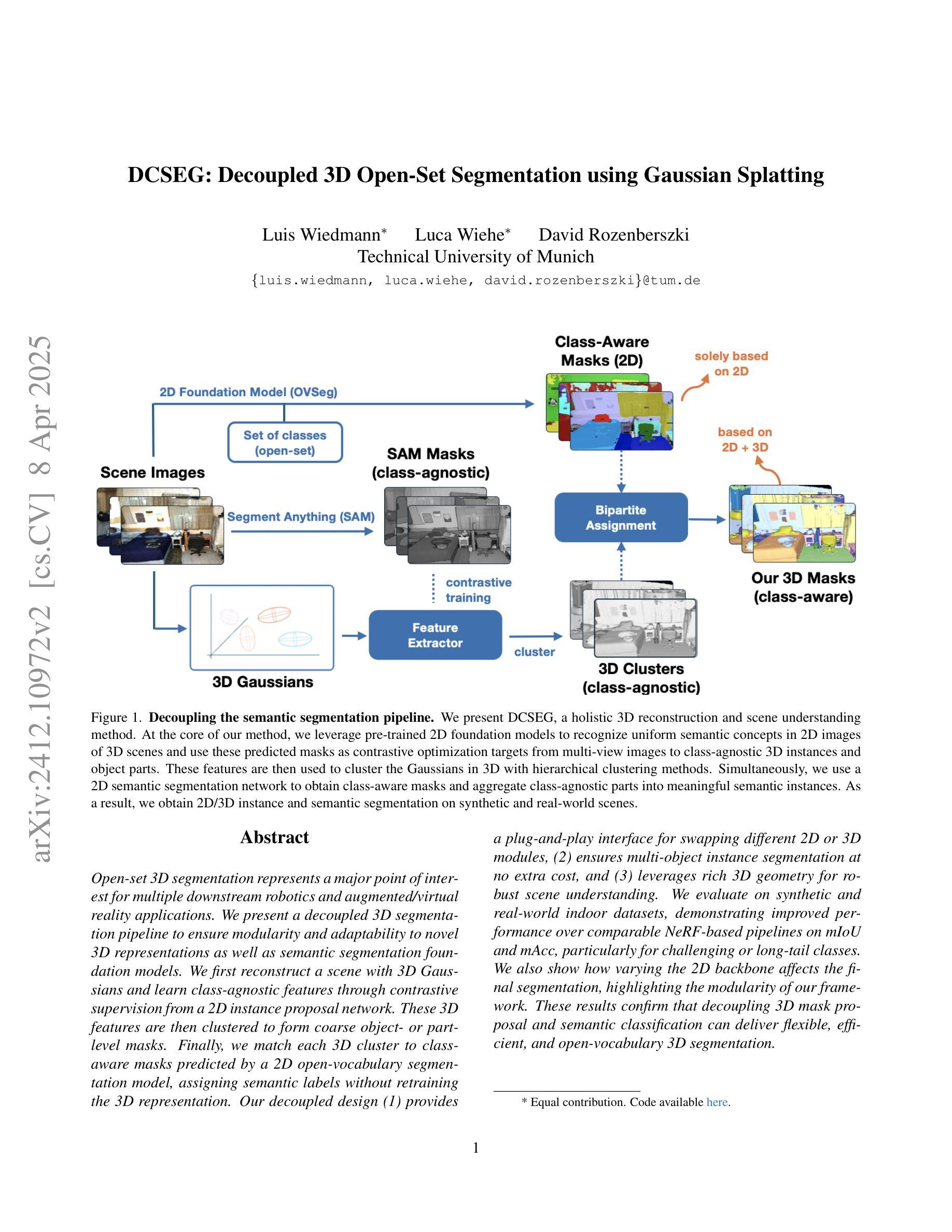

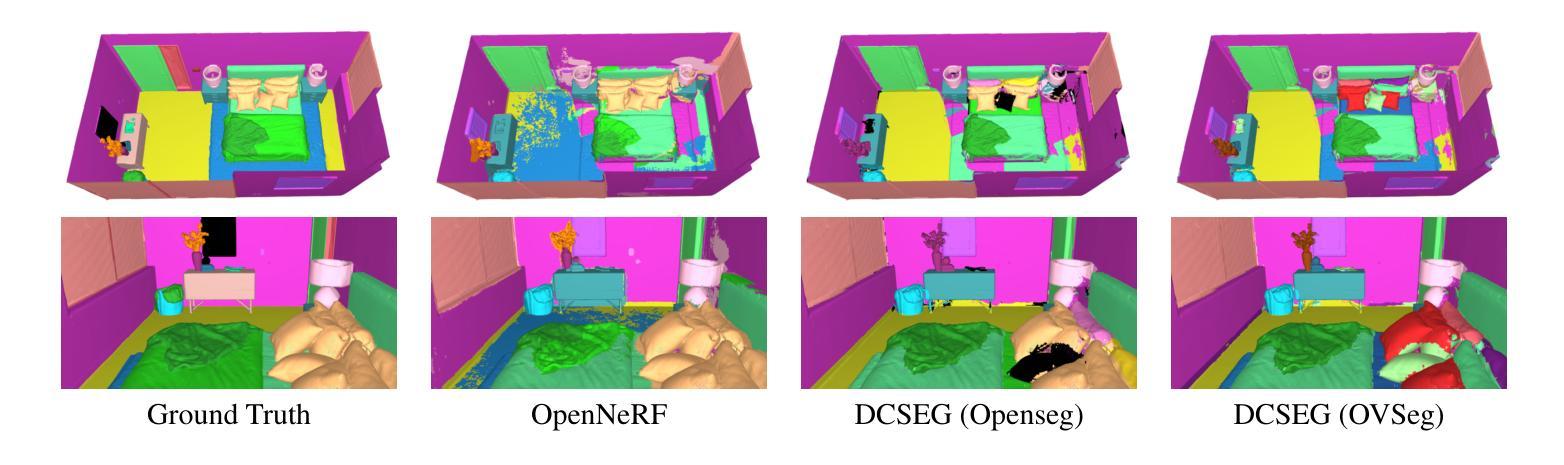

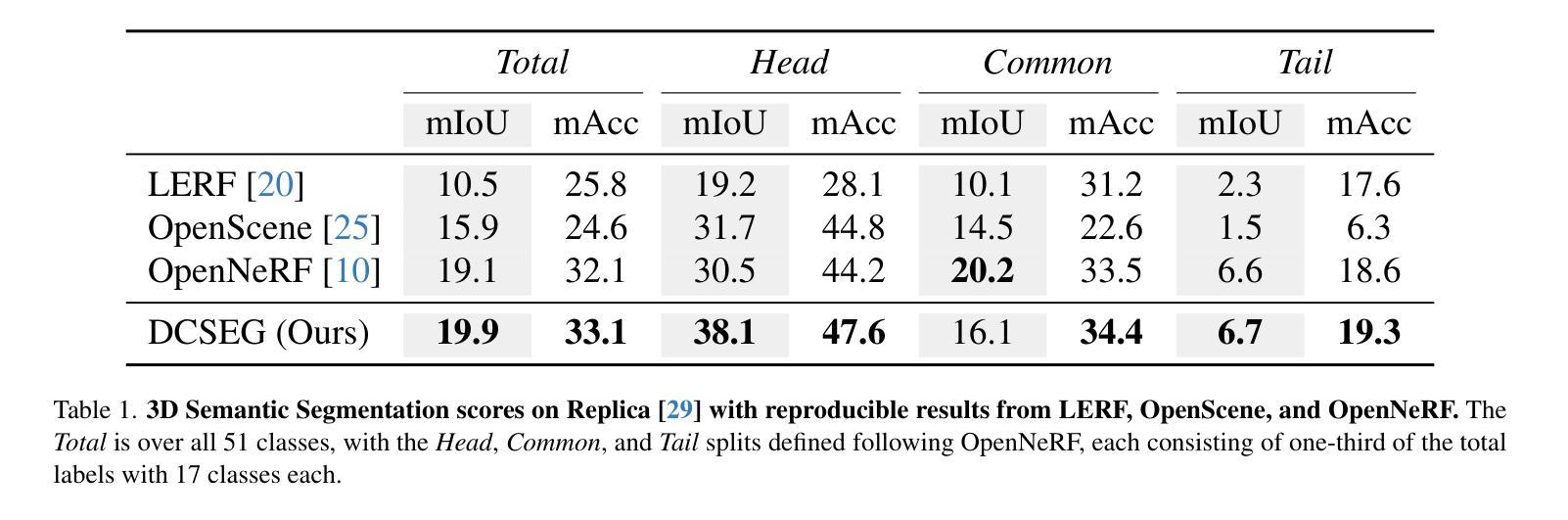

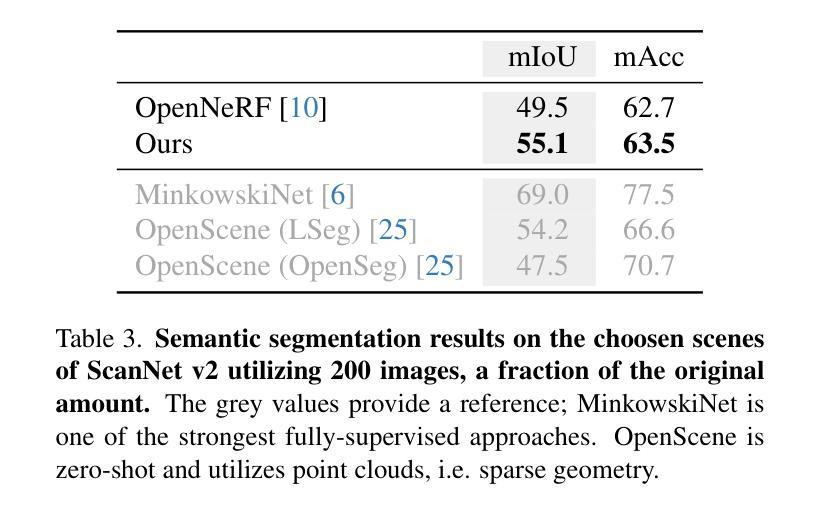

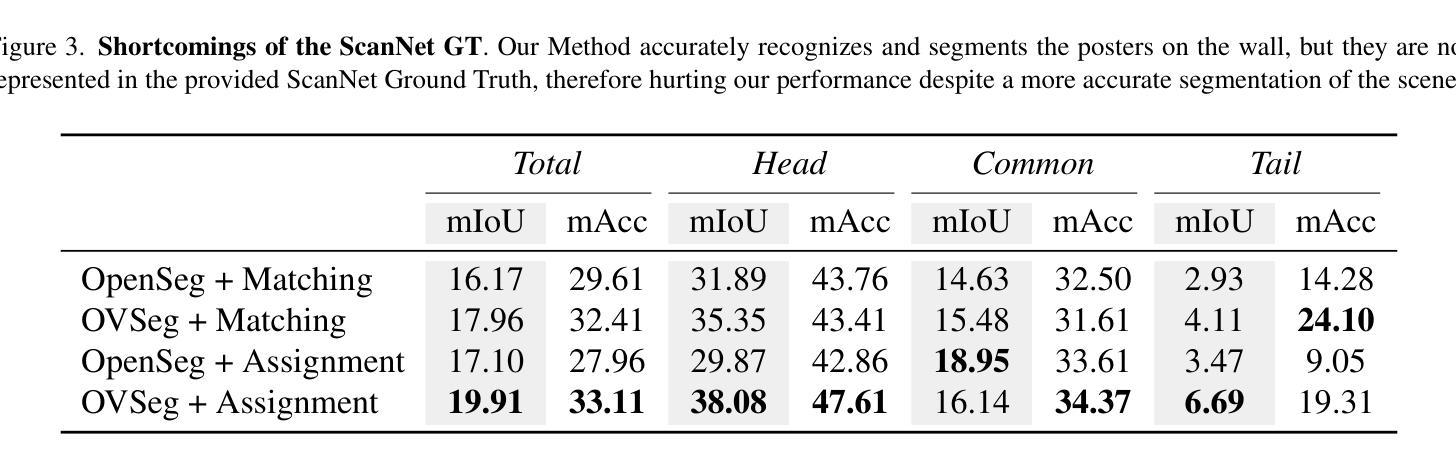

DCSEG: Decoupled 3D Open-Set Segmentation using Gaussian Splatting

Authors:Luis Wiedmann, Luca Wiehe, David Rozenberszki

Open-set 3D segmentation represents a major point of interest for multiple downstream robotics and augmented/virtual reality applications. We present a decoupled 3D segmentation pipeline to ensure modularity and adaptability to novel 3D representations as well as semantic segmentation foundation models. We first reconstruct a scene with 3D Gaussians and learn class-agnostic features through contrastive supervision from a 2D instance proposal network. These 3D features are then clustered to form coarse object- or part-level masks. Finally, we match each 3D cluster to class-aware masks predicted by a 2D open-vocabulary segmentation model, assigning semantic labels without retraining the 3D representation. Our decoupled design (1) provides a plug-and-play interface for swapping different 2D or 3D modules, (2) ensures multi-object instance segmentation at no extra cost, and (3) leverages rich 3D geometry for robust scene understanding. We evaluate on synthetic and real-world indoor datasets, demonstrating improved performance over comparable NeRF-based pipelines on mIoU and mAcc, particularly for challenging or long-tail classes. We also show how varying the 2D backbone affects the final segmentation, highlighting the modularity of our framework. These results confirm that decoupling 3D mask proposal and semantic classification can deliver flexible, efficient, and open-vocabulary 3D segmentation.

开放式集合的3D分割在多下游机器人和增强/虚拟现实应用中引起了广泛关注。我们提出了一种解耦的3D分割管道,以确保模块化并适应新的3D表示以及语义分割基础模型。首先,我们使用3D高斯分布重建场景,并通过来自2D实例提议网络的对比监督学习类别无关的特征。然后对这些3D特征进行聚类,形成粗略的对象或部件级掩码。最后,我们将每个3D聚类与由2D开放词汇分割模型预测的类别感知掩码进行匹配,从而为无需重新训练3D表示的语义标签分配标签。我们的解耦设计(1)提供了用于交换不同2D或3D模块的即插即用接口,(2)确保多目标实例分割无需额外费用,以及(3)利用丰富的3D几何进行稳健的场景理解。我们在合成和真实世界的室内数据集上进行了评估,相较于类似的NeRF管道,在mIoU和mAcc上表现出了更高的性能,尤其是在具有挑战性或长尾类别中。我们还展示了不同的2D主干如何影响最终的分割效果,突显了我们框架的模块化特性。这些结果证实了解耦的3D掩码提议和语义分类可以带来灵活、高效和开放词汇的3D分割。

论文及项目相关链接

PDF To be published in CVPR Workshop on Open-World 3D Scene Understanding with Foundation Models

Summary

本文提出了一种基于解耦的3D分割方法,采用分阶段方式保证对各种新颖的下游应用和表示的高度灵活性和适应性能。该法先用对比性监督学习生成类无关的3D特征,然后通过聚类形成粗物体或部分级遮罩。之后结合现有的三维开放词汇表分割模型与特定的类别相关的2D掩模预测进行匹配,无需重新训练三维表示即可分配语义标签。该设计提供了模块化的接口,可轻松替换不同的二维或三维模块,同时确保多目标实例分割的额外成本为零,并利用丰富的三维几何结构进行稳健的场景理解。经过合成和真实世界室内数据集验证,在平均像素相交度平均精度方面性能优越,尤其是针对具有挑战性的长尾类。本文还展示了不同二维主干网对最终分割的影响,凸显了框架的模块化特性。这些结果证明了将三维掩模提议与语义分类解耦可以实现灵活、高效和开放的词汇表三维分割方法。此方法与传统的基于NeRF的流水线相比有着更高的效率表现。在端到端的开放式环境中处理大规模场景的实例分割时展现出潜力巨大。随着人工智能的快速发展,开放式3D分割将在机器视觉领域中受到越来越多的关注并将在后续为工业自动化生产助力新场景数据测试和个性化展示产品与应用进一步延伸应用价值赋能深度学习新篇章的创新潜力非常值得期待和支持进一步发展实践提供实践指导和思考路径同时也提高了基于实体技术的各种现代应用的质量和效率。这些研究对于未来人工智能的发展具有重大意义。

Key Takeaways

- 提出了一种基于解耦的3D分割方法,确保了高度灵活性和适应性,适应多种下游应用(机器人和虚拟现实)。通过对研究目的以及研究方向的综合表述及深刻的分析未来将有助行业发展概括扼要给出技术方法的精髓及突出特点精准掌握科研内容本质意义符合事实真实可靠且具有实际应用价值强调了新技术方法和方案的有效性和高效性注重信息的精练提炼可以直观地体现出工作的专业水准展示了工作的核心竞争力具有很高的创新能力和深入分析能力在未来的研发进程中对该领域的发展起到重要的推动作用。该方法采用分阶段方式处理任务,提高了效率和性能。

点此查看论文截图