⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-04-16 更新

Let’s Talk About It: Making Scientific Computational Reproducibility Easy

Authors:Lázaro Costa, Susana Barbosa, Jácome Cunha

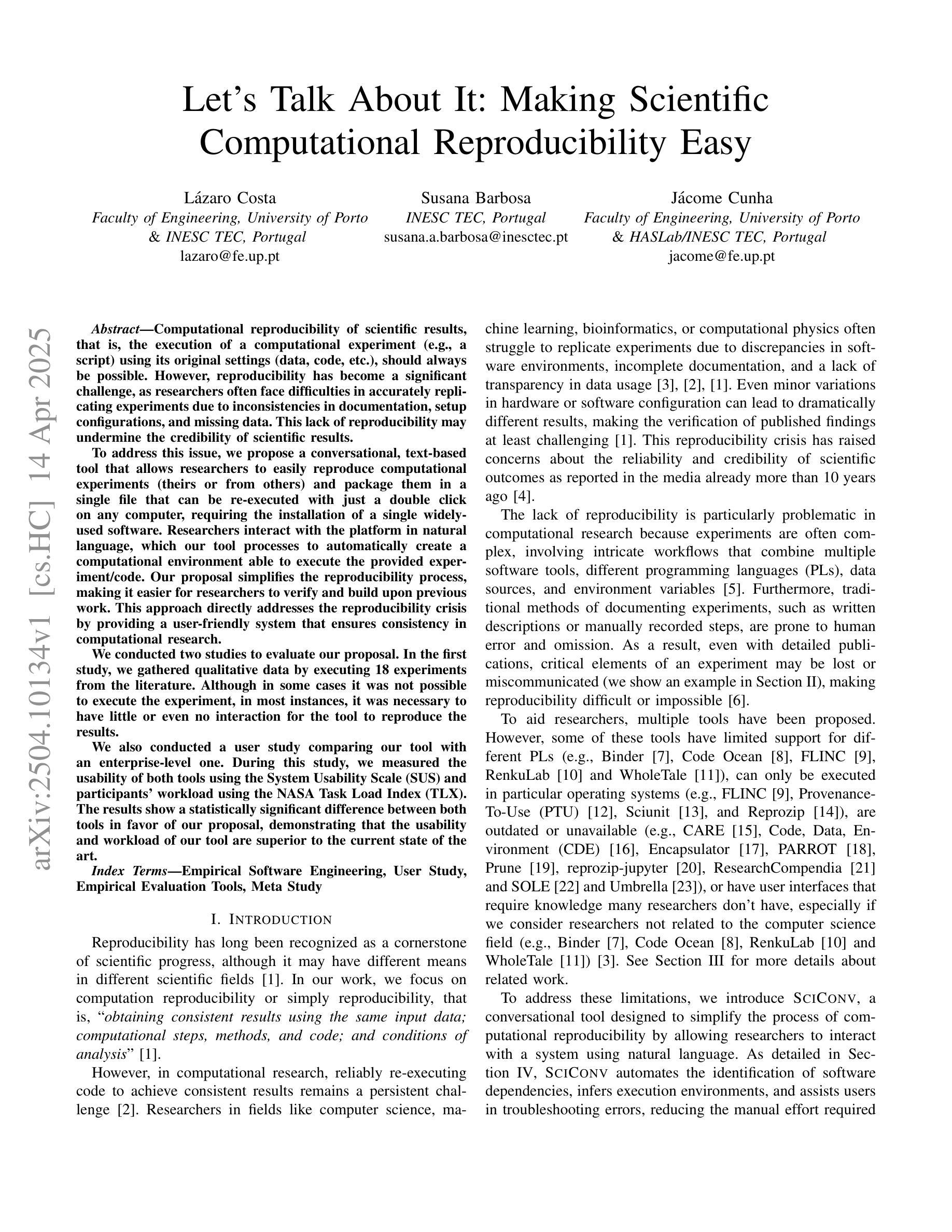

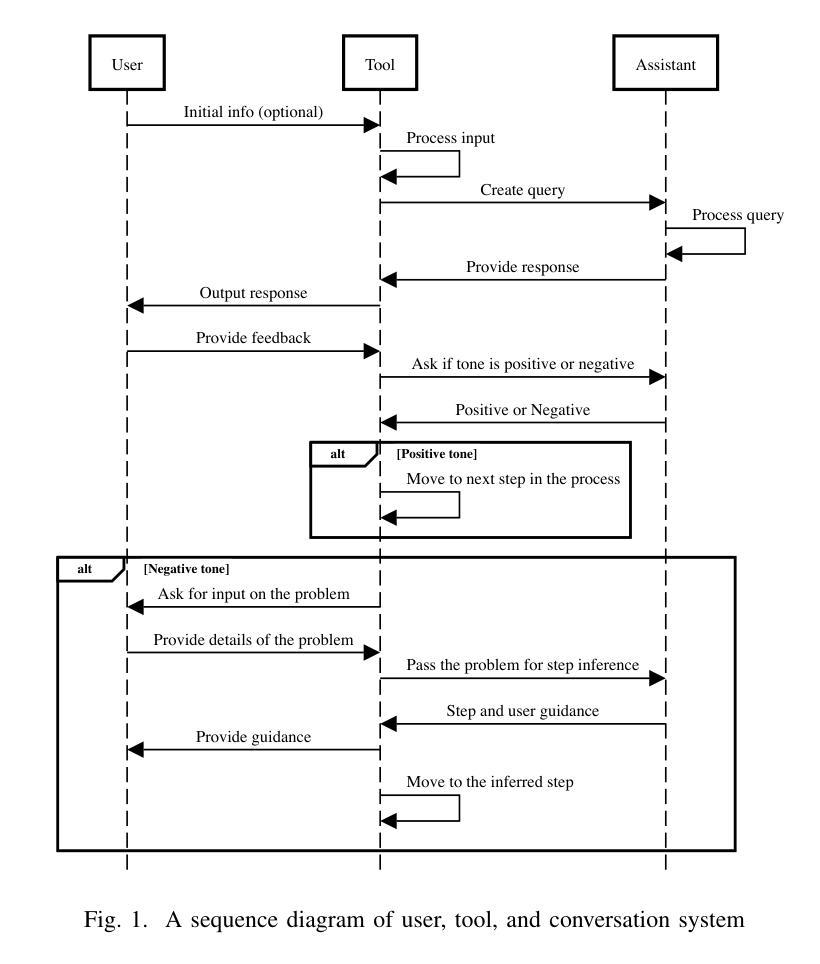

Computational reproducibility of scientific results, that is, the execution of a computational experiment (e.g., a script) using its original settings (data, code, etc.), should always be possible. However, reproducibility has become a significant challenge, as researchers often face difficulties in accurately replicating experiments due to inconsistencies in documentation, setup configurations, and missing data. This lack of reproducibility may undermine the credibility of scientific results. To address this issue, we propose a conversational, text-based tool that allows researchers to easily reproduce computational experiments (theirs or from others) and package them in a single file that can be re-executed with just a double click on any computer, requiring the installation of a single widely-used software. Researchers interact with the platform in natural language, which our tool processes to automatically create a computational environment able to execute the provided experiment/code. We conducted two studies to evaluate our proposal. In the first study, we gathered qualitative data by executing 18 experiments from the literature. Although in some cases it was not possible to execute the experiment, in most instances, it was necessary to have little or even no interaction for the tool to reproduce the results. We also conducted a user study comparing our tool with an enterprise-level one. During this study, we measured the usability of both tools using the System Usability Scale (SUS) and participants’ workload using the NASA Task Load Index (TLX). The results show a statistically significant difference between both tools in favor of our proposal, demonstrating that the usability and workload of our tool are superior to the current state of the art.

科学结果的计算可重复性,即使用其原始设置(数据、代码等)执行计算实验(例如脚本),应该始终可行。然而,由于文档、设置配置和数据缺失等方面的不一致性,研究人员在准确复制实验时经常遇到困难,因此可重复性已成为一项重大挑战。这种缺乏可重复性可能会损害科学结果的信誉。为了解决这一问题,我们提出了一种基于文本、对话式的工具,它允许研究人员轻松复制计算实验(自己的或他人的),并将其打包成一个文件,任何计算机只需双击即可重新执行,只需安装一个广泛使用的软件即可。研究人员使用自然语言与平台交互,我们的工具会处理这些自然语言以自动创建能够执行提供的实验/代码的计算环境。我们进行了两项研究来评估我们的提议。在第一项研究中,我们通过执行文献中的18个实验收集了定性数据。尽管在某些情况下无法执行实验,但在大多数情况下,无需与工具进行太多交互即可重现结果。我们还进行了一项将我们的工具与企业级工具进行比较的用户研究。在这项研究中,我们使用系统可用性量表(SUS)衡量了两种工具的可用性,并使用NASA任务负荷指数(TLX)衡量了参与者的工作量。结果表明,两种工具在可用性方面存在统计学上的显著差异,支持我们的提案,证明我们的工具的可用性和工作量优于当前的技术水平。

论文及项目相关链接

Summary

该文强调计算实验的可重复性在科学研究中的重要性,并指出了现有实现难度。为解决这一问题,研究者提出了一款基于自然语言交互的工具,该工具能够创建计算环境自动执行实验或代码,并将其打包成可在任何计算机上双击执行的单一文件。通过两项研究验证了该工具的有效性和优越性。

Key Takeaways

- 计算实验的可重复性对科学研究的可信度至关重要。

- 由于文档不一致、设置配置缺失和数据缺失等问题,实验的可重复性成为一大挑战。

- 研究者提出了一款基于自然语言交互的工具,旨在简化计算实验的可重复性。

- 该工具允许研究人员通过自然语言与平台交互,自动创建计算环境并执行实验或代码。

- 工具可将计算实验打包成可在任何计算机上双击执行的单一文件。

- 通过两项研究验证了该工具的有效性和优越性,其中一项研究对比了该企业级工具,结果表明所提工具在可用性和工作负载方面均优于当前技术。

点此查看论文截图