⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-04-17 更新

COP-GEN-Beta: Unified Generative Modelling of COPernicus Imagery Thumbnails

Authors:Miguel Espinosa, Valerio Marsocci, Yuru Jia, Elliot J. Crowley, Mikolaj Czerkawski

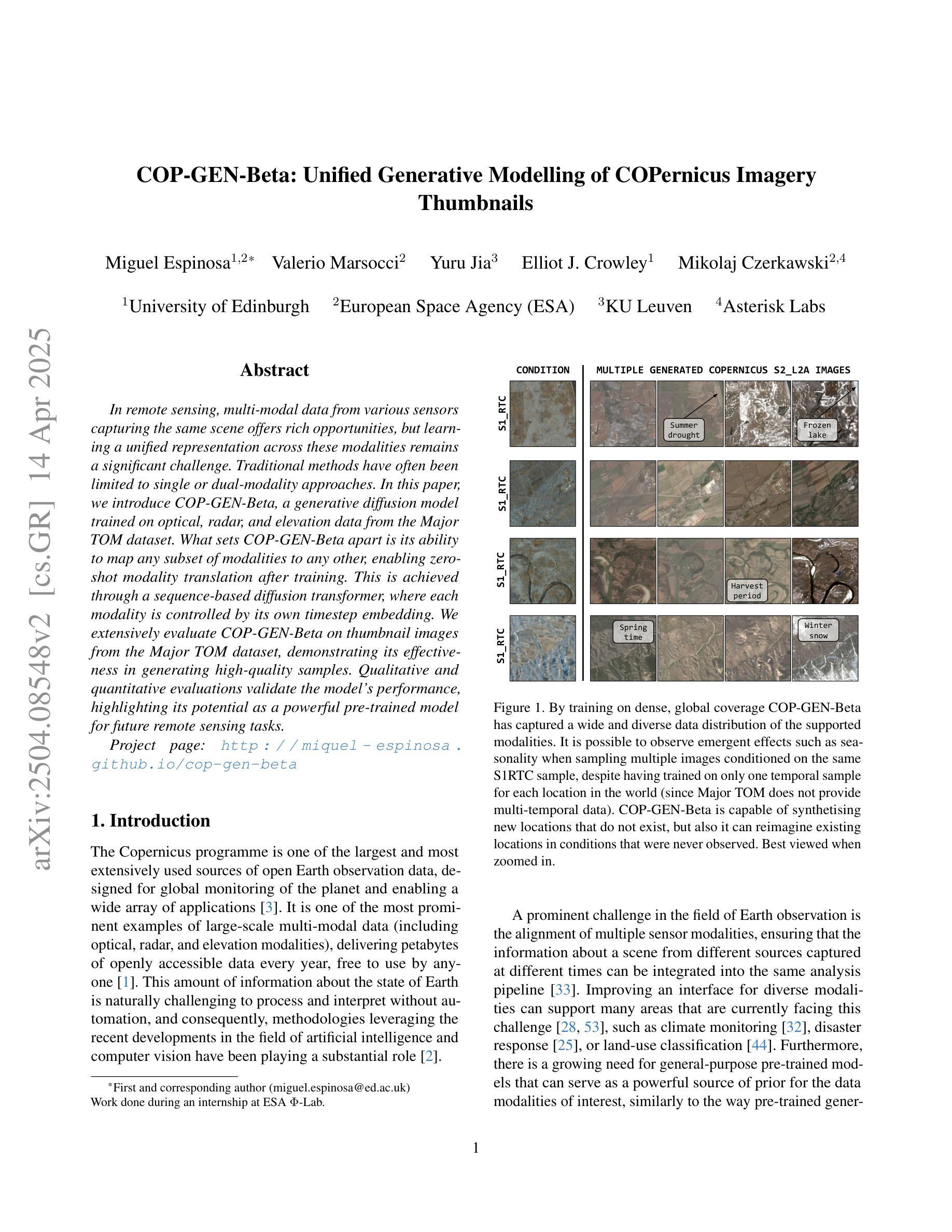

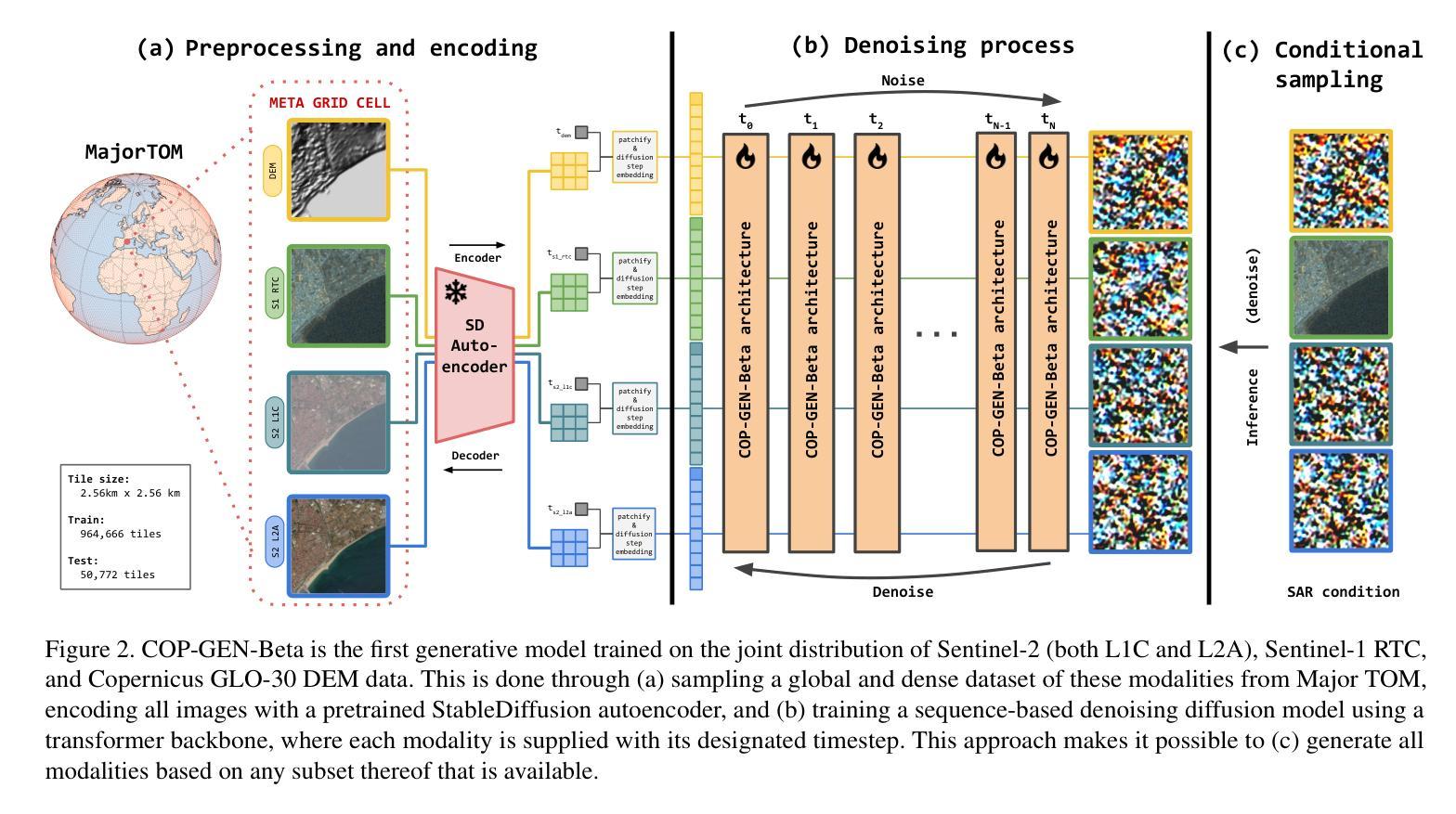

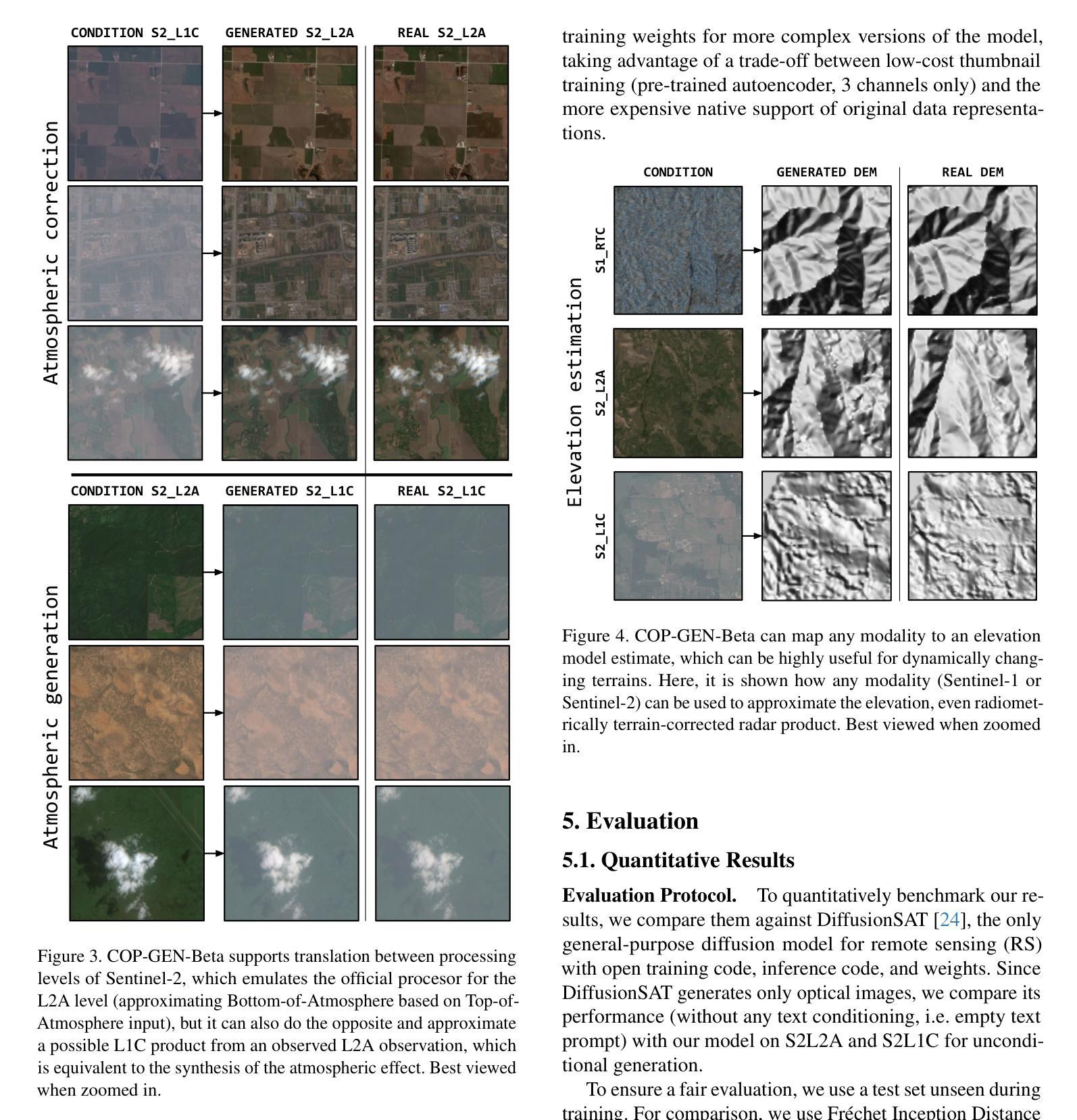

In remote sensing, multi-modal data from various sensors capturing the same scene offers rich opportunities, but learning a unified representation across these modalities remains a significant challenge. Traditional methods have often been limited to single or dual-modality approaches. In this paper, we introduce COP-GEN-Beta, a generative diffusion model trained on optical, radar, and elevation data from the Major TOM dataset. What sets COP-GEN-Beta apart is its ability to map any subset of modalities to any other, enabling zero-shot modality translation after training. This is achieved through a sequence-based diffusion transformer, where each modality is controlled by its own timestep embedding. We extensively evaluate COP-GEN-Beta on thumbnail images from the Major TOM dataset, demonstrating its effectiveness in generating high-quality samples. Qualitative and quantitative evaluations validate the model’s performance, highlighting its potential as a powerful pre-trained model for future remote sensing tasks.

在遥感领域,从不同传感器捕捉同一场景的多模态数据提供了丰富的机会,但学习这些模态的统一表示仍然是一个重大挑战。传统方法通常局限于单一或双模态方法。在本文中,我们介绍了COP-GEN-Beta,这是一个在Major TOM数据集的光学、雷达和地形数据上训练的生成性扩散模型。COP-GEN-Beta的特殊之处在于,它能够将任何模态子集映射到其他模态,实现在训练后的零样本模态翻译。这是通过基于序列的扩散变压器实现的,其中每个模态由其自身的时间步长嵌入控制。我们在Major TOM数据集的缩略图图像上对COP-GEN-Beta进行了广泛评估,证明了其生成高质量样本的有效性。定性和定量评估验证了该模型的性能,突显了其作为未来遥感任务强大预训练模型的潜力。

论文及项目相关链接

PDF Accepted at CVPR 2025 Workshop MORSE

Summary

多模态遥感数据为同一场景的丰富信息提供了机会,但如何学习跨模态的统一表示仍然是一个挑战。本文介绍了一种基于光学、雷达和高度数据的生成扩散模型COP-GEN-Beta。该模型能够实现跨模态零样本翻译,并可通过基于序列的扩散变压器实现不同模态的控制。实验证明,该模型在生成高质量样本方面表现出良好的效果。这为未来的遥感任务提供了强大的预训练模型潜力。

Key Takeaways

- 多模态遥感数据为同一场景提供了丰富的信息机会。

- 传统方法在处理跨模态数据时存在局限性。

- COP-GEN-Beta是一种生成扩散模型,可以处理光学、雷达和高度数据。

- COP-GEN-Beta能够实现零样本模态翻译,即不同模态之间的映射。

- 该模型采用基于序列的扩散变压器结构,通过时间步长嵌入控制不同模态。

- 在Major TOM数据集上进行广泛实验验证,证明了COP-GEN-Beta在生成高质量样本方面的有效性。

点此查看论文截图

CyclePose – Leveraging Cycle-Consistency for Annotation-Free Nuclei Segmentation in Fluorescence Microscopy

Authors:Jonas Utz, Stefan Vocht, Anne Tjorven Buessen, Dennis Possart, Fabian Wagner, Mareike Thies, Mingxuan Gu, Stefan Uderhardt, Katharina Breininger

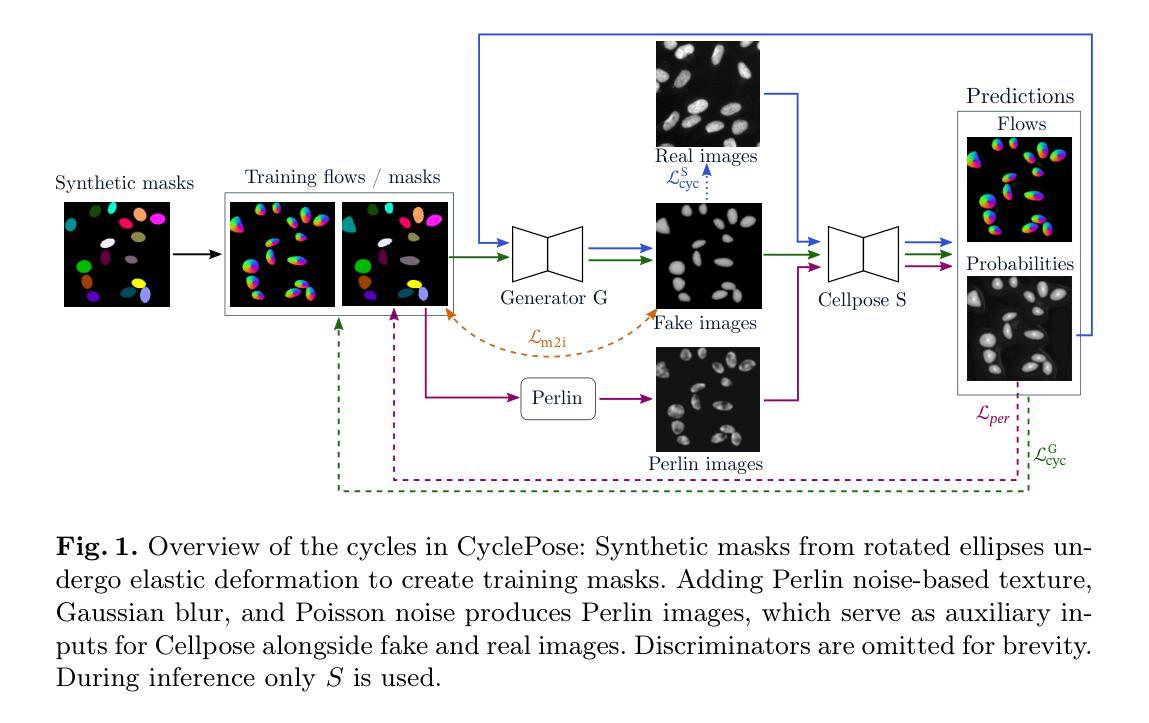

In recent years, numerous neural network architectures specifically designed for the instance segmentation of nuclei in microscopic images have been released. These models embed nuclei-specific priors to outperform generic architectures like U-Nets; however, they require large annotated datasets, which are often not available. Generative models (GANs, diffusion models) have been used to compensate for this by synthesizing training data. These two-stage approaches are computationally expensive, as first a generative model and then a segmentation model has to be trained. We propose CyclePose, a hybrid framework integrating synthetic data generation and segmentation training. CyclePose builds on a CycleGAN architecture, which allows unpaired translation between microscopy images and segmentation masks. We embed a segmentation model into CycleGAN and leverage a cycle consistency loss for self-supervision. Without annotated data, CyclePose outperforms other weakly or unsupervised methods on two public datasets. Code is available at https://github.com/jonasutz/CyclePose

近年来,针对显微图像中的细胞核实例分割,已经推出了许多专门设计的神经网络架构。这些模型嵌入细胞核特异性先验知识,以超越通用架构(如U-Nets)。然而,它们需要大量标注数据集,而这些数据通常不可用。生成模型(GANs,扩散模型)已被用于通过合成训练数据来弥补这一缺陷。这两种两阶段的方法计算成本很高,因为首先需要训练一个生成模型,然后训练一个分割模型。我们提出了CyclePose,这是一个结合了合成数据生成和分割训练的混合框架。CyclePose基于CycleGAN架构,它允许显微镜图像和分割掩膜之间的无配对转换。我们将分割模型嵌入到CycleGAN中,并利用循环一致性损失进行自监督。无需标注数据,CyclePose在两个公共数据集上的表现优于其他弱监督或无监督方法。代码可在https://github.com/jonasutz/CyclePose找到。

论文及项目相关链接

PDF under review for MICCAI 2025

Summary

近期出现多种专为显微图像中的细胞核实例分割设计的神经网络架构,这些模型通过嵌入细胞核特异性先验知识来超越通用架构(如U-Net)。然而,它们需要大量标注数据集,而这些数据通常无法获取。为弥补这一缺陷,研究者使用生成模型(GANs、扩散模型)合成训练数据。然而,这种两阶段方法计算成本高,需先训练生成模型,再训练分割模型。本文提出一种集成合成数据生成与分割训练于一体的混合框架——CyclePose。它基于CycleGAN架构,可实现显微镜图像与分割掩膜之间的无配对转换。将分割模型嵌入CycleGAN中并利用循环一致性损失进行自监督学习。无需标注数据,CyclePose在公共数据集上的表现优于其他弱监督或无监督方法。相关代码可在“链接”找到。

Key Takeaways

- 近年出现多种针对显微图像细胞核实例分割的神经网络架构。

- 这些模型通过嵌入细胞核特异性先验知识来提高性能。

- 现有模型需要大量标注数据集,而这在实际中常常难以实现。

- 生成模型(如GANs、扩散模型)被用于合成训练数据以弥补这一缺陷。

- 两阶段方法计算成本高,需分阶段训练生成模型和分割模型。

- 提出了一种混合框架CyclePose,集成了合成数据生成与分割训练。

点此查看论文截图