⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-04-26 更新

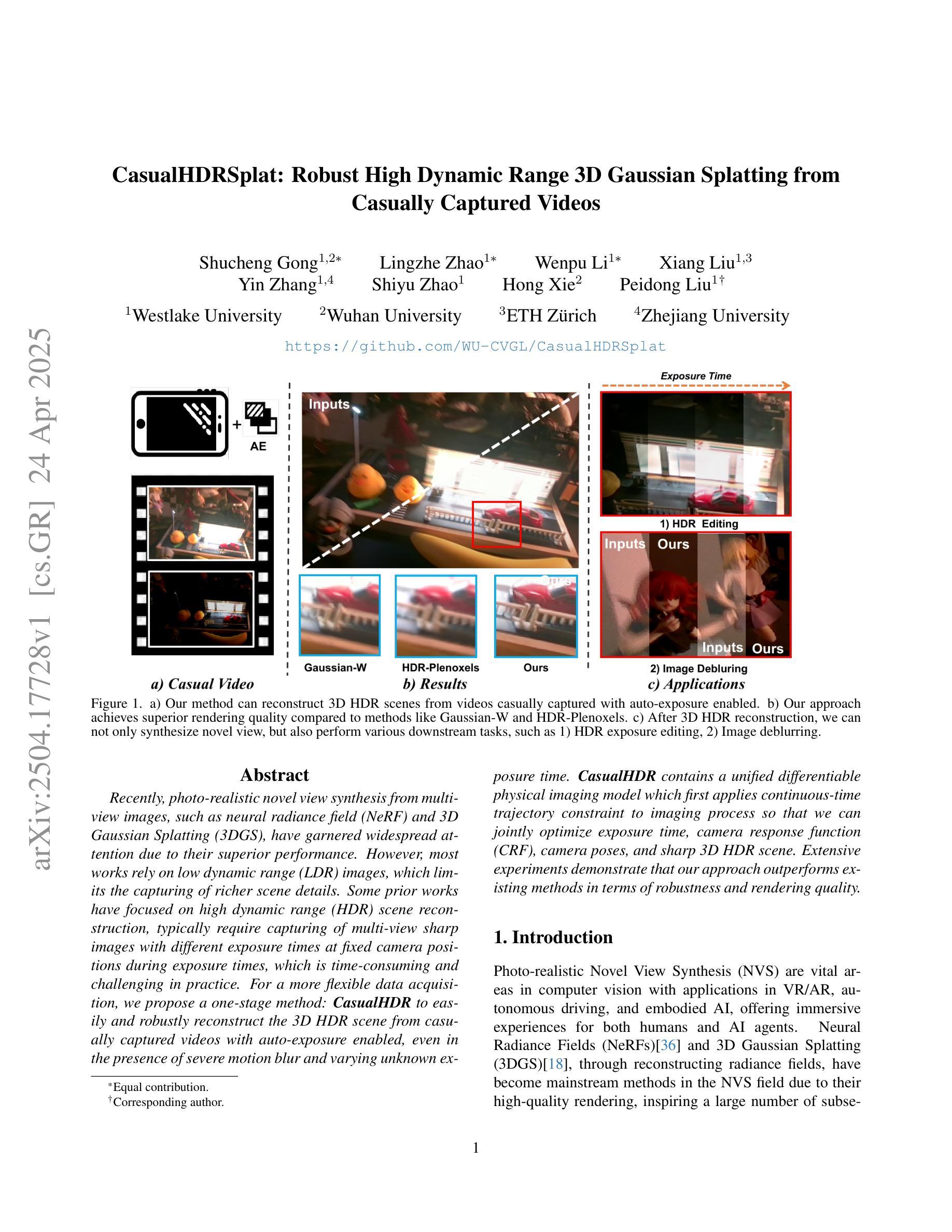

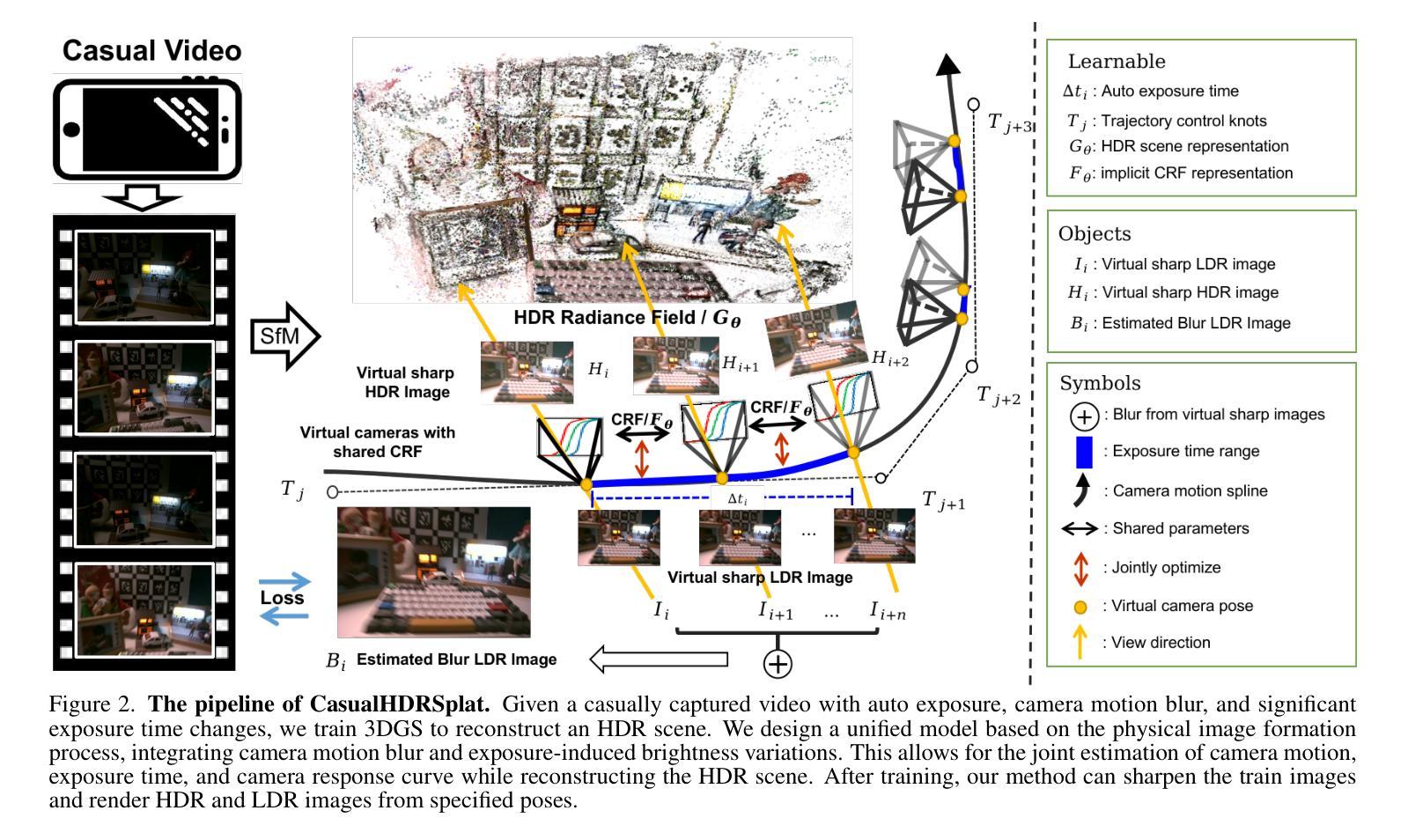

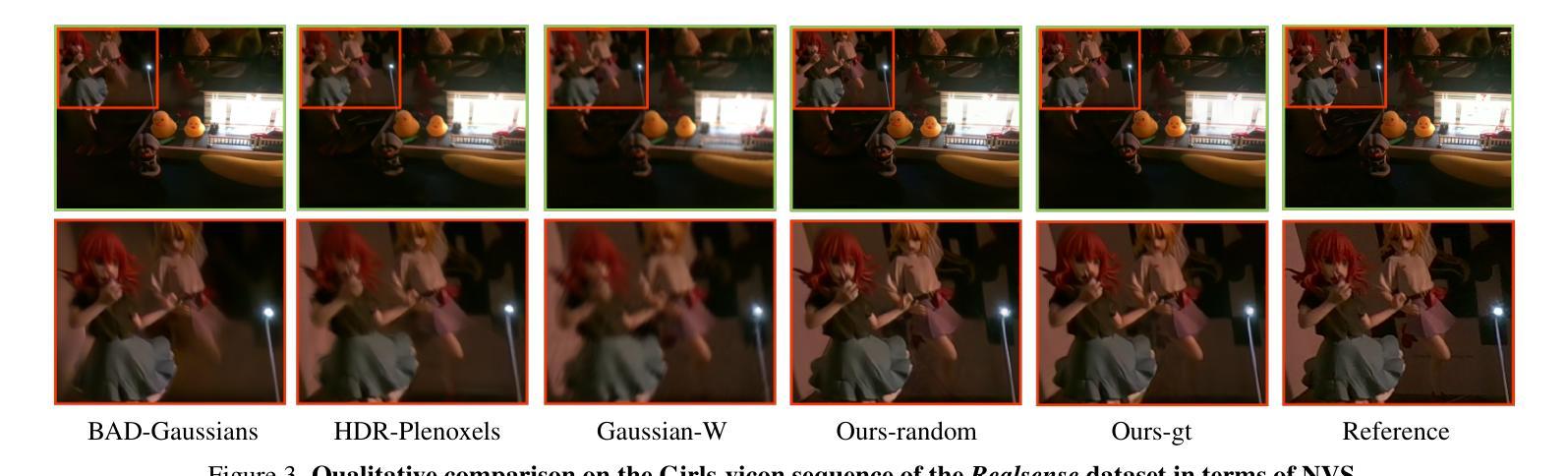

CasualHDRSplat: Robust High Dynamic Range 3D Gaussian Splatting from Casually Captured Videos

Authors:Shucheng Gong, Lingzhe Zhao, Wenpu Li, Hong Xie, Yin Zhang, Shiyu Zhao, Peidong Liu

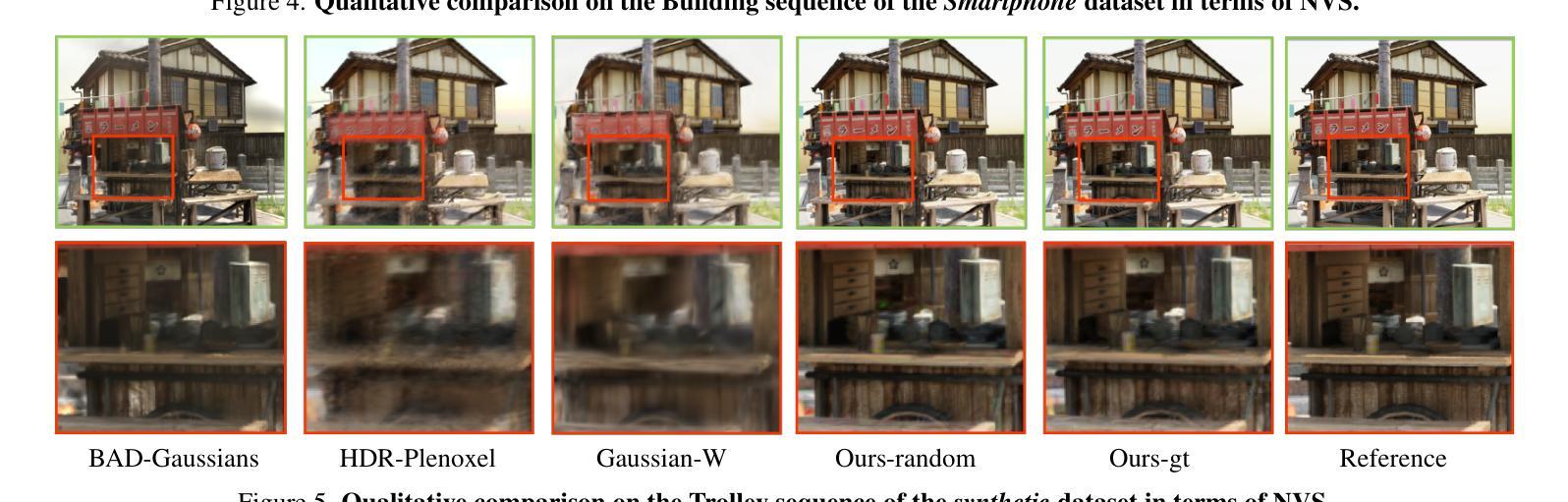

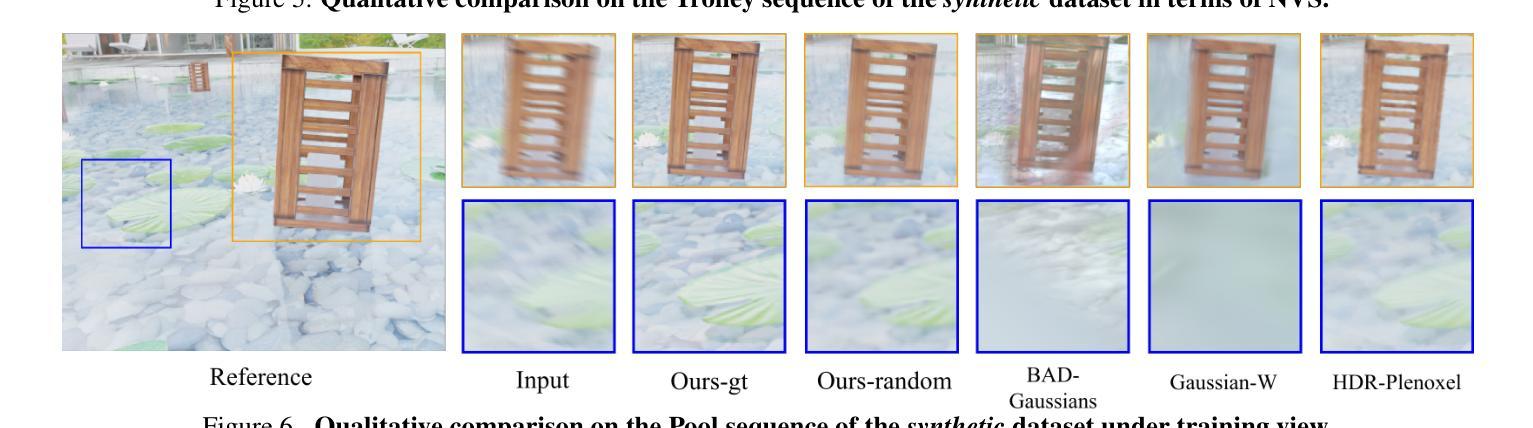

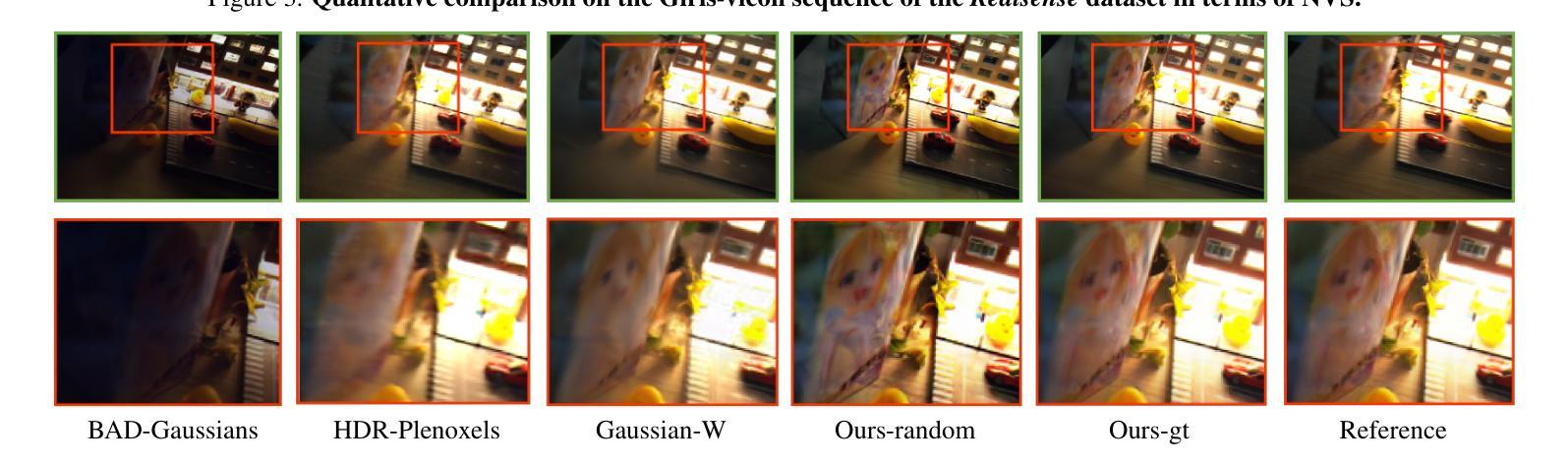

Recently, photo-realistic novel view synthesis from multi-view images, such as neural radiance field (NeRF) and 3D Gaussian Splatting (3DGS), have garnered widespread attention due to their superior performance. However, most works rely on low dynamic range (LDR) images, which limits the capturing of richer scene details. Some prior works have focused on high dynamic range (HDR) scene reconstruction, typically require capturing of multi-view sharp images with different exposure times at fixed camera positions during exposure times, which is time-consuming and challenging in practice. For a more flexible data acquisition, we propose a one-stage method: \textbf{CasualHDRSplat} to easily and robustly reconstruct the 3D HDR scene from casually captured videos with auto-exposure enabled, even in the presence of severe motion blur and varying unknown exposure time. \textbf{CasualHDRSplat} contains a unified differentiable physical imaging model which first applies continuous-time trajectory constraint to imaging process so that we can jointly optimize exposure time, camera response function (CRF), camera poses, and sharp 3D HDR scene. Extensive experiments demonstrate that our approach outperforms existing methods in terms of robustness and rendering quality. Our source code will be available at https://github.com/WU-CVGL/CasualHDRSplat

最近,从多角度图像进行逼真的新型视角合成的方法,如神经网络辐射场(NeRF)和三维高斯涂绘(3DGS)因其卓越的表现而受到广泛关注。然而,大多数研究都依赖于低动态范围(LDR)图像,这限制了捕捉更丰富的场景细节。之前的一些研究聚焦于高动态范围(HDR)场景的重建,通常需要在固定相机位置、不同的曝光时间下拍摄多角度清晰图像,这在实践中既耗时又具有挑战性。为了进行更灵活的数据采集,我们提出了一种一阶段方法:CasualHDRSplat,能够轻松稳健地从具有自动曝光功能的随意拍摄视频重建出三维HDR场景,即使在存在严重运动模糊和未知变化的曝光时间的情况下也是如此。CasualHDRSplat包含一个统一的可微物理成像模型,该模型首先应用连续时间轨迹约束到成像过程中,使我们能够联合优化曝光时间、相机响应函数(CRF)、相机姿态和清晰的3D HDR场景。大量实验表明,我们的方法在稳健性和渲染质量方面优于现有方法。我们的源代码将在https://github.com/WU-CVGL/CasualHDRSplat找到。

论文及项目相关链接

PDF Source Code: https://github.com/WU-CVGL/CasualHDRSplat

Summary

本文介绍了基于神经辐射场(NeRF)和高清重建技术的新研究进展。当前多视角图像合成技术在低动态范围(LDR)图像上的工作取得优异性能,但难以捕捉丰富的场景细节。针对这一问题,本文提出了一种名为CasualHDRSplat的新方法,能够从随意拍摄的视频中自动重建出高清三维场景,即使存在严重的运动模糊和未知的曝光时间。CasualHDRSplat使用一个统一的、可微分的物理成像模型,连续优化曝光时间、相机响应函数(CRF)、相机姿态和清晰的三维高清场景。实验证明,该方法在鲁棒性和渲染质量上优于现有方法。

Key Takeaways

- 神经辐射场(NeRF)和多视角图像合成技术在低动态范围(LDR)图像上的表现已得到广泛关注。

- HDR图像能够捕捉更丰富的场景细节,但目前的方法多在固定相机位置、多视角清晰图像下进行捕捉,实践中有时间消耗大、挑战性高的缺点。

- 提出了一种名为CasualHDRSplat的新方法,能够从随意拍摄的视频中重建出三维高清场景,适应性强,能够处理运动模糊和未知曝光时间的问题。

- CasualHDRSplat使用统一的、可微分的物理成像模型,该模型能够连续优化多个参数,包括曝光时间、相机响应函数(CRF)、相机姿态和三维场景。

- 实验证明,CasualHDRSplat在鲁棒性和渲染质量上超越现有方法。

- 该方法的源代码将在指定的网址上公开,供公众查阅和使用。

点此查看论文截图

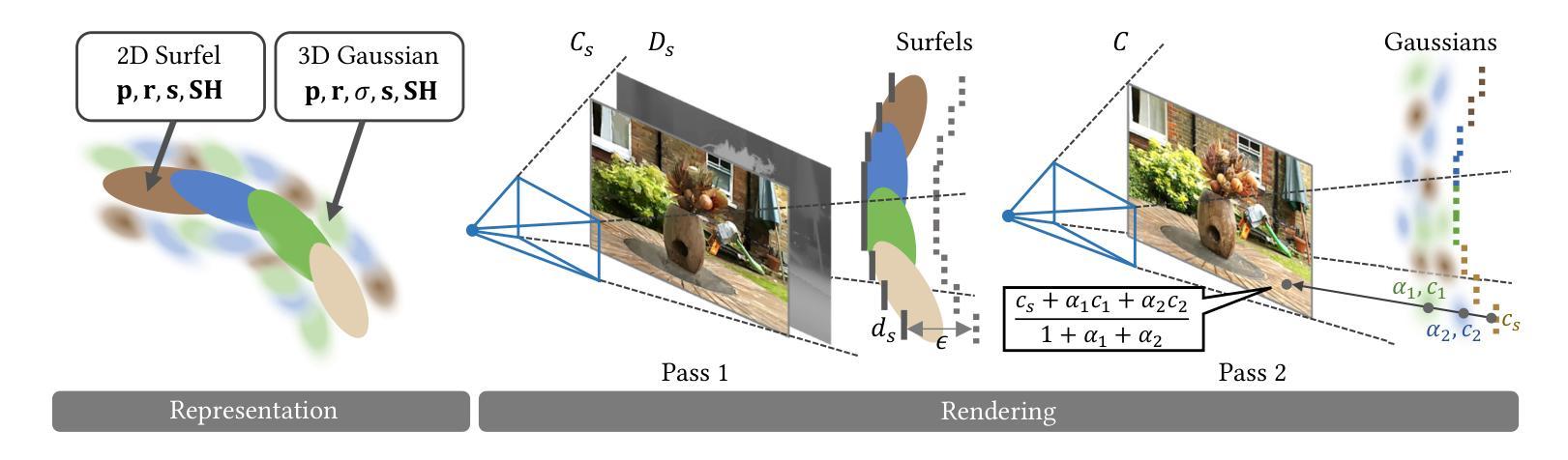

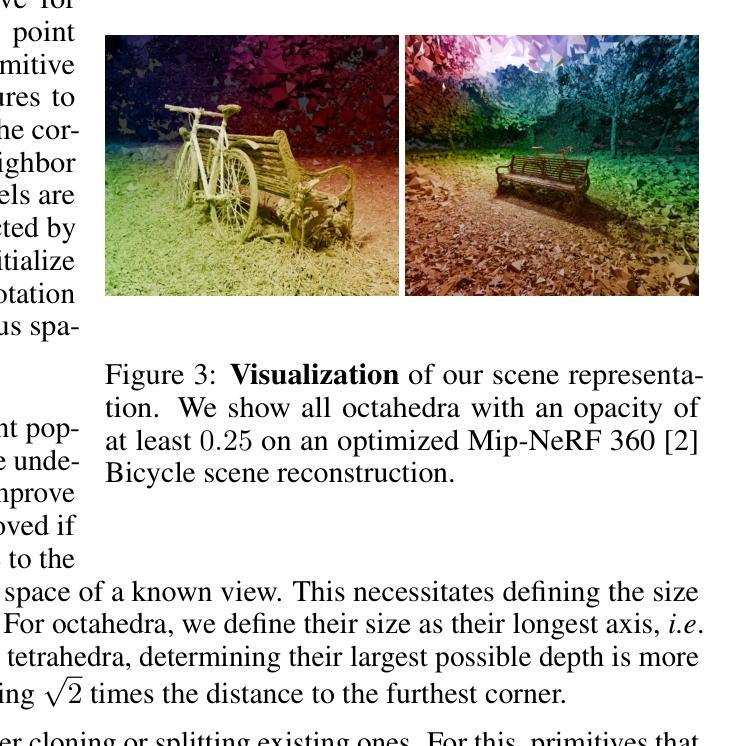

LinPrim: Linear Primitives for Differentiable Volumetric Rendering

Authors:Nicolas von Lützow, Matthias Nießner

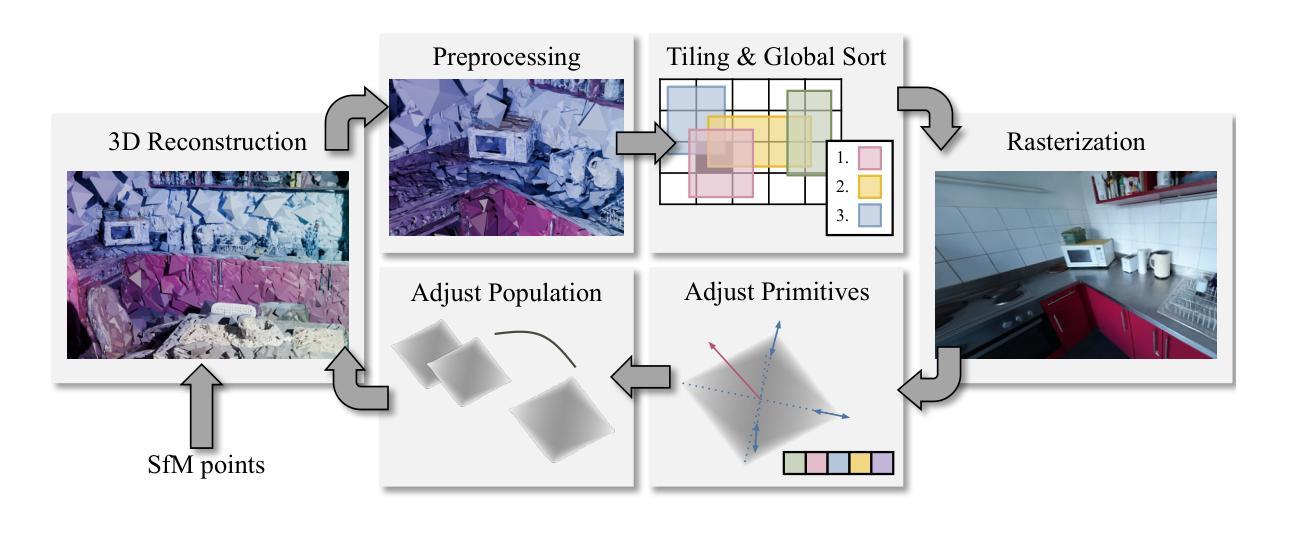

Volumetric rendering has become central to modern novel view synthesis methods, which use differentiable rendering to optimize 3D scene representations directly from observed views. While many recent works build on NeRF or 3D Gaussians, we explore an alternative volumetric scene representation. More specifically, we introduce two new scene representations based on linear primitives - octahedra and tetrahedra - both of which define homogeneous volumes bounded by triangular faces. To optimize these primitives, we present a differentiable rasterizer that runs efficiently on GPUs, allowing end-to-end gradient-based optimization while maintaining real-time rendering capabilities. Through experiments on real-world datasets, we demonstrate comparable performance to state-of-the-art volumetric methods while requiring fewer primitives to achieve similar reconstruction fidelity. Our findings deepen the understanding of 3D representations by providing insights into the fidelity and performance characteristics of transparent polyhedra and suggest that adopting novel primitives can expand the available design space.

体积渲染已经成为现代新颖视图合成方法的核心,这些方法使用可微分的渲染来直接优化从观察到的视角表示的3D场景。虽然许多近期的工作基于NeRF或3D高斯,但我们探索了一种替代的体积场景表示。更具体地说,我们引入两种基于线性原始几何体的新场景表示方法——八面体和四面体,它们都由三角形面定义均匀体积。为了优化这些原始几何体,我们提出了一种可在GPU上高效运行的可微分光线追踪器,允许端到端的基于梯度的优化,同时保持实时渲染能力。通过在实际数据集上的实验,我们展示了与最先进的体积方法相当的性能,同时在使用较少的原始几何体的情况下实现了类似的重建保真度。我们的研究结果加深了对3D表示的理解,为透明多边形的保真度和性能特征提供了见解,并表明采用新型原始几何体可以扩大可用的设计空间。

论文及项目相关链接

PDF Project page: https://nicolasvonluetzow.github.io/LinPrim - Project video: https://youtu.be/NRRlmFZj5KQ

Summary

文中探索了基于线性原始体积的两种新型场景表示方法,即采用正八面体和四面体表示场景体积。为提高优化效率,提出了可在GPU上高效运行的可微分光栅化器。实验证明,该方法与最先进的体积方法在性能上相当,且使用较少的原始体积即可达到相似的重建保真度。此研究加深了对三维表示的理解,为透明多面体的保真度和性能特征提供了见解,并表明采用新型原始体积可以扩大设计空间。

Key Takeaways

- 引入两种新型基于线性原始体积的场景表示方法:正八面体和四面体。

- 新型场景表示方法可以定义均匀体积并通过对三角面进行界限划分。

- 为优化这些原始体积,提出了可在GPU上高效运行的可微分光栅化器。

- 该方法允许端到端的基于梯度的优化,同时保持实时渲染能力。

- 实验证明,该方法与最先进的体积渲染方法在性能上相当。

- 使用较少的原始体积即可达到相似的重建保真度。

点此查看论文截图

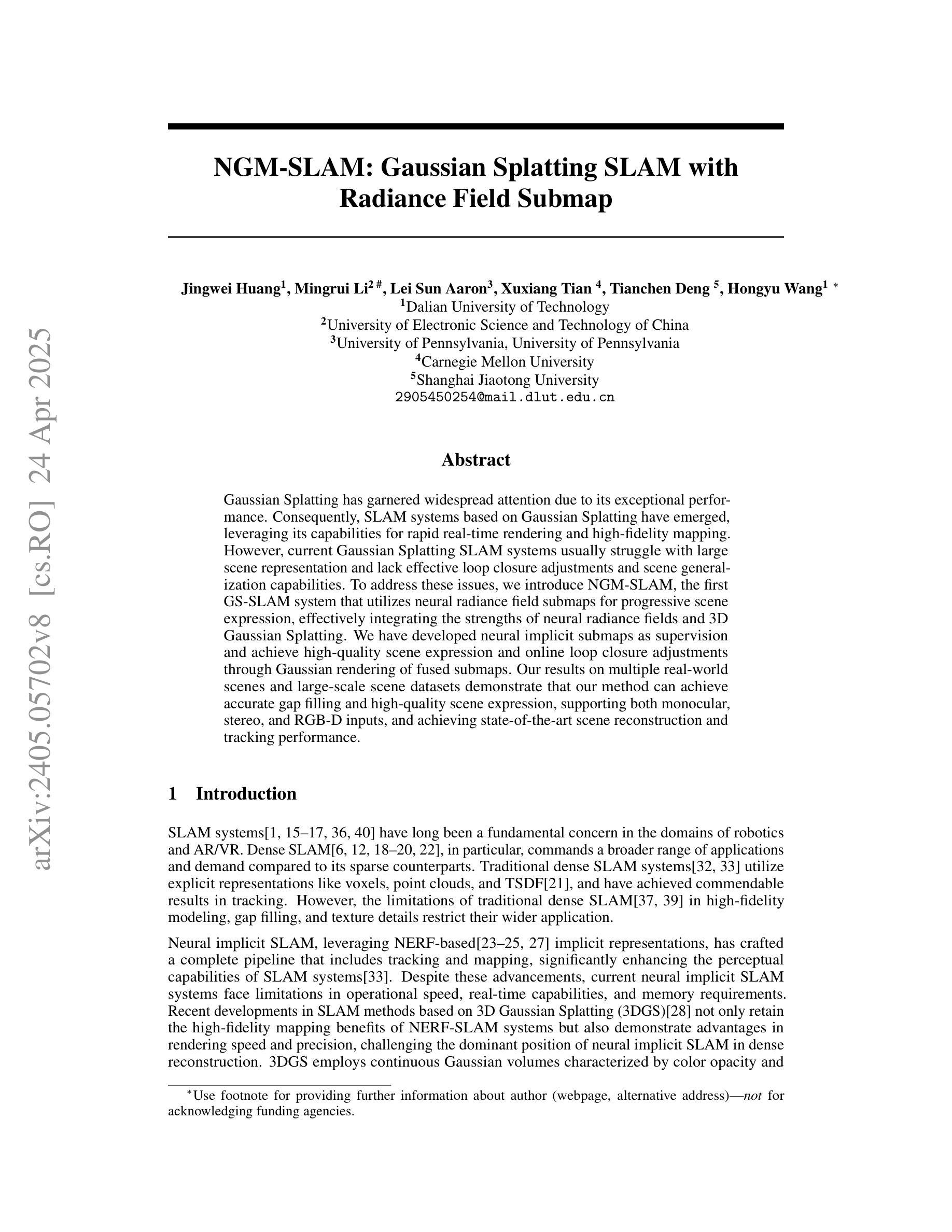

NGM-SLAM: Gaussian Splatting SLAM with Radiance Field Submap

Authors:Jingwei Huang, Mingrui Li, Lei Sun, Aaron Xuxiang Tian, Tianchen Deng, Hongyu Wang

SLAM systems based on Gaussian Splatting have garnered attention due to their capabilities for rapid real-time rendering and high-fidelity mapping. However, current Gaussian Splatting SLAM systems usually struggle with large scene representation and lack effective loop closure detection. To address these issues, we introduce NGM-SLAM, the first 3DGS based SLAM system that utilizes neural radiance field submaps for progressive scene expression, effectively integrating the strengths of neural radiance fields and 3D Gaussian Splatting. We utilize neural radiance field submaps as supervision and achieve high-quality scene expression and online loop closure adjustments through Gaussian rendering of fused submaps. Our results on multiple real-world scenes and large-scale scene datasets demonstrate that our method can achieve accurate hole filling and high-quality scene expression, supporting monocular, stereo, and RGB-D inputs, and achieving state-of-the-art scene reconstruction and tracking performance.

基于高斯混合技术的SLAM系统因其快速实时渲染和高保真映射能力而受到关注。然而,当前的高斯混合SLAM系统通常在大型场景表示方面遇到困难,并且缺乏有效的闭环检测。为了解决这些问题,我们引入了NGM-SLAM,这是第一个利用神经辐射场子图进行渐进场景表达的基于3DGS的SLAM系统,有效地结合了神经辐射场和3D高斯混合的优势。我们以神经辐射场子图作为监督,通过融合子图的高斯渲染,实现了高质量的场景表达和在线闭环调整。我们在多个真实场景和大场景数据集上的结果证明,我们的方法可以实现精确的空缺填充和高质量的场景表达,支持单目、立体和RGB-D输入,达到最先进的场景重建和跟踪性能。

论文及项目相关链接

PDF 9pages, 4 figures

Summary

高斯混合SLAM系统通过引入神经辐射场子图,实现了场景的高效表达与在线闭环调整。该系统结合了神经辐射场与三维高斯拼贴的优势,实现了高质量的场景表达和闭环检测,适用于多种真实场景和大规模场景数据集。

Key Takeaways

- NGM-SLAM是首个基于3DGS的SLAM系统,采用神经辐射场子图进行渐进场景表达。

- 通过融合子图的高斯渲染,实现了高质量的场景表达和在线闭环调整。

- 利用神经辐射场子图作为监督,提高了场景表达的准确性。

- 支持单目、立体和RGB-D输入,适用于多种真实场景和大规模场景数据集。

- 实现了精确的空洞填充和高质量的场景重建。

- NGM-SLAM在场景重建和跟踪性能方面达到了最新水平。

点此查看论文截图

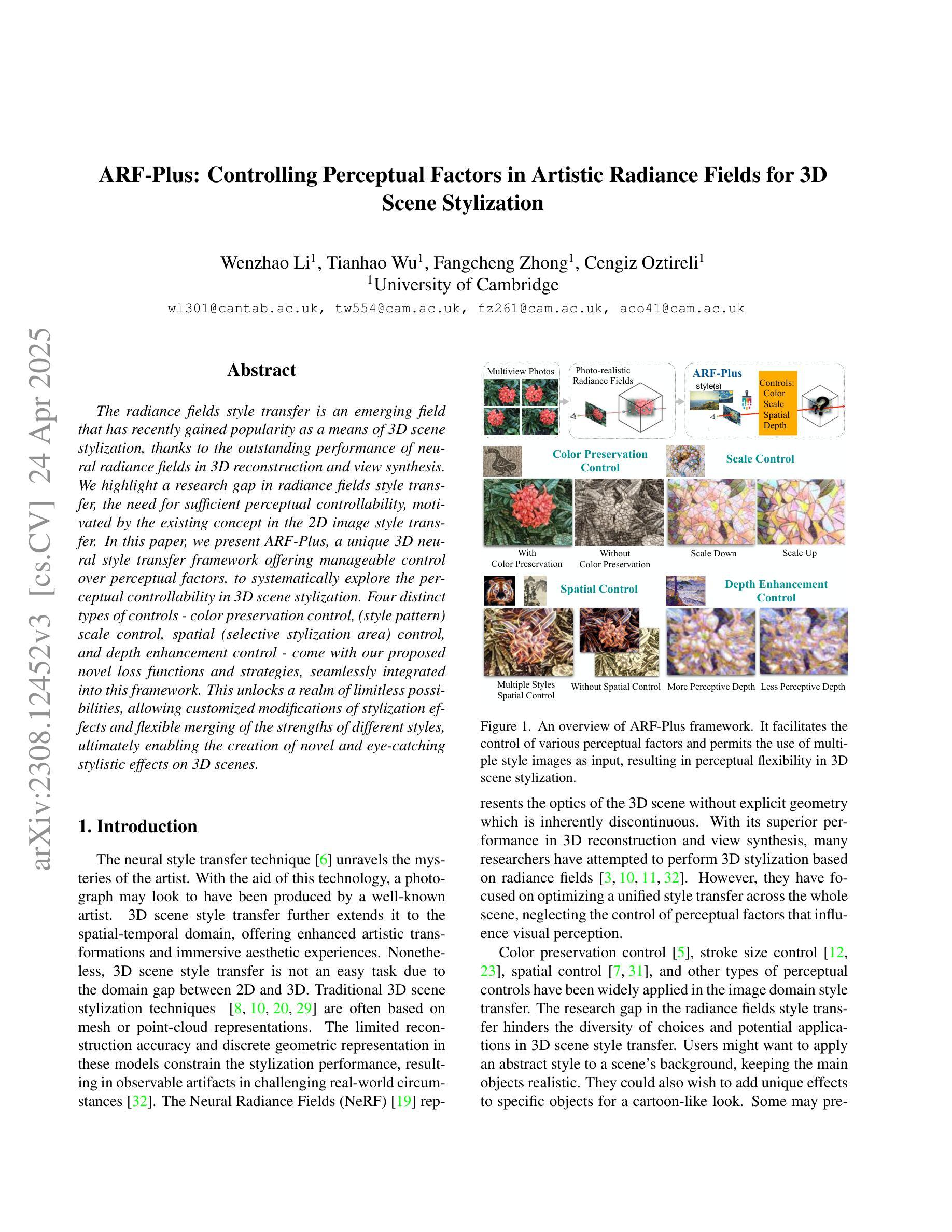

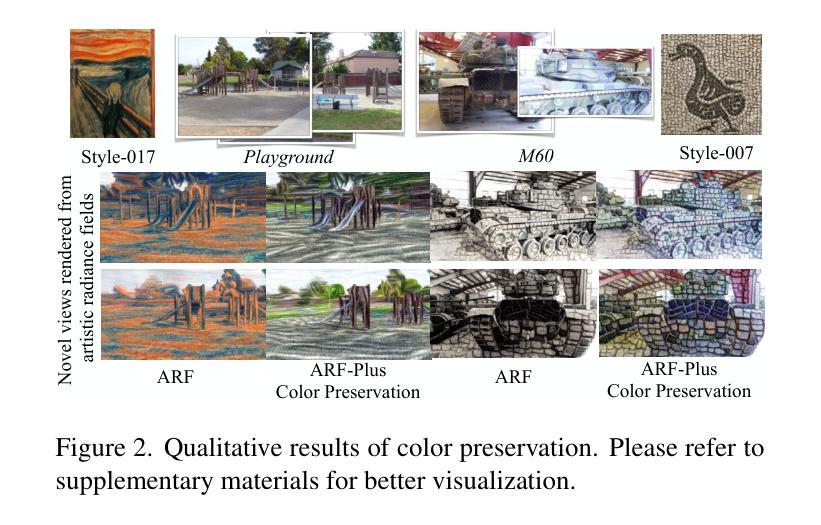

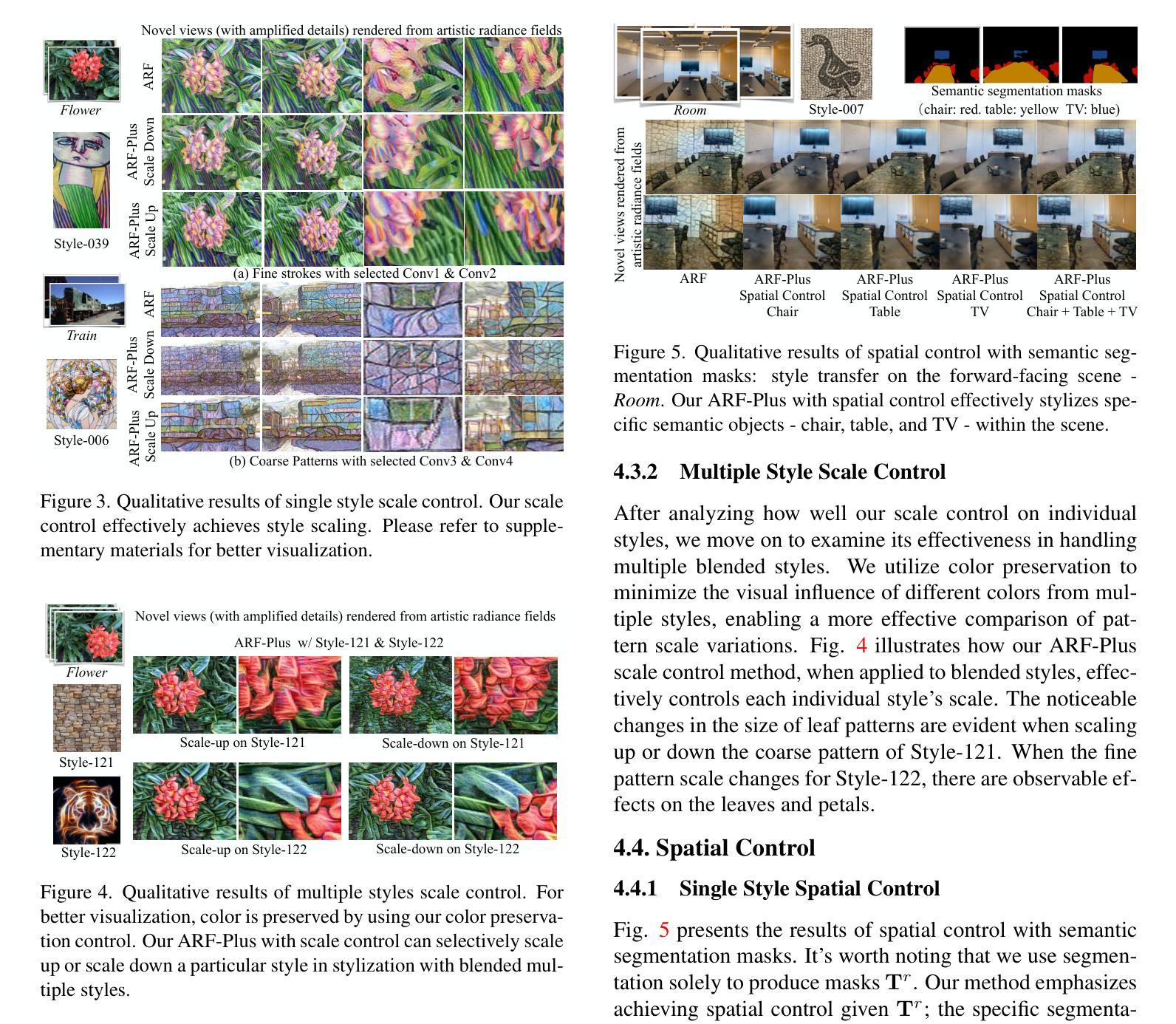

ARF-Plus: Controlling Perceptual Factors in Artistic Radiance Fields for 3D Scene Stylization

Authors:Wenzhao Li, Tianhao Wu, Fangcheng Zhong, Cengiz Oztireli

The radiance fields style transfer is an emerging field that has recently gained popularity as a means of 3D scene stylization, thanks to the outstanding performance of neural radiance fields in 3D reconstruction and view synthesis. We highlight a research gap in radiance fields style transfer, the lack of sufficient perceptual controllability, motivated by the existing concept in the 2D image style transfer. In this paper, we present ARF-Plus, a 3D neural style transfer framework offering manageable control over perceptual factors, to systematically explore the perceptual controllability in 3D scene stylization. Four distinct types of controls - color preservation control, (style pattern) scale control, spatial (selective stylization area) control, and depth enhancement control - are proposed and integrated into this framework. Results from real-world datasets, both quantitative and qualitative, show that the four types of controls in our ARF-Plus framework successfully accomplish their corresponding perceptual controls when stylizing 3D scenes. These techniques work well for individual style inputs as well as for the simultaneous application of multiple styles within a scene. This unlocks a realm of limitless possibilities, allowing customized modifications of stylization effects and flexible merging of the strengths of different styles, ultimately enabling the creation of novel and eye-catching stylistic effects on 3D scenes.

光线场风格转换是一个新兴领域,得益于神经光线场在3D重建和视图合成中的卓越性能,它最近作为3D场景风格化的手段而广受欢迎。我们强调了光线场风格转换中的研究空白,即感知控制性的不足,这一想法受到了2D图像风格转换中现有概念的影响。在本文中,我们提出了ARF-Plus,一个3D神经风格转换框架,提供了对感知因素的可管理控制,以系统地探索3D场景风格化中的感知可控性。提出了四种不同类型的控制并集成到该框架中,包括色彩保持控制、风格模式尺度控制、空间(选择性风格化区域)控制和深度增强控制。来自真实世界数据集的结果,无论是定量还是定性,都表明我们的ARF-Plus框架中的四种控制类型在3D场景风格化时成功地完成了相应的感知控制。这些技术对于单个风格输入以及在场景中应用多种风格的同时都非常有效。这开启了无限的可能性,允许定制修改风格化效果,灵活合并不同风格的优点,最终实现在3D场景上创建新颖且引人注目的风格效果。

论文及项目相关链接

PDF Accepted at WACV 2025. The published version is available at https://ieeexplore.ieee.org/document/10944114

Summary

本文研究了基于辐射场风格的3D场景风格化技术。提出了一种名为ARF-Plus的框架,增加了感知可控性,包括颜色保留控制、风格模式缩放控制、空间选择性风格化区域控制和深度增强控制。实验结果证明了该框架可以有效地实现对3D场景的风格化感知控制,并能同时应用多种风格,创造出新颖、引人注目的效果。

Key Takeaways

- 辐射场风格转移是一个新兴领域,基于神经辐射场在3D重建和视图合成中的出色表现,用于3D场景风格化。

- 当前研究存在感知可控性的缺口,缺乏足够的感知控制手段。

- ARF-Plus框架提供了对感知因素的可控管理,包括颜色保留控制、风格模式缩放控制、空间选择性风格化区域控制和深度增强控制。

- 实验结果表明,ARF-Plus框架成功实现了对3D场景的风格化感知控制。

- 该框架可以同时应用多种风格,创造出新颖、引人注目的效果。

- ARF-Plus框架适用于个体风格输入,并能在场景中灵活合并不同风格的优点。

点此查看论文截图