⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-04-29 更新

Diffusion-Driven Universal Model Inversion Attack for Face Recognition

Authors:Hanrui Wang, Shuo Wang, Chun-Shien Lu, Isao Echizen

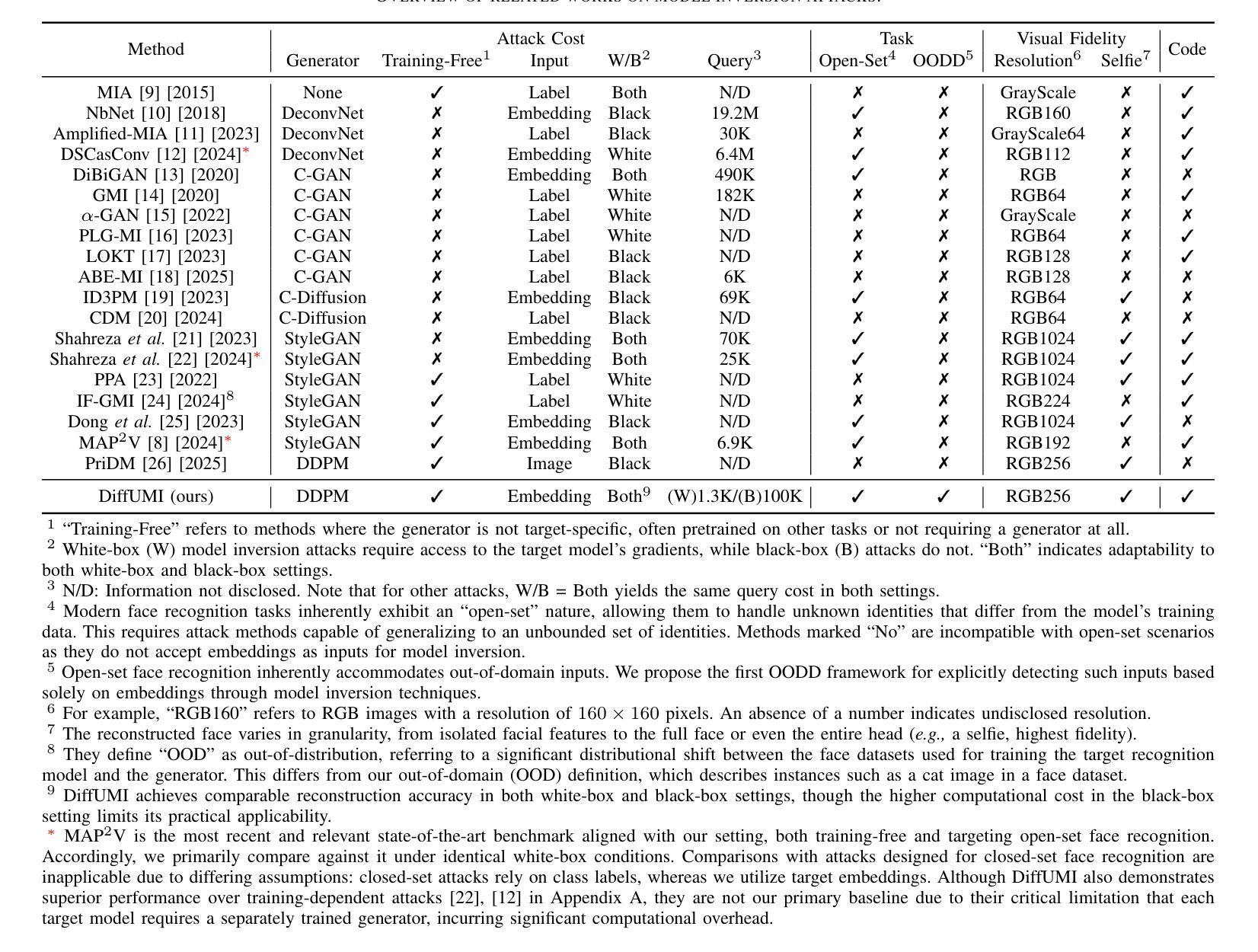

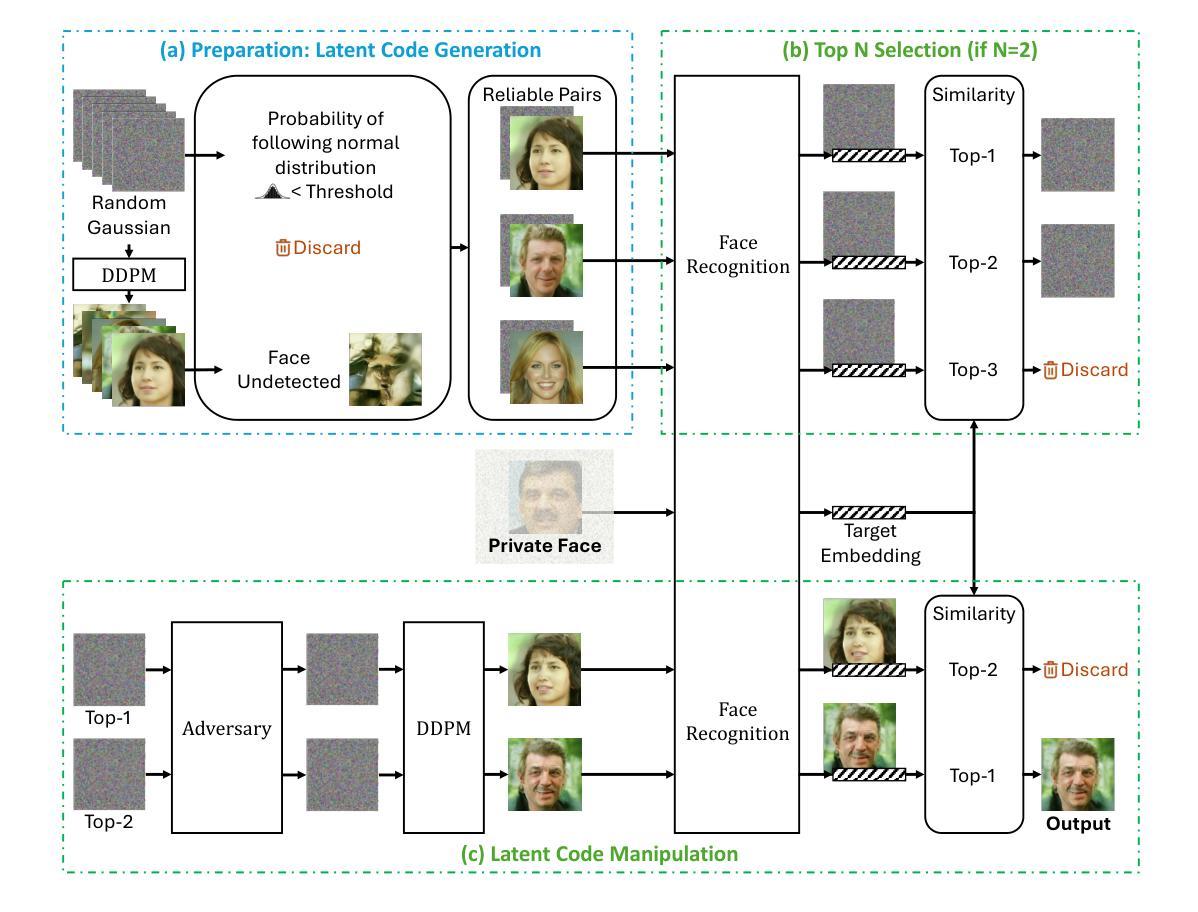

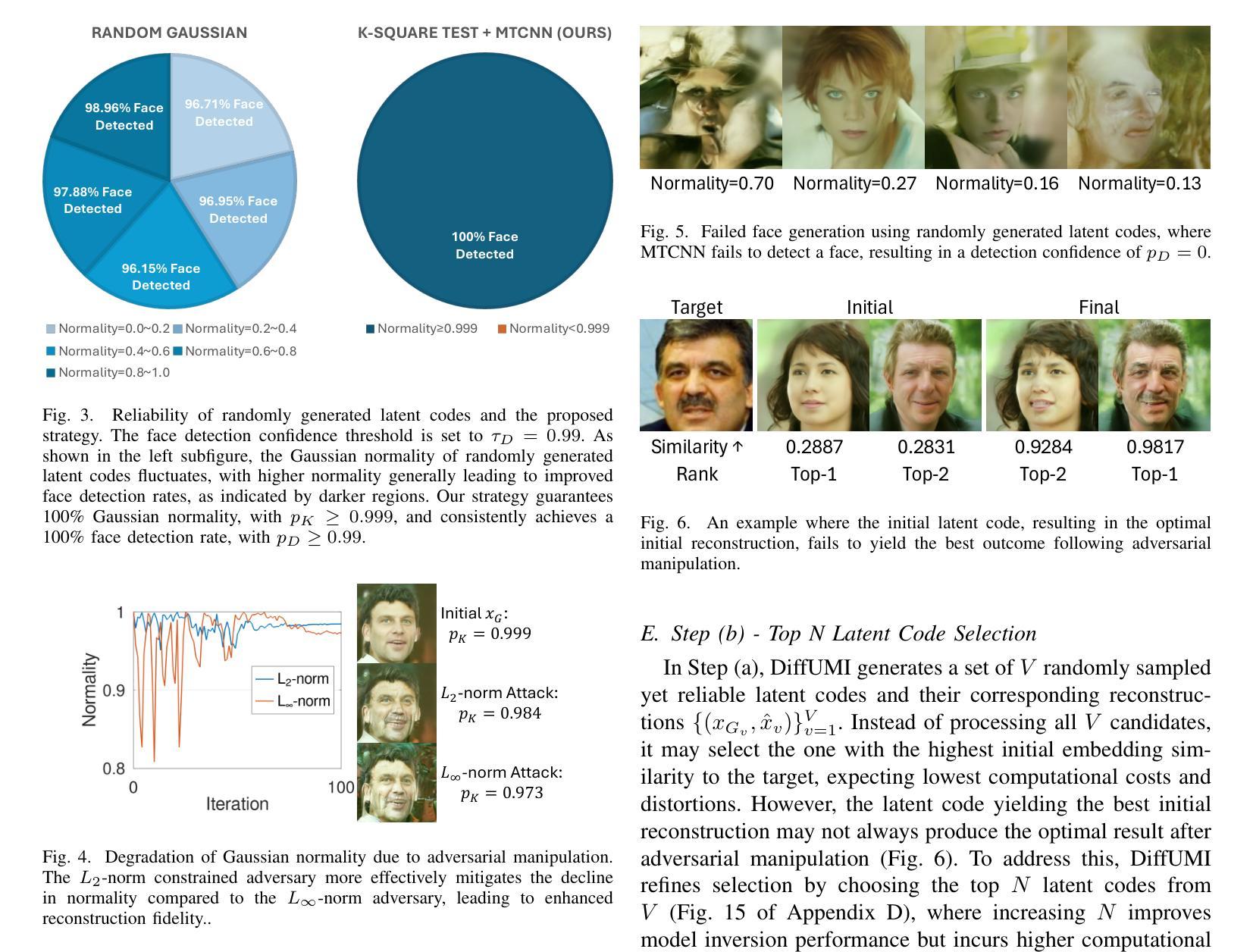

Facial recognition technology poses significant privacy risks, as it relies on biometric data that is inherently sensitive and immutable if compromised. To mitigate these concerns, face recognition systems convert raw images into embeddings, traditionally considered privacy-preserving. However, model inversion attacks pose a significant privacy threat by reconstructing these private facial images, making them a crucial tool for evaluating the privacy risks of face recognition systems. Existing methods usually require training individual generators for each target model, a computationally expensive process. In this paper, we propose DiffUMI, a training-free diffusion-driven universal model inversion attack for face recognition systems. DiffUMI is the first approach to apply a diffusion model for unconditional image generation in model inversion. Unlike other methods, DiffUMI is universal, eliminating the need for training target-specific generators. It operates within a fixed framework and pretrained diffusion model while seamlessly adapting to diverse target identities and models. DiffUMI breaches privacy-preserving face recognition systems with state-of-the-art success, demonstrating that an unconditional diffusion model, coupled with optimized adversarial search, enables efficient and high-fidelity facial reconstruction. Additionally, we introduce a novel application of out-of-domain detection (OODD), marking the first use of model inversion to distinguish non-face inputs from face inputs based solely on embeddings.

人脸识别技术存在重大的隐私风险,因为它依赖于生物识别数据,这些数据本质上是敏感和不可变的。为了减轻这些担忧,人脸识别系统将原始图像转换为嵌入,传统上被认为是保护隐私的。然而,模型反演攻击通过重建这些私人面部图像构成重大隐私威胁,成为评估人脸识别系统隐私风险的重要工具。现有方法通常需要对每个目标模型进行个体生成器训练,这是一个计算成本高昂的过程。在本文中,我们提出了DiffUMI,这是一种无需训练、以扩散驱动的人脸识别系统通用模型反演攻击。DiffUMI是第一个将扩散模型应用于无条件图像生成的方法。与其他方法不同,DiffUMI具有通用性,无需针对目标进行训练生成器。它在固定的框架和预训练的扩散模型内运行,无缝适应不同的目标身份和模型。DiffUMI突破保密人脸识别系统的隐私保护具有最先进的成功记录,证明了无条件扩散模型结合优化的对抗性搜索可以实现高效和高保真面部重建。此外,我们还引入了域外检测(OODD)的新应用,标志着首次使用模型反演仅根据嵌入来区分非面部输入和面部输入。

论文及项目相关链接

Summary

人脸识别技术存在重大隐私风险,因为该技术依赖于生物特征数据,一旦泄露则不可更改。为缓解这一担忧,人脸识别系统将原始图像转化为嵌入数据,这通常被认为具有隐私保护性质。然而,模型反推攻击通过重建这些面部图像,对隐私构成重大威胁,成为评估人脸识别系统隐私风险的重要工具。现有方法通常需要针对每个目标模型单独训练生成器,这是一个计算成本高昂的过程。本文提出了一种无需训练的反向扩散通用模型反推攻击(DiffUMI),用于人脸识别系统。DiffUMI是首次将扩散模型应用于无条件图像生成的反向模型中的方法。与其他方法不同,DiffUMI具有通用性,无需针对目标进行特定训练生成器。它在固定的框架和预训练的扩散模型内运行,可轻松适应不同的目标身份和模型。DiffUMI突破具有隐私保护功能的人脸识别系统并取得成功,证明了无条件扩散模型与优化的对抗搜索相结合,能够实现高效且高保真的人脸重建。此外,我们还首次在模型反推中引入了领域外检测(OODD)的新应用,仅根据嵌入来区分非面部输入和面部输入。

Key Takeaways

- 人脸识别技术存在重大隐私风险,因为依赖于敏感且不可更改的生物特征数据。

- 模型反推攻击能够重建原始面部图像,是对人脸识别系统隐私构成重大威胁的工具。

- 现有模型反推攻击方法通常需要针对每个目标模型进行耗时耗资源的训练。

- 本文提出的DiffUMI是一种无需训练的反向扩散通用模型反推攻击方法,可应用于人脸识别系统。

- DiffUMI首次将扩散模型应用于无条件图像生成的反向模型中,具有通用性并能在固定的框架内运行。

- DiffUMI能实现高效且高保真的人脸重建,证明了其突破具有隐私保护功能的人脸识别系统的能力。

点此查看论文截图