⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-05-01 更新

Creating Your Editable 3D Photorealistic Avatar with Tetrahedron-constrained Gaussian Splatting

Authors:Hanxi Liu, Yifang Men, Zhouhui Lian

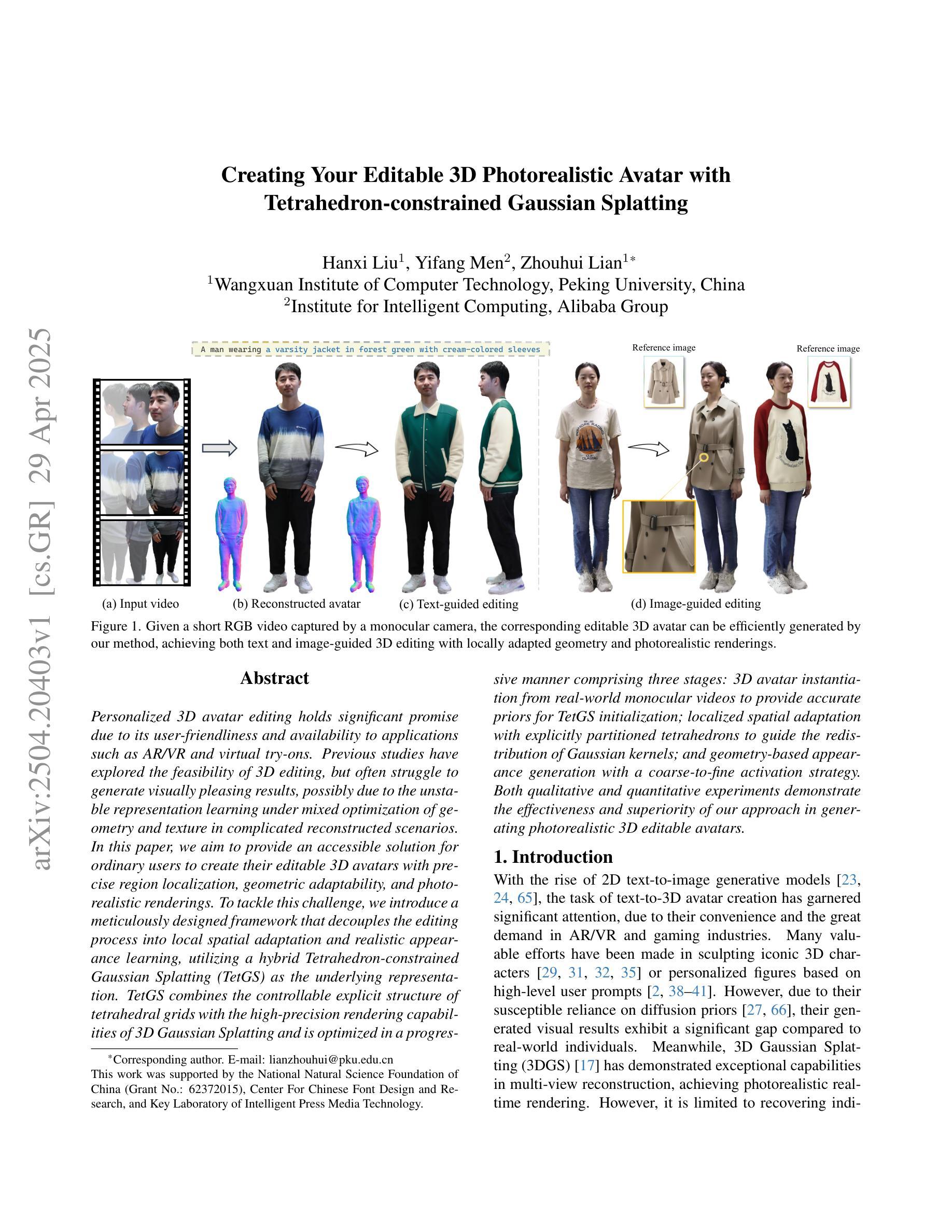

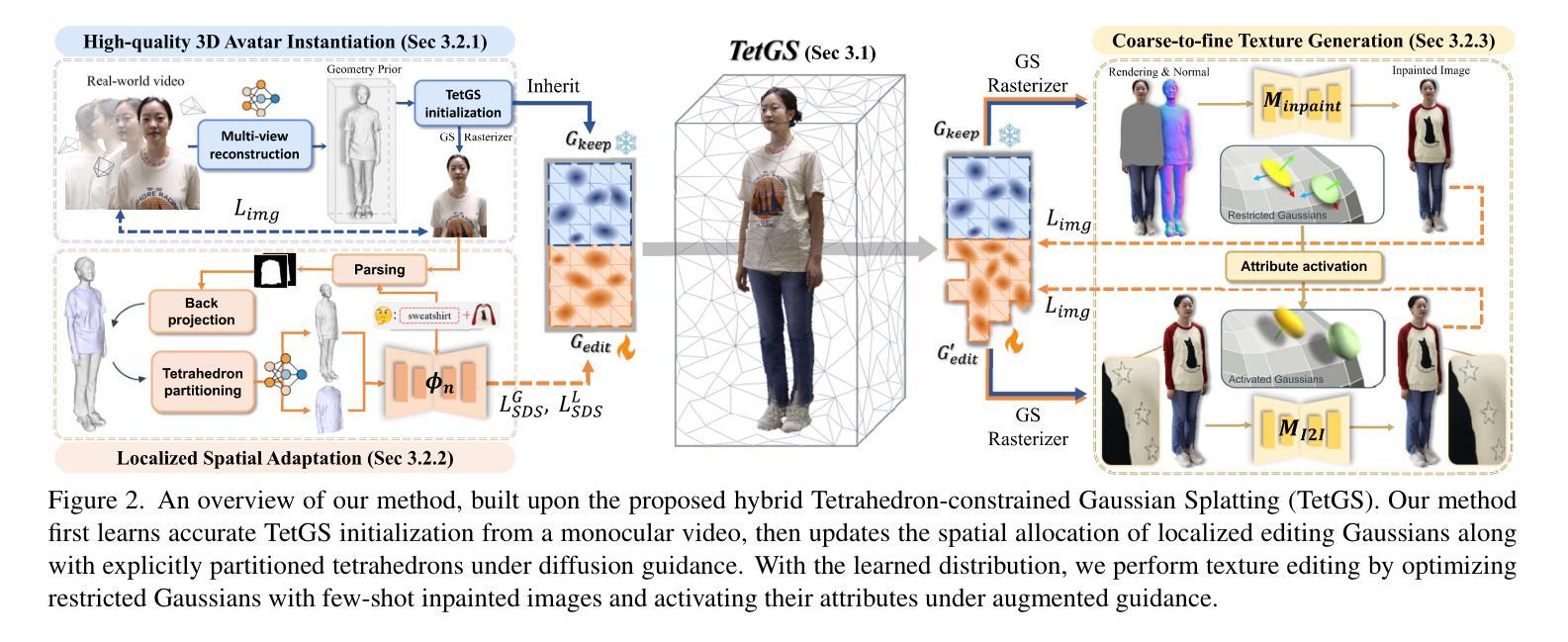

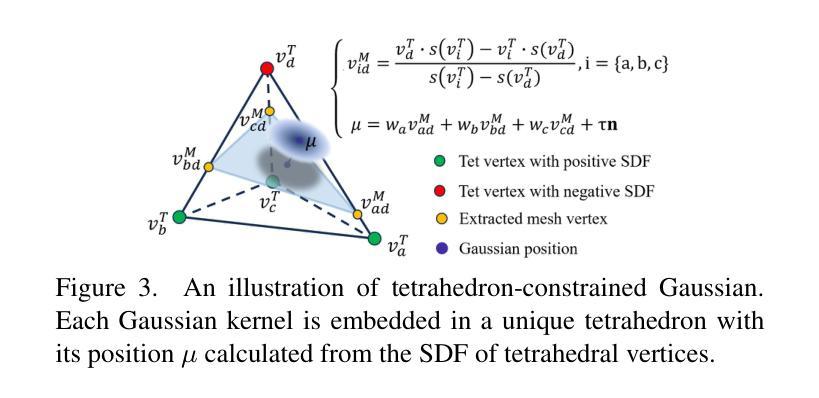

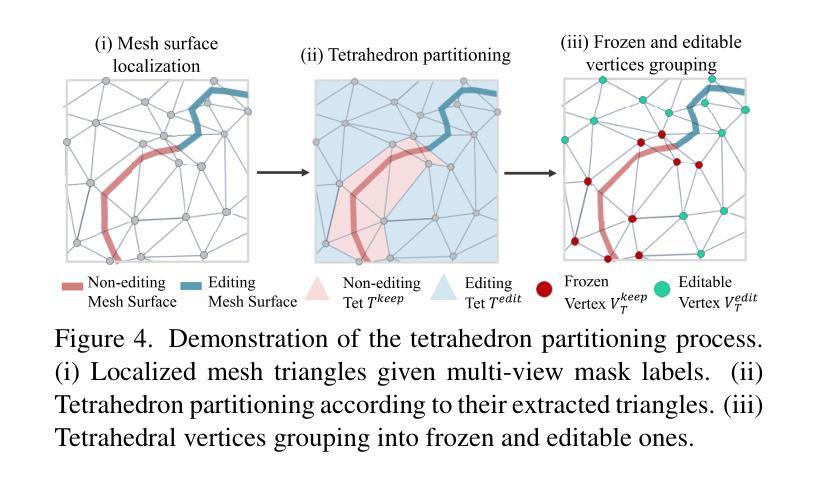

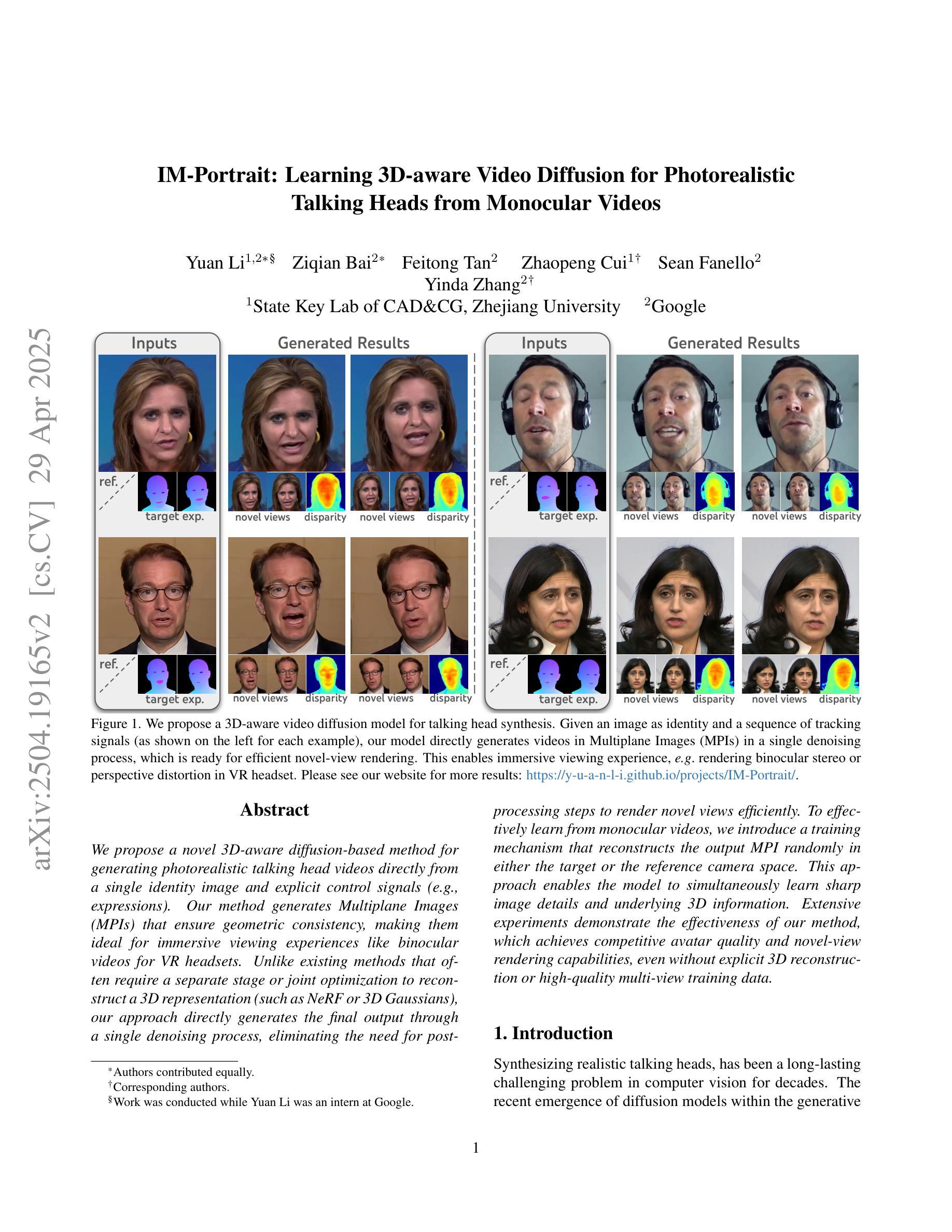

Personalized 3D avatar editing holds significant promise due to its user-friendliness and availability to applications such as AR/VR and virtual try-ons. Previous studies have explored the feasibility of 3D editing, but often struggle to generate visually pleasing results, possibly due to the unstable representation learning under mixed optimization of geometry and texture in complicated reconstructed scenarios. In this paper, we aim to provide an accessible solution for ordinary users to create their editable 3D avatars with precise region localization, geometric adaptability, and photorealistic renderings. To tackle this challenge, we introduce a meticulously designed framework that decouples the editing process into local spatial adaptation and realistic appearance learning, utilizing a hybrid Tetrahedron-constrained Gaussian Splatting (TetGS) as the underlying representation. TetGS combines the controllable explicit structure of tetrahedral grids with the high-precision rendering capabilities of 3D Gaussian Splatting and is optimized in a progressive manner comprising three stages: 3D avatar instantiation from real-world monocular videos to provide accurate priors for TetGS initialization; localized spatial adaptation with explicitly partitioned tetrahedrons to guide the redistribution of Gaussian kernels; and geometry-based appearance generation with a coarse-to-fine activation strategy. Both qualitative and quantitative experiments demonstrate the effectiveness and superiority of our approach in generating photorealistic 3D editable avatars.

个性化3D角色编辑因其用户友好性和在AR/VR及虚拟试穿等领域的应用前景而备受瞩目。尽管已有研究探讨了3D编辑的可行性,但它们往往在生成视觉上令人满意的结果时遇到困难,这可能是由于在复杂的重建场景下几何和纹理混合优化时的表示学习不稳定。在本文中,我们旨在为普通用户提供一种可行的解决方案,以创建可编辑的3D角色,具有精确的区域定位、几何适应性和逼真的渲染效果。为了应对这一挑战,我们引入了一个精心设计的框架,将编辑过程分解为局部空间适应和逼真外观学习,并利用混合四面体约束的高斯溅出(TetGS)作为底层表示。TetGS结合了四面体网格的可控显式结构与3D高斯溅出的高精度渲染能力,并以渐进的方式优化,包括三个阶段:从真实世界的单目视频中实例化3D角色,以为TetGS初始化提供准确的先验;使用明确划分的四面体进行局部空间适应,以指导高斯内核的重分布;以及基于几何的粗糙到精细激活策略的外观生成。定性和定量实验均证明我们的方法在生成逼真的3D可编辑角色方面的有效性和优越性。

论文及项目相关链接

Summary

该文探讨个性化3D角色模型的编辑技术,提出一种易于用户操作的解决方案,能创建可编辑的3D角色模型,具有精确区域定位、几何适应性和逼真渲染特点。文章引入一个精心设计的框架,将编辑过程分解为局部空间适应和真实外观学习,采用混合四面体约束的高斯喷绘(TetGS)作为底层表示。TetGS结合了四面体格子的可控显式结构与3D高斯喷绘的高精度渲染能力,并在逐步优化中分为三个阶段。实验证明该方法生成逼真的3D可编辑角色模型的有效性。

Key Takeaways

- 个性化3D角色模型编辑具有用户友好性和广泛的应用前景,如AR/VR和虚拟试穿。

- 现有研究在生成视觉上令人满意的3D角色模型时遇到困难,可能源于复杂重建场景下的几何和纹理混合优化表示学习的不稳定性。

- 引入的框架将编辑过程分解为局部空间适应和真实外观学习,采用混合TetGS作为底层表示,结合了四面体格子的可控显式结构与3D高斯喷绘的高精度渲染能力。

- 框架包含三个阶段:从真实世界单目视频中实例化3D角色模型,为TetGS初始化提供准确先验;局部空间适应,通过明确划分的四面体引导高斯内核的重分布;基于几何的外观生成,采用从粗到细的激活策略。

- 该方法能够创建具有精确区域定位、几何适应性和逼真渲染的3D可编辑角色模型。

- 定量和定性实验证明了该方法在生成逼真3D可编辑角色模型方面的有效性和优越性。

点此查看论文截图