⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-05-02 更新

VividListener: Expressive and Controllable Listener Dynamics Modeling for Multi-Modal Responsive Interaction

Authors:Shiying Li, Xingqun Qi, Bingkun Yang, Chen Weile, Zezhao Tian, Muyi Sun, Qifeng Liu, Man Zhang, Zhenan Sun

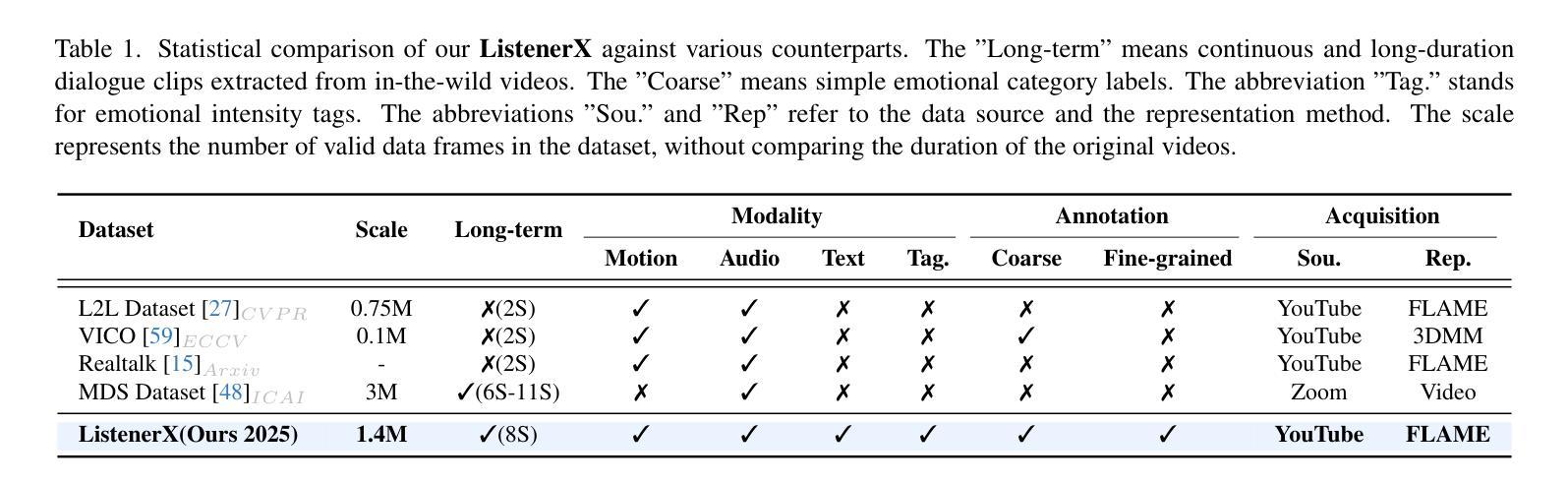

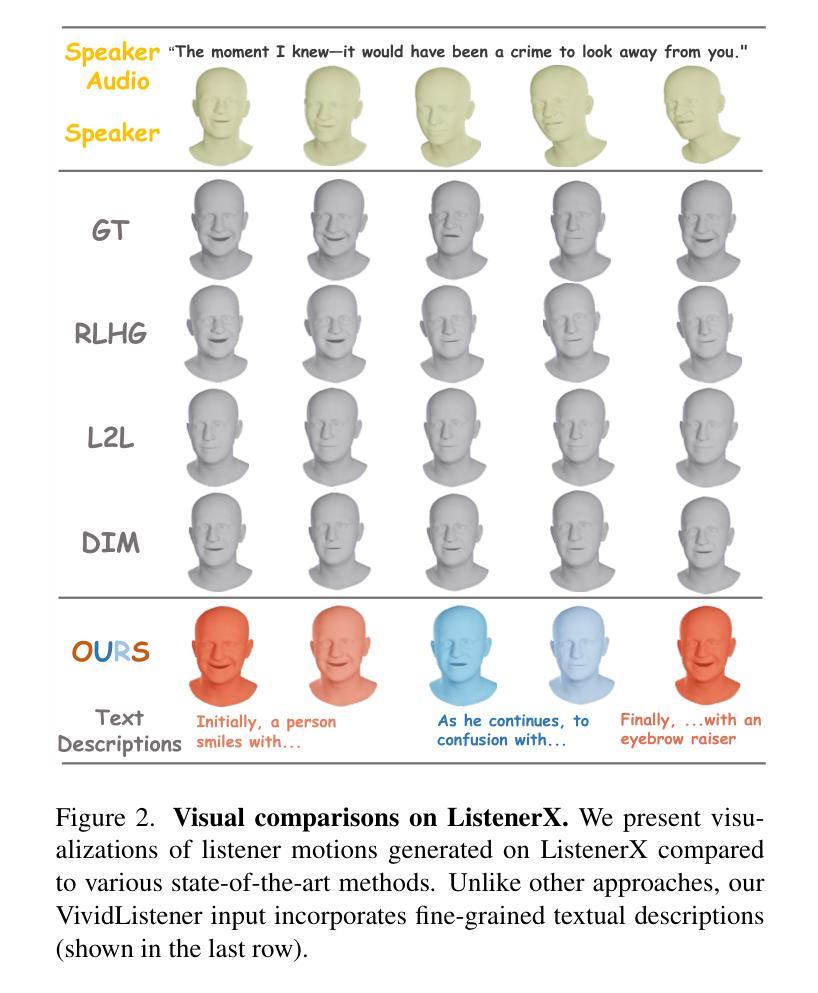

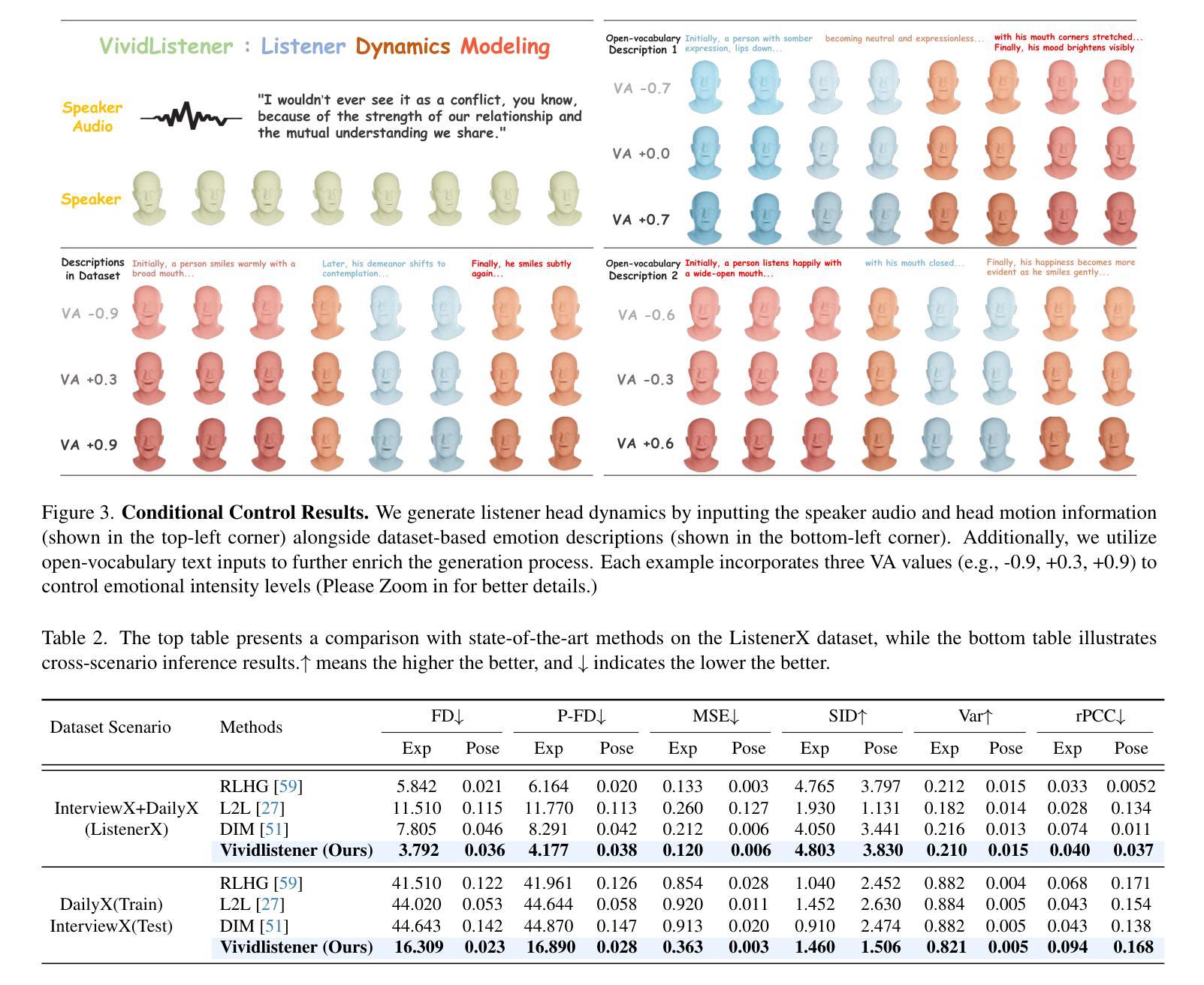

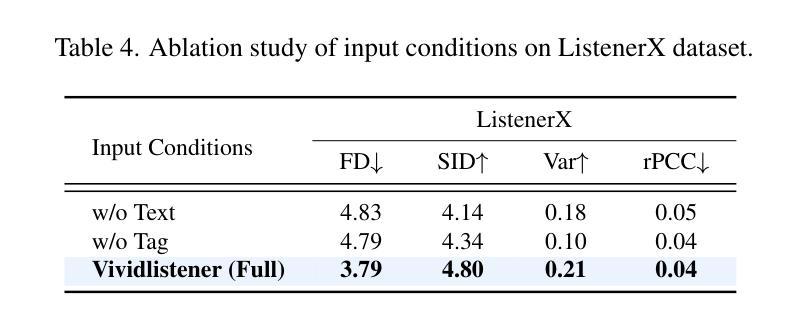

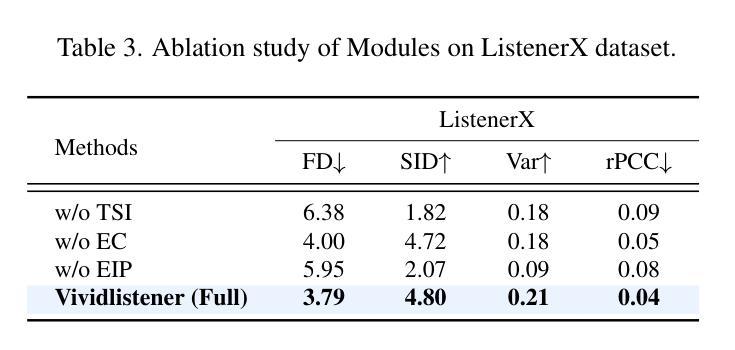

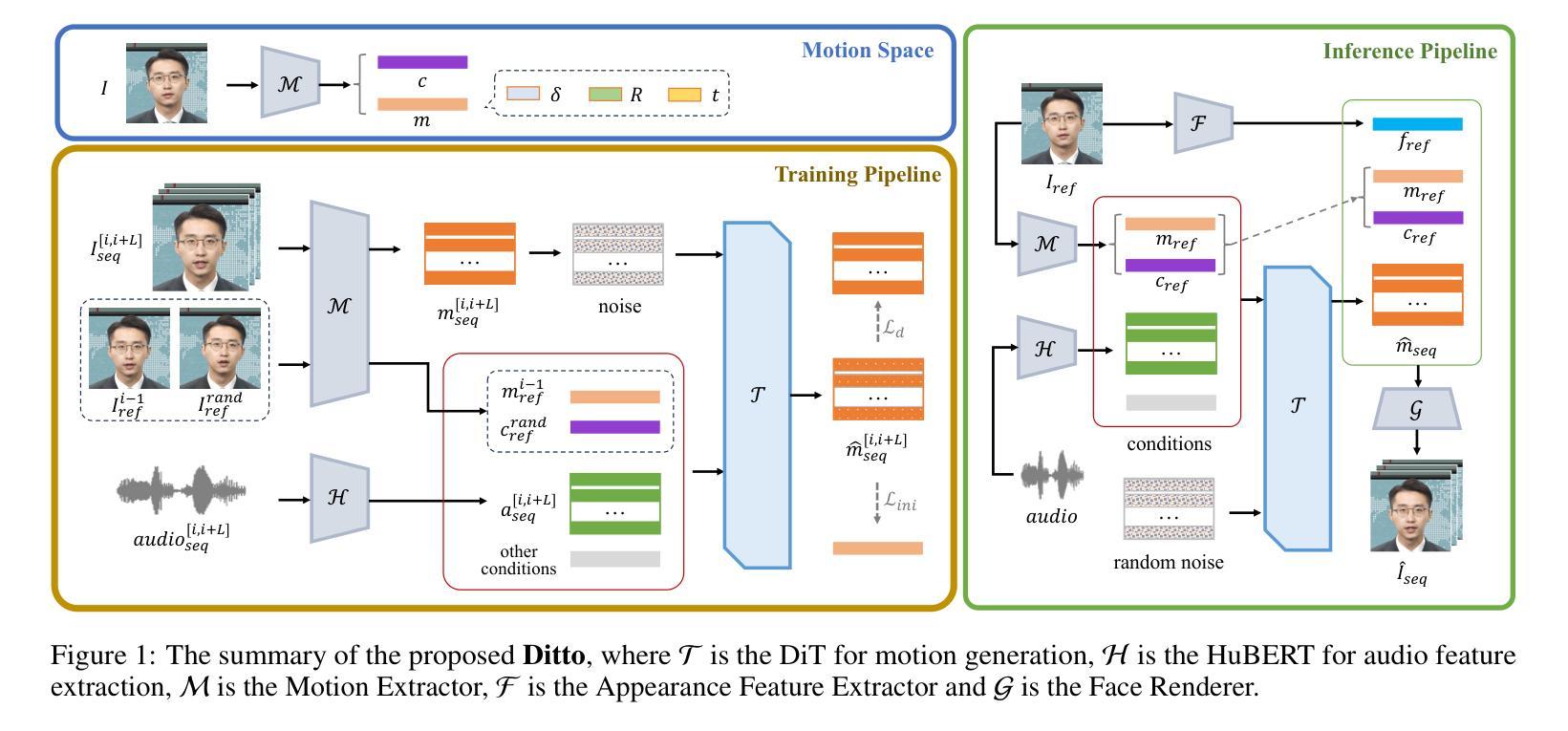

Generating responsive listener head dynamics with nuanced emotions and expressive reactions is crucial for practical dialogue modeling in various virtual avatar animations. Previous studies mainly focus on the direct short-term production of listener behavior. They overlook the fine-grained control over motion variations and emotional intensity, especially in long-sequence modeling. Moreover, the lack of long-term and large-scale paired speaker-listener corpora including head dynamics and fine-grained multi-modality annotations (e.g., text-based expression descriptions, emotional intensity) also limits the application of dialogue modeling.Therefore, we first newly collect a large-scale multi-turn dataset of 3D dyadic conversation containing more than 1.4M valid frames for multi-modal responsive interaction, dubbed ListenerX. Additionally, we propose VividListener, a novel framework enabling fine-grained, expressive and controllable listener dynamics modeling. This framework leverages multi-modal conditions as guiding principles for fostering coherent interactions between speakers and listeners.Specifically, we design the Responsive Interaction Module (RIM) to adaptively represent the multi-modal interactive embeddings. RIM ensures the listener dynamics achieve fine-grained semantic coordination with textual descriptions and adjustments, while preserving expressive reaction with speaker behavior. Meanwhile, we design the Emotional Intensity Tags (EIT) for emotion intensity editing with multi-modal information integration, applying to both text descriptions and listener motion amplitude.Extensive experiments conducted on our newly collected ListenerX dataset demonstrate that VividListener achieves state-of-the-art performance, realizing expressive and controllable listener dynamics.

生成具有细微情绪和生动反应的响应式听者头部动态,对于各种虚拟角色动画中的实际对话建模至关重要。以往的研究主要集中在听者行为的直接短期生成上。他们忽视了运动变化的精细控制以及情绪强度,特别是在长序列建模中。此外,缺乏长期大规模配对的说话者-听者语料库,包括头部动态和精细的跨模态注释(例如基于文本的表达描述、情绪强度等),也限制了对话建模的应用。因此,我们首先新收集了一个大规模的多轮三维二元对话数据集ListenerX,包含超过140万个有效帧的多模态响应交互。此外,我们提出了VividListener这一新型框架,能够实现精细、生动和可控的听者动态建模。该框架利用多模态条件作为指导原则,促进说话者和听者之间的连贯互动。具体来说,我们设计了交互式模块(Responsive Interaction Module, RIM),以自适应地表示多模态交互嵌入。RIM确保听者动态与文本描述和调整实现精细的语义协调,同时保持与说话者行为的生动反应。同时,我们为情感强度标签(Emotional Intensity Tags, EIT)设计了情感强度编辑功能,通过多模态信息整合,既适用于文本描述也适用于听者运动幅度。在我们新收集的ListenerX数据集上进行的广泛实验表明,VividListener达到了最先进的性能,实现了生动且可控的听者动态。

论文及项目相关链接

Summary

该文关注虚拟对话模型中听众头部动态的情感反应与表达。研究指出先前研究主要关注短期内的听众行为产生,忽视了对动作变化和情绪强度的精细控制,特别是在长序列建模中。缺乏包含头部动态和精细多模态注释的大规模配对说话人-听众语料库也限制了对话建模的应用。因此,研究团队首次收集了一个大规模三维双人对话数据集ListenerX,包含超过140万有效帧的多模态响应交互。此外,提出了VividListener框架,该框架实现精细、表达和可控的听众动态建模,利用多模态条件作为指导原则,促进说话人和听众之间的连贯互动。在ListenerX数据集上的广泛实验表明,VividListener实现了最先进的性能,实现了表达和控制听众动态的目标。

Key Takeaways

- 虚拟对话模型中,听众头部动态的情感反应与表达至关重要。

- 现有研究主要关注短期内的听众行为产生,缺乏对动作变化和情绪强度的精细控制,尤其在长序列建模中的考虑。

- 缺乏包含头部动态和精细多模态注释的大规模配对说话人-听众语料库限制了对话建模的应用。

- 新收集的大规模三维双人对话数据集ListenerX包含超过140万有效帧的多模态响应交互。

- VividListener框架实现了精细、表达和可控的听众动态建模,利用多模态条件促进连贯互动。

- VividListener框架包含响应交互模块(RIM),能自适应地表示多模态交互嵌入,确保听众动态与文本描述和调整实现精细协调。

- VividListener通过情绪强度标签(EIT)进行情绪强度编辑,实现多模态信息整合,适用于文本描述和听众动作幅度。

点此查看论文截图