⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-05-16 更新

Q-space Guided Collaborative Attention Translation Network for Flexible Diffusion-Weighted Images Synthesis

Authors:Pengli Zhu, Yingji Fu, Nanguang Chen, Anqi Qiu

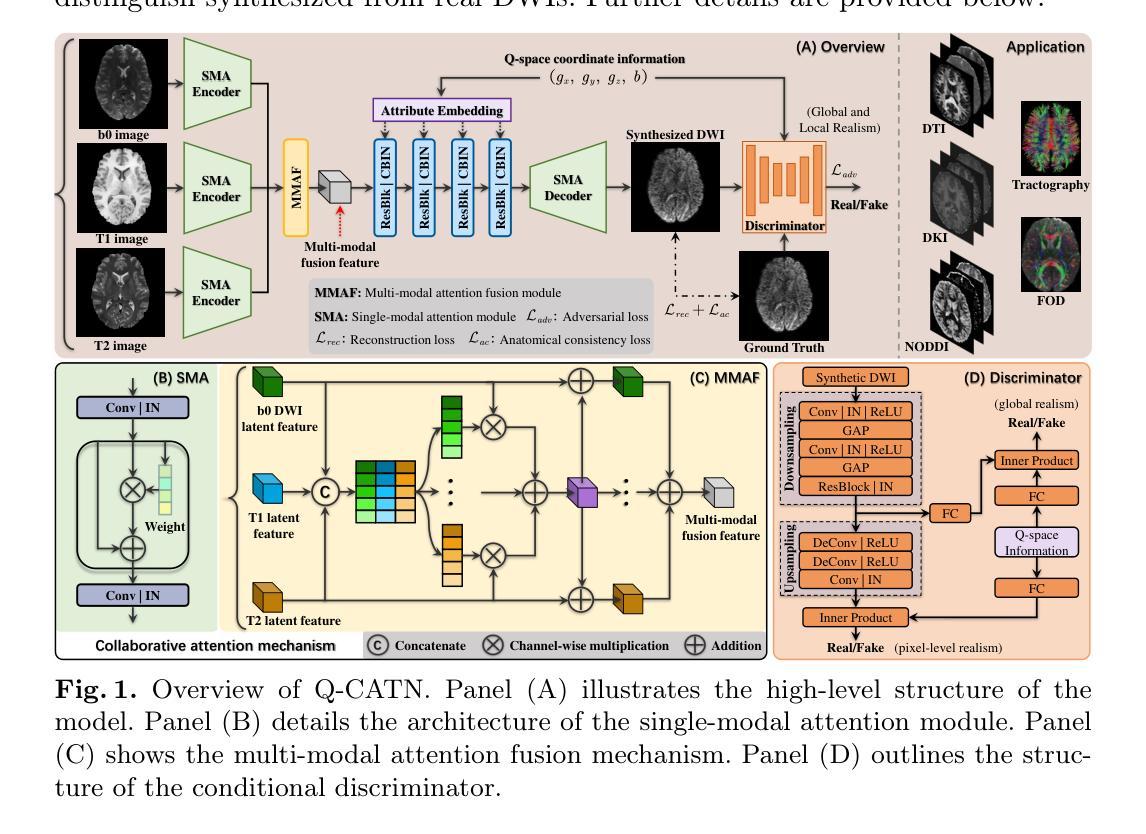

This study, we propose a novel Q-space Guided Collaborative Attention Translation Networks (Q-CATN) for multi-shell, high-angular resolution DWI (MS-HARDI) synthesis from flexible q-space sampling, leveraging the commonly acquired structural MRI data. Q-CATN employs a collaborative attention mechanism to effectively extract complementary information from multiple modalities and dynamically adjust its internal representations based on flexible q-space information, eliminating the need for fixed sampling schemes. Additionally, we introduce a range of task-specific constraints to preserve anatomical fidelity in DWI, enabling Q-CATN to accurately learn the intrinsic relationships between directional DWI signal distributions and q-space. Extensive experiments on the Human Connectome Project (HCP) dataset demonstrate that Q-CATN outperforms existing methods, including 1D-qDL, 2D-qDL, MESC-SD, and QGAN, in estimating parameter maps and fiber tracts both quantitatively and qualitatively, while preserving fine-grained details. Notably, its ability to accommodate flexible q-space sampling highlights its potential as a promising toolkit for clinical and research applications. Our code is available at https://github.com/Idea89560041/Q-CATN.

本研究提出了一种新型的Q空间引导协同注意力翻译网络(Q-CATN),用于从灵活的q空间采样中合成多壳、高分辨率扩散加权成像(MS-HARDI),并利用常用的结构磁共振成像数据进行辅助。Q-CATN采用协同注意力机制,有效提取多模态的互补信息,并根据灵活的q空间信息动态调整其内部表示,从而无需固定的采样方案。此外,我们引入了一系列特定任务的约束以保持扩散加权成像中的解剖真实性,使Q-CATN能够准确学习方向性扩散加权成像信号分布与q空间之间的内在关系。在人类连接组项目(Human Connectome Project,简称HCP)数据集上的大量实验表明,在定量和定性估计参数图和纤维束时,Q-CATN优于现有方法,包括一维- qDL、二维- qDL、MESC-SD和QGAN等,同时保留精细的细节。值得注意的是,其适应灵活q空间采样的能力凸显了其在临床和研究应用中的潜力。我们的代码可在https://github.com/Idea89560041/Q-CATN获取。

论文及项目相关链接

PDF MICCAI 2025

Summary

本研究提出一种新型的Q空间引导协同注意力翻译网络(Q-CATN),用于从灵活的q空间采样进行多壳、高角分辨率DWI(MS-HARDI)合成,利用常见的结构MRI数据进行辅助。Q-CATN采用协同注意力机制,有效提取多模态的互补信息,并根据灵活的q空间信息动态调整其内部表示,无需固定的采样方案。此外,引入了一系列任务特定约束,以在DWI中保留解剖保真度,使Q-CATN能够准确学习方向性DWI信号分布与q空间之间的内在关系。在人类连接组项目(HCP)数据集上的广泛实验表明,Q-CATN在参数映射和纤维束估计方面优于现有方法,包括1D-qDL、2D-qDL、MESC-SD和QGAN,定量和定性评估均表现优异,同时保留精细细节。其适应灵活q空间采样的能力使其在临床和研究应用中具有巨大潜力。

Key Takeaways

- 提出了一种新型的Q空间引导协同注意力翻译网络(Q-CATN),用于多壳、高角分辨率DWI(MS-HARDI)的合成。

- 利用灵活的q空间采样和常见的结构MRI数据进行网络训练。

- Q-CATN采用协同注意力机制,能够从多个模态中提取互补信息并根据q空间信息动态调整内部表示。

- 通过引入任务特定约束,保留了DWI的解剖保真度。

- 在人类连接组项目(HCP)数据集上的实验表明,Q-CATN在参数映射和纤维束估计方面优于其他现有方法。

- Q-CATN能够准确学习方向性DWI信号分布与q空间的内在关系。

点此查看论文截图