⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-05-29 更新

AniCrafter: Customizing Realistic Human-Centric Animation via Avatar-Background Conditioning in Video Diffusion Models

Authors:Muyao Niu, Mingdeng Cao, Yifan Zhan, Qingtian Zhu, Mingze Ma, Jiancheng Zhao, Yanhong Zeng, Zhihang Zhong, Xiao Sun, Yinqiang Zheng

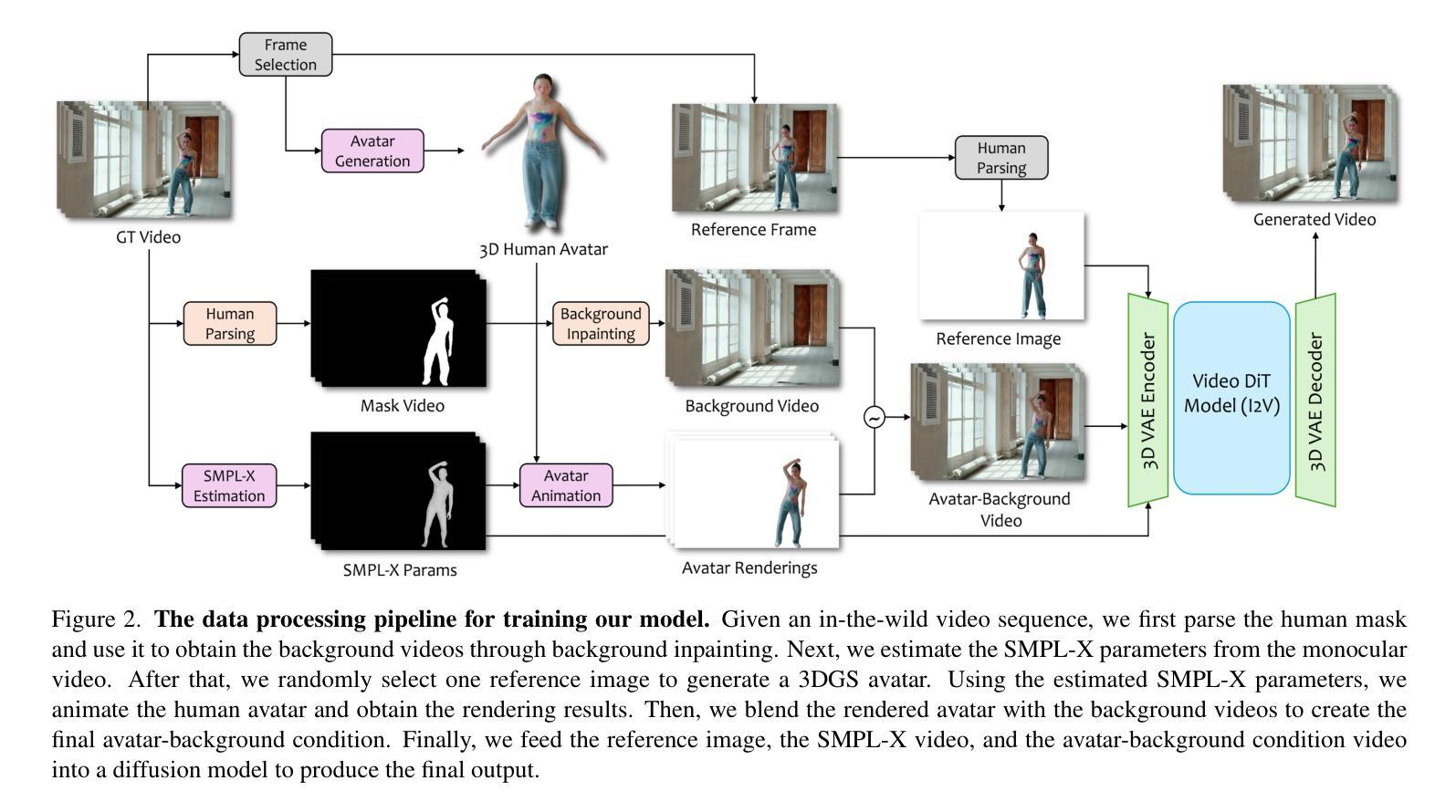

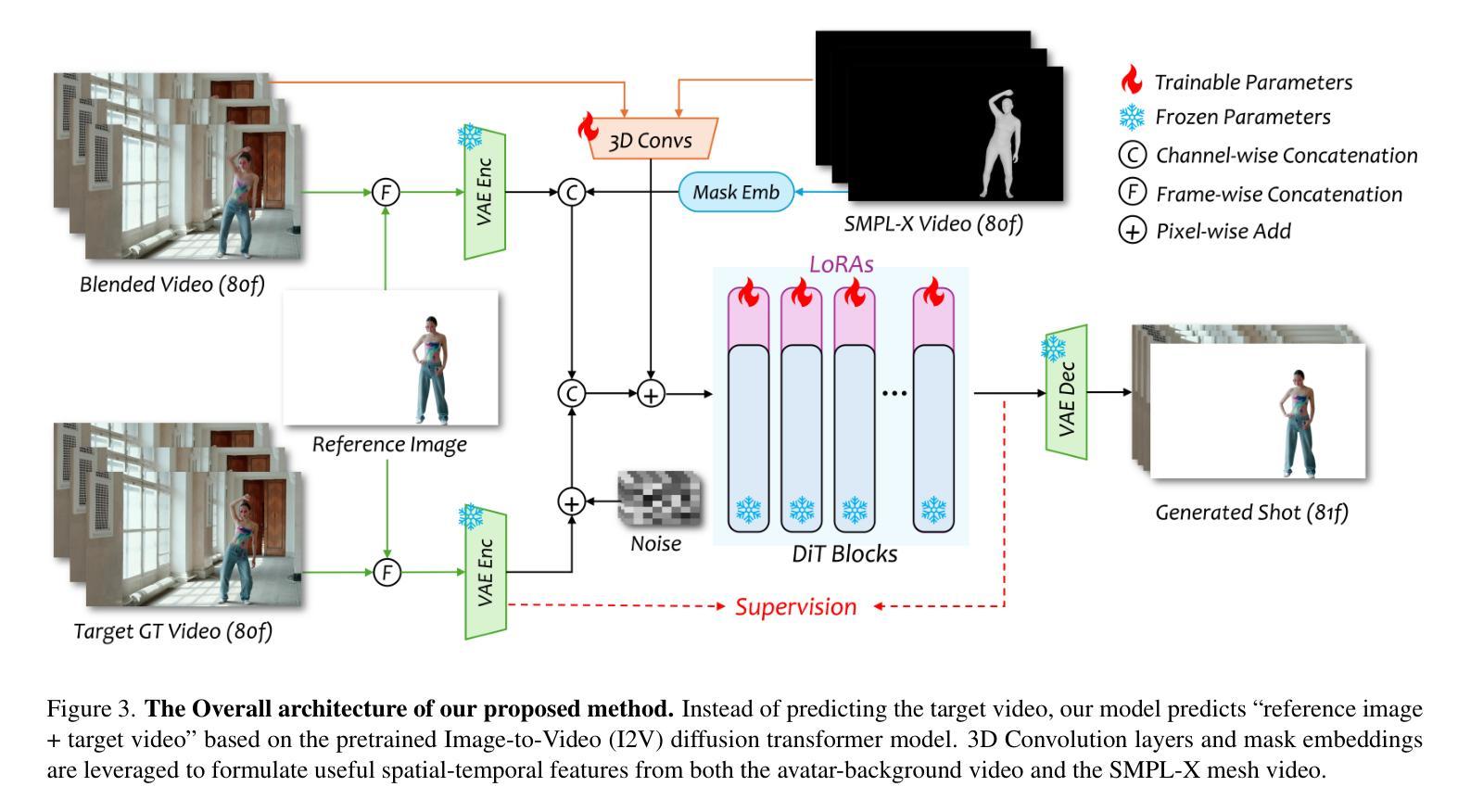

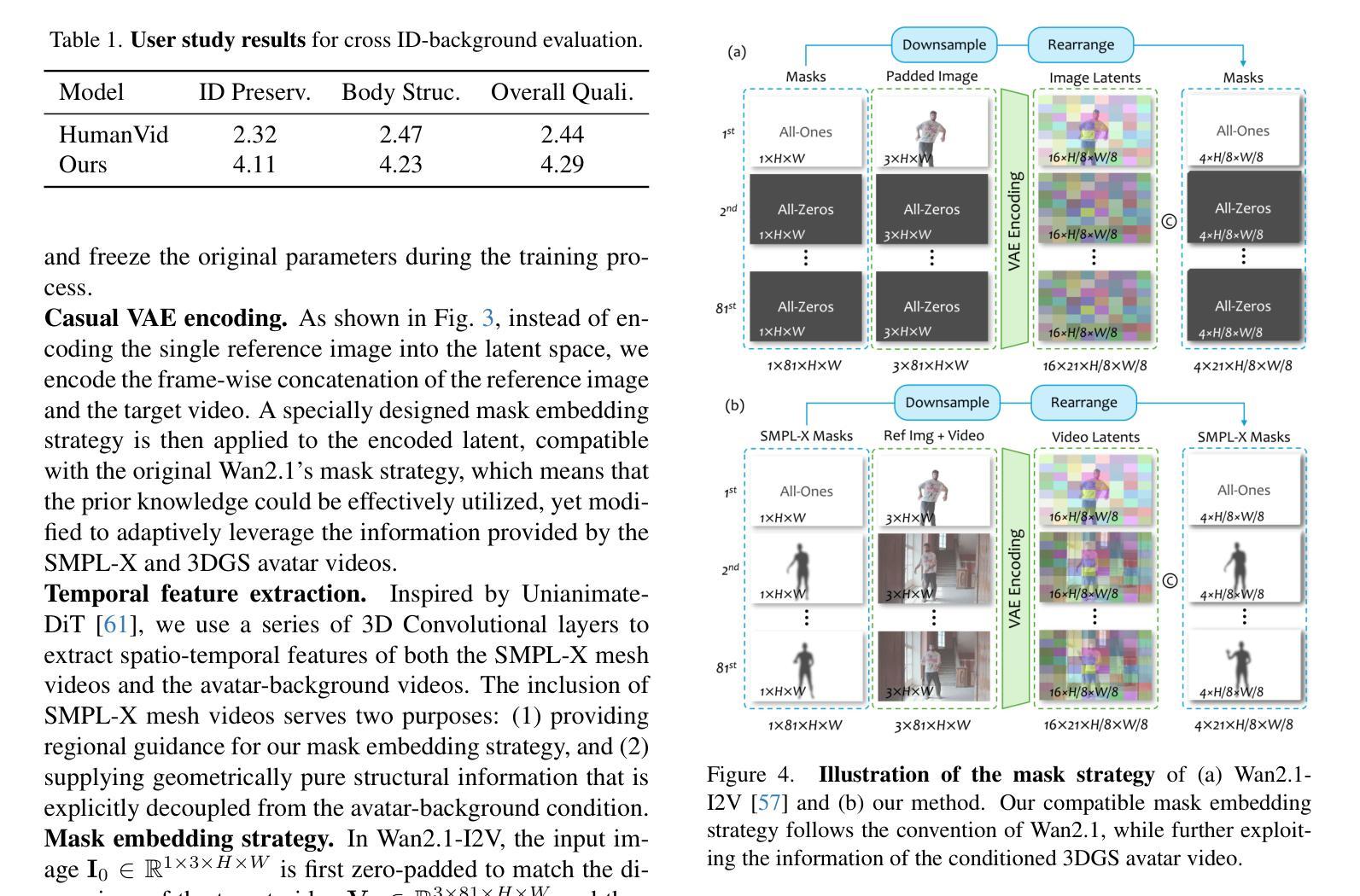

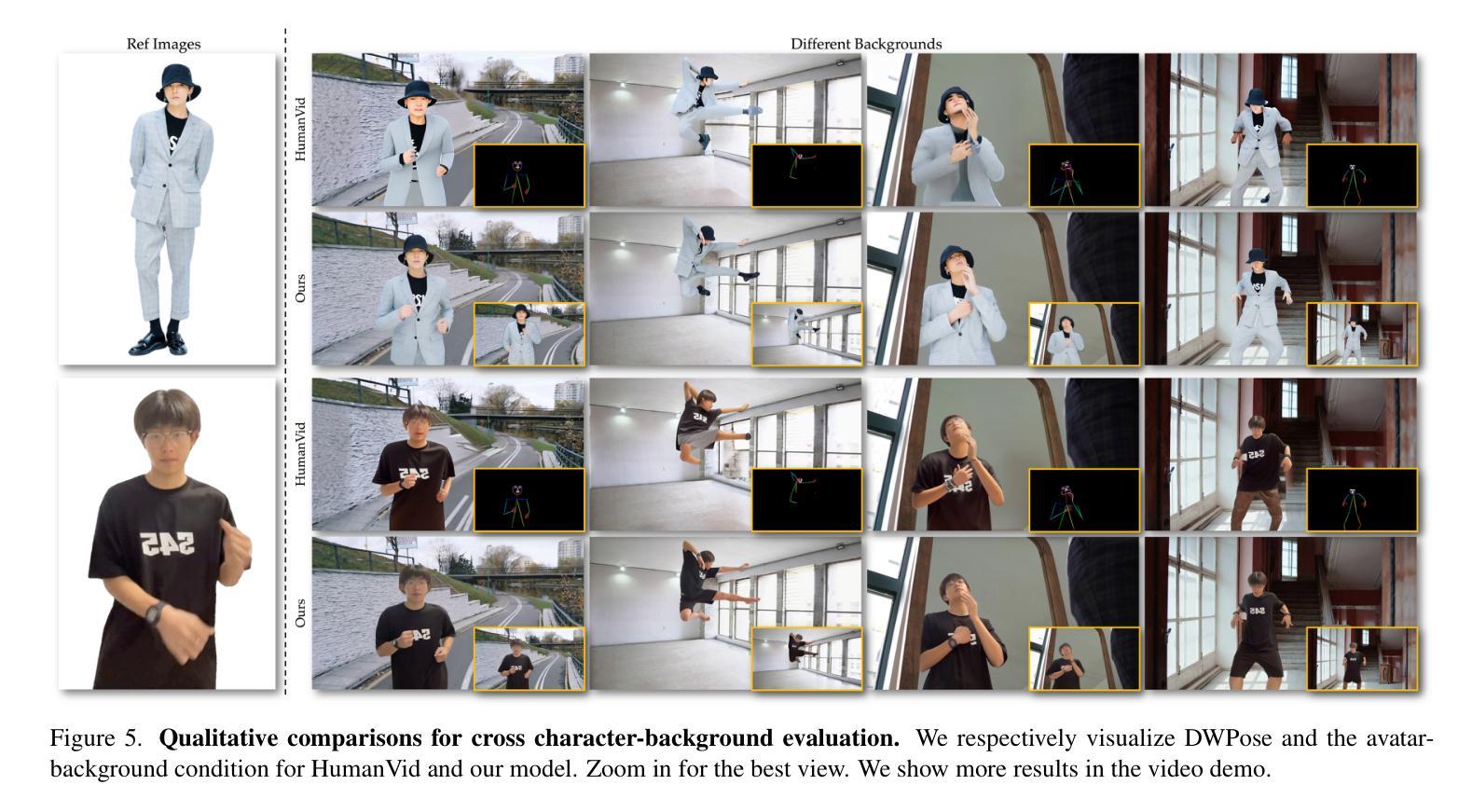

Recent advances in video diffusion models have significantly improved character animation techniques. However, current approaches rely on basic structural conditions such as DWPose or SMPL-X to animate character images, limiting their effectiveness in open-domain scenarios with dynamic backgrounds or challenging human poses. In this paper, we introduce $\textbf{AniCrafter}$, a diffusion-based human-centric animation model that can seamlessly integrate and animate a given character into open-domain dynamic backgrounds while following given human motion sequences. Built on cutting-edge Image-to-Video (I2V) diffusion architectures, our model incorporates an innovative “avatar-background” conditioning mechanism that reframes open-domain human-centric animation as a restoration task, enabling more stable and versatile animation outputs. Experimental results demonstrate the superior performance of our method. Codes will be available at https://github.com/MyNiuuu/AniCrafter.

近期视频扩散模型的进步极大地提升了角色动画技术。然而,当前的方法依赖于基本结构条件,如DWPose或SMPL-X来驱动角色图像,这在具有动态背景或挑战人类姿态的开放场景中应用时效果有限。在本文中,我们介绍了AniCrafter,这是一个基于扩散的人类中心动画模型,可以无缝集成并驱动给定角色进入开放域的动态背景,同时遵循给定的人类运动序列。我们的模型建立在最先进的图像到视频(I2V)扩散架构之上,融入了一种创新的“化身背景”条件机制,将开放域人类中心动画重新构建为一项修复任务,从而实现更稳定和多样化的动画输出。实验结果证明了我们的方法优越性。代码将在https://github.com/MyNiuuu/AniCrafter公开。

论文及项目相关链接

PDF Github: https://github.com/MyNiuuu/AniCrafter

Summary

随着视频扩散模型的最新进展,角色动画技术得到了显著提升。然而,当前方法依赖于基本结构条件(如DWPose或SMPL-X)来驱动角色图像,这在具有动态背景或复杂人类姿态的开放场景中限制了其效果。本文介绍了基于扩散的以人类为中心的动画模型AniCrafter,它能无缝集成并驱动给定角色进入开放域的动态背景,同时跟随给定的人类运动序列。该模型采用先进的Image-to-Video(I2V)扩散架构,并融入创新的“avatar-背景”调节机制,将开放域的人类中心动画重塑为恢复任务,从而实现更稳定和多样化的动画输出。实验结果证明了该方法的卓越性能。

Key Takeaways

- 最新视频扩散模型的进展已经显著提升了角色动画技术。

- 当前动画方法依赖于基本结构条件,在开放场景中的动态背景和复杂人类姿态方面存在局限性。

- 引入了基于扩散的以人类为中心的动画模型AniCrafter。

- AniCrafter能无缝集成并驱动给定角色进入动态背景,并跟随给定的运动序列。

- AniCrafter采用先进的Image-to-Video(I2V)扩散架构。

- “Avatar-背景”调节机制使开放域的人类中心动画更稳定和多样化。

点此查看论文截图