⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-05-31 更新

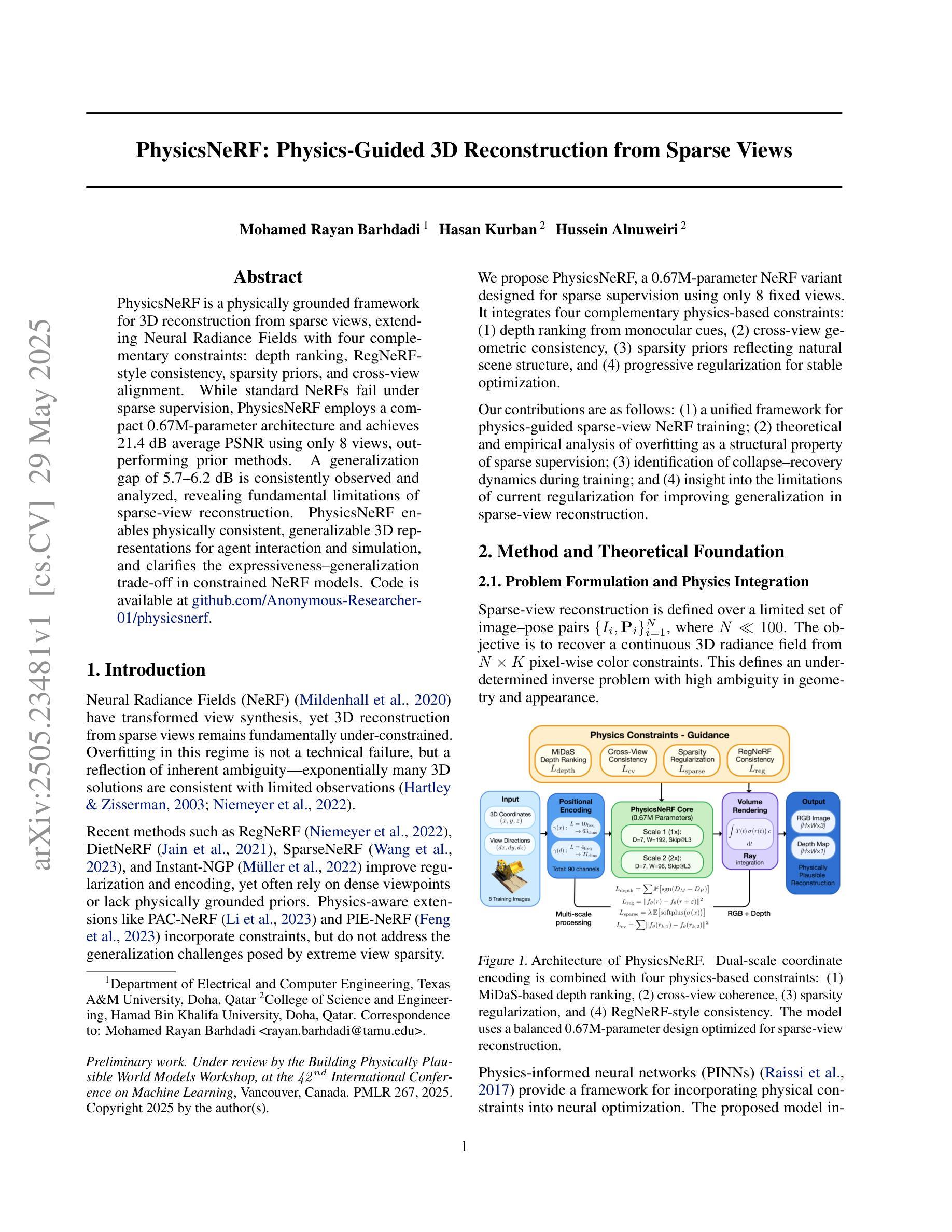

PhysicsNeRF: Physics-Guided 3D Reconstruction from Sparse Views

Authors:Mohamed Rayan Barhdadi, Hasan Kurban, Hussein Alnuweiri

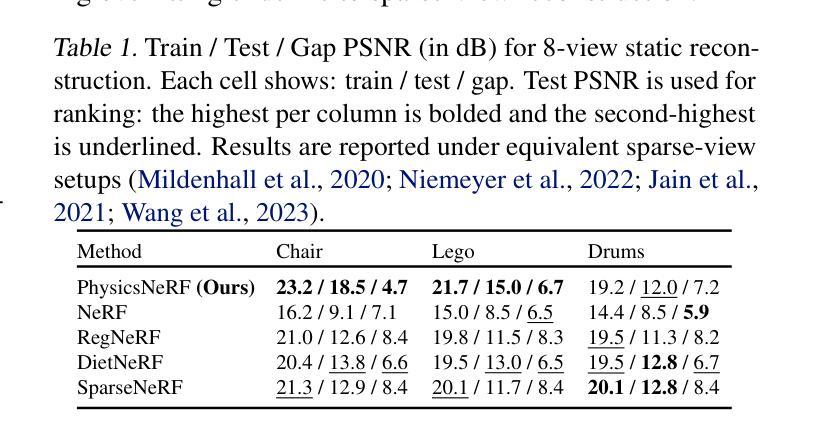

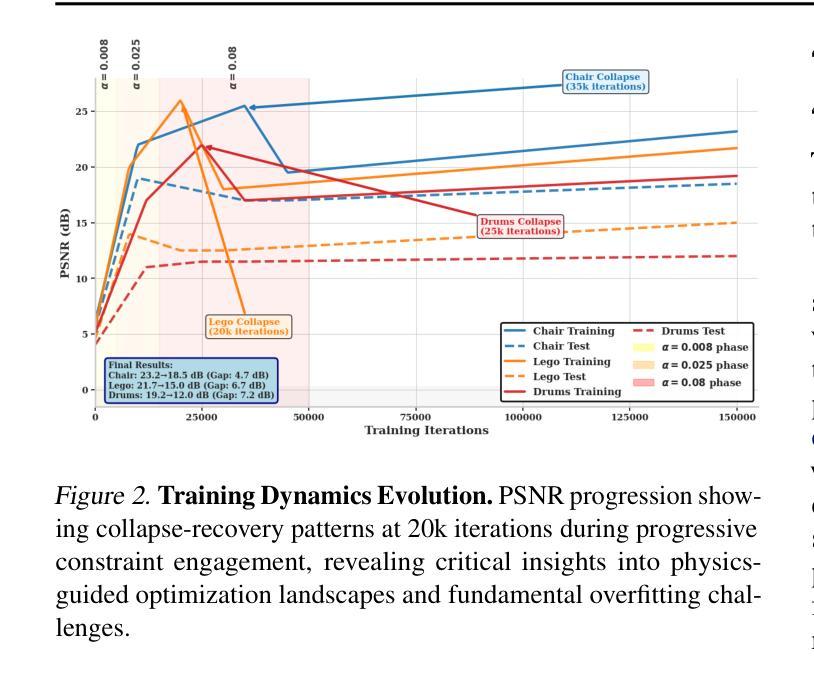

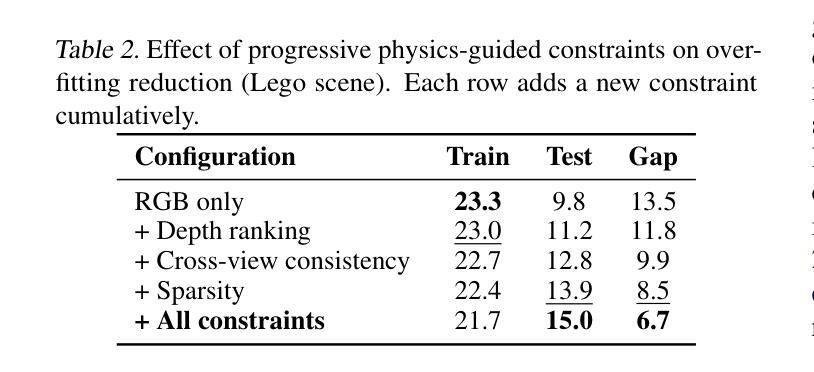

PhysicsNeRF is a physically grounded framework for 3D reconstruction from sparse views, extending Neural Radiance Fields with four complementary constraints: depth ranking, RegNeRF-style consistency, sparsity priors, and cross-view alignment. While standard NeRFs fail under sparse supervision, PhysicsNeRF employs a compact 0.67M-parameter architecture and achieves 21.4 dB average PSNR using only 8 views, outperforming prior methods. A generalization gap of 5.7-6.2 dB is consistently observed and analyzed, revealing fundamental limitations of sparse-view reconstruction. PhysicsNeRF enables physically consistent, generalizable 3D representations for agent interaction and simulation, and clarifies the expressiveness-generalization trade-off in constrained NeRF models.

PhysicsNeRF是一个基于物理的框架,用于从稀疏视角进行3D重建。它扩展了神经辐射场,并增加了四种互补约束:深度排序、RegNeRF风格的一致性、稀疏先验和跨视图对齐。尽管标准NeRF在稀疏监督下会失效,但PhysicsNeRF采用紧凑的0.67M参数架构,仅使用8个视角就实现了21.4 dB的平均峰值信噪比(PSNR),优于先前的方法。观察到并分析了5.7-6.2 dB的一般化差距,揭示了稀疏视图重建的根本局限性。PhysicsNeRF能够实现用于代理交互和模拟的物理一致、可通用的3D表示,并明确了受限NeRF模型的表达力与泛化能力之间的权衡。

论文及项目相关链接

PDF 4 pages, 2 figures, 2 tables. Preliminary work. Under review by the Building Physically Plausible World Models Workshop at the 42nd International Conference on Machine Learning (ICML 2025), Vancouver, Canada

Summary

PhysicsNeRF是一个基于物理的框架,用于从稀疏视角进行3D重建。它通过引入深度排序、RegNeRF风格的一致性、稀疏先验和跨视图对齐等四个互补约束来扩展Neural Radiance Fields。相较于标准NeRF在稀疏监督下的表现不佳,PhysicsNeRF采用紧凑的0.67M参数架构,仅使用8个视角便实现了21.4 dB的平均PSNR,超越了先前的方法。研究还观察到并分析了5.7-6.2 dB的一般化差距,揭示了稀疏视图重建的根本局限性。PhysicsNeRF能够实现物理一致、通用的3D表示,用于代理交互和模拟,并明确了约束NeRF模型中表达力与泛化能力之间的权衡。

Key Takeaways

- PhysicsNeRF是一个基于物理的框架,用于从稀疏视角进行3D重建。

- 它通过引入深度排序等四个互补约束来扩展Neural Radiance Fields。

- 对比标准NeRF,PhysicsNeRF在仅使用8个视角时表现出卓越性能。

- 研究中存在一个一般化差距,揭示了稀疏视图重建的局限性。

- PhysicsNeRF实现了物理一致的3D表示,适用于代理交互和模拟。

- 该研究明确了在约束NeRF模型中表达力与泛化能力之间的权衡。

点此查看论文截图

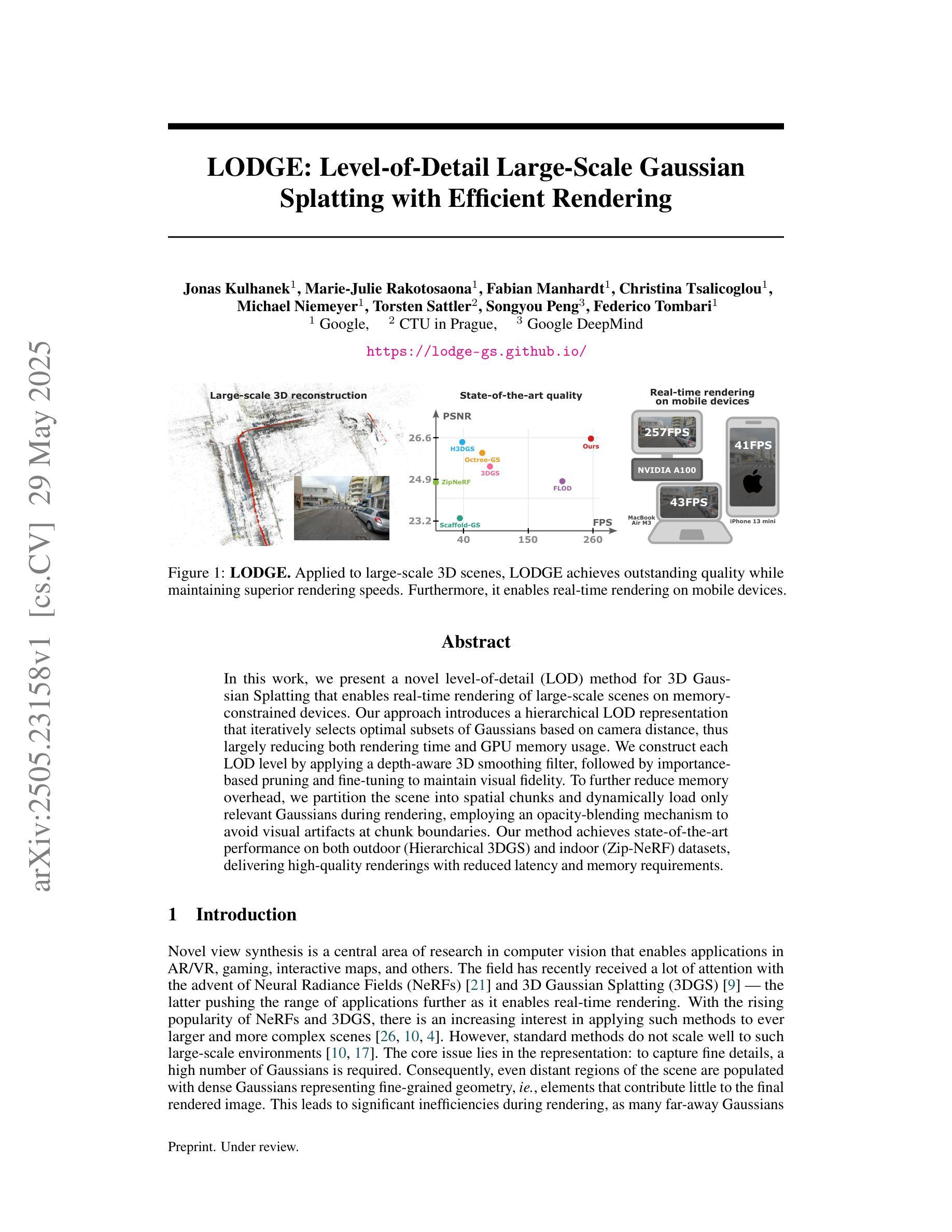

LODGE: Level-of-Detail Large-Scale Gaussian Splatting with Efficient Rendering

Authors:Jonas Kulhanek, Marie-Julie Rakotosaona, Fabian Manhardt, Christina Tsalicoglou, Michael Niemeyer, Torsten Sattler, Songyou Peng, Federico Tombari

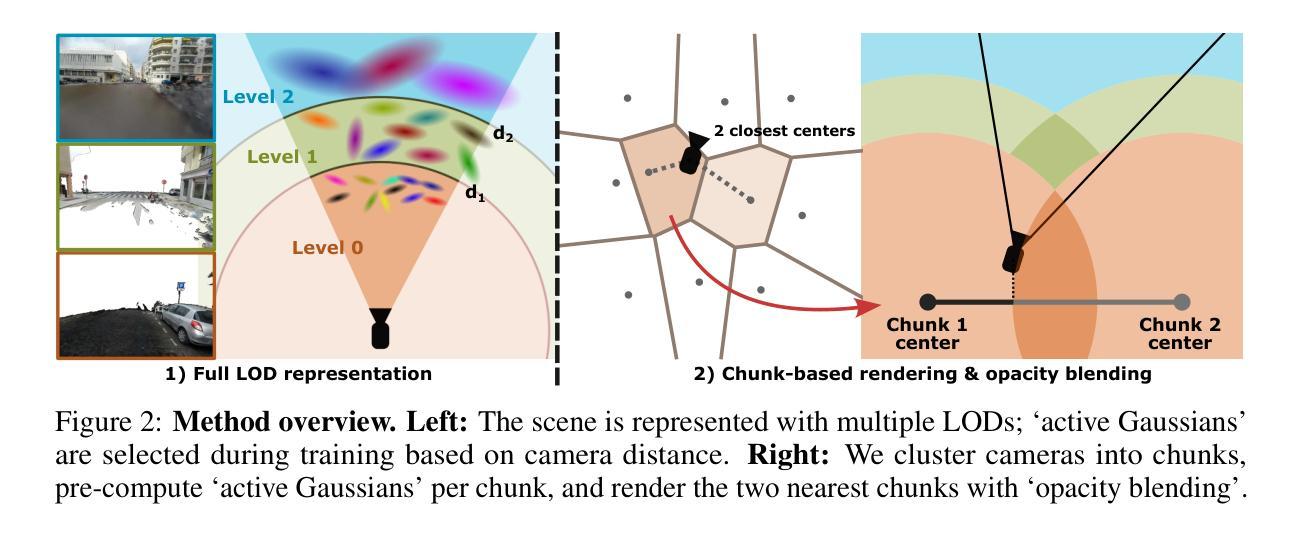

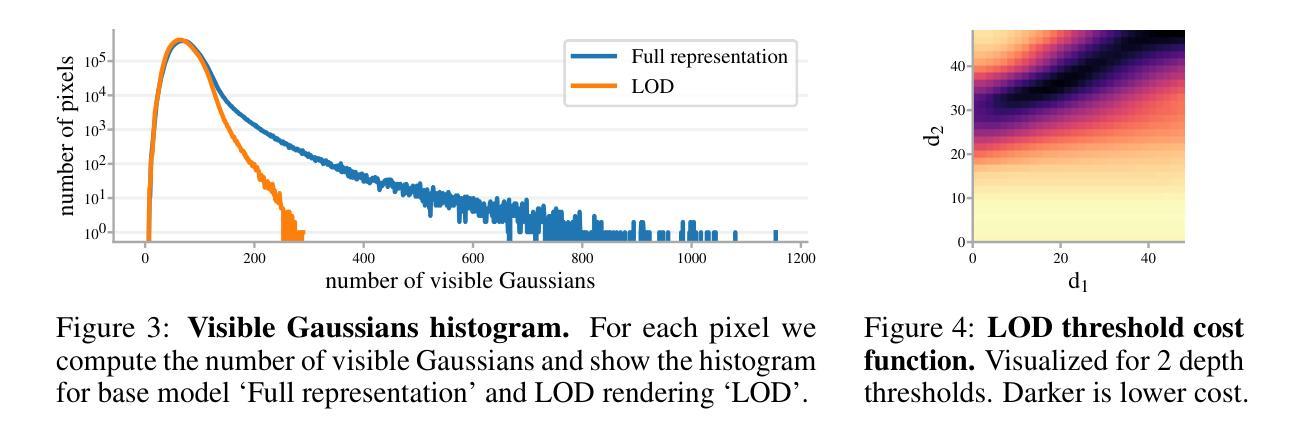

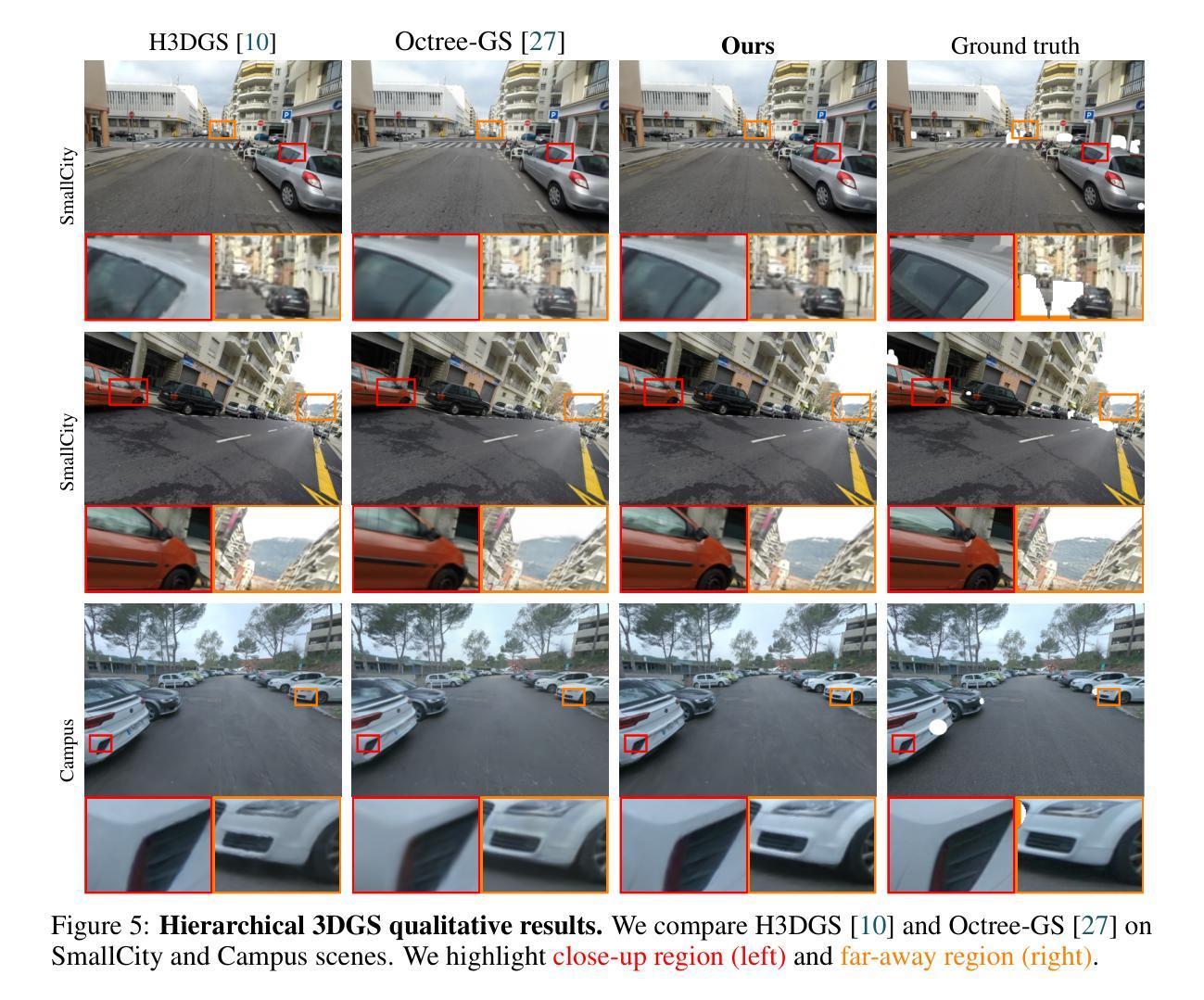

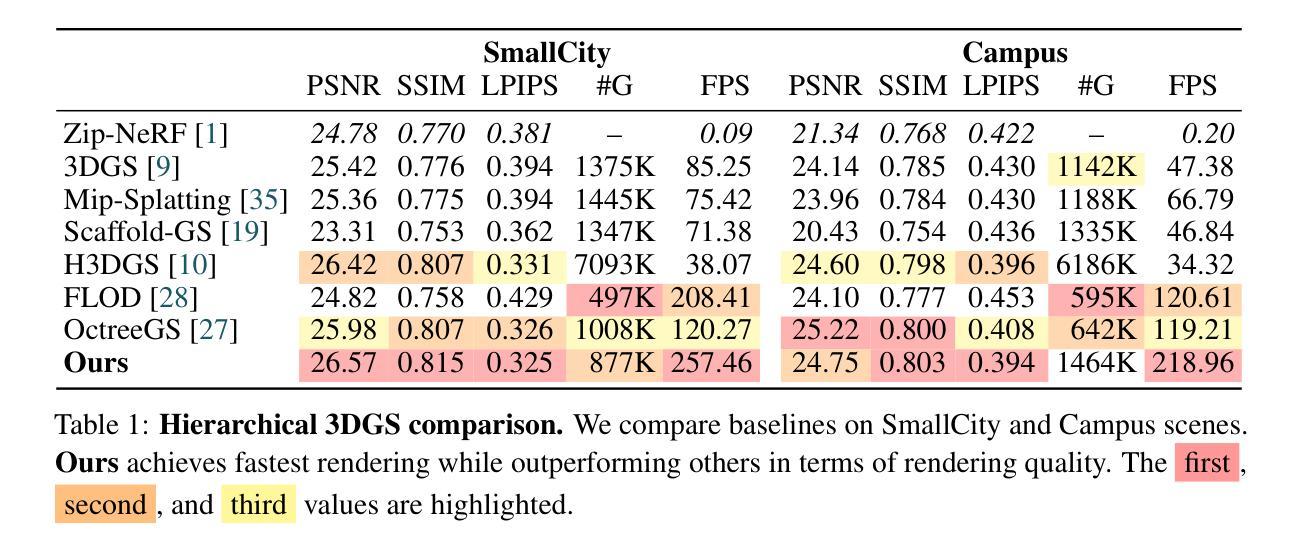

In this work, we present a novel level-of-detail (LOD) method for 3D Gaussian Splatting that enables real-time rendering of large-scale scenes on memory-constrained devices. Our approach introduces a hierarchical LOD representation that iteratively selects optimal subsets of Gaussians based on camera distance, thus largely reducing both rendering time and GPU memory usage. We construct each LOD level by applying a depth-aware 3D smoothing filter, followed by importance-based pruning and fine-tuning to maintain visual fidelity. To further reduce memory overhead, we partition the scene into spatial chunks and dynamically load only relevant Gaussians during rendering, employing an opacity-blending mechanism to avoid visual artifacts at chunk boundaries. Our method achieves state-of-the-art performance on both outdoor (Hierarchical 3DGS) and indoor (Zip-NeRF) datasets, delivering high-quality renderings with reduced latency and memory requirements.

在这项工作中,我们提出了一种用于3D高斯拼贴的新型细节层次(LOD)方法,能够在内存受限的设备上实现大规模场景实时渲染。我们的方法引入了一种层次型LOD表示,根据相机距离迭代选择最优的高斯子集,从而大大降低了渲染时间和GPU内存的使用。我们通过应用深度感知的3D平滑滤波器构建每个LOD级别,然后通过基于重要性的修剪和微调来保持视觉保真度。为了降低内存开销,我们将场景分割成空间块,并在渲染时动态加载相关的高斯,采用不透明度混合机制,以避免在块边界出现视觉伪影。我们的方法在户外(分层3DGS)和室内(Zip-NeRF)数据集上均实现了卓越的性能表现,能在降低延迟和内存要求的同时提供高质量渲染效果。

论文及项目相关链接

PDF Web: https://lodge-gs.github.io/

摘要

本文介绍了一种用于3D高斯拼接的新的细节层次(LOD)方法,能够在内存受限的设备上实现大规模场景的实时渲染。该方法通过引入层次细节表示,根据相机距离迭代选择最优的高斯子集,从而大大减少渲染时间和GPU内存使用。每个细节层次通过深度感知的3D平滑滤波器构建,随后通过重要性驱动的裁剪和微调来维持视觉保真度。为了进一步减少内存开销,将场景分割成空间块,并在渲染时动态加载相关的高斯,采用透明度混合机制以避免块边界处的视觉伪影。该方法在户外(Hierarchical 3DGS)和室内(Zip-NeRF)数据集上均达到最佳性能,可在降低延迟和内存要求的同时提供高质量渲染。

关键见解

- 引入了一种新的细节层次(LOD)方法,用于优化3D高斯拼接的实时渲染。

- 通过迭代选择最优的高斯子集,显著减少渲染时间和GPU内存使用。

- 构建了每个细节层次,采用深度感知的3D平滑滤波器,维持视觉保真度。

- 通过重要性裁剪和微调,进一步优化渲染效果。

- 采用场景空间分割,动态加载相关高斯,降低内存开销。

- 采用了透明度混合机制,避免块边界处的视觉伪影。

点此查看论文截图

Developing Cryptocurrency Trading Strategy Based on Autoencoder-CNN-GANs Algorithms

Authors:Zhuohuan Hu, Richard Yu, Zizhou Zhang, Haoran Zheng, Qianying Liu, Yining Zhou

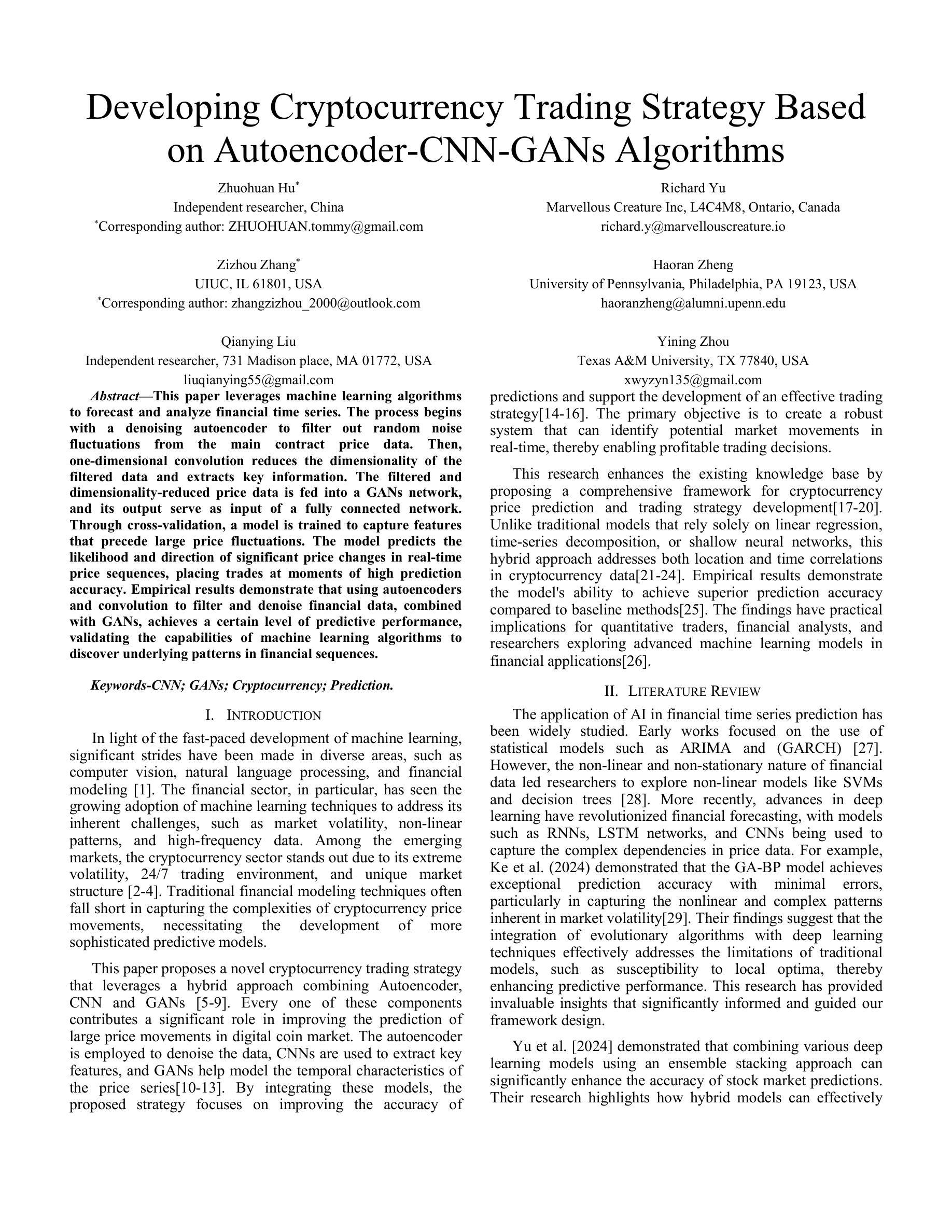

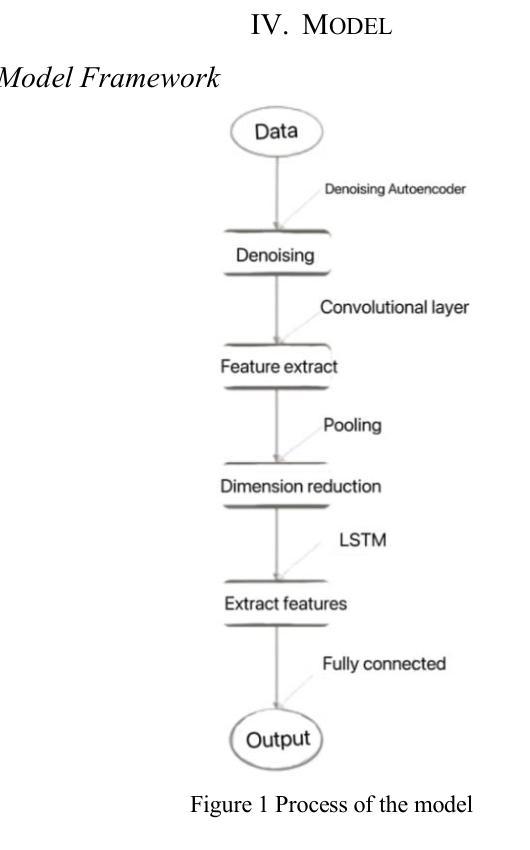

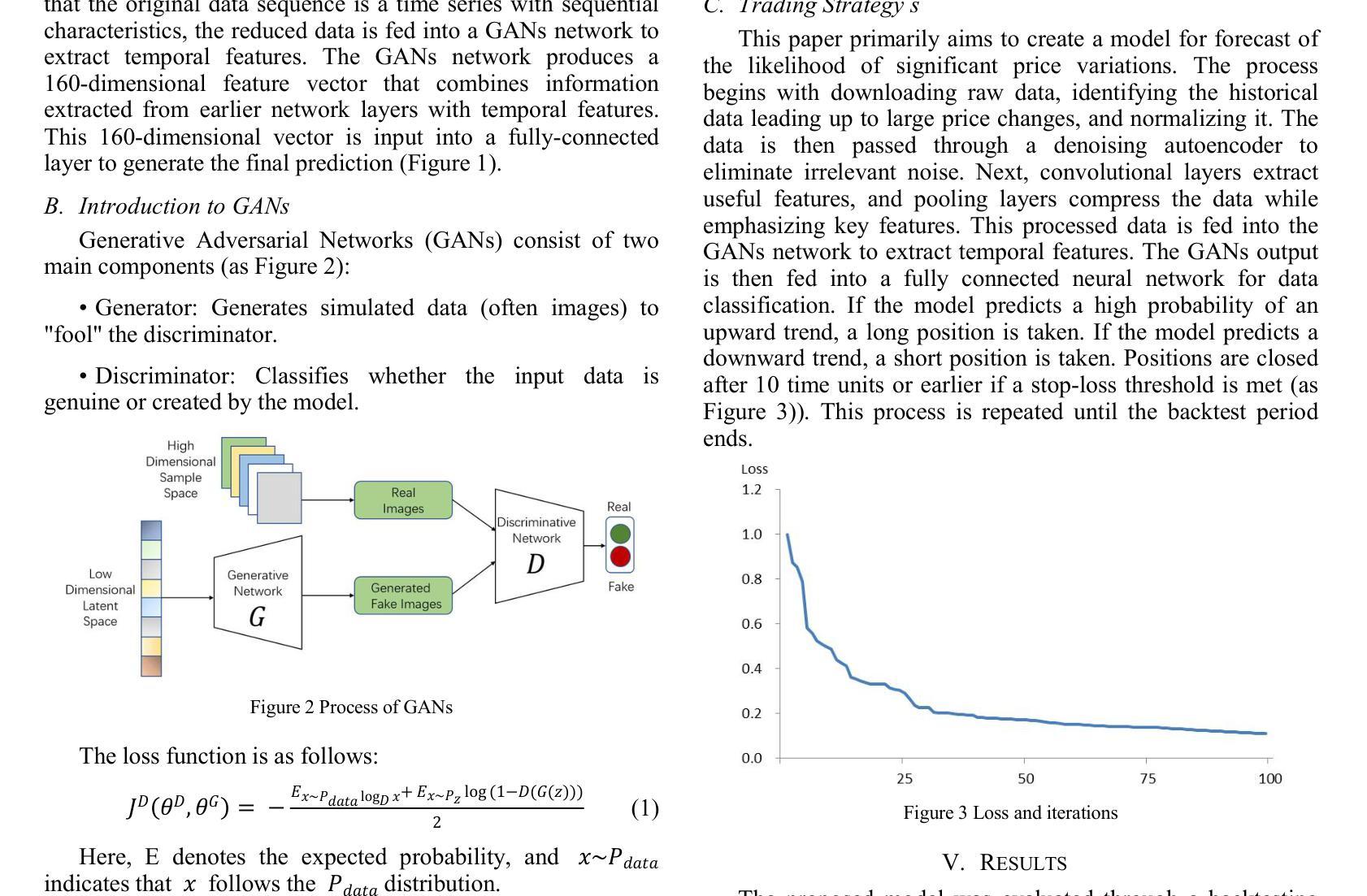

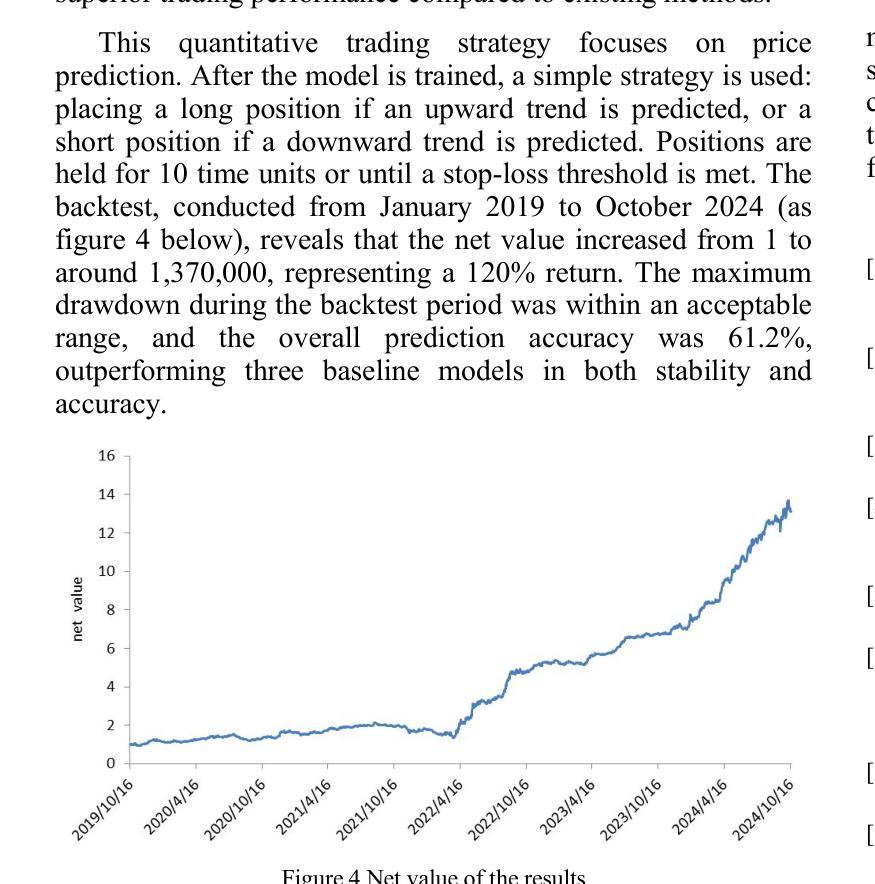

This paper leverages machine learning algorithms to forecast and analyze financial time series. The process begins with a denoising autoencoder to filter out random noise fluctuations from the main contract price data. Then, one-dimensional convolution reduces the dimensionality of the filtered data and extracts key information. The filtered and dimensionality-reduced price data is fed into a GANs network, and its output serve as input of a fully connected network. Through cross-validation, a model is trained to capture features that precede large price fluctuations. The model predicts the likelihood and direction of significant price changes in real-time price sequences, placing trades at moments of high prediction accuracy. Empirical results demonstrate that using autoencoders and convolution to filter and denoise financial data, combined with GANs, achieves a certain level of predictive performance, validating the capabilities of machine learning algorithms to discover underlying patterns in financial sequences. Keywords - CNN;GANs; Cryptocurrency; Prediction.

本文利用机器学习算法对金融时间序列进行预测和分析。流程始于使用降噪自编码器对主合约价格数据进行随机噪声波动的过滤。然后,一维卷积用于降低过滤数据的维度并提取关键信息。经过过滤和降维的价格数据被输入到GANs网络中,其输出作为全连接网络的输入。通过交叉验证,训练模型以捕获先于大价格波动的特征。该模型预测实时价格序列中重大价格变化的可能性和方向,在高预测准确性的时刻进行交易。实证结果表明,使用自编码器和卷积对金融数据进行过滤和降噪,结合GANs,实现了一定的预测性能,验证了机器学习算法在发现金融序列中潜在模式方面的能力。关键词——卷积神经网络;生成对抗网络;加密货币;预测。

论文及项目相关链接

PDF The paper was accepted by 2024 4th International Conference on Artificial Intelligence, Robotics, and Communication(ICAIRC 2024)

Summary:

本文利用机器学习算法对金融时间序列进行预测与分析。通过去噪自编码器过滤原始合约价格数据中的随机噪声波动,一维卷积降低数据维度并提取关键信息。经过处理的数据输入生成对抗网络,其输出再输入全连接网络。通过交叉验证,训练模型捕捉预示大价格波动的特征。该模型能预测实时价格序列中重大价格变动的可能性和方向,在高预测准确率时刻进行交易。实证结果表明,结合自编码器、卷积和生成对抗网络,对金融数据进行过滤、去噪和预测有一定的性能,验证了机器学习算法在发现金融序列中潜在模式的能力。

Key Takeaways:

- 利用去噪自编码器过滤金融时间序列数据的随机噪声。

- 一维卷积用于降低数据维度并提取关键信息。

- 生成的对抗网络结合全连接网络进行价格预测。

- 通过交叉验证训练模型,捕捉预示大价格波动的特征。

- 模型能预测实时价格序列中重大价格变动的可能性和方向。

- 实证结果表明,结合自编码器、卷积和GANs对金融数据进行处理与预测有一定性能。

点此查看论文截图