⚠️ 以下所有内容总结都来自于 大语言模型的能力,如有错误,仅供参考,谨慎使用

🔴 请注意:千万不要用于严肃的学术场景,只能用于论文阅读前的初筛!

💗 如果您觉得我们的项目对您有帮助 ChatPaperFree ,还请您给我们一些鼓励!⭐️ HuggingFace免费体验

2025-06-13 更新

MTVQA: Benchmarking Multilingual Text-Centric Visual Question Answering

Authors:Jingqun Tang, Qi Liu, Yongjie Ye, Jinghui Lu, Shu Wei, Chunhui Lin, Wanqing Li, Mohamad Fitri Faiz Bin Mahmood, Hao Feng, Zhen Zhao, Yangfan He, Kuan Lu, Yanjie Wang, Yuliang Liu, Hao Liu, Xiang Bai, Can Huang

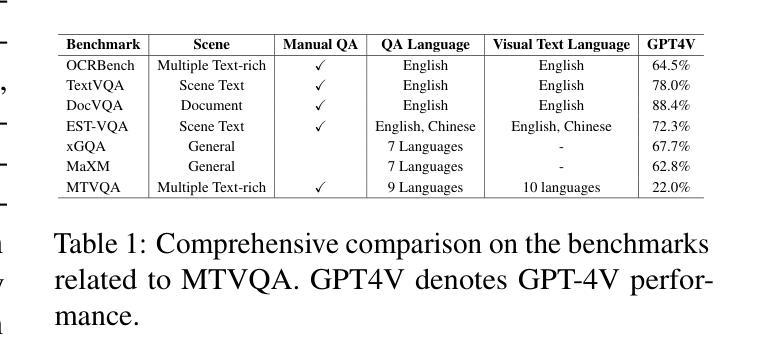

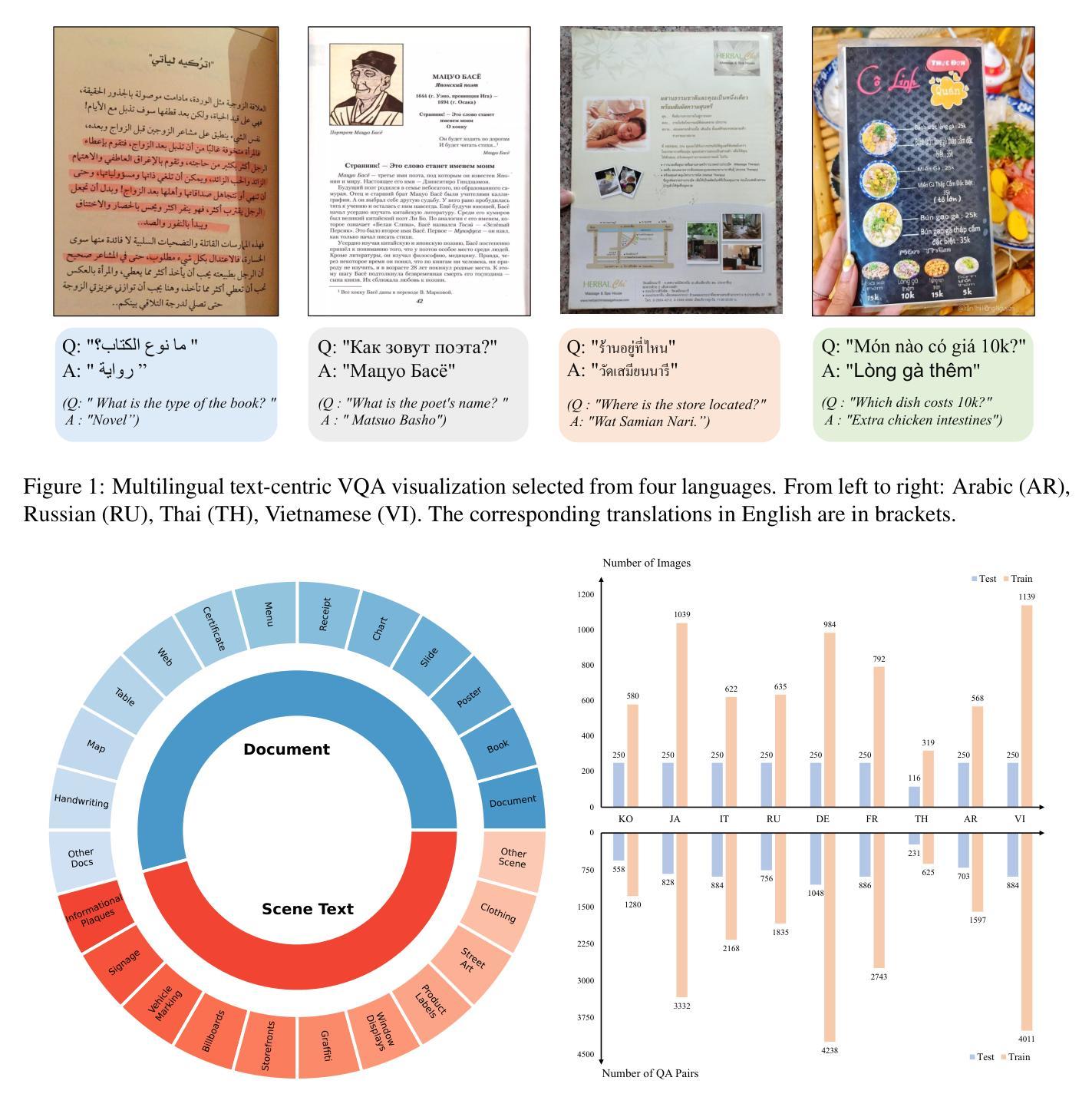

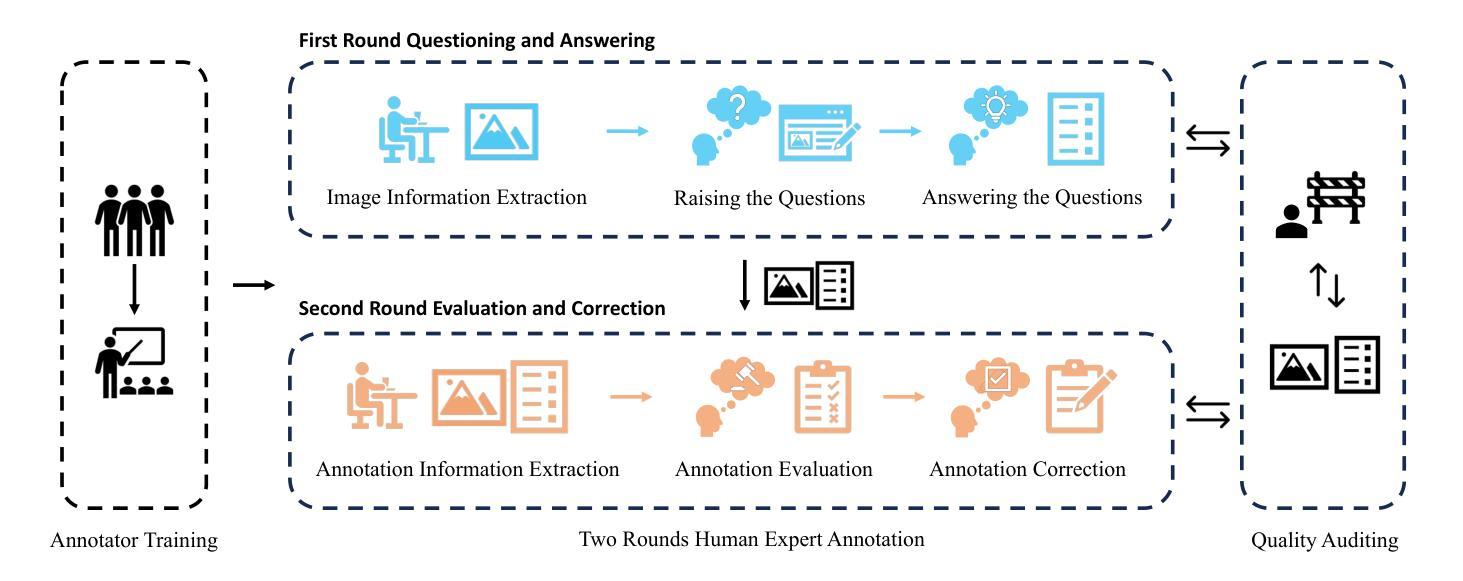

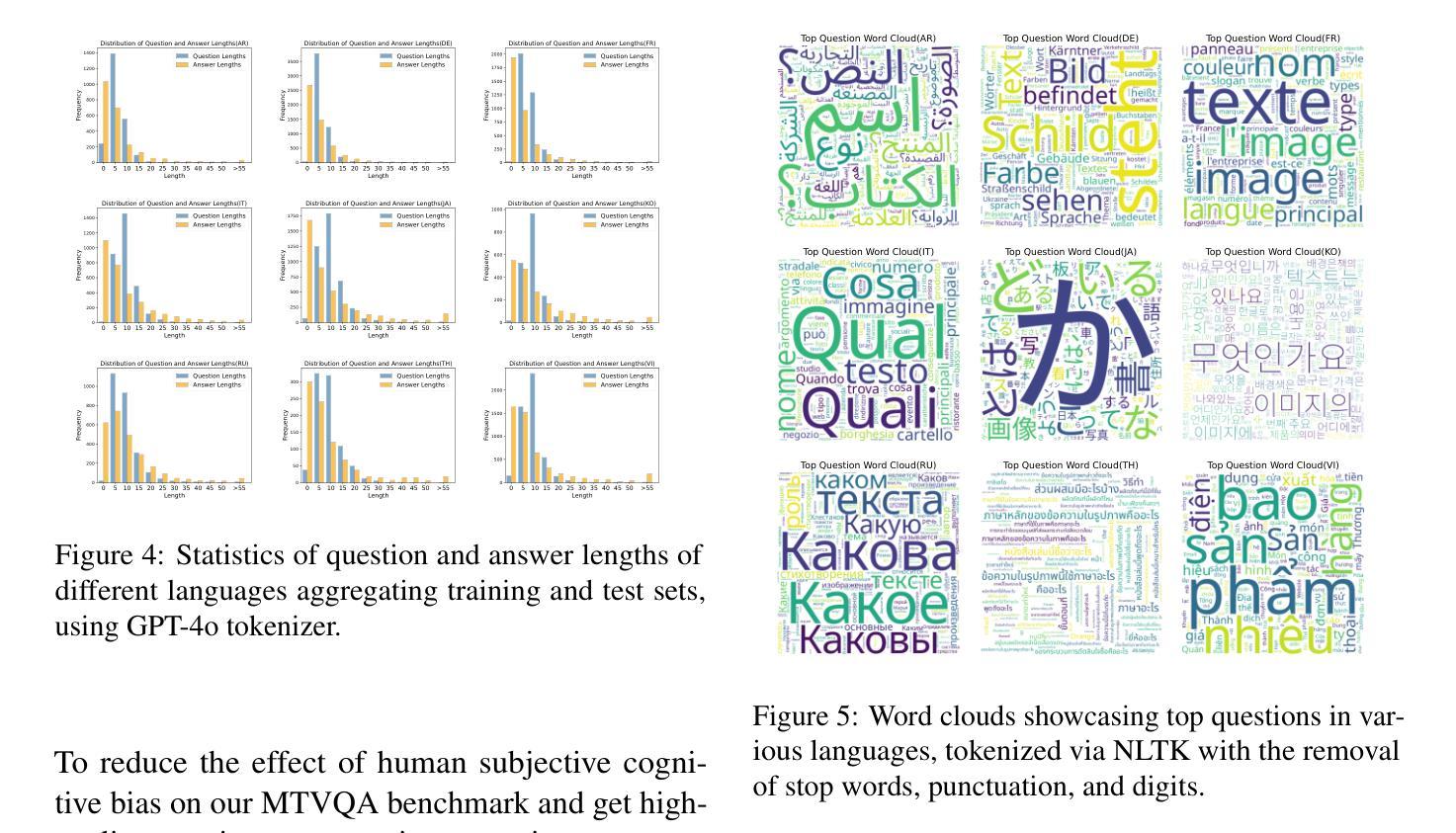

Text-Centric Visual Question Answering (TEC-VQA) in its proper format not only facilitates human-machine interaction in text-centric visual environments but also serves as a de facto gold proxy to evaluate AI models in the domain of text-centric scene understanding. Nonetheless, most existing TEC-VQA benchmarks have focused on high-resource languages like English and Chinese. Despite pioneering works to expand multilingual QA pairs in non-text-centric VQA datasets through translation engines, the translation-based protocol encounters a substantial “visual-textual misalignment” problem when applied to TEC-VQA. Specifically, it prioritizes the text in question-answer pairs while disregarding the visual text present in images. Moreover, it fails to address complexities related to nuanced meaning, contextual distortion, language bias, and question-type diversity. In this work, we tackle multilingual TEC-VQA by introducing MTVQA, the first benchmark featuring high-quality human expert annotations across 9 diverse languages, consisting of 6,778 question-answer pairs across 2,116 images. Further, by comprehensively evaluating numerous state-of-the-art Multimodal Large Language Models~(MLLMs), including Qwen2-VL, GPT-4o, GPT-4V, Claude3, and Gemini, on the MTVQA benchmark, it is evident that there is still a large room for performance improvement (Qwen2-VL scoring 30.9 versus 79.7 for human performance), underscoring the value of MTVQA. Additionally, we supply multilingual training data within the MTVQA dataset, demonstrating that straightforward fine-tuning with this data can substantially enhance multilingual TEC-VQA performance. We aspire that MTVQA will offer the research community fresh insights and stimulate further exploration in multilingual visual text comprehension. The project homepage is available at https://bytedance.github.io/MTVQA/.

文本聚焦的视觉问答(TEC-VQA)在适当的形式下,不仅促进了文本聚焦的视觉环境中的人机交互,还作为评估文本聚焦场景理解领域AI模型的默认黄金标准。然而,现有的TEC-VQA基准测试主要集中在英语和中文等资源丰富的语言上。尽管有开创性的工作通过翻译引擎在非文本聚焦的VQA数据集中扩展了多语言问答对,但基于翻译的方法在应用于TEC-VQA时遇到了严重的“视觉文本不匹配”问题。具体来说,它优先考虑问答对中的文本,而忽视图像中呈现的视觉文本。此外,它无法解决与细微意义、上下文失真、语言偏见和问题类型多样性相关的复杂性。在这项工作中,我们通过引入MTVQA来解决多语言TEC-VQA问题,MTVQA是第一个在9种不同语言中具有高质量人类专家注释的基准测试,包含2116张图片中的6778个问答对。此外,通过全面评估众多最先进的多媒体大规模语言模型(MLLMs),包括Qwen2-VL、GPT-4o、GPT-4V、Claude3和Gemini在MTVQA基准上的表现,显然还有很大的性能提升空间(Qwen2-VL得分为30.9,而人类性能得分为79.7),这凸显了MTVQA的价值。另外,我们在MTVQA数据集中提供了多语言训练数据,证明使用此数据进行直接微调可以显著提高多语言TEC-VQA的性能。我们希望MTVQA能为研究社区提供新的见解,并激发多语言视觉文本理解领域的进一步探索。项目主页可在https://bytedance.github.io/MTVQA/找到。

论文及项目相关链接

PDF Accepted by ACL 2025 findings

摘要

视觉文本关联的文本中心型视觉问答(TEC-VQA)不仅有助于文本中心的视觉环境中的人机交互,而且作为评估文本中心场景理解领域AI模型的默认黄金标准。然而,现有的TEC-VQA基准测试主要集中在英语和中文等资源丰富的语言上。尽管有先驱工作通过翻译引擎扩展了非文本中心型VQA数据集的多语言问答对,但翻译协议应用于TEC-VQA时遇到了显著的“视觉文本不匹配”问题。具体来说,它侧重于问答对中的文本,而忽视图像中的视觉文本。此外,它未能解决与微妙意义、上下文扭曲、语言偏见和问题类型多样性相关的复杂性。在这项工作中,我们通过引入MTVQA来解决多语言TEC-VQA问题,MTVQA是第一个在9种不同语言中含有高质量人类专家注释的基准测试,包含2116张图像中的6778个问答对。此外,通过全面评估多种先进的多模态大型语言模型(MLLMs),包括Qwen2-VL、GPT-4o、GPT-4V、Claude3和Gemini在MTVQA基准上的表现,显然还有很大的性能提升空间(Qwen2-VL得分为30.9,人类性能得分为79.7),这突显了MTVQA的价值。此外,我们在MTVQA数据集中提供了多语言训练数据,证明使用此数据进行简单微调可以大大增强多语言TEC-VQA的性能。我们期望MTVQA能为研究社区提供新的见解,并激发多语言视觉文本理解领域的进一步探索。项目主页地址为https://bytedance.github.io/MTVQA/。

要点:

TEC-VQA的重要性:视觉文本关联的文本中心型视觉问答不仅推动了人机交互的发展,并成为评估AI模型在特定领域表现的标准。

现有基准测试的局限性:大多数TEC-VQA基准测试集中在高资源语言上,如英语和中文。翻译协议应用于TEC-VQA时存在视觉与文本的匹配问题。

MTVQA的引入:首次提出了MTVQA基准测试,涵盖了9种语言的大量高质量问答对数据,解决了多语言TEC-VQA的问题。

模型性能评估:通过对多个先进的多模态大型语言模型在MTVQA上的评估,显示出模型性能仍有大幅提升的空间。

训练数据的重要性:MTVQA数据集中的多语言训练数据对于增强多语言TEC-VQA性能至关重要。

研究的潜力与挑战:MTVQA为研究人员提供了新视角,并激发了对多语言视觉文本理解领域的进一步探索。

点此查看论文截图